网络指南

前言

您不能在实例创建过程中将基于角色的访问控制(RBAC)共享安全组直接应用到实例。要将 RBAC 共享安全组应用到实例,必须首先创建端口,将共享安全组应用到该端口,然后将该端口分配给实例。请参阅 将安全组添加到端口。

对红帽文档提供反馈

我们感谢您对文档提供反馈信息。与我们分享您的成功秘诀。

在 JIRA 中提供文档反馈

使用 Create Issue 表单对文档提供反馈。JIRA 问题将在 Red Hat OpenStack Platform Jira 项目中创建,您可以在其中跟踪您的反馈进度。

- 确保您已登录到 JIRA。如果您没有 JIRA 帐户,请创建一个帐户来提交反馈。

- 点击以下链接打开 Create Issue 页面: Create Issue

- 完成 Summary 和 Description 字段。在 Description 字段中,包含文档 URL、章节或章节号以及问题的详细描述。不要修改表单中的任何其他字段。

- 点 Create。

第 1 章 OpenStack 网络简介

Networking 服务(neutron)是 Red Hat OpenStack Platform (RHOSP)的软件定义型网络(SDN)组件。RHOSP 网络服务管理虚拟机实例的内部和外部流量,并提供路由、分段、DHCP 和元数据等核心服务。它为虚拟网络功能提供 API,以及交换机、路由器、端口和防火墙的管理。

1.1. 管理 RHOSP 网络

通过 Red Hat OpenStack Platform (RHOSP)网络服务(neutron),您可以有效地满足您的站点网络目标。您可以:

提供项目中虚拟机实例的连接。

项目网络主要启用常规(非特权)项目,在不涉及管理员的情况下管理网络。这些网络完全虚拟,需要虚拟路由器与其他项目网络和外部网络(如互联网)交互。项目网络通常还会为实例提供 DHCP 和元数据服务。RHOSP 支持以下项目网络类型: flat、VLAN、VXLAN、GRE 和 GENEVE。

如需更多信息,请参阅管理项目网络。

将虚拟机实例连接到项目外的网络。

提供商网络提供如项目网络的连接。但是,只有管理(非特权)用户可以管理这些网络,因为它们与物理网络基础架构进行接口。RHOSP 支持以下供应商网络类型:扁平和 VLAN。

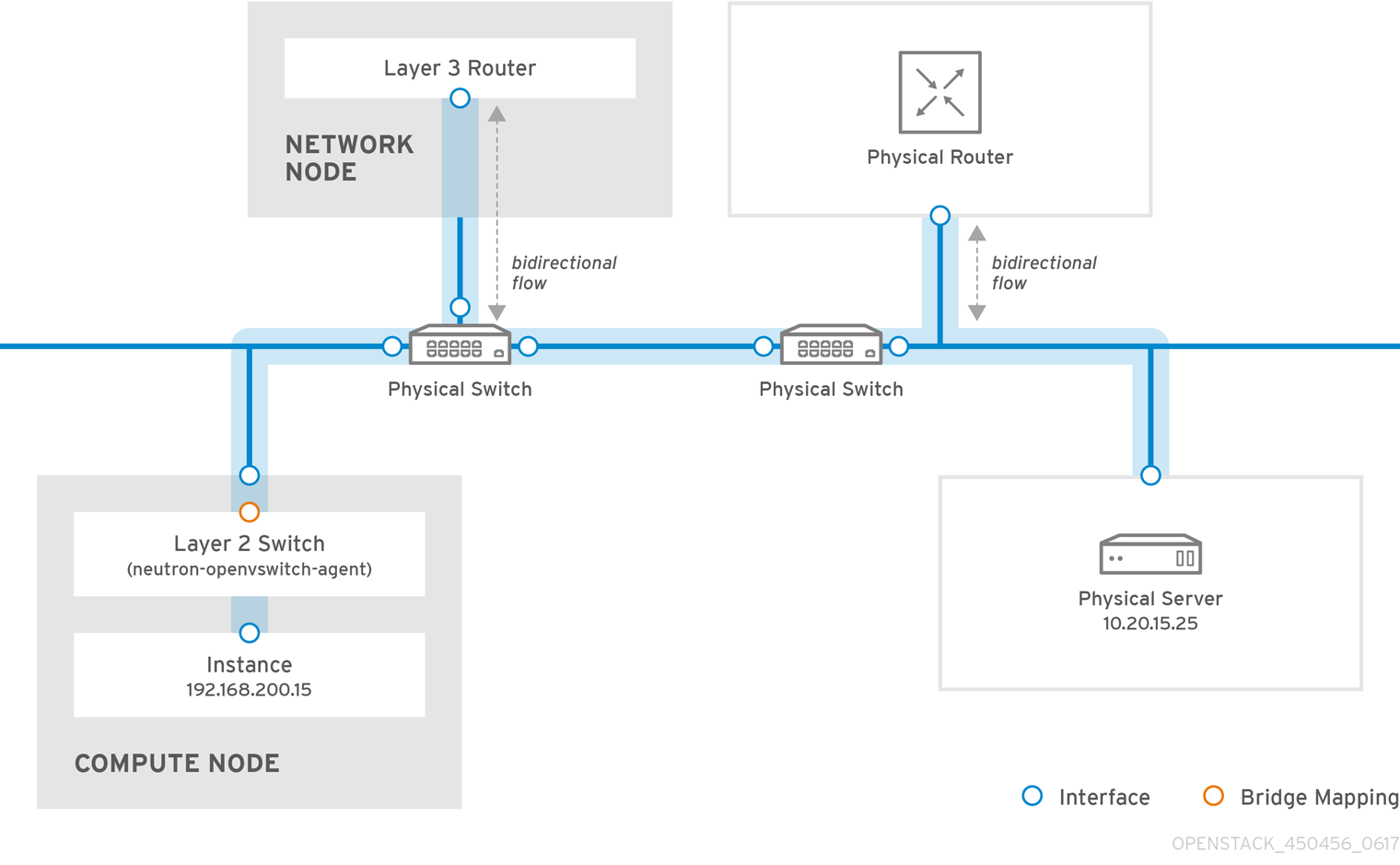

在项目网络内,您可以使用浮动 IP 地址池或单个浮动 IP 地址将入口流量定向到虚拟机实例。使用网桥映射,您可以将物理网络名称(接口标签)与通过 OVS 或 OVN 创建的网桥关联,以允许提供商网络流量访问物理网络。

如需更多信息,请参阅将虚拟机实例连接到物理网络。

创建为边缘计算优化的网络。

Operator 可以创建通常在边缘部署中使用的路由供应商网络,它依赖于多个第 2 层网络段,而不是仅有一个网段的传统网络。

路由提供商网络为最终用户简化云,因为它们只看到一个网络。对于云操作员,路由供应商网络提供可扩展和容错能力。例如,如果发生重大错误,则只有一个片段会受到影响,而不是整个网络失败。

如需更多信息,请参阅 部署路由的供应商网络。

将您的网络资源高度可用。

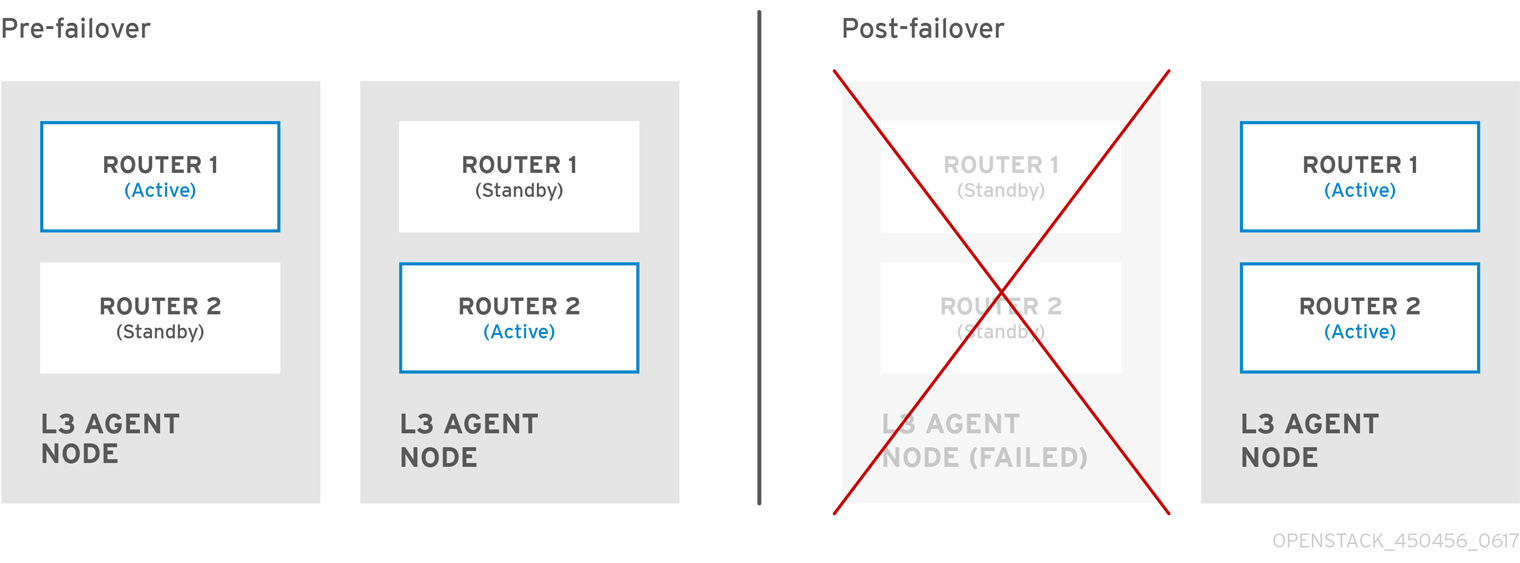

您可以使用可用区(AZ)和虚拟路由器冗余协议(VRRP)保持网络资源高度可用。operator 组附加到不同 AZ 上不同电源源的网络节点。接下来,Operator 调度关键服务,如 DHCP、L3、FW 等,使其位于单独的 AZ 上。

RHOSP 使用 VRRP 使项目路由器和浮动 IP 地址高度可用。集中式路由,分布式虚拟路由(DVR)根据 VRRP 提供替代路由设计,该设计将部署 L3 代理并在每个 Compute 节点上调度路由器。

如需更多信息,请参阅使用可用区使网络资源高度可用。

在端口级别保护您的网络。

安全组为虚拟防火墙规则提供一个容器,用于控制入口(绑定到实例)和出口(从实例绑定)网络流量(通过端口级别出站)。安全组使用默认拒绝策略,仅包含允许特定流量的规则。每个端口都可以以补充的方式引用一个或多个安全组。防火墙驱动程序将安全组规则转换为底层数据包过滤技术的配置,如 iptables。

如需更多信息,请参阅配置共享安全组。

管理端口流量。

通过允许的地址对,您可以识别特定的 MAC 地址、IP 地址或两者,以允许网络流量通过端口传递,而不考虑子网。当您定义允许的地址对时,您可以使用 VRRP (虚拟路由器冗余协议)的协议,该协议在两个虚拟机实例之间浮点 IP 地址以启用快速数据平面故障转移。

如需更多信息,请参阅配置允许的地址对。

优化大型覆盖网络。

使用 L2 Population 驱动程序,您可以启用广播、多播和单播流量,以便在大型覆盖网络上扩展。

如需更多信息,请参阅配置 L2 填充驱动程序。

为虚拟机实例上的流量设置入口和出口限制。

您可以使用服务质量(QoS)策略为实例提供不同的服务级别,以将速率限制应用到出口和入口流量。您可以将 QoS 策略应用到单独的端口。您还可以将 QoS 策略应用到项目网络,其中没有附加特定策略的端口会继承策略。

如需更多信息,请参阅 配置服务质量(QoS)策略。

管理 RHOSP 项目可以创建的网络资源量。

借助网络服务配额选项,您可以设置用户可以创建的网络资源项目数量的限值。这包括端口、子网、网络等资源。

如需更多信息,请参阅管理项目配额。

优化用于网络功能虚拟化(SVVP)的虚拟机实例。

实例可以通过单个虚拟 NIC 发送和接收 VLAN 标记的流量。这对希望 VLAN 标记流量的 NFV 应用程序(VNF)特别有用,允许单个虚拟 NIC 为多个客户或服务提供服务。

在 VLAN 透明网络中,您可以在虚拟机实例中设置 VLAN 标记。VLAN 标签通过网络传输,并由同一 VLAN 上的虚拟机实例消耗,并被其他实例和设备忽略。VLAN 中继通过将 VLAN 合并到单个中继端口来支持 VLAN 感知实例。

如需更多信息,请参阅 VLAN 感知实例。

控制哪些项目可以将实例附加到共享网络。

在 RHOSP 网络服务中使用基于角色的访问控制(RBAC)策略,云管理员可以删除某些项目创建网络的能力,并可以让他们附加到与其项目对应的预先存在的网络。

如需更多信息,请参阅配置 RBAC 策略。

1.2. 网络服务组件

Red Hat OpenStack Platform (RHOSP)网络服务(neutron)包括以下组件:

API Server

RHOSP 网络 API 包括对第 2 层网络和 IP 地址管理(IPAM)的支持,以及第 3 层路由器构造的扩展,它允许第 2 层网络和网关到外部网络之间的路由。RHOSP 网络包括一个增加的插件列表,它允许与各种商业和开源网络技术互操作性,包括路由器、交换机、虚拟交换机和软件定义网络(SDN)控制器。

模块层 2 (ML2)插件和代理

ML2 插件和拔出端口,创建网络或子网,并提供 IP 地址。

消息传递队列

接受和路由代理之间的 RPC 请求,以完成 API 操作。消息队列在 ML2 插件中使用,用于在每个虚拟机监控程序上运行的 neutron 服务器和 neutron 代理之间的 RPC,用于 Open vSwitch 和 Linux 网桥的 ML2 机制驱动程序。

1.3. 模块层 2 (ML2)网络

模块层 2 (ML2)是 Red Hat OpenStack Platform (RHOSP)网络核心插件。ML2 模块设计通过机制驱动程序支持混合网络技术的并发操作。Open Virtual Network (OVN)是 ML2 使用的默认机制驱动程序。

ML2 框架区分了可配置的两种驱动程序:

- 类型驱动程序

定义从技术上实现 RHOSP 网络的方式。

每种可用网络类型都由 ML2 类型驱动程序管理,它们维护任何所需的特定类型网络状态。验证提供商网络的特定于类型的信息,类型驱动程序负责在项目网络中分配空闲片段。类型驱动程序的示例包括 GENEVE、GRE、VXLAN 等。

- 机制驱动程序

定义访问特定类型的 RHOSP 网络的机制。

机制驱动程序使用类型驱动程序建立的信息,并将其应用到已启用的网络机制。机制驱动程序示例是 Open Virtual Networking (OVN)和 Open vSwitch (OVS)。

机制驱动程序可以使用 L2 代理,并使用 RPC 直接与外部设备或控制器交互。您可以同时使用多种机制,并同时键入驱动程序来访问同一虚拟网络的不同端口。

1.4. ML2 网络类型

您可以同时运行多个网络片段。ML2 支持多个网络段的使用和互连。您不必将端口绑定到网络段,因为 ML2 将端口绑定到具有连接性的端口。根据机制驱动程序,ML2 支持以下网络片段类型:

- flat

- VLAN

- GENEVE 隧道

- VXLAN 和 GRE 隧道

- flat

- 所有虚拟机(VM)实例都位于同一网络中,也可以与主机共享。没有 VLAN 标记或其他网络分离。

- VLAN

使用 RHOSP 网络用户可以使用 VLAN ID (802.1Q 标记)创建多个供应商或项目网络,对应于物理网络中存在的 VLAN。这允许实例在环境中相互通信。它们还可以与同一第 2 层 VLAN 上的专用服务器、防火墙、负载均衡器和其他网络基础架构通信。

您可以使用 VLAN 来分段在同一交换机上运行的计算机的网络流量。这意味着,您可以通过将端口配置为不同的网络成员来以逻辑方式划分交换机,以便出于安全原因,您可以使用这些端口来分隔流量。

例如,如果您的交换机总有 24 个端口,您可以将端口 1-6 分配给 VLAN200,并将端口 7-18 分配给 VLAN201。因此,连接到 VLAN200 的计算机与 VLAN201 上的计算机完全分开;它们无法直接通信,如果需要,流量必须通过路由器传递,就像它们是两个独立的物理交换机一样。防火墙也可用于管理哪些 VLAN 可以相互通信。

- GENEVE 隧道

- GENEVE 识别并适应网络虚拟化中不同设备的功能和需求。它为隧道提供框架,而不是针对整个系统的规定。Geneve 定义封装期间添加的元数据内容,并尝试适应各种虚拟化场景。它使用 UDP 作为其传输协议,并且使用可扩展选项标头的大小动态。Geneve 支持单播、多播和广播。GENEVE 类型驱动程序与 ML2/OVN 机制驱动程序兼容。

- VXLAN 和 GRE 隧道

- VXLAN 和 GRE 使用网络覆盖来支持实例间的私有通信。需要 RHOSP 网络路由器,以便流量在 GRE 或 VXLAN 项目网络外到达流量。还需要路由器才能将网络连接的项目网络与外部网络(包括互联网)连接;路由器能够使用浮动 IP 地址直接从外部网络连接实例。VXLAN 和 GRE 类型驱动程序与 ML2/OVS 机制驱动程序兼容。

1.5. 模块第 2 层(ML2)机制驱动程序

模块层 2 (ML2)插件作为带有通用代码库的机制实施。这种方法能够重复使用代码,并消除了代码维护和测试的许多复杂性。

您可以使用编排服务(heat)参数启用机制驱动程序,即 NeutronMechanismDrivers。以下是 heat 自定义环境文件的示例:

parameter_defaults: ... NeutronMechanismDrivers: ansible,ovn,baremetal ...

parameter_defaults:

...

NeutronMechanismDrivers: ansible,ovn,baremetal

...

指定机制驱动程序的顺序很重要。在前面的示例中,如果要使用 baremetal 机制驱动程序绑定端口,则必须在 ansible 前指定 baremetal。否则,ansible 驱动程序将绑定端口,因为它在 NeutronMechanismDrivers 的值列表前面是 baremetal。

从 RHOSP 15 开始,红帽选择 ML2/OVN 作为所有新部署的默认机制驱动程序,因为它为大多数客户提供了 ML2/OVS 机制驱动程序的即时优势。这些优点会随每个发行版本一起实现,同时我们继续增强并改进 ML2/OVN 功能集。

通过 RHOSP 17 发行版本提供对已弃用的 ML2/OVS 机制驱动程序的支持。在此期间,ML2/OVS 驱动程序处于维护模式,接收程序错误修复和正常支持,大多数新功能开发发生在 ML2/OVN 机制驱动程序中。

在 RHOSP 18.0 中,红帽计划完全删除 ML2/OVS 机制驱动程序并停止支持它。

如果您的现有 Red Hat OpenStack Platform (RHOSP)部署使用 ML2/OVS 机制驱动程序,请开始评估计划迁移到机制驱动程序。RHOSP 16.2 支持迁移,并将在 RHOSP 17.1 中被支持。RHOSP 17.0 中包括了迁移工具用于测试目的。

在尝试从 ML2/OVS 迁移到 ML2/OVN 之前,红帽要求您提交一个主动支持问题单。红帽不支持在没有主动支持问题单的情况下进行迁移。请参阅 如何在 Red Hat OpenStack Platform 上为计划活动打开主动问题单?

1.6. Open vSwitch

Open vSwitch (OVS)是一个软件定义的网络(SDN)虚拟交换机,类似于 Linux 软件网桥。OVS 为虚拟网络提供交换服务,支持行业标准 OpenFlow 和 sFlow。OVS 也可以使用第 2 层功能(如 STP、LACP 和 802.1Q VLAN 标记)与物理交换机集成。Open vSwitch 版本 1.11.0-1.el6 或更高版本也支持使用 VXLAN 和 GRE 进行隧道。

有关网络接口绑定的更多信息,请参阅高级 Overcloud 自定义指南中的网络接口绑定。

为降低 OVS 中网络循环的风险,只能有一个接口或单个绑定作为给定网桥的成员。如果需要多个绑定或接口,可以配置多个网桥。

1.7. 打开虚拟网络(OVN)

Open Virtual Network (OVN)是一个系统,支持虚拟机和容器环境中的逻辑网络抽象。有时为 Open vSwitch 称为开源虚拟网络,OVN 会补充 OVS 的现有功能,以添加逻辑网络抽象的原生支持,如逻辑 L2 和 L3 覆盖、安全组和服务,如 DHCP。

物理网络包含物理有线、交换机和路由器。虚拟网络将物理网络扩展到虚拟机监控程序或容器平台,将虚拟机或容器桥接到物理网络中。OVN 逻辑网络是在软件中实施的网络,它通过隧道或其他封装从物理网络中计算。这允许逻辑网络中使用的 IP 和其他地址空间与物理网络中使用的 IP 和其他地址空间重叠,而不会导致冲突。可以在不考虑其运行的物理网络拓扑拓扑的情况下排列逻辑网络拓扑。因此,作为逻辑网络一部分的虚拟机可以在不中断的情况下从一个物理机器迁移到另一个物理机器。

封装层可防止连接到逻辑网络的虚拟机和容器与物理网络上的节点通信。对于集群虚拟机和容器,这可能可以接受甚至需要这样做,但在很多情况下,虚拟机和容器需要连接到物理网络。OVN 提供多种形式的网关来实现这一目的。OVN 部署由多个组件组成:

- 云管理系统(CMS)

- 通过管理 OVN 逻辑网络元素并将 OVN 集成到物理网络中,并将 OVN 逻辑网络基础架构连接到物理网络元素。一些示例包括 OpenStack 和 OpenShift。

- OVN 数据库

- 存储代表 OVN 逻辑和物理网络的数据。

- hypervisor

- 在物理或虚拟机上运行 Open vSwitch,并将 OVN 逻辑网络转换为 OpenFlow。

- 网关

- 通过在隧道和物理网络基础架构间转发数据包,将基于隧道的 OVN 逻辑网络扩展到物理网络中。

1.8. 模块层 2 (ML2)类型和机制驱动程序兼容性

在规划 Red Hat OpenStack Platform (RHOSP)数据网络时,请参考下表,以确定每个修改层 2 (ML2)机制驱动程序支持的网络类型。

| 机制驱动程序 | 支持这些类型驱动程序 | ||||

| flat | GRE | VLAN | VXLAN | GENEVE | |

| 打开虚拟网络(OVN) | 是 | 否 | 是 | 是 [1] | 是 |

| Open vSwitch (OVS) | 是 | 是 | 是 | 是 | 否 |

[1] ML2/OVN VXLAN 支持仅限于每个网络的 4096 个网络和 4096 端口。另外,依赖入口端口的 ACL 无法用于 ML2/OVN 和 VXLAN,因为入口端口没有被传递。

1.9. RHOSP 网络服务的扩展驱动程序

Red Hat OpenStack Platform (RHOSP)网络服务(neutron)可扩展。扩展用于两个目的:它们允许在 API 中引入新功能,而无需更改版本,它们允许引入特定于供应商的 niche 功能。应用程序可以通过对 /extensions URI 执行 GET 来以编程方式列出可用扩展。请注意,这是一个版本化请求;也就是说,一个 API 版本中可用的扩展可能在另一个 API 版本中不可用。

ML2 插件还支持扩展驱动程序,允许其他可插拔驱动程序扩展 ML2 插件中用于网络对象实施的核心资源。扩展驱动程序示例包括支持 QoS、端口安全性等。

第 2 章 使用 ML2/OVN

Red Hat OpenStack Platform (RHOSP)网络由 Networking 服务(neutron)管理。网络服务的核心是 Modular Layer 2 (ML2)插件,RHOSP ML2 插件的默认机制驱动程序是 Open Virtual Networking (OVN)机制驱动程序。

较早的 RHOSP 版本默认使用 Open vSwitch (OVS)机制驱动程序,但红帽建议为大多数部署推荐 ML2/OVN 机制驱动程序。

如果您从 RHOSP 13 ML2/OVS 部署升级到 RHOSP 16,红帽建议升级后从 ML2/OVS 迁移到 ML2/OVN。在某些情况下,ML2/OVN 可能无法满足您的要求。在这些情况下,您可以使用 ML2/OVS 部署 RHOSP。

2.1. RHOSP OVN 架构中的组件列表

RHOSP OVN 架构将 OVS Modular Layer 2 (ML2)机制驱动程序替换为 OVN ML2 机制驱动程序来支持网络 API。OVN 为 Red Hat OpenStack 平台提供网络服务。

如图 2.1 所示,OVN 架构由以下组件和服务组成:

- ML2 插件带有 OVN 机制驱动程序

- ML2 插件将 OpenStack 特定的网络配置转换为平台中立的 OVN 逻辑网络配置。它通常在 Controller 节点上运行。

- OVN 北向(NB)数据库(

ovn-nb) -

此数据库存储 OVN ML2 插件的逻辑 OVN 网络配置。它通常在 Controller 节点上运行,并侦听 TCP 端口

6641。 - OVN 北向服务(

ovn-northd) - 此服务将逻辑网络配置从 OVN NB 数据库转换为逻辑数据路径流,并在 OVN 南向数据库中填充它们。它通常在 Controller 节点上运行。

- OVN 南向(SB)数据库(

ovn-sb) -

这个数据库存储转换的逻辑数据路径流。它通常在 Controller 节点上运行,并侦听 TCP 端口

6642。 - OVN 控制器(

ovn-controller) -

此控制器连接到 OVN SB 数据库,并充当 Open vSwitch 控制器来控制和监控网络流量。它在所有定义

OS::Tripleo::Services::OVNController的 Compute 和网关节点上运行。 - OVN 元数据代理(

ovn-metadata-agent) -

此代理创建

haproxy实例,用于管理用于代理元数据 API 请求的 OVS 接口、网络命名空间和 HAProxy 进程。代理在所有定义OS::TripleO::Services::OVNMetadataAgent的 Compute 和网关节点上运行。 - OVS 数据库服务器(OVSDB)

-

托管 OVN 北向和南向数据库。还与

ovs-vswitchd交互,以托管 OVS 数据库conf.db。

NB 数据库的 schema 文件位于 /usr/share/ovn/ovn-nb.ovsschema 中,SB 数据库架构文件位于 /usr/share/ovn/ovn-sb.ovsschema 中。

图 2.1. RHOSP 环境中的 OVN 架构

2.2. ML2/OVN 数据库

在 Red Hat OpenStack Platform ML2/OVN 部署中,网络配置信息通过共享分布式数据库在进程之间传递。您可以检查这些数据库以验证网络的状态并发现问题。

- OVN 北向数据库

北向数据库(

OVN_Northbound)充当 OVN 和云管理系统(如 Red Hat OpenStack Platform (RHOSP))之间的接口。RHOSP 生成北向数据库的内容。北向数据库包含网络的当前状态,以逻辑端口、逻辑交换机、逻辑路由器等的形式显示。每个 RHOSP 网络服务(neutron)对象在北向数据库的表中表示。

- OVN 南向数据库

-

南向数据库(

OVN_Southbound)包含 OVN 系统的逻辑和物理配置状态,以支持虚拟网络抽象。ovn-controller使用此数据库中的信息配置 OVS 以满足网络服务(neutron)要求。

2.3. Compute 节点上的 ovn-controller 服务

ovn-controller 服务在每个 Compute 节点上运行,并连接到 OVN 南向(SB)数据库服务器,以检索逻辑流。ovn-controller 将这些逻辑流转换为物理 OpenFlow 流,并将流添加到 OVS 网桥(br-int)。要与 ovs-vswitchd 进行通信并安装 OpenFlow 流,ovn-controller 使用在 ovn-controller 启动时传递的 UNIX 套接字路径(如 unix:/var/run/openvswitch/db.sock)连接到本地 ovsdb-server(托管 conf.db)。

ovn-controller 服务需要在 Open_vSwitch 表的 external_ids 列中需要特定的键值对; puppet-ovn 使用 puppet-vswitch 来填充这些字段。以下示例显示了 puppet-vswitch 在 external_ids 列中配置的键值对:

hostname=<HOST NAME> ovn-encap-ip=<IP OF THE NODE> ovn-encap-type=geneve ovn-remote=tcp:OVN_DBS_VIP:6642

hostname=<HOST NAME>

ovn-encap-ip=<IP OF THE NODE>

ovn-encap-type=geneve

ovn-remote=tcp:OVN_DBS_VIP:66422.4. Compute 节点上的 OVN 元数据代理

OVN 元数据代理在 tripleo-heat-templates/deployment/ovn-metadata-container-puppet.yaml 文件中配置,并通过 OS::TripleO::Services::OVNMetadataAgent 包含在默认的 Compute 角色中。因此,带有默认参数的 OVN 元数据代理作为 OVN 部署的一部分被部署。

OpenStack 虚拟机实例通过链接 IP 地址访问网络元数据服务:169.254.169.254。neutron-ovn-metadata-agent 能够访问存在计算元数据 API 的主机网络。每个 HAProxy 都位于无法访问适当的主机网络的网络命名空间中。HAProxy 将必要的标头添加到元数据 API 请求中,然后将请求通过 UNIX 域套接字转发到 neutron-ovn-metadata-agent。

OVN 网络服务为每个虚拟网络创建一个唯一网络命名空间,以启用元数据服务。Compute 节点上的实例访问的每个网络都有对应的元数据命名空间(ovnmeta-<network_uuid>)。

2.5. OVN 可组合服务

Red Hat OpenStack Platform 通常由预定义角色中的节点组成,如 Controller 角色、Compute 角色和不同的存储角色类型。每个默认角色都包含一组在核心 heat 模板集合中定义的服务。

在默认的 Red Hat OpenStack (RHOSP)部署中,ML2/OVN 可组合服务在 Controller 节点上运行。您可以选择创建自定义 Networker 角色,并在专用 Networker 节点上运行 OVN 可组合服务。

OVN 可组合服务 ovn-dbs 部署到名为 ovn-dbs-bundle 的容器中。在默认安装 ovn-dbs 中包含在 Controller 角色中,并在 Controller 节点上运行。由于服务可组合使用,您可以将其分配到另一个角色,如 Networker 角色。

如果您将 OVN 可组合服务分配给另一个角色,请确保该服务与 pacemaker 服务位于同一个节点上,该服务控制 OVN 数据库容器。

2.6. OVN 第 3 层高可用性

OVN 支持第 3 层高可用性(L3 HA),无需任何特殊配置。

在创建路由器时,请勿使用 --ha 选项,因为 OVN 路由器默认具有高可用性。OpenStack router 创建包含 --ha 选项的命令会失败。

OVN 自动将路由器端口调度到所有可用网关节点,它们可作为指定外部网络上的 L3 网关。OVN L3 HA 使用 OVN Logical_Router_Port 表中的 gateway_chassis 列。大多数功能都由带有捆绑的 active_passive 输出的 OpenFlow 规则管理。ovn-controller 处理地址解析协议(ARP)响应器和路由器启用和禁用。为 FIP 和路由器外部地址获取 ARP 也会定期由 ovn-controller 发送。

L3HA 使用 OVN 将路由器恢复回原始网关节点,以避免任何节点成为瓶颈。

BFD 监控

OVN 使用双向转发检测(BFD)协议来监控网关节点的可用性。此协议封装在从节点到节点的 Geneve 隧道之上。

每个网关节点监控部署中星号拓扑中的所有其他网关节点。网关节点还监控计算节点,使网关启用和禁用数据包的路由和 ARP 响应和公告。

每个计算节点使用 BFD 监控每个网关节点,并通过给定路由器的活跃网关节点自动窃取外部流量,如源和目标网络地址转换(SNAT 和 VNI)。Compute 节点不需要监控其他计算节点。

没有检测到外部网络失败,因为 ML2-OVS 配置会发生。

OVN 的 L3 HA 支持以下故障模式:

- 网关节点与网络断开连接(隧道接口)。

-

ovs-vswitchd停止(ovs-switchd负责 BFD 信号) -

OVN-controller停止(ovn-controller将自身作为注册的节点删除)。

这个 BFD 监控机制仅适用于链接失败,不适用于路由失败。

2.7. OVN 和 OVS 机制驱动程序中的功能支持

检查 Red Hat OpenStack Platform (RHOSP)功能的可用性,作为 OVS 到 OVN 机制驱动程序迁移计划的一部分。

| 功能 | OVN RHOSP 16.2 | OVN RHOSP 17.1 | OVS RHOSP 16.2 | OVS RHOSP 17.1 | 附加信息 |

|---|---|---|---|---|---|

| 使用 OVN DHCP 置备裸机 | 否 | 否 | 是 | 是 |

OVN 上的内置 DHCP 服务器无法置备裸机节点。它无法为 provisioning 网络提供 DHCP。Chainbooting iPXE 需要标记(dnsmasq 中的 |

| VLAN 项目(租户网络)端口的 VF (直接)端口的北/南路由 | 否 | 否 | 是 | 是 | 核心 OVN 限制。请参阅 https://bugs.launchpad.net/neutron/+bug/1875852。 |

| 内部 DNS 记录的反向 DNS | 否 | 是 | 是 | 是 | |

| 隔离网络的内部 DNS 解析 | 否 | 否 | 是 | 是 | OVN 不支持隔离网络的内部 DNS 解析,因为它不为 DNS 服务分配端口。这不会影响 OVS 部署,因为 OVS 使用 dnsmasq。请参阅 https://issues.redhat.com/browse/OSP-25661。 |

| 安全组日志记录 | 技术预览 | 是 | 否 | 否 | RHOSP 不支持使用 OVS 机制驱动程序的安全组日志记录。 |

| 无状态安全组 | 否 | 是 | 否 | 否 | 请参阅 配置安全组。 |

| 负载均衡服务分布式虚拟路由(DVR) | 是 | 是 | 否 | 否 | OVS 机制驱动程序通过 Controller 或网络节点路由负载平衡服务流量,即使启用了 DVR。OVN 机制驱动程序通过 Compute 节点直接路由负载平衡服务流量。 |

| IPv6 DVR | 是 | 是 | 否 | 否 | 使用 OVS 机制驱动程序时,RHOSP 不会将 IPv6 流量分发到 Compute 节点,即使启用了 DVR。所有入口/出口流量都通过集中式 Controller 或 Network 节点。如果您需要 IPv6 DVR,请使用 OVN 机制驱动程序。 |

| DVR 和第 3 层高可用性(L3 HA) | 是 | 是 | 否 | 否 |

使用 OVS 机制驱动程序的 RHOSP 部署不支持 DVR 与 L3 HA 结合使用。如果您将 DVR 与 RHOSP director 搭配使用,则禁用 L3 HA。这意味着网络服务仍然在网络节点上调度路由器,并在 L3 代理间共享它们。但是,如果一个代理失败,由此代理托管的所有路由器也会失败。这只会影响 SNAT 流量。红帽建议在这种情况下使用 |

2.8. 使用 ML2/OVN 对非安全端口的限制

如果您在使用默认 ML2/OVN 机制驱动程序的 Red Hat Open Stack Platform (RHOSP)部署中禁用端口安全插件扩展以及大量端口,则端口可能无法访问。

在某些大型 ML2/OVN RHSOP 部署中,ML2/OVN 中的流链限制可能会丢弃指向禁用安全插件的端口的 ARP 请求。

ML2/OVN 可以支持的实际逻辑交换机端口数量没有记录的最大限制,但限制大约有 4,000 个端口。

贡献大约限制的属性是 ML2/OVN 生成的 OpenFlow 管道重新提交的数量,并更改整个逻辑拓扑。

2.9. ML2/OVS 到 ML2/OVN 原位迁移:验证和禁止的情况

红帽会继续测试和优化原位迁移场景。与红帽大客户经理或全球专业服务合作,以确定您的 OVS 部署是否满足有效原位升级场景的条件。

2.9.1. 验证 ML2/OVS 到 ML2/OVN 迁移场景

- DVR 到 DVR

启动:使用 DVR 的 OVS 的 RHOSP 16.1.1 或更高版本。

end: 与 DVR 的 OVN 相同的 RHOSP 版本和发行版本。

SR-IOV 不在启动环境中或迁移后添加。

- 集中式路由 + 使用虚拟功能(VF)端口的 SR-IOV

启动:使用 OVS (无 DVR)和 SR-IOV 的 RHOSP 16.1.1 或更高版本。

end: 与 OVN (无 DVR)和 SR-IOV 相同的 RHOSP 版本和发行版本。

使用 SR-IOV 虚拟功能(VF)端口的工作负载。SR-IOV 物理功能(PF)端口会导致迁移失败。

2.9.2. ML2/OVS 到 ML2/OVN 的原位迁移尚未被验证

在红帽宣布根本问题解决之前,您无法在以下情况下执行从 ML2/OVS 到 ML2/OVN 的原位升级。

- OVS 部署使用网络功能虚拟化(SVVP)

- 红帽支持使用 ML2/OVN 和 NFV 的新部署,但尚未成功测试 ML2/OVS 和 NFV 部署迁移到 ML2/OVN。要跟踪此问题的进度,请参阅 https://bugzilla.redhat.com/show_bug.cgi?id=1925290。

- 带有物理功能(PF)端口的 SR-IOV

- 当任何工作负载使用 SR-IOV PF 端口时,迁移测试会失败。要跟踪此问题的进度,请参阅 https://bugzilla.redhat.com/show_bug.cgi?id=1879546。

- OVS 使用中继端口

- 如果您的 ML2/OVS 部署使用中继端口,请不要执行 ML2/OVS 到 ML2/OVN 迁移。迁移不会在 OVN 环境中正确设置中继端口。要跟踪此问题的进度,请参阅 https://bugzilla.redhat.com/show_bug.cgi?id=1857652。

- 带有 VLAN 项目(租户)网络的 DVR

- 不要使用 DVR 和 VLAN 项目网络迁移到 ML2/OVN。您可以使用集中式路由迁移到 ML2/OVN。要跟踪此问题的进度,请参阅 https://bugzilla.redhat.com/show_bug.cgi?id=1766930。

2.9.3. ML2/OVS 到 ML2/OVN 原位迁移和安全组规则

确保原始 ML2/OVS 部署中的任何自定义安全组规则都与目标 ML2/OVN 部署兼容。

例如,默认安全组包含允许出口到 DHCP 服务器的规则。如果您在 ML2/OVS 部署中删除了这些规则,ML2/OVS 会自动添加允许到 DHCP 服务器的隐式规则。ML2/OVN 不支持这些隐式规则,因此在目标 ML2/OVN 环境中,DHCP 和元数据流量无法访问 DHCP 服务器,实例将无法引导。在这种情况下,要恢复 DHCP 访问,您可以添加以下规则:

2.10. 在新的 RHOSP 16.2 部署中使用 ML2/OVS 而不是默认的 ML2/OVN

在 Red Hat OpenStack Platform (RHOSP) 16.0 及之后的版本部署中,带有 Open Virtual Network (ML2/OVN)的 Modular Layer 2 插件是 RHOSP 网络服务的默认机制驱动程序。如果应用程序需要 ML2/OVS 机制驱动程序,您可以更改此设置。

流程

-

以

stack用户身份登录 undercloud。 在模板文件

/home/stack/templates/containers-prepare-parameter.yaml中,使用ovs而不是ovn作为neutron_driver参数的值:parameter_defaults: ContainerImagePrepare: - set: ... neutron_driver: ovsparameter_defaults: ContainerImagePrepare: - set: ... neutron_driver: ovsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在环境文件中,

/usr/share/openstack-tripleo-heat-templates/environments/services/neutron-ovs.yaml,确保NeutronNetworkType参数包含vxlan或gre而不是geneve。示例

parameter_defaults: ... NeutronNetworkType: 'vxlan'

parameter_defaults: ... NeutronNetworkType: 'vxlan'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行

openstack overcloud deploy命令,并包含您修改的核心 heat 模板、环境文件和您修改的文件。重要环境文件的顺序非常重要,因为后续环境文件中定义的参数和资源具有优先权。

openstack overcloud deploy --templates \ -e <your_environment_files> \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/ \ neutron-ovs.yaml \ -e /home/stack/templates/containers-prepare-parameter.yaml \

$ openstack overcloud deploy --templates \ -e <your_environment_files> \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/ \ neutron-ovs.yaml \ -e /home/stack/templates/containers-prepare-parameter.yaml \Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.11. 升级后保留 ML2/OVS,而不是默认的 ML2/OVN

在 Red Hat OpenStack Platform (RHOSP) 16.0 及之后的版本部署中,带有 Open Virtual Network (ML2/OVN)的 Modular Layer 2 插件是 RHOSP 网络服务的默认机制驱动程序。如果您从使用 ML2/OVS 的较早版本的 RHOSP 升级,您可以在升级后从 ML2/OVN 迁移到 ML2/OVS。

如果在升级后选择继续使用 ML2/OVS,请按照红帽的升级过程操作,且不执行 ML2/OVS-to-ML2/OVN 迁移。

2.12. 使用 ML2/OVN 部署自定义角色

在默认的 Red Hat OpenStack (RHOSP)部署中,ML2/OVN 可组合服务在 Controller 节点上运行。您可以选择使用受支持的自定义角色,如以下示例所述。

- Networker

- 在专用网络器节点上运行 OVN 可组合服务。

- 带有 SR-IOV 的 Networker

- 使用 SR-IOV 在专用 networker 节点上运行 OVN 可组合服务。

- 使用 SR-IOV 的控制器

- 在支持 SR-IOV 的控制器节点上运行 OVN 可组合服务。

您还可以生成自己的自定义角色。

限制

以下限制适用于本发行版本中将 SR-IOV 与 ML2/OVN 和原生 OVN DHCP 搭配使用。

- 所有外部端口都调度到单个网关节点上,因为所有端口只有一个 HA Chassis 组。

- VLAN 租户网络上的 VF (direct)端口上的北路由无法用于 SR-IOV,因为外部端口没有与逻辑路由器的网关端口在一起。请参阅 https://bugs.launchpad.net/neutron/+bug/1875852。

先决条件

- 您知道如何部署自定义角色。有关更多信息,请参阅高级 Overcloud 自定义指南中的可组合服务和自定义角色。

流程

以

stack用户身份登录 undercloud 主机,再提供stackrc文件。source stackrc

$ source stackrcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 选择适合您的部署的自定义角色文件。如果它是您需要,直接在 deploy 命令中使用它。或者,您可以生成组合其他自定义角色文件自己的自定义角色文件。

Expand Deployment 角色 角色文件 Networker 角色

Networker

Networker.yaml带有 SR-IOV 的 Networker 角色

NetworkerSriov

NetworkerSriov.yaml与 SR-IOV 共存控制和网络器

ControllerSriov

ControllerSriov.yaml- [可选] 生成一个新的自定义角色数据文件,该文件将其中一个自定义角色文件与其他自定义角色文件相结合。按照 高级 Overcloud 自定义指南中的 创建 roles_data 文件中 的说明进行操作。根据您的部署包括适当的源角色文件。

- [可选] 要为角色识别特定节点,您可以创建特定的硬件类别,并将类别分配到特定的节点。然后,使用环境文件为角色定义类别,并指定节点数。有关更多信息,请参阅高级 Overcloud 自定义指南中的创建新角色中的示例。

根据您的部署创建一个环境文件。

Expand Deployment 环境文件示例 Networker 角色

neutron-ovn-dvr-ha.yaml

带有 SR-IOV 的 Networker 角色

ovn-sriov.yaml

根据您的部署包括以下设置。

Expand Deployment 设置 Networker 角色

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 带有 SR-IOV 的 Networker 角色

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 与 SR-IOV 共存控制和网络器

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

部署 overcloud。使用

-e选项在部署命令中包含环境文件。在部署命令中包含自定义角色数据文件,以及 -r 选项。例如:-r Networker.yaml或-r mycustomrolesfile.yaml。

验证步骤 - OVN 部署

以 overcloud SSH 用户身份登录 Controller 或 Networker 节点,默认为

heat-admin。示例

ssh heat-admin@controller-0

ssh heat-admin@controller-0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 确保

ovn_metadata_agent在 Controller 和 Networker 节点上运行。sudo podman ps | grep ovn_metadata

$ sudo podman ps | grep ovn_metadataCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

a65125d9588d undercloud-0.ctlplane.localdomain:8787/rh-osbs/rhosp16-openstack-neutron-metadata-agent-ovn:16.2_20200813.1 kolla_start 23 hours ago Up 21 hours ago ovn_metadata_agent

a65125d9588d undercloud-0.ctlplane.localdomain:8787/rh-osbs/rhosp16-openstack-neutron-metadata-agent-ovn:16.2_20200813.1 kolla_start 23 hours ago Up 21 hours ago ovn_metadata_agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确保带有 OVN 服务或专用网络器节点的 Controller 节点已配置为 OVS 的网关。

sudo ovs-vsctl get Open_Vswitch . external_ids:ovn-cms-options

$ sudo ovs-vsctl get Open_Vswitch . external_ids:ovn-cms-optionsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

... enable-chassis-as-gw ...... enable-chassis-as-gw ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证步骤 - SR-IOV 部署

以 overcloud SSH 用户身份登录 Compute 节点,默认为

heat-admin。示例

ssh heat-admin@compute-0

ssh heat-admin@compute-0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 确保

neutron_sriov_agent在 Compute 节点上运行。sudo podman ps | grep neutron_sriov_agent

$ sudo podman ps | grep neutron_sriov_agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

f54cbbf4523a undercloud-0.ctlplane.localdomain:8787/rh-osbs/rhosp16-openstack-neutron-sriov-agent:16.2_20200813.1 kolla_start 23 hours ago Up 21 hours ago neutron_sriov_agent

f54cbbf4523a undercloud-0.ctlplane.localdomain:8787/rh-osbs/rhosp16-openstack-neutron-sriov-agent:16.2_20200813.1 kolla_start 23 hours ago Up 21 hours ago neutron_sriov_agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确保成功检测到 network-available SR-IOV NIC。

sudo podman exec -uroot galera-bundle-podman-0 mysql nova -e 'select hypervisor_hostname,pci_stats from compute_nodes;'

$ sudo podman exec -uroot galera-bundle-podman-0 mysql nova -e 'select hypervisor_hostname,pci_stats from compute_nodes;'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

computesriov-1.localdomain {... {"dev_type": "type-PF", "physical_network": "datacentre", "trusted": "true"}, "count": 1}, ... {"dev_type": "type-VF", "physical_network": "datacentre", "trusted": "true", "parent_ifname": "enp7s0f3"}, "count": 5}, ...} computesriov-0.localdomain {... {"dev_type": "type-PF", "physical_network": "datacentre", "trusted": "true"}, "count": 1}, ... {"dev_type": "type-VF", "physical_network": "datacentre", "trusted": "true", "parent_ifname": "enp7s0f3"}, "count": 5}, ...}computesriov-1.localdomain {... {"dev_type": "type-PF", "physical_network": "datacentre", "trusted": "true"}, "count": 1}, ... {"dev_type": "type-VF", "physical_network": "datacentre", "trusted": "true", "parent_ifname": "enp7s0f3"}, "count": 5}, ...} computesriov-0.localdomain {... {"dev_type": "type-PF", "physical_network": "datacentre", "trusted": "true"}, "count": 1}, ... {"dev_type": "type-VF", "physical_network": "datacentre", "trusted": "true", "parent_ifname": "enp7s0f3"}, "count": 5}, ...}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.13. 带有 ML2/OVN 和原生 OVN DHCP 的 SR-IOV

您可以部署自定义角色,以便在带有原生 OVN DHCP 的 ML2/OVN 部署中使用 SR-IOV。请参阅 第 2.12 节 “使用 ML2/OVN 部署自定义角色”。

限制

以下限制适用于本发行版本中将 SR-IOV 与 ML2/OVN 和原生 OVN DHCP 搭配使用。

- 所有外部端口都调度到单个网关节点上,因为所有端口只有一个 HA Chassis 组。

- VLAN 租户网络上的 VF (direct)端口上的北路由无法用于 SR-IOV,因为外部端口没有与逻辑路由器的网关端口在一起。请参阅 https://bugs.launchpad.net/neutron/+bug/1875852。

第 3 章 管理项目网络

项目网络可帮助您隔离云计算的网络流量。创建项目网络的步骤包括规划和创建网络,以及添加子网和路由器。

3.1. VLAN 计划

在规划 Red Hat OpenStack Platform 部署时,您可以从多个子网开始,您可以从中分配单个 IP 地址。当使用多个子网时,您可以将系统间的流量隔离到 VLAN。

例如,您的管理或 API 流量与服务 Web 流量的系统不同。VLAN 间的流量通过路由器传输,您可以在其中实施防火墙来管理流量流。

您必须规划您的 VLAN 作为整个计划的一部分,其中包括部署中各种类型虚拟网络资源的流量隔离、高可用性和 IP 地址利用率。

单一网络中的最大 VLAN 数量,或者在一个 OVS 代理中,网络节点的最大 VLAN 数量为 4094。如果您需要超过最大 VLAN 数量,您可以创建多个提供商网络(VXLAN 网络)和多个网络节点,每个网络对应一个。每个节点最多可包含 4094 个专用网络。

3.2. 网络流量类型

您可以为您要托管的不同类型的网络流量分配单独的 VLAN。例如,您可以为每个类型的网络都有单独的 VLAN。只有外部网络必须路由到外部物理网络。在本发行版本中,director 提供 DHCP 服务。

您不需要本节中的所有隔离的 VLAN 以用于每个 OpenStack 部署。例如,如果您的云用户不需要根据需要创建临时虚拟网络,您可能不需要项目网络。如果您希望每个虚拟机直接连接到与任何其他物理系统相同的交换机,请将您的 Compute 节点直接连接到提供商网络,并将您的实例配置为使用该提供商网络。

- 置备网络 - 此 VLAN 专用于通过 PXE 引导使用 director 部署新节点。OpenStack Orchestration (heat)将 OpenStack 安装到 overcloud 裸机服务器上。这些服务器附加到物理网络,以便从 undercloud 基础架构接收平台安装镜像。

内部 API 网络 - OpenStack 服务使用内部 API 网络进行通信,包括 API 通信、RPC 消息和数据库通信。此外,此网络用于控制器节点之间的操作消息。在规划 IP 地址分配时,请注意每个 API 服务都需要自己的 IP 地址。特别是,您必须为以下每个服务规划 IP 地址:

- vip-msg (ampq)

- vip-keystone-int

- vip-glance-int

- vip-cinder-int

- vip-nova-int

- vip-neutron-int

- vip-horizon-int

- vip-heat-int

- vip-ceilometer-int

- vip-swift-int

- vip-keystone-pub

- vip-glance-pub

- vip-cinder-pub

- vip-nova-pub

- vip-neutron-pub

- vip-horizon-pub

- vip-heat-pub

- vip-ceilometer-pub

- vip-swift-pub

使用高可用性时,Pacemaker 会在物理节点之间移动 VIP 地址。

- 存储 - 块存储、NFS、iSCSI 和其他存储服务。出于性能的原因,将此网络隔离为单独的物理以太网链接。

- 存储管理 - OpenStack Object Storage (swift)使用此网络在参与副本节点之间同步数据对象。代理服务充当用户请求和底层存储层之间的中间接口。代理接收传入的请求,并找到所需的副本来检索请求的数据。使用 Ceph 后端的服务通过存储管理网络连接,因为它们不直接与 Ceph 交互,而是使用前端服务。请注意,RBD 驱动程序是一个例外;此流量直接连接到 Ceph。

- 项目网络 - Neutron 使用 VLAN 隔离(每个项目网络是网络 VLAN)或利用 VXLAN 或 GRE 进行隧道,为各个项目提供自己的网络。网络流量在每个项目网络中隔离。每个项目网络都有一个与其关联的 IP 子网,多个项目网络可能会使用相同的地址。

- External - 外部网络托管公共 API 端点和到 Dashboard (horizon)的连接。您还可以将此网络用于 SNAT。在生产部署中,通常将单独的网络用于浮动 IP 地址和 NAT。

- 提供商网络 - 使用提供商网络将实例附加到现有网络基础架构。您可以使用提供商网络直接映射到数据中心中的现有物理网络,使用扁平网络或 VLAN 标签。这允许实例与 OpenStack 网络基础架构外部的系统共享相同的第 2 层网络。

3.3. IP 地址消耗

以下系统使用您分配的范围内的 IP 地址:

- 物理节点 - 每个物理 NIC 都需要一个 IP 地址。将物理 NIC 专用于特定功能是常见的做法。例如,将管理和 NFS 流量分配给不同的物理 NIC,有时有多个 NIC 连接到不同的交换机,以实现冗余目的。

- 用于高可用性的虚拟 IP (VIP) - 计划为每个控制器节点共享的每个网络在一个或多个 VIP 之间分配。

3.4. 虚拟网络

以下虚拟资源消耗 OpenStack 网络中的 IP 地址。这些资源被视为云基础架构的本地,不需要外部物理网络中的系统访问这些资源:

- 项目网络 - 每个项目网络需要一个子网,它可用于为实例分配 IP 地址。

- 虚拟路由器 - 每个路由器接口插入到子网都需要一个 IP 地址。如果要使用 DHCP,每个路由器接口需要两个 IP 地址。

- 实例 - 每个实例需要一个托管实例的项目子网的地址。如果需要入口流量,则必须从指定的外部网络为实例分配一个浮动 IP 地址。

- 管理流量 - 包括 OpenStack 服务和 API 流量。所有服务共享少量 VIP。API、RPC 和数据库服务在内部 API VIP 上进行通信。

3.5. 添加网络路由

要允许流量被路由到新网络或从新网络路由,您必须将其子网作为接口添加到现有的虚拟路由器:

- 在控制面板中,选择 Project > Network > Routers。

在 Routers 列表中选择您的虚拟路由器名称,然后单击 Add Interface。

在子网列表中,选择您的新子网的名称。您可以选择在此字段中为接口指定 IP 地址。

点 Add Interface。

您的网络中的实例现在可以与子网外的系统通信。

3.6. 网络计划示例

本例展示了多个容纳多个子网的网络,每个子网被分配一个 IP 地址范围:

| 子网名称 | 地址范围 | 地址数 | 子网掩码 |

|---|---|---|---|

| Provisioning 网络 | 192.168.100.1 - 192.168.100.250 | 250 | 255.255.255.0 |

| 内部 API 网络 | 172.16.1.10 - 172.16.1.250 | 241 | 255.255.255.0 |

| 存储 | 172.16.2.10 - 172.16.2.250 | 241 | 255.255.255.0 |

| 存储管理 | 172.16.3.10 - 172.16.3.250 | 241 | 255.255.255.0 |

| 租户网络(GRE/VXLAN) | 172.16.4.10 - 172.16.4.250 | 241 | 255.255.255.0 |

| 外部网络( incl. 浮动 IP) | 10.1.2.10 - 10.1.3.222 | 469 | 255.255.254.0 |

| 提供商网络(infrastructure) | 10.10.3.10 - 10.10.3.250 | 241 | 255.255.252.0 |

3.7. 创建网络

创建一个网络,以便您的实例可以相互通信,并使用 DHCP 接收 IP 地址。有关外部网络连接的更多信息,请参阅 桥接物理网络。

在创建网络时,务必要知道网络可以托管多个子网。如果您打算在同一网络中托管不同的系统,并且首选在它们之间进行隔离,这非常有用。例如,您可以指定只有一个子网中只有 webserver 流量,而数据库流量则遍历另一个子网。子网相互隔离,希望与其他子网通信的实例都必须由路由器指示其流量。考虑将需要大量流量的系统放在同一子网中,以便它们不需要路由,并避免后续的延迟和负载。

- 在控制面板中,选择 Project > Network > Networks。

点 +Create Network 并指定以下值:

Expand 字段 描述 网络名称

描述性名称,基于网络要执行的角色。如果要将网络与外部 VLAN 集成,请考虑将 VLAN ID 号附加到名称中。例如,

webservers_122,如果在这个子网中托管 HTTP Web 服务器,您的 VLAN 标签为122。或者,如果您打算将网络流量保持私有,而不将网络与外部网络集成,则可以使用内部内部流量。Admin State

控制网络是否立即可用。使用此字段以 Down 状态创建网络,其中逻辑存在但不活跃。如果您不打算立即将网络输入到生产中,这非常有用。

创建子网

决定是否创建子网。例如,如果您打算将这个网络保留为没有网络连接的占位符,您可能不希望创建子网。

点 Next 按钮,然后在 Subnet 选项卡中指定以下值:

Expand 字段 描述 子网名称

为子网输入一个描述性名称。

网络地址

以 CIDR 格式输入地址,其中包含一个值中的 IP 地址范围和子网掩码。要确定地址,计算子网掩码中屏蔽的位数,并将该值附加到 IP 地址范围中。例如,子网掩码 255.255.255.0 具有 24 个屏蔽的位。要将这个掩码与 IPv4 地址范围 192.168.122.0 搭配使用,请指定地址 192.168.122.0/24。

IP 版本

指定互联网协议版本,其中有效类型为 IPv4 或 IPv6。Network Address 字段中的 IP 地址范围必须与您选择的版本匹配。

网关 IP

默认网关的路由器接口的 IP 地址。此地址是路由目标为外部位置的任何流量的下一跳,且必须在 Network Address 字段中指定的范围内。例如,如果您的 CIDR 网络地址是 192.168.122.0/24,则您的默认网关可能是 192.168.122.1。

禁用网关

禁用转发并隔离子网。

点 Next 指定 DHCP 选项:

- 启用 DHCP - 为此子网启用 DHCP 服务。您可以使用 DHCP 自动将 IP 设置分发到您的实例。

IPv6 地址 - 配置模式.如果创建 IPv6 网络,您必须指定如何分配 IPv6 地址和其他信息:

- no Options specifiedd - 如果您要手动设置 IP 地址,或者使用非 OpenStack 感知方法进行地址分配,请选择这个选项。

- ACTIVE (Stateless Address Autoconfiguration) - 实例根据从 OpenStack 网络路由器发送的路由器广告(RA)消息生成 IPv6 地址。使用此配置创建 OpenStack 网络子网,并将 ra_mode 设置为 slaac,并将 address_mode 设置为 slaac。

- DHCPv6 有状态 - 实例从 OpenStack 网络 DHCPv6 服务接收 IPv6 地址以及附加选项(如 DNS)。使用此配置创建将 ra_mode 设置为 dhcpv6-stateful 的子网,并将 address_mode 设置为 dhcpv6-stateful。

- DHCPv6 无状态 - 实例根据从 OpenStack 网络路由器发送的路由器广告(RA)消息生成 IPv6 地址。从 OpenStack Networking DHCPv6 服务分配其他选项(如 DNS)。使用此配置创建将 ra_mode 设置为 dhcpv6-stateless 的子网,并将 address_mode 设置为 dhcpv6-stateless。

- 分配池 - 您希望 DHCP 分配的 IP 地址范围。例如,value 192.168.22.100,192.168.22.150 将该范围内的所有地址视为可用于分配。

DNS 名称服务器 - 网络中可用的 DNS 服务器的 IP 地址。DHCP 将这些地址分发到实例,以进行名称解析。

重要对于 DNS 等战略性服务,最好不要在云中托管这些服务。例如,如果您的云托管 DNS 和云变得不可操作,DNS 不可用,云组件无法相互查找。

- 主机路由 - 静态主机路由。首先,以 CIDR 格式指定目的地网络,后跟要用于路由的下一跳(例如 192.168.23.0/24, 10.1.31.1)。如果需要向实例分发静态路由,请提供这个值。

点 Create。

您可以在 Networks 选项卡中查看完整的网络。您还可以根据需要点 Edit 更改任何选项。在创建实例时,您可以将它们配置为使用其子网,并接收任何指定的 DHCP 选项。

3.8. 使用子网

使用子网为实例授予网络连接。每个实例作为实例创建过程的一部分被分配到子网,因此务必要考虑实例正确放置以最适合其连接要求。

您只能在预先存在的网络中创建子网。请记住,OpenStack 网络中的项目网络可以托管多个子网。如果您打算在同一网络中托管不同的系统,并且首选在它们之间进行隔离,这非常有用。

例如,您可以指定只有一个子网中只有 webserver 流量,而数据库流量则遍历另一个子网。

子网相互隔离,希望与其他子网通信的实例都必须由路由器指示其流量。因此,您可以通过对同一子网中的系统分组需要相互间高的流量,从而减少网络延迟和负载。

3.9. 创建子网

要创建子网,请按照以下步骤执行:

- 在控制面板中,选择 Project > Network > Networks,然后在 Networks 视图中点击您的网络名称。

点 Create Subnet,并指定以下值:

Expand 字段 描述 子网名称

描述性子网名称。

网络地址

CIDR 格式的地址,它包含一个值中的 IP 地址范围和子网掩码。要确定 CIDR 地址,计算子网掩码中屏蔽的位数,并将该值附加到 IP 地址范围中。例如,子网掩码 255.255.255.0 具有 24 个屏蔽的位。要将这个掩码与 IPv4 地址范围 192.168.122.0 搭配使用,请指定地址 192.168.122.0/24。

IP 版本

互联网协议版本,其中有效类型为 IPv4 或 IPv6。Network Address 字段中的 IP 地址范围必须与您选择的协议版本匹配。

网关 IP

默认网关的路由器接口的 IP 地址。此地址是路由目标为外部位置的任何流量的下一跳,且必须在 Network Address 字段中指定的范围内。例如,如果您的 CIDR 网络地址是 192.168.122.0/24,则您的默认网关可能是 192.168.122.1。

禁用网关

禁用转发并隔离子网。

点 Next 指定 DHCP 选项:

- 启用 DHCP - 为此子网启用 DHCP 服务。您可以使用 DHCP 自动将 IP 设置分发到您的实例。

IPv6 地址 - 配置模式.如果创建 IPv6 网络,您必须指定如何分配 IPv6 地址和其他信息:

- no Options specifiedd - 如果您要手动设置 IP 地址,或者使用非 OpenStack 感知方法进行地址分配,请选择这个选项。

- ACTIVE (Stateless Address Autoconfiguration) - 实例根据从 OpenStack 网络路由器发送的路由器广告(RA)消息生成 IPv6 地址。使用此配置创建 OpenStack 网络子网,并将 ra_mode 设置为 slaac,并将 address_mode 设置为 slaac。

- DHCPv6 有状态 - 实例从 OpenStack 网络 DHCPv6 服务接收 IPv6 地址以及附加选项(如 DNS)。使用此配置创建将 ra_mode 设置为 dhcpv6-stateful 的子网,并将 address_mode 设置为 dhcpv6-stateful。

- DHCPv6 无状态 - 实例根据从 OpenStack 网络路由器发送的路由器广告(RA)消息生成 IPv6 地址。从 OpenStack Networking DHCPv6 服务分配其他选项(如 DNS)。使用此配置创建将 ra_mode 设置为 dhcpv6-stateless 的子网,并将 address_mode 设置为 dhcpv6-stateless。

- 分配池 - 您希望 DHCP 分配的 IP 地址范围。例如,value 192.168.22.100,192.168.22.150 将该范围内的所有地址视为可用于分配。

- DNS 名称服务器 - 网络中可用的 DNS 服务器的 IP 地址。DHCP 将这些地址分发到实例,以进行名称解析。

- 主机路由 - 静态主机路由。首先,以 CIDR 格式指定目的地网络,后跟要用于路由的下一跳(例如 192.168.23.0/24, 10.1.31.1)。如果需要向实例分发静态路由,请提供这个值。

点 Create。

您可以在 Subnets 列表中查看子网。您还可以根据需要点 Edit 更改任何选项。在创建实例时,您可以将它们配置为使用其子网,并接收任何指定的 DHCP 选项。

3.10. 添加路由器

OpenStack 网络使用基于 SDN 的虚拟路由器提供路由服务。路由器是实例与外部子网通信的要求,包括在物理网络中。路由器和子网使用接口进行连接,每个子网需要自己的接口到路由器。

路由器的默认网关定义了路由器收到的任何流量的下一跳。它的网络通常配置为使用虚拟网桥将流量路由到外部物理网络。

要创建路由器,请完成以下步骤:

- 在控制面板中,选择 Project > Network > Routers,然后点 Create Router。

- 为新路由器输入一个描述性名称,然后单击 Create router。

- 单击 Routers 列表中新路由器条目旁边的 Set Gateway。

- 在 External Network 列表中,指定要接收目标用于外部位置的网络。

单击 Set Gateway。

添加路由器后,您必须配置您创建的任何子网,以使用此路由器发送流量。您可以通过在子网和路由器之间创建接口来实现此目的。

子网的默认路由不能被覆盖。删除子网的默认路由时,L3 代理也会自动删除路由器命名空间中的对应路由,网络流量也无法从关联的子网流向和移除。如果删除了现有路由器命名空间路由,以解决此问题,请执行以下步骤:

- 解除子网上的所有浮动 IP。

- 将路由器从子网分离。

- 将路由器重新附加到子网。

- 重新附加所有浮动 IP。

3.11. 清除所有资源并删除项目

使用 openstack project purge 命令删除属于特定项目的所有资源,以及删除项目。

例如,要清除 test-project 项目的资源,然后删除项目,请运行以下命令:

3.12. 删除路由器

如果没有连接的接口,您可以删除路由器。

要删除其接口并删除路由器,请完成以下步骤:

- 在控制面板中,选择 Project > Network > Routers,然后点击您要删除的路由器的名称。

- 选择 内部接口类型的接口, 然后单击 Delete Interfaces。

- 从 Routers 列表中,选择目标路由器,再点 Delete Routers。

3.13. 删除子网

如果不再使用子网,可以删除它。但是,如果任何实例仍配置为使用子网,删除尝试会失败,仪表板会显示错误消息。

完成以下步骤以删除网络中的特定子网:

- 在控制面板中,选择 Project > Network > Networks。

- 点网络的名称。

- 选择目标子网,然后单击 Delete Subnets。

3.14. 删除网络

在一些情况下,需要删除之前创建的网络,可能作为内务处理或作为停用过程的一部分。您必须首先删除或分离任何网络仍在使用的接口,然后才能成功删除网络。

要删除项目中的网络以及任何依赖接口,请完成以下步骤:

在控制面板中,选择 Project > Network > Networks。

删除与目标网络子网关联的所有路由器接口。

要删除接口,请通过点击网络列表中的目标网络找到您要删除的网络的 ID 号,查看 ID 字段。与网络关联的所有子网在 Network ID 字段中共享这个值。

导航到 Project > Network > Routers,在 Routers 列表中点虚拟路由器的名称,并找到附加到您要删除的子网的接口。

您可以通过作为网关 IP 的 IP 地址将这个子网与其他子网区分开。您可以通过确保接口的网络 ID 与您在上一步中记录的 ID 匹配,从而进一步验证区别。

- 点您要删除的接口的 Delete Interface 按钮。

- 选择 Project > Network > Networks,然后点击您的网络名称。

单击您要删除的子网的 Delete subnet 按钮。

注意如果您仍然无法在此时删除子网,请确保还没有被任何实例使用。

- 选择 Project > Network > Networks,然后选择您要删除的网络。

- 单击 Delete Networks。

第 4 章 将虚拟机实例连接到物理网络

您可以使用扁平和 VLAN 提供商网络将虚拟机实例直接连接到外部网络。

4.1. OpenStack 网络拓扑概述

OpenStack Networking (neutron)有两个类别的服务分布在多个节点类型中。

- Neutron 服务器 - 此服务运行 OpenStack Networking API 服务器,为最终用户和服务提供 API,以便与 OpenStack 网络交互。此服务器也与底层数据库集成,以存储和检索项目网络、路由器和负载均衡器的详细信息。

Neutron 代理 - 这些服务是为 OpenStack 网络执行网络功能:

-

neutron-dhcp-agent- 管理项目专用网络的 DHCP IP 地址。 -

neutron-l3-agent- 在项目专用网络、外部网络等之间执行第 3 层路由。

-

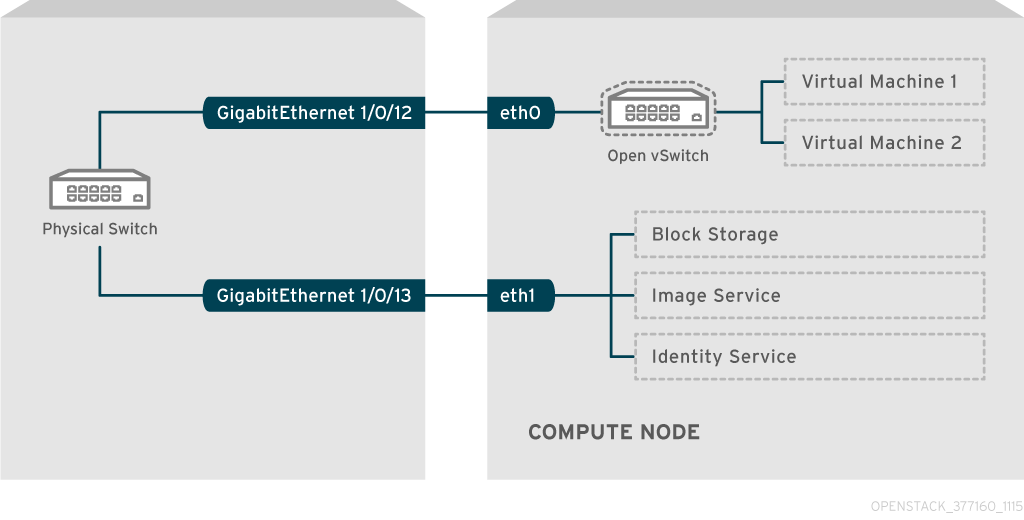

-

Compute 节点 - 此节点托管运行虚拟机的虚拟机监控程序,也称为实例。Compute 节点必须直接连接到网络,以便为实例提供外部连接。此节点通常是 l2 代理运行的位置,如

neutron-openvswitch-agent。

4.2. OpenStack 网络服务的放置

OpenStack 网络服务可以在同一个物理服务器或单独的专用服务器上运行,这些服务器根据其角色命名:

- Controller 节点 - 运行 API 服务的服务器。

- 网络节点 - 运行 OpenStack 网络代理的服务器。

- Compute 节点 - 托管实例的虚拟机监控程序服务器。

本章中的步骤适用于包含这三个节点类型的环境。如果您的部署在同一物理节点上同时具有 Controller 和网络节点角色,则必须从该服务器的两个部分执行这些步骤。这也适用于一个高可用性(HA)环境,所有这三个节点都可能运行 Controller 节点和网络节点服务(HA)。因此,您必须完成所有三个节点上适用于 Controller 和网络节点的小节中的步骤。

4.3. 配置扁平提供商网络

您可以使用扁平提供商网络将实例直接连接到外部网络。如果您有多个物理网络和单独的物理接口,并且希望将每个 Compute 和网络节点连接到这些外部网络,这将非常有用。

先决条件

您有多个物理网络。

本例分别使用名为

physnet1的物理网络,以及physnet2。您有单独的物理接口。

这个示例分别使用单独的物理接口

eth0和eth1。

流程

在 undercloud 主机上,以 stack 用户身份登录,创建自定义 YAML 环境文件。

示例

vi /home/stack/templates/my-modules-environment.yaml

$ vi /home/stack/templates/my-modules-environment.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提示Red Hat OpenStack Platform 编排服务(heat)使用一组名为 template 的计划来安装和配置您的环境。您可以使用自定义环境文件来自定义 overcloud 的各个方面,这是为工作流模板 提供自定义 的特殊模板。

在

parameter_defaults下的 YAML 环境文件中,使用NeutronBridgeMappings指定用于访问外部网络的 OVS 网桥。示例

parameter_defaults: NeutronBridgeMappings: 'physnet1:br-net1,physnet2:br-net2'

parameter_defaults: NeutronBridgeMappings: 'physnet1:br-net1,physnet2:br-net2'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在 Controller 和 Compute 节点的自定义 NIC 配置模板中,使用附加的接口配置网桥。

示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行

openstack overcloud deploy命令,并包含模板和环境文件,包括此修改后的自定义 NIC 模板和新环境文件。重要环境文件的顺序非常重要,因为后续环境文件中定义的参数和资源具有优先权。

示例

openstack overcloud deploy --templates \ -e [your-environment-files] \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/my-neutron-environment.yaml

$ openstack overcloud deploy --templates \ -e [your-environment-files] \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/my-neutron-environment.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

创建一个外部网络(

public1)作为扁平网络,并将它与配置的物理网络(physnet1)关联。将它配置为共享网络(使用

--share),使其他用户创建直接连接到外部网络的虚拟机实例。示例

openstack network create --share --provider-network-type flat --provider-physical-network physnet1 --external public01

# openstack network create --share --provider-network-type flat --provider-physical-network physnet1 --external public01Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

openstack subnet create命令创建子网(public_subnet)。示例

openstack subnet create --no-dhcp --allocation-pool start=192.168.100.20,end=192.168.100.100 --gateway 192.168.100.1 --network public01 public_subnet

# openstack subnet create --no-dhcp --allocation-pool start=192.168.100.20,end=192.168.100.100 --gateway 192.168.100.1 --network public01 public_subnetCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建虚拟机实例,并将其直接连接到新创建的外部网络。

示例

openstack server create --image rhel --flavor my_flavor --network public01 my_instance

$ openstack server create --image rhel --flavor my_flavor --network public01 my_instanceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4. 扁平提供商网络数据包流的工作方式?

本节论述了如何将流量流流和来自具有扁平供应商网络配置的实例的流量。

扁平提供商网络中传出流量流

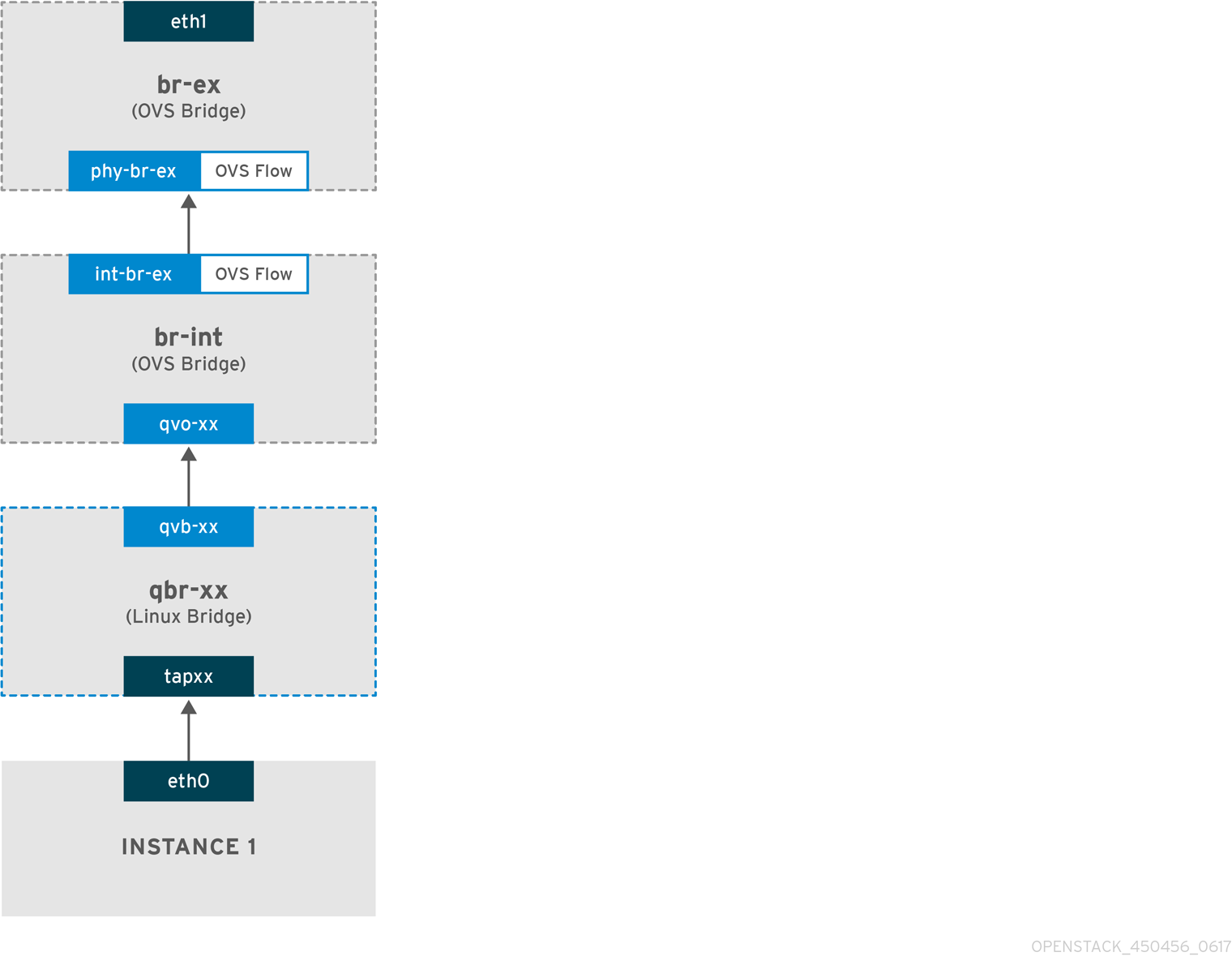

下图描述了离开实例的流量的数据包流,并直接指向外部网络。配置 br-ex 外部网桥后,将物理接口添加到网桥,并将实例生成至 Compute 节点,生成的接口和网桥配置类似于下图中的配置(如果使用 iptables_hybrid 防火墙驱动程序):

-

数据包离开实例的

eth0接口,并到达 linux 网桥qbr-xx。 -

网桥

qbr-xx连接到br-int,使用 veth 对qvb-xx <-> qvo-xxx。这是因为网桥用于应用安全组定义的入站/出站防火墙规则。 -

接口

qvb-xx连接到qbr-xxlinux 网桥,qvoxx连接到br-intOpen vSwitch (OVS) 网桥。

'qbr-xx'Linux 网桥配置示例:

brctl show qbr269d4d73-e7 8000.061943266ebb no qvb269d4d73-e7 tap269d4d73-e7

# brctl show

qbr269d4d73-e7 8000.061943266ebb no qvb269d4d73-e7

tap269d4d73-e7br-int 上的 qvo-xx 配置:

端口 qvo-xx 使用与扁平提供商网络关联的内部 VLAN 标签标记。在本例中,VLAN 标签为 5。当数据包到达 qvo-xx 时,VLAN 标签将附加到数据包标头中。

数据包然后被移到 br-ex OVS 网桥,使用 patch-peer int-br-ex <-> phy-br-ex。

br-int 上的 patch-peer 配置示例:

br-ex 上的 patch-peer 配置示例:

当此数据包在 br-ex 上到达 phy-br-ex 时,br-ex 中的 OVS 流会剥离 VLAN 标签(5)并将其转发到物理接口。

在以下示例中,输出显示 phy-br-ex 的端口号为 2。

以下输出显示了到达 phy-br-ex (in_port=2)的任何数据包,其 VLAN 标签为 5 (dl_vlan=5)。此外,br-ex 中的 OVS 流可剥离 VLAN 标签,并将数据包转发到物理接口。

ovs-ofctl dump-flows br-ex NXST_FLOW reply (xid=0x4): cookie=0x0, duration=4703.491s, table=0, n_packets=3620, n_bytes=333744, idle_age=0, priority=1 actions=NORMAL cookie=0x0, duration=3890.038s, table=0, n_packets=13, n_bytes=1714, idle_age=3764, priority=4,in_port=2,dl_vlan=5 actions=strip_vlan,NORMAL cookie=0x0, duration=4702.644s, table=0, n_packets=10650, n_bytes=447632, idle_age=0, priority=2,in_port=2 actions=drop

# ovs-ofctl dump-flows br-ex

NXST_FLOW reply (xid=0x4):

cookie=0x0, duration=4703.491s, table=0, n_packets=3620, n_bytes=333744, idle_age=0, priority=1 actions=NORMAL

cookie=0x0, duration=3890.038s, table=0, n_packets=13, n_bytes=1714, idle_age=3764, priority=4,in_port=2,dl_vlan=5 actions=strip_vlan,NORMAL

cookie=0x0, duration=4702.644s, table=0, n_packets=10650, n_bytes=447632, idle_age=0, priority=2,in_port=2 actions=drop如果物理接口是另一个 VLAN 标记的接口,则物理接口会将标签添加到数据包中。

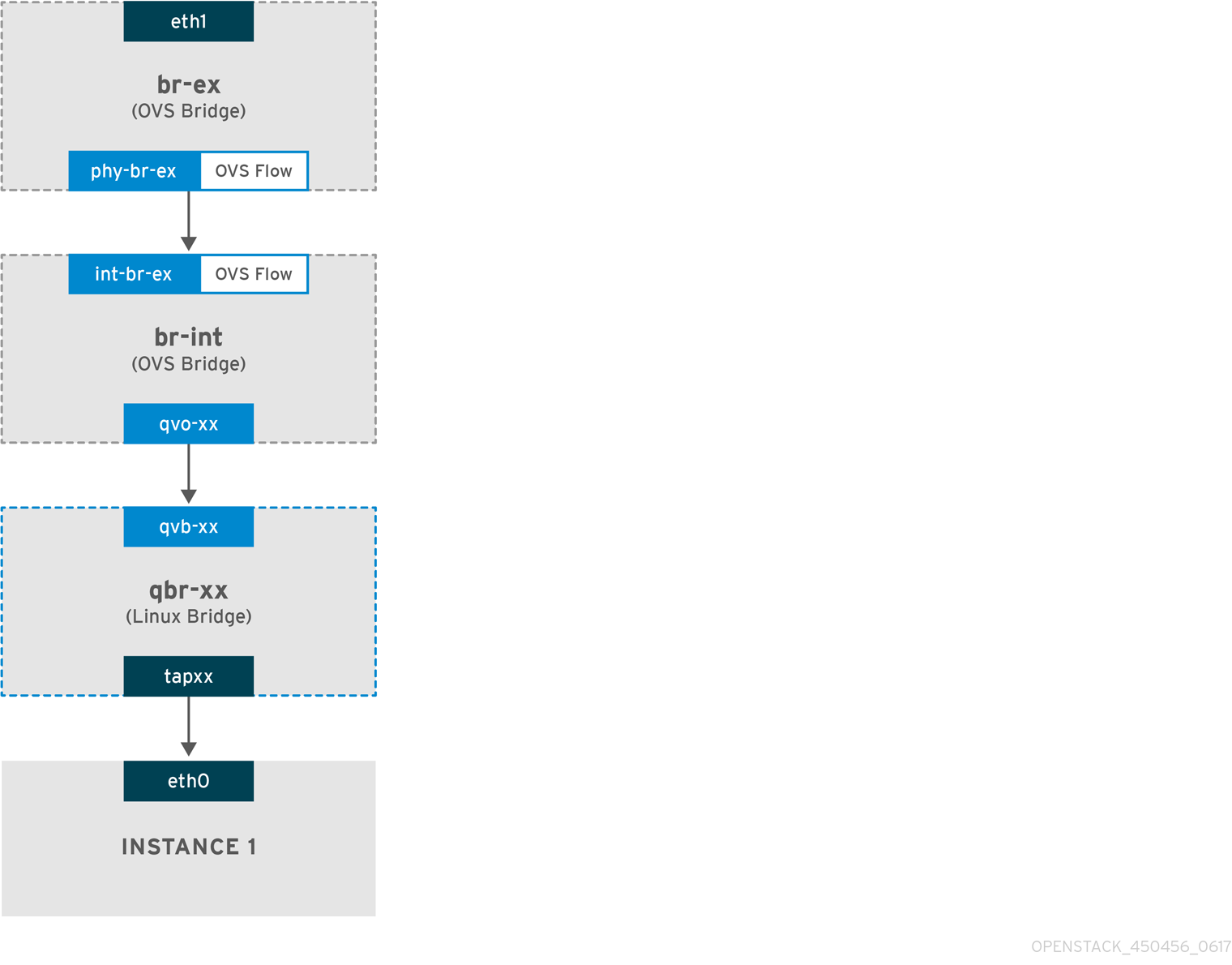

扁平提供商网络中传入流量流

本节包含来自外部网络传入流量流的信息,直到它到达实例的接口。

-

传入流量到达物理节点上的

eth1。 -

数据包传递到

br-ex网桥。 -

数据包通过 patch-peer

phy-br-ex <--> int-br-ex移到br-int。

在以下示例中,int-br-ex 使用端口号 15。请参阅包含 15 (int-br-ex) 的条目:

观察 br-int 上的流量流

当数据包到达

int-br-ex时,br-int网桥内的 OVS 流规则会导致数据包添加内部 VLAN 标签5。请参阅 operations=mod_vlan_vid:5条目:Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

第二条规则管理到达 int-br-ex (in_port=15),没有 VLAN 标签(vlan_tci=0x0000)的数据包):该规则将 VLAN 标签 5 添加到数据包(action

=mod_vlan_vid:5,),并将其转发到HQxxx。 -

在剥离 VLAN 标签后,

qvoxxx接受数据包并将其转发到qvbxx。 - 数据包然后到达实例。

VLAN 标签 5 是一个在带有扁平提供商网络的测试 Compute 节点上使用的示例 VLAN;该值由 neutron-openvswitch-agent 自动分配。对于您自己的扁平提供商网络,这个值可能会有所不同,并且可能因两个单独的 Compute 节点上的同一网络而异。

4.5. 对扁平提供商网络上的实例物理网络连接进行故障排除

"扁平提供商网络数据包流工作方式中提供的输出提供了足够的调试信息,以对扁平提供商网络进行故障排除。以下步骤包含有关故障排除过程的更多信息。

流程

查看

bridge_mappings。验证您使用的物理网络名称是否与

bridge_mapping配置的内容一致。示例

在本例中,物理网络名称为

physnet1。openstack network show provider-flat

$ openstack network show provider-flatCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

... | provider:physical_network | physnet1 ...

... | provider:physical_network | physnet1 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

在本例中,

bridge_mapping配置的内容也是physnet1:grep bridge_mapping /etc/neutron/plugins/ml2/openvswitch_agent.ini

$ grep bridge_mapping /etc/neutron/plugins/ml2/openvswitch_agent.iniCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

bridge_mappings = physnet1:br-ex

bridge_mappings = physnet1:br-exCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查网络配置。

确认网络已创建

为外部,并使用扁平类型:示例

在本例中,查询有关网络

provider-flat的详情:openstack network show provider-flat

$ openstack network show provider-flatCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

... | provider:network_type | flat | | router:external | True | ...

... | provider:network_type | flat | | router:external | True | ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 patch-peer。

验证

br-int和br-ex是否使用 patch-peerint-br-ex <--> phy-br-ex连接。ovs-vsctl show

$ ovs-vsctl showCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

在

br-ex上配置 patch-peer :Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果

bridge_mapping在/etc/neutron/plugins/ml2/openvswitch_agent.ini中正确配置,这个连接会在重启neutron-openvswitch-agent服务时被创建。如果在重启该服务后没有创建连接,请重新检查

bridge_mapping设置。检查网络流。

运行

ovs-ofctl dump-flows br-ex和ovs-ofctl dump-flows br-int,并检查流是否删除传出数据包的内部 VLAN ID,并为传入的数据包添加 VLAN ID。当您在特定 Compute 节点上向这个网络生成实例时,首先添加此流。-

如果在生成实例后没有创建此流,请验证网络是否创建为

flat,为external,且physical_network名称是正确的。此外,查看bridge_mapping设置。 最后,检查

ifcfg-br-ex和ifcfg-ethx配置。确保ethX被添加到br-ex中的端口,并且ifcfg-br-ex和ifcfg-ethx在ip a的输出中有一个UP标志。输出示例

以下输出显示

eth1是br-ex中的端口:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

以下示例演示了

eth1配置为 OVS 端口,并且内核知道从接口传输所有数据包并将其发送到 OVS 网桥br-ex。这可以在条目(master ovs-system)中观察到。ip a 5: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq master ovs-system state UP qlen 1000

$ ip a 5: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq master ovs-system state UP qlen 1000Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

如果在生成实例后没有创建此流,请验证网络是否创建为

4.6. 配置 VLAN 提供商网络

当您将单个 NIC 上的多个 VLAN 标记接口连接到多个提供商网络时,这些新的 VLAN 提供商网络可将虚拟机实例直接连接到外部网络。

先决条件

您有一个物理网络,其范围为 VLAN。

本例使用名为

physnet1的物理网络,其范围为 VLAN,171-172。您的网络和 Compute 节点使用物理接口连接到物理网络。

本例使用网络节点和 Compute 节点,它们连接到物理网络

physnet1,使用物理接口eth1。- 这些接口连接到的交换机端口必须配置为中继所需的 VLAN 范围。

流程

在 undercloud 主机上,以 stack 用户身份登录,创建自定义 YAML 环境文件。

示例

vi /home/stack/templates/my-modules-environment.yaml

$ vi /home/stack/templates/my-modules-environment.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提示Red Hat OpenStack Platform 编排服务(heat)使用一组名为 template 的计划来安装和配置您的环境。您可以使用自定义环境文件来自定义 overcloud 的各个方面,这是为工作流模板 提供自定义 的特殊模板。

在

parameter_defaults下的 YAML 环境文件中,使用NeutronTypeDrivers指定您的网络类型驱动程序。示例

parameter_defaults: NeutronTypeDrivers: vxlan,flat,vlan

parameter_defaults: NeutronTypeDrivers: vxlan,flat,vlanCopy to Clipboard Copied! Toggle word wrap Toggle overflow 配置

NeutronNetworkVLANRanges设置,以反映正在使用的物理网络和 VLAN 范围:示例

parameter_defaults: NeutronTypeDrivers: 'vxlan,flat,vlan' NeutronNetworkVLANRanges: 'physnet1:171:172'

parameter_defaults: NeutronTypeDrivers: 'vxlan,flat,vlan' NeutronNetworkVLANRanges: 'physnet1:171:172'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建外部网络网桥(br-ex),并将端口(eth1)与其关联。

这个示例将 eth1 配置为使用 br-ex :

示例

parameter_defaults: NeutronTypeDrivers: 'vxlan,flat,vlan' NeutronNetworkVLANRanges: 'physnet1:171:172' NeutronBridgeMappings: 'datacentre:br-ex,tenant:br-int'

parameter_defaults: NeutronTypeDrivers: 'vxlan,flat,vlan' NeutronNetworkVLANRanges: 'physnet1:171:172' NeutronBridgeMappings: 'datacentre:br-ex,tenant:br-int'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行

openstack overcloud deploy命令,并包含核心模板和环境文件,包括此新环境文件。重要环境文件的顺序非常重要,因为后续环境文件中定义的参数和资源具有优先权。

示例

openstack overcloud deploy --templates \ -e [your-environment-files] \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/my-neutron-environment.yaml

$ openstack overcloud deploy --templates \ -e [your-environment-files] \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/my-neutron-environment.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

创建外部网络作为类型

vlan,并将它们与配置的physical_network关联。运行以下命令创建两个网络:一个用于 VLAN 171,另一个用于 VLAN 172:

示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建多个子网,并将其配置为使用外部网络。

您可以使用

openstack subnet create或控制面板来创建这些子网。确保从网络管理员收到的外部子网详情正确与每个 VLAN 关联。在本例中,VLAN 171 使用子网

10.65.217.0/24,VLAN 172 使用10.65.218.0/24:示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7. VLAN 提供商网络数据包流的工作方式?

本节论述了如何将流量流流和来自 VLAN 供应商网络配置的实例的流量。

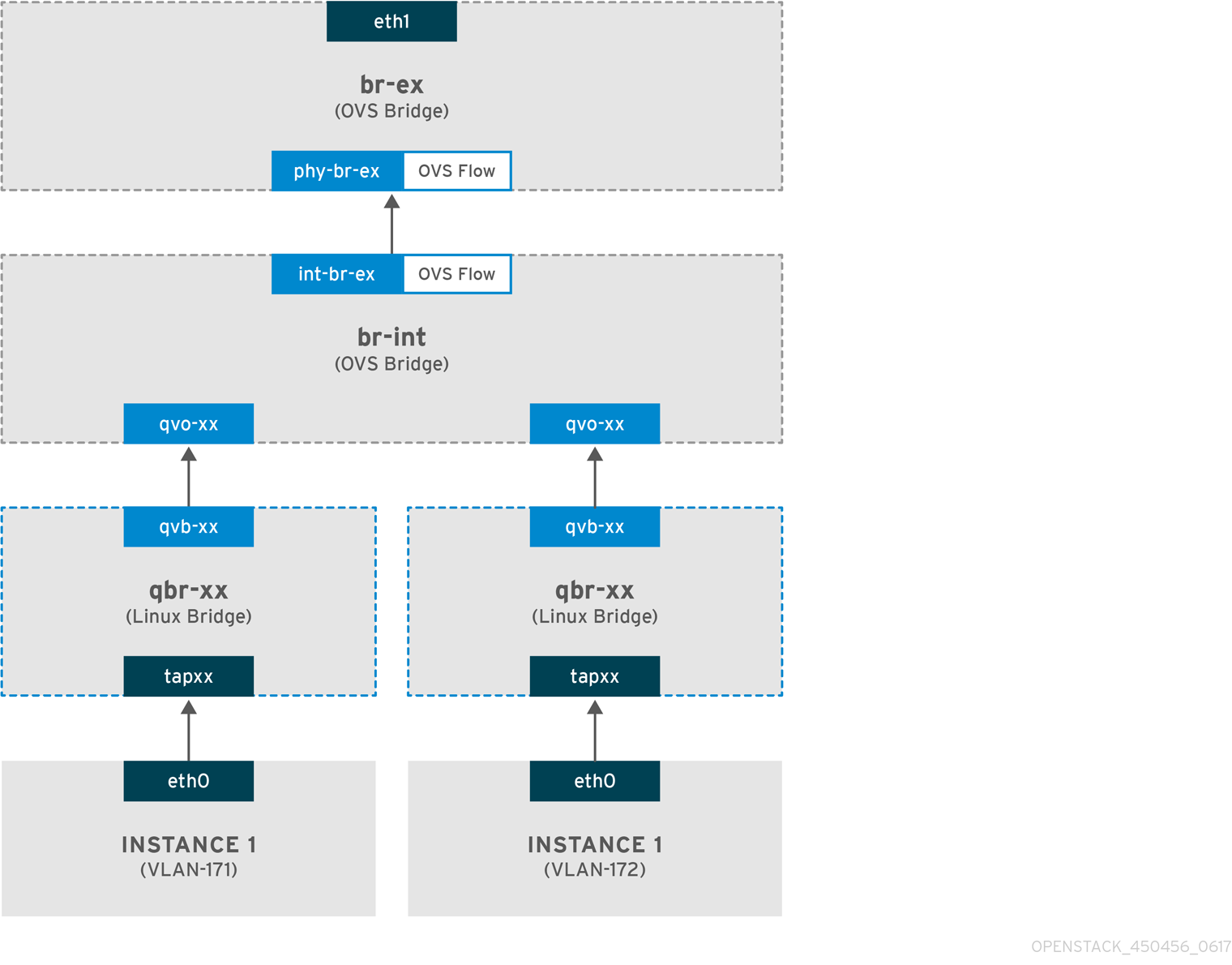

VLAN 提供商网络中传出流量流

下图描述了离开实例的流量的数据包流,并直接指向 VLAN 提供商网络。本例使用附加到两个 VLAN 网络(171 和 172)的两个实例。配置 br-ex 后,向其添加一个物理接口,并将实例生成给 Compute 节点,生成的接口和网桥配置类似于下图中的配置:

- 离开实例的 eth0 接口的数据包会到达连接到实例的 linux 网桥 qbr-xx。

- evince-xx 连接到 br-int,它利用 veth 对 <→HQxxx。

- slirpxx 连接到 linux 网桥 xx-xx,stratxxx 连接到 Open vSwitch 网桥 br-int。

Linux 网桥上的 qbr-xx 配置示例。

这个示例有两个实例和两个对应的 linux 网桥:

br-int 上的 qvoxx 配置:

-

Tailoringxx使用与 VLAN 提供商网络关联的内部 VLAN 标签标记。在本例中,内部 VLAN 标签 2 与 VLAN 提供商网络provider-171关联,VLAN 标签 3 与 VLAN 提供商网络provider-172关联。当数据包到达 qvoxx 时,此 VLAN 标签将添加到数据包标头中。 -

数据包然后被移到 br-ex OVS 网桥,使用 patch-peer

int-br-ex<→phy-br-ex。br-int 上的 patch-peer 示例:

br-ex 上补丁 peer 的示例:

- 当此数据包在 br-ex 上到达 phy-br-ex 时,br-ex 中的 OVS 流会将内部 VLAN 标签替换为与 VLAN 提供商网络关联的实际 VLAN 标签。

以下命令显示 phy-br-ex 的端口号为 4 :

ovs-ofctl show br-ex

4(phy-br-ex): addr:32:e7:a1:6b:90:3e

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps max

# ovs-ofctl show br-ex

4(phy-br-ex): addr:32:e7:a1:6b:90:3e

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps max

以下命令显示到达 phy-br-ex (in_port=4)的任何数据包,它们具有 VLAN 标签 2 (dl_vlan=2)。Open vSwitch 将 VLAN 标签替换为 171 (action=mod_vlan_vid:171,the the),并将数据包转发到物理接口。命令还显示到达 phy-br-ex (in_port=4)的任何数据包,它们具有VLAN 标签 3 (dl_vlan=3)。Open vSwitch 将 VLAN 标签替换为 172 (actions=mod_vlan_vid:172,NORMAL),并将数据包转发到物理接口。neutron-openvswitch-agent 添加这些规则。

- 然后,此数据包被转发到物理接口 eth1。

VLAN 提供商网络中传入流量流

以下示例流在 Compute 节点上测试,使用 VLAN 标签 2 作为提供商网络 provider-171,以及 VLAN tag 3 用于提供商网络 provider-172.流使用网桥 br-int 上的端口 18。

您的 VLAN 提供商网络可能需要不同的配置。此外,网络的配置要求可能因两个不同的 Compute 节点而异。

以下命令显示 int-br-ex,端口号为 18:

ovs-ofctl show br-int

18(int-br-ex): addr:fe:b7:cb:03:c5:c1

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps max

# ovs-ofctl show br-int

18(int-br-ex): addr:fe:b7:cb:03:c5:c1

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps max以下命令显示 br-int 上的流规则。

传入流示例

本例演示了以下 br-int OVS 流:

cookie=0x0, duration=3181.679s, table=0, n_packets=2605, n_bytes=246456, idle_age=0, priority=3,in_port=18,dl_vlan=172 actions=mod_vlan_vid:3,NORMAL

cookie=0x0, duration=3181.679s, table=0, n_packets=2605, n_bytes=246456, idle_age=0,

priority=3,in_port=18,dl_vlan=172 actions=mod_vlan_vid:3,NORMAL- 来自外部网络的 VLAN 标签 172 的数据包通过物理节点上的 eth1 到达 br-ex 网桥。

-

数据包通过 patch-peer

phy-br-ex <-> int-br-ex移到 br-int。 -

数据包与流的标准匹配(

in_port=18,dl_vlan=172)。 -

流

操作(action=mod_vlan_vid:3,the the VLAN tag 172 替换为内部 VLAN 标签 3,并使用正常第 2 层处理将数据包转发到实例。

4.8. VLAN 提供商网络上的实例物理网络连接故障排除

当对 VLAN 提供商网络的连接进行故障排除时,请参阅"VLAN 供应商网络数据包流如何工作"中所述的数据包流。另外,请查看以下配置选项:

流程

验证

bridge_mapping配置中使用的物理网络名称与物理网络名称匹配。示例

openstack network show provider-vlan171

$ openstack network show provider-vlan171Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

... | provider:physical_network | physnet1 ...

... | provider:physical_network | physnet1 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

grep bridge_mapping /etc/neutron/plugins/ml2/openvswitch_agent.ini

$ grep bridge_mapping /etc/neutron/plugins/ml2/openvswitch_agent.iniCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

在这个示例输出中,物理网络名称

physnet1与bridge_mapping配置中使用的名称匹配:bridge_mappings = physnet1:br-ex

bridge_mappings = physnet1:br-exCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确认网络已创建

为外部,类型为vlan,并使用正确的segmentation_id值:示例

openstack network show provider-vlan171

$ openstack network show provider-vlan171Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

... | provider:network_type | vlan | | provider:physical_network | physnet1 | | provider:segmentation_id | 171 | ...

... | provider:network_type | vlan | | provider:physical_network | physnet1 | | provider:segmentation_id | 171 | ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 patch-peer。

验证

br-int和br-ex是否使用 patch-peerint-br-ex <--> phy-br-ex连接。ovs-vsctl show

$ ovs-vsctl showCopy to Clipboard Copied! Toggle word wrap Toggle overflow 此连接是在重启

neutron-openvswitch-agent时创建的,只要bridge_mapping在/etc/neutron/plugins/ml2/openvswitch_agent.ini中正确配置。如果在重启该服务后没有创建此设置,则重新检查

bridge_mapping设置。检查网络流。

-

要查看传出数据包的流,请运行

ovs-ofctl dump-flows br-ex和ovs-ofctl dump-flows br-int,并验证流是否将内部 VLAN ID 映射到外部 VLAN ID (segmentation_id)。 对于传入的数据包,将外部 VLAN ID 映射到内部 VLAN ID。

当您首次向这个网络生成实例时,neutron OVS 代理会添加此流。

-

如果在生成实例后没有创建此流,请确保将网络创建为

vlan,是外部的,并且physical_network名称正确。另外,重新检查bridge_mapping设置。 最后,重新检查

ifcfg-br-ex和ifcfg-ethx配置。确保

br-ex包含端口ethX,并且ifcfg-br-ex和ifcfg-ethx在ip a命令的输出中有一个UP标志。示例

ovs-vsctl show

$ ovs-vsctl showCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在这个示例输出中,

eth1是br-ex中的一个端口:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

ip a

$ ip aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

在本例中,

eth1已添加为端口,并且内核被配置为将接口中的所有数据包移到 OVS 网桥br-ex。这通过条目master ovs-system来演示。5: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq master ovs-system state UP qlen 1000

5: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq master ovs-system state UP qlen 1000Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

要查看传出数据包的流,请运行

4.9. 在 ML2/OVS 部署中为提供商网络启用多播侦听

要防止对 Red Hat OpenStack Platform (RHOSP)提供商网络中的每个端口进行多播数据包,您必须启用多播侦听。在使用带有 Open vSwitch 机制驱动程序(ML2/OVS)的 Modular Layer 2 插件的 RHOSP 部署中,您可以在 YAML 格式的环境文件中声明 RHOSP Orchestration (heat) NeutronEnable IgmpSnooping 参数。

在将它应用到生产环境之前,您应该彻底测试并了解任何多播侦听配置。错误配置可能会破坏多播或导致不正确的网络行为。

先决条件

- 您的配置必须只使用 ML2/OVS 提供商网络。

您的物理路由器还必须启用 IGMP 侦听功能。

也就是说,物理路由器必须在提供商网络上发送 IGMP 查询数据包,以便从多播组成员请求常规 IGMP 报告,以便在 OVS 中维护 snooping 缓存(用于物理网络)。

必须放置 RHOSP 网络服务安全组规则,以允许对虚拟机实例(或禁用端口安全)入站 IGMP。

在本例中,为

ping_ssh安全组创建了一个规则:示例

openstack security group rule create --protocol igmp --ingress ping_ssh

$ openstack security group rule create --protocol igmp --ingress ping_sshCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

在 undercloud 主机上,以 stack 用户身份登录,创建自定义 YAML 环境文件。

示例

vi /home/stack/templates/my-ovs-environment.yaml

$ vi /home/stack/templates/my-ovs-environment.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提示编排服务(heat)使用一组名为 template 的计划来安装和配置您的环境。您可以使用自定义环境文件自定义 overcloud 的各个方面,这是为 heat 模板提供自定义的特殊模板。

在

parameter_defaults下的 YAML 环境文件中,将NeutronEnableIgmpSnooping设置为 true。parameter_defaults: NeutronEnableIgmpSnooping: true ...parameter_defaults: NeutronEnableIgmpSnooping: true ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要确保您在冒号(:)和

true之间添加空格字符。运行

openstack overcloud deploy命令,并包含核心 heat 模板、环境文件和新的自定义环境文件。重要环境文件的顺序非常重要,因为后续环境文件中定义的参数和资源具有优先权。

示例

openstack overcloud deploy --templates \ -e [your-environment-files] \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/my-ovs-environment.yaml

$ openstack overcloud deploy --templates \ -e [your-environment-files] \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/my-ovs-environment.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证多播 snooping 是否已启用。

示例

sudo ovs-vsctl list bridge br-int

# sudo ovs-vsctl list bridge br-intCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

... mcast_snooping_enable: true ... other_config: {mac-table-size="50000", mcast-snooping-disable-flood-unregistered=True} ...... mcast_snooping_enable: true ... other_config: {mac-table-size="50000", mcast-snooping-disable-flood-unregistered=True} ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.10. 在 ML2/OVN 部署中启用多播

要支持多播流量,请修改部署的安全配置,以允许多播流量访问多播组中的虚拟机(VM)实例。要防止多播流量激增,请启用 IGMP 侦听。

在将它应用到生产环境之前,测试并了解任何多播侦听配置。错误配置可能会破坏多播或导致不正确的网络行为。

先决条件

- 具有 ML2/OVN 机制驱动程序的 OpenStack 部署。

流程

配置安全性,以允许到适当虚拟机实例的多播流量。例如,创建一对安全组规则来允许来自 IGMP querier 的 IGMP 流量进入并退出虚拟机实例,以及第三个规则来允许多播流量。

示例

安全组 mySG 允许 IGMP 流量进入并退出虚拟机实例。

openstack security group rule create --protocol igmp --ingress mySG openstack security group rule create --protocol igmp --egress mySG

openstack security group rule create --protocol igmp --ingress mySG openstack security group rule create --protocol igmp --egress mySGCopy to Clipboard Copied! Toggle word wrap Toggle overflow 另一个规则允许多播流量访问虚拟机实例。

openstack security group rule create --protocol udp mySG

openstack security group rule create --protocol udp mySGCopy to Clipboard Copied! Toggle word wrap Toggle overflow 作为设置安全组规则的替代选择,一些运算符选择选择性地禁用网络上的端口安全性。如果您选择禁用端口安全性,请考虑并计划任何相关的安全风险。

在 undercloud 节点上的环境文件中设置 heat 参数

NeutronEnableIgmpSnooping: True。例如,将以下行添加到 ovn-extras.yaml 中。示例

parameter_defaults: NeutronEnableIgmpSnooping: Trueparameter_defaults: NeutronEnableIgmpSnooping: TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将环境文件包含在

openstack overcloud deploy命令中,以及任何与您环境相关的其他环境文件,并部署 overcloud。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将

<other_overcloud_environment_files> 替换为作为现有部署一部分的环境文件列表。

验证

验证多播 snooping 是否已启用。列出北向数据库 Logical_Switch 表。

ovn-nbctl list Logical_Switch

$ ovn-nbctl list Logical_SwitchCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

_uuid : d6a2fbcd-aaa4-4b9e-8274-184238d66a15 other_config : {mcast_flood_unregistered="false", mcast_snoop="true"} ..._uuid : d6a2fbcd-aaa4-4b9e-8274-184238d66a15 other_config : {mcast_flood_unregistered="false", mcast_snoop="true"} ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow Networking Service (neutron) igmp_snooping_enable 配置转换为 OVN 北向数据库中 Logical_Switch 表的 other_config 列中设置的 mcast_snooping_enable 选项。请注意,mcast_flood_unregistered 始终为 "false"。

显示 IGMP 组。

ovn-sbctl list IGMP_group

$ ovn-sbctl list IGMP_groupCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.11. 启用计算元数据访问

如本章中所述的实例直接附加到提供商网络,并将外部路由器配置为其默认网关。不使用 OpenStack Networking (neutron)路由器。这意味着 neutron 路由器无法用于将实例的元数据请求代理到 nova-metadata 服务器,这可能会在运行 cloud-init 时失败。但是,可以通过将 dhcp 代理配置为代理元数据请求来解决这个问题。您可以在 /etc/neutron/dhcp_agent.ini 中启用此功能。例如:

enable_isolated_metadata = True

enable_isolated_metadata = True4.12. 浮动 IP 地址

您可以使用同一网络为实例分配浮动 IP 地址,即使浮动 IP 已与专用网络关联。您从这个网络中作为浮动 IP 分配的地址会绑定到网络节点上的 qrouter-xxx 命名空间,并对关联的私有 IP 地址执行 DNAT-SNAT。相反,您为直接外部网络访问分配的 IP 地址直接在实例内绑定,并允许实例直接与外部网络通信。

第 5 章 管理浮动 IP 地址

除了具有私有、固定 IP 地址外,虚拟机实例还可以有一个公共或浮动 IP 地址来与其他网络通信。本节中的信息论述了如何使用 Red Hat OpenStack Platform (RHOSP)网络服务(neutron)创建和管理浮动 IP。

5.1. 创建浮动 IP 池

您可以使用浮动 IP 地址将入口流量定向到 OpenStack 实例。首先,您必须定义一个有效路由的外部 IP 地址池,然后您可以动态分配给实例。OpenStack 网络将用于该浮动 IP 的所有传入的流量路由到您与浮动 IP 关联的实例。

OpenStack 网络以 CIDR 格式从同一 IP 范围分配浮动 IP 地址分配给所有项目(租户)。因此,所有项目都可以消耗每个浮动 IP 子网的浮动 IP。您可以使用特定项目的配额来管理此行为。例如,您可以将 ProjectA 和 ProjectB 的默认值设置为 10,同时将 ProjectC 的配额设置为 0。

流程

创建外部子网时,您还可以定义浮动 IP 分配池。

openstack subnet create --no-dhcp --allocation-pool start=IP_ADDRESS,end=IP_ADDRESS --gateway IP_ADDRESS --network SUBNET_RANGE NETWORK_NAME

$ openstack subnet create --no-dhcp --allocation-pool start=IP_ADDRESS,end=IP_ADDRESS --gateway IP_ADDRESS --network SUBNET_RANGE NETWORK_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果子网仅托管浮动 IP 地址,请考虑使用

openstack subnet create命令中的--no-dhcp选项禁用 DHCP 分配。示例

openstack subnet create --no-dhcp --allocation_pool start=192.168.100.20,end=192.168.100.100 --gateway 192.168.100.1 --network 192.168.100.0/24 public

$ openstack subnet create --no-dhcp --allocation_pool start=192.168.100.20,end=192.168.100.100 --gateway 192.168.100.1 --network 192.168.100.0/24 publicCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

- 您可以通过为实例分配随机浮动 IP 来验证池是否已正确配置。(请参见后续后续链接。)

5.2. 分配特定的浮动 IP

您可以为虚拟机实例分配特定的浮动 IP 地址。

流程

使用

openstack server add floating ip命令将浮动 IP 地址分配给实例。示例

openstack server add floating ip prod-serv1 192.0.2.200

$ openstack server add floating ip prod-serv1 192.0.2.200Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证步骤

使用

openstack server show命令确认您的浮动 IP 与您的实例相关联。示例

openstack server show prod-serv1

$ openstack server show prod-serv1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. 创建高级网络

在 Dashboard 中从 Admin 视图创建网络时,管理员可使用高级网络选项。使用这些选项指定项目,并定义您要使用的网络类型。

流程

- 在仪表板中,选择 Admin > Networks > Create Network > Project。

- 选择您要使用 Project 下拉列表托管新网络的项目。

查看 Provider Network Type 中的选项:

- Local - 流量保留在本地计算主机上,并有效地与任何外部网络隔离。

- flat - 流量保留在单一网络中,也可以与主机共享。没有 VLAN 标记或其他网络隔离。

- vlan - 使用与物理网络中存在的 VLAN 对应的 VLAN ID 创建网络。此选项允许实例与同一第 2 层 VLAN 上的系统通信。

- GRE - 使用跨多个节点的网络覆盖,以实现实例之间的私有通信。出口覆盖的流量必须路由。

- VXLAN - 与 GRE 类似,并使用网络覆盖跨越多个节点来跨实例之间的私有通信。出口覆盖的流量必须路由。

点 Create Network。

查看 Project Network Topology,以验证网络是否已成功创建。

5.4. 分配随机浮动 IP

您可以从外部 IP 地址池动态为虚拟机实例分配浮动 IP 地址。

先决条件

可路由的外部 IP 地址池。

更多信息请参阅 第 5.1 节 “创建浮动 IP 池”。

流程

输入以下命令从池中分配浮动 IP 地址。在本例中,网络名为

public。示例

openstack floating ip create public

$ openstack floating ip create publicCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

在以下示例中,新分配的浮动 IP 是

192.0.2.200。您可以将其分配给实例。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令查找您的实例:

openstack server list

$ openstack server listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将实例名称或 ID 与浮动 IP 关联。

示例

openstack server add floating ip prod-serv1 192.0.2.200

$ openstack server add floating ip prod-serv1 192.0.2.200Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证步骤

输入以下命令确认您的浮动 IP 与您的实例相关联。

示例

openstack server show prod-serv1

$ openstack server show prod-serv1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.5. 创建多个浮动 IP 池

OpenStack 网络支持每个 L3 代理有一个浮动 IP 池。因此,您必须扩展 L3 代理以创建额外的浮动 IP 池。

流程

-

确保在

/var/lib/config-data/puppet-generated/neutron/etc/neutron/neutron.conf中,对于环境中只有一个 L3 代理,则属性handle_internal_only_routers被设置为True。此选项将 L3 代理配置为仅管理非外部路由器。

5.6. 配置浮动 IP 端口转发

要让用户为浮动 IP 设置端口转发,您必须启用 Red Hat OpenStack Platform (RHOSP)网络服务(neutron) port_forwarding' 服务插件。

先决条件

- 您必须具有 RHOSP 管理员特权。

-

port_forwarding服务插件要求您设置路由器服务插件。

流程

- 以 stack 用户身份登录 undercloud 主机。

查找 stackrc undercloud 凭证文件:

source ~/stackrc

$ source ~/stackrcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在自定义环境 YAML 文件中,设置

port_forwarding服务插件:parameter_defaults: NeutronPluginExtensions: "router,port_forwarding"

parameter_defaults: NeutronPluginExtensions: "router,port_forwarding"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意port_forwarding服务插件要求您设置路由器服务插件。如果您将 ML2/OVS 机制驱动程序与网络服务搭配使用,还必须为 OVS L3 代理设置

port_forwarding扩展:parameter_defaults: NeutronPluginExtensions: "router,port_forwarding" NeutronL3AgentExtensions: "port_forwarding"

parameter_defaults: NeutronPluginExtensions: "router,port_forwarding" NeutronL3AgentExtensions: "port_forwarding"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 部署 overcloud,并包含核心 heat 模板、环境文件和新的自定义环境文件。

重要环境文件的顺序非常重要,因为后续环境文件中定义的参数和资源具有优先权。

openstack overcloud deploy --templates \ -e <your_environment_files> \ -e /home/stack/templates/my-environment.yaml

$ openstack overcloud deploy --templates \ -e <your_environment_files> \ -e /home/stack/templates/my-environment.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow RHOSP 用户现在可以为浮动 IP 设置端口转发。如需更多信息,请参阅 第 5.7 节 “为浮动 IP 创建端口转发”。

验证

提供 overcloud 凭据文件。

示例

source ~/overcloudrc

$ source ~/overcloudrcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确保网络服务已成功载入

port_forwarding和路由器服务插件:openstack extension list --network -c Name -c Alias --max-width 74 | \ grep -i -e 'Neutron L3 Router' -i -e floating-ip-port-forwarding

$ openstack extension list --network -c Name -c Alias --max-width 74 | \ grep -i -e 'Neutron L3 Router' -i -e floating-ip-port-forwardingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

成功验证会生成类似如下的输出:

| Floating IP Port Forwarding | floating-ip-port-forwarding | | Neutron L3 Router | router |

| Floating IP Port Forwarding | floating-ip-port-forwarding | | Neutron L3 Router | router |Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.7. 为浮动 IP 创建端口转发

您可以使用 Red Hat OpenStack Platform Networking 服务(neutron)为浮动 IP 设置端口转发。

先决条件

网络服务必须在加载

port_forwarding服务插件的情况下运行。如需更多信息,请参阅 第 5.6 节 “配置浮动 IP 端口转发”。

流程

提供您的凭据文件。

示例

source ~/overcloudrc

$ source ~/overcloudrcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用以下命令为浮动 IP 创建端口转发:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将

<internal-ip-address> 替换为内部目标 IP 地址。这是与运行应用的实例关联的 IP 地址。

-

将 &

lt;port> 替换为实例所附加的网络服务端口的名称或 ID。 将

--internal中的 <port-number> 替换为内部目标端口号。-protocol-port这是应用程序在实例中使用的端口号。

将

--external中的 <port-number> 替换为外部源端口号。-protocol-port这是在 RHOSP 云外部运行的应用程序的端口号。

-

将

<protocol> 替换为接收端口转发流量的应用程序所使用的协议,如 TCP 或 UDP。 将

<floating-ip> 替换为您要转发的端口流量的浮动 IP。示例

本例为附加到浮动 IP

198.51.100.47的实例创建端口。浮动 IP 使用网络服务端口1adfdb09-e8c6-4708-b5aa-11f50fc22d62。当网络服务检测到传入198.51.100.47:80的外部流量时,它将流量转发到内部 IP 地址203.0.113.107,在 TCP 端口8080上:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

确认网络服务已经为浮动 IP 端口建立了转发。

示例

以下示例验证浮动 IP

198.51.100.47的端口转发是否成功:openstack floating ip port forwarding list 198.51.100.47 --max-width 74

$ openstack floating ip port forwarding list 198.51.100.47 --max-width 74Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

输出显示,发送到 TCP 端口 80 上的浮动 IP

198.51.100.47的流量转发到实例上的端口8080,其内部地址为203.0.113.107:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.8. 桥接物理网络

将您的虚拟网络桥接到物理网络,以启用与虚拟实例的连接。

在此过程中,物理接口 eth0 示例映射到网桥 br-ex; 虚拟网桥充当物理网络和任何虚拟网络之间的中间。

因此,遍历 eth0 的所有流量都使用配置的 Open vSwitch 访问实例。

要将物理 NIC 映射到虚拟 Open vSwitch 网桥,请完成以下步骤:

流程

在文本编辑器中打开

/etc/sysconfig/network-scripts/ifcfg-eth0,并使用站点上网络的值更新以下参数:- IPADDR

- 子网掩码网关

DNS1 (名称服务器)

下面是一个示例:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

在文本编辑器中打开

/etc/sysconfig/network-scripts/ifcfg-br-ex,并使用之前分配给 eth0 的 IP 地址值更新虚拟网桥参数:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 现在,您可以将浮动 IP 地址分配给实例,并将其提供给物理网络。

5.9. 添加接口

您可以使用接口将路由器与子网互连,以便路由器可以将实例发送到其中间子网外目的地的任何流量。

要添加路由器接口并将新接口连接到子网,请完成以下步骤:

此流程使用 Network Topology 功能。使用此功能,您可以在执行网络管理任务的同时查看所有虚拟路由器和网络的图形表示。

- 在仪表板中,选择 Project > Network > Network Topology。

- 找到您要管理的路由器,将鼠标悬停在上面,将鼠标悬停在上面,然后单击 Add Interface。

指定您要连接到路由器的子网。

您还可以指定 IP 地址。该地址可用于测试和故障排除目的,因为成功对此接口的 ping 表示流量按预期路由。

点 Add interface。

Network Topology 图自动更新,以反映路由器和子网之间的新接口连接。

5.10. 删除接口

如果您不再需要路由器为子网定向到子网的流量,您可以删除子网的接口。

要删除接口,请完成以下步骤:

- 在控制面板中,选择 Project > Network > Routers。

- 单击托管您要删除的接口的路由器名称。

- 选择接口类型(内部接口),然后单击 Delete Interfaces。

第 6 章 网络故障排除

Red Hat OpenStack Platform 中网络连接故障排除的诊断过程与物理网络的诊断过程类似。如果使用 VLAN,您可以将虚拟基础架构视为物理网络的中继扩展,而不是由谁独立的环境。ML2/OVS 网络和默认 ML2/OVN 网络故障排除之间存在一些区别。

6.1. 基本 ping 测试

ping 命令是分析网络连接问题的有用工具。结果充当网络连接的基本指标,但可能无法完全排除所有连接问题,比如防火墙阻止实际应用程序流量。ping 命令将流量发送到特定的目的地,然后报告尝试是否成功。

ping 命令是 ICMP 操作。要使用 ping,您必须允许 ICMP 流量遍历任何中间防火墙。

从存在网络问题的机器运行时,ping 测试最有用,因此如果机器看起来完全离线,可能需要通过 VNC 管理控制台连接到命令行。

例如,以下 ping test 命令会验证网络基础架构的多个层才能成功;名称解析、IP 路由和网络切换必须可以正常工作:

您可以使用 Ctrl-c 终止 ping 命令,之后会显示结果摘要。零百分比的数据包丢失表示连接稳定且没有超时。

--- e1890.b.akamaiedge.net ping statistics --- 3 packets transmitted, 3 received, 0% packet loss, time 2003ms rtt min/avg/max/mdev = 13.461/13.498/13.541/0.100 ms

--- e1890.b.akamaiedge.net ping statistics ---

3 packets transmitted, 3 received, 0% packet loss, time 2003ms

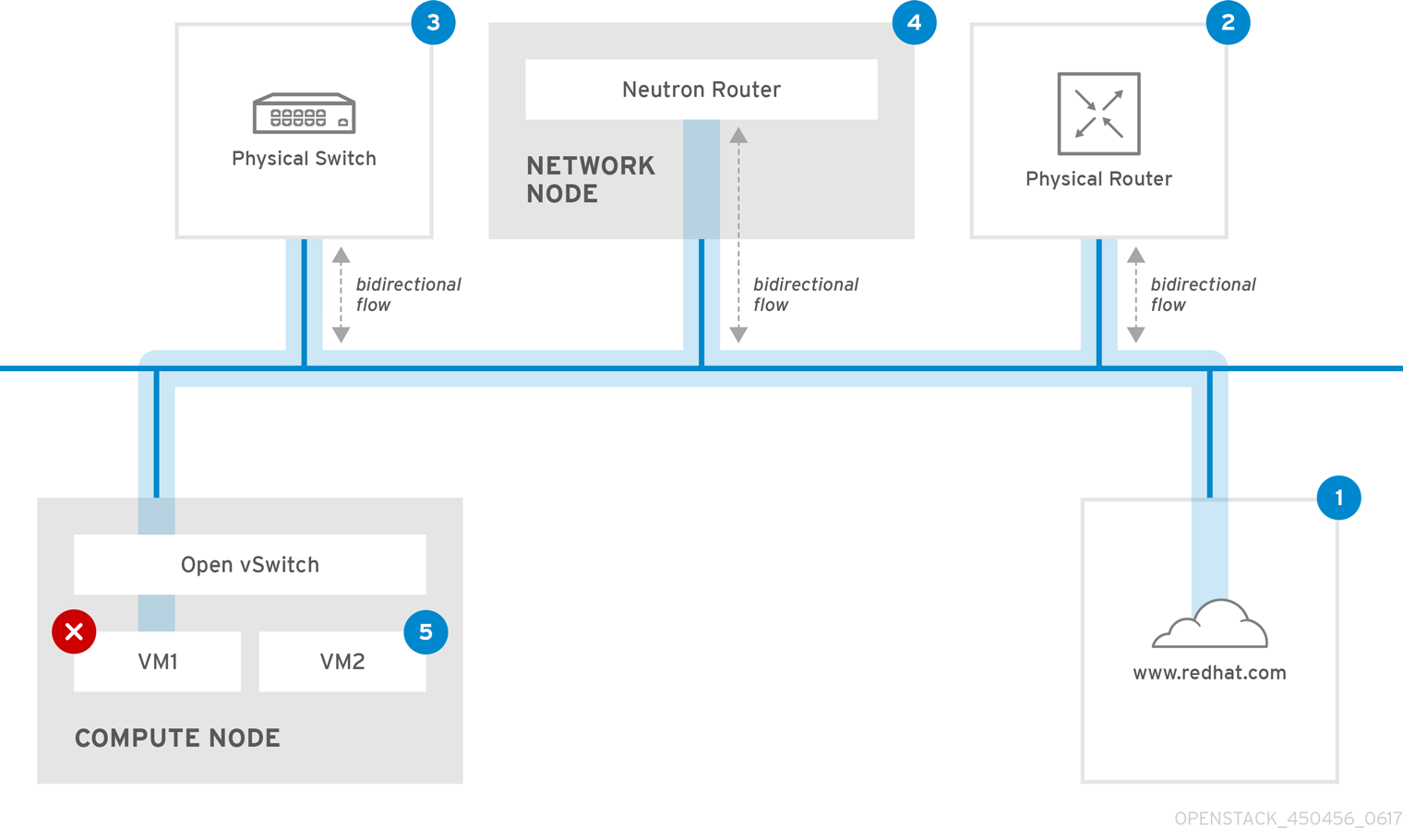

rtt min/avg/max/mdev = 13.461/13.498/13.541/0.100 msping 测试的结果可能会非常困难,具体取决于您测试的目标。例如,下图 VM1 遇到某种形式的连接问题。可能的目的地以蓝色的形式编号,结果来自成功或失败的结果:

互联网 - 常见的第一步是将 ping 测试发送到互联网位置,如 www.example.com。

- 成功 :此测试表示计算机和互联网之间的所有各种网络点都正常运行。这包括虚拟网络和物理网络基础架构。

- 失败 :对距离互联网位置的 ping 测试可能会失败。如果您的网络中的其他机器可以成功 ping 互联网,这证明互联网连接正常工作,且问题可能会在本地机器配置中成功。

物理路由器 - 网络管理员指定将流量定向到外部目的地的路由器接口。

- 成功 :对物理路由器进行 ping 测试可以确定本地网络和底层交换机是否正常工作。这些数据包不会遍历路由器,因此它们不会证明默认网关中是否存在路由问题。

- 失败 :这表示 VM1 和默认网关间的问题。路由器/切换可能会停机,或者您可能使用不正确的默认网关。将配置与您知道的其他服务器上正常工作的配置进行比较。尝试 ping 本地网络中的其他服务器。

Neutron 路由器 - 这是 Red Hat OpenStack Platform 用来指示虚拟机流量的虚拟 SDN (软件定义网络)路由器。

- 成功 :防火墙允许 ICMP 流量,网络节点在线。

- 失败 :确认实例安全组中是否允许 ICMP 流量。检查网络节点是否已在线,确认所有必需的服务是否正在运行,并查看 L3 代理日志(/var/log/neutron/l3-agent.log)。

物理交换机 - 物理交换机管理同一物理网络中节点之间的流量。

- 成功 :虚拟机发送到物理交换机的流量必须通过虚拟网络基础架构传递,这表示此片段正常工作。

- 失败 :检查物理交换机端口是否已配置为中继所需的 VLAN。

VM2 - 在同一 Compute 节点上 ping 同一子网中的虚拟机。

- 成功 :VM1 上的 NIC 驱动程序和基本 IP 配置可以正常工作。

- 失败 :验证 VM1 上的网络配置。或者,VM2 上的防火墙可能只是阻止 ping 流量。此外,验证虚拟切换配置并查看 Open vSwitch 日志文件。

6.2. 查看当前端口状态

基本故障排除任务是创建附加到路由器的所有端口的清单,并确定端口状态(DOWN 或 ACTIVE)。

流程

要查看附加到名为 r1 的路由器的所有端口,请运行以下命令:

openstack port list --router r1

# openstack port list --router r1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要查看每个端口的详情,请运行以下命令:包括您要查看的端口的端口 ID。其结果包括端口状态,在以下示例中表示为

ACTIVE状态:openstack port show b58d26f0-cc03-43c1-ab23-ccdb1018252a

# openstack port show b58d26f0-cc03-43c1-ab23-ccdb1018252aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 为每个端口执行第 2 步以确定其状态。

6.3. 与 VLAN 提供商网络的连接故障排除

OpenStack 网络可以将 VLAN 网络中继到 SDN 交换机。支持 VLAN 标记的提供商网络意味着虚拟实例可以与物理网络中的服务器子网集成。

流程

使用

ping <gateway-IP-address>ping 网关。考虑使用这些命令创建网络的示例:

openstack network create --provider-network-type vlan --provider-physical-network phy-eno1 --provider-segment 120 provider openstack subnet create --no-dhcp --allocation-pool start=192.168.120.1,end=192.168.120.153 --gateway 192.168.120.254 --network provider public_subnet

# openstack network create --provider-network-type vlan --provider-physical-network phy-eno1 --provider-segment 120 provider # openstack subnet create --no-dhcp --allocation-pool start=192.168.120.1,end=192.168.120.153 --gateway 192.168.120.254 --network provider public_subnetCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在本例中,网关 IP 地址为 192.168.120.254。

ping 192.168.120.254

$ ping 192.168.120.254Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果 ping 失败,请执行以下操作:

确认您有关联 VLAN 的网络流。

VLAN ID 可能尚未设置。在本例中,OpenStack 网络配置为将 VLAN 120 中继到提供商网络。(请参阅第 1 步中的 --provider:segmentation_id=120。)

使用命令

ovs-ofctl dump-flows <bridge-name> 来确认网桥接口上的 VLAN 流。在本例中,网桥名为 br-ex :

ovs-ofctl dump-flows br-ex NXST_FLOW reply (xid=0x4): cookie=0x0, duration=987.521s, table=0, n_packets=67897, n_bytes=14065247, idle_age=0, priority=1 actions=NORMAL cookie=0x0, duration=986.979s, table=0, n_packets=8, n_bytes=648, idle_age=977, priority=2,in_port=12 actions=drop

# ovs-ofctl dump-flows br-ex NXST_FLOW reply (xid=0x4): cookie=0x0, duration=987.521s, table=0, n_packets=67897, n_bytes=14065247, idle_age=0, priority=1 actions=NORMAL cookie=0x0, duration=986.979s, table=0, n_packets=8, n_bytes=648, idle_age=977, priority=2,in_port=12 actions=dropCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4. 查看 VLAN 配置和日志文件

要帮助验证或排除部署,您可以:

- 验证 Red Hat Openstack Platform (RHOSP)网络服务(neutron)代理的注册和状态。

- 验证网络配置值,如 VLAN 范围。

流程

使用

openstack network agent list命令来验证 RHOSP Networking 服务代理是否已启动,并使用正确的主机名注册。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

查看

/var/log/containers/neutron/openvswitch-agent.log。查找确认创建过程使用了ovs-ofctl命令来配置 VLAN 中继。 -

验证

/etc/neutron/l3_agent.ini文件中的external_network_bridge。如果在external_network_bridge参数中有一个硬编码的值,则无法将提供商网络与 L3-agent 搭配使用,您无法创建必要的流。external_network_bridge值的格式必须是 'external_network_bridge = "" '。 -

检查

/etc/neutron/plugin.ini文件中的network_vlan_ranges值。对于提供商网络,不要指定数字 VLAN ID。仅在使用 VLAN 隔离项目网络时指定 ID。 -

验证

OVS 代理配置文件网桥映射,以确认映射到phy-eno1的网桥是否存在,并正确连接到eno1。

6.5. 在 ML2/OVN 命名空间中执行基本 ICMP 测试

作为基本的故障排除步骤,您可以尝试从同一第 2 层网络上的 OVN 元数据接口 ping 实例。

先决条件

- RHOSP 部署,使用 ML2/OVN 作为网络服务(neutron)默认机制驱动程序。

流程

- 使用您的 Red Hat OpenStack Platform 凭据登录 overcloud。

-

运行

openstack server list命令以获取虚拟机实例的名称。 运行

openstack server show命令,以确定在其上运行实例的 Compute 节点。示例

openstack server show my_instance -c OS-EXT-SRV-ATTR:host \ -c addresses

$ openstack server show my_instance -c OS-EXT-SRV-ATTR:host \ -c addressesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 登录 Compute 节点主机。

示例

ssh heat-admin@compute0.ctlplane

$ ssh heat-admin@compute0.ctlplaneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行

ip netns list命令来查看 OVN 元数据命名空间。输出示例

ovnmeta-07384836-6ab1-4539-b23a-c581cf072011 (id: 1) ovnmeta-df9c28ea-c93a-4a60-b913-1e611d6f15aa (id: 0)

ovnmeta-07384836-6ab1-4539-b23a-c581cf072011 (id: 1) ovnmeta-df9c28ea-c93a-4a60-b913-1e611d6f15aa (id: 0)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用元数据命名空间运行

ip netns exec命令,以 ping 关联的网络。示例

sudo ip netns exec ovnmeta-df9c28ea-c93a-4a60-b913-1e611d6f15aa \ ping 192.0.2.2

$ sudo ip netns exec ovnmeta-df9c28ea-c93a-4a60-b913-1e611d6f15aa \ ping 192.0.2.2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.6. 从项目网络内进行故障排除(ML2/OVS)

在 Red Hat Openstack Platform (RHOSP) ML2/OVS 网络中,所有项目流量都包含在网络命名空间中,以便项目可以在不相互干扰的情况下配置网络。例如,网络命名空间允许不同的项目具有相同的子网范围 192.168.1.1/24,而不会干扰它们。

先决条件

- RHOSP 部署,使用 ML2/OVS 作为网络服务(neutron)默认机制驱动程序。

流程

使用

openstack network list命令列出所有项目网络,以确定哪个网络命名空间包含网络:openstack network list

$ openstack network listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在此输出中,请注意

web-servers网络的 ID (9cb32fe0-d7fb-432c-b116-f483c6497b08)。命令将网络 ID 附加到网络命名空间,这样您可以在下一步中识别命名空间。输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

ip netns list命令列出所有网络命名空间:ip netns list

# ip netns listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出中包含与

web-servers网络 ID 匹配的命名空间。在这个输出中,命名空间为

qdhcp-9cb32fe0-d7fb-432c-b116-f483c6497b08。输出示例

qdhcp-9cb32fe0-d7fb-432c-b116-f483c6497b08 qrouter-31680a1c-9b3e-4906-bd69-cb39ed5faa01 qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b qdhcp-a0cc8cdd-575f-4788-a3e3-5df8c6d0dd81 qrouter-e9281608-52a6-4576-86a6-92955df46f56

qdhcp-9cb32fe0-d7fb-432c-b116-f483c6497b08 qrouter-31680a1c-9b3e-4906-bd69-cb39ed5faa01 qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b qdhcp-a0cc8cdd-575f-4788-a3e3-5df8c6d0dd81 qrouter-e9281608-52a6-4576-86a6-92955df46f56Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过在命名空间中运行命令(使用

ip netns exec <namespace>作为前缀)检查web-servers网络的配置。本例中使用了

route -n命令。示例

ip netns exec qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b route -n

# ip netns exec qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b route -nCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Kernel IP routing table Destination Gateway Genmask Flags Metric Ref Use Iface 0.0.0.0 172.24.4.225 0.0.0.0 UG 0 0 0 qg-8d128f89-87 172.24.4.224 0.0.0.0 255.255.255.240 U 0 0 0 qg-8d128f89-87 192.168.200.0 0.0.0.0 255.255.255.0 U 0 0 0 qr-8efd6357-96

Kernel IP routing table Destination Gateway Genmask Flags Metric Ref Use Iface 0.0.0.0 172.24.4.225 0.0.0.0 UG 0 0 0 qg-8d128f89-87 172.24.4.224 0.0.0.0 255.255.255.240 U 0 0 0 qg-8d128f89-87 192.168.200.0 0.0.0.0 255.255.255.0 U 0 0 0 qr-8efd6357-96Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.7. 在命名空间中执行高级 ICMP 测试(ML2/OVS)

您可以使用 tcpdump 和 ping 命令的组合对 Red Hat Openstack Platform (RHOSP) ML2/OVS 网络进行故障排除。

先决条件

- RHOSP 部署,使用 ML2/OVS 作为网络服务(neutron)默认机制驱动程序。

流程

使用

tcpdump命令捕获 ICMP 流量:示例

ip netns exec qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b tcpdump -qnntpi any icmp

# ip netns exec qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b tcpdump -qnntpi any icmpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在一个单独的命令行窗口中,对外部网络执行 ping 测试:

示例

ip netns exec qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b ping www.example.com

# ip netns exec qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b ping www.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在运行 tcpdump 会话的终端中,观察 ping 测试的详细结果。

输出示例

tcpdump: listening on any, link-type LINUX_SLL (Linux cooked), capture size 65535 bytes IP (tos 0xc0, ttl 64, id 55447, offset 0, flags [none], proto ICMP (1), length 88) 172.24.4.228 > 172.24.4.228: ICMP host 192.168.200.20 unreachable, length 68 IP (tos 0x0, ttl 64, id 22976, offset 0, flags [DF], proto UDP (17), length 60) 172.24.4.228.40278 > 192.168.200.21: [bad udp cksum 0xfa7b -> 0xe235!] UDP, length 32tcpdump: listening on any, link-type LINUX_SLL (Linux cooked), capture size 65535 bytes IP (tos 0xc0, ttl 64, id 55447, offset 0, flags [none], proto ICMP (1), length 88) 172.24.4.228 > 172.24.4.228: ICMP host 192.168.200.20 unreachable, length 68 IP (tos 0x0, ttl 64, id 22976, offset 0, flags [DF], proto UDP (17), length 60) 172.24.4.228.40278 > 192.168.200.21: [bad udp cksum 0xfa7b -> 0xe235!] UDP, length 32Copy to Clipboard Copied! Toggle word wrap Toggle overflow

当您对流量执行 tcpdump 分析时,您会看到对路由器接口的响应数据包标题,而不是与虚拟机实例的响应。这是预期的行为,因为 qrouter 在返回数据包上执行目标网络地址转换 (DNAT)。

6.8. 为 OVN 故障排除命令创建别名

您可以在 ovn_controller 容器中运行 OVN 命令,如 ovn-nbctl show。容器在 Controller 节点和 Compute 节点上运行。要简化对命令的访问,请创建并提供定义别名的脚本。

先决条件

- 使用 ML2/OVN 作为默认机制驱动程序部署的 Red Hat OpenStack Platform。

流程

以具有访问 OVN 容器所需的权限的用户身份登录到 Controller 主机。

示例

ssh heat-admin@controller-0.ctlplane

$ ssh heat-admin@controller-0.ctlplaneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个 shell 脚本文件,其中包含您要运行的

ovn命令。示例

vi ~/bin/ovn-alias.sh

vi ~/bin/ovn-alias.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加

ovn命令并保存脚本文件。示例

在这个示例中,

ovn-sbctl、ovn-nbctl和ovn-trace命令已添加到别名文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 在 Compute 主机上重复此流程中的步骤。

验证

查找脚本文件。

示例

source ovn-alias.sh

# source ovn-alias.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行命令以确认脚本文件是否正常工作。

示例

ovn-nbctl show

# ovn-nbctl showCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.9. 监控 OVN 逻辑流

OVN 使用作为优先级、匹配和操作的流表的逻辑流。这些逻辑流被分发到在每个 Red Hat Openstack Platform (RHOSP) Compute 节点上运行的 ovn-controller。在 Controller 节点上使用 ovn-sbctl lflow-list 命令来查看完整的逻辑流集合。

先决条件

- 使用 ML2/OVN 作为网络服务(neutron)默认机制驱动程序的 RHOSP 部署。

为 OVN 数据库命令创建别名文件。

流程

以具有访问 OVN 容器所需的权限的用户身份登录到 Controller 主机。

示例

ssh heat-admin@controller-0.ctlplane

$ ssh heat-admin@controller-0.ctlplaneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提供 OVN 数据库命令的别名文件。

更多信息请参阅 第 6.8 节 “为 OVN 故障排除命令创建别名”。

示例

source ~/ovn-alias.sh

source ~/ovn-alias.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow 查看逻辑流:

ovn-sbctl lflow-list

$ ovn-sbctl lflow-listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查输出。

输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow OVN 和 OpenFlow 之间的主要区别包括:

- OVN 端口是位于网络中的某个位置的逻辑实体,而不是单一交换机上的物理端口。

- OVN 为管道中的每个表指定一个名称,除了其数字外。名称描述了管道中该阶段的目的。

- OVN 匹配语法支持复杂的布尔值表达式。

- OVN 逻辑流中支持的操作会超过 OpenFlow 的操作。您可以在 OVN 逻辑流语法中实施更高级别的功能,如 DHCP。

运行 OVN trace。

ovn-trace命令可以模拟数据包如何通过 OVN 逻辑流传输,或者帮助您确定数据包被丢弃的原因。使用以下参数提供ovn-trace命令:- DATAPATH

- 模拟数据包启动的逻辑交换机或逻辑路由器。

- MICROFLOW

模拟的数据包,使用

ovn-sb数据库使用的语法。示例

本例在模拟的数据包中显示

--minimal输出选项,并显示数据包到达其目的地:ovn-trace --minimal sw0 'inport == "sw0-port1" && eth.src == 00:00:00:00:00:01 && eth.dst == 00:00:00:00:00:02'

$ ovn-trace --minimal sw0 'inport == "sw0-port1" && eth.src == 00:00:00:00:00:01 && eth.dst == 00:00:00:00:00:02'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

reg14=0x1,vlan_tci=0x0000,dl_src=00:00:00:00:00:01,dl_dst=00:00:00:00:00:02,dl_type=0x0000 output("sw0-port2");# reg14=0x1,vlan_tci=0x0000,dl_src=00:00:00:00:00:01,dl_dst=00:00:00:00:00:02,dl_type=0x0000 output("sw0-port2");Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例

如需了解更多详细信息,这个相同的模拟数据包的

--summary输出会显示完整的执行管道:ovn-trace --summary sw0 'inport == "sw0-port1" && eth.src == 00:00:00:00:00:01 && eth.dst == 00:00:00:00:00:02'

$ ovn-trace --summary sw0 'inport == "sw0-port1" && eth.src == 00:00:00:00:00:01 && eth.dst == 00:00:00:00:00:02'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

示例输出显示:

-

数据包从

sw0-port1端口输入sw0网络并运行 ingress 管道。 -

outport变量设置为sw0-port2,表示此数据包的预期目的地为sw0-port2。 -

数据包是来自 ingress 管道的输出,它会将其引入

sw0的出口管道,并将outport变量设置为sw0-port2。 输出操作在出口管道中执行,它将数据包输出到

outport变量的当前值,即sw0-port2。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

数据包从

6.10. 监控 OpenFlows