管理 Red Hat Quay

前言

部署 Red Hat Quay registry 后,您可以进一步配置和管理该部署。此处涵盖的主题包括:

- 高级 Red Hat Quay 配置

- 将通知设置为提醒您新的 Red Hat Quay 发行版本

- 使用 SSL/TLS 证书保护连接

- 将操作日志存储定向到 Elasticsearch

- 使用 Clair 配置镜像安全扫描

- 使用 Container Security Operator 扫描 pod 镜像

- 将 Red Hat Quay 与 Quay Bridge Operator 集成至 OpenShift Container Platform 中

- 使用存储库镜像镜像镜像

- 使用 BitTorrent 服务共享 Red Hat Quay 镜像

- 使用 LDAP 验证用户

- 为 Prometheus 和 Grafana 指标启用 Quay

- 设置异地复制

- Red Hat Quay 故障排除

有关 Red Hat Quay 配置字段的完整列表,请参阅 Configure Red Hat Quay 页面。

第 1 章 高级 Red Hat Quay 配置

您可以使用以下方法之一在初始部署后配置 Red Hat Quay:

-

编辑

config.yaml文件。config.yaml文件包含 Red Hat Quay 集群的大部分配置信息。直接编辑config.yaml文件是高级调整和启用特定功能的主要方法。 - 使用 Red Hat Quay API。一些 Red Hat Quay 功能可以通过 API 配置。

本节中的这个内容描述了如何使用上述每个接口以及如何使用高级功能配置部署。

1.1. 使用 API 修改 Red Hat Quay

1.2. 编辑 config.yaml 文件以修改 Red Hat Quay

高级功能可以通过直接编辑 config.yaml 文件来实现。Red Hat Quay 功能和设置的所有配置字段都包括在 Red Hat Quay 配置指南 中。

以下示例是在 config.yaml 文件中直接更改的一个设置。在为其他功能和设置编辑 config.yaml 文件时,请使用本示例作为参考。

1.2.1. 在 Red Hat Quay sign-in 中添加名称和公司

通过将 FEATURE_USER_METADATA 字段设置为 True,会在用户首次登录时提示输入其名称和公司。这是一个可选字段,但可以提供有关 Red Hat Quay 用户的额外数据。

使用以下步骤在 Red Hat Quay 登录页面中添加名称和一个公司。

流程

-

在

config.yaml文件中添加或设置为FEATURE_USER_METADATA配置字段为True。例如:

# ... FEATURE_USER_METADATA: true # ...

# ...

FEATURE_USER_METADATA: true

# ...- 重新部署 Red Hat Quay。

现在,在提示登录时,会要求用户输入以下信息:

第 2 章 使用配置 API

配置工具会公开 4 个端点,可用于构建、验证、捆绑包和部署配置。config-tool API 记录在 https://github.com/quay/config-tool/blob/master/pkg/lib/editor/API.md。在本节中,您将了解如何使用 API 来检索当前配置,以及如何验证您所做的任何更改。

2.1. 检索默认配置

如果您第一次运行配置工具,且没有现有的配置,您可以检索默认配置。以 config 模式启动容器:

sudo podman run --rm -it --name quay_config \ -p 8080:8080 \ registry.redhat.io/quay/quay-rhel8:v3.15.1 config secret

$ sudo podman run --rm -it --name quay_config \

-p 8080:8080 \

registry.redhat.io/quay/quay-rhel8:v3.15.1 config secret

使用配置 API 的配置端点获取默认值:

curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq

$ curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq返回的值是 JSON 格式的默认配置:

2.2. 检索当前配置

如果您已经配置并部署了 Quay registry,请停止容器并以配置模式重启它,将现有配置作为卷载入:

sudo podman run --rm -it --name quay_config \ -p 8080:8080 \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 config secret

$ sudo podman run --rm -it --name quay_config \

-p 8080:8080 \

-v $QUAY/config:/conf/stack:Z \

registry.redhat.io/quay/quay-rhel8:v3.15.1 config secret

使用 API 的配置端点获取当前配置:

curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq

$ curl -X GET -u quayconfig:secret http://quay-server:8080/api/v1/config | jq返回的值是 JSON 格式的当前配置,包括数据库和 Redis 配置数据:

2.3. 使用 API 验证配置

您可以通过将配置发布到 config/validate 端点来验证配置:

返回的值是一个数组,其中包含配置中找到的错误。如果配置有效,则返回空数组 []。

2.4. 确定必填字段

您可以通过将空配置结构发布到 config/validate 端点来确定必填字段:

返回的值是一个数组,表示需要哪些字段:

第 3 章 获取 Red Hat Quay 发行通知

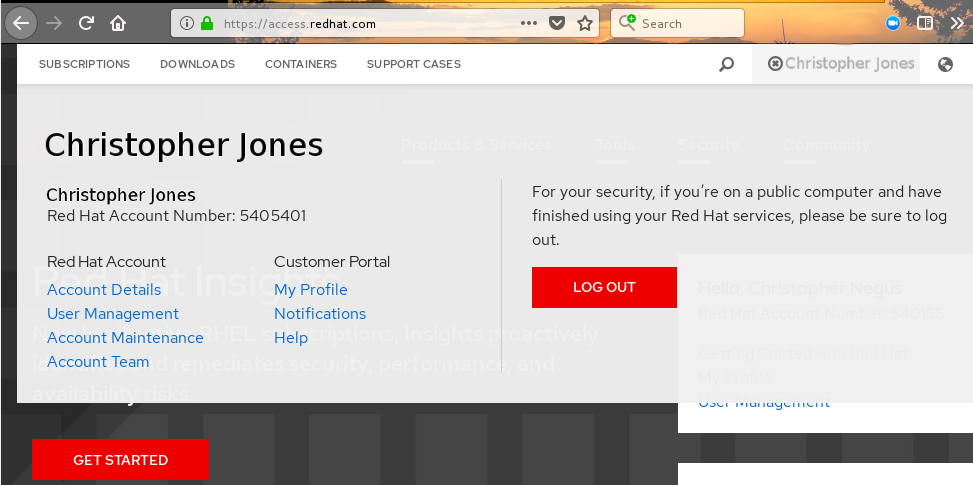

要跟上最新的 Red Hat Quay 版本以及与 Red Hat Quay 相关的其他更改,您可以在 红帽客户门户网站 上注册更新通知。注册通知后,您将收到通知,通知您何时有新的 Red Hat Quay 版本、更新文档或其他 Red Hat Quay 新闻。

- 使用您的红帽客户帐户凭证 登录到红帽客户门户网站。

-

选择您的用户名(右上角)查看红帽帐户和客户门户网站选择:

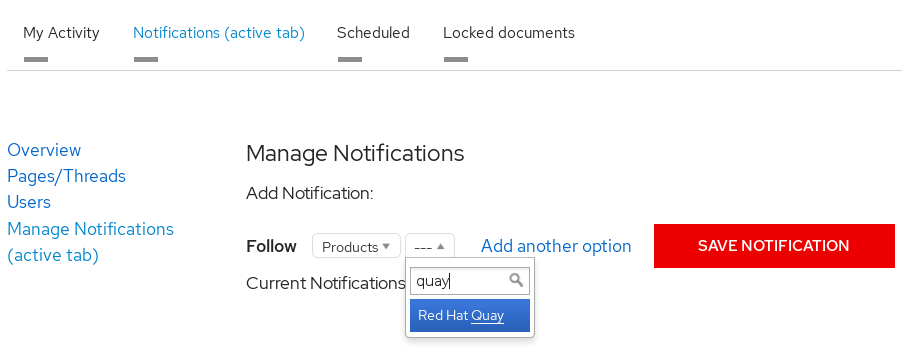

- 选择通知。此时会出现您的个人资料活动页面。

- 选择 Notifications 选项卡。

- 选择 Manage Notifications。

- 选择 Follow,然后从下拉菜单中选择 Products。

-

在 Products 旁边的下拉菜单中,搜索并选择 Red Hat Quay:

- 选择 SAVE NOTIFICATION 按钮。接下来,当 Red Hat Quay 产品有更改时(如新版本),您将收到通知。

第 4 章 使用 SSL 保护到 Red Hat Quay 的连接

4.1. 使用 SSL/TLS

使用 SSL/TLS 的文档 已被修改并移到安全 Red Hat Quay 中。本章将在以后的 Red Hat Quay 版本中删除。

第 5 章 为 Elasticsearch 和 Splunk 配置操作日志存储

默认情况下,使用日志存储在 Red Hat Quay 数据库中,并通过 Web UI 在机构和存储库级别公开。查看日志条目需要适当的管理特权。对于具有大量日志记录操作的部署,您可以在 Elasticsearch 和 Splunk 中存储使用日志,而不是 Red Hat Quay 数据库后端。

5.1. 为 Elasticsearch 配置操作日志存储

要为 Elasticsearch 配置操作日志存储,您必须提供自己的 Elasticsearch 堆栈;它不包含在 Red Hat Quay 中作为可自定义组件。

通过更新 config.yaml 文件,可以在 Red Hat Quay 部署或部署后启用 Elasticsearch 日志记录。配置后,通过 Web UI 为存储库和组织继续提供使用日志访问。

使用以下步骤为 Elasticsearch 配置操作日志存储:

流程

- 获取 Elasticsearch 帐户。

更新 Red Hat Quay

config.yaml文件,使其包含以下信息:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 处理日志数据的方法。

- 2

- 选择 Elasticsearch 或 Kinesis 将日志定向到 AWS 上的中间 Kinesis 流。您需要设置自己的管道,将日志发送到 Elasticsearch,例如 Logstash。

- 3

- 提供 Elasticsearch 服务的系统的主机名或 IP 地址。

- 4

- 在您刚才输入的主机上提供 Elasticsearch 服务的端口号。请注意,该端口必须可从运行 Red Hat Quay registry 的所有系统访问。默认值为 TCP 端口

9200。 - 5

- 如果需要,获取 Elasticsearch 服务访问权限所需的访问密钥。

- 6

- 如果需要,获取 Elasticsearch 服务访问权限所需的 secret 密钥。

- 7

- 是否将 SSL/TLS 用于 Elasticsearch。默认值为

True。 - 8

- 选择要附加到日志条目的前缀。

- 9

- 如果您在 AWS 上运行,请设置 AWS 区域(否则,将其留空)。

可选。如果使用 Kinesis 作为日志制作者,则必须在

config.yaml文件中包括以下字段:kinesis_stream_config: stream_name: <kinesis_stream_name> access_key: <aws_access_key> secret_key: <aws_secret_key> aws_region: <aws_region>kinesis_stream_config: stream_name: <kinesis_stream_name>1 access_key: <aws_access_key>2 secret_key: <aws_secret_key>3 aws_region: <aws_region>4 Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

保存

config.yaml文件并重启 Red Hat Quay 部署。

5.2. 为 Splunk 配置操作日志存储

Splunk 是 Elasticsearch 的一个替代方案,可为 Red Hat Quay 数据提供日志分析。

启用 Splunk 日志记录可以在 Red Hat Quay 部署过程中或使用配置工具部署后完成。配置包括直接将操作日志转发到 Splunk 或 Splunk HTTP 事件收集器(HEC)的选项。

使用以下步骤为您的 Red Hat Quay 部署启用 Splunk。

5.2.1. 为 Splunk 安装和创建用户名

使用以下步骤安装并创建 Splunk 凭证。

流程

- 通过进入到 Splunk 并输入所需凭证来创建 Splunk 帐户。

- 导航到 Splunk Enterprise Free Trial 页面,选择您的平台和安装软件包,然后单击 Download Now。

-

在您的机器上安装 Splunk 软件。出现提示时,创建一个用户名,如 mvapich

_admin和密码。 -

创建用户名和密码后,将为 Splunk 部署提供一个 localhost URL,例如

http://<sample_url>.remote.csb:8000/。在您首选的浏览器中打开 URL。 - 使用安装期间创建的用户名和密码登录。您会被定向到 Splunk UI。

5.2.2. 生成 Splunk 令牌

使用以下步骤之一为 Splunk 创建 bearer 令牌。

5.2.2.1. 使用 Splunk UI 生成 Splunk 令牌

使用以下步骤,使用 Splunk UI 为 Splunk 创建 bearer 令牌。

先决条件

- 已安装 Splunk 并创建了一个用户名。

流程

- 在 Splunk UI 上,进入到 Settings → Tokens。

- 单击 Enable Token Authentication。

- 如果需要,点 Token Settings 并选择 Token Authentication 来确保启用 Token Authentication。

- 可选:为您的令牌设置过期时间。默认值为 30 天。

- 点击 Save。

- 单击 New Token。

- 输入用户和 受众 的信息。

- 可选:设置 Expiration 和 Not Before 信息。

点 Create。您的令牌会出现在 Token 框中。立即复制令牌。

重要如果在复制令牌前关闭框,您必须创建一个新令牌。关闭 New Token 窗口后,整个令牌将不可用。

5.2.2.2. 使用 CLI 生成 Splunk 令牌

使用以下流程,通过 CLI 为 Splunk 创建 bearer 令牌。

先决条件

- 已安装 Splunk 并创建了一个用户名。

流程

在 CLI 中,输入以下

CURL命令以启用令牌身份验证,传递 Splunk 用户名和密码:curl -k -u <username>:<password> -X POST <scheme>://<host>:<port>/services/admin/token-auth/tokens_auth -d disabled=false

$ curl -k -u <username>:<password> -X POST <scheme>://<host>:<port>/services/admin/token-auth/tokens_auth -d disabled=falseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 通过输入以下

CURL命令,传递 Splunk 用户名和密码来创建令牌。curl -k -u <username>:<password> -X POST <scheme>://<host>:<port>/services/authorization/tokens?output_mode=json --data name=<username> --data audience=Users --data-urlencode expires_on=+30d

$ curl -k -u <username>:<password> -X POST <scheme>://<host>:<port>/services/authorization/tokens?output_mode=json --data name=<username> --data audience=Users --data-urlencode expires_on=+30dCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存生成的 bearer 令牌。

5.2.3. 配置 Red Hat Quay 以使用 Splunk

使用以下步骤将 Red Hat Quay 配置为使用 Splunk 或 Splunk HTTP 事件收集器(HEC)。

先决条件

- 已安装 Splunk 并创建了一个用户名。

- 您已生成 Splunk bearer 令牌。

流程

将 Red Hat Quay 配置为使用 Splunk 或 Splunk HTTP 事件收集器(HEC)。

如果选择使用 Splunk,请打开 Red Hat Quay

config.yaml文件并添加以下配置字段:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 字符串.Splunk 集群端点。

- 2

- 整数.Splunk 管理集群端点端口。与 Splunk GUI 托管的端口不同。可以在 Splunk UI 的 Settings → Server Settings → General Settings 下找到。

- 3

- 字符串.为 Splunk 生成的 bearer 令牌。

- 4

- 字符串.用于访问 Splunk 服务的 URL 方案。如果 Splunk 配置为使用 TLS/SSL,则必须为

https。 - 5

- 布尔值.是否启用 TLS/SSL。默认值为

True。 - 6

- 字符串.Splunk 索引前缀。可以是新的或使用的索引。可以从 Splunk UI 创建。

- 7

- 字符串.到包含用于 TLS/SSL 验证的证书颁发机构(CA)的单个

.pem文件的相对容器路径。

如果选择使用 Splunk HEC,请打开 Red Hat Quay

config.yaml文件并添加以下配置字段:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

如果要配置

ssl_ca_path,您必须配置 SSL/TLS 证书,以便 Red Hat Quay 信任它。-

如果您使用独立部署 Red Hat Quay,可以通过将证书文件放在

extra_ca_certs目录或相对容器路径内部并由ssl_ca_path指定来提供 SSL/TLS 证书。 如果使用 Red Hat Quay Operator,请创建一个配置捆绑包 secret,包括 Splunk 服务器的证书颁发机构(CA)。例如:

oc create secret generic --from-file config.yaml=./config_390.yaml --from-file extra_ca_cert_splunkserver.crt=./splunkserver.crt config-bundle-secret

$ oc create secret generic --from-file config.yaml=./config_390.yaml --from-file extra_ca_cert_splunkserver.crt=./splunkserver.crt config-bundle-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

config.yaml中指定conf/stack/extra_ca_certs/splunkserver.crt文件。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

如果您使用独立部署 Red Hat Quay,可以通过将证书文件放在

5.2.4. 创建操作日志

使用以下步骤创建可将操作日志转发到 Splunk 的用户帐户。

您必须使用 Splunk UI 来查看 Red Hat Quay 操作日志。目前,在 Red Hat Quay Usage Logs 页中查看 Splunk 操作日志不被支持,并返回以下消息: Method not implemented。Splunk 不支持日志查找。

先决条件

- 已安装 Splunk 并创建了一个用户名。

- 您已生成 Splunk bearer 令牌。

-

您已配置了 Red Hat Quay

config.yaml文件来启用 Splunk。

流程

- 登录到您的 Red Hat Quay 部署。

- 点您要用来为 Splunk 创建操作日志的组织名称。

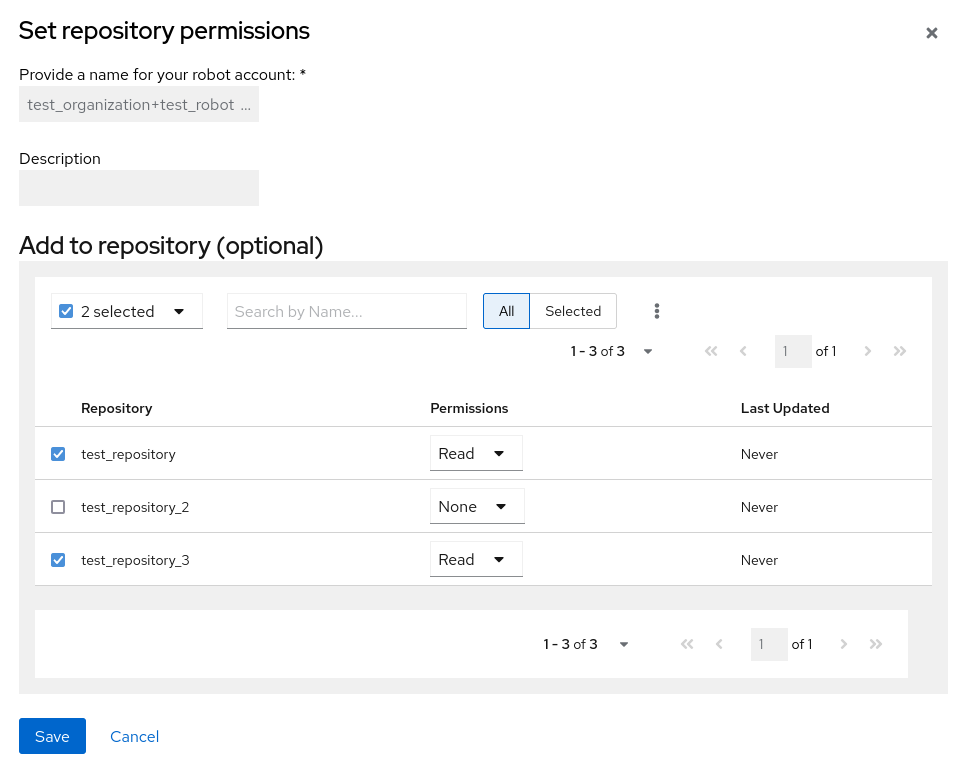

- 在导航窗格中,点 Robot Accounts → Create Robot Account。

-

出现提示时,输入机器人帐户的名称,如

spunkrobotaccount,然后单击 Create robot account。 - 在您的浏览器中,打开 Splunk UI。

- 单击 Search and Reporting。

在搜索栏中,输入索引的名称,如 <mvapich

_log_index_name>,然后按 Enter 键。搜索结果在 Splunk UI 上填充。日志以 JSON 格式转发。响应可能类似如下:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. 了解使用日志

默认情况下,使用日志存储在 Red Hat Quay 数据库中。它们通过 Web UI、机构和存储库级别以及 超级用户 管理面板公开。

数据库日志捕获 Red Hat Quay 中各种事件范围,如更改帐户计划、用户操作和常规操作。日志条目包括诸如操作(kind_id)、执行操作的用户(account_id 或 performer_id)、时间戳(日期时间)以及与操作关联的其他相关数据(metadata_json)。

5.3.1. 查看数据库日志

以下流程演示了如何查看存储在 PostgreSQL 数据库中的存储库日志。

先决条件

- 您有管理特权。

-

已安装

psqlCLI 工具。

流程

输入以下命令登录到 Red Hat Quay PostgreSQL 数据库:

psql -h <quay-server.example.com> -p 5432 -U <user_name> -d <database_name>

$ psql -h <quay-server.example.com> -p 5432 -U <user_name> -d <database_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

psql (16.1, server 13.7) Type "help" for help.

psql (16.1, server 13.7) Type "help" for help.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选。输入以下命令显示 PostgreSQL 数据库的表列表:

quay=> \dt

quay=> \dtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以输入以下命令返回返回日志信息所需的

repository_ids列表:quay=> SELECT id, name FROM repository;

quay=> SELECT id, name FROM repository;Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令使用

logentry3关系来显示有关其中一个软件仓库的日志信息:SELECT * FROM logentry3 WHERE repository_id = <repository_id>;

SELECT * FROM logentry3 WHERE repository_id = <repository_id>;Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

id | kind_id | account_id | performer_id | repository_id | datetime | ip | metadata_json 59 | 14 | 2 | 1 | 6 | 2024-05-13 15:51:01.897189 | 192.168.1.130 | {"repo": "api-repo", "namespace": "test-org"}id | kind_id | account_id | performer_id | repository_id | datetime | ip | metadata_json 59 | 14 | 2 | 1 | 6 | 2024-05-13 15:51:01.897189 | 192.168.1.130 | {"repo": "api-repo", "namespace": "test-org"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在上例中,返回以下信息:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3.2. 日志条目 kind_ids

下表代表了与 Red Hat Quay 操作关联的 kind_ids。

| kind_id | 操作 | 描述 |

|---|---|---|

| 1 | account_change_cc | 信用卡信息更改。 |

| 2 | account_change_password | 更改帐户密码。 |

| 3 | account_change_plan | 帐户计划更改. |

| 4 | account_convert | 帐户转换. |

| 5 | add_repo_accesstoken | 将访问令牌添加到存储库. |

| 6 | add_repo_notification | 向存储库添加通知. |

| 7 | add_repo_permission | 为存储库添加权限. |

| 8 | add_repo_webhook | 将 webhook 添加到存储库. |

| 9 | build_dockerfile | 构建 Dockerfile. |

| 10 | change_repo_permission | 更改存储库的权限。 |

| 11 | change_repo_visibility | 更改存储库的可见性。 |

| 12 | create_application | 创建应用程序。 |

| 13 | create_prototype_permission | 为模型创建权限. |

| 14 | create_repo | 创建存储库. |

| 15 | create_robot | 创建机器人(服务帐户或 bot)。 |

| 16 | create_tag | 创建标签。 |

| 17 | delete_application | 删除应用程序。 |

| 18 | delete_prototype_permission | 删除原型的权限。 |

| 19 | delete_repo | 删除存储库。 |

| 20 | delete_repo_accesstoken | 从存储库删除访问令牌。 |

| 21 | delete_repo_notification | 从存储库删除通知. |

| 22 | delete_repo_permission | 从存储库删除权限。 |

| 23 | delete_repo_trigger | 删除存储库触发器。 |

| 24 | delete_repo_webhook | 从存储库删除 webhook。 |

| 25 | delete_robot | 删除机器人. |

| 26 | delete_tag | 删除标签。 |

| 27 | manifest_label_add | 向清单添加标签。 |

| 28 | manifest_label_delete | 从清单中删除标签。 |

| 29 | modify_prototype_permission | 修改原型的权限. |

| 30 | move_tag | 移动标签。 |

| 31 | org_add_team_member | 将成员添加到团队. |

| 32 | org_create_team | 在组织内创建团队。 |

| 33 | org_delete_team | 删除机构中的团队。 |

| 34 | org_delete_team_member_invite | 删除团队成员邀请。 |

| 35 | org_invite_team_member | 将成员邀请到机构中的团队。 |

| 36 | org_remove_team_member | 从团队中删除成员。 |

| 37 | org_set_team_description | 设置团队的描述。 |

| 38 | org_set_team_role | 设置团队的角色. |

| 39 | org_team_member_invite_accepted | 接受团队成员邀请。 |

| 40 | org_team_member_invite_declined | 拒绝团队成员邀请。 |

| 41 | pull_repo | 从存储库拉取(pull)。 |

| 42 | push_repo | 推送到存储库。 |

| 43 | regenerate_robot_token | 重新生成机器人令牌。 |

| 44 | repo_verb | 通用存储库操作(特定的库操作可以在其他位置定义)。 |

| 45 | reset_application_client_secret | 重置应用的客户端机密。 |

| 46 | revert_tag | 恢复标签。 |

| 47 | service_key_approve | 批准服务密钥。 |

| 48 | service_key_create | 创建服务密钥。 |

| 49 | service_key_delete | 删除服务密钥。 |

| 50 | service_key_extend | 扩展服务密钥。 |

| 51 | service_key_modify | 修改服务密钥。 |

| 52 | service_key_rotate | 轮转服务密钥。 |

| 53 | setup_repo_trigger | 设置存储库触发器. |

| 54 | set_repo_description | 设置存储库的描述。 |

| 55 | take_ownership | 获取资源的所有权。 |

| 56 | update_application | 更新应用程序。 |

| 57 | change_repo_trust | 更改存储库的信任级别。 |

| 58 | reset_repo_notification | 重置存储库通知. |

| 59 | change_tag_expiration | 更改标签的到期日期。 |

| 60 | create_app_specific_token | 创建特定于应用的令牌. |

| 61 | revoke_app_specific_token | 撤销特定应用的令牌. |

| 62 | toggle_repo_trigger | 切换或关闭存储库触发器。 |

| 63 | repo_mirror_enabled | 启用存储库镜像。 |

| 64 | repo_mirror_disabled | 禁用存储库镜像。 |

| 65 | repo_mirror_config_changed | 更改存储库镜像的配置。 |

| 66 | repo_mirror_sync_started | 启动存储库镜像同步。 |

| 67 | repo_mirror_sync_failed | 仓库镜像同步失败。 |

| 68 | repo_mirror_sync_success | 仓库镜像同步成功。 |

| 69 | repo_mirror_sync_now_requested | 请求直接存储库镜像同步。 |

| 70 | repo_mirror_sync_tag_success | 仓库镜像标签同步成功。 |

| 71 | repo_mirror_sync_tag_failed | 仓库镜像标签同步失败。 |

| 72 | repo_mirror_sync_test_success | 仓库镜像同步测试成功。 |

| 73 | repo_mirror_sync_test_failed | 仓库镜像同步测试失败。 |

| 74 | repo_mirror_sync_test_started | 存储库镜像同步测试已启动。 |

| 75 | change_repo_state | 更改存储库的状态. |

| 76 | create_proxy_cache_config | 创建代理缓存配置。 |

| 77 | delete_proxy_cache_config | 删除代理缓存配置。 |

| 78 | start_build_trigger | 启动构建触发器。 |

| 79 | cancel_build | 取消构建. |

| 80 | org_create | 创建机构。 |

| 81 | org_delete | 删除机构。 |

| 82 | org_change_email | 更改组织电子邮件. |

| 83 | org_change_invoicing | 更改组织情况. |

| 84 | org_change_tag_expiration | 更改机构标签过期。 |

| 85 | org_change_name | 更改机构名称。 |

| 86 | user_create | 创建用户。 |

| 87 | user_delete | 删除用户。 |

| 88 | user_disable | 禁用用户。 |

| 89 | user_enable | 启用用户. |

| 90 | user_change_email | 更改用户电子邮件. |

| 91 | user_change_password | 更改用户密码. |

| 92 | user_change_name | 更改用户名。 |

| 93 | user_change_invoicing | 更改用户 invoicing. |

| 94 | user_change_tag_expiration | 更改用户标签过期。 |

| 95 | user_change_metadata | 更改用户元数据。 |

| 96 | user_generate_client_key | 为用户生成客户端密钥。 |

| 97 | login_success | 成功登录。 |

| 98 | logout_success | 成功注销。 |

| 99 | permanently_delete_tag | 永久删除标签。 |

| 100 | autoprune_tag_delete | 自动修剪标签删除。 |

| 101 | create_namespace_autoprune_policy | 创建命名空间自动修剪策略。 |

| 102 | update_namespace_autoprune_policy | 更新命名空间自动修剪策略。 |

| 103 | delete_namespace_autoprune_policy | 删除命名空间自动修剪策略。 |

| 104 | login_failure | 登录尝试失败。 |

第 6 章 Clair 安全扫描程序

6.1. Clair 安全漏洞数据库

Clair 使用以下漏洞数据库来报告您的镜像中的问题:

- Ubuntu Oval 数据库

- Debian 安全跟踪器

- Red Hat Enterprise Linux (RHEL) Oval 数据库

- Dan Oval 数据库

- Oracle Oval 数据库

- alpine SecDB 数据库

- VMware Photon OS 数据库

- Amazon Web Services (AWS) UpdateInfo

- 开源漏洞(OSV)数据库

有关 Clair 如何对不同数据库进行安全映射的信息,请参阅 Claircore Severity 映射。

6.1.1. Clair 的开源漏洞(OSV)数据库的信息

开源漏洞(OSV)是一种漏洞数据库和监控服务,侧重于跟踪和管理开源软件中的安全漏洞。

OSV 提供开源项目中已知安全漏洞的全面、最新的数据库。它涵盖了广泛的开源软件,包括库、框架和软件开发中使用的其他组件。有关包含生态系统的完整列表,请参阅 定义的生态系统。

Clair 还通过开源漏洞(OSV)数据库报告 golang、java 和 ruby 生态系统的漏洞和安全信息。

通过利用 OSV,开发人员和组织可以主动监控和解决其使用的开源组件中的安全漏洞,这有助于降低安全漏洞和数据遭受攻击的风险。

有关 OSV 的更多信息,请参阅 OSV 网站。

6.2. 在独立的 Red Hat Quay 部署上设置 Clair

对于独立的 Red Hat Quay 部署,您可以手动设置 Clair。

流程

在 Red Hat Quay 安装目录中,为 Clair 数据库数据创建新目录:

mkdir /home/<user-name>/quay-poc/postgres-clairv4

$ mkdir /home/<user-name>/quay-poc/postgres-clairv4Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令为

postgres-clairv4文件设置适当的权限:setfacl -m u:26:-wx /home/<user-name>/quay-poc/postgres-clairv4

$ setfacl -m u:26:-wx /home/<user-name>/quay-poc/postgres-clairv4Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令部署 Clair PostgreSQL 数据库:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为您的 Clair 部署安装 PostgreSQL

uuid-ossp模块:sudo podman exec -it postgresql-clairv4 /bin/bash -c 'echo "CREATE EXTENSION IF NOT EXISTS \"uuid-ossp\"" | psql -d clair -U postgres'

$ sudo podman exec -it postgresql-clairv4 /bin/bash -c 'echo "CREATE EXTENSION IF NOT EXISTS \"uuid-ossp\"" | psql -d clair -U postgres'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

CREATE EXTENSION

CREATE EXTENSIONCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意Clair 要求将

uuid-ossp扩展添加到其 PostgreSQL 数据库中。对于具有适当权限的用户,Clair 将自动添加扩展。如果用户没有正确的权限,则必须在启动 Clair 前添加扩展。如果没有扩展,当 Clair 尝试启动时会显示以下错误:

ERROR: Please load the "uuid-ossp" 扩展。(SQLSTATE 42501).如果

Quay容器正在运行,并在配置模式中重启它,将现有配置载入为卷:sudo podman run --rm -it --name quay_config \ -p 80:8080 -p 443:8443 \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 config secret

$ sudo podman run --rm -it --name quay_config \ -p 80:8080 -p 443:8443 \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 config secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 登录到配置工具,再单击 UI 的 Security Scanner 部分中的 Enable Security Scanning。

-

使用

quay-server系统上尚未使用的端口设置 Clair 的 HTTP 端点,例如8081。 使用 Generate PSK 按钮创建预共享密钥(PSK)。

安全扫描器 UI

-

验证并下载 Red Hat Quay 的

config.yaml文件,然后停止运行配置编辑器的Quay容器。 将新配置捆绑包提取到 Red Hat Quay 安装目录中,例如:

tar xvf quay-config.tar.gz -d /home/<user-name>/quay-poc/

$ tar xvf quay-config.tar.gz -d /home/<user-name>/quay-poc/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为您的 Clair 配置文件创建一个文件夹,例如:

mkdir /etc/opt/clairv4/config/

$ mkdir /etc/opt/clairv4/config/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 进入 Clair 配置文件夹:

cd /etc/opt/clairv4/config/

$ cd /etc/opt/clairv4/config/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 Clair 配置文件,例如:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关 Clair 的配置格式的更多信息,请参阅 Clair 配置参考。

使用容器镜像启动 Clair,从您创建的文件中挂载在配置中:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意也有可能运行多个 Clair 容器,但对于单一容器以外的部署场景,我们强烈建议使用 Kubernetes 或 OpenShift Container Platform 等容器编配器。

6.3. OpenShift Container Platform 上的 Clair

要在 OpenShift Container Platform 上的 Red Hat Quay 部署上设置 Clair v4 (Clair),建议使用 Red Hat Quay Operator。默认情况下,Red Hat Quay Operator 会随 Red Hat Quay 部署一起安装或升级 Clair 部署,并自动配置 Clair。

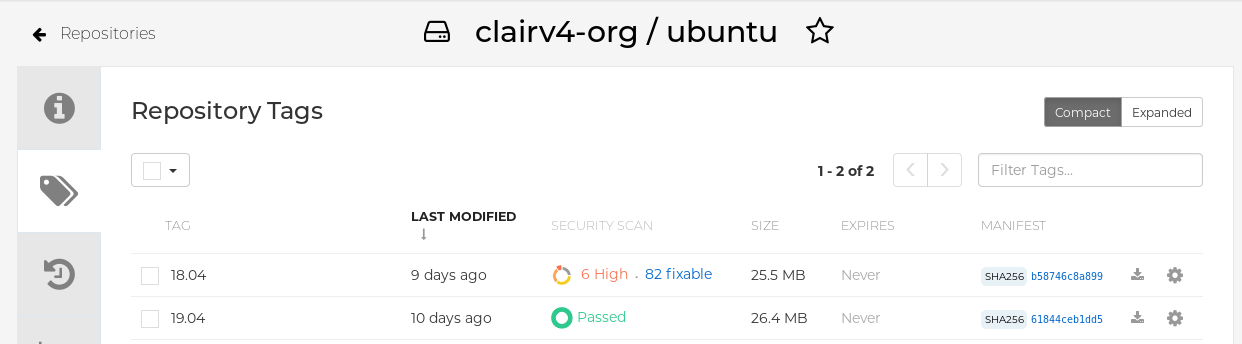

6.4. 测试 Clair

使用以下步骤在一个独立 Red Hat Quay 部署或基于 OpenShift Container Platform Operator 的部署中测试 Clair。

先决条件

- 您已部署了 Clair 容器镜像。

流程

输入以下命令拉取示例镜像:

podman pull ubuntu:20.04

$ podman pull ubuntu:20.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令将镜像标记到 registry:

sudo podman tag docker.io/library/ubuntu:20.04 <quay-server.example.com>/<user-name>/ubuntu:20.04

$ sudo podman tag docker.io/library/ubuntu:20.04 <quay-server.example.com>/<user-name>/ubuntu:20.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令将镜像推送到 Red Hat Quay registry:

sudo podman push --tls-verify=false quay-server.example.com/quayadmin/ubuntu:20.04

$ sudo podman push --tls-verify=false quay-server.example.com/quayadmin/ubuntu:20.04Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 通过 UI 登录您的 Red Hat Quay 部署。

- 单击存储库名称,如 quayadmin/ubuntu。

在导航窗格中,点 Tags。

报告概述

点镜像报告(如 45 个介质 )以显示更详细的报告:

报告详情

注意

注意在某些情况下,Clair 会显示镜像重复报告,如

ubi8/nodejs-12或ubi8/nodejs-16。这是因为名称相同的漏洞用于不同的软件包。这个行为应该带有 Clair 漏洞报告,且不会作为程序错误解决。

第 7 章 仓库镜像

7.1. 仓库镜像

Red Hat Quay 存储库镜像可让您将来自外部容器 registry 或其他本地 registry 的镜像镜像到 Red Hat Quay 集群中。使用存储库镜像,您可以根据存储库名称和标签将镜像同步到 Red Hat Quay。

在启用了存储库镜像的 Red Hat Quay 集群中,您可以执行以下操作:

- 从外部 registry 选择要镜像的存储库

- 添加凭证以访问外部 registry

- 识别要同步的特定容器镜像存储库名称和标签

- 设置同步存储库的时间间隔

- 检查同步的当前状态

要使用镜像功能,您需要执行以下操作:

- 在 Red Hat Quay 配置文件中启用存储库镜像

- 运行存储库镜像 worker

- 创建已镜像的存储库

所有存储库镜像配置均可使用配置工具 UI 或 Red Hat Quay API 执行。

7.2. 与 geo-replication 相比的存储库镜像

Red Hat Quay geo-replication 在数据库共享时在 2 个或多个不同的存储后端之间镜像整个镜像存储后端数据,例如,一个具有两个不同的 blob 存储端点的 Red Hat Quay registry。geo-replication 的主要用例包括:

- 加快对地理分散设置的二进制 Blob 的访问

- 确保镜像内容在区域之间是相同的

存储库镜像将所选存储库或存储库的子集从一个 registry 同步到另一个 registry。registry 有所不同,每个 registry 都有单独的数据库和单独的镜像存储。

镜像的主要用例包括:

- 在不同数据中心或区域中的独立 registry 部署,其中整个内容的某些子集应在数据中心和区域间共享

- 从外部 registry 自动同步或镜像所选(允许)上游存储库到本地 Red Hat Quay 部署

存储库镜像和地理复制可以同时使用。

| 功能/能力 | geo-replication | 仓库镜像 |

|---|---|---|

| 旨在做什么? | 共享的全局 registry | 不同的 registry |

| 复制或镜像尚未完成时会发生什么? | 使用远程副本(下下) | 没有提供镜像 |

| 是否可以访问这两个区域中的所有存储后端? | 是(所有 Red Hat Quay 节点) | 否(区分存储) |

| 用户是否可以将镜像从两个站点推送到同一存储库吗? | 是 | 否 |

| 所有 registry 内容和配置是否适用于所有区域(共享数据库)? | 是 | 否 |

| 用户可以选择要镜像的独立命名空间或存储库吗? | 否 | 是 |

| 用户可以应用过滤器来同步规则? | 否 | 是 |

| 每个区域中允许的独立/不同的角色访问控制配置 | 否 | 是 |

7.3. 使用存储库镜像

以下列表显示 Red Hat Quay 存储库镜像的特性和限制:

- 使用存储库镜像,您可以镜像整个存储库,或有选择限制同步哪些镜像。过滤器可以基于以逗号分隔的标签列表、一系列标签,或者通过 Unix shell 风格的通配符来识别标签。如需更多信息,请参阅 通配符 文档。

- 当将存储库设置为 mirror 时,您无法手动将其他镜像添加到该存储库中。

- 由于已镜像的存储库基于您设置的存储库和标签,因此它将只保存由存储库和标签对表示的内容。例如,如果您更改了标签,以便存储库中的某些镜像不再匹配,则这些镜像将被删除。

- 只有指定的机器机器才能将镜像推送到已镜像的存储库,并取代存储库上设置的任何基于角色的访问控制权限。

- 镜像可以被配置为在失败时回滚,或者以 最佳为先运行。

- 使用已镜像的存储库时,具有读取权限 的用户可以从存储库拉取镜像,但不能将镜像推送到存储库。

- 可以使用您创建的镜像存储库的 Repositories → Mirrors 选项卡在 Red Hat Quay 用户界面中执行已镜像存储库的设置。

- 镜像以设定的间隔同步,但也可以根据需要同步。

7.4. 启用存储库镜像

默认情况下,FEATURE_REPO_MIRROR 设置为 False。要启用镜像功能,您必须在 config.yaml 文件中设置 FEATURE_REPO_MIRROR: true。

流程

在

config.yaml文件中设置FEATURE_REPO_MIRROR: true。例如:# ... FEATURE_REPO_MIRROR: true # ...

# ... FEATURE_REPO_MIRROR: true # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 重启 Red Hat Quay registry。

7.5. 镜像配置字段

Red Hat Quay 中的镜像可启用自动同步存储库与上游源。此功能可用于维护远程容器镜像的本地镜像,确保在断开连接的环境中可用性或通过缓存提高性能。

其他信息

| 字段 | 类型 | 描述 |

|---|---|---|

| FEATURE_REPO_MIRROR | 布尔值 |

启用或禁用存储库镜像 |

| REPO_MIRROR_INTERVAL | Number |

检查存储库镜像候选者之间的秒数 |

| REPO_MIRROR_SERVER_HOSTNAME | 字符串 |

替换 |

| REPO_MIRROR_TLS_VERIFY | 布尔值 |

需要 HTTPS 并在镜像过程中验证 Quay registry 的证书。 |

| REPO_MIRROR_ROLLBACK | 布尔值 |

当设置为

默认 : |

| SKOPEO_TIMEOUT_INTERVAL | 整数 |

在超时前运行镜像任务的秒数。 |

镜像配置示例 YAML

7.6. 镜像 worker

使用以下步骤启动存储库镜像 worker。

流程

如果您还没有使用

/root/ca.crt证书配置 TLS 通信,请输入以下命令以使用repomirror选项启动Quaypod:sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 repomirror

$ sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 repomirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果您使用

/root/ca.crt证书配置了 TLS 通信,请输入以下命令来启动存储库镜像 worker:sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ -v /root/ca.crt:/etc/pki/ca-trust/source/anchors/ca.crt:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 repomirror

$ sudo podman run -d --name mirroring-worker \ -v $QUAY/config:/conf/stack:Z \ -v /root/ca.crt:/etc/pki/ca-trust/source/anchors/ca.crt:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1 repomirrorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.7. 创建已镜像的存储库

当从外部容器 registry 镜像存储库时,必须创建新的私有存储库。通常,使用与目标存储库相同的名称,如 quay-rhel9。

7.7.1. 存储库镜像设置

使用以下步骤调整镜像存储库的设置。

先决条件

- 您已在 Red Hat Quay 配置文件中启用了存储库镜像。

- 您已部署了镜像 worker。

流程

- 导航到 registry 的 Repositories 页面,再单击存储库的名称,如 test-mirror。

- 点 Settings → Repository state。

- 点 Mirror。

- 点 Mirroring 选项卡,并输入连接到外部 registry 的详情,以及标签、调度和访问信息:

在以下字段中输入详情:

-

registry 位置: 您要镜像的外部存储库,如

registry.redhat.io/quay/quay-rhel8。 - 标签: 输入以逗号分隔的单个标签或标签模式列表。(详情请参阅 Tag Patterns 部分。)

- 开始日期: 镜像开始的日期。默认使用当前的日期和时间。

- 同步间隔 : 默认为每 24 小时同步一次。您可以根据小时或天更改。

-

Skopeo timeout internal: 默认为

300秒(5 分钟)。最大超时长度为43200秒(12 小时)。 - robot User: 创建一个新的机器人帐户,或选择一个现有的机器人帐户来进行镜像。

- 用户名 : 用于访问您要镜像的存储库的外部 registry 的用户名。

- Password : 与用户名关联的密码。请注意,密码不能包含需要转义字符(\)的字符。

-

registry 位置: 您要镜像的外部存储库,如

在 Advanced Settings 部分中,您可以选择使用以下选项配置 SSL/TLS 和代理:

- 验证 TLS : 如果您需要 HTTPS 并在与目标远程 registry 通信时验证证书,请选择这个选项。

- 接受 Unsigned Images : 选择此选项允许镜像未签名的镜像。

- HTTP Proxy: 如果您需要 HTTPS,并在与目标远程 registry 通信时验证证书,请选择这个选项。

- HTTPS PROXY: 识别访问远程站点所需的 HTTPS 代理服务器(如果需要代理服务器)。

- no Proxy: 不需要代理的位置列表。

- 填写完所有信息后,单击 Enable Mirror。

7.7.2. 现在同步

使用以下步骤启动镜像操作。

流程

- 导航到 存储库 的镜像选项卡。

- 按 立即同步按钮。

验证

- 单击 Logs 选项卡,以查看可用的日志。

- 镜像完成后,镜像会出现在 Tags 选项卡中。

7.8. 用于镜像的事件通知

存储库镜像有三个通知事件:

- 存储库镜像已启动

- 存储库镜像成功

- Repository Mirror Unsuccessful

事件可以在每个存储库的 Settings 选项卡中配置,并且支持电子邮件、Slack、Quay UI 和 Webhook 等所有现有通知方法。

7.9. 镜像标签模式

必须至少输入一个标签。下表引用可能的镜像标签模式。

7.9.1. 模式语法

| pattern | 描述 |

| * | 匹配所有字符 |

| ? | 匹配任何单个字符 |

| [seq] | 匹配顺序中 的任何字符 |

| [!seq] | 匹配任何不在顺序 中的字符 |

7.9.2. 标签模式示例

| Pattern 示例 | 匹配示例 |

| v3* | v32, v3.1, v3.2, v3.2-4beta, v3.3 |

| v3.* | v3.1、v3.2、v3.2-4beta |

| v3.? | v3.1, v3.2, v3.3 |

| v3.[12] | v3.1, v3.2 |

| v3.[12]* | v3.1、v3.2、v3.2-4beta |

| v3.[!1]* | v3.2, v3.2-4beta, v3.3 |

7.10. 使用已镜像的存储库

创建已镜像的存储库后,您可以使用几种方法来使用该存储库。

从 Repositories 页面中选择已镜像的存储库进行以下任一操作:

- 启用/禁用存储库 :选择左列中的镜像按钮,然后切换 Enabled 复选框来临时启用或禁用存储库。

- 检查镜像日志 :要确保已镜像的存储库正常工作,您可以检查镜像日志。为此,请选择左侧栏中的 Usage Logs 按钮。例如:

- 现在同步镜像 :要立即同步存储库中的镜像,请选择 Sync Now 按钮。

- 更改凭证 :要更改用户名和密码,请从 Credentials 行选择 DELETE。然后,选择 None 并添加在提示时登录到外部 registry 所需的用户名和密码。

- 取消镜像 :要停止镜像,这样可保持当前镜像可用,但停止新的镜像同步,请选择 CANCEL 按钮。

设置机器人权限 :Red Hat Quay 机器人帐户命名为 token,用于保存用于访问外部存储库的凭证。通过将凭证分配给机器机器,该机器可以在需要访问同一外部 registry 的多个已镜像存储库中使用。

您可以通过导航到 Organizations → Robot accounts 将现有的机器人分配给存储库。在这个页面中,您可以查看以下信息:

- 检查将哪些存储库分配给该机器机器。

-

从 PERMISSION 字段中,将

Read、Write或Admin特权分配给该机器人。

- 更改机器人凭证 :Robots 可以存放凭证,如 Kubernetes secret、Docker 登录信息和 Podman 登录信息。要更改机器凭证,请在 robot's account 窗口中选择 Options gear,然后选择 View Credentials。为外部存储库添加适当的凭据,供机器者需要访问。

- 检查并更改常规设置 :从镜像存储库页面的左列中选择 Settings 按钮(齿轮图标)。在生成的页面中,您可以更改与已镜像存储库关联的设置。特别是,您可以更改 User 和 Iceot 权限,以指定哪些用户和机器机器可以从存储库读取或写入到存储库。

7.11. 仓库镜像建议

存储库镜像的最佳实践包括:

- 仓库镜像 pod 可以在任何节点上运行。这意味着您可以在已在运行 Red Hat Quay 的节点上运行镜像。

- 存储库镜像调度到数据库中,并批量运行。因此,存储库 worker 会检查每个存储库镜像配置文件,并在下一次同步需要时读取。更多镜像 worker 意味着可以同时镜像更多存储库。例如,运行 10 个镜像 worker 表示用户可以并行运行 10 个镜像 Operator。如果用户只有 2 个带有 10 个镜像配置的 worker,则只能执行 2 个 operator。

镜像 pod 的最佳数量取决于以下条件:

- 要镜像的存储库总数

- 存储库中的镜像和标签数量以及更改的频率

并行批处理

例如,如果用户正在镜像具有 100 标签的存储库,则镜像将由一个 worker 完成。用户必须考虑需要并行镜像的软件仓库数量,并基于该 worker 数量。

同一存储库中的多个标签无法并行镜像。

第 8 章 IPv6 和双栈部署

您的独立 Red Hat Quay 部署现在可以在只支持 IPv6 的位置提供,如 Telco 和 Edge 环境。也支持双栈网络,以便 Red Hat Quay 部署可以同时侦听 IPv4 和 IPv6。

有关已知限制列表,请参阅 IPv6 限制

8.1. 启用 IPv6 协议系列

使用以下步骤在独立 Red Hat Quay 部署中启用 IPv6 支持。

先决条件

- 您已将 Red Hat Quay 更新至 3.8。

- 您的主机和容器软件平台(Docker、Podman)必须配置为支持 IPv6。

流程

在部署的

config.yaml文件中,添加FEATURE_LISTEN_IP_VERSION参数并将其设置为IPv6,例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 启动或重启您的 Red Hat Quay 部署。

输入以下命令检查您的部署是否侦听 IPv6:

curl <quay_endpoint>/health/instance {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}$ curl <quay_endpoint>/health/instance {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

在部署的 config.yaml 中启用 IPv6 后,所有 Red Hat Quay 功能都可以正常使用,只要您的环境被配置为使用 IPv6,且不受 ipv6-limitations[current limitations] 禁止。

如果您的环境配置为 IPv4,但 FEATURE_LISTEN_IP_VERSION 配置字段被设置为 IPv6,Red Hat Quay 将无法部署。

8.2. 启用双栈协议系列

使用以下步骤在独立 Red Hat Quay 部署上启用双栈(IPv4 和 IPv6)支持。

先决条件

- 您已将 Red Hat Quay 更新至 3.8。

- 您的主机和容器软件平台(Docker、Podman)必须配置为支持 IPv6。

流程

在部署的

config.yaml文件中,添加FEATURE_LISTEN_IP_VERSION参数并将其设置为双栈,例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 启动或重启您的 Red Hat Quay 部署。

输入以下命令检查您的部署是否在侦听这两个频道:

对于 IPv4,输入以下命令:

curl --ipv4 <quay_endpoint> {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}$ curl --ipv4 <quay_endpoint> {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 对于 IPv6,输入以下命令:

curl --ipv6 <quay_endpoint> {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}$ curl --ipv6 <quay_endpoint> {"data":{"services":{"auth":true,"database":true,"disk_space":true,"registry_gunicorn":true,"service_key":true,"web_gunicorn":true}},"status_code":200}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

在部署的 config.yaml 中启用了双栈后,所有 Red Hat Quay 功能都可以正常使用,只要您的环境是为双栈配置的。

8.3. IPv6 和双栈限制

目前,尝试使用通用 Azure Blob 存储配置配置 Red Hat Quay 部署无法在 IPv6 单堆栈环境中工作。因为 Azure Blob 存储的端点不支持 IPv6,所以这个问题还没有临时解决方案。

如需更多信息,请参阅 PROJQUAY-4433。

目前,尝试使用 Amazon S3 CloudFront 配置 Red Hat Quay 部署不适用于 IPv6 单堆栈环境。由于 Amazon S3 CloudFront 的端点不支持 IPv6,所以这个问题还没有临时解决方案。

如需更多信息,请参阅 PROJQUAY-4470。

第 9 章 Red Hat Quay 的 LDAP 身份验证设置

轻量级目录访问协议(LDAP)是一个开放的、厂商中立的行业标准应用程序协议,用于通过互联网协议(IP)网络访问和维护分布式目录信息服务。Red Hat Quay 支持使用 LDAP 作为身份提供程序。

9.1. 启用 LDAP 时的注意事项

在为 Red Hat Quay 部署启用 LDAP 之前,您应该考虑以下内容:

现有的 Red Hat Quay 部署

当您为已经配置了用户的现有 Red Hat Quay 部署启用 LDAP 时,用户名之间可能会出现冲突。例如,在启用 LDAP 之前,在 Red Hat Quay 中手动创建了一个用户 alice。如果 LDAP 目录中也存在 username ,当 alice 第一次使用 LDAP 登录时,Red Hat Quay 会自动创建一个新的用户 alice alice-1。Red Hat Quay 随后会自动将 LDAP 凭据映射到 alice 帐户。出于一致性的原因,您的 Red Hat Quay 部署可能会出现错误。建议您在启用 LDAP 之前从 Red Hat Quay 中删除任何可能冲突的本地帐户名称。

手动创建用户和 LDAP 身份验证

为 LDAP 配置 Red Hat Quay 时,如果配置选项 FEATURE_USER_CREATION 设置为 True,则会在 Red Hat Quay 的数据库中自动创建 LDAP 验证的用户。如果此选项设为 False,则 LDAP 用户的自动创建用户会失败,并且不允许用户登录。在这种情况下,超级用户需要首先创建所需的用户帐户。相反,如果 FEATURE_USER_CREATION 设置为 True,这还意味着用户仍然可以从 Red Hat Quay 登录屏幕创建帐户,即使 LDAP 中还有对等用户。

9.2. 为 Red Hat Quay 配置 LDAP

您可以通过直接更新 config.yaml 文件并重启部署来为 Red Hat Quay 配置 LDAP。在为 Red Hat Quay 配置 LDAP 时,请使用以下步骤作为参考。

直接更新

config.yaml文件,使其包含以下相关信息:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 添加所有所需的 LDAP 字段后,保存更改并重启 Red Hat Quay 部署。

9.3. 启用 LDAP_RESTRICTED_USER_FILTER 配置字段

LDAP_RESTRICTED_USER_FILTER 配置字段是 LDAP_USER_FILTER 配置字段的子集。配置后,此选项允许 Red Hat Quay 管理员在 Red Hat Quay 使用 LDAP 作为其身份验证提供程序时,将 LDAP 用户配置为受限用户。

使用以下步骤在 Red Hat Quay 部署中启用 LDAP 受限用户。

先决条件

- 您的 Red Hat Quay 部署使用 LDAP 作为其身份验证提供程序。

-

您已在

config.yaml文件中配置了LDAP_USER_FILTER字段。

流程

在部署的

config.yaml文件中,添加LDAP_RESTRICTED_USER_FILTER参数,并指定受限用户组,例如members:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 启动或重启您的 Red Hat Quay 部署。

启用 LDAP_RESTRICTED_USER_FILTER 功能后,您的 LDAP Red Hat Quay 用户会受到读取和写入内容的限制,并创建机构。

9.4. 启用 LDAP_SUPERUSER_FILTER 配置字段

配置 LDAP_SUPERUSER_FILTER 字段后,如果 Red Hat Quay 使用 LDAP 作为其身份验证提供程序,Red Hat Quay 可将轻量级目录访问协议(LDAP)用户配置为超级用户。

使用以下步骤在 Red Hat Quay 部署中启用 LDAP 超级用户。

先决条件

- 您的 Red Hat Quay 部署使用 LDAP 作为其身份验证提供程序。

-

您已在

config.yaml文件中配置了LDAP_USER_FILTER字段。

流程

在部署的

config.yaml文件中,添加LDAP_SUPERUSER_FILTER参数,并添加您要配置为超级用户的组,例如root:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将指定的用户配置为超级用户。

- 启动或重启您的 Red Hat Quay 部署。

启用 LDAP_SUPERUSER_FILTER 功能后,您的 LDAP Red Hat Quay 用户具有超级用户特权。以下选项可供超级用户使用:

- 管理用户

- 管理机构

- 管理服务密钥

- 查看更改日志

- 查询用量日志

- 创建全局可见的用户信息

9.5. 常见 LDAP 配置问题

以下错误可能会返回无效的配置。

- 无效凭据。如果您收到这个错误,则管理员 DN 或管理员 DN 密码值不正确。确保您提供准确的管理员 DN 和密码值。

* 验证超级用户 %USERNAME% 失败。返回此错误的原因如下:

- 未找到用户名。

- 用户在远程身份验证系统中不存在。

- LDAP 授权配置不正确。

无法找到当前登录的用户。为 Red Hat Quay 配置 LDAP 时,可能会出现使用 管理员 DN 字段中提供的用户名和密码成功建立 LDAP 连接的情况。但是,如果无法使用 UID Attribute 或 Mail Attribute 字段在指定的 用户 Relative DN 路径中找到当前登录的用户,则通常有两个潜在的原因:

- 当前登录的用户没有 用户 Relative DN 路径。

管理员 DN 没有搜索或读取指定的 LDAP 路径的权限。

要解决这个问题,请确保登录的用户包含在 用户 Relative DN 路径中,或者为 管理员 DN 帐户提供正确的权限。

9.6. LDAP 配置字段

有关 LDAP 配置字段的完整列表,请参阅 LDAP 配置字段

第 10 章 为 Red Hat Quay 配置 OIDC

为 Red Hat Quay 配置 OpenID Connect (OIDC)可以为部署提供几个优点。例如,OIDC 允许用户使用来自 OIDC 供应商的现有凭证(如 Red Hat Single Sign-On、Google、Github、Microsoft 等)向 Red Hat Quay 进行身份验证。OIDC 的其他优点包括集中式用户管理、增强安全性和单点登录(SSO)。总体而言,OIDC 配置可以简化用户身份验证和管理,增强安全性,并为 Red Hat Quay 用户提供无缝的用户体验。

以下流程演示了如何在 Red Hat Quay 的独立部署中配置 Microsoft Entra ID,以及如何在基于 Operator 的 Red Hat Quay 部署上配置 Red Hat Single Sign-On。这些流程可根据您的部署类型进行交换。

按照以下步骤,无论您选择使用什么身份提供程序,您都可以在 Red Hat Quay 中添加任何 OIDC 供应商。

10.1. 在 Red Hat Quay 的独立部署中配置 Microsoft Entra ID OIDC

通过将 Microsoft Entra ID 身份验证与 Red Hat Quay 集成,您的组织可以利用 Microsoft Entra ID 提供的集中式用户管理和安全功能。某些功能包括根据 Microsoft Entra ID 角色和权限管理用户对 Red Hat Quay 存储库的访问权限,以及启用由 Microsoft Entra ID 提供的多因素身份验证和其他安全功能的功能。

Red Hat Quay 的 Azure Active Directory (Microsoft Entra ID)身份验证允许用户使用 Microsoft Entra ID 凭证验证和访问 Red Hat Quay。

使用以下步骤通过直接更新 Red Hat Quay config.yaml 文件来配置 Microsoft Entra ID。

- 使用以下步骤,您可以在 Red Hat Quay 中添加任何 ODIC 供应商,而不考虑正在添加哪些身份提供程序。

-

如果您的系统启用了防火墙,或者启用了代理,则必须将创建的每个 Oauth 应用程序的所有 Azure API 端点列入白名单。否则,会返回以下错误:

x509: certificate signed by unknown authority。

使用以下引用并更新

config.yaml文件,使用您需要的 OIDC 供应商凭证更新您的 config.yaml 文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 包含 OIDC 配置设置的父键。在本例中,所用的父密钥是

AZURE_LOGIN_CONFIG,但字符串AZURE可以根据您的特定需求替换任意任意字符串,如ABC123。但是,以下字符串不被接受:GOOGLE,GITHUB。这些字符串为其对应的身份平台保留,且需要在您使用的平台时进行特定的config.yaml条目。 - 2

- 与身份提供程序一起注册的应用程序的客户端 ID。

- 3

- 与身份提供程序一起注册的应用的客户端机密。

- 4

- 用于身份验证的 OIDC 服务器地址。在本例中,您必须使用

sts.windows.net作为签发者标识符。使用https://login.microsoftonline.com会导致以下错误:Could not create provider for AzureAD。error: oidc: issuer 与供应商返回的签发者不匹配,预期的 "https://login.microsoftonline.com/73f2e714-xxxx-xxxx-xxxx-dffe1df8a5d5" got "https://sts.windows.net/73f2e714-xxxx-xxxx-xxxx-dffe1df8a5d5/"。 - 5

- 正在验证的服务的名称。

- 6

- 用于验证用户电子邮件地址的声明名称。

正确配置 Microsoft Entra ID 结果使用以下格式进行三个重定向:

-

https://QUAY_HOSTNAME/oauth2/<name_of_service>/callback -

https://QUAY_HOSTNAME/oauth2/<name_of_service>/callback/attach -

https://QUAY_HOSTNAME/oauth2/<name_of_service>/callback/cli

-

- 重启 Red Hat Quay 部署。

10.2. 为 Red Hat Quay 配置 Red Hat Single Sign-On

根据 Keycloak 项目,Red Hat Single Sign-On (RH-SSO)是一个红帽提供的开源身份和访问管理(IAM)解决方案。RH-SSO 允许组织在其系统和应用程序之间管理用户身份、安全应用程序和强制实施访问控制策略。它还提供了一个统一的身份验证和授权框架,允许用户一次登录并获得对多个应用和资源的访问权限,而无需重新验证。如需更多信息,请参阅 Red Hat Single Sign-On。

通过在 Red Hat Quay 上配置 Red Hat Single Sign-On,您可以在 Red Hat Quay 和其他 OpenShift Container Platform 等应用平台之间创建无缝身份验证集成。

使用以下步骤为 OpenShift Container Platform 上的 Red Hat Quay Operator 配置 Red Hat Single Sign-On。

先决条件

- 您已设置 Red Hat Single Sign-On Operator。如需更多信息,请参阅 Red Hat Single Sign-On Operator。

- 您已在 OpenShift Container Platform 部署和 Red Hat Single Sign-On 上为 Red Hat Quay 配置了 SSL/TLS。

- 您已生成了一个证书颁发机构(CA),并将其上传到 Red Hat Single Sign-On Operator 和 Red Hat Quay 配置。

流程

导航到 Red Hat Single Sign-On Admin Console。

- 在 OpenShift Container Platform Web 控制台中 导航至 Network → Route。

- 从下拉列表中选择 Red Hat Single Sign-On 项目。

- 在 Routes 表中查找 Red Hat Single Sign-On Admin 控制台。

- 选择您要用来配置 Red Hat Quay 的 Realm。

- 单击导航面板的 Configure 部分下的 Clients,然后单击 Create 按钮为 Red Hat Quay 添加新的 OIDC。

输入以下信息。

-

客户端 ID:

quay-enterprise -

客户端协议:

openid-connect -

根 URL:

https://<quay_endpoint>/

-

客户端 ID:

- 点击 Save。这会导致重定向到 Clients 设置面板。

- 导航到 Access Type 并选择 Confidential。

导航到 Valid Redirect URI。您必须提供三个重定向 URI。该值应该是 Red Hat Quay registry 的完全限定域名,附加了

/oauth2/redhatsso/callback。例如:-

https://<quay_endpoint>/oauth2/redhatsso/callback -

https://<quay_endpoint>/oauth2/redhatsso/callback/attach -

https://<quay_endpoint>/oauth2/redhatsso/callback/cli

-

- 点 Save 并进入新的 Credentials 设置。

- 复制 Secret 的值。

使用以下步骤使用 Red Hat Quay Operator 配置 Red Hat Single Sign-On。

先决条件

- 您已设置 Red Hat Single Sign-On Operator。如需更多信息,请参阅 Red Hat Single Sign-On Operator。

- 您已在 OpenShift Container Platform 部署和 Red Hat Single Sign-On 上为 Red Hat Quay 配置了 SSL/TLS。

- 您已生成了一个证书颁发机构(CA),并将其上传到 Red Hat Single Sign-On Operator 和 Red Hat Quay 配置。

流程

-

进入 Operators → Installed Operators → Red Hat Quay → Quay Registry → Config Bundle Secret 来编辑 Red Hat Quay

config.yaml文件。然后,点击 Actions → Edit Secret。另外,您可以在本地更新config.yaml文件。 在 OpenShift Container Platform

config.yaml文件中的 Red Hat Quay 中添加以下信息:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 包含 OIDC 配置设置的父键。在本例中,所用的父密钥是

AZURE_LOGIN_CONFIG,但字符串AZURE可以根据您的特定需求替换任意任意字符串,如ABC123。但是,以下字符串不被接受:GOOGLE,GITHUB。这些字符串为其对应的身份平台保留,且需要在您使用的平台时进行特定的config.yaml条目。 - 2

- 使用身份提供程序注册的应用程序的客户端 ID,如

quay-enterprise。 - 3

quay-enterpriseOIDC 客户端设置的 Credentials 选项卡中的 Client Secret。- 4

- Red Hat Single Sign-On 实例的完全限定域名(FQDN),附加

/auth/realms/和 Realm 名称。您必须在末尾包括正斜杠,例如https://sso-redhat.example.com//auth/realms/<keycloak_realm_name>/。 - 5

- 在 Red Hat Quay 登录页面中显示的名称,例如

Red Hat Single Sign On。 - 6

- 更改登录屏幕上的图标。例如:

/static/img/RedHat.svg。 - 7

- 用于验证用户电子邮件地址的声明名称。

- 8

- 用于验证用户电子邮件地址的声明名称。

- 9

- 执行登录流时发送到 OIDC 供应商的范围,例如

openid。

- 在启用了 Red Hat Single Sign-On 的 OpenShift Container Platform 部署中重启 Red Hat Quay。

10.3. Red Hat Quay OIDC 部署的团队同步

管理员可以利用支持组或团队同步的 OpenID Connect (OIDC)身份提供程序,将存储库权限应用到 Red Hat Quay 中的一组用户。这允许管理员避免在 Red Hat Quay 和 OIDC 组间手动创建和同步组定义。

10.3.1. 为 Red Hat Quay OIDC 部署启用同步

当 Red Hat Quay 部署使用 OIDC 身份验证程序时,请使用以下步骤启用团队同步。

以下流程不使用特定的 OIDC 供应商。相反,它概述了如何在 OIDC 供应商和 Red Hat Quay 之间处理团队同步的最佳方法。任何 OIDC 供应商都可以用来启用团队同步,但设置可能会因您的供应商而异。

流程

使用以下信息更新

config.yaml文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 必需。此 Red Hat Quay 实例注册的 OIDC 客户端 ID。

- 2

- 必需。此 Red Hat Quay 实例注册的 OIDC 客户端 secret。

- 3

- 必需。用于身份验证的 OIDC 服务器地址。这个 URL 应该是,对 <

OIDC_SERVER>/.well-known/openid-configuration的GET请求会返回供应商的配置信息。此配置信息对于依赖方(RP)与 OpenID Connect 供应商安全交互非常重要,并获取身份验证和授权流程的必要详情。 - 4

- 必需。正在验证的服务的名称。

- 5

- 必需。OIDC 令牌有效负载中的密钥名称,其中包含有关用户组成员资格的信息。此字段允许身份验证系统从 OIDC 令牌中提取组成员资格信息,以便它可用于 Red Hat Quay。

- 6

- 必需。添加 Red Hat Quay 用来与 OIDC 供应商通信的其他范围。必须包括

'openid'。其他范围是可选的。 - 7

- 是否允许或禁用

/userinfo端点。如果使用 Azure Entra ID,请将此字段设置为True。默认值为False。 - 8

- 必需。是否允许团队成员资格从身份验证引擎中的后备组中同步。

- 9

- 可选。如果启用,非超级用户可以设置团队同步。

- 重启 Red Hat Quay registry。

10.3.2. 为团队同步设置 Red Hat Quay 部署

- 通过 OIDC 供应商登录到您的 Red Hat Quay registry。

- 在 Red Hat Quay v2 UI 仪表板中,单击 Create Organization。

-

输入 和 Organization 名称,如

test-org。 - 点机构的名称。

- 在导航窗格中,点 Teams 和 membership。

-

点 Create new team 并输入名称,例如

testteam。 在 Create team 弹出窗口中:

- 可选。将此团队添加到存储库。

-

通过在用户帐户名称中输入,添加团队成员,如

user1。 - 将机器人帐户添加到此团队。此页面提供了创建机器人帐户的选项。

- 点击 Next。

- 在 Review and Finish 页面中,查看您提供的信息,并点击 Review and Finish。

- 要为 Red Hat Quay OIDC 部署启用团队同步,请点击 Teams 和 membership 页面上的 Enable Directory Sync。

如果您的 OIDC 验证器是 Azure Entra ID,或者使用不同的供应商,则会提示您输入组对象 ID。请注意弹出窗口中的消息:

警告请注意,在启用团队同步后,已经属于团队的用户成员资格将被撤销。OIDC 组将是单个数据源。这是一个不可逆的操作。Quay 中团队的用户成员资格将为只读。

- 单击 Enable Sync。

您将返回到 Teams 和 membership 页面。请注意,这个团队的用户已被删除,并在重新登录后重新添加。在这个阶段,只有机器人帐户仍然是团队的一部分。

页面顶部的横幅确认团队已同步:

This team is synchronized with a group in OIDC and its user membership is therefore read-only.

This team is synchronized with a group in OIDC and its user membership is therefore read-only.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 单击 Directory Synchronization Config scala,会显示您的部署与之同步的 OIDC 组。

- 从 Red Hat Quay registry 注销,再继续验证步骤。

验证

使用以下验证过程来确保 user1 显示为团队成员。

- 重新登录您的 Red Hat Quay registry。

-

点 Organizations → test-org → test-team Teams 和 memberships。

user1现在作为这个团队的团队成员显示。

验证

使用以下步骤通过 OIDC 供应商从组中删除 user1,然后将其从 Red Hat Quay 上的团队中删除。

- 进入您的 OIDC 供应商管理控制台。

- 进入 OIDC 供应商的 Users 页面。本页的名称因您的供应商而异。

-

单击与 Red Hat Quay 关联的用户名,如

user1。 - 从配置的身份提供程序中的组中删除该用户。

- 从用户删除或取消分配访问权限。

- 登录到您的 Red Hat Quay registry。

-

点 Organizations → test-org → test-team Teams 和 memberships。

user1已从这个团队中删除。

第 11 章 使用机器人帐户进行无密钥身份验证

在以前的 Red Hat Quay 版本中,机器人帐户令牌在令牌生命周期内有效,除非删除或重新生成。对于不想存储长期密码或管理删除、重新生成或新的身份验证令牌的用户,没有过期的令牌。

使用 Red Hat Quay 3 时,Red Hat Quay 管理员提供了与 Red Hat Single Sign-On (基于 Keycloak 项目)或 Microsoft Entra ID 交换外部 OIDC 令牌的功能。这允许机器人帐户利用上一小时的令牌,这些令牌定期刷新,并可用于验证单个事务。

此功能通过降低机器人令牌在一小时后删除令牌暴露的可能性,从而大大增强了 Red Hat Quay registry 的安全性。

使用机器人帐户配置无密钥身份验证是一个多步骤流程,需要设置机器人联合,从 OIDC 提供程序生成 OAuth2 令牌,并为机器人帐户访问令牌交换 OAuth2 令牌。

11.1. 使用 Red Hat Sign Sign-On 生成 OAuth2 令牌

以下流程演示了如何使用 Red Hat Single Sign-On 生成 OAuth2 令牌。根据您的 OIDC 供应商,这些步骤会有所不同。

流程

在 Red Hat Single Sign-On UI 中:

- 点 Clients,然后是可以请求用户验证的应用程序或服务的名称。

在客户端的 Settings 页面中,确保设置或启用以下选项:

- 客户端 ID

- 有效的重定向 URI

- 客户端身份验证

- 授权

- 标准流程

直接访问授予

注意根据您的设置,设置可能会有所不同。

- 在 Credentials 页面中,存储 Client Secret 以备将来使用。

-

在 Users 页面中,单击 Add user 并输入用户名,如

service-account-quaydev。然后,单击 Create。 - 单击用户的名称,如 Users 页面上的 service-account-quaydev。

- 点 Credentials 标签页 → Set password →,为用户提供密码。如果保证,您可以通过选择 Temporary 选项使此密码临时化。

点 Realm settings 选项卡 → OpenID Endpoint Configuration。存储

/protocol/openid-connect/token端点。例如:http://localhost:8080/realms/master/protocol/openid-connect/token

http://localhost:8080/realms/master/protocol/openid-connect/tokenCopy to Clipboard Copied! Toggle word wrap Toggle overflow

在网页浏览器中,导航到以下 URL:

http://<keycloak_url>/realms/<realm_name>/protocol/openid-connect/auth?response_type=code&client_id=<client_id>

http://<keycloak_url>/realms/<realm_name>/protocol/openid-connect/auth?response_type=code&client_id=<client_id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 出现提示时,使用 service-account-quaydev 用户和您设置的临时密码登录。必要时,提供所需信息并设置永久密码,从而完成登录。

您将被重定向到为客户端提供的 URI 地址。例如:

https://localhost:3000/cb?session_state=5c9bce22-6b85-4654-b716-e9bbb3e755bc&iss=http%3A%2F%2Flocalhost%3A8080%2Frealms%2Fmaster&code=ea5b76eb-47a5-4e5d-8f71-0892178250db.5c9bce22-6b85-4654-b716-e9bbb3e755bc.cdffafbc-20fb-42b9-b254-866017057f43

https://localhost:3000/cb?session_state=5c9bce22-6b85-4654-b716-e9bbb3e755bc&iss=http%3A%2F%2Flocalhost%3A8080%2Frealms%2Fmaster&code=ea5b76eb-47a5-4e5d-8f71-0892178250db.5c9bce22-6b85-4654-b716-e9bbb3e755bc.cdffafbc-20fb-42b9-b254-866017057f43Copy to Clipboard Copied! Toggle word wrap Toggle overflow 记录地址中提供的

代码。例如:code=ea5b76eb-47a5-4e5d-8f71-0892178250db.5c9bce22-6b85-4654-b716-e9bbb3e755bc.cdffafbc-20fb-42b9-b254-866017057f43

code=ea5b76eb-47a5-4e5d-8f71-0892178250db.5c9bce22-6b85-4654-b716-e9bbb3e755bc.cdffafbc-20fb-42b9-b254-866017057f43Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意这是只能一次使用的临时代码。如果需要,您可以刷新页面或重新访问 URL 以获取另一个代码。

在终端中,使用以下

curl -X POST命令来生成临时 OAuth2 访问令牌:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

{"access_token":"eyJhbGciOiJSUzI1NiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJTVmExVHZ6eDd2cHVmc1dkZmc1SHdua1ZDcVlOM01DN1N5T016R0QwVGhVIn0...", "expires_in":60,"refresh_expires_in":1800,"refresh_token":"eyJhbGciOiJIUzUxMiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJiNTBlZTVkMS05OTc1LTQwMzUtYjNkNy1lMWQ5ZTJmMjg0MTEifQ.oBDx6B3pUkXQO8m-M3hYE7v-w25ak6y70CQd5J8f5EuldhvTwpWrC1K7yOglvs09dQxtq8ont12rKIoCIi4WXw","token_type":"Bearer","not-before-policy":0,"session_state":"5c9bce22-6b85-4654-b716-e9bbb3e755bc","scope":"profile email"}{"access_token":"eyJhbGciOiJSUzI1NiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJTVmExVHZ6eDd2cHVmc1dkZmc1SHdua1ZDcVlOM01DN1N5T016R0QwVGhVIn0...", "expires_in":60,"refresh_expires_in":1800,"refresh_token":"eyJhbGciOiJIUzUxMiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJiNTBlZTVkMS05OTc1LTQwMzUtYjNkNy1lMWQ5ZTJmMjg0MTEifQ.oBDx6B3pUkXQO8m-M3hYE7v-w25ak6y70CQd5J8f5EuldhvTwpWrC1K7yOglvs09dQxtq8ont12rKIoCIi4WXw","token_type":"Bearer","not-before-policy":0,"session_state":"5c9bce22-6b85-4654-b716-e9bbb3e755bc","scope":"profile email"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

将

access_token从上一步中存储,因为它将在以下流程中为 Red Hat Quay 机器人帐户令牌交换。

11.2. 使用 Red Hat Quay v2 UI 设置机器人帐户联邦

以下流程演示了如何使用 Red Hat Quay v2 UI 设置机器人帐户联合。此流程使用 Red Hat Single Sign-On,它基于 Keycloak 项目。这些步骤以及设置机器人帐户联邦的信息会根据 OIDC 供应商的不同而有所不同。

先决条件

-

您已创建了一个机构。以下示例使用

fed_test。 -

您已创建了机器人帐户。以下示例使用

fest_test+robot1。 - 您已为 Red Hat Quay 部署配置了 OIDC。以下示例使用 Red Hat Single Sign-On。

流程

在 Red Hat Single Sign-On 主页中:

-

选择用于验证用于 Red Hat Quay 的适当域。存储签发者 URL,例如

https://keycloak-auth-realm.quayadmin.org/realms/quayrealm。 - 点 Users → 要与机器人帐户关联的用户名称进行身份验证。您必须使用生成 OAuth2 访问令牌时所用的同一用户帐户。

在 Details 页面中,存储用户的 ID,例如

449e14f8-9ebeb5-4d59-a63e-b7a77c75f770。注意此步骤中收集的信息会根据您的 OIDC 供应商的不同而有所不同。例如,在 Red Hat Single Sign-On 中,用户的 ID 用作 Subject 来在后续步骤中设置机器人帐户联合。对于不同的 OIDC 供应商,如 Microsoft Entra ID,此信息存储为 主题。

-

选择用于验证用于 Red Hat Quay 的适当域。存储签发者 URL,例如

在 Red Hat Quay registry 中:

- 导航到 Organizations,再单击组织的名称,例如 fed_test。

- 单击 Robot Accounts。

- 点菜单 kebab → Set robot federation。

- 点 + 符号。

在弹出窗口中包括以下信息:

-

签发者 URL:

https://keycloak-auth-realm.quayadmin.org/realms/quayrealm.对于 Red Hat Single Sign-On,这是 Red Hat Single Sign-On 域的 URL。这根据您的 OIDC 供应商可能会有所不同。 -

主题:

449e14f8-9eb5-4d59-a63e-b7a77c75f770.对于 Red Hat Single Sign-On,主题 是 Red Hat Single Sign-On 用户的 ID。这根据您的 OIDC 供应商的不同而有所不同。例如,如果您使用 Microsoft Entra ID,则 主题 将是 主题 或您的 Entra ID 用户。

-

签发者 URL:

- 点击 Save。

11.3. 为 Red Hat Quay 机器人令牌交换 OAuth2 访问令牌

以下流程利用 上一步中生成的访问令牌 来创建新的 Red Hat Quay 机器人帐户令牌。新的 Red Hat Quay 机器人帐户令牌用于您的 OIDC 供应商和 Red Hat Quay 间的身份验证。

以下示例使用 Python 脚本为 Red Hat Quay 机器人令牌交换 OAuth2 访问令牌。

先决条件

-

已安装

python3CLI 工具。

流程

将以下 Python 脚本保存到

.py文件中,如robot_fed_token_auth.pyCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果您的 Red Hat Quay 部署使用自定义 SSL/TLS 证书,则响应必须是

response = requests.get (URL,auth=(robot_user,fed_token),verify=False),其中包括verify=False标志。

将 OAuth2 访问令牌导出为

TOKEN。例如:export TOKEN = eyJhbGciOiJSUzI1NiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJTVmExVHZ6eDd2cHVmc1dkZmc1SHdua1ZDcVlOM01DN1N5T016R0QwVGhVIn0...

$ export TOKEN = eyJhbGciOiJSUzI1NiIsInR5cCIgOiAiSldUIiwia2lkIiA6ICJTVmExVHZ6eDd2cHVmc1dkZmc1SHdua1ZDcVlOM01DN1N5T016R0QwVGhVIn0...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令运行

robot_fed_token_auth.py脚本:python3 robot_fed_token_auth.py

$ python3 robot_fed_token_auth.pyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

<Response [200]> {"token": "string..."}<Response [200]> {"token": "string..."}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要此令牌在一小时后过期。一小时后,必须生成新的令牌。

将机器人帐户访问令牌导出为

QUAY_TOKEN。例如:export QUAY_TOKEN=291cmNlX2FjY2VzcyI6eyJhY2NvdW50Ijp7InJvbGVzIjpbIm1hbmFnZS1hY2NvdW50IiwibWFuYWdlLWFjY291bnQtbGlua3MiLCJ2aWV3LXByb2ZpbGUiXX19LCJzY29wZSI6InByb2ZpbGUgZW1haWwiLCJlbWFpbF92ZXJpZ

$ export QUAY_TOKEN=291cmNlX2FjY2VzcyI6eyJhY2NvdW50Ijp7InJvbGVzIjpbIm1hbmFnZS1hY2NvdW50IiwibWFuYWdlLWFjY291bnQtbGlua3MiLCJ2aWV3LXByb2ZpbGUiXX19LCJzY29wZSI6InByb2ZpbGUgZW1haWwiLCJlbWFpbF92ZXJpZCopy to Clipboard Copied! Toggle word wrap Toggle overflow

11.4. 推送和拉取镜像

在生成了新的机器人帐户访问令牌并导出后,您可以使用访问令牌登录和机器人帐户,并推送和拉取镜像。

先决条件

- 您已将 OAuth2 访问令牌导出到新的机器人帐户访问令牌。

流程

使用

fest_test+robot1机器人帐户和QUAY_TOKEN访问令牌登录到您的 Red Hat Quay registry。例如:podman login <quay-server.example.com> -u fed_test+robot1 -p $QUAY_TOKEN

$ podman login <quay-server.example.com> -u fed_test+robot1 -p $QUAY_TOKENCopy to Clipboard Copied! Toggle word wrap Toggle overflow 从机器人帐户具有正确权限的 Red Hat Quay 存储库拉取镜像。例如:

podman pull <quay-server.example.com/<repository_name>/<image_name>>

$ podman pull <quay-server.example.com/<repository_name>/<image_name>>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 尝试从机器人帐户没有适当权限的 Red Hat Quay 存储库中拉取镜像。例如:

podman pull <quay-server.example.com/<different_repository_name>/<image_name>>

$ podman pull <quay-server.example.com/<different_repository_name>/<image_name>>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Error: initializing source docker://quay-server.example.com/example_repository/busybox:latest: reading manifest in quay-server.example.com/example_repository/busybox: unauthorized: access to the requested resource is not authorized

Error: initializing source docker://quay-server.example.com/example_repository/busybox:latest: reading manifest in quay-server.example.com/example_repository/busybox: unauthorized: access to the requested resource is not authorizedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 一小时后,机器人帐户的凭据被设为过期。之后,您必须为此机器人帐户生成新的访问令牌。

第 12 章 为 Red Hat Quay 配置 AWS STS

对于独立的 Red Hat Quay 部署、Red Hat Quay on OpenShift Container Platform 和 Red Hat OpenShift Service on AWS (ROSA),支持 Amazon Web Services (AWS)安全令牌服务(STS)。AWS STS 是一个 web 服务,用于请求 AWS Identity and Access Management (IAM)用户的临时、具有有限权限的凭证,以及用于您验证或 联邦用户的用户。此功能对于将 Amazon S3 用作对象存储的集群很有用,允许 Red Hat Quay 使用 STS 协议与 Amazon S3 进行身份验证,这可以提高集群的整体安全性,并帮助确保正确验证并授权对敏感数据的访问。

为 OpenShift Container Platform 或 ROSA 配置 AWS STS 需要创建 AWS IAM 用户、创建 S3 角色并配置 Red Hat Quay config.yaml 文件使其包含正确的资源。

使用以下步骤为 Red Hat Quay 配置 AWS STS。

12.1. 将 Red Hat Quay 配置为使用 AWS STS

使用以下步骤编辑 Red Hat Quay config.yaml 文件以使用 AWS STS。

流程

更新 Red Hat Quay 的

config.yaml文件,使其包含以下信息:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 重启 Red Hat Quay 部署。

验证

标记示例镜像,如

busybox,它将推送到存储库。例如:podman tag docker.io/library/busybox <quay-server.example.com>/<organization_name>/busybox:test

$ podman tag docker.io/library/busybox <quay-server.example.com>/<organization_name>/busybox:testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来推送示例镜像:

podman push <quay-server.example.com>/<organization_name>/busybox:test

$ podman push <quay-server.example.com>/<organization_name>/busybox:testCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 导航到您在 Red Hat Quay registry → Tags 中将镜像推送到的 Organization,以验证推送是否成功。

- 进入到 Amazon Web Services (AWS)控制台,找到您的 s3 存储桶。

- 点 s3 存储桶的名称。

- 在 Objects 页面上,单击 datastorage/。

在 datastorage/ 页面中,应该看到以下资源:

- sha256/

上传/

这些资源表示推送成功,并且 AWS STS 已被正确配置。

第 13 章 Red Hat Quay 中的 Prometheus 和 Grafana 指标

Red Hat Quay 会在每个实例上导出 Prometheus- 和 Grafana 兼容的端点,以便轻松监控和警报。

13.1. 公开 Prometheus 端点

13.1.1. 独立 Red Hat Quay

当使用 podman run 启动 Quay 容器时,公开指标端口 9091 :

sudo podman run -d --rm -p 80:8080 -p 443:8443 -p 9091:9091\ --name=quay \ -v $QUAY/config:/conf/stack:Z \ -v $QUAY/storage:/datastorage:Z \ registry.redhat.io/quay/quay-rhel8:v3.15.1

$ sudo podman run -d --rm -p 80:8080 -p 443:8443 -p 9091:9091\

--name=quay \

-v $QUAY/config:/conf/stack:Z \

-v $QUAY/storage:/datastorage:Z \

registry.redhat.io/quay/quay-rhel8:v3.15.1现在,指标将可用:

curl quay.example.com:9091/metrics

$ curl quay.example.com:9091/metrics有关配置 Prometheus 和 Grafana 以监控 Quay 存储库计数的详情,请参阅使用 Prometheus 和 Grafana 监控 Quay。

13.1.2. Red Hat Quay Operator

确定 quay-metrics 服务的集群 IP:

连接到集群,并使用 quay-metrics 服务的集群 IP 和端口访问指标:

13.1.3. 将 Prometheus 设置为消耗指标

Prometheus 需要一种方式来访问集群中运行的所有 Red Hat Quay 实例。在典型的设置中,这通过在名为 DNS 条目中列出所有 Red Hat Quay 实例来实现,然后提供给 Prometheus。

13.1.4. Kubernetes 下的 DNS 配置

可将简单的 Kubernetes 服务配置为 为 Prometheus 提供 DNS 条目。

13.1.5. 手动集群的 DNS 配置

SkyDNS 是不使用 Kubernetes 时管理此 DNS 记录的简单解决方案。SkyDNS 可以在 etcd 集群上运行。您可以在 etcd 存储中添加和删除集群中的每个 Red Hat Quay 实例的条目。SkyDNS 将定期从那里读取它们,并相应地更新 Quay 实例列表。

13.2. 指标简介

Red Hat Quay 提供了有助于监控 registry 的指标,包括常规 registry 使用的指标、上传、下载、垃圾回收和身份验证。

13.2.1. 常规 registry 统计

常规 registry 统计可指示 registry 的增长量。

| 指标名称 | 描述 |

|---|---|

| quay_user_rows | 数据库中的用户数 |

| quay_robot_rows | 数据库中的机器人帐户数 |

| quay_org_rows | 数据库中的机构数量 |

| quay_repository_rows | 数据库中的存储库数 |

| quay_security_scanning_unscanned_images_remaining_total | 未被最新安全扫描程序扫描的镜像数 |

指标输出示例

13.2.2. 队列项

队列项目 指标提供有关 Quay 用来管理工作的多个队列的信息。

| 指标名称 | 描述 |

|---|---|

| quay_queue_items_available | 特定队列中的项目数 |

| quay_queue_items_locked | 正在运行的项目数 |

| quay_queue_items_available_unlocked | 等待处理的项目数 |

指标标签

queue_name : 队列的名称。其中之一:

- exportactionlogs : 排队请求以导出操作日志。这些日志随后会被处理并放入存储中。然后,通过电子邮件将链接发送到请求者。

- namespacegc: 要收集的垃圾命名空间

- 通知: 要发送存储库通知队列

- repositorygc: 要收集垃圾收集的队列存储库

- secscanv4: 特定于 Clair V4 的通知队列

- dockerfilebuild: Quay docker 构建队列

- Imagestoragereplication : 要在多个存储间复制排队 Blob

- chunk_cleanup : 需要删除队列 Blob 段。这仅适用于某些存储实施,如 Swift。

例如,queue labelled repositorygc 包含由存储库垃圾回收 worker 标记的存储库。对于带有 queue_name 标签为 repositorygc 的指标:

- quay_queue_items_locked 是当前删除的存储库数。

- quay_queue_items_available_unlocked 是 worker 等待处理的存储库数量。

指标输出示例

13.2.3. 垃圾回收指标

这些指标显示从垃圾回收(gc)中删除多少个资源。它们显示 gc worker 运行的次数,以及已删除的命名空间、存储库和 Blob 数量。

| 指标名称 | 描述 |

|---|---|

| quay_gc_iterations_total | GCWorker 的迭代数 |

| quay_gc_namespaces_purged_total | NamespaceGCWorker 清除的命名空间数量 |

| quay_gc_repos_purged_total | RepositoryGCWorker 或 NamespaceGCWorker 清除的存储库数量 |

| quay_gc_storage_blobs_deleted_total | 删除的存储 Blob 数量 |

指标输出示例

13.2.3.1. 多部分上传指标

多部分上传指标显示上传到存储的 Blob 数量(S3、Rados、GoogleCloudStorage、RHOCS)。当 Quay 无法正确将 Blob 上传到存储中时,这有助于识别问题。

| 指标名称 | 描述 |

|---|---|

| quay_multipart_uploads_started_total | 将多部分上传到启动的 Quay 存储的数量 |

| quay_multipart_uploads_completed_total | 上传到完成的 Quay 存储的多部分数 |

指标输出示例

13.2.4. 镜像拉取(pull)/拉取指标

有多个与推送和拉取镜像相关的指标。

13.2.4.1. 镜像拉取(pull)总数

| 指标名称 | 描述 |

|---|---|

| quay_registry_image_pulls_total | 从 registry 下载的镜像数量。 |

指标标签

- 协议: 使用的 registry 协议(应该始终为 v2)

- ref: ref 用于拉取 - 标签、清单

- status: 请求的 http 返回码

13.2.4.2. 镜像拉取(pull)的镜像拉取(pull)

| 指标名称 | 描述 |

|---|---|

| quay_registry_image_pulled_estimated_bytes_total | 从 registry 下载的字节数 |

指标标签

- 协议: 使用的 registry 协议(应该始终为 v2)

13.2.4.3. 镜像推送总数

| 指标名称 | 描述 |

|---|---|

| quay_registry_image_pushes_total | 从 registry 上传的镜像数量。 |

指标标签

- 协议: 使用的 registry 协议(应该始终为 v2)

- pstatus: 请求的 http 返回码

- pmedia_type : 上传的清单类型

13.2.4.4. 推送的镜像字节

| 指标名称 | 描述 |

|---|---|

| quay_registry_image_pushed_bytes_total | 上传到 registry 的字节数 |

指标输出示例

# HELP quay_registry_image_pushed_bytes_total number of bytes pushed to the registry

# TYPE quay_registry_image_pushed_bytes_total counter

quay_registry_image_pushed_bytes_total{host="example-registry-quay-app-6df87f7b66-9tfn6",instance="",job="quay",pid="221",process_name="registry:application"} 0

...

# HELP quay_registry_image_pushed_bytes_total number of bytes pushed to the registry

# TYPE quay_registry_image_pushed_bytes_total counter

quay_registry_image_pushed_bytes_total{host="example-registry-quay-app-6df87f7b66-9tfn6",instance="",job="quay",pid="221",process_name="registry:application"} 0

...13.2.5. 身份验证指标

身份验证指标提供身份验证请求数,按 type 标记,以及它是否成功。例如,此指标可用于监控失败的基本身份验证请求。

| 指标名称 | 描述 |

|---|---|

| quay_authentication_attempts_total | 跨 registry 和 API 的身份验证尝试次数 |

指标标签

auth_kind : 使用的 auth 类型,包括:

- 基本的

- oauth

- credentials

- success: true 或 false

指标输出示例

第 14 章 Red Hat Quay 配额管理和强制概述

使用 Red Hat Quay 时,具有超级用户权限的管理员可以通过建立配置的存储配额限制来报告存储消耗并包含 registry 增长。Red Hat Quay 超级用户可以通过以下方式管理其环境的容量限制:

- 配额报告: 通过此设置,管理员可以跟踪其所有机构的存储消耗。此外,用户可以跟踪其所分配组织的存储消耗。

- 配额管理: 通过此设置,管理员可以为 Red Hat Quay 用户定义软和硬检查。软检查告诉用户机构的存储是否消耗达到其配置的阈值。硬检查可防止用户在存储消耗达到配置的限制时推送到 registry。

可以为整个 registry 或 registry 中的特定存储库设置配额。

这些功能中,这些功能允许 Red Hat Quay registry 的服务所有者定义服务级别协议,并支持健康的资源预算。

14.1. 配额管理限制

配额管理功能的一个限制是计算工件推送上的资源消耗会导致计算成为推送的关键路径的一部分。如果没有这种情况,使用数据可能会偏移。

最大存储配额大小取决于所选数据库:

| 变量 | Description |

|---|---|

| Postgres | 8388608 TB |

| MySQL | 8388608 TB |

| SQL Server | 16777216 TB |

14.2. 设置系统范围的默认配额

要指定应用于每个组织和用户的系统范围默认存储配额,您可以使用 DEFAULT_SYSTEM_REJECT_QUOTA_BYTES 配置标志。当设置此字段并且满足配额限制时,系统会自动拒绝新的工件。默认情况下禁用此配置字段。

如果您为机构或用户配置特定的配额,然后删除该配额,则如果已设置了一个配额,则系统范围的默认配额会被应用。同样,如果您为机构或用户配置了特定的配额,然后修改系统范围的默认配额,则更新的系统范围内的默认设置会覆盖任何特定的设置。

以下流程演示了如何配置系统范围的默认配额。

流程

通过在

config.yaml文件中包含DEFAULT_SYSTEM_REJECT_QUOTA_BYTES字段来设置系统范围的默认存储配额。例如:# ... DEFAULT_SYSTEM_REJECT_QUOTA_BYTES: 100gb # ...

# ... DEFAULT_SYSTEM_REJECT_QUOTA_BYTES: 100gb # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 重启 Red Hat Quay registry。

14.3. 使用 Red Hat Quay UI 为机构建立配额

以下流程描述了如何报告存储消耗并为存储库建立存储配额限制。

先决条件

- 超级用户帐户。

- 有足够的存储来满足配额限制的需求。

流程

在

config.yaml文件中设置FEATURE_QUOTA_MANAGEMENT: True,然后重新启动 registry。例如:# ... FEATURE_QUOTA_MANAGEMENT: True # ...

# ... FEATURE_QUOTA_MANAGEMENT: True # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 创建新机构或选择一个现有组织。

- 以超级用户身份登录 registry,再导航到 Super User Admin Panel 上的 Manage Organizations 选项卡。点击您要为其创建存储配额限制的机构的 Options 图标。

- 单击配置配额。

- 对于 Set storage quota,请输入初始配额,例如 10 MiB。然后单击 应用。

可选: 对于 Quota 策略,请选择以下操作 之一。然后,输入 Quota Threshold,然后单击 Add Limit。

- 拒绝 :选择此选项时,超过已建立配额的任何工件都会被拒绝。

警告 :选择了这个选项时,用户会收到超过配置配额的推送工件的通知,但工件可以成功推送。

注意配额阈值百分比决定 Red Hat Quay 何时启动警告用户,即存储库正在接近其分配的存储配额。

验证

输入以下命令拉取示例工件:

podman pull busybox

$ podman pull busyboxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令标记示例工件:

podman tag docker.io/library/busybox quay-server.example.com/testorg/busybox:test

$ podman tag docker.io/library/busybox quay-server.example.com/testorg/busybox:testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令将示例工件推送到机构:

podman push --tls-verify=false quay-server.example.com/testorg/busybox:test

$ podman push --tls-verify=false quay-server.example.com/testorg/busybox:testCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 导航到 Red Hat Quay UI 上的 Super User Admin Panel,然后单击 Manage Organizations。Organizations 页面显示工件使用的配额的总比例。

可选:输入以下命令来拉取第二个示例工件,其意超过已建立的配额:

podman pull nginx

$ podman pull nginxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:输入以下命令标记第二个工件:

podman tag docker.io/library/nginx quay-server.example.com/testorg/nginx

$ podman tag docker.io/library/nginx quay-server.example.com/testorg/nginxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:输入以下命令将第二个工件推送到机构:

podman push --tls-verify=false quay-server.example.com/testorg/nginx

$ podman push --tls-verify=false quay-server.example.com/testorg/nginxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果工件超过定义的配额,并将 Quota 策略设置为 Reject,则返回以下出错信息:

denied: Quota has been exceeded on namespace

denied: Quota has been exceeded on namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果工件超过定义的配额,并将 Quota 策略设置为 Warning,则不会返回错误消息,并且镜像成功推送。

另外,Red Hat Quay UI 上也会在 Red Hat Quay UI 上返回对 Reject 和 Warning 策略的通知。

14.4. 使用 API 管理配额限制

首次创建机构时,它没有建立的配额。您可以使用 API 检查、创建、更改或删除机构的配额限制。

先决条件

- 您已生成了 OAuth 访问令牌。

14.4.1. 使用 API 设置配额

使用以下步骤使用 Red Hat Quay API 设置配额限制。

流程

要为机构设置配额,您可以使用

POST /api/v1/organization/{orgname}/quota端点:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

"Created"

"Created"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

GET /api/v1/organization/{orgname}/quota命令查看您的机构是否已建立的配额:curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://<quay-server.example.com>/api/v1/organization/<organization_name>/quota | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://<quay-server.example.com>/api/v1/organization/<organization_name>/quota | jqCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

[{"id": 1, "limit_bytes": 10737418240, "limit": "10.0 GiB", "default_config": false, "limits": [], "default_config_exists": false}][{"id": 1, "limit_bytes": 10737418240, "limit": "10.0 GiB", "default_config": false, "limits": [], "default_config_exists": false}]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以使用

PUT /api/v1/organization/{orgname}/quota/{quota_id}命令修改现有的配额限制。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

{"id": 1, "limit_bytes": 21474836480, "limit": "20.0 GiB", "default_config": false, "limits": [], "default_config_exists": false}{"id": 1, "limit_bytes": 21474836480, "limit": "20.0 GiB", "default_config": false, "limits": [], "default_config_exists": false}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

14.4.2. 使用 API 查看配额使用量

使用以下步骤使用 Red Hat Quay API 查看配额使用量。

流程

要查看消耗的存储,

GET数据来自 /api/v1/repository 端点:示例命令

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/repository?last_modified=true&namespace=testorg&popularity=true&public=true' | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/repository?last_modified=true&namespace=testorg&popularity=true&public=true' | jqCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要查看机构中存储库的配额报告,请使用 /api/v1/repository 端点:

示例命令

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/repository?last_modified=true&namespace=testorg&popularity=true&public=true'

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/repository?last_modified=true&namespace=testorg&popularity=true&public=true'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要查看机构详情中的配额信息,请使用 /api/v1/organization/{orgname} 端点:

示例命令

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg' | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' 'https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg' | jqCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

14.4.3. 使用 API 设置拒绝和警告限制

您可以使用 Red Hat Quay API 设置 拒绝 和警告 限制。

流程

要设置 reject 和 warning 限制,

POST数据到 /api/v1/organization/{orgname}/quota/{quota_id}/limit 端点。例如:curl -k -X POST -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"type":"Reject","threshold_percent":80}' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota/1/limit$ curl -k -X POST -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"type":"Reject","threshold_percent":80}' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota/1/limitCopy to Clipboard Copied! Toggle word wrap Toggle overflow curl -k -X POST -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"type":"Warning","threshold_percent":50}' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota/1/limit$ curl -k -X POST -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' -d '{"type":"Warning","threshold_percent":50}' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota/1/limitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

14.4.4. 使用 API 查看拒绝和警告限制

您可以使用 Red Hat Quay API 查看拒绝和警告限制。

流程

使用 /api/v1/organization/{orgname}/quota 端点来查看 reject 和 warning 限制。例如:

curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota | jq

$ curl -k -X GET -H "Authorization: Bearer <token>" -H 'Content-Type: application/json' https://example-registry-quay-quay-enterprise.apps.docs.gcp.quaydev.org/api/v1/organization/testorg/quota | jqCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

14.5. 计算 registry 总数

使用以下步骤对 registry 的总计算进行队列。

此功能按需完成。计算 registry 总数是数据库密集型。请谨慎使用。

先决条件

- 以 Red Hat Quay 超级用户身份登录。

流程

- 在 Red Hat Quay UI 中,点击您的 username → Super User Admin Panel。

- 在导航窗格中,单击 Manage Organizations。

- 点 Calculate → Ok。

- 几分钟后,根据 registry 的大小,刷新页面。现在计算总 Registry 大小。

14.6. 永久删除镜像标签

在某些情况下,用户可能想要删除时间窗外的镜像标签。使用以下步骤手动删除镜像标签。

以下流程的结果无法撤消。请谨慎使用。

14.6.1. 使用 Red Hat Quay v2 UI 永久删除镜像标签

使用以下步骤通过 Red Hat Quay v2 UI 永久删除镜像标签。

先决条件

-

您已在

config.yaml文件中将FEATURE_UI_V2设置为True。

流程

在

config.yaml文件中,确保将PERMANENTLY_DELETE_TAGS和RESET_CHILD_MANIFEST_EXPIRATION参数设置为True。例如:PERMANENTLY_DELETE_TAGS: true RESET_CHILD_MANIFEST_EXPIRATION: true

PERMANENTLY_DELETE_TAGS: true RESET_CHILD_MANIFEST_EXPIRATION: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 在导航窗格中,单击 Repositories。

- 单击存储库的名称,例如 quayadmin/busybox。

- 选中要删除的镜像标签框,例如 test。

点 Actions → Permanently Delete。

重要此操作是永久的,无法撤销。

14.6.2. 使用 Red Hat Quay 传统 UI 永久删除镜像标签

使用以下步骤通过 Red Hat Quay legacy UI 永久删除镜像标签。

流程

在

config.yaml文件中,确保将PERMANENTLY_DELETE_TAGS和RESET_CHILD_MANIFEST_EXPIRATION参数设置为True。例如:PERMANENTLY_DELETE_TAGS: true RESET_CHILD_MANIFEST_EXPIRATION: true

PERMANENTLY_DELETE_TAGS: true RESET_CHILD_MANIFEST_EXPIRATION: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 在 Red Hat Quay UI 上,单击 Repositories 和包含您要删除的镜像标签的存储库名称,如 quayadmin/busybox。

- 在导航窗格中,单击 Tags。

- 选中您要删除的标签名称的框,例如 test。

- 点 Actions 下拉菜单并选择 Delete Tags → Delete Tag。

- 单击导航窗格中的 Tag History。

在刚才删除的标签名称上,例如

test,单击 Permanently Delete 类别下的 Delete test。例如:重要这个操作是永久的,无法撤消。

第 15 章 Red Hat Quay auto-pruning 概述

Red Hat Quay 管理员可以对组织和存储库设置多个自动运行策略;管理员也可以在 registry 级别设置自动运行策略,以便它们适用于所有机构,包括所有新创建的机构。此功能允许根据指定条件在机构或存储库内自动删除镜像标签,这允许 Red Hat Quay 机构所有者通过自动修剪内容保留在存储配额下。

目前,添加了两个策略:

- 按标签数修剪镜像。对于此策略,当实际的标签数量超过所需的标签数时,最旧的标签将按其创建日期删除,直到达到所需的标签数量为止。

- 通过创建日期修剪镜像标签。对于此策略,任何创建日期的标签(如 10 天)都将被删除。

在标签被自动修剪后,它们会在删除标签后进入 Red Hat Quay 时间机器或时间,在收集垃圾回收前可以访问该标签。镜像标签的过期时间取决于您的机构的设置。如需更多信息,请参阅 Red Hat Quay 垃圾回收。

用户可以为每个命名空间或存储库配置多个策略,这可通过 Red Hat Quay v2 UI 完成。也可以通过命令行界面(CLI)使用 API 端点来设置策略。

15.1. 自动运行和多个策略的先决条件和限制

以下先决条件和限制适用于自动修剪功能:

- 使用 Red Hat Quay 旧 UI 时,无法使用 auto-pruning。您必须使用 v2 UI 来创建、查看或修改 auto-pruning 策略。

-

只在支持

FOR UPDATE SKIP LOCKEDSQL 命令的数据库中才支持 auto-pruning。 - auto-pruning 在镜像的存储库和只读仓库中不可用。

如果您要配置多个自动修剪策略,规则将在不特定顺序的情况下处理,并在进入下一个规则前立即处理单个结果集。

- 例如,如果某个镜像已经通过一条规则收集垃圾回收,则无法被另一个规则从修剪中排除。

- 如果您同时为机构和存储库设置了自动运行策略,则首先在机构级别设置自动运行策略。

15.2. 带有 auto-pruning 的正则表达式

Red Hat Quay 管理员可以利用 正则表达式 或 regex 来匹配机构和存储库级别自动运行策略的标签子集。这提供了更精细的自动运行策略,以仅针对某些镜像标签进行移除。使用带有自动修剪功能 的正则表达式 时请考虑以下几点:

- 正则表达式 是可选的。

- 如果没有提供 正则表达式,则 auto-pruner 默认为修剪机构或存储库中的所有镜像标签。这些是用户提供的,必须受到 ReDOS 攻击。

- registry 范围策略目前不支持 正则表达式。只有机构和存储库级别的自动运行策略支持 正则表达式。

- 正则表达式 可以配置为修剪 do 或不匹配提供的正则表达式 模式的镜像。

以下一些流程 使用正则表达式 提供示例自动修剪策略,您可以在创建自动修剪策略时用作参考。

15.3. 使用 Red Hat Quay UI 管理自动修剪策略

除 registry 范围自动修剪策略外,所有自动修剪策略都使用 Red Hat Quay v2 UI 或使用 API 创建。这可在配置了 Red Hat Quay config.yaml 文件后完成,以启用 auto-pruning 功能和 v2 UI。

使用 Red Hat Quay 传统 UI 时,此功能不可用。

15.3.1. 配置 Red Hat Quay auto-pruning 功能

使用以下步骤配置 Red Hat Quay config.yaml 文件来启用 auto-pruning 功能。

先决条件

-

您已在

config.yaml文件中将FEATURE_UI_V2设置为True。

流程

在 Red Hat Quay

config.yaml文件中,添加和设置FEATURE_AUTO_PRUNE环境变量为True。例如:# ... FEATURE_AUTO_PRUNE: true # ...

# ... FEATURE_AUTO_PRUNE: true # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

15.3.2. 创建 registry 范围自动运行策略

可以在新的和现有组织中配置 registry 范围自动运行策略。此功能通过强制执行 registry 范围规则来节省 Red Hat Quay 管理员时间、工作量和存储。

Red Hat Quay 管理员必须通过包含 DEFAULT_NAMESPACE_AUTOPRUNE_POLICY 配置字段以及 number_of_tags 或 creation_date 方法来更新 config.yaml 文件来启用此功能。目前,无法使用 v2 UI 或 API 启用此功能。

使用以下步骤为您的 Red Hat Quay registry 创建自动修剪策略。

先决条件

-

您已启用了

FEATURE_AUTO_PRUNE功能。

流程

更新

config.yaml文件,以添加DEFAULT_NAMESPACE_AUTOPRUNE_POLICY配置字段:要设置策略方法,在其创建日期中删除最旧的标签,直到离开提供的标签数量前,请使用

number_of_tags方法:# ... DEFAULT_NAMESPACE_AUTOPRUNE_POLICY: method: number_of_tags value: 2 # ...

# ... DEFAULT_NAMESPACE_AUTOPRUNE_POLICY: method: number_of_tags value: 21 # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 在这种情况下,保留两个标签。

要设置策略方法来删除标签,其创建日期早于提供的时间跨度(例如

5d),请使用creation_date方法:DEFAULT_NAMESPACE_AUTOPRUNE_POLICY: method: creation_date value: 5d

DEFAULT_NAMESPACE_AUTOPRUNE_POLICY: method: creation_date value: 5dCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- 重启 Red Hat Quay 部署。

可选。如果您需要标记并推送镜像来测试此功能:

标记将推送到 Red Hat Quay registry 的四个示例镜像。例如:

podman tag docker.io/library/busybox <quay-server.example.com>/<quayadmin>/busybox:test

$ podman tag docker.io/library/busybox <quay-server.example.com>/<quayadmin>/busybox:testCopy to Clipboard Copied! Toggle word wrap Toggle overflow podman tag docker.io/library/busybox <quay-server.example.com>/<quayadmin>/busybox:test2

$ podman tag docker.io/library/busybox <quay-server.example.com>/<quayadmin>/busybox:test2Copy to Clipboard Copied! Toggle word wrap Toggle overflow podman tag docker.io/library/busybox <quay-server.example.com>/<quayadmin>/busybox:test3

$ podman tag docker.io/library/busybox <quay-server.example.com>/<quayadmin>/busybox:test3Copy to Clipboard Copied! Toggle word wrap Toggle overflow podman tag docker.io/library/busybox <quay-server.example.com>/<quayadmin>/busybox:test4

$ podman tag docker.io/library/busybox <quay-server.example.com>/<quayadmin>/busybox:test4Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令将四个示例镜像推送到启用了 auto-pruning 的 registry 中:

podman push <quay-server.example.com>/quayadmin/busybox:test

$ podman push <quay-server.example.com>/quayadmin/busybox:testCopy to Clipboard Copied! Toggle word wrap Toggle overflow podman push <quay-server.example.com>/<quayadmin>/busybox:test2

$ podman push <quay-server.example.com>/<quayadmin>/busybox:test2Copy to Clipboard Copied! Toggle word wrap Toggle overflow podman push <quay-server.example.com>/<quayadmin>/busybox:test3

$ podman push <quay-server.example.com>/<quayadmin>/busybox:test3Copy to Clipboard Copied! Toggle word wrap Toggle overflow podman push <quay-server.example.com>/<quayadmin>/busybox:test4

$ podman push <quay-server.example.com>/<quayadmin>/busybox:test4Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 检查您将镜像推送到的注册表中是否有四个标签。

-

默认情况下,registry 级别的自动修剪程序每 24 小时运行一次。24 小时后,删除了两个最旧的镜像标签,如果您遵循这些指令,则保留

test3和test4标签。检查您的 Red Hat Quay 组织,以确保删除了两个最旧的标签。

15.3.3. 使用 Red Hat Quay v2 UI 为机构创建一个自动修剪策略

使用以下步骤为使用 Red Hat Quay v2 UI 的机构创建自动修剪策略。

先决条件

-

您已启用了

FEATURE_AUTO_PRUNE功能。 - 您的组织有已推送到的镜像标签。

流程

- 在 Red Hat Quay v2 UI 上,单击导航窗格中的 Organizations。

-

选择要将 auto-pruning 功能应用到的机构名称,如

test_organization。 - 单击 Settings。

单击 Auto-Prune Policies。例如:

- 单击下拉菜单并选择所需的策略,例如 按标签数。

- 选择要保留的标签数。默认情况下,这是在 20 个标签设置的。在本例中,要保留的标签数量设置为 3。

可选。随着 正则表达式 的引入,您可以提供以下选项来微调自动运行策略:

- 匹配 :在选择此选项时,自动修剪与给定 正则表达式 模式匹配的所有标签。

不匹配 :在选择这个选项时,自动修剪与 regex 模式 不匹配 的所有标签。

如果没有选择选项,则自动修剪程序默认为修剪所有镜像标签。

在本例中,单击 Tag pattern 框,再选择 match。在 regex 框中,输入与匹配的标签匹配的模式。例如,要自动修剪所有测试标签,请输入

^。testquota

- 可选。您可以通过点 Add Policy 并输入所需信息来创建第二个自动修剪策略。

点击 Save。此时会出现您的自动修剪策略更新的通知。

使用这个示例,机构被配置为保留三个名为

^testbang 的最新标签。

验证

导航到组织存储库的 Tags 页面。几分钟后,自动修剪 worker 会删除在确定的标准中不再适合的标签。在本例中,它会删除

busybox:test标签,并保留busybox:test2,busybox:test3, 和busybox:test4标签。在标签被自动修剪后,它们进入 Red Hat Quay 时间机器,或者删除标签在收集垃圾回收前可以访问的时间。镜像标签的过期时间取决于您的机构的设置。如需更多信息,请参阅 Red Hat Quay 垃圾回收。

15.3.4. 使用 Red Hat Quay API 为命名空间创建一个自动修剪策略

您可以使用 Red Hat Quay API 端点来管理命名空间自动运行策略。

先决条件

- 您已创建了 OAuth 访问令牌。

- 已登陆到 Red Hat Quay。

流程

输入以下

POST /api/v1/organization/{orgname}/autoprunepolicy/命令,创建一个新策略来限制机构中允许的标签数:curl -X POST -H "Authorization: Bearer <access_token>" -H "Content-Type: application/json" -d '{"method": "number_of_tags", "value": 10}' http://<quay-server.example.com>/api/v1/organization/<organization_name>/autoprunepolicy/$ curl -X POST -H "Authorization: Bearer <access_token>" -H "Content-Type: application/json" -d '{"method": "number_of_tags", "value": 10}' http://<quay-server.example.com>/api/v1/organization/<organization_name>/autoprunepolicy/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 另外,您可以在创建日期后将标签设置为在指定时间过期:

curl -X POST -H "Authorization: Bearer <access_token>" -H "Content-Type: application/json" -d '{ "method": "creation_date", "value": "7d"}' http://<quay-server.example.com>/api/v1/organization/<organization_name>/autoprunepolicy/$ curl -X POST -H "Authorization: Bearer <access_token>" -H "Content-Type: application/json" -d '{ "method": "creation_date", "value": "7d"}' http://<quay-server.example.com>/api/v1/organization/<organization_name>/autoprunepolicy/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

{"uuid": "73d64f05-d587-42d9-af6d-e726a4a80d6e"}{"uuid": "73d64f05-d587-42d9-af6d-e726a4a80d6e"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选。您可以将额外策略添加到机构中,并传递

tagPattern和tagPatternMatches字段,以仅修剪与给定 regex 模式匹配的标签。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

tagPatternMatches设置为True会导致修剪与给定正则表达式模式匹配的标签。在本例中,与^v*匹配的标签会被修剪。

输出示例

{"uuid": "ebf7448b-93c3-4f14-bf2f-25aa6857c7b0"}{"uuid": "ebf7448b-93c3-4f14-bf2f-25aa6857c7b0"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以使用

PUT /api/v1/organization/{orgname}/autoprunepolicy/{policy_uuid}命令更新机构的自动修剪策略。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 此命令不返回输出。继续下一步。

输入以下命令检查自动修剪策略:

curl -X GET -H "Authorization: Bearer <access_token>" http://<quay-server.example.com>/api/v1/organization/<organization_name>/autoprunepolicy/

$ curl -X GET -H "Authorization: Bearer <access_token>" http://<quay-server.example.com>/api/v1/organization/<organization_name>/autoprunepolicy/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例