节点

在 OpenShift Container Platform 中配置和管理节点

摘要

第 1 章 节点概述

1.1. 关于节点

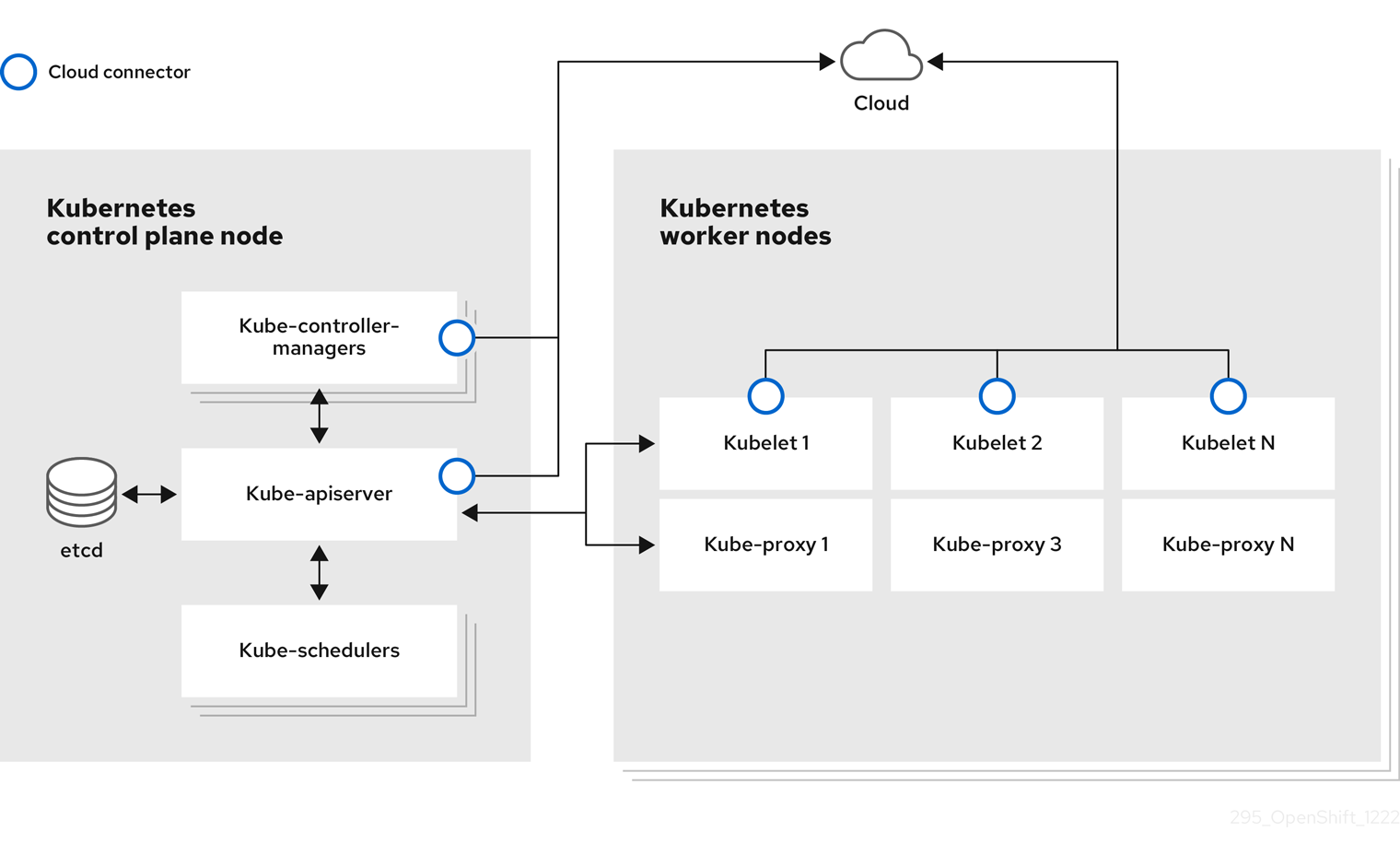

节点是 Kubernetes 集群中的虚拟机或裸机。Worker 节点托管您的应用程序容器,分组为 pod。control plane 节点运行控制 Kubernetes 集群所需的服务。在 OpenShift Container Platform 中,control plane 节点不仅仅包含用于管理 OpenShift Container Platform 集群的 Kubernetes 服务。

在集群中运行稳定和健康的节点是基本运行托管应用程序的基本操作。在 OpenShift Container Platform 中,您可以通过代表节点的 Node 对象访问、管理和监控节点。使用 OpenShift CLI(oc)或 Web 控制台,您可以在节点上执行以下操作。

节点的以下组件负责维护运行 pod 并提供 Kubernetes 运行时环境。

- 容器运行时

- 容器运行时负责运行容器。Kubernetes 提供多个运行时,如 containerd、cri-o、rktlet 和 Docker。

- Kubelet

- kubelet 在节点上运行并读取容器清单。它确保定义的容器已启动且正在运行。kubelet 进程维护工作和节点服务器的状态。kubelet 管理网络流量和端口转发。kubelet 管理仅由 Kubernetes 创建的容器。

- Kube-proxy

- kube-proxy 在集群的每个节点上运行,并维护 Kubernetes 资源之间的网络流量。Kube-proxy 可确保网络环境被隔离并可访问。

- DNS

- 集群 DNS 是一个 DNS 服务器,它为 Kubernetes 服务提供 DNS 记录。由 Kubernetes 启动的容器会在其 DNS 搜索中自动包含此 DNS 服务器。

读取操作

通过读操作,管理员可以或开发人员获取 OpenShift Container Platform 集群中节点的信息。

- 列出集群中的所有节点。

- 获取节点的相关信息,如内存和 CPU 使用量、健康、状态和年龄。

- 列出节点上运行的 pod。

管理操作

作为管理员,您可以通过几个任务轻松地在 OpenShift Container Platform 集群中管理节点:

-

添加或更新节点标签。标签是应用于

Node对象的键值对。您可以使用标签来控制 pod 的调度。 -

使用自定义资源定义(CRD)或

kubeletConfig对象更改节点配置。 -

配置节点以允许或禁止调度 pod。具有

Ready状态的健康 worker 节点默认允许 pod 放置,而 control plane 节点没有;您可以通过将 worker 节点配置为不可调度,并将 control plane 节点配置为可以调度。 -

使用

system-reserved设置为节点分配资源。您可以允许 OpenShift Container Platform 自动决定节点的最佳system-reservedCPU 和内存资源,也可以手动决定并为节点设置最佳资源。 - 根据节点上的处理器内核数、硬限制或两者,配置可在节点上运行的 pod 数量。

- 使用 pod 反关联性来安全地重新引导节点。

- 通过使用计算机器集缩减集群,从集群中删除节点。要从裸机集群中删除节点,您必须首先排空节点上的所有 pod,然后手动删除该节点。

增强操作

OpenShift Container Platform 不仅支持访问和管理节点;作为管理员,您可以在节点上执行以下任务,使集群更高效、应用程序友好,并为开发人员提供更好的环境。

- 使用 Node Tuning Operator,为需要一定等级内核调整的高性能应用程序管理节点级别的性能优化。

- 在节点上启用 TLS 安全配置集,以保护 kubelet 和 Kubernetes API 服务器之间的通信。

- 使用守护进程集在节点上自动运行后台任务。您可以创建并使用守护进程集来创建共享存储,在每个节点上运行日志记录 pod,或者在所有节点上部署监控代理。

- 使用垃圾回收释放节点资源。您可以通过删除终止的容器以及任何正在运行的 pod 不引用的镜像来确保节点高效运行。

- 在一组节点中添加内核参数。

- 将 OpenShift Container Platform 集群配置为在网络边缘(远程 worker 节点)具有 worker 节点。如需有关在 OpenShift Container Platform 集群中具有远程 worker 节点的挑战,以及一些在远程 worker 节点上管理 pod 的建议方法,请参阅在网络边缘使用远程 worker 节点。

1.2. 关于 pod

pod 是节点上共同部署的一个或多个容器。作为集群管理员,您可以定义 pod,为它分配在准备好调度和管理的健康节点上运行。只要容器正在运行,pod 就会运行。在 Pod 被定义并运行后,您无法更改它。使用 pod 时,您可以执行的一些操作包括:

读取操作

作为管理员,您可以通过以下任务来获取项目中的 pod 信息:

- 列出与项目关联的 pod,包括副本数、重启、当前状态和年龄等信息。

- 查看 pod 用量统计,如 CPU、内存和存储消耗。

管理操作

以下任务列表概述了管理员如何在 OpenShift Container Platform 集群中管理 pod。

使用 OpenShift Container Platform 中可用的高级调度功能控制 pod 调度:

- 配置 descheduler 以根据特定策略驱除 pod,以便调度程序将 pod 重新调度到更合适的节点。

- 配置 pod 如何使用 pod 控制器重启后的行为,然后重新启动策略。

- 限制 pod 上的出口和入口流量。

- 从具有 pod 模板的任何对象中添加和移除卷。卷是 pod 中所有容器使用的已挂载文件系统。容器存储是临时的;您可以使用卷来持久保留容器数据。

增强操作

您可以使用 OpenShift Container Platform 中提供的各种工具和功能,更轻松地使用 pod。以下操作涉及使用这些工具和功能来更好地管理 pod。

| 操作 | 用户 | 更多信息 |

|---|---|---|

| 创建并使用 pod 横向自动扩展。 | 开发者 | 您可以使用 pod 横向自动扩展来指定您要运行的 pod 的最小和最大数量,以及 pod 的目标 CPU 使用率或内存使用率。通过使用 pod 横向自动扩展,您可以自动扩展 pod。 |

| 管理员和开发人员 | 作为管理员,通过监控资源和资源要求,使用垂直 pod 自动扩展来更好地利用集群资源。 作为开发人员,使用垂直 pod 自动扩展来确保 pod 在高负载时可以继续工作,方法是将 pod 调度到具有每个 pod 充足资源的节点。 | |

| 使用设备插件提供对外部资源的访问。 | Administrator | 设备插件是在节点(kubelet 的外部)上运行的 gRPC 服务,用于管理特定的硬件资源。您可以部署设插件,以提供一致且可移植的解决方案,以便在集群中使用硬件设备。 |

|

使用 | Administrator |

有些应用程序需要敏感信息,如密码和用户名。您可以使用 |

1.3. 关于容器

容器是 OpenShift Container Platform 应用程序的基本单元,它由应用程序代码与其依赖项、库和二进制文件一起打包。容器提供不同环境间的一致性和多个部署目标:物理服务器、虚拟机 (VM) 和私有或公有云。

Linux 容器技术是一种轻量型机制,用于隔离运行中的进程,仅限制对指定的资源的访问。作为管理员,您可以在 Linux 容器上执行各种任务,例如:

OpenShift Container Platform 提供针对 Init 容器的专用容器。init 容器在应用程序容器之前运行,可以包含应用程序镜像中不存在的工具或设置脚本。您可以在部署 pod 的其余部分之前,使用 Init 容器执行任务。

除了在节点、Pod 和容器上执行特定任务外,您还可使用整个 OpenShift Container Platform 集群来使集群高效和应用程序 pod 具有高可用性。

1.4. 关于节点上的自动扩展 pod

OpenShift Container Platform 提供了三种工具,可用于自动扩展节点上的 pod 数量以及分配给 pod 的资源。

- Pod 横向自动扩展

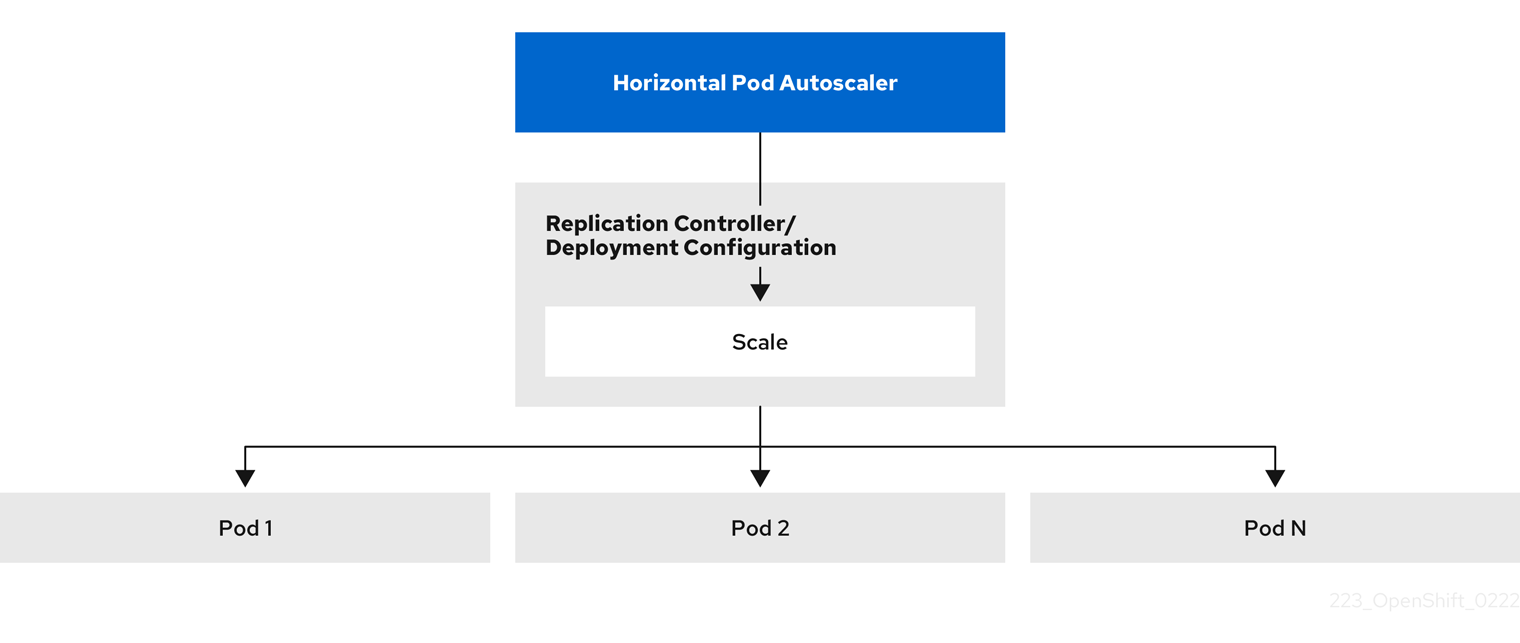

Horizontal Pod Autoscaler (HPA) 可以根据从属于该复制控制器或部署配置的 pod 收集的指标自动增加或减少复制控制器或部署配置的规模。

如需更多信息,请参阅使用 pod 横向自动扩展自动扩展 pod。

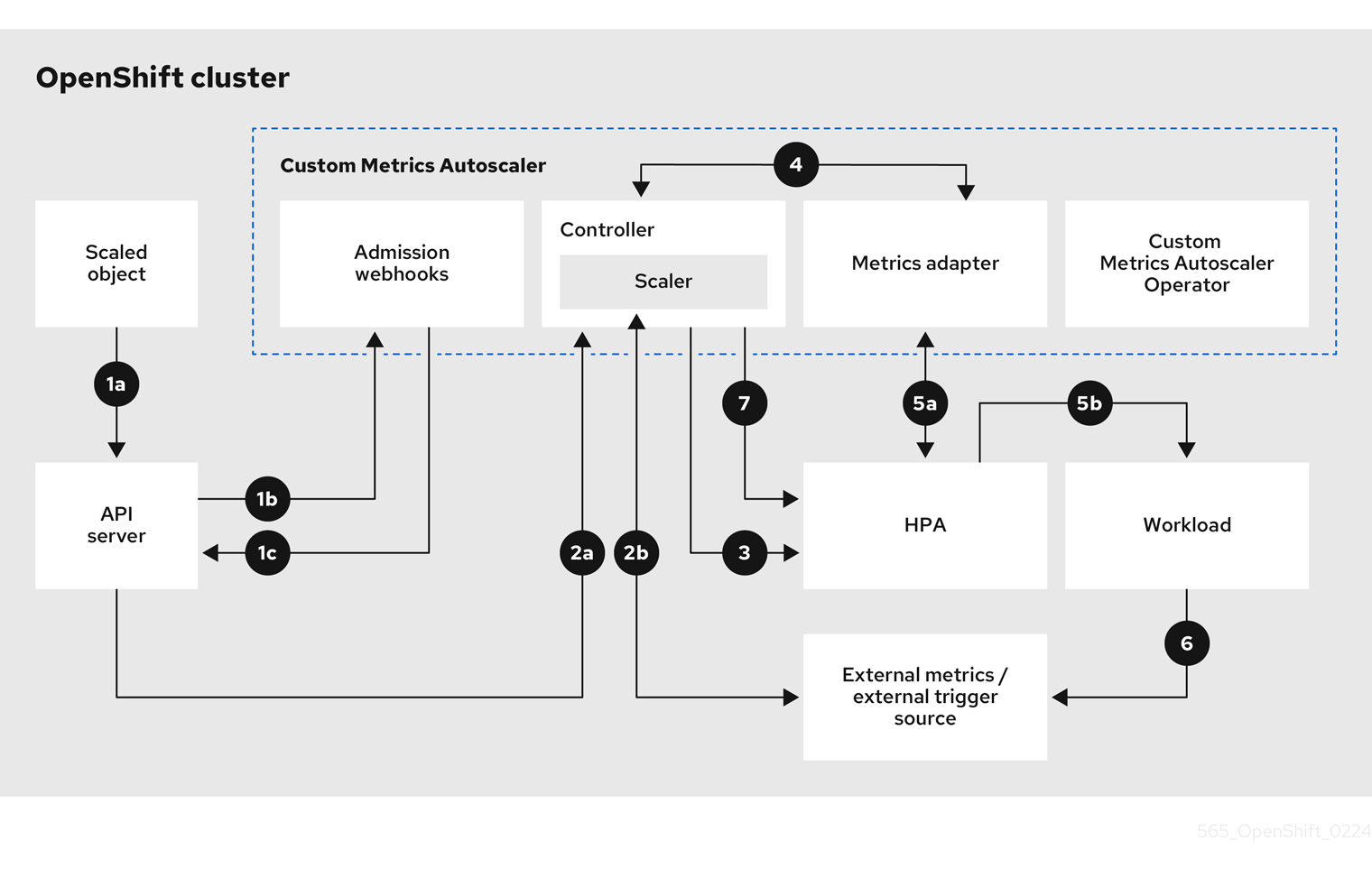

- 自定义 Metrics Autoscaler

自定义 Metrics Autoscaler 可以根据不基于 CPU 或内存的自定义指标自动增加或减少部署、有状态集、自定义资源或作业的 pod 数量。

如需更多信息,请参阅自定义 Metrics Autoscaler Operator 概述。

- Vertical Pod Autoscaler

Vertical Pod Autoscaler (VPA) 可以自动查看 pod 中容器的运行状况和当前的 CPU 和内存资源,并根据它所了解的用量值更新资源限值和请求。

如需更多信息,请参阅使用垂直 pod 自动扩展自动调整 pod 资源级别。

1.5. OpenShift Container Platform 节点的常用术语表

该术语表定义了在节点内容中使用的常用术语。

- Container

- 它是一个轻量级且可执行的镜像,它包括了软件及其所有依赖项。容器虚拟化操作系统,因此您可以在任意位置运行容器,包括数据中心到公共或私有云,甚至在开发人员笔记本电脑中运行。

- 守护进程集

- 确保 pod 副本在 OpenShift Container Platform 集群的合格节点上运行。

- egress

- 通过来自 pod 的网络出站流量进行外部数据共享的过程。

- 垃圾回收

- 清理集群资源的过程,如终止的容器和未被任何正在运行的 Pod 引用的镜像。

- 横向 Pod 自动扩展 (HPA)

- 作为 Kubernetes API 资源和控制器实现。您可以使用 HPA 指定您要运行的 pod 的最小和最大数量。您还可以指定 pod 应该针对的 CPU 或内存使用率。当超过给定 CPU 或内存阈值时,HPA 会扩展或缩放 pod。

- 入口

- 到一个 pod 的传入流量。

- 作业

- 要完成的进程。作业创建一个或多个 pod 对象,并确保指定的 pod 成功完成。

- 标签

- 您可以使用标签(即键值对)来组织并选择对象子集,如 pod。

- 节点

- OpenShift Container Platform 集群中的 worker 机器。节点可以是虚拟机 (VM) 或物理机器。

- Node Tuning Operator

- 您可以使用 Node Tuning Operator,使用 TuneD 守护进程来管理节点级别的性能优化。它保证了自定义性能优化设置以可被守护进程支持的格式传递到在集群中运行的所有容器化的 TuneD 守护进程中。相应的守护进程会在集群的所有节点上运行,每个节点上运行一个。

- 自助服务修复 Operator

- Operator 在集群节点上运行,并检测和重启不健康的节点。

- Pod

- 一个或多个带有共享资源(如卷和 IP 地址)的容器,在 OpenShift Container Platform 集群中运行。pod 是定义、部署和管理的最小计算单元。

- 容限(toleration)

- 表示 pod 允许(但不需要)调度到具有匹配污点的节点组。您可以使用容限来启用调度程序来调度具有匹配污点的 pod。

- 污点(taint)

- 一个核心对象,由一个键、值和效果组成。污点和容限可以一起工作,以确保 pod 不会调度到不相关的节点上。

第 2 章 使用 pod

2.1. 使用 pod

pod 是共同部署在同一主机上的一个或多个容器,也是可被定义、部署和管理的最小计算单元。

2.1.1. 了解 pod

对容器而言,Pod 大致相当于一个机器实例(物理或虚拟)。每个 pod 分配有自己的内部 IP 地址,因此拥有完整的端口空间,并且 pod 内的容器可以共享其本地存储和网络。

Pod 有生命周期,它们经过定义后,被分配到某一节点上运行,然后持续运行,直到容器退出或它们因为其他原因被删除为止。根据策略和退出代码,Pod 可在退出后删除,或被保留下来以启用对容器日志的访问。

OpenShift Container Platform 将 pod 基本上视为不可变;在运行期间无法更改 pod 定义。OpenShift Container Platform 通过终止现有的 pod,再利用修改后的配置和/或基础镜像重新创建 pod,从而实现更改。Pod 也被视为是可抛弃的,不会在重新创建时保持原来的状态。因此,pod 通常应通过更高级别的控制器来管理,而不直接由用户管理。

如需了解每个 OpenShift Container Platform 节点主机的最大 pod 数,请参阅“集群限制”。

不受复制控制器管理的裸机 pod 不能在节点中断时重新调度。

2.1.2. pod 配置示例

OpenShift Container Platform 使用 Kubernetes 的 pod 概念,它是共同部署在同一主机上的一个或多个容器,也是可被定义、部署和管理的最小计算单元。

以下是 pod 的示例定义。它展示了 pod 的许多特性,其中大多数已在其他主题中阐述,因此这里仅简略提及:

Pod 对象定义(YAML)

kind: Pod

apiVersion: v1

metadata:

name: example

labels:

environment: production

app: abc 1

spec:

restartPolicy: Always 2

securityContext: 3

runAsNonRoot: true

seccompProfile:

type: RuntimeDefault

containers: 4

- name: abc

args:

- sleep

- "1000000"

volumeMounts: 5

- name: cache-volume

mountPath: /cache 6

image: registry.access.redhat.com/ubi7/ubi-init:latest 7

securityContext:

allowPrivilegeEscalation: false

runAsNonRoot: true

capabilities:

drop: ["ALL"]

resources:

limits:

memory: "100Mi"

cpu: "1"

requests:

memory: "100Mi"

cpu: "1"

volumes: 8

- name: cache-volume

emptyDir:

sizeLimit: 500Mi

- 1

- pod 可以被“标上”一个或多个标签,然后使用这些标签在一个操作中选择和管理多组 pod。标签以键/值格式保存在

metadata散列中。 - 2

- pod 重启策略,可能的值有

Always、OnFailure和Never。默认值为Always。 - 3

- OpenShift Container Platform 为容器定义了一个安全上下文,指定是否允许其作为特权容器来运行,或者以所选用户身份运行,等等。默认上下文的限制性比较强,但管理员可以根据需要进行修改。

- 4

containers指定包括一个或多个容器定义的数组。- 5

- 容器指定在容器中挂载外部存储卷的位置。

- 6

- 指定要为 pod 提供的卷。卷挂载在指定路径上。不要挂载到容器 root、

/或主机和容器中相同的任何路径。如果容器有足够权限,可能会损坏您的主机系统(如主机的/dev/pts文件)。使用/host挂载主机是安全的。 - 7

- pod 中的每个容器使用自己的容器镜像进行实例化。

- 8

- pod 定义了可供其容器使用的存储卷。

如果将具有高文件数的持久性卷附加到 pod,则这些 pod 可能会失败,或者可能需要很长时间才能启动。如需更多信息,请参阅在 OpenShift 中使用具有高文件计数的持久性卷时,为什么 pod 无法启动或占用大量时间来实现"Ready"状态?

此 pod 定义不包括 OpenShift Container Platform 在 pod 创建并开始其生命周期后自动填充的属性。Kubernetes pod 文档详细介绍了 pod 的功能和用途。

2.1.3. 其他资源

2.2. 查看 pod

作为管理员,您可以查看集群中的 pod,并确定这些 pod 和整个集群的健康状态。

2.2.1. 关于 pod

OpenShift Container Platform 使用 Kubernetes 的 pod 概念,它是共同部署在同一主机上的一个或多个容器,也是可被定义、部署和管理的最小计算单元。对容器而言,Pod 大致相当于机器实例(物理或虚拟)。

您可以查看与特定项目关联的 pod 列表,或者查看 pod 的使用情况统计。

2.2.2. 查看项目中的 pod

您可以查看与当前项目关联的 pod 列表,包括副本数、当前状态、重启次数和 pod 的年龄。

流程

查看项目中的 pod:

切换到对应项目:

$ oc project <project-name>

运行以下命令:

$ oc get pods

例如:

$ oc get pods

输出示例

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165m

添加

-o wide标记来查看 pod IP 地址和 pod 所在的节点。$ oc get pods -o wide

输出示例

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>

2.2.3. 查看 pod 用量统计

您可以显示 pod 的用量统计,这些统计信息为容器提供了运行时环境。这些用量统计包括 CPU、内存和存储的消耗。

先决条件

-

您必须有

cluster-reader权限才能查看用量统计。 - 必须安装 Metrics 才能查看用量统计。

流程

查看用量统计:

运行以下命令:

$ oc adm top pods

例如:

$ oc adm top pods -n openshift-console

输出示例

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15Mi

运行以下命令,以查看带有标签的 pod 用量统计:

$ oc adm top pod --selector=''

您必须选择过滤所基于的选择器(标签查询)。支持

=、==和!=。例如:

$ oc adm top pod --selector='name=my-pod'

2.2.4. 查看资源日志

您可以在 OpenShift CLI (oc) 和 Web 控制台中查看各种资源的日志。日志从日志的尾部或末尾读取。

先决条件

-

访问 OpenShift CLI(

oc)。

流程 (UI)

在 OpenShift Container Platform 控制台中,导航到 Workloads → Pods,或通过您要调查的资源导航到 pod。

注意有些资源(如构建)没有直接查询的 pod。在这种情况下,您可以在资源的 Details 页面中找到 Logs 链接。

- 从下拉菜单中选择一个项目。

- 点您要调查的 pod 的名称。

- 点 Logs。

流程 (CLI)

查看特定 pod 的日志:

$ oc logs -f <pod_name> -c <container_name>

其中:

-f- 可选:指定输出是否遵循要写到日志中的内容。

<pod_name>- 指定 pod 的名称。

<container_name>- 可选:指定容器的名称。当 pod 具有多个容器时,您必须指定容器名称。

例如:

$ oc logs ruby-58cd97df55-mww7r

$ oc logs -f ruby-57f7f4855b-znl92 -c ruby

输出的日志文件内容。

查看特定资源的日志:

$ oc logs <object_type>/<resource_name> 1- 1

- 指定资源类型和名称。

例如:

$ oc logs deployment/ruby

输出的日志文件内容。

2.3. 为 pod 配置 OpenShift Container Platform 集群

作为管理员,您可以为 pod 创建和维护高效的集群。

通过确保集群高效运行,您可以使用一些工具为开发人员提供更好的环境,例如,pod 退出时的行为,确保始终有所需数量的 pod 在运行,何时重启设计为只运行一次的 pod,限制 pod 可以使用的带宽,以及如何在中断时让 pod 保持运行。

2.3.1. 配置 pod 重启后的行为

pod 重启策略决定了 OpenShift Container Platform 在该 pod 中的容器退出时作出何种响应。该策略适用于 pod 中的所有容器。

可能的值有:

-

Always- 在 pod 被重启之前,按规定的延时值(10s,20s,40s)不断尝试重启 pod 中成功退出的容器(最长为 5 分钟)。默认值为Always。 -

OnFailure- 按规定的延时值(10s,20s,40s)不断尝试重启 pod 中失败的容器,上限为 5 分钟。 -

Never- 不尝试重启 pod 中已退出或失败的容器。Pod 立即失败并退出。

在 pod 绑定到某个节点后,该 pod 永远不会绑定到另一个节点。这意味着,需要一个控制器才能使 pod 在节点失败后存活:

| 状况 | 控制器类型 | 重启策略 |

|---|---|---|

| 应该终止的 Pod(例如,批量计算) | 作业 |

|

| 不应该终止的 Pod(例如,Web 服务器) | 复制控制器 |

|

| 每台机器必须运行一个的 Pod | 守护进程集 | 任意 |

如果 pod 上的容器失败且重启策略设为 OnFailure,则 pod 会保留在该节点上并重新启动容器。如果您不希望容器重新启动,请使用 Never 重启策略。

如果整个 pod 失败,OpenShift Container Platform 会启动一个新 pod。开发人员必须解决应用程序可能会在新 pod 中重启的情况。特别是,应用程序必须处理由以往运行产生的临时文件、锁定、不完整输出等结果。

Kubernetes 架构需要来自云提供商的可靠端点。当云提供商停机时,kubelet 会防止 OpenShift Container Platform 重启。

如果底层云提供商端点不可靠,请不要使用云提供商集成来安装集群。应像在非云环境中一样安装集群。不建议在已安装的集群中打开或关闭云提供商集成。

如需详细了解 OpenShift Container Platform 如何使用与失败容器相关的重启策略,请参阅 Kubernetes 文档中的示例状态。

2.3.2. 限制可供 pod 使用的带宽

您可以对 pod 应用服务质量流量控制,有效限制其可用带宽。出口流量(从 pod 传出)按照策略来处理,仅在超出配置的速率时丢弃数据包。入口流量(传入 pod 中)通过控制已排队数据包进行处理,以便有效地处理数据。您对 pod 应用的限制不会影响其他 pod 的带宽。

流程

限制 pod 的带宽:

编写对象定义 JSON 文件,并使用

kubernetes.io/ingress-bandwidth和kubernetes.io/egress-bandwidth注解指定数据流量速度。例如,将 pod 出口和入口带宽限制为 10M/s:受限

Pod对象定义{ "kind": "Pod", "spec": { "containers": [ { "image": "openshift/hello-openshift", "name": "hello-openshift" } ] }, "apiVersion": "v1", "metadata": { "name": "iperf-slow", "annotations": { "kubernetes.io/ingress-bandwidth": "10M", "kubernetes.io/egress-bandwidth": "10M" } } }使用对象定义创建 pod:

$ oc create -f <file_or_dir_path>

2.3.3. 了解如何使用 pod 中断预算来指定必须在线的 pod 数量

pod 中断预算允许在操作过程中指定 pod 的安全限制,如排空节点以进行维护。

PodDisruptionBudget 是一个 API 对象,用于指定在某一时间必须保持在线的副本的最小数量或百分比。在项目中进行这些设置对节点维护(比如缩减集群或升级集群)有益,而且仅在自愿驱除(而非节点失败)时遵从这些设置。

PodDisruptionBudget 对象的配置由以下关键部分组成:

- 标签选择器,即一组 pod 的标签查询。

可用性级别,用来指定必须同时可用的最少 pod 的数量:

-

minAvailable是必须始终可用的 pod 的数量,即使在中断期间也是如此。 -

maxUnavailable是中断期间可以无法使用的 pod 的数量。

-

Available 指的是具有 Ready=True 的 pod 数量。ready=True 指的是能够服务请求的 pod,并应添加到所有匹配服务的负载平衡池中。

允许 maxUnavailable 为 0% 或 0,minAvailable 为 100% 或等于副本数,但这样设置可能会阻止节点排空操作。

对于 OpenShift Container Platform 中的所有机器配置池,maxUnavailable 的默认设置是 1。建议您不要更改这个值,且一次只更新一个 control plane 节点。对于 control plane 池,请不要将这个值改为 3。

您可以使用以下命令来检查所有项目的 pod 中断预算:

$ oc get poddisruptionbudget --all-namespaces

以下示例包含特定于 AWS 上的 OpenShift Container Platform 的一些值。

输出示例

NAMESPACE NAME MIN AVAILABLE MAX UNAVAILABLE ALLOWED DISRUPTIONS AGE openshift-apiserver openshift-apiserver-pdb N/A 1 1 121m openshift-cloud-controller-manager aws-cloud-controller-manager 1 N/A 1 125m openshift-cloud-credential-operator pod-identity-webhook 1 N/A 1 117m openshift-cluster-csi-drivers aws-ebs-csi-driver-controller-pdb N/A 1 1 121m openshift-cluster-storage-operator csi-snapshot-controller-pdb N/A 1 1 122m openshift-cluster-storage-operator csi-snapshot-webhook-pdb N/A 1 1 122m openshift-console console N/A 1 1 116m #...

如果系统中至少有 minAvailable 个 pod 正在运行,则 PodDisruptionBudget 被视为是健康的。超过这一限制的每个 pod 都可被驱除。

根据您的 pod 优先级与抢占设置,可能会无视 pod 中断预算要求而移除较低优先级 pod。

2.3.3.1. 使用 pod 中断预算指定必须在线的 pod 数量

您可以使用 PodDisruptionBudget 对象来指定某一时间必须保持在线的副本的最小数量或百分比。

流程

配置 pod 中断预算:

使用类似以下示例的对象定义来创建 YAML 文件:

apiVersion: policy/v1 1 kind: PodDisruptionBudget metadata: name: my-pdb spec: minAvailable: 2 2 selector: 3 matchLabels: name: my-pod

或者:

apiVersion: policy/v1 1 kind: PodDisruptionBudget metadata: name: my-pdb spec: maxUnavailable: 25% 2 selector: 3 matchLabels: name: my-pod

运行以下命令,将对象添加到项目中:

$ oc create -f </path/to/file> -n <project_name>

2.3.3.2. 为不健康的 pod 指定驱除策略

当您使用 pod 中断预算 (PDB) 来指定必须同时有多少 pod 可用时,您还可以定义驱除不健康 pod 的条件。

您可以选择以下策略之一:

- IfHealthyBudget

- 只有在保护的应用程序没有被中断时,运行的还没有处于健康状态的 pod 才能被驱除。

- AlwaysAllow

无论是否满足 pod 中断预算中的条件,运行的还没有处于健康状态的 pod 都可以被驱除。此策略可帮助驱除出现故障的应用程序,如 pod 处于

CrashLoopBackOff状态或无法报告Ready状态的应用程序。注意建议您在

PodDisruptionBudget对象中将unhealthyPodEvictionPolicy字段设置为AlwaysAllow,以便在节点排空期间支持收集错误的应用程序。默认行为是等待应用程序 pod 处于健康状态,然后才能排空操作。

流程

创建定义

PodDisruptionBudget对象的 YAML 文件,并指定不健康的 pod 驱除策略:pod-disruption-budget.yaml文件示例apiVersion: policy/v1 kind: PodDisruptionBudget metadata: name: my-pdb spec: minAvailable: 2 selector: matchLabels: name: my-pod unhealthyPodEvictionPolicy: AlwaysAllow 1- 1

- 选择

IfHealthyBudget或AlwaysAllow作为不健康 pod 的驱除策略。当unhealthyPodEvictionPolicy字段为空时,默认为IfHealthyBudget。

运行以下命令来创建

PodDisruptionBudget对象:$ oc create -f pod-disruption-budget.yaml

现在,设置了 AlwaysAllow 不健康 pod 驱除策略的 PDB,您可以排空节点并驱除受此 PDB 保护的应用程序的 pod。

其他资源

- 使用功能门启用功能

- Kubernetes 文档中的不健康 Pod 驱除策略

2.3.4. 使用关键 pod 防止删除 pod

有不少核心组件对于集群完全正常工作而言至关重要,但它们在常规集群节点而非主节点上运行。如果一个关键附加组件被驱除,集群可能会停止正常工作。

标记为关键 (critical) 的 Pod 不允许被驱除。

流程

使 pod 成为关键 pod:

创建

Podspec 或编辑现有的 pod,使其包含system-cluster-critical优先级类:apiVersion: v1 kind: Pod metadata: name: my-pdb spec: template: metadata: name: critical-pod priorityClassName: system-cluster-critical 1 # ...- 1

- 绝不可从节点驱除的 pod 的默认优先级类。

此外,对于对集群而言很重要但可在必要时移除的 pod,可以指定

system-node-critical。创建 pod:

$ oc create -f <file-name>.yaml

2.3.5. 当使用带有大量文件的持久性卷时,可以减少 pod 超时的情况

如果存储卷包含多个文件(~1,000,000 或更多),您可能会遇到 pod 超时的问题。

这是因为当挂载卷时,OpenShift Container Platform 会递归更改每个卷内容的所有权和权限,以匹配 pod 的 securityContext 中指定的 fsGroup。对于大型卷,检查和更改所有权和权限可能会非常耗时,从而导致 pod 启动非常慢。

您可以通过应用以下临时解决方案之一来缩短这个延迟:

- 使用安全性上下文约束 (SCC) 跳过卷的 SELinux 重新标记。

-

使用 SCC 中的

fsGroupChangePolicy字段来控制 OpenShift Container Platform 检查和管理卷的所有权和权限的方式。 - 使用 Cluster Resource Override Operator 自动应用 SCC 来跳过 SELinux 重新标记。

- 使用运行时类跳过卷的 SELinux 重新标记。

如需更多信息,请参阅在 OpenShift 中使用具有高文件计数的持久性卷时,为什么 pod 无法启动或占用大量时间来实现"Ready"状态?

2.4. 使用 pod 横向自动扩展自动扩展 pod

作为开发人员,您可以使用 pod 横向自动扩展 (HPA) 来指定 OpenShift Container Platform 如何根据从属于某复制控制器或部署配置的 pod 收集的指标来自动增加或缩小该复制控制器或部署配置的规模。您可以为部署、部署配置、副本集、复制控制器或有状态集创建 HPA。

有关根据自定义指标缩放 pod 的信息,请参阅基于自定义指标自动扩展 pod。

除非需要特定功能或由其他对象提供的行为,否则建议使用 Deployment 对象或 ReplicaSet 对象。如需有关这些对象的更多信息,请参阅了解部署。

2.4.1. 了解 pod 横向自动扩展

您可以创建一个 pod 横向自动扩展来指定您要运行的 pod 的最小和最大数量,以及 pod 的目标 CPU 使用率或内存使用率。

在创建了 pod 横向自动扩展后,OpenShift Container Platform 会开始查询 pod 上的 CPU 和/或内存资源指标。当这些指标可用时,pod 横向自动扩展会计算当前指标使用率与所需指标使用率的比率,并相应地扩展或缩减。查询和缩放是定期进行的,但可能需要一到两分钟时间才会有可用指标。

对于复制控制器,这种缩放直接与复制控制器的副本对应。对于部署配置,缩放直接与部署配置的副本计数对应。注意,自动缩放仅应用到 Complete 阶段的最新部署。

OpenShift Container Platform 会自动考虑资源情况,并防止在资源激增期间进行不必要的自动缩放,比如在启动过程中。处于 unready 状态的 pod 在扩展时具有 0 CPU 用量,自动扩展在缩减时会忽略这些 pod。没有已知指标的 Pod 在扩展时具有 0% CPU 用量,在缩减时具有 100% CPU 用量。这在 HPA 决策过程中提供更高的稳定性。要使用这个功能,您必须配置就绪度检查来确定新 pod 是否准备就绪。

要使用 pod 横向自动扩展,您的集群管理员必须已经正确配置了集群指标。

2.4.1.1. 支持的指标

pod 横向自动扩展支持以下指标:

| 指标 | 描述 | API 版本 |

|---|---|---|

| CPU 使用率 | 已用的 CPU 内核数。可以用来计算 pod 的已请求 CPU 百分比。 |

|

| 内存使用率 | 已用内存量。可以用来计算 pod 的已请求内存百分比。 |

|

对于基于内存的自动缩放,内存用量必须与副本数呈正比增大和减小。平均而言:

- 增加副本数一定会导致每个 pod 的内存(工作集)用量总体降低。

- 减少副本数一定会导致每个 pod 的内存用量总体增高。

使用 OpenShift Container Platform Web 控制台检查应用程序的内存行为,并确保应用程序在使用基于内存的自动缩放前满足这些要求。

以下示例显示了 image-registry Deployment 对象的自动扩展。初始部署需要 3 个 pod。HPA 对象将最小值增加到 5。如果 pod 的 CPU 用量达到 75%,pod 会增加到 7:

$ oc autoscale deployment/image-registry --min=5 --max=7 --cpu-percent=75

输出示例

horizontalpodautoscaler.autoscaling/image-registry autoscaled

image-registry Deployment 对象的 HPA 示例,其中 minReplicas 被设置为 3

apiVersion: autoscaling/v1

kind: HorizontalPodAutoscaler

metadata:

name: image-registry

namespace: default

spec:

maxReplicas: 7

minReplicas: 3

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: image-registry

targetCPUUtilizationPercentage: 75

status:

currentReplicas: 5

desiredReplicas: 0

查看部署的新状态:

$ oc get deployment image-registry

部署中现在有 5 个 pod:

输出示例

NAME REVISION DESIRED CURRENT TRIGGERED BY image-registry 1 5 5 config

2.4.2. HPA 的工作原理?

pod 横向自动扩展(HPA)扩展了 pod 自动扩展的概念。HPA 允许您创建和管理一组负载均衡的节点。当给定的 CPU 或内存阈值被超过时,HPA 会自动增加或减少 pod 数量。

图 2.1. HPA 的高级别工作流

HPA 是 Kubernetes 自动扩展 API 组中的 API 资源。自动扩展器充当控制循环,在同步周期内默认为 15 秒。在此期间,控制器管理器会根据 HPA 的 YAML 文件中定义的 CPU、内存使用率或两者查询 CPU、内存使用或两者。控制器管理器为 HPA 为目标的每个 pod 来获取来自每个 pod 资源指标(如 CPU 或内存)的资源指标的利用率指标。

如果设置了使用值目标,控制器会将利用率值视为各个 pod 中容器对等资源请求的百分比。然后,控制器需要所有目标 pod 的平均利用率,并生成一个用于缩放所需副本数的比率。HPA 配置为从 metrics.k8s.io 获取指标(由 metrics 服务器提供)。由于指标评估的动态性质,副本的数量在扩展一组副本期间会波动。

要实现 HPA,所有目标 pod 都必须在其容器上设置了一个资源请求。

2.4.3. 关于请求和限制

调度程序使用您为 pod 中容器指定的资源请求,来确定要将 pod 放置到哪个节点。kubelet 强制执行您为容器指定的资源限值,以确保容器不允许使用超过指定的限制。kubelet 还保留针对该容器使用的系统资源的请求数量。

如何使用资源指标?

在 pod 规格中,您必须指定资源请求,如 CPU 和内存。HPA 使用此规范来确定资源利用率,然后扩展目标或缩减。

例如,HPA 对象使用以下指标源:

type: Resource

resource:

name: cpu

target:

type: Utilization

averageUtilization: 60在本例中,HPA 将 pod 的平均利用率保持在 scale 目标为 60%。使用率是当前资源使用量与 pod 请求的资源之间的比率。

2.4.4. 最佳实践

所有 pod 都必须配置资源请求

HPA 根据 OpenShift Container Platform 集群中观察的 pod 或内存使用率值做出缩放决定。利用率值计算为各个容器集的资源请求的百分比。缺少资源请求值可能会影响 HPA 的最佳性能。

配置冷却期

在横向 pod 自动扩展过程中,可能会快速扩展事件,而不会造成时间差。配置 cool down 周期,以防止频繁的副本波动。您可以通过配置 stabilizationWindowSeconds 字段指定 cool down period。当用于扩展的指标保持波动时,stabilization 窗口用于限制副本数的波动。自动扩展算法使用这个窗口来推断以前的预期状态,并避免对工作负载扩展不需要的更改。

例如,为 scaleDown 字段指定了 stabilization 窗口:

behavior:

scaleDown:

stabilizationWindowSeconds: 300在上例中,过去 5 分钟的所有所需状态都被视为。此近似滚动的最大值,避免让扩展算法频繁删除 pod,仅在稍后触发同等的 pod 重新创建。

2.4.4.1. 扩展策略

autoscaling/v2 API 允许您为 pod 横向自动扩展添加扩展策略。扩展策略用于控制 OpenShift Container Platform 横向自动扩展(HPA)如何扩展 pod。扩展策略允许您通过设置在指定时间段内扩展的特定数量或特定百分比来限制 HPA 扩展或缩减的速率。您还可以定义一个稳定化窗口(stabilization window),在指标有较大波动时,使用之前计算出的期望状态来控制扩展。您可以为相同的扩展方向创建多个策略,并根据更改的大小决定使用哪些策略。您还可以通过计时的迭代限制缩放。HPA 在迭代过程中扩展 pod,然后在以后的迭代中执行扩展(如果需要)。

带有扩展策略的 HPA 对象示例

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: hpa-resource-metrics-memory

namespace: default

spec:

behavior:

scaleDown: 1

policies: 2

- type: Pods 3

value: 4 4

periodSeconds: 60 5

- type: Percent

value: 10 6

periodSeconds: 60

selectPolicy: Min 7

stabilizationWindowSeconds: 300 8

scaleUp: 9

policies:

- type: Pods

value: 5 10

periodSeconds: 70

- type: Percent

value: 12 11

periodSeconds: 80

selectPolicy: Max

stabilizationWindowSeconds: 0

...

- 1

- 指定扩展策略的方向,可以是

scaleDown或scaleUp。本例为缩减创建一个策略。 - 2

- 定义扩展策略。

- 3

- 决定策略是否在每次迭代过程中根据特定的 pod 数量或 pod 百分比进行扩展。默认值为

pod。 - 4

- 在每次迭代过程中缩放数量(pod 数量或 pod 的百分比)的限制。在按 pod 数量进行缩减时没有默认的值。

- 5

- 决定扩展迭代的长度。默认值为

15秒。 - 6

- 按百分比缩减的默认值为 100%。

- 7

- 如果定义了多个策略,则决定首先使用哪个策略。指定

Max使用允许最多更改的策略,Min使用允许最小更改的策略,或者Disabled阻止 HPA 在策略方向进行扩展。默认值为Max。 - 8

- 决定 HPA 应该重新查看所需状态的时间周期。默认值为

0。 - 9

- 本例为扩展创建了策略。

- 10

- 扩展数量的限制(按 pod 的数量)。扩展 pod 数量的默认值为 4%。

- 11

- 扩展数量的限制(按 pod 的百分比)。按百分比扩展的默认值为 100%。

缩减策略示例

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: hpa-resource-metrics-memory

namespace: default

spec:

...

minReplicas: 20

...

behavior:

scaleDown:

stabilizationWindowSeconds: 300

policies:

- type: Pods

value: 4

periodSeconds: 30

- type: Percent

value: 10

periodSeconds: 60

selectPolicy: Max

scaleUp:

selectPolicy: Disabled

在本例中,当 pod 的数量大于 40 时,则使用基于百分比的策略进行缩减。这个策略会产生较大变化,这是 selectPolicy 需要的。

如果有 80 个 pod 副本,在第一次迭代时 HPA 会将 pod 减少 8 个,即 80 个 pod 的 10%(根据 type: Percent 和 value: 10 参数),持续一分钟(periodSeconds: 60)。对于下一个迭代,pod 的数量为 72。HPA 计算剩余 pod 的 10% 为 7.2,这个数值被舍入到 8,这会缩减 8 个 pod。在每一后续迭代中,将根据剩余的 pod 数量重新计算要缩放的 pod 数量。当 pod 的数量低于 40 时,基于 pod 的策略会被应用,因为基于 pod 的数值会大于基于百分比的数值。HPA 每次减少 4 个 pod(type: Pod 和 value: 4),持续 30 秒(periodSeconds: 30),直到剩余 20 个副本(minReplicas)。

selectPolicy: Disabled 参数可防止 HPA 扩展 pod。如果需要,可以通过调整副本集或部署集中的副本数来手动扩展。

如果设置,您可以使用 oc edit 命令查看扩展策略:

$ oc edit hpa hpa-resource-metrics-memory

输出示例

apiVersion: autoscaling/v1

kind: HorizontalPodAutoscaler

metadata:

annotations:

autoscaling.alpha.kubernetes.io/behavior:\

'{"ScaleUp":{"StabilizationWindowSeconds":0,"SelectPolicy":"Max","Policies":[{"Type":"Pods","Value":4,"PeriodSeconds":15},{"Type":"Percent","Value":100,"PeriodSeconds":15}]},\

"ScaleDown":{"StabilizationWindowSeconds":300,"SelectPolicy":"Min","Policies":[{"Type":"Pods","Value":4,"PeriodSeconds":60},{"Type":"Percent","Value":10,"PeriodSeconds":60}]}}'

...

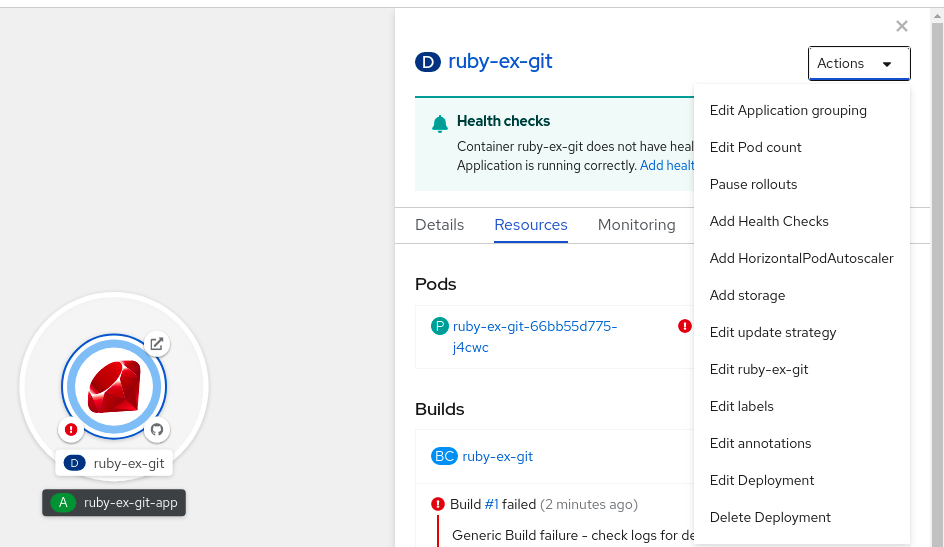

2.4.5. 使用 Web 控制台创建 pod 横向自动扩展

在 web 控制台中,您可以创建一个 pod 横向自动扩展(HPA),用于指定要在 Deployment 或 DeploymentConfig 对象上运行的 pod 的最小和最大数量。您还可以定义 pod 的目标 CPU 或内存用量。

HPA 不能添加到作为 Operator 支持服务、Knative 服务或 Helm chart 一部分的部署中。

流程

在 web 控制台中创建 HPA:

- 在 Topology 视图中,点击节点公开侧面板。

在 Actions 下拉列表中,选择 Add HorizontalPodAutoscaler 来打开 Add HorizontalPodAutoscaler 表单。

图 2.2. 添加 HorizontalPodAutoscaler

在 Add HorizontalPodAutoscaler 表单中,定义名称、最小和最大 pod 限值、CPU 和内存用量,并点 Save。

注意如果缺少 CPU 和内存用量的值,则会显示警告。

在 web 控制台中编辑 HPA:

- 在 Topology 视图中,点击节点公开侧面板。

- 在 Actions 下拉列表中,选择 Edit HorizontalPodAutoscaler 来打开 Edit Horizontal Pod Autoscaler 表单。

- 在 Edit Horizontal Pod Autoscaler 表单中,编辑最小和最大 pod 限值以及 CPU 和内存用量,然后点 Save。

在 web 控制台中创建或编辑 pod 横向自动扩展时,您可以从 Form 视图切换到 YAML 视图。

在 web 控制台中删除 HPA:

- 在 Topology 视图中,点击节点公开侧面板。

- 在 Actions 下拉列表中,选择 Remove HorizontalPodAutoscaler。

- 在确认弹出窗口中点击 Remove 删除 HPA。

2.4.6. 使用 CLI 根据 CPU 使用率创建 pod 横向自动扩展

使用 OpenShift Container Platform CLI,您可以创建一个 pod 横向自动扩展(HPA)来自动扩展现有的 Deployment、DeploymentConfig、ReplicaSet、ReplicationController 或 StatefulSet 对象。HPA 扩展与该对象关联的 pod,以维护您指定的 CPU 用量。

除非需要特定功能或由其他对象提供的行为,否则建议使用 Deployment 对象或 ReplicaSet 对象。

HPA 会在最小和最大数量之间增加和减少副本数,以保持所有 pod 的指定 CPU 使用率。

为 CPU 使用率自动扩展时,您可以使用 oc autoscale 命令,并指定要在任意给定时间运行的 pod 的最小和最大数量,以及 pod 的目标平均 CPU 使用率。如果未指定最小值,则 OpenShift Container Platform 服务器会为 pod 赋予一个默认值。

要自动缩放特定 CPU 值,创建一个带有目标 CPU 和 pod 限制的 HorizontalPodAutoscaler 对象。

先决条件

要使用 pod 横向自动扩展,您的集群管理员必须已经正确配置了集群指标。您可以使用 oc describe PodMetrics <pod-name> 命令来判断是否已配置了指标。如果配置了指标,输出类似于以下示例,其中 Usage 下列出了 Cpu 和 Memory。

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

输出示例

Name: openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

Namespace: openshift-kube-scheduler

Labels: <none>

Annotations: <none>

API Version: metrics.k8s.io/v1beta1

Containers:

Name: wait-for-host-port

Usage:

Memory: 0

Name: scheduler

Usage:

Cpu: 8m

Memory: 45440Ki

Kind: PodMetrics

Metadata:

Creation Timestamp: 2019-05-23T18:47:56Z

Self Link: /apis/metrics.k8s.io/v1beta1/namespaces/openshift-kube-scheduler/pods/openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

Timestamp: 2019-05-23T18:47:56Z

Window: 1m0s

Events: <none>

流程

为 CPU 使用率创建 pod 横向自动扩展:

执行以下之一:

要根据 CPU 使用率百分比来缩放,请为现有对象创建一个

HorizontalPodAutoscaler对象:$ oc autoscale <object_type>/<name> \1 --min <number> \2 --max <number> \3 --cpu-percent=<percent> 4

例如,以下命令显示

image-registryDeployment对象的自动扩展。初始部署需要 3 个 pod。HPA 对象将最小值增加到 5。如果 pod 的 CPU 用量达到 75%,pod 将增加到 7:$ oc autoscale deployment/image-registry --min=5 --max=7 --cpu-percent=75

要扩展特定 CPU 值,请为现有对象创建类似如下的 YAML 文件:

创建一个类似以下示例的 YAML 文件:

apiVersion: autoscaling/v2 1 kind: HorizontalPodAutoscaler metadata: name: cpu-autoscale 2 namespace: default spec: scaleTargetRef: apiVersion: apps/v1 3 kind: Deployment 4 name: example 5 minReplicas: 1 6 maxReplicas: 10 7 metrics: 8 - type: Resource resource: name: cpu 9 target: type: AverageValue 10 averageValue: 500m 11

- 1

- 使用

autoscaling/v2API。 - 2

- 指定此 pod 横向自动扩展对象的名称。

- 3

- 指定要缩放对象的 API 版本:

-

对于

Deployment,ReplicaSet、Statefulset对象,使用apps/v1。 -

对于

ReplicationController,使用v1。 -

对于

DeploymentConfig,使用apps.openshift.io/v1。

-

对于

- 4

- 指定对象类型。对象需要是

Deployment,DeploymentConfig/dc,ReplicaSet/rs,ReplicationController/rc, 或StatefulSet. - 5

- 指定要缩放的对象名称。对象必须存在。

- 6

- 指定缩减时的最小副本数量。

- 7

- 指定扩展时的最大副本数量。

- 8

- 对于内存使用率,使用

metrics参数。 - 9

- 为 CPU 使用率指定

cpu。 - 10

- 设置为

AverageValue。 - 11

- 使用目标 CPU 值设置为

averageValue。

创建 Pod 横向自动扩展:

$ oc create -f <file-name>.yaml

验证 pod 横向自动扩展是否已创建:

$ oc get hpa cpu-autoscale

输出示例

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE cpu-autoscale Deployment/example 173m/500m 1 10 1 20m

2.4.7. 使用 CLI 根据内存使用率创建 pod 横向自动扩展对象

使用 OpenShift Container Platform CLI,您可以创建一个 pod 横向自动扩展(HPA)来自动扩展现有的 Deployment、DeploymentConfig、ReplicaSet、ReplicationController 或 StatefulSet 对象。HPA 扩展与该对象关联的 pod,以维护您指定的平均内存使用率(可以是直接值,也可以是请求的内存百分比)。

除非需要特定功能或由其他对象提供的行为,否则建议使用 Deployment 对象或 ReplicaSet 对象。

HPA 增加和减少最小和最大数量之间的副本数量,以维护所有 pod 的指定内存使用率。

对于内存使用率,您可以指定 pod 的最小和最大数量,以及 pod 的目标平均内存使用率。如果未指定最小值,则 OpenShift Container Platform 服务器会为 pod 赋予一个默认值。

先决条件

要使用 pod 横向自动扩展,您的集群管理员必须已经正确配置了集群指标。您可以使用 oc describe PodMetrics <pod-name> 命令来判断是否已配置了指标。如果配置了指标,输出类似于以下示例,其中 Usage 下列出了 Cpu 和 Memory。

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-129-223.compute.internal -n openshift-kube-scheduler

输出示例

Name: openshift-kube-scheduler-ip-10-0-129-223.compute.internal

Namespace: openshift-kube-scheduler

Labels: <none>

Annotations: <none>

API Version: metrics.k8s.io/v1beta1

Containers:

Name: wait-for-host-port

Usage:

Cpu: 0

Memory: 0

Name: scheduler

Usage:

Cpu: 8m

Memory: 45440Ki

Kind: PodMetrics

Metadata:

Creation Timestamp: 2020-02-14T22:21:14Z

Self Link: /apis/metrics.k8s.io/v1beta1/namespaces/openshift-kube-scheduler/pods/openshift-kube-scheduler-ip-10-0-129-223.compute.internal

Timestamp: 2020-02-14T22:21:14Z

Window: 5m0s

Events: <none>

流程

根据内存使用率创建 pod 横向自动扩展:

为以下之一创建一个 YAML 文件:

要扩展特定内存值,请为现有对象创建类似如下的

HorizontalPodAutoscaler对象:apiVersion: autoscaling/v2 1 kind: HorizontalPodAutoscaler metadata: name: hpa-resource-metrics-memory 2 namespace: default spec: scaleTargetRef: apiVersion: apps/v1 3 kind: Deployment 4 name: example 5 minReplicas: 1 6 maxReplicas: 10 7 metrics: 8 - type: Resource resource: name: memory 9 target: type: AverageValue 10 averageValue: 500Mi 11 behavior: 12 scaleDown: stabilizationWindowSeconds: 300 policies: - type: Pods value: 4 periodSeconds: 60 - type: Percent value: 10 periodSeconds: 60 selectPolicy: Max

- 1

- 使用

autoscaling/v2API。 - 2

- 指定此 pod 横向自动扩展对象的名称。

- 3

- 指定要缩放对象的 API 版本:

-

对于

Deployment、ReplicaSet或Statefulset对象,请使用apps/v1。 -

对于

ReplicationController,使用v1。 -

对于

DeploymentConfig,使用apps.openshift.io/v1。

-

对于

- 4

- 指定对象类型。对象必须是

Deployment、DeploymentConfig、ReplicaSet、ReplicationController或StatefulSet。 - 5

- 指定要缩放的对象名称。对象必须存在。

- 6

- 指定缩减时的最小副本数量。

- 7

- 指定扩展时的最大副本数量。

- 8

- 对于内存使用率,使用

metrics参数。 - 9

- 为内存使用率指定

memory。 - 10

- 将类型设置为

AverageValue。 - 11

- 指定

averageValue和一个特定的内存值。 - 12

- 可选:指定一个扩展策略来控制扩展或缩减率。

要缩放一个百分比,请为现有对象创建一个类似如下的

HorizontalPodAutoscaler对象:apiVersion: autoscaling/v2 1 kind: HorizontalPodAutoscaler metadata: name: memory-autoscale 2 namespace: default spec: scaleTargetRef: apiVersion: apps/v1 3 kind: Deployment 4 name: example 5 minReplicas: 1 6 maxReplicas: 10 7 metrics: 8 - type: Resource resource: name: memory 9 target: type: Utilization 10 averageUtilization: 50 11 behavior: 12 scaleUp: stabilizationWindowSeconds: 180 policies: - type: Pods value: 6 periodSeconds: 120 - type: Percent value: 10 periodSeconds: 120 selectPolicy: Max

- 1

- 使用

autoscaling/v2API。 - 2

- 指定此 pod 横向自动扩展对象的名称。

- 3

- 指定要缩放对象的 API 版本:

-

对于 ReplicationController,使用

v1。 -

对于 DeploymentConfig,使用

apps.openshift.io/v1。 -

对于 Deployment、ReplicaSet 和 Statefulset 对象,使用

apps/v1。

-

对于 ReplicationController,使用

- 4

- 指定对象类型。对象必须是

Deployment、DeploymentConfig、ReplicaSet、ReplicationController或StatefulSet。 - 5

- 指定要缩放的对象名称。对象必须存在。

- 6

- 指定缩减时的最小副本数量。

- 7

- 指定扩展时的最大副本数量。

- 8

- 对于内存使用率,使用

metrics参数。 - 9

- 为内存使用率指定

memory。 - 10

- 设置

Utilization。 - 11

- 为所有 pod 指定

averageUtilization和一个目标平均内存利用率,以请求内存的百分比表示。目标 pod 必须配置内存请求。 - 12

- 可选:指定一个扩展策略来控制扩展或缩减率。

创建 Pod 横向自动扩展:

$ oc create -f <file-name>.yaml

例如:

$ oc create -f hpa.yaml

输出示例

horizontalpodautoscaler.autoscaling/hpa-resource-metrics-memory created

验证 pod 横向自动扩展是否已创建:

$ oc get hpa hpa-resource-metrics-memory

输出示例

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE hpa-resource-metrics-memory Deployment/example 2441216/500Mi 1 10 1 20m

$ oc describe hpa hpa-resource-metrics-memory

输出示例

Name: hpa-resource-metrics-memory Namespace: default Labels: <none> Annotations: <none> CreationTimestamp: Wed, 04 Mar 2020 16:31:37 +0530 Reference: Deployment/example Metrics: ( current / target ) resource memory on pods: 2441216 / 500Mi Min replicas: 1 Max replicas: 10 ReplicationController pods: 1 current / 1 desired Conditions: Type Status Reason Message ---- ------ ------ ------- AbleToScale True ReadyForNewScale recommended size matches current size ScalingActive True ValidMetricFound the HPA was able to successfully calculate a replica count from memory resource ScalingLimited False DesiredWithinRange the desired count is within the acceptable range Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal SuccessfulRescale 6m34s horizontal-pod-autoscaler New size: 1; reason: All metrics below target

2.4.8. 使用 CLI 了解 pod 横向自动扩展状态条件

您可以使用设置的状态条件来判断 pod 横向自动扩展 (HPA) 是否能够缩放,以及目前是否受到某种方式的限制。

HPA 状态条件可通过 v2 版的自动扩展 API 使用。

HPA 可以通过下列状态条件给予响应:

AbleToScale条件指示 HPA 是否能够获取和更新指标,以及是否有任何与退避相关的条件阻碍了缩放。-

True条件表示允许缩放。 -

False条件表示因为指定原因不允许缩放。

-

ScalingActive条件指示 HPA 是否已启用(例如,目标的副本数不为零),并且可以计算所需的指标。-

True条件表示指标工作正常。 -

False条件通常表示获取指标时出现问题。

-

ScalingLimited条件表示所需的规模由 pod 横向自动扩展限定最大或最小限制。-

True条件表示您需要提高或降低最小或最大副本数才能进行缩放。 False条件表示允许请求的缩放。$ oc describe hpa cm-test

输出示例

Name: cm-test Namespace: prom Labels: <none> Annotations: <none> CreationTimestamp: Fri, 16 Jun 2017 18:09:22 +0000 Reference: ReplicationController/cm-test Metrics: ( current / target ) "http_requests" on pods: 66m / 500m Min replicas: 1 Max replicas: 4 ReplicationController pods: 1 current / 1 desired Conditions: 1 Type Status Reason Message ---- ------ ------ ------- AbleToScale True ReadyForNewScale the last scale time was sufficiently old as to warrant a new scale ScalingActive True ValidMetricFound the HPA was able to successfully calculate a replica count from pods metric http_request ScalingLimited False DesiredWithinRange the desired replica count is within the acceptable range Events:- 1

- pod 横向自动扩展状态消息。

-

下例中是一个无法缩放的 pod:

输出示例

Conditions: Type Status Reason Message ---- ------ ------ ------- AbleToScale False FailedGetScale the HPA controller was unable to get the target's current scale: no matches for kind "ReplicationController" in group "apps" Events: Type Reason Age From Message ---- ------ ---- ---- ------- Warning FailedGetScale 6s (x3 over 36s) horizontal-pod-autoscaler no matches for kind "ReplicationController" in group "apps"

下例中是一个无法获得缩放所需指标的 pod:

输出示例

Conditions: Type Status Reason Message ---- ------ ------ ------- AbleToScale True SucceededGetScale the HPA controller was able to get the target's current scale ScalingActive False FailedGetResourceMetric the HPA was unable to compute the replica count: failed to get cpu utilization: unable to get metrics for resource cpu: no metrics returned from resource metrics API

下例中是一个请求的自动缩放低于所需下限的 pod:

输出示例

Conditions: Type Status Reason Message ---- ------ ------ ------- AbleToScale True ReadyForNewScale the last scale time was sufficiently old as to warrant a new scale ScalingActive True ValidMetricFound the HPA was able to successfully calculate a replica count from pods metric http_request ScalingLimited False DesiredWithinRange the desired replica count is within the acceptable range

2.4.8.1. 使用 CLI 查看 pod 横向自动扩展状态条件

您可以查看 pod 横向自动扩展 (HPA) 对 pod 设置的状态条件。

pod 横向自动扩展状态条件可通过 v2 版本的自动扩展 API 使用。

先决条件

要使用 pod 横向自动扩展,您的集群管理员必须已经正确配置了集群指标。您可以使用 oc describe PodMetrics <pod-name> 命令来判断是否已配置了指标。如果配置了指标,输出类似于以下示例,其中 Usage 下列出了 Cpu 和 Memory。

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

输出示例

Name: openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

Namespace: openshift-kube-scheduler

Labels: <none>

Annotations: <none>

API Version: metrics.k8s.io/v1beta1

Containers:

Name: wait-for-host-port

Usage:

Memory: 0

Name: scheduler

Usage:

Cpu: 8m

Memory: 45440Ki

Kind: PodMetrics

Metadata:

Creation Timestamp: 2019-05-23T18:47:56Z

Self Link: /apis/metrics.k8s.io/v1beta1/namespaces/openshift-kube-scheduler/pods/openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

Timestamp: 2019-05-23T18:47:56Z

Window: 1m0s

Events: <none>

流程

要查看 pod 上的状态条件,请使用以下命令并提供 pod 的名称:

$ oc describe hpa <pod-name>

例如:

$ oc describe hpa cm-test

这些条件会出现在输出中的 Conditions 字段里。

输出示例

Name: cm-test

Namespace: prom

Labels: <none>

Annotations: <none>

CreationTimestamp: Fri, 16 Jun 2017 18:09:22 +0000

Reference: ReplicationController/cm-test

Metrics: ( current / target )

"http_requests" on pods: 66m / 500m

Min replicas: 1

Max replicas: 4

ReplicationController pods: 1 current / 1 desired

Conditions: 1

Type Status Reason Message

---- ------ ------ -------

AbleToScale True ReadyForNewScale the last scale time was sufficiently old as to warrant a new scale

ScalingActive True ValidMetricFound the HPA was able to successfully calculate a replica count from pods metric http_request

ScalingLimited False DesiredWithinRange the desired replica count is within the acceptable range

2.4.9. 其他资源

- 如需有关复制控制器和部署控制器的更多信息,请参见了解部署和部署配置。

- 有关使用 HPA 的示例,请参阅 基于 Memory Utilization 的 Horizontal Pod 自动扩展 Quarkus 应用。

2.5. 使用垂直 pod 自动扩展自动调整 pod 资源级别

OpenShift Container Platform Vertical Pod Autoscaler Operator(VPA)会自动检查 pod 中容器的运行状况和当前的 CPU 和内存资源,并根据它所了解的用量值更新资源限值和请求。VPA 使用单独的自定义资源(CR)来更新与工作负载对象关联的所有 Pod,如 Deployment、Deployment Config、StatefulSet、Job、DaemonSet、ReplicaSet 或 ReplicationController。

VPA 可帮助您了解 Pod 的最佳 CPU 和内存使用情况,并可以通过 pod 生命周期自动维护 pod 资源。

2.5.1. 关于 Vertical Pod Autoscaler Operator

Vertical Pod Autoscaler Operator(VPA)作为 API 资源和自定义资源(CR)实现。CR 决定 VPA Operator 对与特定工作负载对象(如守护进程集、复制控制器等)关联的 pod 执行的操作。

VPA Operator 由三个组件组成,每个组件在 VPA 命名空间中都有自己的 pod:

- Recommender

- VPA recommender 监控当前和过去的资源消耗,并根据这些数据决定关联工作负载对象中的 pod 的最佳 CPU 和内存资源。

- Updater

- VPA updater 检查相关工作负载对象中的 pod 是否具有正确的资源。如果资源正确,则 updater 不执行任何操作。如果资源不正确,则 updater 会终止 pod,以便它们的控制器可以使用更新的请求重新创建它们。

- 准入控制器

- VPA 准入控制器在关联的工作负载对象中的每个新 pod 上设置正确的资源请求,无论 pod 是新的,还是因为 VPA updater 的操作由它的控制器重新创建的。

您可以使用默认推荐程序,或使用您自己的备选推荐程序根据您自己的算法自动扩展。

默认推荐器会自动计算这些 pod 中容器的流程以及当前的 CPU 和内存使用情况,并使用这些数据来决定优化的资源限制和请求,以确保这些 pod 始终高效操作。例如,默认推荐器会建议,减少请求资源超过使用资源的 pod 的资源,并为没有请求充足资源的 pod 增加资源。

VPA 每次自动删除任何与建议不兼容的 pod,以便您的应用程序可以在不需要停机的情况下继续满足请求。然后,工作负载对象使用原始资源限制和请求重新部署 pod。VPA 使用一个变异准入 webhook 来更新 pod,在 pod 被允许到节点前,具有优化的资源限制和请求。如果您不希望 VPA 删除 pod,可以查看 VPA 资源限制和请求,并根据需要手动更新 pod。

默认情况下,工作负载对象必须至少指定两个副本,以便 VPA 自动删除其 pod。指定了比这个最小值更少的副本数的工作负载对象不会被删除。如果您手动删除这些 pod,当工作负载对象重新部署 pod 时,VPA 会使用其建议更新新的 pod。您可以通过修改 VerticalPodAutoscalerController 对象来更改这个最小值,如更改 VPA 最小值所示。

例如,您有一个 pod 使用了 CPU 的 50%,但只请求 10%。VPA 会认定该 pod 消耗的 CPU 多于请求的 CPU,并删除 pod。工作负载对象(如副本集)会重启 pod,VPA 使用推荐的资源更新新 pod。

对于开发人员,您可以使用 VPA 来帮助确保 pod 在高负载时可以继续工作,具体方法是将 pod 调度到每个 pod 具有适当资源的节点上。

管理员可以使用 VPA 来更好地利用集群资源,例如防止 pod 保留比所需的 CPU 资源更多的资源。VPA 监控实际使用的工作负载,并对资源进行调整,以确保可以满足其他工作负载的需要。VPA 还维护初始容器配置中指定的限值和请求之间的比例。

如果您停止在集群中运行 VPA,或删除特定的 VPA CR,则已由 VPA 修改的 pod 的资源请求不会改变。任何新 pod 都会根据工作负载对象中的定义获得资源,而不是之前由 VPA 提供的的建议。

2.5.2. 安装 Vertical Pod Autoscaler Operator

您可以使用 OpenShift Container Platform web 控制台安装 Vertical Pod Autoscaler Operator(VPA)。

流程

- 在 OpenShift Container Platform Web 控制台中,点击 Operators → OperatorHub。

- 从可用 Operator 列表中选择 VerticalPodAutoscaler,点 Install。

-

在 Install Operator 页面中,确保选择了 Operator 推荐的命名空间 选项。这会在

openshift-vertical-pod-autoscaler命名空间中创建 Operator。如果这个命名空间还没有存在,会自动创建它。 - 点 Install。

验证

列出 VPA Operator 组件来验证安装:

- 导航到 Workloads → Pods。

-

从下拉菜单中选择

openshift-vertical-pod-autoscaler项目,并验证是否运行了四个 pod。 - 进入 Workloads → Deployments 以验证运行了四个部署。

可选:使用以下命令在 OpenShift Container Platform CLI 中验证安装:

$ oc get all -n openshift-vertical-pod-autoscaler

输出显示四个 pod 和四个部署:

输出示例

NAME READY STATUS RESTARTS AGE pod/vertical-pod-autoscaler-operator-85b4569c47-2gmhc 1/1 Running 0 3m13s pod/vpa-admission-plugin-default-67644fc87f-xq7k9 1/1 Running 0 2m56s pod/vpa-recommender-default-7c54764b59-8gckt 1/1 Running 0 2m56s pod/vpa-updater-default-7f6cc87858-47vw9 1/1 Running 0 2m56s NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/vpa-webhook ClusterIP 172.30.53.206 <none> 443/TCP 2m56s NAME READY UP-TO-DATE AVAILABLE AGE deployment.apps/vertical-pod-autoscaler-operator 1/1 1 1 3m13s deployment.apps/vpa-admission-plugin-default 1/1 1 1 2m56s deployment.apps/vpa-recommender-default 1/1 1 1 2m56s deployment.apps/vpa-updater-default 1/1 1 1 2m56s NAME DESIRED CURRENT READY AGE replicaset.apps/vertical-pod-autoscaler-operator-85b4569c47 1 1 1 3m13s replicaset.apps/vpa-admission-plugin-default-67644fc87f 1 1 1 2m56s replicaset.apps/vpa-recommender-default-7c54764b59 1 1 1 2m56s replicaset.apps/vpa-updater-default-7f6cc87858 1 1 1 2m56s

2.5.3. 关于使用 Vertical Pod Autoscaler Operator

要使用 Vertical Pod Autoscaler Operator(vpa),您需要为集群中的工作负载对象创建 VPA 自定义资源(CR)。VPA 学习并应用与该工作负载对象关联的 pod 的最佳 CPU 和内存资源。您可以使用 VPA 与部署、有状态集、作业、守护进程集、副本集或复制控制器工作负载对象一起使用。VPA CR 必须与您要监控的 pod 位于同一个项目中。

您可以使用 VPA CR 关联一个工作负载对象,并指定 VPA 使用什么模式运行:

-

Auto和Recreate模式会在 pod 生命周期内自动应用 VPA 对 CPU 和内存建议。VPA 会删除项目中任何与建议不兼容的 pod。当由工作负载对象重新部署时,VPA 会在其建议中更新新 pod。 -

Initial模式仅在创建 pod 时自动应用 VPA 建议。 -

Off模式只提供推荐的资源限制和请求信息,用户可以手动应用其中的建议。off模式不会更新 pod。

您还可以使用 CR 使特定容器不受 VPA 评估和更新的影响。

例如,pod 具有以下限制和请求:

resources:

limits:

cpu: 1

memory: 500Mi

requests:

cpu: 500m

memory: 100Mi

在创建了一个设置为 auto 的 VPA 后,VPA 会了解资源使用情况并删除 pod。重新部署时,pod 会使用新的资源限值和请求:

resources:

limits:

cpu: 50m

memory: 1250Mi

requests:

cpu: 25m

memory: 262144k您可以使用以下命令查看 VPA 建议:

$ oc get vpa <vpa-name> --output yaml

几分钟后,输出显示 CPU 和内存请求的建议,如下所示:

输出示例

...

status:

...

recommendation:

containerRecommendations:

- containerName: frontend

lowerBound:

cpu: 25m

memory: 262144k

target:

cpu: 25m

memory: 262144k

uncappedTarget:

cpu: 25m

memory: 262144k

upperBound:

cpu: 262m

memory: "274357142"

- containerName: backend

lowerBound:

cpu: 12m

memory: 131072k

target:

cpu: 12m

memory: 131072k

uncappedTarget:

cpu: 12m

memory: 131072k

upperBound:

cpu: 476m

memory: "498558823"

...

输出显示推荐的资源、目标、最低推荐资源、lowerBound、最高推荐资源、upperBound、以及最新资源建议和 uncappedTarget。

VPA 使用 lessBound 和 upperBound 值来确定一个 pod 是否需要更新。如果 pod 的资源请求低于 lowerBound 值,或高于 upperBound 值,则 VPA 会终止 pod,并使用 target 值重新创建 pod。

2.5.3.1. 更改 VPA 最小值

默认情况下,工作负载对象必须至少指定两个副本,以便 VPA 自动删除和更新其 pod。因此,VPA 不会自动执行指定少于两个副本的工作负载对象。如果 pod 由 VPA 外部的一些进程重启,VPA 会从这些工作负载对象更新的新 pod。您可以通过修改 VerticalPodAutoscalerController 自定义资源(CR)中的 minReplicas 参数来更改此集群范围的最小值。

例如,如果您将 minReplicas 设置为 3,则 VPA 不会为指定少于三个副本的工作负载对象删除和更新 pod。

如果将 minReplicas 设置为 1,则 VPA 可以为只指定一个副本的工作负载对象删除唯一的 pod。只有在 VPA 删除 pod 以调整其资源时,您的工作负载可以允许停机时,才应使用此设置来使用一个副本对象。为了避免使用一个副本的对象出现不必要的停机时间,将带有 podUpdatePolicy 设置的 VPA CR 配置为 Initial,这只有在 VPA 外部的一些进程重启时,或状态为 Off 时才重启。这可让您在适合的时间手动更新 pod。

VerticalPodAutoscalerController 对象示例

apiVersion: autoscaling.openshift.io/v1

kind: VerticalPodAutoscalerController

metadata:

creationTimestamp: "2021-04-21T19:29:49Z"

generation: 2

name: default

namespace: openshift-vertical-pod-autoscaler

resourceVersion: "142172"

uid: 180e17e9-03cc-427f-9955-3b4d7aeb2d59

spec:

minReplicas: 3 1

podMinCPUMillicores: 25

podMinMemoryMb: 250

recommendationOnly: false

safetyMarginFraction: 0.15

2.5.3.2. 自动应用 VPA 建议

要使用 VPA 来自动更新 pod,为特定工作负载对象创建一个 VPA CR,并将 updateMode 设置为 Auto 或 Recreate。

当为工作复杂对象创建 pod 时,VPA 会持续监控容器以分析其 CPU 和内存需求。VPA 会删除任何不满足 VPA 对 CPU 和内存的建议的 pod。重新部署后,pod 根据 VPA 建议使用新的资源限值和请求,并遵循您的应用程序的 pod 中断预算。建议被添加到 VPA CR 的 status 字段中以进行引用。

默认情况下,工作负载对象必须至少指定两个副本,以便 VPA 自动删除其 pod。指定了比这个最小值更少的副本数的工作负载对象不会被删除。如果您手动删除这些 pod,当工作负载对象重新部署 pod 时,VPA 会使用其建议更新新的 pod。您可以通过修改 VerticalPodAutoscalerController 对象来更改这个最小值,如更改 VPA 最小值所示。

Auto 模式的 VPA CR 示例

apiVersion: autoscaling.k8s.io/v1

kind: VerticalPodAutoscaler

metadata:

name: vpa-recommender

spec:

targetRef:

apiVersion: "apps/v1"

kind: Deployment 1

name: frontend 2

updatePolicy:

updateMode: "Auto" 3

在 VPA 可以决定资源建议并将推荐的资源应用到新 pod 之前,操作 pod 必须存在并在项目中运行。

如果工作负载的资源使用情况(如 CPU 和内存)一致,VPA 可以在几分钟内决定资源的建议。如果工作负载的资源使用情况不一致,VPA 必须以各种资源使用量间隔收集指标,以便 VPA 做出准确的建议。

2.5.3.3. 在创建 pod 时自动应用 VPA 建议

要仅在 pod 首次部署时使用 VPA 来应用推荐的资源,为特定的工作负载对象创建一个 VPA CR,将 updateMode 设置为 Initial。

然后,手动删除与您要使用 VPA 建议的工作负载对象关联的 pod。在 Initial 模式中,VPA 不会删除 pod,也不会更新 pod,它会学习新的资源建议。

Initial 模式的 VPA CR 示例

apiVersion: autoscaling.k8s.io/v1

kind: VerticalPodAutoscaler

metadata:

name: vpa-recommender

spec:

targetRef:

apiVersion: "apps/v1"

kind: Deployment 1

name: frontend 2

updatePolicy:

updateMode: "Initial" 3

在 VPA 可以决定推荐的资源并对新 pod 应用建议之前,操作 pod 必须存在并在项目中运行。

要从 VPA 获取最准确的建议,请至少等待 8 天,让 pod 运行以及 VPA 稳定。

2.5.3.4. 手动应用 VPA 建议

要使用 VPA 来仅决定推荐的 CPU 和内存值而不进行实际的应用,对特定的工作负载创建一个 VPA CR,把 updateMode 设置为 off。

当为该工作负载对象创建 pod 时, VPA 会分析容器的 CPU 和内存需求,并在 VPA CR 的 status 字段中记录推荐。VPA 会提供新的资源建议,但不会更新 pod。

使用 Off 模式的 VPA CR 示例

apiVersion: autoscaling.k8s.io/v1

kind: VerticalPodAutoscaler

metadata:

name: vpa-recommender

spec:

targetRef:

apiVersion: "apps/v1"

kind: Deployment 1

name: frontend 2

updatePolicy:

updateMode: "Off" 3

您可以使用以下命令查看建议。

$ oc get vpa <vpa-name> --output yaml

根据建议,您可以编辑工作负载对象以添加 CPU 和内存请求,然后删除 pod 并使用推荐的资源重新部署 pod。

在 VPA 可以决定推荐的资源并对新 pod 应用建议之前,操作 pod 必须存在并在项目中运行。

要从 VPA 获取最准确的建议,请至少等待 8 天,让 pod 运行以及 VPA 稳定。

2.5.3.5. 阻止容器特定容器应用 VPA 建议

如果您的工作负载对象有多个容器,且您不希望 VPA 对所有容器进行评估并进行操作,请为特定工作负载对象创建一个 VPA CR,添加一个 resourcePolicy 已使特定容器不受 VPA 的影响。

当 VPA 使用推荐的资源更新 pod 时,任何带有 resourcePolicy 的容器都不会被更新,且 VPA 不会对这些 pod 中的容器提供建议。

apiVersion: autoscaling.k8s.io/v1

kind: VerticalPodAutoscaler

metadata:

name: vpa-recommender

spec:

targetRef:

apiVersion: "apps/v1"

kind: Deployment 1

name: frontend 2

updatePolicy:

updateMode: "Auto" 3

resourcePolicy: 4

containerPolicies:

- containerName: my-opt-sidecar

mode: "Off"例如,一个 pod 有两个容器,它们有相同的资源请求和限值:

# ...

spec:

containers:

- name: frontend

resources:

limits:

cpu: 1

memory: 500Mi

requests:

cpu: 500m

memory: 100Mi

- name: backend

resources:

limits:

cpu: "1"

memory: 500Mi

requests:

cpu: 500m

memory: 100Mi

# ...

在启用一个带有 backend 排除容器设置的 VPA CR 后,VPA 终止并使用推荐的资源重新创建 pod 的行为只适用于 frontend 容器:

...

spec:

containers:

name: frontend

resources:

limits:

cpu: 50m

memory: 1250Mi

requests:

cpu: 25m

memory: 262144k

...

name: backend

resources:

limits:

cpu: "1"

memory: 500Mi

requests:

cpu: 500m

memory: 100Mi

...2.5.3.6. 性能调优 VPA Operator

作为集群管理员,您可以调整 Vertical Pod Autoscaler Operator (VPA) 的性能,以限制 VPA 对 Kubernetes API 服务器发出请求的速率,并为 VPA recommender, updater 和准入控制器组件 pod 指定 CPU 和内存资源。

另外,您可以将 VPA Operator 配置为仅监控由 VPA 自定义资源 (CR) 管理的工作负载。默认情况下,VPA Operator 会监控集群中的所有工作负载。这允许 VPA Operator 为所有工作负载处理和存储 8 天的历史数据,如果为工作负载创建新的 VPA CR,Operator 可以使用该数据。但是,这会导致 VPA Operator 使用大量 CPU 和内存,这可能会导致 Operator 失败,特别是在大型集群中。通过将 VPA Operator 配置为仅监控 VPA CR 的工作负载,您可以在 CPU 和内存资源上保存。一个权衡方案是,如果您有一个运行的工作负载,并且创建一个 VPA CR 来管理那个工作负载,则 VPA Operator 没有该工作负载的历史数据。因此,在工作负载运行了一段时间后,初始建议并没有这些有用。

这些调整允许您确保 VPA 有足够资源以峰值效率运行,并防止 pod 准入中的节流和可能的延迟。

您可以通过编辑 VerticalPodAutoscalerController 自定义资源 (CR) 在 VPA 组件上执行以下调整:

-

要防止节流和 pod 准入延迟,使用

kube-api-qps和kube-api-burst参数为 Kubernetes API 服务器的 VPA 请求设置 queries-per-second (QPS) 和突发率。 -

为确保足够的 CPU 和内存,请使用标准

cpu和memory资源请求为 VPA 组件 pod 设置 CPU 和内存请求。 -

要将 VPA Operator 配置为仅监控由 VPA CR 管理的工作负载,请将 recommender 组件的

memory-saver参数设置为true。

以下示例 VPA 控制器 CR 设置 VPA API QPS 和突发(burts)率,配置组件 pod 资源请求,并为 recommender 将 memory-saver 设置为 true :

示例 VerticalPodAutoscalerController CR

apiVersion: autoscaling.openshift.io/v1

kind: VerticalPodAutoscalerController

metadata:

name: default

namespace: openshift-vertical-pod-autoscaler

spec:

deploymentOverrides:

admission: 1

container:

args: 2

- '--kube-api-qps=30.0'

- '--kube-api-burst=40.0'

resources:

requests: 3

cpu: 40m

memory: 40Mi

recommender: 4

container:

args:

- '--kube-api-qps=20.0'

- '--kube-api-burst=60.0'

- '--memory-saver=true' 5

resources:

requests:

cpu: 60m

memory: 60Mi

updater: 6

container:

args:

- '--kube-api-qps=20.0'

- '--kube-api-burst=80.0'

resources:

requests:

cpu: 80m

memory: 80Mi

minReplicas: 2

podMinCPUMillicores: 25

podMinMemoryMb: 250

recommendationOnly: false

safetyMarginFraction: 0.15

您可以验证设置是否已应用到每个 VPA 组件 pod。

updater pod 示例

apiVersion: v1

kind: Pod

metadata:

name: vpa-updater-default-d65ffb9dc-hgw44

namespace: openshift-vertical-pod-autoscaler

# ...

spec:

containers:

- args:

- --logtostderr

- --v=1

- --min-replicas=2

- --kube-api-qps=20.0

- --kube-api-burst=80.0

# ...

resources:

requests:

cpu: 80m

memory: 80Mi

# ...

准入控制器 pod 示例

apiVersion: v1

kind: Pod

metadata:

name: vpa-admission-plugin-default-756999448c-l7tsd

namespace: openshift-vertical-pod-autoscaler

# ...

spec:

containers:

- args:

- --logtostderr

- --v=1

- --tls-cert-file=/data/tls-certs/tls.crt

- --tls-private-key=/data/tls-certs/tls.key

- --client-ca-file=/data/tls-ca-certs/service-ca.crt

- --webhook-timeout-seconds=10

- --kube-api-qps=30.0

- --kube-api-burst=40.0

# ...

resources:

requests:

cpu: 40m

memory: 40Mi

# ...

recommender pod 示例

apiVersion: v1

kind: Pod

metadata:

name: vpa-recommender-default-74c979dbbc-znrd2

namespace: openshift-vertical-pod-autoscaler

# ...

spec:

containers:

- args:

- --logtostderr

- --v=1

- --recommendation-margin-fraction=0.15

- --pod-recommendation-min-cpu-millicores=25

- --pod-recommendation-min-memory-mb=250

- --kube-api-qps=20.0

- --kube-api-burst=60.0

- --memory-saver=true

# ...

resources:

requests:

cpu: 60m

memory: 60Mi

# ...

2.5.3.7. 使用一个替代推荐器

您可以根据自己的算法使用自己的推荐器来自动扩展。如果您没有指定替代的推荐器,OpenShift Container Platform 会使用默认的推荐器,它会根据历史使用情况推荐 CPU 和内存请求。因为没有适用于所有工作负载的通用推荐策略,您可能需要为特定工作负载创建和部署不同的推荐器。

例如,当容器出现某些资源行为时,默认的推荐器可能无法准确预测将来的资源使用量,例如,在监控应用程序使用的使用量高峰和闲置间交替的模式,或者重复与深度学习应用程序使用的模式。将默认推荐器用于这些使用行为可能会导致应用程序的过度置备和内存不足(OOM)终止。

有关如何创建推荐器的说明超出了本文档的范围,

流程

为 pod 使用替代推荐器:

为替代推荐器创建服务帐户,并将该服务帐户绑定到所需的集群角色:

apiVersion: v1 1 kind: ServiceAccount metadata: name: alt-vpa-recommender-sa namespace: <namespace_name> --- apiVersion: rbac.authorization.k8s.io/v1 2 kind: ClusterRoleBinding metadata: name: system:example-metrics-reader roleRef: apiGroup: rbac.authorization.k8s.io kind: ClusterRole name: system:metrics-reader subjects: - kind: ServiceAccount name: alt-vpa-recommender-sa namespace: <namespace_name> --- apiVersion: rbac.authorization.k8s.io/v1 3 kind: ClusterRoleBinding metadata: name: system:example-vpa-actor roleRef: apiGroup: rbac.authorization.k8s.io kind: ClusterRole name: system:vpa-actor subjects: - kind: ServiceAccount name: alt-vpa-recommender-sa namespace: <namespace_name> --- apiVersion: rbac.authorization.k8s.io/v1 4 kind: ClusterRoleBinding metadata: name: system:example-vpa-target-reader-binding roleRef: apiGroup: rbac.authorization.k8s.io kind: ClusterRole name: system:vpa-target-reader subjects: - kind: ServiceAccount name: alt-vpa-recommender-sa namespace: <namespace_name>

要在集群中添加备选推荐程序,请创建一个类似如下的 Deployment 对象:

apiVersion: apps/v1 kind: Deployment metadata: name: alt-vpa-recommender namespace: <namespace_name> spec: replicas: 1 selector: matchLabels: app: alt-vpa-recommender template: metadata: labels: app: alt-vpa-recommender spec: containers: 1 - name: recommender image: quay.io/example/alt-recommender:latest 2 imagePullPolicy: Always resources: limits: cpu: 200m memory: 1000Mi requests: cpu: 50m memory: 500Mi ports: - name: prometheus containerPort: 8942 securityContext: allowPrivilegeEscalation: false capabilities: drop: - ALL seccompProfile: type: RuntimeDefault serviceAccountName: alt-vpa-recommender-sa 3 securityContext: runAsNonRoot: true为同一命名空间中的备选推荐器创建新 pod。

$ oc get pods

输出示例

NAME READY STATUS RESTARTS AGE frontend-845d5478d-558zf 1/1 Running 0 4m25s frontend-845d5478d-7z9gx 1/1 Running 0 4m25s frontend-845d5478d-b7l4j 1/1 Running 0 4m25s vpa-alt-recommender-55878867f9-6tp5v 1/1 Running 0 9s

配置包含替代推荐器

Deployment对象名称的 VPA CR。VPA CR 示例,使其包含替代的推荐程序

apiVersion: autoscaling.k8s.io/v1 kind: VerticalPodAutoscaler metadata: name: vpa-recommender namespace: <namespace_name> spec: recommenders: - name: alt-vpa-recommender 1 targetRef: apiVersion: "apps/v1" kind: Deployment 2 name: frontend

2.5.4. 使用 Vertical Pod Autoscaler Operator

您可以通过创建 VPA 自定义资源(CR)来使用 Vertical Pod Autoscaler Operator(VPA)。CR 指明应分析哪些 pod,并决定 VPA 应该对这些 pod 执行的操作。

先决条件

- 要自动扩展的工作负载对象必须存在。

- 如果要使用替代的推荐器,则必须存在包括那个推进器的部署。

流程

为特定工作负载对象创建 VPA CR:

切换到您要缩放的工作负载对象所在的项目。

创建一个 VPA CR YAML 文件:

apiVersion: autoscaling.k8s.io/v1 kind: VerticalPodAutoscaler metadata: name: vpa-recommender spec: targetRef: apiVersion: "apps/v1" kind: Deployment 1 name: frontend 2 updatePolicy: updateMode: "Auto" 3 resourcePolicy: 4 containerPolicies: - containerName: my-opt-sidecar mode: "Off" recommenders: 5 - name: my-recommender- 1

- 指定您需要这个 VPA 管理的工作负载对象类型:

Deployment、StatefulSet、Job、DaemonSet、ReplicaSet或ReplicationController。 - 2

- 指定您希望此 VPA 管理的现有工作负载对象的名称。

- 3

- 指定 VPA 模式:

-

auto会在与控制器关联的 pod 上自动应用推荐的资源。VPA 会终止现有的 pod,并使用推荐的资源限制和请求创建新 pod。 -

recreate会在与工作负载对象关联的 pod 上自动应用推荐的资源。VPA 会终止现有的 pod,并使用推荐的资源限制和请求创建新 pod。recreate模式应该很少使用,只有在需要确保每当资源请求改变时 pod 就需要重启时才使用。 -

Initial在创建与工作负载对象关联的 pod 时自动应用推荐的资源。VPA 会学习新的资源建议,但不会更新 pod。 -

off仅为与工作负载对象关联的 pod 生成资源建议。VPA 不会更新 pod,它只会学习新的资源建议,且不会将建议应用到新 pod。

-

- 4

- 可选。指定不需要受 VPA 影响的容器,将模式设置为

Off。 - 5

- 可选。指定替代的推荐器。

创建 VPA CR:

$ oc create -f <file-name>.yaml

在一段短暂的时间后,VPA 会了解与工作负载对象关联的 pod 中容器的资源使用情况。

您可以使用以下命令查看 VPA 建议:

$ oc get vpa <vpa-name> --output yaml

输出显示 CPU 和内存请求的建议,如下所示:

输出示例

... status: ... recommendation: containerRecommendations: - containerName: frontend lowerBound: 1 cpu: 25m memory: 262144k target: 2 cpu: 25m memory: 262144k uncappedTarget: 3 cpu: 25m memory: 262144k upperBound: 4 cpu: 262m memory: "274357142" - containerName: backend lowerBound: cpu: 12m memory: 131072k target: cpu: 12m memory: 131072k uncappedTarget: cpu: 12m memory: 131072k upperBound: cpu: 476m memory: "498558823" ...

2.5.5. 卸载 Vertical Pod Autoscaler Operator

您可以从 OpenShift Container Platform 集群中删除 Vertical Pod Autoscaler Operator(VPA)。卸载后,已由现有 VPA CR 修改的 pod 的资源请求不会改变。任何新 pod 都会根据工作负载对象中的定义获得资源,而不是之前由 VPA 提供的的建议。

您可以使用 oc delete vpa <vpa-name> 命令删除特定的 VPA CR。在卸载垂直 pod 自动扩展时,同样的操作适用于资源请求。

删除 VPA Operator 后,建议您删除与 Operator 相关的其他组件,以避免潜在的问题。

先决条件

- 已安装 Vertical Pod Autoscaler Operator。

流程

- 在 OpenShift Container Platform web 控制台中,点击 Operators → Installed Operators。

- 切换到 openshift-vertical-pod-autoscaler 项目。

-

对于 VerticalPodAutoscaler Operator,点 Options 菜单

并选择 Uninstall Operator。

并选择 Uninstall Operator。

- 可选: 要删除与 Operator 关联的所有操作对象,请在对话框中选择 Delete all operand instance for this operator 复选框。

- 点 Uninstall。

可选: 使用 OpenShift CLI 删除 VPA 组件:

删除 VPA 命名空间:

$ oc delete namespace openshift-vertical-pod-autoscaler

删除 VPA 自定义资源定义 (CRD) 对象:

$ oc delete crd verticalpodautoscalercheckpoints.autoscaling.k8s.io

$ oc delete crd verticalpodautoscalercontrollers.autoscaling.openshift.io

$ oc delete crd verticalpodautoscalers.autoscaling.k8s.io

删除 CRD 会删除关联的角色、集群角色和角色绑定。

注意此操作会从集群中移除,集群中的所有用户创建的 VPA CR。如果重新安装 VPA,您必须再次创建这些对象。

运行以下命令来删除

MutatingWebhookConfiguration对象:$ oc delete MutatingWebhookConfiguration vpa-webhook-config

删除 VPA Operator:

$ oc delete operator/vertical-pod-autoscaler.openshift-vertical-pod-autoscaler

2.6. 使用 secret 为 pod 提供敏感数据

有些应用程序需要密码和用户名等敏感信息,但您不希望开发人员持有这些信息。

作为管理员,您可以使用 Secret 对象在不以明文方式公开的前提下提供此类信息。

2.6.1. 了解 secret

Secret 对象类型提供了一种机制来保存敏感信息,如密码、OpenShift Container Platform 客户端配置文件和私有源存储库凭证等。secret 将敏感内容与 Pod 分离。您可以使用卷插件将 secret 信息挂载到容器中,系统也可以使用 secret 代表 Pod 执行操作。

主要属性包括:

- Secret 数据可以独立于其定义来引用。

- Secret 数据卷由临时文件工具 (tmpfs) 支持,永远不会停留在节点上。

- secret 数据可以在命名空间内共享。

YAML Secret 对象定义

apiVersion: v1 kind: Secret metadata: name: test-secret namespace: my-namespace type: Opaque 1 data: 2 username: <username> 3 password: <password> stringData: 4 hostname: myapp.mydomain.com 5

您必须先创建 secret,然后创建依赖于此 secret 的 Pod。

在创建 secret 时:

- 使用 secret 数据创建 secret 对象。

- 更新 pod 的服务帐户以允许引用该 secret。

-

创建以环境变量或文件(使用

secret卷)形式消耗 secret 的 pod。

2.6.1.1. secret 的类型

type 字段中的值指明 secret 的键名称和值的结构。此类型可用于强制使 secret 对象中存在用户名和密钥。如果您不想进行验证,请使用 opaque 类型,这也是默认类型。

指定以下一种类型来触发最小服务器端验证,确保 secret 数据中存在特定的键名称:

-

kubernetes.io/basic-auth:使用基本身份验证 -

kubernetes.io/dockercfg:用作镜像 pull secret -

kubernetes.io/dockerconfigjson: 用作镜像 pull secret -

kubernetes.io/service-account-token:用来获取旧的服务帐户 API 令牌 -

kubernetes.io/ssh-auth:与 SSH 密钥身份验证一起使用 -

kubernetes.io/tls:与 TLS 证书颁发机构一起使用

如果您不想要验证,请指定 type: Opaque,即 secret 没有声明键名称或值需要符合任何约定。opaque secret 允许使用无结构 key:value 对,可以包含任意值。

您可以指定其他任意类型,如 example.com/my-secret-type。这些类型不是在服务器端强制执行,而是表明 secret 的创建者意在符合该类型的键/值要求。

有关创建不同类型的 secret 的示例,请参阅 了解如何创建 secret。

2.6.1.2. Secret 数据密钥

Secret 密钥必须在 DNS 子域中。

2.6.1.3. 自动生成的 secret

默认情况下,OpenShift Container Platform 会为每个服务帐户创建以下 secret:

- dockercfg 镜像 pull secret

服务帐户令牌 secret

注意在 OpenShift Container Platform 4.11 之前,在创建服务帐户时会生成第二个服务帐户令牌 secret。此服务帐户令牌 secret 用于访问 Kubernetes API。

从 OpenShift Container Platform 4.11 开始,不再创建第二个服务帐户令牌 secret。这是因为启用了

LegacyServiceAccountTokenNoAutoGeneration上游 Kubernetes 功能门,这会停止自动生成基于 secret 的服务帐户令牌来访问 Kubernetes API。升级到 4.15 后,任何现有的服务帐户令牌 secret 都不会被删除,并可以继续正常工作。

需要此服务帐户令牌 secret 和 docker 配置镜像 pull secret,才能将 OpenShift 镜像 registry 集成到集群的用户身份验证和授权系统中。

但是,如果您不启用 ImageRegistry 功能,或者在 Cluster Image Registry Operator 配置中禁用集成的 OpenShift 镜像 registry,则不会为每个服务帐户生成这些 secret。

不要依赖于这些自动生成的 secret 以供您自己使用;它们可能会在以后的 OpenShift Container Platform 发行版本中删除。

工作负载自动注入投射卷以获取绑定服务帐户令牌。如果您的工作负载需要额外的服务帐户令牌,请在工作负载清单中添加额外的投射卷。绑定服务帐户令牌比服务帐户令牌 secret 更安全,原因如下:

- 绑定服务帐户令牌具有绑定的生命周期。

- 绑定服务帐户令牌包含受众。

- 绑定服务帐户令牌可以绑定到 pod 或 secret,绑定令牌在删除绑定对象时无效。

如需更多信息,请参阅使用卷投射配置绑定服务帐户令牌。

如果您可以接受在一个可读的 API 对象暴露没有过期的令牌,您也可以手动创建服务帐户令牌 secret 来获取令牌。如需更多信息,请参阅创建服务帐户令牌 secret。

其他资源

- 有关请求绑定服务帐户令牌的详情,请参考使用绑定服务帐户令牌

- 有关创建服务帐户令牌 secret 的信息,请参阅创建服务帐户令牌 secret。

2.6.2. 了解如何创建 secret

作为管理员,您必须先创建 secret,然后开发人员才能创建依赖于该 secret 的 pod。

在创建 secret 时:

创建包含您要保留 secret 的数据的 secret 对象。在以下部分中取消每个 secret 类型所需的特定数据。

创建不透明 secret 的 YAML 对象示例

apiVersion: v1 kind: Secret metadata: name: test-secret type: Opaque 1 data: 2 username: <username> password: <password> stringData: 3 hostname: myapp.mydomain.com secret.properties: | property1=valueA property2=valueB

使用

data或stringdata字段,不能同时使用这两个字段。更新 pod 的服务帐户以引用 secret:

使用 secret 的服务帐户的 YAML

apiVersion: v1 kind: ServiceAccount ... secrets: - name: test-secret

创建以环境变量或文件(使用

secret卷)形式消耗 secret 的 pod:pod 的 YAML 使用 secret 数据填充卷中的文件

apiVersion: v1 kind: Pod metadata: name: secret-example-pod spec: securityContext: runAsNonRoot: true seccompProfile: type: RuntimeDefault containers: - name: secret-test-container image: busybox command: [ "/bin/sh", "-c", "cat /etc/secret-volume/*" ] volumeMounts: 1 - name: secret-volume mountPath: /etc/secret-volume 2 readOnly: true 3 securityContext: allowPrivilegeEscalation: false capabilities: drop: [ALL] volumes: - name: secret-volume secret: secretName: test-secret 4 restartPolicy: Neverpod 的 YAML 使用 secret 数据填充环境变量

apiVersion: v1 kind: Pod metadata: name: secret-example-pod spec: securityContext: runAsNonRoot: true seccompProfile: type: RuntimeDefault containers: - name: secret-test-container image: busybox command: [ "/bin/sh", "-c", "export" ] env: - name: TEST_SECRET_USERNAME_ENV_VAR valueFrom: secretKeyRef: 1 name: test-secret key: username securityContext: allowPrivilegeEscalation: false capabilities: drop: [ALL] restartPolicy: Never- 1

- 指定消耗 secret 密钥的环境变量。

构建配置的 YAML 使用 secret 数据填充环境变量

apiVersion: build.openshift.io/v1 kind: BuildConfig metadata: name: secret-example-bc spec: strategy: sourceStrategy: env: - name: TEST_SECRET_USERNAME_ENV_VAR valueFrom: secretKeyRef: 1 name: test-secret key: username from: kind: ImageStreamTag namespace: openshift name: 'cli:latest'- 1

- 指定消耗 secret 密钥的环境变量。

2.6.2.1. Secret 创建限制

若要使用 secret,pod 需要引用该 secret。可以通过三种方式将 secret 用于 Pod:

- 为容器产生环境变量。

- 作为挂载到一个或多个容器上的卷中的文件。

- 在拉取 Pod 的镜像时通过 kubelet 使用。

卷类型 secret 使用卷机制将数据作为文件写入到容器中。镜像拉取 secret 使用服务帐户,将 secret 自动注入到命名空间中的所有 pod。

当模板包含 secret 定义时,模板使用提供的 secret 的唯一方法是确保验证 secret 卷源通过验证,并且指定的对象引用实际指向 Secret 类型的对象。因此,secret 需要在依赖它的任何 Pod 之前创建。确保这一点的最有效方法是通过使用服务帐户自动注入。

Secret API 对象驻留在命名空间中。它们只能由同一命名空间中的 pod 引用。

每个 secret 的大小限制为 1MB。这是为了防止创建可能会耗尽 apiserver 和 kubelet 内存的大型 secret。不过,创建许多较小的 secret 也可能会耗尽内存。

2.6.2.2. 创建不透明 secret

作为管理员,您可以创建一个不透明 secret,它允许您存储包含任意值的无结构 key:value 对。

流程

在控制平面节点上的 YAML 文件中创建

Secret对象。例如:

apiVersion: v1 kind: Secret metadata: name: mysecret type: Opaque 1 data: username: <username> password: <password>- 1

- 指定不透明 secret。

使用以下命令来创建

Secret对象:$ oc create -f <filename>.yaml

在 pod 中使用该 secret:

- 更新 pod 的服务帐户以引用 secret,如 "Understanding how to create secrets" 部分所示。

-

创建以环境变量或文件(使用 secret 卷)形式消耗

secret的 pod,如"创建 secret"部分所示。

其他资源

- 如需有关在 pod 中使用 secret 的更多信息,请参阅了解如何创建 secret。

2.6.2.3. 创建服务帐户令牌 secret

作为管理员,您可以创建一个服务帐户令牌 secret,该 secret 允许您将服务帐户令牌分发到必须通过 API 进行身份验证的应用程序。

建议使用 TokenRequest API 获取绑定的服务帐户令牌,而不使用服务帐户令牌 secret。从 TokenRequest API 获取的令牌比存储在 secret 中的令牌更安全,因为它们具有绑定的生命周期,且不能被其他 API 客户端读取。

只有在无法使用 TokenRequest API 且在可读的 API 对象中存在非过期令牌时,才应创建服务帐户令牌 secret。

有关创建绑定服务帐户令牌的详情,请参考下面的其他参考资料部分。

流程

在控制平面节点上的 YAML 文件中创建

Secret对象:secret对象示例:apiVersion: v1 kind: Secret metadata: name: secret-sa-sample annotations: kubernetes.io/service-account.name: "sa-name" 1 type: kubernetes.io/service-account-token 2使用以下命令来创建

Secret对象:$ oc create -f <filename>.yaml

在 pod 中使用该 secret:

- 更新 pod 的服务帐户以引用 secret,如 "Understanding how to create secrets" 部分所示。

-

创建以环境变量或文件(使用 secret 卷)形式消耗

secret的 pod,如"创建 secret"部分所示。

其他资源

- 如需有关在 pod 中使用 secret 的更多信息,请参阅了解如何创建 secret。

- 有关请求绑定服务帐户令牌的详情,请参考使用绑定服务帐户令牌

- 有关创建服务帐户的详情,请参阅了解并创建服务帐户。

2.6.2.4. 创建基本身份验证 secret

作为管理员,您可以创建一个基本身份验证 secret,该 secret 允许您存储基本身份验证所需的凭证。在使用此 secret 类型时,Secret 对象的 data 参数必须包含以下密钥,采用 base64 格式编码:

-

用户名:用于身份验证的用户名 -

密码:用于身份验证的密码或令牌

您可以使用 stringData 参数使用明文内容。

流程

在控制平面节点上的 YAML 文件中创建

Secret对象:secret对象示例apiVersion: v1 kind: Secret metadata: name: secret-basic-auth type: kubernetes.io/basic-auth 1 data: stringData: 2 username: admin password: <password>

使用以下命令来创建

Secret对象:$ oc create -f <filename>.yaml

在 pod 中使用该 secret:

- 更新 pod 的服务帐户以引用 secret,如 "Understanding how to create secrets" 部分所示。

-

创建以环境变量或文件(使用 secret 卷)形式消耗

secret的 pod,如"创建 secret"部分所示。

其他资源

- 如需有关在 pod 中使用 secret 的更多信息,请参阅了解如何创建 secret。

2.6.2.5. 创建 SSH 身份验证 secret

作为管理员,您可以创建一个 SSH 验证 secret,该 secret 允许您存储用于 SSH 验证的数据。在使用此 secret 类型时,Secret 对象的 data 参数必须包含要使用的 SSH 凭证。

流程

在控制平面节点上的 YAML 文件中创建

Secret对象:secret对象示例:apiVersion: v1 kind: Secret metadata: name: secret-ssh-auth type: kubernetes.io/ssh-auth 1 data: ssh-privatekey: | 2 MIIEpQIBAAKCAQEAulqb/Y ...

使用以下命令来创建

Secret对象:$ oc create -f <filename>.yaml

在 pod 中使用该 secret:

- 更新 pod 的服务帐户以引用 secret,如 "Understanding how to create secrets" 部分所示。

-

创建以环境变量或文件(使用 secret 卷)形式消耗

secret的 pod,如"创建 secret"部分所示。

其他资源

2.6.2.6. 创建 Docker 配置 secret

作为管理员,您可以创建一个 Docker 配置 secret,该 secret 允许您存储用于访问容器镜像 registry 的凭证。

-

kubernetes.io/dockercfg。使用此机密类型存储本地 Docker 配置文件。secret对象的data参数必须包含以 base64 格式编码的.dockercfg文件的内容。 -

kubernetes.io/dockerconfigjson。使用此机密类型存储本地 Docker 配置 JSON 文件。secret对象的data参数必须包含以 base64 格式编码的.docker/config.json文件的内容。

流程

在控制平面节点上的 YAML 文件中创建

Secret对象。Docker 配置

secret对象示例apiVersion: v1 kind: Secret metadata: name: secret-docker-cfg namespace: my-project type: kubernetes.io/dockerconfig 1 data: .dockerconfig:bm5ubm5ubm5ubm5ubm5ubm5ubm5ubmdnZ2dnZ2dnZ2dnZ2dnZ2dnZ2cgYXV0aCBrZXlzCg== 2

Docker 配置 JSON

secret对象示例apiVersion: v1 kind: Secret metadata: name: secret-docker-json namespace: my-project type: kubernetes.io/dockerconfig 1 data: .dockerconfigjson:bm5ubm5ubm5ubm5ubm5ubm5ubm5ubmdnZ2dnZ2dnZ2dnZ2dnZ2dnZ2cgYXV0aCBrZXlzCg== 2

使用以下命令来创建

Secret对象$ oc create -f <filename>.yaml

在 pod 中使用该 secret:

- 更新 pod 的服务帐户以引用 secret,如 "Understanding how to create secrets" 部分所示。

-

创建以环境变量或文件(使用 secret 卷)形式消耗

secret的 pod,如"创建 secret"部分所示。

其他资源

- 如需有关在 pod 中使用 secret 的更多信息,请参阅了解如何创建 secret。

2.6.2.7. 使用 Web 控制台创建 secret

您可以使用 Web 控制台创建 secret。

流程

- 导航到 Workloads → Secrets。

点 Create → From YAML。

手动编辑您的规格的 YAML,或者将文件拖放到 YAML 编辑器。例如:

apiVersion: v1 kind: Secret metadata: name: example namespace: <namespace> type: Opaque 1 data: username: <base64 encoded username> password: <base64 encoded password> stringData: 2 hostname: myapp.mydomain.com

- 点 Create。

点 Add Secret to workload。

- 从下拉菜单中选择要添加的工作负载。

- 点击 Save。

2.6.3. 了解如何更新 secret

修改 secret 值时,值(由已在运行的 pod 使用)不会动态更改。若要更改 secret,您必须删除原始 pod 并创建一个新 pod(可能具有相同的 PodSpec)。

更新 secret 遵循与部署新容器镜像相同的工作流程。您可以使用 kubectl rolling-update 命令。

secret 中的 resourceVersion 值不在引用时指定。因此,如果在 pod 启动的同时更新 secret,则将不能定义用于 pod 的 secret 版本。

目前,无法检查 Pod 创建时使用的 secret 对象的资源版本。按照计划 Pod 将报告此信息,以便控制器可以重启使用旧 resourceVersion 的 Pod。在此期间,请勿更新现有 secret 的数据,而应创建具有不同名称的新数据。

2.6.4. 创建和使用 secret

作为管理员,您可以创建一个服务帐户令牌 secret。这可让您将服务帐户令牌分发到必须通过 API 进行身份验证的应用程序。

流程

运行以下命令,在命名空间中创建服务帐户:

$ oc create sa <service_account_name> -n <your_namespace>

将以下 YAML 示例保存到名为

service-account-token-secret.yaml的文件中。这个示例包括可用于生成服务帐户令牌的Secret对象配置:apiVersion: v1 kind: Secret metadata: name: <secret_name> 1 annotations: kubernetes.io/service-account.name: "sa-name" 2 type: kubernetes.io/service-account-token 3

通过应用文件来生成服务帐户令牌:

$ oc apply -f service-account-token-secret.yaml

运行以下命令,从 secret 获取服务帐户令牌:

$ oc get secret <sa_token_secret> -o jsonpath='{.data.token}' | base64 --decode 1输出示例

ayJhbGciOiJSUzI1NiIsImtpZCI6IklOb2dtck1qZ3hCSWpoNnh5YnZhSE9QMkk3YnRZMVZoclFfQTZfRFp1YlUifQ.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJkZWZhdWx0Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZWNyZXQubmFtZSI6ImJ1aWxkZXItdG9rZW4tdHZrbnIiLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlcnZpY2UtYWNjb3VudC5uYW1lIjoiYnVpbGRlciIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VydmljZS1hY2NvdW50LnVpZCI6IjNmZGU2MGZmLTA1NGYtNDkyZi04YzhjLTNlZjE0NDk3MmFmNyIsInN1YiI6InN5c3RlbTpzZXJ2aWNlYWNjb3VudDpkZWZhdWx0OmJ1aWxkZXIifQ.OmqFTDuMHC_lYvvEUrjr1x453hlEEHYcxS9VKSzmRkP1SiVZWPNPkTWlfNRp6bIUZD3U6aN3N7dMSN0eI5hu36xPgpKTdvuckKLTCnelMx6cxOdAbrcw1mCmOClNscwjS1KO1kzMtYnnq8rXHiMJELsNlhnRyyIXRTtNBsy4t64T3283s3SLsancyx0gy0ujx-Ch3uKAKdZi5iT-I8jnnQ-ds5THDs2h65RJhgglQEmSxpHrLGZFmyHAQI-_SjvmHZPXEc482x3SkaQHNLqpmrpJorNqh1M8ZHKzlujhZgVooMvJmWPXTb2vnvi3DGn2XI-hZxl1yD2yGH1RBpYUHA

- 1

- 将 <sa_token_secret> 替换为服务帐户令牌 secret 的名称。

使用您的服务帐户令牌与集群的 API 进行身份验证:

$ curl -X GET <openshift_cluster_api> --header "Authorization: Bearer <token>" 1 2

2.6.5. 关于将签名证书与 secret 搭配使用

若要与服务进行安全通信,您可以配置 OpenShift Container Platform,以生成一个签名的服务用证书/密钥对,再添加到项目中的 secret 里。

服务用证书 secret 旨在支持需要开箱即用证书的复杂中间件应用程序。它的设置与管理员工具为节点和 master 生成的服务器证书相同。

为服务用证书 secret 配置的服务 Pod 规格。

apiVersion: v1

kind: Service

metadata:

name: registry

annotations:

service.beta.openshift.io/serving-cert-secret-name: registry-cert1

# ...

- 1

- 指定证书的名称

其他 pod 可以信任集群创建的证书(仅对内部 DNS 名称进行签名),方法是使用 pod 中自动挂载的 /var/run/secrets/kubernetes.io/serviceaccount/service-ca.crt 文件中的 CA 捆绑。

此功能的签名算法是 x509.SHA256WithRSA。要手动轮转,请删除生成的 secret。这会创建新的证书。

2.6.5.1. 生成签名证书以便与 secret 搭配使用

要将签名的服务用证书/密钥对用于 pod,请创建或编辑服务以添加到 service.beta.openshift.io/serving-cert-secret-name 注解,然后将 secret 添加到该 pod。

流程

创建服务用证书 secret:

-

编辑服务的

Podspec。 使用您要用于 secret 的名称,添加

service.beta.openshift.io/serving-cert-secret-name注解。kind: Service apiVersion: v1 metadata: name: my-service annotations: service.beta.openshift.io/serving-cert-secret-name: my-cert 1 spec: selector: app: MyApp ports: - protocol: TCP port: 80 targetPort: 9376证书和密钥采用 PEM 格式,分别存储在

tls.crt和tls.key中。创建服务:

$ oc create -f <file-name>.yaml

查看 secret 以确保已成功创建:

查看所有 secret 列表:

$ oc get secrets

输出示例

NAME TYPE DATA AGE my-cert kubernetes.io/tls 2 9m

查看您的 secret 详情:

$ oc describe secret my-cert

输出示例

Name: my-cert Namespace: openshift-console Labels: <none> Annotations: service.beta.openshift.io/expiry: 2023-03-08T23:22:40Z service.beta.openshift.io/originating-service-name: my-service service.beta.openshift.io/originating-service-uid: 640f0ec3-afc2-4380-bf31-a8c784846a11 service.beta.openshift.io/expiry: 2023-03-08T23:22:40Z Type: kubernetes.io/tls Data ==== tls.key: 1679 bytes tls.crt: 2595 bytes

编辑与该 secret 搭配的

Podspec。apiVersion: v1 kind: Pod metadata: name: my-service-pod spec: securityContext: runAsNonRoot: true seccompProfile: type: RuntimeDefault containers: - name: mypod image: redis volumeMounts: - name: my-container mountPath: "/etc/my-path" securityContext: allowPrivilegeEscalation: false capabilities: drop: [ALL] volumes: - name: my-volume secret: secretName: my-cert items: - key: username path: my-group/my-username mode: 511当它可用时,您的 Pod 就可运行。该证书对内部服务 DNS 名称

<service.name>.<service.namespace>.svc有效。证书/密钥对在接近到期时自动替换。在 secret 的

service.beta.openshift.io/expiry注解中查看过期日期,其格式为 RFC3339。注意在大多数情形中,服务 DNS 名称

<service.name>.<service.namespace>.svc不可从外部路由。<service.name>.<service.namespace>.svc的主要用途是集群内或服务内通信,也用于重新加密路由。

2.6.6. secret 故障排除

如果服务证书生成失败并显示以下信息( 服务的 service.beta.openshift.io/serving-cert-generation-error 注解包含):

secret/ssl-key references serviceUID 62ad25ca-d703-11e6-9d6f-0e9c0057b608, which does not match 77b6dd80-d716-11e6-9d6f-0e9c0057b60

生成证书的服务不再存在,或者具有不同的 serviceUID 。您必须删除旧 secret 并清除服务上的以下注解 service.beta.openshift.io/serving-cert-generation-error, service.beta.openshift.io/serving-cert-generation-error-num 以强制重新生成证书:

删除 secret:

$ oc delete secret <secret_name>

清除注解:

$ oc annotate service <service_name> service.beta.openshift.io/serving-cert-generation-error-

$ oc annotate service <service_name> service.beta.openshift.io/serving-cert-generation-error-num-

在用于移除注解的命令中,要移除的注解后面有一个 -。

2.7. 使用外部 secret 存储为 pod 提供敏感数据

有些应用程序需要密码和用户名等敏感信息,但您不希望开发人员持有这些信息。

使用 Kubernetes Secret 对象提供敏感信息的一个替代选择是,使用外部 secret 存储来存储敏感信息。您可以使用 Secrets Store CSI Driver Operator 与外部 secret 存储集成,并将 secret 内容挂载为 pod 卷。

Secret Store CSI Driver Operator 只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

2.7.1. 关于 Secret Store CSI Driver Operator

Kubernetes secret 以 Base64 编码的形式存储。etcd 为这些 secret 提供加密,但在检索 secret 时,它们会被解密并提供给用户。如果没有在集群中正确配置基于角色的访问控制,则具有 API 或 etcd 访问权限的任何人都可以检索或修改 secret。另外,有权在命名空间中创建 pod 的任何人都可以使用该命名空间中的任何 secret 来读取该命名空间中的任何 secret。

要安全地存储和管理您的 secret,您可以将 OpenShift Container Platform Secrets Store Container Storage Interface (CSI) Driver Operator 配置为使用供应商插件从外部 secret 管理系统(如 Azure Key Vault)挂载 secret。应用程序可以使用 secret,但 secret 在应用程序 pod 被销毁后不会在系统中保留。

Secret Store CSI Driver Operator(secrets-store.csi.k8s.io)允许 OpenShift Container Platform 将存储在企业级外部 secret 中的多个 secret、密钥和证书作为卷挂载到 pod 中。Secrets Store CSI Driver Operator 使用 gRPC 与供应商通信,以从指定的外部 secret 存储获取挂载内容。附加卷后,其中的数据将挂载到容器的文件系统。Secret 存储卷以 in-line 形式挂载。

2.7.1.1. Secret 存储供应商

以下 secret 存储供应商可用于 Secret Store CSI Driver Operator:

- AWS Secrets Manager

- AWS Systems Manager Parameter Store

- Azure Key Vault

2.7.1.2. 自动轮转

Secrets Store CSI 驱动程序会定期使用外部 secret 存储中的内容轮转挂载卷中的内容。如果外部 secret 存储中更新了 secret,secret 将在挂载的卷中更新。Secrets Store CSI Driver Operator 每 2 分钟轮询一次更新。

如果启用了将挂载内容作为 Kubernetes secret 同步,则 Kubernetes secret 也会被轮转。

使用 secret 数据的应用程序必须监视是否有对 secret 的更新。

2.7.2. 安装 Secret Store CSI 驱动程序

先决条件

- 访问 OpenShift Container Platform Web 控制台。

- 集群的管理员访问权限。

流程

安装 Secret Store CSI 驱动程序:

安装 Secret Store CSI Driver Operator:

- 登录到 web 控制台。

- 点 Operators → OperatorHub。

- 通过在过滤器框中输入 "Secrets Store CSI" 来查找 Secrets Store CSI Driver Operator。

- 点 Secrets Store CSI Driver Operator 按钮。

- 在 Secrets Store CSI Driver Operator 页面中,点 Install。

在 Install Operator 页面中,确保:

- 选择 All namespaces on the cluster (default)。

- 安装的命名空间 被设置为 openshift-cluster-csi-drivers。

点 Install。

安装完成后,Secret Store CSI Driver Operator 会在 web 控制台的 Installed Operators 部分列出。

为驱动程序创建

ClusterCSIDriver实例 (secrets-store.csi.k8s.io):- 点 Administration → CustomResourceDefinitions → ClusterCSIDriver。

在 Instances 选项卡上,单击 Create ClusterCSIDriver。

使用以下 YAML 文件:

apiVersion: operator.openshift.io/v1 kind: ClusterCSIDriver metadata: name: secrets-store.csi.k8s.io spec: managementState: Managed- 点 Create。

2.7.3. 将 secret 从外部 secret 存储挂载到 CSI 卷

安装 Secret Store CSI Driver Operator 后,您可以将 secret 从以下外部 secret 存储挂载到 CSI 卷:

2.7.3.1. 从 AWS Secrets Manager 挂载 secret

您可以使用 Secrets Store CSI Driver Operator 将 secret 从 AWS Secrets Manager 挂载到 OpenShift Container Platform 中的 CSI 卷。要从 AWS Secrets Manager 挂载 secret,您的集群必须安装在 AWS 上,并使用 AWS 安全令牌服务 (STS)。

先决条件

- 您的集群安装在 AWS 上,并使用 AWS 安全令牌服务 (STS)。

- 已安装 Secrets Store CSI Driver Operator。具体步骤请参阅 安装 Secret Store CSI 驱动程序。

- 您已将 AWS Secrets Manager 配置为存储所需的 secret。

-

您已提取并准备好

ccoctl二进制文件。 -

已安装

jqCLI 工具。 -

您可以使用具有

cluster-admin角色的用户访问集群。

流程

安装 AWS Secrets Manager 供应商:

使用供应商资源的以下配置创建一个 YAML 文件:

重要Secret Store CSI 驱动程序的 AWS Secrets Manager 供应商是一个上游供应商。

此配置会根据上游 AWS 文档中提供的配置进行修改,以便它可以与 OpenShift Container Platform 正常工作。对此配置的更改可能会影响功能。