虚拟化管理指南

管理虚拟环境

摘要

第 1 章 服务器最佳实践

- 在 enforcing 模式下运行 SELinux。使用 setenforce 命令,将 SELinux 设置为在 enforcing 模式下运行。

# setenforce 1

- 删除或禁用任何不必要的服务,如 AutoFS、NFS、FTP、HTTP、NIS、teld、sendmail 等。

- 仅添加服务器上平台管理所需的最少用户帐户数量,并删除不必要的用户帐户。

- 避免在主机上运行任何正式的应用程序。在主机上运行应用程序可能会影响虚拟机性能,并可能会影响服务器稳定性。任何可能导致服务器崩溃的应用程序都将导致服务器中的所有虚拟机停机。

- 将中央位置用于虚拟机安装和镜像。虚拟机映像应存储在

/var/lib/libvirt/images/下。如果您在虚拟机镜像中使用其他目录,请确保将目录 添加到您的 SELinux 策略中,并在开始安装前重新标记它。强烈建议在中央位置使用可共享的网络存储。

第 2 章 sVirt

非虚拟化环境

在非虚拟化环境中,主机物理机器彼此分开,每个主机物理物理机器有一个自包含的环境,由 web 服务器或 DNS 服务器等服务组成。这些服务直接与自己的用户空间通信,托管物理机器的内核和物理硬件,从而直接向网络提供服务。下方的镜像代表非虚拟化环境:

- ??????

- 用户空间 - 所有用户模式应用程序和一些驱动程序执行的内存区域。

- ???

- Web App(网页应用服务器)- 提供可通过浏览器访问的 Web 内容。

- ??????

- Host Kernel - 严格保留用于运行主机物理机器的特权内核、内核扩展和大多数设备驱动程序。

- ???

- DNS 服务器 - 存储 DNS 记录,允许用户使用逻辑名称而不是 IP 地址访问网页。

虚拟化环境

在虚拟环境中,多个虚拟操作系统可以在驻留于主机物理机器的单个内核中运行。下图代表虚拟化环境:

2.1. 安全和虚拟化

2.2. sVirt 标记

# ps -eZ | grep qemu system_u:system_r:svirt_t:s0:c87,c520 27950 ? 00:00:17 qemu-kvm

# ls -lZ /var/lib/libvirt/images/* system_u:object_r:svirt_image_t:s0:c87,c520 image1

| SELinux 上下文 | 键入 / Description |

|---|---|

| system_u:system_r:svirt_t:MCS1 | 客户机虚拟机进程.MCS1 是一个随机 MCS 字段。支持大约 500,000 个标签。 |

| system_u:object_r:svirt_image_t:MCS1 | 客户机虚拟机镜像。只有具有相同 MCS 字段的 svirt_t 进程才能读写这些镜像。 |

| system_u:object_r:svirt_image_t:s0 | 共享读/写内容的 guest 虚拟机.所有 svirt_t 进程都可以写入 svirt_image_t:s0 文件。 |

第 3 章 克隆虚拟机

- 克隆 是单个虚拟机的实例。克隆可用于设置相同虚拟机的网络,也可以分发到其他目的地。

- 模板是虚拟机的 实例,设计为用作克隆的源。您可以从模板创建多个克隆,并对每个克隆进行小幅修改。这对于查看这些更改对系统的影响非常有用。

- 平台级别 信息和配置包括虚拟化解决方案分配给虚拟机的任何内容。示例包括网络接口卡(NIC)的数量及其 MAC 地址。

- 客户机操作系统级别 信息和配置包括虚拟机中配置的任何内容。例如,SSH 密钥。

- 应用程序级别 信息和配置包括在虚拟机上安装的应用程序所配置的任何内容。示例包括激活代码和注册信息。注意本章不包括关于删除应用程序级别的信息,因为信息和方法特定于每个应用程序。

3.1. 为关闭准备虚拟机

过程 3.1. 准备虚拟机以进行克隆

设置虚拟机

- 构建要用于克隆或模板的虚拟机。

- 在克隆上安装任何所需的软件。

- 为操作系统配置任何非唯一的设置。

- 配置任何非唯一的应用设置。

删除网络配置

- 使用以下命令删除任何持久性的 udev 规则:

# rm -f /etc/udev/rules.d/70-persistent-net.rules

注意如果没有删除 udev 规则,则第一个 NIC 的名称可以是 eth1 而不是 eth0。 - 通过对

/etc/sysconfig/network-scripts/ifcfg-eth[x]进行以下编辑,从 ifcfg 脚本中删除唯一的网络详情:- 删除 HWADDR 和 Static 行注意如果 HWADDR 与新 guest 的 MAC 地址不匹配,则将忽略 ifcfg。因此,务必要从文件中删除 HWADDR。

DEVICE=eth[x] BOOTPROTO=none ONBOOT=yes #NETWORK=10.0.1.0 <- REMOVE #NETMASK=255.255.255.0 <- REMOVE #IPADDR=10.0.1.20 <- REMOVE #HWADDR=xx:xx:xx:xx:xx <- REMOVE #USERCTL=no <- REMOVE # Remove any other *unique* or non-desired settings, such as UUID.

- 确保 DHCP 配置仍不包含 HWADDR 或任何唯一信息。

DEVICE=eth[x] BOOTPROTO=dhcp ONBOOT=yes

- 确保该文件包括以下行:

DEVICE=eth[x] ONBOOT=yes

- 如果存在以下文件,请确保它们包含相同的内容:

/etc/sysconfig/networking/devices/ifcfg-eth[x]/etc/sysconfig/networking/profiles/default/ifcfg-eth[x]

注意如果虚拟机使用了 NetworkManager 或任何特殊设置,请确保从 ifcfg 脚本中删除任何其他唯一信息。

删除注册详情

- 使用以下之一删除注册详情:

- 对于 Red Hat Network(RHN)注册的客户机虚拟机,请运行以下命令:

# rm /etc/sysconfig/rhn/systemid - 对于 Red Hat Subscription Manager(RHSM)注册的客户机虚拟机:

- 如果没有使用原始虚拟机,请运行以下命令:

# subscription-manager unsubscribe --all # subscription-manager unregister # subscription-manager clean

- 如果使用原始虚拟机,则只运行以下命令:

# subscription-manager clean注意原始 RHSM 配置集保留在门户网站中。

删除其他唯一详情

- 使用以下命令删除任何 sshd 公钥/私钥对:

# rm -rf /etc/ssh/ssh_host_*注意删除 ssh 密钥可防止 ssh 客户端不信任这些主机时出现问题。 - 删除任何其它应用程序特定标识符或配置,如果在多个机器上运行时可能会导致冲突。

配置虚拟机,使其在下次引导时运行配置向导

- 配置虚拟机,使其在下次引导时通过执行以下操作之一来运行相关配置向导:

- 对于 Red Hat Enterprise Linux 6 及以下,使用以下命令在名为 .unconfigured 的 root 文件系统中创建一个空文件:

# touch /.unconfigured - 对于 Red Hat Enterprise Linux 7,运行以下命令启用第一个引导和 initial-setup 向导:

# sed -ie 's/RUN_FIRSTBOOT=NO/RUN_FIRSTBOOT=YES/' /etc/sysconfig/firstboot # systemctl enable firstboot-graphical # systemctl enable initial-setup-graphical

注意在下次引导时运行的向导取决于从虚拟机中删除的配置。另外,在克隆第一次引导时,建议您更改主机名。

3.2. 克隆虚拟机

3.2.1. 使用 virt-clone 克隆客户机

--original。要查看完整的选项列表,请输入以下命令:

# virt-clone --help例 3.1. 使用 virt-clone 克隆客户机

# virt-clone --original demo --auto-clone例 3.2. 使用 virt-clone 克隆客户机

# virt-clone --connect qemu:///system --original demo --name newdemo --file /var/lib/xen/images/newdemo.img --file /var/lib/xen/images/newdata.img3.2.2. 使用 virt-manager 克隆 Guest

过程 3.2. 使用 virt-manager 克隆虚拟机

打开 virt-manager

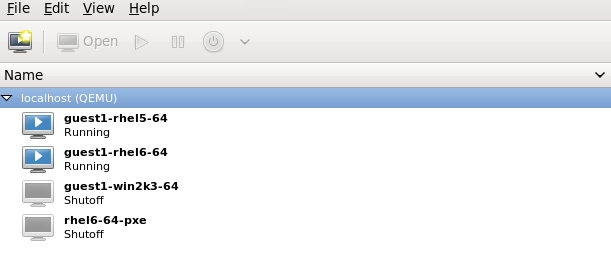

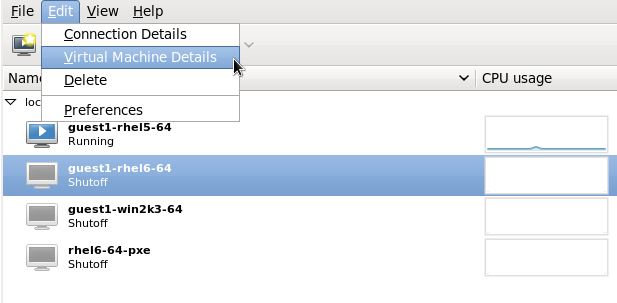

启动 virt-manager。从 和 子菜单启动虚拟机管理器应用程序。或者,以 root 用户身份运行 virt-manager 命令。从 虚拟机管理器 中的 guest 虚拟机列表中选择要克隆的 guest 虚拟机。右键单击要克隆的 guest 虚拟机,然后选择 。此时会打开 Clone Virtual Machine 窗口。图 3.1. 克隆虚拟机窗口

配置克隆

- 要更改克隆的名称,请为克隆输入一个新名称。

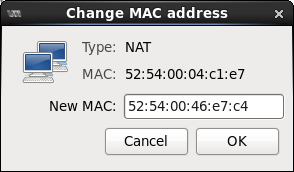

- 要更改网络配置,请单击 Details。为克隆输入新的 MAC 地址。点击 确定。

图 3.2. 更改 MAC Address 窗口

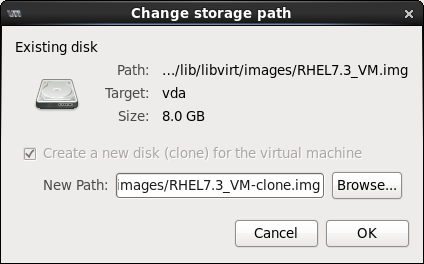

- 对于克隆的客户机虚拟机中的每个磁盘,请选择以下选项之一:

克隆此磁盘- 将为克隆的客户机虚拟机克隆磁盘与 客户机虚拟机名称共享磁盘 - 磁盘将由要克隆的 guest 虚拟机共享并克隆Details- 打开 Change storage path 窗口,为磁盘选择新路径图 3.3. 更改

存储路径窗口

克隆客户端虚拟机

单击 Clone。

第 4 章 KVM 实时迁移

- 负载平衡 - 虚拟机可以在主机物理机器过载时迁移到主机物理机器,或者另一台主机物理机器处于使用不足时。

- 硬件独立性 - 当我们需要升级、添加或删除主机物理机器上的硬件设备时,我们可以安全地将 guest 虚拟机重新定位到其他主机物理机器。这意味着,guest 虚拟机不会因硬件改进而停机。

- 节能 - 可以将虚拟机重新分发到其他主机物理机器,因此可以关闭来节省能源并在低用量时降低成本。

- 地理迁移 - 虚拟机可以移动到低延迟或严重情况下的另一位置。

4.1. 实时迁移要求

迁移要求

- 使用以下协议之一在共享存储上安装的客户机虚拟机:

- 基于光纤通道的 LUN

- iSCSI

- FcoE

- NFS

- GFS2

- SCSI RDMA 协议(SCSI RCP):Infiniband 和 10GbE iWARP 适配器中使用的块导出协议

- 迁移平台和版本应根据表 表 4.1 “实时迁移兼容性” 检查。另请注意,Red Hat Enterprise Linux 6 支持在共享存储上使用 raw 和 qcow2 镜像的客户机虚拟机实时迁移。

- 两个系统都必须打开正确的 TCP/IP 端口。如果使用防火墙,请参考《 Red Hat Enterprise Linux 虚拟化安全指南》, https://access.redhat.com/site/documentation/ 该指南可通过以下网址获取详细的端口信息。

- 导出共享存储介质的独立系统。存储不应位于用于迁移的两个主机物理计算机上。

- 共享存储必须挂载到源和目标系统上的同一位置。挂载的目录名称必须相同。虽然可以使用不同路径保留镜像,但不建议这样做。请注意,如果您打算使用 virt-manager 执行迁移,则路径名称必须相同。但是,如果您想要使用 virsh 执行迁移,则可将不同的网络配置和挂载目录用于帮助 --xml 选项或进行迁移时预告。即使没有共享存储,迁移仍可以通过 --copy-storage-all 选项(已弃用)成功。有关 prehook 的更多信息,请参阅 libvirt.org,以及有关 XML 选项的更多信息,请参阅 第 20 章 操作域 XML。

- 当在公共 bridge+tap 网络中的现有客户端虚拟机上尝试迁移时,源和目标主机物理机器必须位于同一网络中。否则,客户机虚拟机网络在迁移后不会运行。

- 在 Red Hat Enterprise Linux 5 和 6 中,KVM 客户机虚拟机的默认缓存模式被设置为

none,这可以防止磁盘状态不一致。将缓存选项设置为none(例如使用 virsh attach-disk 缓存 none ),导致所有 guest 虚拟机的文件都使用O_DIRECT标记(在调用 open syscall)时打开,从而绕过主机物理机器的缓存,并只在客户端虚拟机上提供缓存。将缓存模式设置为none可防止潜在的不一致问题,并在使用时让虚拟机进行实时迁移。有关将缓存设置为none的详情,请参考 第 13.3 节 “在客户机中添加存储设备”。

libvirtd 服务(# chkconfig libvirtd on)并运行(# service libvirtd start)。还务必要注意,高效迁移的能力取决于 /etc/libvirt/libvirtd.conf 配置文件中的参数设置。

过程 4.1. Configuring libvirtd.conf

- 打开

libvirtd.conf需要以 root 用户身份运行命令:# vim /etc/libvirt/libvirtd.conf

- 根据需要更改参数并保存文件。

- 重启

libvirtd服务:# service libvirtd restart

4.2. 实时迁移和 Red Hat Enterprise Linux 版本兼容性

| 迁移方法 | 发行类型 | 示例 | 实时迁移支持 | 备注 |

|---|---|---|---|---|

| 向前 | 主发行版本 | 5.x → 6.y | 不支持 | |

| 向前 | 次发行版本 | 5.x → 5.y (y>x, x>=4) | 完全支持 | 应报告任何问题 |

| 向前 | 次发行版本 | 6.x → 6.y (y>x, x>=0) | 完全支持 | 应报告任何问题 |

| 向后 | 主发行版本 | 6.x → 5.y | 不支持 | |

| 向后 | 次发行版本 | 5.x → 5.y (x>y,y>=4) | 支持 | 有关已知问题,请参阅 迁移的故障排除 |

| 向后 | 次发行版本 | 6.x → 6.y (x>y, y>=0) | 支持 | 有关已知问题,请参阅 迁移的故障排除 |

迁移的故障排除

- SPICE 的问题 - 我们发现,从 Red Hat Enterprise Linux 6.0 → 6.1 进行迁移时 SPICE 有不兼容的更改。在这种情况下,客户端可能会断开并重新连接,从而导致临时丢失音频和视频。这只是临时性,所有服务将恢复。

- USB 的问题 - Red Hat Enterprise Linux 6.2 添加了 USB 功能,其中包括迁移支持,但不需要注意重置 USB 设备并导致在设备上运行的任何应用程序中止。这个问题已在 Red Hat Enterprise Linux 6.4 中解决,未来版本不应该发生这个问题。为防止这个问题在 6.4 之前的版本中发生,在使用 USB 设备时 abstain 被迁移。

- 迁移协议的问题 - 如果向后兼容未显示"未知部分错误",请重复迁移过程可以解决这个问题,因为它可能是临时的错误。否则,请报告问题。

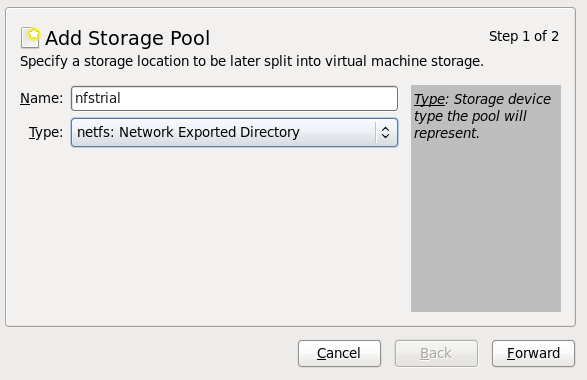

配置网络存储

配置共享存储并在共享存储上安装客户机虚拟机。

4.4. 使用 virsh 进行实时 KVM 迁移

# virsh migrate --live GuestName DestinationURL--live 选项。其它选项在 第 4.4.2 节 “virsh migrate 命令的其它选项” 中列出。

GuestName 参数代表您要迁移的客户机虚拟机的名称。

DestinationURL 参数是目标主机物理机器的连接 URL。目标系统必须运行与 Red Hat Enterprise Linux 相同的版本,它使用相同的虚拟机监控程序,且在 libvirt 正在运行。

DestinationURL 参数有不同的语义:

- 常规迁移:

DestinationURL是目标主机物理机器的 URL,如源客户机虚拟机中看到。 - peer-to-peer migration:

DestinationURL是目标主机物理机器的 URL,如源主机物理机器所示。

/etc/hosts 文件中,需要有目标主机物理机器的条目才能成功迁移。在此文件中输入目标主机物理机器的 IP 地址和主机名,如下例所示,替换您的目标主机物理机器的 IP 地址和主机名:

10.0.0.20 host2.example.com

示例:使用 virsh 进行实时迁移

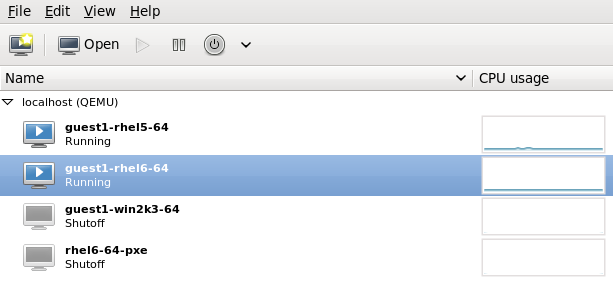

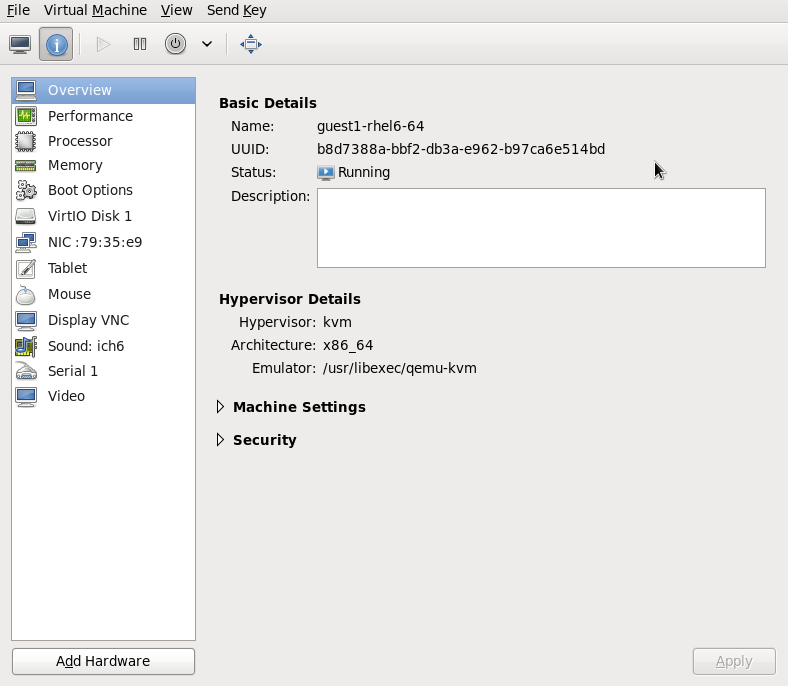

本例从 host1.example.com 迁移到 host2.example.com。更改您的环境的主机物理机器名称。本例迁移一个名为 guest1-rhel6-64 的虚拟机。

验证客户机虚拟机正在运行

从源系统host1.example.com,验证guest1-rhel6-64是否正在运行:[root@host1 ~]# virsh list Id Name State ---------------------------------- 10 guest1-rhel6-64 running

迁移客户机虚拟机

执行以下命令,将 guest 虚拟机实时迁移到目的地host2.example.com。在目标 URL 的末尾附加/system,以告知 libvirt 您需要完全访问。# virsh migrate --live

guest1-rhel6-64 qemu+ssh://host2.example.com/system输入完该命令后,系统将提示您输入目标系统的 root 密码。Wait

根据负载和客户机虚拟机的大小,迁移可能需要一些时间。virsh 仅报告错误.在完全迁移前,客户机虚拟机将继续在源主机物理机器中运行。注意在迁移过程中,完成百分比指示符数可能会在进程完成前减少多次。这是因为重新计算整个进度造成的,因为需要再次复制迁移后更改的源内存页面。因此,此行为是预期的,并不代表迁移中的任何问题。验证客户机虚拟机已到达目标主机

从目标系统host2.example.com,验证guest1-rhel6-64是否正在运行:[root@host2 ~]# virsh list Id Name State ---------------------------------- 10 guest1-rhel6-64 running

virsh dumpxml Guest1 > Guest1.xml virsh -c qemu+ssh://<target-system-FQDN> define Guest1.xml virsh undefine Guest1

4.4.1. 使用 virsh 进行迁移的额外提示

- 打开 libvirtd.conf 文件,如 过程 4.1, “Configuring libvirtd.conf” 所述。

- 查找处理控制部分。

################################################################# # # Processing controls # # The maximum number of concurrent client connections to allow # over all sockets combined. #max_clients = 20 # The minimum limit sets the number of workers to start up # initially. If the number of active clients exceeds this, # then more threads are spawned, upto max_workers limit. # Typically you'd want max_workers to equal maximum number # of clients allowed #min_workers = 5 #max_workers = 20 # The number of priority workers. If all workers from above # pool will stuck, some calls marked as high priority # (notably domainDestroy) can be executed in this pool. #prio_workers = 5 # Total global limit on concurrent RPC calls. Should be # at least as large as max_workers. Beyond this, RPC requests # will be read into memory and queued. This directly impact # memory usage, currently each request requires 256 KB of # memory. So by default upto 5 MB of memory is used # # XXX this isn't actually enforced yet, only the per-client # limit is used so far #max_requests = 20 # Limit on concurrent requests from a single client # connection. To avoid one client monopolizing the server # this should be a small fraction of the global max_requests # and max_workers parameter #max_client_requests = 5 #################################################################

- 更改

max_clients和max_workers参数设置。建议两个参数中的数字都是相同的。max_clients将每迁移(每个一侧)使用 2 个客户端(每个一侧),在目标执行阶段,并在完成阶段的 0 个 worker 中使用 1 个 worker。max_workers重要max_clients和max_workers参数设置适用于所有向 libvirtd 服务的连接的客户机虚拟机。这意味着,使用同一客户机虚拟机的任何用户,并同时执行迁移将保留至max_clients和max_workers参数设置中设置的限值。这就是为什么在执行并发实时迁移前需要仔细考虑最大值。 - 保存文件并重启该服务。注意有些情况下,迁移连接会丢弃,因为已启动但尚未进行身份验证的 ssh 会话太多。默认情况下,

sshd允许任何时候都允许 10 个会话处于"预先身份验证的状态"。此设置由 sshd 配置文件中的MaxStartups参数控制(在此位置:/etc/ssh/sshd_config),这可能需要进行一些调整。应谨慎调整这个参数,因为限制会被实施以防止 DoS 攻击(一般使用资源)。将此值设置为高时,将满足其用途。要更改此参数,请编辑文件/etc/ssh/sshd_config,从 MaxStartups 行的开头删除 #,并将10(默认值)改为一个更高的数字。记住保存文件并重新启动sshd服务。如需更多信息,请参阅sshd_configman page。

4.4.2. virsh migrate 命令的其它选项

--live 之外,virsh migrate accept accept the options:

--direct- 用于直接迁移--p2p- 用于对等的迁移--tunnelled- 用于隧道迁移--persistent- 将域保留为目标主机物理机器的持久性状态--undefinesource- 删除源主机物理机器上的客户机虚拟机--suspend- 在目标主机物理机器上使域处于暂停状态--change-protection- 强制实施在迁移时不对域进行不兼容的配置更改;在虚拟机监控程序支持时此选项会被隐式启用,但如果管理程序缺乏更改保护支持,则可以明确用于拒绝迁移。--unsafe- 强制迁移发生,忽略所有安全步骤。--verbose- 显示迁移的进度。--abort-on-error- 在迁移过程中发生软错误(如 I/O 错误)时取消迁移。--migrateuri- 通常被省略的迁移 URI。--domain[string]- 域名、id 或 uuid--desturi[string]- 目标主机物理机器的连接 URI(普通迁移)或 source(p2p migration)--migrateuri- 迁移 URI,通常可以省略--timeout[seconds]- 强制客户端虚拟机在实时迁移计数器超过 N 秒时暂停。它只能用于实时迁移。启动超时后,迁移便继续在暂停的客户机虚拟机上继续。--dname[string] - 在迁移过程中将客户机虚拟机的名称更改为新名称(如果支持)--XML - 表明的文件名可用于提供在目的地上使用的其他 XML 文件,为域 XML 的任何特定于主机的特定部分提供较大的更改,如访问底层存储时源和目的地之间的命名差异的核算。通常省略这个选项。

4.5. 使用 virt-manager 迁移

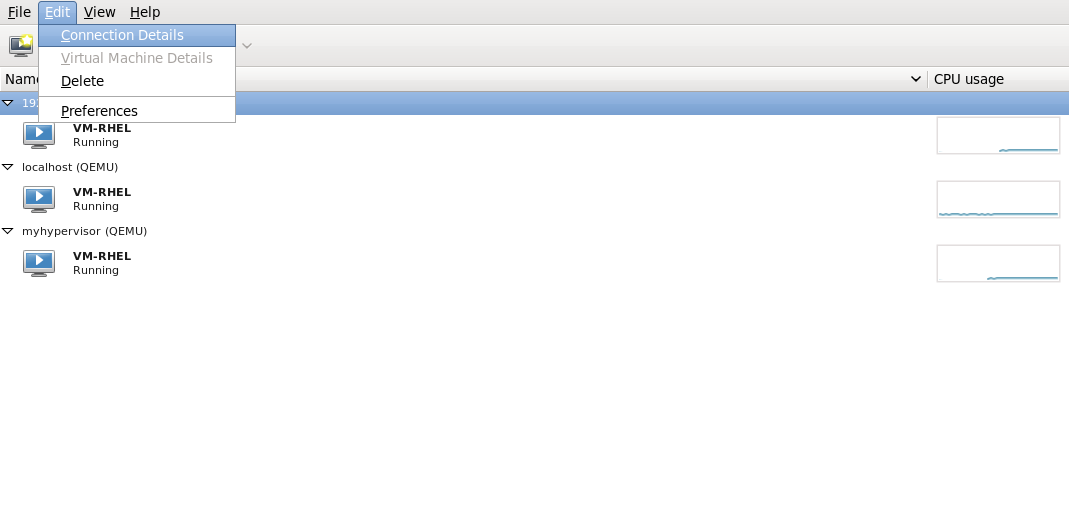

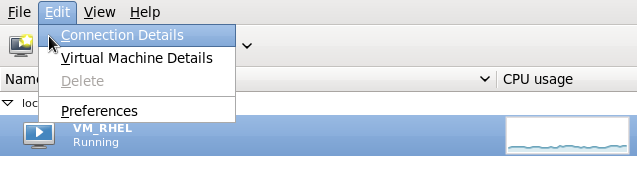

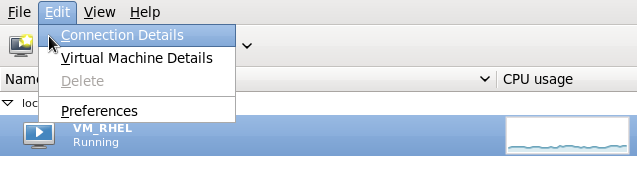

打开 virt-manager

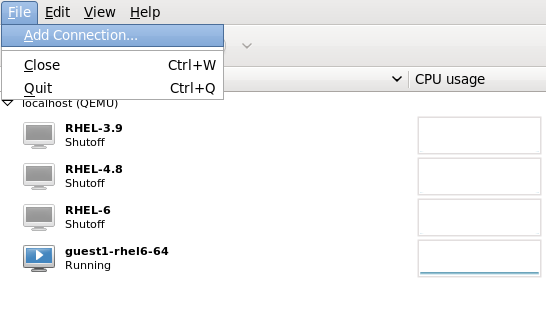

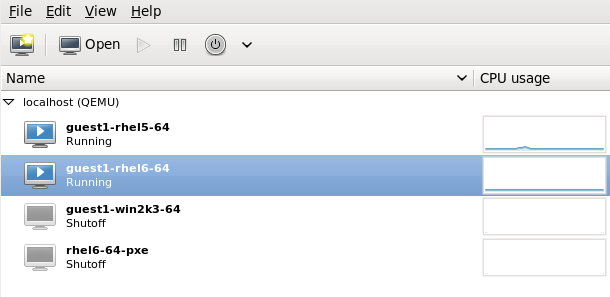

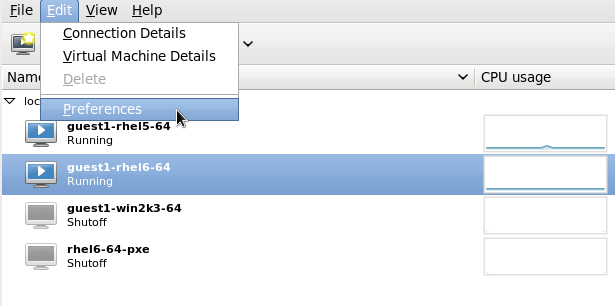

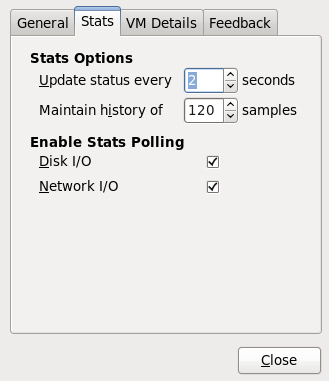

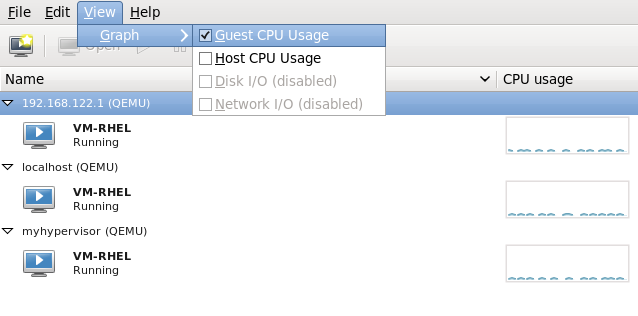

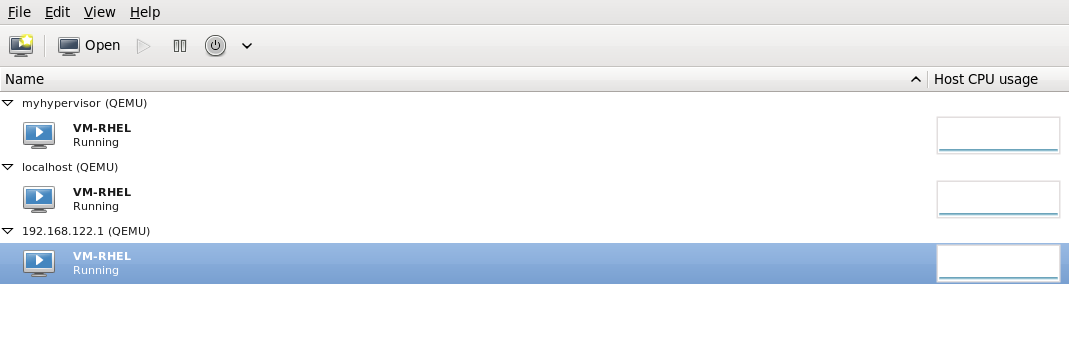

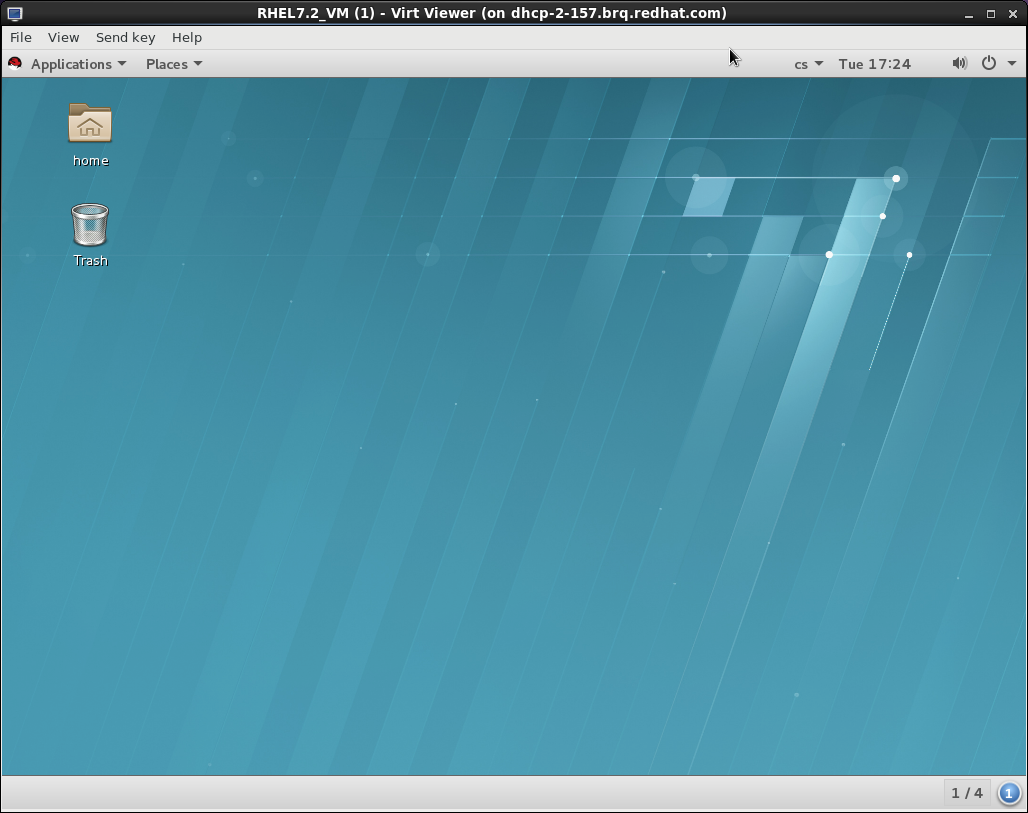

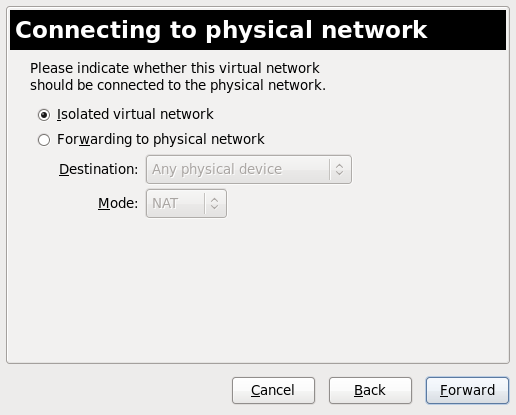

打开 virt-manager。从主菜单栏中选择" → → ",以启动 virt-manager。图 4.1. virt-Manager 主菜单

连接到目标主机物理机器

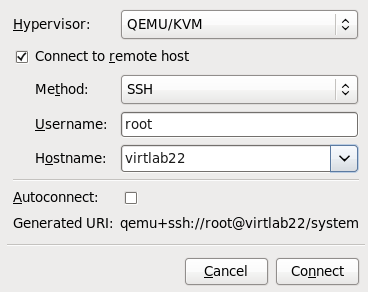

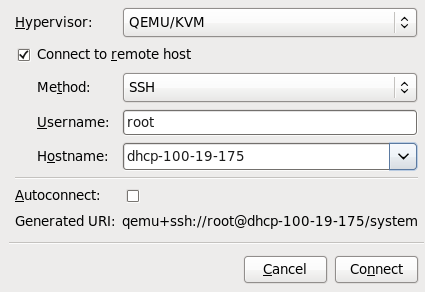

单击 菜单,然后单击 ,以连接到目标主机物理机器。图 4.2. 打开 Add Connection 窗口

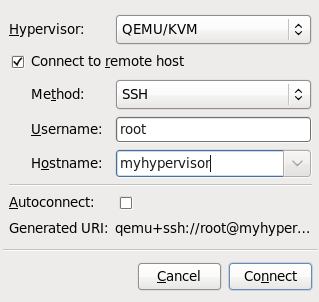

添加连接

此时会出现 Add Connection 窗口。图 4.3. 添加与目标主机物理机器的连接

输入以下详情:

输入以下详情:- 虚拟机监控程序 :选择 。

- method :选择连接方法。

- 用户名 :输入远程主机物理机器的用户名。

- hostname :输入远程主机物理机器的主机名。

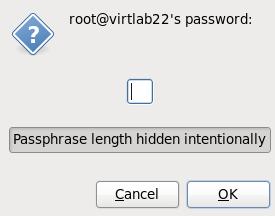

点 按钮。本例中使用了 SSH 连接,因此下一步中必须输入指定用户的密码。图 4.4. 输入密码

迁移客户机虚拟机

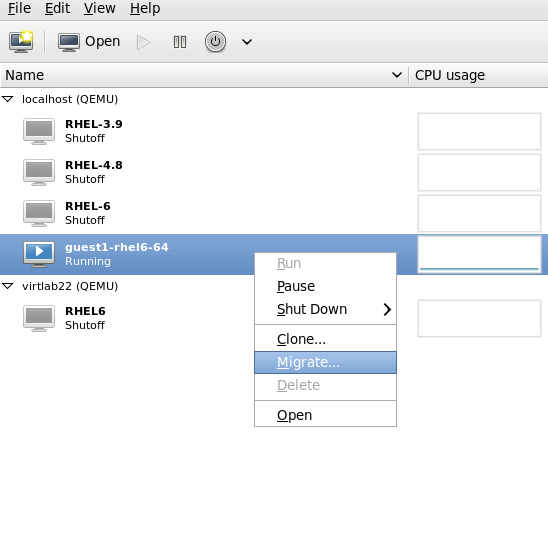

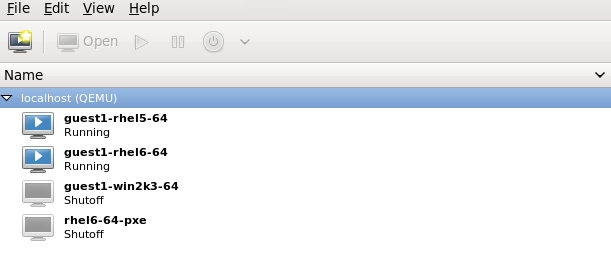

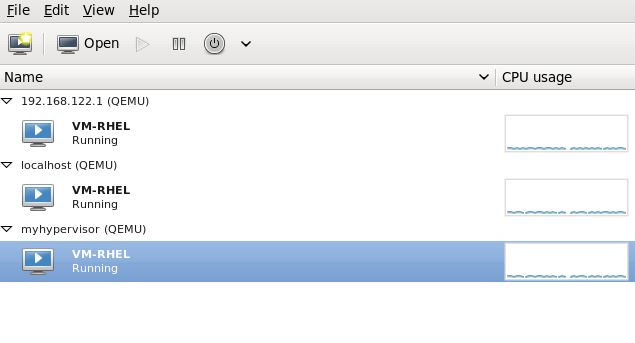

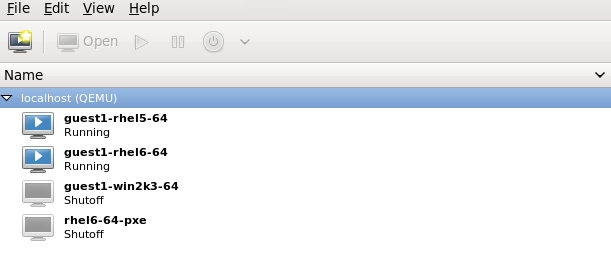

打开源主机物理机器中的客户机列表(单击主机名左侧的小三角),然后右键单击要迁移的 guest(本例中的guest1-rhel6- 64)并单击" "。图 4.5. 选择要迁移的客户端

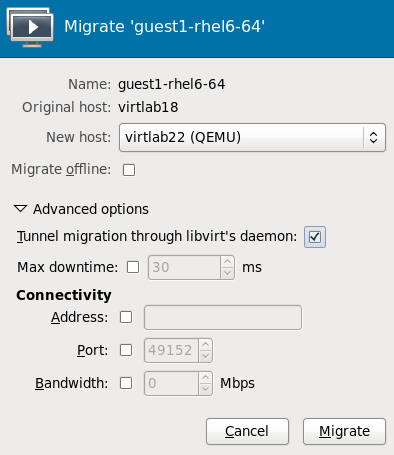

在 字段中,使用下拉列表选择要将 guest 虚拟机迁移到的主机物理机器,然后单击 。

在 字段中,使用下拉列表选择要将 guest 虚拟机迁移到的主机物理机器,然后单击 。图 4.6. 选择目标主机物理机器并启动迁移过程

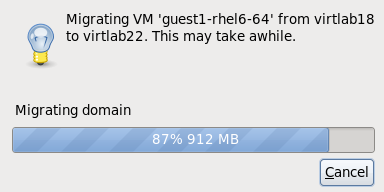

系统将显示进度窗口。

系统将显示进度窗口。图 4.7. 进度窗口

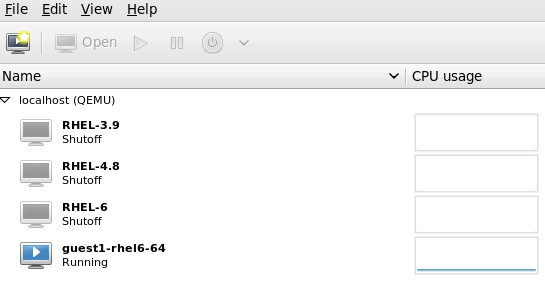

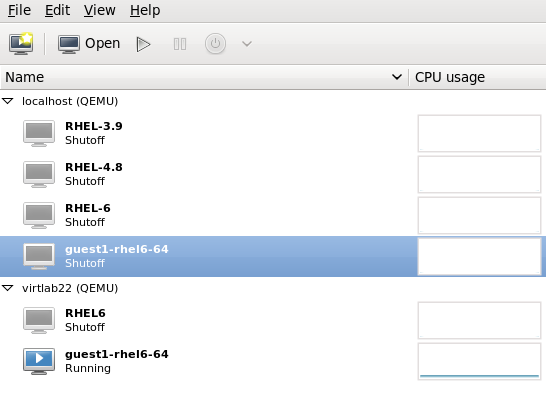

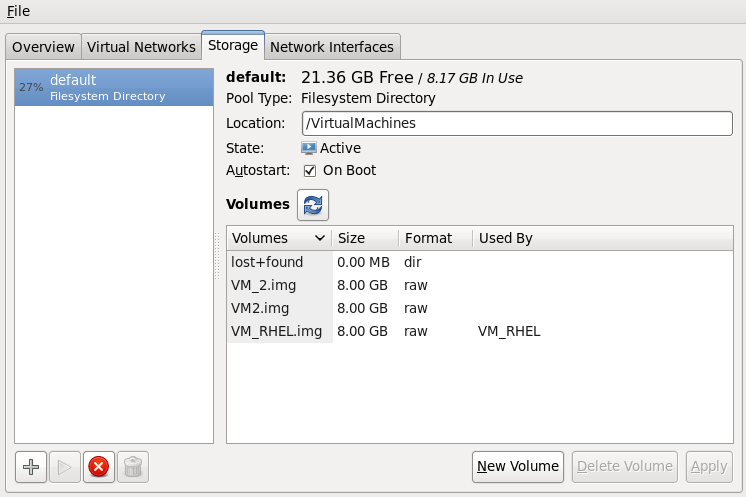

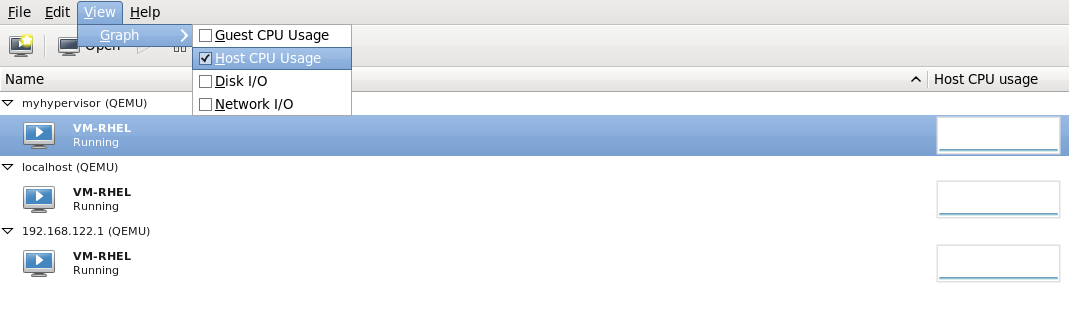

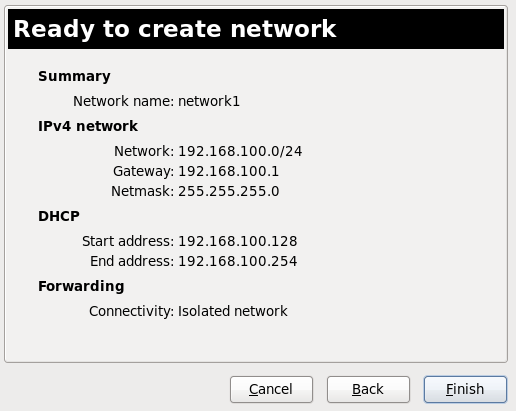

virt-manager 现在显示目标主机上运行的新迁移的客户机虚拟机。在源主机物理机器中运行的客户端虚拟机现在被列为 Shutoff 状态。

virt-manager 现在显示目标主机上运行的新迁移的客户机虚拟机。在源主机物理机器中运行的客户端虚拟机现在被列为 Shutoff 状态。图 4.8. 迁移的客户机虚拟机在目标主机物理机器中运行

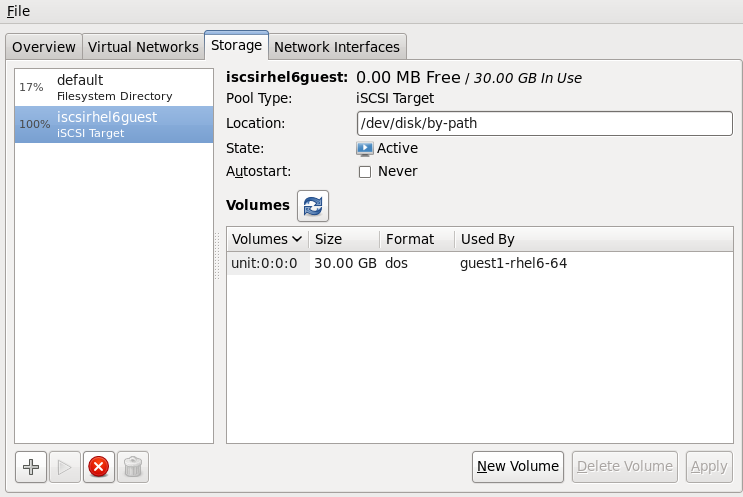

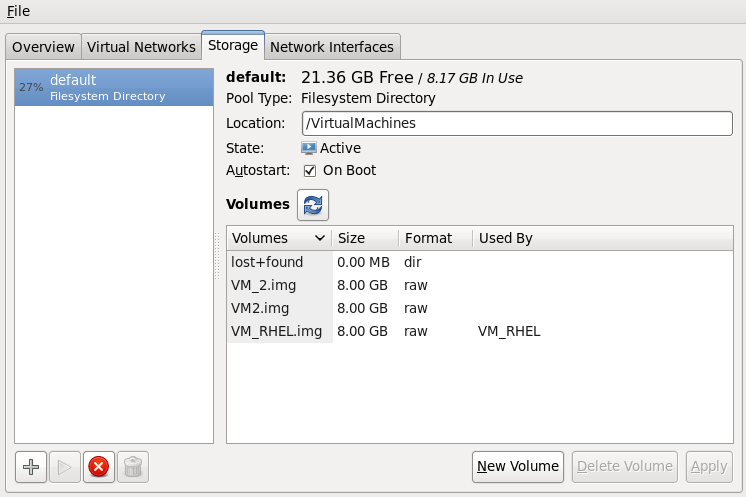

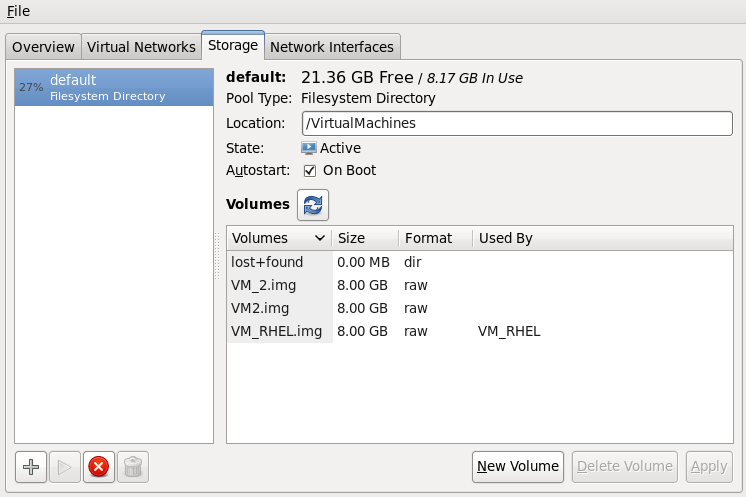

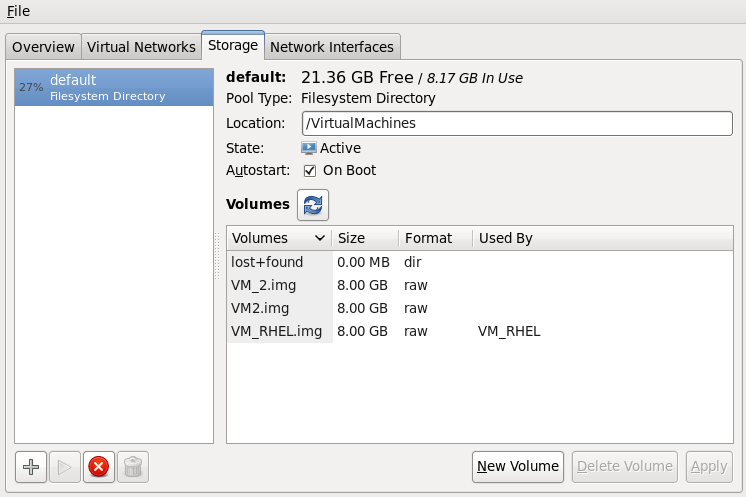

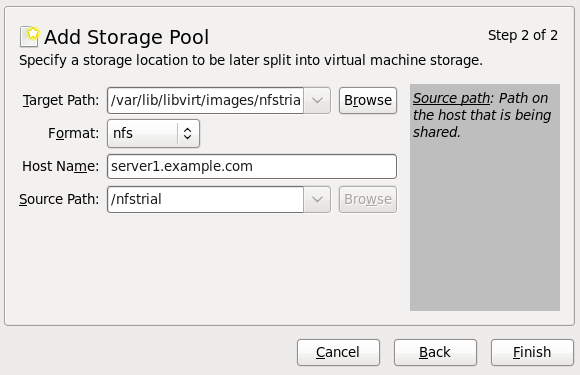

可选 - 查看主机物理机器的存储详情

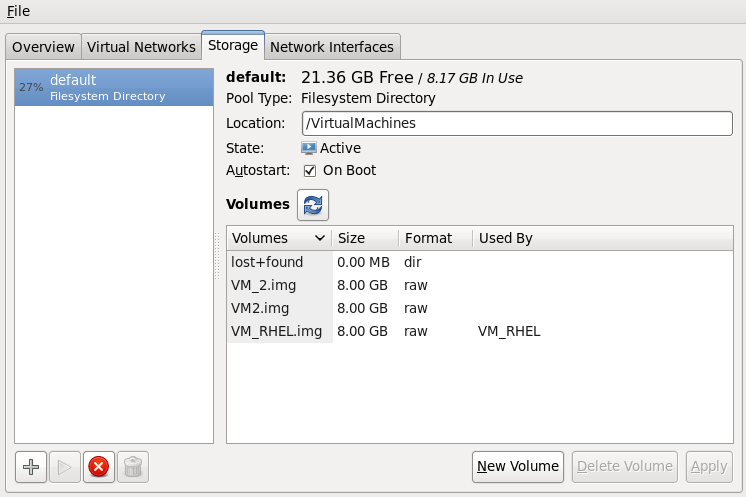

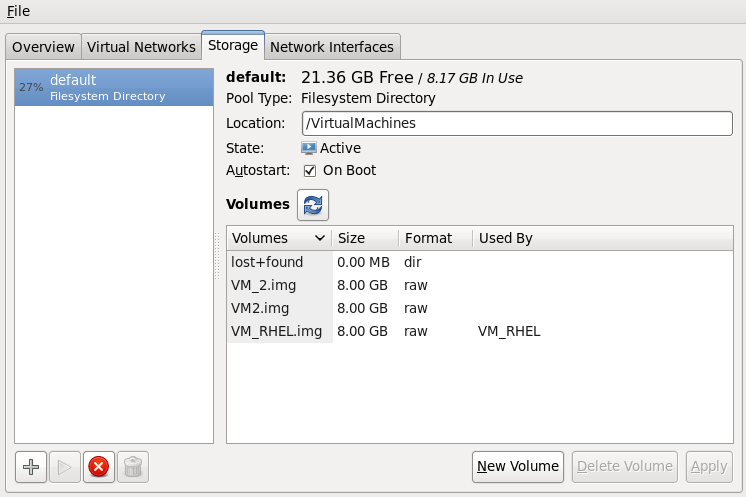

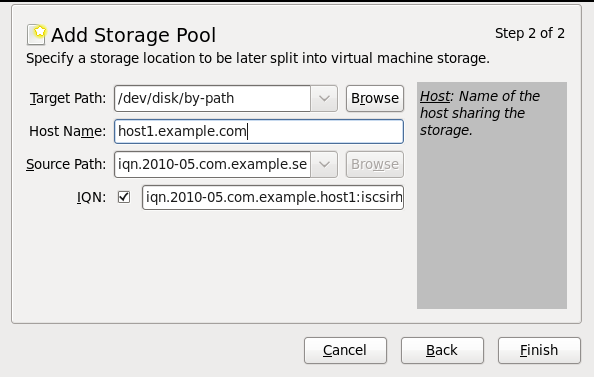

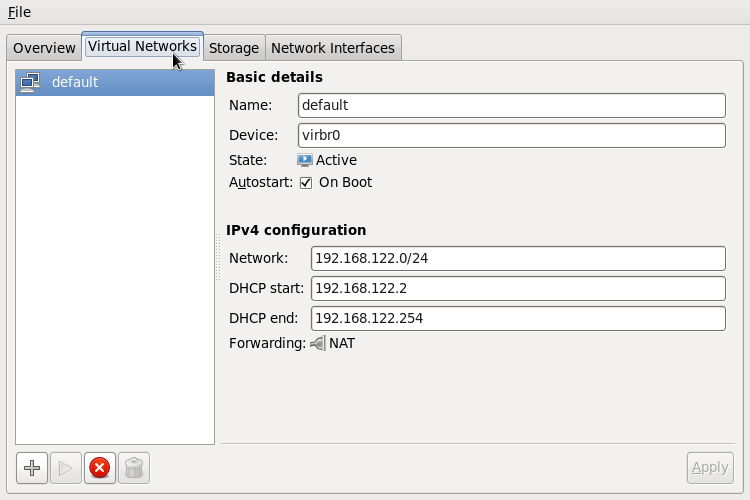

在 菜单中,单击 ,显示 Connection Details 窗口。点 选项卡。显示目标主机物理机器的 iSCSI 目标详情。请注意,迁移的客户机虚拟机被列为使用存储图 4.9. 存储详情

此主机由以下 XML 配置定义:

此主机由以下 XML 配置定义:图 4.10. 目标主机物理机器的 XML 配置

<pool type='iscsi'> <name>iscsirhel6guest</name> <source> <host name='virtlab22.example.com.'/> <device path='iqn.2001-05.com.iscsivendor:0-8a0906-fbab74a06-a700000017a4cc89-rhevh'/> </source> <target> <path>/dev/disk/by-path</path> </target> </pool> ...

第 5 章 客户机的远程管理

5.1. 使用 SSH 进行远程管理

- 您需要 root 登陆到远程机器来管理虚拟机,

- 初始连接设置过程可能很慢,

- 无法对所有主机或客户机撤销用户密钥的标准或简单方法,

- SSH 无法很好地扩展更大的远程机器。

- openssh

- openssh-askpass

- openssh-clients

- openssh-server

为 virt-manager配置无密码管理的 SSH 访问

以下说明假设您从头开始启动,并且尚未设置 SSH 密钥。如果您将 SSH 密钥设置并复制到其它系统中,您可以跳过这个过程。

可选:更改用户

根据需要更改用户。本示例使用本地 root 用户来远程管理其他主机和本地主机。$ su -生成 SSH 密钥对

使用机器 virt-manager 上的公钥对。本例使用~/.ssh/目录中的默认密钥位置。# ssh-keygen -t rsa将密钥复制到远程主机

不带密码或密码短语进行远程登录,需要向受管理的系统分发 SSH 密钥。使用 ssh-copy-id 命令,在提供的系统地址(示例中为root@host2.example.com)将密钥复制到 root 用户。# ssh-copy-id -i ~/.ssh/id_rsa.pub root@host2.example.com root@host2.example.com's password:现在,尝试使用 ssh root@host2.example.com 命令登录到机器,并在.ssh/authorized_keys文件中检查以确保尚未添加意外密钥。根据需要,对其他系统重复此操作。可选:在 ssh-agent 中添加密码短语

下面的说明描述了如何在现有 ssh-agent 中添加密码短语。如果 ssh-agent 未在运行,它将无法运行。为了避免错误或冲突,请确保正确设置了 SSH 参数。如需更多信息,请参阅 Red Hat Enterprise Linux 部署指南。如果需要,将 SSH 密钥的密语添加到 ssh-agent。在本地主机上,使用以下命令添加密码短语(如果有)来启用免密码登录。# ssh-add ~/.ssh/id_rsaSSH 密钥被添加到远程系统。

libvirt 守护进程(libvirtd)

libvirt 守护进程提供用于管理虚拟机的接口。您必须在需要管理的每个远程主机中安装并运行 libvirtd 守护进程。

$ ssh root@somehost # chkconfig libvirtd on # service libvirtd start

libvirtd 和 SSH 后,您应能够远程访问和管理虚拟机。此时您应当能够使用 VNC 访问您的 guest。

使用 virt-manager 访问远程主机

远程主机可以使用 virt-manager GUI 工具进行管理。SSH 密钥必须属于执行 virt-manager 的用户,以便免密码登录才能工作。

- 启动 virt-manager。

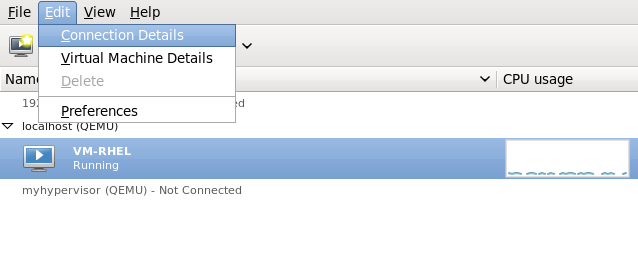

- 打开 -> 菜单。

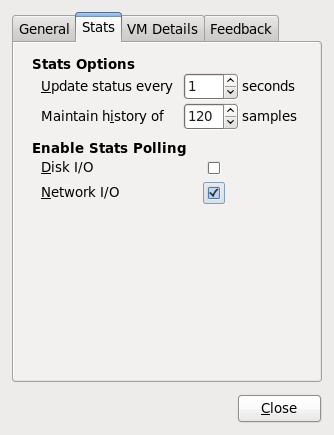

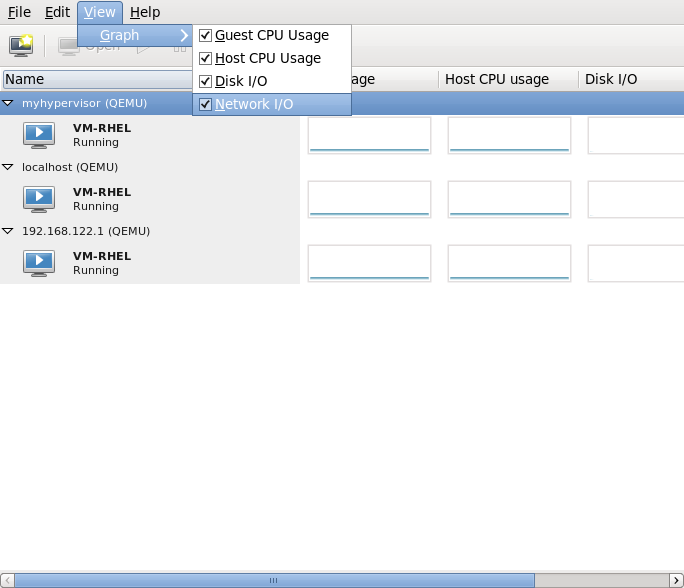

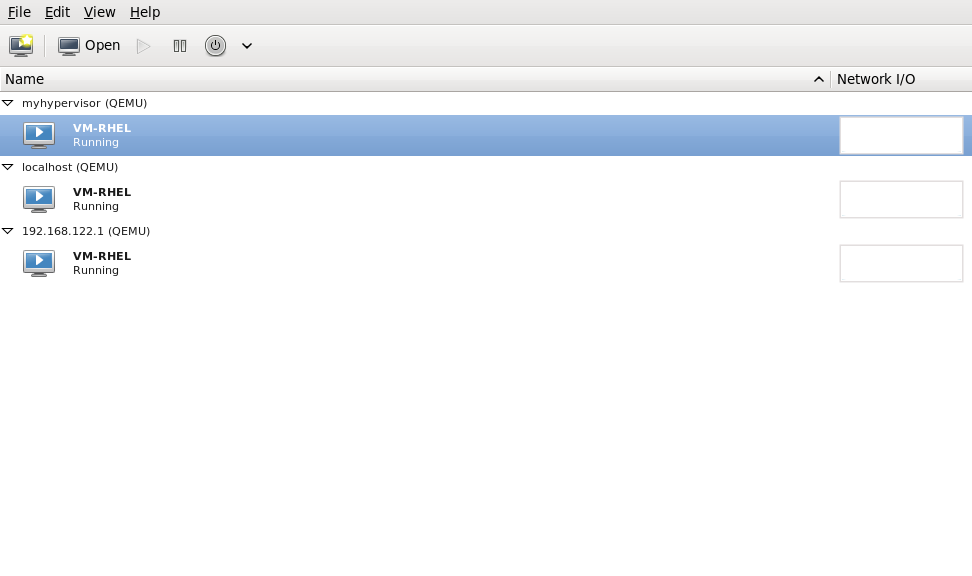

图 5.1. 添加连接菜单

- 使用下拉菜单选择管理程序类型,然后单击" "复选框以打开"连接方法"(在本例中为 Remote tunnel over SSH),然后输入所需的 和 ,然后单击 。

5.2. 使用 TLS 和 SSL 进行远程管理

过程 5.1. 创建用于 TLS 管理的证书颁发机构(CA)密钥

- 开始之前,请确认已安装 certtool 实用程序。如果没有:

# yum install gnutls-utils - 使用以下命令生成私钥:

# certtool --generate-privkey > cakey.pem - 生成密钥后,下一步是创建一个签名文件,以便该密钥可以自我签名。要做到这一点,创建一个带有签名详情的文件并将其命名为

ca.info。此文件应包含以下内容:# vim ca.infocn = Name of your organization ca cert_signing_key

- 使用以下命令生成自签名证书:

# certtool --generate-self-signed --load-privkey cakey.pem --template ca.info --outfile cacert.pem生成文件后,可以使用 rm 命令删除 ca.info 文件。生成过程的结果名为cacert.pem。此文件是公钥(certificate)。加载的文件cakey.pem是私钥。此文件不应保存在共享空间中。保留此密钥私钥。 - 在

/etc/pki/CA/证书颁发机构证书文件,以使它们知道您的 CA 发布的证书可以被信任。要查看此文件的内容,请运行:cacert.pem目录中的所有客户端和服务器上安装 cacert.pem# certtool -i --infile cacert.pem这是设置您的 CA 所需的全部内容。使 CA 的私钥保持安全,因为您需要为客户端和服务器发布证书。

过程 5.2. 发出服务器证书

qemu://mycommonname/system 连接到服务器,因此 CN 字段应该相同,ie mycommoname。

- 为服务器创建私钥。

# certtool --generate-privkey > serverkey.pem - 首先创建名为

server.info的模板文件,为 CA 的私钥生成签名。确保 CN 设置为与服务器的主机名相同:organization = Name of your organization cn = mycommonname tls_www_server encryption_key signing_key

- 使用以下命令创建证书:

# certtool --generate-certificate --load-privkey serverkey.pem --load-ca-certificate cacert.pem --load-ca-privkey cakey.pem \ --template server.info --outfile servercert.pem - 这会导致生成的两个文件:

- ServerKey.pem - 服务器的私钥

- servercert.pem - 服务器的公钥

确保保留私钥 secret 的位置。要查看文件的内容,请执行以下命令:# certtool -i --inifile servercert.pem在打开此文件时,CN=参数应该和之前设置的 CN 相同。例如,mycommonname。 - 在以下位置安装这两个文件:

ServerKey.pem- 服务器的私钥。将此文件放在以下位置:/etc/pki/libvirt/private/serverkey.pemservercert.pem- 服务器的证书。在服务器以下位置安装它:/etc/pki/libvirt/servercert.pem

过程 5.3. 发出客户端证书

- 对于每个客户端(例如 virt-manager)链接到 libvirt 的任何程序,您需要向合适的名称(DN)发送带有 X.509 Distinguished Name(DN)的证书。这需要根据公司级别决定。例如,将使用以下信息:

C=USA,ST=North Carolina,L=Raleigh,O=Red Hat,CN=name_of_client

这个过程与 过程 5.2, “发出服务器证书” 类似,但请注意以下例外情况。 - 使用以下命令生成私钥:

# certtool --generate-privkey > clientkey.pem - 首先创建名为

client.info的模板文件,为 CA 的私钥生成签名。该文件应当包含以下内容(应自定义字段来反映您的地区/位置):country = USA state = North Carolina locality = Raleigh organization = Red Hat cn = client1 tls_www_client encryption_key signing_key

- 使用以下命令签署证书:

# certtool --generate-certificate --load-privkey clientkey.pem --load-ca-certificate cacert.pem \ --load-ca-privkey cakey.pem --template client.info --outfile clientcert.pem - 在客户端机器上安装证书:

# cp clientkey.pem /etc/pki/libvirt/private/clientkey.pem # cp clientcert.pem /etc/pki/libvirt/clientcert.pem

5.3. 传输模式

传输层安全性(TLS)

传输层安全性 TLS 1.0(SSL 3.1)经验证并加密 TCP/IP 套接字,通常侦听公共端口号。要使用这个设置,您需要生成客户端和服务器证书。标准端口为 16514。

UNIX 套接字

UNIX 域套接字仅可在本地计算机上访问。套接字没有加密,并使用 UNIX 权限或 SELinux 进行身份验证。标准套接字名称为 /var/run/libvirt/libvirt-sock 和 /var/run/libvirt/libvirt-sock-ro (用于只读连接)。

SSH

通过安全 Shell 协议(SSH)连接传输。需要安装 Netcat( nc 软件包)。libvirt 守护进程(libvirtd)必须在远程系统上运行。端口 22 必须处于打开状态才能进行 SSH 访问。您应该使用某种 SSH 密钥管理(例如,ssh-agent 实用程序),否则将提示您输入密码。

ext

ext 参数用于任何可通过 libvirt 范围外连接到远程机器的外部程序。这个参数不被支持。

TCP

未加密的 TCP/IP 套接字。不建议在生产环境中使用,这通常是禁用的,但管理员可以启用它进行测试或在可信网络上使用。默认端口为 16509。

远程 URI

virsh 和 libvirt 使用统一资源标识符(URI)连接到远程主机。URI 也可与 virsh 命令的 --connect 参数一起使用,以在远程主机上执行单个命令或迁移。通过使用普通本地 URI 并添加主机名或传输名称,形成远程 URI。作为特殊情况,使用'remote' 的 URI 方案,将告知远程 libvirtd 服务器探测到最佳管理程序驱动程序。这等同于为本地连接传递 NULL URI

driver[+transport]://[username@][hostname][:port]/path[?extraparameters]

- qemu://hostname/

- xen://hostname/

- xen+ssh://hostname/

远程管理参数示例

- 使用 SSH 传输和 SSH 用户名

virtuser连接到一个名为host2的远程 KVM 主机。每个连接的命令是连接 [< name>] [--readonly],其中 < name& gt; 是有效的 URI,如此处所述。有关 virsh connect 命令的详情请参考 第 14.1.5 节 “connect”qemu+ssh://virtuser@hot2/ - 使用 TLS 连接到名为

host2的主机上的远程 KVM 管理程序。qemu://host2/

测试示例

- 使用非标准 UNIX 套接字连接到本地 KVM 管理程序。本例中明确提供了到 UNIX 套接字的完整路径。

qemu+unix:///system?socket=/opt/libvirt/run/libvirt/libvirt-sock - 使用未加密的 TCP/IP 连接到 libvirt 守护进程,使用 IP 地址 10.1.1.10 在端口 5000 上连接到服务器。这会将 test 驱动程序与默认设置搭配使用。

test+tcp://10.1.1.10:5000/default

附加 URI 参数

可以在远程 URI 中附加额外参数。下表 表 5.1 “附加 URI 参数” 涵盖了可识别的参数。其它参数将被忽略。请注意,参数值必须是 URI-escaped(即,在参数前附加一个问号(?),并且特殊字符转换为 URI 格式)。

| 名称 | 传输模式 | 描述 | 用法示例 |

|---|---|---|---|

| name | 所有模式 | 传递给远程 virConnectOpen 功能的名称。名称通常通过从远程 URI 中删除传输、主机名、端口号、用户名和额外参数形成,但在某些情况下可以更好地提供名称。 | name=qemu:///system |

| 命令 | SSH 和 ext | external 命令。对于 ext 传输,这是必需的。对于 ssh,默认为 ssh。为该命令搜索 PATH。 | command=/opt/openssh/bin/ssh |

| socket | UNIX 和 ssh | UNIX 域套接字的路径,用于覆盖默认设置。对于 ssh 传输,这将传递给远程 netcat 命令(请参见 netcat)。 | socket=/opt/libvirt/run/libvirt/libvirt-sock |

| netcat | ssh |

netcat 命令可用于连接到远程系统。默认 netcat 参数使用 nc 命令。对于 SSH 传输,libvirt 使用以下表格构造 SSH 命令:

command -p port [-l username] hostname

netcat -U socket

port、username 和 hostname 参数可作为远程 URI 的一部分指定。command、netcat 和 socket 来自其他的额外参数。

| netcat=/opt/netcat/bin/nc |

| no_verify | tls | 如果设置为非零值,则禁用对服务器证书的客户端检查。请注意,要禁用对客户端的证书或 IP 地址的服务器检查,您必须更改 libvirtd 配置。 | no_verify=1 |

| no_tty | ssh | 如果设置为非零值,则在无法自动登录到远程机器时,这将停止 ssh 询问密码(如果无法自动登录到远程机器)。当您无法访问终端 时使用这个选项。 | no_tty=1 |

第 6 章 使用 KVM 进行过量使用

6.1. 过量使用内存

6.2. 过量使用虚拟 CPU

第 7 章 KSM

qemu-kvm 进程中继承内存。客户机虚拟机运行后,可以在客户机运行相同操作系统或应用程序时,客户机虚拟机操作系统镜像的内容可以共享。

/sys/kernel/mm/ksm/merge_across_nodes 可调项改为 0,以避免在 NUMA 节点间合并页面。内核内存核算统计最终可在大量跨节点合并后相互冲突。因此,numad 在 KSM 守护进程合并大量内存后可能会变得混乱。如果您的系统有大量可用内存,可以通过关闭和禁用 KSM 守护进程来获得更高的性能。有关 NUMA 的更多信息,请参阅 Red Hat Enterprise Linux 性能调优指南。

ksm服务启动并停止 KSM 内核线程。ksmtuned服务控制并调整ksm,动态管理同一页面合并。ksmtuned服务启动ksm,并在不需要内存共享时停止ksm服务。ksmtuned服务必须使用retune参数告知在创建或销毁新客户机时运行。

KSM 服务

ksm 服务包含在 qemu-kvm 软件包中。在 Red Hat Enterprise Linux 6 中默认禁用 KSM。但是,当使用 Red Hat Enterprise Linux 6 作为 KVM 主机物理机器时,它可能会被 ksm/ksmtuned 服务打开。

ksm 服务,则 KSM 仅共享 2000 个页面。这个默认值较低,并提供有限的内存保存优势。

ksm 服务后,KSM 将最多共享主机物理机器系统主内存的一半。启动 ksm 服务,使 KSM 能够共享更多内存。

# service ksm start Starting ksm: [ OK ]

ksm 服务可以添加到默认启动序列中。使用 chkconfig 命令使 ksm 服务持久。

# chkconfig ksm on

KSM 调整服务

ksmtuned 服务没有任何选项。ksmtuned 服务循环并调整 ksm。当客户机虚拟机被创建或销毁时,libvirt 会通知 ksmtuned 服务。

# service ksmtuned start Starting ksmtuned: [ OK ]

retune 参数调整 ksmtuned 服务。retune 参数指示 ksmtuned 手动运行调整功能。

thres- 激活阈值,单位为字节。当把thres值添加到所有qemu-kvm进程 RSZ 超过总系统内存时,会触发 KSM 周期。这个参数在KSM_THRES_COEF中定义的百分比的 kbytes 中相同。

/etc/ksmtuned.conf 文件是 ksmtuned 服务的配置文件。以下文件输出是默认的 ksmtuned.conf 文件。

# Configuration file for ksmtuned. # How long ksmtuned should sleep between tuning adjustments # KSM_MONITOR_INTERVAL=60 # Millisecond sleep between ksm scans for 16Gb server. # Smaller servers sleep more, bigger sleep less. # KSM_SLEEP_MSEC=10 # KSM_NPAGES_BOOST is added to thenpagesvalue, whenfree memoryis less thanthres. # KSM_NPAGES_BOOST=300 # KSM_NPAGES_DECAY Value given is subtracted to thenpagesvalue, whenfree memoryis greater thanthres. # KSM_NPAGES_DECAY=-50 # KSM_NPAGES_MIN is the lower limit for thenpagesvalue. # KSM_NPAGES_MIN=64 # KSM_NAGES_MAX is the upper limit for thenpagesvalue. # KSM_NPAGES_MAX=1250 # KSM_TRES_COEF - is the RAM percentage to be calculated in parameterthres. # KSM_THRES_COEF=20 # KSM_THRES_CONST - If this is a low memory system, and thethresvalue is less thanKSM_THRES_CONST, then resetthresvalue toKSM_THRES_CONSTvalue. # KSM_THRES_CONST=2048 # uncomment the following to enable ksmtuned debug information # LOGFILE=/var/log/ksmtuned # DEBUG=1

KSM 变量和监控

KSM 将监控数据存储在 /sys/kernel/mm/ksm/ 目录中。这个目录中的文件由内核更新,是 KSM 使用和统计数据的准确记录。

/etc/ksmtuned.conf 文件中的可配置变量,如下所示。

/sys/kernel/mm/ksm/ 文件

- full_scans

- 完整扫描运行.

- pages_shared

- 共享的总页面。

- pages_sharing

- 现已共享的页面.

- pages_to_scan

- 页面未扫描。

- pages_unshared

- 页面不再共享。

- pages_volatile

- 易失性页面的数量。

- run

- KSM 进程是否在运行。

- sleep_millisecs

- sleep 毫秒.

DEBUG=1 行添加到 /etc/ksmtuned.conf 文件中,则 KSM 调整活动将存储在 /var/log/ksmtuned 日志文件中。日志文件位置可使用 LOGFILE 参数更改。不建议更改日志文件位置,可能需要特殊配置 SELinux 设置。

取消激活 KSM

KSM 具有性能开销,对于某些环境或主机物理机器系统来说可能太大。

ksmtuned 和 ksm 服务可停用 KSM。停止服务会停用 KSM,但重启后不会保留。

# service ksmtuned stop Stopping ksmtuned: [ OK ] # service ksm stop Stopping ksm: [ OK ]

# chkconfig ksm off # chkconfig ksmtuned off

第 8 章 高级虚拟机管理

8.1. 控制组(cgroups)

8.2. 巨页支持

简介

x86 CPU 通常可在 4kB 页面中解决内存,但它们可以使用更大的页面,称为 大页面。KVM 客户机可以使用巨页内存支持进行部署,从而通过根据 transaction Lookaside Buffer(TLB) 增加 CPU 缓存点击来提高性能。巨页可能会显著提高性能,特别是大型内存和内存密集型工作负载。Red Hat Enterprise Linux 6 通过使用巨页增加页面大小,可以更有效地管理大量内存。

透明大内存页

透明大内存页 (THP)是一个内核功能,可减少应用程序所需的 TLB 条目。通过还允许所有可用内存用作缓存,性能也会提高。

qemu.conf 文件中不需要特殊配置。如果将 /sys/kernel/mm/redhat_transparent_hugepage/enabled 设置为 always,则默认使用巨页。

hugetlbfs 功能。但是,如果没有使用 hugetlbfs,KVM 将使用透明的巨页,而不是常规的 4kB 页面大小。

8.3. 在 Hyper-V Hypervisor 中将 Red Hat Enterprise Linux 作为虚拟机运行

- 升级的 VMBUS 协议 - VMBUS 协议已升级到 Windows 8 级别。作为这一工作的一部分,现在可以在客户端中的所有可用虚拟 CPU 上处理 VMBUS 中断。另外,Red Hat Enterprise Linux 客户机虚拟机和 Windows 主机物理机器之间的信号协议已被优化。

- 概要帧缓冲驱动程序 - 为 Red Hat Enterprise Linux 桌面用户提供增强的图形性能和出色的解决方案。

- 实时虚拟机备份支持 - 为实时 Red Hat Enterprise Linux 客户机虚拟机提供不间断备份支持。

- 固定大小 Linux VHD 的动态扩展 - 允许扩展实时挂载的固定大小 Red Hat Enterprise Linux VHD.

8.4. 客户机虚拟机内存分配

bbytes用于字节KB对于千字节(103 或块 1000 字节)k或KiB用于 kibibytes(210 或块 1024 字节)MB兆字节(10 个6 或块 1,000,000 字节)M或者MiB用于兆字节(220 或块 1,048,576 字节)GB千兆字节(109 或块 1,000,000,000 字节)G或GiB用于千兆字节(230个 或块为 1,073,741,824 字节)TB太字节(1012 或块 1,000,000,000 字节)T或者TiB用于 tebibytes(240 或块 1,099,511,627,776 字节)

memory unit 决定,它默认为 kibibytes(KiB)作为测量结果单位,其中给出的值乘以 210 或 1024 字节的块。

dumpCore,则可用来控制客户机虚拟机的内存是否应该包含在生成的 coredump(dumpCore='on')中,或者不包含(dumpCore='off')。请注意,默认设置为 on,因此如果参数没有设置为 off,则客户机虚拟机内存将包含在 coredump 文件中。

currentMemory 属性决定客户机虚拟机的实际内存分配。这个值可能小于最大分配量,允许即时对客户机虚拟机内存进行膨胀。如果省略此项,则默认为与 memory 元素相同的值。unit 属性的行为与内存的行为相同。

<domain> <memory unit='KiB' dumpCore='off'>524288</memory> <!-- changes the memory unit to KiB and does not allow the guest virtual machine's memory to be included in the generated coredump file --> <currentMemory unit='KiB'>524288</currentMemory> <!-- makes the current memory unit 524288 KiB --> ... </domain>

8.5. 自动启动客户机虚拟机

TestServer,在主机物理机器引导时自动启动。

# virsh autostart TestServer

Domain TestServer marked as autostarted

--disable 参数

# virsh autostart --disable TestServer

Domain TestServer unmarked as autostarted

8.6. 为 guest 虚拟机禁用 SMART 磁盘监控

# service smartd stop # chkconfig --del smartd

8.7. 配置 VNC 服务器

~/.vnc/xstartup 文件,以在每次 vncserver 启动时启动 GNOME 会话。第一次运行 vncserver 脚本时,它将询问您要用于 VNC 会话的密码。有关 vnc 服务器文件的更多信息,请参阅 Red Hat Enterprise Linux 安装指南。

8.8. 生成新唯一 MAC 地址

macgen.py。现在,您可以使用 ./macgen.py 运行脚本,它会生成新的 MAC 地址。输出示例类似如下:

$ ./macgen.py 00:16:3e:20:b0:11

#!/usr/bin/python # macgen.py script to generate a MAC address for guest virtual machines # import random # def randomMAC(): mac = [ 0x00, 0x16, 0x3e, random.randint(0x00, 0x7f), random.randint(0x00, 0xff), random.randint(0x00, 0xff) ] return ':'.join(map(lambda x: "%02x" % x, mac)) # print randomMAC()

8.8.1. 为 guest 虚拟机生成新 MAC 的另一个方法

# echo 'import virtinst.util ; print\ virtinst.util.uuidToString(virtinst.util.randomUUID())' | python # echo 'import virtinst.util ; print virtinst.util.randomMAC()' | python

#!/usr/bin/env python # -*- mode: python; -*- print "" print "New UUID:" import virtinst.util ; print virtinst.util.uuidToString(virtinst.util.randomUUID()) print "New MAC:" import virtinst.util ; print virtinst.util.randomMAC() print ""

8.9. 改进客户机虚拟机响应时间

- 严重过度分配的内存。

- 使用高处理器用量过量使用内存

- 其他(而非 qemu-kvm 进程)在主机物理机器上忙或者停止进程。

8.10. 使用 libvirt 管理虚拟机计时器

<clock> 元素用于确定客户端虚拟机时钟如何与主机物理机器时钟同步。clock 元素具有以下属性:

偏移决定了客户机虚拟机时钟在主机物理时钟中的偏移方式。offset 属性具有以下可能的值:表 8.1. 偏移属性值 值 描述 utc 启动时,客户机虚拟机时钟将同步到 UTC。 localtime 客户端虚拟机时钟将在引导时同步到主机物理机器配置的时区(若有)。 timezone 客户机虚拟机时钟将同步到指定时区,由 timezone属性指定。变量 客户机虚拟机时钟将与 UTC 中的任意偏移同步。增量相对于 UTC 的使用 adjustment属性以秒为单位指定。客户机虚拟机可以自由地调整 Real Time Clock(RTC),期望它在下次重启时将生效。这与utc模式不同,每次重启时会丢失任何 RTC 调整。注意默认情况下,utc 值被设置为虚拟机中的时钟偏移。但是,如果客户端虚拟机时钟使用 localtime 值运行,则需要将时钟偏移改为不同的值,以便使客户端虚拟机时钟与主机物理机器时钟同步。timezone属性决定 guest 虚拟机时钟使用哪个时区。adjustment属性提供客户机虚拟机时钟同步的 delta。以秒为单位,相对于 UTC。

例 8.1. 始终与 UTC 同步

<clock offset="utc" />

例 8.2. 始终与主机物理机器时区同步

<clock offset="localtime" />

例 8.3. 同步到任意时区

<clock offset="timezone" timezone="Europe/Paris" />

例 8.4. 同步到 UTC + 任意偏移

<clock offset="variable" adjustment="123456" />

8.10.1. 时钟的计时器子元素

name 是必需的,所有其他属性都是可选的。

name 属性指定要使用的时间源类型,可以是以下之一:

| 值 | 描述 |

|---|---|

| pit | Programmable Interval Timer - 带有定期中断的计时器。 |

| rtc | 实时时钟 - 持续运行带有定期中断的计时器。 |

| tsc | 时间戳计数器 - 计算重置后空数,没有中断。 |

| kvmclock | KVM 时钟 - KVM 客户机虚拟机的建议时钟源。KVM pvclock 或 kvm-clock 可让 guest 虚拟机读取主机物理机器的墙时钟时间。 |

8.10.2. track

trace 属性指定计时器跟踪的内容。仅对名称值 rtc 有效。

| 值 | 描述 |

|---|---|

| boot | 对应于旧的 主机物理计算机 选项,这是不受支持的跟踪选项。 |

| guest | RTC 始终跟踪 guest 虚拟机时间。 |

| Wall | RTC 始终跟踪主机时间。 |

8.10.3. tickpolicy

tickpolicy 属性分配用于将 ticks 传递给 guest 虚拟机的策略。可接受以下值:

| 值 | 描述 |

|---|---|

| delay | 继续以正常率提供(so ticks 延迟)。 |

| catchup | 以更高的速度来计算。 |

| merge | 勾选合并为一个单行. |

| discard | 所有错过的点数都将被丢弃。 |

8.10.4. 频率、模式和存在

frequency 属性用于设置固定频率,以 Hz 为单位。只有 name 元素的值为 tsc 时,此属性才相关。所有其他计时器以固定频率(pit、rtc) 运行。

模式 决定了如何向客户机虚拟机公开时间源。此属性仅与 tsc 的 name 值相关。所有其他计时器都是始终模拟的。命令如下: < ;timer name='tsc' frequency='NN' mode='auto|native|emulate|smpsafe'/>。模式定义在 表中指定。

| 值 | 描述 |

|---|---|

| auto | 如果 TSC 不稳定,则原生允许本地 TSC 访问。 |

| 原生 | 始终允许原生 TSC 访问。 |

| 模拟 | 始终模拟 TSC。 |

| smpsafe | 始终模拟 TSC 和 Interlock SMP |

present 用于覆盖对客户机虚拟机可见的默认计时器。

| 值 | 描述 |

|---|---|

| 是 | 使这个计时器强制到对 guest 虚拟机可见的。 |

| 否 | 强制此计时器对客户机虚拟机不可见。 |

8.10.5. 使用时钟同步示例

例 8.5. 时钟与 RTC 和 PIT 计时器同步

<clock offset="localtime"> <timer name="rtc" tickpolicy="catchup" track="guest virtual machine" /> <timer name="pit" tickpolicy="delay" /> </clock>

- 客户机虚拟机只能有一个 CPU

- APIC 计时器必须被禁用(使用 "noapictimer" 命令行选项)

- 在 guest 中必须禁用 NoHZ 模式(使用 "nohz=off" 命令行选项)

- 在客户机中必须禁用高分辨率计时器模式(使用 "highres=off" 命令行选项)

- PIT 时钟源与高分辨率计时器模式或 NoHz 模式不兼容。

8.11. 使用 PMU 监控客户机虚拟机性能

# yum install perf.8.12. 虚拟机电源管理

...

<pm>

<suspend-to-disk enabled='no'/>

<suspend-to-mem enabled='yes'/>

</pm>

...

pm 启用(是'yes)或禁用('no')对 S3(暂停到磁盘)和 S4(暂停到内存)的 BIOS 支持。如果未指定任何内容,则管理程序将保留为默认值。

第 9 章 客户机虚拟机设备配置

- 模拟设备是 纯粹的虚拟设备,可模拟实际硬件,允许未经修改的虚拟机操作系统使用其标准驱动程序来配合它们。Red Hat Enterprise Linux 6 支持 216 virtio 设备。

- VirtIO 设备 纯粹的虚拟设备,设计为在虚拟机中最佳工作。VirtIO 设备与模拟设备类似,但非 Linux 虚拟机不包括它们默认需要的驱动程序。虚拟机管理器(virt-manager)和 Red Hat Virtualization Hypervisor(RHV-H)等虚拟化管理软件自动为支持的非 Linux 客户机操作系统安装这些驱动程序。Red Hat Enterprise Linux 6 支持多达 700 个 scsi 磁盘。

- 分配的设备 是公开给虚拟机的物理设备。此方法也称为"passthrough"。设备分配允许虚拟机为一系列任务对 PCI 设备进行独占访问,并允许 PCI 设备出现,就像它们物理附加到客户端操作系统一样。Red Hat Enterprise Linux 6 支持每个虚拟机最多 32 个分配的设备。

/etc/security/limits.conf 中配置,该文件可以被 /etc/libvirt/qemu.conf覆盖)。其他限制因素包括虚拟总线上可用的插槽数,以及 sysctl 设置的打开文件的系统范围限制。

vfio_iommu_type1 模块使用 allow_unsafe_interrupts 选项进行 PCI 设备分配。这可以通过在 /etc/modprobe.d 中添加 .conf 文件(如 local.conf)来永久完成,包含以下内容:

options vfio_iommu_type1 allow_unsafe_interrupts=1或者动态使用 sysfs 条目进行相同的操作:

# echo 1 > /sys/module/vfio_iommu_type1/parameters/allow_unsafe_interrupts

9.1. PCI 设备

过程 9.1. 为 PCI 设备分配准备 Intel 系统

启用 Intel VT-d 规格

Intel VT-d 规格为直接为虚拟机分配物理设备提供了硬件支持。这些规格需要使用 Red Hat Enterprise Linux 的 PCI 设备分配。在 BIOS 中必须启用 Intel VT-d 规格。有些系统制造商默认禁用这些规格。用于参考这些规格的条款在制造商之间有所不同;请参考您的系统厂商文档来获取适当的条款。在内核中激活 Intel VT-d

在/etc/sysconfig/grub文件中,在 GRUB_CMDLINX_LINUX 行的末尾添加intel_iommu=on参数来激活 Intel VT-d。以下示例是已激活 Intel VT-d 的修改 GRUB 文件。GRUB_CMDLINE_LINUX="rd.lvm.lv=vg_VolGroup00/LogVol01 vconsole.font=latarcyrheb-sun16 rd.lvm.lv=vg_VolGroup_1/root vconsole.keymap=us $([ -x /usr/sbin/rhcrashkernel-param ] && /usr/sbin/ rhcrashkernel-param || :) rhgb quiet intel_iommu=on"重新生成配置文件

运行以下命令重新生成 /etc/grub2.cfg:grub2-mkconfig -o /etc/grub2.cfg

请注意,如果您使用基于 UEFI 的主机,则目标文件应为/etc/grub2-efi.cfg。准备好使用

重启系统以启用更改。您的系统现在可以进行 PCI 设备分配。

过程 9.2. 为 PCI 设备分配准备 AMD 系统

启用 AMD IOMMU 规格

在 Red Hat Enterprise Linux 中使用 PCI 设备分配需要 AMD IOMMU 规格。这些规格必须在 BIOS 中启用。有些系统制造商默认禁用这些规格。启用 IOMMU 内核支持

将amd_iommu=on附加到 GRUB_CMDLINX_LINUX 行的末尾,在引号中附加,以便在启动时启用 AMD IOMMU 规格。重新生成配置文件

运行以下命令重新生成 /etc/grub2.cfg:grub2-mkconfig -o /etc/grub2.cfg

请注意,如果您使用基于 UEFI 的主机,则目标文件应为/etc/grub2-efi.cfg。准备好使用

重启系统以启用更改。您的系统现在可以进行 PCI 设备分配。

9.1.1. 使用 virsh 分配 PCI 设备

pci_0000_01_00_0,以及一个名为 guest1-rhel6-64 的完整虚拟化客户机计算机。

过程 9.3. 使用 virsh 将 PCI 设备分配给客户端虚拟机

识别该设备

首先,识别为虚拟机分配设备指定的 PCI 设备。使用 lspci 命令列出可用的 PCI 设备。您可以使用 grep 重新定义 lspci 的输出。本例使用以下输出中突出显示的以太网控制器:# lspci | grep Ethernet 00:19.0 Ethernet controller: Intel Corporation 82567LM-2 Gigabit Network Connection 01:00.0 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01) 01:00.1 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01)此以太网控制器显示短标识符00:19.0。我们需要找出 virsh 使用的完整标识符,以便将此 PCI 设备分配给虚拟机。为此,请使用 virsh nodedev-list 命令列出附加到主机机器的特定类型(pci)的所有设备。然后查看映射到您要使用的设备的简短标识符的字符串输出。本例突出显示映射到以太网控制器的字符串,其 ID 为00:19.0。在本例中,:和.字符在完整标识符中被替换为下划线。# virsh nodedev-list --cap pci pci_0000_00_00_0 pci_0000_00_01_0 pci_0000_00_03_0 pci_0000_00_07_0 pci_0000_00_10_0 pci_0000_00_10_1 pci_0000_00_14_0 pci_0000_00_14_1 pci_0000_00_14_2 pci_0000_00_14_3 pci_0000_00_19_0 pci_0000_00_1a_0 pci_0000_00_1a_1 pci_0000_00_1a_2 pci_0000_00_1a_7 pci_0000_00_1b_0 pci_0000_00_1c_0 pci_0000_00_1c_1 pci_0000_00_1c_4 pci_0000_00_1d_0 pci_0000_00_1d_1 pci_0000_00_1d_2 pci_0000_00_1d_7 pci_0000_00_1e_0 pci_0000_00_1f_0 pci_0000_00_1f_2 pci_0000_00_1f_3 pci_0000_01_00_0 pci_0000_01_00_1 pci_0000_02_00_0 pci_0000_02_00_1 pci_0000_06_00_0 pci_0000_07_02_0 pci_0000_07_03_0记录映射到您要使用的设备的 PCI 设备编号;在其他步骤中,这是必需的。查看设备信息

有关域、总线和功能的信息可在 virsh nodedev-dumpxml 命令的输出中获取:virsh nodedev-dumpxml pci_0000_00_19_0 <device> <name>pci_0000_00_19_0</name> <parent>computer</parent> <driver> <name>e1000e</name> </driver> <capability type='pci'> <domain>0</domain> <bus>0</bus> <slot>25</slot> <function>0</function> <product id='0x1502'>82579LM Gigabit Network Connection</product> <vendor id='0x8086'>Intel Corporation</vendor> <iommuGroup number='7'> <address domain='0x0000' bus='0x00' slot='0x19' function='0x0'/> </iommuGroup> </capability> </device>注意IOMMU 组根据 IOMMU 从 IOMMU 的角度看设备的可见性和隔离决定。每个 IOMMU 组可以包含一个或多个设备。当存在多个设备时,必须声明 IOMMU 组内的所有端点才能分配给一个客户端。这可通过向客户机分配额外端点或使用 virsh nodedev-detach 从主机驱动程序分离来实现。单个组中包含的设备不能在多个虚拟机之间分割或分割在主机和客户机之间。非端点设备(如 PCIe 根端口、交换机端口和网桥)不应与主机驱动程序分离,且不会干扰端点的分配。可以使用 virsh nodedev-dumpxml 输出的 iommuGroup 部分来确定 IOMMU 组中的设备。组的每个成员都通过单独的 "address" 字段提供。这些信息也可以在 sysfs 中使用:$ ls /sys/bus/pci/devices/0000:01:00.0/iommu_group/devices/

输出的示例如下:0000:01:00.0 0000:01:00.1

要只为客户机分配 0000.01.00.0,未使用的端点应当在启动客户机前从主机分离:$ virsh nodedev-detach pci_0000_01_00_1

确定所需的配置详情

如需配置文件所需的值,请参阅 virsh nodedev-dumpxml pci_0000_00_19_0 命令的输出。示例设备具有以下值: bus = 0, slot = 25 和 function = 0。十进制配置使用以下三个值:bus='0' slot='25' function='0'

添加配置详情

运行 virsh edit,指定虚拟机名称,并在 <source>部分中添加一个设备条目,以将 PCI 设备分配到客户端虚拟机。# virsh edit guest1-rhel6-64 <hostdev mode='subsystem' type='pci' managed='yes'> <source> <address domain='0' bus='0' slot='25' function='0'/> </source> </hostdev>或者,运行 virsh attach-device,指定虚拟机名称和客户机 XML 文件:virsh attach-device guest1-rhel6-64

file.xml启动虚拟机

# virsh start guest1-rhel6-64

9.1.2. 使用 virt-manager 分配 PCI 设备

过程 9.4. 使用 virt-manager 将 PCI 设备分配给客户端虚拟机

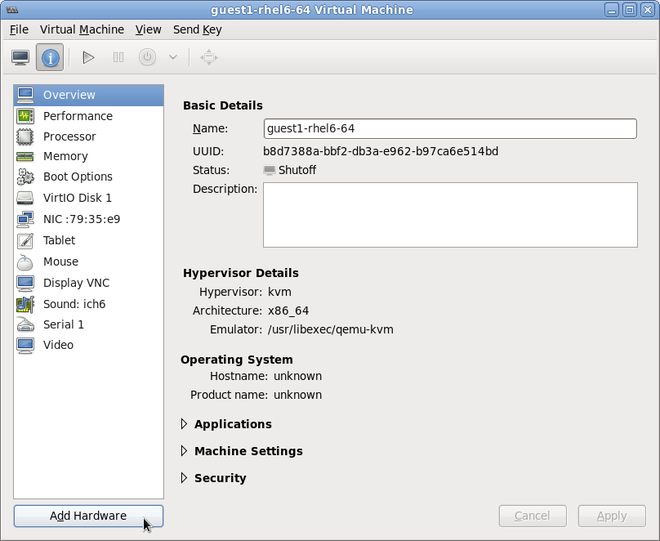

打开硬件设置

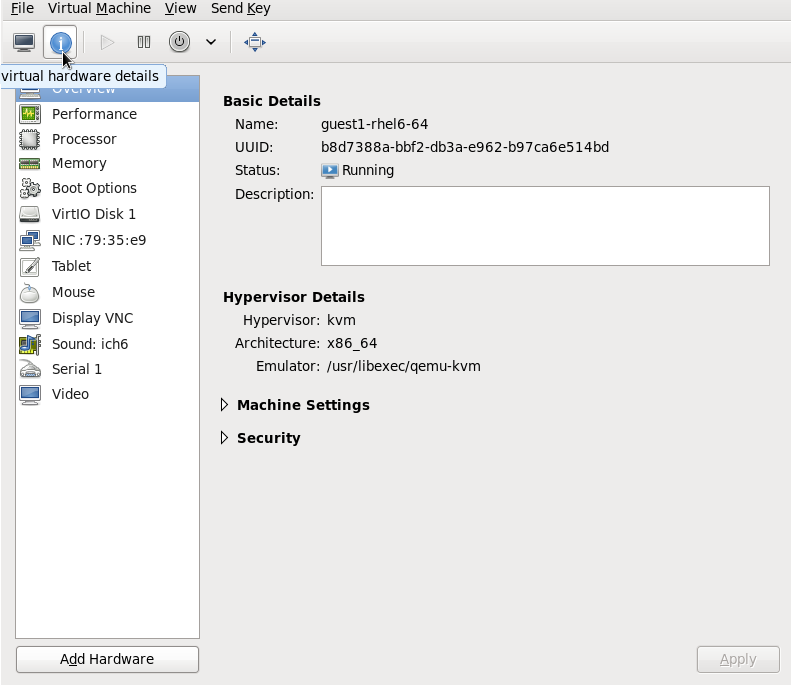

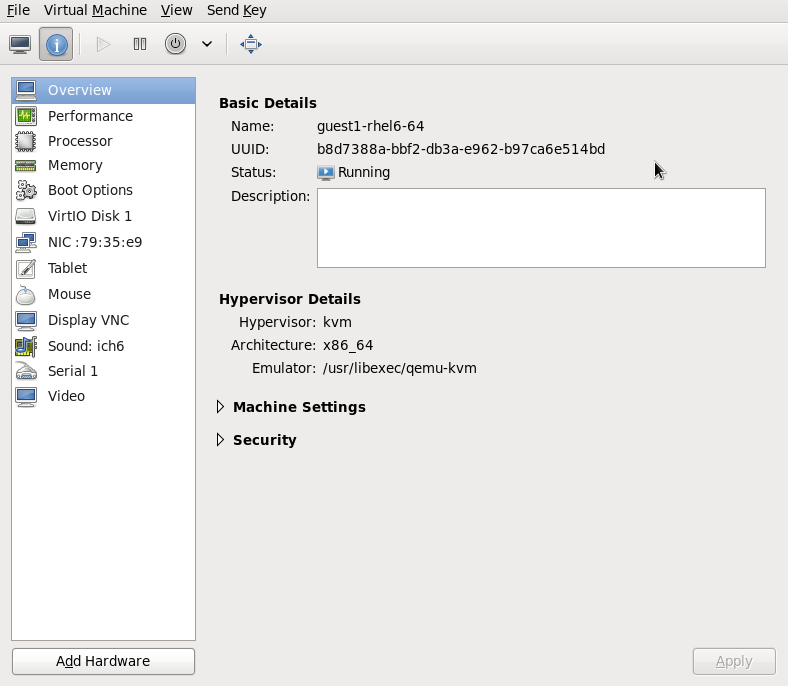

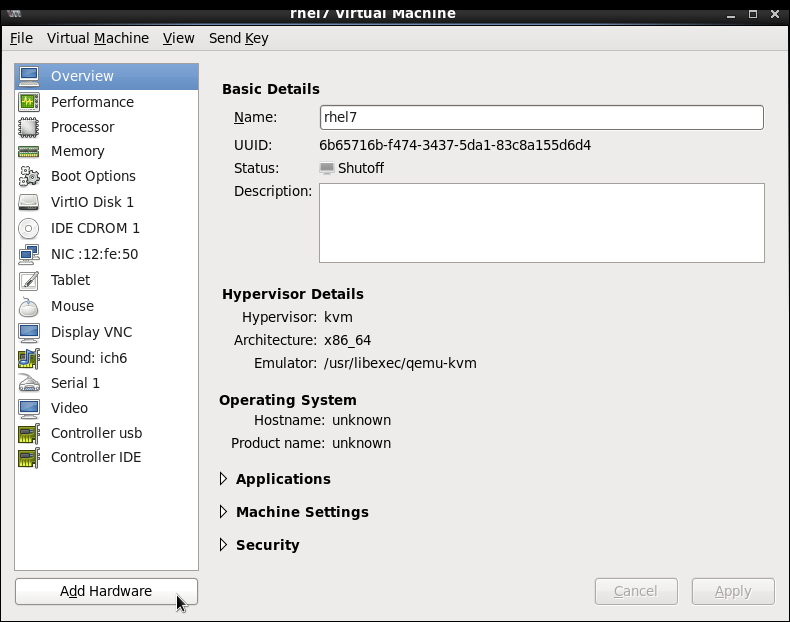

打开 guest 虚拟机, 按钮,向虚拟机添加新设备。图 9.1. 虚拟机硬件信息窗口

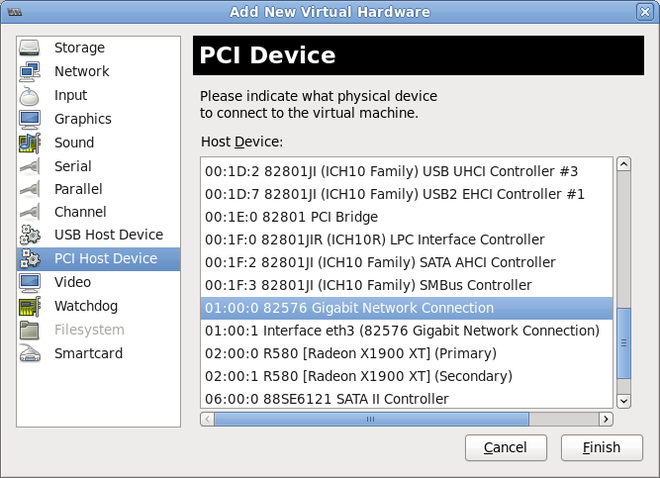

选择 PCI 设备

从左侧的 Hardware 列表中选择 PCI 主机设备。选择一个未使用的 PCI 设备。如果您选择了一个被另一个客户端使用的 PCI 设备,则可能会导致错误。在这个示例中使用备用 82576 网络设备。点 Finish 完成设置。图 9.2. Add new virtual hardware 向导

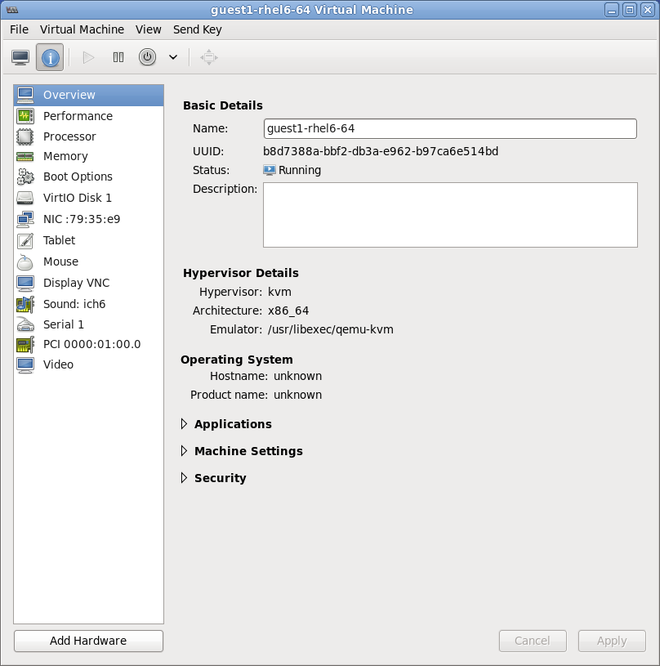

添加新设备

设置已完成,客户端虚拟机现在可以直接访问 PCI 设备。图 9.3. 虚拟机硬件信息窗口

9.1.3. 使用 virt-install 的 PCI 设备分配

--host-device 参数。

过程 9.5. 使用 virt-install 为虚拟机分配 PCI 设备

识别该设备

识别为客户端虚拟机分配设备指定的 PCI 设备。# lspci | grep Ethernet 00:19.0 Ethernet controller: Intel Corporation 82567LM-2 Gigabit Network Connection 01:00.0 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01) 01:00.1 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01)

virsh nodedev-list 命令列出系统中附加的所有设备,并使用字符串识别每个 PCI 设备。要只将输出限制为 PCI 设备,请运行以下命令:# virsh nodedev-list --cap pci pci_0000_00_00_0 pci_0000_00_01_0 pci_0000_00_03_0 pci_0000_00_07_0 pci_0000_00_10_0 pci_0000_00_10_1 pci_0000_00_14_0 pci_0000_00_14_1 pci_0000_00_14_2 pci_0000_00_14_3 pci_0000_00_19_0 pci_0000_00_1a_0 pci_0000_00_1a_1 pci_0000_00_1a_2 pci_0000_00_1a_7 pci_0000_00_1b_0 pci_0000_00_1c_0 pci_0000_00_1c_1 pci_0000_00_1c_4 pci_0000_00_1d_0 pci_0000_00_1d_1 pci_0000_00_1d_2 pci_0000_00_1d_7 pci_0000_00_1e_0 pci_0000_00_1f_0 pci_0000_00_1f_2 pci_0000_00_1f_3 pci_0000_01_00_0 pci_0000_01_00_1 pci_0000_02_00_0 pci_0000_02_00_1 pci_0000_06_00_0 pci_0000_07_02_0 pci_0000_07_03_0

记录 PCI 设备编号;其他步骤中需要该数字。有关域、总线和功能的信息可在 virsh nodedev-dumpxml 命令的输出中获取:# virsh nodedev-dumpxml pci_0000_01_00_0 <device> <name>pci_0000_01_00_0</name> <parent>pci_0000_00_01_0</parent> <driver> <name>igb</name> </driver> <capability type='pci'> <domain>0</domain> <bus>1</bus> <slot>0</slot> <function>0</function> <product id='0x10c9'>82576 Gigabit Network Connection</product> <vendor id='0x8086'>Intel Corporation</vendor> <iommuGroup number='7'> <address domain='0x0000' bus='0x00' slot='0x19' function='0x0'/> </iommuGroup> </capability> </device>注意如果 IOMMU 组中有多个端点,而不是分配给客户机,则需要在启动客户端前手动从主机中手动分离其他端点:$ virsh nodedev-detach pci_0000_00_19_1

有关 IOMMU 组的更多信息,请参阅 注意 中的 第 9.1.1 节 “使用 virsh 分配 PCI 设备”。添加设备

使用 virsh nodedev 命令的 PCI 标识符输出作为--host-device参数的值。virt-install \ --name=guest1-rhel6-64 \ --disk path=/var/lib/libvirt/images/guest1-rhel6-64.img,size=8 \ --nonsparse --graphics spice \ --vcpus=2 --ram=2048 \ --location=http://example1.com/installation_tree/RHEL6.0-Server-x86_64/os \ --nonetworks \ --os-type=linux \ --os-variant=rhel6 --host-device=pci_0000_01_00_0完成安装

完成客户机安装。PCI 设备应当连接到客户端。

9.1.4. 分离分配的 PCI 设备

过程 9.6. 使用 virsh 从客户机中分离 PCI 设备

分离该设备

使用以下命令,通过从客户机的 XML 文件中删除 PCI 设备来从客户机中分离它:# virsh detach-device name_of_guest file.xml

将设备重新关联到主机(可选)

如果设备处于managed模式,请跳过这一步。设备将自动返回到主机。如果该设备没有使用managed模式,使用以下命令将 PCI 设备重新附加到主机机器中:# virsh nodedev-reattach device

例如,要将pci_0000_01_00_0设备重新连接到主机:virsh nodedev-reattach pci_0000_01_00_0

现在,该设备可用于主机使用。

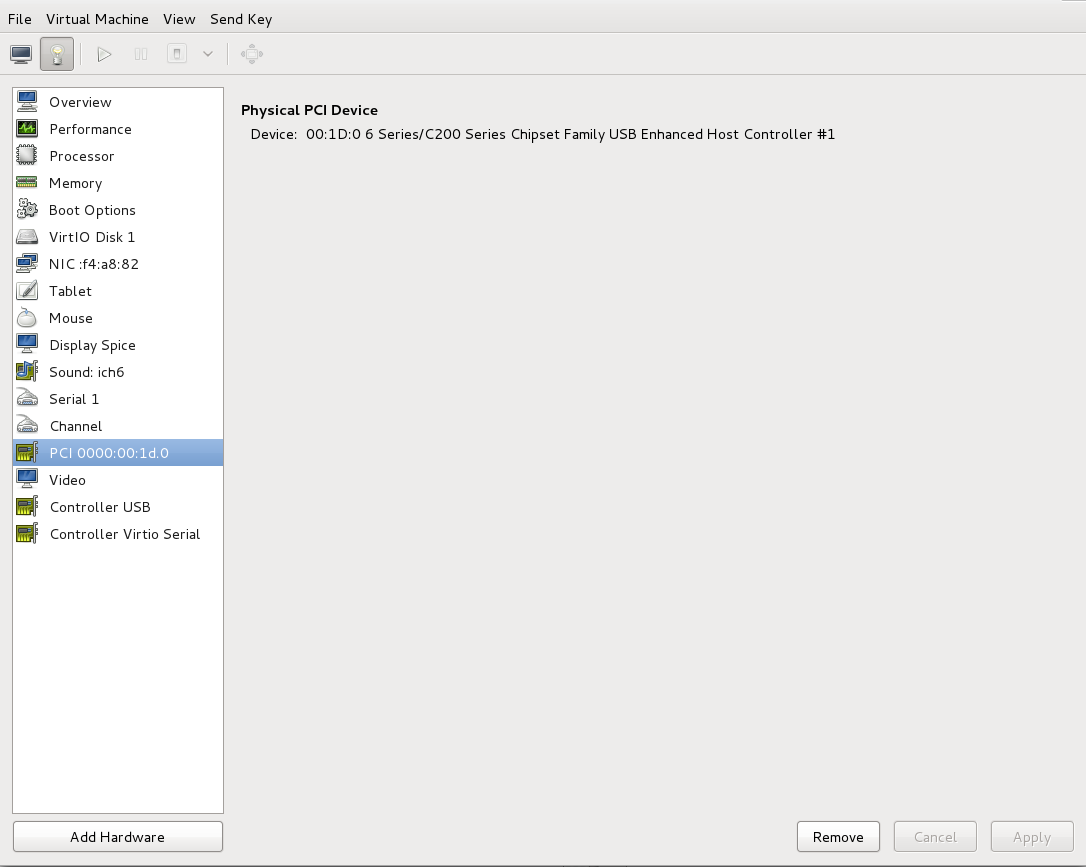

过程 9.7. 使用 virt-manager 从客户机分离 PCI 设备

打开虚拟硬件详情屏幕

在 virt-manager 中,双击包含该设备的虚拟机。选择 Show virtual hardware details 按钮,以显示虚拟硬件的列表。图 9.4. 虚拟硬件详细信息按钮

选择并删除该设备

选择要从左侧面板中虚拟设备列表分离的 PCI 设备。图 9.5. 选择要分离的 PCI 设备

以确认。现在,该设备可用于主机使用。

以确认。现在,该设备可用于主机使用。

9.1.5. 创建 PCI 网桥

9.1.6. PCI Passthrough

<源> 元素指定)直接分配给使用通用设备 透传 的 guest,在第一个选择将设备的 MAC 地址设置为配置后,并使用可选的指定 <虚拟端口> 元素将设备与 802.1Qbh 相关联(请参阅上述为 type='direct' 网络设备的 virtualport 示例)。由于标准单端口 PCI 以太网卡驱动程序设计的限制 - 仅限 SR-IOV(Single Root I/O 虚拟化)虚拟功能(VF)设备,以此方式分配标准单端口 PCI 或 PCIe 以太网卡,请使用传统的 <hostdev> 设备定义。

<type='hostdev'> 接口可以有一个可选的驱动程序子元素,并将 name 属性设置为 "vfio"。要使用旧的 KVM 设备分配,您可以将 name 设置为 "kvm"(或只省略 <驱动程序> 元素,因为 <driver='kvm'> 目前是默认值)。

<hostdev> 设备的功能相似,这种方法为通过设备指定 MAC 地址 <和虚拟端口>。如果不需要这些功能,或者您使用的是支持 SR-IOV 的标准单端口 PCI、PCIe 或 USB 网卡(因此,在分配到客户端域后,任何时候都会丢失配置的 MAC 地址),或者如果您使用比 0.9.11 旧的 libvirt 版本,您应该使用标准 <hostdev> 将设备分配给 guest,而不是 <接口 type=host/dev'>。

图 9.6. PCI 设备分配的 XML 示例

<devices>

<interface type='hostdev'>

<driver name='vfio'/>

<source>

<address type='pci' domain='0x0000' bus='0x00' slot='0x07' function='0x0'/>

</source>

<mac address='52:54:00:6d:90:02'>

<virtualport type='802.1Qbh'>

<parameters profileid='finance'/>

</virtualport>

</interface>

</devices>9.1.7. 使用 SR-IOV 设备配置 PCI 分配(Passthrough)

<hostdev> 为虚拟客户机分配,但因为 SR-IOV VF 网络设备没有永久唯一的 MAC 地址,从而导致客户端虚拟机的网络设置在每次重新引导主机物理机器时都必须重新配置问题。要补救这一点,您需要在将 VF 分配给主机物理机器前设置 MAC 地址,每次客户端虚拟机引导时都需要设置它。要分配这个 MAC 地址以及其他选项,请参阅 过程 9.8, “配置 MAC 地址、vLAN 和虚拟端口,以便在 SR-IOV 中分配 PCI 设备” 中描述的步骤。

过程 9.8. 配置 MAC 地址、vLAN 和虚拟端口,以便在 SR-IOV 中分配 PCI 设备

<hostdev> 元素不能用于特定于功能的项目,如 MAC 地址分配、vLAN 标签 ID 分配或虚拟端口分配,因为 <mac>、<vlan> 和 <virtualport> 元素不是 <hostdev> 的有效子项。当它们对 <接口> 有效时,增加了对新接口类型的支持(<interface type='hostdev'>)。这个新接口设备类型作为接口和 <hostdev> 的混合运行。<>因此,在为客户机虚拟机分配 PCI 设备前,libvirt 在虚拟机 XML 配置文件中初始化特定于网络的硬件/交换机(例如设置 MAC 地址、设置 vLAN 标签或与 802.1Qbh 交换机关联)。有关设置 vLAN 标签的详情,请参考 第 18.14 节 “设置 vLAN Tags”。

关闭客户机虚拟机

使用 virsh shutdown 命令(请参考 第 14.9.1 节 “关闭客户机虚拟机”),关闭名为 guestVM 的客户机虚拟机。# virsh shutdown guestVM收集信息

要使用<接口 type='hostdev'>,您必须有一个支持 SR-IOV 功能的网卡,主机物理机器硬件支持 Intel VT-d 或 AMD IOMMU 扩展,您必须知道您要分配的 VF 的 PCI 地址。打开 XML 文件进行编辑

运行 # virsh save-image-edit 命令以打开 XML 文件进行编辑(详情请参阅 第 14.8.10 节 “编辑域 XML 配置文件” )。由于您要将 guest 虚拟机恢复到以前的运行状态,在这种情况下,--running将用在内。本例中的配置文件的名称是 guestVM.xml,因为客户端虚拟机的名称是 guestVM。# virsh save-image-edit guestVM.xml--running在默认编辑器中打开 guestVM.xml。编辑 XML 文件

更新配置文件(guestVM.xml)使其具有类似如下的<设备>条目:图 9.7. hostdev 接口类型的域 XML 示例

<devices> ... <interface type='hostdev' managed='yes'> <source> <address type='pci' domain='0x0' bus='0x00' slot='0x07' function='0x0'/> <!--these values can be decimal as well--> </source> <mac address='52:54:00:6d:90:02'/> <!--sets the mac address--> <virtualport type='802.1Qbh'> <!--sets the virtual port for the 802.1Qbh switch--> <parameters profileid='finance'/> </virtualport> <vlan> <!--sets the vlan tag--> <tag id='42'/> </vlan> </interface> ... </devices>请注意,如果您不提供 MAC 地址,系统将自动生成,就像其他类型的接口设备一样。另外,只有在您要连接到 802.11Qgh 硬件开关(802.11Qbg)(a.k.a)时,才会使用<virtualport>元素。"VEPA")交换机当前不受支持。重新启动客户机虚拟机

运行 virsh start 命令,以重新启动您在第一步中关闭的 guest 虚拟机(例如,使用 guestVM 作为客户机虚拟机的域名)。如需更多信息,请参阅 第 14.8.1 节 “启动定义的域”。# virsh start guestVM当客户机虚拟机启动时,它会看到由物理主机的适配器(带有配置的 MAC 地址)提供的网络设备。此 MAC 地址在客户机虚拟机之间保持不变,主机物理机器重新引导。

9.1.8. 从 SR-IOV 虚拟功能池设置 PCI 设备分配

- 指定的 VF 必须在每次启动客户机虚拟机时可用,这意味着管理员必须将每个 VF 永久分配给单个客户端虚拟机(或者修改每个 guest 虚拟机的配置文件,以指定目前未使用的 VF 的 PCI 地址)。

- 如果 guest 虚拟机被移动到另一台主机物理计算机,则该主机物理计算机必须在 PCI 总线上同一位置上有相同的硬件(或者,启动之前必须修改客户机虚拟机配置)。

过程 9.9. 创建设备池

关闭客户机虚拟机

使用 virsh shutdown 命令(请参考 第 14.9 节 “关闭客户机虚拟机的关闭、重新启动和关闭”),关闭名为 guestVM 的客户机虚拟机。# virsh shutdown guestVM创建配置文件

使用您选择的编辑器在/tmp目录中创建 XML 文件(例如:throughthrough .xml )。确保将pf dev='eth3'替换为您自己的 SR-IOV 设备的 PF 的 netdev 名称以下是一个网络定义示例,它会在主机 物理机器上使用其物理功能(PF) 为 SR-IOV 适配器提供所有 VF 池:图 9.8. 网络定义域 XML 示例

<network> <name>passthrough</name> <!--This is the name of the file you created--> <forward mode='hostdev' managed='yes'> <pf dev='myNetDevName'/> <!--Use the netdev name of your SR-IOV devices PF here--> </forward> </network>加载新的 XML 文件

运行以下命令,将 /tmp/passthrough.xml 替换为您在上一步中创建的 XML 文件的名称和位置:# virsh net-define /tmp/passthrough.xml重启客户端

运行以下命令将 passthrough.xml 替换为您在上一步中创建的 XML 文件的名称:# virsh net-autostart passthrough # virsh net-start passthrough

重新启动客户机虚拟机

运行 virsh start 命令,以重新启动您在第一步中关闭的 guest 虚拟机(例如,使用 guestVM 作为客户机虚拟机的域名)。如需更多信息,请参阅 第 14.8.1 节 “启动定义的域”。# virsh start guestVM为设备启动 passthrough

虽然只显示单个设备,但 libvirt 会在其域 XML 中使用接口定义(如下所示)在 PF 首次启动时,自动获得与 PF 相关联的所有 VF 列表:图 9.9. 接口网络定义的域 XML 示例

<interface type='network'> <source network='passthrough'> </interface>验证

启动使用网络的第一个客户机后,您可以运行 virsh net-dumpxml passthrough 命令进行验证;您可以获得类似如下的输出:图 9.10. XML 转储文件 透传 内容

<network connections='1'> <name>passthrough</name> <uuid>a6b49429-d353-d7ad-3185-4451cc786437</uuid> <forward mode='hostdev' managed='yes'> <pf dev='eth3'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x10' function='0x1'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x10' function='0x3'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x10' function='0x5'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x10' function='0x7'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x11' function='0x1'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x11' function='0x3'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x11' function='0x5'/> </forward> </network>

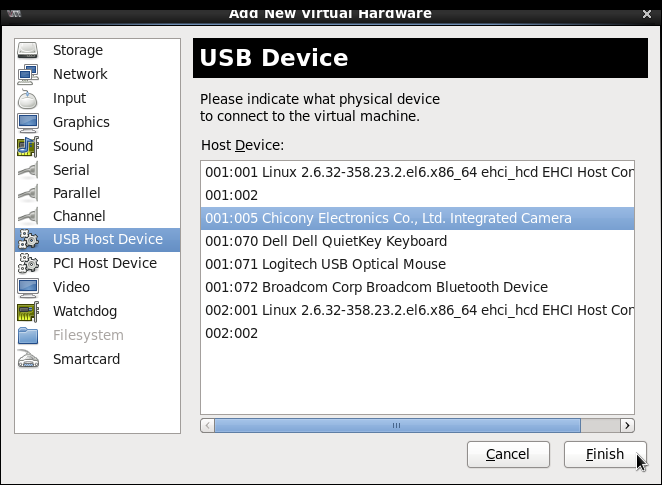

9.2. USB 设备

9.2.1. 为客户机虚拟机分配 USB 设备

- 使用 USB 透传 - 这要求设备物理连接到托管客户机虚拟机的主机物理机器。在这种情况下不需要 SPICE。主机上的 USB 设备可以使用命令行或 virt-manager 传递给客户端。有关 virt 管理器 指示,请参阅 第 15.3.1 节 “将 USB 设备附加到虚拟机”。注意virt-manager 不应该用于热插拔或热拔设备。如果要热插拔/热拔 USB 设备,请参阅 过程 14.1, “热插 USB 设备供客户端虚拟机使用”。

- 使用 USB 重定向 - USB 在主机物理机器中运行时最好使用。用户从本地机器或瘦客户端连接到其/继承的客户机虚拟机。在该本地计算机上,有 SPICE 客户端。用户可以将任何 USB 设备附加到瘦客户机,而 SPICE 客户端会将设备重定向到数据中心的主机物理机器,以便其可供在瘦客户端上运行的客户机虚拟机使用。有关使用 virt-manager 进行 USB 重定向的说明,请参考 第 15.3.1 节 “将 USB 设备附加到虚拟机”,应该注意,使用 TCP 协议(推荐 BZ#1085318)无法进行 USB 重定向。

9.2.2. 在 USB 设备重定向上设置限制

-device usb-redir。filter 属性采用由过滤规则组成的字符串,规则的格式是:

<class>:<vendor>:<product>:<version>:<allow>-1 值指定它接受特定字段的任何值。您可以将 | 用作分隔符,在同一命令行中使用多个规则。

例 9.1. 使用 windows 客户机虚拟机限制重定向的示例

- 准备 Windows 7 客户机虚拟机。

- 将以下代码摘录添加到 guest 虚拟机的 domain xml 文件中:

<redirdev bus='usb' type='spicevmc'> <alias name='redir0'/> <address type='usb' bus='0' port='3'/> </redirdev> <redirfilter> <usbdev class='0x08' vendor='0x1234' product='0xBEEF' version='2.0' allow='yes'/> <usbdev class='-1' vendor='-1' product='-1' version='-1' allow='no'/> </redirfilter> - 启动客户端虚拟机并确认设置更改:

#ps -ef | grep $guest_name-device usb-redir,chardev=charredir0,id=redir0,/ filter=0x08:0x1234:0xBEEF:0x0200:1|-1:-1:-1:-1:0,bus=usb.0,port=3

- 将 USB 设备插入主机物理机器,并使用 virt-manager 连接到客户端虚拟机。

- 在菜单中,单击 ,这将生成以下消息:"Some USB 设备受主机策略阻止"。 并继续。过滤器生效。

- 为确保过滤器正确捕获了 USB 设备供应商和产品,然后在 guest 虚拟机的域 XML 中进行以下更改以允许 USB 重定向。

<redirfilter> <usbdev class='0x08' vendor='0x0951' product='0x1625' version='2.0' allow='yes'/> <usbdev allow='no'/> </redirfilter> - 重新启动 guest 虚拟机,然后使用 virt-viewer 连接到 guest 虚拟机。USB 设备现在会将流量重定向到客户端虚拟机。

9.3. 配置设备控制器

图 9.11. 自动化控制器的域 XML 示例

...

<devices>

<controller type='ide' index='0'/>

<controller type='virtio-serial' index='0' ports='16' vectors='4'/>

<controller type='virtio-serial' index='1'>

<address type='pci' domain='0x0000' bus='0x00' slot='0x0a' function='0x0'/>

</controller>

...

</devices>

...

<控制器类型>,它必须是以下之一:

- ide

- fdc

- scsi

- SATA

- usb

- ccid

- virtio-serial

- pci

<控制器> 元素具有强制属性 <控制器索引>,它是十进制整数,描述总线控制器被遇到的顺序(用于控制器 <地址> 元素)。当 <控制器类型 = 'virtio-serial'> 时,还有两个可选属性(名为 端口和 向量),它控制可以通过控制器连接多少个设备。请注意,Red Hat Enterprise Linux 6 不支持使用每个设备超过 32向量。使用更多的向量将导致迁移客户机虚拟机失败。

<控制器类型 = 'scsi'> 时,有一个可选的属性 模型,它可具有以下值:

- auto

- buslogic

- ibmvscsi

- lsilogic

- lsisas1068

- lsisas1078

- virtio-scsi

- vmpvscsi

<控制器类型 = 'usb'> 时,有一个可选的属性 模型,它可具有以下值:

- piix3-uhci

- piix4-uhci

- ehci

- ich9-ehci1

- ich9-uhci1

- ich9-uhci2

- ich9-uhci3

- vt82c686b-uhci

- pci-ohci

- nec-xhci

<model='none'>。 .

<地址> 可以指定控制器与其主总线的确切关系,以及语义,如 第 9.4 节 “为设备设置地址” 所示。

<驱动程序> 可以指定驱动程序特定选项。目前它只支持属性队列,这指定了控制器的队列数量。为获得最佳性能,建议指定一个与 vCPU 数量匹配的值。

<master>,用于指定与主控制器相配套的关系。companion 控制器与其 master 位于同一个总线上,因此相应的 索引 值应该相等。

图 9.12. USB 控制器的域 XML 示例

...

<devices>

<controller type='usb' index='0' model='ich9-ehci1'>

<address type='pci' domain='0' bus='0' slot='4' function='7'/>

</controller>

<controller type='usb' index='0' model='ich9-uhci1'>

<master startport='0'/>

<address type='pci' domain='0' bus='0' slot='4' function='0' multifunction='on'/>

</controller>

...

</devices>

...

模型 属性,具有以下可能的值:

- pci-root

- pcie-root

- pci-bridge

- dmi-to-pci-bridge

pci-root 和 pcie-root)具有一个可选的 pcihole64 元素,用于指定 pcihole64 单元 属性指定的单位是 pcihole。有些客户机虚拟机(如 Windows Server 2003)可能会导致崩溃,除非禁用 单位 (设置为 0 单元='0')。

index='0',且需要使用 PCI 设备。pci-root 没有地址。如果已在由 model='pci-root' 提供的一个总线上适合一个由 model='pci-root' 或一个大于零的 PCI 总线号,则会自动添加 PCI 网桥。PCI 网桥也可以手动指定,但其地址应仅引用已经指定 PCI 控制器提供的 PCI 总线。PCI 控制器索引中的间隔可能会导致无效的配置。以下 XML 示例可添加到 <devices> 部分:

图 9.13. PCI 网桥的域 XML 示例

...

<devices>

<controller type='pci' index='0' model='pci-root'/>

<controller type='pci' index='1' model='pci-bridge'>

<address type='pci' domain='0' bus='0' slot='5' function='0' multifunction='off'/>

</controller>

</devices>

...

index='0 的 pcie-root 控制器会自动添加到域配置中。pcie-root 也没有地址,但提供 31 个插槽(数字 1-31),且只能用于附加 PCIe 设备。要在具有 pcie-root 控制器的系统中连接标准 PCI 设备,会自动添加带有 model='dmi-to-pci-bridge' 的 pci 控制器。dmi-to-pci-bridge 控制器插入到 PCIe 插槽(由 pcie-root 提供),本身提供 31 个标准 PCI 插槽(非热插拔)。要在客户机系统中拥有热插拔 PCI 插槽,所有由 libvirt 自动终止的 pci-bridge 控制器也会自动创建并连接到自动创建的 dmi-to-pci-bridge 控制器的插槽之一。所有具有 PCI 地址且由 libvirt 自动终止的客户机设备都将放置在此 pci-bridge 设备中。

图 9.14. PCIe 的域 XML 示例(PCI express)

...

<devices>

<controller type='pci' index='0' model='pcie-root'/>

<controller type='pci' index='1' model='dmi-to-pci-bridge'>

<address type='pci' domain='0' bus='0' slot='0xe' function='0'/>

</controller>

<controller type='pci' index='2' model='pci-bridge'>

<address type='pci' domain='0' bus='1' slot='1' function='0'/>

</controller>

</devices>

...

9.4. 为设备设置地址

<地址> 子元素,用于描述设备放置在提供给虚拟客户机的虚拟总线上。如果输入时省略了地址(或地址中的任何可选属性)时,libvirt 将生成一个适当的地址;不过,如果需要更多地控制布局,则需要一个明确的地址。如需包括 <地址> 元素在内的域 XML 设备示例,请参阅 图 9.6 “PCI 设备分配的 XML 示例”。

类型,用于描述该设备所在的总线。在设备和客户机虚拟机架构中限制在给定设备使用的地址的选择。例如: <磁盘设备> 使用 type='drive',而 <控制台> 设备在 i686 或 x86_64 客户机虚拟机构架中使用 type='pci' 。每个地址类型都具有更多可选属性,可控制该设备在总线上的位置,如表中所述:

| 地址类型 | 描述 |

|---|---|

| type='pci' | PCI 地址具有以下额外属性:

|

| type='drive' | 驱动器地址具有以下额外属性:

|

| type='virtio-serial' | 每个 virtio-serial 地址都有以下附加属性:

|

| type='ccid' | 用于智能卡的 CCID 地址具有以下附加属性:

|

| type='usb' | USB 地址有以下附加属性:

|

| type='isa' | ISA 地址有以下附加属性:

|

9.5. 在虚拟机中管理存储控制器

- 通过 virtio-scsi 控制器附加虚拟硬盘驱动器或 CD,

- 通过 QEMU scsi-block 设备从主机传递物理 SCSI 设备,

- 和 允许为每个客户机使用数百个设备 ; 从 28 设备限制 virtio-blk 中有所改进。

过程 9.10. 创建虚拟 SCSI 控制器

- 显示客户机虚拟机的配置(

Guest1),并查找预先存在的 SCSI 控制器:# virsh dumpxml Guest1 | grep controller.*scsi

如果存在设备控制器,命令会输出类似如下的一个或多个行:<controller type='scsi' model='virtio-scsi' index='0'/>

- 如果上一步没有显示设备控制器,使用以下步骤为某个新文件创建一个描述并将其添加到虚拟机中:

- 通过在新文件中写入 <

controller> 元素,并使用 XML 扩展保存文件来创建设备控制器。virtio-scsi-controller.xml,例如:<controller type='scsi' model='virtio-scsi'/>

- 将您刚刚在

virtio-scsi-controller.xml中创建的设备控制器与您的客户机虚拟机(例如,Guest1)关联:# virsh attach-device --config Guest1 ~/virtio-scsi-controller.xml

在本例中,--config选项的行为与磁盘的作用相同。如需更多信息,请参阅 过程 13.2, “在客户机中添加物理块设备”。

- 添加新的 SCSI 磁盘或 CD-ROM。可使用部分 第 13.3.1 节 “在 客户机中添加基于文件的存储” 和 第 13.3.2 节 “在客户机中添加硬盘和其他块设备” 中的方法添加新磁盘。要创建 SCSI 磁盘,请指定以 sd 开头的目标设备名称。

# virsh attach-disk Guest1 /var/lib/libvirt/images/FileName.img sdb --cache none

根据客户机虚拟机中驱动程序的版本,正在运行的 guest 虚拟机可能不会立即检测到新磁盘。按照 Red Hat Enterprise Linux Storage Administration Guide 中的步骤进行操作。

9.6. 随机数字生成器(RNG)设备

virtio-rng 是一个虚拟 RNG(随机数生成器)设备,该设备向客户机虚拟机的操作系统提供 RNG 数据,从而在请求时为客户机虚拟机提供全新的熵。

virtio-rng 时,会在客户端虚拟机中创建 chardev,其位置为 /dev/hwrng/。然后可以打开这个 chardev,并读取从主机物理机器获取熵。为了使客户机应用程序能够透明地使用 virtio-rng 设备的随机性,/dev/hwrng/ 中的输入必须转发到客户机虚拟机中的内核熵池。如果此位置中的信息与 rgnd 守护进程合并(位于 rng-tools 中),则可以实现这一点。

/dev/random 文件。这个过程是在 Red Hat Enterprise Linux 6 客户机虚拟机中手动完成的。

# rngd -b -r /dev/hwrng/ -o /dev/random/

viorng。安装后,虚拟 RNG 设备将使用 Microsoft 提供的 CNG(下一代)API 工作。安装完驱动程序后,virtrng 设备就会出现在 RNG 供应商列表中。

过程 9.11. 使用命令行工具实施 virtio-rng

- 关闭客户机虚拟机。

- 在终端窗口中,使用 virsh edit domain-name 命令打开所需 guest 虚拟机的 XML 文件。

- 编辑

<devices>元素使其包含以下内容:... <devices> <rng model='virtio'> <rate period="2000" bytes="1234"/> <backend model='random'>/dev/random</backend> <source mode='bind' service='1234'> <source mode='connect' host='192.0.2.1' service='1234'> </backend> </rng> </devices> ...

第 10 章 qemu-img 和 QEMU 客户机代理

/usr/share/doc/qemu-*/README.systemtap。

10.1. 使用 qemu-img

检查

对磁盘映像 文件名 执行一致性检查。

# qemu-img check -f qcow2 --output=qcow2 -r all filename-img.qcow2

qcow2 和 vdi 格式支持一致性检查。

-r 尝试修复在检查过程中发现的所有不一致问题,但在修复 -r leaks 集群泄漏时,会修复并处理 -r all 各种错误被修复。请注意,这存在选择错误的修复或隐藏可能已经发生崩溃问题的风险。

Commit(提交)

使用 qemu-img commit 命令将指定文件(文件名)中记录的任何更改提交到文件的基础镜像。(可选)指定文件格式类型(格式)。

# qemu-img commit [-fformat] [-tcache] filename

convert

convert 选项用于将一个可识别的镜像格式转换为另一个镜像格式。

# qemu-img convert [-c] [-p] [-fformat] [-tcache] [-Ooutput_format] [-ooptions] [-Ssparse_size] filename output_filename

-p 参数显示命令的进度(可选而不是每个命令)和 -S 选项允许创建 稀疏文件,该文件包含 在磁盘镜像中。所有目的中的稀疏文件都类似标准文件,但物理块仅包含零(无)。当操作系统看到此文件时,它会将其视为存在,并占用实际磁盘空间,即使实际情况也不会采取任何情况。这在为客户机虚拟机创建磁盘时特别有用,因为这会造成磁盘所占用的磁盘空间比它多得多。例如,如果您在磁盘镜像上的 -S 设置为 50Gb,则您的 10Gb 磁盘空间的 10Gb 的大小将显示为 60Gb,即使实际使用了 10Gb。

filename 将磁盘镜像 output_filename 转换为磁盘镜像 output_format。磁盘镜像可以选择使用 -c 选项压缩,或者通过设置 -o 来使用 -o encryption 选项加密。请注意,-o 参数可用的选项与所选格式不同。

qcow2 格式支持加密或压缩。qcow2 加密使用 AES 格式,以及安全 128 位密钥。qcow2 压缩为只读模式,因此如果压缩的扇区从 qcow2 格式转换,它将被写成为未压缩数据的新格式。

创建

创建新的磁盘大小 size 并格式化 format。

# qemu-img create [-fformat] [-o options] filename [size][preallocation]

-o backing_file=filename 指定基础镜像,则镜像只记录自身和基础镜像之间的区别。除非您使用 commit 命令,否则不会修改后备文件。在这种情况下不需要指定大小。

-o preallocation=off|meta|full|falloc。预分配元数据的镜像大于镜像,无需.但是,在镜像大小增加的情况下,随着镜像的增长,性能会提高。

完整 分配可能需要较长时间的大型镜像。如果您想要实现完全分配且时间为准,使用 falloc 将为您节省时间。

info

info 参数显示有关磁盘映像 文件名 的信息。info 选项的格式如下:

# qemu-img info [-f format] filename

qcow2 镜像采用的空间量。这可以通过运行 qemu-img 来完成。您可以使用 qemu-img check 命令来检查镜像是否为与 qemu-img info 命令的输出相符。请参阅 第 10.1 节 “使用 qemu-img”。

# qemu-img info /dev/vg-90.100-sluo/lv-90-100-sluo image: /dev/vg-90.100-sluo/lv-90-100-sluo file format: qcow2 virtual size: 20G (21474836480 bytes) disk size: 0 cluster_size: 65536

map

# qemu-img map [-f format] [--output=output_format] filename 命令转储镜像文件名及其后备文件链的元数据。具体来说,此命令会转储指定文件的每个扇区的分配状态,以及在后备文件链中分配它的最顶层文件。例如,如果您有一个链,如 c.qcow2 → b.qcow2 → a.qcow2,则 a.qcow 是原始文件,b.qcow2 是对 a.qcow2 和 c.qcow2 的更改是来自 b.qcow2 的 delta 文件。创建此链时,镜像文件会存储普通镜像数据,以及关于什么文件中以及它们在文件所在的位置的信息。此信息称为镜像的元数据。f format 选项是指定镜像文件的格式。可以使用 raw、qcow2、vhdx 和 vmdk 等格式。可能有两个输出选项: human 和 json。

人为默认设置。它旨在更加易读的人类阅读,因此这种格式不应被解析。为了清晰和简单性,默认人格式仅转储文件的已知非零区域。文件的已知零部分将被完全省略,也同样适用于不在整个链中分配的部分。当执行命令时,qemu-img 输出将识别从其中读取数据的文件,以及 文件中的偏移。输出显示为包含四个列的表:前三个是十六进制数字。# qemu-img map -f qcow2 --output=human /tmp/test.qcow2 Offset Length Mapped to File 0 0x20000 0x50000 /tmp/test.qcow2 0x100000 0x80000 0x70000 /tmp/test.qcow2 0x200000 0x1f0000 0xf0000 /tmp/test.qcow2 0x3c00000 0x20000 0x2e0000 /tmp/test.qcow2 0x3fd0000 0x10000 0x300000 /tmp/test.qcow2

- JSON 或 JSON(JavaScript 对象表示法)可供人类读取,但由于编程语言,它也旨在解析。

例如,要在解析器中解析 "qemu-img map" 的输出,则应使用--output=json选项。# qemu-img map -f qcow2 --output=json /tmp/test.qcow2 [{ "start": 0, "length": 131072, "depth": 0, "zero": false, "data": true, "offset": 327680}, { "start": 131072, "length": 917504, "depth": 0, "zero": true, "data": false},如需有关 JSON 格式的更多信息,请参阅 qemu-img(1)手册页。

rebase

更改镜像的后端文件。

# qemu-img rebase [-f format] [-t cache] [-p] [-u] -b backing_file [-F backing_format] filename

qcow2 格式支持更改后备文件(rebase)。

调整大小

更改磁盘镜像 文件名,就像它创建 大小为。无论版本如何,只有采用原始格式的镜像才可以重新定义大小。Red Hat Enterprise Linux 6.1 及之后的版本添加了以 qcow2 格式增加(但不缩小)镜像的功能。

# qemu-img resize filename size

+ 的字节数加前缀,或 - 通过该字节数来减小磁盘镜像的大小。添加单元后缀允许您以千字节(K)、兆字节(M)、千兆字节(G)或 TB(T)为单位设置镜像大小。

# qemu-img resize filename [+|-]size[K|M|G|T]

Snapshot

列出、应用、创建或删除映像的现有快照(快照)(文件名)。

# qemu-img snapshot [ -l | -a snapshot | -c snapshot | -d snapshot ] filename

支持的格式

QEMU-img 旨在将文件转换为以下格式之一:

-

raw - 原始磁盘镜像格式(默认)。这可以是基于文件的最快格式。如果您的文件系统支持 holes(例如,在 Linux 上的 ext2 或 ext3 中,Windows 上的 NTFS),则只有写扇区将被保留空间。使用 qemu-img info 获取镜像或 ls -ls on Unix/Linux 上使用的实际大小。虽然 Raw 镜像提供了最佳性能,但只有 Raw 镜像具有非常基本的功能(例如,没有快照可用)。

-

qcow2 - QEMU 镜像格式,包含最佳功能集的最通用格式。使用它来具有可选的 AES 加密,基于 zlib 的压缩,支持多个虚拟机快照和较小的镜像,这对于不支持 holes 的文件系统( Windows 中的非NTFS 文件系统)非常有用。请注意,这种广泛的功能集以性能为代价。

raw 或 qcow2 格式。通常会自动检测到镜像的格式。除了将这些格式转换为 raw 或 qcow2,也可将其从 raw 或 qcow2 转换为原始格式。

- Bochs

- Bochs 磁盘镜像格式。

- cloop

- Linux 压缩的 Loop 镜像,仅适用于重复使用压缩的 CD-ROM 镜像,例如 Knoppix CD-ROM。

- COW

- user Mode Linux Copy On Write image format。cow 格式仅用于与之前版本兼容。它无法使用 Windows。

- dmg

- MAC 磁盘镜像格式。

- nbd

- 网络块设备.

- Parallels

- 并行虚拟化磁盘映像格式.

- QCOW

- 旧的 QEMU 镜像格式。只适用于与旧版本兼容。

- vdi

- Oracle VM VirtualBox 硬盘映像格式.

- vmdk

- VMware 兼容镜像格式(对版本 1 和 2 的读写支持),对版本 3 具有只读访问权限。

- vpc

- Windows 虚拟 PC 磁盘映像格式.也称为

vhd或 Microsoft 虚拟硬盘映像格式。 - vvfat

- 虚拟 VFAT 磁盘镜像格式。

10.2. QEMU 客户机代理

10.2.1. 安装并启用客户机代理

10.2.2. 设置客户机代理和主机之间的通信

过程 10.1. 设置客户机代理和主机之间的通信

打开客户机 XML

使用 QEMU 客户机代理配置打开客户机 XML。您将需要 guest 名称来打开文件。使用主机机器上的 # virsh list 命令列出它可以识别的客户机。在本例中,guest 的名称是 rhel6 :# virsh edit rhel6编辑客户机 XML 文件

将下列元素添加到 XML 文件并保存更改。图 10.1. 编辑客户机 XML 以配置 QEMU 客户机代理

<channel type='unix'> <source mode='bind' path='/var/lib/libvirt/qemu/rhel6.agent'/> <target type='virtio' name='org.qemu.guest_agent.0'/> </channel>

在客户端中启动 QEMU 客户机代理

如果还没有这样做,请使用 yum install qemu-guest-agent 在客户机虚拟机中下载并安装客户机代理。安装后,按如下所示启动该服务:# service start qemu-guest-agent

10.2.3. 使用 QEMU 客户机代理

- qemu-guest-agent 无法检测到客户端是否连接到频道。

- 客户端无法检测到 qemu-guest-agent 是否断开连接或重新连接后端。

- 如果 virtio-serial 设备重置和 qemu-guest-agent 没有连接到频道(由重启或热插件导致),则客户端中的数据将被丢弃。

- 如果 qemu-guest-agent 在通过 virtio-serial 设备重置后连接到频道,则客户端中的数据将被排队(如果可用缓冲区是否已耗尽),不管是否仍在运行或连接了 qemu-guest-agent。

10.2.4. 将 QEMU 客户机代理与 libvirt 搭配使用

- virsh shutdown --mode=agent - 此关闭方法比 virsh shutdown --mode=acpi 更为可靠,因为与 QEMU 客户机代理一起使用的 virsh shutdown 保证可保证以干净状态关闭合作客户机。如果没有代理,libvirt 需要依赖注入 ACPI 关闭事件,但有些客户机会忽略该事件,因此不会关闭。可用于 virsh reboot 的相同语法。

- virsh snapshot-create --quiesce - 允许 guest 在创建快照之前将其 I/O 刷新到稳定状态,这样就允许在不执行 fsck 或丢失部分数据库交易的情况下使用快照。客户机代理通过提供客户机协作,实现高水平的磁盘内容稳定性。

- virsh setvcpus --guest - 对客户机进行离线设置,使 CPU 离线。

- virsh dompmsuspend - 使用客户机操作系统的电源管理功能安全暂停正在运行的 guest。

10.2.5. 创建客户机虚拟机磁盘备份

- 文件系统应用程序 / 数据库冲刷到虚拟磁盘的工作缓冲区,并停止接受客户端连接

- 应用程序将其数据文件置于一致状态

- 主 hook 脚本返回

- qemu- gazes 文件系统和管理堆栈采用快照

- 已确认快照

- 文件系统功能恢复

/etc/qemu-ga/fsfreeze-hook.d/ 的表行中发出 restorecon -FvvR 命令后,应立即工作。表 10.1 “QEMU 客户机代理软件包内容”

| 文件名 | 描述 |

|---|---|

/etc/rc.d/init.d/qemu-ga | QEMU 客户机代理的服务控制脚本(启动/停止)。 |

/etc/sysconfig/qemu-ga | QEMU 客户机代理的配置文件,因为它由 /etc/rc.d/init.d/qemu-ga 控制脚本读取。设置记录在 文件中,并包含 shell 脚本注释。 |

/usr/bin/qemu-ga | QEMU 客户机代理二进制文件。 |

/usr/libexec/qemu-ga/ | hook 脚本的根目录。 |

/usr/libexec/qemu-ga/fsfreeze-hook | 主 hook 脚本.这里不需要修改。 |

/usr/libexec/qemu-ga/fsfreeze-hook.d/ | 单独、特定于应用程序的 hook 脚本的目录。客户机系统管理员应将 hook 脚本手动复制到此目录,确保它们的正确文件模式位,然后在此目录上运行 restorecon -FvvR。 |

/usr/share/qemu-kvm/qemu-ga/ | 带有示例脚本的目录(例如,仅用于)。此处包含的脚本未执行。 |

/usr/libexec/qemu-ga/fsfreeze-hook 会记录其自身的消息,以及应用程序特定脚本的标准输出和错误消息,在以下日志文件中: /var/log/qemu-ga/fsfreeze-hook.log。有关更多信息,请参阅 wiki.qemu.org 或 libvirt.org 的 qemu-guest-agent wiki 页面。

10.3. 在 Windows 虚拟客户机中运行 QEMU 客户机代理

- Windows XP Service Pack 3(不支持VSS)

- Windows Server 2003 R2 - x86 和 AMD64(不支持VSS)

- Windows Server 2008

- Windows Server 2008 R2

- Windows 7 - x86 和 AMD64

- Windows Server 2012

- Windows Server 2012 R2

- Windows 8 - x86 和 AMD64

- Windows 8.1 - x86 和 AMD64

过程 10.2. 在 Windows 客户端中配置 QEMU 客户机代理

准备 Red Hat Enterprise Linux 主机机器

确保在 Red Hat Enterprise Linux 主机物理机器上安装了以下软件包:- virtio-win,位于

/usr/share/virtio-win/

要在 Windows 客户端中复制驱动程序,请使用以下命令为 qxl 驱动程序生成*.iso文件:# mkisofs -o /var/lib/libvirt/images/virtiowin.iso /usr/share/virtio-win/drivers准备 Windows 客户机

通过将*.iso挂载到 Windows guest 以更新驱动程序,在客户机中安装 virtio-serial driver。启动 guest,然后将驱动程序 .iso 文件连接到 guest(使用名为 hdb的磁盘):# virsh attach-disk guest /var/lib/libvirt/images/virtiowin.iso hdb要使用 Windows 来安装驱动程序,请导航到以下菜单:- 要安装 virtio-win 驱动程序 - Select > > 。

更新 Windows 客户机 XML 配置文件

Windows 客户机的客户机 XML 文件位于 Red Hat Enterprise Linux 主机中。要获取这个文件的访问权限,您需要 Windows 虚拟客户机名称。在主机机器上使用 # virsh list 命令,列出它可识别的客户机。在本例中,guest 的名称是 win7x86。使用 # virsh edit win7x86 命令在 XML 文件中添加以下元素并保存更改。请注意,源套接字名称在主机中必须是唯一的,本例中为 win7x86.agent :图 10.2. 编辑 Windows 客户机 XML 以配置 QEMU 客户机代理

... <channel type='unix'> <source mode='bind' path='/var/lib/libvirt/qemu/win7x86.agent'/> <target type='virtio' name='org.qemu.guest_agent.0'/> <address type='virtio-serial' controller='0' bus='0' port='1'/> </channel> <channel type='spicevmc'> <target type='virtio' name='com.redhat.spice.0'/> <address type='virtio-serial' controller='0' bus='0' port='2'/> </channel> ...重启 Windows 客户机

重启 Windows 客户机以应用更改:# virsh reboot win7x86在 Windows 客户端中准备 QEMU 客户机代理

在 Windows 客户端中准备客户机代理:安装最新的 virtio-win 软件包

在 Red Hat Enterprise Linux 主机物理机器终端窗口中运行以下命令,以查找要安装的文件。请注意,下面显示的 文件可能与系统找到的文件完全相同,但应为最新的官方版本。# rpm -qa|grep virtio-win virtio-win-1.6.8-5.el6.noarch # rpm -iv virtio-win-1.6.8-5.el6.noarch

确认安装已完成

在 virtio-win 软件包完成安装后,检查/usr/share/virtio-win/guest-agent/文件夹,并找到名为 qemu-ga-x64.msi 的文件或 qemu-ga-x86.msi,如下所示:# ls -l /usr/share/virtio-win/guest-agent/ total 1544 -rw-r--r--. 1 root root 856064 Oct 23 04:58 qemu-ga-x64.msi -rw-r--r--. 1 root root 724992 Oct 23 04:58 qemu-ga-x86.msi

安装 .msi 文件

从 Windows 客户机(例如,win7x86)通过双击 文件来安装 qemu-ga-x64.msi 或 qemu-ga-x86.msi。安装后,它将在 System Manager 中的 Windows guest 中显示为 qemu-ga 服务。此管理器可用于监控服务的状态。

10.3.1. 在 Windows Guests 上使用带有 QEMU 客户机代理的 libvirt 命令

- virsh shutdown --mode=agent - 此关闭方法比 virsh shutdown --mode=acpi 更为可靠,因为与 QEMU 客户机代理一起使用的 virsh shutdown 保证可保证以干净状态关闭合作客户机。如果没有代理,libvirt 需要依赖注入 ACPI 关闭事件,但有些客户机会忽略该事件,因此不会关闭。可用于 virsh reboot 的相同语法。

- virsh snapshot-create --quiesce - 允许 guest 在创建快照之前将其 I/O 刷新到稳定状态,这样就允许在不执行 fsck 或丢失部分数据库交易的情况下使用快照。客户机代理通过提供客户机协作,实现高水平的磁盘内容稳定性。

- virsh dompmsuspend - 使用客户机操作系统的电源管理功能安全暂停正在运行的 guest。

10.4. 在设备重定向上设置限制

-device usb-redir。filter 属性采用由过滤规则组成的字符串。规则的格式为:

<class>:<vendor>:<product>:<version>:<allow>-1 值指定它接受特定字段的任何值。您可以将 | 用作分隔符,在同一命令行中使用多个规则。请注意,如果设备没有匹配任何过滤器规则,则不会允许重定向。

例 10.1. 使用 Windows 客户机虚拟机限制重定向

- 准备 Windows 7 客户机虚拟机。

- 在 guest 虚拟机的 XML 文件中添加以下代码摘录:

<redirdev bus='usb' type='spicevmc'> <alias name='redir0'/> <address type='usb' bus='0' port='3'/> </redirdev> <redirfilter> <usbdev class='0x08' vendor='0x1234' product='0xBEEF' version='2.0' allow='yes'/> <usbdev class='-1' vendor='-1' product='-1' version='-1' allow='no'/> </redirfilter> - 启动客户端虚拟机并确认设置更改:

# ps -ef | grep $guest_name-device usb-redir,chardev=charredir0,id=redir0,/ filter=0x08:0x1234:0xBEEF:0x0200:1|-1:-1:-1:-1:0,bus=usb.0,port=3

- 将 USB 设备插入主机物理计算机中,并使用 virt-viewer 连接到客户机虚拟机。

- 点击菜单中的 ,这将生成以下信息:"Some USB 设备受主机策略阻止"。 并继续。过滤器生效。

- 为确保过滤器正确捕获了 USB 设备供应商和产品,然后在主机物理机器的域 XML 中进行以下更改,以允许 USB 重定向。

<redirfilter> <usbdev class='0x08' vendor='0x0951' product='0x1625' version='2.0' allow='yes'/> <usbdev allow='no'/> </redirfilter> - 重新启动 guest 虚拟机,然后使用 virt-viewer 连接到 guest 虚拟机。USB 设备现在会将流量重定向到客户端虚拟机。

10.5. 动态更改附加到虚拟 NIC 的主机物理机器或网桥

- 使用类似如下的配置准备客户端虚拟机:

<interface type='bridge'> <mac address='52:54:00:4a:c9:5e'/> <source bridge='virbr0'/> <model type='virtio'/> </interface> - 为接口更新准备 XML 文件:

# cat br1.xml<interface type='bridge'> <mac address='52:54:00:4a:c9:5e'/> <source bridge='virbr1'/> <model type='virtio'/> </interface> - 启动 guest 虚拟机,确认 guest 虚拟机的网络功能,并检查 guest 虚拟机的 vnetX 是否连接到您指示的网桥。

# brctl show bridge name bridge id STP enabled interfaces virbr0 8000.5254007da9f2 yes virbr0-nic vnet0 virbr1 8000.525400682996 yes virbr1-nic - 使用以下命令,使用新接口参数更新 guest 虚拟机网络:

# virsh update-device test1 br1.xml Device updated successfully - 在 guest 虚拟机上,运行 service network restart。客户机虚拟机获得 virbr1 的新 IP 地址。检查 guest 虚拟机的 vnet0 是否连接到新网桥(virbr1)

# brctl show bridge name bridge id STP enabled interfaces virbr0 8000.5254007da9f2 yes virbr0-nic virbr1 8000.525400682996 yes virbr1-nic vnet0

第 11 章 存储概念

11.1. 存储池

- virtio-blk = 2^63 字节或 8 Exabytes(使用原始文件或磁盘)

- Ext4 = ~ 16 TB(使用 4 KB 块大小)

- XFS = ~8 Exabytes

- 在尝试非常大的镜像大小时,qcow2 和主机文件系统会保留自己的元数据和可扩展性。使用原始磁盘意味着可能会影响可扩展性或最大大小的层数。

/var/lib/libvirt/images/ 目录作为默认存储池。可以将默认存储池改为另一个存储池。

- 本地存储池 - 本地存储池直接附加到主机物理机器服务器。本地存储池包括:本地目录、直接附加磁盘、物理分区和 LVM 卷组。这些存储卷存储客户机虚拟机镜像,或作为额外存储附加到客户机虚拟机。由于本地存储池直接附加到主机物理服务器,它们在开发、测试和小型部署非常有用,不需要迁移或大量客户机虚拟机。本地存储池不适用于许多生产环境,因为本地存储池不支持实时迁移。

- 网络(共享)存储池 - 网络的存储池包括使用标准协议通过网络共享的存储设备。使用 virt-manager 在主机物理机之间迁移虚拟机时需要网络存储,但在使用 virsh 迁移时是可选的。网络的存储池由 libvirt 管理。网络存储池支持的协议包括:

- 基于光纤通道的 LUN

- iSCSI

- NFS

- GFS2

- SCSI RDMA 协议(SCSI RCP), InfiniBand 和 10GbE iWARP 适配器中使用的块导出协议。

11.2. 卷

引用卷

要引用特定卷,可以使用三种方法:

- 卷和存储池的名称

- 卷可以通过名称来指代,以及它所属的存储池的标识符。在 virsh 命令行中,格式为

--poolstorage_pool volume_name。例如,在 guest_images 池中名为 firstimage 的卷。# virsh vol-info --pool guest_images firstimage Name: firstimage Type: block Capacity: 20.00 GB Allocation: 20.00 GB virsh #

- 主机物理机器系统中存储的的完整路径

- 卷也可能由文件系统中的完整路径来引用。使用此方法时,不需要包含池标识符。例如,名为 secondimage.img 的卷,对主机物理机器系统作为 /images/secondimage.img 可见。该镜像可以指代为 /images/secondimage.img。

# virsh vol-info /images/secondimage.img Name: secondimage.img Type: file Capacity: 20.00 GB Allocation: 136.00 kB

- 唯一卷密钥

- 当卷首次在虚拟化系统中创建时,将生成唯一标识符并为其分配它。唯一标识符术语 卷键。此卷密钥的格式因所使用的存储而异。与基于块的存储(如 LVM)一同使用时,卷密钥可能会采用以下格式:

c3pKz4-qPVc-Xf7M-7WNM-WJc8-qSiz-mtvpGn

与基于文件的存储一起使用时,卷密钥可能是卷存储的完整路径的副本。/images/secondimage.img

例如,卷键为 Wlvnf7-a4a3-Tlje-lJDa-9eak-PZBv-LoZuUr:# virsh vol-info Wlvnf7-a4a3-Tlje-lJDa-9eak-PZBv-LoZuUr Name: firstimage Type: block Capacity: 20.00 GB Allocation: 20.00 GB

- vol-name

- 当提供卷路径或卷密钥时,返回卷名称。

# virsh vol-name /dev/guest_images/firstimage firstimage # virsh vol-name Wlvnf7-a4a3-Tlje-lJDa-9eak-PZBv-LoZuUr

- vol-path

- 当提供卷密钥或存储池标识符和卷名称时,返回卷路径。

# virsh vol-path Wlvnf7-a4a3-Tlje-lJDa-9eak-PZBv-LoZuUr /dev/guest_images/firstimage # virsh vol-path --pool guest_images firstimage /dev/guest_images/firstimage

- vol-key 命令

- 当提供卷路径或存储池标识符和卷名称时,返回卷密钥。

# virsh vol-key /dev/guest_images/firstimage Wlvnf7-a4a3-Tlje-lJDa-9eak-PZBv-LoZuUr # virsh vol-key --pool guest_images firstimage Wlvnf7-a4a3-Tlje-lJDa-9eak-PZBv-LoZuUr

第 12 章 存储池

例 12.1. NFS 存储池

/path/to/share should mounted on /vm_data)。当池启动时,libvirt 将共享挂载到指定目录中,就像系统管理员登录并执行 nfs.example.com:/path/to/share /vmdata 一样。如果池配置为自动启动,libvirt 可确保 NFS 共享挂载到 libvirt 启动时指定的目录中。

12.1. 基于磁盘的存储池

/dev/sdb)。使用分区(例如 /dev/sdb1)或 LVM 卷。

12.1.1. 使用 virsh 创建基于磁盘的存储池

在磁盘上创建 GPT 磁盘标签

磁盘必须使用 GUID 分区表 (GPT)磁盘标签重新标记。GPT 磁盘标签允许在每个设备中创建大量分区(最多 128 个分区)。GPT 分区表可以存储比 MS-DOS 分区表更多的分区数据。# parted /dev/sdb GNU Parted 2.1 Using /dev/sdb Welcome to GNU Parted! Type 'help' to view a list of commands. (parted) mklabel New disk label type? gpt (parted) quit Information: You may need to update /etc/fstab. #

创建存储池配置文件

创建包含新设备所需的存储池信息的临时 XML 文本文件。该文件必须采用如下所示的格式,并包含以下字段:- <name>guest_images_disk</name>

name参数决定存储池的名称。本例在示例中使用名称 guest_images_disk。- <device path='/dev/sdb'/>

- 带有

device属性的path参数指定存储设备的设备路径。这个示例使用 /dev/sdb 设备。 - <target> <path>/dev</path></target>

- 带有

target子参数的文件系统path参数决定主机物理机器文件系统中的位置,以附加使用此存储池创建的卷。例如:sdb1、sdb2、sdb3。使用 /dev/,如以下示例所示,从这个存储池创建的卷可以作为 /dev /sdb1、/dev/sdb2、/ dev/sdb3 进行访问。 - <format type='gpt'/>

format参数指定分区表类型。这个示例使用以下示例中的 gpt 与上一步中创建的 GPT 磁盘标签类型匹配。

使用文本编辑器为存储池设备创建 XML 文件。例 12.2. 基于磁盘的存储设备存储池

<pool type='disk'> <name>guest_images_disk</name> <source> <device path='/dev/sdb'/> <format type='gpt'/> </source> <target> <path>/dev</path> </target> </pool>附加该设备

使用 virsh pool-define 命令和上一步中创建的 XML 配置文件添加存储池定义。# virsh pool-define ~/guest_images_disk.xml Pool guest_images_disk defined from /root/guest_images_disk.xml # virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images_disk inactive no

启动存储池

使用 virsh pool-start 命令启动存储池。验证已使用 virsh pool-list --all 命令启动池。# virsh pool-start guest_images_disk Pool guest_images_disk started # virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images_disk active no

打开自动启动

为存储池打开autostart。autostart 将libvirtd服务配置为在服务启动时启动存储池。# virsh pool-autostart guest_images_disk Pool guest_images_disk marked as autostarted # virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images_disk active yes

验证存储池配置

验证存储池是否已正确创建,报告的大小是否正确,以及状态报告正在运行。# virsh pool-info guest_images_disk Name: guest_images_disk UUID: 551a67c8-5f2a-012c-3844-df29b167431c State: running Capacity: 465.76 GB Allocation: 0.00 Available: 465.76 GB # ls -la /dev/sdb brw-rw----. 1 root disk 8, 16 May 30 14:08 /dev/sdb # virsh vol-list guest_images_disk Name Path -----------------------------------------

可选:删除临时配置文件

如果不需要,请删除临时存储池 XML 配置文件。# rm ~/guest_images_disk.xml

12.1.2. 使用 virsh 删除存储池

- 为了避免同一池的其他客户机虚拟机出现任何问题,最好停止存储池并释放其使用中的任何资源。

# virsh pool-destroy guest_images_disk

- 删除存储池的定义

# virsh pool-undefine guest_images_disk

12.2. 基于分区的存储池

/dev/sdc)分区到一个 500GB、ext4 格式化分区(/dev/sdc1)。我们使用以下步骤为其设置一个存储池。

12.2.1. 使用 virt-manager 创建基于分区的存储池

过程 12.1. 使用 virt-manager 创建基于分区的存储池

打开存储池设置

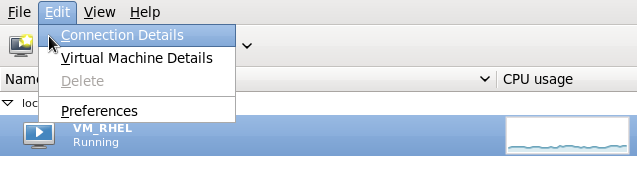

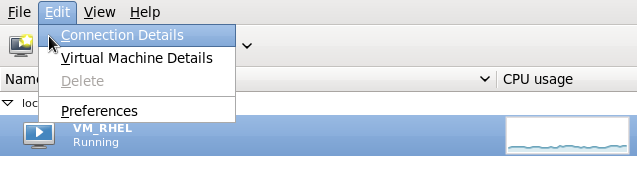

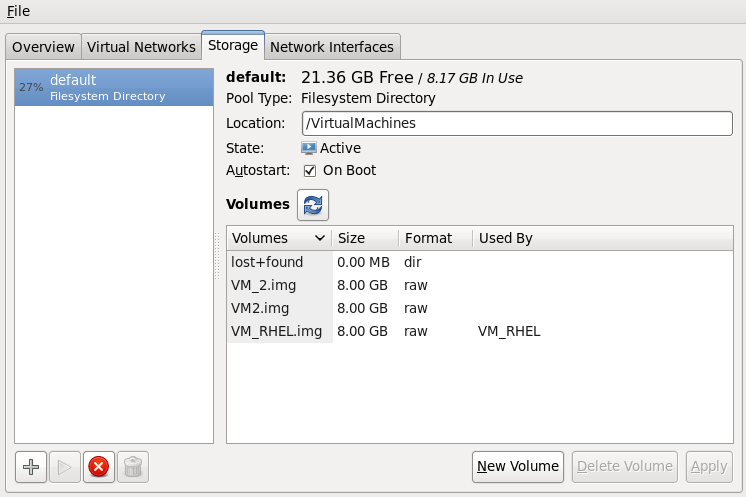

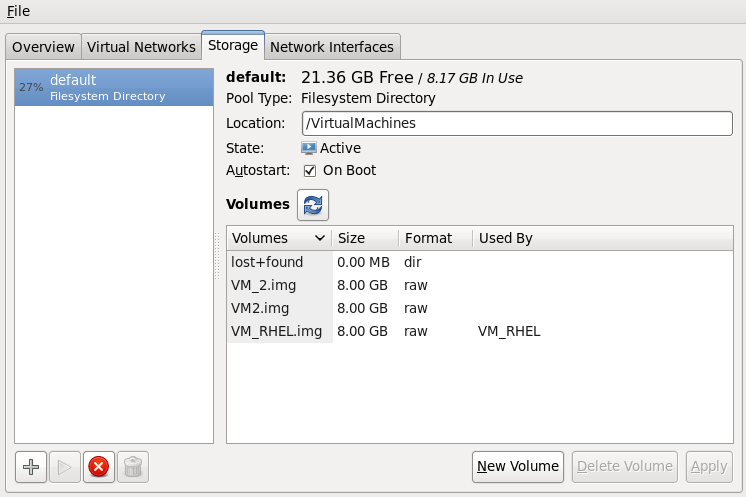

- 在 virt-manager 图形界面,从主窗口中选择主机物理计算机。打开 Edit 菜单,然后选择 Connection Details

图 12.1. 连接详情

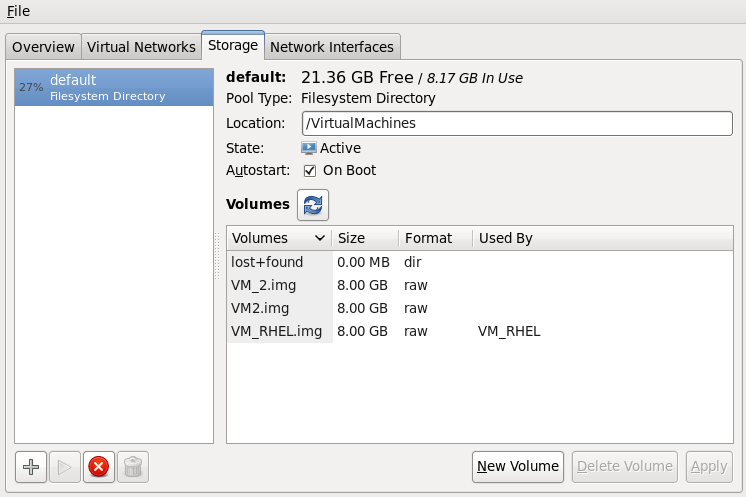

- 单击 Connection Details 窗口中的 Storage 选项卡。

图 12.2. 存储标签

创建新存储池

添加新池(第 1 部分)

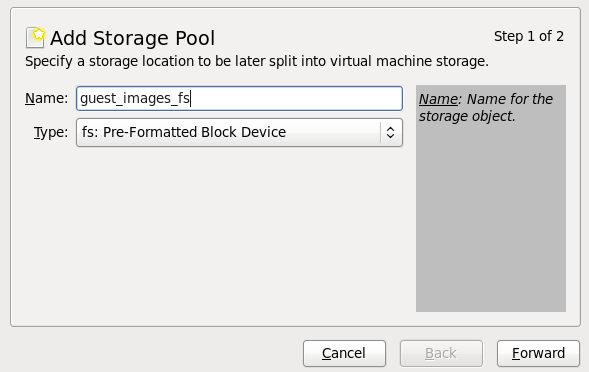

按 + 按钮(添加池按钮)。此时会出现 Add a New Storage Pool 向导。为存储池选择一个 。这个示例使用名称 guest_images_fs。将 更改为 fs: PreFormatted Block Device。图 12.3. 存储池名称和类型

按 按钮继续。

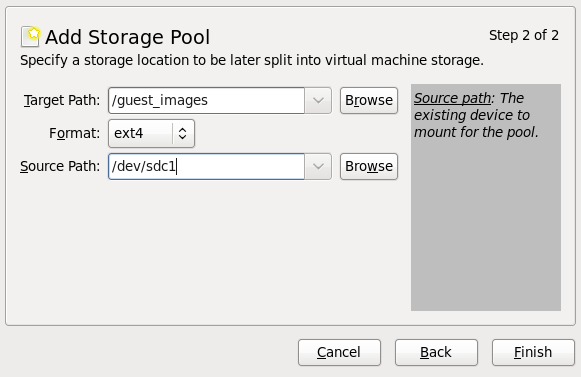

按 按钮继续。添加新池(第 2 部分)

更改 、 和 字段。图 12.4. 存储池路径和格式

- 目标路径

- 在 字段中,为存储池输入挂载源设备的位置。如果该位置尚不存在,virt-manager 将创建目录。

- 格式

- 从 列表中选择一个格式。设备使用所选格式进行格式化。这个示例使用 ext4 文件系统,它是默认的 Red Hat Enterprise Linux 文件系统。

- 源路径

- 在 Source Path 字段中输入设备。这个示例使用 /dev/sdc1 设备。

验证详细信息,然后按 "按钮创建存储池。

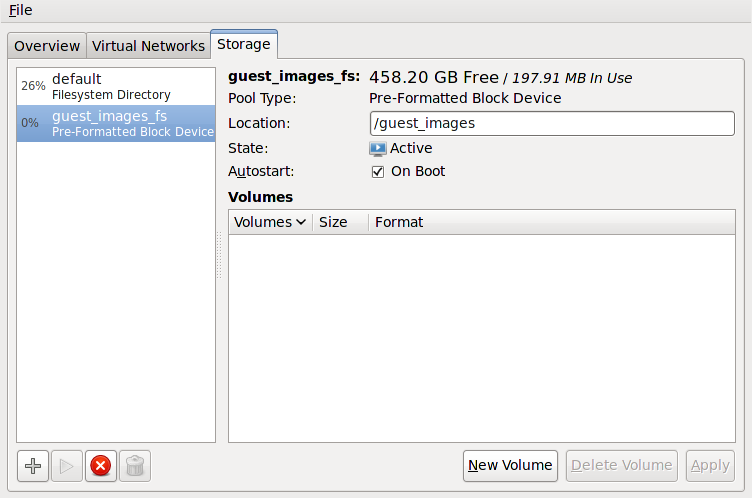

验证新存储池

在几秒钟后,新存储池会出现在左侧的存储列表中。验证大小已如预期报告,本例中为 458.20 GB 空闲。验证 字段将新存储池报告为 Active。选择存储池。在 字段中,单击 复选框。这将确保无论libvirtd服务启动时都能启动存储设备。图 12.5. 存储列表确认

现在创建了存储池,关闭 Connection Details 窗口。

现在创建了存储池,关闭 Connection Details 窗口。

12.2.2. 使用 virt-manager 删除存储池

- 为了避免同一池的其他客户机虚拟机出现任何问题,最好停止存储池并释放其使用中的任何资源。要做到这一点,选择您要停止的存储池,并点击 Storage 窗口底部的红色 X 图标。

图 12.6. 停止图标

- 点 Trash can 图标删除存储池。只有您首先停止存储池时才会启用此图标。

12.2.3. 使用 virsh 创建基于分区的存储池

/dev/sdb)。不应该对整个磁盘或块设备进行写入访问权限。仅使用此方法将分区(例如 /dev/sdb1)分配给存储池。

过程 12.2. 使用 virsh 创建预格式化的块设备存储池

创建存储池定义

使用 virsh pool-define-as 命令创建一个新的存储池定义。必须提供三个选项来定义预格式化的磁盘作为存储池:- 分区名称

name参数决定存储池的名称。本例使用以下示例中的 guest_images_fs 名称。- device

- 带有

device属性的path参数指定存储设备的设备路径。这个示例使用分区 /dev/sdc1。 - mountpoint

- 挂载格式化设备的本地文件系统中的

mountpoint。如果挂载点目录不存在,则 virsh 命令可以创建该目录。本例中使用了 /guest_images 目录。

# virsh pool-define-as guest_images_fs fs - - /dev/sdc1 - "/guest_images" Pool guest_images_fs defined

新的池和挂载点现已创建。验证新池

列出 present 存储池。# virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images_fs inactive no

创建挂载点

使用 virsh pool-build 命令为预格式化的文件系统存储池创建挂载点。# virsh pool-build guest_images_fs Pool guest_images_fs built # ls -la /guest_images total 8 drwx------. 2 root root 4096 May 31 19:38 . dr-xr-xr-x. 25 root root 4096 May 31 19:38 .. # virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images_fs inactive no

启动存储池

使用 virsh pool-start 命令将文件系统挂载到挂载点,并让池可用。# virsh pool-start guest_images_fs Pool guest_images_fs started # virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images_fs active no

打开自动启动

默认情况下,使用 virsh 定义的存储池不会设置为在每次libvirtd启动时自动启动。要补救这一点,请使用 virsh pool-autostart 命令启用自动启动。现在,每次libvirtd启动时都会自动启动存储池。# virsh pool-autostart guest_images_fs Pool guest_images_fs marked as autostarted # virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images_fs active yes

验证存储池

验证存储池是否已正确创建,报告的大小与预期相同,并且报告为运行 状态。验证文件系统的挂载点中存在"lost+found"目录,表示挂载该设备。# virsh pool-info guest_images_fs Name: guest_images_fs UUID: c7466869-e82a-a66c-2187-dc9d6f0877d0 State: running Persistent: yes Autostart: yes Capacity: 458.39 GB Allocation: 197.91 MB Available: 458.20 GB # mount | grep /guest_images /dev/sdc1 on /guest_images type ext4 (rw) # ls -la /guest_images total 24 drwxr-xr-x. 3 root root 4096 May 31 19:47 . dr-xr-xr-x. 25 root root 4096 May 31 19:38 .. drwx------. 2 root root 16384 May 31 14:18 lost+found

12.2.4. 使用 virsh 删除存储池

- 为了避免同一池的其他客户机虚拟机出现任何问题,最好停止存储池并释放其使用中的任何资源。

# virsh pool-destroy guest_images_disk

- 另外,如果要删除存储池所在的目录,请使用以下命令:

# virsh pool-delete guest_images_disk

- 删除存储池的定义

# virsh pool-undefine guest_images_disk

12.3. 基于目录的存储池

12.3.1. 使用 virt-manager 创建基于目录的存储池

创建本地目录

可选:为存储池创建新目录

在主机物理计算机中为存储池创建 目录。这个示例使用名为 /guest virtual_images 的目录。# mkdir /guest_images

设置目录所有权

更改 目录的用户和组所有权。目录必须由 root 用户所有。# chown root:root /guest_images

设置目录权限

更改 目录的文件权限。# chmod 700 /guest_images

验证更改

验证权限已被修改。输出显示正确配置了空目录。# ls -la /guest_images total 8 drwx------. 2 root root 4096 May 28 13:57 . dr-xr-xr-x. 26 root root 4096 May 28 13:57 ..

配置 SELinux 文件上下文

为新目录配置正确的 SELinux 上下文。请注意,池的名称和 目录不需要匹配。但是,当您关闭客户端虚拟机时,libvirt 必须把上下文设置为默认值。目录的上下文决定了这个默认值。值得显式标记目录 virt_image_t,因此,当客户机虚拟机关闭时,镜像会标记为"virt_image_t",因此与在主机物理机器上运行的其他进程隔离开来。# semanage fcontext -a -t virt_image_t '/guest_images(/.*)?' # restorecon -R /guest_images

打开存储池设置

- 在 virt-manager 图形界面,从主窗口中选择主机物理计算机。打开 Edit 菜单,然后选择 Connection Details

图 12.7. 连接详情窗口

- 单击 Connection Details 窗口中的 Storage 选项卡。

图 12.8. 存储标签

创建新存储池

添加新池(第 1 部分)

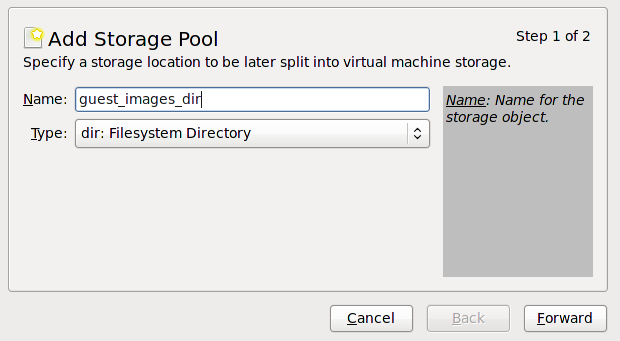

按 + 按钮(添加池按钮)。此时会出现 Add a New Storage Pool 向导。为存储池选择一个 。这个示例使用名称 guest_images。将 更改为 dir: Filesystem Directory。图 12.9. 将存储池命名为

按 按钮继续。

按 按钮继续。添加新池(第 2 部分)

更改 字段。例如: /guest_images。验证详细信息,然后按 "按钮创建存储池。

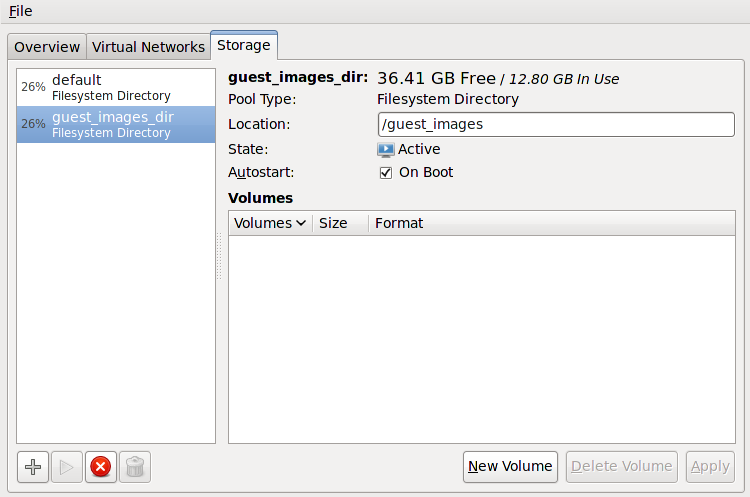

验证新存储池

在几秒钟后,新存储池会出现在左侧的存储列表中。验证大小已如预期报告,本例中为 36.41 GB 空闲。验证 字段将新存储池报告为 Active。选择存储池。在 字段中,确认选中 复选框。这将确保无论libvirtd服务启动时都启动存储池。图 12.10. 验证存储池信息

现在创建了存储池,关闭 Connection Details 窗口。

现在创建了存储池,关闭 Connection Details 窗口。

12.3.2. 使用 virt-manager 删除存储池

- 为了避免同一池的其他客户机虚拟机出现任何问题,最好停止存储池并释放其使用中的任何资源。要做到这一点,选择您要停止的存储池,并点击 Storage 窗口底部的红色 X 图标。

图 12.11. 停止图标

- 点 Trash can 图标删除存储池。只有您首先停止存储池时才会启用此图标。

12.3.3. 使用 virsh 创建基于目录的存储池

创建存储池定义

使用 virsh pool-define-as 命令定义新的存储池。创建基于目录的存储池需要两个选项:- 存储池的名称。这个示例使用名称 guest_images。本例中使用的所有进一步 virsh 命令使用此名称。

- 用于存储客户机镜像文件的文件系统目录的路径。如果该目录不存在,virsh 将创建该目录。这个示例使用 /guest_images 目录。

# virsh pool-define-as guest_images dir - - - - "/guest_images" Pool guest_images defined

验证是否列出了存储池

验证存储池对象是否已正确创建,状态则报告为不活动。# virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images inactive no

创建本地目录

使用 virsh pool-build 命令为目录 guest_images (例如,如下所示)构建基于目录的存储池:# virsh pool-build guest_images Pool guest_images built # ls -la /guest_images total 8 drwx------. 2 root root 4096 May 30 02:44 . dr-xr-xr-x. 26 root root 4096 May 30 02:44 .. # virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images inactive no

启动存储池

使用 virsh 命令 pool-start 启用目录存储池,从而允许池的卷用作客户机磁盘镜像。# virsh pool-start guest_images Pool guest_images started # virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images active no

打开自动启动

为存储池打开autostart。autostart 将libvirtd服务配置为在服务启动时启动存储池。# virsh pool-autostart guest_images Pool guest_images marked as autostarted # virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images active yes

验证存储池配置

验证存储池是否已正确创建,其大小会被正确报告,并且报告为运行 状态。如果希望池可以被访问,即使客户机虚拟机没有运行,请确保将永久报告为yes。如果您希望池在服务启动时自动启动,请确保将Autostart报告为yes。# virsh pool-info guest_images Name: guest_images UUID: 779081bf-7a82-107b-2874-a19a9c51d24c State: running Persistent: yes Autostart: yes Capacity: 49.22 GB Allocation: 12.80 GB Available: 36.41 GB # ls -la /guest_images total 8 drwx------. 2 root root 4096 May 30 02:44 . dr-xr-xr-x. 26 root root 4096 May 30 02:44 .. #

12.3.4. 使用 virsh 删除存储池

- 为了避免同一池的其他客户机虚拟机出现任何问题,最好停止存储池并释放其使用中的任何资源。

# virsh pool-destroy guest_images_disk

- 另外,如果要删除存储池所在的目录,请使用以下命令:

# virsh pool-delete guest_images_disk

- 删除存储池的定义

# virsh pool-undefine guest_images_disk

12.4. 基于 LVM 的存储池

12.4.1. 使用 virt-manager 创建基于 LVM 的存储池

可选:为 LVM 卷创建新分区

这些步骤描述了如何在新硬盘中创建新分区和 LVM 卷组。警告这个过程将从所选存储设备中删除所有数据。创建新分区

使用 fdisk 命令从命令行创建新磁盘分区。以下示例创建一个使用存储设备/dev/sdb上的整个磁盘的新分区。# fdisk /dev/sdb Command (m for help):

为新分区按n。- 在主分区中按

p。Command action e extended p primary partition (1-4)

- 选择可用分区号。在这个示例中,通过输入

1来选择第一个分区。Partition number (1-4):

1 - 按

Enter输入默认柱面。First cylinder (1-400, default 1):

- 选择分区的大小。在这个示例中,通过按

Enter来分配整个磁盘。Last cylinder or +size or +sizeM or +sizeK (2-400, default 400):

- 按

t设置分区类型。Command (m for help):

t - 选择您在前面的步骤中创建的分区。在这个示例中,分区号是

1。Partition number (1-4):

1 - 为 Linux LVM 分区输入

8e。Hex code (type L to list codes):

8e - 将更改写入磁盘并退出。

Command (m for help):

wCommand (m for help):q 创建新 LVM 卷组

使用 vgcreate 命令创建一个新的 LVM 卷组。这个示例创建名为 guest_images_lvm 的卷组。# vgcreate guest_images_lvm /dev/sdb1 Physical volume "/dev/vdb1" successfully created Volume group "guest_images_lvm" successfully created

新的 LVM 卷组 guest_images_lvm 现在可以用于基于 LVM 的存储池。打开存储池设置

- 在 virt-manager 图形界面中,从主窗口中选择主机。打开 Edit 菜单,然后选择 Connection Details

图 12.12. 连接详情

- 点 Storage 选项卡。

图 12.13. 存储标签

创建新存储池

启动向导

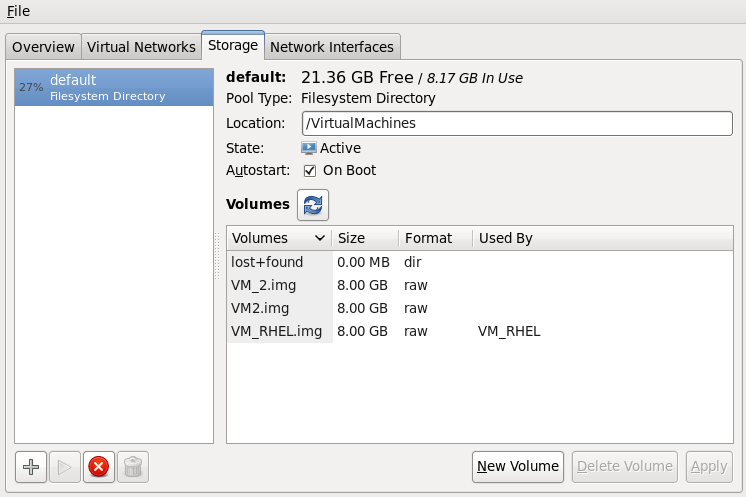

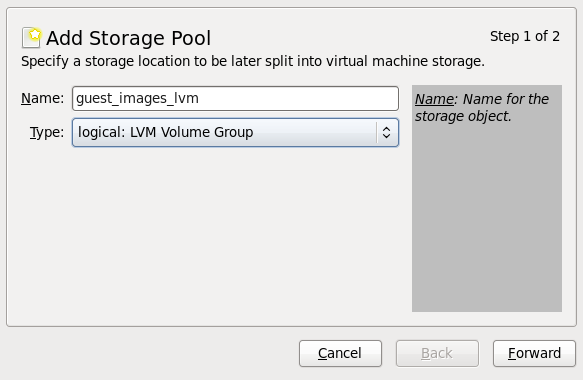

按 + 按钮(添加池按钮)。此时会出现 Add a New Storage Pool 向导。为存储池选择一个 。在本例中,我们使用 guest_images_lvm。然后将类型更改为 逻辑:LVM 卷组,然后图 12.14. 添加 LVM 存储池

按 按钮继续。

按 按钮继续。添加新池(第 2 部分)

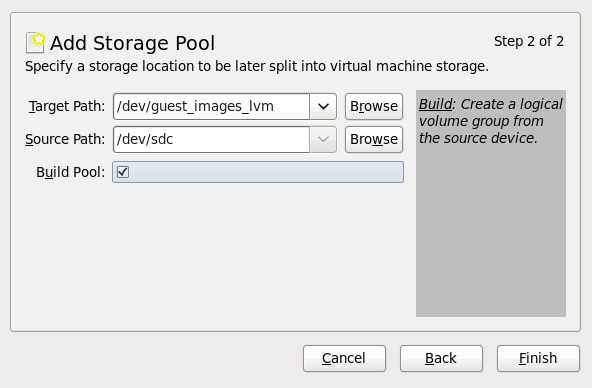

更改 字段。这个示例使用 /guest_images。现在填写 和 字段,然后选中 复选框。- 使用 字段选择现有 LVM 卷组或新卷组的名称。默认格式为

/dev/storage_pool_name。本例使用名为 /dev/guest_images_lvm 的新卷组。 - 如果在 。对于新的 LVM 卷组,在 Source Path 字段中输入存储设备的位置。这个示例使用空白分区 /dev/sdc。

- 复选框指示 virt-manager 创建新的 LVM 卷组。如果您使用现有的卷组,则不应选择 复选框。本示例使用空分区来创建新卷组,因此必须选择 复选框。

图 12.15. 添加目标和源

验证详细信息并按 "按钮格式化 LVM 卷组并创建存储池。

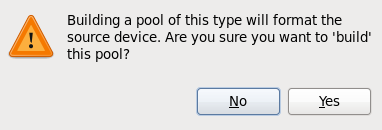

验证详细信息并按 "按钮格式化 LVM 卷组并创建存储池。确认要格式化的设备

此时会出现一个警告信息。图 12.16. 警告信息

按" 是 "按钮继续清除存储设备上的所有数据并创建存储池。

按" 是 "按钮继续清除存储设备上的所有数据并创建存储池。

验证新存储池

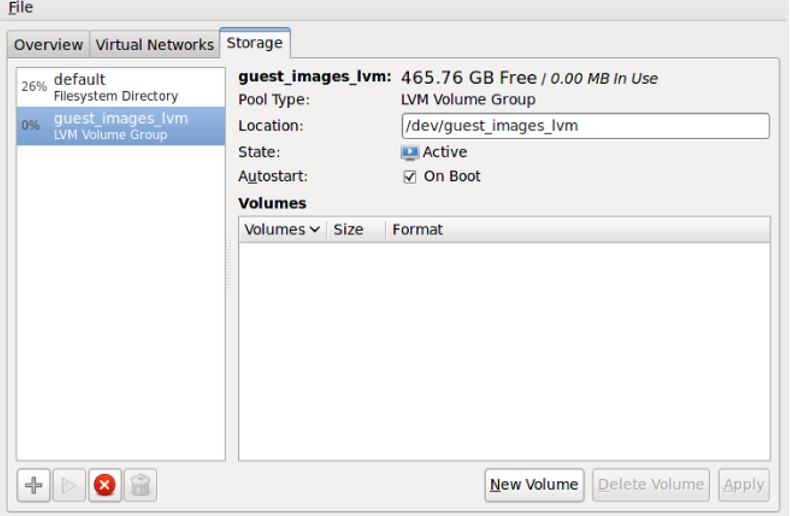

新存储池将在几秒钟后左侧的列表中显示。验证您期望的详细信息,如示例中 465.76 GB 可用。另外,验证 字段会报告新的存储池为 Active。通常最好启用了 复选框,以确保存储池在 libvirtd 自动启动。图 12.17. 确认 LVM 存储池详情

关闭 Host Details 对话框,因为任务现已完成。

关闭 Host Details 对话框,因为任务现已完成。

12.4.2. 使用 virt-manager 删除存储池

- 为了避免同一池的其他客户机虚拟机出现任何问题,最好停止存储池并释放其使用中的任何资源。要做到这一点,选择您要停止的存储池,并点击 Storage 窗口底部的红色 X 图标。

图 12.18. 停止图标

- 点 Trash can 图标删除存储池。只有您首先停止存储池时才会启用此图标。

12.4.3. 使用 virsh 创建基于 LVM 的存储池

/dev/sdc)。它只是一个示例,您的设置应根据情况替代。

过程 12.3. 使用 virsh 创建基于 LVM 的存储池

- 定义池名称 guest_images_lvm。

# virsh pool-define-as guest_images_lvm logical - - /dev/sdc libvirt_lvm \ /dev/libvirt_lvm Pool guest_images_lvm defined

- 根据指定名称构建池。如果您使用已存在的卷组,请跳过这一步。

# virsh pool-build guest_images_lvm Pool guest_images_lvm built

- 初始化新池。

# virsh pool-start guest_images_lvm Pool guest_images_lvm started

- 使用 vgs 命令显示卷组信息。

# vgs VG #PV #LV #SN Attr VSize VFree libvirt_lvm 1 0 0 wz--n- 465.76g 465.76g

- 将池设置为自动启动。

# virsh pool-autostart guest_images_lvm Pool guest_images_lvm marked as autostarted

- 使用 virsh 命令列出可用的池。

# virsh pool-list --all Name State Autostart ----------------------------------------- default active yes guest_images_lvm active yes

- 以下命令演示了在此池中创建三个卷(volume1、 volume2 和 volume3)。