安全强化

增强 Red Hat Enterprise Linux 9 系统的安全性

摘要

对红帽文档提供反馈

我们感谢您对我们文档的反馈。让我们了解如何改进它。

通过 Jira 提交反馈(需要帐户)

- 登录到 Jira 网站。

- 点顶部导航栏中的 Create

- 在 Summary 字段中输入描述性标题。

- 在 Description 字段中输入您对改进的建议。包括文档相关部分的链接。

- 点对话框底部的 Create。

第 1 章 在安装过程中和安装后保护 RHEL

安全性甚至在您开始安装 Red Hat Enterprise Linux 之前就已经开始了。从一开始就安全地配置系统可以使以后更容易实施其他安全设置。

1.1. 磁盘分区

对于裸机上安装以及支持调整虚拟磁盘硬件和包含已安装了操作系统的文件系统的虚拟化或云环境,推荐的磁盘分区实践有所不同。

为了确保在 裸机安装 上隔离和保护数据,请为 /boot、/、/home、/tmp 和 /var/tmp/ 目录创建单独的分区:

/boot-

这个分区是系统在启动过程中读取的第一个分区。引导装载程序和用于将系统引导到 Red Hat Enterprise Linux 9 的内核镜像存储在这个分区中。此分区不应加密。如果此分区包含在

/中,并且该分区已加密或者不可用,那么您的系统将无法引导。 /home-

当用户数据(

/home)存储在/而不是独立分区中时,分区可能会填满,从而导致操作系统不稳定。另外,当将您的系统升级到 Red Hat Enterprise Linux 9 的下一版本时,当您可以把数据保存在/home分区时,因为在安装过程中不会覆盖它,这更为容易。如果 root 分区(/)损坏,则您的数据将永久丢失。通过使用单独的分区,对数据丢失有稍微多一点的保护。您还可以将此分区作为频繁备份的目标。 /tmp和/var/tmp/。-

/tmp和/var/tmp/目录都是用来存储不需要长期存储的数据。但是,如果大量数据填充了其中一个目录,则它可能会消耗掉您的所有存储空间。如果发生这种情况,且这些目录存储在/中,则您的系统可能会变得不稳定并崩溃。因此,将这些目录移到它们自己的分区中是一个不错的想法。

对于 虚拟机或云实例,单独的 /boot、/home、/tmp 和 /var/tmp 分区是可选的,因为如果开始填满了,您可以增加虚拟磁盘大小和 / 分区。设置监控,以定期检查 / 分区使用情况,以便在相应增加虚拟磁盘大小之前,其不会填满。

在安装过程中,您可以选择加密分区。您必须提供密码短语。此密语充当解锁批量加密密钥的密钥,该密钥用于保护分区的数据。

1.2. 在安装过程中限制网络连接

安装 Red Hat Enterprise Linux 9 时,安装介质代表系统在特定时间的快照。因此,它可能没有最新的安全修复程序,并且可能容易受到某些问题的攻击,这些问题是在安装介质提供的系统发布后才修复的。

安装有潜在漏洞的操作系统时,始终将暴露限制在最近的必要网络区内。最安全的选择是"无网络"区,这意味着在安装过程中使计算机断开连接。在某些情况下,LAN 或内部网连接就足够了,而互联网连接的风险最大。要遵循最佳安全实践,请从网络安装 Red Hat Enterprise Linux 9 时,选择与您的软件仓库最接近的区域。

1.3. 安装所需的最少软件包

最好只安装您要使用的软件包,因为计算机上的每一款软件都可能包含漏洞。如果您要从 DVD 介质安装,请仔细选择要在安装过程中安装的软件包。如果您发现需要其他软件包,您可在以后将其添加到系统中。

1.4. 安装后流程

以下步骤是安装 Red Hat Enterprise Linux 9 后应立即执行的安全相关步骤。

更新您的系统。以 root 用户身份输入以下命令:

# dnf update虽然在安装 Red Hat Enterprise Linux 时会自动启用防火墙服务

firewalld,但它可以被明确禁用,例如,在 Kickstart 配置中。在这种情况下,请重新启用防火墙。要启动

firewalld,请以 root 用户身份输入以下命令:# systemctl start firewalld # systemctl enable firewalld

要提高安全性,请禁用您不需要的服务。例如,如果您的计算机上没有安装打印机,请使用以下命令禁用

cups服务:# systemctl disable cups要查看活动状态的服务,请输入以下命令:

$ systemctl list-units | grep service

1.5. 使用 Web 控制台禁用 SMT 以防止 CPU 安全问题

在出现滥用 CPU SMT 的攻击时禁用 Simultaneous Multi Threading(SMT)。禁用 SMT 可缓解安全漏洞(如 L1TF 或 MDS)对系统的影响。

禁用 SMT 可能会降低系统性能。

先决条件

您已安装了 RHEL 9 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

步骤

登录到 RHEL 9 web 控制台。

详情请参阅 登录到 web 控制台。

- 在 Overview 选项卡中,找到 系统信息 字段并点查看硬件详细信息。

在 CPU Security 行上,点 Mitigations。

如果这个链接不存在,这意味着您的系统不支持 SMT,因此不会受到这个安全漏洞的影响。

- 在 CPU Security Toggles 表中,打开 Disable simultaneous multithreading (nosmt) 选项。

- 点按钮。

系统重启后,CPU 不再使用 SMT。

第 2 章 将 RHEL 切换到 FIPS 模式

要启用联邦信息处理标准(FIPS) 140-3 强制的加密模块,您必须在 FIPS 模式下操作 RHEL 9。如果您的目标是遵循FIPS,在 FIPS 模式下开始安装是推荐的方法。

RHEL 9 的加密模块尚未获得 FIPS 140-3 要求的认证。

2.1. Federal Information Processing Standards 140 和 FIPS 模式

联邦信息处理标准(FIPS)公共 140 是国家标准与技术研究所开发的一系列计算机安全标准,以确保加密模块的质量。FIPS 140 标准可确保加密工具正确实现其算法。运行时加密算法和完整性自我测试是一些机制,用于确保系统使用符合标准要求的加密机制。

RHEL 在 FIPS 模式中

要确保 RHEL 系统生成并使用所有带有 FIPS 批准的算法的加密密钥,您必须将 RHEL 切换到 FIPS 模式。

您可以使用以下方法之一启用 FIPS 模式:

- 在 FIPS 模式下开始安装

- 安装后将系统切换到 FIPS 模式

如果您的目的是 FIPS 合规性,请在 FIPS 模式下开始安装。这可避免加密密钥材料重新生成和与转换已部署的系统相关的结果系统的合规性的重新评估。

要操作 FIPS 兼容系统,请在 FIPS 模式下创建所有加密密钥资料。另外,加密密钥材料不得离开 FIPS 环境,除非它被安全封装,且永远不会在非 FIPS 环境下解封。

安装后切换到 FIPS 模式

使用 fips-mode-setup 工具将系统切换到 FIPS 模式不能保证符合 FIPS 140 标准。将系统设置为 FIPS 模式后,可能无法重新生成所有加密密钥。例如,在具有用户加密密钥的现有 IdM 域中,您无法重新生成所有密钥。如果您无法在 FIPS 模式下开始安装,在安装后,请始终启用 FIPS 模式作为第一步,然后再进行安装后配置步骤或安装任何工作负载。

fips-mode-setup 工具也在内部使用 FIPS 系统范围的加密策略。但是,在 update-crypto-policies --set FIPS 命令所执行的操作之上,fips-mode-setup 使用 fips-finish-install 工具来确保 FIPS dracut 模块的安装,它还在内核命令行中添加 fips=1 引导选项,并重新生成初始 RAM 磁盘。

另外,在 FIPS 模式中强制需要的限制取决于 /proc/sys/crypto/fips_enabled 文件的内容。如果文件包含 1,RHEL 核心加密组件切换到模式,在此模式中,它们只使用加密算法的 FIPS 批准的实现。如果 /proc/sys/crypto/fips_enabled 包含 0 ,则加密组件不会启用其 FIPS 模式。

crypto-policies 中的 FIPS

FIPS 系统范围的加密策略有助于配置更高级别的限制。因此,支持加密灵活性的通信协议不会宣布系统在选择时拒绝的密码。例如,ChaCha20 算法不是 FIPS 批准的,并且 FIPS 加密策略确保 TLS 服务器和客户端不宣布 TLS_ECDHE_ECDSA_WITH_CHACHA20_POLY1305_SHA256 TLS 密码套件,因为任何尝试使用此类密码都会失败。

如果您在 FIPS 模式下操作 RHEL,并使用提供其自己的与 FIPS 模式相关的配置选项的应用程序,则可以忽略这些选项以及相应的应用程序指导。在 FIPS 模式下运行的系统,系统范围的加密策略只强制执行与 FIPS 兼容的加密。例如,如果系统在 FIPS 模式下运行,则忽略 Node.js 配置选项 --enable-fips。如果您在没有对在 FIPS 模式下运行的系统使用 --enable-fips 选项,则不符合 FIPS-140 合规性要求。

RHEL 9 的加密模块尚未获得美国国家标准与技术研究院(NIST)加密模块验证计划(CMVP)的 FIPS 140-3 要求认证。您可以在 产品合规 红帽客户门户网站页中看到 FIPS - Federal Information Processing Standards 部分的加密模块的验证状态。

在 FIPS 模式下运行的 RHEL 9.2 及更新的版本强制任何 TLS 1.2 连接都必须使用Extended Master Secret (EMS)扩展(RFC 7627),因为 FIPS 140-3 标准需要。因此,不支持 EMS 或 TLS 1.3 的旧客户端无法连接到在 FIPS 模式下运行的 RHEL 9 服务器,FIPS 模式下的 RHEL 9 客户端无法连接到只支持没有 EMS 的 TLS 1.2 的服务器。请参阅 Red Hat Enterprise Linux 9.2 强制的 TLS 扩展"Extended Master Secret" 解决方案文章。

2.2. 安装启用了 FIPS 模式的系统

要启用联邦信息处理标准(FIPS) 140 强制的加密模块自我检查,请在系统安装过程中启用 FIPS 模式。

仅在 RHEL 安装过程中启用 FIPS 模式可确保系统使用 FIPS 批准的算法生成所有密钥,并持续监控测试。

完成 FIPS 模式的设置后,如果不将系统置于不一致状态,您无法关闭 FIPS 模式。如果您的场景需要这个更改,则唯一的正确方法是完全重装系统。

步骤

-

在系统安装过程中,将

fips=1选项添加到内核命令行。 - 在软件选择阶段,请勿安装任何第三方软件。

- 安装后,系统会自动以 FIPS 模式启动。

验证

系统启动后,检查是否启用了 FIPS 模式:

$ fips-mode-setup --check FIPS mode is enabled.

其他资源

2.3. 将系统切换到 FIPS 模式

系统范围的加密策略包含一个策略级别,它根据联邦信息处理标准(FIPS)出版物 140 的要求启用加密算法。在内部启用或禁用 FIPS 模式的 fips-mode-setup 工具使用 FIPS 系统范围的加密策略。

使用 FIPS 系统范围的加密策略将系统切换到 FIPS 模式不能保证符合 FIPS 140 标准。将系统设置为 FIPS 模式后,可能无法重新生成所有加密密钥。例如,在具有用户加密密钥的现有 IdM 域中,您无法重新生成所有密钥。

仅 在 RHEL 安装过程中启用 FIPS 模式 可确保系统使用 FIPS 批准的算法生成所有密钥,并持续监控测试。

fips-mode-setup 工具在内部使用 FIPS 策略。但是,在使用 --set FIPS 选项的 update-crypto-policies 命令之上,fips-mode-setup 使用 fips-finish-install 工具确保 FIPS dracut 模块的安装,它还在内核命令行中添加 fips=1 引导选项,并重新生成初始 RAM 磁盘。

完成 FIPS 模式的设置后,如果不将系统置于不一致状态,您无法关闭 FIPS 模式。如果您的场景需要这个更改,则唯一的正确方法是完全重装系统。

RHEL 9 的加密模块尚未获得 FIPS 140-3 要求的认证。

步骤

将系统切换到 FIPS 模式:

# fips-mode-setup --enable Kernel initramdisks are being regenerated. This might take some time. Setting system policy to FIPS Note: System-wide crypto policies are applied on application start-up. It is recommended to restart the system for the change of policies to fully take place. FIPS mode will be enabled. Please reboot the system for the setting to take effect.重启您的系统以允许内核切换到 FIPS 模式:

# reboot

验证

重启后,您可以检查 FIPS 模式的当前状态:

# fips-mode-setup --check FIPS mode is enabled.

其他资源

-

系统中

FIPS-mode-setup (8)手册页 - 美国国家标准与技术研究院(NIST)网站上的 对加密模块的安全要求。

2.4. 在容器中启用 FIPS 模式

要启用联邦信息处理标准发布 140-2 (FIPS 模式)所要求的完整的加密模块自我检查,主机系统内核必须运行在 FIPS 模式下。podman 工具会在支持的容器上自动启用 FIPS 模式。

fips-mode-setup 命令无法在容器中正常工作,在这种情况下无法用来启用或检查 FIPS 模式。

RHEL 9 的加密模块尚未获得 FIPS 140-3 要求的认证。

先决条件

- 主机系统必须处于 FIPS 模式。

步骤

-

在启用了 FIPS 模式的系统上,

podman工具会在支持的容器上自动启用 FIPS 模式。

其他资源

2.5. 使用与 FIPS 140-3 不兼容的加密的 RHEL 应用程序列表

要传递所有相关加密认证,如 FIPS 140-3,请使用核心加密组件集中的库。除 libgcrypt 外,这些库也会遵循 RHEL 系统范围的加密策略。

如需了解核心加密组件的概述、有关如何选择它们的信息、它们如何集成到操作系统中、它们如何支持硬件安全模块和智能卡,以及如何对它们应用加密认证,请参阅 RHEL 核心加密组件 。

使用与 FIPS 140-3 不兼容的加密的 RHEL 9 应用程序列表

- Bacula

- 实施 CRAM-MD5 身份验证协议。

- Cyrus SASL

- 使用 SCRAM-SHA-1 身份验证方法。

- Dovecot

- 使用 SCRAM-SHA-1。

- Emacs

- 使用 SCRAM-SHA-1。

- FreeRADIUS

- 使用 MD5 和 SHA-1 进行身份验证协议。

- Ghostscript

- 自定义加密实现(MD5、RC4、SHA-2、AES)来加密和解密文档

- GRUB

-

支持需要 SHA-1 的传统固件协议,并包含

libgcrypt库。 - iPXE

- 实施 TLS 堆栈。

- Kerberos

- 保留对 SHA-1 的支持(与 Windows 互操作性)。

- Lasso

-

lasso_wsse_username_token_derive_key()KDF(key derivation function)使用 SHA-1。 - MariaDB、MariaDB Connector

-

mysql_native_password身份验证插件使用 SHA-1。 - MySQL

-

mysql_native_password使用 SHA-1。 - OpenIPMI

- RAKP-HMAC-MD5 验证方法没有被 FIPS 批准使用,且不适用于 FIPS 模式。

- Ovmf(UEFI 固件)、Edk2、shim

- 全加密堆栈(OpenSSL 库的嵌入式副本)。

- Perl

- 使用 HMAC, HMAC-SHA1, HMAC-MD5, SHA-1, SHA-224,…

- Pidgin

- 实现 DES 和 RC4 密码。

- PKCS #12 文件处理 (OpenSSL、GnuTLS、NSS、Firefox、Java)

- PKCS #12 的所有用法都不兼容 FIPS,因为用于计算整个文件 HMAC 的 Key Derivation Function (KDF) 都不是 FIPS。因此,PKP #12 文件被视为纯文本,用于 FIPS 合规性。对于 key-transport 的目的,使用 FIPS 批准的加密方案嵌套 PKCS #12 (.p12) 文件。

- Poppler

- 如果原始 PDF 中存在这些算法(例如 MD5、RC4 和 SHA-1),则可使用签名、密码和加密保存 PDF。

- PostgreSQL

- 实现 Blowfish、DES 和 MD5。KDF 使用 SHA-1。

- QAT Engine

- 加密原语的混合硬件和软件实现(RSA、EC、DH、AES、…)

- Ruby

- 提供不安全的 MD5 和 SHA-1 库函数。

- Samba

- 保留对 RC4 和 DES 的支持(与 Windows 互操作性)。

- Syslinux

- BIOS 密码使用 SHA-1。

- SWTPM

- 在 OpenSSL 用法中明确禁用 FIPS 模式。

- Unbound

- DNS 规范要求 DNSSEC 解析器使用 DNSKEY 记录中的 SHA-1-based 算法进行验证。

- Valgrind

- AES、SHA 哈希。[1]

- zip

- 自定义加密实现(不安全的 PKWARE 加密算法),以使用密码加密和解密存档。

其他资源

- 合规活动和政府标准 知识库文章中的FIPS 140-2 和 FIPS 140-3 部分

- RHEL 核心加密组件 知识库文章

第 3 章 使用系统范围的加密策略

系统范围的加密策略是一个系统组件,它配置核心加密子系统,包括 TLS、IPsec、SSH、DNSSec 和 Kerberos 协议。它提供了一小组策略,管理员可以选择这些策略。

3.1. 系统范围的加密策略

设置系统范围的策略时,RHEL 中的应用程序会遵守它,并拒绝使用不符合该策略的算法和协议,除非您明确要求应用程序这样做。也就是说,在运行系统提供的配置时,策略适用于应用程序的默认行为,但在需要时您可以覆盖它。

RHEL 9 包含以下预定义的策略:

DEFAULT- 默认的系统范围加密策略级别为当前威胁模型提供了安全设置。它允许 TLS 1.2 和 1.3 协议,以及 IKEv2 和 SSH2 协议。如果 RSA 密钥和 Diffie-Hellman 参数至少是 2048 位,则可以接受它们。

LEGACY- 确保与 Red Hat Enterprise Linux 6 及更早版本的最大兼容性;由于攻击面增加而不太安全。SHA-1 允许用作 TLS 哈希、签名和算法。CBC-mode 密码可以和 SSH 一起使用。使用 GnuTLS 的应用程序允许使用 SHA-1 签名的证书。它允许 TLS 1.2 和 1.3 协议,以及 IKEv2 和 SSH2 协议。如果 RSA 密钥和 Diffie-Hellman 参数至少是 2048 位,则可以接受它们。

FUTURE更严格的前瞻性安全级别,旨在测试未来可能的策略。此策略不允许在 DNSSec 或 HMAC 中使用 SHA-1。SHA2-224 和 SHA3-224 哈希被拒绝。禁用 128 位密码。CBC-mode 密码被禁用,除了 Kerberos 中。它允许 TLS 1.2 和 1.3 协议,以及 IKEv2 和 SSH2 协议。如果 RSA 密钥和 Diffie-Hellman 参数至少是 3072 位,则可以接受它们。如果您的系统在公共互联网上进行通信,您可能会遇到互操作性问题。

重要因为客户门户网站 API 中的证书使用的加密密钥不满足

FUTURE系统范围的加密策略的要求,所以redhat-support-tool程序目前无法使用这个策略级别。要临时解决这个问题,在连接到客户门户网站 API 时使用

DEFAULT加密策略。FIPS符合 FIPS 140 要求。

fips-mode-setup工具将 RHEL 系统切换到 FIPS 模式,在内部使用此策略。切换到FIPS策略不能保证符合 FIPS 140 标准。在将系统设置为 FIPS 模式后,还必须重新生成所有加密密钥。这在很多情况下是不可能的。RHEL 还提供

FIPS:OSPP系统范围的子策略,其中包含对通用标准(CC)认证所需的加密算法的进一步限制。设置了此子策略后,系统的互操作性会降低。例如,您无法使用比 3072 位少的 RSA 和 DH 密钥、其它的 SSH 算法和几个 TLS 组。设置FIPS:OSPP也会阻止连接到 Red Hat Content Delivery Network (CDN)结构。另外,您无法将活动目录(AD)集成到使用FIPS:OSPP的 IdM 部署中,使用FIPS:OSPP的 RHEL 主机和 AD 域之间的通信可能无法工作,或者某些 AD 帐户可能无法进行身份验证。注意设置了

FIPS:OSPP加密子策略后,您的系统不符合 CC 。使您的 RHEL 系统符合 CC 标准的唯一正确方法是遵循cc-config软件包中提供的指导。有关已认证的 RHEL 版本的列表、验证报告以及 CC 指南的链接,请参阅合规活动和政府标准知识库文章中的 通用标准 部分。

红帽不断调整所有策略级别,以便所有库都提供安全的默认值,但使用 LEGACY 策略时除外。虽然 LEGACY 配置文件不提供安全默认值,但它不包括任何易被利用的算法。因此,在 Red Hat Enterprise Linux 生命周期内,任何所提供的策略中启用的算法或可接受的密钥大小可能会发生变化。

此变更反映了新的安全标准和新的安全研究。如果您必须确保 Red Hat Enterprise Linux 的整个生命周期内与特定系统的互操作性,对于与该系统交互的组件,您应该选择不使用系统范围的加密策略,或使用自定义加密策略重新启用特定的算法。

只有在应用程序支持它们时,策略级别中才允许所描述的具体算法和密码:

LEGACY | DEFAULT | FIPS | FUTURE | |

|---|---|---|---|---|

| IKEv1 | 否 | 否 | 否 | 否 |

| 3DES | 否 | 否 | 否 | 否 |

| RC4 | 否 | 否 | 否 | 否 |

| DH | 最少 2048 位 | 最少 2048 位 | 最少 2048 位 | 最少 3072 位 |

| RSA | 最少 2048 位 | 最少 2048 位 | 最少 2048 位 | 最少 3072 位 |

| DSA | 否 | 否 | 否 | 否 |

| TLS v1.1 和更早版本 | 否 | 否 | 否 | 否 |

| TLS v1.2 及更新版本 | 是 | 是 | 是 | 是 |

| 数字签名和证书中的 SHA-1 | 是 | 否 | 否 | 否 |

| CBC 模式密码 | 是 | 否[a] | 否[b] | 否[c] |

| 密钥小于 256 位的对称密码 | 是 | 是 | 是 | 否 |

[a]

SSH 禁用 CBC 密码

[b]

除了 Kerberos 外,所有协议都禁用了 CBC 密码

[c]

除了 Kerberos 外,所有协议都禁用了 CBC 密码

| ||||

其他资源

-

您系统上的

crypto-policies (7)和update-crypto-policies (8)手册页

3.2. 更改系统范围的加密策略

您可以使用 update-crypto-policies 工具更改系统上的系统范围加密策略,并重启系统。

先决条件

- 您在系统上具有 root 权限。

步骤

可选:显示当前加密策略:

$ update-crypto-policies --show DEFAULT设置新的加密策略:

# update-crypto-policies --set <POLICY> <POLICY>

将

<POLICY>替换为您要设置的策略或子策略,如FUTURE、LEGACY或FIPS:OSPP。重启系统:

# reboot

验证

显示当前加密策略:

$ update-crypto-policies --show

<POLICY>

其他资源

- 有关系统范围加密策略的更多信息,请参阅 系统范围加密策略

3.3. 将系统范围的加密策略切换到与早期版本兼容的模式

Red Hat Enterprise Linux 9 中的默认系统范围的加密策略不允许使用旧的不安全协议进行通讯。对于需要与 Red Hat Enterprise Linux 6 兼容,以及需要与更早的版本兼容的情况,可以使用不太安全的 LEGACY 策略级别。

切换到 LEGACY 策略级别会导致系统和应用程序的安全性较低。

步骤

要将系统范围的加密策略切换到

LEGACY级别,请以root用户身份输入以下命令:# update-crypto-policies --set LEGACY Setting system policy to LEGACY

其他资源

-

有关可用的加密策略级别列表,请查看您系统中的

update-crypto-policies (8)手册页。 -

有关定义自定义加密策略的信息,请参阅

update-crypto-policies (8)手册页中的 自定义策略 部分,以及您系统的crypto-policies (7)手册页中的加密策略定义格式部分。

3.4. 重新启用 SHA-1

使用 SHA-1 算法创建和验证签名在 DEFAULT 加密策略中受到限制。如果您的场景需要使用 SHA-1 来验证现有或第三方加密签名,您可以通过应用 SHA1 子策略来启用该签名,RHEL 9 默认提供它。请注意,它较弱了系统的安全性。

先决条件

-

系统使用

DEFAULT系统范围的加密策略。

步骤

将

SHA1子策略应用到DEFAULT加密策略:# update-crypto-policies --set DEFAULT:SHA1 Setting system policy to DEFAULT:SHA1 Note: System-wide crypto policies are applied on application start-up. It is recommended to restart the system for the change of policies to fully take place.重启系统:

# reboot

验证

显示当前加密策略:

# update-crypto-policies --show DEFAULT:SHA1

使用 update-crypto-policies --set LEGACY 切换到 LEGACY 加密策略命令也会启用 SHA-1 进行签名。但是,LEGACY 加密策略还启用了其他弱加密算法,使您的系统变得更加容易受到攻击。这个临时解决方案只适用于需要启用其他传统加密算法比 SHA-1 签名的情况。

其他资源

- 从 RHEL 9 SSH 到 RHEL 6 系统无法正常工作 (红帽知识库)

- 使用 SHA-1 签名的软件包无法安装或升级 (红帽知识库)

3.5. 在 web 控制台中设置系统范围的加密策略

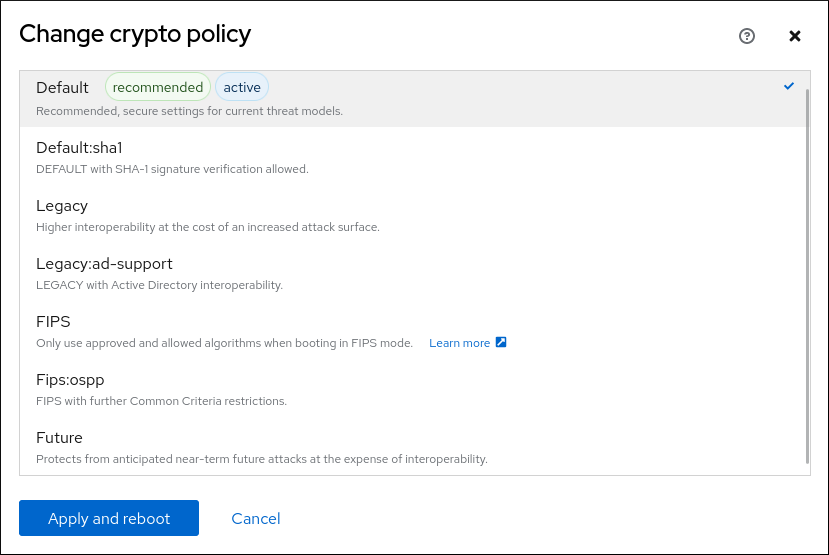

您可以在 RHEL web 控制台界面中直接设置系统范围的加密策略和子策略。除了四个预定义的系统范围的加密策略外,您现在还可以通过图形界面应用以下策略和子策略的组合:

DEFAULT:SHA1-

启用了

SHA-1算法的DEFAULT策略。 LEGACY:AD-SUPPORT-

具有不太安全设置的

LEGACY策略提高了活动目录服务的互操作性。 FIPS:OSPP-

信息技术安全评估标准的通用标准需要具有进一步限制的

FIPS策略。

因为 FIPS:OSPP 系统范围的子策略包含对通用标准(CC)认证所需的加密算法的进一步限制,在设置它后,系统的互操作性降低。例如,您无法使用比 3072 位少的 RSA 和 DH 密钥、其它的 SSH 算法和几个 TLS 组。设置 FIPS:OSPP 也会阻止连接到 Red Hat Content Delivery Network (CDN)结构。另外,您无法将活动目录(AD)集成到使用 FIPS:OSPP的 IdM 部署中,使用 FIPS:OSPP 的 RHEL 主机和 AD 域之间的通信可能无法工作,或者某些 AD 帐户可能无法进行身份验证。

请注意,在设置了 FIPS:OSPP 加密子策略后,您的 系统不符合 CC。使您的 RHEL 系统符合 CC 标准的唯一正确方法是遵循 cc-config 软件包中提供的指导。有关已认证的 RHEL 版本的列表、验证报告以及 CC 指南的链接,请参阅 国家信息保障合作伙伴(NIAP) 网站上托管的合规活动和政府标准知识库文章的 通用标准 部分。

先决条件

您已安装了 RHEL 9 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

-

您有

root特权或权限来使用sudo输入管理命令的命令。

流程

登录到 RHEL 9 web 控制台。

详情请参阅 登录到 web 控制台。

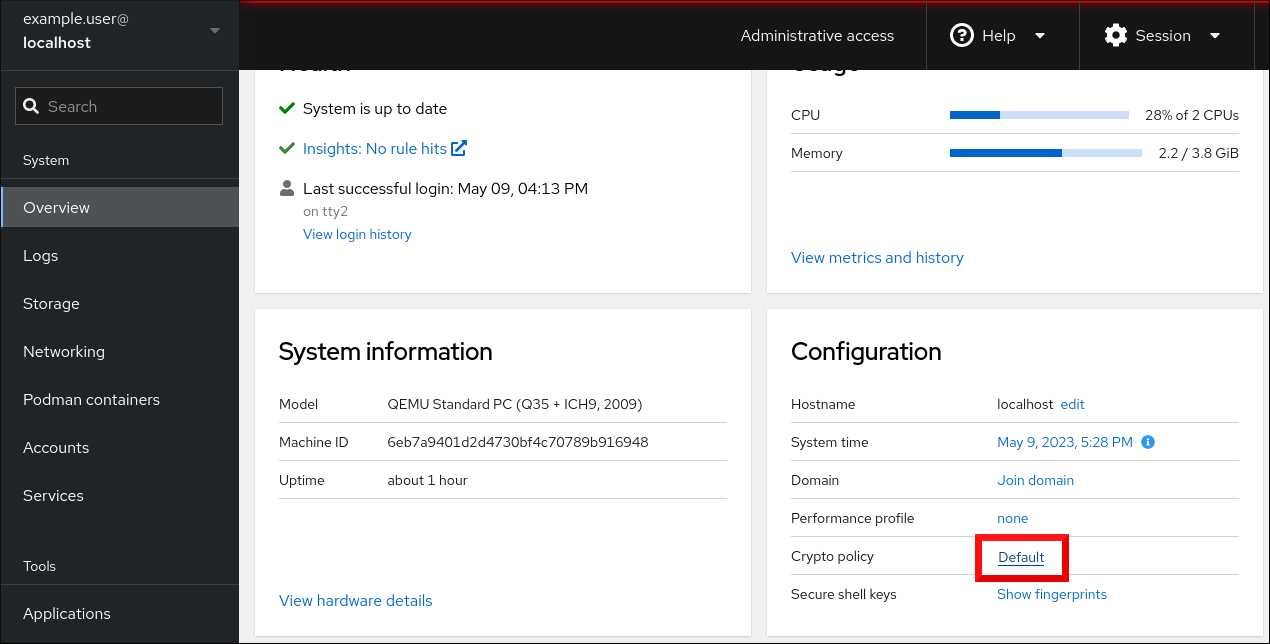

在 Overview 页面的 Configuration 卡中,点 Crypto 策略旁的当前策略值。

在 Change crypto policy 对话框窗口中,点您要在系统中开始使用的策略。

- 点按钮。

验证

重启后,重新登录到 web 控制台,并检查 Crypto policy 值是否与您选择的值相符。

或者,您可以输入

update-crypto-policies --show命令来在终端中显示当前系统范围的加密策略。

3.6. 将应用程序从下列系统范围的加密策略中排除

您可以通过在应用程序中直接配置受支持的密码套件和协议来自定义应用程序所使用的加密设置。

您还可以从 /etc/crypto-policies/back-ends 目录中删除与应用程序相关的符号链接,并使用您自定义的加密设置来替换它。此配置可防止对使用排除后端的应用程序使用系统范围的加密策略。此外,红帽不支持此修改。

3.6.1. 选择不使用系统范围的加密策略的示例

wget

要自定义 wget 网络下载器所使用的加密设置,请使用 --secure-protocol 和 --ciphers 选项。例如:

$ wget --secure-protocol=TLSv1_1 --ciphers="SECURE128" https://example.com

如需更多信息,请参阅 wget(1) 手册页中的 HTTPS(SSL/TLS)选项部分。

curl

要指定 curl 工具使用的密码,请使用 --ciphers 选项,并提供以冒号分隔的密码列表作为值。例如:

$ curl https://example.com --ciphers '@SECLEVEL=0:DES-CBC3-SHA:RSA-DES-CBC3-SHA'

如需更多信息,请参阅 curl(1) 手册页。

Firefox

尽管您无法在 Firefox Web 浏览器中选择不使用系统范围的加密策略,但您可以在 Firefox 的配置编辑器中进一步限制受支持的密码和 TLS 版本。在地址栏中输入 about:config ,并根据需要修改 security.tls.version.min 选项的值。将 security.tls.version.min 设置为 1,允许将 TLS 1.0 作为最低要求,security.tls.version.min 2 启用 TLS 1.1,如此等等。

OpenSSH

要为您的 OpenSSH 服务器选择不使用系统范围的加密策略,请在位于 /etc/ssh/sshd_config.d/ 目录中的置入配置文件中指定加密策略,具有小于 50 的 2 位数前缀,以便按字典顺序排列在 50-redhat.conf 文件之前,并带有 .conf 后缀,例如 49-crypto-policy-override.conf。

详情请查看 sshd_config(5) 手册页。

要为您的 OpenSSH 客户端选择不使用系统范围的加密策略,请执行以下任务之一:

-

对于给定的用户,使用

~/.ssh/config文件中特定于用户的配置覆盖全局ssh_config。 -

对于整个系统,在

/etc/ssh/ssh_config.d/目录中的置入配置文件中指定加密策略,具有小于 50 的两位数前缀,以便按字典顺序排列在50-redhat.conf文件之前,并具有.conf后缀,例如49-crypto-policy-override.conf。

详情请查看 ssh_config(5) 手册页。

Libreswan

有关详细信息,请参阅 安全网络 文档中的 配置不使用系统范围加密策略的 IPsec 连接 。

其他资源

-

您系统上的

update-crypto-policies (8)手册页

3.7. 使用子策略自定义系统范围的加密策略

使用这个流程来调整启用的加密算法或协议集。

您可以在现有系统范围的加密策略之上应用自定义子策略,或者从头开始定义此类策略。

范围策略的概念允许为不同的后端启用不同的算法集合。您可以将每个配置指令限制到特定的协议、库或服务。

另外,指令也可以使用星号来指定使用通配符的多个值。

/etc/crypto-policies/state/CURRENT.pol 文件列出了通配符扩展后当前应用了系统范围加密策略中的所有设置。要使您的加密策略更严格,请考虑使用 /usr/share/crypto-policies/policies/FUTURE.pol 文件中列出的值。

您可以在 /usr/share/crypto-policies/policies/modules/ 目录中找到示例子策略。这个目录中的子策略文件还包含注释掉的行中的描述。

流程

签出到

/etc/crypto-policies/policies/modules/目录:# cd /etc/crypto-policies/policies/modules/为您的调整创建子策略,例如:

# touch MYCRYPTO-1.pmod # touch SCOPES-AND-WILDCARDS.pmod

重要在策略模块的文件名中使用大写字母。

在您选择的文本编辑器中打开策略模块并插入修改系统范围加密策略的选项,例如:

# vi MYCRYPTO-1.pmodmin_rsa_size = 3072 hash = SHA2-384 SHA2-512 SHA3-384 SHA3-512

# vi SCOPES-AND-WILDCARDS.pmod# Disable the AES-128 cipher, all modes cipher = -AES-128-* # Disable CHACHA20-POLY1305 for the TLS protocol (OpenSSL, GnuTLS, NSS, and OpenJDK) cipher@TLS = -CHACHA20-POLY1305 # Allow using the FFDHE-1024 group with the SSH protocol (libssh and OpenSSH) group@SSH = FFDHE-1024+ # Disable all CBC mode ciphers for the SSH protocol (libssh and OpenSSH) cipher@SSH = -*-CBC # Allow the AES-256-CBC cipher in applications using libssh cipher@libssh = AES-256-CBC+

- 将更改保存到模块文件中。

将您的策略调整应用到

DEFAULT系统范围加密策略级别:# update-crypto-policies --set DEFAULT:MYCRYPTO-1:SCOPES-AND-WILDCARDS要使您的加密设置对已经运行的服务和应用程序有效,请重启系统:

# reboot

验证

检查

/etc/crypto-policies/state/CURRENT.pol文件是否包含您的更改,例如:$ cat /etc/crypto-policies/state/CURRENT.pol | grep rsa_size min_rsa_size = 3072

其他资源

-

您系统的

update-crypto-policies (8)手册页中的 自定义策略 部分 -

系统上的

crypto-policies (7)手册页中的加密策略定义格式部分 - 红帽博客文章 在 RHEL 8.2 中如何自定义加密策略

3.8. 创建并设置自定义系统范围的加密策略

对于特定场景,您可以通过创建和使用完整的策略文件来自定义系统范围的加密策略。

步骤

为自定义创建一个策略文件:

# cd /etc/crypto-policies/policies/ # touch MYPOLICY.pol

或者,从复制四个预定义策略级别中的一个开始:

# cp /usr/share/crypto-policies/policies/DEFAULT.pol /etc/crypto-policies/policies/MYPOLICY.pol在您选择的文本编辑器中编辑带有自定义加密策略的文件以满足您的要求,例如:

# vi /etc/crypto-policies/policies/MYPOLICY.pol将系统范围的加密策略切换到自定义级别:

# update-crypto-policies --set MYPOLICY要使您的加密设置对已经运行的服务和应用程序有效,请重启系统:

# reboot

其他资源

-

update-crypto-policies (8)手册页中的 自定义策略 部分和您系统的crypto-policies (7)手册页中的加密策略定义格式部分 - 如何在 RHEL 中自定义加密策略红帽博客

3.9. 使用 crypto_policies RHEL 系统角色增强带有 FUTURE 加密策略的安全性

您可以使用 crypto_policies RHEL 系统角色在受管节点上配置 FUTURE 策略。例如,此策略有助于实现:

- 未来应对新兴威胁:预见计算能力的前进.

- 增强安全性:更强大的加密标准需要更长的密钥长度和更安全的算法。

- 遵守高安全性标准:例如在医疗保健、电信和财务方面,数据敏感度很高,并且强大的加密可用性至关重要。

通常,FUTURE 适合处理高度敏感数据的环境,准备将来的法规,或采用长期安全策略。

传统系统或软件不必支持更现代化且更严格的算法和协议,由 FUTURE 策略实施。例如,旧的系统可能不支持 TLS 1.3 或更大的密钥大小。这可能导致兼容性问题。

另外,使用强大的算法通常会增加计算工作负载,这可能会对您的系统性能造成负面影响。

先决条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

用于连接到受管节点的帐户具有

sudo权限。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:--- - name: Configure cryptographic policies hosts: managed-node-01.example.com tasks: - name: Configure the FUTURE cryptographic security policy on the managed node ansible.builtin.include_role: name: rhel-system-roles.crypto_policies vars: - crypto_policies_policy: FUTURE - crypto_policies_reboot_ok: true示例 playbook 中指定的设置包括以下内容:

crypto_policies_policy:未来-

在受管节点上配置所需的加密策略(

FUTURE)。它可以是基本策略,也可以是带有一些子策略的基本策略。必须在受管节点上提供指定的基本策略和子策略。默认值为null。这意味着配置没有被更改,crypto_policiesRHEL 系统角色只会收集 Ansible 事实。 crypto_policies_reboot_ok: true-

会导致系统在加密策略更改后重新启动,以确保所有服务和应用程序都将读取新的配置文件。默认值为

false。

有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.crypto_policies/README.md文件。验证 playbook 语法:

$ ansible-playbook --syntax-check ~/playbook.yml请注意,这个命令只验证语法,不会防止错误但有效的配置。

运行 playbook:

$ ansible-playbook ~/playbook.yml

因为 FIPS:OSPP 系统范围的子策略包含对通用标准(CC)认证所需的加密算法的进一步限制,在设置它后,系统的互操作性降低。例如,您无法使用比 3072 位少的 RSA 和 DH 密钥、其它的 SSH 算法和几个 TLS 组。设置 FIPS:OSPP 也会阻止连接到 Red Hat Content Delivery Network (CDN)结构。另外,您无法将活动目录(AD)集成到使用 FIPS:OSPP的 IdM 部署中,使用 FIPS:OSPP 的 RHEL 主机和 AD 域之间的通信可能无法工作,或者某些 AD 帐户可能无法进行身份验证。

请注意,在设置了 FIPS:OSPP 加密子策略后,您的 系统不符合 CC。使您的 RHEL 系统符合 CC 标准的唯一正确方法是遵循 cc-config 软件包中提供的指导。有关已认证的 RHEL 版本的列表、验证报告以及 CC 指南的链接,请参阅 国家信息保障合作伙伴(NIAP) 网站上托管的合规活动和政府标准知识库文章的 通用标准 部分。

验证

在控制节点上,创建另一个 playbook,例如名为

verify_playbook.yml:--- - name: Verification hosts: managed-node-01.example.com tasks: - name: Verify active cryptographic policy ansible.builtin.include_role: name: rhel-system-roles.crypto_policies - name: Display the currently active cryptographic policy ansible.builtin.debug: var: crypto_policies_active示例 playbook 中指定的设置包括以下内容:

crypto_policies_active-

导出的 Ansible 事实,其中含有当前活动的策略名称,格式为

crypto_policies_policy变量接受的格式。

验证 playbook 语法:

$ ansible-playbook --syntax-check ~/verify_playbook.yml运行 playbook:

$ ansible-playbook ~/verify_playbook.yml TASK [debug] ************************** ok: [host] => { "crypto_policies_active": "FUTURE" }crypto_policies_active变量显示受管节点上的活动策略。

其他资源

-

/usr/share/ansible/roles/rhel-system-roles.crypto_policies/README.mdfile -

/usr/share/doc/rhel-system-roles/crypto_policies/directory -

update-crypto-policies (8)和crypto-policies (7)手册页

第 4 章 通过 PKCS#11 将应用程序配置为使用加密硬件

分离有关专用加密设备的 secret 信息部分,如用于最终用户身份验证的智能卡和加密令牌,以及用于服务器应用程序的硬件安全模块(HSM),提供额外的安全层。在 RHEL 中,通过 PKCS #11 API 对加密硬件的支持在不同的应用程序之间是一致的,并且加密硬件上的机密隔离不是一项复杂的任务。

4.1. 通过 PKCS #11 的加密硬件支持

公钥加密标准(PKCS)#11向保存加密信息并执行加密功能的加密设备定义了一个应用编程接口(API)。

PKCS #11 引入了 加密令牌,它是一个以统一方式向应用程序提供每个硬件或软件设备的对象。因此,应用程序会查看通常被人使用的智能卡,以及通常被计算机作为 PKCS #11 加密令牌使用的硬件安全模块等设备。

PKCS #11 令牌可以存储各种对象类型,包括证书、数据对象以及公有、私有或机密密钥。这些对象通过 PKCS #11 Uniform Resource Identifier (URI)模式来唯一标识。

PKCS #11 URI 是一种标准方法,其根据对象属性来识别 PKCS #11 模块中的特定对象。这可让您以 URI 格式,使用同样的配置字符串来配置所有的库和应用程序。

RHEL 默认为智能卡提供 OpenSC PKCS #11 驱动程序。但是,硬件令牌和 HSM 可以有自己的 PKCS #11 模块,这些模块在系统中没有对应项。您可以使用 p11-kit 工具注册这样的 PKCS #11 模块,它作为系统中注册的智能卡驱动程序的包装器。

要使您自己的 PKCS #11 模块在系统上正常工作,请在 /etc/pkcs11/modules/ 目录中添加一个新的文本文件

您可以通过在 /etc/pkcs11/modules/ 目录中创建一个新的文本文件,来将自己的 PKCS #11 模块添加到系统。例如,p11-kit 中的 OpenSC 配置文件如下所示:

$ cat /usr/share/p11-kit/modules/opensc.module

module: opensc-pkcs11.so其他资源

4.2. 通过保存在智能卡中的 SSH 密钥进行身份验证

您可以在智能卡中创建和存储 ECDSA 和 RSA 密钥,并由 OpenSSH 客户端中的智能卡进行身份验证。智能卡验证替换了默认密码验证。

前提条件

-

在客户端中安装了

opensc软件包,pcscd服务正在运行。

流程

列出所有由 OpenSC PKCS #11 模块提供的密钥,包括其 PKCS #11 URIs,并将输出保存到

key.pub文件:$ ssh-keygen -D pkcs11: > keys.pub将公钥传送到远程服务器。使用带有上一步中创建的 key

.pub文件的ssh-copy-id命令:$ ssh-copy-id -f -i keys.pub <username@ssh-server-example.com>使用 ECDSA 密钥连接到 < ssh-server-example.com >。您只能使用 URI 的子集,它唯一引用您的密钥,例如:

$ ssh -i "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $因为 OpenSSH 使用

p11-kit-proxy打包程序和 OpenSC PKCS modprobe 模块注册到p11-kit工具,所以您可以简化上一个命令:$ ssh -i "pkcs11:id=%01" <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $如果您跳过 PKCS #11 URI 的

id=部分,则 OpenSSH 会加载代理模块中可用的所有密钥。这可减少输入所需的数量:$ ssh -i pkcs11: <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $可选:您可以使用

~/.ssh/config文件中的同一 URI 字符串使配置持久:$ cat ~/.ssh/config IdentityFile "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" $ ssh <ssh-server-example.com> Enter PIN for 'SSH key': [ssh-server-example.com] $

ssh客户端工具现在自动使用来自智能卡中的这个 URI 和密钥。

其他资源

-

您系统上的

p11-kit (8),opensc.conf (5),pcscd (8),ssh (1)和ssh-keygen (1)手册页

4.3. 配置应用程序以使用智能卡上的证书进行身份验证

通过在应用程序中使用智能卡进行身份验证可能会提高安全性并简化自动化。您可以使用以下方法将公钥加密标准(PKCS) #11 URI 集成到应用程序中:

-

Firefoxweb 浏览器会自动加载p11-kit-proxyPKCS #11 模块。这意味着系统中的每个支持的智能卡都会被自动检测到。对于使用 TLS 客户端身份验证,不需要额外的设置,当服务器请求它们时,会自动使用智能卡中的密钥和证书。 -

如果您的应用程序使用

GnuTLS或NSS库,则它已支持 PKCS #11 URI。另外,依赖OpenSSL库的应用程序可以通过openssl-pkcs11软件包提供的pkcs11引擎访问加密硬件模块,包括智能卡。 -

需要使用智能卡上的私钥,且不使用

NSS、GnuTLS或OpenSSL的应用程序可以直接使用p11-kitAPI 来使用加密硬件模块,包括智能卡,而不是使用特定 PKCS #11 模块的 PKCS #11 API。 使用

wget网络下载工具,您可以指定 PKCS #11 URI ,而不是本地存储的私钥和证书的路径。这可能会简化为需要安全存储私钥和证书的任务创建脚本。例如:$ wget --private-key 'pkcs11:token=softhsm;id=%01;type=private?pin-value=111111' --certificate 'pkcs11:token=softhsm;id=%01;type=cert' https://example.com/在使用

curl工具时,您也可以指定 PKCS #11 URI:$ curl --key 'pkcs11:token=softhsm;id=%01;type=private?pin-value=111111' --cert 'pkcs11:token=softhsm;id=%01;type=cert' https://example.com/注意由于 PIN 是一种安全措施,它控制对保存在智能卡中的密钥的访问,而配置文件中包含纯文本形式的 PIN,因此请考虑采取额外的保护来防止攻击者读取 PIN。例如,您可以使用

pin-source属性并提供file:从文件中读取 PIN 的 URI。请参阅 RFC 7512:PKCS #11 URI Scheme Query Attribute Semantics 了解更多信息。请注意,不支持将命令路径用作pin-source属性的值。

其他资源

-

curl (1),wget (1), 和p11-kit (8)man page

4.4. 在 Apache 中使用 HSM 保护私钥

Apache HTTP 服务器可以使用存储在硬件安全模块(HSM)上的私钥,这有助于防止密钥泄漏和中间人攻击。请注意,对于繁忙的服务器,这通常需要高性能的 HSM 。

对于 HTTPS 协议形式的安全通信,Apache HTTP 服务器(httpd)使用 OpenSSL 库。OpenSSL 本身不支持 PKCS #11 。要使用 HSMs,您必须安装 openssl-pkcs11 软件包,该软件包通过引擎界面提供对 PKCS #11 模块的访问。您可以使用 PKCS #11 URI 而不是常规文件名在 /etc/httpd/conf.d/ssl.conf 配置文件中指定服务器密钥和证书,例如:

SSLCertificateFile "pkcs11:id=%01;token=softhsm;type=cert" SSLCertificateKeyFile "pkcs11:id=%01;token=softhsm;type=private?pin-value=111111"

安装 httpd-manual 软件包以获取 Apache HTTP 服务器的完整文档,包括 TLS 配置。/etc/httpd/conf.d/ssl.conf 配置文件中的指令在 /usr/share/httpd/manual/mod_ssl.html 文件中进行了详细的描述。

4.5. 使用 HSM 保护 Nginx 中的私钥

Nginx HTTP 服务器可以使用存储在硬件安全模块(HSM)上的私钥,这有助于防止密钥泄漏和中间人攻击。请注意,对于繁忙的服务器,这通常需要高性能的 HSM 。

因为 Nginx 也使用 OpenSSL 进行加密操作,所以对 PKCS #11 的支持必须通过 openssl-pkcs11 引擎。nginx 目前只支持从 HSM 加载私钥,证书必须作为常规文件单独提供。修改 /etc/nginx/nginx.conf 配置文件中 server 部分的 ssl_certificate 和 ssl_certificate_key 选项:

ssl_certificate /path/to/cert.pem ssl_certificate_key "engine:pkcs11:pkcs11:token=softhsm;id=%01;type=private?pin-value=111111";

请注意,在 Nginx 配置文件中,PKCS #11 URI 需要 engine:pkcs 11: 前缀。这是因为其它 pkcs11 前缀引用引擎名称。

第 5 章 使用 polkit 控制对智能卡的访问

要涵盖智能卡中内置的机制(如 PIN 、PIN 平板和生物识别技术)无法防止的可能的威胁,以及更精细的控制,RHEL 使用 polkit 框架来控制对智能卡的访问控制。

系统管理员配置 polkit 以适合特定的场景,如非特权或非本地用户或服务的智能卡访问。

5.1. 通过 polkit 的智能卡访问控制

个人计算机/智能卡(PC/SC)协议指定将智能卡及其读卡器整合成计算系统的标准。在 RHEL 中,pcc-lite 软件包提供了中间件来访问使用 PC/SC API 的智能卡。此软件包的一部分 pcscd (PC/SC 智能卡)守护进程,确保系统可以使用 PC/SC 协议访问智能卡。

因为在智能卡内置的访问控制机制(如 PIN、PIN 平板 和生物识别技术)没有涵盖所有可能的威胁,所以 RHEL 使用 polkit 框架进行更强大的访问控制。polkit 授权管理器可以对特权操作授予访问权限。除了授予对磁盘的访问权限外,您还可以使用 polkit 来指定保护智能卡的策略。例如,您可以定义哪些用户可以使用智能卡执行哪些操作。

安装 pcsc-lite 软件包并启动 pcscd 守护进程后,系统会强制使用 /usr/share/polkit-1/actions/ 目录中定义的策略。默认的系统范围的策略位于 /usr/share/polkit-1/actions/org.debian.pcsc-lite.policy 文件中。polkit 策略文件使用 XML 格式,其语法在系统的 polkit (8) man page 中进行了描述。

polkitd 服务监控 /etc/polkit-1/rules.d/ 和 /usr/share/polkit-1/rules.d/ 这些目录中存储的规则文件的任何更改。该文件包含 JavaScript 格式的授权规则。系统管理员可以在这两个目录中添加自定义规则文件,并且 polkitd 根据其文件名按照字母顺序读取它们。如果两个文件具有相同的名称,则首先读取 /etc/polkit-1/rules.d/ 中的文件。

如果您需要在系统安全服务守护进程(SSSD)没有以 root 用户身份运行时启用智能卡支持,您必须安装 sssd-polkit-rules 软件包。软件包提供了 polkit 与 SSSD 的集成。

其他资源

-

您系统上的

polkit (8),polkitd (8)和pcscd (8)手册页

5.3. 向 PC/SC 显示关于 polkit 授权的更多详细信息

在默认配置中,polkit 授权框架仅将有限的信息发送到 Journal 日志。您可以通过添加新的规则来扩展与 PC/SC 协议相关的 polkit 日志条目。

先决条件

-

您已在系统上安装了

pcsc-lite软件包。 -

pcscd守护进程正在运行。

步骤

在

/etc/polkit-1/rules.d/目录中创建一个新文件:# touch /etc/polkit-1/rules.d/00-test.rules在您选择的编辑器中编辑该文件,例如:

# vi /etc/polkit-1/rules.d/00-test.rules插入以下行:

polkit.addRule(function(action, subject) { if (action.id == "org.debian.pcsc-lite.access_pcsc" || action.id == "org.debian.pcsc-lite.access_card") { polkit.log("action=" + action); polkit.log("subject=" + subject); } });保存文件并退出编辑器。

重启

pcscd和polkit服务:# systemctl restart pcscd.service pcscd.socket polkit.service

验证

-

为

pcscd发出一个授权请求。例如,打开 Firefox Web 浏览器,或者使用opensc软件包提供的pkcs11-tool -L命令。 显示扩展的日志条目,例如:

# journalctl -u polkit --since "1 hour ago" polkitd[1224]: <no filename>:4: action=[Action id='org.debian.pcsc-lite.access_pcsc'] polkitd[1224]: <no filename>:5: subject=[Subject pid=2020481 user=user' groups=user,wheel,mock,wireshark seat=null session=null local=true active=true]

其他资源

-

polkit(8)和polkitd(8)手册页。

5.4. 其他资源

- 控制对智能卡访问 的红帽博客文章。

第 6 章 扫描系统以了解配置合规性和漏洞

合规审计是一个确定给定对象是否遵循合规策略中指定的所有规则的流程。合规策略由安全专业人员定义的,他们通常以检查清单的形式指定计算环境应使用的必要设置。

跨组织甚至同一组织内不同系统之间的合规政策可能有很大差异。这些政策之间的差异取决于每个系统的用途及其对组织的重要性。自定义软件设置和部署特征也需要自定义策略检查表。

6.1. RHEL 中的配置合规工具

您可以使用以下配置合规工具在 Red Hat Enterprise Linux 中执行一个全自动的合规审计。这些工具基于安全内容自动化协议(SCAP)标准,专为自动定制合规策略而设计。

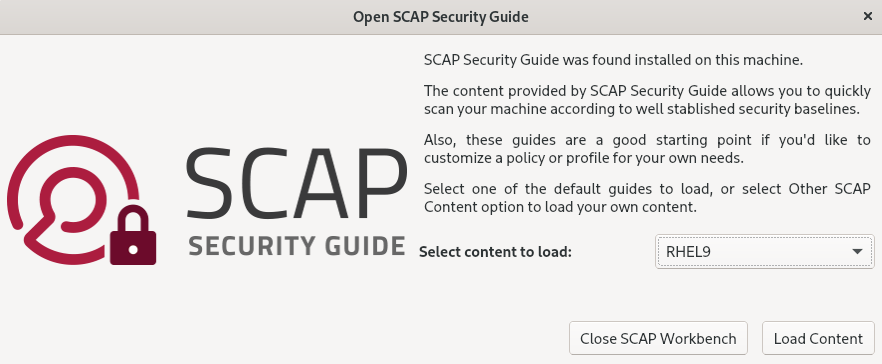

- SCAP 工作台

-

scap-workbench图形工具旨在在单个本地或远程系统上执行配置和漏洞扫描。您还可以根据这些扫描和评估,使用它来生成安全报告。 - OpenSCAP

OpenSCAP库附带的oscap命令行工具旨在对本地系统上执行配置和漏洞扫描,以验证配置合规性内容,并根据这些扫描和评估生成报告和指南。重要在使用 OpenSCAP 时可能会遇到内存消耗问题,这可能会导致程序过早停止,并阻止生成任何结果文件。详情请查看 OpenSCAP 内存消耗问题 知识库文章。

- SCAP 安全指南(SSG)

-

scap-security-guide软件包为 Linux 系统提供安全策略的集合。该指南包括一个实用强化建议目录,在适用的情况下与政府的要求相关联。该项目弥补了一般性政策要求和具体实施指南间的差距。 - 脚本检查引擎(SCE)

-

通过 SCE (其是 SCAP 协议的扩展),管理员可以使用脚本语言(如 Bash、Python 和 Ruby)编写其安全内容。SCE 扩展在

openscap-engine-sce软件包中提供。SCE 本身不是 SCAP 标准的一部分。

要在多个系统上远程执行自动合规审计,您可以使用 Red Hat Satellite 的 OpenSCAP 解决方案。

其他资源

-

您系统上的

oscap (8),scap-workbench (8), 和scap-security-guide (8)man page - 红帽安全演示:创建自定义安全策略内容到 Automate 安全合规性

- 红帽安全演示:使用 RHEL 安全技术保护您自己

- 在 Red Hat Satellite 中管理安全合规性

6.2. 漏洞扫描

6.2.1. 红帽安全咨询 OVAL 源

Red Hat Enterprise Linux 安全审计功能是基于安全内容自动化协议(SCAP)标准的。SCAP 是一种多用途规格框架,支持自动化配置、漏洞和补丁检查、技术控制合规性活动和安全衡量。

SCAP 规范创建一个生态系统,其中安全内容的格式是众所周知的且标准化的,尽管扫描程序或策略编辑器的实现并不是强制性的。这使得组织能够一次性构建它们的安全策略(SCAP 内容),无论他们使用了多少家安全供应商。

开放式漏洞评估语言(OVAL)是 SCAP 最基本、最古老的组件。与其他工具和自定义脚本不同,OVAL 以声明式方法描述资源的必需状态。OVAL 代码从不直接执行,而是使用称为扫描器的 OVAL 解释器工具。OVAL 的声明性质可确保评估的系统状态不会被意外修改。

与所有其他 SCAP 组件一样,OVAL 也是基于 XML。SCAP 标准定义了多个文档格式。每一个都包括一种不同的信息,用于不同的目的。

红帽产品安全团队 通过跟踪和调查影响红帽客户的所有安全问题,来帮助客户评估和管理风险。它在红帽客户门户网站上提供及时、简洁的补丁和安全公告。红帽创建和支持 OVAL 补丁定义,提供机器可读的安全公告版本。

由于平台、版本及其他因素之间存在差异,红帽产品安全严重性等级评级无法直接与第三方提供的通用漏洞评分系统(CVSS)基准评级一致。因此,我们建议您使用 RHSA OVAL 定义,而不是第三方提供的定义。

RHSA OVAL 定义 可以单独提供,也可以作为一个完整的软件包提供,并在红帽客户门户网站上提供新安全公告的一小时内进行更新。

每个 OVAL 补丁定义将一对一地映射到红帽安全公告(RHSA)。由于 RHSA 可以包含对多个漏洞的修复,因此每个漏洞都通过其通用漏洞和风险(CVE)名称单独列出,并在我们的公共 bug 数据库中有一个指向其条目的链接。

RHSA OVAL 定义旨在检查系统上安装的 RPM 软件包是否存易受攻击的版本。可以扩展这些定义以包括进一步的检查,例如,查找软件包是否在易受攻击的配置中被使用。这些定义旨在涵盖红帽所提供的软件和更新。需要其他定义来检测第三方软件的补丁状态。

Red Hat Enterprise Linux 合规服务的 Red Hat Insights 可帮助 IT 安全和合规性管理员评估、监控和报告 Red Hat Enterprise Linux 系统安全策略合规性。您还可以完全在合规服务 UI 中创建和管理 SCAP 安全策略。

其他资源

6.2.2. 扫描系统漏洞

oscap命令行实用程序使您能够扫描本地系统,验证配置合规性内容,并根据这些扫描和评估生成报告和指南。此工具充当 OpenSCAP 库的前端,并根据它所处理的 SCAP 内容类型将其功能分组到模块(子命令)。

前提条件

-

openscap-scanner和bzip2软件包已安装。

流程

下载系统的最新 RHSA OVAL 定义:

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xml扫描系统漏洞并将结果保存到 vulnerability.html 文件中:

# oscap oval eval --report vulnerability.html rhel-9.oval.xml

验证

在您选择的浏览器中检查结果,例如:

$ firefox vulnerability.html &

其他资源

-

系统上的

oscap (8)手册页 - Red Hat OVAL 定义

- OpenSCAP 内存消耗问题

6.2.3. 扫描远程系统的漏洞

您可以通过 SSH 协议使用 oscap-ssh 工具,通过 OpenSCAP 扫描程序检查远程系统上的漏洞。

前提条件

-

openscap-utils和bzip2软件包已安装在您用于扫描的系统中。 -

openscap-scanner软件包已安装在远程系统上。 - SSH 服务器在远程系统上运行。

流程

下载系统的最新 RHSA OVAL 定义:

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xml扫描远程系统上的漏洞,并将结果保存到文件中:

# oscap-ssh <username>@<hostname> <port> oval eval --report <scan-report.html> rhel-9.oval.xml替换:

-

带有用户名和远程系统主机名的

<username>@<hostname>。 -

您可以通过端口号

<port>访问远程系统,例如22。 -

使用

oscap保存扫描结果的文件名<scan-report.html>。

-

带有用户名和远程系统主机名的

其他资源

-

oscap-ssh(8) - Red Hat OVAL 定义

- OpenSCAP 内存消耗问题

6.3. 配置合规性扫描

6.3.1. RHEL 中的配置合规性

您可以使用配置合规性扫描来遵循特定组织定义的基准。例如,如果您与美国政府合作,您可能需要使您的系统与操作系统保护配置文件(OSPP)保持一致,如果您是一个支付处理器,您可能需要使您的系统与支付卡行业数据安全标准(PCI-DSS)保持一致。您还可以执行配置合规性扫描来强化您的系统安全。

红帽建议您遵循 SCAP 安全指南软件包中提供的安全内容自动化协议(SCAP)的内容,因为它符合红帽针对受影响组件的最佳实践。

SCAP 安全指南软件包提供了符合 SCAP 1.2 和 SCAP 1.3 标准的内容。openscap 扫描器实用程序与SCAP安全指南包中提供的SCAP 1.2和SCAP 1.3内容兼容。

执行配置合规性扫描不能保证系统是合规的。

SCAP 安全指南套件以数据流文档的形式为多个平台提供配置文件。数据流是包含定义、基准、配置文件和单个规则的文件。每条规则都规定了合规的适用性和要求。RHEL 提供多个配置文件来遵守安全策略。除了行业标准之外,红帽数据流还包含用于修复失败规则的信息。

合规性扫描资源的结构

Data stream ├── xccdf | ├── benchmark | ├── profile | | ├──rule reference | | └──variable | ├── rule | ├── human readable data | ├── oval reference ├── oval ├── ocil reference ├── ocil ├── cpe reference └── cpe └── remediation

配置文件是基于安全策略的一组规则,如 OSPP、PCI-DSS 和健康保险可移植性和责任法案(HIPAA)。这可让您以自动化的方式审核系统,以符合安全标准。

您可以修改(定制)配置文件来自定义某些规则,例如密码长度。有关配置文件定制的更多信息,请参阅 使用 SCAP Workbench 自定义安全配置文件。

6.3.2. OpenSCAP 扫描的可能结果

根据应用到 OpenSCAP 扫描的数据流和配置文件,以及系统的各种属性,每个规则可能会产生一个特定的结果。以下是可能的结果,以及其含义的简要解释:

- Pass

- 扫描没有发现与此规则有任何冲突。

- Fail

- 扫描发现与此规则有冲突。

- Not checked

- OpenSCAP 对此规则不执行自动评估。手动检查您的系统是否符合此规则。

- Not applicable

- 此规则不适用于当前配置。

- Not selected

- 此规则不是配置文件的一部分。OpenSCAP 不评估此规则,也不会在结果中显示这些规则。

- Error

-

扫描遇到了错误。要获得更多信息,您可以输入带有

--verbose DEVEL选项的oscap命令。在红帽客户门户上提交支持问题单,或在 Red Hat Jira 的 RHEL 项目中 创建一个问题单。 - Unknown

-

扫描遇到了意外情况。要获得更多信息,您可以输入带有

'--verbose DEVEL选项的oscap命令。在红帽客户门户上提交支持问题单,或在 Red Hat Jira 的 RHEL 项目中 创建一个问题单。

6.3.3. 查看配置文件是否符合配置合规

在决定使用配置文件进行扫描或补救前,您可以使用 oscap info 子命令列出它们并检查其详细描述。

前提条件

-

openscap-scanner和scap-security-guide软件包已安装。

流程

列出 SCAP 安全指南项目所提供的带有安全合规配置文件的所有可用文件:

$ ls /usr/share/xml/scap/ssg/content/ ssg-rhel9-ds.xml使用

oscap info子命令显示有关所选数据流的详细信息。包含数据流的 XML 文件由其名称中的-ds字符串表示。在Profiles部分,您可以找到可用的配置文件及其 ID 列表:$ oscap info /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml Profiles: … Title: Australian Cyber Security Centre (ACSC) Essential Eight Id: xccdf_org.ssgproject.content_profile_e8 Title: Health Insurance Portability and Accountability Act (HIPAA) Id: xccdf_org.ssgproject.content_profile_hipaa Title: PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 Id: xccdf_org.ssgproject.content_profile_pci-dss …从数据流文件中选择一个配置文件,并显示所选配置文件的更多详情。为此,可使用带有

--profile选项的oscap info,后跟上一命令输出中显示的 ID 的最后一部分。例如,HIPPA 配置文件的 ID 是xccdf_org.ssgproject.content_profile_hipaa,--profile选项的值为hipaa:$ oscap info --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml … Profile Title: Health Insurance Portability and Accountability Act (HIPAA) Description: The HIPAA Security Rule establishes U.S. national standards to protect individuals’ electronic personal health information that is created, received, used, or maintained by a covered entity. …

其他资源

-

您系统上的

scap-security-guide (8)手册页 - OpenSCAP 内存消耗问题

6.3.4. 评估配置是否符合特定基准

您可以确定您的系统或远程系统是否符合特定基准,并使用 oscap 命令行工具将结果保存在报告中。

前提条件

-

openscap-scanner和scap-security-guide软件包已安装。 - 您知道系统应遵守的基准中的配置文件的 ID。要查找 ID,请参阅 查看配置合规性的配置文件 部分。

步骤

扫描本地系统以确定是否符合所选的配置文件,并将扫描结果保存到文件中:

$ oscap xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml替换:

-

使用

oscap保存扫描结果的文件名<scan-report.html>。 -

系统应该遵守的配置文件 ID

<profileID>,例如hipaa。

-

使用

可选:扫描远程系统以确定是否符合所选的配置文件,并将扫描结果保存到文件中:

$ oscap-ssh <username>@<hostname> <port> xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml替换:

-

带有用户名和远程系统主机名的

<username>@<hostname>。 -

您可以访问远程系统的

<port>端口号。 -

使用

oscap保存扫描结果的文件名<scan-report.html>。 -

系统应该遵守的配置文件 ID

<profileID>,例如hipaa。

-

带有用户名和远程系统主机名的

其他资源

-

您系统上的

scap-security-guide (8)手册页 -

/usr/share/doc/scap-security-guide/目录中的SCAP 安全指南文档 -

/usr/share/doc/scap-security-guide/guides/ssg-rhel9-guide-index.html- [Red Hat Enterprise Linux 9 的安全配置指南]与scap-security-guide-doc软件包一起安装 - OpenSCAP 内存消耗问题

6.4. 修复系统,使其与特定基准一致

您可以修复 RHEL 系统,以与特定基准保持一致。您可以修复系统,使其与 SCAP 安全指南提供的任何配置文件保持一致。有关列出可用配置文件的详情,请查看 查看配置合规的配置文件 部分。

如果不小心使用,在启用了 Remediate 选项的情况下运行系统评估可能会导致系统无法正常工作。红帽不提供任何自动的方法来恢复由安全补救机制所做的更改。在 RHEL 系统上的默认配置中支持修复。如果在安装后更改了您的系统,运行补救可能无法使其与所需安全配置兼容。

先决条件

-

scap-security-guide软件包已安装。

步骤

使用带有

--remediate选项的oscap命令修复系统:# oscap xccdf eval --profile <profileID> --remediate /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml将

<profileID>替换为系统应该遵守的配置文件的 ID,例如hipaa。- 重启您的系统。

验证

使用配置文件评估系统的合规性,并将扫描结果保存到文件中:

$ oscap xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml替换:

-

使用

oscap保存扫描结果的文件名<scan-report.html>。 -

系统应该遵守的配置文件 ID

<profileID>,例如hipaa。

-

使用

其他资源

-

您系统上的

scap-security-guide (8)和oscap (8)手册页

6.5. 使用 SSG Ansible playbook 修复系统以与特定基准保持一致

您可以使用 SCAP 安全指南项目中的 Ansible playbook 文件修复您的系统,使其与特定的基准保持一致。本例使用 Health Insurance Portability and Accountability Act (HIPAA)配置文件,但您可以进行修复,以与 SCAP 安全指南提供的任何其他配置集保持一致。有关列出可用配置文件的详情,请查看 查看配置合规的配置文件 部分。

如果不小心使用,在启用了 Remediate 选项的情况下运行系统评估可能会导致系统无法正常工作。红帽不提供任何自动的方法来恢复由安全补救机制所做的更改。在 RHEL 系统上的默认配置中支持修复。如果在安装后更改了您的系统,运行补救可能无法使其与所需安全配置兼容。

先决条件

-

scap-security-guide软件包已安装。 -

ansible-core软件包已安装。如需更多信息,请参阅 Ansible 安装指南。

流程

使用 Ansible 修复您的系统,使其与 HIPAA 保持一致:

# ansible-playbook -i localhost, -c local /usr/share/scap-security-guide/ansible/rhel9-playbook-hipaa.yml- 重新启动系统。

验证

使用 HIPAA 配置文件评估系统的合规性,并将扫描结果保存到文件中:

# oscap xccdf eval --profile hipaa --report <scan-report.html> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml将

<scan-report.html>替换为oscap保存扫描结果的文件名。

其他资源

-

您系统上的

scap-security-guide (8)和oscap (8)手册页 - Ansible 文档

6.6. 创建修复 Ansible playbook,使系统与特定的基准一致

您可以创建一个 Ansible playbook,其只包含使您的系统与特定基准保持一致所需的修正。此 playbook 更小,因为它没有涵盖已满足要求。创建 playbook 不会以任何方式修改您的系统,您只需为后续应用程序准备一个文件。这个示例使用了健康保险可移植性和责任法案(HIPAA)配置文件。

在 RHEL 9 中,Ansible Engine 被 ansible-core 软件包替代,该软件包只包含内置模块。请注意,很多 Ansible 补救使用社区和可端口操作系统接口(POSIX)集合中的模块,它们没有包含在内置模块中。在这种情况下,您可以使用 Bash 补救来作为 Ansible 补救的替代。RHEL 9.0 中的 Red Hat Connector 包括修复 playbook 与 Ansible Core 正常工作所需的 Ansible 模块。

先决条件

-

scap-security-guide软件包已安装。

步骤

扫描系统并保存结果:

# oscap xccdf eval --profile hipaa --results <hipaa-results.xml> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml使用结果在文件中找到结果 ID 的值:

# oscap info <hipaa-results.xml>根据在第 1 步中生成的文件生成 Ansible playbook:

# oscap xccdf generate fix --fix-type ansible --result-id <xccdf_org.open-scap_testresult_xccdf_org.ssgproject.content_profile_hipaa> --output <hipaa-remediations.yml> <hipaa-results.xml>-

查看生成的文件,其中包含在第 1 步中执行扫描过程中失败的规则的 Ansible 修复。查看生成的文件后,您可以使用

ansible-playbook <hipaa-remediations.yml>命令应用它。

验证

-

在您选择的文本编辑器中,检查生成的

<hipaa-remediations.yml>文件是否包含在第 1 步中执行的扫描中失败的规则。

其他资源

-

您系统上的

scap-security-guide (8)和oscap (8)手册页 - Ansible 文档

6.7. 为后续应用程序创建补救 Bash 脚本

使用此流程创建一个 Bash 脚本,其中包含使您的系统与 HIPAA 等安全配置文件一致的补救。通过以下步骤,您不需要对系统进行任何修改,您只需为后续应用准备一个文件。

先决条件

-

scap-security-guide软件包已安装在您的 RHEL 系统上。

流程

使用

oscap命令扫描系统,并将结果保存到 XML 文件中。在以下示例中,oscap会根据hipaa配置文件评估系统:# oscap xccdf eval --profile hipaa --results <hipaa-results.xml> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml使用结果在文件中找到结果 ID 的值:

# oscap info <hipaa-results.xml>根据在第 1 步中生成的结果文件生成 Bash 脚本:

# oscap xccdf generate fix --fix-type bash --result-id <xccdf_org.open-scap_testresult_xccdf_org.ssgproject.content_profile_hipaa> --output <hipaa-remediations.sh> <hipaa-results.xml>-

<hipaa-remediations.sh>文件包含在第 1 步中执行扫描过程中失败的规则的补救。查看生成的文件后,当您位于与此文件相同的目录中时,您可以使用./<hipaa-remediations.sh>命令应用它。

验证

-

在您选择的文本编辑器中,检查

<hipaa-remediations.sh>文件是否包含在第 1 步中执行的扫描中失败的规则。

其他资源

-

在您的系统中

scap-security-guide (8),oscap (8), 和bash (1)手册页

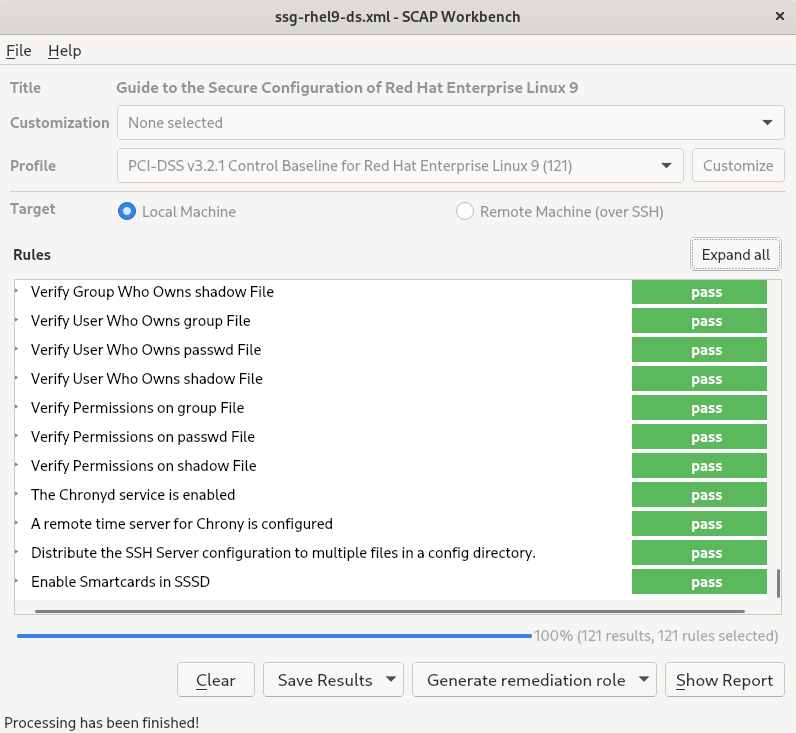

6.8. 使用 SCAP Workbench 用自定义配置文件扫描系统

scap-workbench软件包中包含的SCAP Workbench是一个图形化的实用程序,用户可以在单个本地或远程系统上进行配置和漏洞扫描,对系统进行修复,并根据扫描评估结果生成报告。请注意,与 oscap 命令行工具相比,SCAP Workbench 的功能有限。SCAP Workbench 以数据流文件的形式处理安全内容。

6.8.1. 使用 SCAP Workbench 来扫描和修复系统

要根据所选的安全策略来评估您的系统,请使用以下流程。

先决条件

-

scap-workbench软件包已经安装在您的系统中。

流程

要从

GNOME Classic桌面环境运行SCAP Workbench,请按 Super 键进入Activities Overview,输入scap-workbench,然后按 Enter。或者,使用:$ scap-workbench &使用以下其中一个选项来选择安全策略:

-

开始窗口中的

Load Content按钮 -

打开 SCAP 安全指南中的内容 在

File中打开Other Content,搜索相关的 XCCDF、SCAP RPM 或数据流文件。

-

开始窗口中的

您可以选择 复选框来允许自动修正系统配置。启用此选项后,

SCAP Workbench会尝试根据策略所应用的安全规则来修改系统配置。这个过程应该修复系统扫描过程中失败的相关检查。警告如果不小心使用,在启用了

Remediate选项的情况下运行系统评估可能会导致系统无法正常工作。红帽不提供任何自动的方法来恢复由安全补救机制所做的更改。在 RHEL 系统上的默认配置中支持修复。如果在安装后更改了您的系统,运行补救可能无法使其与所需安全配置兼容。单击按钮,使用所选配置文件扫描您的系统。

-

要以 XCCDF、ARF 或 HTML 文件的形式保存扫描结果,请点击 组合框。选择

HTML Report选项,以人类可读的格式生成扫描报告。XCCDF 和 ARF(数据流)格式适合进一步自动处理。您可以重复选择所有三个选项。 - 要将基于结果的补救导出到文件,请使用 弹出菜单。

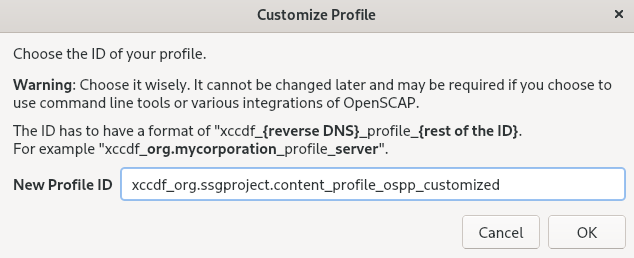

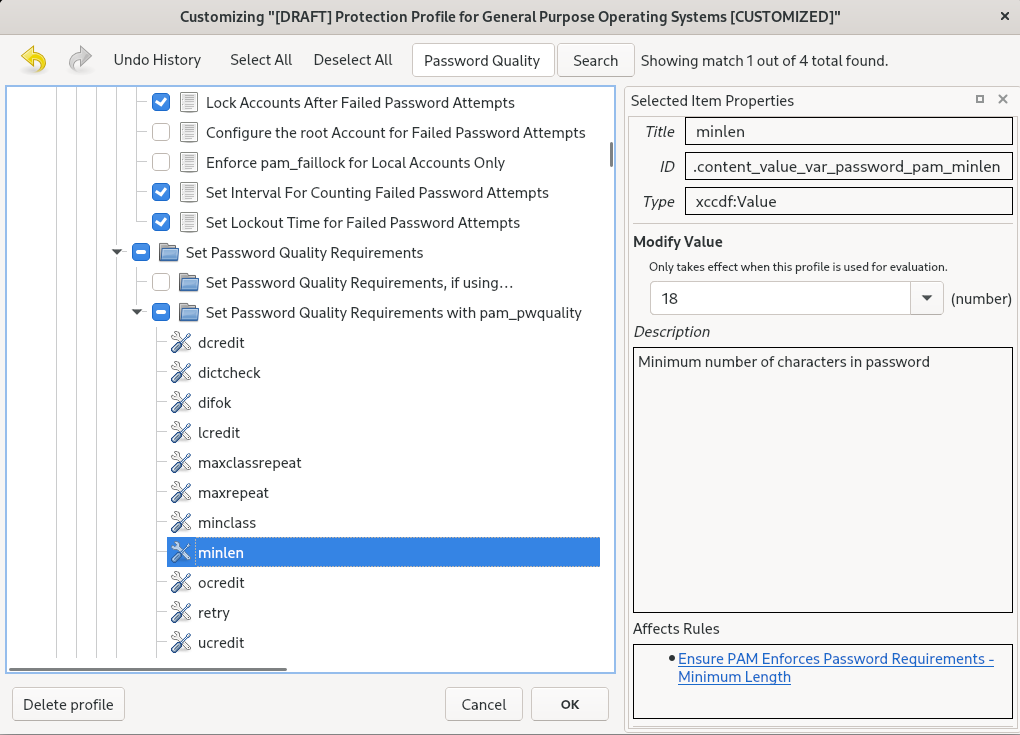

6.8.2. 使用 SCAP Workbench 自定义安全配置文件

您可以通过更改某些规则中的参数(如最小密码长度)、删除以不同方式涵盖的规则,并选择额外的规则来自定义安全配置文件,以实现内部策略。您不能通过自定义配置文件来定义新规则。

以下流程演示了如何使用 SCAP Workbench 来自定义(定制)配置文件。您还可以保存定制的配置文件,以便在 oscap 命令行工具中使用。。

先决条件

-

scap-workbench软件包已经安装在您的系统中。

流程

-

运行

SCAP Workbench,选择要自定义的配置文件,方法是使用打开 SCAP 安全指南中的内容或者在File菜单中打开其他内容。 要根据您的需要调整所选的安全配置文件,请点击 按钮。

这会打开新的 Customization 窗口,允许您在不修改原始数据流文件的情况下修改当前选择的配置文件。选择新的配置文件 ID。

- 使用将规则组织成逻辑组的树结构或 字段查找要修改的规则。

使用树结构中的复选框来包含或排除规则,或者在适用情况下修改规则中的值。

- 点击 按钮以确认修改。

要永久存储您的修改,请使用以下选项之一:

-

使用

File菜单中的Save Customization Only分别保存自定义文件。 通过在

File菜单中的Save All来一次保存所有安全内容。如果您选择了

Into a directory选项,SCAP Workbench将数据流文件和自定义文件保存到指定的位置。您可以使用它作为备份解决方案。通过选择

As RPM选项,您可以指示SCAP Workbench创建包含数据流文件和自定义文件的 RPM 软件包。这对于将安全内容分发到无法远程扫描的系统以及交付内容以供进一步处理非常有用。

-

使用

-

因为

SCAP Workbench不支持对定制配置文件的基于结果的补救,所以请使用oscap命令行工具导出的补救。

6.9. 安装后立即部署符合安全配置文件的系统

您可以在安装过程后立即使用 OpenSCAP 套件来部署符合安全配置文件(如 OSPP、PCI-DSS 和 HIPAA 配置文件)的 RHEL 系统,。使用此部署方法,您可以使用修复脚本(例如密码强度和分区的规则)应用之后无法应用的特定规则。

6.9.1. 配置文件与 Server with GUI 不兼容

作为 SCAP 安全指南 的一部分提供的某些安全配置文件与 Server with GUI 基本环境中包含的扩展软件包集不兼容。因此,在安装与以下配置文件兼容的系统时,请不要选择 Server with GUI :

| 配置文件名称 | 配置文件 ID | 原因 | 备注 |

|---|---|---|---|

| [DRAFT] CIS Red Hat Enterprise Linux 9 基准(第 2 级 - 服务器) |

|

软件包 | |

| [DRAFT] CIS Red Hat Enterprise Linux 9 基准(第 1 级 - 服务器) |

|

软件包 | |

| DISA STIG for Red Hat Enterprise Linux 9 |

|

软件包 | 要将 RHEL 系统安装为 Server with GUI 以与 DISA STIG 一致,您可以使用 DISA STIG with GUI profile BZ#1648162 |

6.9.2. 使用图形安装部署基本兼容 RHEL 系统

使用此流程部署与特定基准兼容的 RHEL 系统。这个示例为常规目的操作系统(OSPP)使用保护配置集。

作为 SCAP 安全指南 的一部分提供的某些安全配置文件与 Server with GUI 基本环境中包含的扩展软件包集不兼容。如需了解更多详细信息,请参阅 与 GUI 服务器不兼容的配置文件。

前提条件

-

您已引导到

图形安装程序。请注意,OSCAP Anaconda Add-on 不支持交互式文本安装。 -

您已访问

安装概述窗口。

流程

-

在

安装概述窗口中点击软件选择。此时会打开软件选择窗口。 -

在

Base Environment窗格中选择服务器环境。您只能选择一个基本环境。 -

点击

完成应用设置并返回安装概述窗口。 -

由于 OSPP 有必须满足的严格的分区要求,所以为

/boot、/home、/var、/tmp、/var/log、/var/tmp和/var/log/audit创建单独的分区。 -

点击

安全策略。此时会打开Security Policy窗口。 -

要在系统中启用安全策略,将

Apply security policy切换为ON。 -

从配置集栏中选择

Protection Profile for General Purpose Operating Systems. -

点

Select Profile来确认选择。 -

确认在窗口底部显示

Changes that were done or need to be done。完成所有剩余的手动更改。 完成图形安装过程。

注意图形安装程序在安装成功后自动创建对应的 Kickstart 文件。您可以使用

/root/anaconda-ks.cfg文件自动安装兼容 OSPP 的系统。

验证

要在安装完成后检查系统当前的状态,请重启系统并启动新的扫描:

# oscap xccdf eval --profile ospp --report eval_postinstall_report.html /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

其他资源

6.9.3. 使用 Kickstart 部署符合基线的 RHEL 系统

您可以部署与特定基准一致的 RHEL 系统。这个示例为常规目的操作系统(OSPP)使用保护配置集。

前提条件

-

scap-security-guide软件包会在 RHEL 9 系统中安装。

流程

-

在您选择的编辑器中打开

/usr/share/scap-security-guide/kickstart/ssg-rhel9-ospp-ks.cfgKickstart 文件。 -

更新分区方案以符合您的配置要求。为了实现 OSPP 合规性,必须保留

/boot、/home、/var、/tmp、/var/log、/var/tmp和/var/log/audit的独立分区,您只能更改分区的大小。 - 按照 使用 Kickstart 执行自动安装 中所述来开始 Kickstart 安装。

对于 OSPP 的要求,不检查 Kickstart 文件中的密码。

验证

要在安装完成后检查系统当前的状态,请重启系统并启动新的扫描:

# oscap xccdf eval --profile ospp --report eval_postinstall_report.html /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

6.10. 扫描容器和容器镜像以查找漏洞

使用这个流程查找容器或容器镜像中的安全漏洞。

前提条件

-

openscap-utils和bzip2软件包已安装。

流程

下载系统的最新 RHSA OVAL 定义:

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xml获取容器或容器镜像的 ID,例如:

# podman images REPOSITORY TAG IMAGE ID CREATED SIZE registry.access.redhat.com/ubi9/ubi latest 096cae65a207 7 weeks ago 239 MB扫描容器或容器镜像的漏洞,并将结果保存到 vulnerability.html 文件中:

# oscap-podman 096cae65a207 oval eval --report vulnerability.html rhel-9.oval.xml请注意,

oscap-podman命令需要 root 特权,容器的 ID 是第一个参数。

验证

在您选择的浏览器中检查结果,例如:

$ firefox vulnerability.html &

其他资源

-

如需更多信息,请参阅

oscap-podman(8)和oscap(8)手册页。

6.11. 使用特定基准评估容器或容器镜像的安全性合规

您可以使用特定的安全基准评估容器或容器镜像的合规性,如 Operating System Protection Profile(OSPP)、Payment Card Industry Data Security Standard(PCI-DSS)和 Health Insurance Portability and Accountability Act(HIPAA)。

前提条件

-

openscap-utils和scap-security-guide软件包已安装。 - 有对系统的 root 访问权限。

流程

查找容器或容器镜像的 ID:

-

要查找容器的 ID,请输入

podman ps -a命令。 -

要查找容器镜像的 ID,请输入

podman images命令。

-

要查找容器的 ID,请输入

使用配置集评估容器或容器镜像的合规性,并将扫描结果保存到文件中:

# oscap-podman <ID> xccdf eval --report <scan-report.html> --profile <profileID> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml替换:

-

<ID> 带有容器或容器镜像的 ID -

使用

oscap保存扫描结果的文件名替换<scan-report.html> -

<profileId> 带有系统应该遵循的配置集 ID,例如hipaa、ospp、或pci-dss

-

验证

在您选择的浏览器中检查结果,例如:

$ firefox <scan-report.html> &

标记为 notapplicable 的规则仅适用于裸机和虚拟化系统,不适用于容器或容器镜像。

其他资源

-

oscap-podman(8)和scap-security-guide(8)手册页。 -

/usr/share/doc/scap-security-guide/目录。

6.12. RHEL 9 支持 SCAP 安全指南配置集

只使用 RHEL 的特定次要版本中提供的 SCAP 内容。这是因为,参与强化的组件有时会使用新功能进行更新。修改 SCAP 内容来反映这些更新,但并不总是向后兼容的。

在以下表格中,您可以找到 RHEL 9 中提供的配置集,以及与配置集匹配的策略版本。

| 配置文件名称 | 配置文件 ID | 策略版本 |

|---|---|---|

| 法国信息系统安全局(ANSSI)BP-028 增强级 |

| 2.0 |

| 法国信息系统安全部(ANSSI)BP-028 高级别 |

| 2.0 |

| 法国信息系统安全局(ANSSI)BP-028 中级 |

| 2.0 |

| 法国信息系统安全局(ANSSI)BP-028 最低级 |

| 2.0 |

| CCN Red Hat Enterprise Linux 9 - 高级 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 基本 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 中级 |

| 2022-10 |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

| 2.0.0 |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

| 2.0.0 |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

| 2.0.0 |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

| 2.0.0 |

| [DRAFT] 在非保障信息系统和机构中未分类的信息(NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| 未版本化 |

| 健康保险可移植性和责任法案(HIPAA) |

| 未版本化 |

| 澳大利亚网络安全中心(ACSC)ISM 官方 |

| 未版本化 |

| 常规目的操作系统的保护配置文件 |

| 4.3 |

| 适用于 Red Hat Enterprise Linux 9 的 PCI-DSS v3.2.1 控制基本行 |

|

RHEL 9.5.0:4.0 |

| 用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

|

RHEL 9.5.0:V1R3 |

| 用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

|

RHEL 9.5.0:V1R3 |

| CCN Red Hat Enterprise Linux 9 - 基本 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 中级 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 高级 |

| 2022-10 |

| 配置文件名称 | 配置文件 ID | 策略版本 |

|---|---|---|

| 法国信息系统安全局(ANSSI)BP-028 增强级 |

| 2.0 |

| 法国信息系统安全部(ANSSI)BP-028 高级别 |

| 2.0 |

| 法国信息系统安全局(ANSSI)BP-028 中级 |

| 2.0 |

| 法国信息系统安全局(ANSSI)BP-028 最低级 |

| 2.0 |

| CCN Red Hat Enterprise Linux 9 - 高级 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 基本 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 中级 |

| 2022-10 |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

|

RHEL 9.4.0 到 RHEL 9.4.2:1.0.0 |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

|

RHEL 9.4.0 到 RHEL 9.4.2:1.0.0 |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

|

RHEL 9.4.0 到 RHEL 9.4.2:1.0.0 |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

|

RHEL 9.4.0 到 RHEL 9.4.2:1.0.0 |

| [DRAFT] 在非保障信息系统和机构中未分类的信息(NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| 未版本化 |

| 健康保险可移植性和责任法案(HIPAA) |

| 未版本化 |

| 澳大利亚网络安全中心(ACSC)ISM 官方 |

| 未版本化 |

| 常规目的操作系统的保护配置文件 |

| 4.3 |

| 适用于 Red Hat Enterprise Linux 9 的 PCI-DSS v3.2.1 控制基本行 |

|

RHEL 9.4.0 到 RHEL 9.4.4:4.0 |

| 用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

|

RHEL 9.4.0:V1R2 |

| 用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

|

RHEL 9.4.0:V1R2 |

| CCN Red Hat Enterprise Linux 9 - 基本 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 中级 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 高级 |

| 2022-10 |

| 配置文件名称 | 配置文件 ID | 策略版本 |

|---|---|---|

| 法国信息系统安全局(ANSSI)BP-028 增强级 |

| 2.0 |

| 法国信息系统安全部(ANSSI)BP-028 高级别 |

| 2.0 |

| 法国信息系统安全局(ANSSI)BP-028 中级 |

| 2.0 |

| 法国信息系统安全局(ANSSI)BP-028 最低级 |

| 2.0 |

| CCN Red Hat Enterprise Linux 9 - 高级 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 基本 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 中级 |

| 2022-10 |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

| 1.0.0 |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

| 1.0.0 |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

| 1.0.0 |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

| 1.0.0 |

| [DRAFT] 在非保障信息系统和机构中未分类的信息(NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| 未版本化 |

| 健康保险可移植性和责任法案(HIPAA) |

| 未版本化 |

| 澳大利亚网络安全中心(ACSC)ISM 官方 |

| 未版本化 |

| 常规目的操作系统的保护配置文件 |

| 4.3 |

| 适用于 Red Hat Enterprise Linux 9 的 PCI-DSS v3.2.1 控制基本行 |

|

RHEL 9.3.0 到 RHEL 9.3.2:3.2.1 |

| 用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

|

RHEL 9.3.0:草案[a] |

| 用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

|

RHEL 9.3.0:DRAFT[a] |

| CCN Red Hat Enterprise Linux 9 - 基本 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 中级 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 高级 |

| 2022-10 |

[a]

DISA 尚未发布 RHEL 9 的官方基准

| ||

| 配置文件名称 | 配置文件 ID | 策略版本 |

|---|---|---|

| 法国信息系统安全局(ANSSI)BP-028 增强级 |

|

RHEL 9.2.0 到 RHEL 9.2.2:1.2 |

| 法国信息系统安全部(ANSSI)BP-028 高级别 |

|

RHEL 9.2.0 到 RHEL 9.2.2:1.2 |

| 法国信息系统安全局(ANSSI)BP-028 中级 |

|

RHEL 9.2.0 到 RHEL 9.2.2:1.2 |

| 法国信息系统安全局(ANSSI)BP-028 最低级 |

|

RHEL 9.2.0 到 RHEL 9.2.2:1.2 |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

|

RHEL 9.2.0 到 RHEL 9.2.10:1.0.0 |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

|

RHEL 9.2.0 到 RHEL 9.2.10:1.0.0 |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

|

RHEL 9.2.0 到 RHEL 9.2.10:1.0.0 |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

|

RHEL 9.2.0 到 RHEL 9.2.10:1.0.0 |

| [DRAFT] 在非保障信息系统和机构中未分类的信息(NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| 未版本化 |

| 健康保险可移植性和责任法案(HIPAA) |

| 未版本化 |

| 澳大利亚网络安全中心(ACSC)ISM 官方 |

| 未版本化 |

| 常规目的操作系统的保护配置文件 |

| 4.2.1 |

| 适用于 Red Hat Enterprise Linux 9 的 PCI-DSS v3.2.1 控制基本行 |

|

RHEL 9.2.0 到 RHEL 9.2.5:3.2.1 |

| 用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

|

RHEL 9.2.0 到 RHEL 9.2.4:DRAFT[a] |

| 用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

|

RHEL 9.2.0 到 9.2.4 :DRAFT[a] |

| CCN Red Hat Enterprise Linux 9 - 基本 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 中级 |

| 2022-10 |

| CCN Red Hat Enterprise Linux 9 - 高级 |

| 2022-10 |

| 配置文件名称 | 配置文件 ID | 策略版本 |

|---|---|---|

| 法国信息系统安全局(ANSSI)BP-028 增强级 |

| 1.2 |

| 法国信息系统安全部(ANSSI)BP-028 高级别 |

| 1.2 |

| 法国信息系统安全局(ANSSI)BP-028 中级 |

| 1.2 |

| 法国信息系统安全局(ANSSI)BP-028 最低级 |

| 1.2 |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

|

RHEL 9.1.0 和 RHEL 9.1.1:DRAFT[a] |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

|

RHEL 9.1.0 和 RHEL 9.1.1:DRAFT[a] |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

|

RHEL 9.1.0 和 RHEL 9.1.1:DRAFT[a] |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

|

RHEL 9.1.0 和 RHEL 9.1.1:DRAFT[a] |

| [DRAFT] 在非保障信息系统和机构中未分类的信息(NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| 未版本化 |

| 健康保险可移植性和责任法案(HIPAA) |

| 未版本化 |

| 澳大利亚网络安全中心(ACSC)ISM 官方 |

| 未版本化 |

| 常规目的操作系统的保护配置文件 |

| 4.2.1 |

| 适用于 Red Hat Enterprise Linux 9 的 PCI-DSS v3.2.1 控制基本行 |

| 3.2.1 |

| [草案]]用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

| 草案[a] |

| [草案] 用于 Red Hat Enterprise Linux 9 的带有 GUI 的国防信息系统局安全技术实施指南(DISA STIG) |

| 草案[a] |

[a]

CIS 尚未发布 RHEL 9 的官方基准

| ||

| 配置文件名称 | 配置文件 ID | 策略版本 |

|---|---|---|

| 法国信息系统安全局(ANSSI)BP-028 增强级 |

|

RHEL 9.0.0 到 RHEL 9.0.10:1.2 |

| 法国信息系统安全部(ANSSI)BP-028 高级别 |

|

RHEL 9.0.0 到 RHEL 9.0.10:1.2 |

| 法国信息系统安全局(ANSSI)BP-028 中级 |

|

RHEL 9.0.0 到 RHEL 9.0.10:1.2 |

| 法国信息系统安全局(ANSSI)BP-028 最低级 |

|

RHEL 9.0.0 到 RHEL 9.0.10:1.2 |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

|

RHEL 9.0.0 到 RHEL 9.0.6:DRAFT[a] |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 服务器 |

|

RHEL 9.0.0 到 RHEL 9.0.6:DRAFT[a] |

| 第 1 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

|

RHEL 9.0.0 到 RHEL 9.0.6:DRAFT[a] |

| 第 2 级 CIS Red Hat Enterprise Linux 9 基准 - 工作站 |

|

RHEL 9.0.0 到 RHEL 9.0.6:DRAFT[a] |

| [DRAFT] 在非保障信息系统和机构中未分类的信息(NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| 未版本化 |

| 健康保险可移植性和责任法案(HIPAA) |

| 未版本化 |

| 澳大利亚网络安全中心(ACSC)ISM 官方 |

| 未版本化 |

| 常规目的操作系统的保护配置文件 |

|

RHEL 9.0.0 到 RHEL 9.0.2:DRAFT |

| 适用于 Red Hat Enterprise Linux 9 的 PCI-DSS v3.2.1 控制基本行 |

|

RHEL 9.0.0 到 RHEL 9.0.14:3.2.1 |

| 用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

|

RHEL 9.0.0 到 RHEL 9.0.13:DRAFT[a] |

| 用于 Red Hat Enterprise Linux 9 的国防信息系统局安全技术实施指南(DISA STIG) |

|

RHEL 9.0.0 到 RHEL 9.0.13:DRAFT[a] |

| CCN Red Hat Enterprise Linux 9 - 基本 |

| RHEL 9.0.11 及更新版本:2022-10 |

| CCN Red Hat Enterprise Linux 9 - 中级 |

| RHEL 9.0.11 及更新版本:2022-10 |

| CCN Red Hat Enterprise Linux 9 - 高级 |

| RHEL 9.0.11 及更新版本:2022-10 |

第 7 章 使用 Keylime 确保系统完整性

借助 Keylime,您可以持续监控远程系统的完整性,并在引导时验证系统状态。您还可以将加密文件发送到被监控的系统,并指定监控系统失败时触发的自动化操作。

7.1. Keylime 的工作原理

您可以配置 Keylime 代理执行以下操作之一或多个操作:

- 运行时完整性监控

- Keylime 运行时完整性监控会持续监控在其上部署了代理的系统,并测量包含在 allowlist 中但不包含在 excludelist 中的文件的完整性。

- 测量的引导

- Keylime 测量的引导会验证引导时的系统状态。

Keylime 的信任概念基于受信任的平台模块 (TPM) 技术。TPM 是一个带有集成加密密钥的硬件、固件或虚拟组件。通过轮询 TPM 参考并比较对象的哈希,Keylime 提供远程系统的初始和运行时监控。

运行在虚拟机或使用虚拟 TPM 运行的 Keylime 取决于底层主机的完整性。在依赖虚拟环境中的 Keylime 测量前,请确保信任主机环境。

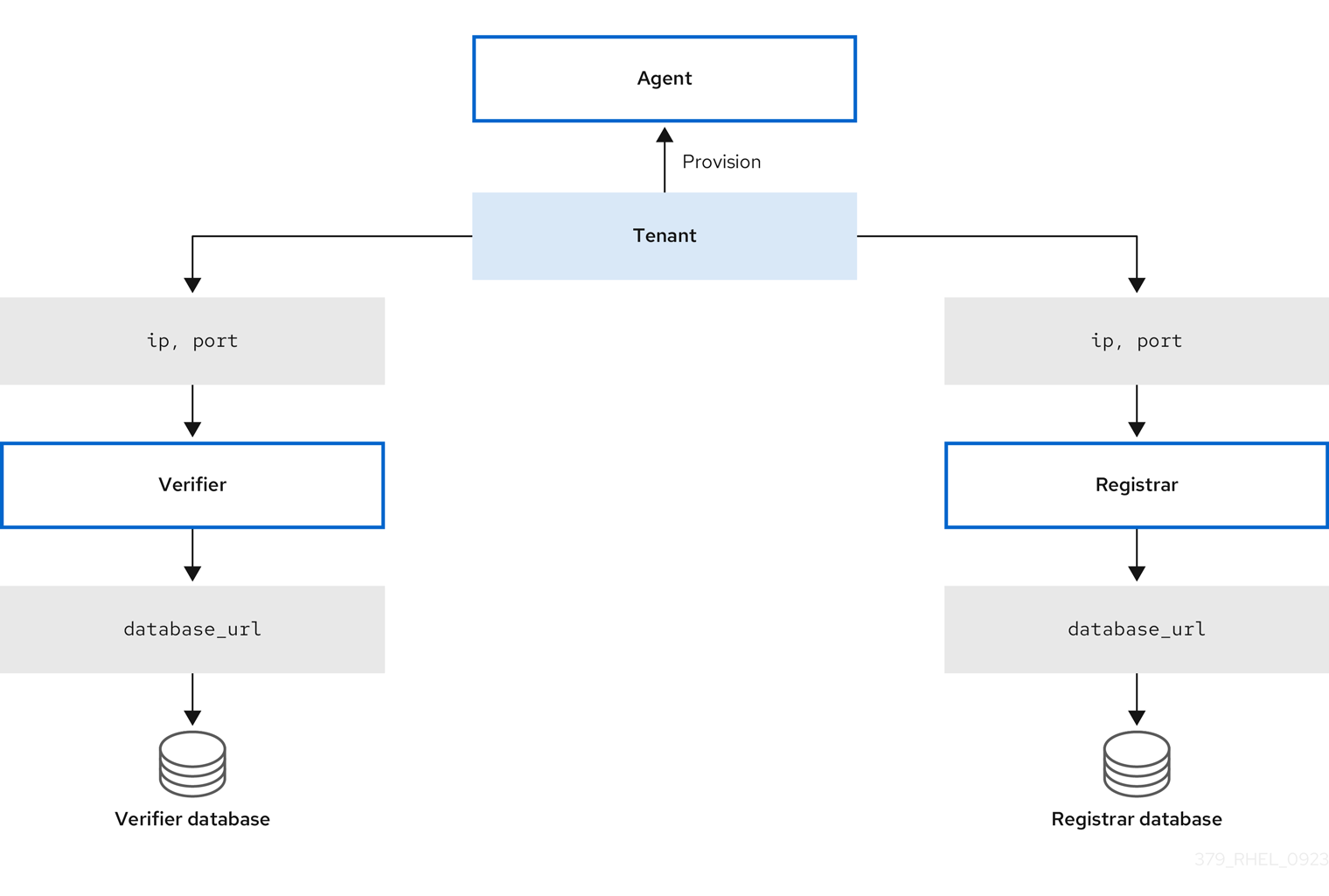

Keylime 由三个主要组件组成:

- 验证器

-

初始并持续验证运行代理的系统的完整性。您可以从软件包、容器或

keylime_serverRHEL 系统角色部署 verifier。 - 注册器

-

包含所有代理的数据库,它托管 TPM 供应商的公钥。您可以从软件包、容器或

keylime_serverRHEL 系统角色部署注册商。 - Agent

- 部署到由验证器测量的远程系统。

此外,Keylime 将 keylime_tenant 实用程序用于许多功能,包括在目标系统上调配代理。

图 7.1. 通过配置进行主精简组件之间的连接

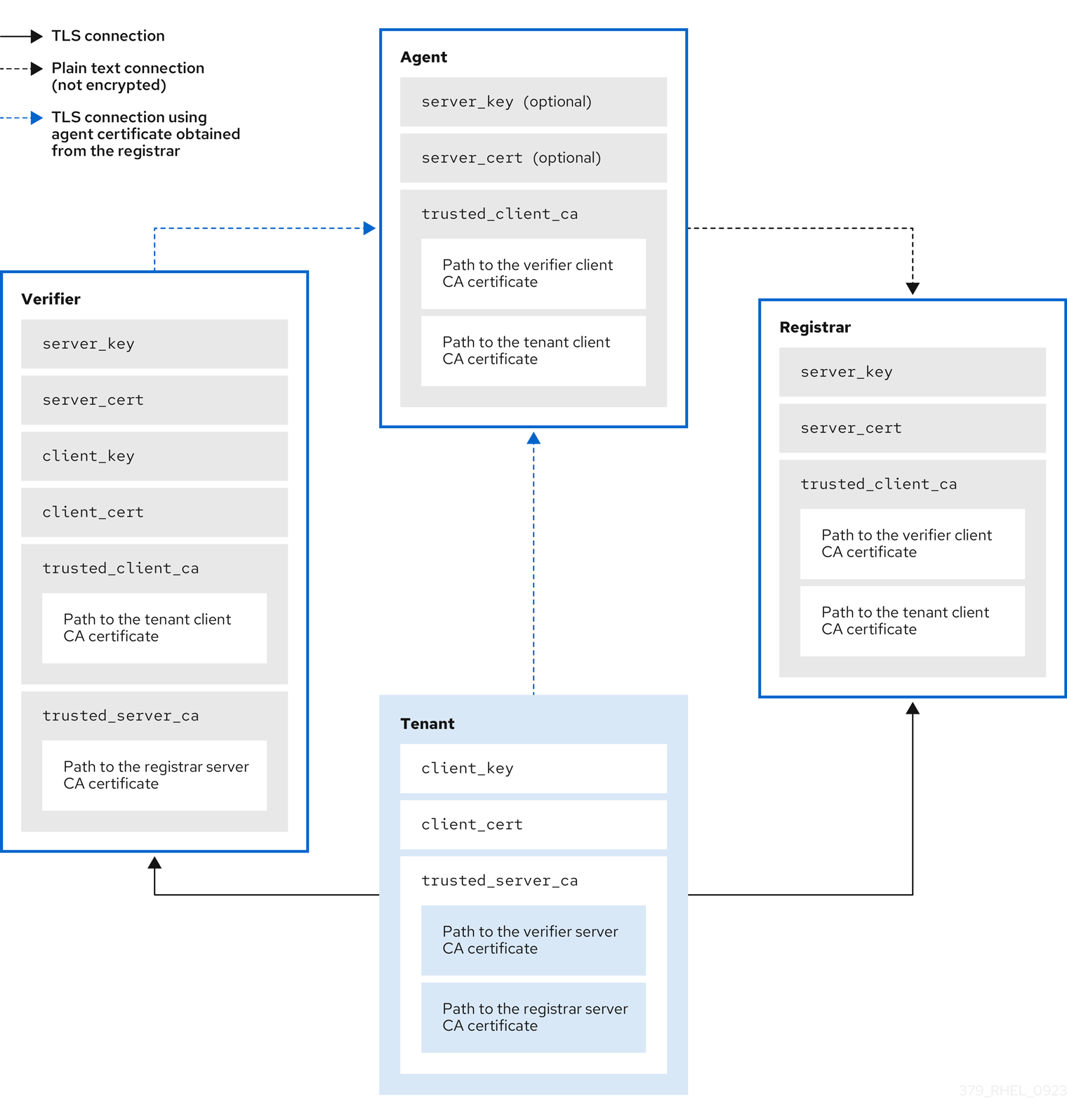

Keylime 通过使用组件与租户之间交换的密钥和证书,确保监控系统的完整性。对于此链的安全基础,请使用您可以信任的证书颁发机构(CA)。

如果代理没有接收密钥和证书,它会生成一个密钥以及一个自签名证书,而无需 CA。

图 7.2. 关键精简组件证书和密钥之间的连接

7.2. 从软件包部署 Keylime verifier

验证器是 Keylime 中最重要的组件。它执行系统完整性的初始和定期检查,并支持使用代理安全地引导加密密钥。验证器对其控制接口使用双向 TLS 加密。

要维护信任链,请保持运行验证器的系统的安全,并在您的控制之下。

您可以根据您的要求,在单独的系统或作为 Keylime 注册器的同一系统上安装验证器。在单独的系统上运行验证器和注册器可提供更好的性能。

要将配置文件保留在置入目录中,请使用具有两位数字前缀的文件名,例如 /etc/keylime/verifier.conf.d/00-verifier-ip.conf。配置处理以字典顺序读取置入目录中的文件,并对每个选项设置为它读取的最后一个值。

前提条件

-

您在要安装 Keylime 组件的系统上有

root权限和网络连接。 - 您有来自您的证书颁发机构的有效密钥和证书。

可选:您可以访问 Keylime 保存来自验证器的数据的数据库。您可以使用以下数据库管理系统:

- SQLite (默认)

- PostgreSQL

- MySQL

- MariaDB

流程

安装 Keylime 验证器:

# dnf install keylime-verifier通过在

/etc/keylime/verifier.conf.d/目录中创建一个新的.conf文件来定义验证器的 IP 地址和端口,例如:/etc/keylime/verifier.conf.d/00-verifier-ip.conf,其内容如下:[verifier] ip = <verifier_IP_address>

-

将

<verifier_IP_address>替换为验证器的 IP 地址。或者,使用ip = *或ip = 0.0.0.0将验证器绑定到所有可用 IP 地址。 -

另外,您还可以使用

port选项更改验证器的端口默认值8881。

-

将

可选:为代理列表配置 verifier 的数据库。默认配置使用验证器的

/var/lib/keylime/cv_data.sqlite/目录中的 SQLite 数据库。您可以通过在/etc/keylime/verifier.conf.d/目录中创建一个新的.conf文件来定义一个不同的数据库,例如:/etc/keylime/verifier.conf.d/00-db-url.conf,其内容如下:[verifier] database_url = <protocol>://<name>:<password>@<ip_address_or_hostname>/<properties>将

<protocol>://<name>:<password>@<ip_address_or_hostname>/<properties>替换为数据库的 URL,如postgresql://verifier:UQ?nRNY9g7GZzN7@198.51.100.1/verifierdb。确保您使用的凭证为 Keylime 提供了权限,来创建数据库结构。

将证书和密钥添加到验证器(verifier)中。您可以让 Keylime 生成它们,或使用现有的密钥和证书生成它们:

-

使用默认

tls_dir = generate选项,Keylime 在/var/lib/keylime/cv_ca/目录中为验证器、注册器和租户生成新证书。 要在配置中加载现有的密钥和证书,请在验证器配置中定义其位置。证书必须可以被运行 Keylime 服务的

keylime用户访问。在

/etc/keylime/verifier.conf.d/目录中创建一个新的.conf文件,例如:/etc/keylime/verifier.conf.d/00-keys-and-certs.conf,其内容如下:[verifier] tls_dir = /var/lib/keylime/cv_ca server_key = </path/to/server_key> server_key_password = <passphrase1> server_cert = </path/to/server_cert> trusted_client_ca = ['</path/to/ca/cert1>', '</path/to/ca/cert2>'] client_key = </path/to/client_key> client_key_password = <passphrase2> client_cert = </path/to/client_cert> trusted_server_ca = ['</path/to/ca/cert3>', '</path/to/ca/cert4>']

注意使用绝对路径定义密钥和证书位置。或者,相对路径是从

tls_dir选项中定义的目录解析的。

-

使用默认

在防火墙中打开端口:

# firewall-cmd --add-port 8881/tcp # firewall-cmd --runtime-to-permanent

如果您使用其他端口,请将

8881替换为.conf文件中定义的端口号。启动验证器(verifier)服务:

# systemctl enable --now keylime_verifier注意在默认配置中,在启动

keylime_registrar服务前启动keylime_verifier,因为验证器会为其他 Keylime 组件创建 CA 和证书。使用自定义证书时不需要这个顺序。

验证

检查

keylime_verifier服务是否活跃且在运行:# systemctl status keylime_verifier ● keylime_verifier.service - The Keylime verifier Loaded: loaded (/usr/lib/systemd/system/keylime_verifier.service; disabled; vendor preset: disabled) Active: active (running) since Wed 2022-11-09 10:10:08 EST; 1min 45s ago

7.3. 将 Keylime verifier 部署为容器

Keylime 验证器对系统完整性执行初始和定期检查,并支持使用代理安全地 bootstrap 加密密钥。您可以将 Keylime 验证器配置为容器,而不是 RPM 方法,而主机上无需有任何二进制文件或软件包。容器部署提供更好的隔离、模块化和 Keylime 组件的可重复性。

启动容器后,会使用默认的配置文件部署 Keylime 验证器。您可以使用一个或多个以下方法自定义配置:

- 将包含配置文件的目录挂载到容器上。这在所有 RHEL 9 版本中提供。

- 直接在容器上修改环境变量。这在 RHEL 9.3 及更新版本中提供。修改环境变量会覆盖配置文件中的值。

前提条件

-

podman软件包及其依赖项已安装在系统上。 可选:您可以访问 Keylime 保存验证器中数据的数据库。您可以使用以下数据库管理系统:

- SQLite (默认)

- PostgreSQL

- MySQL

- MariaDB

- 您有来自您的证书颁发机构的有效密钥和证书。

流程

可选:安装

keylime-verifier软件包,以访问配置文件。您可以配置没有此软件包的容器,但这可能更容易修改软件包提供的配置文件。# dnf install keylime-verifier通过在

/etc/keylime/verifier.conf.d/目录中创建一个新的.conf文件,来将验证器绑定到所有可用 IP 地址上,例如:/etc/keylime/verifier.conf.d/00-verifier-ip.conf,其内容如下:[verifier] ip = *

-

另外,您还可以使用

port选项更改验证器的端口默认值8881。

-

另外,您还可以使用

可选:为代理列表配置 verifier 的数据库。默认配置使用验证器的

/var/lib/keylime/cv_data.sqlite/目录中的 SQLite 数据库。您可以通过在/etc/keylime/verifier.conf.d/目录中创建一个新的.conf文件来定义一个不同的数据库,例如:/etc/keylime/verifier.conf.d/00-db-url.conf,其内容如下:[verifier] database_url = <protocol>://<name>:<password>@<ip_address_or_hostname>/<properties>将

<protocol>://<name>:<password>@<ip_address_or_hostname>/<properties>替换为数据库的 URL,如postgresql://verifier:UQ?nRNY9g7GZzN7@198.51.100.1/verifierdb。确保您使用的凭证对 Keylime 有权限,以创建数据库结构。

将证书和密钥添加到验证器(verifier)中。您可以让 Keylime 生成它们,或使用现有的密钥和证书生成它们:

-

使用默认

tls_dir = generate选项,Keylime 在/var/lib/keylime/cv_ca/目录中为验证器、注册器和租户生成新证书。 要在配置中加载现有的密钥和证书,请在验证器配置中定义其位置。证书必须可以被运行 Keylime 进程的

keylime用户访问。在

/etc/keylime/verifier.conf.d/目录中创建一个新的.conf文件,例如:/etc/keylime/verifier.conf.d/00-keys-and-certs.conf,其内容如下:[verifier] tls_dir = /var/lib/keylime/cv_ca server_key = </path/to/server_key> server_cert = </path/to/server_cert> trusted_client_ca = ['</path/to/ca/cert1>', '</path/to/ca/cert2>'] client_key = </path/to/client_key> client_cert = </path/to/client_cert> trusted_server_ca = ['</path/to/ca/cert3>', '</path/to/ca/cert4>']

注意使用绝对路径定义密钥和证书位置。或者,相对路径是从

tls_dir选项中定义的目录解析的。

-

使用默认

在防火墙中打开端口:

# firewall-cmd --add-port 8881/tcp # firewall-cmd --runtime-to-permanent

如果您使用其他端口,请将

8881替换为.conf文件中定义的端口号。运行容器:

$ podman run --name keylime-verifier \ -p 8881:8881 \ -v /etc/keylime/verifier.conf.d:/etc/keylime/verifier.conf.d:Z \ -v /var/lib/keylime/cv_ca:/var/lib/keylime/cv_ca:Z \ -d \ -e KEYLIME_VERIFIER_SERVER_KEY_PASSWORD=<passphrase1> \ -e KEYLIME_VERIFIER_CLIENT_KEY_PASSWORD=<passphrase2> \ registry.access.redhat.com/rhel9/keylime-verifier

-

-p选项在主机和容器上打开默认端口8881。 -v选项为目录创建到容器的绑定挂载。-

使用

Z选项,Podman 使用私有未共享标签标记内容。这意味着只有当前容器可以使用私有卷。

-

使用

-

-d选项在后台运行分离的容器。 -

选项

-e KEYLIME_VERIFIER_SERVER_KEY_PASSWORD=<passphrase1>定义服务器密钥密码短语。 -

选项

-e KEYLIME_VERIFIER_CLIENT_KEY_PASSWORD=<passphrase2>定义客户端密钥密码短语。 -

您可以使用选项

-e KEYLIME_VERIFIER_<ENVIRONMENT_VARIABLE>=<value>,使用环境变量覆盖配置选项。要修改附加选项,请为每个环境变量单独插入-e选项。有关环境变量及其默认值的完整列表,请参阅 Keylime 环境变量。

-

验证

检查容器是否正在运行:

$ podman ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 80b6b9dbf57c registry.access.redhat.com/rhel9/keylime-verifier:latest keylime_verifier 14 seconds ago Up 14 seconds 0.0.0.0:8881->8881/tcp keylime-verifier

后续步骤

其他资源

- 有关 Keylime 组件的更多信息,请参阅 Keylime 是如何工作的。

- 有关配置 Keylime 验证器的更多信息,请参阅 配置 Keylime 验证器。

-

有关

podman run命令的更多信息,请参阅系统中的podman-run (1)手册页。

7.4. 从软件包部署 Keylime registrar

注册器是包含所有代理的数据库的 Keylime 组件,它托管 TPM 供应商的公钥。在注册器的 HTTPS 服务接受可信平台模块(TPM)公钥后,它提供了一个接口来获取这些公钥以进行检查配额。

要维护信任链,请保持运行注册器的系统的安全,并在您的控制之下。

您可以根据您的要求,在单独的系统或作为 Keylime 按整齐的同一系统上安装注册器。在单独的系统上运行验证器和注册器可提供更好的性能。

要将配置文件保留在置入目录中,请使用具有两位数字前缀的文件名,例如 /etc/keylime/registrar.conf.d/00-registrar-ip.conf。配置处理以字典顺序读取置入目录中的文件,并对每个选项设置为它读取的最后一个值。

前提条件

- 您有访问安装和运行 Keylime 验证器的系统的网络权限。更多信息请参阅 第 7.2 节 “从软件包部署 Keylime verifier”。

-

您在要安装 Keylime 组件的系统上有

root权限和网络连接。 您可以访问 Keylime 保存来自注册中心的数据的数据库。您可以使用以下数据库管理系统:

- SQLite (默认)

- PostgreSQL

- MySQL

- MariaDB

- 您有来自您的证书颁发机构的有效密钥和证书。

流程

安装 Keylime 注册器:

# dnf install keylime-registrar通过在

/etc/keylime/registrar.conf.d/目录中创建一个新的.conf文件来定义注册中心的 IP 地址和端口,例如:/etc/keylime/registrar.conf.d/00-registrar-ip.conf,其内容如下:[registrar] ip = <registrar_IP_address>-

将

<registrar_IP_address>替换为注册中心的 IP 地址。或者,使用ip = *或ip = 0.0.0.0将注册器绑定到所有可用 IP 地址。 -

可选,使用

port选项更改 Keylime 代理连接的端口。默认值为8890。 -

可选,使用

tls_port选项更改 Keylime 验证器和租户连接的 TLS 端口。默认值为8891。

-

将

可选:为代理列表配置注册数据库。默认配置使用 registrar 的

/var/lib/keylime/reg_data.sqlite目录中的 SQLite 数据库。您可以在/etc/keylime/registrar.conf.d/目录中创建一个新的.conf文件,例如:/etc/keylime/registrar.conf.d/00-db-url.conf,其内容如下:[registrar] database_url = <protocol>://<name>:<password>@<ip_address_or_hostname>/<properties>将

<protocol>://<name>:<password>@<ip_address_or_hostname>/<properties>替换为数据库的 URL,如postgresql://registrar:EKYX-bqY2?#raXm@198.51.100.1/registrardb。确保您使用的凭证对 Keylime 有权限,以创建数据库结构。

在注册器中添加证书和密钥:

-

您可以使用默认配置,并将密钥和证书加载到

/var/lib/keylime/reg_ca/目录中。 或者,您可以在配置中定义密钥和证书的位置。在

/etc/keylime/registrar.conf.d/目录中创建一个新的.conf文件,例如:/etc/keylime/registrar.conf.d/00-keys-and-certs.conf,其内容如下:[registrar] tls_dir = /var/lib/keylime/reg_ca server_key = </path/to/server_key> server_key_password = <passphrase1> server_cert = </path/to/server_cert> trusted_client_ca = ['</path/to/ca/cert1>', '</path/to/ca/cert2>']

注意使用绝对路径定义密钥和证书位置。或者,您可以在

tls_dir选项中定义目录,并使用相对于该目录的路径。

-

您可以使用默认配置,并将密钥和证书加载到

在防火墙中打开端口:

# firewall-cmd --add-port 8890/tcp --add-port 8891/tcp # firewall-cmd --runtime-to-permanent

如果您使用其他端口,请将

8890或8891替换为.conf文件中定义的端口号。启动

keylime_registrar服务:# systemctl enable --now keylime_registrar注意在默认配置中,在启动

keylime_registrar服务前启动keylime_verifier,因为验证器会为其他 Keylime 组件创建 CA 和证书。使用自定义证书时不需要这个顺序。

验证

检查

keylime_registrar服务是否活跃且在运行:# systemctl status keylime_registrar ● keylime_registrar.service - The Keylime registrar service Loaded: loaded (/usr/lib/systemd/system/keylime_registrar.service; disabled; vendor preset: disabled) Active: active (running) since Wed 2022-11-09 10:10:17 EST; 1min 42s ago ...

7.5. 将 Keylime registrar 部署为容器

注册器是包含一个所有代理的数据库的 Keylime 组件,它托管可信平台模块(TPM)提供商的公钥。在注册器的 HTTPS 服务接受 TPM 公钥后,它提供一个接口来获取这些公钥,以检查引用。您可以将 Keylime 注册器配置为一个容器,而不是 RPM 方法,在主机上无需任何二进制文件或软件包。容器部署提供更好的隔离、模块化和 Keylime 组件的可重复性。

启动容器后,会使用默认配置文件部署 Keylime 注册器。您可以使用一个或多个以下方法自定义配置:

- 将包含配置文件的目录挂载到容器上。这在所有 RHEL 9 版本中提供。

- 直接在容器上修改环境变量。这在 RHEL 9.3 及更新版本中提供。修改环境变量会覆盖配置文件中的值。

前提条件

-

podman软件包及其依赖项已安装在系统上。 可选:您可以访问 Keylime 保存注册器中数据的数据库。您可以使用以下数据库管理系统:

- SQLite (默认)

- PostgreSQL

- MySQL

- MariaDB

- 您有来自您的证书颁发机构的有效密钥和证书。

流程

可选:安装

keylime-registrar软件包,以访问配置文件。您可以配置没有此软件包的容器,但这可能更容易修改软件包提供的配置文件。# dnf install keylime-registrar通过在

/etc/keylime/registrar.conf.d/目录中创建一个新的.conf文件,来将注册器绑定到所有可用的 IP 地址,例如/etc/keylime/registrar.conf.d/00-registrar-ip.conf,其内容如下:[registrar] ip = *

-

可选,使用

port选项更改 Keylime 代理连接的端口。默认值为8890。 -

可选,使用

tls_port选项更改 Keylime 租户连接的 TLS 端口。默认值为8891。

-

可选,使用

可选:为代理列表配置注册数据库。默认配置使用 registrar 的

/var/lib/keylime/reg_data.sqlite目录中的 SQLite 数据库。您可以在/etc/keylime/registrar.conf.d/目录中创建一个新的.conf文件,例如:/etc/keylime/registrar.conf.d/00-db-url.conf,其内容如下:[registrar] database_url = <protocol>://<name>:<password>@<ip_address_or_hostname>/<properties>将

<protocol>://<name>:<password>@<ip_address_or_hostname>/<properties>替换为数据库的 URL,如postgresql://registrar:EKYX-bqY2?#raXm@198.51.100.1/registrardb。确保您使用的凭证对 Keylime 有权限,以创建数据库结构。

在注册器中添加证书和密钥:

-

您可以使用默认配置,并将密钥和证书加载到

/var/lib/keylime/reg_ca/目录中。 或者,您可以在配置中定义密钥和证书的位置。在

/etc/keylime/registrar.conf.d/目录中创建一个新的.conf文件,例如:/etc/keylime/registrar.conf.d/00-keys-and-certs.conf,其内容如下:[registrar] tls_dir = /var/lib/keylime/reg_ca server_key = </path/to/server_key> server_cert = </path/to/server_cert> trusted_client_ca = ['</path/to/ca/cert1>', '</path/to/ca/cert2>']

注意使用绝对路径定义密钥和证书位置。或者,您可以在

tls_dir选项中定义目录,并使用相对于该目录的路径。

-

您可以使用默认配置,并将密钥和证书加载到

在防火墙中打开端口:

# firewall-cmd --add-port 8890/tcp --add-port 8891/tcp # firewall-cmd --runtime-to-permanent

如果您使用其他端口,请将

8890或8891替换为.conf文件中定义的端口号。运行容器:

$ podman run --name keylime-registrar \ -p 8890:8890 \ -p 8891:8891 \ -v /etc/keylime/registrar.conf.d:/etc/keylime/registrar.conf.d:Z \ -v /var/lib/keylime/reg_ca:/var/lib/keylime/reg_ca:Z \ -d \ -e KEYLIME_REGISTRAR_SERVER_KEY_PASSWORD=<passphrase1> \ registry.access.redhat.com/rhel9/keylime-registrar

-

-p选项打开主机和容器上的默认端口8890和8881。 -v选项为目录创建到容器的绑定挂载。-

使用

Z选项,Podman 使用私有未共享标签标记内容。这意味着只有当前容器可以使用私有卷。

-

使用

-

-d选项在后台运行分离的容器。 -

选项

-e KEYLIME_VERIFIER_SERVER_KEY_PASSWORD=<passphrase1>定义服务器密钥密码短语。 -

您可以使用选项

-e KEYLIME_REGISTRAR_<ENVIRONMENT_VARIABLE>=<value>,使用环境变量覆盖配置选项。要修改附加选项,请为每个环境变量单独插入-e选项。有关环境变量及其默认值的完整列表,请参阅 第 7.12 节 “Keylime 环境变量”。

-

验证

检查容器是否正在运行:

$ podman ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 07d4b4bff1b6 localhost/keylime-registrar:latest keylime_registrar 12 seconds ago Up 12 seconds 0.0.0.0:8881->8881/tcp, 0.0.0.0:8891->8891/tcp keylime-registrar

其他资源

- 有关 Keylime 组件的更多信息,请参阅 第 7.1 节 “Keylime 的工作原理”。

- 有关配置 Keylime 注册器的更多信息,请参阅 第 7.4 节 “从软件包部署 Keylime registrar”。

-

有关

podman run命令的更多信息,请参阅系统中的podman-run (1)手册页。

7.6. 使用 RHEL 系统角色部署 Keylime 服务器

您可以使用 keylime_server RHEL 系统角色设置验证器和注册器,它们是 Keylime 服务器组件。keylime_server 角色在每个节点上安装和配置 verifier 和 registrar 组件。

在 Ansible 控制节点上执行此步骤。

有关 Keylime 的更多信息,请参阅 8.1。Keylime 是如何工作的。

前提条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

用于连接到受管节点的帐户具有

sudo权限。 - 要在其上运行此 playbook 的受管节点或受管节点组列在 Ansible 清单文件中。

流程

创建定义所需角色的 playbook:

创建新 YAML 文件,并在文本编辑器中打开,例如:

# vi keylime-playbook.yml插入以下内容:

--- - name: Manage keylime servers hosts: all vars: keylime_server_verifier_ip: "{{ ansible_host }}" keylime_server_registrar_ip: "{{ ansible_host }}" keylime_server_verifier_tls_dir: <ver_tls_directory> keylime_server_verifier_server_cert: <ver_server_certfile> keylime_server_verifier_server_key: <ver_server_key> keylime_server_verifier_server_key_passphrase: <ver_server_key_passphrase> keylime_server_verifier_trusted_client_ca: <ver_trusted_client_ca_list> keylime_server_verifier_client_cert: <ver_client_certfile> keylime_server_verifier_client_key: <ver_client_key> keylime_server_verifier_client_key_passphrase: <ver_client_key_passphrase> keylime_server_verifier_trusted_server_ca: <ver_trusted_server_ca_list> keylime_server_registrar_tls_dir: <reg_tls_directory> keylime_server_registrar_server_cert: <reg_server_certfile> keylime_server_registrar_server_key: <reg_server_key> keylime_server_registrar_server_key_passphrase: <reg_server_key_passphrase> keylime_server_registrar_trusted_client_ca: <reg_trusted_client_ca_list> roles: - rhel-system-roles.keylime_server您可以在 keylime_server RHEL 系统角色的变量 中找到更多有关变量的信息。

运行 playbook:

$ ansible-playbook <keylime-playbook.yml>

验证

检查

keylime_verifier服务是否活跃并在受管主机上运行:# systemctl status keylime_verifier ● keylime_verifier.service - The Keylime verifier Loaded: loaded (/usr/lib/systemd/system/keylime_verifier.service; disabled; vendor preset: disabled) Active: active (running) since Wed 2022-11-09 10:10:08 EST; 1min 45s ago检查

keylime_registrar服务是否活跃且在运行:# systemctl status keylime_registrar ● keylime_registrar.service - The Keylime registrar service Loaded: loaded (/usr/lib/systemd/system/keylime_registrar.service; disabled; vendor preset: disabled) Active: active (running) since Wed 2022-11-09 10:10:17 EST; 1min 42s ago ...

7.7. keylime_server RHEL 系统角色的变量

当使用 keylime_server RHEL 系统角色设置 Keylime 服务器时,您可以为注册器和验证器自定义以下变量。

用于配置 Keylime 验证器的 keylime_server RHEL 系统角色变量的列表

keylime_server_verifier_ip- 定义 verifier 的 IP 地址。

keylime_server_verifier_tls_dir-

指定存储密钥和证书的目录。如果设置为 default,verifier 将使用

/var/lib/keylime/cv_ca目录。 keylime_server_verifier_server_key_passphrase- 指定解密服务器私钥的密码短语。如果值为空,则私钥没有加密。

keylime_server_verifier_server_cert:指定 Keylime verifier 服务器证书文件。

keylime_server_verifier_trusted_client_ca-

定义可信客户端 CA 证书的列表。您必须将文件存储在

keylime_server_verifier_tls_dir选项中设置的目录中。 keylime_server_verifier_client_key- 定义包含 Keylime verifier 私钥的文件。

keylime_server_verifier_client_key_passphrase- 定义解密客户端私钥文件的密码短语。如果值为空,则私钥没有加密。

keylime_server_verifier_client_cert- 定义 Keylime verifier 客户端证书文件。

keylime_server_verifier_trusted_server_ca-

定义可信服务器 CA 证书的列表。您必须将文件存储在

keylime_server_verifier_tls_dir选项中设置的目录中。

用于设置 keylime_server RHEL 系统角色的注册器变量的列表

keylime_server_registrar_ip- 定义 registrar 的 IP 地址。

keylime_server_registrar_tls_dir-

指定存储 registrar 密钥和证书的目录。如果将其设置为 default,registrar 将使用

/var/lib/keylime/reg_ca目录。 keylime_server_registrar_server_key- 定义 Keylime registrar 私有服务器密钥文件。

keylime_server_registrar_server_key_passphrase- 指定解密 registrar 的服务器私钥的密码短语。如果值为空,则私钥没有加密。

keylime_server_registrar_server_cert- 指定 Keylime registrar 服务器证书文件。

keylime_server_registrar_trusted_client_ca-

定义可信客户端 CA 证书的列表。您必须将文件存储在

keylime_server_registrar_tls_dir选项中设置的目录中。

7.8. 从软件包部署 Keylime 租户

Keylime 对许多功能使用 keylime_tenant 工具,包括在目标系统上置备代理。您可以在任何系统上安装 keylime_tenant,包括运行其他 Keylime 组件的系统,或者根据要求在单独的系统上安装。

前提条件

-

您在要安装 Keylime 组件的系统上有

root权限和网络连接。 您对配置了其他 Keylime 组件的系统有网络访问权限:

- 验证器

- 更多信息请参阅 第 7.2 节 “从软件包部署 Keylime verifier”。

- 注册器

- 更多信息请参阅 第 7.4 节 “从软件包部署 Keylime registrar”。

流程

安装 Keylime 租户:

# dnf install keylime-tenant通过编辑

/etc/keylime/tenant.conf.d/00-verifier-ip.conf文件将租户的连接定义到 Keylime 验证器的连接:[tenant] verifier_ip = <verifier_ip>-

将

<verifier_ip>替换为验证器系统的 IP 地址。 -

如果验证器使用与默认值

8881不同的端口,请添加verifier_port = <verifier_port>设置。

-

将

通过编辑

/etc/keylime/tenant.conf.d/00-registrar-ip.conf文件将租户的连接定义到 Keylime 注册器的连接:[tenant] registrar_ip = <registrar_ip>-

将

<registrar_ip>替换为注册器系统的 IP 地址。 -

如果注册器使用与默认值

8891不同的端口,请添加registrar_port = <registrar_port>设置。

-

将

在租户中添加证书和密钥:

-

您可以使用默认配置,并将密钥和证书加载到

/var/lib/keylime/cv_ca目录。 或者,您可以在配置中定义密钥和证书的位置。在

/etc/keylime/tenant.conf.d/目录中创建一个新的.conf文件,例如:/etc/keylime/tenant.conf.d/00-keys-and-certs.conf,其内容如下:[tenant] tls_dir = /var/lib/keylime/cv_ca client_key = tenant-key.pem client_key_password = <passphrase1> client_cert = tenant-cert.pem trusted_server_ca = ['</path/to/ca/cert>']

trusted_server_ca参数接受到验证器和注册器服务器 CA 证书的路径。您可以提供多个以逗号分隔的路径,例如,验证器和注册器使用不同的 CA。注意使用绝对路径定义密钥和证书位置。或者,您可以在

tls_dir选项中定义目录,并使用相对于该目录的路径。

-

您可以使用默认配置,并将密钥和证书加载到

-

可选:如果无法使用

/var/lib/keylime/tpm_cert_store目录中的证书验证可信平台模块(TPM)签署密钥(EK),请将证书添加到该目录。这在使用具有模拟 TPM 的虚拟机时会出现这种情况。

验证

检查 verifier 的状态:

# keylime_tenant -c cvstatus Reading configuration from ['/etc/keylime/logging.conf'] 2022-10-14 12:56:08.155 - keylime.tpm - INFO - TPM2-TOOLS Version: 5.2 Reading configuration from ['/etc/keylime/tenant.conf'] 2022-10-14 12:56:08.157 - keylime.tenant - INFO - Setting up client TLS... 2022-10-14 12:56:08.158 - keylime.tenant - INFO - Using default client_cert option for tenant 2022-10-14 12:56:08.158 - keylime.tenant - INFO - Using default client_key option for tenant 2022-10-14 12:56:08.178 - keylime.tenant - INFO - TLS is enabled. 2022-10-14 12:56:08.178 - keylime.tenant - WARNING - Using default UUID d432fbb3-d2f1-4a97-9ef7-75bd81c00000 2022-10-14 12:56:08.221 - keylime.tenant - INFO - Verifier at 127.0.0.1 with Port 8881 does not have agent d432fbb3-d2f1-4a97-9ef7-75bd81c00000.如果正确设置了,且没有配置代理,验证器会响应它无法识别的默认代理 UUID。

检查 registrar 的状态:

# keylime_tenant -c regstatus Reading configuration from ['/etc/keylime/logging.conf'] 2022-10-14 12:56:02.114 - keylime.tpm - INFO - TPM2-TOOLS Version: 5.2 Reading configuration from ['/etc/keylime/tenant.conf'] 2022-10-14 12:56:02.116 - keylime.tenant - INFO - Setting up client TLS... 2022-10-14 12:56:02.116 - keylime.tenant - INFO - Using default client_cert option for tenant 2022-10-14 12:56:02.116 - keylime.tenant - INFO - Using default client_key option for tenant 2022-10-14 12:56:02.137 - keylime.tenant - INFO - TLS is enabled. 2022-10-14 12:56:02.137 - keylime.tenant - WARNING - Using default UUID d432fbb3-d2f1-4a97-9ef7-75bd81c00000 2022-10-14 12:56:02.171 - keylime.registrar_client - CRITICAL - Error: could not get agent d432fbb3-d2f1-4a97-9ef7-75bd81c00000 data from Registrar Server: 404 2022-10-14 12:56:02.172 - keylime.registrar_client - CRITICAL - Response code 404: agent d432fbb3-d2f1-4a97-9ef7-75bd81c00000 not found 2022-10-14 12:56:02.172 - keylime.tenant - INFO - Agent d432fbb3-d2f1-4a97-9ef7-75bd81c00000 does not exist on the registrar. Please register the agent with the registrar. 2022-10-14 12:56:02.172 - keylime.tenant - INFO - {"code": 404, "status": "Agent d432fbb3-d2f1-4a97-9ef7-75bd81c00000 does not exist on registrar 127.0.0.1 port 8891.", "results": {}}如果正确设置了,且没有配置代理,注册器会响应它无法识别的默认代理 UUID。

其他资源

-

对于

keylime_tenant工具程序的额外高级选项,请输入keylime_tenant -h命令。

7.9. 从软件包部署 Keylime 代理

Keylime 代理是部署到被 Keylime 监控的所有系统的组件。

默认情况下,Keylime 代理将其所有数据保存在被监控系统的 /var/lib/keylime/ 目录中。

要将配置文件保留在置入目录中,请使用具有两位数字前缀的文件名,例如 /etc/keylime/agent.conf.d/00-registrar-ip.conf。配置处理以字典顺序读取置入目录中的文件,并对每个选项设置为它读取的最后一个值。

前提条件

-

您有对被监控系统的

root权限。 -

监控的系统有一个受信任的平台模块(TPM)。要验证,请输入

tpm2_pcrread命令。如果输出返回多个哈希,则代表 TPM 可用。 您对配置了其他 Keylime 组件的系统有网络访问权限:

- 验证器

- 如需更多信息,请参阅 配置 Keylime 验证器。

- 注册器

- 如需更多信息,请参阅 配置 Keylime 注册器。

- 租户

- 如需更多信息,请参阅 配置 Keylime 租户。

- 在监控的系统上启用了完整性测量架构(IMA)。如需更多信息,请参阅 启用完整性测量架构和扩展验证模块。

流程

安装 Keylime 代理:

# dnf install keylime-agent这个命令会安装

keylime-agent-rust软件包。在配置文件中定义代理的 IP 地址和端口。在

/etc/keylime/agent.conf.d/目录中创建一个新的.conf文件,例如:/etc/keylime/agent.conf.d/00-agent-ip.conf,其内容如下:[agent] ip = '<agent_ip>'注意Keylime 代理配置使用 TOML 格式,它与用于其他组件配置的 INI 格式不同。因此,使用有效 TOML 语法输入值,例如,在带单引号的路径以及带方括号的多个路径的数组。

-

将

<agent_IP_address>替换为代理的 IP 地址。或者,使用ip = '*'或ip = '0.0.0.0'将代理绑定到所有可用 IP 地址。 -

另外,您还可以使用

port = '<agent_port>'选项更改代理端口的默认值9002。

-

将

在配置文件中定义注册的 IP 地址和端口。在

/etc/keylime/agent.conf.d/目录中创建一个新的.conf文件,例如:/etc/keylime/agent.conf.d/00-registrar-ip.conf,其内容如下:[agent] registrar_ip = '<registrar_IP_address>'-

将

<registrar_IP_address>替换为注册中心的 IP 地址。 -

另外,您还可以使用