호스팅된 컨트롤 플레인

OpenShift Container Platform에서 호스팅된 컨트롤 플레인 사용

초록

1장. 호스팅된 컨트롤 플레인 릴리스 노트

릴리스 노트에는 사용되지 않는 새로운 기능, 변경 사항 및 알려진 문제에 대한 정보가 포함되어 있습니다.

1.1. OpenShift Container Platform 4.20의 호스팅된 컨트롤 플레인 릴리스 노트

이번 릴리스에서는 OpenShift Container Platform 4.20의 호스팅된 컨트롤 플레인을 사용할 수 있습니다. OpenShift Container Platform 4.20의 호스팅된 컨트롤 플레인은 Kubernetes Operator 버전 2.10에 대한 다중 클러스터 엔진을 지원합니다.

1.1.1. 새로운 기능 및 개선 사항

1.1.1.1. 호스트 클러스터에서 워크로드 확장

이제 호스팅된 클러스터의 워크로드를 축소하지 않고 scale UpOnly 동작을 사용하여 워크로드를 확장할 수 있습니다. 자세한 내용은 호스팅 클러스터의 워크로드 확장을 참조하십시오.

1.1.1.2. 호스트 클러스터에서 워크로드 확장 및 축소

이제 호스팅된 클러스터에서 scale UpAndScaleDown 동작을 사용하여 워크로드를 확장하고 축소할 수 있습니다. 자세한 내용은 호스트 클러스터의 워크로드 확장 및 축소를 참조하십시오.

1.1.1.3. 호스트 클러스터에서 무시된 라벨의 균형 조정

노드 풀을 확장한 후 balancingIgnoredLabels 를 설정하여 노드 풀에 머신을 균등하게 배포할 수 있습니다. 자세한 내용은 호스트 클러스터에서 분산을 무시한 라벨을 참조하십시오.

1.1.1.4. 호스트 클러스터에서 우선순위 확장기 설정

이제 호스트 클러스터에서 우선 순위 확장기를 구성하여 우선 순위가 낮은 머신보다 우선 순위가 높은 머신을 생성할 수 있습니다. 자세한 내용은 호스팅 클러스터에서 우선순위 확장기 설정을 참조하십시오.

1.1.1.5. 연결이 끊긴 환경에서 IBM Z의 호스팅된 컨트롤 플레인은 일반적으로 사용 가능

이 릴리스에서 연결이 끊긴 환경에서 IBM Z의 호스팅 컨트롤 플레인은 일반 Availablilty 기능입니다. 자세한 내용은 연결이 끊긴 환경에서 IBM Z에 호스팅된 컨트롤 플레인 배포를 참조하십시오.

1.1.2. 버그 수정

-

이번 업데이트 이전에는

hc.spec.configuration.apiServer.servingCerts.namedCertificates의 사용자 정의 인증서에 대한 SAN 검증에서*.example.com과 같은 와일드카드 DNS 패턴을 올바르게 처리하지 못했습니다. 결과적으로 사용자 정의 인증서의 와일드카드 DNS 패턴은 탐지되지 않고 내부 Kubernetes API 서버 인증서 SAN과 충돌하여 인증서 검증 실패 및 잠재적인 배포 문제가 발생할 수 있었습니다. 이 릴리스에서는 RFC 호환 와일드카드 지원을 포함하도록 향상된 DNS SAN 충돌 감지 기능을 제공하여*.example.com일치하는 와일드카드 패턴을 올바르게 처리하는 양방향 충돌 검증을 구현합니다.결과적으로 와일드카드 DNS 패턴이 올바르게 검증되어 인증서 충돌을 방지하고 와일드카드 인증서 지원을 통해 더 안정적인 호스트 클러스터 배포를 보장합니다. (OCPBUGS-60381) -

이번 업데이트 이전에는 Azure 클라우드 공급자가 Azure 로드 밸런서에 대해 기본 ping 대상인

HTTP:10256/healthz를 설정하지 않았습니다. 대신 Azure에서 실행된LoadBalancer유형의 서비스에는TCP:30810의 ping 대상이 있었습니다. 그 결과 클러스터 전체 서비스에 대한 상태 프로브가 작동하지 않았으며 업그레이드 중에 다운타임이 발생했습니다. 이번 릴리스에서는 클라우드 구성의ClusterServiceLoadBalancerHealthProbeMode속성이shared로 설정됩니다. 결과적으로 Azure의 로드 밸런서에는 노드에서 실행되는kube-proxy상태 끝점을 가리키는HTTP:10256/healthz올바른 상태 점검 대상인 HTTP:10256/healthz가 있습니다. (OCPBUGS-58031) -

이번 업데이트 이전에는

HostedCluster리소스에서additionalTrustBundle매개변수를 제거한 후 HyperShift Operator에서user-ca-bundle구성 맵을 지우지 못했습니다. 그 결과user-ca-bundle구성 맵이 업데이트되지 않아 Ignition 페이로드를 생성하지 못했습니다. 이번 릴리스에서는 HyperShift Operator가HostedCluster리소스에서 제거될 때 컨트롤 플레인 네임스페이스에서user-ca-bundle구성 맵을 적극적으로 제거합니다. 결과적으로user-ca-bundle구성 맵이 올바르게 지워 ignition 페이로드 생성이 활성화됩니다. (OCPBUGS-57336) -

이번 업데이트 이전에는 Kubernetes API 서버 서비스 게시 전략이

PublicAndPrivate엔드포인트 액세스를 통해LoadBalancer인 경우 외부 DNS Operator가 DNS 레코드를 등록하지 않은 경우에도 프라이빗 라우터에서 OAuth 경로를 허용한 경우 AWS에서 호스팅 클러스터를 생성하려고 했습니다. 그 결과 개인 라우터에서 경로 URL을 올바르게 확인하지 못했으며 OAuth 서버에 액세스할 수 없었습니다. Console Cluster Operator도 시작되지 않았으며 호스트 클러스터 설치에 실패했습니다. 이번 릴리스에서는 개인 라우터가 외부 DNS가 정의된 경우에만 OAuth 경로를 허용합니다. 그렇지 않으면 라우터가 관리 클러스터의 경로를 허용합니다. 결과적으로 OAuth 경로에 액세스하고 Console Cluster Operator가 올바르게 시작되고 호스팅 클러스터 설치에 성공합니다. (OCPBUGS-56914) -

이번 릴리스 이전에는 관리 OpenShift 클러스터의 IDMS 또는 ICSP에서 registry.redhat.io 또는 registry.redhat.io/redhat을 가리키는 소스를 정의하고 미러 레지스트리에 필요한 OLM 카탈로그 이미지가 포함되지 않은 경우, 무단 이미지 가져오기로 인해

HostedCluster리소스에 대한 프로비저닝이 중단되었습니다. 그 결과HostedCluster리소스가 배포되지 않았으며 미러링된 레지스트리에서 필수 카탈로그 이미지를 가져올 수 없는 차단된 상태로 남아 있었습니다. 이번 릴리스에서는 권한 부여 오류로 인해 필요한 이미지를 가져올 수 없는 경우 이제 프로비저닝이 명시적으로 실패합니다. OLM CatalogSource 이미지 확인을 위해 레지스트리 재정의 논리가 레지스트리의 루트(예: registry.redhat.io)의 일치를 허용하도록 개선되었습니다. 레지스트리 덮어쓰기에서 작동 중인 이미지를 생성하지 않는 경우 원래ImageReference를 사용하기 위한 대체 메커니즘도 도입되었습니다. 결과적으로 적절한 경우 시스템이 원래 소스에서 올바르게 가져오기 때문에 미러 레지스트리에 필요한 OLM 카탈로그 이미지가 없는 경우에도HostedCluster리소스를 성공적으로 배포할 수 있습니다. (OCPBUGS-56492) -

이번 업데이트 이전에는 AWS 클라우드 공급자가 AWS 로드 밸런서에 대해 기본 ping 대상인

HTTP:10256/healthz를 설정하지 않았습니다. AWS에서 실행되는LoadBalancer유형의 서비스의 경우 AWS에서 생성된 로드 밸런서 오브젝트에는TCP:32518의 ping 대상이 있습니다. 그 결과 클러스터 전체 서비스에 대한 상태 프로브가 작동하지 않았으며 업그레이드하는 동안 해당 서비스가 중단되었습니다. 이번 릴리스에서는 클라우드 구성의ClusterServiceLoadBalancerHealthProbeMode속성이Shared로 설정됩니다. 이 클라우드 구성은 AWS 클라우드 공급자에게 전달됩니다. 결과적으로 AWS의 로드 밸런서에는 노드에서 실행 중인kube-proxy상태 끝점을 가리키는 올바른 상태 점검 ping 대상인HTTP:10256/healthz가 있습니다. (OCPBUGS-56011) -

이번 업데이트 이전에는

--disable-cluster-capabilities옵션을 사용하여 이미지 레지스트리 기능을 비활성화하면 호스팅된 컨트롤 플레인에서 이미지 레지스트리에 대한 관리 ID를 구성해야 합니다. 이번 릴리스에서는 이미지 레지스트리가 비활성화되면 이미지 레지스트리 관리 ID 구성이 선택 사항입니다. (OCPBUGS-55892) -

이번 업데이트 이전에는 관리 클러스터의

ImageDigestMirrorSet(IDMS) 및ImageContentSourcePolicy(ICSP) 리소스가 이미지 교체를 위해 루트 레지스트리 이름만 미러 또는 소스로 지정할 수 있다는 점을 고려하지 않고 처리되었습니다. 그 결과 루트 레지스트리 이름만 사용한 IDMS 및 ICSP 항목이 예상대로 작동하지 않았습니다. 이번 릴리스에서는 미러 교체 논리에서 루트 레지스트리 이름만 제공되는 경우를 올바르게 처리합니다. 결과적으로 문제가 더 이상 발생하지 않으며 루트 레지스트리 미러 교체가 지원됩니다. (OCPBUGS-54483) -

이번 업데이트 이전에는 호스팅된 컨트롤 플레인이

HostedCluster리소스에 레지스트리 메타데이터 및 릴리스 이미지 공급자 캐시를 올바르게 유지하지 않았습니다. 그 결과HostedCluster컨트롤러 조정에서 릴리스 및 이미지 메타데이터의 캐시가 재설정되었습니다. 이번 릴리스에서는HostedCluster리소스에서 캐시 손실을 수정하는 데 사용하는 일반적인 레지스트리 공급자가 도입되었습니다. 이렇게 하면 이미지 풀 및 네트워크 트래픽 수가 줄어들어 전체 성능이 향상됩니다. (OCPBUGS-53259) -

이번 업데이트 이전에는 클라이언트 시크릿을 지정하지 않은 OIDC 클라이언트를 사용하여

HostedCluster리소스에 대해 OIDC 공급자를 구성하면 시스템에서 기본 시크릿 이름을 자동으로 생성합니다. 결과적으로 보안을 사용하지 않는 OIDC 공용 클라이언트를 구성할 수 없었습니다. 이 릴리스에서는 이 문제가 해결되었습니다. 클라이언트 시크릿을 제공하지 않으면 기본 시크릿 이름이 생성되지 않으므로 공용 클라이언트에 대한 적절한 지원이 활성화됩니다. (OCPBUGS-58149) - 이번 업데이트 이전에는 여러 미러 이미지로 인해 이미지 조회 실패로 인해 호스팅된 컨트롤 플레인 페이로드 오류가 발생했습니다. 이로 인해 사용자가 호스팅된 클러스터를 생성할 수 없었습니다. 이번 릴리스에서는 호스트된 컨트롤 플레인 페이로드에서 여러 미러를 지원하므로 기본 미러를 사용할 수 없는 경우 오류가 발생하지 않습니다. 결과적으로 사용자는 호스팅된 클러스터를 생성할 수 있습니다. (OCPBUGS-54720)

이번 업데이트 이전에는 호스팅 클러스터가 시간이 지남에 따라 여러 버전으로 업그레이드되면

HostedCluster리소스의 버전 기록이 10개의 항목을 초과하는 경우가 있었습니다. 그러나 API에는 버전 기록 필드에 대해 최대 10개의 항목의 엄격한 검증 제한이 있었습니다. 결과적으로 버전 기록이 10개의 항목을 초과하면 사용자가HostedCluster리소스를 편집하거나 업데이트할 수 없었습니다. 주석 추가(예: 클러스터 크기 덮어쓰기의 경우) 또는 요청 제공 노드 크기 조정과 같은 유지 관리 작업을 수행하는 작업은 "status.version.history: Too many: 11: must have at most 10 items"로 검증 오류로 실패했습니다. 이 오류로 인해 ROSA SREs가 고객 API 액세스에 영향을 미칠 수 있는 중요한 유지 관리 작업을 수행하지 못했습니다.이번 릴리스에서는

HostedClusterAPI의 버전 기록 필드에서 최대 항목 검증 제약 조건이 제거되어 검증 오류를 트리거하지 않고 기록이 10개 항목 이상으로 증가할 수 있습니다. 결과적으로 이제 버전 기록에 있는 항목 수와 관계없이HostedCluster리소스를 편집하고 업데이트할 수 있으므로 관리자가 여러 버전 업그레이드가 발생한 클러스터에서 필요한 유지 관리 작업을 수행할 수 있습니다. (OCPBUGS-58200)이번 업데이트 이전에는 CLI 리팩토링에 따라

MarkPersistentFlagRequired함수가 올바르게 작동을 중지했습니다. 클러스터 생성에 중요한--name및--pull-secret플래그는 필수로 표시되지만 검증은 적용되지 않았습니다. 결과적으로 사용자는 필요한--name또는--pull-secret플래그를 제공하지 않고hypershift create cluster명령을 실행할 수 있었으며 CLI에서 이러한 필수 플래그가 누락되었다고 즉시 경고하지 않았습니다. 이로 인해 배포가 잘못 구성되고 나중에 오류 메시지가 혼동될 수 있었습니다.이번 릴리스에서는

RawCreateOptions.Validate()함수에 명시적으로 검증하여--name및--pull-secret플래그가 있는지 확인하여 플래그 중 하나가 누락되었을 때 명확한 오류 메시지를 반환합니다. 또한 올바른 검증을 보장하기 위해 기본 "example" 값이 name 필드에서 제거됩니다. 결과적으로 사용자가 필수--name또는--pull-secret플래그 없이 클러스터를 생성하려고 하면 이제 필요한 플래그가 누락되었음을 나타내는 즉각적이고 명확한 오류 메시지가 표시됩니다(예: "Error: --name is required" 또는 "Error: --pull-secret is required"), 이로 인해 잘못 구성된 배포를 방지하고 사용자 환경을 개선할 수 있습니다. (OCPBUGS-37323)이번 업데이트 이전에는

GetSupportedOCPVersions()함수의 변수 섀도우 버그로 인해supportedVersions변수가:=대신=을 사용하여 잘못 할당되어 의도한 외부 범위 변수를 업데이트하지 않고 즉시 삭제되었던 로컬 변수를 생성했습니다. 결과적으로 사용자가 HyperShift Operator를 사용하여hypershift version명령을 실행할 때 CLI는 서버 버전에 <unknown>을 표시하거나 "nil pointer dereference" 오류와 함께 패닉을 표시하여 사용자가 배포된 HyperShift Operator 버전을 확인하지 못하도록 합니다.이번 릴리스에서는

GetSupportedOCPVersions()함수의supportedVersions :=에서supportedVersions =로 변수 할당을 수정하여 구성 맵을 외부 범위 변수에 적절하게 할당하여 지원되는 버전 데이터가 올바르게 입력되도록 합니다. 결과적으로 HyperShift Operator가 배포되고 실행 중인 Operator버전을 확인할 수 있도록 hypershift버전 명령에서 서버 버전(예: 서버 버전: f001510b35842df352d1ab55d961be3fdc2dae32")이 올바르게 표시됩니다. (OCPBUGS-57316)- 이번 업데이트 이전에는 HyperShift Operator가 모든 경우에 Kubernetes API Server SAN(주체 대체 이름)을 검증했습니다. 결과적으로 사용자는 PKI(공개 키 인프라) 조정 중에 잘못된 API 서버 SAN이 발생하는 경우가 있었습니다. 이번 릴리스에서는 PKI 조정이 비활성화되지 않은 경우에만 Kubernetes API 서버 SAN의 유효성을 검사합니다. (OCPBUGS-56457)

이번 업데이트 이전에는 공유 수신 컨트롤러에서

HostedCluster.Spec.KubeAPIServerDNSName필드를 처리하지 않았으므로 사용자 정의 kube-apiserver DNS 이름이 라우터 구성에 추가되지 않았습니다. 그 결과 사용자 정의 DNS 이름(HostedCluster.Spec.KubeAPIServerDNSName을 통해)을 사용하는 호스팅된 컨트롤 플레인에서 kube-apiserver로 향하는 트래픽이 올바르게 라우팅되지 않아KubeAPIExternalName기능이 공유 수신을 사용하는 플랫폼에서 작동하지 않습니다.이번 릴리스에서는 공유 수신 컨트롤러에

HostedCluster.Spec.KubeAPIServerDNSName에 대한 처리가 추가되었습니다. 호스트 클러스터가 사용자 지정 kube-apiserver DNS 이름을 지정하면 컨트롤러가 이제 트래픽을 kube-apiserver 서비스로 보내는 경로를 자동으로 생성합니다. 결과적으로 사용자 정의 kube-apiserver DNS 이름으로 향하는 트래픽이 공유 수신 컨트롤러에서 올바르게 라우팅되므로KubeAPIExternalName기능이 공유 수신을 사용하는 플랫폼에서 작동할 수 있습니다. (OCPBUGS-57790)

1.1.3. 확인된 문제

-

주석 및

ManagedCluster리소스 이름이 일치하지 않으면 Kubernetes Operator 콘솔의 다중 클러스터 엔진에 클러스터가Pending 가져오기로 표시됩니다. 다중 클러스터 엔진 Operator는 클러스터를 사용할 수 없습니다. 주석이 없고ManagedCluster이름이HostedCluster리소스의Infra-ID값과 일치하지 않는 경우에도 동일한 문제가 발생합니다. - Kubernetes Operator 콘솔에 다중 클러스터 엔진을 사용하여 기존 호스트 클러스터에 새 노드 풀을 추가하면 동일한 OpenShift Container Platform 버전이 옵션 목록에 두 번 이상 표시될 수 있습니다. 원하는 버전의 목록에서 인스턴스를 선택할 수 있습니다.

노드 풀이 작업자가 0개로 축소되면 콘솔의 호스트 목록에는 노드가

준비됨 상태로 계속 표시됩니다. 다음 두 가지 방법으로 노드 수를 확인할 수 있습니다.- 콘솔에서 노드 풀로 이동하여 0개의 노드가 있는지 확인합니다.

명령줄 인터페이스에서 다음 명령을 실행합니다.

다음 명령을 실행하여 0개의 노드가 노드 풀에 있는지 확인합니다.

oc get nodepool -A

$ oc get nodepool -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 0 노드가 클러스터에 있는지 확인합니다.

oc get nodes --kubeconfig

$ oc get nodes --kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 0 에이전트가 클러스터에 바인딩된 것으로 보고되었는지 확인합니다.

oc get agents -A

$ oc get agents -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

듀얼 스택 네트워크를 사용하는 환경에서 호스팅 클러스터를 생성할 때

ContainerCreating상태에서 Pod가 중단될 수 있습니다. 이 문제는openshift-service-ca-operator리소스에서 DNS 확인에 필요한metrics-tls시크릿을 생성할 수 없기 때문에 발생합니다. 결과적으로 Pod는 Kubernetes API 서버를 확인할 수 없습니다. 이 문제를 해결하려면 듀얼 스택 네트워크의 DNS 서버 설정을 구성합니다. 관리 클러스터와 동일한 네임스페이스에 호스팅 클러스터를 생성한 경우 관리형 호스팅 클러스터를 분리하면 호스팅 클러스터를 포함하여 관리 클러스터 네임스페이스의 모든 항목이 삭제됩니다. 다음 상황에서는 관리 클러스터와 동일한 네임스페이스에 호스팅 클러스터를 생성할 수 있습니다.

- 기본 호스팅 클러스터 네임스페이스를 사용하여 Kubernetes Operator 콘솔용 다중 클러스터 엔진을 통해 에이전트 플랫폼에 호스팅된 클러스터를 생성하셨습니다.

- 호스팅된 클러스터 네임스페이스를 호스팅된 클러스터 이름과 동일하게 지정하여 명령줄 인터페이스 또는 API를 통해 호스팅된 클러스터를 생성하셨습니다.

-

콘솔 또는 API를 사용하여 호스트 클러스터의

spec.services.servicePublishingStrategy.nodePort.address필드에 IPv6 주소를 지정하면 8 hextets가 있는 전체 IPv6 주소가 필요합니다. 예를 들어2620:52:0:1306::30을 지정하는 대신2620:52:0:1306:0:0:0:30을 지정해야 합니다.

1.1.4. 일반 가용성 및 기술 프리뷰 기능

이 릴리스의 일부 기능은 현재 기술 프리뷰 단계에 있습니다. 이러한 실험적 기능은 프로덕션용이 아닙니다. 이러한 기능에 대한 지원 범위에 대한 자세한 내용은 Red Hat 고객 포털에서 기술 프리뷰 기능 지원 범위를 참조하십시오.

IBM Power 및 IBM Z의 경우 다음과 같은 예외가 적용됩니다.

- 버전 4.20 이상의 경우 64비트 x86 아키텍처 또는 s390x 아키텍처를 기반으로 하는 머신 유형 및 IBM Power 또는 IBM Z에서 노드 풀을 실행해야 합니다.

- 버전 4.19 이하의 경우 64비트 x86 아키텍처를 기반으로 하는 머신 유형 및 IBM Power 또는 IBM Z의 노드 풀에서 컨트롤 플레인을 실행해야 합니다.

| 기능 | 4.18 | 4.19 | 4.20 |

|---|---|---|---|

| 베어 메탈이 아닌 에이전트 시스템을 사용하는 OpenShift Container Platform용 호스팅 컨트롤 플레인 | 기술 프리뷰 | 기술 프리뷰 | 기술 프리뷰 |

| RHOSP의 OpenShift Container Platform용 호스팅 컨트롤 플레인 | 개발자 프리뷰 | 기술 프리뷰 | 기술 프리뷰 |

| 사용자 정의 테인트 및 톨러레이션 | 기술 프리뷰 | 기술 프리뷰 | 기술 프리뷰 |

| OpenShift Virtualization을 위해 호스팅된 컨트롤 플레인의 NVIDIA GPU 장치 | 기술 프리뷰 | 기술 프리뷰 | 기술 프리뷰 |

| 연결이 끊긴 환경에서 IBM Z에서 호스팅되는 컨트롤 플레인 | 기술 프리뷰 | 기술 프리뷰 | 일반적으로 사용 가능 |

2장. 호스팅된 컨트롤 플레인 개요

독립 실행형 또는 호스팅된 컨트롤 플레인 구성의 두 가지 다른 컨트롤 플레인 구성을 사용하여 OpenShift Container Platform 클러스터를 배포할 수 있습니다. 독립 실행형 구성은 전용 가상 머신 또는 물리적 시스템을 사용하여 컨트롤 플레인을 호스팅합니다. OpenShift Container Platform의 호스팅된 컨트롤 플레인을 사용하면 각 컨트롤 플레인의 전용 가상 또는 물리적 머신 없이도 관리 클러스터에서 컨트롤 플레인을 Pod로 생성합니다.

2.1. 호스트된 컨트롤 플레인 소개

호스팅되는 컨트롤 플레인은 다음 플랫폼에서 Kubernetes Operator에 지원되는 멀티 클러스터 엔진 버전을 사용하여 사용할 수 있습니다.

- 에이전트 공급자를 사용하여 베어 메탈

- 비베어 메탈 에이전트 시스템, 기술 프리뷰 기능

- OpenShift Virtualization

- AWS(Amazon Web Services)

- IBM Z

- IBM Power

- RHOSP(Red Hat OpenStack Platform) 17.1, 기술 프리뷰 기능

호스트된 컨트롤 플레인 기능은 기본적으로 활성화되어 있습니다.

다중 클러스터 엔진 Operator는 RHACM(Red Hat Advanced Cluster Management)의 통합 부분이며 RHACM에서 기본적으로 활성화됩니다. 그러나 호스팅된 컨트롤 플레인을 사용하려면 RHACM이 필요하지 않습니다.

2.1.1. 호스트된 컨트롤 플레인 아키텍처

OpenShift Container Platform은 종종 클러스터가 컨트롤 플레인과 데이터 플레인으로 구성된 결합형 또는 독립 실행형 모델로 배포됩니다. 컨트롤 플레인에는 상태를 확인하는 API 끝점, 스토리지 끝점, 워크로드 스케줄러, 작업자가 포함됩니다. 데이터 플레인에는 워크로드 및 애플리케이션이 실행되는 컴퓨팅, 스토리지 및 네트워킹이 포함됩니다.

독립 실행형 컨트롤 플레인은 쿼럼을 보장하기 위해 최소 수를 사용하여 물리적 또는 가상 노드 전용 그룹에 의해 호스팅됩니다. 네트워크 스택이 공유됩니다. 클러스터에 대한 관리자 액세스는 클러스터의 컨트롤 플레인, 머신 관리 API 및 클러스터 상태에 기여하는 기타 구성 요소를 시각화할 수 있습니다.

독립 실행형 모델이 제대로 작동하지만 일부 상황에서는 컨트롤 플레인 및 데이터 플레인이 분리되는 아키텍처가 필요합니다. 이러한 경우 데이터 플레인은 전용 물리적 호스팅 환경을 사용하는 별도의 네트워크 도메인에 있습니다. 컨트롤 플레인은 Kubernetes의 네이티브 배포 및 상태 저장 세트와 같은 고급 프리미티브를 사용하여 호스팅됩니다. 컨트롤 플레인은 다른 워크로드로 처리됩니다.

2.1.2. 호스팅된 컨트롤 플레인의 장점

호스팅된 컨트롤 플레인을 사용하면 진정한 하이브리드 클라우드 접근 방식을 구축하고 다른 여러 가지 이점을 누릴 수 있습니다.

- 컨트롤 플레인이 분리되고 전용 호스팅 서비스 클러스터에서 호스팅되므로 관리와 워크로드 간의 보안 경계가 더욱 강화됩니다. 결과적으로 클러스터의 인증 정보를 다른 사용자에게 유출될 가능성이 줄어듭니다. 인프라 시크릿 계정 관리도 분리되므로 클러스터 인프라 관리자는 실수로 컨트롤 플레인 인프라를 삭제할 수 없습니다.

- 호스팅된 컨트롤 플레인을 사용하면 더 적은 수의 노드에서 많은 컨트롤 플레인을 실행할 수 있습니다. 이로 인해 클러스터 비용이 더 경제적이 됩니다.

- 컨트롤 플레인은 OpenShift Container Platform에서 시작되는 Pod로 구성되므로 컨트롤 플레인이 빠르게 시작됩니다. 모니터링, 로깅, 자동 확장과 같은 컨트롤 플레인 및 워크로드에 동일한 원칙이 적용됩니다.

- 인프라 화면에서 레지스트리, HAProxy, 클러스터 모니터링, 스토리지 노드 및 기타 인프라 구성 요소를 테넌트의 클라우드 공급자 계정으로 푸시하여 테넌트에서 사용을 분리할 수 있습니다.

- 운영 화면에서 다중 클러스터 관리는 더 중앙 집중화되어 클러스터 상태 및 일관성에 영향을 미치는 외부 요인이 줄어듭니다. 사이트 안정성 엔지니어는 문제를 디버그하고 클러스터 데이터 플레인으로 이동하여 문제 해결 시간 (TTR: Time to Resolution)이 단축되고 생산성 향상으로 이어질 수 있습니다.

2.2. 호스팅된 컨트롤 플레인과 OpenShift Container Platform의 차이점

호스팅된 컨트롤 플레인은 OpenShift Container Platform의 폼 요소입니다. 호스팅된 클러스터와 독립형 OpenShift Container Platform 클러스터는 다르게 구성 및 관리됩니다. OpenShift Container Platform과 호스팅된 컨트롤 플레인의 차이점을 알아보려면 다음 표를 참조하십시오.

2.2.1. 클러스터 생성 및 라이프사이클

| OpenShift Container Platform | 호스팅된 컨트롤 플레인 |

|---|---|

|

|

기존 OpenShift Container Platform 클러스터에서 |

2.2.2. 클러스터 구성

| OpenShift Container Platform | 호스팅된 컨트롤 플레인 |

|---|---|

|

|

|

2.2.3. etcd 암호화

| OpenShift Container Platform | 호스팅된 컨트롤 플레인 |

|---|---|

|

AES-GCM 또는 AES-CBC와 함께 |

Amazon Web Services의 AES-CBC 또는 KMS와 함께 |

2.2.4. Operator 및 컨트롤 플레인

| OpenShift Container Platform | 호스팅된 컨트롤 플레인 |

|---|---|

| 독립 실행형 OpenShift Container Platform 클러스터에는 각 컨트롤 플레인 구성 요소에 대한 별도의 Operator가 포함되어 있습니다. | 호스팅된 클러스터에는 관리 클러스터의 호스팅된 컨트롤 플레인 네임스페이스에서 실행되는 컨트롤 플레인 Operator라는 단일 Operator가 포함되어 있습니다. |

| etcd는 컨트롤 플레인 노드에 마운트된 스토리지를 사용합니다. etcd 클러스터 Operator는 etcd를 관리합니다. | etcd는 스토리지에 영구 볼륨 클레임을 사용하며 Control Plane Operator에서 관리합니다. |

| Ingress Operator, 네트워크 관련 Operator 및 OLM(Operator Lifecycle Manager)은 클러스터에서 실행됩니다. | Ingress Operator, 네트워크 관련 Operator 및 OLM(Operator Lifecycle Manager)은 관리 클러스터의 호스팅된 컨트롤 플레인 네임스페이스에서 실행됩니다. |

| OAuth 서버는 클러스터 내에서 실행되며 클러스터의 경로를 통해 노출됩니다. | OAuth 서버는 컨트롤 플레인 내부에서 실행되며 관리 클러스터의 경로, 노드 포트 또는 로드 밸런서를 통해 노출됩니다. |

2.2.5. 업데이트

| OpenShift Container Platform | 호스팅된 컨트롤 플레인 |

|---|---|

|

CVO(Cluster Version Operator)는 업데이트 프로세스를 오케스트레이션하고 |

호스팅된 컨트롤 플레인 업데이트로 인해 |

| OpenShift Container Platform 클러스터를 업데이트하면 컨트롤 플레인 및 컴퓨팅 머신이 모두 업데이트됩니다. | 호스팅 클러스터를 업데이트한 후 컨트롤 플레인만 업데이트됩니다. 노드 풀 업데이트를 별도로 수행합니다. |

2.2.6. 머신 구성 및 관리

| OpenShift Container Platform | 호스팅된 컨트롤 플레인 |

|---|---|

|

|

|

| 컨트롤 플레인 시스템 세트를 사용할 수 있습니다. | 컨트롤 플레인 시스템 세트가 없습니다. |

|

|

|

|

|

|

| 머신 및 머신 세트는 클러스터에 노출됩니다. | 업스트림 Cluster CAPI Operator의 머신, 머신 세트 및 머신 배포는 머신을 관리하는 데 사용되지만 사용자에게 노출되지 않습니다. |

| 클러스터를 업데이트할 때 모든 머신 세트가 자동으로 업그레이드됩니다. | 호스트된 클러스터 업데이트와 독립적으로 노드 풀을 업데이트합니다. |

| 클러스터에서 인플레이스 업그레이드만 지원됩니다. | 호스팅된 클러스터에서 교체 및 인플레이스 업그레이드가 모두 지원됩니다. |

| Machine Config Operator는 머신 구성을 관리합니다. | Machine Config Operator는 호스팅된 컨트롤 플레인에 존재하지 않습니다. |

|

|

|

| MCP(Machine Config Daemon)는 각 노드의 구성 변경 및 업데이트를 관리합니다. | 인플레이스 업그레이드의 경우 노드 풀 컨트롤러는 구성에 따라 머신을 업데이트하는 런타임 Pod를 생성합니다. |

| SR-IOV Operator와 같은 머신 구성 리소스를 수정할 수 있습니다. | 머신 구성 리소스를 수정할 수 없습니다. |

2.2.7. 네트워킹

| OpenShift Container Platform | 호스팅된 컨트롤 플레인 |

|---|---|

| Kube API 서버와 노드가 동일한 VPC(Virtual Private Cloud)에 있으므로 Kube API 서버는 노드와 직접 통신합니다. | Kube API 서버는 Konnectivity를 통해 노드와 통신합니다. Kube API 서버 및 노드는 다른 VPC(Virtual Private Cloud)에 있습니다. |

| 노드는 내부 로드 밸런서를 통해 Kube API 서버와 통신합니다. | 노드는 외부 로드 밸런서 또는 노드 포트를 통해 Kube API 서버와 통신합니다. |

2.2.8. 웹 콘솔

| OpenShift Container Platform | 호스팅된 컨트롤 플레인 |

|---|---|

| 웹 콘솔에는 컨트롤 플레인의 상태가 표시됩니다. | 웹 콘솔에 컨트롤 플레인의 상태가 표시되지 않습니다. |

| 웹 콘솔을 사용하여 클러스터를 업데이트할 수 있습니다. | 웹 콘솔을 사용하여 호스팅된 클러스터를 업데이트할 수 없습니다. |

| 웹 콘솔에는 시스템과 같은 인프라 리소스가 표시됩니다. | 웹 콘솔에 인프라 리소스가 표시되지 않습니다. |

|

웹 콘솔을 사용하여 | 웹 콘솔을 사용하여 머신을 구성할 수 없습니다. |

2.3. 호스팅된 컨트롤 플레인, 다중 클러스터 엔진 Operator 및 RHACM 간의 관계

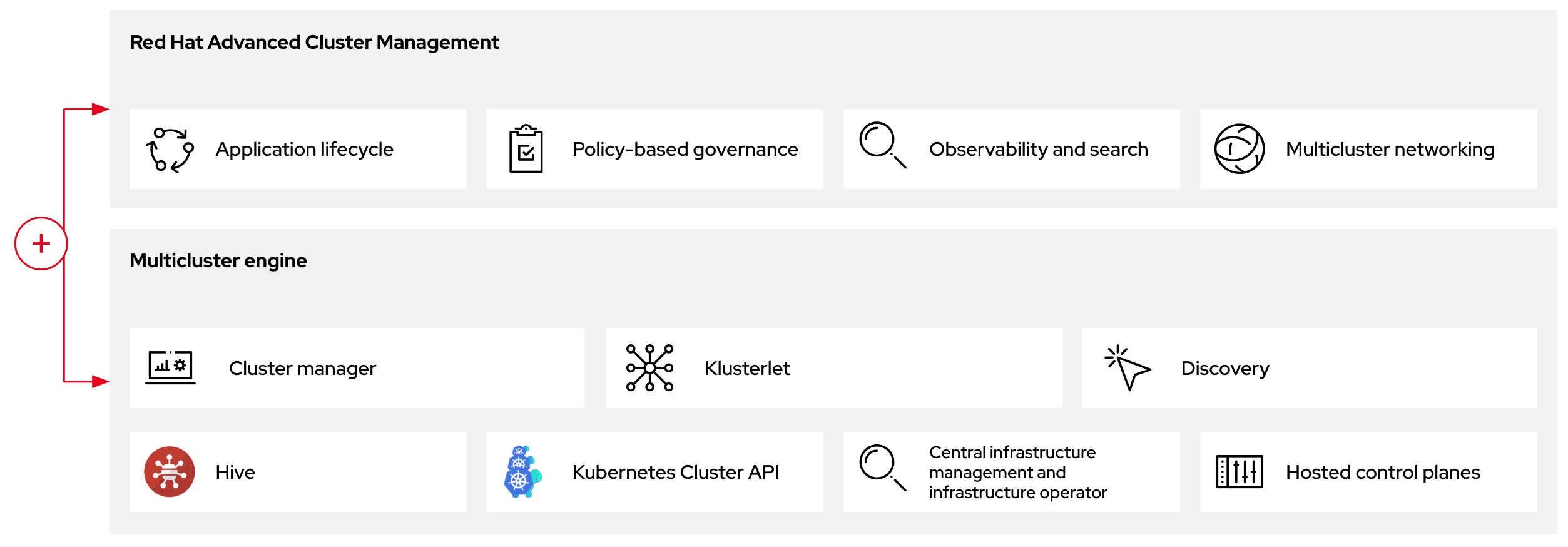

Kubernetes Operator에 다중 클러스터 엔진을 사용하여 호스팅되는 컨트롤 플레인을 구성할 수 있습니다. 멀티 클러스터 엔진 Operator 클러스터 라이프사이클은 다양한 인프라 클라우드 공급자, 프라이빗 클라우드 및 온프레미스 데이터 센터에서 Kubernetes 클러스터를 생성, 가져오기, 관리 및 제거하는 프로세스를 정의합니다.

다중 클러스터 엔진 Operator는 RHACM(Red Hat Advanced Cluster Management)의 통합 부분이며 RHACM에서 기본적으로 활성화됩니다. 그러나 호스팅된 컨트롤 플레인을 사용하려면 RHACM이 필요하지 않습니다.

다중 클러스터 엔진 Operator는 OpenShift Container Platform 및 RHACM 허브 클러스터에 대한 클러스터 관리 기능을 제공하는 클러스터 라이프사이클 Operator입니다. 멀티 클러스터 엔진 Operator는 클러스터 플릿 관리를 개선하고 클라우드 및 데이터 센터 전체에서 OpenShift Container Platform 클러스터 라이프사이클 관리를 지원합니다.

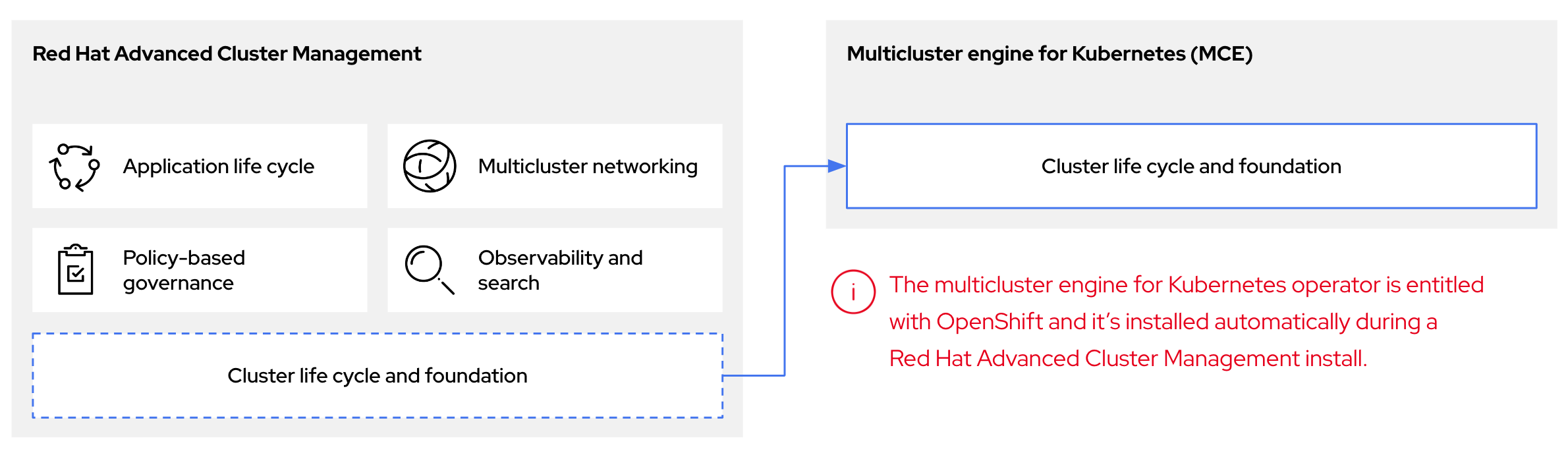

그림 2.1. 클러스터 라이프사이클 및 기반

OpenShift Container Platform에서 다중 클러스터 엔진 Operator를 독립 실행형 클러스터 관리자 또는 RHACM 허브 클러스터의 일부로 사용할 수 있습니다.

관리 클러스터를 호스팅 클러스터라고도 합니다.

독립 실행형 또는 호스팅된 컨트롤 플레인 구성의 두 가지 다른 컨트롤 플레인 구성을 사용하여 OpenShift Container Platform 클러스터를 배포할 수 있습니다. 독립 실행형 구성은 전용 가상 머신 또는 물리적 시스템을 사용하여 컨트롤 플레인을 호스팅합니다. OpenShift Container Platform의 호스팅된 컨트롤 플레인을 사용하면 각 컨트롤 플레인의 전용 가상 또는 물리적 머신 없이도 관리 클러스터에서 컨트롤 플레인을 Pod로 생성합니다.

그림 2.2. RHACM 및 다중 클러스터 엔진 Operator 소개 다이어그램

2.3.1. RHACM에서 다중 클러스터 엔진 Operator 호스트 클러스터 검색

호스트 클러스터를 RHACM(Red Hat Advanced Cluster Management) 허브 클러스터로 가져와서 RHACM 관리 구성 요소를 사용하여 관리하려면 Red Hat Advanced Cluster Management 공식 설명서의 지침을 참조하십시오.

2.4. 호스팅된 컨트롤 플레인 버전 관리

호스팅된 컨트롤 플레인 기능에는 별도의 버전 관리 및 지원 수준이 필요할 수 있는 다음 구성 요소가 포함되어 있습니다.

- 관리 클러스터

- HyperShift Operator

-

호스트된 컨트롤 플레인(

hcp) 명령줄 인터페이스(CLI) -

Hypershift.openshift.ioAPI - Control Plane Operator

2.4.1. 관리 클러스터

프로덕션 사용을 위한 관리 클러스터에서는 소프트웨어 카탈로그를 통해 사용할 수 있는 Kubernetes Operator용 다중 클러스터 엔진이 필요합니다. 다중 클러스터 엔진 Operator는 HyperShift Operator의 지원되는 빌드를 번들로 제공합니다. 관리 클러스터가 계속 지원되려면 다중 클러스터 엔진 Operator가 실행되는 OpenShift Container Platform 버전을 사용해야 합니다. 일반적으로 다중 클러스터 엔진 Operator의 새 릴리스는 다음 OpenShift Container Platform 버전에서 실행됩니다.

- OpenShift Container Platform의 최신 GA 버전

- OpenShift Container Platform의 최신 GA 버전 이전의 두 가지 버전

관리 클러스터에서 HyperShift Operator를 통해 설치할 수 있는 OpenShift Container Platform 버전의 전체 목록은 HyperShift Operator 버전에 따라 다릅니다. 그러나 목록에는 항상 관리 클러스터와 동일한 OpenShift Container Platform 버전과 관리 클러스터를 기준으로 두 개의 이전 마이너 버전이 포함됩니다. 예를 들어 관리 클러스터가 4.17을 실행 중이고 지원되는 다중 클러스터 엔진 Operator인 경우 HyperShift Operator는 4.17, 4.16, 4.15 및 4.14 호스팅 클러스터를 설치할 수 있습니다.

OpenShift Container Platform의 각 메이저, 마이너 또는 패치 버전 릴리스에서 호스팅되는 컨트롤 플레인의 두 가지 구성 요소가 릴리스됩니다.

- HyperShift Operator

-

hcp명령줄 인터페이스(CLI)

2.4.2. HyperShift Operator

HyperShift Operator는 HostedCluster API 리소스로 표시되는 호스팅 클러스터의 라이프사이클을 관리합니다. HyperShift Operator는 각 OpenShift Container Platform 릴리스와 함께 릴리스됩니다. HyperShift Operator는 hypershift 네임스페이스에 supported-versions 구성 맵을 생성합니다. 구성 맵에는 지원되는 호스팅 클러스터 버전이 포함되어 있습니다.

동일한 관리 클러스터에서 다른 버전의 컨트롤 플레인을 호스팅할 수 있습니다.

supported-versions 구성 맵 오브젝트의 예

2.4.3. 호스팅된 컨트롤 플레인 CLI

hcp CLI를 사용하여 호스트된 클러스터를 생성할 수 있습니다. 다중 클러스터 엔진 Operator에서 CLI를 다운로드할 수 있습니다. hcp version 명령을 실행하면 CLI에서 kubeconfig 파일에 대해 지원하는 최신 OpenShift Container Platform이 출력에 표시됩니다.

2.4.4. hypershift.openshift.io API

HostedCluster 및 NodePool 과 같은 hypershift.openshift.io API 리소스를 사용하여 대규모로 OpenShift Container Platform 클러스터를 생성하고 관리할 수 있습니다. HostedCluster 리소스에는 컨트롤 플레인 및 일반 데이터 플레인 구성이 포함되어 있습니다. HostedCluster 리소스를 생성할 때 연결된 노드가 없는 완전히 작동하는 컨트롤 플레인이 있습니다. NodePool 리소스는 HostedCluster 리소스에 연결된 확장 가능한 작업자 노드 집합입니다.

API 버전 정책은 일반적으로 Kubernetes API 버전 관리 정책과 일치합니다.

호스팅된 컨트롤 플레인을 업데이트하려면 호스팅된 클러스터 및 노드 풀을 업데이트해야 합니다. 자세한 내용은 "호스팅된 컨트롤 플레인 업데이트"를 참조하십시오.

2.4.5. Control Plane Operator

Control Plane Operator는 다음 아키텍처의 각 OpenShift Container Platform 페이로드 릴리스 이미지의 일부로 릴리스됩니다.

- amd64

- arm64

- 다중 아키텍처

2.5. 호스팅된 컨트롤 플레인의 일반 개념 및 가상 사용자집

OpenShift Container Platform에 호스팅되는 컨트롤 플레인을 사용하는 경우 주요 개념과 관련 가상 사용자를 이해하는 것이 중요합니다.

2.5.1. 개념

- 데이터 플레인

- 워크로드 및 애플리케이션이 실행되는 컴퓨팅, 스토리지 및 네트워킹이 포함된 클러스터의 일부입니다.

- 호스트된 클러스터

- 관리 클러스터에서 호스팅되는 컨트롤 플레인 및 API 끝점이 있는 OpenShift Container Platform 클러스터입니다. 호스트된 클러스터에는 컨트롤 플레인과 해당 데이터 플레인이 포함됩니다.

- 호스트된 클러스터 인프라

- 테넌트 또는 최종 사용자 클라우드 계정에 존재하는 네트워크, 컴퓨팅 및 스토리지 리소스입니다.

- 호스트된 컨트롤 플레인

- 호스팅된 클러스터의 API 끝점에 의해 노출되는 관리 클러스터에서 실행되는 OpenShift Container Platform 컨트롤 플레인입니다. 컨트롤 플레인의 구성 요소에는 etcd, Kubernetes API 서버, Kubernetes 컨트롤러 관리자 및 VPN이 포함됩니다.

- 호스트 클러스터

- 관리 클러스터를 참조하십시오.

- 관리형 클러스터

- 허브 클러스터가 관리하는 클러스터입니다. 이 용어는 Kubernetes Operator의 다중 클러스터 엔진에서 Red Hat Advanced Cluster Management에서 관리하는 클러스터 라이프사이클에 따라 다릅니다. 관리형 클러스터는 관리 클러스터와 동일하지 않습니다. 자세한 내용은 관리 클러스터를 참조하십시오.

- 관리 클러스터

- HyperShift Operator가 배포되고 호스팅된 클러스터의 컨트롤 플레인이 호스팅되는 OpenShift Container Platform 클러스터입니다. 관리 클러스터는 호스팅 클러스터와 동일합니다.

- 관리 클러스터 인프라

- 관리 클러스터의 네트워크, 컴퓨팅 및 스토리지 리소스입니다.

- 노드 풀

- 호스트 클러스터와 연결된 컴퓨팅 노드 세트를 관리하는 리소스입니다. 컴퓨팅 노드는 호스팅된 클러스터 내에서 애플리케이션과 워크로드를 실행합니다.

2.5.2. 가상 사용자

- 클러스터 인스턴스 관리자

-

이 역할의 사용자는 독립 실행형 OpenShift Container Platform의 관리자와 동일한 것으로 간주됩니다. 이 사용자에게는 프로비저닝된 클러스터에

cluster-admin역할이 있지만 클러스터 업데이트 또는 구성 시 전원이 켜지지 않을 수 있습니다. 이 사용자는 클러스터에 예상된 일부 구성을 확인하기 위해 읽기 전용 액세스 권한이 있을 수 있습니다. - 클러스터 인스턴스 사용자

- 이 역할의 사용자는 독립 실행형 OpenShift Container Platform의 개발자와 동일한 것으로 간주됩니다. 이 사용자에게는 소프트웨어 카탈로그 또는 시스템에 대한 보기가 없습니다.

- 클러스터 서비스 소비자

- 이 역할에서 컨트롤 플레인 및 작업자 노드를 요청하거나, 드라이브 업데이트를 요청하거나, 외부화된 구성을 수정할 수 있다고 가정합니다. 일반적으로 이 사용자는 클라우드 인증 정보 또는 인프라 암호화 키를 관리하거나 액세스하지 않습니다. 클러스터 서비스 소비자 가상 사용자는 호스트된 클러스터를 요청하고 노드 풀과 상호 작용할 수 있습니다. 이 역할에는 논리 경계 내에서 호스팅된 클러스터 및 노드 풀을 생성, 읽기, 업데이트 또는 삭제하는 RBAC가 있다고 가정합니다.

- 클러스터 서비스 공급자

이 역할에는 일반적으로 관리 클러스터에 대한

cluster-admin역할이 있고 HyperShift Operator의 가용성을 모니터링하고 소유할 수 있는 RBAC와 테넌트의 호스트 클러스터에 대한 컨트롤 플레인이 있는 사용자입니다. 클러스터 서비스 공급자 개인은 다음 예제를 포함하여 여러 활동을 담당합니다.- 컨트롤 플레인 가용성, 가동 시간 및 안정성에 대한 서비스 수준 오브젝트 보유

- 컨트롤 플레인을 호스팅할 관리 클러스터의 클라우드 계정 구성

- 사용 가능한 컴퓨팅 리소스에 대한 호스트 인식이 포함된 사용자 프로비저닝 인프라 구성

3장. 호스팅된 컨트롤 플레인 배포 준비

3.1. 호스트된 컨트롤 플레인 요구 사항

호스트된 컨트롤 플레인의 컨텍스트에서 관리 클러스터 는 HyperShift Operator가 배포되고 호스팅된 클러스터의 컨트롤 플레인이 호스팅되는 OpenShift Container Platform 클러스터입니다.

컨트롤 플레인은 호스팅된 클러스터와 연결되며 단일 네임스페이스에서 Pod로 실행됩니다. 클러스터 서비스 소비자가 호스팅된 클러스터를 생성할 때 컨트롤 플레인과 독립적인 작업자 노드를 생성합니다.

다음 요구 사항은 호스트된 컨트롤 플레인에 적용됩니다.

- HyperShift Operator를 실행하려면 관리 클러스터에 3개 이상의 작업자 노드가 필요합니다.

-

DNS(Domain Name Service) 프로토콜이 예상대로 작동하도록 하려면 TCP(Transmission Control Protocol) 및 UDP(User Datagram Protocol)에서 방화벽 포트

53을 열어야 합니다. - 베어 메탈 플랫폼 또는 OpenShift Virtualization과 같이 관리 클러스터와 작업자 노드를 온프레미스에서 모두 실행할 수 있습니다. 또한 AWS(Amazon Web Services)와 같은 클라우드 인프라에서 관리 클러스터와 작업자 노드를 모두 실행할 수 있습니다.

-

AWS 및 작업자 노드에서 관리 클러스터를 실행하거나 온프레미스에서 작업자 노드를 실행하는 것과 같은 혼합 인프라를 사용하거나 온프레미스에서 AWS 및 관리 클러스터에서 작업자 노드를 실행하는 경우

PublicAndPrivate게시 전략을 사용하고 지원 매트릭스의 대기 시간 요구 사항을 따라야 합니다. - Bare Metal Operator가 머신을 시작하는 베어 메탈 호스트(BMH) 배포에서 호스팅된 컨트롤 플레인은 BMC(Baseboard Management Controller)에 연결할 수 있어야 합니다. 보안 프로필에서 Cluster Baremetal Operator에서 Redfish 자동화를 활성화하기 위해 BMH에 BMC가 있는 네트워크에 액세스할 수 없는 경우 BYO ISO 지원을 사용할 수 있습니다. 그러나 BYO 모드에서는 OpenShift Container Platform에서 BMH의 전원을 자동화할 수 없습니다.

3.1.1. 호스팅된 컨트롤 플레인 지원 매트릭스

Kubernetes Operator용 멀티 클러스터 엔진에 HyperShift Operator가 포함되어 있으므로 호스트된 컨트롤 플레인 릴리스는 다중 클러스터 엔진 Operator 릴리스와 일치합니다. 자세한 내용은 OpenShift Operator 라이프 사이클 을 참조하십시오.

3.1.1.1. 관리 클러스터 지원

지원되는 독립 실행형 OpenShift Container Platform 클러스터는 관리 클러스터가 될 수 있습니다.

단일 노드 OpenShift Container Platform 클러스터는 관리 클러스터로 지원되지 않습니다. 리소스 제약 조건이 있는 경우 독립 실행형 OpenShift Container Platform 컨트롤 플레인과 호스팅된 컨트롤 플레인 간에 인프라를 공유할 수 있습니다. 자세한 내용은 "호스트 및 독립 실행형 컨트롤 플레인 간 공유 인프라"를 참조하십시오.

다음 표는 다중 클러스터 엔진 Operator 버전을 지원하는 관리 클러스터 버전에 매핑합니다.

| 관리 클러스터 버전 | 지원되는 다중 클러스터 엔진 Operator 버전 |

|---|---|

| 4.14 - 4.17 | 2.6 |

| 4.15 - 4.17 | 2.7 |

| 4.16 - 4.18 | 2.8 |

| 4.17 - 4.19 | 2.9 |

| 4.18 - 4.20 | 2.10 |

3.1.1.2. 호스트된 클러스터 지원

호스트 클러스터의 경우 관리 클러스터 버전과 호스팅된 클러스터 버전 간에는 직접적인 관계가 없습니다. 호스팅된 클러스터 버전은 다중 클러스터 엔진 Operator 버전에 포함된 HyperShift Operator에 따라 다릅니다.

관리 클러스터와 호스팅 클러스터 간에 최대 대기 시간이 200ms인지 확인합니다. 이 요구 사항은 관리 클러스터가 AWS에 있고 컴퓨팅 노드가 온프레미스인 경우와 같이 혼합 인프라 배포에서 특히 중요합니다.

다음 표에서는 다중 클러스터 엔진 Operator 버전과 연결된 HyperShift Operator를 사용하여 생성할 수 있는 호스팅 클러스터 버전을 보여줍니다.

HyperShift Operator는 다음 표에서 호스팅된 클러스터 버전을 지원하지만 다중 클러스터 엔진 Operator는 현재 버전보다 2 이전 버전만 지원합니다. 예를 들어 현재 호스팅된 클러스터 버전이 4.20인 경우 multicluster 엔진 Operator는 버전 4.18을 지금까지 지원합니다. 다중 클러스터 엔진 Operator에서 지원하는 버전 중 하나 이전 버전보다 이전 버전의 호스팅 클러스터를 사용하려면 멀티 클러스터 엔진 Operator에서 관리되지 않도록 호스트된 클러스터를 분리하거나 이전 버전의 multicluster engine Operator를 사용할 수 있습니다. 멀티 클러스터 엔진 Operator에서 호스트 클러스터를 분리하는 방법은 관리에서 클러스터 제거(RHACM 문서)를 참조하십시오. 다중 클러스터 엔진 Operator 지원에 대한 자세한 내용은 The multicluster engine for Kubernetes operator 2.10 Support Matrix (Red Hat Knowledgebase)를 참조하십시오.

| 호스팅 클러스터 버전 | 다중 클러스터 엔진 Operator 2.6의 Hypershift Operator | 다중 클러스터 엔진 Operator 2.7의 Hypershift Operator | 다중 클러스터 엔진 Operator 2.8의 Hypershift Operator | 다중 클러스터 엔진 Operator 2.9의 Hypershift Operator | 다중 클러스터 엔진 Operator 2.10의 Hypershift Operator |

|---|---|---|---|---|---|

| 4.14 | 제공됨 | 제공됨 | 제공됨 | 제공됨 | 제공됨 |

| 4.15 | 제공됨 | 제공됨 | 제공됨 | 제공됨 | 제공됨 |

| 4.16 | 제공됨 | 제공됨 | 제공됨 | 제공됨 | 제공됨 |

| 4.17 | 없음 | 제공됨 | 제공됨 | 제공됨 | 제공됨 |

| 4.18 | 없음 | 없음 | 제공됨 | 제공됨 | 제공됨 |

| 4.19 | 없음 | 없음 | 없음 | 제공됨 | 제공됨 |

| 4.20 | 없음 | 없음 | 없음 | 없음 | 제공됨 |

3.1.1.3. 호스트된 클러스터 플랫폼 지원

호스트된 클러스터는 하나의 인프라 플랫폼만 지원합니다. 예를 들어 다른 인프라 플랫폼에서 여러 노드 풀을 생성할 수 없습니다.

다음 표는 호스팅된 컨트롤 플레인의 각 플랫폼에 지원되는 OpenShift Container Platform 버전을 나타냅니다.

IBM Power 및 IBM Z의 경우:

- 64비트 x86 아키텍처 또는 s390x 아키텍처를 기반으로 하는 머신 유형에서 컨트롤 플레인을 실행해야 합니다.

- IBM Power 또는 IBM Z에서 노드 풀을 실행해야 합니다.

다음 표에서 관리 클러스터 버전은 다중 클러스터 엔진 Operator가 활성화된 OpenShift Container Platform 버전입니다.

| 호스트된 클러스터 플랫폼 | 관리 클러스터 버전 | 호스팅 클러스터 버전 |

|---|---|---|

| Amazon Web Services | 4.16 - 4.20 | 4.16 - 4.20 |

| IBM Power | 4.17 - 4.20 | 4.17 - 4.20 |

| IBM Z | 4.17 - 4.20 | 4.17 - 4.20 |

| OpenShift Virtualization | 4.14 - 4.20 | 4.14 - 4.20 |

| 베어 메탈 | 4.14 - 4.20 | 4.14 - 4.20 |

| 비 바이어(bare-metal) 에이전트 머신 (기술 프리뷰) | 4.16 - 4.20 | 4.16 - 4.20 |

| Red Hat OpenStack Platform (RHOSP) (기술 프리뷰) | 4.19 - 4.20 | 4.19 - 4.20 |

3.1.1.4. 다중 아키텍처 지원

다음 표는 플랫폼별로 구성된 여러 아키텍처의 호스팅 컨트롤 플레인에 대한 지원 상태를 나타냅니다.

| OpenShift Container Platform 버전 | ARM64 컨트롤 플레인 | ARM64 컴퓨팅 노드 |

|---|---|---|

| 4.20 | 정식 출시일 (GA) | 정식 출시일 (GA) |

| 4.19 | 정식 출시일 (GA) | 정식 출시일 (GA) |

| 4.18 | 정식 출시일 (GA) | 정식 출시일 (GA) |

| 4.17 | 정식 출시일 (GA) | 정식 출시일 (GA) |

| 4.16 | 기술 프리뷰 | 정식 출시일 (GA) |

| 4.15 | 기술 프리뷰 | 정식 출시일 (GA) |

| 4.14 | 기술 프리뷰 | 정식 출시일 (GA) |

| OpenShift Container Platform 버전 | ARM64 컨트롤 플레인 | ARM64 컴퓨팅 노드 |

|---|---|---|

| 4.20 | 사용할 수 없음 | 기술 프리뷰 |

| 4.19 | 사용할 수 없음 | 기술 프리뷰 |

| 4.18 | 사용할 수 없음 | 기술 프리뷰 |

| 4.17 | 사용할 수 없음 | 기술 프리뷰 |

| 4.16 | 사용할 수 없음 | 기술 프리뷰 |

| 4.15 | 사용할 수 없음 | 기술 프리뷰 |

| 4.14 | 사용할 수 없음 | 기술 프리뷰 |

| OpenShift Container Platform 버전 | ARM64 컨트롤 플레인 | ARM64 컴퓨팅 노드 |

|---|---|---|

| 4.20 | 사용할 수 없음 | 사용할 수 없음 |

| 4.19 | 사용할 수 없음 | 사용할 수 없음 |

| 4.18 | 사용할 수 없음 | 사용할 수 없음 |

| 4.17 | 사용할 수 없음 | 사용할 수 없음 |

| OpenShift Container Platform 버전 | 컨트롤 플레인 | 컴퓨팅 노드 |

|---|---|---|

| 4.20 |

|

|

| 4.19 |

|

|

| 4.18 |

|

|

| 4.17 |

|

|

| OpenShift Container Platform 버전 | 컨트롤 플레인 | 컴퓨팅 노드 |

|---|---|---|

| 4.20 |

|

|

| 4.19 |

|

|

| 4.18 |

|

|

| 4.17 |

|

|

| OpenShift Container Platform 버전 | ARM64 컨트롤 플레인 | ARM64 컴퓨팅 노드 |

|---|---|---|

| 4.20 | 사용할 수 없음 | 사용할 수 없음 |

| 4.19 | 사용할 수 없음 | 사용할 수 없음 |

| 4.18 | 사용할 수 없음 | 사용할 수 없음 |

| 4.17 | 사용할 수 없음 | 사용할 수 없음 |

| 4.16 | 사용할 수 없음 | 사용할 수 없음 |

| 4.15 | 사용할 수 없음 | 사용할 수 없음 |

| 4.14 | 사용할 수 없음 | 사용할 수 없음 |

3.1.1.5. 다중 클러스터 엔진 Operator 업데이트

다른 버전의 multicluster 엔진 Operator로 업데이트할 때 다중 클러스터 엔진 Operator 버전에 포함된 HyperShift Operator가 호스트된 클러스터 버전을 지원하는 경우 호스팅된 클러스터를 계속 실행할 수 있습니다. 다음 표는 업데이트된 다중 클러스터 엔진 Operator 버전에서 지원되는 호스팅 클러스터 버전을 보여줍니다.

HyperShift Operator는 다음 표에서 호스팅된 클러스터 버전을 지원하지만 다중 클러스터 엔진 Operator는 현재 버전보다 2 이전 버전만 지원합니다. 예를 들어 현재 호스팅된 클러스터 버전이 4.20인 경우 multicluster 엔진 Operator는 버전 4.18을 지금까지 지원합니다. 다중 클러스터 엔진 Operator에서 지원하는 버전 중 하나 이전 버전보다 이전 버전의 호스팅 클러스터를 사용하려면 멀티 클러스터 엔진 Operator에서 관리되지 않도록 호스트된 클러스터를 분리하거나 이전 버전의 multicluster engine Operator를 사용할 수 있습니다. 멀티 클러스터 엔진 Operator에서 호스트 클러스터를 분리하는 방법은 관리에서 클러스터 제거(RHACM 문서)를 참조하십시오. 다중 클러스터 엔진 Operator 지원에 대한 자세한 내용은 The multicluster engine for Kubernetes operator 2.10 Support Matrix (Red Hat Knowledgebase)를 참조하십시오.

| 업데이트된 다중 클러스터 엔진 Operator 버전 | 지원되는 호스팅 클러스터 버전 |

|---|---|

| 2.5에서 2.6으로 업데이트됨 | OpenShift Container Platform 4.14 - 4.15 |

| 2.6에서 2.7로 업데이트 | OpenShift Container Platform 4.14 - 4.16 |

| 2.7에서 2.8로 업데이트되었습니다. | OpenShift Container Platform 4.14 - 4.17 |

| 2.8에서 2.9로 업데이트되었습니다. | OpenShift Container Platform 4.14 - 4.18 |

| 2.9에서 2.10으로 업데이트되었습니다. | OpenShift Container Platform 4.14 - 4.19 |

예를 들어 관리 클러스터에 OpenShift Container Platform 4.18 호스팅 클러스터가 있고 다중 클러스터 엔진 Operator 2.8에서 2.9로 업데이트하는 경우 호스팅된 클러스터를 계속 실행할 수 있습니다.

3.1.1.6. 기술 프리뷰 기능

다음 목록은 이 릴리스의 기술 프리뷰 상태가 있는 기능을 나타냅니다.

- 베어 메탈이 아닌 에이전트 시스템을 사용하는 호스팅된 컨트롤 플레인

- 호스트된 컨트롤 플레인에 대한 사용자 정의 테인트 및 허용 오차

- OpenShift Virtualization을 위해 호스팅된 컨트롤 플레인의 NVIDIA GPU 장치

- RHOSP(Red Hat OpenStack Platform)에서 호스팅되는 컨트롤 플레인

3.1.2. FIPS 지원 호스트 클러스터

호스팅된 컨트롤 플레인의 바이너리는 FIP와 호환되며 호스트된 컨트롤 플레인 명령줄 인터페이스를 제외하고 hcp.

FIPS 지원 호스팅 클러스터를 배포하려면 FIPS 지원 관리 클러스터를 사용해야 합니다. 관리 클러스터에 대한 FIPS 모드를 활성화하려면 FIPS 모드에서 작동하도록 구성된 RHEL(Red Hat Enterprise Linux) 컴퓨터에서 설치 프로그램을 실행해야 합니다. RHEL에서 FIPS 모드를 구성하는 방법에 대한 자세한 내용은 RHEL을 FIPS 모드로 전환 을 참조하십시오.

FIPS 모드에서 부팅된 RHEL 또는 Red Hat Enterprise Linux CoreOS(RHCOS)를 실행하는 경우 OpenShift Container Platform 코어 구성 요소는 x86_64, ppc64le 및 s390x 아키텍처에서만 FIPS 140-2/140-3 검증에 대해 NIST에 제출된 RHEL 암호화 라이브러리를 사용합니다.

FIPS 모드에서 관리 클러스터를 설정한 후 호스트된 클러스터 생성 프로세스가 해당 관리 클러스터에서 실행됩니다.

3.1.3. 호스팅된 컨트롤 플레인의 CIDR 범위

OpenShift Container Platform에 호스팅되는 컨트롤 플레인을 배포하려면 다음과 같은 필수 Classless Inter-Domain Routing (CIDR) 서브넷 범위를 사용합니다.

-

v4InternalSubnet: 100.65.0.0/16 (OVN-Kubernetes) -

clusterNetwork: 10.132.0.0/14 (pod 네트워크) -

serviceNetwork: 172.31.0.0/16

OpenShift Container Platform CIDR 범위 정의에 대한 자세한 내용은 "CIDR 범위 정의"를 참조하십시오.

3.2. 호스팅된 컨트롤 플레인의 크기 조정 지침

호스트 클러스터 워크로드 및 작업자 노드 수를 포함한 많은 요인은 특정 수의 작업자 노드 내에 적합한 호스팅 컨트롤 플레인 수에 영향을 미칩니다. 이 크기 조정 가이드를 사용하여 호스트된 클러스터 용량 계획에 도움이 됩니다. 이 가이드에서는 고가용성 호스팅 컨트롤 플레인 토폴로지를 가정합니다. 로드 기반 크기 조정 예제는 베어 메탈 클러스터에서 측정되었습니다. 클라우드 기반 인스턴스에는 메모리 크기와 같은 제한 요소가 다를 수 있습니다.

다음 리소스 사용률 크기 조정을 재정의하고 메트릭 서비스 모니터링을 비활성화할 수 있습니다.

OpenShift Container Platform 버전 4.12.9 이상에서 테스트된 다음 고가용성 호스팅 컨트롤 플레인 요구 사항을 참조하십시오.

- 78 Pod

- etcd의 경우 3GiB PV

- 최소 vCPU: 약 5.5코어

- 최소 메모리: 약 19GiB

3.2.1. Pod 제한

각 노드의 maxPods 설정은 컨트롤 플레인 노드에 들어갈 수 있는 호스트 클러스터 수에 영향을 미칩니다. 모든 control-plane 노드에서 maxPods 값을 기록하는 것이 중요합니다. 고가용성 호스팅 컨트롤 플레인마다 약 75개의 Pod를 계획합니다.

베어 메탈 노드의 경우 기본 maxPods 설정 250는 제한 요소가 될 수 있습니다. 이는 머신에 많은 리소스가 부족하더라도 Pod 요구 사항을 충족하는 각 노드에 대해 약 3개의 호스팅 컨트롤 플레인이 적합하기 때문입니다. KubeletConfig 값을 구성하여 maxPods 값을 500으로 설정하면 호스트된 컨트롤 플레인 밀도가 증가할 수 있으므로 추가 컴퓨팅 리소스를 활용할 수 있습니다.

3.2.2. 요청 기반 리소스 제한

클러스터에서 호스팅할 수 있는 최대 호스팅 컨트롤 플레인 수는 Pod의 호스팅된 컨트롤 플레인 CPU 및 메모리 요청을 기반으로 계산됩니다.

고가용성 호스트 컨트롤 플레인은 5개의 vCPU 및 18GiB 메모리를 요청하는 78 Pod로 구성됩니다. 이러한 기준 번호는 클러스터 작업자 노드 리소스 용량과 비교하여 호스팅되는 컨트롤 플레인의 최대 수를 추정합니다.

3.2.3. 로드 기반 제한

클러스터에서 호스팅할 수 있는 최대 호스팅 컨트롤 플레인 수는 일부 워크로드가 호스팅된 컨트롤 플레인 Kubernetes API 서버에 배치될 때 호스팅된 컨트롤 플레인 CPU 및 메모리 사용률을 기반으로 계산됩니다.

다음 방법은 워크로드가 증가할 때 호스팅된 컨트롤 플레인 리소스 사용률을 측정하는 데 사용됩니다.

- KubeVirt 플랫폼을 사용하는 동안 각각 8 vCPU 및 32GiB를 사용하는 9개의 작업자가 있는 호스트 클러스터

다음 정의에 따라 API 컨트롤 플레인 과부하에 중점을 두도록 구성된 워크로드 테스트 프로필입니다.

- 각 네임스페이스에 대해 생성된 오브젝트로, 총 네임스페이스 100개까지 확장

- 연속 오브젝트 삭제 및 생성에 대한 추가 API 과부하

- 워크로드 쿼리-초당 (QPS) 및 Burst 설정은 클라이언트 측 제한을 제거하기 위해 높은 설정

로드가 1000개의 QPS로 증가하면 호스트된 컨트롤 플레인 리소스 사용률이 9개의 vCPU 및 2.5GB 메모리로 증가합니다.

일반적인 크기 조정을 위해 중간 호스트 클러스터 로드인 1000 QPS API 속도와 호스트 클러스터 로드가 많은 2000 QPS API를 고려하십시오.

이 테스트에서는 예상되는 API 로드에 따라 컴퓨팅 리소스 사용률을 높이기 위한 추정 요소를 제공합니다. 정확한 사용률 비율은 클러스터 워크로드의 유형 및 속도에 따라 다를 수 있습니다.

다음 예제에서는 워크로드 및 API 속도 정의에 대한 호스팅된 컨트롤 플레인 리소스 스케일링을 보여줍니다.

| QPS(API 속도) | vCPU 사용 | 메모리 사용량(GiB) |

|---|---|---|

| 낮은 부하 (50 QPS 미만) | 2.9 | 11.1 |

| 중간 로드 (1000 QPS) | 11.9 | 13.6 |

| 높은 부하 (2000 QPS) | 20.9 | 16.1 |

호스트된 컨트롤 플레인 크기 조정은 API 활동, etcd 활동 또는 둘 다로 인해 발생하는 컨트롤 플레인 로드 및 워크로드에 관한 것입니다. 데이터베이스 실행과 같은 데이터 플레인 로드에 중점을 둔 호스팅된 Pod 워크로드는 API 비율이 높지 않을 수 있습니다.

3.2.4. 크기 조정 계산 예

이 예제에서는 다음 시나리오에 대한 크기 조정 지침을 제공합니다.

-

hypershift.openshift.io/control-plane노드로 레이블이 지정된 베어 메탈 작업자 세 개 -

maxPods값이 500으로 설정 - 예상되는 API 속도는 로드 기반 제한에 따라 중간 또는 약 1000입니다.

| 제한 설명 | 서버 1 | 서버 2 |

|---|---|---|

| 작업자 노드의 vCPU 수 | 64 | 128 |

| 작업자 노드의 메모리(GiB) | 128 | 256 |

| 작업자당 최대 Pod 수 | 500 | 500 |

| 컨트롤 플레인을 호스팅하는 데 사용되는 작업자 수 | 3 | 3 |

| 최대 QPS 대상 속도(초당 API 요청) | 1000 | 1000 |

| 작업자 노드 크기 및 API 속도를 기반으로 계산된 값 | 서버 1 | 서버 2 | 계산 노트 |

| vCPU 요청을 기반으로 작업자당 최대 호스트 컨트롤 플레인 | 12.8 | 25.6 | 호스트된 컨트롤 플레인당 총 vCPU 요청 수 5개 |

| vCPU 사용을 기반으로 작업자당 최대 호스트 컨트롤 플레인 | 5.4 | 10.7 | vCPUS Cryostat (2.9 측정 유휴 vCPU 사용량 + (QPS 대상 비율 Cryostat 1000) × 9.0 QPS 증가당 vCPU 사용량 측정) |

| 메모리 요청을 기반으로 작업자당 최대 호스트 컨트롤 플레인 | 7.1 | 14.2 | 작업자 메모리 GiB Cryostat 18GiB의 호스트된 컨트롤 플레인당 총 메모리 요청 |

| 메모리 사용량을 기반으로 작업자당 최대 호스트된 컨트롤 플레인 | 9.4 | 18.8 | 작업자 메모리 GiB Cryostat (1.1 측정 유휴 메모리 사용량 + (QPS 대상 비율 Cryostat 1000) × 2.5는 1000 QPS 증가당 메모리 사용량 측정) |

| 노드 Pod 제한에 따라 작업자당 최대 호스트 컨트롤 플레인 | 6.7 | 6.7 |

호스팅된 컨트롤 플레인당 500 |

| 이전에 언급된 최소 최대값 | 5.4 | 6.7 | |

| vCPU 제한 요소 |

| ||

| 관리 클러스터 내의 최대 호스트 컨트롤 플레인 수 | 16 | 20 | 이전에 언급된 최소 최대 × 3 개의 컨트롤 플레인 작업자 |

| 이름 | 설명 |

|

| 클러스터가 고가용성 호스팅 컨트롤 플레인 리소스 요청을 기반으로 호스팅할 수 있는 최대 호스트 컨트롤 플레인 수입니다. |

|

| 모든 호스팅 컨트롤 플레인이 클러스터 Kube API 서버에 약 50 QPS를 생성하는 경우 클러스터에서 호스팅할 수 있는 호스트 컨트롤 플레인의 최대 최대 수입니다. |

|

| 모든 호스팅된 컨트롤 플레인이 클러스터 Kube API 서버에 약 1000개의 QPS를 생성하는 경우 클러스터에서 호스팅할 수 있는 호스트 컨트롤 플레인의 최대 최대 수입니다. |

|

| 모든 호스팅된 컨트롤 플레인이 약 2000 QPS를 클러스터 Kube API 서버로 만드는 경우 클러스터에서 호스팅할 수 있는 호스팅되는 컨트롤 플레인의 최대 수입니다. |

|

| 클러스터에서 호스트된 컨트롤 플레인의 기존 평균 QPS를 기반으로 호스팅할 수 있는 최대 호스트 컨트롤 플레인 수입니다. 활성 호스트 컨트롤 플레인이 없는 경우 낮은 QPS를 기대할 수 있습니다. |

3.3. 리소스 사용률 측정 덮어쓰기

리소스 사용률에 대한 기준 측정 세트는 호스트된 클러스터마다 다를 수 있습니다.

3.3.1. 호스트 클러스터의 리소스 사용률 측정 덮어쓰기

클러스터 워크로드의 유형 및 속도를 기반으로 리소스 사용률 측정을 덮어쓸 수 있습니다.

프로세스

다음 명령을 실행하여

ConfigMap리소스를 생성합니다.oc create -f <your-config-map-file.yaml>

$ oc create -f <your-config-map-file.yaml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow <

your-config-map-file.yaml>을hcp-sizing-baseline구성 맵이 포함된 YAML 파일의 이름으로 바꿉니다.local-cluster네임스페이스에hcp-sizing-baseline구성 맵을 생성하여 덮어쓸 측정값을 지정합니다. 구성 맵은 다음 YAML 파일과 유사할 수 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hypershift-addon-agent배포를 삭제하여hypershift-addon-agentPod를 다시 시작합니다.oc delete deployment hypershift-addon-agent \ -n open-cluster-management-agent-addon

$ oc delete deployment hypershift-addon-agent \ -n open-cluster-management-agent-addonCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

hypershift-addon-agentPod 로그를 관찰합니다. 다음 명령을 실행하여 재정의된 측정이 구성 맵에서 업데이트되었는지 확인합니다.oc logs hypershift-addon-agent -n open-cluster-management-agent-addon

$ oc logs hypershift-addon-agent -n open-cluster-management-agent-addonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 로그는 다음 출력과 유사할 수 있습니다.

출력 예

2024-01-05T19:41:05.392Z INFO agent.agent-reconciler agent/agent.go:793 setting cpuRequestPerHCP to 5 2024-01-05T19:41:05.392Z INFO agent.agent-reconciler agent/agent.go:802 setting memoryRequestPerHCP to 18 2024-01-05T19:53:54.070Z INFO agent.agent-reconciler agent/hcp_capacity_calculation.go:141 The worker nodes have 12.000000 vCPUs 2024-01-05T19:53:54.070Z INFO agent.agent-reconciler agent/hcp_capacity_calculation.go:142 The worker nodes have 49.173369 GB memory

2024-01-05T19:41:05.392Z INFO agent.agent-reconciler agent/agent.go:793 setting cpuRequestPerHCP to 5 2024-01-05T19:41:05.392Z INFO agent.agent-reconciler agent/agent.go:802 setting memoryRequestPerHCP to 18 2024-01-05T19:53:54.070Z INFO agent.agent-reconciler agent/hcp_capacity_calculation.go:141 The worker nodes have 12.000000 vCPUs 2024-01-05T19:53:54.070Z INFO agent.agent-reconciler agent/hcp_capacity_calculation.go:142 The worker nodes have 49.173369 GB memoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow hcp-sizing-baseline구성 맵에서 재정의된 측정이 제대로 업데이트되지 않으면hypershift-addon-agentPod 로그에 다음 오류 메시지가 표시될 수 있습니다.오류 예

2024-01-05T19:53:54.052Z ERROR agent.agent-reconciler agent/agent.go:788 failed to get configmap from the hub. Setting the HCP sizing baseline with default values. {"error": "configmaps \"hcp-sizing-baseline\" not found"}2024-01-05T19:53:54.052Z ERROR agent.agent-reconciler agent/agent.go:788 failed to get configmap from the hub. Setting the HCP sizing baseline with default values. {"error": "configmaps \"hcp-sizing-baseline\" not found"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.2. 메트릭 서비스 모니터링 비활성화

하이퍼shift-addon 관리 클러스터 애드온을 활성화한 후 OpenShift Container Platform 모니터링이 hypershift- 에서 메트릭을 수집할 수 있도록 기본적으로 메트릭 서비스 모니터링이 구성됩니다.

addon

프로세스

다음 단계를 완료하여 메트릭 서비스 모니터링을 비활성화할 수 있습니다.

다음 명령을 실행하여 허브 클러스터에 로그인합니다.

oc login

$ oc loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hypershift-addon-deploy-config배포 구성 사양을 편집합니다.oc edit addondeploymentconfig hypershift-addon-deploy-config \ -n multicluster-engine

$ oc edit addondeploymentconfig hypershift-addon-deploy-config \ -n multicluster-engineCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예와 같이

disableMetrics=true사용자 지정 변수를 사양에 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

disableMetrics=true사용자 지정 변수는 신규 및 기존hypershift-addon관리 클러스터 애드온 모두에 대한 메트릭 서비스 모니터링을 비활성화합니다.

다음 명령을 실행하여 구성 사양에 변경 사항을 적용합니다.

oc apply -f <filename>.yaml

$ oc apply -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. 호스팅된 컨트롤 플레인 명령줄 인터페이스 설치

호스트된 컨트롤 플레인 명령줄 인터페이스인 hcp 는 호스팅된 컨트롤 플레인을 시작하는 데 사용할 수 있는 툴입니다. 관리 및 구성과 같은 Day 2 작업의 경우 GitOps 또는 자체 자동화 툴을 사용합니다.

3.4.1. 터미널에서 호스팅된 컨트롤 플레인 명령줄 인터페이스 설치

터미널에서 호스팅되는 컨트롤 플레인 CLI(명령줄 인터페이스) hcp 를 설치할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform 클러스터에 Kubernetes Operator 2.5 이상을 위한 다중 클러스터 엔진을 설치했습니다. Red Hat Advanced Cluster Management를 설치할 때 멀티 클러스터 엔진 Operator가 자동으로 설치됩니다. OpenShift Container Platform 소프트웨어 카탈로그의 Operator로 Red Hat Advanced Management 없이 다중 클러스터 엔진 Operator를 설치할 수도 있습니다.

프로세스

다음 명령을 실행하여

hcp바이너리를 다운로드하려면 URL을 가져옵니다.oc get ConsoleCLIDownload hcp-cli-download -o json | jq -r ".spec"

$ oc get ConsoleCLIDownload hcp-cli-download -o json | jq -r ".spec"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hcp바이너리를 다운로드합니다.wget <hcp_cli_download_url>

$ wget <hcp_cli_download_url>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

hcp_cli_download_url을 이전 단계에서 얻은 URL로 바꿉니다.

다음 명령을 실행하여 다운로드한 아카이브의 압축을 풉니다.

tar xvzf hcp.tar.gz

$ tar xvzf hcp.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hcp바이너리 파일을 실행 가능하게 만듭니다.chmod +x hcp

$ chmod +x hcpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hcp바이너리 파일을 경로의 디렉터리로 이동합니다.sudo mv hcp /usr/local/bin/.

$ sudo mv hcp /usr/local/bin/.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Mac 컴퓨터에서 CLI를 다운로드하는 경우 hcp 바이너리 파일에 대한 경고가 표시될 수 있습니다. 바이너리 파일을 실행할 수 있도록 보안 설정을 조정해야 합니다.

검증

다음 명령을 실행하여 사용 가능한 매개변수 목록이 표시되는지 확인합니다.

hcp create cluster <platform> --help

$ hcp create cluster <platform> --help1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

hcp create cluster명령을 사용하여 호스팅된 클러스터를 생성하고 관리할 수 있습니다. 지원되는 플랫폼은aws,agent,kubevirt입니다.

3.4.2. 웹 콘솔을 사용하여 호스팅된 컨트롤 플레인 명령줄 인터페이스 설치

OpenShift Container Platform 웹 콘솔을 사용하여 호스팅된 컨트롤 플레인 CLI(명령줄 인터페이스), hcp 를 설치할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform 클러스터에 Kubernetes Operator 2.5 이상을 위한 다중 클러스터 엔진을 설치했습니다. Red Hat Advanced Cluster Management를 설치할 때 멀티 클러스터 엔진 Operator가 자동으로 설치됩니다. OpenShift Container Platform 소프트웨어 카탈로그의 Operator로 Red Hat Advanced Management 없이 다중 클러스터 엔진 Operator를 설치할 수도 있습니다.

프로세스

- OpenShift Container Platform 웹 콘솔에서 도움말 아이콘 → 명령줄 툴 을 클릭합니다.

- 플랫폼에 대한 hcp CLI 다운로드를 클릭합니다.

다음 명령을 실행하여 다운로드한 아카이브의 압축을 풉니다.

tar xvzf hcp.tar.gz

$ tar xvzf hcp.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 바이너리 파일을 실행 가능하게 만듭니다.

chmod +x hcp

$ chmod +x hcpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 바이너리 파일을 경로의 디렉터리로 이동합니다.

sudo mv hcp /usr/local/bin/.

$ sudo mv hcp /usr/local/bin/.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Mac 컴퓨터에서 CLI를 다운로드하는 경우 hcp 바이너리 파일에 대한 경고가 표시될 수 있습니다. 바이너리 파일을 실행할 수 있도록 보안 설정을 조정해야 합니다.

검증

다음 명령을 실행하여 사용 가능한 매개변수 목록이 표시되는지 확인합니다.

hcp create cluster <platform> --help

$ hcp create cluster <platform> --help1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

hcp create cluster명령을 사용하여 호스팅된 클러스터를 생성하고 관리할 수 있습니다. 지원되는 플랫폼은aws,agent,kubevirt입니다.

3.4.3. 콘텐츠 게이트웨이를 사용하여 호스팅된 컨트롤 플레인 명령줄 인터페이스 설치

콘텐츠 게이트웨이를 사용하여 호스팅된 컨트롤 플레인 CLI(명령줄 인터페이스), hcp 를 설치할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform 클러스터에 Kubernetes Operator 2.7 이상용 다중 클러스터 엔진을 설치했습니다. Red Hat Advanced Cluster Management를 설치할 때 멀티 클러스터 엔진 Operator가 자동으로 설치됩니다. Red Hat Advanced Management 없이 OpenShift Container Platform OperatorHub의 Operator로 다중 클러스터 엔진 Operator를 설치할 수도 있습니다.

프로세스

-

콘텐츠 게이트웨이로 이동하여

hcp바이너리를 다운로드합니다. 다음 명령을 실행하여 다운로드한 아카이브의 압축을 풉니다.

tar xvzf hcp.tar.gz

$ tar xvzf hcp.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hcp바이너리 파일을 실행 가능하게 만듭니다.chmod +x hcp

$ chmod +x hcpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hcp바이너리 파일을 경로의 디렉터리로 이동합니다.sudo mv hcp /usr/local/bin/.

$ sudo mv hcp /usr/local/bin/.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Mac 컴퓨터에서 CLI를 다운로드하는 경우 hcp 바이너리 파일에 대한 경고가 표시될 수 있습니다. 바이너리 파일을 실행할 수 있도록 보안 설정을 조정해야 합니다.

검증

다음 명령을 실행하여 사용 가능한 매개변수 목록이 표시되는지 확인합니다.

hcp create cluster <platform> --help

$ hcp create cluster <platform> --help1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

hcp create cluster명령을 사용하여 호스팅된 클러스터를 생성하고 관리할 수 있습니다. 지원되는 플랫폼은aws,agent,kubevirt입니다.

3.5. 호스트된 클러스터 워크로드 배포

OpenShift Container Platform의 호스트된 컨트롤 플레인을 시작하기 전에 호스트 클러스터의 Pod를 인프라 노드에 예약할 수 있도록 노드에 레이블을 올바르게 지정해야 합니다. 다음과 같은 이유로 노드 레이블 지정도 중요합니다.

-

고가용성 및 적절한 워크로드 배포를 보장합니다. 예를 들어 OpenShift Container Platform 서브스크립션에 컨트롤 플레인 워크로드 수가 발생하지 않도록 하려면

node-role.kubernetes.io/infra레이블을 설정할 수 있습니다. - 컨트롤 플레인 워크로드가 관리 클러스터의 다른 워크로드와 분리되어 있는지 확인하려면 다음을 수행하십시오.

컨트롤 플레인 워크로드가 배포에 대한 올바른 멀티 테넌시 배포 수준에서 구성되었는지 확인하려면 다음을 수행합니다. 배포 수준은 다음과 같습니다.

- 모든 공유: 호스팅된 클러스터의 컨트롤 플레인은 컨트롤 플레인에 지정된 모든 노드에서 실행할 수 있습니다.

- 격리 요청: 자체 전용 노드에서 Serving Pod가 요청됩니다.

- 공유 없음: 모든 컨트롤 플레인에는 자체 전용 노드가 있습니다.

노드를 단일 호스트 클러스터에 배치하는 방법에 대한 자세한 내용은 "관리 클러스터 노드 정의"를 참조하십시오.

워크로드에 관리 클러스터를 사용하지 마십시오. 컨트롤 플레인이 실행되는 노드에서 워크로드가 실행되지 않아야 합니다.

3.5.1. 관리 클러스터 노드 레이블 지정

호스팅된 컨트롤 플레인을 배포하기 위한 적절한 노드 레이블링은 사전 요구 사항입니다.

관리 클러스터 관리자는 관리 클러스터 노드에서 다음 레이블 및 테인트를 사용하여 컨트롤 플레인 워크로드를 예약합니다.

-

Hypershift.openshift.io/control-plane: true: 이 레이블과 테인트를 사용하여 호스트된 컨트롤 플레인 워크로드를 실행하는 노드를 전용으로 사용합니다.true값을 설정하면 컨트롤 플레인 노드를 관리 클러스터의 인프라 구성 요소 또는 실수로 배포된 워크로드와 같은 다른 구성 요소와 공유하지 않습니다. -

Hypershift.openshift.io/cluster: ${HostedControlPlane Namespace}: 노드를 단일 호스트 클러스터에 전용으로 설정하려면 이 레이블과 테인트를 사용합니다.

control-plane Pod를 호스팅하는 노드에 다음 레이블을 적용합니다.

-

node-role.kubernetes.io/infra: 서브스크립션에 컨트롤 플레인 워크로드 수가 발생하지 않도록 이 라벨을 사용합니다. topology.kubernetes.io/zone: 관리 클러스터 노드에서 이 레이블을 사용하여 장애 도메인에서 고가용성 클러스터를 배포합니다. 영역은 위치, 랙 이름 또는 영역이 설정된 노드의 호스트 이름이 될 수 있습니다. 예를 들어 관리 클러스터에는worker-1a,worker-1b,worker-2a및worker-2b와 같은 노드가 있습니다.worker-1a및worker-1b노드는rack1에 있으며worker-2a및 worker-2b 노드는rack2에 있습니다. 각 랙을 가용성 영역으로 사용하려면 다음 명령을 입력합니다.oc label node/worker-1a node/worker-1b topology.kubernetes.io/zone=rack1

$ oc label node/worker-1a node/worker-1b topology.kubernetes.io/zone=rack1Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc label node/worker-2a node/worker-2b topology.kubernetes.io/zone=rack2

$ oc label node/worker-2a node/worker-2b topology.kubernetes.io/zone=rack2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

호스팅된 클러스터의 Pod에는 허용 오차가 있으며 스케줄러는 선호도 규칙을 사용하여 스케줄링합니다. Pod는 컨트롤 플레인 및 Pod에 대한 클러스터 의 테인트를 허용합니다. 스케줄러는 hypershift.openshift.io/control-plane 및 hypershift.openshift.io/cluster: ${HostedControlPlane Namespace} 로 레이블이 지정된 노드에 Pod 예약에 우선순위를 지정합니다.

ControllerAvailabilityPolicy 옵션의 경우 호스팅된 컨트롤 플레인 명령줄 인터페이스인 hcp, deploy의 기본값인 HighlyAvailable 을 사용합니다. 이 옵션을 사용하면 topology.kubernetes.io/zone 을 토폴로지 키로 설정하여 다양한 장애 도메인에서 호스트된 클러스터 내에서 각 배포에 대한 Pod를 예약할 수 있습니다. 다른 장애 도메인에서 호스팅된 클러스터 내에서 배포에 대한 Pod 예약은 고가용성 컨트롤 플레인에만 사용할 수 있습니다.

프로세스

호스트 클러스터를 활성화하려면 다음 예와 같이 Pod를 인프라 노드에 예약해야 합니다. HostedCluster.spec.nodeSelector 를 설정합니다.

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""이렇게 하면 각 호스팅된 클러스터의 호스팅 컨트롤 플레인이 적합한 인프라 노드 워크로드이며 기본 OpenShift Container Platform 노드에 액세스할 필요가 없습니다.

3.5.2. 우선순위 클래스

기본 제공 우선순위 클래스 4개가 호스트된 클러스터 Pod의 우선 순위 및 선점에 영향을 미칩니다. 다음과 같은 순서로 관리 클러스터에 Pod를 생성할 수 있습니다.

-

Hypershift-operator: HyperShift Operator Pod -

Hypershift-etcd: etcd 용 Pod -

Hypershift-api-critical: API 호출 및 리소스 승인에 필요한 Pod입니다. 이러한 Pod에는kube-apiserver, 집계 API 서버 및 웹 후크와 같은 Pod가 포함됩니다. -

Hypershift-control-plane: API-critical는 아니지만 클러스터 버전 Operator와 같이 높은 우선 순위가 필요한 컨트롤 플레인의 Pod입니다.

3.5.3. 사용자 정의 테인트 및 톨러레이션

기본적으로 호스트 클러스터의 Pod는 control-plane 및 cluster taint를 허용합니다. 그러나 호스팅된 클러스터가 HostedCluster.spec.tolerations 를 설정하여 호스트당 클러스터별로 해당 테인트를 허용할 수 있도록 노드에서 사용자 지정 테인트를 사용할 수도 있습니다.

호스팅된 클러스터에 대한 허용 오차를 전달하는 것은 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 다음 링크를 참조하십시오.

설정 예

spec:

tolerations:

- effect: NoSchedule

key: kubernetes.io/custom

operator: Exists

spec:

tolerations:

- effect: NoSchedule

key: kubernetes.io/custom

operator: Exists

--tolerations hcp CLI 인수를 사용하여 클러스터를 생성하는 동안 호스트된 클러스터에 허용 오차를 설정할 수도 있습니다.

CLI 인수 예

--toleration="key=kubernetes.io/custom,operator=Exists,effect=NoSchedule"

--toleration="key=kubernetes.io/custom,operator=Exists,effect=NoSchedule"

호스트별로 호스팅된 클러스터 Pod 배치를 세밀하게 제어하려면 nodeSelectors 와 함께 사용자 정의 허용 오차를 사용합니다. 호스트 클러스터 그룹을 공동 배치하고 다른 호스팅 클러스터에서 격리할 수 있습니다. 인프라 및 컨트롤 플레인 노드에 호스팅 클러스터를 배치할 수도 있습니다.

호스팅된 클러스터의 허용 오차는 컨트롤 플레인의 Pod에만 분배됩니다. 가상 머신을 실행하기 위해 pod와 같은 관리 클러스터 및 인프라 관련 Pod에서 실행되는 다른 Pod를 구성하려면 다른 프로세스를 사용해야 합니다.

3.5.4. 컨트롤 플레인 격리

호스트된 컨트롤 플레인을 구성하여 네트워크 트래픽 또는 컨트롤 플레인 Pod를 분리할 수 있습니다.

3.5.4.1. 네트워크 정책 격리

호스트된 각 컨트롤 플레인은 전용 Kubernetes 네임스페이스에서 실행되도록 할당됩니다. 기본적으로 Kubernetes 네임스페이스는 모든 네트워크 트래픽을 거부합니다.

다음 네트워크 트래픽은 Kubernetes CNI(Container Network Interface)에서 강제 적용하는 네트워크 정책을 통해 허용됩니다.

- 동일한 네임스페이스(Intra-tenant)의 수신 pod-to-pod 통신

-

테넌트의 호스트된

kube-apiserverPod에 포트 6443의 수신 -

network.openshift.io/policy-group: 모니터링 라벨을 사용하여 관리 클러스터 Kubernetes 네임스페이스의 메트릭 스크랩을 모니터링할 수 있습니다.

3.5.4.2. 컨트롤 플레인 Pod 격리

네트워크 정책 외에도 각 호스팅된 컨트롤 플레인 포드는 restricted 보안 컨텍스트 제약 조건을 사용하여 실행됩니다. 이 정책은 모든 호스트 기능에 대한 액세스를 거부하고 고객 컨트롤 플레인을 호스팅하는 각 네임스페이스에 고유하게 할당된 SELinux 컨텍스트를 사용하여 Pod를 UID로 실행해야 합니다.

이 정책은 다음 제약 조건을 확인합니다.

- Pod는 권한으로 실행할 수 없습니다.

- Pod는 호스트 디렉터리 볼륨을 마운트할 수 없습니다.

- Pod는 사전 할당된 UID 범위에서 사용자로 실행해야 합니다.

- Pod는 사전 할당된 MCS 라벨을 사용하여 실행해야 합니다.

- Pod는 호스트 네트워크 네임스페이스에 액세스할 수 없습니다.

- Pod는 호스트 네트워크 포트를 노출할 수 없습니다.

- Pod는 호스트 PID 네임스페이스에 액세스할 수 없습니다.

-

기본적으로 Pod는

KILL,MKNOD,SETUID및SETGID와 같은 Linux 기능을 삭제합니다.

각 관리 클러스터 작업자 노드에서 kubelet 및 crio 와 같은 관리 구성 요소는 호스팅된 컨트롤 플레인을 지원하는 Pod의 SELinux 컨텍스트에 액세스할 수 없는 SELinux 레이블로 보호됩니다.

다음 SELinux 레이블은 주요 프로세스 및 소켓에 사용됩니다.

-

kubelet:

system_u:system_r:unconfined_service_t:s0 -

crio:

system_u:system_r:container_runtime_t:s0 -

crio.sock:

system_u:object_r:container_var_run_t:s0 -

<example user container processes>:

system_u:system_r:container_t:s0:c14,c24

3.6. 호스팅된 컨트롤 플레인 기능 활성화 또는 비활성화

호스팅된 컨트롤 플레인 기능 및 hypershift-addon 관리 클러스터 애드온은 기본적으로 활성화되어 있습니다. 기능을 비활성화하거나 비활성화한 후 수동으로 활성화하려면 다음 절차를 참조하십시오.

3.6.1. 수동으로 호스트된 컨트롤 플레인 기능 활성화

호스팅된 컨트롤 플레인을 수동으로 활성화해야 하는 경우 다음 단계를 완료합니다.

프로세스

다음 명령을 실행하여 기능을 활성화합니다.

oc patch mce multiclusterengine --type=merge -p \ '{"spec":{"overrides":{"components":[{"name":"hypershift","enabled": true}]}}}'$ oc patch mce multiclusterengine --type=merge -p \ '{"spec":{"overrides":{"components":[{"name":"hypershift","enabled": true}]}}}'1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 기본

MultiClusterEngine리소스 인스턴스 이름은multiclusterengine이지만 다음 명령을 실행하여 클러스터에서MultiClusterEngine이름을 가져올 수 있습니다.$ oc get mce.

다음 명령을 실행하여

MultiClusterEngine사용자 정의 리소스에서hypershift및hypershift-local-hosting기능이 활성화되어 있는지 확인합니다.oc get mce multiclusterengine -o yaml

$ oc get mce multiclusterengine -o yaml1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 기본

MultiClusterEngine리소스 인스턴스 이름은multiclusterengine이지만 다음 명령을 실행하여 클러스터에서MultiClusterEngine이름을 가져올 수 있습니다.$ oc get mce.

출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6.1.1. local-cluster의 하이퍼shift-addon 관리 클러스터 애드온 수동 활성화

호스팅된 컨트롤 플레인 기능을 활성화하면 하이퍼shift-addon 관리 클러스터 애드온이 자동으로 활성화됩니다. hypershift-addon 관리 클러스터 애드온을 수동으로 활성화해야 하는 경우 hypershift-addon 을 사용하여 local-cluster 에 HyperShift Operator를 설치하려면 다음 단계를 완료합니다.

프로세스

다음 예와 유사한 파일을 생성하여

hypershift-addon이라는ManagedClusterAddon애드온을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 파일을 적용합니다.

oc apply -f <filename>

$ oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow filename을 생성한 파일의 이름으로 바꿉니다.다음 명령을 실행하여

hypershift-addon관리 클러스터 애드온이 설치되었는지 확인합니다.oc get managedclusteraddons -n local-cluster hypershift-addon

$ oc get managedclusteraddons -n local-cluster hypershift-addonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 애드온이 설치된 경우 출력은 다음 예와 유사합니다.

NAME AVAILABLE DEGRADED PROGRESSING hypershift-addon True

NAME AVAILABLE DEGRADED PROGRESSING hypershift-addon TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow

하이퍼shift-addon 관리 클러스터 애드온이 설치되어 있으며 호스팅 클러스터를 사용하여 호스팅 클러스터를 생성하고 관리할 수 있습니다.

3.6.2. 호스트된 컨트롤 플레인 기능 비활성화

HyperShift Operator를 설치 제거하고 호스팅된 컨트롤 플레인 기능을 비활성화할 수 있습니다. 호스팅된 컨트롤 플레인 기능을 비활성화할 때 호스트 클러스터 항목 관리에 설명된 대로 다중 클러스터 엔진 Operator에서 호스팅 클러스터 및 관리 클러스터 리소스를 제거해야 합니다.

3.6.2.1. HyperShift Operator 설치 제거

HyperShift Operator를 설치 제거하고 local-cluster 에서 hypershift-addon 을 비활성화하려면 다음 단계를 완료하십시오.

프로세스

다음 명령을 실행하여 호스트 클러스터가 실행되고 있지 않은지 확인합니다.

oc get hostedcluster -A

$ oc get hostedcluster -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow 중요호스트 클러스터가 실행 중인 경우

hypershift-addon이 비활성화된 경우에도 HyperShift Operator가 제거되지 않습니다.다음 명령을 실행하여

hypershift-addon을 비활성화합니다.oc patch mce multiclusterengine --type=merge -p \ '{"spec":{"overrides":{"components":[{"name":"hypershift-local-hosting","enabled": false}]}}}'$ oc patch mce multiclusterengine --type=merge -p \1 '{"spec":{"overrides":{"components":[{"name":"hypershift-local-hosting","enabled": false}]}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 기본

MultiClusterEngine리소스 인스턴스 이름은multiclusterengine이지만 다음 명령을 실행하여 클러스터에서MultiClusterEngine이름을 가져올 수 있습니다.$ oc get mce.

참고hypershift-addon을 비활성화한 후 다중 클러스터 엔진 Operator 콘솔에서local-cluster의hypershift-addon을 비활성화할 수도 있습니다.

3.6.2.2. 호스트된 컨트롤 플레인 기능 비활성화

호스팅된 컨트롤 플레인 기능을 비활성화하려면 다음 단계를 완료합니다.

사전 요구 사항

- HyperShift Operator를 설치 제거했습니다. 자세한 내용은 "HyperShift Operator 제거"를 참조하십시오.

프로세스

다음 명령을 실행하여 호스팅된 컨트롤 플레인 기능을 비활성화합니다.

oc patch mce multiclusterengine --type=merge -p \ '{"spec":{"overrides":{"components":[{"name":"hypershift","enabled": false}]}}}'$ oc patch mce multiclusterengine --type=merge -p \1 '{"spec":{"overrides":{"components":[{"name":"hypershift","enabled": false}]}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 기본

MultiClusterEngine리소스 인스턴스 이름은multiclusterengine이지만 다음 명령을 실행하여 클러스터에서MultiClusterEngine이름을 가져올 수 있습니다.$ oc get mce.

다음 명령을 실행하여

hypershift및hypershift-local-hosting기능이MultiClusterEngine사용자 정의 리소스에서 비활성화되어 있는지 확인할 수 있습니다.oc get mce multiclusterengine -o yaml

$ oc get mce multiclusterengine -o yaml1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 기본

MultiClusterEngine리소스 인스턴스 이름은multiclusterengine이지만 다음 명령을 실행하여 클러스터에서MultiClusterEngine이름을 가져올 수 있습니다.$ oc get mce.

hypershift및hypershift-local-hosting에enabled:flags가false로 설정된 다음 예제를 참조하십시오.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4장. 호스트된 컨트롤 플레인 배포

4.1. AWS에 호스팅된 컨트롤 플레인 배포

호스팅 클러스터는 관리 클러스터에서 호스팅되 는 API 끝점 및 컨트롤 플레인이 있는 OpenShift Container Platform 클러스터입니다. 호스트된 클러스터에는 컨트롤 플레인과 해당 데이터 플레인이 포함됩니다. 온프레미스에서 호스팅되는 컨트롤 플레인을 구성하려면 관리 클러스터에 Kubernetes Operator용 다중 클러스터 엔진을 설치해야 합니다. hypershift-addon 관리 클러스터 애드온을 사용하여 기존 관리 클러스터에 HyperShift Operator를 배포하면 해당 클러스터를 관리 클러스터로 활성화하고 호스팅된 클러스터를 생성할 수 있습니다. 로컬 클러스터 관리 클러스터에 대해 애드온은 기본적으로 활성화되어 있습니다.

하이퍼shift-addon 관리 클러스터

다중 클러스터 엔진 Operator 콘솔 또는 호스팅된 컨트롤 플레인 CLI(명령줄 인터페이스), hcp 를 사용하여 호스팅된 클러스터를 생성할 수 있습니다. 호스팅된 클러스터는 관리 클러스터로 자동으로 가져옵니다. 그러나 이 자동 가져오기 기능을 다중 클러스터 엔진 Operator로 비활성화 할 수 있습니다.

4.1.1. AWS에 호스팅된 컨트롤 플레인 배포 준비

AWS(Amazon Web Services)에 호스팅된 컨트롤 플레인을 배포할 준비가 되면 다음 정보를 고려하십시오.

- 각 호스트 클러스터에는 클러스터 전체 이름이 있어야 합니다. 호스트된 클러스터 이름은 다중 클러스터 엔진 Operator가 이를 관리하기 위해 기존 관리 클러스터와 같을 수 없습니다.

-

클러스터를 호스팅

클러스터이름으로 사용하지 마십시오. - 호스팅된 컨트롤 플레인의 동일한 플랫폼에서 관리 클러스터 및 작업자를 실행합니다.

- 호스트된 클러스터는 다중 클러스터 엔진 Operator 관리 클러스터의 네임스페이스에서 생성할 수 없습니다.

4.1.1.1. 관리 클러스터를 구성하기 위한 사전 요구 사항

관리 클러스터를 구성하려면 다음 사전 요구 사항이 있어야 합니다.

- OpenShift Container Platform 클러스터에 Kubernetes Operator 2.5 이상을 위한 다중 클러스터 엔진을 설치했습니다. RHACM(Red Hat Advanced Cluster Management)을 설치할 때 multicluster engine Operator가 자동으로 설치됩니다. 멀티 클러스터 엔진 Operator는 OpenShift Container Platform 소프트웨어 카탈로그의 Operator로 RHACM 없이 설치할 수도 있습니다.

다중 클러스터 엔진 Operator에 대해 하나 이상의 관리형 OpenShift Container Platform 클러스터가 있어야 합니다.

local-cluster는 다중 클러스터 엔진 Operator 버전 2.5 이상에서 자동으로 가져옵니다. 다음 명령을 실행하여 허브 클러스터의 상태를 확인할 수 있습니다.oc get managedclusters local-cluster

$ oc get managedclusters local-clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

awsCLI(명령줄 인터페이스) 를 설치했습니다. -

호스팅된 컨트롤 플레인 CLI(

hcp)를 설치했습니다.

4.1.2. hcp CLI를 사용하여 AWS에서 호스트된 클러스터에 액세스

hcp CLI(명령줄 인터페이스)를 사용하여 kubeconfig 파일을 생성하여 호스팅된 클러스터에 액세스할 수 있습니다.

프로세스

다음 명령을 입력하여

kubeconfig파일을 생성합니다.hcp create kubeconfig --namespace <hosted_cluster_namespace> \ --name <hosted_cluster_name> > <hosted_cluster_name>.kubeconfig

$ hcp create kubeconfig --namespace <hosted_cluster_namespace> \ --name <hosted_cluster_name> > <hosted_cluster_name>.kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow kubeconfig파일을 저장한 후 다음 명령을 입력하여 호스팅된 클러스터에 액세스할 수 있습니다.oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodes

$ oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.3. Amazon Web Services S3 버킷 및 S3 OIDC 시크릿 생성

AWS(Amazon Web Services)에서 호스팅된 클러스터를 생성하고 관리하려면 S3 버킷 및 S3 OIDC 시크릿을 생성해야 합니다.

프로세스

다음 명령을 실행하여 클러스터의 호스트 OIDC 검색 문서에 액세스할 수 있는 S3 버킷을 생성합니다.

aws s3api create-bucket --bucket <bucket_name> \ --create-bucket-configuration LocationConstraint=<region> \ --region <region>

$ aws s3api create-bucket --bucket <bucket_name> \1 --create-bucket-configuration LocationConstraint=<region> \2 --region <region>3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow aws s3api delete-public-access-block --bucket <bucket_name>

$ aws s3api delete-public-access-block --bucket <bucket_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;bucket_name>을 생성 중인 S3 버킷의 이름으로 바꿉니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;bucket_name>을 생성 중인 S3 버킷의 이름으로 바꿉니다.

aws s3api put-bucket-policy --bucket <bucket_name> \ --policy file://policy.json

$ aws s3api put-bucket-policy --bucket <bucket_name> \1 --policy file://policy.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;bucket_name>을 생성 중인 S3 버킷의 이름으로 바꿉니다.

참고Mac 컴퓨터를 사용하는 경우 정책이 작동하려면 버킷 이름을 내보내야 합니다.

-

HyperShift Operator에 대해

hypershift-operator-oidc-provider-s3-credentials라는 OIDC S3 시크릿을 생성합니다. -

로컬 클러스터네임스페이스에 시크릿을 저장합니다. 다음 표를 참조하여 보안에 다음 필드가 포함되어 있는지 확인합니다.

Expand 표 4.1. AWS 시크릿의 필수 필드 필드 이름 설명 bucket호스팅된 클러스터에 대한 호스트 OIDC 검색 문서에 대한 공용 액세스 권한이 있는 S3 버킷이 포함되어 있습니다.

credentials버킷에 액세스할 수 있는

기본프로필의 자격 증명이 포함된 파일에 대한 참조입니다. 기본적으로 HyperShift는기본프로필만 사용하여버킷을 작동합니다.regionS3 버킷의 리전을 지정합니다.

AWS 시크릿을 생성하려면 다음 명령을 실행합니다.

oc create secret generic <secret_name> \ --from-file=credentials=<path>/.aws/credentials \ --from-literal=bucket=<s3_bucket> \ --from-literal=region=<region> \ -n local-cluster

$ oc create secret generic <secret_name> \ --from-file=credentials=<path>/.aws/credentials \ --from-literal=bucket=<s3_bucket> \ --from-literal=region=<region> \ -n local-clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고보안에 대한 재해 복구 백업은 자동으로 활성화되지 않습니다. 재해 복구를 위해

hypershift-operator-oidc-provider-s3-credentials시크릿을 백업할 수 있는 레이블을 추가하려면 다음 명령을 실행합니다.oc label secret hypershift-operator-oidc-provider-s3-credentials \ -n local-cluster cluster.open-cluster-management.io/backup=true

$ oc label secret hypershift-operator-oidc-provider-s3-credentials \ -n local-cluster cluster.open-cluster-management.io/backup=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.4. 호스팅된 클러스터에 대해 라우팅 가능한 퍼블릭 영역 생성

호스팅된 클러스터의 애플리케이션에 액세스하려면 라우팅 가능한 퍼블릭 영역을 구성해야 합니다. 퍼블릭 영역이 있는 경우 이 단계를 건너뜁니다. 그렇지 않으면 퍼블릭 영역이 기존 기능에 영향을 미칩니다.

프로세스

DNS 레코드에 대해 라우팅 가능한 퍼블릭 영역을 생성하려면 다음 명령을 입력합니다.

aws route53 create-hosted-zone \ --name <basedomain> \ --caller-reference $(whoami)-$(date --rfc-3339=date)

$ aws route53 create-hosted-zone \ --name <basedomain> \1 --caller-reference $(whoami)-$(date --rfc-3339=date)Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;basedomain>을 기본 도메인으로 바꿉니다(예:www.example.com).

4.1.5. AWS IAM 역할 및 STS 인증 정보 생성

AWS(Amazon Web Services)에서 호스팅된 클러스터를 생성하기 전에 AWS IAM 역할 및 STS 인증 정보를 생성해야 합니다.

프로세스

다음 명령을 실행하여 사용자의 Amazon 리소스 이름(ARN)을 가져옵니다.

aws sts get-caller-identity --query "Arn" --output text

$ aws sts get-caller-identity --query "Arn" --output textCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

arn:aws:iam::1234567890:user/<aws_username>

arn:aws:iam::1234567890:user/<aws_username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 단계에서 이 출력을 <

arn>의 값으로 사용합니다.역할에 대한 신뢰 관계 구성이 포함된 JSON 파일을 생성합니다. 다음 예제를 참조하십시오.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;arn>을 이전 단계에서 언급한 사용자의 ARN으로 바꿉니다.

다음 명령을 실행하여 IAM(Identity and Access Management) 역할을 생성합니다.

aws iam create-role \ --role-name <name> \ --assume-role-policy-document file://<file_name>.json \ --query "Role.Arn"

$ aws iam create-role \ --role-name <name> \1 --assume-role-policy-document file://<file_name>.json \2 --query "Role.Arn"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

arn:aws:iam::820196288204:role/myrole

arn:aws:iam::820196288204:role/myroleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 역할에 대한 다음 권한 정책이 포함된

policy.json이라는 JSON 파일을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

policy.json파일을 역할에 연결합니다.aws iam put-role-policy \ --role-name <role_name> \ --policy-name <policy_name> \ --policy-document file://policy.json

$ aws iam put-role-policy \ --role-name <role_name> \1 --policy-name <policy_name> \2 --policy-document file://policy.json3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

sts-creds.json이라는 JSON 파일에서 STS 자격 증명을 검색합니다.aws sts get-session-token --output json > sts-creds.json

$ aws sts get-session-token --output json > sts-creds.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow sts-creds.json파일의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.6. 호스팅된 컨트롤 플레인에 AWS PrivateLink 활성화

PrivateLink를 사용하여 AWS(Amazon Web Services)에서 호스팅되는 컨트롤 플레인을 프로비저닝하려면 호스팅된 컨트롤 플레인에 대해 AWS PrivateLink를 활성화합니다.

프로세스

-

HyperShift Operator에 대한 AWS 인증 정보 시크릿을 생성하고

hypershift-operator-private-link-credentials로 이름을 지정합니다. 보안은 관리 클러스터로 사용 중인 관리 클러스터의 네임스페이스인 관리 클러스터 네임스페이스에 있어야 합니다.local-cluster를 사용한 경우local-cluster네임스페이스에 시크릿을 생성합니다. - 다음 표를 참조하여 보안에 필수 필드가 포함되어 있는지 확인합니다.

| 필드 이름 | 설명 | 선택 사항 또는 필수 |

|---|---|---|

|

| Private Link에서 사용할 수 있는 리전 | 필수 항목 |

|

| 인증 정보 액세스 키 ID입니다. | 필수 항목 |

|

| 인증 정보 액세스 키 시크릿입니다. | 필수 항목 |

AWS 시크릿을 생성하려면 다음 명령을 실행합니다.

oc create secret generic <secret_name> \ --from-literal=aws-access-key-id=<aws_access_key_id> \ --from-literal=aws-secret-access-key=<aws_secret_access_key> \ --from-literal=region=<region> -n local-cluster

$ oc create secret generic <secret_name> \

--from-literal=aws-access-key-id=<aws_access_key_id> \

--from-literal=aws-secret-access-key=<aws_secret_access_key> \

--from-literal=region=<region> -n local-cluster

보안에 대한 재해 복구 백업은 자동으로 활성화되지 않습니다. 다음 명령을 실행하여 재해 복구를 위해 hypershift-operator-private-link-credentials 시크릿을 백업할 수 있는 레이블을 추가합니다.

oc label secret hypershift-operator-private-link-credentials \ -n local-cluster \ cluster.open-cluster-management.io/backup=""

$ oc label secret hypershift-operator-private-link-credentials \

-n local-cluster \

cluster.open-cluster-management.io/backup=""4.1.7. AWS에서 호스팅된 컨트롤 플레인의 외부 DNS 활성화

컨트롤 플레인과 데이터 플레인은 호스팅된 컨트롤 플레인에서 분리되어 있습니다. 다음 두 개의 독립적인 영역에서 DNS를 구성할 수 있습니다.

-

호스트 클러스터 내의 워크로드에 대한 수신(예:

*.apps.service-consumer-domain.com). -

서비스 공급자 도메인을 통한 API 또는 OAuth 끝점과 같은 관리 클러스터 내의 서비스 끝점에 대한 수신:

*.service-provider-domain.com.

hostedCluster.spec.dns 의 입력은 호스팅 클러스터 내의 워크로드에 대한 수신을 관리합니다. hostedCluster.spec.services.servicePublishingStrategy.route.hostname 의 입력은 관리 클러스터 내의 서비스 끝점에 대한 수신을 관리합니다.

외부 DNS는 LoadBalancer 또는 Route 의 게시 유형을 지정하고 해당 게시 유형의 호스트 이름을 제공하는 호스팅 클러스터 서비스에 대한 이름 레코드를 생성합니다. Private 또는 PublicAndPrivate 엔드포인트 액세스 유형이 있는 호스팅 클러스터의 경우 APIServer 및 OAuth 서비스만 호스트 이름을 지원합니다. 프라이빗 호스트 클러스터의 경우 DNS 레코드는 VPC의 VPC(Virtual Private Cloud) 끝점의 프라이빗 IP 주소로 확인됩니다.

호스팅된 컨트롤 플레인은 다음 서비스를 노출합니다.

-

APIServer -

OIDC

HostedCluster 사양에서 servicePublishingStrategy 필드를 사용하여 이러한 서비스를 노출할 수 있습니다. 기본적으로 LoadBalancer 및 Route 유형의 servicePublishingStrategy 에서는 다음 방법 중 하나로 서비스를 게시할 수 있습니다.

-

LoadBalancer유형의서비스상태에 있는 로드 밸런서의 호스트 이름을 사용하여 다음을 수행합니다. -

Route리소스의status.host필드를 사용합니다.

그러나 관리 서비스 컨텍스트에 호스팅된 컨트롤 플레인을 배포할 때 이러한 방법은 기본 관리 클러스터의 ingress 하위 도메인과 관리 클러스터 라이프사이클 및 재해 복구에 대한 제한 옵션을 노출할 수 있습니다.

LoadBalancer 및 Route 게시 유형에 DNS indirection이 계층화된 경우 관리형 서비스 운영자는 서비스 수준 도메인을 사용하여 모든 공용 호스팅 클러스터 서비스를 게시할 수 있습니다. 이 아키텍처를 사용하면 DNS 이름을 새 LoadBalancer 또는 경로에 다시 매핑할 수 있으며 관리 클러스터의 인그레스 도메인을 노출하지 않습니다. 호스팅된 컨트롤 플레인은 외부 DNS를 사용하여 해당 간접 계층을 달성합니다.

관리 클러스터의 hypershift 네임스페이스에 HyperShift Operator와 함께 external-dns 를 배포할 수 있습니다. 외부 DNS는 external-dns.alpha.kubernetes.io/hostname 주석이 있는 서비스 또는 경로를 감시합니다. 해당 주석은 A 레코드 또는 경로 (예: CNAME 레코드)와 같은 서비스를 가리키는 DNS 레코드를 생성하는 데 사용됩니다.

클라우드 환경에서만 외부 DNS를 사용할 수 있습니다. 다른 환경의 경우 DNS 및 서비스를 수동으로 구성해야 합니다.

외부 DNS에 대한 자세한 내용은 외부 DNS 를 참조하십시오.

4.1.7.1. 사전 요구 사항

AWS(Amazon Web Services)에서 호스팅된 컨트롤 플레인에 대한 외부 DNS를 설정하려면 다음 사전 요구 사항을 충족해야 합니다.

- 외부 공용 도메인을 생성하셨습니다.

- AWS Route53 관리 콘솔에 액세스할 수 있습니다.

- 호스팅된 컨트롤 플레인에 대해 AWS PrivateLink를 활성화했습니다.

4.1.7.2. 호스팅된 컨트롤 플레인의 외부 DNS 설정

외부 DNS 또는 서비스 수준 DNS를 사용하여 호스팅되는 컨트롤 플레인을 프로비저닝할 수 있습니다.

-

HyperShift Operator에 대한 AWS(Amazon Web Services) 인증 정보 시크릿을 생성하고

local-cluster네임스페이스에hypershift-operator-external-dns-credentials이름을 지정합니다. 다음 표를 참조하여 보안에 필수 필드가 있는지 확인합니다.

Expand 표 4.3. AWS 시크릿의 필수 필드 필드 이름 설명 선택 사항 또는 필수 provider서비스 수준 DNS 영역을 관리하는 DNS 공급자입니다.

필수 항목

domain-filter서비스 수준 도메인입니다.

필수 항목

credentials모든 외부 DNS 유형을 지원하는 자격 증명 파일입니다.

AWS 키를 사용할 때 선택 사항

aws-access-key-id인증 정보 액세스 키 ID입니다.

AWS DNS 서비스를 사용할 때 선택 사항

aws-secret-access-key인증 정보 액세스 키 시크릿입니다.

AWS DNS 서비스를 사용할 때 선택 사항

AWS 시크릿을 생성하려면 다음 명령을 실행합니다.

oc create secret generic <secret_name> \ --from-literal=provider=aws \ --from-literal=domain-filter=<domain_name> \ --from-file=credentials=<path_to_aws_credentials_file> -n local-cluster

$ oc create secret generic <secret_name> \ --from-literal=provider=aws \ --from-literal=domain-filter=<domain_name> \ --from-file=credentials=<path_to_aws_credentials_file> -n local-clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고보안에 대한 재해 복구 백업은 자동으로 활성화되지 않습니다. 재해 복구를 위해 시크릿을 백업하려면 다음 명령을 입력하여

hypershift-operator-external-dns-credentials를 추가합니다.oc label secret hypershift-operator-external-dns-credentials \ -n local-cluster \ cluster.open-cluster-management.io/backup=""

$ oc label secret hypershift-operator-external-dns-credentials \ -n local-cluster \ cluster.open-cluster-management.io/backup=""Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.7.3. 퍼블릭 DNS 호스팅 영역 생성

외부 DNS Operator는 퍼블릭 DNS 호스팅 영역을 사용하여 퍼블릭 호스팅 클러스터를 생성합니다.

퍼블릭 DNS 호스팅 영역을 생성하여 외부 DNS 도메인 필터로 사용할 수 있습니다. AWS Route 53 관리 콘솔에서 다음 단계를 완료합니다.

프로세스

- Route 53 관리 콘솔에서 호스팅 영역 생성을 클릭합니다.

- 호스팅 영역 구성 페이지에서 도메인 이름을 입력하고 공용 호스팅 영역이 유형으로 선택되어 있는지 확인하고 호스트 영역 생성 을 클릭합니다.

- 영역이 생성되면 레코드 탭에서 Value/Route 트래픽의 값을 열로 기록해 둡니다.

- 기본 도메인에서 NS 레코드를 생성하여 DNS 요청을 위임된 영역으로 리디렉션합니다. 값 필드에 이전 단계에서 기록한 값을 입력합니다.

- 레코드 생성을 클릭합니다.

새 하위 영역에 테스트 항목을 생성하고 다음 예와 같이

dig명령을 사용하여 테스트하여 DNS 호스팅 영역이 작동하는지 확인합니다.dig +short test.user-dest-public.aws.kerberos.com

$ dig +short test.user-dest-public.aws.kerberos.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

192.168.1.1

192.168.1.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow LoadBalancer및Route서비스의 호스트 이름을 설정하는 호스팅 클러스터를 생성하려면 다음 명령을 입력합니다.hcp create cluster aws --name=<hosted_cluster_name> \ --endpoint-access=PublicAndPrivate \ --external-dns-domain=<public_hosted_zone> ...

$ hcp create cluster aws --name=<hosted_cluster_name> \ --endpoint-access=PublicAndPrivate \ --external-dns-domain=<public_hosted_zone> ...1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;public_hosted_zone>을 생성한 공개 호스팅 영역으로 바꿉니다.

호스트된 클러스터에 대한

services블록의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Control Plane Operator는 Services 및 Routes 리소스를 생성하고 external-dns.alpha.kubernetes.io/hostname 주석으로 주석을 추가합니다. 서비스 및 경로 의 경우 컨트롤 플레인 Operator는 서비스 끝점의 servicePublishingStrategy 필드에 있는 hostname 매개변수 값을 사용합니다. DNS 레코드를 만들려면 external-dns 배포와 같은 메커니즘을 사용할 수 있습니다.

공용 서비스에 대해서만 서비스 수준 DNS를 간접으로 구성할 수 있습니다. hypershift.local 프라이빗 영역을 사용하므로 프라이빗 서비스의 호스트 이름을 설정할 수 없습니다.

다음 표에서는 서비스 및 엔드포인트 조합에 대한 호스트 이름을 설정하는 것이 유효한 시기를 보여줍니다.

| 서비스 | 퍼블릭 | PublicAndPrivate | 프라이빗 |

|---|---|---|---|

|

| Y | Y | N |

|

| Y | Y | N |

|

| Y | N | N |

|

| Y | N | N |

4.1.7.4. AWS에서 외부 DNS를 사용하여 호스트 클러스터 생성

AWS(Amazon Web Services)에서 PublicAndPrivate 또는 Public publishing 전략을 사용하여 호스팅 클러스터를 생성하려면 관리 클러스터에 다음과 같은 아티팩트가 구성되어 있어야 합니다.

- 퍼블릭 DNS 호스팅 영역

- 외부 DNS Operator

- HyperShift Operator

hcp CLI(명령줄 인터페이스)를 사용하여 호스팅된 클러스터를 배포할 수 있습니다.

프로세스

관리 클러스터에 액세스하려면 다음 명령을 입력합니다.

export KUBECONFIG=<path_to_management_cluster_kubeconfig>

$ export KUBECONFIG=<path_to_management_cluster_kubeconfig>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 입력하여 External DNS Operator가 실행 중인지 확인합니다.

oc get pod -n hypershift -lapp=external-dns

$ oc get pod -n hypershift -lapp=external-dnsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE external-dns-7c89788c69-rn8gp 1/1 Running 0 40s

NAME READY STATUS RESTARTS AGE external-dns-7c89788c69-rn8gp 1/1 Running 0 40sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 외부 DNS를 사용하여 호스팅된 클러스터를 생성하려면 다음 명령을 입력합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Amazon 리소스 이름(ARN)을 지정합니다(예:

arn:aws:iam::820196288204:role/myrole). - 2

- 인스턴스 유형을 지정합니다(예:

m6i.xlarge). - 3

- AWS 리전을 지정합니다(예:

us-east-1). - 4

- 호스팅된 클러스터 이름을 지정합니다(예:

my-external-aws). - 5

- 서비스 소비자가 소유한 공개 호스팅 영역을 지정합니다(예:

service-consumer-domain.com). - 6

- 노드 복제본 수를 지정합니다(예: 2).

- 7

- 풀 시크릿 파일의 경로를 지정합니다.

- 8

- 사용하려는 지원되는 OpenShift Container Platform 버전을 지정합니다(예:

4.20.0-multi). - 9

- 서비스 공급자가 소유한 공개 호스팅 영역을 지정합니다(예:

service-provider-domain.com). - 10

- 을

PublicAndPrivate로 설정합니다. 공용 또는PublicAndPrivate - 11

- AWS STS 자격 증명 파일의 경로를 지정합니다(예:

/home/user/sts-creds/sts-creds.json).

4.1.7.5. 사용자 정의 DNS 이름 정의

클러스터 관리자는 노드 부트스트랩 및 컨트롤 플레인 통신에 사용되는 내부 끝점과 다른 외부 API DNS 이름을 사용하여 호스팅 클러스터를 생성할 수 있습니다. 다음과 같은 이유로 다른 DNS 이름을 정의할 수 있습니다.

- 내부 루트 CA에 바인딩되는 컨트롤 플레인 기능을 중단하지 않고 사용자용 TLS 인증서를 공용 CA의 인증서로 교체하려면 다음을 수행합니다.

- 분할 수평 DNS 및 NAT 시나리오를 지원합니다.

-

올바른

kubeconfig및 DNS 구성으로Show Login Command기능과 같은 기능을 사용할 수 있는 독립 실행형 컨트롤 플레인과 유사한 환경을 보장하기 위해 다음을 수행합니다.

HostedCluster 오브젝트의 kubeAPIServerDNSName 매개변수에 도메인 이름을 입력하여 초기 설정 중 또는 설치 후 작업 중에 DNS 이름을 정의할 수 있습니다.

사전 요구 사항

-

kubeAPIServerDNSName매개변수에 설정한 DNS 이름을 다루는 유효한 TLS 인증서가 있습니다. - 올바른 주소에 도달하고 가리킬 수 있는 확인 가능한 DNS 이름 URI가 있습니다.

프로세스

HostedCluster오브젝트의 사양에서kubeAPIServerDNSName매개변수와 도메인의 주소를 추가하고 다음 예와 같이 사용할 인증서를 지정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

kubeAPIServerDNSName매개변수의 값은 유효한 도메인이어야 합니다.

kubeAPIServerDNSName 매개변수를 정의하고 인증서를 지정하면 Control Plane Operator 컨트롤러에서 custom-admin- 라는 kubeconfig 파일을 생성합니다. 여기서 파일이 kubeconfig HostedControlPlane 네임스페이스에 저장됩니다. 인증서 생성은 루트 CA에서 발생하며 HostedControlPlane 네임스페이스는 만료 및 갱신을 관리합니다.

Control Plane Operator는 HostedControlPlane 네임스페이스에서 CustomKubeconfig 라는 새 kubeconfig 파일을 보고합니다. 해당 파일은 kubeAPIServerDNSName 매개변수에서 정의된 새 서버를 사용합니다.

사용자 정의 kubeconfig 파일에 대한 참조는 HostedCluster 오브젝트의 CustomKubeconfig 로 status 매개변수에 있습니다. CustomKubeConfig 매개변수는 선택 사항이며 kubeAPIServerDNSName 매개변수가 비어 있지 않은 경우에만 매개변수를 추가할 수 있습니다. CustomKubeConfig 매개변수를 설정한 후 매개변수는 HostedCluster 네임스페이스에서 < hosted_cluster_name>-custom-admin-kubeconfig 라는 보안 생성을 트리거합니다. 시크릿을 사용하여 HostedCluster API 서버에 액세스할 수 있습니다. 설치 후 작업 중에 CustomKubeConfig 매개변수를 제거하면 모든 관련 보안 및 상태 참조가 삭제됩니다.

사용자 정의 DNS 이름을 정의해도 데이터 플레인에 직접적인 영향을 미치지 않으므로 예상되는 롤아웃이 발생하지 않습니다. HostedControlPlane 네임스페이스는 HyperShift Operator에서 변경 사항을 수신하고 해당 매개변수를 삭제합니다.

HostedCluster 오브젝트의 사양에서 kubeAPIServerDNSName 매개변수를 제거하면 새로 생성된 모든 보안 및 CustomKubeconfig 참조가 클러스터 및 status 매개변수에서 제거됩니다.

4.1.8. AWS에서 호스트 클러스터 생성

hcp CLI(명령줄 인터페이스)를 사용하여 AWS(Amazon Web Services)에서 호스팅된 클러스터를 생성할 수 있습니다.

AWS(Amazon Web Services)에서 호스팅되는 컨트롤 플레인의 경우 기본적으로 AMD64 호스팅 클러스터를 사용합니다. 그러나 호스팅된 컨트롤 플레인이 ARM64 호스팅 클러스터에서 실행되도록 할 수 있습니다. 자세한 내용은 " ARM64 아키텍처에서 호스팅된 클러스터 실행"을 참조하십시오.

노드 풀 및 호스팅 클러스터의 호환 가능한 조합은 다음 표를 참조하십시오.

| 호스트된 클러스터 | 노드 풀 |

|---|---|

| AMD64 | AMD64 또는 ARM64 |

| ARM64 | ARM64 또는 AMD64 |

사전 요구 사항

-

호스트된 컨트롤 플레인 CLI,

hcp를 설정했습니다. -

로컬 클러스터 관리 클러스터를관리 클러스터로 활성화했습니다. - AWS IAM(Identity and Access Management) 역할 및 AWS STS(Security Token Service) 인증 정보를 생성하셨습니다.

프로세스

AWS에서 호스팅된 클러스터를 생성하려면 다음 명령을 실행합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 호스팅된 클러스터의 이름을 지정합니다(

예: ). - 2

- 인프라 이름을 지정합니다. <

hosted_cluster_name> 및 <. 그러지 않으면 Kubernetes Operator 콘솔의 다중 클러스터 엔진에 클러스터가 제대로 표시되지 않을 수 있습니다.infra_id>에 동일한 값을 제공해야 합니다 - 3

- 기본 도메인을 지정합니다(예:

example.com). - 4

- AWS STS 자격 증명 파일의 경로를 지정합니다(예:

/home/user/sts-creds/sts-creds.json). - 5

- 풀 시크릿의 경로를 지정합니다(예:

/user/name/pullsecret). - 6

- AWS 리전 이름을 지정합니다(예:

us-east-1). - 7

- 노드 풀 복제본 수를 지정합니다(예:

3). - 8

- 기본적으로 모든

HostedCluster및NodePool사용자 정의 리소스는클러스터네임스페이스에 생성됩니다.--namespace <namespace> 매개변수를 사용하여 특정 네임스페이스에서HostedCluster및NodePool사용자 정의 리소스를 생성할 수 있습니다. - 9

- Amazon 리소스 이름(ARN)을 지정합니다(예:

arn:aws:iam::820196288204:role/myrole). - 10

- EC2 인스턴스가 공유 또는 단일 테넌트 하드웨어에서 실행되는지 여부를 표시하려면 이 필드를 포함합니다.

--render-into플래그는 Kubernetes 리소스를 이 필드에 지정하는 YAML 파일에 렌더링합니다. 그런 다음 다음 단계로 이동하여 YAML 파일을 편집합니다.

이전 명령에

--render-into플래그를 포함하는 경우 지정된 YAML 파일을 편집합니다. YAML 파일에서NodePool사양을 편집하여 다음 예와 유사하게 EC2 인스턴스를 공유 또는 단일 테넌트 하드웨어에서 실행해야 하는지 여부를 나타냅니다.YAML 파일의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

호스팅 클러스터의 상태를 확인하여

AVAILABLE의 값이True인지 확인합니다. 다음 명령을 실행합니다.oc get hostedclusters -n <hosted_cluster_namespace>

$ oc get hostedclusters -n <hosted_cluster_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 노드 풀 목록을 가져옵니다.

oc get nodepools --namespace <hosted_cluster_namespace>

$ oc get nodepools --namespace <hosted_cluster_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.8.1. AWS에서 호스트된 클러스터에 액세스

리소스에서 kubeconfig 파일 및 kubeadmin 자격 증명을 직접 가져와서 호스팅된 클러스터에 액세스할 수 있습니다.

호스팅된 클러스터의 액세스 보안에 대해 잘 알고 있어야 합니다. 호스팅 클러스터 네임스페이스에는 호스팅된 클러스터 리소스가 포함되어 있으며 호스팅된 컨트롤 플레인 네임스페이스는 호스팅된 컨트롤 플레인이 실행되는 위치입니다. 보안 이름 형식은 다음과 같습니다.

-

kubeconfigsecret: <hosted-cluster-namespace>-<name>-admin-kubeconfig. 예를 들어 cluster-hypershift-demo-admin-kubeconfig. -

kubeadmin암호 시크릿: <hosted-cluster-namespace>-<name>-kubeadmin-password. 예를 들어 cluster-hypershift-demo-kubeadmin-password.

프로세스

kubeconfig시크릿에는 Base64로 인코딩된kubeconfig필드가 포함되어 있으며 다음 명령과 함께 사용할 파일에 디코딩하고 저장할 수 있습니다.oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodes

$ oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow kubeadmin암호 시크릿도 Base64로 인코딩됩니다. 이를 디코딩하고 암호를 사용하여 호스팅된 클러스터의 API 서버 또는 콘솔에 로그인할 수 있습니다.

4.1.8.2. kubeadmin 인증 정보를 사용하여 AWS에서 호스트된 클러스터에 액세스

AWS(Amazon Web Services)에서 호스팅된 클러스터를 생성한 후 kubeconfig 파일을 가져오고 시크릿 및 kubeadmin 인증 정보를 가져와 호스팅된 클러스터에 액세스할 수 있습니다.

호스팅 클러스터 네임스페이스에는 호스팅된 클러스터 리소스와 액세스 보안이 포함됩니다. 호스팅된 컨트롤 플레인은 호스팅된 컨트롤 플레인 네임스페이스에서 실행됩니다.

보안 이름 형식은 다음과 같습니다.

-

kubeconfig시크릿: <hosted_cluster_namespace>-<name>-admin-kubeconfig. 예를 들어 cluster-hypershift-demo-admin-kubeconfig. -

kubeadmin암호 시크릿: <hosted_cluster_namespace>-<name>-kubeadmin-password. 예를 들어 cluster-hypershift-demo-kubeadmin-password.

kubeadmin 암호 시크릿은 Base64로 인코딩되며 kubeconfig 시크릿에는 Base64로 인코딩된 kubeconfig 구성이 포함되어 있습니다. Base64로 인코딩된 kubeconfig 구성을 디코딩하여 < hosted_cluster_name>.kubeconfig 파일에 저장해야 합니다.

프로세스

호스트된

클러스터에 액세스하려면 디코딩된 kubeconfig 구성이 포함된 <hosted_cluster_name>.kubeconfig파일을 사용합니다. 다음 명령을 실행합니다.oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodes

$ oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow API 서버 또는 호스팅된 클러스터의 콘솔에 로그인하려면

kubeadmin암호 시크릿을 디코딩해야 합니다.

4.1.8.3. hcp CLI를 사용하여 AWS에서 호스트된 클러스터에 액세스

hcp CLI(명령줄 인터페이스)를 사용하여 호스팅된 클러스터에 액세스할 수 있습니다.

프로세스

다음 명령을 입력하여

kubeconfig파일을 생성합니다.hcp create kubeconfig --namespace <hosted_cluster_namespace> \ --name <hosted_cluster_name> > <hosted_cluster_name>.kubeconfig

$ hcp create kubeconfig --namespace <hosted_cluster_namespace> \ --name <hosted_cluster_name> > <hosted_cluster_name>.kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow kubeconfig파일을 저장한 후 다음 명령을 입력하여 호스팅된 클러스터에 액세스합니다.oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodes

$ oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.9. 호스트된 클러스터에서 사용자 정의 API 서버 인증서 구성

API 서버의 사용자 정의 인증서를 구성하려면 HostedCluster 구성의 spec.configuration.apiServer 섹션에 인증서 세부 정보를 지정합니다.

day-1 또는 day-2 작업 중에 사용자 정의 인증서를 구성할 수 있습니다. 그러나 호스트 클러스터 생성 중에 서비스 게시 전략은 변경할 수 없으므로 구성하려는 Kubernetes API 서버의 호스트 이름이 무엇인지 알아야 합니다.

사전 요구 사항