Contrôle

Configurer et utiliser la pile de surveillance dans OpenShift Container Platform

Résumé

Chapitre 1. Aperçu de la surveillance

1.1. À propos de la surveillance de la plateforme OpenShift Container

OpenShift Container Platform inclut une pile de surveillance préconfigurée, préinstallée et auto-mise à jour qui fournit une surveillance pour les composants de base de la plate-forme. Vous avez également la possibilité d'activer la surveillance pour des projets définis par l'utilisateur.

Un administrateur de cluster peut configurer la pile de surveillance avec les configurations prises en charge. OpenShift Container Platform offre les meilleures pratiques de surveillance dès sa sortie de l'emballage.

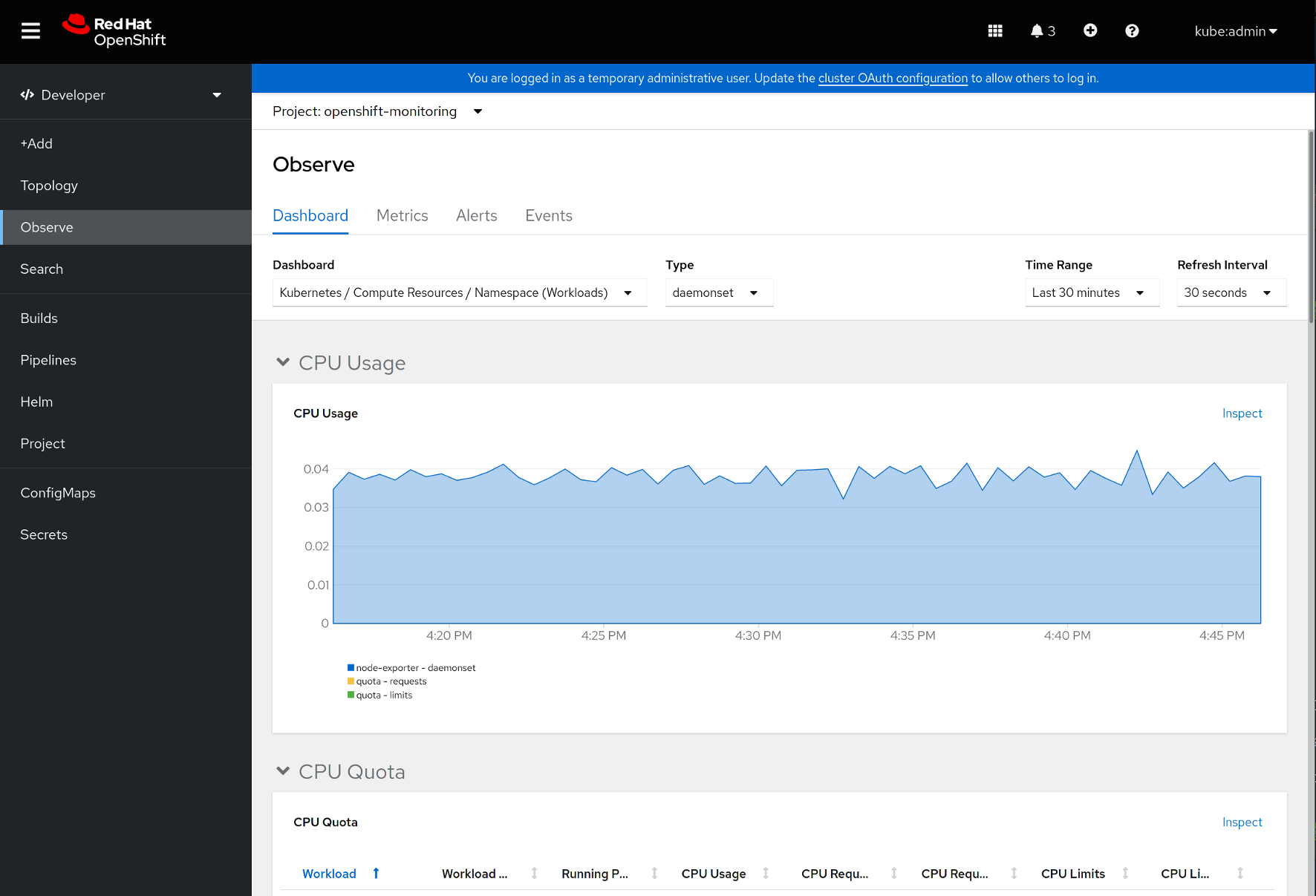

Un ensemble d'alertes est inclus par défaut et permet d'informer immédiatement les administrateurs des problèmes rencontrés par un cluster. Les tableaux de bord par défaut de la console web d'OpenShift Container Platform incluent des représentations visuelles des métriques du cluster pour vous aider à comprendre rapidement l'état de votre cluster. Avec la console web d'OpenShift Container Platform, vous pouvez voir et gérer les métriques, les alertes et examiner les tableaux de bord de surveillance.

Dans la section Observe de la console web d'OpenShift Container Platform, vous pouvez accéder et gérer les fonctionnalités de surveillance telles que les métriques, les alertes, les tableaux de bord de surveillance et les cibles de métriques.

Après l'installation d'OpenShift Container Platform, les administrateurs de clusters peuvent optionnellement activer la surveillance pour les projets définis par l'utilisateur. Grâce à cette fonctionnalité, les administrateurs de clusters, les développeurs et les autres utilisateurs peuvent spécifier comment les services et les pods sont surveillés dans leurs propres projets. En tant qu'administrateur de cluster, vous pouvez trouver des réponses à des problèmes courants tels que l'indisponibilité des métriques utilisateur et la consommation élevée d'espace disque par Prometheus dans Dépannage des problèmes de surveillance.

1.2. Comprendre la pile de surveillance

La pile de surveillance d'OpenShift Container Platform est basée sur le projet open source Prometheus et son écosystème élargi. La pile de surveillance comprend les éléments suivants :

-

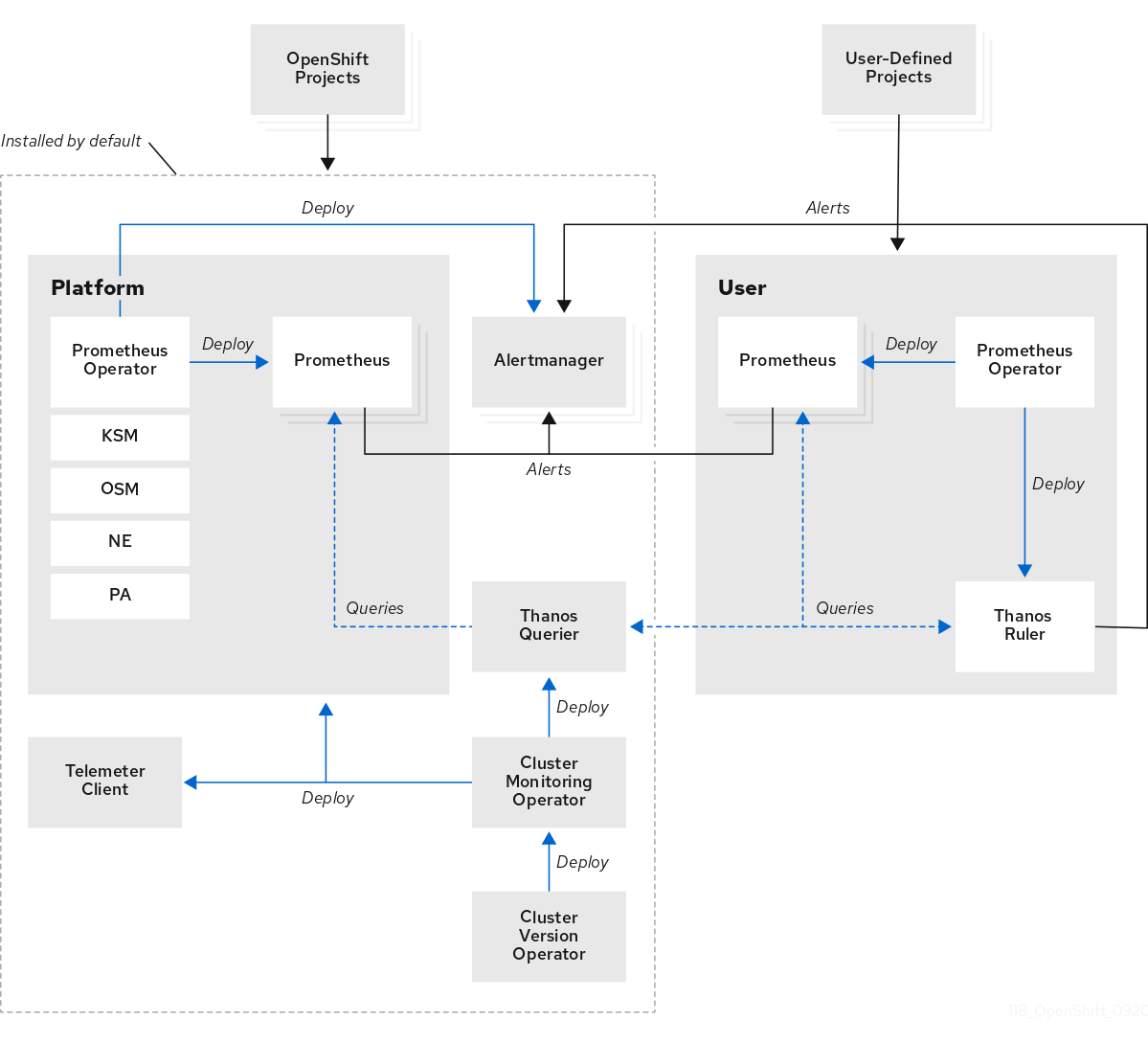

Default platform monitoring components. Un ensemble de composants de surveillance de la plateforme est installé par défaut dans le projet

openshift-monitoringlors de l'installation d'OpenShift Container Platform. Cela permet de surveiller les composants principaux d'OpenShift Container Platform, y compris les services Kubernetes. La pile de surveillance par défaut permet également de surveiller l'état des clusters à distance. Ces composants sont illustrés dans la section Installed by default dans le diagramme suivant. -

Components for monitoring user-defined projects. Après l'activation optionnelle du contrôle pour les projets définis par l'utilisateur, des composants de contrôle supplémentaires sont installés dans le projet

openshift-user-workload-monitoring. Cela permet de surveiller les projets définis par l'utilisateur. Ces composants sont illustrés dans la section User dans le diagramme suivant.

1.2.1. Composants de surveillance par défaut

Par défaut, la pile de surveillance d'OpenShift Container Platform 4.12 inclut ces composants :

| Composant | Description |

|---|---|

| Opérateur de suivi de groupe | L'opérateur de surveillance de cluster (CMO) est un composant central de la pile de surveillance. Il déploie, gère et met automatiquement à jour les instances de Prometheus et d'Alertmanager, l'interrogateur Thanos, le client Telemeter et les cibles de mesure. Le CMO est déployé par l'opérateur de version de cluster (CVO). |

| Opérateur Prométhée |

L'opérateur Prometheus (PO) du projet |

| Prometheus | Prometheus est le système de surveillance sur lequel repose la pile de surveillance d'OpenShift Container Platform. Prometheus est une base de données de séries temporelles et un moteur d'évaluation de règles pour les métriques. Prometheus envoie des alertes à Alertmanager pour traitement. |

| Adaptateur Prométhée |

L'adaptateur Prometheus (PA dans le diagramme précédent) traduit les requêtes de nœuds et de pods Kubernetes pour les utiliser dans Prometheus. Les métriques de ressources traduites comprennent les métriques d'utilisation du processeur et de la mémoire. L'adaptateur Prometheus expose l'API de métriques de ressources de cluster pour l'autoscaling horizontal de pods. L'adaptateur Prometheus est également utilisé par les commandes |

| Gestionnaire d'alerte | Le service Alertmanager gère les alertes reçues de Prometheus. Alertmanager est également responsable de l'envoi des alertes aux systèmes de notification externes. |

|

|

L'agent exportateur |

|

|

L'exportateur |

|

|

L'agent |

| Enquêteur Thanos | Thanos Querier agrège et éventuellement déduplique les métriques de base d'OpenShift Container Platform et les métriques pour les projets définis par l'utilisateur dans une interface unique et multi-tenant. |

| Client Télémètre | Telemeter Client envoie une sous-section des données des instances Prometheus de la plate-forme à Red Hat pour faciliter la surveillance à distance de la santé des grappes. |

Tous les composants de la pile de surveillance sont surveillés par la pile et sont automatiquement mis à jour lorsque OpenShift Container Platform est mis à jour.

Tous les composants de la pile de surveillance utilisent les paramètres de profil de sécurité TLS qui sont configurés de manière centralisée par un administrateur de cluster. Si vous configurez un composant de la pile de surveillance qui utilise des paramètres de sécurité TLS, le composant utilise les paramètres de profil de sécurité TLS qui existent déjà dans le champ tlsSecurityProfile de la ressource globale OpenShift Container Platform apiservers.config.openshift.io/cluster.

1.2.2. Objectifs de surveillance par défaut

Outre les composants de la pile elle-même, la pile de surveillance par défaut assure la surveillance :

- CoreDNS

- Elasticsearch (si la journalisation est installée)

- etcd

- Fluentd (si la journalisation est installée)

- HAProxy

- Registre des images

- Kubelets

- Serveur API Kubernetes

- Gestionnaire de contrôleur Kubernetes

- Ordonnanceur Kubernetes

- Serveur API OpenShift

- Gestionnaire de contrôleur OpenShift

- Gestionnaire du cycle de vie des opérateurs (OLM)

Chaque composant d'OpenShift Container Platform est responsable de sa configuration de surveillance. Pour les problèmes liés à la surveillance d'un composant d'OpenShift Container Platform, ouvrez une question Jira sur ce composant, et non sur le composant de surveillance général.

D'autres composants du framework OpenShift Container Platform peuvent également exposer des métriques. Pour plus de détails, consultez leur documentation respective.

1.2.3. Composants pour le suivi de projets définis par l'utilisateur

OpenShift Container Platform 4.12 inclut une amélioration optionnelle de la pile de surveillance qui vous permet de surveiller les services et les pods dans des projets définis par l'utilisateur. Cette fonctionnalité comprend les composants suivants :

| Composant | Description |

|---|---|

| Opérateur Prométhée |

L'opérateur Prometheus (PO) du projet |

| Prometheus | Prometheus est le système de surveillance qui permet de surveiller les projets définis par l'utilisateur. Prometheus envoie des alertes à Alertmanager pour traitement. |

| Règle de Thanos | Thanos Ruler est un moteur d'évaluation des règles pour Prometheus qui est déployé en tant que processus distinct. Dans OpenShift Container Platform 4.12, Thanos Ruler fournit une évaluation des règles et des alertes pour la surveillance des projets définis par l'utilisateur. |

| Gestionnaire d'alerte | Le service Alertmanager gère les alertes reçues de Prometheus et de Thanos Ruler. Alertmanager est également chargé d'envoyer des alertes définies par l'utilisateur à des systèmes de notification externes. Le déploiement de ce service est facultatif. |

Les composants du tableau précédent sont déployés après l'activation de la surveillance pour les projets définis par l'utilisateur.

Tous les composants de la pile de surveillance sont surveillés par la pile et sont automatiquement mis à jour lorsque OpenShift Container Platform est mis à jour.

1.2.4. Suivi des objectifs pour les projets définis par l'utilisateur

Lorsque la surveillance est activée pour les projets définis par l'utilisateur, vous pouvez surveiller :

- Les mesures sont fournies par des points d'extrémité de service dans des projets définis par l'utilisateur.

- Pods fonctionnant dans des projets définis par l'utilisateur.

1.3. Glossaire des termes courants pour la surveillance de OpenShift Container Platform

Ce glossaire définit les termes communs utilisés dans l'architecture d'OpenShift Container Platform.

- Gestionnaire d'alerte

- Alertmanager traite les alertes reçues de Prometheus. Alertmanager est également responsable de l'envoi des alertes aux systèmes de notification externes.

- Règles d'alerte

- Les règles d'alerte contiennent un ensemble de conditions qui définissent un état particulier au sein d'un cluster. Les alertes sont déclenchées lorsque ces conditions sont remplies. Une règle d'alerte peut se voir attribuer une gravité qui définit la manière dont les alertes sont acheminées.

- Opérateur de suivi de groupe

- L'opérateur de surveillance de cluster (CMO) est un composant central de la pile de surveillance. Il déploie et gère les instances Prometheus telles que le Thanos Querier, le Telemeter Client et les cibles de métriques pour s'assurer qu'elles sont à jour. Le CMO est déployé par l'opérateur de version de cluster (CVO).

- Opérateur de version de cluster

- Le Cluster Version Operator (CVO) gère le cycle de vie des Cluster Operators, dont beaucoup sont installés par défaut dans OpenShift Container Platform.

- carte de configuration

-

Une carte de configuration permet d'injecter des données de configuration dans les pods. Vous pouvez référencer les données stockées dans une carte de configuration dans un volume de type

ConfigMap. Les applications fonctionnant dans un pod peuvent utiliser ces données. - Conteneur

- Un conteneur est une image légère et exécutable qui comprend un logiciel et toutes ses dépendances. Les conteneurs virtualisent le système d'exploitation. Par conséquent, vous pouvez exécuter des conteneurs n'importe où, d'un centre de données à un nuage public ou privé, en passant par l'ordinateur portable d'un développeur.

- ressource personnalisée (CR)

- Un CR est une extension de l'API Kubernetes. Vous pouvez créer des ressources personnalisées.

- etcd

- etcd est le magasin clé-valeur d'OpenShift Container Platform, qui stocke l'état de tous les objets de ressources.

- Fluentd

- Fluentd recueille les journaux des nœuds et les transmet à Elasticsearch.

- Kubelets

- S'exécute sur les nœuds et lit les manifestes des conteneurs. S'assure que les conteneurs définis ont démarré et sont en cours d'exécution.

- Serveur API Kubernetes

- Le serveur API Kubernetes valide et configure les données pour les objets API.

- Gestionnaire de contrôleur Kubernetes

- Le gestionnaire de contrôleur Kubernetes régit l'état du cluster.

- Ordonnanceur Kubernetes

- Le planificateur Kubernetes alloue les pods aux nœuds.

- étiquettes

- Les étiquettes sont des paires clé-valeur que vous pouvez utiliser pour organiser et sélectionner des sous-ensembles d'objets tels qu'un pod.

- nœud

- Une machine de travail dans le cluster OpenShift Container Platform. Un nœud est soit une machine virtuelle (VM), soit une machine physique.

- Opérateur

- La méthode préférée pour empaqueter, déployer et gérer une application Kubernetes dans un cluster OpenShift Container Platform. Un opérateur prend les connaissances opérationnelles humaines et les encode dans un logiciel qui est emballé et partagé avec les clients.

- Gestionnaire du cycle de vie des opérateurs (OLM)

- OLM vous aide à installer, mettre à jour et gérer le cycle de vie des applications natives Kubernetes. OLM est une boîte à outils open source conçue pour gérer les opérateurs de manière efficace, automatisée et évolutive.

- Stockage permanent

- Stocke les données même après l'arrêt de l'appareil. Kubernetes utilise des volumes persistants pour stocker les données de l'application.

- Réclamation de volume persistante (PVC)

- Vous pouvez utiliser un PVC pour monter un PersistentVolume dans un Pod. Vous pouvez accéder au stockage sans connaître les détails de l'environnement en nuage.

- nacelle

- Le pod est la plus petite unité logique de Kubernetes. Un pod est composé d'un ou plusieurs conteneurs à exécuter dans un worker node.

- Prometheus

- Prometheus est le système de surveillance sur lequel repose la pile de surveillance d'OpenShift Container Platform. Prometheus est une base de données de séries temporelles et un moteur d'évaluation de règles pour les métriques. Prometheus envoie des alertes à Alertmanager pour traitement.

- Adaptateur Prométhée

- L'adaptateur Prometheus traduit les requêtes de nœuds et de pods Kubernetes pour les utiliser dans Prometheus. Les mesures de ressources traduites comprennent l'utilisation du processeur et de la mémoire. L'adaptateur Prometheus expose l'API de métriques de ressources de cluster pour l'autoscaling horizontal de pods.

- Opérateur Prométhée

-

L'opérateur Prometheus (PO) du projet

openshift-monitoringcrée, configure et gère les instances Prometheus et Alertmanager de la plateforme. Il génère également automatiquement des configurations de cibles de surveillance basées sur des requêtes d'étiquettes Kubernetes. - Silences

- Un silence peut être appliqué à une alerte pour empêcher l'envoi de notifications lorsque les conditions de l'alerte sont remplies. Vous pouvez mettre une alerte en sourdine après la notification initiale, pendant que vous travaillez à la résolution du problème sous-jacent.

- stockage

- OpenShift Container Platform prend en charge de nombreux types de stockage, à la fois pour les fournisseurs sur site et dans le nuage. Vous pouvez gérer le stockage des conteneurs pour les données persistantes et non persistantes dans un cluster OpenShift Container Platform.

- Règle de Thanos

- Thanos Ruler est un moteur d'évaluation des règles pour Prometheus qui est déployé en tant que processus distinct. Dans OpenShift Container Platform, Thanos Ruler fournit une évaluation des règles et des alertes pour la surveillance des projets définis par l'utilisateur.

- console web

- Une interface utilisateur (UI) pour gérer OpenShift Container Platform.

1.5. Prochaines étapes

Chapitre 2. Configuration de la pile de surveillance

Le programme d'installation d'OpenShift Container Platform 4 ne propose qu'un faible nombre d'options de configuration avant l'installation. La configuration de la plupart des composants du framework OpenShift Container Platform, y compris la pile de surveillance des clusters, se fait après l'installation.

Cette section explique quelle configuration est prise en charge, montre comment configurer la pile de surveillance et présente plusieurs scénarios de configuration courants.

2.1. Conditions préalables

- La pile de surveillance impose des exigences supplémentaires en matière de ressources. Consultez les recommandations relatives aux ressources informatiques dans le document Scaling the Cluster Monitoring Operator et vérifiez que vous disposez de ressources suffisantes.

2.2. Maintenance et soutien pour la surveillance

La manière prise en charge de configurer la surveillance de OpenShift Container Platform consiste à la configurer à l'aide des options décrites dans ce document. Do not use other configurations, as they are unsupported. Les paradigmes de configuration peuvent changer entre les versions de Prometheus, et de tels cas ne peuvent être gérés de manière gracieuse que si toutes les possibilités de configuration sont contrôlées. Si vous utilisez des configurations autres que celles décrites dans cette section, vos modifications disparaîtront car le site cluster-monitoring-operator réconcilie toutes les différences. L'Opérateur réinitialise tout à l'état défini par défaut et par conception.

2.2.1. Considérations relatives au soutien pour le suivi

Les modifications suivantes ne sont explicitement pas prises en charge :

-

Creating additional

ServiceMonitor,PodMonitor, andPrometheusRuleobjects in theopenshift-*andkube-*projects. Modifying any resources or objects deployed in the

openshift-monitoringoropenshift-user-workload-monitoringprojects. Les ressources créées par la pile de surveillance de OpenShift Container Platform ne sont pas destinées à être utilisées par d'autres ressources, car il n'y a aucune garantie quant à leur compatibilité ascendante.NoteLa configuration Alertmanager est déployée en tant que ressource secrète dans l'espace de noms

openshift-monitoring. Si vous avez activé une instance distincte d'Alertmanager pour le routage des alertes définies par l'utilisateur, une configuration d'Alertmanager est également déployée en tant que ressource secrète dans l'espace de nomsopenshift-user-workload-monitoring. Pour configurer des routes supplémentaires pour n'importe quelle instance d'Alertmanager, vous devez décoder, modifier et ensuite encoder ce secret. Cette procédure est une exception supportée à la déclaration précédente.- Modifying resources of the stack. La pile de surveillance d'OpenShift Container Platform s'assure que ses ressources sont toujours dans l'état qu'elle attend d'elles. Si elles sont modifiées, la pile les réinitialise.

-

Deploying user-defined workloads to

openshift-*, andkube-*projects. Ces projets sont réservés aux composants fournis par Red Hat et ne doivent pas être utilisés pour des charges de travail définies par l'utilisateur. - Installing custom Prometheus instances on OpenShift Container Platform. Une instance personnalisée est une ressource personnalisée Prometheus (CR) gérée par l'opérateur Prometheus.

-

Enabling symptom based monitoring by using the

Probecustom resource definition (CRD) in Prometheus Operator.

La rétrocompatibilité des métriques, des règles d'enregistrement ou des règles d'alerte n'est pas garantie.

2.2.2. Politique de soutien au suivi des opérateurs

Les opérateurs de surveillance garantissent que les ressources de surveillance d'OpenShift Container Platform fonctionnent comme prévu et testé. Si le contrôle de l'opérateur de version de cluster (CVO) d'un opérateur est outrepassé, l'opérateur ne répond pas aux changements de configuration, ne réconcilie pas l'état prévu des objets du cluster et ne reçoit pas de mises à jour.

Bien qu'il puisse être utile de remplacer le contrôle de l'OVE pour un opérateur lors du débogage, cette opération n'est pas prise en charge et l'administrateur du cluster assume le contrôle total des configurations et des mises à niveau des composants individuels.

Remplacement de l'opérateur de version du cluster

Le paramètre spec.overrides peut être ajouté à la configuration de l'OVC pour permettre aux administrateurs de fournir une liste de dérogations au comportement de l'OVC pour un composant. La définition du paramètre spec.overrides[].unmanaged à true pour un composant bloque les mises à niveau du cluster et alerte l'administrateur lorsqu'une dérogation CVO a été définie :

Disabling ownership via cluster version overrides prevents upgrades. Please remove overrides before continuing.

Disabling ownership via cluster version overrides prevents upgrades. Please remove overrides before continuing.La définition d'une dérogation CVO place l'ensemble du cluster dans un état non pris en charge et empêche la pile de surveillance d'être réconciliée avec l'état prévu. Cela a un impact sur les fonctions de fiabilité intégrées aux opérateurs et empêche la réception des mises à jour. Les problèmes signalés doivent être reproduits après la suppression de toute dérogation pour que l'assistance puisse avoir lieu.

2.3. Préparation de la configuration de la pile de surveillance

Vous pouvez configurer la pile de surveillance en créant et en mettant à jour des cartes de configuration de la surveillance.

2.3.1. Création d'une carte de configuration pour la surveillance des clusters

Pour configurer les composants de surveillance de base d'OpenShift Container Platform, vous devez créer l'objet cluster-monitoring-config ConfigMap dans le projet openshift-monitoring.

Lorsque vous enregistrez vos modifications dans l'objet cluster-monitoring-config ConfigMap , certains ou tous les pods du projet openshift-monitoring peuvent être redéployés. Le redéploiement de ces composants peut parfois prendre un certain temps.

Conditions préalables

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez installé l'OpenShift CLI (

oc).

Procédure

Vérifier si l'objet

cluster-monitoring-configConfigMapexiste :oc -n openshift-monitoring get configmap cluster-monitoring-config

$ oc -n openshift-monitoring get configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Si l'objet

ConfigMapn'existe pas :Créez le manifeste YAML suivant. Dans cet exemple, le fichier s'appelle

cluster-monitoring-config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Appliquer la configuration pour créer l'objet

ConfigMap:oc apply -f cluster-monitoring-config.yaml

$ oc apply -f cluster-monitoring-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.2. Création d'une carte de configuration de surveillance de la charge de travail définie par l'utilisateur

Pour configurer les composants qui contrôlent les projets définis par l'utilisateur, vous devez créer l'objet user-workload-monitoring-config ConfigMap dans le projet openshift-user-workload-monitoring.

Lorsque vous enregistrez vos modifications dans l'objet user-workload-monitoring-config ConfigMap , certains ou tous les pods du projet openshift-user-workload-monitoring peuvent être redéployés. Le redéploiement de ces composants peut parfois prendre un certain temps. Vous pouvez créer et configurer la carte de configuration avant d'activer pour la première fois la surveillance des projets définis par l'utilisateur, afin d'éviter d'avoir à redéployer souvent les pods.

Conditions préalables

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez installé l'OpenShift CLI (

oc).

Procédure

Vérifier si l'objet

user-workload-monitoring-configConfigMapexiste :oc -n openshift-user-workload-monitoring get configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring get configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Si l'objet

user-workload-monitoring-configConfigMapn'existe pas :Créez le manifeste YAML suivant. Dans cet exemple, le fichier s'appelle

user-workload-monitoring-config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Appliquer la configuration pour créer l'objet

ConfigMap:oc apply -f user-workload-monitoring-config.yaml

$ oc apply -f user-workload-monitoring-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLes configurations appliquées à l'objet

user-workload-monitoring-configConfigMapne sont pas activées à moins qu'un administrateur de cluster n'ait activé la surveillance pour les projets définis par l'utilisateur.

2.4. Configuration de la pile de surveillance

Dans OpenShift Container Platform 4.12, vous pouvez configurer la pile de surveillance à l'aide des objets cluster-monitoring-config ou user-workload-monitoring-config ConfigMap . Les cartes de configuration configurent l'opérateur de surveillance de cluster (CMO), qui configure à son tour les composants de la pile.

Conditions préalables

If you are configuring core OpenShift Container Platform monitoring components:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez créé l'objet

cluster-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

If you are configuring components that monitor user-defined projects:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin, ou en tant qu'utilisateur ayant le rôleuser-workload-monitoring-config-editdans le projetopenshift-user-workload-monitoring. -

Vous avez créé l'objet

user-workload-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

-

Vous avez installé l'OpenShift CLI (

oc).

Procédure

Modifiez l'objet

ConfigMap.To configure core OpenShift Container Platform monitoring components:

Modifiez l'objet

cluster-monitoring-configConfigMapdans le projetopenshift-monitoring:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez votre configuration sous

data/config.yamlsous la forme d'une paire clé-valeur<component_name>: <component_configuration>:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacer

<component>et<configuration_for_the_component>en conséquence.L'exemple d'objet

ConfigMapsuivant configure une revendication de volume persistant (PVC) pour Prometheus. Cela concerne uniquement l'instance Prometheus qui surveille les composants de base d'OpenShift Container Platform :Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Définit le composant Prometheus et les lignes suivantes définissent sa configuration.

To configure components that monitor user-defined projects:

Modifiez l'objet

user-workload-monitoring-configConfigMapdans le projetopenshift-user-workload-monitoring:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez votre configuration sous

data/config.yamlsous la forme d'une paire clé-valeur<component_name>: <component_configuration>:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacer

<component>et<configuration_for_the_component>en conséquence.L'exemple suivant d'objet

ConfigMapconfigure une période de rétention des données et des demandes minimales de ressources de conteneur pour Prometheus. Cela concerne l'instance Prometheus qui surveille uniquement les projets définis par l'utilisateur :Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Définit le composant Prometheus et les lignes suivantes définissent sa configuration.

- 2

- Configure une période de rétention des données de 24 heures pour l'instance Prometheus qui surveille les projets définis par l'utilisateur.

- 3

- Définit une demande de ressources minimale de 200 millicores pour le conteneur Prometheus.

- 4

- Définit une demande de ressource pod minimale de 2 GiB de mémoire pour le conteneur Prometheus.

NoteLe composant Prometheus config map est appelé

prometheusK8sdans l'objetcluster-monitoring-configConfigMapetprometheusdans l'objetuser-workload-monitoring-configConfigMap.

Enregistrez le fichier pour appliquer les modifications à l'objet

ConfigMap. Les pods concernés par la nouvelle configuration sont redémarrés automatiquement.NoteLes configurations appliquées à l'objet

user-workload-monitoring-configConfigMapne sont pas activées à moins qu'un administrateur de cluster n'ait activé la surveillance pour les projets définis par l'utilisateur.AvertissementLorsque des modifications sont enregistrées dans une carte de configuration de surveillance, les pods et autres ressources du projet concerné peuvent être redéployés. Les processus de surveillance en cours dans ce projet peuvent également être redémarrés.

2.5. Composants de surveillance configurables

Ce tableau présente les composants de surveillance que vous pouvez configurer et les clés utilisées pour spécifier les composants dans les objets cluster-monitoring-config et user-workload-monitoring-config ConfigMap :

| Composant | cluster-monitoring-config config map key | user-workload-monitoring-config config map key |

|---|---|---|

| Opérateur Prométhée |

|

|

| Prometheus |

|

|

| Gestionnaire d'alerte |

|

|

| kube-state-metrics |

| |

| openshift-state-metrics |

| |

| Client Télémètre |

| |

| Adaptateur Prométhée |

| |

| Enquêteur Thanos |

| |

| Règle de Thanos |

|

La clé Prometheus est appelée prometheusK8s dans l'objet cluster-monitoring-config ConfigMap et prometheus dans l'objet user-workload-monitoring-config ConfigMap .

2.6. Déplacement des composants de surveillance vers différents nœuds

Vous pouvez déplacer n'importe quel composant de la pile de surveillance vers des nœuds spécifiques.

Conditions préalables

If you are configuring core OpenShift Container Platform monitoring components:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez créé l'objet

cluster-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

If you are configuring components that monitor user-defined projects:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin, ou en tant qu'utilisateur ayant le rôleuser-workload-monitoring-config-editdans le projetopenshift-user-workload-monitoring. -

Vous avez créé l'objet

user-workload-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

-

Vous avez installé l'OpenShift CLI (

oc).

Procédure

Modifiez l'objet

ConfigMap:To move a component that monitors core OpenShift Container Platform projects:

Modifiez l'objet

cluster-monitoring-configConfigMapdans le projetopenshift-monitoring:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Spécifiez la contrainte

nodeSelectorpour le composant sousdata/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacez

<component>en conséquence et remplacez<node_key>: <node_value>par la carte de paires clé-valeur qui spécifie un groupe de nœuds de destination. Souvent, une seule paire clé-valeur est utilisée.Le composant ne peut être exécuté que sur les nœuds dont les étiquettes sont constituées de chacune des paires clé-valeur spécifiées. Les nœuds peuvent également avoir des étiquettes supplémentaires.

ImportantDe nombreux composants de surveillance sont déployés en utilisant plusieurs pods sur différents nœuds du cluster afin de maintenir une haute disponibilité. Lorsque vous déplacez des composants de surveillance vers des nœuds étiquetés, assurez-vous que suffisamment de nœuds correspondants sont disponibles pour maintenir la résilience du composant. Si une seule étiquette est spécifiée, assurez-vous que suffisamment de nœuds contiennent cette étiquette pour distribuer tous les pods du composant sur des nœuds distincts. Vous pouvez également spécifier plusieurs étiquettes, chacune se rapportant à des nœuds individuels.

NoteSi les composants de surveillance restent dans l'état

Pendingaprès avoir configuré la contraintenodeSelector, vérifiez dans les journaux du pod les erreurs relatives aux taches et aux tolérances.Par exemple, pour déplacer les composants de surveillance des projets principaux d'OpenShift Container Platform vers des nœuds spécifiques étiquetés

nodename: controlplane1,nodename: worker1,nodename: worker2, etnodename: worker2, utilisez :Copy to Clipboard Copied! Toggle word wrap Toggle overflow

To move a component that monitors user-defined projects:

Modifiez l'objet

user-workload-monitoring-configConfigMapdans le projetopenshift-user-workload-monitoring:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Spécifiez la contrainte

nodeSelectorpour le composant sousdata/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacez

<component>en conséquence et remplacez<node_key>: <node_value>par la carte des paires clé-valeur qui spécifie les nœuds de destination. Souvent, une seule paire clé-valeur est utilisée.Le composant ne peut être exécuté que sur les nœuds dont les étiquettes sont constituées de chacune des paires clé-valeur spécifiées. Les nœuds peuvent également avoir des étiquettes supplémentaires.

ImportantDe nombreux composants de surveillance sont déployés en utilisant plusieurs pods sur différents nœuds du cluster afin de maintenir une haute disponibilité. Lorsque vous déplacez des composants de surveillance vers des nœuds étiquetés, assurez-vous que suffisamment de nœuds correspondants sont disponibles pour maintenir la résilience du composant. Si une seule étiquette est spécifiée, assurez-vous que suffisamment de nœuds contiennent cette étiquette pour distribuer tous les pods du composant sur des nœuds distincts. Vous pouvez également spécifier plusieurs étiquettes, chacune se rapportant à des nœuds individuels.

NoteSi les composants de surveillance restent dans l'état

Pendingaprès avoir configuré la contraintenodeSelector, vérifiez dans les journaux du pod les erreurs relatives aux taches et aux tolérances.Par exemple, pour déplacer les composants de surveillance des projets définis par l'utilisateur vers des nœuds de travail spécifiques étiquetés

nodename: worker1,nodename: worker2, etnodename: worker2, utilisez :Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Enregistrez le fichier pour appliquer les modifications. Les composants concernés par la nouvelle configuration sont automatiquement déplacés vers les nouveaux nœuds.

NoteLes configurations appliquées à l'objet

user-workload-monitoring-configConfigMapne sont pas activées à moins qu'un administrateur de cluster n'ait activé la surveillance pour les projets définis par l'utilisateur.AvertissementLorsque des modifications sont enregistrées dans une carte de configuration de surveillance, les pods et autres ressources du projet concerné peuvent être redéployés. Les processus de surveillance en cours dans ce projet peuvent également être redémarrés.

2.7. Attribution de tolérances aux composants de surveillance

Vous pouvez assigner des tolérances à n'importe quel composant de la pile de surveillance afin de pouvoir les déplacer vers des nœuds altérés.

Conditions préalables

If you are configuring core OpenShift Container Platform monitoring components:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez créé l'objet

cluster-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

If you are configuring components that monitor user-defined projects:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin, ou en tant qu'utilisateur ayant le rôleuser-workload-monitoring-config-editdans le projetopenshift-user-workload-monitoring. -

Vous avez créé l'objet

user-workload-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

-

Vous avez installé l'OpenShift CLI (

oc).

Procédure

Modifiez l'objet

ConfigMap:To assign tolerations to a component that monitors core OpenShift Container Platform projects:

Modifiez l'objet

cluster-monitoring-configConfigMapdans le projetopenshift-monitoring:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Spécifiez

tolerationspour le composant :Copy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacer

<component>et<toleration_specification>en conséquence.Par exemple,

oc adm taint nodes node1 key1=value1:NoScheduleajoute une taint ànode1avec la clékey1et la valeurvalue1. Cela empêche les composants de surveillance de déployer des pods surnode1à moins qu'une tolérance ne soit configurée pour cette anomalie. L'exemple suivant configure le composantalertmanagerMainpour qu'il tolère l'altération de l'exemple :Copy to Clipboard Copied! Toggle word wrap Toggle overflow

To assign tolerations to a component that monitors user-defined projects:

Modifiez l'objet

user-workload-monitoring-configConfigMapdans le projetopenshift-user-workload-monitoring:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Spécifiez

tolerationspour le composant :Copy to Clipboard Copied! Toggle word wrap Toggle overflow Remplacer

<component>et<toleration_specification>en conséquence.Par exemple,

oc adm taint nodes node1 key1=value1:NoScheduleajoute une taint ànode1avec la clékey1et la valeurvalue1. Cela empêche les composants de surveillance de déployer des pods surnode1à moins qu'une tolérance ne soit configurée pour cette anomalie. L'exemple suivant configure le composantthanosRulerpour qu'il tolère l'altération de l'exemple :Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Enregistrez le fichier pour appliquer les modifications. La nouvelle configuration de placement des composants est appliquée automatiquement.

NoteLes configurations appliquées à l'objet

user-workload-monitoring-configConfigMapne sont pas activées à moins qu'un administrateur de cluster n'ait activé la surveillance pour les projets définis par l'utilisateur.AvertissementLorsque des modifications sont enregistrées dans une carte de configuration de surveillance, les pods et autres ressources du projet concerné peuvent être redéployés. Les processus de surveillance en cours dans ce projet peuvent également être redémarrés.

2.8. Définition de la taille limite du corps pour le raclage des métriques

Par défaut, aucune limite n'est fixée pour la taille du corps non compressé des données renvoyées par les cibles de métriques analysées. Vous pouvez définir une limite pour la taille du corps afin d'éviter que Prometheus ne consomme une quantité excessive de mémoire lorsque les cibles raclées renvoient une réponse contenant une grande quantité de données. En outre, en définissant une limite de taille de corps, vous pouvez réduire l'impact qu'une cible malveillante peut avoir sur Prometheus et sur le cluster dans son ensemble.

Après avoir défini une valeur pour enforcedBodySizeLimit, l'alerte PrometheusScrapeBodySizeLimitHit se déclenche lorsqu'au moins une cible de balayage Prometheus répond avec un corps de réponse supérieur à la valeur configurée.

Si les données métriques extraites d'une cible ont une taille de corps non compressée supérieure à la limite de taille configurée, l'extraction échoue. Prometheus considère alors que cette cible est en panne et définit sa valeur métrique up sur 0, ce qui peut déclencher l'alerte TargetDown.

Conditions préalables

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez installé l'OpenShift CLI (

oc).

Procédure

Modifiez l'objet

cluster-monitoring-configConfigMapdans l'espace de nomsopenshift-monitoring:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter une valeur pour

enforcedBodySizeLimitàdata/config.yaml/prometheusK8safin de limiter la taille du corps qui peut être acceptée par raclage ciblé :Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Spécifier la taille maximale du corps des cibles de métriques scrappées. L'exemple suivant (

enforcedBodySizeLimit) limite la taille non compressée de chaque cible scrappée à 40 mégaoctets. Les valeurs numériques valides utilisent le format de taille des données Prometheus : B (octets), KB (kilooctets), MB (mégaoctets), GB (gigaoctets), TB (téraoctets), PB (pétaoctets) et EB (exaoctets). La valeur par défaut est0, ce qui signifie qu'il n'y a pas de limite. Vous pouvez également définir la valeurautomaticpour calculer automatiquement la limite en fonction de la capacité de la grappe.

Enregistrez le fichier pour appliquer automatiquement les modifications.

AvertissementLorsque vous enregistrez les modifications apportées à une carte de configuration

cluster-monitoring-config, les pods et autres ressources du projetopenshift-monitoringpeuvent être redéployés. Les processus de surveillance en cours d'exécution dans ce projet peuvent également redémarrer.

2.9. Configuration du stockage persistant

L'exécution de la surveillance des clusters avec un stockage persistant signifie que vos mesures sont stockées dans un volume persistant (PV) et peuvent survivre au redémarrage ou à la recréation d'un pod. Cette solution est idéale si vous souhaitez que vos données de mesure ou d'alerte soient protégées contre la perte de données. Pour les environnements de production, il est fortement recommandé de configurer le stockage persistant. En raison des exigences élevées en matière d'entrées-sorties, il est préférable d'utiliser le stockage local.

2.9.1. Conditions préalables au stockage permanent

- Consacrez suffisamment d'espace de stockage persistant local pour éviter que le disque ne soit saturé. La quantité de stockage nécessaire dépend du nombre de modules.

- Vérifiez que vous disposez d'un volume persistant (PV) prêt à être réclamé par la réclamation de volume persistant (PVC), un PV pour chaque réplique. Prometheus et Alertmanager ayant tous deux deux répliques, vous avez besoin de quatre PV pour prendre en charge l'ensemble de la pile de surveillance. Les PV sont disponibles auprès de l'opérateur de stockage local, mais pas si vous avez activé le stockage à provisionnement dynamique.

Utilisez

Filesystemcomme valeur de type de stockage pour le paramètrevolumeModelorsque vous configurez le volume persistant.NoteSi vous utilisez un volume local pour le stockage persistant, n'utilisez pas de volume de bloc brut, qui est décrit avec

volumeMode: Blockdans l'objetLocalVolume. Prometheus ne peut pas utiliser de volumes de blocs bruts.

2.9.2. Configuration d'une revendication de volume persistant local

Pour que les composants de surveillance utilisent un volume persistant (PV), vous devez configurer une réclamation de volume persistant (PVC).

Conditions préalables

If you are configuring core OpenShift Container Platform monitoring components:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez créé l'objet

cluster-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

If you are configuring components that monitor user-defined projects:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin, ou en tant qu'utilisateur ayant le rôleuser-workload-monitoring-config-editdans le projetopenshift-user-workload-monitoring. -

Vous avez créé l'objet

user-workload-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

-

Vous avez installé l'OpenShift CLI (

oc).

Procédure

Modifiez l'objet

ConfigMap:To configure a PVC for a component that monitors core OpenShift Container Platform projects:

Modifiez l'objet

cluster-monitoring-configConfigMapdans le projetopenshift-monitoring:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez votre configuration PVC pour le composant sous

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Voir la documentation Kubernetes sur PersistentVolumeClaims pour plus d'informations sur la façon de spécifier

volumeClaimTemplate.L'exemple suivant configure un PVC qui réclame un stockage persistant local pour l'instance Prometheus qui surveille les composants principaux d'OpenShift Container Platform :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Dans l'exemple ci-dessus, la classe de stockage créée par l'Opérateur de stockage local s'appelle

local-storage.L'exemple suivant configure un PVC qui demande un stockage persistant local pour Alertmanager :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

To configure a PVC for a component that monitors user-defined projects:

Modifiez l'objet

user-workload-monitoring-configConfigMapdans le projetopenshift-user-workload-monitoring:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez votre configuration PVC pour le composant sous

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Voir la documentation Kubernetes sur PersistentVolumeClaims pour plus d'informations sur la façon de spécifier

volumeClaimTemplate.L'exemple suivant configure un PVC qui réclame un stockage persistant local pour l'instance Prometheus qui surveille les projets définis par l'utilisateur :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Dans l'exemple ci-dessus, la classe de stockage créée par l'Opérateur de stockage local s'appelle

local-storage.L'exemple suivant configure un PVC qui réclame un stockage persistant local pour Thanos Ruler :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLes besoins en stockage du composant

thanosRulerdépendent du nombre de règles évaluées et du nombre d'échantillons générés par chaque règle.

Enregistrez le fichier pour appliquer les modifications. Les pods concernés par la nouvelle configuration sont redémarrés automatiquement et la nouvelle configuration de stockage est appliquée.

NoteLes configurations appliquées à l'objet

user-workload-monitoring-configConfigMapne sont pas activées à moins qu'un administrateur de cluster n'ait activé la surveillance pour les projets définis par l'utilisateur.AvertissementLorsque des modifications sont enregistrées dans une carte de configuration de surveillance, les pods et autres ressources du projet concerné peuvent être redéployés. Les processus de surveillance en cours dans ce projet peuvent également être redémarrés.

2.9.3. Redimensionnement d'un volume de stockage persistant

OpenShift Container Platform ne prend pas en charge le redimensionnement d'un volume de stockage persistant existant utilisé par des ressources StatefulSet, même si la ressource sous-jacente StorageClass utilisée prend en charge le dimensionnement du volume persistant. Par conséquent, même si vous mettez à jour le champ storage pour une réclamation de volume persistant (PVC) existante avec une taille plus grande, ce paramètre ne sera pas propagé au volume persistant (PV) associé.

Cependant, le redimensionnement d'un PV est toujours possible en utilisant un processus manuel. Si vous souhaitez redimensionner un PV pour un composant de surveillance tel que Prometheus, Thanos Ruler ou Alertmanager, vous pouvez mettre à jour la carte de configuration appropriée dans laquelle le composant est configuré. Ensuite, corrigez le PVC, puis supprimez et rendez les pods orphelins. Le fait de rendre les pods orphelins recrée immédiatement la ressource StatefulSet et met automatiquement à jour la taille des volumes montés dans les pods avec les nouveaux paramètres du PVC. Aucune interruption de service ne se produit au cours de ce processus.

Conditions préalables

-

Vous avez installé l'OpenShift CLI (

oc). If you are configuring core OpenShift Container Platform monitoring components:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez créé l'objet

cluster-monitoring-configConfigMap. - Vous avez configuré au moins un PVC pour les composants de surveillance de base d'OpenShift Container Platform.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

If you are configuring components that monitor user-defined projects:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin, ou en tant qu'utilisateur ayant le rôleuser-workload-monitoring-config-editdans le projetopenshift-user-workload-monitoring. -

Vous avez créé l'objet

user-workload-monitoring-configConfigMap. - Vous avez configuré au moins un PVC pour les composants qui surveillent les projets définis par l'utilisateur.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

Procédure

Modifiez l'objet

ConfigMap:To resize a PVC for a component that monitors core OpenShift Container Platform projects:

Modifiez l'objet

cluster-monitoring-configConfigMapdans le projetopenshift-monitoring:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter une nouvelle taille de stockage pour la configuration PVC du composant sous

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow L'exemple suivant configure un PVC qui définit le stockage persistant local à 100 gigaoctets pour l'instance Prometheus qui surveille les composants principaux d'OpenShift Container Platform :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow L'exemple suivant configure un PVC qui définit le stockage persistant local pour Alertmanager à 40 gigaoctets :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

To resize a PVC for a component that monitors user-defined projects:

NoteVous pouvez redimensionner les volumes des instances Thanos Ruler et Prometheus qui surveillent les projets définis par l'utilisateur.

Modifiez l'objet

user-workload-monitoring-configConfigMapdans le projetopenshift-user-workload-monitoring:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Mettre à jour la configuration du PVC pour le composant de surveillance sous

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow L'exemple suivant configure la taille du PVC à 100 gigaoctets pour l'instance Prometheus qui surveille les projets définis par l'utilisateur :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow L'exemple suivant définit la taille du PVC à 20 gigaoctets pour Thanos Ruler :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLes besoins en stockage du composant

thanosRulerdépendent du nombre de règles évaluées et du nombre d'échantillons générés par chaque règle.

Enregistrez le fichier pour appliquer les modifications. Les pods concernés par la nouvelle configuration redémarrent automatiquement.

AvertissementLorsque vous enregistrez les modifications apportées à une carte de configuration de surveillance, les pods et autres ressources du projet concerné peuvent être redéployés. Les processus de surveillance en cours d'exécution dans ce projet peuvent également être redémarrés.

Patch manuel de chaque PVC avec la demande de stockage mise à jour. L'exemple suivant redéfinit la taille du stockage pour le composant Prometheus dans l'espace de noms

openshift-monitoringà 100Gi :for p in $(oc -n openshift-monitoring get pvc -l app.kubernetes.io/name=prometheus -o jsonpath='{range .items[*]}{.metadata.name} {end}'); do \ oc -n openshift-monitoring patch pvc/${p} --patch '{"spec": {"resources": {"requests": {"storage":"100Gi"}}}}'; \ done$ for p in $(oc -n openshift-monitoring get pvc -l app.kubernetes.io/name=prometheus -o jsonpath='{range .items[*]}{.metadata.name} {end}'); do \ oc -n openshift-monitoring patch pvc/${p} --patch '{"spec": {"resources": {"requests": {"storage":"100Gi"}}}}'; \ doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow Supprime le StatefulSet sous-jacent avec le paramètre

--cascade=orphan:oc delete statefulset -l app.kubernetes.io/name=prometheus --cascade=orphan

$ oc delete statefulset -l app.kubernetes.io/name=prometheus --cascade=orphanCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9.4. Modification de la durée et de la taille de rétention des données de métrologie Prometheus

Par défaut, Prometheus conserve automatiquement les données de mesure pendant 15 jours. Vous pouvez modifier la durée de conservation pour changer le délai de suppression des données en spécifiant une valeur de temps dans le champ retention. Vous pouvez également configurer la quantité maximale d'espace disque utilisée par les données de mesure conservées en spécifiant une valeur de taille dans le champ retentionSize. Si les données atteignent cette limite de taille, Prometheus supprime d'abord les données les plus anciennes jusqu'à ce que l'espace disque utilisé soit à nouveau inférieur à la limite.

Notez les comportements suivants de ces paramètres de conservation des données :

-

La politique de conservation basée sur la taille s'applique à tous les répertoires de blocs de données du répertoire

/prometheus, y compris les blocs persistants, les données WAL (write-ahead log) et les blocs m-mappés. -

Les données des répertoires

/walet/head_chunkssont prises en compte dans la limite de taille de rétention, mais Prometheus ne purge jamais les données de ces répertoires sur la base de politiques de rétention basées sur la taille ou le temps. Ainsi, si vous définissez une limite de taille de rétention inférieure à la taille maximale définie pour les répertoires/walet/head_chunks, vous avez configuré le système pour qu'il ne conserve aucun bloc de données dans les répertoires de données/prometheus. - La politique de conservation basée sur la taille n'est appliquée que lorsque Prometheus coupe un nouveau bloc de données, ce qui se produit toutes les deux heures lorsque le WAL contient au moins trois heures de données.

-

Si vous ne définissez pas explicitement de valeurs pour

retentionouretentionSize, la durée de conservation est fixée par défaut à 15 jours et la taille de la conservation n'est pas définie. -

Si vous définissez des valeurs pour

retentionetretentionSize, les deux valeurs s'appliquent. Si des blocs de données dépassent la durée de conservation définie ou la limite de taille définie, Prometheus purge ces blocs de données. -

Si vous définissez une valeur pour

retentionSizeet que vous ne définissez pasretention, seule la valeurretentionSizes'applique. -

Si vous ne définissez pas de valeur pour

retentionSizeet que vous ne définissez qu'une valeur pourretention, seule la valeurretentions'applique.

Conditions préalables

If you are configuring core OpenShift Container Platform monitoring components:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez créé l'objet

cluster-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

If you are configuring components that monitor user-defined projects:

- Un administrateur de cluster a activé la surveillance des projets définis par l'utilisateur.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin, ou en tant qu'utilisateur ayant le rôleuser-workload-monitoring-config-editdans le projetopenshift-user-workload-monitoring. -

Vous avez créé l'objet

user-workload-monitoring-configConfigMap.

-

Vous avez installé l'OpenShift CLI (

oc).

L'enregistrement des modifications apportées à une carte de configuration de surveillance peut redémarrer les processus de surveillance et redéployer les pods et autres ressources dans le projet concerné. Les processus de surveillance en cours dans ce projet peuvent également redémarrer.

Procédure

Modifiez l'objet

ConfigMap:To modify the retention time and size for the Prometheus instance that monitors core OpenShift Container Platform projects:

Modifiez l'objet

cluster-monitoring-configConfigMapdans le projetopenshift-monitoring:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez la configuration du temps de rétention et de la taille sous

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le temps de rétention : un nombre directement suivi de

ms(millisecondes),s(secondes),m(minutes),h(heures),d(jours),w(semaines) ouy(années). Vous pouvez également combiner des valeurs temporelles pour des périodes spécifiques, comme1h30m15s. - 2

- La taille de rétention : un nombre directement suivi de

B(octets),KB(kilo-octets),MB(méga-octets),GB(giga-octets),TB(téra-octets),PB(péta-octets) etEB(exa-octets).

L'exemple suivant définit la durée de rétention à 24 heures et la taille de rétention à 10 gigaoctets pour l'instance Prometheus qui surveille les composants principaux d'OpenShift Container Platform :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

To modify the retention time and size for the Prometheus instance that monitors user-defined projects:

Modifiez l'objet

user-workload-monitoring-configConfigMapdans le projetopenshift-user-workload-monitoring:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez la configuration du temps de rétention et de la taille sous

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le temps de rétention : un nombre directement suivi de

ms(millisecondes),s(secondes),m(minutes),h(heures),d(jours),w(semaines) ouy(années). Vous pouvez également combiner des valeurs temporelles pour des périodes spécifiques, comme1h30m15s. - 2

- La taille de rétention : un nombre directement suivi de

B(octets),KB(kilo-octets),MB(méga-octets),GB(giga-octets),TB(téra-octets),PB(péta-octets) ouEB(exa-octets).

L'exemple suivant définit la durée de conservation à 24 heures et la taille de conservation à 10 gigaoctets pour l'instance Prometheus qui surveille les projets définis par l'utilisateur :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- Enregistrez le fichier pour appliquer les modifications. Les pods concernés par la nouvelle configuration redémarrent automatiquement.

2.9.5. Modifier le temps de rétention des données de métriques de la règle de Thanos

Par défaut, pour les projets définis par l'utilisateur, Thanos Ruler conserve automatiquement les données de mesure pendant 24 heures. Vous pouvez modifier la durée de conservation des données en spécifiant une valeur de temps dans la carte de configuration user-workload-monitoring-config, dans l'espace de noms openshift-user-workload-monitoring.

Conditions préalables

-

Vous avez installé l'OpenShift CLI (

oc). - Un administrateur de cluster a activé la surveillance des projets définis par l'utilisateur.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-adminou en tant qu'utilisateur ayant le rôleuser-workload-monitoring-config-editdans le projetopenshift-user-workload-monitoring. -

Vous avez créé l'objet

user-workload-monitoring-configConfigMap.

L'enregistrement des modifications apportées à une carte de configuration de surveillance peut redémarrer les processus de surveillance et redéployer les pods et autres ressources dans le projet concerné. Les processus de surveillance en cours dans ce projet peuvent également redémarrer.

Procédure

Modifiez l'objet

user-workload-monitoring-configConfigMapdans le projetopenshift-user-workload-monitoring:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez la configuration du temps de rétention sous

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Spécifiez la durée de rétention au format suivant : un nombre directement suivi de

ms(millisecondes),s(secondes),m(minutes),h(heures),d(jours),w(semaines) ouy(années). Vous pouvez également combiner des valeurs temporelles pour des heures spécifiques, comme1h30m15s. La valeur par défaut est24h.

L'exemple suivant fixe la durée de conservation à 10 jours pour les données de Thanos Ruler :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enregistrez le fichier pour appliquer les modifications. Les pods concernés par la nouvelle configuration redémarrent automatiquement.

2.10. Configuration du stockage en écriture à distance

Vous pouvez configurer le stockage en écriture à distance pour permettre à Prometheus d'envoyer les métriques ingérées à des systèmes distants pour un stockage à long terme. Cette opération n'a aucune incidence sur la manière dont Prometheus stocke les métriques, ni sur la durée de ce stockage.

Conditions préalables

If you are configuring core OpenShift Container Platform monitoring components:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez créé l'objet

cluster-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

If you are configuring components that monitor user-defined projects:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-adminou en tant qu'utilisateur ayant le rôleuser-workload-monitoring-config-editdans le projetopenshift-user-workload-monitoring. -

Vous avez créé l'objet

user-workload-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

-

Vous avez installé l'OpenShift CLI (

oc). - Vous avez configuré un point d'extrémité compatible avec l'écriture à distance (tel que Thanos) et vous connaissez l'URL du point d'extrémité. Consultez la documentation sur les points d'extrémité et le stockage à distance de Prometheus pour obtenir des informations sur les points d'extrémité compatibles avec la fonction d'écriture à distance.

Vous avez configuré les informations d'authentification dans un objet

Secretpour le point de terminaison d'écriture à distance. Vous devez créer le secret dans le même espace de noms que l'objet Prometheus pour lequel vous configurez l'écriture à distance : l'espace de nomsopenshift-monitoringpour la surveillance de la plate-forme par défaut ou l'espace de nomsopenshift-user-workload-monitoringpour la surveillance de la charge de travail de l'utilisateur.ImportantPour réduire les risques de sécurité, utilisez HTTPS et l'authentification pour envoyer des mesures à un point final.

Procédure

Suivez ces étapes pour configurer l'écriture à distance pour la surveillance de la plate-forme par défaut dans la carte de configuration cluster-monitoring-config de l'espace de noms openshift-monitoring.

Si vous configurez l'écriture à distance pour l'instance Prometheus qui surveille les projets définis par l'utilisateur, apportez des modifications similaires à la carte de configuration user-workload-monitoring-config dans l'espace de noms openshift-user-workload-monitoring. Notez que le composant de carte de configuration Prometheus est appelé prometheus dans l'objet user-workload-monitoring-config ConfigMap et non prometheusK8s, comme c'est le cas dans l'objet cluster-monitoring-config ConfigMap .

Modifiez l'objet

cluster-monitoring-configConfigMapdans le projetopenshift-monitoring:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

Ajouter une section

remoteWrite:sousdata/config.yaml/prometheusK8s. Ajoutez une URL de point final et des informations d'authentification dans cette section :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- L'URL du point de terminaison d'écriture à distance.

- 2

- La méthode d'authentification et les informations d'identification pour le point de terminaison. Les méthodes d'authentification actuellement prises en charge sont AWS Signature Version 4, l'authentification par HTTP et l'en-tête de requête

Authorization, l'authentification de base, OAuth 2.0 et le client TLS. Voir Supported remote write authentication settings ci-dessous pour des exemples de configuration des méthodes d'authentification prises en charge.

Ajouter des valeurs de configuration après les informations d'authentification :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Les paramètres de configuration du relabel d'écriture.

Pour

<write_relabel_configs>, substituez une liste de configurations d'étiquetage en écriture pour les mesures que vous souhaitez envoyer au point de terminaison distant.L'exemple suivant montre comment transmettre une métrique unique appelée

my_metric:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Voir la documentation Prometheus relabel_config pour plus d'informations sur les options de configuration de write relabel.

Enregistrez le fichier pour appliquer les modifications à l'objet

ConfigMap. Les pods concernés par la nouvelle configuration redémarrent automatiquement.NoteLes configurations appliquées à l'objet

user-workload-monitoring-configConfigMapne sont pas activées à moins qu'un administrateur de cluster n'ait activé la surveillance pour les projets définis par l'utilisateur.AvertissementL'enregistrement des modifications apportées à un objet de surveillance

ConfigMappeut entraîner le redéploiement des pods et d'autres ressources dans le projet concerné. L'enregistrement des modifications peut également redémarrer les processus de surveillance en cours dans ce projet.

2.10.1. Paramètres d'authentification de l'écriture à distance pris en charge

Vous pouvez utiliser différentes méthodes pour vous authentifier auprès d'un point de terminaison d'écriture distant. Les méthodes d'authentification actuellement prises en charge sont AWS Signature Version 4, l'authentification de base, l'autorisation, OAuth 2.0 et le client TLS. Le tableau suivant fournit des détails sur les méthodes d'authentification prises en charge pour l'écriture à distance.

| Méthode d'authentification | Champ de la carte de configuration | Description |

|---|---|---|

| Signature AWS version 4 |

| Cette méthode utilise l'authentification AWS Signature Version 4 pour signer les demandes. Vous ne pouvez pas utiliser cette méthode simultanément avec l'autorisation, OAuth 2.0 ou l'authentification de base. |

| authentification de base |

| L'authentification de base définit l'en-tête d'autorisation sur chaque demande d'écriture à distance avec le nom d'utilisateur et le mot de passe configurés. |

| autorisation |

|

L'autorisation définit l'en-tête |

| OAuth 2.0 |

|

Une configuration OAuth 2.0 utilise le type de subvention des informations d'identification du client. Prometheus récupère un jeton d'accès sur |

| Client TLS |

| Une configuration client TLS spécifie le certificat de l'autorité de certification, le certificat du client et les informations du fichier clé du client utilisés pour s'authentifier avec le serveur de point d'accès en écriture distant à l'aide de TLS. L'exemple de configuration suppose que vous avez déjà créé un fichier de certificat CA, un fichier de certificat client et un fichier de clé client. |

2.10.1.1. Emplacement de la carte de configuration pour les paramètres d'authentification

La figure suivante montre l'emplacement de la configuration de l'authentification dans l'objet ConfigMap pour la surveillance de la plate-forme par défaut.

- 1

- L'URL du point de terminaison d'écriture à distance.

- 2

- Détails de la configuration requise pour la méthode d'authentification du point de terminaison. Les méthodes d'authentification actuellement prises en charge sont Amazon Web Services (AWS) Signature Version 4, autorisation, authentification de base, OAuth 2.0 et client TLS.

Si vous configurez l'écriture à distance pour l'instance Prometheus qui surveille les projets définis par l'utilisateur, modifiez la carte de configuration user-workload-monitoring-config dans l'espace de noms openshift-user-workload-monitoring. Notez que le composant de la carte de configuration Prometheus est appelé prometheus dans l'objet user-workload-monitoring-config ConfigMap et non prometheusK8s, comme c'est le cas dans l'objet cluster-monitoring-config ConfigMap .

2.10.1.2. Exemple de paramètres d'authentification de l'écriture à distance

Les exemples suivants montrent différents paramètres d'authentification que vous pouvez utiliser pour vous connecter à un point final d'écriture à distance. Chaque exemple montre également comment configurer un objet Secret correspondant qui contient les informations d'authentification et d'autres paramètres pertinents. Chaque exemple configure l'authentification pour une utilisation avec la surveillance de la plate-forme par défaut dans l'espace de noms openshift-monitoring.

Exemple de YAML pour l'authentification AWS Signature Version 4

L'exemple suivant montre les paramètres d'un secret sigv4 nommé sigv4-credentials dans l'espace de noms openshift-monitoring.

Les exemples suivants montrent des paramètres d'authentification d'écriture à distance AWS Signature Version 4 qui utilisent un objet Secret nommé sigv4-credentials dans l'espace de noms openshift-monitoring:

- 1

- La région AWS.

- 2 4

- Le nom de l'objet

Secretcontenant les identifiants d'accès à l'API AWS. - 3

- La clé qui contient la clé d'accès à l'API AWS dans l'objet

Secretspécifié. - 5

- La clé qui contient la clé secrète de l'API AWS dans l'objet

Secretspécifié. - 6

- Le nom du profil AWS utilisé pour l'authentification.

- 7

- L'identifiant unique de l'Amazon Resource Name (ARN) attribué à votre rôle.

Exemple de YAML pour l'authentification de base

L'exemple suivant montre des paramètres d'authentification de base pour un objet Secret nommé rw-basic-auth dans l'espace de noms openshift-monitoring:

L'exemple suivant montre une configuration d'écriture à distance basicAuth qui utilise un objet Secret nommé rw-basic-auth dans l'espace de noms openshift-monitoring. Il suppose que vous avez déjà configuré les informations d'authentification pour le point final.

Exemple de YAML pour l'authentification avec un jeton de porteur à l'aide d'un objet Secret

L'exemple suivant montre les paramètres du jeton de support pour un objet Secret nommé rw-bearer-auth dans l'espace de noms openshift-monitoring:

- 1

- Le jeton d'authentification.

Les exemples suivants montrent des paramètres de carte de configuration de jetons de support qui utilisent un objet Secret nommé rw-bearer-auth dans l'espace de noms openshift-monitoring:

Exemple de YAML pour l'authentification OAuth 2.0

L'exemple suivant montre des paramètres OAuth 2.0 pour un objet Secret nommé oauth2-credentials dans l'espace de noms openshift-monitoring:

La figure suivante présente un exemple de configuration de l'authentification d'écriture à distance oauth2 qui utilise un objet Secret nommé oauth2-credentials dans l'espace de noms openshift-monitoring:

- 1 3

- Le nom de l'objet

Secretcorrespondant. Notez queClientIdpeut également faire référence à un objetConfigMap, bien queclientSecretdoive faire référence à un objetSecret. - 2 4

- La clé qui contient les informations d'identification OAuth 2.0 dans l'objet

Secretspécifié. - 5

- L'URL utilisée pour obtenir un jeton avec les adresses

clientIdetclientSecret. - 6

- Les champs d'application OAuth 2.0 pour la demande d'autorisation. Ces champs d'application limitent les données auxquelles les jetons peuvent accéder.

- 7

- Les paramètres de la demande d'autorisation OAuth 2.0 requis pour le serveur d'autorisation.

Exemple de YAML pour l'authentification du client TLS

L'exemple suivant montre des exemples de paramètres client TLS pour un objet tls Secret nommé mtls-bundle dans l'espace de noms openshift-monitoring.

L'exemple suivant montre une configuration d'authentification d'écriture à distance tlsConfig qui utilise un objet TLS Secret nommé mtls-bundle.

- 1 3 5

- Le nom de l'objet

Secretcorrespondant qui contient les informations d'authentification TLS. Notez quecaetcertpeuvent alternativement faire référence à un objetConfigMap, bien quekeySecretdoive faire référence à un objetSecret. - 2

- La clé de l'objet

Secretspécifié qui contient le certificat de l'autorité de certification pour le point d'extrémité. - 4

- La clé de l'objet

Secretspécifié qui contient le certificat du client pour le point d'extrémité. - 6

- La clé de l'objet

Secretspécifié qui contient le secret de la clé du client.

2.11. Ajout d'étiquettes d'identification des clusters aux métriques

Si vous gérez plusieurs clusters OpenShift Container Platform et que vous utilisez la fonction d'écriture à distance pour envoyer des données de métriques de ces clusters vers un emplacement de stockage externe, vous pouvez ajouter des étiquettes d'ID de cluster pour identifier les données de métriques provenant de différents clusters. Vous pouvez ensuite interroger ces étiquettes pour identifier le cluster source d'une métrique et distinguer ces données de données de métriques similaires envoyées par d'autres clusters.

Ainsi, si vous gérez de nombreux clusters pour plusieurs clients et que vous envoyez des données de mesure à un système de stockage centralisé unique, vous pouvez utiliser des étiquettes d'identification de cluster pour interroger les mesures d'un cluster ou d'un client particulier.

La création et l'utilisation d'étiquettes d'identification de grappes comportent trois étapes générales :

- Configuration des paramètres d'étiquetage en écriture pour le stockage en écriture à distance.

- Ajout d'étiquettes d'identification des clusters aux métriques.

- L'interrogation de ces étiquettes permet d'identifier la grappe ou le client source d'une mesure.

2.11.1. Création d'étiquettes d'identification des clusters pour les métriques

Vous pouvez créer des étiquettes d'ID de cluster pour les métriques destinées à la surveillance de la plate-forme par défaut et à la surveillance de la charge de travail de l'utilisateur.

Pour la surveillance de la plate-forme par défaut, vous ajoutez des étiquettes d'ID de cluster pour les métriques dans les paramètres write_relabel pour le stockage en écriture à distance dans la carte de configuration cluster-monitoring-config dans l'espace de noms openshift-monitoring.

Pour la surveillance de la charge de travail de l'utilisateur, vous modifiez les paramètres de la carte de configuration user-workload-monitoring-config dans l'espace de noms openshift-user-workload-monitoring.

Conditions préalables

-

Vous avez installé l'OpenShift CLI (

oc). - Vous avez configuré le stockage en écriture à distance.

If you are configuring default platform monitoring components:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez créé l'objet

cluster-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

If you are configuring components that monitor user-defined projects:

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-adminou en tant qu'utilisateur ayant le rôleuser-workload-monitoring-config-editdans le projetopenshift-user-workload-monitoring. -

Vous avez créé l'objet

user-workload-monitoring-configConfigMap.

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

Procédure

Modifiez l'objet

cluster-monitoring-configConfigMapdans le projetopenshift-monitoring:oc -n openshift-monitoring edit configmap cluster-monitoring-config