Le réseautage

Configuration du réseau dédié OpenShift

Résumé

Chapitre 1. À propos du réseautage

Le Red Hat OpenShift Networking est un écosystème de fonctionnalités, de plugins et de fonctionnalités de réseau avancées qui améliorent le réseau Kubernetes avec des fonctionnalités liées au réseau avancées dont votre cluster a besoin pour gérer le trafic réseau pour un ou plusieurs clusters hybrides. Cet écosystème de capacités de mise en réseau intègre l’entrée, la sortie, l’équilibrage de charge, le débit haute performance, la sécurité et la gestion du trafic inter et intra-cluster. L’écosystème Red Hat OpenShift Networking fournit également des outils d’observabilité basés sur les rôles pour réduire ses complexités naturelles.

Ce qui suit sont quelques-unes des fonctionnalités de réseau Red Hat OpenShift les plus couramment utilisées disponibles sur votre cluster:

- Cluster Network Operator pour la gestion des plugins réseau

Le réseau de cluster primaire fourni par l’un des plugins d’interface réseau de conteneurs (CNI) suivants:

- Le plugin réseau OVN-Kubernetes, qui est le plugin CNI par défaut.

- Le plugin réseau OpenShift SDN, qui a été déprécié dans OpenShift 4.16 et supprimé dans OpenShift 4.17.

Avant de mettre à niveau OpenShift Dedicated clusters configurés avec le plugin réseau OpenShift SDN vers la version 4.17, vous devez migrer vers le plugin réseau OVN-Kubernetes. Cliquez ici pour plus d’informations sur la migration du plugin réseau OpenShift SDN vers le plugin réseau OVN-Kubernetes dans la section Ressources supplémentaires.

Ressources supplémentaires

Chapitre 2. Opérateurs de réseautage

2.1. L’opérateur DNS dans OpenShift dédié

Dans OpenShift Dedicated, l’opérateur DNS déploie et gère une instance CoreDNS pour fournir un service de résolution de noms aux pods à l’intérieur du cluster, permet la découverte de Kubernetes Service basé sur DNS et résout les noms internes cluster.local.

2.1.1. Contrôle de l’état de l’opérateur DNS

L’opérateur DNS implémente l’API dns du groupe d’API operator.openshift.io. L’opérateur déploie CoreDNS à l’aide d’un jeu de démons, crée un service pour l’ensemble de démons et configure le kubelet pour demander aux pods d’utiliser l’adresse IP du service CoreDNS pour la résolution de nom.

Procédure

L’opérateur DNS est déployé lors de l’installation avec un objet de déploiement.

La commande oc get permet d’afficher l’état du déploiement:

oc get -n openshift-dns-operator deployment/dns-operator

$ oc get -n openshift-dns-operator deployment/dns-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME READY UP-TO-DATE AVAILABLE AGE dns-operator 1/1 1 1 23h

NAME READY UP-TO-DATE AVAILABLE AGE dns-operator 1/1 1 1 23hCopy to Clipboard Copied! Toggle word wrap Toggle overflow La commande oc get permet d’afficher l’état de l’opérateur DNS:

oc get clusteroperator/dns

$ oc get clusteroperator/dnsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE MESSAGE dns 4.1.15-0.11 True False False 92m

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE MESSAGE dns 4.1.15-0.11 True False False 92mCopy to Clipboard Copied! Toggle word wrap Toggle overflow AVAILABLE, PROGRESSING et DEGRADED fournissent des informations sur le statut de l’Opérateur. AVAILABLE est vrai quand au moins 1 pod du jeu de démon CoreDNS signale une condition d’état disponible, et le service DNS a une adresse IP en cluster.

2.1.2. Afficher le DNS par défaut

Chaque nouvelle installation OpenShift Dedicated a un dns.operator nommé par défaut.

Procédure

La commande oc described permet d’afficher les dns par défaut:

oc describe dns.operator/default

$ oc describe dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.3. En utilisant le transfert DNS

Le transfert DNS vous permet de remplacer la configuration de transfert par défaut dans le fichier /etc/resolv.conf de la manière suivante:

Indiquez les serveurs de noms (spec.servers) pour chaque zone. Lorsque la zone transférée est le domaine d’entrée géré par OpenShift Dedicated, le serveur de noms en amont doit être autorisé pour le domaine.

ImportantIl faut spécifier au moins une zone. Dans le cas contraire, votre cluster peut perdre des fonctionnalités.

- Fournir une liste de serveurs DNS en amont (spec.upstreamResolvers).

- Changez la stratégie de transfert par défaut.

La configuration de transfert DNS pour le domaine par défaut peut avoir à la fois les serveurs par défaut spécifiés dans le fichier /etc/resolv.conf et les serveurs DNS en amont.

Procédure

La modification de l’objet DNS Operator nommé par défaut:

oc edit dns.operator/default

$ oc edit dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow Après avoir émis la commande précédente, l’opérateur crée et met à jour la carte de configuration nommée dns-default avec des blocs de configuration de serveur supplémentaires basés sur spec.servers.

ImportantLorsque vous spécifiez des valeurs pour le paramètre zones, assurez-vous que vous ne transmettez que des zones spécifiques, telles que votre intranet. Il faut spécifier au moins une zone. Dans le cas contraire, votre cluster peut perdre des fonctionnalités.

Dans le cas où aucun des serveurs n’a une zone correspondant à la requête, la résolution de nom revient aux serveurs DNS en amont.

Configuration du transfert DNS

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Doit se conformer à la syntaxe du nom de service rfc6335.

- 2

- Doit être conforme à la définition d’un sous-domaine dans la syntaxe du nom de service rfc1123. Le domaine cluster, cluster.local, est un sous-domaine invalide pour le champ zones.

- 3

- Définit la stratégie pour sélectionner les résolveurs en amont listés dans le forwardPlugin. La valeur par défaut est aléatoire. Il est également possible d’utiliser les valeurs RoundRobin et Sequential.

- 4

- Au maximum 15 amonts sont permis par forwardPlugin.

- 5

- Il est possible d’utiliser upstreamResolvers pour remplacer la stratégie de transfert par défaut et transférer la résolution DNS vers les résolveurs DNS spécifiés (résolutionurs en amont) pour le domaine par défaut. Dans le cas où vous ne fournissez pas de résolveurs en amont, les requêtes de nom DNS vont aux serveurs déclarés dans /etc/resolv.conf.

- 6

- Détermine l’ordre dans lequel les serveurs en amont listés en amont sont sélectionnés pour la requête. Il est possible de spécifier l’une de ces valeurs : aléatoire, RoundRobin ou séquentiel. La valeur par défaut est séquentielle.

- 7

- Lorsqu’elle est omise, la plate-forme choisit un défaut, normalement le protocole de la demande du client d’origine. Définissez sur TCP pour spécifier que la plate-forme doit utiliser TCP pour toutes les requêtes DNS en amont, même si la demande client utilise UDP.

- 8

- Il est utilisé pour configurer le type de transport, le nom du serveur et le paquet CA personnalisé optionnel à utiliser lors du transfert de requêtes DNS à un résolveur en amont.

- 9

- Il est possible de spécifier deux types d’amont : SystemResolvConf ou Network. Le SystemResolvConf configure l’amont pour utiliser /etc/resolv.conf et Network définit un Networkresolver. Il est possible d’en spécifier un ou les deux.

- 10

- Dans le cas où le type spécifié est Network, vous devez fournir une adresse IP. Le champ d’adresse doit être une adresse IPv4 ou IPv6 valide.

- 11

- Dans le cas où le type spécifié est Network, vous pouvez éventuellement fournir un port. Le champ port doit avoir une valeur comprise entre 1 et 65535. Dans le cas où vous ne spécifiez pas un port pour l’amont, le port par défaut est 853.

2.1.4. Contrôle de l’état de l’opérateur DNS

Il est possible d’inspecter l’état et d’afficher les détails de l’opérateur DNS à l’aide de la commande oc described.

Procédure

Afficher l’état de l’opérateur DNS:

oc describe clusteroperators/dns

$ oc describe clusteroperators/dnsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Bien que les messages et l’orthographe puissent varier dans une version spécifique, la sortie d’état attendue ressemble à:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.5. Affichage des journaux de l’opérateur DNS

En utilisant la commande oc logs, vous pouvez afficher les journaux DNS Operator.

Procédure

Consultez les journaux de l’opérateur DNS:

oc logs -n openshift-dns-operator deployment/dns-operator -c dns-operator

$ oc logs -n openshift-dns-operator deployment/dns-operator -c dns-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.6. Définition du niveau de journal CoreDNS

Les niveaux de log pour CoreDNS et l’opérateur CoreDNS sont définis en utilisant différentes méthodes. Il est possible de configurer le niveau de journal CoreDNS pour déterminer la quantité de détails dans les messages d’erreur enregistrés. Les valeurs valides pour le niveau de journal CoreDNS sont Normal, Debug et Trace. Le logLevel par défaut est normal.

Le niveau de journal des erreurs CoreDNS est toujours activé. Les paramètres de niveau de journal suivants rapportent différentes réponses d’erreur:

- LogLevel: Normal active la classe "erreurs": log . { erreur de classe }.

- LogLevel: Debug active la classe "denial": log . { erreur de déni de classe }.

- LogLevel: Trace permet la classe "all": log . {classe tout }.

Procédure

Afin de définir logLevel sur Debug, entrez la commande suivante:

oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Debug"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Debug"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow Afin de définir logLevel sur Trace, entrez la commande suivante:

oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Trace"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Trace"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

La vérification

Afin de s’assurer que le niveau de journal souhaité a été défini, vérifiez la carte de configuration:

oc get configmap/dns-default -n openshift-dns -o yaml

$ oc get configmap/dns-default -n openshift-dns -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow À titre d’exemple, après avoir configuré le logLevel sur Trace, vous devriez voir cette strophe dans chaque bloc de serveur:

errors log . { class all }errors log . { class all }Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.7. Définition du niveau de journal de l’opérateur CoreDNS

Les niveaux de log pour CoreDNS et CoreDNS Operator sont définis en utilisant différentes méthodes. Les administrateurs de clusters peuvent configurer le niveau de journal de l’opérateur pour suivre plus rapidement les problèmes DNS OpenShift. Les valeurs valides pour operatorLogLevel sont Normal, Debug et Trace. La trace a les informations les plus détaillées. L’opérateurloglogLevel par défaut est normal. Il y a sept niveaux de journalisation pour les problèmes d’opérateur: Trace, Debug, Info, Avertissement, Erreur, Fatal et Panic. Après que le niveau de journalisation est défini, les entrées de journal avec cette sévérité ou quoi que ce soit au-dessus, il sera enregistré.

- OperatorLogLevel: "Normal" set logrus.SetLogLevel("Info").

- OperatorLogLevel: "Debug" définit logrus.SetLogLevel("Debug").

- OperatorLogLevel: "Trace" définit logrus.SetLogLevel("Trace").

Procédure

Afin de définir operatorLogLevel sur Debug, entrez la commande suivante:

oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Debug"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Debug"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow Afin de définir operatorLogLevel sur Trace, entrez la commande suivante:

oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Trace"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Trace"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

La vérification

Afin d’examiner le changement qui en résulte, entrez la commande suivante:

oc get dnses.operator -A -oyaml

$ oc get dnses.operator -A -oyamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Il faut voir deux entrées de niveau de journal. L’opérateur operatorLogLevel s’applique aux problèmes d’opérateur DNS OpenShift, et le logLevel s’applique au daemonset des pods CoreDNS:

logLevel: Trace operatorLogLevel: Debug

logLevel: Trace operatorLogLevel: DebugCopy to Clipboard Copied! Toggle word wrap Toggle overflow Afin d’examiner les journaux du daemonset, entrez la commande suivante:

oc logs -n openshift-dns ds/dns-default

$ oc logs -n openshift-dns ds/dns-defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.8. Réglage du cache CoreDNS

Dans le cas de CoreDNS, vous pouvez configurer la durée maximale de mise en cache réussie ou infructueuse, également connue respectivement sous le nom de mise en cache positive ou négative. Le réglage de la durée du cache des réponses de requête DNS peut réduire la charge pour tous les résolveurs DNS en amont.

La définition des champs TTL à des valeurs basses pourrait entraîner une charge accrue sur le cluster, tous les résolveurs en amont, ou les deux.

Procédure

Éditez l’objet DNS Operator nommé par défaut en exécutant la commande suivante:

oc edit dns.operator.openshift.io/default

$ oc edit dns.operator.openshift.io/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow De modifier les valeurs de mise en cache en temps-à-vie (TTL):

Configuration de la mise en cache DNS

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- La valeur de la chaîne 1h est convertie en son nombre respectif de secondes par CoreDNS. En cas d’omission de ce champ, la valeur est supposée être 0s et le cluster utilise la valeur par défaut interne de 900s comme repli.

- 2

- La valeur de la chaîne peut être une combinaison d’unités telles que 0.5h10m et est convertie en son nombre respectif de secondes par CoreDNS. En cas d’omission de ce champ, la valeur est supposée être 0s et le cluster utilise la valeur par défaut interne de 30s comme un repli.

La vérification

Afin d’examiner la modification, regardez à nouveau la carte de configuration en exécutant la commande suivante:

oc get configmap/dns-default -n openshift-dns -o yaml

oc get configmap/dns-default -n openshift-dns -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Assurez-vous que vous voyez des entrées qui ressemblent à l’exemple suivant:

cache 3600 { denial 9984 2400 }cache 3600 { denial 9984 2400 }Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.9. Des tâches avancées

2.1.9.1. Changer l’état de gestion de l’opérateur DNS

L’opérateur DNS gère le composant CoreDNS pour fournir un service de résolution de noms pour les pods et les services dans le cluster. L’état de gestion de l’opérateur DNS est défini sur Gestion par défaut, ce qui signifie que l’opérateur DNS gère activement ses ressources. Il est possible de le changer en Ungaged, ce qui signifie que l’opérateur DNS ne gère pas ses ressources.

Les cas suivants sont des cas d’utilisation pour changer l’état de gestion de l’opérateur DNS:

- Il s’agit d’un développeur et vous souhaitez tester une modification de configuration pour voir s’il corrige un problème dans CoreDNS. Il est possible d’empêcher l’opérateur DNS d’écraser la modification de configuration en définissant l’état de gestion sur Ungaged.

- Il s’agit d’un administrateur de cluster et vous avez signalé un problème avec CoreDNS, mais vous devez appliquer une solution de contournement jusqu’à ce que le problème soit résolu. Le champ État de gestion de l’opérateur DNS peut être défini sur Ungaged pour appliquer la solution de contournement.

Procédure

Change managementState to Ungaged dans l’opérateur DNS:

oc patch dns.operator.openshift.io default --type merge --patch '{"spec":{"managementState":"Unmanaged"}}'oc patch dns.operator.openshift.io default --type merge --patch '{"spec":{"managementState":"Unmanaged"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow État de l’opérateur DNS utilisant la ligne de commande jsonpath JSON parser:

oc get dns.operator.openshift.io default -ojsonpath='{.spec.managementState}'$ oc get dns.operator.openshift.io default -ojsonpath='{.spec.managementState}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

"Unmanaged"

"Unmanaged"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Il n’est pas possible de mettre à niveau l’état de gestion sur Ungaged.

2.1.9.2. Contrôle du positionnement des pod DNS

L’opérateur DNS a deux ensembles de démons: un pour CoreDNS appelé dns-default et un pour la gestion du fichier /etc/hosts appelé node-resolver.

Les pods CoreDNS peuvent être attribués et exécutés sur des nœuds spécifiés. Ainsi, si l’administrateur du cluster a configuré des stratégies de sécurité qui interdisent la communication entre paires de nœuds, vous pouvez configurer des pods CoreDNS pour s’exécuter sur un ensemble restreint de nœuds.

Le service DNS est disponible pour tous les pods si les circonstances suivantes sont vraies:

- Les gousses DNS s’exécutent sur certains nœuds dans le cluster.

- Les nœuds sur lesquels les pods DNS ne s’exécutent pas ont une connectivité réseau aux nœuds sur lesquels les pod DNS s’exécutent,

Le jeu de démons de résolution de nœuds doit s’exécuter sur chaque hôte de nœuds, car il ajoute une entrée pour le registre d’images de cluster pour prendre en charge les images en tirant. Les pods node-resolver n’ont qu’un seul travail : rechercher l’adresse IP du cluster du service image-registry.openshift-image-registry.svc et l’ajouter à /etc/hosts sur l’hôte du nœud afin que le temps d’exécution du conteneur puisse résoudre le nom du service.

En tant qu’administrateur de cluster, vous pouvez utiliser un sélecteur de nœuds personnalisé pour configurer le jeu de démon pour que CoreDNS s’exécute ou ne s’exécute pas sur certains nœuds.

Conditions préalables

- C’est toi qui as installé le CLI.

- En tant qu’utilisateur, vous êtes connecté au cluster avec des privilèges cluster-admin.

- L’état de gestion de votre opérateur DNS est configuré sur Managed.

Procédure

Afin de permettre au jeu de démon pour CoreDNS de s’exécuter sur certains nœuds, configurez une tainte et une tolérance:

Définissez une tainte sur les nœuds que vous souhaitez contrôler le placement des pod DNS en entrant la commande suivante:

oc adm taint nodes <node_name> dns-only=abc:NoExecute

$ oc adm taint nodes <node_name> dns-only=abc:NoExecute1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <node_name> par le nom réel du nœud.

De modifier l’objet DNS Operator nommé par défaut pour inclure la tolérance correspondante en entrant la commande suivante:

oc edit dns.operator/default

$ oc edit dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow Indiquez une touche tainte et une tolérance pour la tainte. La tolérance suivante correspond à la tainte définie sur les nœuds.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Facultatif: Pour spécifier le placement des nœuds à l’aide d’un sélecteur de nœuds, modifiez l’opérateur DNS par défaut:

Éditer l’objet DNS Operator nommé par défaut pour inclure un sélecteur de nœuds:

spec: nodePlacement: nodeSelector: node-role.kubernetes.io/control-plane: ""spec: nodePlacement: nodeSelector:1 node-role.kubernetes.io/control-plane: ""Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ce sélecteur de nœuds garantit que les gousses CoreDNS s’exécutent uniquement sur les nœuds de plan de contrôle.

2.1.9.3. Configuration du transfert DNS avec TLS

Lorsque vous travaillez dans un environnement hautement réglementé, vous pourriez avoir besoin de la possibilité de sécuriser le trafic DNS lorsque vous transmettez des demandes à des résolveurs en amont afin que vous puissiez assurer un trafic DNS supplémentaire et la confidentialité des données.

Gardez à l’esprit que CoreDNS met en cache les connexions transférées pendant 10 secondes. CoreDNS tiendra une connexion TCP ouverte pendant ces 10 secondes si aucune demande n’est émise. Avec de grands clusters, assurez-vous que votre serveur DNS est conscient qu’il pourrait obtenir de nombreuses nouvelles connexions à tenir ouvert parce que vous pouvez lancer une connexion par nœud. Configurez votre hiérarchie DNS en conséquence pour éviter les problèmes de performance.

Lorsque vous spécifiez des valeurs pour le paramètre zones, assurez-vous que vous ne transmettez que des zones spécifiques, telles que votre intranet. Il faut spécifier au moins une zone. Dans le cas contraire, votre cluster peut perdre des fonctionnalités.

Procédure

La modification de l’objet DNS Operator nommé par défaut:

oc edit dns.operator/default

$ oc edit dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow Les administrateurs de clusters peuvent configurer la sécurité des couches de transport (TLS) pour les requêtes DNS transmises.

Configuration du transfert DNS avec TLS

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Doit se conformer à la syntaxe du nom de service rfc6335.

- 2

- Doit être conforme à la définition d’un sous-domaine dans la syntaxe du nom de service rfc1123. Le domaine cluster, cluster.local, est un sous-domaine invalide pour le champ zones. Le domaine cluster, cluster.local, est un sous-domaine invalide pour les zones.

- 3

- Lorsque vous configurez TLS pour les requêtes DNS transmises, définissez le champ de transport pour avoir la valeur TLS.

- 4

- Lors de la configuration de TLS pour les requêtes DNS transmises, il s’agit d’un nom de serveur obligatoire utilisé dans le cadre de l’indication de nom de serveur (SNI) pour valider le certificat de serveur TLS en amont.

- 5

- Définit la stratégie pour sélectionner les résolveurs en amont. La valeur par défaut est aléatoire. Il est également possible d’utiliser les valeurs RoundRobin et Sequential.

- 6

- C’est nécessaire. L’utiliser pour fournir des résolveurs en amont. Au maximum 15 entrées en amont sont autorisées par entrée forwardPlugin.

- 7

- En option. Il peut être utilisé pour remplacer la stratégie par défaut et transférer la résolution DNS vers les résolveurs DNS spécifiés (résolutionurs en amont) pour le domaine par défaut. Dans le cas où vous ne fournissez pas de résolveurs en amont, les requêtes de nom DNS vont aux serveurs de /etc/resolv.conf.

- 8

- Le type réseau est uniquement autorisé lors de l’utilisation de TLS et vous devez fournir une adresse IP. Le type de réseau indique que ce résolveur en amont doit gérer les demandes transmises séparément des résolveurs en amont listés dans /etc/resolv.conf.

- 9

- Le champ d’adresse doit être une adresse IPv4 ou IPv6 valide.

- 10

- En option, vous pouvez fournir un port. Le port doit avoir une valeur comprise entre 1 et 65535. Dans le cas où vous ne spécifiez pas un port pour l’amont, le port par défaut est 853.

NoteLorsque les serveurs sont indéfinis ou invalides, la carte de configuration ne contient que le serveur par défaut.

La vérification

Afficher la carte de configuration:

oc get configmap/dns-default -n openshift-dns -o yaml

$ oc get configmap/dns-default -n openshift-dns -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de DNS ConfigMap basé sur l’exemple de transfert TLS

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Les modifications apportées à forwardPlugin déclenchent une mise à jour continue du jeu de démon CoreDNS.

2.2. L’opérateur d’entrée dans OpenShift dédié

L’opérateur Ingress implémente l’API IngressController et est le composant responsable de l’accès externe aux services de cluster dédiés OpenShift.

2.2.1. Opérateur d’ingénieur dédié OpenShift

Lorsque vous créez votre cluster dédié OpenShift, les pods et les services s’exécutant sur le cluster reçoivent chacun leurs propres adresses IP. Les adresses IP sont accessibles à d’autres pods et services en cours d’exécution à proximité, mais ne sont pas accessibles aux clients externes.

L’opérateur Ingress permet aux clients externes d’accéder à votre service en déployant et en gérant un ou plusieurs contrôleurs Ingress basés sur HAProxy pour gérer le routage. Les ingénieurs de fiabilité du site Red Hat (SRE) gèrent l’opérateur Ingress pour les clusters dédiés à OpenShift. Bien que vous ne puissiez pas modifier les paramètres de l’opérateur Ingress, vous pouvez afficher les configurations, l’état et les journaux par défaut du contrôleur Ingress, ainsi que l’état de l’opérateur Ingress.

2.2.2. L’actif de configuration Ingress

Le programme d’installation génère une ressource Ingress dans le groupe API config.openshift.io, cluster-ingress-02-config.yml.

Définition YAML de la ressource Ingress

Le programme d’installation stocke cette ressource dans le fichier cluster-ingress-02-config.yml dans le répertoire manifestes. Cette ressource Ingress définit la configuration à l’échelle du cluster pour Ingress. Cette configuration Ingress est utilisée comme suit:

- L’opérateur Ingress utilise le domaine à partir de la configuration du cluster Ingress comme domaine pour le contrôleur Ingress par défaut.

- L’opérateur de serveur d’API OpenShift utilise le domaine à partir de la configuration du cluster Ingress. Ce domaine est également utilisé lors de la génération d’un hôte par défaut pour une ressource Route qui ne spécifie pas un hôte explicite.

2.2.3. Ingress Paramètres de configuration du contrôleur

La ressource personnalisée IngressController (CR) inclut des paramètres de configuration optionnels que vous pouvez configurer pour répondre aux besoins spécifiques de votre organisation.

| Le paramètre | Description |

|---|---|

|

| domaine est un nom DNS desservi par le contrôleur Ingress et est utilisé pour configurer plusieurs fonctionnalités:

La valeur de domaine doit être unique parmi tous les contrôleurs Ingress et ne peut pas être mise à jour. En cas de vide, la valeur par défaut est ingress.config.openshift.io/cluster .spec.domain. |

|

| les répliques sont le nombre de répliques du contrôleur Ingress. Dans le cas contraire, la valeur par défaut est 2. |

|

| endpointPublishingStrategy est utilisé pour publier les points de terminaison Ingress Controller sur d’autres réseaux, activer l’intégration de l’équilibreur de charge et fournir l’accès à d’autres systèmes. Dans les environnements cloud, utilisez le champ loadBalancer pour configurer la stratégie de publication des points de terminaison pour votre contrôleur Ingress. Les champs endpointPublishingStrategy suivants peuvent être configurés:

Dans le cas contraire, la valeur par défaut est basée sur infrastructure.config.openshift.io/cluster .status.platform:

Dans la plupart des plateformes, la valeur endpointPublishingStrategy peut être mise à jour. Dans GCP, vous pouvez configurer les champs de fin suivantsPublishingStrategy:

Lorsque vous avez besoin de mettre à jour la valeur endpointPublishingStrategy après le déploiement de votre cluster, vous pouvez configurer les champs endpointPublishingStrategy suivants:

|

|

| La valeur defaultCertificate est une référence à un secret qui contient le certificat par défaut qui est servi par le contrôleur Ingress. Lorsque les Routes ne spécifient pas leur propre certificat, le certificat par défaut est utilisé. Le secret doit contenir les clés et données suivantes: * tls.crt: contenu du fichier de certificat * tls.key: contenu du fichier clé Dans le cas contraire, un certificat wildcard est automatiquement généré et utilisé. Le certificat est valable pour le domaine et les sous-domaines Ingress Controller, et l’AC du certificat généré est automatiquement intégrée au magasin de confiance du cluster. Le certificat en service, qu’il soit généré ou spécifié par l’utilisateur, est automatiquement intégré au serveur OAuth intégré OpenShift Dedicated. |

|

| le namespaceSelector est utilisé pour filtrer l’ensemble d’espaces de noms desservis par le contrôleur Ingress. Ceci est utile pour la mise en œuvre de fragments. |

|

| RouteSelector est utilisé pour filtrer l’ensemble de Routes desservies par le contrôleur Ingress. Ceci est utile pour la mise en œuvre de fragments. |

|

| le nodePlacement permet un contrôle explicite sur la planification du contrôleur d’Ingress. Dans le cas contraire, les valeurs par défaut sont utilisées. Note Le paramètre nodePlacement comprend deux parties, nodeSelector et tolérances. À titre d’exemple: |

|

| le fichier tlsSecurityProfile spécifie les paramètres des connexions TLS pour les contrôleurs Ingress. Dans le cas contraire, la valeur par défaut est basée sur la ressource apiservers.config.openshift.io/cluster. Lors de l’utilisation des types de profils anciens, intermédiaires et modernes, la configuration efficace du profil est sujette à changement entre les versions. À titre d’exemple, compte tenu d’une spécification pour utiliser le profil intermédiaire déployé sur la version X.Y.Z.Z, une mise à niveau pour libérer X.Y.Z+1 peut entraîner l’application d’une nouvelle configuration de profil sur le contrôleur Ingress, ce qui entraîne un déploiement. La version TLS minimale pour les contrôleurs Ingress est 1.1, et la version TLS maximum est 1.3. Note Les chiffrements et la version TLS minimale du profil de sécurité configuré sont reflétés dans le statut TLSProfile. Important L’opérateur Ingress convertit le TLS 1.0 d’un profil Old ou Custom en 1.1. |

|

| clientTLS authentifie l’accès du client au cluster et aux services; par conséquent, l’authentification TLS mutuelle est activée. Dans le cas contraire, le client TLS n’est pas activé. clientTLS a les sous-champs requis, spec.clientTLS.clientCertificatePolicy et spec.clientTLS.ClientCA. Le sous-champ ClientCertificatePolicy accepte l’une des deux valeurs requises ou facultatives. Le sous-champ ClientCA spécifie une carte de configuration qui se trouve dans l’espace de noms openshift-config. La carte de configuration doit contenir un paquet de certificats CA. AllowedSubjectPatterns est une valeur optionnelle qui spécifie une liste d’expressions régulières, qui sont appariées avec le nom distingué sur un certificat client valide pour filtrer les requêtes. Les expressions régulières doivent utiliser la syntaxe PCRE. Au moins un modèle doit correspondre au nom distingué d’un certificat client; sinon, le contrôleur Ingress rejette le certificat et nie la connexion. Dans le cas contraire, le Contrôleur Ingress ne rejette pas les certificats basés sur le nom distingué. |

|

| RouteAdmission définit une politique pour traiter de nouvelles revendications d’itinéraire, telles que l’autorisation ou le refus de revendications dans les espaces de noms. le nom de namespaceOwnership décrit comment les revendications des noms d’hôte doivent être traitées dans les espaces de noms. La valeur par défaut est Strict.

WildcardPolicy décrit comment les routes avec les stratégies de wildcard sont gérées par le contrôleur d’Ingress.

|

|

| la journalisation définit les paramètres de ce qui est enregistré où. Lorsque ce champ est vide, les journaux opérationnels sont activés mais les journaux d’accès sont désactivés.

|

|

| httpHeaders définit la stratégie pour les en-têtes HTTP. En définissant l’en-tête HTTP d’IngressControllerHTTPHeaders, vous spécifiez quand et comment le contrôleur d’ingénierie définit les en-têtes HTTP Forwarded, X-Forwarded-Forwarded-Host, X-Forwarded-Port, X-Forwarded-Proto et X-Forwarded-Proto-Version. La stratégie par défaut est définie à l’annexe.

En définissant l’en-têteNameCaseAdjustments, vous pouvez spécifier les ajustements de cas qui peuvent être appliqués aux noms d’en-tête HTTP. Chaque ajustement est spécifié comme un nom d’en-tête HTTP avec la capitalisation souhaitée. Ainsi, spécifier X-Forwarded-For indique que l’en-tête x-forwarded-for HTTP doit être ajusté pour avoir la capitalisation spécifiée. Ces ajustements ne sont appliqués qu’aux routes de texte clair, terminées par bord et recryptées, et uniquement lorsque vous utilisez HTTP/1. En ce qui concerne les en-têtes de requête, ces ajustements sont appliqués uniquement pour les itinéraires qui ont l’annotation réelle haproxy.router.openshift.io/h1-adjust-case=true. Dans le cas des en-têtes de réponse, ces ajustements sont appliqués à toutes les réponses HTTP. Dans le cas où ce champ est vide, aucun en-tête de requête n’est ajusté. actions spécifie les options pour effectuer certaines actions sur les en-têtes. Les en-têtes ne peuvent pas être réglés ou supprimés pour les connexions de passage TLS. Le champ actions a des sous-champs supplémentaires spec.httpHeader.actions.response et spec.httpHeader.actions.request:

|

|

| httpCompression définit la stratégie de compression du trafic HTTP.

|

|

| httpErrorCodePages spécifie les pages personnalisées de réponse au code d’erreur HTTP. IngressController utilise par défaut des pages d’erreur intégrées dans l’image IngressController. |

|

| httpCaptureCookies spécifie les cookies HTTP que vous souhaitez capturer dans les journaux d’accès. Lorsque le champ httpCaptureCookies est vide, les journaux d’accès ne capturent pas les cookies. Dans tout cookie que vous souhaitez capturer, les paramètres suivants doivent être dans votre configuration IngressController:

À titre d’exemple: httpCaptureCookies:

- matchType: Exact

maxLength: 128

name: MYCOOKIE

|

|

| httpCaptureHeaders spécifie les en-têtes HTTP que vous souhaitez capturer dans les journaux d’accès. Lorsque le champ httpCaptureHeaders est vide, les journaux d’accès ne capturent pas les en-têtes. httpCaptureHeaders contient deux listes d’en-têtes à capturer dans les journaux d’accès. Les deux listes de champs d’en-tête sont requête et réponse. Dans les deux listes, le champ nom doit spécifier le nom de l’en-tête et le champ de longueur max doit spécifier la longueur maximale de l’en-tête. À titre d’exemple: |

|

| LogningOptions spécifie les options pour régler les performances des pods Ingress Controller.

|

|

| logEmptyRequests spécifie les connexions pour lesquelles aucune demande n’est reçue et enregistrée. Ces requêtes vides proviennent de sondes de santé d’équilibreur de charge ou de connexions spéculatives du navigateur Web (préconnection) et l’enregistrement de ces demandes peut être indésirable. Cependant, ces requêtes peuvent être causées par des erreurs réseau, auquel cas la journalisation des requêtes vides peut être utile pour diagnostiquer les erreurs. Ces requêtes peuvent être causées par des scans de ports, et l’enregistrement des requêtes vides peut aider à détecter les tentatives d’intrusion. Les valeurs autorisées pour ce champ sont Log et Ignore. La valeur par défaut est Log. Le type LoggingPolicy accepte l’une ou l’autre des deux valeurs:

|

|

| HTTPEmptyRequestsPolicy décrit comment les connexions HTTP sont gérées si les temps de connexion sont écoulés avant la réception d’une demande. Les valeurs autorisées pour ce champ sont Répondre et Ignorer. La valeur par défaut est Répondre. Le type HTTPEmptyRequestsPolicy accepte l’une ou l’autre des deux valeurs:

Ces connexions proviennent de sondes de santé d’équilibreur de charge ou de connexions spéculatives par navigateur Web (préconnection) et peuvent être ignorées en toute sécurité. Cependant, ces demandes peuvent être causées par des erreurs de réseau, de sorte que le réglage de ce champ à Ignore peut entraver la détection et le diagnostic des problèmes. Ces requêtes peuvent être causées par des scans de ports, auquel cas l’enregistrement des requêtes vides peut aider à détecter les tentatives d’intrusion. |

2.2.3.1. Ingress Controller TLS Profils de sécurité

Les profils de sécurité TLS offrent aux serveurs un moyen de réguler les chiffrements qu’un client de connexion peut utiliser lors de la connexion au serveur.

2.2.3.1.1. Comprendre les profils de sécurité TLS

Il est possible d’utiliser un profil de sécurité TLS (Transport Layer Security) pour définir quels chiffrements TLS sont requis par divers composants dédiés à OpenShift. Les profils de sécurité TLS dédiés OpenShift sont basés sur les configurations recommandées par Mozilla.

Il est possible de spécifier l’un des profils de sécurité TLS suivants pour chaque composant:

| Le profil | Description |

|---|---|

|

| Ce profil est destiné à être utilisé avec des clients ou des bibliothèques hérités. Le profil est basé sur la configuration recommandée par l’ancienne compatibilité rétrograde. L’ancien profil nécessite une version TLS minimale de 1.0. Note Dans le cas du contrôleur Ingress, la version TLS minimale est convertie de 1.0 à 1.1. |

|

| Ce profil est la configuration recommandée pour la majorité des clients. C’est le profil de sécurité TLS par défaut pour le contrôleur Ingress, le kubelet et le plan de contrôle. Le profil est basé sur la configuration de compatibilité intermédiaire recommandée. Le profil intermédiaire nécessite une version TLS minimale de 1.2. |

|

| Ce profil est destiné à une utilisation avec des clients modernes qui n’ont pas besoin de rétrocompatibilité. Ce profil est basé sur la configuration de compatibilité moderne recommandée. Le profil Moderne nécessite une version TLS minimale de 1.3. |

|

| Ce profil vous permet de définir la version TLS et les chiffrements à utiliser. Avertissement Faites preuve de prudence lors de l’utilisation d’un profil personnalisé, car les configurations invalides peuvent causer des problèmes. |

Lors de l’utilisation de l’un des types de profil prédéfinis, la configuration de profil efficace est sujette à changement entre les versions. À titre d’exemple, compte tenu d’une spécification pour utiliser le profil intermédiaire déployé sur la version X.Y.Z.Z, une mise à niveau pour libérer X.Y.Z+1 pourrait entraîner l’application d’une nouvelle configuration de profil, entraînant un déploiement.

2.2.3.1.2. Configuration du profil de sécurité TLS pour le contrôleur Ingress

Afin de configurer un profil de sécurité TLS pour un contrôleur Ingress, modifiez la ressource personnalisée IngressController (CR) pour spécifier un profil de sécurité TLS prédéfini ou personnalisé. Lorsqu’un profil de sécurité TLS n’est pas configuré, la valeur par défaut est basée sur le profil de sécurité TLS défini pour le serveur API.

Exemple IngressController CR qui configure l’ancien profil de sécurité TLS

Le profil de sécurité TLS définit la version minimale de TLS et les chiffrements TLS pour les connexions TLS pour les contrôleurs d’Ingress.

Les chiffrements et la version TLS minimale du profil de sécurité TLS configuré dans la ressource personnalisée IngressController (CR) sous Profil Status.Tls et le profil de sécurité TLS configuré sous Profil de sécurité Spec.Tls. Dans le cas du profil de sécurité TLS personnalisé, les chiffrements spécifiques et la version TLS minimale sont listés sous les deux paramètres.

L’image HAProxy Ingress Controller prend en charge TLS 1.3 et le profil Modern.

L’opérateur Ingress convertit également le TLS 1.0 d’un profil Old ou Custom en 1.1.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle cluster-admin.

Procédure

Editez le CR IngressController CR dans le projet openshift-ingress-operator pour configurer le profil de sécurité TLS:

oc edit IngressController default -n openshift-ingress-operator

$ oc edit IngressController default -n openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter le champ spec.tlsSecurityProfile:

Exemple IngressController CR pour un profil personnalisé

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Indiquez le type de profil de sécurité TLS (ancien, intermédiaire ou personnalisé). La valeur par défaut est intermédiaire.

- 2

- Indiquez le champ approprié pour le type sélectionné:

-

ancien: {} -

intermédiaire: {} -

coutume:

-

- 3

- Dans le cas du type personnalisé, spécifiez une liste de chiffrements TLS et une version minimale acceptée de TLS.

- Enregistrez le fichier pour appliquer les modifications.

La vérification

Assurez-vous que le profil est défini dans IngressController CR:

oc describe IngressController default -n openshift-ingress-operator

$ oc describe IngressController default -n openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.3.1.3. Configuration de l’authentification TLS mutuelle

Il est possible de configurer le contrôleur Ingress pour activer l’authentification mutuelle TLS (mTLS) en définissant une valeur spec.clientTLS. La valeur clientTLS configure le contrôleur Ingress pour vérifier les certificats clients. Cette configuration inclut la définition d’une valeur clientCA, qui est une référence à une carte de configuration. La carte de configuration contient le paquet de certificats CA codé par PEM qui est utilisé pour vérifier le certificat d’un client. En option, vous pouvez également configurer une liste de filtres sujets de certificat.

Lorsque la valeur clientCA spécifie un point de distribution de liste de révocation de certificat X509v3 (CRL), l’opérateur Ingress télécharge et gère une carte de configuration CRL basée sur le point de distribution HTTP URI X509v3 CRL spécifié dans chaque certificat fourni. Le contrôleur Ingress utilise cette carte de configuration lors de la négociation mTLS/TLS. Les demandes qui ne fournissent pas de certificats valides sont rejetées.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle cluster-admin.

- Il y a un paquet de certificats CA codé par PEM.

Dans le cas où votre groupe CA fait référence à un point de distribution de LCR, vous devez également inclure le certificat d’entité finale ou de feuille au paquet CA client. Ce certificat doit avoir inclus un URI HTTP sous les points de distribution CRL, comme décrit dans la RFC 5280. À titre d’exemple:

Issuer: C=US, O=Example Inc, CN=Example Global G2 TLS RSA SHA256 2020 CA1 Subject: SOME SIGNED CERT X509v3 CRL Distribution Points: Full Name: URI:http://crl.example.com/example.crlIssuer: C=US, O=Example Inc, CN=Example Global G2 TLS RSA SHA256 2020 CA1 Subject: SOME SIGNED CERT X509v3 CRL Distribution Points: Full Name: URI:http://crl.example.com/example.crlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Procédure

Dans l’espace de noms openshift-config, créez une carte de configuration à partir de votre paquet CA:

oc create configmap \ router-ca-certs-default \ --from-file=ca-bundle.pem=client-ca.crt \ -n openshift-config

$ oc create configmap \ router-ca-certs-default \ --from-file=ca-bundle.pem=client-ca.crt \1 -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- La clé de données cartographique de configuration doit être ca-bundle.pem, et la valeur des données doit être un certificat CA au format PEM.

Éditer la ressource IngressController dans le projet openshift-ingress-operator:

oc edit IngressController default -n openshift-ingress-operator

$ oc edit IngressController default -n openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez le champ spec.clientTLS et les sous-champs pour configurer le TLS mutuel:

Exemple IngressController CR pour un profil clientTLS qui spécifie les modèles de filtrage

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - En option, obtenez le Nom Distinguished (DN) pour AuthorSubjectPatterns en entrant la commande suivante.

openssl x509 -in custom-cert.pem -noout -subject subject= /CN=example.com/ST=NC/C=US/O=Security/OU=OpenShift

$ openssl x509 -in custom-cert.pem -noout -subject

subject= /CN=example.com/ST=NC/C=US/O=Security/OU=OpenShift2.2.4. Afficher le contrôleur Ingress par défaut

L’opérateur Ingress est une caractéristique centrale d’OpenShift Dedicated et est activé hors de la boîte.

Chaque nouvelle installation OpenShift Dedicated a un ingresscontroller nommé par défaut. Il peut être complété par des contrôleurs Ingress supplémentaires. En cas de suppression de l’ingresscontroller par défaut, l’opérateur Ingress le recréera automatiquement en une minute.

Procédure

Afficher le contrôleur Ingress par défaut:

oc describe --namespace=openshift-ingress-operator ingresscontroller/default

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.5. Afficher le statut de l’opérateur Ingress

Consultez et inspectez l’état de votre opérateur Ingress.

Procédure

Consultez le statut de votre opérateur Ingress:

oc describe clusteroperators/ingress

$ oc describe clusteroperators/ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.6. Afficher les journaux du contrôleur Ingress

Consultez les journaux de vos contrôleurs Ingress.

Procédure

Consultez vos journaux Ingress Controller:

oc logs --namespace=openshift-ingress-operator deployments/ingress-operator -c <container_name>

$ oc logs --namespace=openshift-ingress-operator deployments/ingress-operator -c <container_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.7. Afficher l’état Ingress Controller

Il est possible d’afficher l’état d’un contrôleur d’Ingress particulier.

Procédure

Afficher l’état d’un contrôleur Ingress:

oc describe --namespace=openshift-ingress-operator ingresscontroller/<name>

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.8. Création d’un contrôleur Ingress personnalisé

En tant qu’administrateur de cluster, vous pouvez créer un nouveau contrôleur d’Ingress personnalisé. Étant donné que le contrôleur Ingress par défaut peut changer lors des mises à jour dédiées d’OpenShift, la création d’un contrôleur Ingress personnalisé peut être utile lors de la maintenance manuelle d’une configuration qui persiste entre les mises à jour de cluster.

Cet exemple fournit une spécification minimale pour un contrôleur d’Ingress personnalisé. Afin de personnaliser davantage votre contrôleur Ingress personnalisé, voir "Configuring the Ingress Controller".

Conditions préalables

- Installez le OpenShift CLI (oc).

- Connectez-vous en tant qu’utilisateur avec des privilèges cluster-admin.

Procédure

Créez un fichier YAML qui définit l’objet IngressController personnalisé:

Exemple de fichier custom-ingress-controller.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Indiquez le nom personnalisé de l’objet IngressController.

- 2

- Indiquez le nom du secret avec le certificat de wildcard personnalisé.

- 3

- La réplique minimale doit être UNE

- 4

- Indiquez le domaine à votre nom de domaine. Le domaine spécifié sur l’objet IngressController et le domaine utilisé pour le certificat doivent correspondre. À titre d’exemple, si la valeur de domaine est "custom_domain.mycompany.com", le certificat doit avoir SAN *.custom_domain.mycompany.com (avec le *. ajouté au domaine).

Créez l’objet en exécutant la commande suivante:

oc create -f custom-ingress-controller.yaml

$ oc create -f custom-ingress-controller.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.9. Configuration du contrôleur Ingress

2.2.9.1. Définition d’un certificat par défaut personnalisé

En tant qu’administrateur, vous pouvez configurer un contrôleur Ingress pour utiliser un certificat personnalisé en créant une ressource secrète et en modifiant la ressource personnalisée IngressController (CR).

Conditions préalables

- Il faut avoir une paire de certificats/clés dans des fichiers codés PEM, où le certificat est signé par une autorité de certification de confiance ou par une autorité de certification privée de confiance que vous avez configurée dans un PKI personnalisé.

Le certificat répond aux exigences suivantes:

- Le certificat est valable pour le domaine d’entrée.

- Le certificat utilise l’extension subjectAltName pour spécifier un domaine wildcard, tel que *.apps.ocp4.example.com.

Il faut avoir un IngressController CR. Il est possible d’utiliser la valeur par défaut:

oc --namespace openshift-ingress-operator get ingresscontrollers

$ oc --namespace openshift-ingress-operator get ingresscontrollersCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME AGE default 10m

NAME AGE default 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Lorsque vous avez des certificats intermédiaires, ils doivent être inclus dans le fichier tls.crt du secret contenant un certificat par défaut personnalisé. La commande est importante lorsque vous spécifiez un certificat; énumérez votre(s) certificat(s) intermédiaire(s) après tout certificat(s) serveur(s).

Procédure

Ce qui suit suppose que le certificat personnalisé et la paire de clés sont dans les fichiers tls.crt et tls.key dans le répertoire de travail actuel. Les noms de chemin réels sont remplacés par tls.crt et tls.key. Il est également possible de remplacer un autre nom par défaut lors de la création de la ressource Secret et de la référencer dans IngressController CR.

Cette action entraînera le redéploiement du contrôleur Ingress, en utilisant une stratégie de déploiement mobile.

Créez une ressource Secret contenant le certificat personnalisé dans l’espace de noms openshift-ingress à l’aide des fichiers tls.crt et tls.key.

oc --namespace openshift-ingress create secret tls custom-certs-default --cert=tls.crt --key=tls.key

$ oc --namespace openshift-ingress create secret tls custom-certs-default --cert=tls.crt --key=tls.keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow Actualisez l’IngressController CR pour faire référence au nouveau secret de certificat:

oc patch --type=merge --namespace openshift-ingress-operator ingresscontrollers/default \ --patch '{"spec":{"defaultCertificate":{"name":"custom-certs-default"}}}'$ oc patch --type=merge --namespace openshift-ingress-operator ingresscontrollers/default \ --patch '{"spec":{"defaultCertificate":{"name":"custom-certs-default"}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow La mise à jour a été efficace:

echo Q |\ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null |\ openssl x509 -noout -subject -issuer -enddate

$ echo Q |\ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null |\ openssl x509 -noout -subject -issuer -enddateCopy to Clipboard Copied! Toggle word wrap Toggle overflow là où:

<domaine>- Indique le nom de domaine de base de votre cluster.

Exemple de sortie

subject=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = *.apps.example.com issuer=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = example.com notAfter=May 10 08:32:45 2022 GM

subject=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = *.apps.example.com issuer=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = example.com notAfter=May 10 08:32:45 2022 GMCopy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceAlternativement, vous pouvez appliquer le YAML suivant pour définir un certificat par défaut personnalisé:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Le nom secret du certificat doit correspondre à la valeur utilisée pour mettre à jour le CR.

Lorsque l’IngressController CR a été modifié, l’opérateur Ingress met à jour le déploiement du contrôleur Ingress pour utiliser le certificat personnalisé.

2.2.9.2. La suppression d’un certificat par défaut personnalisé

En tant qu’administrateur, vous pouvez supprimer un certificat personnalisé que vous avez configuré un contrôleur Ingress à utiliser.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle cluster-admin.

- L’OpenShift CLI (oc) a été installé.

- Auparavant, vous avez configuré un certificat par défaut personnalisé pour le contrôleur Ingress.

Procédure

Afin de supprimer le certificat personnalisé et de restaurer le certificat qui est livré avec OpenShift Dedicated, entrez la commande suivante:

oc patch -n openshift-ingress-operator ingresscontrollers/default \ --type json -p $'- op: remove\n path: /spec/defaultCertificate'

$ oc patch -n openshift-ingress-operator ingresscontrollers/default \ --type json -p $'- op: remove\n path: /spec/defaultCertificate'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Il peut y avoir un retard pendant que le cluster réconcilie la nouvelle configuration du certificat.

La vérification

Afin de confirmer que le certificat de cluster original est restauré, entrez la commande suivante:

echo Q | \ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null | \ openssl x509 -noout -subject -issuer -enddate

$ echo Q | \ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null | \ openssl x509 -noout -subject -issuer -enddateCopy to Clipboard Copied! Toggle word wrap Toggle overflow là où:

<domaine>- Indique le nom de domaine de base de votre cluster.

Exemple de sortie

subject=CN = *.apps.<domain> issuer=CN = ingress-operator@1620633373 notAfter=May 10 10:44:36 2023 GMT

subject=CN = *.apps.<domain> issuer=CN = ingress-operator@1620633373 notAfter=May 10 10:44:36 2023 GMTCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.9.3. Auto-échelle d’un contrôleur Ingress

Il est possible d’adapter automatiquement un contrôleur Ingress pour répondre de manière dynamique aux exigences de performance ou de disponibilité de routage, telles que l’exigence d’augmenter le débit.

La procédure suivante fournit un exemple pour la mise à l’échelle du contrôleur Ingress par défaut.

Conditions préalables

- L’OpenShift CLI (oc) est installé.

- En tant qu’utilisateur, vous avez accès à un cluster OpenShift dédié avec le rôle cluster-admin.

Le Custom Metrics Autoscaler Operator et un contrôleur KEDA associé ont été installés.

- Il est possible d’installer l’opérateur en utilisant OperatorHub sur la console Web. Après avoir installé l’opérateur, vous pouvez créer une instance de KedaController.

Procédure

Créez un compte de service à authentifier avec Thanos en exécutant la commande suivante:

oc create -n openshift-ingress-operator serviceaccount thanos && oc describe -n openshift-ingress-operator serviceaccount thanos

$ oc create -n openshift-ingress-operator serviceaccount thanos && oc describe -n openshift-ingress-operator serviceaccount thanosCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créez manuellement le jeton secret de compte de service avec la commande suivante:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Définissez un objet TriggerAuthentication dans l’espace de noms openshift-ingress-operator en utilisant le jeton du compte de service.

Créez l’objet TriggerAuthentication et passez la valeur de la variable secrète au paramètre TOKEN:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Créer et appliquer un rôle pour la lecture des métriques à partir de Thanos:

Créez un nouveau rôle, thanos-metrics-reader.yaml, qui lit des métriques à partir de pods et de nœuds:

à propos de Thanos-metrics-reader.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Appliquez le nouveau rôle en exécutant la commande suivante:

oc apply -f thanos-metrics-reader.yaml

$ oc apply -f thanos-metrics-reader.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Ajoutez le nouveau rôle au compte de service en entrant les commandes suivantes:

oc adm policy -n openshift-ingress-operator add-role-to-user thanos-metrics-reader -z thanos --role-namespace=openshift-ingress-operator

$ oc adm policy -n openshift-ingress-operator add-role-to-user thanos-metrics-reader -z thanos --role-namespace=openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm policy -n openshift-ingress-operator add-cluster-role-to-user cluster-monitoring-view -z thanos

$ oc adm policy -n openshift-ingress-operator add-cluster-role-to-user cluster-monitoring-view -z thanosCopy to Clipboard Copied! Toggle word wrap Toggle overflow NoteL’argument add-cluster-role-to-user n’est requis que si vous utilisez des requêtes cross-namespace. L’étape suivante utilise une requête de l’espace de noms kube-metrics qui nécessite cet argument.

Créez un nouveau fichier ScaledObject YAML, ingress-autoscaler.yaml, qui cible le déploiement par défaut du contrôleur Ingress:

Exemple ScaledObject Définition

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- La ressource personnalisée que vous ciblez. Dans ce cas, le contrôleur Ingress.

- 2

- Facultatif: Le nombre maximum de répliques. En cas d’omission de ce champ, le maximum par défaut est défini à 100 répliques.

- 3

- Le point d’extrémité du service Thanos dans l’espace de noms de surveillance openshift.

- 4

- L’espace de noms Ingress Operator.

- 5

- Cette expression évalue cependant de nombreux nœuds de travail sont présents dans le cluster déployé.

ImportantLorsque vous utilisez des requêtes cross-namespace, vous devez cibler le port 9091 et non le port 9092 dans le champ serverAddress. Il faut aussi avoir des privilèges élevés pour lire les métriques à partir de ce port.

Appliquez la définition de ressource personnalisée en exécutant la commande suivante:

oc apply -f ingress-autoscaler.yaml

$ oc apply -f ingress-autoscaler.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

La vérification

Assurez-vous que le contrôleur Ingress par défaut est mis à l’échelle pour correspondre à la valeur retournée par la requête kube-state-metrics en exécutant les commandes suivantes:

La commande grep permet de rechercher dans le fichier Ingress Controller YAML des répliques:

oc get -n openshift-ingress-operator ingresscontroller/default -o yaml | grep replicas:

$ oc get -n openshift-ingress-operator ingresscontroller/default -o yaml | grep replicas:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

replicas: 3

replicas: 3Copy to Clipboard Copied! Toggle word wrap Toggle overflow Faites entrer les gousses dans le projet openshift-ingress:

oc get pods -n openshift-ingress

$ oc get pods -n openshift-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME READY STATUS RESTARTS AGE router-default-7b5df44ff-l9pmm 2/2 Running 0 17h router-default-7b5df44ff-s5sl5 2/2 Running 0 3d22h router-default-7b5df44ff-wwsth 2/2 Running 0 66s

NAME READY STATUS RESTARTS AGE router-default-7b5df44ff-l9pmm 2/2 Running 0 17h router-default-7b5df44ff-s5sl5 2/2 Running 0 3d22h router-default-7b5df44ff-wwsth 2/2 Running 0 66sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.9.4. Evoluation d’un contrôleur Ingress

Adaptez manuellement un contrôleur Ingress pour répondre aux exigences de performance de routage ou de disponibilité telles que l’exigence d’augmenter le débit. les commandes OC sont utilisées pour mettre à l’échelle la ressource IngressController. La procédure suivante fournit un exemple pour la mise à l’échelle de l’IngreressController par défaut.

La mise à l’échelle n’est pas une action immédiate, car il faut du temps pour créer le nombre désiré de répliques.

Procédure

Afficher le nombre actuel de répliques disponibles pour le logiciel IngressController par défaut:

oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

2

2Copy to Clipboard Copied! Toggle word wrap Toggle overflow Adaptez le logiciel IngressController par défaut au nombre de répliques souhaité à l’aide de la commande oc patch. L’exemple suivant met à l’échelle le IngressController par défaut à 3 répliques:

oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"replicas": 3}}' --type=merge$ oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"replicas": 3}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

ingresscontroller.operator.openshift.io/default patched

ingresscontroller.operator.openshift.io/default patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow Assurez-vous que l’IngreressController par défaut a mis à l’échelle le nombre de répliques que vous avez spécifiées:

oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

3

3Copy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceAlternativement, vous pouvez appliquer le YAML suivant pour mettre à l’échelle un contrôleur Ingress en trois répliques:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Lorsque vous avez besoin d’une quantité différente de répliques, modifiez la valeur des répliques.

2.2.9.5. Configuration de la journalisation des accès Ingress

Il est possible de configurer le contrôleur Ingress pour activer les journaux d’accès. Lorsque vous avez des clusters qui ne reçoivent pas beaucoup de trafic, vous pouvez vous connecter à un sidecar. Lorsque vous avez des clusters de trafic élevés, afin d’éviter de dépasser la capacité de la pile de journalisation ou de vous intégrer à une infrastructure de journalisation en dehors d’OpenShift Dedicated, vous pouvez transférer les journaux à un point de terminaison syslog personnalisé. Il est également possible de spécifier le format des journaux d’accès.

L’enregistrement des conteneurs est utile pour activer les journaux d’accès sur les clusters à faible trafic lorsqu’il n’y a pas d’infrastructure de journalisation Syslog existante, ou pour une utilisation à court terme lors du diagnostic des problèmes avec le contrôleur Ingress.

Le syslog est nécessaire pour les clusters à fort trafic où les journaux d’accès pourraient dépasser la capacité de la pile OpenShift Logging, ou pour les environnements où toute solution de journalisation doit s’intégrer à une infrastructure de journalisation Syslog existante. Les cas d’utilisation Syslog peuvent se chevaucher.

Conditions préalables

- Connectez-vous en tant qu’utilisateur avec des privilèges cluster-admin.

Procédure

Configurer la connexion d’accès Ingress à un sidecar.

Afin de configurer la journalisation des accès Ingress, vous devez spécifier une destination à l’aide de spec.logging.access.destination. Afin de spécifier l’enregistrement à un conteneur sidecar, vous devez spécifier Container spec.logging.access.destination.type. L’exemple suivant est une définition Ingress Controller qui se connecte à une destination Container:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Lorsque vous configurez le contrôleur Ingress pour se connecter à un sidecar, l’opérateur crée un conteneur nommé logs à l’intérieur du Pod de contrôleur Ingress:

oc -n openshift-ingress logs deployment.apps/router-default -c logs

$ oc -n openshift-ingress logs deployment.apps/router-default -c logsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

2020-05-11T19:11:50.135710+00:00 router-default-57dfc6cd95-bpmk6 router-default-57dfc6cd95-bpmk6 haproxy[108]: 174.19.21.82:39654 [11/May/2020:19:11:50.133] public be_http:hello-openshift:hello-openshift/pod:hello-openshift:hello-openshift:10.128.2.12:8080 0/0/1/0/1 200 142 - - --NI 1/1/0/0/0 0/0 "GET / HTTP/1.1"

2020-05-11T19:11:50.135710+00:00 router-default-57dfc6cd95-bpmk6 router-default-57dfc6cd95-bpmk6 haproxy[108]: 174.19.21.82:39654 [11/May/2020:19:11:50.133] public be_http:hello-openshift:hello-openshift/pod:hello-openshift:hello-openshift:10.128.2.12:8080 0/0/1/0/1 200 142 - - --NI 1/1/0/0/0 0/0 "GET / HTTP/1.1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Configurer la journalisation des accès Ingress à un point de terminaison Syslog.

Afin de configurer la journalisation des accès Ingress, vous devez spécifier une destination à l’aide de spec.logging.access.destination. Afin de spécifier la connexion à une destination de point de terminaison Syslog, vous devez spécifier Syslog pour spec.logging.access.destination.type. Dans le cas où le type de destination est Syslog, vous devez également spécifier un point d’extrémité de destination en utilisant spec.logging.access.destination.syslog.address et vous pouvez spécifier une installation en utilisant spec.logging.access.destination.syslog.facility. L’exemple suivant est une définition Ingress Controller qui se connecte à une destination Syslog:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLe port de destination syslog doit être UDP.

L’adresse de destination syslog doit être une adresse IP. Il ne prend pas en charge le nom d’hôte DNS.

Configurer la journalisation des accès Ingress avec un format de journal spécifique.

Il est possible de spécifier spec.logging.access.httpLogFormat pour personnaliser le format du journal. L’exemple suivant est une définition du contrôleur Ingress qui se connecte à un point de terminaison syslog avec l’adresse IP 1.2.3.4 et le port 10514:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Désactiver l’enregistrement des accès Ingress.

Afin de désactiver la journalisation des accès Ingress, laissez spec.logging ou spec.logging.access vide:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Autoriser le contrôleur Ingress à modifier la longueur du journal HAProxy lors de l’utilisation d’un sidecar.

Employez spec.logging.access.destination.syslog.maxLength si vous utilisez spec.logging.access.destination.type: Syslog.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Employez spec.logging.access.destination.container.maxLength si vous utilisez spec.logging.access.destination.type: Container.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.9.6. Configuration du nombre de threads Ingress Controller

L’administrateur de cluster peut définir le nombre de threads pour augmenter le nombre de connexions entrantes qu’un cluster peut gérer. Il est possible de corriger un contrôleur Ingress existant pour augmenter la quantité de threads.

Conditions préalables

- Ce qui suit suppose que vous avez déjà créé un contrôleur Ingress.

Procédure

Actualisez le contrôleur Ingress pour augmenter le nombre de threads:

oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"threadCount": 8}}}'$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"threadCount": 8}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLorsque vous avez un nœud capable d’exécuter de grandes quantités de ressources, vous pouvez configurer spec.nodePlacement.nodeSelector avec des étiquettes correspondant à la capacité du nœud prévu, et configurer spec.tuningOptions.threadCount à une valeur appropriée.

2.2.9.7. Configuration d’un contrôleur Ingress pour utiliser un équilibreur de charge interne

Lors de la création d’un contrôleur Ingress sur les plates-formes cloud, le contrôleur Ingress est publié par défaut par un équilibreur de charge dans le cloud public. En tant qu’administrateur, vous pouvez créer un contrôleur Ingress qui utilise un équilibreur de charge dans le cloud interne.

Lorsque vous souhaitez modifier la portée d’un IngressController, vous pouvez modifier le paramètre .spec.endpointPublishingStrategy.loadBalancer.scope après la création de la ressource personnalisée (CR).

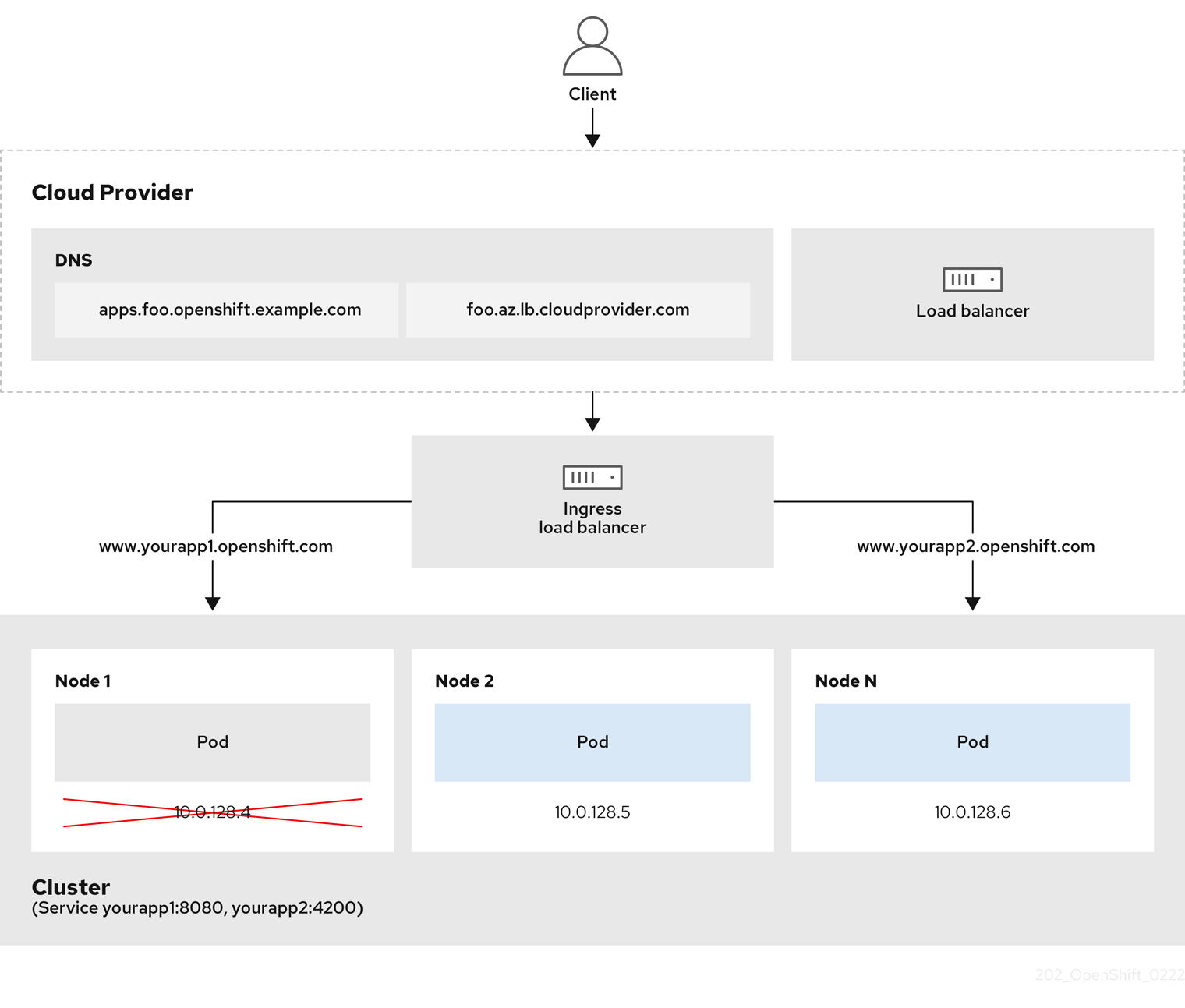

Figure 2.1. Diagramme de LoadBalancer

Le graphique précédent montre les concepts suivants relatifs à OpenShift Dedicated Ingress LoadBalancerService endpoint:

- Il est possible de charger l’équilibre externe, à l’aide de l’équilibreur de charge du fournisseur de cloud, ou en interne, à l’aide de l’équilibreur de charge OpenShift Ingress Controller.

- Il est possible d’utiliser l’adresse IP unique de l’équilibreur de charge et les ports plus familiers, tels que 8080 et 4200, comme indiqué sur le cluster représenté dans le graphique.

- Le trafic de l’équilibreur de charge externe est dirigé vers les pods, et géré par l’équilibreur de charge, comme indiqué dans le cas d’un nœud vers le bas. Consultez la documentation de Kubernetes Services pour plus de détails sur la mise en œuvre.

Conditions préalables

- Installez le OpenShift CLI (oc).

- Connectez-vous en tant qu’utilisateur avec des privilèges cluster-admin.

Procédure

Créez une ressource personnalisée IngressController (CR) dans un fichier nommé <name>-ingress-controller.yaml, comme dans l’exemple suivant:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créez le contrôleur Ingress défini à l’étape précédente en exécutant la commande suivante:

oc create -f <name>-ingress-controller.yaml

$ oc create -f <name>-ingress-controller.yaml1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <name> par le nom de l’objet IngressController.

Facultatif: Confirmer que le contrôleur Ingress a été créé en exécutant la commande suivante:

oc --all-namespaces=true get ingresscontrollers

$ oc --all-namespaces=true get ingresscontrollersCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.9.8. Définir l’intervalle de contrôle de santé Ingress Controller

L’administrateur du cluster peut définir l’intervalle de contrôle de santé pour définir combien de temps le routeur attend entre deux contrôles de santé consécutifs. Cette valeur est appliquée globalement par défaut pour tous les itinéraires. La valeur par défaut est de 5 secondes.

Conditions préalables

- Ce qui suit suppose que vous avez déjà créé un contrôleur Ingress.

Procédure

Actualisez le contrôleur Ingress pour modifier l’intervalle entre les contrôles de santé arrière:

oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"healthCheckInterval": "8s"}}}'$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"healthCheckInterval": "8s"}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteAfin de remplacer l’intervale healthCheckInterval pour une seule route, utilisez l’itinéraire annotation router.openshift.io/haproxy.health.check.interval

2.2.9.9. Configuration du contrôleur Ingress par défaut pour que votre cluster soit interne

Il est possible de configurer le contrôleur Ingress par défaut pour que votre cluster soit interne en le supprimant et en le recréant.

Lorsque vous souhaitez modifier la portée d’un IngressController, vous pouvez modifier le paramètre .spec.endpointPublishingStrategy.loadBalancer.scope après la création de la ressource personnalisée (CR).

Conditions préalables

- Installez le OpenShift CLI (oc).

- Connectez-vous en tant qu’utilisateur avec des privilèges cluster-admin.

Procédure

Configurez le contrôleur Ingress par défaut pour que votre cluster soit interne en le supprimant et en le recréant.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.9.10. Configuration de la politique d’admission d’itinéraire

Les administrateurs et les développeurs d’applications peuvent exécuter des applications dans plusieurs espaces de noms avec le même nom de domaine. C’est pour les organisations où plusieurs équipes développent des microservices qui sont exposés sur le même nom d’hôte.

Autoriser les réclamations dans les espaces de noms ne devrait être activé que pour les clusters ayant confiance entre les espaces de noms, sinon un utilisateur malveillant pourrait prendre en charge un nom d’hôte. C’est pourquoi la politique d’admission par défaut interdit les revendications de nom d’hôte dans les espaces de noms.

Conditions préalables

- Les privilèges d’administrateur de cluster.

Procédure

Éditez le champ .spec.routeAdmission de la variable ressource ingresscontroller à l’aide de la commande suivante:

oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=merge$ oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de configuration du contrôleur Ingress

spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceAlternativement, vous pouvez appliquer les YAML suivants pour configurer la politique d’admission d’itinéraire:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.9.11. En utilisant des routes wildcard

Le contrôleur HAProxy Ingress a pris en charge les routes wildcard. L’opérateur Ingress utilise wildcardPolicy pour configurer la variable d’environnement ROUTER_ALLOW_WILDCARD_ROUTES du contrôleur Ingress.

Le comportement par défaut du contrôleur Ingress est d’admettre des itinéraires avec une stratégie de carte sauvage de None, qui est rétrocompatible avec les ressources existantes IngressController.

Procédure

Configurez la stratégie de wildcard.

À l’aide de la commande suivante pour modifier la ressource IngressController:

oc edit IngressController

$ oc edit IngressControllerCopy to Clipboard Copied! Toggle word wrap Toggle overflow Dans la section Spécification, définissez le champ wildcardPolicy sur WildcardsDisallowed ou WildcardsAllowed:

spec: routeAdmission: wildcardPolicy: WildcardsDisallowed # or WildcardsAllowedspec: routeAdmission: wildcardPolicy: WildcardsDisallowed # or WildcardsAllowedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.9.12. Configuration d’en-tête HTTP

Le logiciel OpenShift Dedicated fournit différentes méthodes pour travailler avec les en-têtes HTTP. Lorsque vous configurez ou supprimez des en-têtes, vous pouvez utiliser des champs spécifiques dans le contrôleur d’Ingress ou un itinéraire individuel pour modifier les en-têtes de requête et de réponse. Il est également possible de définir certains en-têtes en utilisant des annotations d’itinéraire. Les différentes façons de configurer les en-têtes peuvent présenter des défis lorsque vous travaillez ensemble.

Il est possible de définir ou de supprimer uniquement des en-têtes au sein d’un IngressController ou Route CR, vous ne pouvez pas les ajouter. Lorsqu’un en-tête HTTP est défini avec une valeur, cette valeur doit être complète et ne pas nécessiter d’ajouter à l’avenir. Dans les situations où il est logique d’ajouter un en-tête, comme l’en-tête X-Forwarded-Forwarded, utilisez le champ spec.httpHeaders.forwardedHeaderPolicy, au lieu de spec.httpHeaders.actions.

2.2.9.12.1. Ordre de préséance

Lorsque le même en-tête HTTP est modifié à la fois dans le contrôleur Ingress et dans un itinéraire, HAProxy priorise les actions de certaines manières selon qu’il s’agit d’une requête ou d’un en-tête de réponse.

- Dans le cas des en-têtes de réponse HTTP, les actions spécifiées dans le contrôleur Ingress sont exécutées après les actions spécifiées dans un itinéraire. Cela signifie que les actions spécifiées dans le Contrôleur Ingress ont préséance.

- Dans le cas des en-têtes de requête HTTP, les actions spécifiées dans une route sont exécutées après les actions spécifiées dans le contrôleur Ingress. Cela signifie que les actions spécifiées dans l’itinéraire ont préséance.

À titre d’exemple, un administrateur de cluster définit l’en-tête de réponse X-Frame-Options avec la valeur DENY dans le contrôleur Ingress en utilisant la configuration suivante:

Exemple IngressController spec

Le propriétaire de route définit le même en-tête de réponse que l’administrateur du cluster défini dans le contrôleur Ingress, mais avec la valeur SAMEORIGIN en utilisant la configuration suivante:

Exemple de route Spécification