論理ボリュームマネージャーの管理

Red Hat Enterprise Linux 7

LVM 論理ボリュームの設定および管理

概要

本書では、クラスター環境における LVM の実行に関する情報など、LVM 論理ボリュームマネージャーについて説明します。

第1章 LVM 論理ボリュームマネージャー

リンクのコピーリンクがクリップボードにコピーされました!

この章では、Red Hat Enterprise Linux 7 の初期リリース以降のリリースに新たに組み込まれている LVM 論理ボリュームマネージャーの機能についてまとめています。さらに、論理ボリュームマネージャー (LVM) のコンポーネントの概要を説明します。

1.1. 新機能と変更点

リンクのコピーリンクがクリップボードにコピーされました!

このセクションでは、Red Hat Enterprise Linux 7 の初期リリース以降に加えられた LVM 論理ボリュームマネージャーの機能のリストを提供します。

1.1.1. Red Hat Enterprise Linux 7.1 の新機能および変更された機能

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 7.1 には、ドキュメントや機能を対象とする以下の更新および変更が含まれています。

- シンプロビジョニングされたボリュームと、シンプロビジョングされたスナップショットに関する記載がわかりやすくなりました。LVM シンプロビジョニングに関する追加情報は、lvmthin(7) man ページを参照してください。シンプロビジョングされた論理ボリュームに関する全般的な情報は、「シンプロビジョニングされた論理ボリューム (シンボリューム)」 を参照してください。シンプロビジョニングのスナップショットボリュームの詳細は、「シンプロビジョニングされたスナップショットボリューム」 を参照してください。

- 本書では、lvm dumpconfig コマンドの説明を 「lvmconfig コマンド」 にまとめています。Red Hat Enterprise Linux 7.2 リリースでは、このコマンドの名前が lvmconfig に変更になりました。ただし、以前の形式は引き続き機能します。

- このマニュアルは、LVM プロファイルについて 「LVM プロファイル」 で説明しています。

- 本書では、lvm コマンドの説明を 「lvm コマンドを使用した LVM 情報の表示」 に追加しています。

- Red Hat Enterprise Linux 7.1 リリースでは、「論理ボリュームのアクティブ化の制御」 に記載されているように、lvcreate および lvchange コマンドの -k および -K オプションを使用して、シンプールスナップショットのアクティブ化を制御できます。

- 本書では、vgimport コマンドの

--force引数を説明しています。これにより、物理ボリュームがないボリュームグループをインポートし、その後 vgreduce --removemissing コマンドを実行できます。vgimport コマンドの詳細は、「ボリュームグループの別のシステムへの移動」 を参照してください。 - 本書では、vgreduce コマンドの

--mirrorsonly引数を説明しています。この引数を使用すると、障害が発生した物理ボリュームのミラーイメージである論理ボリュームのみを削除することができます。このオプションの使用方法については、「ボリュームグループの別のシステムへの移動」 を参照してください。

さらに、ドキュメント全体にわたり、技術的な内容の若干の修正と明確化を行いました。

1.1.2. Red Hat Enterprise Linux 7.2 の新機能および変更された機能

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 7.2 ではドキュメントと機能が以下のように更新/変更されています。

- 多くの LVM 処理コマンドでは、

-Sオプションまたは--selectオプションで、これらのコマンドの選択基準を定義するようになりました。LVM 選択基準については、新しい付録 付録C LVM 選択基準 に記載されています。 - 本書では、キャッシュ論理ボリュームの作成に関する基本的な手順について 「LVM 論理ボリュームの作成」 で説明します。

- 本書のトラブルシューティングに関する章に、新しいセクション 「マルチパスデバイスに対する重複した PV 警告」 が追加されました。

- Red Hat Enterprise Linux 7.2 リリースでは、lvm dumpconfig コマンドの名前が lvmconfig に変更になりましたが、古い形式は引き続き動作するようになりました。ただし、以前の書式は引き続き利用できます。この変更は本書全体に反映されています。

さらに、ドキュメント全体にわたり、技術的な内容の若干の修正と明確化を行いました。

1.1.3. Red Hat Enterprise Linux 7.3 の新機能および変更された機能

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 7.3 ではドキュメントと機能が以下のように更新、変更されています。

- LVM は RAID0 セグメントタイプをサポートします。RAID0 では、ストライプサイズの単位で、複数のデータサブボリュームに論理ボリュームデータが分散されます。RAID0 ボリュームの作成については、「RAID0 ボリュームの作成 (Red Hat Enterprise Linux 7.3 以降)」 を参照してください。

- lvm fullreport コマンドを使用して、物理ボリューム、ボリュームグループ、論理ボリューム、物理ボリュームセグメント、および論理ボリュームセグメントに関する情報を一度に報告できます。このコマンドとその機能の詳細は、lvm-fullreport(8)の man ページを参照してください。

- LVM は、LVM コマンドの実行中に収集された操作、メッセージ、および各オブジェクトのステータス (完全なオブジェクト ID 付き) のログが含まれるログレポートをサポートします。LVM ログレポートの例は、「コマンドログレポート (Red Hat Enterprise Linux 7.3 以降)」 を参照してください。LVM ログレポートの詳細は、lvmreport(7) man ページを参照してください。

- LVM 表示コマンドで

--reportformatオプションを使用して、JSON 形式で出力を表示できます。JSON 形式で表示された出力例は、「JSON 形式の出力 (Red Hat Enterprise Linux 7.3 以降)」 を参照してください。 lvm.conf設定ファイルでrecord_lvs_historyメタデータオプションを有効にして、削除したシンプロビジョニングのスナップショットとシン論理ボリュームを追跡するようにシステムを設定できるようになりました。これにより、元の依存関係チェーンから削除され、過去の論理ボリュームになった論理ボリュームを含む、完全なシンスナップショット依存関係チェーンを表示できます。過去の論理ボリュームについては、「過去の論理ボリュームの追跡および表示 (Red Hat Enterprise Linux 7.3 以降)」 を参照してください。

さらに、ドキュメント全体にわたり、技術的な内容の若干の修正と明確化を行いました。

1.1.4. Red Hat Enterprise Linux 7.4 の新機能および変更された機能

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 7.4 では、ドキュメントと機能が以下のように更新、変更されています。

- Red Hat Enterprise Linux 7.4 では、RAID テイクオーバーおよび RAID の再成形 (reshaping) に対応します。機能の概要は、「RAID テイクオーバー (Red Hat Enterprise Linux 7.4 以降)」 と 「RAID 論理ボリュームの再成形 (Red Hat Enterprise Linux 7.4 以降)」 を参照してください。

1.2. 論理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

ボリューム管理により、物理ストレージに抽象化レイヤーが作成され、論理ストレージボリュームを作成できるようになりました。様々な面で、物理ストレージを直接使用するよりも柔軟性が高くなります。論理ボリュームを作成すると、物理ディスクのサイズに制限されなくなります。また、ハードウェアストレージ設定がソフトウェアから見えなくなるため、アプリケーションを停止したりファイルシステムをアンマウントしたりせずに、サイズ変更や移動が可能になります。したがって、運用コストが削減できます。

物理ストレージを直接使用する場合と比較して、論理ボリュームには、以下のような利点があります。

- 容量の柔軟性論理ボリュームを使用すると、ディスクとパーティションを 1 つの論理ボリュームに集約できるため、ファイルシステムを複数のディスクに拡張できます。

- サイズ変更可能なストレージプール基になるディスクデバイスを再フォーマットしたり、パーティションを再作成したりせずに、簡単なソフトウェアコマンドを使用して論理ボリュームのサイズを拡大または縮小できます。

- オンラインデータ移動より新しく、迅速で、障害耐性の高いストレージサブシステムを導入するために、システムがアクティブな状態でもデータを移動できます。データは、ディスクが使用中の場合でもディスクに再配置できます。たとえば、ホットスワップ可能なディスクを削除する前に空にできます。

- 便利なデバイスの命名論理ストレージボリュームは、ユーザーが命名をカスタマイズしたグループで管理できます。

- ディスクのストライピング2 つ以上のディスクにまたがってデータをストライプ化する論理ボリュームを作成できます。これにより、スループットが大幅に向上します。

- ボリュームのミラーリング論理ボリュームは、データのミラーを設定する際に便利な方法を提供します。

- ボリュームスナップショット論理ボリュームを使用すると、一貫したバックアップが可能なデバイススナップショットを取ったり、実際のデータに影響を及ぼすことなく変更の影響をテストしたりできます。

LVM にこれらの機能を実装する方法は、後の章で説明します。

1.3. LVM アーキテクチャーの概要

リンクのコピーリンクがクリップボードにコピーされました!

注記

LVM2 には LVM1 との下位互換性があります。vgconvert コマンドを使用して、ボリュームグループを LVM1 形式から LVM2 形式に変換できます。LVM メタデータ形式の変換に関する情報は、vgconvert(8)の man ページを参照してください。

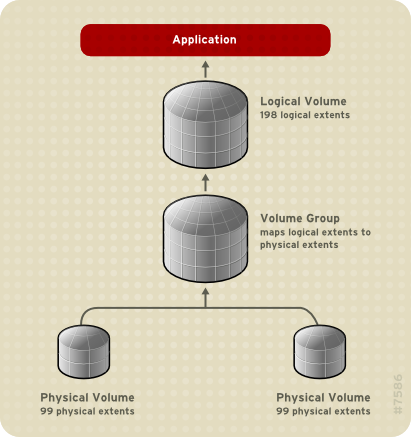

LVM 論理ボリュームの基になる物理ストレージユニットは、パーティション、ディスク全体などのブロックデバイスです。このデバイスは、LVM 物理ボリューム (Physical Volume: PV) として初期化されます。

LVM 論理ボリュームを作成する場合は、物理ボリュームをボリュームグループ (Volume Group: VG) に統合します。これによりディスク領域のプールが作成され、そこから LVM 論理ボリューム (Logical Volume: LV) を割り当てます。このプロセスは、ディスクをパーティションに分割する方法に類似しています。論理ボリュームは、ファイルシステムやアプリケーション (データベースなど) に使用されます。

図1.1「LVM 論理ボリュームのコンポーネント」 は、LVM 論理ボリュームのコンポーネントを簡略に示しています。

図1.1 LVM 論理ボリュームのコンポーネント

LVM 論理ボリュームのコンポーネントの詳細は、2章LVM コンポーネント を参照してください。

1.4. Red Hat High Availability クラスターの LVM 論理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat High Availability Add-On で対応している LVM ボリュームでは、2 つのクラスター設定を使用できます。

- クラスターの 1 つのノードのみが 1 度にストレージにアクセスする、アクティブ/パッシブフェイルオーバー設定の HA-LVM (High Availability LVM) ボリューム。

- 1 つ以上のクラスターが同時にストレージにアクセスする必要がある、アクティブ/アクティブ設定の CLVM (Clustered Logical Volume) を使用する LVM ボリューム。CLVM は Resilient Storage Add-On の一部です。

1.4.1. CLVM または HA-LVM の選択

リンクのコピーリンクがクリップボードにコピーされました!

CLVM または HA-LVM をいつ使用するかは、デプロイされたアプリケーションまたはサービスの必要性に応じて決定する必要があります。

- クラスターの複数のノードが、アクティブ/アクティブシステムで LVM ボリュームへの同時読み取りまたは書き込みを必要とする場合、CLVMD を使用する必要があります。CLVMD は、クラスターのノード全体で LVM ボリュームのアクティベーションおよび変更を同時に調整するシステムを提供します。CLVMD のクラスターロックサービスは、クラスターのさまざまなノードがボリュームと対話し、レイアウトに変更を加え、LVM メタデータを保護します。この保護は、

lvm.confファイルでlocking_typeを 3 に設定し、複数のクラスターノード全体で CLVMD によって管理され、アクティベートされるボリュームグループにクラスター化フラグを設定するなど、該当するボリュームグループの設定が適切に行われます。 - 単一のメンバーのみが 1 度に指定の LVM ボリュームにアクセスする必要があり、アクティブ/パッシブに共有リソースを管理するよう HA クラスターが設定された場合、CLVMD クラスターロックサービスを使用せずに HA-LVM を使用することができます。

ほとんどのアプリケーションは、その他のインスタンスと同時に実行するように設計または最適化されていないため、アクティブ/パッシブ設定での実行により適しています。論理ボリュームがミラーリングされていない場合、クラスター化された論理ボリュームでクラスター対応でないアプリケーションを実行すると、パフォーマンスが低下することがあります。これは、論理ボリューム自体にクラスター通信のオーバーヘッドが発生するためです。クラスター対応のアプリケーションは、クラスターファイルシステムとクラスター対応の論理ボリュームにより発生するパフォーマンスの低下を上回るパフォーマンスの向上を実現できるようにする必要があります。実現が容易かどうかは、アプリケーションやワークロードによって異なります。クラスターの要件を判断し、アクティブ/アクティブのクラスターを最適化する努力に価値があるかどうかを判断して、どちらの LVM を使用するかを選択します。ほとんどの場合は、HA-LVM を使用すると HA を最適化できます。

HA-LVM および CLVM は、複数のマシンが変更を重複して行うと発生する LVM メタデータとその論理ボリュームの破損を防ぐという点で似ています。これは、複数のマシンがオーバーラッピングの変更を許可されている場合に発生します。HA-LVM では、論理ボリュームは、アクティベートする場合は排他的に行うように制限されているため、一度に 1 つのマシンでしかアクティブになりません。そのため、ストレージドライバーのローカル (非クラスター) 実装のみが使用されます。このようにクラスターの調整オーバーヘッドが発生しないようにすると、パフォーマンスが向上します。CLVM にはこのような制限はなく、ユーザーはクラスターのすべてのマシンで論理ボリュームをアクティベートすることができます。これにより、クラスター対応のストレージドライバーの使用が強制され、クラスター対応のファイルシステムとアプリケーションが優先されます。

1.4.2. クラスター内での LVM ボリュームの設定

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 7 では、クラスターは Pacemaker で管理されます。HA-LVM および CLVM 論理ボリュームは、Pacemaker クラスターと併用される場合のみサポートされ、クラスターリソースとして設定する必要があります。

- HA-LVM ボリュームを Pacemaker クラスターの一部として設定する手順は、High Availability Add-On の管理のRed Hat High Availability クラスターのアクティブ/パッシブ Apache HTTP サーバーを参照してください。この手順には以下が含まれます。

- LVM 論理ボリュームの設定

- クラスターのみがボリュームグループをアクティベートできるようにする

- LVM ボリュームをクラスターリソースとして設定する

- クラスターで CLVM ボリュームを設定する手順はGlobal File System 2のクラスターでの GFS2 ファイルシステムの設定を参照してください。

第2章 LVM コンポーネント

リンクのコピーリンクがクリップボードにコピーされました!

この章では、LVM 論理ボリュームのコンポーネントについて説明します。

2.1. 物理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

LVM 論理ボリュームの基になる物理ストレージユニットは、パーティション、ディスク全体などのブロックデバイスです。LVM 論理ボリューム用にデバイスを使用する場合は、デバイスを物理ボリューム (PV) として初期化する必要があります。ブロックデバイスを物理ボリュームとして初期化すると、デバイスの先頭位置にラベルが付けられます。

LVM ラベルは、デフォルトでは 2 番目の 512 バイトセクターに配置されます。物理ボリュームを作成する場合は、先頭の 4 つのセクターのいずれかにラベルを配置することにより、このデフォルト設定を書き換えることができます。これにより、必要に応じて LVM ボリュームを、このセクターを利用する他のユーザーと併用できるようになります。

デバイスがシステムの起動時に任意の順序で初期化されても、LVM ラベルにより物理デバイスの識別とデバイスの順序付けが正しく行われます。LVM ラベルは、再起動してもクラスター全体で維持されます。

LVM ラベルは、デバイスを LVM 物理ボリュームとして識別するものです。これには、物理ボリューム用のランダムな一意識別子 (UUID) が含まれます。また、ブロックデバイスのサイズもバイト単位で保存し、LVM メタデータがデバイスのどこに保存されているかも記録します。

LVM メタデータには、システムにある LVM ボリュームグループの設定詳細が含まれています。デフォルトでは、メタデータの複製コピーが、ボリュームグループ内で、すべての物理ボリュームの、すべてのメタデータ領域に保存されています。LVM メタデータのサイズは小さく、ASCII 形式が使用されます。

現在、LVM では、各物理ボリュームにメタデータのコピーを 1 つまたは 2 つ保存できます。コピーをゼロにすることもできます。デフォルトでは 1 つ保存されます。物理ボリューム上に保存するメタデータのコピー数を一度設定したら、その数を後で変更することはできません。最初のコピーはデバイスの先頭にあるラベルの後に保存されます。2 つ目のコピーがある場合は、デバイスの最後に配置されます。意図したものとは別のディスクに誤って書き込みを行い、ディスクの先頭領域を上書きしてしまった場合でも、デバイス後部にある 2 つ目のコピーでメタデータを復元できます。

LVM メタデータとメタデータパラメーターの変更に関する詳細は、付録E LVM ボリュームグループメタデータ を参照してください。

2.1.1. LVM 物理ボリュームのレイアウト

リンクのコピーリンクがクリップボードにコピーされました!

図2.1「物理ボリュームレイアウト」 は、LVM 物理ボリュームのレイアウトを示しています。LVM ラベルが 2 番目のセクターにあり、その後にメタデータ領域、使用可能なデバイス領域と続きます。

注記

Linux カーネル (および本書) では、セクターのサイズを 512 バイトとしています。

図2.1 物理ボリュームレイアウト

2.1.2. ディスク上の複数パーティション

リンクのコピーリンクがクリップボードにコピーされました!

LVM の使用により、ディスクパーティションから物理ボリュームを作成できます。Red Hat では、以下のような理由により、ディスク全体に対応するパーティションを 1 つ作成し、1 つの LVM 物理ボリュームとしてラベルを付けることを推奨しています。

- 管理上の利便性各ディスクが一度だけ表示されると、システムのハードウェアの追跡が簡単になります。これは、特にディスクに障害が発生した場合に役に立ちます。さらに、1 つのディスクに物理ボリュームが複数あると、システムの起動時に、不明なパーティションに関するカーネルの警告が発生する可能性があります。

- ストライピングのパフォーマンスLVM は、2 つの物理ボリュームが同じ物理ディスクにあるかどうかを認識しません。2 つの物理ボリュームが同じ物理ディスクにあるときに、ストライプ化された論理ボリュームを作成すると、作成されたボリュームのディスクは同じでも、パーティションは異なる可能性があります。このとき、パフォーマンスは、改善ではなく低下します。

1 つのディスクを、複数の LVM 物理ボリュームに分割しないといけない場合があります (推奨はされません)。たとえば、ディスクがほとんどないシステムで、既存システムを LVM ボリュームに移行する場合に、パーティション間でデータを移動しなければならない場合があります。さらに、大容量のディスクが存在し、管理目的で複数のボリュームグループを必要とする場合は、そのディスクにパーティションを設定する必要があります。ディスクに複数のパーティションがあり、そのパーティションがいずれも同じボリュームグループにある場合に、ストライプ化ボリュームを作成するときは、論理ボリュームに追加するパーティションを注意して指定してください。

2.2. ボリュームグループ

リンクのコピーリンクがクリップボードにコピーされました!

物理ボリュームはボリュームグループ (VG) に統合されます。これにより、論理ボリュームに割り当て可能なディスク領域のプールが作成されます。

ボリュームグループ内で、割り当て可能なディスク領域は、エクステントと呼ばれる固定サイズの単位に分割されます。割り当て可能な領域の最小単位は、1 エクステントです。エクステントは、物理ボリュームでは物理エクステントと呼ばれます。

論理ボリュームには、物理エクステントと同じサイズの論理エクステントが割り当てられます。そのため、エクステントのサイズは、ボリュームグループ内のすべての論理ボリュームで同じになります。ボリュームグループは、論理エクステントを物理エクステントにマッピングします。

2.3. LVM 論理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

LVM では、ボリュームグループは論理ボリュームに分割されます。以下のセクションでは、論理ボリュームのタイプを説明します。

2.3.1. リニアボリューム

リンクのコピーリンクがクリップボードにコピーされました!

リニアボリュームは、複数の物理ボリュームの領域を 1 つの論理ボリュームに統合します。たとえば、60GB ディスクが 2 つある場合は、120GB の論理ボリュームを作成できます。物理ストレージは連結されます。

リニアボリュームを作成すると、論理ボリュームの領域に、物理エクステントの範囲が順番に割り当てられます。たとえば、図2.2「エクステントのマッピング」 にあるように、1 から 99 までの論理エクステントが 1 つ目の物理ボリュームにマッピングされ、100 から 198 までの論理エクステントが 2 つ目の物理ボリュームにマッピングされます。アプリケーションからは、サイズが 198 エクステントのデバイスが 1 つあるように見えます。

図2.2 エクステントのマッピング

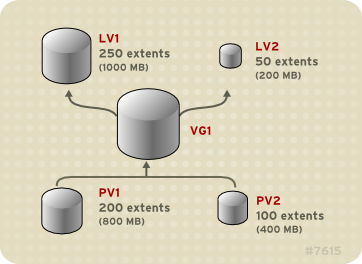

論理ボリュームを設定する物理ボリュームのサイズは、同じである必要はありません。図2.3「サイズの異なる物理ボリュームを用いたリニアボリューム」 物理エクステントサイズが 4MB のボリュームグループ

VG1 を表示します。このボリュームグループには、PV1 と PV2 という名前の 2 つの物理ボリュームが含まれます。1 エクステントは 4MB なので、物理ボリュームが分割される単位は 4MB になります。この例では、PV1 は 200 エクステントのサイズ(800MB)で、PV2 はサイズが 100 エクステント(400 MB)です。リニアボリュームは、エクステントサイズ 1 から 300 (4MB から 1200MB) の間で作成できます。この例では、LV1 という名前のリニアボリュームのサイズは 300 エクステントです。

図2.3 サイズの異なる物理ボリュームを用いたリニアボリューム

物理エクステントのプールから、必要なサイズの複数のリニア論理ボリュームを設定できます。図2.4「複数の論理ボリューム」 は、図2.3「サイズの異なる物理ボリュームを用いたリニアボリューム」 と同じボリュームグループを示していますが、この場合、2 つの論理ボリュームがボリュームグループから抜け出されています。

LV1 は、サイズが 250 のエクステント(1000MB)と LV2 (サイズが 50 エクステント)の LV2 です。

図2.4 複数の論理ボリューム

2.3.2. ストライプ化論理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

LVM 論理ボリュームにデータを書き込む際に、ファイルシステムは、基になる物理ボリューム全体にデータを分配します。このとき、ストライプ化論理ボリュームを作成すると、データを物理ボリュームに書き込む方法を制御できます。順次の読み取りおよび書き込みが大量に行われる場合には、これによりデータ I/O の効率を向上できます。

ストライピングは、ラウンドロビン式で、指定した数の物理ボリュームにデータを書き込んでいくことで、パフォーマンスを向上させます。I/O は、ストライピングでは並行して実行されます。これにより、ストライプで追加される各物理ボリュームでは、ほぼ直線的なパフォーマンスの向上が期待できます。

以下は、3 つの物理ボリュームにデータがストライプ化されている状態を示しています。この図は、以下のようになります。

- データの 1 番目のストライプは、1 番目の物理ボリュームに書き込まれます。

- データの 2 番目のストライプは、2 番目の物理ボリュームに書き込まれます。

- データの 3 番目のストライプは、3 番目の物理ボリュームに書き込まれます。

- データの 4 番目のストライプは、1 番目の物理ボリュームに書き込まれます。

ストライプ化された論理ボリュームでは、ストライプのサイズは、エクステントのサイズより小さくなります。

図2.5 3 つの PV にまたがるデータのストライピング

ストライプ化論理ボリュームは、別のデバイスセットを最初のセットの末端に連結すれば拡張できます。ストライプ化論理ボリュームを拡張するには、ストライプに対応するボリュームグループを設定する、基になる物理ボリュームセットに、十分な空き領域が必要です。たとえば、ボリュームグループ全域を使用している 2 way ストライプがある場合は、そのボリュームグループに物理ボリュームを 1 つだけ追加しても、ストライプは拡張できません。ボリュームグループには物理ボリュームを 2 つ以上追加する必要があります。ストライプ化ボリュームの拡張の詳細は、「ストライプ化ボリュームの拡張」 を参照してください。

2.3.3. RAID 論理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

LVM は、RAID0、1、4、5、6、および 10 に対応します。LVM RAID ボリュームには以下の特徴があります。

- LVM で作成および管理される RAID 論理ボリュームは、MD カーネルドライバーを使用します。

- RAID1 イメージはアレイから一時的に切り離して、後でアレイにマージし直すことができます。

- LVM RAID ボリュームはスナップショットに対応

RAID 論理ボリュームの作成方法は、「RAID 論理ボリューム」 を参照してください。

注記

RAID 論理ボリュームはクラスターには対応していません。RAID 論理ボリュームは、1 台のマシンに作成して排他的にアクティブにすることができますが、複数のマシンで同時にアクティブにすることはできません。

2.3.4. シンプロビジョニングされた論理ボリューム (シンボリューム)

リンクのコピーリンクがクリップボードにコピーされました!

論理ボリュームは、シンプロビジョニングにできます。これにより、利用可能なエクステントよりも大きな論理ボリュームを作成できます。シンプロビジョニングを使用すると、シンプールと呼ばれる、空き領域のストレージプールを管理でき、アプリケーションで必要になった時に任意の数のデバイスに割り当てることができます。後でアプリケーションが実際に論理ボリュームに書き込むときに割り当てられるように、シンプールにバインドするデバイスを作成できます。シンプールは、ストレージ領域をコスト効率よく割り当てる必要がある場合に、動的に拡張できます。

注記

クラスターのノード間では、シンボリュームに対応していません。シンプールとそのすべてのシンボリュームは、1 つのクラスターノードで排他的にアクティブにする必要があります。

ストレージ管理者は、シンプロビジョニングを使用することで物理ストレージをオーバーコミットできるため、多くの場合は、追加のストレージを購入する必要がなくなります。たとえば、10 人のユーザーから、各自のアプリケーションに使用するファイルシステムをそれぞれ 100GB 要求された場合、ストレージ管理者は各ユーザーに 100GB のファイルシステムを作成します (ただし、実際には 100GB 未満のストレージが、必要に応じて使用されます)。

注記

シンプロビジョニングを使用する場合は、ストレージ管理者がストレージプールを監視し、容量が満杯になり始めたら容量を追加することが重要です。

利用可能な領域をすべて使用できるようにするために、LVM はデータの破棄に対応します。これにより、破棄されたファイルや、その他のブロック範囲で以前に使用された領域を再利用できます。

シンボリュームの作成方法は、「シンプロビジョニングされた論理ボリュームの作成」 を参照してください。

シンボリュームは、新たに実装されたコピーオンライト (COW) スナップショット論理ボリュームに対応します。これにより、多くの仮想デバイスでシンプール内の同一データを共有できます。シンプロビジョニングのスナップショットボリュームの詳細は、「シンプロビジョニングされたスナップショットボリューム」 を参照してください。

2.3.5. スナップショットボリューム

リンクのコピーリンクがクリップボードにコピーされました!

LVM スナップショット機能により、サービスを中断せずに任意の時点でデバイスの仮想イメージを作成できます。スナップショットの取得後に作成元のデバイスに変更が加えられると、データが変更する前に、これから変更する部分のコピーがスナップショット機能により作成されるため、このコピーを使用して、デバイスの状態を再構築できます。

注記

LVM は、シンプロビジョニングのスナップショットに対応しますシンプロビジョニングのスナップショットボリュームの詳細は、「シンプロビジョニングされたスナップショットボリューム」 を参照してください。

注記

LVM スナップショットは、クラスターのノード間では対応していません。クラスター化されたボリュームグループ内にスナップショットボリュームは作成できません。

スナップショットは、スナップショットの作成後に変更したデータ部分のみをコピーするため、スナップショット機能に必要なストレージは最小限になります。たとえば、複製元の大部分が更新されない場合は、その容量の 3-5 % があればスナップショットを十分に維持することができます。

注記

ファイルシステムのスナップショットコピーは仮想コピーであり、ファイルシステムのメディアバックアップを実際に作成するわけではありません。スナップショットは、バックアップの代替手順にはなりません。

作成元のボリュームへの変更を保管するために確保する領域は、スナップショットのサイズによって異なります。たとえば、スナップショットを作成してから作成元を完全に上書きした場合に、その変更を保管するのに必要なスナップショットのサイズは、作成元のボリュームと同じか、それ以上になります。スナップショットのサイズは、予想される変更レベルに応じて決定する必要があります。たとえば、

/usr など、その大部分が読み取り用ボリュームの有効期間の短いスナップショットに必要な領域は、/home など、書き込みの数が多いボリュームの有効期間の長いスナップショットに必要な領域よりも小さくなります。

スナップショットが満杯になると、作成元のボリュームの変更を追跡できなくなるため、そのスナップショットは無効になります。スナップショットのサイズは定期的に監視する必要があります。ただし、スナップショットのサイズは完全に変更することが可能なため、ストレージに余裕があれば、スナップショットが停止しないように、スナップショットのボリュームサイズを拡大できます。逆に、スナップショットのボリュームサイズが必要以上に大きければ、そのボリュームのサイズを縮小して、他の論理ボリュームで必要となる領域を確保できます。

スナップショットのファイルシステムを作成しても、作成元への完全な読み取り/書き込みのアクセスは引き続き可能です。スナップショット上のチャンクを変更した場合は、そのチャンクにマークが付けられ、そこには、作成元のボリュームのコピーは入りません。

スナップショット機能にはいくつかの用途があります。

- 最も一般的な用途は、継続的にデータを更新している稼動中のシステムを停止せずに、論理ボリューム上でバックアップを実行する必要がある場合にスナップショットを撮ることです。

- スナップショットファイルシステムで fsck コマンドを実行してファイルシステムの整合性を確認し、元のファイルシステムを修復する必要があるかどうかを判断できます。

- スナップショットは読み取りおよび書き込み用であるため、スナップショットを撮ってそのスナップショットにテストを実行することにより、実際のデータに触れることなく、実稼働データにアプリケーションのテストを実行できます。

- LVM ボリュームを作成して、Red Hat の仮想化と併用することが可能です。LVM スナップショットを使用して、仮想ゲストイメージのスナップショットを作成できます。このスナップショットは、最小限のストレージを使用して、既存のゲストの変更や新規ゲストの作成を行う上で利便性の高い方法を提供します。Red Hat Virtualization による LVM ベースのストレージプールの作成についての詳細は、『仮想化管理ガイド』 を参照してください。

スナップショットボリュームの作成に関する情報は、「スナップショットボリュームの作成」 を参照してください。

lvconvert コマンドの

--merge オプションを使用して、スナップショットを作成元のボリュームにマージできます。この機能の用途の 1 つがシステムロールバックの実行で、データやファイルを紛失した場合や、システムを以前の状態に復元する必要がある場合に行います。スナップショットボリュームのマージの結果作成される論理ボリュームには、複製元のボリューム名、マイナー番号、UUID が付けられ、マージされたスナップショットは削除されます。このオプションの使用方法については、「スナップショットボリュームのマージ」 を参照してください。

2.3.6. シンプロビジョニングされたスナップショットボリューム

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux は、シンプロビジョニングのスナップショットボリュームのサポートを提供します。シンプロビジョニングのスナップショットボリュームにより、多くの仮想デバイスを同じデータボリュームに格納できます。これにより管理が簡略化され、スナップショットボリューム間でのデータ共有が可能になります。

シンボリュームや、LVM スナップショットボリュームの場合、シンプロビジョニングのスナップショットボリュームは、クラスターのノード間では対応していません。スナップショットボリュームは、1 つのクラスターノードで排他的にアクティブにする必要があります。

シンプロビジョニングのスナップショットボリュームの利点は以下のとおりです。

- 同じボリュームからのスナップショットが複数ある場合に、シンプロビジョニングのスナップショットボリュームを使用すれば、ディスクの使用量を減らすことができます。

- 作成元が同じスナップショットが複数ある場合は、作成元に 1 回書き込むことにより、1 回の COW 操作でデータを保存できます。作成元のスナップショットの数を増やしても、速度が大幅に低下することはありません。

- シンプロビジョニングのスナップショットボリュームは、別のスナップショットの作成元の論理ボリュームとして使用できます。これにより、再帰的スナップショット (スナップショットのスナップショットのそのまたスナップショットなど) の深度を任意に決定できます。

- シン論理ボリュームのスナップショットにより、シン論理ボリュームを作成することもできます。COW 操作が必要になるまで、あるいはスナップショット自体が書き込まれるまで、データ領域は消費されません。

- シンプロビジョニングのスナップショットボリュームは、作成元とともにアクティブにしておく必要はありません。そのため、スナップショットボリュームが多数ある場合は、作成元のみをアクティブにし、スナップショットボリュームはアクティブにしないでおくことができます。

- シンプロビジョニングのスナップショットボリュームの作成元を削除すると、そのボリュームのスナップショットは、それぞれ独立したシンプロビジョニングボリュームになります。したがって、スナップショットとその作成元のボリュームをマージする代わりに、作成元のボリュームを削除し、その独立したボリュームを新たな作成元ボリュームにして、シンプロビジョニングのスナップショットを新たに作成できます。

シンプロビジョニングのスナップショットボリュームを使用する利点は数多くありますが、古い LVM スナップショットボリューム機能の方がニーズに適している場合もあります。

- シンプールのチャンクサイズは変更できません。シンプールのチャンクサイズが大きい場合 (1MB など) や、そのチャンクのサイズでは効率的ではない短期間のスナップショットが必要な場合は、代わりに以前のスナップショット機能を使用できます。

- シンプロビジョニングのスナップショットボリュームのサイズを制限することはできません。スナップショットは、必要な場合はシンプール内の全領域を使用します。これは、ニーズに適さない場合があります。

一般的には、使用するスナップショットの形式を決定する際に、使用しているサイトの特定要件を考慮するようにしてください。

注記

シンプロビジョニングを使用する場合は、ストレージ管理者がストレージプールを監視し、容量が満杯になり始めたら容量を追加することが重要です。シンプロビジョニングのスナップショットボリュームの設定および表示に関する情報は、「シンプロビジョニングされたスナップショットボリュームの作成」 を参照してください。

2.3.7. キャッシュボリューム

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 7.1 リリースでは、LVM は高速ブロックデバイス (SSD ドライブなど) を、大規模な低速ブロックデバイスのライトバックまたはライトスルーキャッシュとして使用することをサポートします。既存の論理ボリュームのパフォーマンスを改善するためにキャッシュ論理ボリュームを作成したり、大規模で低速なデバイスと共に小規模で高速なデバイスで設定される新規のキャッシュ論理ボリュームを作成したりできます。

LVM キャッシュボリュームを作成する方法は、「LVM 論理ボリュームの作成」 を参照してください。

第3章 LVM 管理の概要

リンクのコピーリンクがクリップボードにコピーされました!

この章では、LVM 論理ボリュームを設定するのに使用する管理手順の概要を説明します。本章は、必要なステップについて全般的な理解を図ることを目的としています。一般的な LVM 設定手順の具体的な手順は、5章LVM 設定の例 を参照してください。

LVM 管理の実行に使用できる CLI コマンドの説明は、4章CLI コマンドでの LVM 管理 を参照してください。

3.1. 論理ボリューム作成の概要

リンクのコピーリンクがクリップボードにコピーされました!

以下は、LVM 論理ボリュームを作成するのに必要な手順の概要です。

- LVM ボリューム用に使用するパーティションを物理ボリュームとして初期化します (この操作によってラベル付けされます)。

- ボリュームグループを作成します。

- 論理ボリュームを作成します。

論理ボリュームを作成したら、ファイルシステムを作成してマウントします。本書の例では、GFS2 ファイルシステムを使用します。

- mkfs.gfs2 コマンドを使用して、論理ボリューム上に GFS2 ファイルシステムを作成します。

- mkdir コマンドでマウントポイントを作成します。クラスター化システムでは、そのクラスター内のすべてのノードにマウントポイントを作成します。

- ファイルシステムをマウントします。システムの各ノードの

fstabファイルに行を追加することができます。

注記

GFS2 ファイルシステムはスタンドアロンシステム、またはクラスター設定で実装することが可能ですが、Red Hat Enterprise Linux 7 リリースでは、GFS2 を 1 ノードのファイルシステムとして使用することはサポートしていません。Red Hat は、クラスターファイルシステムのスナップショットのマウントを目的 (例: バックアップ) とした、単一ノードの GFS2 ファイルシステムを引き続きサポートします。

LVM セットアップ情報の保存エリアは、ボリュームが作成されたマシンではなく物理ボリュームにあるため、LVM ボリュームの作成はマシンから独立して行われます。ストレージを使用するサーバーにはローカルコピーがありますが、物理ボリュームにあるものから再作成することもできます。LVM のバージョンが互換性を持つ場合には、物理ボリュームを異なるサーバーに接続できます。

3.2. 論理ボリュームのファイルシステムの拡張

リンクのコピーリンクがクリップボードにコピーされました!

論理ボリュームのファイルシステムを拡張するには、以下の手順を実行します。

- 既存のボリュームグループに、論理ボリュームを拡張するのに十分な空き領域があるかどうかを調べます。空き領域が足りない場合は、次の手順を実行します。

- pvcreate コマンドを使用して、新しい物理ボリュームを作成します。

- vgextend コマンドを使用して、新しい物理ボリュームを含めるように、拡張している論理ボリュームを含むボリュームグループを拡張します。

- ボリュームグループがより大きなファイルシステムを含めるのに十分な大きさになったら、lvresize コマンドで論理ボリュームを拡張します。

- 論理ボリュームでファイルシステムのサイズを変更します。

lvresize コマンドの

-r オプションを使用することで、1 つのコマンドで論理ボリュームを拡張し、基になるファイルシステムのサイズを変更できることに注意してください。

3.3. 論理ボリュームのバックアップ

リンクのコピーリンクがクリップボードにコピーされました!

メタデータのバックアップとアーカイブは、

lvm.conf ファイルで無効になっていない限り、ボリュームグループまたは論理ボリュームの設定変更時に常に自動的に作成されます。デフォルトでは、メタデータのバックアップは /etc/lvm/backup ファイルに保存され、メタデータのアーカイブは /etc/lvm/archive ファイルに保存されます。/etc/lvm/archive ファイルに保存されているメタデータのアーカイブが保持される期間と、保存されるアーカイブファイルの数は、lvm.conf ファイルに設定できるパラメーターにより決まります。日ごとのシステムバックアップには、バックアップに /etc/lvm ディレクトリーの内容が含まれている必要があります。

メタデータバックアップでは、論理ボリュームのユーザーとシステムのデータはバックアップされない点に注意してください。

vgcfgbackup コマンドを使用すると、手動でメタデータを

/etc/lvm/backup ファイルにバックアップできます。vgcfgrestore コマンドを使用してメタデータを復元できます。vgcfgbackup および vgcfgrestore コマンドは、「ボリュームグループメタデータのバックアップ」 で説明されています。

3.4. ロギング

リンクのコピーリンクがクリップボードにコピーされました!

すべてのメッセージ出力は、以下についてそれぞれ選択されたロギングレベルで、ロギングモジュールから出力されます。

- 標準出力/エラー

- syslog

- ログファイル

- 外部ログ関数

ロギングレベルは、

/etc/lvm/lvm.conf ファイルで設定されます。このファイルは、付録B LVM 設定ファイル で説明されています。

3.5. メタデータデーモン (lvmetad)

リンクのコピーリンクがクリップボードにコピーされました!

LVM はオプションで、デーモン(lvmetad)および

udev ルールで実装された中央メタデータキャッシュを使用できます。メタデータデーモンには、LVM コマンドのパフォーマンスを向上する主な目的が 2 つあります。これにより、udev は、論理ボリュームまたはボリュームグループ全体がシステムで利用可能になったときに、自動的にアクティブにすることができます。

lvm.conf 設定ファイルで global/use_lvmetad 変数を 1 に設定すると、LVM がデーモンを使用するように設定されています。これはデフォルト値です。lvm.conf 設定ファイルの詳細は、付録B LVM 設定ファイル を参照してください。

注記

現在、lvmetad デーモンはノード間ではサポートされておらず、ロックタイプはローカルのファイルベースにする必要があります。lvmconf --enable-cluster/--disable-cluster コマンドを使用すると、

use_lvmetad 設定を含む lvm.conf ファイルが適切に設定されます( locking_type=3の場合は 0 である必要があります)。ただし、Pacemaker クラスターでは、ocf:heartbeat:clvm リソースエージェント自体がこれらのパラメーターを開始手順の一部として設定することに注意してください。

use_lvmetad の値を 1 から 0 に変更する場合は、以下のコマンドを使用して lvmetad サービスを手動で再起動するか、停止する必要があります。

systemctl stop lvm2-lvmetad.service

# systemctl stop lvm2-lvmetad.service

通常、各 LVM コマンドを使用すると、ディスクスキャンが実行され、関連するすべての物理ボリュームが検索され、ボリュームグループのメタデータが読み取られます。ただし、メタデータデーモンが実行中で有効な場合、このスキャンは負荷がかかるため省略できます。代わりに、

udev ルールを使用して、各デバイスが利用可能になったときに lvmetad デーモンは 1 回だけスキャンします。これにより I/O の量が大幅に削減されるため、特にディスクが多いシステムで LVM 操作を完了するのに必要な時間を減らすことができます。

実行時に新規のボリュームグループが利用可能な場合 (例: ホットプラグまたは iSCSI を使用)、その論理ボリュームを使用するにはアクティブにする必要があります。lvmetad デーモンが有効な場合には、

lvm.conf 設定ファイルの activation/auto_activation_volume_list オプションを使用して、自動的にアクティベートするボリュームグループまたは論理ボリューム(あるいはその両方)のリストを設定できます。lvmetad デーモンを使用しない場合は、手動でアクティベートする必要があります。

注記

lvmetad デーモンが実行しているときに、pvscan --cache device コマンドを実行すると、

/etc/lvm/lvm.conf ファイルの filter = 設定が適用されません。デバイスをフィルタリングするには、global_filter = 設定を使用する必要があります。グローバルフィルターに失敗したデバイスは LVM では開かれず、スキャンもされません。VM で LVM を使用しているときに、VM 内のデバイスのコンテンツを物理ホストでスキャンする必要がない場合などは、グローバルフィルターの使用が必要になる場合があります。

3.6. lvm コマンドを使用した LVM 情報の表示

リンクのコピーリンクがクリップボードにコピーされました!

lvm コマンドは、LVM サポートおよび設定に関する情報を表示するのに使用できる組み込みオプションを提供します。

- lvm devtypes認識されているビルトインブロックデバイスのタイプを表示します (Red Hat Enterprise Linux リリース 6.6 以降)。

- lvm formats認識されているメタデータ形式を表示します。

- lvm helpLVM ヘルプテキストを表示します。

- lvm segtypes認識されている論理ボリュームセグメントタイプを表示します。

- lvm tagsこのホストに定義したタグを表示します。LVM オブジェクトタグの詳細は、付録D LVM オブジェクトタグ を参照してください。

- lvm version現在のバージョン情報を表示します。

第4章 CLI コマンドでの LVM 管理

リンクのコピーリンクがクリップボードにコピーされました!

この章では、論理ボリュームを作成し、保守するために LVM CLI (Command Line Interface) コマンドで実行できる個別の管理タスクについてまとめています。

LVM コマンドラインインターフェイス (CLI) の他にも、System Storage Manager (SSM) を使用して LVM 論理ボリュームを設定することができます。SSM と LVM の使用方法については、『ストレージ管理ガイド』 を参照してください。

4.1. CLI コマンドの使用

リンクのコピーリンクがクリップボードにコピーされました!

すべての LVM CLI コマンドに共通する特性がいくつかあります。

コマンドラインの引数でサイズが必要な場合は、常に単位を明示的に指定できます。単位を指定しないと、デフォルトで KB または MB が指定されます。LVM CLI コマンドでは、分数を使用できません。

コマンドライン引数で単位を指定する場合は、LVM が大文字と小文字を区別しません。たとえば、M と m は同じで、2 の累乗 (1024 の倍数) が使用されます。ただし、コマンドで

--units 引数を指定すると、小文字は、単位が 1024 の倍数であることを示し、その単位は 1000 の倍数であることを示します。

ここで、コマンドではボリュームグループまたは論理ボリューム名を引数として取り、完全パス名はオプションになります。vg0 という名前のボリュームグループ内の論理ボリューム

lvol0 は、vg0 /lvol0 として指定できます。ボリュームグループのリストは必須ですが、空の場合は、ボリュームグループのリストが置き換えられます。論理ボリュームのリストが必要ですが、ボリュームグループを指定すると、そのボリュームグループにある論理ボリュームがすべて置き換えられます。たとえば、lvdisplay vg0 コマンドは、ボリュームグループ vg0 内のすべての論理ボリュームを表示します。

すべての LVM コマンドは、出力の詳細レベルを上げるために複数回入力できる

-v 引数を受け入れます。たとえば、次の例は、lvcreate コマンドのデフォルト出力を示しています。

lvcreate -L 50MB new_vg Rounding up size to full physical extent 52.00 MB Logical volume "lvol0" created

# lvcreate -L 50MB new_vg

Rounding up size to full physical extent 52.00 MB

Logical volume "lvol0" created

以下のコマンドは、lvcreate コマンドの出力と

-v 引数を表示します。

また、

-vv、-vvv、-vvvv 引数を使用して、コマンドの実行に関する詳細を表示することもできます。-vvvv 引数は、この時点で情報の最大数を提供します。以下の例は、 lvcreate コマンドで -vvvv 引数を指定して、出力の最初の行のみを示しています。

コマンドの

--help 引数を使用して、LVM CLI コマンドのヘルプを表示できます。

commandname --help

# commandname --help

コマンドの man ページを表示するには、man コマンドを実行します。

man commandname

# man commandname

man lvm コマンドは、LVM に関する一般的なオンライン情報を提供します。

すべての LVM オブジェクトは、内部的には、オブジェクトを作成する際に割り当てられる UUID で参照されます。これは、ボリュームグループの一部である

/dev/sdf という物理ボリュームを削除し、プラグインし直したときに、現在 /dev/sdk であることを確認する場合に役立ちます。LVM は、物理ボリュームを、デバイス名ではなく UUID で識別するため、デバイス名が変わっても物理ボリュームを見つけることができます。物理ボリュームの作成時に物理ボリュームの UUID を指定する方法については、「物理ボリュームメタデータの復元」 を参照してください。

4.2. 物理ボリュームの管理

リンクのコピーリンクがクリップボードにコピーされました!

このセクションでは、物理ボリューム管理の様々な場面で使用するコマンドについて説明します。

4.2.1. 物理ボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

以下のセクションでは、物理ボリュームの作成に使用するコマンドを説明します。

4.2.1.1. パーティションタイプの設定

リンクのコピーリンクがクリップボードにコピーされました!

ディスクデバイス全体を物理ボリュームに使用している場合は、そのディスクにはパーティションテーブルを含めないでください。ディスクパーティションが DOS の場合は、fdisk、cfdisk などのコマンドを使用して、パーティション ID を 0x8e に設定する必要があります。ディスクデバイス全体に物理ボリュームがある場合は、パーティションテーブルのみを消去する必要がありますが、このとき、そのディスクにあるデータはすべて効果的に破棄されます。以下のコマンドを使用すれば、最初のセクターをゼロで初期化し、既存のパーティションテーブルを削除できます。

dd if=/dev/zero of=PhysicalVolume bs=512 count=1

# dd if=/dev/zero of=PhysicalVolume bs=512 count=14.2.1.2. 物理ボリュームの初期化

リンクのコピーリンクがクリップボードにコピーされました!

pvcreate コマンドを使用して、物理ボリュームとして使用するブロックデバイスを初期化します。初期化は、ファイルシステムのフォーマットと同様です。

以下のコマンドは、

/dev/sdd、/dev/sde、および /dev/sdf を LVM 物理ボリュームとして初期化し、後で LVM 論理ボリュームとして使用します。

pvcreate /dev/sdd /dev/sde /dev/sdf

# pvcreate /dev/sdd /dev/sde /dev/sdf

ディスク全体ではなく、パーティションを初期化するには、パーティションで pvcreate コマンドを実行します。以下の例では、パーティション

/dev/hdb1 を LVM 物理ボリュームとして初期化し、後で LVM 論理ボリュームとして使用します。

pvcreate /dev/hdb1

# pvcreate /dev/hdb14.2.1.3. ブロックデバイスのスキャン

リンクのコピーリンクがクリップボードにコピーされました!

以下の例のように、lvmdiskscan コマンドを使用して、物理ボリュームとして使用できるブロックデバイスをスキャンできます。

4.2.2. 物理ボリュームの表示

リンクのコピーリンクがクリップボードにコピーされました!

LVM 物理ボリュームのプロパティーを表示するのに使用できるコマンドは、pvs、pvdisplay、および pvscan の 3 つです。

pvs コマンド:物理ボリュームの情報を設定可能な形式で出力します。pvs コマンドでは形式をかなり自由に制御できるため、スクリプト作成に役立ちます。pvs コマンドで出力をカスタマイズする詳細な方法は、「LVM 用のカスタム報告」 を参照してください。

pvdisplay コマンドは、各物理ボリュームの詳細の複数行出力を提供します。物理プロパティー (サイズ、エクステント、ボリュームグループなど) が、決められた形式で表示されます。

以下の例は、1 つの物理ボリュームに対する pvdisplay コマンドの出力を示しています。

pvscan コマンド:システムにある物理ボリュームで対応している LVM ブロックデバイスをすべてスキャンします。

以下のコマンドでは、検出された物理デバイスがすべて表示されます。

このコマンドで、特定の物理ボリュームがスキャンされないように、

lvm.conf ファイルでフィルターを定義できます。フィルターを使用してスキャンされるデバイスを制御する方法は、「フィルターを使用した LVM デバイススキャンの制御」 を参照してください。

4.2.3. 物理ボリューム上での割り当て防止

リンクのコピーリンクがクリップボードにコピーされました!

pvchange コマンドを使用すると、1 つまたは複数の物理ボリュームの空き領域で物理エクステントが割り当てられないようにすることができます。これは、ディスクエラーが発生した場合や、物理ボリュームを取り除く場合に必要となる可能性があります。

次のコマンドは、

/dev/sdk1 での物理エクステントの割り当てを許可しません。

pvchange -x n /dev/sdk1

# pvchange -x n /dev/sdk1

pvchange コマンドで

-xy 引数を使用すると、以前は許可されていない割り当てを許可できます。

4.2.4. 物理ボリュームのサイズ変更

リンクのコピーリンクがクリップボードにコピーされました!

何らかの理由で基礎となるブロックデバイスのサイズを変更する必要がある場合は、pvresize コマンドを使用して LVM のサイズを更新します。このコマンドは、LVM が物理ボリュームを使用しているときに実行できます。

4.2.5. 物理ボリュームの削除

リンクのコピーリンクがクリップボードにコピーされました!

デバイスを LVM で使用する必要がなくなった場合は、pvremove コマンドを使用して LVM ラベルを削除できます。pvremove コマンドを実行すると、空の物理ボリュームにある LVM メタデータをゼロにします。

削除する物理ボリュームがボリュームグループの一部になっている場合は、「ボリュームグループからの物理ボリュームの削除」 の説明に従って、vgreduce コマンドで、ボリュームグループから物理ボリュームを取り除く必要があります。

pvremove /dev/ram15 Labels on physical volume "/dev/ram15" successfully wiped

# pvremove /dev/ram15

Labels on physical volume "/dev/ram15" successfully wiped

4.3. ボリュームグループの管理

リンクのコピーリンクがクリップボードにコピーされました!

本セクションでは、ボリュームグループ管理のさまざまな特徴を実行するコマンドを説明します。

4.3.1. ボリュームグループの作成

リンクのコピーリンクがクリップボードにコピーされました!

1 つまたは複数の物理ボリュームからボリュームグループを作成するには、vgcreate コマンドを使用します。vgcreate コマンドは、名前で新しいボリュームグループを作成し、そこに物理ボリュームを 1 つ以上追加します。

以下のコマンドは、物理ボリューム

/dev/sdd1 および /dev/sde1 を含む vg1 という名前のボリュームグループを作成します。

vgcreate vg1 /dev/sdd1 /dev/sde1

# vgcreate vg1 /dev/sdd1 /dev/sde1

ボリュームグループの作成に物理ボリュームが使用されると、ディスク領域はデフォルトで 4MB のエクステントに分割されます。このエクステントは、論理ボリュームのサイズを拡張/縮小する最小単位です。エクステントの数が多くても、論理ボリュームの I/O パフォーマンスに影響を与えることはありません。

エクステントサイズのデフォルトサイズが適切でない場合は、vgcreate コマンドに

-s オプションを使用して、エクステントサイズを指定できます。vgcreate コマンドに -p 引数と -l 引数を使用すると、ボリュームグループに追加可能な物理ボリュームまたは論理ボリュームの数に制限をかけることができます。

デフォルトでは、ボリュームグループは、同じ物理ボリューム上に並行ストライプを配置しないなど、常識的な規則に従って物理エクステントを割り当てます。これは、normal の割り当てポリシーです。vgcreate コマンドで --alloc 引数を使用して、連続 した、任意の場所、またはクローズの割り当てポリシーを指定でき ます。一般的に、normal 以外の割り当てポリシーは、異常な範囲または非標準のエクステント割り当てを指定する必要がある特別な場合にのみ必要になります。LVM で物理エクステントを割り当てる方法の詳細は、「LVM の割り当て」 を参照してください。

LVM ボリュームグループと基礎となる論理ボリュームは、

/dev ディレクトリー内のデバイス特殊ファイルディレクトリーツリーに、以下のレイアウトで含まれます。

/dev/vg/lv/

/dev/vg/lv/

たとえば、

myvg1 と myvg2 のボリュームグループを作成し、それぞれに lv01、lv02、および lv03 という名前の 3 つの論理ボリュームを作成すると、デバイス特有のファイルが 6 つ作成されます。

デバイス特有のファイルは、対応する論理ボリュームがアクティブになっていないと表示されません。

LVM におけるデバイスの最大サイズは、64 ビット CPU 上で 8 エクサバイトです。

4.3.2. LVM の割り当て

リンクのコピーリンクがクリップボードにコピーされました!

LVM の操作で物理エクステントを 1 つまたは複数の論理ボリュームに割り当てる必要がある場合、割り当ては以下のように行われます。

- ボリュームグループで割り当てられていない物理エクステントのセットが、割り当てのために生成されます。コマンドラインの末尾に物理エクステントの範囲を指定すると、指定した物理ボリュームの中で、その範囲内で割り当てられていない物理エクステントだけが、割り当て用エクステントとして考慮されます。

- 割り当てポリシーは順番に試行されます。最も厳格なポリシー(

contiguous)から始まり、最後は--allocオプションで指定した割り当てポリシーか、特定の論理ボリュームまたはボリュームグループにデフォルトとして設定されている割り当てポリシーが試行されます。割り当てポリシーでは、埋める必要がある空の論理ボリューム領域の最小番号の論理エクステントから始まり、割り当てポリシーによる制限に従って、できるだけ多くの領域の割り当てを行います。領域が足りなくなると、LVM は次のポリシーに移動します。

割り当てポリシーの制限は以下のとおりです。

- contiguous の割り当てポリシーでは、論理ボリュームの最初の論理エクステントではない論理エクステントの物理的な場所が、その直前の論理エクステントの物理的な場所に隣接して

いる必要があります。論理ボリュームがストライプ化またはミラーリングされる場合、連続した割り当て制限は、スペースが必要な各ストライプまたはミラーイメージ(leg)に個別に適用されます。 clingの割り当てポリシーでは、既存の論理ボリュームに追加する論理エクステントに使用される物理ボリュームが、その論理ボリュームの最初の 1 つ以上の論理エクステントによってすでに使用されている必要があります。設定パラメーターallocation/cling_tag_listが定義されている場合には、一覧表示されたタグのいずれかが両方の物理ボリュームに存在する場合、2 つの物理ボリュームが一致します。これにより、割り当てのために、同様のプロパティー (物理的な場所など) が設定されている物理ボリュームのグループにタグを付け、その物理ボリュームを同等なものとして処理できます。cling ポリシーを LVM タグと併用して、LVM ボリュームの拡張時に使用する追加の物理ボリュームを指定する方法の詳細は、「割り当てポリシーを閉じた論理ボリュームの拡張」 を参照してください。論理ボリュームがストライプ化またはミラーリングされる場合、移動した割り当て制限は、領域が必要な各ストライプまたはミラーイメージ(leg)に個別に適用されます。normalの割り当てポリシーは、並列論理ボリューム内の同じオフセットにある並列論理ボリューム(つまり、別のストライプまたはミラーイメージ/レッグ)にすでに割り当てられている論理エクステントと同じ物理ボリュームを共有する物理エクステントを選択しません。ミラーデータを保持するために、論理ボリュームと同時にミラーログを割り当てる場合、normalの割り当てポリシーは、最初にログとデータに対して異なる物理ボリュームを選択しようとします。これが可能でなく、allocation/mirror_logs_require_separate_pvs設定パラメーターが 0 に設定されている場合は、ログがデータの一部と物理ボリュームを共有できるようになります。同様に、シンプールメタデータを割り当てる場合、normalの割り当てポリシーはミラーログの割り当てと同じ考慮事項に従います。これは、allocation/thin_pool_metadata_require_separate_pvs設定パラメーターの値に基づいています。- 割り当て要求を満たすのに十分な空きエクステントがあっても、normal の割り当てポリシーによって使用されていない場合は、たとえ同じ物理ボリュームに 2 つのストライプを配置することでパフォーマンスが低下する場合でも、anywhere 割り当てポリシーによってパフォーマンスが低下します。

割り当てポリシーは、vgchange コマンドを使用して変更できます。

注記

定義された割り当てポリシーに従って、このセクションで説明されている以上のレイアウトの操作が必要な場合は、今後のバージョンでコードが変更する可能性があることに注意してください。たとえば、割り当て可能な空き物理エクステントの数が同じ 2 つの空の物理ボリュームをコマンドラインで指定する場合、現行バージョンの LVM では、それが表示されている順番に使用が検討されます。ただし、今後のリリースで、そのプロパティーが変更されない保証はありません。特定の論理ボリューム用に特定のレイアウトを取得することが重要な場合は、各手順に適用される割り当てポリシーに基づいて LVM がレイアウトを決定することがないように、lvcreate と lvconvert を順に使用してレイアウトを構築してください。

特定のケースで、割り当てプロセスがどのように行われているかを確認するには、コマンドに

-vvvv オプションを追加するなどして、デバッグロギングの出力を表示します。

4.3.3. クラスター内でのボリュームグループ作成

リンクのコピーリンクがクリップボードにコピーされました!

vgcreate コマンドを使用して、単一のノードで作成するのと同じく、クラスター環境に CLVM ボリュームグループを作成します。

注記

Red Hat Enterprise Linux 7 では、クラスターは Pacemaker で管理されます。クラスター化された LVM 論理ボリュームは Pacemaker クラスターと併用される場合のみサポートされ、クラスターリソースとして設定する必要があります。クラスター内での LVM ボリュームの設定に関する詳細は、「Red Hat High Availability クラスターの LVM 論理ボリューム」 を参照してください。

クラスターのメンバーが共有するボリュームグループは、vgcreate -cy または vgchange -cy コマンドで clustered 属性を設定して作成する必要があります。CLVMD が実行されている場合、クラスター属性は自動的に設定されます。この clustered 属性は、ボリュームグループが CLVMD によって管理および保護される必要があることを示します。クラスターによって共有されず、単一のホストのみが認識できるボリュームグループを作成する場合は、この clustered 属性を vgcreate -cn または vgchange -cn コマンドで無効にする必要があります。

デフォルトでは、clustered 属性で共有ストレージに作成されたボリュームグループは、その共有ストレージにアクセス可能なすべてのコンピューターによって認識されます。ただし、vgcreate コマンドの

-cn オプションを使用して、ローカルにあるボリュームグループを作成し、クラスター内の 1 つのノードにのみ表示することができます。

クラスター環境で以下のコマンドを実行すると、コマンドを実行しているノードに対してローカルとなるボリュームグループが作成されます。このコマンドは、物理ボリューム

/dev/sdd1 および /dev/sde1 を含むローカルボリューム vg1 を作成します。

vgcreate -c n vg1 /dev/sdd1 /dev/sde1

# vgcreate -c n vg1 /dev/sdd1 /dev/sde1

vgchange コマンドの

-c オプションを使用して、既存のボリュームグループがローカルまたはクラスター化されているかどうかを変更できます。これについては、「ボリュームグループのパラメーター変更」 で説明されています。

既存のボリュームグループがクラスター化ボリュームグループであるかどうかは、vgs コマンドで確認できます。これは、ボリュームがクラスター化されている場合に c 属性を表示します。以下のコマンドは、ボリュームグループ

VolGroup00 および testvg1 の属性を表示します。この例では、VolGroup00 はクラスター化されていませんが、testvg1 は、Attr 見出しの c 属性で示されるようにクラスター化されています。

vgs VG #PV #LV #SN Attr VSize VFree VolGroup00 1 2 0 wz--n- 19.88G 0 testvg1 1 1 0 wz--nc 46.00G 8.00M

# vgs

VG #PV #LV #SN Attr VSize VFree

VolGroup00 1 2 0 wz--n- 19.88G 0

testvg1 1 1 0 wz--nc 46.00G 8.00M

4.3.4. ボリュームグループへの物理ボリュームの追加

リンクのコピーリンクがクリップボードにコピーされました!

物理ボリュームを既存のボリュームグループに追加するには、vgextend コマンドを使用します。vgextend コマンドは、空き物理ボリュームを 1 つ以上追加して、ボリュームグループの容量を増やします。

以下のコマンドは、物理ボリューム

/dev/sdf1 をボリュームグループ vg1 に追加します。

vgextend vg1 /dev/sdf1

# vgextend vg1 /dev/sdf14.3.5. ボリュームグループの表示

リンクのコピーリンクがクリップボードにコピーされました!

LVM ボリュームグループのプロパティーを表示するのに使用できるコマンドは 2 つあります。vgs および vgdisplay です。

vgscan コマンドは、ボリュームグループのすべてのディスクをスキャンし、LVM キャッシュファイルを再構築するにも、ボリュームグループを表示します。vgscan コマンドの詳細は、「キャッシュファイル構築のためのボリュームグループのディスクスキャン」 を参照してください。

vgs コマンド:ボリュームグループの情報を設定可能な形式で提供し、1 ボリュームグループにつき 1 行ずつ表示します。vgs コマンドでは、形式をかなり自由に制御できるため、スクリプト作成に役立ちます。vgs コマンドを使用して出力をカスタマイズする方法は、「LVM 用のカスタム報告」 を参照してください。

vgdisplay コマンドは、決められた形式でボリュームグループのプロパティー(サイズ、エクステント、物理ボリュームの数など)を表示します。以下の例は、ボリュームグループ

new_vg に対する vgdisplay コマンドの出力を示しています。ボリュームグループを指定しないと、既存のボリュームグループがすべて表示されます。

4.3.6. キャッシュファイル構築のためのボリュームグループのディスクスキャン

リンクのコピーリンクがクリップボードにコピーされました!

vgscan コマンド:システム内で対応しているすべてのディスクデバイスをスキャンし、LVM 物理ボリュームおよびボリュームグループを検索します。これにより、

/etc/lvm/cache/.cache ファイルに LVM キャッシュファイルが作成され、現在の LVM デバイスのリストを維持します。

LVM は、システムの起動時に、vgcreate コマンドを実行するとき、LVM が不整合を検出したときなど、システム起動時やその他のタイミングで vgscan コマンドを自動的に実行します。

注記

ハードウェア設定を変更し、ノードにデバイスを追加または削除する場合に、vgscan コマンドを手動で実行し、システムの起動時に存在しなかったシステムに新しいデバイスを確認させる必要がある場合があります。これは、たとえば、SAN 上のシステムに新しいディスクを追加したり、物理ボリュームとしてラベルが付けられた新しいディスクをホットプラグする場合に必要になる可能性があります。

/etc/lvm/lvm.conf ファイルでフィルターを定義して、特定のデバイスを回避するためにスキャンを制限できます。フィルターを使用してスキャンされるデバイスを制御する方法は、「フィルターを使用した LVM デバイススキャンの制御」 を参照してください。

以下の例は、vgscan コマンドの出力を示しています。

vgscan Reading all physical volumes. This may take a while... Found volume group "new_vg" using metadata type lvm2 Found volume group "officevg" using metadata type lvm2

# vgscan

Reading all physical volumes. This may take a while...

Found volume group "new_vg" using metadata type lvm2

Found volume group "officevg" using metadata type lvm2

4.3.7. ボリュームグループからの物理ボリュームの削除

リンクのコピーリンクがクリップボードにコピーされました!

ボリュームグループから未使用の物理ボリュームを削除するには、vgreduce コマンドを使用します。vgreduce コマンドは、空の物理ボリュームを 1 つまたは複数削除して、ボリュームグループの容量を縮小します。これにより、物理ボリュームが解放され、異なるボリュームグループで使用したり、システムから削除できるようになります。

ボリュームグループから物理ボリュームを削除する前に、pvdisplay コマンドを使用して、その物理ボリュームが論理ボリュームで使用されていないことを確認できます。

物理ボリュームが使用中の場合は、pvmove コマンドを使用して、データを別の物理ボリュームに移行する必要があります。次に、vgreduce コマンドを使用して物理ボリュームを削除します。

以下のコマンドは、ボリュームグループ

my_volume_group から物理ボリューム /dev/hda1 を削除します。

vgreduce my_volume_group /dev/hda1

# vgreduce my_volume_group /dev/hda1

論理ボリュームに、障害のある物理ボリュームが含まれる場合は、その論理ボリュームを使用することはできません。見つからない物理ボリュームをボリュームグループから削除します。その物理ボリュームに論理ボリュームが割り当てられていない場合は、vgreduce コマンドの

--removemissing パラメーターを使用できます。

障害が発生した物理ボリュームに、セグメントタイプが mirror の論理ボリュームの

ミラー イメージが含まれる場合は、vgreduce --removemissing --mirrorsonly --force コマンドを使用して、ミラーからそのイメージを削除できます。これにより、物理ボリュームのミラーイメージである論理ボリュームのみが削除されます。

LVM ミラーの障害から回復する方法は、「LVM ミラー障害からの回復」 を参照してください。ボリュームグループから紛失した物理ボリュームを削除する方法は、「紛失した物理ボリュームのボリュームグループからの削除」 を参照してください。

4.3.8. ボリュームグループのアクティブ化と非アクティブ化

リンクのコピーリンクがクリップボードにコピーされました!

ボリュームグループを作成すると、デフォルトでアクティブになります。これは、そのグループ内の論理ボリュームがアクセス可能で、かつ変更される可能性があることを意味します。

ボリュームグループを非アクティブ化し、カーネルに認識されないようにする必要のある様々な状況があります。ボリュームグループを非アクティブまたは非アクティブにするには、vgchange コマンドの

-a (--available)引数を使用します。

以下の例では、ボリュームグループ

my_volume_group を非アクティブにします。

vgchange -a n my_volume_group

# vgchange -a n my_volume_group

クラスターロッキングが有効な場合には、e を追加すると、1 つのノードでボリュームグループが排他的にアクティブ化または非アクティブ化されます。l を追加すると、ローカルノードでのみボリュームグループがアクティブ化または非アクティブ化されます。単一ホストのスナップショットを使用する論理ボリュームは、一度に 1 つのノードでしか利用できないため、常に排他的にアクティブ化されます。

「論理ボリュームグループのパラメーター変更」 で説明されているように、lvchange コマンドを使用して個別の論理ボリュームを非アクティブ化できます。クラスター内の個別ノード上で論理ボリュームをアクティブ化する方法は、「クラスター内の個別ノードでの論理ボリュームのアクティブ化」 を参照してください。

4.3.9. ボリュームグループのパラメーター変更

リンクのコピーリンクがクリップボードにコピーされました!

「ボリュームグループのアクティブ化と非アクティブ化」 で説明されているように、vgchange コマンドは、ボリュームグループを非アクティブ化およびアクティブ化するために使用されます。また、このコマンドを使用して、既存のボリュームグループに関するボリュームグループパラメーターを変更することもできます。

以下のコマンドは、ボリュームグループ

vg00 の論理ボリュームの最大数を 128 に変更します。

vgchange -l 128 /dev/vg00

# vgchange -l 128 /dev/vg00

vgchange コマンドで変更できるボリュームグループパラメーターの説明は、vgchange(8)の man ページを参照してください。

4.3.10. ボリュームグループの削除

リンクのコピーリンクがクリップボードにコピーされました!

論理ボリュームがないボリュームグループを削除するには、vgremove コマンドを使用します。

vgremove officevg Volume group "officevg" successfully removed

# vgremove officevg

Volume group "officevg" successfully removed

4.3.11. ボリュームグループの分割

リンクのコピーリンクがクリップボードにコピーされました!

ボリュームグループの物理ボリュームを分割して新しいボリュームグループを作成するには、vgsplit コマンドを使用します。

論理ボリュームはボリュームグループ間で分割することはできません。それぞれの既存の論理ボリュームは完全に物理ボリューム上に存在し、既存または新規のボリュームグループを形成している必要があります。ただし、必要に応じて、pvmove コマンドを使用して分割を強制することができます。

以下の例では、新しいボリュームグループ

smallvg を、元のボリュームグループ bigvg から分割します。

vgsplit bigvg smallvg /dev/ram15 Volume group "smallvg" successfully split from "bigvg"

# vgsplit bigvg smallvg /dev/ram15

Volume group "smallvg" successfully split from "bigvg"

4.3.12. ボリュームグループの統合

リンクのコピーリンクがクリップボードにコピーされました!

2 つのボリュームグループを統合して 1 つのボリュームグループにするには、vgmerge コマンドを使用します。ボリュームの物理エクステントサイズが同じで、かつ両ボリュームグループの物理ボリュームおよび論理ボリュームのサマリーがマージ先ボリュームグループの制限内に収まる場合は、非アクティブなマージ元のボリュームを、アクティブまたは非アクティブのマージ先ボリュームにマージができます。

以下のコマンドは、非アクティブなボリュームグループ

my_vg をアクティブまたは非アクティブなボリュームグループ databases にマージして、詳細なランタイム情報を提供します。

vgmerge -v databases my_vg

# vgmerge -v databases my_vg4.3.13. ボリュームグループメタデータのバックアップ

リンクのコピーリンクがクリップボードにコピーされました!

メタデータのバックアップとアーカイブは、

lvm.conf ファイルで無効になっていない限り、ボリュームグループまたは論理ボリュームへの設定変更時に自動的に作成されます。デフォルトでは、メタデータのバックアップは /etc/lvm/backup ファイルに保存され、メタデータのアーカイブは /etc/lvm/archive ファイルに保存されます。vgcfgbackup コマンドを使用すると、手動でメタデータを /etc/lvm/backup ファイルにバックアップできます。

vgcfgrestore コマンドは、ボリュームグループのメタデータを、アーカイブからボリュームグループのすべての物理ボリュームに復元します。

vgcfgrestore コマンドを使用して物理ボリュームのメタデータを復元する例は、「物理ボリュームメタデータの復元」 を参照してください。

4.3.14. ボリュームグループの名前変更

リンクのコピーリンクがクリップボードにコピーされました!

vgrename コマンドを使用して、既存のボリュームグループの名前を変更します。

以下のいずれかのコマンドにより、既存のボリュームグループ

vg02 の名前が my_volume_groupに変更されます。

vgrename /dev/vg02 /dev/my_volume_group

# vgrename /dev/vg02 /dev/my_volume_groupvgrename vg02 my_volume_group

# vgrename vg02 my_volume_group4.3.15. ボリュームグループの別のシステムへの移動

リンクのコピーリンクがクリップボードにコピーされました!

LVM ボリュームグループ全体を、別のシステムに移動できます。これを行うときは、vgexport コマンドと vgimport コマンドを使用することが推奨されます。

注記

vgimport コマンドの

--force 引数を使用できます。これにより、物理ボリュームがないボリュームグループをインポートし、その後 vgreduce --removemissing コマンドを実行できます。

vgexport コマンドは、非アクティブなボリュームグループにシステムがアクセスできないようにするため、物理ボリュームの割り当てを解除できます。vgimport コマンドは、vgexport コマンドで非アクティブになった後に、そのボリュームグループに再びマシンにアクセスできるようにします。

ボリュームグループを 2 つのシステム間で移行するには、以下の手順に従います。

- ボリュームグループ内のアクティブなボリュームのファイルにアクセスしているユーザーがいないことを確認してから、論理ボリュームをアンマウントします。

- vgchange コマンドの

-a n引数を使用して、ボリュームグループを非アクティブとしてマークします。これにより、ボリュームグループでこれ以上の動作ができなくなります。 - vgexport コマンドを使用してボリュームグループをエクスポートします。これにより、削除するシステムからボリュームグループへアクセスできなくなります。ボリュームグループのエクスポート後、以下の例のように、pvscan コマンドを実行すると、物理ボリュームは、エクスポートされたボリュームグループにあるものとして表示されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次にシステムがシャットダウンする時に、ボリュームグループを設定していたディスクを外して、新しいシステムに接続できます。 - ディスクが新しいシステムに接続されたら、vgimport コマンドを使用してボリュームグループをインポートし、新しいシステムからアクセスできるようにします。

- vgchange コマンドで

-a y引数を使用して、ボリュームグループをアクティブにします。 - ファイルシステムをマウントして使用できるようにします。

4.3.16. ボリュームグループディレクトリーの再作成

リンクのコピーリンクがクリップボードにコピーされました!

ボリュームグループディレクトリーと論理ボリューム特殊ファイルを再作成するには、vgmknodes コマンドを使用します。このコマンドは、アクティブな論理ボリュームに必要な

/dev ディレクトリー内の LVM2 特殊ファイルを確認します。このコマンドは不足しているファイルを作成し、未使用のファイルを削除します。

vgscan コマンドに mknodes 引数を指定すると、vgmknodes コマンドを vgscan コマンドに組み込むことができます。

4.4. 論理ボリュームの管理

リンクのコピーリンクがクリップボードにコピーされました!

このセクションでは、論理ボリューム管理の様々な要素を実行するコマンドを説明します。

4.4.1. リニア論理ボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

論理ボリュームを作成するには、lvcreate コマンドを使用します。論理ボリュームに名前を指定しないと、デフォルトの名前

lvol# が使用されます。ここで、# は論理ボリュームの内部番号になります。

論理ボリュームを作成すると、論理ボリュームがボリュームグループから作成され、ボリュームグループを設定する物理ボリュームの空きエクステントが使用されます、通常、論理ボリュームは、その下層の物理ボリュームで次に使用可能な空き領域を使用します。通常、論理ボリュームは、次に解放された物理ボリュームで使用できる領域を使用します。論理ボリュームを編集すると、物理ボリューム内の領域を再割り当てます。

以下のコマンドは、ボリュームグループ

vg1 に、論理ボリューム 10 ギガバイトを作成します。

lvcreate -L 10G vg1

# lvcreate -L 10G vg1

論理ボリュームサイズのデフォルト単位はメガバイトです。以下のコマンドは、ボリュームグループ

testvg に 1500 メガバイトのリニア論理ボリューム testlv を作成し、ブロックデバイス /dev/testvg/testlv を作成します。

lvcreate -L 1500 -n testlv testvg

# lvcreate -L 1500 -n testlv testvg

以下のコマンドは、ボリュームグループ

vg0 の空きエクステントから gfslv という名前の 50 ギガバイト論理ボリュームを作成します。

lvcreate -L 50G -n gfslv vg0

# lvcreate -L 50G -n gfslv vg0

lvcreate の

-l 引数を使用すると、論理ボリュームのサイズをエクステントで指定できます。この引数を使用すると、関連するボリュームグループ、論理ボリューム、または物理ボリュームセットのサイズの割合も指定できます。接尾辞 %VG はボリュームグループの合計サイズ、接尾辞 %FREE はボリュームグループの残りの空き容量、そして接尾辞 %PVS は物理ボリュームの空き容量を示します。スナップショットの場合は、サイズに接尾辞 %ORIGIN を使用して、元の論理ボリュームの合計サイズをパーセンテージで指定することができます (100%ORIGIN にすると、元の論理ボリューム全体が使用されます)。サイズをパーセンテージで指定した場合は、新規の論理ボリュームにおける論理エクステントに上限が設定されます。したがって、作成する LV の論理エクステントの正確な数は、コマンドが完了するまで決定されません。

以下のコマンドは、ボリュームグループ

testvg の 60% 領域を使用する、論理ボリューム mylv を作成します。

lvcreate -l 60%VG -n mylv testvg

# lvcreate -l 60%VG -n mylv testvg

以下のコマンドは、ボリュームグループ

testvg の未割り当て領域をすべて使用する、論理ボリューム yourlv を作成します。

lvcreate -l 100%FREE -n yourlv testvg

# lvcreate -l 100%FREE -n yourlv testvg

lvcreate コマンドに

-l 引数を使用すると、ボリュームグループ全体を使用する論理ボリュームを作成できます。もう 1 つの方法では、vgdisplay コマンドを使用して合計 PE サイズを検索し、その結果を lvcreate コマンドへの入力として使用します。

以下のコマンドは、ボリュームグループ

testvg を入力する論理ボリューム mylv を作成します。

vgdisplay testvg | grep "Total PE" Total PE 10230 lvcreate -l 10230 -n mylv testvg

# vgdisplay testvg | grep "Total PE"

Total PE 10230

# lvcreate -l 10230 -n mylv testvg

論理ボリュームの作成に使用した下層の物理ボリュームは、物理ボリュームを削除する必要がある場合に重要になる可能性があります。そのため、論理ボリュームを作成する際にはこの可能性を考慮する必要があります。ボリュームグループから物理ボリュームを削除する方法は、「ボリュームグループからの物理ボリュームの削除」 を参照してください。

ボリュームグループで、特定の物理ボリュームから論理ボリュームを割り当てる場合は、lvcreate コマンドラインの最後に物理ボリュームを指定します。以下のコマンドは、ボリュームグループ

testvg に、物理ボリューム /dev/sdg1 から割り当てた論理ボリューム testlv を作成します。

lvcreate -L 1500 -n testlv testvg /dev/sdg1

# lvcreate -L 1500 -n testlv testvg /dev/sdg1

論理ボリュームに使用する物理ボリュームのエクステントを指定することができます。以下の例では、ボリュームグループ

testvg で、エクステントが 0 から 24 の物理ボリューム /dev/sda1 とエクステント 50 から 124 の物理ボリューム /dev/sdb1 からリニア論理ボリュームを作成します。

lvcreate -l 100 -n testlv testvg /dev/sda1:0-24 /dev/sdb1:50-124

# lvcreate -l 100 -n testlv testvg /dev/sda1:0-24 /dev/sdb1:50-124

以下の例では、エクステントが 0 から 25 の物理ボリューム

/dev/sda1 からリニア論理ボリュームを作成し、エクステント 100 で論理ボリュームの配置を続行します。

lvcreate -l 100 -n testlv testvg /dev/sda1:0-25:100-

# lvcreate -l 100 -n testlv testvg /dev/sda1:0-25:100-

論理ボリュームのエクステントの割り当て方法に関するデフォルトポリシーは inherit で、ボリュームグループに同じポリシーが適用されます。このポリシーは lvchange コマンドを使用して変更できます。割り当てポリシーの詳細は、「ボリュームグループの作成」 を参照してください。

4.4.2. ストライプ化ボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

連続的な読み取りと書き込みが大量に行われる場合は、ストライプ化論理ボリュームを作成すると、データ I/O が効率が上がります。ストライプ化ボリュームに関する一般的な情報は、「ストライプ化論理ボリューム」 を参照してください。

ストライプ化論理ボリュームを作成する場合は、lvcreate コマンドの

-i 引数を使用してストライプの数を指定します。これにより、論理ボリュームがストライプ化される物理ボリュームの数が決定します。ストライプ数は、ボリュームグループ内の物理ボリュームの数よりも多くすることはできません (--alloc anywhere 引数が使用されない限り)。

ストライプ化論理ボリュームを設定する下層の物理デバイスのサイズが異なる場合、ストライブ化ボリュームの最大サイズは、一番小さいデバイスにより決まります。2 レッグのストライプの最大サイズは、小さい方のデバイスの 2 倍になります。3 レッグのストライプの最大サイズは、一番小さいデバイスの 3 倍になります。

以下のコマンドは、64 キロバイトのストライプを持つ 2 つの物理ボリュームにまたがってストライプ化論理ボリュームを作成します。論理ボリュームのサイズは 50 ギガバイトで、

gfslv という名前で、ボリュームグループ vg0 から取り除かれます。

lvcreate -L 50G -i 2 -I 64 -n gfslv vg0

# lvcreate -L 50G -i 2 -I 64 -n gfslv vg0

リニアボリュームと同じく、ストライプに使用する物理ボリュームのエクステントを指定できます。以下のコマンドは、ストライプボリューム 100 エクステントをサイズで作成します。このエクステントのサイズは、2 つの物理ボリューム間の

ストライプ(striplv )で、ボリュームグループ testvg にあります。ストライプは、/dev/sda1 のセクター 0-49 と、/dev/sdb1 のセクター 50 - 99 を使用します。

lvcreate -l 100 -i 2 -n stripelv testvg /dev/sda1:0-49 /dev/sdb1:50-99 Using default stripesize 64.00 KB Logical volume "stripelv" created

# lvcreate -l 100 -i 2 -n stripelv testvg /dev/sda1:0-49 /dev/sdb1:50-99

Using default stripesize 64.00 KB

Logical volume "stripelv" created

4.4.3. RAID 論理ボリューム

リンクのコピーリンクがクリップボードにコピーされました!

LVM は、RAID0、1、4、5、6、および 10 に対応します。

注記

RAID 論理ボリュームはクラスターには対応していません。RAID 論理ボリュームは、1 台のマシンに作成して排他的にアクティブにすることができますが、複数のマシンで同時にアクティブにすることはできません。排他的ではないミラー化されたボリュームが必要な場合は、「ミラー化ボリュームの作成」 で説明されているように、セグメントタイプの

mirror を指定してボリュームを作成する必要があります。

RAID 論理ボリュームを作成するには、raid タイプを lvcreate コマンドの

--type 引数として指定します。表4.1「RAID のセグメントタイプ」 では、可能な RAID セグメントタイプを説明します。

| セグメントタイプ | 説明 | ||

|---|---|---|---|

raid1 | RAID1 ミラーリング。-m を指定し、ストライピングを指定しない場合の、lvcreate コマンドの --type 引数のデフォルト値になります。 | ||

raid4 | RAID4 専用パリティーディスク | ||

raid5 | raid5_lsと同じ | ||

raid5_la |

| ||

raid5_ra |

| ||

raid5_ls |

| ||

raid5_rs |

| ||

raid6 | raid6_zrと同じ | ||

raid6_zr |

| ||

raid6_nr |

| ||

raid6_nc |

| ||

raid10 |

| ||

raid0/raid0_meta (Red Hat Enterprise Linux 7.3 以降) | ストライピング。RAID0 では、ストライプサイズの単位で、複数のデータサブボリュームに論理ボリュームデータが分散されます。これは、パフォーマンスを向上させるために使用します。論理ボリュームのデータは、いずれかのデータサブボリュームで障害が発生すると失われます。RAID0 ボリュームの作成については、「RAID0 ボリュームの作成 (Red Hat Enterprise Linux 7.3 以降)」 を参照してください。 |

ほとんどのユーザーの場合、5 つの使用可能なプライマリータイプ(

raid1、raid4、raid5、raid6、raid10)のいずれかを指定するだけで十分です。

RAID 論理ボリュームを作成するとき、LVM は、データまたはアレイ内のパリティーサブボリュームごとに、サイズが 1 エクステントのメタデータサブボリュームを作成します。たとえば、2 方向の RAID1 アレイを作成すると、メタデータサブボリュームが 2 つ(

lv_rmeta_0 および lv_rmeta_1)と、データサブボリュームが 2 つ(lv_rimage_0 および lv_rimage_ 1)作成されます。同様に、3 方向のストライプ(および暗黙的なパリティーデバイスが 1 つ)の RAID4 を作成すると、メタデータサブボリュームが 4 つ(lv_rmeta_0、lv_rmeta _1、lv_rmeta_2、および lv_rmeta_3)、4 つのデータサブボリューム(lv_rimage_0、lv_rimage_1、lv_rimage _2、および lv_rimage_3 )が作成されます。

以下のコマンドは、ボリュームグループ

my_vg 内に、1 ギガバイトの 2 方向の RAID1 アレイ my_lv を作成します。

lvcreate --type raid1 -m 1 -L 1G -n my_lv my_vg

# lvcreate --type raid1 -m 1 -L 1G -n my_lv my_vg-m 引数に指定する値に応じて、さまざまなコピー数を指定して RAID1 アレイを作成できます。同様に、-i argument オプションに、RAID 4、5、または 6 の論理ボリュームのストライプ数を指定します。-I 引数でストライプのサイズを指定することもできます。

以下のコマンドは、ボリュームグループ

my_vg に、サイズが 1 ギガバイトで、名前が my_lv の RAID5 アレイ(ストライプ 3 つ + 暗黙的なパリティードライブ 1 つ)を作成します。ストライプ数の指定は、LVM ストライプ化ボリュームの場合と同じように行います。パリティードライブは、正確な数だけ自動的に追加されます。

lvcreate --type raid5 -i 3 -L 1G -n my_lv my_vg

# lvcreate --type raid5 -i 3 -L 1G -n my_lv my_vg

以下のコマンドは、ボリュームグループ

my_vg に、サイズが 1 ギガバイトで、名前が my_lv の RAID6 アレイ(ストライプ 3 つ + 暗黙的なパリティードライブ 2 つ)を作成します。

lvcreate --type raid6 -i 3 -L 1G -n my_lv my_vg

# lvcreate --type raid6 -i 3 -L 1G -n my_lv my_vg

LVM で RAID 論理ボリュームを作成した後、他の LVM 論理ボリュームと同じようにボリュームをアクティブ化、変更、削除、表示、および使用することができます。

RAID10 論理ボリュームを作成する際に、

sync 操作で論理ボリュームを初期化するのに必要なバックグラウンド I/O は、特に RAID 論理ボリュームを多数作成している場合に、その他の I/O 操作(ボリュームグループメタデータへの更新など)を LVM デバイスに押し出す可能性があります。これにより、他の LVM 操作が遅くなる可能性があります。

RAID 論理ボリュームが初期化される速度は、復旧スロットルを実装することで制御できます。

sync 操作が実行される速度は、lvcreate コマンドの --minrecoveryrate および --maxrecoveryrate オプションを使用して、これらの操作の最小および最大 I/O 速度を設定することにより制御できます。オプションは以下のように指定します。

--maxrecoveryrate Rate[bBsSkKmMgG]RAID 論理ボリュームの最大復旧速度を設定し、通常の I/O 操作が押し出されないようにします。速度 アレイ内の各デバイスに対して、1 秒あたりの量を指定します。接尾辞を指定しない場合は、kiB/sec/device (デバイスごとに kiB/秒) と見なされます。復旧速度を 0 に設定すると無制限になります。--minrecoveryrate Rate[bBsSkKmMgG]RAID 論理ボリュームの最小復旧速度を設定し、負荷の高い通常の I/O がある場合でも、sync操作の I/O が最小スループットを達成できるようにします。速度 アレイ内の各デバイスに対して、1 秒あたりの量を指定します。接尾辞を指定しない場合は、kiB/sec/device (デバイスごとに kiB/秒) と見なされます。

以下のコマンドは、最大速度が 128 kiB/sec/device で、サイズが 10 ギガバイトのストライプが 3 つある、2 方向の RAID10 アレイを作成します。このアレイは

my_lv という名前で、ボリュームグループ my_vg にあります。

lvcreate --type raid10 -i 2 -m 1 -L 10G --maxrecoveryrate 128 -n my_lv my_vg

# lvcreate --type raid10 -i 2 -m 1 -L 10G --maxrecoveryrate 128 -n my_lv my_vg

RAID のスクラブ操作の最小および最大復旧速度を指定することもできます。RAID スクラビングの情報は、「RAID 論理ボリュームのスクラビング」 を参照してください。

注記

LVM RAID Calculator を使用すると、RAID ストレージで論理ボリュームを作成するコマンドを生成できます。このアプリケーションは、現在のストレージまたは作成予定のストレージについて入力した情報を使用してコマンドを生成します。LVM RAID Calculator アプリケーションは、https://access.redhat.com/labs/lvmraidcalculator/ で使用できます。

以下のセクションでは、LVM RAID デバイスで実行できる管理タスクについて説明します。

4.4.3.1. RAID0 ボリュームの作成 (Red Hat Enterprise Linux 7.3 以降)

リンクのコピーリンクがクリップボードにコピーされました!

RAID0 ボリュームを作成するコマンドの書式は以下のとおりです。

lvcreate --type raid0[_meta] --stripes Stripes --stripesize StripeSize VolumeGroup [PhysicalVolumePath ...]

lvcreate --type raid0[_meta] --stripes Stripes --stripesize StripeSize VolumeGroup [PhysicalVolumePath ...]

| パラメーター | 説明 |

|---|---|

--type raid0[_meta] | raid0 を指定すると、メタデータボリュームなしで RAID0 ボリュームが作成されます。raid0_meta を指定すると、メタデータボリュームとともに RAID0 ボリュームが作成されます。RAID0 には耐障害性がないため、RAID1/10 の場合のようにミラーリングされたすべてのデータブロックを格納したり、RAID4/5/6 の場合のようにすべてのパリティーブロックを計算して格納する必要はありません。したがって、ミラーリングされたブロックまたはパリティーブロックの再同期の進行状態を把握するメタデータボリュームは必要ありません。ただし、RAID0 から RAID4/5/6/10 への変換ではメタデータボリュームが必須になり、raid0_meta を指定すると、割り当ての失敗を防ぐために、これらのメタデータが事前に割り当てられます。 |

--stripes Stripes | 論理ボリュームを分散するデバイスの数を指定します。 |

--stripesize StripeSize | 各ストライプのサイズをキロバイト単位で指定します。これは、次のデバイスに移動する前にデバイスに書き込まれるデータの量です。 |

VolumeGroup | 使用するボリュームグループを指定します。 |

PhysicalVolumePath ... | 使用するデバイスを指定します。指定しない場合は、LVM によって、Stripes オプションに指定されているデバイスの数が、各ストライプに 1 つずつ選択されます。 |

4.4.3.2. リニアデバイスの RAID デバイスへの変換

リンクのコピーリンクがクリップボードにコピーされました!

既存のリニア論理ボリュームを RAID デバイスに変換するには、lvconvert コマンドの

--type 引数を使用します。

以下のコマンドは、ボリュームグループ

my_vg のリニア論理ボリューム my_lv を、2 方向の RAID1 アレイに変換します。

lvconvert --type raid1 -m 1 my_vg/my_lv

# lvconvert --type raid1 -m 1 my_vg/my_lv

RAID 論理ボリュームは、メタデータとデータサブボリュームのペアで設定されているため、リニアデバイスを RAID1 アレイに変換すると、メタデータサブボリュームが作成され、リニアボリュームが存在する物理ボリューム (のいずれか) にある、作成元の論理ボリュームに関連付けられます。イメージは、メタデータ/データサブボリュームのペアに追加されます。たとえば、作成元のデバイスは以下のとおりです。

lvs -a -o name,copy_percent,devices my_vg LV Copy% Devices my_lv /dev/sde1(0)

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv /dev/sde1(0)

2 方向の RAID1 アレイに変換すると、デバイスには、以下のデータとメタデータサブボリュームのペアが含まれます。

複製元の論理ボリュームとペアのメタデータイメージを同じ物理ボリュームに配置できないと、lvconvert は失敗します。

4.4.3.3. LVM RAID1 論理ボリュームの LVM リニア論理ボリュームへの変換

リンクのコピーリンクがクリップボードにコピーされました!

lvconvert コマンドを使用して、既存の RAID1 LVM 論理ボリュームを LVM リニア論理ボリュームに変換するには、

-m0 引数を指定します。これにより、RAID アレイを設定する全 RAID データサブボリュームおよび全 RAID メタデータサブボリュームが削除され、最高レベルの RAID1 イメージがリニア論理ボリュームとして残されます。

以下の例は、既存の LVM RAID1 論理ボリュームを示しています。

以下のコマンドは、LVM RAID1 論理ボリューム

my_vg/my_lv を、LVM リニアデバイスに変換します。

lvconvert -m0 my_vg/my_lv lvs -a -o name,copy_percent,devices my_vg LV Copy% Devices my_lv /dev/sde1(1)

# lvconvert -m0 my_vg/my_lv

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv /dev/sde1(1)

LVM RAID1 論理ボリューム を LVM リニアボリュームに変換する場合は、削除する物理ボリュームを指定できます。以下の例は、2 つのイメージ(

/dev/sda1 および /dev/sdb1 )で設定される LVM RAID1 論理ボリュームのレイアウトを示しています。この例では、lvconvert コマンドは /dev/sda1 を削除して、/dev/sdb1 をリニアデバイスを設定する物理ボリュームとして残すように指定します。

4.4.3.4. ミラー化 LVM デバイスの RAID1 デバイスへの変換

リンクのコピーリンクがクリップボードにコピーされました!

lvconvert コマンドを使用して、セグメントタイプが

mirror の既存のミラーリングされた LVM デバイスを RAID1 LVM デバイスに変換するには、--type raid1 引数を指定します。これにより、ミラーサブボリューム(*_mimage_*)の名前が RAID サブボリューム(*_rimage_*)に変更されます。さらに、ミラーログは削除され、対応するデータサブボリュームと同じ物理ボリュームのデータサブボリューム用に、メタデータサブボリューム(*_rmeta_*)が作成されます。

以下の例は、ミラー化論理ボリューム

my_vg/my_lv のレイアウトを示しています。

以下のコマンドは、ミラー化論理ボリューム

my_vg/my_lv を、RAID1 論理ボリュームに変換します。

4.4.3.5. RAID 論理ボリュームのサイズ変更

リンクのコピーリンクがクリップボードにコピーされました!

RAID 論理ボリュームのサイズは、以下の方法で変更できます。

- いずれのタイプの RAID 論理ボリュームのサイズも、lvresize コマンドまたは lvextend コマンドで増やすことができます。これは、RAID イメージの数を変更するものではありません。ストライプ化 RAID 論理ボリュームでは、ストライプ化 RAID 論理ボリュームの作成時と同じ、ストライプを丸める制約が適用されます。RAID ボリュームの拡張の詳細は、「RAID ボリュームの拡張」 を参照してください。

- いずれのタイプの RAID 論理ボリュームのサイズも、lvresize コマンドまたは lvreduce コマンドで減らすことができます。これは、RAID イメージの数を変更するものではありません。lvextend コマンドでは、ストライプ化 RAID 論理ボリュームの作成時と同じストライプを丸める制約が適用されます。論理ボリュームのサイズを変更するコマンド例は、「論理ボリュームの縮小」 を参照してください。

- Red Hat Enterprise Linux 7.4 では、lvconvert コマンドで

--stripes Nパラメーターを使用すると、ストライプ化 RAID 論理ボリューム(raid4/5/6/10)のストライプの数を変更できます。このように、ストライプを追加または削除することで、RAID 論理ボリュームのサイズを増減できます。raid10ボリュームにはストライプを追加することしかできないため注意してください。この機能は、同じ RAID レベルを維持しながら、RAID 論理ボリュームの属性を変更することができる、RAID の 再成形 機能になります。RAID 再成形と、lvconvert コマンドを使用して RAID 論理ボリュームを再生成する例は、lvmraid(7)の man ページを参照してください。

4.4.3.6. 既存の RAID1 デバイス内のイメージ数の変更

リンクのコピーリンクがクリップボードにコピーされました!

既存の RAID1 アレイ内のイメージ数は、LVM ミラーリングの初期実装でイメージ数を変更する場合と同様に変更できます。lvconvert コマンドを使用して、追加または削除するメタデータ/データサブボリュームのペアの数を指定します。LVM ミラーリングの初期実装におけるボリューム設定の変更方法については、「ミラー化ボリューム設定の変更」 を参照してください。

lvconvert コマンドを使用して RAID1 デバイスにイメージを追加する場合は、作成されるデバイス用イメージの総数を指定するか、デバイスに追加するイメージ数を指定できます。メタデータ/データイメージのペアを置く物理ボリュームを指定することもできます。

メタデータサブボリューム(

*_rmeta_*という名前)は、対応するデータサブボリューム( *_rimage_*)と同じ物理デバイスに常に存在します。メタデータ/データのサブボリュームのペアは、--alloc anywhere を指定しない限り、RAID アレイにある別のメタデータ/データサブボリュームのペアと同じ物理ボリュームには作成されません。

RAID1 ボリュームにイメージを追加するコマンドの形式は、以下のとおりです。

lvconvert -m new_absolute_count vg/lv [removable_PVs] lvconvert -m +num_additional_images vg/lv [removable_PVs]

lvconvert -m new_absolute_count vg/lv [removable_PVs]

lvconvert -m +num_additional_images vg/lv [removable_PVs]

たとえば、以下のコマンドは、2 方向の RAID1 アレイである LVM デバイス

my_vg/my_lv を表示します。

以下のコマンドは、2 方向の RAID1 デバイス

my_vg/my_lv を、3 方向の RAID1 デバイスに変換します。

イメージを RAID1 アレイに追加する場合は、イメージに使用する物理ボリュームを指定できます。次のコマンドは、2 方向の RAID1 デバイス

my_vg/my_lv を 3 方向の RAID1 デバイスに変換し、物理ボリューム /dev/sdd1 がアレイに使用されるように指定します。

RAID1 アレイからイメージを削除するには、以下のコマンドを使用します。lvconvert コマンドを使用して RAID1 デバイスからイメージを削除する場合、作成されるデバイスのイメージの合計数を指定するか、デバイスから削除するイメージ数を指定できます。または、デバイスを削除する物理ボリュームを指定することもできます。

lvconvert -m new_absolute_count vg/lv [removable_PVs] lvconvert -m -num_fewer_images vg/lv [removable_PVs]

lvconvert -m new_absolute_count vg/lv [removable_PVs]

lvconvert -m -num_fewer_images vg/lv [removable_PVs]

また、イメージとその関連付けられたメタデータのサブボリュームを削除すると、それよりも大きな番号のイメージがそのスロットを引き継ぎます。

lv_rimage_ 0、lv_rimage_ 1、および lv_rimage _2 で構成される 3 方向 RAID1 アレイからlv_rimage_ 1 を削除すると、これにより lv_rimage_ 0 と lv_rimage_ 1 で構成される RAID1 アレイが作成されます。lv_rimage_ 2 の名前が、空のスロットを引き継いで lv_rimage_ 1 になります。

以下の例は、3 方向の RAID1 論理ボリューム

my_vg/my_lv のレイアウトを示しています。

以下のコマンドは、3 方向の RAID1 論理ボリュームを、2 方向の RAID1 論理ボリュームに変換します。

以下のコマンドは、3 方向の RAID1 論理ボリュームを 2 方向 RAID1 論理ボリュームに変換し、

/dev/sde1 として削除するイメージを含む物理ボリュームを指定します。

4.4.3.7. RAID イメージを複数の論理ボリュームに分割

リンクのコピーリンクがクリップボードにコピーされました!

RAID 論理ボリュームのイメージを分割して新しい論理ボリュームを形成できます。RAID イメージを分割する手順は、「ミラー化論理ボリュームの冗長イメージの分割」 で説明されているように、ミラー化論理ボリュームの冗長イメージを分割する手順と同じです。

RAID イメージを分割するコマンドの形式は、以下のとおりです。

lvconvert --splitmirrors count -n splitname vg/lv [removable_PVs]

lvconvert --splitmirrors count -n splitname vg/lv [removable_PVs]

既存の RAID1 論理ボリュームから RAID イメージを削除する場合と同様に (「既存の RAID1 デバイス内のイメージ数の変更」 で説明)、RAID データのサブボリューム (およびその関連付けられたメタデータのサブボリューム) をデバイスから削除する場合、それより大きい番号のイメージは、そのスロットを埋めるために番号が変更になります。そのため、RAID アレイを構成する論理ボリューム上のインデックス番号は連続する整数となります。

注記

RAID1 アレイがまだ同期していない場合は、RAID イメージを分割できません。

以下の例は、2 方向の RAID1 論理ボリューム

my_lv を、my_lv と new の 2 つのリニア論理ボリュームに分割します。

以下の例は、3 方向の RAID1 論理ボリューム

my_lv を、2 方向の RAID1 論理ボリューム my_lv とリニア論理ボリューム newに分割します。

4.4.3.8. RAID イメージの分割とマージ

リンクのコピーリンクがクリップボードにコピーされました!

lvconvert コマンドの

--splitmirrors 引数とともに --trackchanges 引数を使用すると、すべての変更を追跡しながら、RAID1 アレイのイメージを一時的に読み取り専用に分割できます。これにより、イメージの分割後に変更になったアレイの部分のみを再同期する一方で、後でそのイメージをアレイにマージし直すことができます。

RAID イメージを分割する lvconvert コマンドの形式は、以下のとおりです。

lvconvert --splitmirrors count --trackchanges vg/lv [removable_PVs]

lvconvert --splitmirrors count --trackchanges vg/lv [removable_PVs]

--trackchanges 引数を使用して RAID イメージを分割する場合、分割するイメージを指定することはできますが、分割されるボリューム名を変更することはできません。また、分割して作成されたボリュームには以下の制限があります。

- 作成された新規ボリュームは読み取り専用です。

- 新規ボリュームのサイズは変更できません。

- 残りのアレイの名前は変更できません。

- 残りのアレイのサイズは変更できません。

- 新規のボリュームと、残りのアレイを個別にアクティブにすることはできません。

指定した

--trackchanges 引数を使用して分割されたイメージをマージするには、lvconvert コマンドに --merge 引数を指定して実行します。イメージをマージすると、イメージが分割されてから変更したアレイの部分のみが再同期されます。

RAID イメージをマージする lvconvert コマンドの形式は、以下のとおりです。

lvconvert --merge raid_image

lvconvert --merge raid_image

以下の例は、残りのアレイへの変更を追跡する一方で、RAID1 論理ボリュームを作成し、そのボリュームからイメージを分割します。

以下の例は、残りのアレイへの変更の追跡時に、RAID1 ボリュームからイメージを分割します。その後、ボリュームをアレイにマージし直しています。

RAID1 ボリュームからイメージを分割したら、2 番目の lvconvert --splitmirrors コマンドを実行し、

--trackchanges 引数を指定せずにイメージを分割する初期 lvconvert コマンドを繰り返すことで、分割された永続化できます。これにより、--trackchanges 引数が作成されたリンクが破損します。

--trackchanges 引数を使用してイメージを分割した後に、意図的に追跡されているイメージを永続的に分割しない限り、そのアレイで後続の lvconvert --splitmirrors コマンドを発行することはできません。

以下の一連のコマンドは、イメージを分割してこれを追跡してから、追跡されるイメージを永久に分割します。

ただし、以下の一連のコマンドは失敗する点に注意してください。

同様に、以下の一連のコマンドも失敗します。分割されたイメージが追跡されていないためです。

4.4.3.9. RAID 障害ポリシーの設定

リンクのコピーリンクがクリップボードにコピーされました!

LVM RAID は、

lvm.conf ファイルの raid_fault_policy フィールドで定義された設定に基づいて、デバイス障害を自動で処理します。

raid_fault_policyフィールドがallocateに設定されている場合、システムは障害が発生したデバイスをボリュームグループの予備デバイスに置き換えようとします。予備のデバイスがないと、システムログにレポートが送信されます。raid_fault_policyフィールドがwarnに設定されている場合、システムは警告を生成し、デバイスが失敗したことを示します。これにより、ユーザーは実施する一連の動作を確認できます。

残りのデバイスで該当するポリシーに対応できる限り、RAID 論理ボリュームは操作を続行します。

4.4.3.9.1. allocateRAID 障害ポリシー

リンクのコピーリンクがクリップボードにコピーされました!

以下の例では、

raid_fault_policy フィールドは lvm.conf ファイルで allocate に設定されています。RAID 論理ボリュームは、以下のように配置されます。

/dev/sde デバイスに障害が発生した場合、システムログはエラーメッセージを表示します。

raid_fault_policy フィールドが allocate に設定されているため、障害が発生したデバイスは、ボリュームグループの新しいデバイスに置き換えられます。

障害が発生したデバイスを交換しても、LVM は、障害が発生したデバイスが見つけられないと示すことに注意してください。これは、障害が発生したデバイスが、RAID 論理ボリュームからは削除されても、ボリュームグループからは削除されていないためです。障害が発生したデバイスをボリュームグループから削除するには、vgreduce --removemissing VG を実行します。

raid_fault_policy が allocate に設定されているが、予備のデバイスがない場合は、割り当てに失敗し、論理ボリュームはそのままになります。割り当てが失敗した場合は、「warnRAID 障害ポリシー」 で説明されているように、ドライブを修正し、その後で論理ボリュームを非アクティブ化およびアクティブ化できます。また、「RAID デバイスの交換」 で説明されているように、障害が発生したデバイスを置き換えることも可能です。

4.4.3.9.2. warnRAID 障害ポリシー

リンクのコピーリンクがクリップボードにコピーされました!

以下の例では、

raid_fault_policy フィールドは lvm.conf ファイルで warn に設定されています。RAID 論理ボリュームは、以下のように配置されます。

/dev/sdh デバイスが失敗すると、システムログはエラーメッセージを表示します。ただし、この場合、LVM はイメージの 1 つを置き換えて、RAID デバイスを自動的に修復しようとはしません。代わりに、デバイスに障害が発生した場合は、以下に示すように lvconvert コマンドの --repair 引数を使用してデバイスを置き換えることができます。

障害が発生したデバイスを交換しても、LVM は、障害が発生したデバイスが見つけられないと示すことに注意してください。これは、障害が発生したデバイスが、RAID 論理ボリュームからは削除されても、ボリュームグループからは削除されていないためです。障害が発生したデバイスをボリュームグループから削除するには、vgreduce --removemissing VG を実行します。

デバイス障害が一時的な障害であったり、障害が発生したデバイスの修復が可能な場合は、lvchange コマンドの

--refresh オプションを使用して、障害が発生したデバイスの復旧を開始できます。これまでは、論理ボリュームを非アクティブ化してからアクティブ化することが必要でした。

次のコマンドは、論理ボリュームを更新します。

lvchange --refresh my_vg/my_lv

# lvchange --refresh my_vg/my_lv4.4.3.10. RAID デバイスの交換

リンクのコピーリンクがクリップボードにコピーされました!

RAID は従来の LVM ミラーリングとは異なります。LVM ミラーリングでは、障害が発生したデバイスを削除する必要がありました。削除しないと、ミラー化論理ボリュームがハングします。RAID アレイは、障害があるデバイスがあっても稼働し続けることができます。RAID1 以外の RAID タイプでデバイスを削除すると、レベルが低い RAID に変換されます (たとえば、RAID6 から RAID5、もしくは RAID4 または RAID5 から RAID0)。したがって、障害が発生したデバイスを無条件に削除してから交換するのではなく、lvconvert コマンドで

--replace 引数を使用して、RAID ボリュームのデバイスを 1 回で置き換えることができます。

lvconvert --replace の形式は、以下のとおりです。

lvconvert --replace dev_to_remove vg/lv [possible_replacements]

lvconvert --replace dev_to_remove vg/lv [possible_replacements]

以下の例では、RAID1 論理ボリュームを作成した後に、そのボリューム内のデバイスを交換しています。

以下の例では、RAID1 論理ボリュームを作成した後に、そのボリュームのデバイスを交換し、交換したデバイスに使用する物理ボリュームを指定しています。

一度に 2 つ以上の RAID デバイスを交換するには、以下の例のように複数の

replace 引数を指定します。

注記

lvconvert --replace コマンドを使用して交換ドライブを指定する場合、交換用のドライブは、アレイですでに使用されている追加領域から割り当てるべきではありません。たとえば、

lv_rimage_0 と lv_rimage_ 1 は同じ物理ボリュームに配置しないでください。

4.4.3.11. RAID 論理ボリュームのスクラビング

リンクのコピーリンクがクリップボードにコピーされました!

LVM は、RAID 論理ボリュームのスクラビングに対応します。RAID スクラビングは、アレイ内のデータおよびパリティーブロックをすべて読み込み、それが一貫しているかどうかを確認するプロセスです。

lvchange コマンドの

--syncaction オプションを使用して、RAID スクラビング操作を開始します。check または repair のいずれかの操作を指定します。check 操作はアレイを超え、アレイ内の不一致の数を記録しますが、それらを修復しません。修復 操作では、検出時に不一致が修正します。

RAID 論理ボリュームのスクラビングを実行するコマンドの形式は以下のとおりです。

lvchange --syncaction {check|repair} vg/raid_lv

lvchange --syncaction {check|repair} vg/raid_lv注記

lvchange --syncaction repair vg/raid_lv 操作は、lvconvert --repair vg/raid_lv と同じ機能を実行しません。lvchange --syncaction repair 操作は、アレイでバックグラウンドの同期操作を開始しますが、lvconvert --repair 操作は、ミラーまたは RAID 論理ボリュームで障害が発生したデバイスを修復または交換するように設計されています。

新しい RAID スクラビング操作をサポートするため、lvs コマンドは、

raid_sync_action と raid_mismatch_count の 2 つの新しい出力可能なフィールドをサポートするようになりました。これらのフィールドは、デフォルトでは出力されません。これらのフィールドを表示するには、以下のように lvs の -o パラメーターを使用して指定します。

lvs -o +raid_sync_action,raid_mismatch_count vg/lv

lvs -o +raid_sync_action,raid_mismatch_count vg/lvraid_sync_action フィールドは、raid ボリュームが現在実行している同期操作を表示します。これには、以下のいずれかの値を使用できます。

idle: すべての同期操作が完了している(何も実行しません)。再同期: アレイを初期化、またはマシン障害後の復旧を実行する。recover: アレイ内のデバイスの置き換えcheck: アレイの不一致を検索する。repair: 不整合を検索し、修復します。

raid_mismatch_count フィールドは、check 操作時に見つかった不一致の数を表示します。

lvs コマンドの

Cpy%Sync フィールドは、check および repair を含む raid_sync_action 操作のいずれかの進捗を出力するようになりました。

lvs コマンドの

lv_attr フィールドは、RAID スクラビング操作をサポートする追加のインジケーターを提供するようになりました。このフィールドのビット 9 は、論理ボリュームの正常性を示し、以下のインジケーターに対応するようになりました。

- (m) ismatches (不一致) は、RAID 論理ボリュームに不一致があることを示します。この文字は、スクラビング操作で RAID に一貫性がない部分があることを検出した後に表示されます。

- (r)efresh (更新) は、LVM がデバイスラベルを読み取り、デバイスを稼働できると認識した場合でも、RAID アレイのデバイスに障害が発生し、カーネルがこれを障害と認識していることを示します。この論理ボリュームを、デバイスが利用可能になったことをカーネルに通知するために更新する (refresh) か、もしくはデバイスに障害が発生したと思われる場合はデバイスを置き換える (replace) 必要があります。

lvs コマンドについての情報は、「オブジェクト表示フィールド」 を参照してください。

RAID スクラビング操作を実行する際に、

sync 操作で必要になるバックグラウンド I/O は、その他の I/O 操作(ボリュームグループメタデータへの更新など)を LVM デバイスに押し出す可能性があります。これにより、他の LVM 操作が遅くなる可能性があります。復旧スロットルを実装して RAID 論理ボリュームのスクラビングを実行する速度を制御できます。

sync 操作が実行される速度は、lvchange コマンドの --minrecoveryrate および --maxrecoveryrate オプションを使用して、これらの操作の最小および最大 I/O 速度を設定することにより制御できます。オプションは以下のように指定します。

--maxrecoveryrate Rate[bBsSkKmMgG]RAID 論理ボリュームの最大復旧速度を設定し、通常の I/O 操作が押し出されないようにします。速度 アレイ内の各デバイスに対して、1 秒あたりの量を指定します。接尾辞を指定しない場合は、kiB/sec/device (デバイスごとに kiB/秒) と見なされます。復旧速度を 0 に設定すると無制限になります。--minrecoveryrate Rate[bBsSkKmMgG]RAID 論理ボリュームの最小復旧速度を設定し、負荷の高い通常の I/O がある場合でも、sync操作の I/O が最小スループットを達成できるようにします。速度 アレイ内の各デバイスに対して、1 秒あたりの量を指定します。接尾辞を指定しない場合は、kiB/sec/device (デバイスごとに kiB/秒) と見なされます。

4.4.3.12. RAID テイクオーバー (Red Hat Enterprise Linux 7.4 以降)

リンクのコピーリンクがクリップボードにコピーされました!

LVM は、Raid テイクオーバー をサポートします。これは、RAID 論理ボリュームの RAID レベルを別のレベル (たとえば RAID 5 から RAID 6) へ変えることを意味します。RAID レベルの変更は、通常、デバイスの耐障害性を増減したり、論理ボリュームのストライプ化をやり直すために行われます。RAID テイクオーバーには lvconvert を使用します。RAID テイクオーバーの詳細と、lvconvert を使用して RAID 論理ボリュームを変換する例は、lvmraid(7)の man ページを参照してください。

4.4.3.13. RAID 論理ボリュームの再成形 (Red Hat Enterprise Linux 7.4 以降)

リンクのコピーリンクがクリップボードにコピーされました!

RAID 再成形 は、同じ RAID レベルを維持しつつ、RAID 論理ボリュームの属性を変更することを示しています。変更できる属性には、RAID レイアウト、ストライプのサイズ、ストライプの数などがあります。RAID 再成形と、lvconvert コマンドを使用して RAID 論理ボリュームを再生成する例は、lvmraid(7)の man ページを参照してください。

4.4.3.14. RAID1 論理ボリュームでの I/O 操作の制御

リンクのコピーリンクがクリップボードにコピーされました!

lvchange コマンドの

--writemostly パラメーターおよび --writebehind パラメーターを使用して、RAID1 論理ボリュームのデバイスの I/O 操作を制御できます。これらのパラメーターを使用する書式は以下のとおりです。

--[RAID]writemostly PhysicalVolume[:{t|y|n}]RAID1 論理ボリュームのデバイスをwrite-mostlyとしてマークします。これらのドライブのすべての読み取りは、必要でない限り回避されます。このパラメーターを設定することにより、ドライブに対する I/O 操作の回数を最小限に抑えることができます。デフォルトでは、論理ボリュームに指定した物理ボリュームのwrite-mostly属性を yes に設定します。:nを物理ボリュームに追加してwrite-mostlyフラグを削除したり、:tを指定して値を切り替えたりすることができます。--writemostly引数は、1 つのコマンドで複数回指定できるため、論理ボリューム内のすべての物理ボリュームに対して、一度に書き込み属性を切り替えることができます。--[raid]writebehind IOCountwrite-mostlyとしてマークされている RAID1 論理ボリュームのデバイスに許可される未処理の書き込みの最大数を指定します。この値を上回ると書き込みは同期され、設定要素になっているデバイスへの書き込みがすべて、アレイが書き込みの完了を知らせる前に完了してしまいます。この値をゼロに設定すると、設定はクリアになり、システムが値を任意に選択できるようになります。

4.4.3.15. RAID 論理ボリュームのリージョンサイズの変更 (Red Hat Enterprise Linux 7.4 以降)

リンクのコピーリンクがクリップボードにコピーされました!

RAID 論理ボリュームを作成すると、論理ボリュームのリージョンサイズは、

/etc/lvm/lvm.conf ファイルの raid_region_size パラメーターの値になります。このデフォルト値は、lvcreate コマンドの -R オプションで上書きできます。

RAID 論理ボリュームを作成したら、lvconvert コマンドの

-R オプションを使用してボリュームのリージョンサイズを変更できます。以下の例では、論理ボリューム vg/raidlv のリージョンサイズを 4096K に変更します。リージョンサイズを変更する場合は、RAID ボリュームを同期する必要があります。

lvconvert -R 4096K vg/raid1 Do you really want to change the region_size 512.00 KiB of LV vg/raid1 to 4.00 MiB? [y/n]: y Changed region size on RAID LV vg/raid1 to 4.00 MiB.

# lvconvert -R 4096K vg/raid1

Do you really want to change the region_size 512.00 KiB of LV vg/raid1 to 4.00 MiB? [y/n]: y

Changed region size on RAID LV vg/raid1 to 4.00 MiB.

4.4.4. ミラー化ボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

Red Hat Enterprise Linux 7.0 リリースの場合、「RAID 論理ボリューム」 で説明されているように、LVM は RAID 1/4/5/6/10 に対応します。RAID 論理ボリュームはクラスターには対応していません。RAID 論理ボリュームは、1 台のマシンに作成して排他的にアクティブにすることができますが、複数のマシンで同時にアクティブにすることはできません。排他的ではないミラー化されたボリュームが必要な場合は、このセクションで説明するように、セグメントタイプの

mirror を指定してボリュームを作成する必要があります。

注記

mirror セグメントタイプを指定した既存の LVM デバイスを RAID1 LVM デバイスに変換する方法は、「ミラー化 LVM デバイスの RAID1 デバイスへの変換」 を参照してください。

注記

ミラー化された LVM 論理ボリュームをクラスター内に作成するには、単一ノード上に

mirror のセグメントタイプでミラー化 LVM 論理ボリュームを作成するのと同じコマンドと手順が必要です。ただし、クラスター内にミラー化された LVM ボリュームを作成するには、クラスターとクラスターミラーインフラストラクチャーが実行中で、クラスターがクォーラムである必要があり、クラスターロッキングを有効にするには lvm.conf ファイルのロッキングタイプを適切に設定する必要があります。クラスター内におけるミラー化ボリュームの作成例は、「クラスター内でのミラー化 LVM 論理ボリュームの作成」 をご覧ください。

単一クラスター内の複数のノードから短時間に連続して複数の LVM ミラーを作成または変換するコマンドを実行しようとすると、これらのコマンドのバックログが生じる場合があります。これによって、要求した操作がタイムアウトになって失敗する可能性があります。この問題を回避するために、そのクラスターのいずれかのノードから、クラスターミラー作成コマンドを実行することを推奨します。

ミラー化ボリュームを作成する場合、lvcreate コマンドの

-m 引数で作成するデータのコピー数を指定します。-m1 を指定すると、ファイルシステムの 2 つのコピー (リニア論理ボリュームと 1 つのコピー) が作成されます。同様に、-m2 を指定すると 2 つのミラーを作成し、ファイルシステムの 3 つのコピーを生成します。

以下のコマンドは、ミラーが 1 つあるミラー化論理ボリュームを作成します。ボリュームのサイズは 50 ギガバイトで、

mirrorlv という名前であり、ボリュームグループ vg0 から取得されます。

lvcreate --type mirror -L 50G -m 1 -n mirrorlv vg0

# lvcreate --type mirror -L 50G -m 1 -n mirrorlv vg0

デフォルトでは、LVM ミラーデバイスは、複製されるデバイスを、サイズが 512KB のリージョンに分割します。lvcreate コマンドの

-R 引数を使用して、リージョンサイズをメガバイトで指定できます。また、lvm.conf ファイルで mirror_region_size 設定を編集して、デフォルトのリージョンサイズを変更することもできます。

注記

クラスターインフラストラクチャーの制限により、デフォルトのリージョンサイズ (512KB) では、1.5TB を超えるクラスターミラーは作成できません。1.5TB よりも大きなミラーを必要とするユーザーは、リージョンサイズをデフォルトよりも大きくする必要があります。リージョンサイズが小さいままだと、LVM の作成がハングしてします。また、その他の LVM コマンドでもハングの可能性があります。

1.5TB を超えるミラーのリージョンサイズを指定する一般的なガイドラインとして、lvcreate コマンドの

-R 引数としてその番号を使用して、ミラーサイズをテラバイトで取得し、その番号を次の 2 の累乗に上げることができます。たとえば、ミラーサイズが 1.5TB の場合は、-R 2 を指定できます。ミラーサイズが 3TB の場合は、-R 4 を指定できます。ミラーサイズが 5TB の場合、-R 8 を指定できます。

以下のコマンドは、リージョンサイズが 2MB のミラー化論理ボリュームを作成します。

lvcreate --type mirror -m 1 -L 2T -R 2 -n mirror vol_group

# lvcreate --type mirror -m 1 -L 2T -R 2 -n mirror vol_group

ミラーが作成されると、ミラーのリージョンは同期されます。ミラーコンポーネントが大きい場合は、同期プロセスに時間がかかる可能性があります。回復する必要のないミラーを新規に作成する場合は、最初のデバイスからの初期同期が不要であることを示す

--nosync 引数を指定できます。

LVM は、単一または複数のミラーと同期するリージョンを追跡するのに使用する小さなログを維持します。デフォルトでは、このログはディスクに保持され、再起動後も永続化するため、マシンが再起動/クラッシュするたびにミラーを再同期する必要はありません。

--mirrorlog 引数を使用すると、このログがメモリーで保持されるように指定できるため、余分なログデバイスが不要になります。ただし、この場合は、再起動のたびにミラー全体を再同期する必要がでてきます。

以下のコマンドは、ボリュームグループ

bigvg からミラー化論理ボリュームを作成します。論理ボリュームは ondiskmirvol という名前で、ミラーが 1 つあります。ボリュームのサイズは 12MB で、ミラーログをメモリーに保持します。

lvcreate --type mirror -L 12MB -m 1 --mirrorlog core -n ondiskmirvol bigvg Logical volume "ondiskmirvol" created

# lvcreate --type mirror -L 12MB -m 1 --mirrorlog core -n ondiskmirvol bigvg

Logical volume "ondiskmirvol" created

このミラーログは、ミラーレッグが作成されるデバイスとは異なるデバイスで作成されます。ただし、vgcreate コマンドの

--alloc anywhere 引数を使用して、ミラーレッグのいずれかと同じデバイスにミラーログを作成できます。ただし、これによりパフォーマンスが低下する場合がありますが、配下のデバイスが 2 つしかなくてもミラーを作成できます。

以下のコマンドは、単一のミラーを持つミラー化論理ボリュームを作成します。このミラーログはミラーレッグの 1 つと同じデバイス上にあります。この例では、ボリュームグループ

vg0 は 2 つのデバイスのみで設定されます。このコマンドを使用すると、ボリュームグループ vg0 に、名前が mirrorlv という名前の 500 MB のボリュームが作成されます。

lvcreate --type mirror -L 500M -m 1 -n mirrorlv -alloc anywhere vg0

# lvcreate --type mirror -L 500M -m 1 -n mirrorlv -alloc anywhere vg0注記

クラスター化されたミラーでは、ミラーログ管理は、その時点でクラスター ID の最も低いクラスターノードによって行われます。そのため、クラスターミラーログを保持するデバイスがクラスターのサブセット上で利用できなくなる場合、最も低い ID を持つクラスターノードがミラーログへのアクセスを保持する限り、クラスター化されたミラーは影響を受けることなく、機能を継続することができます。ミラーは影響を受けないため、自動修正アクション (修復) も実行されません。ただし、最も低い ID のクラスターノードがミラーログにアクセスできなくなると、(他のノードからログへのアクセスが可能かどうかにかかわらず) 自動アクションが作動します。

ミラーリングされているミラーログを作成するには、

--mirrorlog ミラーリングされた 引数を指定できます。以下のコマンドは、ボリュームグループ bigvg からミラー化論理ボリュームを作成します。論理ボリュームは twologvol という名前で、1 つのミラーがあります。このボリュームのサイズは 12MB で、ミラーログがミラー化され、各ログは別個のデバイス上に保管されます。

lvcreate --type mirror -L 12MB -m 1 --mirrorlog mirrored -n twologvol bigvg Logical volume "twologvol" created

# lvcreate --type mirror -L 12MB -m 1 --mirrorlog mirrored -n twologvol bigvg

Logical volume "twologvol" created

標準のミラーログと同様に、vgcreate コマンドの

--alloc anywhere 引数を使用すると、ミラーレッグと同じデバイスに冗長ミラーログを作成できます。これによってパフォーマンスが低下する可能性がありますが、各ログを別個のデバイス上に保管するための配下のデバイス数がミラーレッグに対して十分でない場合でも、冗長ミラーログの作成が可能となります。

ミラーが作成されると、ミラーのリージョンは同期されます。ミラーコンポーネントが大きい場合は、同期プロセスに時間がかかる可能性があります。回復する必要のないミラーを新規に作成する場合は、最初のデバイスからの初期同期が不要であることを示す

--nosync 引数を指定できます。

ミラーレッグとログ用に使用するデバイス、およびそのデバイスで使用するエクステントを指定することができます。ログを特定のディスクに強制するには、それが配置されるディスク上のエクステントを正確に 1 つ指定します。LVM は、コマンドラインでデバイスがリスト表示される順序を必ずしも優先しません。物理ボリュームがリストにあれば、それが割り当てが実行される唯一の領域になります。割り当て済みの物理エクステントがリストにある場合、そのエクステントは無視されます。

以下のコマンドは、単一のミラーとミラー化されない単一ログを持つミラー化論理ボリュームを作成します。ボリュームのサイズは 500 MB で、これは

mirrorlv という名前で、ボリュームグループ vg0 から取得されます。最初のミラーレッグはデバイス /dev/sda1 にあり、2 番目のミラーレッグはデバイス /dev/sdb1 にあり、ミラーログは /dev/sdc1 にあります。

lvcreate --type mirror -L 500M -m 1 -n mirrorlv vg0 /dev/sda1 /dev/sdb1 /dev/sdc1

# lvcreate --type mirror -L 500M -m 1 -n mirrorlv vg0 /dev/sda1 /dev/sdb1 /dev/sdc1

以下のコマンドは、ミラーが 1 つあるミラー化論理ボリュームを作成します。ボリュームのサイズは 500 MB で、これは

mirrorlv という名前で、ボリュームグループ vg0 から取得されます。最初のミラーレッグは、デバイス /dev/sda1 のエクステント 0 から 499、ミラーの 2 番目のレッグは、デバイス /dev/sdb1 のエクステント 0 から 499 に、ミラーログはデバイス /dev/sdc1 のエクステント 0 から始まります。エクステントサイズは 1MB です。指定されたエクステントのいずれかが割り当て済みである場合は、それらは無視されます。

lvcreate --type mirror -L 500M -m 1 -n mirrorlv vg0 /dev/sda1:0-499 /dev/sdb1:0-499 /dev/sdc1:0

# lvcreate --type mirror -L 500M -m 1 -n mirrorlv vg0 /dev/sda1:0-499 /dev/sdb1:0-499 /dev/sdc1:0注記

単一の論理ボリューム内でストライピングとミラーリングを併用することが可能です。論理ボリュームの作成と同時にミラーの数 (

--mirrors X) とストライプの数 (--stripes Y) を指定すると、ミラーデバイスの設定デバイスがストライプ化されます。

4.4.4.1. ミラー化論理ボリュームの障害ポリシー

リンクのコピーリンクがクリップボードにコピーされました!

lvm.conf ファイルの activation セクションにある mirror_image_fault_policy パラメーターおよび mirror_log_fault_policy パラメーターを使用すると、デバイスの障害が発生した場合にミラー化論理ボリュームがどのように動作するかを定義できます。これらのパラメーターが remove に設定されると、システムは障害のあるデバイスを削除して、そのデバイスなしで実行しようとします。これらのパラメーターが 割り当て に設定されると、システムは障害のあるデバイスを削除し、そのデバイスの代わりとなる新しいデバイスの領域の割り当てを試みます。代替に適切なデバイスと領域を割り当てることができない場合、このポリシーは remove ポリシーのように機能します。

デフォルトでは、

mirror_log_fault_policy パラメーターは allocate に設定されます。ログにこのポリシーを使用すると、処理が高速になり、クラッシュやシステムの再起動時にも同期状態を記憶する機能が維持されます。このポリシーを remove に設定すると、ログデバイスに障害が発生したときに、ミラーがインメモリーログを使用するよう変換されます。この場合、ミラーはクラッシュと再起動後に同期状態を記憶せず、ミラー全体が再同期されます。

デフォルトでは、

mirror_image_fault_policy パラメーターは remove に設定されます。このポリシーでは、ミラーイメージに障害が発生すると、良好なコピーが 1 つしか残っていない場合は、ミラーが非ミラー化デバイスに変換されます。ミラーデバイス用にこのポリシーを allocate に設定するには、ミラーでデバイスを再同期する必要があります。これは処理に時間がかかりますが、デバイスのミラー特性を保持します。

注記

LVM ミラーにデバイス障害が発生すると、2 段階の回復プロセスが実行されます。第 1 段階では、障害が発生したデバイスの削除が行われます。これによってミラーは、単一のリニアデバイスに縮小されます。第 2 段階では、

mirror_log_fault_policy パラメーターが allocate に設定されている場合、障害が発生したデバイスの置き換えを試みます。ただし、第 2 段階では、他のデバイスが利用可能である場合、ミラーが以前使用していたデバイスの中から、障害とは関係のないデバイスが選択されるという保証はない点に注意してください。

LVM ミラー障害の発生時に手作業で回復する方法については、「LVM ミラー障害からの回復」 を参照してください。

4.4.4.2. ミラー化論理ボリュームの冗長イメージの分割

リンクのコピーリンクがクリップボードにコピーされました!

ミラー化論理ボリュームの冗長イメージを分割して、新たな論理ボリュームを形成することができます。イメージを分割するには、lvconvert コマンドの

--splitmirrors 引数を使用して、分割する冗長イメージの数を指定します。コマンドの --name 引数を使用して、newly-split-off 論理ボリュームの名前を指定する必要があります。

以下のコマンドは、ミラー化論理ボリューム

vg/lv から、copy という名前の新しい論理ボリュームを分割します。新しい論理ボリュームには 2 つのミラーレッグが含まれます。この例では、LVM は分割するデバイスを選択しています。

lvconvert --splitmirrors 2 --name copy vg/lv

# lvconvert --splitmirrors 2 --name copy vg/lv

分割するデバイスを指定することが可能です。以下のコマンドは、ミラー化論理ボリューム

vg/lv から、copy という名前の新しい論理ボリュームを分割します。新しい論理ボリュームには、/dev/sdc1 と /dev/sde1 のデバイスで設定される 2 つのミラーレッグが含まれます。

lvconvert --splitmirrors 2 --name copy vg/lv /dev/sd[ce]1

# lvconvert --splitmirrors 2 --name copy vg/lv /dev/sd[ce]14.4.4.3. ミラー化論理ボリュームの修復

リンクのコピーリンクがクリップボードにコピーされました!

lvconvert --repair コマンドを使用すると、ディスク障害後にミラーを修復できます。これによって、ミラーは整合性のある状態に戻ります。lvconvert --repair コマンドは、インタラクティブなコマンドで、システムで障害が発生したデバイスの置き換えを試行するかどうかを指定するように求められます。

- プロンプトを省略して、障害が発生したデバイスをすべて置き換えるには、コマンドラインで

-yオプションを指定します。 - プロンプトを省略して、障害が発生したデバイスのいずれも置き換えるには、コマンドラインで

-fオプションを指定します。 - プロンプトを省略し、それでもミラーイメージとミラーログの代替ポリシーを示すには、

lvm.confファイルの mirror_log_fault_policy パラメーターおよびmirror_device_fault_policy--use-policies引数を指定します。

4.4.4.4. ミラー化ボリューム設定の変更

リンクのコピーリンクがクリップボードにコピーされました!

lvconvert コマンドを使用すると、論理ボリュームに含まれるミラーの数を増減できます。これにより、論理ボリュームをミラー化ボリュームからリニアボリュームに、またはリニアボリュームからミラー化ボリュームに変換できます。また、このコマンドを使用して、

corelog などの既存の論理ボリュームの他のミラーパラメーターを再設定することもできます。

リニアボリュームをミラー化ボリュームに変換する際には、既存ボリューム用にミラーレッグを作成することになります。つまり、ボリュームグループにはミラーレッグ用とミラーログ用のデバイスと領域がなければならないことを意味します。

ミラーレッグを 1 つ失うと、LVM はそのボリュームをリニアボリュームに変換するため、ミラーの冗長性なしにボリュームに引き続きアクセスできます。レッグを置き換えたら、lvconvert コマンドを使用してミラーを復元します。この手順は、「LVM ミラー障害からの回復」 で提供されています。

以下のコマンドは、リニア論理ボリューム

vg00/lvol1 をミラー化論理ボリュームに変換します。

lvconvert -m1 vg00/lvol1

# lvconvert -m1 vg00/lvol1

以下のコマンドは、ミラー化論理ボリューム

vg00/lvol1 をリニア論理ボリュームに変換し、ミラーレッグを削除します。

lvconvert -m0 vg00/lvol1

# lvconvert -m0 vg00/lvol1

以下の例は、既存の論理ボリューム

vg00/lvol1 にミラーレッグを追加します。この例は、lvconvert コマンドがボリュームを 2 つのミラーレッグを持つボリュームに変更する前後のボリュームの設定を示しています。

4.4.5. シンプロビジョニングされた論理ボリュームの作成

リンクのコピーリンクがクリップボードにコピーされました!

論理ボリュームは、シンプロビジョニングにできます。これにより、利用可能なエクステントよりも大きな論理ボリュームを作成できます。シンプロビジョニングを使用すると、シンプールと呼ばれる、空き領域のストレージプールを管理でき、アプリケーションで必要になった時に任意の数のデバイスに割り当てることができます。後でアプリケーションが実際に論理ボリュームに書き込むときに割り当てられるように、シンプールにバインドするデバイスを作成できます。シンプールは、ストレージ領域をコスト効率よく割り当てる必要がある場合に、動的に拡張できます。

注記

このセクションでは、シンプロビジョニングされた論理ボリュームを作成し、拡張するために使用する基本的なコマンドの概要を説明します。LVM シンプロビジョニングの詳細と、シンプロビジョニングされた論理ボリュームと共に LVM コマンドおよびユーティリティーを使用する方法は、lvmthin(7) man ページを参照してください。

注記

クラスターのノード間では、シンボリュームに対応していません。シンプールとそのすべてのシンボリュームは、1 つのクラスターノードで排他的にアクティブにする必要があります。

シンボリュームを作成する場合は、以下のタスクを実行します。

- vgcreate コマンドを使用して、ボリュームグループを作成します。

- lvcreate コマンドを使用して、シンプールを作成します。

- lvcreate コマンドを使用して、シンプール内にシンボリュームを作成します。

lvcreate コマンドに

-T (または --thin)オプションを使用して、シンプールまたはシンボリュームを作成できます。また、lvcreate の -T オプションを使用して、1 つのコマンドで同時にプール内にシンプールとシンボリュームの両方を作成することもできます。

以下のコマンドは、lvcreate コマンドの

-T オプションを使用して、mythinpool という名前のシンプールを作成します。これは、ボリュームグループ vg001 にあり、サイズは 100M です。物理領域のプールを作成しているため、プールのサイズを指定する必要があります。lvcreate コマンドの -T オプションは引数を取りません。コマンドで指定する他のオプションから、作成されるデバイスのタイプが推測されます。

以下のコマンドは、lvcreate コマンドの

-T オプションを使用して、シンプール vg001/mythinpool に thinvolume という名前のシンボリュームを作成します。ここでは、ボリュームを含むプールよりも大きなボリュームの仮想サイズを指定している点に注意してください。

以下のコマンドは、lvcreate コマンドに

-T オプションを使用して、プール内にシンプールとシンボリュームを作成します。これは、lvcreate コマンドにサイズと仮想サイズ引数の両方を指定します。このコマンドは、ボリュームグループ vg001 にシンプール mythinpool を作成し、そのプールに thinvolume という名前の シンボリューム も作成します。

また、lvcreate コマンドの

--thinpool パラメーターを指定して、シンプールを作成することもできます。-T オプションとは異なり、- thinpool パラメーターには、作成するシンプール論理ボリュームの名前である引数が必要です。以下の例は、lvcreate コマンドで --thinpool パラメーターを指定して、mythinpool という名前のシンプールを作成します。これは、ボリュームグループ vg001 にあり、サイズは 100M です。

チャンクサイズを使用するには、以下の基準を使用します。

- チャンクサイズが小さいほどメタデータが大きくなり、パフォーマンスが妨げられますが、スナップショットによる領域使用率が向上します。

- 大規模なチャンクサイズではメタデータ操作が少なくなりますが、スナップショットの効率が低くなります。

LVM2 は、以下のようにチャンクサイズを計算します。

デフォルトでは、LVM は 64KiB のチャンクサイズで始まり、シンプールメタデータデバイスのサイズが 128MiB を超えると、その値を増やします。これにより、メタデータサイズが圧縮されます。これにより、チャンクサイズの値が大きくなるため、スナップショットの使用効率が低くなります。この場合、チャンクのサイズが小さく、メタデータサイズが大きくなる方が適しています。

ボリュームデータサイズが TiB の範囲にある場合は、サポートされる最大サイズであるメタデータサイズとして ~15.8GiB を使用し、要件に応じてチャンクサイズを設定します。ただし、このボリュームデータサイズを拡張し、チャンクサイズを小さくする必要がある場合は、メタデータサイズを拡大することはできません。

警告

Red Hat は、少なくともデフォルトのチャンクサイズを使用することを推奨します。チャンクサイズが小さすぎる場合で、ボリュームのメタデータの容量が不足すると、ボリュームはデータを作成できません。論理ボリュームを監視して、拡張またはメタデータボリュームが完全に満杯になる前にストレージをさらに作成します。メタデータ用の領域が不足しないように、シンプールのチャンクサイズは十分な大きさになるようにしてください。

プールの作成で、ストライピングに対応しています。以下のコマンドは、2 つの 64 kB ストライプと 256 kB のチャンクサイズを持つボリュームグループ

vg001 に pool という名前の 100M シン プール を作成します。また、1T のシンボリューム vg00/thin_lv も作成します。

lvcreate -i 2 -I 64 -c 256 -L 100M -T vg00/pool -V 1T --name thin_lv

# lvcreate -i 2 -I 64 -c 256 -L 100M -T vg00/pool -V 1T --name thin_lv

lvextend コマンドを使用して、シンボリュームのサイズを拡張できます。ただし、シンプールのサイズを縮小することはできません。

以下のコマンドは、既存のシンプールのサイズ (100M) を変更し、100M 拡張します。

他の論理ボリュームのタイプと同様に、lvrename を使用してボリュームの名前を変更したり、lvremove でボリュームを削除したりできます。また、lvs コマンドおよび lvdisplay コマンドを使用してボリュームの情報を表示できます。

デフォルトでは、lvcreate コマンドは、式(Pool_LV_size / Pool_LV_chunk_size * 64)に従って、シンプールのメタデータ論理ボリュームのサイズを設定します。スナップショットが大量にある場合や、シンプールのサイズが小さく、後で大きくなることが予測される場合は、lvcreate コマンドの