管理ガイド

Red Hat Enterprise Virtualization の管理タスク

概要

第1章 Red Hat Enterprise Virtualization 環境の管理とメンテナンス

- ホストや仮想マシンなどの物理/仮想リソースの管理。これには、ホストのアップグレードや追加、ドメインのインポート、異種のハイパーバイザーで作成された仮想マシンの変換、仮想マシンプールのメンテナンスなどが含まれます。

- 1 台のホストに対する過度の負荷やメモリー/ディスク容量の不足などの潜在的な問題を特定するためのシステムリソース全体のモニタリングと必要措置の実施 (例: 仮想マシンを別のホストに移行して負荷を軽減したり、マシンをシャットダウンしてリソースを解放したりするなど) 。

- 仮想マシンの新規要件への対応 (例: オペレーティングシステムのアップグレード、追加メモリー割り当てなど)。

- タグを使用してカスタマイズしたオブジェクトプロパティーの管理

- 公開ブックマークとして保存した検索の管理

- ユーザー設定の管理やパーミッションレベルの設定

- 特定のユーザー、仮想マシン、またはシステム全体の機能のトラブルシューティング

- 一般レポートおよび明細レポートの生成

1.1. グローバル設定

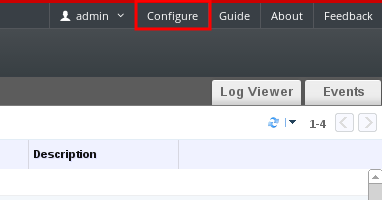

図1.1 設定ウィンドウへのアクセス

1.1.1. ロール

1.1.1.1. 新規ロールの作成

手順1.1 新規ロールの作成

- ヘッダーバーで 設定 ボタンをクリックすると 設定 ウィンドウが開きます。このウィンドウには、デフォルトのユーザー/管理者ロールとカスタムロールの一覧が表示されます

- 新規作成 をクリックすると 新規ロール のウィンドウが開きます。

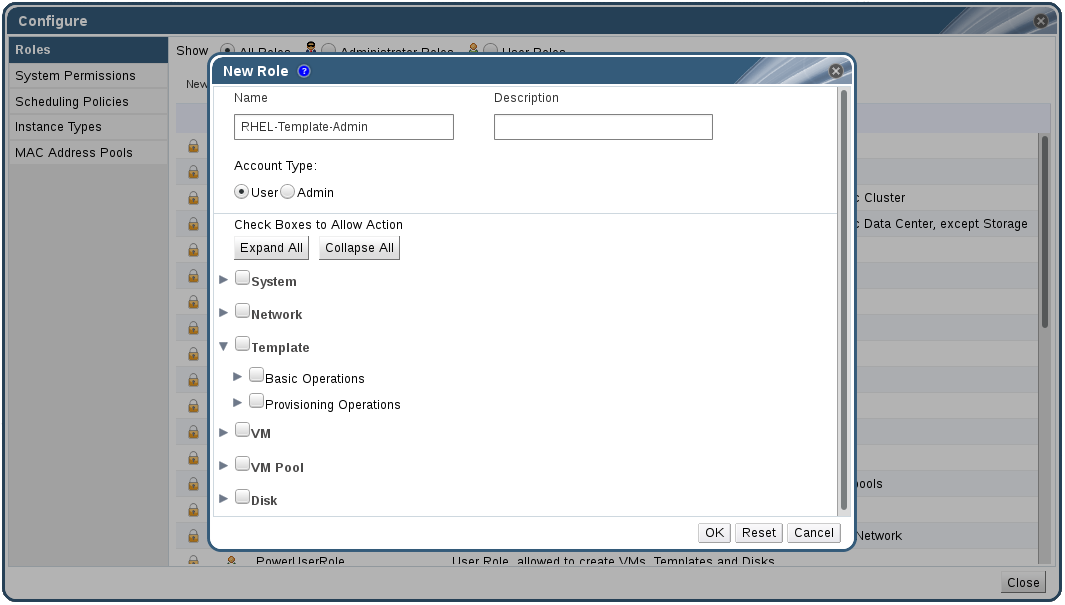

図1.2 新規ロールのウィンドウ

- 新規ロールの 名前 と 説明 を入力します。

- アカウントタイプ に 管理者 または ユーザー のいずれかを選択します。

- 操作を許可するチェックボックス の一覧に表示されているオブジェクトに対するパーミッションは、 または ボタンを使用して表示を展開または折りたたむことができます。また、オブジェクト別にオプションを展開または折りたたむことも可能です。

- オブジェクト別に、設定中のロールで許可するアクションにはチェックを入れ、許可しないアクションからはチェックを外します。

- をクリックして、変更を適用します。ロールの一覧に新規ロールが表示されます。

1.1.1.2. ロールの編集とコピー

手順1.2 ロールの編集とコピー

- ヘッダーバーで 設定 ボタンをクリックすると 設定 ウィンドウが開きます。このウィンドウには、デフォルトのユーザー/管理者ロールとカスタムロールの一覧が表示されます

- 変更するロールを選択し、編集 をクリックすると ロールの編集 ウィンドウが開きます。また、コピー をクリックすると、ロールのコピー ウィンドウが開きます。

- 必要な場合には、ロールの 名前 と 説明 を編集します。

- 一覧表示されているオブジェクトに対するパーミッションは、 または のボタンを使用して表示を展開または折り畳むことができます。また、オブジェクト別にオプションを展開または折り畳むことも可能です。

- オブジェクト別に、編集中のロールで許可するアクションにはチェックを入れ、許可しないアクションからはチェックを外します。

- をクリックして、変更を適用します。

1.1.1.3. ユーザーロールと認証の例

例1.1 クラスターのパーミッション

Accounts という名前の Red Hat Enterprise Virtualization クラスターにまとめられています。Sarah は、このクラスターの ClusterAdmin ロールを割り当てられました。仮想マシンはクラスターの子オブジェクトであるため、クラスター内の全仮想マシンを管理できるようになります。仮想マシンの管理には、ディスクなどの仮想リソースの編集/追加/削除や、スナップショットの作成などが含まれますが、このクラスター外のリソースは一切管理できません。ClusterAdmin は管理者ロールなので、管理ポータルを使用してこれらのリソースを管理できますが、ユーザーポータルを介したアクセスは一切提供されません。

例1.2 VM PowerUser のパーミッション

johndesktop という仮想デスクトップを作成しました。John には、johndesktop 仮想マシンに対する UserVmManager ロールが割り当てられました。これによって、John は、ユーザーポータルを使用してこの 1 台の仮想マシンにアクセスすることができます。UserVmManager のパーミッションがあるので、仮想マシンの設定を変更したり、新規仮想ディスクなどのリソースを追加したりすることができます。UserVmManager はユーザーロールであるため、管理ポータルは使用できません。

例1.3 データセンターパワーユーザーロールのパーミッション

PowerUserRole パーミッションが割り当てられました。新規仮想マシンを作成する際には、ストレージドメイン内での仮想マシンディスクイメージ作成など、そのデータセンター内のいくつかのコンポーネントに変更を加える必要があるためです。

DataCenterAdmin の権限を Penelope に割り当てるのとは異なる点に注意してください。Penelope はデータセンターの PowerUser としてユーザーポータルにログインし、そのデータセンター内の仮想マシンに対して仮想マシン固有のアクションを実行することができますが、データセンターへのホストやストレージのアタッチなど、データセンターレベルの操作は実行できません。

例1.4 ネットワーク管理者のパーミッション

NetworkAdmin の権限があると、そのデータセンター内でのネットワークの追加/削除や、そのデータセンターに属する全仮想マシン用のネットワークのアタッチ/デタッチが可能です。

VnicProfileUser パーミッションと UserVmManager パーミッションを Pat に付与しました。Pat はこれらのパーミッションを使用して、ユーザーポータル の 拡張 タブで、仮想マシンへのネットワークインターフェース追加など、簡単な管理タスクを実行することができますが、仮想マシンを実行しているホストのネットワークや、仮想マシンが属するデータセンターのネットワークを変更するパーミッションはありません。

例1.5 カスタムロールのパーミッション

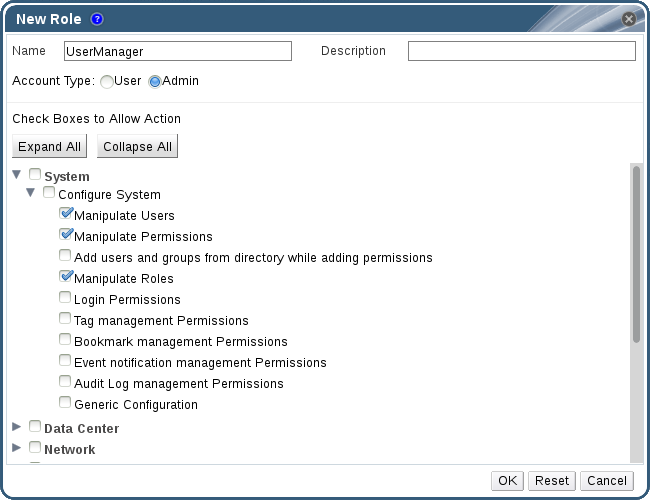

図1.3 UserManager のカスタムロール

システム 下にまとめられており、システム内のその他すべてのオブジェクトに適用されることになります。ロールには、管理者 の アカウントタイプ が指定されています。これにより、Rachel がこのロールを割り当てられると、管理ポータルは使用できますが、ユーザーポータルは使用できないことになります。

1.1.2. システムパーミッション

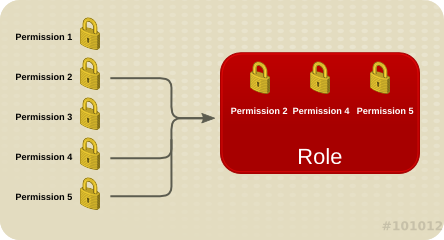

図1.4 パーミッッション & ロール

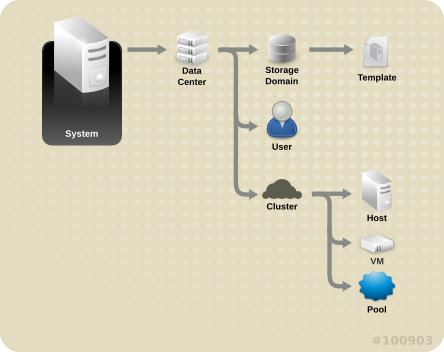

図1.5 Red Hat Enterprise Virtualization のオブジェクト階層

1.1.2.1. ユーザーのプロパティー

1.1.2.2. ユーザーロールと管理者ロール

- 管理者ロール: 管理ポータル を使用して物理/仮想リソースを管理できます。管理者ロールにより、ユーザーポータルで操作を行うためのパーミッションも付与されますが、このパーミッションは、ユーザーポータルでユーザーに何が表示されるかとは関係ありません。

- ユーザーロール: ユーザーポータル を使用して仮想マシンやテンプレートの管理とアクセスができます。ユーザーロールにより、ユーザーポータルでそのユーザーに表示される項目が決定します。管理者ロールが設定されたユーザーに付与されるパーミッションは、ユーザーポータルでそのユーザーが行うことができる操作に反映されます。

administrator ロールが割り当てられている場合は、管理ポータル を使用してクラスター内の仮想マシンを管理することができますが、ユーザーポータル 内の仮想マシンには一切アクセスすることはできません。そのためには、user ロールが必要です。

1.1.2.3. ユーザーロール

| ロール | 特権 | 備考 |

|---|---|---|

| UserRole | 仮想マシンとプールにアクセスして使用することができます。 | ユーザーポータルにログインし、割り当てられた仮想マシンとプールを使用したり、仮想マシンのステータスや詳細情報を確認したりすることができます。 |

| PowerUserRole | 仮想マシンとテンプレートの作成および管理ができます。 | このロールをユーザーに適用するには、設定 ウィンドウを使用して環境全体で設定するか、特定のデータセンターまたはクラスターで設定します。たとえば、PowerUserRole がデータセンターレベルで適用されると、PowerUser はそのデータセンター内で仮想マシンおよびテンプレートの作成ができます。 |

| UserVmManager | 仮想マシンのシステム管理者 | 仮想マシンの管理およびスナップショットの作成と使用ができます。ユーザーポータル内で仮想マシンを作成したユーザーには、そのマシンに対する UserVmManager ロールが自動的に割り当てられます。 |

| ロール | 特権 | 備考 |

|---|---|---|

| UserTemplateBasedVm | テンプレートのみを使用できる制限付き権限 | テンプレートを使用して仮想マシンを作成することができます。 |

| DiskOperator | 仮想ディスクのユーザー | 仮想ディスクの使用/表示/編集ができます。仮想ディスクがアタッチされた仮想マシンを使用するパーミッションは継承されます。 |

| VmCreator | ユーザーポータルで仮想マシンを作成することができます。 | このロールは特定の仮想マシンに適用するのではなく、設定 ウィンドウから全環境でユーザーに適用するか、特定のデータセンターまたはクラスターに適用します。クラスターにこのロールを適用する場合は、データセンター全体、または特定のストレージドメインに対して DiskCreator ロールも適用する必要があります。 |

| TemplateCreator | 割り当てられたリソース内で仮想マシンのテンプレートの作成/編集/管理/削除ができます。 | このロールは個別のテンプレートに適用されません。設定 ウィンドウを使用して、環境全体でこのロールをユーザーに適用します。または、特定のデータセンター、クラスター、ストレージドメインでこのロールを適用します。 |

| DiskCreator | 割り当てられたクラスターまたはデータセンター内で仮想マシンディスクの作成/編集/管理/削除ができます。 | このロールは個別の仮想ディスクに適用されません。環境全体でこのロールをユーザーに適用するには 設定 ウィンドウを使用します。または、特定のデータセンター/ストレージドメインを対象にこのロールを適用します。 |

| TemplateOwner | テンプレートの編集や削除、またテンプレートのユーザーパーミッションの割り当てや管理ができます。 | このロールは、テンプレートを作成したユーザーに自動的に割り当てられます。テンプレートに対する TemplateOwner パーミッションのないその他のユーザーは、そのテンプレートを表示または使用することはできません。 |

| VnicProfileUser | 仮想マシンおよびテンプレートの論理ネットワークおよびネットワークインターフェースのユーザー | 特定の論理ネットワークにネットワークインターフェースをアタッチ/デタッチできます。 |

1.1.2.4. 管理者ロール

| ロール | 権限 | 備考 |

|---|---|---|

| SuperUser | Red Hat Enterprise Virtualization 環境のシステム管理者 | すべてのオブジェクトおよびレベルに対する完全なパーミッションがあり、全データセンターの全オブジェクトを管理できます。 |

| ClusterAdmin | クラスターの管理者 | 特定のクラスター下の全オブジェクトに対する管理者パーミッションがあります。 |

| DataCenterAdmin | データセンターの管理者 | ストレージを除く特定のデータセンター下の全オブジェクトに対する管理者パーミッションがあります。 |

重要

| ロール | 権限 | 備考 |

|---|---|---|

| TemplateAdmin | 仮想マシンテンプレートの管理者 | ストレージドメインやテンプレートのネットワーク詳細の作成/削除/設定やドメイン間のテンプレートの移動ができます。 |

| StorageAdmin | ストレージの管理者 | 割り当て済みのストレージドメインを作成/削除/設定/管理できます。 |

| HostAdmin | ホストの管理者 | 特定のホストをアタッチ/削除/設定/管理できます。 |

| NetworkAdmin | ネットワークの管理者 | 特定のデータセンターまたはクラスターのネットワークの設定と管理ができます。データセンターまたはクラスターのネットワーク管理者は、クラスター内の仮想プールに対するネットワークパーミッションも継承します。 |

| VmPoolAdmin | 仮想プールのシステム管理者 | 仮想プールの作成/削除/設定、仮想プールユーザーの割り当て/削除、およびプール内の仮想マシンに対する基本操作ができます。 |

| GlusterAdmin | Gluster ストレージ管理者 | Gluster ストレージボリュームを作成、削除、設定、管理することができます。 |

| VmImporterExporter | 仮想マシンのインポート/エクスポートに関する管理者 | 仮想マシンのインポートとエクスポートを実行することが可能です。また、他のユーザーによってエクスポートされた仮想マシンとテンプレートをすべて表示することができます。 |

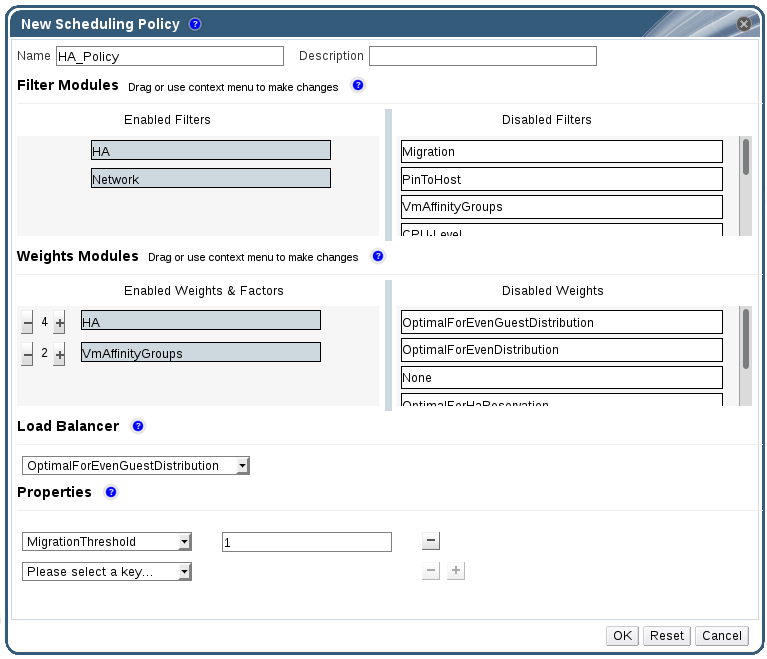

1.1.3. スケジューリングポリシー

1.1.3.1. スケジューリングポリシーの作成

手順1.3 スケジューリングポリシーの作成

- 管理ポータルのヘッダーバーで ボタンをクリックして 設定 ウィンドウを開きます。

- スケジューリングポリシー をクリックしてスケジューリングポリシーのタブを表示します。

- をクリックして 新規スケジューリングポリシー ウィンドウを開きます。

図1.6 新規スケジューリングポリシーウィンドウ

- スケジューリングポリシーの 名前 と 説明 を入力します。

- フィルターモジュールを設定します。

- フィルターモジュール セクションで、スケジューリングポリシーに適用する対象のフィルターモジュールを 無効なフィルター セクションから 有効なフィルター セクションにドラッグ&ドロップします。

- 特定のフィルターモジュールを 最初 に設定して優先順位を最も高くすることや、最後 に設定して優先順位を最も低くして基本的な最適化を行うことも可能です。優先順位を設定するには、任意のフィルターモジュールを右クリックし、カーソルで 位置 をポイントして 最初 または 最後 を選択します。

- 加重値モジュールを設定します。

- 加重値モジュール セクションで、スケジューリングポリシーに適用する対象の加重値モジュールを 無効な加重値 セクションから 有効な加重値と係数 セクションにドラッグ&ドロップします。

- 有効な加重値と係数の左側にある または ボタンを使用して、それらのモジュールの加重値を増減します。

- 負荷分散ポリシーを指定します。

- ロードバランサー セクションのドロップダウンメニューで、スケジューリングポリシーに適用する負荷分散ポリシーを選択します。

- プロパティー セクションのドロップダウンメニューで、スケジューリングポリシーに適用する負荷分散のプロパティーを選択し、そのプロパティーの右側にあるテキストフィールドに値を指定します。

- または ボタンを使用して、プロパティーを追加/削除します。

- をクリックします。

1.1.3.2. 新規スケジューリングポリシーおよびスケジューリングポリシーの編集ウィンドウの設定

|

フィールド名

|

説明

|

|---|---|

|

名前

|

スケジューリングポリシーの名前。ここで指定した名前は、Red Hat Enterprise Virtualization Manager でスケジューリングポリシーを参照するのに使用されます。

|

|

説明

|

スケジューリングポリシーの説明。このフィールドへの入力は推奨されますが、必須ではありません。

|

|

フィルターモジュール

|

クラスター内の仮想マシンを実行することのできるホストを制御するためのフィルターのセット。フィルターを有効にすると、そのフィルターにより指定されている以下のような条件を満たさないホストは除外されます。

|

|

加重値モジュール

|

仮想マシンを実行することのできるクラスター内のホストを決定する際に考慮される要素の相対的な優先順位を制御するための加重値

|

|

ロードバランサー

|

このドロップダウンメニューにより、適用する負荷分散モジュールを選択することができます。負荷分散モジュールは、高使用率から低使用率のホストへの仮想マシン移行に使用されるロジックを決定します。

|

|

プロパティー

|

このドロップダウンメニューでは、負荷分散モジュールのプロパティーを追加/削除することができます。このメニューは、スケジューリングポリシーで負荷分散モジュールを選択した場合にのみに利用できます。デフォルトではプロパティーは定義されず、提供されるプロパティーは選択した負荷分散モジュール固有です。 または ボタンを使用して負荷分散モジュールにプロパティーを追加/削除します。

|

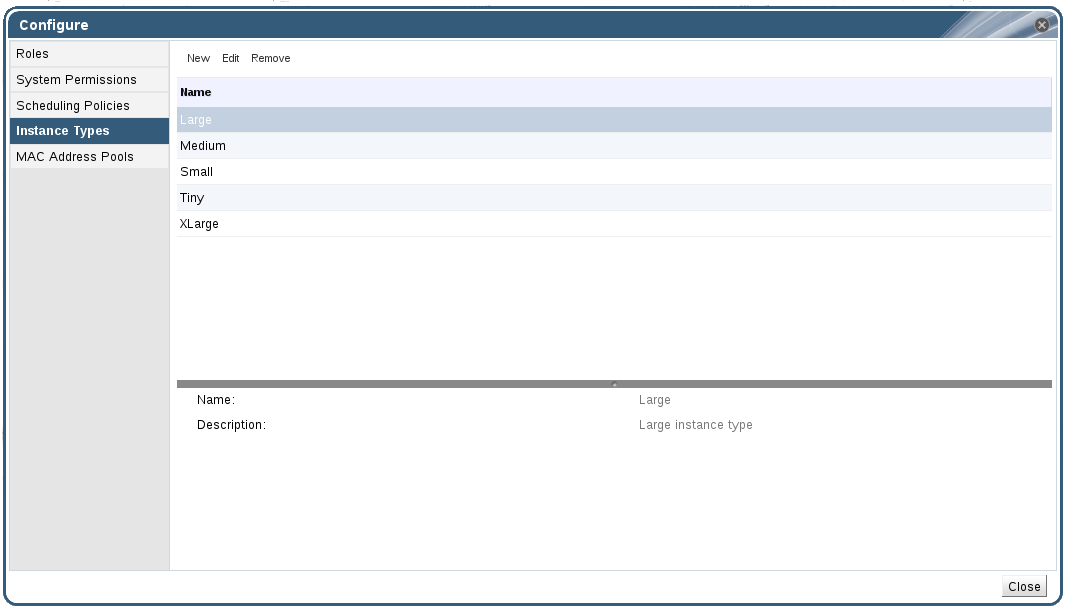

1.1.4. インスタンスのタイプ

|

名前

|

メモリー

|

VCPU

|

|---|---|---|

|

Tiny

|

512 MB

|

1

|

|

Small

|

2 GB

|

1

|

|

Medium

|

4 GB

|

2

|

|

Large

|

8 GB

|

2

|

|

XLarge

|

16 GB

|

4

|

図1.7 インスタンスタイプのタブ

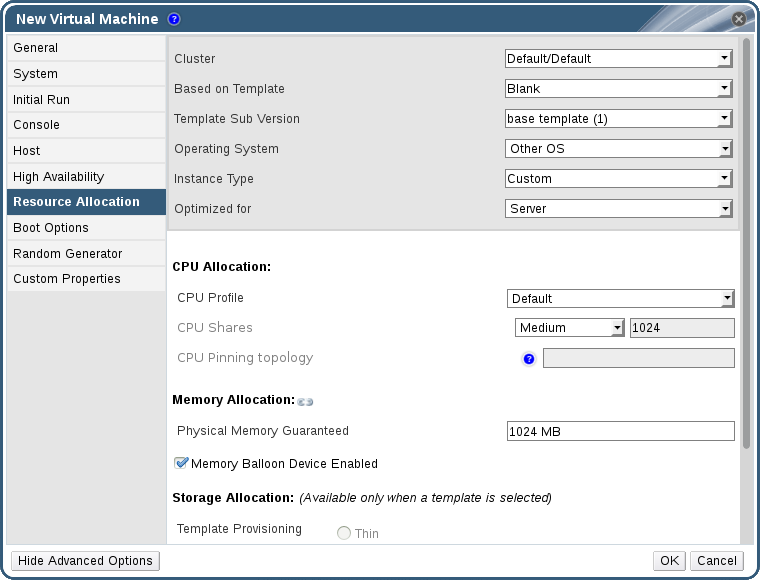

). If the value of one of these fields is changed, the virtual machine will be detached from the instance type, changing to Custom, and the chain will appear broken (

). If the value of one of these fields is changed, the virtual machine will be detached from the instance type, changing to Custom, and the chain will appear broken (

). However, if the value is changed back, the chain will relink and the instance type will move back to the selected one.

). However, if the value is changed back, the chain will relink and the instance type will move back to the selected one.

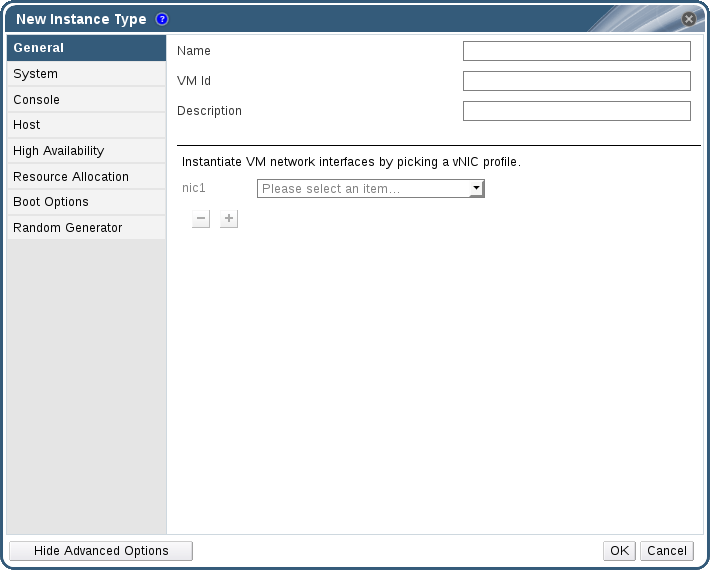

1.1.4.1. インスタンスタイプの作成

手順1.4 インスタンスタイプの作成

- ヘッダーバーで 設定 をクリックします。

- インスタンスタイプ タブを開きます。

- をクリックして、新規インスタンスタイプ ウィンドウを開きます。

図1.8 新規インスタンスタイプのウィンドウ

- インスタンスタイプの 名前 と 説明 を入力します。

- をクリックし、必要に応じて、インスタンスタイプの項目を設定します。新規インスタンスタイプ ウィンドウに表示される設定項目は、新規仮想マシン ウィンドウの設定項目と同じですが、関連するフィールドのみが表示されます。『仮想マシン管理ガイド』の「新規仮想マシンおよび仮想マシンの編集ウィンドウの設定」のセクションを参照してください。

- をクリックします。

1.1.4.2. インスタンスタイプの編集

手順1.5 インスタンスタイプのプロパティーの編集

- ヘッダーバーで をクリックします。

- タブをクリックします。

- 編集するインスタンスタイプを選択します。

- をクリックして インスタンスタイプの編集 ウィンドウを開きます。

- 必要に応じて設定を変更します。

- をクリックします。

1.1.4.3. インスタンスタイプの削除

手順1.6 インスタンスタイプの削除

- ヘッダーバーで をクリックします。

- タブをクリックします。

- 削除するインスタンスタイプを選択します。

- をクリックして インスタンスタイプの削除 ウィンドウを開きます。

- いずれかの仮想マシンが削除するインスタンスタイプをベースとしている場合には、アタッチされている仮想マシンが一覧表示された警告のウィンドウが表示されます。このインスタンスタイプの削除を続行するには、操作を承認 のチェックボックスを選択して OK をクリックします。続行しない場合には をクリックします。

- をクリックします。

1.1.5. MAC アドレスプール

1.1.5.1. MAC アドレスプールの作成

手順1.7 MAC アドレスプールの作成

- ヘッダーバーで 設定 ボタンをクリックして ウィンドウを開きます。

- MAC アドレスプール タブをクリックします。

- ボタンをクリックして、MAC アドレスプールの新規作成 ウィンドウを開きます。

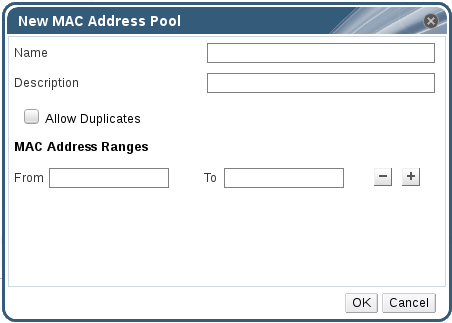

図1.9 MAC アドレスプールの新規作成ウィンドウ

- 新規作成する MAC アドレスプールの 名前 と 説明 を入力します。

- 1 つのプールで同じ MAC アドレスを複数回使用できるようにするには、重複を許可する チェックボックスを選択します。MAC アドレスプールは、重複した MAC アドレスを自動的には使用しませんが、重複のオプションを有効にすると、ユーザーは重複した MAC アドレスを手動で指定することができます。

注記

1 つの MAC アドレスプールで重複のオプションを無効にし、別の MAC アドレスプールで重複のオプションを有効にした場合には、重複が無効な MAC アドレスプールでは、各 MAC アドレスを 1 回しか使用できませんが、重複のオプションが有効なプールでは、MAC アドレスを複数回使用することができます。 - 必要な MAC アドレス範囲 を指定します。複数の範囲を入力するには、範囲の先頭 と 範囲の末尾 のフィールドの横にあるプラス (+) のボタンをクリックします。

- をクリックします。

1.1.5.2. MAC アドレスプールの編集

手順1.8 MAC アドレスプールのプロパティー

- ヘッダーバーで 設定 ボタンをクリックして ウィンドウを開きます。

- MAC アドレスプール タブをクリックします。

- 編集する MAC アドレスプールを選択します。

- ボタンをクリックすると、MAC アドレスプールの編集 ウィンドウが開きます。

- 必要に応じて、名前、説明、重複を許可する、MAC アドレスの範囲 のフィールドを変更します。

注記

MAC アドレス範囲の更新時に、既存の NIC の MAC アドレスは再割り当てされません。割り当て済みの MAC アドレスが、新しい MAC アドレスの範囲外となった場合には、ユーザー指定の MAC アドレスとして追加され、その MAC アドレスプールによって引き続きトラッキングされます。 - をクリックします。

1.1.5.3. MAC アドレスプールのパーミッションの編集

手順1.9 MAC アドレスプールのパーミッションの編集

- ヘッダーバーで 設定 ボタンをクリックして 設定 ウィンドウを開きます。

- MAC アドレスプール タブをクリックします。

- 対象の MAC アドレスプールを選択します。

- MAC アドレスプールのユーザーパーミッションを編集します。

- MAC アドレスプールにユーザーパーミッションを追加するには、以下の手順を実行します。

- 設定 ウィンドウの最下部にあるユーザーパーミッションペインで 追加 をクリックします。

- 対象のユーザーを検索して選択します。

- 割り当てるロール ドロップダウンリストから必要なロールを選択します。

- OK をクリックすると、ユーザーパーミッションが追加されます。

- MAC アドレスプールからユーザーパーミッションを削除するには、以下の手順を実行します。

- 設定 ウィンドウの最下部にあるユーザーパーミッションペインで削除するユーザーパーミッションを選択します。

- 削除 をクリックすると、ユーザーパーミッションが削除されます。

1.1.5.4. MAC アドレスプールの削除

手順1.10 MAC アドレスプールの削除

- ヘッダーバーで 設定 ボタンをクリックして ウィンドウを開きます。

- MAC アドレスプール タブをクリックします。

- 削除する MAC アドレスプールを選択します。

- ボタンをクリックして、MAC アドレスプールの削除 ウィンドウを開きます。

- をクリックします。

パート I. リソースの管理

第2章 QoS (Quality of Service)

2.1. ストレージ QoS

2.1.1. ストレージ QoS エントリーの作成

手順2.1 ストレージ QoS エントリーの作成

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインで QoS タブをクリックします。

- ストレージ をクリックします。

- をクリックします。

- QoS 名 のフィールドに QoS エントリーの名前を入力します。

- 説明 フィールドに QoS エントリーの説明を入力します。

- スループットの QoS を指定します。

- スループット のチェックボックスを選択します。

- 合計 のフィールドに総スループットの最大許容値を入力します。

- 読み取り フィールドに読み取り操作の最大許容スループットを入力します。

- 書き込み フィールドに書き込み操作の最大許容スループットを入力します。

- 入出力の QoS を指定します。

- IOps のチェックボックスを選択します。

- 合計 のフィールドに入出力操作の最大許容数を入力します。

- 読み取り のフィールドに入力操作の最大許容数を入力します。

- 書き込み のフィールドに出力操作の最大許容数を入力します。

- をクリックします。

2.1.2. ストレージ QoS エントリーの削除

手順2.2 ストレージ QoS エントリーの削除

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインで QoS タブをクリックします。

- ストレージ をクリックします。

- 削除するストレージ QoS エントリーを選択します。

- をクリックします。

- プロンプトが表示されたら をクリックします。

[無制限] に設定されます。

2.2. 仮想マシンネットワークの QoS

重要

2.2.1. 仮想マシンネットワーク QoS エントリーの作成

手順2.3 仮想マシンネットワーク QoS エントリーの作成

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインの QoS タブをクリックします。

- をクリックします。

- ボタンをクリックします。

- 名前 のフィールドに仮想マシンネットワーク QoS エントリーの名前を入力します。

- 受信 および 送信 ネットワークトラフィックの上限値を入力します。

- をクリックします。

2.2.2. 新規仮想マシンネットワーク QoS の設定および 仮想マシンネットワーク QoS の編集ウィンドウ

|

フィールド名

|

説明

|

|---|---|

|

データセンター

|

仮想マシンネットワーク QoS ポリシーを追加するデータセンター。このフィールドは、選択されているデータセンターによって自動的に設定されます。

|

|

名前

|

Manager 内で表示される仮想マシンネットワーク QoS ポリシーの名前

|

|

受信

|

受信トラフィックに適用される設定。この設定を有効にするには 受信 チェックボックスにチェックを入れ、無効にするには外します。

|

|

送信

|

送信トラフィックに適用される設定。この設定を有効にするには 送信 チェックボックスにチェックを入れ、無効にするには外します。

|

2.2.3. 仮想マシンネットワーク QoS エントリーの削除

手順2.4 仮想マシンネットワーク QoS エントリーの削除

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインの QoS タブをクリックします。

- 仮想マシンネットワーク を選択します。

- 削除する仮想マシンネットワーク QoS エントリーを選択します。

- をクリックします。

- プロンプトが表示されたら をクリックします。

2.3. ホストネットワークの QoS

2.3.1. ホストネットワーク QoS エントリーの作成

手順2.5 ホストネットワーク QoS エントリーの作成

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインで QoS タブをクリックします。

- ホストネットワーク をクリックします。

- をクリックします。

- QoS 名 のフィールドに QoS エントリーの名前を入力します。

- 説明 フィールドに QoS エントリーの説明を入力します。

- 加重シェア、速度の上限 [Mbps]、および コミット速度 [Mbps] に適切な値を入力します。

- をクリックします。

2.3.2. 「新規ホストネットワーク QoS」と「ホストネットワーク QoS の編集」の設定

|

フィールド名

|

説明

|

|---|---|

|

データセンター

|

ホストネットワーク QoS ポリシーを追加するデータセンター。このフィールドは、選択されているデータセンターによって自動的に設定されます。

|

|

QoS 名

|

Manager 内で表示されるホストネットワーク QoS ポリシーの名前

|

|

説明

|

ホストネットワーク QoS ポリシーの説明

|

|

送信

|

送信トラフィックに適用される設定

|

2.3.3. ホストネットワーク QoS エントリーの削除

手順2.6 ホストネットワーク QoS エントリーの削除

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインの QoS タブをクリックします。

- ホストネットワーク をクリックします。

- 削除するネットワーク QoS エントリーを選択します。

- をクリックします。

- プロンプトが表示されたら をクリックします。

2.4. CPU QoS

2.4.1. CPU QoS エントリーの作成

手順2.7 CPU QoS エントリーの作成

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインで QoS タブをクリックします。

- CPU をクリックします。

- をクリックします。

- QoS 名 のフィールドに QoS エントリーの名前を入力します。

- 説明 フィールドに QoS エントリーの説明を入力します。

- 上限 フィールドには、QoS エントリーが許容する最大処理能力をパーセンテージで入力します。

%のシンボルは入力しないでください。 - をクリックします。

2.4.2. CPU QoS エントリーの削除

手順2.8 CPU QoS エントリーの削除

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインで QoS タブをクリックします。

- CPU をクリックします。

- 削除する CPU QoS エントリーを選択します。

- をクリックします。

- プロンプトが表示されたら をクリックします。

[無制限] に設定されます。

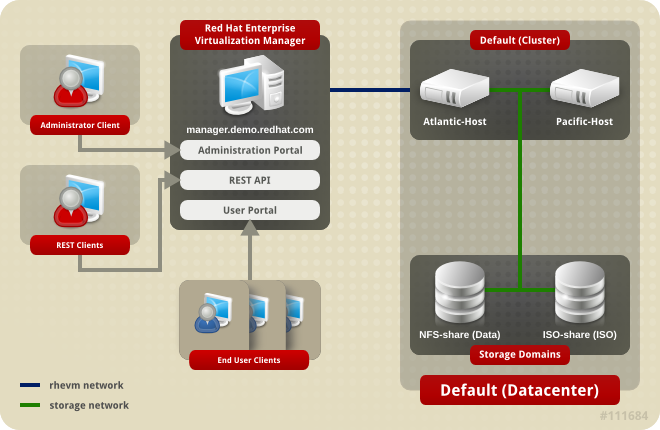

第3章 データセンター

3.1. データセンターについて

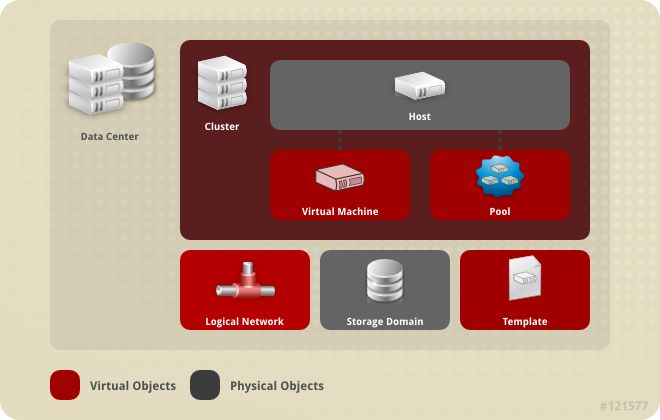

図3.1 データセンター

図3.2 データセンターのオブジェクト

3.2. Storage Pool Manager

3.3. SPM の優先度

3.4. データセンター内で問題のあるオブジェクトをイベントタブで特定する手順

3.5. データセンターのタスク

3.5.1. 新しいデータセンターの作成

注記

手順3.1 新しいデータセンターの作成

- データセンター リソースタブを選択すると、結果一覧にデータセンターがすべて表示されます。

- 次に ボタンをクリックして、新規データセンター ウィンドウを開きます。

- データセンターの 名前 と 説明 を入力します。

- ドロップダウンメニューからデータセンターのストレージの タイプ、互換バージョン、クォータモード を選びます。

- オプションで、データセンター用の MAC アドレスプールを変更します。デフォルトの MAC アドレスプールは、デフォルトで事前に選択されます。MAC アドレスプールの作成についての詳しい説明は、「MAC アドレスプール」を参照してください。

- MAC アドレスプール タブをクリックします。

- MAC アドレスプール のドロップダウンリストから、必要な MAC アドレスを選択します。

- をクリックしデータセンターを作成すると、新規データセンター - ガイド ウィンドウが開きます。

- 新規データセンター - ガイド ウィンドウでは、データセンターに設定する必要のあるエンティティーが表示されます。これらのエンティティーを設定するか、 ボタンを押して後ほど設定を行います。設定を再開するにはデータセンターを選択し、 ボタンを押してください。

3.5.2. 新規データセンターウィンドウおよびデータセンターの編集ウィンドウの設定

|

フィールド

|

説明/アクション

|

|---|---|

|

名前

|

データセンターの名前。このテキストフィールドは最長で 40 文字に制限されており、アルファベットの大文字/小文字、数字、ハイフン、アンダースコアを任意に組み合わせた一意名にする必要があります。

|

|

説明

| データセンターの説明。このフィールドへの入力は推奨されますが、必須ではありません。 |

|

タイプ

|

ストレージのタイプ。以下のいずれかを選択します。

データドメインのタイプによってデータセンターのタイプが決定し、作成後に変更すると大幅なサービスの中断を招きます。同じデータセンターに複数のタイプのストレージドメイン (iSCSI、NFS、FC、POSIX、Gluster) を追加することができますが、ローカルドメインと共有ドメインを混在させることはできません。

|

|

互換バージョン

|

Red Hat Enterprise Virtualization のバージョン。以下のいずれかを選択します。

|

|

クォータモード

| クォータは、Red Hat Enterprise Virtualizaton に搭載されているリソース制限ツールです。以下のいずれかを選択します。

|

|

MAC アドレスプール

|

データセンターの MAC アドレスプール。他の MAC アドレスプールが割り当てられていない場合には、デフォルトの MAC アドレスプールが使用されます。MAC アドレスプールについての詳しい説明は、「MAC アドレスプール」を参照してください。

|

3.5.3. データセンターの再初期化: リカバリーの手順

手順3.2 データセンターの再初期化

- データセンター リソースタブをクリックして再初期化するデータセンターを選択します。

- データセンターにアタッチされているストレージドメインがメンテナンスモードになっていることを確認してください。

- データセンターを右クリックし、ドロップダウンメニューから データセンターを再初期化 を選択して データセンターの再初期化 ウィンドウを開きます。

- データセンターの再初期化 ウィンドウでは使用可能な (デタッチされた状態で、メンテナンスモードに入っている) ストレージドメインをすべて表示します。データセンターに追加するストレージドメインのラジオボタンをクリックしてください。

- 操作を承認 のチェックボックスを選択します。

- ウィンドウを閉じてデータセンターを再初期化するには をクリックします。

3.5.4. データセンターの削除

手順3.3 データセンターの削除

- データセンターにアタッチされているストレージドメインがメンテナンスモードになっていることを確認してください。

- データセンター リソースタブをクリックし、削除するデータセンターを選択します。

- をクリックすると データセンターの削除 の確認ウィンドウが開きます。

- をクリックします。

3.5.5. データセンターの強制削除

Non Responsive になった場合には、データセンターは Non Responsive になります。いずれの状況でも、データセンターを 削除 することはできません。

手順3.4 データセンターの強制削除

- データセンター リソースタブをクリックし、削除するデータセンターを選択します。

- 強制削除 をクリックすると、データセンターの強制削除 の確認ウィンドウが開きます。

- 操作を承認 のチェックボックスを選択します。

- OK をクリックします。

3.5.6. データセンターの互換バージョンの変更

注記

手順3.5 データセンターの互換バージョンの変更

- 管理ポータルで データセンター タブをクリックします。

- 表示された一覧の中から、変更するデータセンターを選択します。

- をクリックします。

- 互換バージョン を必要な値に変更します。

- をクリックして、データセンターの互換バージョンを変更 の確認ウィンドウを開きます。

- をクリックして確定します。

警告

3.6. データセンターとストレージドメイン

3.6.1. データセンターへの既存データドメインのアタッチ

手順3.6 データセンターへの既存データドメインのアタッチ

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインの ストレージ タブを選択し、データセンターにすでにアタッチされているストレージドメインを表示します。

- をクリックし、ストレージのアタッチ ウィンドウを開きます。

- データセンターにアタッチするデータドメインのチェックボックスを選択します。チェックボックスを複数選択して複数のデータドメインをアタッチすることが可能です。

- をクリックします。

3.6.2. データセンターへの既存 ISO ドメインのアタッチ

手順3.7 データセンターへの既存 ISO ドメインのアタッチ

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインの ストレージ タブを選択し、すでにデータセンターにアタッチされているストレージドメインを表示します。

- をクリックして、ISO ライブラリーのアタッチ ウィンドウを開きます。

- 対象の ISO ドメインのラジオボタンをクリックします。

- をクリックします。

3.6.3. データセンターへの既存エクスポートドメインのアタッチ

手順3.8 データセンターへの既存エクスポートドメインのアタッチ

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインの ストレージ タブを選択し、データセンターにすでにアタッチされているストレージドメインを表示します。

- をクリックすると、エクスポートドメインのアタッチ ウィンドウが開きます。

- 対象のエクスポートドメインのラジオボタンをクリックします。

- をクリックします。

3.6.4. データセンターからのストレージドメインのデタッチ

注記

手順3.9 データセンターからのストレージドメインのデタッチ

- データセンター リソースタブをクリックして対象のデータセンターを選択します。

- 詳細ペインの ストレージ タブを選択し、データセンターにアタッチされているストレージドメインを表示します。

- デタッチするストレージドメインを選択します。ストレージドメインが

アクティブである場合は、 をクリックして、ストレージドメインのメンテナンス の確認ウィンドウを開きます。 - をクリックしてメンテナンスモードを開始します。

- をクリックすると、ストレージのデタッチ の確認ウィンドウが開きます。

- をクリックします。

3.7. データセンターとパーミッション

3.7.1. データセンターのシステムパーミッション管理

- データセンターに関連付けられたクラスターの作成/削除

- データセンターに関連付けられたホスト、仮想マシン、プールの作成/削除

- データセンターに関連付けられた仮想マシンのユーザーパーミッションの編集

注記

3.7.2. データセンターの管理者ロール

以下の表には、データセンターの管理に適用可能な管理者のロールと権限についての説明をまとめています。

| ロール | 権限 | 備考 |

|---|---|---|

| DataCenterAdmin | データセンター管理者 | ストレージを除く、特定のデータセンター内の全物理/仮想リソース (クラスター、ホスト、テンプレート、仮想マシンを含む) を使用、作成、削除、管理することができます。 |

| NetworkAdmin | ネットワーク管理者 | 特定のデータセンターのネットワークを設定、管理できます。データセンターのネットワーク管理者は、データセンター内の仮想マシンに対するネットワークパーミッションも継承します。 |

3.7.3. リソースに対する管理者およびユーザーロールの割り当て

手順3.10 リソースへのロール割り当て

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のリソースを選択します。

- 詳細ペインの タブをクリックして、 選択したリソースに割り当てられたユーザー、ユーザーのロール、継承されたパーミッションを一覧表示します。

- をクリックします。

- 検索 テキストボックスに既存ユーザーの名前またはユーザー名を入力し、 をクリックします。結果一覧に表示される検索候補からユーザーを選択します。

- 割り当てるロール ドロップダウンリストからロールを選択します。

- をクリックします。

3.7.4. リソースからの管理者またはユーザーロールの削除

手順3.11 リソースからのロール削除

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のリソースを選択します。

- 詳細ペインの タブをクリックして、 選択したリソースに割り当てられたユーザー、ユーザーのロール、継承されたパーミッションを一覧表示します。

- リソースから削除するユーザーを選択します。

- をクリックします。パーミッションが削除されることを確認する パーミッションの削除 ウィンドウが開きます。

- をクリックします。

第4章 クラスター

4.1. クラスターについて

図4.1 クラスター

4.2. クラスターのタスク

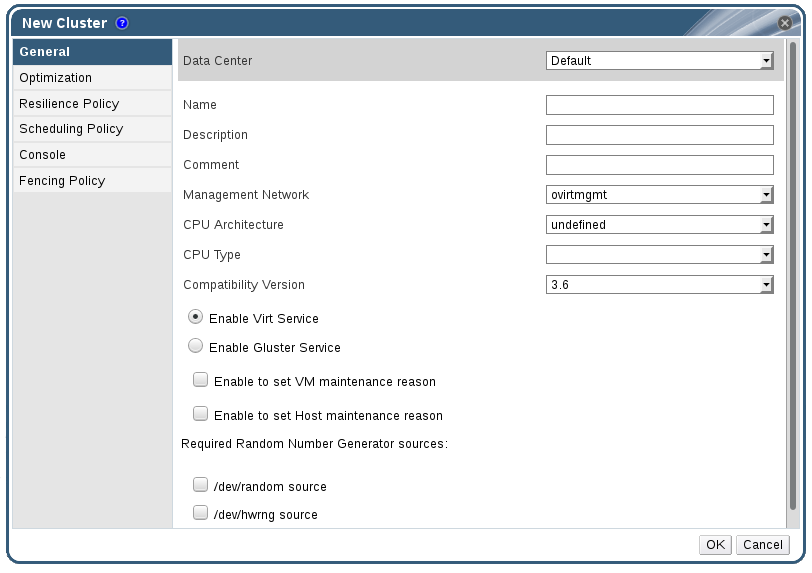

4.2.1. 新規クラスターの作成

手順4.1 新規クラスターの作成

- クラスター リソースタブを選択します。

- をクリックします。

- ドロップダウンメニューからクラスターが属する データセンター を選択します。

- クラスターの 名前 と 説明 を入力します。

- 管理ネットワーク ドロップダウンリストでネットワークを選択して、管理ネットワークのロールを割り当てます。

- ドロップダウンリストから CPU アーキテクチャー と CPU タイプ を選択します。CPU のプロセッサーファミリーが、クラスターにアタッチするホストの最小限必要な CPU タイプに適合していることが重要です。この条件が満たされない場合には、ホストは稼働しません。

注記

Intel および AMD のいずれの CPU タイプでも、CPU モデルは最も古いものから最も新しいものに論理的な順序でリストされます。クラスターに異なる複数の CPU モデルが含まれている場合には、最も古い CPU モデルを選択してください。各 CPU モデルについての詳しい情報は、https://access.redhat.com/solutions/634853 を参照してください。 - ドロップダウンリストからクラスターの 互換バージョン を選択します。

- クラスターに仮想マシンホストまたは Gluster 対応ノードを事前設定するかどうかに応じて、Virt サービスを有効にする または Gluster サービスを有効にする のいずれかのラジオボタンを選択します。Gluster サービスを有効にしたクラスターには、Red Hat Enterprise Virtualization Hypervisor ホストを追加することはできない点に注意してください。

- オプションで、仮想マシンのメンテナンスを行う理由の設定を有効にする のチェックボックスを選択して、Manager から仮想マシンをシャットダウンする際の理由フィールド (オプション) を有効にして、管理者によりメンテナンスの説明を提示できるようにします。

- オプションで、ホストのメンテナンスを行う理由の設定を有効にする のチェックボックスを選択して、Manager からホストをメンテナンスモードに切り替える際の理由フィールド (オプション) を有効にして、管理者がメンテナンスの説明を提示できるようにします。

- /dev/random source (Linux 提供のデバイス) または /dev/hwrng source (外部のハードウェアデバイス) のチェックボックスを選択して、クラスター内の全ホストが使用する乱数ジェネレーターデバイスを指定します。

- 最適化 タブをクリックし、クラスターのメモリーページ共有の閾値を選択します。またオプションで、クラスターのホストで CPU スレッド処理とメモリーバルーニングを有効化します。

- 耐障害性ポリシー タブをクリックして、仮想マシン移行ポリシーを選択します。

- スケジューリングポリシー タブをクリックして、そのクラスター内のホストのスケジューリングポリシーの設定、スケジューラーの最適化の設定、信頼済みサービスの有効化、HA 予約の有効化、カスタムのシリアル番号ポリシーの指定などをオプションで設定します。

- オプションとして、グローバルの SPICE プロキシー (該当する場合) を上書きするには、コンソール タブをクリックして、そのクラスター内のホストのSPICE プロキシーのアドレスを指定します。

- フェンシングポリシー タブをクリックして、クラスター内のフェンシングを有効化/無効化して、フェンシングオプションを選択します。

- をクリックしてクラスターを作成すると、新規クラスター - ガイド ウィンドウが開きます。

- 新規クラスター - ガイド ウィンドウでは、データセンターに設定する必要のあるエンティティーが表示されます。これらのエンティティーを設定するか、 ボタンを押して後ほど設定を行います。設定を再開するにはクラスターを選択し、 ボタンを押してください。

4.2.2. 新規クラスターおよびクラスターの編集ウィンドウの設定とコントロール

4.2.2.1. クラスターの全般設定

図4.2 新規クラスターウィンドウ

|

フィールド

|

説明/アクション

|

|---|---|

|

データセンター

|

クラスターが所属するデータセンター。このデータセンターは、クラスターを追加する前に作成しておく必要があります。

|

|

名前

|

クラスターの名前。このテキストフィールドは最長で 40 文字に制限されており、アルファベットの大文字/小文字、数字、ハイフン、アンダースコアを任意に組み合わせた一意名にする必要があります。

|

|

説明 / コメント

| クラスターの説明または補注。これらのフィールドへの入力は推奨されますが、必須ではありません。 |

|

管理ネットワーク

|

管理ネットワークロールに割り当てられる論理ネットワーク。デフォルトでは ovirtmgmt です。既存のクラスターの管理ネットワークは、詳細ペインの 論理ネットワーク タブの ボタンを押して変更するのが唯一の方法です。

|

| CPU アーキテクチャー | クラスターの CPU アーキテクチャー。選択する CPU アーキテクチャーによって、異なる CPU タイプが利用できます。

|

|

CPU タイプ

| クラスターの CPU タイプ。以下のいずれかを選択します。

|

|

互換バージョン

| Red Hat Enterprise Virtualization のバージョン。以下のいずれかを選択します。

|

|

Virt サービスを有効にする

| このラジオボタンを選択した場合に、そのクラスター内のホストは仮想マシンの実行に使用されます。 |

|

Gluster サービスを有効にする

| このラジオボタンを選択した場合に、そのクラスター内のホストは Red Hat Gluster Storage Server のノードとして使用され、仮想マシンは実行しません。このオプションが有効化されているクラスターには、Red Hat Enterprise Virtualization Hypervisor ホストを追加することはできません。 |

|

既存の Gluster 設定をインポート

|

このチェックボックスは、Gluster サービスを有効にする のラジオボタンが選択されている場合にのみ表示されます。このオプションにより、既存の Gluster 対応クラスターおよびそのクラスターにアタッチされた全ホストを Red Hat Enterprise Virtualization Manager にインポートすることができます。

次のオプションは、インポートするクラスター内の各ホストに必要となります。

|

| 仮想マシンのメンテナンスを行う理由の設定を有効にする | このチェックボックスを選択した場合には、Manager を使用してクラスター内の仮想マシンをシャットダウンする際に、オプションの理由のフィールドが表示され、メンテナンスの理由を入力することができます。この理由は、ログに表示され、また仮想マシンの電源が再度オンになると表示されます。 |

| ホストのメンテナンスを行う理由の設定を有効にする | このチェックボックスが選択されている場合には、Manager からクラスター内のホストをメンテナンスモードに切り替えると、オプションの理由のフィールドが表示されます。これにより、メンテナンスの理由を入力することが可能となります。この理由は、ログに表示され、またホストを再度アクティブにすると表示されます。 |

| 必要な乱数ジェネレーターのソース: |

以下のチェックボックスのいずれかを選択する場合は、クラスター内の全ホストでそのデバイスが利用可能である必要があります。この設定により、乱数ジェネレーターデバイスからエントロピーを仮想マシンに渡すことができるようになります。

|

4.2.2.2. 最適化の設定

|

フィールド

|

説明/アクション

|

|---|---|

|

メモリーの最適化

|

|

|

CPU スレッド

|

スレッドをコアとしてカウント のチェックボックスを選択すると、ホストのコア数を上回るプロセッサーコア合計数の仮想マシンを実行することができます。

公開されたホストのスレッドは、コアとして扱われ、仮想マシンに活用することができます。たとえば、1 コアあたり 2 スレッドの 24 コアシステム (合計 48 スレッド) は、それぞれ最大 48 コアの仮想マシンを実行することができ、ホスト CPU の負荷を算出するアルゴリズムは、2 倍の利用可能コアに対して負荷を比較します。

|

|

メモリーバルーン

|

メモリーバルーンの最適化を有効にする のチェックボックスを選択すると、このクラスター内のホストで実行されている仮想マシンのメモリーのオーバーコミットが有効になります。このオプションが設定されると、Memory Overcommit Manager (MOM) が可能な箇所で可能な場合にバルーニングを開始します。各仮想マシンに確保されているメモリーのサイズが上限となります。

バルーンを稼働させるには、バルーンデバイスと適切なドライバーが必要です。クラスターレベル 3.2 以降の仮想マシンにはすべて、特に削除していない限り、バルーンデバイスが含まれています。このクラスター内の各ホストは、ステータスが

Up に切り替わった時点でバルーンポリシーの更新を受信します。必要な場合には、ホスト上でステータスを変更せずにバルーンポリシーを手動で更新することができます。「クラスター内のホスト上での MOM ポリシーの更新」を参照してください。

シナリオによっては、バルーニングが KSM と競合する可能性があることを認識しておくことが重要です。そのような場合には、MOM がバルーンサイズの調整を試みて、競合を最小限に抑えます。また、一部のシナリオでは、バルーニングによって、仮想マシンでパフォーマンスが十分最適化されない可能性があります。バルーニングの最適化は、慎重に使用することを推奨します。

|

|

KSM コントロール

|

KSM を有効化 のチェックボックスを選択すると、MOM が有効になり、必要な場合に、CPU を犠牲にしてもメモリーを節約することでより高いメリットが得られる場合に Kernel Same-page Merging (KSM) を実行します。

|

4.2.2.3. 耐障害性ポリシー設定

|

ステータス

|

説明

|

|---|---|

|

Non Operational

|

Non Operational (非稼働状態) のホストとは、Manager を使用して通信することができますが、設定が正しくありません (例: 論理ネットワークが見つからないなど)。ホストが非稼働状態になった場合には、仮想マシンのマイグレーションはクラスターの耐障害性ポリシーによって決定されます。

|

|

Non Responsive

|

Non Responsive (応答なし) のホストは、Manager を使用して通信することはできません。ホストが応答なしの状態になった場合には、高可用性に設定されている全仮想マシンは同じクラスター内の別のホスト上で再起動されます。

|

|

フィールド

|

説明/アクション

|

|---|---|

|

仮想マシンを移行する

|

定義した優先度の順に、すべての仮想マシンを移行します。

|

|

高可用性の仮想マシンのみを移行する

|

高可用性の仮想マシンのみ移行し、他のホストが過負荷状態になるのを防ぎます。

|

|

仮想マシンを移行しない

| 仮想マシンが移行されないようにします。 |

4.2.2.4. スケジューリングポリシーの設定

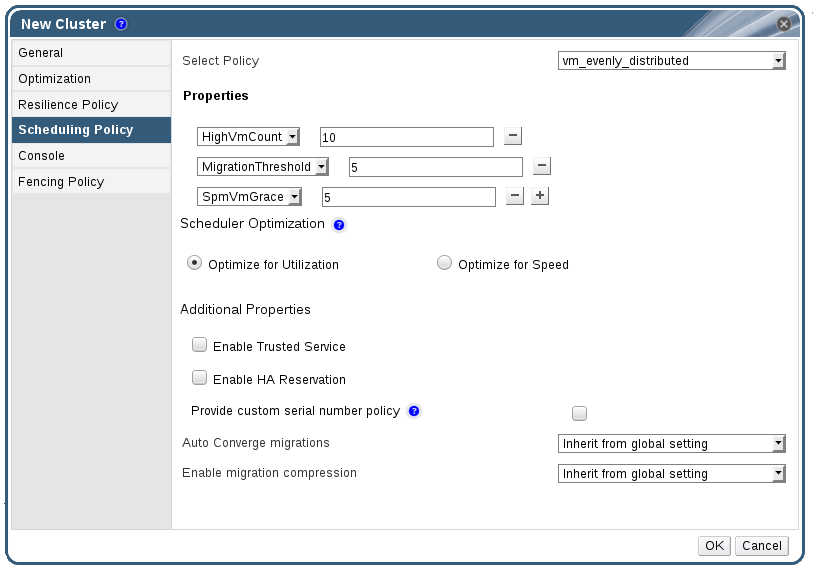

図4.3 スケジューリングポリシーの設定: vm_evenly_distributed

|

フィールド

|

説明/アクション

|

|---|---|

|

ポリシーを選択

|

ドロップダウンリストからポリシーを選択します。

|

|

プロパティー

|

以下のプロパティーは、選択したポリシーに応じて表示され、必要に応じて編集することができます。

|

|

スケジューラーの最適化

|

ホストの加重/順序のスケジューリングを最適化します。

|

|

信頼済みサービスを有効にする

|

OpenAttestation サーバーとの統合を有効にします。この設定を有効にする前に、

engine-config ツールを使用して OpenAttestation サーバーの詳細を入力します。

|

|

HA 予約を有効にする

|

Manager による高可用性仮想マシン用のクラスターキャパシティーのモニタリングを有効にします。Manager は、既存のホストで予期しないエラーが発生した場合に、高可用性に指定されている仮想マシンを移行するための適切なキャパシティーをクラスター内で確保します。

|

|

カスタムのシリアル番号ポリシーを指定する

|

このチェックボックスを選択すると、クラスター内の仮想マシンのシリアル番号ポリシーを指定することができます。以下のいずれかのオプションを選択してください。

|

|

移行の自動収束

|

このオプションは、クラスター内の仮想マシンのライブマイグレーション中に自動収束を使用するかどうかを設定することができます。ワークロードが大きくサイズの大きい仮想マシンは、ライブマイグレーション中に到達する転送率よりも早くメモリーをダーティーな状態にして、移行を収束できないようにする可能性があります。QEMU の自動収束機能は、仮想マシンの移行を強制的に収束させることができます。QEMU は収束されていないことを自動検出し、仮想マシンで vCPU のスロットルを減らします。デフォルトでは、自動収束はグローバルレベルで無効化されています。

|

|

移行時の圧縮の有効化

|

このオプションでは、クラスター内の仮想マシンのライブマイグレーション中に移行の圧縮を使用するかどうかを設定することができます。この機能は、Xor Binary Zero Run-Length-Encoding を使用して、仮想マシンのダウンタイムおよび、メモリーの書き込みの多いワークロードを実行する仮想マシンやメモリー更新パターンがスパースなアプリケーションの合計ライブマイグレーション時間を減らします。デフォルトでは、移行の圧縮はグローバルレベルで無効化されています。

|

mom.Controllers.Balloon - INFO Ballooning guest:half1 from 1096400 to 1991580 のようなバルーニングコマンドが /var/log/vdsm/mom.log にログ記録されます。/var/log/vdsm/mom.log は、Memory Overcommit Manager のログファイルです。

4.2.2.5. クラスターのコンソール設定

|

フィールド

|

説明/アクション

|

|---|---|

|

クラスターの SPICE プロキシーを定義

|

グローバル設定で定義されている SPICE プロキシーの上書きを有効にするには、このチェックボックスを選択します。この機能は、ハイパーバイザーが属するネットワークの外部からユーザーが接続する場合 (例: ユーザーポータルからの接続) に有用です。

|

|

SPICE プロキシーアドレスを上書き

|

SPICE クライアントが仮想マシンに接続するのに使用するプロキシー。このアドレスは、以下の形式で指定する必要があります。

protocol://[host]:[port] |

4.2.2.6. フェンシングポリシーの設定

| フィールド | 説明/アクション |

|---|---|

| フェンシングを有効にする | クラスターでフェンシングを有効にします。フェンシングはデフォルトで有効化されていますが、必要に応じて無効にすることができます。たとえば、一時的なネットワークの問題が発生している場合、または発生することが予想される場合に、診断またはメンテナンスの作業が完了するまでの間、管理者はフェンシングを無効にすることができます。フェンシングが無効になると、応答なしの状態のホストで実行されている高可用性の仮想マシンは、別のホストでは再起動されなくなる点に注意してください。 |

| ホストがストレージの有効なリースを持っている場合はフェンシングをスキップ | このチェックボックスを選択した場合には、ステータスが Non Responsive で、かつストレージにまだ接続されているクラスター内のホストはフェンシングされません。 |

| クラスターの接続性に問題がある場合はフェンシングをスキップ | このチェックボックスを選択すると、クラスター内で接続の問題が発生しているホストの割合が定義済みの 閾値 以上となった場合にフェンシングが一時的に無効となります。閾値 の値はドロップダウンリストから選択します。設定可能な値は、25、50、 75、100 です。 |

4.2.3. リソースの編集

リソースのプロパティーを編集します。

手順4.2 リソースの編集

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のリソースを選択します。

- をクリックして 編集 ウィンドウを開きます。

- 必要なプロパティーを変更して をクリックします。

新規プロパティーがリソースに保存されました。プロパティーフィールドが無効の場合には、編集 ウィンドウは閉じません。

4.2.4. クラスター内のホストに負荷および電源管理のポリシーを設定する手順

手順4.3 ホストに負荷および電源管理のポリシーを設定する手順

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のクラスターを選択します。

- クリックすると、クラスターの編集 ウィンドウが表示されます。

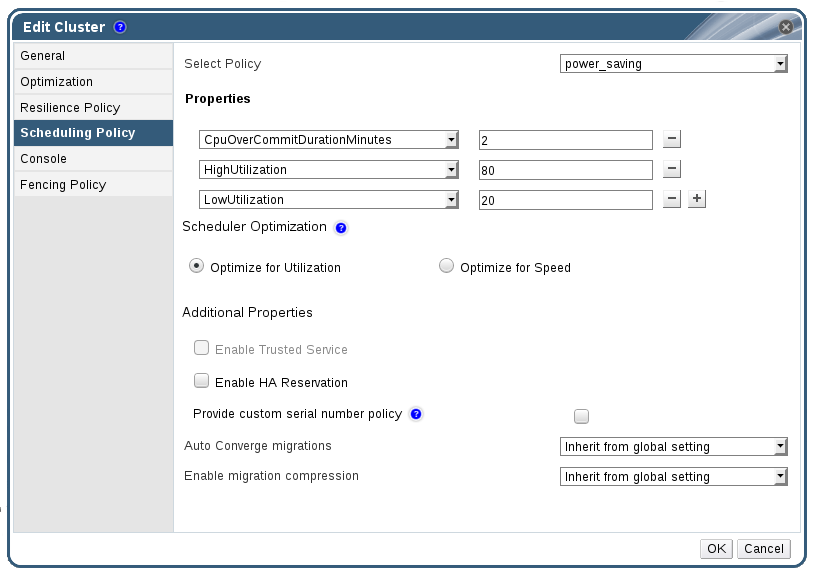

図4.4 スケジューリングポリシーの編集

- 以下のポリシーのいずれかを選択します。

- none

- vm_evenly_distributed

- HighVmCount フィールドには、各ホストで実行可能な仮想マシンの最大数を設定します。

- MigrationThreshold フィールドには、使用率が最も高いホスト上の仮想マシン数と使用率が最も低いホスト上の仮想マシン数の差異を定義します。

- SpmVmGrace フィールドで定義するスロット数により、SPM ホスト上で仮想マシン用に確保されるスロット数が他のホストよりもどれだけ少なくなるかを指定します。

- evenly_distributed

- CpuOverCommitDurationMinutes フィールドには、スケジューリングポリシーが対応するまでに、ホストが所定の使用率外で CPU 負荷を実行できる時間 (分単位) を設定します。

- HighUtilization フィールドには、他のホストへの仮想マシン移行を開始する CPU 使用率を入力します。

- MinFreeMemoryForUnderUtilized には、仮想マシンが他のホストへの移行を開始する、必要な空きメモリー容量の最小値を MB 単位でを入力します。

- MaxFreeMemoryForOverUtilized には、仮想マシンが他のホストへの移行を開始する、必要な最大空きメモリー容量を MB 単位でを入力します。

- power_saving

- CpuOverCommitDurationMinutes フィールドには、スケジューリングポリシーが対応するまでに、ホストが所定の使用率外で CPU 負荷を実行できる時間 (分単位) を設定します。

- LowUtilization フィールドには、ホストが十分に活用されていないと見なされる CPU 使用率の下限を入力します。

- HighUtilization フィールドには、他のホストへの仮想マシン移行を開始する CPU 使用率を入力します。

- MinFreeMemoryForUnderUtilized には、仮想マシンが他のホストへの移行を開始する、必要な空きメモリー容量の最小値を MB 単位でを入力します。

- MaxFreeMemoryForOverUtilized には、仮想マシンが他のホストへの移行を開始する、必要な最大空きメモリー容量を MB 単位でを入力します。

- クラスターの スケジューラーの最適化 には、以下のいずれかを選択します。

- 使用率で最適化 を選択すると、スケジューリングに加重モジュールが含まれ、最適の選択が可能となります。

- スピードで最適化 を選択すると、保留中の要求が 10 件以上ある場合には、ホストの重み付けをスキップします。

engine-configツールを使用してサーバーの詳細を設定済みで、OpenAttestation サーバーを使用してホストを検証する場合は、信頼済みサービスを有効にする のチェックボックスを選択します。- オプションとして、Manager による高可用性仮想マシン用のクラスターキャパシティーのモニタリングを有効にするには、HA 予約を有効にする のチェックボックスにチェックを入れます。

- オプションとして、クラスター内の仮想マシンのシリアル番号ポリシーを指定するには、カスタムのシリアル番号ポリシーを指定する チェックボックスにチェックを入れて、以下のオプションのいずれかを選択します。

- ホストの UUID を仮想マシンのシリアル番号として設定するには、Host ID を選択します。

- 仮想マシンの UUID を仮想マシンのシリアル番号として設定するには、Vm ID を選択します。

- カスタムのシリアル番号を指定するには、カスタムのシリアル番号 を選択します。

- をクリックします。

4.2.5. クラスター内のホスト上での MOM ポリシーの更新

手順4.4 ホスト上での MOM ポリシーの同期

- クラスター タブをクリックして、対象のホストが属するクラスターを選択します。

- 詳細ペインの ホスト タブをクリックして、MOM ポリシーを更新する必要のあるホストを選択します。

- をクリックします。

4.2.6. CPU プロファイル

4.2.6.1. CPU プロファイルの作成

手順4.5 CPU プロファイルの作成

- クラスター リソースタブをクリックしてクラスターを選択します。

- 詳細ペインで CPU プロファイル のサブタブをクリックします。

- をクリックします。

- 名前 フィールドに CPU プロファイルの名前を入力します。

- 説明 フィールドに CPU プロファイルの説明を入力します。

- QoS 一覧から CPU プロファイルに適用する QoS を選択します。

- をクリックします。

4.2.6.2. CPU プロファイルの削除

手順4.6 CPU プロファイルの削除

- クラスター リソースタブをクリックしてクラスターを選択します。

- 詳細ペインで CPU プロファイル のサブタブをクリックします。

- 削除する CPU プロファイルを選択します。

- をクリックします。

- をクリックします。

default CPU プロファイルが自動的に割り当てられます。

4.2.7. 既存の Red Hat Gluster Storage クラスターのインポート

gluster peer status コマンドを実行すると、そのクラスターに属するホストの一覧が表示されます。各ホストのフィンガープリントは手動で確認して、パスワードを提供する必要があります。クラスター内のいずれかのホストが停止しているか、または到達不可な時には、クラスターをインポートすることはできません。新たにインポートされたホストには、VDSM はインストールされていないので、インポートした後には、ブートストラップスクリプトにより必要な VDSM パッケージがすべてホストにインストールされ、ホストが再起動されます。

重要

手順4.7 Red Hat Enterprise Virtualization Manager への既存の Red Hat Gluster Storage クラスターのインポート

- クラスター リソースタブを選択すると、結果一覧に全クラスターが表示されます。

- 次に ボタンをクリックして、新規クラスター ウィンドウを開きます。

- ドロップダウンメニューからクラスターが属する データセンター を選択します。

- クラスターの 名前 と 説明 を入力します。

- Gluster サービスを有効にする のラジオボタンと 既存の Gluster 設定をインポート のチェックボックスを選択します。既存の Gluster 設定をインポート のフィールドは、Gluster サービスを有効にする のラジオボタンを選択した場合のみに表示されます。

- アドレス フィールドに、クラスター内の任意のサーバーのホスト名または IP アドレスを入力します。ホストの フィンガープリント が表示され、正しいホストに接続していることを確認します。ホストが到達不可の場合、またはネットワークエラーが発生している場合には、フィンガープリント フィールドに フィンガープリントの取得でエラーが発生しました というエラーメッセージが表示されます。

- サーバーの root パスワード を入力し、OK をクリックします。

- ホストの追加 ウィンドウが開き、クラスターに属するホストの一覧が表示されます。

- 各ホストの 名前 と root パスワード を入力します。

- 全ホストで同じパスワードを使用する場合は、共通のパスワードを使用 のチェックボックスを選択し、表示されているテキストフィールドにパスワードを入力します。をクリックし、入力したパスワードを全ホストに設定します。フィンガープリントが有効であることを確認した上で をクリックし、変更を送信します。

4.2.8. ホストの追加ウィンドウの設定

| フィールド | 説明 |

|---|---|

| 共通のパスワードを使用 | クラスター内の全ホストに同じパスワードを使用するには、このチェックボックスにチェックを入れます。パスワード フィールドにパスワードを入力して、適用 ボタンをクリックすると、そのパスワードが全ホストに設定されます。 |

| 名前 | ホスト名を入力します。 |

| ホスト名/IP アドレス | このフィールドには、新規クラスター ウィンドウで指定したホストの完全修飾ドメイン名または IP アドレスが自動的に入力されます。 |

| root パスワード | ホストごとに異なる root パスワードを使用する場合には、このフィールドにパスワードを入力します。このフィールドにより、クラスター内の全ホストに対して指定した共通パスワードが上書きされます。 |

| フィンガープリント | ホストのフィンガープリントが表示され、正しいホストに接続することを確認します。このフィールドには、新規クラスター ウィンドウで指定したホストのフィンガープリントが自動的に入力されます。 |

4.2.9. クラスターの削除

削除前にクラスターからすべてのホストを移動します。

注記

手順4.8 クラスターの削除

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のクラスターを選択します。

- クラスター内にホストがないことを確認します。

- をクリックすると クラスターの削除 の確認ウィンドウが開きます。

- をクリックします。

クラスターが削除されました。

4.2.10. クラスターの互換バージョンの変更

注記

手順4.9 クラスターの互換バージョンの変更

- 管理ポータルで クラスター タブをクリックします。

- 表示された一覧の中から、変更するクラスターを選択します。

- をクリックします。

- 互換バージョン を必要な値に変更します。

- をクリックして、クラスターの互換バージョンを変更 の確認ウィンドウを開きます。

- をクリックして確定します。

警告

4.3. クラスターとパーミッション

4.3.1. クラスターに対するシステムパーミッションの管理

- 関連付けられたクラスターの作成/削除

- クラスターに関連付けられたホスト、仮想マシン、プールの作成/削除

- クラスターに関連付けられた仮想マシンのユーザーパーミッションの編集

注記

4.3.2. クラスター管理者ロール

以下の表には、クラスターの管理に適用可能な管理者ロールと権限についての説明をまとめています。

| ロール | 権限 | 備考 |

|---|---|---|

| ClusterAdmin | クラスター管理者 |

特定のクラスター内の全物理/仮想リソース (ホスト、テンプレート、仮想マシンを含む) を使用、作成、削除、管理することができます。クラスター内のネットワークプロパティーを設定することができます (ディスプレイネットワークの指定、ネットワークを必須または任意にマークするなど)。

ただし、ClusterAdmin には、クラスターにネットワークをアタッチ/デタッチするパーミッションはありません。この操作を行うには、NetworkAdmin パーミッションが必要です。

|

| NetworkAdmin | ネットワーク管理者 | 特定のクラスターのネットワークを設定、管理できます。クラスターのネットワーク管理者はクラスター内の仮想マシンに対するネットワークパーミッションも継承します。 |

4.3.3. リソースに対する管理者およびユーザーロールの割り当て

手順4.10 リソースへのロール割り当て

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のリソースを選択します。

- 詳細ペインの タブをクリックして、 選択したリソースに割り当てられたユーザー、ユーザーのロール、継承されたパーミッションを一覧表示します。

- をクリックします。

- 検索 テキストボックスに既存ユーザーの名前またはユーザー名を入力し、 をクリックします。結果一覧に表示される検索候補からユーザーを選択します。

- 割り当てるロール ドロップダウンリストからロールを選択します。

- をクリックします。

4.3.4. リソースからの管理者またはユーザーロールの削除

手順4.11 リソースからのロール削除

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のリソースを選択します。

- 詳細ペインの タブをクリックして、 選択したリソースに割り当てられたユーザー、ユーザーのロール、継承されたパーミッションを一覧表示します。

- リソースから削除するユーザーを選択します。

- をクリックします。パーミッションが削除されることを確認する パーミッションの削除 ウィンドウが開きます。

- をクリックします。

第5章 論理ネットワーク

5.1. 論理ネットワークのタスク

5.1.1. ネットワークタブの使用

- クラスターおよびホストへのネットワークのアタッチ/デタッチ

- 仮想マシンおよびテンプレートからのネットワークインターフェースの削除

- ユーザーがネットワークにアクセスして管理するためのパーミッションの追加/削除

警告

重要

- ディレクトリーサービス

- DNS

- ストレージ

5.1.2. データセンターまたはクラスター内での新規論理ネットワークの作成

手順5.1 データセンターまたはクラスター内での新規論理ネットワークの作成

- データセンター または クラスター リソースタブをクリックして、結果一覧からデータセンターまたはクラスターを選択します。

- 詳細ペインの 論理ネットワーク タブをクリックして既存の論理ネットワークを表示します。

- データセンター の詳細ペインから をクリックし、新規論理ネットワーク ウィンドウを開きます。

- クラスター の詳細ペインから をクリックし、新規論理ネットワーク ウィンドウを開きます。

- 論理ネットワークの 名前、説明、および コメント を入力します。

- オプションとして、外部プロバイダー上に作成する チェックボックスを選択します。ドロップダウンリストから 外部プロバイダー を選択し、物理ネットワーク の IP アドレスを指定します。外部プロバイダー上に作成する を選択した場合には、ネットワークラベル、仮想マシンネットワーク、および MTU オプションは無効になります。

- ネットワークラベル のテキストフィールドには、その論理ネットワーク用に新規ラベルを入力するか、既存のラベルを選択します。

- オプションで VLAN タグ付けを有効にする を選択します。

- オプションで 仮想マシンネットワーク を無効にします。

- MTU 値を デフォルト (1500) または カスタム に設定します。

- クラスター タブから、ネットワークを割り当てるクラスターを選択します。その論理ネットワークを必須ネットワークにするかどうかも指定することができます。

- 外部プロバイダー上に作成する を選択した場合には、サブネット タブが表示されます。この サブネット タブで サブネットを作成 を選択して、その論理ネットワークが提供するサブネットの 名前、CIDR、ゲートウェイ アドレスを入力し、 IP バージョン を選択します。また、必要に応じて、DNS サーバーも追加することができます。

- 必要に応じて、仮想 NIC プロファイル タブから、仮想 NIC プロファイルを論理ネットワークに追加します。

- OK をクリックします。

注記

5.1.3. 論理ネットワークの編集

手順5.2 論理ネットワークの編集

重要

- データセンター リソースタブをクリックして、結果一覧内で論理ネットワークのデータセンターを選択します。

- 詳細ペインの 論理ネットワーク タブをクリックし、クラスター内の論理ネットワークを表示します。

- 論理ネットワークを選択して をクリックし、論理ネットワークの編集 ウィンドウを開きます。

- 必要な設定を編集します。

- OK をクリックして変更を保存します。

注記

5.1.4. 論理ネットワークの削除

ovirtmgmt 管理ネットワークとして使用する必要があります。

手順5.3 論理ネットワークの削除

- データセンター リソースタブをクリックして、結果一覧内で論理ネットワークのデータセンターを選択します。

- 詳細ペインの 論理ネットワーク タブをクリックし、クラスター内の論理ネットワークを表示します。

- 論理ネットワークを選択して をクリックすると、論理ネットワークの削除 ウィンドウが開きます。

- オプションで、ネットワークが外部プロバイダーから提供されている場合は このネットワークを外部プロバイダーからも削除する のチェックボックスにチェックを入れることで、Manager と外部プロバイダーの両方から論理ネットワークを削除することができます。

- OK をクリックします。

5.1.5. 論理ネットワークのゲートウェイの表示/編集

手順5.4 論理ネットワークのゲートウェイの表示/編集

- ホスト リソースタブをクリックして、対象のホストを選択します。

- 詳細ペインにある ネットワークインターフェース タブをクリックし、ホストにアタッチされたネットワークインターフェースおよびその設定を一覧表示します。

- ボタンをクリックすると ホストネットワークの設定 ウィンドウが開きます。

- 割り当てられた論理ネットワークの上にマウスを移動し、鉛筆のアイコンをクリックすると、管理ネットワークの編集 ウィンドウが開きます。

5.1.6. 新規ネットワークおよび論理ネットワークの編集ウィンドウの設定とコントロール

5.1.6.1. 論理ネットワークの全般設定

|

フィールド名

|

説明

|

|---|---|

|

名前

|

論理ネットワークの名前。このテキストフィールドは最長で 15 文字に制限されており、アルファベットの大文字/小文字、数字、ハイフン、アンダースコアを任意に組み合わせた一意名にする必要があります。

|

|

説明

|

論理ネットワークの説明。このテキストフィールドは、最長で 40 文字に制限されています。

|

|

コメント

|

論理ネットワークに関する、プレーンテキスト形式の人間が判読できるコメントを追加するためのフィールド

|

|

外部プロバイダー上に作成する

|

外部プロバイダーとして Manager に追加済みの OpenStack Networking Service インスタンスに論理ネットワークを作成することができます。

外部プロバイダー: 論理ネットワークの作成先となる外部プロバイダーを選択することができます。

|

|

VLAN タグ付けを有効にする

|

VLAN タグ付けは、論理ネットワーク上のネットワークトラフィックすべてに特定の特性を指定するセキュリティー機能です。VLAN タグが付いたトラフィックは、同じ特性を持つインターフェース以外で読み取ることはできません。論理ネットワークで VLAN を使用すると、1 つのネットワークインターフェースを異なる VLAN タグの付いた複数の論理ネットワークに関連付けることができます。VLAN タグ付けを有効にする場合は、テキスト入力フィールドに数値を入力してください。

|

|

仮想マシンネットワーク

|

そのネットワークを仮想マシンのみが使用する場合には、このオプションを選択します。ネットワークが仮想マシンには関係のないトラフィック (例: ストレージ用の通信など) に使用される場合には、このチェックボックスは選択しないでください。

|

|

MTU

|

デフォルト を選択して論理ネットワークの最大転送単位 (MTU) を括弧内の値に設定するか、カスタム を選択してカスタムの MTU を設定します。この設定を使用すると、新規論理ネットワークがサポートする MTU 値と、そのネットワークがインターフェース接続するハードウェアがサポートする MTU 値を適合させることができます。カスタム を選択した場合は、テキスト入力フィールドに数値を入力してください。

|

|

ネットワークラベル

|

ネットワークの新規ラベルを指定したり、ホストネットワークインターフェースにすでにアタッチされている既存のラベルから選択したりすることができます。既存のラベルを選択した場合には、論理ネットワークは、そのラベルが付いた全ホストネットワークインターフェースに自動的に割り当てられます。

|

5.1.6.2. 論理ネットワークのクラスターの設定

|

フィールド名

|

説明

|

|---|---|

|

クラスターに対するネットワークのアタッチ/デタッチ

|

データセンター内のクラスターに論理ネットワークをアタッチ/デタッチして、その論理ネットワークが個別のクラスターの必須ネットワークとなるかどうかを指定することができます。

名前: 設定を適用するクラスターの名前。この値は編集できません。

すべてをアタッチ: データセンター内の全クラスターに論理ネットワークをアタッチ/デタッチすることができます。もしくは、各クラスター名の横にある アタッチ チェックボックスを選択または選択解除して、特定のクラスターに論理ネットワークをアタッチ/デタッチします。

すべて必須: その論理ネットワークを全クラスター上の必須ネットワークとするかどうかを指定することができます。もしくは、各クラスター名の横にある 必須 チェックボックスを選択または選択解除して、特定のクラスターでその論理ネットワークを必須ネットワークとするかどうかを指定します。

|

5.1.6.3. 論理ネットワークの仮想 NIC プロファイルの設定

|

フィールド名

|

説明

|

|---|---|

|

仮想 NIC プロファイル

|

対象の論理ネットワークに 1 つまたは複数の仮想 NIC プロファイルを指定することができます。仮想 NIC プロファイルの横にあるプラスまたはマイナスのボタンをクリックすると、論理ネットワークに仮想 NIC プロファイルを追加または削除することができます。最初のフィールドには、仮想 NIC プロファイルの名前を入力します。

パブリック: 対象のプロファイルを全ユーザーが利用できるかどうかを指定することができます。

QoS: ネットワークのサービス品質 (QoS) プロファイルを仮想 NIC プロファイルに指定することができます。

|

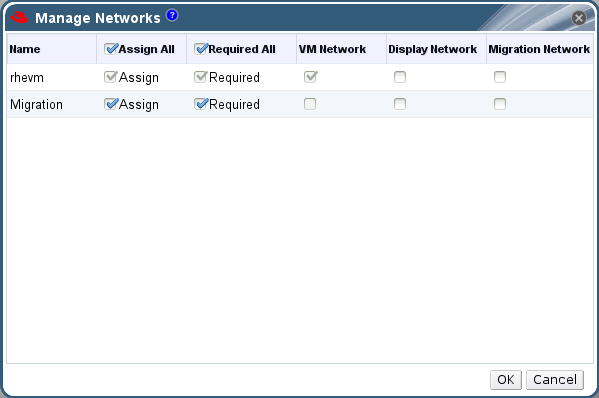

5.1.7. ネットワークの管理ウィンドウで論理ネットワークに特定のトラフィックタイプを指定する手順

手順5.5 論理ネットワークのトラフィックタイプの指定

- クラスター リソースタブをクリックして、結果一覧からクラスターを選択します。

- 詳細ペインの 論理ネットワーク タブをクリックし、クラスターに割り当てられた論理ネットワークを表示します。

- をクリックし、ネットワークの管理 ウィンドウを開きます。

図5.1 ネットワークの管理

- 該当するチェックボックスを選択します。

- をクリックして変更を保存し、ウィンドウを閉じます。

注記

5.1.8. ネットワークの管理ウィンドウの設定

|

フィールド

|

説明/アクション

|

|---|---|

|

割り当て

|

論理ネットワークをクラスター内の全ホストに割り当てます。

|

|

必須

|

関連付けられているホストが正常に機能するためには、「必須」とマークされているネットワークは稼働状態を維持する必要があります。必須ネットワークが機能を停止すると、そのネットワークに関連付けられたホストはいずれも非稼働状態となります。

|

|

仮想マシンネットワーク

| 「仮想マシンネットワーク」とマークされている論理ネットワークは、仮想マシンのネットワークに関連するネットワークトラフィックを伝送します。 |

|

ディスプレイネットワーク

| 「ディスプレイネットワーク」とマークされている論理ネットワークは、SPICE および仮想ネットワークコントローラーに関連するネットワークトラフィックを伝送します。 |

|

移行ネットワーク

| 「移行ネットワーク」とマークされている論理ネットワークは、仮想マシンおよびストレージの移行トラフィックを伝送します。 |

5.1.9. NIC の Virtual Function 設定の編集

手順5.6 NIC の Virtual Function 設定の編集

- SR-IOV 対応のホストを選択して、詳細ペインの ネットワークインターフェース タブをクリックします。

- をクリックすると ホストネットワークの設定 ウィンドウが開きます。

- Select an SR-IOV-capable NIC, marked with a

, and click the pencil icon to open the Edit Virtual Functions (SR-IOV) configuration of NIC window.

, and click the pencil icon to open the Edit Virtual Functions (SR-IOV) configuration of NIC window.

- Virtual Function の数を編集するには、VF 設定数 のドロップダウンボタンをクリックして、VF 数 テキストフィールドを編集します。

重要

VF の数を変更すると、新規 VF が作成される前にそのネットワークインターフェース上の以前の VF は削除されます。これには、仮想マシンが直接アタッチされていた VF も含まれます。 - 全ネットワーク チェックボックスはデフォルトで選択され、全ネットワークが Virtual Function にアクセスすることができます。Virtual Function にアクセス可能な仮想ネットワークを指定するには、特定のネットワーク ラジオボタンを選択して、全ネットワークの一覧が表示してから、指定するネットワークのチェックボックスを選択するか、ラベル テキストフィールドを使用して 1 つまたは複数のネットワークラベルに基づいてネットワークを自動的に選択します。

- をクリックしてウィンドウを閉じます。ホストネットワークの設定 ウィンドウで ボタンをクリックするまで設定の変更は有効にならない点に注意してください。

5.2. 仮想ネットワークインターフェースカード

5.2.1. 仮想 NIC プロファイルの概要

5.2.2. 仮想 NIC プロファイルの作成と編集

注記

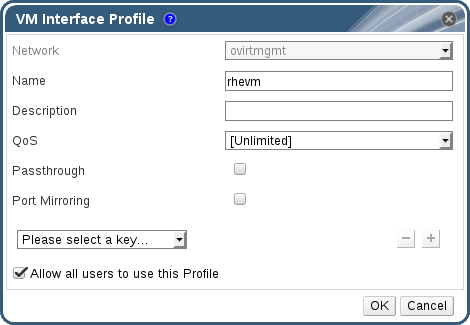

手順5.7 仮想 NIC プロファイルの作成と編集

- ネットワーク リソースタブをクリックし、結果一覧で論理ネットワークを選択します。

- 詳細ペインで 仮想 NIC プロファイル タブを選択します。ツリーモードで論理ネットワークを選択した場合には、ナビゲーションペインで 仮想 NIC プロファイル タブを選択することができます。

- または をクリックすると、仮想マシンインターフェースのプロファイル ウィンドウが表示されます。

図5.2 仮想マシンインターフェースのプロファイルウィンドウ

- プロファイルの 名前 と 説明 を入力します。

- QoS 一覧から対象の QoS を選択します。

- 仮想 NIC でパススルーを有効化して Virtual Function のデバイスの直接割り当てができるようにするには、パススルー チェックボックスを選択します。パススルーのプロパティーを有効にすると、QoS とポートミラーリングは互換性がないため無効になります。パススルーに関する詳しい説明は、「仮想 NIC プロファイルでのパススルーの有効化」を参照してください。

- ポートミラーリング および 全ユーザーにこのプロファイルの使用を許可する のチェックボックスを使用して、これらのオプションを切り替えます。

- カスタムプロパティーの一覧からカスタムプロパティーを 1 つ選択します。このフィールドには、デフォルトで キーを選択してください と表示されます。 および のボタンを使用して、カスタムプロパティーを追加または削除します。

- をクリックします。

注記

5.2.3. 仮想マシンインターフェースのプロファイルウィンドウの設定

|

フィールド名

|

説明

|

|---|---|

|

ネットワーク

|

仮想 NIC プロファイルを適用する利用可能なネットワークのドロップダウンメニュー

|

|

名前

|

仮想 NIC プロファイルの名前。1 - 50 文字のアルファベットの大文字/小文字、数字、ハイフン、アンダースコアを任意に組み合わせた一意名にする必要があります。

|

| 説明 |

仮想 NIC プロファイルの説明。このフィールドは、必須ではありませんが、記入することを推奨します。

|

| QoS |

仮想 NIC プロファイルに適用する利用可能なネットワーク QoS ポリシーのドロップダウンメニュー。QoS ポリシーは仮想 NIC の受信/送信トラフィックを制御します。

|

| パススルー |

パススルーのプロパティーを切り替えるためのチェックボックス。パススルーにより、仮想 NIC をホストの Virtual Function に直接接続することができます。仮想 NIC プロファイルが仮想マシンにアタッチされている場合には、パススループロパティーは編集できません。

パススルーを有効にした場合には、QoS とポートミラーリングは仮想 NIC プロファイルで無効化されます。

|

| ポートミラーリング |

ポートミラーリングを切り替えるためのチェックボックス。ポートミラーリングは、論理ネットワーク上のレイヤー 3 ネットワークトラフィックを仮想マシン上の仮想インターフェースにコピーします。デフォルトでは選択されません。詳しくは、『テクニカルリファレンス』の「ポートミラーリング」のセクションを参照してください。

|

| デバイスのカスタムプロパティー |

仮想 NIC プロファイルに適用する利用可能なカスタムプロパティーを選択するためのドロップダウンメニュー。プロパティーを追加する場合は ボタンを、削除する場合は ボタンを使用します。

|

| 全ユーザーにこのプロファイルの使用を許可する |

環境内の全ユーザーがこのプロファイルを利用できるかどうかの設定を切り替えるためのチェックボックス。デフォルトで選択されます。

|

5.2.4. 仮想 NIC プロファイルでのパススルーの有効化

手順5.8 パススルーの有効化

- ネットワーク の結果一覧から論理ネットワークを選択してから詳細ペインの 仮想 NIC プロファイル タブをクリックすると、その論理ネットワークの全仮想 NIC プロファイルが表示されます。

- をクリックすると、仮想マシンインターフェースのプロファイル ウィンドウが表示されます。

- プロファイルの 名前 と 説明 を入力します。

- パススルー チェックボックスを選択します。これにより、QoS と ポートミラーリング が無効になります。

- 必要な場合には、カスタムプロパティーの一覧からカスタムプロパティーを 1 つ選択します。このフィールドには、デフォルトで キーを選択してください と表示されます。 および のボタンを使用して、カスタムプロパティーを追加または削除します。

- をクリックしてプロファイルを保存し、ウィンドウを閉じます。

5.2.5. 仮想 NIC プロファイルの削除

手順5.9 仮想 NIC プロファイルの削除

- ネットワーク リソースタブをクリックし、結果一覧で論理ネットワークを選択します。

- 詳細ペインで プロファイル タブを選択すると、利用可能な仮想 NIC プロファイルが表示されます。ツリーモードで論理ネットワークを選択した場合には、ナビゲーションペインで 仮想 NIC プロファイル タブを選択することができます。

- プロファイルを 1 つまたは複数選択して をクリックすると、仮想マシンインターフェースのプロファイルの削除 ウィンドウが開きます。

- をクリックしてプロファイルを削除し、ウィンドウを閉じます。

5.2.6. 仮想 NIC プロファイルへのセキュリティーグループの割り当て

注記

注記

neutron security-group-list

# neutron security-group-list手順5.10 仮想 NIC プロファイルへのセキュリティーグループの割り当て

- ネットワーク タブをクリックし、結果一覧で論理ネットワークを選択します。

- 詳細ペインで 仮想 NIC プロファイル タブをクリックします。

- をクリックするか、既存の仮想 NIC プロファイルを選択して をクリックすると、仮想マシンインターフェースのプロファイル ウィンドウが開きます。

- カスタムプロパティーのドロップダウンリストから SecurityGroups を選択します。カスタムプロパティーのドロップダウンを空欄のままにした場合には、デフォルトのセキュリティーグループが適用されます。デフォルトのセキュリティー設定は、すべての送信トラフィックと内部通信を許可しますが、デフォルトのセキュリティーグループ外からの受信トラフィックはすべて拒否します。後で SecurityGroups プロパティーを削除しても、適用済みのセキュリティーグループには影響を及ぼしません。

- テキストフィールドに仮想 NIC プロファイルにアタッチするセキュリティーグループの ID を入力します。

- をクリックします。

5.2.7. 仮想NIC プロファイルのユーザーパーミッション

手順5.11 仮想NIC プロファイルのユーザーパーミッション

- ネットワーク タブをクリックし、結果一覧で論理ネットワークを選択します。

- 仮想 NIC プロファイル のリソースタブを選択すると仮想 NIC プロファイルが表示されます。

- 詳細ペインで パーミッション タブを選択すると、そのプロファイルに対する現在のユーザーパーミッションが表示されます。

- ボタンをクリックして ユーザーへのシステム権限の追加 ウィンドウを開くか、 ボタンをクリックして パーミッションの削除 ウィンドウを開いて、仮想 NIC プロファイルに対するユーザーパーミッションの追加または削除を行います。

5.2.8. UCS 統合のための仮想 NIC プロファイルの設定

vdsm-hook-vmfex-devフックにより、仮想 NIC プロファイルを設定して、仮想マシンは Cisco の UCS で定義されたポートプロファイルに接続することができます。UCS で定義されたポートプロファイルには、UCS 内で仮想インターフェースを設定するのに使用するプロパティーと設定が含まれます。vdsm-hook-vmfex-dev フックは、VDSM でデフォルトでインストールされます。詳しくは、「付録A VDSM とフック」を参照してください。

注記

手順5.12 カスタムデバイスプロパティーの設定

- Red Hat Enterprise Virtualization Manager 上で、

vmfexのカスタムプロパティーを設定し、--cverを使用してクラスターの互換レベルを指定します。engine-config -s CustomDeviceProperties='{type=interface;prop={vmfex=^[a-zA-Z0-9_.-]{2,32}$}}' --cver=3.6# engine-config -s CustomDeviceProperties='{type=interface;prop={vmfex=^[a-zA-Z0-9_.-]{2,32}$}}' --cver=3.6Copy to Clipboard Copied! Toggle word wrap Toggle overflow vmfexのカスタムプロパティーが追加されたことを確認します。engine-config -g CustomDeviceProperties

# engine-config -g CustomDevicePropertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow - engine を再起動します。

service ovirt-engine restart

# service ovirt-engine restartCopy to Clipboard Copied! Toggle word wrap Toggle overflow

手順5.13 UCS 統合のための仮想 NIC プロファイルの設定

- ネットワーク リソースタブをクリックし、結果一覧で論理ネットワークを選択します。

- 詳細ペインで 仮想 NIC プロファイル タブを選択します。ツリーモードで論理ネットワークを選択すると、ナビゲーションペインで 仮想 NIC プロファイル タブを選択することができます。

- または をクリックして、仮想マシンインターフェースのプロファイル ウィンドウを開きます。

- プロファイルの 名前 と 説明 を入力します。

- カスタムプロパティーの一覧から

vmfexのカスタムプロパティーを選択して、UCS ポートプロファイル名を入力します。 - をクリックします。

5.3. 外部プロバイダーネットワーク

5.3.1. 外部プロバイダーからのネットワークのインポート

手順5.14 外部プロバイダーからのネットワークのインポート

- ネットワーク タブをクリックします。

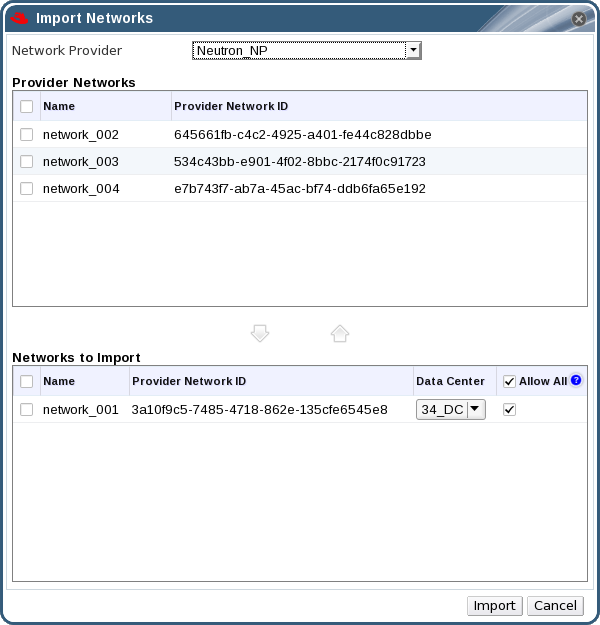

- ボタンをクリックすると ネットワークのインポート ウィンドウが開きます。

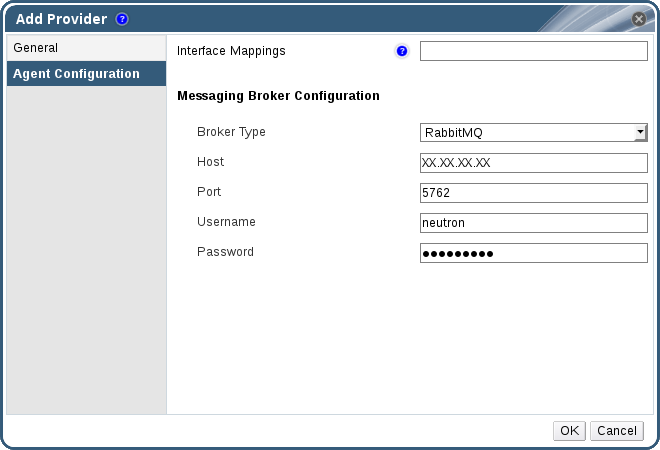

図5.3 ネットワークのインポートウィンドウ

- ネットワークプロバイダー のドロップダウンリストから外部プロバイダーを選択します。プロバイダーが提供するネットワークは自動的に検出され、プロバイダーネットワーク 一覧に表示されます。

- チェックボックスを使用して、プロバイダーネットワーク 一覧からインポートするネットワークを選択し、下向きの矢印をクリックしてそのネットワークを インポートするネットワーク 一覧に移動します。

- インポートするネットワークの名前は、カスタマイズすることが可能です。名前をカスタマイズするには、名前 のコラムでそのネットワークの名前をクリックして編集します。

- データセンター ドロップダウンリストから、ネットワークのインポート先となるデータセンターを選択します。

- オプションとして、ネットワークの使用が全ユーザーに許可されないようにするには、インポートするネットワーク リストのネットワークの 全ユーザーに許可 チェックボックスのチェックを外します。

- ボタンをクリックします。

重要

5.3.2. 外部プロバイダーネットワークの使用における制限事項

- 外部プロバイダーから提供される論理ネットワークは、仮想マシンネットワークとして使用する必要があり、ディスプレイネットワークとしては使用できません。

- 同じ論理ネットワークを複数回インポートすることが可能ですが、インポート先が異なるデータセンターの場合のみです。

- 外部プロバイダーによって提供される論理ネットワークは、Manager 内で編集することはできません。外部プロバイダーによって提供される論理ネットワークの情報を編集するには、その論理ネットワークを提供する OpenStack Networking Service から直接、論理ネットワークを編集する必要があります。

- ポートミラーリングは、外部プロバイダーによって提供される論理ネットワークに接続された仮想ネットワークインターフェースカードには使用できません。

- 外部プロバイダーが提供する論理ネットワークを仮想マシンが使用している場合には、その論理ネットワークが仮想マシンにより使用されている間は、Manager からそのプロバイダーを削除することはできません。

- 外部プロバイダーによって提供されるネットワークは、必須ではありません。このため、そのような論理ネットワークがインポートされたクラスターのスケジューリングでは、ホストの選択中にそれらの論理ネットワークは考慮されません。また、そのような論理ネットワークがインポートされたクラスター内のホスト上の論理ネットワークの可用性を確保するのは、ユーザーの責任となります。

重要

重要

5.3.3. 外部プロバイダーの論理ネットワーク上のサブネット設定

5.3.3.1. 外部プロバイダーの論理ネットワーク上のサブネット設定

5.3.3.2. 外部プロバイダーの論理ネットワークへのサブネット追加

手順5.15 外部プロバイダーの論理ネットワークへのサブネット追加

- ネットワーク タブをクリックします。

- 外部プロバイダーにより提供される論理ネットワークのうち、サブネットを追加する論理ネットワークをクリックします。

- 詳細ペインの サブネット タブをクリックします。

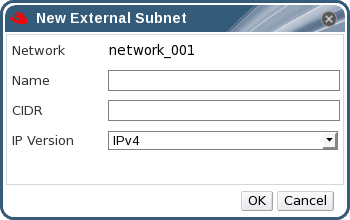

- ボタンをクリックし、新規外部サブネット ウィンドウを開きます。

図5.4 新規外部サブネットウィンドウ

- 新規サブネットの 名前 と CIDR を入力します。

- IP バージョン のドロップダウンメニューから、IPv4 または IPv6 のいずれかを選択します。

- をクリックします。

5.3.3.3. 外部プロバイダーの論理ネットワークからのサブネット削除

手順5.16 外部プロバイダーの論理ネットワークからのサブネット削除

- ネットワーク タブをクリックします。

- 外部プロバイダーにより提供される論理ネットワークのうち、サブネットを削除する論理ネットワークをクリックします。

- 詳細ペインの サブネット タブをクリックします。

- 削除するサブネットをクリックします。

- をクリックし、プロンプトが表示されたら をクリックします。

5.4. 論理ネットワークおよびパーミッション

5.4.1. ネットワークに対するシステムパーミッションの管理

- ネットワークの作成/編集/削除

- ポートミラーリングの設定などのネットワーク設定の編集

- クラスターおよび仮想マシンを含むリソースへのネットワークのアタッチ/デタッチ

5.4.2. ネットワークの管理者およびユーザーのロール

以下の表には、ネットワークの管理に適用可能な管理者とユーザーのロールと権限についての説明をまとめています。

| ロール | 特権 | 備考 |

|---|---|---|

| NetworkAdmin | データセンター、クラスター、ホスト、仮想マシン、またはテンプレートのネットワーク管理者。ネットワークを作成したユーザーには、作成したネットワークに対する NetworkAdmin パーミッションが自動的に割り当てられます。 | 特定のデータセンター、クラスター、ホスト、仮想マシン、またはテンプレートのネットワークを設定管理することができます。データセンターまたはクラスターのネットワーク管理者は、クラスター内の仮想プールのネットワークパーミッションを継承します。仮想マシンネットワークにポートミラーリングを設定するには、そのネットワークに対する NetworkAdmin ロールと、仮想マシンに対する UserVmManager ロールを適用します。 |

| VnicProfileUser | 仮想マシンおよびテンプレートの論理ネットワークおよびネットワークインターフェースのユーザー | 特定の論理ネットワークにネットワークインターフェースをアタッチ/デタッチできます。 |

5.4.3. リソースに対する管理者およびユーザーロールの割り当て

手順5.17 リソースへのロール割り当て

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のリソースを選択します。

- 詳細ペインの タブをクリックして、 選択したリソースに割り当てられたユーザー、ユーザーのロール、継承されたパーミッションを一覧表示します。

- をクリックします。

- 検索 テキストボックスに既存ユーザーの名前またはユーザー名を入力し、 をクリックします。結果一覧に表示される検索候補からユーザーを選択します。

- 割り当てるロール ドロップダウンリストからロールを選択します。

- をクリックします。

5.4.4. リソースからの管理者またはユーザーロールの削除

手順5.18 リソースからのロール削除

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のリソースを選択します。

- 詳細ペインの タブをクリックして、 選択したリソースに割り当てられたユーザー、ユーザーのロール、継承されたパーミッションを一覧表示します。

- リソースから削除するユーザーを選択します。

- をクリックします。パーミッションが削除されることを確認する パーミッションの削除 ウィンドウが開きます。

- をクリックします。

5.5. ホストとネットワーク

5.5.1. ホストの機能のリフレッシュ

手順5.19 ホストの機能をリフレッシュする手順

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のホストを選択します。

- 機能をリフレッシュ ボタンをクリックします。

5.5.2. ホストネットワークインターフェースの編集とホストへの論理ネットワークの割り当て

重要

手順5.20 ホストネットワークインターフェースの編集とホストへの論理ネットワークの割り当て

- ホスト リソースタブをクリックして、対象のホストを選択します。

- 詳細ペインにある ネットワークインターフェース タブをクリックします。

- ボタンをクリックすると ホストネットワークの設定 ウィンドウが開きます。

- 論理ネットワークを物理ホストに割り当てるには、その論理ネットワークを選択して、その物理ホストのネットワークインターフェースの横にある 割り当て済み論理ネットワーク のエリアにドラッグします。もしくは、論理ネットワークを右クリックしてドロップダウンメニューからネットワークインターフェースを選択します。

- 論理ネットワークを設定します。

- 割り当てられた論理ネットワークの上にマウスを移動し、鉛筆のアイコンをクリックすると、管理ネットワークの編集 ウィンドウが開きます。

- None、DHCP、Static の中から ブートプロトコル を選択します。Static を選択した場合には、IP、ネットマスク / ルーティングプレフィックス、ゲートウェイ を入力してください。

- デフォルトのホストネットワーク QoS を上書きするには、QoS を上書き を選択して、以下のフィールドに必要な値を入力します。

- 加重シェア: 特定のネットワークに割り当てる論理リンクのキャパシティーを、同じ論理リンクにアタッチされた他のネットワークに対して相対的に示します。シェアの具体的な値は、そのリンク上の全ネットワークのシェアの和によって異なります。デフォルトでは、これは、1-100 の範囲内の数値です。

- 速度の上限 [Mbps]: ネットワークが使用する最大帯域幅

- コミット速度 [Mbps]: ネットワークに必要な最小の帯域幅。要求されるコミット速度は保証されず、ネットワークインフラストラクチャーや同じ論理リンク上の他のネットワークに要求されるコミット速度によって異なります。

ホストネットワーク QoS の設定に関する詳しい情報は、「ホストネットワークの QoS」を参照してください。 - ネットワークブリッジを設定するには、カスタムプロパティー のドロップダウンメニューをクリックして を選択します。有効なキーと値を [key]=[value] の構文で入力します。エントリーが複数ある場合は、空白文字で区切ります。以下のキーが有効です (値は例として提示しています)。これらのパラメーターに関する詳しい説明は、「bridge_opts パラメーター」を参照してください。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - ethtool のプロパティーを設定するには、カスタムプロパティー のドロップダウンメニューをクリックして を選択します。有効なキーと値を [key]=[value] の構文で入力します。エントリーが複数ある場合は、空白文字で区切ります。 オプションはデフォルトでは使用できないので、engine 設定ツールを使用して追加する必要があります。詳しくは、「Red Hat Enterprise Virtualization Managerで Ethtool を使用するための設定方法」を参照してください。ethtool のプロパティーに関する詳しい情報は、『Red Hat Enterprise Linux 6 Deployment Guide』 または man ページを参照してください。

- 論理ネットワークの定義がホスト上のネットワーク設定と同期されていない場合には、ネットワークを同期 のチェックボックスを選択します。論理ネットワークが同期されるまでは、その論理ネットワークを編集したり、他のインターフェースに移動したりすることはできません。

注記

以下のいずれかの条件が該当する場合には、ネットワークは同期されていると見なされません。- 仮想マシンネットワーク が物理ホストのネットワークと異なる場合。

- VLAN ID が物理ホストネットワークと異なる場合。

- カスタム の MTU が論理ネットワークで設定済みで、かつ物理ホストのネットワークと異なる場合。

- ネットワーク接続をチェックするには、ホストと Engine 間の接続を検証 のチェックボックスを選択します。この操作は、ホストがメンテナンスモードに入っている場合のみに機能します。

- 環境をリブートした時に変更が維持されるようにするには、ネットワーク設定を保存 のチェックボックスを選択します。

- をクリックします。

注記

5.5.3. 論理ネットワークを使用した単一ネットワークインターフェースへの複数の VLAN 追加

重要

手順5.21 論理ネットワークを使用した、ネットワークインターフェースへの複数の VLAN 追加

- ホスト リソースタブをクリックして、VLAN タグ付きの論理ネットワークが割り当てられたクラスターに関連付けられているホストを結果一覧から選択します。

- 詳細ペインにある ネットワークインターフェース タブをクリックし、データセンターにアタッチされた物理ネットワークインターフェースを一覧表示します。

- をクリックすると ホストネットワークの設定 ウィンドウが開きます。

- VLAN タグの付いた論理ネットワークを物理ネットワークインターフェースの横にある 割り当て済み論理ネットワーク のエリアにドラッグします。VLAN タグ付けにより、物理ネットワークインターフェースに複数の論理ネットワークを割り当てることができます。

- 割り当て済み論理ネットワークの上にマウスを移動し、鉛筆のアイコンをクリックすると、ネットワークの編集 ウィンドウが開きます。論理ネットワークの定義がホスト上のネットワーク設定と同期されていない場合には、ネットワークを同期 のチェックボックスを選択します。次のいずれかの ブートプロトコル を選択します。OK をクリックします。

- None

- DHCP

- StaticIP アドレス と サブネットマスク を入力します。

- ネットワークのチェックを実行するには、ホストと Engine 間の接続を検証 のチェックボックスを選択します。この検証は、ホストがメンテナンスモードに入っている場合のみに機能します。

- ネットワーク設定を保存 チェックボックスを選択します。

- をクリックします。

5.5.4. ホストネットワークインターフェースへのネットワークラベルの追加

手順5.22 ホストネットワークインターフェースへのネットワークラベルの追加

- ホスト リソースタブをクリックして、VLAN タグ付きの論理ネットワークが割り当てられたクラスターに関連付けられているホストを結果一覧から選択します。

- 詳細ペインにある ネットワークインターフェース タブをクリックし、データセンターにアタッチされた物理ネットワークインターフェースを一覧表示します。

- をクリックすると ホストネットワークの設定 ウィンドウが開きます。

- をクリックして を右クリックします。ラベルを付ける物理ネットワークインターフェースを選択します。

- ラベル のテキストフィールドにネットワークラベル名を入力します。

- をクリックします。

5.5.5. ボンディング

5.5.5.1. Red Hat Enterprise Virtualization におけるボンディングロジック

- いずれかのデバイスが論理ネットワークをすでに伝送しているかどうか。

- デバイスは、互換性のある論理ネットワークを伝送しているかどうか。

| ボンディングシナリオ | 結果 |

|---|---|

|

NIC + NIC

|

新規ボンディングの作成 ウィンドウが表示され、新規ボンディングデバイスを設定することができます。

ネットワークインターフェースが互換性のない論理ネットワークを伝送している場合には、新規ボンディングを形成するデバイスから互換性のない論理ネットワークをデタッチするまで、ボンディング操作は失敗します。

|

|

NIC + Bond

|

NIC がボンディングデバイスに追加されます。NIC とボンディングデバイスが伝送する各論理ネットワークに互換性がある場合には、それらの論理ネットワークはすべて、この操作で作成されるボンディングデバイスに追加されます。

ボンディングデバイスが互換性のない論理ネットワークを伝送している場合には、新規ボンディングを形成するデバイスから互換性のない論理ネットワークをデタッチするまで、ボンディング操作は失敗します。

|

|

Bond + Bond

|

ボンディングデバイスが論理ネットワークにアタッチされていない場合、または互換性のある論理ネットワークにアタッチされている場合には、新規ボンディングデバイスが作成されます。これには、すべてのネットワークインターフェースが含まれ、ボンディングを構成するデバイスの全論理ネットワークを伝送します。新規ボンディングの作成 ウィンドウが表示され、新規ボンディングの設定を行うことができます。

ボンディングデバイスが互換性のない論理ネットワークを伝送している場合には、新規ボンディングを形成するデバイスから互換性のない論理ネットワークをデタッチするまで、ボンディング操作は失敗します。

|

5.5.5.2. ボンディング

重要

ボンディングモード

モード 0 (round-robin ポリシー)- このモードは、ネットワークインターフェースカードを順番に使用してパケットを送信します。パケットの送信は、ボンディングで最初に利用可能なネットワークインターフェースカードから、最後に利用可能なネットワークインターフェースカードまでループで使用をくり返します。それ以降のループでもすべて、最初に利用可能なネットワークインターフェースカードから使用されます。モード 0 では、ネットワークに対して耐障害性や負荷分散が提供されていますが、ブリッジと併用できないため、仮想マシンの論理ネットワークとの互換性はありません。

モード 1 (active-backup ポリシー)- このモードは、すべてのネットワークインターフェースカードをバックアップ状態に設定して、1 つだけアクティブなカードを残します。アクティブなネットワークインターフェースカードで障害が発生すると、バックアップに設定されていたネットワークインターフェースカードの 1 つが、障害の発生したインターフェースに代わって、ボンディング内で唯一のアクティブインターフェースになります。1 つ以上のポートでアドレスが表示されていると、有効なネットワークインターフェースカードの MAC アドレスを反映するためにボンディングの MAC アドレスが変更された場合に混乱が生じる可能性があり、このような混乱を避ける目的で、モード 1 のボンディングの MAC アドレスは、1 つのポートだけで表示されます。モード 1 は耐障害性を提供し、Red Hat Enterprise Virtualization でサポートされています。

モード 2 (XOR ポリシー)- このモードは、送信元と送信先の MAC アドレスの XOR (排他的理論和) をネットワークインターフェースカードのスレーブ数で除算した剰余に基づいて、パケット送信に用いるネットワークインターフェースカードを選択します。この計算により、各送信先の MAC アドレスに必ず同じネットワークインターフェースカードが選択されるようにします。モード 2 は耐障害性と負荷分散を提供し、Red Hat Enterprise Virtualization でサポートされています。

モード 3 (broadcast ポリシー)- このモードは、全パケットをすべてのネットワークインターフェースカードに送信します。モード 3 は耐障害性を提供し、Red Hat Enterprise Virtualization でサポートされています。

モード 4 (IEEE 802.3ad ポリシー)- このモードは、任意の集約グループを作成し、このグループ内のインターフェースが速度およびデュプレックスの設定を共有します。モード 4 は、IEEE 802.3ad 仕様に従ってアクティブな集約グループ内のネットワークインターフェースカードをすべて使用します。このモードも、Red Hat Enterprise Virtualization でサポートされています。

モード 5 (adaptive transmit load balancing ポリシー)- このモードは、ボンディング内の各ネットワークインターフェースカードの負荷に応じて発信トラフィックが分散され、現在のネットワークインターフェースカードが全着信トラフィックを受信するようにします。トラフィックの受信に割り当てられているネットワークインターフェースカードに障害が発生した場合には、着信トラフィックの受信ロールは別のネットワークインターフェースカードに割り当てられます。モード 5 はブリッジと併用できないため、仮想マシンの論理ネットワークとの互換性はありません。

モード 6 (adaptive load balancing ポリシー)- このモードは、モード 5 (adaptive transmit load balancing ポリシー) に IPv4 トラフィックの受信負荷分散を組み合わせたポリシーで、特別なスイッチ要件はありません。ARP ネゴシエーションを使用して受信負荷の分散を行います。モード 6 はブリッジと併用できないため、仮想マシンの論理ネットワークとの互換性はありません。

5.5.5.3. 管理ポータルを使用したボンディングデバイスの作成

手順5.23 管理ポータルを使用したボンディングデバイスの作成

- ホスト リソースタブをクリックして、結果一覧でホストを選択します。

- 詳細ペインにある ネットワークインターフェース タブをクリックし、ホストにアタッチされた物理ネットワークインターフェースを一覧表示します。

- をクリックすると ホストネットワークの設定 ウィンドウが開きます。

- 一方のデバイスを選択して、他方のデバイスの上にドラグアンドドロップすると、新規ボンディングの作成 ウィンドウが開きます。または、一方のデバイスを右クリックして、他方のデバイスをドロップダウンメニューから選択します。デバイスに互換性がない場合には、ボンディングの操作は失敗して、互換性問題の解決方法を示したメッセージが表示されます。

- ドロップダウンメニューから ボンディング名 および ボンディングモード を選択します。ボンディングモード 1、2、4、5 を選択することができます。その他のモードを設定するには、カスタム オプションを使用します。

- をクリックしてボンディングを作成し、新規ボンディングの作成 ウィンドウを閉じます。

- 新規作成したボンディングデバイスに論理ネットワークを割り当てます。

- オプションとして、ホストと Engine 間の接続を検証 および ネットワーク設定を保存 を選択することができます。

- をクリックして変更を受け入れ、ホストネットワークの設定 ウィンドウを閉じます。

5.5.5.4. ホストインターフェースのカスタムボンディングオプションの使用例

例5.1 xmit_hash_policy

mode=4 xmit_hash_policy=layer2+3

mode=4 xmit_hash_policy=layer2+3例5.2 ARP モニタリング

arp_interval を設定するには、カスタム ボンディングモードを選択して、テキストフィールドに以下の値を入力します。

mode=1 arp_interval=1 arp_ip_target=192.168.0.2

mode=1 arp_interval=1 arp_ip_target=192.168.0.2例5.3 プライマリー

mode=1 primary=eth0

mode=1 primary=eth05.5.6. ホストの完全修飾ドメイン名の変更

手順5.24 ハイパーバイザーホストの完全修飾ドメイン名の更新

- ハイパーバイザーをメンテナンスモードに切り替えて、仮想マシンが別のハイパーバイザーにライブマイグレーションされるようにします。詳しい説明は、「ホストのメンテナンスモードへの切り替え」を参照してください。または、全仮想マシンを手動でシャットダウンして、別のハイパーバイザーに移行します。詳しくは、『仮想マシン管理ガイド』の「手動での仮想マシン移行」のセクションを参照してください。

- をクリックしてから をクリックし、管理ポータルからホストを削除します。

- RHEL ベースのホストの場合

- Red Hat Enterprise Linux 6 の場合

/etc/sysconfig/networkファイルを編集し、ホスト名を更新して保存します。vi /etc/sysconfig/network

# vi /etc/sysconfig/network HOSTNAME=NEW_FQDNCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Enterprise Linux 7 の場合ホスト名を更新するには、hostnamectl ツールを使用します。その他のオプションについては、『Red Hat Enterprise Linux 7 ネットワークガイド』の「ホスト名の設定」の章を参照してください。

hostnamectl set-hostname NEW_FQDN

# hostnamectl set-hostname NEW_FQDNCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- Red Hat Enterprise Virtualization Hypervisors (RHEV-H) の場合テキストユーザーインターフェースで Network の画面を選択して右矢印キーを押し、Hostname フィールドに新規ホスト名を入力します。 を選択して Enter を押します。

- ホストをリブートします。

- Manager にホストを再登録します。詳しくは、『インストールガイド』の「管理ポータルからハイパーバイザーを手動で追加する方法」のセクションを参照してください。

5.5.7. Red Hat Enterprise Virtualization Hypervisor (RHEV-H) の IP アドレスの変更

手順5.25

- ハイパーバイザーをメンテナンスモードに切り替えて、仮想マシンが別のハイパーバイザーにライブマイグレーションされるようにします。詳しい説明は、「ホストのメンテナンスモードへの切り替え」を参照してください。または、全仮想マシンを手動でシャットダウンして、別のハイパーバイザーに移行します。詳しくは、『仮想マシン管理ガイド』の「手動での仮想マシン移行」のセクションを参照してください。

- をクリックしてから をクリックし、管理ポータルからホストを削除します。

adminユーザーとして Hypervisor にログインします。- F2 を押して を選択し、Enter を押してレスキューシェルに入ります。

/etc/sysconfig/network-scripts/ifcfg-ovirtmgmtファイルを編集して、IP アドレスを変更します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - ネットワークサービスを再起動して、IP アドレスが更新されたことを確認します。

- Red Hat Enterprise Linux 6 の場合

service network restart

# service network restartCopy to Clipboard Copied! Toggle word wrap Toggle overflow ifconfig ovirtmgmt

# ifconfig ovirtmgmtCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat Enterprise Linux 7 の場合

systemctl restart network.service

# systemctl restart network.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow ip addr show ovirtmgmt

# ip addr show ovirtmgmtCopy to Clipboard Copied! Toggle word wrap Toggle overflow

exitと入力してレスキューシェルを終了し、テキストユーザーインターフェースに戻ります。- Manager にホストを再登録します。詳しくは、『インストールガイド』の「管理ポータルからハイパーバイザーを手動で追加する方法」のセクションを参照してください。

第6章 ホスト

6.1. Red Hat Enterprise Virtualization ホストについて

- システム内の単一のクラスターのみに属していること。

- AMD-V または Intel VT ハードウェア仮想化拡張機能をサポートする CPU が搭載されていること。

- クラスター作成時に選択した仮想 CPU タイプで公開される全機能をサポートする CPU が搭載されていること。

- 最小で 2 GB の RAM が搭載されていること。

- システムパーミッションを持つシステム管理者を 1 名指定可能であること。

6.2. Red Hat Enterprise Virtualization Hypervisor ホスト

重要

6.3. Satellite ホストプロバイダーのホスト

6.4. Red Hat Enterprise Linux ホスト

Red Hat Enterprise Linux Server エンタイトルメントと Red Hat Enterprise Virtualization エンタイトルメントをアタッチする必要もあります。

重要

6.5. ホストのタスク

6.5.1. Satellite ホストプロバイダーのホストの追加

手順6.1 Satellite ホストプロバイダーのホストの追加

- ホスト リソースタブをクリックすると、結果一覧にホストが一覧表示されます。

- をクリックすると、新規ホスト ウィンドウが表示されます。

- ドロップダウンメニューで、新規ホスト用の ホストクラスター を選択します。

- Foreman/Satellite のチェックボックスを選択して、Satellite ホストプロバイダーを追加するためのオプションを表示し、ホストを追加するプロバイダーを選択します。

- 検出されたホスト または プロビジョン済みホスト のいずれかを選択します。

- 検出されたホスト (デフォルトオプション): ドロップダウンリストからホスト、ホストグループ、コンピュートリソースを選択します。

- プロビジョン済みホスト: プロバイダーのホスト のドロップダウンリストからホストを 1 つ選択します。

外部プロバイダーから取得可能なホストに関する情報は、自動的に設定され、必要に応じて編集することができます。 - 新規ホストの 名前、アドレス、SSH ポート (プロビジョン済みホストのみ) を入力します。

- ホストに使用する認証のメソッドを選択します。

- パスワード認証を使用するには、root ユーザーのパスワードを入力します。

- 公開鍵認証を使用するには、SSH 公開鍵 フィールドに表示される鍵をホスト上の

/root/.ssh/authorized_hostsにコピーします (プロビジョン済みホストのみ)。

- Red Hat Enterprise Linux ホストを追加するための必須手順が完了しました。次に、 の展開ボタンをクリックして、ホストの詳細設定を表示します。

- オプションとして、ファイアウォールの自動設定を無効にすることができます。

- オプションとして、JSON プロトコルの使用を無効にすることができます。

- オプションとして、ホストの SSH フィンガープリントを追加し、セキュリティーを強化することができます。手動での追加または自動取得が可能です。

- 対象のタブで 電源管理 、SPM 、コンソール、および ネットワークプロバイダー を設定することができる状態になりました。ただし、これらの設定は、Red Hat Enterprise Linux ホストの追加に必須ではないため、このセクションでは説明していません。

- をクリックしてホストを追加し、ウィンドウを閉じます。

Installing のステータスでホスト一覧に表示され、詳細ペインでインストールの進捗状況を確認することができます。インストールが完了するとステータスは Reboot になります。ステータスが Up に変わるには、ホストをアクティブ化する必要があります。

6.5.2. ホストを対象とする Satellite のエラータ管理の設定

重要

手順6.2 ホストを対象とする Satellite のエラータ管理の設定

- Satellite サーバーを外部プロバイダーとして追加します。詳しい説明は、「ホストプロビジョニング用の Red Hat Satellite インスタンスの追加」を参照してください。

- 対象のホストを Satellite サーバーに関連付けます。

注記

ホストは、Satellite サーバーにコンテンツホストとして登録し、katello-agent パッケージをインストールする必要があります。ホスト登録の設定方法についての詳しい情報は、『Red Hat Satellite User Guide』の「Configuring a Host for Registration」のセクションを参照してください。また、ホストの登録および katello-agent パッケージのインストール方法に関する詳しい情報は、『Red Hat Satellite User Guide』の「Registration」のセクションを参照してください。- ホスト タブをクリックして、結果一覧でホストを選択します。

- をクリックし、ホストの編集 ウィンドウを開きます。

- チェックボックスにチェックを付けます。

- ドロップダウンリストから対象の Satellite サーバーを選択します。

- をクリックします。

6.5.3. 新規ホストおよびホストの編集ウィンドウの設定とコントロール

6.5.3.1. ホストの全般設定

|

フィールド名

|

説明

|

|---|---|

|

データセンター

|

ホストが属するデータセンター。Red Hat Enterprise Virtualization Hypervisor ホストは、Gluster が有効化されたクラスターには追加できません。

|

|

ホストクラスター

|

ホストが属するクラスター

|

|

Foreman/Satellite を使用する

|

Satellite ホストプロバイダーによって提供されるホストを追加するためのオプションを表示/非表示にするには、このチェックボックスを選択/選択解除します。以下のオプションを設定することができます。

検出されたホスト

プロビジョン済みホスト

|

|

名前

|

クラスターの名前。このテキストフィールドは最長で 40 文字に制限されており、アルファベットの大文字/小文字、数字、ハイフン、アンダースコアを任意に組み合わせた一意名にする必要があります。

|

|

コメント

|

ホストに関する、プレーンテキスト形式の人間が判読できるコメントを追加するためのフィールド

|

|

アドレス

|

ホストの IP アドレス、または解決可能なホスト名

|

|

パスワード

|

ホストの root ユーザーのパスワード。ホストを追加する時にのみ指定することができ、それ以降は編集できません。

|

|

SSH 公開鍵

|

ホストとの認証で、パスワードを使用する代わりに Manager の SSH キーを使用する場合には、テキストボックスの内容をホストの

/root/.ssh/authorized_hosts ファイルにコピーします。

|

|

ホストのファイアウォールを自動設定

|

新規ホストを追加する際には、Manager がホストのファイアウォール上の必要なポートを開くことができます。この設定はデフォルトで有効化されています。これは、詳細パラメーター です。

|

|

JSON プロトコルを使用する

|

このチェックボックスはデフォルトで有効化されます。これは、詳細パラメーター の設定です。

|

|

SSH フィンガープリント

|

ホストの SSH フィンガープリントを して、ホストが返すフィンガープリントと比較し、それらが一致しているかどうかを確認することができます。これは 詳細パラメーター です。

|

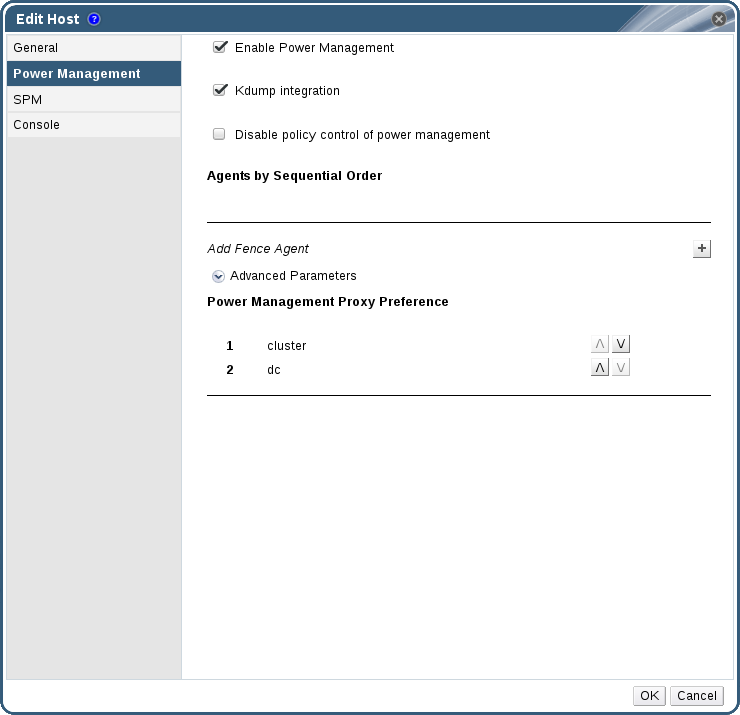

6.5.3.2. ホストの電源管理の設定

|

フィールド名

|

説明

|

|---|---|

|

電源管理を有効にする

|

ホストで電源管理を有効にします。このチェックボックスを選択して、電源管理 タブの残りのフィールドを有効にします。

|

|

Kdump 統合

|

カーネルクラッシュダンプの実行中にホストがフェンシングされるのを防ぎ、クラッシュダンプが中断されないようにします。新しい Red Hat Enterprise Linux 6.6 および 7.1 以降のバージョンでは、kdump はデフォルトで利用可能です。ホストで kdump が利用可能であっても、設定が有効でない (kdump サービスが起動できない) 場合には、Kdump 統合 を有効にすると、ホストのインストールが失敗します。このようなエラーが発生した場合には、「fence_kdump の詳細設定」を参照してください。

|

|

電源管理のポリシー制御を無効にする

|

電源管理は、ホストの クラスター で設定されている スケジューリングポリシー によって制御されます。電源管理を有効にすると、ホストの使用率が定義済みの下限値に達した場合には、Manager が、そのホストマシンの電源を切断し、また負荷分散でそのホストが必要となった場合や、クラスター内で空いているホストが不足した場合には、そのホストを再起動します。ポリシー制御を無効にする場合は、このチェックボックスを選択します。

|

|

順次に使用するエージェント

|

ホストのフェンスエージェントを一覧表示します。フェンスエージェントは、順次、同時、またはそれらの両方を組み合わせて使用することができます。

デフォルトでは、フェンスエージェントは順次に使用されます。フェンスエージェントの使用順序を変更するには、上向き/下向きのボタンを使用してください。

2 つのフェンスエージェントを同時に使用するには、一方のフェンスエージェントの横にある 同時に使用するフェンスエージェント のドロップダウンリストからもう一方のフェンスエージェントを選択します。 同時に使用するフェンスエージェントのグループにフェンスエージェントをさらに追加するには、その追加のフェンスエージェントの横にある 同時に使用するフェンスエージェント ドロップダウンリストから対象のグループを選択して設定することができます。

|

|

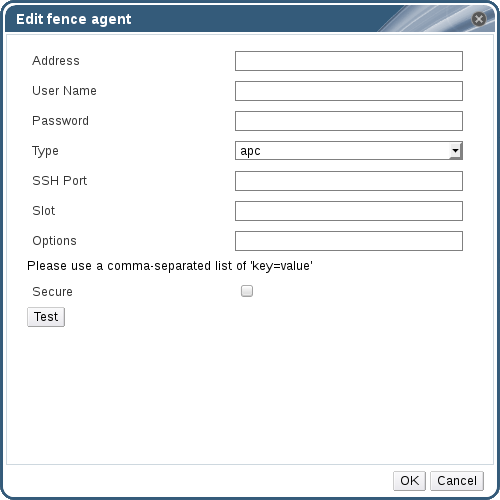

フェンスエージェントの追加

|

プラス () のボタンをクリックして、新規フェンスエージェントを追加します。フェンスエージェントの編集 ウィンドウが開きます。以下の表には、このウィンドウ内のフィールドについての詳しい説明をまとめています。

|

|

電源管理プロキシーの設定

|

デフォルトでは、Manager がホストと同じ cluster 内のフェンシングプロキシーを検索するように指定されます。フェンシングプロキシーが見つからない場合には、Manager は同じ dc (データセンター) 内を検索します。これらのリソースの使用順序を変更するには、上向き/下向きのボタンを使用します。このフィールドは、詳細パラメーター の下にあります。

|

|

フィールド名

|

説明

|

|---|---|

|

アドレス

|

ホストの電源管理デバイスにアクセスするアドレス。解決可能なホスト名または IP アドレス

|

|

ユーザー名

|

電源管理デバイスにアクセスするユーザーアカウント。デバイスにユーザーを設定するか、デフォルトのユーザーを使用してください。

|

|

パスワード

|

電源管理デバイスにアクセスするユーザーのパスワード

|

|

タイプ

|

ホストの電源管理デバイスのタイプ。

以下のいずれかを選択します。

|

|

SSH ポート

|

電源管理デバイスがホストとの通信に使用するポート番号

|

|

スロット

|

電源管理デバイスのブレードの特定に使用する番号

|

|

サービスプロファイル

|

電源管理デバイスのブレードの特定に使用するサービスプロファイル名。このフィールドは、デバイスタイプが

cisco_ucs の場合に スロット フィールドの代わりに表示されます。

|

|

オプション

|

電源管理デバイス固有のオプション。'key=value' として指定します。使用可能なオプションについては、ホストの電源管理デバイスのマニュアルを参照してください。

Red Hat Enterprise Linux 7 ホストで、電源管理デバイスに cisco_ucs を使用する場合には、オプション フィールドに

ssl_insecure=1 を追記する必要もあります。

|

|

セキュリティー保護

|

電源管理デバイスがホストにセキュアに接続できるようにするには、このチェックボックスを選択します。この接続には、電源管理エージェントに応じて、ssh、ssl、またはその他の認証プロトコルを使用することができます。

|

6.5.3.3. SPM 優先度の設定

|

フィールド名

|

説明

|

|---|---|

|

SPM 優先度

|

ホストに Storage Pool Manager (SPM) のロールが割り当てられる優先度を定義します。優先度のオプションは、低、標準、高 です。優先度が低の場合は、そのホストに SPM のロールが割り当てられる確率が低くなり、高の場合は確率が高くなります。デフォルト設定は標準です。

|

6.5.3.4. ホストコンソールの設定

|

フィールド名

|

説明

|

|---|---|

|

ディスプレイアドレスを上書き

|

ホストのディスプレイアドレスを上書きするには、このチェックボックスを選択します。この機能は、ホストが内部 IP アドレスで定義され、かつ NAT ファイアウォールの内側にある場合に有用です。ユーザーが内部ネットワークの外から仮想マシンに接続すると、仮想マシンを実行しているホストのプライベートアドレスの代わりに、パブリック IP アドレスまたは FQDN (外部ネットワークでパブリック IP アドレスに解決される) がそのマシンによって返されます。

|

|

ディスプレイアドレス

|

このフィールドに指定するディスプレイアドレスは、そのホスト上で実行する全仮想マシンに使用されます。アドレスは完全修飾ドメイン名または IP アドレスの形式にする必要があります。

|

6.5.4. ホストの電源管理設定値の設定

重要

Maintenance モードに入っていることを確認します。このモードに入っていない場合には、そのホストで実行されている仮想マシン、ホストの再起動時にすべて強制終了され、実稼働環境が停止してしまうことになります。ホストが Maintenance モードに正しく設定されていない場合は、警告のメッセージが表示されます。

手順6.3 電源管理設定値の設定

- ホスト タブをクリックして、結果一覧でホストを選択します。

- をクリックし、ホストの編集 ウィンドウを開きます。

- 電源管理 タブをクリックし、電源管理設定を表示します。

- 電源管理を有効にする のチェックボックスを選択し、フィールドを有効にします。

- kdump 統合 チェックボックスを選択して、カーネルクラッシュダンプの実行中にホストがフェンシングされないようにします。

重要

既存のホストに Kdump 統合 を有効にする場合には、kdump を設定するためにそのホストを再インストールする必要があります。 「仮想化ホストの再インストール」を参照してください。 - オプションで、ホストの クラスター の スケジューリングポリシー によってホストの電源管理が制御されないようにするには、電源管理のポリシー制御を無効にする のチェックボックスを選択します。

- プラス () のボタンをクリックして、新規電源管理デバイスを追加します。フェンスエージェントの編集 ウィンドウが開きます。

- 電源管理デバイスの アドレス、ユーザー名、および パスワード を適切なフィールドに入力します。

- ドロップダウンリストから、電源管理デバイスの タイプ を選択します。

- 電源管理デバイスがホストとの通信に使用する SSH ポート 番号を入力します。

- 電源管理デバイスのブレードの特定に使用する スロット 番号を入力します。

- 電源管理デバイスの オプション を入力します。'key=value' エントリーのコンマ区切りリストを使用してください。

- 電源管理デバイスからホストへのセキュアな接続を有効にするには、セキュリティー保護 のチェックボックスを選択します。

- をクリックして、設定が正しいことを確認します。検証が正常に完了すると、「Test Succeeded, Host Status is: on」というメッセージが表示されます。

- をクリックして フェンスエージェントの編集 ウィンドウを閉じます。

- 電源管理 タブでは、オプションとして 詳細パラメーター の箇所を展開し、上下に移動するボタンを使用して Manager がホストの cluster および dc (データセンター) でフェンシングプロキシーを探す順序を指定します。

- をクリックします。

6.5.5. ホストの Storage Pool Manager の設定

手順6.4 SPM 設定値の設定

- ホスト リソースタブをクリックして、結果一覧でホストを選択します。

- をクリックし、ホストの編集 ウィンドウを開きます。

- SPM タブをクリックすると、SPM 優先度 の設定画面が表示されます。

- ラジオボタンで、そのホストに適切な SPM 優先度を選択します。

- をクリックして設定を保存し、ウィンドウを閉じます。

6.5.6. リソースの編集

手順6.5 リソースの編集

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のリソースを選択します。

- をクリックして 編集 ウィンドウを開きます。

- 必要なプロパティーを変更して をクリックします。

6.5.7. ホストのメンテナンスモードへの切り替え

手順6.6 ホストをメンテナンスモードに切り替える手順

- ホスト リソースタブをクリックして、対象のホストを選択します。

- をクリックすると ホストのメンテナンス の確認ウィンドウが開きます。

- オプションとして、ホストのメンテナンス 確認ウィンドウで、ホストをメンテナンスモードに切り替える 理由 を入力して、メンテナンスモードに切り替える理由を指定することができます。この理由は、ログとホストの再アクティブ化時に表示されます。

注記

ホストのメンテナンスの 理由 フィールドは、クラスターの設定で有効化されている場合にのみ表示されます。詳しくは、 「クラスターの全般設定」を参照してください。 - をクリックしてメンテナンスモードを開始します。

Preparing for Maintenance に変わり、操作が正常に完了すると最終的に Maintenance となります。VDSM は、ホストのメンテナンスモード中には停止しません。

注記

6.5.8. メンテナンスモードのホストのアクティブ化

手順6.7 メンテナンスモードのホストのアクティブ化

- ホスト リソースタブをクリックして、ホストを選択します。

- をクリックします。

Unassigned に切り替わり、操作が完了すると最終的には Up となります。これで仮想マシンをこのホスト上で実行できるようになりました。このホストをメンテナンスモードに切り替えた際に別のホストに移行されていた仮想マシンは、ホストのアクティブ化時に自動的にこのホストには戻されませんが、手動で移行することができます。メンテナンスモードに切り替える前にホストが Storage Pool Manager (SPM) だった場合には、ホストがアクティブ化されても、SPM ロールは自動的に元には戻りません。

6.5.9. ホストの削除

手順6.8 ホストの削除

- 管理ポータルで、ホスト リソースタブをクリックして、結果一覧でホストを選択します。

- ホストをメンテナンスモードに切り替えます。

- をクリックすると ホストの削除 の確認ウィンドウが開きます。

- ホストが Red Hat Gluster Storage クラスターに属し、ボリュームブリックがある場合、もしくはホストが応答していない場合には、強制削除 のチェックボックスを選択します。

- をクリックします。

6.5.10. 仮想化ホストの再インストール

重要

手順6.9 Red Hat Enterprise Virtualization Hypervisor および Red Hat Enterprise Linux ホストの再インストール

- ホスト リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のホストを選択します。

- ボタンをクリックします。クラスターレベルでマイグレーションが有効化されている場合には、このホストで実行中の仮想マシンは別のホストに移行されます。ホストが SPM の場合には、SPM 機能も別のホストに移動します。ホストがメンテナンスモードに入るとステータスが変わります。

- 再インストール をクリックすると、ホストのインストール ウィンドウが開きます。

- をクリックしてホストを再インストールします。

重要

6.5.11. タグを使用したホストのカスタマイズ

手順6.10 タグを使用したホストのカスタマイズ

- ホスト リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のホストを選択します。

- をクリックすると、タグの割り当て ウィンドウが開きます。

図6.1 タグの割り当てのウィンドウ

- タグの割り当て のウィンドウには、使用可能なタグがすべて一覧表示されます。対象のタグのチェックボックスを選択します。

- をクリックしてタグを割り当て、ウィンドウを閉じます。

6.5.12. ホストのエラータの表示

手順6.11 ホストのエラータの表示

- ホスト リソースタブをクリックして、結果一覧でホストを選択します。

- 詳細ペインで 全般 タブをクリックします。

- 全般 タブ内の エラータ サブタブをクリックします。

6.5.13. ホストのヘルスステータスの確認

- OK: アイコンなし

- Info:

- Warning:

- Error:

- Failure:

GET 要求には、ヘルスステータスが記載された external_status 要素が含まれます。

6.5.14. ホストデバイスの表示

手順6.12 ホストデバイスの表示

- ホスト リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のホストを選択します。

- 詳細ペインの ホストデバイス タブをクリックします。

6.5.15. GPU パススルーに向けたホストおよびゲストシステムの準備

grub 設定ファイルに必要な変更を加える必要があります。また、変更を有効にするには、両マシンを再起動する必要もあります。

手順6.13 GPU パススルーに向けた準備

- ホストサーバーにログインし、

lspciを使用して GPU デバイスのベンダーおよびデバイス識別子を確認します。lspci -nn

$ lspci -nn ... 01:00.0 VGA compatible controller [0300]: NVIDIA Corporation GM107GL [Quadro K2200] [10de:13ba] (rev a2) 01:00.1 Audio device [0403]: NVIDIA Corporation Device [10de:0fbc] (rev a1) ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上記の例の応答では、ビデオとオーディオの vendor:device 識別子はそれぞれ10de:13baと10de:0fbcです。 grub設定ファイルを開き、GRUB_CMDLINE_LINUXの行で、vendor:device 識別子をpci-stubドライバーにバインディングするように変更します。vi /etc/default/grub

$ vi /etc/default/grub ... GRUB_CMDLINE_LINUX="nofb splash=quiet console=tty0 ... pci-stub.ids=10de:13ba,10de:0fbc" ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 難読化を回避するためには、対応するドライバーをブラックリストすることを推奨します。以下の例では、GRUB_CMDLINE_LINUXの行をさらに変更して、nVidia の nouveau ドライバーをブラックリストに追加しています。vi /etc/default/grub

$ vi /etc/default/grub ... GRUB_CMDLINE_LINUX="nofb splash=quiet console=tty0 ... pci-stub.ids=10de:13ba,10de:0fbc rdblacklist=nouveau" ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow grub設定ファイルを保存します。grub.cfgをリフレッシュしてからサーバーを再起動し、変更を有効にします。grub2-mkconfig -o /boot/grub2/grub.cfg reboot

$ grub2-mkconfig -o /boot/grub2/grub.cfg $ rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow lspciコマンドを実行して、デバイスがpci-stubドライバーにバインドされていることを確認します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - ホストの GPU デバイスに直接アタッチされる仮想マシンにログインし、ゲストの

grub設定ファイルで対応するドライバーをブラックリストに追加します。vi /etc/default/grub

$ vi /etc/default/grub ... GRUB_CMDLINE_LINUX="nofb splash=quiet console=tty0 ... rdblacklist=nouveau" ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow grub.cfgをリフレッシュしてから仮想マシンを再起動し、変更を有効にします。grub2-mkconfig -o /boot/grub2/grub.cfg reboot

$ grub2-mkconfig -o /boot/grub2/grub.cfg $ rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.6. ホストの耐障害性

6.6.1. ホストの高可用性

6.6.2. Red Hat Enterprise Virtualization におけるプロキシーを使用した電源管理

- フェンシングが必要なホストと同じクラスター内にある任意のホスト

- フェンシングが必要なホストと同じデータセンター内にある任意のホスト

6.6.3. ホスト上でのフェンシングパラメーターの設定

手順6.14 ホスト上でのフェンシングパラメーターの設定

- ホスト リソースタブ、ツリーモード、または検索機能を使用して、結果一覧に表示された候補の中から対象のホストを選択します。

- をクリックし、ホストの編集 ウィンドウを開きます。

- 電源管理 タブをクリックします。

図6.2 電源管理の設定

- 電源管理を有効にする のチェックボックスを選択し、フィールドを有効にします。

- kdump 統合 チェックボックスを選択して、カーネルクラッシュダンプの実行中にホストがフェンシングされないようにします。

重要

既存のホストに Kdump 統合 を有効にする場合には、kdump を設定するためにそのホストを再インストールする必要があります。 「仮想化ホストの再インストール」を参照してください。 - オプションで、ホストのクラスターの スケジューリングポリシー がホストの電源管理を制御しないようにするには、電源管理のポリシー制御を無効にする のチェックボックスを選択します。

- プラス () のボタンをクリックして、新規電源管理デバイスを追加します。フェンスエージェントの編集 ウィンドウが開きます。

図6.3 フェンスエージェントの編集

- 電源管理デバイスの アドレス、ユーザー名、および パスワード を入力します。

- ドロップダウンリストから、電源管理デバイスの タイプ を選択します。

注記

Red Hat Enterprise Virtualization 3.5 以降のバージョンでは、カスタムの電源管理デバイスを使用することができます。カスタムの電源管理デバイスの設定方法については、https://access.redhat.com/articles/1238743 の記事を参照してください。 - 電源管理デバイスがホストとの通信に使用する SSH ポート 番号を入力します。

- 電源管理デバイスのブレードの特定に使用する スロット 番号を入力します。

- 電源管理デバイスの オプション を入力します。'key=value' エントリーのコンマ区切りリストを使用してください。

- 電源管理デバイスからホストへのセキュアな接続を有効にするには、セキュリティー保護 のチェックボックスを選択します。

- ボタンをクリックして、設定が正しいことを確認します。検証が正常に完了すると、「Test Succeeded, Host Status is: on」というメッセージが表示されます。

警告

電源管理のパラメーター (ユーザー ID、パスワード、オプションなど) がテストされるのは、セットアップ時のみで、それ以降は手動で実行します。パラメーターが正しくないことを警告するアラートを無視した場合や、電源管理デバイスで変更されたパラメーターが Red Hat Enterprise Virtualization Manager では同じように変更されていない場合には、フェンシングを最も必要とする時に失敗してしまう可能性があります。 - をクリックして フェンスエージェントの編集 ウィンドウを閉じます。

- 電源管理 タブでは、オプションとして 詳細パラメーター の箇所を展開し、上下に移動するボタンを使用して Manager がホストの cluster および dc (データセンター) でフェンシングプロキシーを探す順序を指定します。

- をクリックします。

6.6.4. fence_kdump の詳細設定

kdump サービスは、新しい Red Hat Enterprise Linux 6.6 および 7.1 のホストと Hypervisor ではデフォルトで実装されています。これらのバージョンよりも前のホストでは、Kdump 統合 は有効にすることはできないので、この機能を使用するにはホストをアップグレードする必要があります。

- 有効: kdump が適切に設定されており、kdump サービスが実行中です。

- 無効: kdump サービスは実行されていません (その場合には、kdump 統合は適切に機能しません)。

- 不明: kdump ステータスを報告しない、旧バージョンの VDSM を使用しているホストでのみ発生します。

新規ホスト または ホストの編集 ウィンドウの 電源管理 タブで Kdump 統合 を有効にすると、標準的な fence_kdump 構成が設定されます。環境のネットワーク設定が単純で、かつ Manager の FQDN が全ホストで解決可能な場合に使用するには、デフォルトの fence_kdump 設定で十分です。

engine-config を使用して、適切なホスト名または IP アドレスを設定することができます。

engine-config -s FenceKdumpDestinationAddress=A.B.C.D

engine-config -s FenceKdumpDestinationAddress=A.B.C.D- Manager に 2 つの NIC があり、一方がパブリックで、他方が fence_kdump メッセージの指定送信先の場合。

- 異なる IP またはポートで fence_kdump リスナーを実行する必要がある場合。