クラスターの更新

OpenShift Container Platform クラスターの更新

概要

第1章 OpenShift の更新について

1.1. OpenShift の更新の概要

OpenShift Container Platform 4 では、Web コンソールまたは OpenShift CLI (oc) を使用して、OpenShift Container Platform クラスターを 1 回の操作で更新できます。プラットフォーム管理者は、Web コンソールの Administration → Cluster Settings に移動するか、oc adm upgrade コマンドの出力を確認して、新しい更新オプションを表示できます。

Red Hat はパブリック OpenShift Update Service (OSUS) をホストします。これは、公式レジストリーの OpenShift Container Platform リリースイメージに基づいて更新の可能性を示すグラフを提供します。グラフには、パブリック OCP リリースの更新情報が含まれます。OpenShift Container Platform クラスターはデフォルトで OSUS に接続するように設定されており、OSUS は既知の更新ターゲットに関する情報をクラスターに応答します。

クラスター管理者または自動更新コントローラーのいずれかが、Cluster Version Operator (CVO) のカスタムリソース (CR) を新しいバージョンで編集すると、更新が開始されます。クラスターを新たに指定したバージョンに合わせて調整するために、CVO はイメージレジストリーからターゲットリリースイメージを取得し、クラスターへの変更適用を開始します。

Operator Lifecycle Manager (OLM) を介して以前にインストールされた Operator は、異なる更新プロセスに従います。詳細は、インストール済み Operator の更新 を参照してください。

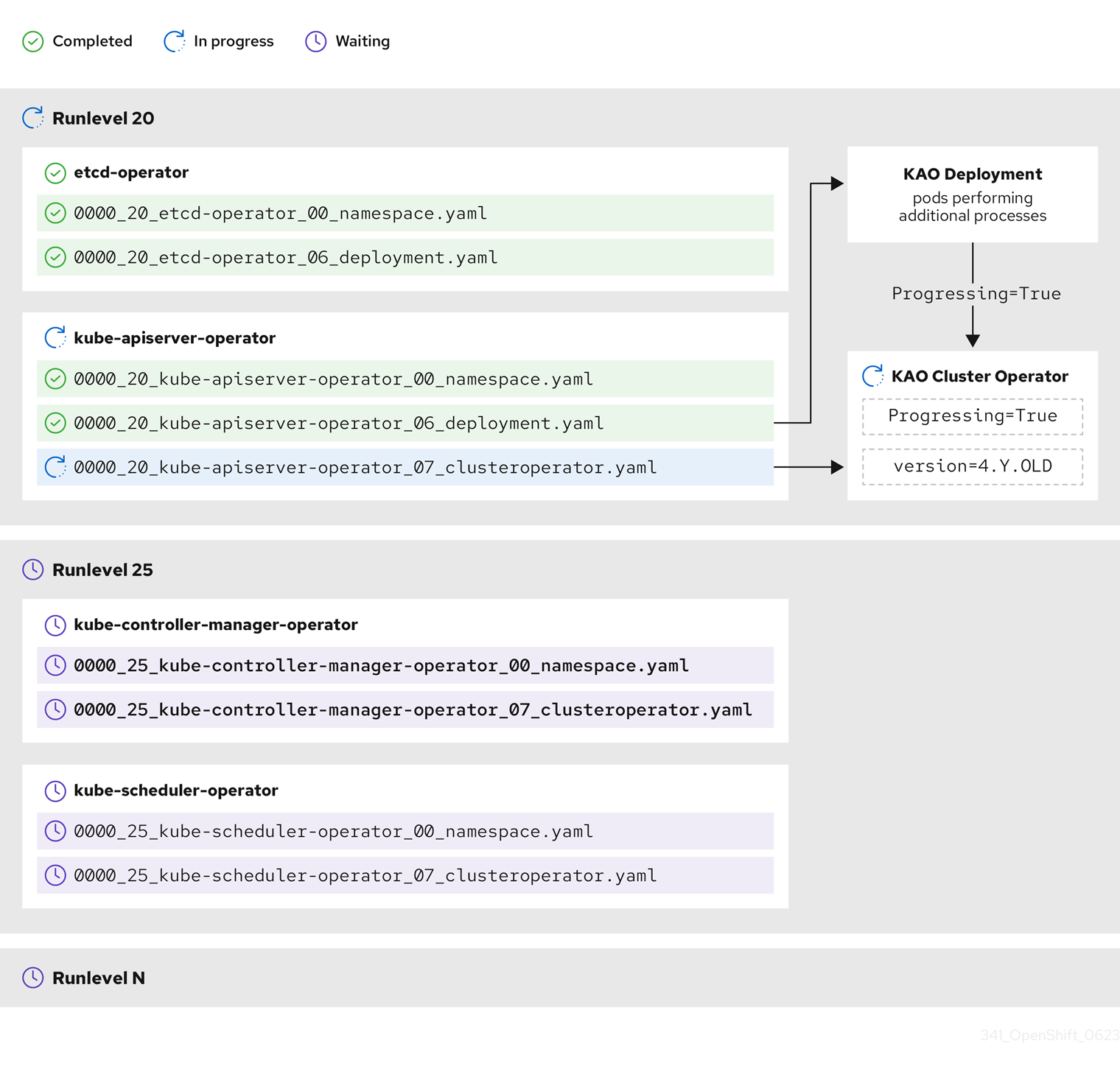

ターゲットリリースイメージには、特定の OCP バージョンを形成するすべてのクラスターコンポーネントのマニフェストファイルが含まれます。クラスターを新しいバージョンに更新する場合、CVO は Runlevels と呼ばれる別のステージでマニフェストを適用します。すべてではありませんが、ほとんどのマニフェストは、いずれかのクラスター Operator をサポートしています。CVO がクラスター Operator にマニフェストを適用すると、Operator が指定された新しいバージョンに適合させるために更新タスクを実行する可能性があります。

CVO は、適用された各リソースの状態と、すべてのクラスター Operator によって報告される状態を監視します。CVO は、アクティブな Runlevel のすべてのマニフェストおよびクラスター Operator が安定した状態に達した場合にのみ更新を続行します。CVO がこのプロセスを通じてコントロールプレーン全体を更新した後、Machine Config Operator (MCO) がオペレーティングシステムとクラスター内のすべてのノードの設定を更新します。

1.1.1. 更新の可用性に関するよくある質問

OpenShift Container Platform クラスターで更新が利用可能になるかどうか、またいつ利用可能になるかに影響を与える要因がいくつかあります。次のリストは、更新の入手可能性に関する一般的な質問を示しています。

各更新チャネルの違いは何ですか?

-

新しいリリースは、最初に

candidateチャネルに追加されます。 -

最終テストが成功すると、

candidateチャネルのリリースがfastチャネルに昇格され、正誤表が公開され、リリースは完全にサポートされるようになります。 遅延の後、

fastチャネルでのリリースは最終的にstableチャネルに昇格されます。この遅延は、fastチャネルとstableチャネルの唯一の違いを表します。注記最新の z-stream リリースの場合、この遅延は通常 1 ~ 2 週間かかる可能性があります。ただし、最新のマイナーバージョンへの最初の更新の遅延にはさらに時間がかかる場合があり、通常は 45 ~ 90 日かかります。

-

stableチャネルにプロモートされたリリースは、同時にeusチャネルにもプロモートされます。eusチャネルの主な目的は、コントロールプレーンのみの更新を実行するクラスターの利便性を高めることです。

stable チャネルでのリリースは fast チャネルでのリリースよりも安全ですか、それともよりサポートされていますか?

-

fastチャネルのリリースで回帰が特定された場合、その回帰がstableチャネルのリリースで特定された場合と同じ程度に解決され、管理されます。 -

fastチャネルとstableチャネルのリリースの唯一の違いは、リリースがfastチャネル上にしばらく存在した後にのみstableチャネルに表示されることです。これにより、新しい更新のリスクが発見されるまでの時間が長くなります。 -

この遅延の後、

fastチャネルで利用可能なリリースは必ず安定チャネルでも利用可能になります。

更新はサポートされているが推奨されていないとはどういう意味ですか?

- Red Hat は、複数のソースからのデータを継続的に評価して、あるバージョンから別のバージョンへの更新が問題を引き起こすかどうかを判断します。問題が特定された場合、更新パスはユーザーに推奨されなくなる場合があります。ただし、更新パスが推奨されない場合でも、更新を実行する場合はサポートが提供されます。

Red Hat は、ユーザーが特定のバージョンに更新することをブロックしません。Red Hat は条件付き更新のリスクを宣言する場合がありますが、これは特定のクラスターに適用される場合と適用されない場合があります。

- 宣言されたリスクにより、クラスター管理者はサポートされている更新に関する詳細なコンテキストが得られます。クラスター管理者はリスクを受け入れて、その特定のターゲットバージョンに更新することができます。この更新プログラムは、条件付きリスクの観点から推奨されていないにもかかわらず、常にサポートされています。

特定のリリースへの更新が推奨されなくなった場合はどうすればよいですか?

- Red Hat がリグレッションのためにサポートされているリリースから更新の推奨事項を削除した場合、リグレッションを修正する将来のバージョンに、代替となる更新の推奨事項が提供されます。問題の修正とテスト、選択したチャネルへの昇格に、時間がかかる可能性があります。

次の z-stream リリースが高速で安定したチャネルで利用できるようになるまで、どれくらいかかりますか?

具体的な頻度はさまざまな要因によって異なりますが、最新のマイナーバージョンの新しい z-stream リリースは通常、ほぼ毎週公開されます。古いマイナーバージョンは時間の経過とともに安定してきており、新しい z-stream リリースが利用可能になるまでにさらに時間がかかる場合があります。

重要これらは、z-stream リリースに関する過去のデータに基づく推定にすぎません。Red Hat は、必要に応じてリリース頻度を変更する権利を保持しています。問題がいくらでも発生すると、このリリースサイクルに不規則性や遅れが生じる可能性があります。

-

Z-stream リリースが公開されると、そのマイナーバージョンの

fastチャネルにも表示されます。遅延後、z-stream リリースがそのマイナーバージョンのstableチャネルに表示される場合があります。

1.1.2. OpenShift Update Service について

OpenShift Update Service (OSUS) は、Red Hat Enterprise Linux CoreOS (RHCOS) を含む OpenShift Container Platform に更新の推奨項目を提供します。コンポーネント Operator のグラフ、または 頂点 とそれらを結ぶ 辺 を含む図表が提示されます。グラフのエッジでは、安全に更新できるバージョンが表示されます。頂点は、マネージドクラスターコンポーネントの意図された状態を指定する更新ペイロードです。

クラスター内の Cluster Version Operator (CVO) は、OpenShift Update Service をチェックして、グラフの現在のコンポーネントバージョンとグラフの情報に基づき、有効な更新および更新パスを確認します。更新をリクエストすると、CVO は対応するリリースイメージを使用してクラスターを更新します。リリースアーティファクトは、コンテナーイメージとして Quay でホストされます。

OpenShift Update Service が互換性のある更新のみを提供できるようにするために、リリース検証 Pipeline で自動化を支援します。それぞれのリリースアーティファクトについて、他のコンポーネントパッケージだけでなくサポートされているクラウドプラットフォームおよびシステムアーキテクチャーとの互換性の有無が検証されます。Pipeline がリリースの適合性を確認した後に、OpenShift Update Service は更新が利用可能であることを通知します。

OpenShift Update Service は、現在のクラスターに推奨される更新をすべて表示します。OpenShift Update Service が推奨する更新パスがない場合には、更新またはターゲットリリースに関連する既知の問題がある可能性があります。

連続更新モード中は、2 つのコントローラーが実行されます。1 つのコントローラーはペイロードマニフェストを絶えず更新し、そのマニフェストをクラスターに適用し、Operator が利用可能か、アップグレード中か、失敗しているかに応じて Operator の制御されたロールアウトのステータスを出力します。2 つ目のコントローラーは OpenShift Update Service をポーリングして、更新が利用可能かどうかを判別します。

新しいバージョンへの更新のみがサポートされています。クラスターを以前のバージョンに戻したりロールバックしたりすることはサポートされていません。更新が失敗した場合は、Red Hat サポートに連絡してください。

更新プロセスで、Machine Config Operator (MCO) は新規設定をクラスターマシンに適用します。MCO は、マシン設定プールの maxUnavailable フィールドで指定されたノードの数を制限し、それらを使用不可としてマークします。デフォルトで、この値は 1 に設定されます。MCO は、topology.kubernetes.io/zone ラベルに基づいて、影響を受けるノードをゾーンごとにアルファベット順に更新します。ゾーンに複数のノードがある場合は、最も古いノードが最初に更新されます。ベアメタルデプロイメントなど、ゾーンを使用しないノードの場合、ノードは経過時間ごとに更新され、最も古いノードが最初に更新されます。MCO は、マシン設定プールの maxUnavailable フィールドで指定されたノード数を一度に更新します。次に、MCO は新しい設定を適用して、マシンを再起動します。

OpenShift Container Platform のすべてのマシン設定プールにおける maxUnavailable のデフォルト設定は 1 です。この値を変更せず、一度に 1 つのコントロールプレーンノードを更新することを推奨します。コントロールプレーンプールのこの値を 3 に変更しないでください。

Red Hat Enterprise Linux (RHEL) マシンをワーカーとして使用する場合は、最初に OpenShift API をそれらのマシンで更新する必要があるため、MCO は kubelet を更新しません。

新規バージョンの仕様は古い kubelet に適用されるため、RHEL マシンを Ready 状態に戻すことができません。マシンが利用可能になるまでは更新を完了できません。ただし、利用不可のノードの最大数は、その数のマシンがサービス停止状態のマシンとして分離されても通常のクラスター操作が継続できるようにするために設定されます。

OpenShift Update Service は Operator および 1 つ以上のアプリケーションインスタンスで構成されます。

1.1.3. クラスター Operator の状態タイプについて

クラスター Operator のステータスには、Operator の現在の正常性状態を通知する状態タイプが含まれています。以下の定義では、一般的な ClusterOperator の状態タイプをいくつか取り上げています。追加の状態タイプがあり、Operator 固有の言語を使用する Operator は省略されています。

Cluster Version Operator (CVO) は、クラスター管理者が OpenShift Container Platform クラスターのステータス状態をよりよく理解できるように、クラスター Operator からステータス状態を収集します。

-

Available: 条件タイプ

Availableは、Operator が機能しており、クラスターで使用可能であることを示します。ステータスがFalseの場合、オペランドの少なくとも 1 つの部分が機能していないため、管理者が介入する必要があります。 Progressing: 条件タイプ

Progressingは、Operator がアクティブに新しいコードをロールアウトしている、設定の変更を伝達している、またはある安定状態から別の安定状態に移行していることを示します。Operator が以前の既知の状態を調整している場合は、状態タイプ

ProgressingはTrueとして報告されません。監視されたクラスターの状態が変化し、Operator がそれに反応している場合は、ある安定状態から別の安定状態に移行しているため、ステータスはTrueとして報告されます。Degraded: 状態タイプ

Degradedは、Operator の現在の状態が一定期間にわたって必要な状態に一致しないことを示します。期間はコンポーネントによって異なる場合がありますが、Degradedステータスは、Operator の状態が継続的に監視されていることを表します。そのため、Operator のDegraded状態が変動することはありません。ある状態から別の状態への移行期間が短すぎるために

Degradedを報告できない場合は、別の状態タイプが報告される可能性があります。Operator は、通常の更新中、Degradedを報告しません。Operator は、最終的に管理者の介入を必要とする永続的なインフラストラクチャー障害への対応として、機能Degradedを報告する場合があります。注記この状態タイプは、調査と調整が必要な可能性があることを示しているにすぎません。Operator が使用可能である限り、

Degraded状態によってユーザーワークロードの障害やアプリケーションのダウンタイムが発生することはありません。Upgradeable: 条件タイプ

Upgradeableは、Operator が、現在のクラスターの状態に基づいて、安全に更新できるかどうかを示します。メッセージフィールドには、クラスターを正常に更新するために管理者が行う必要があることについて、人間が判読できる説明が含まれています。CVO は、この状態がTrue、Unknown、または状態がない場合に更新を許可します。UpgradeableステータスがFalseの場合、マイナー更新のみが影響を受け、CVO は、強制されない限り、影響を受ける更新をクラスターが実行できないようにします。

1.1.4. クラスターバージョン条件タイプについて

Cluster Version Operator (CVO) は、クラスター Operator およびその他のコンポーネントを監視し、クラスターバージョンとその Operator の両方のステータスを収集します。このステータスには、OpenShift Container Platform クラスターの正常性と現在の状態を通知する条件タイプが含まれます。

Available、Progressing、Upgradeable に加えて、クラスターのバージョンと Operator に影響する条件タイプがあります。

-

Failing: クラスターバージョン条件タイプ

Failingは、クラスターが目的の状態に到達できず、異常であり、管理者の介入が必要であることを示します。 -

Invalid: クラスターバージョン条件タイプ

Invalidは、サーバーがアクションを実行できないエラーがクラスターバージョンにあることを示します。この条件が設定されているかぎり、CVO は現在の状態のみを調整します。 -

RetrievedUpdates: クラスターバージョン条件タイプ

RetrievedUpdatesは、利用可能な更新が上流の更新サーバーから取得されたかどうかを示します。取得前の条件はUnknownです。更新が最近失敗したか、取得できなかった場合は、False、availableUpdatesフィールドが最新および正確である場合は、Trueです。 -

ReleaseAccepted:

Trueステータスのクラスターバージョン条件タイプReleaseAcceptedは、要求されたリリースペイロードが、イメージの検証および前提条件のチェック中、失敗せずに、正常に読み込まれたことを示します。 -

ImplicitlyEnabledCapabilities:

Trueステータスのクラスターバージョン条件タイプImplicitlyEnabledCapabilitiesは、ユーザーが現在spec.capabilitiesを介して要求していない有効な機能があることを示します。関連するリソースが以前に CVO によって管理されていた場合、CVO は機能の無効化をサポートしません。

1.1.5. 一般的な用語

- コントロールプレーン

- コントロールプレーンマシンで構成される コントロールプレーン は、OpenShift Container Platform クラスターを管理します。コントロールプレーンマシンは、コンピュートマシン (ワーカーマシンとしても知られる) のワークロードを管理します。

- Cluster Version Operator

- Cluster Version Operator (CVO) は、クラスターの更新プロセスを開始します。現在のクラスターバージョンに基づいて OSUS を確認し、利用可能または可能な更新パスを含むグラフを取得します。

- Machine Config Operator

- Machine Config Operator (MCO) は、オペレーティングシステムおよびマシン設定を管理するクラスターレベルの Operator です。プラットフォーム管理者は、MCO を介して、systemd、CRI-O、Kubelet、カーネル、NetworkManager、およびワーカーノード上のその他のシステム機能を設定および更新できます。

- OpenShift Update Service

- OpenShift Update Service (OSUS) は、Red Hat Enterprise Linux CoreOS (RHCOS) を含む OpenShift Container Platform に OTA (over-the-air) 更新を提供します。コンポーネント Operator のグラフ、または頂点とそれらを結ぶ辺を含む図表が提示されます。

- チャネル

- チャネル は、OpenShift Container Platform のマイナーバージョンに関連付けられた更新戦略を宣言します。OSUS は、この設定された戦略を使用して、その戦略と一致する更新エッジを推奨します。

- 推奨される更新エッジ

- 推奨される更新エッジ は、OpenShift Container Platform リリース間の推奨される更新です。特定の更新が推奨されるかどうかは、クラスターの設定済みチャネル、現在のバージョン、既知のバグ、およびその他の情報によって異なります。OSUS は、推奨されるエッジを、すべてのクラスターで実行される CVO に伝達します。

1.2. クラスターの更新の仕組み

以下のセクションでは、OpenShift Container Platform (OCP) 更新プロセスの各主要点を詳しく説明しています。更新の仕組みの概要は、OpenShift 更新の概要 を参照してください。

1.2.1. Cluster Version Operator

Cluster Version Operator (CVO) は、OpenShift Container Platform の更新プロセスを調整および促進する主要コンポーネントです。インストールや標準的なクラスター操作を実行する間、CVO はマネージドクラスター Operator のマニフェストとクラスター内リソースを常に比較し、これらのリソースの実際の状態が求められる状態と一致するように、不一致を調整します。

1.2.1.1. ClusterVersion オブジェクト

Cluster Version Operator (CVO) が監視するリソースの 1 つに、ClusterVersion リソースがあります。

管理者と OpenShift コンポーネントは、ClusterVersion オブジェクトを通じて CVO と通信または対話できます。CVO に求められる状態は ClusterVersion オブジェクトを通じて宣言され、現在の CVO 状態はオブジェクトのステータスに反映されます。

ClusterVersion オブジェクトは直接変更しないでください。代わりに、oc CLI や Web コンソールなどのインターフェイスを使用して、更新ターゲットを宣言します。

CVO は、ClusterVersion リソースの spec プロパティーで宣言されたターゲットとする状態とクラスターを継続的に調整します。必要なリリースと実際のリリースが異なる場合、その調整によってクラスターが更新されます。

可用性データの更新

ClusterVersion リソースには、クラスターが利用できる更新に関する情報も含まれています。これには、利用可能な更新プログラムも含まれますが、クラスターに適用される既知のリスクのため推奨されません。これらの更新は条件付き更新として知られています。CVO が ClusterVersion リソース内の利用可能な更新に関する情報をどのように維持するかは、「更新の可用性評価」セクションを参照してください。

以下のコマンドを使用して、利用可能なすべての更新を確認できます。

oc adm upgrade --include-not-recommended

$ oc adm upgrade --include-not-recommendedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記追加の

--include-not-recommendedパラメーターには、利用可能ではあるが、クラスターに適用される既知のリスクのため推奨されない更新が含まれます。出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm upgradeコマンドは、利用可能な更新に関する情報をClusterVersionリソースにクエリーし、人間が判読できる形式で表示します。CVO が作成した基礎となる可用性データを直接検査する方法の 1 つに、次のコマンドを使用して

ClusterVersionリソースをクエリーする方法があります。oc get clusterversion version -o json | jq '.status.availableUpdates'

$ oc get clusterversion version -o json | jq '.status.availableUpdates'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 同様のコマンドを使用して条件付き更新を確認できます。

oc get clusterversion version -o json | jq '.status.conditionalUpdates'

$ oc get clusterversion version -o json | jq '.status.conditionalUpdates'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.2.1.2. 更新の可用性評価

Cluster Version Operator (CVO) は、OpenShift Update Service (OSUS) に対して、更新の可能性に関する最新データを定期的にクエリーします。このデータは、クラスターがサブスクライブしているチャネルに基づいています。次に、CVO は更新の推奨事項に関する情報を、ClusterVersion リソースの availableUpdates フィールドまたは conditionalUpdates フィールドに保存します。

CVO は、条件付き更新の更新リスクを定期的に確認します。これらのリスクは、OSUS によって提供されるデータを通じて伝えられます。このデータには、そのバージョンに更新されたクラスターに影響を与える可能性がある各バージョンの既知の問題に関する情報が含まれています。ほとんどのリスクは、特定のサイズのクラスターや特定のクラウドプラットフォームにデプロイされたクラスターなど、特定の特性を持つクラスターに限定されます。

CVO は、各条件付き更新の条件付きリスクに関する情報に対して、継続的にクラスターの特性を評価します。CVO は、クラスターが基準に一致することを検出すると、その情報を ClusterVersion リソースの conditionalUpdates フィールドに保存します。CVO は、クラスターが更新のリスクに一致しないこと、または更新に関連するリスクがないことを検出すると、ターゲットバージョンを ClusterVersion リソースの availableUpdates フィールドに保存します。

Web コンソールまたは OpenShift CLI (oc) のユーザーインターフェイスは、この情報をセクションの見出しで表示します。サポートされているが推奨されていない 更新の推奨事項には、管理者が情報に基づいて更新に関する決定を下せるように、リスクに関する詳細リソースへのリンクが含まれています。

1.2.2. リリースイメージ

リリースイメージは、特定の OpenShift Container Platform (OCP) バージョンのディストリビューションメカニズムです。これには、リリースメタデータ、リリースバージョンに一致する Cluster Version Operator (CVO) バイナリー、個々の OpenShift Cluster Operator のデプロイに必要なすべてのマニフェスト、この OpenShift バージョンを構成するすべてのコンテナーイメージへの SHA ダイジェストバージョン参照リストが含まれています。

次のコマンドを実行して、特定のリリースイメージの内容を検査できます。

oc adm release extract <release image>

$ oc adm release extract <release image>出力例

1.2.3. プロセスワークフローの更新

以下の手順は、OpenShift Container Platform (OCP) 更新プロセスの詳細なワークフローを示しています。

-

ターゲットバージョンは、

ClusterVersionリソースのspec.desiredUpdate.versionフィールドに保存され、Web コンソールまたは CLI から管理されます。 -

Cluster Version Operator (CVO) は、

ClusterVersionリソースのdesiredUpdateが現在のクラスターのバージョンとは異なることを検出します。OpenShift Update Service からのグラフデータを使用して、CVO は必要なクラスターバージョンをリリースイメージのプル仕様に解決します。 - CVO は、リリースイメージの整合性と信頼性を検証します。Red Hat は、イメージ SHA ダイジェストを一意で不変のリリースイメージ識別子として使用し、公開されたリリースイメージに関する暗号署名されたステートメントを事前定義された場所に公開します。CVO はビルトイン公開鍵のリストを使用して、チェックされたリリースイメージに一致するステートメントの存在と署名を検証します。

-

CVO は、

openshift-cluster-versionnamespace にversion-$version-$hashという名前のジョブを作成します。このジョブはリリースイメージを実行しているコンテナーを使用するため、クラスターはコンテナーランタイムを通じてイメージをダウンロードします。次に、ジョブはマニフェストとメタデータをリリースイメージから CVO がアクセス可能な共有ボリュームに展開します。 - CVO は、展開されたマニフェストとメタデータを検証します。

- CVO はいくつかの前提条件をチェックして、クラスター内で問題のある状態が検出されないことを確認します。特定の状態により、更新が続行できない場合があります。これらの状態は、CVO 自体によって決定されるか、Operator が更新に問題ありと判断するクラスターの詳細を検出する個々のクラスター Operator によって報告されます。

-

CVO は、承認されたリリースを

status.desiredに記録し、新しい更新に関するstatus.historyエントリーを作成します。 - CVO は、リリースイメージからマニフェストの調整を開始します。クラスター Operator は Runlevels と呼ばれる別のステージで更新され、CVO は次のレベルに進む前に Runlevel 内のすべての Operator が更新を完了するようにします。

- CVO 自体のマニフェストはプロセスの早い段階で適用されます。CVO デプロイメントが適用されると、現在の CVO Pod が停止し、新しいバージョンを使用する CVO Pod が開始されます。新しい CVO は、残りのマニフェストの調整を進めます。

-

更新は、コントロールプレーン全体が新しいバージョンに更新されるまで続行されます。個々のクラスター Operator は、クラスターのドメインで更新タスクを実行することがあり、その場合は実行中に、

Progressing=True状態を通して状態を報告します。 - Machine Config Operator (MCO) マニフェストはプロセスの最後に適用されます。その後、更新された MCO は、すべてのノードのシステム設定とオペレーティングシステムの更新を開始します。各ノードは、再びワークロードの受け入れを開始する前に、ドレイン、更新、および再起動される可能性があります。

クラスターは、コントロールプレーンの更新が完了した後、通常はすべてのノードが更新される前に更新済みであることを報告します。更新後、CVO はすべてのクラスターリソースを、リリースイメージで提供される状態と一致するように維持します。

1.2.4. 更新時のマニフェストの適用方法について

リリースイメージで提供される一部のマニフェストは、依存関係があるため、特定の順序で適用する必要があります。たとえば、CustomResourceDefinition リソースは、一致するカスタムリソースの前に作成する必要があります。さらに、クラスター内の断絶を最小限に抑えるために、個々のクラスター Operator は論理的な順序に従い更新される必要があります。Cluster Version Operator (CVO) は、Runlevels の概念を通じてこの論理的な順序を実装します。

これらの依存関係は、リリースイメージのマニフェストのファイル名でエンコードされます。

0000_<runlevel>_<component>_<manifest-name>.yaml

0000_<runlevel>_<component>_<manifest-name>.yaml以下に例を示します。

0000_03_config-operator_01_proxy.crd.yaml

0000_03_config-operator_01_proxy.crd.yamlCVO は内部でマニフェストの依存関係グラフをビルドします。ここで CVO は次のルールに従います。

- 更新中、より低位の Runlevel のマニフェストは、高位の Runlevel のマニフェストよりも先に適用されます。

- 1 つの Runlevel 内で、異なるコンポーネントのマニフェストを並行して適用できます。

- 1 つの Runlevel 内で、単一のコンポーネントのマニフェストは辞書式の順序で適用されます。

次に、CVO は生成された依存関係グラフの順にマニフェストを適用します。

一部のリソースタイプでは、CVO はマニフェストの適用後にリソースを監視し、リソースが安定した状態に達して場合に限り正常に更新されたとみなします。この状態に達するまでに時間がかかる場合があります。これは特に ClusterOperator リソースに当てはまりますが、CVO はクラスター Operator が自身を更新するのを待ってから、その ClusterOperator ステータスを更新します。

CVO は、Runlevel のすべてのクラスター Operator が以下の状態になるまで待機してから、次の Runlevel に進みます。

-

クラスター Operator は

Available=Trueの状態です。 -

クラスター Operator は

Degraded=Falseの状態です。

- クラスター Operator は、ClusterOperator リソースで必要なバージョンになったことを宣言します。

一部のアクションは、完了するまでにかなりの時間がかかる場合があります。CVO は、後続の Runlevel で安全に続行できるように、アクションが完了するのを待ちます。新しいリリースのマニフェストを初めて調整する場合、合計で 60 ~ 120 分かかることが予想されます。更新期間に影響を与える要因の詳細は、OpenShift Container Platform の更新期間についてを参照してください。

前のサンプル図では、CVO は Runlevel 20 ですべての作業が完了するまで待機しています。CVO はすべてのマニフェストを Runlevel の Operator に適用しましたが、kube-apiserver-operator ClusterOperator は一部のアクションを新しいバージョンがデプロイされた後に実行します。kube-apiserver-operator ClusterOperator は、 Progressing=True の状態であることと、新しいバージョンを status.versions で調整済みとして宣言しないことによって、進捗を宣言します。CVO は、ClusterOperator が許容可能なステータスを報告するまで待機し、その後、Runlevel 25 でマニフェストの調整を開始します。

1.2.5. Machine Config Operator によるノードの更新方法

Machine Config Operator (MCO) は、新しいマシン設定を各コントロールプレーンノードとコンピュートノードに適用します。マシン設定の更新時に、コントロールプレーンノードとコンピュートノードは、マシンプールが並行して更新される独自のマシン設定プールに編成されます。.spec.maxUnavailable パラメーター (デフォルト値は 1) は、マシン設定プール内の更新プロセスを同時に実行できるノードの数を決定します。

OpenShift Container Platform のすべてのマシン設定プールにおける maxUnavailable のデフォルト設定は 1 です。この値を変更せず、一度に 1 つのコントロールプレーンノードを更新することを推奨します。コントロールプレーンプールのこの値を 3 に変更しないでください。

マシン設定の更新プロセスが開始されると、MCO はプール内の現在利用できないノードの数を確認します。使用できないノードの数が .spec.maxUnavailable の値よりも少ない場合、MCO はプール内の使用可能なノードに対して次の一連のアクションを開始します。

ノードを遮断してドレインします。

注記ノードが遮断されている場合、ワークロードをそのノードにスケジュールすることはできません。

- ノードのシステム設定およびオペレーティングシステム (OS) を更新します。

- ノードを再起動します。

- ノードの遮断を解除します。

このプロセスが実行されているノードは、社団が解除されてワークロードが再度スケジュールされるまで使用できません。MCO は、使用できないノードの数が .spec.maxUnavailable の値と等しくなるまでノードの更新を開始します。

ノードが更新を完了して使用可能になると、マシン設定プール内の使用不可ノードの数は再び .spec.maxUnavailable より少なくなります。更新する必要があるノードが残っている場合、MCO は .spec.maxUnavailable 制限に再度達するまで、ノード上で更新プロセスを開始します。このプロセスは、各コントロールプレーンノードとコンピュートノードが更新されるまで繰り返されます。

次のワークフロー例は、5 つのノードを持つマシン設定プールでこのプロセスがどのように発生するかを示しています。ここでの .spec.maxUnavailable は 3 で、最初はすべてのノードが使用可能です。

- MCO はノード 1、2、3 を遮断し、それらのドレインを開始します。

- ノード 2 は、ドレインを完了して再起動すると再び使用可能になります。MCO はノード 4 を遮断し、そのドレインを開始します。

- ノード 1 は、ドレインを完了して再起動すると再び使用可能になります。MCO はノード 5 を遮断し、そのドレインを開始します。

- ノード 3 は、ドレインを完了して再起動すると再び使用可能になります。

- ノード 5 は、ドレインを完了して再起動すると再び使用可能になります。

- ノード 4 は、ドレインを完了して再起動すると再び使用可能になります。

各ノードの更新プロセスは他のノードから独立しているため、上記の例におけるノードの一部は、MCO によって遮断された順序とは異なる順序で更新を終了します。

次のコマンドを実行して、マシン設定の更新ステータスを確認できます。

oc get mcp

$ oc get mcp出力例

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-acd1358917e9f98cbdb599aea622d78b True False False 3 3 3 0 22h worker rendered-worker-1d871ac76e1951d32b2fe92369879826 False True False 2 1 1 0 22h

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE

master rendered-master-acd1358917e9f98cbdb599aea622d78b True False False 3 3 3 0 22h

worker rendered-worker-1d871ac76e1951d32b2fe92369879826 False True False 2 1 1 0 22h1.3. 更新チャネルとリリースについて

更新チャネルは、クラスターを更新する予定の OpenShift Container Platform マイナーバージョンをユーザーが宣言するメカニズムです。また、ユーザーは、更新のタイミングとサポートレベルを、fast、stable、candidate、および eus チャネルオプションから選択することもできます。Cluster Version Operator は、チャネル宣言に基づく更新グラフを他の条件付き情報と共に使用して、クラスターで利用可能な推奨更新と条件付き更新のリストを提供します。

更新チャネルは、OpenShift Container Platform のマイナーバージョンに対応します。チャネルのバージョン番号は、クラスターの現在のマイナーバージョンよりも新しいバージョンであっても、クラスターが最終的に更新されるターゲットマイナーバージョンを表します。

例えば、OpenShift Container Platform 4.10 更新チャネルは以下の推奨事項を提供します。

- 4.10 内の更新。

- 4.9 内での更新。

- 4.9 から 4.10 への更新。すべての 4.9 クラスターが、z-stream の最小バージョン要件をすぐに満たさなくても、最終的に 4.10 に更新できます。

-

eus-4.10のみ: 4.8 内で更新。 -

eus-4.10のみ: 4.8 から 4.9 を経て 4.10 に更新され、すべての 4.8 クラスターが最終的に 4.10 に更新されます。

4.10 更新チャネルでは、4.11 以降のリリースへの更新は推奨されません。この戦略により、管理者は OpenShift Container Platform の次のマイナーバージョンに更新することを明示的に決定する必要があります。

更新チャネルはリリースの選択のみを制御し、インストールするクラスターのバージョンには影響しません。OpenShift Container Platform の特定のバージョンの openshift-install バイナリーファイルは、常にそのバージョンをインストールします。

OpenShift Container Platform 4.14 は、以下の更新チャネルを提供します。

-

stable-4.14 -

eus-4.y(EUS バージョンでのみ提供され、EUS バージョン間の更新を容易にするためのもの) -

fast-4.14 -

candidate-4.14

Cluster Version Operator を更新推奨サービスから利用可能な更新を取得する必要がない場合は、OpenShift CLI で oc adm upgrade channel コマンドを使用して空のチャネルを設定できます。この設定は、クラスターがネットワークアクセスが制限された状況で、ローカルで到達可能な更新に関する推奨サービスがない場合に役立ちます。

Red Hat は、OpenShift Update Service によって提案されたバージョンにのみ更新することが推奨されます。マイナーバージョン更新の場合、バージョンは連続している必要があります。Red Hat は、非連続バージョンへの更新をテストせず、以前のバージョンとの互換性を保証できません。

1.3.1. 更新チャネル

1.3.1.1. fast-4.14 チャネル

fast-4.14 チャネルは、Red Hat が OpenShift Container Platform 4.14 の新しいバージョンを一般公開 (GA) リリースとして宣言するとすぐに更新されます。そのため、これらのリリースは完全にサポートされており、実稼働環境での使用を目的としています。

1.3.1.2. stable-4.14 チャネル

fast-4.14 チャネルにはエラータが公開されるとすぐにリリースが含まれますが、リリースは遅れて stable-4.14 チャネルに追加されます。この遅延の間に、複数のソースからデータが収集され、製品のリグレッションの兆候がないか分析されます。相当数のデータポイントが収集されると、これらのリリースは stable チャネルに追加されます。

かなりの数のデータポイントを取得するのに必要な時間は多くの要因によって異なるため、高速チャネルと安定チャネルの間の遅延期間に関して、サービスレベル目標 (SLO) は設定されていません。詳細は、「Choosing the correct channel for your cluster」を参照してください。

新しくインストールされたクラスターは、デフォルトで安定したチャネルを使用します。

1.3.1.3. eus-4.y チャネル

stable チャネルのほかに、番号が偶数の OpenShift Container Platform マイナーバージョンはすべて Extended Update Support (延長更新サポート) (EUS) を提供します。stable チャネルに昇格したリリースは、同時に EUS チャネルにも昇格されます。EUS チャネルの主な目的は、コントロールプレーンのみの更新を実行するクラスターの利便性を高めることです。

標準サブスクライバーと非 EUS サブスクライバーの両方が、すべての EUS リポジトリーと必要な RPM (rhel-*-eus-rpms) にアクセスして、ドライバーのデバッグやビルドなどの重要な目的をサポートできます。

1.3.1.4. candidate-4.14 チャネル

candidate-4.14 チャネルは、リリースがビルドされるとすぐに、サポートなしですが、早期にその機能が使用できます。candidate チャネルのみに存在するリリースには、最終的な GA リリースの完全な機能セットが含まれていないか、GA の前に機能が削除される可能性があります。さらに、これらのリリースは完全な Red Hat 品質保証の対象ではなく、後の GA リリースへの更新パスが提供されない可能性があります。これらの考慮事項を鑑みると、candidate チャネルは、クラスターの破棄と再作成が許容されるテスト目的にのみ適しています。

1.3.1.5. チャネルでの更新推奨

OpenShift Container Platform には更新推奨サービスがあり、インストール済みの OpenShift Container Platform バージョンと、次のリリースにアクセスするためにチャネル内のパスを確認できるようになっています。更新パスも、現在選択されているチャネルとそのプロモーション特性に関連するバージョンに限定されます。

お使いのチャネルでは、以下のリリースが確認できます。

- 4.14.0

- 4.14.1

- 4.14.3

- 4.14.4

このサービスは、テスト済みで重大なリグレッションが確認されていない更新のみを推奨します。たとえば、クラスターが 4.14.1 にあり、OpenShift Container Platform が 4.14.4 を提案している場合は、4.14.1 から 4.14.4 に更新しても問題はありません。

パッチの連続する番号のみに依存しないようにしてください。今回の例では、4.14.2 はこのチャネルでは今も、これまでも利用できなかったため、4.14.2 では推奨またはサポートされていません。

1.3.1.6. 更新の推奨と条件付き更新

Red Hat は、サポートチャネルに追加する前後で、新規リリースバージョンおよび、このような新規リリースバージョンに関連する更新パスをモニタリングしています。

Red Hat は、サポート対象リリースから更新の推奨を削除する場合には、今後のバージョンに対して、そのリグレッションを修正する、代わりとなる更新の推奨が提供される予定です。ただし、問題の修正とテスト、選択したチャネルへの昇格に、時間がかかる可能性があります。

OpenShift Container Platform 4.10 以降、確認された更新リスクは、該当する更新の条件付き更新リスクとして宣言されます。既知の各リスクは、すべてのクラスターに適用される場合もあれば、特定の条件に一致するクラスターのみに適用される場合もあります。たとえば、Platform を None に、CNI プロバイダーを OpenShiftSDN に設定しています。Cluster Version Operator (CVO) は、現在のクラスター状態に対する既知のリスクを継続的に評価します。該当するリスクがない場合は、更新を推奨します。リスクが一致する場合、更新はサポートされますが、推奨はされません。また、参照リンクが提供されます。参照リンクは、クラスター管理者がリスクを受け入れて更新するかどうかを決定するのに役立ちます。

Red Hat が条件付き更新リスクを宣言することを選択した場合、関連するすべてのチャネルで同時に宣言します。条件付き更新リスクの宣言は、サポートされているチャネルに更新がプロモートされる前、または後に発生する可能性があります。

1.3.1.7. クラスターに適したチャネルの選択

適切なチャネルを選択する際には、2 つの点を決定する必要があります。

まず、クラスターの更新に必要なマイナーバージョンを選択します。現在のバージョンに一致するチャネルを選択すると、z-stream 更新のみが適用され、機能更新は受信されません。現在のバージョンよりも新しいバージョンを含む利用可能なチャネルを選択すると、更新を 1 回または複数回行うことで、対象のバージョンに更新されます。クラスターには、現在のバージョン、次のバージョン、または次の EUS バージョンに該当するチャネルのみが提供されます。

多数のマイナーバージョンをまたいだ更新を計画することは複雑であるため、1 回のコントロールプレーンのみの更新を超える更新の計画を支援するチャネルは提供されていません。

次に、目的とするロールアウト戦略を選択する必要があります。Red Hat がリリース GA を宣言したらすぐに fast チャネルから選択して更新するか、Red Hat がリリースを stable チャネルにプロモートするのを待つかを選択できます。fast-4.14 と stable-4.14 で提供される更新の推奨はいずれも完全にサポートされており、同じように進行中のデータ分析からの恩恵を受けます。リリースを stable チャネルに昇格させる前の昇格の遅延は、2 つのチャネルの唯一の違いです。最新の z-stream への更新は通常、1~2 週間以内に stable チャネルに昇格されますが、最新のマイナーへの更新を最初にロールアウトするまでの時間は、通常 45 ~ 90 日と、はるかに長くなります。安定したチャネルへの昇格を待つとスケジュール計画に影響する可能性があるため、希望のチャネルを選択する際は昇格の遅延を考慮してください。

また、組織が fast チャネルに永続的または一時的に移行する要因がいくつかあります。

- 遅滞なく、お使いの環境に影響を与えている既知の問題に対する特定の修正を適用する場合。

- 遅滞なく CVE 修正プログラムを適用する場合。CVE 修正によりリグレッションが発生する可能性があるため、CVE 修正を含む z-stream には引き続き昇格に時間がかかります。

- 内部テストプロセス。組織がリリースの認定に数週間かかる場合は、待たずに昇格プロセスと同時にテストすることを推奨します。こうすることで、Red Hat に対して遠隔測定からのシグナルが送られ、ロールアウトに考慮されるので、お客様に影響を与えている問題をより迅速に修正できます。

1.3.1.8. ネットワークが制限された環境のクラスター

OpenShift Container Platform クラスターのコンテナーイメージを独自に管理する場合には、製品リリースに関連する Red Hat エラータを確認し、更新への影響に関するコメントに留意する必要があります。更新時に、インターフェイスにこれらのバージョン間の切り替えに関する警告が表示される場合があります。そのため、これらの警告を無視するかどうかを決める前に適切なバージョンを選択していることを確認する必要があります。

1.3.1.9. チャネル間の切り替え

チャネルは、Web コンソールまたは adm upgrade channel コマンドで切り換えることができます。

oc adm upgrade channel <channel>

$ oc adm upgrade channel <channel>Web コンソールは、現在のリリースを含まないチャネルに切り替えると、アラートを表示します。Web コンソールは、現在のリリースのないチャネルにある更新を推奨していません。ただし、任意の時点で元のチャネルに戻ることができます。

チャネルの変更は、クラスターのサポート可能性に影響を与える可能性があります。以下の条件が適用されます。

-

stable-4.14チャネルからfast-4.14チャネルに切り換える場合も、クラスターは引き続きサポートされます。 -

candidate-4.14チャネルにいつでも切り換えることはできますが、このチャネルの一部のリリースはサポートされない可能性があります。 -

現在のリリースが一般公開リリースの場合、

candidate-4.14チャネルからfast-4.14チャネルに切り換えることができます。 -

fast-4.14チャネルからstable-4.14チャネルに常に切り換えることができます。現在のリリースが最近プロモートされた場合は、リリースがstable-4.14にプロモートされるまでに最長 1 日分の遅延が生じる可能性があります。

1.4. OpenShift Container Platform の更新期間について

OpenShift Container Platform の更新期間は、デプロイメントのトポロジーによって異なります。このページは、更新期間に影響を与える要因を理解し、ご使用の環境でクラスターの更新にかかる時間を見積もるのに役立ちます。

1.4.1. 更新期間に影響する要因

次の要因は、クラスターの更新期間に影響を与える可能性があります。

Machine Config Operator (MCO) による新しいマシン設定へのコンピュートノードの再起動

マシン設定プールの

MaxUnavailableの値警告OpenShift Container Platform のすべてのマシン設定プールにおける

maxUnavailableのデフォルト設定は1です。この値を変更せず、一度に 1 つのコントロールプレーンノードを更新することを推奨します。コントロールプレーンプールのこの値を3に変更しないでください。- Pod 中断バジェット (PDB) に設定されたレプリカの最小数またはパーセンテージ

- クラスター内のノード数

- クラスターノードの可用性

1.4.2. クラスターの更新フェーズ

OpenShift Container Platform では、クラスターの更新は 2 つのフェーズで行われます。

- Cluster Version Operator (CVO) ターゲット更新ペイロードのデプロイメント

- Machine Config Operator (MCO) ノードの更新

1.4.2.1. Cluster Version Operator ターゲット更新ペイロードのデプロイメント

Cluster Version Operator (CVO) は、ターゲットの更新リリースイメージを取得し、クラスターに適用します。Pod として実行されるすべてのコンポーネントはこのフェーズ中に更新されますが、ホストコンポーネントは Machine Config Operator (MCO) によって更新されます。このプロセスには 60 ~ 120 分かかる場合があります。

更新の CVO フェーズでは、ノードは再起動されません。

1.4.2.2. Machine Config Operator ノードの更新

Machine Config Operator (MCO) は、新しいマシン設定を各コントロールプレーンとコンピュートノードに適用します。このプロセス中に、MCO はクラスターの各ノードで次の一連のアクションを実行します。

- すべてのノードを遮断してドレインする

- オペレーティングシステム (OS) を更新する

- ノードを再起動します。

- すべてのノードのコードを解除し、ノードでワークロードをスケジュールします

ノードが遮断されている場合、ワークロードをそのノードにスケジュールすることはできません。

このプロセスが完了するまでの時間は、ノードやインフラストラクチャーの設定など、いくつかの要因によって異なります。このプロセスは、ノードごとに完了するまでに 5 分以上かかる場合があります。

MCO に加えて、次のパラメーターの影響を考慮する必要があります。

- コントロールプレーンノードの更新期間は予測可能であり、多くの場合、コンピュートノードよりも短くなります。これは、コントロールプレーンのワークロードが適切な更新と迅速なドレインに合わせて調整されているためです。

-

Machine Config Pool (MCP) で

maxUnavailableフィールドを1より大きい値に設定することで、コンピュートノードを並行して更新できます。MCO は、maxUnavailableで指定された数のノードを遮断し、それらを更新不可としてマークします。 -

MCP で

maxUnavailableを増やすと、プールがより迅速に更新されるのに役立ちます。ただし、maxUnavailableの設定が高すぎて、複数のノードが同時に遮断されている場合、レプリカを実行するスケジュール可能なノードが見つからないため、Pod 中断バジェット (PDB) で保護されたワークロードのドレインに失敗する可能性があります。MCP のmaxUnavailableを増やす場合は、PDB で保護されたワークロードを排出できるように、スケジュール可能なノードがまだ十分にあることを確認してください。 更新を開始する前に、すべてのノードが使用可能であることを確認する必要があります。ノードが利用できないと、

maxUnavailableおよび Pod 中断バジェットに影響するため、利用できないノードがあると、更新期間に大きな影響を与える可能性があります。ターミナルからノードのステータスを確認するには、次のコマンドを実行します。

oc get node

$ oc get nodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ノードのステータスが

NotReadyまたはSchedulingDisabledの場合、ノードは使用できず、更新期間に影響します。Compute → Node を展開することで、Web コンソールの Administrator パースペクティブからノードのステータスを確認できます。

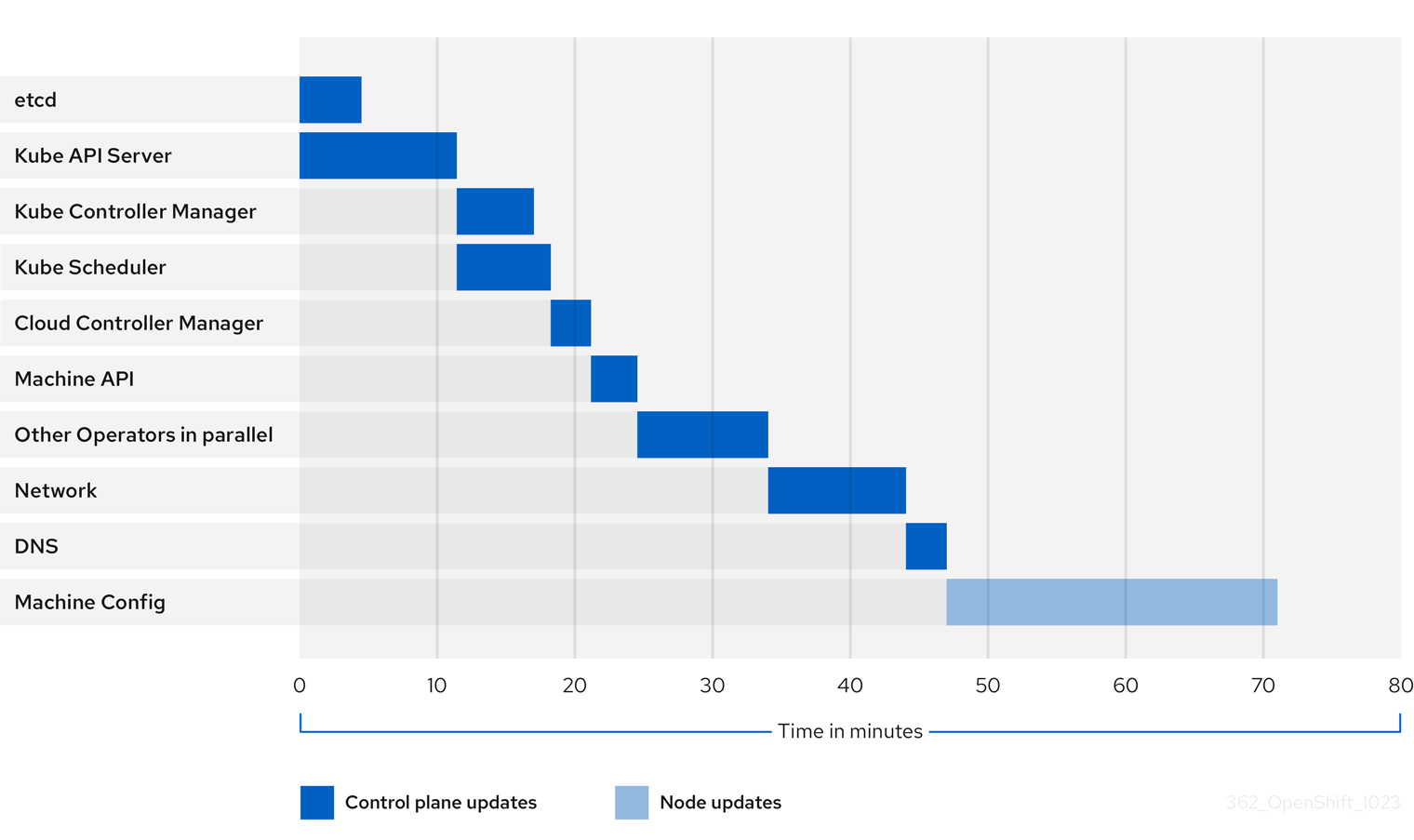

1.4.2.3. クラスター Operator の更新期間の例

前の図は、クラスター Operator が新しいバージョンに更新するのにかかる時間の例を示しています。この例は、3 ノードの AWS OVN クラスターに基づいています。このクラスターには、正常なコンピュート MachineConfigPool があり、ドレインに時間がかかるワークロードがなく、4.13 から 4.14 に更新されます。

- クラスターとその Operator の具体的な更新期間は、ターゲットバージョン、ノードの量、ノードにスケジュールされたワークロードの種類など、クラスターのいくつかの特性に基づいて変化する可能性があります。

- Cluster Version Operator などの一部のオペレーターは、短時間で自身を更新します。これらの Operator は図から省略されているか、「並列のその他の Operator」というラベルが付いたより広範な Operator のグループに含まれています。

各クラスター Operator には、それ自体の更新にかかる時間に影響する特性があります。たとえば、この例の Kube API Server Operator の更新には 11 分以上かかりました。これは、kube-apiserver が正常な終了サポートを提供しているためです。つまり、実行中の既存のリクエストは正常に完了できます。これにより、kube-apiserver のシャットダウンに時間がかかる可能性があります。この Operator の場合は、更新中のクラスター機能の中断を防止および制限するために、更新速度が犠牲になります。

Operator の更新期間に影響を与えるもう 1 つの特性は、Operator が DaemonSet を利用するかどうかです。Network Operator と DNS Operator はフルクラスター DaemonSet を利用するため、バージョン変更のデプロイメントに時間がかかる場合があります。これが、これらの Operator の更新に時間がかかる理由の 1 つです。

一部の Operator の更新期間は、クラスター自体の特性に大きく依存します。たとえば、Machine Config Operator の更新では、クラスター内の各ノードにマシン設定の変更が適用されます。多くのノードを含むクラスターは、ノードが少ないクラスターと比較して、Machine Config Operator の更新にかかる時間が長くなります。

各クラスター Operator には、更新できるステージが割り当てられます。同じステージ内の Operator は同時に更新できますが、特定のステージの Operator は、前のステージがすべて完了するまで更新を開始できません。詳細は、「関連情報」セクションの「更新中にマニフェストが適用される方法について」を参照してください。

1.4.3. クラスター更新時間の概算

同様のクラスターの履歴更新期間は、将来のクラスター更新の最適な概算を提供します。ただし、履歴データが利用できない場合は、次の規則を使用してクラスターの更新時間を概算することができます。

Cluster update time = CVO target update payload deployment time + (# node update iterations x MCO node update time)

Cluster update time = CVO target update payload deployment time + (# node update iterations x MCO node update time)

ノード更新反復は、並行して更新される 1 つ以上のノードで構成されます。コントロールプレーンノードは常に、コンピュートノードと並行して更新されます。さらに、maxUnavailable 値に基づいて、1 つ以上のコンピュートノードを並行して更新できます。

OpenShift Container Platform のすべてのマシン設定プールにおける maxUnavailable のデフォルト設定は 1 です。この値を変更せず、一度に 1 つのコントロールプレーンノードを更新することを推奨します。コントロールプレーンプールのこの値を 3 に変更しないでください。

例えば、更新時間を概算するには、3 つのコントロールプレーンノードと 6 つのコンピュートノードを持つ OpenShift Container Platform クラスターがあり、各ホストの再起動に約 5 分かかるとします。

特定のノードの再起動にかかる時間は、大幅に異なります。クラウドインスタンスでは、再起動に約 1 ~ 2 分かかる場合がありますが、物理的なベアメタルホストでは、再起動に 15 分以上かかる場合があります。

シナリオ 1:

コントロールプレーンとコンピュートノードの Machine Config Pool (MCP) の両方で maxUnavailable を 1 に設定すると、6 つのコンピュートノードすべてが反復ごとに次々と更新されます。

Cluster update time = 60 + (6 x 5) = 90 minutes

Cluster update time = 60 + (6 x 5) = 90 minutesシナリオ 2

コンピュートノード MCP の maxUnavailable を 2 に設定すると、2 つのコンピュートノードが反復ごとに並行して更新されます。したがって、すべてのノードを更新するには合計 3 回の反復が必要です。

Cluster update time = 60 + (3 x 5) = 75 minutes

Cluster update time = 60 + (3 x 5) = 75 minutes

maxUnavailable のデフォルト設定は、OpenShift Container Platform のすべての MCP で 1 です。コントロールプレーン MCP で maxUnavailable を変更しないことを推奨します。

1.4.4. Red Hat Enterprise Linux (RHEL) コンピュートノード

Red Hat Enterprise Linux (RHEL) コンピュートノードでは、ノードのバイナリーコンポーネントを更新するために openshift-ansible を追加で使用する必要があります。RHEL コンピュートノードの更新に費やされる実際の時間は、Red Hat Enterprise Linux CoreOS (RHCOS) コンピュートノードと大きく変わらないはずです。

第2章 クラスターの更新の準備

2.1. OpenShift Container Platform 4.14 への更新の準備

更新を正常に初期化するためにクラスター管理者が実行する必要がある管理タスクと、更新を確実に成功させるためのオプションのガイドラインを詳しく説明します。

2.1.1. RHEL 9.2 マイクロアーキテクチャー要件の変更

OpenShift Container Platform は現在、RHEL 9.2 ホストオペレーティングシステムをベースとしています。マイクロアーキテクチャーの要件が x86_64-v2、Power9、Z14 に増加しました。RHEL マイクロアーキテクチャー要件ドキュメント を参照してください。この ナレッジベース に記載されている手順に従って、更新前に互換性を確認できます。

正しいマイクロアーキテクチャー要件がないと、更新プロセスは失敗します。各アーキテクチャーに適切なサブスクリプションを購入してください。詳細は Get Started with Red Hat Enterprise Linux - additional architectures を参照してください。

2.1.2. Kubernetes API の非推奨化と削除

OpenShift Container Platform 4.14 は Kubernetes 1.27 を使用します。これにより、複数の非推奨 API が削除されました。

クラスター管理者は、クラスターを OpenShift Container Platform 4.13 から 4.14 にアップグレードする前に、手動で確認を行う必要があります。削除された API が、クラスター上で実行されている、またはクラスターと対話しているワークロード、ツール、またはその他のコンポーネントによって引き続き使用される OpenShift Container Platform 4.14 にアップグレードした後の問題を防ぐ上で役立ちます。管理者は、削除が予定されている使用中の API に対するクラスターの評価を実施し、影響を受けるコンポーネントを移行して適切な新規 API バージョンを使用する必要があります。この評価および移行が完了したら、管理者は確認応答を提供できます。

OpenShift Container Platform 4.13 クラスターを 4.14 に更新する前に、管理者の確認を提供する必要があります。

2.1.2.1. Kubernetes API の削除

OpenShift Container Platform 4.14 は Kubernetes 1.27 を使用します。これにより、以下の非推奨 API が削除されました。適切な API バージョンを使用するには、マニフェストと API クライアントを移行する必要があります。削除された API の移行について、詳細は Kubernetes documentation を参照してください。

| リソース | 削除された API | 移行先 |

|---|---|---|

|

|

|

|

2.1.2.2. 削除された API に対するクラスターの評価

削除される API が使用されている場所を管理者が特定するのに役立つ方法は複数あります。ただし、OpenShift Container Platform は、アイドル状態や外部ツールが使用されるワークロードなどのすべてのインスタンスを特定できません。すべてのワークロードと削除された API のインスタンスに対する他の統合を適切に評価することは管理者の責任です。

2.1.2.2.1. 削除された API の使用を特定するためのアラートの確認

次のリリースで削除予定の API が使用されている場合に 2 つのアラートが発生します。

-

APIRemovedInNextReleaseInUse: OpenShift Container Platform の次のリリースで削除される API の場合 -

APIRemovedInNextEUSReleaseInUse: 次の OpenShift Container Platform Extended Update Support (EUS) リリースで削除される API の場合

これらのアラートのいずれかがクラスターで実行している場合は、アラートを確認し、マニフェストおよび API クライアントを移行して新規 API バージョンを使用することによりアラートをクリアします。

アラートにはこの情報が含まれないため、APIRequestCount API を使用して、使用中の API と削除された API を使用しているワークロードに関する詳細情報を取得します。さらに、API によってはこれらのアラートがトリガーされない場合もありますが、APIRequestCount がキャプチャーします。アラートは、機密性が低くなるように調整して、実稼働システムでのアラートの疲弊を回避します。

2.1.2.2.2. APIRequestCount を使用して削除された API の使用状況を特定

APIRequestCount API を使用して API 要求を追跡し、それらのいずれかが削除された API のいずれかを使用しているかどうかを確認することができます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

以下のコマンドを実行し、出力された

REMOVEDINRELEASE列を確認して、現在使用中の削除された API を特定します。oc get apirequestcounts

$ oc get apirequestcountsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要結果に表示される以下のエントリーは無視しても問題はありません。

-

system:serviceaccount:kube-system:generic-garbage-collectorおよびsystem:serviceaccount:kube-system:namespace-controllerユーザーは、削除するリソースの検索時に登録されたすべての API を呼び出すので、結果に表示される可能性があります。 -

system:kube-controller-managerおよびsystem:cluster-policy-controllerユーザーは、さまざまなポリシーを適用しながらすべてのリソースをウォークスルーするため、結果に表示される場合があります。

-o jsonpathを使用して結果をフィルタリングすることもできます。oc get apirequestcounts -o jsonpath='{range .items[?(@.status.removedInRelease!="")]}{.status.removedInRelease}{"\t"}{.metadata.name}{"\n"}{end}'$ oc get apirequestcounts -o jsonpath='{range .items[?(@.status.removedInRelease!="")]}{.status.removedInRelease}{"\t"}{.metadata.name}{"\n"}{end}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

1.27 csistoragecapacities.v1beta1.storage.k8s.io 1.29 flowschemas.v1beta2.flowcontrol.apiserver.k8s.io 1.29 prioritylevelconfigurations.v1beta2.flowcontrol.apiserver.k8s.io

1.27 csistoragecapacities.v1beta1.storage.k8s.io 1.29 flowschemas.v1beta2.flowcontrol.apiserver.k8s.io 1.29 prioritylevelconfigurations.v1beta2.flowcontrol.apiserver.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

2.1.2.2.3. APIRequestCount を使用して削除された API を使用しているワークロードを特定

特定の API バージョンの APIRequestCount リソースを確認することで、API を使用しているワークロードを特定できます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

以下のコマンドを実行して

usernameおよびuserAgentを確認すると、API を使用しているワークロードの特定に役立ちます。oc get apirequestcounts <resource>.<version>.<group> -o yaml

$ oc get apirequestcounts <resource>.<version>.<group> -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

oc get apirequestcounts csistoragecapacities.v1beta1.storage.k8s.io -o yaml

$ oc get apirequestcounts csistoragecapacities.v1beta1.storage.k8s.io -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -o jsonpathを使用して、APIRequestCountリソースからusernameおよびuserAgentの値を抽出することもできます。oc get apirequestcounts csistoragecapacities.v1beta1.storage.k8s.io \ -o jsonpath='{range .status.currentHour..byUser[*]}{..byVerb[*].verb}{","}{.username}{","}{.userAgent}{"\n"}{end}' \ | sort -k 2 -t, -u | column -t -s, -NVERBS,USERNAME,USERAGENT$ oc get apirequestcounts csistoragecapacities.v1beta1.storage.k8s.io \ -o jsonpath='{range .status.currentHour..byUser[*]}{..byVerb[*].verb}{","}{.username}{","}{.userAgent}{"\n"}{end}' \ | sort -k 2 -t, -u | column -t -s, -NVERBS,USERNAME,USERAGENTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

VERBS USERNAME USERAGENT list watch system:kube-controller-manager cluster-policy-controller/v0.0.0 list watch system:kube-controller-manager kube-controller-manager/v1.26.5+0abcdef list watch system:kube-scheduler kube-scheduler/v1.26.5+0abcdef

VERBS USERNAME USERAGENT list watch system:kube-controller-manager cluster-policy-controller/v0.0.0 list watch system:kube-controller-manager kube-controller-manager/v1.26.5+0abcdef list watch system:kube-scheduler kube-scheduler/v1.26.5+0abcdefCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.2.3. 削除された API インスタンスの移行

削除された Kubernetes API を移行する方法は、Kubernetes ドキュメントの Deprecated API Migration Guide を参照してください。

2.1.2.4. 管理者の確認の提供

削除された API についてクラスターを評価し、削除された API を移行すると、クラスターが OpenShift Container Platform 4.13 から 4.14 にアップグレードできることを確認できます。

この管理者の確認を提供する前に、削除された API のすべての使用が解決され、必要に応じて移行されたことを確認するすべての責任は管理者にあることに注意してください。OpenShift Container Platform はその評価を支援できますが、とくにアイドル状態のワークロードや外部ツールなど、削除された API の考えられるすべての用途を特定することはできません。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

以下のコマンドを実行して、評価が完了し、クラスターが OpenShift Container Platform 4.14 で Kubernetes API を削除する準備ができていることを確認します。

oc -n openshift-config patch cm admin-acks --patch '{"data":{"ack-4.13-kube-1.27-api-removals-in-4.14":"true"}}' --type=merge$ oc -n openshift-config patch cm admin-acks --patch '{"data":{"ack-4.13-kube-1.27-api-removals-in-4.14":"true"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.3. 条件付き更新のリスク評価

条件付き更新 は、使用可能な更新ターゲットですが、クラスターに適用される既知のリスクのため推奨されません。Cluster Version Operator (CVO) は、OpenShift Update Service (OSUS) に定期的にクエリーを実行して、更新の推奨事項に関する最新のデータを取得します。ターゲットとなりうる一部の更新には、それに関連するリスクが含まれる可能性があります。

CVO は条件付きリスクを評価します。そのリスクがクラスターに当てはまらない場合、クラスターはそのターゲットバージョンを推奨される更新パスとして使用できます。リスクが当てはまると判断された場合、または何らかの理由で CVO がリスクを評価できない場合、クラスターはその更新ターゲットを条件付き更新として使用できます。

ターゲットバージョンに更新しようとしているときに条件付き更新が発生した場合は、クラスターをそのバージョンに更新するリスクを評価する必要があります。一般的に、そのターゲットバージョンに更新する必要性が特にない場合は、推奨される更新パスが Red Hat から提供されるまで待つのが最善です。

ただし、そのバージョンに更新する明確な理由がある場合 (たとえば重要な CVE を修正する必要がある場合など)、CVE を修正する利点が、更新によってクラスターに問題が発生するリスクを上回る可能性があります。以下のタスクを実行して、Red Hat の更新リスク評価に同意するか判断してください。

- 実稼働環境で問題なく更新を完了できると確信が持てるまで、非実稼働環境で幅広くテストしてください。

- 条件付き更新の説明に記載されているリンクを使用してバグを調査し、使用しているクラスターに問題を引き起こす可能性があるか判断します。リスクを把握するためにサポートが必要な場合は、Red Hat サポートにお問い合わせください。

2.1.4. クラスター更新前の etcd バックアップ

etcd バックアップには、クラスターとそのすべてのリソースオブジェクトの状態が記録されます。現在機能不全状態にあるクラスターを復元できない障害シナリオでは、バックアップを使用してクラスターの状態の復元を試みることができます。

更新のコンテキストでは、更新によってクラスターの以前のバージョンに戻さないと修正できない壊滅的な状態が発生した場合に、クラスターの etcd 復元を試みることができます。etcd 復元は、実行中のクラスターにとって破壊的で不安定になる可能性があるため、最後の手段としてのみ使用してください。

etcd 復元は重大な影響をもたらすため、ロールバックソリューションとして使用することは意図されていません。クラスターの以前のバージョンへのロールバックはサポートされていません。更新が完了しない場合は、Red Hat サポートにお問い合わせください。

etcd 復元の実行可能性に影響を与える要因がいくつかあります。詳細は、「etcd データのバックアップ」および「以前のクラスター状態への復元」を参照してください。

2.1.5. クラスター更新のベストプラクティス

OpenShift Container Platform は、更新中のワークロードの中断を最小限に抑える堅牢な更新エクスペリエンスを提供します。更新要求時にクラスターがアップグレード可能な状態にない限り、更新は開始されません。

この設計では、更新を開始する前にいくつかの重要な条件を強制しますが、クラスターの更新が成功する可能性を高めるために実行できるアクションは多数あります。

2.1.5.1. OpenShift Update Service 推奨バージョンの選択

OpenShift Update Service (OSUS) は、クラスターがサブスクライブしているチャネルなどをはじめとするクラスターの特性に基づき、更新に関する推奨を提示します。Cluster Version Operator は、これらの推奨事項を推奨される更新または条件付き更新として保存します。OSUS が推奨していないバージョンへの更新を試行できますが、推奨される更新パスに従うことで、ユーザーはクラスター上での既知の問題や予期せぬ結果の発生から保護されます。

更新を確実に成功させるためには、OSUS が推奨する更新ターゲットのみを選択してください。

2.1.5.2. クラスター上ですべての重大アラートに対処する

重大なアラートには、常に可能な限り早く対処する必要がありますが、クラスターの更新を開始する前にこれらのアラートに対処し、問題を解決することが特に重要です。更新を開始する前に重大アラートに対処しなければ、クラスターが問題のある状態に陥る可能性があります。

Web コンソールの Administrator パースペクティブで、Observe → Alerting に移動して重大なアラートを見つけます。

2.1.5.2.1. 重複したエンコーディングヘッダーが削除されていることを確認してください。

更新前に、重複する Transfer-Encoding ヘッダーの問題を記録するルートがある場合は、DuplicateTransferEncodingHeadersDetected アラートが表示されます。これは、OpenShift Container Platform 4.14 で、以前の OpenShift Container Platform リリースにおける HAProxy 2.2 から HAProxy 2.6 へのアップグレードが原因です。このアラートに対処しないと、複数の Transfer-Encoding ヘッダーを送信するアプリケーションがルートを介して到達できなくなります。

この問題を軽減するには、問題のあるアプリケーションを更新して、複数の Transfer-Encoding ヘッダーを送信しなくなりました。たとえば、アプリケーション設定ファイルで重複したヘッダーを削除する必要がある場合があります。

詳細は、Red Hat ナレッジベースアーティクル libvirt-lxc を使用した Linux コンテナー (廃止) を参照してください。

2.1.5.3. クラスターの状態が Upgradable であることを確認する

1 つ以上の Operator が 1 時間以上 Upgradeable 条件を True として報告しなかった場合、クラスター内で ClusterNotUpgradeable 警告アラートがトリガーされます。このアラートがパッチ更新をブロックすることはほぼありませんが、このアラートを解決し、すべての Operator が Upgradeable に対して True と報告するまで、マイナーバージョンの更新は実行できません。

Upgradeable 条件の詳細には、追加リソースセクションの「クラスター Operator の条件タイプ」を参照してください。

2.1.5.4. 十分な予備ノードが利用可能であることを確認する

特にクラスターの更新を開始する場合は、予備のノード容量がほとんどない、またはまったくない状態でクラスターを実行するべきではありません。ノードが実行されておらず、使用できない場合、クラスターのワークロードの中断を最小限に抑えつつ更新を実行するという能力が制限される可能性があります。

クラスターの maxUnavailable 仕様の設定値によっては、使用できないノードがある場合にクラスターはマシン設定の変更をノードに適用できない可能性があります。さらに、コンピュートノードに十分な予備容量がない場合、最初のノードが更新のためにオフラインになっている間、ワークロードを一時的に別のノードに移行できない可能性があります。

ノード更新が成功する可能性を高めるために、各ワーカープールに十分な使用可能なノードがあること、およびコンピュートノードに十分な予備容量があることを確認してください。

OpenShift Container Platform のすべてのマシン設定プールにおける maxUnavailable のデフォルト設定は 1 です。この値を変更せず、一度に 1 つのコントロールプレーンノードを更新することを推奨します。コントロールプレーンプールのこの値を 3 に変更しないでください。

2.1.5.5. クラスターの PodDisruptionBudget が適切に設定されていることを確認する

PodDisruptionBudget オブジェクトを使用して、常に使用可能でなければならない Pod レプリカの最小数または割合を定義できます。この設定により、クラスター更新などのメンテナンスタスク中にワークロードが中断されないように保護できます。

ただし、クラスターの更新中にノードがドレインおよび更新されないように、特定のトポロジーに対して PodDisruptionBudget を設定できます。

クラスターの更新を計画する際には、次の要因に対する PodDisruptionBudget オブジェクトの設定を確認してください。

-

高可用性ワークロードの場合は、

PodDisruptionBudgetで禁止されることなく一時的にオフラインにできるレプリカがあることを確認してください。 -

高可用性以外のワークロードの場合は、

PodDisruptionBudgetで保護されていないこと、または最終的にこれらのワークロードをドレインするための代替メカニズム (定期的な再起動や最終的な終了の保証など) があることを確認してください。

2.2. 手動で維持された認証情報でクラスターを更新する準備

手動で維持された認証情報をを含むクラスターの Cloud Credential Operator (CCO) の upgradable ステータスはデフォルトで false となります。

-

4.12 から 4.13 などのマイナーリリースの場合は、このステータスを使用することで、権限を更新して

CloudCredentialリソースにアノテーションを付けて権限が次のバージョンの要件に合わせて更新されていることを指定するまで、更新できなくなります。このアノテーションは、UpgradableステータスをTrueに変更します。 - 4.13.0 から 4.13.1 などの z-stream リリースの場合には、権限は追加または変更されないため、更新はブロックされません。

手動で維持された認証情報を使用してクラスターを更新する前に、更新後の OpenShift Container Platform バージョンのリリースイメージにおける新規認証情報または変更された認証情報に対応する必要があります。

2.2.1. 手動で維持された認証情報を使用したクラスターの更新要件

手動で維持された認証情報を Cloud Credential Operator (CCO) で使用するクラスターを更新する前に、新しいリリースのクラウドプロバイダーリソースを更新する必要があります。

クラスターのクラウド認証情報管理が CCO ユーティリティー (ccoctl) を使用して設定されている場合、ccoctl ユーティリティーを使用してリソースを更新します。ccoctl ユーティリティーなしで手動モードを使用するように設定されたクラスターの場合、リソースを手動で更新する必要があります。

クラウドプロバイダーのリソースを更新したら、クラスターの upgradeable-to アノテーションを更新して、更新の準備ができていることを示す必要があります。

クラウドプロバイダーリソースと upgradeable-to アノテーションを更新するプロセスは、コマンドラインツールを使用しなければ完了できません。

2.2.1.1. プラットフォームタイプ別のクラウド認証情報の設定オプションと更新要件

一部のプラットフォームでは、CCO のモードを 1 つしか使用できません。そのようなプラットフォームにインストールされているクラスターの場合、プラットフォームタイプによって認証情報の更新要件が決まります。

CCO のモードを複数サポートしているプラットフォームの場合、クラスターが使用するように設定されているモードを判別し、その設定に必要なアクションを実行する必要があります。

図2.1 プラットフォームタイプ別の認証情報の更新要件

- Red Hat OpenStack Platform (RHOSP) と VMware vSphere

これらのプラットフォームは、手動モードでの CCO の使用をサポートしていません。これらのプラットフォーム上のクラスターでは、クラウドプロバイダーのリソース変更が自動的に処理され、

upgradeable-toアノテーションへの更新は必要ありません。これらのプラットフォーム上にあるクラスターの管理者は、更新プロセスの手動で維持された認証情報セクションをスキップする必要があります。

- IBM Cloud と Nutanix

これらのプラットフォームにインストールされたクラスターは、

ccoctlユーティリティーを使用して設定されます。これらのプラットフォーム上にあるクラスターの管理者は、以下のアクションを実行する必要があります。

-

新しいリリースの

CredentialsRequestカスタムリソース (CR) を抽出して準備します。 -

新しいリリースの

ccoctlユーティリティーを設定し、それを使用してクラウドプロバイダーリソースを更新します。 -

upgradeable-toアノテーションで、クラスターの更新準備が完了したことを示します。

-

新しいリリースの

- Microsoft Azure Stack Hub

これらのクラスターは、有効期間の長い認証情報と手動モードを使用し、

ccoctlユーティリティーは使用しません。これらのプラットフォーム上にあるクラスターの管理者は、以下のアクションを実行する必要があります。

-

新しいリリースの

CredentialsRequestカスタムリソース (CR) を抽出して準備します。 - 新しいリリースのクラウドプロバイダーリソースを手動で更新します。

-

upgradeable-toアノテーションで、クラスターの更新準備が完了したことを示します。

-

新しいリリースの

- Amazon Web Services (AWS)、グローバル Microsoft Azure、Google Cloud Platform (GCP)

これらのプラットフォームにインストールされたクラスターは、複数の CCO モードをサポートします。

必要な更新プロセスは、クラスターが使用するように設定されたモードにより異なります。CCO がクラスターで使用するように設定されたモードが不明な場合は、Web コンソールまたは CLI を使用して判別できます。

2.2.1.2. Web コンソールを使用した Cloud Credential Operator モードの判別

Cloud Credential Operator (CCO) がどのモードを使用するように設定されているかは、Web コンソールを使用して判別できます。

複数の CCO モードをサポートするのは、Amazon Web Services (AWS)、グローバル Microsoft Azure、および Google Cloud Platform (GCP) クラスターのみです。

前提条件

- クラスター管理者パーミッションを持つ OpenShift Container Platform アカウントにアクセスできる。

手順

-

cluster-adminロールを持つユーザーとして OpenShift Container Platform Web コンソールにログインします。 - Administration → Cluster Settings に移動します。

- Cluster Settings ページで、Configuration タブを選択します。

- Configuration resource で CloudCredential を選択します。

- CloudCredential details ページで、YAML タブを選択します。

YAML ブロックで、

spec.credentialsModeの値を確認します。次の値が可能ですが、すべてのプラットフォームですべてがサポートされているわけではありません。-

'': CCO はデフォルトモードで動作しています。この設定では、CCO は、インストール中に提供されたクレデンシャルに応じて、ミントモードまたはパススルーモードで動作します。 -

Mint: CCO はミントモードで動作しています。 -

Passthrough: CCO はパススルーモードで動作しています。 -

Manual: CCO は手動モードで動作します。

重要spec.credentialsModeが''、Mint、またはManualである AWS、GCP、またはグローバル Microsoft Azure クラスターの特定の設定を判断するには、さらに調査する必要があります。AWS および GCP クラスターは、ルートシークレットが削除されたミントモードの使用をサポートします。クラスターが、mint モードを使用するように設定されている場合や、デフォルトで mint モードを使用するように設定されている場合、更新前に root シークレットがクラスターに存在するか確認する必要があります。

手動モードを使用する AWS、GCP、またはグローバル Microsoft Azure クラスターは、AWS STS、GCP Workload Identity、または Microsoft Entra Workload ID を使用してクラスターの外部からクラウド認証情報を作成および管理するように設定されている場合があります。クラスター

Authenticationオブジェクトを調べることで、クラスターがこの戦略を使用しているかどうかを判断できます。-

mint モードのみを使用する AWS または GCP クラスター: クラスターがルートシークレットなしで動作しているかどうかを判断するには、Workloads → Secrets に移動し、クラウドプロバイダーのルートシークレットを探します。

注記Project ドロップダウンが All Projects に設定されていることを確認します。

Expand プラットフォーム シークレット名 AWS

aws-credsGCP

gcp-credentials- これらの値のいずれかが表示される場合、クラスターはルートシークレットが存在するミントモードまたはパススルーモードを使用しています。

- これらの値が表示されない場合、クラスターはルートシークレットが削除されたミントモードで CCO を使用しています。

手動モードのみを使用する AWS、GCP、または global Microsoft Azure クラスター: クラスターがクラスターの外部からクラウド認証情報を作成および管理するように設定されているかどうかを判断するには、クラスター

Authenticationオブジェクトの YAML 値を確認する必要があります。- Administration → Cluster Settings に移動します。

- Cluster Settings ページで、Configuration タブを選択します。

- Configuration resource で Authentication を選択します。

- Authentication details ページで、YAML タブを選択します。

YAML ブロックで、

.spec.serviceAccountIssuerパラメーターの値を確認します。-

クラウドプロバイダーに関連付けられた URL が含まれる値は、CCO がコンポーネントの短期認証情報を使用して手動モードを使用していることを示します。このクラスターは、クラスターの外からクラウド認証情報を作成および管理するために

ccoctlユーティリティーを使用して設定されています。 -

空の値 (

'') は、クラスターが手動モードで CCO を使用しているが、ccoctlユーティリティーを使用して設定されていないことを示します。

-

クラウドプロバイダーに関連付けられた URL が含まれる値は、CCO がコンポーネントの短期認証情報を使用して手動モードを使用していることを示します。このクラスターは、クラスターの外からクラウド認証情報を作成および管理するために

次のステップ

- mint モードまたは passthrough モードで動作する CCO が含まれ、root シークレットが存在するクラスターを更新する場合、クラウドプロバイダーリソースを更新する必要はなく、更新プロセスの次の手順に進むことができます。

- クラスターが、root シークレットが削除された状態で mint モードの CCO を使用している場合、更新プロセスの次の手順に進む前に、管理者レベルの認証情を使用して認証情報シークレットを元に戻す必要があります。

クラスターが CCO ユーティリティー (

ccoctl) を使用して設定されている場合、次のアクションを実行する必要があります。-

新しいリリースの

CredentialsRequestカスタムリソース (CR) を抽出して準備します。 -

新しいリリースの

ccoctlユーティリティーを設定し、それを使用してクラウドプロバイダーリソースを更新します。 -

upgradeable-toアノテーションを更新して、クラスターの更新準備が完了していることを示します。

-

新しいリリースの

クラスターが手動モードで CCO を使用しており、

ccoctlユーティリティーを使用して設定されていない場合は、以下のアクションを実行する必要があります。-

新しいリリースの

CredentialsRequestカスタムリソース (CR) を抽出して準備します。 - 新しいリリースのクラウドプロバイダーリソースを手動で更新します。

-

upgradeable-toアノテーションを更新して、クラスターの更新準備が完了していることを示します。

-

新しいリリースの

2.2.1.3. CLI を使用した Cloud Credential Operator モードの判別

CLI を使用して、Cloud Credential Operator (CCO) が使用するように設定されているモードを判別できます。

複数の CCO モードをサポートするのは、Amazon Web Services (AWS)、グローバル Microsoft Azure、および Google Cloud Platform (GCP) クラスターのみです。

前提条件

- クラスター管理者パーミッションを持つ OpenShift Container Platform アカウントにアクセスできる。

-

OpenShift CLI (

oc) がインストールされている。

手順

-

cluster-adminロールを持つユーザーとしてクラスターのocにログインします。 CCO が使用するように設定されているモードを確認するには、次のコマンドを入力します。

oc get cloudcredentials cluster \ -o=jsonpath={.spec.credentialsMode}$ oc get cloudcredentials cluster \ -o=jsonpath={.spec.credentialsMode}Copy to Clipboard Copied! Toggle word wrap Toggle overflow すべてのプラットフォームですべてがサポートされているわけではありませんが、次の出力値が可能です。

-

'': CCO はデフォルトモードで動作しています。この設定では、CCO は、インストール中に提供されたクレデンシャルに応じて、ミントモードまたはパススルーモードで動作します。 -

Mint: CCO はミントモードで動作しています。 -

Passthrough: CCO はパススルーモードで動作しています。 -

Manual: CCO は手動モードで動作します。

重要spec.credentialsModeが''、Mint、またはManualである AWS、GCP、またはグローバル Microsoft Azure クラスターの特定の設定を判断するには、さらに調査する必要があります。AWS および GCP クラスターは、ルートシークレットが削除されたミントモードの使用をサポートします。クラスターが、mint モードを使用するように設定されている場合や、デフォルトで mint モードを使用するように設定されている場合、更新前に root シークレットがクラスターに存在するか確認する必要があります。

手動モードを使用する AWS、GCP、またはグローバル Microsoft Azure クラスターは、AWS STS、GCP Workload Identity、または Microsoft Entra Workload ID を使用してクラスターの外部からクラウド認証情報を作成および管理するように設定されている場合があります。クラスター

Authenticationオブジェクトを調べることで、クラスターがこの戦略を使用しているかどうかを判断できます。-

mint モードのみを使用する AWS または GCP クラスター: クラスターがルートシークレットなしで動作しているかどうかを判断するには、次のコマンドを実行します。

oc get secret <secret_name> \ -n=kube-system

$ oc get secret <secret_name> \ -n=kube-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow <secret_name>は、AWS の場合はaws-creds、GCP の場合はgcp-credentialsです。ルートシークレットが存在する場合、このコマンドの出力はシークレットに関する情報を返します。エラーは、ルートシークレットがクラスターに存在しないことを示します。

手動モードのみを使用する AWS、GCP、またはグローバル Microsoft Azure クラスター: クラスターの外部からクラウド認証情報を作成および管理するようにクラスターが設定されているかどうかを確認するには、次のコマンドを実行します。

oc get authentication cluster \ -o jsonpath \ --template='{ .spec.serviceAccountIssuer }'$ oc get authentication cluster \ -o jsonpath \ --template='{ .spec.serviceAccountIssuer }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは、クラスター

Authenticationオブジェクトの.spec.serviceAccountIssuerパラメーターの値を表示します。-

クラウドプロバイダーに関連付けられた URL の出力は、CCO がコンポーネントの短期認証情報を使用して手動モードを使用していることを示します。このクラスターは、クラスターの外からクラウド認証情報を作成および管理するために

ccoctlユーティリティーを使用して設定されています。 -

空の出力は、クラスターが手動モードで CCO を使用しているが、

ccoctlユーティリティーを使用して設定されていないことを示します。

-

クラウドプロバイダーに関連付けられた URL の出力は、CCO がコンポーネントの短期認証情報を使用して手動モードを使用していることを示します。このクラスターは、クラスターの外からクラウド認証情報を作成および管理するために

次のステップ

- mint モードまたは passthrough モードで動作する CCO が含まれ、root シークレットが存在するクラスターを更新する場合、クラウドプロバイダーリソースを更新する必要はなく、更新プロセスの次の手順に進むことができます。

- クラスターが、root シークレットが削除された状態で mint モードの CCO を使用している場合、更新プロセスの次の手順に進む前に、管理者レベルの認証情を使用して認証情報シークレットを元に戻す必要があります。

クラスターが CCO ユーティリティー (

ccoctl) を使用して設定されている場合、次のアクションを実行する必要があります。-

新しいリリースの

CredentialsRequestカスタムリソース (CR) を抽出して準備します。 -

新しいリリースの

ccoctlユーティリティーを設定し、それを使用してクラウドプロバイダーリソースを更新します。 -

upgradeable-toアノテーションを更新して、クラスターの更新準備が完了していることを示します。

-

新しいリリースの

クラスターが手動モードで CCO を使用しており、

ccoctlユーティリティーを使用して設定されていない場合は、以下のアクションを実行する必要があります。-

新しいリリースの

CredentialsRequestカスタムリソース (CR) を抽出して準備します。 - 新しいリリースのクラウドプロバイダーリソースを手動で更新します。

-

upgradeable-toアノテーションを更新して、クラスターの更新準備が完了していることを示します。

-

新しいリリースの

2.2.2. 認証情報要求リソースの抽出と準備

Cloud Credential Operator (CCO) を使用するクラスターを手動モードで更新する前に、新しいリリース用の CredentialsRequest カスタムリソース (CR) を抽出して準備する必要があります。

前提条件

-

仕様している更新バージョンのバージョンに一致する OpenShift CLI (

oc) をインストールしている。 -

cluster-admin権限を持つユーザーとしてクラスターにログインしている。

手順

次のコマンドを実行して、適用する更新のプル仕様を取得します。

oc adm upgrade

$ oc adm upgradeCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドの出力には、次のような利用可能な更新のプル仕様が含まれます。

部分的な出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、使用するリリースイメージを

$RELEASE_IMAGE変数に設定します。RELEASE_IMAGE=<update_pull_spec>

$ RELEASE_IMAGE=<update_pull_spec>Copy to Clipboard Copied! Toggle word wrap Toggle overflow <update_pull_spec>は、使用するリリースイメージのプル仕様です。以下に例を示します。quay.io/openshift-release-dev/ocp-release@sha256:6a899c54dda6b844bb12a247e324a0f6cde367e880b73ba110c056df6d018032

quay.io/openshift-release-dev/ocp-release@sha256:6a899c54dda6b844bb12a247e324a0f6cde367e880b73ba110c056df6d018032Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、OpenShift Container Platform リリースイメージから

CredentialsRequestカスタムリソース (CR) のリストを抽出します。oc adm release extract \ --from=$RELEASE_IMAGE \ --credentials-requests \ --included \ --to=<path_to_directory_for_credentials_requests>

$ oc adm release extract \ --from=$RELEASE_IMAGE \ --credentials-requests \ --included \1 --to=<path_to_directory_for_credentials_requests>2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドにより、それぞれの

CredentialsRequestオブジェクトに YAML ファイルが作成されます。リリースイメージの各

CredentialsRequestについて、spec.secretRef.namespaceフィールドのテキストと一致するネームスペースがクラスターに存在することを確認します。このフィールドには、クレデンシャルの設定を保持する生成されたシークレットが保存されます。サンプル AWS

CredentialsRequestオブジェクトCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- このフィールドは、生成されたシークレットを保持するために存在する必要がある namespace を示します。

他のプラットフォームの

CredentialsRequestCR も同様の形式ですが、プラットフォーム固有の異なる値があります。クラスターが

spec.secretRef.namespaceで指定された名前の namespace をまだ持っていないCredentialsRequestCR には、次のコマンドを実行して namespace を作成します。oc create namespace <component_namespace>

$ oc create namespace <component_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

次のステップ

-

クラスターのクラウド認証情報管理が CCO ユーティリティー (

ccoctl) を使用して設定されている場合は、ccoctlユーティリティーをクラスター更新用に設定し、それを使用してクラウドプロバイダーリソースを更新します。 -

クラスターが

ccoctlユーティリティーを使用して設定されていない場合は、クラウドプロバイダーのリソースを手動で更新します。

2.2.3. クラスター更新のための Cloud Credential Operator ユーティリティーの設定

Cloud Credential Operator (CCO) を手動モードで使用するクラスターをアップグレードして、クラスターの外からクラウド認証情報を作成および管理する場合は、CCO ユーティリティー (ccoctl) バイナリーを抽出して準備します。

ccoctl ユーティリティーは、Linux 環境で実行する必要がある Linux バイナリーです。

前提条件

- クラスター管理者のアクセスを持つ OpenShift Container Platform アカウントを使用できる。

-

OpenShift CLI (

oc) がインストールされている。

-

クラスターは、クラスターの外からクラウド認証情報を作成および管理するために

ccoctlユーティリティーを使用して設定されている。 -

OpenShift Container Platform リリースイメージから

CredentialsRequestカスタムリソース (CR) を抽出し、spec.secretRef.namespaceフィールドのテキストと一致する namespace がクラスター内に存在している。

手順

次のコマンドを実行して、OpenShift Container Platform リリースイメージの変数を設定します。

RELEASE_IMAGE=$(oc get clusterversion -o jsonpath={..desired.image})$ RELEASE_IMAGE=$(oc get clusterversion -o jsonpath={..desired.image})Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、OpenShift Container Platform リリースイメージから CCO コンテナーイメージを取得します。

CCO_IMAGE=$(oc adm release info --image-for='cloud-credential-operator' $RELEASE_IMAGE -a ~/.pull-secret)

$ CCO_IMAGE=$(oc adm release info --image-for='cloud-credential-operator' $RELEASE_IMAGE -a ~/.pull-secret)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記$RELEASE_IMAGEのアーキテクチャーが、ccoctlツールを使用する環境のアーキテクチャーと一致していることを確認してください。以下のコマンドを実行して、OpenShift Container Platform リリースイメージ内の CCO コンテナーイメージから

ccoctlバイナリーを抽出します。oc image extract $CCO_IMAGE --file="/usr/bin/ccoctl" -a ~/.pull-secret

$ oc image extract $CCO_IMAGE --file="/usr/bin/ccoctl" -a ~/.pull-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、権限を変更して

ccoctlを実行可能にします。chmod 775 ccoctl

$ chmod 775 ccoctlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ccoctlが使用できることを確認するには、help ファイルを表示します。コマンドを実行するときは、相対ファイル名を使用します。以下に例を示します。./ccoctl.rhel9

$ ./ccoctl.rhel9Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.4. Cloud Credential Operator ユーティリティーを使用したクラウドプロバイダーリソースの更新

CCO ユーティリティー (ccoctl) を使用して設定された OpenShift Container Platform クラスターをアップグレードするプロセスは、インストール時にクラウドプロバイダーリソースを作成するプロセスに似ています。

AWS クラスターでは、一部の ccoctl コマンドが AWS API 呼び出しを行い、AWS リソースを作成または変更します。--dry-run フラグを使用して、API 呼び出しを回避できます。このフラグを使用すると、代わりにローカルファイルシステムに JSON ファイルが作成されます。JSON ファイルを確認して変更し、AWS CLI ツールで --cli-input-json パラメーターを使用して適用できます。

前提条件

-

OpenShift Container Platform リリースイメージから

CredentialsRequestカスタムリソース (CR) を抽出し、spec.secretRef.namespaceフィールドのテキストと一致する namespace がクラスター内に存在している。 -

リリースイメージから

ccoctlバイナリーを抽出して設定している。

手順

ccoctlツールを使用して、クラウドプロバイダーのコマンドを実行して、すべてのCredentialsRequestオブジェクトを処理します。以下のコマンドはCredentialsRequestオブジェクトを処理します。例2.1 Amazon Web Services (AWS)

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- AWS リソースを個別に作成するには、「カスタマイズを使用した AWS へのクラスターのインストール」コンテンツの「AWS リソースの個別の作成」手順を使用します。このオプションは、AWS リソースを変更する前に

ccoctlツールが作成する JSON ファイルを確認する必要がある場合、またはccoctlツールが AWS リソースを自動的に作成するために使用するプロセスが組織の要件を満たしていない場合に役立つ可能性があります。 - 2

- 追跡用に作成されたクラウドリソースにタグを付けるために使用される名前です。

- 3

- クラウドリソースが作成される AWS リージョンです。

- 4

- コンポーネント

CredentialsRequestオブジェクトのファイルを含むディレクトリーを指定します。 - 5

- オプション:

ccoctlユーティリティーがオブジェクトを作成するディレクトリーを指定します。デフォルトでは、ユーティリティーは、コマンドが実行されるディレクトリーにオブジェクトを作成します。 - 6

- オプション: デフォルトでは、

ccoctlユーティリティーは OpenID Connect (OIDC) 設定ファイルをパブリック S3 バケットに保存し、S3 URL をパブリック OIDC エンドポイントとして使用します。代わりに、パブリック CloudFront 配布 URL を介して IAM ID プロバイダーによってアクセスされるプライベート S3 バケットに OIDC 設定を保存するには、--create-private-s3-bucketパラメーターを使用します。

例2.2 Google Cloud Platform (GCP)

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例2.3 IBM Cloud

ccoctl ibmcloud create-service-id \ --credentials-requests-dir=<path_to_credential_requests_directory> \ --name=<cluster_name> \ --output-dir=<installation_directory> \ --resource-group-name=<resource_group_name>

$ ccoctl ibmcloud create-service-id \ --credentials-requests-dir=<path_to_credential_requests_directory> \1 --name=<cluster_name> \2 --output-dir=<installation_directory> \3 --resource-group-name=<resource_group_name>4 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例2.4 Microsoft Azure

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

nameパラメーターの値は、Azure リソースグループを作成するために使用します。新しい Azure リソースグループを作成する代わりに既存の Azure リソースグループを使用するには、--oidc-resource-group-nameを指定し、その値として既存のグループ名を使用します。- 2

- 既存のクラスターのリージョンを指定します。

- 3

- 既存のクラスターのサブスクリプション ID を指定します。

- 4

- 既存のクラスターから OIDC 発行者 URL を指定します。この値は、以下のコマンドを実行して取得できます。

oc get authentication cluster \ -o jsonpath \ --template='{ .spec.serviceAccountIssuer }'$ oc get authentication cluster \ -o jsonpath \ --template='{ .spec.serviceAccountIssuer }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 5

- DNS ゾーンを含むリソースグループの名前を指定します。

- 6

- Azure リソースグループを指定します。この値は、以下のコマンドを実行して取得できます。

oc get infrastructure cluster \ -o jsonpath \ --template '{ .status.platformStatus.azure.resourceGroupName }'$ oc get infrastructure cluster \ -o jsonpath \ --template '{ .status.platformStatus.azure.resourceGroupName }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

例2.5 Nutanix

ccoctl nutanix create-shared-secrets \ --credentials-requests-dir=<path_to_credentials_requests_directory> \ --output-dir=<ccoctl_output_dir> \ --credentials-source-filepath=<path_to_credentials_file>

$ ccoctl nutanix create-shared-secrets \ --credentials-requests-dir=<path_to_credentials_requests_directory> \1 --output-dir=<ccoctl_output_dir> \2 --credentials-source-filepath=<path_to_credentials_file>3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform リリースイメージの各

CredentialsRequestオブジェクトで定義されているとおり、ccoctlはCredentialsRequestオブジェクトごとに必要なプロバイダーリソースと権限ポリシーを作成します。次のコマンドを実行して、シークレットをクラスターに適用します。

ls <path_to_ccoctl_output_dir>/manifests/*-credentials.yaml | xargs -I{} oc apply -f {}$ ls <path_to_ccoctl_output_dir>/manifests/*-credentials.yaml | xargs -I{} oc apply -f {}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

クラウドプロバイダーにクエリーを実行することで、必要なプロバイダーのリソースと権限ポリシーが作成されていることを確認できます。詳細は、適切なクラウドプロバイダーのドキュメントでロールまたはサービスアカウントの一リストを参照してください。

次のステップ

-

upgradeable-toアノテーションを更新して、クラスターをアップグレードする準備ができていることを示します。

2.2.5. クラウドプロバイダーのリソースを手動で更新する

手動でメンテナンスされる認証情報でクラスターをアップグレードする前に、アップグレードするリリースイメージ用に新しい認証情報のシークレットを作成する必要があります。また、既存の認証情報に必要なアクセス許可を確認し、それらのコンポーネントの新しいリリースでの新しいアクセス許可要件に対応する必要があります。

前提条件

-

OpenShift Container Platform リリースイメージから

CredentialsRequestカスタムリソース (CR) を抽出し、spec.secretRef.namespaceフィールドのテキストと一致する namespace がクラスター内に存在している。

手順

新しいリリースイメージで追加される

CredentialsRequestカスタムリソースのシークレットを含む YAML ファイルを作成します。シークレットは、それぞれのCredentialsRequestオブジェクトに、spec.secretRefに定義される namespace およびシークレット名を使用して保存する必要があります。例2.6 サンプル AWS YAML ファイル

シークレットを含むサンプル AWS

CredentialsRequestオブジェクトCopy to Clipboard Copied! Toggle word wrap Toggle overflow サンプル AWS

SecretオブジェクトCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例2.7 サンプル Azure YAML ファイル

注記Global Azure と Azure Stack Hub は、同じ

CredentialsRequestオブジェクトとシークレット形式を使用します。シークレットを含むサンプル Azure

CredentialsRequestオブジェクトCopy to Clipboard Copied! Toggle word wrap Toggle overflow サンプル Azure

SecretオブジェクトCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例2.8 サンプル GCP YAML ファイル

シークレットを含むサンプル GCP

CredentialsRequestオブジェクトのCopy to Clipboard Copied! Toggle word wrap Toggle overflow サンプル GCP

SecretオブジェクトCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

シークレットに保存される既存の認証情報の

CredentialsRequestカスタムリソースにパーミッション要件を変更した場合は、必要に応じてパーミッションを更新します。

次のステップ

-

upgradeable-toアノテーションを更新して、クラスターをアップグレードする準備ができていることを示します。

2.2.6. クラスターがアップグレードの準備ができていることを示す

手動で維持された認証情報をを含むクラスターの Cloud Credential Operator (CCO) の upgradable ステータスはデフォルトで false となります。

前提条件

-

アップグレード先のリリースイメージについて、手動で、または Cloud Credential Operator ユーティリティー (

ccoctl) を使用して、新しい認証情報を処理しました。 -

OpenShift CLI (

oc) がインストールされている。

手順

-

cluster-adminロールを持つユーザーとしてクラスターのocにログインします。 次のコマンドを実行して

CloudCredentialリソースを編集し、metadataフィールド内にupgradeable-toアノテーションを追加します。oc edit cloudcredential cluster

$ oc edit cloudcredential clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 追加するテキスト

... metadata: annotations: cloudcredential.openshift.io/upgradeable-to: <version_number> ...... metadata: annotations: cloudcredential.openshift.io/upgradeable-to: <version_number> ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow <version_number>はアップグレード先のバージョンで、形式はx.y.zです。たとえば、OpenShift Container Platform 4.12.2 には4.12.2を使用します。アノテーションを追加してから、upgradeable のステータスが変更されるまで、数分かかる場合があります。

検証

- Web コンソールの Administrator パースペクティブで、Administration → Cluster Settings に移動します。

CCO ステータスの詳細を表示するには、Cluster Operators リストで cloud-credential をクリックします。

-

Conditions セクションの Upgradeable ステータスが False の場合に、

upgradeable-toアノテーションに間違いがないことを確認します。

-

Conditions セクションの Upgradeable ステータスが False の場合に、

- Conditions セクションの Upgradeable ステータスが True の場合、OpenShift Container Platform のアップグレードを開始します。

2.3. Kernel Module Management (KMM) モジュールのプリフライト検証

KMM モジュールが適用されたクラスターでアップグレードを実行する前に、KMM を使用してインストールされたカーネルモジュールが、クラスターのアップグレード、および場合によってはカーネルのアップグレード後に、ノードにインストールできることを確認する必要があります。プリフライトは、クラスターにロードされたすべての Module を並行して検証しようとします。プリフライトは、ある Module の検証が完了するのを待たずに、別の Module の検証を開始します。

2.3.1. 検証のキックオフ

プリフライト検証は、クラスター内に PreflightValidationOCP リソースを作成することによってトリガーされます。この仕様には、次の 2 つのフィールドが含まれます。

releaseImage- クラスターがアップグレードされる OpenShift Container Platform バージョンのリリースイメージの名前を提供する必須フィールド。

pushBuiltImage-

trueの場合、ビルドおよび署名の検証中に作成されたイメージがリポジトリーにプッシュされます。このフィールドはデフォルトでfalseです。

2.3.2. 検証のライフサイクル

プリフライト検証は、クラスターにロードされたすべてのモジュールの検証を試みます。検証が成功した後、プリフライトは Module リソースでの検証の実行を停止します。モジュールの検証が失敗した場合は、モジュール定義を変更することができ、Preflight は次のループで再度モジュールの検証を試行します。

追加のカーネルにプリフライト検証を実行する場合は、そのカーネル用に別の PreflightValidationOCP リソースを作成する必要があります。すべてのモジュールが検証されたら、PreflightValidationOCP リソースを削除することを推奨します。

2.3.3. 検証のステータス

PreflightValidationOCP リソースは、検証を試行している、または試行したクラスター内の各モジュールのステータスと進行状況を .status.modules リストに報告します。そのリストの要素には次のフィールドが含まれます。

lastTransitionTime-

Moduleリソースのステータスが、別のステータスに移行した最後の時刻。これは、基礎となるステータスが変更されたときになります。不明な場合には、API フィールドが変更された時点を使用することも可能です。 name-

Moduleリソースの名前。 namespace-

Moduleリソースの namespace。 statusReason- ステータスに関する動詞の説明。

verificationStage実行されている検証段階を説明します。

-

image: イメージの存在確認 -

build: ビルドプロセスの検証 -

sign: 署名プロセスの検証

-

verificationStatusモジュール検証のステータス:

-

true: 検証済みです -

false: 検証に失敗しました -

error: 検証プロセス中にエラーが発生しました -

unknown: 検証が開始されていません

-

2.3.4. モジュールごとのプリフライト検証ステージ

プリフライトは、クラスター内に存在するすべての KMM モジュールに次の検証を実行します。

- イメージの検証ステージ

- ビルドの検証ステージ

- 署名の検証ステージ

2.3.4.1. イメージの検証ステージ

イメージの検証は常に、実行されるプリフライト検証の最初のステージです。イメージの検証が成功した場合、その特定のモジュールで他の検証は実行されません。

イメージの検証は、次の 2 つのステージで構成されます。

- イメージの存在とアクセシビリティー。コードは、モジュール内のアップグレードされたカーネル用に定義されたイメージにアクセスし、そのマニフェストを取得しようとします。

-

今後の

modprobeの実行のために、Moduleで定義されたカーネルモジュールが正しいパスに存在することを確認します。この検証が成功した場合は、カーネルモジュールが正しい Linux ヘッダーでコンパイルされた可能性が高いです。正しいパスは<dirname>/lib/modules/<upgraded_kernel>/です。

2.3.4.2. ビルドの検証ステージ

ビルドの検証は、イメージの検証が失敗し、Module にアップグレードされたカーネルに関連する build セクションがある場合のみ、実行されます。ビルドの検証は、ビルドジョブを実行し、それが正常に終了したことを検証しようとします。

次に示すように、depmod を実行する場合は、カーネルバージョンを指定する必要があります。

RUN depmod -b /opt ${KERNEL_VERSION}

$ RUN depmod -b /opt ${KERNEL_VERSION}

PushBuiltImage フラグが PreflightValidationOCP カスタムリソース (CR) で定義されている場合は、結果のイメージをリポジトリーにプッシュしようとします。結果のイメージ名は、Module CR の containerImage フィールドの定義から取得されます。

アップグレードされたカーネルに sign セクションが定義されている場合、結果のイメージは Module CR の containerImage フィールドではなく、一時的なイメージ名になります。これは、結果のイメージが Sign フローの製品である必要があるためです。

2.3.4.3. 署名の検証ステージ

署名検証は、イメージ検証が失敗した場合にのみ実行されます。Module リソースにはアップグレードカーネルに関連する sign セクションがあり、Module にアップグレードされたカーネルに関連する build セクションがあった場合は、ビルド検証が正常に終了します。署名検証では、署名ジョブを実行し、それが正常に完了したかどうかを検証します。

PushBuiltImage フラグが PreflightValidationOCP CR で定義されている場合、署名の検証は結果のイメージをレジストリーにプッシュしようとします。結果のイメージは、常に Module の ContainerImage フィールドで定義されたイメージです。入力イメージは、Build ステージの出力、または UnsignedImage フィールドで定義されたイメージのいずれかです。

build セクションが存在する場合、sign セクションの入力イメージは、build セクションの出力イメージになります。したがって、入力イメージを sign セクションで使用できるようにするには、PreflightValidationOCP CR で PushBuiltImage フラグを定義する必要があります。

2.3.5. PreflightValidationOCP リソースの例

このセクションでは、YAML 形式の PreflightValidationOCP リソースの例を示します。

この例では、現在存在するすべてのモジュールを、OpenShift Container Platform リリース 4.11.18 (以下のリリースイメージが指す) に含まれる今後のカーネルバージョンに対して検証します。

quay.io/openshift-release-dev/ocp-release@sha256:22e149142517dfccb47be828f012659b1ccf71d26620e6f62468c264a7ce7863

quay.io/openshift-release-dev/ocp-release@sha256:22e149142517dfccb47be828f012659b1ccf71d26620e6f62468c264a7ce7863

.spec.pushBuiltImage が true に設定されているため、KMM はビルド/署名の結果のイメージを定義済みのリポジトリーにプッシュします。

第3章 クラスターの更新の実行

3.1. CLI を使用したクラスターの更新

OpenShift CLI (oc) を使用して、OpenShift Container Platform クラスターでマイナーバージョンおよびパッチの更新を実行できます。

3.1.1. 前提条件

-

admin権限を持つユーザーとしてクラスターにアクセスできる。RBAC の使用によるパーミッションの定義および適用 を参照してください。 - 更新が失敗し、クラスターを以前の状態に復元する必要がある場合に備えて、最新の etcd バックアップ を用意している。

- Pod 障害による永続ボリュームの復元が必要な場合に備えて、最新の Container Storage Interface (CSI) ボリュームのスナップショット を用意している。

- RHEL7 ワーカーは、RHEL8 または RHCOS ワーカーに置き換えられます。Red Hat は、RHEL7 から RHEL8 への RHEL ワーカーのインプレース更新をサポートしていません。このようなホストは、オペレーティングシステムをクリーンインストールして置き換える必要があります。

- Operator Lifecycle Manager (OLM) を通じて以前にインストールされたすべての Operator を、ターゲットリリースと互換性のあるバージョンに更新している。Operator を更新することで、デフォルトの OperatorHub カタログが、クラスターの更新時に現行のマイナーバージョンから次のマイナーバージョンに切り替わる際、確実に有効な更新パスがあるようにします。インストール済み Operator の更新 を参照し、互換性を確認する方法の詳細を確認して、インストール済みの Operator を必要に応じて更新してください。

- すべてのマシン設定プール (MCP) が実行中であり、一時停止していないことを確認します。一時停止した MCP に関連付けられたノードは、更新プロセス中にスキップされます。カナリアロールアウト更新ストラテジーを実行している場合は、MCP を一時停止できる。

- クラスターが手動で維持された認証情報を使用している場合は、新しいリリース用にクラウドプロバイダーリソースを更新します。これがクラスターの要件かどうかを判断する方法などの詳細は、手動で維持された認証情報でクラスターを更新する準備 を参照してください。

-

クラスターで次のマイナーバージョンへの更新ができるように、すべての

Upgradeable=False条件に対応してください。アラートは、アップグレードできない 1 つ以上のクラスター Operator がある場合に Cluster Settings ページの上部に表示されます。引き続き、現在使用しているマイナーリリースについて、次に利用可能なパッチ更新に更新できます。 - Kubernetes 1.27 で削除された API のリストを確認し、影響を受けるすべてのコンポーネントを移行して新しい API バージョンを使用し、管理者に承認を提供します。詳細は、OpenShift Container Platform 4.14 への更新の準備 を参照してください。

-

Operator を実行している場合、または Pod 中断バジェットを使用してアプリケーションを設定している場合は、更新プロセス中に中断が発生する可能性があります。

PodDisruptionBudget で minAvailableが 1 に設定されている場合、削除プロセスをブロックする可能性がある保留中のマシン設定を適用するためにノードがドレインされます。複数のノードが再起動された場合に、すべての Pod が 1 つのノードでのみ実行される可能性があり、PodDisruptionBudgetフィールドはノードのドレインを防ぐことができます。

- 更新が完了しなかった場合、Cluster Version Operator (CVO) は、更新の調整を試みている間、ブロックしているコンポーネントのステータスを報告します。クラスターの以前のバージョンへのロールバックはサポートされていません。更新が完了しない場合は、Red Hat サポートにお問い合わせください。

-

unsupportedConfigOverridesセクションを使用して Operator の設定を変更することはサポートされておらず、クラスターの更新をブロックする可能性があります。クラスターを更新する前に、この設定を削除する必要があります。

3.1.2. MachineHealthCheck リソースの一時停止

更新プロセスで、クラスター内のノードが一時的に利用できなくなる可能性があります。ワーカーノードの場合、マシンのヘルスチェックにより、このようなノードは正常ではないと識別され、それらが再起動される場合があります。このようなノードの再起動を回避するには、クラスターを更新する前にすべての MachineHealthCheck リソースを一時停止します。

前提条件

-

OpenShift CLI (

oc) がインストールされている。

手順

一時停止する利用可能なすべての

MachineHealthCheckリソースをリスト表示するには、以下のコマンドを実行します。oc get machinehealthcheck -n openshift-machine-api

$ oc get machinehealthcheck -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow マシンヘルスチェックを一時停止するには、

cluster.x-k8s.io/paused=""アノテーションをMachineHealthCheckリソースに追加します。以下のコマンドを実行します。oc -n openshift-machine-api annotate mhc <mhc-name> cluster.x-k8s.io/paused=""

$ oc -n openshift-machine-api annotate mhc <mhc-name> cluster.x-k8s.io/paused=""Copy to Clipboard Copied! Toggle word wrap Toggle overflow アノテーション付きの

MachineHealthCheckリソースは以下の YAML ファイルのようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要クラスターの更新後にマシンヘルスチェックを再開します。チェックを再開するには、以下のコマンドを実行して

MachineHealthCheckリソースから pause アノテーションを削除します。oc -n openshift-machine-api annotate mhc <mhc-name> cluster.x-k8s.io/paused-

$ oc -n openshift-machine-api annotate mhc <mhc-name> cluster.x-k8s.io/paused-Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.3. 単一ノードの OpenShift Container Platform の更新

コンソールまたは CLI のいずれかを使用して、単一ノードの OpenShift Container Platform クラスターを更新またはアップグレードできます。

ただし、以下の制限事項に注意してください。

-

他にヘルスチェックを実行するノードがないので、

MachineHealthCheckリソースを一時停止する時に課される前提条件は必要ありません。 - etcd バックアップを使用した単一ノードの OpenShift Container Platform クラスターの復元は、正式にはサポートされていません。ただし、更新に失敗した場合は、etcd バックアップを実行することが推奨されます。コントロールプレーンが正常である場合には、バックアップを使用してクラスターを以前の状態に復元できる場合があります。

単一ノードの OpenShift Container Platform クラスターを更新するには、ダウンタイムが必要です。更新には、自動再起動も含まれる可能性があります。ダウンタイムの時間は、以下のシナリオのように更新ペイロードによって異なります。

- 更新ペイロードに再起動が必要なオペレーティングシステムの更新が含まれる場合には、ダウンタイムは、クラスター管理およびユーザーのワークロードに大きく影響します。

- 更新に含まれるマシン設定の変更で、再起動の必要がない場合には、ダウンタイムは少なくなり、クラスター管理およびユーザーワークロードへの影響は低くなります。この場合、クラスターに、ワークロードの再スケジューリングするノードが他にないため、単一ノードの OpenShift Container Platform でノードのドレイン (解放) のステップが省略されます。

- 更新ペイロードにオペレーティングシステムの更新またはマシン設定の変更が含まれていない場合は、API が短時間してすぐに解決します。

更新パッケージのバグなどの制約があり、再起動後に単一ノードが再起動されないことがあります。この場合、更新は自動的にロールバックされません。

3.1.4. CLI を使用したクラスターの更新

OpenShift CLI (oc) を使用して、クラスターの更新を確認および要求できます。

利用可能な OpenShift Container Platform アドバイザリーおよび更新については、カスタマーポータルの エラータ のセクションを参照してください。

前提条件

-

仕様している更新バージョンのバージョンに一致する OpenShift CLI (

oc) をインストールしている。 -

cluster-admin権限を持つユーザーとしてクラスターにログインしている。 -

すべての

MachineHealthCheckリソースを一時停止している。

手順

利用可能な更新を確認し、適用する必要のある更新のバージョン番号をメモします。

oc adm upgrade

$ oc adm upgradeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記- 利用可能な更新がない場合でも、サポート対象であるが推奨はされない更新が利用できる可能性があります。詳細は、条件付き更新パスに沿った更新 を参照してください。

-

Control Plane Onlyの更新を実行する方法の詳細情報は、関連情報セクションに記載されている コントロールプレーンのみの更新を実行するための準備 ページを参照してください。

組織の要件に基づいて、適切な更新チャネルを設定します。たとえば、チャネルを

stable-4.13またはfast-4.13に設定できます。チャネルの詳細は、追加リソースセクションにリストされている 更新チャネルとリリースについて を参照してください。oc adm upgrade channel <channel>

$ oc adm upgrade channel <channel>Copy to Clipboard Copied! Toggle word wrap Toggle overflow たとえば、チャネルを

stable-4.14に設定するには、以下を実行します。oc adm upgrade channel stable-4.14

$ oc adm upgrade channel stable-4.14Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要実稼働クラスターの場合、

stable-*、eus-*またはfast-*チャネルにサブスクライブする必要があります。注記次のマイナーバージョンに移行する準備ができたら、そのマイナーバージョンに対応するチャネルを選択します。更新チャネルの宣言が早ければ早いほど、クラスターはターゲットバージョンへの更新パスをより効果的に推奨できます。クラスターは、利用可能なすべての可能な更新プログラムを評価し、最適な更新プログラムの推奨事項を選択するために、しばらく時間がかかる場合があります。更新の推奨事項は、その時点で利用可能な更新オプションに基づいているため、時間の経過とともに変化する可能性があります。

ターゲットマイナーバージョンへの更新パスが表示されない場合は、次のマイナーバージョンがパスで利用可能になるまで、現在のバージョンの最新のパッチリリースにクラスターを更新し続けます。

更新を適用します。

最新バージョンに更新するには、以下を実行します。

oc adm upgrade --to-latest=true

$ oc adm upgrade --to-latest=true1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のバージョンに更新するには、以下を実行します。

oc adm upgrade --to=<version>

$ oc adm upgrade --to=<version>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要oc adm upgrade --helpを使用する場合、--forceのオプションがリストされています。--forceオプションを使用すると、リリースの検証や前提条件のチェックをはじめとするクラスター側のガードがバイパスされるため、これは 可能な限り使用しないでください。--forceを使用しても、更新が成功することは保証されません。ガードをバイパスすると、クラスターが危険にさらされます。

クラスターバージョン Operator を確認します。

oc adm upgrade

$ oc adm upgradeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新が完了したら、クラスターのバージョンが新たなバージョンに更新されていることを確認できます。

oc adm upgrade

$ oc adm upgradeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターを次のマイナーバージョン (バージョン X.y から X.(y+1) など) に更新する場合は、新しい機能に依存するワークロードをデプロイする前に、ノードが更新されていることを確認することが推奨されます。

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.5. 条件付き更新パスに沿った更新

Web コンソールまたは OpenShift CLI (oc) を使用して、推奨される条件付き更新パスに沿って更新できます。クラスターで条件付き更新が推奨されない場合は、OpenShift CLI (oc) 4.10 以降を使用して条件付き更新パスに沿って更新できます。

手順

リスクが適用される可能性があるため推奨されない場合に更新の説明を表示するには、次のコマンドを実行します。

oc adm upgrade --include-not-recommended

$ oc adm upgrade --include-not-recommendedCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラスター管理者が潜在的な既知のリスクを評価し、それが現在のクラスターに受け入れられると判断した場合、管理者は次のコマンドを実行して安全ガードを放棄し、更新を続行できます。

oc adm upgrade --allow-not-recommended --to <version> <.>

$ oc adm upgrade --allow-not-recommended --to <version> <.>Copy to Clipboard Copied! Toggle word wrap Toggle overflow <.>

<version>は、前のコマンドの出力から取得した、サポートされているが推奨されていない更新バージョンです。

3.1.6. CLI を使用した更新サーバーの変更

更新サーバーの変更は任意です。OpenShift Update Service (OSUS) がローカルにインストールされ、設定されている場合は、更新時にローカルサーバーを使用できるようにサーバーの URL を upstream として設定する必要があります。upstream のデフォルト値は https://api.openshift.com/api/upgrades_info/v1/graph です。

手順

クラスターバージョンで

upstreamパラメーター値を変更します。oc patch clusterversion/version --patch '{"spec":{"upstream":"<update-server-url>"}}' --type=merge$ oc patch clusterversion/version --patch '{"spec":{"upstream":"<update-server-url>"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow <update-server-url>変数は、更新サーバーの URL を指定します。出力例

clusterversion.config.openshift.io/version patched

clusterversion.config.openshift.io/version patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2. Web コンソールを使用してクラスターを更新

Web コンソールを使用して、OpenShift Container Platform クラスターでマイナーバージョンおよびパッチの更新を実行できます。

Web コンソールまたは oc adm upgrade channel <channel> を使用して更新チャネルを変更します。4.14 チャネルに変更した後、CLI を使用したクラスターの更新 の手順に従って、更新を完了することができます。

3.2.1. OpenShift Container Platform クラスターを更新する前に

更新する前に、以下を考慮してください。

- 最近 etcd をバックアップしました。

-

PodDisruptionBudgetでminAvailableが1に設定されている場合、エビクションプロセスをブロックする可能性がある保留中のマシン設定を適用するためにノードがドレインされます。複数のノードが再起動された場合に、すべての Pod が 1 つのノードでのみ実行される可能性があり、PodDisruptionBudgetフィールドはノードのドレインを防ぐことができます。 - クラスターが手動で維持された認証情報を使用している場合は、新しいリリース用にクラウドプロバイダーリソースを更新する必要がある可能性があります。

- 管理者確認の要求をチェックして推奨されるアクションを実行し、準備ができたら確認する必要があります。

- 更新にかかる時間を考慮し、ワーカーノードまたはカスタムプールノードを更新して部分的な更新を実行できます。各プールのプログレスバー内で一時停止および再開できます。

- 更新が完了しなかった場合、Cluster Version Operator (CVO) は、更新の調整を試みている間、ブロックしているコンポーネントのステータスを報告します。クラスターの以前のバージョンへのロールバックはサポートされていません。更新が完了しない場合は、Red Hat サポートにお問い合わせください。

-

unsupportedConfigOverridesセクションを使用して Operator の設定を変更することはサポートされておらず、クラスターの更新をブロックする可能性があります。クラスターを更新する前に、この設定を削除する必要があります。

3.2.2. Web コンソールを使用した更新サーバーの変更

更新サーバーの変更は任意です。OpenShift Update Service (OSUS) がローカルにインストールされ、設定されている場合は、更新時にローカルサーバーを使用できるようにサーバーの URL を upstream として設定する必要があります。

前提条件

-

cluster-admin権限でクラスターにアクセスできる。 - OpenShift Container Platform Web コンソールにアクセスできる。

手順

- Administration → Cluster Settings に移動し、version をクリックします。

YAML タブをクリックし、

upstreamパラメーター値を編集します。出力例

... spec: clusterID: db93436d-7b05-42cc-b856-43e11ad2d31a upstream: '<update-server-url>' ...... spec: clusterID: db93436d-7b05-42cc-b856-43e11ad2d31a upstream: '<update-server-url>'1 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<update-server-url>変数は、更新サーバーの URL を指定します。

デフォルトの

upstreamはhttps://api.openshift.com/api/upgrades_info/v1/graphです。- Save をクリックします。

3.2.3. Web コンソールを使用した MachineHealthCheck リソースの一時停止

更新プロセスで、クラスター内のノードが一時的に利用できなくなる可能性があります。ワーカーノードの場合、マシンのヘルスチェックにより、このようなノードは正常ではないと識別され、それらが再起動される場合があります。このようなノードの再起動を回避するには、クラスターを更新する前にすべての MachineHealthCheck リソースを一時停止します。

前提条件

-

cluster-admin権限でクラスターにアクセスできる。 - OpenShift Container Platform Web コンソールにアクセスできる。

手順

- OpenShift Container Platform Web コンソールにログインします。

- Compute → MachineHealthChecks に移動します。

マシンヘルスチェックを一時停止するには、

cluster.x-k8s.io/paused=""アノテーションを各MachineHealthCheckリソースに追加します。たとえば、アノテーションをmachine-api-termination-handlerリソースに追加するには、以下の手順を実行します。-

machine-api-termination-handlerの横にあるオプションメニュー をクリックし、Edit annotations をクリックします。

をクリックし、Edit annotations をクリックします。

- アノテーションの編集 ダイアログで、更に追加 をクリックします。

-

キー および 値 フィールドにそれぞれ

cluster.x-k8s.io/pausedと""の値を追加し、保存 をクリックします。

-

3.2.4. Web コンソールを使用したクラスターの更新

更新が利用可能な場合、Web コンソールからクラスターを更新できます。

利用可能な OpenShift Container Platform アドバイザリーおよび更新については、カスタマーポータルの エラータ のセクションを参照してください。

前提条件

-

cluster-admin権限を持つユーザーとして Web コンソールにアクセスできる。 - OpenShift Container Platform Web コンソールにアクセスできる。

-

すべての

MachineHealthCheckリソースを一時停止している。 - Operator Lifecycle Manager (OLM) を通じて以前にインストールされたすべての Operator を、ターゲットリリースと互換性のあるバージョンに更新している。Operator を更新することで、デフォルトの OperatorHub カタログが、クラスターの更新時に現行のマイナーバージョンから次のマイナーバージョンに切り替わる際、確実に有効な更新パスがあるようにします。「関連情報」セクションの「インストール済み Operator の更新」を参照し、互換性を確認する方法の詳細を確認して、インストールされている Operator を必要に応じて更新してください。

- マシン設定プール (MCP) は実行中であり、一時停止されていない。一時停止した MCP に関連付けられたノードは、更新プロセス中にスキップされます。カナリアロールアウト更新ストラテジーを実行している場合は、MCP を一時停止できる。

- RHEL7 ワーカーは、RHEL8 または RHCOS ワーカーに置き換えられます。Red Hat は、RHEL7 から RHEL8 への RHEL ワーカーのインプレース更新をサポートしていません。このようなホストは、オペレーティングシステムをクリーンインストールして置き換える必要があります。

手順

- Web コンソールから、Administration → Cluster Settings をクリックし、Details タブの内容を確認します。

実稼働クラスターの場合は、チャネル が、

stable-4.14など、更新するバージョンの正しいチャネルに設定されていることを確認してください。重要実稼働クラスターの場合は、