1.7. クラスターライフサイクルの概要

multicluster engine Operator は、OpenShift Container Platform および Red Hat Advanced Cluster Management ハブクラスターにクラスター管理機能を提供するクラスターライフサイクル Operator です。multicluster engine Operator は、クラスターフリートの管理を強化し、クラウドとデータセンター全体の OpenShift Container Platform クラスターライフサイクル管理を支援するソフトウェア Operator です。multicluster engine Operator は、Red Hat Advanced Cluster Management の有無にかかわらず使用できます。Red Hat Advanced Cluster Management は、multicluster engine Operator を自動的にインストールし、さらにマルチクラスター機能を提供します。

以下のドキュメントを参照してください。

- クラスターライフサイクルのアーキテクチャー

- 認証情報の管理の概要

- リリースイメージ

- クラスターの作成

- クラスターのインポート

- クラスターへのアクセス

- マネージドクラスターのスケーリング

- 作成されたクラスターの休止

- クラスターのアップグレード

- クラスタープロキシーアドオンの有効化

- マネージドクラスターで実行する Ansible Automation Platform タスクの設定

- ClusterClaims

- ManagedClusterSets

- Placement

- クラスタープールの管理 (テクノロジープレビュー)

- ManagedServiceAccount の有効化

- クラスターのライフサイクルの詳細設定

- 管理からのクラスターの削除

1.7.1. クラスターライフサイクルのアーキテクチャー

クラスターライフサイクルには、ハブクラスター と マネージドクラスター の 2 種類のクラスターが必要です。

ハブクラスターは、multicluster engine Operator が自動的にインストールされる OpenShift Container Platform (または Red Hat Advanced Cluster Management) のメインクラスターです。ハブクラスターを使用して他の Kubernetes クラスターの作成、管理、および監視を行うことができます。ハブクラスターを使用してクラスターを作成できますが、ハブクラスターが管理する既存のクラスターをインポートすることもできます。

マネージドクラスターを作成すると、クラスターは Red Hat OpenShift Container Platform クラスターインストーラーと Hive リソースを使用して作成されます。OpenShift Container Platform インストーラーを使用してクラスターをインストールするプロセスの詳細は、OpenShift Container Platform ドキュメントの OpenShift Container Platform インストールの概要 を参照してください。

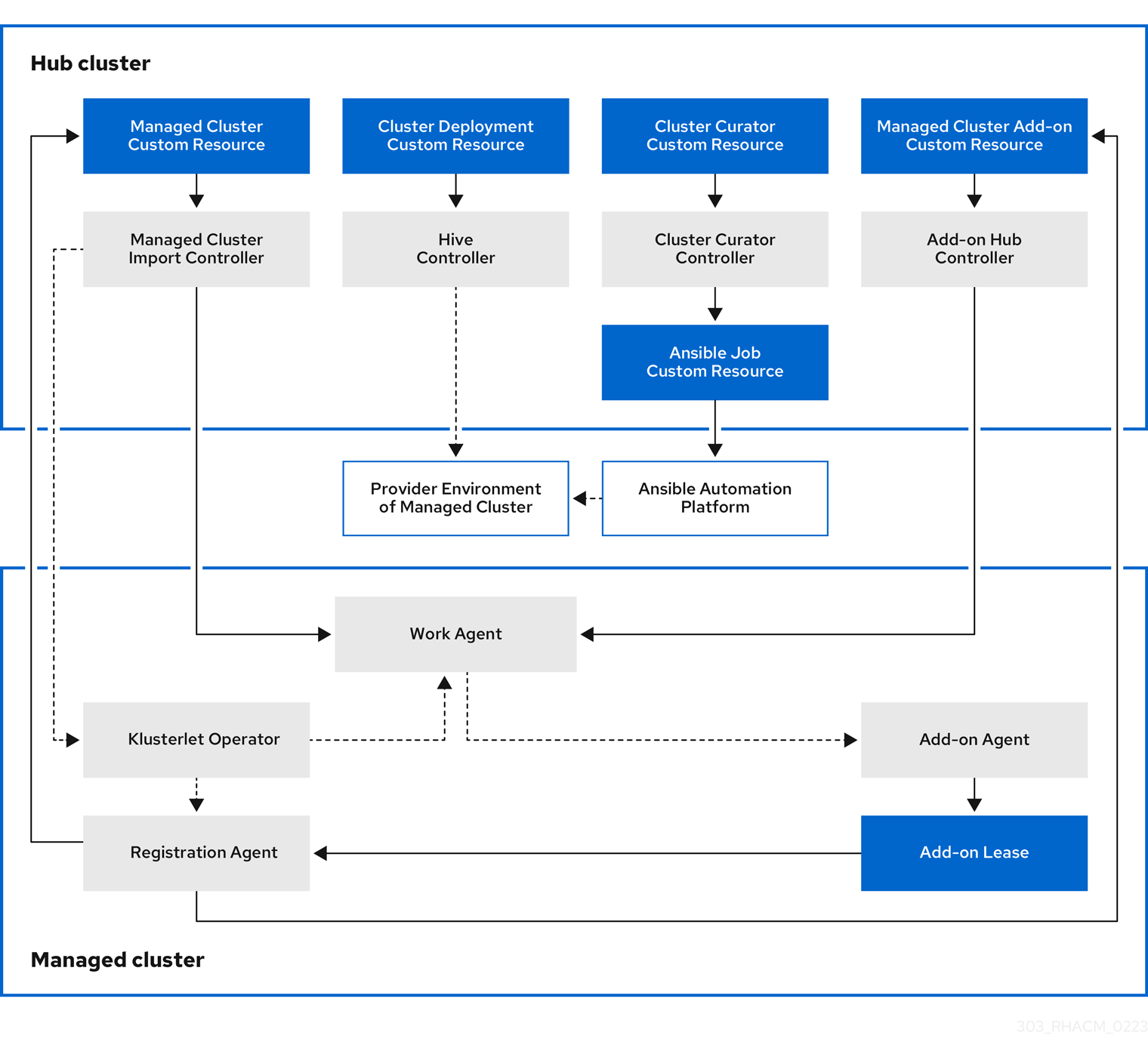

次の図は、クラスター管理用の multicluster engine for Kubernetes Operator とともにインストールされるコンポーネントを示しています。

クラスターライフサイクル管理のアーキテクチャーのコンポーネントには、以下の項目が含まれます。

1.7.1.1. ハブクラスター

- マネージドクラスターのインポートコントローラー は、klusterlet Operator をマネージドクラスターにデプロイします。

- Hive コントローラー は、multicluster engine for Kubernetes Operator を使用して作成したクラスターをプロビジョニングします。また、Hive コントローラーは、multicluster engine for Kubernetes Operator によって作成されたマネージドクラスターを破棄します。

- クラスターキュレーターコントローラー は、マネージドクラスターの作成またはアップグレード時にクラスターインフラストラクチャー環境を設定するためのプレフックまたはポストフックとして Ansible ジョブを作成します。

- マネージドクラスターアドオンがハブクラスターで有効になると、その アドオンハブコントローラー がハブクラスターにデプロイされます。アドオンハブコントローラー は、アドオンエージェント をマネージドクラスターにデプロイします。

1.7.1.2. マネージドクラスター

- klusterlet Operator マネージドクラスターに登録およびワークコントローラーをデプロイします。

登録エージェント は、マネージドクラスターとマネージドクラスターアドオンをハブクラスターに登録します。また、登録エージェントは、マネージドクラスターとマネージドクラスターアドオンのステータスを維持します。次のアクセス許可が Clusterrole 内に自動的に作成され、マネージドクラスターがハブクラスターにアクセスできるようになります。

- エージェントは、ハブクラスターが管理する所有クラスターを取得または更新できます。

- エージェントが、ハブクラスターが管理する所有クラスターのステータスを更新できるようにします。

- エージェントが証明書をローテーションできるようにします。

-

エージェントが

coordination.k8s.ioリースをgetまたはupdateできるようにします。 -

エージェントがマネージドクラスターアドオンを

getできるようにします。 - エージェントがマネージドクラスターアドオンのステータスを更新できるようにします。

- ワークエージェント は、アドオンエージェントをマネージドクラスターに適用します。マネージドクラスターによるハブクラスターへのアクセスを許可する権限は、Clusterrole 内に自動的に作成され、エージェントはイベントをハブクラスターに送信できます。

クラスターの追加と管理を続行するには、クラスターライフサイクルの概要 を参照してください。

1.7.2. リリースイメージ

クラスターをビルドするときは、リリースイメージで指定されているバージョンの Red Hat OpenShift Container Platform を使用します。デフォルトでは、OpenShift Container Platform は clusterImageSets リソースを使用して、サポートされているリリースイメージのリストを取得します。

リリースイメージの詳細は、読み続けてください。

1.7.2.1. リリースイメージの指定

multicluster engine for Kubernetes Operator を使用してプロバイダー上にクラスターを作成する場合は、新しいクラスターに使用するリリースイメージを指定します。リリースイメージを指定するには、次のトピックを参照してください。

1.7.2.1.1. ClusterImageSets の検索

リリースイメージを参照する YAML ファイルは、acm-hive-openshift-releases GitHub リポジトリーに保持されます。これらのファイルは、コンソールで利用可能なリリースイメージのリストを作成します。これには、OpenShift Container Platform における最新の fast チャネルイメージが含まれます。

コンソールには、OpenShift Container Platform の 3 つの最新バージョンの最新リリースイメージのみが表示されます。たとえば、コンソールオプションに以下のリリースイメージが表示される可能性があります。

quay.io/openshift-release-dev/ocp-release:4.15.1-x86_64

コンソールには最新バージョンが表示され、最新のリリースイメージを使用してクラスターを作成するのに役立ちます。特定のバージョンのクラスターを作成する必要がある場合は、古いリリースイメージバージョンも利用できます。

注記: コンソールでクラスターを作成する場合は、visible: 'true' ラベルを持つイメージのみを選択できます。ClusterImageSet リソース内のこのラベルの例は、以下の内容で提供されます。4.x.1 は、製品の最新バージョンに置き換えます。

追加のリリースイメージは保管されますが、コンソールには表示されません。利用可能なリリースイメージをすべて表示するには、次のコマンドを実行します。

oc get clusterimageset

oc get clusterimageset

リポジトリーには、clusterImageSets ディレクトリーがあります。これは、リリースイメージを操作するときに使用するディレクトリーです。clusterImageSets ディレクトリーには、次のディレクトリーがあります。

- Fast: サポート対象の各 OpenShift Container Platform バージョンのリリースイメージの内、最新バージョンを参照するファイルが含まれます。このフォルダー内のリリースイメージはテストされ、検証されており、サポートされます。

Releases: 各 OpenShift Container Platform バージョン (stable、fast、および candidate チャネル) のリリースイメージすべてを参照するファイルが含まれます。

注記: これらのリリースすべてがテストされおらず、安定版とみなされているわけではありません。

Stable: サポート対象の各 OpenShift Container Platform バージョンのリリースイメージの内、最新の安定版 2 つを参照するファイルが含まれます。

注記: デフォルトでは、リリースイメージの現在のリストは 1 時間ごとに更新されます。製品をアップグレードした後、リストに製品の新しいバージョンの推奨リリースイメージバージョンが反映されるまでに最大 1 時間かかる場合があります。

1.7.2.1.2. ClusterImageSets の設定

次のオプションを使用して ClusterImageSets を設定できます。

オプション 1: コンソールでクラスターを作成するには、使用する特定の

ClusterImageSetのイメージ参照を指定します。指定した新しいエントリーはそれぞれ保持され、将来のすべてのクラスタープロビジョニングで使用できます。次のエントリーの例を参照してください。quay.io/openshift-release-dev/ocp-release:4.6.8-x86_64

quay.io/openshift-release-dev/ocp-release:4.6.8-x86_64Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

オプション 2: GitHub リポジトリー

acm-hive-openshift-releasesから YAML ファイルClusterImageSetsを手動で作成し、適用します。 -

オプション 3: フォークされた GitHub リポジトリーから

ClusterImageSetsの自動更新を有効にするには、cluster-image-set-controller GitHub リポジトリーのREADME.mdに従います。

1.7.2.1.3. 別のアーキテクチャーにクラスターをデプロイするためのリリースイメージの作成

両方のアーキテクチャーのファイルを持つリリースイメージを手動で作成することで、ハブクラスターのアーキテクチャーとは異なるアーキテクチャーでクラスターを作成できます。

たとえば、ppc64le、aarch64、または s390x アーキテクチャーで実行されているハブクラスターから x86_64 クラスターを作成する必要があるとします。両方のファイルセットでリリースイメージを作成する場合に、新規のリリースイメージにより OpenShift Container Platform リリースレジストリーがマルチアーキテクチャーイメージマニフェストを提供できるので、クラスターの作成は成功します。

OpenShift Container Platform では、デフォルトで複数のアーキテクチャーがサポートされます。以下の clusterImageSet を使用してクラスターをプロビジョニングできます。4.x.0 は、現在サポートされているバージョンに置き換えます。

複数のアーキテクチャーをサポートしない OpenShift Container Platform イメージのリリースイメージを作成するには、アーキテクチャータイプについて以下のような手順を実行します。

OpenShift Container Platform リリースレジストリー から、

x86_64、s390x、aarch64、およびppc64leリリースイメージを含む マニフェスト一覧 を作成します。以下のコマンド例を実行して、Quay リポジトリー から環境内の両方のアーキテクチャーのマニフェストリストをプルします。

4.x.1は、製品の最新バージョンに置き換えます。podman pull quay.io/openshift-release-dev/ocp-release:4.x.1-x86_64 podman pull quay.io/openshift-release-dev/ocp-release:4.x.1-ppc64le podman pull quay.io/openshift-release-dev/ocp-release:4.x.1-s390x podman pull quay.io/openshift-release-dev/ocp-release:4.x.1-aarch64

podman pull quay.io/openshift-release-dev/ocp-release:4.x.1-x86_64 podman pull quay.io/openshift-release-dev/ocp-release:4.x.1-ppc64le podman pull quay.io/openshift-release-dev/ocp-release:4.x.1-s390x podman pull quay.io/openshift-release-dev/ocp-release:4.x.1-aarch64Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、イメージを管理するプライベートリポジトリーにログインします。

<private-repo>は、リポジトリーへのパスに置き換えます。podman login <private-repo>

podman login <private-repo>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 環境に適用される以下のコマンドを実行して、リリースイメージマニフェストをプライベートリポジトリーに追加します。

4.x.1は、製品の最新バージョンに置き換えます。<private-repo>は、リポジトリーへのパスに置き換えます。podman push quay.io/openshift-release-dev/ocp-release:4.x.1-x86_64 <private-repo>/ocp-release:4.x.1-x86_64 podman push quay.io/openshift-release-dev/ocp-release:4.x.1-ppc64le <private-repo>/ocp-release:4.x.1-ppc64le podman push quay.io/openshift-release-dev/ocp-release:4.x.1-s390x <private-repo>/ocp-release:4.x.1-s390x podman push quay.io/openshift-release-dev/ocp-release:4.x.1-aarch64 <private-repo>/ocp-release:4.x.1-aarch64

podman push quay.io/openshift-release-dev/ocp-release:4.x.1-x86_64 <private-repo>/ocp-release:4.x.1-x86_64 podman push quay.io/openshift-release-dev/ocp-release:4.x.1-ppc64le <private-repo>/ocp-release:4.x.1-ppc64le podman push quay.io/openshift-release-dev/ocp-release:4.x.1-s390x <private-repo>/ocp-release:4.x.1-s390x podman push quay.io/openshift-release-dev/ocp-release:4.x.1-aarch64 <private-repo>/ocp-release:4.x.1-aarch64Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、新しい情報のマニフェストを作成します。

podman manifest create mymanifest

podman manifest create mymanifestCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、両方のリリースイメージへの参照をマニフェストリストに追加します。

4.x.1は、製品の最新バージョンに置き換えます。<private-repo>は、リポジトリーへのパスに置き換えます。podman manifest add mymanifest <private-repo>/ocp-release:4.x.1-x86_64 podman manifest add mymanifest <private-repo>/ocp-release:4.x.1-ppc64le podman manifest add mymanifest <private-repo>/ocp-release:4.x.1-s390x podman manifest add mymanifest <private-repo>/ocp-release:4.x.1-aarch64

podman manifest add mymanifest <private-repo>/ocp-release:4.x.1-x86_64 podman manifest add mymanifest <private-repo>/ocp-release:4.x.1-ppc64le podman manifest add mymanifest <private-repo>/ocp-release:4.x.1-s390x podman manifest add mymanifest <private-repo>/ocp-release:4.x.1-aarch64Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、マニフェストリスト内のリストを既存のマニフェストとマージします。

<private-repo>は、リポジトリーへのパスに置き換えます。4.x.1は、最新バージョンに置き換えます。podman manifest push mymanifest docker://<private-repo>/ocp-release:4.x.1

podman manifest push mymanifest docker://<private-repo>/ocp-release:4.x.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ハブクラスターで、リポジトリーのマニフェストを参照するリリースイメージを作成します。

以下の例のような情報を含む YAML ファイルを作成します。

<private-repo>は、リポジトリーへのパスに置き換えます。4.x.1は、最新バージョンに置き換えます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ハブクラスターで以下のコマンドを実行し、変更を適用します。

<file-name>を、先の手順で作成した YAML ファイルの名前に置き換えます。oc apply -f <file-name>.yaml

oc apply -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- OpenShift Container Platform クラスターの作成時に新規リリースイメージを選択します。

- Red Hat Advanced Cluster Management コンソールを使用してマネージドクラスターをデプロイする場合は、クラスター作成プロセス時に Architecture フィールドにマネージドクラスターのアーキテクチャーを指定します。

作成プロセスでは、マージされたリリースイメージを使用してクラスターを作成します。

1.7.2.1.4. 関連情報

- リリースイメージを参照する YAML ファイルは、acm-hive-openshift-releases GitHub リポジトリーを参照してください。

-

フォークされた GitHub リポジトリーから

ClusterImageSetsの自動更新を有効にする方法は、cluster-image-set-controller GitHub リポジトリー を参照してください。

1.7.2.2. 接続環境におけるリリースイメージのカスタムリストの管理

すべてのクラスターに同じリリースイメージを使用することもできます。クラスターの作成時に利用可能なリリースイメージのカスタムリストを作成し、作業を簡素化します。利用可能なリリースイメージを管理するには、以下の手順を実行します。

- acm-hive-openshift-releases GitHub をフォークします。

-

クラスターの作成時に使用できるイメージの YAML ファイルを追加します。Git コンソールまたはターミナルを使用して、イメージを

./clusterImageSets/stable/または./clusterImageSets/fast/ディレクトリーに追加します。 -

cluster-image-set-git-repoという名前のmulticluster-enginenamespace にConfigMapを作成します。次の例を参照してください。ただし、2.xは 2.7 に置き換えてください。

次の手順でフォークされたリポジトリーに変更をマージすることで、メインリポジトリーから利用可能な YAML ファイルを取得できます。

- フォークしたリポジトリーに変更をコミットし、マージします。

-

acm-hive-openshift-releasesリポジトリーのクローンを作成した後に高速リリースイメージのリストを同期するには、cluster-image-set-git-repoConfigMapの channel フィールドの値をfastに更新します。 -

安定版リリースイメージを同期して表示するには、

cluster-image-set-git-repoConfigMapの channel フィールドの値をstableに更新します。

ConfigMap を更新すると、約 1 分以内に、利用可能な安定リリースイメージのリストが現在利用可能なイメージで更新されます。

以下のコマンドを使用して、利用可能ものを表示し、デフォルトの設定を削除します。

<clusterImageSet_NAME>を正しい名前に置き換えます。oc get clusterImageSets oc delete clusterImageSet <clusterImageSet_NAME>

oc get clusterImageSets oc delete clusterImageSet <clusterImageSet_NAME>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

クラスターの作成時に、コンソールで現在利用可能なリリースイメージの一覧を表示します。

ConfigMap を通じて利用できる他のフィールドは、cluster-image-set-controller GitHub リポジトリーの README を参照してください。

1.7.2.3. 非接続環境におけるリリースイメージのカスタムリストの管理

場合によっては、ハブクラスターにインターネット接続がないときに、リリースイメージのカスタムリストを管理する必要があります。リリースイメージの独自のカスタムリストを作成しておくと、クラスターの作成時にそのリストを使用できます。非接続環境で利用可能なリリースイメージを管理するには、次の手順を実行します。

- オンラインのシステムの場合は、acm-hive-openshift-releases GitHub リポジトリー に移動して、利用可能なクラスターイメージセットにアクセスします。

-

clusterImageSetsディレクトリーを、非接続の multicluster engine Operator クラスターにアクセスできるシステムにコピーします。 マネージドクラスターに合わせて次の手順を実行して、クラスターイメージセットを含むオフラインリポジトリーとマネージドクラスター間のマッピングを追加します。

-

OpenShift Container Platform マネージドクラスターの場合は、イメージレジストリーリポジトリーのミラーリングの設定 を参照し、

ImageContentSourcePolicyオブジェクトを使用してマッピングを完了する方法を確認します。 -

OpenShift Container Platform クラスターではないマネージドクラスターの場合は、

ManageClusterImageRegistryカスタムリソース定義を使用してイメージセットの場所を上書きします。マッピング用にクラスターを上書きする方法は、インポート用のマネージドクラスターでのレジストリーイメージの指定 を参照してください。

-

OpenShift Container Platform マネージドクラスターの場合は、イメージレジストリーリポジトリーのミラーリングの設定 を参照し、

-

コンソールまたは CLI を使用して、

clusterImageSetYAML コンテンツを手動で追加することにより、クラスターを作成するときに使用できるイメージの YAML ファイルを追加します。 残りの OpenShift Container Platform リリースイメージの

clusterImageSetYAML ファイルを、イメージの保存先の正しいオフラインリポジトリーを参照するように変更します。変更後は次の例のようになります。spec.releaseImageはリリースイメージのオフラインイメージレジストリーを使用します。リリースイメージはダイジェストによって参照されます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - YAML ファイルで参照されているオフラインイメージレジストリーにイメージがロードされていることを確認します。

次のコマンドを実行して、イメージダイジェストを取得します。

oc adm release info <tagged_openshift_release_image> | grep "Pull From"

oc adm release info <tagged_openshift_release_image> | grep "Pull From"Copy to Clipboard Copied! Toggle word wrap Toggle overflow <tagged_openshift_release_image>は、サポートされている OpenShift Container Platform バージョンのタグ付きイメージに置き換えます。以下の出力例を参照してください。Pull From: quay.io/openshift-release-dev/ocp-release@sha256:69d1292f64a2b67227c5592c1a7d499c7d00376e498634ff8e1946bc9ccdddfe

Pull From: quay.io/openshift-release-dev/ocp-release@sha256:69d1292f64a2b67227c5592c1a7d499c7d00376e498634ff8e1946bc9ccdddfeCopy to Clipboard Copied! Toggle word wrap Toggle overflow イメージタグとダイジェストの詳細は、イメージストリームでのイメージの参照 を参照してください。

各 YAML ファイルに以下のコマンドを入力して、各

clusterImageSetsを作成します。oc create -f <clusterImageSet_FILE>

oc create -f <clusterImageSet_FILE>Copy to Clipboard Copied! Toggle word wrap Toggle overflow clusterImageSet_FILEを、クラスターイメージセットファイルの名前に置き換えます。以下に例を示します。oc create -f img4.11.9-x86_64.yaml

oc create -f img4.11.9-x86_64.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 追加するリソースごとにこのコマンドを実行すると、使用可能なリリースイメージのリストが表示されます。

-

または、クラスターの作成コンソールに直接イメージ URL を貼り付けることもできます。イメージ URL を追加すると、新しい

clusterImageSetsが存在しない場合に作成されます。 - クラスターの作成時に、コンソールで現在利用可能なリリースイメージの一覧を表示します。

1.7.2.4. 利用可能なリリースイメージの同期

MultiClusterHub Operator を使用してハブクラスターコンポーネントを管理、アップグレード、およびインストールする Red Hat Advanced Cluster Management ハブクラスターがある場合は、リリースイメージのリストを同期して、利用可能な最新バージョンを選択できるようします。リリースイメージは acm-hive-openshift-releases リポジトリーで入手でき、頻繁に更新されます。

1.7.2.4.1. 安定性レベル

リリースイメージの安定性には、次の表に示すように 3 つのレベルがあります。

| カテゴリー | 説明 |

|---|---|

| candidate | 最新のイメージ。テストされていないため、バグがある可能性があります。 |

| fast | 部分的にテストされたイメージですが、stable バージョンよりも安定性が低い可能性があります。 |

| stable | 完全にテストされたイメージ。これらのイメージは、クラスターを正しくインストールおよび構築できることが確認されています。 |

1.7.2.4.2. リリースイメージリストの更新

Linux または Mac オペレーティングシステムを使用してイメージのリストを更新および同期するには、次の手順を実行します。

-

インストーラーが管理する

acm-hive-openshift-releasesサブスクリプションが有効になっている場合は、MultiClusterHubリソースのdisableUpdateClusterImageSetsの値をtrueに設定してサブスクリプションを無効にします。 - acm-hive-openshift-releases の GitHub リポジトリーをクローンします。

次のコマンドを実行して、サブスクリプションを削除します。

oc delete -f subscribe/subscription-fast

oc delete -f subscribe/subscription-fastCopy to Clipboard Copied! Toggle word wrap Toggle overflow candidateリリースイメージを同期して表示するには、Linux または Mac オペレーティングシステムを使用して次のコマンドを実行します。make subscribe-candidate

make subscribe-candidateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 約 1 分後に、

candidateリリースイメージの最新リストが利用可能になります。fastリリースイメージを同期して表示するには、以下のコマンドを実行します。make subscribe-fast

make subscribe-fastCopy to Clipboard Copied! Toggle word wrap Toggle overflow 約 1 分後に、

fastリリースイメージの最新リストが利用可能になります。stableリリースイメージに接続し、Red Hat Advanced Cluster Management ハブクラスターを同期します。Linux または Mac オペレーティングシステムを使用して次のコマンドを実行します。make subscribe-stable

make subscribe-stableCopy to Clipboard Copied! Toggle word wrap Toggle overflow 利用可能な

candidate、fast、およびstableリリースイメージのリストが、現在利用可能なイメージで約 1 分ほどで更新されます。- クラスターの作成時に、Red Hat Advanced Cluster Management コンソールで現在利用可能なリリースイメージの一覧を表示します。

更新の表示を停止するには、次のコマンドを実行して、これらのチャネルのいずれかから登録を解除します。

oc delete -f subscribe/subscription-fast

oc delete -f subscribe/subscription-fastCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.7.3. クラスターの作成

multicluster engine Operator を使用して、複数のクラウドプロバイダーに Red Hat OpenShift Container Platform クラスターを作成する方法を説明します。

multicluster engine Operator は、OpenShift Container Platform で提供される Hive Operator を使用して、オンプレミスクラスターと Hosted Control Plane を除くすべてのプロバイダーのクラスターをプロビジョニングします。オンプレミスクラスターをプロビジョニングする場合、multicluster engine Operator は OpenShift Container Platform で提供される Central Infrastructure Management および Assisted Installer 機能を使用します。Hosted Control Plane のホステッドクラスターは、HyperShift Operator を使用してプロビジョニングされます。

1.7.3.1. CLI を使用したクラスターの作成

Multicluster engine for Kubernetes Operator は、内部の Hive コンポーネントを使用して Red Hat OpenShift Container Platform クラスターを作成します。クラスターの作成方法は、以下の情報を参照してください。

1.7.3.1.1. 前提条件

クラスターを作成する前に、clusterImageSets リポジトリーのクローンを作成し、ハブクラスターに適用しておく。以下の手順を実行します。

クローンするには、次のコマンドを実行します。ただし、

2.xは、multicluster engine Operator のバージョンに置き換えます。git clone https://github.com/stolostron/acm-hive-openshift-releases.git cd acm-hive-openshift-releases git checkout origin/backplane-<2.x>

git clone https://github.com/stolostron/acm-hive-openshift-releases.git cd acm-hive-openshift-releases git checkout origin/backplane-<2.x>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 次のコマンドを実行して、ハブクラスターに適用します。

find clusterImageSets/fast -type d -exec oc apply -f {} \; 2> /dev/nullfind clusterImageSets/fast -type d -exec oc apply -f {} \; 2> /dev/nullCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターを作成するときに、OpenShift Container Platform リリースイメージを選択します。

注記: Nutanix プラットフォームを使用する場合は、

ClusterImageSetリソースのreleaseImageにx86_64アーキテクチャーを使用し、visibleのラベル値を'true'に設定してください。以下の例を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

ハブクラスターの

KubeAPIServer証明書検証ストラテジーを確認し、デフォルトのUseAutoDetectedCABundleストラテジーが機能することを確認する。ストラテジーを手動で変更する必要がある場合は、ハブクラスターのKubeAPIServer検証ストラテジーの設定 を参照してください。

1.7.3.1.2. ClusterDeployment を使用してクラスターを作成する

ClusterDeployment は、クラスターのライフサイクルを制御するために使用される Hive カスタムリソースです。

Using Hive のドキュメントに従って ClusterDeployment カスタムリソースを作成し、個別のクラスターを作成します。

1.7.3.1.3. ClusterPool を使用してクラスターを作成

ClusterPool は、複数のクラスターを作成するために使用される Hive カスタムリソースでもあります。

Cluster Pools のドキュメントに従って、Hive ClusterPool API でクラスターを作成します。

1.7.3.2. クラスター作成時の追加のマニフェストの設定

追加の Kubernetes リソースマニフェストは、クラスター作成のインストールプロセス中に設定できます。これは、ネットワークの設定やロードバランサーの設定など、シナリオの追加マニフェストを設定する必要がある場合に役立ちます。

1.7.3.2.1. 前提条件

追加のリソースマニフェストが含まれる config map リソースを指定する ClusterDeployment リソースへの参照を追加する。

注記: ClusterDeployment リソースと config map は同じ namespace にある必要があります。

1.7.3.2.2. 例を使用してクラスター作成中に追加のマニフェストを設定する

リソースマニフェストを含む config map を使用して追加のマニフェストを設定する場合は、次の手順を実行します。

YAML ファイルを作成し、次のサンプルコンテンツを追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記: サンプル

ConfigMapには、別のConfigMapリソースを含むマニフェストが含まれています。リソースマニフェストのConfigMapには、data.<resource_name>\.yamlというパターンでリソース設定を追加することにより、複数のキーを含めることができます。以下のコマンドを実行してこのファイルを適用します。

oc apply -f <filename>.yaml

oc apply -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow リソースマニフェストの

ConfigMapを参照してClusterDeploymentを使用して追加のマニフェストを設定する場合は、次の手順を実行します。YAML ファイルを作成し、次のサンプルコンテンツを追加します。リソースマニフェスト

ConfigMapはspec.provisioning.manifestsConfigMapRefで参照されます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行してこのファイルを適用します。

oc apply -f <filename>.yaml

oc apply -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.7.3.3. Amazon Web Services でのクラスターの作成

multicluster engine Operator コンソールを使用して、Amazon Web Services (AWS) 上に Red Hat OpenShift Container Platform クラスターを作成できます。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターの作成について不明な点がある場合は、OpenShift Container Platform ドキュメントの AWS へのインストール でプロセスの詳細を確認してください。

1.7.3.3.1. 前提条件

AWS でクラスターを作成する前に、以下の前提条件を確認してください。

- ハブクラスターをデプロイしている。

- AWS 認証情報がある。詳細は、Amazon Web Services の認証情報の作成 を参照してください。

- AWS で設定されたドメインがある。ドメインの設定方法は、AWS アカウントの設定 を参照してください。

- ユーザー名、パスワード、アクセスキー ID およびシークレットアクセスキーなど、Amazon Web Services (AWS) のログイン認証情報がある。Understanding and Getting Your Security Credentials を参照してください。

OpenShift Container Platform イメージのプルシークレットがある。イメージプルシークレットの使用 を参照してください。

注記: クラウドプロバイダーでクラウドプロバイダーのアクセスキーを変更する場合は、コンソールでクラウドプロバイダーの対応する認証情報を手動で更新する必要もあります。これは、マネージドクラスターがホストされ、マネージドクラスターの削除を試みるクラウドプロバイダーで認証情報の有効期限が切れる場合に必要です。

1.7.3.3.2. AWS クラスターの作成

AWS クラスターの作成に関する次の重要な情報を参照してください。

-

クラスターを作成する前に情報を確認し、必要に応じてカスタマイズする場合は、YAML: On を選択して、パネルに

install-config.yamlファイルの内容を表示できます。更新がある場合は、カスタム設定で YAML ファイルを編集できます。 - クラスターを作成すると、コントローラーはクラスターとリソースの namespace を作成します。その namespace には、そのクラスターインスタンスのリソースのみを含めるようにしてください。

- クラスターを 破棄 すると、namespace とその中のすべてのリソースが削除されます。

-

クラスターを既存のクラスターセットに追加する場合は、そのクラスターセットで追加できる適切なパーミッションが必要です。クラスターの作成時に

cluster-admin権限がない場合に、clusterset-admin権限があるクラスターセットを選択する必要があります。 -

指定されたクラスターセットに対して適切なパーミッションがないと、クラスターの作成に失敗します。選択するクラスターセットがない場合には、クラスター管理者に連絡して、任意のクラスターセットへの

clusterset-admin権限を受け取ってください。 -

マネージドクラスターはすべて、マネージドクラスターセットに関連付けられている必要があります。マネージドクラスターを

ManagedClusterSetに割り当てない場合は、デフォルトのマネージドクラスターセットに自動的に追加されます。 - AWS アカウントで設定した、選択した認証情報に関連付けられているベース DNS ドメインがすでに存在する場合、その値がフィールドに入力されます。値は、上書きすると変更できます。この名前はクラスターのホスト名で使用されます。

- このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。利用可能なイメージのリストからイメージを選択します。使用したいイメージがない場合は、使用したいイメージの URL を入力します。

ノードプールには、コントロールプレーンプールとワーカープールが含まれます。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。情報には以下のフィールドが含まれます。

- region: ノードプールが必要なリージョンを指定します。

- CPU アーキテクチャー: マネージドクラスターのアーキテクチャータイプがハブクラスターのアーキテクチャーと同じでない場合は、プール内のマシンの命令セットアーキテクチャーの値を入力します。有効な値は amd64、ppc64le、s390x、および arm64 です。

- ゾーン: コントロールプレーンプールを実行する場所を指定します。より分散されているコントロールプレーンノードグループでは、リージョンで複数のゾーンを選択できます。ゾーンが近くにある場合はパフォーマンスの速度が向上しますが、ゾーンの距離が離れると、より分散されます。

- インスタンスタイプ: コントロールプレーンノードのインスタンスタイプを指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。

- ルートストレージ: クラスターに割り当てるルートストレージの量を指定します。

ワーカープールにワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。オプションの情報には以下のフィールドが含まれます。

- ゾーン: ワーカープールを実行する場所を指定します。より分散されているノードグループでは、リージョンで複数のゾーンを選択できます。ゾーンが近くにある場合はパフォーマンスの速度が向上しますが、ゾーンの距離が離れると、より分散されます。

- インスタンスタイプ: ワーカープールのインスタンスタイプを指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。

- ノード数: ワーカープールのノード数を指定します。ワーカープールを定義する場合にこの設定は必須です。

- ルートストレージ: ワーカープールに割り当てるルートストレージの量を指定します。ワーカープールを定義する場合にこの設定は必須です。

- クラスターにはネットワークの詳細が必要であり、IPv6 を使用するには複数のネットワークが必要です。Add network をクリックして、追加のネットワークを追加できます。

認証情報で提供されるプロキシー情報は、プロキシーフィールドに自動的に追加されます。情報をそのまま使用することも、上書きすることも、プロキシーを有効にする場合に情報を追加することもできます。次のリストには、プロキシーの作成に必要な情報が含まれています。

-

HTTP プロキシー:

HTTPトラフィックのプロキシーとして使用する URL を指定します。 -

HTTPS プロキシー:

HTTPSトラフィックに使用するセキュアなプロキシー URL を指定します。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシーサイトなし: プロキシーをバイパスする必要のあるサイトのコンマ区切りリスト。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加の信頼バンドル: HTTPS 接続のプロキシーに必要な 1 つ以上の追加の CA 証明書。

-

HTTP プロキシー:

1.7.3.3.3. コンソールを使用したクラスターの作成

新しいクラスターを作成するには、次の手順を参照してください。代わりに既存のクラスターを インポート する場合は、クラスターのインポート を参照してください。

注記: クラスターのインポートには、クラスターの詳細で提示された oc コマンドを実行する必要はありません。クラスターを作成すると、multicluster engine Operator で管理されるように自動的に設定されます。

- Infrastructure > Clusters に移動します。

- Clusters ページで、以下を実行します。Cluster > Create cluster をクリックし、コンソールで手順を完了します。

- 任意: コンソールに情報を入力するときにコンテンツの更新を表示するには、YAML: On を選択します。

認証情報を作成する必要がある場合は、Amazon Web Services の認証情報の作成 を参照してください。

クラスターの名前はクラスターのホスト名で使用されます。

Red Hat Advanced Cluster Management for Kubernetes を使用しており、マネージドクラスターの klusterlet を特定のノードで実行するように設定する場合は、オプション: 特定のノードで実行するように klusterlet を設定する で必要な手順を参照してください。

1.7.3.3.4. 関連情報

- AWS プライベート設定情報は、AWS GovCloud クラスターの作成時に使用されます。その環境での クラスターの作成は、Amazon Web Services GovCloud でのクラスターの作成 を参照してください。

- 詳細は、AWS アカウントの設定 を参照してください。

- リリースイメージの詳細については、リリースイメージ を参照してください。

- サポートされているインスタントタイプの詳細は、AWS 汎用インスタンス などのクラウドプロバイダーのサイトにアクセスしてください。

1.7.3.4. Amazon Web Services GovCloud でのクラスターの作成

コンソールを使用して、Amazon Web Services (AWS) または AWS GovCloud で Red Hat OpenShift Container Platform クラスターを作成できます。この手順では、AWS GovCloud でクラスターを作成する方法を説明します。AWS でクラスターを作成する手順は、Amazon Web Services でのクラスターの作成 を参照してください。

AWS GovCloud は、政府のドキュメントをクラウドに保存するために必要な追加の要件を満たすクラウドサービスを提供します。AWS GovCloud でクラスターを作成する場合、環境を準備するために追加の手順を実行する必要があります。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターの作成について不明な点がある場合は、OpenShift Container Platform ドキュメントの AWS の government リージョンへのクラスターのインストール を参照して、プロセスの詳細を確認してください。以下のセクションでは、AWS GovCloud でクラスターを作成する手順を説明します。

1.7.3.4.1. 前提条件

AWS GovCloud クラスターを作成する前に、以下の前提条件を満たす必要があります。

- ユーザー名、パスワード、アクセスキー ID、およびシークレットアクセスキーなどの AWS ログイン認証情報が必要です。Understanding and Getting Your Security Credentials を参照してください。

- AWS 認証情報がある。詳細は、Amazon Web Services の認証情報の作成 を参照してください。

- AWS で設定されたドメインがある。ドメインの設定方法は、AWS アカウントの設定 を参照してください。

- OpenShift Container Platform イメージのプルシークレットがある。イメージプルシークレットの使用 を参照してください。

- ハブクラスター用の既存の Red Hat OpenShift Container Platform クラスターを備えた Amazon Virtual Private Cloud (VPC) が必要です。この VPC は、マネージドクラスターリソースまたはマネージドクラスターサービスエンドポイントに使用される VPC とは異なる必要があります。

- マネージドクラスターリソースがデプロイされる VPC が必要です。これは、ハブクラスターまたはマネージドクラスターサービスエンドポイントに使用される VPC と同じにすることはできません。

- マネージドクラスターサービスエンドポイントを提供する 1 つ以上の VPC が必要です。これは、ハブクラスターまたはマネージドクラスターリソースに使用される VPC と同じにすることはできません。

- Classless Inter-Domain Routing (CIDR) によって指定される VPC の IP アドレスが重複しないようにしてください。

-

Hive namespace 内で認証情報を参照する

HiveConfigカスタムリソースが必要です。このカスタムリソースは、マネージドクラスターサービスエンドポイント用に作成した VPC でリソースを作成するためにアクセスできる必要があります。

注記: クラウドプロバイダーでクラウドプロバイダーのアクセスキーを変更する場合は、multicluster engine Operator コンソールでクラウドプロバイダーの対応する認証情報を手動で更新する必要もあります。これは、マネージドクラスターがホストされ、マネージドクラスターの削除を試みるクラウドプロバイダーで認証情報の有効期限が切れる場合に必要です。

1.7.3.4.2. Hive を AWS GovCloud にデプロイするように設定します。

AWS GovCloud でのクラスターの作成は、標準の AWS でクラスターを作成することとほぼ同じですが、AWS GovCloud でクラスターの AWS PrivateLink を準備するために追加の手順を実行する必要があります。

1.7.3.4.2.1. リソースおよびエンドポイントの VPC の作成

前提条件に記載されているように、ハブクラスターが含まれる VPC に加えて、2 つの VPC が必要です。VPC を作成する具体的な手順は、Amazon Web Services ドキュメントの VPC の作成 を参照してください。

- プライベートサブネットを使用してマネージドクラスターの VPC を作成します。

- プライベートサブネットを使用して、マネージドクラスターサービスエンドポイントの 1 つ以上の VPC を作成します。リージョンの各 VPC には 255 VPC エンドポイントの制限があるため、そのリージョン内の 255 を超えるクラスターをサポートするには、複数の VPC が必要です。

各 VPC について、リージョンのサポートされるすべてのアベイラビリティーゾーンにサブネットを作成します。コントローラーの要件があるため、各サブネットには少なくとも 255 以上の使用可能な IP アドレスが必要です。

以下の例は、

us-gov-east-1リージョンに 6 つのアベイラビリティーゾーンを持つ VPC のサブネットを設定する方法を示しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow - すべてのハブクラスター (ハブクラスター VPC) に、ピアリング、転送ゲートウェイ、およびすべての DNS 設定が有効になっている VPC エンドポイント用に作成した VPC へのネットワーク接続があることを確認します。

- AWS GovCloud 接続に必要な AWS PrivateLink の DNS 設定を解決するために必要な VPC のリストを収集します。これには、少なくとも設定中の multicluster engine Operator インスタンスの VPC を含めます。さまざまな Hive コントローラーが存在するすべての VPC のリストを含めることもできます。

1.7.3.4.2.2. VPC エンドポイントのセキュリティーグループの設定

AWS の各 VPC エンドポイントには、エンドポイントへのアクセスを制御するためにセキュリティーグループが割り当てられます。Hive が VPC エンドポイントを作成する場合、セキュリティーグループは指定しません。VPC のデフォルトのセキュリティーグループは VPC エンドポイントに割り当てられます。VPC のデフォルトのセキュリティーグループには、VPC エンドポイントが Hive インストーラー Pod から作成されるトラフィックを許可するルールが必要です。詳細は、AWS ドキュメントの エンドポイントポリシーを使用した VPC エンドポイントへのアクセスの制御 を参照してください。

たとえば、Hive が hive-vpc (10.1.0.0/16) で実行されている場合は、VPC エンドポイントが作成される VPC のデフォルトセキュリティーグループに、10.1.0.0/16 からのイングレスを許可するルールが必要です。

1.7.3.4.2.3. AWS PrivateLink の権限の設定

AWS PrivateLink を設定するには、複数の認証情報が必要です。これらの認証情報に必要な権限は、認証情報のタイプによって異なります。

ClusterDeployment の認証情報には、以下の権限が必要です。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow エンドポイント VPC アカウントの HiveConfig の認証情報

.spec.awsPrivateLink.credentialsSecretRefには、以下の権限が必要です。Copy to Clipboard Copied! Toggle word wrap Toggle overflow VPC をプライベートホストゾーンに関連付けるために

HiveConfigカスタムリソースに指定された認証情報 (.spec.awsPrivateLink.associatedVPCs[$idx].credentialsSecretRef)。VPC が置かれているアカウントには、以下の権限が必要です。route53:AssociateVPCWithHostedZone route53:DisassociateVPCFromHostedZone ec2:DescribeVPCs

route53:AssociateVPCWithHostedZone route53:DisassociateVPCFromHostedZone ec2:DescribeVPCsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

ハブクラスターの Hive namespace 内に認証情報シークレットがあることを確認します。

HiveConfig カスタムリソースは、特定の提供される VPC でリソースを作成する権限を持つ Hive namespace 内で認証情報を参照する必要があります。AWS GovCloud での AWS クラスターのプロビジョニングに使用する認証情報がすでに Hive namespace にある場合は、別の認証情報を作成する必要はありません。AWS GovCloud での AWS クラスターのプロビジョニングに使用する認証情報がまだ Hive namespace にない場合、現在の認証情報を置き換えるか、Hive namespace に追加の認証情報を作成できます。

HiveConfig カスタムリソースには、以下の内容が含まれている必要があります。

- 指定された VPC のリソースをプロビジョニングするために必要な権限を持つ AWS GovCloud 認証情報。

OpenShift Container Platform クラスターインストールの VPC のアドレス、およびマネージドクラスターのサービスエンドポイント。

ベストプラクティス: OpenShift Container Platform クラスターのインストールおよびサービスエンドポイントに異なる VPC を使用します。

以下の例は、認証情報の内容を示しています。

AWS PrivateLink が endpointVPCInventory 一覧でサポートされているすべてのリージョンから VPC を含めることができます。コントローラーは、ClusterDeployment の要件を満たす VPC を選択します。

詳細は、Hive ドキュメント を参照してください。

1.7.3.4.3. コンソールを使用したクラスターの作成

コンソールからクラスターを作成するには、Infrastructure > Clusters > Create cluster AWS > Standalone に移動して、コンソールで手順を実行します。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、クラスターのインポート でインポート手順を参照してください。

AWS GovCloud クラスターを作成する場合、選択する認証情報は AWS GovCloud リージョンのリソースにアクセスできる必要があります。クラスターをデプロイするために必要な権限を持つ場合は、Hive namespace にある AWS GovCloud シークレットを使用できます。コンソールに既存の認証情報が表示されます。認証情報を作成する必要がある場合は、Amazon Web Services の認証情報の作成 を参照してください。

クラスターの名前はクラスターのホスト名で使用されます。

重要: クラスターを作成すると、コントローラーはクラスターとそのリソースの namespace を作成します。その namespace には、そのクラスターインスタンスのリソースのみを含めるようにしてください。クラスターを破棄すると、namespace とその中のすべてのリソースが削除されます。

ヒント: YAML: On を選択すると、コンソールに情報を入力する際にコンテンツの更新が表示されます。

クラスターを既存のクラスターセットに追加する場合は、そのクラスターセットで追加できる適切なパーミッションが必要です。クラスターの作成時に cluster-admin 権限がない場合に、clusterset-admin 権限があるクラスターセットを選択する必要があります。指定されたクラスターセットに対して適切なパーミッションがないと、クラスターの作成に失敗します。選択するクラスターセットがない場合には、クラスター管理者に連絡して、任意のクラスターセットへの clusterset-admin 権限を受け取ってください。

マネージドクラスターはすべて、マネージドクラスターセットに関連付けられている必要があります。マネージドクラスターを ManagedClusterSet に割り当てない場合は、デフォルト のマネージドクラスターセットに自動的に追加されます。

AWS または AWS GovCloud アカウントで設定した、選択した認証情報に関連付けられているベース DNS ドメインがすでに存在する場合、その値がフィールドに入力されます。値は、上書きすると変更できます。この名前はクラスターのホスト名で使用されます。詳細は、AWS アカウントの設定 を参照してください。

このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージの URL を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。

ノードプールには、コントロールプレーンプールとワーカープールが含まれます。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。情報には以下のフィールドが含まれます。

-

リージョン: クラスターリソースを作成するリージョン。AWS GovCloud プロバイダーでクラスターを作成する場合、ノードプールの AWS GovCloud リージョンを含める必要があります。たとえば、

us-gov-west-1です。 - CPU アーキテクチャー: マネージドクラスターのアーキテクチャータイプがハブクラスターのアーキテクチャーと同じでない場合は、プール内のマシンの命令セットアーキテクチャーの値を入力します。有効な値は amd64、ppc64le、s390x、および arm64 です。

- ゾーン: コントロールプレーンプールを実行する場所を指定します。より分散されているコントロールプレーンノードグループでは、リージョンで複数のゾーンを選択できます。ゾーンが近くにある場合はパフォーマンスの速度が向上しますが、ゾーンの距離が離れると、より分散されます。

- インスタンスタイプ: コントロールプレーンノードのインスタンスタイプを指定します。これは、以前に指定した CPU アーキテクチャー と同じにする必要があります。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。

- ルートストレージ: クラスターに割り当てるルートストレージの量を指定します。

ワーカープールにワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。オプションの情報には以下のフィールドが含まれます。

- プール名: プールの一意の名前を指定します。

- ゾーン: ワーカープールを実行する場所を指定します。より分散されているノードグループでは、リージョンで複数のゾーンを選択できます。ゾーンが近くにある場合はパフォーマンスの速度が向上しますが、ゾーンの距離が離れると、より分散されます。

- インスタンスタイプ: ワーカープールのインスタンスタイプを指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。

- ノード数: ワーカープールのノード数を指定します。ワーカープールを定義する場合にこの設定は必須です。

- ルートストレージ: ワーカープールに割り当てるルートストレージの量を指定します。ワーカープールを定義する場合にこの設定は必須です。

クラスターにはネットワークの詳細が必要であり、IPv6 を使用するには複数のネットワークが必要です。AWS GovCloud クラスターの場合は、Machine CIDR フィールドに Hive VPC のアドレスのブロックの値を入力します。Add network をクリックして、追加のネットワークを追加できます。

認証情報で提供されるプロキシー情報は、プロキシーフィールドに自動的に追加されます。情報をそのまま使用することも、上書きすることも、プロキシーを有効にする場合に情報を追加することもできます。次のリストには、プロキシーの作成に必要な情報が含まれています。

-

HTTP プロキシー URL:

HTTPトラフィックのプロキシーとして使用する URL を指定します。 -

HTTPS プロキシー URL:

HTTPSトラフィックに使用するセキュアなプロキシー URL を指定します。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシードメインなし: プロキシーをバイパスする必要のあるドメインのコンマ区切りリスト。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加の信頼バンドル: HTTPS 接続のプロキシーに必要な 1 つ以上の追加の CA 証明書。

AWS GovCloud クラスターを作成するか、プライベート環境を使用する場合は、AMI ID およびサブネット値を使用して、AWS プライベート設定 ページのフィールドに入力します。ClusterDeployment.yaml ファイルで spec:platform:aws:privateLink:enabled の値が true に設定されていることを確認します。これは、Use private configuration を選択すると自動的に設定されます。

クラスターを作成する前に情報を確認し、必要に応じてカスタマイズする場合は、YAML: On を選択して、パネルに install-config.yaml ファイルの内容を表示できます。更新がある場合は、カスタム設定で YAML ファイルを編集できます。

注記: クラスターのインポートには、クラスターの詳細で提示された oc コマンドを実行する必要はありません。クラスターを作成すると、そのクラスターは multicluster engine for Kubernetes Operator の管理下で自動的に設定されます。

Red Hat Advanced Cluster Management for Kubernetes を使用しており、マネージドクラスターの klusterlet を特定のノードで実行するように設定する場合は、オプション: 特定のノードで実行するように klusterlet を設定する で必要な手順を参照してください。

クラスターにアクセスする 手順は、クラスターへのアクセスに進みます。

1.7.3.5. Microsoft Azure でのクラスターの作成

multicluster engine Operator コンソールを使用して、Microsoft Azure または Microsoft Azure Government に Red Hat OpenShift Container Platform クラスターをデプロイできます。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターの作成について不明な点がある場合は、OpenShift Container Platform ドキュメントの Azure へのインストール でプロセスの詳細を確認してください。

1.7.3.5.1. 前提条件

Azure でクラスターを作成する前に、以下の前提条件を確認してください。

- ハブクラスターをデプロイしている。

- Azure 認証情報がある。詳細は、Microsoft Azure の認証情報の作成 を参照してください。

- Azure または Azure Government に設定済みドメインがある。ドメイン設定の方法は、Configuring a custom domain name for an Azure cloud service を参照してください。

- ユーザー名とパスワードなどの Azure ログイン認証情報がある。Microsoft Azure Portal を参照してください。

-

clientId、clientSecretおよびtenantIdなどの Azure サービスプリンシパルがある。azure.microsoft.com を参照してください。 - OpenShift Container Platform イメージプルシークレットがある。イメージプルシークレットの使用 を参照してください。

注記: クラウドプロバイダーでクラウドプロバイダーのアクセスキーを変更する場合は、multicluster engine Operator のコンソールでクラウドプロバイダーの対応する認証情報を手動で更新する必要もあります。これは、マネージドクラスターがホストされ、マネージドクラスターの削除を試みるクラウドプロバイダーで認証情報の有効期限が切れる場合に必要です。

1.7.3.5.2. コンソールを使用したクラスターの作成

multicluster engine Operator コンソールからクラスターを作成するには、Infrastructure > Clusters に移動します。Clusters ページで、Create cluster をクリックし、コンソールの手順を実行します。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、クラスターのインポート でインポート手順を参照してください。

認証情報を作成する必要がある場合は、Microsoft Azure の認証情報の作成 に記載される詳細を参照してください。

クラスターの名前はクラスターのホスト名で使用されます。

重要: クラスターを作成すると、コントローラーはクラスターとそのリソースの namespace を作成します。その namespace には、そのクラスターインスタンスのリソースのみを含めるようにしてください。クラスターを破棄すると、namespace とその中のすべてのリソースが削除されます。

ヒント: YAML: On を選択すると、コンソールに情報を入力する際にコンテンツの更新が表示されます。

クラスターを既存のクラスターセットに追加する場合は、そのクラスターセットで追加できる適切なパーミッションが必要です。クラスターの作成時に cluster-admin 権限がない場合に、clusterset-admin 権限があるクラスターセットを選択する必要があります。指定されたクラスターセットに対して適切なパーミッションがないと、クラスターの作成に失敗します。選択するクラスターセットがない場合には、クラスター管理者に連絡して、任意のクラスターセットへの clusterset-admin 権限を受け取ってください。

マネージドクラスターはすべて、マネージドクラスターセットに関連付けられている必要があります。マネージドクラスターを ManagedClusterSet に割り当てない場合は、デフォルト のマネージドクラスターセットに自動的に追加されます。

Azure アカウントで設定した、選択した認証情報に関連付けられているベース DNS ドメインがすでに存在する場合、その値がフィールドに入力されます。値は、上書きすると変更できます。詳細は、Configuring a custom domain name for an Azure cloud service を参照してください。この名前はクラスターのホスト名で使用されます。

このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージの URL を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。

ノードプールには、コントロールプレーンプールとワーカープールが含まれます。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。この情報には、次のオプションフィールドが含まれます。

- リージョン: ノードプールを実行するリージョンを指定します。より分散されているコントロールプレーンノードグループでは、リージョンで複数のゾーンを選択できます。ゾーンが近くにある場合はパフォーマンスの速度が向上しますが、ゾーンの距離が離れると、より分散されます。

- CPU アーキテクチャー: マネージドクラスターのアーキテクチャータイプがハブクラスターのアーキテクチャーと同じでない場合は、プール内のマシンの命令セットアーキテクチャーの値を入力します。有効な値は amd64、ppc64le、s390x、および arm64 です。

クラスターの作成後に、コントロールプレーンプールのタイプおよびルートストレージの割り当て (必須) を変更できます。

ワーカープールに 1 つまたは複数のワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。情報には以下のフィールドが含まれます。

- ゾーン: ワーカープールを実行することを指定します。より分散されているノードグループでは、リージョンで複数のゾーンを選択できます。ゾーンが近くにある場合はパフォーマンスの速度が向上しますが、ゾーンの距離が離れると、より分散されます。

- インスタンスタイプ: インスタンスのタイプとサイズは、作成後に変更できます。

Add network をクリックして、追加のネットワークを追加できます。IPv6 アドレスを使用している場合は、複数のネットワークが必要です。

認証情報で提供されるプロキシー情報は、プロキシーフィールドに自動的に追加されます。情報をそのまま使用することも、上書きすることも、プロキシーを有効にする場合に情報を追加することもできます。次のリストには、プロキシーの作成に必要な情報が含まれています。

-

HTTP プロキシー:

HTTPトラフィックのプロキシーとして使用する URL。 -

HTTPS プロキシー:

HTTPSトラフィックに使用するセキュアなプロキシー URL。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシーなし: プロキシーをバイパスする必要のあるドメインのコンマ区切りリスト。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加の信頼バンドル: HTTPS 接続のプロキシーに必要な 1 つ以上の追加の CA 証明書。

クラスターを作成する前に情報を確認し、必要に応じてカスタマイズする場合は、YAML スイッチをクリックして On にすると、パネルに install-config.yaml ファイルの内容が表示されます。更新がある場合は、カスタム設定で YAML ファイルを編集できます。

Red Hat Advanced Cluster Management for Kubernetes を使用しており、マネージドクラスターの klusterlet を特定のノードで実行するように設定する場合は、オプション: 特定のノードで実行するように klusterlet を設定する で必要な手順を参照してください。

注記: クラスターのインポートには、クラスターの詳細で提示された oc コマンドを実行する必要はありません。クラスターを作成すると、multicluster engine Operator で管理されるように自動的に設定されます。

クラスターにアクセスする 手順は、クラスターへのアクセスに進みます。

1.7.3.6. Google Cloud Platform でのクラスターの作成

Google Cloud Platform (GCP) で Red Hat OpenShift Container Platform クラスターを作成する手順に従います。GCP の詳細は、Google Cloud Platform を参照してください。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターの作成について不明な点がある場合は、OpenShift Container Platform ドキュメントの GCP のインストール でプロセスの詳細を確認してください。

1.7.3.6.1. 前提条件

GCP でクラスターを作成する前に、次の前提条件を確認してください。

- ハブクラスターをデプロイしている。

- GCP 認証情報がある。詳細は、Google Cloud Platform の認証情報の作成 を参照してください。

- GCP に設定済みのドメインがある。ドメインの設定方法は、Setting up a custom domain を参照してください。

- ユーザー名とパスワードを含む GCP ログイン認証情報がある。

- OpenShift Container Platform イメージのプルシークレットがある。イメージプルシークレットの使用 を参照してください。

注記: クラウドプロバイダーでクラウドプロバイダーのアクセスキーを変更する場合は、multicluster engine Operator のコンソールでクラウドプロバイダーの対応する認証情報を手動で更新する必要もあります。これは、マネージドクラスターがホストされ、マネージドクラスターの削除を試みるクラウドプロバイダーで認証情報の有効期限が切れる場合に必要です。

1.7.3.6.2. コンソールを使用したクラスターの作成

multicluster engine Operator コンソールからクラスターを作成するには、Infrastructure > Clusters に移動します。Clusters ページで、Create cluster をクリックし、コンソールの手順を実行します。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、クラスターのインポート でインポート手順を参照してください。

認証情報を作成する必要がある場合は、Google Cloud Platform の認証情報の作成 を参照してください。

クラスターの名前はクラスターのホスト名で使用されます。GCP クラスターの命名に適用される制限がいくつかあります。この制限には、名前を goog で開始しないことや、名前に google に類似する文字および数字のグループが含まれないことなどがあります。制限の完全な一覧は、Bucket naming guidelines を参照してください。

重要: クラスターを作成すると、コントローラーはクラスターとそのリソースの namespace を作成します。その namespace には、そのクラスターインスタンスのリソースのみを含めるようにしてください。クラスターを破棄すると、namespace とその中のすべてのリソースが削除されます。

ヒント: YAML: On を選択すると、コンソールに情報を入力する際にコンテンツの更新が表示されます。

クラスターを既存のクラスターセットに追加する場合は、そのクラスターセットで追加できる適切なパーミッションが必要です。クラスターの作成時に cluster-admin 権限がない場合に、clusterset-admin 権限があるクラスターセットを選択する必要があります。指定されたクラスターセットに対して適切なパーミッションがないと、クラスターの作成に失敗します。選択するクラスターセットがない場合には、クラスター管理者に連絡して、任意のクラスターセットへの clusterset-admin 権限を受け取ってください。

マネージドクラスターはすべて、マネージドクラスターセットに関連付けられている必要があります。マネージドクラスターを ManagedClusterSet に割り当てない場合は、デフォルト のマネージドクラスターセットに自動的に追加されます。

選択した GCP アカウントの認証情報に関連付けられているベース DNS ドメインがすでに存在する場合、その値がフィールドに入力されます。値は、上書きすると変更できます。詳細は、Setting up a custom domain を参照してください。この名前はクラスターのホスト名で使用されます。

このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージの URL を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。

ノードプールには、コントロールプレーンプールとワーカープールが含まれます。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。情報には以下のフィールドが含まれます。

- リージョン: コントロールプレーンプールを実行するリージョンを指定します。リージョンが近くにある場合はパフォーマンスの速度が向上しますが、リージョンの距離が離れると、より分散されます。

- CPU アーキテクチャー: マネージドクラスターのアーキテクチャータイプがハブクラスターのアーキテクチャーと同じでない場合は、プール内のマシンの命令セットアーキテクチャーの値を入力します。有効な値は amd64、ppc64le、s390x、および arm64 です。

コントロールプレーンプールのインスタンスタイプを指定できます。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。

ワーカープールに 1 つまたは複数のワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。情報には以下のフィールドが含まれます。

- インスタンスタイプ: インスタンスのタイプとサイズは、作成後に変更できます。

- ノード数: ワーカープールを定義するときに必要な設定です。

ネットワークの詳細が必要であり、IPv6 アドレスを使用するには複数のネットワークが必要です。Add network をクリックして、追加のネットワークを追加できます。

認証情報で提供されるプロキシー情報は、プロキシーフィールドに自動的に追加されます。情報をそのまま使用することも、上書きすることも、プロキシーを有効にする場合に情報を追加することもできます。次のリストには、プロキシーの作成に必要な情報が含まれています。

-

HTTP プロキシー:

HTTPトラフィックのプロキシーとして使用する URL。 -

HTTPS プロキシー:

HTTPSトラフィックに使用するセキュアなプロキシー URL。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシーサイトなし: プロキシーをバイパスする必要のあるサイトのコンマ区切りリスト。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加の信頼バンドル: HTTPS 接続のプロキシーに必要な 1 つ以上の追加の CA 証明書。

クラスターを作成する前に情報を確認し、必要に応じてカスタマイズする場合は、YAML: On を選択して、パネルに install-config.yaml ファイルの内容を表示できます。更新がある場合は、カスタム設定で YAML ファイルを編集できます。

Red Hat Advanced Cluster Management for Kubernetes を使用しており、マネージドクラスターの klusterlet を特定のノードで実行するように設定する場合は、オプション: 特定のノードで実行するように klusterlet を設定する で必要な手順を参照してください。

注記: クラスターのインポートには、クラスターの詳細で提示された oc コマンドを実行する必要はありません。クラスターを作成すると、multicluster engine Operator で管理されるように自動的に設定されます。

クラスターにアクセスする 手順は、クラスターへのアクセスに進みます。

1.7.3.7. VMware vSphere でのクラスターの作成

multicluster engine Operator コンソールを使用して、VMware vSphere に Red Hat OpenShift Container Platform クラスターをデプロイできます。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターの作成について不明な点がある場合は、OpenShift Container Platform ドキュメントの vSphere のインストール でプロセスの詳細を確認してください。

1.7.3.7.1. 前提条件

vSphere でクラスターを作成する前に、次の前提条件を確認してください。

- サポートされている OpenShift Container Platform バージョンにハブクラスターがデプロイされている。

- vSphere 認証情報がある。詳細は、VMware vSphere の認証情報の作成 を参照してください。

- OpenShift Container Platform イメージプルシークレットがある。イメージプルシークレットの使用 を参照してください。

デプロイする VMware インスタンスについて、以下の情報がある。

- API および Ingress インスタンスに必要な静的 IP アドレス

以下の DNS レコード。

次の API ベースドメインは静的 API VIP を指す必要があります。

api.<cluster_name>.<base_domain>

api.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のアプリケーションベースドメインは、Ingress VIP の静的 IP アドレスを指す必要があります。

*.apps.<cluster_name>.<base_domain>

*.apps.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.7.3.7.2. コンソールを使用したクラスターの作成

multicluster engine Operator コンソールからクラスターを作成するには、Infrastructure > Clusters に移動します。Clusters ページで、Create cluster をクリックし、コンソールの手順を実行します。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、クラスターのインポート でインポート手順を参照してください。

認証情報を作成する必要がある場合は、認証情報の作成の詳細について、VMware vSphere の認証情報の作成 を参照してください。

クラスターの名前はクラスターのホスト名で使用されます。

重要: クラスターを作成すると、コントローラーはクラスターとそのリソースの namespace を作成します。その namespace には、そのクラスターインスタンスのリソースのみを含めるようにしてください。クラスターを破棄すると、namespace とその中のすべてのリソースが削除されます。

ヒント: YAML: On を選択すると、コンソールに情報を入力する際にコンテンツの更新が表示されます。

クラスターを既存のクラスターセットに追加する場合は、そのクラスターセットで追加できる適切なパーミッションが必要です。クラスターの作成時に cluster-admin 権限がない場合に、clusterset-admin 権限があるクラスターセットを選択する必要があります。指定されたクラスターセットに対して適切なパーミッションがないと、クラスターの作成に失敗します。選択するクラスターセットがない場合には、クラスター管理者に連絡して、任意のクラスターセットへの clusterset-admin 権限を受け取ってください。

マネージドクラスターはすべて、マネージドクラスターセットに関連付けられている必要があります。マネージドクラスターを ManagedClusterSet に割り当てない場合は、デフォルト のマネージドクラスターセットに自動的に追加されます。

vSphere アカウントで設定した、選択した認証情報に関連付けられているベースドメインがすでに存在する場合、その値がフィールドに入力されます。値は、上書きすると変更できます。詳細は、カスタマイズによる vSphere へのクラスターのインストール を参照してください。値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。この名前はクラスターのホスト名で使用されます。

このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージの URL を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。

注記: OpenShift Container Platform バージョン 4.15 以降のリリースイメージがサポートされています。

ノードプールには、コントロールプレーンプールとワーカープールが含まれます。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。この情報には、CPU アーキテクチャー フィールドが含まれます。次のフィールドの説明を表示します。

- CPU アーキテクチャー: マネージドクラスターのアーキテクチャータイプがハブクラスターのアーキテクチャーと同じでない場合は、プール内のマシンの命令セットアーキテクチャーの値を入力します。有効な値は amd64、ppc64le、s390x、および arm64 です。

ワーカープールに 1 つまたは複数のワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。この情報には、ソケットあたりのコア数、CPU、Memory_min MiB、GiB 単位の _Disk サイズ、および ノード数 が含まれます。

ネットワーク情報が必要です。IPv6 を使用するには、複数のネットワークが必要です。必要なネットワーク情報の一部は、次のフィールドに含まれています。

- vSphere ネットワーク名: VMware vSphere ネットワーク名を指定します。

API VIP: 内部 API 通信に使用する IP アドレスを指定します。

注記: 値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。指定しない場合は、DNS を事前設定して

api.が正しく解決されるようにします。Ingress VIP: Ingress トラフィックに使用する IP アドレスを指定します。

注記: 値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。指定しない場合は、DNS を事前設定して

test.apps.が正しく解決されるようにします。

Add network をクリックして、追加のネットワークを追加できます。IPv6 アドレスを使用している場合は、複数のネットワークが必要です。

認証情報で提供されるプロキシー情報は、プロキシーフィールドに自動的に追加されます。情報をそのまま使用することも、上書きすることも、プロキシーを有効にする場合に情報を追加することもできます。次のリストには、プロキシーの作成に必要な情報が含まれています。

-

HTTP プロキシー:

HTTPトラフィックのプロキシーとして使用する URL を指定します。 -

HTTPS プロキシー:

HTTPSトラフィックに使用するセキュアなプロキシー URL を指定します。値の指定がない場合は、HTTP Proxy URLと同じ値がHTTPおよびHTTPSの両方に使用されます。 -

プロキシーサイトなし: プロキシーをバイパスする必要のあるサイトのコンマ区切りリストを指定します。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加の信頼バンドル: HTTPS 接続のプロキシーに必要な 1 つ以上の追加の CA 証明書。

非接続インストールを定義するには、Disconnected installation をクリックします。VMware vSphere プロバイダーと非接続インストールを使用してクラスターを作成する際に、ミラーレジストリーにアクセスするための証明書が必要な場合は、クラスターを作成する際の認証情報または Disconnected installation セクションを設定するときに、Configuration for disconnected installation セクションの Additional trust bundle フィールドにその証明書を入力する必要があります。

Add automation template をクリックしてテンプレートを作成できます。

クラスターを作成する前に情報を確認し、必要に応じてカスタマイズする場合は、YAML スイッチをクリックして On にすると、パネルに install-config.yaml ファイルの内容が表示されます。更新がある場合は、カスタム設定で YAML ファイルを編集できます。

Red Hat Advanced Cluster Management for Kubernetes を使用しており、マネージドクラスターの klusterlet を特定のノードで実行するように設定する場合は、オプション: 特定のノードで実行するように klusterlet を設定する で必要な手順を参照してください。

注記: クラスターのインポートには、クラスターの詳細で提示された oc コマンドを実行する必要はありません。クラスターを作成すると、multicluster engine Operator で管理されるように自動的に設定されます。

クラスターにアクセスする 手順は、クラスターへのアクセスに進みます。

1.7.3.8. Red Hat OpenStack Platform でのクラスターの作成

multicluster engine Operator コンソールを使用して、Red Hat OpenStack Platform に Red Hat OpenShift Container Platform クラスターをデプロイできます。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順を完了した後、クラスターの作成について質問がある場合は、プロセスの詳細は、OpenShift Container Platform ドキュメントの OpenStack へのインストール を参照してください。

1.7.3.8.1. 前提条件

Red Hat OpenStack Platform でクラスターを作成する前に、以下の前提条件を確認してください。

- OpenShift Container Platform バージョン 4.6 以降にデプロイされたハブクラスターが必要です。

- Red Hat OpenStack Platform の認証情報がある。詳細は、Red Hat OpenStack Platform の認証情報の作成 を参照してください。

- OpenShift Container Platform イメージプルシークレットがある。イメージプルシークレットの使用 を参照してください。

デプロイする Red Hat OpenStack Platform インスタンスに関する以下の情報がある。

-

コントロールプレーンとワーカーインスタンスのフレーバー名 (例:

m1.xlarge) - Floating IP アドレスを提供する外部ネットワークのネットワーク名

- API および Ingress インスタンスに必要な静的 IP アドレス

以下の DNS レコード。

次の API ベースドメインは、API のフローティング IP アドレスを指す必要があります。

api.<cluster_name>.<base_domain>

api.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のアプリケーションベースドメインは、ingress:app-name のフローティング IP アドレスを指す必要があります。

*.apps.<cluster_name>.<base_domain>

*.apps.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

コントロールプレーンとワーカーインスタンスのフレーバー名 (例:

1.7.3.8.2. コンソールを使用したクラスターの作成

multicluster engine Operator コンソールからクラスターを作成するには、Infrastructure > Clusters に移動します。Clusters ページで、Create cluster をクリックし、コンソールの手順を実行します。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、クラスターのインポート でインポート手順を参照してください。

認証情報を作成する必要がある場合は、Red Hat OpenStack Platform の認証情報の作成 を参照してください。

クラスターの名前はクラスターのホスト名で使用されます。名前には 15 文字以上指定できません。値は、認証情報の要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。

重要: クラスターを作成すると、コントローラーはクラスターとそのリソースの namespace を作成します。その namespace には、そのクラスターインスタンスのリソースのみを含めるようにしてください。クラスターを破棄すると、namespace とその中のすべてのリソースが削除されます。

ヒント: YAML: On を選択すると、コンソールに情報を入力する際にコンテンツの更新が表示されます。

クラスターを既存のクラスターセットに追加する場合は、そのクラスターセットで追加できる適切なパーミッションが必要です。クラスターの作成時に cluster-admin 権限がない場合に、clusterset-admin 権限があるクラスターセットを選択する必要があります。指定されたクラスターセットに対して適切なパーミッションがないと、クラスターの作成に失敗します。選択するクラスターセットがない場合には、クラスター管理者に連絡して、任意のクラスターセットへの clusterset-admin 権限を受け取ってください。

マネージドクラスターはすべて、マネージドクラスターセットに関連付けられている必要があります。マネージドクラスターを ManagedClusterSet に割り当てない場合は、デフォルト のマネージドクラスターセットに自動的に追加されます。

Red Hat OpenStack Platform アカウントで設定した、選択した認証情報に関連付けられているベース DNS ドメインがすでに存在する場合、その値がフィールドに入力されます。値は、上書きすると変更できます。詳細は、Red Hat OpenStack Platform ドキュメントの ドメインの管理 を参照してください。この名前はクラスターのホスト名で使用されます。

このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージの URL を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。OpenShift Container Platform バージョン 4.6.x 以降のリリースイメージのみがサポートされます。

ノードプールには、コントロールプレーンプールとワーカープールが含まれます。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。マネージドクラスターのアーキテクチャータイプがハブクラスターのアーキテクチャーと同じでない場合は、プール内のマシンの命令セットアーキテクチャーの値を入力します。有効な値は amd64、ppc64le、s390x、および arm64 です。

コントロールプレーンプールのインスタンスタイプを追加する必要がありますが、インスタンスの作成後にインスタンスのタイプとサイズを変更できます。

ワーカープールに 1 つまたは複数のワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。情報には以下のフィールドが含まれます。

- インスタンスタイプ: インスタンスのタイプとサイズは、作成後に変更できます。

- ノード数: ワーカープールのノード数を指定します。ワーカープールを定義する場合にこの設定は必須です。

クラスターにはネットワークの詳細が必要です。IPv4 ネットワーク用に 1 つ以上のネットワークの値を指定する必要があります。IPv6 ネットワークの場合は、複数のネットワークを定義する必要があります。

Add network をクリックして、追加のネットワークを追加できます。IPv6 アドレスを使用している場合は、複数のネットワークが必要です。

認証情報で提供されるプロキシー情報は、プロキシーフィールドに自動的に追加されます。情報をそのまま使用することも、上書きすることも、プロキシーを有効にする場合に情報を追加することもできます。次のリストには、プロキシーの作成に必要な情報が含まれています。

-

HTTP プロキシー:

HTTPトラフィックのプロキシーとして使用する URL を指定します。 -

HTTPS プロキシー:

HTTPSトラフィックに使用するセキュアなプロキシー URL。値が指定されていない場合、HTTP Proxyと同じ値がHTTPとHTTPSの両方に使用されます。 -

プロキシーなし: プロキシーをバイパスする必要のあるサイトのコンマ区切りリストを定義します。ドメイン名をピリオド (

.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。アステリスク (*) を追加し、すべての宛先のプロキシーをバイパスします。 - 追加の信頼バンドル: HTTPS 接続のプロキシーに必要な 1 つ以上の追加の CA 証明書。

Disconnected installation をクリックして、オフラインインストールイメージを定義できます。Red Hat OpenStack Platform プロバイダーとオフラインインストールを使用してクラスターを作成する際に、ミラーレジストリーにアクセスするための証明書が必要な場合は、クラスターを作成する際の認証情報または Disconnected installation セクションを設定するときに、Configuration for disconnected installation セクションの Additional trust bundle フィールドにその証明書を入力する必要があります。

クラスターを作成する前に情報を確認し、必要に応じてカスタマイズする場合は、YAML スイッチをクリックして On にすると、パネルに install-config.yaml ファイルの内容が表示されます。更新がある場合は、カスタム設定で YAML ファイルを編集できます。

内部認証局 (CA) を使用するクラスターを作成する場合、以下の手順を実行してクラスターの YAML ファイルをカスタマイズする必要があります。

レビューステップで YAML スイッチをオンにし、CA 証明書バンドルを使用してリストの上部に

Secretオブジェクトを挿入します。注記: Red Hat OpenStack Platform 環境が複数の機関によって署名された証明書を使用してサービスを提供する場合、バンドルには、必要なすべてのエンドポイントを検証するための証明書を含める必要があります。ocp3という名前のクラスターの追加は以下の例のようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例のように、Hive

ClusterDeploymentオブジェクトを変更して、spec.platform.openstackにcertificatesSecretRefの値を指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上記の例では、

clouds.yamlファイルのクラウド名がopenstackであることを前提としています。

Red Hat Advanced Cluster Management for Kubernetes を使用しており、マネージドクラスターの klusterlet を特定のノードで実行するように設定する場合は、オプション: 特定のノードで実行するように klusterlet を設定する で必要な手順を参照してください。

注記: クラスターのインポートには、クラスターの詳細で提示された oc コマンドを実行する必要はありません。クラスターを作成すると、multicluster engine Operator で管理されるように自動的に設定されます。

クラスターにアクセスする 手順は、クラスターへのアクセスに進みます。

1.7.3.9. オンプレミス環境でのクラスターの作成

コンソールを使用して、オンプレミスの Red Hat OpenShift Container Platform クラスターを作成できます。クラスターは、VMware vSphere、Red Hat OpenStack、Nutanix、またはベアメタル環境上のシングルノード OpenShift クラスター、マルチノードクラスター、およびコンパクトな 3 ノードクラスターにすることができます。

プラットフォームの値が platform=none に設定されているため、クラスターをインストールするプラットフォームとのプラットフォーム統合はありません。シングルノード OpenShift クラスターには、コントロールプレーンサービスとユーザーワークロードをホストするシングルノードのみが含まれます。この設定は、クラスターのリソースフットプリントを最小限に抑えたい場合に役立ちます。

Red Hat OpenShift Container Platform で利用できる機能であるゼロタッチプロビジョニング機能を使用して、エッジリソース上に複数のシングルノード OpenShift クラスターをプロビジョニングすることもできます。ゼロタッチプロビジョニングの詳細は、OpenShift Container Platform ドキュメントの ネットワークファーエッジのクラスター を参照してください。

1.7.3.9.1. 前提条件

オンプレミス環境にクラスターを作成する前に、以下の前提条件を確認してください。

- サポートされている OpenShift Container Platform バージョンにハブクラスターがデプロイされている。

- 設定済みホストのホストインベントリーを備えた設定済みインフラストラクチャー環境がある。

- クラスターの作成に必要なイメージを取得できるように、ハブクラスターにインターネットアクセスがある (接続環境) か、インターネットに接続されている内部レジストリーまたはミラーレジストリーへの接続がある (非接続環境)。

- オンプレミス認証情報が設定されている。

- OpenShift Container Platform イメージプルシークレットがある。イメージプルシークレットの使用 を参照してください。

次の DNS レコードが必要です。

次の API ベースドメインは静的 API VIP を指す必要があります。

api.<cluster_name>.<base_domain>

api.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のアプリケーションベースドメインは、Ingress VIP の静的 IP アドレスを指す必要があります。

*.apps.<cluster_name>.<base_domain>

*.apps.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

ハブクラスターの

KubeAPIServer証明書検証ストラテジーを確認し、デフォルトのUseAutoDetectedCABundleストラテジーが機能することを確認する。ストラテジーを手動で変更する必要がある場合は、ハブクラスターのKubeAPIServer検証ストラテジーの設定 を参照してください。

1.7.3.9.2. コンソールを使用したクラスターの作成

コンソールからクラスターを作成するには、次の手順を実行します。

- Infrastructure > Clusters に移動します。

- Clusters ページで、Create cluster をクリックし、コンソールの手順を実行します。

- クラスターのタイプとして Host inventory を選択します。

支援インストールでは、次のオプションを使用できます。

- 既存の検出されたホストを使用する: 既存のホストインベントリーにあるホストのリストからホストを選択します。

- 新規ホストの検出: 既存のインフラストラクチャー環境にないホストを検出します。インフラストラクチャー環境にあるものを使用するのではなく、独自のホストを検出します。

認証情報を作成する必要がある場合、詳細は オンプレミス環境の認証情報の作成 を参照してください。

クラスターの名前は、クラスターのホスト名で使用されます。

重要: クラスターを作成すると、コントローラーはクラスターとそのリソースの namespace を作成します。その namespace には、そのクラスターインスタンスのリソースのみを含めるようにしてください。クラスターを破棄すると、namespace とその中のすべてのリソースが削除されます。

注記: YAML: On を選択すると、コンソールに情報を入力する際にコンテンツの更新が表示されます。

クラスターを既存のクラスターセットに追加する場合は、そのクラスターセットで追加できる適切なパーミッションが必要です。クラスターの作成時に cluster-admin 権限がない場合に、clusterset-admin 権限があるクラスターセットを選択する必要があります。指定されたクラスターセットに対して適切なパーミッションがないと、クラスターの作成に失敗します。選択するクラスターセットがない場合には、クラスター管理者に連絡して、任意のクラスターセットへの clusterset-admin 権限を受け取ってください。

マネージドクラスターはすべて、マネージドクラスターセットに関連付けられている必要があります。マネージドクラスターを ManagedClusterSet に割り当てない場合は、デフォルト のマネージドクラスターセットに自動的に追加されます。

プロバイダーアカウントで設定した、選択した認証情報に関連付けられているベース DNS ドメインがすでに存在する場合、その値がフィールドに入力されます。値は上書きすると変更できますが、この設定はクラスターの作成後には変更できません。プロバイダーのベースドメインは、Red Hat OpenShift Container Platform クラスターコンポーネントへのルートの作成に使用されます。これは、クラスタープロバイダーの DNS で Start of Authority (SOA) レコードとして設定されます。

OpenShift version は、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージの URL を入力できます。詳細は、リリースイメージ を参照してください。

サポート対象の OpenShift Container Platform バージョンを選択すると、Install single node OpenShift を選択するオプションが表示されます。シングルノード OpenShift クラスターには、コントロールプレーンサービスとユーザーワークロードをホストするシングルノードが含まれます。シングルノード OpenShift クラスターの作成後にノードを追加する方法の詳細は、インフラストラクチャー環境へのホストのスケーリング を参照してください。

クラスターをシングルノード OpenShift クラスターにする場合は、シングルノード OpenShift オプションを選択します。以下の手順を実行することで、シングルノードの OpenShift クラスターにワーカーを追加できます。

- コンソールから、Infrastructure > Clusters に移動し、作成したクラスターまたはアクセスするクラスターの名前を選択します。

- Actions > Add hosts を選択して、ワーカーを追加します。

注記: シングルノード OpenShift コントロールプレーンには 8 つの CPU コアが必要ですが、マルチノードコントロールプレーンクラスターのコントロールプレーンノードには 4 つの CPU コアしか必要ありません。

クラスターを確認して保存すると、クラスターはドラフトクラスターとして保存されます。Clusters ページでクラスター名を選択すると、作成プロセスを閉じてプロセスを終了することができます。

既存のホストを使用している場合は、ホストを独自に選択するか、自動的に選択するかどうかを選択します。ホストの数は、選択したノード数に基づいています。たとえば、シングルノード OpenShift クラスターではホストが 1 つだけ必要ですが、標準の 3 ノードクラスターには 3 つのホストが必要です。

このクラスターの要件を満たす利用可能なホストの場所は、ホストの場所 のリストに表示されます。ホストと高可用性設定の分散には、複数の場所を選択します。

既存のインフラストラクチャー環境がない新しいホストを検出する場合は、Discovery Image を使用したホストインベントリーへのホストの追加 の手順を実行します。

ホストがバインドされ、検証に合格したら、以下の IP アドレスを追加してクラスターのネットワーク情報を入力します。

API VIP: 内部 API 通信に使用する IP アドレスを指定します。

注記: 値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。指定しない場合は、DNS を事前設定して

api.が正しく解決されるようにします。Ingress VIP: Ingress トラフィックに使用する IP アドレスを指定します。

注記: 値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。指定しない場合は、DNS を事前設定して

test.apps.が正しく解決されるようにします。

Red Hat Advanced Cluster Management for Kubernetes を使用しており、マネージドクラスターの klusterlet を特定のノードで実行するように設定する場合は、オプション: 特定のノードで実行するように klusterlet を設定する で必要な手順を参照してください。

Clusters ナビゲーションページで、インストールのステータスを表示できます。

クラスターにアクセスする 手順は、クラスターへのアクセスに進みます。

1.7.3.9.3. コマンドラインを使用したクラスターの作成

Central Infrastructure Management 管理コンポーネント内のアシステッドインストーラー機能を使用して、コンソールを使用せずにクラスターを作成することもできます。この手順を完了したら、生成された検出イメージからホストを起動できます。通常、手順の順序は重要ではありませんが、順序が必要な場合は注意してください。

1.7.3.9.3.1. namespace を作成します。

リソースの namespace が必要です。すべてのリソースを共有 namespace に保持すると便利です。この例では、namespace の名前に sample-namespace を使用していますが、assisted-installer 以外の任意の名前を使用できます。次のファイルを作成して適用して namespace を作成します。

apiVersion: v1 kind: Namespace metadata: name: sample-namespace

apiVersion: v1

kind: Namespace

metadata:

name: sample-namespace1.7.3.9.3.2. プルシークレットを namespace に追加する

以下のカスタムリソースを作成し、適用して プルシークレット を namespace に追加します。

1.7.3.9.3.3. ClusterImageSet の生成

以下のカスタムリソースを作成して適用することで、CustomImageSet を生成してクラスターの OpenShift Container Platform のバージョンを指定します。

注記: ハブクラスターとは異なるアーキテクチャーを持つマネージドクラスターをインストールする場合は、マルチアーキテクチャーの ClusterImageSet を作成する必要があります。詳細は、別のアーキテクチャーにクラスターをデプロイするためのリリースイメージの作成 を参照してください。

1.7.3.9.3.4. ClusterDeployment カスタムリソースを作成します。

ClusterDeployment カスタムリソース定義は、クラスターのライフサイクルを制御する API です。これは、クラスターリソースを定義する spec.ClusterInstallRef 設定で AgentClusterInstall カスタムリソースを参照します。

以下の例に基づいて ClusterDeployment カスタムリソースを作成して適用します。

- 1

AgentClusterInstallリソースの名前を使用します。- 2

- Add the pull secret to the namespace でダウンロードしたプルシークレットを使用します。

1.7.3.9.3.5. AgentClusterInstall カスタムリソースを作成します。

AgentClusterInstall カスタムリソースでは、クラスターの要件の多くを指定できます。たとえば、クラスターネットワーク設定、プラットフォーム、コントロールプレーンの数、およびワーカーノードを指定できます。

次の例のようなカスタムリソースを作成して追加します。

- 1

- クラスターが作成される環境のプラットフォームタイプを指定します。有効な値は、

BareMetal、None、VSphere、Nutanix、またはExternalです。 - 2

ClusterDeploymentリソースに使用したものと同じ名前を使用します。- 3

- Generate a ClusterImageSet で生成した

ClusterImageSetを使用します。 - 4

- SSH 公開鍵を指定すると、インストール後にホストにアクセスできるようになります。

1.7.3.9.3.6. オプション: NMStateConfig カスタムリソースを作成する

NMStateConfig カスタムリソースは、静的 IP アドレスなどのホストレベルのネットワーク設定がある場合にのみ必要です。NMStateConfig カスタムリソースを作成する場合は、InfraEnv カスタムリソースを作成する前にこの手順を完了する必要があります。InfraEnv カスタムリソースの spec.nmStateConfigLabelSelector の値は、NMStateConfig カスタムリソースを参照します。

次の例のような NMStateConfig カスタムリソースを作成して適用します。必要に応じて値を置き換えます。

重要:

-

InfraEnvカスタムリソースのspec.nmStateConfigLabelSelector.matchLabelsフィールドに、demo-nmstate-labelのラベル名と値を含める必要があります。 - DHCP または静的ネットワークプロトコルを使用する場合は、MAC アドレスを追加する必要があります。

spec.config フィールドに追加できる NMState の追加の例は、OpenShift Container Platform Assisted Installer ドキュメントの 追加の NMState 設定例 を参照してください。

1.7.3.9.3.7. InfraEnv カスタムリソースを作成します。

InfraEnv カスタムリソースは、検出 ISO を作成する設定を提供します。このカスタムリソース内で、プロキシー設定、Ignition オーバーライドの値を特定し、NMState ラベルを指定します。このカスタムリソースの spec.nmStateConfigLabelSelector の値は、NMStateConfig カスタムリソースを参照します。

注: オプションの NMStateConfig カスタムリソースを含める場合は、InfraEnv カスタムリソースでそちらを参照する必要があります。NMStateConfig カスタムリソースを作成する前に InfraEnv カスタムリソースを作成した場合は、InfraEnv カスタムリソースを編集して NMStateConfig カスタムリソースを参照し、参照の追加後に ISO をダウンロードします。

以下のカスタムリソースを作成して適用します。

- 1

- Create the ClusterDeployment の

clusterDeploymentリソース名を置き換えます。 - 2

- ClusterDeployment の作成 の

clusterDeploymentリソース namespace を置き換えます。

1.7.3.9.3.7.1. InfraEnv のフィールドの表

| フィールド | 任意または必須 | 説明 |

|---|---|---|

|

| 任意 | SSH 公開鍵を指定できます。指定すると、検出 ISO イメージからホストを起動するときにホストにアクセスできるようになります。 |

|

| 任意 |

ホストの静的 IP、ブリッジ、ボンディングなどの高度なネットワーク設定を統合します。ホストネットワーク設定は、選択したラベルを持つ 1 つ以上の |

|

| 任意 | proxy セクションでは、検出中にホストに必要なプロキシー設定を指定できます。 |

注記: IPv6 を使用してプロビジョニングする場合、noProxy 設定で CIDR アドレスブロックを定義することはできません。各アドレスを個別に定義する必要があります。

1.7.3.9.3.8. 検出イメージからホストを起動します。

残りの手順では、前の手順で取得した検出 ISO イメージからホストを起動する方法を説明します。

次のコマンドを実行して、namespace から検出イメージをダウンロードします。

curl --insecure -o image.iso $(kubectl -n sample-namespace get infraenvs.agent-install.openshift.io myinfraenv -o=jsonpath="{.status.isoDownloadURL}")curl --insecure -o image.iso $(kubectl -n sample-namespace get infraenvs.agent-install.openshift.io myinfraenv -o=jsonpath="{.status.isoDownloadURL}")Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 検出イメージを仮想メディア、USB ドライブ、または別の保管場所に移動し、ダウンロードしたディスカバリーイメージからホストを起動します。

Agentリソースは自動的に作成されます。これはクラスターに登録されており、検出イメージから起動したホストを表します。次のコマンドを実行して、Agentのカスタムリソースを承認し、インストールを開始します。oc -n sample-namespace patch agents.agent-install.openshift.io 07e80ea9-200c-4f82-aff4-4932acb773d4 -p '{"spec":{"approved":true}}' --type mergeoc -n sample-namespace patch agents.agent-install.openshift.io 07e80ea9-200c-4f82-aff4-4932acb773d4 -p '{"spec":{"approved":true}}' --type mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow エージェント名と UUID は、実際の値に置き換えます。

前のコマンドの出力に、

APPROVEDパラメーターの値がtrueであるターゲットクラスターのエントリーが含まれている場合、承認されたことを確認できます。

1.7.3.9.4. 関連情報

- CLI を使用して Nutanix プラットフォーム上にクラスターを作成するときに必要な追加の手順は、Red Hat OpenShift Container Platform ドキュメントの API を使用した Nutanix へのホストの追加 および Nutanix インストール後の設定 を参照してください。

- ゼロタッチプロビジョニングの詳細は、OpenShift Container Platform ドキュメントの ネットワーク遠端のクラスター を参照してください。

- イメージプルシークレットの使用 を参照してください。

- オンプレミス環境の認証情報の作成 を参照してください。

- リリースイメージ を参照してください。

- Discovery Image を使用したホストのホストインベントリーへの追加 を参照してください。

1.7.3.10. プロキシー環境でのクラスターの作成

ハブクラスターがプロキシーサーバー経由で接続されている場合は、Red Hat OpenShift Container Platform クラスターを作成できます。クラスターを正常に作成するには、以下のいずれかの状況に該当している必要があります。

- multicluster engine Operator に、作成するマネージドクラスターとのプライベートネットワーク接続があり、マネージドクラスターがプロキシーを使用してインターネットにアクセスできる。

- マネージドクラスターはインフラストラクチャープロバイダーにあるが、ファイアウォールポートを使用することでマネージドクラスターからハブクラスターへの通信が可能になる。

プロキシーで設定されたクラスターを作成するには、以下の手順を実行します。

シークレットに保存されている

install-configYAML に次の情報を追加して、ハブクラスターでcluster-wide-proxy設定を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow usernameは、プロキシーサーバーのユーザー名に置き換えます。passwordは、プロキシーサーバーへのアクセス時に使用するパスワードに置き換えます。proxy.example.comは、プロキシーサーバーのパスに置き換えます。portは、プロキシーサーバーとの通信ポートに置き換えます。wildcard-of-domainは、プロキシーをバイパスするドメインのエントリーに置き換えます。provisioning-network/CIDRは、プロビジョニングネットワークの IP アドレスと割り当てられた IP アドレスの数 (CIDR 表記) に置き換えます。BMC-address-range/CIDRは、BMC アドレスおよびアドレス数 (CIDR 表記) に置き換えます。- クラスターの作成手順を実行してクラスターをプロビジョニングします。クラスターの作成 を参照してプロバイダーを選択します。

注: install-config YAML は、クラスターをデプロイする場合にのみ使用できます。クラスターをデプロイした後、install-config YAML に加えた新しい変更は適用されません。導入後に設定を更新するには、ポリシーを使用する必要があります。詳細は、Pod ポリシー を参照してください。

1.7.3.10.1. 関連情報

1.7.3.11. AgentClusterInstall プロキシーの設定

AgentClusterInstall プロキシーフィールドは、インストール中のプロキシー設定を決定し、作成されたクラスターにクラスター全体のプロキシーリソースを作成するために使用されます。

1.7.3.11.1. AgentClusterInstall の設定

AgentClusterInstall プロキシーを設定するには、プロキシー 設定を AgentClusterInstall リソースに追加します。httpProxy、httpsProxy、noProxy を使用した次の YAML サンプルを参照してください。

- 1

httpProxyは、HTTP リクエストのプロキシーの URL です。ユーザー名とパスワードの値は、プロキシーサーバーの認証情報に置き換えます。proxy.example.comは、プロキシーサーバーのパスに置き換えます。- 2

httpsProxyは、HTTPS リクエストのプロキシーの URL です。値を自分の認証情報に置き換えます。portは、プロキシーサーバーとの通信ポートに置き換えます。- 3

noProxyは、プロキシーを使用しないドメインと CIDR のコンマ区切りリストです。wildcard-of-domainは、プロキシーをバイパスするドメインのエントリーに置き換えます。provisioning-network/CIDRは、プロビジョニングネットワークの IP アドレスと割り当てられた IP アドレスの数 (CIDR 表記) に置き換えます。BMC-address-range/CIDRは、BMC アドレスおよびアドレス数 (CIDR 表記) に置き換えます。

1.7.3.11.2. 関連情報

1.7.4. クラスターのインポート

別の Kubernetes クラウドプロバイダーからクラスターをインポートできます。インポート後、ターゲットのクラスターが multicluster engine Operator ハブクラスターのマネージドクラスターになります。特に指定されていない限りは通常、ハブクラスターとターゲットのマネージドクラスターにアクセスできる場所で、インポートタスクを実行できます。

- ハブクラスターは 他 のハブクラスターの管理はできず、自己管理のみが可能です。ハブクラスターは、自動的にインポートして自己管理できるように設定されています。ハブクラスターは手動でインポートする必要はありません。

-

ハブクラスターを削除して再度インポートする場合は、

local-cluster:trueラベルをManagedClusterリソースに追加する必要があります。

重要: クラスターライフサイクルで、Cloud Native Computing Foundation (CNCF) Kubernetes Conformance Program を通じて認定されたすべてのプロバイダーがサポートされるようになりました。ハイブリッドクラウドマルチクラスター管理用に CNCF が認識するベンダーを選択します。

CNCF プロバイダーの使用については、以下の情報を参照してください。

- CNCF プロバイダーが Certified Kubernetes Conformance で認定されている方法を学習します。

- CNCF サードパーティープロバイダーに関する Red Hat サポート情報については、Red Hat サポート サードパーティーコンポーネント または Red Hat サポートへの問い合わせ を参照してください。

-

独自の CNCF 適合認定クラスターを用意する場合は、OpenShift Container Platform CLI

ocコマンドを Kubernetes CLI コマンドkubectlに変更する必要があります。

クラスターを管理できるようにクラスターをインポートする方法の詳細は、次のトピックを参照してください。

必要なユーザータイプまたはアクセスレベル: クラスター管理者

1.7.4.1. コンソールを使用したマネージドクラスターのインポート

multicluster engine for Kubernetes Operator をインストールしたら、クラスターをインポートして管理できるようになります。コンソールを使用してマネージドクラスターをインポートする方法は、以下を参照してください。

1.7.4.1.1. 前提条件

- デプロイされたハブクラスター。ベアメタルクラスターをインポートする場合、サポートされている Red Hat OpenShift Container Platform バージョンにハブクラスターがインストールされている。

- 管理するクラスター。

-

base64コマンドラインツール。 -

OpenShift Container Platform によって作成されていないクラスターをインポートする場合、定義された

multiclusterhub.spec.imagePullSecret。このシークレットは、multicluster engine for Kubernetes Operator のインストール時に作成済みである可能性があります。このシークレットを定義する方法の詳細は、カスタムイメージプルシークレット を参照してください。 -

ハブクラスターの

KubeAPIServer証明書検証ストラテジーを確認し、デフォルトのUseAutoDetectedCABundleストラテジーが機能することを確認する。ストラテジーを手動で変更する必要がある場合は、ハブクラスターのKubeAPIServer検証ストラテジーの設定 を参照してください。

Required user type or access level: クラスター管理者

1.7.4.1.2. 新規プルシークレットの作成

新しいプルシークレットを作成する必要がある場合は、以下の手順を実行します。

- cloud.redhat.com から Kubernetes プルシークレットをダウンロードします。

- プルシークレットをハブクラスターの namespace に追加します。

次のコマンドを実行して、

open-cluster-managementnamespace に新しいシークレットを作成します。oc create secret generic pull-secret -n <open-cluster-management> --from-file=.dockerconfigjson=<path-to-pull-secret> --type=kubernetes.io/dockerconfigjson

oc create secret generic pull-secret -n <open-cluster-management> --from-file=.dockerconfigjson=<path-to-pull-secret> --type=kubernetes.io/dockerconfigjsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow open-cluster-managementをハブクラスターの namespace の名前に置き換えます。ハブクラスターのデフォルトの namespace はopen-cluster-managementです。path-to-pull-secretを、ダウンロードしたプルシークレットへのパスに置き換えます。シークレットは、インポート時にマネージドクラスターに自動的にコピーされます。

-

以前にインストールされたエージェントが、インポートするクラスターから削除されていることを確認します。エラーを回避するには、

open-cluster-management-agentおよびopen-cluster-management-agent-addonnamespace を削除する必要があります。 Red Hat OpenShift Dedicated 環境にインポートする場合には、以下の注意点を参照してください。

- ハブクラスターを Red Hat OpenShift Dedicated 環境にデプロイしている必要があります。

-

Red Hat OpenShift Dedicated のデフォルト権限は dedicated-admin ですが、namespace を作成するための権限がすべて含まれているわけではありません。multicluster engine Operator を使用してクラスターをインポートおよび管理するには、

cluster-admin権限が必要です。

-

以前にインストールされたエージェントが、インポートするクラスターから削除されていることを確認します。エラーを回避するには、

1.7.4.1.3. クラスターのインポート

利用可能なクラウドプロバイダーごとに、コンソールから既存のクラスターをインポートできます。

注記: ハブクラスターは別のハブクラスターを管理できません。ハブクラスターは、自動的にインポートおよび自己管理するように設定されるため、ハブクラスターを手動でインポートして自己管理する必要はありません。

デフォルトでは、namespace がクラスター名と namespace に使用されますが、これは変更できます。

重要: クラスターを作成すると、コントローラーはクラスターとそのリソースの namespace を作成します。その namespace には、そのクラスターインスタンスのリソースのみを含めるようにしてください。クラスターを破棄すると、namespace とその中のすべてのリソースが削除されます。

マネージドクラスターはすべて、マネージドクラスターセットに関連付けられている必要があります。マネージドクラスターを ManagedClusterSet に割り当てない場合は、クラスターは default マネージドクラスターセットに自動的に追加されます。

クラスターを別のクラスターセットに追加する場合は、クラスターセットへの clusterset-admin 権限が必要です。クラスターのインポート時に cluster-admin 権限がない場合は、clusterset-admin 権限を持つクラスターセットを選択する必要があります。指定されたクラスターセットに適切な権限がない場合、クラスターのインポートは失敗します。選択するクラスターセットが存在しない場合は、クラスター管理者に連絡して、クラスターセットへの clusterset-admin 権限を受け取ってください。

OpenShift Container Platform Dedicated クラスターをインポートし、vendor=OpenShiftDedicated のラベルを追加してベンダーを指定しない場合、vendor=auto-detect のラベルを追加すると、managed-by=platform ラベルがクラスターに自動的に追加されます。この追加されたラベルを使用して、クラスターを OpenShift Container Platform Dedicated クラスターとして識別し、OpenShift Container Platform Dedicated クラスターをグループとして取得できます。

以下の表は、クラスターをインポートする方法を指定する インポートモード で使用できるオプションを示しています。

| import コマンドの手動実行 | Red Hat Ansible Automation Platform テンプレートなど、コンソールで情報を完了および送信した後に、提供されたコマンドをターゲットクラスターで実行してクラスターをインポートします。 |

| 既存クラスターのサーバー URL および API トークンを入力します。 | インポートするクラスターのサーバー URL および API トークンを指定します。クラスターのアップグレード時に実行する Red Hat Ansible Automation Platform テンプレートを指定できます。 |

|

|

インポートするクラスターの |

注記: Ansible Automation Platform ジョブを作成して実行するには、OperatorHub から Red Hat Ansible Automation Platform Resource Operator をインストールし、実行する必要があります。

クラスター API アドレスを設定するには、任意: Configuring the cluster API address を参照してください。

マネージドクラスター klusterlet を特定のノードで実行するように設定するには、オプション: 特定のノードで実行するように klusterlet を設定する を参照してください。

1.7.4.1.3.1. オプション: クラスター API アドレスの設定

oc get managedcluster コマンドの実行時に表に表示される URL を設定して、クラスターの詳細ページにある Cluster API アドレス をオプションで設定します。

-

cluster-admin権限がある ID でハブクラスターにログインします。 -

ターゲットに設定されたマネージドクラスターの

kubeconfigファイルを設定します。 次のコマンドを実行して、インポートするクラスターのマネージドクラスターエントリーを編集します。

cluster -nameをマネージドクラスターの名前に置き換えます。oc edit managedcluster <cluster-name>

oc edit managedcluster <cluster-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例のように、YAML ファイルの

ManagedCluster仕様にManagedClusterClientConfigsセクションを追加します。spec: hubAcceptsClient: true managedClusterClientConfigs: - url: <https://api.new-managed.dev.redhat.com>

spec: hubAcceptsClient: true managedClusterClientConfigs: - url: <https://api.new-managed.dev.redhat.com>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- URL の値を、インポートするマネージドクラスターへの外部アクセスを提供する URL に置き換えます。

1.7.4.1.3.2. オプション: 特定のノードで実行するように klusterlet を設定する

マネージドクラスターの nodeSelector と tolerations アノテーションを設定することで、マネージドクラスター klusterlet を実行するノードを指定できます。これらを設定するには、次の手順を実行します。

- コンソールのクラスターページから、更新するマネージドクラスターを選択します。

YAML コンテンツを表示するには、YAML スイッチを

Onに設定します。注記: YAML エディターは、クラスターをインポートまたは作成するときにのみ使用できます。インポートまたは作成後にマネージドクラスターの YAML 定義を編集するには、OpenShift Container Platform コマンドラインインターフェイスまたは Red Hat Advanced Cluster Management 検索機能を使用する必要があります。

-

nodeSelectorアノテーションをマネージドクラスターの YAML 定義に追加します。このアノテーションのキーは、open-cluster-management/nodeSelectorです。このアノテーションの値は、JSON 形式の文字列マップです。 tolerationsエントリーをマネージドクラスターの YAML 定義に追加します。このアノテーションのキーは、open-cluster-management/tolerationsです。このアノテーションの値は、JSON 形式の toleration リストを表します。結果の YAML は次の例のようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

KlusterletConfig を使用して、マネージドクラスターの nodeSelector と tolerations を設定することもできます。これらを設定するには、次の手順を実行します。

注: KlusterletConfig を使用する場合、マネージドクラスターは、マネージドクラスターのアノテーションの設定ではなく、KlusterletConfig 設定の構成を使用します。

次のサンプル YAML の内容を適用します。必要に応じて値を置き換えます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

agent.open-cluster-management.io/klusterlet-config: `<klusterletconfigName>アノテーションをマネージドクラスターに追加し、<klusterletconfigName>をKlusterletConfigの名前に置き換えます。

1.7.4.1.4. インポートされたクラスターの削除

以下の手順を実行して、インポートされたクラスターと、マネージドクラスターで作成された open-cluster-management-agent-addon を削除します。

Clusters ページで、Actions > Detach cluster をクリックしてマネージメントからクラスターを削除します。

注記: local-cluster という名前のハブクラスターをデタッチしようとする場合は、デフォルトの disableHubSelfManagement 設定が false である点に注意してください。この設定が原因で、ハブクラスターがデタッチされると、自身を再インポートして管理し、MultiClusterHub コントローラーが調整されます。ハブクラスターがデタッチプロセスを完了して再インポートするのに時間がかかる場合があります。プロセスが完了するのを待たずにハブクラスターを再インポートする場合は、次のコマンドを実行して multiclusterhub-operator Pod を再起動し、再インポートを高速化できます。

oc delete po -n open-cluster-management `oc get pod -n open-cluster-management | grep multiclusterhub-operator| cut -d' ' -f1`

oc delete po -n open-cluster-management `oc get pod -n open-cluster-management | grep multiclusterhub-operator| cut -d' ' -f1`

disableHubSelfManagement の値を true に指定して、自動的にインポートされないように、ハブクラスターの値を変更できます。詳細は、disableHubSelfManagement のトピックを参照してください。

1.7.4.1.4.1. 関連情報

- カスタムイメージプルシークレット の定義方法の詳細は、カスタムイメージプルシークレットを参照してください。

- disableHubSelfManagement トピックを参照してください。

1.7.4.2. CLI を使用したマネージドクラスターのインポート

multicluster engine for Kubernetes Operator をインストールしたら、Red Hat OpenShift Container Platform CLI を使用して、クラスターをインポートおよび管理できるようになります。自動インポートシークレットを使用するか、man コマンドを使用して、CLI でマネージドクラスターをインポートする方法は、以下のトピックを参照してください。

重要: ハブクラスターは別のハブクラスターを管理できません。ハブクラスターは、ローカルクラスター として自動的にインポートおよび管理されるようにセットアップされます。ハブクラスターは、手動でインポートして自己管理する必要はありません。ハブクラスターを削除して再度インポートする場合は、local-cluster:true ラベルを追加する必要があります。

1.7.4.2.1. 前提条件

- デプロイされたハブクラスター。ベアメタルクラスターをインポートする場合、サポートされている OpenShift Container Platform バージョンにハブクラスターがインストールされている。

- 管理する別のクラスター。

- OpenShift Container Platform CLI。OpenShift Container Platform CLI のインストールと設定については、OpenShift CLI の使用を開始する を参照してください。

-

OpenShift Container Platform によって作成されていないクラスターをインポートする場合、定義された

multiclusterhub.spec.imagePullSecret。このシークレットは、multicluster engine for Kubernetes Operator のインストール時に作成済みである可能性があります。このシークレットを定義する方法の詳細は、カスタムイメージプルシークレット を参照してください。 -

ハブクラスターの

KubeAPIServer証明書検証ストラテジーを確認し、デフォルトのUseAutoDetectedCABundleストラテジーが機能することを確認する。ストラテジーを手動で変更する必要がある場合は、ハブクラスターのKubeAPIServer検証ストラテジーの設定 を参照してください。

1.7.4.2.2. サポート対象のアーキテクチャー

- Linux (x86_64, s390x, ppc64le)

- macOS

1.7.4.2.3. クラスターインポートの準備

CLI を使用してマネージドクラスターをインポートする前に、以下の手順を実行する必要があります。

次のコマンドを実行して、ハブクラスターにログインします。

oc login

oc loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow ハブクラスターで次のコマンドを実行して、プロジェクトおよび namespace を作成します。

<cluster_name>で定義されているクラスター名は、YAML ファイルとコマンドでクラスター namespace としても使用されます。oc new-project <cluster_name>

oc new-project <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要:

cluster.open-cluster-management.io/managedClusterラベルは、マネージドクラスターの namespace に対して自動的に追加および削除されます。手動でマネージドクラスター namespace に追加したり、削除したりしないでください。以下の内容例で

managed-cluster.yamlという名前のファイルを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow cloudおよびvendorの値をauto-detectする場合、Red Hat Advanced Cluster Management はインポートしているクラスターからクラウドおよびベンダータイプを自動的に検出します。オプションで、auto-detectの値をクラスターのクラウドおよびベンダーの値に置き換えることができます。以下の例を参照してください。cloud: Amazon vendor: OpenShift

cloud: Amazon vendor: OpenShiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、YAML ファイルを

ManagedClusterリソースに適用します。oc apply -f managed-cluster.yaml

oc apply -f managed-cluster.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

これで、自動インポートシークレットを使用してクラスターをインポートする か、手動でクラスターをインポートする のいずれかに進むことができます。

1.7.4.2.4. 自動インポートシークレットを使用したクラスターのインポート

自動インポートシークレットを使用してマネージドクラスターをインポートするには、クラスターの kubeconfig ファイルへの参照、またはクラスターの kube API サーバーとトークンのペアのいずれかの参照を含むシークレットを作成する必要があります。自動インポートシークレットを使用してクラスターをインポートするには、以下の手順を実行します。

-

インポートするマネージドクラスターの

kubeconfigファイル、または kube API サーバーおよびトークンを取得します。kubeconfigファイルまたは kube API サーバーおよびトークンの場所を特定する方法は、Kubernetes クラスターのドキュメントを参照してください。 ${CLUSTER_NAME} namespace に

auto-import-secret.yamlファイルを作成します。以下のテンプレートのようなコンテンツを使用して、

auto-import-secret.yamlという名前の YAML ファイルを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、<cluster_name> namespace に YAML ファイルを適用します。

oc apply -f auto-import-secret.yaml

oc apply -f auto-import-secret.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記: デフォルトでは、自動インポートシークレットは 1 回使用され、インポートプロセスが完了すると削除されます。自動インポートシークレットを保持する場合は、

managedcluster-import-controller.open-cluster-management.io/keeping-auto-import-secretをシークレットに追加します。これを追加するには、以下のコマンドを実行します。oc -n <cluster_name> annotate secrets auto-import-secret managedcluster-import-controller.open-cluster-management.io/keeping-auto-import-secret=""

oc -n <cluster_name> annotate secrets auto-import-secret managedcluster-import-controller.open-cluster-management.io/keeping-auto-import-secret=""Copy to Clipboard Copied! Toggle word wrap Toggle overflow

インポートしたクラスターのステータス (

JOINEDおよびAVAILABLE) を確認します。ハブクラスターから以下のコマンドを実行します。oc get managedcluster <cluster_name>

oc get managedcluster <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターで以下のコマンドを実行して、マネージドクラスターにログインします。

oc login

oc loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、インポートするクラスターの Pod ステータスを検証できます。

oc get pod -n open-cluster-management-agent

oc get pod -n open-cluster-management-agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow

klusterlet アドオンのインポート に進むことができます。

1.7.4.2.5. クラスターの手動インポート

重要: import コマンドには、インポートされた各マネージドクラスターにコピーされるプルシークレット情報が含まれます。インポートしたクラスターにアクセスできるユーザーであれば誰でも、プルシークレット情報を表示することもできます。

マネージドクラスターを手動でインポートするには、以下の手順を実行します。

以下のコマンドを実行して、ハブクラスターでインポートコントローラーによって生成された

klusterlet-crd.yamlファイルを取得します。oc get secret <cluster_name>-import -n <cluster_name> -o jsonpath={.data.crds\\.yaml} | base64 --decode > klusterlet-crd.yamloc get secret <cluster_name>-import -n <cluster_name> -o jsonpath={.data.crds\\.yaml} | base64 --decode > klusterlet-crd.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、ハブクラスターにインポートコントローラーによって生成された

import.yamlファイルを取得します。oc get secret <cluster_name>-import -n <cluster_name> -o jsonpath={.data.import\\.yaml} | base64 --decode > import.yamloc get secret <cluster_name>-import -n <cluster_name> -o jsonpath={.data.import\\.yaml} | base64 --decode > import.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow インポートするクラスターで次の手順を実行します。

次のコマンドを入力して、インポートするマネージドクラスターにログインします。

oc login

oc loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、手順 1 で生成した

klusterlet-crd.yamlを適用します。oc apply -f klusterlet-crd.yaml

oc apply -f klusterlet-crd.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、以前に生成した

import.yamlファイルを適用します。oc apply -f import.yaml

oc apply -f import.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ハブクラスターから次のコマンドを実行して、インポートするマネージドクラスターの

JOINEDおよびAVAILABLEステータスを検証できます。oc get managedcluster <cluster_name>

oc get managedcluster <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

klusterlet アドオンのインポート に進むことができます。

1.7.4.2.6. klusterlet アドオンのインポート

KlusterletAddonConfig klusterlet アドオン設定を実装して、マネージドクラスターで他のアドオンを有効にします。次の手順を実行して、設定ファイルを作成して適用します。

以下の例のような YAML ファイルを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

ファイルは

klusterlet-addon-config.yamlとして保存します。 以下のコマンドを実行して YAML を適用します。

oc apply -f klusterlet-addon-config.yaml

oc apply -f klusterlet-addon-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow アドオンは、インポートするマネージドクラスターのステータスが

AVAILABLEになると、インストールされます。以下のコマンドを実行して、インポートするクラスターのアドオンの Pod ステータスを検証できます。

oc get pod -n open-cluster-management-agent-addon

oc get pod -n open-cluster-management-agent-addonCopy to Clipboard Copied! Toggle word wrap Toggle overflow