クラスター

クラウドプロバイダー間でクラスターを作成、インポート、および管理する方法については、詳細をご覧ください。

概要

第1章 クラスターの管理

Red Hat Advanced Cluster Management for Kubernetes コンソールを使用した、クラウドプロバイダー全体におけるクラスターの作成、インポート、管理の方法を説明します。

以下のトピックでは、クラウドプロバイダー全体でクラスターを管理する方法について説明します。

- サポート対象のクラウド

- クラスターのサイズ調整

- リリースイメージ

- ベアメタルアセットの作成および変更

- インフラストラクチャー環境の作成

- 認証情報の管理の概要

- クラスターの作成

- ハブクラスターへのターゲットのマネージドクラスターのインポート

- プロキシー環境でのクラスターの作成

- クラスタープロキシーアドオンの有効化

- 特定のクラスター管理ロールの設定

- クラスターラベルの管理

- ManagedClusterSets の管理 (テクノロジープレビュー)

- Placement での ManagedClustersSets の使用

- クラスタープールの管理 (テクノロジープレビュー)

- マネージドクラスターで実行する Ansible Tower タスクの設定

- クラスタープールからのクラスターの要求

- Discovery の概要 (テクノロジープレビュー)

- クラスターのアップグレード

- マネージメントからのクラスターの削除

- クラスターのバックアップおよび復元 Operator(テクノロジープレビュー)

- VolSync を使用した永続ボリュームの複製

1.1. クラスターライフサイクルのアーキテクチャー

Red Hat Advanced Cluster Management for Kubernetes には、ハブクラスター と マネージド クラスターの 2 つの主なクラスタータイプがあります。

ハブクラスターは、Red Hat Advanced Cluster Management for Kubernetes でインストールされたメインとなるクラスターのことです。ハブクラスターを使用して他の Kubernetes クラスターの作成、管理、および監視を行うことができます。

マネージドクラスターは、ハブクラスターが管理する Kubernetes クラスターです。Red Hat Advanced Cluster Management ハブクラスターを使用してクラスターを作成することもできますが、ハブクラスターで管理する既存のクラスターをインポートすることもできます。

Red Hat Advanced Cluster Management を使用してマネージドクラスターを作成する場合、クラスターは、Hive リソースを備えた Red Hat OpenShift Container Platform クラスターインストーラーを使用して作成されます。OpenShift Container Platform インストーラーでクラスターのインストールプロセスについての詳細は、OpenShift Container Platform ドキュメントの OpenShift Container Platform インストールの概要 を参照してください。

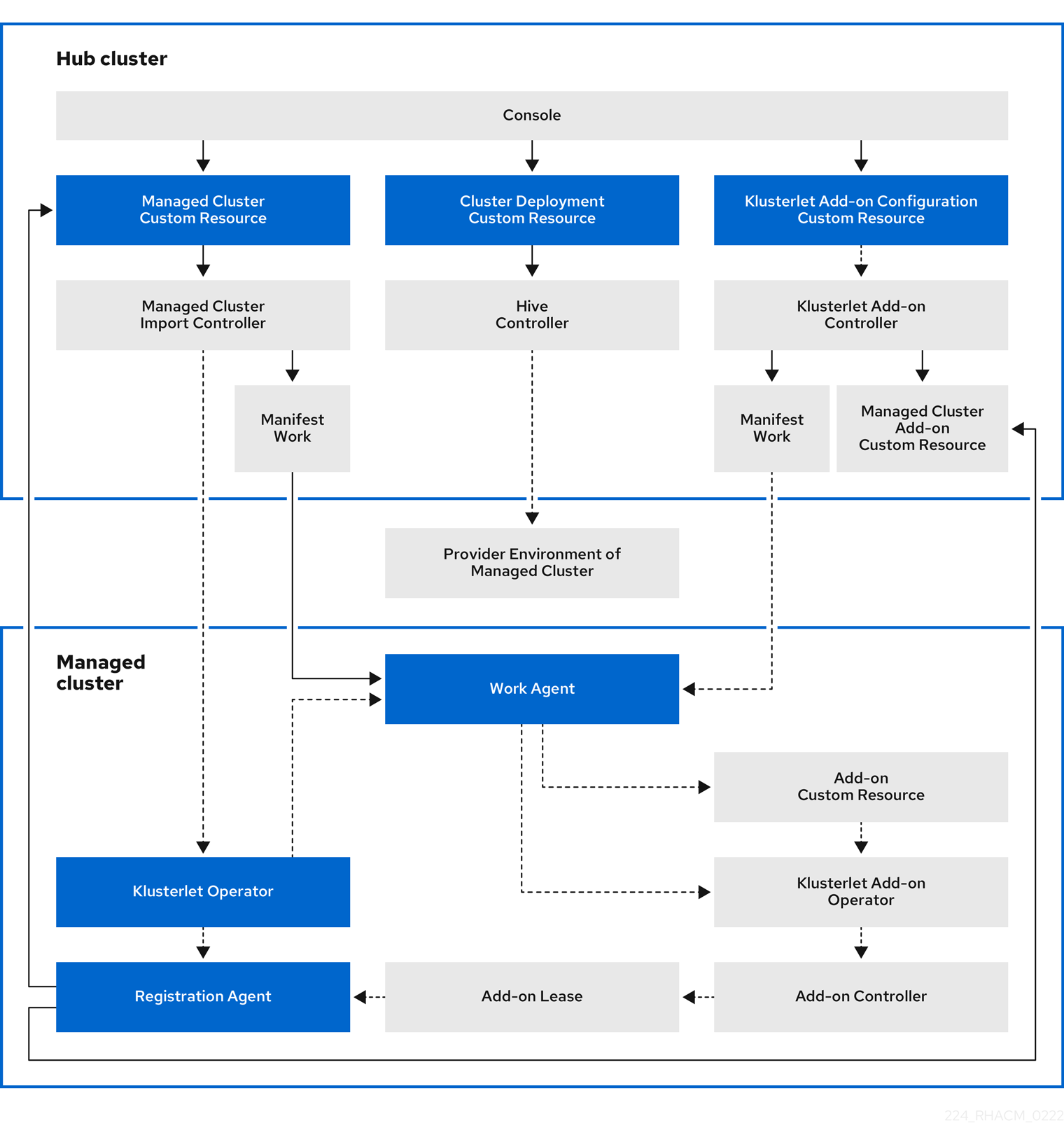

以下の図は、Red Hat Advanced Cluster Management for クラスター管理でインストールされるコンポーネントを示しています。

クラスターライフサイクル管理のアーキテクチャーのコンポーネントには、以下の項目が含まれます。

ハブクラスターのコンポーネント:

- コンソール: Red Hat Advanced Cluster Management マネージドクラスターのクラスターライフサイクルを管理する Web ベースのインターフェイスを提供します。

- Hive Controller: Red Hat Advanced Cluster Management で作成するクラスターをプロビジョニングします。Hive コントローラーは、Red Hat Advanced Cluster Management で作成されたマネージドクラスターをデタッチおよび破棄します。

- マネージドクラスターのインポートコントローラー: klusterlet Operator をマネージドクラスターにデプロイします。

- klusterlet アドオンコントローラー: klusterlet アドオン Operator をマネージドクラスターにデプロイします。

マネージドクラスター上のコンポーネント:

- klusterlet Operator: マネージドクラスターに登録およびワークコントローラーをデプロイします。

登録エージェント: ハブクラスターを使用してマネージドクラスターを登録します。マネージドクラスターがハブクラスターにアクセスできるように、以下のパーミッションが自動的に作成されます。

Clusterrole

- エージェントが証明書をローテーションできるようにします。

-

エージェントが、ハブクラスターが管理するクラスターを

取得/一覧表示/更新/監視できるようにします。 - ハブクラスターが管理するクラスターのステータスを、エージェントが更新できるようにします。

ハブクラスターのハブクラスター namespace で作成されたロール

-

マネージドクラスター登録エージェントが

coordination.k8s.ioリースを取得または更新できるようにします。 -

エージェントがマネージドクラスターアドオンを

取得/一覧表示/監視できるようにします。 - エージェントがマネージドクラスターアドオンのステータスを更新できるようにします。

-

マネージドクラスター登録エージェントが

ワークエージェント: マニフェストはマネージドクラスターで機能します。マネージドクラスターがハブクラスターにアクセスできるように、以下のパーミッションが自動的に作成されます。

ハブクラスターのハブクラスター namespace で作成されたロール

- ワークエージェントがイベントをハブクラスターに送信できるようにします。

-

エージェントが

manifestworksリソースを取得/一覧表示/監視/更新できるようにします。 -

エージェントが

manifestworksリソースのステータスを更新できるようにします。

- klusterlet アドオン Operator: アドオンコンポーネントをデプロイします。

1.2. サポート対象のクラウド

Red Hat Advanced Cluster Management for Kubernetes で利用可能なクラウドプロバイダーについて説明します。また、利用可能なマネージドプロバイダーに関するドキュメントも参照してください。サポート対象のクラウドの詳細は、サポートマトリックス を参照してください。

ベストプラクティス: マネージドクラスターのプロバイダーには、最新版の Kubernetes を使用してください。

1.2.1. サポート対象のハブクラスタープロバイダー

ハブクラスターとしてサポートされるのは、Red Hat OpenShift Container Platform 4.6.1 以降です。

- Amazon Web Services 上の Red Hat OpenShift Container Platform を参照してください。

- Red Hat OpenShift Container Platform on Microsoft Azure を参照してください。

- Red Hat OpenShift Container Platform on Google Cloud Platform を参照してください。

- Red Hat OpenShift Dedicated (OSD) を参照してください。

- IBM Cloud (ROKS) 上の Red Hat OpenShift Container Platform を参照してください。

- Azure for Red Hat OpenShift (ARO) を参照してください。

- Red Hat OpenShift Container Platform on VMware vSphere を参照してください。

- Red Hat OpenShift Container Platform on OpenStack を参照してください。

- OpenShift on Amazon Web Services (ROSA) を参照してください。

- IBM Power Systems 上の OpenShift Container Platform を参照してください。

- z/VM を使用した IBM Z および LinuxONE へのインストール を参照してください。

1.2.2. サポート対象のマネージドクラスタープロバイダー

マネージドクラスターとしてサポートされるのは、Red Hat OpenShift Container Platform 3.11.200 以降、4.6.1 以降です。

利用可能なマネージドクラスターのオプションおよびドキュメントは以下を参照してください。

- Amazon Web Services 上の Red Hat OpenShift Container Platform を参照してください。

- Red Hat OpenShift Container Platform on Microsoft Azure を参照してください。

- Red Hat OpenShift Container Platform on Google Cloud Platform を参照してください。

- Red Hat OpenShift Dedicated (OSD) を参照してください。

- IBM Cloud (ROKS) 上の Red Hat OpenShift Container Platform を参照してください。

- Azure Red Hat OpenShift (ARO) を参照してください。

- Red Hat OpenShift Container Platform on VMware vSphere を参照してください。

- Red Hat OpenShift Container Platform on OpenStack を参照してください。

- OpenShift on Amazon Web Services (ROSA) を参照してください。

- About Red Hat OpenShift Kubernetes Engine を参照してください。

- Amazon Elastic Kubernetes Service (Kubernetes 1.21 以降) を参照してください。

- Google Kubernetes Engine (Kubernetes 1.22.2 以降) を参照してください。

- IBM Cloud Kubernetes Service 概説 (Kubernetes 1.22.3 以降) を参照してください。

- Azure Kubernetes Service (Kubernetes 1.22.2 以降) を参照してください。

- Red Hat OpenShift Container Platform (4.6.1 以降) on IBM Z を参照してください。

- IBM Power Systems 上の OpenShift Container Platform を参照してください。

1.2.3. kubectl の設定

前述したベンダーのドキュメントを参照し、kubectl の設定方法を確認してください。マネージドクラスターをハブクラスターにインポートする場合には kubectl をインストールしておく必要があります。詳細は、ハブクラスターへのターゲットのマネージドクラスターのインポート を参照してください。

1.3. クラスターのサイズ変更 (テクノロジープレビュー)

仮想マシンのサイズやノード数などのマネージドクラスターの仕様をカスタマイズできます。

Red Hat Advanced Cluster Management for Kubernetes が管理するクラスターの多くは、Red Hat Advanced Cluster Management コンソールまたはコマンドライン、MachinePool リソースを使用してスケーリングできます。MachinePool リソースは、ハブクラスター上の Kubernetes リソースで、MachineSet リソースをマネージドクラスターでグループ化します。MachinePool リソースは、ゾーンの設定、インスタンスタイプ、ルートストレージなど、マシンリソースのセットを均一に設定します。また、マネージドクラスターで、必要なノード数を手動で設定したり、ノードの自動スケーリングを設定したりするのに役立ちます。

1.3.1. Red Hat Advanced Cluster Management で作成したマネージドクラスターのスケーリング

MachinePool リソースを使用して Red Hat Advanced Cluster Management で作成されたクラスターのスケーリングは、テクノロジープレビュー機能であり、Red Hat Advanced Cluster Management で作成されたベアメタルクラスターではサポートされません。

1.3.1.1. 自動スケーリング

自動スケーリングを設定すると、トラフィックが少ない場合にリソースをスケールダウンし、多くのリソースが必要な場合に十分にリソースを確保できるようにスケールアップするなど、必要に応じてクラスターに柔軟性を持たせることができます。

1.3.1.1.1. 自動スケーリングの有効化

Red Hat Advanced Cluster Management コンソールを使用して、

MachinePoolリソースで自動スケーリングを有効化するには、以下の手順を実行します。- Red Hat Advanced Cluster Management ナビゲーションで Infrastructure > Clusters に移動します。

- ターゲットクラスターの名前をクリックし、クラスターの詳細を表示します。

- Machine pools タブを選択して、マシンプール情報を表示します。

- マシンプールページのターゲットマシンプールの Options メニューから Enable autoscale を選択します。

- マシンセットレプリカの最小数および最大数を選択します。マシンセットレプリカは、クラスターのノードに直接マップします。

Scale を選択して変更を送信します。

変更内容をコンソール De 反映するのに数分かかる場合があります。Machine pools タブの通知がある場合は、View machines をクリックしてスケーリング操作のステータスを表示できます。

コマンドラインを使用して

MachinePoolリソースで自動スケーリングを有効にするには、以下の手順を実行します。以下のコマンドを実行して、マシンプールの一覧を表示します。

oc get machinepools -n <managed-cluster-namespace>

managed-cluster-namespaceは、ターゲットのマネージドクラスターの namespace に置き換えます。以下のコマンドを入力してマシンプールの YAML ファイルを編集します。

oc edit machinepool <name-of-MachinePool-resource> -n <namespace-of-managed-cluster>

name-of-MachinePool-resourceは、MachinePoolリソースの名前に置き換えます。namespace-of-managed-clusterは、マネージドクラスターの namespace 名に置き換えます。-

YAML ファイルから

spec.replicasフィールドを削除します。 -

spec.autoscaling.minReplicas設定およびspec.autoscaling.maxReplicasフィールドをリソース YAML に追加します。 -

レプリカの最小数を

minReplicas設定に追加します。 -

レプリカの最大数を

maxReplicas設定に追加します。 - ファイルを保存して変更を送信します。

マシンプールの自動スケーリングが有効になりました。

1.3.1.1.2. 自動スケーリングの無効化

コンソールまたはコマンドラインを使用して自動スケーリングを無効にできます。

Red Hat Advanced Cluster Management コンソールを使用して自動スケーリングを無効にするには、以下の手順を実行します。

- Red Hat Advanced Cluster Management ナビゲーションで Infrastructure > Clusters に移動します。

- ターゲットクラスターの名前をクリックし、クラスターの詳細を表示します。

- Machine pools タブを選択して、マシンプール情報を表示します。

- マシンプールページから、ターゲットマシンプールの Options メニューから autoscale を無効にします。

- 必要なマシンセットのレプリカ数を選択します。マシンセットのレプリカは、クラスター上のノードを直接マップします。

- Scale を選択して変更を送信します。コンソールに表示されるまでに数分かかる場合があります。

- Machine pools タブの通知で View machine をクリックし、スケーリングのステータスを表示します。

コマンドラインを使用して自動スケーリングを無効にするには、以下の手順を実行します。

以下のコマンドを実行して、マシンプールの一覧を表示します。

oc get machinepools -n <managed-cluster-namespace>

managed-cluster-namespaceは、ターゲットのマネージドクラスターの namespace に置き換えます。以下のコマンドを入力してマシンプールの YAML ファイルを編集します。

oc edit machinepool <name-of-MachinePool-resource> -n <namespace-of-managed-cluster>

name-of-MachinePool-resourceは、MachinePoolリソースの名前に置き換えます。namespace-of-managed-clusterは、マネージドクラスターの namespace 名に置き換えます。-

YAML ファイルから

spec.autoscalingフィールドを削除します。 -

spec.replicasフィールドをリソース YAML に追加します。 -

replicasの設定にレプリカ数を追加します。 - ファイルを保存して変更を送信します。

自動スケーリングが無効になりました。

1.3.1.2. クラスターの手動スケーリング

クラスターの自動スケーリングを有効にしない場合は、Red Hat Advanced Cluster Management コンソールまたはコマンドラインで、クラスターが管理するレプリカの静的数を変更できます。これにより、必要に応じてサイズを増減できます。

1.3.1.2.1. コンソールを使用した手作業でのクラスターのスケーリング

Red Hat Advanced Cluster Management コンソールを使用して MachinePool リソースをスケーリングするには、以下の手順を実行します。

- Red Hat Advanced Cluster Management ナビゲーションで Infrastructure > Clusters に移動します。

- ターゲットクラスターの名前をクリックし、クラスターの詳細を表示します。

Machine pools タブを選択して、マシンプール情報を表示します。

注記: Autoscale フィールドの値が

Enabledになっている場合に、自動スケーリングの無効化 の手順を実行して自動スケーリング機能を無効にするようにしてください。- マシンプールの Options メニューから、Scale machine pool を選択します。

- マシンプールをスケーリングするようにマシンセットのレプリカ数を調整します。

- Scale を選択して変更を実装します。

1.3.1.2.2. コマンドラインを使用した手作業でのクラスターのスケーリング

コマンドラインを使用して MachinePool リソースをスケーリングするには、以下の手順を実行します。

以下のコマンドを実行して、マシンプールの一覧を表示します。

oc get machinepools -n <managed-cluster-namespace>

managed-cluster-namespaceは、ターゲットのマネージドクラスターの namespace に置き換えます。以下のコマンドを入力してマシンプールの YAML ファイルを編集します。

oc edit machinepool <name-of-MachinePool-resource> -n <namespace-of-managed-cluster>

name-of-MachinePool-resourceは、MachinePoolリソースの名前に置き換えます。namespace-of-managed-clusterは、マネージドクラスターの namespace 名に置き換えます。-

YAML の

spec.replicas設定は、レプリカの数に更新します。 - ファイルを保存して変更を送信します。

クラスターが新しいサイズ設定を使用するようになりました。

1.3.2. インポートされたマネージドクラスターのスケーリング

インポートしたマネージドクラスターには、Red Hat Advanced Cluster Management で作成したクラスターと同じリソースがありません。そのため、クラスターのスケーリングの手順が異なります。プロバイダーのドキュメントには、インポートしたクラスターのスケーリング方法に関する情報が含まれます。

利用可能なプロバイダーごとの推奨設定は以下の一覧を参照してください。ただし、詳細な情報については、ドキュメントも参照してください。

1.3.2.1. OpenShift Container Platform クラスター

お使いのバージョンに該当する OpenShift Container Platform ドキュメントの クラスターのスケーリングに関する推奨プラクティス および MachineSet の手動によるスケーリング を参照してください。

1.3.2.2. Amazon Elastic Kubernetes Services

インポートした Amazon EKS クラスターにあるノード数を変更する場合は、Cluster autoscaler でクラスターのスケーリングに関する情報を参照してください。

1.3.2.3. Google Kubernetes Engine

インポートした Google Kubernetes Engine クラスターにあるノード数を変更する場合は、Resizing a cluster でクラスターのスケーリングに関する情報を参照してください。

1.3.2.4. Microsoft Azure Kubernetes Service

インポートした Azure Kubernetes Services クラスターにあるノード数を変更する場合は、Scaling a cluster でクラスターのスケーリングに関する情報を参照してください。

1.3.2.5. VMware vSphere

インポートした VMware vSphere クラスターにあるノード数を変更する場合は、Edit cluster settings でクラスターのスケーリングに関する情報を参照してください。

1.3.2.6. Red Hat OpenStack Platform

インポートした Red Hat OpenStack Platform クラスターにあるノード数を変更する場合は、Auto scaling for instances でクラスターのスケーリングに関する情報を参照してください。

1.3.2.7. ベアメタルクラスター

インポートしたベアメタルクラスターにあるノード数を変更する場合には、Expanding the cluster でクラスターのスケーリングに関する情報を参照してください。

注記: ベアメタルクラスターは、ハブクラスターが OpenShift Container Platform バージョン 4.6 以降である場合にのみサポートされます。

1.3.2.8. IBM Kubernetes Service

インポートした IBM Kubernetes Service クラスターにあるノード数を変更する場合は、Adding worker nodes and zones to clusters でクラスターのスケーリングに関する情報を参照してください。

1.3.2.9. IBM Power Systems

インポートした IBM Power Systems クラスターにあるノード数を変更する場合には、need link でクラスターのスケーリングに関する情報を参照してください。

1.3.2.10. IBM Z および LinuxONE

インポートした IBM Z および LinuxONE Systems クラスターにあるノード数を変更する場合には、need link でクラスターのスケーリングに関する情報を参照してください。

1.4. リリースイメージ

Red Hat Advanced Cluster Management for Kubernetes を使用してプロバイダーでクラスターを作成する場合は、新規クラスターに使用するリリースイメージを指定する必要があります。リリースイメージでは、クラスターのビルドに使用する Red Hat OpenShift Container Platform のバージョンを指定します。

acm-hive-openshift-releases GitHub リポジトリーの YAML ファイルを使用して、リリースイメージを参照します。Red Hat Advanced Cluster Management はこれらのファイルを使用して、コンソールで利用可能なリリースイメージの一覧を作成します。これには、OpenShift Container Platform における最新の fast チャネルイメージが含まれます。コンソールには、OpenShift Container Platform の 3 つの最新バージョンの最新リリースイメージのみが表示されます。たとえば、コンソールオプションに以下のリリースイメージが表示される可能性があります。

- quay.io/openshift-release-dev/ocp-release:4.6.23-x86_64

- quay.io/openshift-release-dev/ocp-release:4.9.0-x86_64

注記: コンソールでクラスターの作成時に選択できるのは、visible: 'true' のラベルが付いたリリースイメージのみです。ClusterImageSet リソースのこのラベルの例は以下の内容で提供されます。

apiVersion: config.openshift.io/v1

kind: ClusterImageSet

metadata:

labels:

channel: fast

visible: 'true'

name: img4.9.8-x86-64-appsub

spec:

releaseImage: quay.io/openshift-release-dev/ocp-release:4.9.8-x86_64

追加のリリースイメージは保管されますが、コンソールには表示されません。利用可能なすべてのリリースイメージを表示するには、CLI で kubectl get clusterimageset を実行します。最新のリリースイメージでクラスターを作成することが推奨されるため、コンソールには最新バージョンのみがあります。特定バージョンのクラスター作成が必要となる場合があります。そのため、古いバージョンが利用可能となっています。Red Hat Advanced Cluster Management はこれらのファイルを使用して、コンソールで利用可能なリリースイメージの一覧を作成します。これには、OpenShift Container Platform における最新の fast チャネルイメージが含まれます。

リポジトリーには、clusterImageSets ディレクトリーおよび subscription ディレクトリーが含まれます。これらのディレクトリーは、リリースイメージの操作時に使用します。

リポジトリーには、clusterImageSets ディレクトリーおよび subscription ディレクトリーが含まれます。これらのディレクトリーは、リリースイメージの操作時に使用します。

clusterImageSets ディレクトリーには以下のディレクトリーが含まれます。

- Fast: サポート対象の各 OpenShift Container Platform バージョンのリリースイメージの内、最新バージョンを参照するファイルが含まれます。このフォルダー内のリリースイメージはテストされ、検証されており、サポートされます。

- Releases: 各 OpenShift Container Platform バージョン (stable、fast、および candidate チャネル) のリリースイメージをすべて参照するファイルが含まれます。注記: このリリースはすべてテストされ、安定していると判別されているわけではありません。

- Stable: サポート対象の各 OpenShift Container Platform バージョンのリリースイメージの内、最新の安定版 2 つを参照するファイルが含まれます。

注記: デフォルトでは、リリースイメージの現在の一覧は 1 時間ごとに更新されます。製品をアップグレードした後、リストに製品の新しいバージョンの推奨リリースイメージバージョンが反映されるまでに最大 1 時間かかる場合があります。

独自の ClusterImageSets は以下の 3 つの方法でキュレートできます。

3 つの方法のいずれかの最初のステップは、最新の fast チャンネルイメージを自動的に更新する付属のサブスクリプションを無効にすることです。最新の fast の ClusterImageSets の自動キュレーションを無効にするには、multiclusterhub リソースでインストーラーパラメーターを使用します。spec.disableUpdateClusterImageSets パラメーターを true と false の間で切り替えることにより、Red Hat Advanced Cluster Management でインストールしたサブスクリプションが、それぞれ無効または有効になります。独自のイメージをキューレートする場合は、spec.disableUpdateClusterImageSets を true に設定してサブスクリプションを無効にします。

オプション 1: クラスターの作成時にコンソールで使用する特定の ClusterImageSet のイメージ参照を指定します。指定する新規エントリーはそれぞれ保持され、将来のすべてのクラスタープロビジョニングで利用できます。たとえば、エントリーは quay.io/openshift-release-dev/ocp-release:4.6.8-x86_64 のようになります。

オプション 2: GitHub リポジトリー acm-hive-openshift-releases から YAML ファイル ClusterImageSets を手動で作成し、適用します。

オプション 3: GitHub リポジトリー acm-hive-openshift-releases の README.md に従って、フォークした GitHub リポジトリーから ClusterImageSets の自動更新を有効にします。

subscription ディレクトリーには、リリースイメージの一覧がプルされる場所を指定するファイルが含まれます。

Red Hat Advanced Cluster Management のデフォルトのリリースイメージは、Quay.io デフォルトで提供されます。

このイメージは、acm-hive-openshift-releases GitHub repository for release 2.4 のファイルで参照されます。

1.4.1. 利用可能なリリースイメージの同期

リリースイメージは頻繁に更新されるため、リリースイメージの一覧を同期して、利用可能な最新バージョンを選択できるようにする必要があります。リリースイメージは、リリース 2.4 の acm-hive-openshift-releases の GitHub リポジトリーから入手できます。

リリースイメージの安定性には、以下の 3 つのレベルがあります。

| カテゴリー | 説明 |

| stable | 完全にテストされたイメージで、クラスターを正常にインストールしてビルドできることが確認されています。 |

| fast | 部分的にテスト済みですが、stable バージョンよりも安定性が低い可能性があります。 |

| candidate | テストはしていませんが、最新のイメージです。バグがある可能性もあります。 |

一覧を更新するには、以下の手順を実行します。

-

インストーラーが管理する

acm-hive-openshift-releasesサブスクリプションが有効になっている場合は、multiclusterhubリソースのdisableUpdateClusterImageSetsの値をtrueに設定してサブスクリプションを無効にします。 - リリース 2.4 の acm-hive-openshift-releases GitHub リポジトリーのクローンを作成します。

以下のコマンドのようなコマンドを入力して、サブスクリプションを削除します。

oc delete -f subscribe/subscription-fast

以下のコマンドを入力して、stable リリースイメージに接続し、Red Hat Advanced Cluster Management for Kubernetes のハブクラスターに同期します。

make subscribe-stable

注記: この

makeコマンドは、Linux または MacOS のオペレーティングシステムを使用している場合のみ実行できます。約 1 分後に、

安定版のリリースイメージの最新の一覧が利用可能になります。Fast リリースイメージを同期して表示するには、以下のコマンドを実行します。

make subscribe-fast

注記: この

makeコマンドは、Linux または MacOS のオペレーティングシステムを使用している場合のみ実行できます。このコマンド実行の約 1 分後に、利用可能な

stableとfastのリリースイメージの一覧が、現在利用可能なイメージに更新されます。candidateリリースイメージを同期して表示するには、以下のコマンドを実行します。make subscribe-candidate

注記: この

makeコマンドは、Linux または MacOS のオペレーティングシステムを使用している場合のみ実行できます。このコマンド実行の約 1 分後に、利用可能な

stable、fast、およびcandidateのリリースイメージの一覧が、現在利用可能なイメージに更新されます。

- クラスターの作成時に、Red Hat Advanced Cluster Management コンソールで現在利用可能なリリースイメージの一覧を表示します。

以下の形式でコマンドを入力して、これらのチャネルのサブスクライブを解除して更新の表示を停止することができます。

oc delete -f subscribe/subscription-fast

1.4.1.1. 接続時におけるリリースイメージのカスタム一覧の管理

すべてのクラスターに同じリリースイメージが使用されるようにします。クラスターの作成時に利用可能なリリースイメージのカスタム一覧を作成し、作業を簡素化します。利用可能なリリースイメージを管理するには、以下の手順を実行します。

-

インストーラーが管理する

acm-hive-openshift-releasesサブスクリプションが有効になっている場合は、multiclusterhubリソースのdisableUpdateClusterImageSetsの値をtrueに設定して無効にします。 - acm-hive-openshift-releases GitHub repository 2.4 branch をフォークします。

./subscribe/channel.yamlファイルを更新して、stolostronではなく、フォークしたリポジトリーの GitHub 名にアクセスするようにspec: pathnameを変更します。この手順では、ハブクラスターによるリリースイメージの取得先を指定します。更新後の内容は以下の例のようになります。spec: type: Git pathname: https://github.com/<forked_content>/acm-hive-openshift-releases.git

forked_contentはフォークしたリポジトリーのへのパスに置き換えます。- Red Hat Advanced Cluster Management for Kubernetes を使用してクラスターを作成する時に利用できるようにイメージの YAML ファイルを ./clusterImageSets/stable/ または ./clusterImageSets/fast/* ディレクトリーに追加します。*ヒント: フォークしたリポジトリーに変更をマージすることで、利用可能な YAML ファイルはメインのリポジトリーから取得できます。

- フォークしたリポジトリーに変更をコミットし、マージします。

acm-hive-openshift-releasesリポジトリーをクローンした後に fast リリースイメージの一覧を同期するには、以下のコマンドを入力して fast イメージを更新します。make subscribe-fast

注記: この

makeコマンドは、Linux または MacOS のオペレーティングシステムを使用している場合のみ実行できます。このコマンドを実行後に、利用可能な fast リリースイメージの一覧が、現在利用可能なイメージに約 1 分ほどで更新されます。

デフォルトでは、fast イメージのみが一覧表示されます。stable リリースイメージを同期して表示するには、以下のコマンドを実行します。

make subscribe-stable

注記: この

makeコマンドは、Linux または MacOS のオペレーティングシステムを使用している場合のみ実行できます。このコマンドを実行後に、利用可能な安定版のリリースイメージの一覧が、現在利用可能なイメージに約 1 分ほどで更新されます。

デフォルトでは、Red Hat Advanced Cluster Management は、複数の ClusterImageSets を事前に読み込みます。以下のコマンドを使用して、利用可能ものを表示し、デフォルトの設定を削除します。

oc get clusterImageSets oc delete clusterImageSet <clusterImageSet_NAME>

注記:

multiclusterhubのdisableUpdateClusterImageSetsの値をtrueに設定して、インストーラー管理のClusterImageSetsの自動更新をまだ無効にしていない場合は、削除するイメージが自動的に再作成されます。- クラスターの作成時に、Red Hat Advanced Cluster Management コンソールで現在利用可能なリリースイメージの一覧を表示します。

1.4.1.2. 非接続時におけるリリースイメージのカスタム一覧の管理

ハブクラスターにインターネット接続がない場合は、リリースイメージのカスタムリストを管理しないといけない場合があります。クラスターの作成時に利用可能なリリースイメージのカスタム一覧を作成します。非接続時に、利用可能なリリースイメージを管理するには、以下の手順を実行します。

- オンラインシステムを使用している場合は、GitHub リポジトリー acm-hive-openshift-releases に移動し、バージョン 2.4 で利用可能なクラスターイメージセットにアクセスします。

-

clusterImageSetsディレクトリーを、非接続の Red Hat Advanced Cluster Management for Kubernetes ハブクラスターにアクセス可能なシステムにコピーします。 管理対象クラスターに適合する次の手順を実行して、管理対象クラスターと切断されたリポジトリーの間にクラスターイメージセットを含むマッピングを追加します。

-

OpenShift Container Platform マネージドクラスターの場合は、

ImageContentSourcePolicyオブジェクトを使用してマッピングを完了する方法についての詳細は、イメージレジストリーリポジトリーのミラーリングの設定 を参照してください。 -

OpenShift Container Platform クラスターではないマネージドクラスターの場合は、

ManageClusterImageRegistryCRD を使用してイメージセットの場所を上書きします。マッピング用にクラスターを上書きする方法については、カスタム ManagedClusterImageRegistry CRD を使用したクラスターのインポート を参照してください。

-

OpenShift Container Platform マネージドクラスターの場合は、

-

clusterImageSetYAML を手作業で追加し、Red Hat Advanced Cluster Management for Kubernetes コンソールを使用してクラスターを作成する時に利用できるようにイメージの YAML ファイルを追加します。 残りの OpenShift Container Platform リリースイメージの

clusterImageSetYAML ファイルを、イメージの保存先の正しいオフラインリポジトリーを参照するように変更します。更新は次の例のようになります。apiVersion: hive.openshift.io/v1 kind: ClusterImageSet metadata: name: img4.4.0-rc.6-x86-64 spec: releaseImage: IMAGE_REGISTRY_IPADDRESS_or_DNSNAME/REPO_PATH/ocp-release:4.4.0-rc.6-x86_64YAML ファイルで参照されているオフラインイメージレジストリーにイメージがロードされていることを確認します。

各 YAML ファイルに以下のコマンドを入力して、各

clusterImageSetsを作成します。oc create -f <clusterImageSet_FILE>

clusterImageSet_FILEを、クラスターイメージセットファイルの名前に置き換えます。以下は例になります。oc create -f img4.9.9-x86_64.yaml

追加するリソースごとにこのコマンドを実行すると、利用可能なリリースイメージの一覧が使用できるようになります。

- または Red Hat Advanced Cluster Management のクラスター作成のコンソールに直接イメージの URL を貼り付けることもできます。イメージ URL が存在しない場合は、イメージ URL を追加すると新しい clusterImageSets が作成されます。

- クラスターの作成時に、Red Hat Advanced Cluster Management コンソールで現在利用可能なリリースイメージの一覧を表示します。

1.5. ベアメタルアセットの作成および変更

ベアメタルアセットとは、OpenShift Container Platform クラスターで実行されるように設定する仮想サーバーまたは物理サーバーです。Red Hat Advanced Cluster Management for Kubernetes は管理者が作成するベアメタルアセットに接続できます。ベアメタルアセットはマネージドクラスターにデプロイできます。

ハブクラスターのインベントリーコントローラーは、ベアメタルのアセットのインベントリーレコードを保持する BareMetalAsset というカスタムリソース定義 (CRD) を定義します。マネージドクラスターをプロビジョニングする場合、インベントリーコントローラーは、マネージドクラスター内にある対応する BareMetalHost リソースと、BareMetalAsset インベントリーレコードを調整します。

Red Hat Advanced Cluster Management は BareMetalAsset CR を使用して、設定管理データベース (CMDB) または同様のシステムで入力したレコードに基づいてクラスターハードウェアをプロビジョニングします。外部ツールまたは自動化は CMDB をポーリングし、Red Hat Advanced Cluster Management API を使用して、マネージドクラスターでの後続のデプロイメントに備え、対応する BareMetalAsset と Secret リソースをハブクラスターに作成します。

以下の手順を使用して、Red Hat Advanced Cluster Management が管理するクラスターのベアメタルアセットを作成して管理します。

1.5.1. 前提条件

ベアメタルアセットを作成する前に、以下の前提条件を満たす必要があります。

- OpenShift Container Platform バージョン 4.6 以降に、Red Hat Advanced Cluster Management ハブクラスターをデプロイしている。

- Red Hat Advanced Cluster Management ハブクラスターがベアメタルアセットに接続できるようにアクセスを設定している。

ベアメタルアセット、およびベアメタルアセットへのログインまたは管理に必要なパーミッションを指定したログイン認証情報を設定している。

注記: ベアメタルアセットの認証情報には、管理者が提供するアセットの項目 (ユーザー名、パスワード、 Baseboard Management Controller (BMC) アドレス の起動 NIC MAC アドレス) が含まれます。

1.5.2. コンソールを使用したベアメタルアセットの作成

Red Hat Advanced Cluster Management for Kubernetes コンソールを使用してベアメタルアセットを作成するには、以下の手順を実行します。

- ナビゲーションメニューから infrastructure > Bare metal assets に移動します。

- Bare metal assets ページで Create bare metal asset をクリックします。

- クラスターの作成時に識別できるようにアセット名を入力します。

ベアメタルアセットを作成する namespace を入力します。

注記: ベアメタルアセット、ベアメタルのマネージドクラスター、および関連シークレットは同じ namespace に配置する必要があります。

この namespace にアクセスできるユーザーは、クラスターの作成時にこのアセットをクラスターに関連付けることができます。

BMC アドレスを入力します。このコントローラーで、ホストとの通信が可能になります。以下のプロトコルがサポートされます。

- IPMI。詳細は、IPMI 2.0 Specification を参照してください。

- iDRAC。詳細は、Support for Integrated Dell Remote Access Controller 9 (iDRAC9) を参照してください。

- iRMC。詳細は、Data Sheet: FUJITSU Software ServerView Suite integrated Remote Management Controller - iRMC S5 を参照してください。

- Redfish。詳細は、Redfish specification を参照してください。

- ベアメタルアセットのユーザー名とパスワードを入力します。

- ベアメタルアセットのブート NIC MAC アドレスを追加します。これは、ネットワーク接続されたホストの NIC の MAC アドレスで、ベアメタルアセットにホストをプロビジョニングする時に使用します。

ベアメタルでのクラスターの作成 に進んでください。

1.5.3. CLI を使用したベアメタルアセットの作成

BareMetalAsset CR を使用して、クラスター内の特定の namespace のベアメタルアセットを作成します。各 BareMetalAsset には、同じ namespace に対応の Secret があり、そこには BMC (Baseboard Management Controller) 認証情報およびシークレット名が含まれます。

1.5.3.1. 前提条件

- ハブクラスターに Red Hat Advanced Cluster Management for Kubernetes のハブクラスターをインストールしている。

- Red Hat OpenShift CLI (oc) をインストールしている。

-

cluster-admin権限を持つユーザーとしてログインしている。

1.5.3.2. ベアメタルノードの作成

- 環境にベアメタルアセットをインストールしてプロビジョニングします。

- BMC の電源をオンにし、ハードウェアの IPMI または Redfish BMC アドレスおよび MAC アドレスを書き留めます。

以下の

BareMetalAssetおよびSecretCR を作成し、ファイルをbaremetalasset-cr.yamlとして保存します。apiVersion: inventory.open-cluster-management.io/v1alpha1 kind: BareMetalAsset metadata: name: <baremetalasset-machine> namespace: <baremetalasset-namespace> spec: bmc: address: ipmi://<out_of_band_ip>:<port> credentialsName: baremetalasset-machine-secret bootMACAddress: "00:1B:44:11:3A:B7" hardwareProfile: "hardwareProfile" role: "<role>" clusterName: "<cluster name>" --- apiVersion: v1 kind: Secret metadata: name: baremetalasset-machine-secret type: Opaque data: username: <username> password: <password>-

baremetalasset-machineは、ベアメタルアセットが置かれているマシンの名前に置き換えます。作成時に、マネージドクラスターのBareMetalHostは、ハブクラスター上の対応するBareMetalAssetと同じ名前を取得します。BareMetalHost名は常に対応するBareMetalAsset名と一致している必要があります。 -

baremetalasset-namespaceは、ベアメタルアセットが作成されるクラスター namespace に置き換えます。 -

out_of_band_ipおよびportは、ベアメタルアセットのアドレスおよびポートに置き換えます。Redfish アドレス設定には、redfish://<out-of-band-ip>/redfish/v1/Systems/1のアドレス形式を使用します。 -

roleは、workerか、masterに置き換えるか、またはマシンのロールの種類に応じて空のままにします。role設定を使用して、クラスター内の固有のマシンロールタイプに、ベアメタルアセットを一致させます。指定のマシンロールタイプのBareMetalAssetリソースは、別のロールを満たすためには使用しないでください。roleの値は、キーがinventory.open-cluster-management.io/roleのラベル値として使用されます。これにより、クラスター管理アプリケーションまたはユーザーは、特定のロール向けに用意されたインベントリーについてクエリーできます。 -

cluster_nameは、クラスターの名前に置き換えます。この名前は、クラスター管理アプリケーションまたはユーザーが、特定のクラスターに関連付けられたインベントリーのクエリーに使用します。クラスターデプロイメントに追加せずにベアメタルアセットを作成するには、この値を空欄のままにします。 -

usernameは、シークレットのユーザー名に置き換えます。 -

passwordは、シークレットのパスワードに置き換えます。

-

以下のコマンドを実行して

BareMetalAssetCR を作成します。$ oc create -f baremetalasset-cr.yaml

BareMetalAssetが正常に作成されていることを確認します。$ oc get baremetalassets -A

出力例

NAMESPACE NAME AGE ocp-example-bm baremetalasset-machine 2m ocp-example-bm csv-f24-h27-000-r630-master-1-1 4d21h

1.5.4. コンソールを使用したベアメタルアセットの一括インポート

CSV 形式の一覧を使用して、Red Hat Advanced Cluster Management for Kubernetes コンソールでベアメタルアセットを一括インポートできます。

1.5.4.1. 前提条件

- 1 つ以上のスポーククラスターを管理するハブクラスターに Red Hat Advanced Cluster Management をインストールしている。

- OpenShift Container Platform CLI (oc) をインストールしている。

-

cluster-admin権限を持つユーザーとしてログインしている。

1.5.4.2. アセットのインポート

ベアメタルアセットをインポートするには、以下の手順を実行します。

- Red Hat Advanced Cluster Management コンソールのナビゲーションメニューで Cluster management > Bare metal assets を選択します。

Import assets を選択し、ベアメタルアセットのデータを含む CSV ファイルをインポートします。CSV ファイルには、以下のヘッダーコラムが必要です。

hostName, hostNamespace, bmcAddress, macAddress, role (optional), username, password

1.5.5. ベアメタルアセットの変更

ベアメタルアセットの設定を変更する必要がある場合は、以下の手順を実行します。

- Red Hat Advanced Cluster Management for Kubernetes コンソールのナビゲーションで、Infrastructure > Bare metal assets を選択します。

- テーブルで変更するアセットのオプションメニューを選択します。

- Edit asset を選択します。

1.5.6. ベアメタルアセットの削除

ベアメタルアセットがどのクラスターにも使用されなくなった場合は、利用可能なベアメタルアセット一覧から削除できます。使用されていないアセットを削除することで、利用可能なアセット一覧が簡素化されて、対象のアセットが誤って選択されないようにします。

コンソールでベアメタルアセットを削除するには、以下の手順を実行します。

- Red Hat Advanced Cluster Management for Kubernetes コンソールのナビゲーションで、Infrastructure > Bare metal assets を選択します。

- テーブルで削除するアセットのオプションメニューを選択します。

- Delete asset を選択します。

1.5.7. REST API を使用したベアメタルアセットの作成

OpenShift Container Platform REST API を使用して、Red Hat Advanced Cluster Management クラスターで使用するベアメタルアセットを管理できます。これは、お使いの環境でベアメタルアセットを管理するために別の CMDB アプリケーションまたはデータベースがある場合に役立ちます。

1.5.7.1. 前提条件

- ハブクラスターに Red Hat Advanced Cluster Management for Kubernetes のハブクラスターをインストールしている。

- OpenShift Container Platform CLI (oc) をインストールしている。

-

cluster-admin権限を持つユーザーとしてログインしている。

1.5.7.2. ベアメタルノードの作成

REST API を使用してベアメタルアセットを作成するには、以下を実行します。

ハブクラスターのログイントークンを取得して、コマンドラインでクラスターにログインします。以下は例になります。

$ oc login --token=<login_token> --server=https://<hub_cluster_api_url>:6443

以下の curl コマンドを、クラスターに追加するベアメタルアセットの詳細を使用して変更し、コマンドを実行します。

$ curl --location --request POST '<hub_cluster_api_url>:6443/apis/inventory.open-cluster-management.io/v1alpha1/namespaces/<bare_metal_asset_namespace>/baremetalassets?fieldManager=kubectl-create' \ --header 'Authorization: Bearer <login_token>' \ --header 'Content-Type: application/json' \ --data-raw '{ "apiVersion": "inventory.open-cluster-management.io/v1alpha1", "kind": "BareMetalAsset", "metadata": { "name": "<baremetalasset_name>", "namespace": "<bare_metal_asset_namespace>" }, "spec": { "bmc": { "address": "ipmi://<ipmi_address>", "credentialsName": "<credentials-secret>" }, "bootMACAddress": "<boot_mac_address>", "clusterName": "<cluster_name>", "hardwareProfile": "hardwareProfile", "role": "worker" } }'-

baremetalasset-nameは、ベアメタルアセットの名前に置き換えます。作成時に、マネージドクラスターのBareMetalHostは、ハブクラスター上の対応するBareMetalAssetと同じ名前を取得します。BareMetalHost名は常に対応するBareMetalAsset名と一致している必要があります。 -

baremetalasset-namespaceは、ベアメタルアセットが作成されるクラスター namespace に置き換えます。 -

out_of_band_ipおよびportは、ベアメタルアセットのアドレスおよびポートに置き換えます。Redfish アドレス設定には、redfish://<out-of-band-ip>/redfish/v1/Systems/1のアドレス形式を使用します。 -

roleは、workerか、masterに置き換えるか、またはマシンのロールの種類に応じて空のままにします。role設定を使用して、クラスター内の固有のマシンロールタイプに、ベアメタルアセットを一致させます。指定のマシンロールタイプのBareMetalAssetリソースは、別のロールを満たすためには使用しないでください。roleの値は、キーがinventory.open-cluster-management.io/roleのラベル値として使用されます。これにより、クラスター管理アプリケーションまたはユーザーは、特定のロール向けに用意されたインベントリーについてクエリーできます。 cluster_nameは、クラスターの名前に置き換えます。この名前は、クラスター管理アプリケーションまたはユーザーが、特定のクラスターに関連付けられたインベントリーのクエリーに使用します。クラスターデプロイメントに追加せずにベアメタルアセットを作成するには、この値を空欄のままにします。注記: 以前の curl コマンドでは、API サーバーが HTTPS 経由で提供され、安全にアクセスされることを前提としています。開発またはテスト環境では、

--insecureパラメーターを指定できます。

-

ヒント: --v=9 を oc コマンドに追加して、結果となるアクションの出力を未加工で表示できます。これは、oc コマンドの REST API ルートの認定に役立ちます。

1.6. インフラストラクチャー環境の作成

Red Hat Advanced Cluster Management for Kubernetes コンソールを使用して、インフラストラクチャー環境を作成して、ホストを管理し、それらのホストでクラスターを作成できます。

インフラストラクチャー環境は、次の機能をサポートしています。

- クラスターのゼロタッチプロビジョニング: スクリプトを使用してクラスターを展開します。詳細は、Red Hat OpenShift Container Platform ドキュメントの Deploying distributed units at scale in a disconnected environment を参照してください。

- レイトバインディング: インフラストラクチャー管理者がホストを起動できるようにします。クラスター作成者は、後でクラスターをそのホストにバインドできます。レイトバインディングを使用する場合、クラスター作成者はインフラストラクチャーに対する管理者権限を持っている必要はありません。

-

デュアルスタック: IPv4 と IPv6 の両方のアドレスを持つクラスターをデプロイします。デュアルスタックは、

OVN-Kubernetesネットワーク実装を使用して、複数のサブネットをサポートします。 - リモートワーカーノードの追加: リモートワーカーノードを作成して実行した後、クラスターに追加します。これにより、バックアップ目的で他の場所にノードを追加する柔軟性が提供されます。

- NMState を使用した静的 IP: NMState API を使用して、環境の静的 IP アドレスを定義します。

- Red Hat Advanced Cluster Management バージョン 2.3 を Assisted Installer 静的 IP アドレス指定を使用して Red Hat Advanced Cluster Management 2.4 にアップグレードします。ハブクラスター上の Red Hat Advanced Cluster Management をバージョン 2.3 から 2.4 にアップグレードすると、ハブクラスター上のインフラストラクチャー Operator およびインフラストラクチャーオペランド、または支援付きのサービスがバージョン 2.3 から 2.4 バンドル版にアップグレードされます。管理対象クラスターは自動的にアップグレードされません。

1.6.1. 前提条件

インフラストラクチャー観葉を作成する前に、以下の前提条件を満たす必要があります。

- OpenShift Container Platform バージョン 4.9 以降に、Red Hat Advanced Cluster Management ハブクラスターをデプロイしておく。

- クラスターを作成するために必要なイメージを取得するための、Red Hat Advanced Cluster Management ハブクラスターへのインターネットアクセス (接続済み)、あるいはインターネットへの接続がある内部またはミラーレジストリーへの接続 (非接続) がある。

- ハブクラスター上にある設定済みの Central Infrastructure Management(CIM) 機能のインスタンス。手順は Configuring the Central Infrastructure Management service を参照してください。

- OpenShift Container Platform プルシークレット。詳細は、イメージプルシークレットの使用 を参照してください。

-

デフォルトで

~/.ssh/id_rsa.pubファイルにある SSH キーです。 - 設定されたストレージクラス。

- 非接続環境のみ: OpenShift Container Platform ドキュメントの 非接続環境の準備 の手順を実行します。

1.6.2. Central Infrastructure Management サービスの有効化

CIM サービスは、Red Hat Advanced Cluster Management で提供され、OpenShift Container Platform クラスターをデプロイします。Red Hat Advanced Cluster Management ハブクラスターで MultiClusterHub Operator が有効になっているときにデプロイされますが、必ず有効化しておく必要があります。

CIM サービスを有効にするには、以下の手順を実行します。

Red Hat Advanced Cluster Management バージョン 2.4.0 のみ。Red Hat Advanced Cluster Management バージョン 2.4.1 以降を実行している場合は、この手順を省略します。以下のコマンドを実行して、

HiveConfigリソースを変更して CIM サービスの機能ゲートを有効にします。oc patch hiveconfig hive --type merge -p '{"spec":{"targetNamespace":"hive","logLevel":"debug","featureGates":{"custom":{"enabled":["AlphaAgentInstallStrategy"]},"featureSet":"Custom"}}}'provisioningリソースを変更し、以下のコマンドを実行してベアメタル Operator がすべての namespace を監視できるようにします。oc patch provisioning provisioning-configuration --type merge -p '{"spec":{"watchAllNamespaces": true }}'以下の手順を実行して

AgentServiceConfigCR を作成します。以下の

YAMLコンテンツをagent_service_config.yamlファイルに保存します。apiVersion: agent-install.openshift.io/v1beta1 kind: AgentServiceConfig metadata: name: agent spec: databaseStorage: accessModes: - ReadWriteOnce resources: requests: storage: <db_volume_size> filesystemStorage: accessModes: - ReadWriteOnce resources: requests: storage: <fs_volume_size> osImages: - openshiftVersion: "<ocp_version>" version: "<ocp_release_version>" url: "<iso_url>" rootFSUrl: "<root_fs_url>" cpuArchitecture: "x86_64"db_volume_sizeはdatabaseStorageフィールドのボリュームサイズに置き換えます (例:50M)。この値は、クラスターのデータベーステーブルやデータベースビューなどのファイルを格納するために割り当てられるストレージの量を指定します。クラスターが多い場合は、より高い値を使用する必要がある場合があります。fs_volume_sizeを、filesystemStorageフィールドのボリュームのサイズ (例:50M) に置き換えます。この値は、クラスターのログ、マニフェスト、およびkubeconfigファイルを保存するために割り当てられるストレージのサイズを指定します。クラスターが多い場合は、より高い値を使用する必要がある場合があります。ocp_versionは、インストールする OpenShift Container Platform バージョンに置き換えます (例:4.9)。ocp_release_versionは、特定のインストールバージョン (例:49.83.2021032516400) に置き換えます。iso_urlは、 ISO URL に置き換えます (例:https://mirror.openshift.com/pub/openshift-v4/x86_64/dependencies/rhcos/4.10/4.10.3/rhcos-4.10.3-x86_64-live.x86_64.iso)。他の値は https://mirror.openshift.com/pub/openshift-v4/x86_64/dependencies/rhcos/4.10/4.10.3/ にあります。root_fs_urlは、ルート FS イメージの URL に置き換えます (例:https://mirror.openshift.com/pub/openshift-v4/x86_64/dependencies/rhcos/4.10/4.10.3/rhcos-4.10.3-x86_64-live-rootfs.x86_64.img)。他の値は https://mirror.openshift.com/pub/openshift-v4/x86_64/dependencies/rhcos/4.10/4.10.3/ にあります。以下のコマンドを実行して AgentServiceConfig CR を作成します。

oc create -f agent_service_config.yaml

出力は次の例のような内容になります。

agentserviceconfig.agent-install.openshift.io/agent created

CIM サービスが設定されました。assisted-service と assisted-image-service デプロイメントをチェックして、Pod の準備ができ、実行されていることを確認して、正常性を検証できます。コンソールを使用したインフラストラクチャー環境の作成 に進んでください。

1.6.3. コンソールを使用したインフラストラクチャー環境の作成

Red Hat Advanced Cluster Management コンソールからインフラストラクチャー環境を作成するには、以下の手順を実行します。

- ナビゲーションメニューから Infrastructure > Clusters に移動します。

- インフラストラクチャー環境 ページで、Create infrastructure environment をクリックします。

お使いのインフラストラクチャー環境設定に以下の情報を追加します。

Name: お使いの環境の一意の名前。

重要: クラスターの削除時にこのインフラストラクチャー環境が誤って削除されないようにするために、このインフラストラクチャー環境の名前は環境内のクラスターの名前と同じにすることはできません。

- ネットワークタイプ: 環境に追加可能なホストのタイプを指定できます。ベアメタルホストを使用している場合には、静的 IP オプションのみを使用できます。

- Location: ホストの地理的な場所を指定します。地理的な場所を使用すると、クラスターの作成時に、クラスター上のデータの保存場所を簡単に判断できます。

- Labels: インフラストラクチャー環境にラベルを追加できる任意のフィールド。これにより、検索がかんたんになり、特徴がよく似た他の環境とグループ化できます。ネットワークタイプと場所に対して行った選択は、自動的にラベルの一覧に追加されます。

- プルシークレット: OpenShift Container Platform リソースへのアクセスを可能にする OpenShift Container Platform プルシークレット。

-

SSH 公開鍵: ホストとのセキュアな通信を可能にする SSH キー。これは通常

~/.ssh/id_rsa.pubファイルにあります。 すべてのクラスターでプロキシー設定を有効にする必要がある場合は、有効にする設定を選択します。この設定は、以下の情報を入力する必要があります。

- HTTP Proxy URL: 検出サービスへのアクセス時に使用する必要のある URL。

-

HTTPS Proxy URL: 検出サービスへのアクセス時に使用する必要のあるセキュアなプロキシー URL。

httpsはまだサポートされていないため、形式はhttpである必要があります。 - プロキシードメインなし: プロキシーをバイパスする必要のあるドメインのコンマ区切りリスト。ドメイン名をピリオド (.) で開始し、そのドメインにあるすべてのサブドメインを組み込みます。(*) を追加し、すべての宛先のプロキシーをバイパスします。

ホストをインフラストラクチャー環境に追加して、続行できるようになりました。

1.6.4. インフラストラクチャー環境へのアクセス

インフラストラクチャー環境にアクセスするには、Red Hat Advanced Cluster Management コンソールでInfrastructure > Infrastructure environments を選択します。一覧からインフラストラクチャー環境を選択し、そのインフラストラクチャー環境の詳細とホストを表示します。

1.6.5. インフラストラクチャー環境へのホストの追加

Red Hat Advanced Cluster Management for Kubernetes コンソールを使用してインフラストラクチャー環境にホストを追加します。ホストを追加すると、クラスターの作成時に設定済みホストを簡単に選択できます。

以下の手順を実行して、新規スポットを追加します。

- Red Hat Advanced Cluster Management ナビゲーションで Infrastructure > Infrastructure environments に移動します。

- ホストを追加するインフラストラクチャー環境を選択して、その設定を表示します。

- ホスト タブを選択して、その環境にすでに追加されているホストを表示します。利用可能なホストが表に表示されるまでに数分かかる場合があります。

- ホストを追加 を選択して、ホストをインフラストラクチャー環境に追加します。

- Discovery ISO または Baseboard Management Controller(BMC) を選択して、ホストの情報を入力します。

Discovery ISO オプションを選択した場合は、以下の手順を実行します。

- コンソールで提供されるコマンドをコピーして ISO をダウンロードするか、Download Discovery ISO を選択します。

- ブート可能なデバイスで以下のコマンドを実行し、各ホストを起動します。

- セキュリティーを強化する場合は、検出された各ホストに対して Approve host を選択する必要があります。この追加手順では、ISO ファイルが変更されたり、アクセス権のないユーザーにより実行された場合に備えて保護します。

-

localhostに指定されたホスト名を一意の名前に変更します。

Baseboard Management Controller(BMC) オプションを選択した場合は、以下の手順を実行します。

注記: ホストを追加する BMC オプションは、ハブクラスターがベアメタルプラットフォームで実行されている場合にのみ使用できます。

- ホストの BMC の接続詳細を追加します。

ホストの追加 を選択して、ブートプロセスを開始します。ホストは、検出 ISO イメージを使用して自動的に起動され、起動時にホストの一覧に追加されます。

BMC オプションを使用してホストを追加すると、ホストは自動的に承認されます。

このインフラストラクチャー環境にオンプレミスクラスターを作成できるようになりました。クラスター作成の詳細は、Creating a cluster in an on-premises environment を参照してください。

1.7. クラスターの作成

Red Hat Advanced Cluster Management for Kubernetes を使用した、クラウドプロバイダー全体にクラスターを作成する方法を説明します。

1.7.1. クラスター作成時の追加のマニフェストの設定

追加の Kubernetes リソースマニフェストは、クラスター作成のインストールプロセス中に設定できます。これは、ネットワークの設定やロードバランサーの設定など、シナリオの追加マニフェストを設定する必要がある場合に役立ちます。

クラスターを作成する前に、追加のリソースマニフェストが含まれる ConfigMap を指定する ClusterDeployment リソースへの参照を追加する必要があります。

注記: ClusterDeployment リソースと ConfigMap は同じ namespace にある必要があります。以下の例で、どのような内容かを紹介しています。

リソースマニフェストを含む ConfigMap

ConfigMapリソースが別のマニフェストが含まれるConfigMap。リソースマニフェストのConfigMapには、data.<resource_name>\.yamlパターンに追加されたリソース設定が指定されたキーを複数含めることができます。kind: ConfigMap apiVersion: v1 metadata: name: <my-baremetal-cluster-install-manifests> namespace: <mynamespace> data: 99_metal3-config.yaml: | kind: ConfigMap apiVersion: v1 metadata: name: metal3-config namespace: openshift-machine-api data: http_port: "6180" provisioning_interface: "enp1s0" provisioning_ip: "172.00.0.3/24" dhcp_range: "172.00.0.10,172.00.0.100" deploy_kernel_url: "http://172.00.0.3:6180/images/ironic-python-agent.kernel" deploy_ramdisk_url: "http://172.00.0.3:6180/images/ironic-python-agent.initramfs" ironic_endpoint: "http://172.00.0.3:6385/v1/" ironic_inspector_endpoint: "http://172.00.0.3:5150/v1/" cache_url: "http://192.168.111.1/images" rhcos_image_url: "https://releases-art-rhcos.svc.ci.openshift.org/art/storage/releases/rhcos-4.3/43.81.201911192044.0/x86_64/rhcos-43.81.201911192044.0-openstack.x86_64.qcow2.gz"リソースマニフェスト

ConfigMapが参照される ClusterDeploymentリソースマニフェスト

ConfigMapはspec.provisioning.manifestsConfigMapRefで参照されます。apiVersion: hive.openshift.io/v1 kind: ClusterDeployment metadata: name: <my-baremetal-cluster> namespace: <mynamespace> annotations: hive.openshift.io/try-install-once: "true" spec: baseDomain: test.example.com clusterName: <my-baremetal-cluster> controlPlaneConfig: servingCertificates: {} platform: baremetal: libvirtSSHPrivateKeySecretRef: name: provisioning-host-ssh-private-key provisioning: installConfigSecretRef: name: <my-baremetal-cluster-install-config> sshPrivateKeySecretRef: name: <my-baremetal-hosts-ssh-private-key> manifestsConfigMapRef: name: <my-baremetal-cluster-install-manifests> imageSetRef: name: <my-clusterimageset> sshKnownHosts: - "10.1.8.90 ecdsa-sha2-nistp256 AAAAE2VjZHNhLXvVVVKUYVkuyvkuygkuyTCYTytfkufTYAAAAIbmlzdHAyNTYAAABBBKWjJRzeUVuZs4yxSy4eu45xiANFIIbwE3e1aPzGD58x/NX7Yf+S8eFKq4RrsfSaK2hVJyJjvVIhUsU9z2sBJP8=" pullSecretRef: name: <my-baremetal-cluster-pull-secret>

1.7.2. Amazon Web Services でのクラスターの作成

Red Hat Advanced Cluster Management for Kubernetes コンソールを使用して、Amazon Web Services (AWS) で Red Hat OpenShift Container Platform クラスターを作成できます。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターを作成する場合、このプロセスの詳細について、OpenShift Container Platform ドキュメントの AWS へのインストール を参照してください。

1.7.2.1. 前提条件

AWS でクラスターを作成する前に、以下の前提条件を満たす必要があります。

- Red Hat Advanced Cluster Management for Kubernetes のハブクラスターをデプロイしている。

- Amazon Web Services で Kubernetes クラスターを作成できるようにする Red Hat Advanced Cluster Management for Kubernetes ハブクラスターにインターネットアクセスがある。

- AWS 認証情報。詳細は、Amazon Web Services の認証情報の作成 を参照してください。

- AWS で設定されたドメイン。ドメインの設定方法は、AWS アカウントの設定 を参照してください。

- ユーザー名、パスワード、アクセスキー ID およびシークレットアクセスキーなど、Amazon Web Services (AWS) のログイン認証情報。Understanding and getting your AWS credentials を参照してください。

- OpenShift Container Platform イメージプルシークレット。イメージプルシークレットの使用 を参照してください。

注記: クラウドプロバイダーのアクセスキーを変更する場合は、プロビジョニングしたクラスターアクセスキーを手動で更新する必要があります。詳細は、既知の問題の プロビジョニングしたクラスターのシークレットの自動更新はサポートされない を参照してください。

1.7.2.2. コンソールを使用したクラスターの作成

Red Hat Advanced Cluster Management for Kubernetes コンソールからクラスターを作成するには、以下の手順を実行します。

- ナビゲーションメニューから Infrastructure > Clusters に移動します。

Clusters ページで、Create cluster をクリックします。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、ハブクラスターへのターゲットマネージドクラスターのインポート の手順を参照してください。

- インフラストラクチャープロバイダー用の Kubernetes ディストリビューションおよび Amazon Web Services を選択します。残りの手順は、選択した内容により異なります。

- 一覧で利用可能な認証情報から、お使いのインフラストラクチャープロバイダーの認証情報を選択します。設定されていない場合や、新たに設定する場合は、Add credential を参照してください。認証情報の作成に関する詳細は、Amazon Web Services の認証情報の作成 を参照してください。

クラスターの詳細を追加します。

クラスターの名前を入力します。この名前はクラスターのホスト名で使用されます。

ヒント: コンソールに情報を入力する時に

yamlコンテンツの更新内容を表示するには、YAML を ON に切り替えるように設定します。-

クラスターセットを既存のクラスターセットに追加する場合は、クラスターセット を 1 つ指定します。クラスターの作成時に

cluster-admin権限がない場合は、クラスターを作成するclusterset-adminパーミッションがあるクラスターセットを選択する必要があります。クラスターセットを選択しないと、クラスターの作成には失敗します。選択するクラスターセットが存在しない場合は、クラスター管理者に連絡して、クラスターセットへのclusterset-adminパーミッションを受け取ってください。 - AWS アカウントに設定した Base DNS domain 情報を指定します。選択した認証情報にベースドメインが紐付けされている場合は、その値がこのフィールドに設定されます。値は、上書きすると変更できます。詳細は、AWS アカウントの設定 を参照してください。この名前はクラスターのホスト名で使用されます。

- クラスターに使用する リリースイメージ を指定します。このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージへの url を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。

- クラスターに関連付ける 追加のラベル を追加します。これらのラベルは、クラスターを特定し、検索結果を絞り込むのに役立ちます。

コントロールプレーンプールに関する詳細を入力します。コントロールプレーンプールには、クラスター向けに作成されたコントロールプレーンノードが 3 つあります。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。オプションの情報には以下のフィールドが含まれます。

- コントロールプレーンプールを実行する ゾーン を指定します。より分散されているコントロールプレーンノードグループでは、リージョンで複数のゾーンを選択できます。ゾーンが近くにある場合はパフォーマンスの速度が向上しますが、ゾーンの距離が離れると、より分散されます。

- コントロールプレーンノードのインスタンスタイプを指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。デフォルト値は mx5.xlarge - 4 vCPU, 16 GiB RAM - General Purpose です。

- Root ストレージ の割り当てを入力します。デフォルト値は、ルートストレージ 100 GiB です。

ワーカープールに関する情報を入力します。ワーカープールにワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。オプションの情報には以下のフィールドが含まれます。

- ワーカープールの名前を追加します。

- ワーカープールを実行する ゾーン を指定します。より分散されているノードグループでは、リージョンで複数のゾーンを選択できます。ゾーンが近くにある場合はパフォーマンスの速度が向上しますが、ゾーンの距離が離れると、より分散されます。

- ワーカープールの インスタンスタイプ を指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。デフォルト値は mx5.xlarge - 4 vCPU, 16 GiB RAM - General Purpose です。

- ワーカープールの Node count を入力します。ワーカープールを定義する場合にこの設定は必須です。

Root ストレージ の割り当てを入力します。デフォルト値は、ルートストレージ 100 GiB です。ワーカープールを定義する場合にこの設定は必須です。

Add worker pool をクリックして追加のワーカープールを定義できます。

クラスターのネットワーク情報を入力します。この情報は必須です。IPv6 を使用するには、複数のネットワークが必要です。

-

ネットワークタイプ を選択します。デフォルト値は

OpenShiftSDNです。IPv6 を使用するには、OVNKubernetes の設定は必須です。 -

Cluster network CIDR を選択します。これは、Pod IP アドレスに使用できる IP アドレスの数およびリストです。このブロックは他のネットワークブロックと重複できません。デフォルト値は

10.128.0.0/14です。 -

ネットワークホストの接頭辞 を指定します。これにより、各ノードにサブネット接頭辞の長さを設定します。デフォルト値は

23です。 -

サービスネットワーク CIDR でサービスの IP アドレスのブロックを指定します。このブロックは他のネットワークブロックと重複できません。デフォルト値は

172.30.0.0/16です。 マシン CIDR で OpenShift Container Platform ホストで使用される IP アドレスのブロックを指定します。このブロックは他のネットワークブロックと重複できません。デフォルト値は

10.0.0.0/16です。Add network をクリックして、追加のネットワークを追加できます。IPv6 アドレスを使用している場合は、複数のネットワークが必要です。

-

ネットワークタイプ を選択します。デフォルト値は

- プロキシーを有効にする場合は、プロキシー情報を追加します。

クラスターのインストールまたはアップグレードの前後に実行する Ansible Automation template (任意) を追加します。

Add automation template をクリックしてテンプレートを作成できます。

情報を確認し、必要に応じてカスタマイズします。

-

YAML スライダーを On にクリックし、パネルに

install-config.yamlファイルの内容を表示します。 - YAML ファイルをカスタム設定で編集します。

-

YAML スライダーを On にクリックし、パネルに

Create を選択してクラスターを作成します。

注記: クラスターのインポートには、クラスターの詳細で提示された

kubectlコマンドを実行する必要はありません。クラスターを作成すると、Red Hat Advanced Cluster Management で管理されるように自動的に設定されます。

1.7.2.3. クラスターへのアクセス

Red Hat Advanced Cluster Management for Kubernetes で管理されるクラスターにアクセスするには、以下の手順を実行します。

- Red Hat Advanced Cluster Management ナビゲーションメニューで Infrastructure > Clusters に移動します。

- 作成したクラスターまたはアクセスするクラスターの名前を選択します。クラスターの詳細が表示されます。

- Reveal credentials を選択し、クラスターのユーザー名およびパスワードを表示します。クラスターにログインする際に使用するため、この値を書き留めてください。

- クラスターにリンクする Console URL を選択します。

- 手順 3 で確認したユーザー ID およびパスワードを使用して、クラスターにログインします。

1.7.3. Microsoft Azure でのクラスターの作成

Red Hat Advanced Cluster Management for Kubernetes コンソールを使用して、Microsoft Azure または Microsoft Azure Government で Red Hat OpenShift Container Platform クラスターをデプロイできます。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターを作成する場合、このプロセスの詳細について、OpenShift Container Platform ドキュメントの Azure へのインストール を参照してください。

1.7.3.1. 前提条件

Azure でクラスターを作成する前に、以下の前提条件を満たす必要があります。

- Red Hat Advanced Cluster Management for Kubernetes のハブクラスターをデプロイしている。

- Azure または Azure Government で Kubernetes クラスターを作成できるようにする Red Hat Advanced Cluster Management for Kubernetes ハブクラスターでのインターネットアクセスがある。

Azure 認証情報。

詳細は、Microsoft Azure の認証情報の作成 を参照してください。

Azure または Azure Government で設定されたドメイン。

ドメイン設定の方法は、Configuring a custom domain name for an Azure cloud service を参照してください。

- ユーザー名とパスワードなどの Azure ログイン認証情報。Microsoft Azure Portal を参照してください。

clientId、clientSecret、tenantIdなどの Azure サービスプリンシパル。azure.microsoft.com を参照してください。

OpenShift Container Platform イメージプルシークレット。

イメージプルシークレットの使用 を参照してください。

注記: クラウドプロバイダーのアクセスキーを変更する場合は、プロビジョニングしたクラスターアクセスキーを手動で更新する必要があります。詳細は、既知の問題の プロビジョニングしたクラスターのシークレットの自動更新はサポートされない を参照してください。

1.7.3.2. コンソールを使用したクラスターの作成

Red Hat Advanced Cluster Management for Kubernetes コンソールからクラスターを作成するには、以下の手順を実行します。

- ナビゲーションメニューから Infrastructure > Clusters に移動します。

Clusters ページで、Create cluster をクリックします。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、ハブクラスターへのターゲットマネージドクラスターのインポート の手順を参照してください。

- インフラストラクチャープロバイダーに Kubernetes ディストリビューションおよび Microsoft Azure を選択します。残りの手順は、選択した内容により異なります。

- 一覧で利用可能な認証情報から、お使いのインフラストラクチャープロバイダーの認証情報を選択します。設定されていない場合や、新たに設定する場合は、Add credential を参照してください。認証情報の作成に関する詳細は、Microsoft Azure の認証情報の作成 を参照してください。

クラスターの詳細を追加します。

クラスターの名前を入力します。この名前はクラスターのホスト名で使用されます。

ヒント: コンソールに情報を入力する時に

yamlコンテンツの更新内容を表示するには、YAML を ON に切り替えるように設定します。-

クラスターセットを既存のクラスターセットに追加する場合は、クラスターセット を 1 つ指定します。クラスターの作成時に

cluster-admin権限がない場合は、クラスターを作成するclusterset-adminパーミッションがあるクラスターセットを選択する必要があります。クラスターセットを選択しないと、クラスターの作成には失敗します。選択するクラスターセットが存在しない場合は、クラスター管理者に連絡して、クラスターセットへのclusterset-adminパーミッションを受け取ってください。 - Azure アカウントに設定した Base DNS domain 情報を指定します。選択した認証情報にベースドメインが紐付けされている場合は、その値がこのフィールドに設定されます。値は、上書きすると変更できます。詳細は、Configuring a custom domain name for an Azure cloud service を参照してください。この名前はクラスターのホスト名で使用されます。

- クラスターに使用する リリースイメージ を指定します。このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージの URL を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。

- クラスターに関連付ける 追加のラベル を追加します。これらのラベルは、クラスターを特定し、検索結果を絞り込むのに役立ちます。

コントロールプレーンプールに関する詳細を入力します。コントロールプレーンプールには、クラスター向けに作成されたコントロールプレーンノードが 3 つあります。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。オプションの情報には以下のフィールドが含まれます。

- コントロールプレーンプールを実行する リージョン を指定します。より分散されているコントロールプレーンノードグループでは、リージョンで複数のゾーンを選択できます。ゾーンが近くにある場合はパフォーマンスの速度が向上しますが、ゾーンの距離が離れると、より分散されます。

- コントロールプレーンノードのインスタンスタイプを指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。デフォルト値は、Standard_D4s_v3 - 4 vCPU, 16 GiB RAM - General Purpose です。

- Root ストレージ の割り当てを入力します。デフォルト値は、ルートストレージ 128 GiB です。

ワーカープールに関する情報を入力します。ワーカープールにワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。オプションの情報には以下のフィールドが含まれます。

- ワーカープールの名前を追加します。

- ワーカープールを実行する ゾーン を指定します。より分散されているノードグループでは、リージョンで複数のゾーンを選択できます。ゾーンが近くにある場合はパフォーマンスの速度が向上しますが、ゾーンの距離が離れると、より分散されます。

- ワーカープールの インスタンスタイプ を指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。デフォルト値は Standard_D2s_v3 - 2 vCPU, 8 GiB - General Purpose です。

- ワーカープールの Node count を入力します。ワーカープールを定義する場合にこの設定は必須です。

Root ストレージ の割り当てを入力します。デフォルト値は、ルートストレージ 128 GiB です。ワーカープールを定義する場合にこの設定は必須です。

Add worker pool をクリックして追加のワーカープールを定義できます。

クラスターのネットワーク情報を入力します。この情報は必須です。IPv6 を使用するには、複数のネットワークが必要です。

-

ネットワークタイプ を選択します。デフォルト値は

OpenShiftSDNです。IPv6 を使用するには、OVNKubernetes の設定は必須です。 -

Cluster network CIDR を選択します。これは、Pod IP アドレスに使用できる IP アドレスの数およびリストです。このブロックは他のネットワークブロックと重複できません。デフォルト値は

10.128.0.0/14です。 -

ネットワークホストの接頭辞 を指定します。これにより、各ノードにサブネット接頭辞の長さを設定します。デフォルト値は

23です。 -

サービスネットワーク CIDR でサービスの IP アドレスのブロックを指定します。このブロックは他のネットワークブロックと重複できません。デフォルト値は

172.30.0.0/16です。 マシン CIDR で OpenShift Container Platform ホストで使用される IP アドレスのブロックを指定します。このブロックは他のネットワークブロックと重複できません。デフォルト値は

10.0.0.0/16です。Add network をクリックして、追加のネットワークを追加できます。IPv6 アドレスを使用している場合は、複数のネットワークが必要です。

-

ネットワークタイプ を選択します。デフォルト値は

- プロキシーを有効にする場合は、プロキシー情報を追加します。

クラスターのインストールまたはアップグレードの前後に実行する Ansible Automation template (任意) を追加します。

Add automation template をクリックしてテンプレートを作成できます。

情報を確認し、必要に応じてカスタマイズします。

-

YAML スライダーを On にクリックし、パネルに

install-config.yamlファイルの内容を表示します。 - YAML ファイルをカスタム設定で編集します。

-

YAML スライダーを On にクリックし、パネルに

Create を選択してクラスターを作成します。

注記: クラスターのインポートには、クラスターの詳細で提示された

kubectlコマンドを実行する必要はありません。クラスターを作成すると、Red Hat Advanced Cluster Management で管理されるように自動的に設定されます。

1.7.3.3. クラスターへのアクセス

Red Hat Advanced Cluster Management for Kubernetes で管理されるクラスターにアクセスするには、以下の手順を実行します。

- Red Hat Advanced Cluster Management for Kubernetes ナビゲーションメニューで Infrastructure > Clusters に移動します。

- 作成したクラスターまたはアクセスするクラスターの名前を選択します。クラスターの詳細が表示されます。

- Reveal credentials を選択し、クラスターのユーザー名およびパスワードを表示します。クラスターにログインする際に使用するため、この値を書き留めてください。

- クラスターにリンクする Console URL を選択します。

- 手順 3 で確認したユーザー ID およびパスワードを使用して、クラスターにログインします。

1.7.4. Google Cloud Platform でのクラスターの作成

Google Cloud Platform (GCP) で Red Hat OpenShift Container Platform クラスターを作成する手順に従います。Google Cloud Platform の詳細は、Google Cloud Platform を参照してください。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターを作成する場合、このプロセスの詳細について、OpenShift Container Platform ドキュメントの GCP へのインストール を参照してください。

1.7.4.1. 前提条件

GCP でクラスターを作成する前に、以下の前提条件を満たす必要があります。

- Red Hat Advanced Cluster Management for Kubernetes のハブクラスターをデプロイしている。

- GCP で Kubernetes クラスターを作成できるようにする Red Hat Advanced Cluster Management for Kubernetes ハブクラスターでのインターネットアクセスがある。

- GCP 認証情報。詳細は、Google Cloud Platform の認証情報の作成 を参照してください。

- GCP に設定されたドメイン。ドメインの設定方法は、Setting up a custom domain を参照してください。

- ユーザー名とパスワードなどの GCP ログイン認証情報。

- OpenShift Container Platform イメージプルシークレット。イメージプルシークレットの使用 を参照してください。

注記: クラウドプロバイダーのアクセスキーを変更する場合は、プロビジョニングしたクラスターアクセスキーを手動で更新する必要があります。詳細は、既知の問題の プロビジョニングしたクラスターのシークレットの自動更新はサポートされない を参照してください。

1.7.4.2. コンソールを使用したクラスターの作成

Red Hat Advanced Cluster Management for Kubernetes コンソールからクラスターを作成するには、以下の手順を実行します。

- ナビゲーションメニューから Infrastructure > Clusters に移動します。

Clusters ページで、Create Cluster タブを選択します。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、ハブクラスターへのターゲットマネージドクラスターのインポート の手順を参照してください。

- インフラストラクチャープロバイダーに、Kubernetes ディストリビューションおよび Google Cloud を選択します。残りの手順は、選択した内容により異なります。

- 一覧で利用可能な認証情報からお使いの認証情報を選択します。設定されていない場合や、新たに設定する場合は、Add credential を参照してください。認証情報の作成に関する詳細は、Google Cloud Platform の認証情報の作成 を参照してください。

クラスターの詳細を追加します。

クラスターの名前を入力します。この名前はクラスターのホスト名で使用されます。GCP クラスターの命名に適用される制限がいくつかあります。この制限には、名前を

googで開始しないことや、名前にgoogleに類似する文字および数字のグループが含まれないことなどがあります。制限の完全な一覧は、Bucket naming guidelines を参照してください。ヒント: コンソールに情報を入力する時に

yamlコンテンツの更新内容を表示するには、YAML を ON に切り替えるように設定します。-

クラスターセットを既存のクラスターセットに追加する場合は、クラスターセット を 1 つ指定します。クラスターの作成時に

cluster-admin権限がない場合は、クラスターを作成するclusterset-adminパーミッションがあるクラスターセットを選択する必要があります。クラスターセットを選択しないと、クラスターの作成には失敗します。選択するクラスターセットが存在しない場合は、クラスター管理者に連絡して、クラスターセットへのclusterset-adminパーミッションを受け取ってください。 - GCP アカウントに設定した Base DNS domain 情報を指定します。選択した認証情報にベースドメインが紐付けされている場合は、その値がこのフィールドに設定されます。値は、上書きすると変更できます。この名前はクラスターのホスト名で使用されます。詳細は、Setting up a custom domain を参照してください。

- クラスターに使用する リリースイメージ を指定します。このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージへの url を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。

- クラスターに関連付ける 追加のラベル を追加します。これらのラベルは、クラスターを特定し、検索結果を絞り込むのに役立ちます。

コントロールプレーンプールに関する詳細を入力します。コントロールプレーンプールには、クラスター向けに作成されたコントロールプレーンノードが 3 つあります。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。オプションの情報には以下のフィールドが含まれます。

- コントロールプレーンプールを実行する リージョン を指定します。リージョンが近くにある場合はパフォーマンスの速度が向上しますが、リージョンの距離が離れると、より分散されます。

- コントロールプレーンノードのインスタンスタイプを指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。デフォルト値は、n1-standard-1 - n1-standard-1 1 vCPU - General Purpose です。

ワーカープールに関する情報を入力します。ワーカープールにワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。オプションの情報には以下のフィールドが含まれます。

- ワーカープールの名前を追加します。

- ワーカープールの インスタンスタイプ を指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。デフォルト値は、n1-standard-4 - 4 vCPU 15 GiB RAM - General Purpose です。

ワーカープールの Node count を入力します。ワーカープールを定義する場合にこの設定は必須です。

Add worker pool をクリックして追加のワーカープールを定義できます。

クラスターのネットワーク情報を入力します。この情報は必須です。IPv6 を使用するには、複数のネットワークが必要です。

-

ネットワークタイプ を選択します。デフォルト値は

OpenShiftSDNです。IPv6 を使用するには、OVNKubernetes の設定は必須です。 -

Cluster network CIDR を選択します。これは、Pod IP アドレスに使用できる IP アドレスの数およびリストです。このブロックは他のネットワークブロックと重複できません。デフォルト値は

10.128.0.0/14です。 -

ネットワークホストの接頭辞 を指定します。これにより、各ノードにサブネット接頭辞の長さを設定します。デフォルト値は

23です。 -

サービスネットワーク CIDR でサービスの IP アドレスのブロックを指定します。このブロックは他のネットワークブロックと重複できません。デフォルト値は

172.30.0.0/16です。 マシン CIDR で OpenShift Container Platform ホストで使用される IP アドレスのブロックを指定します。このブロックは他のネットワークブロックと重複できません。デフォルト値は

10.0.0.0/16です。Add network をクリックして、追加のネットワークを追加できます。IPv6 アドレスを使用している場合は、複数のネットワークが必要です。

-

ネットワークタイプ を選択します。デフォルト値は

- プロキシーを有効にする場合は、プロキシー情報を追加します。

クラスターのインストールまたはアップグレードの前後に実行する Ansible Automation template (任意) を追加します。

Add automation template をクリックしてテンプレートを作成できます。

情報を確認し、必要に応じてカスタマイズします。

-

YAML スライダーを On にクリックし、パネルに

install-config.yamlファイルの内容を表示します。 - YAML ファイルをカスタム設定で編集します。

-

YAML スライダーを On にクリックし、パネルに

Create を選択してクラスターを作成します。

注記: クラスターのインポートには、クラスターの詳細で提示された

kubectlコマンドを実行する必要はありません。クラスターを作成すると、Red Hat Advanced Cluster Management で管理されるように自動的に設定されます。

1.7.4.3. クラスターへのアクセス

Red Hat Advanced Cluster Management for Kubernetes で管理されるクラスターにアクセスするには、以下の手順を実行します。

- Red Hat Advanced Cluster Management for Kubernetes ナビゲーションメニューで Infrastructure > Clusters に移動します。

- 作成したクラスターまたはアクセスするクラスターの名前を選択します。クラスターの詳細が表示されます。

- Reveal credentials を選択し、クラスターのユーザー名およびパスワードを表示します。クラスターにログインする際に使用するため、この値を書き留めてください。

- クラスターにリンクする Console URL を選択します。

- 手順 3 で確認したユーザー ID およびパスワードを使用して、クラスターにログインします。

1.7.5. VMware vSphere でのクラスターの作成

Red Hat Advanced Cluster Management for Kubernetes コンソールを使用して、VMware vSphere で Red Hat OpenShift Container Platform クラスターをデプロイできます。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターを作成する場合、このプロセスの詳細について、OpenShift Container Platform ドキュメントの vSphere へのインストール を参照してください。

1.7.5.1. 前提条件

vSphere でクラスターを作成する前に、以下の前提条件を満たす必要があります。

- OpenShift Container Platform バージョン 4.6 以降に Red Hat Advanced Cluster Management ハブクラスターをデプロイしている。

- vSphere で Kubernetes クラスターを作成できるように Red Hat Advanced Cluster Management ハブクラスターでのインターネットアクセスがある。

- vSphere 認証情報。詳細は、VMware vSphere での認証情報の作成 を参照してください。

- OpenShift Container Platform イメージプルシークレット。イメージプルシークレットの使用 を参照してください。

デプロイする VMware インスタンスについての以下の情報。

- API および Ingress インスタンスに必要な静的 IP アドレス。

以下の DNS レコード。

-

api.<cluster_name>.<base_domain>。静的 API VIP を参照する必要があります。 -

*.apps.<cluster_name>.<base_domain>。Ingress VIP の静的 IP アドレスを参照する必要があります。

-

1.7.5.2. コンソールを使用したクラスターの作成

Red Hat Advanced Cluster Management コンソールからクラスターを作成するには、以下の手順を実行します。

- ナビゲーションメニューから Infrastructure > Clusters に移動します。

Clusters ページで、Create cluster をクリックします。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、ハブクラスターへのターゲットマネージドクラスターのインポート の手順を参照してください。

- インフラストラクチャープロバイダーに Kubernetes ディストリビューションおよび VMware vSphere を選択します。残りの手順は、選択した内容により異なります。

- 一覧で利用可能な認証情報から、お使いのインフラストラクチャープロバイダーの認証情報を選択します。設定されていない場合や、新たに設定する場合は、Add credential を参照してください。認証情報の作成に関する詳細は、VMware vSphere の認証情報の作成 を参照してください。

クラスターの詳細を追加します。

クラスターの名前を入力します。値は、認証情報の要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。この名前はクラスターのホスト名で使用されます。

ヒント: コンソールに情報を入力する時に

yamlコンテンツの更新内容を表示するには、YAML を ON に切り替えるように設定します。-

クラスターセットを既存のクラスターセットに追加する場合は、クラスターセット を 1 つ指定します。クラスターの作成時に

cluster-admin権限がない場合は、クラスターを作成するclusterset-adminパーミッションがあるクラスターセットを選択する必要があります。クラスターセットを選択しないと、クラスターの作成には失敗します。選択するクラスターセットが存在しない場合は、クラスター管理者に連絡して、クラスターセットへのclusterset-adminパーミッションを受け取ってください。 - VMware vSphere アカウントに設定した Base DNS domain 情報を指定します。値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。この名前はクラスターのホスト名で使用されます。選択した認証情報にベースドメインが紐付けされている場合は、その値がこのフィールドに設定されます。値は、上書きすると変更できます。詳細は、AWS アカウントの設定 を参照してください。この名前はクラスターのホスト名で使用されます。

クラスターに使用する リリースイメージ を指定します。このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージへの url を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。

注記: OpenShift Container Platform バージョン 4.5.x 以降のリリースイメージのみがサポートされます。

- クラスターに関連付ける 追加のラベル を追加します。これらのラベルは、クラスターを特定し、検索結果を絞り込むのに役立ちます。

コントロールプレーンプールに関する詳細を入力します。コントロールプレーンプールには、クラスター向けに作成されたコントロールプレーンノードが 3 つあります。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。必要な情報には以下のフィールドが含まれます。

- クラスターに割り当てる ソケットごとにコア を 1 つ以上指定します。

- コントロールプレーンノードに割り当てる CPU の数を指定します。

- 割り当てる メモリー サイズを MB 単位で指定します。

- コントロールプレーンノード用に作成するディスクサイズを追加します。

ワーカープールに関する情報を入力します。ワーカープールにワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。情報には以下のフィールドが含まれます。

- ワーカープールの名前を追加します。

- クラスターに割り当てる ソケットごとにコア を 1 つ以上指定します。

- 割り当てる CPU の数を指定します。

- 割り当てる メモリー サイズを MB 単位で指定します。

- 作成する ディスクのサイズ (GiB 単位) を追加します。

ノード数 を追加し、クラスター内のワーカーノードの数を指定します。

Add worker pool をクリックして追加のワーカープールを定義できます。

クラスターネットワークオプションを設定します。この情報は必須です。IPv6 を使用するには、複数のネットワークが必要です。

- vSphere ネットワーク名: VMware vSphere ネットワーク名

API VIP: 内部 API 通信に使用する IP アドレス

注記: 値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。指定しない場合は、DNS を事前設定して

api.が正しく解決されるようにします。Ingress VIP: Ingress トラフィックに使用する IP アドレス

注記: 値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。指定しない場合は、DNS を事前設定して

test.apps.が正しく解決されるようにします。Add network をクリックして、追加のネットワークを追加できます。IPv6 アドレスを使用している場合は、複数のネットワークが必要です。

- プロキシーを有効にする場合は、プロキシー情報を追加します。

クラスターのインストールまたはアップグレードの前後に実行する Ansible Automation template (任意) を追加します。

Add automation template をクリックしてテンプレートを作成できます。

情報を確認し、必要に応じてカスタマイズします。

-

YAML スライダーを On にクリックし、パネルに

install-config.yamlファイルの内容を表示します。 - YAML ファイルをカスタム設定で編集します。

-

YAML スライダーを On にクリックし、パネルに

Create を選択してクラスターを作成します。

注記: クラスターのインポートには、クラスターの詳細で提示された

kubectlコマンドを実行する必要はありません。クラスターを作成すると、Red Hat Advanced Cluster Management で管理されるように自動的に設定されます。

1.7.5.3. クラスターへのアクセス

Red Hat Advanced Cluster Management で管理されるクラスターにアクセスするには、以下の手順を実行します。

- Red Hat Advanced Cluster Management ナビゲーションメニューで Infrastructure > Clusters に移動します。

- 作成したクラスターまたはアクセスするクラスターの名前を選択します。クラスターの詳細が表示されます。

- Reveal credentials を選択し、クラスターのユーザー名およびパスワードを表示します。クラスターへのログイン時にこの値を使用します。

- クラスターにリンクする Console URL を選択します。

- 手順 3 で確認したユーザー ID およびパスワードを使用して、クラスターにログインします。

1.7.6. Red Hat OpenStack Platform でのクラスターの作成

Red Hat Advanced Cluster Management for Kubernetes コンソールを使用して、Red Hat OpenStack Platform で Red Hat OpenShift Container Platform クラスターをデプロイできます。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターを作成する場合、このプロセスの詳細について、OpenShift Container Platform ドキュメントの OpenStack へのインストール を参照してください。

1.7.6.1. 前提条件

Red Hat OpenStack Platform でクラスターを作成する前に、以下の前提条件を満たす必要があります。

- OpenShift Container Platform バージョン 4.6 以降に Red Hat Advanced Cluster Management ハブクラスターをデプロイしている。

- Red Hat OpenStack Platform で Kubernetes クラスターを作成できるように Red Hat Advanced Cluster Management ハブクラスターでのインターネットアクセスがある。

- Red Hat OpenStack Platform の認証情報。詳細は、Red Hat OpenStack Platform の認証情報の作成 を参照してください。

- OpenShift Container Platform イメージプルシークレット。イメージプルシークレットの使用 を参照してください。

デプロイする Red Hat OpenStack Platform インスタンスについての以下の情報。

- コントロールプレーンとワーカーインスタンスのフレーバー名。たとえば、m1.xlarge です。

- Floating IP アドレスを提供する外部ネットワークのネットワーク名。

- API および Ingress インスタンスに必要な静的 IP アドレス。

以下の DNS レコード。

-

api.<cluster_name>.<base_domain>。API の Floating IP アドレスを参照する必要があります。 -

*.apps.<cluster_name>.<base_domain>。Ingreess の Floating IP アドレスを参照する必要があります。

-

1.7.6.2. コンソールを使用したクラスターの作成

Red Hat Advanced Cluster Management コンソールからクラスターを作成するには、以下の手順を実行します。

- ナビゲーションメニューから Infrastructure > Clusters に移動します。

Clusters ページで、Create cluster をクリックします。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、ハブクラスターへのターゲットマネージドクラスターのインポート の手順を参照してください。

- インフラストラクチャープロバイダーに Kubernetes ディストリビューションおよび Red Hat OpenStack を選択します。残りの手順は、選択した内容により異なります。

- 一覧で利用可能な認証情報から、お使いのインフラストラクチャープロバイダーの認証情報を選択します。設定されていない場合や、新たに設定する場合は、Add credential を参照してください。認証情報の作成に関する詳細は、Red Hat OpenStack Platform の認証情報の作成 を参照してください。

クラスターの詳細を追加します。

クラスターの名前を入力します。この名前はクラスターのホスト名で使用されます。名前には 15 文字以上指定できません。

注記: 値は、認証情報の要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。

ヒント: コンソールに情報を入力する時に

yamlコンテンツの更新内容を表示するには、YAML を ON に切り替えるように設定します。-

クラスターセットを既存のクラスターセットに追加する場合は、クラスターセット を 1 つ指定します。クラスターの作成時に

cluster-admin権限がない場合は、クラスターを作成するclusterset-adminパーミッションがあるクラスターセットを選択する必要があります。クラスターセットを選択しないと、クラスターの作成には失敗します。選択するクラスターセットが存在しない場合は、クラスター管理者に連絡して、クラスターセットへのclusterset-adminパーミッションを受け取ってください。 Red Hat OpenStack Platform アカウントに設定した Base DNS domain 情報を指定します。選択した認証情報にベースドメインが紐付けされている場合は、その値がこのフィールドに設定されます。値は、上書きすると変更できます。値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。

詳細は、Red Hat OpenStack Platform ドキュメントの ドメインの管理 を参照してください。この名前はクラスターのホスト名で使用されます。

クラスターに使用する リリースイメージ を指定します。このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージへの url を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。

注記: OpenShift Container Platform バージョン 4.6.x 以降のリリースイメージのみがサポートされます。

- クラスターに関連付ける 追加のラベル を追加します。これらのラベルは、クラスターを特定し、検索結果を絞り込むのに役立ちます。

コントロールプレーンノードの詳細を入力します。コントロールプレーンプールには、クラスター向けに作成されたコントロールプレーンノードが 3 つあります。コントロールプレーンノードは、クラスターアクティビティーの管理を共有します。オプションの情報には以下のフィールドが含まれます。

- コントロールプレーンノードのインスタンスタイプを指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。デフォルト値は m1.xlarge です。

ワーカープールに関する情報を入力します。ワーカープールに 1 つまたは複数のワーカーノードを作成し、クラスターのコンテナーワークロードを実行できます。ワーカーノードは、1 つのワーカープールに属することも、複数のワーカープールに分散させることもできます。ワーカーノードが指定されていない場合は、コントロールプレーンノードもワーカーノードとして機能します。オプションの情報には以下のフィールドが含まれます。

- ワーカープールの名前を追加します。

- ワーカープールの インスタンスタイプ を指定します。インスタンスの作成後にインスタンスのタイプやサイズを変更できます。デフォルト値は m1.xlarge です。

ワーカープールの Node count を入力します。ワーカープールを定義する場合にこの設定は必須です。

Add worker pool をクリックして追加のワーカープールを定義できます。

クラスターのネットワーク情報を入力します。IPv4 ネットワーク用に 1 つ以上のネットワークの値を指定する必要があります。IPv6 ネットワークの場合は、複数のネットワークを定義する必要があります。

- External network name に Red Hat OpenStack Platform の外部ネットワーク名を追加します。

- API Floating IP アドレス を追加します。既存の Floating IP アドレスは、OpenShift Container Platform API の外部ネットワーク用です。値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。

- Ingress Floating IP アドレスを追加します。既存の Floating IP アドレスは、Ingress ポートの外部ネットワーク上にあります。値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。既存の Floating IP アドレスは、Ingress ポートの外部ネットワーク上にあります。

- プライベートネットワークの名前解決をサポートする External DNS IP addresses を追加します。

-

デプロイする Pod ネットワークプロバイダープラグインを指定する ネットワークタイプ を指定します。使用できる値は

OVNKubernetesまたはOpenShiftSDNです。デフォルト値はOpenShiftSDNです。IPv6 を使用するには、OVNKubernetes の設定は必須です。 -

Cluster network CIDR を選択します。クラスターで使用するために予約される IP アドレスのグループです。クラスターに十分な数値を指定し、その範囲に他のクラスターの IP アドレスを追加しないようにします。デフォルト値は

10.128.0.0/14です。 -

Network host prefix を指定して、それぞれの個別ノードに割り当てるサブネット接頭辞の長さを設定します。デフォルト値は

23です。 -

サービスネットワーク CIDR でサービスの IP アドレスのブロックを指定します。このブロックは他のネットワークブロックと重複できません。デフォルト値は

172.30.0.0/16です。 マシン CIDR で OpenShift Container Platform ホストで使用される IP アドレスのブロックを指定します。このブロックは他のネットワークブロックと重複できません。デフォルト値は

10.0.0.0/16です。Add network をクリックして、追加のネットワークを追加できます。IPv6 アドレスを使用している場合は、複数のネットワークが必要です。

- プロキシーを有効にする場合は、プロキシー情報を追加します。

クラスターのインストールまたはアップグレードの前後に実行する Ansible Automation template (任意) を追加します。

Add automation template をクリックしてテンプレートを作成できます。

情報を確認し、必要に応じてカスタマイズします。

-

YAML スライダーを On にクリックし、パネルに

install-config.yamlファイルの内容を表示します。 - YAML ファイルをカスタム設定で編集します。

-

YAML スライダーを On にクリックし、パネルに

Create を選択してクラスターを作成します。

注記: クラスターのインポートには、クラスターの詳細で提示された

kubectlコマンドを実行する必要はありません。クラスターを作成すると、Red Hat Advanced Cluster Management で管理されるように自動的に設定されます。

1.7.6.3. クラスターへのアクセス

Red Hat Advanced Cluster Management で管理されるクラスターにアクセスするには、以下の手順を実行します。

- Red Hat Advanced Cluster Management ナビゲーションメニューで Infrastructure > Clusters に移動します。

- 作成したクラスターまたはアクセスするクラスターの名前を選択します。クラスターの詳細が表示されます。

- Reveal credentials を選択し、クラスターのユーザー名およびパスワードを表示します。クラスターへのログイン時にこの値を使用します。

- クラスターにリンクする Console URL を選択します。

- 手順 3 で確認したユーザー ID およびパスワードを使用して、クラスターにログインします。

1.7.7. ベアメタルでのクラスターの作成

Red Hat Advanced Cluster Management for Kubernetes コンソールを使用して、ベアメタル環境で Red Hat OpenShift Container Platform クラスターを作成できます。

クラスターを作成する場合、作成プロセスでは、Hive リソースを使用して OpenShift Container Platform インストーラーを使用します。この手順の完了後にクラスターを作成する場合、このプロセスの詳細について、OpenShift Container Platform ドキュメントの ベアメタルへのインストール を参照してください。

1.7.7.1. 前提条件

ベアメタル環境にクラスターを作成する前に、以下の前提条件を満たす必要があります。

- OpenShift Container Platform バージョン 4.6 以降に、Red Hat Advanced Cluster Management for Kubernetes ハブクラスターをデプロイしている。

- クラスターを作成するために必要なイメージを取得するための、Red Hat Advanced Cluster Management for Kubernetes ハブクラスターへのインターネットアクセス (接続済み)、あるいはインターネットへの接続がある内部またはミラーレジストリーへの接続 (非接続) がある。

- Hive クラスターの作成に使用されるブートストラップ仮想マシンを実行する一時的な外部 KVM ホスト。詳細は、プロビジョナーホストの準備 を参照してください。

- デプロイされた Red Hat Advanced Cluster Management for Kubernetes ハブクラスターが、プロビジョニングネットワークにルーティングできる。

- ベアメタルサーバーのログイン資格情報。これには、前の項目のブートストラップ仮想マシンからの libvirt URI、SSH 秘密鍵、および SSH の既知のホストのリストが含まれます。詳細は、OpenShift インストール環境の設定 について参照してください。

- 設定済みのベアメタルクレデンシャル。詳細は ベアメタルのクレデンシャルの作成 を参照してください。

- ユーザー名、パスワード、ベースボード管理コントローラー (BMC) アドレスなどのベアメタル環境のログイン認証情報。

- ベアメタルアセットが証明書の検証を有効にしている場合は、ベアメタルアセットを設定します。詳細は、ベアメタルアセットの作成および変更 を参照してください。

OpenShift Container Platform イメージプルシークレット。イメージプルシークレットの使用 を参照してください。

注記:

- ベアメタルアセット、ベアメタルのマネージドクラスター、および関連シークレットは同じ namespace に配置する必要があります。

- クラウドプロバイダーのアクセスキーを変更する場合は、プロビジョニングしたクラスターアクセスキーを手動で更新する必要があります。詳細は、既知の問題の プロビジョニングしたクラスターのシークレットの自動更新はサポートされない を参照してください。

1.7.7.2. コンソールを使用したクラスターの作成

Red Hat Advanced Cluster Management コンソールからクラスターを作成するには、以下の手順を実行します。

- ナビゲーションメニューから Infrastructure > Clusters に移動します。

Clusters ページで、Create cluster をクリックします。

注記: この手順では、クラスターを作成します。既存のクラスターをインポートする場合は、ハブクラスターへのターゲットマネージドクラスターのインポート の手順を参照してください。

- インフラストラクチャープロバイダーに Kubernetes ディストリビューションおよび Bare Metal を選択します。残りの手順は、選択した内容により異なります。

- 一覧で利用可能な認証情報からお使いの認証情報を選択します。設定されていない場合や、新たに設定する場合は、Add credential を参照してください。認証情報の作成に関する詳細は、ベアメタルの認証情報の作成 を参照してください。

クラスターの詳細を追加します。

クラスターの名前を入力します。ベアメタルクラスターの場合は、名前を任意で指定できません。この名前は、クラスター URL に関連付けられています。使用するクラスター名が DNS およびネットワーク設定と一致していることを確認します。

ヒント: コンソールに情報を入力する時に

yamlコンテンツの更新内容を表示するには、YAML を ON に切り替えるように設定します。-

クラスターセットを既存のクラスターセットに追加する場合は、クラスターセット を 1 つ指定します。クラスターの作成時に

cluster-admin権限がない場合は、クラスターを作成するclusterset-adminパーミッションがあるクラスターセットを選択する必要があります。クラスターセットを選択しないと、クラスターの作成には失敗します。選択するクラスターセットが存在しない場合は、クラスター管理者に連絡して、クラスターセットへのclusterset-adminパーミッションを受け取ってください。 - ベアメタルプロバイダーアカウントに設定した Base DNS domain 情報を指定します。プロバイダーのベースドメインは、Red Hat OpenShift Container Platform クラスターコンポーネントへのルートの作成に使用されます。これは、クラスタープロバイダーの DNS で Start of Authority (SOA) レコードとして設定されます。選択した認証情報にベースドメインが紐付けされている場合は、その値がこのフィールドに設定されます。値は上書きすると変更できますが、この設定はクラスターの作成後には変更できません。詳細は、OpenShift Container Platform ドキュメントの ベアメタルへのインストール を参照してください。この名前はクラスターのホスト名で使用されます。

- クラスターに使用する リリースイメージ を指定します。このリリースイメージで、クラスターの作成に使用される OpenShift Container Platform イメージのバージョンを特定します。使用するバージョンが利用可能な場合は、イメージの一覧からイメージを選択できます。標準イメージ以外のイメージを使用する場合は、使用するイメージの URL を入力できます。リリースイメージの詳細は、リリースイメージ を参照してください。

- クラスターに関連付ける 追加のラベル を追加します。これらのラベルは、クラスターを特定し、検索結果を絞り込むのに役立ちます。

認証情報に関連付けられたホスト一覧から、お使いのホストを選択します。ハイパーバイザーと同じブリッジネットワークにあるベアメタルアセットを 3 つ以上選択します。

ホストの一覧は、既存のベアメタルアセットからコンパイルされます。ベアメタルホストで最新のファームウェアを実行していることを確認してください。実行していないと、プロビジョニングが失敗する可能性があります。ベアメタルアセットを作成していない場合は、作成プロセスを続行する前に Import assets を選択して作成またはインポートを行うことができます。ベアメタルアセットの詳細は、ベアメタルアセットの作成および変更 を参照してください。Disable certificate verification を選択して要件を無視することができます。

クラスターネットワークオプションを設定します。以下の表では、ネットワークオプションとその説明をまとめています。

パラメーター 説明 必須またはオプション プロビジョニングネットワーク CIDR

プロビジョニングに使用するネットワークの CIDR。このサンプル形式は 172.30.0.0/16 です。

必須

プロビジョニングネットワークインターフェイス

プロビジョニングネットワークに接続されたコントロールプレーンノード上のネットワークインターフェイス名。

必須

プロビジョニングネットワークブリッジ

プロビジョニングネットワークに接続されているハイパーバイザーのブリッジ名。

必須

外部ネットワークブリッジ

外部ネットワークに接続されているハイパーバイザーのブリッジ名。

必須

API VIP

内部 API 通信に使用する仮想 IP。

api.<cluster_name>.<Base DNS domain>パスが正しく解決されるように、DNS は A/AAAA または CNAME レコードで事前設定する必要があります。必須

Ingress VIP

Ingress トラフィックに使用する仮想 IP。

*.apps.<cluster_name>.<Base DNS domain>パスが正しく解決されるように、DNS は A/AAAA または CNAME レコードで事前設定する必要があります。オプション

ネットワークタイプ

デプロイする Pod ネットワークプロバイダープラグイン。OpenShift Container Platform 4.3 でサポートされるのは、OpenShiftSDN プラグインのみです。OVNKubernetes プラグインは、OpenShift Container Platform 4.3、4.4、および 4.5 でテクノロジープレビューとしてご利用いただけます。通常、これは OpenShift Container Platform バージョン 4.6 以降で利用できます。OVNKubernetes は IPv6 と共に使用する必要があります。デフォルト値は

OpenShiftSDNです。必須

クラスターのネットワーク CIDR

Pod IP アドレスの割り当てに使用する IP アドレスのブロック。OpenShiftSDN ネットワークプラグインは複数のクラスターネットワークをサポートします。複数のクラスターネットワークのアドレスブロックには重複が許可されません。予想されるワークロードに適したサイズのアドレスプールを選択してください。デフォルト値は 10.128.0.0/14 です。

必須

ネットワークホストの接頭辞

それぞれの個別ノードに割り当てるサブネット接頭辞の長さ。たとえば、hostPrefix が 23 に設定される場合は、各ノードに指定の cidr から /23 サブネットが割り当てられます (510 (2^(32 - 23) - 2) Pod IP アドレスが許可されます)。デフォルトは 23 です。

必須

サービスネットワーク CIDR

サービスの IP アドレスのブロック。OpenShiftSDN が許可するのは serviceNetwork ブロック 1 つだけです。このアドレスは他のネットワークブロックと重複できません。デフォルト値は 172.30.0.0/16 です。

必須

マシン CIDR

OpenShift Container Platform ホストで使用される IP アドレスのブロック。このアドレスブロックは他のネットワークブロックと重複できません。デフォルト値は 10.0.0.0/16 です。

必須

Add network をクリックして、追加のネットワークを追加できます。IPv6 アドレスを使用している場合は、複数のネットワークが必要です。

- プロキシーを有効にする場合は、プロキシー情報を追加します。

クラスターのインストールまたはアップグレードの前後に実行する Ansible Automation template (任意) を追加します。

Add automation template をクリックしてテンプレートを作成できます。

情報を確認し、必要に応じてカスタマイズします。

-

YAML スライダーを On にクリックし、パネルに

install-config.yamlファイルの内容を表示します。 - YAML ファイルをカスタム設定で編集します。

-

YAML スライダーを On にクリックし、パネルに

Create を選択してクラスターを作成します。

注記: クラスターのインポートには、クラスターの詳細で提示された

kubectlコマンドを実行する必要はありません。クラスターを作成すると、Red Hat Advanced Cluster Management で管理されるように自動的に設定されます。

1.7.7.3. クラスターへのアクセス

Red Hat Advanced Cluster Management for Kubernetes で管理されるクラスターにアクセスするには、以下の手順を実行します。

- Red Hat Advanced Cluster Management for Kubernetes ナビゲーションメニューで Infrastructure > Clusters に移動します。

- 作成したクラスターまたはアクセスするクラスターの名前を選択します。クラスターの詳細が表示されます。

- Reveal credentials を選択し、クラスターのユーザー名およびパスワードを表示します。クラスターにログインする際に使用するため、この値を書き留めてください。

- クラスターにリンクする Console URL を選択します。

- 手順 3 で確認したユーザー ID およびパスワードを使用して、クラスターにログインします。

1.7.8. オンプレミス環境でのクラスターの作成 (テクノロジープレビュー)

Red Hat Advanced Cluster Management for Kubernetes コンソールを使用して、オンプレミスの Red Hat OpenShift Container Platform クラスターを作成できます。

注記: Red Hat Advanced Cluster Management のオンプレミスデプロイメントはテクノロジープレビュー機能ですが、OpenShift Container Platform バージョン 4.9 では、結果として生成される単一ノードの OpenShift(SNO) クラスターは、ベアメタルのデプロイメントに対してのみ完全にサポートされています。

1.7.8.1. 前提条件

オンプレミスの環境にクラスターを作成する前に、以下の前提条件を満たす必要があります。

- OpenShift Container Platform バージョン 4.9 以降に、Red Hat Advanced Cluster Management ハブクラスターをデプロイしておく。

- 設定済みのインフラストラクチャー環境に、設定済みホストを指定しておく。

- クラスターを作成するために必要なイメージを取得するための、Red Hat Advanced Cluster Management for Kubernetes ハブクラスターへのインターネットアクセス (接続済み)、あるいはインターネットへの接続がある内部またはミラーレジストリーへの接続 (非接続) がある。

- オンプレミス認証情報が設定されている。詳細は、Creating a credential for an on-premises environment を参照してください。

- OpenShift Container Platform イメージプルシークレット。イメージプルシークレットの使用 を参照してください。

1.7.8.2. コンソールを使用したクラスターの作成

Red Hat Advanced Cluster Management コンソールからクラスターを作成するには、以下の手順を実行します。

- ナビゲーションメニューから Infrastructure > Clusters に移動します。

- Clusters ページで、Create cluster をクリックします。

- インフラストラクチャープロバイダーに On-premises を選択します。残りの手順は、選択した内容により異なります。

- 一覧で利用可能な認証情報からお使いの認証情報を選択します。設定されていない場合や、新たに設定する場合は、Add credential を参照してください。認証情報の作成に関する詳細は、Creating a credential for an on-premises environment を参照してください。

クラスターの詳細を追加します。

クラスターの名前を入力します。

ヒント: コンソールに情報を入力する時に

yamlコンテンツの更新内容を表示するには、YAML を ON に切り替えるように設定します。-

クラスターセットを既存のクラスターセットに追加する場合は、クラスターセット を 1 つ指定します。クラスターの作成時に

cluster-admin権限がない場合は、クラスターを作成するclusterset-adminパーミッションがあるクラスターセットを選択する必要があります。クラスターセットを選択しないと、クラスターの作成には失敗します。選択するクラスターセットが存在しない場合は、クラスター管理者に連絡して、クラスターセットへのclusterset-adminパーミッションを受け取ってください。 - プロバイダーアカウントに設定した Base DNS domain 情報を指定します。プロバイダーのベースドメインは、Red Hat OpenShift Container Platform クラスターコンポーネントへのルートの作成に使用されます。これは、クラスタープロバイダーの DNS で Start of Authority (SOA) レコードとして設定されます。選択した認証情報にベースドメインが紐付けされている場合は、その値がこのフィールドに設定されます。値は上書きすると変更できますが、この設定はクラスターの作成後には変更できません。

- クラスターを SNO クラスターに指定する場合は、SNO オプションを選択します。SNO クラスターは、標準クラスターが作成する 3 つのノードではなく、1 つのノードだけを作成します。

- クラスターに関連付ける 追加のラベル を追加します。これらのラベルは、クラスターを特定し、検索結果を絞り込むのに役立ちます。

- クラスターの作成またはアップグレード時に実行する Automation テンプレートを設定します。

クラスターを確認し、保存します。

ヒント: この時点でクラスターを確認し、保存した後に、クラスターはドラフトクラスターとして保存されます。Clusters ページでクラスター名を選択すると、作成プロセスを閉じてプロセスを終了することができます。

独自にホストを選択するかどうか、またはそれらのホストを自動的に選択するかを選びます。ホストの数は、選択したノード数に基づいています。たとえば、SNO クラスターではホストが 1 つだけ必要ですが、標準の 3 ノードクラスターには 3 つのホストが必要です。

このクラスターの要件を満たす利用可能なホストの場所は、ホストの場所 の一覧に表示されます。ホストと高可用性設定の分散については、複数の場所を選択します。

-

ホストがバインディングを終了して

Boundステータスを表示したら、バインドされたホストのオプションの一覧からクラスターのサブネットを選択します。 以下の IP アドレスを追加します。

API VIP: 内部 API 通信に使用する IP アドレス

注記: 値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。指定しない場合は、DNS を事前設定して

api.が正しく解決されるようにします。Ingress VIP: Ingress トラフィックに使用する IP アドレス

注記: 値は、要件セクションに記載されている DNS レコードの作成に使用した名前と一致させる必要があります。指定しない場合は、DNS を事前設定して

test.apps.が正しく解決されるようにします。

- 情報を確認します。

- Create を選択してクラスターを作成します。

クラスターがインストールされています。Clusters ナビゲーションページで、インストールのステータスを表示できます。

1.7.8.3. クラスターへのアクセス

Red Hat Advanced Cluster Management で管理されるクラスターにアクセスするには、以下の手順を実行します。

- Red Hat Advanced Cluster Management ナビゲーションメニューで Infrastructure > Clusters に移動します。

- 作成したクラスターまたはアクセスするクラスターの名前を選択します。クラスターの詳細が表示されます。

- Reveal credentials を選択し、クラスターのユーザー名およびパスワードを表示します。これらの値をコピーして、クラスターにログイン時に使用します。

- クラスターにリンクする Console URL を選択します。

- 手順 3 で確認したユーザー ID およびパスワードを使用して、クラスターにログインします。

1.7.9. 作成されたクラスターの休止 (テクノロジープレビュー)

Red Hat Advanced Cluster Management for Kubernetes を使用して作成されたクラスターを休止し、リソースを節約できます。休止状態のクラスターに必要となるリソースは、実行中のものより少なくなるので、クラスターを休止状態にしたり、休止状態を解除したりすることで、プロバイダーのコストを削減できる可能性があります。この機能は、以下の環境の Red Hat Advanced Cluster Management で作成したクラスターにのみ該当します。

- Amazon Web Services

- Microsoft Azure

- Google Cloud Platform

1.7.9.1. コンソールを使用したクラスターの休止

Red Hat Advanced Cluster Management コンソールを使用して、Red Hat Advanced Cluster Management で作成したクラスターを休止するには、以下の手順を実行します。

- Red Hat Advanced Cluster Management ナビゲーションメニューで Infrastructure > Clusters に移動します。Manage clusters タブが選択されていることを確認します。

- 休止するクラスターを特定します。

- そのクラスターの Options メニューから Hibernate cluster を選択します。注記: Hibernate cluster オプションが利用できない場合には、クラスターを休止状態にすることはできません。これは、クラスターがインポートされており、Red Hat Advanced Cluster Management で作成されていない場合に、発生する可能性があります。

- 確認ダイアログボックスの Hibernate を選択して、クラスターを休止します。

Clusters ページのクラスターのステータスは、プロセスが完了すると Hibernating になります。

ヒント: Clusters ページで休止するするクラスターを選択し、Actions > Hibernate cluster を選択して、複数のクラスターを休止できます。

選択したクラスターが休止状態になりました。

1.7.9.2. CLI を使用したクラスターの休止

CLI を使用して、Red Hat Advanced Cluster Management が作成したクラスターを休止するには、以下の手順を実行します。

以下のコマンドを入力して、休止するクラスターの設定を編集します。

oc edit clusterdeployment <name-of-cluster> -n <namespace-of-cluster>

name-of-clusterは、休止するクラスター名に置き換えます。namespace-of-clusterは、休止するクラスターの namespace に置き換えます。-

spec.powerStateの値はHibernatingに変更します。 以下のコマンドを実行して、クラスターのステータスを表示します。

oc get clusterdeployment <name-of-cluster> -n <namespace-of-cluster> -o yaml

name-of-clusterは、休止するクラスター名に置き換えます。namespace-of-clusterは、休止するクラスターの namespace に置き換えます。クラスターを休止するプロセスが完了すると、クラスターのタイプの値は

type=Hibernatingになります。

選択したクラスターが休止状態になりました。

1.7.9.3. コンソールを使用して休止中のクラスターの通常操作を再開する手順

Red Hat Advanced Cluster Management コンソールを使用して、休止中のクラスターの通常操作を再開するには、以下の手順を実行します。

- Red Hat Advanced Cluster Management ナビゲーションメニューで Infrastructure > Clusters に移動します。Manage clusters タブが選択されていることを確認します。

- 休止状態で、再開させるクラスターを見つけます。

- クラスターの Options メニューから Resume cluster を選択します。

- 確認ダイアログボックスの Resume を選択して、クラスターの機能を再開します。

プロセスを完了すると、Clusters ページのクラスターのステータスは Ready になります。

ヒント: Clusters ページで、再開するクラスターを選択し、Actions > Resume cluster の順に選択して、複数のクラスターを再開できます。

選択したクラスターで通常の操作が再開されました。

1.7.9.4. CLI を使用して休止中のクラスターの通常操作を再開する手順

CLI を使用して、休止中のクラスターの通常操作を再開するには、以下の手順を実行します。

以下のコマンドを入力してクラスターの設定を編集します。

oc edit clusterdeployment <name-of-cluster> -n <namespace-of-cluster>

name-of-clusterは、休止するクラスター名に置き換えます。namespace-of-clusterは、休止するクラスターの namespace に置き換えます。-

spec.powerStateの値をRunningに変更します。 以下のコマンドを実行して、クラスターのステータスを表示します。

oc get clusterdeployment <name-of-cluster> -n <namespace-of-cluster> -o yaml

name-of-clusterは、休止するクラスター名に置き換えます。namespace-of-clusterは、休止するクラスターの namespace に置き換えます。クラスターの再開プロセスが完了すると、クラスターのタイプの値は

type=Runningになります。

選択したクラスターで通常の操作が再開されました。

1.8. ハブクラスターへのターゲットのマネージドクラスターのインポート

別の Kubernetes クラウドプロバイダーからクラスターをインポートできます。インポートすると、ターゲットクラスターは Red Hat Advanced Cluster Management for Kubernetes ハブクラスターのマネージドクラスターになります。指定されていない場合は、ハブクラスターとターゲットのマネージドクラスターにアクセスできる場所で、インポートタスクを実行します。

ハブクラスターは 他 のハブクラスターの管理はできず、自己管理のみが可能です。ハブクラスターは、自動的にインポートして自己管理できるように設定されています。ハブクラスターは手動でインポートする必要はありません。

ただし、ハブクラスターを削除して、もう一度インポートする場合は、local-cluster:true ラベルを追加する必要があります。

コンソールまたは CLI からのマネージドクラスターの設定は、以下の手順から選択します。

必要なユーザータイプまたはアクセスレベル: クラスター管理者

1.8.1. コンソールを使用した既存クラスターのインポート