ネットワークの設定および管理

ネットワークインターフェイス、ファイアウォール、および高度なネットワーク機能の管理

概要

- ボンディング、VLAN、ブリッジ、トンネル、およびその他のネットワークタイプを設定して、ホストをネットワークに接続できます。

- ローカルホストとネットワーク全体に対して、パフォーマンスが重要なファイアウォールを構築できます。REHL には、

firewalldサービス、nftablesフレームワーク、Express Data Path (XDP) などのパケットフィルタリングソフトウェアが含まれています。 - RHEL は、ポリシーベースのルーティングや Multipath TCP (MPTCP) などの高度なネットワーク機能もサポートします。

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

第1章 一貫したネットワークインターフェイス命名の実装

udev デバイスマネージャーは、Red Hat Enterprise Linux で一貫したデバイス命名を実装します。デバイスマネージャーは、さまざまな命名スキームをサポートしています。デフォルトでは、ファームウェア、トポロジー、および場所の情報に基づいて固定名を割り当てます。

一貫したデバイス命名を使用しない場合、Linux カーネルは固定の接頭辞とインデックスを組み合わせて名前をネットワークインターフェイスに割り当てます。カーネルがネットワークデバイスを初期化すると、インデックスが増加します。たとえば、eth0 は、起動時にプローブされる最初のイーサネットデバイスを表します。別のネットワークインターフェイスコントローラーをシステムに追加すると、再起動後にデバイスが異なる順序で初期化される可能性があるため、カーネルデバイス名の割り当てが一定でなくなります。その場合、カーネルはデバイスに別の名前を付けることがあります。

この問題を解決するために、udev は一貫したデバイス名を割り当てます。これには、次の利点があります。

- 再起動してもデバイス名が変わりません。

- ハードウェアを追加または削除しても、デバイス名が固定されたままになります。

- 不具合のあるハードウェアをシームレスに交換できます。

- ネットワークの命名はステートレスであり、明示的な設定ファイルは必要ありません。

通常、Red Hat は、一貫したデバイス命名が無効になっているシステムはサポートしていません。例外は、Red Hat ナレッジベースのソリューション記事 Is it safe to set net.ifnames=0 を参照してください。

1.1. udev デバイスマネージャーによるネットワークインターフェイスの名前変更の仕組み

ネットワークインターフェイスの一貫した命名スキームを実装するために、udev デバイスマネージャーは次のルールファイルを記載されている順番どおりに処理します。

オプション:

/usr/lib/udev/rules.d/60-net.rules/usr/lib/udev/rules.d/60-net.rulesファイルは、非推奨の/usr/lib/udev/rename_deviceヘルパーユーティリティーが/etc/sysconfig/network-scripts/ifcfg-*ファイルのHWADDRパラメーターを検索することを定義します。変数に設定した値がインターフェイスの MAC アドレスに一致すると、ヘルパーユーティリティーは、インターフェイスの名前を、ifcfgファイルのDEVICEパラメーターに設定した名前に変更します。システムがキーファイル形式の NetworkManager 接続プロファイルのみを使用する場合、

udevはこの手順をスキップします。Dell システムのみ:

/usr/lib/udev/rules.d/71-biosdevname.rulesこのファイルは、

biosdevnameパッケージがインストールされている場合にのみ存在します。このルールファイルは、前の手順でインターフェイスの名前が変更されていない場合に、biosdevnameユーティリティーが命名ポリシーに従ってインターフェイスの名前を変更することを定義します。注記biosdevnameは Dell システムにのみインストールして使用してください。/usr/lib/udev/rules.d/75-net-description.rulesこのファイルは、

udevがネットワークインターフェイスを検査し、udevの内部変数にプロパティーを設定する方法を定義します。これらの変数は、次のステップで/usr/lib/udev/rules.d/80-net-setup-link.rulesファイルによって処理されます。一部のプロパティーは未定義である場合があります。/usr/lib/udev/rules.d/80-net-setup-link.rulesこのファイルは

udevサービスのnet_setup_linkビルトインを呼び出します。udevは/usr/lib/systemd/network/99-default.linkファイルのNamePolicyパラメーターのポリシーの順序に基づいてインターフェイスの名前を変更します。詳細は、ネットワークインターフェイスの命名ポリシー を参照してください。どのポリシーも適用されない場合、

udevはインターフェイスの名前を変更しません。

1.2. ネットワークインターフェイスの命名ポリシー

デフォルトでは、udev デバイスマネージャーは /usr/lib/systemd/network/99-default.link ファイルを使用して、インターフェイスの名前を変更するときに適用するデバイス命名ポリシーを決定します。このファイルの NamePolicy パラメーターは、udev がどのポリシーをどの順序で使用するかを定義します。

NamePolicy=kernel database onboard slot path

NamePolicy=kernel database onboard slot path

次の表では、NamePolicy パラメーターで指定された最初に一致するポリシーに基づく、udev のさまざまなアクションを説明します。

| ポリシー | 説明 | 名前の例 |

|---|---|---|

| kernel |

デバイス名が予測可能であるとカーネルが通知した場合、 |

|

| database |

このポリシーは、 |

|

| onboard | デバイス名には、ファームウェアまたは BIOS が提供するオンボードデバイスのインデックス番号が含まれます。 |

|

| slot | デバイス名には、ファームウェアまたは BIOS が提供する PCI Express (PCIe) ホットプラグのスロットインデックス番号が含まれます。 |

|

| path | デバイス名には、ハードウェアのコネクターの物理的な場所が含まれます。 |

|

| mac | デバイス名には MAC アドレスが含まれます。デフォルトでは、Red Hat Enterprise Linux はこのポリシーを使用しませんが、管理者はこのポリシーを有効にすることができます。 |

|

1.3. ネットワークインターフェイスの命名スキーム

udev デバイスマネージャーは、デバイスドライバーが提供する一定のインターフェイス属性を使用して、一貫したデバイス名を生成します。

新しいバージョンの udev によってサービスが特定のインターフェイス名を作成する方法が変更された場合、Red Hat は、新しいスキームバージョンを追加し、システム上の systemd.net-naming-scheme(7) man ページに詳細を記載します。デフォルトでは、Red Hat Enterprise Linux (RHEL) 10 は、ユーザーが RHEL のそれ以降のマイナーバージョンをインストールまたは更新した場合でも、rhel-10.0 命名スキームを使用します。

デフォルト以外のスキームを使用する場合は、ネットワークインターフェイスの命名スキームを切り替える ことができます。

さまざまなデバイスタイプおよびプラットフォームの命名スキームの詳細は、システム上の systemd.net-naming-scheme(7) man ページを参照してください。

1.4. 別のネットワークインターフェイス命名スキームへの切り替え

デフォルトでは、Red Hat Enterprise Linux (RHEL) 10 は、ユーザーが RHEL のそれ以降のマイナーバージョンをインストールまたは更新した場合でも、rhel-10.0 命名スキームを使用します。デフォルトの命名スキームはほとんどの状況に適していますが、次のような理由で別のスキームバージョンに切り替える必要がある場合もあります。

- 新しいスキームによりインターフェイス名にスロット番号などの追加属性を追加すると、デバイスをより適切に識別できるようになります。

-

新しいスキームにより、カーネルによって割り当てられたデバイス名 (

eth*) にudevがフォールバックするのを防ぐことができます。これは、ドライバーが 2 つ以上のインターフェイスに対して一意の名前を生成するのに十分な一意の属性を提供していない場合に発生します。

前提条件

- サーバーのコンソールにアクセスできる。

手順

ネットワークインターフェイスをリスト表示します。

ip link show 2: eno1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...# ip link show 2: eno1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow インターフェイスの MAC アドレスを記録します。

オプション: ネットワークインターフェイスの

ID_NET_NAMING_SCHEMEプロパティーを表示して、RHEL が現在使用している命名スキームを特定します。udevadm info --query=property /sys/class/net/eno1 | grep "ID_NET_NAMING_SCHEME" ID_NET_NAMING_SCHEME=rhel-8.0

# udevadm info --query=property /sys/class/net/eno1 | grep "ID_NET_NAMING_SCHEME" ID_NET_NAMING_SCHEME=rhel-8.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow このプロパティーは

loループバックデバイスでは使用できないことに注意してください。インストールされているすべてのカーネルのコマンドラインに

net.naming-scheme=<scheme>オプションを追加します。次に例を示します。grubby --update-kernel=ALL --args=net.naming-scheme=rhel-8.4

# grubby --update-kernel=ALL --args=net.naming-scheme=rhel-8.4Copy to Clipboard Copied! Toggle word wrap Toggle overflow システムを再起動します。

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow 記録した MAC アドレスに基づいて、命名スキームの変更により変更されたネットワークインターフェイスの新しい名前を特定します。

ip link show 2: eno1np0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...# ip link show 2: eno1np0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow スキームを切り替えた後、

udevによって、指定された MAC アドレスを持つデバイスにeno1np0という名前が付けられます。これは以前はeno1という名前でした。以前の名前を持つインターフェイスを使用する NetworkManager 接続プロファイルを特定します。

nmcli -f device,name connection show DEVICE NAME eno1 example_profile ...

# nmcli -f device,name connection show DEVICE NAME eno1 example_profile ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接続プロファイルの

connection.interface-nameプロパティーを新しいインターフェイス名に設定します。nmcli connection modify example_profile connection.interface-name "eno1np0"

# nmcli connection modify example_profile connection.interface-name "eno1np0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接続プロファイルを再アクティブ化します。

nmcli connection up example_profile

# nmcli connection up example_profileCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ネットワークインターフェイスの

ID_NET_NAMING_SCHEMEプロパティーを表示して、RHEL が現在使用している命名スキームを特定します。udevadm info --query=property /sys/class/net/eno1np0 | grep "ID_NET_NAMING_SCHEME" ID_NET_NAMING_SCHEME=_rhel-8.4

# udevadm info --query=property /sys/class/net/eno1np0 | grep "ID_NET_NAMING_SCHEME" ID_NET_NAMING_SCHEME=_rhel-8.4Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.5. IBM Z プラットフォームでの予測可能な RoCE デバイス名の決定

Red Hat Enterprise Linux (RHEL) 8.7 以降では、udev デバイスマネージャーは IBM Z 上の RoCE インターフェイスの名前を次のように設定します。

-

ホストがデバイスに一意の識別子 (UID) を強制する場合、

udevはUID に基づく一貫したデバイス名 (例:eno<UID_in_decmal>) を割り当てます。 ホストがデバイスに UID を強制しない場合、設定によって動作が異なります。

-

デフォルトでは、

udevは予測できない名前をデバイスに使用します。 -

net.naming-scheme=rhel-8.7カーネルコマンドラインオプションを設定すると、udevはデバイスの機能識別子 (FID) に基づく一貫したデバイス名 (例:ens<FID_in_decmal>) を割り当てます。

-

デフォルトでは、

次の場合は、IBM Z 上の RoCE インターフェイスに、予測可能なデバイス名を手動で設定します。

ホストが RHEL 8.6 以前を実行しており、デバイスに UID を強制している。RHEL 8.7 以降のバージョンに更新する予定である。

RHEL 8.7 以降のバージョンに更新した後は、

udevは一貫したインターフェイス名を使用します。ただし、更新前に予測できないデバイス名を使用していた場合、NetworkManager 接続プロファイルは引き続きそれらの名前を使用し、影響を受けるプロファイルを更新するまでアクティベートできません。- ホストが RHEL 8.7 以降を実行しており、UID を強制していない。RHEL 9 にアップグレードする予定である。

udev ルールまたは systemd リンクファイルを使用してインターフェイスの名前を手動で変更する前に、予測可能なデバイス名を決定する必要があります。

前提条件

- RoCE コントローラーがシステムにインストールされている。

-

sysfsutilsパッケージがインストールされている。

手順

利用可能なネットワークデバイスを表示し、RoCE デバイスの名前を確認します。

ip link show ... 2: enP5165p0s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 ...

# ip link show ... 2: enP5165p0s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow /sys/ファイルシステム内のデバイスパスを表示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の手順では、

Device pathフィールドに表示されているパスを使用します。<device_path>/uid_id_uniqueファイルの値を表示します。以下に例を示します。cat /sys/devices/pci142d:00/142d:00:00.0/uid_id_unique

# cat /sys/devices/pci142d:00/142d:00:00.0/uid_id_uniqueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 表示された値は、UID の一意性が強制されるかどうかを示します。この値は後の手順で必要になります。

一意の識別子を決定します。

UID の一意性が強制されている場合 (

1)、<device_path>/uidファイルに保存されている UID を表示します。以下に例を示します。cat /sys/devices/pci142d:00/142d:00:00.0/uid

# cat /sys/devices/pci142d:00/142d:00:00.0/uidCopy to Clipboard Copied! Toggle word wrap Toggle overflow UID の一意性が強制されていない場合 (

0)、<device_path>/function_idファイルに保存されている FID を表示します。以下に例を示します。cat /sys/devices/pci142d:00/142d:00:00.0/function_id

# cat /sys/devices/pci142d:00/142d:00:00.0/function_idCopy to Clipboard Copied! Toggle word wrap Toggle overflow

コマンドの出力には、UID 値と FID 値が 16 進数で表示されます。

16 進数の識別子を 10 進数に変換します。以下に例を示します。

printf "%d\n" 0x00001402 5122

# printf "%d\n" 0x00001402 5122Copy to Clipboard Copied! Toggle word wrap Toggle overflow 予測可能なデバイス名を決定するには、UID の一意性が強制されるかどうかに基づいて、対応する接頭辞に 10 進数の形式の識別子を追加します。

-

UID の一意性が強制される場合は、

eno接頭辞に識別子を追加します (例:eno5122)。 -

UID の一意性が強制されない場合は、

ens接頭辞に識別子を追加します (例:ens5122)。

-

UID の一意性が強制される場合は、

1.6. インストール時のイーサネットインターフェイスの接頭辞のカスタマイズ

イーサネットインターフェイスにデフォルトのデバイス命名ポリシーを使用しない場合は、Red Hat Enterprise Linux (RHEL) のインストール時にカスタムデバイス接頭辞を設定できます。

Red Hat は、RHEL のインストール時に接頭辞を設定した場合にのみ、カスタマイズされたイーサネット接頭辞を持つシステムをサポートします。すでにデプロイされているシステムでの prefixdevname ユーティリティーの使用はサポートされていません。

インストール時にデバイス接頭辞を設定した場合、udev サービスはインストール後にイーサネットインターフェイスに <prefix><index> という形式を使用します。たとえば、接頭辞 net を設定すると、サービスはイーサネットインターフェイスに net0、net1 などの名前を割り当てます。

udev サービスはカスタム接頭辞にインデックスを追加し、既知のイーサネットインターフェイスのインデックス値を保存します。インターフェイスを追加すると、udev は、以前に割り当てたインデックス値より 1 大きいインデックス値を新しいインターフェイスに割り当てます。

前提条件

- 接頭辞が ASCII 文字で構成されている。

- 接頭辞が英数字の文字列である。

- 接頭辞が 16 文字未満である。

-

接頭辞が、

eth、eno、ens、emなどの他の既知のネットワークインターフェイス接頭辞と競合しない。

手順

- Red Hat Enterprise Linux インストールメディアを起動します。

ブートマネージャーで、次の手順を実行します。

-

Install Red Hat Enterprise Linux <version>エントリーを選択します。 - Tab を押してエントリーを編集します。

-

net.ifnames.prefix=<prefix>をカーネルオプションに追加します。 - Enter を押してインストールプログラムを起動します。

-

- Red Hat Enterprise Linux をインストールします。

検証

インターフェイス名を確認するには、ネットワークインターフェイスを表示します。

ip link show ... 2: net0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...# ip link show ... 2: net0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.7. udev ルールを使用したユーザー定義のネットワークインターフェイス名の設定

udev ルールを使用して、組織の要件を反映したカスタムネットワークインターフェイス名を実装できます。

手順

名前を変更するネットワークインターフェイスを特定します。

ip link show ... enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...# ip link show ... enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow インターフェイスの MAC アドレスを記録します。

インターフェイスのデバイスタイプ ID を表示します。

cat /sys/class/net/enp1s0/type 1

# cat /sys/class/net/enp1s0/type 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow /etc/udev/rules.d/70-persistent-net.rulesファイルを作成し、名前を変更する各インターフェイスのルールを追加します。SUBSYSTEM=="net",ACTION=="add",ATTR{address}=="<MAC_address>",ATTR{type}=="<device_type_id>",NAME="<new_interface_name>"SUBSYSTEM=="net",ACTION=="add",ATTR{address}=="<MAC_address>",ATTR{type}=="<device_type_id>",NAME="<new_interface_name>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要ブートプロセス中に一貫したデバイス名が必要な場合は、ファイル名として

70-persistent-net.rulesのみを使用してください。RAM ディスクイメージを再生成すると、dracutユーティリティーはこの名前のファイルをinitrdイメージに追加します。たとえば、次のルールを使用して、MAC アドレス

00:00:5e:00:53:1aのインターフェイスの名前をprovider0に変更します。SUBSYSTEM=="net",ACTION=="add",ATTR{address}=="00:00:5e:00:53:1a",ATTR{type}=="1",NAME="provider0"SUBSYSTEM=="net",ACTION=="add",ATTR{address}=="00:00:5e:00:53:1a",ATTR{type}=="1",NAME="provider0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション:

initrdRAM ディスクイメージを再生成します。dracut -f

# dracut -fCopy to Clipboard Copied! Toggle word wrap Toggle overflow この手順は、RAM ディスクにネットワーク機能が必要な場合にのみ必要です。たとえば、ルートファイルシステムが iSCSI などのネットワークデバイスに保存されている場合がこれに当てはまります。

名前を変更するインターフェイスを使用する NetworkManager 接続プロファイルを特定します。

nmcli -f device,name connection show DEVICE NAME enp1s0 example_profile ...

# nmcli -f device,name connection show DEVICE NAME enp1s0 example_profile ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接続プロファイルの

connection.interface-nameプロパティーの設定を解除します。nmcli connection modify example_profile connection.interface-name ""

# nmcli connection modify example_profile connection.interface-name ""Copy to Clipboard Copied! Toggle word wrap Toggle overflow 一時的に、新しいインターフェイス名と以前のインターフェイス名の両方に一致するように接続プロファイルを設定します。

nmcli connection modify example_profile match.interface-name "provider0 enp1s0"

# nmcli connection modify example_profile match.interface-name "provider0 enp1s0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow システムを再起動します。

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow リンクファイルで指定した MAC アドレスを持つデバイスの名前が

Provider0に変更されていることを確認します。ip link show provider0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...# ip link show provider0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいインターフェイス名のみと一致するように接続プロファイルを設定します。

nmcli connection modify example_profile match.interface-name "provider0"

# nmcli connection modify example_profile match.interface-name "provider0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow これで、接続プロファイルから古いインターフェイス名が削除されました。

接続プロファイルを再アクティブ化します。

nmcli connection up example_profile

# nmcli connection up example_profileCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.8. systemd リンクファイルを使用したユーザー定義のネットワークインターフェイス名の設定

systemd リンクファイルを使用して、組織の要件を反映したカスタムネットワークインターフェイス名を実装できます。

前提条件

- NetworkManager がこのインターフェイスを管理していない。または、対応する接続プロファイルが キーファイル形式 を使用している。

手順

名前を変更するネットワークインターフェイスを特定します。

ip link show ... enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...# ip link show ... enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow インターフェイスの MAC アドレスを記録します。

/etc/systemd/network/ディレクトリーがない場合は作成します。mkdir -p /etc/systemd/network/

# mkdir -p /etc/systemd/network/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 名前を変更するインターフェイスごとに、次の内容を含む

70-*.linkファイルを/etc/systemd/network/ディレクトリーに作成します。[Match] MACAddress=<MAC_address> [Link] Name=<new_interface_name>

[Match] MACAddress=<MAC_address> [Link] Name=<new_interface_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要udevのルールベースのソリューションとファイル名の一貫性を保つために、接頭辞70-を付けたファイル名を使用してください。たとえば、MAC アドレス

00:00:5e:00:53:1aのインターフェイスの名前をprovider0に変更するには、次の内容を含む/etc/systemd/network/70-provider0.linkファイルを作成します。[Match] MACAddress=00:00:5e:00:53:1a [Link] Name=provider0

[Match] MACAddress=00:00:5e:00:53:1a [Link] Name=provider0Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション:

initrdRAM ディスクイメージを再生成します。dracut -f

# dracut -fCopy to Clipboard Copied! Toggle word wrap Toggle overflow この手順は、RAM ディスクにネットワーク機能が必要な場合にのみ必要です。たとえば、ルートファイルシステムが iSCSI などのネットワークデバイスに保存されている場合がこれに当てはまります。

名前を変更するインターフェイスを使用する NetworkManager 接続プロファイルを特定します。

nmcli -f device,name connection show DEVICE NAME enp1s0 example_profile ...

# nmcli -f device,name connection show DEVICE NAME enp1s0 example_profile ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接続プロファイルの

connection.interface-nameプロパティーの設定を解除します。nmcli connection modify example_profile connection.interface-name ""

# nmcli connection modify example_profile connection.interface-name ""Copy to Clipboard Copied! Toggle word wrap Toggle overflow 一時的に、新しいインターフェイス名と以前のインターフェイス名の両方に一致するように接続プロファイルを設定します。

nmcli connection modify example_profile match.interface-name "provider0 enp1s0"

# nmcli connection modify example_profile match.interface-name "provider0 enp1s0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow システムを再起動します。

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow リンクファイルで指定した MAC アドレスを持つデバイスの名前が

Provider0に変更されていることを確認します。ip link show provider0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...# ip link show provider0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいインターフェイス名のみと一致するように接続プロファイルを設定します。

nmcli connection modify example_profile match.interface-name "provider0"

# nmcli connection modify example_profile match.interface-name "provider0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow これで、接続プロファイルから古いインターフェイス名が削除されました。

接続プロファイルを再度アクティベートします。

nmcli connection up example_profile

# nmcli connection up example_profileCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.9. systemd リンクファイルを使用したネットワークインターフェイスへの代替名の割り当て

代替インターフェイス名の命名を使用すると、カーネルはネットワークインターフェイスに追加の名前を割り当てることができます。この代替名は、ネットワークインターフェイス名を必要とするコマンドで通常のインターフェイス名と同じように使用できます。

前提条件

- 代替名に ASCII 文字が使用されている。

- 代替名が 128 文字未満である。

手順

ネットワークインターフェイス名とその MAC アドレスを表示します。

ip link show ... enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...# ip link show ... enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 代替名を割り当てるインターフェイスの MAC アドレスを記録します。

/etc/systemd/network/ディレクトリーがない場合は作成します。mkdir -p /etc/systemd/network/

# mkdir -p /etc/systemd/network/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 代替名が必要なインターフェイスごとに、

/etc/systemd/network/ディレクトリーに、一意の名前と.link接尾辞を持つ/usr/lib/systemd/network/99-default.linkファイルのコピーを作成します。次に例を示します。cp /usr/lib/systemd/network/99-default.link /etc/systemd/network/98-lan.link

# cp /usr/lib/systemd/network/99-default.link /etc/systemd/network/98-lan.linkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 前のステップで作成したファイルを変更します。

[Match]セクションを次のように書き換え、AlternativeNameエントリーを[Link]セクションに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow たとえば、次の内容を含む

/etc/systemd/network/70-altname.linkファイルを作成して、MAC アドレス00:00:5e:00:53:1aのインターフェイスに代替名としてproviderを割り当てます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow initrdRAM ディスクイメージを再生成します。dracut -f

# dracut -fCopy to Clipboard Copied! Toggle word wrap Toggle overflow システムを再起動します。

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

代替インターフェイス名を使用します。たとえば、代替名

providerを使用してデバイスの IP アドレス設定を表示します。ip address show provider 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff altname provider ...# ip address show provider 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff altname provider ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第2章 イーサネット接続の設定

NetworkManager は、ホストにインストールされている各イーサネットアダプターの接続プロファイルを作成します。デフォルトでは、このプロファイルは IPv4 接続と IPv6 接続の両方に DHCP を使用します。次の場合は、この自動作成されたプロファイルを変更するか、新しいプロファイルを追加してください。

- ネットワークに、静的 IP アドレス設定などのカスタム設定が必要な場合

- ホストが異なるネットワーク間をローミングするため、複数のプロファイルが必要な場合

Red Hat Enterprise Linux は、イーサネット接続を設定するためのさまざまなオプションを管理者に提供します。以下に例を示します。

-

nmcliを使用して、コマンドラインで接続を設定します。 -

nmtuiを使用して、テキストベースのユーザーインターフェイスで接続を設定します。 -

GNOME Settings メニューまたは

nm-connection-editorアプリケーションを使用して、グラフィカルインターフェイスで接続を設定します。 - nmstatectl を使用して、Nmstate API を介して接続を設定する。

- RHEL システムロールを使用して、1 つまたは複数のホストで接続の設定を自動化します。

Microsoft Azure クラウドで実行しているホストでイーサネット接続を手動で設定する場合は、cloud-init サービスを無効にするか、クラウド環境から取得したネットワーク設定を無視するように設定します。それ以外の場合は、cloud-init は、手動で設定したネットワーク設定を次回の再起動時に上書きされます。

2.1. nmcli を使用したイーサネット接続の設定

イーサネット経由でホストをネットワークに接続する場合は、nmcli ユーティリティーを使用してコマンドラインで接続の設定を管理できます。

前提条件

- サーバーの構成に物理または仮想イーサネットネットワークインターフェイスコントローラー (NIC) が存在する。

手順

NetworkManager 接続プロファイルをリストします。

nmcli connection show NAME UUID TYPE DEVICE Wired connection 1 a5eb6490-cc20-3668-81f8-0314a27f3f75 ethernet enp1s0

# nmcli connection show NAME UUID TYPE DEVICE Wired connection 1 a5eb6490-cc20-3668-81f8-0314a27f3f75 ethernet enp1s0Copy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトでは、NetworkManager はホスト内の各 NIC のプロファイルを作成します。この NIC を特定のネットワークにのみ接続する予定がある場合は、自動作成されたプロファイルを調整してください。この NIC をさまざまな設定のネットワークに接続する予定がある場合は、ネットワークごとに個別のプロファイルを作成してください。

追加の接続プロファイルを作成する場合は、次のように実行します。

nmcli connection add con-name <connection-name> ifname <device-name> type ethernet

# nmcli connection add con-name <connection-name> ifname <device-name> type ethernetCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存のプロファイルを変更するには、この手順をスキップしてください。

オプション: 接続プロファイルの名前を変更します。

nmcli connection modify "Wired connection 1" connection.id "Internal-LAN"

# nmcli connection modify "Wired connection 1" connection.id "Internal-LAN"Copy to Clipboard Copied! Toggle word wrap Toggle overflow ホストに複数のプロファイルがある場合は、わかりやすい名前を付けると、プロファイルの目的を識別しやすくなります。

接続プロファイルの現在の設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv4 を設定します。

DHCP を使用するには、次のように実行します。

nmcli connection modify Internal-LAN ipv4.method auto

# nmcli connection modify Internal-LAN ipv4.method autoCopy to Clipboard Copied! Toggle word wrap Toggle overflow ipv4.methodがすでにauto(デフォルト) に設定されている場合は、この手順をスキップしてください。静的 IPv4 アドレス、ネットワークマスク、デフォルトゲートウェイ、DNS サーバー、および検索ドメインを設定するには、次のように実行します。

nmcli connection modify Internal-LAN ipv4.method manual ipv4.addresses 192.0.2.1/24 ipv4.gateway 192.0.2.254 ipv4.dns 192.0.2.200 ipv4.dns-search example.com

# nmcli connection modify Internal-LAN ipv4.method manual ipv4.addresses 192.0.2.1/24 ipv4.gateway 192.0.2.254 ipv4.dns 192.0.2.200 ipv4.dns-search example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow

IPv6 設定を行います。

ステートレスアドレス自動設定 (SLAAC) を使用するには、次のように実行します。

nmcli connection modify Internal-LAN ipv6.method auto

# nmcli connection modify Internal-LAN ipv6.method autoCopy to Clipboard Copied! Toggle word wrap Toggle overflow ipv6.methodがすでにauto(デフォルト) に設定されている場合は、この手順をスキップしてください。静的 IPv6 アドレス、ネットワークマスク、デフォルトゲートウェイ、DNS サーバー、および検索ドメインを設定するには、次のように実行します。

nmcli connection modify Internal-LAN ipv6.method manual ipv6.addresses 2001:db8:1::fffe/64 ipv6.gateway 2001:db8:1::fffe ipv6.dns 2001:db8:1::ffbb ipv6.dns-search example.com

# nmcli connection modify Internal-LAN ipv6.method manual ipv6.addresses 2001:db8:1::fffe/64 ipv6.gateway 2001:db8:1::fffe ipv6.dns 2001:db8:1::ffbb ipv6.dns-search example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow

プロファイルの他の設定をカスタマイズするには、次のコマンドを使用します。

nmcli connection modify <connection-name> <setting> <value>

# nmcli connection modify <connection-name> <setting> <value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 値はスペースまたはセミコロンで引用符で囲みます。

プロファイルをアクティブ化します。

nmcli connection up Internal-LAN

# nmcli connection up Internal-LANCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

NIC の IP 設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv4 デフォルトゲートウェイを表示します。

ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv6 デフォルトゲートウェイを表示します。

ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref medium

# ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref mediumCopy to Clipboard Copied! Toggle word wrap Toggle overflow DNS 設定を表示します。

cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 複数の接続プロファイルが同時にアクティブな場合、

nameserverエントリーの順序は、これらのプロファイルの DNS 優先度の値と接続タイプによって異なります。pingユーティリティーを使用して、このホストがパケットを他のホストに送信できることを確認します。ping <host-name-or-IP-address>

# ping <host-name-or-IP-address>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

トラブルシューティング

- ネットワークケーブルがホストとスイッチに差し込まれていることを確認します。

- リンク障害がこのホストだけに存在するか、同じスイッチに接続された他のホストにも存在するかを確認します。

- ネットワークケーブルとネットワークインターフェイスが予想どおりに機能していることを確認します。ハードウェア診断手順を実行し、不具合のあるケーブルとネットワークインターフェイスカードを交換します。

- ディスクの設定がデバイスの設定と一致しない場合は、NetworkManager を起動するか再起動して、インメモリー接続を作成することで、デバイスの設定を反映します。この問題の詳細と回避方法は、Red Hat ナレッジベースソリューション NetworkManager duplicates a connection after restart of NetworkManager service を参照してください。

2.2. nmcli インタラクティブエディターを使用したイーサネット接続の設定

イーサネット経由でホストをネットワークに接続する場合は、nmcli ユーティリティーを使用してコマンドラインで接続の設定を管理できます。

前提条件

- サーバーの構成に物理または仮想イーサネットネットワークインターフェイスコントローラー (NIC) が存在する。

手順

NetworkManager 接続プロファイルをリストします。

nmcli connection show NAME UUID TYPE DEVICE Wired connection 1 a5eb6490-cc20-3668-81f8-0314a27f3f75 ethernet enp1s0

# nmcli connection show NAME UUID TYPE DEVICE Wired connection 1 a5eb6490-cc20-3668-81f8-0314a27f3f75 ethernet enp1s0Copy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトでは、NetworkManager はホスト内の各 NIC のプロファイルを作成します。この NIC を特定のネットワークにのみ接続する予定がある場合は、自動作成されたプロファイルを調整してください。この NIC をさまざまな設定のネットワークに接続する予定がある場合は、ネットワークごとに個別のプロファイルを作成してください。

nmcliインタラクティブモードで起動します。追加の接続プロファイルを作成するには、次のように実行します。

nmcli connection edit type ethernet con-name "<connection-name>"

# nmcli connection edit type ethernet con-name "<connection-name>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 既存の接続プロファイルを変更するには、次のように実行します。

nmcli connection edit con-name "<connection-name>"

# nmcli connection edit con-name "<connection-name>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

オプション: 接続プロファイルの名前を変更します。

nmcli> set connection.id Internal-LAN

nmcli> set connection.id Internal-LANCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホストに複数のプロファイルがある場合は、わかりやすい名前を付けると、プロファイルの目的を識別しやすくなります。

nmcliが引用符を名前の一部としてしまうことを避けるため、スペースを含む ID を設定する場合は引用符を使用しないでください。たとえば、Example Connectionを ID として設定するには、set connection.id Example Connectionと入力します。接続プロファイルの現在の設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しい接続プロファイルを作成する場合は、ネットワークインターフェイスを設定します。

nmcli> set connection.interface-name enp1s0

nmcli> set connection.interface-name enp1s0Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv4 を設定します。

DHCP を使用するには、次のように実行します。

nmcli> set ipv4.method auto

nmcli> set ipv4.method autoCopy to Clipboard Copied! Toggle word wrap Toggle overflow ipv4.methodがすでにauto(デフォルト) に設定されている場合は、この手順をスキップしてください。静的 IPv4 アドレス、ネットワークマスク、デフォルトゲートウェイ、DNS サーバー、および検索ドメインを設定するには、次のように実行します。

nmcli> ipv4.addresses 192.0.2.1/24 Do you also want to set 'ipv4.method' to 'manual'? [yes]: yes nmcli> ipv4.gateway 192.0.2.254 nmcli> ipv4.dns 192.0.2.200 nmcli> ipv4.dns-search example.com

nmcli> ipv4.addresses 192.0.2.1/24 Do you also want to set 'ipv4.method' to 'manual'? [yes]: yes nmcli> ipv4.gateway 192.0.2.254 nmcli> ipv4.dns 192.0.2.200 nmcli> ipv4.dns-search example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow

IPv6 設定を行います。

ステートレスアドレス自動設定 (SLAAC) を使用するには、次のように実行します。

nmcli> set ipv6.method auto

nmcli> set ipv6.method autoCopy to Clipboard Copied! Toggle word wrap Toggle overflow ipv6.methodがすでにauto(デフォルト) に設定されている場合は、この手順をスキップしてください。静的 IPv6 アドレス、ネットワークマスク、デフォルトゲートウェイ、DNS サーバー、および検索ドメインを設定するには、次のように実行します。

nmcli> ipv6.addresses 2001:db8:1::fffe/64 Do you also want to set 'ipv6.method' to 'manual'? [yes]: yes nmcli> ipv6.gateway 2001:db8:1::fffe nmcli> ipv6.dns 2001:db8:1::ffbb nmcli> ipv6.dns-search example.com

nmcli> ipv6.addresses 2001:db8:1::fffe/64 Do you also want to set 'ipv6.method' to 'manual'? [yes]: yes nmcli> ipv6.gateway 2001:db8:1::fffe nmcli> ipv6.dns 2001:db8:1::ffbb nmcli> ipv6.dns-search example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow

接続をアクティベートして保存します。

nmcli> save persistent

nmcli> save persistentCopy to Clipboard Copied! Toggle word wrap Toggle overflow インタラクティブモードを終了します。

nmcli> quit

nmcli> quitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

NIC の IP 設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv4 デフォルトゲートウェイを表示します。

ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv6 デフォルトゲートウェイを表示します。

ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref medium

# ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref mediumCopy to Clipboard Copied! Toggle word wrap Toggle overflow DNS 設定を表示します。

cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 複数の接続プロファイルが同時にアクティブな場合、

nameserverエントリーの順序は、これらのプロファイルの DNS 優先度の値と接続タイプによって異なります。pingユーティリティーを使用して、このホストがパケットを他のホストに送信できることを確認します。ping <host-name-or-IP-address>

# ping <host-name-or-IP-address>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

トラブルシューティング

- ネットワークケーブルがホストとスイッチに差し込まれていることを確認します。

- リンク障害がこのホストだけに存在するか、同じスイッチに接続された他のホストにも存在するかを確認します。

- ネットワークケーブルとネットワークインターフェイスが予想どおりに機能していることを確認します。ハードウェア診断手順を実行し、不具合のあるケーブルとネットワークインターフェイスカードを交換します。

- ディスクの設定がデバイスの設定と一致しない場合は、NetworkManager を起動するか再起動して、インメモリー接続を作成することで、デバイスの設定を反映します。この問題の詳細と回避方法は、Red Hat ナレッジベースソリューション NetworkManager duplicates a connection after restart of NetworkManager service を参照してください。

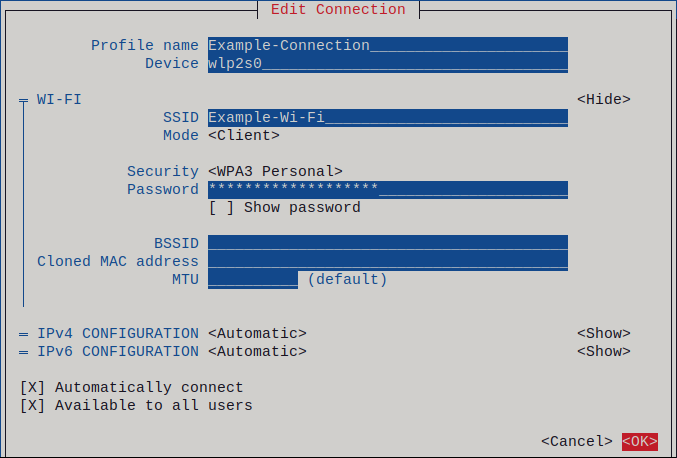

2.3. nmtui を使用したイーサネット接続の設定

イーサネット経由でホストをネットワークに接続する場合は、nmtui アプリケーションを使用して、テキストベースのユーザーインターフェイスで接続の設定を管理できます。nmtui では、グラフィカルインターフェイスを使用せずに、新しいプロファイルの作成や、ホスト上の既存のプロファイルの更新を行います。

nmtui で以下を行います。

- カーソルキーを使用してナビゲートします。

- ボタンを選択して Enter を押します。

- Space を使用してチェックボックスをオンまたはオフにします。

- 前の画面に戻るには、ESC を使用します。

前提条件

- サーバーの構成に物理または仮想イーサネットネットワークインターフェイスコントローラー (NIC) が存在する。

手順

接続に使用するネットワークデバイス名がわからない場合は、使用可能なデバイスを表示します。

nmcli device status DEVICE TYPE STATE CONNECTION enp1s0 ethernet unavailable -- ...

# nmcli device status DEVICE TYPE STATE CONNECTION enp1s0 ethernet unavailable -- ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow nmtuiを開始します。nmtui

# nmtuiCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Edit a connection 選択し、Enter を押します。

新しい接続プロファイルを追加するか、既存の接続プロファイルを変更するかを選択します。

新しいプロファイルを作成するには、以下を実行します。

- Add を押します。

- ネットワークタイプのリストから Ethernet を選択し、Enter を押します。

- 既存のプロファイルを変更するには、リストからプロファイルを選択し、Enter を押します。

オプション: 接続プロファイルの名前を更新します。

ホストに複数のプロファイルがある場合は、わかりやすい名前を付けると、プロファイルの目的を識別しやすくなります。

- 新しい接続プロファイルを作成する場合は、ネットワークデバイス名を connection フィールドに入力します。

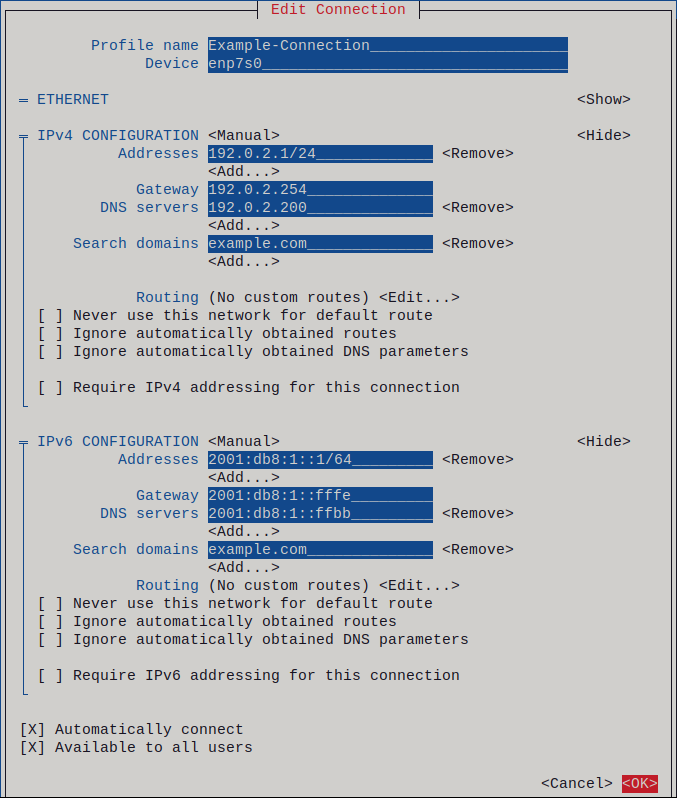

環境に応じて、

IPv4 configurationおよびIPv6 configuration領域に IP アドレス設定を設定します。これを行うには、これらの領域の横にあるボタンを押して、次を選択します。- この接続に IP アドレスが必要ない場合は、Disabled にします。

- DHCP サーバーが IP アドレスをこの NIC に動的に割り当てる場合は、Automatic にします。

ネットワークで静的 IP アドレス設定が必要な場合は、Manual にします。この場合、さらにフィールドに入力する必要があります。

- 設定するプロトコルの横にある Show を押して、追加のフィールドを表示します。

Addresses の横にある Add を押して、IP アドレスとサブネットマスクを Classless Inter-Domain Routing (CIDR) 形式で入力します。

サブネットマスクを指定しない場合、NetworkManager は IPv4 アドレスに

/32サブネットマスクを設定し、IPv6 アドレスに/64サブネットマスクを設定します。- デフォルトゲートウェイのアドレスを入力します。

- DNS servers の横にある Add を押して、DNS サーバーのアドレスを入力します。

- Search domains の横にある Add を押して、DNS 検索ドメインを入力します。

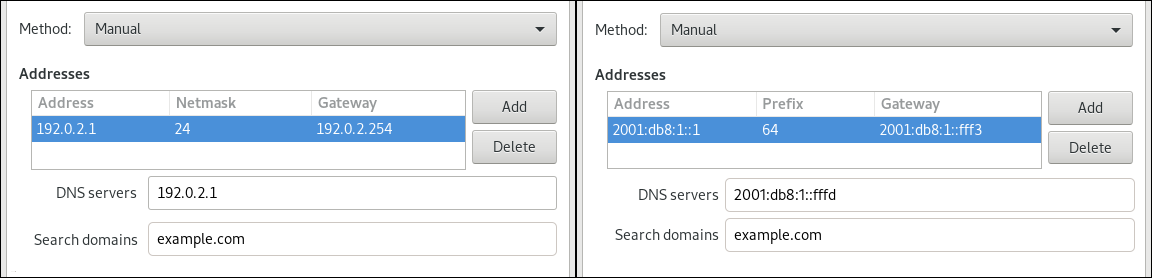

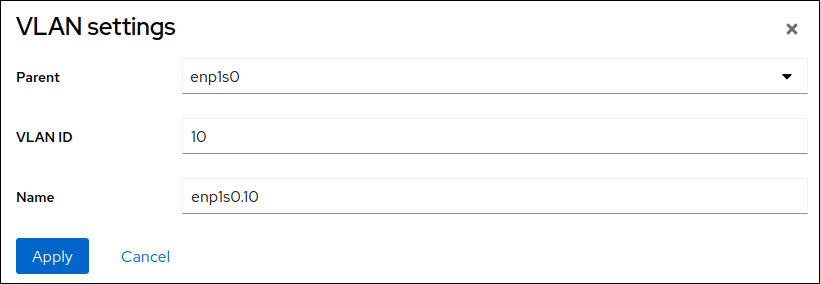

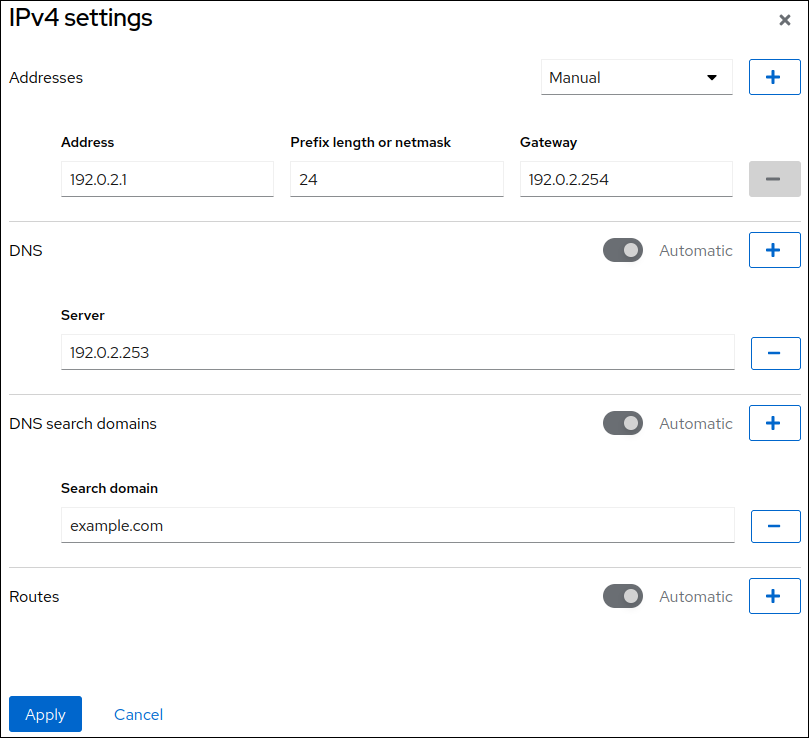

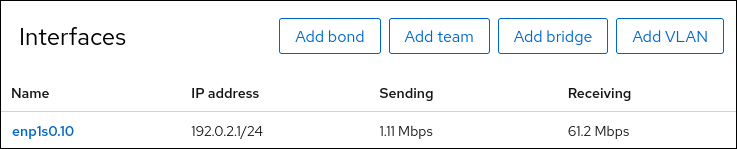

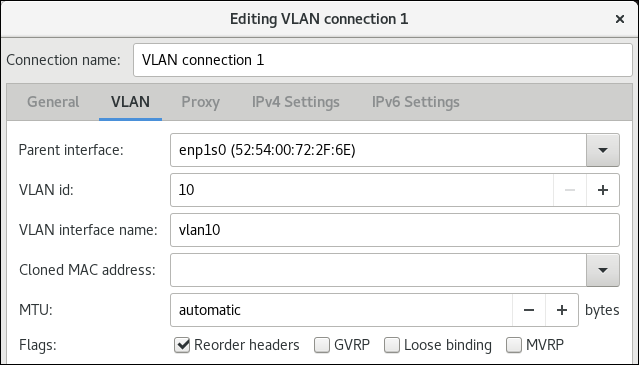

図2.1 静的 IP アドレス設定によるイーサネット接続の例

- OK を押すと、新しい接続が作成され、自動的にアクティブ化されます。

- Back を押してメインメニューに戻ります。

-

Quit を選択し、Enter キーを押して

nmtuiアプリケーションを閉じます。

検証

NIC の IP 設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv4 デフォルトゲートウェイを表示します。

ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv6 デフォルトゲートウェイを表示します。

ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref medium

# ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref mediumCopy to Clipboard Copied! Toggle word wrap Toggle overflow DNS 設定を表示します。

cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 複数の接続プロファイルが同時にアクティブな場合、

nameserverエントリーの順序は、これらのプロファイルの DNS 優先度の値と接続タイプによって異なります。pingユーティリティーを使用して、このホストがパケットを他のホストに送信できることを確認します。ping <host-name-or-IP-address>

# ping <host-name-or-IP-address>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

トラブルシューティング

- ネットワークケーブルがホストとスイッチに差し込まれていることを確認します。

- リンク障害がこのホストだけに存在するか、同じスイッチに接続された他のホストにも存在するかを確認します。

- ネットワークケーブルとネットワークインターフェイスが予想どおりに機能していることを確認します。ハードウェア診断手順を実行し、不具合のあるケーブルとネットワークインターフェイスカードを交換します。

- ディスクの設定がデバイスの設定と一致しない場合は、NetworkManager を起動するか再起動して、インメモリー接続を作成することで、デバイスの設定を反映します。この問題の詳細と回避方法は、Red Hat ナレッジベースソリューション NetworkManager duplicates a connection after restart of NetworkManager service を参照してください。

2.4. control-center によるイーサネット接続の設定

イーサネット経由でホストをネットワークに接続する場合は、GNOME 設定メニューを使用して、グラフィカルインターフェイスで接続の設定を管理できます。

control-center は、nm-connection-editor アプリケーションまたは nmcli ユーティリティーほど多くの設定オプションに対応していないことに注意してください。

前提条件

- サーバーの構成に物理または仮想イーサネットネットワークインターフェイスコントローラー (NIC) が存在する。

- GNOME がインストールされている。

手順

-

Super キーを押して

Settingsを入力し、Enter を押します。 - 左側のナビゲーションにある Network を選択します。

新しい接続プロファイルを追加するか、既存の接続プロファイルを変更するかを選択します。

- 新しいプロファイルを作成するには、Ethernet エントリーの横にある ボタンをクリックします。

- 既存のプロファイルを変更するには、プロファイルエントリーの横にある歯車アイコンをクリックします。

オプション: Identity タブで、接続プロファイルの名前を更新します。

ホストに複数のプロファイルがある場合は、わかりやすい名前を付けると、プロファイルの目的を識別しやすくなります。

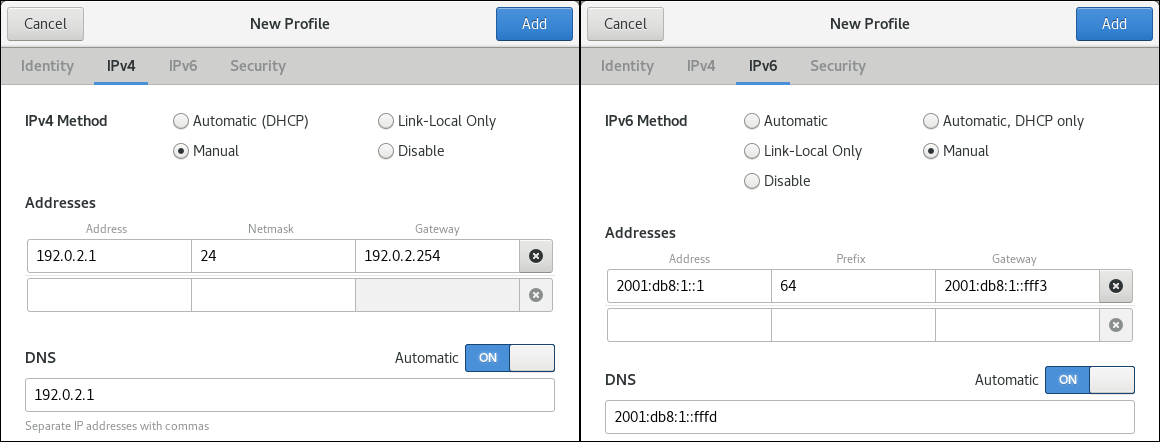

環境に応じて、IPv4 タブと IPv6 タブで IP アドレス設定を設定します。

-

DHCP または IPv6 ステートレスアドレス自動設定 (SLAAC) を使用するには、方法として

Automatic (DHCP)を選択します (デフォルト)。 静的 IP アドレス、ネットワークマスク、デフォルトゲートウェイ、DNS サーバー、および検索ドメインを設定するには、方法として

Manualを選択し、タブのフィールドに入力します。

-

DHCP または IPv6 ステートレスアドレス自動設定 (SLAAC) を使用するには、方法として

接続プロファイルを追加するか変更するかに応じて、 または ボタンをクリックして接続を保存します。

GNOME の

control-centerは、接続を自動的にアクティブにします。

検証

NIC の IP 設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv4 デフォルトゲートウェイを表示します。

ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv6 デフォルトゲートウェイを表示します。

ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref medium

# ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref mediumCopy to Clipboard Copied! Toggle word wrap Toggle overflow DNS 設定を表示します。

cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 複数の接続プロファイルが同時にアクティブな場合、

nameserverエントリーの順序は、これらのプロファイルの DNS 優先度の値と接続タイプによって異なります。pingユーティリティーを使用して、このホストがパケットを他のホストに送信できることを確認します。ping <host-name-or-IP-address>

# ping <host-name-or-IP-address>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

トラブルシューティングの手順

- ネットワークケーブルがホストとスイッチに差し込まれていることを確認します。

- リンク障害がこのホストだけに存在するか、同じスイッチに接続された他のホストにも存在するかを確認します。

- ネットワークケーブルとネットワークインターフェイスが予想どおりに機能していることを確認します。ハードウェア診断手順を実行し、不具合のあるケーブルとネットワークインターフェイスカードを交換します。

- ディスクの設定がデバイスの設定と一致しない場合は、NetworkManager を起動するか再起動して、インメモリー接続を作成することで、デバイスの設定を反映します。この問題の詳細と回避方法は、Red Hat ナレッジベースソリューション NetworkManager duplicates a connection after restart of NetworkManager service を参照してください。

2.5. nm-connection-editor を使用したイーサネット接続の設定

イーサネット経由でホストをネットワークに接続する場合は、nm-connection-editor アプリケーションを使用して、グラフィカルインターフェイスで接続の設定を管理できます。

前提条件

- サーバーの構成に物理または仮想イーサネットネットワークインターフェイスコントローラー (NIC) が存在する。

- GNOME がインストールされている。

手順

ターミナルを開き、次のコマンドを入力します。

nm-connection-editor

$ nm-connection-editorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新しい接続プロファイルを追加するか、既存の接続プロファイルを変更するかを選択します。

新しいプロファイルを作成するには、以下を実行します。

- ボタンをクリックします。

- 接続タイプとして Ethernet を選択し、 をクリックします。

- 既存のプロファイルを変更するには、プロファイルエントリーをダブルクリックします。

オプション: Connection フィールドでプロファイルの名前を更新します。

ホストに複数のプロファイルがある場合は、わかりやすい名前を付けると、プロファイルの目的を識別しやすくなります。

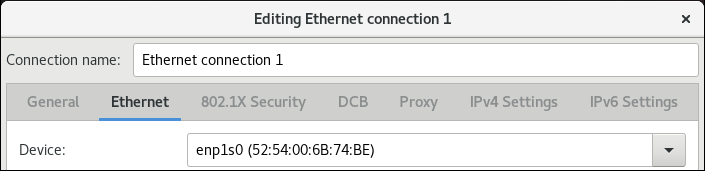

新しいプロファイルを作成する場合は、

Ethernetタブでデバイスを選択します。

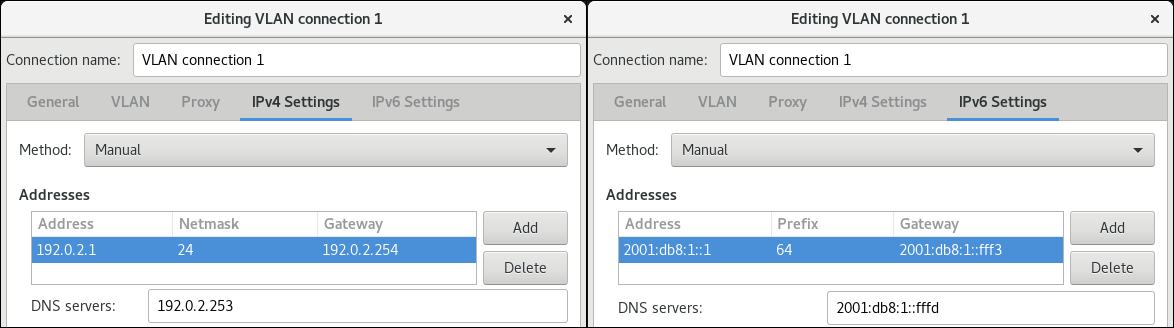

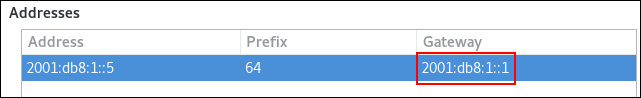

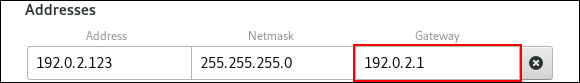

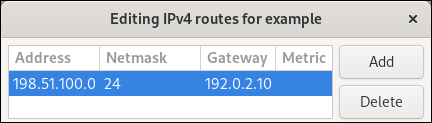

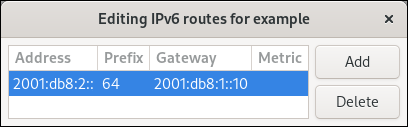

環境に応じて、IPv4 Settings タブと IPv6 Settings タブで IP アドレス設定を設定します。

-

DHCP または IPv6 ステートレスアドレス自動設定 (SLAAC) を使用するには、方法として

Automatic (DHCP)を選択します (デフォルト)。 静的 IP アドレス、ネットワークマスク、デフォルトゲートウェイ、DNS サーバー、および検索ドメインを設定するには、方法として

Manualを選択し、タブのフィールドに入力します。

-

DHCP または IPv6 ステートレスアドレス自動設定 (SLAAC) を使用するには、方法として

- をクリックします。

- nm-connection-editor を閉じます。

検証

NIC の IP 設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv4 デフォルトゲートウェイを表示します。

ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv6 デフォルトゲートウェイを表示します。

ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref medium

# ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref mediumCopy to Clipboard Copied! Toggle word wrap Toggle overflow DNS 設定を表示します。

cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 複数の接続プロファイルが同時にアクティブな場合、

nameserverエントリーの順序は、これらのプロファイルの DNS 優先度の値と接続タイプによって異なります。pingユーティリティーを使用して、このホストがパケットを他のホストに送信できることを確認します。ping <host-name-or-IP-address>

# ping <host-name-or-IP-address>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

トラブルシューティングの手順

- ネットワークケーブルがホストとスイッチに差し込まれていることを確認します。

- リンク障害がこのホストだけに存在するか、同じスイッチに接続された他のホストにも存在するかを確認します。

- ネットワークケーブルとネットワークインターフェイスが予想どおりに機能していることを確認します。ハードウェア診断手順を実行し、不具合のあるケーブルとネットワークインターフェイスカードを交換します。

- ディスクの設定がデバイスの設定と一致しない場合は、NetworkManager を起動するか再起動して、インメモリー接続を作成することで、デバイスの設定を反映します。この問題の詳細と回避方法は、Red Hat ナレッジベースソリューション NetworkManager duplicates a connection after restart of NetworkManager service を参照してください。

2.6. nmstatectl でインターフェイス名を指定して静的 IP アドレスによるイーサネット接続を設定する

nmstatectl ユーティリティーを使用して、Nmstate API を介してイーサネット接続を設定します。Nmstate API は、設定を行った後、結果が設定ファイルと一致することを確認します。何らかの障害が発生した場合には、nmstatectl は自動的に変更をロールバックし、システムが不正な状態のままにならないようにします。

Nmstate を使用すると、静的 IP アドレス、ゲートウェイ、および DNS 設定を使用してイーサネット接続を設定し、それらを指定のインターフェイス名に割り当てることができます。

前提条件

- サーバーの構成に物理または仮想イーサネットネットワークインターフェイスコントローラー (NIC) が存在する。

-

nmstateパッケージがインストールされている。

手順

以下の内容を含む YAML ファイル (例:

~/create-ethernet-profile.yml) を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow これらの設定では、次の設定を使用して

enp1s0デバイスのイーサネット接続プロファイルを定義します。-

静的 IPv4 アドレス:

192.0.2.1(サブネットマスクが/24) -

静的 IPv6 アドレス:

2001:db8:1::1(サブネットマスクが/64) -

IPv4 デフォルトゲートウェイ -

192.0.2.254 -

IPv6 デフォルトゲートウェイ -

2001:db8:1::fffe -

IPv4 DNS サーバー -

192.0.2.200 -

IPv6 DNS サーバー -

2001:db8:1::ffbb -

DNS 検索ドメイン -

example.com

-

静的 IPv4 アドレス:

設定をシステムに適用します。

nmstatectl apply ~/create-ethernet-profile.yml

# nmstatectl apply ~/create-ethernet-profile.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

現在の状態を YAML 形式で表示します。

nmstatectl show enp1s0

# nmstatectl show enp1s0Copy to Clipboard Copied! Toggle word wrap Toggle overflow NIC の IP 設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv4 デフォルトゲートウェイを表示します。

ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv6 デフォルトゲートウェイを表示します。

ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref medium

# ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref mediumCopy to Clipboard Copied! Toggle word wrap Toggle overflow DNS 設定を表示します。

cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 複数の接続プロファイルが同時にアクティブな場合、

nameserverエントリーの順序は、これらのプロファイルの DNS 優先度の値と接続タイプによって異なります。pingユーティリティーを使用して、このホストがパケットを他のホストに送信できることを確認します。ping <host-name-or-IP-address>

# ping <host-name-or-IP-address>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7. network RHEL システムロールとインターフェイス名を使用した静的 IP アドレスでのイーサネット接続の設定

Red Hat Enterprise Linux ホストをイーサネットネットワークに接続するには、ネットワークデバイスの NetworkManager 接続プロファイルを作成します。Ansible と network RHEL システムロールを使用すると、このプロセスを自動化し、Playbook で定義されたホスト上の接続プロファイルをリモートで設定できます。

network RHEL システムロールを使用すると、静的 IP アドレス、ゲートウェイ、および DNS 設定を使用してイーサネット接続を設定し、それらを指定のインターフェイス名に割り当てることができます。

通常、管理者は Playbook を再利用します。Ansible が静的 IP アドレスを割り当てるホストごとに、個別の Playbook を管理することはありません。そうすることにより、Playbook 内の変数を使用し、外部ファイルで設定を維持できます。その結果、複数のホストに個別の設定を動的に割り当てるために必要な Playbook が 1 つだけになります。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。 - サーバーの構成に物理または仮想イーサネットデバイスが存在する。

- 管理対象ノードが NetworkManager を使用してネットワークを設定している。

手順

~/inventoryファイルを編集し、ホストエントリーにホスト固有の設定を追加します。managed-node-01.example.com interface=enp1s0 ip_v4=192.0.2.1/24 ip_v6=2001:db8:1::1/64 gateway_v4=192.0.2.254 gateway_v6=2001:db8:1::fffe managed-node-02.example.com interface=enp1s0 ip_v4=192.0.2.2/24 ip_v6=2001:db8:1::2/64 gateway_v4=192.0.2.254 gateway_v6=2001:db8:1::fffe

managed-node-01.example.com interface=enp1s0 ip_v4=192.0.2.1/24 ip_v6=2001:db8:1::1/64 gateway_v4=192.0.2.254 gateway_v6=2001:db8:1::fffe managed-node-02.example.com interface=enp1s0 ip_v4=192.0.2.2/24 ip_v6=2001:db8:1::2/64 gateway_v4=192.0.2.254 gateway_v6=2001:db8:1::fffeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow この Playbook は、インベントリーファイルから各ホストの特定の値を動的に読み取り、すべてのホストで同じ設定に対して Playbook 内の静的な値を使用します。

Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイルを参照してください。Playbook の構文を検証します。

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

管理対象ノードの Ansible fact をクエリーし、アクティブなネットワーク設定を確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8. network RHEL システムロールとデバイスパスを使用した静的 IP アドレスでのイーサネット接続の設定

Red Hat Enterprise Linux ホストをイーサネットネットワークに接続するには、ネットワークデバイスの NetworkManager 接続プロファイルを作成します。Ansible と network RHEL システムロールを使用すると、このプロセスを自動化し、Playbook で定義されたホスト上の接続プロファイルをリモートで設定できます。

network RHEL システムロールを使用すると、静的 IP アドレス、ゲートウェイ、および DNS 設定を使用してイーサネット接続を設定し、それらを名前ではなくパスに基づいてデバイスに割り当てることができます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。 - サーバーの構成に物理または仮想イーサネットデバイスが存在する。

- 管理対象ノードが NetworkManager を使用してネットワークを設定している。

-

デバイスのパスがわかっている。

udevadm info /sys/class/net/<device_name> | grep ID_PATH=コマンドを使用すると、デバイスパスを表示できます。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow サンプル Playbook で指定されている設定は次のとおりです。

match-

設定を適用するために満たす必要がある条件を定義します。この変数は

pathオプションでのみ使用できます。 path-

デバイスの永続パスを定義します。固定パスまたは式の形式で設定できます。値には修飾子とワイルドカードを含めることができます。この例では、PCI ID

0000:00:0[1-3].0に一致するデバイスには設定を適用しますが、0000:00:02.0に一致するデバイスには適用しません。

Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイルを参照してください。Playbook の構文を検証します。

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

管理対象ノードの Ansible fact をクエリーし、アクティブなネットワーク設定を確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9. nmstatectl でインターフェイス名を指定して動的 IP アドレスによる Ethernet 接続を設定する

nmstatectl ユーティリティーを使用して、Nmstate API を介してイーサネット接続を設定します。Nmstate API は、設定を行った後、結果が設定ファイルと一致することを確認します。何らかの障害が発生した場合には、nmstatectl は自動的に変更をロールバックし、システムが不正な状態のままにならないようにします。

Nmstate を使用すると、DHCP サーバーおよび IPv6 ステートレスアドレス自動設定 (SLAAC) から IP アドレス、ゲートウェイ、および DNS 設定を取得するイーサネット接続を設定できます。指定したインターフェイス名に接続プロファイルを割り当てることができます。

前提条件

- サーバーの構成に物理または仮想イーサネットネットワークインターフェイスコントローラー (NIC) が存在する。

- DHCP サーバーをネットワークで使用できる。

-

nmstateパッケージがインストールされている。

手順

以下の内容を含む YAML ファイル (例:

~/create-ethernet-profile.yml) を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow これらの設定では、

enp1s0デバイスのイーサネット接続プロファイルを定義します。接続では、DHCP サーバーと IPv6 ステートレスアドレス自動設定 (SLAAC) から、IPv4 アドレス、IPv6 アドレス、デフォルトゲートウェイ、ルート、DNS サーバー、および検索ドメインを取得します。設定をシステムに適用します。

nmstatectl apply ~/create-ethernet-profile.yml

# nmstatectl apply ~/create-ethernet-profile.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

現在の状態を YAML 形式で表示します。

nmstatectl show enp1s0

# nmstatectl show enp1s0Copy to Clipboard Copied! Toggle word wrap Toggle overflow NIC の IP 設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv4 デフォルトゲートウェイを表示します。

ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102Copy to Clipboard Copied! Toggle word wrap Toggle overflow IPv6 デフォルトゲートウェイを表示します。

ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref medium

# ip -6 route show default default via 2001:db8:1::fffe dev enp1s0 proto static metric 102 pref mediumCopy to Clipboard Copied! Toggle word wrap Toggle overflow DNS 設定を表示します。

cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 複数の接続プロファイルが同時にアクティブな場合、

nameserverエントリーの順序は、これらのプロファイルの DNS 優先度の値と接続タイプによって異なります。pingユーティリティーを使用して、このホストがパケットを他のホストに送信できることを確認します。ping <host-name-or-IP-address>

# ping <host-name-or-IP-address>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.10. network RHEL システムロールとインターフェイス名を使用した動的 IP アドレスでのイーサネット接続の設定

Red Hat Enterprise Linux ホストをイーサネットネットワークに接続するには、ネットワークデバイスの NetworkManager 接続プロファイルを作成します。Ansible と network RHEL システムロールを使用すると、このプロセスを自動化し、Playbook で定義されたホスト上の接続プロファイルをリモートで設定できます。

network RHEL システムロールを使用すると、DHCP サーバーおよび IPv6 ステートレスアドレス自動設定 (SLAAC) から IP アドレス、ゲートウェイ、および DNS 設定を取得するイーサネット接続を設定できます。このロールを使用すると、指定のインターフェイス名に接続プロファイルを割り当てることができます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。 - サーバーの構成に物理または仮想イーサネットデバイスが存在する。

- ネットワーク内で DHCP サーバーと SLAAC が利用できる。

- 管理対象ノードが NetworkManager サービスを使用してネットワークを設定している。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow サンプル Playbook で指定されている設定は次のとおりです。

dhcp4: yes- DHCP、PPP、または同様のサービスからの自動 IPv4 アドレス割り当てを有効にします。

auto6: yes-

IPv6 自動設定を有効にします。デフォルトでは、NetworkManager はルーター広告を使用します。ルーターが

managedフラグを通知すると、NetworkManager は DHCPv6 サーバーに IPv6 アドレスと接頭辞を要求します。

Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイルを参照してください。Playbook の構文を検証します。

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

管理対象ノードの Ansible fact をクエリーし、インターフェイスが IP アドレスと DNS 設定を受信したことを確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.11. network RHEL システムロールとデバイスパスを使用した動的 IP アドレスでのイーサネット接続の設定

Red Hat Enterprise Linux ホストをイーサネットネットワークに接続するには、ネットワークデバイスの NetworkManager 接続プロファイルを作成します。Ansible と network RHEL システムロールを使用すると、このプロセスを自動化し、Playbook で定義されたホスト上の接続プロファイルをリモートで設定できます。

network RHEL システムロールを使用すると、DHCP サーバーおよび IPv6 ステートレスアドレス自動設定 (SLAAC) から IP アドレス、ゲートウェイ、および DNS 設定を取得するイーサネット接続を設定できます。このロールにより、インターフェイス名ではなくパスに基づいてデバイスに接続プロファイルを割り当てることができます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。 - サーバーの構成に物理または仮想イーサネットデバイスが存在する。

- ネットワーク内で DHCP サーバーと SLAAC が利用できる。

- 管理対象ホストは、NetworkManager を使用してネットワークを設定します。

-

デバイスのパスがわかっている。

udevadm info /sys/class/net/<device_name> | grep ID_PATH=コマンドを使用すると、デバイスパスを表示できます。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow サンプル Playbook で指定されている設定は次のとおりです。

match: path-

設定を適用するために満たす必要がある条件を定義します。この変数は

pathオプションでのみ使用できます。 path: <path_and_expressions>-

デバイスの永続パスを定義します。固定パスまたは式の形式で設定できます。値には修飾子とワイルドカードを含めることができます。この例では、PCI ID

0000:00:0[1-3].0に一致するデバイスには設定を適用しますが、0000:00:02.0に一致するデバイスには適用しません。 dhcp4: yes- DHCP、PPP、または同様のサービスからの自動 IPv4 アドレス割り当てを有効にします。

auto6: yes-

IPv6 自動設定を有効にします。デフォルトでは、NetworkManager はルーター広告を使用します。ルーターが

managedフラグを通知すると、NetworkManager は DHCPv6 サーバーに IPv6 アドレスと接頭辞を要求します。

Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイルを参照してください。Playbook の構文を検証します。

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

管理対象ノードの Ansible fact をクエリーし、インターフェイスが IP アドレスと DNS 設定を受信したことを確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.12. インターフェイス名による単一の接続プロファイルを使用した複数のイーサネットインターフェイスの設定

ほとんどの場合、1 つの接続プロファイルには 1 つのネットワークデバイスの設定が含まれています。ただし、接続プロファイルでインターフェイス名を設定する場合、NetworkManager はワイルドカードもサポートします。ホストが動的 IP アドレス割り当てを使用してイーサネットネットワーク間をローミングする場合、この機能を使用して、複数のイーサネットインターフェイスに使用できる単一の接続プロファイルを作成できます。

前提条件

- サーバーの構成に物理または仮想イーサネットデバイスが複数存在する。

- DHCP サーバーをネットワークで使用できる。

- ホストに接続プロファイルが存在しません。

手順

enpで始まるすべてのインターフェイス名に適用される接続プロファイルを追加します。nmcli connection add con-name "Wired connection 1" connection.multi-connect multiple match.interface-name enp* type ethernet

# nmcli connection add con-name "Wired connection 1" connection.multi-connect multiple match.interface-name enp* type ethernetCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

単一接続プロファイルのすべての設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 3は、インターフェイスが特定の瞬間に複数回アクティブになる可能性があることを示します。接続プロファイルは、match.interface-nameパラメーターのパターンに一致するすべてのデバイスを使用するため、接続プロファイルには同じ Universally Unique Identifier (UUID) があります。接続のステータスを表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.13. PCI ID を使用した複数のイーサネットインターフェイスの単一接続プロファイルの設定

PCI ID は、システムに接続されているデバイスの一意の識別子です。接続プロファイルは、PCI ID のリストに基づいてインターフェイスを照合することにより、複数のデバイスを追加します。この手順を使用して、複数のデバイス PCI ID を単一の接続プロファイルに接続できます。

前提条件

- サーバーの構成に物理または仮想イーサネットデバイスが複数存在する。

- DHCP サーバーをネットワークで使用できる。

- ホストに接続プロファイルが存在しません。

手順

デバイスパスを特定します。たとえば、

enpで始まるすべてのインターフェイスのデバイスパスを表示するには、次のように実行します。udevadm info /sys/class/net/enp* | grep ID_PATH= ... E: ID_PATH=pci-0000:07:00.0 E: ID_PATH=pci-0000:08:00.0

# udevadm info /sys/class/net/enp* | grep ID_PATH= ... E: ID_PATH=pci-0000:07:00.0 E: ID_PATH=pci-0000:08:00.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 0000:00:0[7-8].0式に一致するすべての PCI ID に適用される接続プロファイルを追加します。nmcli connection add type ethernet connection.multi-connect multiple match.path "pci-0000:07:00.0 pci-0000:08:00.0" con-name "Wired connection 1"

# nmcli connection add type ethernet connection.multi-connect multiple match.path "pci-0000:07:00.0 pci-0000:08:00.0" con-name "Wired connection 1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

接続のステータスを表示します。

nmcli connection show NAME UUID TYPE DEVICE Wired connection 1 9cee0958-512f-4203-9d3d-b57af1d88466 ethernet enp7s0 Wired connection 1 9cee0958-512f-4203-9d3d-b57af1d88466 ethernet enp8s0 ...

# nmcli connection show NAME UUID TYPE DEVICE Wired connection 1 9cee0958-512f-4203-9d3d-b57af1d88466 ethernet enp7s0 Wired connection 1 9cee0958-512f-4203-9d3d-b57af1d88466 ethernet enp8s0 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接続プロファイルのすべての設定を表示するには、次のコマンドを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow この接続プロファイルは、

match.pathパラメーターのパターンに一致する PCI ID を持つすべてのデバイスを使用するため、接続プロファイルには同じ Universally Unique Identifier (UUID) があります。

第3章 ネットワークボンディングの設定

ネットワークボンディングは、物理ネットワークインターフェイスと仮想ネットワークインターフェイスを組み合わせるか集約して、より高いスループットまたは冗長性を備えた論理インターフェイスを提供する方法です。ボンディングでは、カーネルがすべての操作を排他的に処理します。イーサネットデバイスや VLAN など、さまざまなタイプのデバイスでネットワークボンディングを作成できます。

Red Hat Enterprise Linux は、ボンディングデバイスを設定するためのさまざまなオプションを管理者に提供します。以下に例を示します。

-

nmcliを使用し、コマンドラインを使用してボンディング接続を設定します。 - RHEL Web コンソールを使用し、Web ブラウザーを使用してボンディング接続を設定します。

-

nmtuiを使用して、テキストベースのユーザーインターフェイスでボンディング接続を設定します。 -

nm-connection-editorアプリケーションを使用して、グラフィカルインターフェイスでボンディング接続を設定します。 -

nmstatectlを使用して、Nmstate API を介してボンディング接続を設定します。 - RHEL システムロールを使用して、1 つまたは複数のホストでボンディング設定を自動化します。

3.1. コントローラーおよびポートインターフェイスのデフォルト動作の理解

NetworkManager サービスを使用してチームまたはボンディングのポートインターフェイスを管理またはトラブルシューティングする場合は、以下のデフォルトの動作を考慮してください。

- コントローラーインターフェイスを起動しても、ポートインターフェイスは自動的に起動しない。

- ポートインターフェイスを起動すると、コントローラーインターフェイスは毎回、起動する。

- コントローラーインターフェイスを停止すると、ポートインターフェイスも停止する。

- ポートのないコントローラーは、静的 IP 接続を開始できる。

- コントローラーにポートがない場合は、DHCP 接続の開始時にポートを待つ。

- DHCP 接続でポートを待機中のコントローラーは、キャリアを伴うポートの追加時に完了する。

- DHCP 接続でポートを待機中のコントローラーは、キャリアを伴わないポートを追加する時に待機を継続する。

3.2. ボンディングモードに応じたアップストリームのスイッチ設定

使用するボンディングモードに応じて、スイッチでポートを設定する必要があります。

| ボンディングモード | スイッチの設定 |

|---|---|

|

| Link Aggregation Control Protocol (LACP) ネゴシエーションによるものではなく、静的な EtherChannel を有効にする必要があります。 |

|

| このスイッチで必要な設定は必要ありません。 |

|

| LACP ネゴシエーションによるものではなく、静的な EtherChannel を有効にする必要があります。 |

|

| LACP ネゴシエーションによるものではなく、静的な EtherChannel を有効にする必要があります。 |

|

| LACP ネゴシエーションにより設定された EtherChannel が有効になっている必要があります。 |

|

| このスイッチで必要な設定は必要ありません。 |

|

| このスイッチで必要な設定は必要ありません。 |

スイッチの設定方法の詳細は、スイッチのドキュメントを参照してください。

特定のネットワークボンディング機能 (例: fail-over メカニズム) は、ネットワークスイッチなしでのダイレクトケーブル接続に対応していません。詳細は、Red Hat ナレッジベースのソリューション記事 Is bonding supported with direct connection using crossover cables を参照してください。

3.3. nmcli を使用したネットワークボンディングの設定

コマンドラインでネットワークボンディングを設定するには、nmcli ユーティリティーを使用します。

前提条件

- サーバーに、2 つ以上の物理ネットワークデバイスまたは仮想ネットワークデバイスがインストールされている。

- ボンディングのポートとしてイーサネットデバイスを使用するには、物理または仮想のイーサネットデバイスがサーバーにインストールされている。

ボンディングのポートにチーム、ブリッジ、または VLAN デバイスを使用するには、ボンディングの作成時にこれらのデバイスを作成するか、次の説明に従って事前にデバイスを作成することができます。

手順

ボンドインターフェイスを作成します。

nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup"

# nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup"Copy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは、

active-backupモードを使用するbond0という名前のボンディングを作成します。Media Independent Interface (MII) 監視間隔も設定する場合は、

miimon=intervalオプションをbond.optionsプロパティーに追加します。次に例を示します。nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup,miimon=1000"

# nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup,miimon=1000"Copy to Clipboard Copied! Toggle word wrap Toggle overflow ネットワークインターフェイスを表示して、ボンドに追加する予定のインターフェイス名を書き留めます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、以下のように設定されています。

-

enp7s0およびenp8s0は設定されません。これらのデバイスをポートとして使用するには、次のステップに接続プロファイルを追加します。 -

bridge0およびbridge1には既存の接続プロファイルがあります。これらのデバイスをポートとして使用するには、次の手順でプロファイルを変更します。

-

インターフェイスをボンディングに割り当てます。

ボンディングに割り当てるインターフェイスが設定されていない場合は、インターフェイス用に新しい接続プロファイルを作成します。

nmcli connection add type ethernet slave-type bond con-name bond0-port1 ifname enp7s0 master bond0 nmcli connection add type ethernet slave-type bond con-name bond0-port2 ifname enp8s0 master bond0

# nmcli connection add type ethernet slave-type bond con-name bond0-port1 ifname enp7s0 master bond0 # nmcli connection add type ethernet slave-type bond con-name bond0-port2 ifname enp8s0 master bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow これらのコマンドは、

enp7s0およびenp8s0のプロファイルを作成し、bond0接続に追加します。既存の接続プロファイルをボンディングに割り当てるには、以下を実行します。

これらの接続の

masterパラメーターをbond0に設定します。nmcli connection modify bridge0 master bond0 nmcli connection modify bridge1 master bond0

# nmcli connection modify bridge0 master bond0 # nmcli connection modify bridge1 master bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow これらのコマンドは、

bridge0およびbridge1という名前の既存の接続プロファイルをbond0接続に割り当てます。接続を再度アクティブにします。

nmcli connection up bridge0 nmcli connection up bridge1

# nmcli connection up bridge0 # nmcli connection up bridge1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

IPv4 を設定します。

静的 IPv4 アドレス、ネットワークマスク、デフォルトゲートウェイ、および DNS サーバーを

bond0接続に設定するには、次のように実行します。nmcli connection modify bond0 ipv4.addresses '192.0.2.1/24' ipv4.gateway '192.0.2.254' ipv4.dns '192.0.2.253' ipv4.dns-search 'example.com' ipv4.method manual

# nmcli connection modify bond0 ipv4.addresses '192.0.2.1/24' ipv4.gateway '192.0.2.254' ipv4.dns '192.0.2.253' ipv4.dns-search 'example.com' ipv4.method manualCopy to Clipboard Copied! Toggle word wrap Toggle overflow - DHCP を使用するために必要な操作はありません。

- このボンディングデバイスを他のデバイスのポートとして使用する予定の場合は、何もする必要はありません。

IPv6 設定を行います。

静的 IPv6 アドレス、ネットワークマスク、デフォルトゲートウェイ、および DNS サーバーを

bond0接続に設定するには、次のように実行します。nmcli connection modify bond0 ipv6.addresses '2001:db8:1::1/64' ipv6.gateway '2001:db8:1::fffe' ipv6.dns '2001:db8:1::fffd' ipv6.dns-search 'example.com' ipv6.method manual

# nmcli connection modify bond0 ipv6.addresses '2001:db8:1::1/64' ipv6.gateway '2001:db8:1::fffe' ipv6.dns '2001:db8:1::fffd' ipv6.dns-search 'example.com' ipv6.method manualCopy to Clipboard Copied! Toggle word wrap Toggle overflow - ステートレスアドレス自動設定 (SLAAC) を使用する場合、アクションは必要ありません。

- このボンディングデバイスを他のデバイスのポートとして使用する予定の場合は、何もする必要はありません。

オプション: ボンディングポートにパラメーターを設定する場合は、次のコマンドを使用します。

nmcli connection modify bond0-port1 bond-port.<parameter> <value>

# nmcli connection modify bond0-port1 bond-port.<parameter> <value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接続をアクティベートします。

nmcli connection up bond0

# nmcli connection up bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow ポートが接続されており、

CONNECTIONコラムがポートの接続名を表示していることを確認します。nmcli device DEVICE TYPE STATE CONNECTION ... enp7s0 ethernet connected bond0-port1 enp8s0 ethernet connected bond0-port2

# nmcli device DEVICE TYPE STATE CONNECTION ... enp7s0 ethernet connected bond0-port1 enp8s0 ethernet connected bond0-port2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接続のいずれかのポートをアクティブにすると、NetworkManager はボンディングもアクティブにしますが、他のポートはアクティブにしません。ボンディングが有効な場合に、Red Hat Enterprise Linux がすべてのポートを自動的に有効にするように設定できます。

ボンディングの接続で

connection.autoconnect-slavesパラメーターを有効にします。nmcli connection modify bond0 connection.autoconnect-slaves 1

# nmcli connection modify bond0 connection.autoconnect-slaves 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow ブリッジを再度アクティブにします。

nmcli connection up bond0

# nmcli connection up bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ネットワークデバイスの 1 つからネットワークケーブルを一時的に取り外し、ボンディング内の他のデバイスがトラフィックを処理しているかどうかを確認します。

ソフトウェアユーティリティーを使用して、リンク障害イベントを適切にテストする方法がないことに注意してください。

nmcliなどの接続を非アクティブにするツールでは、ポート設定の変更を処理するボンディングドライバーの機能のみが表示され、実際のリンク障害イベントは表示されません。ボンドのステータスを表示します。

cat /proc/net/bonding/bond0

# cat /proc/net/bonding/bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. RHEL Web コンソールを使用したネットワークボンディングの設定

Web ブラウザーベースのインターフェイスを使用してネットワーク設定を管理する場合は、RHEL Web コンソールを使用してネットワークボンディングを設定します。

前提条件

- サーバーに、2 つ以上の物理ネットワークデバイスまたは仮想ネットワークデバイスがインストールされている。

- ボンディングのメンバーとしてイーサネットデバイスを使用するには、物理または仮想のイーサネットデバイスがサーバーにインストールされている。

チーム、ブリッジ、または VLAN デバイスを結合のメンバーとして使用するには、次の説明に従って事前に作成します。

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

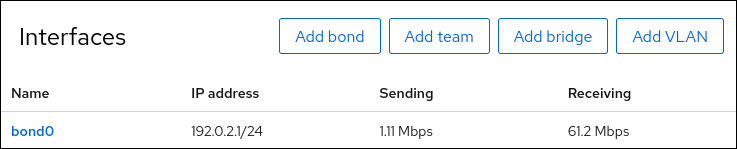

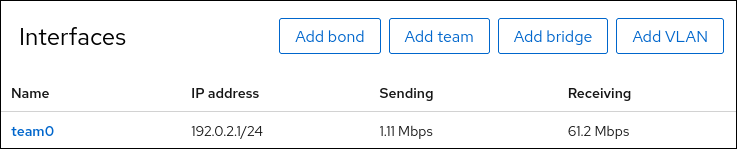

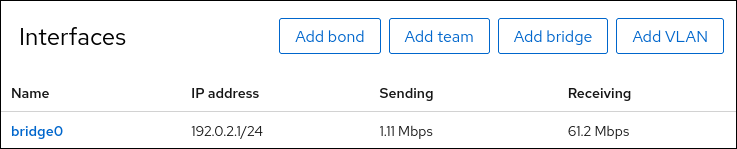

- 画面左側のナビゲーションで Networking タブを選択します。

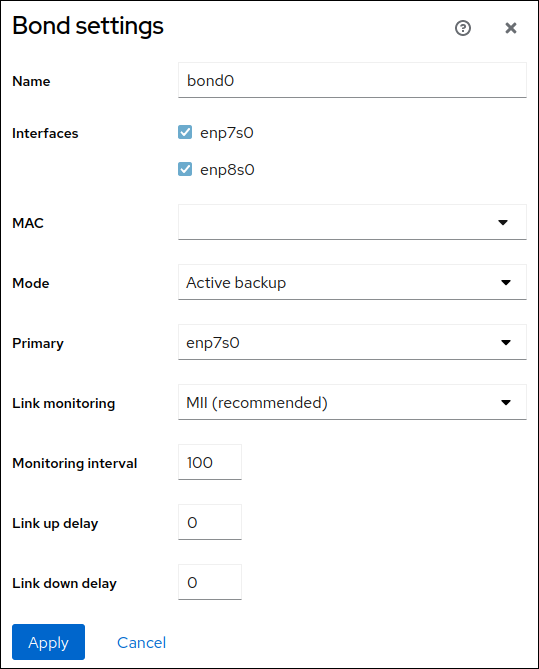

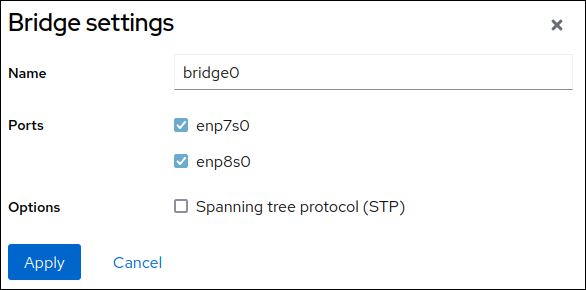

- Interfaces セクションで をクリックします。

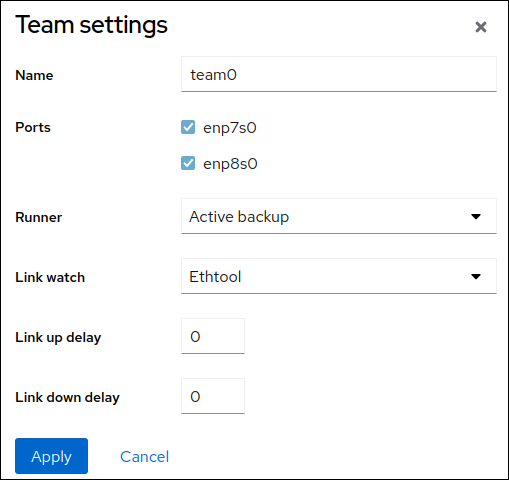

- 作成するボンドデバイスの名前を入力します。

- 結合のメンバーにするインターフェイスを選択します。

結合のモードを選択します。

Active backup を選択すると、Web コンソールに追加フィールド Primary が表示され、ここで優先するアクティブデバイスを選択できます。

-

リンクモニタリング監視モードを設定します。たとえば、Adaptive load balancing モードを使用する場合は、

ARPに設定します。 オプション: モニター間隔、リンクアップ遅延、およびリンクダウン遅延の設定を調整します。通常、トラブルシューティングの目的でのみデフォルトを変更します。

- をクリックします。

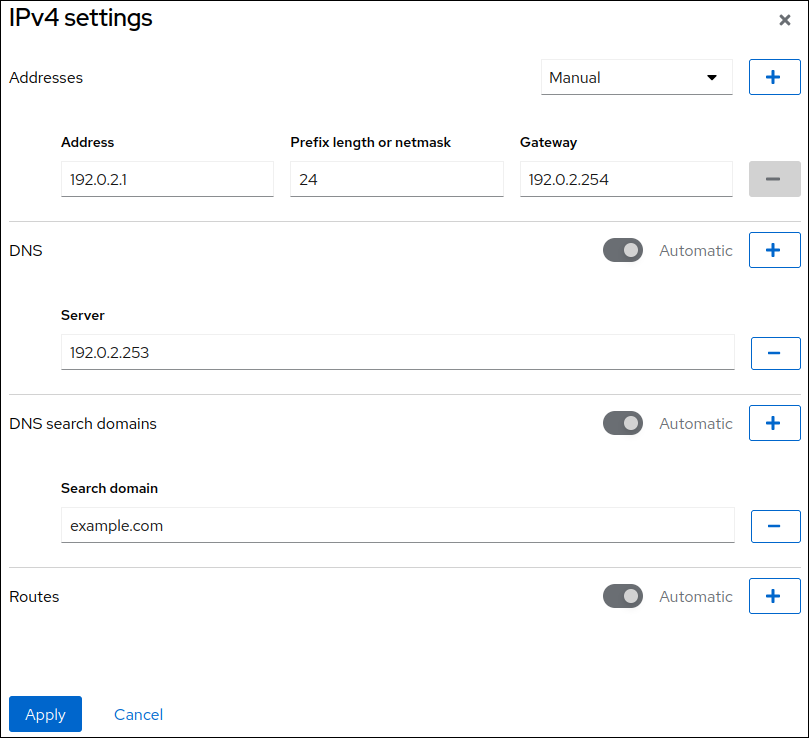

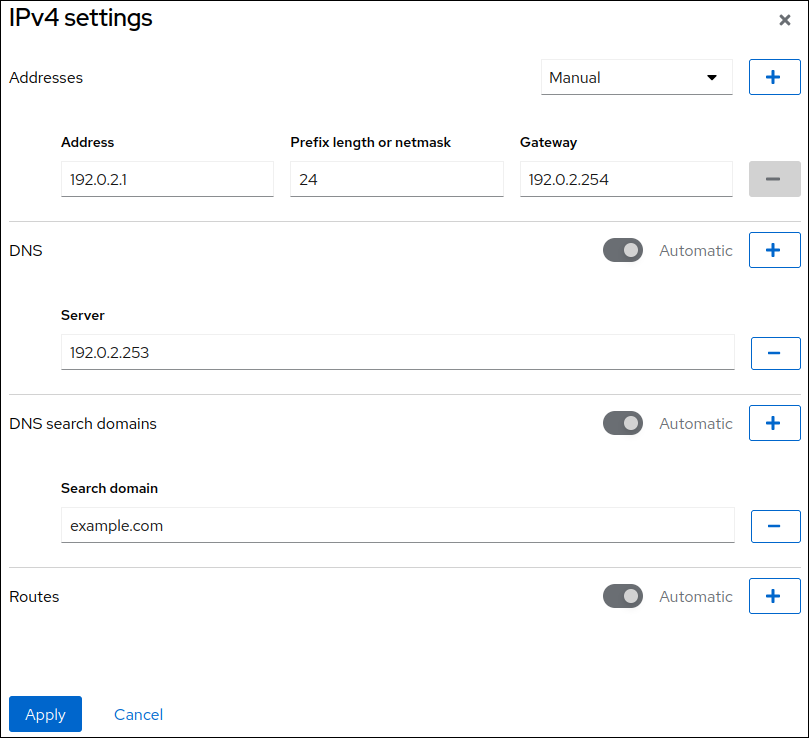

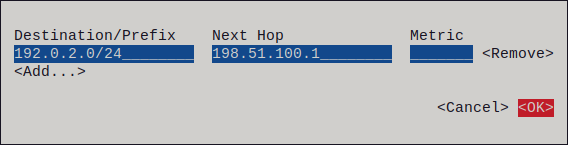

デフォルトでは、ボンドは動的 IP アドレスを使用します。静的 IP アドレスを設定する場合:

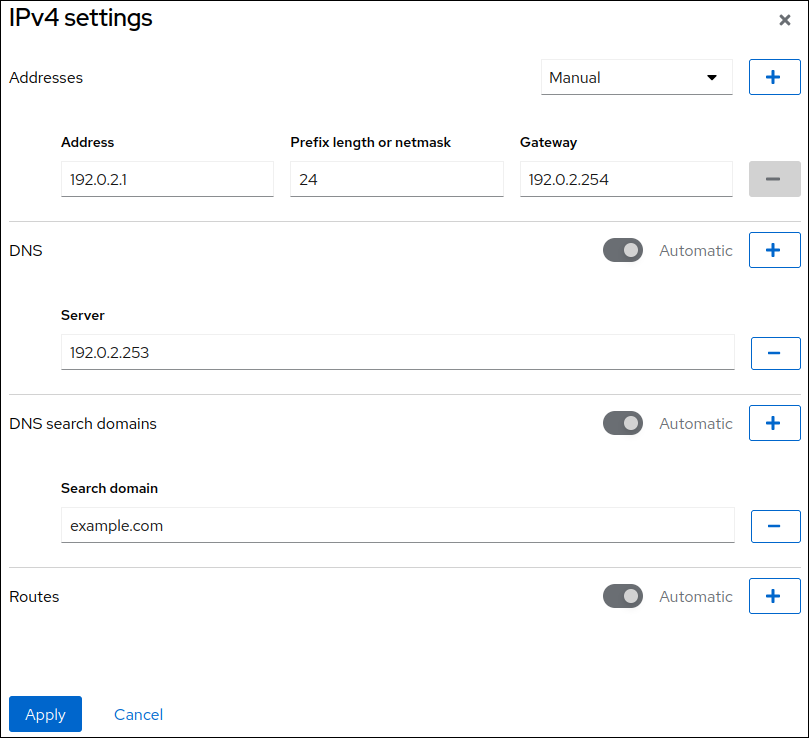

- Interfaces セクションでボンドの名前をクリックします。

- 設定するプロトコルの横にある Edit をクリックします。

- Addresses の横にある Manual を選択し、IP アドレス、接頭辞、およびデフォルトゲートウェイを入力します。

- DNS セクションで ボタンをクリックし、DNS サーバーの IP アドレスを入力します。複数の DNS サーバーを設定するには、この手順を繰り返します。

- DNS search domains セクションで、 ボタンをクリックし、検索ドメインを入力します。

インターフェイスにスタティックルートが必要な場合は、Routes セクションで設定します。

- をクリックします。

検証

画面左側のナビゲーションで Networking タブを選択し、インターフェイスに着信および発信トラフィックがあるか確認します。

ネットワークデバイスの 1 つからネットワークケーブルを一時的に取り外し、ボンディング内の他のデバイスがトラフィックを処理しているかどうかを確認します。

ソフトウェアユーティリティーを使用して、リンク障害イベントを適切にテストする方法がないことに注意してください。Web コンソールなどの接続を非アクティブ化するツールは、実際のリンク障害イベントではなく、メンバー設定の変更を処理するボンディングドライバーの機能のみを示します。

ボンドのステータスを表示します。

cat /proc/net/bonding/bond0

# cat /proc/net/bonding/bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. nmtui を使用したネットワークボンディングの設定

nmtui アプリケーションは、NetworkManager 用のテキストベースのユーザーインターフェイスを提供します。nmtui を使用して、グラフィカルインターフェイスを使用せずにホスト上でネットワークボンドを設定できます。

nmtui で以下を行います。

- カーソルキーを使用してナビゲートします。

- ボタンを選択して Enter を押します。

- Space を使用してチェックボックスをオンまたはオフにします。

- 前の画面に戻るには、ESC を使用します。

前提条件

- サーバーに、2 つ以上の物理ネットワークデバイスまたは仮想ネットワークデバイスがインストールされている。

- イーサネットデバイスをボンディングのポートとして使用するために、物理または仮想イーサネットデバイスがサーバーにインストールされている。

手順

ネットワークボンドを設定するネットワークデバイス名がわからない場合は、使用可能なデバイスを表示します。

nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet unavailable -- enp8s0 ethernet unavailable -- ...

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet unavailable -- enp8s0 ethernet unavailable -- ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow nmtuiを開始します。nmtui

# nmtuiCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Edit a connection 選択し、Enter を押します。

- Add を押します。

- ネットワークタイプのリストから Bond を選択し、Enter を押します。

オプション: 作成する NetworkManager プロファイルの名前を入力します。

ホストに複数のプロファイルがある場合は、わかりやすい名前を付けると、プロファイルの目的を識別しやすくなります。

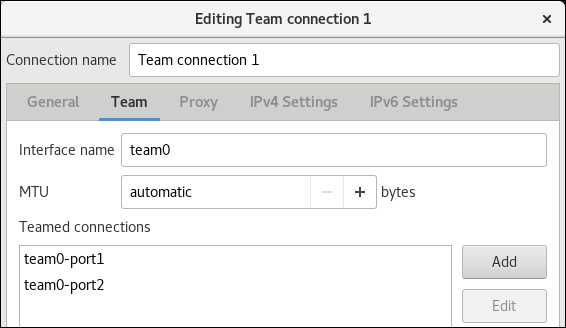

- 作成するボンドデバイス名を Device フィールドに入力します。

作成するボンドにポートを追加します。

- Slaves リストの横にある Add を押します。

- ボンドにポートとして追加するインターフェイスのタイプ (例: Ethernet) を選択します。

- オプション: このボンドポート用に作成する NetworkManager プロファイルの名前を入力します。

- ポートのデバイス名を Device フィールドに入力します。

OK を押して、ボンディング設定のウィンドウに戻ります。

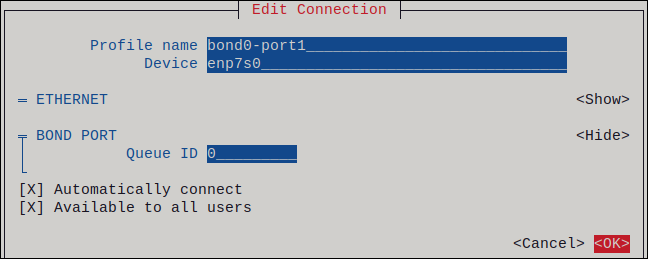

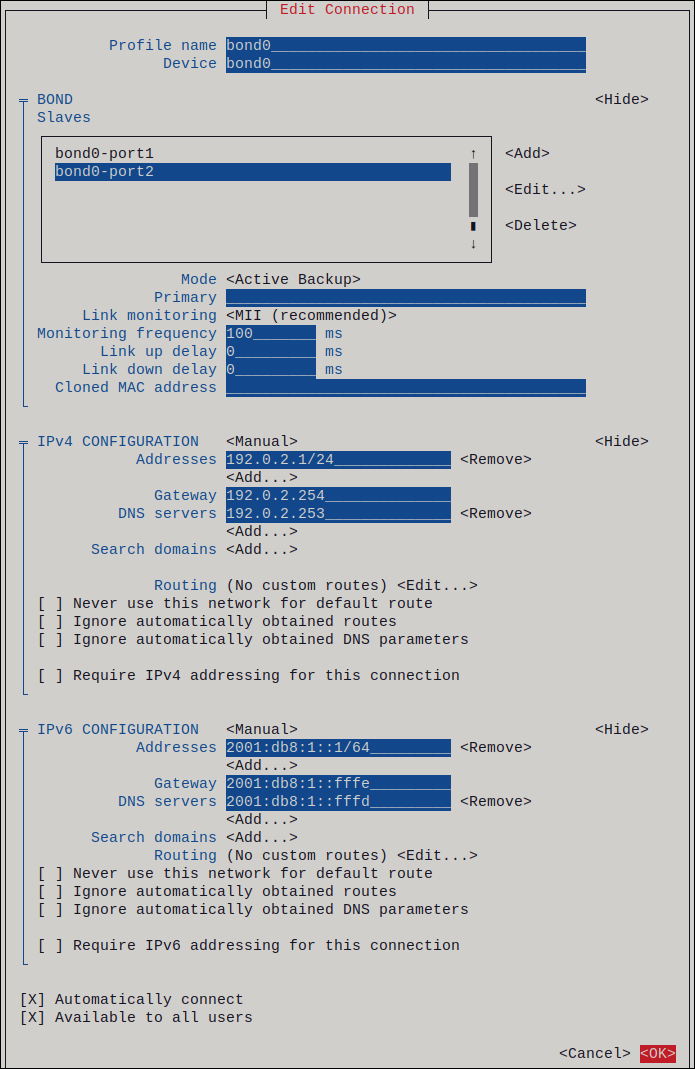

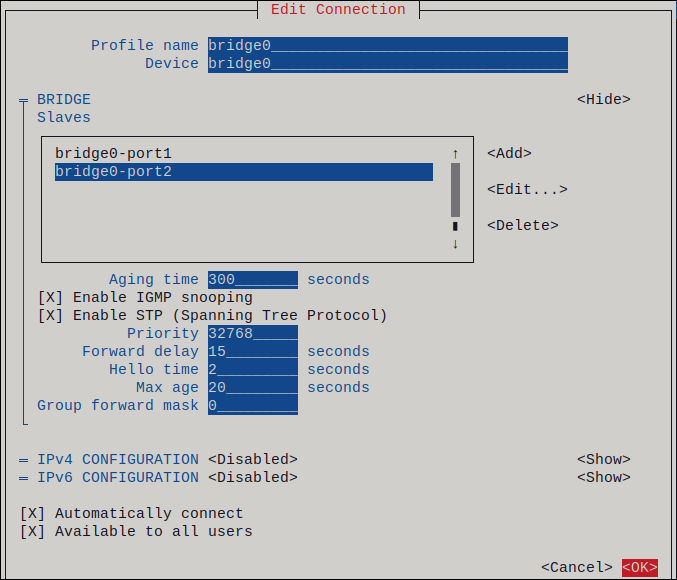

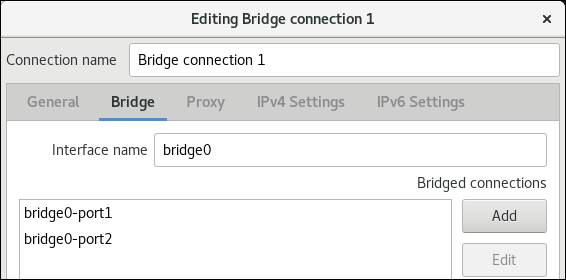

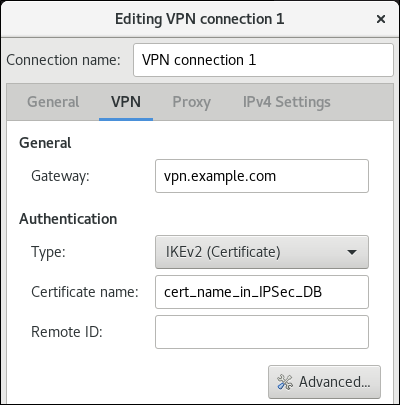

図3.1 イーサネットデバイスをポートとしてボンドに追加する

- ボンドにさらにポートを追加するには、これらの手順を繰り返します。

-

ボンディングモードを設定します。設定した値に応じて、

nmtuiは、選択したモードに関連する設定の追加フィールドを表示します。 環境に応じて、IPv4 configuration および IPv6 configuration 領域に IP アドレス設定を設定します。これを行うには、これらの領域の横にあるボタンを押して、次を選択します。

-

ボンドが IP アドレスを必要としない場合は

Disabledにします。 -

DHCP サーバーまたはステートレスアドレス自動設定 (SLAAC) が IP アドレスをボンディングに動的に割り当てる場合は、

Automaticにします。 ネットワークで静的 IP アドレス設定が必要な場合は、

Manualにします。この場合、さらにフィールドに入力する必要があります。- 設定するプロトコルの横にある Show を押して、追加のフィールドを表示します。

Addresses の横にある Add を押して、IP アドレスとサブネットマスクを Classless Inter-Domain Routing (CIDR) 形式で入力します。

サブネットマスクを指定しない場合、NetworkManager は IPv4 アドレスに

/32サブネットマスクを設定し、IPv6 アドレスに/64サブネットマスクを設定します。- デフォルトゲートウェイのアドレスを入力します。

- DNS servers の横にある Add を押して、DNS サーバーのアドレスを入力します。

- Search domains の横にある Add を押して、DNS 検索ドメインを入力します。

図3.2 静的 IP アドレス設定によるボンド接続例

-

ボンドが IP アドレスを必要としない場合は

- OK を押すと、新しい接続が作成され、自動的にアクティブ化されます。

- Back を押してメインメニューに戻ります。

-

Quit を選択し、Enter キーを押して

nmtuiアプリケーションを閉じます。

検証

ネットワークデバイスの 1 つからネットワークケーブルを一時的に取り外し、ボンディング内の他のデバイスがトラフィックを処理しているかどうかを確認します。

ソフトウェアユーティリティーを使用して、リンク障害イベントを適切にテストする方法がないことに注意してください。

nmcliなどの接続を非アクティブにするツールでは、ポート設定の変更を処理するボンディングドライバーの機能のみが表示され、実際のリンク障害イベントは表示されません。ボンドのステータスを表示します。

cat /proc/net/bonding/bond0

# cat /proc/net/bonding/bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. nm-connection-editor を使用したネットワークボンディングの設定

グラフィカルインターフェイスで Red Hat Enterprise Linux を使用する場合は、nm-connection-editor アプリケーションを使用してネットワークボンディングを設定できます。

nm-connection-editor は、新しいポートだけをボンドに追加できることに注意してください。既存の接続プロファイルをポートとして使用するには、nmcli を使用したネットワークボンディングの設定 の説明に従って nmcli ユーティリティーを使用してボンディングを作成します。

前提条件

- サーバーに、2 つ以上の物理ネットワークデバイスまたは仮想ネットワークデバイスがインストールされている。

- ボンディングのポートとしてイーサネットデバイスを使用するには、物理または仮想のイーサネットデバイスがサーバーにインストールされている。

- ボンディングのポートとしてチーム、ボンディング、または VLAN デバイスを使用するには、これらのデバイスがまだ設定されていないことを確認してください。

手順

ターミナルを開き、

nm-connection-editorと入力します。nm-connection-editor

$ nm-connection-editorCopy to Clipboard Copied! Toggle word wrap Toggle overflow - ボタンをクリックして、新しい接続を追加します。

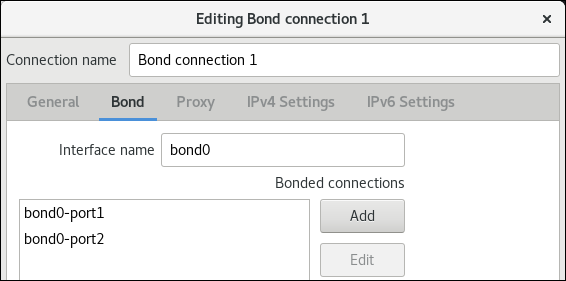

- 接続タイプ Bond を選択し、 をクリックします。

Bond タブで、以下を行います。

- 必要に応じて、Interface name フィールドにボンドインターフェイスの名前を設定します。

ボタンをクリックして、ネットワークインターフェイスをポートとしてボンドに追加します。

- インターフェイスの接続タイプを選択します。たとえば、有線接続に Ethernet を選択します。

- 必要に応じて、ポートの接続名を設定します。

- イーサネットデバイスの接続プロファイルを作成する場合は、Ethernet タブを開き、Device フィールドでポートとしてボンディングに追加するネットワークインターフェイスを選択します。別のデバイスタイプを選択した場合は、それに応じて設定します。イーサネットインターフェイスは、設定されていないボンディングでのみ使用できることに注意してください。

- をクリックします。

ボンディングに追加する各インターフェイスで直前の手順を繰り返します。

- 必要に応じて、Media Independent Interface (MII) の監視間隔などの他のオプションを設定します。

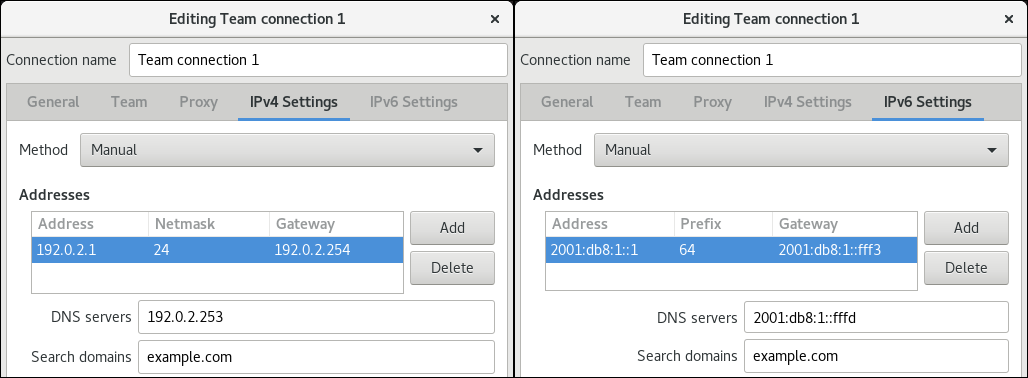

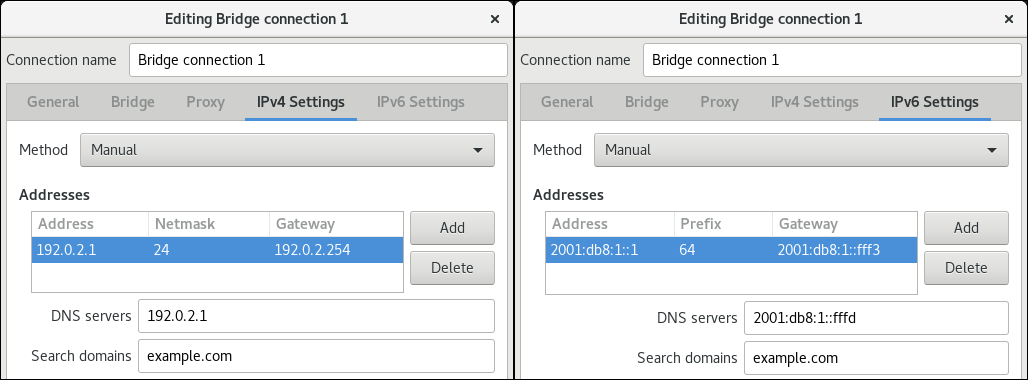

IPv4 Settings タブと IPv6 Settings タブの両方で IP アドレス設定を設定します。

- このブリッジデバイスを他のデバイスのポートとして使用する場合は、Method フィールドを Disabled に設定します。

- DHCP を使用するには、Method フィールドをデフォルトの Automatic (DHCP) のままにします。

静的 IP 設定を使用するには、Method フィールドを Manual に設定し、それに応じてフィールドに値を入力します。

- をクリックします。

-

nm-connection-editorを閉じます。

検証

ネットワークデバイスの 1 つからネットワークケーブルを一時的に取り外し、ボンディング内の他のデバイスがトラフィックを処理しているかどうかを確認します。

ソフトウェアユーティリティーを使用して、リンク障害イベントを適切にテストする方法がないことに注意してください。

nmcliなどの接続を非アクティブにするツールでは、ポート設定の変更を処理するボンディングドライバーの機能のみが表示され、実際のリンク障害イベントは表示されません。ボンドのステータスを表示します。

cat /proc/net/bonding/bond0

# cat /proc/net/bonding/bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7. nmstatectl を使用したネットワークボンディングの設定

nmstatectl ユーティリティーを使用して、Nmstate API を介してネットワークボンディングを設定します。Nmstate API は、設定を行った後、結果が設定ファイルと一致することを確認します。何らかの障害が発生した場合には、nmstatectl は自動的に変更をロールバックし、システムが不正な状態のままにならないようにします。

環境に応じて、YAML ファイルを適宜調整します。たとえば、ボンディングでイーサネットアダプターとは異なるデバイスを使用するには、ボンディングで使用するポートの Base-iface 属性と type 属性を調整します。

前提条件

- サーバーに、2 つ以上の物理ネットワークデバイスまたは仮想ネットワークデバイスがインストールされている。

- 物理または仮想のイーサネットデバイスをサーバーにインストールしてボンディングでポートとしてイーサネットデバイスを使用する。

-

ポートリストでインターフェイス名を設定し、対応するインターフェイスを定義して、ボンディングのポートとしてチーム、ブリッジ、または VLAN デバイスを使用する。 -

nmstateパッケージがインストールされている。

手順

以下の内容を含む YAML ファイルを作成します (例:

~/create-bond.yml)。Copy to Clipboard Copied! Toggle word wrap Toggle overflow これらの設定では、次の設定を使用してネットワークボンディングを定義します。

-

ボンドのネットワークインターフェイス:

enp1s0およびenp7s0 -

モード:

active-backup -

静的 IPv4 アドレス: サブネットマスクが

/24の192.0.2.1 -

静的 IPv6 アドレス:

2001:db8:1::1(/64サブネットマスクあり) -

IPv4 デフォルトゲートウェイ:

192.0.2.254 -

IPv6 デフォルトゲートウェイ:

2001:db8:1::fffe -

IPv4 DNS サーバー:

192.0.2.200 -

IPv6 DNS サーバー:

2001:db8:1::ffbb -

DNS 検索ドメイン:

example.com

-

ボンドのネットワークインターフェイス:

設定をシステムに適用します。

nmstatectl apply ~/create-bond.yml

# nmstatectl apply ~/create-bond.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

デバイスおよび接続の状態を表示します。

nmcli device status DEVICE TYPE STATE CONNECTION bond0 bond connected bond0

# nmcli device status DEVICE TYPE STATE CONNECTION bond0 bond connected bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接続プロファイルのすべての設定を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 接続設定を YAML 形式で表示します。

nmstatectl show bond0

# nmstatectl show bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.8. network RHEL システムロールを使用したネットワークボンディングの設定

ネットワークインターフェイスをボンディングで組み合わせると、より高いスループットまたは冗長性を備えた論理インターフェイスを提供できます。ボンディングを設定するには、NetworkManager 接続プロファイルを作成します。Ansible と network RHEL システムロールを使用すると、このプロセスを自動化し、Playbook で定義されたホスト上の接続プロファイルをリモートで設定できます。

network RHEL システムロールを使用してネットワークボンディングを設定できます。ボンディングの親デバイスの接続プロファイルが存在しない場合は、このロールによって作成することもできます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。 - サーバーに、2 つ以上の物理ネットワークデバイスまたは仮想ネットワークデバイスがインストールされている。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow サンプル Playbook で指定されている設定は次のとおりです。

type: <profile_type>- 作成するプロファイルのタイプを設定します。このサンプル Playbook では、3 つの接続プロファイルを作成します。1 つはボンディング用、2 つはイーサネットデバイス用です。

dhcp4: yes- DHCP、PPP、または同様のサービスからの自動 IPv4 アドレス割り当てを有効にします。

auto6: yes-

IPv6 自動設定を有効にします。デフォルトでは、NetworkManager はルーター広告を使用します。ルーターが

managedフラグを通知すると、NetworkManager は DHCPv6 サーバーに IPv6 アドレスと接頭辞を要求します。 mode: <bond_mode>ボンディングモードを設定します。可能な値は次のとおりです。

-

balance-rr(デフォルト) -

active-backup -

balance-xor -

broadcast -

802.3ad -

balance-tlb -

balance-alb

設定したモードに応じて、Playbook で追加の変数を設定する必要があります。

-

Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイルを参照してください。Playbook の構文を検証します。

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ネットワークデバイスの 1 つからネットワークケーブルを一時的に取り外し、ボンディング内の他のデバイスがトラフィックを処理しているかどうかを確認します。

ソフトウェアユーティリティーを使用して、リンク障害イベントを適切にテストする方法がないことに注意してください。

nmcliなどの接続を非アクティブにするツールでは、ポート設定の変更を処理するボンディングドライバーの機能のみが表示され、実際のリンク障害イベントは表示されません。

3.9. VPN を中断せずにイーサネットとワイヤレス接続間の切り替えを可能にするネットワークボンディングの作成

ワークステーションを会社のネットワークに接続する RHEL ユーザーは、通常、リモートリソースにアクセスするのに VPN を使用します。ただし、イーサネット接続と Wi-Fi 接続間のワークステーションスイッチ (たとえば、イーサネット接続のあるドッキングステーションからラップトップを解放した場合など) は、VPN 接続が中断されます。この問題を回避するには、active-backup モードでイーサネット接続および Wi-Fi 接続を使用するネットワークボンディングを作成します。

前提条件

- ホストに、イーサネットデバイスと Wi-Fi デバイスが含まれている。

イーサネットおよび Wi-Fi NetworkManager 接続プロファイルが作成され、両方の接続が独立して機能します。

この手順では、以下の接続プロファイルを使用して

bond0という名前のネットワークボンディングを作成します。-

enp11s0u1イーサネットデバイスに関連付けられたDocking_station -

wlp1s0Wi-Fi デバイスに関連付けられたWi-Fi

-

手順

active-backupモードでボンドインターフェイスを作成します。nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup"

# nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup"Copy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは、インターフェイスおよび接続プロファイル

bond0の両方に名前を付けます。ボンディングの IPv4 設定を設定します。

- ネットワークの DHCP サーバーが IPv4 アドレスをホストに割り当てる場合は、何もする必要はありません。

ローカルネットワークに静的 IPv4 アドレスが必要な場合は、アドレス、ネットワークマスク、デフォルトゲートウェイ、DNS サーバー、および DNS 検索ドメインを

bond0接続に設定します。nmcli connection modify bond0 ipv4.addresses '192.0.2.1/24' nmcli connection modify bond0 ipv4.gateway '192.0.2.254' nmcli connection modify bond0 ipv4.dns '192.0.2.253' nmcli connection modify bond0 ipv4.dns-search 'example.com' nmcli connection modify bond0 ipv4.method manual

# nmcli connection modify bond0 ipv4.addresses '192.0.2.1/24' # nmcli connection modify bond0 ipv4.gateway '192.0.2.254' # nmcli connection modify bond0 ipv4.dns '192.0.2.253' # nmcli connection modify bond0 ipv4.dns-search 'example.com' # nmcli connection modify bond0 ipv4.method manualCopy to Clipboard Copied! Toggle word wrap Toggle overflow

ボンディングの IPv6 設定を設定します。

- ネットワークのルーターまたは DHCP サーバーが IPv6 アドレスをホストに割り当てる場合、アクションは必要ありません。

ローカルネットワークに静的 IPv6 アドレスが必要な場合は、アドレス、ネットワークマスク、デフォルトゲートウェイ、DNS サーバー、および DNS 検索ドメインを

bond0接続に設定します。nmcli connection modify bond0 ipv6.addresses '2001:db8:1::1/64' nmcli connection modify bond0 ipv6.gateway '2001:db8:1::fffe' nmcli connection modify bond0 ipv6.dns '2001:db8:1::fffd' nmcli connection modify bond0 ipv6.dns-search 'example.com' nmcli connection modify bond0 ipv6.method manual

# nmcli connection modify bond0 ipv6.addresses '2001:db8:1::1/64' # nmcli connection modify bond0 ipv6.gateway '2001:db8:1::fffe' # nmcli connection modify bond0 ipv6.dns '2001:db8:1::fffd' # nmcli connection modify bond0 ipv6.dns-search 'example.com' # nmcli connection modify bond0 ipv6.method manualCopy to Clipboard Copied! Toggle word wrap Toggle overflow

接続プロファイルを表示します。

nmcli connection show NAME UUID TYPE DEVICE Docking_station 256dd073-fecc-339d-91ae-9834a00407f9 ethernet enp11s0u1 Wi-Fi 1f1531c7-8737-4c60-91af-2d21164417e8 wifi wlp1s0 ...

# nmcli connection show NAME UUID TYPE DEVICE Docking_station 256dd073-fecc-339d-91ae-9834a00407f9 ethernet enp11s0u1 Wi-Fi 1f1531c7-8737-4c60-91af-2d21164417e8 wifi wlp1s0 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のステップでは、接続プロファイルとイーサネットデバイス名が必要です。

イーサネット接続の接続プロファイルをボンドに割り当てます。

nmcli connection modify Docking_station master bond0

# nmcli connection modify Docking_station master bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow Wi-Fi 接続の接続プロファイルをボンディングに割り当てます。

nmcli connection modify Wi-Fi master bond0

# nmcli connection modify Wi-Fi master bond0Copy to Clipboard Copied! Toggle word wrap Toggle overflow Wi-Fi ネットワークが MAC フィルタリングを使用して、許可リストの MAC アドレスのみがネットワークにアクセスできるようにするには、NetworkManager がアクティブなポートの MAC アドレスをボンドに動的に割り当てるように設定します。

nmcli connection modify bond0 +bond.options fail_over_mac=1