仮想化の設定および管理

ホストの設定、仮想マシンの作成および管理、ならびに Red Hat Enterprise Linux 8 の仮想化機能の理解

概要

- 仮想化の機能およびユースケース

- コマンドラインユーティリティーと Web コンソールを使用して、ホストと仮想マシンを管理する方法

- Intel 64、AMD64、IBM POWER、IBM Z など、さまざまなシステムアーキテクチャーにおける仮想化のサポート制限

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

第1章 RHEL における仮想化について

本章では、仮想化の概念や、Linux における仮想化の実装について参考になるように、RHEL 8 における仮想化の概要、基本な内容、利点、コンポーネントなど、Red Hat が提供する仮想化ソリューションを説明します。

1.1. 仮想化とは

RHEL 8 では 仮想化機能 が提供され、RHEL 8 を実行するマシンが、複数の仮想マシン (VM) (ゲスト とも呼ばれます) を ホスト できるようにします。仮想マシンは、ホストの物理ハードウェアとコンピューティングリソースを使用して、独立した仮想化オペレーティングシステム (ゲスト OS) を、ホストのオペレーティングシステムのユーザー空間プロセスとして実行します

つまり、仮想化により、オペレーティングシステム内にオペレーティングシステムを追加できます。

仮想マシンを使用すると、ソフトウェアの設定や機能を安全にテストしたり、レガシーソフトウェアを実行したり、ハードウェアのワークロードの効率を最適化したりできます。利点の詳細は、仮想化の利点 を参照してください。

仮想化の詳細は、仮想化のトピックページ を参照してください。

次のステップ

- Red Hat Enterprise Linux 8 で仮想化を試す場合は、Getting started with virtualization を参照してください。

- Red Hat は、Red Hat Enterprise Linux 8 の仮想化以外にも、専門化した仮想化ソリューションを多数提供しています。各ソリューションには、さまざまなユーザーフォーカスおよび機能があります。詳細は、Red Hat virtualization solutions を参照してください。

1.2. 仮想化の利点

仮想マシンの使用には、物理マシンを使用する場合と比較して、以下の利点があります。

リソースの柔軟性と詳細な割り当て

仮想マシンは、通常、物理マシンであるホストマシンで稼働し、使用するゲスト OS に物理ハードウェアを割り当てることもできます。ただし、仮想マシンへの物理リソースの割り当てはソフトウェアレベルで行うため、柔軟性が非常に高くなります。仮想マシンは、ホストメモリー、CPU、またはストレージ領域で設定可能な割合を指定して、非常に詳細なリソース要求を指定できます。

たとえば、ゲスト OS がディスクとして見るものは、ホストファイルシステムではファイルとして表示され、そのディスクのサイズは、物理ディスクで利用可能なサイズよりも少なくなります。

ソフトウェアで制御される設定

仮想マシン全体の設定は、ホスト上のデータとして保存され、ソフトウェア制御下にあります。したがって、仮想マシンの作成、削除、クローン作成、移行、リモートからの操作、リモートストレージへの接続などを簡単に行うことができます。

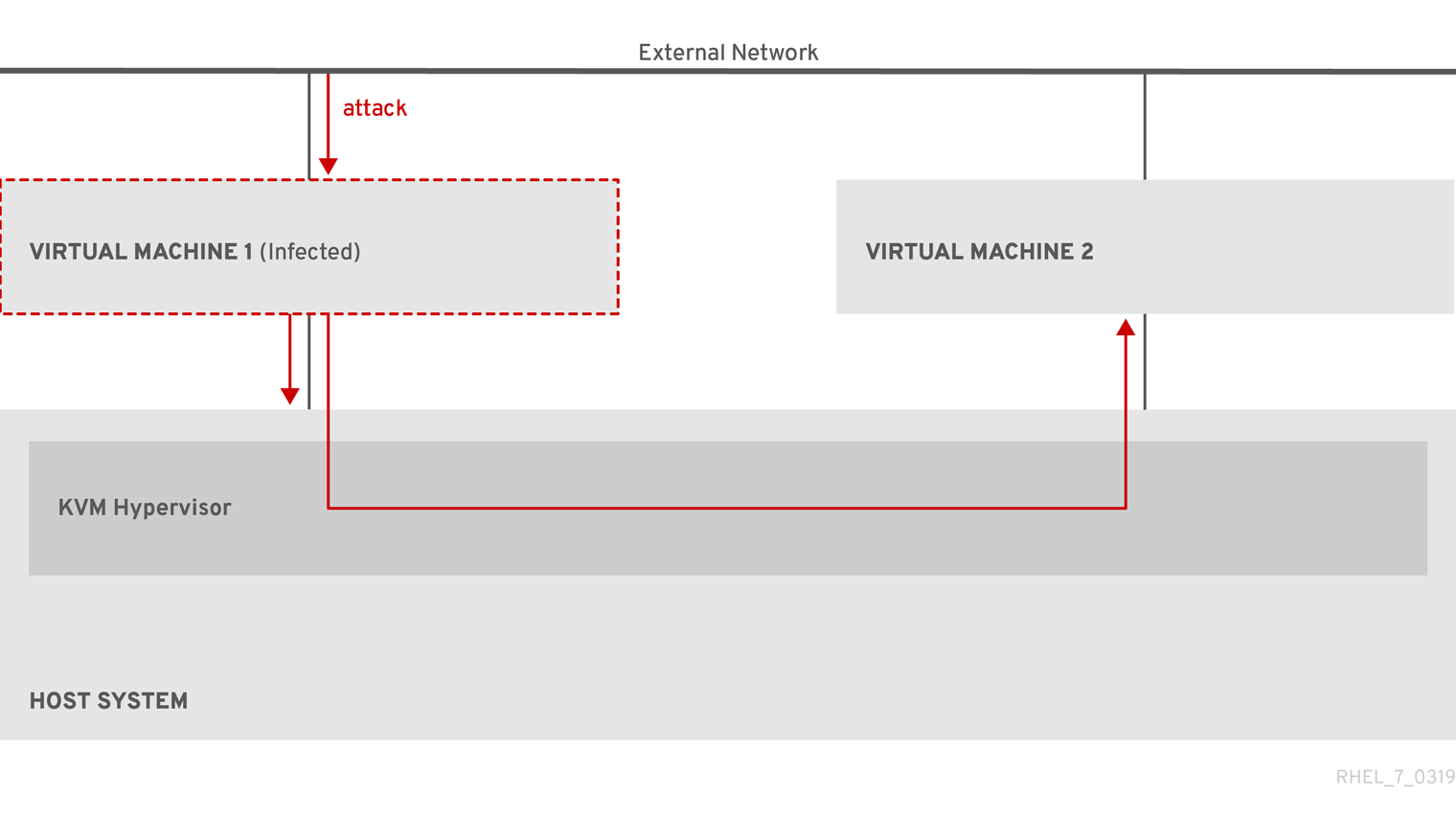

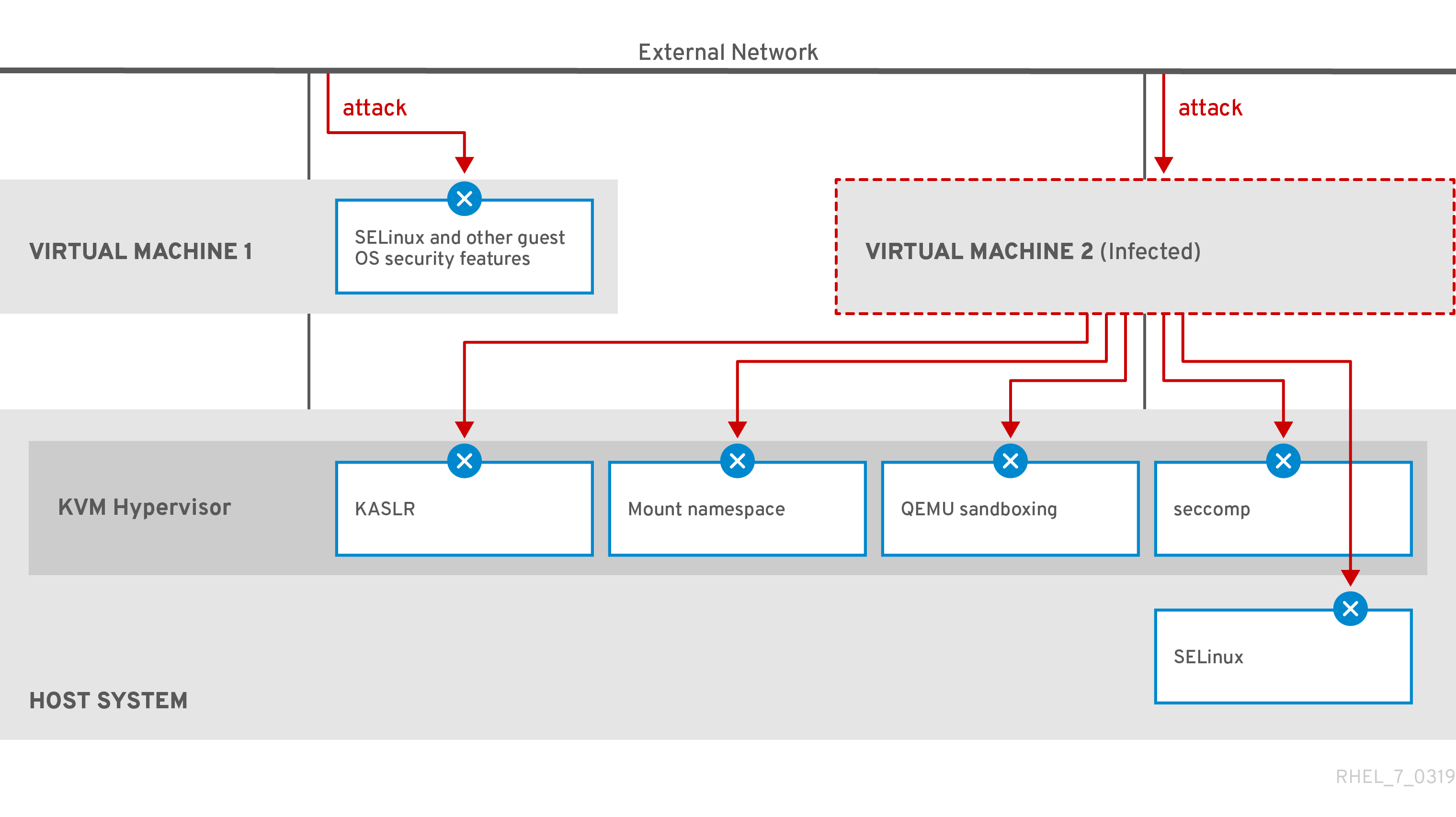

ホストからの分離

ゲスト OS は、ホストの OS とは別の仮想化カーネルで実行します。つまり、任意の OS を仮想マシンにインストールでき、ゲスト OS が不安定になっても、または不正アクセスされても、ホストには影響を及ぼしません。

領域とコスト効率

1 台の物理マシンで仮想マシンを多数ホストできます。したがって、複数の物理マシンが同じタスクを実行する必要がないため、物理ハードウェアに対する領域、電力、およびメンテナンスの要件が低くなります。

ソフトウェアの互換性

仮想マシンは、ホストとは異なる OS を使用できるため、仮想化により、本来はホスト OS 用にリリースされていないアプリケーションを実行できるようになります。たとえば、RHEL 7 のゲスト OS を使用すると、RHEL 7 用にリリースされたアプリケーションを RHEL 8 ホストシステムで実行できます。

注記RHEL 8 ホストでは、すべてのオペレーティングシステムがゲスト OS としてサポートされているわけではありません。詳細は、Recommended features in RHEL 8 virtualization を参照してください。

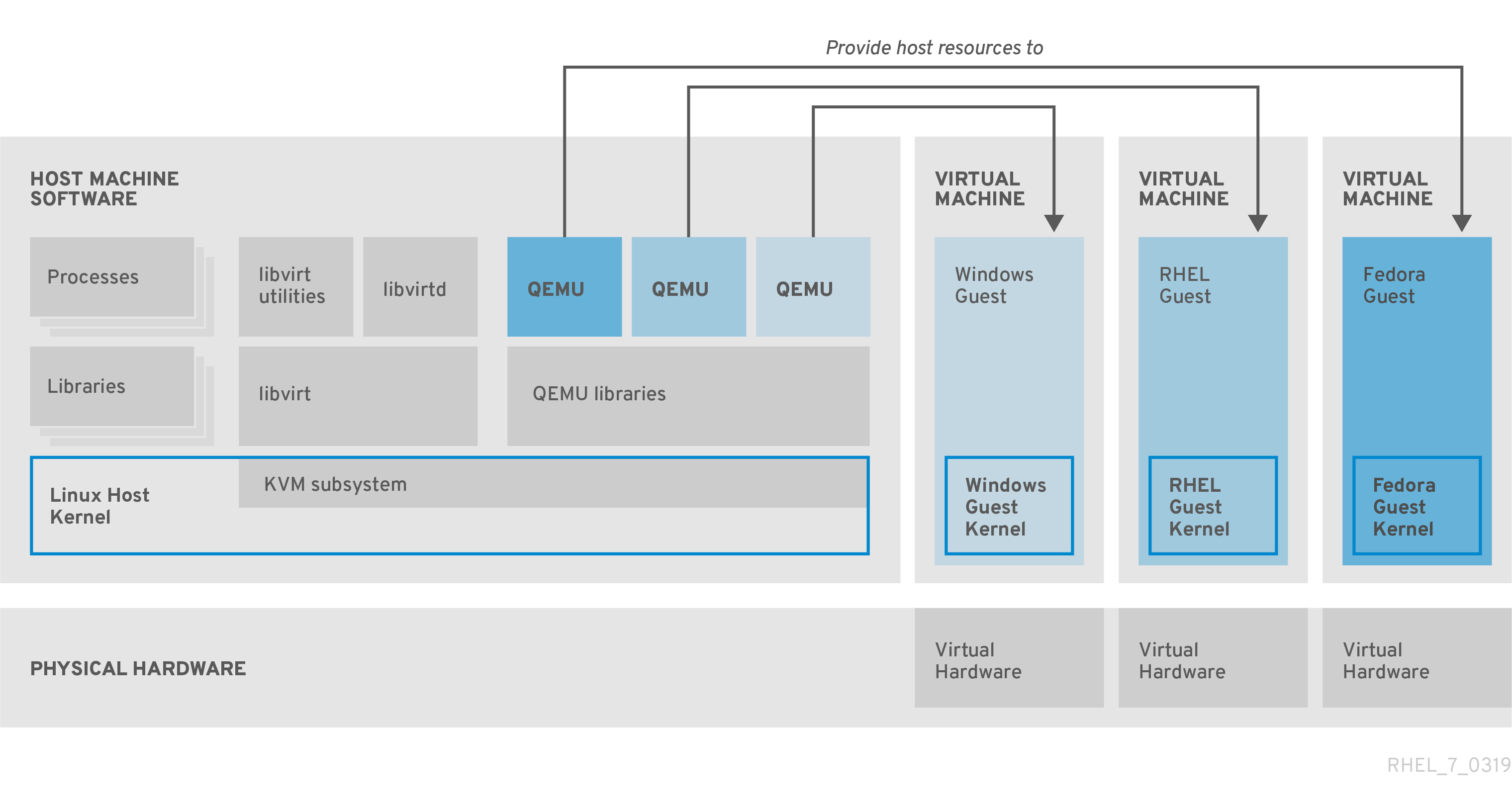

1.3. 仮想マシンコンポーネントおよびその相互作用

RHEL 8 の仮想化は、以下の主要ソフトウェアコンポーネントで設定されています。

ハイパーバイザー

RHEL 8 で仮想マシンを作成する基礎となる部分は、ハードウェアを制御し、ホストマシンで複数のオペレーティングシステムを実行できるようにするソフトウェア層で、ハイパーバイザー と呼ばれます。

ハイパーバイザーには、KVM (Kernel-based Virtual Machine) モジュールと仮想化カーネルドライバーが含まれます。このコンポーネントでは、ホストマシンの Linux カーネルにより、ユーザー空間のソフトウェアに仮想化のリソースが提供されます。

ユーザー空間レベルでは、QEMU エミュレーターが、ゲスト OS を実行できる完全に仮想化されたハードウェアプラットフォームをシミュレートし、リソースがホストでどのように割り当てられ、ゲストに示されるかを管理します。

さらに、libvirt ソフトウェアスイートが管理層および通信層として機能し、QEMU とのやり取りを容易にし、セキュリティールールを適用し、仮想マシンを設定して実行するための追加ツールを多数提供します。

XML 設定

ホストベースの XML 設定ファイル (ドメイン XML ファイルとも呼ばれます) では、個別の仮想マシンの設定およびデバイスをすべて決定します。設定には以下が含まれます。

- メタデータ (仮想マシンの名前、タイムゾーン、その他の仮想マシンの情報など)

- 仮想マシンのデバイスの説明 (仮想 CPU (vCPU)、ストレージデバイス、入出力デバイス、ネットワークインターフェイスカード、その他の物理ハードウェアおよび仮想ハードウェアなど)

- 仮想マシンの設定 (使用可能な最大メモリー量、再起動設定、仮想マシンの動作に関するその他の設定など)

XML 設定の内容の詳細は、仮想マシンの XML 設定例 を参照してください。

コンポーネントのインタラクション

仮想マシンが起動すると、ハイパーバイザーは XML 設定を使用して、ホストのユーザー空間プロセスとして仮想マシンのインスタンスを作成します。ハイパーバイザーは、仮想マシンプロセスが、ホストベースのインターフェイス (virsh ユーティリティー、virt-install ユーティリティー、guestfish ユーティリティー、Web コンソールの GUI など) にアクセスできるようにします。

このような仮想化ツールを使用すると、libvirt が、入力を QEMU の命令に変換します。QEMU が命令を KVM に伝え、カーネルが命令を実行するのに必要なリソースを適切に割り当てるようになります。これにより、QEMU が、仮想マシンの作成や修正、仮想マシンのオペレーティングシステムでのアクションの実行など、対応するユーザー空間を変更します。

QEMU はアーキテクチャーの必須コンポーネントですが、セキュリティーに関する懸念があるため、RHEL 8 システムで直接使用することは意図されていません。したがって、Red Hat は、qemu-* コマンドをサポート対象外としており、libvirt を使用して QEMU と相互作用することを強く推奨します。

ホストベースのインターフェイスの詳細は、仮想管理に使用するツールおよびインターフェイス を参照してください。

図1.1 RHEL 8 の仮想アーキテクチャー

1.4. 仮想管理に使用するツールおよびインターフェイス

RHEL 9 の仮想化は、コマンドライン (CLI) または複数のグラフィカルユーザーインターフェイス (GUI) を使用して管理できます。

コマンドラインインターフェイス

CLI は、RHEL 8 で仮想化を管理する最も強力な方法です。仮想マシン (VM) 管理用の CLI コマンドでは、以下のものがよく知られています。

virsh - 指定した引数に応じて、多種多様な目的を持つ多目的仮想コマンドラインユーティリティーおよびシェル。以下に例を示します。

-

仮想マシンの起動およびシャットダウン -

virsh startおよびvirsh shutdown -

利用可能な仮想マシンのリスト表示 -

virsh list -

設定ファイルからの仮想マシンの作成 -

virsh create -

仮想化シェルの入力 -

virsh

詳細は、システム上の

virsh(1)man ページを参照してください。-

仮想マシンの起動およびシャットダウン -

-

virt-install- 新しい仮想マシンを作成する CLI ユーティリティー。詳細は、システム上のvirt-install(1)man ページを参照してください。 -

virt-xml- 仮想マシンの設定を編集するユーティリティー。 -

guestfish- 仮想マシンのディスクイメージを調べ、修正するユーティリティー。詳細は、システム上のguestfish(1)man ページを参照してください。

グラフィカルユーザーインターフェイス

以下の GUI を使用して、RHEL 8 で仮想化を管理できます。

RHEL 8 の Web コンソール (Cockpit とも呼ばれています) は、仮想マシンおよび仮想化ホストの管理用に、リモートからアクセスでき、簡単に使用できるグラフィカルユーザーインターフェイスを提供します。

Web コンソールを使用した基本的な仮想化管理の手順については、Managing virtual machines in the web console を参照してください。

仮想マシンマネージャー (virt-manager) アプリケーションは、仮想マシンおよび仮想化ホストの管理に使用する GUI を提供します。

重要virt-manager は、RHEL 8 でも引き続き対応していますが、非推奨になっています。後続のリリースでは、Web コンソールがその代替となる予定です。したがって、GUI で仮想化を管理する場合は、Web コンソールを使用することが推奨されます。

ただし、RHEL 8 では、virt-manager またはコマンドラインのいずれか一方からしかアクセスできない機能もあります。詳細は、Differences between virtualization features in Virtual Machine Manager and the web console を参照してください。

Gnome Boxes アプリケーションは、仮想マシンおよびリモートシステムを表示したりアクセスしたりするための、軽量のグラフィカルインタフェースです。GNOME Boxes は、主にデスクトップシステムで使用するように設計されています。

重要Gnome Boxes は、GNOME デスクトップ環境に含まれ、RHEL 8 で対応しています、Red Hat は、Web コンソールを使用して、GUI で仮想化を管理することを推奨します。

1.5. Red Hat の仮想化ソリューション

以下の Red Hat 製品は、RHEL 8 仮想化機能に構築されており、RHEL 8 で利用可能な KVM 仮想化機能を拡張します。また、RHEL 8 仮想化の制限 の多くが、このような製品には適用されません。

- OpenShift Virtualization

KubeVirt テクノロジーに基づいて、OpenShift Virtualization は Red Hat OpenShift Container Platform の一部であり、仮想マシンをコンテナーで実行することができます。

OpenShift Virtualization の詳細は、Red Hat ハイブリッドクラウド のページを参照してください。

- Red Hat OpenStack Platform (RHOSP)

Red Hat OpenStack Platform は、安全で信頼性の高いパブリックまたはプライベートの OpenStack クラウドを作成、デプロイ、および拡張するための統合基盤を提供します。

Red Hat OpenStack Platform の詳細は、Red Hat カスタマーポータル または Red Hat OpenStack Platform ドキュメントスイート を参照してください。

RHEL ではサポートされておらず、他の Red Hat 仮想化ソリューションでサポートされている仮想化機能の詳細は、RHEL 8 仮想化でサポートされていない機能 を参照してください。

第2章 仮想化の使用

RHEL 8 の仮想化 を使用をする場合は、以下の手順に従ってください。これに対するデフォルトの方法はコマンドラインインターフェイス (CLI) ですが、便宜上、手順の一部は Web コンソールの GUI で完了できます。

- 仮想化モジュールを有効にし、仮想化パッケージをインストールします。Enabling virtualization を参照してください。

仮想マシンを作成します。

- CLI については、コマンドラインを使用した仮想マシンの作成を 参照してください。

- GUI の場合は、Creating virtual machines and installing guest operating systems using the web console を参照してください。

仮想マシンを起動します。

- CLI については、コマンドラインを使用して仮想マシンを起動するを 参照してください。

- GUI の場合は、Starting virtual machines using the web console を参照してください。

仮想マシンに接続します。

- CLI の場合は、Connecting to a virtual machine using SSH または Opening a virtual machine graphical console using Virt Viewer を参照してください。

- GUI の場合は、Interacting with virtual machines using the web console を参照してください。

現在、Web コンソールでは、仮想マシン管理機能のサブセットしか提供されないため、RHEL 8 での仮想化の高度な使用には、コマンドラインを使用することが推奨されます。

2.1. 仮想化の有効化

RHEL 8 で仮想化を使用するには、仮想化モジュールを有効にし、仮想化パッケージをインストールして、システムが仮想マシン (VM) をホストするように設定されていることを確認する必要があります。

前提条件

- ホストマシンに RHEL 8 がインストールされ、登録されている。

システムが仮想ホストとして機能するように、以下のハードウェア要件を満たしている。

最低でも、以下のシステムリソースが利用できる。

- ホスト用に 6 GB と、各仮想マシン用に 6 GB の空きディスク容量。

- ホスト用に 2 GB と、各仮想マシン用に 2 GB の RAM。

- ホスト上の 4 つの CPU通常、仮想マシンは、割り当てられた 1 つの vCPU で実行できますが、Red Hat は、高負荷時に仮想マシンが応答しなくならないように、仮想マシンごとに 2 つ以上の vCPU を割り当てることを推奨します。

ホストマシンのアーキテクチャーが KVM 仮想化 に対応している。

- 特に、RHEL 8 は、64 ビット ARM アーキテクチャー (ARM 64) では仮想化に対応していません。

以下の手順は、AMD64 および Intel 64 のアーキテクチャー (x86_64) に適用されます。対応しているアーキテクチャーが異なるホストで仮想化を有効にする場合は、以下のいずれかのセクションを参照してください。

手順

RHEL 8 仮想化モジュールにパッケージをインストールします。

yum module install virt

# yum module install virtCopy to Clipboard Copied! Toggle word wrap Toggle overflow virt-installパッケージおよびvirt-viewerパッケージをインストールします。yum install virt-install virt-viewer

# yum install virt-install virt-viewerCopy to Clipboard Copied! Toggle word wrap Toggle overflow libvirtdサービスを開始します。systemctl start libvirtd

# systemctl start libvirtdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

システムが仮想ホストとして準備されていることを確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow virt-host-validateチェックの戻り値を確認し、適切なアクションを実行します。-

virt-host-validateのすべての項目でPASS値が返された場合は、システムに 仮想マシンを作成する 準備ができています。 -

いずれかの項目で

FAILが返された場合は、表示される指示に従って問題を解決してください。 -

いずれかの項目で

WARNが返された場合は、表示される指示に従って仮想化機能を向上させることを検討してください。

-

トラブルシューティング

KVM 仮想化がホスト CPU でサポートされていない場合は、

virt-host-validateは以下の出力を生成します。QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)Copy to Clipboard Copied! Toggle word wrap Toggle overflow ただし、このようなホストシステムにある仮想マシンは、パフォーマンス上の問題が発生するのではなく、起動に失敗します。

これを回避するには、仮想マシンの XML 設定の

<domain type>値をqemuに変更します。ただし、Red Hat はqemuドメインタイプを使用する仮想マシンに対応していないため、実稼働環境ではこれを設定しないことを強く推奨している点に注意してください。

2.2. 仮想マシンの作成

RHEL 9 で仮想マシンを作成する場合は、コマンドライン または RHEL 9 Web コンソール を使用します。

2.2.1. コマンドラインを使用した仮想マシンの作成

コマンドラインを使用して RHEL 9 で仮想マシン (VM) を作成するには、virt-install ユーティリティーを使用します。

前提条件

- ホストシステムで仮想化が 有効 になっている。

- ディスク領域、RAM、CPU など、仮想マシンに割り当てるのに十分なシステムリソースがある。推奨される値は、仮想マシンで行うタスクやワークロードにより大きく異なる可能性があります。

オペレーティングシステム (OS) のインストールソースがローカルまたはネットワークで利用できる。これには、次のいずれかを使用できます。

- インストールメディアの ISO イメージ

既存の仮想マシンインストールのディスクイメージ

警告RHEL 8 では、ホストの CD-ROM デバイスまたは DVD-ROM デバイスからインストールすることができません。RHEL 8 で利用可能な仮想マシンのインストール方法を使用する際に、インストールソースに CD-ROM または DVD-ROM を選択するとインストールに失敗します。詳細は、Red Hat ナレッジベースソリューション RHEL 7 or higher can’t install guest OS from CD/DVD-ROM を参照してください。

また、Red Hat がサポートするのは、限られたゲストオペレーティングシステムのセット のみです。

- 任意: インストールをより速く、簡単に設定するために、キックスタートファイルを利用できます。

手順

仮想マシンを作成して OS のインストールを開始するには、以下の必須引数を指定して、virt-install コマンドを使用します。

-

--name: 新しいマシンの名前 -

--memory: 割り当てるメモリーの量 -

--vcpus: 割り当てる仮想 CPU の数 -

--disk: 割り当てるストレージのタイプとサイズ -

--cdromまたは--location: OS インストールソースのタイプと場所

選択したインストール方法に応じて、必要なオプションと値が異なります。例は、以下のコマンドを参照してください。

リストされているコマンドは、デフォルトの SPICE プロトコルの代わりに VNC リモート表示プロトコルを使用します。現在、VNC には SPICE が備えている機能の一部がありませんが、RHEL 9 では完全にサポートされています。その結果、ホストを RHEL 9 に移行しても、VNC を使用する VM の動作が停止することはありません。詳細は、RHEL 9 の採用における考慮事項 を参照してください。

次のコマンドでは、demo-guest1 という名前の仮想マシンを作成し、ローカルの /home/username/Downloads/Win10install.iso ファイルに保存されている ISO イメージから、Windows 10 OS をインストールします。この仮想マシンには、2048 MiB の RAM と 2 つの vCPU が割り当てられ、80 GiB の qcow2 仮想ディスクも自動的に割り当てられます。

virt-install \ --graphics vnc \ --name demo-guest1 --memory 2048 \ --vcpus 2 --disk size=80 --os-variant win10 \ --cdrom /home/username/Downloads/Win10install.iso# virt-install \ --graphics vnc \ --name demo-guest1 --memory 2048 \ --vcpus 2 --disk size=80 --os-variant win10 \ --cdrom /home/username/Downloads/Win10install.isoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドは、demo-guest2 という名前の仮想マシンを作成し、/home/username/Downloads/rhel9.iso イメージを使用して、ライブ CD から RHEL 9 OS を実行します。この仮想マシンにはディスク領域が割り当てられないため、セッション中に行った変更は保持されません。また、仮想マシンには、4096 MiB の RAM と、4 つの vCPU が割り当てられます。

virt-install \ --graphics vnc \ --name demo-guest2 --memory 4096 --vcpus 4 \ --disk none --livecd --os-variant rhel8.0 \ --cdrom /home/username/Downloads/rhel8.iso# virt-install \ --graphics vnc \ --name demo-guest2 --memory 4096 --vcpus 4 \ --disk none --livecd --os-variant rhel8.0 \ --cdrom /home/username/Downloads/rhel8.isoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドは、demo-guest3 という名前の RHEL 9 仮想マシンを作成し、既存のディスクイメージ /home/username/backup/disk.qcow2 に接続します。これは、マシン間でハードドライブを物理的に移動するのと似ています。したがって、demo-guest3 で使用できる OS およびデータは、イメージが処理された方法により決定します。また、仮想マシンには、2048 MiB の RAM および 2 つの vCPU が割り当てられます。

virt-install \ --graphics vnc \ --name demo-guest3 --memory 2048 --vcpus 2 \ --os-variant rhel8.0 --import \ --disk /home/username/backup/disk.qcow2# virt-install \ --graphics vnc \ --name demo-guest3 --memory 2048 --vcpus 2 \ --os-variant rhel8.0 --import \ --disk /home/username/backup/disk.qcow2Copy to Clipboard Copied! Toggle word wrap Toggle overflow ディスクイメージをインポートする場合は、

--os-variantオプションを使用することが強く推奨されます。このオプションを指定しないと、作成された仮想マシンのパフォーマンスに影響を及ぼします。次のコマンドは、demo-guest4 という名前の仮想マシンを作成し、URL

http://example.com/OS-installからインストールします。インストールを開始するには、作業中の OS インストールツリーを URL に指定する必要があります。さらに、OS は、キックスタートファイル /home/username/ks.cfg で自動的に設定されます。この仮想マシンには、2048 MiB の RAM、2 つの vCPU、および 160 GiB の qcow2 仮想ディスクも割り当てられます。virt-install \ --graphics vnc \ --name demo-guest4 --memory 2048 --vcpus 2 --disk size=160 \ --os-variant rhel8.0 --location http://example.com/OS-install \ --initrd-inject /home/username/ks.cfg --extra-args="inst.ks=file:/ks.cfg console=tty0 console=ttyS0,115200n8"# virt-install \ --graphics vnc \ --name demo-guest4 --memory 2048 --vcpus 2 --disk size=160 \ --os-variant rhel8.0 --location http://example.com/OS-install \ --initrd-inject /home/username/ks.cfg --extra-args="inst.ks=file:/ks.cfg console=tty0 console=ttyS0,115200n8"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドは、demo-guest5 という名前の仮想マシンを作成し、グラフィックスがない、テキストのみのモードである

RHEL9.isoイメージファイルからインストールします。ゲストコンソールをシリアルコンソールに接続します。仮想マシンには、16384 MiB のメモリー、16 個の vCPU、および 280 GiB のディスクが割り当てられます。このようなインストールは、低速なネットワークリンクを介してホストに接続する際に便利です。virt-install \ --name demo-guest5 --memory 16384 --vcpus 16 --disk size=280 \ --os-variant rhel8.0 --location RHEL8.iso \ --graphics none --extra-args='console=ttyS0'# virt-install \ --name demo-guest5 --memory 16384 --vcpus 16 --disk size=280 \ --os-variant rhel8.0 --location RHEL8.iso \ --graphics none --extra-args='console=ttyS0'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドは、demo-guest6 という名前の仮想マシンを作成します。この仮想マシンの設定は demo-guest5 と同じですが、リモートホスト 192.0.2.1 に置かれます。

virt-install \ --connect qemu+ssh://root@192.0.2.1/system --name demo-guest6 --memory 16384 \ --vcpus 16 --disk size=280 --os-variant rhel8.0 --location RHEL8.iso \ --graphics none --extra-args='console=ttyS0'# virt-install \ --connect qemu+ssh://root@192.0.2.1/system --name demo-guest6 --memory 16384 \ --vcpus 16 --disk size=280 --os-variant rhel8.0 --location RHEL8.iso \ --graphics none --extra-args='console=ttyS0'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

- 仮想マシンが問題なく作成されると、仮想マシンのグラフィカルコンソールで virt-viewer 画面が開き、ゲスト OS のインストールが開始します。

トラブルシューティング

virt-installがcannot find default networkエラーを出力する場合は、以下のようにします。libvirt-daemon-config-networkパッケージがインストールされていることを確認します。{PackageManagerCommand} info libvirt-daemon-config-network Installed Packages Name : libvirt-daemon-config-network [...]# {PackageManagerCommand} info libvirt-daemon-config-network Installed Packages Name : libvirt-daemon-config-network [...]Copy to Clipboard Copied! Toggle word wrap Toggle overflow libvirtのデフォルトネットワークがアクティブで、自動的に起動するように設定されていることを確認します。virsh net-list --all Name State Autostart Persistent -------------------------------------------- default active yes yes

# virsh net-list --all Name State Autostart Persistent -------------------------------------------- default active yes yesCopy to Clipboard Copied! Toggle word wrap Toggle overflow そうでない場合は、デフォルトのネットワークをアクティブにし、自動起動に設定します。

virsh net-autostart default Network default marked as autostarted virsh net-start default Network default started

# virsh net-autostart default Network default marked as autostarted # virsh net-start default Network default startedCopy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトのネットワークをアクティベートしても以下のエラーが出て失敗する場合は、

libvirt-daemon-config-networkパッケージが正常にインストールされていません。error: failed to get network 'default' error: Network not found: no network with matching name 'default'

error: failed to get network 'default' error: Network not found: no network with matching name 'default'Copy to Clipboard Copied! Toggle word wrap Toggle overflow この問題を修正するには、以下のコマンドで

libvirt-daemon-config-networkを再インストールします。{PackageManagerCommand} reinstall libvirt-daemon-config-network# {PackageManagerCommand} reinstall libvirt-daemon-config-networkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のようなエラーでデフォルトのネットワークをアクティベートできない場合には、デフォルトネットワークのサブネットとホストの既存インターフェイスで競合が発生しています。

error: Failed to start network default error: internal error: Network is already in use by interface ens2

error: Failed to start network default error: internal error: Network is already in use by interface ens2Copy to Clipboard Copied! Toggle word wrap Toggle overflow これを修正するには、

virsh net-edit defaultコマンドを使用して、設定の192.0.2.*の値を、ホストで使用していないサブネットに変更します。

2.2.2. Web コンソールを使用した仮想マシンの作成、およびゲストのオペレーティングシステムのインストール

RHEL 8 ホストの GUI で仮想マシンを管理するには、Web コンソールを使用します。次のセクションでは、RHEL 8 Web コンソールを使用して仮想マシンを作成し、仮想マシンにゲストオペレーティングシステムをインストールする方法を説明します。

現在、Web コンソールを使用して作成された VM は、デフォルトで SPICE リモートデスクトッププロトコルを使用します。ただし、SPICE は RHEL 9 ではサポートされていないため、ホストを RHEL 9 にアップグレードすると、VM は動作しなくなります。詳細は、RHEL 9 の採用における考慮事項 を参照してください。

RHEL 9 で正しく動作する VNC プロトコルを使用する仮想マシンを作成するには、コマンドライン を使用します。

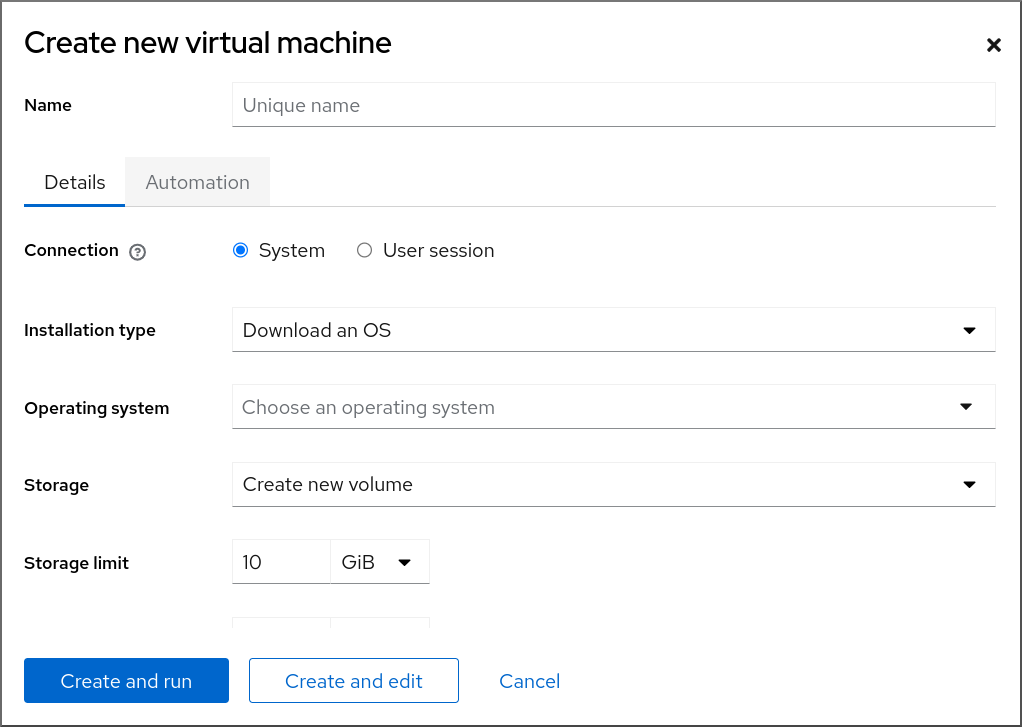

2.2.2.1. Web コンソールを使用した仮想マシンの作成

RHEL 8 Web コンソールが接続しているホストマシン上に仮想マシンを作成するには、以下の手順を使用します。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- ホストシステムで仮想化が有効になっている。

- Web コンソールの仮想マシンプラグインがホストシステムにインストールされている。

- ディスク領域、RAM、CPU など、仮想マシンに割り当てるのに十分なシステムリソースがある。推奨される値は、仮想マシンで行うタスクやワークロードにより大きく異なる可能性がある。

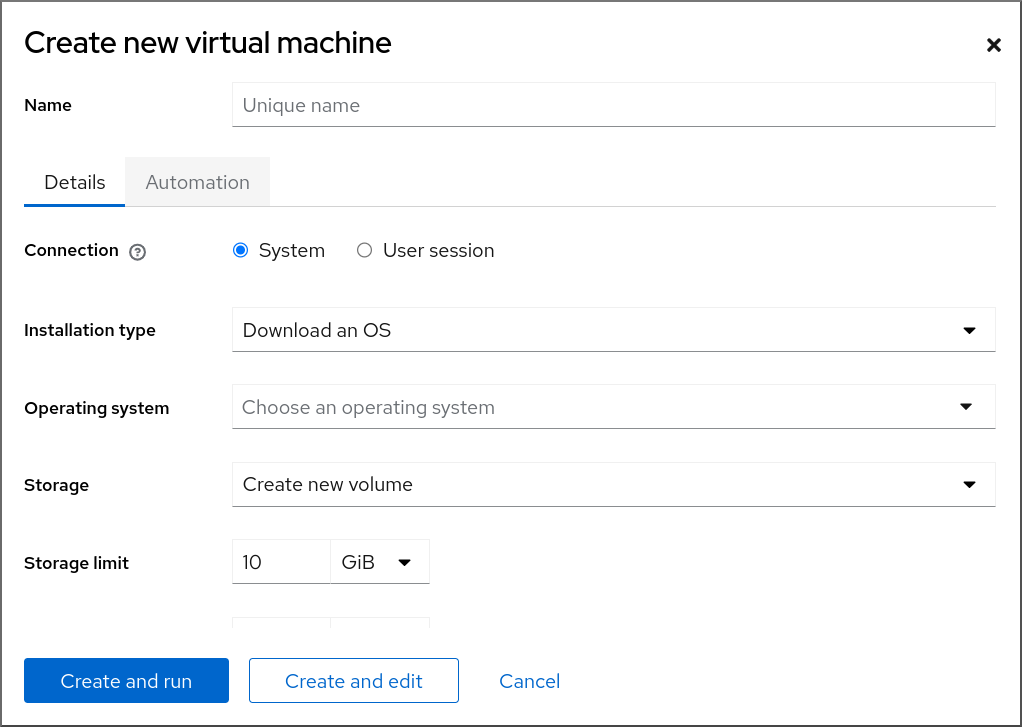

手順

Web コンソールの Virtual Machines インターフェイスで、 をクリックします。

Create new virtual machine ダイアログが表示されます。

作成する仮想マシンの基本設定を入力します。

- 名前 - 仮想マシンの名前

- 接続 - セッションに付与される権限のレベル。詳細は、Web コンソールで関連するダイアログボックスをデプロイメントしてください。

- インストールタイプ - インストールでは、ローカルのインストールメディア、URL、PXE ネットワークブート、クラウドベースイメージを使用したり、または限定されたオペレーティングシステムのセットからオペレーティングシステムをダウンロードしたりできます。

Operating system - 仮想マシン上で実行されているゲストオペレーティングシステム。Red Hat がサポートするのは、限られたゲストオペレーティングシステムのセット のみです。

注記Web コンソールから Red Hat Enterprise Linux を直接ダウンロードしてインストールする場合は、Offline token フィールドにオフライントークンを追加する必要があります。

- Storage - ストレージのタイプ。

- Storage Limit - ストレージ領域の容量。

- Memory - メモリーの容量。

仮想マシンを作成します。

- 仮想マシンでオペレーティングシステムを自動的にインストールする場合は、 をクリックします。

- オペレーティングシステムをインストールする前に仮想マシンを編集する場合は、 をクリックします。

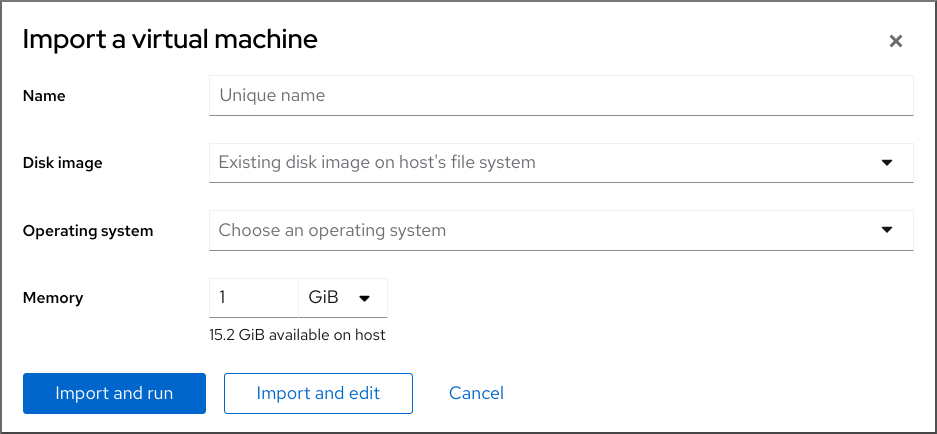

2.2.2.2. Web コンソールでディスクイメージをインポートして仮想マシンを作成する手順

RHEL 8 Web コンソールで既存の仮想マシンインストールのディスクイメージをインポートすることで、仮想マシンを作成できます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインがシステムにインストールされている。

- ディスク領域、RAM、CPU など、仮想マシンに割り当てるのに十分なシステムリソースがある。推奨値は、仮想マシンで行うタスクやワークロードにより大きく異なる可能性があります。

- 既存の仮想マシンインストールのディスクイメージがダウンロードされている。

手順

Web コンソールの Virtual Machines インターフェイスで、 をクリックします。

Import a virtual machine ダイアログが表示されます。

作成する仮想マシンの基本設定を入力します。

- 名前 - 仮想マシンの名前

- ディスクイメージ - ホストシステム上の仮想マシンに存在するディスクイメージのパスです。

- Operating system - 仮想マシンディスク上で実行されているオペレーティングシステム。Red Hat がサポートするのは、限られたゲストオペレーティングシステムのセット のみです。

- Memory - 仮想マシンによる使用のために割り当てるメモリーの容量。

仮想マシンをインポートします。

- 仮想マシン設定をさらに編集せずに仮想マシンにオペレーティングシステムをインストールするには、 をクリックします。

- オペレーティングシステムのインストール前に仮想マシン設定を編集するには、 をクリックします。

2.2.2.3. Web コンソールを使用したゲストのオペレーティングシステムのインストール

仮想マシンを初めて起動するときは、仮想マシンにオペレーティングシステムをインストールする必要があります。

新しい仮想マシンを作成するときに または をクリックすると、仮想マシン作成時にオペレーティングシステムのインストールルーチンが自動的に開始されます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインがホストシステムにインストールされている。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

Virtual Machines インターフェイスで、ゲスト OS をインストールする仮想マシンをクリックします。

選択した仮想マシンの基本情報を含む新しいページが開き、仮想マシンのさまざまな側面を管理するための制御を行います。

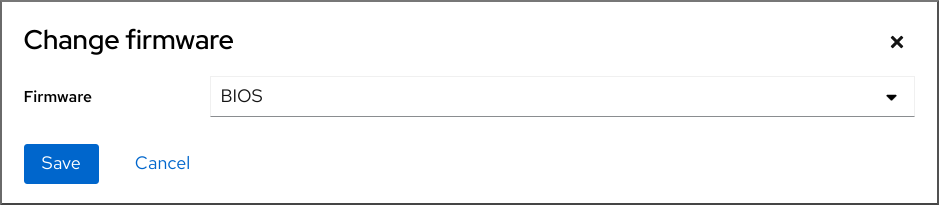

オプション: ファームウェアを変更します。

注記新しい仮想マシンの作成時に または を選択し、かつ仮想マシンに OS がまだインストールされていない場合にのみ、ファームウェアを変更できます。

- ファームウェアをクリックします。

- Change Firmware ウィンドウで、必要なファームウェアを選択します。

- をクリックします。

をクリックします。

仮想マシンコンソールで、オペレーティングシステムのインストールルーチンが実行します。

トラブルシューティング

- インストールルーチンが失敗した場合は、インストールを再度開始する前に、仮想マシンを削除して再作成します。

2.2.3. Web コンソールを使用したクラウドイメージ認証による仮想マシンの作成

デフォルトでは、ディストリビューションクラウドイメージにはログインアカウントがありません。ただし、RHEL Web コンソールを使用して、仮想マシンを作成し、root アカウントとユーザーアカウントのログイン認証情報を指定して、cloud-init に渡すことができるようになりました。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

- ホストシステムで仮想化が 有効 になっている。

- ディスク領域、RAM、CPU など、仮想マシンに割り当てるのに十分なシステムリソースがある。推奨される値は、仮想マシンで行うタスクやワークロードにより大きく異なる可能性があります。

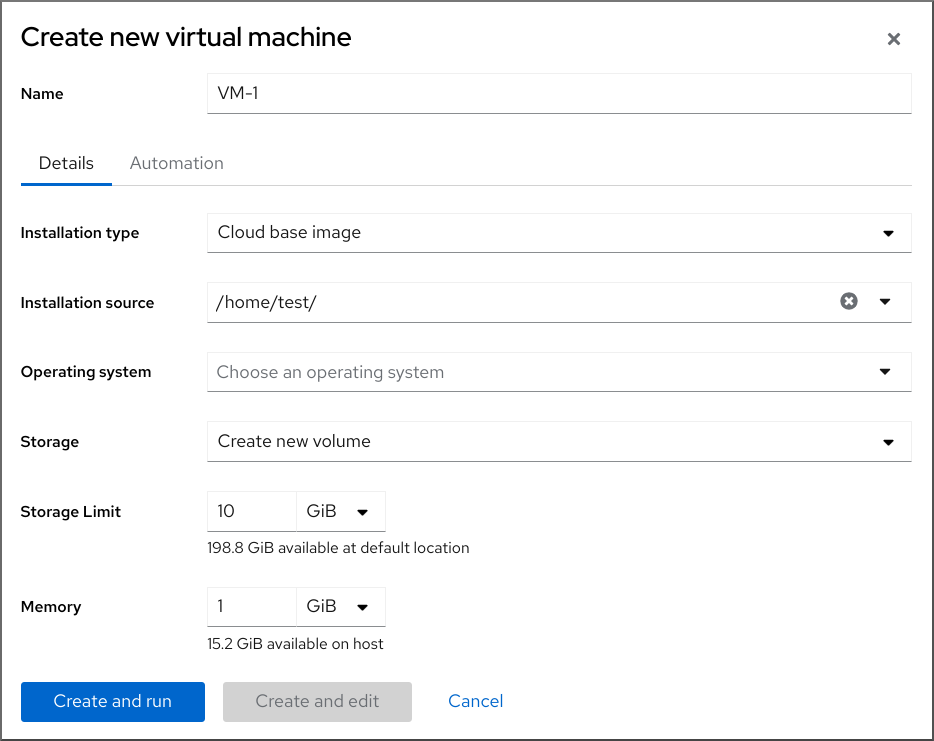

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

Web コンソールの インターフェイスで、 をクリックします。

仮想マシンの新規作成ダイアログが表示されます。

- 名前 フィールドに、仮想マシンの名前を入力します。

Details タブの Installation type フィールドで、Cloud base image を選択します。

- インストールソース フィールドで、ホストシステム上のイメージファイルへのパスを設定します。

作成する仮想マシンの設定を入力します。

- オペレーティングシステム - 仮想マシンのオペレーティングシステム。Red Hat がサポートするのは、限られたゲストオペレーティングシステムのセット のみです。

- ストレージ - 仮想マシンを設定するストレージの種類

- ストレージのサイズ - 仮想マシンを設定するストレージ容量

- メモリー - 仮想マシンを設定するメモリーのサイズ

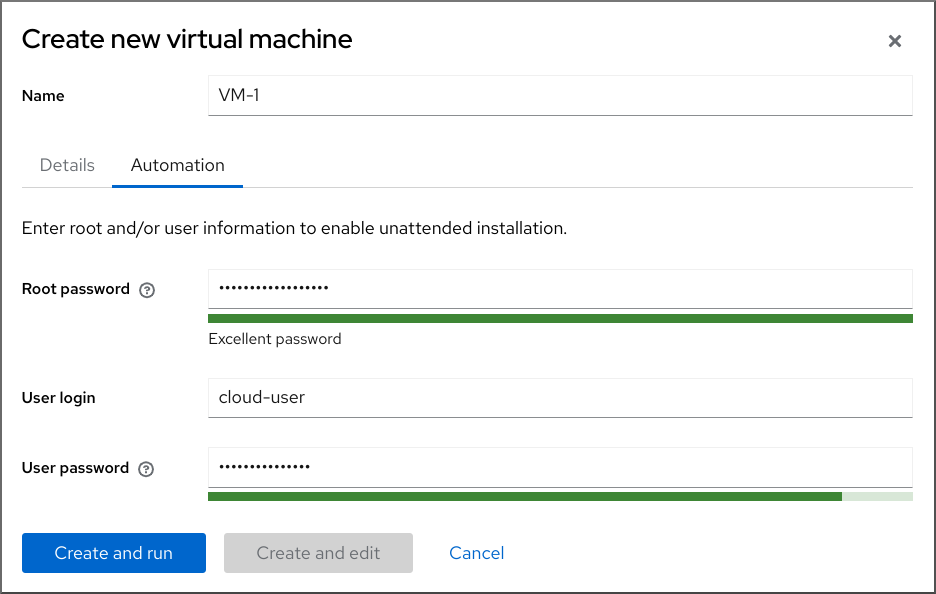

Automation タブをクリックします。

クラウド認証の認証情報を設定します。

- root パスワード - 仮想マシンの root パスワードを入力します。root パスワードを設定しない場合は、フィールドを空白のままにします。

- ユーザーログイン - cloud-init ユーザーログインを入力します。ユーザーアカウントを作成しない場合は、このフィールドを空白のままにします。

ユーザーパスワード - パスワードを入力します。ユーザーアカウントを作成しない場合は、このフィールドを空白のままにします。

をクリックします。

仮想マシンが作成されます。

2.3. 仮想マシンの起動

RHEL 9 で仮想マシン (VM) を起動する場合は、コマンドライン または Web コンソール GUI を使用できます。

前提条件

- 仮想マシンを起動する前に仮想マシンを作成しておく。理想としては、OS をインストールしておく。手順は、Creating virtual machines を参照してください。

2.3.1. コマンドラインを使用した仮想マシンの起動

コマンドライン (CLI) を使用して、シャットダウンした仮想マシン (VM) を起動したり、保存した仮想マシンを復元したりできます。CLI を使用すると、ローカル仮想マシンとリモート仮想マシンの両方を起動できます。

前提条件

- すでに定義されている非アクティブな仮想マシン

- 仮想マシンの名前

リモート仮想マシンの場合は、以下も設定されている。

- 仮想マシンが置かれているホストの IP アドレス

- ホストへの root アクセス権限

手順

ローカルの仮想マシンには、

virsh startユーティリティーを使用します。たとえば、次のコマンドは仮想マシン demo-guest1 を起動します。

virsh start demo-guest1 Domain 'demo-guest1' started

# virsh start demo-guest1 Domain 'demo-guest1' startedCopy to Clipboard Copied! Toggle word wrap Toggle overflow リモートホストにある仮想マシンでは、ホストへの QEMU+SSH 接続と共に

virsh startユーティリティーを使用します。たとえば、次のコマンドは、ホスト 192.0.2.1 にある仮想マシン demo-guest1 を起動します。

virsh -c qemu+ssh://root@192.0.2.1/system start demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' started

# virsh -c qemu+ssh://root@192.0.2.1/system start demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' startedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.2. Web コンソールを使用した仮想マシンの起動

仮想マシンが 停止 状態にある場合は、RHEL 9 Web コンソールを使用して起動できます。ホストの起動時に、仮想マシンが自動的に起動するように設定することもできます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

- すでに定義されている非アクティブな仮想マシン

- 仮想マシンの名前

手順

インターフェイスで、起動する仮想マシンをクリックします。

選択した仮想マシンの詳細情報を含む新しいページが開き、仮想マシンのシャットダウンおよび削除を制御できます。

をクリックします。

仮想マシンが起動し、そのコンソールまたはグラフィカル出力に接続 できます。

オプション: ホスト起動時に仮想マシンが自動的に起動するように設定するには、Overview セクションの

Autostartチェックボックスを切り替えます。libvirt が管理していないネットワークインターフェイスを使用する場合は、systemd 設定も変更する必要があります。そうしないと、影響を受ける仮想マシンが起動できなくなる可能性があります。starting virtual machines automatically when the host starts を参照してください。

2.3.3. ホストの起動時に仮想マシンを自動的に起動する

実行中の仮想マシン (VM) のホストが再起動すると、仮想マシンはシャットダウンされるため、デフォルトで手動で再起動する必要があります。ホストの実行中に仮想マシンがアクティブであることを確認するには、仮想マシンが自動的に起動するように設定できます。

前提条件

手順

virsh autostartユーティリティーを使用して、ホストの起動時に仮想マシンが自動的に起動するように設定します。たとえば、次のコマンドは、demo-guest1 仮想マシンを自動的に起動するように設定します。

virsh autostart demo-guest1 Domain 'demo-guest1' marked as autostarted

# virsh autostart demo-guest1 Domain 'demo-guest1' marked as autostartedCopy to Clipboard Copied! Toggle word wrap Toggle overflow libvirtが管理していないネットワークインターフェイスを使用する場合は、systemd 設定にも追加の変更を行う必要があります。これを行わないと、影響を受ける仮想マシンの起動に失敗する可能性があります。注記このようなインターフェイスには、以下の例が含まれます。

-

NetworkManagerが作成したブリッジデバイス -

<forward mode='bridge'/>を使用するように設定されたネットワーク

systemd 設定ディレクトリーツリーに、

libvirtd.service.dディレクトリーが存在しない場合は作成します。mkdir -p /etc/systemd/system/libvirtd.service.d/

# mkdir -p /etc/systemd/system/libvirtd.service.d/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以前に作成したディレクトリーに、

10-network-online.confsystemd ユニットオーバーライドファイルを作成します。このファイルの内容は、libvirtd サービスのデフォルトの systemd 設定を上書きします。touch /etc/systemd/system/libvirtd.service.d/10-network-online.conf

# touch /etc/systemd/system/libvirtd.service.d/10-network-online.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 10-network-online.confファイルに以下の行を追加します。この設定変更により、ホストのネットワークの準備ができてから、systemd がlibvirtdサービスを開始できるようになります。[Unit] After=network-online.target

[Unit] After=network-online.targetCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

検証

仮想マシンの設定を表示し、自動開始 オプションが有効になっていることを確認します。

たとえば、次のコマンドは、自動開始 オプションなど、demo-guest1 仮想マシンの基本情報を表示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow libvirt が管理していないネットワークインターフェイスを使用する場合は、

10-network-online.confファイルの内容が次の出力と一致するかどうかを確認してください。cat /etc/systemd/system/libvirtd.service.d/10-network-online.conf [Unit] After=network-online.target

$ cat /etc/systemd/system/libvirtd.service.d/10-network-online.conf [Unit] After=network-online.targetCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4. 仮想マシンへの接続

RHEL 8 で仮想マシンと相互作用するには、以下のいずれかの方法で接続する必要があります。

- Web コンソールインターフェイスを使用する場合は、Web コンソールインターフェイスの仮想マシンペインを使用します。詳細は、Web コンソールを使用した仮想マシンとの相互作用 を参照してください。

- Web コンソールを使用せずに、仮想マシンのグラフィカル表示と相互作用する必要がある場合は、Virt Viewer アプリケーションを使用します。詳細は、Virt Viewer で仮想マシンのグラフィカルコンソールを開く方法 を参照してください。

- グラフィック表示ができない、または必要ない場合は、SSH の端末接続 を使用します。

- ネットワークを使用してシステムから仮想マシンに到達できない場合は、virsh コンソール を使用します。

接続先の仮想マシンがローカルホストではなくリモートホストにある場合は、リモートホストにより便利にアクセスできるように、システムを設定することもできます。

2.4.1. Web コンソールを使用した仮想マシンとの相互作用

RHEL 8 Web コンソールで仮想マシンと相互作用するには、仮想マシンのコンソールに接続する必要があります。グラフィカルコンソールおよびシリアルコンソールの両方が含まれます。

- Web コンソールで仮想マシンのグラフィカルインターフェイスを操作するには、グラフィカルコンソール を使用します。

- リモートビューアーで仮想マシンのグラフィカルインターフェイスを操作する場合は、リモートビューアーでグラフィカルコンソールの表示 を参照してください。

- Web コンソールで仮想マシンの CLI を操作するには、シリアルコンソール を使用します。

2.4.1.1. Web コンソールで仮想マシンのグラフィカルコンソールの表示

仮想マシンのコンソールインターフェイスを使用すると、RHEL 9 Web コンソールに、選択した仮想マシンのグラフィカル出力を表示できます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

- ホストおよび仮想マシンの両方が、グラフィカルインターフェイスに対応している。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

インターフェイスで、グラフィカルコンソールを表示する仮想マシンをクリックします。

仮想マシンの概要とコンソールセクションがある新しいページが開きます。

コンソールドロップダウンメニューで を選択します。

Web インターフェイスのメニューの下に VNC コンソールが表示されます。

グラフィカルコンソールが Web インターフェイスに表示されます。

をクリックします。

実際のマシンの場合と同じように、マウスとキーボードを使用して仮想マシンのコンソールと相互作用できるようになりました。仮想マシンコンソールには、仮想マシンで実行しているアクティビティーが表示されます。

Web コンソールを実行しているホストで、特定の鍵の組み合わせ (Ctrl+Alt+Del など) を傍受して、仮想マシンに送信しないようにできます。

このようなキーの組み合わせを送信する場合は、 メニューをクリックして、送信するキーシーケンスを選択します。

たとえば、仮想マシンに Ctrl+Alt+Del の組み合わせを送信するには、 メニューをクリックして、 メニューエントリーを選択します。

トラブルシューティング

- グラフィカルコンソールをクリックしても効果がない場合は、コンソールを全画面表示にします。これは、マウスカーソルオフセットの既知の問題です。

2.4.1.2. Web コンソールを使用して、リモートビューアーでグラフィカルコンソールを表示する方法

Web コンソールインターフェイスを使用して、選択した仮想マシンのグラフィカルコンソールを Virt Viewer などのリモートビューアーに表示することができます。

Web コンソールから Virt Viewer を起動できます。その他の VNC および SPICE のリモートビューアーは手動で起動できます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

- ホストおよび仮想マシンの両方が、グラフィカルインターフェイスに対応している。

Virt Viewer でグラフィカルコンソールを表示する前に、Web コンソールが接続しているマシンに Virt Viewer をインストールする必要があります。

をクリックします。

virt ビューアー (

.vv) ファイルをダウンロードします。- ファイルを開き、Virt Viewer を起動します。

リモートビューアーは、ほとんどのオペレーティングシステムで使用できます。ブラウザーの拡張機能やプラグインによっては、Web コンソールで Virt Viewer を開けないことがあります。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

インターフェイスで、グラフィカルコンソールを表示する仮想マシンをクリックします。

仮想マシンの概要とコンソールセクションがある新しいページが開きます。

コンソールドロップダウンメニューで を選択します。

をクリックします。

Virt Viewer でグラフィカルコンソールが開きます。

実際のマシンの場合と同じように、マウスとキーボードを使用して仮想マシンのコンソールと相互作用できます。仮想マシンコンソールには、仮想マシンで実行しているアクティビティーが表示されます。

Web コンソールを実行しているサーバーで、特定の鍵の組み合わせ (Ctrl+Alt+Del など) を傍受して、仮想マシンに送信しないようにできます。

このようなキーの組み合わせを送信する場合は、 メニューをクリックして、送信するキーシーケンスを選択します。

たとえば、仮想マシンに Ctrl+Alt+F1 の組み合わせを送信するには、 メニューをクリックして、 メニューエントリーを選択します。

トラブルシューティング

- グラフィカルコンソールをクリックしても効果がない場合は、コンソールを全画面表示にします。これは、マウスカーソルオフセットの既知の問題です。

Web コンソールでリモートビューアーを起動することができない場合、または最適ではない場合は、以下のプロトコルを使用して、任意のビューアーアプリケーションに手動で接続できます。

-

アドレス - デフォルトのアドレスーは

127.0.0.1です。/etc/libvirt/qemu.confのvnc_listenパラメーターまたはspice_listenパラメーターを変更して、ホストの IP アドレスに変更できます。 - SPICE ポート - 5900

- VNC ポート - 5901

-

アドレス - デフォルトのアドレスーは

2.4.1.3. Web コンソールで仮想マシンのシリアルコンソールの表示

RHEL 8 Web コンソールで、選択した仮想マシンのシリアルコンソールを表示できます。これは、グラフィカルインターフェイスでホストマシンまたは仮想マシンを設定していない場合に便利です。

シリアルコンソールの詳細は、Opening a virtual machine serial console を参照してください。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

ペインで、シリアルコンソールを表示する仮想マシンをクリックします。

仮想マシンの概要とコンソールセクションがある新しいページが開きます。

コンソールドロップダウンメニューで を選択します。

グラフィカルコンソールが Web インターフェイスに表示されます。

仮想マシンからシリアルコンソールへの接続を切断して、再接続できます。

- 仮想マシンからシリアルコンソールへの接続を切断するには、 をクリックします。

- シリアルコンソールを仮想マシンに再接続するには、 をクリックします。

2.4.1.4. Web コンソールで SPICE リモートディスプレイプロトコルを VNC に置き換える

SPICE リモート表示プロトコルは RHEL 8 では非推奨となり、RHEL 9 では削除されます。SPICE プロトコルを使用するように設定された仮想マシン (VM) がある場合は、Web コンソールを使用して SPICE プロトコルを VNC プロトコルに置き換えることができます。ただし、オーディオや USB パススルーなどの一部の SPICE デバイスは、VNC プロトコルに適切な代替機能が存在しないため、仮想マシンから削除されます。

デフォルトでは、RHEL 8 仮想マシンは SPICE プロトコルを使用するように設定されています。SPICE から VNC に切り替えない場合、これらの仮想マシンは RHEL 9 に移行できません。

前提条件

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

- SPICE リモートディスプレイプロトコルを使用するように設定され、すでにシャットダウンされている既存の仮想マシンがある。

手順

Web コンソールの仮想マシンインターフェイスで、SPICE プロトコルを使用するように設定されている仮想マシンのメニューボタン をクリックします。

さまざまな仮想マシン操作を制御するためのドロップダウンメニューが開きます。

をクリックします。

Replace SPICE devices ダイアログが開きます。

注記SPICE プロトコルを使用する既存の仮想マシンが複数ある場合は、このダイアログにそれらがリストされます。このダイアログで、1 つのステップで SPICE から VNC の使用に切り替える仮想マシンを複数選択できます。

をクリックします。

操作が成功したことを確認するメッセージが表示されます。

検証

- ボタンをクリックして仮想マシンを起動します。

仮想マシン概要インターフェイスを開きます。

インターフェイスの コンソール ペインに

VNC コンソールオプションが表示されれば、変換は成功しています。

2.4.2. Virt Viewer で仮想マシンのグラフィカルコンソールを開く方法

KVM 仮想マシンのグラフィカルコンソールに接続して、Virt Viewer デスクトップアプリケーションで開く場合は、以下の手順を行います。

前提条件

- システム、および接続している仮想マシンが、グラフィカルディスプレイに対応している。

- ターゲットの仮想マシンがリモートホストにある場合は、そのホストへの接続およびルートアクセス権限が確保されている。

- オプション: ターゲット仮想マシンがリモートホストにある場合は、リモートホストにアクセスしやすくなる ように libvirt と SSH を設定した。

手順

ローカルの仮想マシンに接続するには、次のコマンドを使用して、guest-name を、接続する仮想マシンの名前に置き換えます。

virt-viewer guest-name

# virt-viewer guest-nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow リモートの仮想マシンに接続するには、SSH プロトコルで

virt-viewerコマンドを実行します。たとえば、次のコマンドは、root 権限で、リモートシステム 192.0.2.1 にある guest-name という名前の仮想マシンに接続します。接続には、192.0.2.1 用の root 認証も必要になります。virt-viewer --direct --connect qemu+ssh://root@192.0.2.1/system guest-name root@192.0.2.1's password:

# virt-viewer --direct --connect qemu+ssh://root@192.0.2.1/system guest-name root@192.0.2.1's password:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

接続が正しく機能している場合は、Virt Viewer 画面に仮想マシンのディスプレイが表示されます。

実際のマシンの場合と同じように、マウスとキーボードを使用して仮想マシンのコンソールと相互作用できます。仮想マシンコンソールには、仮想マシンで実行しているアクティビティーが表示されます。

トラブルシューティング

- グラフィカルコンソールをクリックしても効果がない場合は、コンソールを全画面表示にします。これは、マウスカーソルオフセットの既知の問題です。

2.4.3. SSH を使用した仮想マシンへの接続

SSH 接続プロトコルを使用して仮想マシンの端末と相互作用するには、以下の手順に従います。

前提条件

- ターゲットの仮想マシンへのネットワーク接続および root アクセス権がある。

- ターゲットの仮想マシンがリモートホストにある場合は、そのホストへの接続およびルートのアクセス権限もある。

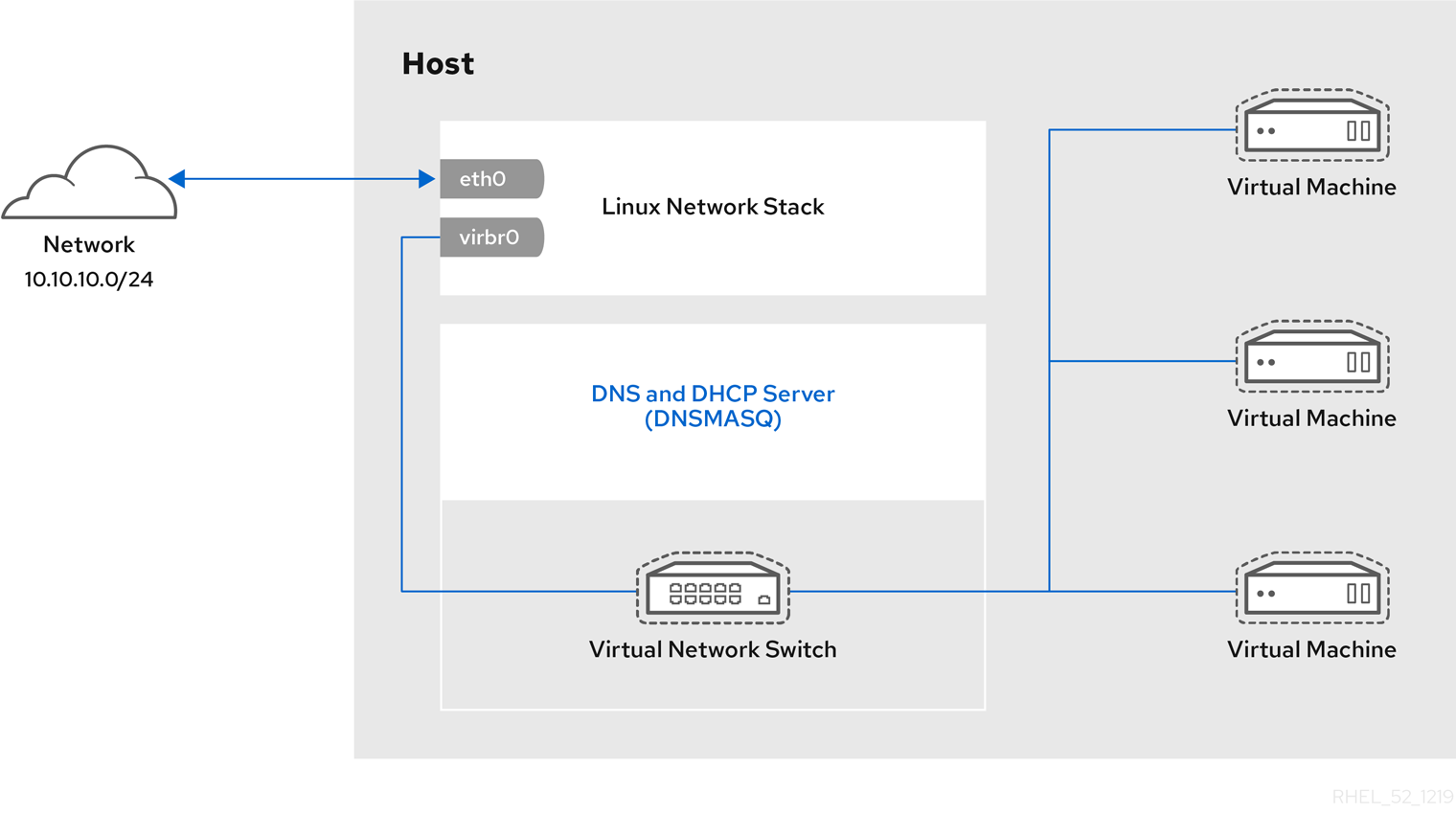

仮想マシンネットワークは、

libvirtが生成したdnsmasqにより IP アドレスを割り当てます。これは、たとえば、libvirtNAT ネットワーク などに該当します。特に、仮想マシンが次のネットワーク設定のいずれかを使用している場合、SSH を使用して仮想マシンに接続することはできません。

-

hostdevインターフェイス - ダイレクトインターフェイス

- ブリッジインターフェイス

-

libvirt-nssコンポーネントを仮想マシンのホストにインストールして有効にしている。そうでない場合は、以下を行います。libvirt-nssパッケージをインストールします。yum install libvirt-nss

# yum install libvirt-nssCopy to Clipboard Copied! Toggle word wrap Toggle overflow /etc/nsswitch.confファイルを編集し、libvirt_guestをhosts行に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

リモート仮想マシンに接続する場合は、最初に SSH でその物理ホストに接続します。以下の例は、root 認証情報を使用してホストマシン

192.0.2.1に接続する方法を示しています。ssh root@192.0.2.1 root@192.0.2.1's password: Last login: Mon Sep 24 12:05:36 2021 root~#

# ssh root@192.0.2.1 root@192.0.2.1's password: Last login: Mon Sep 24 12:05:36 2021 root~#Copy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンの名前とユーザーアクセスの認証情報を使用して、仮想マシンに接続します。たとえば、以下は、root 認証情報を使用して、仮想マシン

testguest1に接続します。ssh root@testguest1 root@testguest1's password: Last login: Wed Sep 12 12:05:36 2018 root~]#

# ssh root@testguest1 root@testguest1's password: Last login: Wed Sep 12 12:05:36 2018 root~]#Copy to Clipboard Copied! Toggle word wrap Toggle overflow

トラブルシューティング

仮想マシンの名前が分からない場合は、

virsh list --allコマンドを使用すると、ホストで利用可能な仮想マシンのリストを表示できます。virsh list --all Id Name State ---------------------------------------------------- 2 testguest1 running - testguest2 shut off

# virsh list --all Id Name State ---------------------------------------------------- 2 testguest1 running - testguest2 shut offCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.4. 仮想マシンのシリアルコンソールを開く

virsh console コマンドを使用すると、仮想マシンのシリアルコンソールに接続できます。

これは、仮想マシンが次のような場合に役に立ちます。

- VNC プロトコルまたは SPICE プロトコルは提供されないため、GUI ツールのビデオ表示が提供されない

- ネットワークに接続されていないため、SSH を使用して 相互作用できない

前提条件

ホスト上の GRUB ブートローダーは、シリアルコンソールを使用するように設定する必要があります。確認するには、ホスト上の

/etc/default/grubファイルにGRUB_TERMINAL=serialパラメーターが含まれていることを確認します。sudo grep GRUB_TERMINAL /etc/default/grub GRUB_TERMINAL=serial

$ sudo grep GRUB_TERMINAL /etc/default/grub GRUB_TERMINAL=serialCopy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンには、

console type='pty'などのシリアルコンソールデバイスが設定されている必要がある。確認するには、以下の手順を実施します。virsh dumpxml vm-name | grep console <console type='pty' tty='/dev/pts/2'> </console>

# virsh dumpxml vm-name | grep console <console type='pty' tty='/dev/pts/2'> </console>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンに、カーネルコマンドラインでシリアルコンソールが設定されている。これを確認するには、仮想マシン上の

cat /proc/cmdlineコマンド出力に console=<console-name> が含まれている必要があります。<console-name> はアーキテクチャー固有です。AMD64 および Intel 64 の場合:

ttyS0注記この手順の次のコマンドは

ttyS0を使用します。cat /proc/cmdline BOOT_IMAGE=/vmlinuz-3.10.0-948.el7.x86_64 root=/dev/mapper/rhel-root ro console=tty0 console=ttyS0,9600n8 rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb

# cat /proc/cmdline BOOT_IMAGE=/vmlinuz-3.10.0-948.el7.x86_64 root=/dev/mapper/rhel-root ro console=tty0 console=ttyS0,9600n8 rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgbCopy to Clipboard Copied! Toggle word wrap Toggle overflow シリアルコンソールが仮想マシンに正しく設定されていない場合は、virsh コンソール を仮想マシンに接続すると、応答のないゲストコンソールに接続できます。ただし、Ctrl+] ショートカットを使用して、応答しないコンソールを終了することができます。

仮想マシンでシリアルコンソールを設定するには、以下を行います。

仮想マシンで、

console=ttyS0カーネルオプションを有効にします。grubby --update-kernel=ALL --args="console=ttyS0"

# grubby --update-kernel=ALL --args="console=ttyS0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 変更を反映させない可能性があるカーネルオプションをクリアします。

grub2-editenv - unset kernelopts

# grub2-editenv - unset kerneloptsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 仮想マシンを再起動します。

serial-getty@<console-name>サービスを有効にする必要があります。たとえば、AMD64 および Intel 64 の場合:systemctl status serial-getty@ttyS0.service ○ serial-getty@ttyS0.service - Serial Getty on ttyS0 Loaded: loaded (/usr/lib/systemd/system/serial-getty@.service; enabled; preset: enabled)# systemctl status serial-getty@ttyS0.service ○ serial-getty@ttyS0.service - Serial Getty on ttyS0 Loaded: loaded (/usr/lib/systemd/system/serial-getty@.service; enabled; preset: enabled)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

ホストシステムで、

virsh consoleコマンドを使用します。次の例では、libvirt ドライバーが安全なコンソール処理に対応していると、仮想マシン guest1 に接続します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - virsh コンソールは、標準のコマンドラインインターフェイスと同じ方法で相互作用できます。

2.4.5. リモートの仮想化ホストへの簡単なアクセスの設定

libvirt ユーティリティーを使用してリモートホストシステムの仮想マシンを管理する場合は、-c qemu+ssh://root@hostname/system 構文を使用することが推奨されます。たとえば、ホスト 192.0.2.1 で、root で virsh list コマンドを実行します。

ただし、SSH および libvirt の設定を変更すれば、接続の詳細を完全に指定する必要がなくなります。以下に例を示します。

この改善機能を有効にするには、以下の手順を行います。

手順

~/.ssh/configファイルを以下のように編集します。ここで、host-alias は特定のリモートホストに関連付けられた短縮名および root@192.0.2.1 のエイリアス、hosturl は host の URL アドレスです。vi ~/.ssh/config Host example-host-alias User root Hostname 192.0.2.1

# vi ~/.ssh/config Host example-host-alias User root Hostname 192.0.2.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow /etc/libvirt/libvirt.confファイルを以下のように編集します。example-qemu-host-alias は、QEMU および libvirt ユーティリティーがqemu+ssh://192.0.2.1/systemに目的のホスト example-host-alias を関連付けるホストエイリアスです。vi /etc/libvirt/libvirt.conf uri_aliases = [ "example-qemu-host-alias=qemu+ssh://example-host-alias/system", ]

# vi /etc/libvirt/libvirt.conf uri_aliases = [ "example-qemu-host-alias=qemu+ssh://example-host-alias/system", ]Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ローカルシステムで libvirt ベースのユーティリティーを使用し、

-c qemu-host-aliasパラメーターを追加することで、リモートの仮想マシンを管理できることを確認します。これにより、リモートホストの SSH でコマンドが自動的に実行されます。たとえば、以下のコマンドにより、前の手順で example-qemu-host-alias としてセットアップした接続である、192.0.2.1 リモートホスト上の仮想マシンがリスト表示されることを確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記virshの他に、-c(または--connect) オプションと、上記のリモートホストアクセス設定は、以下のユーティリティーで使用できます。

次のステップ

libvirt ユーティリティーを、1 台のリモートホストで排他的に使用する場合は、libvirt ベースのユーティリティーのデフォルトターゲットとして特定の接続を設定することもできます。ただし、ローカルホストまたは別のリモートホストでも仮想マシンを管理する場合、この方法は推奨されません。

/etc/libvirt/libvirt.confファイルを編集して、uri_defaultパラメーターの値を、デフォルトの libvirt ターゲットとして example-qemu-host-alias に設定できます。# These can be used in cases when no URI is supplied by the application # (@uri_default also prevents probing of the hypervisor driver). # uri_default = "example-qemu-host-alias"

# These can be used in cases when no URI is supplied by the application # (@uri_default also prevents probing of the hypervisor driver). # uri_default = "example-qemu-host-alias"Copy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、指定したリモートホストで、libvirt ベースのコマンドがすべて自動的に実行されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow リモートホストに接続する場合、リモートシステムへの root パスワードの入力を回避できます。そのためには、以下の方法を 1 つ以上行います。

- リモートホストへのキーベースの SSH アクセスを設定する

- SSH 接続の多重化を使用して、リモートシステムに接続する。

- Identity Management における Kerberos 認証

-

-c(または--connect) オプションを使用して、virt-install、

リモートホスト上の virt-viewer、virsh、および virt-manager コマンド。

2.4.6. コマンドラインを使用して SPICE リモートディスプレイプロトコルを VNC に置き換える

SPICE リモート表示プロトコルは RHEL 8 では非推奨となり、RHEL 9 では削除されます。SPICE プロトコルを使用するように設定された仮想マシン (VM) がある場合は、コマンドラインを使用して SPICE プロトコルを VNC プロトコルに置き換えることができます。ただし、オーディオや USB パススルーなどの一部の SPICE デバイスは、VNC プロトコルに適切な代替機能が存在しないため、仮想マシンから削除されます。

デフォルトでは、RHEL 8 仮想マシンは SPICE プロトコルを使用するように設定されています。SPICE から VNC に切り替えないと、これらの仮想マシンは RHEL 9 に移行できません。

前提条件

- SPICE リモートディスプレイプロトコルを使用するように設定され、すでにシャットダウンされている既存の仮想マシンがある。

手順

ホスト上で次のコマンドを実行し、`<vm-name>` を VNC に変換する仮想マシンの名前に置き換えます。

virt-xml <vm-name> --edit --convert-to-vnc Domain 'vm-name' defined successfully

# virt-xml <vm-name> --edit --convert-to-vnc Domain 'vm-name' defined successfullyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

変換した仮想マシンの設定を検査し、グラフィックタイプが

vncとしてリストされていることを確認します。virsh dumpxml -xml <vm-name> | grep "graphics" <graphics type='vnc' port='5900' autoport='yes' listen='127.0.0.1'>

# virsh dumpxml -xml <vm-name> | grep "graphics" <graphics type='vnc' port='5900' autoport='yes' listen='127.0.0.1'>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.7. VNC パスワードの設定

仮想マシン (VM) のグラフィカル出力へのアクセスを管理するには、仮想マシンの VNC コンソールのパスワードを設定できます。

仮想マシンに VNC パスワードが設定されている場合、仮想マシンのユーザーは、たとえば virt-viewer ユーティリティーを使用して仮想マシンの VNC グラフィカルコンソールを表示したり操作したりするときに、パスワードを入力する必要があります。

VNC パスワードは、仮想マシン環境のセキュリティーを確保するのに十分な手段ではありません。詳細は、VNC セキュリティーに関する QEMU のドキュメント を参照してください。

また、VNC パスワードは、仮想マシンの設定にプレーンテキストで保存されます。そのため、パスワードを有効にする場合は、ユーザーが仮想マシン設定を表示できないようにする必要があります。

前提条件

VNC パスワードで保護する仮想マシンに VNC グラフィックスが設定されている。

これが当てはまるかどうかを確認するには、次のように

virsh dumpxmlコマンドを使用します。virsh dumpxml <vm-name> | grep graphics <graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1> </graphics>

# virsh dumpxml <vm-name> | grep graphics <graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1> </graphics>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

VNC パスワードを割り当てる仮想マシンの設定を開きます。

virsh edit <vm-name>

# virsh edit <vm-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定の

<graphics>行に、passwd属性とパスワード文字列を追加します。パスワードは 8 文字以下にする必要があります。<graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1 passwd='<password>'>

<graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1 passwd='<password>'>Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: さらに、パスワードの有効期限が切れる日時を定義します。

<graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1 passwd='<password>' passwdValidTo='2025-02-01T15:30:00'>

<graphics type='vnc' ports='-1' autoport=yes listen=127.0.0.1 passwd='<password>' passwdValidTo='2025-02-01T15:30:00'>Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、パスワードは 2025 年 2 月 1 日 15:30 UTC に期限切れになります。

- 設定を保存します。

検証

変更した仮想マシンを起動します。

virsh start <vm-name>

# virsh start <vm-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow たとえば、

virt-viewerユーティリティーを使用して、仮想マシンのグラフィカルコンソールを開きます。virt-viewer <vm-name>

# virt-viewer <vm-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow VNC パスワードが正しく設定されている場合は、パスワードの入力を要求するダイアログウィンドウが表示されます。

2.5. 仮想マシンのシャットダウン

RHEL 9 でホストされている実行中の仮想マシンをシャットダウンするには、コマンドライン または Web コンソール GUI を使用します。

2.5.1. コマンドラインを使用した仮想マシンのシャットダウン

仮想マシン (VM) をシャットダウンするには、仮想マシンが応答するかどうかに応じて異なる手順が必要です。

応答可能な仮想マシンのシャットダウン

ゲストに接続している 場合は、ゲストオペレーティングシステムに適したシャットダウンコマンドまたは GUI 要素を使用します。

注記GNOME デスクトップを使用する Linux ゲストなどの一部の環境では、ゲストをサスペンドまたはハイバネート状態にするために GUI 電源ボタンを使用すると、代わりに仮想マシンがシャットダウンされることがあります。

または、ホストで

virsh shut downコマンドを使用します。仮想マシンがローカルホストにある場合は、以下のコマンドを実行します。

virsh shutdown demo-guest1 Domain 'demo-guest1' is being shutdown

# virsh shutdown demo-guest1 Domain 'demo-guest1' is being shutdownCopy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンがリモートホスト (この例では 192.0.2.1) にある場合は、以下のコマンドを実行します。

virsh -c qemu+ssh://root@192.0.2.1/system shutdown demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' is being shutdown

# virsh -c qemu+ssh://root@192.0.2.1/system shutdown demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' is being shutdownCopy to Clipboard Copied! Toggle word wrap Toggle overflow

応答しない仮想マシンのシャットダウン

応答しない場合など、仮想マシンを強制的にシャットダウンする場合は、そのホストで virsh destroy コマンドを実行します。

virsh destroy demo-guest1 Domain 'demo-guest1' destroyed

# virsh destroy demo-guest1

Domain 'demo-guest1' destroyed

virsh destroy コマンドは、仮想マシンの設定またはディスクイメージを削除するわけではありません。物理マシンから電源コードを抜くのと同様に、仮想マシンの実行中のインスタンスを終了するだけです。

virsh destroy によって、仮想マシンのファイルシステムが破損することがまれにあります。そのため、他のすべてのシャットダウン方法が失敗した場合にのみ、このコマンドを使用することを推奨します。

検証

ホスト上で、仮想マシンのリストを表示してステータスを確認します。

virsh list --all Id Name State ------------------------------------------ 1 demo-guest1 shut off

# virsh list --all Id Name State ------------------------------------------ 1 demo-guest1 shut offCopy to Clipboard Copied! Toggle word wrap Toggle overflow

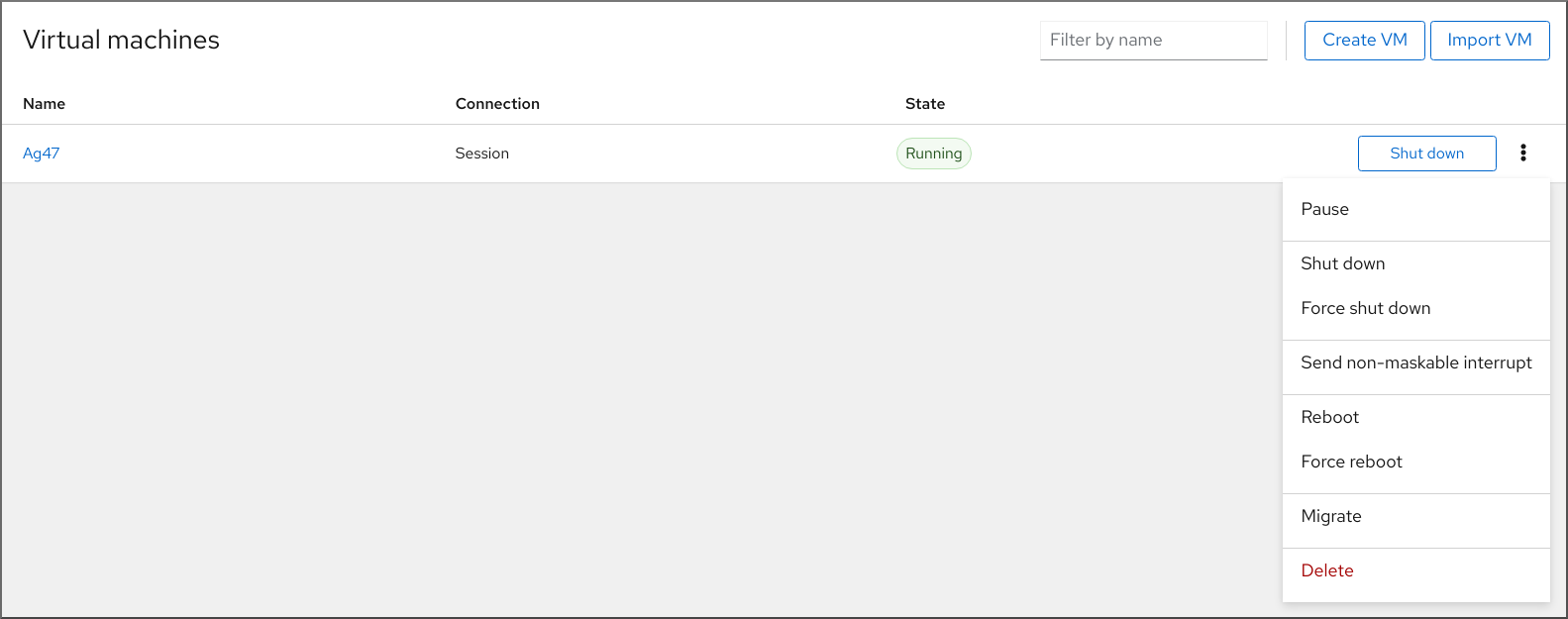

2.5.2. Web コンソールを使用した仮想マシンのシャットダウンおよび再起動

RHEL 8 Web コンソールを使用して、実行中の仮想マシンを シャットダウン または 再起動 できます。仮想マシンが応答しない場合は、マスク不可割り込みを送信できます。

2.5.2.1. Web コンソールで仮想マシンのシャットダウン

仮想マシンが 稼働 状態であれば、RHEL 9 Web コンソールを使用してシャットダウンできます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

手順

- インターフェイスで、シャットダウンする仮想マシンがある行を見つけます。

行の右側で、 をクリックします。

仮想マシンがシャットダウンします。

トラブルシューティング

- 仮想マシンがシャットダウンしない場合には、 ボタンの横にある をクリックして、 を選択します。

- 応答しない仮想マシンをシャットダウンするには、マスク不可割り込みを送信 することもできます。

2.5.2.2. Web コンソールを使用した仮想マシンの再起動

仮想マシンが 稼働 状態であれば、RHEL 9 Web コンソールを使用して再起動できます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

手順

- インターフェイスで、再起動する仮想マシンの行を見つけます。

行の右側にあるメニューボタン をクリックします。

アクションのドロップダウンメニューが表示されます。

ドロップダウンメニューで、 をクリックします。

仮想マシンがシャットダウンして再起動します。

トラブルシューティング

- 仮想マシンが再起動しない場合には ボタンのとなりにある をクリックして を選択します。

- 応答しない仮想マシンをシャットダウンするには、マスク不可割り込みを送信 することもできます。

2.5.2.3. Web コンソールでマスク不可割り込みを仮想マシンに送信する手順

NMI (マスク不可割り込み) を送信すると、応答しない稼働中の仮想マシンが応答またはシャットダウンする可能性があります。たとえば、Ctrl+Alt+Del の NMI を、標準入力に応答しない仮想マシンに送信できます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

- インターフェイスで、NMI を送信する仮想マシンの行を見つけます。

行の右側にあるメニューボタン をクリックします。

アクションのドロップダウンメニューが表示されます。

ドロップダウンメニューで、 をクリックします。

NMI が仮想マシンに送信されます。

2.6. 仮想マシンの削除

RHEL 9 で仮想マシンを削除するには、コマンドライン または Web コンソール GUI を使用します。

2.6.1. コマンドラインを使用した仮想マシンの削除

仮想マシンを削除するには、コマンドラインでその XML 設定および関連するストレージファイルをホストから削除します。以下の手順を実施します。

前提条件

- 仮想マシンからの重要なデータのバックアップを作成している。

- 仮想マシンをシャットダウンしている。

- その他の仮想マシンが、同じ関連ストレージを使用しないようにしている。

手順

virsh undefineユーティリティーを使用します。たとえば、次のコマンドは、guest1 仮想マシン、関連のあるストレージボリューム、および不揮発性 RAM が存在する場合はそれを削除します。

virsh undefine guest1 --remove-all-storage --nvram Domain 'guest1' has been undefined Volume 'vda'(/home/images/guest1.qcow2) removed.

# virsh undefine guest1 --remove-all-storage --nvram Domain 'guest1' has been undefined Volume 'vda'(/home/images/guest1.qcow2) removed.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

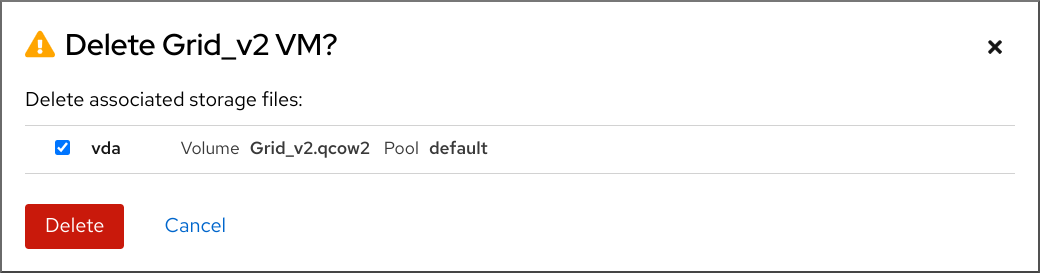

2.6.2. Web コンソールを使用した仮想マシンの削除

RHEL 8 Web コンソールが接続しているホストから、仮想マシンおよび関連ストレージファイルを削除する場合は、以下の手順を行います。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

- 仮想マシンからの重要なデータのバックアップを作成している。

- 他の仮想マシンが同じ関連ストレージを使用していないことを確認します。

- オプション: 仮想マシンをシャットダウンします。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

インターフェイスで、削除する仮想マシンのメニューボタン をクリックします。

仮想マシン操作を制御するためのドロップダウンメニューが表示されます。

をクリックします。

確認ダイアログが表示されます。

- オプション: 仮想マシンに関連付けられているストレージファイルのすべてまたは一部を削除するには、削除するストレージファイルの横にあるチェックボックスをオンにします。

をクリックします。

仮想マシンと、選択したストレージファイルが削除されます。

第3章 IBM POWER での仮想化の使用

IBM POWER8 または POWER9 のハードウェアで RHEL 8 を使用する場合は、KVM 仮想化を使用できます。ただし、システムで KVM ハイパーバイザーを有効にする 場合は、AMD64 および Intel64 のアーキテクチャーの仮想化に、追加の手順が必要になります。特定の RHEL 8 の仮想化機能には、IBM POWER の 機能が異なったり、制限されている ものもあります。

以下のセクションの情報とは別に、IBM POWER で仮想化を使用すると、AMD64 および Intel 64 と同じように機能します。したがって、IBM POWER で仮想化を使用する方法は、その他の RHEL 8 仮想化ドキュメントを参照してください。

3.1. IBM POWER での仮想化の有効化

KVM ハイパーバイザーを設定し、RHEL 8 を実行している IBM POWER8 または IBM POWER9 のシステムで仮想マシンを作成するには、以下の手順に従います。

前提条件

- ホストマシンに RHEL 8 がインストールされ、登録されている。

最低でも、以下のシステムリソースが利用できる。

- ホスト用に 6 GB と、各仮想マシン用に 6 GB の空きディスク容量。

- ホスト用に 2 GB と、各仮想マシン用に 2 GB の RAM。

- ホスト上の 4 つの CPU通常、仮想マシンは、割り当てられた 1 つの vCPU で実行できますが、Red Hat は、高負荷時に仮想マシンが応答しなくならないように、仮想マシンごとに 2 つ以上の vCPU を割り当てることを推奨します。

CPU マシンタイプは、IBM POWER 仮想化に対応している必要があります。

これを確認するには、

/proc/cpuinfoファイルでプラットフォーム情報を探してください。grep ^platform /proc/cpuinfo/ platform : PowerNV

# grep ^platform /proc/cpuinfo/ platform : PowerNVCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドの出力に

PowerNVエントリーが含まれる場合は、マシンタイプ PowerNV を実行しており、IBM POWER で仮想化を使用できます。

手順

KVM-HV カーネルモジュールを読み込みます。

modprobe kvm_hv

# modprobe kvm_hvCopy to Clipboard Copied! Toggle word wrap Toggle overflow KVM カーネルモジュールが読み込まれていることを確認します。

lsmod | grep kvm

# lsmod | grep kvmCopy to Clipboard Copied! Toggle word wrap Toggle overflow KVM が正常に読み込まれると、このコマンドの出力には

kvm_hvが含まれます。仮想化モジュールにパッケージをインストールします。

yum module install virt

# yum module install virtCopy to Clipboard Copied! Toggle word wrap Toggle overflow virt-installパッケージをインストールします。yum install virt-install

# yum install virt-installCopy to Clipboard Copied! Toggle word wrap Toggle overflow libvirtdサービスを開始します。systemctl start libvirtd

# systemctl start libvirtdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

システムが仮想ホストとして準備されていることを確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow virt-host-validate のすべての項目で

PASS値が返された場合は、システムに 仮想マシンを作成する 準備ができています。いずれかの項目で

FAILが返された場合は、表示される指示に従って問題を解決してください。いずれかの項目で

WARNが返された場合は、表示される指示に従って仮想化機能を向上させることを検討してください。

トラブルシューティング

KVM 仮想化がホスト CPU でサポートされていない場合は、virt-host-validate は以下の出力を生成します。

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)Copy to Clipboard Copied! Toggle word wrap Toggle overflow ただし、このようなホストシステムにある仮想マシンは、パフォーマンス上の問題が発生するのではなく、起動に失敗します。

これを回避するには、仮想マシンの XML 設定の

<domain type>値をqemuに変更します。ただし、Red Hat はqemuドメインタイプを使用する仮想マシンに対応していないため、実稼働環境ではこれを設定しないことを強く推奨している点に注意してください。

3.2. IBM POWER の仮想化と AMD64 および Intel 64 の相違点

IBM POWER システムにおける RHEL 8 の KVM 仮想化は、AMD64 および Intel 64 の KVM とは異なります。特に以下のの点が異なります。

- メモリー要件

- IBM POWER 上の仮想マシンは、より多くのメモリーを消費します。したがって、IBM POWER ホストの仮想マシンに推奨される最小メモリー割り当ては 2GB RAM です。

- ディスプレイプロトコル

IBM POWER システムでは、SPICE プロトコルに対応していません。仮想マシンのグラフィック出力を表示するには、

VNCプロトコルを使用します。さらに、次の仮想グラフィックスカードデバイスにのみ対応しています。-

vga--vga stdモードでのみ対応され、-vga cirrusモードでは対応されません。 -

virtio-vga -

virtio-gpu

-

- SMBIOS

- SMBIOS 設定は利用できません。

- メモリー割り当てエラー

Power8 の仮想マシン (互換モードの仮想マシンを含む) は、以下のようなエラーで失敗する場合があります。

qemu-kvm: Failed to allocate KVM HPT of order 33 (try smaller maxmem?): Cannot allocate memory

qemu-kvm: Failed to allocate KVM HPT of order 33 (try smaller maxmem?): Cannot allocate memoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow これは、RHEL 7.3 以前をゲスト OS として使用する仮想マシンで発生する可能性が非常に高くなります。

この問題を解決するには、ホストのカーネルコマンドラインに

kvm_cma_resv_ratio=memoryを追加して、ゲストのハッシュページテーブル (HPT) に使用できる CMA メモリープールを増やします。memory は、CMA プールに予約する必要があるホストメモリーの割合 (デフォルトは 5) です。- Huge page

THP (Transparent Huge page) は、IBM POWER8 の仮想マシンのパフォーマンスには大きな利点をもたらすことはありません。ただし、IBM POWER9 仮想マシンでは、THP から期待どおりの利点を得ることができます。

また、IBM POWER8 システムの静的 Huge Page のサイズは、16 MiB および 16 GiB です。これは、AMD64、Intel 64、および IBM POWER9 の 2 MiB および 1 GiB とは対照的です。したがって、静的 Huge Page を設定した仮想マシンを、IBM POWER8 ホストから IBM POWER9 ホストに移行するには、最初に仮想マシンに 1GiB の Huge Page を設定する必要があります。

- kvm-clock

-

kvm-clockサービスは、IBM POWER9 の仮想マシンで時間管理用に設定する必要はありません。 - pvpanic

IBM POWER9 システムは、

pvpanicデバイスに対応していません。ただし、このアーキテクチャーでは、同等の機能がデフォルトで利用でき、アクティベートされます。仮想マシンで有効にするには、preserve値で XML 設定要素<on_crash>を使用します。また、

<devices>セクションから<panic>要素を必ず削除してください。その要素があると、仮想マシンが IBM POWER システムで起動できなくなる可能性があるためです。- シングルスレッドホスト

- IBM POWER8 システムでは、仮想マシンに対応するために、ホストマシンを シングルスレッドモード で稼働する必要があります。これは、qemu-kvm パッケージがインストールされていると、自動的に設定されます。ただし、シングルスレッドホストで実行している仮想マシンは、複数のスレッドを使用できます。

- 周辺機器

AMD64 および Intel 64 のシステムで対応している周辺デバイスの多くが、IBM POWER システムでは対応されていないか、別のデバイスが代替として対応されています。

-

ioh3420およびxio3130-downstreamを含む PCI-E 階層に使用されるデバイスには対応していません。この機能は、spapr-pci-host-bridgeデバイスが提供する複数の独立した PCI root ブリッジに置き換えられます。 - UHCI コントローラーおよび EHCI PCI コントローラーには対応していません。代わりに OHCI コントローラーおよび xHCI コントローラーを使用してください。

-

仮想 IDE CD-ROM (

ide-cd) を含む IDE デバイスと、仮想 IDE ディスク (ide-hd) には対応していません。代わりにvirtio-scsiデバイスおよびvirtio-blkデバイスを使用してください。 -

エミュレートされた PCI NIC (

rtl8139) には対応していません。代わりにvirtio-netデバイスを使用してください。 -

intel-hda、hda-output、およびAC97を含むサウンドデバイスは対応していません。 -

usb-redir、usb-tabletなどの USB リダイレクトデバイスには対応していません。

-

- v2v および p2v

-

virt-v2vユーティリティーおよびvirt-p2vユーティリティーは、AMD64 および Intel 64 のアーキテクチャーでのみ対応しており、IBM POWER では提供されません。

関連情報

- Red Hat がサポートする各システムアーキテクチャーで、一部のサポート対象およびサポート対象外の仮想化機能を比較する場合は、RHEL 8 における仮想化機能のサポートの概要 を参照してください。

第4章 IBM Z での仮想化の使用

IBM Z ハードウェアで RHEL 8 を使用する場合は、KVM 仮想化を使用できます。ただし、システムで KVM ハイパーバイザーを有効にする 場合は、AMD64 および Intel 64 のアーキテクチャーの仮想化に、追加の手順が必要です。RHEL 8 の仮想化機能には、IBM Z の 機能が異なったり、制限されている ものもあります。

以下のセクションの情報とは別に、IBM Z で仮想化を使用すると、AMD64 および Intel 64 と同じように機能します。したがって、IBM Z で仮想化を使用する方法は、その他の RHEL 8 仮想化ドキュメントを参照してください。

z/VM OS における KVM の実行はサポートされていません。

4.1. IBM Z での仮想化の有効化

KVM ハイパーバイザーを設定し、RHEL 8 を実行している IBM Z システムで仮想マシンを作成するには、以下の手順に従います。

前提条件

ホストマシンに RHEL 8.6 以降がインストールされ、登録されている。

重要すでに RHEL 8.5 以前を使用して IBM Z マシンで仮想化を有効化している場合は、代わりに仮想化モジュールを再設定し、システムを更新する必要があります。手順は、How virtualization on IBM Z differs from AMD64 and Intel 64 を参照してください。

最低でも、以下のシステムリソースが利用できる。

- ホスト用に 6 GB と、各仮想マシン用に 6 GB の空きディスク容量。

- ホスト用に 2 GB と、各仮想マシン用に 2 GB の RAM。

- ホスト上の 4 つの CPU通常、仮想マシンは、割り当てられた 1 つの vCPU で実行できますが、Red Hat は、高負荷時に仮想マシンが応答しなくならないように、仮想マシンごとに 2 つ以上の vCPU を割り当てることを推奨します。

- IBM Z ホストシステムでは IBM z14 CPU 以降が使用されています。

RHEL 8 が論理パーティション (LPAR) にインストールされている。また、LPAR が start-interpretive execution (SIE) 仮想機能に対応している。

これを確認するには、

/proc/cpuinfoファイルでsieを検索します。grep sie /proc/cpuinfo features : esan3 zarch stfle msa ldisp eimm dfp edat etf3eh highgprs te sie

# grep sie /proc/cpuinfo features : esan3 zarch stfle msa ldisp eimm dfp edat etf3eh highgprs te sieCopy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

KVM カーネルモジュールを読み込みます。

modprobe kvm

# modprobe kvmCopy to Clipboard Copied! Toggle word wrap Toggle overflow KVM カーネルモジュールが読み込まれていることを確認します。

lsmod | grep kvm

# lsmod | grep kvmCopy to Clipboard Copied! Toggle word wrap Toggle overflow KVM が正常に読み込まれると、このコマンドの出力には

kvmが含まれます。virt:rhel/commonモジュールにパッケージをインストールします。yum module install virt:rhel/common

# yum module install virt:rhel/commonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想化サービスを起動します。

for drv in qemu network nodedev nwfilter secret storage interface; do systemctl start virt${drv}d{,-ro,-admin}.socket; done# for drv in qemu network nodedev nwfilter secret storage interface; do systemctl start virt${drv}d{,-ro,-admin}.socket; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

システムが仮想ホストとして準備されていることを確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow virt-host-validate のすべての項目で

PASS値が返された場合は、システムに 仮想マシンを作成する 準備ができています。いずれかの項目で

FAILが返された場合は、表示される指示に従って問題を解決してください。いずれかの項目で

WARNが返された場合は、表示される指示に従って仮想化機能を向上させることを検討してください。

トラブルシューティング

KVM 仮想化がホスト CPU でサポートされていない場合は、virt-host-validate は以下の出力を生成します。

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)Copy to Clipboard Copied! Toggle word wrap Toggle overflow ただし、このようなホストシステムにある仮想マシンは、パフォーマンス上の問題が発生するのではなく、起動に失敗します。

これを回避するには、仮想マシンの XML 設定の

<domain type>値をqemuに変更します。ただし、Red Hat はqemuドメインタイプを使用する仮想マシンに対応していないため、実稼働環境ではこれを設定しないことを強く推奨している点に注意してください。

4.2. IBM Z の仮想化の RHEL 8.5 から RHEL 8.6 以降への更新

RHEL 8.6 より前の IBM Z ハードウェアに RHEL 8 をインストールしている場合は、RHEL 8 のベース RPM ストリームとは別に、AV ストリームから仮想化 RPM を取得する必要があります。RHEL 8.6 以降、以前は AV ストリームからのみ利用可能だった仮想化 RPM がベース RHEL ストリームで利用可能になりました。さらに、AV ストリームは、RHEL 8 の将来のマイナーリリースで廃止される予定です。そのため、AV ストリームの使用は推奨されなくなりました。

以下の手順に従うと、AV ストリームを無効にし、RHEL 8.6 以降のバージョンで利用可能な仮想化 RPM へのアクセスが有効になります。

前提条件

virt:avモジュールがインストールされている IBM Z で RHEL 8.5 を使用している。これを確認するには、以下を実行します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

virt:avモジュールを無効にします。yum disable virt:av

# yum disable virt:avCopy to Clipboard Copied! Toggle word wrap Toggle overflow システムにすでに含まれている既存の仮想化パッケージおよびモジュールを削除します。

yum module reset virt -y

# yum module reset virt -yCopy to Clipboard Copied! Toggle word wrap Toggle overflow パッケージを最新の RHEL バージョンにアップグレードします。

yum update

# yum updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、システムで

virt:rhelモジュールも自動的に有効になります。

検証

システムの

virtモジュールがrhelストリームによって提供されていることを確認します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3. IBM Z の仮想化と、AMD64 および Intel 64 の仮想化の相違点

IBM Z システムの RHEL 8 の KVM 仮想化は、以下の点で AMD64 システムおよび Intel 64 システムの KVM とは異なります。

- PCI デバイスおよび USB デバイス

IBM Z は、仮想 PCI デバイスおよび USB デバイスに対応していません。したがって、

virtio-*-pciデバイスに対応していないため、代わりにvirtio-*-ccwデバイスを使用してください。たとえば、virtio-net-pciの代わりにvirtio-net-ccwを使用します。PCI パススルーとも呼ばれる PCI デバイスの直接アタッチに対応しています。

- サポートされているゲスト OS

- Red Hat が IBM Z でホストする仮想マシンをサポートするのは、仮想マシンがゲストオペレーティングシステムとして RHEL 7、8、または 9 を使用している場合のみです。

- デバイスの起動順序

IBM Z は、XML 設定要素

<boot dev='device'>に対応していません。デバイスの起動順序を定義するには、XML の<devices>セクションで、<boot order='number'>要素を使用します。注記すべてのホストアーキテクチャーで、起動順序の管理に

<boot order='number'>を使用することを推奨します。さらに、

<boot>要素でアーキテクチャー固有のloadparm属性を使用して、必要なブートエントリーを選択できます。たとえば、次の例では、ブートシーケンスでディスクを最初に使用する必要があり、そのディスクで Linux ディストリビューションが利用可能な場合は、2 番目のブートエントリーが選択されます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - メモリーのホットプラグ

- IBM Z では、実行中の仮想マシンにメモリーを追加することはできません。実行中の仮想マシン (メモリーの ホットアンプラグ) からメモリーを削除することは、IBM Z や、AMD64 および Intel 64 でもできないことに注意してください。

- NUMA トポロジー

-

CPU の Non-Uniform Memory Access (NUMA) トポロジーは、IBM Z 上の

libvirtでは対応していません。したがって、このシステムでは、NUMA を使用して vCPU パフォーマンスをチューニングすることはできません。 - GPU デバイス

- IBM Z システムでは GPU デバイスの割り当て はサポートされていません。

- vfio-ap

- IBM Z ホストの仮想マシンは、vfio-ap 暗号デバイスパススルーを使用しますが、その他のアーキテクチャーでは対応していません。

- vfio-ccw

- IBM Z ホスト上の仮想マシンは、他のアーキテクチャーではサポートされていない vfio-ccw ディスクデバイスパススルーを使用できます。

- SMBIOS

- IBM Z では、SMBIOS 設定は利用できません。

- Watchdog デバイス

IBM Z ホストの仮想マシンでウォッチドッグデバイスを使用する場合は、

diag288モデルを使用します。以下に例を示します。<devices> <watchdog model='diag288' action='poweroff'/> </devices>

<devices> <watchdog model='diag288' action='poweroff'/> </devices>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - kvm-clock

-

kvm-clockサービスは、AMD64 システムおよび Intel 64 システムに固有のものであり、IBM Z の仮想マシンの時間管理用に設定する必要はありません。 - v2v および p2v

-

virt-v2vユーティリティーおよびvirt-p2vユーティリティーは、AMD64 および Intel 64 のアーキテクチャーでのみ対応しており、IBM Z では提供されません。 - ネストされた仮想化

- ネストされた仮想マシンを作成するには、AMD64 および Intel 64 とは別の設定を IBM Z で作成する必要があります。詳細は、Creating nested virtual machines を参照してください。

- 以前のリリースでグラフィカル出力なし

-

ホストで RHEL 8.3 以前のマイナーバージョンを使用している場合は、VNC プロトコルを使用して仮想マシンに接続すると、仮想マシンのグラフィカル出力を表示できません。これは、

gnome-desktopユーティリティーが、IBM Z の以前のバージョンの RHEL ではサポートされていなかったためです。また、IBM Z では、SPICE ディスプレイプロトコルは機能しません。 - 移行

後のホストモデル (たとえば IBM z14 から z15) に正常に移行したり、ハイパーバイザーを更新したりするには、

host-modelの CPU モードを使用します。host-passthroughおよびmaximumCPU モードは、一般的に移行に対して安全ではないため、推奨しません。customCPU モードで明示的な CPU モデルを指定する場合は、次のガイドラインに従ってください。-

-baseで終わる CPU モデルは使用しない。 -

qemu、max、またはhostCPU モデルは使用しない。

古いホストモデルへの移行 (z15 から z14 など)、または以前のバージョンの QEMU、KVM、RHEL カーネルへの移行の場合、最後に

-baseが付いていない使用可能な最も古いホストモデルの CPU タイプを使用します。-

ソースホストと宛先ホストの両方を実行している場合は、代わりに宛先ホストで

virsh hypervisor-cpu-baselineコマンドを使用して、適切な CPU モデルを取得できます。詳細は、仮想マシン移行のホスト CPU の互換性の確認 を参照してください。 - RHEL 8 でサポートされているマシンタイプの詳細については、RHEL 8 仮想化で推奨される機能 を参照してください。

-

- PXE インストールおよび起動

PXE を使用して IBM Z で 仮想マシンを実行する場合は、

pxelinux.cfg/defaultファイルに特定の設定が必要です。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 安全な実行

-

仮想マシンの XML 設定で

<launchSecurity type="s390-pv"/>を定義することにより、準備されたセキュアなゲストイメージで仮想マシンを起動できます。これにより、仮想マシンのメモリーが暗号化され、ハイパーバイザーによる不要なアクセスから保護されます。

仮想マシンを安全な実行モードで実行している場合、次の機能はサポートされないことに注意してください。

-

vfioを使用したデバイスパススルー -

virsh domstatsおよびvirsh memstatを使用したメモリー情報の取得 -

memballoonおよびvirtio-rng仮想デバイス - huge page を使用したメモリーバッキング

- ライブマイグレーションおよび非ライブマイグレーション

- 仮想マシンの保存および復元

-

メモリースナップショットを含む仮想マシンスナップショット (

--memspecオプションを使用) -

完全なメモリーダンプ。代わりに、

virsh dumpコマンドに--memory-onlyオプションを指定してください。 - 248 以上の vCPU。セキュアゲストの vCPU 制限は 247 です。

- ネストされた仮想化

4.4. 次のステップ

IBM Z システム上に仮想マシンを設定する場合は、Spectre 脆弱性からゲスト OS を保護することを推奨します。そうするには、

virsh editコマンドを使用して、次のいずれかの方法で、仮想マシンの XML 設定を変更し、その CPU を設定します。ホストの CPU モデルを使用します。

<cpu mode='host-model' check='partial'> <model fallback='allow'/> </cpu>

<cpu mode='host-model' check='partial'> <model fallback='allow'/> </cpu>Copy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、ホストが

ppa15機能およびbpb機能に対応している場合は、ゲストでも利用できます。特定のホストモデルを使用している場合は、

ppa15機能およびpbp機能を追加します。次の例では、zEC12 CPU モデルを使用します。<cpu mode='custom' match='exact' check='partial'> <model fallback='allow'>zEC12</model> <feature policy='force' name='ppa15'/> <feature policy='force' name='bpb'/> </cpu><cpu mode='custom' match='exact' check='partial'> <model fallback='allow'>zEC12</model> <feature policy='force' name='ppa15'/> <feature policy='force' name='bpb'/> </cpu>Copy to Clipboard Copied! Toggle word wrap Toggle overflow z12 CPU を使用するホストマシンの CPU モデル

z114およびz196でppa15を使用している場合は、最新のマイクロコードレベル (バンドル 95 以降) を使用する必要があります。

第5章 仮想マシンでの QEMU ゲストエージェント機能の有効化

RHEL 9 システムでホストされている仮想マシンの特定の機能を使用するには、まず QEMU ゲストエージェント (GA) を使用するように仮想マシンを設定する必要があります。

これらの機能の完全なリストは、QEMU ゲストエージェントを必要とする仮想化機能 を参照してください。

仮想マシン上で QEMU GA を設定するために必要な具体的な手順は、仮想マシンが使用するゲストオペレーティングシステムによって異なります。

- Linux 仮想マシンの場合は、Linux ゲストでの QEMU ゲストエージェントの有効化 参照してください。

- Windows 仮想マシンの場合は、Windows ゲストでの QEMU ゲストエージェントの有効化 を参照してください。

5.1. Linux ゲストでの QEMU ゲストエージェントの有効化

RHEL ホストが Linux 仮想マシン上で 特定の操作のサブセット を実行できるようにするには、QEMU ゲストエージェント (GA) を有効にする必要があります。

実行中の仮想マシンとシャットダウンした仮想マシンの両方で、QEMU GA を有効にできます。

手順

QEMU GA の XML 設定ファイル (例:

qemuga.xml) を作成します。touch qemuga.xml

# touch qemuga.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルに以下の行を追加します。

<channel type='unix'> <source mode='bind' path='/var/lib/libvirt/qemu/f16x86_64.agent'/> <target type='virtio' name='org.qemu.guest_agent.0'/> </channel>

<channel type='unix'> <source mode='bind' path='/var/lib/libvirt/qemu/f16x86_64.agent'/> <target type='virtio' name='org.qemu.guest_agent.0'/> </channel>Copy to Clipboard Copied! Toggle word wrap Toggle overflow XML ファイルを使用して、仮想マシンの設定に QEMU GA を追加します。

仮想マシンが実行中の場合は、次のコマンドを使用します。

virsh attach-device <vm-name> qemuga.xml --live --config

# virsh attach-device <vm-name> qemuga.xml --live --configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンがシャットダウンされている場合は、次のコマンドを使用します。

virsh attach-device <vm-name> qemuga.xml --config

# virsh attach-device <vm-name> qemuga.xml --configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Linux ゲストオペレーティングシステムで、QEMU GA をインストールします。

yum install qemu-guest-agent

# yum install qemu-guest-agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow ゲストで QEMU GA サービスを起動します。

systemctl start qemu-guest-agent

# systemctl start qemu-guest-agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

QEMU GA が Linux 仮想マシンで有効化および実行されていることを確認するには、次のいずれかを実行します。

-

ゲストオペレーティングシステムで、

systemctl status qemu-guest-agent | grep Loadedコマンドを使用します。出力にenabledが含まれる場合、仮想マシン上で QEMU GA がアクティブになっています。 -

ホストで

virsh domfsinfo <vm-name>コマンドを使用します。何らかの出力が表示された場合、指定した仮想マシン上で QEMU GA がアクティブになっています。

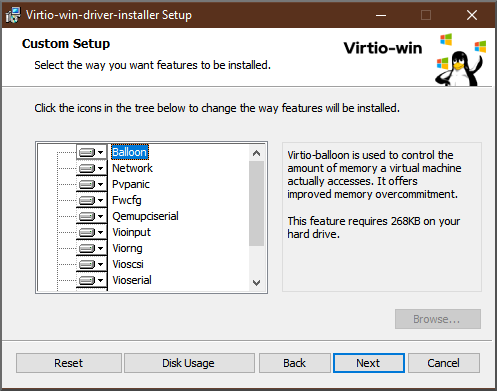

5.2. Windows ゲストでの QEMU ゲストエージェントの有効化

RHEL ホストが Windows 仮想マシン上で 特定の操作のサブセット を実行できるようにするには、QEMU ゲストエージェント (GA) を有効にする必要があります。これを行うには、QEMU ゲストエージェントインストーラーを含むストレージデバイスを、既存の仮想マシンに追加するか、新しい仮想マシンを作成するときに追加し、Windows ゲストオペレーティングシステムにドライバーをインストールします。

グラフィカルインターフェイスを使用してゲストエージェント (GA) をインストールするには、以下の手順を参照してください。コマンドラインで GA をインストールするには、Microsoft Windows Installer (MSI) を使用してください。

前提条件

- ゲストエージェントを含むインストールメディアが仮想マシンに接続されている。メディアの準備手順は、Preparing virtio driver installation media on a host machine を参照してください。

手順

-

Windows ゲストオペレーティングシステムで、

File Explorerアプリケーションを開きます。 -

この PCをクリックします。 -

デバイスおよびドライブペインで、virtio-winメディアを開きます。 -

guest-agentフォルダーを開きます。 仮想マシンにインストールされているオペレーティングシステムに基づいて、次のいずれかのインストーラーを実行します。

-

32 ビットオペレーティングシステムを使用している場合は、

qemu-ga-i386.msiインストーラーを実行します。 -

64 ビットオペレーティングシステムを使用している場合は、

qemu-ga-x86_64.msiインストーラーを実行します。

-

32 ビットオペレーティングシステムを使用している場合は、

-

オプション: ホストと Windows ゲスト間の通信インターフェイスとして準仮想化シリアルドライバー (

virtio-serial) を使用する場合は、virtio-serialドライバーが Windows ゲストにインストールされていることを確認します。virtioドライバーのインストールの詳細は、Windows ゲストへの virtio ドライバーのインストール を参照してください。

検証

Windows 仮想マシンで、Services ウィンドウに移動します。

Computer Management > Services

-

QEMU Guest AgentのステータスがRunningであることを確認します。

5.3. QEMU ゲストエージェントを必要とする仮想化機能

仮想マシン (VM) で QEMU ゲストエージェント (GA) を有効にすると、ホスト上で次のコマンドを使用して仮想マシンを管理できます。

virsh shutdown --mode=agent-

このシャットダウン方法は、

virsh shutdown --mode=acpiよりも信頼性が高くなります。これは、QEMU GA で使用するvirsh shutdownは、確実にクリーンな状態で協調ゲストをシャットダウンするためです。

virsh domfsfreezeおよびvirsh domfsthaw- ゲストファイルシステムを分離してフリーズします。

virsh domfstrimゲストにファイルシステムをトリミングするように指示します。これにより、移行中に転送する必要のあるデータを削減できます。

重要このコマンドを使用して Linux 仮想マシンを管理する場合は、ゲストオペレーティングシステムで次の SELinux ブール値も設定する必要があります。

setsebool virt_qemu_ga_read_nonsecurity_files on

# setsebool virt_qemu_ga_read_nonsecurity_files onCopy to Clipboard Copied! Toggle word wrap Toggle overflow virsh domtime- ゲストの時計をクエリーまたは設定します。

virsh setvcpus --guest- ゲストに CPU をオフラインにするように指示します。これは、CPU をホットアンプラグできない場合に便利です。

virsh domifaddr --source agent- QEMU GA を使用してゲストオペレーティングシステムの IP アドレスをクエリーします。たとえば、ゲストインターフェイスがホストインターフェイスに直接接続されている場合に便利です。

virsh domfsinfo- 実行中のゲストにマウントされているファイルシステムのリストを表示します。

virsh set-user-password- ゲストの特定のユーザーアカウントのパスワードを設定します。

virsh set-user-sshkeysゲストの特定のユーザーの認可された SSH 鍵ファイルを編集します。

重要このコマンドを使用して Linux 仮想マシンを管理する場合は、ゲストオペレーティングシステムで次の SELinux ブール値も設定する必要があります。

setsebool virt_qemu_ga_manage_ssh on

# setsebool virt_qemu_ga_manage_ssh onCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第6章 Web コンソールでの仮想マシンの管理

RHEL 8 ホストのグラフィカルインターフェイスで仮想マシンを管理する場合は、RHEL 8 Web コンソールの Virtual Machines ペインを使用できます。

6.1. Web コンソールを使用した仮想マシンの管理の概要

RHEL 8 Web コンソールは、Web ベースのシステム管理インターフェイスです。Web コンソールは、その機能の 1 つとして、ホストシステムで仮想マシンをグラフィカルに表示してその仮想マシンの作成、アクセス、および設定を可能にします。

Web コンソールを使用して RHEL 8 で仮想マシンを管理するには、最初に、仮想化用の Web コンソールプラグイン をインストールする必要があります。

次のステップ

- Web コンソールで仮想マシンの管理を有効にする手順は、Web コンソールの設定による仮想マシンの管理 を参照してください。

- Web コンソールで使用できる仮想マシン管理アクションの包括的なリストは、Virtual machine management features available in the web console を参照してください。

- Web コンソールでは使用できず、virt-manager アプリケーションで使用できる機能のリストは、Differences between virtualization features in Virtual Machine Manager and the web console を参照してください。

6.2. 仮想マシンを管理するために Web コンソールを設定

Web コンソールの仮想マシン (VM) プラグインをインストールして、RHEL 8 Web コンソールを使用してホストで仮想マシンを管理できるようにしてある。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

手順

cockpit-machinesプラグインをインストールします。yum install cockpit-machines

# yum install cockpit-machinesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

インストールに成功すると、 が Web コンソールのサイドメニューに表示されます。

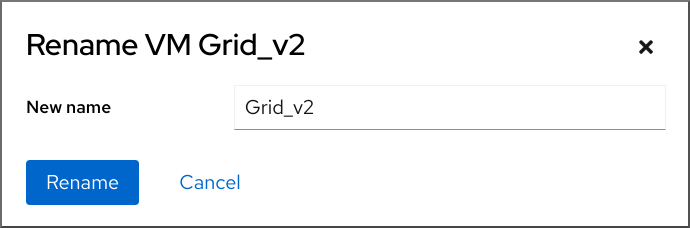

6.3. Web コンソールを使用した仮想マシンの名前の変更

名前の競合を避けるために、またはユースケースに基づいて新しい一意の名前を割り当てるために、既存の仮想マシンの名前を変更することが必要な場合があります。RHEL Web コンソールを使用して仮想マシンの名前を変更できます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

- 仮想マシンがシャットダウンされている。

手順

インターフェイスで、名前を変更する仮想マシンのメニューボタン をクリックします。

仮想マシン操作を制御するためのドロップダウンメニューが表示されます。

をクリックします。

Rename a VM ダイアログが表示されます。

- New name フィールドに、仮想マシンの名前を入力します。

- をクリックします。

検証

- 新しい仮想マシン名が インターフェイスに表示されていることを確認します。

6.4. Web コンソールで利用可能な仮想マシンの管理機能

RHEL 9 Web コンソールを使用すると、システム上の仮想マシンを管理する以下のアクションを実行できます。

| タスク | 詳細は以下参照 |

|---|---|

| 仮想マシンの作成およびゲストオペレーティングシステムでのインストール | |

| 仮想マシンの削除 | |

| 仮想マシンび起動、シャットダウンし、再起動 | |

| さまざまなコンソールを使用した仮想マシンへの接続および操作 | |

| 仮想マシンに関するさまざまな情報の表示 | |

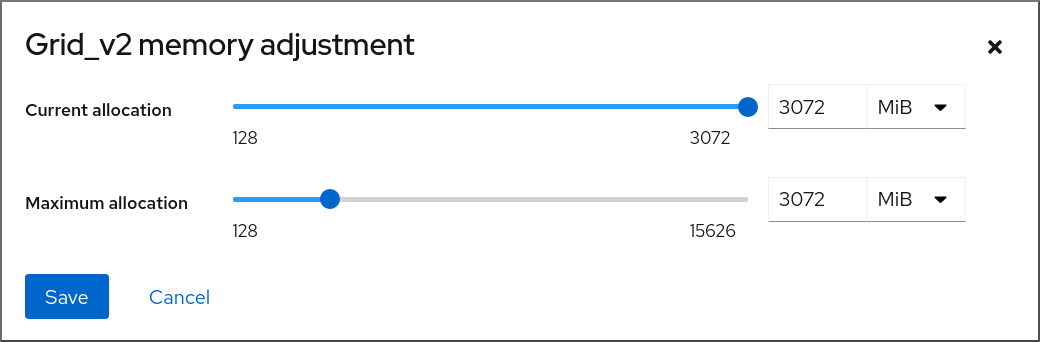

| 仮想マシンに割り当てられたホストメモリーの調整 | |

| 仮想マシンのネットワーク接続管理 | |

| ホストでの利用可能な仮想マシンストレージ管理および仮想ディスクを仮想マシンへの割り当て | |

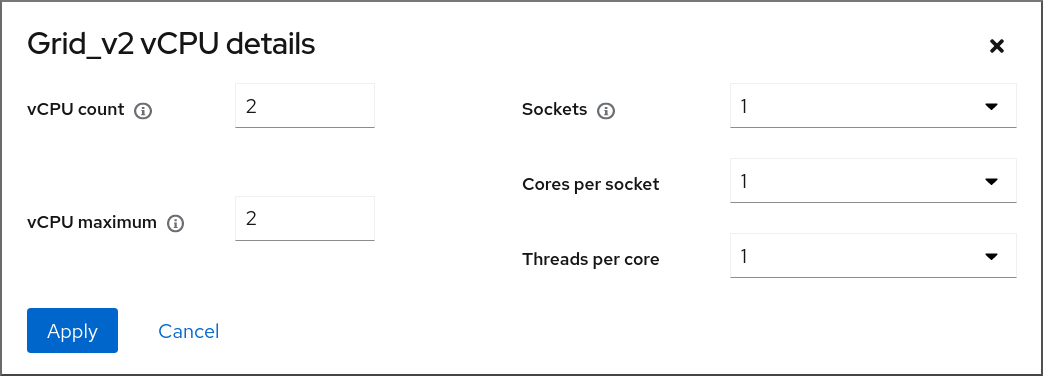

| 仮想マシンの仮想 CPU 設定 | |

| 仮想マシンのライブマイグレーション | |

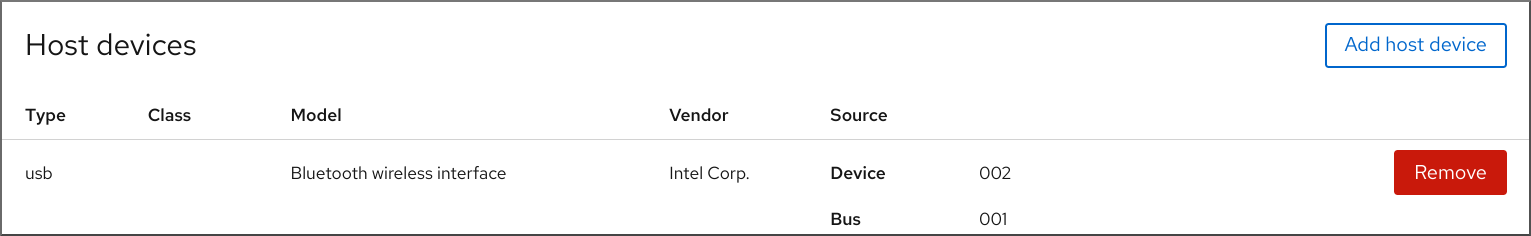

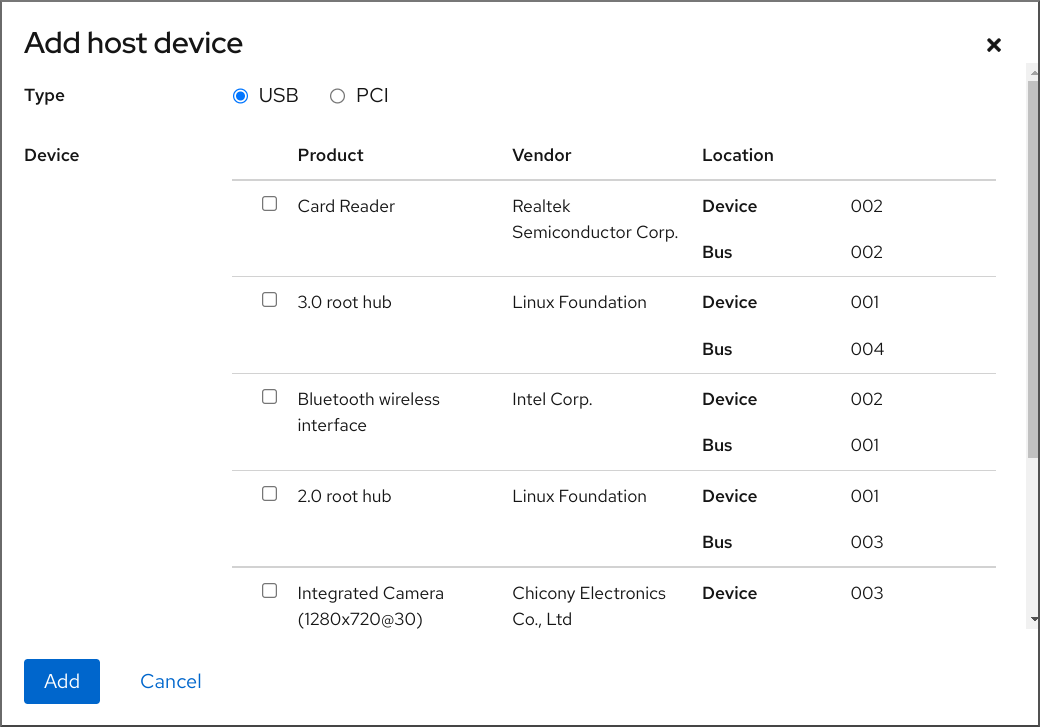

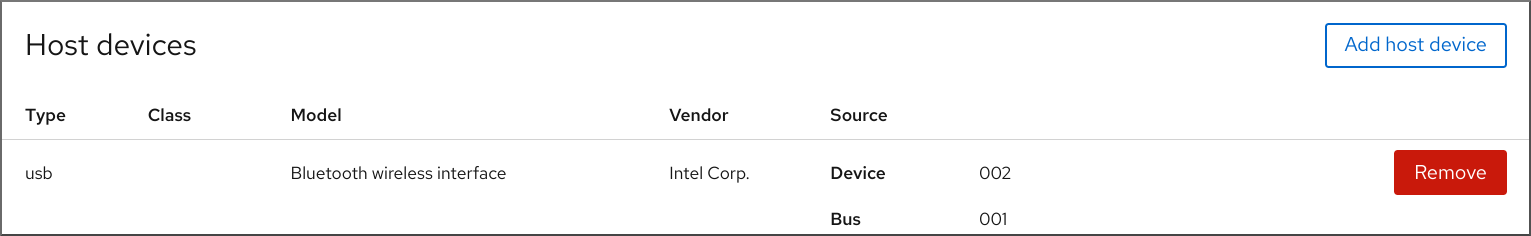

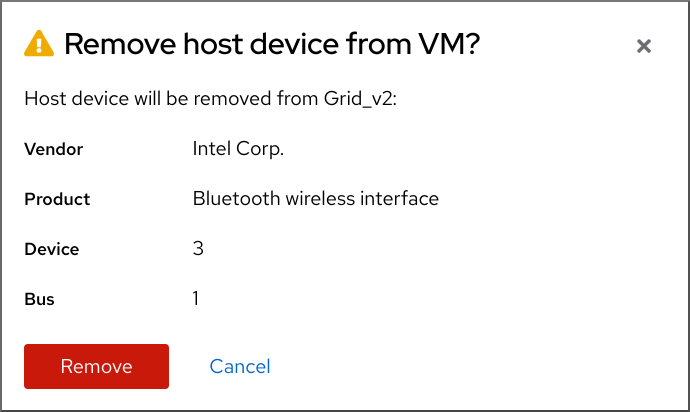

| ホストデバイスの管理 | |

| 仮想光学ドライブを管理する | |

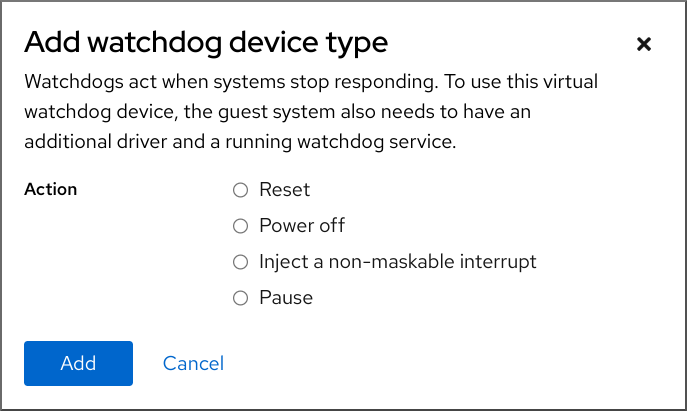

| ウォッチドッグデバイスを接続する |

6.5. 仮想マシンマネージャーと Web コンソールでの仮想化機能の相違点

仮想マシンマネージャー (virt-manager) は、RHEL 8 で対応していますが、非推奨になっています。後続の主要なリリースでは、Web コンソールがその代替となる予定です。したがって、GUI で仮想化を管理する場合は、Web コンソールを使用することが推奨されます。

ただし、RHEL 8 では、virt-manager またはコマンドラインでのみ実行可能な仮想マシン管理タスクがあります。次の表は、virt-manager で使用でき、RHEL 8.0 Web コンソールでは使用できない機能を示しています。

この機能は、RHEL 8 の後続のマイナーバージョンで利用可能な場合は、Web コンソールのサポートの列に、最小バージョンの RHEL 8 が表示されます。

| タスク | Web コンソールでのサポートが導入されました。 | CLI を使用した代替方法 |

|---|---|---|

| ホストの起動時に起動する仮想マシンを設定 | RHEL 8.1 |

|

| 仮想マシンの一時停止 | RHEL 8.1 |

|

| 中断している仮想マシンの再開 | RHEL 8.1 |

|

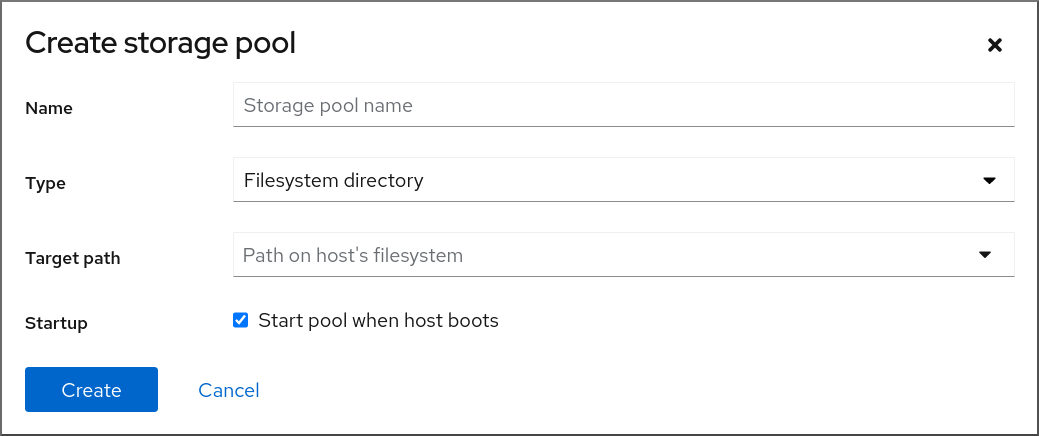

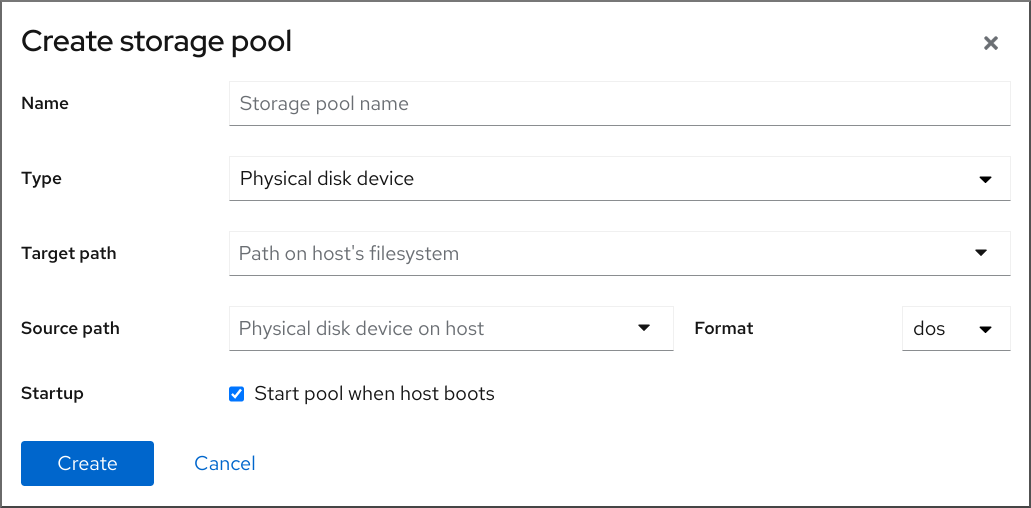

| ファイルシステムディレクトリーストレージプールの作成 | RHEL 8.1 |

|

| NFS ストレージプールの作成 | RHEL 8.1 |

|

| 物理ディスクデバイスのストレージプールの作成 | RHEL 8.1 |

|

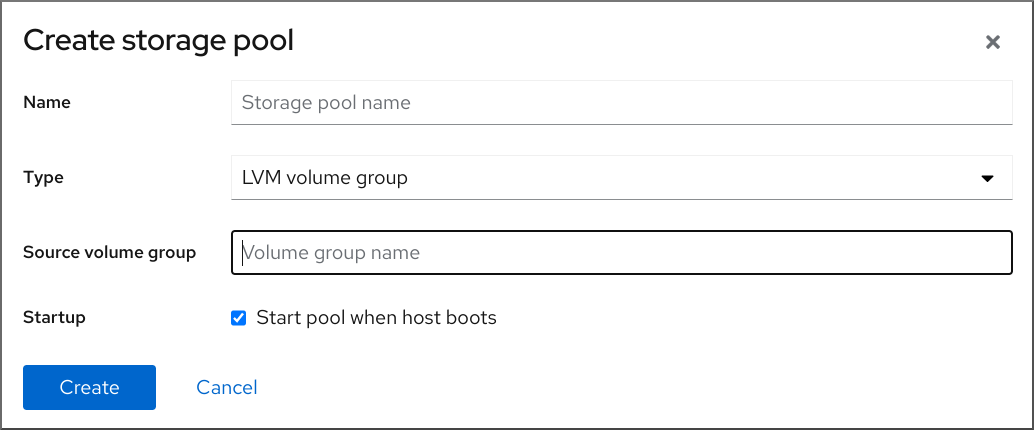

| LVM ボリュームグループストレージプールの作成 | RHEL 8.1 |

|

| パーティションベースのストレージプールの作成 | 現在利用不可 |

|

| GlusterFS ベースのストレージプールの作成 | 現在利用不可 |

|

| SCSI デバイスを使用した vHBA ベースのストレージプールの作成 | 現在利用不可 |

|

| マルチパスベースのストレージプールの作成 | 現在利用不可 |

|

| RBD ベースのストレージプールの作成 | 現在利用不可 |

|

| ストレージボリュームの新規作成 | RHEL 8.1 |

|

| 新しい仮想ネットワークの追加 | RHEL 8.1 |

|

| 仮想ネットワークの削除 | RHEL 8.1 |

|

| ホストマシンのインターフェイスから仮想マシンへのブリッジを作成 | 現在利用不可 |

|

| スナップショットの作成 | 現在利用不可 |

|

| スナップショットへの復帰 | 現在利用不可 |

|

| スナップショットの削除 | 現在利用不可 |

|

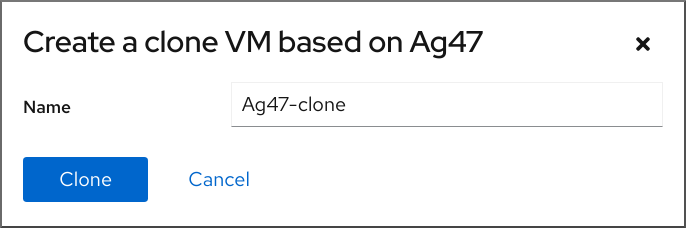

| 仮想マシンのクローン作成 | RHEL 8.4 |

|

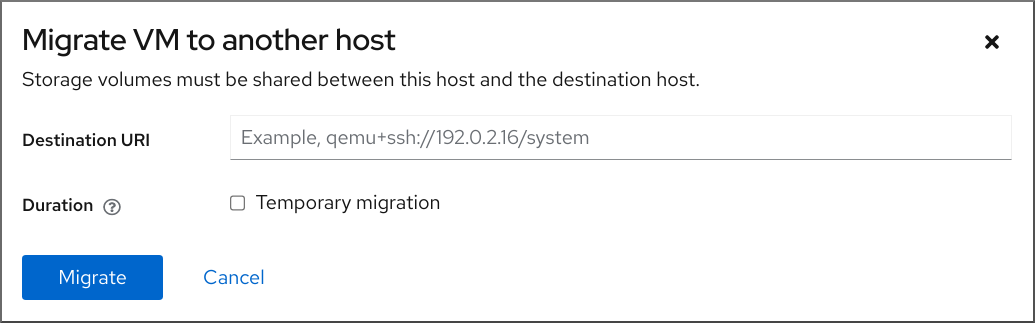

| 仮想マシンの別のホストマシンへの移行 | RHEL 8.5 |

|

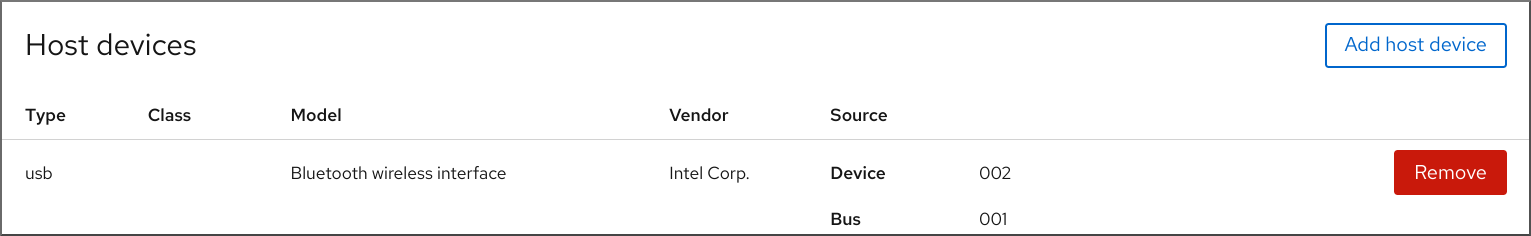

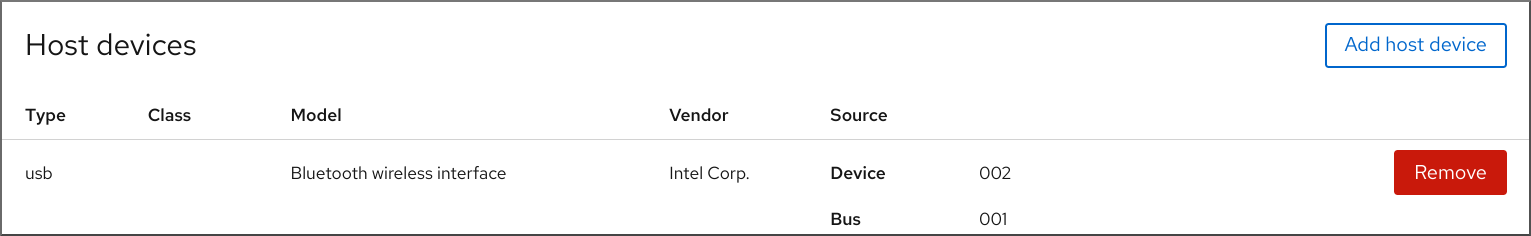

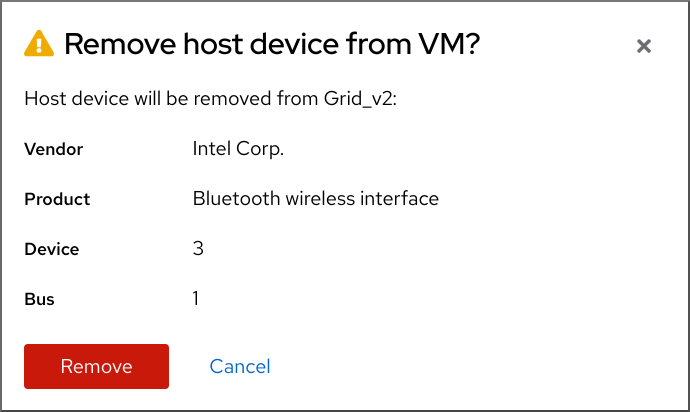

| ホストデバイスの仮想マシンへの割り当て | RHEL 8.5 |

|

| 仮想マシンからのホストデバイスの削除 | RHEL 8.5 |

|

第7章 仮想マシンに関する情報の表示

RHEL 9 での仮想化デプロイメントのあらゆる側面を調整またはトラブルシューティングする必要がある場合、通常、最初に実行する必要がある手順は、仮想マシン (VM) の現在の状態と設定に関する情報を表示することです。これは、コマンドライン または Web コンソール を使用して実行できます。仮想マシンの XML 設定 で情報を表示することもできます。

7.1. コマンドラインを使用した仮想マシン情報の表示

ホストおよびその設定で仮想マシンに関する情報を取得するには、以下のコマンドのいずれかまたは複数コマンドを使用します。

手順

ホストで仮想マシンのリストを取得するには、次のコマンドを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 特定の仮想マシンに関する基本的な情報を取得するには、次のコマンドを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 特定の仮想マシンの XML 設定をすべて取得するには、次のコマンドを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンの XML 設定の例と注釈は、仮想マシンの XML 設定例 を参照してください。

仮想マシンのディスクおよびその他のブロックデバイスに関する情報は、次のコマンドを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンのストレージを管理する手順は、Managing storage for virtual machines を参照してください。

仮想マシンのファイルシステムとそのマウントポイントに関する情報を取得するには、次のコマンドを実行します。

virsh domfsinfo testguest3 Mountpoint Name Type Target ------------------------------------ / dm-0 xfs /boot vda1 xfs

# virsh domfsinfo testguest3 Mountpoint Name Type Target ------------------------------------ / dm-0 xfs /boot vda1 xfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

特定の仮想マシンの vCPU に関する詳細を取得するには、次のコマンドを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンで vCPU を設定し、最適化するには、仮想マシンの CPU パフォーマンスの最適化 を参照してください。

ホスト上の仮想ネットワークインターフェイスのリストを表示するには、次のコマンドを実行します。

virsh net-list --all Name State Autostart Persistent --------------------------------------------- default active yes yes labnet active yes yes

# virsh net-list --all Name State Autostart Persistent --------------------------------------------- default active yes yes labnet active yes yesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のインターフェイスに関する情報は、次のコマンドを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ネットワークインターフェイス、仮想マシンネットワーク、およびこれらの設定手順の詳細は、仮想マシンのネットワーク接続の設定 を参照してください。

- ホスト上のストレージプールとストレージボリュームに関する情報を表示する手順は、CLI を使用した仮想マシンのストレージ情報の表示 を参照してください。

7.2. Web コンソールを使用した仮想マシン情報の表示

RHEL 9 Web コンソールを使用して、Web コンソールセッションがアクセスできるすべての 仮想マシン および ストレージプール に関する情報を表示することができます。

Web コンソールセッションの接続先である 選択した仮想マシンに関する情報 を表示できます。これには、ディスク、仮想ネットワークインターフェイス、および リソースの使用量 に関する情報が含まれます。

7.2.1. Web コンソールで仮想化の概要を表示

Web コンソールを使用して、仮想マシン、ストレージプール、およびネットワークに関する概要情報を含む仮想化の概要にアクセスできます。

前提条件

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

手順

Web コンソールのサイドメニューで、 をクリックします。

利用可能なストレージプール、利用可能なネットワーク、および Web コンソールが接続する仮想マシンに関する情報を含むダイアログボックスが表示されます。

この情報には以下が含まれます。

- ストレージプール - Web コンソールからアクセス可能なストレージプールの数とその状態です (アクティブまたは非アクティブ)。

- ネットワーク - Web コンソールからアクセス可能なネットワークの数とその状態です (アクティブまたは非アクティブ)。

- 名前 - 仮想マシンの名前

- 接続 - libvirt 接続、システム、またはセッションの種類。

- 状態 - 仮想マシンの状態

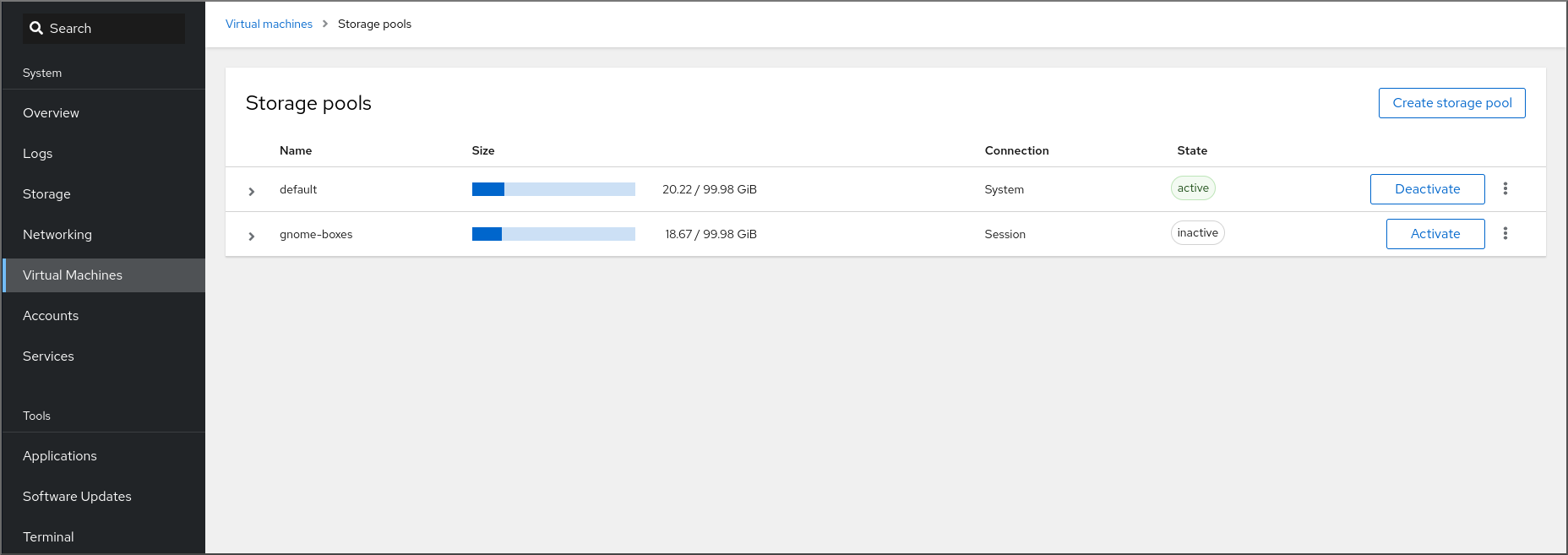

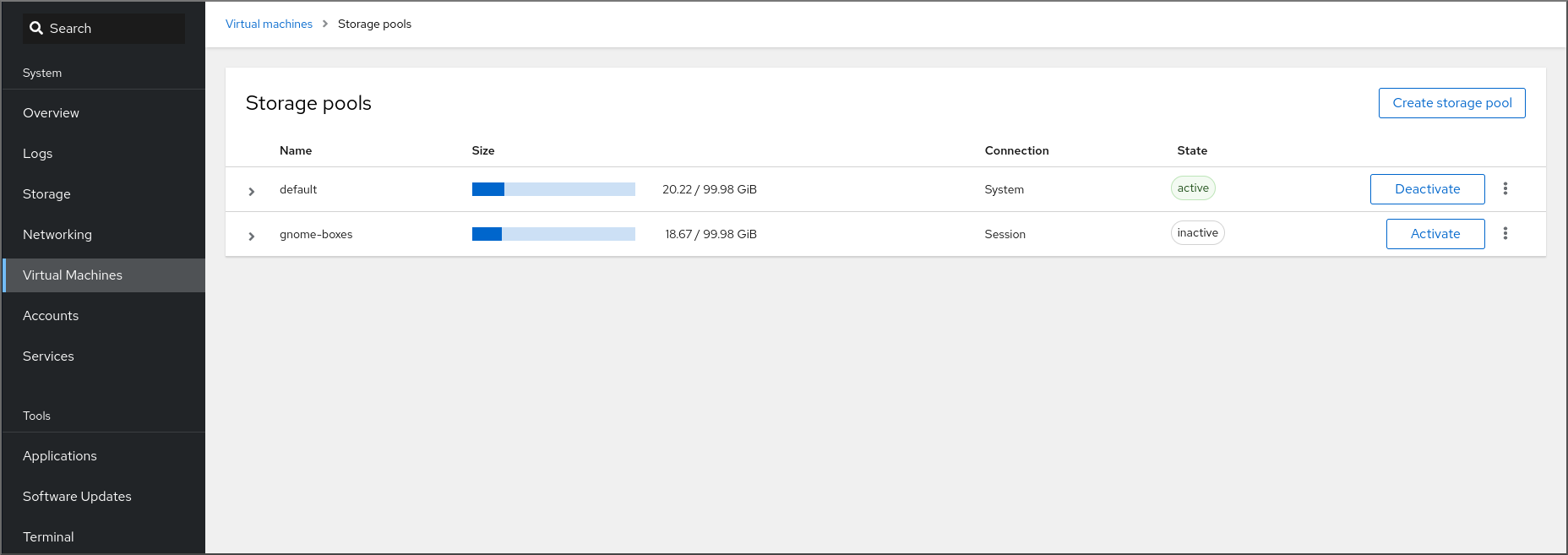

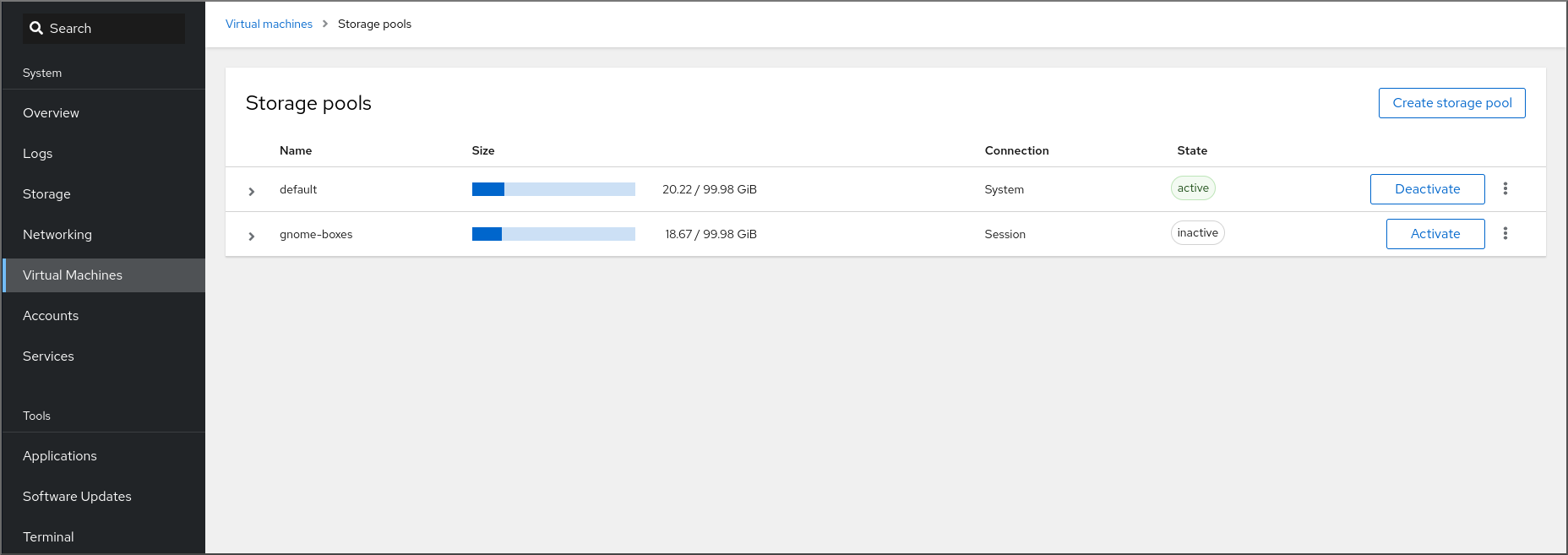

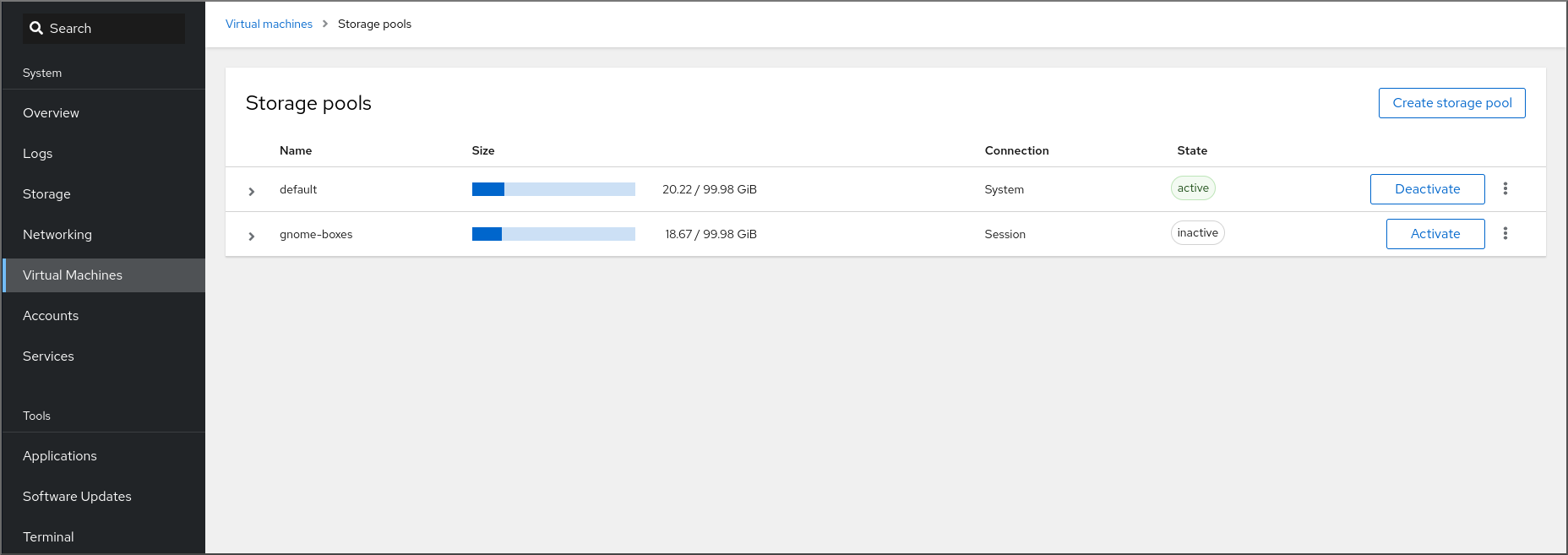

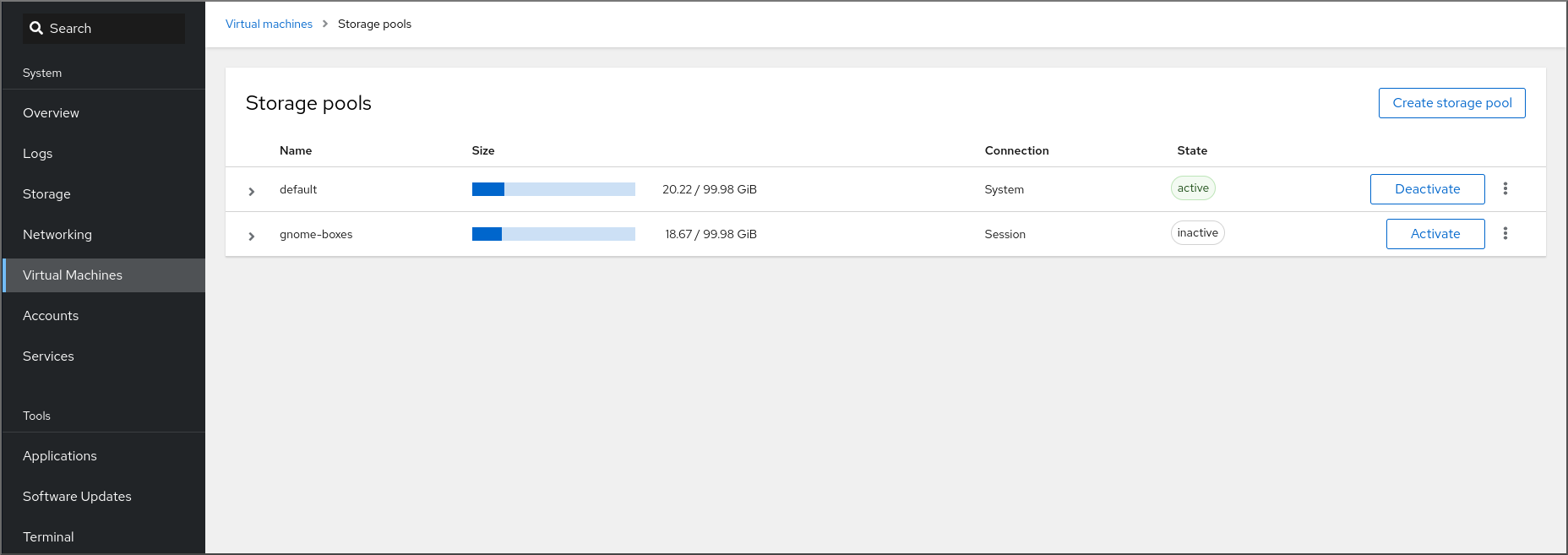

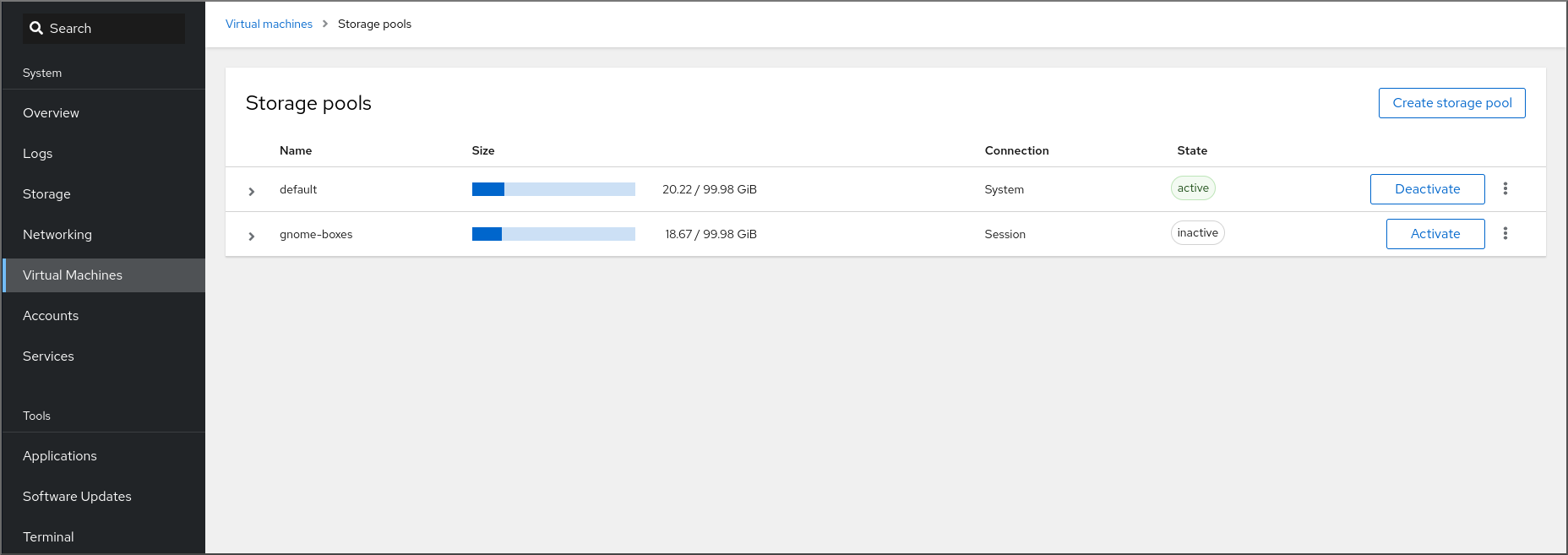

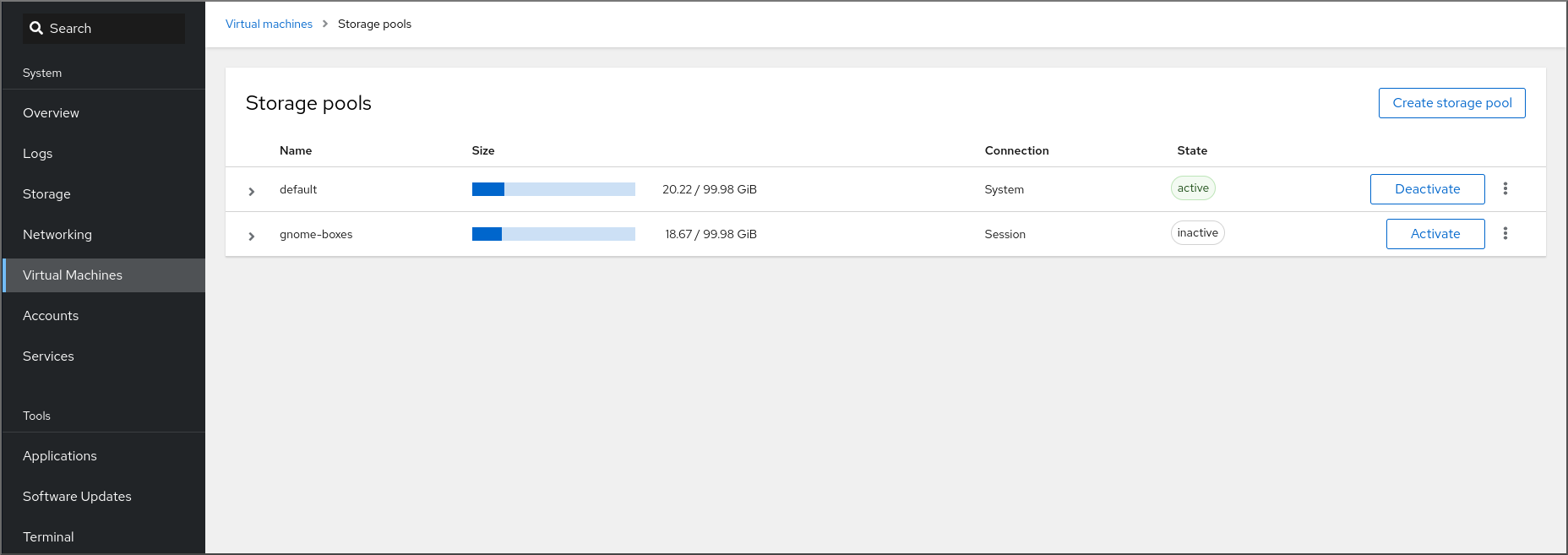

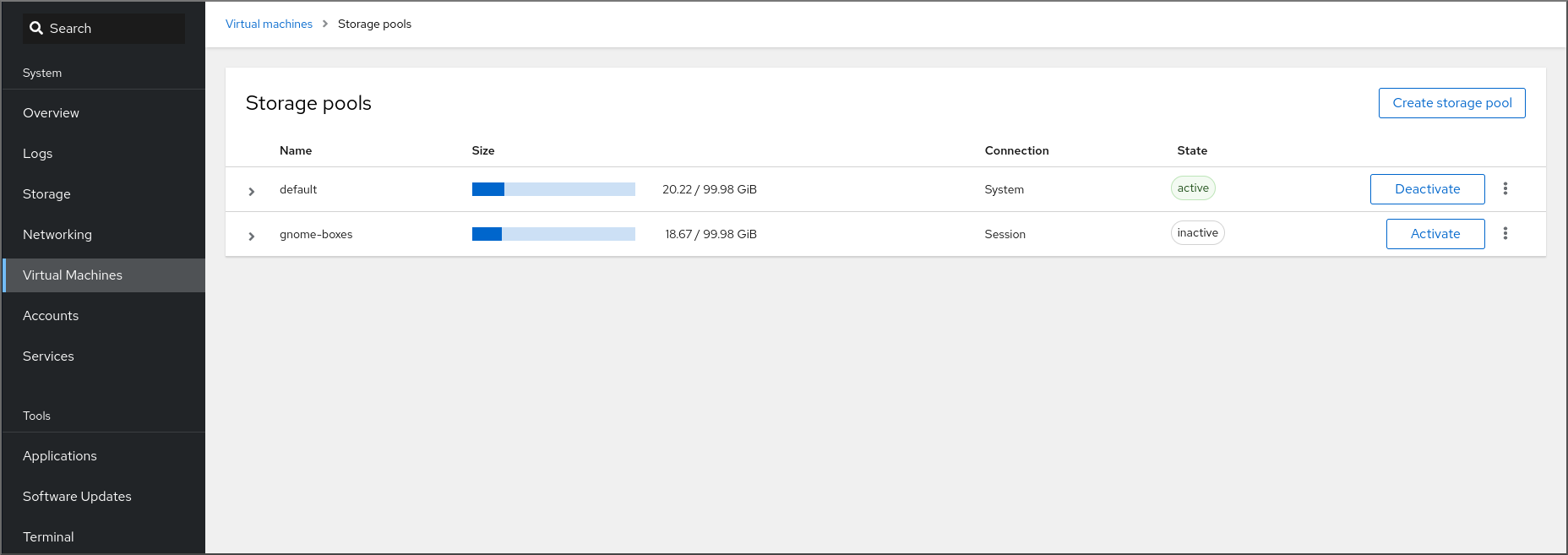

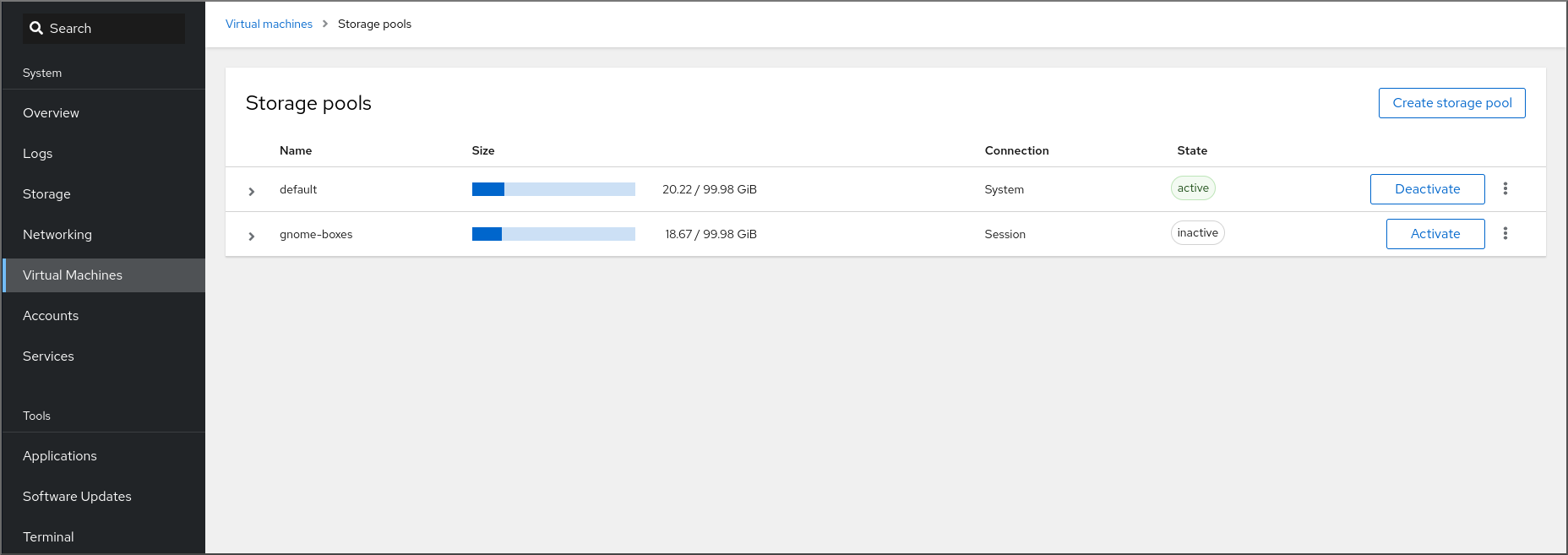

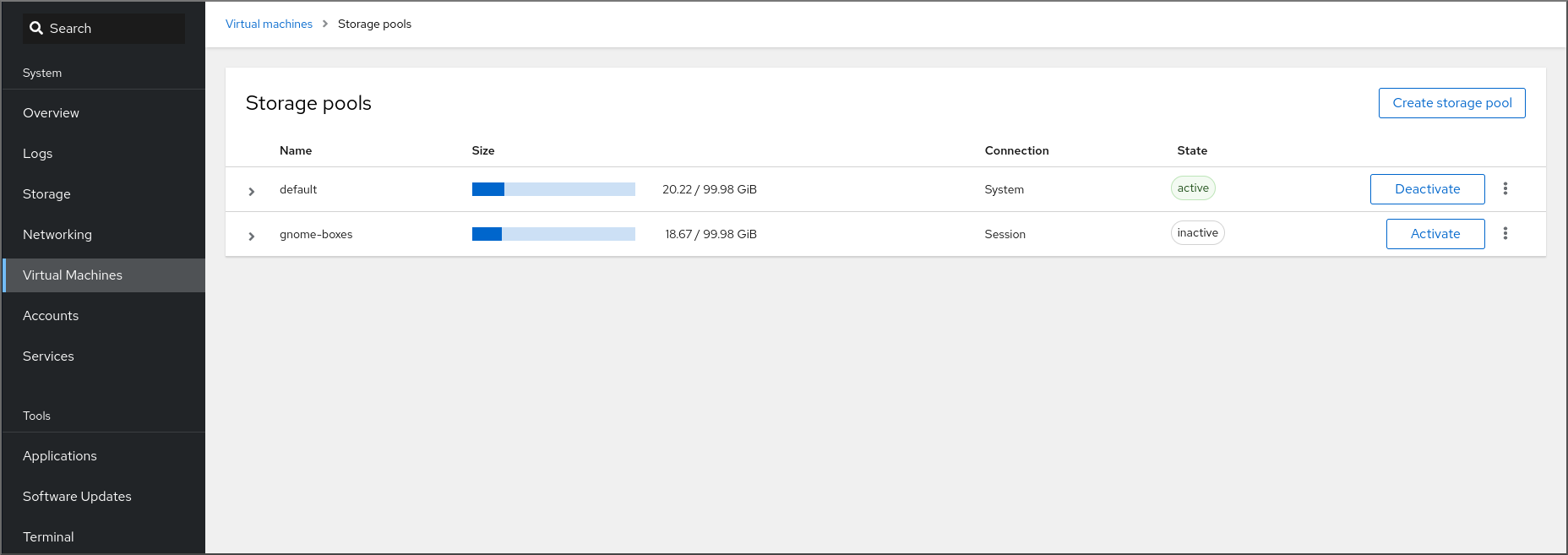

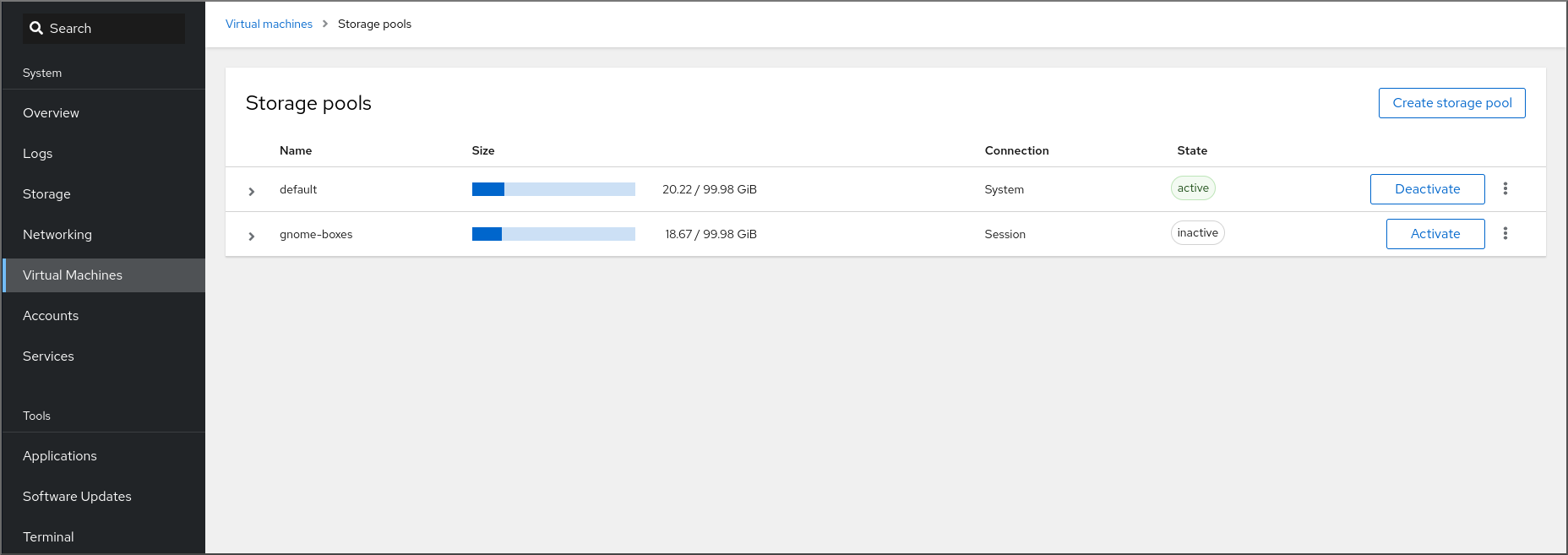

7.2.2. Web コンソールを使用したストレージプール情報の表示

Web コンソールを使用して、システムで利用可能なストレージプールの詳細情報を表示できます。ストレージプールを使用すると、仮想マシンのディスクイメージを作成できます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

インターフェイスで をクリックします。

Storage pools 画面が表示され、設定されているストレージプールの一覧が示されます。

この情報には以下が含まれます。

- 名前 - ストレージプールの名前

- サイズ - 現在の割り当てとストレージプールの合計容量。

- 接続 - ストレージプールのアクセスに使用される接続

- 状態 - ストレージプールのステータス

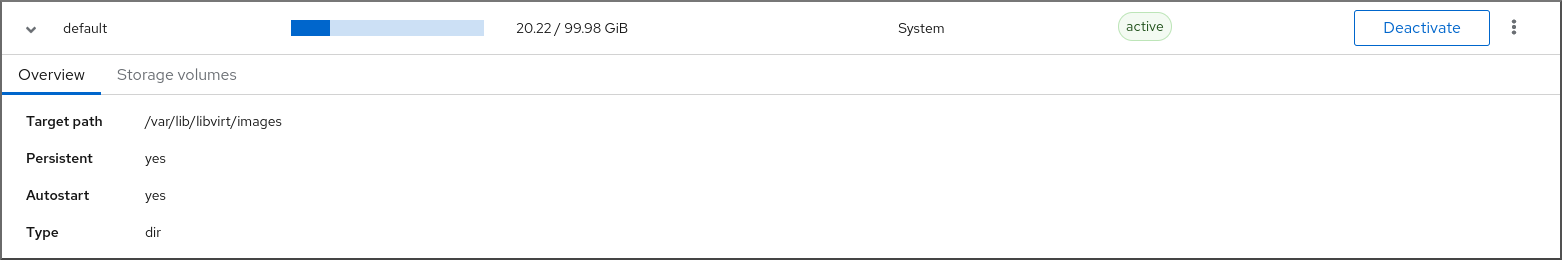

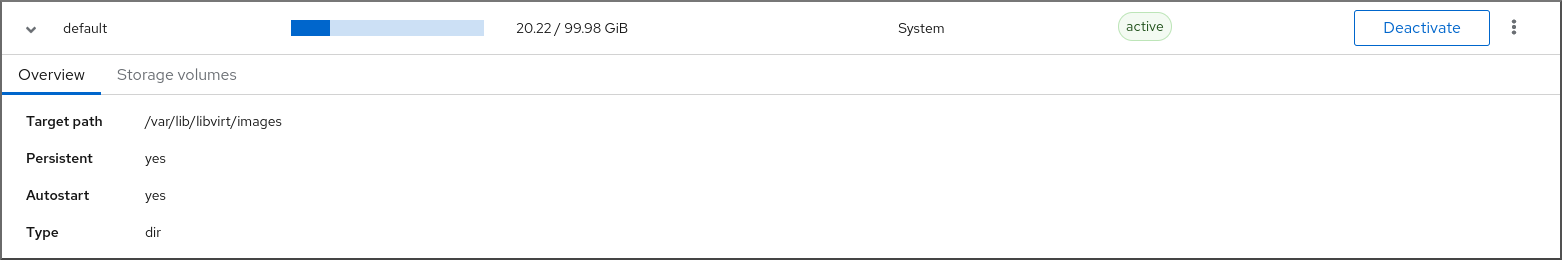

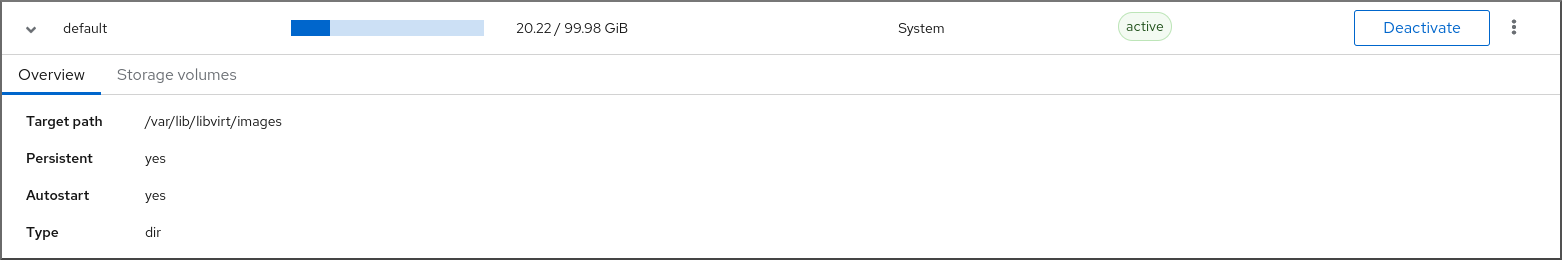

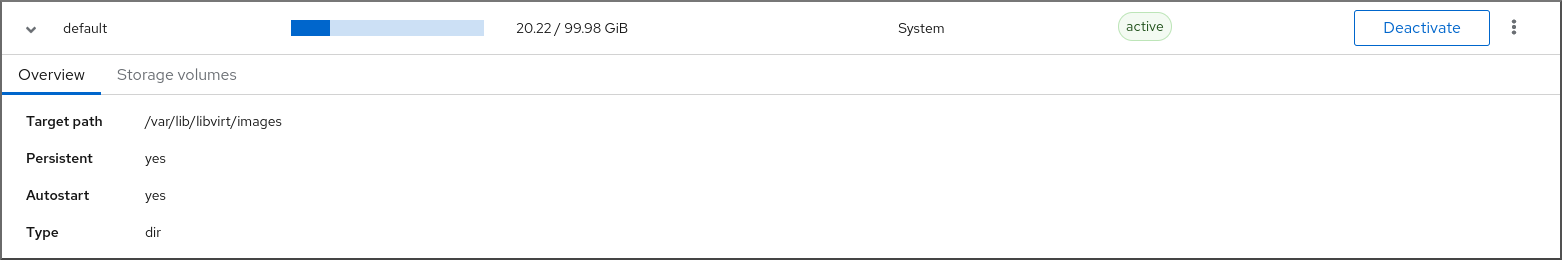

情報を表示するストレージプールの横にある矢印をクリックします。

行がデプロイメントされ、選択したストレージプールに関する詳細情報を含む概要ペインが表示されます。

この情報には以下が含まれます。

- ターゲットパス - ストレージプールの場所です。

- 永続的 - ストレージプールの設定が永続的であるかどうかを示します。

- 自動起動 - システムの起動時にストレージプールが自動的に起動するかどうかを示します。

- 種類 - ストレージプールの種類。

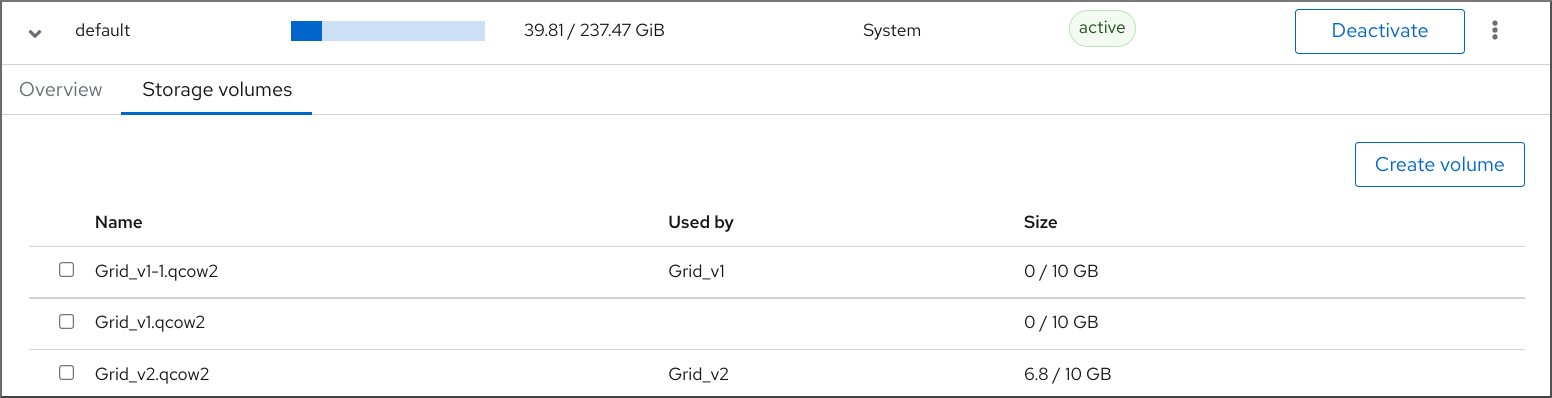

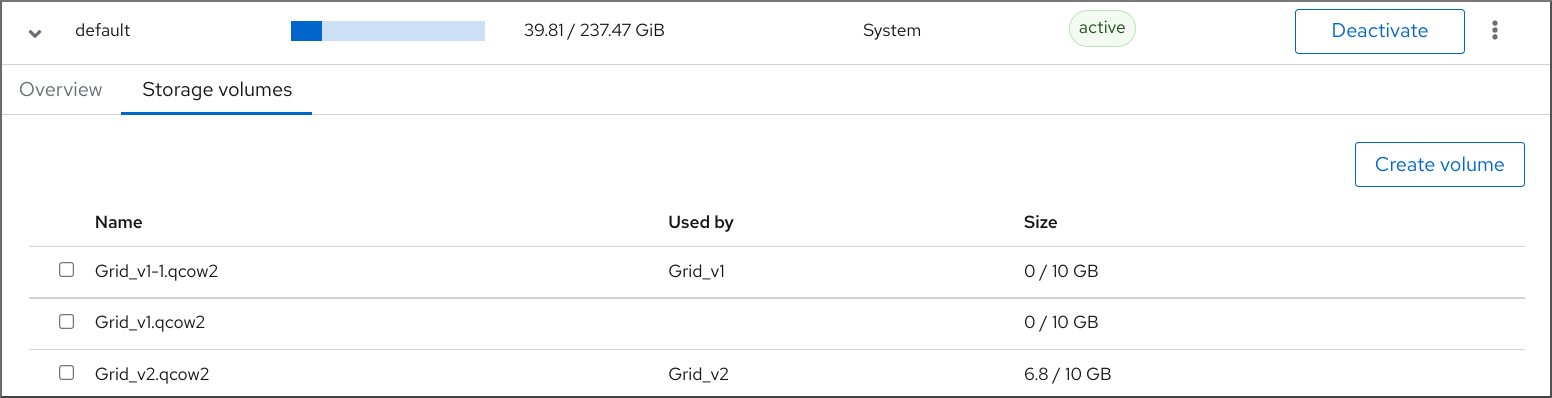

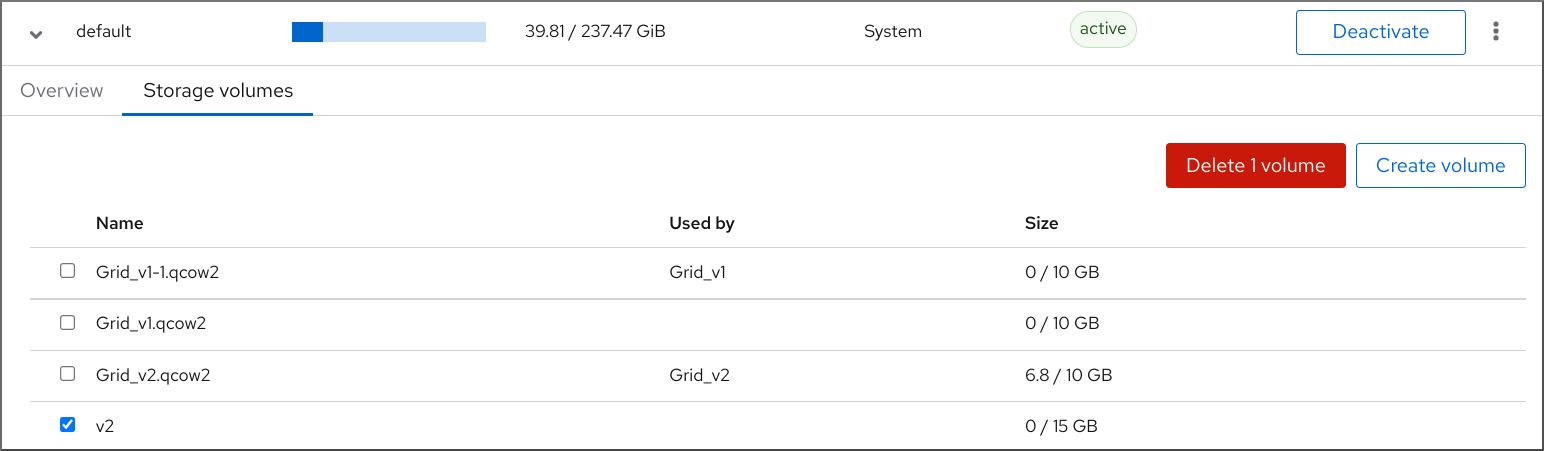

ストレージプールに関連付けられているストレージボリュームのリストを表示する場合は、 をクリックします。

ストレージボリュームペインが表示され、設定したストレージボリュームのリストが表示されます。

この情報には以下が含まれます。

- 名前 - ストレージボリュームの名前。

- 使用者 - 現在ストレージボリュームを使用している仮想マシン。

- サイズ - ボリュームのサイズ。

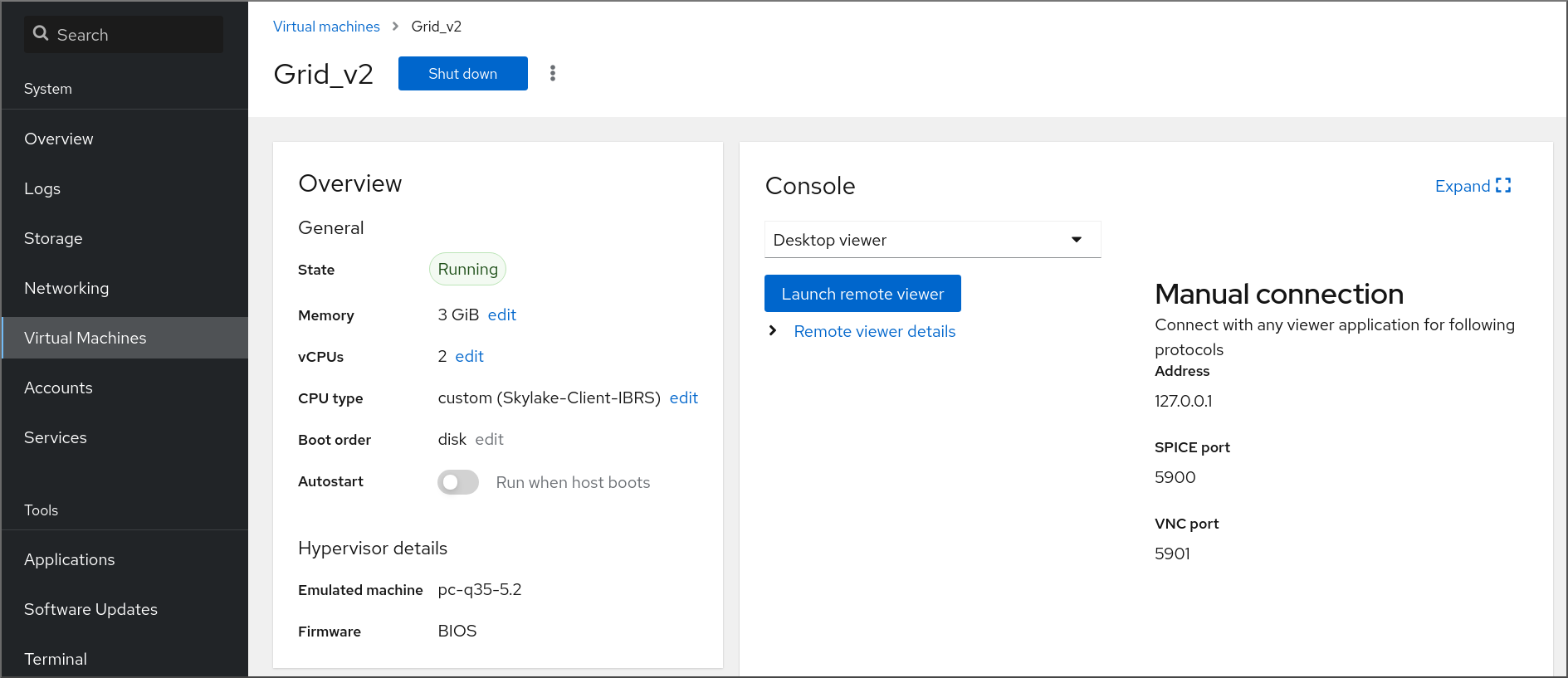

7.2.3. Web コンソールで仮想マシン基本情報の表示

Web コンソールを使用して、選択した仮想マシンに関する基本情報 (割り当てられたリソース、ハイパーバイザーの詳細など) を表示できます。

前提条件

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

- Web コンソールのサイドメニューで、 をクリックします。

情報を表示する仮想マシンをクリックします。

新しいページが開き、選択した仮想マシンに関する基本情報を含む Overview セクションと、仮想マシンのグラフィカルインターフェイスにアクセスするための Console セクションが表示されます。

概要セクションには、次の一般的な仮想マシンの詳細が記載されています。

- 状態 - 仮想マシンの状態 (実行中またはシャットオフ)。

- メモリー - 仮想マシンに割り当てるメモリー容量

- CPU - 仮想マシンに設定されている仮想 CPU の数とタイプ。

- ブート順序 - 仮想マシンに設定されたブート順序

- 自動起動 - 仮想マシンで自動起動が有効になっているかどうか

この情報には、以下のハイパーバイザーの詳細も含まれます。

- エミュレートされたマシン - 仮想マシンによりエミュレートされたマシンタイプ

- ファームウェア - 仮想マシンのファームウェア。

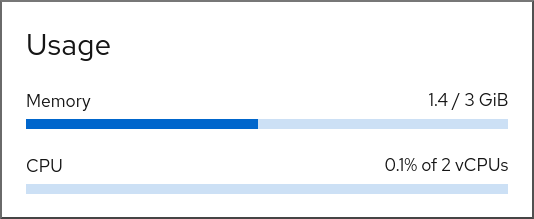

7.2.4. Web コンソールで仮想マシンのリソース使用状況の表示

Web コンソールを使用して、選択した仮想マシンのメモリーと仮想 CPU 使用率を表示できます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

インターフェイスで、情報を表示する仮想マシンを選択します。

新しいページが開き、選択した仮想マシンに関する基本情報を含む Overview セクションと、仮想マシンのグラフィカルインターフェイスにアクセスするための Console セクションが表示されます。

までスクロールします。

使用率セクションには、仮想マシンのメモリーおよび仮想 CPU 使用率に関する情報が表示されます。

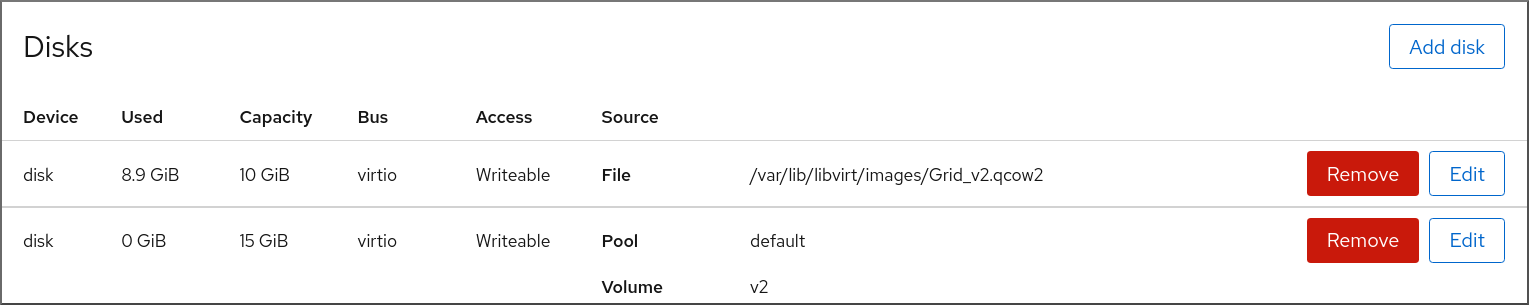

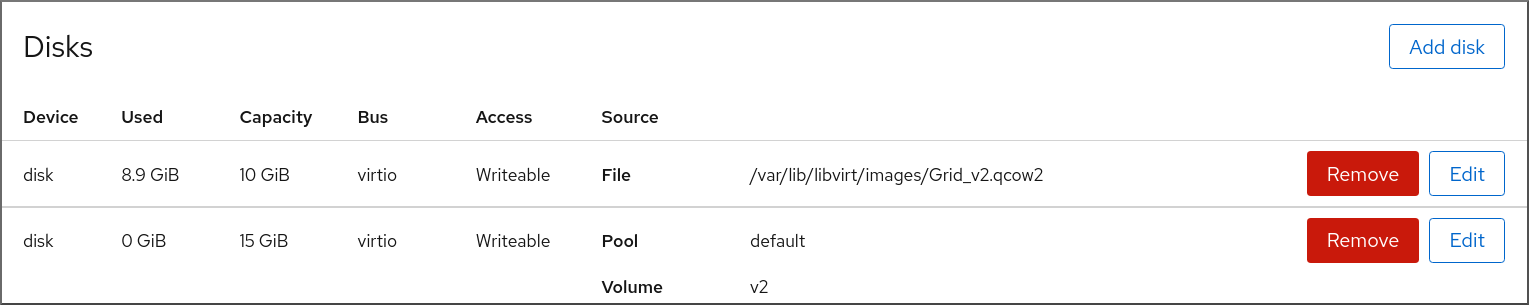

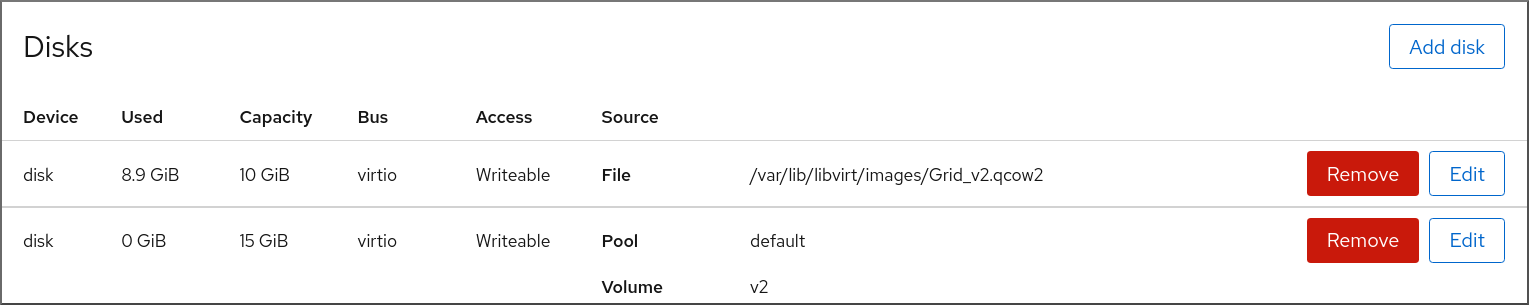

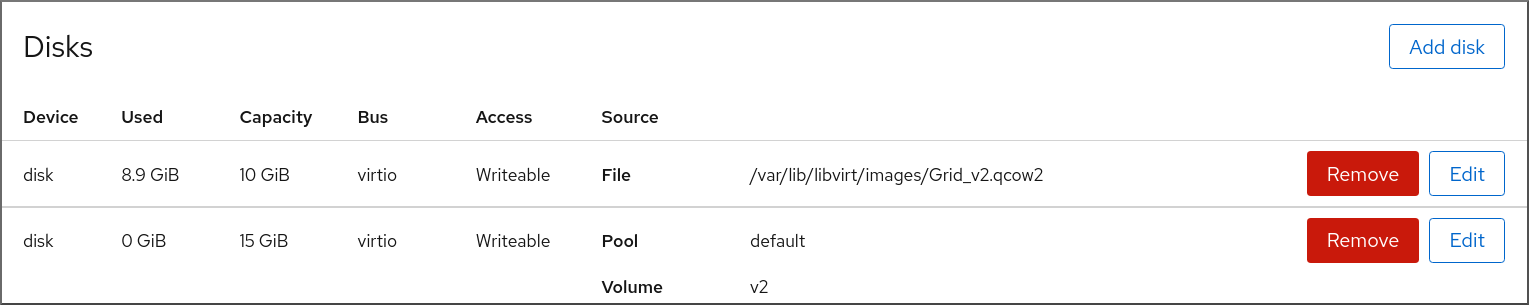

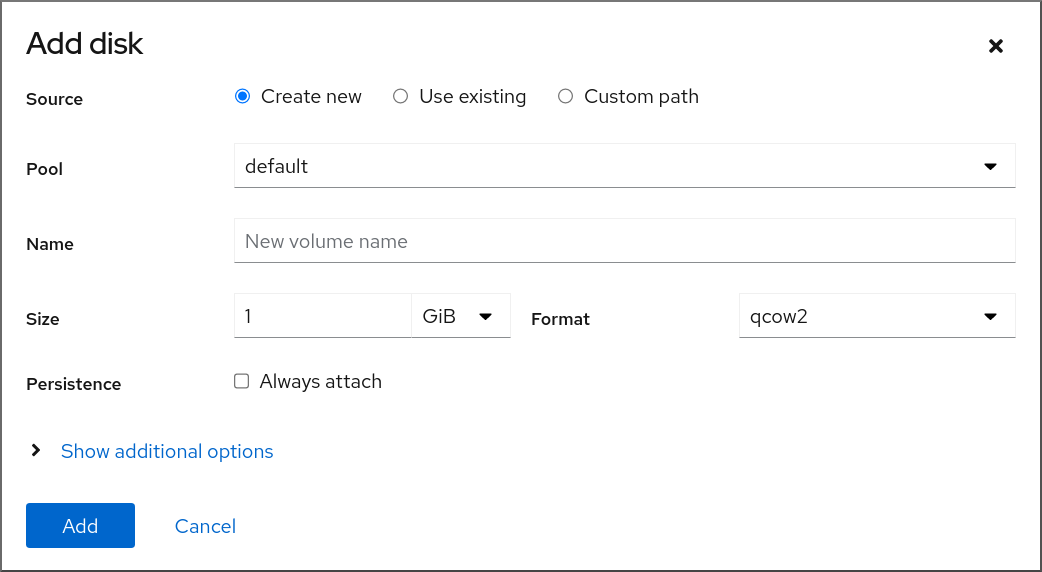

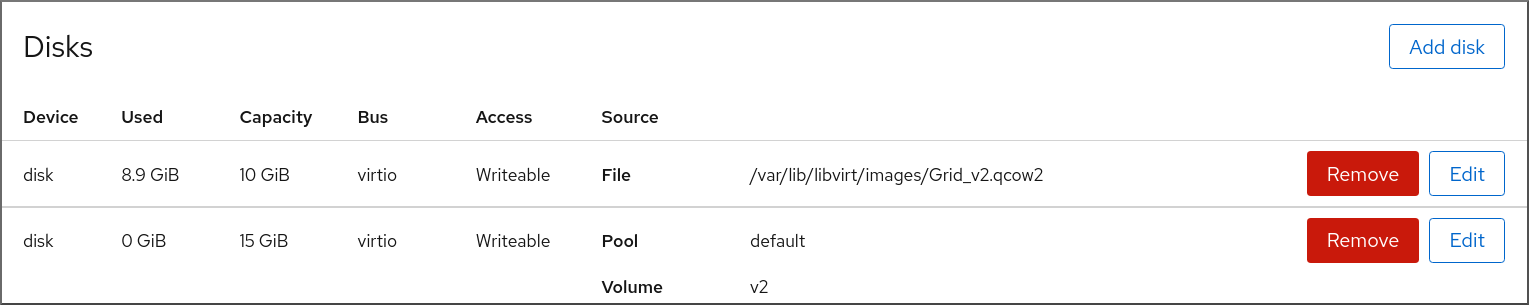

7.2.5. Web コンソールで仮想マシンのディスク情報の表示

Web コンソールを使用して、選択した仮想マシンに割り当てられたディスクの詳細情報を表示できます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

情報を表示する仮想マシンをクリックします。

新しいページが開き、選択した仮想マシンに関する基本情報を含む Overview セクションと、仮想マシンのグラフィカルインターフェイスにアクセスするための Console セクションが表示されます。

までスクロールします。

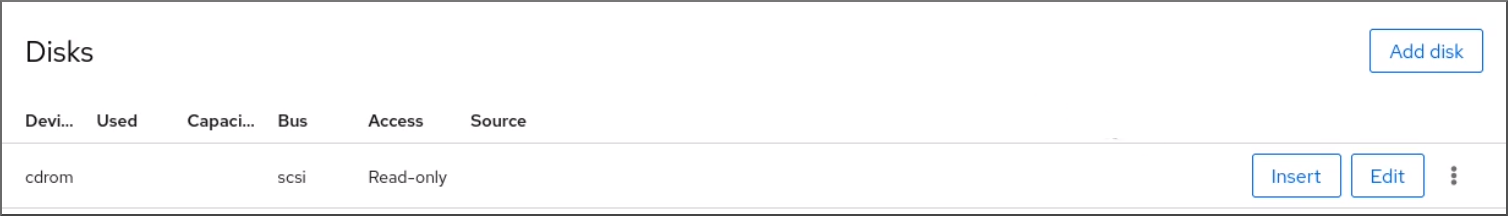

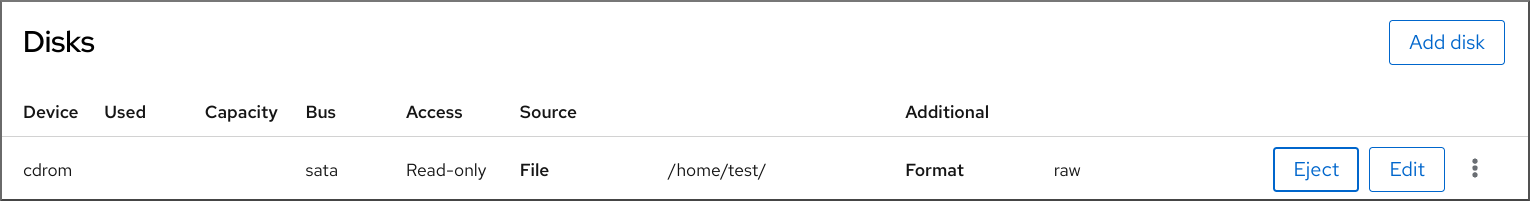

ディスクセクションには、仮想マシンに割り当てられたディスクに関する情報と、ディスクの Add、または Edit のオプションが表示されます。

この情報には以下が含まれます。

- デバイス - ディスクのデバイスの種類。

- 使用済み - 現在割り当てられているディスク容量。

- 容量 - ストレージボリュームの最大サイズ。

- バス - エミュレートされるディスクデバイスの種類。

-

アクセス - ディスクが書き込み可能 かどうか、読み取り専用 であるか。

rawディスクの場合は、書き込み可能および共有 へのアクセスを設定することもできます。 - ソース - ディスクデバイスまたはファイル

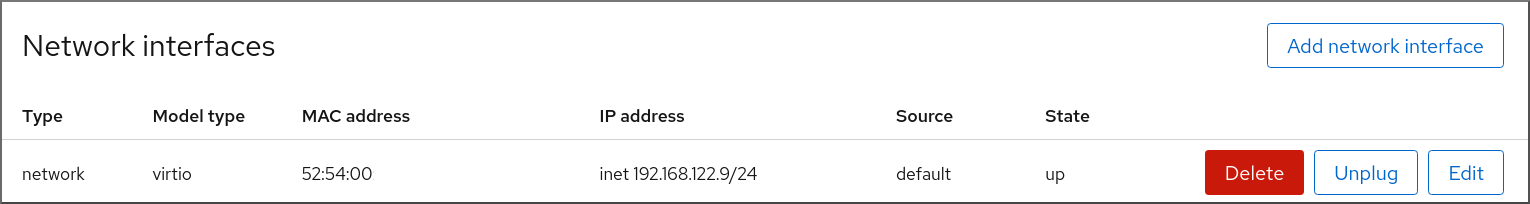

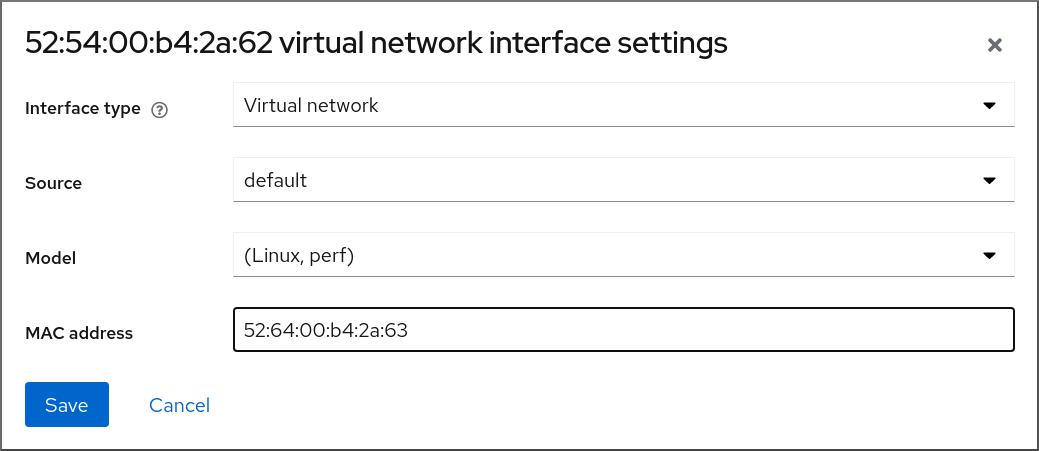

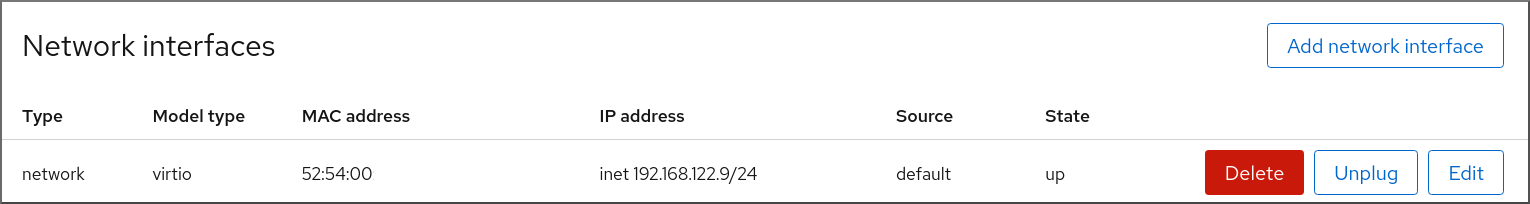

7.2.6. Web コンソールで仮想ネットワークインターフェイス情報の表示および編集

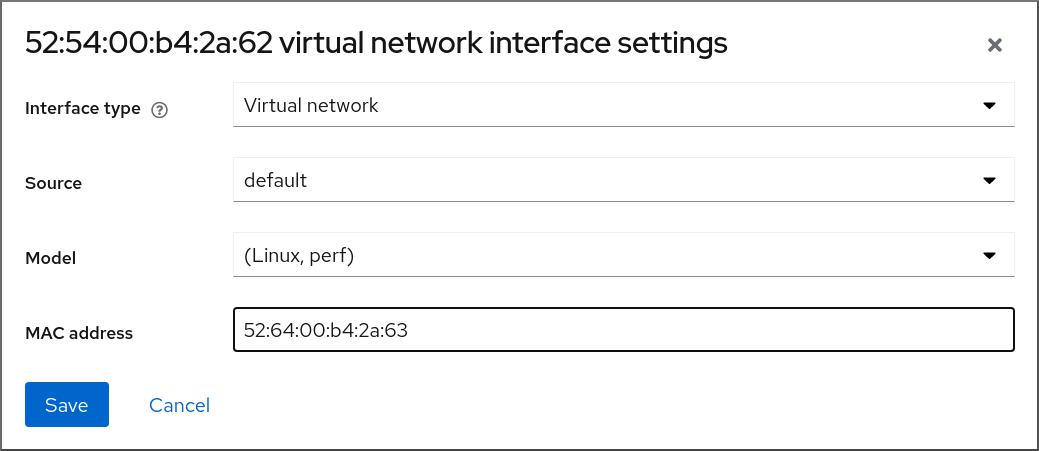

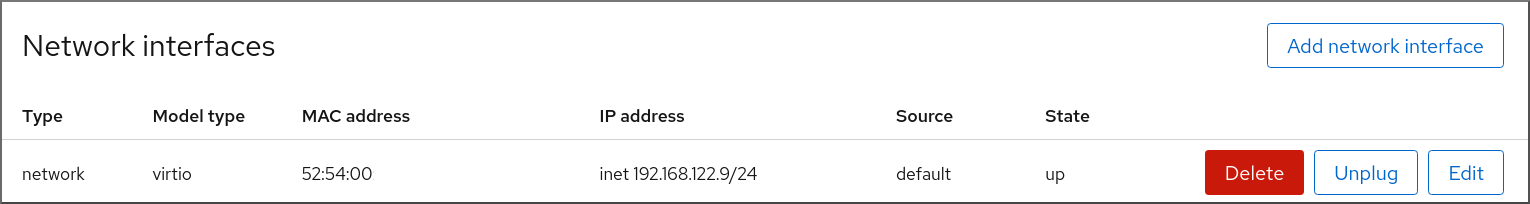

RHEL 9 Web コンソールを使用して、選択した仮想マシンで仮想ネットワークインターフェイスを表示および変更することができます。

前提条件

- RHEL 8 Web コンソールがインストールされている。

- cockpit サービスが有効になっている。

ユーザーアカウントが Web コンソールにログインできる。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- Web コンソールの仮想マシンプラグインが システムにインストールされている。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

インターフェイスで、情報を表示する仮想マシンを選択します。

新しいページが開き、選択した仮想マシンに関する基本情報を含む Overview セクションと、仮想マシンのグラフィカルインターフェイスにアクセスするための Console セクションが表示されます。

までスクロールします。