2.3. Kamelet Binding でのデータソースの Kafka トピックへの接続

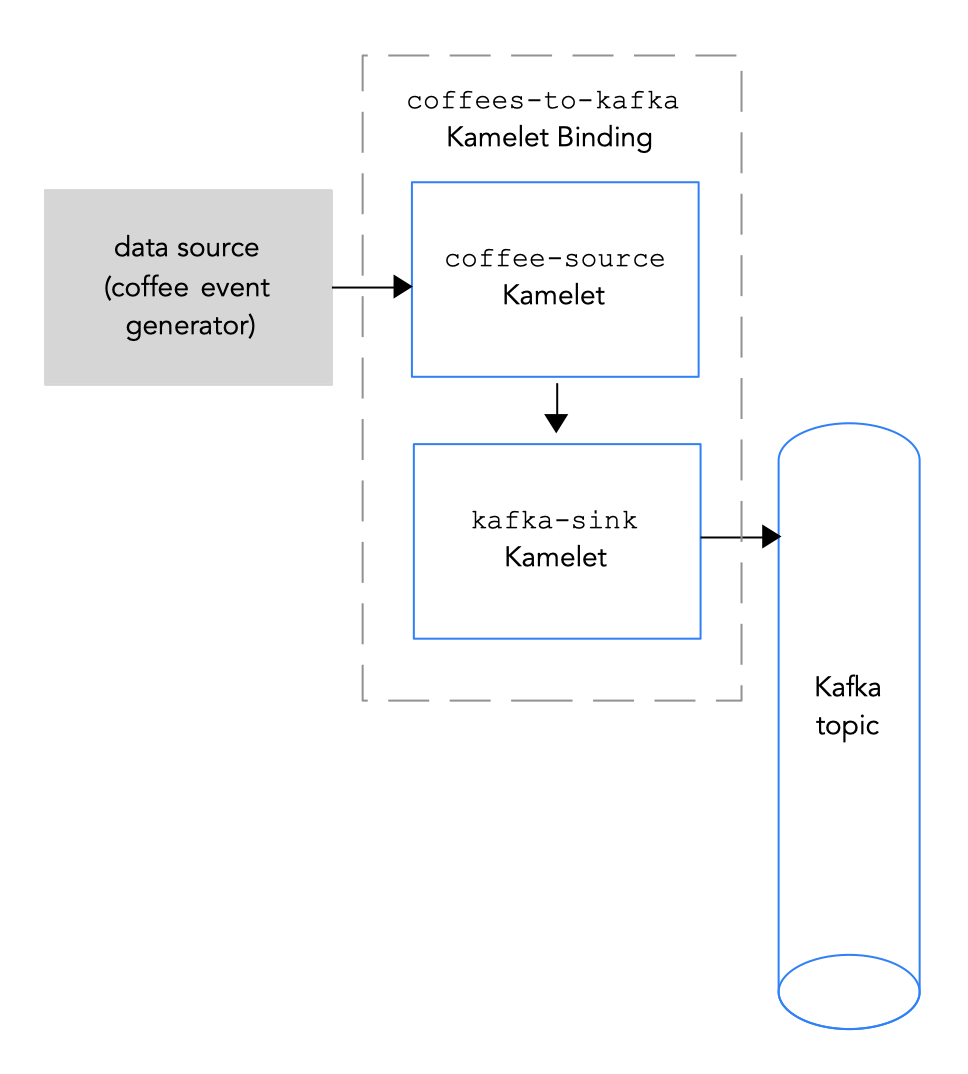

データソースを Kafka トピックに接続するには、図 2.2で説明されているように Kamelet Binding を作成します。

図 2.2 データソースの Kafka トピックへの接続

図 2.2 データソースの Kafka トピックへの接続

前提条件

イベントの送信先となる Kafka トピックの名前を知っておく必要があります。

この手順の例では、イベントを受信するために

test-topicを使用します。Kafka インスタンスの以下のパラメーターの値を知っている必要があります。

- bootstrapServers: Kafka Broker URL のコンマ区切りリスト

-

password: Kafka に対して認証を行うためのパスワード。OpenShift Streams では、これは

credentials.jsonファイルpasswordです。AMQ Streams の認証されていない kafka インスタンスでは、任意の空でない文字列を指定できます。 user: Kafka に対して認証するユーザー名。OpenShift Streams では、これは

credentials.jsonファイルclientIDです。AMQ Streams の認証されていない kafka インスタンスでは、任意の空でない文字列を指定できます。OpenShift Streams の使用時にこれらの値を取得する方法は、Kafka クレデンシャルの取得 を参照してください。

-

securityProtocol: Kafka ブローカーと通信するためのセキュリティープロトコルを知っている必要があります。OpenShift Streams の Kafka クラスターでは、

SASL_SSL(デフォルト) です。AMQ Streams 上の Kafka クラスターでは、PLAINTEXTになります。

Camel K インテグレーションに追加する Kamelets と必要なインスタンスパラメーターを知っている必要があります。

この手順の Kamelets の例は次のとおりです。

coffee-sourceKamelet: 各イベントを送信する頻度を指定するオプションのパラメーターperiodがあります。ソース Kamelet の例 のコードを、coffee-source.kamelet.yamlファイルという名前のファイルにコピーしてから、以下のコマンドを実行して、これをリソースとして namespace に追加できます。oc apply -f coffee-source.kamelet.yaml-

Kamelet Catalog で提供される

kafka-sinkKamelet。Kafka トピックがこのバインディングでデータ (データコンシューマー) を受信しているため、kafka-sinkKamelet を使用します。

手順

データソースを Kafka トピックに接続するには、Kamelet Binding を作成します。

任意のエディターで、以下の基本構造で YAML ファイルを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Kamelet Binding の名前を追加します。この例では、バインディングが

coffee-sourceKamelet をkafka-sinkKamelet に接続するため、名前はcoffees-to-kafkaになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Kamelet Binding のソースの場合は、データソース Kamelet を指定し (たとえば、

coffee-sourceKamelet はコーヒーに関するデータが含まれるイベントを生成します)、Kamelet のパラメーターを設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Kamelet Binding のシンクの場合は、

kafka-sinkKamelet およびその必要なプロパティーを指定します。たとえば、Kafka クラスターが OpenShift Streams 上にある場合:

-

userプロパティーには、clientID指定します (例:srvc-acct-eb575691-b94a-41f1-ab97-50ade0cd1094) -

passwordプロパティーには、password指定します (例:facf3df1-3c8d-4253-aa87-8c95ca5e1225) securityProtocolプロパティーを設定する必要はありません。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 別の例として、Kafka クラスターが AMQ Streams 上にある場合、

securityProtocolプロパティーを“PLAINTEXT”に設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

-

YAML ファイルを保存します (例:

coffees-to-kafka.yaml)。 - OpenShift プロジェクトにログインします。

Kamelet Binding をリソースとして OpenShift namespace に追加します。

oc apply -f <kamelet binding filename>以下に例を示します。

oc apply -f coffees-to-kafka.yamlCamel K Operator は、

KameletBindingリソースを使用して Camel K インテグレーションを生成し、実行します。ビルドに数分かかる場合があります。KameletBindingリソースのステータスを表示するには、次のコマンドを実行します。oc get kameletbindingsインテグレーションの状態を表示するには、以下を実行します。

oc get integrationsインテグレーションのログを表示するには、以下を実行します。

kamel logs <integration> -n <project>以下に例を示します。

kamel logs coffees-to-kafka -n my-camel-k-kafka