고급 네트워킹

OpenShift Container Platform의 전문화된 고급 네트워킹 주제

초록

1장. 끝점에 대한 연결 확인

CNO(Cluster Network Operator)는 클러스터 내 리소스 간에 연결 상태 검사를 수행하는 연결 확인 컨트롤러인 컨트롤러를 실행합니다. 상태 점검 결과를 검토하여 연결 문제를 진단하거나 현재 조사하고 있는 문제의 원인으로 네트워크 연결을 제거할 수 있습니다.

1.1. 수행되는 연결 상태 점검

클러스터 리소스에 도달할 수 있는지 확인하기 위해 다음 클러스터 API 서비스 각각에 TCP 연결이 수행됩니다.

- Kubernetes API 서버 서비스

- Kubernetes API 서버 끝점

- OpenShift API 서버 서비스

- OpenShift API 서버 끝점

- 로드 밸런서

클러스터의 모든 노드에서 서비스 및 서비스 끝점에 도달할 수 있는지 확인하기 위해 다음 대상 각각에 TCP 연결이 수행됩니다.

- 상태 점검 대상 서비스

- 상태 점검 대상 끝점

1.2. 연결 상태 점검 구현

연결 검증 컨트롤러는 클러스터의 연결 확인 검사를 오케스트레이션합니다. 연결 테스트의 결과는 openshift-network-diagnostics의 PodNetworkConnectivity 오브젝트에 저장됩니다. 연결 테스트는 병렬로 1분마다 수행됩니다.

CNO(Cluster Network Operator)는 클러스터에 여러 리소스를 배포하여 연결 상태 점검을 전달하고 수신합니다.

- 상태 점검 소스

-

이 프로그램은

Deployment오브젝트에서 관리하는 단일 포드 복제본 세트에 배포됩니다. 프로그램은PodNetworkConnectivity오브젝트를 사용하고 각 오브젝트에 지정된spec.targetEndpoint에 연결됩니다. - 상태 점검 대상

- 클러스터의 모든 노드에서 데몬 세트의 일부로 배포된 포드입니다. 포드는 인바운드 상태 점검을 수신 대기합니다. 모든 노드에 이 포드가 있으면 각 노드로의 연결을 테스트할 수 있습니다.

노드 선택기를 사용하여 네트워크 연결 소스 및 대상이 실행되는 노드를 구성할 수 있습니다. 또한 소스 및 대상 Pod에 대해 허용 가능한 허용 오차 를 지정할 수 있습니다. 구성은 config.openshift.io/v1 API 그룹에 있는 네트워크 API의 싱글톤 클러스터 사용자 정의 리소스에 정의됩니다.

구성을 업데이트한 후 Pod 예약이 수행됩니다. 따라서 구성을 업데이트하기 전에 선택기에서 사용하려는 노드 레이블을 적용해야 합니다. 네트워크 연결을 업데이트한 후 적용되는 레이블은 Pod 배치가 무시됩니다.

다음 YAML의 기본 구성을 참조하십시오.

연결 소스 및 대상 Pod의 기본 구성

- 1

- 네트워크 진단 구성을 지정합니다. 값을 지정하지 않거나 빈 오브젝트가 지정되고

spec.disableNetworkDiagnostics=true가network.operator.openshift.io사용자 정의 리소스에 설정된 경우 네트워크 진단이 비활성화됩니다.설정된 경우 이 값은spec.disableNetworkDiagnostics=true를 덮어씁니다. - 2

- 진단 모드를 지정합니다. 값은 빈 문자열,

All또는Disabled일 수 있습니다. 빈 문자열은All을 지정하는 것과 동일합니다. - 3

- 선택 사항: 연결 확인 소스 Pod에 대한 선택기를 지정합니다.

nodeSelector및tolerations필드를 사용하여sourceNodePod를 추가로 지정할 수 있습니다. 이는 소스 및 대상 Pod 모두에 대해 선택 사항입니다. 생략하거나 둘 다 사용하거나 둘 중 하나만 사용할 수 있습니다. - 4

- 선택 사항: 연결 확인 대상 Pod에 대한 선택기를 지정합니다.

nodeSelector및tolerations필드를 사용하여targetNodePod를 추가로 지정할 수 있습니다. 이는 소스 및 대상 Pod 모두에 대해 선택 사항입니다. 생략하거나 둘 다 사용하거나 둘 중 하나만 사용할 수 있습니다.

1.3. Pod 연결 점검 배치 구성

클러스터 관리자는 cluster 라는 network.config.openshift.io 오브젝트를 수정하여 연결 점검 Pod가 실행되는 노드를 구성할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다.

프로세스

다음 명령을 입력하여 연결 점검 구성을 편집합니다.

oc edit network.config.openshift.io cluster

$ oc edit network.config.openshift.io clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

텍스트 편집기에서

networkDiagnostics스탠자를 업데이트하여 소스 및 대상 Pod에 원하는 노드 선택기를 지정합니다. - 변경 사항을 저장하고 텍스트 편집기를 종료합니다.

검증

- 다음 명령을 입력하여 소스 및 대상 Pod가 의도한 노드에서 실행 중인지 확인합니다.

oc get pods -n openshift-network-diagnostics -o wide

$ oc get pods -n openshift-network-diagnostics -o wide출력 예

1.4. PodNetworkConnectivityCheck 오브젝트 필드

PodNetworkConnectivityCheck 오브젝트 필드는 다음 표에 설명되어 있습니다.

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

|

다음과 같은 형식의 오브젝트 이름:

|

|

|

|

오브젝트와 연결된 네임스페이스입니다. 이 값은 항상 |

|

|

|

연결 확인이 시작된 포드의 이름입니다(예: |

|

|

|

연결 검사의 대상입니다(예: |

|

|

| 사용할 TLS 인증서 설정입니다. |

|

|

| 해당하는 경우 사용되는 TLS 인증서의 이름입니다. 기본값은 빈 문자열입니다. |

|

|

| 연결 테스트의 조건 및 최근 연결 성공 및 실패의 로그를 나타내는 오브젝트입니다. |

|

|

| 연결 확인의 최신 상태 및 모든 이전 상태입니다. |

|

|

| 실패한 시도에서의 연결 테스트 로그입니다. |

|

|

| 중단 기간을 포함하는 테스트 로그를 연결합니다. |

|

|

| 성공적인 시도에서의 연결 테스트 로그입니다. |

다음 표에서는 status.conditions 배열에서 오브젝트 필드를 설명합니다.

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

| 연결 조건이 하나의 상태에서 다른 상태로 전환된 시간입니다. |

|

|

| 사람이 읽기 쉬운 형식으로 마지막 전환에 대한 세부 정보입니다. |

|

|

| 머신에서 읽을 수 있는 형식으로 전환의 마지막 상태입니다. |

|

|

| 조건의 상태: |

|

|

| 조건의 유형입니다. |

다음 표에서는 status.conditions 배열에서 오브젝트 필드를 설명합니다.

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

| 연결 오류가 해결될 때부터의 타임 스탬프입니다. |

|

|

| 서비스 중단의 성공적인 종료와 관련된 로그 항목을 포함한 연결 로그 항목입니다. |

|

|

| 사람이 읽을 수 있는 형식의 중단 세부 정보에 대한 요약입니다. |

|

|

| 연결 오류가 먼저 감지될 때부터의 타임 스탬프입니다. |

|

|

| 원래 오류를 포함한 연결 로그 항목입니다. |

1.4.1. 연결 로그 필드

연결 로그 항목의 필드는 다음 표에 설명되어 있습니다. 오브젝트는 다음 필드에서 사용됩니다.

-

status.failures[] -

status.successes[] -

status.outages[].startLogs[] -

status.outages[].endLogs[]

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

| 작업 기간을 기록합니다. |

|

|

| 사람이 읽을 수 있는 형식으로 상태를 제공합니다. |

|

|

|

머신에서 읽을 수 있는 형식으로 상태의 이유를 제공합니다. 값은 |

|

|

| 로그 항목이 성공 또는 실패인지를 나타냅니다. |

|

|

| 연결 확인 시작 시간입니다. |

1.5. 끝점에 대한 네트워크 연결 확인

클러스터 관리자는 API 서버, 로드 밸런서, 서비스 또는 Pod와 같은 끝점의 연결을 확인하고 네트워크 진단이 활성화되어 있는지 확인할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

다음 명령을 입력하여 네트워크 진단이 활성화되었는지 확인합니다.

oc get network.config.openshift.io cluster -o yaml

$ oc get network.config.openshift.io cluster -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 입력하여 현재

PodNetworkConnectivityCheck오브젝트를 나열합니다.oc get podnetworkconnectivitycheck -n openshift-network-diagnostics

$ oc get podnetworkconnectivitycheck -n openshift-network-diagnosticsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 연결 테스트 로그를 확인합니다.

- 이전 명령의 출력에서 연결 로그를 검토할 끝점을 식별합니다.

다음 명령을 입력하여 오브젝트를 확인합니다.

oc get podnetworkconnectivitycheck <name> \ -n openshift-network-diagnostics -o yaml

$ oc get podnetworkconnectivitycheck <name> \ -n openshift-network-diagnostics -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 여기서

<name>은PodNetworkConnectivityCheck오브젝트의 이름을 지정합니다.출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2장. 클러스터 네트워크의 MTU 변경

클러스터 관리자는 클러스터 설치 후 클러스터 네트워크의 최대 전송 단위(MTU)를 변경할 수 있습니다. MTU 변경을 종료하려면 클러스터 노드를 재부팅해야 하므로 이러한 변경이 중단됩니다.

2.1. 클러스터 MTU 정보

설치 중에 클러스터 네트워크 MTU는 클러스터 노드의 기본 네트워크 인터페이스 MTU에 따라 자동으로 설정됩니다. 일반적으로 감지된 MTU를 재정의할 필요가 없습니다.

다음 이유 중 하나로 클러스터 네트워크의 MTU를 변경할 수 있습니다.

- 클러스터 설치 중에 감지된 MTU는 인프라에 적합하지 않습니다.

- 이제 최적의 성능을 위해 다른 MTU가 필요한 노드 추가와 같이 클러스터 인프라에 다른 MTU가 필요합니다.

OVN-Kubernetes 네트워크 플러그인만 MTU 값 변경을 지원합니다.

2.1.1. 서비스 중단 고려 사항

클러스터에서 최대 전송 단위(MTU) 변경을 시작하면 다음과 같은 영향이 서비스 가용성에 영향을 미칠 수 있습니다.

- 새 MTU로의 마이그레이션을 완료하려면 두 개 이상의 롤링 재부팅이 필요합니다. 이 기간 동안 일부 노드를 다시 시작할 수 없으므로 사용할 수 없습니다.

- 절대 TCP 시간 간격보다 짧은 시간 초과 간격으로 클러스터에 배포된 특정 애플리케이션은 MTU 변경 중에 중단될 수 있습니다.

2.1.2. MTU 값 선택

MTU(최대 전송 단위) 마이그레이션을 계획할 때 고려해야 할 두 개의 관련 MTU 값이 있습니다.

- 하드웨어 MTU: 이 MTU 값은 네트워크 인프라의 세부 사항에 따라 설정됩니다.

-

클러스터 네트워크 MTU: 이 MTU 값은 클러스터 네트워크 오버레이 오버헤드를 고려하여 하드웨어 MTU보다 항상 적습니다. 특정 오버헤드는 네트워크 플러그인에 따라 결정됩니다. OVN-Kubernetes의 경우 오버헤드는

100바이트입니다.

클러스터에 다른 노드에 대한 다른 MTU 값이 필요한 경우 클러스터의 모든 노드에서 사용하는 가장 낮은 MTU 값에서 네트워크 플러그인의 오버헤드 값을 제거해야 합니다. 예를 들어, 클러스터의 일부 노드에 9001의 MTU가 있고 일부에는 1500의 MTU가 있는 경우 이 값을 1400으로 설정해야 합니다.

노드에서 허용되지 않는 MTU 값을 선택하지 않으려면 ip -d link 명령을 사용하여 네트워크 인터페이스에서 허용하는 최대 MTU 값(maxmtu)을 확인합니다.

2.1.3. 마이그레이션 프로세스의 작동 방식

다음 표는 프로세스의 사용자 시작 단계와 마이그레이션이 수행하는 작업 간에 분할하여 마이그레이션 프로세스를 요약합니다.

| 사용자 시작 단계 | OpenShift Container Platform 활동 |

|---|---|

| Cluster Network Operator 구성에서 다음 값을 설정합니다.

| CNO(Cluster Network Operator): 각 필드가 유효한 값으로 설정되어 있는지 확인합니다.

제공된 값이 유효한 경우 CNO는 MCO(Machine Config Operator): 클러스터의 각 노드에 대해 롤링 재부팅을 수행합니다. |

| 클러스터의 노드에 대한 기본 네트워크 인터페이스의 MTU를 재구성합니다. 다음 방법 중 하나를 사용하여 이 작업을 수행할 수 있습니다.

| 해당 없음 |

|

네트워크 플러그인의 CNO 구성에서 | MCO(Machine Config Operator): 새 MTU 구성으로 클러스터의 각 노드를 롤링 재부팅합니다. |

2.2. 클러스터 네트워크 MTU 변경

클러스터 관리자는 클러스터의 최대 전송 단위(MTU)를 늘리거나 줄일 수 있습니다.

MTU 마이그레이션 프로세스 중에 노드의 MTU 값을 롤백할 수는 없지만 MTU 마이그레이션 프로세스가 완료된 후 값을 롤백할 수 있습니다.

MTU 업데이트가 적용되므로 마이그레이션이 중단되고 클러스터의 노드를 일시적으로 사용할 수 없게 될 수 있습니다.

다음 절차에서는 시스템 구성, DHCP(Dynamic Host Configuration Protocol) 또는 ISO 이미지를 사용하여 클러스터 네트워크 MTU를 변경하는 방법을 설명합니다. DHCP 또는 ISO 접근 방식을 사용하는 경우 절차를 완료하기 위해 클러스터를 설치한 후 유지한 구성 아티팩트를 참조해야 합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 계정을 사용하여 클러스터에 액세스할 수 있습니다. -

클러스터의 대상 MTU를 식별했습니다. OVN-Kubernetes 네트워크 플러그인의 MTU는 클러스터에서 가장 낮은 하드웨어 MTU 값보다

100으로 설정해야 합니다. - 노드가 물리적 시스템인 경우 클러스터 네트워크와 연결된 네트워크 스위치가 점보 프레임을 지원하는지 확인합니다.

- 노드가 VM(가상 머신)인 경우 하이퍼바이저 및 연결된 네트워크 스위치가 점보 프레임을 지원하는지 확인합니다.

2.2.1. 현재 클러스터 MTU 값 확인

다음 절차를 사용하여 클러스터 네트워크의 현재 최대 전송 단위(MTU)를 가져옵니다.

프로세스

클러스터 네트워크의 현재 MTU를 가져오려면 다음 명령을 입력합니다.

oc describe network.config cluster

$ oc describe network.config clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.2. 하드웨어 MTU 구성 준비

클러스터 노드에 대한 하드웨어 최대 전송 단위(MTU)를 구성하는 방법은 여러 가지가 있습니다. 다음 예제에서는 가장 일반적인 방법만 보여줍니다. 인프라 MTU의 정확성을 확인합니다. 클러스터 노드에서 하드웨어 MTU를 구성하는 기본 방법을 선택합니다.

프로세스

하드웨어 MTU에 대한 구성을 준비합니다.

하드웨어 MTU가 DHCP로 지정된 경우 다음 dnsmasq 구성과 같은 DHCP 구성을 업데이트합니다.

dhcp-option-force=26,<mtu>

dhcp-option-force=26,<mtu>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<mtu>- 알릴 DHCP 서버의 하드웨어 MTU를 지정합니다.

- 하드웨어 MTU가 PXE를 사용하여 커널 명령줄로 지정된 경우 그에 따라 해당 구성을 업데이트합니다.

하드웨어 MTU가 NetworkManager 연결 구성에 지정된 경우 다음 단계를 완료합니다. 이 방법은 DHCP, 커널 명령줄 또는 기타 방법으로 네트워크 구성을 명시적으로 지정하지 않는 경우 OpenShift Container Platform의 기본값입니다. 클러스터 노드는 다음 절차에 따라 수정되지 않은 상태로 작동하도록 동일한 기본 네트워크 구성을 사용해야 합니다.

다음 명령을 입력하여 기본 네트워크 인터페이스를 찾습니다.

oc debug node/<node_name> -- chroot /host nmcli -g connection.interface-name c show ovs-if-phys0

$ oc debug node/<node_name> -- chroot /host nmcli -g connection.interface-name c show ovs-if-phys0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<node_name>- 클러스터에 있는 노드의 이름을 지정합니다.

<

interface>-mtu.conf 파일에 다음NetworkManager구성을 생성합니다.[connection-<interface>-mtu] match-device=interface-name:<interface> ethernet.mtu=<mtu>

[connection-<interface>-mtu] match-device=interface-name:<interface> ethernet.mtu=<mtu>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<interface>- 기본 네트워크 인터페이스 이름을 지정합니다.

<mtu>- 새 하드웨어 MTU 값을 지정합니다.

2.2.3. MachineConfig 오브젝트 생성

다음 절차에 따라 MachineConfig 오브젝트를 생성합니다.

프로세스

두 개의

MachineConfig오브젝트를 생성합니다. 하나는 컨트롤 플레인 노드용이고 다른 하나는 클러스터의 작업자 노드에 사용됩니다.control-plane-interface.bu파일에 다음 Butane 구성을 생성합니다.참고구성 파일에 지정하는 Butane 버전이 OpenShift Container Platform 버전과 일치해야 하며 항상

0으로 끝나야 합니다. 예:4.20.0. Butane에 대한 자세한 내용은 “Butane 을 사용하여 머신 구성 생성”을 참조하십시오.Copy to Clipboard Copied! Toggle word wrap Toggle overflow worker-interface.bu파일에 다음 Butane 구성을 생성합니다.참고구성 파일에 지정하는 Butane 버전이 OpenShift Container Platform 버전과 일치해야 하며 항상

0으로 끝나야 합니다. 예:4.20.0. Butane에 대한 자세한 내용은 “Butane 을 사용하여 머신 구성 생성”을 참조하십시오.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

다음 명령을 실행하여 Butane 구성에서

MachineConfig오브젝트를 생성합니다.for manifest in control-plane-interface worker-interface; do butane --files-dir . $manifest.bu > $manifest.yaml done$ for manifest in control-plane-interface worker-interface; do butane --files-dir . $manifest.bu > $manifest.yaml doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 주의이 절차의 뒷부분에서 명시적으로 지시할 때까지 이러한 머신 구성을 적용하지 마십시오. 이러한 머신 구성을 적용하면 클러스터에 대한 안정성이 손실됩니다.

2.2.4. MTU 마이그레이션 시작

다음 절차에 따라 MTU 마이그레이션을 시작합니다.

프로세스

MTU 마이그레이션을 시작하려면 다음 명령을 입력하여 마이그레이션 구성을 지정합니다. Machine Config Operator는 MTU 변경을 준비하기 위해 클러스터에서 노드를 롤링 재부팅합니다.

oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": { "mtu": { "network": { "from": <overlay_from>, "to": <overlay_to> } , "machine": { "to" : <machine_to> } } } } }'$ oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": { "mtu": { "network": { "from": <overlay_from>, "to": <overlay_to> } , "machine": { "to" : <machine_to> } } } } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<overlay_from>- 현재 클러스터 네트워크 MTU 값을 지정합니다.

<overlay_to>-

클러스터 네트워크의 대상 MTU를 지정합니다. 이 값은

<machine_to>값을 기준으로 설정됩니다. OVN-Kubernetes의 경우 이 값은<machine_to>값보다100미만이어야 합니다. <machine_to>- 기본 호스트 네트워크의 기본 네트워크 인터페이스에 대한 MTU를 지정합니다.

oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": { "mtu": { "network": { "from": 1400, "to": 9000 } , "machine": { "to" : 9100} } } } }'$ oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": { "mtu": { "network": { "from": 1400, "to": 9000 } , "machine": { "to" : 9100} } } } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Machine Config Operator가 각 머신 구성 풀에서 머신을 업데이트할 때 Operator는 각 노드를 하나씩 재부팅합니다. 모든 노드가 업데이트될 때까지 기다려야 합니다. 다음 명령을 입력하여 머신 구성 풀 상태를 확인합니다.

oc get machineconfigpools

$ oc get machineconfigpoolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 업데이트된 노드의 상태가

UPDATED=true,UPDATING=false,DEGRADED=false입니다.참고기본적으로 Machine Config Operator는 풀당 한 번에 하나의 머신을 업데이트하여 클러스터 크기에 따라 마이그레이션에 걸리는 총 시간을 늘립니다.

2.2.5. 머신 구성 확인

다음 절차에 따라 머신 구성을 확인합니다.

프로세스

호스트의 새 머신 구성 상태를 확인합니다.

머신 구성 상태 및 적용된 머신 구성 이름을 나열하려면 다음 명령을 입력합니다.

oc describe node | egrep "hostname|machineconfig"

$ oc describe node | egrep "hostname|machineconfig"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

kubernetes.io/hostname=master-0 machineconfiguration.openshift.io/currentConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/desiredConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/reason: machineconfiguration.openshift.io/state: Done

kubernetes.io/hostname=master-0 machineconfiguration.openshift.io/currentConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/desiredConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/reason: machineconfiguration.openshift.io/state: DoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 구문이 올바른지 확인합니다.

-

machineconfiguration.openshift.io/state필드의 값은Done입니다. -

machineconfiguration.openshift.io/currentConfig필드의 값은machineconfiguration.openshift.io/desiredConfig필드의 값과 동일합니다.

-

머신 구성이 올바른지 확인하려면 다음 명령을 입력합니다.

oc get machineconfig <config_name> -o yaml | grep ExecStart

$ oc get machineconfig <config_name> -o yaml | grep ExecStartCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<config_name>-

machineconfiguration.openshift.io/currentConfig필드에서 머신 구성의 이름을 지정합니다.

머신 구성은 다음 업데이트를 systemd 구성에 포함해야 합니다.

ExecStart=/usr/local/bin/mtu-migration.sh

ExecStart=/usr/local/bin/mtu-migration.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.6. 새 하드웨어 MTU 값 적용

새 하드웨어 최대 전송 단위(MTU) 값을 적용하려면 다음 절차를 사용하십시오.

프로세스

기본 네트워크 인터페이스 MTU 값을 업데이트합니다.

NetworkManager 연결 구성을 사용하여 새 MTU를 지정하는 경우 다음 명령을 입력합니다. MachineConfig Operator는 클러스터에서 노드의 롤링 재부팅을 자동으로 수행합니다.

for manifest in control-plane-interface worker-interface; do oc create -f $manifest.yaml done$ for manifest in control-plane-interface worker-interface; do oc create -f $manifest.yaml doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow - DHCP 서버 옵션 또는 커널 명령줄 및 PXE로 새 MTU를 지정하는 경우 인프라에 필요한 변경을 수행합니다.

Machine Config Operator가 각 머신 구성 풀에서 머신을 업데이트할 때 Operator는 각 노드를 하나씩 재부팅합니다. 모든 노드가 업데이트될 때까지 기다려야 합니다. 다음 명령을 입력하여 머신 구성 풀 상태를 확인합니다.

oc get machineconfigpools

$ oc get machineconfigpoolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 업데이트된 노드의 상태가

UPDATED=true,UPDATING=false,DEGRADED=false입니다.참고기본적으로 Machine Config Operator는 풀당 한 번에 하나의 머신을 업데이트하여 클러스터 크기에 따라 마이그레이션에 걸리는 총 시간을 늘립니다.

호스트의 새 머신 구성 상태를 확인합니다.

머신 구성 상태 및 적용된 머신 구성 이름을 나열하려면 다음 명령을 입력합니다.

oc describe node | egrep "hostname|machineconfig"

$ oc describe node | egrep "hostname|machineconfig"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

kubernetes.io/hostname=master-0 machineconfiguration.openshift.io/currentConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/desiredConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/reason: machineconfiguration.openshift.io/state: Done

kubernetes.io/hostname=master-0 machineconfiguration.openshift.io/currentConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/desiredConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/reason: machineconfiguration.openshift.io/state: DoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 구문이 올바른지 확인합니다.

-

machineconfiguration.openshift.io/state필드의 값은Done입니다. -

machineconfiguration.openshift.io/currentConfig필드의 값은machineconfiguration.openshift.io/desiredConfig필드의 값과 동일합니다.

-

머신 구성이 올바른지 확인하려면 다음 명령을 입력합니다.

oc get machineconfig <config_name> -o yaml | grep path:

$ oc get machineconfig <config_name> -o yaml | grep path:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<config_name>-

machineconfiguration.openshift.io/currentConfig필드에서 머신 구성의 이름을 지정합니다.

머신 구성이 성공적으로 배포된 경우 이전 출력에는

/etc/NetworkManager/conf.d/99-<interface>-mtu.conf파일 경로와ExecStart=/usr/local/bin/mtu-migration.sh행이 포함됩니다.

2.2.7. MTU 마이그레이션 완료

다음 절차를 사용하여 MTU 마이그레이션을 완료합니다.

프로세스

MTU 마이그레이션을 완료하려면 OVN-Kubernetes 네트워크 플러그인에 대해 다음 명령을 입력합니다.

oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": null, "defaultNetwork":{ "ovnKubernetesConfig": { "mtu": <mtu> }}}}'$ oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": null, "defaultNetwork":{ "ovnKubernetesConfig": { "mtu": <mtu> }}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<mtu>-

<

overlay_to>로 지정한 새 클러스터 네트워크 MTU를 지정합니다.

MTU 마이그레이션을 완료한 후 각 머신 구성 풀 노드는 하나씩 재부팅됩니다. 모든 노드가 업데이트될 때까지 기다려야 합니다. 다음 명령을 입력하여 머신 구성 풀 상태를 확인합니다.

oc get machineconfigpools

$ oc get machineconfigpoolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 업데이트된 노드의 상태가

UPDATED=true,UPDATING=false,DEGRADED=false입니다.

검증

클러스터 네트워크의 현재 MTU를 가져오려면 다음 명령을 입력합니다.

oc describe network.config cluster

$ oc describe network.config clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 노드의 기본 네트워크 인터페이스에 대한 현재 MTU를 가져옵니다.

클러스터의 노드를 나열하려면 다음 명령을 입력합니다.

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 노드에서 기본 네트워크 인터페이스에 대한 현재 MTU 설정을 가져오려면 다음 명령을 입력합니다.

oc adm node-logs <node> -u ovs-configuration | grep configure-ovs.sh | grep mtu | grep <interface> | head -1

$ oc adm node-logs <node> -u ovs-configuration | grep configure-ovs.sh | grep mtu | grep <interface> | head -1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<node>- 이전 단계의 출력에서 노드를 지정합니다.

<interface>- 노드의 기본 네트워크 인터페이스 이름을 지정합니다.

출력 예

ens3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 8051

ens3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 8051Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3장. SCTP(Stream Control Transmission Protocol) 사용

클러스터 관리자는 베어 메탈 클러스터에서 SCTP(Stream Control Transmission Protocol)를 사용할 수 있습니다.

3.1. OpenShift Container Platform에서 SCTP 지원

클러스터 관리자는 클러스터의 호스트에서 SCTP를 활성화 할 수 있습니다. RHCOS(Red Hat Enterprise Linux CoreOS)에서 SCTP 모듈은 기본적으로 비활성화되어 있습니다.

SCTP는 IP 네트워크에서 실행되는 안정적인 메시지 기반 프로토콜입니다.

활성화하면 Pod, 서비스, 네트워크 정책에서 SCTP를 프로토콜로 사용할 수 있습니다. type 매개변수를 ClusterIP 또는 NodePort 값으로 설정하여 Service를 정의해야 합니다.

3.1.1. SCTP 프로토콜을 사용하는 구성의 예

protocol 매개변수를 포드 또는 서비스 오브젝트의 SCTP 값으로 설정하여 SCTP를 사용하도록 포드 또는 서비스를 구성할 수 있습니다.

다음 예에서는 pod가 SCTP를 사용하도록 구성되어 있습니다.

다음 예에서는 서비스가 SCTP를 사용하도록 구성되어 있습니다.

다음 예에서 NetworkPolicy 오브젝트는 특정 레이블이 있는 모든 Pod의 포트 80에서 SCTP 네트워크 트래픽에 적용되도록 구성되어 있습니다.

3.2. SCTP(스트림 제어 전송 프로토콜) 활성화

클러스터 관리자는 클러스터의 작업자 노드에 블랙리스트 SCTP 커널 모듈을 로드하고 활성화할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

다음 YAML 정의가 포함된

load-sctp-module.yaml파일을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow MachineConfig오브젝트를 생성하려면 다음 명령을 입력합니다.oc create -f load-sctp-module.yaml

$ oc create -f load-sctp-module.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항: MachineConfig Operator가 구성 변경 사항을 적용하는 동안 노드의 상태를 보려면 다음 명령을 입력합니다. 노드 상태가

Ready로 전환되면 구성 업데이트가 적용됩니다.oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3. SCTP(Stream Control Transmission Protocol)의 활성화 여부 확인

SCTP 트래픽을 수신하는 애플리케이션으로 pod를 만들고 서비스와 연결한 다음, 노출된 서비스에 연결하여 SCTP가 클러스터에서 작동하는지 확인할 수 있습니다.

사전 요구 사항

-

클러스터에서 인터넷에 액세스하여

nc패키지를 설치합니다. -

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

SCTP 리스너를 시작하는 포드를 생성합니다.

다음 YAML로 pod를 정의하는

sctp-server.yaml파일을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 입력하여 pod를 생성합니다.

oc create -f sctp-server.yaml

$ oc create -f sctp-server.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

SCTP 리스너 pod에 대한 서비스를 생성합니다.

다음 YAML을 사용하여 서비스를 정의하는

sctp-service.yaml파일을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스를 생성하려면 다음 명령을 입력합니다.

oc create -f sctp-service.yaml

$ oc create -f sctp-service.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

SCTP 클라이언트에 대한 pod를 생성합니다.

다음 YAML을 사용하여

sctp-client.yaml파일을 만듭니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pod오브젝트를 생성하려면 다음 명령을 입력합니다.oc apply -f sctp-client.yaml

$ oc apply -f sctp-client.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

서버에서 SCTP 리스너를 실행합니다.

서버 Pod에 연결하려면 다음 명령을 입력합니다.

oc rsh sctpserver

$ oc rsh sctpserverCopy to Clipboard Copied! Toggle word wrap Toggle overflow SCTP 리스너를 시작하려면 다음 명령을 입력합니다.

nc -l 30102 --sctp

$ nc -l 30102 --sctpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

서버의 SCTP 리스너에 연결합니다.

- 터미널 프로그램에서 새 터미널 창 또는 탭을 엽니다.

sctpservice서비스의 IP 주소를 얻습니다. 다음 명령을 실행합니다.oc get services sctpservice -o go-template='{{.spec.clusterIP}}{{"\n"}}'$ oc get services sctpservice -o go-template='{{.spec.clusterIP}}{{"\n"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 클라이언트 Pod에 연결하려면 다음 명령을 입력합니다.

oc rsh sctpclient

$ oc rsh sctpclientCopy to Clipboard Copied! Toggle word wrap Toggle overflow SCTP 클라이언트를 시작하려면 다음 명령을 입력합니다.

<cluster_IP>를sctpservice서비스의 클러스터 IP 주소로 변경합니다.nc <cluster_IP> 30102 --sctp

# nc <cluster_IP> 30102 --sctpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4장. 보조 인터페이스 지표와 네트워크 연결 연관 짓기

관리자는 pod_network_info 지표를 사용하여 보조 네트워크 인터페이스를 분류하고 모니터링할 수 있습니다. 지표는 일반적으로 연결된 NetworkAttachmentDefinition 리소스를 기반으로 인터페이스 유형을 식별하는 레이블을 추가하여 이 작업을 수행합니다.

4.1. 모니터링을 위한 보조 네트워크 메트릭 확장

보조 장치 또는 인터페이스는 다양한 용도로 사용됩니다. 효과적인 집계 및 모니터링을 허용하려면 보조 네트워크 인터페이스의 지표를 분류해야 합니다.

노출된 지표는 인터페이스를 포함하지만 인터페이스가 시작되는 위치는 지정하지 않습니다. 추가 인터페이스가 없는 경우 이 작업을 수행할 수 있습니다. 그러나 인터페이스 이름에만 의존하는 것은 목적을 식별하고 메트릭을 효과적으로 사용하기 어렵기 때문에 보조 인터페이스를 추가할 때 문제가 됩니다.

보조 인터페이스를 추가할 때 해당 이름은 추가 순서에 따라 달라집니다. 보조 인터페이스는 각각 다른 목적을 제공할 수 있는 별도의 네트워크에 속할 수 있습니다.

pod_network_name_info 를 사용하면 인터페이스 유형을 식별하는 추가 정보를 사용하여 현재 지표를 확장할 수 있습니다. 이러한 방식으로 지표를 집계하고 특정 인터페이스 유형에 특정 경보를 추가할 수 있습니다.

네트워크 유형은 NetworkAttachmentDefinition 리소스의 이름과 생성되며 서로 다른 보조 네트워크 클래스를 구분합니다. 예를 들어 서로 다른 네트워크에 속하거나 서로 다른 CNI를 사용하는 서로 다른 인터페이스는 서로 다른 네트워크 연결 정의 이름을 사용합니다.

4.2. 네트워크 지표 데몬

네트워크 지표 데몬은 네트워크 관련 지표를 수집하고 게시하는 데몬 구성 요소입니다.

kubelet은 이미 관찰 가능한 네트워크 관련 지표를 게시하고 있습니다. 이러한 지표는 다음과 같습니다.

-

container_network_receive_bytes_total -

container_network_receive_errors_total -

container_network_receive_packets_total -

container_network_receive_packets_dropped_total -

container_network_transmit_bytes_total -

container_network_transmit_errors_total -

container_network_transmit_packets_total -

container_network_transmit_packets_dropped_total

이러한 지표의 레이블에는 다음이 포함됩니다.

- 포드 이름

- 포드 네임스페이스

-

인터페이스 이름(예:

eth0)

이러한 지표는 예를 들면 Multus를 통해 Pod에 새 인터페이스를 추가할 때까지는 인터페이스 이름이 무엇을 나타내는지 명확하지 않기 때문에 잘 작동합니다.

인터페이스 레이블은 인터페이스 이름을 나타내지만 해당 인터페이스가 무엇을 의미하는지는 명확하지 않습니다. 인터페이스가 다양한 경우 모니터링 중인 지표에서 어떤 네트워크를 참조하는지 파악하기란 불가능합니다.

이 문제는 다음 섹션에 설명된 새로운 pod_network_name_info를 도입하여 해결됩니다.

4.3. 네트워크 이름이 있는 지표

네트워크 지표 데몬 세트에서는 고정 값이 0 인 pod_network_name_info 게이지 지표를 게시합니다.

pod_network_name_info의 예

pod_network_name_info{interface="net0",namespace="namespacename",network_name="nadnamespace/firstNAD",pod="podname"} 0

pod_network_name_info{interface="net0",namespace="namespacename",network_name="nadnamespace/firstNAD",pod="podname"} 0네트워크 이름 레이블은 Multus에서 추가한 주석을 사용하여 생성됩니다. 네트워크 연결 정의가 속하는 네임스페이스와 네트워크 연결 정의의 이름입니다.

새 지표 단독으로는 많은 가치를 제공하지 않지만 네트워크 관련 container_network_* 지표와 결합되는 경우 보조 네트워크 모니터링을 더 잘 지원합니다.

다음과 같은 promql 쿼리를 사용하면 값이 포함된 새 메트릭과 k8s.v1.cni.cncf.io/network-status 주석에서 검색된 네트워크 이름을 가져올 수 있습니다.

5장. BGP 라우팅

5.1. BGP 라우팅 정보

이 기능은 클러스터에 대한 기본 BGP(Border Gateway Protocol) 라우팅 기능을 제공합니다.

MetalLB Operator를 사용하고 MetalLB Operator 이외의 클러스터 관리자 또는 타사 클러스터 구성 요소에서 생성한 metallb-system 네임스페이스에 기존 FRRConfiguration CR이 있는 경우 해당 CR이 openshift-frr-k8s 네임스페이스에 복사되거나 해당 타사 클러스터 구성 요소가 새 네임스페이스를 사용하는지 확인해야 합니다. 자세한 내용은 FRR-K8s 리소스 마이그레이션 을 참조하십시오.

5.1.1. BGP(Border Gateway Protocol) 라우팅 정보

OpenShift Container Platform은 Linux, UNIX 및 유사한 운영 체제용 무료 오픈 소스 인터넷 라우팅 프로토콜 제품군인 FRRouting(FRR)을 통한 BGP 라우팅을 지원합니다. FR-K8s는 Kubernetes 호환 방식으로 FRR API의 하위 집합을 표시하는 Kubernetes 기반 데몬 세트입니다. 클러스터 관리자는 FRRConfiguration CR(사용자 정의 리소스)을 사용하여 FRRR 서비스에 액세스할 수 있습니다.

5.1.1.1. 지원되는 플랫폼

BGP 라우팅은 다음 인프라 유형에서 지원됩니다.

- 베어 메탈

BGP 라우팅을 사용하려면 네트워크 공급자에 대해 BGP를 올바르게 구성해야 합니다. 네트워크 공급자의 중단 또는 잘못된 구성으로 인해 클러스터 네트워크가 중단될 수 있습니다.

5.1.1.2. MetalLB Operator와 함께 사용할 고려 사항

MetalLB Operator는 클러스터에 대한 애드온으로 설치됩니다. MetalLB Operator를 배포하면 추가 라우팅 기능 공급자로 FRR-K8s를 자동으로 활성화하고 이 기능에 의해 설치된 FRR-K8s 데몬을 사용합니다.

4.18로 업그레이드하기 전에 MetalLB Operator(클러스터 관리자 또는 기타 구성 요소에 의해 추가됨)에서 관리하지 않는 metallb-system 네임스페이스의 기존 FRRConfiguration 을 openshift-frr-k8s 네임스페이스에 수동으로 복사하여 필요한 경우 네임스페이스를 생성해야 합니다.

MetalLB Operator를 사용하고 클러스터 관리자 또는 MetalLB Operator 이외의 타사 클러스터 구성 요소가 생성된 metallb-system 네임스페이스에 기존 FRRConfiguration CR이 있는 경우 다음을 수행해야 합니다.

-

이러한 기존

FRRConfigurationCR이openshift-frr-k8s네임스페이스에 복사되었는지 확인합니다. -

타사 클러스터 구성 요소가 생성한

FRRConfigurationCR에 새 네임스페이스를 사용하는지 확인합니다.

5.1.1.3. CNO(Cluster Network Operator) 구성

Cluster Network Operator API는 다음 API 필드를 노출하여 BGP 라우팅을 구성합니다.

-

spec.additionalRoutingCapabilities: 클러스터의 FRR-K8s 데몬 배포를 활성화합니다. 이 데몬은 경로 알림과 독립적으로 사용할 수 있습니다. 활성화되면 FRR-K8s 데몬이 모든 노드에 배포됩니다.

5.1.1.4. BGP 라우팅 사용자 정의 리소스

다음 사용자 정의 리소스는 BGP 라우팅을 구성하는 데 사용됩니다.

FRRConfiguration- 이 사용자 정의 리소스는 BGP 라우팅에 대한 FRR 구성을 정의합니다. 이 CR은 네임스페이스가 지정됩니다.

5.1.2. FRRConfiguration CRD 구성

다음 섹션에서는 FRRConfiguration CR(사용자 정의 리소스)을 사용하는 참조 예제를 제공합니다.

5.1.2.1. 라우터 필드

router 필드를 사용하여 각 VRF(Virtual Routing and Forwarding) 리소스에 대해 여러 라우터를 구성할 수 있습니다. 각 라우터에 대해 Autonomous System Number (ASN)를 정의해야 합니다.

다음 예와 같이 BGP(Border Gateway Protocol) 조합 조합 목록을 정의할 수도 있습니다.

FRRConfiguration CR 예

5.1.2.2. toAdvertise 필드

기본적으로 FRR-K8s 는 라우터 구성의 일부로 구성된 접두사를 알리지 않습니다. 이를 광고하기 위해, 귀하는 toAdvertise 필드를 사용합니다.

다음 예제와 같이 접두사의 하위 집합을 알릴 수 있습니다.

FRRConfiguration CR 예

- 1

- 접두사의 하위 집합을 알립니다.

다음 예제에서는 모든 접두사를 알리는 방법을 보여줍니다.

FRRConfiguration CR 예

- 1

- 모든 접두사를 알립니다.

5.1.2.3. 수신자 필드

기본적으로 FRR-K8s 는 인접자가 알리는 접두사를 처리하지 않습니다. toReceive 필드를 사용하여 이러한 주소를 처리할 수 있습니다.

다음 예제와 같이 접두사의 하위 집합에 대해 구성할 수 있습니다.

FRRConfiguration CR 예

다음 예제에서는 발표된 모든 접두사를 처리하도록 FRR을 구성합니다.

FRRConfiguration CR 예

5.1.2.4. bgp 필드

bgp 필드를 사용하여 다양한 BFD 프로필을 정의하고 이를 인접지와 연결할 수 있습니다. 다음 예에서 BFD 는 BGP 세션을 백업하고 FRR 은 링크 실패를 감지할 수 있습니다.

FRRConfiguration CR 예

5.1.2.5. nodeSelector 필드

기본적으로 FRR-K8s 는 데몬이 실행 중인 모든 노드에 구성을 적용합니다. nodeSelector 필드를 사용하여 구성을 적용할 노드를 지정할 수 있습니다. 예를 들면 다음과 같습니다.

FRRConfiguration CR 예

5.1.2.6. 인터페이스 필드

interface 필드를 사용하여 다음 예제 구성을 사용하여 번호가 지정되지 않은 BGP 피어링을 구성할 수 있습니다.

FRRConfiguration CR 예

- 1

- 번호가 지정되지 않은 BGP 피어링을 활성화합니다.

interface 필드를 사용하려면 두 BGP 피어 간에 지점 간 계층 2 연결을 설정해야 합니다. IPv4, IPv6 또는 듀얼 스택과 함께 번호가 지정되지 않은 BGP 피어링을 사용할 수 있지만 IPv6 RAs(Router Advertisements)를 활성화해야 합니다. 각 인터페이스는 하나의 BGP 연결로 제한됩니다.

이 필드를 사용하는 경우 spec.bgp.routers.neighbors.address 필드에 값을 지정할 수 없습니다.

FRRConfiguration 사용자 정의 리소스의 필드는 다음 표에 설명되어 있습니다.

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

| FRR이 구성할 라우터를 지정합니다( VRF당 하나씩). |

|

|

| 세션의 로컬 종료에 사용할 자동 시스템 번호(ASN)입니다. |

|

|

|

|

|

|

| 이 라우터에서 세션을 설정하는 데 사용되는 호스트 vrf를 지정합니다. |

|

|

| BGP 세션을 설정하는 포인을 지정합니다. |

|

|

|

세션의 원격 끝에 사용할 ASN을 지정합니다. 이 필드를 사용하는 경우 |

|

|

|

명시적으로 설정하지 않고 세션의 원격 끝에 사용할 ASN을 감지합니다. 동일한 ASN이 있는 인접지의 |

|

|

|

세션을 설정할 IP 주소를 지정합니다. 이 필드를 사용하는 경우 |

|

|

| 세션을 설정할 때 사용할 인터페이스 이름을 지정합니다. 이 필드를 사용하여 번호가 지정되지 않은 BGP 피어링을 구성합니다. 두 BGP 피어 간에 지점 간 계층 2 연결이 있어야 합니다. IPv4, IPv6 또는 듀얼 스택과 함께 번호가 지정되지 않은 BGP 피어링을 사용할 수 있지만 IPv6 RAs(Router Advertisements)를 활성화해야 합니다. 각 인터페이스는 하나의 BGP 연결로 제한됩니다. |

|

|

| 세션을 설정할 때 사용할 포트를 지정합니다. 기본값은 179입니다. |

|

|

|

BGP 세션을 설정하는 데 사용할 암호를 지정합니다. |

|

|

|

피어에 대한 인증 시크릿의 이름을 지정합니다. 시크릿은 "kubernetes.io/basic-auth" 유형이어야 하며 FRR-K8s 데몬과 동일한 네임스페이스에 있어야 합니다. "password" 키는 암호를 시크릿에 저장합니다. |

|

|

| RFC4271에 따라 요청된 BGP 보류 시간을 지정합니다. 기본값은 180s입니다. |

|

|

|

RFC4271에 따라 요청된 BGP keepalive 시간을 지정합니다. 기본값은 |

|

|

| BGP가 인접한 연결 시도 사이에 대기하는 시간을 지정합니다. |

|

|

| BGPPeer가 멀티 홉 떨어져 있는지 여부를 나타냅니다. |

|

|

| BGP 세션과 연결된 BFD 세션에 사용할 BFD 프로필의 이름을 지정합니다. 설정되지 않은 경우 BFD 세션이 설정되지 않습니다. |

|

|

| 인접지 및 관련 속성에 알리는 접두사 목록을 나타냅니다.Represents the list of prefixes to advertise to a neighbor, and the associated properties. |

|

|

| 인접지에게 알리기 위한 접두사 목록을 지정합니다. 이 목록은 라우터에서 정의한 접두사와 일치해야 합니다. |

|

|

|

접두사를 처리할 때 사용할 모드를 지정합니다. 접두사 목록의 접두사만 허용하도록 |

|

|

| 공개된 로컬 기본 설정과 연결된 접두사를 지정합니다. 광고할 수 있도록 허용된 접두사에 로컬 기본 설정과 연결된 접두사를 지정해야 합니다. |

|

|

| 로컬 기본 설정과 연결된 접두사를 지정합니다. |

|

|

| 접두사와 연결된 로컬 기본 설정을 지정합니다. |

|

|

| 공개된 BGP 커뮤니티와 관련된 접두사를 지정합니다. 광고하려는 접두사 목록에 로컬 기본 설정과 연결된 접두사를 포함해야 합니다. |

|

|

| 커뮤니티와 연결된 접두사를 지정합니다. |

|

|

| 접두사와 연결된 커뮤니티를 지정합니다. |

|

|

| 인접자로부터 수신할 접두사를 지정합니다. |

|

|

| 인접자로부터 수신하려는 정보를 지정합니다. |

|

|

| 인접지에서 허용되는 접두사를 지정합니다. |

|

|

|

접두사를 처리할 때 사용할 모드를 지정합니다. |

|

|

| IPv4 및 IPv6 경로 교환을 별도의 BGP 세션으로 분리하지 못하도록 MP BGP를 비활성화합니다. |

|

|

| 이 라우터 인스턴스에서 알릴 접두사를 모두 지정합니다. |

|

|

| 토론을 구성할 때 사용할 bfd 프로필 목록을 지정합니다. |

|

|

| 구성의 다른 부분에서 참조할 BFD 프로필의 이름입니다. |

|

|

|

이 시스템에서 제어 패킷을 수신할 수 있는 최소 간격(밀리초)을 지정합니다. 기본값은 |

|

|

|

이 시스템에서 BFD 제어 패킷을 밀리초 단위로 보내는 데 사용할 최소 전송 간격을 지정합니다. 기본값은 |

|

|

| 패킷 손실을 확인하기 위해 감지 수를 구성합니다. 연결 손실 감지 타이머를 확인하려면 원격 전송 간격을 이 값으로 곱합니다. |

|

|

|

이 시스템에서 처리할 수 있는 최소 에코 수신 전송 간격을 밀리초 단위로 구성합니다. 기본값은 |

|

|

| 에코 전송 모드를 활성화하거나 비활성화합니다. 이 모드는 기본적으로 비활성화되어 있으며 멀티 홉 설정에서 지원되지 않습니다. |

|

|

| 세션을 패시브로 표시합니다. 수동 세션은 연결을 시작하지 않고 응답을 시작하기 전에 피어의 제어 패킷을 기다립니다. |

|

|

| 멀티 홉 세션만 사용할 수 있습니다. 들어오는 BFD 제어 패킷에 대해 예상되는 최소 TTL을 구성합니다. |

|

|

| 이 구성을 적용하려는 노드를 제한합니다. 지정된 경우 라벨이 지정된 선택기와 일치하는 노드만 구성을 적용하려고 합니다. 지정하지 않으면 모든 노드에서 이 구성을 적용하려고 합니다. |

|

|

| FRRConfiguration의 관찰 상태를 정의합니다. |

5.2. BGP 라우팅 활성화

클러스터 관리자는 클러스터에 대한 OVN-Kubernetes BGP(Border Gateway Protocol) 라우팅 지원을 활성화할 수 있습니다.

5.2.1. BGP(Border Gateway Protocol) 라우팅 활성화

클러스터 관리자는 베어 메탈 인프라에서 클러스터에 대한 BGP(Border Gateway Protocol) 라우팅 지원을 활성화할 수 있습니다.

MetalLB Operator와 함께 BGP 라우팅을 사용하는 경우 필요한 BGP 라우팅 지원이 자동으로 활성화됩니다. BGP 라우팅 지원을 수동으로 활성화할 필요가 없습니다.

5.2.1.1. BGP 라우팅 지원 활성화

클러스터 관리자는 클러스터에 대한 BGP 라우팅 지원을 활성화할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin역할의 사용자로 클러스터에 로그인되어 있습니다. - 클러스터는 호환 가능한 인프라에 설치됩니다.

프로세스

동적 라우팅 공급자를 활성화하려면 다음 명령을 입력합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. BGP 라우팅 비활성화

클러스터 관리자는 클러스터에 대한 OVN-Kubernetes BGP(Border Gateway Protocol) 라우팅 지원을 활성화할 수 있습니다.

5.3.1. BGP(Border Gateway Protocol) 라우팅 비활성화

클러스터 관리자는 베어 메탈 인프라에서 클러스터에 대한 BGP(Border Gateway Protocol) 라우팅 지원을 비활성화할 수 있습니다.

5.3.1.1. BGP 라우팅 지원 활성화

클러스터 관리자는 클러스터에 대한 BGP 라우팅 지원을 비활성화할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin역할의 사용자로 클러스터에 로그인되어 있습니다. - 클러스터는 호환 가능한 인프라에 설치됩니다.

프로세스

동적 라우팅을 비활성화하려면 다음 명령을 입력합니다.

oc patch Network.operator.openshift.io/cluster --type=merge -p '{ "spec": { "additionalRoutingCapabilities": null } }'$ oc patch Network.operator.openshift.io/cluster --type=merge -p '{ "spec": { "additionalRoutingCapabilities": null } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. FRR-K8s 리소스 마이그레이션

OpenShift Container Platform 4.17 및 이전 릴리스의 metallb-system 네임스페이스에 있는 모든 사용자가 생성한 FRR-K8s CR(사용자 정의 리소스)은 openshift-frr-k8s 네임스페이스로 마이그레이션해야 합니다. 클러스터 관리자는 이 절차의 단계를 완료하여 FRR-K8s 사용자 정의 리소스를 마이그레이션합니다.

5.4.1. FRR-K8s 리소스 마이그레이션

FRR-K8s FRRConfiguration 사용자 정의 리소스를 metallb-system 네임스페이스에서 openshift-frr-k8s 네임스페이스로 마이그레이션할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin역할의 사용자로 클러스터에 로그인되어 있습니다.

프로세스

Metal LB Operator가 배포된 이전 버전의 OpenShift Container Platform에서 업그레이드할 때 사용자 정의 FRRConfiguration 구성을 metallb-system 네임스페이스에서 openshift-frr-k8s 네임스페이스로 수동으로 마이그레이션해야 합니다. 이러한 CR을 이동하려면 다음 명령을 입력합니다.

openshift-frr-k8s네임스페이스를 생성하려면 다음 명령을 입력합니다.oc create namespace openshift-frr-k8s

$ oc create namespace openshift-frr-k8sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 마이그레이션을 자동화하려면 다음 콘텐츠를 사용하여

migrate.sh라는 쉘 스크립트를 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 마이그레이션을 실행하려면 다음 명령을 실행합니다.

bash migrate.sh

$ bash migrate.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

마이그레이션이 성공했는지 확인하려면 다음 명령을 실행합니다.

oc get frrconfigurations.frrk8s.metallb.io -n openshift-frr-k8s

$ oc get frrconfigurations.frrk8s.metallb.io -n openshift-frr-k8sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

마이그레이션이 완료되면 metallb-system 네임스페이스에서 FRRConfiguration 사용자 정의 리소스를 제거할 수 있습니다.

6장. 경로 알림

6.1. 경로 알림 정보

이 기능은 OVN-Kubernetes 네트워크 플러그인에 대한 경로 알림 기능을 제공합니다. BGP(Border Gateway Router) 공급자가 필요합니다. 자세한 내용은 BGP 라우팅 정보를 참조하십시오.

6.1.1. Border Gateway Protocol을 사용하여 클러스터 네트워크 경로 광고

OVN-Kubernetes 네트워크 플러그인은 라우팅 알림이 활성화된 상태에서 기본 Pod 네트워크 및 CUDN(클러스터 사용자 정의) 네트워크에 대한 네트워크 경로 광고( EgressIPs 포함)를 지원하고 공급자 네트워크에서 기본 pod 네트워크 및 CUDN으로 경로를 가져옵니다. 공급자 네트워크에서 기본 Pod 네트워크 및 CUDN에서 공개된 IP 주소에 직접 연결할 수 있습니다.

예를 들어 기본 Pod 네트워크로 경로를 가져올 수 있으므로 더 이상 각 노드에서 경로를 수동으로 구성할 필요가 없습니다. 이전에는 routingViaHost 매개변수를 true 로 설정하고 각 노드의 경로를 수동으로 구성하여 유사한 구성에 근접할 수 있었습니다. 경로 알림을 사용하면 routingViaHost 매개변수가 false 로 설정된 상태에서 이 작업을 원활하게 수행할 수 있습니다.

클러스터의 Network 사용자 정의 리소스 CR에서 routingViaHost 매개변수를 true 로 설정할 수도 있지만 유사한 구성을 시뮬레이션하려면 각 노드의 경로를 수동으로 구성해야 합니다. 경로 알림을 활성화하면 각 노드 하나씩 수동으로 경로를 구성하지 않고도 Network CR에 routingViaHost=false 를 설정할 수 있습니다.

공급자 네트워크의 경로 리플렉터가 지원되며 대규모 네트워크에서 경로를 알리는 데 필요한 BGP 연결 수를 줄일 수 있습니다.

경로 알림 활성화와 함께 EgressIP를 사용하는 경우 계층 3 공급자 네트워크는 EgressIP 페일오버를 인식합니다. 즉, 다른 계층 2 세그먼트에서 EgressIP를 호스팅하는 클러스터 노드를 찾을 수 있지만 계층 2 공급자 네트워크만 인식하기 전에 모든 송신 노드가 동일한 계층 2 세그먼트에 있어야 했습니다.

6.1.1.1. 지원되는 플랫폼

BGP(Border Gateway Protocol)를 사용하는 광고 경로는 베어 메탈 인프라 유형에서 지원됩니다.

6.1.1.2. 인프라 요구사항

라우팅 알림을 사용하려면 네트워크 인프라에 대해 BGP를 구성해야 합니다. 네트워크 인프라의 중단 또는 잘못된 구성으로 인해 클러스터 네트워크가 중단될 수 있습니다.

6.1.1.3. 다른 네트워킹 기능과의 호환성

경로 알림은 다음 OpenShift Container Platform 네트워킹 기능을 지원합니다.

- 여러 외부 게이트웨이(MEG)

- 이 기능에서는 MEG가 지원되지 않습니다.

- EgressIPs

EgressIP의 사용 및 알림을 지원합니다. 송신 IP 주소가 있는 노드는 EgressIP를 알립니다. 송신 IP 주소는 송신 노드와 동일한 계층 2 네트워크 서브넷에 있어야 합니다. 다음과 같은 제한 사항이 적용됩니다.

- 계층 2 모드에서 작동하는 CUDN(사용자 정의 네트워크)의 EgressIP는 지원되지 않습니다.

- 추가 네트워크 인터페이스에 할당된 송신 IP 주소와 송신 IP 주소가 모두 할당된 네트워크의 EgressIP는 비현실적입니다. 모든 EgressIP는 EgressIP가 할당되는 것과 동일한 인터페이스를 통해 이러한 세션이 설정되는지 여부에 관계없이 선택한 FRRConfiguration 인스턴스의 모든 BGP 세션에 광고되며 이로 인해 원하지 않는 광고가 발생할 수 있습니다.

- 서비스

- MetalLB Operator와 함께 작동하여 공급자 네트워크에 서비스를 알립니다.

- 송신 서비스

- 완전 지원.

- 송신 방화벽

- 완전 지원.

- 송신 QoS

- 완전 지원.

- 네트워크 정책

- 완전 지원.

- 직접 Pod 수신

- 기본 클러스터 네트워크 및 CUDN(클러스터 사용자 정의) 네트워크에 대한 완전한 지원

6.1.1.4. MetalLB Operator와 함께 사용할 고려 사항

MetalLB Operator는 클러스터에 대한 애드온으로 설치됩니다. MetalLB Operator를 배포하면 FRR-K8s를 추가 라우팅 기능 공급자로 자동으로 활성화합니다. 이 기능과 MetalLB Operator는 동일한 FRR-K8s 배포를 사용합니다.

6.1.1.5. 클러스터 사용자 정의 네트워크 이름 지정 (CUDN) 고려 사항

FRRConfiguration CR에서 VRF 장치를 참조할 때 VRF 이름은 15자 미만의 VRF 이름의 CUDN 이름과 동일합니다. VRF 이름을 CUDN 이름에서 유추할 수 있도록 VRF 이름을 15자를 넘지 않는 것이 좋습니다.

6.1.1.6. BGP 라우팅 사용자 정의 리소스

다음 CR(사용자 정의 리소스)은 BGP를 사용하여 경로 알림을 구성하는 데 사용됩니다.

RouteAdvertisements-

이 CR은 BGP 라우팅에 대한 알림을 정의합니다. 이 CR에서 OVN-Kubernetes 컨트롤러는 클러스터 네트워크 경로를 알리도록 FRR 데몬을 구성하는

FRRConfiguration오브젝트를 생성합니다. 이 CR은 클러스터 범위입니다. FRRConfiguration-

이 CR은 BGP 피어를 정의하고 공급자 네트워크에서 클러스터 네트워크로 경로 가져오기를 구성하는 데 사용됩니다.

RouteAdvertisements오브젝트를 적용하기 전에 BGP 피어를 구성하기 위해 처음에 하나 이상의 FRRConfiguration 오브젝트를 정의해야 합니다. 이 CR은 네임스페이스가 지정됩니다.

6.1.1.7. FRRConfiguration 오브젝트의 OVN-Kubernetes 컨트롤러 생성

FRRConfiguration 오브젝트는 각 노드에 적용되는 적절한 광고 접두사를 사용하여 RouteAdvertisements CR에서 선택한 각 네트워크 및 노드에 대해 생성됩니다. OVN-Kubernetes 컨트롤러는 RouteAdvertisements-CR 선택 노드가 RouteAdvertisements-CR-selected FRR 구성에서 선택한 노드의 서브 세트인지 확인합니다.

수신할 접두사의 모든 필터링 또는 선택은 RouteAdvertisement CR에서 생성된 FRRConfiguration 오브젝트에서는 고려되지 않습니다. 다른 FRRConfiguration 개체에서 수신하도록 접두사를 구성합니다. OVN-Kubernetes는 VRF에서 적절한 네트워크로 경로를 가져옵니다.

6.1.1.8. CNO(Cluster Network Operator) 구성

CNO(Cluster Network Operator) API는 여러 필드를 노출하여 경로 알림을 구성합니다.

-

spec.additionalRoutingCapabilities.providers: 경로를 알리는 데 필요한 추가 라우팅 공급자를 지정합니다. 지원되는 유일한 값은FRR-K8S 데몬을 클러스터에 배포할 수 있는 FRR입니다. 활성화되면 FRR-K8S 데몬이 모든 노드에 배포됩니다. -

spec.defaultNetwork.ovnKubernetesConfig.routeAdvertisements: 기본 클러스터 네트워크 및 CUDN 네트워크에 대한 경로 알림을 활성화합니다. 이 기능을 활성화하려면spec.additionalRoutingCapabilities필드를FRR로 설정해야 합니다.

6.1.2. RouteAdvertisements 오브젝트 구성

다음 속성을 사용하여 클러스터 범위인 RouteAdvertisements 오브젝트를 정의할 수 있습니다.

RouteAdvertisements CR(사용자 정의 리소스)의 필드는 다음 표에 설명되어 있습니다.

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

|

|

|

|

|

알릴 다양한 유형의 네트워크 목록을 포함할 수 있는 배열을 지정합니다. |

|

|

|

OVN-Kubernetes 기반 |

|

|

| 기본 클러스터 네트워크 및 클러스터 사용자 정의 네트워크(CUDN)에서 알릴 네트워크를 지정합니다. |

|

|

|

선택한 노드로 알림을 제한합니다. advertisement |

|

|

|

에서 경로를 알릴 라우터를 결정합니다. 경로는 선택한 |

6.1.3. BGP를 사용한 Pod IP 주소 광고의 예

다음 예제에서는 BGP(Border Gateway Protocol)를 사용하여 Pod IP 주소 및 EgressIP를 알리기 위한 몇 가지 구성을 설명합니다. 외부 네트워크 테두리 라우터에는 172.18.0.5 IP 주소가 있습니다. 이러한 구성에서는 클러스터 네트워크의 모든 노드로 경로를 릴레이할 수 있는 외부 경로 리플렉션을 구성했다고 가정합니다.

6.1.3.1. 기본 클러스터 네트워크 알림

이 시나리오에서는 기본 클러스터 네트워크가 외부 네트워크에 노출되므로 Pod IP 주소와 EgressIP가 공급자 네트워크에 광고됩니다.

이 시나리오는 다음 FRRConfiguration 오브젝트에 의존합니다.

FRRConfiguration CR

OVN-Kubernetes 컨트롤러에서 이 RouteAdvertisements CR을 볼 때 기본 클러스터 네트워크의 경로를 알리기 위해 선택한 FRR 데몬을 기반으로 추가 FRRConfiguration 개체를 생성합니다.

OVN-Kubernetes에서 생성된 FRRConfiguration CR의 예

생성된 FRRConfiguration 오브젝트에서 < default_network_host_subnet >은 공급자 네트워크에 알리는 기본 클러스터 네트워크의 서브넷입니다.

6.1.3.2. BGP를 통해 클러스터 사용자 정의 네트워크에서 Pod IP 광고

이 시나리오에서는 Blue 클러스터 사용자 정의 네트워크(CUDN)가 외부 네트워크에 노출되므로 네트워크의 Pod IP 주소 및 EgressIP가 공급자 네트워크에 광고됩니다.

이 시나리오는 다음 FRRConfiguration 오브젝트에 의존합니다.

FRRConfiguration CR

이 FRRConfiguration 오브젝트를 사용하면 인접한 172.18.0.5 에서 기본 VRF로 경로를 가져오고 기본 클러스터 네트워크에서 사용할 수 있습니다.

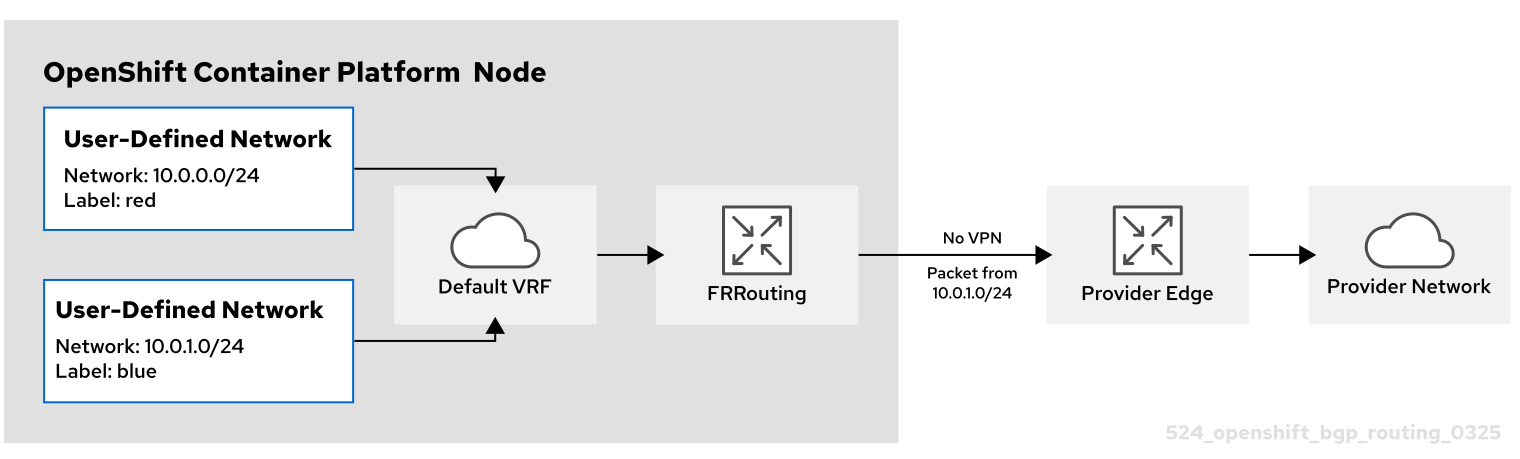

다음 다이어그램에 설명된 대로 CUDN은 기본 VRF를 통해 광고됩니다.

- Red CUDN

-

빨간색이라는 CUDN과 연결된redVRF라는 VRF -

서브넷

10.0.0.0/24

-

- Blue CUDN

-

blue라는 CUDN과 연결된blue라는 VRF -

10.0.1.0/24서브넷

-

이 구성에서는 별도의 두 개의 CUDN이 정의됩니다. 빨간색 네트워크는 10.0.0.0/24 서브넷을 처리하고 blue 네트워크는 10.0.1.0/24 서브넷을 다룹니다. 빨간색 및 파란색 네트워크는 export: true 로 레이블이 지정됩니다.

다음 RouteAdvertisements CR은 빨간색 및 파란색 테넌트에 대한 구성을 설명합니다.

빨간색 및 파란색 테넌트에 대한 RouteAdvertisements CR

OVN-Kubernetes 컨트롤러에서 이 RouteAdvertisements CR을 볼 때 해당 경로를 알리기 위해 선택한 FRR 데몬을 기반으로 추가 FRRConfiguration 오브젝트를 생성합니다. 다음 예제는 선택된 노드 및 네트워크에 따라 생성된 FRRConfiguration 오브젝트 수를 사용하여 이러한 구성 오브젝트 중 하나입니다.

OVN-Kubernetes에서 생성된 FRRConfiguration CR의 예

생성된 FRRConfiguration 오브젝트는 네트워크 blue에 속하는 서브넷 10.0.1.0/24 를 구성하여 기본 VRF로 가져오고 172.18.0.5 인접자에게 광고합니다. FRRConfiguration 오브젝트는 각 노드에 적용되는 적절한 접두사를 사용하여 RouteAdvertisements CR에서 선택한 각 네트워크 및 노드에 대해 생성됩니다.

targetVRF 필드를 생략하면 경로가 유출되고 기본 VRF를 통해 광고됩니다. 또한 초기 FRRConfiguration 오브젝트 정의 후 기본 VRF로 가져온 경로도 blue VRF로 가져옵니다.

6.1.3.3. VPN을 사용하여 BGP를 통해 클러스터 사용자 정의 네트워크에서 Pod IP 광고

이 시나리오에서는 VLAN 인터페이스가 파란색 네트워크와 연결된 VRF 장치에 연결됩니다. 이 설정은 VRF lite 설계를 제공합니다. 여기서 FRR-K8S는 파란색 네트워크 VRF/VLAN 링크의 해당 BGP 세션을 다음 홉 제공 에지(PE) 라우터에 통해서만 파란색 네트워크를 알리는 데 사용됩니다. 빨간색 테넌트는 동일한 구성을 사용합니다. 파란색 및 빨간색 네트워크는 export: true 로 레이블이 지정됩니다.

이 시나리오에서는 EgressIP 사용을 지원하지 않습니다.

다음 다이어그램에서는 이 구성을 보여줍니다.

- Red CUDN

-

빨간색이라는 CUDN과 연결된redVRF라는 VRF - VRF 장치에 연결되어 외부 PE 라우터에 연결된 VLAN 인터페이스

-

10.0.2.0/24의 할당된 서브넷

-

- Blue CUDN

-

blue라는 CUDN과 연결된blue라는 VRF - VRF 장치에 연결되어 외부 PE 라우터에 연결된 VLAN 인터페이스

-

10.0.1.0/24의 할당된 서브넷

-

이 방법은 OVN-Kubernetes 네트워크 플러그인의 ovnKubernetesConfig.gatewayConfig 사양에 routingViaHost=true 를 설정하는 경우에만 사용할 수 있습니다.

다음 구성에서 추가 FRRConfiguration CR은 파란색 및 빨간색 VLAN의 PE 라우터로 피어링을 구성합니다.

BGP VPN 설정을 위해 수동으로 구성된 FRRConfiguration CR

다음 RouteAdvertisements CR은 파란색 및 빨간색 테넌트에 대한 구성을 설명합니다.

Blue 및 빨간색 테넌트에 대한 RouteAdvertisements CR

RouteAdvertisements CR에서 targetVRF 가 auto 로 설정되어 선택한 개별 네트워크에 해당하는 VRF 장치 내에서 알림이 발생합니다. 이 시나리오에서는 blue의 Pod 서브넷이 Blue VRF 장치를 통해 알려지고 빨간색의 pod 서브넷은 빨간색 VRF 장치를 통해 광고됩니다. 또한 각 BGP 세션은 초기 FRRConfiguration 개체에서 정의한 대로 해당 CUDN VRF로만 경로를 가져옵니다.

OVN-Kubernetes 컨트롤러에서 이 RouteAdvertisements CR을 볼 때 파란색 및 빨간색 테넌트의 경로를 알리도록 FRR 데몬을 구성하는 선택된 항목을 기반으로 추가 FRRConfiguration 개체를 생성합니다.

Blue 및 빨간색 테넌트를 위해 OVN-Kubernetes에서 생성한 FRRConfiguration CR

이 시나리오에서는 피어링 관계를 정의하는 FRRConfiguration CR에서 수신할 경로 필터링 또는 선택을 수행해야 합니다.

6.2. 경로 알림 활성화

클러스터 관리자는 클러스터에 대한 추가 경로 알림을 구성할 수 있습니다. OVN-Kubernetes 네트워크 플러그인을 사용해야 합니다.

6.2.1. 경로 알림 활성화

클러스터 관리자는 클러스터에 대한 추가 라우팅 지원을 활성화할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin역할의 사용자로 클러스터에 로그인되어 있습니다. - 클러스터는 호환 가능한 인프라에 설치됩니다.

프로세스

라우팅 공급자 및 추가 경로 알림을 활성화하려면 다음 명령을 입력합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3. 경로 알림 비활성화

클러스터 관리자는 클러스터에 대한 추가 경로 알림을 비활성화할 수 있습니다.

6.3.1. 경로 알림 비활성화

클러스터 관리자는 클러스터에 대한 추가 경로 알림을 비활성화할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin역할의 사용자로 클러스터에 로그인되어 있습니다. - 클러스터는 호환 가능한 인프라에 설치됩니다.

프로세스

추가 라우팅 지원을 비활성화하려면 다음 명령을 입력합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4. 경로 알림 설정 예

클러스터 관리자는 클러스터에 대한 다음 예제 경로 알림 설정을 구성할 수 있습니다. 이 구성은 경로 알림을 구성하는 방법을 보여주는 샘플로 사용됩니다.

6.4.1. 샘플 경로 알림 설정

클러스터 관리자는 클러스터에 대한 BGP(Border Gateway Protocol) 라우팅 지원을 활성화할 수 있습니다. 이 구성은 경로 알림을 구성하는 방법을 보여주는 샘플로 사용됩니다. 구성은 전체 메시 설정이 아닌 경로 리플렉션을 사용합니다.

BGP 라우팅은 베어 메탈 인프라에서만 지원됩니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 클러스터에 로그인합니다. - 클러스터는 베어 메탈 인프라에 설치됩니다.

- FRR 데몬 컨테이너를 실행하려는 클러스터에 액세스할 수 있는 베어 메탈 시스템이 있어야 합니다.

프로세스

다음 명령을 실행하여

RouteAdvertisements기능 게이트가 활성화되어 있는지 확인합니다.oc get featuregate -oyaml | grep -i routeadvertisement

$ oc get featuregate -oyaml | grep -i routeadvertisementCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

- name: RouteAdvertisements

- name: RouteAdvertisementsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 CNO(Cluster Network Operator)를 구성합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow CNO가 모든 노드를 다시 시작하는 데 몇 분이 걸릴 수 있습니다.

다음 명령을 실행하여 노드의 IP 주소를 가져옵니다.

oc get node -owide

$ oc get node -owideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 각 노드의 기본 Pod 네트워크를 가져옵니다.

oc get node <node_name> -o=jsonpath={.metadata.annotations.k8s\\.ovn\\.org/node-subnets}$ oc get node <node_name> -o=jsonpath={.metadata.annotations.k8s\\.ovn\\.org/node-subnets}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

{"default":["10.129.0.0/23"],"ns1.udn-network-primary-layer3":["10.150.6.0/24"]}{"default":["10.129.0.0/23"],"ns1.udn-network-primary-layer3":["10.150.6.0/24"]}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 베어 메탈 하이퍼바이저에서 다음 명령을 실행하여 사용할 외부 FRR 컨테이너의 IP 주소를 가져옵니다.

ip -j -d route get <a cluster node's IP> | jq -r '.[] | .dev' | xargs ip -d -j address show | jq -r '.[] | .addr_info[0].local'

$ ip -j -d route get <a cluster node's IP> | jq -r '.[] | .dev' | xargs ip -d -j address show | jq -r '.[] | .addr_info[0].local'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예와 같이 각 노드의 IP 주소를 포함하는 FRR용

frr.conf파일을 만듭니다.frr.conf구성 파일 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 콘텐츠가 포함된

데몬이라는 파일을 생성합니다.데몬구성 파일 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

frr.conf와데몬파일을 모두 동일한 디렉토리에 저장합니다(예:/tmp/frr). 다음 명령을 실행하여 외부 FRR 컨테이너를 생성합니다.

sudo podman run -d --privileged --network host --rm --ulimit core=-1 --name frr --volume /tmp/frr:/etc/frr quay.io/frrouting/frr:9.1.0

$ sudo podman run -d --privileged --network host --rm --ulimit core=-1 --name frr --volume /tmp/frr:/etc/frr quay.io/frrouting/frr:9.1.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음

FRRConfiguration및RouteAdvertisements구성을 생성합니다.다음 콘텐츠를 포함하는

receive_all.yaml파일을 생성합니다.receive_all.yaml구성 파일의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 콘텐츠가 포함된

ra.yaml파일을 생성합니다.ra.yaml구성 파일의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow

다음 명령을 실행하여

receive_all.yaml및ra.yaml파일을 적용합니다.for f in receive_all.yaml ra.yaml; do oc apply -f $f; done

$ for f in receive_all.yaml ra.yaml; do oc apply -f $f; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

구성이 적용되었는지 확인합니다.

다음 명령을 실행하여

FRRConfiguration구성이 생성되었는지 확인합니다.oc get frrconfiguration -A

$ oc get frrconfiguration -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

RouteAdvertisements구성이 생성되었는지 확인합니다.oc get ra -A

$ oc get ra -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME STATUS default Accepted

NAME STATUS default AcceptedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

다음 명령을 실행하여 외부 FRR 컨테이너 ID를 가져옵니다.

sudo podman ps | grep frr

$ sudo podman ps | grep frrCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

22cfc713890e quay.io/frrouting/frr:9.1.0 /usr/lib/frr/dock... 5 hours ago Up 5 hours ago frr

22cfc713890e quay.io/frrouting/frr:9.1.0 /usr/lib/frr/dock... 5 hours ago Up 5 hours ago frrCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이전 단계에서 얻은 컨테이너 ID를 사용하여 외부 FRR 컨테이너의

vtysh세션의 BGP 주변 및 경로를 확인합니다. 다음 명령을 실행합니다.sudo podman exec -it <container_id> vtysh -c "show ip bgp"

$ sudo podman exec -it <container_id> vtysh -c "show ip bgp"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 각 클러스터 노드에 대해

frr-k8sPod를 찾습니다.oc -n openshift-frr-k8s get pod -owide

$ oc -n openshift-frr-k8s get pod -owideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform 클러스터에서 다음 명령을 실행하여 FRR 컨테이너의 클러스터 노드의

frr-k8sPod에서 BGP 경로를 확인합니다.oc -n openshift-frr-k8s -c frr rsh frr-k8s-86wmq

$ oc -n openshift-frr-k8s -c frr rsh frr-k8s-86wmqCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 클러스터 노드의 IP 경로를 확인합니다.

vtysh

sh-5.1# vtyshCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Hello, this is FRRouting (version 8.5.3). Copyright 1996-2005 Kunihiro Ishiguro, et al.

Hello, this is FRRouting (version 8.5.3). Copyright 1996-2005 Kunihiro Ishiguro, et al.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 IP 경로를 확인합니다.

worker-2# show ip bgp

worker-2# show ip bgpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform 클러스터에서 다음 명령을 실행하여 노드를 디버깅합니다.

oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Temporary namespace openshift-debug-lbtgh is created for debugging node... Starting pod/worker-2-debug-zrg4v ... To use host binaries, run `chroot /host` Pod IP: 192.168.111.25 If you don't see a command prompt, try pressing enter.

Temporary namespace openshift-debug-lbtgh is created for debugging node... Starting pod/worker-2-debug-zrg4v ... To use host binaries, run `chroot /host` Pod IP: 192.168.111.25 If you don't see a command prompt, try pressing enter.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 BGP 경로가 광고되고 있는지 확인합니다.

ip route show | grep bgp

sh-5.1# ip route show | grep bgpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7장. PTP 하드웨어 사용

7.1. OpenShift 클러스터 노드의 PTP 정보

PTP(Precision Time Protocol)는 네트워크의 클럭을 동기화하는 데 사용됩니다. 하드웨어 지원과 함께 사용할 경우 PTP는 마이크로초 미만의 정확성을 수행할 수 있으며 NTP(Network Time Protocol)보다 더 정확합니다.

PTP가 있는 openshift-sdn 클러스터에서 하드웨어 타임스탬프에 UDP(User Datagram Protocol)를 사용하고 OVN-Kubernetes 플러그인으로 마이그레이션하는 경우 OVS(Open vSwitch) 브리지와 같은 기본 인터페이스 장치에 하드웨어 타임스탬프를 적용할 수 없습니다. 결과적으로 UDP 버전 4 구성은 br-ex 인터페이스에서 작동할 수 없습니다.

OpenShift Container Platform 클러스터 노드에서 linuxptp 서비스를 구성하고 PTP 가능 하드웨어를 사용할 수 있습니다.

PTP Operator를 배포하여 OpenShift Container Platform 웹 콘솔 또는ocCLI(OpenShift CLI)를 사용하여 PTP를 설치합니다. PTP Operator는 linuxptp 서비스를 생성 및 관리하고 다음 기능을 제공합니다.

- 클러스터에서 PTP 가능 장치 검색.

-

linuxptp서비스의 구성 관리. -

PTP Operator

cloud-event-proxy사이드카를 사용하여 애플리케이션의 성능 및 안정성에 부정적인 영향을 주는 PTP 클록 이벤트 알림

PTP Operator는 베어 메탈 인프라에서만 프로비저닝된 클러스터에서 PTP 가능 장치와 함께 작동합니다.

7.1.1. PTP 도메인의 요소

PTP는 네트워크에 연결된 여러 노드를 각 노드의 클럭과 동기화하는 데 사용됩니다. PTP에 의해 동기화된 클록은 리더 후속 계층 구조로 구성됩니다. 계층 구조는 모든 클럭에서 실행되는 최상의 마스터 클럭(BMC) 알고리즘에 의해 자동으로 생성되고 업데이트됩니다. 후속 클럭은 리더 클록과 동기화되며 후속 클럭은 다른 다운스트림 클록의 소스가 될 수 있습니다.

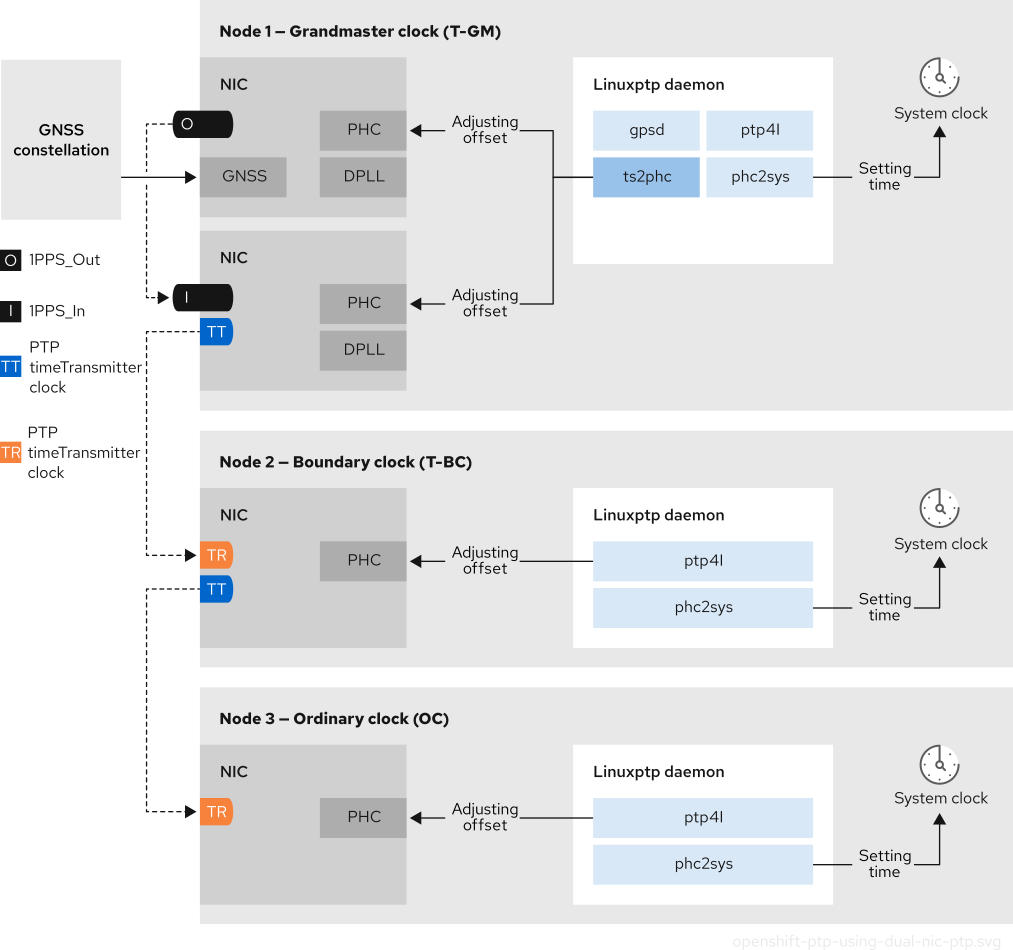

그림 7.1. 네트워크의 PTP 노드

다음은 3가지 기본 PTP 클록 유형에 대해 설명합니다.

- GRandmaster 클록

- 마스터 클록은 네트워크의 다른 클록에 표준 시간 정보를 제공하며 정확하고 안정적인 동기화를 보장합니다. 타임스탬프를 작성하고 다른 클록의 시간 요청에 응답합니다. Grandmaster 클럭은 GNSS(Global Navigation Satellite System) 시간 소스와 동기화됩니다. Grandmaster 클록은 네트워크에서 신뢰할 수 있는 시간 소스이며 다른 모든 장치에 시간 동기화를 제공할 책임이 있습니다.

- 경계 클록

- 경계 클록에는 두 개 이상의 통신 경로에 포트가 있으며, 동시에 소스와 다른 대상 클록의 대상일 수 있습니다. 경계 클록은 대상 클록으로 작동합니다. 대상 클럭이 타이밍 메시지를 수신하고 지연을 조정한 다음 네트워크를 전달하기 위한 새 소스 시간 신호를 생성합니다. 경계 클록은 소스 클록과 정확하게 동기화되는 새로운 타이밍 패킷을 생성하며 소스 클럭에 직접 보고하는 연결된 장치의 수를 줄일 수 있습니다.

- 일반 클록

- 일반 클록에는 네트워크의 위치에 따라 소스 또는 대상 클록의 역할을 수행할 수 있는 단일 포트가 연결되어 있습니다. 일반 클록은 타임스탬프를 읽고 쓸 수 있습니다.

7.1.1.1. NTP를 통한 PTP의 이점

PTP가 NTP를 능가하는 주요 이점 중 하나는 다양한 NIC(네트워크 인터페이스 컨트롤러) 및 네트워크 스위치에 있는 하드웨어 지원입니다. 특수 하드웨어를 사용하면 PTP가 메시지 전송 지연을 고려하여 시간 동기화의 정확성을 향상시킬 수 있습니다. 최대한의 정확성을 달성하려면 PTP 클록 사이의 모든 네트워킹 구성 요소를 PTP 하드웨어를 사용하도록 설정하는 것이 좋습니다.

NIC는 전송 및 수신 즉시 PTP 패킷을 타임스탬프할 수 있으므로 하드웨어 기반 PTP는 최적의 정확성을 제공합니다. 이를 운영 체제에서 PTP 패킷을 추가로 처리해야 하는 소프트웨어 기반 PTP와 비교합니다.

PTP를 활성화하기 전에 필수 노드에 대해 NTP가 비활성화되어 있는지 확인합니다. MachineConfig 사용자 정의 리소스를 사용하여 chrony 타임 서비스 (chronyd)를 비활성화할 수 있습니다. 자세한 내용은 chrony 타임 서비스 비활성화를 참조하십시오.

7.1.2. OpenShift Container Platform 노드에서 linuxptp 및 gpsd 개요

OpenShift Container Platform은 높은 정밀 네트워크 동기화를 위해 linuxptp 및 gpsd 패키지와 함께 PTP Operator를 사용합니다. linuxptp 패키지는 네트워크에서 PTP 타이밍을 위한 툴과 데몬을 제공합니다. GNSS(Global Navigation Satellite System)가 있는 클러스터 호스트는 gpsd 를 사용하여 GNSS 클럭 소스와 상호 작용할 수 있습니다.

linuxptp 패키지에는 시스템 클럭 동기화를 위한 ts2phc,pmc,ptp4l, phc2sys 프로그램이 포함되어 있습니다.

- ts2phc

ts2phc는 PTP 장치에서 PTP 하드웨어 클럭(PHC)을 높은 수준의 정확성으로 동기화합니다.ts2phc는 마스터 클록 구성에 사용됩니다. 정확한 타이밍은 GNSS(Global Navigation Satellite System)와 같은 높은 정확도의 클럭 소스를 신호로 수신합니다. GNSS는 대규모 분산 네트워크에서 사용하기 위해 정확하고 신뢰할 수 있는 동기화 시간 소스를 제공합니다. GNSS 클록은 일반적으로 몇 나노초의 정확도로 시간 정보를 제공합니다.ts2phc시스템 데몬은 할드마스터 클록에서 시간 정보를 읽고 CryostatC 형식으로 변환하여 네트워크의 다른 PTP 장치로 타이밍 정보를 보냅니다. CryostatC 시간은 네트워크의 다른 장치에서 시계를 마스터 클록과 동기화하는 데 사용됩니다.- pmc

-

PMC는 IEEE 표준 1588.1588에 따라 PTP 관리 클라이언트(pmc)를 구현합니다.PMC는ptp4l시스템 데몬에 대한 기본 관리 액세스를 제공합니다.PMC는 표준 입력에서 읽고 선택한 전송을 통해 출력을 전송하여 수신하는 응답을 출력합니다. - ptp4l

ptp4l은 PTP 경계 클록과 일반 클록을 구현하고 시스템 데몬으로 실행됩니다.ptp4l은 다음을 수행합니다.- 하드웨어 타임스탬프를 사용하여 소스 클록과 synchronizes the source clock with hardware time stamping

- 소프트웨어 타임스탬프를 사용하여 시스템 클록을 소스 클록에 동기화

- phc2sys

-

phc2sys는 네트워크 인터페이스 컨트롤러(NIC)의 CryostatC에 시스템 시계를 동기화합니다.phc2sys시스템 데몬은 타이밍 정보를 지속적으로 모니터링합니다. 타이밍 오류를 감지하면 CryostatC가 시스템 시계를 수정합니다.

gpsd 패키지에는 호스트 클럭과 GNSS 클럭 동기화를 위한 ubxtool,gspipe,gpsd 프로그램이 포함되어 있습니다.

- ubxtool

-

ubxtoolCLI를 사용하면 u-blox GPS 시스템과 통신할 수 있습니다.ubxtoolCLI는 u-blox 바이너리 프로토콜을 사용하여 GPS와 통신합니다. - gpspipe

-

gpspipe는gpsd출력에 연결하여stdout에 파이프합니다. - gpsd

-

GPSD는 호스트에 연결된 하나 이상의 GPS 또는 AIS 수신기를 모니터링하는 서비스 데몬입니다.

7.1.3. PTP 할 마스터 클록에 대한 GNSS 타이밍 개요

OpenShift Container Platform은 클러스터에서 GNSS(Global Navigation Satellite System) 소스 및 마스터 클록(T-GM)에서 정확한 PTP 타이밍을 수신할 수 있습니다.

OpenShift Container Platform은 Intel E810 Westport 채널 NIC가 있는 GNSS 소스의 PTP 타이밍만 지원합니다.

그림 7.2. GNSS 및 T-GM과의 동기화 개요

- GNSS(Global navigation Satellite System)

GNSS는 전 세계 수신기에 위치 지정, 탐색 및 타이밍 정보를 제공하는 데 사용되는 Satellite 기반 시스템입니다. PTP에서 GNSS 수신기는 종종 매우 정확하고 안정적인 참조 클록 소스로 사용됩니다. 이러한 수신기는 여러 GNSS Satellite에서 신호를 수신하므로 정확한 시간 정보를 계산할 수 있습니다. GNSS에서 얻은 타이밍 정보는 PTP 할 마스터 클록에 의해 참조로 사용됩니다.

GNSS를 참조로 사용하면 PTP 네트워크의 마스터 클록은 다른 장치에 매우 정확한 타임스탬프를 제공하여 전체 네트워크에서 정확한 동기화를 가능하게 할 수 있습니다.

- Digital Phase-Locked Cryostat (DPLL)

- DPLL은 네트워크의 다양한 PTP 노드 간에 클럭 동기화를 제공합니다. DPLL은 로컬 시스템 클럭 신호의 단계를 들어오는 동기화 신호의 단계와 비교합니다(예: PTP 할 마스터 클록에서 PTP 메시지). DPLL은 로컬 클럭과 참조 클록 사이의 단계 차이를 최소화하기 위해 현지 클록 빈도 및 단계를 지속적으로 조정합니다.

7.1.3.1. GNSS 동기화 PTP grandmaster 클록에서 윤초 이벤트 처리

윤초는 국제 Atomic Time(TAI)과 동기화된 유지를 위해 UTC(Coordinated Universal Time)에 때때로 적용되는 1초 조정입니다. UTC 윤초는 예측할 수 없습니다. 국제적으로 합의된 윤초는 leap-seconds.list 에 나열됩니다. 이 파일은 IERS(International Earth Rotation and Reference Systems Service)에 의해 정기적으로 업데이트됩니다. 처리되지 않은 윤초는 훨씬 엣지 RAN 네트워크에 상당한 영향을 미칠 수 있습니다. 이를 통해 far edge RAN 애플리케이션이 즉시 음성 통화 및 데이터 세션의 연결을 끊을 수 있습니다.

7.1.4. PTP 및 클럭 동기화 오류 이벤트 정보

vRAN(가상 RAN)과 같은 클라우드 네이티브 애플리케이션에서는 전체 네트워크의 작동에 중요한 하드웨어 타이밍 이벤트에 대한 알림에 액세스해야 합니다. PTP 클럭 동기화 오류는 대기 시간이 짧은 애플리케이션의 성능 및 안정성에 부정적인 영향을 미칠 수 있습니다(예: 분산 장치(DU)에서 실행되는 vRAN 애플리케이션).

PTP 동기화 손실은 RAN 네트워크에 심각한 오류입니다. 노드에서 동기화가 손실된 경우 라디오가 종료될 수 있으며 네트워크 Over the Air (OTA) 트래픽이 무선 네트워크의 다른 노드로 이동될 수 있습니다. 클러스터 노드에서 PTP 클럭 동기화 상태를 DU에서 실행 중인 vRAN 애플리케이션에 통신할 수 있도록 함으로써 이벤트 알림이 워크로드 오류와 비교하여 완화됩니다.

이벤트 알림은 동일한 DU 노드에서 실행되는 vRAN 애플리케이션에서 사용할 수 있습니다. 게시/서브스크립션 REST API는 이벤트 알림을 메시징 버스에 전달합니다. 게시/서브스크립션 메시징 또는 pub-sub 메시징은 주제에 게시된 모든 메시지가 주제에 대한 모든 구독자에 의해 즉시 수신되는 비동기 서비스 간 통신 아키텍처입니다.

PTP Operator는 모든 PTP 가능 네트워크 인터페이스에 대한 빠른 이벤트 알림을 생성합니다. 소비자 애플리케이션은 PTP 이벤트 REST API v2를 사용하여 PTP 이벤트를 구독할 수 있습니다.

PTP 빠른 이벤트 알림은 PTP 일반 클럭, PTP 할 마스터 클록 또는 PTP 경계 클록을 사용하도록 구성된 네트워크 인터페이스에 사용할 수 있습니다.

7.1.5. 2 카드 E810 NIC 구성 참조

OpenShift Container Platform은 T-GM (T-GM) 및 경계 클럭 (T-BC)의 PTP 타이밍을 위해 단일 및 듀얼 NIC Intel E810 하드웨어를 지원합니다.

- 듀얼 NIC 할드 마스터 클록

듀얼 NIC 하드웨어가 있는 클러스터 호스트를 PTP 할 마스터 클록으로 사용할 수 있습니다. 하나의 NIC는 글로벌 탐색 Satellite 시스템(GNSS)에서 타이밍 정보를 수신합니다. 두 번째 NIC는 E810 NIC faceplate에서 SMA1 Tx/Rx 연결을 사용하여 첫 번째 NIC에서 타이밍 정보를 수신합니다. 클러스터 호스트의 시스템 클럭은 GNSS satellite에 연결된 NIC에서 동기화됩니다.

듀얼 NIC 할 마스터 클록은 RRU(Remote radio Unit) 및 BBU(Baseband Unit)가 동일한 라디오 셀 사이트에 있는 분산 RAN(D-RAN) 구성의 기능입니다. D-RAN은 여러 사이트에 라디오 기능을 배포하고 이를 코어 네트워크에 백홀 연결로 연결합니다.

그림 7.3. 듀얼 NIC 할드 마스터 클록

참고듀얼 NIC T-GM 구성에서 단일

ts2phc프로그램은 각 NIC에 대해 하나씩 두 개의 PTP 하드웨어 클럭(PHC)에서 작동합니다.- 듀얼 NIC 경계 클록

중반 대역(VDU)을 제공하는 5G 통신 네트워크의 경우 각 가상 분산 장치(vDU)는 6개의 무선 장치(RU)에 대한 연결이 필요합니다. 이러한 연결을 위해 각 vDU 호스트에는 경계 클록으로 구성된 두 개의 NIC가 필요합니다.

듀얼 NIC 하드웨어를 사용하면 각 NIC가 다운스트림 클록에 대해 별도의

ptp4l인스턴스를 사용하여 각 NIC를 동일한 업스트림 리더 클록에 연결할 수 있습니다.- 듀얼 NIC 경계 클럭을 사용하는 고가용성 시스템 클럭

Intel E810-XXVDA4 Salem 채널 듀얼 NIC 하드웨어를 고가용성 시스템 클록에 대한 타이밍을 제공하는 듀얼 PTP 경계 클록으로 구성할 수 있습니다. 이 구성은 다른 NIC에 여러 시간 소스가 있는 경우 유용합니다. 고가용성을 통해 두 타이밍 소스 중 하나가 손실되거나 연결이 끊어진 경우 노드가 타이밍 동기화를 손실하지 않습니다.

각 NIC는 동일한 업스트림 리더 클록에 연결됩니다. 고가용성 경계 클록은 여러 PTP 도메인을 사용하여 대상 시스템 클록과 동기화합니다. T-BC를 고가용성으로 사용할 수 있는 경우 NIC CryostatC 클럭을 동기화하는 하나 이상의

ptp4l인스턴스가 실패하더라도 호스트 시스템 클럭이 올바른 오프셋을 유지할 수 있습니다. 단일 SFP 포트 또는 케이블 오류가 발생하면 경계 클록은 리더 클록과 동기화됩니다.경계 클럭 리더 소스 선택은 A-BMCA 알고리즘을 사용하여 수행됩니다. 자세한 내용은 ITU-T 권장 사항 G.8275.1 을 참조하십시오.

7.1.6. 듀얼 포트 NIC를 사용하여 PTP 일반 클록의 중복 개선

OpenShift Container Platform은 PTP 타이밍에 대한 일반 클록으로 단일 포트 NIC(네트워크 인터페이스 카드)를 지원합니다. 중복성을 개선하기 위해 하나의 포트를 active로 사용하고 다른 하나는 대기 상태로 듀얼 포트 NIC를 구성할 수 있습니다.

이중 포트 NIC 중복을 사용하는 일반 클록으로 linuxptp 서비스를 구성하는 것은 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

이 구성에서 듀얼 포트 NIC의 포트는 다음과 같이 작동합니다.

-

활성 포트는

다음포트 상태에서 일반 클록으로 작동합니다. -

대기 포트는

Listening포트 상태에 남아 있습니다. - 활성 포트가 실패하면 대기 포트가 활성 상태로 전환되어 계속 PTP 타이밍 동기화를 보장합니다.

-

두 포트 모두 결함이 발생하면 클럭 상태가

HOLDOVER상태로 이동하면 리더 클록으로 다시 동기화되기 전에 holdover 제한 시간이 만료될 때 freeRUN상태가 됩니다.

7.1.6.1. 하드웨어 요구 사항

x86_64 또는 AArch64 아키텍처 노드에 중복성을 추가하여 PTP 일반 클록을 구성할 수 있습니다.

x86_64 아키텍처 노드의 경우 노드는 PTP를 지원하고 Intel E810과 같은 NIC당 단일 PTP 하드웨어 클럭(PHC)을 노출하는 듀얼 포트 NIC를 제공해야 합니다.

AArch64 아키텍처 노드의 경우 다음 듀얼 포트 NIC만 사용할 수 있습니다.

- NVIDIA ConnectX-7 시리즈

NIC 모드에서 NVIDIA BlueField-3 시리즈

- 인터페이스를 중복성이 향상된 일반 클록으로 구성하기 전에 NIC 모드에서 NVIDIA BlueField-3 시리즈 DPU를 구성해야 합니다. NIC 모드 구성에 대한 자세한 내용은 BlueField-3 (NVIDIA 문서), BlueField Management (NVIDIA 문서) 및 Host BIOS HII UEFI 메뉴 (NVIDIA 문서)에서 BlueField-3의 NIC 모드 구성 을 참조하십시오.

- NIC 모드로 변경한 후 카드를 다시 시작해야 합니다. 카드를 다시 시작하는 방법에 대한 자세한 내용은 NVIDIA BlueField Reset and Reboot Procedures (NVIDIA 문서)를 참조하십시오.

- 지원되는 최신 NVIDIA 드라이버 및 펌웨어를 사용하여 적절한 PTP 지원을 보장하고 NIC당 단일 CryostatC를 노출합니다.

7.1.7. 3-card Intel E810 PTP grandmaster 클록

OpenShift Container Platform은 Intel E810 NIC가 PTP grandmaster 클럭(T-GM)인 클러스터 호스트를 지원합니다.

- 3 카드 할드 마스터 클록

NIC가 3개인 클러스터 호스트를 PTP 할 마스터 클록으로 사용할 수 있습니다. 하나의 NIC는 글로벌 탐색 Satellite 시스템(GNSS)에서 타이밍 정보를 수신합니다. 두 번째 및 세 번째 NIC는 E810 NIC faceplate에서 SMA1 Tx/Rx 연결을 사용하여 첫 번째 NIC에서 타이밍 정보를 수신합니다. 클러스터 호스트의 시스템 클럭은 GNSS satellite에 연결된 NIC에서 동기화됩니다.

3- 카드 NIC 할 마스터 클록은 분산 RAN (D-RAN) 구성에 사용할 수 있습니다. 여기서 radio Unit (RU)는 프론트 haul 스위치없이 분산 장치 (DU)에 직접 연결되어 있습니다. 예를 들어 RU와 DU가 동일한 라디오 셀 사이트에 있는 경우입니다. D-RAN은 여러 사이트에 라디오 기능을 배포하고 이를 코어 네트워크에 백홀 연결로 연결합니다.

그림 7.4. 3-card Intel E810 PTP grandmaster 클록

참고3 카드 T-GM 구성에서 단일

ts2phc프로세스는 시스템의 3ts2phc인스턴스로 보고합니다.

7.2. PTP 장치 구성

PTP Operator는 NodePtpDevice.ptp.openshift.io CRD(custom resource definition)를 OpenShift Container Platform에 추가합니다.

설치 시 PTP Operator는 각 노드에서 PTP(Precision Time Protocol) 가능 네트워크 장치를 클러스터에서 검색합니다. Operator는 호환되는 PTP 가능 네트워크 장치를 제공하는 각 노드에 대해 NodePtpDevice CR(사용자 정의 리소스) 오브젝트를 생성하고 업데이트합니다.

기본 제공 PTP 기능이 있는 NIC(네트워크 인터페이스 컨트롤러) 하드웨어에는 장치별 구성이 필요한 경우가 있습니다. PtpConfig CR(사용자 정의 리소스)에서 플러그인을 구성하여 PTP Operator에서 지원되는 하드웨어에 하드웨어별 NIC 기능을 사용할 수 있습니다. linuxptp-daemon 서비스는 plugin 스탠자에서 named 매개 변수를 사용하여 특정 하드웨어 구성에 따라 linuxptp 프로세스 ptp4l 및 phc2sys 를 시작합니다.

OpenShift Container Platform 4.20에서 Intel E810 NIC는 PtpConfig 플러그인에서 지원됩니다.

7.2.1. CLI를 사용하여 PTP Operator 설치

클러스터 관리자는 CLI를 사용하여 Operator를 설치할 수 있습니다.

사전 요구 사항

- PTP를 지원하는 하드웨어가 있는 노드로 베어 메탈 하드웨어에 설치된 클러스터

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다.

프로세스

PTP Operator의 네임스페이스를 생성합니다.

다음 YAML을

ptp-namespace.yaml파일에 저장합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow NamespaceCR을 생성합니다.oc create -f ptp-namespace.yaml

$ oc create -f ptp-namespace.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

PTP Operator에 대한 Operator 그룹을 생성합니다.

다음 YAML을

ptp-operatorgroup.yaml파일에 저장합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow OperatorGroupCR을 생성합니다.oc create -f ptp-operatorgroup.yaml

$ oc create -f ptp-operatorgroup.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

PTP Operator에 등록합니다.

다음 YAML을

ptp-sub.yaml파일에 저장합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow SubscriptionCR을 생성합니다.oc create -f ptp-sub.yaml

$ oc create -f ptp-sub.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Operator가 설치되었는지 확인하려면 다음 명령을 입력합니다.

oc get csv -n openshift-ptp -o custom-columns=Name:.metadata.name,Phase:.status.phase

$ oc get csv -n openshift-ptp -o custom-columns=Name:.metadata.name,Phase:.status.phaseCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Name Phase 4.20.0-202301261535 Succeeded

Name Phase 4.20.0-202301261535 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.2. 웹 콘솔을 사용하여 PTP Operator 설치

클러스터 관리자는 웹 콘솔을 사용하여 PTP Operator를 설치할 수 있습니다.

이전 섹션에서 언급한 것처럼 네임스페이스 및 Operator group을 생성해야 합니다.

프로세스

OpenShift Container Platform 웹 콘솔을 사용하여 PTP Operator를 설치합니다.

- OpenShift Container Platform 웹 콘솔에서 에코시스템 → 소프트웨어 카탈로그 를 클릭합니다.

- 사용 가능한 Operator 목록에서 PTP Operator를 선택한 다음 설치를 클릭합니다.

- Operator 설치 페이지의 클러스터의 특정 네임스페이스에서 openshift-ptp를 선택합니다. 그런 다음, 설치를 클릭합니다.

선택 사항: PTP Operator가 설치되었는지 확인합니다.

- 에코시스템 → 설치된 Operator 페이지로 전환합니다.

PTP Operator가 openshift-ptp 프로젝트에 InstallSucceeded 상태로 나열되어 있는지 확인합니다.

참고설치 중에 Operator는 실패 상태를 표시할 수 있습니다. 나중에 InstallSucceeded 메시지와 함께 설치에 성공하면 이 실패 메시지를 무시할 수 있습니다.

Operator가 설치된 것으로 나타나지 않으면 다음과 같이 추가 문제 해결을 수행합니다.

- 에코시스템 → 설치된 Operator 페이지로 이동하여 Operator 서브스크립션 및 설치 계획 탭의 상태에 장애 또는 오류가 있는지 검사합니다.

-

Workloads → Pod 페이지로 이동하여

openshift-ptp프로젝트에서 Pod 로그를 확인합니다.

7.2.3. 클러스터에서 PTP 가능 네트워크 장치 검색

클러스터에 존재하는 PTP 가능 네트워크 장치를 식별하여 구성할 수 있습니다.

전제 조건

- PTP Operator를 설치했습니다.

프로세스

클러스터에서 PTP 가능 네트워크 장치의 전체 목록을 반환하려면 다음 명령을 실행합니다.

oc get NodePtpDevice -n openshift-ptp -o yaml

$ oc get NodePtpDevice -n openshift-ptp -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.4. linuxptp 서비스를 할 마스터 클록으로 구성

호스트 NIC를 구성하는 PtpConfig CR(사용자 정의 리소스)을 생성하여 linuxptp 서비스(ptp4l,phc2sys,ts2phc)를 마스터 클록(T-GM)으로 구성할 수 있습니다.

ts2phc 유틸리티를 사용하면 시스템 시계를 PTP 할 마스터 클록과 동기화하여 노드가 PTP 일반 클럭 및 경계 클록으로 정밀한 클럭을 스트리밍할 수 있습니다.

다음 예제 PtpConfig CR을 기반으로 하여 Intel Westport Channel E810-XXVDA4T 네트워크 인터페이스의 linuxptp 서비스를 T-GM으로 구성합니다.

PTP 빠른 이벤트를 구성하려면 ptp4lOpts,ptp4lConf 및 ptpClockThreshold 에 적절한 값을 설정합니다. ptpClockThreshold 는 이벤트가 활성화된 경우에만 사용됩니다. 자세한 내용은 " PTP 빠른 이벤트 알림 게시자 구성"을 참조하십시오.

사전 요구 사항

- 프로덕션 환경의 T-GM 클록의 경우 베어 메탈 클러스터 호스트에 Intel E810 Westport 채널 NIC를 설치합니다.

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다. - PTP Operator를 설치합니다.

프로세스

PtpConfigCR을 생성합니다. 예를 들면 다음과 같습니다.요구 사항에 따라 배포에 다음 T-GM 구성 중 하나를 사용하십시오. YAML을

grandmaster-clock-ptp-config.yaml파일에 저장합니다.예 7.1. E810 NIC의 PTP 마스터 클럭 구성

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고E810 Westport Channel NIC의 경우

ts2phc.nmea_serialport값을/dev/gnss0로 설정합니다.다음 명령을 실행하여 CR을 생성합니다.

oc create -f grandmaster-clock-ptp-config.yaml

$ oc create -f grandmaster-clock-ptp-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

PtpConfig프로필이 노드에 적용되었는지 확인합니다.다음 명령을 실행하여

openshift-ptp네임스페이스에서 Pod 목록을 가져옵니다.oc get pods -n openshift-ptp -o wide

$ oc get pods -n openshift-ptp -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE IP NODE linuxptp-daemon-74m2g 3/3 Running 3 4d15h 10.16.230.7 compute-1.example.com ptp-operator-5f4f48d7c-x7zkf 1/1 Running 1 4d15h 10.128.1.145 compute-1.example.com

NAME READY STATUS RESTARTS AGE IP NODE linuxptp-daemon-74m2g 3/3 Running 3 4d15h 10.16.230.7 compute-1.example.com ptp-operator-5f4f48d7c-x7zkf 1/1 Running 1 4d15h 10.128.1.145 compute-1.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 프로필이 올바른지 확인합니다.

PtpConfig프로필에 지정한 노드에 해당하는linuxptp데몬의 로그를 검사합니다. 다음 명령을 실행합니다.oc logs linuxptp-daemon-74m2g -n openshift-ptp -c linuxptp-daemon-container

$ oc logs linuxptp-daemon-74m2g -n openshift-ptp -c linuxptp-daemon-containerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.4.1. linuxptp 서비스를 2 E810 NIC의 할마스터 클록으로 구성

NIC를 구성하는 PtpConfig CR(사용자 정의 리소스)을 2 E810 NIC의 grandmaster 클럭(T-GM)으로 linuxptp 서비스(ptp4l,phc2sys,ts2phc)를 구성할 수 있습니다.

다음 E810 NIC의 경우 linuxptp 서비스를 T-GM으로 구성할 수 있습니다.

- Intel E810-XXVDA4T Westport 채널 NIC

- Intel E810-CQDA2T Logan Beach NIC

분산 RAN(D-RAN) 사용 사례의 경우 다음과 같이 2개의 NIC에 대해 PTP를 구성할 수 있습니다.

- NIC 1은 GNSS(Global navigation satellite System) 시간 소스와 동기화됩니다.

-

NIC 2는 NIC가 제공하는 1PPS 타이밍 출력과 동기화됩니다. 이 구성은

PtpConfigCR의 PTP 하드웨어 플러그인에서 제공합니다.

2 카드 PTP T-GM 구성에서는 ptp4l 의 인스턴스 1개와 ts2phc 의 인스턴스 1개를 사용합니다. ptp4l 및 ts2phc 프로그램은 각각 NIC마다 하나씩 두 개의 PTP 하드웨어 클럭(PHC)에서 작동하도록 구성됩니다. 호스트 시스템 클록은 GNSS 시간 소스에 연결된 NIC에서 동기화됩니다.

다음 예제 PtpConfig CR을 기반으로 하여 이중 Intel E810 네트워크 인터페이스의 경우 linuxptp 서비스를 T-GM으로 구성합니다.

PTP 빠른 이벤트를 구성하려면 ptp4lOpts,ptp4lConf 및 ptpClockThreshold 에 적절한 값을 설정합니다. ptpClockThreshold 는 이벤트가 활성화된 경우에만 사용됩니다. 자세한 내용은 " PTP 빠른 이벤트 알림 게시자 구성"을 참조하십시오.

사전 요구 사항

- 프로덕션 환경의 T-GM 클록의 경우 베어 메탈 클러스터 호스트에 두 개의 Intel E810 NIC를 설치합니다.

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다. - PTP Operator를 설치합니다.

프로세스

PtpConfigCR을 생성합니다. 예를 들면 다음과 같습니다.다음 YAML을

grandmaster-clock-ptp-config-dual-nics.yaml파일에 저장합니다.예 7.2. 듀얼 E810 NIC에 대한 PTP 마스터 클록 구성

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고ts2phc.nmea_serialport의 값을/dev/gnss0로 설정합니다.다음 명령을 실행하여 CR을 생성합니다.

oc create -f grandmaster-clock-ptp-config-dual-nics.yaml

$ oc create -f grandmaster-clock-ptp-config-dual-nics.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

PtpConfig프로필이 노드에 적용되었는지 확인합니다.다음 명령을 실행하여

openshift-ptp네임스페이스에서 Pod 목록을 가져옵니다.oc get pods -n openshift-ptp -o wide

$ oc get pods -n openshift-ptp -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE IP NODE linuxptp-daemon-74m2g 3/3 Running 3 4d15h 10.16.230.7 compute-1.example.com ptp-operator-5f4f48d7c-x7zkf 1/1 Running 1 4d15h 10.128.1.145 compute-1.example.com

NAME READY STATUS RESTARTS AGE IP NODE linuxptp-daemon-74m2g 3/3 Running 3 4d15h 10.16.230.7 compute-1.example.com ptp-operator-5f4f48d7c-x7zkf 1/1 Running 1 4d15h 10.128.1.145 compute-1.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 프로필이 올바른지 확인합니다.

PtpConfig프로필에 지정한 노드에 해당하는linuxptp데몬의 로그를 검사합니다. 다음 명령을 실행합니다.oc logs linuxptp-daemon-74m2g -n openshift-ptp -c linuxptp-daemon-container

$ oc logs linuxptp-daemon-74m2g -n openshift-ptp -c linuxptp-daemon-containerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.4.2. linuxptp 서비스를 3 E810 NIC의 할마스터 클록으로 구성

NIC를 구성하는 PtpConfig CR(사용자 정의 리소스)을 3 E810 NIC의 grandmaster 클럭(T-GM)으로 linuxptp 서비스(ptp4l,phc2sys,ts2phc)를 구성할 수 있습니다.

다음 E810 NIC에 대해 3개의 NIC를 사용하여 linuxptp 서비스를 T-GM으로 구성할 수 있습니다.

- Intel E810-XXVDA4T Westport 채널 NIC

- Intel E810-CQDA2T Logan Beach NIC

분산 RAN(D-RAN) 사용 사례의 경우 다음과 같이 3개의 NIC에 대해 PTP를 구성할 수 있습니다.

- NIC 1이 GNSS(Global Navigation Satellite System)와 동기화됩니다.

- NIC 2 및 3은 1PPS faceplate 연결을 사용하여 NIC 1과 동기화됩니다.

다음 예제 PtpConfig CR을 기반으로 linuxptp 서비스를 3 카드 Intel E810 T-GM으로 구성합니다.

사전 요구 사항

- 프로덕션 환경의 T-GM 클록의 경우 베어 메탈 클러스터 호스트에 3개의 Intel E810 NIC를 설치합니다.

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다. - PTP Operator를 설치합니다.

프로세스

PtpConfigCR을 생성합니다. 예를 들면 다음과 같습니다.다음 YAML을

three-nic-grandmaster-clock-ptp-config.yaml파일에 저장합니다.예 7.3. 3개의 E810 NIC에 대한 PTP 마스터 클록 구성

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고ts2phc.nmea_serialport의 값을/dev/gnss0로 설정합니다.다음 명령을 실행하여 CR을 생성합니다.

oc create -f three-nic-grandmaster-clock-ptp-config.yaml

$ oc create -f three-nic-grandmaster-clock-ptp-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

PtpConfig프로필이 노드에 적용되었는지 확인합니다.다음 명령을 실행하여

openshift-ptp네임스페이스에서 Pod 목록을 가져옵니다.oc get pods -n openshift-ptp -o wide

$ oc get pods -n openshift-ptp -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE IP NODE linuxptp-daemon-74m3q 3/3 Running 3 4d15h 10.16.230.7 compute-1.example.com ptp-operator-5f4f48d7c-x6zkn 1/1 Running 1 4d15h 10.128.1.145 compute-1.example.com

NAME READY STATUS RESTARTS AGE IP NODE linuxptp-daemon-74m3q 3/3 Running 3 4d15h 10.16.230.7 compute-1.example.com ptp-operator-5f4f48d7c-x6zkn 1/1 Running 1 4d15h 10.128.1.145 compute-1.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 프로필이 올바른지 확인합니다. 다음 명령을 실행하고

PtpConfig프로필에 지정한 노드에 해당하는linuxptp데몬의 로그를 검사합니다.oc logs linuxptp-daemon-74m3q -n openshift-ptp -c linuxptp-daemon-container

$ oc logs linuxptp-daemon-74m3q -n openshift-ptp -c linuxptp-daemon-containerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.5. Grandmaster 클럭 PtpConfig 구성 참조

다음 참조 정보는 linuxptp 서비스(ptp4l,phc2sys,ts2phc)를 마스터 클록으로 구성하는 PtpConfig CR(사용자 정의 리소스)의 구성 옵션을 설명합니다.

| PtpConfig CR 필드 | 설명 |

|---|---|

|

|

마스터 클록 작업에 대한 NIC를 구성하는

플러그인 메커니즘을 사용하면 PTP Operator가 자동화된 하드웨어 구성을 수행할 수 있습니다. Intel Westport Channel NIC 또는 Intel Logan Beach NIC의 경우 |

|

|

|

|

|

|

|

| 데이터를 삭제하기 전에 발신자로부터 전송(TX) 타임스탬프를 대기할 최대 시간(TX)을 지정합니다. |

|

| JBOD 경계 클럭 시간 지연 값을 지정합니다. 이 값은 네트워크 시간 장치 간에 전달되는 시간 값을 수정하는 데 사용됩니다. |

|

|

참고

여기에 나열된 네트워크 인터페이스가 grandmaster로 구성되어 있고 |

|

|

|

|

|

|

|

|

선택 사항: |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

7.2.5.1. Grandmaster 클럭 클래스 동기화 상태 참조

다음 표는 PTP 할 마스터 클록 (T-GM) gm.ClockClass 상태를 설명합니다. 클럭 클래스는 PRTC(Basic Reference Time Clock) 또는 기타 타이밍 소스와 관련하여 정확성 및 안정성을 기반으로 T-GM 시계를 분류합니다.

홀드오버 사양은 PTP 클럭이 기본 시간 소스에서 업데이트를 수신하지 않고도 동기화를 유지할 수 있는 시간입니다.

| 클럭 클래스 상태 | 설명 |

|---|---|

|

|

T-GM 클록은 |

|

|

T-GM 클록은 |

|

|

T-GM 시계는 |

자세한 내용은 "상시/시간 추적 정보", ITU-T G.8275.1/Y.1369.1 권장 사항을 참조하십시오.

7.2.5.2. Intel E810 NIC 하드웨어 구성 참조

이 정보를 사용하여 Intel E810 하드웨어 플러그인을 사용하여 E810 네트워크 인터페이스를 PTP 마스터 클록으로 구성하는 방법을 파악합니다. 하드웨어 핀 구성은 네트워크 인터페이스가 시스템의 다른 구성 요소 및 장치와 상호 작용하는 방식을 결정합니다. Intel E810 NIC에는 외부 1PPS 신호를 위한 네 개의 커넥터가 있습니다: SMA1,SMA2,U.FL1 및 U.FL2.

| 하드웨어 핀 | 권장 설정 | 설명 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

다음 예와 같이 spec.profile.plugins.e810.pins 매개변수를 사용하여 Intel E810 NIC에서 핀 구성을 설정할 수 있습니다.

pins:

<interface_name>:

<connector_name>: <function> <channel_number>

pins:

<interface_name>:

<connector_name>: <function> <channel_number>다음과 같습니다.

<function > : 핀의 역할을 지정합니다. 다음 값은 pin 역할과 연결됩니다.

-

0: disabled -

1: RX (Receive timestamping) -

2: TX (Transmit timestamping)

<channel number > : 물리적 커넥터와 관련된 번호입니다. 다음 채널 번호는 물리적 커넥터와 연결되어 있습니다.

-

1:SMA1또는U.FL1 -

2:SMA2또는U.FL2

예:

-

0 1:SMA1또는U.FL1에 매핑된 핀을 비활성화합니다. -

1 2: Rx 함수를SMA2또는U.FL2에 할당합니다.

SMA1 및 U.FL1 커넥터는 채널 1을 공유합니다. SMA2 및 U.FL2 커넥터는 채널 2를 공유합니다.

spec.profile.plugins.e810.ublxCmds 매개변수를 설정하여 PtpConfig CR(사용자 정의 리소스)에서 GNSS 시계를 구성합니다.

T-GM GPS 마케이터 케이블 신호 지연을 보완하려면 오프셋 값을 구성해야 합니다. 최적의 T-GM radio offset 값을 구성하려면 GNSS radio cable signal 지연을 정확하게 측정하십시오. Red Hat은 이러한 측정을 지원하거나 필요한 지연 오프셋에 대한 값을 제공할 수 없습니다.

이러한 ublxCmds 스탠자 각각 ubxtool 명령을 사용하여 호스트 NIC에 적용되는 구성에 해당합니다. 예를 들면 다음과 같습니다.

- 1

- 나노초 단위의 T-GM 마더레이션 지연 오프셋입니다. 필요한 지연 오프셋 값을 얻으려면 외부 테스트 장치를 사용하여 케이블 지연을 측정해야 합니다.

다음 표에서는 동일한 ubxtool 명령을 설명합니다.

| ubxtool 명령 | 설명 |

|---|---|

|

|

사도전압 제어를 가능하게 하고, |

|

| Angon이 GPS 신호를 수신할 수 있도록 합니다. |

|

| Galileo GPS satellite에서 신호를 수신하도록 Angalileo GPS Satellite를 구성합니다. |

|

| GLONASS GPS Satellite에서 신호를 수신하지 못하게 합니다. |

|

| 마진이 BeiDou GPS Satellite에서 신호를 수신하지 못하도록 비활성화합니다. |

|

| SBAS GPS Satellite에서 신호를 수신하지 못하게 합니다. |

|

| 초기 위치 추정을 개선하도록 GNSS 수신기 설문 조사 프로세스를 구성합니다. 최적의 결과를 얻으려면 최대 24 시간이 걸릴 수 있습니다. |

|

| 하드웨어의 자동화된 단일 검사를 실행하고 NIC 상태 및 구성 설정에 대해 보고합니다. |

7.2.5.3. Dual E810 NIC 구성 참조

이 정보를 사용하여 Intel E810 하드웨어 플러그인을 사용하여 E810 네트워크 인터페이스를 PTP 할 마스터 클록(T-GM)으로 구성하는 방법을 파악합니다.

듀얼 NIC 클러스터 호스트를 구성하기 전에 1PPS faceplace 연결을 사용하여 두 NIC를 SMA1 케이블과 연결해야 합니다.

듀얼 NIC T-GM을 구성할 때 SMA1 연결 포트를 사용하여 NIC를 연결할 때 발생하는 1PPS 신호 지연을 보완해야 합니다. 케이블 길이, 주변 온도 및 구성 요소 및 제조 허용 오차와 같은 다양한 요인은 신호 지연에 영향을 미칠 수 있습니다. 지연을 보완하려면 신호 지연을 오프셋하는 데 사용하는 특정 값을 계산해야 합니다.

| PtpConfig field | 설명 |

|---|---|

|

| PTP Operator E810 하드웨어 플러그인을 사용하여 E810 하드웨어 핀을 구성합니다.

|

|

|

|

|

|

|

spec.profile.plugins.e810.pins 목록의 각 값은 < function > < channel_number > 형식을 따릅니다.

다음과 같습니다.

<function > : 핀 역할을 지정합니다. 다음 값은 pin 역할과 연결됩니다.

-

0: disabled -

1: 수신 (Rx) - 1PPS IN의 경우 -

2: 전송 (Tx) - 1PPS OUT 용

<channel_number >: 물리적 커넥터와 관련된 번호입니다. 다음 채널 번호는 물리적 커넥터와 연결되어 있습니다.

-

1:SMA1또는U.FL1 -

2:SMA2또는U.FL2

예:

-

2 1:SMA1에서1PPS OUT(Tx)을 활성화합니다. -

1 1:SMA1에서1PPS IN(Rx)을 활성화합니다.

PTP Operator는 이러한 값을 Intel E810 하드웨어 플러그인에 전달하여 각 NIC의 sysfs 핀 구성 인터페이스에 씁니다.

7.2.5.4. 3-card E810 NIC 구성 참조

이 정보를 사용하여 E810 NIC를 PTP 할 마스터 클록(T-GM)으로 구성하는 방법을 파악합니다.

3 카드 클러스터 호스트를 구성하기 전에 1PPS faceplate 연결을 사용하여 3 NIC를 연결해야 합니다. 기본 NIC 1PPS_out 출력은 다른 2 NIC를 제공합니다.

3 카드 T-GM을 구성할 때 SMA1 연결 포트를 사용하여 NIC를 연결할 때 발생하는 1PPS 신호 지연을 보완해야 합니다. 케이블 길이, 주변 온도 및 구성 요소 및 제조 허용 오차와 같은 다양한 요인은 신호 지연에 영향을 미칠 수 있습니다. 지연을 보완하려면 신호 지연을 오프셋하는 데 사용하는 특정 값을 계산해야 합니다.

| PtpConfig field | 설명 |

|---|---|

|

| PTP Operator E810 하드웨어 플러그인을 사용하여 E810 하드웨어 핀을 구성합니다.

|

|

|

|

|

|

|

7.2.6. GNSS를 소스로 사용하는 마스터 클록의 홀드오버

holdover를 사용하면 GNSS(Global navigation satellite system) 소스를 사용할 수 없는 경우 T-GM(T-GM) 클럭을 동기화 성능을 유지할 수 있습니다. 이 기간 동안 T-GM 클럭은 타이밍 중단을 줄이기 위해 내부 오실레이터 및 홀드오버 매개변수에 의존합니다.

PTPConfig CR(사용자 정의 리소스)에서 다음 holdover 매개변수를 구성하여 홀드오버 동작을 정의할 수 있습니다.

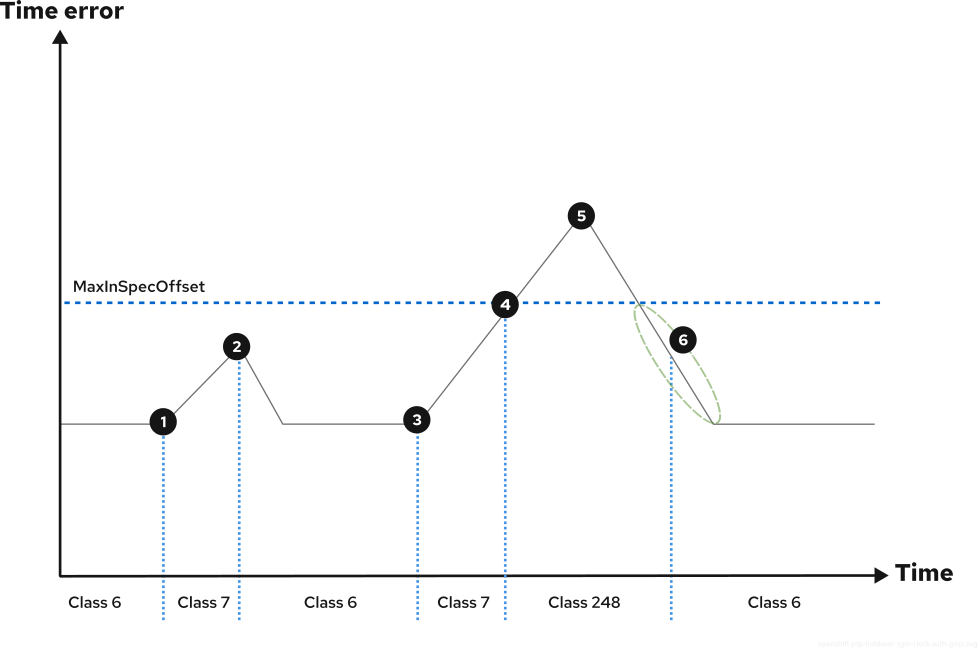

MaxInSpecOffset-

나노초 단위로 허용되는 최대 오프셋을 지정합니다. T-GM 시계가

MaxInSpecOffset값을 초과하면 freeRUN상태(clock 클래스 상태gm.ClockClass 248)로 전환됩니다. LocalHoldoverTimeout-

free

RUN상태로 전환하기 전에 T-GM 클럭이 홀드오버 상태에 남아 있는 최대 기간(초)을 지정합니다. LocalMaxHoldoverOffSet- T-GM 클럭이 나노초 단위의 홀드오버 상태 중에 도달할 수 있는 최대 오프셋을 지정합니다.

MaxInSpecOffset 값이 LocalMaxHoldoverOffset 값보다 적고 T-GM 클럭이 최대 오프셋 값을 초과하면 T-GM 클럭이 홀드오버 상태에서 free RUN 상태로 전환됩니다.

LocalMaxHoldoverOffSet 값이 MaxInSpecOffset 값보다 작으면 클럭이 최대 오프셋에 도달하기 전에 홀오버 타임아웃이 수행됩니다. 이 문제를 해결하려면 MaxInSpecOffset 필드와 LocalMaxHoldoverOffset 필드를 동일한 값으로 설정합니다.

클럭 클래스 상태에 대한 자세한 내용은 "Grandmaster clock class sync state reference" 문서를 참조하십시오.

T-GM 클록은 로컬MaxHoldoverOffSet 및 매개 변수를 사용하여 기울기를 계산합니다. 슬로프는 시간 경과에 따라 단계 오프셋이 변경되는 비율입니다. 이는 초당 나노초 단위로 측정되며, 여기서 set 값은 지정된 기간 동안 오프셋이 얼마나 증가했는지를 나타냅니다.