3.2. S3 API를 사용하여 Ceph Object Gateway에 액세스

개발자는 Amazon S3 API 사용을 시작하기 전에 Ceph Object Gateway 및 STS(Secure Token Service)에 대한 액세스를 구성해야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 실행 중인 Ceph Object Gateway입니다.

- RESTful 클라이언트입니다.

3.2.1. S3 인증

Ceph Object Gateway에 대한 요청은 인증 또는 인증되지 않을 수 있습니다. Ceph Object Gateway는 인증되지 않은 요청이 익명 사용자가 보낸 것으로 가정합니다. Ceph Object Gateway는 가능 ACL을 지원합니다.

대부분의 사용 사례에서 클라이언트는 Amazon SDK의 AmazonS3Client for Java 및 Python Boto와 같은 기존 오픈 소스 라이브러리를 사용합니다. 오픈 소스 라이브러리를 사용하면 액세스 키 및 시크릿 키에서 간단히 전달하고 라이브러리가 요청 헤더 및 인증 서명을 빌드합니다. 그러나 요청을 생성하고 서명할 수도 있습니다.

요청을 인증하려면 요청에 액세스 키와 기본 64 인코딩 해시 기반 Message Authentication Code(HMAC)를 Ceph Object Gateway 서버로 전송해야 합니다. Ceph Object Gateway는 S3 호환 인증 방법을 사용합니다.

예제

위의 예에서 ACCESS_KEY 를 액세스 키 ID의 값과 콜론(:)으로 바꿉니다. HASH_OF_HEADER_AND_SECRET 을 정식 헤더 문자열의 해시 및 액세스 키 ID에 해당하는 시크릿으로 바꿉니다.

헤더 문자열 및 시크릿의 해시 생성

헤더 문자열 및 시크릿의 해시를 생성하려면 다음을 수행합니다.

- 헤더 문자열의 값을 가져옵니다.

- 요청 헤더 문자열을 표준 형식으로 정규화합니다.

- SHA-1 해시 알고리즘을 사용하여 HMAC를 생성합니다.

-

hmac결과를 base-64로 인코딩합니다.

헤더 정규화

헤더를 표준 형식으로 정규화하려면 다음을 수행합니다.

-

모든

content-headers를 가져옵니다. -

content-type및content-md5 -

content-헤더 이름이 소문자인지 확인합니다. -

콘텐츠 헤더를 사전순으로 정렬합니다. -

날짜헤더가 있는지 확인하고 지정된 날짜가 offset이 아닌 journalctlT를 사용하는지 확인합니다. -

x-amz-로 시작하는 모든 헤더를 가져옵니다. -

x-amz-헤더가 모두 소문자인지 확인합니다. -

x-amz-헤더를 사전 정렬합니다. - 동일한 필드 이름의 여러 인스턴스를 단일 필드에 결합하고 필드 값을 쉼표로 구분합니다.

- 헤더 값의 공백 및 줄 바꿈을 단일 공백으로 교체합니다.

- 콜론 전후에 공백을 제거합니다.

- 각 헤더 뒤에 새 행을 추가합니다.

- 헤더를 요청 헤더에 다시 병합합니다.

HASH_OF_HEADER_AND_SECRET 을 base-64로 인코딩된 HMAC 문자열로 바꿉니다.

추가 리소스

- 자세한 내용은 Amazon Simple Storage Service 설명서의 REST 요청 서명 및 인증 섹션을 참조하십시오.

3.2.2. S3 서버 측 암호화

Ceph Object Gateway는 S3 API(애플리케이션 프로그래밍 인터페이스)에 대해 업로드된 오브젝트의 서버 측 암호화를 지원합니다. 서버 측 암호화는 S3 클라이언트가 암호화되지 않은 형식으로 HTTP를 통해 데이터를 전송하고 Ceph Object Gateway는 해당 데이터를 Red Hat Ceph Storage 클러스터에 암호화된 형식으로 저장합니다.

Red Hat은 SLO(Dynamic Large Object) 또는 DLO(Dynamic Large Object)의 S3 개체 암호화를 지원하지 않습니다.

암호화를 사용하려면 클라이언트 요청이 SSL 연결을 통해 요청을 보내야 합니다. Ceph Object Gateway에서 SSL을 사용하지 않는 한 Red Hat은 클라이언트의 S3 암호화를 지원하지 않습니다. 그러나 테스트를 위해 관리자는 ceph config set client.rgw 명령을 사용하여 rgw_crypt_require_ssl 구성 설정을 false 로 설정한 다음 Ceph Object Gateway 인스턴스를 다시 시작하여 테스트 중에 SSL을 비활성화할 수 있습니다.

프로덕션 환경에서는 SSL을 통해 암호화된 요청을 보내지 못할 수 있습니다. 이러한 경우 서버 측 암호화와 함께 HTTP를 사용하여 요청을 보냅니다.

서버 측 암호화를 사용하여 HTTP를 구성하는 방법에 대한 자세한 내용은 아래의 추가 리소스 섹션을 참조하십시오.

암호화 키 관리를 위한 두 가지 옵션이 있습니다.

고객 제공 키

S3 클라이언트는 고객 제공 키를 사용할 때 암호화된 데이터를 읽거나 쓰기 위한 각 요청과 함께 암호화 키를 전달합니다. 이러한 키를 관리하는 것은 고객의 책임이 있습니다. 고객은 각 오브젝트를 암호화하는 데 사용되는 Ceph Object Gateway를 기억할 수 있어야 합니다.

Ceph Object Gateway는 Amazon SSE-C 사양에 따라 S3 API에서 고객 제공 키 동작을 구현합니다.

고객이 키 관리를 처리하고 S3 클라이언트가 키를 Ceph Object Gateway에 전달하므로 Ceph Object Gateway는 이 암호화 모드를 지원하기 위해 특별한 구성이 필요하지 않습니다.

키 관리 서비스

키 관리 서비스를 사용하는 경우 보안 키 관리 서비스는 키를 저장하고 Ceph Object Gateway는 필요에 따라 데이터를 암호화하거나 암호 해독하는 요청을 처리하기 위해 해당 키를 검색합니다.

Ceph Object Gateway는 Amazon SSE-KMS 사양에 따라 S3 API에서 키 관리 서비스 동작을 구현합니다.

현재 테스트된 유일한 키 관리 구현은 HashiCorp Vault 및 OpenStack Barbican입니다. 그러나 OpenStack Barbican은 기술 프리뷰이며 프로덕션 시스템에서 사용할 수 없습니다.

3.2.3. S3 액세스 제어 목록

Ceph Object Gateway는 S3 호환 ACL(액세스 제어 목록) 기능을 지원합니다. ACL은 사용자가 버킷 또는 오브젝트에서 수행할 수 있는 작업을 지정하는 액세스 권한 부여 목록입니다. 각 부여는 버킷에 적용할 때 오브젝트에 적용되는 것과 다른 의미가 있습니다.

| 권한 | bucket | 개체 |

|---|---|---|

|

| 권한 부여자는 버킷의 오브젝트를 나열할 수 있습니다. | 권한 부여자는 오브젝트를 읽을 수 있습니다. |

|

| 부여자는 버킷에 오브젝트를 작성하거나 삭제할 수 있습니다. | 해당 없음 |

|

| 권한 부여자는 버킷 ACL을 읽을 수 있습니다. | 권한 부여자는 오브젝트 ACL을 읽을 수 있습니다. |

|

| 권한 부여자는 버킷 ACL을 작성할 수 있습니다. | 권한 부여자는 오브젝트 ACL에 쓸 수 있습니다. |

|

| 권한 부여자는 버킷에서 오브젝트에 대한 전체 권한을 갖습니다. | 권한 부여자는 오브젝트 ACL을 읽거나 쓸 수 있습니다. |

3.2.4. S3를 사용하여 Ceph Object Gateway에 대한 액세스 준비

게이트웨이 서버에 액세스하기 전에 Ceph Object Gateway 노드에서 사전 요구 사항을 따라야 합니다.

사전 요구 사항

- Ceph Object Gateway 소프트웨어 설치.

- Ceph Object Gateway 노드에 대한 루트 수준 액세스.

프로세스

root로서 방화벽에서 포트8080을 엽니다.firewall-cmd --zone=public --add-port=8080/tcp --permanent firewall-cmd --reload

[root@rgw ~]# firewall-cmd --zone=public --add-port=8080/tcp --permanent [root@rgw ~]# firewall-cmd --reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow Object Gateway 구성 및 관리 가이드에서 언급한 대로 게이트웨이에 사용하는 와일드카드를 DNS 서버에 추가합니다.

로컬 DNS 캐싱을 위해 게이트웨이 노드를 설정할 수도 있습니다. 이렇게 하려면 다음 단계를 실행합니다.

root로서dnsmasq를 설치하고 설정합니다.yum install dnsmasq echo "address=/.FQDN_OF_GATEWAY_NODE/IP_OF_GATEWAY_NODE" | tee --append /etc/dnsmasq.conf systemctl start dnsmasq systemctl enable dnsmasq

[root@rgw ~]# yum install dnsmasq [root@rgw ~]# echo "address=/.FQDN_OF_GATEWAY_NODE/IP_OF_GATEWAY_NODE" | tee --append /etc/dnsmasq.conf [root@rgw ~]# systemctl start dnsmasq [root@rgw ~]# systemctl enable dnsmasqCopy to Clipboard Copied! Toggle word wrap Toggle overflow IP_OF_GATEWAY_NODE및FQDN_OF_GATEWAY_NODE를 게이트웨이 노드의 IP 주소 및 FQDN으로 바꿉니다.root로 NetworkManager를 중지합니다.systemctl stop NetworkManager systemctl disable NetworkManager

[root@rgw ~]# systemctl stop NetworkManager [root@rgw ~]# systemctl disable NetworkManagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow root로 게이트웨이 서버의 IP를 이름 서버로 설정합니다.echo "DNS1=IP_OF_GATEWAY_NODE" | tee --append /etc/sysconfig/network-scripts/ifcfg-eth0 echo "IP_OF_GATEWAY_NODE FQDN_OF_GATEWAY_NODE" | tee --append /etc/hosts systemctl restart network systemctl enable network systemctl restart dnsmasq

[root@rgw ~]# echo "DNS1=IP_OF_GATEWAY_NODE" | tee --append /etc/sysconfig/network-scripts/ifcfg-eth0 [root@rgw ~]# echo "IP_OF_GATEWAY_NODE FQDN_OF_GATEWAY_NODE" | tee --append /etc/hosts [root@rgw ~]# systemctl restart network [root@rgw ~]# systemctl enable network [root@rgw ~]# systemctl restart dnsmasqCopy to Clipboard Copied! Toggle word wrap Toggle overflow IP_OF_GATEWAY_NODE및FQDN_OF_GATEWAY_NODE를 게이트웨이 노드의 IP 주소 및 FQDN으로 바꿉니다.하위 도메인 요청을 확인합니다.

ping mybucket.FQDN_OF_GATEWAY_NODE

[user@rgw ~]$ ping mybucket.FQDN_OF_GATEWAY_NODECopy to Clipboard Copied! Toggle word wrap Toggle overflow FQDN_OF_GATEWAY_NODE를 게이트웨이 노드의 FQDN으로 바꿉니다.주의로컬 DNS 캐싱을 위해 게이트웨이 서버를 설정하는 것은 테스트 목적으로만 사용됩니다. 이 작업을 수행한 후에는 외부 네트워크에 액세스할 수 없습니다. Red Hat Ceph Storage 클러스터 및 게이트웨이 노드에 적절한 DNS 서버를 사용하는 것이 좋습니다.

-

Object Gateway 구성 및 관리 가이드에서 언급된

S3액세스에 대한radosgw사용자를 신중하게 생성하고 생성된access_key및secret_key를 복사합니다.S3액세스 및 후속 버킷 관리 작업에 이러한 키가 필요합니다.

3.2.5. Ruby AWS S3를 사용하여 Ceph Object Gateway에 액세스

Ruby 프로그래밍 언어와 함께 S3 액세스를 위해 aws-s3 gem을 사용할 수 있습니다. Ruby AWS::S3 을 사용하여 Ceph Object Gateway 서버에 액세스하는 데 사용되는 노드에서 아래 설명된 단계를 실행합니다.

사전 요구 사항

- Ceph Object Gateway에 대한 사용자 수준 액세스.

- Ceph Object Gateway에 액세스하는 노드에 대한 루트 수준 액세스.

- 인터넷 액세스.

프로세스

ruby패키지를 설치합니다.yum install ruby

[root@dev ~]# yum install rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고위의 명령은

ruby및rubygems및ruby-libs와 같은 필수 종속성을 설치합니다. 명령이 모든 종속 항목을 설치하지 않으면 별도로 설치합니다.aws-s3Ruby 패키지를 설치합니다.gem install aws-s3

[root@dev ~]# gem install aws-s3Copy to Clipboard Copied! Toggle word wrap Toggle overflow 프로젝트 디렉터리를 생성합니다.

mkdir ruby_aws_s3 cd ruby_aws_s3

[user@dev ~]$ mkdir ruby_aws_s3 [user@dev ~]$ cd ruby_aws_s3Copy to Clipboard Copied! Toggle word wrap Toggle overflow 연결 파일을 생성합니다.

vim conn.rb

[user@dev ~]$ vim conn.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을

conn.rb파일에 붙여넣습니다.구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow FQDN_OF_GATEWAY_NODE를 Ceph Object Gateway 노드의 FQDN으로 바꿉니다.MY_ACCESS_KEY및MY_SECRET_KEY를 Red Hat Ceph Storage Object Gateway 구성 및 관리 가이드에 언급된 대로radosgw사용자를S3액세스 권한을 생성할 때 생성된access_key및secret_key로 바꿉니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x conn.rb

[user@dev ~]$ chmod +x conn.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./conn.rb | echo $?

[user@dev ~]$ ./conn.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일에 값을 올바르게 제공한 경우 명령의 출력은

0입니다.버킷을 생성하기 위한 새 파일을 생성합니다.

vim create_bucket.rb

[user@dev ~]$ vim create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.create('my-new-bucket1')#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.create('my-new-bucket1')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x create_bucket.rb

[user@dev ~]$ chmod +x create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./create_bucket.rb

[user@dev ~]$ ./create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 명령 출력이

true이면 버킷my-new-bucket1이 성공적으로 생성되었습니다.소유 버킷을 나열할 새 파일을 생성합니다.

vim list_owned_buckets.rb

[user@dev ~]$ vim list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x list_owned_buckets.rb

[user@dev ~]$ chmod +x list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./list_owned_buckets.rb

[user@dev ~]$ ./list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력은 다음과 같아야 합니다.

my-new-bucket1 2020-01-21 10:33:19 UTC

my-new-bucket1 2020-01-21 10:33:19 UTCCopy to Clipboard Copied! Toggle word wrap Toggle overflow 오브젝트를 생성하기 위한 새 파일을 생성합니다.

vim create_object.rb

[user@dev ~]$ vim create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x create_object.rb

[user@dev ~]$ chmod +x create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./create_object.rb

[user@dev ~]$ ./create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이렇게 하면

Hello World!문자열이 포함된hello.txt파일이 생성됩니다.버킷의 콘텐츠를 나열할 새 파일을 생성합니다.

vim list_bucket_content.rb

[user@dev ~]$ vim list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능하게 만듭니다.

chmod +x list_bucket_content.rb

[user@dev ~]$ chmod +x list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./list_bucket_content.rb

[user@dev ~]$ ./list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력은 다음과 같습니다.

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMT

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 빈 버킷을 삭제하기 위한 새 파일을 생성합니다.

vim del_empty_bucket.rb

[user@dev ~]$ vim del_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.delete('my-new-bucket1')#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.delete('my-new-bucket1')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x del_empty_bucket.rb

[user@dev ~]$ chmod +x del_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./del_empty_bucket.rb | echo $?

[user@dev ~]$ ./del_empty_bucket.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow 버킷이 성공적으로 삭제되면 명령에서 출력으로

0을 반환합니다.참고create_bucket.rb파일을 편집하여 빈 버킷을 생성합니다(예:my-new-bucket4,my-new-bucket5). 다음으로 빈 버킷을 삭제하기 전에 위에서 언급한del_empty_bucket.rb파일을 적절하게 편집합니다.비어 있지 않은 버킷을 삭제하기 위한 새 파일을 생성합니다.

vim del_non_empty_bucket.rb

[user@dev ~]$ vim del_non_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.delete('my-new-bucket1', :force => true)#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.delete('my-new-bucket1', :force => true)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x del_non_empty_bucket.rb

[user@dev ~]$ chmod +x del_non_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./del_non_empty_bucket.rb | echo $?

[user@dev ~]$ ./del_non_empty_bucket.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow 버킷이 성공적으로 삭제되면 명령에서 출력으로

0을 반환합니다.오브젝트를 삭제하기 위한 새 파일을 생성합니다.

vim delete_object.rb

[user@dev ~]$ vim delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

#!/usr/bin/env ruby load 'conn.rb' AWS::S3::S3Object.delete('hello.txt', 'my-new-bucket1')#!/usr/bin/env ruby load 'conn.rb' AWS::S3::S3Object.delete('hello.txt', 'my-new-bucket1')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x delete_object.rb

[user@dev ~]$ chmod +x delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./delete_object.rb

[user@dev ~]$ ./delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이렇게 하면

hello.txt개체가 삭제됩니다.

3.2.6. Ruby AWS SDK를 사용하여 Ceph Object Gateway에 액세스

Ruby 프로그래밍 언어와 함께 S3 액세스를 위해 aws-sdk gem을 사용할 수 있습니다. Ruby AWS::SDK 를 사용하여 Ceph Object Gateway 서버에 액세스하는 데 사용되는 노드에서 아래 설명된 단계를 실행합니다.

사전 요구 사항

- Ceph Object Gateway에 대한 사용자 수준 액세스.

- Ceph Object Gateway에 액세스하는 노드에 대한 루트 수준 액세스.

- 인터넷 액세스.

프로세스

ruby패키지를 설치합니다.yum install ruby

[root@dev ~]# yum install rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고위의 명령은

ruby및rubygems및ruby-libs와 같은 필수 종속성을 설치합니다. 명령이 모든 종속 항목을 설치하지 않으면 별도로 설치합니다.aws-sdkRuby 패키지를 설치합니다.gem install aws-sdk

[root@dev ~]# gem install aws-sdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 프로젝트 디렉터리를 생성합니다.

mkdir ruby_aws_sdk cd ruby_aws_sdk

[user@dev ~]$ mkdir ruby_aws_sdk [user@dev ~]$ cd ruby_aws_sdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 연결 파일을 생성합니다.

vim conn.rb

[user@dev ~]$ vim conn.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을

conn.rb파일에 붙여넣습니다.구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow FQDN_OF_GATEWAY_NODE를 Ceph Object Gateway 노드의 FQDN으로 바꿉니다.MY_ACCESS_KEY및MY_SECRET_KEY를 Red Hat Ceph Storage Object Gateway 구성 및 관리 가이드에 언급된 대로radosgw사용자를S3액세스 권한을 생성할 때 생성된access_key및secret_key로 바꿉니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x conn.rb

[user@dev ~]$ chmod +x conn.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./conn.rb | echo $?

[user@dev ~]$ ./conn.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일에 값을 올바르게 제공한 경우 명령의 출력은

0입니다.버킷을 생성하기 위한 새 파일을 생성합니다.

vim create_bucket.rb

[user@dev ~]$ vim create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x create_bucket.rb

[user@dev ~]$ chmod +x create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./create_bucket.rb

[user@dev ~]$ ./create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 명령의 출력이

true이면my-new-bucket2버킷이 성공적으로 생성되었습니다.소유 버킷을 나열할 새 파일을 생성합니다.

vim list_owned_buckets.rb

[user@dev ~]$ vim list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x list_owned_buckets.rb

[user@dev ~]$ chmod +x list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./list_owned_buckets.rb

[user@dev ~]$ ./list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력은 다음과 같아야 합니다.

my-new-bucket2 2020-01-21 10:33:19 UTC

my-new-bucket2 2020-01-21 10:33:19 UTCCopy to Clipboard Copied! Toggle word wrap Toggle overflow 오브젝트를 생성하기 위한 새 파일을 생성합니다.

vim create_object.rb

[user@dev ~]$ vim create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x create_object.rb

[user@dev ~]$ chmod +x create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./create_object.rb

[user@dev ~]$ ./create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이렇게 하면

Hello World!문자열이 포함된hello.txt파일이 생성됩니다.버킷의 콘텐츠를 나열할 새 파일을 생성합니다.

vim list_bucket_content.rb

[user@dev ~]$ vim list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능하게 만듭니다.

chmod +x list_bucket_content.rb

[user@dev ~]$ chmod +x list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./list_bucket_content.rb

[user@dev ~]$ ./list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력은 다음과 같습니다.

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMT

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 빈 버킷을 삭제하기 위한 새 파일을 생성합니다.

vim del_empty_bucket.rb

[user@dev ~]$ vim del_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x del_empty_bucket.rb

[user@dev ~]$ chmod +x del_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./del_empty_bucket.rb | echo $?

[user@dev ~]$ ./del_empty_bucket.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow 버킷이 성공적으로 삭제되면 명령에서 출력으로

0을 반환합니다.참고create_bucket.rb파일을 편집하여 빈 버킷을 생성합니다(예:my-new-bucket6,my-new-bucket7). 다음으로 빈 버킷을 삭제하기 전에 위에서 언급한del_empty_bucket.rb파일을 적절하게 편집합니다.비어 있지 않은 버킷을 삭제하기 위한 새 파일을 생성합니다.

vim del_non_empty_bucket.rb

[user@dev ~]$ vim del_non_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x del_non_empty_bucket.rb

[user@dev ~]$ chmod +x del_non_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./del_non_empty_bucket.rb | echo $?

[user@dev ~]$ ./del_non_empty_bucket.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow 버킷이 성공적으로 삭제되면 명령에서 출력으로

0을 반환합니다.오브젝트를 삭제하기 위한 새 파일을 생성합니다.

vim delete_object.rb

[user@dev ~]$ vim delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행 가능으로 설정합니다.

chmod +x delete_object.rb

[user@dev ~]$ chmod +x delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 실행합니다.

./delete_object.rb

[user@dev ~]$ ./delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이렇게 하면

hello.txt개체가 삭제됩니다.

3.2.7. PHP를 사용하여 Ceph Object Gateway에 액세스

S3 액세스에 PHP 스크립트를 사용할 수 있습니다. 이 절차에서는 버킷 또는 오브젝트 삭제와 같은 다양한 작업을 수행하는 몇 가지 예제 PHP 스크립트를 제공합니다.

아래 예제는 php v5.4.16 및 aws-sdk v2.8.24 에 대해 테스트합니다.

사전 요구 사항

- 개발 워크스테이션에 대한 루트 수준 액세스.

- 인터넷 액세스.

프로세스

php패키지를 설치합니다.yum install php

[root@dev ~]# yum install phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

PHP용

aws-sdk의 zip 아카이브를 다운로드 하여 압축을 풉니다. 프로젝트 디렉터리를 생성합니다.

mkdir php_s3 cd php_s3

[user@dev ~]$ mkdir php_s3 [user@dev ~]$ cd php_s3Copy to Clipboard Copied! Toggle word wrap Toggle overflow 추출된

aws디렉터리를 프로젝트 디렉터리에 복사합니다. 예를 들면 다음과 같습니다.cp -r ~/Downloads/aws/ ~/php_s3/

[user@dev ~]$ cp -r ~/Downloads/aws/ ~/php_s3/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 연결 파일을 생성합니다.

vim conn.php

[user@dev ~]$ vim conn.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow conn.php파일에 다음 내용을 붙여넣습니다.구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow FQDN_OF_GATEWAY_NODE를 게이트웨이 노드의 FQDN으로 바꿉니다.MY_ACCESS_KEY및MY_SECRET_KEY를 Red Hat Ceph Storage Object Gateway 구성 및 관리 가이드에 언급된 대로S3액세스를 위해radosgw사용자를 생성할 때 생성된access_key및secret_key로 바꿉니다.PATH_TO_AWS를php프로젝트 디렉터리에 복사한 추출된aws디렉터리의 절대 경로로 바꿉니다.파일을 저장하고 편집기를 종료합니다.

파일을 실행합니다.

php -f conn.php | echo $?

[user@dev ~]$ php -f conn.php | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일에 값을 올바르게 제공한 경우 명령의 출력은

0입니다.버킷을 생성하기 위한 새 파일을 생성합니다.

vim create_bucket.php

[user@dev ~]$ vim create_bucket.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 새 파일에 붙여넣습니다.

구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행합니다.

php -f create_bucket.php

[user@dev ~]$ php -f create_bucket.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 소유 버킷을 나열할 새 파일을 생성합니다.

vim list_owned_buckets.php

[user@dev ~]$ vim list_owned_buckets.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행합니다.

php -f list_owned_buckets.php

[user@dev ~]$ php -f list_owned_buckets.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력은 다음과 유사해야 합니다.

my-new-bucket3 2020-01-21 10:33:19 UTC

my-new-bucket3 2020-01-21 10:33:19 UTCCopy to Clipboard Copied! Toggle word wrap Toggle overflow 먼저

hello.txt라는 소스 파일을 생성하여 오브젝트를 생성합니다.echo "Hello World!" > hello.txt

[user@dev ~]$ echo "Hello World!" > hello.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 새 php 파일을 생성합니다.

vim create_object.php

[user@dev ~]$ vim create_object.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행합니다.

php -f create_object.php

[user@dev ~]$ php -f create_object.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 그러면 버킷

my-new-bucket3에hello.txt오브젝트가 생성됩니다.버킷의 콘텐츠를 나열할 새 파일을 생성합니다.

vim list_bucket_content.php

[user@dev ~]$ vim list_bucket_content.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행합니다.

php -f list_bucket_content.php

[user@dev ~]$ php -f list_bucket_content.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력은 다음과 유사합니다.

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMT

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 빈 버킷을 삭제하기 위한 새 파일을 생성합니다.

vim del_empty_bucket.php

[user@dev ~]$ vim del_empty_bucket.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행합니다.

php -f del_empty_bucket.php | echo $?

[user@dev ~]$ php -f del_empty_bucket.php | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow 버킷이 성공적으로 삭제되면 명령에서 출력으로

0을 반환합니다.참고create_bucket.php파일을 편집하여 빈 버킷을 만듭니다(예:my-new-bucket4,my-new-bucket5). 다음으로 빈 버킷을 삭제하기 전에 위에서 언급한del_empty_bucket.php파일을 적절하게 편집합니다.중요비어 있지 않은 버킷 삭제는 현재 PHP 2 및 최신 버전의

aws-sdk에서 지원되지 않습니다.오브젝트를 삭제하기 위한 새 파일을 생성합니다.

vim delete_object.php

[user@dev ~]$ vim delete_object.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 내용을 파일에 붙여넣습니다.

구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 저장하고 편집기를 종료합니다.

파일을 실행합니다.

php -f delete_object.php

[user@dev ~]$ php -f delete_object.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이렇게 하면

hello.txt개체가 삭제됩니다.

3.2.8. 보안 토큰 서비스

Amazon Web Services의 STS(Secure Token Service)는 사용자를 인증하기 위한 임시 보안 인증 정보 집합을 반환합니다.

Red Hat Ceph Storage Object Gateway는 IAM(Identity and Access Management)을 위한 Amazon STS API(애플리케이션 프로그래밍 인터페이스)의 하위 집합을 지원합니다.

사용자는 STS에 대해 먼저 인증하고 후속 요청에서 사용할 수 있는 수명이 짧은 S3 액세스 키 및 시크릿 키를 받습니다.

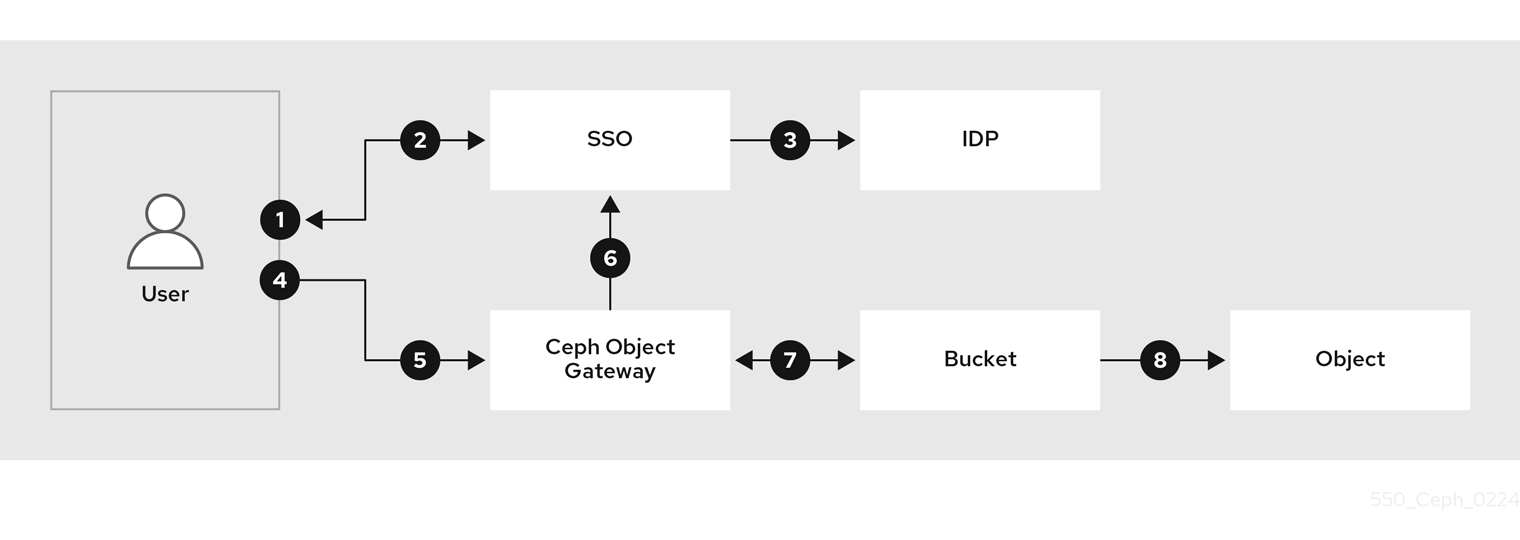

Red Hat Ceph Storage는 OIDC 공급자를 구성하여 Single Sign-On과 통합하여 S3 사용자를 인증할 수 있습니다. 이 기능을 사용하면 Object Storage 사용자가 로컬 Ceph Object Gateway 데이터베이스가 아닌 엔터프라이즈 ID 공급자에 대해 인증할 수 있습니다. 예를 들어 SSO가 백엔드의 엔터프라이즈 IDP에 연결된 경우 오브젝트 스토리지 사용자는 엔터프라이즈 자격 증명을 사용하여 Ceph Object Gateway S3 엔드포인트를 인증하고 액세스할 수 있습니다.

IAM 역할 정책 기능과 함께 STS를 사용하면 미세 조정된 권한 부여 정책을 생성하여 데이터에 대한 액세스를 제어할 수 있습니다. 이를 통해 개체 스토리지 데이터에 대한 RBAC(역할 기반 액세스 제어) 또는 ABAC( Attribute-Based Access Control) 권한 부여 모델을 구현할 수 있으므로 데이터에 액세스할 수 있는 사용자를 완전히 제어할 수 있습니다.

STS를 사용하여 워크플로우를 단순화하여 S3 리소스에 액세스 가능

- 사용자는 Red Hat Ceph Storage에서 S3 리소스에 액세스하려고 합니다.

- 사용자는 SSO 공급자에 대해 인증해야 합니다.

- SSO 공급자는 IDP와 결합되고 사용자 인증 정보가 유효한지 확인하고, 사용자가 인증되고 SSO가 사용자에게 토큰을 제공합니다.

- SSO에서 제공하는 토큰을 사용하여 사용자는 Ceph Object Gateway STS 엔드포인트에 액세스하여 사용자에게 S3 리소스에 대한 액세스 권한을 제공하는 IAM 역할을 가정하도록 요청합니다.

- Red Hat Ceph Storage 게이트웨이는 사용자 토큰을 수신하고 SSO에서 토큰의 유효성을 확인하도록 요청합니다.

- SSO가 토큰을 검증하면 사용자가 역할을 가정할 수 있습니다. STS를 통해 사용자는 S3 리소스에 액세스할 수 있는 임시 액세스 및 시크릿 키를 사용합니다.

- 사용자가 가정한 IAM 역할에 연결된 정책에 따라 사용자는 S3 리소스 집합에 액세스할 수 있습니다.

- 예를 들어 버킷 A에 대해 읽고 버킷 B에 씁니다.

추가 리소스

- Amazon Web Services Secure Token Service 시작 페이지.

- STS Lite 및 Keystone에 대한 자세한 내용은 Red Hat Ceph Storage 개발자 가이드 의 Keystone과 함께 STS Lite 구성 및 사용을 참조하십시오.

- STS Lite 및 Keystone의 제한 사항에 대한 자세한 내용은 Red Hat Ceph Storage Developer Guide 의 STS Lite 사용 제한 사항 섹션을 참조하십시오.

3.2.8.1. Secure Token Service 애플리케이션 프로그래밍 인터페이스

Ceph Object Gateway는 다음과 같은 STS(Secure Token Service) 애플리케이션 프로그래밍 인터페이스(API)를 구현합니다.

AssumeRole

이 API는 계정 간 액세스를 위한 임시 자격 증명 세트를 반환합니다. 이러한 임시 인증 정보를 사용하면 Role과 연결된 권한 정책과 Assume Role API와 연결된 정책 모두 사용할 수 있습니다. RoleArn 및 RoleSessionName 요청 매개변수는 필요하지만 다른 요청 매개변수는 선택 사항입니다.

RoleArn- 설명

- 길이가 20~ 2048자인 Amazon 리소스 이름(ARN)을 가정하는 역할입니다.

- 유형

- 문자열

- 필수 항목

- 제공됨

RoleSessionName- 설명

-

가정할 역할 세션 이름을 식별합니다. 역할 세션 이름은 다른 주체 또는 다른 이유로 역할을 가정할 때 세션을 고유하게 식별할 수 있습니다. 이 매개변수의 값은 2~64자 길이입니다.

=,,.. . ,@,-문자는 허용되지만 공백은 허용되지 않습니다. - 유형

- 문자열

- 필수 항목

- 제공됨

정책- 설명

- 인라인 세션에서 사용할 JSON 형식의 IAM(ID 및 액세스 관리 정책)입니다. 이 매개변수의 값은 1~48자 길이입니다.

- 유형

- 문자열

- 필수 항목

- 없음

DurationSeconds- 설명

-

세션 기간(초)이며 최소

900초의 최대 값43200초입니다. 기본값은3600초입니다. - 유형

- 정수

- 필수 항목

- 없음

ExternalId- 설명

- 다른 계정에 대한 역할을 가정할 때 사용 가능한 경우 고유한 외부 ID를 제공합니다. 이 매개변수의 값은 2~1224자 길이입니다.

- 유형

- 문자열

- 필수 항목

- 없음

serialnumber- 설명

- 연결된 MFA(다중 인증) 장치의 사용자 ID 번호입니다. 매개 변수의 값은 9~256자 길이인 하드웨어 장치 또는 가상 장치의 일련 번호일 수 있습니다.

- 유형

- 문자열

- 필수 항목

- 없음

TokenCode- 설명

- 신뢰 정책에 MFA(다중 인증)가 필요한 경우 MFA(다중 인증) 장치에서 생성된 값입니다. MFA 장치가 필요하며 이 매개변수의 값이 비어 있거나 만료된 경우 AssumeRole 호출에서 "access denied" 오류 메시지를 반환합니다. 이 매개변수의 값은 고정 길이인 6자입니다.

- 유형

- 문자열

- 필수 항목

- 없음

AssumeRoleWithWebIdentity

이 API는 OpenID Connect 또는 OAuth 2.0 ID 공급자와 같은 애플리케이션에서 인증한 사용자의 임시 인증 정보 세트를 반환합니다. RoleArn 및 RoleSessionName 요청 매개변수는 필요하지만 다른 요청 매개변수는 선택 사항입니다.

RoleArn- 설명

- 길이가 20~ 2048자인 Amazon 리소스 이름(ARN)을 가정하는 역할입니다.

- 유형

- 문자열

- 필수 항목

- 제공됨

RoleSessionName- 설명

-

가정할 역할 세션 이름을 식별합니다. 역할 세션 이름은 다른 주체 또는 다른 이유로 역할을 가정할 때 세션을 고유하게 식별할 수 있습니다. 이 매개변수의 값은 2~64자 길이입니다.

=,,.. . ,@,-문자는 허용되지만 공백은 허용되지 않습니다. - 유형

- 문자열

- 필수 항목

- 제공됨

정책- 설명

- 인라인 세션에서 사용할 JSON 형식의 IAM(ID 및 액세스 관리 정책)입니다. 이 매개변수의 값은 1~48자 길이입니다.

- 유형

- 문자열

- 필수 항목

- 없음

DurationSeconds- 설명

-

세션 기간(초)이며 최소

900초의 최대 값43200초입니다. 기본값은3600초입니다. - 유형

- 정수

- 필수 항목

- 없음

ProviderId- 설명

- ID 공급자의 도메인 이름의 정규화된 호스트 구성 요소입니다. 이 매개변수의 값은 OAuth 2.0 액세스 토큰에만 유효하며 길이는 4~ 2048자입니다.

- 유형

- 문자열

- 필수 항목

- 없음

WebIdentityToken- 설명

- ID 공급자에서 제공하는 OpenID Connect ID 토큰 또는 OAuth 2.0 액세스 토큰입니다. 이 매개변수의 값은 4~48자 길이입니다.

- 유형

- 문자열

- 필수 항목

- 없음

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 개발자 가이드 의 Secure Token Service API 사용 예제 섹션을 참조하십시오.

- Amazon Web Services 보안 토큰 서비스, AssumeRole 작업.

- AssumeRoleWithWebIdentity 작업인 Amazon Web Services 보안 토큰 서비스.

3.2.8.2. 보안 토큰 서비스 구성

rgw_sts_key, rgw_s3_auth_use_sts 옵션을 설정하여 Ceph Object Gateway와 함께 사용할 STS(Secure Token Service)를 구성합니다.

S3 및 STS API는 동일한 네임스페이스에 동일하며 Ceph Object Gateway의 동일한 끝점에서 둘 다 액세스할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 실행 중인 Ceph Object Gateway입니다.

- Ceph Manager 노드에 대한 루트 수준 액세스.

프로세스

Ceph Object Gateway 클라이언트에 대해 다음 구성 옵션을 설정합니다.

구문

ceph config set RGW_CLIENT_NAME rgw_sts_key STS_KEY ceph config set RGW_CLIENT_NAME rgw_s3_auth_use_sts true

ceph config set RGW_CLIENT_NAME rgw_sts_key STS_KEY ceph config set RGW_CLIENT_NAME rgw_s3_auth_use_sts trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow rgw_sts_key는 세션 토큰을 암호화하거나 해독하는 데 사용되는 STS 키이며 정확히 16진수 문자입니다.중요STS 키는 영숫자여야 합니다.

예제

ceph config set client.rgw rgw_sts_key 7f8fd8dd4700mnop ceph config set client.rgw rgw_s3_auth_use_sts true

[root@mgr ~]# ceph config set client.rgw rgw_sts_key 7f8fd8dd4700mnop [root@mgr ~]# ceph config set client.rgw rgw_s3_auth_use_sts trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 추가된 키를 적용하려면 Ceph Object Gateway를 다시 시작합니다.

참고NAME열에 있는ceph orch ps명령의 출력을 사용하여 SERVICE_TYPE.ID 정보를 가져옵니다.스토리지 클러스터의 개별 노드에서 Ceph Object Gateway를 다시 시작하려면 다음을 수행합니다.

구문

systemctl restart ceph-CLUSTER_ID@SERVICE_TYPE.ID.service

systemctl restart ceph-CLUSTER_ID@SERVICE_TYPE.ID.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

systemctl restart ceph-c4b34c6f-8365-11ba-dc31-529020a7702d@rgw.realm.zone.host01.gwasto.service

[root@host01 ~]# systemctl restart ceph-c4b34c6f-8365-11ba-dc31-529020a7702d@rgw.realm.zone.host01.gwasto.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 스토리지 클러스터의 모든 노드에서 Ceph Object Gateway를 다시 시작하려면 다음을 수행합니다.

구문

ceph orch restart SERVICE_TYPE

ceph orch restart SERVICE_TYPECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph orch restart rgw

[ceph: root@host01 /]# ceph orch restart rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow

추가 리소스

- STS API에 대한 자세한 내용은 Red Hat Ceph Storage 개발자 가이드 의 Secure Token Service 애플리케이션 프로그래밍 인터페이스 섹션을 참조하십시오.

- Ceph 구성 데이터베이스 사용에 대한 자세한 내용은 Red Hat Ceph Storage 구성 가이드 의 Ceph 구성 기본 장을 참조하십시오.

3.2.8.3. OpenID Connect 공급자의 사용자 생성

Ceph Object Gateway와 OpenID Connect 공급자 간의 신뢰를 설정하려면 사용자 엔티티와 역할 신뢰 정책을 생성합니다.

사전 요구 사항

- Ceph Object Gateway 노드에 대한 사용자 수준 액세스.

- 보안 토큰 서비스가 구성되어 있습니다.

프로세스

새 Ceph 사용자를 생성합니다.

구문

radosgw-admin --uid USER_NAME --display-name "DISPLAY_NAME" --access_key USER_NAME --secret SECRET user create

radosgw-admin --uid USER_NAME --display-name "DISPLAY_NAME" --access_key USER_NAME --secret SECRET user createCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

radosgw-admin --uid TESTER --display-name "TestUser" --access_key TESTER --secret test123 user create

[user@rgw ~]$ radosgw-admin --uid TESTER --display-name "TestUser" --access_key TESTER --secret test123 user createCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph 사용자 기능을 구성합니다.

구문

radosgw-admin caps add --uid="USER_NAME" --caps="oidc-provider=*"

radosgw-admin caps add --uid="USER_NAME" --caps="oidc-provider=*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

radosgw-admin caps add --uid="TESTER" --caps="oidc-provider=*"

[user@rgw ~]$ radosgw-admin caps add --uid="TESTER" --caps="oidc-provider=*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow STS(Secure Token Service) API를 사용하여 역할 신뢰 정책에 조건을 추가합니다.

구문

"{\"Version\":\"2020-01-17\",\"Statement\":[{\"Effect\":\"Allow\",\"Principal\":{\"Federated\":[\"arn:aws:iam:::oidc-provider/IDP_URL\"]},\"Action\":[\"sts:AssumeRoleWithWebIdentity\"],\"Condition\":{\"StringEquals\":{\"IDP_URL:app_id\":\"AUD_FIELD\"\}\}\}\]\}""{\"Version\":\"2020-01-17\",\"Statement\":[{\"Effect\":\"Allow\",\"Principal\":{\"Federated\":[\"arn:aws:iam:::oidc-provider/IDP_URL\"]},\"Action\":[\"sts:AssumeRoleWithWebIdentity\"],\"Condition\":{\"StringEquals\":{\"IDP_URL:app_id\":\"AUD_FIELD\"\}\}\}\]\}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 중요위 구문 예제의

app_id는 들어오는 토큰의AUD_FIELD필드와 일치해야 합니다.

추가 리소스

- Amazon 웹 사이트의 OpenID Connect ID 공급자 문서는 Obtaining the Root CA Thumbprint 문서를 참조하십시오.

- STS API에 대한 자세한 내용은 Red Hat Ceph Storage 개발자 가이드 의 Secure Token Service 애플리케이션 프로그래밍 인터페이스 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage 개발자 가이드 의 Secure Token Service API 사용 예제 섹션을 참조하십시오.

3.2.8.4. OpenID Connect 공급자의 지문 가져오기

OpenID Connect 공급자의 (IDP) 구성 문서를 가져옵니다.

OIDC 프로토콜 표준을 따르는 모든 SSO는 Ceph Object Gateway에서 작동할 것으로 예상됩니다. Red Hat은 다음 SSO 공급자에서 테스트했습니다.

- Red Hat Single Sing-on

- Keycloak

사전 요구 사항

-

openssl및curl패키지 설치.

프로세스

IDP의 URL에서 구성 문서를 가져옵니다.

구문

curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "IDP_URL:8000/CONTEXT/realms/REALM/.well-known/openid-configuration" \ | jq .curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "IDP_URL:8000/CONTEXT/realms/REALM/.well-known/openid-configuration" \ | jq .Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "http://www.example.com:8000/auth/realms/quickstart/.well-known/openid-configuration" \ | jq .[user@client ~]$ curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "http://www.example.com:8000/auth/realms/quickstart/.well-known/openid-configuration" \ | jq .Copy to Clipboard Copied! Toggle word wrap Toggle overflow IDP 인증서를 가져옵니다.

구문

curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "IDP_URL/CONTEXT/realms/REALM/protocol/openid-connect/certs" \ | jq .curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "IDP_URL/CONTEXT/realms/REALM/protocol/openid-connect/certs" \ | jq .Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "http://www.example.com/auth/realms/quickstart/protocol/openid-connect/certs" \ | jq .[user@client ~]$ curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "http://www.example.com/auth/realms/quickstart/protocol/openid-connect/certs" \ | jq .Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고x5c인증서는 SSO 공급자에 따라/certs경로 또는/jwks경로에서 사용할 수 있습니다.이전 명령의 "x5c" 응답 결과를 복사하여

certificate.crt파일에 붙여넣습니다. 시작 시--BEGIN CERTIFICATE- 및 --END CERTIFICATE-를 포함합니다.예제

-----BEGIN CERTIFICATE----- MIIDYjCCAkqgAwIBAgIEEEd2CDANBgkqhkiG9w0BAQsFADBzMQkwBwYDVQQGEwAxCTAHBgNVBAgTADEJMAcGA1UEBxMAMQkwBwYDVQQKEwAxCTAHBgNVBAsTADE6MDgGA1UEAxMxYXV0aHN2Yy1pbmxpbmVtZmEuZGV2LnZlcmlmeS5pYm1jbG91ZHNlY3VyaXR5LmNvbTAeFw0yMTA3MDUxMzU2MzZaFw0zMTA3MDMxMzU2MzZaMHMxCTAHBgNVBAYTADEJMAcGA1UECBMAMQkwBwYDVQQHEwAxCTAHBgNVBAoTADEJMAcGA1UECxMAMTowOAYDVQQDEzFhdXRoc3ZjLWlubGluZW1mYS5kZXYudmVyaWZ5LmlibWNsb3Vkc2VjdXJpdHkuY29tMIIBIjANBgkqhkiG9w0BAQEFAAOCAQ8AMIIBCgKCAQEAphyu3HaAZ14JH/EXetZxtNnerNuqcnfxcmLhBz9SsTlFD59ta+BOVlRnK5SdYEqO3ws2iGEzTvC55rczF+hDVHFZEBJLVLQe8ABmi22RAtG1P0dA/Bq8ReFxpOFVWJUBc31QM+ummW0T4yw44wQJI51LZTMz7PznB0ScpObxKe+frFKd1TCMXPlWOSzmTeFYKzR83Fg9hsnz7Y8SKGxi+RoBbTLT+ektfWpR7O+oWZIf4INe1VYJRxZvn+qWcwI5uMRCtQkiMknc3Rj6Eupiqq6FlAjDs0p//EzsHAlW244jMYnHCGq0UP3oE7vViLJyiOmZw7J3rvs3m9mOQiPLoQIDAQABMA0GCSqGSIb3DQEBCwUAA4IBAQCeVqAzSh7Tp8LgaTIFUuRbdjBAKXC9Nw3+pRBHoiUTdhqO3ualyGih9m/js/clb8Vq/39zl0VPeaslWl2NNX9zaK7xo+ckVIOY3ucCaTC04ZUn1KzZu/7azlN0C5XSWg/CfXgU2P3BeMNzc1UNY1BASGyWn2lEplIVWKLaDZpNdSyyGyaoQAIBdzxeNCyzDfPCa2oSO8WH1czmFiNPqR5kdknHI96CmsQdi+DT4jwzVsYgrLfcHXmiWyIAb883hR3Pobp+Bsw7LUnxebQ5ewccjYmrJzOk5Wb5FpXBhaJH1B3AEd6RGalRUyc/zUKdvEy0nIRMDS9x2BP3NVvZSADD -----END CERTIFICATE-----

-----BEGIN CERTIFICATE----- MIIDYjCCAkqgAwIBAgIEEEd2CDANBgkqhkiG9w0BAQsFADBzMQkwBwYDVQQGEwAxCTAHBgNVBAgTADEJMAcGA1UEBxMAMQkwBwYDVQQKEwAxCTAHBgNVBAsTADE6MDgGA1UEAxMxYXV0aHN2Yy1pbmxpbmVtZmEuZGV2LnZlcmlmeS5pYm1jbG91ZHNlY3VyaXR5LmNvbTAeFw0yMTA3MDUxMzU2MzZaFw0zMTA3MDMxMzU2MzZaMHMxCTAHBgNVBAYTADEJMAcGA1UECBMAMQkwBwYDVQQHEwAxCTAHBgNVBAoTADEJMAcGA1UECxMAMTowOAYDVQQDEzFhdXRoc3ZjLWlubGluZW1mYS5kZXYudmVyaWZ5LmlibWNsb3Vkc2VjdXJpdHkuY29tMIIBIjANBgkqhkiG9w0BAQEFAAOCAQ8AMIIBCgKCAQEAphyu3HaAZ14JH/EXetZxtNnerNuqcnfxcmLhBz9SsTlFD59ta+BOVlRnK5SdYEqO3ws2iGEzTvC55rczF+hDVHFZEBJLVLQe8ABmi22RAtG1P0dA/Bq8ReFxpOFVWJUBc31QM+ummW0T4yw44wQJI51LZTMz7PznB0ScpObxKe+frFKd1TCMXPlWOSzmTeFYKzR83Fg9hsnz7Y8SKGxi+RoBbTLT+ektfWpR7O+oWZIf4INe1VYJRxZvn+qWcwI5uMRCtQkiMknc3Rj6Eupiqq6FlAjDs0p//EzsHAlW244jMYnHCGq0UP3oE7vViLJyiOmZw7J3rvs3m9mOQiPLoQIDAQABMA0GCSqGSIb3DQEBCwUAA4IBAQCeVqAzSh7Tp8LgaTIFUuRbdjBAKXC9Nw3+pRBHoiUTdhqO3ualyGih9m/js/clb8Vq/39zl0VPeaslWl2NNX9zaK7xo+ckVIOY3ucCaTC04ZUn1KzZu/7azlN0C5XSWg/CfXgU2P3BeMNzc1UNY1BASGyWn2lEplIVWKLaDZpNdSyyGyaoQAIBdzxeNCyzDfPCa2oSO8WH1czmFiNPqR5kdknHI96CmsQdi+DT4jwzVsYgrLfcHXmiWyIAb883hR3Pobp+Bsw7LUnxebQ5ewccjYmrJzOk5Wb5FpXBhaJH1B3AEd6RGalRUyc/zUKdvEy0nIRMDS9x2BP3NVvZSADD -----END CERTIFICATE-----Copy to Clipboard Copied! Toggle word wrap Toggle overflow 인증서 지문을 가져옵니다.

구문

openssl x509 -in CERT_FILE -fingerprint -noout

openssl x509 -in CERT_FILE -fingerprint -nooutCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

openssl x509 -in certificate.crt -fingerprint -noout SHA1 Fingerprint=F7:D7:B3:51:5D:D0:D3:19:DD:21:9A:43:A9:EA:72:7A:D6:06:52:87

[user@client ~]$ openssl x509 -in certificate.crt -fingerprint -noout SHA1 Fingerprint=F7:D7:B3:51:5D:D0:D3:19:DD:21:9A:43:A9:EA:72:7A:D6:06:52:87Copy to Clipboard Copied! Toggle word wrap Toggle overflow - SHA1 지문에서 모든 콜론을 제거하고 이를 IAM 요청에서 IDP 엔티티를 생성하기 위한 입력으로 사용합니다.

추가 리소스

- Amazon 웹 사이트의 OpenID Connect ID 공급자 문서는 Obtaining the Root CA Thumbprint 문서를 참조하십시오.

- STS API에 대한 자세한 내용은 Red Hat Ceph Storage 개발자 가이드 의 Secure Token Service 애플리케이션 프로그래밍 인터페이스 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage 개발자 가이드 의 Secure Token Service API 사용 예제 섹션을 참조하십시오.

3.2.8.5. OpenID Connect 공급자 등록

OpenID Connect 공급자의 (IDP) 구성 문서를 등록합니다.

사전 요구 사항

-

openssl및curl패키지 설치. - 보안 토큰 서비스가 구성되어 있습니다.

- OIDC 공급자용으로 생성된 사용자입니다.

- OIDC의 지문을 가져옵니다.

프로세스

토큰에서 URL을 추출합니다.

예제

bash check_token_isv.sh | jq .iss "https://keycloak-sso.apps.ocp.example.com/auth/realms/ceph"

[root@host01 ~]# bash check_token_isv.sh | jq .iss "https://keycloak-sso.apps.ocp.example.com/auth/realms/ceph"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph Object Gateway에 OIDC 공급자를 등록합니다.

예제

aws --endpoint https://cephproxy1.example.com:8443 iam create-open-id-connect-provider --url https://keycloak-sso.apps.ocp.example.com/auth/realms/ceph --thumbprint-list 00E9CFD697E0B16DD13C86B0FFDC29957E5D24DF

[root@host01 ~]# aws --endpoint https://cephproxy1.example.com:8443 iam create-open-id-connect-provider --url https://keycloak-sso.apps.ocp.example.com/auth/realms/ceph --thumbprint-list 00E9CFD697E0B16DD13C86B0FFDC29957E5D24DFCopy to Clipboard Copied! Toggle word wrap Toggle overflow OIDC 공급자가 Ceph Object Gateway에 추가되었는지 확인합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2.8.6. IAM 역할 및 정책 생성

IAM 역할 및 정책을 생성합니다.

사전 요구 사항

-

openssl및curl패키지 설치. - 보안 토큰 서비스가 구성되어 있습니다.

- OIDC 공급자용으로 생성된 사용자입니다.

- OIDC의 지문을 가져옵니다.

- Ceph Object Gateway의 OIDC 공급자가 등록되었습니다.

프로세스

JWT 토큰을 검색하고 검증합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 토큰을 확인합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예에서 jq 필터는 토큰의 하위 필드에서 사용하며 ceph 로 설정됩니다.

역할 속성을 사용하여 JSON 파일을 생성합니다.

Statement를허용으로 설정하고Action을AssumeRoleWithWebIdentity로 설정합니다.sub:ceph와 조건을 일치하는 JWT 토큰을 사용하여 모든 사용자에게 액세스를 허용합니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow JSON 파일을 사용하여 Ceph Object Gateway 역할을 생성합니다.

예제

radosgw-admin role create --role-name rgwadmins \ --assume-role-policy-doc=$(jq -rc . /root/role-rgwadmins.json)

[root@host01 ~]# radosgw-admin role create --role-name rgwadmins \ --assume-role-policy-doc=$(jq -rc . /root/role-rgwadmins.json)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

.

3.2.8.7. S3 리소스 액세스

S3 리소스에 액세스하려면 STS 자격 증명을 사용하여 Assume 역할을 확인합니다.

사전 요구 사항

-

openssl및curl패키지 설치. - 보안 토큰 서비스가 구성되어 있습니다.

- OIDC 공급자용으로 생성된 사용자입니다.

- OIDC의 지문을 가져옵니다.

- Ceph Object Gateway의 OIDC 공급자가 등록되었습니다.

- 생성된 IAM 역할 및 정책

프로세스

다음은 S3 리소스에 액세스하기 위해 STS를 사용하여 임시 액세스 및 시크릿 키를 가져오는 경우의 예입니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 스크립트를 실행합니다.

예제

source ./test-assume-role.sh s3admin passw0rd rgwadmins aws s3 mb s3://testbucket aws s3 ls

[root@host01 ~]# source ./test-assume-role.sh s3admin passw0rd rgwadmins [root@host01 ~]# aws s3 mb s3://testbucket [root@host01 ~]# aws s3 lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2.9. Keystone으로 STS Lite 구성 및 사용 (기술 프리뷰)

Amazon STS(Secure Token Service) 및 S3 API는 동일한 네임스페이스에 공존합니다. STS 옵션은 Keystone 옵션과 함께 구성할 수 있습니다.

Ceph Object Gateway에서 동일한 엔드포인트를 사용하여 S3 및 STS API에 모두 액세스할 수 있습니다.

사전 요구 사항

- Red Hat Ceph Storage 5.0 이상.

- 실행 중인 Ceph Object Gateway입니다.

- Boto Python 모듈 버전 3 이상을 설치합니다.

- Ceph Manager 노드에 대한 루트 수준 액세스.

- OpenStack 노드에 대한 사용자 수준 액세스.

프로세스

Ceph Object Gateway 클라이언트에 대해 다음 구성 옵션을 설정합니다.

구문

ceph config set RGW_CLIENT_NAME rgw_sts_key STS_KEY ceph config set RGW_CLIENT_NAME rgw_s3_auth_use_sts true

ceph config set RGW_CLIENT_NAME rgw_sts_key STS_KEY ceph config set RGW_CLIENT_NAME rgw_s3_auth_use_sts trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow rgw_sts_key는 세션 토큰을 암호화하거나 해독하는 데 사용되는 STS 키이며 정확히 16진수 문자입니다.중요STS 키는 영숫자여야 합니다.

예제

ceph config set client.rgw rgw_sts_key 7f8fd8dd4700mnop ceph config set client.rgw rgw_s3_auth_use_sts true

[root@mgr ~]# ceph config set client.rgw rgw_sts_key 7f8fd8dd4700mnop [root@mgr ~]# ceph config set client.rgw rgw_s3_auth_use_sts trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenStack 노드에서 EC2 자격 증명을 생성합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 생성된 인증 정보를 사용하여 GetSessionToken API를 사용하여 임시 보안 인증 정보 세트를 가져옵니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 임시 인증 정보를 얻으려면 S3 호출을 수행하는 데 사용할 수 있습니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 새 S3Access 역할을 생성하고 정책을 구성합니다.

관리 CAPS가 있는 사용자를 할당합니다.

구문

radosgw-admin caps add --uid="USER" --caps="roles=*"

radosgw-admin caps add --uid="USER" --caps="roles=*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

radosgw-admin caps add --uid="gwadmin" --caps="roles=*"

[root@mgr ~]# radosgw-admin caps add --uid="gwadmin" --caps="roles=*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow S3Access 역할을 생성합니다.

구문

radosgw-admin role create --role-name=ROLE_NAME --path=PATH --assume-role-policy-doc=TRUST_POLICY_DOC

radosgw-admin role create --role-name=ROLE_NAME --path=PATH --assume-role-policy-doc=TRUST_POLICY_DOCCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

radosgw-admin role create --role-name=S3Access --path=/application_abc/component_xyz/ --assume-role-policy-doc=\{\"Version\":\"2012-10-17\",\"Statement\":\[\{\"Effect\":\"Allow\",\"Principal\":\{\"AWS\":\[\"arn:aws:iam:::user/TESTER\"\]\},\"Action\":\[\"sts:AssumeRole\"\]\}\]\}[root@mgr ~]# radosgw-admin role create --role-name=S3Access --path=/application_abc/component_xyz/ --assume-role-policy-doc=\{\"Version\":\"2012-10-17\",\"Statement\":\[\{\"Effect\":\"Allow\",\"Principal\":\{\"AWS\":\[\"arn:aws:iam:::user/TESTER\"\]\},\"Action\":\[\"sts:AssumeRole\"\]\}\]\}Copy to Clipboard Copied! Toggle word wrap Toggle overflow S3Access 역할에 권한 정책을 연결합니다.

구문

radosgw-admin role-policy put --role-name=ROLE_NAME --policy-name=POLICY_NAME --policy-doc=PERMISSION_POLICY_DOC

radosgw-admin role-policy put --role-name=ROLE_NAME --policy-name=POLICY_NAME --policy-doc=PERMISSION_POLICY_DOCCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

radosgw-admin role-policy put --role-name=S3Access --policy-name=Policy --policy-doc=\{\"Version\":\"2012-10-17\",\"Statement\":\[\{\"Effect\":\"Allow\",\"Action\":\[\"s3:*\"\],\"Resource\":\"arn:aws:s3:::example_bucket\"\}\]\}[root@mgr ~]# radosgw-admin role-policy put --role-name=S3Access --policy-name=Policy --policy-doc=\{\"Version\":\"2012-10-17\",\"Statement\":\[\{\"Effect\":\"Allow\",\"Action\":\[\"s3:*\"\],\"Resource\":\"arn:aws:s3:::example_bucket\"\}\]\}Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

이제 다른 사용자가

gwadmin사용자의 역할을 가정할 수 있습니다. 예를 들어gwuser사용자는gwadmin사용자의 권한을 가정할 수 있습니다. 사용자의

access_key및secret_key값을 기록해 둡니다.예제

radosgw-admin user info --uid=gwuser | grep -A1 access_key

[root@mgr ~]# radosgw-admin user info --uid=gwuser | grep -A1 access_keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

AssumeRole API 호출을 사용하여 assuming user의

access_key및secret_key값을 제공합니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 중요AssumeRole API에는 S3Access 역할이 필요합니다.

추가 리소스

- Boto Python 모듈 설치에 대한 자세한 내용은 Red Hat Ceph Storage Object Gateway 가이드 의 S3 액세스 테스트 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage Object Gateway 가이드 의 사용자 생성 섹션을 참조하십시오.

3.2.10. Keystone과 STS Lite 사용의 제한 사항 해결 (기술 프리뷰)

Keystone의 제한 사항은 STS(Secure Token Service) 요청을 지원하지 않는다는 것입니다. 또 다른 제한 사항은 페이로드 해시가 요청에 포함되어 있지 않음입니다. 이 두 가지 제한 사항을 해결하려면 Boto 인증 코드를 수정해야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터 버전 5.0 이상.

- 실행 중인 Ceph Object Gateway입니다.

- Boto Python 모듈, 버전 3 이상 설치

프로세스

Boto의

auth.py파일을 열고 편집합니다.코드 블록에 다음 4행을 추가합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 코드 블록에 다음 두 행을 추가합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

추가 리소스

- Boto Python 모듈 설치에 대한 자세한 내용은 Red Hat Ceph Storage Object Gateway 가이드 의 S3 액세스 테스트 섹션을 참조하십시오.