파일 시스템 관리

Red Hat Enterprise Linux 8에서 파일 시스템 생성, 수정 및 관리

초록

Red Hat 문서에 관한 피드백 제공

문서 개선을 위한 의견에 감사드립니다. 어떻게 개선할 수 있는지 알려주십시오.

Jira를 통해 피드백 제출 (계정 필요)

- Jira 웹 사이트에 로그인합니다.

- 상단 탐색 모음에서 생성 을 클릭합니다.

- 요약 필드에 설명 제목을 입력합니다.

- 설명 필드에 개선을 위한 제안을 입력합니다. 문서의 관련 부분에 대한 링크를 포함합니다.

- 대화 상자 하단에서 생성 을 클릭합니다.

1장. 사용 가능한 파일 시스템 개요

애플리케이션에 적합한 파일 시스템을 선택하는 것은 사용 가능한 많은 옵션과 관련된 절충으로 인해 중요한 결정입니다.

다음 섹션에서는 Red Hat Enterprise Linux 8에 기본적으로 포함된 파일 시스템과 애플리케이션에 가장 적합한 파일 시스템에 대한 권장 사항에 대해 설명합니다.

1.1. 파일 시스템 유형

Red Hat Enterprise Linux 8은 다양한 파일 시스템(FS)을 지원합니다. 다양한 유형의 파일 시스템은 다양한 종류의 문제를 해결하며 애플리케이션별로 사용됩니다. 가장 일반적인 수준에서 사용 가능한 파일 시스템을 다음과 같은 주요 유형으로 그룹화할 수 있습니다.

| 유형 | 파일 시스템 | 속성 및 사용 사례 |

|---|---|---|

| 디스크 또는 로컬 FS | XFS | XFS는 RHEL의 기본 파일 시스템입니다. Red Hat은 성능에 대한 호환성 또는 코너 사례와 같은 구체적인 이유가 없는 한 XFS를 로컬 파일 시스템으로 배포하는 것이 좋습니다. |

| ext4 | ext4는 이전 ext2 및 ext3 파일 시스템에서 진화한 Linux의 이점을 제공합니다. 대부분의 경우 성능에서 XFS를 경쟁합니다. ext4 파일 시스템 및 파일 크기에 대한 지원 제한은 XFS의 지원 한도보다 낮습니다. | |

| 네트워크 또는 클라이언트 및 서버 FS | NFS | NFS를 사용하여 동일한 네트워크의 여러 시스템 간에 파일을 공유합니다. |

| SMB | Microsoft Windows 시스템에서 파일 공유에 SMB를 사용합니다. | |

| 공유 스토리지 또는 공유 디스크 FS | GFS2 | Cryostat2는 컴퓨팅 클러스터 구성원에게 공유 쓰기 액세스 권한을 제공합니다. 이는 가능한 한 로컬 파일 시스템의 기능적 경험을 바탕으로 안정성과 안정성에 중점을 두고 있습니다. SAS Grid, Tibco MQ, IBM Websphere MQ 및 Red Hat Active MQ가 Cryostat2에 성공적으로 배포되었습니다. |

| volume-managing FS | Stratis(기술 프리뷰) | Stratis는 XFS 및 LVM의 조합에 구축된 볼륨 관리자입니다. Stratis의 목적은 Btrfs 및 ZFS와 같은 볼륨 관리 파일 시스템에서 제공하는 기능을 에뮬레이션하는 것입니다. 이 스택을 수동으로 빌드할 수는 있지만 Stratis는 구성 복잡성을 줄이고 모범 사례를 구현하며 오류 정보를 통합합니다. |

1.2. 로컬 파일 시스템

로컬 파일 시스템은 로컬 서버에서 실행되고 스토리지에 직접 연결된 파일 시스템입니다.

예를 들어 로컬 파일 시스템은 내부 SATA 또는 SAS 디스크에 대한 유일한 선택이며 서버에 로컬 드라이브가 있는 내부 하드웨어 RAID 컨트롤러가 있는 경우 사용됩니다. 로컬 파일 시스템은 SAN에서 내보낸 장치를 공유하지 않을 때 SAN에 연결된 스토리지에 사용되는 가장 일반적인 파일 시스템이기도 합니다.

모든 로컬 파일 시스템은 POSIX와 호환되며 지원되는 모든 Red Hat Enterprise Linux 릴리스와 완벽하게 호환됩니다. POSIX 호환 파일 시스템은 read(), write() 및 seek() 와 같은 잘 정의된 시스템 호출 세트를 지원합니다.

파일 시스템 선택을 고려할 때 파일 시스템이 얼마나 커야 하는지, 어떤 고유 기능이 있어야 하는지, 워크로드에서 수행하는 방법에 따라 파일 시스템을 선택합니다.

- 사용 가능한 로컬 파일 시스템

- XFS

- ext4

1.3. XFS 파일 시스템

XFS는 단일 호스트에서 매우 큰 파일 및 파일 시스템을 지원하는 확장성이 뛰어나고 강력한 고성능 저널링 파일 시스템입니다. 이는 Red Hat Enterprise Linux 8의 기본 파일 시스템입니다. XFS는 원래 SGI 초반에서 개발되었으며 매우 큰 서버 및 스토리지 어레이에서 오랫동안 실행되고 있습니다.

XFS의 기능은 다음과 같습니다.

- 신뢰성

- 메타데이터 저널링: 시스템을 다시 시작하고 파일 시스템을 다시 마운트할 때 재생할 수 있는 파일 시스템 작업 기록을 유지하여 시스템 충돌 후 파일 시스템 무결성을 보장합니다.

- 광범위한 런타임 메타데이터 일관성 검사

- 확장 가능한 빠른 복구 유틸리티

- 할당량 저널링. 이로 인해 충돌 후 긴 할당량 일관성 점검이 필요하지 않습니다.

- 확장 및 성능

- 지원되는 파일 시스템 크기 최대 1024TiB

- 다수의 동시 작업을 지원하는 기능

- 사용 가능한 공간 관리의 확장성을 위한 B-트리 인덱싱

- 정교한 메타데이터 읽기 알고리즘

- 스트리밍 비디오 워크로드에 대한 최적화

- 할당 체계

- 범위 기반 할당

- 스트라이프 인식 할당 정책

- 지연된 할당

- 공간 사전 할당

- 동적으로 할당된 inode

- 기타 기능

- reflink 기반 파일 복사

- 긴밀하게 통합된 백업 및 복원 유틸리티

- 온라인 조각 모음

- 온라인 파일 시스템 확장

- 포괄적인 진단 기능

-

확장 속성(

xattr). 이를 통해 시스템은 파일당 여러 개의 추가 이름/값 쌍을 연결할 수 있습니다. - 프로젝트 또는 디렉터리 할당량. 이렇게 하면 디렉터리 트리에 대한 할당량 제한이 허용됩니다.

- 하위 타임 스탬프

성능 특성

XFS는 엔터프라이즈 워크로드가 있는 대규모 시스템에서 높은 성능을 제공합니다. 대규모 시스템은 비교적 많은 CPU 수, 여러 HBA 및 외부 디스크 어레이에 대한 연결이 있는 시스템입니다. XFS는 다중 스레드 병렬 I/O 워크로드가 있는 소규모 시스템에서도 잘 작동합니다.

XFS는 단일 스레드 메타데이터 집약적인 워크로드(예: 단일 스레드에서 많은 수의 작은 파일을 만들거나 삭제하는 워크로드)에 대해 상대적으로 낮은 성능을 제공합니다.

1.4. ext4 파일 시스템

ext4 파일 시스템은 ext 파일 시스템 제품군의 4세대입니다. 이는 Red Hat Enterprise Linux 6의 기본 파일 시스템입니다.

ext4 드라이버는 ext2 및 ext3 파일 시스템을 읽고 쓸 수 있지만 ext4 파일 시스템 형식은 ext2 및 ext3 드라이버와 호환되지 않습니다.

ext4는 다음과 같은 몇 가지 새롭고 향상된 기능을 추가합니다.

- 지원되는 파일 시스템 크기 최대 50TiB

- 범위 기반 메타데이터

- 지연된 할당

- 저널 체크섬

- 대규모 스토리지 지원

범위 기반 메타데이터 및 지연된 할당 기능은 파일 시스템에서 사용된 공간을 추적하는 보다 작고 효율적인 방법을 제공합니다. 이러한 기능을 통해 파일 시스템 성능이 향상되고 메타데이터에서 사용하는 공간을 줄일 수 있습니다. 지연된 할당을 사용하면 데이터가 디스크에 플러시될 때까지 파일 시스템이 새로 작성된 사용자 데이터에 대한 영구 위치를 연기할 수 있습니다. 이렇게 하면 더 크고 연속적인 할당을 허용할 수 있으므로 성능이 향상되어 파일 시스템이 훨씬 더 나은 정보로 결정을 내릴 수 있습니다.

ext4에서 fsck 유틸리티를 사용하는 파일 시스템 복구 시간은 ext2 및 ext3보다 훨씬 빠릅니다. 일부 파일 시스템 복구에는 최대 6배의 성능 향상이 입증되었습니다.

1.5. XFS 및 ext4 비교

XFS는 RHEL의 기본 파일 시스템입니다. 이 섹션에서는 XFS 및 ext4의 사용과 기능을 비교합니다.

- 메타데이터 오류 동작

-

ext4에서는 파일 시스템에 메타데이터 오류가 발생할 때 동작을 구성할 수 있습니다. 기본 동작은 작업을 계속하는 것입니다. XFS는 복구할 수 없는 메타데이터 오류가 발생하면 파일 시스템을 종료하고

EFSCORRUPTED오류를 반환합니다. - 할당량

ext4에서는 파일 시스템을 생성할 때 기존 파일 시스템에서 할당량을 활성화할 수 있습니다. 그런 다음 마운트 옵션을 사용하여 할당량 시행을 구성할 수 있습니다.

XFS 할당량은 다시 마운트할 수 있는 옵션이 아닙니다. 초기 마운트에서 할당량을 활성화해야 합니다.

XFS 파일 시스템에서

quotacheck명령을 실행하면 적용되지 않습니다. 할당량 회계를 처음 활성화하면 XFS는 할당량을 자동으로 확인합니다.- 파일 시스템 크기 조정

- XFS에는 파일 시스템의 크기를 줄이는 유틸리티가 없습니다. XFS 파일 시스템의 크기만 늘릴 수 있습니다. 이에 비해 ext4는 파일 시스템의 확장 및 축소를 모두 지원합니다.

- inode 번호

ext4 파일 시스템은 2개 이상의 inode를 지원하지 않습니다.

XFS는 동적 inode 할당을 지원합니다. XFS 파일 시스템에서 사용할 수 있는 공간의 양은 전체 파일 시스템 공간의 백분율로 계산됩니다. 시스템이 inode가 실행되지 않도록 하려면 파일 시스템에 여유 공간이 남아 있는 경우 관리자는 파일 시스템을 생성한 후 이 백분율을 조정할 수 있습니다.

특정 애플리케이션은 XFS 파일 시스템에서 232 보다 큰 inode 번호를 올바르게 처리할 수 없습니다. 이러한 애플리케이션에서는

EOVERFLOW반환 값을 사용하여 32비트 stat 호출이 실패할 수 있습니다. inode 수는 다음 조건에서 232 를 초과합니다.- 파일 시스템은 256바이트 inode가 있는 1TiB보다 큽니다.

- 파일 시스템은 512바이트 inode가 있는 2TiB보다 큽니다.

애플리케이션이 대규모 inode 번호로 실패하는 경우

-o inode32옵션으로 XFS 파일 시스템을 마운트하여 232 미만의 inode 번호를 적용합니다.inode32를 사용하면 64비트 숫자로 이미 할당된 inode에는 영향을 미치지 않습니다.중요특정 환경에 필요한 경우가 아니면

inode32옵션을 사용하지 마십시오.inode32옵션은 할당 동작을 변경합니다. 그 결과 더 낮은 디스크 블록에 inode를 할당할 수 있는 공간이 없는 경우ENOSPC오류가 발생할 수 있습니다.

1.6. 로컬 파일 시스템 선택

애플리케이션 요구 사항을 충족하는 파일 시스템을 선택하려면 파일 시스템을 배포할 대상 시스템을 이해해야 합니다. 일반적으로 ext4에 대한 특정 사용 사례가 없는 경우 XFS를 사용합니다.

- XFS

- 대규모 배포의 경우 특히 대규모 파일(MB 단위) 및 높은 I/O 동시성을 처리할 때 XFS를 사용합니다. XFS는 대역폭이 200MB/s보다 크고 IOPS가 1000개 이상인 환경에서 최적의 성능을 발휘합니다. 그러나 ext4에 비해 메타데이터 작업에 더 많은 CPU 리소스를 사용하고 파일 시스템 축소를 지원하지 않습니다.

- ext4

- I/O 대역폭이 제한된 소규모 시스템 또는 환경의 경우 ext4가 더 적합할 수 있습니다. 처리량이 낮은 I/O 워크로드 및 환경에서 더 나은 성능을 제공합니다. ext4는 오프라인 축소 기능도 지원하므로 파일 시스템의 크기를 조정해야 합니다.

대상 서버 및 스토리지 시스템에 애플리케이션의 성능을 벤치마킹하여 선택한 파일 시스템이 성능 및 확장성 요구 사항을 충족하는지 확인합니다.

| 시나리오 | 권장되는 파일 시스템 |

|---|---|

| 특수 사용 사례 없음 | XFS |

| 대규모 서버 | XFS |

| 대규모 스토리지 장치 | XFS |

| 대용량 파일 | XFS |

| 다중 스레드 I/O | XFS |

| 단일 스레드 I/O | ext4 |

| 제한된 I/O 기능 (1000 IOPS 미만) | ext4 |

| 제한된 대역폭 (200MB/s 미만) | ext4 |

| CPU 바인딩된 워크로드 | ext4 |

| 오프라인 축소 지원 | ext4 |

1.7. 네트워크 파일 시스템

클라이언트/서버 파일 시스템이라고도 하는 네트워크 파일 시스템을 사용하면 클라이언트 시스템이 공유 서버에 저장된 파일에 액세스할 수 있습니다. 이를 통해 여러 시스템의 여러 사용자가 파일 및 스토리지 리소스를 공유할 수 있습니다.

이러한 파일 시스템은 파일 시스템 집합을 하나 이상의 클라이언트로 내보내는 하나 이상의 서버에서 빌드됩니다. 클라이언트 노드는 기본 블록 스토리지에 액세스할 수 없지만 더 나은 액세스 제어를 허용하는 프로토콜을 사용하여 스토리지와 상호 작용합니다.

- 사용 가능한 네트워크 파일 시스템

- RHEL 고객을 위한 가장 일반적인 클라이언트/서버 파일 시스템은 NFS 파일 시스템입니다. RHEL은 네트워크를 통해 로컬 파일 시스템을 내보낼 NFS 서버 구성 요소와 이러한 파일 시스템을 가져오는 NFS 클라이언트를 모두 제공합니다.

- RHEL에는 Windows 상호 운용성을 위해 널리 사용되는 Microsoft SMB 파일 서버를 지원하는 CIFS 클라이언트도 포함되어 있습니다. 사용자 공간 Samba 서버는 Windows 클라이언트에 RHEL 서버의 Microsoft SMB 서비스를 제공합니다.

1.10. 볼륨 관리 파일 시스템

볼륨 관리 파일 시스템은 단순성 및 스택 내 최적화를 위해 전체 스토리지 스택을 통합합니다.

- 사용 가능한 볼륨 관리 파일 시스템

- Red Hat Enterprise Linux 8은 Stratis 볼륨 관리자를 기술 프리뷰로 제공합니다. Stratis는 파일 시스템 계층에 XFS를 사용하여 LVM, 장치 매퍼 및 기타 구성 요소와 통합합니다.

Stratis는 Red Hat Enterprise Linux 8.0에서 처음 릴리스되었습니다. Red Hat은 더 이상 사용되지 않는 Btrfs를 사용할 때 생성되는 격차를 채우는 것이 중요합니다. Stratis 1.0은 사용자의 복잡성을 숨기는 동시에 중요한 스토리지 관리 작업을 수행할 수 있는 직관적인 명령줄 기반 볼륨 관리자입니다.

- 볼륨 관리

- 풀 생성

- 씬 스토리지 풀

- 스냅샷

- 자동화된 읽기 캐시

Stratis는 강력한 기능을 제공하지만 현재 Btrfs 또는 ZFS와 비교할 수 있는 특정 기능이 없습니다. 특히 CRC는 자기 회복을 위해 지원하지 않습니다.

2장. RHEL 시스템 역할을 사용하여 로컬 스토리지 관리

Ansible을 사용하여 LVM 및 로컬 파일 시스템(FS)을 관리하려면 RHEL 8에서 사용할 수 있는 RHEL 시스템 역할 중 하나인 스토리지 역할을 사용할 수 있습니다.

스토리지 역할을 사용하면 RHEL 7.7부터 여러 시스템 및 모든 RHEL 버전에서 디스크 및 논리 볼륨에서 파일 시스템 관리를 자동화할 수 있습니다.

RHEL 시스템 역할 및 적용 방법에 대한 자세한 내용은 RHEL 시스템 역할 소개를 참조하십시오.

2.1. 스토리지 RHEL 시스템 역할을 사용하여 블록 장치에서 XFS 파일 시스템 생성

예제 Ansible 플레이북은 storage 역할을 사용하여 기본 매개 변수를 사용하여 블록 장치에 XFS 파일 시스템을 생성합니다. /dev/sdb 장치 또는 마운트 지점 디렉터리의 파일 시스템이 없으면 플레이북에서 해당 시스템을 생성합니다.

스토리지 역할은 파티션되지 않은 전체 디스크 또는 LV(논리 볼륨)에서만 파일 시스템을 생성할 수 있습니다. 파티션에 파일 시스템을 만들 수 없습니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

프로세스

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제 플레이북에 지정된 설정은 다음과 같습니다.

이름: barefs-

볼륨 이름(예의

barefs)은 현재 임의의 상태입니다.스토리지역할은disks특성에 나열된 디스크 장치로 볼륨을 식별합니다. fs_type: <file_system>-

기본 파일 시스템 XFS를 사용하려면

fs_type매개변수를 생략할 수 있습니다. disks: <list_of_disks_and_volumes>디스크 및 LV 이름의 YAML 목록입니다. LV에 파일 시스템을 생성하려면 볼륨 그룹을 포함하여

disks속성 아래에 LVM 설정을 제공합니다. 자세한 내용은 스토리지 RHEL 시스템 역할을 사용하여 논리 볼륨 생성 또는 크기 조정을 참조하십시오.LV 장치의 경로를 제공하지 마십시오.

플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2. 스토리지 RHEL 시스템 역할을 사용하여 파일 시스템을 영구적으로 마운트

예제 Ansible 플레이북은 storage 역할을 사용하여 기존 파일 시스템을 영구적으로 마운트합니다. 이를 통해 /etc/fstab 파일에 적절한 항목을 추가하여 파일 시스템을 즉시 사용할 수 있고 영구적으로 마운트할 수 있습니다. 이렇게 하면 재부팅 시 파일 시스템을 마운트 상태로 유지할 수 있습니다. /dev/sdb 장치 또는 마운트 지점 디렉터리의 파일 시스템이 없으면 플레이북에서 해당 시스템을 생성합니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

프로세스

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. 스토리지 RHEL 시스템 역할을 사용하여 논리 볼륨 생성 또는 크기 조정

스토리지 역할을 사용하여 다음 작업을 수행합니다.

- 여러 디스크로 구성된 볼륨 그룹에 LVM 논리 볼륨을 만들려면 다음을 수행합니다.

- LVM에서 기존 파일 시스템의 크기를 조정하려면 다음을 수행합니다.

- 풀의 총 크기의 백분율로 LVM 볼륨 크기를 표현하려면

볼륨 그룹이 없으면 역할이 생성됩니다. 논리 볼륨이 볼륨 그룹에 있는 경우 크기가 플레이북에 지정된 것과 일치하지 않으면 크기가 조정됩니다.

논리 볼륨을 줄이는 경우 데이터 손실을 방지하기 위해 논리 볼륨의 파일 시스템이 축소되는 논리 볼륨의 공간을 사용하지 않도록 해야 합니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

프로세스

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제 플레이북에 지정된 설정은 다음과 같습니다.

size: <size>- 단위(예: GiB) 또는 백분율(예: 60 %)을 사용하여 크기를 지정해야 합니다.

플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

지정된 볼륨이 요청된 크기로 생성되거나 크기가 조정되었는지 확인합니다.

ansible managed-node-01.example.com -m command -a 'lvs myvg'

# ansible managed-node-01.example.com -m command -a 'lvs myvg'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4. 스토리지 RHEL 시스템 역할을 사용하여 온라인 블록 삭제 활성화

온라인 블록 삭제 옵션으로 XFS 파일 시스템을 마운트하여 사용되지 않는 블록을 자동으로 삭제할 수 있습니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

프로세스

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

온라인 블록 삭제 옵션이 활성화되어 있는지 확인합니다.

ansible managed-node-01.example.com -m command -a 'findmnt /mnt/data'

# ansible managed-node-01.example.com -m command -a 'findmnt /mnt/data'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. 스토리지 RHEL 시스템 역할을 사용하여 파일 시스템 생성 및 마운트

예제 Ansible 플레이북은 storage 역할을 사용하여 파일 시스템을 생성하고 마운트합니다. 이를 통해 /etc/fstab 파일에 적절한 항목을 추가하여 파일 시스템을 즉시 사용할 수 있고 영구적으로 마운트할 수 있습니다. 이렇게 하면 재부팅 시 파일 시스템을 마운트 상태로 유지할 수 있습니다. /dev/sdb 장치 또는 마운트 지점 디렉터리의 파일 시스템이 없으면 플레이북에서 해당 시스템을 생성합니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

프로세스

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제 플레이북에 지정된 설정은 다음과 같습니다.

disks: <list_of_devices>- 역할이 볼륨을 생성할 때 사용하는 장치 이름의 YAML 목록입니다.

fs_type: <file_system>-

역할이 볼륨에 설정해야 하는 파일 시스템을 지정합니다.

xfs,ext3,ext4,swap또는포맷되지않음을 선택할 수 있습니다. label-name: <file_system_label>- 선택 사항: 파일 시스템의 레이블을 설정합니다.

mount_point: < directory>-

선택 사항: 볼륨을 자동으로 마운트해야 하는 경우

mount_point변수를 볼륨을 마운트해야 하는 디렉터리로 설정합니다.

플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. 스토리지 RHEL 시스템 역할을 사용하여 RAID 볼륨 구성

스토리지 시스템 역할을 사용하면 Red Hat Ansible Automation Platform 및 Ansible-Core를 사용하여 RHEL에서 RAID 볼륨을 구성할 수 있습니다. 요구 사항에 맞게 RAID 볼륨을 구성하는 매개 변수를 사용하여 Ansible 플레이북을 생성합니다.

장치 이름은 예를 들어 시스템에 새 디스크를 추가할 때 특정 상황에서 변경될 수 있습니다. 따라서 데이터 손실을 방지하려면 플레이북에서 영구 이름 지정 속성을 사용합니다. 영구 이름 지정 속성에 대한 자세한 내용은 영구 이름 지정 특성 개요 를 참조하십시오.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

프로세스

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

배열이 올바르게 생성되었는지 확인합니다.

ansible managed-node-01.example.com -m command -a 'mdadm --detail /dev/md/data'

# ansible managed-node-01.example.com -m command -a 'mdadm --detail /dev/md/data'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7. 스토리지 RHEL 시스템 역할을 사용하여 RAID로 LVM 풀 구성

스토리지 시스템 역할을 사용하면 Red Hat Ansible Automation Platform을 사용하여 RHEL에서 RAID로 LVM 풀을 구성할 수 있습니다. 사용 가능한 매개 변수로 Ansible 플레이북을 설정하여 RAID로 LVM 풀을 구성할 수 있습니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

프로세스

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

풀이 RAID에 있는지 확인합니다.

ansible managed-node-01.example.com -m command -a 'lsblk'

# ansible managed-node-01.example.com -m command -a 'lsblk'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8. 스토리지 RHEL 시스템 역할을 사용하여 RAID LVM 볼륨의 스트라이프 크기 구성

스토리지 시스템 역할을 사용하면 Red Hat Ansible Automation Platform을 사용하여 RHEL에서 RAID LVM 볼륨의 스트라이프 크기를 구성할 수 있습니다. 사용 가능한 매개 변수로 Ansible 플레이북을 설정하여 RAID로 LVM 풀을 구성할 수 있습니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

프로세스

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

스트라이프 크기가 필요한 크기로 설정되어 있는지 확인합니다.

ansible managed-node-01.example.com -m command -a 'lvs -o+stripesize /dev/my_pool/my_volume'

# ansible managed-node-01.example.com -m command -a 'lvs -o+stripesize /dev/my_pool/my_volume'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.9. 스토리지 RHEL 시스템 역할을 사용하여 LVM-VDO 볼륨 구성

스토리지 RHEL 시스템 역할을 사용하여 활성화된 압축 및 중복 제거로 LVM(LVM-VDO)에서 VDO 볼륨을 생성할 수 있습니다.

스토리지 시스템 역할은 LVM-VDO를 사용하므로 풀당 하나의 볼륨만 생성할 수 있습니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

프로세스

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제 플레이북에 지정된 설정은 다음과 같습니다.

vdo_pool_size: <size>- 볼륨이 장치에서 사용하는 실제 크기입니다. 사용자가 읽을 수 있는 형식으로 크기를 지정할 수 있습니다(예: 10GiB). 단위를 지정하지 않으면 기본값은 바이트입니다.

size: <size>- VDO 볼륨의 가상 크기입니다.

플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --syntax-check ~/playbook.yml

$ ansible-playbook --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook ~/playbook.yml

$ ansible-playbook ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

압축 및 중복 제거의 현재 상태를 확인합니다.

ansible managed-node-01.example.com -m command -a 'lvs -o+vdo_compression,vdo_compression_state,vdo_deduplication,vdo_index_state' LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert VDOCompression VDOCompressionState VDODeduplication VDOIndexState mylv1 myvg vwi-a-v--- 3.00t vpool0 enabled online enabled online

$ ansible managed-node-01.example.com -m command -a 'lvs -o+vdo_compression,vdo_compression_state,vdo_deduplication,vdo_index_state' LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert VDOCompression VDOCompressionState VDODeduplication VDOIndexState mylv1 myvg vwi-a-v--- 3.00t vpool0 enabled online enabled onlineCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.10. 스토리지 RHEL 시스템 역할을 사용하여 LUKS2 암호화된 볼륨 생성

storage 역할을 사용하여 Ansible 플레이북을 실행하여 LUKS로 암호화된 볼륨을 생성하고 구성할 수 있습니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

프로세스

중요한 변수를 암호화된 파일에 저장합니다.

자격 증명 모음을 생성합니다.

ansible-vault create ~/vault.yml New Vault password: <vault_password> Confirm New Vault password: <vault_password>

$ ansible-vault create ~/vault.yml New Vault password: <vault_password> Confirm New Vault password: <vault_password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ansible-vault create명령이 편집기를 열고 <key > : < value> 형식으로 중요한 데이터를 입력합니다.luks_password: <password>

luks_password: <password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 변경 사항을 저장하고 편집기를 종료합니다. Ansible은 자격 증명 모음의 데이터를 암호화합니다.

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 플레이북에 사용되는 모든 변수에 대한 자세한 내용은 제어 노드의

/usr/share/ansible/roles/rhel-system-roles.storage/README.md파일을 참조하십시오.플레이북 구문을 확인합니다.

ansible-playbook --ask-vault-pass --syntax-check ~/playbook.yml

$ ansible-playbook --ask-vault-pass --syntax-check ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

ansible-playbook --ask-vault-pass ~/playbook.yml

$ ansible-playbook --ask-vault-pass ~/playbook.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

LUKS 암호화된 볼륨의

luksUUID값을 찾습니다.ansible managed-node-01.example.com -m command -a 'cryptsetup luksUUID /dev/sdb' 4e4e7970-1822-470e-b55a-e91efe5d0f5c

# ansible managed-node-01.example.com -m command -a 'cryptsetup luksUUID /dev/sdb' 4e4e7970-1822-470e-b55a-e91efe5d0f5cCopy to Clipboard Copied! Toggle word wrap Toggle overflow 볼륨의 암호화 상태를 확인합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 생성된 LUKS 암호화된 볼륨을 확인합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3장. 웹 콘솔을 사용하여 파티션 관리

웹 콘솔을 사용하여 RHEL 8에서 파일 시스템을 관리하는 방법을 알아봅니다.

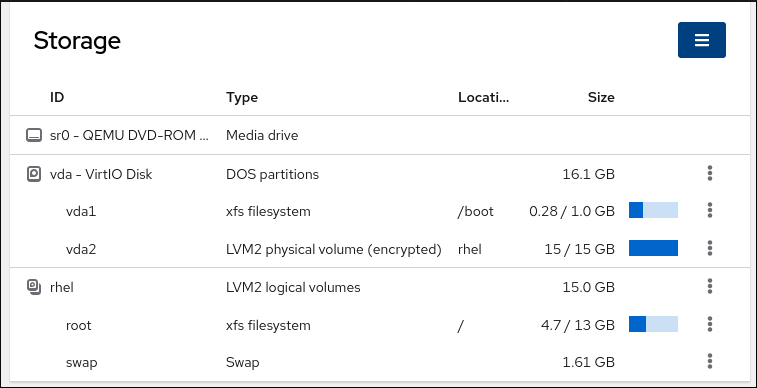

3.1. 웹 콘솔에서 파일 시스템으로 포맷된 파티션 표시

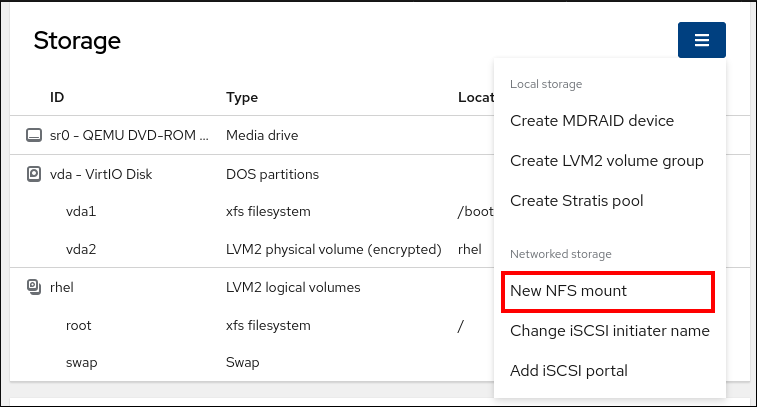

웹 콘솔의 Storage 섹션에는 Filesystems 테이블에서 사용 가능한 모든 파일 시스템이 표시됩니다.

파일 시스템으로 포맷된 파티션 목록 외에도 페이지를 사용하여 새 스토리지를 생성할 수도 있습니다.

사전 요구 사항

-

cockpit-storaged패키지가 시스템에 설치됩니다.

- RHEL 8 웹 콘솔을 설치했습니다.

- cockpit 서비스를 활성화했습니다.

사용자 계정이 웹 콘솔에 로그인할 수 있습니다.

자세한 내용은 웹 콘솔 설치 및 활성화를 참조하십시오.

절차

RHEL 8 웹 콘솔에 로그인합니다.

자세한 내용은 웹 콘솔에 로그인 을 참조하십시오.

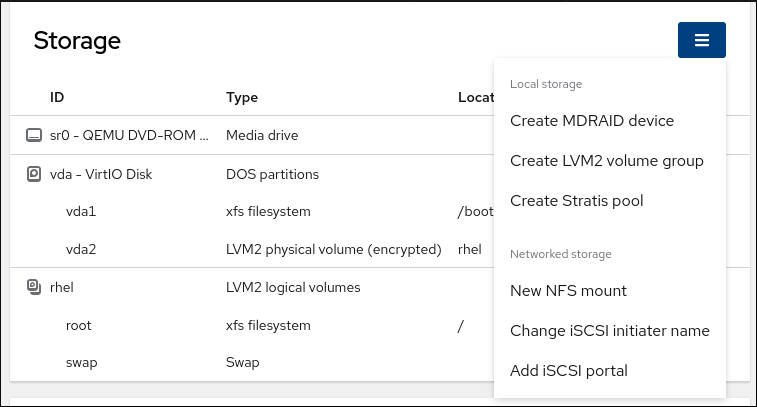

스토리지 탭을 클릭합니다.

스토리지 표에서 파일 시스템, ID, 유형, 위치, 크기 및 각 파티션에서 사용할 수 있는 공간을 사용하여 포맷된 모든 파티션을 확인할 수 있습니다.

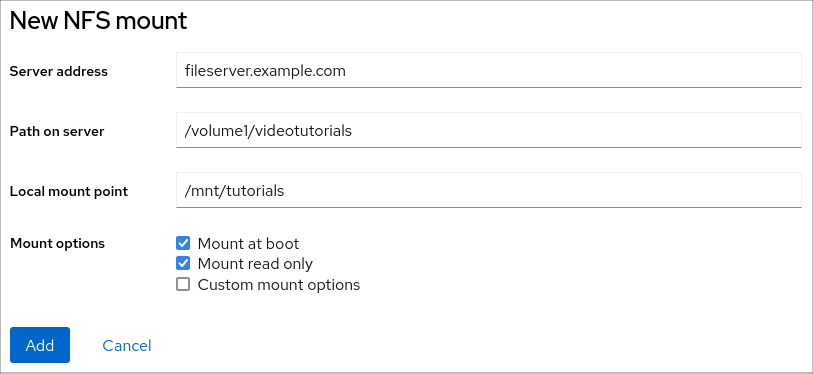

오른쪽 상단에 있는 드롭다운 메뉴를 사용하여 새 로컬 또는 네트워크 스토리지를 생성할 수도 있습니다.

3.2. 웹 콘솔에서 파티션 생성

새 파티션을 만들려면 다음을 수행합니다.

- 기존 파티션 테이블 사용

- 파티션 만들기

사전 요구 사항

-

cockpit-storaged패키지가 시스템에 설치됩니다. - 웹 콘솔을 설치하고 액세스할 수 있어야 합니다. 자세한 내용은 웹 콘솔 설치를 참조하십시오.

- 시스템에 연결된 포맷되지 않은 볼륨은 Storage 탭의 Storage 테이블에 표시됩니다.

절차

RHEL 8 웹 콘솔에 로그인합니다.

자세한 내용은 웹 콘솔에 로그인 을 참조하십시오.

- 스토리지 탭을 클릭합니다.

- 스토리지 테이블에서 파티션할 장치를 클릭하여 해당 장치의 페이지 및 옵션을 엽니다.

- 장치 페이지에서 메뉴 버튼을 클릭하고 파티션 테이블 만들기 를 선택합니다.

Cryo stat 디스크 대화 상자에서 다음을 선택합니다.

파티션:

- 모든 시스템 및 장치와 호환 (MBR)

- 최신 시스템 및 하드 디스크와 호환 > 2TB (GPT)

- 파티셔닝 없음

덮어쓰기:

RHEL 웹 콘솔에서 0으로 전체 디스크를 다시 작성하려면 0이 포함된 기존 데이터 덮어쓰기 확인란을 선택합니다. 이 옵션은 프로그램이 전체 디스크를 통과해야 하지만 더 안전합니다. 디스크에 데이터가 포함되어 있고 덮어써야 하는 경우 이 옵션을 사용합니다.

제로가 0인 기존 데이터를 덮어쓰 지 않은 경우 RHEL 웹 콘솔은 디스크 헤더만 다시 작성합니다. 이렇게 하면 포맷 속도가 증가합니다.

- Cryostat 클릭합니다.

- 생성한 파티션 테이블 옆에 있는 Cryostat 메뉴 버튼을 클릭합니다. 기본적으로 Free space 로 이름이 지정됩니다.

- 클릭합니다.

- 파티션 만들기 대화 상자에서 파일 시스템의 이름을 입력합니다.

- 마운트 지점을 추가합니다.

유형 드롭다운 메뉴에서 파일 시스템을 선택합니다.

- XFS 파일 시스템은 대규모 논리 볼륨을 지원하며 중단 없이 물리적 드라이브를 온라인 상태로 전환하며 기존 파일 시스템을 확장합니다. 다른 강력한 기본 설정이 없는 경우 이 파일 시스템을 선택한 상태로 두십시오.

ext4 파일 시스템은 다음을 지원합니다.

- 논리 볼륨

- 중단 없이 온라인 물리적 드라이브 전환

- 파일 시스템 확장

- 파일 시스템 축소

추가 옵션은 LUKS(Linux Unified Key Setup)에서 수행하는 파티션 암호화를 활성화하여 암호를 사용하여 볼륨을 암호화하는 것입니다.

- 생성할 볼륨의 크기를 입력합니다.

RHEL 웹 콘솔에서 0으로 전체 디스크를 다시 작성하려면 0이 포함된 기존 데이터 덮어쓰기 확인란을 선택합니다. 이 옵션은 프로그램이 전체 디스크를 통과해야 하지만 더 안전합니다. 디스크에 데이터가 포함되어 있고 덮어써야 하는 경우 이 옵션을 사용합니다.

제로가 0인 기존 데이터를 덮어쓰 지 않은 경우 RHEL 웹 콘솔은 디스크 헤더만 다시 작성합니다. 이렇게 하면 포맷 속도가 증가합니다.

볼륨을 암호화하려면 암호화 드롭다운 메뉴에서 암호화 유형을 선택합니다.

볼륨을 암호화하지 않으려면 암호화 없음 을 선택합니다.

- 부팅 시 드롭다운 메뉴에서 볼륨을 마운트할 시기를 선택합니다.

마운트 옵션 섹션의 경우:

- 볼륨을 읽기 전용 논리 볼륨으로 마운트하려면 마운트 읽기 전용 확인란을 선택합니다.

- 사용자 지정 마운트 옵션 확인란을 선택하고 기본 마운트 옵션을 변경하려면 마운트 옵션을 추가합니다.

파티션을 만듭니다.

- 파티션을 만들고 마운트하려면 버튼을 클릭합니다.

파티션을 만들려면 버튼을 클릭합니다.

볼륨 크기 및 선택한 포맷 옵션에 따라 포맷 지정에 몇 분이 걸릴 수 있습니다.

검증

- 파티션이 성공적으로 추가되었는지 확인하려면 Storage 탭으로 전환하고 Storage 테이블을 확인하고 새 파티션이 나열되어 있는지 확인합니다.

3.3. 웹 콘솔에서 파티션 삭제

웹 콘솔 인터페이스에서 파티션을 제거할 수 있습니다.

사전 요구 사항

-

cockpit-storaged패키지가 시스템에 설치됩니다.

- RHEL 8 웹 콘솔을 설치했습니다.

- cockpit 서비스를 활성화했습니다.

사용자 계정이 웹 콘솔에 로그인할 수 있습니다.

자세한 내용은 웹 콘솔 설치 및 활성화를 참조하십시오.

절차

RHEL 8 웹 콘솔에 로그인합니다.

자세한 내용은 웹 콘솔에 로그인 을 참조하십시오.

- 스토리지 탭을 클릭합니다.

- 파티션을 삭제할 장치를 클릭합니다.

- 장치 페이지 및 GPT 파티션 섹션에서 삭제하려는 파티션 있는 메뉴 버튼을 클릭합니다.

드롭다운 메뉴에서 를 선택합니다.

RHEL 웹 콘솔은 현재 파티션을 사용하는 모든 프로세스를 종료하고 삭제하기 전에 파티션을 마운트 해제합니다.

검증

- 파티션이 성공적으로 제거되었는지 확인하려면 Storage 탭으로 전환하고 Storage 테이블을 확인합니다.

6장. 영구 이름 지정 속성 개요

시스템 관리자는 영구 명명 속성을 사용하여 여러 시스템 부팅을 통해 신뢰할 수 있는 스토리지 설정을 빌드하는 스토리지 볼륨을 참조해야 합니다.

6.1. 비영구적 명명 속성의 단점

Red Hat Enterprise Linux는 스토리지 장치를 식별하는 다양한 방법을 제공합니다. 특히 드라이브에 설치하거나 다시 포맷할 때 잘못된 장치에 실수로 액세스하지 않으려면 올바른 옵션을 사용하여 각 장치를 식별하는 것이 중요합니다.

전통적으로 /dev/sd(주 번호)형식의 비영구적 이름은 Linux에서 스토리지 장치를 참조하기 위해사용됩니다. 주요 번호 범위 및 부 번호 범위 및 관련 sd 이름은 감지되면 각 장치에 할당됩니다. 즉, 장치 탐지 순서가 변경되면 주요 번호 범위와 연결된 sd 이름 간의 연결이 변경될 수 있습니다.

이러한 순서 변경은 다음과 같은 상황에서 발생할 수 있습니다.

- 시스템 부팅 프로세스의 병렬화는 각 시스템 부팅 시 다른 순서로 스토리지 장치를 감지합니다.

-

디스크의 전원을 켜거나 SCSI 컨트롤러에 응답하지 못합니다. 그러면 일반 장치 프로브에서 검색되지 않습니다. 디스크는 시스템에서 액세스할 수 없으며 그 이후의 장치에는 연결된

sd이름이 아래로 이동한 등 주요 번호 및 부 번호가 있습니다. 예를 들어 일반적으로sdb라고 하는 디스크를 탐지하지 않으면 일반적으로 assdc라고 하는 디스크가sdb로 표시됩니다. -

SCSI 컨트롤러(호스트 버스 어댑터 또는 HBA)를 초기화하지 못하면 해당 HBA에 연결된 모든 디스크를 탐지하지 않습니다. 나중에 조사하는 HBA에 연결된 모든 디스크에는 서로 다른 주요 및 부 번호 범위가 할당되며 다양한 관련

sd이름이 할당됩니다. - 시스템에 다른 유형의 HBA가 있으면 드라이버 초기화 순서가 변경됩니다. 이로 인해 해당 HBA에 연결된 디스크가 다른 순서로 탐지됩니다. HBA가 시스템의 다른 PCI 슬롯으로 이동되는 경우에도 발생할 수 있습니다.

-

Fibre 채널, iSCSI 또는 FCoE 어댑터를 사용하여 시스템에 연결된 디스크는 스토리지 장치를 프로브할 때 액세스할 수 없을 수 있습니다(예: 스토리지 어레이 또는 교차 스위치의 전원이 꺼짐). 이 문제는 정전 후 시스템을 재부팅할 때 시스템을 부팅하는 것보다 스토리지 어레이가 온라인 상태가 되는 데 시간이 오래 걸리는 경우 발생할 수 있습니다. 일부 파이버 채널 드라이버는 WWPN 매핑에 영구 SCSI 대상 ID를 지정하는 메커니즘을 지원하지만 이는 주요 번호 범위와 연결된

sd이름을 예약하지 않습니다. 일관된 SCSI 대상 ID 번호만 제공합니다.

이러한 이유로 /etc/fstab 파일에서와 같이 장치를 참조할 때 주 번호 범위 또는 관련 sd 이름을 사용하는 것이 바람직하지 않게 합니다. 잘못된 장치가 마운트되고 데이터 손상이 발생할 수 있습니다.

그러나 경우에 따라 장치가 오류를 보고하는 경우와 같이 다른 메커니즘을 사용하는 경우에도 sd 이름을 참조해야 합니다. 이는 Linux 커널이 장치와 관련된 커널 메시지에서 sd 이름(및 SCSI host/channel/target/LUNples)을 사용하기 때문입니다.

6.2. 파일 시스템 및 장치 식별자

파일 시스템 식별자는 파일 시스템 자체에 연결되지만 장치 식별자는 물리적 블록 장치에 연결됩니다. 적절한 스토리지 관리를 위해서는 차이점을 이해하는 것이 중요합니다.

파일 시스템 식별자

파일 시스템 식별자는 블록 장치에 생성된 특정 파일 시스템과 연결됩니다. 식별자는 파일 시스템의 일부로도 저장됩니다. 파일 시스템을 다른 장치로 복사해도 여전히 동일한 파일 시스템 식별자를 전달합니다. 그러나 mkfs 유틸리티로 포맷하여 장치를 다시 작성하는 경우 장치는 특성을 손실됩니다.

파일 시스템 식별자는 다음과 같습니다.

- 고유 식별자 (UUID)

- 레이블

장치 식별자

장치 식별자는 블록 장치(예: 디스크 또는 파티션)에 연결됩니다. mkfs 유틸리티로 포맷하는 등의 장치를 다시 작성하는 경우 장치는 파일 시스템에 저장되지 않기 때문에 속성을 유지합니다.

장치 식별자는 다음과 같습니다.

- WWID(WWID)

- 파티션 UUID

- 일련 번호

권장 사항

- 논리 볼륨과 같은 일부 파일 시스템은 여러 장치에 걸쳐 있습니다. Red Hat은 장치 식별자가 아닌 파일 시스템 식별자를 사용하여 이러한 파일 시스템에 액세스하는 것을 권장합니다.

6.3. /dev/disk/의 udev 메커니즘에서 관리하는 장치 이름

udev 메커니즘은 Linux의 모든 유형의 장치에 사용되며 스토리지 장치에만 국한되지 않습니다. /dev/disk/ 디렉터리에 다양한 종류의 영구 이름 지정 속성을 제공합니다. 스토리지 장치의 경우 Red Hat Enterprise Linux에는 /dev/disk/ 디렉터리에 심볼릭 링크를 생성하는 udev 규칙이 포함되어 있습니다. 이를 통해 다음을 통해 스토리지 장치를 참조할 수 있습니다.

- 해당 콘텐츠

- 고유 식별자

- 일련 번호.

udev 명명 속성은 영구적이지만 시스템 재부팅 시 자체적으로 변경되지 않지만 일부 속성도 구성할 수 있습니다.

6.3.1. 파일 시스템 식별자

/dev/disk/by-uuid/의 UUID 속성

이 디렉터리의 항목은 장치에 저장된 콘텐츠(즉, 데이터)의 고유 식별자 (UUID)로 스토리지 장치를 참조하는 심볼릭 이름을 제공합니다. 예를 들면 다음과 같습니다.

/dev/disk/by-uuid/3e6be9de-8139-11d1-9106-a43f08d823a6

/dev/disk/by-uuid/3e6be9de-8139-11d1-9106-a43f08d823a6

UUID를 사용하여 다음 구문으로 /etc/fstab 파일의 장치를 참조할 수 있습니다.

UUID=3e6be9de-8139-11d1-9106-a43f08d823a6

UUID=3e6be9de-8139-11d1-9106-a43f08d823a6파일 시스템을 만들 때 UUID 속성을 구성할 수 있으며 나중에 변경할 수도 있습니다.

/dev/disk/by-label/의 Label 속성

이 디렉터리의 항목은 장치에 저장된 콘텐츠(즉, 데이터)의 레이블 별로 스토리지 장치를 참조하는 심볼릭 이름을 제공합니다.

예를 들면 다음과 같습니다.

/dev/disk/by-label/Boot

/dev/disk/by-label/Boot

라벨을 사용하여 다음 구문으로 /etc/fstab 파일의 장치를 참조할 수 있습니다.

LABEL=Boot

LABEL=Boot파일 시스템을 생성할 때 Label 속성을 구성할 수 있으며 나중에 변경할 수도 있습니다.

6.3.2. 장치 식별자

/dev/disk/by-id/의 WWID 속성

WWID(World Wide Identifier)는 SCSI 표준에서 모든 SCSI 장치에서 요구하는 영구적인 시스템 독립 식별자 입니다. WWID 식별자는 모든 스토리지 장치에 대해 고유하며 장치에 액세스하는 데 사용되는 경로와 독립적입니다. 식별자는 장치의 속성이지만 장치의 콘텐츠(즉, 데이터)에 저장되지 않습니다.

이 식별자는 장치 식별 Vital Product Data(0 x83 페이지) 또는 유닛 일련 번호 페이지)를 검색하기 위해 SCSI Inquiry를 발행하여 가져올 수 있습니다.

(0x80

Red Hat Enterprise Linux는 WWID 기반 장치 이름에서 해당 시스템의 현재 /dev/sd 이름으로의 적절한 매핑을 자동으로 유지합니다. 애플리케이션은 /dev/disk/by-id/ 이름을 사용하여 장치 경로가 변경되더라도, 여러 시스템에서 장치에 액세스하는 경우에도 디스크의 데이터를 참조할 수 있습니다.

예 6.1. WWID 매핑

| WWID symlink | 비영구적 장치 | 참고 |

|---|---|---|

|

|

|

페이지가 |

|

|

|

페이지가 |

|

|

| 디스크 파티션 |

시스템에서 제공하는 이러한 영구 이름 외에도 udev 규칙을 사용하여 스토리지의 WWID에 매핑되는 고유한 영구 이름을 구현할 수도 있습니다.

/dev/disk/by-partuuid의 파티션 UUID 속성

PARTUUID(파티션 UUID) 특성은 GPT 파티션 테이블에 정의된 파티션을 식별합니다.

예 6.2. 파티션 UUID 매핑

| PARTUUID symlink | 비영구적 장치 |

|---|---|

|

|

|

|

|

|

|

|

|

/dev/disk/by-path/의 Path 속성

이 특성은 장치에 액세스하는 데 사용되는 하드웨어 경로에서 스토리지 장치를 참조하는 심볼릭 이름을 제공합니다.

Path 속성은 하드웨어 경로의 일부(예: PCI ID, 대상 포트 또는 LUN 번호)가 변경되면 실패합니다. 따라서 Path 속성은 신뢰할 수 없습니다. 그러나 Path 속성은 다음 시나리오 중 하나에서 유용할 수 있습니다.

- 나중에 교체할 디스크를 식별해야 합니다.

- 특정 위치에 있는 디스크에 스토리지 서비스를 설치할 계획입니다.

6.4. DM Multipath를 사용한 전 세계 식별자

WWID(WWID)와 비영구 장치 이름 간에 매핑되도록 DM(Device Mapper) Multipath를 구성할 수 있습니다.

시스템에서 장치로 이동하는 경로가 여러 개인 경우 DM Multipath는 WWID를 사용하여 이를 탐지합니다. 그런 다음 DM Multipath는 /dev/mapper/wwid 디렉터리에 /dev/mapper/3600508b400105df70000e00000ac0000 에 하나의 "pseudo-device"를 표시합니다.

multipath -l 명령은 비영구 식별자에 대한 매핑을 표시합니다.

-

Host:Channel:Target:LUN -

/dev/sd이름 -

major:마이너번호

예 6.3. 다중 경로 구성의 WWID 매핑

multipath -l 명령의 출력 예:

DM Multipath는 각 WWID 기반 장치 이름의 적절한 매핑을 시스템의 해당 /dev/sd 이름에 자동으로 유지합니다. 이러한 이름은 경로 변경 시 영구적이며 서로 다른 시스템에서 장치에 액세스할 때 일관적입니다.

DM Multipath의 user_friendly_names 기능을 사용하면 WWID가 /dev/mapper/mpathN 형식의 이름에 매핑됩니다. 기본적으로 이 매핑은 /etc/multipath/bindings 파일에서 유지됩니다. 이러한 mpathN 이름은 해당 파일이 유지되는 동안 유지됩니다.

user_friendly_names 를 사용하는 경우 클러스터에서 일관된 이름을 얻으려면 추가 단계가 필요합니다.

6.5. udev 장치 명명 규칙의 제한 사항

다음은 udev 명명 규칙의 몇 가지 제한 사항입니다.

-

udev 메커니즘이 udev이벤트에대해 udev규칙이 처리될 때 스토리지 장치를 쿼리하는 기능을 사용할 수 있으므로 쿼리를 수행할 때 장치에 액세스할 수 없습니다. 서버가 서버 섀시에 있지 않은 경우 파이버 채널, iSCSI 또는 FCoE 스토리지 장치에서 이 문제가 발생할 가능성이 높습니다. -

커널은 언제든지

udev이벤트를 보낼 수 있으므로 규칙이 처리되고 장치에 액세스할 수 없는 경우/dev/disk/by-*/링크가 제거될 수 있습니다. -

udev 이벤트가 생성되고 많은 장치가 감지되고 사용자 공간 udevd 서비스에서 각 이벤트를 처리하는 데 약간의 시간이 걸리는 경우와 같이 udev이벤트가 생성될 때 사이에 지연이 발생할 수 있습니다. 이로 인해 커널이 장치를 감지하는 경우와/dev/disk/by-*/이름을 사용할 수 있는 시기 사이에 지연이 발생할 수 있습니다. -

규칙에서 호출한

blkid와 같은 외부 프로그램은 잠시 동안 장치를 열 수 있으므로 다른 용도로는 장치에 액세스할 수 없습니다. -

/dev/disk/의

udev메커니즘에서 관리하는 장치 이름은 주요 릴리스 간에 변경될 수 있으므로 링크를 업데이트해야 합니다.

6.6. 영구 이름 지정 속성 나열

비영구 스토리지 장치의 영구 이름 지정 속성을 확인할 수 있습니다.

절차

UUID 및 레이블 속성을 나열하려면

lsblk유틸리티를 사용합니다.lsblk --fs storage-device

$ lsblk --fs storage-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

예 6.4. 파일 시스템의 UUID 및 레이블 보기

lsblk --fs /dev/sda1 NAME FSTYPE LABEL UUID MOUNTPOINT sda1 xfs Boot afa5d5e3-9050-48c3-acc1-bb30095f3dc4 /boot

$ lsblk --fs /dev/sda1 NAME FSTYPE LABEL UUID MOUNTPOINT sda1 xfs Boot afa5d5e3-9050-48c3-acc1-bb30095f3dc4 /bootCopy to Clipboard Copied! Toggle word wrap Toggle overflow PARTUUID 특성을 나열하려면

--output +PARTUUID옵션과 함께lsblk유틸리티를 사용합니다.lsblk --output +PARTUUID

$ lsblk --output +PARTUUIDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

예 6.5. 파티션의 PARTUUID 속성 보기

lsblk --output +PARTUUID /dev/sda1 NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT PARTUUID sda1 8:1 0 512M 0 part /boot 4cd1448a-01

$ lsblk --output +PARTUUID /dev/sda1 NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT PARTUUID sda1 8:1 0 512M 0 part /boot 4cd1448a-01Copy to Clipboard Copied! Toggle word wrap Toggle overflow WWID 특성을 나열하려면

/dev/disk/by-id/디렉터리에 있는 심볼릭 링크의 대상을 검사합니다. 예를 들면 다음과 같습니다.예 6.6. 시스템의 모든 스토리지 장치의 WWID 보기

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.7. 영구 이름 지정 속성 수정

파일 시스템의 UUID 또는 레이블 영구 이름 지정 속성을 변경할 수 있습니다.

udev 속성 변경은 백그라운드에서 수행되며 시간이 오래 걸릴 수 있습니다. udevadm settle 명령은 변경 사항이 완전히 등록될 때까지 대기하여 다음 명령이 새 속성을 올바르게 사용할 수 있도록 합니다.

다음 명령에서 다음을 수행합니다.

-

new-uuid 를 설정할 UUID로 바꿉니다(예:

1cdfbc07-1c90-4984-b5ec-f61943f5ea50).uuidgen명령을 사용하여 UUID를 생성할 수 있습니다. -

new-label 을 레이블로 바꿉니다(예:

backup_data).

사전 요구 사항

- XFS 파일 시스템의 속성을 수정하는 경우 먼저 마운트 해제합니다.

절차

XFS 파일 시스템의 UUID 또는 레이블 속성을 변경하려면

xfs_admin유틸리티를 사용합니다.xfs_admin -U new-uuid -L new-label storage-device udevadm settle

# xfs_admin -U new-uuid -L new-label storage-device # udevadm settleCopy to Clipboard Copied! Toggle word wrap Toggle overflow ext4, ext3 또는 ext 2 파일 시스템의 UUID 또는 레이블 속성을 변경하려면

tune2fs유틸리티를 사용합니다.tune2fs -U new-uuid -L new-label storage-device udevadm settle

# tune2fs -U new-uuid -L new-label storage-device # udevadm settleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 스왑 볼륨의 UUID 또는 레이블 속성을 변경하려면

swaplabel유틸리티를 사용합니다.swaplabel --uuid new-uuid --label new-label swap-device udevadm settle

# swaplabel --uuid new-uuid --label new-label swap-device # udevadm settleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7장. parted를 사용하는 파티션 작업

parted 는 디스크 파티션을 조작하는 프로그램입니다. MS-DOS 및 GPT를 포함한 여러 파티션 테이블 형식을 지원합니다. 새로운 운영 체제의 공간을 만들고, 디스크 사용량을 재구성하고, 데이터를 새 하드 디스크에 복사하는 데 유용합니다.

7.1. parted로 파티션 테이블 보기

블록 장치의 파티션 테이블을 표시하여 파티션 레이아웃과 개별 파티션에 대한 세부 정보를 확인합니다. parted 유틸리티를 사용하여 블록 장치에서 파티션 테이블을 볼 수 있습니다.

절차

parted유틸리티를 시작합니다. 예를 들어 다음 출력에는/dev/sda가 나열됩니다.parted /dev/sda

# parted /dev/sdaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파티션 테이블 보기:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항: 다음을 검사하려는 장치로 전환합니다.

(parted) select block-device

(parted) select block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

출력 명령 출력에 대한 자세한 설명은 다음을 참조하십시오.

모델: ATA SAMSUNG MZNLN256 (scsi)- 디스크 유형, 제조업체, 모델 번호 및 인터페이스.

디스크 /dev/sda: 256GB- 블록 장치 및 스토리지 용량의 파일 경로입니다.

파티션 테이블: msdos- 디스크 레이블 유형입니다.

숫자-

파티션 번호입니다. 예를 들어, 번호가 1인 파티션은

/dev/sda1에 해당합니다. 시작및종료- 파티션을 시작하고 종료하는 장치의 위치입니다.

유형- 유효한 유형은 metadata, free, primary, 확장 또는 논리입니다.

파일 시스템-

파일 시스템 유형입니다. 장치의

파일 시스템필드에 값이 표시되지 않으면 파일 시스템 유형을 알 수 없음을 의미합니다.parted유틸리티는 암호화된 장치에서 파일 시스템을 인식할 수 없습니다. 플래그-

파티션에 설정된 플래그를 나열합니다. 사용 가능한 플래그는

boot,root,swap,hidden,raid,lvm또는lba입니다.

7.2. parted가 있는 디스크에 파티션 테이블 만들기

parted 유틸리티를 사용하여 파티션 테이블로 블록 장치를 보다 쉽게 포맷합니다.

파티션 테이블로 블록 장치를 포맷하면 장치에 저장된 모든 데이터가 삭제됩니다.

절차

대화식

parted쉘을 시작합니다.parted block-device

# parted block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 장치에 파티션 테이블이 이미 있는지 확인합니다.

(parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow 장치에 이미 파티션이 포함된 경우 다음 단계에서 삭제됩니다.

새 파티션 테이블을 만듭니다.

(parted) mklabel table-type

(parted) mklabel table-typeCopy to Clipboard Copied! Toggle word wrap Toggle overflow table-type 을 원하는 파티션 테이블 유형으로 바꿉니다.

-

MBR 용 MSDOS -

GPT

용GPT

-

예 7.1. GUID 파티션 테이블(GPT) 만들기

디스크에 GPT 테이블을 만들려면 다음을 사용합니다.

(parted) mklabel gpt

(parted) mklabel gptCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령을 입력한 후 변경 사항이 적용되기 시작합니다.

파티션 테이블을 보고 해당 테이블이 생성되었는지 확인합니다.

(parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow parted쉘을 종료합니다.(parted) quit

(parted) quitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. parted로 파티션 만들기

시스템 관리자는 parted 유틸리티를 사용하여 디스크에 새 파티션을 만들 수 있습니다.

필요한 파티션은 스왑,/boot/, 및 / (root) 입니다.

사전 요구 사항

- 디스크의 파티션 테이블입니다.

- 생성하려는 파티션이 2TiB보다 크면 GUID 파티션 테이블(GPT) 으로 디스크를 포맷합니다.

절차

parted유틸리티를 시작합니다.parted block-device

# parted block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 현재 파티션 테이블을 보고 사용 가능한 공간이 충분한지 확인합니다.

(parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 사용 가능한 공간이 충분하지 않은 경우 파티션의 크기를 조정합니다.

파티션 테이블에서 다음을 결정합니다.

- 새 파티션의 시작 및 끝점입니다.

- MBR의 경우 어떤 파티션 유형이 필요합니까.

새 파티션을 만듭니다.

(parted) mkpart part-type name fs-type start end

(parted) mkpart part-type name fs-type start endCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

part-type 을

기본,논리또는 확장으로바꿉니다. MBR 파티션 테이블에만 적용됩니다. - 이름을 임의의 파티션 이름으로 바꿉니다. GPT 파티션 테이블에 필요합니다.

-

fs-type 을

xfs,ext2,ext3,ext4,fat16,fat32,hfs,hfs+,linux-swap,ntfs또는reiserfs로 바꿉니다. fs-type 매개변수는 선택 사항입니다.parted유틸리티는 파티션에 파일 시스템을 생성하지 않습니다. -

start 및 end 를 파티션의 시작 및 종료 지점을 결정하는 크기로 바꾸고 디스크 시작부터 계산합니다.

512MiB,20GiB또는1.5TiB와 같은 크기 접미사를 사용할 수 있습니다. 기본 크기는 메가바이트입니다.

예 7.2. 작은 기본 파티션 만들기

1024MiB에서 STATUS 테이블의 기본 파티션을 2048MiB까지 만들려면 다음을 사용합니다.

(parted) mkpart primary 1024MiB 2048MiB

(parted) mkpart primary 1024MiB 2048MiBCopy to Clipboard Copied! Toggle word wrap Toggle overflow 변경 사항은 명령을 입력한 후 적용을 시작합니다.

-

part-type 을

파티션 테이블을 보고 생성된 파티션이 올바른 파티션 유형, 파일 시스템 유형 및 크기의 파티션 테이블에 있는지 확인합니다.

(parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow parted쉘을 종료합니다.(parted) quit

(parted) quitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 새 장치 노드를 등록합니다.

udevadm settle

# udevadm settleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 커널이 새 파티션을 인식하는지 확인합니다.

cat /proc/partitions

# cat /proc/partitionsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4. parted로 파티션 제거

parted 유틸리티를 사용하면 디스크 파티션을 제거하여 디스크 공간을 확보할 수 있습니다.

절차

대화식

parted쉘을 시작합니다.parted block-device

# parted block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

블록 장치를 파티션을 제거하려는 장치의 경로로 바꿉니다(예:

/dev/sda).

-

블록 장치를 파티션을 제거하려는 장치의 경로로 바꿉니다(예:

현재 파티션 테이블을 보고 삭제할 파티션의 마이너 수를 결정합니다.

(parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파티션을 제거합니다.

(parted) rm minor-number

(parted) rm minor-numberCopy to Clipboard Copied! Toggle word wrap Toggle overflow - minor-number 를 제거하려는 파티션의 마이너 번호로 바꿉니다.

변경 사항은 이 명령을 입력하는 즉시 적용을 시작합니다.

파티션 테이블에서 파티션을 제거했는지 확인합니다.

(parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow parted쉘을 종료합니다.(parted) quit

(parted) quitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 커널이 파티션이 제거되었는지 확인합니다.

cat /proc/partitions

# cat /proc/partitionsCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

/etc/fstab파일이 있는 경우 파티션을 제거합니다. 제거된 파티션을 선언하는 행을 찾아 파일에서 제거합니다. 시스템이 새

/etc/fstab구성을 등록하도록 마운트 장치를 다시 생성합니다.systemctl daemon-reload

# systemctl daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow 스왑 파티션을 삭제하거나 LVM을 제거한 경우 커널 명령줄에서 파티션에 대한 모든 참조를 제거하십시오.

활성 커널 옵션을 나열하고 옵션이 제거된 파티션을 참조하는지 확인합니다.

grubby --info=ALL

# grubby --info=ALLCopy to Clipboard Copied! Toggle word wrap Toggle overflow 삭제된 파티션을 참조하는 커널 옵션을 제거합니다.

grubby --update-kernel=ALL --remove-args="option"

# grubby --update-kernel=ALL --remove-args="option"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

초기 부팅 시스템에서 변경 사항을 등록하려면

initramfs파일 시스템을 다시 빌드합니다.dracut --force --verbose

# dracut --force --verboseCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.5. parted로 파티션 크기 조정

parted 유틸리티를 사용하여 사용하지 않는 디스크 공간을 사용하도록 파티션을 확장하거나 다른 용도로 용량을 사용하도록 파티션을 축소합니다.

사전 요구 사항

- 파티션을 축소하기 전에 데이터를 백업합니다.

- 생성하려는 파티션이 2TiB보다 크면 GUID 파티션 테이블(GPT) 으로 디스크를 포맷합니다.

- 파티션을 축소하려면 먼저 크기가 조정된 파티션보다 크지 않도록 파일 시스템을 축소합니다.

XFS는 축소를 지원하지 않습니다.

절차

parted유틸리티를 시작합니다.parted block-device

# parted block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 현재 파티션 테이블을 확인합니다.

(parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파티션 테이블에서 다음을 결정합니다.

- 파티션의 마이너 번호입니다.

- 크기 조정 후 기존 파티션 및 해당 새 종료 지점의 위치입니다.

파티션 크기를 조정합니다.

(parted) resizepart 1 2GiB

(parted) resizepart 1 2GiBCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1 을 크기 조정 중인 파티션의 마이너 번호로 바꿉니다.

-

2 를 크기가 조정된 파티션의 새 끝 지점을 결정하는 크기로 바꾸고 디스크 처음부터 계산합니다.

512MiB,20GiB또는1.5TiB와 같은 크기 접미사를 사용할 수 있습니다. 기본 크기는 메가바이트입니다.

파티션 테이블을 보고 크기 조정 파티션이 올바른 크기의 파티션 테이블에 있는지 확인합니다.

(parted) print

(parted) printCopy to Clipboard Copied! Toggle word wrap Toggle overflow parted쉘을 종료합니다.(parted) quit

(parted) quitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 커널이 새 파티션을 등록하는지 확인합니다.

cat /proc/partitions

# cat /proc/partitionsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 선택 사항: 파티션을 확장한 경우 파일 시스템도 확장합니다.

8장. 디스크 재파티션을 위한 전략

디스크를 다시 분할하는 방법은 다양합니다. 여기에는 다음이 포함됩니다.

- 파티션되지 않은 여유 공간을 사용할 수 있습니다.

- 사용되지 않은 파티션을 사용할 수 있습니다.

- 활발하게 사용되는 파티션의 여유 공간을 사용할 수 있습니다.

다음 예제는 명확성을 위해 단순화되며 Red Hat Enterprise Linux를 실제로 설치할 때 정확한 파티션 레이아웃을 반영하지 않습니다.

8.1. 파티션되지 않은 여유 공간 사용

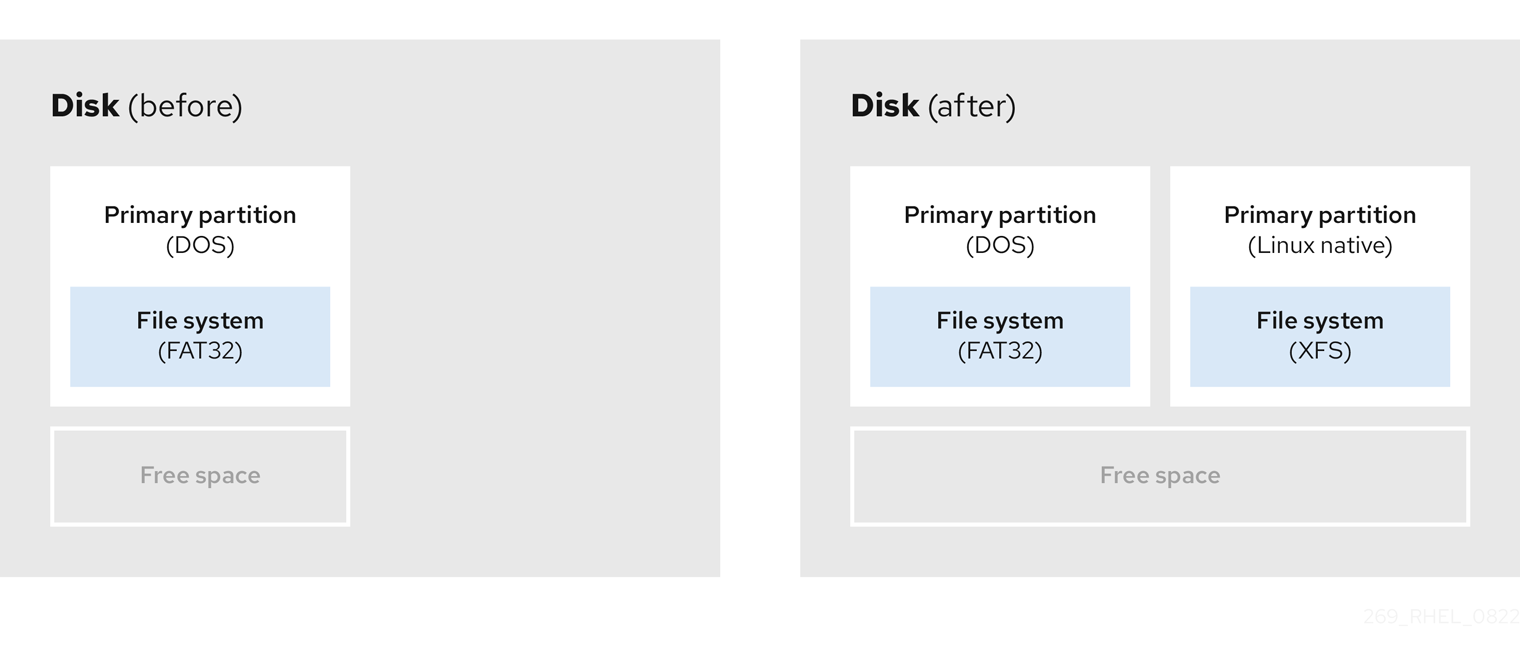

이미 정의되어 있고 전체 하드 디스크에 걸쳐 있지 않은 파티션은 정의된 파티션에 속하지 않는 할당되지 않은 공간을 남겨 둡니다. 다음 다이어그램에서는 이것이 어떻게 보이는지 보여줍니다.

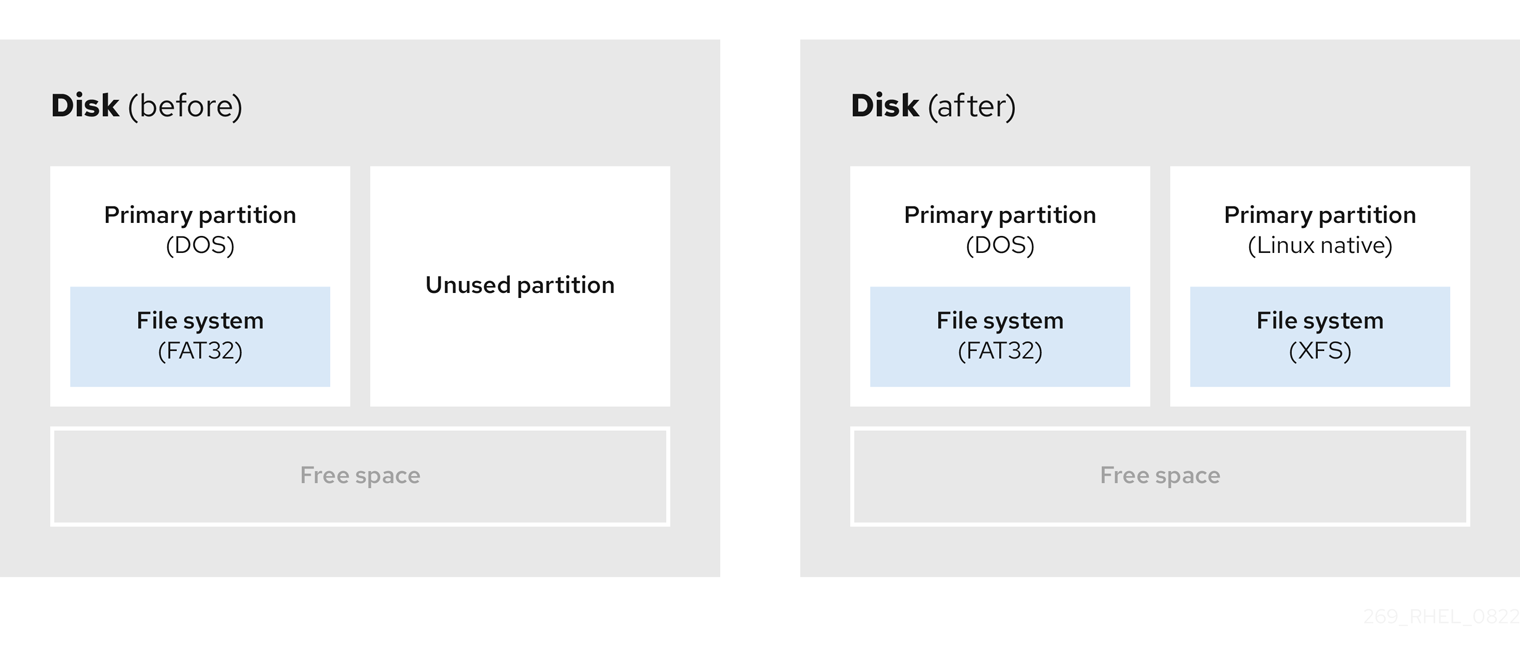

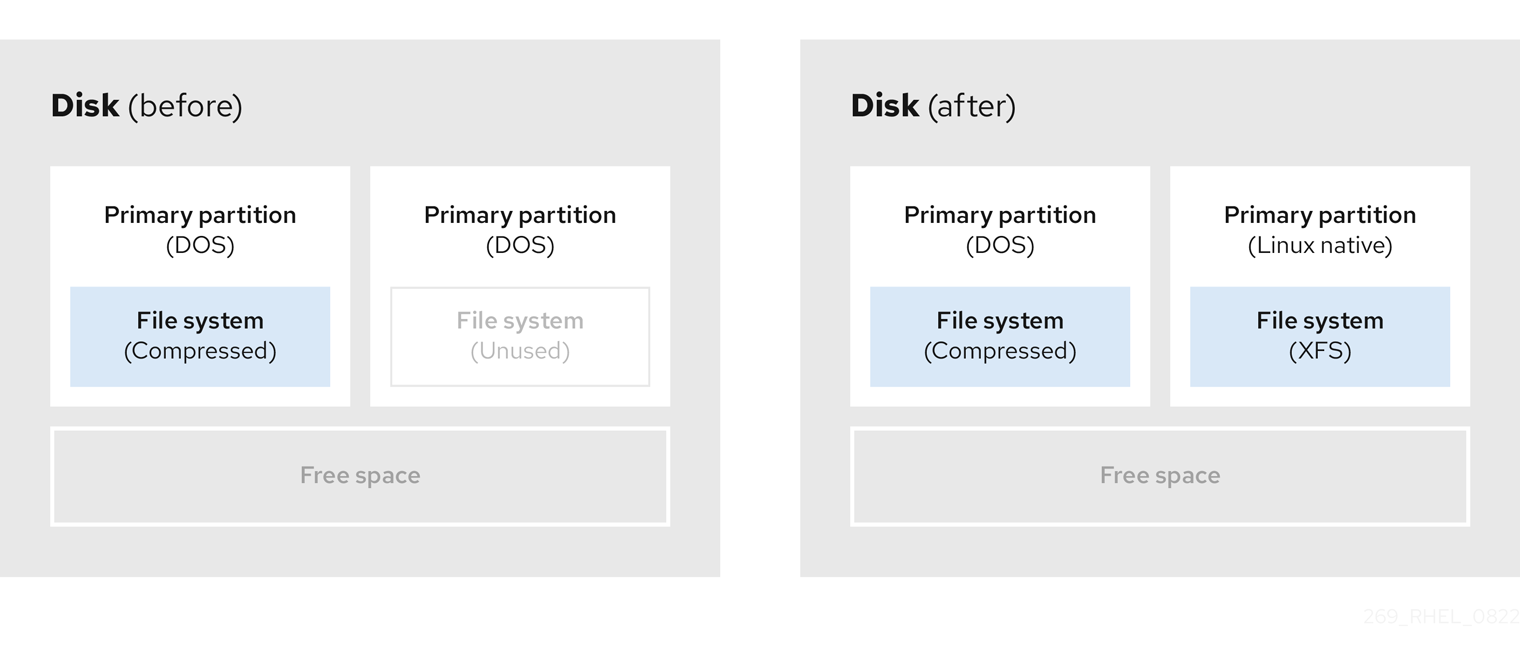

그림 8.1. 여유 공간이 파티션되지 않은 디스크

첫 번째 다이어그램은 하나의 기본 파티션과 할당되지 않은 공간이 있는 정의되지 않은 파티션이 있는 디스크를 나타냅니다. 두 번째 다이어그램은 공간이 할당된 두 개의 정의된 파티션이 있는 디스크를 나타냅니다.

사용하지 않는 하드 디스크도 이 범주에 속합니다. 유일한 차이점은 모든 공간이 정의된 파티션의 일부가 아니라는 것입니다.

새 디스크에서 사용되지 않는 공간을 통해 필요한 파티션을 만들 수 있습니다. 대부분의 사전 설치된 운영 체제는 디스크 드라이브에서 사용 가능한 모든 공간을 차지하도록 구성됩니다.

8.2. 사용되지 않은 파티션의 공간 사용

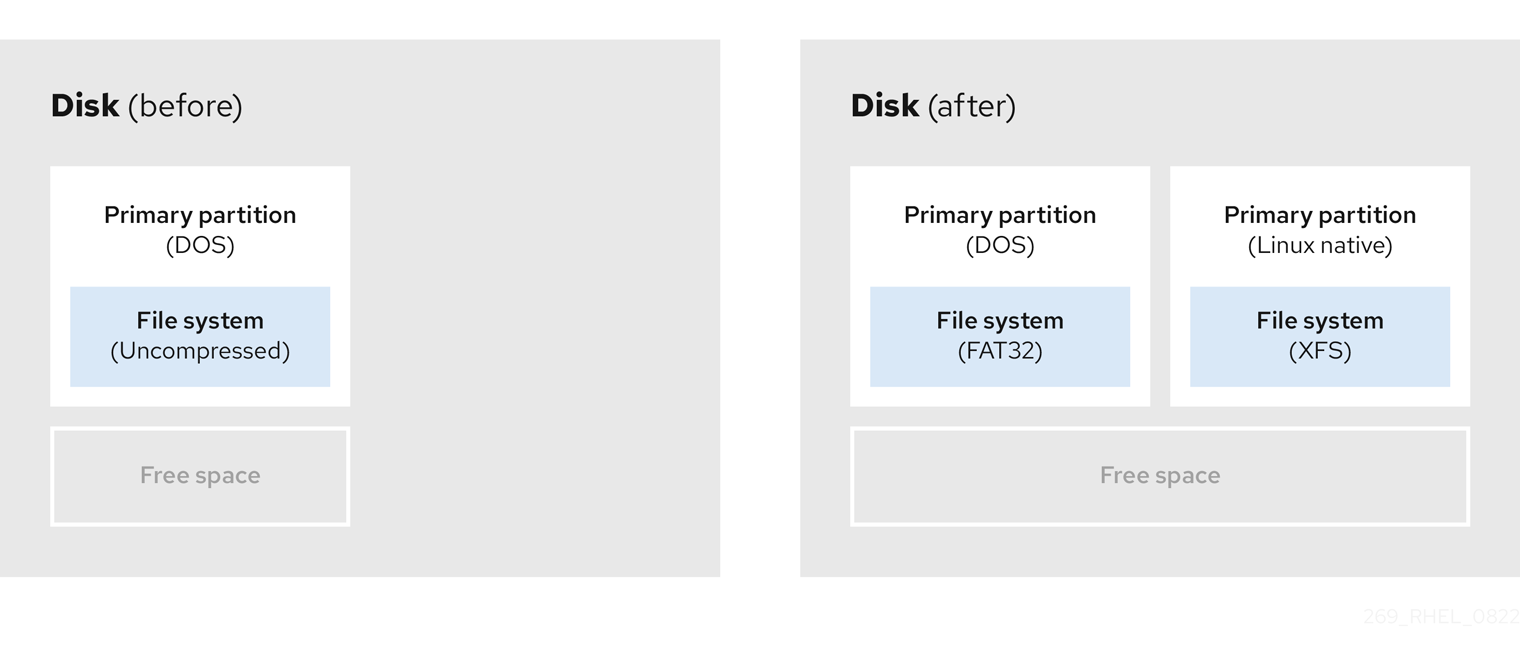

다음 예에서 첫 번째 다이어그램은 사용되지 않은 파티션이 있는 디스크를 나타냅니다. 두 번째 다이어그램은 Linux에서 사용되지 않은 파티션을 찾는 것을 나타냅니다.

그림 8.2. 사용되지 않는 파티션이 있는 디스크

사용되지 않은 파티션에 할당된 공간을 사용하려면 파티션을 삭제한 다음 적절한 Linux 파티션을 만듭니다. 또는 설치 프로세스 중에 사용되지 않은 파티션을 삭제하고 새 파티션을 수동으로 만듭니다.

8.3. 활성 파티션의 여유 공간 사용

이 프로세스에는 이미 사용 중인 활성 파티션에 필요한 여유 공간이 포함되어 있으므로 이 프로세스를 관리하기 어려울 수 있습니다. 대부분의 경우 소프트웨어가 사전 설치된 컴퓨터 하드 디스크에는 운영 체제 및 데이터를 보유한 더 큰 파티션이 포함되어 있습니다.

활성 파티션에서 운영 체제(OS)를 사용하려면 OS를 다시 설치해야 합니다. 사전 설치된 소프트웨어를 포함하는 일부 컴퓨터는 원래 OS를 재설치하기 위한 설치 미디어를 포함하지 않습니다. 원래 파티션과 OS 설치를 제거하기 전에 이것이 OS에 적용되는지 확인하십시오.

사용 가능한 여유 공간 사용을 최적화하기 위해, 안전하지 않거나 파괴되지 않은 재파운딩 방법을 사용할 수 있습니다.

8.3.1. destructive repartitioning

안전하지 않은 재파티션은 하드 드라이브에서 파티션을 제거하고 대신 작은 여러 파티션을 만듭니다. 이 방법을 사용하면 전체 내용이 삭제되므로 원래 파티션에서 필요한 모든 데이터를 백업하십시오.

기존 운영 체제에 대해 더 작은 파티션을 생성한 후 다음을 수행할 수 있습니다.

- 소프트웨어 재설치.

- 데이터를 복원합니다.

- Red Hat Enterprise Linux 설치를 시작하십시오.

다음 다이어그램은 안전하지 않은 repartitioning 방법 사용에 대한 단순화된 표현입니다.

그림 8.3. 디스크에서 안전하지 않은 재파티셔닝 작업

이 방법은 원래 파티션에 이전에 저장된 모든 데이터를 삭제합니다.

8.3.2. 안전하지 않은 재파티셔닝

데이터 손실 없이 파티션 재파티브 크기 조정이 지연되지 않습니다. 이 방법은 신뢰할 수 있지만 큰 드라이브에서 처리 시간이 오래 걸립니다.

다음은 거부된 복원을 시작하는 데 도움이 될 수 있는 메서드 목록입니다.

- 기존 데이터 압축

일부 데이터의 저장 위치는 변경할 수 없습니다. 이렇게 하면 파티션이 필요한 크기로 크기를 조정하는 것을 방지할 수 있으며 궁극적으로 안전하지 않은 재파티션 프로세스가 발생할 수 있습니다. 이미 존재하는 파티션의 데이터를 압축하면 필요에 따라 파티션의 크기를 조정하는 데 도움이 될 수 있습니다. 또한 사용 가능한 공간을 최대화하는 데 도움이 될 수 있습니다.

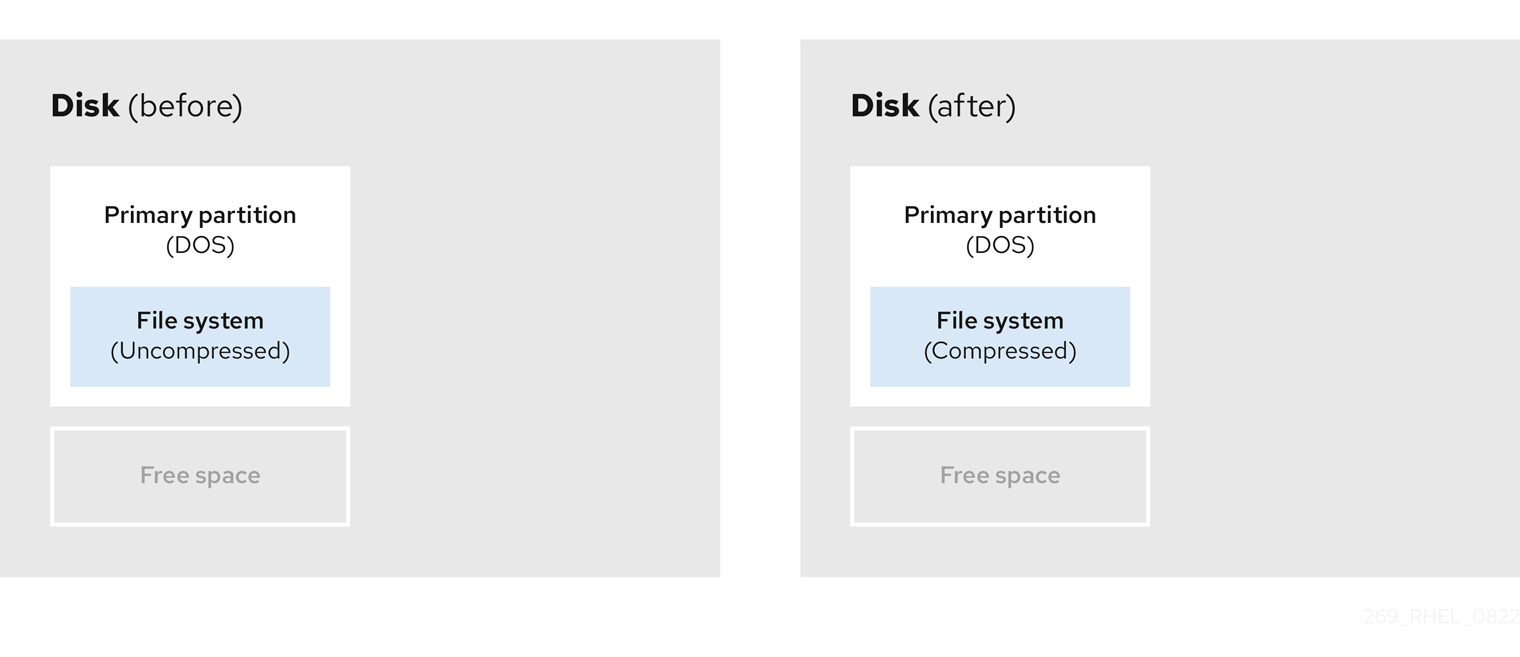

다음 다이어그램은 이 프로세스를 간단하게 나타냅니다.

그림 8.4. 디스크의 데이터 압축

가능한 데이터 손실을 방지하려면 압축 프로세스를 계속하기 전에 백업을 만듭니다.

- 기존 파티션의 크기 조정

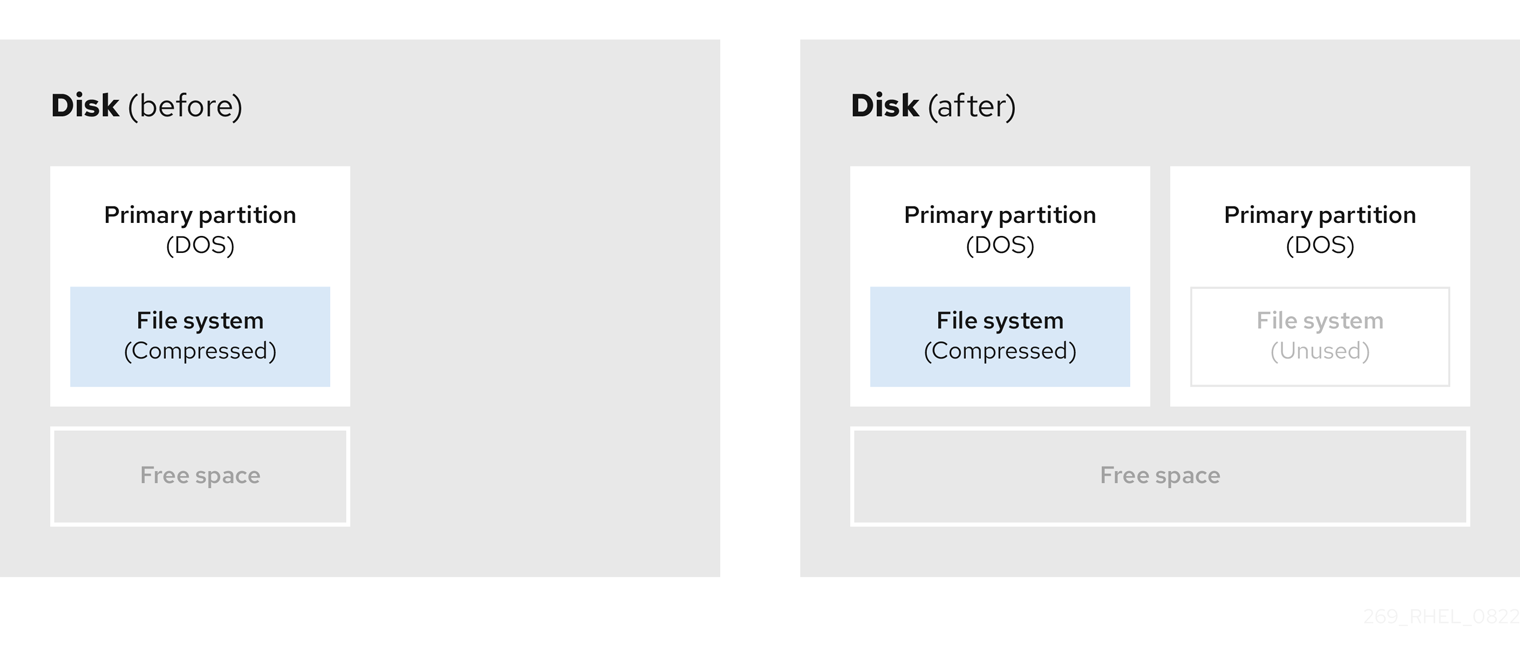

기존 파티션의 크기를 조정하면 더 많은 공간을 확보할 수 있습니다. 소프트웨어 크기 조정에 따라 결과가 다를 수 있습니다. 대부분의 경우 원래 파티션과 동일한 유형의 포맷되지 않은 새 파티션을 만들 수 있습니다.

크기 조정 후 수행하는 단계는 사용하는 소프트웨어에 따라 달라질 수 있습니다. 다음 예에서 모범 사례는 새 Cryostat(디스크 운영 체제) 파티션을 삭제하고 대신 Linux 파티션을 생성하는 것입니다. 크기 조정 프로세스를 시작하기 전에 디스크에 가장 적합한 항목을 확인합니다.

그림 8.5. 디스크의 파티션 크기 조정

- 선택 사항: 새 파티션 만들기

소프트웨어 크기 조정의 일부 부분은 Linux 기반 시스템을 지원합니다. 이러한 경우 크기 조정 후 새로 생성된 파티션을 삭제할 필요가 없습니다. 나중에 새 파티션을 만드는 것은 사용하는 소프트웨어에 따라 다릅니다.

다음 다이어그램은 새 파티션을 만들기 전후에 디스크 상태를 나타냅니다.

그림 8.6. 최종 파티션 구성이 있는 디스크

9장. XFS 시작하기

XFS 파일 시스템을 생성하고 유지 관리하는 방법에 대한 개요입니다.

9.1. XFS 파일 시스템

XFS는 단일 호스트에서 매우 큰 파일 및 파일 시스템을 지원하는 확장성이 뛰어나고 강력한 고성능 저널링 파일 시스템입니다. 이는 Red Hat Enterprise Linux 8의 기본 파일 시스템입니다. XFS는 원래 SGI 초반에서 개발되었으며 매우 큰 서버 및 스토리지 어레이에서 오랫동안 실행되고 있습니다.

XFS의 기능은 다음과 같습니다.

- 신뢰성

- 메타데이터 저널링: 시스템을 다시 시작하고 파일 시스템을 다시 마운트할 때 재생할 수 있는 파일 시스템 작업 기록을 유지하여 시스템 충돌 후 파일 시스템 무결성을 보장합니다.

- 광범위한 런타임 메타데이터 일관성 검사

- 확장 가능한 빠른 복구 유틸리티

- 할당량 저널링. 이로 인해 충돌 후 긴 할당량 일관성 점검이 필요하지 않습니다.

- 확장 및 성능

- 지원되는 파일 시스템 크기 최대 1024TiB

- 다수의 동시 작업을 지원하는 기능

- 사용 가능한 공간 관리의 확장성을 위한 B-트리 인덱싱

- 정교한 메타데이터 읽기 알고리즘

- 스트리밍 비디오 워크로드에 대한 최적화

- 할당 체계

- 범위 기반 할당

- 스트라이프 인식 할당 정책

- 지연된 할당

- 공간 사전 할당

- 동적으로 할당된 inode

- 기타 기능

- reflink 기반 파일 복사

- 긴밀하게 통합된 백업 및 복원 유틸리티

- 온라인 조각 모음

- 온라인 파일 시스템 확장

- 포괄적인 진단 기능

-

확장 속성(

xattr). 이를 통해 시스템은 파일당 여러 개의 추가 이름/값 쌍을 연결할 수 있습니다. - 프로젝트 또는 디렉터리 할당량. 이렇게 하면 디렉터리 트리에 대한 할당량 제한이 허용됩니다.

- 하위 타임 스탬프

성능 특성

XFS는 엔터프라이즈 워크로드가 있는 대규모 시스템에서 높은 성능을 제공합니다. 대규모 시스템은 비교적 많은 CPU 수, 여러 HBA 및 외부 디스크 어레이에 대한 연결이 있는 시스템입니다. XFS는 다중 스레드 병렬 I/O 워크로드가 있는 소규모 시스템에서도 잘 작동합니다.

XFS는 단일 스레드 메타데이터 집약적인 워크로드(예: 단일 스레드에서 많은 수의 작은 파일을 만들거나 삭제하는 워크로드)에 대해 상대적으로 낮은 성능을 제공합니다.

9.2. ext4 및 XFS와 함께 사용되는 툴 비교

이 섹션에서는 ext4 및 XFS 파일 시스템에서 일반적인 작업을 수행하는 데 사용할 툴을 비교합니다.

| Task | ext4 | XFS |

|---|---|---|

| 파일 시스템 생성 |

|

|

| 파일 시스템 검사 |

|

|

| 파일 시스템 크기 조정 |

|

|

| 파일 시스템의 이미지 저장 |

|

|

| 파일 시스템 레이블 또는 튜닝 |

|

|

| 파일 시스템 백업 |

|

|

| 할당량 관리 |

|

|

| 파일 매핑 |

|

|

10장. XFS 파일 시스템 생성

시스템 관리자는 블록 장치에 XFS 파일 시스템을 생성하여 파일과 디렉터리를 저장할 수 있습니다.

10.1. mkfs.xfs를 사용하여 XFS 파일 시스템 생성

다음 절차에서는 블록 장치에서 XFS 파일 시스템을 생성하는 방법을 설명합니다.

절차

파일 시스템을 생성하려면 다음을 수행합니다.

장치가 일반 파티션인 경우 LVM 볼륨, MD 볼륨, 디스크 또는 유사한 장치인 경우 다음 명령을 사용합니다.

mkfs.xfs block-device

# mkfs.xfs block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

block-device 를 블록 장치의 경로로 바꿉니다. 예를 들어

/dev/sdb1,/dev/disk/by-uuid/05e99ec8-def1-4a5e-8a9d-5945339ceb2a또는/dev/my-volgroup/my-lv입니다. - 일반적으로 기본 옵션은 일반적인 용도에 적합합니다.

-

기존 파일 시스템이 포함된 블록 장치에서

mkfs.xfs를 사용하는 경우-f옵션을 추가하여 해당 파일 시스템을 덮어씁니다.

-

block-device 를 블록 장치의 경로로 바꿉니다. 예를 들어

하드웨어 RAID 장치에서 파일 시스템을 생성하려면 시스템이 장치의 스트라이프를 올바르게 감지하는지 확인합니다.

스트라이프 정보가 올바른 경우 추가 옵션이 필요하지 않습니다. 파일 시스템을 생성합니다.

mkfs.xfs block-device

# mkfs.xfs block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 정보가 올바르지 않으면

-d옵션의su및sw매개 변수를 사용하여 스트라이프를 수동으로 지정합니다.su매개 변수는 RAID 청크 크기를 지정하고sw매개 변수는 RAID 장치의 데이터 디스크 수를 지정합니다.예를 들면 다음과 같습니다.

mkfs.xfs -d su=64k,sw=4 /dev/sda3

# mkfs.xfs -d su=64k,sw=4 /dev/sda3Copy to Clipboard Copied! Toggle word wrap Toggle overflow

다음 명령을 사용하여 시스템이 새 장치 노드를 등록할 때까지 기다립니다.

udevadm settle

# udevadm settleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

11장. XFS 파일 시스템 백업

시스템 관리자는 xfsdump 를 사용하여 XFS 파일 시스템을 파일 또는 테이프에 백업할 수 있습니다. 이는 간단한 백업 메커니즘을 제공합니다.

11.1. XFS 백업의 기능

이 섹션에서는 xfsdump 유틸리티를 사용하여 XFS 파일 시스템을 백업하는 주요 개념과 기능에 대해 설명합니다.

xfsdump 유틸리티를 사용하여 다음을 수행할 수 있습니다.

일반 파일 이미지에 대한 백업을 수행합니다.

백업은 일반 파일에 한 개만 쓸 수 있습니다.

테이프 드라이브에 백업을 수행합니다.

xfsdump유틸리티를 사용하면 동일한 테이프에 여러 백업을 작성할 수도 있습니다. 백업은 여러 개의 테이프에 걸쳐 있을 수 있습니다.하나의 테이프 장치로 여러 파일 시스템을 백업하려면 XFS 백업이 이미 포함된 테이프에 백업을 작성하면 됩니다. 그러면 이전 백업에 새 백업이 추가됩니다. 기본적으로

xfsdump는 기존 백업을 덮어쓰지 않습니다.증분 백업 생성.

xfsdump유틸리티는 덤프 수준을 사용하여 다른 백업이 상대적인 기본 백업을 결정합니다. 0에서 9 사이의 숫자는 덤프 수준을 높이는 것을 나타냅니다. 증분 백업은 더 낮은 수준의 마지막 덤프 이후 변경된 파일만 백업합니다.- 전체 백업을 수행하려면 파일 시스템에서 수준 0 덤프를 수행합니다.

- 레벨 1 덤프는 전체 백업 후 첫 번째 증분 백업입니다. 다음 증분 백업은 수준 2로, 마지막 레벨 1 덤프 이후 변경된 파일만 백업하는 등 최대 레벨 9로 백업됩니다.

- size, subtree 또는 inode 플래그를 사용하여 백업에서 파일을 제외하여 필터링합니다.

11.2. xfsdump를 사용하여 XFS 파일 시스템 백업

다음 절차에서는 XFS 파일 시스템의 콘텐츠를 파일 또는 테이프로 백업하는 방법을 설명합니다.

사전 요구 사항

- 백업할 수 있는 XFS 파일 시스템입니다.

- 백업을 저장할 수 있는 다른 파일 시스템 또는 테이프 드라이브.

절차

다음 명령을 사용하여 XFS 파일 시스템을 백업합니다.

xfsdump -l level [-L label] \ -f backup-destination path-to-xfs-filesystem

# xfsdump -l level [-L label] \ -f backup-destination path-to-xfs-filesystemCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

수준을 백업의 덤프 수준으로 바꿉니다.

0을 사용하여 전체 백업 또는1-9를 수행하여 이에 해당하는 증분 백업을 수행합니다. -

backup-destination 을 백업을 저장하려는 경로로 바꿉니다. 대상은 일반 파일, 테이프 드라이브 또는 원격 테이프 장치일 수 있습니다. 예를 들어 파일의 경우

/backup-files/Data.xfsdump, 테이프 드라이브의 경우/dev/st0입니다. -

path-to-xfs-filesystem 을 백업하려는 XFS 파일 시스템의 마운트 지점으로 교체합니다. 예를 들면

/mnt/data/입니다. 파일 시스템을 마운트해야 합니다. -

여러 파일 시스템을 백업하고 단일 테이프 장치에 저장할 때

-L 레이블 옵션을 사용하여 세션 레이블을각 백업에 추가하여 복원 시 쉽게 식별할 수 있습니다. 레이블을 백업의 이름(예:backup_data)으로 바꿉니다.

-

수준을 백업의 덤프 수준으로 바꿉니다.

예 11.1. 여러 XFS 파일 시스템 백업

/boot/ 및 /data/디렉터리에 마운트된 XFS 파일 시스템의 콘텐츠를 백업하고 /backup-files/디렉터리에 파일로 저장하려면 다음을 수행합니다.xfsdump -l 0 -f /backup-files/boot.xfsdump /boot xfsdump -l 0 -f /backup-files/data.xfsdump /data

# xfsdump -l 0 -f /backup-files/boot.xfsdump /boot # xfsdump -l 0 -f /backup-files/data.xfsdump /dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow 단일 테이프 장치에서 여러 파일 시스템을 백업하려면

-L 레이블 옵션을 사용하여 각 백업에 세션 레이블을추가합니다.xfsdump -l 0 -L "backup_boot" -f /dev/st0 /boot xfsdump -l 0 -L "backup_data" -f /dev/st0 /data

# xfsdump -l 0 -L "backup_boot" -f /dev/st0 /boot # xfsdump -l 0 -L "backup_data" -f /dev/st0 /dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow

12장. 백업에서 XFS 파일 시스템 복원

시스템 관리자는 xfsrestore 유틸리티를 사용하여 xfs dump 유틸리티로 생성된 XFS 백업을 파일 또는 테이프에 저장할 수 있습니다.

12.1. 백업에서 XFS 복원의 기능

xfsrestore 유틸리티는 xfsdump 에서 생성한 백업에서 파일 시스템을 복원합니다. xfsrestore 유틸리티에는 다음 두 가지 모드가 있습니다.

- 단순 모드를 사용하면 사용자가 전체 파일 시스템을 수준 0 덤프에서 복원할 수 있습니다. 이는 기본값 모드입니다.

- 누적 모드를 사용하면 증분 백업(즉, 레벨 1에서 수준 9)으로 파일 시스템을 복원할 수 있습니다.

고유한 세션 ID 또는 세션 레이블 은 각 백업을 식별합니다. 여러 백업이 포함된 테이프에서 백업을 복원하려면 해당 세션 ID 또는 레이블이 필요합니다.

백업에서 특정 파일을 추출, 추가 또는 삭제하려면 xfsrestore 대화형 모드를 입력합니다. 대화형 모드는 백업 파일을 조작할 수 있는 명령 집합을 제공합니다.

12.2. xfsrestore를 사용하여 백업에서 XFS 파일 시스템 복원

다음 절차에서는 파일 또는 테이프 백업에서 XFS 파일 시스템의 콘텐츠를 복원하는 방법을 설명합니다.

사전 요구 사항

- XFS 파일 시스템 백업에 설명된 대로 XFS 파일 시스템의 파일 또는 DVD 백업.

- 백업을 복원할 수 있는 스토리지 장치입니다.

절차

백업을 복원하는 명령은 전체 백업 또는 증분식에서 복원하는지 여부에 따라 다르거나 단일 테이프 장치에서 여러 백업을 복원하는지 여부에 따라 다릅니다.

xfsrestore [-r] [-S session-id] [-L session-label] [-i] -f backup-location restoration-path

# xfsrestore [-r] [-S session-id] [-L session-label] [-i] -f backup-location restoration-pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

backup-location 을 백업 위치로 교체합니다. 이는 일반 파일, 테이프 드라이브 또는 원격 테이프 장치일 수 있습니다. 예를 들어 파일의 경우

/backup-files/Data.xfsdump, 테이프 드라이브의 경우/dev/st0입니다. -

restore -path 를 파일 시스템을 복원하려는 디렉토리의 경로로 바꿉니다. 예를 들면

/mnt/data/입니다. -

증분식(레벨 1에서 수준 9) 백업에서 파일 시스템을 복원하려면

-r옵션을 추가합니다. 여러 백업이 포함된 테이프 장치에서 백업을 복원하려면

-S 또는 -L옵션을 사용하여 백업을 지정합니다.S

옵션을사용하면 세션 ID로 백업을 선택할 수 있지만-L옵션을 사용하면 세션 레이블로 선택할 수 있습니다. 세션 ID 및 세션 레이블을 얻으려면xfsrestore -I명령을 사용합니다.session-id 를 백업의 세션 ID로 바꿉니다. 예를 들면

b74a3586-e52e-4a4a-8775-c3334fa8ea2c입니다. session-label 을 백업의 session 레이블로 바꿉니다. 예를 들면my_backup_session_label입니다.xfsrestore를 대화식으로 사용하려면-i옵션을 사용합니다.대화식 대화 상자는

xfsrestore가 지정된 장치 읽기를 마친 후에 시작됩니다. 대화형xfsrestore쉘에서 사용 가능한 명령에는cd,ls,add,delete,extract가 있습니다. 전체 명령 목록은help명령을 사용합니다.

-

backup-location 을 백업 위치로 교체합니다. 이는 일반 파일, 테이프 드라이브 또는 원격 테이프 장치일 수 있습니다. 예를 들어 파일의 경우

예 12.1. 여러 XFS 파일 시스템 복원

XFS 백업 파일을 복원하고

/mnt/아래의 디렉터리에 내용을 저장하려면 다음을 수행하십시오.xfsrestore -f /backup-files/boot.xfsdump /mnt/boot/ xfsrestore -f /backup-files/data.xfsdump /mnt/data/

# xfsrestore -f /backup-files/boot.xfsdump /mnt/boot/ # xfsrestore -f /backup-files/data.xfsdump /mnt/data/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 여러 백업이 포함된 테이프 장치에서 복원하려면 세션 레이블 또는 세션 ID로 각 백업을 지정합니다.

xfsrestore -L "backup_boot" -f /dev/st0 /mnt/boot/ xfsrestore -S "45e9af35-efd2-4244-87bc-4762e476cbab" \ -f /dev/st0 /mnt/data/

# xfsrestore -L "backup_boot" -f /dev/st0 /mnt/boot/ # xfsrestore -S "45e9af35-efd2-4244-87bc-4762e476cbab" \ -f /dev/st0 /mnt/data/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

12.3. 테이프에서 XFS 백업을 복원할 때 정보 메시지

여러 파일 시스템의 백업으로 테이프에서 백업을 복원할 때 xfsrestore 유틸리티에서 메시지를 발행할 수 있습니다. 이 메시지는 xfsrestore 가 테이프의 각 백업을 순차적으로 검사할 때 요청된 백업과 일치하는지 여부를 알려줍니다. 예를 들면 다음과 같습니다.

일치하는 백업이 있을 때까지 정보 메시지는 계속 표시됩니다.

13장. XFS 파일 시스템 크기 증가

시스템 관리자는 XFS 파일 시스템의 크기를 늘려 더 큰 스토리지 용량을 완전히 사용할 수 있습니다.

현재 XFS 파일 시스템의 크기를 줄일 수 없습니다.

13.1. xfs_growfs를 사용하여 XFS 파일 시스템의 크기 증가

다음 절차에서는 xfs_growfs 유틸리티를 사용하여 XFS 파일 시스템을 확장하는 방법을 설명합니다.

사전 요구 사항

- 기본 블록 장치가 나중에 크기 조정된 파일 시스템을 보관할 적절한 크기인지 확인합니다. 영향을 받는 블록 장치에 적절한 크기 조정 방법을 사용합니다.

- XFS 파일 시스템을 마운트합니다.

절차

XFS 파일 시스템이 마운트되는 동안

xfs_growfs유틸리티를 사용하여 크기를 늘립니다.xfs_growfs file-system -D new-size

# xfs_growfs file-system -D new-sizeCopy to Clipboard Copied! Toggle word wrap Toggle overflow - file-system 을 XFS 파일 시스템의 마운트 지점으로 교체합니다.

D

옵션을 사용하여new-size 를 파일 시스템 블록 수에 지정된 파일 시스템의 원하는 새 크기로 바꿉니다.지정된 XFS 파일 시스템의 kB에서 블록 크기를 확인하려면

xfs_info유틸리티를 사용합니다.xfs_info block-device ... data = bsize=4096 ...

# xfs_info block-device ... data = bsize=4096 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

D

옵션을사용하지 않으면xfs_growfs는 파일 시스템을 기본 장치에서 지원하는 최대 크기로 확장합니다.

14장. XFS 오류 동작 구성

다른 I/O 오류가 발생할 때 XFS 파일 시스템이 작동하는 방식을 구성할 수 있습니다.

14.1. XFS에서 구성 가능한 오류 처리

XFS 파일 시스템은 I/O 작업 중에 오류가 발생할 때 다음 방법 중 하나로 응답합니다.

XFS는 작업이 성공하거나 XFS가 설정된 제한에 도달할 때까지 I/O 작업을 반복적으로 재시도합니다.

제한은 최대 재시도 횟수 또는 재시도 횟수를 기반으로 합니다.

- XFS는 오류를 영구적이라고 간주하고 파일 시스템에서 작업을 중지합니다.

XFS가 다음과 같은 오류 조건에 반응하는 방법을 구성할 수 있습니다.

EIO- 읽거나 쓸 때 오류 발생

ENOSPC- 장치에 공간이 없습니다

ENODEV- 장치를 찾을 수 없습니다

XFS에서 오류를 영구적으로 간주할 때까지 최대 재시도 횟수와 최대 시간(초)을 설정할 수 있습니다. XFS는 제한에 도달하면 작업을 재시도하지 않습니다.

파일 시스템을 마운트 해제할 때 다른 구성과 관계없이 XFS가 즉시 재시도를 취소하도록 XFS를 구성할 수도 있습니다. 이 구성을 사용하면 지속 오류에도 불구하고 마운트 해제 작업이 성공할 수 있습니다.

기본 동작

각 XFS 오류 조건의 기본 동작은 오류 컨텍스트에 따라 다릅니다. ENODEV 와 같은 일부 XFS 오류는 재시도 횟수와 관계없이 치명적이고 복구할 수 없는 것으로 간주됩니다. 기본 재시도 제한은 0입니다.

14.2. 특정 및 정의되지 않은 XFS 오류 상태에 대한 구성 파일

다음 디렉터리에서는 다양한 오류 조건에 대해 XFS 오류 동작을 제어하는 구성 파일을 저장합니다.

/sys/fs/xfs/device/error/metadata/EIO/-

EIO오류 상태의 경우 /sys/fs/xfs/device/error/metadata/ENODEV/-

ENODEV오류 상태의 경우 /sys/fs/xfs/device/error/metadata/ENOSPC/-

ENOSPC오류 상태의 경우 /sys/fs/xfs/device/error/default/- 정의되지 않은 다른 모든 오류 조건의 일반적인 구성

각 디렉터리에는 재시도 제한을 구성하기 위한 다음 구성 파일이 포함되어 있습니다.

max_retries- 는 XFS가 작업을 재시도하는 최대 횟수를 제어합니다.

retry_timeout_seconds- XFS가 작업을 재시도하는 것을 중지하는 시간 제한을 초 단위로 지정합니다.

14.3. 특정 조건에 대한 XFS 동작 설정

다음 절차에서는 XFS가 특정 오류 조건에 반응하는 방법을 구성합니다.

절차

최대 재시도 횟수, 재시도 시간 제한 또는 둘 다 설정합니다.

최대 재시도 횟수를 설정하려면

max_retries파일에 원하는 숫자를 씁니다.echo value > /sys/fs/xfs/device/error/metadata/condition/max_retries

# echo value > /sys/fs/xfs/device/error/metadata/condition/max_retriesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 시간 제한을 설정하려면 원하는 시간(초)을

retry_timeout_seconds파일에 기록합니다.echo value > /sys/fs/xfs/device/error/metadata/condition/retry_timeout_second

# echo value > /sys/fs/xfs/device/error/metadata/condition/retry_timeout_secondCopy to Clipboard Copied! Toggle word wrap Toggle overflow

값은 -1 사이의 숫자에서 C 서명된 정수 유형의 최대 값입니다. 64비트 Linux를 기반으로 하는 2147483647입니다.

두 제한 모두에서 값

-1은 지속 재시도에 사용되고0은 즉시 중지됩니다.device 는

/dev/디렉터리에 있는 장치 이름입니다(예:sda).

14.4. 정의되지 않은 조건의 XFS 동작 설정

다음 절차에서는 XFS가 공통 구성을 공유하는 모든 정의되지 않은 오류 조건에 반응하는 방법을 구성합니다.

절차

최대 재시도 횟수, 재시도 시간 제한 또는 둘 다 설정합니다.

최대 재시도 횟수를 설정하려면

max_retries파일에 원하는 숫자를 씁니다.echo value > /sys/fs/xfs/device/error/metadata/default/max_retries

# echo value > /sys/fs/xfs/device/error/metadata/default/max_retriesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 시간 제한을 설정하려면 원하는 시간(초)을

retry_timeout_seconds파일에 기록합니다.echo value > /sys/fs/xfs/device/error/metadata/default/retry_timeout_seconds

# echo value > /sys/fs/xfs/device/error/metadata/default/retry_timeout_secondsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

값은 -1 사이의 숫자에서 C 서명된 정수 유형의 최대 값입니다. 64비트 Linux를 기반으로 하는 2147483647입니다.

두 제한 모두에서 값

-1은 지속 재시도에 사용되고0은 즉시 중지됩니다.device 는

/dev/디렉터리에 있는 장치 이름입니다(예:sda).

14.5. XFS 마운트 해제 동작 설정

이 절차에서는 파일 시스템을 마운트 해제할 때 XFS가 오류 조건에 반응하는 방법을 구성합니다.

파일 시스템에서 fail_at_unmount 옵션을 설정하면 마운트 해제하는 동안 다른 모든 오류 구성이 덮어쓰고 I/O 작업을 다시 시도하지 않고 파일 시스템을 즉시 마운트 해제합니다. 이렇게 하면 영구 오류가 발생해도 마운트 해제 작업이 성공적으로 수행됩니다.

마운트 해제 프로세스에서 해당 파일 시스템의 sysfs 인터페이스에서 구성 파일을 제거하므로 마운트 해제 프로세스가 시작된 후에는 fail_at_unmount 값을 변경할 수 없습니다. 파일 시스템 마운트 해제를 시작하기 전에 마운트 해제 동작을 구성해야 합니다.

절차

fail_at_unmount옵션을 활성화하거나 비활성화합니다.파일 시스템이 마운트 해제될 때 모든 작업을 다시 시도하는 것을 취소하려면 옵션을 활성화합니다.

echo 1 > /sys/fs/xfs/device/error/fail_at_unmount

# echo 1 > /sys/fs/xfs/device/error/fail_at_unmountCopy to Clipboard Copied! Toggle word wrap Toggle overflow max_retries 및가 파일 시스템을 마운트 해제할 때 제한을 다시 시도하려면 옵션을 비활성화합니다.retry_timeout_secondsecho 0 > /sys/fs/xfs/device/error/fail_at_unmount

# echo 0 > /sys/fs/xfs/device/error/fail_at_unmountCopy to Clipboard Copied! Toggle word wrap Toggle overflow

device 는

/dev/디렉터리에 있는 장치 이름입니다(예:sda).

15장. 파일 시스템 확인 및 복구

RHEL은 파일 시스템을 확인하고 복구할 수 있는 파일 시스템 관리 유틸리티를 제공합니다. 이러한 도구를 fsck 툴이라고 합니다. 여기서 fsck 는 파일 시스템 검사 의 단축된 버전입니다. 대부분의 경우 이러한 유틸리티는 필요한 경우 시스템 부팅 중에 자동으로 실행되지만 필요한 경우 수동으로 호출할 수도 있습니다.

파일 시스템 검사기는 파일 시스템 전체에서 메타데이터 일관성만 보장합니다. 파일 시스템에 포함된 실제 데이터를 인식하지 못하며 데이터 복구 도구가 아닙니다.

15.1. 파일 시스템 확인이 필요한 시나리오

관련 fsck 도구를 사용하여 다음 중 하나라도 발생하는 경우 시스템을 확인할 수 있습니다.

- 시스템이 부팅되지 않음

- 특정 디스크의 파일이 손상됩니다

- 파일 시스템이 종료되거나 불일치로 인해 읽기 전용으로 변경됨

- 파일 시스템의 파일에 액세스할 수 없습니다.

파일 시스템 불일치는 하드웨어 오류, 스토리지 관리 오류, 소프트웨어 버그 등 다양한 이유로 발생할 수 있습니다.

파일 시스템 점검 툴은 하드웨어 문제를 복구할 수 없습니다. 복구가 성공적으로 작동하려면 파일 시스템을 완전히 읽고 쓸 수 있어야 합니다. 하드웨어 오류로 인해 파일 시스템이 손상된 경우 먼저 파일 시스템을 적절한 디스크(예: dd(8) 유틸리티)로 이동해야 합니다.

저널링 파일 시스템의 경우 일반적으로 부팅 시 필요한 경우 저널을 재생해야 하며 이는 일반적으로 매우 짧은 작업입니다.

그러나 파일 시스템이 일관되지 않거나 손상되는 경우 저널링 파일 시스템의 경우에도 파일 시스템 검사기를 사용하여 파일 시스템을 복구해야 합니다.

부팅 시 /etc/fstab 의 여섯 번째 필드를 0 으로 설정하여 파일 시스템 확인을 비활성화할 수 있습니다. 그러나 부팅 시 fsck 문제(예: 매우 큰 파일 시스템 또는 원격 파일 시스템)가 없는 한 Red Hat은 이 작업을 수행하지 않는 것이 좋습니다.

15.2. fsck 실행의 잠재적 부작용

일반적으로 파일 시스템 확인 및 복구 도구를 실행하면 검색된 불일치 중 일부를 자동으로 복구할 수 있습니다. 경우에 따라 다음과 같은 문제가 발생할 수 있습니다.

- 심각하게 손상된 inode 또는 디렉터리를 복구할 수 없는 경우 폐기할 수 있습니다.

- 파일 시스템에 대한 중요한 변경 사항이 발생할 수 있습니다.

예기치 않거나 바람직하지 않은 변경이 영구적으로 수행되지 않도록 하려면 절차에 설명된 예방 조치를 따릅니다.

15.3. XFS에서 오류 처리 메커니즘

이 섹션에서는 XFS가 파일 시스템에서 다양한 유형의 오류를 처리하는 방법에 대해 설명합니다.

불명확한 마운트 해제

저널링은 파일 시스템에서 발생하는 메타데이터 변경 트랜잭션 레코드를 유지합니다.

시스템 충돌, 정전 또는 기타 불명확한 마운트 해제가 발생하는 경우 XFS는 저널(로그라고도 함)을 사용하여 파일 시스템을 복구합니다. 커널은 XFS 파일 시스템을 마운트할 때 저널 복구를 수행합니다.

손상

이 컨텍스트에서 손상 은 로 인해 발생한 파일 시스템에 대한 오류를 의미합니다. 예를 들면 다음과 같습니다.

- 하드웨어 오류

- 스토리지 펌웨어, 장치 드라이버, 소프트웨어 스택 또는 파일 시스템 자체의 버그

- 파일 시스템 외부에 있는 항목에서 파일 시스템의 일부를 덮어쓰는 문제

XFS가 파일 시스템 또는 파일 시스템 메타데이터의 손상을 탐지하면 파일 시스템을 종료하고 시스템 로그에서 오류를 보고할 수 있습니다. /var 디렉토리를 호스팅하는 파일 시스템에서 손상이 발생하면 재부팅 후 이러한 로그를 사용할 수 없습니다.

예 15.1. XFS 손상을 보고하는 시스템 로그 항목

사용자 공간 유틸리티는 손상된 XFS 파일 시스템에 액세스하려고 할 때 일반적으로 Input/output 오류 메시지를 보고합니다. 손상된 로그를 사용하여 XFS 파일 시스템을 마운트하면 마운트 실패 및 다음과 같은 오류 메시지가 표시됩니다.

mount: /mount-point: mount(2) system call failed: Structure needs cleaning.

mount: /mount-point: mount(2) system call failed: Structure needs cleaning.

문제를 복구하려면 xfs_repair 유틸리티를 수동으로 사용해야 합니다.

15.4. xfs_repair을 사용하여 XFS 파일 시스템 확인

xfs_repair 유틸리티를 사용하여 XFS 파일 시스템의 읽기 전용 확인을 수행합니다. 다른 파일 시스템 복구 유틸리티와 달리 xfs_repair 는 XFS 파일 시스템을 완전히 마운트 해제하지 않은 경우에도 부팅 시 실행되지 않습니다. 무해한 마운트 해제의 경우 XFS는 마운트 시 로그를 재생하여 일관된 파일 시스템을 보장합니다. xfs_repair 는 먼저 다시 마운트하지 않고 더티 로그로 XFS 파일 시스템을 복구할 수 없습니다.

fsck.xfs 바이너리가 xfsprogs 패키지에 있지만 부팅 시 fsck.file 시스템 바이너리를 찾는 initscripts 만 충족할 수 있습니다. fsck.xfs 는 종료 코드 0으로 즉시 종료됩니다.

절차

파일 시스템을 마운트 및 마운트 해제하여 로그를 재생합니다.

mount file-system umount file-system

# mount file-system # umount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고구조에서 마운트에 실패하면 정리 오류가 필요한 경우 로그가 손상되고 재생되지 않습니다. 예행 연습에서 결과적으로 디스크에서 손상을 더 많이 검색하고 보고해야 합니다.

xfs_repair유틸리티를 사용하여 파일 시스템을 확인하는 예행 연습을 수행합니다. 모든 오류가 출력되며 파일 시스템을 수정하지 않고 수행할 작업을 나타냅니다.xfs_repair -n block-device

# xfs_repair -n block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일 시스템을 마운트합니다.

mount file-system

# mount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

15.5. xfs_repair을 사용하여 XFS 파일 시스템 복구

이 절차에서는 xfs_repair 유틸리티를 사용하여 손상된 XFS 파일 시스템을 복구합니다.

절차

xfs_eatadump유틸리티를 사용하여 진단 또는 테스트를 위해 복구하기 전에 메타데이터 이미지를 생성합니다. 소프트웨어 버그로 인해 손상이 발생할 경우 사전 리페어 파일 시스템 메타데이터 이미지는 지원 조사에 유용할 수 있습니다. 사전 리페어 이미지에 있는 손상 패턴은 근본 원인 분석에 도움이 될 수 있습니다.xfs_eatadump디버깅 도구를 사용하여 XFS 파일 시스템의 메타데이터를 파일로 복사합니다. 결과metadump파일을 표준 압축 유틸리티를 사용하여 압축하여 대형메타 덤프 파일을 지원하도록 전송해야 하는 경우 파일크기를 줄일 수 있습니다.xfs_metadump block-device metadump-file

# xfs_metadump block-device metadump-fileCopy to Clipboard Copied! Toggle word wrap Toggle overflow

파일 시스템을 다시 마운트하여 로그를 다시 실행합니다.

mount file-system umount file-system

# mount file-system # umount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow xfs_repair유틸리티를 사용하여 마운트 해제된 파일 시스템을 복구합니다.마운트에 성공하면 추가 옵션이 필요하지 않습니다.

xfs_repair block-device

# xfs_repair block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구조와 함께 마운트에 실패한 경우 정리 오류가 필요한 경우 로그가 손상되고 재생할 수 없습니다.

-L옵션(로그0을 강제 적용)을 사용하여 로그를 지웁니다.주의이 명령을 실행하면 충돌 시 모든 메타데이터 업데이트가 손실되어 파일 시스템이 손상되고 데이터가 손실될 수 있습니다. 로그를 재생할 수 없는 경우 마지막 수단으로만 사용해야 합니다.

xfs_repair -L block-device

# xfs_repair -L block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

파일 시스템을 마운트합니다.

mount file-system

# mount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

15.6. ext2, ext3 및 ext4에서 메커니즘 처리 오류

ext2, ext3 및 ext4 파일 시스템은 e2fsck 유틸리티를 사용하여 파일 시스템 점검 및 복구를 수행합니다. 파일 이름 fsck.ext2,fsck.ext3, fsck.ext4 는 e2fsck 유틸리티에 대한 하드 링크입니다. 이러한 바이너리는 부팅 시 자동으로 실행되며 확인 중인 파일 시스템과 파일 시스템의 상태에 따라 동작이 다릅니다.

전체 파일 시스템 점검 및 복구는 메타데이터 저널링 파일 시스템이 아니며 저널이 없는 ext4 파일 시스템의 경우 ext2에 대해 호출됩니다.

메타데이터 저널링이 있는 ext3 및 ext4 파일 시스템의 경우 저널은 사용자 공간에서 재생되고 유틸리티가 종료됩니다. 이는 저널 재생이 충돌 후 일관된 파일 시스템을 보장하기 때문에 기본 동작입니다.

마운트된 상태에서 이러한 파일 시스템이 메타데이터 불일치와 만나면 파일 시스템 수퍼 블록에 이 팩트를 기록합니다. e2fsck 가 이러한 오류로 파일 시스템이 표시된 것을 발견하면 e2fsck 는 저널을 재생한 후(있는 경우) 전체 검사를 수행합니다.

15.7. e2fsck를 사용하여 ext2, ext3 또는 ext4 파일 시스템 확인

이 절차에서는 e2fsck 유틸리티를 사용하여 ext2, ext3 또는 ext4 파일 시스템을 확인합니다.

절차

파일 시스템을 다시 마운트하여 로그를 다시 실행합니다.

mount file-system umount file-system

# mount file-system # umount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예행 연습을 수행하여 파일 시스템을 확인합니다.

e2fsck -n block-device

# e2fsck -n block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고모든 오류가 출력되며 파일 시스템을 수정하지 않고 수행할 작업을 나타냅니다. 일관성 검사의 이후 단계에서 복구 모드로 실행되는 경우 초기 단계에서 수정된 불일치를 발견하므로 추가 오류를 출력할 수 있습니다.

15.8. e2fsck를 사용하여 ext2, ext3 또는 ext4 파일 시스템 복구

이 절차에서는 e2fsck 유틸리티를 사용하여 손상된 ext2, ext3 또는 ext4 파일 시스템을 복구합니다.

절차

지원 조사를 위해 파일 시스템 이미지를 저장합니다. 소프트웨어 버그로 인해 손상이 발생할 경우 사전 리페어 파일 시스템 메타데이터 이미지는 지원 조사에 유용할 수 있습니다. 사전 리페어 이미지에 있는 손상 패턴은 근본 원인 분석에 도움이 될 수 있습니다.

참고심각하게 손상된 파일 시스템으로 인해 메타데이터 이미지 생성에 문제가 발생할 수 있습니다.

테스트용으로 이미지를 만드는 경우

-r옵션을 사용하여 파일 시스템 자체와 동일한 크기의 스파스 파일을 만듭니다. 그런 다음e2fsck가 결과 파일에 직접 작동할 수 있습니다.e2image -r block-device image-file

# e2image -r block-device image-fileCopy to Clipboard Copied! Toggle word wrap Toggle overflow 보관할 이미지를 생성하거나 진단용으로 제공되는 경우

-Q옵션을 사용하여 전송에 적합한 좀 더 작은 파일 형식을 만듭니다.e2image -Q block-device image-file

# e2image -Q block-device image-fileCopy to Clipboard Copied! Toggle word wrap Toggle overflow

파일 시스템을 다시 마운트하여 로그를 다시 실행합니다.

mount file-system umount file-system

# mount file-system # umount file-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일 시스템을 자동으로 복구합니다. 사용자 개입이 필요한 경우

e2fsck는 출력에 수정되지 않은 문제를 나타내고 이 상태를 종료 코드에서 반영합니다.e2fsck -p block-device

# e2fsck -p block-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

16장. 파일 시스템 마운트

시스템 관리자는 시스템에 파일 시스템을 마운트하여 해당 시스템의 데이터에 액세스할 수 있습니다.

16.1. Linux 마운트 메커니즘

Linux에서 파일 시스템을 마운트하는 기본 개념은 다음과 같습니다.

Linux, UNIX 및 유사한 운영 체제에서는 여러 파티션 및 이동식 장치(예: CD, DVD 또는 USB 플래시 드라이브)에 있는 파일 시스템을 디렉토리 트리의 특정 지점(마운트 지점)에 연결할 수 있으며 다시 분리할 수 있습니다. 파일 시스템이 디렉터리에 마운트되는 동안 디렉터리의 원래 콘텐츠에 액세스할 수 없습니다.

Linux에서는 파일 시스템이 이미 연결된 디렉터리에 파일 시스템을 마운트하지 못하게 합니다.

마운트할 때 다음과 같이 장치를 식별할 수 있습니다.

-

UUID(UUID):

UUID=34795a28-ca6d-4fd8-a347-73671d0c19cb -

볼륨 레이블: 예를 들면

LABEL=home입니다. -

비영구적 블록 장치의 전체 경로: 예를 들면

/dev/sda3입니다.

필요한 모든 정보 없이 mount 명령을 사용하여 장치 이름, 대상 디렉터리 또는 파일 시스템 유형이 없는 파일 시스템을 마운트하면 mount 유틸리티에서 /etc/fstab 파일의 내용을 읽고 지정된 파일 시스템이 나열되는지 확인합니다. /etc/fstab 파일에는 장치 이름 목록과 선택한 파일 시스템이 마운트되도록 설정된 디렉토리와 파일 시스템 유형 및 마운트 옵션이 포함되어 있습니다. 따라서 /etc/fstab 에 지정된 파일 시스템을 마운트할 때 다음 명령 구문만으로 충분합니다.

마운트 지점별 마운트:

mount directory

# mount directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 블록 장치에 의한 마운트:

mount device

# mount deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

16.2. 현재 마운트된 파일 시스템 나열

findmnt 유틸리티를 사용하여 명령줄에서 현재 마운트된 모든 파일 시스템을 나열합니다.

절차

마운트된 모든 파일 시스템을 나열하려면

findmnt유틸리티를 사용합니다.findmnt

$ findmntCopy to Clipboard Copied! Toggle word wrap Toggle overflow 나열된 파일 시스템을 특정 파일 시스템 유형으로만 제한하려면

--types옵션을 추가합니다.findmnt --types fs-type

$ findmnt --types fs-typeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

예 16.1. XFS 파일 시스템만 나열

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

16.3. 마운트로 파일 시스템 마운트

mount 유틸리티를 사용하여 파일 시스템을 마운트합니다.

사전 요구 사항

선택한 마운트 지점에 파일 시스템이 이미 마운트되어 있지 않은지 확인합니다.

findmnt mount-point

$ findmnt mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow

절차

특정 파일 시스템을 연결하려면

mount유틸리티를 사용합니다.mount device mount-point

# mount device mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예 16.2. XFS 파일 시스템 마운트

예를 들어 UUID로 식별된 로컬 XFS 파일 시스템을 마운트하려면 다음을 수행합니다.

mount UUID=ea74bbec-536d-490c-b8d9-5b40bbd7545b /mnt/data

# mount UUID=ea74bbec-536d-490c-b8d9-5b40bbd7545b /mnt/dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow 마운트가 파일 시스템 유형을 자동으로 인식할 수 없는 경우--types옵션을 사용하여 지정합니다.mount --types type device mount-point

# mount --types type device mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예 16.3. NFS 파일 시스템 마운트

예를 들어 원격 NFS 파일 시스템을 마운트하려면 다음을 수행합니다.

mount --types nfs4 host:/remote-export /mnt/nfs

# mount --types nfs4 host:/remote-export /mnt/nfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

16.4. 마운트 지점 이동

마운트 유틸리티를 사용하여 마운트된 파일 시스템의 마운트 지점을 다른 디렉토리로 변경합니다.

절차

파일 시스템이 마운트된 디렉터리를 변경하려면 다음을 수행합니다.

mount --move old-directory new-directory

# mount --move old-directory new-directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예 16.4. 홈 파일 시스템 이동

예를 들어

/mnt/userdirs/ 디렉터리에 마운트된 파일 시스템을마운트 지점으로 이동하려면 다음을 수행합니다./home/mount --move /mnt/userdirs /home

# mount --move /mnt/userdirs /homeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일 시스템이 예상대로 이동되었는지 확인합니다.

findmnt ls old-directory ls new-directory

$ findmnt $ ls old-directory $ ls new-directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

16.5. umount로 파일 시스템 마운트 해제

umount 유틸리티를 사용하여 파일 시스템을 마운트 해제합니다.

절차

다음 명령 중 하나를 사용하여 파일 시스템을 마운트 해제합니다.

마운트 지점별:

umount mount-point

# umount mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow 장치별:

umount device

# umount deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

다음과 유사한 오류로 명령이 실패하면 프로세스가 해당 프로세스에서 리소스를 사용하고 있기 때문에 파일 시스템이 사용 중임을 의미합니다.

umount: /run/media/user/FlashDrive: target is busy.

umount: /run/media/user/FlashDrive: target is busy.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일 시스템이 사용 중인 경우

fuser유틸리티를 사용하여 액세스하는 프로세스를 확인합니다. 예를 들면 다음과 같습니다.fuser --mount /run/media/user/FlashDrive /run/media/user/FlashDrive: 18351

$ fuser --mount /run/media/user/FlashDrive /run/media/user/FlashDrive: 18351Copy to Clipboard Copied! Toggle word wrap Toggle overflow 나중에 파일 시스템을 사용하여 프로세스를 중지하고 다시 마운트 해제하십시오.

16.6. 웹 콘솔에서 파일 시스템 마운트 및 마운트 해제

RHEL 시스템에서 파티션을 사용할 수 있으려면 파티션에 파일 시스템을 장치로 마운트해야 합니다.

파일 시스템도 마운트 해제할 수 있으며 RHEL 시스템은 이를 사용하지 않습니다. 파일 시스템을 마운트 해제하면 장치를 삭제, 제거 또는 다시 포맷할 수 있습니다.

사전 요구 사항

-

cockpit-storaged패키지가 시스템에 설치됩니다.

- RHEL 8 웹 콘솔을 설치했습니다.

- cockpit 서비스를 활성화했습니다.

사용자 계정이 웹 콘솔에 로그인할 수 있습니다.

자세한 내용은 웹 콘솔 설치 및 활성화를 참조하십시오.

- 파일 시스템을 마운트 해제하려면 시스템에 파티션에 저장된 파일, 서비스 또는 애플리케이션을 사용하지 않는지 확인합니다.

절차

RHEL 8 웹 콘솔에 로그인합니다.

자세한 내용은 웹 콘솔에 로그인 을 참조하십시오.

- 스토리지 탭을 클릭합니다.

- 스토리지 테이블의 파티션을 삭제할 볼륨을 선택합니다.

- GPT 파티션 섹션에서 마운트 또는 마운트 해제하려는 파일 시스템이 있는 파티션 옆에 있는 메뉴 버튼을 클릭합니다.

- 또는 클릭합니다.

16.7. 일반적인 마운트 옵션

다음 표에는 마운트 유틸리티의 가장 일반적인 옵션이 나열되어 있습니다. 다음 구문을 사용하여 이러한 마운트 옵션을 적용할 수 있습니다.

mount --options option1,option2,option3 device mount-point

# mount --options option1,option2,option3 device mount-point| 옵션 | 설명 |

|---|---|

|

| 파일 시스템에서 비동기 입력 및 출력 작업을 활성화합니다. |

|

|

|

|

|

|

|

| 특정 파일 시스템에서 바이너리 파일을 실행할 수 있습니다. |

|

| 이미지를 루프 장치로 마운트합니다. |

|

|

기본 동작은 |

|

| 특정 파일 시스템에서 바이너리 파일 실행을 허용하지 않습니다. |

|

| 파일 시스템을 마운트하고 마운트 해제하기 위해 일반 사용자(즉, root 이외의)를 허용하지 않습니다. |

|

| 이미 마운트된 경우 파일 시스템을 다시 마운트합니다. |

|

| 읽기 전용 파일 시스템을 마운트합니다. |

|

| 읽기 및 쓰기용으로 파일 시스템을 마운트합니다. |

|

| 일반 사용자(즉, root 이외의)가 파일 시스템을 마운트하고 마운트 해제할 수 있습니다. |

17장. 여러 마운트 지점에 마운트 공유

시스템 관리자는 마운트 지점을 복제하여 여러 디렉토리에서 파일 시스템에 액세스할 수 있도록 할 수 있습니다.

17.2. 개인 마운트 지점 중복 생성

마운트 지점을 개인 마운트로 복제합니다. 나중에 중복 또는 원래 마운트 지점 아래에 마운트한 파일 시스템은 다른 마운트 지점에 반영되지 않습니다.

프로세스

원래 마운트 지점에서 가상 파일 시스템(VFS) 노드를 생성합니다.

mount --bind original-dir original-dir

# mount --bind original-dir original-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow 원래 마운트 지점을 비공개로 표시합니다.

mount --make-private original-dir

# mount --make-private original-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow 또는 선택한 마운트 지점과 그 아래의 모든 마운트 지점의 마운트 유형을 변경하려면

--make-private대신--make-rprivate옵션을 사용합니다.중복을 생성합니다.

mount --bind original-dir duplicate-dir

# mount --bind original-dir duplicate-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow

예 17.1. 개인 마운트 지점으로 /media를 /mnt로 중복

/media디렉토리에서 VFS 노드를 생성합니다.mount --bind /media /media

# mount --bind /media /mediaCopy to Clipboard Copied! Toggle word wrap Toggle overflow /media디렉터리를 비공개로 표시합니다.mount --make-private /media

# mount --make-private /mediaCopy to Clipboard Copied! Toggle word wrap Toggle overflow /mnt에서 중복을 생성합니다.mount --bind /media /mnt

# mount --bind /media /mntCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이제

/media및/mnt가 콘텐츠를 공유하지만/media내의 마운트는/mnt에 표시되지 않는지 확인할 수 있습니다. 예를 들어 CD-ROM 드라이브에 비어 있지 않은 미디어가 포함되어 있고/media/cdrom/디렉터리가 있는 경우 다음을 사용합니다.mount /dev/cdrom /media/cdrom ls /media/cdrom EFI GPL isolinux LiveOS ls /mnt/cdrom #

# mount /dev/cdrom /media/cdrom # ls /media/cdrom EFI GPL isolinux LiveOS # ls /mnt/cdrom #Copy to Clipboard Copied! Toggle word wrap Toggle overflow /mnt디렉터리에 마운트된 파일 시스템이/media에 반영되지 않았는지도 확인할 수 있습니다. 예를 들어/dev/sdc1장치를 사용하는 비어 있지 않은 USB 플래시 드라이브가 연결되고/mnt/flashdisk/디렉터리가 있는 경우 다음을 사용합니다.mount /dev/sdc1 /mnt/flashdisk ls /media/flashdisk ls /mnt/flashdisk en-US publican.cfg

# mount /dev/sdc1 /mnt/flashdisk # ls /media/flashdisk # ls /mnt/flashdisk en-US publican.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow

17.4. 슬레이브 마운트 지점 복제 생성

마운트 지점을 슬레이브 마운트 유형으로 복제합니다. 나중에 원래 마운트 지점 아래에 마운트한 파일 시스템은 중복에 반영되지만 다른 방법은 반영되지 않습니다.

프로세스

원래 마운트 지점에서 가상 파일 시스템(VFS) 노드를 생성합니다.

mount --bind original-dir original-dir

# mount --bind original-dir original-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow 원래 마운트 지점을 공유로 표시합니다.

mount --make-shared original-dir

# mount --make-shared original-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow 또는 선택한 마운트 지점과 그 아래의 모든 마운트 지점의 마운트 유형을 변경하려면

--make-shared대신--make-rshared옵션을 사용합니다.중복을 생성하고

슬레이브유형으로 표시합니다.mount --bind original-dir duplicate-dir mount --make-slave duplicate-dir

# mount --bind original-dir duplicate-dir # mount --make-slave duplicate-dirCopy to Clipboard Copied! Toggle word wrap Toggle overflow

예 17.3. 슬레이브 마운트 지점으로 /media를 /mnt로 분할

이 예제에서는 /media 디렉터리의 콘텐츠를 /mnt 에 표시할 수 있지만 /mnt 디렉터리에 마운트가 없는 경우 /media 에 반영되는 방법을 보여줍니다.

/media디렉토리에서 VFS 노드를 생성합니다.mount --bind /media /media

# mount --bind /media /mediaCopy to Clipboard Copied! Toggle word wrap Toggle overflow /media디렉터리를 공유로 표시합니다.mount --make-shared /media

# mount --make-shared /mediaCopy to Clipboard Copied! Toggle word wrap Toggle overflow /mnt에서 중복을 만들고슬레이브로 표시합니다.mount --bind /media /mnt mount --make-slave /mnt

# mount --bind /media /mnt # mount --make-slave /mntCopy to Clipboard Copied! Toggle word wrap Toggle overflow /media내의 마운트도/mnt에 표시되는지 확인합니다. 예를 들어 CD-ROM 드라이브에 비어 있지 않은 미디어가 포함되어 있고/media/cdrom/디렉터리가 있는 경우 다음을 사용합니다.mount /dev/cdrom /media/cdrom ls /media/cdrom EFI GPL isolinux LiveOS ls /mnt/cdrom EFI GPL isolinux LiveOS

# mount /dev/cdrom /media/cdrom # ls /media/cdrom EFI GPL isolinux LiveOS # ls /mnt/cdrom EFI GPL isolinux LiveOSCopy to Clipboard Copied! Toggle word wrap Toggle overflow 또한

/mnt디렉터리에 마운트된 파일 시스템이/media에 반영되지 않았는지 확인합니다. 예를 들어/dev/sdc1장치를 사용하는 비어 있지 않은 USB 플래시 드라이브가 연결되고/mnt/flashdisk/디렉터리가 있는 경우 다음을 사용합니다.mount /dev/sdc1 /mnt/flashdisk ls /media/flashdisk ls /mnt/flashdisk en-US publican.cfg

# mount /dev/sdc1 /mnt/flashdisk # ls /media/flashdisk # ls /mnt/flashdisk en-US publican.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow

17.5. 마운트 지점이 중복되지 않도록 방지

마운트 지점을 바인딩할 수 없음으로 표시하여 다른 마운트 지점에서 복제할 수 없습니다.

절차

마운트 지점 유형을 바인딩할 수 없는 마운트로 변경하려면 다음을 사용합니다.

mount --bind mount-point mount-point mount --make-unbindable mount-point

# mount --bind mount-point mount-point # mount --make-unbindable mount-pointCopy to Clipboard Copied! Toggle word wrap Toggle overflow 또는 선택한 마운트 지점과 그 아래의 모든 마운트 지점에 대한 마운트 유형을 변경하려면

--make-옵션을 사용합니다.unbindable 대신 --make-runbindable이 마운트를 복제하는 후속 시도는 다음 오류와 함께 실패합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

예 17.4. /media가 중복되지 않도록 방지

/media디렉터리가 공유되지 않도록 하려면 다음을 사용하십시오.mount --bind /media /media mount --make-unbindable /media

# mount --bind /media /media # mount --make-unbindable /mediaCopy to Clipboard Copied! Toggle word wrap Toggle overflow

18장. 영속적으로 파일 시스템 마운트

시스템 관리자는 파일 시스템을 영구적으로 마운트하여 이동할 수 없는 스토리지를 구성할 수 있습니다.

18.1. /etc/fstab 파일

/etc/fstab 구성 파일을 사용하여 파일 시스템의 영구 마운트 지점을 제어합니다. /etc/fstab 파일의 각 행은 파일 시스템의 마운트 지점을 정의합니다.

여기에는 공백으로 구분된 6개의 필드가 포함됩니다.

-

영구 속성 또는

/dev디렉터리의 경로로 식별되는 블록 장치입니다. - 장치가 마운트될 디렉터리입니다.

- 장치의 파일 시스템.

-

기본 옵션으로 부팅 시 파티션을 마운트하는

defaults옵션이 포함된 파일 시스템의 마운트 옵션입니다. mount 옵션 필드는x-마운트 장치 옵션도 인식합니다.systemd. 옵션 형식으로 systemd -

덤프유틸리티의 백업 옵션입니다. -

fsck유틸리티의 순서를 확인합니다.

systemd-fstab-generator 는 항목을 /etc/fstab 파일에서 systemd-mount 장치로 동적으로 변환합니다. systemd 자동 마운트 장치는 systemd-mount 장치를 마스킹하지 않는 한 수동 활성화 중에 /etc/fstab 에서 LVM 볼륨을 마운트합니다.

예 18.1. / 파일 시스템etc/fstab의 /boot

| 블록 장치 | 마운트 지점 | 파일 시스템 | 옵션 | Backup | 검사 |

|---|---|---|---|---|---|

|

|

|

|

|

|

|

systemd 서비스는 /etc/fstab 의 항목에서 마운트 유닛을 자동으로 생성합니다.

18.2. /etc/fstab에 파일 시스템 추가

/etc/fstab 구성 파일에서 파일 시스템의 영구 마운트 지점을 구성합니다.

절차

파일 시스템의 UUID 속성을 확인합니다.

lsblk --fs storage-device

$ lsblk --fs storage-deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

예 18.2. 파티션의 UUID 보기

lsblk --fs /dev/sda1 NAME FSTYPE LABEL UUID MOUNTPOINT sda1 xfs Boot ea74bbec-536d-490c-b8d9-5b40bbd7545b /boot

$ lsblk --fs /dev/sda1 NAME FSTYPE LABEL UUID MOUNTPOINT sda1 xfs Boot ea74bbec-536d-490c-b8d9-5b40bbd7545b /bootCopy to Clipboard Copied! Toggle word wrap Toggle overflow 마운트 지점 디렉터리가 없으면 생성합니다.

mkdir --parents mount-point