监控

在 OpenShift Container Platform 中配置和使用监控堆栈

摘要

第 1 章 关于 OpenShift Container Platform 监控

1.1. 关于 OpenShift Container Platform 监控

OpenShift Container Platform 包括一个预配置、预安装和自我更新的监控堆栈,可为核心平台组件提供监控。您还可以选择为用户定义的项目启用监控。

集群管理员可以使用支持的配置对监控堆栈进行配置。OpenShift Container Platform 提供了与监控相关的现成的最佳实践。

其中默认包括一组警报,可立即就集群问题通知管理员。OpenShift Container Platform Web 控制台中的默认仪表板包括集群指标的直观表示,以帮助您快速了解集群状态。通过 OpenShift Container Platform Web 控制台,您可以访问指标和管理警报。

安装 OpenShift Container Platform 后,集群管理员可以选择性地为用户定义的项目启用监控。通过使用此功能,集群管理员、开发人员和其他用户可以指定在其自己的项目中如何监控服务和 Pod。作为集群管理员,您可以查找常见问题的回答,如用户指标不可用,以及 Prometheus 对监控问题进行故障排除的磁盘空间高可用性。

1.2. 监控堆栈架构

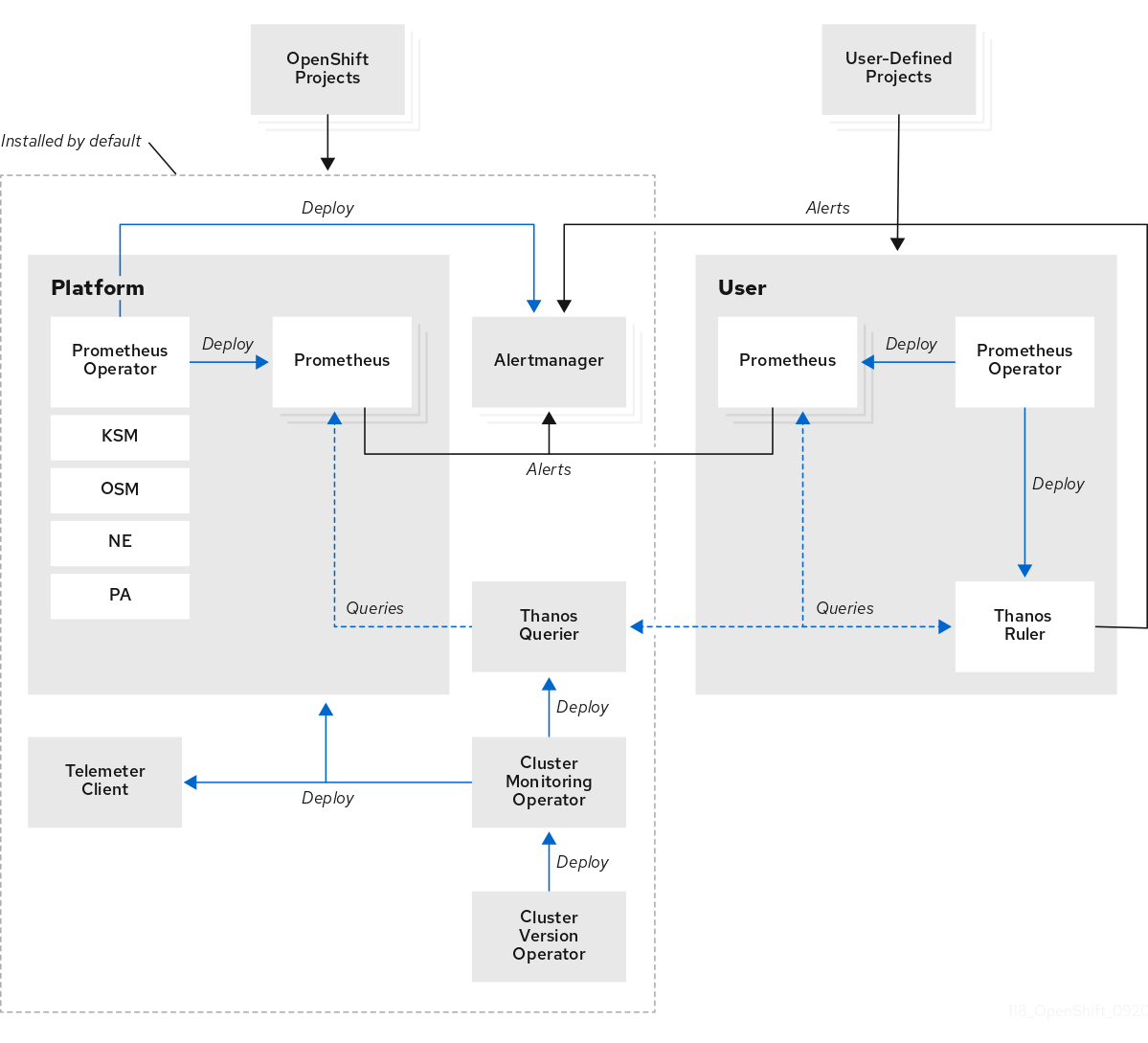

OpenShift Container Platform 监控堆栈基于 Prometheus 开源项目及其更广的生态系统。监控堆栈包括用于监控用户定义的项目的默认监控组件和组件。

1.2.1. 了解监控堆栈

监控堆栈包括以下组件:

默认平台监控组件。在 OpenShift Container Platform 安装过程中,默认会在

openshift-monitoring项目中安装一组平台监控组件。这为包括 Kubernetes 服务在内的核心集群组件提供了监控。默认监控堆栈还为集群启用远程健康状态监控。下图中的默认安装部分说明了这些组件。

-

用于监控用户定义项目的组件。在选择性地为用户定义的项目启用监控后,会在

openshift-user-workload-monitoring项目中安装其他监控组件。这为用户定义的项目提供了监控。下图中的用户部分说明了这些组件。

1.2.2. 默认监控组件

默认情况下,OpenShift Container Platform 4.14 监控堆栈包括以下组件:

| 组件 | 描述 |

|---|---|

| Cluster Monitoring Operator | Cluster Monitoring Operator (CMO) 是监控堆栈的核心组件。它部署、管理和自动更新 Prometheus 和 Alertmanager 实例、Thanos Querier、Teleme Client 和 metrics 目标。CMO 由 Cluster Version Operator (CVO) 部署。 |

| Prometheus Operator |

|

| Prometheus | Prometheus 是 OpenShift Container Platform 监控堆栈所依据的监控系统。Prometheus 是一个时间序列数据库和用于指标的规则评估引擎。Prometheus 将警报发送到 Alertmanager 进行处理。 |

| Prometheus Adapter |

Prometheus Adapter(上图中的 PA)负责转换 Kubernetes 节点和 Pod 查询以便在 Prometheus 中使用。转换的资源指标包括 CPU 和内存使用率指标。Prometheus Adapter 会公开用于 Pod 横向自动扩展的集群资源指标 API。Prometheus Adapter 也用于 |

| Alertmanager | Alertmanager 服务处理从 Prometheus 接收的警报。Alertmanager 还负责将警报发送到外部通知系统。 |

| kube-state-metrics 代理 | kube-state-metrics 导出器代理(上图中的 KSM)将 Kubernetes 对象转换为 Prometheus 可使用的指标。 |

| monitoring-plugin | monitoring-plugin 动态插件组件在 OpenShift Container Platform Web 控制台的 Observe 部分中部署监控页面。您可以使用 Cluster Monitoring Operator (CMO) 配置映射设置来管理 web 控制台页面的 monitoring-plugin 资源。 |

| openshift-state-metrics 代理 | openshift-state-metrics 导出器(上图中的 OSM)通过添加了对特定 OpenShift Container Platform 资源的指标数据扩展了 kube-state-metrics。 |

| node-exporter 代理 | node-exporter 代理(上图中的NE)会收集有关集群中每个节点的指标。node-exporter 代理部署在每个节点上。 |

| Thanos querier | Thanos Querier 将 OpenShift Container Platform 核心指标和用于用户定义项目的指标聚合在单个多租户接口下,并选择性地进行重复数据删除。 |

| Telemeter Client | Telemeter Client 将数据的子部分从平台 Prometheus 实例发送到红帽,以便为集群提供远程健康状态监控。 |

监控堆栈监控堆栈内的所有组件。更新 OpenShift Container Platform 时,组件会自动更新。

1.2.2.1. 默认监控目标

除了堆栈本身的组件外,默认的监控堆栈还会监控额外的平台组件。

以下是监控目标的示例:

- CoreDNS

- etcd

- HAProxy

- 镜像 registry

- Kubelets

- Kubernetes API 服务器

- Kubernetes 控制器管理器

- Kubernetes 调度程序

- OpenShift API 服务器

- OpenShift Controller Manager

- Operator Lifecycle Manager (OLM)

- 具体目标列表可能会因集群功能和安装的组件而异。

- 每个 OpenShift Container Platform 组件负责自己的监控配置。对于 OpenShift Container Platform 组件监控的问题,请针对具体组件(而非常规的监控组件)创建一个Jira 程序错误报告。

其他 OpenShift Container Platform 框架组件也可能会公开指标。如需详细信息,请参阅相应的文档。

1.2.3. 用于监控用户定义的项目的组件

OpenShift Container Platform 包括对监控堆栈的可选增强,供您用于监控用户定义的项目中的服务和 Pod。此功能包括以下组件:

| 组件 | 描述 |

|---|---|

| Prometheus Operator |

|

| Prometheus | Prometheus 是为用户定义的项目提供监控的监控系统。Prometheus 将警报发送到 Alertmanager 进行处理。 |

| Thanos Ruler | Thanos Ruler 是 Prometheus 的一个规则评估引擎,作为一个独立的进程来部署。在 OpenShift Container Platform 中,Thanos Ruler 为监控用户定义的项目提供规则和警报评估。 |

| Alertmanager | Alertmanager 服务处理从 Prometheus 和 Thanos Ruler 接收的警报。Alertmanager 还负责将用户定义的警报发送到外部通知系统。部署该服务是可选的。 |

在为用户定义的项目启用监控后,会部署上表中的组件。

所有这些组件都由堆栈监控,并在 OpenShift Container Platform 更新时自动更新。

1.2.3.1. 用户定义的项目的监控目标

为用户定义的项目启用监控后,您可以监控:

- 通过用户定义的项目中的服务端点提供的指标。

- 在用户定义的项目中运行的 Pod。

1.2.4. 高可用性集群中的监控堆栈

默认情况下,在多节点集群中,以下组件以高可用性(HA)模式运行,以防止数据丢失和服务中断:

- Prometheus

- Alertmanager

- Thanos Ruler

- Thanos querier

- Prometheus Adapter

- 监控插件

组件在两个 pod 之间复制,每个 pod 在单独的节点上运行。这意味着监控堆栈可以容忍一个 pod 的丢失。

- Prometheus 处于 HA 模式

- 这两个副本都独立提取同一目标并评估相同的规则。

- 副本不会相互通信。因此,数据在 pod 之间可能会有所不同。

- 处于 HA 模式的 Alertmanager

- 这两个副本将相互同步通知和静默状态。这样可确保每个通知至少发送一次。

- 如果副本间无法通信,或者在接收端有问题,则通知仍然会被发送,但可能会重复。

Prometheus、Alertmanager 和 Thanos Ruler 是有状态组件。为确保高可用性,您必须为它们配置持久性存储。

1.2.5. 监控堆栈中的 TLS 安全性和轮转

了解 TLS 配置集和证书轮转如何在 OpenShift Container Platform 监控堆栈中工作,以保持通信安全。

- 监控组件的 TLS 安全配置集

-

监控堆栈的所有组件都使用集群管理员集中配置的 TLS 安全配置集设置。监控堆栈组件使用全局 OpenShift Container Platform

apiservers.config.openshift.io/cluster资源中的tlsSecurityProfile字段中已存在的 TLS 安全配置集设置。 - TLS 证书轮转和自动重启

Cluster Monitoring Operator 管理监控组件的内部 TLS 证书生命周期。这些证书保护监控组件之间的内部通信。

在证书轮转过程中,CMO 会更新 secret 和配置映射,这会触发受影响 pod 的自动重启。这是一个预期的行为,pod 会自动恢复。

以下示例显示了证书轮转过程中发生的事件:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.2.6. OpenShift Container Platform 监控的常见术语表

此术语表定义了 OpenShift Container Platform 架构中使用的常见术语。

- Alertmanager

- Alertmanager 处理从 Prometheus 接收的警报。Alertmanager 还负责将警报发送到外部通知系统。

- 警报规则

- 警报规则包含一组概述集群中特定状态的条件。当这些条件满足时会触发警报。可为警报规则分配一个严重性来定义警报的路由方式。

- Cluster Monitoring Operator

- Cluster Monitoring Operator (CMO) 是监控堆栈的核心组件。它部署和管理 Prometheus 实例,如 Thanos Querier、Telemeter Client 和 metrics 目标,以确保它们保持最新状态。CMO 由 Cluster Version Operator (CVO) 部署。

- Cluster Version Operator

- Cluster Version Operator (CVO) 管理集群 Operator 的生命周期,其中许多默认安装在 OpenShift Container Platform 中。

- 配置映射

-

配置映射提供将配置数据注入 pod 的方法。您可以在类型为

ConfigMap的卷中引用存储在配置映射中的数据。在 pod 中运行的应用程序可以使用这个数据。 - Container

- 容器是一个轻量级的可执行镜像,包括软件及其所有依赖项。容器将虚拟化操作系统。因此,您可以在数据中心、公共或私有云以及开发人员的笔记本电脑中运行容器。

- 自定义资源 (CR)

- CR 是 Kubernetes API 的扩展。您可以创建自定义资源。

- etcd

- etcd 是 OpenShift Container Platform 的键值存储,它存储所有资源对象的状态。

- Fluentd

Fluentd 是一个日志收集器,它驻留在每个 OpenShift Container Platform 节点上。它收集应用程序、基础架构和审计日志并将其转发到不同的输出。

注意Fluentd 已被弃用,计划在以后的发行版本中删除。红帽将在当前发行生命周期中将提供对这个功能的 bug 修复和支持,但此功能将不再获得改进。作为 Fluentd 的替代选择,您可以使用 Vector。

- Kubelets

- 在节点上运行并读取容器清单。确保定义的容器已启动且正在运行。

- Kubernetes API 服务器

- Kubernetes API 服务器验证并配置 API 对象的数据。

- Kubernetes 控制器管理器

- Kubernetes 控制器管理器管理集群的状态。

- Kubernetes 调度程序

- Kubernetes 调度程序将 pod 分配给节点。

- labels

- 标签是可用于组织和选择对象子集(如 pod)的键值对。

- node

- OpenShift Container Platform 集群中的 worker 机器。节点是虚拟机 (VM) 或物理计算机。

- Operator

- 在 OpenShift Container Platform 集群中打包、部署和管理 Kubernetes 应用程序的首选方法。Operator 将人类操作知识编码到一个软件程序中,易于打包并与客户共享。

- Operator Lifecycle Manager (OLM)

- OLM 可帮助您安装、更新和管理 Kubernetes 原生应用程序的生命周期。OLM 是一个开源工具包,用于以有效、自动化且可扩展的方式管理 Operator。

- 持久性存储

- 即便在设备关闭后也存储数据。Kubernetes 使用持久性卷来存储应用程序数据。

- 持久性卷声明 (PVC)

- 您可以使用 PVC 将 PersistentVolume 挂载到 Pod 中。您可以在不了解云环境的详情的情况下访问存储。

- pod

- pod 是 Kubernetes 中的最小逻辑单元。pod 由一个或多个容器组成,可在 worker 节点上运行。

- Prometheus

- Prometheus 是 OpenShift Container Platform 监控堆栈所依据的监控系统。Prometheus 是一个时间序列数据库和用于指标的规则评估引擎。Prometheus 将警报发送到 Alertmanager 进行处理。

- Prometheus adapter

- Prometheus Adapter 会转换 Kubernetes 节点和 pod 查询以便在 Prometheus 中使用。转换的资源指标包括 CPU 和内存使用率。Prometheus Adapter 会公开用于 Pod 横向自动扩展的集群资源指标 API。

- Prometheus Operator

-

openshift-monitoring项目中的 Prometheus Operator (PO) 负责创建、配置和管理平台 Prometheus 和 Alertmanager 实例。它还会根据 Kubernetes 标签查询来自动生成监控目标配置。 - 静默

- 可对警报应用静默,以防止在警报条件满足时发送通知。在您着手处理根本问题的同时,您可在初始通知后将警报静音。

- storage

- OpenShift Container Platform 支持许多类型的存储,包括内部存储和云供应商。您可以在 OpenShift Container Platform 集群中管理持久性和非持久性数据的容器存储。

- Thanos Ruler

- Thanos Ruler 是 Prometheus 的一个规则评估引擎,作为一个独立的进程来部署。在 OpenShift Container Platform 中,Thanos Ruler 为监控用户定义的项目提供规则和警报评估。

- Vector

- Vector 是一个日志收集器,它部署到每个 OpenShift Container Platform 节点。它从每个节点收集日志数据,转换数据并将其转发到配置的输出。

- Web 控制台

- 用于管理 OpenShift Container Platform 的用户界面(UI)。

1.3. 了解监控堆栈 - 主要概念

熟悉 OpenShift Container Platform 监控概念和术语。了解如何提高集群的性能和规模,存储和记录数据,管理指标和警报等。

1.3.1. 关于性能和可扩展性

您可以优化集群的性能和扩展。您可以通过执行以下操作来配置默认的监控堆栈:

控制监控组件的放置和分发:

- 使用节点选择器将组件移到特定的节点。

- 分配容限以启用将组件移到污点节点。

- 使用 pod 拓扑分布限制。

- 为指标提取设置正文大小限制。

- 管理 CPU 和内存资源。

- 使用指标集合配置集。

1.3.1.1. 使用节点选择器移动监控组件

通过将 nodeSelector 约束与标记的节点搭配使用,您可以将任何监控堆栈组件移到特定的节点上。通过这样做,您可以控制集群中监控组件的放置和分发。

通过控制监控组件的放置和分发,您可以根据特定要求或策略优化系统资源使用、提高性能和隔离工作负载。

节点选择器与其他约束一起使用

如果使用节点选择器约束移动监控组件,请注意集群可能存在其他限制来控制 pod 调度:

- 拓扑分布约束可能处于放置状态来控制 pod 放置。

- Prometheus、Alertmanager 和其他监控组件会放置硬反关联性规则,以确保这些组件的多个 pod 始终分散到不同的节点上,因此始终具有高可用性。

将 pod 调度到节点时,pod 调度程序会在决定 pod 放置时尝试满足所有现有的限制。也就是说,当 pod 调度程序决定将哪些 pod 放置到哪些节点上时,所有约束都会编译。

因此,如果您配置节点选择器约束,但无法满足现有的约束,pod 调度程序无法与所有约束匹配,也不会调度 pod 放置到节点上。

为保持监控组件的弹性和高可用性,请确保有足够的节点可用,并在配置节点选择器约束以移动组件时匹配所有约束。

1.3.1.2. 关于用于监控的 pod 拓扑分布限制

当 OpenShift Container Platform pod 部署到多个可用区时,您可以使用 pod 拓扑分布约束来控制监控 pod 如何分散到网络拓扑中。

Pod 拓扑分布约束适合在分层拓扑内控制 pod 调度,节点分散到不同的基础架构级别,如这些区域内的地区和区域。另外,通过能够在不同区中调度 pod,您可以在某些情况下提高网络延迟。

您可以为 Cluster Monitoring Operator 部署的所有 pod 配置 pod 拓扑分布限制,以控制如何在区调度到节点的 pod 副本。这样可确保 pod 具有高可用性并更有效地运行,因为工作负载分散在不同的数据中心或分层基础架构区域中。

1.3.1.3. 关于为监控组件指定限制和请求

您可以为以下核心平台监控组件配置资源限值和请求:

- Alertmanager

- kube-state-metrics

- monitoring-plugin

- node-exporter

- openshift-state-metrics

- Prometheus

- Prometheus Adapter

- Prometheus Operator 及其准入 Webhook 服务

- Telemeter Client

- Thanos querier

您可以为监控用户定义的项目的以下组件配置资源限值和请求:

- Alertmanager

- Prometheus

- Thanos Ruler

通过定义资源限值,您可以限制容器的资源使用情况,这会阻止容器超过 CPU 和内存资源指定的最大值。

通过定义资源请求,您可以指定容器只能调度到具有足够 CPU 和内存资源的节点,以匹配请求的资源。

1.3.1.4. 关于指标集合配置集

指标集合配置集只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

默认情况下,Prometheus 会收集由 OpenShift Container Platform 组件中的所有默认指标目标公开的指标。但是,在某些情况下,您可能希望 Prometheus 从集群收集较少的指标:

- 集群管理员只需要警报、遥测和控制台指标,且不需要其他指标数据。

- 集群大小增加,且收集的默认指标数据的大小现在需要显著增加 CPU 和内存资源。

您可以使用指标集合配置集来收集默认指标数据数量或最小指标数据。当您收集最小指标数据时,警报等基本监控功能将继续工作。同时,Prometheus 所需的 CPU 和内存资源会减少。

您可以启用两个指标集合配置集之一:

- full :Prometheus 会收集由所有平台组件公开的指标数据。此设置是默认设置。

- minimal :Prometheus 仅收集平台警报、记录规则、遥测和控制台仪表板所需的指标数据。

1.3.2. 关于存储和记录数据

您可以存储和记录数据,以帮助您保护数据并使用它们进行故障排除。您可以通过执行以下操作来配置默认的监控堆栈:

配置持久性存储:

- 通过将指标和警报数据存储在持久性卷(PV)中来保护您的指标和警报数据。因此,它们可以在 pod 重启或重新创建后保留。

- 避免获取重复的通知,并在 Alertmanager pod 重启时丢失警报静默。

- 修改 Prometheus 和 Thanos Ruler 指标数据的保留时间和大小。

配置日志记录以帮助您排除集群的问题:

- 为 Metrics 服务器配置审计日志。

- 为监控设置日志级别。

- 为 Prometheus 和 Thanos Querier 启用查询日志记录。

1.3.2.1. Prometheus 指标的保留时间和大小

默认情况下,Prometheus 会在以下持续时间内保留指标数据:

- 核心平台监控 :15 天

- 监控用户定义的项目: 24 小时

您可以修改 Prometheus 实例的保留时间,以更改在多久后删除数据。您还可以设置保留指标数据使用的最大磁盘空间量。如果数据达到这个大小限制,Prometheus 会首先删除最旧的数据,直到使用的磁盘空间重新低于限制。

请注意这些数据保留设置的行为:

-

基于大小的保留策略适用于

/prometheus目录中的所有数据块目录,包括持久性块、写入级日志(WAL)数据和 mmapped 块。 -

/wal和/head_chunks目录中的数据计入保留大小限制,但 Prometheus 永远不会根据基于大小或基于时间的保留策略从这些目录中清除数据。因此,如果您设置了保留大小限制,它小于为/wal和/head_chunks目录设置的最大容量,则表示您将系统配置为不保留/prometheus数据目录中的任何数据块。 - 只有在 Prometheus 切断新的数据块时,才会应用基于大小的保留策略,即在 WAL 最多包含三小时数据后每两小时进行。

-

如果没有为

retention或retentionSize明确定义值,则保留时间默认为 15 天,用于核心平台监控,为用户定义的项目监控 24 小时。不设置保留大小。 -

如果

retention和retentionSize都定义了值,则会应用这两个值。如果任何数据块超过定义的保留时间或定义的大小限制,Prometheus 会清除这些数据块。 -

如果您为

retentionSize定义了值,且没有定义retention,则只应用retentionSize值。 -

如果您没有为

retentionSize定义值,且只为retention定义了值,则只应用retention值。 -

如果将

retentionSize或retention值设置为0,则应用默认的设置。默认设置将核心平台监控的保留时间设置为 15 天,用户定义的项目监控为 24 小时。默认情况下,不会设置保留大小。

数据压缩每两小时进行一次。因此,持久性卷 (PV) 可能会在压缩前已被填满,可能会超过 retentionSize 限制。在这种情况下,KubePersistentVolumeFillingUp 警报会触发,直到 PV 上的空间低于 retentionSize 限制。

1.3.3. 了解指标

在 OpenShift Container Platform 4.14 中,集群组件的监控方式是提取通过服务端点公开的指标。您还可以为用户定义的项目配置指标集合。借助指标,您可以监控集群组件和您自己的工作负载的表现情况。

您可以通过在应用程序级别使用 Prometheus 客户端库来定义您要为您自己的工作负载提供的指标。

在 OpenShift Container Platform 中,指标通过 /metrics 规范名称下的 HTTP 服务端点公开。您可以通过针对 http://<endpoint>/metrics 运行 curl 查询来列出服务的所有可用指标。例如,您可以向 prometheus-example-app 示例应用程序公开路由,然后运行以下命令来查看其所有可用指标:

curl http://<example_app_endpoint>/metrics

$ curl http://<example_app_endpoint>/metrics输出示例

1.3.3.1. 控制用户定义的项目中未绑定指标属性的影响

开发人员可以使用键值对的形式为指标定义属性。潜在的键值对数量与属性的可能值数量对应。具有无限数量可能值的属性被称为未绑定属性。例如,customer_id 属性不绑定,因为它有无限多个可能的值。

每个分配的键值对都有唯一的时间序列。在标签中使用许多未绑定属性可导致所创建的时间序列数量出现指数增加。这可能会影响 Prometheus 性能,并消耗大量磁盘空间。

集群管理员可以使用以下方法控制用户定义的项目中未绑定指标属性的影响:

- 限制用户定义的项目中每个目标提取可接受的示例数量

- 限制提取标签数量、标签名称长度以及标签值长度

- 创建在达到提取示例阈值或无法提取目标时触发的警报

限制提取示例可帮助防止在标签中添加多个未绑定属性导致的问题。开发人员还可以通过限制其为指标定义的未绑定属性数量来防止底层原因。使用绑定到一组有限可能值的属性可减少潜在的键-值对组合数量。

1.3.3.2. 在指标中添加集群 ID 标签

如果您管理多个 OpenShift Container Platform 集群,并使用远程写入功能将指标数据从这些集群发送到外部存储位置,您可以添加集群 ID 标签来识别来自不同集群的指标数据。然后,您可以查询这些标签来标识指标的源集群,并区分与其他集群发送的类似指标数据的数据。

这样,如果您为多个客户管理多个集群,并将指标数据发送到单个集中存储系统,您可以使用集群 ID 标签查询特定集群或客户的指标。

创建并使用集群 ID 标签涉及三个常规步骤:

- 配置远程写入存储的写重新标记设置。

- 将集群 ID 标签添加到指标。

- 查询这些标签以标识源集群或指标客户。

1.3.4. 关于监控仪表板

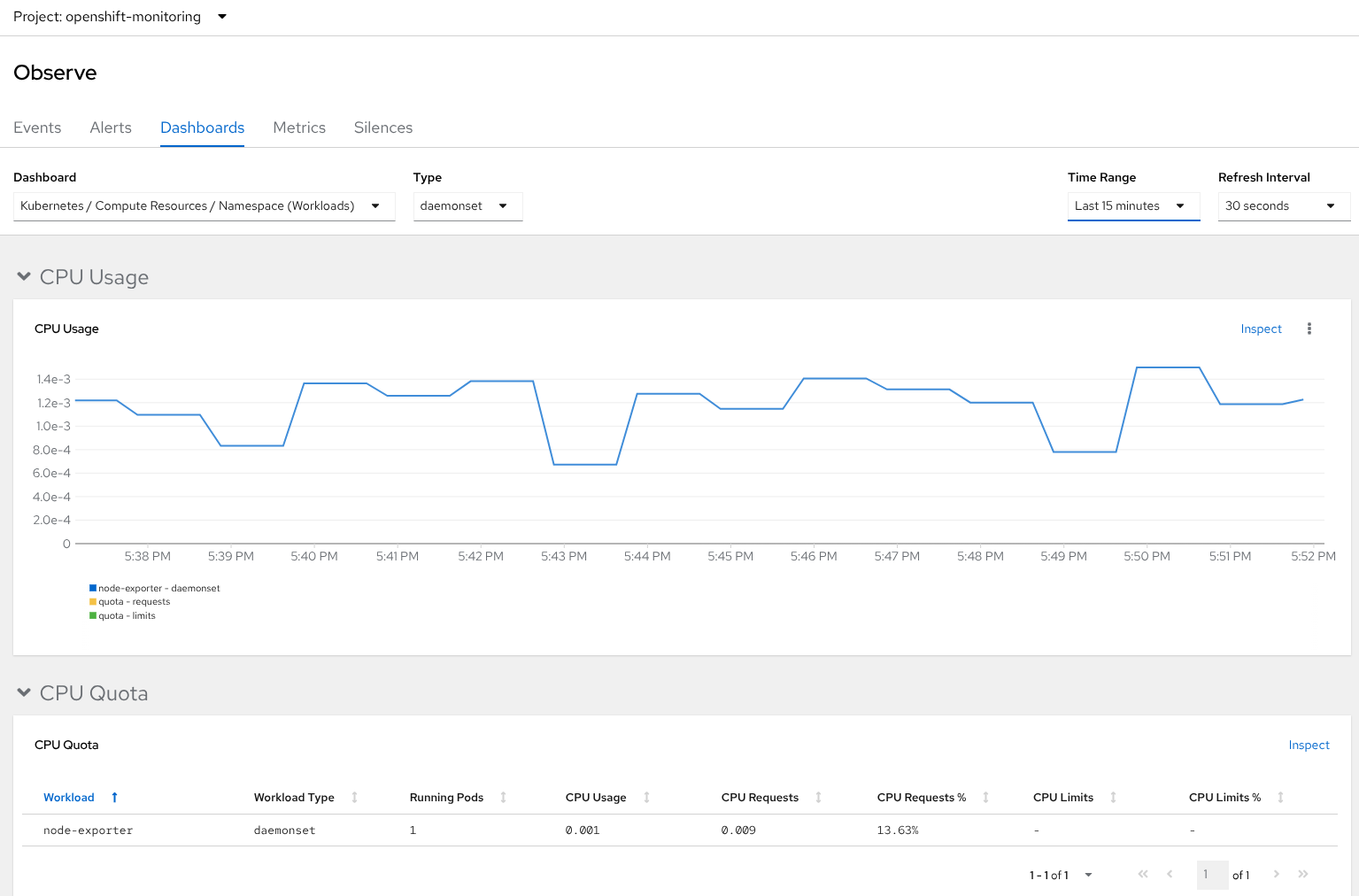

OpenShift Container Platform 提供了一组监控仪表板,可帮助您了解集群组件和用户定义的工作负载的状态。

1.3.4.1. Administrator 视角中的监控仪表板

使用 Administrator 视角访问 OpenShift Container Platform 核心组件的仪表板,包括以下项目:

- API 性能

- etcd

- Kubernetes 计算资源

- Kubernetes 网络资源

- Prometheus

- 与集群和节点性能相关的 USE 方法仪表板

- 节点性能指标

图 1.1. Administrator 视角中的仪表板示例

1.3.4.2. Developer 视角中的监控仪表板

使用 Developer 视角访问为所选项目提供以下应用程序指标的 Kubernetes 计算资源仪表板:

- CPU 用量

- 内存用量

- 带宽信息

- 数据包速率信息

图 1.2. Developer 视角中的仪表板示例

1.3.5. 管理警报

在 OpenShift Container Platform 中,您可以通过 Alerting UI 管理警报、静默和警报规则。

- 警报规则。警报规则包含一组概述集群中特定状态的条件。当这些条件满足时会触发警报。可为警报规则分配一个严重性来定义警报的路由方式。

- 警报。当警报规则中定义的条件为满足时会触发警报。警报提供一条通知,说明一组情况在 OpenShift Container Platform 集群中显而易见。

- 静默。可对警报应用静默,以防止在警报条件满足时发送通知。在您着手处理根本问题的同时,可在初始通知后将警报静音。

Alerting UI 中可用的警报、静默和警报规则与您可访问的项目相关。例如,如果您以具有 cluster-admin 角色的用户身份登录,您可以访问所有警报、静默和警报规则。

1.3.5.1. 管理静默

您可以在 Administrator 和 Developer 视角中的 OpenShift Container Platform Web 控制台中为警报创建静默。创建静默后,不会在警报触发时收到有关警报的通知。

当您收到了初始警报通知,并且不希望在解决与这个初始警报相关的底层问题时接收到因为解决相关问题所触发的警报通知,可以创建静默。

在创建静默时,您必须指定它是立即激活,还是稍后激活。您还必须设置静默在多长一段时间后到期。

在创建静默后,您可以查看、编辑这个静默,并可以使其过期。

在创建静默时,它们会在 Alertmanager pod 之间复制。但是,如果您没有为 Alertmanager 配置持久性存储,静默可能会丢失。例如,如果所有 Alertmanager pod 同时重启,会出现这种情况。

1.3.5.2. 管理用于核心平台监控的警报规则

OpenShift Container Platform 监控包括一组用于平台指标的默认警报规则。作为集群管理员,您可以以两种方式自定义这组规则:

-

通过调整阈值或添加和修改标签来修改现有平台警报规则的设置。例如,您可以将一个警报的

severity标签从warning改为critical以帮助您来处理相关的问题。 -

通过基于

openshift-monitoring命名空间中的核心平台指标构建查询表达式,定义和添加新的自定义警报规则。

核心平台警报规则考虑

- 新的警报规则必须基于默认的 OpenShift Container Platform 监控指标。

-

您必须在

openshift-monitoring命名空间中创建AlertingRule和AlertRelabelConfig对象。 - 您只能添加和修改警报规则。您无法创建新的记录规则或修改现有的记录规则。

-

如果您使用

AlertRelabelConfig对象修改现有平台警报规则,您的修改不会反映在 Prometheus 警报 API 中。因此,任何丢弃的警报仍出现在 OpenShift Container Platform web 控制台中,即使它们不再被转发到 Alertmanager。另外,任何对警报的修改(如更改了severity标签)都不会出现在 web 控制台中。

1.3.5.3. 为核心平台监控优化警报规则的建议

如果您需要自定义核心平台警报规则来满足机构的特定需求,请遵循以下准则,确保自定义规则可以实现预期的目且高效。

- 使用尽可能少的新规则。仅创建符合您特定要求的规则。通过使用最少的规则数量,您可以在监控环境中创建更易管理且集中的警报系统。

- 专注于症状而不是原因。创建规则来通知用户症状而不是造成症状的根本原因。这可以确保,在出现相关症状时用户可以获得警报,用户可以调查触发警报的根本原因。使用这个策略,可以显著降低了您需要创建的规则的总数量。

- 在实施更改之前,规划并评估您的需求。首先,明确哪些症状是重要的,以及在出现这些症状时您希望用户执行哪些操作。然后,评估现有规则,决定是否可以通过修改这些规则来实现您的目的,而不用为每个症状都创建一个新的规则。通过修改现有规则并谨慎创建新规则,可帮助您简化警报系统。

- 提供明确的警报信息。当您创建警报消息时,包括症状的描述、可能的原因和推荐的操作。包括的信息应该明确、简明,并包括故障排除步骤或更多相关信息的链接。这样做有助于用户快速评估情况并做出适当响应。

- 包括严重性级别。为您的规则分配严重性级别,以提示用户在出现症状并触发警报时如何响应。例如,将警报严重性级别定为 关键(Critical) 信号,代表相关人员需要马上做出响应。通过定义严重性级别,可以帮助用户决定在收到警报时应如何响应,并确保对紧急的问题马上做出响应

1.3.5.4. 关于为用户定义的项目创建警报规则

如果您为用户定义的项目创建警报规则,请在定义新规则时请考虑以下关键行为和重要限制:

除了核心平台监控的默认指标外,用户定义的警报规则也可以包括由其自身项目公开的指标。您不能包含其他用户定义的项目的指标。

例如,

ns1用户定义的项目的警报规则除核心平台指标(如 CPU 和内存指标)外还可以使用ns1项目公开的指标。但是,该规则无法包含来自不同ns2用户定义的项目的指标。要缩短延迟并最小化核心平台监控组件的负载,您可以将

openshift.io/prometheus-rule-evaluation-scope: leaf-prometheus标签添加到规则中。此标签只强制openshift-user-workload-monitoring项目中部署的 Prometheus 实例评估警报规则,并防止 Thanos Ruler 实例这样做。重要如果警报规则具有此标签,则您的警报规则只能使用用户定义的项目公开的这些指标。您基于默认平台指标创建的警报规则可能无法触发警报。

1.3.5.5. 为用户定义的项目管理警报规则

在 OpenShift Container Platform 中,您可以查看、编辑和删除用户定义的项目中的警报规则。

警报规则注意事项

- 默认的警报规则专门用于 OpenShift Container Platform 集群。

- 有些警报规则特意使用相同的名称。它们发送关于同一事件但具有不同阈值和/或不同严重性的警报。

- 如果较低严重性警报在较高严重性警报触发的同时触发,禁止规则可防止在这种情况下发送通知。

1.3.5.6. 为用户定义的项目优化警报

要优化您自己的项目的警报,您可以在创建警报规则时考虑以下建议:

- 尽可能减少您为项目创建的警报规则数量。创建警报规则来针对会影响您的条件通知您。如果您为不会影响您的条件生成多个警报,则更难以注意到相关警报。

- 为症状而不是原因创建警报规则。创建警报规则来针对条件通知您,而无论根本原因是什么。然后可以调查原因。如果每个警报规则都只与特定原因相关,则需要更多警报规则。然后,可能会错过一些原因。

- 在编写警报规则前进行规划。确定对您很重要的症状以及一旦发生您想要采取什么操作。然后为每个症状构建警报规则。

- 提供明确的警报信息。在警报消息中说明症状和推荐操作。

- 在警报规则中包含严重性级别。警报的严重性取决于当报告的症状发生时您需要如何做出反应。例如,如果症状需要个人或关键响应团队立即关注,就应该触发关键警报。

1.3.5.7. 搜索和过滤警报、静默和警报规则

您可以过滤 Alerting UI 中显示的警报、静默和警报规则。本节介绍每个可用的过滤选项。

1.3.5.7.1. 了解警报过滤器

在 Administrator 视角中,Alerting UI 中的 Alerts 页面针对与 OpenShift Container Platform 默认项目和用户定义的项目相关的警报提供了详细信息。该页面包括每个警报的严重性、状态和来源摘要。另外还会显示警报进入其当前状态的时间。

您可以按警报状态、严重性和来源进行过滤。默认情况下,只会显示处于 Firing 状态的 Platform 警报。下面描述了每个警报过滤选项:

State 过滤器:

-

Firing。警报正在触发,因为满足警报条件,且可选的

for持续时间已过。当条件保持 true 时,警报将继续触发。 - Pending。该警报处于活跃状态,但正在等待警报规则中指定的持续时间,然后再触发警报。

- Silenced。现在,警报在定义的时间段内处于静默状态。静默会根据您定义的一组标签选择器临时将警报静音。对于与所有列出的值或正则表达式匹配的警报,不会发送通知。

-

Firing。警报正在触发,因为满足警报条件,且可选的

Severity 过滤器:

- Critical。触发了警报的条件可能会产生重大影响。该警报在触发时需要立即关注,并且通常会传给个人或关键响应团队。

- Warning。该警报针对可能需要注意的事件提供警告通知,以防止问题的发生。警告通常会路由到一个问题单系统进行非即时的审阅。

- Info。该警报仅用于提供信息。

- None。该警报没有定义的严重性。

- 您还可以针对与用户定义的项目相关的警报创建自定义严重性定义。

Source 过滤器:

- Platform。平台级别的警报仅与 OpenShift Container Platform 默认项目相关。这些项目提供 OpenShift Container Platform 核心功能。

- User。用户警报与用户定义的项目相关。这些警报是用户创建的,并可自定义。用户定义的工作负载监控可在安装后启用,以便您观察自己的工作负载。

1.3.5.7.2. 了解静默过滤器

在 Administrator 视角中,Alerting UI 中的 Silences 页面针对应用到 OpenShift Container Platform 默认项目和用户定义项目中的警报的静默提供了详细信息。该页面包括每个静默的状态以及静默结束时间的摘要。

您可以按静默状态进行过滤。默认情况下,仅显示 Active 和 Pending 静默。下面描述了每个静默状态过滤器选项:

State 过滤器:

- Active。静默处于活跃状态,在静默到期前,警报将静音。

- Pending。静默已被调度,但还没有激活。

- Expired。静默已过期,如果满足警报条件,将发送通知。

1.3.5.7.3. 了解警报规则过滤器

在 Administrator 视角中,Alerting UI 中的 Alerts Rules 页面针对与 OpenShift Container Platform 默认项目和用户定义的项目相关的警报规则提供了详细信息。该页面包括每个警报规则的状态、严重性和来源摘要。

您可以按警报状态、严重性和来源过滤警报规则。默认情况下,只会显示 Platform 警报规则。下面描述了每个警报规则过滤选项:

警报状态 过滤器:

-

Firing。警报正在触发,因为满足警报条件,且可选的

for持续时间已过。当条件保持 true 时,警报将继续触发。 - Pending。该警报处于活跃状态,但正在等待警报规则中指定的持续时间,然后再触发警报。

- Silenced。现在,警报在定义的时间段内处于静默状态。静默会根据您定义的一组标签选择器临时将警报静音。对于与所有列出的值或正则表达式匹配的警报,不会发送通知。

- Not Firing。警报未触发。

-

Firing。警报正在触发,因为满足警报条件,且可选的

Severity 过滤器:

- Critical。警报规则中定义的条件可能会产生重大影响。如果满足这些条件,需要立即关注。与该规则相关的警报通常会传给个人或关键响应团队。

- Warning。警报规则中定义的条件可能需要注意,以防止问题的发生。与该规则相关的警报通常会路由到一个问题单系统进行非即时的审阅。

- Info。警报规则仅提供信息警报。

- None。该警报规则没有定义的严重性。

- 您还可以针对与用户定义的项目相关的警报规则创建自定义严重性定义。

Source 过滤器:

- Platform。平台级别的警报规则仅与 OpenShift Container Platform 默认项目相关。这些项目提供 OpenShift Container Platform 核心功能。

- User。用户定义的工作负载警报规则与用户定义的项目相关。这些警报规则是用户创建的,并可自定义。用户定义的工作负载监控可在安装后启用,以便您观察自己的工作负载。

1.3.5.7.4. 在 Developer 视角中搜索和过滤警报、静默和警报规则

在 Developer 视角中,Alerting UI 中的 Alerts 页面提供了与所选项目相关的警报和静默的组合视图。对于每个显示的警报,都提供了相关警报规则的链接。

在该视图中,您可以按警报状态和严重性进行过滤。默认情况下,如果您有访问所选项目的权限,则会显示项目中的所有警报。这些过滤器与针对 Administrator 视角描述的过滤器相同。

1.3.6. 了解用户定义的项目的警报路由

作为集群管理员,您可以为用户定义的项目启用警报路由。使用此功能,您可以允许具有 alert-routing-edit 集群角色的用户为用户定义的项目配置警报通知路由和接收器。这些通知由默认的 Alertmanager 实例路由,如果启用,则为专用于用户定义的监控的可选 Alertmanager 实例。

然后,用户可以通过为用户定义的项目创建或编辑 AlertmanagerConfig 对象来创建和配置用户定义的警报路由,而无需管理员的帮助。

用户为用户定义的项目定义了警报路由后,用户定义的警报通知会路由如下:

-

如果使用默认平台 Alertmanager 实例,到

openshift-monitoring命名空间中的alertmanager-mainpod。 -

如果您为用户定义的项目启用了一个单独的 Alertmanager 实例,到

openshift-user-workload-monitoring命名空间中的alertmanager-user-workloadPod。

查看用户定义的项目的警报路由的以下限制:

-

对于用户定义的警报规则,用户定义的路由范围到定义资源的命名空间。例如,命名空间

ns1中的路由配置仅适用于同一命名空间中的PrometheusRules资源。 -

当命名空间不包括在用户定义的监控中时,命名空间中的

AlertmanagerConfig资源将成为 Alertmanager 配置的一部分。

1.3.7. 将通知发送到外部系统

在 OpenShift Container Platform 4.14 中,可在 Alerting UI 中查看触发警报。默认不会将警报配置为发送到任何通知系统。您可以将 OpenShift Container Platform 配置为将警报发送到以下类型的接收器:

- PagerDuty

- Webhook

- 电子邮件

- Slack

通过将警报路由到接收器,您可在出现故障时及时向适当的团队发送通知。例如,关键警报需要立即关注,通常会传给个人或关键响应团队。相反,提供非关键警告通知的警报可能会被路由到一个问题单系统进行非即时的审阅。

使用 watchdog 警报检查警报是否工作正常

OpenShift Container Platform 监控功能包含持续触发的 watchdog 警报。Alertmanager 重复向已配置的通知提供程序发送 watchdog 警报通知。此提供程序通常会配置为在其停止收到 watchdog 警报时通知管理员。这种机制可帮助您快速识别 Alertmanager 和通知提供程序之间的任何通信问题。

第 2 章 开始使用

2.1. 对监控的维护和支持

并非所有监控堆栈配置选项都公开。配置 OpenShift Container Platform 监控的唯一支持的方法是,使用 Cluster Monitoring Operator (CMO) 的 Cluster Monitoring Operator 的 Config map 参考中所述的选项来配置。请勿使用其他配置,因为不受支持。

各个 Prometheus 发行版本的配置范例可能会有所变化,只有掌握了所有可能的配置,才能稳妥应对这样的配置变化。如果您使用 Cluster Monitoring Operator 的 Config map 引用中描述的配置,您的更改可能会丢失,因为 Cluster Monitoring Operator 会自动协调任何区别,并将任何不支持的更改重置为最初定义的状态。

2.1.1. 对监控的支持注意事项

指标、记录规则或警报规则的向后兼容性无法被保证。

明确不支持以下修改:

-

在

openshift-*和kube-*项目中创建额外的ServiceMonitor、PodMonitor和PrometheusRule对象。 修改

openshift-monitoring或openshift-user-workload-monitoring项目中部署的任何资源或对象。OpenShift Container Platform 监控堆栈所创建的资源并不是为了供任何其他资源使用,因为不能保证向后兼容性。注意Alertmanager 配置作为

openshift-monitoring命名空间中的alertmanager-mainsecret 资源部署。如果您为用户定义的警报路由启用了单独的 Alertmanager 实例,则 Alertmanager 配置也会部署为openshift-user-workload-monitoring命名空间中的alertmanager-user-workloadsecret 资源。要为 Alertmanager 实例配置额外的路由,您需要对该 secret 进行解码、修改,然后再进行编码。该程序是对前述声明的一个受支持例外。- 修改堆栈的资源。OpenShift Container Platform 监控堆栈确保其资源始终处于期望的状态。如果修改了资源,堆栈会重置它们。

-

将用户定义的工作负载部署到

openshift-*和kube-*项目。这些项目是为红帽提供的组件保留的,不应该用于用户定义的工作负载。 -

使用 Prometheus Operator 中的

Probe自定义资源定义(CRD)启用基于症状的监控。 -

手动将监控资源部署到具有

openshift.io/cluster-monitoring: "true"标签的命名空间中。 -

将

openshift.io/cluster-monitoring: "true"标签添加到命名空间。该标签只适用于带有 OpenShift Container Platform 核心组件和红帽认证的组件的命名空间。 - 在 OpenShift Container Platform 上安装自定义 Prometheus 实例。自定义资源 (CR) 是由 Prometheus Operator 管理的 Prometheus 自定义资源 (CR)。

2.1.2. 监控 Operator 的支持策略

监控 Operator 确保 OpenShift Container Platform 监控资源按设计和测试的方式正常工作。如果某个 Operator 的 Cluster Version Operator (CVO) 控制被覆盖,该 Operator 不会响应配置更改,协调集群对象的预期状态或接收更新。

虽然在调试过程中覆盖 Operator 的 CVO 可能有所帮助,但该操作不受支持,集群管理员需要完全掌控各个组件的配置和升级。

覆盖 Cluster Version Operator

可将 spec.overrides 参数添加到 CVO 的配置中,以便管理员提供对组件的 CVO 行为覆盖的列表。将一个组件的 spec.overrides[].unmanaged 参数设置为 true 会阻止集群升级并在设置 CVO 覆盖后提醒管理员:

Disabling ownership via cluster version overrides prevents upgrades. Please remove overrides before continuing.

Disabling ownership via cluster version overrides prevents upgrades. Please remove overrides before continuing.设置 CVO 覆盖会使整个集群处于不受支持的状态,并导致监控堆栈无法被协调到其预期状态。这会影响 Operator 内置的可靠性功能,并妨碍接收更新。在删除所有覆盖后,必须可以重现报告的问题方可获得支持。

2.1.3. 监控组件的支持版本列表

以下列表包含有关 OpenShift Container Platform 4.12 及更新的版本的监控组件版本的信息:

| OpenShift Container Platform | Prometheus Operator | Prometheus | Prometheus Adapter | Alertmanager | kube-state-metrics 代理 | monitoring-plugin | node-exporter 代理 | Thanos |

|---|---|---|---|---|---|---|---|---|

| 4.14 | 0.67.1 | 2.46.0 | 0.10.0 | 0.25.0 | 2.9.2 | 1.0.0 | 1.6.1 | 0.30.2 |

| 4.13 | 0.63.0 | 2.42.0 | 0.10.0 | 0.25.0 | 2.8.1 | N/A | 1.5.0 | 0.30.2 |

| 4.12 | 0.60.1 | 2.39.1 | 0.10.0 | 0.24.0 | 2.6.0 | N/A | 1.4.0 | 0.28.1 |

openshift-state-metrics 代理和 Telemeter Client 是特定于 OpenShift 的组件。因此,它们的版本与 OpenShift Container Platform 的版本对应。

2.2. 核心平台监控第一步

安装 OpenShift Container Platform 后,核心平台监控组件会立即开始收集指标,您可以查询和查看。默认 in-cluster 监控堆栈包括核心平台 Prometheus 实例,从集群收集指标以及路由警报的核心 Alertmanager 实例,以及其他组件。根据谁将监控堆栈以及作为集群管理员使用监控堆栈,您可以进一步配置这些监控组件以适应不同场景中的不同用户的需求。

2.2.1. 配置核心平台监控:安装后步骤

安装 OpenShift Container Platform 后,集群管理员通常会配置核心平台监控以满足您的需要。这些活动包括为 Prometheus、Alertmanager 和其他监控组件设置存储和配置选项。

默认情况下,在新安装的 OpenShift Container Platform 系统中,用户可以查询和查看收集的指标。如果您希望用户接收警报通知,您只需要配置警报接收器。此处列出的任何其他配置选项都是可选的。

-

如果不存在,创建

cluster-monitoring-configConfigMap对象。 - 配置默认平台警报的通知,以便 Alertmanager 可以将警报发送到外部通知系统,如电子邮件、Slack 或 PagerDuty。

对于短期的数据保留期,请为 Prometheus 和 Alertmanager 配置持久性存储以存储指标和警报数据。为 Prometheus 和 Thanos Ruler 指定指标数据保留参数。

重要- 在多节点集群中,您必须为 Prometheus、Alertmanager 和 Thanos Ruler 配置持久性存储,以确保高可用性。

-

默认情况下,在新安装的 OpenShift Container Platform 系统中,监控

ClusterOperator资源会报告PrometheusDataPersistenceNotConfigured状态信息,提醒您没有配置存储。

对于长期的数据保留,配置远程写入功能,使 Prometheus 能够将最接近的指标发送到远程系统以进行存储。

重要务必将集群 ID 标签添加到指标数据中用于远程写入存储配置的指标。

- 为需要访问特定监控功能的非管理员用户分配监控集群角色。

- 为监控堆栈组件分配容限,以便管理员可以将它们移到污点节点上。

- 为指标集合 设置正文大小限制,以帮助避免在提取目标返回包含大量数据时 Prometheus 消耗大量内存的情况。

- 为集群修改或创建警报规则。这些规则指定触发警报的条件,如高 CPU 或内存用量、网络延迟等。

- 指定监控组件的资源限值和请求,以确保运行监控组件的容器有足够的 CPU 和内存资源。

当将监控堆栈配置为满足您的需求时,Prometheus 会从指定的服务收集指标,并根据设置存储这些指标。您可以进入 OpenShift Container Platform Web 控制台中的 Observe 页面来查看和查询收集的指标、管理警报、识别性能瓶颈以及根据需要扩展资源:

2.3. 用户工作负载监控第一步

作为集群管理员,除了对核心平台进行监控外,您还可以有选择性地为用户定义的项目启用监控。这样,非管理员用户(如开发人员)可以监控核心平台之外的自己的项目。

集群管理员通常需要完成以下操作来配置用户定义的项目,以便用户可以查看收集的指标、查询这些指标并接收其自己的项目的警报:

- 启用用户工作负载监控。

-

通过分配

monitoring-rules-view,monitoring-rules-edit, 或monitoring-edit集群角色,为非管理员用户授予权限来监控用户定义的项目。 -

分配

user-workload-monitoring-config-edit角色,为非管理员用户授予配置用户定义的项目的权限。 - 为用户定义的项目启用警报路由,以便开发人员和其他用户能够为其项目配置自定义警报和警报路由。

- 如果需要,为用户定义的项目配置警报路由,以使用专用于用户定义的项目的可选 Alertmanager 实例。

- 为用户定义的警报配置通知。

- 如果您使用平台 Alertmanager 实例进行用户定义的警报路由,请为默认平台警报和用户定义的警报配置不同的警报接收器。

2.4. 开发人员和非管理员用户步骤

在启用对用户定义的项目的监控后,开发人员和其他非管理员用户可以执行以下操作来设置并使用自己项目的监控功能:

第 3 章 配置核心平台监控

3.1. 准备配置核心平台监控堆栈

在安装前,OpenShift Container Platform 安装程序只提供少量的配置选项。大多数 OpenShift Container Platform 框架组件(包括集群监控堆栈)都在安装后进行配置。

本节介绍可以配置哪些监控组件以及如何准备配置监控堆栈。

- 并非所有监控堆栈的配置参数都会被公开。只有在 Cluster Monitoring Operator 的 Config map 引用中列出的参数和字段才支持进行配置。

- 监控堆栈会带来额外的资源需求。参阅 扩展 Cluster Monitoring Operator 中的计算资源建议,并确认您有足够的资源。

3.1.1. 可配置的监控组件

下表显示了您可以配置的监控组件,以及 cluster-monitoring-config 配置映射中用来指定这些组件的键。

| 组件 | cluster-monitoring-config 配置映射键 |

|---|---|

| Prometheus Operator |

|

| Prometheus |

|

| Alertmanager |

|

| Thanos querier |

|

| kube-state-metrics |

|

| monitoring-plugin |

|

| openshift-state-metrics |

|

| Telemeter Client |

|

| Prometheus Adapter |

|

ConfigMap 对象的不同配置更改会导致不同的结果:

- Pod 不会重新部署。因此,没有服务中断。

受影响的 pod 被重新部署:

- 对于单节点集群,这会导致临时服务中断。

- 对于多节点集群,因为高可用性,受影响的 pod 会逐渐推出,监控堆栈仍然可用。

- 无论高可用性如何,配置和重新定义持久性卷的大小始终会导致服务中断。

每个需要更改配置映射中的步骤都包括其预期的结果。

3.1.2. 创建集群监控配置映射

您可以通过在 openshift-monitoring 项目中创建和更新 cluster-monitoring-config 配置映射来配置 OpenShift Container Platform 核心监控组件。Cluster Monitoring Operator (CMO) 然后配置监控堆栈的核心组件。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

已安装 OpenShift CLI(

oc)。

流程

检查

cluster-monitoring-configConfigMap对象是否存在:oc -n openshift-monitoring get configmap cluster-monitoring-config

$ oc -n openshift-monitoring get configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果

ConfigMap对象不存在:创建以下 YAML 清单。在本例中,该文件名为

cluster-monitoring-config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 应用配置以创建

ConfigMap对象:oc apply -f cluster-monitoring-config.yaml

$ oc apply -f cluster-monitoring-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.3. 为核心平台监控授予用户权限

集群管理员可以监控所有 OpenShift Container Platform 核心项目和用户定义的项目。

您还可以为核心平台监控授予开发人员和其他用户不同的权限。您可以通过分配以下监控角色或集群角色之一来授予权限:

| Name | 描述 | 项目 |

|---|---|---|

|

| 具有此角色的用户能够访问 Thanos Querier API 端点。另外,它还授予对核心平台 Prometheus API 和用户定义的 Thanos Ruler API 端点的访问权限。 |

|

|

|

具有此角色的用户可以管理用于核心平台监控的 |

|

|

| 具有此角色的用户可以管理用于核心平台监控的 Alertmanager API。它们也可以在 OpenShift Container Platform Web 控制台的 Administrator 视角中管理警报静默。 |

|

|

| 具有此角色的用户可以监控 Alertmanager API 以进行核心平台监控。它们也可以在 OpenShift Container Platform Web 控制台的 Administrator 视角中查看警报静默。 |

|

|

|

具有此集群角色的用户具有与 |

必须与 |

3.1.3.1. 使用 Web 控制台授予用户权限

您可以使用 OpenShift Container Platform Web 控制台为 openshift-monitoring 项目或自己的项目授予用户权限。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 - 要将角色分配到的用户帐户已存在。

流程

- 在 OpenShift Container Platform Web 控制台的 Administrator 视角中,进入 User Management → RoleBindings → Create binding。

- 在 Binding Type 部分中,选择 Namespace Role Binding 类型。

- 在 Name 字段中输入角色绑定的名称。

在 Namespace 字段中,选择要授予访问权限的项目。

重要您使用此流程向用户授予的监控角色或集群角色权限只适用于您在 Namespace 字段中选择的项目。

- 从 Role Name 列表中选择监控角色或集群角色。

- 在 Subject 部分,选择 User。

- 在 Subject Name 字段中,输入用户名称。

- 选择 Create 以应用角色绑定。

3.1.3.2. 使用 CLI 授予用户权限

您可以使用 OpenShift CLI (oc) 为 openshift-monitoring 项目或自己的项目授予用户权限。

无论您选择的角色或集群角色,都必须作为集群管理员将其与特定项目进行绑定。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 - 要将角色分配到的用户帐户已存在。

-

已安装 OpenShift CLI(

oc)。

流程

要为项目的用户分配监控角色,请输入以下命令:

oc adm policy add-role-to-user <role> <user> -n <namespace> --role-namespace <namespace>

$ oc adm policy add-role-to-user <role> <user> -n <namespace> --role-namespace <namespace>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<role>替换为您要监控角色,<user>替换为您要为其分配角色的用户,<namespace>替换为您要授予访问权限的项目。

要为项目的用户分配监控集群角色,请输入以下命令:

oc adm policy add-cluster-role-to-user <cluster-role> <user> -n <namespace>

$ oc adm policy add-cluster-role-to-user <cluster-role> <user> -n <namespace>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<cluster-role>替换为您要监控的集群角色,<user>替换为您要为其分配集群角色的用户,<namespace>替换为您要授予访问权限的项目。

3.2. 为核心平台监控配置性能和可扩展性

您可以配置监控堆栈来优化集群的性能和扩展。以下文档提供了有关如何分发监控组件的信息,并控制监控堆栈对 CPU 和内存资源的影响。

3.2.1. 控制监控组件的放置和分发

您可以将监控堆栈组件移到特定的节点上:

-

使用带有标记节点的

nodeSelector约束,将任何监控堆栈组件移到特定的节点上。 - 分配容限以启用将组件移到污点节点。

通过这样做,您可以控制集群中监控组件的放置和分发。

通过控制监控组件的放置和分发,您可以根据特定要求或策略优化系统资源使用、提高性能和隔离工作负载。

3.2.1.1. 将监控组件移到其他节点

要指定运行监控堆栈组件的集群中的节点,请在 cluster-monitoring-config 配置映射中为组件配置 nodeSelector 约束,以匹配分配给节点的标签。

您不能将节点选择器约束直接添加到现有调度的 pod 中。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。

流程

如果您还没有这样做,请在要运行监控组件的节点中添加标签:

oc label nodes <node_name> <node_label>

$ oc label nodes <node_name> <node_label>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<node_name>替换为您要添加标签的节点的名称。将<node_label>替换为所需标签的名称。

编辑

openshift-monitoring项目中的cluster-monitoring-configConfigMap对象:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下为组件指定nodeSelector约束的节点标签:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果在配置

nodeSelector约束后监控组件仍然处于Pending状态,请检查 Pod 事件中与污点和容限相关的错误。- 保存文件以使改变生效。新配置中指定的组件会自动移到新节点上,受新配置影响的 pod 会被重新部署。

3.2.1.2. 为监控组件分配容忍(tolerations)

您可以为任何监控堆栈组件分配容忍,以便将其移到污点。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为组件指定

tolerations:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 相应地替换

<component>和<toleration_specification>。例如,

oc adm taint nodes node1 key1=value1:NoSchedule会将一个键为key1且值为value1的污点添加到node1。这会防止监控组件在node1上部署 Pod,除非为该污点配置了容限。以下示例将alertmanagerMain组件配置为容许示例污点:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

3.2.2. 为指标提取设置正文大小限制

默认情况下,针对从提取的指标目标返回的数据的未压缩正文大小没有限制。您可以设置正文大小限制,以帮助避免在提取目标返回包含大量数据时 Prometheus 消耗大量内存的情况。另外,通过设置正文大小限制,您可以降低恶意目标在 Prometheus 和整个集群中可能对这个影响。

为 enforcedBodySizeLimit 设置了一个值后,当至少有一个 Prometheus scrape 目标回复大于配置的值时,PrometheusScrapeBodySizeLimitHit 会触发警报。

如果从目标中提取的指标数据有一个不压缩的正文大小超过配置的大小限制,则提取会失败。然后,Prometheus 会认为这个目标为停机状态,并将其 up 指标值设置为 0, 它将触发一个 TargetDown 警报。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring命名空间中的cluster-monitoring-configConfigMap对象:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将

enforcedBodySizeLimit的值添加到data/config.yaml/prometheusK8s中,以限制每个目标提取可接受的正文大小:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定提取指标目标的最大正文大小。这个

enforceBodySizeLimit示例将每个目标提取的未压缩大小限制为 40MB。有效数字值使用 Prometheus 数据大小格式:B (bytes), KB (kilobytes), MB (megabytes), GB (gigabytes), TB (terabytes), PB (petabytes), and EB (exabytes)。默认值为0,代表没有指定限制。您还可以将值设为automatic,以根据集群容量自动计算限制。

- 保存文件以使改变生效。新的配置会被自动应用。

3.2.3. 管理监控组件的 CPU 和内存资源

您可以通过为这些组件的资源限值和请求指定值来确保运行监控组件的容器具有足够的 CPU 和内存资源。

您可以为 openshift-monitoring 命名空间中的核心平台监控组件配置这些限制和请求。

3.2.3.1. 指定限制和请求

要配置 CPU 和内存资源,请在 openshift-monitoring 命名空间中的 cluster-monitoring-config ConfigMap 对象中指定资源限值和请求值。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建了名为

cluster-monitoring-config的ConfigMap对象。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加值来为您要配置的每个组件定义资源限值和请求。

重要确保为限制设置的值始终高于为请求设置的值。否则,会出现错误,容器将不会运行。

设置资源限值和请求示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

3.2.4. 选择指标集合配置集

指标集合配置集只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

要为 OpenShift Container Platform 核心监控组件选择指标集合配置集,请编辑 cluster-monitoring-config ConfigMap 对象。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已使用

FeatureGate自定义资源 (CR) 启用了技术预览功能。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

您可以使用具有

cluster-admin集群角色的用户身份访问集群。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-configConfigMap对象:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml/prometheusK8s下添加 metrics collection 配置集设置:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指标集合配置集的名称。可用值为

full或minimal。如果没有指定值,或者配置映射中不存在collectionProfile键名称,则会使用full的默认设置。

以下示例将 Prometheus 核心平台实例的指标集合配置集设置为

minimal:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。新的配置会被自动应用。

3.2.5. 配置 pod 拓扑分布限制

您可以为 Cluster Monitoring Operator 部署的所有 pod 配置 pod 拓扑分布限制,以控制如何在区调度到节点的 pod 副本。这样可确保 pod 具有高可用性并更有效地运行,因为工作负载分散在不同的数据中心或分层基础架构区域中。

您可以使用 cluster-monitoring-config 配置映射为监控 pod 配置 pod 拓扑分布限制。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml字段中添加以下设置来配置 pod 拓扑分布限制:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定您要为其设置 pod 拓扑分布限制的组件名称。

- 2

- 为

maxSkew指定数字值,它定义了允许不均匀分布 pod 的程度。 - 3

- 为

topologyKey指定节点标签键。带有具有此键和相同值标签的节点被视为在同一拓扑中。调度程序会尝试将大量 pod 放置到每个域中。 - 4

- 为

whenUnsatisfiable指定一个值。可用选项包括DoNotSchedule和ScheduleAnyway。如果您希望maxSkew值定义目标拓扑和全局最小值中匹配 pod 数量之间允许的最大值,则指定DoNotSchedule。如果您希望调度程序仍然调度 pod,但为可能降低 skew 的节点赋予更高的优先级,请指定ScheduleAnyway。 - 5

- 指定

labelSelector来查找匹配的 pod。与此标签选择器匹配的 Pod 被计算,以确定其对应拓扑域中的 pod 数量。

Prometheus 配置示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

3.3. 为核心平台监控存储和记录数据

存储和记录您的指标和警报数据,配置日志以指定记录哪些活动,控制 Prometheus 保留数据的时长,并为数据设置最大磁盘空间量。这些操作可帮助您保护数据并将其用于故障排除。

3.3.1. 配置持久性存储

使用持久性存储运行集群监控以获取以下优点:

- 通过将指标和警报数据存储在持久性卷(PV)中来保护您的指标和警报数据。因此,它们可以在 pod 重启或重新创建后保留。

- 避免获取重复的通知,并在 Alertmanager pod 重启时丢失警报静默。

在多节点集群中,您必须为 Prometheus、Alertmanager 和 Thanos Ruler 配置持久性存储,以确保高可用性。

在生产环境中,强烈建议配置持久性存储。

3.3.1.1. 持久性存储的先决条件

- 分配充足的专用持久性存储,以确保磁盘不会被填满。

在配置持久性卷时,使用

Filesystem作为volumeMode参数的存储类型值。重要-

不要使用原始块卷,它由

PersistentVolume资源中的volumeMode: Block描述。Prometheus 无法使用原始块卷。 - Prometheus 不支持兼容 POSIX 的文件系统。例如,一些 NFS 文件系统实现不兼容 POSIX。如果要使用 NFS 文件系统进行存储,请验证与其 NFS 实现完全兼容 POSIX 的供应商。

-

不要使用原始块卷,它由

3.3.1.2. 配置持久性卷声明

要将持久性卷 (PV) 用于监控组件,您必须配置持久性卷声明 (PVC)。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将组件的 PVC 配置添加到

data/config.yaml下:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下示例配置了一个 PVC 来声明 Prometheus 的持久性存储:

PVC 配置示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署并应用新的存储配置。

警告当您使用 PVC 配置更新配置映射时,受影响的

StatefulSet对象会被重新创建,从而导致临时服务中断。

3.3.1.3. 重新定义持久性卷大小

您可以为监控组件(如 Prometheus 或 Alertmanager)重新定义持久性卷(PV)大小。您需要手动扩展持久性卷声明 (PVC),然后更新配置组件的配置映射。

您只能扩展 PVC 的大小。无法缩小存储大小。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 - 至少有一个 PVC 用于 OpenShift Container Platform 核心监控组件。

-

已安装 OpenShift CLI(

oc)。

流程

- 使用更新的存储请求手动扩展 PVC。如需更多信息,请参阅 扩展持久性卷 中的"使用文件系统扩展持久性卷声明 (PVC) "。

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下为组件添加新存储大小:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下示例将 Prometheus 实例的新 PVC 请求设置为 100GB:

prometheusK8s的存储配置示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

警告当您使用新存储大小更新配置映射时,受影响的

StatefulSet对象会被重新创建,从而导致临时服务中断。

3.3.2. 修改 Prometheus 指标数据的保留时间和大小

默认情况下,Prometheus 为核心平台监控保留 15 天指标数据。您可以修改 Prometheus 实例的保留时间,以便在删除数据时更改。您还可以设置保留指标数据使用的最大磁盘空间量。

数据压缩每两小时进行一次。因此,持久性卷 (PV) 可能会在压缩前已被填满,可能会超过 retentionSize 限制。在这种情况下,KubePersistentVolumeFillingUp 警报会触发,直到 PV 上的空间低于 retentionSize 限制。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下添加保留时间和大小配置:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下示例将 Prometheus 实例的保留时间设置为 24 小时,保留大小设为 10GB:

为 Prometheus 设置保留时间示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

3.3.3. 配置专用服务监控器

您可以配置 OpenShift Container Platform 核心平台监控,以使用专用服务监控器来收集资源指标管道的指标。

启用后,专用服务监控器会从 kubelet 端点公开两个额外的指标,并将 honorTimestamps 字段的值设置为 true。

通过启用专用服务监控器,您可以提高由 oc adm top pod 命令或 Horizontal Pod Autoscaler 使用的基于 Prometheus Adapter 的 CPU 用量测量的一致性。

3.3.3.1. 启用专用服务监控器

您可以通过在 openshift-monitoring 命名空间中的 cluster-monitoring-config ConfigMap 对象中配置 dedicatedServiceMonitors 键,将核心平台监控配置为使用专用服务监控器。

前提条件

-

已安装 OpenShift CLI(

oc)。 -

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。

流程

编辑

openshift-monitoring命名空间中的cluster-monitoring-configConfigMap对象:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如以下示例所示,添加一个

enabled: true键-值对:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

enabled字段的值设置为true以部署一个专用服务监控器,该监控器公开 kubelet/metrics/resource端点。

保存文件以自动应用更改。

警告当您保存对

cluster-monitoring-config配置映射的更改时,可能会重新部署openshift-monitoring项目中的 Pod 和其他资源。该项目中正在运行的监控进程可能会重启。

3.3.4. 为 Prometheus Adapter 设置审计日志级别

在默认平台监控中,您可以为 Prometheus Adapter 配置审计日志级别。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。

流程

您可以在默认 openshift-monitoring 项目中为 Prometheus Adapter 设置审计日志级别:

编辑

openshift-monitoring项目中的cluster-monitoring-configConfigMap对象:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下的k8sPrometheusAdapter/audit部分中添加profile:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 应用到 Prometheus Adapter 的审计日志级别。

使用

profile:参数的以下值之一设置审计日志级别:-

None:不记录事件。 -

Metadata:仅记录请求的元数据,如用户、时间戳等。不要记录请求文本和响应文本。metadata是默认的审计日志级别。 -

Request:仅记录元数据和请求文本,而不记录响应文本。这个选项不适用于非资源请求。 -

RequestResponse:日志事件元数据、请求文本和响应文本。这个选项不适用于非资源请求。

-

- 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

验证

-

在配置映射的

k8sPrometheusAdapter/audit/profile下,将日志级别设置为Request并保存文件。 确认 Prometheus Adapter 的 pod 正在运行。以下示例列出了

openshift-monitoring项目中的 pod 状态:oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确认正确配置了审计日志级别和审计日志文件路径:

oc -n openshift-monitoring get deploy prometheus-adapter -o yaml

$ oc -n openshift-monitoring get deploy prometheus-adapter -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

... - --audit-policy-file=/etc/audit/request-profile.yaml - --audit-log-path=/var/log/adapter/audit.log

... - --audit-policy-file=/etc/audit/request-profile.yaml - --audit-log-path=/var/log/adapter/audit.logCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确认

openshift-monitoring项目中的prometheus-adapter部署中应用了正确的日志级别:oc -n openshift-monitoring exec deploy/prometheus-adapter -c prometheus-adapter -- cat /etc/audit/request-profile.yaml

$ oc -n openshift-monitoring exec deploy/prometheus-adapter -c prometheus-adapter -- cat /etc/audit/request-profile.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果您为

ConfigMap对象中的 Prometheus Adapter 输入了一个未识别的profile值,则不会对 Prometheus Adapter 进行任何更改,Cluster Monitoring Operator 会记录错误。查看 Prometheus Adapter 的审计日志:

oc -n openshift-monitoring exec -c <prometheus_adapter_pod_name> -- cat /var/log/adapter/audit.log

$ oc -n openshift-monitoring exec -c <prometheus_adapter_pod_name> -- cat /var/log/adapter/audit.logCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.5. 为监控组件设置日志级别

您可以为 Alertmanager、Prometheus Operator、Prometheus 和 Thanos Querier 配置日志级别。

以下日志级别可应用到 cluster-monitoring-config ConfigMap 对象中的相关组件:

-

debug。记录调试、信息、警告和错误消息。 -

info。记录信息、警告和错误消息。 -

warn。仅记录警告和错误消息。 -

error。仅记录错误消息。

默认日志级别为 info。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下为组件添加logLevel: <log_level>:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

通过查看相关项目中的部署或 Pod 配置来确认已应用了日志级别。以下示例检查

prometheus-operator部署的日志级别:oc -n openshift-monitoring get deploy prometheus-operator -o yaml | grep "log-level"

$ oc -n openshift-monitoring get deploy prometheus-operator -o yaml | grep "log-level"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

- --log-level=debug

- --log-level=debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查组件的 Pod 是否正在运行。以下示例列出了 pod 的状态:

oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果

ConfigMap中包含了一个未识别的loglevel值,则组件的 Pod 可能无法成功重启。

3.3.6. 为 Prometheus 启用查询日志文件

您可以将 Prometheus 配置为将引擎运行的所有查询写入到日志文件。

由于不支持日志轮转,因此仅在需要对问题进行故障排除时才临时启用此功能。完成故障排除后,通过恢复您对 ConfigMap 对象所做的更改来禁用查询日志记录,以启用该功能。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将 Prometheus 的

queryLogFile参数添加到data/config.yaml下:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 添加要记录查询的文件的完整路径。

- 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

验证组件的 pod 是否正在运行。以下示例命令列出了 pod 的状态:

oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 读取查询日志:

oc -n openshift-monitoring exec prometheus-k8s-0 -- cat <path>

$ oc -n openshift-monitoring exec prometheus-k8s-0 -- cat <path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要在检查了记录的查询信息后,恢复配置映射的设置。

3.3.7. 为 Thanos Querier 启用查询日志记录

对于 openshift-monitoring 项目中的默认平台监控,您可以启用 Cluster Monitoring Operator 来记录 Thanos Querier 运行的所有查询。

由于不支持日志轮转,因此仅在需要对问题进行故障排除时才临时启用此功能。完成故障排除后,通过恢复您对 ConfigMap 对象所做的更改来禁用查询日志记录,以启用该功能。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。

流程

您可以在 openshift-monitoring 项目中为 Thanos Querier 启用查询日志记录:

编辑

openshift-monitoring项目中的cluster-monitoring-configConfigMap对象:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml中添加thanosQuerier部分并添加值,如下例所示:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

验证

验证 Thanos Querier pod 是否正在运行。以下示例命令列出了

openshift-monitoring项目中的 pod 状态:oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用以下示例命令作为模型运行测试查询:

token=`oc create token prometheus-k8s -n openshift-monitoring`

$ token=`oc create token prometheus-k8s -n openshift-monitoring`Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc -n openshift-monitoring exec -c prometheus prometheus-k8s-0 -- curl -k -H "Authorization: Bearer $token" 'https://thanos-querier.openshift-monitoring.svc:9091/api/v1/query?query=cluster_version'

$ oc -n openshift-monitoring exec -c prometheus prometheus-k8s-0 -- curl -k -H "Authorization: Bearer $token" 'https://thanos-querier.openshift-monitoring.svc:9091/api/v1/query?query=cluster_version'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来读取查询日志:

oc -n openshift-monitoring logs <thanos_querier_pod_name> -c thanos-query

$ oc -n openshift-monitoring logs <thanos_querier_pod_name> -c thanos-queryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意因为

thanos-querierpod 是高度可用的(HA)pod,所以您可能只能看到一个 pod 的日志。-

检查日志记录的查询信息后,通过将配置映射中的

enableRequestLogging值更改为false来禁用查询日志记录。

3.4. 为核心平台监控配置指标

配置指标集合,以监控集群组件和您自己的工作负载的执行方式。

您可以将最接近的指标发送到远程系统进行长期存储,并将集群 ID 标签添加到指标,以识别来自不同集群的数据。

3.4.1. 配置远程写入存储

您可以配置远程写入存储,使 Prometheus 能够将最接近的指标发送到远程系统,以进行长期存储。这样做不会影响 Prometheus 存储指标的方式和时长。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。 您已设置了一个远程写入兼容端点(如 Thanos),并且知道端点 URL。有关与远程写入功能兼容的端点的信息,请参阅 Prometheus 远程端点和存储文档。

重要红帽只提供配置远程写入发送者的信息,而不提供有关配置接收器端点的指导。客户负责设置自己的端点,这些端点与远程写入兼容。端点接收器配置的问题不包括在红帽产品支持中。

您已为远程写入端点在

Secret对象中设置身份验证凭证。您必须在openshift-monitoring命名空间中创建 secret。警告要减少安全风险,请使用 HTTPS 和身份验证向端点发送指标。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml/prometheusK8s下添加一个remoteWrite:部分,如下例所示:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在身份验证凭证后添加 write relabel 配置值:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 为您要发送到远程端点的指标添加配置。

转发一个名为

my_metric的单个指标的示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在

my_namespace命名空间中转发名为my_metric_1和my_metric_2的指标示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。新的配置会被自动应用。

3.4.1.1. 支持的远程写入身份验证设置

您可以使用不同的方法通过远程写入端点进行身份验证。目前支持的身份验证方法有 AWS 签名版本 4、基本身份验证、授权、OAuth 2.0 和 TLS 客户端。下表提供有关用于远程写入的受支持身份验证方法的详情。

| 身份验证方法 | 配置映射字段 | 描述 |

|---|---|---|

| AWS 签名版本 4 |

| 此方法使用 AWS 签名版本 4 身份验证为请求签名。您不能搭配授权、OAuth 2.0 或基本身份验证同时使用此方法。 |

| 基本身份验证(Basic authentication) |

| 基本身份验证使用配置的用户名和密码在每个远程写入请求上设置授权标头。 |

| 授权 |

|

授权使用配置的令牌在每个远程写入请求上设置 |

| OAuth 2.0 |

|

OAuth 2.0 配置使用客户端凭据授予类型。Prometheus 使用指定的客户端 ID 和客户端 secret 从 |

| TLS 客户端 |

| TLS 客户端配置指定 CA 证书、客户端证书和客户端密钥文件信息,用于使用 TLS 与远程写入端点服务器进行身份验证。示例配置假定您已创建了 CA 证书文件、客户端证书文件和客户端密钥文件。 |

3.4.1.2. 远程写入身份验证设置示例

以下示例展示了可用于连接到远程写入端点的不同身份验证设置。每个示例还演示了如何配置包含身份验证凭据和其他相关设置的对应 Secret 对象。每个示例配置身份验证,以用于 openshift-monitoring 命名空间中的默认平台监控。

3.4.1.2.1. AWS 签名版本 4 验证的 YAML 示例

以下显示了 openshift-monitoring 命名空间中名为 sigv4-credentials 的 sigv4 secret 的设置。

下面显示了一个 AWS Signature Version 4 远程写入身份验证设置示例,它使用一个在 openshift-monitoring 命名空间中的名为 sigv4-credentials 的 Secret 对象:

3.4.1.2.2. 用于基本身份验证的 YAML 示例

以下显示了 openshift-monitoring 命名空间中名为 rw-basic-auth 的 Secret 对象基本身份验证设置示例:

以下示例显示了使用 openshift-monitoring 命名空间中名为 rw-basic-auth 的 Secret 对象的 basicAuth 远程写入配置。它假设您已为端点设置了身份验证凭据。

3.4.1.2.3. 使用 Secret 对象通过 bearer 令牌进行身份验证的 YAML 示例

以下显示了 openshift-monitoring 命名空间中名为 rw-bearer-auth 的 Secret 对象的 bearer 令牌设置:

- 1

- 身份验证令牌。

以下显示了在 openshift-monitoring 命名空间中使用名为 rw-bearer-auth 的 Secret 对象的 bearer 令牌配置映射设置示例:

3.4.1.2.4. 用于 OAuth 2.0 验证的 YAML 示例

以下显示了 openshift-monitoring 命名空间中名为 oauth2-credentials 的 Secret 对象的 OAuth 2.0 设置示例:

下面显示了一个 oauth2 远程写入身份验证示例配置,它使用 openshift-monitoring 命名空间中名为 oauth2-credentials 的 Secret 对象:

3.4.1.2.5. TLS 客户端身份验证的 YAML 示例

以下显示了 openshift-monitoring 命名空间中名为 mtls-bundle 的 tls Secret 对象的 TLS 客户端设置示例。

以下示例显示了使用名为 mtls-bundle 的 TLS Secret 对象的 tlsConfig 远程写入身份验证配置。

3.4.1.3. 远程写入队列配置示例

您可以使用 queueConfig 对象来远程写入,以调优远程写入队列参数。以下示例显示了 queue 参数,以及它们在 openshift-monitoring 命名空间中默认平台监控的默认值。

使用默认值进行远程写入参数配置示例

3.4.1.4. 远程写入指标表

下表包含远程写入和远程 write-adjacent 指标,其中包含进一步的描述,以帮助在远程写入配置过程中解决问题。

| 指标 | 描述 |

|---|---|

|

| 显示 Prometheus 存储在任何样本的 write-ahead 日志(WAL)的最新时间戳。 |

|

| 显示远程写入队列成功发送的最新时间戳。 |

|

| 远程写入无法发送的示例数量,必须重新发送到远程存储。如果此指标一直稳定在高速率,则表示网络或远程存储端点的问题。 |

|

| 显示当前为每个远程端点运行多少个分片。 |

|

| 根据当前的写入吞吐量和传入与发送样本的速率显示计算的分片数量。 |

|

| 显示基于当前配置的分片的最大数量。 |

|

| 显示基于当前配置的分片的最小数量。 |

|

| Prometheus 当前正在写入新数据的 WAL 段文件。 |

|

| 每个远程写入实例当前读取的 WAL 段文件。 |

3.4.2. 为指标创建集群 ID 标签

您可以通过在 openshift-monitoring 命名空间中为 cluster-monitoring-config 配置映射中添加远程写入存储的 write_relabel 设置来为指标创建集群 ID 标签。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。 - 您已配置了远程写入存储。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml/prometheusK8s/remoteWrite中的writeRelabelConfigs:部分添加集群 ID 重新标记配置值:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下示例演示了如何使用集群 ID 标签

cluster_id转发指标:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。新的配置会被自动应用。

3.5. 为核心平台监控配置警报和通知

您可以配置本地或远程 Alertmanager 实例,将警报从 Prometheus 路由到端点接收器。您还可以将自定义标签附加到所有时间序列和警报,以添加有用的元数据信息。

3.5.1. 配置外部 Alertmanager 实例

OpenShift Container Platform 监控堆栈包含一个本地 Alertmanager 实例,用于从 Prometheus 路由警报。

您可以添加外部 Alertmanager 实例来路由 OpenShift Container Platform 核心项目的警报。

如果您为多个集群添加相同的外部 Alertmanager 配置,并且为每个集群禁用本地实例,则可以使用单个外部 Alertmanager 实例管理多个集群的警报路由。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

data/config.yaml/prometheusK8s下的配置详情添加一个additionalAlertmanagerConfigs部分:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<alertmanager_specification>替换为额外的 Alertmanager 实例的身份验证和其他配置详情。目前支持的身份验证方法有 bearer 令牌 (bearerToken) 和客户端 TLS (tlsConfig)。

以下示例配置映射使用带有客户端 TLS 身份验证的 bearer 令牌为 Prometheus 配置额外的 Alertmanager:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

3.5.1.1. 禁用本地 Alertmanager

在 OpenShift Container Platform 监控堆栈的 openshift-monitoring 项目中默认启用从 Prometheus 实例路由警报的本地 Alertmanager。

如果您不需要本地 Alertmanager,可以通过在 openshift-monitoring 项目中配置 cluster-monitoring-config 配置映射来禁用它。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建了

cluster-monitoring-config配置映射。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下为alertmanagerMain组件添加enabled: false:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。应用更改时,Alertmanager 实例会自动禁用。

3.5.2. 为 Alertmanager 配置 secret

OpenShift Container Platform 监控堆栈包括 Alertmanager,它将警报从 Prometheus 路由到端点接收器。如果您需要通过接收器进行身份验证以便 Alertmanager 能够向它发送警报,您可以将 Alertmanager 配置为使用包含接收器身份验证凭据的 secret。

例如,您可以将 Alertmanager 配置为使用 secret 与需要由私有证书颁发机构 (CA) 发布的证书的端点接收器进行身份验证。您还可以将 Alertmanager 配置为使用 secret 与需要用于基本 HTTP 身份验证密码文件的接收器进行身份验证。在这两种情况下,身份验证详情都包含在 Secret 对象中,而不是包括在 ConfigMap 对象中。

3.5.2.1. 在 Alertmanager 配置中添加 secret

您可以通过编辑 openshift-monitoring 项目中的 cluster-monitoring-config 配置映射,将 secret 添加到 Alertmanager 配置中。

将 secret 添加到配置映射后,secret 作为一个卷挂载到 Alertmanager Pod 的 alertmanager 容器中的 /etc/alertmanager/secrets/<secret_name 的卷中。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建了

cluster-monitoring-config配置映射。 -

您已创建了要在

openshift-monitoring项目中的 Alertmanager 中配置的 secret。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml/alertmanagerMain下添加一个secrets:部分,并具有以下配置:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下示例配置映射设置将 Alertmanager 配置为使用名为

test-secret-basic-auth和test-secret-api-token的两个Secret对象:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。新的配置会被自动应用。

3.5.3. 在时间序列和警报中附加额外标签

您可以使用 Prometheus 的外部标签功能,将自定义标签附加到离开 Prometheus 的所有时间序列和警报。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

您已创建

cluster-monitoring-configConfigMap对象。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-monitoring项目中的cluster-monitoring-config配置映射:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下定义您要为每个指标添加的标签:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<key>: <value>替换为键值对,其中<key>是新标签的唯一名称,<value>是它的值。

警告-

不要使用

prometheus或prometheus_replica作为键的名称,因为它们是保留的并会被覆盖。 -

不要使用

cluster作为密钥名称。使用它可能会导致开发人员仪表板无法看到数据的问题。

例如,要将关于区域和环境的元数据添加到所有时间序列和警报中,请使用以下示例:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

3.5.4. 配置警报通知

在 OpenShift Container Platform 4.14 中,您可以在 Alerting UI 中查看触发警报。您可以通过配置警报接收器,将 Alertmanager 配置为发送有关默认平台警报的通知。

Alertmanager 默认不会发送通知。强烈建议您通过 web 控制台或通过 alertmanager-main secret 配置警报接收器来接收通知。

3.5.4.1. 为默认平台警报配置警报路由

您可以将 Alertmanager 配置为发送通知,以接收来自集群的重要警报。通过编辑 openshift-monitoring 命名空间中的 alertmanager-main secret 中的默认配置来自定义 Alertmanager 如何发送通知有关默认平台警报的通知。

OpenShift Container Platform Alertmanager 配置中也支持支持上游 Alertmanager 的所有功能。要检查受支持的上游 Alertmanager 版本的所有配置选项,请参阅 Alertmanager 配置 (Prometheus 文档)。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

已安装 OpenShift CLI(

oc)。

流程

从

alertmanager-mainsecret 中提取当前活跃的 Alertmanager 配置,并将其保存为本地alertmanager.yaml文件:oc -n openshift-monitoring get secret alertmanager-main --template='{{ index .data "alertmanager.yaml" }}' | base64 --decode > alertmanager.yaml$ oc -n openshift-monitoring get secret alertmanager-main --template='{{ index .data "alertmanager.yaml" }}' | base64 --decode > alertmanager.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

打开

alertmanager.yaml文件。 编辑 Alertmanager 配置:

可选:更改默认的 Alertmanager 配置:

默认 Alertmanager secret YAML 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 添加警报接收器配置:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将 PagerDuty 配置为警报接收器示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 定义 PagerDuty 集成密钥。

将电子邮件配置为警报接收器的示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要Alertmanager 需要外部 SMTP 服务器来发送电子邮件警报。要配置电子邮件警报接收器,请确保您具有外部 SMTP 服务器所需的连接详情。

添加路由配置:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 警告不要使用

match,match_re,target_match,target_match_re,source_match, 和source_match_re键名称,它们已弃用,并计划在以后的发行版本中删除。警报路由示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 前面的示例将由

example-app服务触发的critica严重性的警报路由到team-frontend-page接收器。通常,这些类型的警报会传给个人或关键响应团队。

应用文件中的新配置:

oc -n openshift-monitoring create secret generic alertmanager-main --from-file=alertmanager.yaml --dry-run=client -o=yaml | oc -n openshift-monitoring replace secret --filename=-

$ oc -n openshift-monitoring create secret generic alertmanager-main --from-file=alertmanager.yaml --dry-run=client -o=yaml | oc -n openshift-monitoring replace secret --filename=-Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过视觉化路由树来验证路由配置:

oc exec alertmanager-main-0 -n openshift-monitoring -- amtool config routes show --alertmanager.url http://localhost:9093

$ oc exec alertmanager-main-0 -n openshift-monitoring -- amtool config routes show --alertmanager.url http://localhost:9093Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.4.2. 使用 OpenShift Container Platform Web 控制台配置警报路由

您可以通过 OpenShift Container Platform Web 控制台配置警报路由,以确保了解集群出现的重要问题。

OpenShift Container Platform Web 控制台提供比 alertmanager-main secret 配置警报路由的设置更少。要通过访问更多配置设置配置警报路由,请参阅"配置默认平台警报的警报路由"。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。

流程

在 Administrator 视角中,进入 Administration → Cluster Settings → Configuration → Alertmanager。

注意或者,您还可以通过 notification drawer 访问同一页面。选择 OpenShift Container Platform Web 控制台右上角的铃铛图标,并在 AlertmanagerReceiverNotConfigured 警报中选择 Configure。

- 在页面的 Receivers 部分中,点 Create Receiver。

- 在 Create Receiver 表单中,添加 Receiver Name,然后从列表中选择 Receiver Type。

编辑接收器配置:

对于 PagerDuty 接收器:

- 选择集成类型并添加 PagerDuty 集成密钥。

- 添加 PagerDuty 安装的 URL。

- 如果要编辑客户端和事件详情或严重性规格,请点 Show advanced configuration。

对于 Webhook 接收器:

- 添加将 HTTP POST 请求发送到的端点。

- 如果要编辑将已解析的警报发送给接收器的默认选项,请点 Show advanced configuration。

对于电子邮件接收器:

- 添加要将通知发送到的电子邮件地址。

添加 SMTP 配置详情,包括发送通知的地址、用来发送电子邮件的智能主机和端口号、SMTP 服务器的主机名以及验证详情。

重要Alertmanager 需要外部 SMTP 服务器来发送电子邮件警报。要配置电子邮件警报接收器,请确保您具有外部 SMTP 服务器所需的连接详情。

- 选择是否需要 TLS。

- 如果要将默认选项编辑为不向接收器发送已解析的警报,或编辑电子邮件通知正文配置,请点 Show advanced configuration。

对于 Slack 接收器:

- 添加 Slack Webhook 的 URL。

- 添加要将通知发送到的 Slack 频道或用户名。

- 如果要将默认选项编辑为不向接收器发送已解析的警报,或编辑图标和用户名配置,请选择 Show advanced configuration。您还可以选择是否查找并链接频道名称和用户名。

默认情况下,如果触发的警报带有与所有选择器匹配的标签,将被发送到接收器。如果您希望触发的警报在发送到接收器前完全匹配的标签值,请执行以下步骤:

- 在表单的 Routing Labels 部分中添加路由标签名称和值。

- 点 Add label 来添加更多路由标签。

- 点 Create 创建接收器。

3.5.4.3. 为默认平台警报和用户定义的警报配置不同的警报接收器

您可以为默认平台警报和用户定义的警报配置不同的警报接收器,以确保以下结果:

- 所有默认平台警报都发送到团队拥有的接收器,以收取这些警报。

- 所有用户定义的警报都发送到另一个接收器,以便团队只能专注于平台警报。

您可以使用 Cluster Monitoring Operator 添加到所有平台警报的 openshift_io_alert_source="platform" 标签来实现此目的:

-

使用

openshift_io_alert_source="platform"matcher 来匹配默认平台警报。 -

使用

openshift_io_alert_source!="platform"或'openshift_io_alert_source=""匹配程序来匹配用户定义的警报。

如果您启用了专用于用户定义的警报的 Alertmanager 实例,则此配置不适用。

第 4 章 配置用户工作负载监控

4.1. 准备配置用户工作负载监控堆栈

本节介绍可以配置哪些用户定义的监控组件、如何启用用户工作负载监控以及如何准备配置用户工作负载监控堆栈。

- 并非所有监控堆栈的配置参数都会被公开。只有在 Cluster Monitoring Operator 的 Config map 引用中列出的参数和字段才支持进行配置。

- 监控堆栈会带来额外的资源需求。参阅 扩展 Cluster Monitoring Operator 中的计算资源建议,并确认您有足够的资源。

4.1.1. 可配置的监控组件

下表显示了您可以配置的监控组件,以及 user-workload-monitoring-config 配置映射中用来指定这些组件的键。

| 组件 | user-workload-monitoring-config 配置映射键 |

|---|---|

| Prometheus Operator |

|

| Prometheus |

|

| Alertmanager |

|

| Thanos Ruler |

|

ConfigMap 对象的不同配置更改会导致不同的结果:

- Pod 不会重新部署。因此,没有服务中断。

受影响的 pod 被重新部署:

- 对于单节点集群,这会导致临时服务中断。

- 对于多节点集群,因为高可用性,受影响的 pod 会逐渐推出,监控堆栈仍然可用。

- 无论高可用性如何,配置和重新定义持久性卷的大小始终会导致服务中断。

每个需要更改配置映射中的步骤都包括其预期的结果。

4.1.2. 为用户定义的项目启用监控

在 OpenShift Container Platform 中,除了默认的平台监控外,您还可以为用户定义的项目启用监控。您可以监控 OpenShift Container Platform 中的自己的项目,而无需额外的监控解决方案。使用这个功能可以集中监控核心平台组件和用户定义的项目。

使用 Operator Lifecycle Manager (OLM) 安装的 Prometheus Operator 版本与用户定义的监控不兼容。因此,OpenShift Container Platform 不支持作为由 OLM Prometheus Operator 管理的 Prometheus 自定义资源 (CR) 安装的自定义 Prometheus 实例。

4.1.2.1. 为用户定义的项目启用监控

集群管理员可以通过在集群监控 ConfigMap 中设置 enableUserWorkload: true 字段来为用户定义的项目启用监控。

要为用户定义的项目启用监控,您必须先删除任何自定义 Prometheus 实例。

您必须可以使用具有 cluster-admin 集群角色的用户访问集群,才能在 OpenShift Container Platform 中为用户定义的项目启用监控。然后,集群管理员可以选择性地授予用户权限来配置负责监控用户定义的项目的组件。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 -

已安装 OpenShift CLI(

oc)。 -

您已创建

cluster-monitoring-configConfigMap对象。 您已选择性地创建并配置

openshift-user-workload-monitoring项目中的user-workload-monitoring-configConfigMap。您可以在该ConfigMap中为监控用户定义的项目的组件添加配置选项。注意每次您将配置更改保存到

user-workload-monitoring-configConfigMap时,都会重新部署openshift-user-workload-monitoring项目中的 Pod。可能需要稍等片刻,这些组件才会重新部署。

流程

编辑

cluster-monitoring-configConfigMap对象:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将

enableUserWorkload: true添加到data/config.yaml下:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 当设置为

true时,enableUserWorkload参数为集群中用户定义的项目启用监控。

保存文件以使改变生效。然后会自动启用对用户定义的项目的监控。

注意如果您为用户定义的项目启用监控,则默认创建

user-workload-monitoring-configConfigMap对象。验证

prometheus-operator、prometheus-user-workload和thanos-ruler-user-workloadPod 是否在openshift-user-workload-monitoring项目中运行。Pod 启动可能需要片刻时间:oc -n openshift-user-workload-monitoring get pod

$ oc -n openshift-user-workload-monitoring get podCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.2.2. 授予用户权限来为用户定义的项目配置监控

作为集群管理员,您可以将 user-workload-monitoring-config-edit 角色分配给用户。这授予为用户定义的项目配置和管理监控的权限,而不授予他们配置和管理 OpenShift Container Platform 核心监控组件的权限。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 - 要将角色分配到的用户帐户已存在。

-

已安装 OpenShift CLI(

oc)。

流程

将

user-workload-monitoring-config-edit角色分配给openshift-user-workload-monitoring项目中的用户:oc -n openshift-user-workload-monitoring adm policy add-role-to-user \ user-workload-monitoring-config-edit <user> \ --role-namespace openshift-user-workload-monitoring

$ oc -n openshift-user-workload-monitoring adm policy add-role-to-user \ user-workload-monitoring-config-edit <user> \ --role-namespace openshift-user-workload-monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 通过显示相关角色绑定来验证用户是否已正确分配给

user-workload-monitoring-config-edit角色:oc describe rolebinding <role_binding_name> -n openshift-user-workload-monitoring

$ oc describe rolebinding <role_binding_name> -n openshift-user-workload-monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例命令

oc describe rolebinding user-workload-monitoring-config-edit -n openshift-user-workload-monitoring

$ oc describe rolebinding user-workload-monitoring-config-edit -n openshift-user-workload-monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 在本例中,

user1分配给user-workload-monitoring-config-edit角色。

4.1.3. 为用户定义的项目启用警报路由

在 OpenShift Container Platform 中,管理员可以为用户定义的项目启用警报路由。这个过程由以下步骤组成:

为用户定义的项目启用警报路由:

- 使用默认平台 Alertmanager 实例。

- 仅对用户定义的项目使用单独的 Alertmanager 实例。

- 授予用户权限来为用户定义的项目配置警报路由。

完成这些步骤后,开发人员和其他用户可以为用户定义的项目配置自定义警报和警报路由。

4.1.3.1. 为用户定义的警报路由启用平台 Alertmanager 实例

您可以允许用户创建使用 Alertmanager 主平台实例的用户定义警报路由配置。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 - 集群管理员为用户定义的项目启用了监控。

-

已安装 OpenShift CLI(

oc)。

流程

编辑

cluster-monitoring-configConfigMap对象:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下添加alertmanagerMain部分中的enableUserAlertmanagerConfig: true:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

enableUserAlertmanagerConfig值设置为true,以便用户创建使用 Alertmanager 主平台实例的用户定义警报路由配置。

- 保存文件以使改变生效。新的配置会被自动应用。

4.1.3.2. 为用户定义的警报路由启用一个单独的 Alertmanager 实例

在一些集群中,您可能想要为用户定义的项目部署专用 Alertmanager 实例,这有助于降低默认平台 Alertmanager 实例的负载,并更好地将用户定义的警报与默认平台警报分开。在这些情况下,您可以选择性地启用一个单独的 Alertmanager 实例,以仅为用户定义的项目发送警报。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 - 您已为用户定义的项目启用了监控。

-

已安装 OpenShift CLI(

oc)。

流程

编辑

user-workload-monitoring-configConfigMap对象:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下,添加alertmanager部分的enabled: true和enableAlertmanagerConfig: true:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。用于用户定义的项目的 Alertmanager 专用实例会自动启动。

验证

验证

user-workloadAlertmanager 实例是否已启动:oc -n openshift-user-workload-monitoring get alertmanager

$ oc -n openshift-user-workload-monitoring get alertmanagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME VERSION REPLICAS AGE user-workload 0.24.0 2 100s

NAME VERSION REPLICAS AGE user-workload 0.24.0 2 100sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.3.3. 授予用户权限来为用户定义的项目配置警报路由

您可以授予用户权限来为用户定义的项目配置警报路由。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 - 您已为用户定义的项目启用了监控。

- 要将角色分配到的用户帐户已存在。

-

已安装 OpenShift CLI(

oc)。

流程

将

alert-routing-edit集群角色分配给用户定义的项目中的用户:oc -n <namespace> adm policy add-role-to-user alert-routing-edit <user>

$ oc -n <namespace> adm policy add-role-to-user alert-routing-edit <user>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 对于

<namespace>,替换用户定义的项目的命名空间,如ns1。对于<user>,替换您要为其分配该角色的帐户的用户名。

4.1.4. 授予用户权限来监控用户定义的项目

集群管理员可以监控所有 OpenShift Container Platform 核心项目和用户定义的项目。

您还可以向开发人员和其他用户授予不同的权限:

- 监控用户定义的项目

- 要配置用于监控用户定义的项目的组件。

- 为用户定义的项目配置警报路由

- 为用户定义的项目管理警报和静默

您可以通过分配以下监控角色或集群角色之一来授予权限:

| 角色名称 | 描述 | 项目 |

|---|---|---|

|

|

具有此角色的用户可以编辑 |

|

|

| 如果启用了用户定义的 Alertmanager,具有此角色的用户对用户定义的 Alertmanager API 具有读取访问权限。 |

|

|

| 如果启用了用户定义的 Alertmanager,具有此角色的用户对用户定义的 Alertmanager API 具有读写访问权限。 |

|

| 集群角色名称 | 描述 | 项目 |

|---|---|---|

|

|

具有此集群角色的用户具有用户定义的项目的 |

可以与 |

|

|

具有此集群角色的用户可为用户定义的项目创建、修改和删除 |

可以与 |

|

|

具有此集群角色的用户具有与具有 |

可以与 |

|

|

具有此集群角色的用户可为用户定义的项目创建、更新和删除 |

可以与 |

4.1.4.1. 使用 Web 控制台授予用户权限

您可以使用 OpenShift Container Platform Web 控制台为 openshift-monitoring 项目或自己的项目授予用户权限。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 - 要将角色分配到的用户帐户已存在。

流程

- 在 OpenShift Container Platform Web 控制台的 Administrator 视角中,进入 User Management → RoleBindings → Create binding。

- 在 Binding Type 部分中,选择 Namespace Role Binding 类型。

- 在 Name 字段中输入角色绑定的名称。

在 Namespace 字段中,选择要授予访问权限的项目。

重要您使用此流程向用户授予的监控角色或集群角色权限只适用于您在 Namespace 字段中选择的项目。

- 从 Role Name 列表中选择监控角色或集群角色。

- 在 Subject 部分,选择 User。

- 在 Subject Name 字段中,输入用户名称。

- 选择 Create 以应用角色绑定。

4.1.4.2. 使用 CLI 授予用户权限

您可以使用 OpenShift CLI (oc) 授予用户权限来监控其自己的项目。

无论您选择的角色或集群角色,都必须作为集群管理员将其与特定项目进行绑定。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户身份访问集群。 - 要将角色分配到的用户帐户已存在。

-

已安装 OpenShift CLI(

oc)。

流程

要为项目的用户分配监控角色,请输入以下命令:

oc adm policy add-role-to-user <role> <user> -n <namespace> --role-namespace <namespace>

$ oc adm policy add-role-to-user <role> <user> -n <namespace> --role-namespace <namespace>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<role>替换为您要监控角色,<user>替换为您要为其分配角色的用户,<namespace>替换为您要授予访问权限的项目。

要为项目的用户分配监控集群角色,请输入以下命令:

oc adm policy add-cluster-role-to-user <cluster-role> <user> -n <namespace>

$ oc adm policy add-cluster-role-to-user <cluster-role> <user> -n <namespace>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<cluster-role>替换为您要监控的集群角色,<user>替换为您要为其分配集群角色的用户,<namespace>替换为您要授予访问权限的项目。

4.1.5. 将用户定义的项目从监控中排除

用户工作负载监控中可以排除个别用户定义的项目。为此,只需将 openshift.io/user-monitoring 标签添加到项目的命名空间,值设为 false。

流程

将标签添加到项目命名空间:

oc label namespace my-project 'openshift.io/user-monitoring=false'

$ oc label namespace my-project 'openshift.io/user-monitoring=false'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要重新启用监控,请从命名空间中删除该标签:

oc label namespace my-project 'openshift.io/user-monitoring-'

$ oc label namespace my-project 'openshift.io/user-monitoring-'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果项目有任何活跃的监控目标,Prometheus 可能需要几分钟时间在添加标签后停止提取它们。

4.1.6. 为用户定义的项目禁用监控

为用户定义的项目启用监控后,您可以通过在集群监控 ConfigMap 对象中设置 enableUserWorkload: false 来再次禁用它。

另外,您也可以通过删除 enableUserWorkload: true 来为用户定义的项目禁用监控。

流程

编辑

cluster-monitoring-configConfigMap对象:oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下将enableUserWorkload:设置为false:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 保存文件以使改变生效。然后会自动禁用对用户定义的项目的监控。

检查

prometheus-operator、prometheus-user-workload和thanos-ruler-user-workloadPod 是否已在openshift-user-workload-monitoring项目中终止。这可能需要片刻时间:oc -n openshift-user-workload-monitoring get pod

$ oc -n openshift-user-workload-monitoring get podCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

No resources found in openshift-user-workload-monitoring project.

No resources found in openshift-user-workload-monitoring project.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

在禁用了对用户定义的项目的监控时,openshift-user-workload-monitoring 项目中的 user-workload-config ConfigMap 对象不会被自动删除。这是为了保留您可能已在 ConfigMap 中创建的任何自定义配置。

4.2. 为用户工作负载监控配置性能和可扩展性

您可以配置监控堆栈来优化集群的性能和扩展。以下文档提供了有关如何分发监控组件的信息,并控制监控堆栈对 CPU 和内存资源的影响。

4.2.1. 控制监控组件的放置和分发

您可以将监控堆栈组件移到特定的节点上:

-

使用带有标记节点的

nodeSelector约束,将任何监控堆栈组件移到特定的节点上。 - 分配容限以启用将组件移到污点节点。

通过这样做,您可以控制集群中监控组件的放置和分发。

通过控制监控组件的放置和分发,您可以根据特定要求或策略优化系统资源使用、提高性能和隔离工作负载。

4.2.1.1. 将监控组件移到其他节点

您可以将监控用户定义的项目的工作负载的任何组件移到特定的 worker 节点。

不允许组件移到控制平面或基础架构节点。

先决条件

-

您可以使用具有

cluster-admin集群角色或具有openshift-user-workload-monitoring项目中的user-workload-monitoring-config-edit角色的用户访问集群。 - 集群管理员为用户定义的项目启用了监控。

-

已安装 OpenShift CLI(

oc)。

流程

如果您还没有这样做,请在要运行监控组件的节点中添加标签:

oc label nodes <node_name> <node_label>

$ oc label nodes <node_name> <node_label>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<node_name>替换为您要添加标签的节点的名称。将<node_label>替换为所需标签的名称。

在

openshift-user-workload-monitoring项目中编辑user-workload-monitoring-configConfigMap对象:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

data/config.yaml下为组件指定nodeSelector约束的节点标签:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果在配置

nodeSelector约束后监控组件仍然处于Pending状态,请检查 Pod 事件中与污点和容限相关的错误。- 保存文件以使改变生效。新配置中指定的组件会自动移到新节点上,受新配置影响的 pod 会被重新部署。

4.2.1.2. 为监控组件分配容忍(tolerations)

您可以为监控用户定义的项目的组件分配容限,以便将其移到污点的 worker 节点。在控制平面或基础架构节点上不允许调度。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户访问集群,也可以使用在openshift-user-workload-monitoring项目中具有user-workload-monitoring-config-edit角色的用户访问集群。 - 集群管理员为用户定义的项目启用了监控。

-

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-user-workload-monitoring项目中的user-workload-monitoring-config配置映射:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为组件指定

tolerations:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 相应地替换

<component>和<toleration_specification>。例如,

oc adm taint nodes node1 key1=value1:NoSchedule会将一个键为key1且值为value1的污点添加到node1。这会防止监控组件在node1上部署 Pod,除非为该污点配置了容限。以下示例将thanosRuler组件配置为容许示例污点:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。受新配置影响的 Pod 会自动重新部署。

4.2.2. 管理监控组件的 CPU 和内存资源

您可以通过为这些组件的资源限值和请求指定值来确保运行监控组件的容器具有足够的 CPU 和内存资源。

您可以为监控 openshift-user-workload-monitoring 命名空间中的用户定义的项目的监控组件配置这些限制和请求。

4.2.2.1. 指定限制和请求

要配置 CPU 和内存资源,请在 openshift-user-workload-monitoring 命名空间中的 user-workload-monitoring-config ConfigMap 对象中指定资源限值和请求值。

先决条件

-

您可以使用具有

cluster-admin集群角色的用户访问集群,也可以使用在openshift-user-workload-monitoring项目中具有user-workload-monitoring-config-edit角色的用户访问集群。 -

已安装 OpenShift CLI(

oc)。

流程

编辑

openshift-user-workload-monitoring项目中的user-workload-monitoring-config配置映射:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config