Clusters

使用多集群引擎 operator 流程、发行注记和故障排除信息查找集群管理。在没有 Red Hat Advanced Cluster Management 的情况下安装 multicluster engine operator。

摘要

第 1 章 带有多集群引擎 operator 的集群生命周期概述

multicluster engine operator 是集群生命周期 Operator,它为 OpenShift Container Platform 和 Red Hat Advanced Cluster Management hub 集群提供集群管理功能。在 hub 集群中,您可以创建和管理集群,也可以销毁您创建的任何集群。您还可以休眠、恢复和分离集群。

multicluster engine operator 是集群生命周期 Operator,它为 Red Hat OpenShift Container Platform 和 Red Hat Advanced Cluster Management hub 集群提供集群管理功能。如果安装了 Red Hat Advanced Cluster Management,则不需要安装 multicluster engine operator,因为它会被自动安装。

信息:

- 集群通过 Hive 资源使用 OpenShift Container Platform 集群安装程序创建。您可以在 OpenShift Container Platform 文档中的 安装概述 中找到有关安装 OpenShift Container Platform 集群的过程的更多信息。

- 在 OpenShift Container Platform 集群中,您可以使用 multicluster engine operator 作为集群生命周期功能的独立集群管理器,或者将其用作 Red Hat Advanced Cluster Management hub 集群的一部分。

- 如果您只使用 OpenShift Container Platform,则订阅中包含该 Operator。访问 OpenShift Container Platform 文档中的关于 Kubernetes operator 的多集群引擎。

- 如果订阅 Red Hat Advanced Cluster Management,您还会收到安装 Operator。您可以使用 Red Hat Advanced Cluster Management hub 集群创建、管理和监控其他 Kubernetes 集群。

- 发行镜像是您创建集群时使用的 OpenShift Container Platform 版本。对于使用 Red Hat Advanced Cluster Management 创建的集群,您可以启用自动升级发行镜像。有关 Red Hat Advanced Cluster Management 中发行镜像的更多信息,请参阅 发行镜像。

- 使用托管 OpenShift Container Platform 的 control plane,您可以在托管集群中创建 pod 作为 pod,而无需为每个 control plane 专用物理机器。请参阅 OpenShift Container Platform 文档中的 托管 control plane 概述。

如果您使用多集群引擎 operator 2.6 及更早版本,则托管的 control plane 文档位于 Red Hat Advanced Cluster Management 产品文档中。请参阅 Red Hat Advanced Cluster Management Hosted control plane。

1.1. 控制台概述

OpenShift Container Platform 控制台插件包括在 OpenShift Container Platform Web 控制台中,并可集成。要使用这个功能,必须启用控制台插件。Multicluster engine operator 在 Infrastructure 和 Credentials 导航项中显示某些控制台功能。如果安装了 Red Hat Advanced Cluster Management,您会看到更多的控制台功能。

注: 在启用插件后,您可以从 OpenShift Container Platform 控制台下拉菜单中选择 All Clusters 来访问 OpenShift Container Platform 控制台中的 Red Hat Advanced Cluster Management。

- 要禁用插件,请确保处于 OpenShift Container Platform 控制台的 Administrator 视角中。

- 在导航中找到 Administration,再点 Cluster Settings,然后点 Configuration 选项卡。

-

从 Configuration resources 列表中,点带有

operator.openshift.ioAPI 组的 Console 资源,其中包含 web 控制台的集群范围配置。 -

点 Console 插件 选项卡。

mce插件被列出。注: 如果安装了 Red Hat Advanced Cluster Management,它也会被列为acm。 - 从表中修改插件状态。几分钟后,会提示您输入刷新控制台。

1.2. multicluster engine operator 基于角色的访问控制

RBAC 在控制台和 API 一级进行验证。控制台中的操作可根据用户访问角色权限启用或禁用。查看以下部分以了解有关产品中特定生命周期的 RBAC 的更多信息:

1.2.1. 角色概述

有些产品资源是基于集群范围的,有些则是命名空间范围。您必须将集群角色绑定和命名空间角色绑定应用到用户,以使访问控制具有一致性。查看支持的以下角色定义表列表:

1.2.1.1. 角色定义表

| 角色 | 定义 |

|---|---|

|

|

这是 OpenShift Container Platform 的默认角色。具有集群范围内的绑定到 |

|

|

具有集群范围内的绑定到 |

|

|

具有集群范围内的绑定到 |

|

|

具有集群范围内的绑定到 |

|

|

具有集群范围内的绑定到 |

|

|

具有集群范围内的绑定到 |

|

|

admin、edit 和 view 是 OpenShift Container Platform 的默认角色。具有命名空间范围绑定的用户可以访问特定命名空间中的 |

重要:

- 任何用户都可以从 OpenShift Container Platform 创建项目,这为命名空间授予管理员角色权限。

-

如果用户无法访问集群的角色,则无法看到集群名称。集群名称显示有以下符号:

-。

RBAC 在控制台和 API 一级进行验证。控制台中的操作可根据用户访问角色权限启用或禁用。查看以下部分以了解有关产品中特定生命周期的 RBAC 的更多信息。

1.2.2. 集群生命周期 RBAC

查看以下集群生命周期 RBAC 操作:

为所有受管集群创建和管理集群角色绑定。例如,输入以下命令创建到集群角色

open-cluster-management:cluster-manager-admin的集群角色绑定:oc create clusterrolebinding <role-binding-name> --clusterrole=open-cluster-management:cluster-manager-admin --user=<username>

oc create clusterrolebinding <role-binding-name> --clusterrole=open-cluster-management:cluster-manager-admin --user=<username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 这个角色是一个超级用户,可访问所有资源和操作。您可以创建集群范围的

managedcluster资源、用于管理受管集群的资源的命名空间,以及使用此角色的命名空间中的资源。您可能需要添加需要角色关联的 ID用户名,以避免权限错误。运行以下命令,为名为

cluster-name的受管集群管理集群角色绑定:oc create clusterrolebinding (role-binding-name) --clusterrole=open-cluster-management:admin:<cluster-name> --user=<username>

oc create clusterrolebinding (role-binding-name) --clusterrole=open-cluster-management:admin:<cluster-name> --user=<username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 此角色对集群范围的

managedcluster资源具有读写访问权限。这是必要的,因为managedcluster是一个集群范围的资源,而不是命名空间范围的资源。输入以下命令,创建到集群角色

admin的命名空间角色绑定:oc create rolebinding <role-binding-name> -n <cluster-name> --clusterrole=admin --user=<username>

oc create rolebinding <role-binding-name> -n <cluster-name> --clusterrole=admin --user=<username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 此角色对受管集群命名空间中的资源具有读写访问权限。

为

open-cluster-management:view:<cluster-name>集群角色创建一个集群角色绑定,以查看名为cluster-name的受管集群,输入以下命令:oc create clusterrolebinding <role-binding-name> --clusterrole=open-cluster-management:view:<cluster-name> --user=<username>

oc create clusterrolebinding <role-binding-name> --clusterrole=open-cluster-management:view:<cluster-name> --user=<username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 此角色具有对集群范围的

managedcluster资源的读取访问权限。这是必要的,因为managedcluster是一个集群范围的资源。输入以下命令,创建到集群角色

view的命名空间角色绑定:oc create rolebinding <role-binding-name> -n <cluster-name> --clusterrole=view --user=<username>

oc create rolebinding <role-binding-name> -n <cluster-name> --clusterrole=view --user=<username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 此角色对受管集群命名空间中的资源具有只读访问权限。

输入以下命令来查看您可以访问的受管集群列表:

oc get managedclusters.clusterview.open-cluster-management.io

oc get managedclusters.clusterview.open-cluster-management.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 此命令供没有集群管理员特权的管理员和用户使用。

输入以下命令来查看您可以访问的受管集群集列表:

oc get managedclustersets.clusterview.open-cluster-management.io

oc get managedclustersets.clusterview.open-cluster-management.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 此命令供没有集群管理员特权的管理员和用户使用。

1.2.2.1. 集群池 RBAC

查看以下集群池 RBAC 操作:

作为集群管理员,通过创建受管集群集并使用集群池置备集群,并通过向组添加角色来授予管理员权限。请参见以下示例:

使用以下命令为

server-foundation-clusterset受管集群集授予admin权限:oc adm policy add-cluster-role-to-group open-cluster-management:clusterset-admin:server-foundation-clusterset server-foundation-team-admin

oc adm policy add-cluster-role-to-group open-cluster-management:clusterset-admin:server-foundation-clusterset server-foundation-team-adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用以下命令为

server-foundation-clusterset受管集群授予view权限:oc adm policy add-cluster-role-to-group open-cluster-management:clusterset-view:server-foundation-clusterset server-foundation-team-user

oc adm policy add-cluster-role-to-group open-cluster-management:clusterset-view:server-foundation-clusterset server-foundation-team-userCopy to Clipboard Copied! Toggle word wrap Toggle overflow

为集群池

server-foundation-clusterpool创建命名空间。查看以下示例以授予角色权限:运行以下命令,为

server-foundation-team-admin授予server-foundation-clusterpool的admin权限:oc adm new-project server-foundation-clusterpool oc adm policy add-role-to-group admin server-foundation-team-admin --namespace server-foundation-clusterpool

oc adm new-project server-foundation-clusterpool oc adm policy add-role-to-group admin server-foundation-team-admin --namespace server-foundation-clusterpoolCopy to Clipboard Copied! Toggle word wrap Toggle overflow

作为团队管理员,在集群池命名空间中创建一个名为

ocp46-aws-clusterpool的集群池,带有集群设置标签cluster.open-cluster-management.io/clusterset=server-foundation-clusterset:-

server-foundation-webhook检查集群池是否有集群设置标签,以及用户是否有权在集群集中创建集群池。 -

server-foundation-controller为server-foundation-team-user授予对server-foundation-clusterpool命名空间的view权限。

-

创建集群池时,集群池会创建一个

clusterdeployment。继续阅读以获取更多详细信息:-

server-foundation-controller为server-foundation-team-admin授予对clusterdeployment命名空间的admin权限。 server-foundation-controller为server-foundation-team-user授予对clusterdeployment名空间的view权限。注 :作为

team-admin和team-user,您有clusterpool、clusterdeployment和clusterclaim的admin权限

-

1.2.2.2. 集群生命周期的控制台和 API RBAC 表

查看以下集群生命周期控制台和 API RBAC 表:

| 资源 | Admin | Edit | View |

|---|---|---|---|

| Clusters | read、update、delete | - | 读取 |

| 集群集 | get、update、bind、join | 未提及 edit 角色 | get |

| 受管集群 | read、update、delete | 未提及 edit 角色 | get |

| AWS 供应商连接。 | create、read、update 和 delete | - | 读取 |

| API | Admin | Edit | View |

|---|---|---|---|

|

对于这个 API 您可以使用 | 创建、读取、更新、删除 | 读取、更新 | 读取 |

|

对于这个 API 您可以使用 | 读取 | 读取 | 读取 |

|

| update | update | |

|

对于这个 API 您可以使用 | 创建、读取、更新、删除 | 读取、更新 | 读取 |

|

| 读取 | 读取 | 读取 |

|

对于这个 API 您可以使用 | 创建、读取、更新、删除 | 读取、更新 | 读取 |

|

| 创建、读取、更新、删除 | 读取、更新 | 读取 |

|

| 创建、读取、更新、删除 | 读取、更新 | 读取 |

|

| 创建、读取、更新、删除 | 读取、更新 | 读取 |

|

| 创建、读取、更新、删除 | 读取、更新 | 读取 |

|

| 创建、读取、更新、删除 | 读取、更新 | 读取 |

|

| 创建、读取、更新、删除 | 读取、更新 | 读取 |

|

| 创建、读取、更新、删除 | 读取、更新 | 读取 |

1.2.2.3. 基于角色的凭证访问控制

对凭证的访问由 Kubernetes 控制。凭据作为 Kubernetes secret 存储和保护。以下权限适用于在 Red Hat Advanced Cluster Management for Kubernetes 中访问 secret:

- 有权在命名空间中创建 secret 的用户可以创建凭证。

- 有权读取命名空间中的 secret 的用户也可以查看凭证。

-

具有 Kubernetes 集群角色

admin和edit的用户可以创建和编辑 secret。 -

具有 Kubernetes 集群角色

view的用户无法查看 secret,因为读取 secret 的内容可以访问服务帐户凭证。

1.3. 网络配置

将您的网络设置配置为允许连接。

重要: 可信 CA 捆绑包在 multicluster engine operator 命名空间中可用,但该增强需要更改您的网络。可信 CA 捆绑包 ConfigMap 使用 trusted-ca-bundle 的默认名称。您可以通过在名为 TRUSTED_CA_BUNDLE 的环境变量中提供 Operator 来更改此名称。如需更多信息 ,请参阅 Red Hat OpenShift Container Platform 的网络部分中的配置集群范围代理。

有关 multicluster engine operator 集群网络要求,请查看下表:

| 方向 | Source | 目的地 | 协议 | port | 描述 |

|---|---|---|---|---|---|

| 出站到受管集群 |

hub 集群上的 Hive 和 | 置备的受管集群的 Kubernetes API 服务器 | HTTPS | 6443 | 置备的受管集群的 Kubernetes API 服务器 |

| 出站到受管集群 | hub 集群上的 ironic 服务 | 受管集群中的 ironic Python 代理 | TCP | 9999 | 运行 Ironic Python Agent 和 Ironic 编排器服务的裸机节点之间的通信 |

| 来自受管集群的内向流量 | Baseboard Management Controller (BMC) | Ironic 服务旁边的 HTTP 服务器 | TCP | 6180, 6183 | Baseboard Management Controller (BMC)访问虚拟介质的端口 6180 和 6183。引导固件访问端口 6180 |

| 来自受管集群的内向流量 | 受管集群中的 ironic Python 代理 | hub 集群上的 ironic 服务 | TCP | 6385 | Ironic Python 代理和 hub 集群上的 Ironic 服务之间的通信 |

| 来自受管集群的内向流量 | 受管集群中的集群代理附加组件代理 | 集群代理 ANP 服务 | TCP | 443 | 受管集群上的集群代理附加组件代理和 hub 集群上的 Cluster Proxy 附加组件 ANP 服务之间的通信 |

| 来自受管集群的内向流量 | klusterlet 代理和附加代理 | hub 集群上的 Kubernetes API 服务器 | HTTPS | 6443 | 来自受管集群的多集群引擎 operator 集群的 Kubernetes API 服务器 |

注: 如果受管集群中的 klusterlet 代理需要代理设置来访问 hub 集群上的 apiserver,而不是直接连接,请参阅在 hub 集群和受管集群间配置代理。

1.4. 使用多集群引擎 operator 的集群生命周期发行注记

了解新功能、增强功能、支持、弃用、删除和勘误程序错误修复。

重要: OpenShift Container Platform 发行注记没有包括在此文档中。对于 OpenShift Container Platform 集群,请参阅 OpenShift Container Platform 发行注记。git Deprecated: multicluster engine operator 2.3 及更早的版本不再被支持。文档可能仍然可用,但没有任何勘误或其他更新。

最佳实践: 升级到最新版本。

- 除非仅在最新版本的 OpenShift Container Platform 上引入并测试特定组件或功能,否则文档会参考最早支持的 OpenShift Container Platform 版本。

- 有关完全支持信息,请参阅 multicluster engine operator 支持列表。如需生命周期信息,请参阅 Red Hat OpenShift Container Platform 生命周期政策。

- 如果您在当前支持的某个版本或产品文档时遇到问题,请访问 红帽支持,您可以在其中进行故障排除、查看知识库文章、与支持团队连接,或创建一个问题单。您必须使用您的凭证登录。

- 您还可以访问红帽客户门户文档,Red Hat Customer Portal FAQ。

1.4.1. 使用多集群引擎 operator 的集群生命周期新功能

了解在不同基础架构云供应商、私有云和内部数据中心的创建、导入、管理和销毁 Kubernetes 集群的新功能。

有关完全支持信息,请参阅 multicluster engine operator 支持列表。如需生命周期信息,请参阅 Red Hat OpenShift Container Platform 生命周期政策。

重要: 集群管理现在支持所有通过云原生计算基础(CNCF) Kubernetes 一致性计划认证的供应商。为混合云多集群管理选择 CNCF 可识别的供应商。

请参阅以下有关使用 CNCF 供应商的信息:

- 了解 CNCF 供应商如何通过认证的 Kubernetes 一致性进行认证。

- 有关 CNCF 第三方供应商的信息,请参阅红帽 与第三方组件的支持,或 联系红帽支持。

-

如果您具有自己的 CNCF 一致性认证集群,您需要将 OpenShift Container Platform CLI

oc命令改为 Kubernetes CLI 命令kubectl。

1.4.1.1. 组件的新功能和增强

了解有关特定组件的新功能的更多信息。

注意: 一些功能和组件 作为技术预览 发布。

重要: 托管 control plane 文档现在包括在 OpenShift Container Platform 文档中。请参阅 OpenShift Container Platform 文档中的 托管 control plane 概述。

如果您使用 multicluster engine operator 2.6 及更早版本,则托管的 control plane 文档位于 Red Hat Advanced Cluster Management 产品文档中。请参阅 Red Hat Advanced Cluster Management Hosted control plane。

1.4.1.2. 集群管理

了解 multicluster engine operator 的集群生命周期的新功能和增强。

-

现在,您可以设置一个持续时间来选择 klusterlet 清单中的

kubeconfigbootstrap 何时过期。如需更多信息,请参阅 导入集群。 - 现在,您可以在将 Assisted Installer 安装的受管集群从一个 hub 集群移动到另一个 hub 集群后,导入所有集群资源并继续使用它们。如需更多信息,请参阅 导入集群资源。

- 现在,您可以使用服务帐户凭证连接到 OpenShift Cluster Manager。如需更多信息,请参阅为 Red Hat OpenShift Cluster Manager 创建凭证。

- 现在,您可以在导入受管集群时指定 CA 捆绑包。如需更多信息,请参阅 导入受管集群(技术预览)时自定义 hub 集群 API 服务器的服务器 URL 和 CA 捆绑包。

-

现在,您可以手动配置 hub 集群

KubeAPIServer验证策略。如需更多信息,请参阅配置 hub 集群KubeAPIServer验证策略

1.4.2. 使用多集群引擎 Operator 的集群生命周期的勘误更新

对于多集群引擎 operator,勘误更新会在发布时自动应用。

如果没有列出发行注记,则该产品目前没有勘误版本。

重要: 为了便于参考,JIRA 链接和 JIRA 号可能会添加到内容中并在内部使用。用户可能不能使用访问的链接。

1.4.2.1. Errata 2.7.6

- 为一个或多个产品容器镜像提供更新。

1.4.2.2. Errata 2.7.5

- 为一个或多个产品容器镜像提供更新。

- 升级 Golang JSON Web 令牌,以修复在标头解析过程中分配过量内存的错误。

1.4.2.3. Errata 2.7.4

- 为一个或多个产品容器镜像提供更新。

1.4.2.4. Errata 2.7.3

- 为一个或多个产品容器镜像提供更新。

1.4.2.5. Errata 2.7.2

1.4.2.6. Errata 2.7.1

- 为一个或多个产品容器镜像提供更新。

1.4.3. 使用多集群引擎 Operator 的集群生命周期的已知问题和限制

查看 multicluster engine operator 的集群生命周期 的已知问题和限制,或从上一版本中继续存在的已知问题。

集群管理已知问题和限制是 multicluster engine operator 文档的集群生命周期 的一部分。与 Red Hat Advanced Cluster Management 集成的 multicluster engine operator 的已知问题包括在 Red Hat Advanced Cluster Management 发行注记中。

重要: OpenShift Container Platform 发行注记没有包括在此文档中。对于 OpenShift Container Platform 集群,请参阅 OpenShift Container Platform 发行注记。

1.4.3.1. 安装

了解在 multicluster engine operator 安装过程中已知的问题和限制。

当在带有托管 control plane 集群的 OpenShift Service 上安装 multicluster engine operator 时,安装状态可能会处于 Installing 状态。local-cluster 可能也处于 Unknown 状态。

当您检查 hub 集群上的 open-cluster-management-agent 命名空间中的 klusterlet-agent pod 日志时,您会看到类似如下的错误:

E0809 18:45:29.450874 1 reflector.go:147] k8s.io/client-go@v0.29.4/tools/cache/reflector.go:229: Failed to watch *v1.CertificateSigningRequest: failed to list *v1.CertificateSigningRequest: Get "https://api.xxx.openshiftapps.com:443/apis/certificates.k8s.io/v1/certificatesigningrequests?limit=500&resourceVersion=0": tls: failed to verify certificate: x509: certificate signed by unknown authority

E0809 18:45:29.450874 1 reflector.go:147] k8s.io/client-go@v0.29.4/tools/cache/reflector.go:229: Failed to watch *v1.CertificateSigningRequest: failed to list *v1.CertificateSigningRequest: Get "https://api.xxx.openshiftapps.com:443/apis/certificates.k8s.io/v1/certificatesigningrequests?limit=500&resourceVersion=0": tls: failed to verify certificate: x509: certificate signed by unknown authority要解决这个问题,请配置 hub 集群 API 服务器验证策略。完成以下步骤:

-

如果

KlusterletConfig资源不存在,则创建一个名为global的 KlusterletConfig 资源。 将

spec.hubKubeAPIServerConfig.serverVerificationStrategy设置为UseSystemTruststore。请参见以下示例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过在 hub 集群中运行以下命令来应用资源。将

<filename> 替换为您的文件的名称:oc apply -f <filename>

oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果

local-cluster状态在一分钟内没有恢复,请在 hub 集群中运行以下命令来导出并解码import.yaml文件:oc get secret local-cluster-import -n local-cluster -o jsonpath={.data.import\.yaml} | base64 --decode > import.yamloc get secret local-cluster-import -n local-cluster -o jsonpath={.data.import\.yaml} | base64 --decode > import.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 hub 集群中运行以下命令来应用该文件:

oc apply -f import.yaml

oc apply -f import.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4.3.1.2. installNamespace 字段只能有一个值

启用 managed-serviceaccount 附加组件时,ManagedClusterAddOn 资源中的 installNamespace 字段必须有 open-cluster-management-agent-addon 值。其他值将被忽略。managed-serviceaccount 附加组件代理总是在受管集群上的 open-cluster-management-agent-addon 命名空间中部署。

1.4.3.2. Cluster

了解 multicluster engine operator 的集群生命周期的已知问题和限制,如创建、发现、导入和删除集群的问题,以及 multicluster engine operator 的更多集群管理问题。

如果您使用 node-role.kubernetes.io/infra 污点对基础架构节点具有 NoExecute 效果,则附加组件 pod 可能会卡住。

要临时解决这个问题,对于 node-role.kubernetes.io/infra 污点使用 NoSchedule effect 而不是 NoExecute,或者从您的基础架构节点中删除 node-role.kubernetes.io/infra 污点。

1.4.3.2.2. nmstate的限制

通过配置复制和粘贴功能来加快开发速度。要在 assisted-installer 中配置 copy-from-mac 功能,您必须将 mac-address 添加到 nmstate 定义接口和 mac-mapping 接口。mac-mapping 接口在 nmstate 定义接口之外提供。因此,您必须提供相同的 mac-address 两次。

如果您安装了不同版本的 VolSync,请将 v0.6.0 替换为您的安装版本。

1.4.3.2.3. 删除受管集群集不会自动删除其标签

删除 ManagedClusterSet 后,添加到每个受管集群的标签不会被自动删除。从已删除受管集群集中包含的每个受管集群手动删除该标签。该标签类似以下示例:cluster.open-cluster-management.io/clusterset:<ManagedClusterSet Name>。

1.4.3.2.4. ClusterClaim 错误

如果您针对 ClusterPool 创建 Hive ClusterClaim 并手动将 ClusterClaimspec 生命周期字段设置为无效的 golang 时间值,则产品将停止实现并协调所有 ClusterClaims,而不仅仅是不正确的声明。

您在 clusterclaim-controller pod 日志中看到以下错误,这是带有 PoolName 和无效生命周期的 特定示例 :

E0203 07:10:38.266841 1 reflector.go:138] sigs.k8s.io/controller-runtime/pkg/cache/internal/informers_map.go:224: Failed to watch *v1.ClusterClaim: failed to list *v1.ClusterClaim: v1.ClusterClaimList.Items: []v1.ClusterClaim: v1.ClusterClaim.v1.ClusterClaim.Spec: v1.ClusterClaimSpec.Lifetime: unmarshalerDecoder: time: unknown unit "w" in duration "1w", error found in #10 byte of ...|time":"1w"}},{"apiVe|..., bigger context ...|clusterPoolName":"policy-aas-hubs","lifetime":"1w"}},{"apiVersion":"hive.openshift.io/v1","kind":"Cl|...

E0203 07:10:38.266841 1 reflector.go:138] sigs.k8s.io/controller-runtime/pkg/cache/internal/informers_map.go:224: Failed to watch *v1.ClusterClaim: failed to list *v1.ClusterClaim: v1.ClusterClaimList.Items: []v1.ClusterClaim: v1.ClusterClaim.v1.ClusterClaim.Spec: v1.ClusterClaimSpec.Lifetime: unmarshalerDecoder: time: unknown unit "w" in duration "1w", error found in #10 byte of ...|time":"1w"}},{"apiVe|..., bigger context ...|clusterPoolName":"policy-aas-hubs","lifetime":"1w"}},{"apiVersion":"hive.openshift.io/v1","kind":"Cl|...您可以删除无效的声明。

如果删除了不正确的声明,则声明可以在不需要进一步交互的情况下再次成功进行协调。

1.4.3.2.5. 产品频道与置备的集群不同步

clusterimageset 处于 fast 频道,但置备的集群处于 stable 频道。目前,产品不会将 频道 同步到置备的 OpenShift Container Platform 集群。

进入 OpenShift Container Platform 控制台中的正确频道。点 Administration > Cluster Settings > Details Channel。

1.4.3.2.6. 在创建内部集群时需要选择子网

使用控制台创建内部集群时,您必须为集群选择一个可用的子网。它没有标记为必填字段。

1.4.3.2.7. 在代理环境中使用 Ansible 自动化进行集群置备失败

当满足以下条件时,配置为自动置备受管集群的 Automation 模板可能会失败:

- hub 集群启用了集群范围代理。

- Ansible Automation Platform 只能通过代理访问。

1.4.3.2.8. 无法手动删除受管集群命名空间

您无法手动删除受管集群的命名空间。受管集群命名空间会在受管集群分离后自动删除。如果在分离受管集群前手动删除受管集群命名空间,受管集群会在删除受管集群后显示持续终止状态。要删除此正在终止的受管集群,请从分离的受管集群中手动删除终结器。

1.4.3.2.9. 不支持为置备的集群进行自动 secret 更新

当您在云供应商一端更改云供应商访问密钥时,您还需要在 multicluster engine operator 的控制台中更新此云供应商的对应凭证。当凭证在托管受管集群的云供应商过期并尝试删除受管集群时,需要此项。

1.4.3.2.10. 销毁集群的进程没有完成

当销毁受管集群时,在一小时后仍然继续显示 Destroying 状态,且集群不会被销毁。要解决这个问题请完成以下步骤:

- 手动确保云中没有孤立的资源,,且清理与受管集群关联的所有供应商资源。

输入以下命令为正在删除的受管集群打开

ClusterDeployment:oc edit clusterdeployment/<mycluster> -n <namespace>

oc edit clusterdeployment/<mycluster> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将

mycluster替换为您要销毁的受管集群的名称。使用受管集群的命名空间替换

namespace。-

删除

hive.openshift.io/deprovisionfinalizer,以强制停止尝试清理云中的集群资源的进程。 -

保存您的更改,验证

ClusterDeployment是否已不存在。 运行以下命令手动删除受管集群的命名空间:

oc delete ns <namespace>

oc delete ns <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用受管集群的命名空间替换

namespace。

您不能使用 Red Hat Advanced Cluster Management 控制台升级 OpenShift Container Platform Dedicated 环境中的 OpenShift Container Platform 受管集群。

1.4.3.2.12. 工作管理器附加搜索详情

特定受管集群中特定资源的搜索详情页面可能会失败。在进行搜索前,您必须确保受管集群中的 work-manager 附加组件处于 Available 状态。

在 Red Hat Advanced Cluster Management 版本 2.10 及更新的版本中默认启用 ManagedServiceAccount 和集群代理附加组件。如果升级后禁用了附加组件,您必须手动启用 ManagedServiceAccount 和集群代理附加组件,以便在非 OpenShift Container Platform 受管集群上使用 pod 日志功能。

请参阅 ManagedServiceAccount 附加组件 以了解如何启用 ManagedServiceAccount 和使用集群代理附加组件 以了解如何启用集群代理附加组件。

当您在 OpenShift Container Platform 4.10.z 上使用集群范围代理配置创建托管服务集群时,nodeip-configuration.service 服务不会在 worker 节点上启动。

1.4.3.2.15. 客户端无法访问 iPXE 脚本

iPXE 是开源网络引导固件。如需了解更多详细信息,请参阅 iPXE。

引导节点时,一些 DHCP 服务器中的 URL 长度限制会关闭 InfraEnv 自定义资源定义中的 ipxeScript URL,从而导致在控制台中的以下错误消息:

no bootable devices

要临时解决这个问题,请完成以下步骤:

在使用辅助安装时应用

InfraEnv自定义资源定义以公开bootArtifacts,它可能类似以下文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

创建代理服务器以使用短 URL 公开

bootArtifacts。 运行以下命令复制

bootArtifacts并将其添加到代理中:for artifact in oc get infraenv qe2 -ojsonpath="{.status.bootArtifacts}" | jq ". | keys[]" | sed "s/\"//g" do curl -k oc get infraenv qe2 -ojsonpath="{.status.bootArtifacts.${artifact}}"` -o $artifactfor artifact in oc get infraenv qe2 -ojsonpath="{.status.bootArtifacts}" | jq ". | keys[]" | sed "s/\"//g" do curl -k oc get infraenv qe2 -ojsonpath="{.status.bootArtifacts.${artifact}}"` -o $artifactCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

将

ipxeScript工件代理 URL 添加到libvirt.xml中的bootp参数。

如果您在 Red Hat Advanced Cluster Management 2.6 中使用已删除的 BareMetalAssets API,则在升级到 Red Hat Advanced Cluster Management 2.7 后无法删除 ClusterDeployment,因为 BareMetalAssets API 绑定到 ClusterDeployment。

要临时解决这个问题,请在升级到 Red Hat Advanced Cluster Management 2.7 前运行以下命令来删除 finalizers:

oc patch clusterdeployment <clusterdeployment-name> -p '{"metadata":{"finalizers":null}}' --type=merge

oc patch clusterdeployment <clusterdeployment-name> -p '{"metadata":{"finalizers":null}}' --type=merge1.4.3.2.17. 受管集群在部署后处于 Pending 状态

聚合流是置备的默认过程。当您使用 Bare Metal Operator (BMO)将主机连接到 live ISO 时,Ironic Python 代理执行以下操作:

- 它运行裸机安装程序置备基础架构中的步骤。

- 它启动 Assisted Installer 代理,代理处理其余的安装和配置过程。

如果 Assisted Installer 代理启动缓慢,且部署受管集群,受管集群可能会处于 Pending 状态,且没有任何代理资源。您可以通过禁用聚合流来解决这个问题。

重要: 当您禁用聚合流时,只有 Assisted Installer 代理在 live ISO 中运行,减少打开的端口数量并禁用您在 Ironic Python 代理代理启用的任何功能,包括:

- 预置备磁盘清理

- iPXE 引导固件

- BIOS 配置

要决定要在不禁用聚合流的情况下启用或禁用哪些端口号,请参阅 网络配置。

要禁用聚合流,请完成以下步骤:

在 hub 集群中创建以下 ConfigMap:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 当您将参数值设置为 "false" 时,您也会禁用 Ironic Python Agent 启用的任何功能。

运行以下命令来应用 ConfigMap:

oc annotate --overwrite AgentServiceConfig agent unsupported.agent-install.openshift.io/assisted-service-configmap=my-assisted-service-config

oc annotate --overwrite AgentServiceConfig agent unsupported.agent-install.openshift.io/assisted-service-configmap=my-assisted-service-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4.3.2.18. ManagedClusterSet API 规格限制

使用 Clustersets API 时不支持 selectorType: LaberSelector 设置。支持 selectorType: ExclusiveClusterSetLabel 设置。

当使用 ClusterCurator 资源升级 OpenShift Container Platform Dedicated 集群时,升级会失败,因为 Cluster curator 不支持 OpenShift Container Platform Dedicated 集群。

1.4.3.2.20. 自定义入口域无法正确应用

您可以在安装受管集群时使用 ClusterDeployment 资源指定自定义 ingress 域,但更改仅在使用 SyncSet 资源安装后才会生效。因此,clusterdeployment.yaml 文件中的 spec 字段显示您指定的自定义入口域,但 status 仍然会显示默认域。

1.4.3.2.21. ManagedClusterAddon status becomes stuck

如果您在 ManagedClusterAddon 中定义配置来覆盖 ClusterManagementAddon 中的一些配置,则 ManagedClusterAddon 可能会处于以下状态:

progressing... mca and work configs mismatch

progressing... mca and work configs mismatch

当您检查 ManagedClusterAddon 状态时,配置的一部分有一个空的 spec 哈希,即使配置存在。请参见以下示例:

要解决这个问题,请运行以下命令来删除 ManagedClusterAddon,以重新安装并恢复 ManagedClusterAddon。将 <cluster-name& gt; 替换为 ManagedClusterAddon 命名空间。将 <addon-name& gt; 替换为 ManagedClusterAddon 名称:

oc -n <cluster-name> delete managedclusteraddon <addon-name>

oc -n <cluster-name> delete managedclusteraddon <addon-name>1.4.3.3. 中央基础架构管理

当使用 infrastructure operator for Red Hat OpenShift 创建 OpenShift Container Platform 集群时,ISO 镜像的文件名可能太长。镜像名称长会导致镜像置备和集群置备失败。要确定这是否是问题,请完成以下步骤:

运行以下命令,查看您要置备的集群的裸机主机信息:

oc get bmh -n <cluster_provisioning_namespace>

oc get bmh -n <cluster_provisioning_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行

describe命令以查看错误信息:oc describe bmh -n <cluster_provisioning_namespace> <bmh_name>

oc describe bmh -n <cluster_provisioning_namespace> <bmh_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 类似以下示例的错误表示文件名的长度问题:

Status: Error Count: 1 Error Message: Image provisioning failed: ... [Errno 36] File name too long ...

Status: Error Count: 1 Error Message: Image provisioning failed: ... [Errno 36] File name too long ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

如果出现这个问题,这通常位于以下 OpenShift Container Platform 版本中,因为 Red Hat OpenShift 的基础架构 Operator 不使用镜像服务:

- 4.8.17 及更早版本

- 4.9.6 及更早版本

为了避免这个错误,将 OpenShift Container Platform 升级到 4.8.18 或更高版本,或 4.9.7 或更高版本。

1.4.3.3.2. 无法使用主机清单来通过发现镜像引导,并自动添加主机

您不能使用主机清单或 InfraEnv 自定义资源来通过发现镜像进行两个引导,并自动添加主机。如果您将之前的 InfraEnv 资源用于 BareMetalHost 资源,并且希望自行引导镜像,您可以通过创建一个新的 InfraEnv 资源来解决此问题。

如果要在 4.16 之前使用 Red Hat OpenShift Container Platform 版本安装单节点 OpenShift 集群,您的 InfraEnv 自定义资源和引导的主机必须使用相同的 OpenShift Container Platform 版本来安装单节点 OpenShift 集群。如果版本不匹配,安装会失败。

要临时解决这个问题,请在使用 Discovery ISO 引导主机前编辑 InfraEnv 资源,并包含以下内容:

apiVersion: agent-install.openshift.io/v1beta1 kind: InfraEnv spec: osImageVersion: 4.15

apiVersion: agent-install.openshift.io/v1beta1

kind: InfraEnv

spec:

osImageVersion: 4.15

osImageVersion 字段必须与您要安装的 Red Hat OpenShift Container Platform 集群版本匹配。

在 MultiClusterEngine 和 MultiClusterHub 资源中配置的 tolerations 和 nodeSelector 设置不会影响本地集群中部署的 managed-serviceaccount 代理。本地集群中并不总是需要 managed-serviceaccount 附加组件。

如果需要 managed-serviceaccount 附加组件,您可以通过完成以下步骤来临时解决这个问题:

-

创建

addonDeploymentConfig自定义资源。 -

为本地集群和

managed-serviceaccount代理设置tolerations和nodeSelector值。 -

更新本地集群命名空间中的

managed-serviceaccountManagedClusterAddon,以使用您创建的addonDeploymentConfig自定义资源。

请参阅 为 klusterlet 附加组件配置 nodeSelectors 和 tolerations,以了解更多有关如何使用 addonDeploymentConfig 自定义资源为附加组件配置 容限 和 nodeSelector 的更多信息。

1.4.3.3.5. 在删除 BareMetalHost 资源后节点关闭

如果您从 hub 集群中删除 BareMetalHost 资源,节点会关闭。您可以再次手动打开节点电源。

1.4.4. 使用多集群引擎 Operator 弃用和删除集群生命周期

了解产品何时被弃用或从多集群引擎 operator 中删除。考虑推荐操作中的备选操作和详细信息,它们显示在当前版本的表中和之前两个版本。如果没有为该部分添加条目,则会删除表。

已弃用: 不再支持 multicluster engine operator 2.3 及更早的版本。文档可能仍然可用,但没有任何勘误或其他更新。

最佳实践: 升级到最新版本。

1.4.4.1. API 弃用和删除

multicluster engine operator 遵循 API 的 Kubernetes 弃用指南。有关该策略的更多详细信息,请参阅 Kubernetes Deprecation Policy。多集群引擎 operator API 仅在以下时间表外已弃用或删除:

-

所有

V1API 已正式发布(GA),提供 12 个月或跨三个发行版本(以更长的时间为准)的支持。V1 API 没有被删除,但可能会在这个时间限制外被弃用。 -

所有

betaAPI 通常在九个月或跨三个发行版本(以更长的时间为准)内可用。Beta API 不会在这个时间限制外被删除。 -

所有

alphaAPI 都不是必需的,但如果对用户有好处,则可能会被列为已弃用或删除。

1.4.4.1.1. API 弃用

| 产品或类别 | 受影响的项 | Version | 推荐的操作 | 详情和链接 |

|---|---|---|---|---|

| ManagedServiceAccount |

| 2.4 |

使用 | None |

1.4.4.2. 启用

| 产品或类别 | 受影响的项 | Version | 推荐的操作 | 详情和链接 |

|---|---|---|---|---|

| KlusterletConfig |

| 2.7 |

使用 | None |

| KlusterletConfig |

| 2.7 |

使用 | None |

| KlusterletConfig |

| 2.7 |

使用 | None |

1.4.4.3. 删除

一个删除(removed) 的项通常是在之前的版本中被弃用的功能,在该产品中不再可用。您必须将 alternatives 用于删除的功能。考虑使用推荐操作中的相应的替代操作,详情在下表中提供:

| 产品或类别 | 受影响的项 | Version | 推荐的操作 | 详情和链接 |

|---|---|---|---|---|

| 集群生命周期 | 在 Red Hat Virtualization 上创建集群 | 2.6 | None | None |

| 集群生命周期 | klusterlet Operator Lifecycle Manager Operator | 2.6 | None | None |

1.5. 安装和升级多集群引擎 Operator

multicluster engine operator 是一个软件 operator,用于增强集群团队管理。multicluster engine operator 支持跨云和数据中心的 Red Hat OpenShift Container Platform 和 Kubernetes 集群生命周期管理。

除非仅在最新版本的 OpenShift Container Platform 上引入并测试特定组件或功能,否则文档会参考最早支持的 OpenShift Container Platform 版本。

有关完全支持信息,请参阅 multicluster engine operator 支持列表。如需生命周期信息,请参阅 Red Hat OpenShift Container Platform 生命周期政策。

重要: 如果您使用 Red Hat Advanced Cluster Management,则在集群中已安装了 multicluster engine for Kubernetes operator。

已弃用: 不再支持 multicluster engine operator 2.3 及更早的版本。文档可能仍然可用,但没有任何勘误或其他更新。

最佳实践: 升级到最新版本。

请参阅以下文档:

1.5.1. 在线安装

multicluster engine operator 安装有 Operator Lifecycle Manager,用于管理安装、升级和删除包含 multicluster engine operator 的组件。

需要的访问权限:集群管理员

重要:

-

您不能在外部集群中配置了

ManagedCluster资源的集群中安装 multicluster engine operator。在安装 multicluster engine operator 之前,您必须从外部集群中删除ManagedCluster资源。 -

对于 OpenShift Container Platform Dedicated 环境,必须具有

cluster-admin权限。默认情况下,dedicated-admin角色没有在 OpenShift Container Platform Dedicated 环境中创建命名空间所需的权限。 - 默认情况下,多集群引擎 Operator 组件安装在 OpenShift Container Platform 集群的 worker 节点上,而无需额外的配置。您可以使用 OpenShift Container Platform OperatorHub Web 控制台界面或使用 OpenShift Container Platform CLI 将多集群引擎 Operator 安装到 worker 节点上。

- 如果您使用基础架构节点配置了 OpenShift Container Platform 集群,您可以使用带有其他资源参数的 OpenShift Container Platform CLI 将 multicluster engine operator 安装到这些基础架构节点上。详情请参阅在基础架构节点上安装多集群引擎部分。

如果您计划导入不是由 OpenShift Container Platform 或多集群引擎 operator 创建的 Kubernetes 集群,则需要配置镜像 pull secret。有关如何配置镜像 pull secret 和其他高级配置的详情,请参考 本文档的高级配置 部分中的选项。

1.5.1.1. 先决条件

在安装 multicluster engine operator 前,请查看以下先决条件:

- 您的 OpenShift Container Platform 集群必须通过控制台访问 OperatorHub 目录中的 multicluster engine operator。

- 您需要访问 catalog.redhat.com。

-

您的集群 没有在 外部集群中配置

ManagedCluster资源。 支持的 OpenShift Container Platform 版本必须部署到您的环境中,且必须通过 OpenShift Container Platform CLI 登录。请参阅以下安装文档:

- OpenShift Container Platform 文档中的安装 概述。

-

您的 OpenShift Container Platform 命令行界面(CLI)被配置为运行

oc命令。如需有关安装和配置 OpenShift Container Platform CLI 的信息,请参阅 CLI 入门。 - OpenShift Container Platform 权限必须允许创建命名空间。

要在 OpenShift Container Platform Dedicated 环境中安装,请参阅以下内容:

- 您必须已配置并运行了 OpenShift Container Platform Dedicated 环境。

-

您必须在要安装引擎的 OpenShift Container Platform Dedicated 环境中具有

cluster-admin授权。

- 如果您计划使用 Red Hat OpenShift Container Platform 提供的 Assisted Installer 创建受管集群,请参阅 OpenShift Container Platform 文档中的 准备使用 Assisted Installer 安装 部分。

1.5.1.2. 确认 OpenShift Container Platform 安装

您必须有一个受支持的 OpenShift Container Platform 版本,包括 registry 和存储服务,并可以正常工作。有关安装 OpenShift Container Platform 的更多信息,请参阅 OpenShift Container Platform 文档。

- 验证 multicluster engine operator 尚未安装在 OpenShift Container Platform 集群中。multicluster engine operator 只允许在每个 OpenShift Container Platform 集群中有一个安装。如果没有安装,请继续执行以下步骤。

要确保正确设置 OpenShift Container Platform 集群,请使用以下命令访问 OpenShift Container Platform Web 控制台:

kubectl -n openshift-console get route console

kubectl -n openshift-console get route consoleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请参见以下示例输出:

console console-openshift-console.apps.new-coral.purple-chesterfield.com console https reencrypt/Redirect None

console console-openshift-console.apps.new-coral.purple-chesterfield.com console https reencrypt/Redirect NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

在浏览器中打开 URL 并检查结果。如果控制台 URL 显示

console-openshift-console.router.default.svc.cluster.local,当安装 OpenShift Container Platform 时把openshift_master_default_subdomain设置为这个值。请参阅以下 URL 示例:https://console-openshift-console.apps.new-coral.purple-chesterfield.com。

您可以继续安装 multicluster engine operator。

1.5.1.3. 从 OperatorHub Web 控制台界面安装

最佳实践: 从 OpenShift Container Platform 导航中的 Administrator 视图,安装 OpenShift Container Platform 提供的 OperatorHub Web 控制台界面。

- 选择 Operators > OperatorHub 来访问可用 operator 列表,选择 multicluster engine for Kubernetes operator。

-

点

Install。 在 Operator 安装页面中,选择安装选项:

命名空间:

- 多集群引擎 operator 引擎必须安装在自己的命名空间或项目中。

-

默认情况下,OperatorHub 控制台安装过程会创建一个名为

multicluster-engine的命名空间。最佳实践: 继续使用multicluster-engine命名空间(如果可用)。 -

如果已存在名为

multicluster-engine的命名空间,请选择不同的命名空间。

- Channel:选择与要安装的发行版本相对应的频道。当您选择频道时,它会安装指定的发行版本,并确定以后获得该发行版本中的勘误更新。

Approval strategy:批准策略指定了用户需要如何处理应用到您的频道或发行版本的更新。

- 选择 Automatic (默认选择)以确保会自动应用该发行版本中的任何更新。

- 选择 Manual 在有更新可用时接收通知。如果您对更新的应用有疑问,这可能是您的最佳实践。

注: 要升级到下一个次版本,您必须返回到 OperatorHub 页面,并为更当前的发行版本选择一个新频道。

- 选择 Install 以应用您的更改并创建 Operator。

请参阅以下流程来创建 MultiClusterEngine 自定义资源。

- 在 OpenShift Container Platform 控制台导航中,选择 Installed Operators > multicluster engine for Kubernetes。

- 选择 MultiCluster Engine 选项卡。

- 选择 Create MultiClusterEngine。

更新 YAML 文件中的默认值。请参阅文档中的 MultiClusterEngine 高级配置部分中的选项。

- 以下示例显示了您可以复制到编辑器中的默认模板:

apiVersion: multicluster.openshift.io/v1 kind: MultiClusterEngine metadata: name: multiclusterengine spec: {}apiVersion: multicluster.openshift.io/v1 kind: MultiClusterEngine metadata: name: multiclusterengine spec: {}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

选择 Create 来初始化自定义资源。多集群引擎 operator 引擎最多可能需要 10 分钟才能构建并启动。

创建 MultiClusterEngine 资源后,在 MultiCluster Engine 标签页中资源的状态为

Available。

1.5.1.4. 通过 OpenShift Container Platform CLI 安装

创建一个 multicluster engine operator 引擎命名空间,其中包含 Operator 的要求。运行以下命令,其中

namespace是 Kubernetes operator 命名空间的多集群引擎的名称。在 OpenShift Container Platform 环境中,namespace的值可能被称为 Project(项目)。oc create namespace <namespace>

oc create namespace <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将项目命名空间切换到您创建的命名空间。

使用在第1 步中创建的 Kubernetes operator 命名空间的多集群引擎名称替换 namespace。oc project <namespace>

oc project <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 YAML 文件来配置

OperatorGroup资源。每个命名空间只能有一个 operator 组。将default替换为 operator 组的名称。将namespace替换为项目命名空间的名称。请参见以下示例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

OperatorGroup资源。将operator-group替换为您创建的 operator 组 YAML 文件的名称:oc apply -f <path-to-file>/<operator-group>.yaml

oc apply -f <path-to-file>/<operator-group>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 YAML 文件来配置 OpenShift Container Platform 订阅。文件内容类似以下示例:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注: 要配置基础架构节点,请参阅为多集群引擎 operator 配置基础架构节点。

运行以下命令来创建 OpenShift Container Platform 订阅。使用您创建的订阅文件的名称替换

subscription:oc apply -f <path-to-file>/<subscription>.yaml

oc apply -f <path-to-file>/<subscription>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 YAML 文件来配置

MultiClusterEngine自定义资源。您的默认模板应类似以下示例:apiVersion: multicluster.openshift.io/v1 kind: MultiClusterEngine metadata: name: multiclusterengine spec: {}apiVersion: multicluster.openshift.io/v1 kind: MultiClusterEngine metadata: name: multiclusterengine spec: {}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注: 要在基础架构节点上安装多集群引擎 Operator,请参阅 MultiClusterEngine 自定义资源附加配置 部分:

运行以下命令来创建

MultiClusterEngine自定义资源。将custom-resource替换为自定义资源文件的名称:oc apply -f <path-to-file>/<custom-resource>.yaml

oc apply -f <path-to-file>/<custom-resource>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果此步骤失败并显示以下错误,则仍然会创建并应用这些资源。创建资源后几分钟内再次运行命令:

error: unable to recognize "./mce.yaml": no matches for kind "MultiClusterEngine" in version "operator.multicluster-engine.io/v1"

error: unable to recognize "./mce.yaml": no matches for kind "MultiClusterEngine" in version "operator.multicluster-engine.io/v1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来获取自定义资源。在运行以下命令后,在

status.phase字段中显示MultiClusterEngine自定义资源状态Available可能需要最多 10 分钟时间:oc get mce -o=jsonpath='{.items[0].status.phase}'oc get mce -o=jsonpath='{.items[0].status.phase}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

如果您要重新安装多集群引擎 operator 且 pod 没有启动,请参阅故障排除重新安装失败以了解解决这个问题的步骤。

备注:

-

具有

ClusterRoleBinding的ServiceAccount会自动向 multicluster engine operator 以及有权访问安装 multicluster engine operator 的命名空间的用户凭证授予集群管理员特权。

现在,您可以将 OpenShift Container Platform 集群配置为包含基础架构节点来运行批准的管理组件。在基础架构节点上运行组件可避免为运行这些管理组件的节点分配 OpenShift Container Platform 订阅配额。请参阅为多集群引擎 operator 配置基础架构节点。

1.5.2. 为多集群引擎 operator 配置基础架构节点

配置 OpenShift Container Platform 集群,使其包含基础架构节点来运行批准的多集群引擎 operator 管理组件。在基础架构节点上运行组件可避免为运行多集群引擎 operator 管理组件的节点分配 OpenShift Container Platform 订阅配额。

将基础架构节点添加到 OpenShift Container Platform 集群后,请按照 OpenShift Container Platform CLI 指令安装,并将以下配置添加到 Operator Lifecycle Manager 订阅和 MultiClusterEngine 自定义资源。

1.5.2.1. 将基础架构节点配置为 OpenShift Container Platform 集群

按照 OpenShift Container Platform 文档中的 创建基础架构机器集 中所述的步骤进行操作。基础架构节点配置有 Kubernetes 污点和容限,以便防止非管理工作负载在它们上运行。

为了与多集群引擎 operator 提供的基础架构节点启用兼容,请确保您的基础架构节点应用了以下 污点和容限 :

1.5.2.2. Operator Lifecycle Manager 订阅配置

配置 Operator Lifecycle Manager 订阅。

在应用 Operator Lifecycle Manager 订阅前,添加以下配置:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 更新任何附加组件,使其包含以下节点选择器和容限。请参阅为 klusterlet 附加组件配置 nodeSelectors 和 tolerations。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 如果您使用 Red Hat OpenShift Data Foundation 作为存储置备程序,请确保 Container Storage Interface pod 可以在基础架构节点上运行。请参阅 Red Hat OpenShift Data Foundation 文档中的管理容器存储接口(CSI)组件放置 的更多信息。

1.5.2.3. MultiClusterEngine 自定义资源额外配置

在应用 MultiClusterEngine 自定义资源前添加以下附加配置:

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""1.5.3. 在断开连接的网络中安装

您可能需要在没有连接到互联网的 Red Hat OpenShift Container Platform 集群上安装 multicluster engine operator。在断开连接的引擎中安装的步骤需要一些与连接安装相同的步骤。

重要: 您必须在没有安装早于 2.5 的 Red Hat Advanced Cluster Management for Kubernetes 的集群上安装多集群引擎 Operator。multicluster engine operator 无法在 2.5 之前的版本上与 Red Hat Advanced Cluster Management for Kubernetes 共存,因为它们提供了一些相同的管理组件。建议您在之前没有安装 Red Hat Advanced Cluster Management 的集群上安装 multicluster engine Operator。如果您在 2.5.0 或更高版本中使用 Red Hat Advanced Cluster Management for Kubernetes,则 multicluster engine operator 已安装在集群中。

您必须下载软件包副本以在安装过程中访问它们,而不是在安装过程中直接从网络访问它们。

1.5.3.1. 先决条件

在安装 multicluster engine operator 前,您必须满足以下要求:

- 支持的 OpenShift Container Platform 版本必须部署到您的环境中,且必须使用 CLI 登录。

您需要访问 catalog.redhat.com。

注: 要管理裸机集群,您需要一个受支持的 OpenShift Container Platform 版本。

请参阅 OpenShift Container Platform 文档中的安装 概述。

- 您的 Red Hat OpenShift Container Platform 权限必须允许创建命名空间。

- 必须有一 个有互联网连接的工作站来下载 operator 的依赖软件包。

1.5.3.2. 确认 OpenShift Container Platform 安装

- 您必须有一个受支持的 OpenShift Container Platform 版本,包括 registry 和存储服务,在集群中安装并正常工作。如需有关 OpenShift Container Platform 的信息,请参阅 OpenShift Container Platform 文档。

连接后,使用以下命令访问 OpenShift Container Platform Web 控制台进行验证:

oc -n openshift-console get route console

oc -n openshift-console get route consoleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请参见以下示例输出:

console console-openshift-console.apps.new-name.purple-name.com console https reencrypt/Redirect None

console console-openshift-console.apps.new-name.purple-name.com console https reencrypt/Redirect NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 本例中的控制台 URL 为

https:// console-openshift-console.apps.new-coral.purple-chesterfield.com。在浏览器中打开 URL 并检查结果。如果控制台 URL 显示

console-openshift-console.router.default.svc.cluster.local,当安装 OpenShift Container Platform 时把openshift_master_default_subdomain设置为这个值。

1.5.3.3. 在断开连接的环境中安装

重要: 您需要将所需的镜像下载到镜像 registry 中,以便在断开连接的环境中安装 Operator。如果没有下载,您可能会在部署过程中收到 ImagePullBackOff 错误。

按照以下步骤在断开连接的环境中安装多集群引擎 Operator:

创建镜像 registry。如果您还没有镜像 registry,请完成 Red Hat OpenShift Container Platform 文档中的 Disconnected 安装镜像 主题中的步骤来创建。

如果已有镜像 registry,可以配置和使用现有 registry。

注: 对于裸机,您需要在

install-config.yaml文件中为断开连接的 registry 提供证书信息。要访问受保护的断开连接的 registry 中的镜像,您必须提供证书信息,以便 operator 的多集群引擎可以访问 registry。- 复制 registry 中的证书信息。

-

在编辑器中打开

install-config.yaml文件。 -

找到

additionalTrustBundle: |条目。 在

additionalTrustBundle行后添加证书信息。内容应类似以下示例:additionalTrustBundle: | -----BEGIN CERTIFICATE----- certificate_content -----END CERTIFICATE----- sshKey: >-

additionalTrustBundle: | -----BEGIN CERTIFICATE----- certificate_content -----END CERTIFICATE----- sshKey: >-Copy to Clipboard Copied! Toggle word wrap Toggle overflow

重要: 如果需要以下监管策略,则需要额外的镜像 registry:

-

Container Security Operator 策略:查找

registry.redhat.io/quay源中的镜像。 -

Compliance Operator 策略:查找

registry.redhat.io/compliance源中的镜像。 Gatekeeper Operator 策略:查找

registry.redhat.io/gatekeeper源中的镜像。参阅以下所有三个 operator 的镜像列表示例:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

Container Security Operator 策略:查找

-

保存

install-config.yaml文件。 创建一个包含

ImageContentSourcePolicy的 YAML 文件,其名称为mce-policy.yaml。注: 如果您在正在运行的集群中修改此操作,则会导致所有节点的滚动重启。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令应用 ImageContentSourcePolicy 文件:

oc apply -f mce-policy.yaml

oc apply -f mce-policy.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 启用断开连接的 Operator Lifecycle Manager Red Hat Operator 和 Community Operator。

multicluster engine operator 包含在 Operator Lifecycle Manager Red Hat Operator 目录中。

- 为 Red Hat Operator 目录配置离线 Operator Lifecycle Manager。按照 Red Hat OpenShift Container Platform 文档中受限网络部分中使用 Operator Lifecycle Manager 中的步骤操作。

- 从 Operator Lifecycle Manager 目录继续为 Kubernetes 安装 multicluster engine operator。

如需了解所需步骤,请参阅在线安装。

1.5.4. 使用策略升级断开连接的集群

如果您有 Red Hat Advanced Cluster Management for Kubernetes hub 集群,它使用 MultiClusterHub operator 来管理、升级和安装 hub 集群组件,您可以使用 OpenShift Update Service 和 Red Hat Advanced Cluster Management 策略在断开连接的环境中升级多个集群。

OpenShift Update Service 是一个单独的 operator 和操作对象,它监控受管集群的可用版本,并使其可用于在断开连接的环境中升级。OpenShift Update Service 可以执行以下操作:

- 监测何时有适用于断开连接的集群的升级。

- 使用图形数据文件识别哪些更新需要被镜像到您的本地站点进行升级。

- 使用控制台,通知您的集群有可用的升级。

- 先决条件

- 准备断开连接的镜像 registry

- 为 OpenShift Update Service 部署 Operator

- 构建图形数据 init 容器

- 为已镜像的 registry 配置证书

- 部署 OpenShift Update Service 实例

- 可选:部署策略以覆盖默认 registry

- 部署策略来部署断开连接的目录源

- 部署策略以更改受管集群参数

- 查看可用升级

- 选择一个频道

- 升级集群

- 其他资源

请参阅 OpenShift Container Platform 文档中的 为镜像 registry 访问配置额外的信任存储,以了解更多有关外部 registry CA 证书的信息。

1.5.4.1. 先决条件

您必须满足以下先决条件,才能使用 OpenShift Update Service 升级断开连接的集群:

- 您需要安装 Red Hat Advanced Cluster Management。请参阅 Red Hat Advanced Cluster Management 安装和升级文档。

- 您需要一个在受支持的 Red Hat OpenShift Container Platform 版本中运行的 hub 集群,并配置了受限 OLM。如需有关如何配置 受限 OLM 的详细信息,请参阅在受限网络中使用 Operator Lifecycle Manager。在配置受限 OLM 时记录目录源镜像。

- 您需要一个 hub 集群管理的 OpenShift Container Platform 集群。

您需要一个可以访问可以镜像集群镜像的本地存储库的凭证。如需更多信息,请参阅 断开连接的安装镜像。

注: 您升级的集群当前版本的镜像必须作为其中一个镜像保持可用。如果升级失败,集群会在尝试升级时恢复到集群的版本。

1.5.4.2. 准备断开连接的镜像 registry

您必须镜像要升级到的镜像,以及您要从本地镜像 registry 升级到的当前镜像。

完成以下步骤以镜像镜像:

创建一个包含类似以下示例内容的脚本文件。将

<pull-secret> 替换为 OpenShift Container Platform pull secret 的路径:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 运行该脚本来对镜像进行镜像、配置设置并将发行镜像与发行内容分开。

1.5.4.3. 为 OpenShift Update Service 部署 Operator

要在 OpenShift Container Platform 环境中为 OpenShift Update Service 部署 Operator,请完成以下步骤:

- 在 hub 集群中,访问 OpenShift Container Platform operator hub。

-

通过选择

OpenShift Update Service Operator来部署 Operator,并根据需要更新默认值。Operator 的部署会创建一个名为openshift-update-service的新项目。 - 等待 Operator 的安装完成。

您可以通过运行 oc get pods 命令检查安装的状态。验证 Operator 是否处于 running 状态。

1.5.4.4. 构建图形数据 init 容器

OpenShift Update Service 使用图形数据信息来查找可用的升级。在连接的环境中,OpenShift Update Service 会直接从 update-service 图形数据 GitHub 仓库中提取可用于升级的图形数据 信息。

在断开连接的环境中,您必须使用 init 容器 使图形数据在本地存储库中可用。

完成以下步骤以创建图形数据 init 容器:

运行以下命令克隆 图形数据 Git 存储库:

git clone https://github.com/openshift/cincinnati-graph-data

git clone https://github.com/openshift/cincinnati-graph-dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个文件,其中包含您的图形数据

init信息。您可以在cincinnati-operatorGitHub 仓库中找到 Dockerfile 示例。-

FROM值是 OpenShift Update Service 查找镜像的外部 registry。 -

RUN命令创建目录并打包升级文件。 -

CMD命令将软件包文件复制到本地库并提取文件进行升级。

-

运行以下命令以构建

图形数据 init 容器:podman build -f <docker-path> -t <graph-path>:latest

podman build -f <docker-path> -t <graph-path>:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将 <

;docker-path> 替换为您在上一步中创建的文件的路径。使用本地图形数据 init 容器的路径替换。

运行以下命令来推送

图形数据 init 容器:podman push <graph-path>:latest --authfile=<pull-secret>.json

podman push <graph-path>:latest --authfile=<pull-secret>.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用本地图形数据 init 容器的路径替换。

将

<pull-secret> 替换为 pull secret 文件的路径。

可选: 如果您没有安装 podman,请在第 3 和 4 步中将 podman 替换为 docker。

1.5.4.5. 为已镜像的 registry 配置证书

如果您使用安全的外部容器 registry 来存储已镜像的 OpenShift Container Platform 发行镜像,OpenShift Update Service 需要访问此 registry 来构建升级图。

完成以下步骤以配置您的 CA 证书以用于 OpenShift Update Service Pod:

-

查找位于

image.config.openshift.io的 OpenShift Container Platform 外部 registry API。这是存储外部 registry CA 证书的位置。如需更多信息,请参阅其他资源部分中的 为镜像 registry 访问 配置额外的信任存储。 在

openshift-config命名空间中创建 ConfigMap,并在updateservice-registry部分添加您的 CA 证书。请参见以下示例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑

image.config.openshift.ioAPI 中的cluster资源,将additionalTrustedCA字段设置为您创建的 ConfigMap 的名称。运行以下命令,并将 <trusted_ca> 替换为新 ConfigMap 的路径:oc patch image.config.openshift.io cluster -p '{"spec":{"additionalTrustedCA":{"name":"<trusted_ca>"}}}' --type mergeoc patch image.config.openshift.io cluster -p '{"spec":{"additionalTrustedCA":{"name":"<trusted_ca>"}}}' --type mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

OpenShift Update Service Operator 会监视 image.config.openshift.io API 和您在 openshift-config 命名空间中创建的 ConfigMap 是否有变化,然后在 CA 证书已更改时重启部署。

1.5.4.6. 部署 OpenShift Update Service 实例

在 hub 集群上完成 OpenShift Update Service 实例部署后,实例位于集群升级的镜像被镜像并可用于断开连接的受管集群。

完成以下步骤以部署实例:

- 如果您不想使用 Operator 的默认命名空间,请在控制台中进入到 Administration > Namespaces 来更改它。

- 在 OpenShift Container Platform 控制台的 Installed Operators 部分中,选择 OpenShift Update Service Operator。

- 在菜单中选择 Create Instance。

粘贴 OpenShift Update Service 实例中的内容。您的 YAML 实例可能类似以下清单:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 选择 Create 来创建实例。

-

在 hub 集群 CLI 中输入

oc get pods命令来查看实例创建的状态。

它可能需要几分钟时间。当命令结果显示实例和操作器正在运行时,进程已完成。

1.5.4.7. 可选:部署策略以覆盖默认 registry

只有在将发行版本镜像到已镜像的 registry 时,才适用以下步骤。

已弃用: PlacementRule

OpenShift Container Platform 具有一个默认的镜像 registry 值,用于指定它找到升级软件包的位置。在断开连接的环境中,您可以创建一个策略来替换该值,并将该值替换为您对发行版本镜像进行镜像的本地镜像 registry 的路径。

完成以下步骤以创建策略:

- 登录到 hub 集群的 OpenShift Container Platform 环境。

- 在控制台中,选择 Governance > Create policy。

- 将 YAML 开关设置为 On 以查看策略的 YAML 版本。

- 删除 YAML 代码中的所有内容。

将以下 YAML 内容粘贴到窗口以创建自定义策略:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 选择 Enforce if supported。

- 选择 Create 来创建策略。

1.5.4.8. 部署策略来部署断开连接的目录源

您可以将 Catalogsource 策略推送到受管集群,将默认位置从连接的位置更改为断开连接的本地 registry。

完成以下步骤以更改默认位置:

1.5.4.9. 部署策略以更改受管集群参数

您可以将 ClusterVersion 策略推送到受管集群,以更改它检索升级的默认位置。

完成以下步骤:

在受管集群中,通过运行以下命令确认 ClusterVersion upstream 参数目前是默认的公共 OpenShift Update Service 操作对象:

oc get clusterversion -o yaml

oc get clusterversion -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 hub 集群中,运行以下命令来识别到 OpenShift Update Service 操作对象的路由 URL:

oc get routes

oc get routesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 记住以后的结果。

- 在 hub 集群控制台菜单中,选择 Governance > Create a policy。

-

将

YAML切换设置为 On 以查看策略的 YAML 版本。 -

删除

YAML代码中的所有内容。 将以下

YAML内容粘贴到窗口以创建自定义策略:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 使用 hub 集群 OpenShift Update Service 操作对象的路径替换。如果没有指定,选择所有集群。

您可以完成以下步骤来确定操作对象的路径:

-

在 hub 集群上运行

oc get get routes -A命令。 查找

update-service的路由。到操作对象的路径是

HOST/PORT字段的值。

- 选择 Enforce if supported。

- 选择 Create 来创建策略。

在受管集群 CLI 中,运行以下命令来确认

ClusterVersion中的 upstream 参数已使用本地 hub 集群 OpenShift Update Service URL 更新:oc get clusterversion -o yaml

oc get clusterversion -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 结果应该类似以下内容:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.5.4.10. 查看可用升级

您可以通过完成以下步骤来查看受管集群可用升级列表:

- 在控制台中,选择 Infrastructure > Clusters。

- 选择处于 Ready 状态的一个集群。

- 在 Actions 菜单中选择 Upgrade cluster。

- 验证可选的升级路径是否可用。

注: 如果当前版本没有镜像到本地镜像存储库,则不会显示可用的升级版本。

1.5.4.11. 选择一个频道

您可以使用 Red Hat Advanced Cluster Management 控制台为 OpenShift Container Platform 上的集群升级选择一个频道。这些版本必须在镜像 registry 上可用。

完成选择频道中的步骤为您的升级指定频道。

1.5.4.12. 升级集群

配置断开连接的 registry 后,Red Hat Advanced Cluster Management 和 OpenShift Update Service 使用断开连接的 registry 来查找是否有可用的升级。

如果没有可用的升级,请确保您有集群当前级别的发行镜像,且至少有一个后续级别的镜像位于本地存储库中。

如果集群当前版本的发行镜像不可用,则没有可用的升级。

完成以下步骤进行升级:

- 在控制台中,选择 Infrastructure > Clusters。

- 如果有可用的升级,找到您要选择的集群。

- 如果有可用的升级,集群的 Distribution version 列会显示可用的升级。

- 选择集群的 Options 菜单,然后选择 Upgrade cluster。

- 为升级选择目标版本,然后选择 Upgrade。

如果集群升级失败,Operator 通常会重试升级,停止并报告故障组件的状态。在某些情况下,升级过程会一直通过尝试完成此过程进行循环。不支持在升级后将集群还原到以前的版本。如果您的集群升级失败,请联系红帽支持以寻求帮助。

1.5.4.12.1. 其他资源

请参阅 OpenShift Container Platform 文档中的 为镜像 registry 访问配置额外的信任存储,以了解更多有关外部 registry CA 证书的信息。

1.5.5. 高级配置

multicluster engine operator 使用部署所有所需组件的 operator 安装。multicluster engine operator 可以在安装过程中或安装后进一步配置。了解有关高级配置选项的更多信息。

1.5.5.1. 部署的组件

在 MultiClusterEngine 自定义资源中添加一个或多个属性:

| Name | 描述 | Enabled |

| assisted-service | 使用最小基础架构先决条件和全面的预动态验证安装 OpenShift Container Platform | True |

| cluster-lifecycle | 为 OpenShift Container Platform 和 Kubernetes hub 集群提供集群管理功能 | True |

| cluster-manager | 管理集群环境中的各种与集群相关的操作 | True |

| cluster-proxy-addon |

使用反向代理服务器在 hub 和受管集群中自动安装 | True |

| console-mce | 启用 multicluster engine operator 控制台插件 | True |

| discovery | 在 OpenShift Cluster Manager 中发现并标识新集群 | True |

| hive | 置备并执行 OpenShift Container Platform 集群的初始配置 | True |

| hypershift | 以成本和时间效率以及跨云可移植性大规模托管 OpenShift Container Platform control plane | True |

| hypershift-local-hosting | 在本地集群环境中为启用本地托管功能 | True |

| image-based-install-operator | 为单节点 OpenShift 集群提供站点配置以完成安装 | False |

| local-cluster | 启用部署 multicluster engine operator 的本地 hub 集群的导入和自助管理 | True |

| managedserviceacccount | 将服务帐户同步到受管集群,并将令牌作为 secret 资源收集,以回 hub 集群 | True |

| server-foundation | 为多集群环境中的服务器端操作提供基础服务 | True |

当您将 multicluster engine operator 安装到集群中时,并非所有列出的组件都会默认启用。

您可以通过在 MultiClusterEngine 自定义资源中添加一个或多个属性来进一步配置多集群引擎 operator。继续读取以了解有关您可以添加的属性的信息。

1.5.5.2. 控制台和组件配置

以下示例显示了可用于启用或禁用组件的 spec.overrides 默认模板:

-

使用组件的名称替换

name。

或者,您可以运行以下命令。将 namespace 替换为项目的名称,将 name 替换为组件的名称:

oc patch MultiClusterEngine <multiclusterengine-name> --type=json -p='[{"op": "add", "path": "/spec/overrides/components/-","value":{"name":"<name>","enabled":true}}]'

oc patch MultiClusterEngine <multiclusterengine-name> --type=json -p='[{"op": "add", "path": "/spec/overrides/components/-","value":{"name":"<name>","enabled":true}}]'1.5.5.3. local-cluster 启用

默认情况下,运行 multicluster engine operator 的集群管理其自身。要在没有集群管理其自身的情况下安装 multicluster engine operator,在 MultiClusterEngine 部分中的 spec.overrides.components 设置中指定以下值:

-

name值将 hub 集群标识为local-cluster。 -

enabled设置指定功能是启用还是禁用。当值为true时,hub 集群会自己管理。当值为false时,hub 集群不自己管理。

由自身管理的 hub 集群在集群列表中被指定为 local-cluster。

1.5.5.4. 自定义镜像 pull secret

如果您计划导入不是由 OpenShift Container Platform 或 operator 多集群引擎创建的 Kubernetes 集群,生成一个包含 OpenShift Container Platform pull secret 信息的 secret,以便从发布 registry 中访问授权内容。

OpenShift Container Platform 集群的 secret 要求由 Kubernetes operator 的 OpenShift Container Platform 和多集群引擎自动解决,因此如果您没有导入其他类型的 Kubernetes 集群,则不必创建 secret。

重要: 这些 secret 是特定于命名空间的,因此请确保处于用于引擎的命名空间中。

- 选择 Download pull secret 从 cloud.redhat.com/openshift/install/pull-secret 下载 OpenShift Container Platform pull secret 文件。您的 OpenShift Container Platform pull secret 与您的 Red Hat Customer Portal ID 相关联,在所有 Kubernetes 供应商中都是相同的。

运行以下命令来创建 secret:

oc create secret generic <secret> -n <namespace> --from-file=.dockerconfigjson=<path-to-pull-secret> --type=kubernetes.io/dockerconfigjson

oc create secret generic <secret> -n <namespace> --from-file=.dockerconfigjson=<path-to-pull-secret> --type=kubernetes.io/dockerconfigjsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

将

secret替换为您要创建的 secret 的名称。 -

将

namespace替换为项目命名空间,因为 secret 是特定于命名空间的。 -

将

path-to-pull-secret替换为您下载的 OpenShift Container Platform pull secret 的路径。

-

将

以下示例显示,如果使用自定义 pull secret,要使用的 spec.imagePullSecret 模板。将 secret 替换为 pull secret 的名称:

1.5.5.5. 目标命名空间

可通过在 MultiClusterEngine 自定义资源中指定位置,在指定的命名空间中安装操作对象。此命名空间在 MultiClusterEngine 自定义资源的应用程序上创建。

重要: 如果没有指定目标命名空间,Operator 将安装到 multicluster-engine 命名空间,并在 MultiClusterEngine 自定义资源规格中设置它。

以下示例显示了可以用来指定目标命名空间的 spec.targetNamespace 模板。使用目标命名空间的名称替换 target。注: target 目标命名空间不能是 default 命名空间:

1.5.5.6. availabilityConfig

hub 集群有两个可用功能:High 和 Basic。默认情况下,hub 集群的可用性为 High,hub 集群组件副本数 为 2。它提供了对故障转移功能的支持,但消耗的资源数量比可用性为 Basic(副本数为1) 的集群多。

重要: 如果您在单节点 OpenShift 集群中使用 multicluster engine operator,请将 spec.availabilityConfig 设置为 Basic。

以下示例显示了具有 Basic 可用性的 spec.availabilityConfig 模板:

1.5.5.7. nodeSelector

您可以在 MultiClusterEngine 中定义一组节点选择器,以安装到集群中的特定节点。以下示例显示了将 pod 分配给带有标签 node-role.kubernetes.io/infra 的节点的 spec.nodeSelector :

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""要为 Red Hat Advanced Cluster Management for Kubernetes hub 集群定义一组节点选择器,请参阅产品文档中的 nodeSelector。

1.5.5.8. 容限(tolerations)

您可以定义容限列表,以允许 MultiClusterEngine 容许在集群中定义的特定污点。以下示例显示了与 node-role.kubernetes.io/infra 污点匹配的 spec.tolerations :

spec:

tolerations:

- key: node-role.kubernetes.io/infra

effect: NoSchedule

operator: Exists

spec:

tolerations:

- key: node-role.kubernetes.io/infra

effect: NoSchedule

operator: Exists默认情况下,以上 infra-node 容限在 pod 上设置,而不在配置中指定任何容限。在配置中自定义容限将替换此默认行为。

要为 Red Hat Advanced Cluster Management for Kubernetes hub 集群定义 容限列表,请参阅产品文档中的容限。

1.5.5.9. ManagedServiceAccount add-on

ManagedServiceAccount 附加组件允许您在受管集群中创建或删除服务帐户。要在启用此附加组件的环境中安装,请在 spec.overrides 的 MultiClusterEngine 规格中包括以下内容:

在创建 MultiClusterEngine 后,可以在命令行中编辑资源并将 managedserviceaccount 组件设置为 enabled: true 来启用 ManagedServiceAccount 附加组件。或者,您可以运行以下命令,将 <multiclusterengine-name> 替换为 MultiClusterEngine 资源的名称。

oc patch MultiClusterEngine <multiclusterengine-name> --type=json -p='[{"op": "add", "path": "/spec/overrides/components/-","value":{"name":"managedserviceaccount","enabled":true}}]'

oc patch MultiClusterEngine <multiclusterengine-name> --type=json -p='[{"op": "add", "path": "/spec/overrides/components/-","value":{"name":"managedserviceaccount","enabled":true}}]'1.5.6. 卸装

在卸载 Kubernetes operator 的多集群引擎时,您会看到两个不同的流程级别: 删除自定义资源 和完整的 Operator 卸载。完成卸载过程最多可能需要五分钟。

-

删除自定义资源是最基本的卸载类型,它会删除

MultiClusterEngine实例的自定义资源,但会保留其他所需的 operator 资源。如果您计划使用相同的设置和组件重新安装,这个卸载级别很有用。 - 第二个级别是更完整的卸载,可删除大多数 Operator 组件,不包括自定义资源定义等组件。当您继续执行此步骤时,它会删除所有没有通过删除自定义资源而被删除的组件和订阅。在卸载后,您必须在重新安装自定义资源前重新安装 Operator。

1.5.6.1. 先决条件:分离启用的服务

在卸载 Kubernetes operator 的多集群引擎前,您必须分离所有由该引擎管理的集群。为了避免错误,分离仍由引擎管理的所有集群,然后尝试再次卸载。

如果附加了受管集群,您可能会看到以下信息。

Cannot delete MultiClusterEngine resource because ManagedCluster resource(s) exist

Cannot delete MultiClusterEngine resource because ManagedCluster resource(s) existCopy to Clipboard Copied! Toggle word wrap Toggle overflow 有关分离集群的更多信息,请参阅从管理部分删除集群,方法是在 创建集群 中选择您的供应商信息。

1.5.6.2. 使用命令删除资源

-

如果还没有运行 oc 命令,请确保 OpenShift Container Platform CLI 配置为运行

oc命令。如需有关如何配置oc命令的更多信息 ,请参阅 OpenShift Container Platform 文档中的 OpenShift CLI 入门。 输入以下命令来更改到您的项目命名空间。将 namespace 替换为项目命名空间的名称:

oc project <namespace>

oc project <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令删除

MultiClusterEngine自定义资源:oc delete multiclusterengine --all

oc delete multiclusterengine --allCopy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以输入以下命令来查看进度:

oc get multiclusterengine -o yaml

oc get multiclusterengine -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

输入以下命令删除在其中安装的命名空间中 multicluster-engine

ClusterServiceVersion:

此处显示的 CSV 版本可能会有所不同。

1.5.6.3. 使用控制台删除组件

当使用 Red Hat OpenShift Container Platform 控制台卸载时,需要删除 operator。使用控制台完成以下步骤进行卸载:

- 在 OpenShift Container Platform 控制台导航中,选择 Operators > Installed Operators > multicluster engine for Kubernetes.

删除

MultiClusterEngine自定义资源。- 选择 Multiclusterengine 标签页

- 选择 MultiClusterEngine 自定义资源的 Options 菜单。

- 选择 Delete MultiClusterEngine。

根据以下部分中的步骤运行清理脚本。

提示: 如果您计划为 Kubernetes operator 版本重新安装相同的多集群引擎,您可以跳过这个过程中的其余步骤并重新安装自定义资源。

- 进入 Installed Operators。

- 选择 Options 菜单并选择 Uninstall operator 来删除 Kubernetes_ operator 的 _ multicluster 引擎。

1.5.6.4. 卸载故障排除

如果没有删除多集群引擎自定义资源,请通过运行清理脚本删除潜在的剩余工件。

将以下脚本复制到一个文件中:

#!/bin/bash oc delete apiservice v1.admission.cluster.open-cluster-management.io v1.admission.work.open-cluster-management.io oc delete validatingwebhookconfiguration multiclusterengines.multicluster.openshift.io oc delete mce --all

#!/bin/bash oc delete apiservice v1.admission.cluster.open-cluster-management.io v1.admission.work.open-cluster-management.io oc delete validatingwebhookconfiguration multiclusterengines.multicluster.openshift.io oc delete mce --allCopy to Clipboard Copied! Toggle word wrap Toggle overflow

如需更多信息,请参阅 断开连接的安装镜像。

1.6. 管理凭证

在使用 multicluster engine operator 的云服务供应商上创建和管理 Red Hat OpenShift Container Platform 集群需要一个凭证。凭据存储云提供商的访问信息。每个提供程序帐户都需要自己的凭据,就像单个提供程序中的每个域一样。

您可以创建和管理集群凭证。凭据存储为 Kubernetes secret。secret 复制到受管集群的命名空间,以便受管集群的控制器可以访问 secret。更新凭证时,secret 的副本会在受管集群命名空间中自动更新。

注: 对现有受管集群,对 pull secret、SSH 密钥或基域的更改不会反映,因为它们已使用原始凭证置备。

需要的访问权限: Edit

1.6.1. 为 Amazon Web Services 创建凭证

您需要一个凭证才能使用多集群引擎 operator 控制台在 Amazon Web Services (AWS)上部署和管理 Red Hat OpenShift Container Platform 集群。

需要的访问权限: Edit

注: 必须在使用 multicluster engine operator 创建集群前完成此步骤。

1.6.1.1. 先决条件

创建凭证前必须满足以下先决条件:

- 已部署多集群引擎 operator hub 集群

- 可通过互联网访问 multicluster engine operator hub 集群,以便它在 Amazon Web Services (AWS)上创建 Kubernetes 集群

- AWS 登录凭证,其中包括访问密钥 ID 和 secret 访问密钥。请参阅了解并获取您的安全凭证。

- 允许在 AWS 上安装集群的帐户权限。有关如何配置 AWS 帐户 的说明,请参阅配置 AWS 帐户。

1.6.1.2. 使用控制台管理凭证

要从 multicluster engine operator 控制台创建凭证,请完成控制台中的步骤。

从导航菜单开始。单击 Credentials 以从现有凭证选项中进行选择。提示: 为方便起见,同时为了提高安全性,创建一个命名空间,专门用于托管您的凭证。

您可以选择为您的凭证添加基本 DNS 域。如果您将基本 DNS 域添加到凭证中,则在使用此凭证创建集群时,会自动填充到正确的字段中。请参见以下步骤:

- 为您的 AWS 帐户添加 AWS 访问密钥 ID。请参阅 登录到 AWS 以查找您的 ID。

- 提供新 AWS Secret 访问密钥的内容。

如果要启用代理,请输入代理信息:

-

HTTP 代理 URL:用作

HTTP流量的代理的 URL。 -

HTTPS 代理 URL:用于

HTTPS流量的安全代理 URL。如果没有提供值,则使用相同的值HTTP Proxy URL,用于HTTP和HTTPS。 -

无代理域:应当绕过代理的以逗号分隔的域列表。使用一个句点 (

.) 开始的域名,包含该域中的所有子域。添加一个星号*以绕过所有目的地的代理。 - 其他信任捆绑包:代理 HTTPS 连接所需的一个或多个额外 CA 证书。

-

HTTP 代理 URL:用作

- 输入 Red Hat OpenShift pull secret。请参阅下载 Red Hat OpenShift pull secret 以下载您的 pull secret。

- 添加可让您连接到集群的 SSH 私钥和 SSH 公钥。您可以使用现有密钥对,或使用密钥生成程序创建新密钥对。

要创建使用此凭证的集群,完成 Creating a cluster on Amazon Web Services 或 Creating a cluster on Amazon Web Services GovCloud 中的步骤。

您可以在控制台中编辑凭证。如果使用这个供应商连接创建集群,则来自 <cluster-namespace> 的 <cluster-name>-aws-creds> secret 将使用新凭证进行更新。

注:更新凭证不适用于集群池声明的集群。

当您不再管理使用凭证的集群时,请删除凭证来保护凭证中的信息。选择要批量删除的 Actions,或者选择您要删除的凭证旁边的选项菜单。

1.6.1.2.1. 创建 S3 secret

要创建 Amazon Simple Storage Service (S3) secret,请在控制台中完成以下任务:

- 点 Add credential > AWS > S3 Bucket。如果您点 For Hosted Control Plane,则会提供名称和命名空间。

输入提供的以下字段信息:

-

bucket 名称:添加 S3 存储桶的名称。 -

aws_access_key_id: 为您的 AWS 帐户添加 AWS 访问密钥 ID。登录到 AWS 以查找您的 ID。 -

aws_secret_access_key: 为您的新 AWS Secret 访问密钥提供内容。 -

区域:输入您的 AWS 区域。

-

1.6.1.3. 使用 API 创建不透明的 secret

要使用 API 为 Amazon Web Services 创建不透明 secret,请在类似以下示例的 YAML preview 窗口中应用 YAML 内容:

备注:

- Opaque secret 在控制台中是不可见的。

- 不透明 secret 在您选择的受管集群命名空间中创建。Hive 使用 opaque secret 来置备集群。当使用 Red Hat Advanced Cluster Management 控制台置备集群时,您预先创建的凭证将复制到受管集群命名空间中,作为 opaque secret。

-

在控制台中为您的凭证添加标签,以查看您的 secret。例如,以下 AWS S3 Bucket

oc label secret会附加type=awss3和credentials --from-file=….:

oc label secret hypershift-operator-oidc-provider-s3-credentials -n local-cluster "cluster.open-cluster-management.io/type=awss3" oc label secret hypershift-operator-oidc-provider-s3-credentials -n local-cluster "cluster.open-cluster-management.io/credentials=credentials="

oc label secret hypershift-operator-oidc-provider-s3-credentials -n local-cluster "cluster.open-cluster-management.io/type=awss3"

oc label secret hypershift-operator-oidc-provider-s3-credentials -n local-cluster "cluster.open-cluster-management.io/credentials=credentials="1.6.1.4. 其他资源

1.6.2. 为 Microsoft Azure 创建凭证

您需要一个凭证来使用多集群引擎 operator 控制台在 Microsoft Azure 或 Microsoft Azure Government 上创建和管理 Red Hat OpenShift Container Platform 集群。

需要的访问权限: Edit

注:这个过程是使用多集群引擎 operator 创建集群的先决条件。

1.6.2.1. 先决条件

创建凭证前必须满足以下先决条件:

- 已部署多集群引擎 operator hub 集群。

- 可通过互联网访问 multicluster engine operator hub 集群,以便它在 Azure 上创建 Kubernetes 集群。

- Azure 登录凭证,其中包括您的基域资源组和 Azure Service Principal JSON。请参阅 Microsoft Azure 门户以获取您的登录凭证。

- 允许在 Azure 上安装集群的帐户权限。如需更多信息,请参阅 如何配置云服务和配置 Azure 帐户。

1.6.2.2. 使用控制台管理凭证

要从 multicluster engine operator 控制台创建凭证,请完成控制台中的步骤。从导航菜单开始。单击 Credentials 以从现有凭证选项中进行选择。提示: 为方便起见,同时为了提高安全性,创建一个命名空间,专门用于托管您的凭证。

- 可选:为您的凭证添加基本 DNS 域。如果您将基本 DNS 域添加到凭证中,则在使用此凭证创建集群时,会自动填充到正确的字段中。

-

选择集群的环境是

AzurePublicCloud还是AzureUSrianCloud。Azure 政府环境的设置有所不同,因此请确保正确设置此设置。 - 为您的 Azure 帐户添加 基本域资源组名称。此条目是您使用 Azure 帐户创建的资源名称。您可以在 Azure 界面中选择 Home > DNS Zones 来查找您的基域资源组名称。请参阅使用 Azure CLI 创建 Azure 服务主体,以查找您的基域资源组名称。

为您的客户端 ID 提供内容。当您使用以下命令创建服务主体时,这个值作为

appId属性被生成:az ad sp create-for-rbac --role Contributor --name <service_principal> --scopes <subscription_path>

az ad sp create-for-rbac --role Contributor --name <service_principal> --scopes <subscription_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将 service_principal 替换为您的服务主体名。

添加您的 客户端 Secret。当您使用以下命令创建服务主体时,这个值作为

password属性被生成:az ad sp create-for-rbac --role Contributor --name <service_principal> --scopes <subscription_path>

az ad sp create-for-rbac --role Contributor --name <service_principal> --scopes <subscription_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将 service_principal 替换为您的服务主体名。

添加您的 订阅 ID。这个值是以下命令输出中的

id属性:az account show

az account showCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加您的租户 ID。这个值是以下命令输出中的

tenantId属性:az account show

az account showCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果要启用代理,请输入代理信息:

-

HTTP 代理 URL:用作

HTTP流量的代理的 URL。 -

HTTPS 代理 URL:用于

HTTPS流量的安全代理 URL。如果没有提供值,则使用相同的值HTTP Proxy URL,用于HTTP和HTTPS。 -

无代理域:应当绕过代理的以逗号分隔的域列表。使用一个句点 (

.) 开始的域名,包含该域中的所有子域。添加一个星号*以绕过所有目的地的代理。 - 其他信任捆绑包:代理 HTTPS 连接所需的一个或多个额外 CA 证书。

-

HTTP 代理 URL:用作

- 输入您的 Red Hat OpenShift pull secret。请参阅下载 Red Hat OpenShift pull secret 以下载您的 pull secret。

- 添加用于连接到集群的 SSH 私钥和 SSH 公钥。您可以使用现有密钥对,或使用密钥生成程序创建新密钥对。

要创建使用此凭证的集群,您可以完成在 Microsoft Azure 上创建集群 中的步骤。

您可以在控制台中编辑凭证。

当您不再管理使用凭证的集群时,请删除凭证来保护凭证中的信息。选择要批量删除的 Actions,或者选择您要删除的凭证旁边的选项菜单。

1.6.2.3. 使用 API 创建不透明的 secret

要使用 API 而不是控制台为 Microsoft Azure 创建不透明 secret,请在类似以下示例的 YAML preview 窗口中应用 YAML 内容:

备注:

- Opaque secret 在控制台中是不可见的。

- 不透明 secret 在您选择的受管集群命名空间中创建。Hive 使用 opaque secret 来置备集群。当使用 Red Hat Advanced Cluster Management 控制台置备集群时,您预先创建的凭证将复制到受管集群命名空间中,作为 opaque secret。

1.6.2.4. 其他资源

- 请参阅 Microsoft Azure Portal。

- 请参阅如何配置云服务。

- 请参阅配置 Azure 帐户。

- 请参阅使用 Azure CLI 创建 Azure 服务主体,以查找您的基域资源组名称。

- 下载 Red Hat OpenShift pull secret。

- 如需有关如何 生成密钥的更多信息,请参阅为集群节点 SSH 访问生成密钥对。

- 请参阅在 Microsoft Azure 上创建集群

- 返回到为 Microsoft Azure 创建凭证。

1.6.3. 为 Google Cloud Platform 创建凭证

您需要一个凭证来使用 multicluster engine operator 控制台在 Google Cloud Platform (GCP) 上创建和管理 Red Hat OpenShift Container Platform 集群。

需要的访问权限: Edit

注:这个过程是使用多集群引擎 operator 创建集群的先决条件。

1.6.3.1. 先决条件

创建凭证前必须满足以下先决条件:

- 已部署多集群引擎 operator hub 集群

- 可通过互联网访问 multicluster engine operator hub 集群,以便它在 GCP 上创建 Kubernetes 集群

- GCP 登录凭证,其中包括用户 Google Cloud Platform 项目 ID 和 Google Cloud Platform 服务帐户 JSON 密钥。请参阅创建和管理项目。

- 允许在 GCP 上安装集群的帐户权限。有关如何配置帐户的说明,请参阅配置 GCP 项目。

1.6.3.2. 使用控制台管理凭证

要从 multicluster engine operator 控制台创建凭证,请完成控制台中的步骤。

从导航菜单开始。单击 Credentials 以从现有凭证选项中进行选择。提示: 为方便和安全起见,创建一个命名空间,专门用于托管您的凭证。

您可以选择为您的凭证添加基本 DNS 域。如果您将基本 DNS 域添加到凭证中,则在使用此凭证创建集群时,会自动填充到正确的字段中。请参见以下步骤:

- 为您的 GCP 帐户添加 Google Cloud Platform 项目 ID。请参阅登录到 GCP 以检索您的设置。

- 添加 Google Cloud Platform 服务帐户 JSON 密钥。请参阅 Create service account 文档,以创建您的服务帐户 JSON 密钥。按照 GCP 控制台的步骤进行操作。

- 提供您的新 Google Cloud Platform 服务帐户 JSON 密钥 的内容。

如果要启用代理,请输入代理信息:

-

HTTP 代理 URL:用作

HTTP流量的代理的 URL。 -

HTTPS 代理 URL:用于

HTTPS流量的安全代理 URL。如果没有提供值,则使用相同的值HTTP Proxy URL,用于HTTP和HTTPS。 -

无代理域:应当绕过代理的以逗号分隔的域列表。使用一个句点 (

.) 开始的域名,包含该域中的所有子域。添加星号 (*) 以绕过所有目的地的代理。 - 其他信任捆绑包:代理 HTTPS 连接所需的一个或多个额外 CA 证书。

-

HTTP 代理 URL:用作

- 输入 Red Hat OpenShift pull secret。请参阅下载 Red Hat OpenShift pull secret 以下载您的 pull secret。

- 添加 SSH 私钥和 SSH 公钥以便您访问集群。您可以使用现有密钥对,或使用密钥生成程序创建新密钥对。

要在创建集群时使用此连接,您可以完成在 Google Cloud Platform 上创建集群中的步骤。

您可以在控制台中编辑凭证。

当您不再管理使用凭证的集群时,请删除凭证来保护凭证中的信息。选择要批量删除的 Actions,或者选择您要删除的凭证旁边的选项菜单。

1.6.3.3. 使用 API 创建不透明的 secret

要使用 API 而不是控制台为 Google Cloud Platform 创建不透明 secret,请在类似以下示例的 YAML preview 窗口中应用 YAML 内容:

备注:

- Opaque secret 在控制台中是不可见的。

- 不透明 secret 在您选择的受管集群命名空间中创建。Hive 使用 opaque secret 来置备集群。当使用 Red Hat Advanced Cluster Management 控制台置备集群时,您预先创建的凭证将复制到受管集群命名空间中,作为 opaque secret。

1.6.3.4. 其他资源

- 请参阅创建和管理项目。

- 请参阅配置 GCP 项目。

- 登录到 GCP。

- 请参阅创建服务账户来创建服务帐户 JSON 密钥。

- 下载 Red Hat OpenShift pull secret。

- 如需有关如何 生成密钥的更多信息,请参阅为集群节点 SSH 访问生成密钥对。

- 请参阅在 Google Cloud Platform 上创建集群

1.6.4. 为 VMware vSphere 创建凭证

您需要一个凭证才能使用多集群引擎 operator 控制台在 VMware vSphere 上部署和管理 Red Hat OpenShift Container Platform 集群。

需要的访问权限: Edit

1.6.4.1. 先决条件

创建凭证前必须满足以下先决条件:

- 您必须先为 VMware vSphere 创建凭证,然后才能使用 multicluster engine operator 创建集群。

- 在受支持的 OpenShift Container Platform 版本上部署的 hub 集群。

- hub 集群的互联网访问,以便它在 VMware vSphere 上创建 Kubernetes 集群。

使用安装程序置备的基础架构时为 OpenShift Container Platform 配置了 VMware vSphere 登录凭证和 vCenter 要求。请参阅使用自定义在 vSphere 上安装集群。这些凭证包括以下信息:

- vCenter 帐户权限。

- 集群资源。

- DHCP 可用。

- ESXi 主机的时间已同步(例如: NTP)。

1.6.4.2. 使用控制台管理凭证

要从 multicluster engine operator 控制台创建凭证,请完成控制台中的步骤。

从导航菜单开始。单击 Credentials 以从现有凭证选项中进行选择。提示: 为方便起见,同时为了提高安全性,创建一个命名空间,专门用于托管您的凭证。

您可以选择为您的凭证添加基本 DNS 域。如果您将基本 DNS 域添加到凭证中,则在使用此凭证创建集群时,会自动填充到正确的字段中。请参见以下步骤:

- 添加 VMware vCenter 服务器完全限定主机名或 IP 地址。该值必须在 vCenter 服务器 root CA 证书中定义。如果可能,请使用完全限定主机名。

- 添加 VMware vCenter 用户名。

- 添加 VMware vCenter 密码。

添加 VMware vCenter root CA 证书。

-

您可以使用 VMware vCenter 服务器的证书在

download.zip软件包中下载证书,地址为https://<vCenter_address>/certs/download.zip。将 vCenter_address 替换为 vCenter 服务器的地址。 -

解包

download.zip。 使用

certs/<platform>目录中有.0扩展名的证书。提示: 您可以使用

ls certs/<platform>命令列出平台的所有可用证书。将

<platform>替换为您的平台的缩写:lin、mac或win.例如:

certs/lin/3a343545.0最佳实践: 通过运行

cat certs/lin/*.0 > ca.crt命令,将多个带有.0扩展的证书链接到一起。- 添加 VMware vSphere 集群名称。

- 添加 VMware vSphere 数据中心。

- 添加 VMware vSphere 默认数据存储。

- 添加 VMware vSphere 磁盘类型。

- 添加 VMware vSphere 文件夹。

- 添加 VMware vSphere 资源池。

-

您可以使用 VMware vCenter 服务器的证书在

只用于断开连接的安装:使用所需信息完成 Configuration for disconnected installation 子字段:

- Cluster OS image:此值包含用于 Red Hat OpenShift Container Platform 集群机器的镜像的 URL。

镜像内容源:此值包含断开连接的 registry 路径。该路径包含所有用于断开连接的安装镜像的主机名、端口和库路径。示例:

repository.com:5000/openshift/ocp-release。该路径会在

install-config.yaml中创建一个到 Red Hat OpenShift Container Platform 发行镜像的镜像内容源策略映射。例如,repository.com:5000生成此imageContentSource内容:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Additional trust bundle:此值提供访问镜像 registry 所需的证书文件内容。

注: 如果您要从断开连接的环境中的一个 hub 部署受管集群,并希望在安装后自动导入它们,使用

YAML编辑器将镜像内容源策略添加到install-config.yaml文件中。以下示例中显示了一个示例:- mirrors: - registry.example.com:5000/rhacm2 source: registry.redhat.io/rhacm2

- mirrors: - registry.example.com:5000/rhacm2 source: registry.redhat.io/rhacm2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

如果要启用代理,请输入代理信息:

-

HTTP 代理 URL:用作

HTTP流量的代理的 URL。 -

HTTPS 代理 URL:用于

HTTPS流量的安全代理 URL。如果没有提供值,则使用相同的值HTTP Proxy URL,用于HTTP和HTTPS。 -

无代理域:应当绕过代理的以逗号分隔的域列表。使用一个句点 (

.) 开始的域名,包含该域中的所有子域。添加星号 (*) 以绕过所有目的地的代理。 - 其他信任捆绑包:代理 HTTPS 连接所需的一个或多个额外 CA 证书。

-

HTTP 代理 URL:用作

- 输入 Red Hat OpenShift pull secret。请参阅下载 Red Hat OpenShift pull secret 以下载您的 pull secret。

添加可让您连接到集群的 SSH 私钥和 SSH 公钥。

您可以使用现有密钥对,或使用密钥生成程序创建新密钥对。

要创建使用此凭证的集群,您可以完成在 VMware vSphere 上创建集群中的步骤。

您可以在控制台中编辑凭证。

当您不再管理使用凭证的集群时,请删除凭证来保护凭证中的信息。选择要批量删除的 Actions,或者选择您要删除的凭证旁边的选项菜单。

1.6.4.3. 使用 API 创建不透明的 secret

要使用 API 而不是控制台为 VMware vSphere 创建不透明 secret,请在类似以下示例的 YAML preview 窗口中应用 YAML 内容:

备注:

- Opaque secret 在控制台中是不可见的。

- 不透明 secret 在您选择的受管集群命名空间中创建。Hive 使用 opaque secret 来置备集群。当使用 Red Hat Advanced Cluster Management 控制台置备集群时,您预先创建的凭证将复制到受管集群命名空间中,作为 opaque secret。

1.6.4.4. 其他资源

1.6.5. 为 Red Hat OpenStack 创建凭证

您需要一个凭证才能使用多集群引擎 operator 控制台在 Red Hat OpenStack Platform 上部署和管理受支持的 Red Hat OpenShift Container Platform 集群。

注: 在使用 multicluster engine operator 创建集群前,您必须为 Red Hat OpenStack Platform 创建凭证。

1.6.5.1. 先决条件

创建凭证前必须满足以下先决条件:

- 在受支持的 OpenShift Container Platform 版本上部署的 hub 集群。

- 可通过互联网访问 hub 集群,以便它在 Red Hat OpenStack Platform 上创建 Kubernetes 集群。

- 使用安装程序置备的基础架构时,为 OpenShift Container Platform 配置 Red Hat OpenStack Platform 登录凭证和 Red Hat OpenStack Platform 要求。请参阅使用自定义配置在 OpenStack 上安装集群。

下载或创建

clouds.yaml文件来访问 CloudStack API。在clouds.yaml文件中:- 确定要使用的云身份验证部分名称。

- 在 username 行后马上添加一个 password 行。

1.6.5.2. 使用控制台管理凭证

要从 multicluster engine operator 控制台创建凭证,请完成控制台中的步骤。

从导航菜单开始。单击 Credentials 以从现有凭证选项中进行选择。要增强安全性和方便性,您可以创建一个命名空间,专门用于托管凭证。

- 可选:您可以为凭证添加基本 DNS 域。如果您添加了基本 DNS 域,则在使用此凭证创建集群时,会自动填充到正确的字段中。

-

添加 Red Hat OpenStack Platform

cloud.yaml文件内容。clouds.yaml文件的内容(包括密码)提供了连接到 Red Hat OpenStack Platform 服务器所需的信息。文件内容必须包含密码,它是一个紧接在username后面的一个新行。 -

添加您的 Red Hat OpenStack Platform 名称。此条目是在

clouds.yaml的 cloud 部分中指定的名称,用于建立与 Red Hat OpenStack Platform 服务器的通信。 -

可选 : 对于使用内部证书颁发机构的配置,请在 Internal CA certificate 字段中输入您的证书,以使用证书信息自动更新

clouds.yaml。 只用于断开连接的安装:使用所需信息完成 Configuration for disconnected installation 子字段:

- Cluster OS image:此值包含用于 Red Hat OpenShift Container Platform 集群机器的镜像的 URL。

镜像内容源:此值包含断开连接的 registry 路径。该路径包含所有用于断开连接的安装镜像的主机名、端口和库路径。示例:

repository.com:5000/openshift/ocp-release。该路径会在

install-config.yaml中创建一个到 Red Hat OpenShift Container Platform 发行镜像的镜像内容源策略映射。例如,repository.com:5000生成此imageContentSource内容:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Additional trust bundle:此值提供访问镜像 registry 所需的证书文件内容。

注: 如果您要从断开连接的环境中的一个 hub 部署受管集群,并希望在安装后自动导入它们,使用

YAML编辑器将镜像内容源策略添加到install-config.yaml文件中。以下示例中显示了一个示例:- mirrors: - registry.example.com:5000/rhacm2 source: registry.redhat.io/rhacm2

- mirrors: - registry.example.com:5000/rhacm2 source: registry.redhat.io/rhacm2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

如果要启用代理,请输入代理信息:

-

HTTP 代理 URL:用作

HTTP流量的代理的 URL。 -

HTTPS 代理 URL:用于

HTTPS流量的安全代理 URL。如果没有提供值,则使用相同的值HTTP Proxy URL,用于HTTP和HTTPS。 -

无代理域:应当绕过代理的以逗号分隔的域列表。使用一个句点 (

.) 开始的域名,包含该域中的所有子域。添加一个星号*以绕过所有目的地的代理。 - 其他信任捆绑包:代理 HTTPS 连接所需的一个或多个额外 CA 证书。

-

HTTP 代理 URL:用作

- 输入 Red Hat OpenShift pull secret。请参阅下载 Red Hat OpenShift pull secret 以下载您的 pull secret。

- 添加可让您连接到集群的 SSH 私钥和 SSH 公钥。您可以使用现有密钥对,或使用密钥生成程序创建新密钥对。

- 点 Create。

- 查看新凭据信息,然后单击 Add。添加凭证时,会将其添加到凭证列表中。

要创建使用此凭证的集群,您可以完成在 Red Hat OpenStack Platform 上创建集群中的步骤。

您可以在控制台中编辑凭证。

当您不再管理使用凭证的集群时,请删除凭证来保护凭证中的信息。选择要批量删除的 Actions,或者选择您要删除的凭证旁边的选项菜单。

1.6.5.3. 使用 API 创建不透明的 secret

要使用 API 而不是控制台为 Red Hat OpenStack Platform 创建不透明 secret,请在类似以下示例的 YAML preview 窗口中应用 YAML 内容:

备注:

- Opaque secret 在控制台中是不可见的。

- 不透明 secret 在您选择的受管集群命名空间中创建。Hive 使用 opaque secret 来置备集群。当使用 Red Hat Advanced Cluster Management 控制台置备集群时,您预先创建的凭证将复制到受管集群命名空间中,作为 opaque secret。

1.6.5.4. 其他资源

1.6.6. 为 Red Hat OpenShift Cluster Manager 创建凭证

添加 OpenShift Cluster Manager 凭证,以便您可以发现集群。

需要的访问权限: Administrator

1.6.6.1. 先决条件

您需要 OpenShift Cluster Manager 帐户的 API 令牌,也可以使用单独的服务帐户。

- 要获取 API 令牌,请参阅 下载 OpenShift Cluster Manager API 令牌。

- 要使用服务帐户,您必须在创建服务帐户时获取客户端 ID 和客户端 secret。输入凭证以在 Kubernetes operator 的多集群引擎上创建 OpenShift Cluster Manager 凭证。请参阅创建和管理服务帐户。

1.6.6.2. 使用控制台添加凭证

您需要添加凭证来发现集群。要从 multicluster engine operator 控制台创建凭证,请完成控制台中的步骤:

- 登录到您的集群。

- 点 Credentials > Credential type 以从现有凭证选项中选择。

- 为方便起见,同时为了提高安全性,创建一个命名空间,专门用于托管您的凭证。

- 单击 Add credential。

- 选择 Red Hat OpenShift Cluster Manager 选项。

- 选择身份验证方法之一。

备注:

- 当您不再管理使用凭证的集群时,请删除凭证来保护凭证中的信息。

- 如果您的凭证被删除,或者 OpenShift Cluster Manager API 令牌已过期或被撤销,则会删除相关的发现集群。

1.6.7. 为 Ansible Automation Platform 创建凭证

您需要一个凭证才能使用多集群引擎 operator 控制台来部署和管理使用 Red Hat Ansible Automation Platform 的 Red Hat OpenShift Container Platform 集群。

需要的访问权限: Edit

注:必须在创建 Automation 模板前完成此步骤,以便在集群中启用自动化。

1.6.7.1. 先决条件

创建凭证前必须满足以下先决条件:

- 已部署多集群引擎 operator hub 集群

- 多集群引擎 operator hub 集群的互联网访问

- Ansible 登录凭证,其中包括 Ansible Automation Platform 主机名和 OAuth 令牌;请参阅 Ansible Automation Platform 的凭证。

- 允许您安装 hub 集群并使用 Ansible 的帐户权限。了解有关 Ansible 用户的更多信息。

1.6.7.2. 使用控制台管理凭证

要从 multicluster engine operator 控制台创建凭证,请完成控制台中的步骤。

从导航菜单开始。单击 Credentials 以从现有凭证选项中进行选择。提示: 为方便起见,同时为了提高安全性,创建一个命名空间,专门用于托管您的凭证。

您在创建 Ansible 凭据时提供的 Ansible 令牌和主机 URL 会自动更新,以便在您编辑凭据时使用该凭据的自动化。更新复制到任何使用 Ansible 凭据的自动化中,包括与集群生命周期、监管和应用程序管理自动化相关的自动化。这可确保自动化在更新凭证后继续运行。

您可以在控制台中编辑凭证。Ansible 凭据在自动化中自动更新,您在凭据中更新该凭据时使用该凭据。

要创建使用此凭证的 Ansible 作业,您可以完成配置 Ansible Automation Platform 任务以在受管集群上运行的步骤。

当您不再管理使用凭证的集群时,请删除凭证来保护凭证中的信息。选择要批量删除的 Actions,或者选择您要删除的凭证旁边的选项菜单。

1.6.8. 为内部环境创建凭证

您需要一个凭证才能使用控制台在内部环境中部署和管理 Red Hat OpenShift Container Platform 集群。凭证指定用于集群的连接。

需要的访问权限: Edit

1.6.8.1. 先决条件

创建凭证前需要满足以下先决条件:

- 已部署 hub 集群。

- 可通过互联网访问 hub 集群,以便它在基础架构环境中创建 Kubernetes 集群。

- 对于断开连接的环境,您必须配置了一个镜像 registry,您可以在其中复制发行镜像以进行集群创建。如需更多信息,请参阅 OpenShift Container Platform 文档中的 断开连接的安装镜像。

- 支持在内部环境中安装集群的帐户权限。

1.6.8.2. 使用控制台管理凭证

要从控制台创建凭证,请完成控制台中的步骤。

从导航菜单开始。单击 Credentials 以从现有凭证选项中进行选择。提示: 为方便起见,同时为了提高安全性,创建一个命名空间,专门用于托管您的凭证。

- 为您的凭证类型选择 Host inventory。

- 您可以选择为您的凭证添加基本 DNS 域。如果您将基本 DNS 域添加到凭证中,则在使用此凭证创建集群时,会自动填充到正确的字段中。如果没有添加 DNS 域,您可以在创建集群时添加它。

- 输入您的 Red Hat OpenShift pull secret。创建集群时会自动输入此 pull secret 并指定此凭证。您可以从 Pull secret 下载 pull secret。如需有关 pull secret 的更多信息,请参阅使用镜像 pull secret。

-

输入您的

SSH 公钥。创建集群时,也会自动输入此SSH 公钥并指定此凭证。 - 选择 Add 来创建您的凭证。

要创建使用此凭证的集群,您可以完成在内部环境中创建集群中的步骤。

当您不再管理使用凭证的集群时,请删除凭证来保护凭证中的信息。选择要批量删除的 Actions,或者选择您要删除的凭证旁边的选项菜单。

1.7. 集群生命周期简介

multicluster engine operator 是集群生命周期 Operator,它为 OpenShift Container Platform 和 Red Hat Advanced Cluster Management hub 集群提供集群管理功能。multicluster engine operator 是一个软件 Operator,它增强了集群集管理,并支持跨云和数据中心的 OpenShift Container Platform 集群生命周期管理。您可以在没有 Red Hat Advanced Cluster Management 的情况下使用 multicluster engine operator。Red Hat Advanced Cluster Management 还自动安装多集群引擎 operator,并提供进一步的多集群功能。

请参阅以下文档:

1.7.1. 集群生命周期架构

集群生命周期需要两种类型的集群:hub 集群和受管集群。

hub 集群是带有 multicluster engine operator 的 OpenShift Container Platform (或 Red Hat Advanced Cluster Management)主集群。您可以使用 hub 集群创建、管理和监控其他 Kubernetes 集群。您可以使用 hub 集群创建集群,同时也可以导入现有集群由 hub 集群管理。

在创建受管集群时,集群会使用 Hive 资源的 Red Hat OpenShift Container Platform 集群安装程序创建集群。您可以通过阅读 OpenShift Container Platform 文档中的安装 概述 来找到有关使用 OpenShift Container Platform 安装程序安装集群的过程的更多信息。

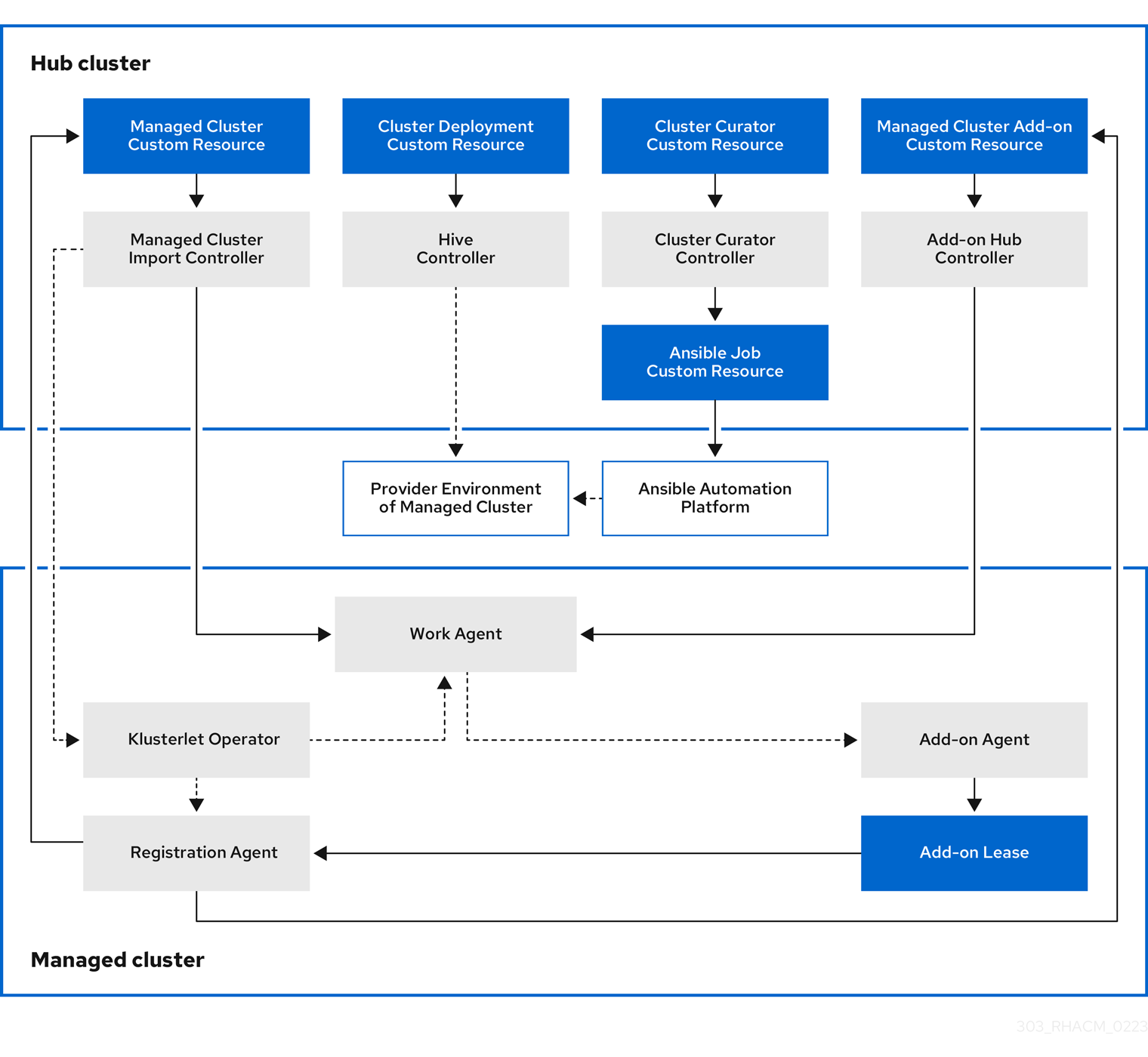

下图显示了为集群管理的 multicluster engine 安装的组件:

集群生命周期管理架构的组件包括以下项目:

1.7.1.1. hub 集群

- 受管集群导入控制器将 klusterlet Operator 部署到受管集群。

- Hive 控制器使用 Kubernetes operator 的多集群引擎置备您创建的集群。Hive Controller 还销毁由 Kubernetes operator 的多集群引擎创建的受管集群。

- 集群 curator 控制器将 Ansible 作业创建为 pre-hook 或 post-hook,以便在创建或升级受管集群时配置集群基础架构环境。

- 当在 hub 集群中启用了受管集群附加组件时,会在 hub 集群中部署其 附加组件 hub 控制器。附加组件 hub 控制器将附加组件代理 部署到受管集群。

1.7.1.2. 受管集群(managed cluster)

- klusterlet Operator 在受管集群中部署注册和工作控制器。

Registration Agent 将受管集群和受管集群附加组件注册到 hub 集群。Registration Agent 还维护受管集群和受管集群附加组件的状态。以下权限会在 Clusterrole 中自动创建,以允许受管集群访问 hub 集群:

- 允许代理获取或更新 hub 集群管理的所有权集群

- 允许代理更新 hub 集群管理的拥有集群状态

- 允许代理轮转其证书

-

允许代理

get或updatecoordination.k8s.io租期 -

允许代理

get受管集群附加组件 - 允许代理更新其受管集群附加组件的状态

- 工作代理将 Add-on Agent 应用到受管集群。允许受管集群访问 hub 集群的权限会在 Clusterrole 中自动创建,并允许代理向 hub 集群发送事件。

要继续添加和管理集群,请参阅集群生命周期简介。

1.7.2. 发行镜像

构建集群时,请使用发行镜像指定的 Red Hat OpenShift Container Platform 版本。默认情况下,OpenShift Container Platform 使用 clusterImageSets 资源来获取支持的发行镜像列表。

继续阅读以了解更多有关发行镜像的信息:

1.7.2.1. 指定发行镜像

当使用 multicluster engine for Kubernetes operator 在供应商处创建集群时,请指定用于新集群的发行镜像。要指定发行镜像,请参阅以下主题:

1.7.2.1.1. 查找 ClusterImageSets

引用发行镜像的 YAML 文件在 acm-hive-openshift-releases GitHub 仓库中维护。这些文件用于在控制台中创建可用发行镜像的列表。这包括 OpenShift Container Platform 的最新快速频道镜像。

控制台仅显示三个 OpenShift Container Platform 最新版本的最新发行镜像。例如,您可能在控制台选项中看到以下发行镜像:

quay.io/openshift-release-dev/ocp-release:4.15.1-x86_64

控制台会显示最新版本,以帮助您使用最新发行镜像创建集群。如果您需要创建特定版本的集群,也可使用旧的发行镜像版本。

注: 您只能在控制台中创建集群时选择带有 visible: 'true' 标签的镜像。ClusterImageSet 资源中的此标签示例在以下内容中提供。将 4.x.1 替换为该产品的当前版本: