2.14. Ceph 重新平衡和恢复

当管理员添加 Ceph OSD 到 Ceph 存储集群时,Ceph 将更新 cluster map。这会更改 cluster map 也会改变对象放置,因为修改后的群集映射也会更改 CRUSH 计算的输入。CRUSH 平均放置数据,但随机放置.因此,当管理员添加新 OSD 时,只有少量数据移动。数据量通常是新 OSD 的数量划分为集群中的数据总量。例如,在具有 50 个 OSD 的集群中,在添加 OSD 时可能会移动 1/50th 或 2% 的数据。

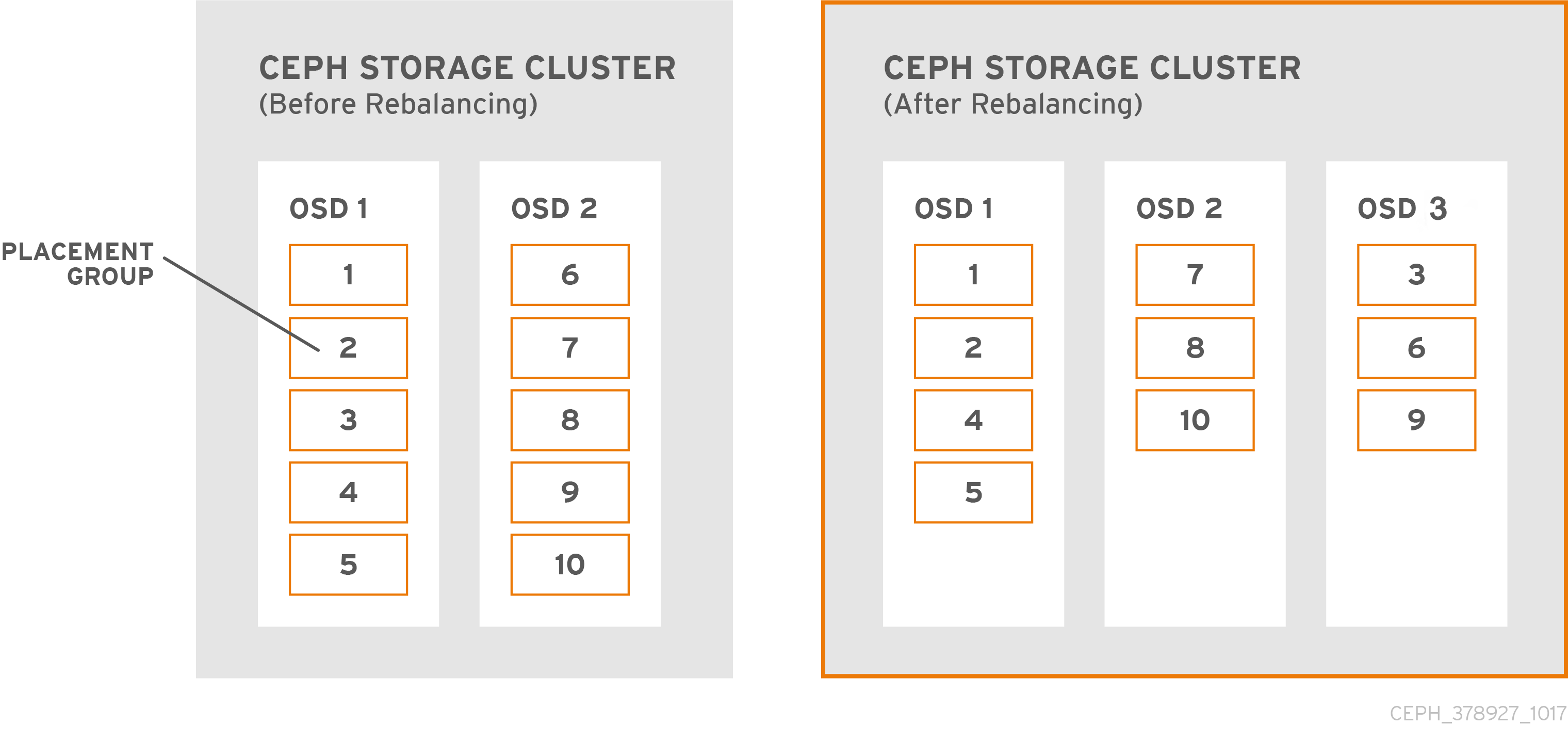

下图说明了重新平衡过程,其中部分(但不是所有)PG 从示意图中现有的 OSD 1 和 2 迁移到示意图中的新 OSD OSD 3。即使重新平衡,CRUSH 仍然稳定。许多 PG 保留在原始配置中,每个 OSD 都会添加一些容量,因此新的 OSD 在集群重新平衡后不会出现负载高峰。