5.2. 运行从 Python 代码生成的数据科学管道

在上一节中,您可以使用 GUI 管道编辑器创建一个简单的管道。通常,使用可以版本控制和与他人共享的代码创建管道。Kubeflow 管道(kfp) SDK 为创建管道提供了一个 Python API。SDK 可作为 Python 软件包提供,您可以使用 pip install kfp 命令安装。使用这个软件包,您可以使用 Python 代码创建管道,然后将其编译为 YAML 格式。然后,您可以将 YAML 代码导入到 OpenShift AI 中。

本教程不描述如何使用 SDK 的详细信息。相反,它为您提供了查看和上传的文件。

(可选)通过导航到

fraud-detection-notebooks项目的管道目录来查看 JupyterLab 环境中提供的 Python 代码。它包含以下文件:-

7_get_data_train_upload.py是主管道代码。 build.sh是一个构建管道并创建 YAML 文件的脚本。为方便起见,

build.sh脚本的输出在7_get_data_train_upload.yaml文件中提供。7_get_data_train_upload.yaml输出文件位于顶级fraud-detection目录中。

-

-

右键点击

7_get_data_train_upload.yaml文件,然后点 Download。 将

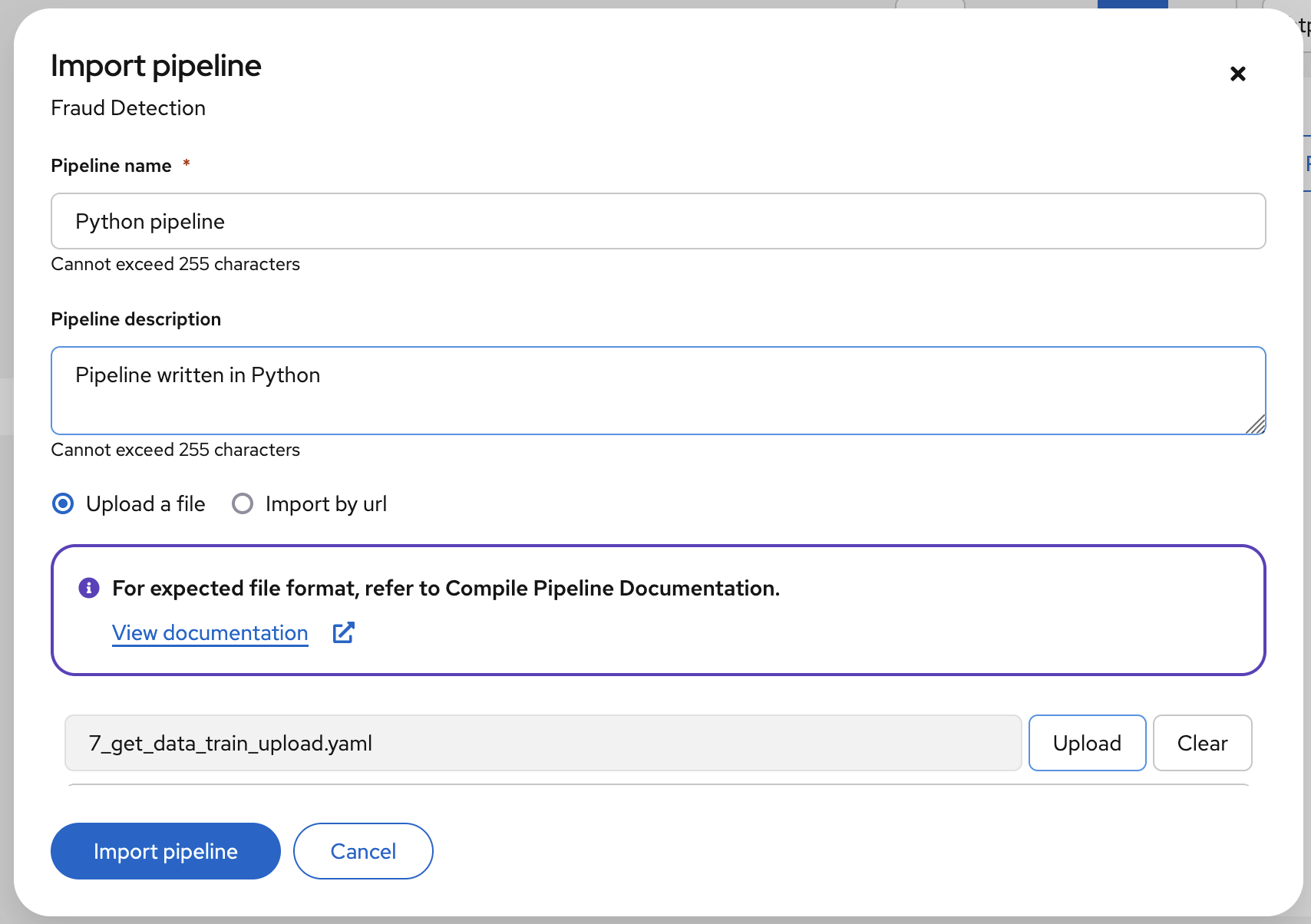

7_get_data_train_upload.yaml文件上传到 OpenShift AI。- 在 OpenShift AI 仪表板中,导航到您的数据科学项目页面。点 Pipelines 选项卡,然后点 Import pipeline。

- 输入 Pipeline 名称和 Pipeline 描述 的值。

点 Upload,然后从您的本地文件选择

7_get_data_train_upload.yaml来上传管道。点 Import pipeline 导入并保存管道。

管道显示在图形视图中。

-

选择 Actions

Create run。 在 Create run 页面中,提供以下值:

-

对于 Experiment,请将值

保留为默认值。 -

对于" 名称 ",请输入任何名称,例如

Run 1。 对于 Pipeline,选择您上传的管道。

您可以将其他字段保留为默认值。

-

对于 Experiment,请将值

点 Create run 创建运行。

新的运行立即启动。