3.3. Apache Kafka 的接收器

Apache Kafka sink 是集群中启用了 Apache Kafka 时可用的事件 sink 类型。您可以使用 Kafka sink 将事件从事件源发送到 Kafka 主题。

3.3.1. 使用 YAML 创建 Apache Kafka sink

您可以创建一个 Kafka 接收器将事件发送到 Kafka 主题。默认情况下,Kafka sink 使用二进制内容模式,其效率比结构化模式更高效。要使用 YAML 创建 Kafka sink,您必须创建一个 YAML 文件来定义 KafkaSink 对象,然后使用 oc apply 命令应用它。

先决条件

-

在集群中安装了 OpenShift Serverless Operator、Knative Eventing 和

KnativeKafka自定义资源 (CR) 。 - 您已创建了一个项目,或者具有适当的角色和权限访问项目,以便在 OpenShift Container Platform 中创建应用程序和其他工作负载。

- 您可以访问 Red Hat AMQ Streams(Kafka)集群,该集群会生成您要导入的 Kafka 信息。

-

安装 OpenShift CLI (

oc) 。

流程

创建一个

KafkaSink对象定义作为一个 YAML 文件:Kafka sink YAML

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要创建 Kafka sink,请应用

KafkaSinkYAML 文件:oc apply -f <filename>

$ oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 配置事件源,以便在其 spec 中指定 sink:

连接到 API 服务器源的 Kafka sink 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

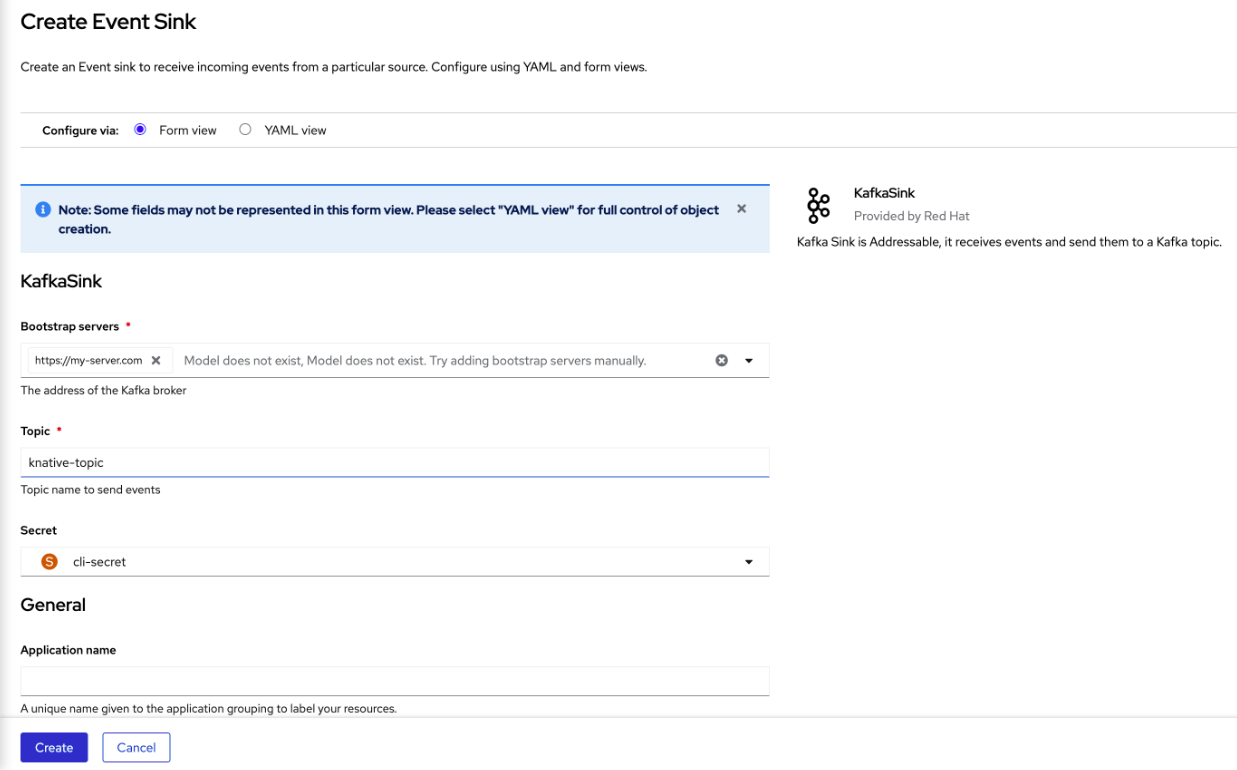

您可以使用 OpenShift Container Platform Web 控制台中的 Developer 视角创建一个 Kafka 接收器将事件发送到 Kafka 主题。默认情况下,Kafka sink 使用二进制内容模式,其效率比结构化模式更高效。

作为开发人员,您可以创建一个事件 sink 来从特定源接收事件并将其发送到 Kafka 主题。

先决条件

- 您已从 OperatorHub 安装了带有 Knative Serving、Knative Eventing 和 Knative 代理的 OpenShift Serverless Operator。

- 您已在 Kafka 环境中创建了一个 Kafka 主题。

流程

- 在 Developer 视角中,进入到 +Add 视图。

- 点 Eventing 目录中的 Event Sink。

-

在目录项中搜索

KafkaSink并点它。 - 点 Create Event Sink。

在表单视图中,键入 bootstrap 服务器的 URL,这是主机名和端口的组合。

- 键入要发送事件数据的主题名称。

- 键入事件 sink 的名称。

- 点 Create。

验证

- 在 Developer 视角中,进入 Topology 视图。

- 点创建的事件 sink 在右侧面板中查看其详情。

3.3.3. 为 Apache Kafka sink 配置安全性

Apache Kafka 客户端和服务器使用 传输层安全性 (TLS) 来加密 Knative 和 Kafka 之间的流量,以及用于身份验证。TLS 是 Apache Kafka 的 Knative 代理实现唯一支持的流量加密方法。

Apache Kafka 使用 简单身份验证和安全层 (SASL) 进行身份验证。如果在集群中使用 SASL 身份验证,用户则必须向 Knative 提供凭证才能与 Kafka 集群通信,否则无法生成或消耗事件。

先决条件

-

OpenShift Serverless Operator、Knative Eventing 和

KnativeKafka自定义资源(CR)已安装在 OpenShift Container Platform 集群中。 -

在

KnativeKafkaCR 中启用了 Kafka sink。 - 您已创建了一个项目,或者具有适当的角色和权限访问项目,以便在 OpenShift Container Platform 中创建应用程序和其他工作负载。

-

您有一个 Kafka 集群 CA 证书存储为一个

.pem文件。 -

您有一个 Kafka 集群客户端证书,并存储为

.pem文件的密钥。 -

已安装 OpenShift (

oc) CLI。 -

您已选择使用 SASL 机制,例如

PLAIN、SCRAM-SHA-256或SCRAM-SHA-512。

流程

在与

KafkaSink对象相同的命名空间中创建一个 secret:重要证书和密钥必须采用 PEM 格式。

对于使用 SASL 时没有加密的身份验证:

oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SASL_PLAINTEXT \ --from-literal=sasl.mechanism=<sasl_mechanism> \ --from-literal=user=<username> \ --from-literal=password=<password>

$ oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SASL_PLAINTEXT \ --from-literal=sasl.mechanism=<sasl_mechanism> \ --from-literal=user=<username> \ --from-literal=password=<password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 对于使用 TLS 的 SASL 和加密进行身份验证:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果您使用公共云管理的 Kafka 服务,可以省略

ca.crt来使用系统的 root CA 设置。

使用 TLS 进行身份验证和加密:

oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SSL \ --from-file=ca.crt=<my_caroot.pem_file_path> \ --from-file=user.crt=<my_cert.pem_file_path> \ --from-file=user.key=<my_key.pem_file_path>

$ oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SSL \ --from-file=ca.crt=<my_caroot.pem_file_path> \1 --from-file=user.crt=<my_cert.pem_file_path> \ --from-file=user.key=<my_key.pem_file_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果您使用公共云管理的 Kafka 服务,可以省略

ca.crt来使用系统的 root CA 设置。

创建或修改

KafkaSink对象,并在authspec 中添加对 secret 的引用:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 应用

KafkaSink对象:oc apply -f <filename>

$ oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow