节点

Red Hat OpenShift Service on AWS 节点

摘要

第 1 章 节点概述

1.1. 关于节点

节点是 Kubernetes 集群中的虚拟机或裸机。Worker 节点托管您的应用程序容器,分组为 pod。control plane 节点运行控制 Kubernetes 集群所需的服务。在 Red Hat OpenShift Service on AWS 中,control plane 节点托管在红帽拥有的 AWS 帐户中。红帽为您完全管理 control plane 基础架构。

Worker 节点无法保证长远,可能随时替换,作为 OpenShift 的正常操作和管理的一部分。如需了解更多详细信息,请参阅 节点生命周期。

在集群中运行稳定和健康的节点是基本运行托管应用程序的基本操作。在 Red Hat OpenShift Service on AWS 中,您可以通过代表节点的 Node 对象访问、管理和监控节点。使用 OpenShift CLI(oc)或 Web 控制台,您可以在节点上执行以下操作。

节点的以下组件负责维护运行 pod 并提供 Kubernetes 运行时环境。

- 容器运行时

- 容器运行时负责运行容器。Red Hat OpenShift Service on AWS 在集群中的每个 Red Hat Enterprise Linux CoreOS (RHCOS)节点上部署 CRI-O 容器运行时。Windows Machine Config Operator (WMCO)在其 Windows 节点上部署容器运行时。

- Kubelet

- kubelet 在节点上运行并读取容器清单。它确保定义的容器已启动且正在运行。kubelet 进程维护工作和节点服务器的状态。kubelet 管理网络流量和端口转发。kubelet 管理仅由 Kubernetes 创建的容器。

- DNS

- 集群 DNS 是一个 DNS 服务器,它为 Kubernetes 服务提供 DNS 记录。由 Kubernetes 启动的容器会在其 DNS 搜索中自动包含此 DNS 服务器。

1.1.1. 读取操作

通过读取操作,管理员可以或开发人员获取 Red Hat OpenShift Service on AWS 集群中节点的信息。

- 列出集群中的所有节点。

- 获取节点的相关信息,如内存和 CPU 使用量、健康、状态和年龄。

- 列出节点上运行的 pod。

1.1.2. 增强操作

Red Hat OpenShift Service on AWS 为您提供不仅仅是访问和管理节点的权限;作为管理员,您可以在节点上执行以下任务,使集群更高效、应用程序友好,并为开发人员提供更好的环境。

- 使用 Node Tuning Operator,为需要一定等级内核调整的高性能应用程序管理节点级别的性能优化。

- 使用守护进程集在节点上自动运行后台任务。您可以创建并使用守护进程集来创建共享存储,在每个节点上运行日志记录 pod,或者在所有节点上部署监控代理。

1.2. 关于 pod

pod 是节点上共同部署的一个或多个容器。作为集群管理员,您可以定义 pod,为它分配在准备好调度和管理的健康节点上运行。只要容器正在运行,pod 就会运行。在 Pod 被定义并运行后,您无法更改它。使用 pod 时,您可以执行的一些操作包括:

1.2.1. 读取操作

作为管理员,您可以通过以下任务来获取项目中的 pod 信息:

- 列出与项目关联的 pod,包括副本数、重启、当前状态和年龄等信息。

- 查看 pod 用量统计,如 CPU、内存和存储消耗。

1.2.2. 管理操作

以下任务列表概述了管理员如何在 Red Hat OpenShift Service on AWS 集群中管理 pod。

使用 Red Hat OpenShift Service on AWS 中提供的高级调度功能控制 pod 调度:

- 节点到 pod 的绑定规则,如 pod 关联性、节点关联性 和 反关联性。

- 节点标签和选择器。

- Pod 拓扑分布约束。

- 配置 pod 如何使用 pod 控制器重启后的行为,然后重新启动策略。

- 限制 pod 上的出口和入口流量。

- 从具有 pod 模板的任何对象中添加和移除卷。卷是 pod 中所有容器使用的已挂载文件系统。容器存储是临时的;您可以使用卷来持久保留容器数据。

1.2.3. 增强操作

您可以使用 Red Hat OpenShift Service on AWS 中提供的各种工具和功能,更轻松地使用 pod。以下操作涉及使用这些工具和功能来更好地管理 pod。

-

Secrets:有些应用程序需要敏感信息,如密码和用户名。管理员可以使用

Secret对象为 pod 提供机密数据,使用Secret对象。

1.3. 关于容器

容器是 Red Hat OpenShift Service on AWS 应用程序的基本单元,它由应用程序代码与其依赖项、库和二进制文件一起打包。容器提供不同环境间的一致性和多个部署目标:物理服务器、虚拟机 (VM) 和私有或公有云。

Linux 容器技术是一种轻量型机制,用于隔离运行中的进程,仅限制对指定的资源的访问。作为管理员,您可以在 Linux 容器上执行各种任务,例如:

Red Hat OpenShift Service on AWS 提供了一个名为 Init containers 的专用容器。init 容器在应用程序容器之前运行,可以包含应用程序镜像中不存在的工具或设置脚本。您可以在部署 pod 的其余部分之前,使用 Init 容器执行任务。

除了在节点、Pod 和容器上执行特定的任务外,您还可以与整个 Red Hat OpenShift Service on AWS 集群一起使用,以保持集群高效和应用程序 pod 具有高可用性。

1.4. Red Hat OpenShift Service on AWS 节点的常用术语表

该术语表定义了在节点内容中使用的常用术语。

- Container

- 它是一个轻量级且可执行的镜像,它包括了软件及其所有依赖项。容器虚拟化操作系统,因此您可以在任意位置运行容器,包括数据中心到公共或私有云,甚至在开发人员笔记本电脑中运行。

- 守护进程集

- 确保 pod 副本在 Red Hat OpenShift Service on AWS 集群的合格节点上运行。

- egress

- 通过来自 pod 的网络出站流量进行外部数据共享的过程。

- 垃圾回收

- 清理集群资源的过程,如终止的容器和未被任何正在运行的 Pod 引用的镜像。

- 入口

- 到一个 pod 的传入流量。

- 作业

- 要完成的进程。作业创建一个或多个 pod 对象,并确保指定的 pod 成功完成。

- 标签

- 您可以使用标签(即键值对)来组织并选择对象子集,如 pod。

- 节点

- Red Hat OpenShift Service on AWS 集群中的 worker 机器。节点可以是虚拟机 (VM) 或物理机器。

- Node Tuning Operator

- 您可以使用 Node Tuning Operator,使用 TuneD 守护进程来管理节点级别的性能优化。它保证了自定义性能优化设置以可被守护进程支持的格式传递到在集群中运行的所有容器化的 TuneD 守护进程中。相应的守护进程会在集群的所有节点上运行,每个节点上运行一个。

- 自助服务修复 Operator

- Operator 在集群节点上运行,并检测和重启不健康的节点。

- Pod

- 在 Red Hat OpenShift Service on AWS 集群中运行的一个或多个带有共享资源(如卷和 IP 地址)的容器。pod 是定义、部署和管理的最小计算单元。

- 容限(toleration)

- 表示 pod 允许(但不需要)调度到具有匹配污点的节点组。您可以使用容限来启用调度程序来调度具有匹配污点的 pod。

- 污点(taint)

- 一个核心对象,由一个键、值和效果组成。污点和容限可以一起工作,以确保 pod 不会调度到不相关的节点上。

第 2 章 使用 pod

2.1. 使用 pod

pod 是共同部署在同一主机上的一个或多个容器,也是可被定义、部署和管理的最小计算单元。

2.1.1. 了解 pod

对容器而言,Pod 大致相当于一个机器实例(物理或虚拟)。每个 pod 分配有自己的内部 IP 地址,因此拥有完整的端口空间,并且 pod 内的容器可以共享其本地存储和网络。

Pod 有生命周期,它们经过定义后,被分配到某一节点上运行,然后持续运行,直到容器退出或它们因为其他原因被删除为止。根据策略和退出代码,Pod 可在退出后删除,或被保留下来以启用对容器日志的访问。

Red Hat OpenShift Service on AWS 将 pod 视为不可变,在 pod 运行时无法对 pod 定义进行更改。Red Hat OpenShift Service on AWS 通过终止现有的 pod 并使用修改后的配置、基础镜像或两者重新创建它来实现更改。Pod 也被视为是可抛弃的,不会在重新创建时保持原来的状态。因此,pod 通常应通过更高级别的控制器来管理,而不直接由用户管理。

不受复制控制器管理的裸机 pod 不能在节点中断时重新调度。

2.1.2. pod 配置示例

Red Hat OpenShift Service on AWS 利用 Kubernetes 的 pod 概念,它是共同部署在同一主机上的一个或多个容器,也是可被定义、部署和管理的最小计算单元。

以下是 pod 的示例定义。它展示了 pod 的许多特性,其中大多数已在其他主题中阐述,因此这里仅简略提及:

Pod 对象定义(YAML)

- 1

- pod 可以被“标上”一个或多个标签,然后使用这些标签在一个操作中选择和管理多组 pod。标签以键/值格式保存在

metadata散列中。 - 2

- pod 重启策略,可能的值有

Always、OnFailure和Never。默认值为Always。 - 3

- Red Hat OpenShift Service on AWS 为容器定义了一个安全上下文,指定是否允许其作为特权容器运行,以所选用户身份运行,等等。默认上下文的限制性比较强,但管理员可以根据需要进行修改。

- 4

containers指定包括一个或多个容器定义的数组。- 5

- 容器指定在容器中挂载外部存储卷的位置。

- 6

- 指定要为 pod 提供的卷。卷挂载在指定路径上。不要挂载到容器 root、

/或主机和容器中相同的任何路径。如果容器有足够权限,可能会损坏您的主机系统(如主机的/dev/pts文件)。使用/host挂载主机是安全的。 - 7

- pod 中的每个容器使用自己的容器镜像进行实例化。

- 8

- pod 定义了可供其容器使用的存储卷。

如果将具有高文件数的持久性卷附加到 pod,则这些 pod 可能会失败,或者可能需要很长时间才能启动。如需更多信息,请参阅在 OpenShift 中使用具有高文件计数的持久性卷时,为什么 pod 无法启动或占用大量时间来实现"Ready"状态?

此 pod 定义不包括在 Pod 创建并开始生命周期后,Red Hat OpenShift Service on AWS 填充的属性。Kubernetes pod 文档详细介绍了 pod 的功能和用途。

2.1.3. 了解资源请求和限值

您可以使用 pod 规格为 pod 指定 CPU 和内存请求和限值,如 "Example pod 配置" 或 pod 控制对象的规格所示。

CPU 和内存请求 指定 Pod 需要运行最少的资源,帮助 Red Hat OpenShift Service on AWS 在具有足够资源的节点上调度 pod。

CPU 和内存限值定义 pod 可消耗的资源的最大数量,防止 pod 消耗过多的资源,并可能影响同一节点上的其他 pod。

使用以下原则处理 CPU 和内存请求和限值:

使用 CPU 节流强制实施 CPU 限制。当容器接近其 CPU 限制时,内核会限制对指定为容器限制的 CPU 的访问。因此,CPU 限制是内核强制执行的硬限制。Red Hat OpenShift Service on AWS 可以允许容器长时间超过其 CPU 限值。但是,容器运行时不会终止过量使用 CPU 的 pod 或容器。

CPU 限制和请求以 CPU 单位计算。一个 CPU 单元相当于 1 个物理处理器内核,或者 1 个虚拟内核,具体取决于节点是物理主机还是在物理机中运行的虚拟机。允许部分请求。例如,当您为一个容器定义了 CPU 请求为

0.5,您请求的 CPU 时间是请求1.0CPU 的 CPU 时间的一半。对于 CPU 单元,0.1等同于100m,它可以被理解为 one hundred millicpu 或 one hundred millicores。CPU 资源始终是一个绝对数量的资源,而不是一个相对数量。注意默认情况下,可分配给 pod 的最小 CPU 量为 10 mCPU。您可以在 pod 规格中请求低于 10 mCPU 的资源限值。但是,pod 仍然会被分配 10 个 mCPU。

内存限制由内核通过 OOM(out of memory)kill 来强制实施。当容器使用超过其内存限值时,内核可以终止该容器。但是,只有在内核检测到内存压力时,才会终止。因此,过度分配内存的容器可能不会立即被终止。这意味着,内存限制被强制实现。容器可以使用比其内存限值更多的内存。如果存在,容器可能会被终止。

您可以使用这些数量后缀之一将内存表示为普通整数或固定点号:

E,P,T,G,M, 或k。您还可以使用两的指数:Ei,Pi,Ti,Gi,Mi, 或Ki。

如果运行 pod 的节点有足够的可用资源,则容器可以使用比请求更多的 CPU 或内存资源。但是,容器不能超过对应的限制。例如,如果您将容器内存请求设置为 256 MiB,并且该容器位于调度到具有 8GiB 内存且没有其他 pod 的节点的 pod 中,则容器可以尝试使用超过请求的 256 MiB 的内存。

这个行为不适用于 CPU 和内存限值。这些限制适用于 kubelet 和容器运行时,并由内核实施。在 Linux 节点上,内核使用 cgroups 强制实施限制。

2.2. 查看 pod

作为管理员,您可以查看集群 pod,检查其健康状况,并评估集群的整体健康状况。您还可以查看与特定项目关联的 pod 列表,或者查看 pod 的使用情况统计。定期查看 pod 可帮助您提早检测问题,跟踪资源使用量并确保集群稳定性。

2.2.1. 查看项目中的 pod

您可以显示 pod 用量统计,如 CPU、内存和存储消耗,以监控容器运行时环境并确保有效的资源使用。

流程

输入以下命令更改项目:

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令来获取 pod 列表:

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165m

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:添加

-o wide标志来查看 pod IP 地址和 pod 所在的节点。例如:oc get pods -o wide

$ oc get pods -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.2. 查看 pod 用量统计

您可以显示 pod 的用量统计,这些统计信息为容器提供了运行时环境。这些用量统计包括 CPU、内存和存储的消耗。

先决条件

-

您必须有

cluster-reader权限才能查看用量统计。 - 必须安装 Metrics 才能查看用量统计。

流程

输入以下命令来查看用量统计:

oc adm top pods -n <namespace>

$ oc adm top pods -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15Mi

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15MiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:添加--

selector=''标签来查看带有标签的 pod 的用量统计。请注意,您必须选择要过滤的标签查询,如=、==或!=。例如:oc adm top pod --selector='<pod_name>'

$ oc adm top pod --selector='<pod_name>'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.3. 查看资源日志

您可以在 OpenShift CLI (oc)或 Web 控制台中查看资源的日志。默认情况下,日志显示自末尾(或尾部)查看资源的日志可帮助您对问题进行故障排除并监控资源行为。

2.2.3.1. 使用 Web 控制台查看资源日志

使用以下步骤使用 Red Hat OpenShift Service on AWS Web 控制台查看资源日志。

流程

在 Red Hat OpenShift Service on AWS 控制台中,进入 Workloads → Pods,或通过您要调查的资源导航到 pod。

注意有些资源(如构建)没有直接查询的 pod。在这种情况下,您可以在资源的 Details 页面中找到 Logs 链接。

- 从下拉菜单中选择一个项目。

- 点您要调查的 pod 的名称。

- 点 Logs。

2.2.3.2. 使用 CLI 查看资源日志

使用以下步骤使用命令行界面(CLI)查看资源日志。

先决条件

-

访问 OpenShift CLI(

oc)。

流程

输入以下命令来查看特定 pod 的日志:

oc logs -f <pod_name> -c <container_name>

$ oc logs -f <pod_name> -c <container_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

-f- 可选:指定输出是否遵循要写到日志中的内容。

<pod_name>- 指定 pod 的名称。

<container_name>- 可选:指定容器的名称。当 pod 具有多个容器时,您必须指定容器名称。

例如:

oc logs -f ruby-57f7f4855b-znl92 -c ruby

$ oc logs -f ruby-57f7f4855b-znl92 -c rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令来查看特定资源的日志:

oc logs <object_type>/<resource_name>

$ oc logs <object_type>/<resource_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

oc logs deployment/ruby

$ oc logs deployment/rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. 为 pod 配置 Red Hat OpenShift Service on AWS 集群

作为管理员,您可以为 pod 创建和维护高效的集群。

通过确保集群高效运行,您可以使用一些工具为开发人员提供更好的环境,例如,pod 退出时的行为,确保始终有所需数量的 pod 在运行,何时重启设计为只运行一次的 pod,限制 pod 可以使用的带宽,以及如何在中断时让 pod 保持运行。

2.3.1. 配置 pod 重启后的行为

Pod 重启策略决定 Red Hat OpenShift Service on AWS 在该 pod 中的容器退出时如何响应。该策略适用于 pod 中的所有容器。

可能的值有:

-

Always- 在 pod 被重启之前,按规定的延时值(10s,20s,40s)不断尝试重启 pod 中成功退出的容器(最长为 5 分钟)。默认值为Always。 -

OnFailure- 按规定的延时值(10s,20s,40s)不断尝试重启 pod 中失败的容器,上限为 5 分钟。 -

Never- 不尝试重启 pod 中已退出或失败的容器。Pod 立即失败并退出。

在 pod 绑定到某个节点后,该 pod 永远不会绑定到另一个节点。这意味着,需要一个控制器才能使 pod 在节点失败后存活:

| 状况 | 控制器类型 | 重启策略 |

|---|---|---|

| 应该终止的 Pod(例如,批量计算) | 作业 |

|

| 不应该终止的 Pod(例如,Web 服务器) | 复制控制器 |

|

| 每台机器必须运行一个的 Pod | 守护进程集 | 任意 |

如果 pod 上的容器失败且重启策略设为 OnFailure,则 pod 会保留在该节点上并重新启动容器。如果您不希望容器重新启动,请使用 Never 重启策略。

如果整个 pod 失败,Red Hat OpenShift Service on AWS 会启动新的 pod。开发人员必须解决应用程序可能会在新 pod 中重启的情况。特别是,应用程序必须处理由以往运行产生的临时文件、锁定、不完整输出等结果。

Kubernetes 架构需要来自云提供商的可靠端点。当云供应商停机时,kubelet 会阻止 Red Hat OpenShift Service on AWS 重启。

如果底层云提供商端点不可靠,请不要使用云提供商集成来安装集群。应像在非云环境中一样安装集群。不建议在已安装的集群中打开或关闭云提供商集成。

如需了解 Red Hat OpenShift Service on AWS 如何使用带有失败容器的重启策略,请参阅 Kubernetes 文档中的示例状态。

2.3.2. 限制可供 pod 使用的带宽

您可以对 pod 应用服务质量流量控制,有效限制其可用带宽。出口流量(从 pod 传出)按照策略来处理,仅在超出配置的速率时丢弃数据包。入口流量(传入 pod 中)通过控制已排队数据包进行处理,以便有效地处理数据。您对 pod 应用的限制不会影响其他 pod 的带宽。

流程

限制 pod 的带宽:

编写对象定义 JSON 文件,并使用

kubernetes.io/ingress-bandwidth和kubernetes.io/egress-bandwidth注解指定数据流量速度。例如,将 pod 出口和入口带宽限制为 10M/s:受限

Pod对象定义Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用对象定义创建 pod:

oc create -f <file_or_dir_path>

$ oc create -f <file_or_dir_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.3. 了解如何使用 pod 中断预算来指定必须在线的 pod 数量

pod 中断预算允许在操作过程中指定 pod 的安全限制,如排空节点以进行维护。

PodDisruptionBudget 是一个 API 对象,用于指定在某一时间必须保持在线的副本的最小数量或百分比。在项目中进行这些设置对节点维护(比如缩减集群或升级集群)有益,而且仅在自愿驱除(而非节点失败)时遵从这些设置。

PodDisruptionBudget 对象的配置由以下关键部分组成:

- 标签选择器,即一组 pod 的标签查询。

可用性级别,用来指定必须同时可用的最少 pod 的数量:

-

minAvailable是必须始终可用的 pod 的数量,即使在中断期间也是如此。 -

maxUnavailable是中断期间可以无法使用的 pod 的数量。

-

Available 指的是具有 Ready=True 的 pod 数量。ready=True 指的是能够服务请求的 pod,并应添加到所有匹配服务的负载平衡池中。

允许 maxUnavailable 为 0% 或 0,minAvailable 为 100% 或等于副本数,但这样设置可能会阻止节点排空操作。

对于 Red Hat OpenShift Service on AWS 中的所有机器配置池,maxUnavailable 的默认设置是 1。建议您不要更改这个值,且一次只更新一个 control plane 节点。对于 control plane 池,请不要将这个值改为 3。

您可以使用以下命令来检查所有项目的 pod 中断预算:

oc get poddisruptionbudget --all-namespaces

$ oc get poddisruptionbudget --all-namespaces以下示例包含特定于 AWS 上的 Red Hat OpenShift Service 的一些值。

输出示例

如果系统中至少有 minAvailable 个 pod 正在运行,则 PodDisruptionBudget 被视为是健康的。超过这一限制的每个 pod 都可被驱除。

根据您的 pod 优先级与抢占设置,可能会无视 pod 中断预算要求而移除较低优先级 pod。

2.3.3.1. 使用 pod 中断预算指定必须在线的 pod 数量

您可以使用 PodDisruptionBudget 对象来指定某一时间必须保持在线的副本的最小数量或百分比。

流程

配置 pod 中断预算:

使用类似以下示例的对象定义来创建 YAML 文件:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 或者:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,将对象添加到项目中:

oc create -f </path/to/file> -n <project_name>

$ oc create -f </path/to/file> -n <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. 创建和使用配置映射

以下部分定义配置映射以及如何创建和使用它们。

2.5.1. 了解配置映射

许多应用程序需要使用配置文件、命令行参数和环境变量的某些组合来需要配置。在 Red Hat OpenShift Service on AWS 中,这些配置工件与镜像内容分离,以便使容器化应用程序可以移植。

ConfigMap 对象提供将容器注入配置数据的机制,同时保持容器与 Red Hat OpenShift Service on AWS 无关。配置映射可用于存储细粒度信息(如个别属性)或粗粒度信息(如完整配置文件或 JSON blob)。

ConfigMap 对象包含配置数据的键值对,这些数据可在 Pod 中消耗或用于存储控制器等系统组件的配置数据。例如:

ConfigMap 对象定义

从二进制文件(如镜像)创建配置映射时,您可以使用 binaryData 字段。

可以在 Pod 中以各种方式消耗配置数据。配置映射可用于:

- 在容器中填充环境变量值

- 设置容器中的命令行参数

- 填充卷中的配置文件

用户和系统组件可以在配置映射中存储配置数据。

配置映射与 secret 类似,但设计为能更加便捷地支持与不含敏感信息的字符串配合。

2.5.1.1. 配置映射限制

在 pod 中可以消耗它的内容前,必须创建配置映射。

可以编写控制器来容许缺少的配置数据。根据具体情况使用配置映射来参考各个组件。

ConfigMap 对象驻留在一个项目中。

它们只能被同一项目中的 pod 引用。

Kubelet 只支持为它从 API 服务器获取的 pod 使用配置映射。

这包括使用 CLI 创建或间接从复制控制器创建的 pod。它不包括使用 Red Hat OpenShift Service on AWS 节点的 --manifest-url 标志、its- config 标志或其 REST API 创建的 pod,因为这些不是创建 pod 的通用方法。

2.5.2. 在 Red Hat OpenShift Service on AWS Web 控制台中创建配置映射

您可以在 Red Hat OpenShift Service on AWS Web 控制台中创建配置映射。

流程

以集群管理员身份创建配置映射:

-

在 Administrator 视角中,选择

Workloads→Config Maps。 - 在该页面右上方选择 Create Config Map。

- 输入配置映射的内容。

- 选择 Create。

-

在 Administrator 视角中,选择

以开发者身份创建配置映射:

-

在 Developer 视角中,选择

Config Maps。 - 在该页面右上方选择 Create Config Map。

- 输入配置映射的内容。

- 选择 Create。

-

在 Developer 视角中,选择

2.5.3. 使用 CLI 创建配置映射

您可以使用以下命令从目录、特定文件或文字值创建配置映射。

流程

创建配置映射:

oc create configmap <configmap_name> [options]

$ oc create configmap <configmap_name> [options]Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.3.1. 从目录创建配置映射

您可以使用 --from-file 标志从目录创建配置映射。这个方法允许您使用目录中的多个文件来创建配置映射。

目录中的每个文件用于在配置映射中填充键,其中键的名称是文件名,键的值是文件的内容。

例如,以下命令会创建一个带有 example-files 目录内容的配置映射:

oc create configmap game-config --from-file=example-files/

$ oc create configmap game-config --from-file=example-files/查看配置映射中的密钥:

oc describe configmaps game-config

$ oc describe configmaps game-config输出示例

您可以看到,映射中的两个键都是从命令中指定的目录中的文件名创建的。这些密钥的内容可能非常大,因此 oc describe 的输出只显示键的名称及其大小。

前提条件

您必须有一个目录,其中包含您要使用填充配置映射的数据的文件。

以下流程使用这些示例文件:

game.properties和ui.properties:cat example-files/game.properties

$ cat example-files/game.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow cat example-files/ui.properties

$ cat example-files/ui.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNice

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNiceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

输入以下命令,创建包含此目录中每个文件内容的配置映射:

oc create configmap game-config \ --from-file=example-files/$ oc create configmap game-config \ --from-file=example-files/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

使用带有

-o选项的oc get命令以查看键的值:oc get configmaps game-config -o yaml

$ oc get configmaps game-config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.3.2. 从文件创建配置映射

您可以使用 --from-file 标志从文件创建配置映射。您可以多次将 --from-file 选项传递给 CLI。

您还可以通过将 key=value 表达式传递给 --from-file 选项,在配置映射中为从文件中导入的内容指定要设置的键。例如:

oc create configmap game-config-3 --from-file=game-special-key=example-files/game.properties

$ oc create configmap game-config-3 --from-file=game-special-key=example-files/game.properties

如果从文件创建一个配置映射,您可以在不会破坏非 UTF8 数据的项中包含非 UTF8 的数据。Red Hat OpenShift Service on AWS 会检测二进制文件,并透明地将文件编码为 MIME。在服务器上,MIME 有效负载被解码并存储而不会损坏数据。

前提条件

您必须有一个目录,其中包含您要使用填充配置映射的数据的文件。

以下流程使用这些示例文件:

game.properties和ui.properties:cat example-files/game.properties

$ cat example-files/game.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow cat example-files/ui.properties

$ cat example-files/ui.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNice

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNiceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

通过指定特定文件来创建配置映射:

oc create configmap game-config-2 \ --from-file=example-files/game.properties \ --from-file=example-files/ui.properties$ oc create configmap game-config-2 \ --from-file=example-files/game.properties \ --from-file=example-files/ui.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 通过指定键值对来创建配置映射:

oc create configmap game-config-3 \ --from-file=game-special-key=example-files/game.properties$ oc create configmap game-config-3 \ --from-file=game-special-key=example-files/game.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

使用

-o选项为对象输入oc get命令,以查看文件中的键值:oc get configmaps game-config-2 -o yaml

$ oc get configmaps game-config-2 -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

-o选项为对象输入oc get命令,以查看键值对中的键值:oc get configmaps game-config-3 -o yaml

$ oc get configmaps game-config-3 -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 这是您在前面的步骤中设置的密钥。

2.5.3.3. 从字面值创建配置映射

您可以为配置映射提供字面值。

--from-literal 选项采用 key=value 语法,它允许直接在命令行中提供字面值。

流程

通过指定字面值来创建配置映射:

oc create configmap special-config \ --from-literal=special.how=very \ --from-literal=special.type=charm$ oc create configmap special-config \ --from-literal=special.how=very \ --from-literal=special.type=charmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

使用带有

-o选项的oc get命令以查看键的值:oc get configmaps special-config -o yaml

$ oc get configmaps special-config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.4. 用例: 在 pod 中使用配置映射

以下小节描述了在 pod 中消耗 ConfigMap 对象时的一些用例。

2.5.4.1. 使用配置映射在容器中填充环境变量

您可以使用配置映射在容器中填充各个环境变量,或从构成有效环境变量名称的所有键填充容器中的环境变量。

例如,请考虑以下配置映射:

有两个环境变量的 ConfigMap

带有一个环境变量的ConfigMap

流程

您可以使用

configMapKeyRef部分在 pod 中使用此ConfigMap的键。配置为注入特定环境变量的

Pod规格示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 当此 pod 运行时,pod 日志包括以下输出:

SPECIAL_LEVEL_KEY=very log_level=INFO

SPECIAL_LEVEL_KEY=very log_level=INFOCopy to Clipboard Copied! Toggle word wrap Toggle overflow

示例输出中没有列出 SPECIAL_TYPE_KEY=charm,因为设置了 optional: true。

2.5.4.2. 使用配置映射为容器命令设置命令行参数

您可以通过 Kubernetes 替换语法 $(VAR_NAME),使用配置映射来设置容器中的命令或参数的值。

例如,请考虑以下配置映射:

流程

要将值注入到容器中的一个命令中,使用您要用作环境变量的键。然后,您可以使用

$(VAR_NAME)语法在容器的命令中引用它们。配置为注入特定环境变量的 pod 规格示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 使用您要用作环境变量的键将值注入到容器中的命令中。

当此 pod 运行时,test-container 容器中运行的 echo 命令的输出如下:

very charm

very charmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.4.3. 使用配置映射将内容注入卷

您可以使用配置映射将内容注入卷。

ConfigMap 自定义资源(CR)示例

流程

您可以使用配置映射将内容注入卷中有两个不同的选项。

使用配置映射将内容注入卷的最基本方法是在卷中填充键为文件名称的文件,文件的内容是键值:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 包含密钥的文件。

当这个 pod 运行时,cat 命令的输出将是:

very

veryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 您还可以控制投射配置映射键的卷中的路径:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 配置映射键的路径。

当这个 pod 运行时,cat 命令的输出将是:

very

veryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. 在 pod 调度决策中纳入 pod 优先级

您可以在集群中启用 pod 优先级与抢占功能。pod 优先级代表与其他 pod 相比此 pod 的重要性,并根据优先级进行队列处理。抢占(preemption)则允许集群驱除低优先级 pod 或与之争抢,从而在合适的节点上没有可用空间时能够调度优先级较高的 pod。pod 优先级也会影响 pod 的调度顺序以及节点上资源不足驱除顺序。

要使用优先级与抢占功能,引用 pod 规格中的优先级类,以应用该权重以进行调度。

2.6.1. 了解 pod 优先级

当您使用 pod 优先级与抢占功能时,调度程序会根据优先级来调度待处理 pod,而待处理 pod 会放在调度队列中优先级较低的其他待处理 pod 的前面。因此,如果达到调度要求,较高优先级的 pod 可能比低优先级的 pod 更早调度。如果 pod 无法调度,调度程序会继续调度其他较低优先级 pod。

2.6.1.1. Pod 优先级类

您可以为 pod 分配一个优先级类,它是一种非命名空间的对象,用于定义从名称到优先级整数值的映射。数值越大,优先级越高。

优先级类对象可以取小于或等于 1000000000(十亿)的 32 位整数值。对于不得被抢占或被驱除的关键 pod,请保留大于或等于 10 亿的数值。默认情况下,Red Hat OpenShift Service on AWS 有两个保留优先级类,用于关键系统 pod 有保证调度。

oc get priorityclasses

$ oc get priorityclasses输出示例

NAME VALUE GLOBAL-DEFAULT AGE system-node-critical 2000001000 false 72m system-cluster-critical 2000000000 false 72m openshift-user-critical 1000000000 false 3d13h cluster-logging 1000000 false 29s

NAME VALUE GLOBAL-DEFAULT AGE

system-node-critical 2000001000 false 72m

system-cluster-critical 2000000000 false 72m

openshift-user-critical 1000000000 false 3d13h

cluster-logging 1000000 false 29ssystem-node-critical - 此优先级类的值为 2000001000,用于所有不得从节点上驱除的 pod。具有此优先级类的 pod 示例是

ovnkube-node等。许多关键组件默认包括system-node-critical优先级类,例如:- master-api

- master-controller

- master-etcd

- ovn-kubernetes

- sync

system-cluster-critical - 此优先级类的值是 2000000000(二十亿),用于对集群而言很重要的 pod。在某些情况下,具有此优先级类的 Pod 可以从节点中驱除。例如,配置了

system-node-critical优先级类的 pod 可以拥有优先权。不过,此优先级类确实能够保证调度。具有此优先级类的 pod 示例有 fluentd 以及 descheduler 这样的附加组件等。许多关键组件默认包括system-cluster-critical优先级类,例如:- fluentd

- metrics-server

- descheduler

-

openshift-user-critical - 您可以使用带有重要 pod 的

priorityClassName字段,这些 pod 无法绑定其资源消耗,且没有可预测的资源消耗行为。openshift-monitoring和openshift-user-workload-monitoring命名空间下的 Prometheus Pod 使用openshift-user-criticalpriorityClassName。监控工作负载使用system-critical作为其第一个priorityClass,但在监控使用过量内存时造成问题,且无法驱除它们。因此,监控会丢弃优先级,为调度程序带来灵活性,并围绕移动繁重的工作负载来保持关键节点正常操作。 - cluster-logging - 此优先级类供 Fluentd 用于确保 Fluentd pod 优先于其他应用调度到节点上。

2.6.1.2. Pod 优先级名称

拥有一个或多个优先级类后,您可以创建 pod,并在 Pod 规格中指定优先级类名称。优先准入控制器使用优先级类名称字段来填充优先级的整数值。如果没有找到给定名称的优先级类,pod 将被拒绝。

2.6.2. 了解 pod 抢占

当开发人员创建 pod 时,pod 会排入某一队列。如果开发人员为 pod 配置了 pod 优先级或抢占,调度程序会从队列中选取 pod,并尝试将 pod 调度到某个节点上。如果调度程序无法在满足 pod 的所有指定要求的适当节点上找到空间,则会为待处理 pod 触发抢占逻辑。

当调度程序在节点上抢占一个或多个 pod 时,较高优先级 Pod spec 的 nominatedNodeName 字段 将设为该节点的名称,nodename 字段也是如此。调度程序使用 nominatedNodeName 字段来跟踪为 pod 保留的资源,同时也向用户提供与集群中抢占相关的信息。

在调度程序抢占了某一较低优先级 pod 后,调度程序会尊重该 pod 的安全终止期限。如果在调度程序等待较低优先级 pod 终止过程中另一节点变为可用,调度程序会将较高优先级 pod 调度到该节点上。因此,Pod spec 的 nominatedNodeName 字段和 nodeName 字段可能会有所不同。

另外,如果调度程序在某一节点上抢占 pod 并正在等待终止,这时又有优先级比待处理 pod 高的 pod 需要调度,那么调度程序可以改为调度这个优先级更高的 pod。在这种情况下,调度程序会清除待处理 pod 的 nominatedNodeName,使该 pod 有资格调度到其他节点上。

抢占不一定从节点中移除所有较低优先级 pod。调度程序可以通过移除一部分较低优先级 pod 调度待处理 pod。

只有待处理 pod 能够调度到节点时,调度程序才会对这个节点考虑 pod 抢占。

2.6.2.1. 非抢占优先级类

抢占策略设置为 Never 的 Pod 会放置在较低优先级 pod 的调度队列中,但无法抢占其他 pod。等待调度的非抢占 pod 会保留在调度队列中,直到资源可用且可以调度。非抢占 pod 与其他 pod 一样,受调度程序后退避的影响。这意味着,如果调度程序尝试调度这些 pod,它们会以较低频率重试,允许在调度前调度其他优先级较低的 pod。

非抢占 pod 仍可被其他高优先级 pod 抢占。

2.6.2.2. Pod 抢占和其他调度程序设置

如果启用 pod 优先级与抢占功能,请考虑其他的调度程序设置:

- pod 优先级和 pod 中断预算

- pod 中断预算指定某一时间必须保持在线的副本的最小数量或百分比。如果您指定了 pod 中断预算,Red Hat OpenShift Service on AWS 会在抢占 pod 时考虑它们。调度程序会尝试在不违反 pod 中断预算的前提下抢占 pod。如果找不到这样的 pod,则可能会无视 pod 中断预算要求而抢占较低优先级 pod。

- pod 优先级和 pod 关联性

- pod 关联性要求将新 pod 调度到与具有同样标签的其他 pod 相同的节点上。

如果待处理 pod 与节点上的一个或多个低优先级 pod 具有 pod 间关联性,调度程序就不能在不违反关联要求的前提下抢占较低优先级 pod。这时,调度程序会寻找其他节点来调度待处理 pod。但是,不能保证调度程序能够找到合适的节点,因此可能无法调度待处理 pod。

要防止这种情况,请仔细配置优先级相同的 pod 的 pod 关联性。

2.6.2.3. 安全终止被抢占的 pod

在抢占 pod 时,调度程序会等待 pod 安全终止期限到期,使 pod 能够完成工作并退出。如果 pod 在到期后没有退出,调度程序会终止该 pod。此安全终止期限会在调度程序抢占该 pod 的时间和待处理 pod 调度到节点的时间之间造成一个时间差。

要尽量缩短这个时间差,可以为较低优先级 pod 配置较短的安全终止期限。

2.6.3. 配置优先级和抢占

您可以通过创建优先级类对象并使用 pod 规格中的 priorityClassName 将 pod 与优先级关联来应用 pod 优先级与抢占。

您不能直接将优先级类添加到现有调度的 pod 中。

流程

配置集群以使用优先级与抢占功能:

通过创建类似如下的 YAML 文件,定义 pod spec 使其包含优先级类的名称:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定要用于此 pod 的优先级类。

创建 pod:

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以将优先级名称直接添加到 pod 配置或 pod 模板中。

2.7. 使用节点选择器将 pod 放置到特定节点

节点选择器指定一个键值对映射。使用节点中的自定义标签和 pod 中指定的选择器来定义规则。

若要使 pod 有资格在某一节点上运行,pod 必须具有指定为该节点上标签的键值对。

如果您在同一 pod 配置中同时使用节点关联性和节点选择器,请查看下方的重要注意事项。

2.7.1. 使用节点选择器控制 pod 放置

您可以使用节点上的 pod 和标签上的节点选择器来控制 pod 的调度位置。使用节点选择器时,Red Hat OpenShift Service on AWS 会将 pod 调度到包含匹配标签的节点。

您可向节点、计算机器集或机器配置添加标签。将标签添加到计算机器集可确保节点或机器停机时,新节点具有该标签。如果节点或机器停机,添加到节点或机器配置的标签不会保留。

要将节点选择器添加到现有 pod 中,将节点选择器添加到该 pod 的控制对象中,如 ReplicaSet 对象、DaemonSet 对象、StatefulSet 对象、Deployment 对象或 DeploymentConfig 对象。任何属于该控制对象的现有 pod 都会在具有匹配标签的节点上重新创建。如果要创建新 pod,可以将节点选择器直接添加到 pod 规格中。如果 pod 没有控制对象,您必须删除 pod,编辑 pod 规格并重新创建 pod。

您不能直接将节点选择器添加到现有调度的 pod 中。

先决条件

要将节点选择器添加到现有 pod 中,请确定该 pod 的控制对象。例如, router-default-66d5cf9464-m2g75 pod 由 router-default-66d5cf9464 副本集控制:

oc describe pod router-default-66d5cf9464-7pwkc

$ oc describe pod router-default-66d5cf9464-7pwkc输出示例

Web 控制台在 pod YAML 的 ownerReferences 下列出控制对象:

流程

将匹配的节点选择器添加到 pod:

要将节点选择器添加到现有和未来的 pod,请向 pod 的控制对象添加节点选择器:

带有标签的

ReplicaSet对象示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 添加节点选择器。

要将节点选择器添加到一个特定的新 pod,直接将选择器添加到

Pod对象中:使用节点选择器的

Pod对象示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意您不能直接将节点选择器添加到现有调度的 pod 中。

第 3 章 使用自定义 Metrics Autoscaler Operator 自动扩展 pod

3.1. 发行注记

3.1.1. 自定义 Metrics Autoscaler Operator 发行注记

Red Hat OpenShift 的自定义 Metrics Autoscaler Operator 发行注记介绍了新的功能和增强功能、已弃用的功能以及已知的问题。

Custom Metrics Autoscaler Operator 使用基于 Kubernetes 的 Event Driven Autoscaler (KEDA),并基于 Red Hat OpenShift Service on AWS 横向自动扩展(HPA)构建。

Custom Metrics Autoscaler Operator for Red Hat OpenShift 作为可安装的组件提供,它与 Red Hat OpenShift Service on AWS 核心不同。Red Hat OpenShift Container Platform 生命周期政策概述了发行版本兼容性。

3.1.1.1. 支持的版本

下表为每个 Red Hat OpenShift Service on AWS 版本定义自定义 Metrics Autoscaler Operator 版本。

| Version | Red Hat OpenShift Service on AWS 版本 | 公开发行(GA) |

|---|---|---|

| 2.17.2-2 | 4.20 | 公开发行(GA) |

| 2.17.2-2 | 4.19 | 公开发行(GA) |

| 2.17.2-2 | 4.18 | 公开发行(GA) |

| 2.17.2-2 | 4.17 | 公开发行(GA) |

| 2.17.2-2 | 4.16 | 公开发行(GA) |

| 2.17.2-2 | 4.15 | 公开发行(GA) |

| 2.17.2-2 | 4.14 | 公开发行(GA) |

| 2.17.2-2 | 4.13 | 公开发行(GA) |

| 2.17.2-2 | 4.12 | 公开发行(GA) |

发布日期:2025 年 10 月 21 日

此 Custom Metrics Autoscaler Operator 2.17.2-2 发行版本是 Custom Metrics Autoscaler Operator 的 2.17.2 版本的重新构建,使用较新的基础镜像和 Go 编译器。Custom Metrics Autoscaler Operator 的代码没有变化。以下公告可用于自定义 Metrics Autoscaler Operator:

在安装此版本的 Custom Metrics Autoscaler Operator 之前,请删除任何以前安装的技术预览版本或基于 Kubernetes 的社区支持的 Event Driven Autoscaler (KEDA)。

3.1.2. Custom Metrics Autoscaler Operator 的过去发行版本发行注记

以下发行注记适用于以前的自定义 Metrics Autoscaler Operator 版本。

有关当前版本,请参阅自定义 Metrics Autoscaler Operator 发行注记。

3.1.2.1. 自定义 Metrics Autoscaler Operator 2.17.2 发行注记

发布日期:2025 年 9 月 25 日

此自定义 Metrics Autoscaler Operator 2.17.2 发行版本解决了 CVE 报告的安全漏洞问题。以下公告可用于自定义 Metrics Autoscaler Operator:

在安装此版本的 Custom Metrics Autoscaler Operator 之前,请删除任何以前安装的技术预览版本或基于 Kubernetes 的社区支持的 Event Driven Autoscaler (KEDA)。

3.1.2.1.1. 新功能及功能增强

3.1.2.1.1.1. KEDA 控制器在安装过程中自动创建

现在,安装自定义 Metrics Autoscaler Operator 时会自动创建 KEDA 控制器。在以前的版本中,您需要手动创建 KEDA 控制器。您可以根据需要编辑自动创建的 KEDA 控制器。

3.1.2.1.1.2. 支持 Kubernetes 工作负载触发器

Cluster Metrics Autoscaler Operator 现在支持使用 Kubernetes 工作负载触发器根据与特定标签选择器匹配的 pod 数量扩展 pod。

3.1.2.1.1.3. 绑定服务帐户令牌的支持

Cluster Metrics Autoscaler Operator 现在支持绑定服务帐户令牌。在以前的版本中,Operator 只支持旧的服务帐户令牌,出于安全原因而被分阶段使用绑定服务帐户令牌。

3.1.2.1.2. 程序错误修复

- 在以前的版本中,KEDA 控制器不支持卷挂载。因此,您无法在 Kafka scaler 中使用 Kerberos。在这个版本中,KEDA 控制器支持卷挂载。(OCPBUGS-42559)

-

在以前的版本中,

keda-operator部署对象日志中的 KEDA 版本会报告 Custom Metrics Autoscaler Operator 基于一个不正确的 KEDA 版本。在这个版本中,日志中会报告了正确的 KEDA 版本。(OCPBUGS-58129)

3.1.2.2. 自定义 Metrics Autoscaler Operator 2.15.1-4 发行注记

发布日期:25 年 3 月 31 日

此自定义 Metrics Autoscaler Operator 2.15.1-4 发行版本解决了 CVE 报告的安全漏洞问题。以下公告可用于自定义 Metrics Autoscaler Operator:

在安装此版本的 Custom Metrics Autoscaler Operator 之前,请删除任何以前安装的技术预览版本或基于 Kubernetes 的社区支持的 Event Driven Autoscaler (KEDA)。

3.1.2.2.1. 新功能及功能增强

3.1.2.2.1.1. CMA 多架构构建

使用此版本的自定义 Metrics Autoscaler Operator,您可以在 ARM64 Red Hat OpenShift Service on AWS 集群上安装并运行 Operator。

3.1.2.3. 自定义 Metrics Autoscaler Operator 2.14.1-467 发行注记

此自定义 Metrics Autoscaler Operator 2.14.1-467 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行 Operator 提供了 CVE 和程序错误修复。以下公告可用于 RHSA-2024:7348。

在安装此版本的 Custom Metrics Autoscaler Operator 之前,请删除任何以前安装的技术预览版本或基于 Kubernetes 的社区支持的 Event Driven Autoscaler (KEDA)。

3.1.2.3.1. 程序错误修复

- 在以前的版本中,自定义 Metrics Autoscaler Operator pod 的 root 文件系统是可写的,这并不是必需的,并可能会造成安全问题。在这个版本中,pod root 文件系统为只读方式,解决了潜在的安全问题。(OCPBUGS-37989)

3.1.2.4. 自定义 Metrics Autoscaler Operator 2.14.1-454 发行注记

此自定义 Metrics Autoscaler Operator 2.14.1-454 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行 Operator 提供了 CVE、新功能和程序错误修复。以下公告可用于 RHBA-2024:5865。

在安装此版本的 Custom Metrics Autoscaler Operator 之前,请删除任何以前安装的技术预览版本或基于 Kubernetes 的社区支持的 Event Driven Autoscaler (KEDA)。

3.1.2.4.1. 新功能及功能增强

Custom Metrics Autoscaler Operator 现在可以使用 Cron trigger,根据每个小时的调度来扩展 pod。当您指定的时间段启动时,Custom Metrics Autoscaler Operator 会将 pod 扩展至所需数量。当时间段结束时,Operator 会缩减到以前的级别。

如需更多信息,请参阅了解 Cron 触发器。

3.1.2.4.2. 程序错误修复

-

在以前的版本中,如果您更改了

KedaController自定义资源中的审计配置参数,则keda-metrics-server-audit-policy配置映射不会被更新。因此,在自定义 Metrics Autoscaler 初始部署后,您无法更改审计配置参数。在这个版本中,对审计配置的更改现在可以在配置映射中正确显示,允许您在安装后随时更改审计配置。(OCPBUGS-32521)

3.1.2.5. Custom Metrics Autoscaler Operator 2.13.1 发行注记

此自定义 Metrics Autoscaler Operator 2.13.1-421 发行版本提供了一个新功能,并在 Red Hat OpenShift Service on AWS 集群中运行 Operator。以下公告可用于 RHBA-2024:4837。

在安装此版本的 Custom Metrics Autoscaler Operator 之前,请删除任何以前安装的技术预览版本或基于 Kubernetes 的社区支持的 Event Driven Autoscaler (KEDA)。

3.1.2.5.1. 新功能及功能增强

Custom Metrics Autoscaler Operator 现在可以使用自定义服务 CA 证书安全地连接到启用了 TLS 的指标源,如外部 Kafka 集群或外部 Prometheus 服务。默认情况下,Operator 仅使用自动生成的服务证书来连接到 on-cluster 服务。KedaController 对象中有一个新字段,您可以使用配置映射载入自定义服务器 CA 证书以连接到外部服务。

如需更多信息,请参阅 Custom Metrics Autoscaler 的自定义 CA 证书。

3.1.2.5.2. 程序错误修复

-

在以前的版本中,

custom-metrics-autoscaler和custom-metrics-autoscaler-adapter镜像缺少时区信息。因此,带有cron触发器的扩展对象无法正常工作,因为控制器无法找到时区信息。在这个版本中,镜像构建被更新为包含时区信息。因此,包含cron触发器的对象现在可以正常工作。Custom Metrics Autoscaler 目前不支持包含cron触发器的扩展对象。(OCPBUGS-34018)

3.1.2.6. 自定义 Metrics Autoscaler Operator 2.12.1-394 发行注记

此自定义 Metrics Autoscaler Operator 2.12.1-394 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行 Operator 提供了程序错误修复。以下公告可用于 RHSA-2024:2901。

在安装此版本的 Custom Metrics Autoscaler Operator 之前,请删除任何以前安装的技术预览版本或基于 Kubernetes 的社区支持的 Event Driven Autoscaler (KEDA)。

3.1.2.6.1. 程序错误修复

-

在以前的版本中,当对无效 JSON 的特定表单进行 unmarshaling 处理时,

protojson.Unmarshal函数会进入一个死循环。当 unmarshaling 到包含google.protobuf.Any值或设置了UnmarshalOptions.DiscardUnknown选项时,可能会出现此条件。此发行版本解决了这个问题。(OCPBUGS-30305) -

在以前的版本中,当解析多部分表单时,可以明确使用

Request.ParseMultipartForm方法明,或使用Request.FormValue、Request.PostFormValue或Request.FormFile方法隐式应用,解析表单的总大小限制不适用于消耗的内存。这可能导致内存耗尽。在这个版本中,解析过程可以正确地限制最大大小。(OCPBUGS-30360) -

在以前的版本中,当遵循 HTTP 重定向到不在匹配子域或初始域的完全匹配的域时,HTTP 客户端不会转发敏感标头,如

Authorization或Cookie。例如,从example.com到www.example.com的重定向会转发Authorization标头,但重定向到www.example.org不会转发标头。此发行版本解决了这个问题。(OCPBUGS-30365) -

在以前的版本中,验证包含带有未知公钥算法的证书的证书链会导致证书验证过程 panic。此条件会影响将

Config.ClientAuth参数设置为VerifyClientCertIfGiven或RequireAndVerifyClientCert值的所有加密和 Transport Layer Security (TLS) 客户端和服务器。默认行为是 TLS 服务器无法验证客户端证书。此发行版本解决了这个问题。(OCPBUGS-30370) -

在以前的版本中,如果从

MarshalJSON方法返回的错误包含用户控制的数据,攻击者可以使用数据中断 HTML 模板软件包的上下文自动转义行为。此条件允许后续操作将意外内容注入模板。此发行版本解决了这个问题。(OCPBUGS-30397) -

在以前的版本中,

net/http和golang.org/x/net/http2Go 软件包没有限制为 HTTP/2 请求读取的CONTINUATION帧的数量。这个条件可能会导致过量消耗 CPU。此发行版本解决了这个问题。(OCPBUGS-30894)

3.1.2.7. 自定义 Metrics Autoscaler Operator 2.12.1-384 发行注记

此自定义 Metrics Autoscaler Operator 2.12.1-384 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行的 Operator 提供了程序错误修复。以下公告可用于 RHBA-2024:2043。

在安装自定义 Metrics Autoscaler Operator 的这个版本前,请删除任何以前安装的技术预览版本或社区支持的 KEDA 版本。

3.1.2.7.1. 程序错误修复

-

在以前的版本中,

custom-metrics-autoscaler和custom-metrics-autoscaler-adapter镜像缺少时区信息。因此,带有cron触发器的扩展对象无法正常工作,因为控制器无法找到时区信息。在这个版本中,镜像构建被更新为包含时区信息。因此,包含cron触发器的对象现在可以正常工作。(OCPBUGS-32395)

3.1.2.8. 自定义 Metrics Autoscaler Operator 2.12.1-376 发行注记

此自定义 Metrics Autoscaler Operator 2.12.1-376 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行的 Operator 提供安全更新和程序错误修复。以下公告可用于 RHSA-2024:1812。

在安装自定义 Metrics Autoscaler Operator 的这个版本前,请删除任何以前安装的技术预览版本或社区支持的 KEDA 版本。

3.1.2.8.1. 程序错误修复

- 在以前的版本中,如果在扩展对象元数据中指定无效值,如不存在的命名空间,则底层 scaler 客户端无法释放或关闭其客户端描述符,从而导致内存泄漏。在这个版本中,当出现错误时可以正确地关闭底层客户端描述符,从而导致内存泄漏。(OCPBUGS-30145)

-

在以前的版本中,

keda-metrics-apiserverpod 的ServiceMonitor自定义资源 (CR) 无法正常工作,因为 CR 引用了http的错误指标端口名称。在这个版本中,ServiceMonitorCR 修正了引用metrics的正确端口名称。因此,Service Monitor 可以正常工作。(OCPBUGS-25806)

3.1.2.9. 自定义 Metrics Autoscaler Operator 2.11.2-322 发行注记

此自定义 Metrics Autoscaler Operator 2.11.2-322 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行 Operator 提供了安全更新和程序错误修复。以下公告可用于 RHSA-2023:6144。

在安装自定义 Metrics Autoscaler Operator 的这个版本前,请删除任何以前安装的技术预览版本或社区支持的 KEDA 版本。

3.1.2.9.1. 程序错误修复

- 因为自定义 Metrics Autoscaler Operator 版本 3.11.2-311 已被发布,所以在 Operator 部署中不需要卷挂载,所以自定义 Metrics Autoscaler Operator pod 会每 15 分钟重启。在这个版本中,在 Operator 部署中添加了所需的卷挂载。因此,Operator 不再每 15 分钟重启。(OCPBUGS-22361)

此自定义 Metrics Autoscaler Operator 2.11.2-311 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行 Operator 提供了新功能和程序错误修复。自定义 Metrics Autoscaler Operator 2.11.2-311 的组件在 RHBA-2023:5981 中发布。

在安装自定义 Metrics Autoscaler Operator 的这个版本前,请删除任何以前安装的技术预览版本或社区支持的 KEDA 版本。

3.1.2.10.1. 新功能及功能增强

自定义 Metrics Autoscaler Operator 2.11.2-311 可以安装在 Red Hat OpenShift Service on AWS 和 OpenShift Dedicated 受管集群上。自定义 Metrics Autoscaler Operator 的早期版本只能安装在 openshift-keda 命名空间中。这导致 Operator 无法在 Red Hat OpenShift Service on AWS 和 OpenShift Dedicated 集群上安装。此版本的自定义 Metrics Autoscaler 允许安装到其他命名空间,如 openshift-operators 或 keda,启用安装到 Red Hat OpenShift Service on AWS 和 OpenShift Dedicated 集群。

3.1.2.10.2. 程序错误修复

-

在以前的版本中,如果安装并配置 Custom Metrics Autoscaler Operator,但没有使用,OpenShift CLI 会在任何

oc命令输入后报告could not get resource list for external.metrics.k8s.io/v1beta1: Got empty response for: external.metrics.k8s.io/v1beta1错误。虽然这个消息并没有什么危害,但可能会造成混淆。在这个版本中,Got empty response for: external.metrics…不再会出现。(OCPBUGS-15779) - 在以前的版本中,任何注解或标签更改为由自定义 Metrics Autoscaler 管理的对象在修改 Keda Controller 时(例如在配置更改后)会被自定义 Metrics Autoscaler 恢复。这会导致对象中的标签持续更改。自定义 Metrics Autoscaler 现在使用自己的注解来管理标签和注解,注解或标签不再被错误地恢复。(OCPBUGS-15590)

此自定义 Metrics Autoscaler Operator 2.10.1-267 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行 Operator 提供了新功能和程序错误修复。自定义 Metrics Autoscaler Operator 2.10.1-267 组件在 RHBA-2023:4089 中发布。

在安装自定义 Metrics Autoscaler Operator 的这个版本前,请删除任何以前安装的技术预览版本或社区支持的 KEDA 版本。

3.1.2.11.1. 程序错误修复

-

在以前的版本中,

custom-metrics-autoscaler和custom-metrics-autoscaler-adapter镜像不包含时区信息。因此,带有 cron 触发器的扩展对象无法正常工作,因为控制器无法找到时区信息。在这个版本中,镜像构建包含时区信息。因此,包含 cron 触发器的对象现在可以正常工作。(OCPBUGS-15264) -

在以前的版本中,自定义 Metrics Autoscaler Operator 会尝试拥有所有受管对象,包括其他命名空间中的对象和集群范围的对象。因此,自定义 Metrics Autoscaler Operator 无法创建角色绑定来读取 API 服务器所需的凭证。这会导致

kube-system命名空间中出现错误。在这个版本中,自定义 Metrics Autoscaler Operator 会跳过将ownerReference字段添加到另一个命名空间中的任何对象或任何集群范围的对象。现在,角色绑定会被创建,且没有任何错误。(OCPBUGS-15038) -

在以前的版本中,自定义 Metrics Autoscaler Operator 将

ownerReferences字段添加到openshift-keda命名空间中。虽然这不会造成功能问题,但存在此字段可能会给集群管理员造成混淆。在这个版本中,自定义 Metrics Autoscaler Operator 不会将ownerReference字段添加到openshift-keda命名空间中。因此,openshift-keda命名空间不再有一个 superfluousownerReference字段。(OCPBUGS-15293) -

在以前的版本中,如果您使用使用 pod 身份以外的身份验证方法配置的 Prometheus 触发器,并且

podIdentity参数设置为none,则触发器将无法扩展。在这个版本中,OpenShift 的自定义 Metrics Autoscaler 可以正确地处理nonepod 身份提供程序类型。因此,使用 pod 身份以外的身份验证方法配置的 Prometheus 触发器,其podIdentity参数设置为none现在可以正确扩展。(OCPBUGS-15274)

3.1.2.12. 自定义 Metrics Autoscaler Operator 2.10.1 发行注记

此自定义 Metrics Autoscaler Operator 2.10.1 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行的 Operator 提供了新功能和程序错误修复。自定义 Metrics Autoscaler Operator 2.10.1 的组件在 RHEA-2023:3199 中发布。

在安装自定义 Metrics Autoscaler Operator 的这个版本前,请删除任何以前安装的技术预览版本或社区支持的 KEDA 版本。

3.1.2.12.1. 新功能及功能增强

3.1.2.12.1.1. 自定义 Metrics Autoscaler Operator 正式发布

现在,自定义 Metrics Autoscaler Operator 从自定义 Metrics Autoscaler Operator 版本 2.10.1 开始正式发布。

使用扩展作业进行扩展只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

3.1.2.12.1.2. 性能指标

现在,您可以使用 Prometheus Query Language (PromQL) 查询自定义 Metrics Autoscaler Operator 的指标。

3.1.2.12.1.3. 暂停扩展对象的自定义指标自动扩展

现在,您可以根据需要暂停扩展对象的自动扩展,并在就绪时恢复自动扩展。

3.1.2.12.1.4. 副本回退到扩展的对象

现在,如果扩展对象无法从源获取指标,您可以指定要回退到的副本数。

3.1.2.12.1.5. 为扩展对象自定义 HPA 命名

现在,您可以在扩展的对象中为 pod 横向自动扩展指定自定义名称。

3.1.2.12.1.6. 激活和扩展阈值

因为 pod 横向自动扩展 (HPA) 无法扩展到 0 个副本或从 0 个副本进行扩展,所以在 HPA 执行缩放后,自定义 Metrics Autoscaler Operator 会进行该扩展。现在,您可以根据副本数指定 HPA 接管自动扩展的时间。这可以提高扩展策略的灵活性。

3.1.2.13. 自定义 Metrics Autoscaler Operator 2.8.2-174 发行注记

此自定义 Metrics Autoscaler Operator 2.8.2-174 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行 Operator 提供了新功能和程序错误修复。Custom Metrics Autoscaler Operator 2.8.2-174 组件在 RHEA-2023:1683 中发布。

自定义 Metrics Autoscaler Operator 版本 2.8.2-174 是一个技术预览功能。

3.1.2.13.1. 新功能及功能增强

3.1.2.13.1.1. Operator 升级支持

现在,您可以从 Custom Metrics Autoscaler Operator 的早期版本升级。有关升级 Operator 的信息,请参阅"添加资源"中的"删除 Operator 更新频道"。

3.1.2.13.1.2. must-gather 支持

现在,您可以使用 Red Hat OpenShift Service on AWS must-gather 工具收集有关自定义 Metrics Autoscaler Operator 及其组件的数据。目前,使用带有自定义 Metrics Autoscaler 的 must-gather 工具的过程与其他 Operator 不同。如需更多信息,请参阅"添加资源"中的调试数据。

3.1.2.14. 自定义 Metrics Autoscaler Operator 2.8.2 发行注记

此自定义 Metrics Autoscaler Operator 2.8.2 发行版本为在 Red Hat OpenShift Service on AWS 集群中运行的 Operator 提供了新功能和程序错误修复。自定义 Metrics Autoscaler Operator 2.8.2 组件在 RHSA-2023:1042 中发布。

自定义 Metrics Autoscaler Operator 版本 2.8.2 是一个技术预览功能。

3.1.2.14.1. 新功能及功能增强

3.1.2.14.1.1. 审计日志记录

现在,您可以收集并查看自定义 Metrics Autoscaler Operator 及其相关组件的审计日志。审计日志是安全相关的按时间排序的记录,记录各个用户、管理员或其他系统组件影响系统的一系列活动。

3.1.2.14.1.2. 基于 Apache Kafka 指标扩展应用程序

现在,您可以使用 KEDA Apache kafka 触发器/scaler 根据 Apache Kafka 主题扩展部署。

3.1.2.14.1.3. 根据 CPU 指标扩展应用程序

现在,您可以使用 KEDA CPU 触发器/scaler 根据 CPU 指标扩展部署。

3.1.2.14.1.4. 根据内存指标扩展应用程序

现在,您可以使用 KEDA 内存触发器/scaler 根据内存指标扩展部署。

3.2. 自定义 Metrics Autoscaler Operator 概述

作为开发者,您可以使用 Custom Metrics Autoscaler Operator for Red Hat OpenShift 指定 Red Hat OpenShift Service on AWS 如何根据不基于 CPU 或内存的自定义指标自动增加或减少部署、有状态集、自定义资源或作业的数量。

Custom Metrics Autoscaler Operator 是一个基于 Kubernetes Event Driven Autoscaler (KEDA) 的可选 Operator,允许使用 pod 指标以外的其他指标源扩展工作负载。

自定义指标自动扩展目前仅支持 Prometheus、CPU、内存和 Apache Kafka 指标。

Custom Metrics Autoscaler Operator 根据特定应用程序的自定义外部指标扩展 pod。您的其他应用程序继续使用其他扩展方法。您可以配置 触发器 (也称为 scaler),这是自定义指标自动扩展器用来决定如何扩展的事件和指标的来源。自定义指标自动扩展使用 metrics API 将外部指标转换为 Red Hat OpenShift Service on AWS 可以使用的形式。自定义指标自动扩展会创建一个执行实际缩放的 pod 横向自动扩展(HPA)。

要使用自定义指标自动扩展,您可以为工作负载创建一个 ScaledObject 或 ScaledJob 对象,这是定义扩展元数据的自定义资源(CR)。您可以指定要缩放的部署或作业、要缩放的指标源 (trigger) 以及其他参数,如允许的最小和最大副本数。

您只能为每个您要扩展的工作负载创建一个扩展对象或扩展作业。另外,您不能在同一工作负载中使用扩展的对象或扩展作业以及 pod 横向自动扩展 (HPA)。

自定义指标自动扩展与 HPA 不同,可以缩减为零。如果将自定义指标自动扩展 CR 中的 minReplicaCount 值设置为 0,自定义指标自动扩展会将工作负载从 1 缩减到 0 个副本或从 0 个副本扩展到 1。这称为 激活阶段。扩展至 1 个副本后,HPA 会控制扩展。这称为 扩展阶段。

某些触发器允许您更改由集群指标自动扩展扩展的副本数量。在所有情况下,配置激活阶段的参数始终使用相同的短语,前缀为 激活。例如,如果 threshold 参数配置缩放,则 activationThreshold 将配置激活。通过配置激活和扩展阶段,您可以提高扩展策略的灵活性。例如,您可以配置更高的激活阶段,以便在指标特别低时防止扩展或缩减。

当每个决策不同时,激活值的优先级高于扩展值。例如,如果 threshold 被设置为 10,并且 activationThreshold 为 50,如果指标报告 40,则缩放器不会激活,并且 pod 缩减为零,即使 HPA 需要 4 个实例。

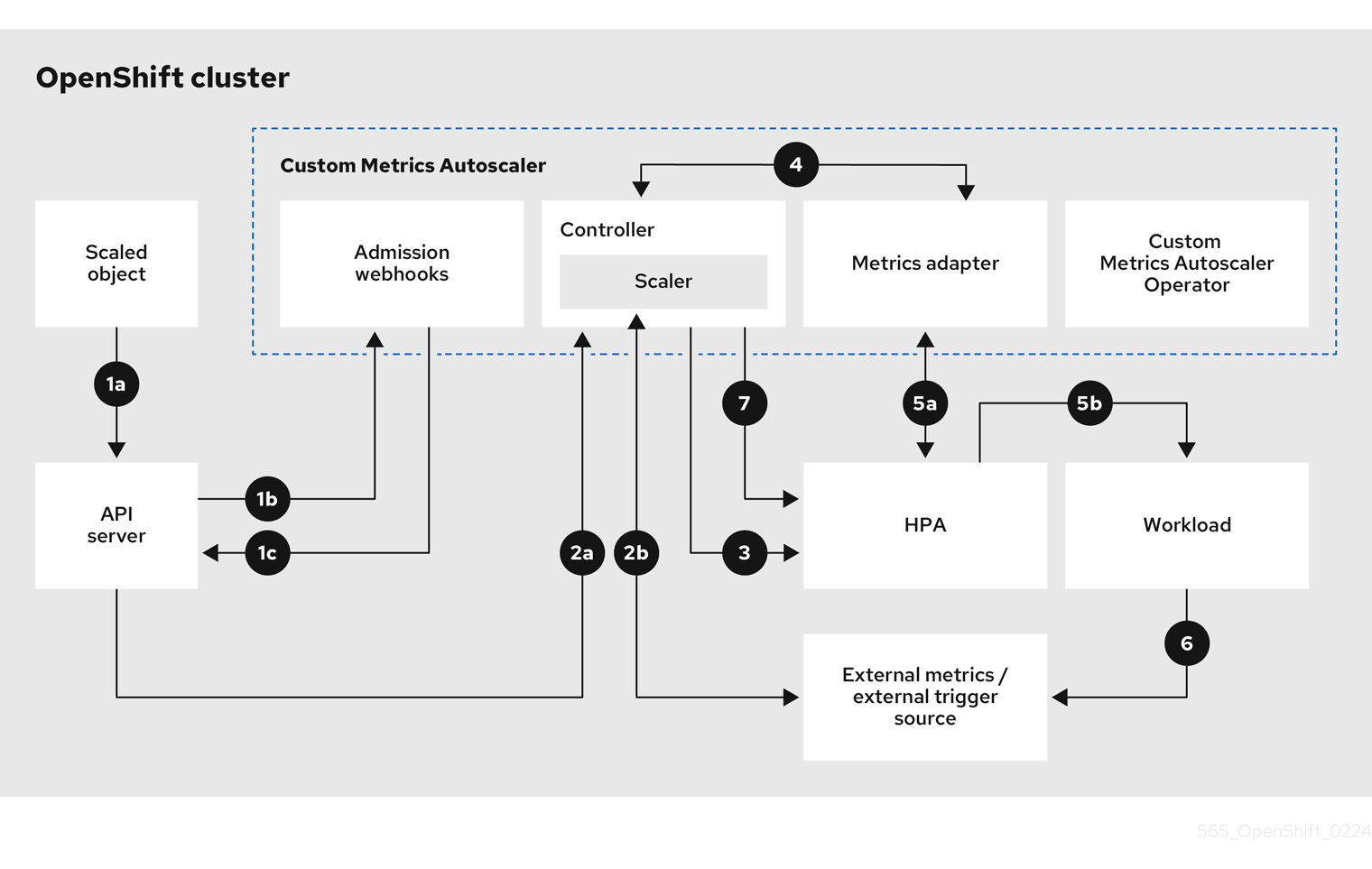

图 3.1. 自定义指标自动扩展工作流

- 您可以为集群中的工作负载创建或修改扩展对象自定义资源。对象包含该工作负载的扩展配置。在接受新对象前,OpenShift API 服务器将其发送到自定义指标自动扩展准入 webhook 进程,以确保对象有效。如果验证成功,API 服务器会保留对象。

- 自定义指标自动扩展控制器监视是否有新的或修改的扩展对象。当 OpenShift API 服务器通知更改控制器时,控制器会监控任何外部触发器源(也称为数据源)在对象中指定以更改指标数据。一个或多个 scalers 请求从外部触发器源扩展数据。例如,对于 Kafka 触发器类型,控制器使用 Kafka scaler 与 Kafka 实例通信来获取触发器请求的数据。

- 控制器为扩展的对象创建一个 pod 横向自动扩展对象。因此,Horizontal Pod Autoscaler (HPA) Operator 开始监控与触发器关联的扩展数据。HPA 请求从集群 OpenShift API 服务器端点扩展数据。

- OpenShift API 服务器端点由自定义指标自动扩展指标适配器提供。当 metrics 适配器收到自定义指标的请求时,它使用 GRPC 连接控制器来请求它以获取从 scaler 接收的最新触发器数据。

- HPA 根据从 metrics adapter 接收的数据做出缩放决策,并通过增加或减少副本来扩展工作负载。

- 当它运行时,工作负载可能会影响扩展指标。例如,如果扩展工作负载以处理 Kafka 队列中的工作,则队列大小会在工作负载处理所有工作后减小。因此,工作负载会缩减。

-

如果指标位于

minReplicaCount值指定的范围内,自定义指标自动扩展控制器会禁用所有扩展,并将副本数保留为固定级别。如果指标超过该范围,自定义指标自动扩展控制器将启用扩展并允许 HPA 扩展工作负载。当禁用扩展时,HPA 不会执行任何操作。

3.2.1. Custom Metrics Autoscaler 的自定义 CA 证书

默认情况下,自定义 Metrics Autoscaler Operator 使用自动生成的服务 CA 证书连接到 on-cluster 服务。

如果要使用需要自定义 CA 证书的非集群服务,您可以将所需的证书添加到配置映射中。然后,将配置映射添加到 KedaController 自定义资源,如安装自定义指标自动扩展中所述。Operator 在启动时加载这些证书,并将其注册为 Operator 信任的证书。

配置映射可以包含一个或多个包含一个或多个 PEM 编码 CA 证书的证书文件。或者,您可以为每个证书文件使用单独的配置映射。

如果稍后更新配置映射以添加额外的证书,您必须重启 keda-operator-* pod 以使更改生效。

3.3. 安装自定义指标自动扩展

您可以使用 Red Hat OpenShift Service on AWS Web 控制台安装自定义 Metrics Autoscaler Operator。

安装会创建以下五个 CRD:

-

ClusterTriggerAuthentication -

KedaController -

ScaledJob -

ScaledObject -

TriggerAuthentication

安装过程还会创建 KedaController 自定义资源(CR)。如果需要,您可以修改默认的 KedaController CR。如需更多信息,请参阅"编辑 Keda Controller CR"。

如果要安装一个低于 2.17.2 的自定义 Metrics Autoscaler Operator 版本,您必须手动创建 Keda Controller CR。您可以使用"编辑 Keda Controller CR"中描述的流程来创建 CR。

3.3.1. 安装自定义指标自动扩展

您可以使用以下步骤安装自定义 Metrics Autoscaler Operator。

先决条件

-

您可以使用具有

cluster-admin角色的用户访问集群。 - 删除之前安装的 Cluster Metrics Autoscaler Operator 的技术预览版本。

删除基于社区的 KEDA 的任何版本。

另外,运行以下命令来删除 KEDA 1.x 自定义资源定义:

oc delete crd scaledobjects.keda.k8s.io

$ oc delete crd scaledobjects.keda.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete crd triggerauthentications.keda.k8s.io

$ oc delete crd triggerauthentications.keda.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

确保

keda命名空间存在。如果没有,则必须安全地创建keda命名空间。 可选:如果您需要自定义 Metrics Autoscaler Operator 连接到非集群服务,如外部 Kafka 集群或外部 Prometheus 服务,请将任何所需的服务 CA 证书放在配置映射中。配置映射必须存在于安装 Operator 的同一命名空间中。例如:

oc create configmap -n openshift-keda thanos-cert --from-file=ca-cert.pem

$ oc create configmap -n openshift-keda thanos-cert --from-file=ca-cert.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

- 在 Red Hat OpenShift Service on AWS web 控制台中,点 Ecosystem → Software Catalog。

- 从可用的 Operator 列表中选择 Custom Metrics Autoscaler,然后点 Install。

- 在 Install Operator 页面中,确保为 Installation Mode 选择了 A specific namespace on the cluster 选项。

- 对于 Installed Namespace,点 Select a namespace。

点 Select Project:

-

如果存在

keda命名空间,请从列表中选择 keda。 如果

keda命名空间不存在:- 选择 Create Project 以打开 Create Project 窗口。

-

在 Name 字段中输入

keda。 -

在 Display Name 字段中输入描述性名称,如

keda。 - 可选:在 Display Name 字段中,为命名空间添加描述。

- 点 Create。

-

如果存在

- 点 Install。

列出自定义 Metrics Autoscaler Operator 组件来验证安装:

- 导航到 Workloads → Pods。

-

从下拉菜单中选择

keda项目,并验证custom-metrics-autoscaler-operatorautoscaler pod 是否正在运行。 -

进入到 Workloads → Deployments 以验证

custom-metrics-autoscaler-operator部署是否正在运行。

可选:使用以下命令在 OpenShift CLI 中验证安装:

oc get all -n keda

$ oc get all -n kedaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出结果类似如下:

输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.2. 编辑 Keda Controller CR

您可以使用以下步骤修改 KedaController 自定义资源 (CR),它会在安装自定义 Metrics Autoscaler Operator 过程中自动安装。

流程

- 在 Red Hat OpenShift Service on AWS web 控制台中,点 Ecosystem → Installed Operators。

- 点 Custom Metrics Autoscaler。

- 在 Operator Details 页面中,点 KedaController 选项卡。

在 KedaController 选项卡中,点 Create KedaController 并编辑文件。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定自定义 Metrics Autoscaler Operator 应该在其中扩展应用程序的单个命名空间。将它留空,或将其留空,以便在所有命名空间中扩展应用程序。此字段应具有命名空间或为空。默认值为空。

- 2

- 指定自定义 Metrics Autoscaler Operator 日志消息的详细程度。允许的值有

debug、info和error。默认为info。 - 3

- 指定 Custom Metrics Autoscaler Operator 日志消息的日志记录格式。允许的值是

console或json。默认为console。 - 4

- 可选:使用 CA 证书指定一个或多个配置映射,自定义 Metrics Autoscaler Operator 可以使用它们安全地连接到启用了 TLS 的指标源。

- 5

- 可选:添加容器挂载路径。

- 6

- 可选:添加一个

volumes块来列出每个投射卷源。 - 7

- 指定自定义 Metrics Autoscaler Metrics 服务器的日志记录级别。允许的值是

0(info) 和4(debug)。默认值为0。 - 8

- 激活自定义 Metrics Autoscaler Operator 的审计日志记录,并指定要使用的审计策略,如"配置审计日志记录"部分中所述。

- 点 Save 保存更改。

3.4. 了解自定义指标自动扩展触发器

触发器(也称为 scalers)提供自定义 Metrics Autoscaler Operator 用来扩展 pod 的指标。

自定义指标自动扩展目前支持 Prometheus、CPU、内存、Apache Kafka 和 cron 触发器。

您可以使用 ScaledObject 或 ScaledJob 自定义资源为特定对象配置触发器,如后面的章节中所述。

您可以配置一个证书颁发机构与扩展对象一起使用,或配置为集群中的所有扩展程序。

3.4.1. 了解 Prometheus 触发器

您可以基于 Prometheus 指标扩展 pod,该指标可以使用已安装的 Red Hat OpenShift Service on AWS 监控或外部 Prometheus 服务器作为指标源。如需有关使用 Red Hat OpenShift Service on AWS 监控所需的配置作为指标源的信息,请参阅"配置自定义指标自动扩展以使用 Red Hat OpenShift Service on AWS 监控"。

如果 Prometheus 从自定义指标自动扩展扩展的应用程序收集指标,请不要在自定义资源中将最小副本设置为 0。如果没有应用程序 pod,自定义指标自动扩展没有任何要缩放的指标。

带有 Prometheus 目标的扩展对象示例

- 1

- 指定 Prometheus 作为触发器类型。

- 2

- 指定 Prometheus 服务器的地址。本例使用 Red Hat OpenShift Service on AWS 监控。

- 3

- 可选:指定您要缩放的对象的命名空间。如果使用 Red Hat OpenShift Service on AWS 监控作为指标的源,则需要此参数。

- 4

- 指定在

external.metrics.k8s.ioAPI 中标识指标的名称。如果您使用的是多个触发器,则所有指标名称都必须是唯一的。 - 5

- 指定触发扩展的值。必须指定为带引号的字符串值。

- 6

- 指定要使用的 Prometheus 查询。

- 7

- 指定要使用的身份验证方法。Prometheus scalers 支持 bearer 身份验证 (

bearer)、基本身份验证 (basic) 或 TLS 身份验证 (tls)。您可以在触发器身份验证中配置特定的身份验证参数,如以下部分所述。根据需要,您还可以使用 secret。 - 8

- 9

- 可选:指定在 Prometheus 目标丢失时触发器应如何进行操作。

-

如果为

true,当 Prometheus 目标丢失时触发器将继续操作。这是默认的行为。 -

如果为

false,当 Prometheus 目标丢失时触发器会返回错误。

-

如果为

- 10

- 可选:指定是否应跳过证书检查。例如,如果在测试环境中运行并使用 Prometheus 端点上的自签名证书,您可以跳过检查。

-

如果为

false,则执行证书检查。这是默认的行为。 如果为

true,则不会执行证书检查。重要不建议跳过检查。

-

如果为

- 11

- 可选:为此 Prometheus 触发器使用的 HTTP 客户端指定 HTTP 请求超时(以毫秒为单位)。这个值会覆盖任何全局超时设置。

3.4.1.1. 使用 Prometheus 和 DCGM 指标配置基于 GPU 的自动扩展

您可以使用带有 NVIDIA Data Center GPU Manager (DCGM)指标的自定义 Metrics Autoscaler,根据 GPU 使用率扩展工作负载。这对需要 GPU 资源的 AI 和机器学习工作负载特别有用。

带有基于 GPU 的自动扩展的 Prometheus 目标的扩展对象示例

您可以使用安装的 Red Hat OpenShift Service on AWS Prometheus 监控作为自定义指标自动扩展使用的指标的来源。但是,需要执行一些额外的配置。

要使扩展的对象能够读取 AWS Prometheus 指标上的 Red Hat OpenShift Service,您必须使用触发器身份验证或集群触发器身份验证来提供所需的身份验证信息。以下流程因您使用的触发器验证方法而异。如需有关触发器身份验证的更多信息,请参阅"了解自定义指标自动扩展身份验证"。

外部 Prometheus 源不需要这些步骤。

您必须执行以下任务,如本节所述:

- 创建一个服务帐户。

- 创建触发器身份验证。

- 创建角色。

- 将该角色添加到服务帐户。

- 在 Prometheus 使用的触发器验证对象中引用令牌。

先决条件

- 必须安装 Red Hat OpenShift Service on AWS 监控。

- 在 Red Hat OpenShift Service on AWS 监控中必须启用对 用户定义的工作负载的监控,如 创建用户定义的工作负载监控配置映射 部分所述。

- 必须安装 Custom Metrics Autoscaler Operator。

流程

改为适当的项目:

oc project <project_name>

$ oc project <project_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定以下项目之一:

- 如果使用触发器身份验证,请使用您要缩放的对象指定项目。

-

如果使用集群触发器身份验证,请指定

openshift-keda项目。

如果集群没有服务帐户,请创建一个服务帐户:

使用以下命令创建

服务帐户对象:oc create serviceaccount thanos

$ oc create serviceaccount thanos1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定服务帐户的名称。

使用服务帐户令牌创建触发器身份验证:

创建一个类似以下示例的 YAML 文件:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 CR 对象:

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

创建用于读取 Thanos 指标的角色:

使用以下参数创建 YAML 文件:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 CR 对象:

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

创建用于读取 Thanos 指标的角色绑定:

创建一个类似以下示例的 YAML 文件:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 CR 对象:

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

现在,您可以部署扩展的对象或扩展作业来为应用程序启用自动扩展,如"了解如何添加自定义指标自动扩展"中所述。要将 Red Hat OpenShift Service on AWS 监控用作源,在触发器或 scaler 中,您必须包括以下参数:

-

triggers.type必须是prometheus -

triggers.metadata.serverAddress必须是https://thanos-querier.openshift-monitoring.svc.cluster.local:9092 -

triggers.metadata.authModes必须是bearer -

triggers.metadata.namespace必须设置为要缩放的对象的命名空间 -

triggers.authenticationRef必须指向上一步中指定的触发器身份验证资源

3.4.2. 了解 CPU 触发器

您可以根据 CPU 指标扩展 pod。此触发器使用集群指标作为指标的源。

自定义指标自动扩展扩展与对象关联的 pod,以维护您指定的 CPU 用量。自动缩放器增加或减少最小和最大数量之间的副本数量,以维护所有 pod 的指定 CPU 使用率。内存触发器考虑整个 pod 的内存使用率。如果 pod 有多个容器,则内存触发器会考虑 pod 中所有容器的总内存使用率。

-

此触发器不能与

ScaledJob自定义资源一起使用。 -

当使用内存触发器扩展对象时,对象不会扩展到

0,即使您使用多个触发器。

使用 CPU 目标扩展对象示例

3.4.3. 了解内存触发器

您可以根据内存指标扩展 pod。此触发器使用集群指标作为指标的源。

自定义指标自动扩展扩展与对象关联的 pod,以维护您指定的平均内存用量。自动缩放器会增加和减少最小和最大数量之间的副本数量,以维护所有 pod 的指定内存使用率。内存触发器考虑整个 pod 的内存使用率。如果 pod 有多个容器,则内存使用率是所有容器的总和。

-

此触发器不能与

ScaledJob自定义资源一起使用。 -

当使用内存触发器扩展对象时,对象不会扩展到

0,即使您使用多个触发器。

使用内存目标扩展对象示例

3.4.4. 了解 Kafka 触发器

您可以根据 Apache Kafka 主题或支持 Kafka 协议的其他服务扩展 pod。自定义指标自动扩展不会缩放 Kafka 分区数量,除非在扩展的对象或扩展任务中将 allowIdleConsumers 参数设置为 true。

如果消费者组数量超过主题中的分区数量,则额外的消费者组处于闲置状态。要避免这种情况,默认情况下副本数不会超过:

- 如果指定了主题,则主题上的分区数量

- 如果没有指定主题,则消费者组中的所有主题的分区数量

-

在扩展对象或扩展作业 CR 中指定的

maxReplicaCount

您可以使用 allowIdleConsumers 参数禁用这些默认行为。

使用 Kafka 目标扩展对象示例

- 1

- 指定 Kafka 作为触发器类型。

- 2

- 指定 Kafka 在处理偏移滞后的 Kafka 主题的名称。

- 3

- 指定要连接的 Kafka 代理的逗号分隔列表。

- 4

- 指定用于检查主题上的偏移以及处理相关滞后的 Kafka 消费者组的名称。

- 5

- 可选:指定触发扩展的平均目标值。必须指定为带引号的字符串值。默认值为

5。 - 6

- 可选:指定激活阶段的目标值。必须指定为带引号的字符串值。

- 7

- 可选:为 Kafka 使用者指定 Kafka 偏移重置策略。可用值包括:

latest和earliest。默认为latest。 - 8

- 可选:指定 Kafka 副本数是否可以超过主题中的分区数量。

-

如果为

true,则 Kafka 副本数可能会超过主题上的分区数量。这允许闲置 Kafka 用户。 -

如果为

false,则 Kafka 副本数不能超过主题上的分区数量。这是默认值。

-

如果为

- 9

- 指定当 Kafka 分区没有有效偏移时触发器的行为方式。

-

如果为

true,则该分区的用户将缩减为零。 -

如果为

false,则 scaler 为该分区保留单个消费者。这是默认值。

-

如果为

- 10

- 可选:指定触发器是否为当前偏移与之前轮询周期的当前偏移量相同或排除分区滞后。

-

如果为

true,则扩展程序会排除这些分区中的分区滞后。 -

如果为

false,则触发器在所有分区中包含所有消费者滞后。这是默认值。

-

如果为

- 11

- 可选:指定 Kafka 代理的版本。必须指定为带引号的字符串值。默认值为

1.0.0。 - 12

- 可选:指定一个以逗号分隔的分区 ID 列表来限制缩放。如果设置,则仅考虑计算滞后列出的 ID。必须指定为带引号的字符串值。默认为考虑所有分区。

- 13

- 可选:指定是否对 Kafka 使用 TSL 客户端身份验证。默认为

禁用。有关配置 TLS 的详情,请参考 "Understanding custom metrics autoscaler trigger authentications"。

3.4.5. 了解 Cron 触发器

您可以根据时间范围扩展 pod。

当时间范围启动时,自定义指标自动扩展会将与对象关联的 pod 从配置的最少 pod 数量扩展到所需的 pod 数量。在时间范围结束时,容器集将重新扩展到配置的最小值。时间段必须以 cron 格式进行配置。

在以下示例中,从印度标准时间 6:00 AM 到 6:30 PM 时将与此扩展对象关联的 pod 从 0 扩展到 100。

使用 Cron trigger 扩展对象示例

3.4.6. 了解 Kubernetes 工作负载触发器

您可以根据与特定标签选择器匹配的 pod 数量扩展 pod。

Custom Metrics Autoscaler Operator 会跟踪具有相同命名空间中的特定标签的 pod 数量,然后根据标记为扩展对象的 pod 数量来计算 关系。使用这个关系,自定义 Metrics Autoscaler Operator 根据 ScaledObject 或 ScaledJob 规格中的扩展策略扩展对象。

pod 数量包含 Succeeded 或 Failed 阶段的 pod。

例如,如果您有一个frontend部署和一个backend部署。您可以使用 kubernetes-workload 触发器根据 frontend pod 的数量扩展 backend 部署。如果 frontend pod 数量增加,Operator 将扩展 backend pod 以维护指定的比率。在本例中,如果有 10 个带有 app=frontend pod 选择器的 pod,Operator 会将后端 Pod 扩展为 5,以便维护缩放对象中设置的 0.5 比例。

使用 Kubernetes 工作负载触发器的扩展对象示例

- 1

- 指定 Kubernetes 工作负载触发器。

- 2

- 指定一个或多个 pod 选择器和/或以逗号分开的选择器,用于获取 pod 数量。

- 3

- 指定扩展工作负载和与选择器匹配的 pod 数量之间的目标关系。关系按照以下公式计算:

relation = (pods that match the selector) / (scaled workload pods)

relation = (pods that match the selector) / (scaled workload pods)Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 4

- 可选:指定 scaler 激活阶段的目标值。默认值为

0。

3.5. 了解自定义指标自动扩展触发器身份验证

触发器身份验证允许您在扩展对象或可供关联容器使用的扩展作业中包含身份验证信息。您可以使用触发器身份验证来传递 Red Hat OpenShift Service on AWS secret、平台原生 pod 身份验证机制、环境变量等。

您可以在与您要缩放的对象相同的命名空间中定义一个 TriggerAuthentication 对象。该触发器身份验证只能由该命名空间中的对象使用。

另外,要在多个命名空间中对象间共享凭证,您可以创建一个可在所有命名空间中使用的 ClusterTriggerAuthentication 对象。

触发验证和集群触发器身份验证使用相同的配置。但是,集群触发器身份验证需要在扩展对象的验证引用中有一个额外的 kind 参数。

使用绑定服务帐户令牌的触发器身份验证示例

使用绑定服务帐户令牌的集群触发器身份验证示例

使用 secret 进行基本身份验证的触发器身份验证示例

用于基本身份验证的 secret 示例

- 1

- 提供给触发器身份验证的用户名和密码。

data小节中的值必须采用 base-64 编码。

使用 secret 进行 CA 详情的触发器身份验证示例

带有证书颁发机构 (CA) 详细信息的 secret 示例

使用 bearer 令牌的触发器身份验证示例

bearer 令牌的 secret 示例

- 1

- 指定与 bearer 身份验证一起使用的 bearer 令牌。该值必须采用 base-64 编码。

使用环境变量的触发器身份验证示例

使用 pod 身份验证供应商的触发器身份验证示例

其他资源

3.5.1. 使用触发器身份验证

您可以使用触发器验证和集群触发器身份验证,方法是使用自定义资源来创建身份验证,然后添加对扩展对象或扩展任务的引用。

先决条件

- 必须安装 Custom Metrics Autoscaler Operator。

- 如果您使用绑定的服务帐户令牌,则服务帐户必须存在。

如果您使用绑定服务帐户令牌,则必须存在一个基于角色的访问控制(RBAC)对象,使自定义 Metrics Autoscaler Operator 从服务帐户请求服务帐户令牌。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

如果使用 secret,

Secret对象必须存在。

流程

创建

TriggerAuthentication或ClusterTriggerAuthentication对象。创建定义对象的 YAML 文件:

使用绑定服务帐户令牌的触发器身份验证示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

TriggerAuthentication对象:oc create -f <filename>.yaml

$ oc create -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

创建或编辑使用触发器身份验证的

ScaledObjectYAML 文件:运行以下命令,创建定义对象的 YAML 文件:

使用触发器身份验证的扩展对象示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用集群触发器身份验证的扩展对象示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建扩展的对象:

oc apply -f <filename>

$ oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. 了解如何添加自定义指标自动扩展

要添加自定义指标自动扩展,请为部署、有状态集或自定义资源创建 ScaledObject 自定义资源。为作业创建 ScaledJob 自定义资源。

您只能为每个您要扩展的工作负载创建一个扩展对象。另外,您不能在同一工作负载中使用扩展的对象和 pod 横向自动扩展(HPA)。

3.6.1. 在工作负载中添加自定义指标自动扩展

您可以为 Deployment、StatefulSet 或 custom resource 对象创建的工作负载创建自定义指标自动扩展。

先决条件

- 必须安装 Custom Metrics Autoscaler Operator。

如果您使用自定义指标自动扩展来根据 CPU 或内存进行扩展:

您的集群管理员必须已配置了集群指标。您可以使用

oc describe PodMetrics <pod-name>命令来判断是否已配置了指标。如果配置了指标,输出将类似以下示例,CPU 和 Memory 在 Usage 下显示。oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 与您要缩放的对象关联的 pod 必须包含指定的内存和 CPU 限值。例如:

pod 规格示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

创建一个类似如下的 YAML 文件:只有名称

<2>, 对象名称<4>, 和对象类型<5>是必需的。缩放对象示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 可选:指定自定义 Metrics Autoscaler Operator 将副本扩展到指定的值和停止自动扩展,如 "Pausing the custom metrics autoscaler for a workload" 部分所述。

- 2

- 指定此自定义指标自动扩展的名称。

- 3

- 可选:指定目标资源的 API 版本。默认为

apps/v1。 - 4

- 指定要缩放的对象名称。

- 5

- 指定

kind为Deployment,StatefulSet或CustomResource。 - 6

- 可选:指定目标资源中的容器的名称,其中的自定义自动扩展器获取包含 secret 的环境变量等。默认为

.spec.template.spec.containers[0]。 - 7

- 可选。指定一个在最后的触发器报告后等待的时间(以秒为单位),在经过这个时间后才会将部署缩减为

0(如果minReplicaCount设置为0)。默认值为300。 - 8

- 可选:指定扩展时的最大副本数量。默认值为

100。 - 9

- 可选:指定缩减时的最小副本数量。

- 10

- 可选:指定审计日志的参数。如"配置审计日志记录"部分中所述。

- 11

- 可选:指定在扩展程序无法从源中获取由

failureThreshold参数定义的次数时回退到的副本数。有关回退行为的更多信息,请参阅 KEDA 文档。 - 12

- 可选:指定在出现回退时要使用的副本数。输入以下选项之一或省略该参数:

-

输入

static,以使用fallback.replicas参数指定的副本数。这是默认值。 -

输入

currentReplicas以维护当前副本数。 -

如果该数量高于

fallback.replicas参数,则输入currentReplicasIfHigher以维护当前的副本数。如果当前副本数低于fallback.replicas参数,请使用fallback.replicas值。 -

如果该数量低于

fallback.replicas参数,输入currentReplicasIfLower以维护当前的副本数。如果当前副本数高于fallback.replicas参数,请使用fallback.replicas值。

-

输入

- 13

- 可选:指定检查每个触发器的时间间隔(以秒为单位)。默认值为

30。 - 14

- 可选:指定是否在删除扩展对象后将目标资源扩展为原始副本数。默认为

false,这会在删除扩展对象时保留副本数。 - 15

- 可选:指定 pod 横向自动扩展的名称。默认为

keda-hpa-{scaled-object-name}。 - 16

- 可选:指定一个扩展策略来控制用来扩展或缩减 pod 的速度,如"扩展策略"部分中所述。

- 17

- 指定用作扩展基础的触发器,如"识别自定义指标自动扩展触发器"部分中所述。本例使用 Red Hat OpenShift Service on AWS 监控。

- 18

- 可选:指定触发器身份验证或集群触发器身份验证。如需更多信息,请参阅附加资源部分中的 了解自定义指标自动扩展触发器身份验证。

-

输入

TriggerAuthentication来使用触发器身份验证。这是默认值。 -

输入

ClusterTriggerAuthentication来使用集群触发器身份验证。

-

输入

运行以下命令来创建自定义指标自动扩展:

oc create -f <filename>.yaml

$ oc create -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

查看命令输出,以验证是否已创建自定义指标自动扩展:

oc get scaledobject <scaled_object_name>

$ oc get scaledobject <scaled_object_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME SCALETARGETKIND SCALETARGETNAME MIN MAX TRIGGERS AUTHENTICATION READY ACTIVE FALLBACK AGE scaledobject apps/v1.Deployment example-deployment 0 50 prometheus prom-triggerauthentication True True True 17s

NAME SCALETARGETKIND SCALETARGETNAME MIN MAX TRIGGERS AUTHENTICATION READY ACTIVE FALLBACK AGE scaledobject apps/v1.Deployment example-deployment 0 50 prometheus prom-triggerauthentication True True True 17sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意输出中的以下字段:

-

TRIGGERS:指示正在使用的触发器或缩放器。 -

AUTHENTICATION:指示所使用的任何触发器身份验证的名称。 READY:指示扩展对象是否准备好启动缩放:-

如果为

True,则扩展的对象已就绪。 -

如果

False,由于您创建的对象中的一个或多个对象有问题,扩展的对象将不可用。

-

如果为

ACTIVE:指示扩展是否发生:-

如果为

True,则会进行缩放。 -

如果

False,则不会发生缩放,因为您创建的一个或多个对象中没有指标或多个问题。

-

如果为

FALLBACK:指示自定义指标自动扩展是否能够从源获取指标-

如果

False,自定义指标自动扩展器会获取指标。 -

如果为

True,自定义指标自动扩展会获取指标,因为您创建的一个或多个对象中没有指标或多个问题。

-

如果

-

3.7. 暂停扩展对象的自定义指标自动扩展

您可以根据需要暂停并重启工作负载的自动扩展。

例如,您可能想要在执行集群维护前暂停自动扩展,或通过删除非传输工作负载来避免资源不足。

3.7.1. 暂停自定义指标自动扩展

您可以通过将 autoscaling.keda.sh/paused-replicas 注解添加到扩展对象的自定义指标自动扩展中来暂停扩展对象的自动扩展。自定义指标自动扩展将该工作负载的副本扩展到指定的值,并暂停自动扩展,直到注解被删除为止。

流程

使用以下命令编辑工作负载的

ScaledObjectCR:oc edit ScaledObject scaledobject

$ oc edit ScaledObject scaledobjectCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用任何值添加

autoscaling.keda.sh/paused-replicas注解:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定自定义 Metrics Autoscaler Operator 将副本扩展到指定的值,并停止自动扩展。

3.7.2. 为扩展的对象重启自定义指标自动扩展

您可以通过删除该 ScaledObject 的 autoscaling.keda.sh/paused-replicas 注解来重启暂停的自定义指标自动扩展。

流程

使用以下命令编辑工作负载的

ScaledObjectCR:oc edit ScaledObject scaledobject

$ oc edit ScaledObject scaledobjectCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除

autoscaling.keda.sh/paused-replicas注解。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 删除此注解以重启暂停的自定义指标自动扩展。

3.8. 收集审计日志

您可以收集审计日志,它们是与安全相关的按时间排序的记录,记录各个用户、管理员或其他系统组件影响系统的一系列活动。

例如,审计日志可帮助您了解自动扩展请求来自哪里。当后端因为用户应用程序发出的请求造成过载时,这个信息非常重要,您需要确定哪个是有问题的应用程序。

3.8.1. 配置审计日志记录

您可以通过编辑 KedaController 自定义资源来为自定义 Metrics Autoscaler Operator 配置审计。日志通过 KedaController CR 中的持久性卷声明发送到卷的审计日志文件。

先决条件

- 必须安装 Custom Metrics Autoscaler Operator。

流程

编辑

KedaController自定义资源以添加auditConfig小节:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定审计日志的输出格式,可以是

legacy或json。 - 2

- 指定用于存储日志数据的现有持久性卷声明。所有来自 API 服务器的请求都会记录到此持久性卷声明。如果将此字段留空,日志数据将发送到 stdout。

- 3

- 指定应记录哪些事件及其应包含哪些数据:

-

None:不记录事件。 -

Metadata:仅记录请求的元数据,如用户、时间戳等。不要记录请求文本和响应文本。这是默认值。 -

Request:仅记录元数据和请求文本,而不记录响应文本。这个选项不适用于非资源请求。 -

RequestResponse:日志事件元数据、请求文本和响应文本。这个选项不适用于非资源请求。

-

- 4

- 指定没有创建事件的阶段。

- 5

- 指定是否省略请求的 managed 字段,并从写入 API 审计日志的响应正文,可以是

true来省略字段,或false包含字段。 - 6

- 指定审计日志的大小和生命周期。

-

MaxAge:根据文件名中编码的时间戳,保留审计日志文件的最大天数。 -

maxBackup:要保留的审计日志文件的最大数量。设置为0以保留所有审计日志文件。 -

maxsize:在轮转审计日志文件前以 MB 为单位的最大大小。

-

验证

直接查看审计日志文件:

获取

keda-metrics-apiserver the pod的名称:oc get pod -n keda

oc get pod -n kedaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE custom-metrics-autoscaler-operator-5cb44cd75d-9v4lv 1/1 Running 0 8m20s keda-metrics-apiserver-65c7cc44fd-rrl4r 1/1 Running 0 2m55s keda-operator-776cbb6768-zpj5b 1/1 Running 0 2m55s

NAME READY STATUS RESTARTS AGE custom-metrics-autoscaler-operator-5cb44cd75d-9v4lv 1/1 Running 0 8m20s keda-metrics-apiserver-65c7cc44fd-rrl4r 1/1 Running 0 2m55s keda-operator-776cbb6768-zpj5b 1/1 Running 0 2m55sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用类似如下的命令查看日志数据:

oc logs keda-metrics-apiserver-<hash>|grep -i metadata

$ oc logs keda-metrics-apiserver-<hash>|grep -i metadata1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 可选: 您可以使用

grep命令指定要显示的日志级别:Metadata、Request、RequestResponse。

例如:

oc logs keda-metrics-apiserver-65c7cc44fd-rrl4r|grep -i metadata

$ oc logs keda-metrics-apiserver-65c7cc44fd-rrl4r|grep -i metadataCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

... {"kind":"Event","apiVersion":"audit.k8s.io/v1","level":"Metadata","auditID":"4c81d41b-3dab-4675-90ce-20b87ce24013","stage":"ResponseComplete","requestURI":"/healthz","verb":"get","user":{"username":"system:anonymous","groups":["system:unauthenticated"]},"sourceIPs":["10.131.0.1"],"userAgent":"kube-probe/1.28","responseStatus":{"metadata":{},"code":200},"requestReceivedTimestamp":"2023-02-16T13:00:03.554567Z","stageTimestamp":"2023-02-16T13:00:03.555032Z","annotations":{"authorization.k8s.io/decision":"allow","authorization.k8s.io/reason":""}} ...... {"kind":"Event","apiVersion":"audit.k8s.io/v1","level":"Metadata","auditID":"4c81d41b-3dab-4675-90ce-20b87ce24013","stage":"ResponseComplete","requestURI":"/healthz","verb":"get","user":{"username":"system:anonymous","groups":["system:unauthenticated"]},"sourceIPs":["10.131.0.1"],"userAgent":"kube-probe/1.28","responseStatus":{"metadata":{},"code":200},"requestReceivedTimestamp":"2023-02-16T13:00:03.554567Z","stageTimestamp":"2023-02-16T13:00:03.555032Z","annotations":{"authorization.k8s.io/decision":"allow","authorization.k8s.io/reason":""}} ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

另外,您可以查看特定的日志:

使用类似如下的命令登录到

keda-metrics-apiserver thepod:oc rsh pod/keda-metrics-apiserver-<hash> -n keda

$ oc rsh pod/keda-metrics-apiserver-<hash> -n kedaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

oc rsh pod/keda-metrics-apiserver-65c7cc44fd-rrl4r -n keda

$ oc rsh pod/keda-metrics-apiserver-65c7cc44fd-rrl4r -n kedaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 进入

/var/audit-policy/目录:cd /var/audit-policy/

sh-4.4$ cd /var/audit-policy/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 列出可用的日志:

ls

sh-4.4$ lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

log-2023.02.17-14:50 policy.yaml

log-2023.02.17-14:50 policy.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 根据需要查看日志:

cat <log_name>/<pvc_name>|grep -i <log_level>

sh-4.4$ cat <log_name>/<pvc_name>|grep -i <log_level>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 可选: 您可以使用

grep命令指定要显示的日志级别:Metadata、Request、RequestResponse。

例如:

cat log-2023.02.17-14:50/pvc-audit-log|grep -i Request

sh-4.4$ cat log-2023.02.17-14:50/pvc-audit-log|grep -i RequestCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

... {"kind":"Event","apiVersion":"audit.k8s.io/v1","level":"Request","auditID":"63e7f68c-04ec-4f4d-8749-bf1656572a41","stage":"ResponseComplete","requestURI":"/openapi/v2","verb":"get","user":{"username":"system:aggregator","groups":["system:authenticated"]},"sourceIPs":["10.128.0.1"],"responseStatus":{"metadata":{},"code":304},"requestReceivedTimestamp":"2023-02-17T13:12:55.035478Z","stageTimestamp":"2023-02-17T13:12:55.038346Z","annotations":{"authorization.k8s.io/decision":"allow","authorization.k8s.io/reason":"RBAC: allowed by ClusterRoleBinding \"system:discovery\" of ClusterRole \"system:discovery\" to Group \"system:authenticated\""}} ...... {"kind":"Event","apiVersion":"audit.k8s.io/v1","level":"Request","auditID":"63e7f68c-04ec-4f4d-8749-bf1656572a41","stage":"ResponseComplete","requestURI":"/openapi/v2","verb":"get","user":{"username":"system:aggregator","groups":["system:authenticated"]},"sourceIPs":["10.128.0.1"],"responseStatus":{"metadata":{},"code":304},"requestReceivedTimestamp":"2023-02-17T13:12:55.035478Z","stageTimestamp":"2023-02-17T13:12:55.038346Z","annotations":{"authorization.k8s.io/decision":"allow","authorization.k8s.io/reason":"RBAC: allowed by ClusterRoleBinding \"system:discovery\" of ClusterRole \"system:discovery\" to Group \"system:authenticated\""}} ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.9. 收集调试数据

在提交问题单时同时提供您的集群信息,可以帮助红帽支持为您进行排除故障。

要帮助排除您的问题,请提供以下信息:

-

使用

must-gather工具收集的数据。 - 唯一的集群 ID。

您可以使用 must-gather 工具来收集有关自定义 Metrics Autoscaler Operator 及其组件的数据,包括以下项目:

-

keda命名空间及其子对象。 - Custom Metric Autoscaler Operator 安装对象。

- Custom Metric Autoscaler Operator CRD 对象。

3.9.1. 收集调试数据

以下命令为自定义 Metrics Autoscaler Operator 运行 must-gather 工具:

oc adm must-gather --image="$(oc get packagemanifests openshift-custom-metrics-autoscaler-operator \

-n openshift-marketplace \

-o jsonpath='{.status.channels[?(@.name=="stable")].currentCSVDesc.annotations.containerImage}')"

$ oc adm must-gather --image="$(oc get packagemanifests openshift-custom-metrics-autoscaler-operator \

-n openshift-marketplace \

-o jsonpath='{.status.channels[?(@.name=="stable")].currentCSVDesc.annotations.containerImage}')"

标准 Red Hat OpenShift Service on AWS must-gather 命令 oc adm must-gather 不会收集自定义 Metrics Autoscaler Operator 数据。

先决条件

-

以具有

dedicated-admin角色的用户身份登录到 Red Hat OpenShift Service on AWS。 -

安装了 Red Hat OpenShift Service on AWS CLI (

oc)。

流程

-

进入存储

must-gather数据的目录。 执行以下之一:

要只获取自定义 Metrics Autoscaler Operator

must-gather数据,请使用以下命令:oc adm must-gather --image="$(oc get packagemanifests openshift-custom-metrics-autoscaler-operator \ -n openshift-marketplace \ -o jsonpath='{.status.channels[?(@.name=="stable")].currentCSVDesc.annotations.containerImage}')"$ oc adm must-gather --image="$(oc get packagemanifests openshift-custom-metrics-autoscaler-operator \ -n openshift-marketplace \ -o jsonpath='{.status.channels[?(@.name=="stable")].currentCSVDesc.annotations.containerImage}')"Copy to Clipboard Copied! Toggle word wrap Toggle overflow must-gather命令的自定义镜像直接从 Operator 软件包清单中拉取,以便它可用于提供 Custom Metric Autoscaler Operator 的任何集群。除了 Custom Metric Autoscaler Operator 信息外,要收集默认的

must-gather数据:使用以下命令获取自定义 Metrics Autoscaler Operator 镜像并将其设置为环境变量:

IMAGE="$(oc get packagemanifests openshift-custom-metrics-autoscaler-operator \ -n openshift-marketplace \ -o jsonpath='{.status.channels[?(@.name=="stable")].currentCSVDesc.annotations.containerImage}')"$ IMAGE="$(oc get packagemanifests openshift-custom-metrics-autoscaler-operator \ -n openshift-marketplace \ -o jsonpath='{.status.channels[?(@.name=="stable")].currentCSVDesc.annotations.containerImage}')"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用带有自定义 Metrics Autoscaler Operator 镜像的

oc adm must-gather:oc adm must-gather --image-stream=openshift/must-gather --image=${IMAGE}$ oc adm must-gather --image-stream=openshift/must-gather --image=${IMAGE}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

例 3.1. Custom Metric Autoscaler 的 must-gather 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 从工作目录中创建的

must-gather目录创建一个压缩文件。例如,在使用 Linux 操作系统的计算机上运行以下命令:tar cvaf must-gather.tar.gz must-gather.local.5421342344627712289/

$ tar cvaf must-gather.tar.gz must-gather.local.5421342344627712289/1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

must-gather-local.5421342344627712289/替换为实际目录名称。

- 在红帽客户门户中为您的问题单附上压缩文件。

3.10. 查看 Operator 指标

Custom Metrics Autoscaler Operator 会公开从集群监控组件中提取的可随时使用的指标。您可以使用 Prometheus Query Language (PromQL) 来分析和诊断问题来查询指标。控制器 pod 重启时会重置所有指标。

3.10.1. 访问性能指标

您可以使用 Red Hat OpenShift Service on AWS Web 控制台访问指标并运行查询。

流程

- 在 Red Hat OpenShift Service on AWS web 控制台中选择 Administrator 视角。

- 选择 Observe → Metrics。

- 要创建自定义查询,请将 PromQL 查询添加到 Expression 字段中。

- 要添加多个查询,选择 Add Query。

3.10.1.1. 提供的 Operator 指标

Custom Metrics Autoscaler Operator 会公开以下指标,您可以使用 Red Hat OpenShift Service on AWS Web 控制台查看这些指标。

| 指标名称 | 描述 |

|---|---|

|

|

特定的 scaler 是活跃的还是不活跃的。值 |

|

| 每个 scaler 的指标的当前值,由计算目标平均值中的 Horizontal Pod Autoscaler (HPA) 使用。 |

|

| 从每个 scaler 检索当前指标的延迟。 |

|

| 每个 scaler 发生的错误数量。 |

|

| 所有 scaler 遇到的错误总数。 |

|

| 每个扩展的对象发生的错误数量。 |

|

| 每个命名空间中的自定义 Metrics Autoscaler 自定义资源总数,每种自定义资源类型。 |

|

| 根据触发器类型的触发器总数。 |

自定义 Metrics Autoscaler Admission Webhook 指标

自定义 Metrics Autoscaler Admission Webhook 也会公开以下 Prometheus 指标。

| 指标名称 | 描述 |

|---|---|

|

| 扩展对象验证的数量。 |

|

| 验证错误的数量。 |

3.11. 删除自定义 Metrics Autoscaler Operator

您可以从 Red Hat OpenShift Service on AWS 集群中删除自定义指标自动扩展。删除自定义 Metrics Autoscaler Operator 后,删除与 Operator 相关的其他组件以避免出现潜在的问题。

首先删除 KedaController 自定义资源(CR)。如果您不删除 KedaController CR,在删除 keda 项目时,AWS 上的 Red Hat OpenShift Service 会挂起。如果在删除 CR 前删除了自定义 Metrics Autoscaler Operator,您将无法删除 CR。

3.11.1. 卸载自定义 Metrics Autoscaler Operator

使用以下步骤从 Red Hat OpenShift Service on AWS 集群中删除自定义指标自动扩展。

先决条件

- 必须安装 Custom Metrics Autoscaler Operator。

流程

- 在 Red Hat OpenShift Service on AWS web 控制台中,点 Ecosystem → Installed Operators。

- 切换到 keda 项目。

删除

KedaController自定义资源。- 找到 CustomMetricsAutoscaler Operator 并点 KedaController 选项卡。

- 找到自定义资源,然后点 Delete KedaController。

- 点 Uninstall。

删除自定义 Metrics Autoscaler Operator:

- 点 Ecosystem → Installed Operators。

-

找到 CustomMetricsAutoscaler Operator 并点 Options 菜单

并选择 Uninstall Operator。

并选择 Uninstall Operator。

- 点 Uninstall。

可选: 使用 OpenShift CLI 删除自定义指标自动扩展组件:

删除自定义指标自动扩展 CRD:

-

clustertriggerauthentications.keda.sh -

kedacontrollers.keda.sh -

scaledjobs.keda.sh -

scaledobjects.keda.sh -

triggerauthentications.keda.sh

oc delete crd clustertriggerauthentications.keda.sh kedacontrollers.keda.sh scaledjobs.keda.sh scaledobjects.keda.sh triggerauthentications.keda.sh

$ oc delete crd clustertriggerauthentications.keda.sh kedacontrollers.keda.sh scaledjobs.keda.sh scaledobjects.keda.sh triggerauthentications.keda.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除 CRD 会删除关联的角色、集群角色和角色绑定。但是,可能存在一些必须手动删除的集群角色。

-

列出任何自定义指标自动扩展集群角色:

oc get clusterrole | grep keda.sh

$ oc get clusterrole | grep keda.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除列出的自定义指标自动扩展集群角色。例如:

oc delete clusterrole.keda.sh-v1alpha1-admin

$ oc delete clusterrole.keda.sh-v1alpha1-adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow 列出任何自定义指标自动扩展集群角色绑定:

oc get clusterrolebinding | grep keda.sh

$ oc get clusterrolebinding | grep keda.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除列出的自定义指标自动扩展集群角色绑定。例如:

oc delete clusterrolebinding.keda.sh-v1alpha1-admin

$ oc delete clusterrolebinding.keda.sh-v1alpha1-adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow

删除自定义指标自动扩展项目:

oc delete project keda

$ oc delete project kedaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除 Cluster Metric Autoscaler Operator:

oc delete operator/openshift-custom-metrics-autoscaler-operator.keda

$ oc delete operator/openshift-custom-metrics-autoscaler-operator.kedaCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 4 章 控制节点上的 pod 放置(调度)

4.1. 使用调度程序控制 pod 放置

Pod 调度是一个内部过程,决定新 pod 如何放置到集群内的节点上。

调度程度代码具有明确隔离,会监测创建的新 pod 并确定最适合托管它们的节点。然后,它会利用主 API 为 pod 创建 pod 至节点的绑定。

- 默认 pod 调度

- Red Hat OpenShift Service on AWS 附带一个满足大多数用户需求的默认调度程序。默认调度程序使用内置和自定义工具来决定最适合 pod 的调度程序。

- 高级 pod 调度

当您可能希望更多地控制新 pod 的放置位置时,Red Hat OpenShift Service on AWS 高级调度功能允许您配置 pod,以便需要 pod,或者优先在特定节点上运行,或者与特定的 pod 一起运行。

您可以使用以下调度功能来控制 pod 放置:

4.1.1. 关于默认调度程序

默认 Red Hat OpenShift Service on AWS pod 调度程序负责确定新 pod 放置到集群内的节点上。它从 pod 读取数据,并查找最适合配置的配置集的节点。它完全独立存在,作为独立解决方案。它不会修改 pod;它会为将 pod 绑定到特定节点的 pod 创建绑定。

4.1.1.1. 了解默认调度

现有的通用调度程序是平台默认提供的调度程序引擎,它可通过三步操作来选择托管 pod 的节点:

- 过滤节点

- 根据指定的约束或要求过滤可用的节点。这可以通过使用名为 predicates, 或 filters 的过滤器函数列表在每个节点上运行来实现。

- 排列过滤后节点列表的优先顺序

- 这可以通过一系列 priority, 或 scoring 来实现,这些函数为其分配分数介于 0 到 10 之间,0 表示不适合,10 则表示最适合托管该 pod。调度程序配置还可以为每个评分功能使用简单的 权重 (正数值)。每个评分功能提供的节点分数乘以权重(大多数分数的默认权重为 1),然后将每个节点通过为所有分数提供的分数相加。管理员可以使用这个权重属性为某些分数赋予更高的重要性。

- 选择最适合的节点

- 节点按照分数排序,系统选择分数最高的节点来托管该 pod。如果多个节点的分数相同,则随机选择其中一个。

4.1.2. 调度程序用例

在 Red Hat OpenShift Service on AWS 中调度的一个重要用例是支持灵活的关联性和反关联性策略。

4.1.2.1. 关联性

管理员应能够配置调度程序,在任何一个甚至多个拓扑级别上指定关联性。特定级别上的关联性指示所有属于同一服务的 pod 调度到属于同一级别的节点。这会让管理员确保对等 pod 在地理上不会过于分散,以此处理应用程序对延迟的要求。如果同一关联性组中没有节点可用于托管 pod,则不调度该 pod。

如果您需要更好地控制 pod 的调度位置,请参阅使用节点关联性规则控制节点上的 pod 放置,以及使用关联性和反关联性规则相对于其他 pod 放置 pod。

管理员可以利用这些高级调度功能,来指定 pod 可以调度到哪些节点,并且相对于其他 pod 来强制或拒绝调度。

4.1.2.2. 反关联性

管理员应能够配置调度程序,在任何一个甚至多个拓扑级别上指定反关联性。特定级别上的反关联性(或分散)指示属于同一服务的所有 pod 分散到属于该级别的不同节点上。这样可确保应用程序合理分布,以实现高可用性目的。调度程序尝试在所有适用的节点之间尽可能均匀地平衡服务 pod。

如果您需要更好地控制 pod 的调度位置,请参阅使用节点关联性规则控制节点上的 pod 放置,以及使用关联性和反关联性规则相对于其他 pod 放置 pod。

管理员可以利用这些高级调度功能,来指定 pod 可以调度到哪些节点,并且相对于其他 pod 来强制或拒绝调度。

4.2. 使用关联性和反关联性规则相对于其他 pod 放置 pod

关联性是 pod 的一个属性,用于控制它们希望调度到的节点。反关联性是 pod 的一个属性,用于阻止 pod 调度到某个节点上。

在 AWS 上的 Red Hat OpenShift Service 中,pod 关联性和 pod 反关联性 允许您根据其他 pod 上的键值标签限制 pod 有资格调度到哪些节点。

4.2.1. 了解 pod 关联性

您可以借助 pod 关联性和 pod 反关联性来根据其他 pod 上的键/值标签限制 pod 有资格调度到哪些节点。

- 如果新 pod 上的标签选择器与当前 pod 上的标签匹配,pod 关联性可以命令调度程序将新 pod 放置到与其他 pod 相同的节点上。

- 如果新 pod 上的标签选择器与当前 pod 上的标签匹配,pod 反关联性可以阻止调度程序将新 pod 放置到与具有相同标签的 pod 相同的节点上。

例如,您可以使用关联性规则,在服务内或相对于其他服务中的 pod 来分散或聚拢 pod。如果特定服务的 pod 的性能已知会受到另一服务的 pod 影响,那么您可以利用反关联性规则,防止前一服务的 pod 调度到与后一服务的 pod 相同的节点上。或者,您可以将服务的 pod 分散到节点间、可用性区域或可用性集,以减少相关的故障。

标签选择器可能与带有多个 pod 部署的 pod 匹配。在配置反关联性规则时,请使用标签的唯一组合以避免匹配的 pod。

pod 关联性规则有两种,即必要规则和偏好规则。

必须满足必要规则,pod 才能调度到节点上。偏好规则指定在满足规则时调度程序会尝试强制执行规则,但不保证一定能强制执行成功。

根据 pod 优先级和抢占设置,调度程序可能无法在不违反关联性要求的前提下为 pod 找到适合的节点。若是如此,pod 可能不会被调度。

要防止这种情况,请仔细配置优先级相同的 pod 的 pod 关联性。

您可以通过 Pod 规格文件配置 pod 关联性/反关联性。您可以指定必要规则或偏好规则,或同时指定这两种规则。如果您同时指定,节点必须首先满足必要规则,然后尝试满足偏好规则。

以下示例显示了配置了 pod 关联性和反关联性的 Pod 规格。

在本例中,pod 关联性规则指明,只有当节点至少有一个已在运行且具有键 security 和值 S1 的标签的 pod 时,pod 才可以调度到这个节点上。pod 反关联性则表示,如果节点已在运行带有键 security 和值 S2.的标签的 pod,则 pod 将偏向于不调度到该节点上。

具有 pod 关联性的 Pod 配置文件示例

具有 pod 反关联性的 Pod 配置文件示例

如果节点标签在运行时改变,使得不再满足 pod 上的关联性规则,pod 会继续在该节点上运行。

4.2.2. 配置 pod 关联性规则

以下步骤演示了一个简单的双 pod 配置,它创建一个带有某标签的 pod,以及一个使用关联性来允许随着该 pod 一起调度的 pod。

您不能直接将关联性添加到调度的 pod 中。

流程

创建 pod 规格中具有特定标签的 pod:

使用以下内容创建 YAML 文件:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 pod。

oc create -f <pod-spec>.yaml

$ oc create -f <pod-spec>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

在创建其他 pod 时,配置以下参数以添加关联性:

使用以下内容创建 YAML 文件:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 添加 pod 关联性。

- 2

- 配置

requiredDuringSchedulingIgnoredDuringExecution参数或preferredDuringSchedulingIgnoredDuringExecution参数。 - 3

- 指定必须满足的