6.4. 配置 Kafka

Kafka 使用属性文件来存储静态配置。配置文件的建议位置为 /opt/kafka/config/server.properties。配置文件必须可由 kafka 用户读取。

AMQ Streams 附带了一个示例配置文件,它突出显示了该产品的基本和高级功能。它可在 AMQ Streams 安装目录中的 config/server.properties 下找到。

本章解释了最重要的配置选项。

6.4.1. ZooKeeper

Kafka 代理需要 ZooKeeper 存储其配置的某些部分,并协调集群(例如,决定哪个节点是哪个分区的领导)。ZooKeeper 集群的连接详情保存在配置文件中。字段 zookeeper.connect 包含以逗号分隔的主机名和 zookeeper 集群成员端口列表。

例如:

zookeeper.connect=zoo1.my-domain.com:2181,zoo2.my-domain.com:2181,zoo3.my-domain.com:2181

zookeeper.connect=zoo1.my-domain.com:2181,zoo2.my-domain.com:2181,zoo3.my-domain.com:2181

Kafka 将使用这些地址连接到 ZooKeeper 集群。使用这个配置,所有 Kafka znodes 都会直接在 ZooKeeper 数据库的根目录中创建。因此,这样的 ZooKeeper 集群只能用于单个 Kafka 集群。要将多个 Kafka 集群配置为使用单个 ZooKeeper 集群,在 Kafka 配置文件中 ZooKeeper 连接字符串末尾指定基本(前缀)路径:

zookeeper.connect=zoo1.my-domain.com:2181,zoo2.my-domain.com:2181,zoo3.my-domain.com:2181/my-cluster-1

zookeeper.connect=zoo1.my-domain.com:2181,zoo2.my-domain.com:2181,zoo3.my-domain.com:2181/my-cluster-16.4.2. 监听器

监听器 用于连接到 Kafka 代理。每个 Kafka 代理都可以配置为使用多个监听程序。每个侦听器都需要不同的配置,以便它可以侦听不同的端口或网络接口。

要配置监听程序,请编辑配置文件中的 listeners 属性(/opt/kafka/config/server.properties)。以逗号分隔列表的形式将监听程序添加到 listeners 属性中。按如下方式配置每个属性:

<listenerName>://<hostname>:<port>

<listenerName>://<hostname>:<port>

如果 <hostname> 为空,则 Kafka 将使用 java.net.InetAddress.getCanonicalHostName() 类作为主机名。

多个监听程序配置示例

listeners=internal-1://:9092,internal-2://:9093,replication://:9094

listeners=internal-1://:9092,internal-2://:9093,replication://:9094

当 Kafka 客户端连接到 Kafka 集群时,它首先连接到 bootstrap 服务器,这是集群节点之一。bootstrap 服务器为客户端提供集群中的所有代理列表,客户端会分别连接到每个代理。代理列表基于配置 的监听程序。

公告的监听程序

另外,您可以使用 advertised.listeners 属性为客户端提供不同于监听程序属性中给出的一系列不同的监听程序地址。如果其他网络基础架构(如代理)在客户端和代理之间,或者会使用外部 DNS 名称而不是 IP 地址,这很有用。

advertised.listeners 属性的格式与 listeners 属性相同。

公告监听程序配置示例

listeners=internal-1://:9092,internal-2://:9093 advertised.listeners=internal-1://my-broker-1.my-domain.com:1234,internal-2://my-broker-1.my-domain.com:1235

listeners=internal-1://:9092,internal-2://:9093

advertised.listeners=internal-1://my-broker-1.my-domain.com:1234,internal-2://my-broker-1.my-domain.com:1235

公告的监听程序的名称必须与监听程序属性中列出的名称匹配。

inter-broker 监听程序

用于 Kafka 代理间通信的 inter-broker 侦听程序。需要代理间通信:

- 在不同代理间协调工作负载

- 在存储在不同代理的分区间复制消息

- 处理控制器中的管理任务,如分区领导更改

可以把 inter-broker 侦听器分配给您选择的端口。当配置了多个监听器时,您可以在 inter.broker.listener.name 属性中定义 inter-broker 侦听器的名称。

在这里,inter-broker 侦听器被命名为 REPLICATION :

listeners=REPLICATION://0.0.0.0:9091 inter.broker.listener.name=REPLICATION

listeners=REPLICATION://0.0.0.0:9091

inter.broker.listener.name=REPLICATIONcontrol plane 监听程序

默认情况下,控制器和其他代理之间的通信使用 inter-broker 侦听器。控制器负责协调管理任务,如分区领导更改。

您可以为控制器连接启用专用 control plane 监听程序。control plane 侦听器可以分配给您选择的端口。

要启用 control plane 侦听程序,请使用监听程序名称配置 control.plane.listener.name 属性:

listeners=CONTROLLER://0.0.0.0:9090,REPLICATION://0.0.0.0:9091 ... control.plane.listener.name=CONTROLLER

listeners=CONTROLLER://0.0.0.0:9090,REPLICATION://0.0.0.0:9091

...

control.plane.listener.name=CONTROLLER启用 control plane 侦听程序可能会提高集群性能,因为控制器通信不会因为代理中的数据复制不会延迟。数据复制通过 inter-broker 侦听程序继续。

如果没有配置 control.plane.listener,控制器连接将使用 inter-broker 侦听器。

6.4.3. 提交日志

Apache Kafka 在提交日志中存储从制作者接收的所有记录。提交日志包含实际数据,采用 Kafka 需要提供的记录形式。这些不是记录代理操作的应用程序日志文件。

日志目录

您可以使用 log.dirs 属性文件配置日志目录,将提交日志存储在一个或多个日志目录中。它应该设置为在安装过程中创建的 /var/lib/kafka 目录:

log.dirs=/var/lib/kafka

log.dirs=/var/lib/kafka出于性能考虑,您可以将 log.dirs 配置为多个目录,并将其每个目录放在不同的物理设备中,以提高磁盘 I/O 性能。例如:

log.dirs=/var/lib/kafka1,/var/lib/kafka2,/var/lib/kafka3

log.dirs=/var/lib/kafka1,/var/lib/kafka2,/var/lib/kafka36.4.4. 代理 ID

代理 ID 是集群中每个代理的唯一标识符。您可以分配一个大于或等于 0 的整数,作为代理 ID。代理 ID 用于在重启或崩溃后识别代理,因此 id 稳定且不会随时间变化。代理 ID 在代理属性文件中配置:

broker.id=1

broker.id=16.4.5. zookeeper 身份验证

默认情况下,zookeeper 和 Kafka 之间的连接不会被身份验证。但是,Kafka 和 ZooKeeper 支持 Java 认证和授权服务(JAAS),可用于使用简单身份验证和安全层(SASL)设置身份验证。ZooKeeper 支持使用带有本地存储凭证的 DIGEST-MD5 SASL 机制进行身份验证。

6.4.5.1. JAAS 配置

ZooKeeper 连接的 SASL 身份验证必须在 JAAS 配置文件中配置。默认情况下,Kafka 将使用名为 Client 的 JAAS 上下文连接到 ZooKeeper。客户端 上下文应该在 /opt/kafka/config/jass.conf 文件中配置。该上下文必须启用 PLAIN SASL 身份验证,如下例所示:

Client {

org.apache.kafka.common.security.plain.PlainLoginModule required

username="kafka"

password="123456";

};

Client {

org.apache.kafka.common.security.plain.PlainLoginModule required

username="kafka"

password="123456";

};6.4.5.2. 启用 ZooKeeper 身份验证

这个流程描述了如何在连接到 ZooKeeper 时使用 SASL DIGEST-MD5 机制启用身份验证。

先决条件

- ZooKeeper 中启用了 客户端到服务器的身份验证

启用 SASL DIGEST-MD5 身份验证

在所有 Kafka 代理节点上,创建或编辑

/opt/kafka/config/jaas.confJAAS 配置文件并添加以下上下文:Client { org.apache.kafka.common.security.plain.PlainLoginModule required username="<Username>" password="<Password>"; };Client { org.apache.kafka.common.security.plain.PlainLoginModule required username="<Username>" password="<Password>"; };Copy to Clipboard Copied! Toggle word wrap Toggle overflow 用户名和密码应该与 ZooKeeper 中配置的值相同。

以下示例显示了

客户端上下文:Client { org.apache.kafka.common.security.plain.PlainLoginModule required username="kafka" password="123456"; };Client { org.apache.kafka.common.security.plain.PlainLoginModule required username="kafka" password="123456"; };Copy to Clipboard Copied! Toggle word wrap Toggle overflow 逐一重启所有 Kafka 代理节点。要将 JAAS 配置传递给 Kafka 代理,请使用

KAFKA_OPTS环境变量。su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.properties

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 有关在多节点集群中重启代理的详情,请参考 第 4.3 节 “执行 Kafka 代理的安全滚动重启”。

6.4.6. 授权

Kafka 代理中的授权使用 authorizer 插件实现。

在本节中,我们介绍了如何使用 Kafka 提供的 AclAuthorizer 插件。

或者,您可以使用自己的授权插件。例如,如果您使用 基于 OAuth 2.0 令牌的身份验证,您可以使用 OAuth 2.0 授权。

6.4.6.1. 简单 ACL 授权器

Authorizer 插件(包括 AclAuthorizer )通过 authorizer.class.name 属性启用:

authorizer.class.name=kafka.security.auth.AclAuthorizer

authorizer.class.name=kafka.security.auth.AclAuthorizer

所选授权程序需要完全限定名称。对于 AclAuthorizer,完全限定名称为 kafka.security.auth.AclAuthorizer。

6.4.6.1.1. ACL 规则

AclAuthorizer 使用 ACL 规则来管理对 Kafka 代理的访问。

ACL 规则以以下格式定义:

主体 P 允许/拒绝来自主机 H 的 Kafka 资源 R 中的操作 O

例如,可以设置规则以便该用户:

John 可以查看 主机 127.0.0.1的主题 注释

Host 是 John 进行连接的机器的 IP 地址。

在大多数情况下,用户是制作者或消费者应用程序:

Consumer01 可以对来自主机 127.0.0.1 的消费者组账户有写入权限。

如果没有 ACL 规则

如果给定资源没有 ACL 规则,则拒绝所有操作。通过在 Kafka 配置文件 /opt/kafka/config/server.properties 中将属性 allow.everyone.if.no.acl.found 设置为 true 来更改此行为。

6.4.6.1.2. 主体

principal(主体)代表用户的身份。ID 的格式取决于客户端用来连接到 Kafka 的身份验证机制:

-

User:ANONYMOUS(当未进行身份验证时) 当使用简单身份验证机制(如 PLAIN 或 SCRAM)连接时,user:<

username>。例如

User:adminorUser:user1。在使用 TLS 客户端身份验证连接时,user:&

lt;DistinguishedName>。例如

User:CN=user1,O=MyCompany,L=Prague,C=CZ。-

使用

Kerberos 连接时 user:<Kerberos username>。

DistinguishedName 是与客户端证书区分的名称。

Kerberos 用户名是 Kerberos 主体的主要部分,在使用 Kerberos 进行连接时默认使用它。您可以使用 sasl.kerberos.principal.to.local.rules 属性来配置 Kafka 主体如何从 Kerberos 主体构建。

6.4.6.1.3. 用户身份验证

要使用授权,您需要为客户端启用和使用身份验证。否则,所有连接都将具有主要 用户:ANONYMOUS。

有关验证方法的更多信息,请参阅加密和身份验证。

6.4.6.1.4. 超级用户

无论 ACL 规则如何,超级用户都可以执行所有操作。

超级用户使用属性 super.users 在 Kafka 配置文件中定义。

例如:

super.users=User:admin,User:operator

super.users=User:admin,User:operator6.4.6.1.5. 副本代理身份验证

启用授权后,它将适用于所有监听程序和所有连接。这包括用于在代理间复制数据的代理连接。如果启用授权,请确保您使用身份验证进行代理连接,并为代理提供足够权限的用户。例如,如果代理之间的身份验证使用 kafka-broker 用户,则超级用户配置必须包含用户名 super.users=User:kafka-broker。

6.4.6.1.6. 支持的资源

您可以将 Kafka ACL 应用到这些类型的资源:

- topics

- 消费者组

- 集群

- TransactionId

- DelegationToken

6.4.6.1.7. 支持的操作

AclAuthorizer 授权对资源的操作。

下表中包含 X 的字段标记每个资源支持的操作。

| topics | 消费者组 | 集群 | |

|---|---|---|---|

| 读 | X | X | |

| 写 | X | ||

| 创建 | X | ||

| 删除 | X | ||

| 改变 | X | ||

| Describe | X | X | X |

| ClusterAction | X | ||

| All | X | X | X |

6.4.6.1.8. ACL 管理选项

ACL 规则使用 bin/kafka-acls.sh 工具进行管理,该工具作为 Kafka 发布软件包的一部分提供。

使用 kafka-acls.sh 参数选项来添加、列出和删除 ACL 规则,并执行其他功能。

这些参数需要双性约定,如 --add。

| 选项 | 类型 | 描述 | 默认 |

|---|---|---|---|

|

| 操作 | 添加 ACL 规则。 | |

|

| 操作 | 删除 ACL 规则。 | |

|

| 操作 | 列出 ACL 规则。 | |

|

| 操作 | 授权器的完全限定类名称。 |

|

|

| Configuration | 传递给授权器进行初始化的键/值对。

对于 | |

|

| 资源 | 用于连接到 Kafka 集群的主机/端口对。 |

使用这个选项或 |

|

| 资源 |

传递给 Admin Client 的配置文件,它与 | |

|

| 资源 | 将集群指定为 ACL 资源。 | |

|

| 资源 | 将主题名称指定为 ACL 资源。

用作通配符的星号(

单个命令可指定多个 | |

|

| 资源 | 将消费者组名称指定为 ACL 资源。

单个命令可指定多个 | |

|

| 资源 | 将事务 ID 指定为 ACL 资源。 事务传递意味着,生产者发送到多个分区的所有消息都必须成功或发送任何分区。

用作通配符的星号( | |

|

| 资源 | 将委派令牌指定为 ACL 资源。

用作通配符的星号( | |

|

| Configuration |

指定

使用

|

|

|

| 主体 | 添加到允许 ACL 规则的主体。

单个命令可指定多个 | |

|

| 主体 | 添加到拒绝 ACL 规则的主体。

单个命令可指定多个 | |

|

| 主体 |

与

单个命令可指定多个 | |

|

| 主机 |

允许访问 不支持主机名或 CIDR 范围。 |

如果指定了 |

|

| 主机 |

拒绝访问 不支持主机名或 CIDR 范围。 |

如果指定了 |

|

| 操作 | 允许或拒绝某个操作。

单个命令可在单个命令中指定多个Multiple | All |

|

| 快捷键 | 允许或拒绝消息制作者需要的所有操作的快捷方式(主题中为 WRITE 和 DESCRIBE,集群中为 CREATE)。 | |

|

| 快捷键 | 允许或拒绝消息使用者所需的所有操作的快捷方式(主题为 READ 和 DESCRIBE,读者组)。 | |

|

| 快捷键 |

与 如果制作者被授权根据特定的事务 ID 发送消息,则会自动启用 Idepmotence。 | |

|

| 快捷键 | 接受所有查询且不提示的快捷方式。 |

6.4.6.2. 启用授权

此流程描述了如何为 Kafka 代理中的授权启用 AclAuthorizer 插件。

先决条件

- AMQ Streams 安装 在所有用作 Kafka 代理的主机上。

流程

编辑

/opt/kafka/config/server.propertiesKafka 配置文件,以使用AclAuthorizer。authorizer.class.name=kafka.security.auth.AclAuthorizer

authorizer.class.name=kafka.security.auth.AclAuthorizerCopy to Clipboard Copied! Toggle word wrap Toggle overflow - (重新)启动 Kafka 代理。

6.4.6.3. 添加 ACL 规则

当使用 AclAuthorizer 插件根据访问控制列表(ACL)控制对 Kafka 代理的访问时,您可以使用 kafka-acls.sh 工具添加新的 ACL 规则。

先决条件

- 用户已创建并授予适当的权限来访问 Kafka 资源。

- AMQ Streams 安装 在所有用作 Kafka 代理的主机上。

- 在 Kafka 代理中启用授权。

流程

使用

--add选项运行kafka-acls.sh。示例:

允许

user1和user2使用MyConsumerGroup消费者组从myTopic读取。opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --add --operation Read --topic myTopic --allow-principal User:user1 --allow-principal User:user2 opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --add --operation Describe --topic myTopic --allow-principal User:user1 --allow-principal User:user2 opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --add --operation Read --operation Describe --group MyConsumerGroup --allow-principal User:user1 --allow-principal User:user2

opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --add --operation Read --topic myTopic --allow-principal User:user1 --allow-principal User:user2 opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --add --operation Describe --topic myTopic --allow-principal User:user1 --allow-principal User:user2 opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --add --operation Read --operation Describe --group MyConsumerGroup --allow-principal User:user1 --allow-principal User:user2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 拒绝

user1访问从 IP 地址 host127.0.0.1读取myTopic。opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --add --operation Describe --operation Read --topic myTopic --group MyConsumerGroup --deny-principal User:user1 --deny-host 127.0.0.1

opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --add --operation Describe --operation Read --topic myTopic --group MyConsumerGroup --deny-principal User:user1 --deny-host 127.0.0.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 添加

user1作为带有MyConsumerGroup的myTopic的消费者。opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --add --consumer --topic myTopic --group MyConsumerGroup --allow-principal User:user1

opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --add --consumer --topic myTopic --group MyConsumerGroup --allow-principal User:user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.6.4. 列出 ACL 规则

当使用 AclAuthorizer 插件根据访问控制列表(ACL)控制对 Kafka 代理的访问时,您可以使用 kafka-acls.sh 实用程序列出现有的 ACL 规则。

先决条件

流程

使用

--list选项运行kafka-acls.sh。例如:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.6.5. 删除 ACL 规则

当使用 AclAuthorizer 插件根据访问控制列表(ACL)控制对 Kafka 代理的访问时,您可以使用 kafka-acls.sh 工具删除现有 ACL 规则。

先决条件

流程

使用

--remove选项运行kafka-acls.sh。示例:

删除 ACL,允许

user1和user2使用MyConsumerGroup消费者组从myTopic读取。opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --remove --operation Read --topic myTopic --allow-principal User:user1 --allow-principal User:user2 opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --remove --operation Describe --topic myTopic --allow-principal User:user1 --allow-principal User:user2 opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --remove --operation Read --operation Describe --group MyConsumerGroup --allow-principal User:user1 --allow-principal User:user2

opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --remove --operation Read --topic myTopic --allow-principal User:user1 --allow-principal User:user2 opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --remove --operation Describe --topic myTopic --allow-principal User:user1 --allow-principal User:user2 opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --remove --operation Read --operation Describe --group MyConsumerGroup --allow-principal User:user1 --allow-principal User:user2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 删除 ACL 添加

user1作为带有MyConsumerGroup的myTopic的消费者。opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --remove --consumer --topic myTopic --group MyConsumerGroup --allow-principal User:user1

opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --remove --consumer --topic myTopic --group MyConsumerGroup --allow-principal User:user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 删除 ACL,拒绝

user1访问从 IP 地址 host127.0.0.1读取myTopic。opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --remove --operation Describe --operation Read --topic myTopic --group MyConsumerGroup --deny-principal User:user1 --deny-host 127.0.0.1

opt/kafka/bin/kafka-acls.sh --bootstrap-server localhost:9092 --remove --operation Describe --operation Read --topic myTopic --group MyConsumerGroup --deny-principal User:user1 --deny-host 127.0.0.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.7. zookeeper 授权

当在 Kafka 和 ZooKeeper 间启用身份验证时,您可以使用 ZooKeeper 访问控制列表(ACL)规则自动控制对 ZooKeeper 中存储的 Kafka 元数据的访问。

6.4.7.1. ACL 配置

ZooKeeper ACL 规则的强制由 config/server.properties Kafka 配置文件中的 zookeeper.set.acl 属性控制。

此属性默认设置为 true,并通过设置为 true 来启用:

zookeeper.set.acl=true

zookeeper.set.acl=true

如果启用了 ACL 规则,当在 ZooKeeper 中创建 znode 时,只有创建它的 Kafka 用户才可以修改或删除它。所有其他用户具有只读权限。

Kafka 仅为新创建的 ZooKeeper znodes 设置 ACL 规则。如果仅在集群首次启动后启用 ACL,zookeeper-security-migration.sh 工具可在所有现有 znodes 中设置 ACL。

ZooKeeper 中数据的机密性

ZooKeeper 中存储的数据包括:

- 主题名称及其配置

- 当使用 SASL SCRAM 身份验证时,Salted 和散列用户凭证。

但是 ZooKeeper 不会存储任何使用 Kafka 发送和接收的记录。ZooKeeper 中存储的数据被假定为非机密。

如果要将数据视为机密(例如,因为主题名称包含客户 ID),则保护的唯一选项在网络级别隔离 ZooKeeper,只允许访问 Kafka 代理。

6.4.7.2. 为新的 Kafka 集群启用 ZooKeeper ACL

这个步骤描述了如何为新 Kafka 集群在 Kafka 配置中启用 ZooKeeper ACL。仅在 Kafka 集群首次启动前使用此流程。有关在已在运行的集群中启用 ZooKeeper ACL,请参阅 第 6.4.7.3 节 “在现有 Kafka 集群中启用 ZooKeeper ACL”。

先决条件

流程

编辑

/opt/kafka/config/server.propertiesKafka 配置文件,在所有集群节点上将zookeeper.set.acl字段设置为true。zookeeper.set.acl=true

zookeeper.set.acl=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 启动 Kafka 代理。

6.4.7.3. 在现有 Kafka 集群中启用 ZooKeeper ACL

此流程描述了如何在 Kafka 配置中为正在运行的 Kafka 集群启用 ZooKeeper ACL。使用 zookeeper-security-migration.sh 工具,在所有存在的 znodes 中设置 ZooKeeper ACL。zookeeper-security-migration.sh 可作为 AMQ Streams 的一部分,并可在 bin 目录中找到。

先决条件

- Kafka 集群 已配置且正在运行。

启用 ZooKeeper ACL

编辑

/opt/kafka/config/server.propertiesKafka 配置文件,在所有集群节点上将zookeeper.set.acl字段设置为true。zookeeper.set.acl=true

zookeeper.set.acl=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 逐一重启所有 Kafka 代理。

有关在多节点集群中重启代理的详情,请参考 第 4.3 节 “执行 Kafka 代理的安全滚动重启”。

使用

zookeeper-security-migration.sh工具在所有现有 ZooKeeperznodes中设置 ACL。su - kafka cd /opt/kafka KAFKA_OPTS="-Djava.security.auth.login.config=./config/jaas.conf"; ./bin/zookeeper-security-migration.sh --zookeeper.acl=secure --zookeeper.connect=<ZooKeeperURL> exit

su - kafka cd /opt/kafka KAFKA_OPTS="-Djava.security.auth.login.config=./config/jaas.conf"; ./bin/zookeeper-security-migration.sh --zookeeper.acl=secure --zookeeper.connect=<ZooKeeperURL> exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

su - kafka cd /opt/kafka KAFKA_OPTS="-Djava.security.auth.login.config=./config/jaas.conf"; ./bin/zookeeper-security-migration.sh --zookeeper.acl=secure --zookeeper.connect=zoo1.my-domain.com:2181 exit

su - kafka cd /opt/kafka KAFKA_OPTS="-Djava.security.auth.login.config=./config/jaas.conf"; ./bin/zookeeper-security-migration.sh --zookeeper.acl=secure --zookeeper.connect=zoo1.my-domain.com:2181 exitCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.8. 加密和身份验证

AMQ Streams 支持加密和身份验证,它们被配置为监听程序配置的一部分。

6.4.8.1. 侦听器配置

Kafka 代理中的加密和身份验证会根据监听程序配置。有关 Kafka 侦听器配置的详情,请参考 第 6.4.2 节 “监听器”。

Kafka 代理中的每个监听程序都使用自己的安全协议配置。配置属性 listener.security.protocol.map 定义哪个监听程序使用哪个安全协议。它将每个侦听器名称映射到其安全协议。支持的安全协议有:

PLAINTEXT- 没有加密或身份验证的监听程序。

SSL- 使用 TLS 加密(可选)使用 TLS 客户端证书进行身份验证的监听程序。

SASL_PLAINTEXT- 没有加密但使用基于 SASL 的身份验证的监听程序。

SASL_SSL- 带有基于 TLS 的加密和基于 SASL 的身份验证的监听程序。

根据以下 监听程序配置 :

listeners=INT1://:9092,INT2://:9093,REPLICATION://:9094

listeners=INT1://:9092,INT2://:9093,REPLICATION://:9094

listener.security.protocol.map 可能如下所示:

listener.security.protocol.map=INT1:SASL_PLAINTEXT,INT2:SASL_SSL,REPLICATION:SSL

listener.security.protocol.map=INT1:SASL_PLAINTEXT,INT2:SASL_SSL,REPLICATION:SSL

这会将监听器 INT1 配置为通过 SASL 身份验证使用未加密的连接,监听器 INT2 与 SASL 身份验证使用加密连接,并将 REPLICATION 接口配置为使用 TLS 加密(可能与 TLS 客户端身份验证)。同一安全协议可以多次使用。以下示例也是有效的配置:

listener.security.protocol.map=INT1:SSL,INT2:SSL,REPLICATION:SSL

listener.security.protocol.map=INT1:SSL,INT2:SSL,REPLICATION:SSL此类配置将对所有接口使用 TLS 加密和 TLS 身份验证。以下章节将更详细地说明如何配置 TLS 和 SASL。

6.4.8.2. TLS 加密

Kafka 支持 TLS 加密与 Kafka 客户端的通信。

要使用 TLS 加密和服务器身份验证,必须提供包含私钥和公钥的密钥存储。这通常使用 Java 密钥存储(JKS)格式的文件来完成。在 ssl.keystore.location 属性中设置到此文件的路径。ssl.keystore.password 属性应用于设置保护密钥存储的密码。例如:

ssl.keystore.location=/path/to/keystore/server-1.jks ssl.keystore.password=123456

ssl.keystore.location=/path/to/keystore/server-1.jks

ssl.keystore.password=123456

在某些情况下,使用额外的密码来保护私钥。任何此类密码都可以使用 ssl.key.password 属性进行设置。

Kafka 可以使用由证书颁发机构和自签名密钥签名的密钥。使用由证书颁发机构签名的密钥应始终是首选的方法。为了允许客户端验证其正在连接的 Kafka 代理的身份,证书应始终包含公告的主机名 (CN) 或 Subject Alternative Name(SAN)。

可以将不同的 SSL 配置用于不同的监听程序。所有以 ssl. 开头的选项都可以加上 listener.name.<NameOfTheListener>. 前缀,其中监听程序的名称必须始终为小写。这将覆盖该特定侦听器的默认 SSL 配置。以下示例演示了如何为不同的监听程序使用不同的 SSL 配置:

其他 TLS 配置选项

除了上面描述的主要 TLS 配置选项外,Kafka 还支持很多选项来微调 TLS 配置。例如,要启用或禁用 TLS / SSL 协议或密码套件:

ssl.cipher.suites- 启用的密码套件列表。每个密码套件都是用于 TLS 连接的身份验证、加密、MAC 和密钥交换算法的组合。默认情况下启用所有可用的密码套件。

ssl.enabled.protocols-

启用的 TLS/SSL 协议列表。默认为

TLSv1.2,TLSv1.1,TLSv1。

6.4.8.3. 启用 TLS 加密

这个步骤描述了如何在 Kafka 代理中启用加密。

先决条件

- AMQ Streams 安装 在所有用作 Kafka 代理的主机上。

流程

- 为集群中的所有 Kafka 代理生成 TLS 证书。证书应将其公告和 bootstrap 地址在其 Common Name 或 Subject Alternative Name 中具有公告和 bootstrap 地址。

编辑所有集群节点中的

/opt/kafka/config/server.propertiesKafka 配置文件:-

更改

listener.security.protocol.map字段,为您要使用 TLS 加密的监听程序指定SSL协议。 -

使用代理证书将

ssl.keystore.location选项设置为 JKS 密钥存储的路径。 将

ssl.keystore.password选项设置为用来保护密钥存储的密码。例如:

listeners=UNENCRYPTED://:9092,ENCRYPTED://:9093,REPLICATION://:9094 listener.security.protocol.map=UNENCRYPTED:PLAINTEXT,ENCRYPTED:SSL,REPLICATION:PLAINTEXT ssl.keystore.location=/path/to/keystore/server-1.jks ssl.keystore.password=123456

listeners=UNENCRYPTED://:9092,ENCRYPTED://:9093,REPLICATION://:9094 listener.security.protocol.map=UNENCRYPTED:PLAINTEXT,ENCRYPTED:SSL,REPLICATION:PLAINTEXT ssl.keystore.location=/path/to/keystore/server-1.jks ssl.keystore.password=123456Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

更改

- (重新)启动 Kafka 代理

6.4.8.4. 身份验证

对于身份验证,您可以使用:

- 基于加密连接的 X.509 证书的 TLS 客户端身份验证

- 支持的 Kafka SASL(Simple Authentication and Security Layer)机制

- 基于 OAuth 2.0 令牌的身份验证

6.4.8.4.1. TLS 客户端身份验证

TLS 客户端身份验证只能用于已经使用 TLS 加密的连接。要使用 TLS 客户端身份验证,可以为代理提供带有公钥的信任存储。这些密钥可用于验证连接到代理的客户端。信任存储应以 Java 密钥存储(JKS)格式提供,并且应包含证书颁发机构的公钥。所有由信任存储中包含的证书颁发机构签名的公钥和私钥的客户都将经过身份验证。truststore 的位置使用字段 ssl.truststore.location 进行设置。如果信任存储受密码保护,则应在 ssl.truststore.password 属性中设置密码。例如:

ssl.truststore.location=/path/to/keystore/server-1.jks ssl.truststore.password=123456

ssl.truststore.location=/path/to/keystore/server-1.jks

ssl.truststore.password=123456

配置了 truststore 后,必须使用 ssl.client.auth 属性启用 TLS 客户端身份验证。此属性可设置为三个不同的值之一:

none- TLS 客户端身份验证已关闭。(默认值)

requested- TLS 客户端身份验证是可选的。客户端将被要求使用 TLS 客户端证书进行身份验证,但它们也可以选择不进行。

required- 客户端需要使用 TLS 客户端证书进行身份验证。

当客户端使用 TLS 客户端身份验证进行身份验证时,经过身份验证的主体名称是与经过身份验证的客户端证书区分名称。例如,具有可分辨名称 CN=someuser 的证书的用户将使用以下主体 CN=someuser,OU=Unknown,O=Unknown,L=Unknown,ST=Unknown,C=Unknown,C=Unknown,C=Unknown,C=Unknown 进行身份验证。如果没有使用 TLS 客户端身份验证并禁用 SASL,则主体名称为 ANONYMOUS。

6.4.8.4.2. SASL 身份验证

SASL 身份验证使用 Java 认证和授权服务(JAAS)进行配置。JAAS 也用于验证 Kafka 和 ZooKeeper 之间的连接。JAAS 使用自己的配置文件。此文件的建议位置为 /opt/kafka/config/jaas.conf。该文件必须可由 kafka 用户读取。在运行 Kafka 时,使用 Java 系统属性 java.security.auth.login.config 来指定此文件的位置。启动代理节点时必须将此属性传递给 Kafka:

KAFKA_OPTS="-Djava.security.auth.login.config=/path/to/my/jaas.config"; bin/kafka-server-start.sh

KAFKA_OPTS="-Djava.security.auth.login.config=/path/to/my/jaas.config"; bin/kafka-server-start.sh

通过普通未加密的连接以及 TLS 连接支持 SASL 身份验证。可以为每个监听程序单独启用 SASL。要启用它,listener.security.protocol.map 中的安全协议必须是 SASL_PLAINTEXT 或 SASL_SSL。

Kafka 中的 SASL 身份验证支持几种不同的机制:

PLAIN- 根据用户名和密码实施身份验证。用户名和密码存储在 Kafka 配置中。

SCRAM-SHA-256和SCRAM-SHA-512- 使用 Salted Challenge Response Authentication Mechanism (SCRAM) 实现验证。SCRAM 凭证集中存储在 ZooKeeper 中。在 ZooKeeper 集群节点在私有网络中隔离运行时,可以使用 SCRAM。

GSSAPI- 对 Kerberos 服务器实施身份验证。

PLAIN 机制以未加密的格式通过网络发送用户名和密码。因此,它只应该与 TLS 加密结合使用。

SASL 机制通过 JAAS 配置文件配置。Kafka 使用名为 KafkaServer 的 JAAS 上下文。在 JAAS 中配置后,必须在 Kafka 配置中启用 SASL 机制。这使用 sasl.enabled.mechanisms 属性完成。此属性包含以逗号分隔的启用机制列表:

sasl.enabled.mechanisms=PLAIN,SCRAM-SHA-256,SCRAM-SHA-512

sasl.enabled.mechanisms=PLAIN,SCRAM-SHA-256,SCRAM-SHA-512

如果用于 inter-broker 通信的监听程序正在使用 SASL,则必须使用属性 sasl.mechanism.inter.broker.protocol 指定它应使用的 SASL 机制。例如:

sasl.mechanism.inter.broker.protocol=PLAIN

sasl.mechanism.inter.broker.protocol=PLAIN

将用于 openshift-broker 通信的用户名和密码,该通信必须使用字段 username 和 password 在 KafkaServer JAAS 上下文中指定。

SASL PLAIN

要使用 PLAIN 机制,允许在 JAAS 上下文中直接指定允许连接的用户名和密码。以下示例显示了为 SASL PLAIN 身份验证配置的上下文。这个示例配置三个不同的用户:

-

admin -

user1 -

user2

与用户数据库的 JAAS 配置文件应保持在所有 Kafka 代理上同步。

当 SASL PLAIN 也用于内部代理身份验证时,username 和 password 属性应包含在 JAAS 上下文中:

SASL SCRAM

Kafka 中的 SCRAM 身份验证由两个机制组成: SCRAM-SHA-256 和 SCRAM-SHA-512。这些机制仅在使用的哈希算法中有所不同 - SHA-256 与更强大的 SHA-512。要启用 SCRAM 身份验证,HMQ 配置文件必须包括以下配置:

KafkaServer {

org.apache.kafka.common.security.scram.ScramLoginModule required;

};

KafkaServer {

org.apache.kafka.common.security.scram.ScramLoginModule required;

};当在 Kafka 配置文件中启用 SASL 身份验证时,可以列出两个 SCRAM 机制。但是,只能为 inter-broker 通信选择一个。例如:

sasl.enabled.mechanisms=SCRAM-SHA-256,SCRAM-SHA-512 sasl.mechanism.inter.broker.protocol=SCRAM-SHA-512

sasl.enabled.mechanisms=SCRAM-SHA-256,SCRAM-SHA-512

sasl.mechanism.inter.broker.protocol=SCRAM-SHA-512

SCRAM 机制的用户凭证存储在 ZooKeeper 中。kafka-configs.sh 工具可用于管理它们。例如,运行以下命令来添加用户 user1,其密码为 123456:

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --add-config 'SCRAM-SHA-256=[password=123456],SCRAM-SHA-512=[password=123456]' --entity-type users --entity-name user1

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --add-config 'SCRAM-SHA-256=[password=123456],SCRAM-SHA-512=[password=123456]' --entity-type users --entity-name user1要删除用户凭证,请使用:

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name user1

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name user1SASL GSSAPI

使用 Kerberos 进行身份验证的 SASL 机制称为 GSSAPI。要配置 Kerberos SASL 身份验证,应将以下配置添加到 JAAS 配置文件中:

Kerberos 主体中的域名必须始终为大写。

除了 JAAS 配置外,还需要在 Kafka 配置中的 sasl.kerberos.service.name 属性中指定 Kerberos 服务名称:

sasl.enabled.mechanisms=GSSAPI sasl.mechanism.inter.broker.protocol=GSSAPI sasl.kerberos.service.name=kafka

sasl.enabled.mechanisms=GSSAPI

sasl.mechanism.inter.broker.protocol=GSSAPI

sasl.kerberos.service.name=kafka多个 SASL 机制

Kafka 可以同时使用多个 SASL 机制。不同的 JAAS 配置可以都添加到同一上下文中:

启用多个机制时,客户端将能够选择想要使用的机制。

6.4.8.5. 启用 TLS 客户端身份验证

此流程描述了如何在 Kafka 代理中启用 TLS 客户端身份验证。

流程

- 准备包含用于签署用户证书的证书颁发机构的公钥的 JKS 信任存储。

编辑所有集群节点中的

/opt/kafka/config/server.propertiesKafka 配置文件:-

使用用户证书的证书颁发机构,将

ssl.truststore.location选项设置为 JKS 信任存储的路径。 -

将

ssl.truststore.password选项设置为用来保护信任存储的密码。 将

ssl.client.auth选项设置为required。例如:

ssl.truststore.location=/path/to/truststore.jks ssl.truststore.password=123456 ssl.client.auth=required

ssl.truststore.location=/path/to/truststore.jks ssl.truststore.password=123456 ssl.client.auth=requiredCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

使用用户证书的证书颁发机构,将

- (重新)启动 Kafka 代理

6.4.8.6. 启用 SASL PLAIN 身份验证

这个步骤描述了如何在 Kafka 代理中启用 SASL PLAIN 身份验证。

先决条件

- AMQ Streams 安装 在所有用作 Kafka 代理的主机上。

流程

编辑或创建

/opt/kafka/config/jaas.confJAAS 配置文件。此文件应包含您的所有用户及其密码。请确定在所有 Kafka 代理上这个文件都是相同的。例如:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑所有集群节点中的

/opt/kafka/config/server.propertiesKafka 配置文件:-

更改

listener.security.protocol.map字段,为您要使用 SASL PLAIN 身份验证的监听程序指定SASL_PLAINTEXT或SASL_SSL协议。 将

sasl.enabled.mechanisms选项设置为PLAIN。例如:

listeners=INSECURE://:9092,AUTHENTICATED://:9093,REPLICATION://:9094 listener.security.protocol.map=INSECURE:PLAINTEXT,AUTHENTICATED:SASL_PLAINTEXT,REPLICATION:PLAINTEXT sasl.enabled.mechanisms=PLAIN

listeners=INSECURE://:9092,AUTHENTICATED://:9093,REPLICATION://:9094 listener.security.protocol.map=INSECURE:PLAINTEXT,AUTHENTICATED:SASL_PLAINTEXT,REPLICATION:PLAINTEXT sasl.enabled.mechanisms=PLAINCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

更改

使用 KAFKA_OPTS 环境变量(重新)启动 Kafka 代理,将 JAAS 配置传递给 Kafka 代理。

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.properties

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.8.7. 启用 SASL SCRAM 身份验证

这个步骤描述了如何在 Kafka 代理中启用 SASL SCRAM 身份验证。

先决条件

- AMQ Streams 安装 在所有用作 Kafka 代理的主机上。

流程

编辑或创建

/opt/kafka/config/jaas.confJAAS 配置文件。为KafkaServer上下文启用ScramLoginModule。请确定在所有 Kafka 代理上这个文件都是相同的。例如:

KafkaServer { org.apache.kafka.common.security.scram.ScramLoginModule required; };KafkaServer { org.apache.kafka.common.security.scram.ScramLoginModule required; };Copy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑所有集群节点中的

/opt/kafka/config/server.propertiesKafka 配置文件:-

更改

listener.security.protocol.map字段,为您要使用 SASL SCRAM 身份验证的监听程序指定SASL_PLAINTEXT或SASL_SSL协议。 将

sasl.enabled.mechanisms选项设置为SCRAM-SHA-256或SCRAM-SHA-512。例如:

listeners=INSECURE://:9092,AUTHENTICATED://:9093,REPLICATION://:9094 listener.security.protocol.map=INSECURE:PLAINTEXT,AUTHENTICATED:SASL_PLAINTEXT,REPLICATION:PLAINTEXT sasl.enabled.mechanisms=SCRAM-SHA-512

listeners=INSECURE://:9092,AUTHENTICATED://:9093,REPLICATION://:9094 listener.security.protocol.map=INSECURE:PLAINTEXT,AUTHENTICATED:SASL_PLAINTEXT,REPLICATION:PLAINTEXT sasl.enabled.mechanisms=SCRAM-SHA-512Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

更改

使用 KAFKA_OPTS 环境变量(重新)启动 Kafka 代理,将 JAAS 配置传递给 Kafka 代理。

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.properties

su - kafka export KAFKA_OPTS="-Djava.security.auth.login.config=/opt/kafka/config/jaas.conf"; /opt/kafka/bin/kafka-server-start.sh -daemon /opt/kafka/config/server.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.8.8. 添加 SASL SCRAM 用户

这个步骤描述了如何使用 SASL SCRAM 为身份验证添加新用户。

流程

使用

kafka-configs.sh工具添加新的 SASL SCRAM 用户。bin/kafka-configs.sh --bootstrap-server <broker_address> --alter --add-config 'SCRAM-SHA-512=[password=<Password>]' --entity-type users --entity-name <Username>

bin/kafka-configs.sh --bootstrap-server <broker_address> --alter --add-config 'SCRAM-SHA-512=[password=<Password>]' --entity-type users --entity-name <Username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --add-config 'SCRAM-SHA-512=[password=123456]' --entity-type users --entity-name user1

bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --add-config 'SCRAM-SHA-512=[password=123456]' --entity-type users --entity-name user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.8.9. 删除 SASL SCRAM 用户

这个流程描述了如何在使用 SASL SCRAM 身份验证时删除用户。

流程

使用

kafka-configs.sh工具删除 SASL SCRAM 用户。/opt/kafka/bin/kafka-configs.sh --bootstrap-server <broker_address> --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name <Username>

/opt/kafka/bin/kafka-configs.sh --bootstrap-server <broker_address> --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name <Username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

/opt/kafka/bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name user1

/opt/kafka/bin/kafka-configs.sh --bootstrap-server localhost:9092 --alter --delete-config 'SCRAM-SHA-512' --entity-type users --entity-name user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.9. 使用基于 OAuth 2.0 令牌的身份验证

AMQ Streams 支持使用 OAUTHBEARER 和 PLAIN 机制使用 OAuth 2.0 身份验证。

OAuth 2.0 启用应用程序之间的基于令牌的标准化身份验证和授权,使用中央授权服务器签发对资源有限访问权限的令牌。

您可以配置 OAuth 2.0 身份验证,然后配置 OAuth 2.0 授权。

Kafka 代理和客户端都需要配置为使用 OAuth 2.0。OAuth 2.0 身份验证也可以与基于 simple 或 OPA 的 Kafka 授权一起使用。

使用 OAuth 2.0 身份验证,应用程序客户端可以在不公开帐户凭据的情况下访问应用服务器(称为 资源服务器)上的资源。

应用程序客户端通过访问令牌作为身份验证方法传递,应用服务器也可以用来决定要授予的访问权限级别。授权服务器处理访问权限的授予和查询有关访问权限的查询。

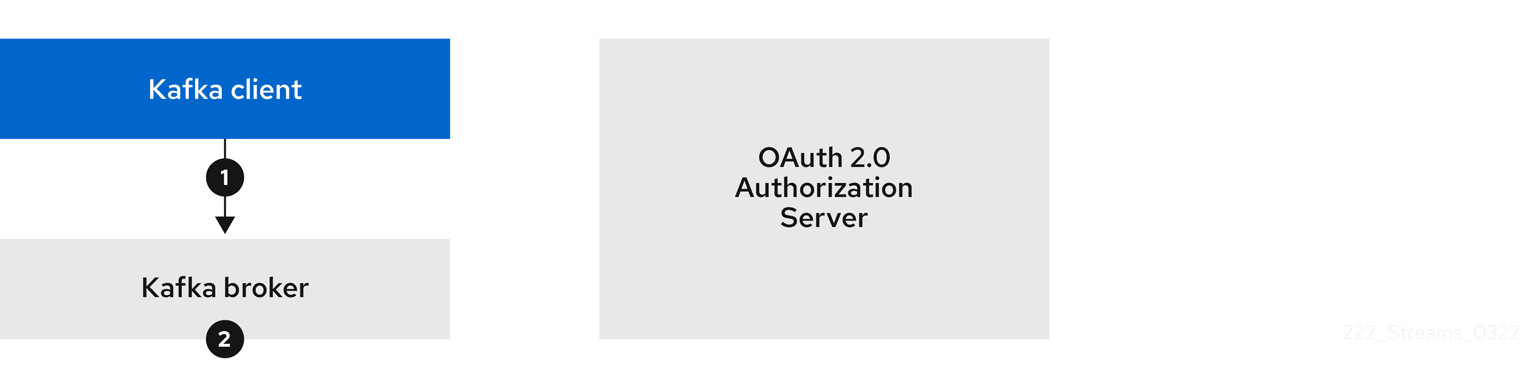

在 AMQ Streams 上下文中:

- Kafka 代理充当 OAuth 2.0 资源服务器

- Kafka 客户端充当 OAuth 2.0 应用程序客户端

Kafka 客户端在 Kafka 代理验证。代理和客户端根据需要与 OAuth 2.0 授权服务器通信,以获取或验证访问令牌。

对于 AMQ Streams 部署,OAuth 2.0 集成提供:

- 对 Kafka 代理的服务器端 OAuth 2.0 支持

- 客户端 OAuth 2.0 支持 Kafka MirrorMaker、Kafka Connect 和 Kafka Bridge

RHEL 上的 AMQ Streams 包括两个 OAuth 2.0 库:

kafka-oauth-client-

提供名为

io.strimzi.kafka.oauth.client.JaasClientOauthLoginCallbackHandler的自定义登录回调处理器类。要处理OAUTHBEARER身份验证机制,请使用 Apache Kafka 提供的OAuthBearerLoginModule的登录回调处理程序。 kafka-oauth-common-

提供

kafka-oauth-client库所需的一些功能的帮助程序库。

提供的客户端库还依赖于一些额外的第三方库,例如: keycloak-core、jackson-databind 和 slf4j-api。

我们建议使用 Maven 项目打包客户端,以确保包含所有依赖项库。依赖项库可能会在以后的版本中有所变化。

6.4.9.1. OAuth 2.0 身份验证机制

AMQ Streams 支持 OAUTHBEARER 和 PLAIN 机制进行 OAuth 2.0 身份验证。这两个机制都允许 Kafka 客户端使用 Kafka 代理建立经过身份验证的会话。客户端、授权服务器和 Kafka 代理之间的身份验证流因每种机制而异。

我们建议您将客户端配置为尽可能使用 OAUTHBEARER。OAUTHBEARER 提供比 PLAIN 更高的安全性,因为客户端凭证不会与 Kafka 代理共享。考虑仅在不支持 OAUTHBEARER 的 Kafka 客户端中使用 PLAIN。

您可以将 Kafka 代理监听程序配置为使用 OAuth 2.0 身份验证来连接客户端。如果需要,可以在同一 oauth 侦听器上使用 OAUTHBEARER 和 PLAIN 机制。支持每个机制的属性必须在 oauth 侦听器配置中明确指定。

OAUTHBEARER 概述

要使用 OAUTHBEARER,请将 Kafka 代理的 OAuth 身份验证监听程序配置中的 sasl.enabled.mechanisms 设置为 OAUTHBEARER。有关详细配置,请参阅 第 6.4.9.2 节 “OAuth 2.0 Kafka 代理配置”。

listener.name.client.sasl.enabled.mechanisms=OAUTHBEARER

listener.name.client.sasl.enabled.mechanisms=OAUTHBEARER许多 Kafka 客户端工具使用库,在协议级别为 OAUTHBEARER 提供基本支持。为了支持应用程序开发,AMQ Streams 为上游 Kafka Client Java 库(但不适用于其他库)提供了一个 OAuth 回调处理器。因此,您不需要编写自己的回调处理程序。应用客户端可以使用回调处理程序来提供访问令牌。使用 Go 等其他语言编写的客户端必须使用自定义代码连接到授权服务器并获取访问令牌。

使用 OAUTHBEARER 时,客户端启动带有 Kafka 代理的会话进行凭证交换,其中凭证采用回调处理器提供的 bearer 令牌的形式。使用回调,您可以使用三种方法配置令牌置备:

- 客户端 ID 和 Secret (使用 OAuth 2.0 客户端凭证 机制)

- 一个长期的访问令牌,在配置时手动获取

- 一个长期的刷新令牌,在配置时手动获取

OAUTHBEARER 身份验证只能由支持协议级别的 OAUTHBEARER 机制的 Kafka 客户端使用。

PLAIN 概述

要使用 PLAIN,请将 PLAIN 添加到 sasl.enabled.mechanisms 的值。

listener.name.client.sasl.enabled.mechanisms=OAUTHBEARER,PLAIN

listener.name.client.sasl.enabled.mechanisms=OAUTHBEARER,PLAINPLAIN 是所有 Kafka 客户端工具使用的简单身份验证机制。要启用 PLAIN 以用于 OAuth 2.0 身份验证,AMQ Streams 提供了 OAuth 2.0 over PLAIN 服务器端的回调。

使用 AMQ Streams 实现 PLAIN,客户端凭证不会存储在 ZooKeeper 中。相反,客户端凭证会在兼容授权服务器后进行集中处理,这与使用 OAUTHBEARER 身份验证类似。

当与 OAuth 2.0 over PLAIN 回调搭配使用时,Kafka 客户端使用以下方法之一与 Kafka 代理进行身份验证:

- 客户端 ID 和 secret (使用 OAuth 2.0 客户端凭证 机制)

- 一个长期的访问令牌,在配置时手动获取

对于这两种方法,客户端必须提供 PLAIN username 和 password 属性,将凭证传递给 Kafka 代理。客户端使用这些属性传递客户端 ID 和 secret 或用户名和访问令牌。

客户端 ID 和 secret 用于获取访问令牌。

访问令牌作为 password 属性值传递。您可以使用或不使用 $accessToken: 前缀传递访问令牌。

-

如果您在监听器配置中配置令牌端点(

oauth.token.endpoint.uri),则需要前缀。 -

如果您没有在监听器配置中配置令牌端点(

oauth.token.endpoint.uri),则不需要前缀。Kafka 代理将密码解析为原始访问令牌。

如果将密码设置为访问令牌,则必须将用户名设置为 Kafka 代理从访问令牌获取的相同的主体名称。您可以使用 oauth.username.claim, oauth.fallback.username.claim, oauth.fallback.username.prefix, 和 oauth.userinfo.endpoint.uri 属性在监听器中指定用户名提取选项。用户名提取过程还取决于您的授权服务器;特别是,它将客户端 ID 映射到帐户名称。

OAuth over PLAIN 不支持使用(已弃用)OAuth 2.0 密码授权机制传递用户名和密码(密码授予)。

6.4.9.1.1. 使用属性或变量配置 OAuth 2.0

您可以使用 Java Authentication and Authorization Service(JAAS)属性或环境变量来配置 OAuth 2.0 设置。

-

JAAS 属性在

server.properties配置文件中配置,并传递为listener.name.LISTENER-NAME.oauthbearer.sasl.jaas.config属性的键值对。 如果使用环境变量,您仍然需要在

server.properties文件中提供listener.name.LISTENER-NAME.oauthbearer.sasl.jaas.config属性,但您可以忽略其他 JAAS 属性。您可以使用大写或大写环境变量命名约定。

AMQ Streams OAuth 2.0 库使用以以下开始的属性:

-

OAuth.用于配置身份验证 -

strimzi.到 configure OAuth 2.0 authorization

6.4.9.2. OAuth 2.0 Kafka 代理配置

用于 OAuth 2.0 验证的 Kafka 代理配置涉及:

- 在授权服务器中创建 OAuth 2.0 客户端

- 在 Kafka 集群中配置 OAuth 2.0 身份验证

与授权服务器相关,Kafka 代理和 Kafka 客户端都被视为 OAuth 2.0 客户端。

6.4.9.2.1. 授权服务器上的 OAuth 2.0 客户端配置

要配置 Kafka 代理以验证会话启动期间收到的令牌,建议的做法是在授权服务器中创建一个 OAuth 2.0 client 定义(配置为 confidential),并启用了以下客户端凭证:

-

客户端 ID

kafka-broker(例如) - 客户端 ID 和 secret 作为身份验证机制

只有在使用授权服务器的非公共内省端点时,您只需要使用客户端 ID 和 secret。使用公共授权服务器端点时,通常不需要凭据,因为快速的本地 JWT 令牌验证。

6.4.9.2.2. Kafka 集群中的 OAuth 2.0 身份验证配置

要在 Kafka 集群中使用 OAuth 2.0 身份验证,您可以在 Kafka server.properties 文件中为 Kafka 集群启用 OAuth 身份验证监听程序配置。最低配置是必需的。您还可以配置 TLS 侦听器,其中 TLS 用于代理间通信。

您可以使用以下方法之一配置授权服务器进行令牌验证的代理:

- 快速本地令牌验证: JWKS 端点与签名的 JWT 格式的访问令牌相结合

- 内省端点

您可以配置 OAUTHBEARER 或 PLAIN 身份验证,或两者。

以下示例显示了应用 全局 监听器配置的最低配置,这意味着,内部代理间通信通过与应用程序客户端相同的监听程序进行。

这个示例还显示了一个特定监听程序的 OAuth 2.0 配置,在其中您可以指定 listener.name.LISTENER-NAME.sasl.enabled.mechanisms 而不是 sasl.enabled.mechanisms。LISTENER-NAME 是监听器不区分大小写的名称。在这里,我们将侦听器的 CLIENT 命名为 listener.name.client.sasl.enabled.mechanisms。

这个示例使用 OAUTHBEARER 身份验证。

示例:使用 JWKS 端点进行 OAuth 2.0 身份验证的最小监听程序配置

- 1

- 为通过 SASL 进行凭证交换的 OAUTHBEARER 机制。

- 2

- 配置要连接的客户端应用程序的监听程序。

系统主机名用作公告的主机名,客户端必须解析才能重新连接。本例中,侦听器名为CLIENT。 - 3

- 指定监听器的频道协议。

SASL_SSL用于 TLS。SASL_PLAINTEXT用于未加密的连接(无 TLS),但存在丢失和截获 TCP 连接层的风险。 - 4

- 为 CLIENT 侦听器指定 OAUTHBEARER 机制。客户端名称(

CLIENT)通常在listeners属性中使用大写指定,对于listener.name属性是小写 (listener.name.client),当为listener.name.client.*属性的一部分时是小写。 - 5

- 指定用于代理间通信的 OAUTHBEARER 机制。

- 6

- 指定用于代理间通信的监听程序。配置有效需要规格。

- 7

- 在客户端监听器上配置 OAuth 2.0 身份验证。

- 8

- 配置客户端和代理间通信的身份验证设置。

oauth.client.id、oauth.client.secret和auth.token.endpoint.uri属性与 inter-broker 配置相关。 - 9

- 有效的签发者 URI。仅接受此签发者发布的访问令牌。例如 :https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME

- 10

- JWKS 端点 URL。例如: https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/certs。

- 11

- 令牌声明(或密钥),其中包含令牌中实际用户名。用户名是用于识别用户的 主体。该值将取决于身份验证流和使用的授权服务器。

- 12

- Kafka 代理的客户端 ID,适用于所有代理。这是在 授权服务器中注册的客户端为

kafka-broker。 - 13

- Kafka 代理的 secret,适用于所有代理。

- 14

- 您的授权服务器的 OAuth 2.0 令牌端点 URL。对于生产环境,请始终使用

https://urls。例如: https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/token。 - 15

- 为内部代理通信启用(且只需要)OAuth 2.0 身份验证。

- 16

- (可选)在令牌过期时强制会话到期,同时激活 Kafka 重新身份验证机制。如果指定的值小于访问令牌过期的时间,则客户端必须在实际令牌到期前重新进行身份验证。默认情况下,当访问令牌过期时,会话不会过期,客户端也不会尝试重新身份验证。

以下示例显示了 TLS 侦听器的最低配置,其中 TLS 用于 inter-broker 通信。

示例:用于 OAuth 2.0 身份验证的 TLS 侦听器配置

- 1

- inter-broker 通信和客户端应用程序需要单独的配置。

- 2

- 将 REPLICATION 侦听器配置为使用 TLS,CLIENT 侦听器通过未加密的频道使用 SASL。客户端可以在生产环境中使用加密的频道(

SASL_SSL)。 - 3

ssl.属性定义 TLS 配置。- 4

- 随机数生成器实施。如果没有设置,则使用 Java platform SDK 默认。

- 5

- 主机名验证。如果设置为空字符串,则主机名验证将关闭。如果没有设置,则默认值为

HTTPS,它会强制验证服务器证书的主机名。 - 6

- 侦听器的密钥存储的路径。

- 7

- 监听器的信任存储的路径。

- 8

- 指定 REPLICATION 侦听器的客户端必须在建立 TLS 连接时与客户端证书进行身份验证(用于代理连接)。

- 9

- 为 OAuth 2.0 配置 CLIENT 侦听器。与授权服务器连接应使用安全 HTTPS 连接。

以下示例显示了使用 PLAIN 身份验证机制通过 SASL 进行凭证交换的 OAuth 2.0 身份验证的最低配置。使用快速本地令牌验证。

示例: PLAIN 验证的最小监听程序配置

- 1

- 为客户端应用程序配置要连接的监听程序(本例中为

CLIENT)。系统主机名用作公告的主机名,客户端必须解析才能重新连接。由于这是唯一配置的监听程序,它也用于代理间通信。 - 2

- 将

CLIENT侦听程序示例配置为通过未加密的频道使用 SASL。在生产环境中,客户端应使用加密通道(SASL_SSL)来防御 TCP 连接层窃听和截获。 - 3

- 为通过 SASL 和 OAUTHBEARER 进行凭证交换启用 PLAIN 身份验证机制。OAUTHBEARER 也被指定,因为它是 inter-broker 通信所必需的。Kafka 客户端可以选择使用哪个机制进行连接。

- 4

- 指定用于代理间通信的 OAUTHBEARER 身份验证机制。

- 5

- 为 inter-broker 通信指定监听程序(本例中为

CLIENT)。需要有效配置才能生效。 - 6

- 为 OAUTHBEARER 机制配置服务器回调处理器。

- 7

- 使用 OAUTHBEARER 机制为客户端和代理间通信配置身份验证设置。

oauth.client.id、oauth.client.secret和oauth.token.endpoint.uri属性与 inter-broker 配置相关。 - 8

- 有效的签发者 URI。仅接受来自此签发者的访问令牌。例如: https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME

- 9

- JWKS 端点 URL。例如 :https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/certs

- 10

- 令牌声明(或密钥),其中包含令牌中实际用户名。用户名是标识用户 的主体。该值取决于身份验证流以及使用的授权服务器。

- 11

- Kafka 代理的客户端 ID,适用于所有代理。这是在 授权服务器中注册的客户端为

kafka-broker。 - 12

- Kafka 代理的 secret (适用于所有代理)。

- 13

- 您的授权服务器的 OAuth 2.0 令牌端点 URL。对于生产环境,请始终使用

https://urls。例如 :https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/token - 14

- 为代理间通信启用 OAuth 2.0 身份验证。

- 15

- 为 PLAIN 身份验证配置服务器回调处理器。

- 16

- 使用 PLAIN 身份验证为客户端通信配置身份验证设置。

oauth.token.endpoint.uri是一个可选属性,它使用 OAuth 2.0 客户端凭证机制启用 OAuth 2.0 over PLAIN。 - 17

- 有效的签发者 URI。仅接受来自此签发者的访问令牌。例如: https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME

- 18

- JWKS 端点 URL。例如 :https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/certs

- 19

- 令牌声明(或密钥),其中包含令牌中实际用户名。用户名是标识用户 的主体。该值取决于身份验证流和使用的授权服务器。

- 20

- 您的授权服务器的 OAuth 2.0 令牌端点 URL。PLAIN 机制的额外配置。如果指定,客户端可以使用

$accessToken:前缀传递访问令牌作为密码,来通过 PLAIN 进行身份验证。对于生产环境,请始终使用

https://urls。例如: https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/token。 - 21

- (可选)在令牌过期时强制会话到期,同时激活 Kafka 重新身份验证机制。如果指定的值小于访问令牌过期的时间,则客户端必须在实际令牌到期前重新进行身份验证。默认情况下,当访问令牌过期时,会话不会过期,客户端也不会尝试重新身份验证。

6.4.9.2.3. 快速本地 JWT 令牌验证配置

快速本地 JWT 令牌验证在本地检查 JWT 令牌签名。

本地检查可确保令牌:

-

通过为访问令牌包含

Bearer的(typ)声明值来符合类型 - 有效(未过期)

-

具有与

validIssuerURI匹配的签发者

在配置监听器时,您可以指定 有效的签发者 URI,以便拒绝任何未由授权服务器发布的令牌。

授权服务器不需要在快速的本地 JWT 令牌验证期间联系。您可以通过指定由 OAuth 2.0 授权服务器公开的 JWKs 端点 URI 来激活快速本地 JWT 令牌验证。端点包含验证已签名的 JWT 令牌的公钥,这些令牌由 Kafka 客户端作为凭证发送。

所有与授权服务器通信都应使用 HTTPS 执行。

对于 TLS 侦听器,您可以配置证书信任存储并指向信任存储文件。

快速本地 JWT 令牌验证的属性示例

- 1

- 有效的签发者 URI。仅接受此签发者发布的访问令牌。例如 :https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME

- 2

- JWKS 端点 URL。例如: https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/certs。

- 3

- 端点刷新之间的期间(默认为 300)。

- 4

- 连续尝试刷新 JWKS 公钥之间的最小暂停(以秒为单位)。当遇到未知签名密钥时,JWKS 密钥刷新在常规定期调度后调度,且至少在最后一次刷新尝试后出现指定暂停。刷新密钥遵循 exponential backoff 规则,重试不成功刷新,且持续增加暂停,直到它到达

oauth.jwks.refresh.seconds。默认值为 1。 - 5

- JWKs 证书的持续时间在过期前被视为有效。默认为

360秒。如果您指定较长的时间,请考虑允许访问撤销的证书的风险。 - 6

- 令牌声明(或密钥),其中包含令牌中实际用户名。用户名是用于识别用户的 主体。该值将取决于身份验证流和使用的授权服务器。

- 7

- TLS 配置中使用的信任存储的位置。

- 8

- 用于访问 truststore 的密码。

- 9

- PKCS #12 格式的 truststore 类型。

6.4.9.2.4. OAuth 2.0 内省端点配置

使用 OAuth 2.0 内省端点进行令牌验证将收到的访问令牌视为不透明。Kafka 代理向内省端点发送访问令牌,该端点使用验证所需的令牌信息做出响应。最重要的是,如果特定的访问令牌有效,以及令牌何时过期的信息,它会返回最新的信息。

要配置基于 OAuth 2.0 内省的验证,您可以指定一个 内省端点 URI,而不是为快速本地 JWT 令牌验证指定的 JWKs 端点 URI。根据授权服务器,通常必须指定 client ID 和 client secret,因为内省端点通常受到保护。

内省端点的属性示例

- 1

- OAuth 2.0 内省端点 URI。例如: https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/token/introspect。

- 2

- Kafka 代理的客户端 ID。

- 3

- Kafka 代理的 secret。

- 4

- TLS 配置中使用的信任存储的位置。

- 5

- 用于访问 truststore 的密码。

- 6

- PKCS #12 格式的 truststore 类型。

- 7

- 令牌声明(或密钥),其中包含令牌中实际用户名。用户名是用于识别用户的 主体。

oauth.username.claim的值取决于使用的授权服务器。

6.4.9.3. Kafka 代理的会话重新身份验证

您可以将 OAuth 监听程序配置为使用 Kafka 会话重新身份验证 在 Kafka 客户端和 Kafka 代理之间进行 OAuth 2.0 会话。这种机制在定义的时间段内在客户端和代理之间强制实施经过身份验证的会话的到期。当会话过期时,客户端会立即通过重新使用现有连接而不是丢弃它来启动新的会话。

默认情况下,会话重新身份验证被禁用。您可以在 server.properties 文件中启用它。为启用了 OAUTHBEARER 或 PLAIN 作为 SASL 机制的 TLS 侦听器设置 connections.max.reauth.ms 属性。

您可以为每个监听程序指定会话重新身份验证。例如:

listener.name.client.oauthbearer.connections.max.reauth.ms=3600000

listener.name.client.oauthbearer.connections.max.reauth.ms=3600000会话重新身份验证必须由客户端使用的 Kafka 客户端库支持。

会话重新身份验证可用于快速 本地 JWT 或 内省端点 令牌验证。

客户端重新身份验证

当代理的验证会话过期时,客户端必须通过向代理发送新的有效访问令牌而无需丢弃连接来重新验证到现有会话。

如果令牌验证成功,则使用现有连接启动新的客户端会话。如果客户端无法重新验证,代理会在进一步尝试发送或接收消息时关闭连接。如果使用 Kafka 客户端库 2.2 或更高版本的 Java 客户端,如果代理上启用了重新身份验证机制,则会自动重新验证。

如果使用,会话重新身份验证也适用于刷新令牌。当会话过期时,客户端会使用其刷新令牌来刷新访问令牌。然后,客户端使用新的访问令牌通过现有连接重新进行身份验证。

OAUTHBEARER 和 PLAIN 的会话到期

配置了会话重新身份验证时,会话到期会不同,对 OAUTHBEARER 和 PLAIN 身份验证不同。

对于 OAUTHBEARER 和 PLAIN,使用 客户端 ID 和 secret 方法:

-

代理的经过身份验证的会话将在配置的

connections.max.reauth.ms时过期。 - 如果访问令牌在配置时间前过期,则会话会更早过期。

对于使用 长期访问令牌 方法的 PLAIN:

-

代理的经过身份验证的会话将在配置的

connections.max.reauth.ms时过期。 - 如果在配置的时间之前访问令牌过期,重新身份验证将失败。虽然尝试会话重新身份验证,但 PLAIN 没有刷新令牌的机制。

如果没有配置 connection.max.reauth.ms,OAUTHBEARER 和 PLAIN 客户端可以无限期地连接到代理,而无需重新验证。经过身份验证的会话不会以访问令牌到期到期结尾。但是,这在配置授权时可以考虑,例如使用 keycloak 授权或安装自定义授权器。

6.4.9.4. OAuth 2.0 Kafka 客户端配置

Kafka 客户端被配置为:

- 从授权服务器获取有效访问令牌(客户端 ID 和 Secret)所需的凭证

- 使用授权服务器提供的工具获取有效的长期访问令牌或刷新令牌

发送到 Kafka 代理的唯一信息是一个访问令牌。用于与授权服务器进行身份验证的凭证从不会发送到代理。

当客户端获取访问令牌时,不需要与授权服务器进一步通信。

最简单的机制是使用客户端 ID 和 Secret 进行身份验证。使用长期的访问令牌或长期的刷新令牌会增加复杂性,因为对授权服务器工具还有额外的依赖。

如果您使用长期的访问令牌,您可能需要在授权服务器中配置客户端,以增加令牌的最大生命周期。

如果 Kafka 客户端没有直接配置访问令牌,客户端会在 Kafka 会话发起授权服务器的过程中交换访问令牌的凭证。Kafka 客户端交换:

- 客户端 ID 和 Secret

- 客户端 ID、刷新令牌和(可选)secret

- 用户名和密码,带有客户端 ID 和(可选)secret

6.4.9.5. OAuth 2.0 客户端身份验证流

OAuth 2.0 身份验证流依赖于底层 Kafka 客户端和 Kafka 代理配置。流也必须受到使用的授权服务器的支持。

Kafka 代理监听程序配置决定了客户端如何使用访问令牌进行身份验证。客户端可以传递客户端 ID 和机密来请求访问令牌。

如果侦听器配置为使用 PLAIN 身份验证,客户端可以通过客户端 ID 和 secret 或用户名和访问令牌进行身份验证。这些值作为 PLAIN 机制 username 和 password 属性传递。

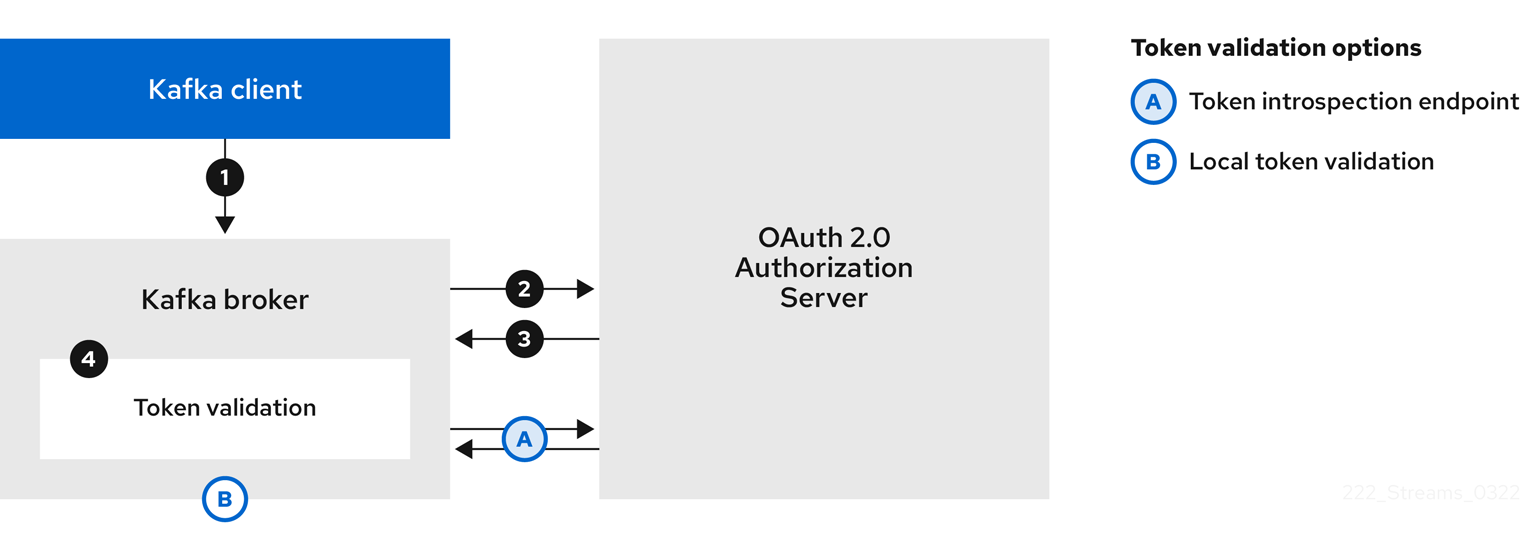

侦听器配置支持以下令牌验证选项:

- 您可以根据 JWT 签名检查和本地令牌内省使用快速本地令牌验证,而无需联系授权服务器。授权服务器提供带有公共证书的 JWKS 端点,用于验证令牌中的签名。

- 您可以使用授权服务器提供的令牌内省端点调用。每次建立新的 Kafka 代理连接时,代理都会将从客户端接收的访问令牌传递给授权服务器。Kafka 代理检查响应,以确认令牌是否有效。

授权服务器可能只允许使用不透明访问令牌,这意味着无法进行本地令牌验证。

Kafka 客户端凭证也可以为以下验证类型配置:

- 使用之前生成的长期访问令牌进行直接本地访问

- 与授权服务器联系,以获取要发布的新访问令牌(使用客户端 ID 和 secret,或者刷新令牌,或用户名和密码)

6.4.9.5.1. 使用 SASL OAUTHBEARER 机制的客户端身份验证流示例

您可以使用 SASL OAUTHBEARER 机制为 Kafka 身份验证使用以下通信流。

使用客户端 ID 和 secret 的客户端,代理将验证委派给授权服务器

- Kafka 客户端使用客户端 ID 和 secret 从授权服务器请求访问令牌,以及可选的刷新令牌。或者,客户端也可以使用用户名和密码进行身份验证。

- 授权服务器生成新的访问令牌。

- Kafka 客户端使用 SASL OAUTHBEARER 机制通过 Kafka 代理进行身份验证来传递访问令牌。

- Kafka 代理通过使用自己的客户端 ID 和 secret,在授权服务器上调用令牌内省端点来验证访问令牌。

- 如果令牌有效,则会建立 Kafka 客户端会话。

使用客户端 ID 和 secret 的客户端,代理执行快速本地令牌验证

- Kafka 客户端使用令牌端点、使用客户端 ID 和 secret 以及刷新令牌(可选)从令牌端点验证。或者,客户端也可以使用用户名和密码进行身份验证。

- 授权服务器生成新的访问令牌。

- Kafka 客户端使用 SASL OAUTHBEARER 机制通过 Kafka 代理进行身份验证来传递访问令牌。

- Kafka 代理使用 JWT 令牌签名检查和本地令牌内省在本地验证访问令牌。

使用长期访问令牌的客户端,代理委派验证到授权服务器

- Kafka 客户端使用 SASL OAUTHBEARER 机制通过 Kafka 代理进行身份验证,以传递长期访问令牌。

- Kafka 代理通过使用自己的客户端 ID 和 secret,在授权服务器上调用令牌内省端点来验证访问令牌。

- 如果令牌有效,则会建立 Kafka 客户端会话。

使用长期访问令牌的客户端,代理执行快速本地验证

- Kafka 客户端使用 SASL OAUTHBEARER 机制通过 Kafka 代理进行身份验证,以传递长期访问令牌。

- Kafka 代理使用 JWT 令牌签名检查和本地令牌内省在本地验证访问令牌。

快速的本地 JWT 令牌签名验证仅适用于短期的令牌,因为如果已撤销令牌,就不会通过授权服务器检查该授权服务器。令牌到期时间写入到令牌,但可以随时进行撤销,因此不能在不联系授权服务器的情况下被考虑。发布的任何令牌都将被视为有效,直到其过期为止。

6.4.9.5.2. 使用 SASL PLAIN 机制的客户端身份验证流示例

您可以使用 OAuth PLAIN 机制对 Kafka 身份验证使用以下通信流。

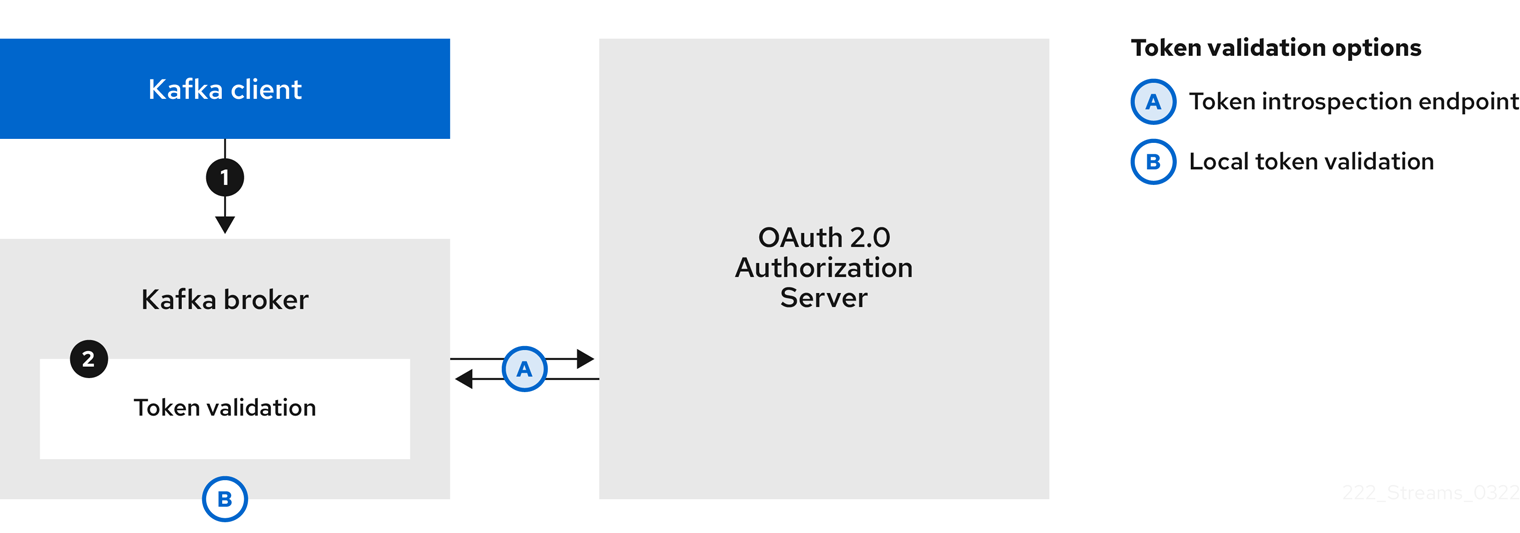

使用客户端 ID 和 secret 的客户端以及代理获取客户端的访问令牌

-

Kafka 客户端以用户名和密码形式

传递clientId。 -

Kafka 代理使用令牌端点将

clientId和secret传递给授权服务器。 - 如果客户端凭据无效,授权服务器会返回新的访问令牌或错误。

Kafka 代理以以下方法之一验证令牌:

- 如果指定了令牌内省端点,Kafka 代理通过在授权服务器上调用端点来验证访问令牌。如果令牌验证成功,则会建立会话。

- 如果使用本地令牌内省,则不会向授权服务器发出请求。Kafka 代理使用 JWT 令牌签名检查在本地验证访问令牌。

使用没有客户端 ID 和 secret 的长期访问令牌的客户端

- Kafka 客户端会传递用户名和密码。密码提供访问令牌的值,该令牌已在运行客户端之前手动获取和配置。

密码通过或不使用

$accessToken:字符串前缀来传递,具体取决于 Kafka 代理侦听程序是否配置了令牌端点来进行身份验证。-

如果配置了令牌端点,密码应以

$accessToken:前缀,以便代理知道 password 参数包含访问令牌而不是客户端 secret。Kafka 代理将用户名解释为帐户用户名。 -

如果没有在 Kafka 代理监听程序上配置令牌端点(强制使用

no-client-credentials 模式),密码应提供没有前缀的访问令牌。Kafka 代理将用户名解释为帐户用户名。在这个模式中,客户端不使用客户端 ID 和 secret,password参数始终被解释为原始访问令牌。

-

如果配置了令牌端点,密码应以

Kafka 代理以以下方法之一验证令牌:

- 如果指定了令牌内省端点,Kafka 代理通过在授权服务器上调用端点来验证访问令牌。如果令牌验证成功,则会建立会话。

- 如果使用本地令牌内省,则不会向授权服务器发出请求。Kafka 代理使用 JWT 令牌签名检查在本地验证访问令牌。

6.4.9.6. 配置 OAuth 2.0 身份验证

OAuth 2.0 用于在 Kafka 客户端和 AMQ Streams 组件间交互。

要将 OAuth 2.0 用于 AMQ Streams,您必须:

6.4.9.6.1. 将 Red Hat Single Sign-On 配置为 OAuth 2.0 授权服务器

此流程描述了如何将 Red Hat Single Sign-On 部署为授权服务器,并将其配置为与 AMQ Streams 集成。

授权服务器为身份验证和授权提供了一个中央点,以及用户、客户端和权限的管理。Red Hat Single Sign-On 有了一个域概念,域 代表一组单独的用户、客户端、权限和其他配置。您可以使用默认 master 域,或创建一个新域。每个 realm 会公开自己的 OAuth 2.0 端点,这意味着应用程序客户端和应用服务器都需要使用相同的域。

要将 OAuth 2.0 与 AMQ Streams 搭配使用,请使用部署 Red Hat Single Sign-On 来创建和管理身份验证域。

如果您已经部署了 Red Hat Single Sign-On,您可以跳过部署步骤并使用您的当前部署。

开始前

您需要熟悉使用红帽单点登录。

有关安装和管理说明,请参阅:

先决条件

- AMQ Streams 和 Kafka 正在运行

对于 Red Hat Single Sign-On 部署:

流程

Install Red Hat Single Sign-On.

您可以从 ZIP 文件或使用 RPM 安装。

登录到 Red Hat Single Sign-On Admin 控制台,为 AMQ Streams 创建 OAuth 2.0 策略。

部署 Red Hat Single Sign-On 时提供登录详情。

创建并启用域。

您可以使用现有的 master 域。

- 如果需要,调整域的会话和令牌超时。

-

创建名为

kafka-broker的客户端。 在 Settings 选项卡中设置:

-

访问 Type 为

Confidential -

Standard Flow Enabled 为

OFF为这个客户端禁用 Web 登录 -

Service Accounts Enabled 为

ON,以允许此客户端在其自己的名称中进行身份验证

-

访问 Type 为

- 在继续操作前,点 Save。

- 在 选项卡中,记录使用 AMQ Streams Kafka 集群配置的 secret。

对要连接到 Kafka 代理的任何应用程序客户端重复客户端创建步骤。

为每个新客户端创建一个定义。

您将在您的配置中将名称用作客户端 ID。

接下来要做什么

部署和配置授权服务器后,将 Kafka 代理配置为使用 OAuth 2.0。

6.4.9.6.2. 为 Kafka 代理配置 OAuth 2.0 支持

此流程描述了如何配置 Kafka 代理,以便代理监听程序可以使用授权服务器使用 OAuth 2.0 身份验证。

我们建议通过配置 TLS 侦听器来通过加密接口使用 OAuth 2.0。不建议使用普通监听程序。

使用支持您选择的授权服务器以及您要实施的授权类型的属性配置 Kafka 代理。

开始前

有关 Kafka 代理监听程序的配置和验证的更多信息,请参阅:

有关监听器配置中使用的属性的描述,请参阅:

先决条件

- AMQ Streams 和 Kafka 正在运行

- 部署了 OAuth 2.0 授权服务器

流程

在

server.properties文件中配置 Kafka 代理监听程序配置。例如,使用 OAUTHBEARER 机制:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将代理连接设置配置为

listener.name.client.oauthbearer.sasl.jaas.config的一部分。此处的示例显示了连接配置选项。

示例 1:使用 JWKS 端点配置的本地令牌验证

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例 2:通过 OAuth 2.0 内省端点将令牌验证委派给授权服务器

listener.name.client.oauthbearer.sasl.jaas.config=org.apache.kafka.common.security.oauthbearer.OAuthBearerLoginModule required \ oauth.introspection.endpoint.uri="https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/introspection" \ # ...

listener.name.client.oauthbearer.sasl.jaas.config=org.apache.kafka.common.security.oauthbearer.OAuthBearerLoginModule required \ oauth.introspection.endpoint.uri="https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/introspection" \ # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果需要,配置对授权服务器的访问。

生产环境通常需要这一步,除非使用 service mesh 等技术来配置容器外的安全频道。

提供用于连接安全授权服务器的自定义信任存储。访问授权服务器时始终需要 SSL。

设置属性来配置信任存储。

例如:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果证书主机名与访问 URL 主机名不匹配,您可以关闭证书主机名验证:

oauth.ssl.endpoint.identification.algorithm=""

oauth.ssl.endpoint.identification.algorithm=""Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查可确保与授权服务器的连接是真实的。您可能想要在非生产环境中关闭验证。

根据您选择的身份验证流程配置附加属性:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 您的授权服务器的 OAuth 2.0 令牌端点 URL。对于生产环境,请始终使用

https://urls。当使用KeycloakRBACAuthorizer或启用了 OAuth 2.0 的监听程序时,需要用于 Inter-broker 间通信。 - 2

- (可选 )自定义声明检查。JsonPath 过滤器查询,该查询在验证期间将其他自定义规则应用到 JWT 访问令牌。如果访问令牌不包含必要的数据,则会被拒绝。使用 introspection 端点方法时,自定义检查将应用到内省端点响应 JSON。

- 3

- (可选)传递给令牌端点的

scope参数。获取访问令牌进行代理身份验证时使用的 scope。它还在使用clientId和secret的 PLAIN 客户端验证中用于 OAuth 2.0 的客户端名称。这只会影响获取令牌的能力,以及令牌的内容,具体取决于授权服务器。它不会影响监听程序的令牌验证规则。 - 4

- (可选) 对象检查。如果您的授权服务器提供

aud(audience)声明,并且您希望强制读者检查,请将ouath.check.audience设置为true。受众检查标识令牌的预期接收者。因此,Kafka 代理将拒绝在其aud声明中没有clientId的令牌。默认为false。 - 5

- (可选)传递给令牌端点的

audience参数。在获取用于代理身份验证的访问令牌时,需要使用 audience。它还在使用clientId和secret的 PLAIN 客户端验证中用于 OAuth 2.0 的客户端名称。这只会影响获取令牌的能力,以及令牌的内容,具体取决于授权服务器。它不会影响监听程序的令牌验证规则。 - 6

- 有效的签发者 URI。仅接受此签发者发布的访问令牌。(始终必需。)

- 7

- Kafka 代理配置的客户端 ID,适用于所有代理。这是在 授权服务器中注册的客户端为

kafka-broker。当内省端点用于令牌验证时,或者在使用KeycloakRBACAuthorizer时是必需的。 - 8

- Kafka 代理配置的 secret,适用于所有代理。当代理必须向授权服务器(客户端 secret、访问令牌或刷新令牌)进行身份验证时,必须指定刷新令牌。

- 9

- (可选)连接到授权服务器时连接超时(以秒为单位)。默认值为 60。

- 10

- (可选)连接到授权服务器时的读取超时(以秒为单位)。默认值为 60。

- 11

- 将失败的 HTTP 请求重试到授权服务器的次数上限。默认值为 0,表示没有执行重试。要有效地使用这个选项,请考虑减少

oauth.connect.timeout.seconds和oauth.read.timeout.seconds选项的超时时间。但请注意,重试可能会阻止当前 worker 线程对其他请求使用,如果太多请求停滞,可能会导致 Kafka 代理无响应。 - 12

- 在尝试另一个失败 HTTP 请求重试到授权服务器前等待的时间。默认情况下,这段时间设为零,这意味着不会应用暂停。这是因为,导致失败请求的很多问题都是可快速解决的网络 glitches 或代理问题。但是,如果您的授权服务器处于压力或遇到高流量,您可能希望将此选项设置为 100 ms 或更高值,以减少服务器上的负载并增加成功重试的可能性。

- 13

- JsonPath 查询,用于从 JWT 令牌或内省端点响应中提取组信息。默认情况下不设置。这可以供自定义授权者用于根据用户组做出授权决策。

- 14

- 以单个分隔字符串返回时用于解析组信息的分隔符。默认值为 ','(comma)。

根据您如何应用 OAuth 2.0 身份验证以及所使用的授权服务器类型,添加额外的配置设置:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果您的授权服务器不提供

iss声明,则无法执行签发者检查。在这种情况下,将oauth.check.issuer设置为false,且不指定oauth.valid.issuer.uri。默认为true。 - 2

- 授权服务器可能无法提供单个属性来识别常规用户和客户端。当客户端使用自己的名称进行身份验证时,服务器可能会提供 客户端 ID。当用户使用用户名和密码进行身份验证时,要获取刷新令牌或访问令牌时,除了客户端 ID 外,服务器可能会提供 username 属性。如果主用户 ID 属性不可用,则使用此回退选项指定用户名声明(attribute)。

- 3

- 当

oauth.fallback.username.claim适用的情况下,可能需要防止用户名声明的值和回退用户名声明之间的名称冲突。例如,存在名为producer的客户端,但也存在名为producer的常规用户。为了区分两者,您可以使用此属性向客户端的用户 ID 添加前缀。 - 4

- (仅在使用

oauth.introspection.endpoint.uri)取决于您使用的授权服务器时,内省端点可能会也可能不会返回 令牌类型 属性,或者可能包含不同的值。您可以指定来自内省端点的响应的有效令牌类型值。 - 5

- (仅在使用

oauth.introspection.endpoint.uri时使用,可以配置或实施授权服务器,以便在内省端点响应中不提供任何可识别的信息。要获取用户 ID,您可以将userinfo端点的 URI 配置为回退。oauth.fallback.username.claim、oauth.fallback.username.claim和oauth.fallback.username.prefix设置应用到userinfo端点的响应。

接下来要做什么

6.4.9.6.3. 配置 Kafka Java 客户端以使用 OAuth 2.0

配置 Kafka 制作者和消费者 API,以使用 OAuth 2.0 与 Kafka 代理交互。向客户端 pom.xml 文件添加一个回调插件,然后为 OAuth 2.0 配置客户端。

在客户端配置中指定以下内容:

SASL (简单身份验证和安全层)安全协议:

-

SASL_SSL用于通过 TLS 加密连接进行身份验证 SASL_PLAINTEXT用于通过未加密的连接进行身份验证将

SASL_SSL用于生产环境,SASL_PLAINTEXT仅用于本地开发。使用SASL_SSL时,需要额外的ssl.truststore配置。安全连接(https://)需要信任存储配置到 OAuth 2.0 授权服务器。要验证 OAuth 2.0 授权服务器,请将授权服务器的 CA 证书添加到客户端配置中的信任存储中。您可以使用 PEM 或 PKCS #12 格式配置信任存储。

-

Kafka SASL 机制:

-

OAUTHBEARER用于使用 bearer 令牌进行凭证交换 -

PLAIN来传递客户端凭证(clientId + secret)或访问令牌

-

实现 SASL 机制的 JAAS (Java 认证和授权服务)模块:

-

org.apache.kafka.common.security.oauthbearer.OAuthBearerLoginModule实施 OAUTHBEARER 机制 -

org.apache.kafka.common.security.plain.PlainLoginModule实施 PLAIN 机制

-

SASL 身份验证属性,它支持以下身份验证方法:

- OAuth 2.0 客户端凭证

- OAuth 2.0 密码授予(已弃用)

- 访问令牌

- 刷新令牌

将 SASL 身份验证属性添加为 JAAS 配置(sasl.jaas.config)。如何配置身份验证属性取决于您用于访问 OAuth 2.0 授权服务器的身份验证方法。在此过程中,属性在属性文件中指定,然后加载到客户端配置中。

您还可以将身份验证属性指定为环境变量,或指定为 Java 系统属性。对于 Java 系统属性,您可以使用 setProperty 设置它们,并使用 -D 选项在命令行中传递它们。

先决条件

- AMQ Streams 和 Kafka 正在运行

- 部署了 OAuth 2.0 授权服务器,并配置了对 Kafka 代理的 OAuth 访问

- 为 OAuth 2.0 配置 Kafka 代理

流程

将带有 OAuth 2.0 支持的客户端库添加到 Kafka 客户端的

pom.xml文件中:<dependency> <groupId>io.strimzi</groupId> <artifactId>kafka-oauth-client</artifactId> <version>0.12.0.redhat-00006</version> </dependency>

<dependency> <groupId>io.strimzi</groupId> <artifactId>kafka-oauth-client</artifactId> <version>0.12.0.redhat-00006</version> </dependency>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过在属性文件中指定以下配置来配置客户端属性:

- 安全协议

- SASL 机制

JAAS 模块和身份验证属性,取决于所使用的方法

例如,我们可以将以下内容添加到

client.properties文件中:客户端凭证机制属性

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 用于 TLS 加密连接的

SASL_SSL安全协议。使用SASL_PLAINTEXTover unencrypted 连接仅进行本地开发。 - 2

- 指定为

OAUTHBEARER或PLAIN的 SASL 机制。 - 3

- 用于安全访问 Kafka 集群的信任存储配置。

- 4

- 授权服务器令牌端点的 URI。

- 5

- 客户端 ID,这是在授权服务器中创建客户端时使用的名称。

- 6

- 在授权服务器中创建 客户端 时创建的客户端 secret。

- 7

- 位置包含授权服务器的公钥证书(

truststore.p12)。 - 8

- 用于访问 truststore 的密码。

- 9

- truststore 类型。

- 10

- (可选)从令牌端点请求令牌的

范围。授权服务器可能需要客户端来指定范围。 - 11

- (可选)从令牌端点请求令牌的

听众。授权服务器可能需要客户端来指定受众。

密码授予机制属性

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 访问令牌属性

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Kafka 客户端的长期访问令牌。

刷新令牌属性

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

将 OAUTH 2.0 身份验证的客户端属性输入到 Java 客户端代码中。

显示客户端属性输入示例

Properties props = new Properties(); try (FileReader reader = new FileReader("client.properties", StandardCharsets.UTF_8)) { props.load(reader); }Properties props = new Properties(); try (FileReader reader = new FileReader("client.properties", StandardCharsets.UTF_8)) { props.load(reader); }Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 验证 Kafka 客户端可以访问 Kafka 代理。

6.4.10. 使用基于 OAuth 2.0 令牌的授权

AMQ Streams 支持通过 Red Hat Single Sign-On Authorization Services 使用基于 OAuth 2.0 令牌的授权,它允许您集中管理安全策略和权限。

Red Hat Single Sign-On 中定义的安全策略和权限用于授予对 Kafka 代理上资源的访问权限。用户和客户端与允许对 Kafka 代理执行特定操作的策略进行匹配。

Kafka 允许所有用户默认对代理进行完全访问,同时还提供 AclAuthorizer 插件来配置基于 Access Control Lists (ACL)的授权。

ZooKeeper 存储 ACL 规则,以根据 用户名 授予或拒绝对资源的访问。但是,红帽单点登录基于 OAuth 2.0 令牌的授权在您希望实现对 Kafka 代理的访问控制方面具有更大的灵活性。另外,您可以将 Kafka 代理配置为使用 OAuth 2.0 授权和 ACL。

6.4.10.1. OAuth 2.0 授权机制

AMQ Streams 中的 OAuth 2.0 授权使用红帽单点登录服务器授权服务 REST 端点,通过在特定用户上应用定义的安全策略来扩展基于令牌的身份验证,并为该用户提供授予不同资源的权限列表。策略使用角色和组将权限与用户匹配。OAuth 2.0 授权根据从 Red Hat Single Sign-On Authorization Services 用户获得的授予者列表在本地强制实施权限。

6.4.10.1.1. Kafka 代理自定义授权器

AMQ Streams 提供了 Red Hat Single Sign-On authorizer (KeycloakRBACAuthorizer)。为了能够将 Red Hat Single Sign-On 提供的 Red Hat Single Sign-On REST 端点用于授权服务,您可以在 Kafka 代理上配置自定义授权器。

授权程序根据需要从授权服务器获取授予权限的列表,并在 Kafka Broker 上本地强制实施授权,为每个客户端请求做出快速授权决策。

6.4.10.2. 配置 OAuth 2.0 授权支持

这个步骤描述了如何使用 Red Hat Single Sign-On Authorization Services 将 Kafka 代理配置为使用 OAuth 2.0 授权服务。

开始前

考虑某些用户所需的访问权限或希望限制某些用户。您可以使用红帽单点登录 组、角色、客户端和 用户在 Red Hat Single Sign-On 中配置访问权限。

通常,组用于根据组织部门或地理位置匹配用户。和 角色用于根据用户的功能匹配用户。

使用红帽单点登录,您可以在 LDAP 中存储用户和组,而客户端和角色不能以这种方式存储。存储和访问用户数据可能是您选择如何配置授权策略的一个因素。

无论在 Kafka 代理上实现的授权是什么,超级用户始终对 Kafka 代理具有不受限制的访问。

先决条件

- AMQ Streams 必须通过 Red Hat Single Sign-On 配置为使用 OAuth 2.0 进行基于令牌的身份验证。设置授权时,您可以使用相同的 Red Hat Single Sign-On 服务器端点。

- 您需要了解如何管理红帽单点登录授权服务的政策和权限,如 红帽单点登录文档中所述。

流程

- 访问 Red Hat Single Sign-On Admin 控制台,或使用 Red Hat Single Sign-On Admin CLI 为您在设置 OAuth 2.0 身份验证时创建的 Kafka 代理客户端启用 Authorization Services。

- 使用 Authorization Services 为客户端定义资源、授权范围、策略和权限。

- 通过分配角色和组,将权限绑定到用户和客户端。

将 Kafka 代理配置为使用 Red Hat Single Sign-On 授权。

将以下内容添加到 Kafka

server.properties配置文件中,以在 Kafka 中安装 authorizer:authorizer.class.name=io.strimzi.kafka.oauth.server.authorizer.KeycloakRBACAuthorizer principal.builder.class=io.strimzi.kafka.oauth.server.OAuthKafkaPrincipalBuilder

authorizer.class.name=io.strimzi.kafka.oauth.server.authorizer.KeycloakRBACAuthorizer principal.builder.class=io.strimzi.kafka.oauth.server.OAuthKafkaPrincipalBuilderCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加 Kafka 代理的配置来访问授权服务器和授权服务。

在此我们显示作为额外属性添加到

server.properties的示例配置,但您也可以使用大写或大写的命名规则将它们定义为环境变量。strimzi.authorization.token.endpoint.uri="https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/token" strimzi.authorization.client.id="kafka"

strimzi.authorization.token.endpoint.uri="https://AUTH-SERVER-ADDRESS/auth/realms/REALM-NAME/protocol/openid-connect/token"1 strimzi.authorization.client.id="kafka"2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow (可选)为特定 Kafka 集群添加配置。

例如:

strimzi.authorization.kafka.cluster.name="kafka-cluster"

strimzi.authorization.kafka.cluster.name="kafka-cluster"1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 特定 Kafka 集群的名称。名称用于目标权限,从而可以在同一 Red Hat Single Sign-On 域中管理多个集群。默认值为

kafka-cluster。

(可选)到简单授权。

例如:

strimzi.authorization.delegate.to.kafka.acl="false"

strimzi.authorization.delegate.to.kafka.acl="false"1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果 Red Hat Single Sign-On Authorization Services 策略无法访问,将授权委派给 Kafka

AclAuthorizer。默认值为false。

(可选)添加与授权服务器的 TLS 连接配置。

例如:

strimzi.authorization.ssl.truststore.location=<path-to-truststore> strimzi.authorization.ssl.truststore.password=<my-truststore-password> strimzi.authorization.ssl.truststore.type=JKS strimzi.authorization.ssl.secure.random.implementation=SHA1PRNG strimzi.authorization.ssl.endpoint.identification.algorithm=HTTPS

strimzi.authorization.ssl.truststore.location=<path-to-truststore>1 strimzi.authorization.ssl.truststore.password=<my-truststore-password>2 strimzi.authorization.ssl.truststore.type=JKS3 strimzi.authorization.ssl.secure.random.implementation=SHA1PRNG4 strimzi.authorization.ssl.endpoint.identification.algorithm=HTTPS5 Copy to Clipboard Copied! Toggle word wrap Toggle overflow (可选)配置授权服务器的授权刷新。授权刷新作业通过枚举活跃令牌并请求每个令牌的最新授权来工作。

例如:

strimzi.authorization.grants.refresh.period.seconds="120" strimzi.authorization.grants.refresh.pool.size="10"

strimzi.authorization.grants.refresh.period.seconds="120"1 strimzi.authorization.grants.refresh.pool.size="10"2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow (可选)与授权服务器通信时配置网络超时。

例如:

strimzi.authorization.connect.timeout.seconds="60" strimzi.authorization.read.timeout.seconds="60" strimzi.authorization.http.retries="2"

strimzi.authorization.connect.timeout.seconds="60"1 strimzi.authorization.read.timeout.seconds="60"2 strimzi.authorization.http.retries="2"3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 连接到 Red Hat Single Sign-On 令牌端点时的连接超时(以秒为单位)。默认值为

60。 - 2

- 连接到 Red Hat Single Sign-On 令牌端点时的读取超时(以秒为单位)。默认值为

60。 - 3

- 对授权服务器失败的 HTTP 请求重试(不暂停)的最大次数。默认值为

0,表示没有执行重试。要有效地使用这个选项,请考虑减少strimzi.authorization.connect.timeout.seconds和strimzi.authorization.read.timeout.seconds选项的超时时间。但请注意,重试可能会阻止当前 worker 线程对其他请求使用,如果太多请求停滞,可能会导致 Kafka 代理无响应。

- 通过以客户端或具有特定角色的用户访问 Kafka 代理来验证配置的权限,确保它们具有必要的访问权限,或者没有应该具有访问权限。

6.4.11. 使用 OPA 基于策略的授权

开源策略代理(OPA)是一个开源策略引擎。您可以将 OPA 与 AMQ Streams 集成,作为基于策略的授权机制,允许在 Kafka 代理上进行客户端操作。

从客户端发出请求时,OPA 将根据为 Kafka 访问定义的策略评估请求,然后允许或拒绝请求。

红帽不支持 OPA 服务器。

6.4.11.1. 定义 OPA 策略

在将 OPA 与 AMQ Streams 集成前,请考虑如何定义策略,以提供精细的访问控制。

您可以为 Kafka 集群、消费者组和主题定义访问控制。例如,您可以定义一个授权策略,允许从制作者客户端写入到特定代理主题的访问。

为此,策略可以指定:

- 与制作者客户端关联的用户主体和主机地址

- 允许客户端 的操作

-

策略适用的 资源类型 (

topic)和资源名称

允许或拒绝决策将写入到策略中,并根据提供的请求和客户端识别数据提供响应。

在我们的示例中,生产者客户端必须满足允许写入该主题的策略。

6.4.11.2. 连接到 OPA

要启用 Kafka 访问 OPA 策略引擎以查询访问控制策略,您可以在您的 Kafka server.properties 文件中配置自定义 OPA authorizer 插件 (kafka-authorizer-opa-VERSION.jar)。

客户端发出请求时,OPA 策略引擎将通过指定的 URL 地址和 REST 端点来查询 OPA 策略引擎,该端点必须是定义的策略的名称。

该插件提供了客户端请求的详细信息 - 用户主体、操作和资源 - 以 JSON 格式针对策略进行检查。详细信息将包括客户端的唯一身份;例如,使用 TLS 身份验证时将区分名称与客户端证书进行区分。

OPA 使用数据向插件提供响应 - true 或 false - 允许或拒绝请求。

6.4.11.3. 配置 OPA 授权支持

此流程描述了如何配置 Kafka 代理以使用 OPA 授权。

开始前

考虑某些用户所需的访问权限或希望限制某些用户。您可以使用 用户和 Kafka 资源 的组合来定义 OPA 策略。

可以设置 OPA 从 LDAP 数据源加载用户信息。

无论在 Kafka 代理上实现的授权是什么,超级用户始终对 Kafka 代理具有不受限制的访问。

先决条件

- OPA 服务器必须可用于连接。

- Kafka 的 OPA 授权器插件

流程

编写授权客户端请求在 Kafka 代理上执行操作所需的 OPA 策略。

请参阅 定义 OPA 策略。

现在,将 Kafka 代理配置为使用 OPA。

请参阅 连接到 OPA。

确保插件文件包含在 Kafka 类路径中。

在 Kafka

server.properties配置文件中添加以下内容来启用 OPA 插件:authorizer.class.name: com.bisnode.kafka.authorization.OpaAuthorizer

authorizer.class.name: com.bisnode.kafka.authorization.OpaAuthorizerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 Kafka 代理的

server.properties中添加更多配置,以访问 OPA 策略引擎和策略。例如:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 使用具有 且没有正确授权的客户端访问 Kafka 代理来验证配置的权限。