Nœuds

Configurer et gérer les nœuds dans OpenShift Container Platform

Résumé

Chapitre 1. Vue d'ensemble des nœuds

1.1. À propos des nœuds

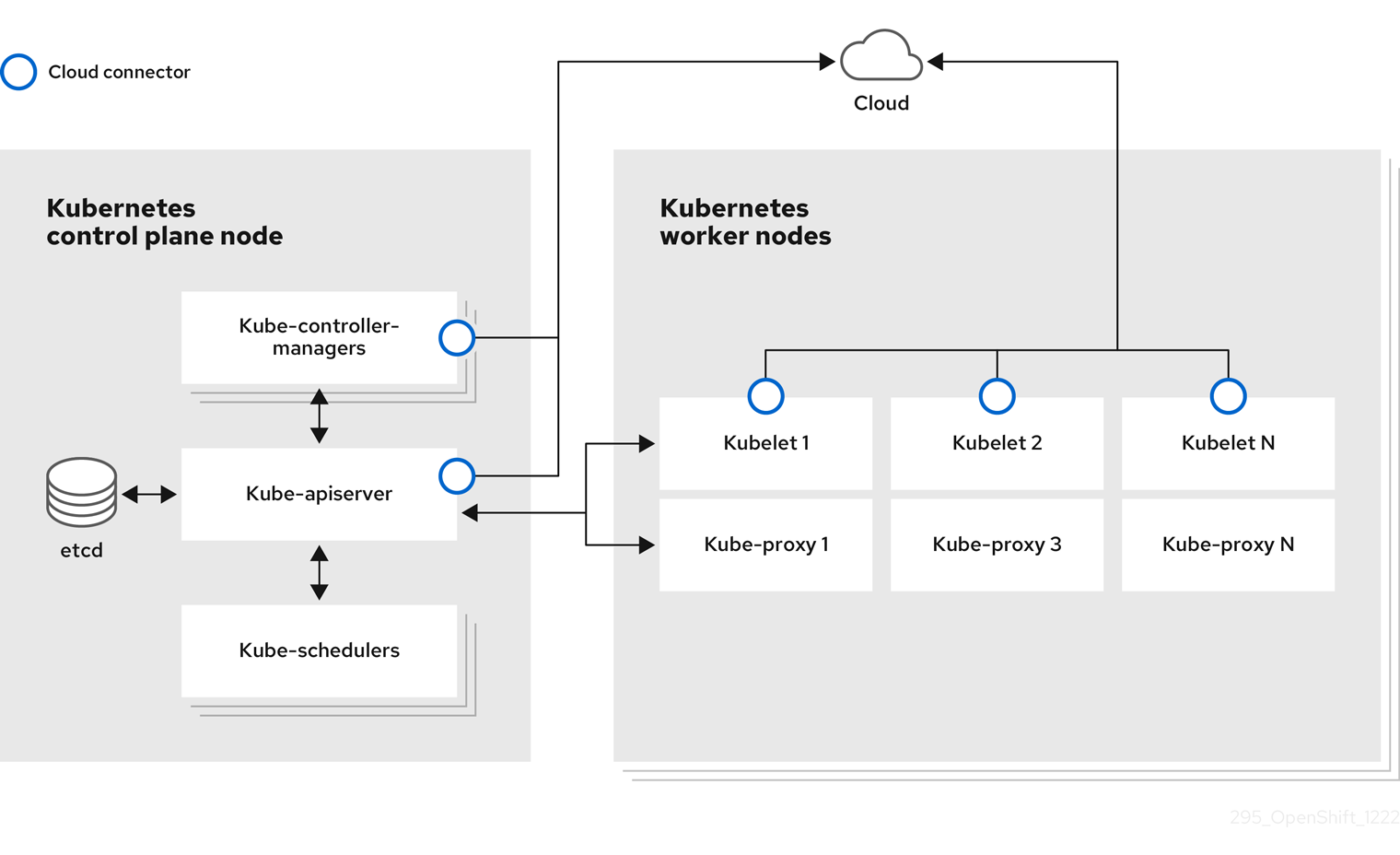

Un nœud est une machine virtuelle ou bare-metal dans un cluster Kubernetes. Les nœuds de travail hébergent vos conteneurs d'application, regroupés sous forme de pods. Les nœuds du plan de contrôle exécutent les services nécessaires au contrôle du cluster Kubernetes. Dans OpenShift Container Platform, les nœuds du plan de contrôle contiennent plus que les services Kubernetes pour gérer le cluster OpenShift Container Platform.

Disposer de nœuds stables et sains dans un cluster est fondamental pour le bon fonctionnement de votre application hébergée. Dans OpenShift Container Platform, vous pouvez accéder à un nœud, le gérer et le surveiller par le biais de l'objet Node représentant le nœud. À l'aide de la CLI OpenShift (oc) ou de la console Web, vous pouvez effectuer les opérations suivantes sur un nœud.

Les composants suivants d'un nœud sont chargés de maintenir l'exécution des pods et de fournir l'environnement d'exécution Kubernetes.

- Exécution du conteneur: : Le runtime de conteneur est responsable de l'exécution des conteneurs. Kubernetes propose plusieurs runtimes tels que containerd, cri-o, rktlet et Docker.

- Kubelet: : Kubelet s'exécute sur les nœuds et lit les manifestes des conteneurs. Il s'assure que les conteneurs définis ont démarré et sont en cours d'exécution. Le processus kubelet maintient l'état du travail et du serveur de nœuds. Kubelet gère les règles du réseau et la redirection des ports. Le kubelet gère les conteneurs qui sont créés par Kubernetes uniquement.

- Kube-proxy: : Kube-proxy s'exécute sur chaque nœud du cluster et maintient le trafic réseau entre les ressources Kubernetes. Un Kube-proxy garantit que l'environnement réseau est isolé et accessible.

- DNS: : Cluster DNS est un serveur DNS qui sert les enregistrements DNS pour les services Kubernetes. Les conteneurs démarrés par Kubernetes incluent automatiquement ce serveur DNS dans leurs recherches DNS.

Opérations de lecture

Les opérations de lecture permettent à un administrateur ou à un développeur d'obtenir des informations sur les nœuds d'un cluster OpenShift Container Platform.

- Liste de tous les nœuds d'une grappe.

- Obtenir des informations sur un nœud, telles que l'utilisation de la mémoire et de l'unité centrale, l'état de santé, le statut et l'âge.

- Liste des pods en cours d'exécution sur un nœud.

Opérations de gestion

En tant qu'administrateur, vous pouvez facilement gérer un nœud dans un cluster OpenShift Container Platform grâce à plusieurs tâches :

-

Ajouter ou mettre à jour les étiquettes des nœuds. Une étiquette est une paire clé-valeur appliquée à un objet

Node. Vous pouvez contrôler l'ordonnancement des pods à l'aide des étiquettes. -

Modifier la configuration du nœud à l'aide d'une définition de ressource personnalisée (CRD) ou de l'objet

kubeletConfig. -

Configurez les nœuds pour qu'ils autorisent ou non la planification des modules. Les nœuds de travail sains ayant un statut

Readyautorisent le placement de pods par défaut, tandis que les nœuds du plan de contrôle ne le font pas. Vous pouvez modifier ce comportement par défaut en configurant les nœuds de travail pour qu'ils ne soient pas ordonnançables et les nœuds du plan de contrôle pour qu'ils soient ordonnançables. -

Allouez des ressources aux nœuds à l'aide du paramètre

system-reserved. Vous pouvez permettre à OpenShift Container Platform de déterminer automatiquement les ressources optimalessystem-reservedCPU et mémoire pour vos nœuds, ou vous pouvez déterminer et définir manuellement les meilleures ressources pour vos nœuds. - Configurez le nombre de pods pouvant être exécutés sur un nœud en fonction du nombre de cœurs de processeur du nœud, d'une limite stricte ou des deux.

- Redémarrer un nœud avec élégance en utilisant l'anti-affinité des pods.

- Supprimez un nœud d'un cluster en réduisant la taille du cluster à l'aide d'un ensemble de machines de calcul. Pour supprimer un nœud d'un cluster bare-metal, vous devez d'abord drainer tous les pods sur le nœud, puis supprimer manuellement le nœud.

Opérations de renforcement

OpenShift Container Platform vous permet de faire plus que d'accéder aux nœuds et de les gérer ; en tant qu'administrateur, vous pouvez effectuer les tâches suivantes sur les nœuds pour rendre le cluster plus efficace, plus convivial pour les applications et pour fournir un meilleur environnement à vos développeurs.

- Gérer les réglages au niveau des nœuds pour les applications à hautes performances qui nécessitent un certain niveau de réglage du noyau en utilisant l'opérateur de réglage des nœuds.

- Activez les profils de sécurité TLS sur le nœud pour protéger la communication entre le kubelet et le serveur API Kubernetes.

- Exécuter automatiquement des tâches d'arrière-plan sur les nœuds à l'aide d'ensembles de démons. Vous pouvez créer et utiliser des ensembles de démons pour créer un stockage partagé, exécuter un pod de journalisation sur chaque nœud ou déployer un agent de surveillance sur tous les nœuds.

- Libérez les ressources des nœuds à l'aide de la collecte des ordures (garbage collection). Vous pouvez vous assurer que vos nœuds fonctionnent efficacement en supprimant les conteneurs terminés et les images qui ne sont pas référencées par les pods en cours d'exécution.

- Ajouter des arguments de noyau à un ensemble de nœuds.

- Configurez un cluster OpenShift Container Platform pour avoir des nœuds de travailleur à la périphérie du réseau (nœuds de travailleur à distance). Pour plus d'informations sur les défis posés par les nœuds de télétravail dans un cluster OpenShift Container Platform et sur certaines approches recommandées pour gérer les pods sur un nœud de télétravail, voir Utilisation de nœuds de télétravail à la périphérie du réseau.

1.2. À propos des cosses

Un pod est un ou plusieurs conteneurs déployés ensemble sur un nœud. En tant qu'administrateur de cluster, vous pouvez définir un module, l'affecter à un nœud sain prêt à être programmé et le gérer. Un module fonctionne tant que les conteneurs sont en cours d'exécution. Vous ne pouvez pas modifier un module une fois qu'il a été défini et qu'il est en cours d'exécution. Voici quelques opérations que vous pouvez effectuer lorsque vous travaillez avec des modules :

Opérations de lecture

En tant qu'administrateur, vous pouvez obtenir des informations sur les pods d'un projet en effectuant les tâches suivantes :

- Liste des pods associés à un projet, avec des informations telles que le nombre de répliques et de redémarrages, l'état actuel et l'âge.

- Afficher les statistiques d'utilisation des pods, telles que la consommation de l'unité centrale, de la mémoire et du stockage.

Opérations de gestion

La liste de tâches suivante donne un aperçu de la façon dont un administrateur peut gérer les pods dans un cluster OpenShift Container Platform.

Contrôler la planification des pods en utilisant les fonctionnalités avancées de planification disponibles dans OpenShift Container Platform :

- Règles de liaison entre les nœuds, telles que l'affinité entre les nœuds, l'affinité entre les nœuds et l'anti-affinité.

- Etiquettes et sélecteurs de nœuds.

- Taches et tolérances.

- Contraintes d'étalement de la topologie des pods.

- Programmation secondaire.

- Configurer l 'ordonnanceur pour qu'il expulse les pod s sur la base de stratégies spécifiques afin que l'ordonnanceur réorganise les pods vers des nœuds plus appropriés.

- Configurer le comportement des pods après un redémarrage à l'aide de contrôleurs de pods et de politiques de redémarrage.

- Limiter le trafic de sortie et d'entrée sur un pod.

- Ajoutez et supprimez des volumes à n'importe quel objet ayant un modèle de pod. Un volume est un système de fichiers monté accessible à tous les conteneurs d'un module. Le stockage des conteneurs est éphémère ; vous pouvez utiliser des volumes pour conserver les données des conteneurs.

Opérations de renforcement

Vous pouvez travailler avec des pods plus facilement et plus efficacement à l'aide de divers outils et fonctionnalités disponibles dans OpenShift Container Platform. Les opérations suivantes impliquent l'utilisation de ces outils et fonctionnalités pour mieux gérer les pods.

| Fonctionnement | User | Plus d'informations |

|---|---|---|

| Créer et utiliser un pod autoscaler horizontal. | Développeur | Vous pouvez utiliser un pod autoscaler horizontal pour spécifier le nombre minimum et maximum de pods que vous souhaitez exécuter, ainsi que l'utilisation de l'unité centrale ou de la mémoire que vos pods doivent viser. En utilisant un autoscaler de pods horizontal, vous pouvez automatiquement mettre à l'échelle les pods. |

| Administrateur et développeur | En tant qu'administrateur, utilisez un pod autoscaler vertical pour mieux utiliser les ressources du cluster en surveillant les ressources et les besoins en ressources des charges de travail. En tant que développeur, utilisez un autoscaler vertical de pods pour vous assurer que vos pods restent opérationnels pendant les périodes de forte demande en planifiant les pods sur des nœuds disposant de suffisamment de ressources pour chaque pod. | |

| Permettre l'accès à des ressources externes à l'aide de plugins pour appareils. | Administrateur | Un plugin de périphérique est un service gRPC fonctionnant sur les nœuds (externe au kubelet), qui gère des ressources matérielles spécifiques. Vous pouvez déployer un plugin de périphérique afin de fournir une solution cohérente et portable pour consommer des périphériques matériels à travers les clusters. |

|

Fournir des données sensibles aux pods à l'aide de l'objet | Administrateur |

Certaines applications ont besoin d'informations sensibles, telles que les mots de passe et les noms d'utilisateur. Vous pouvez utiliser l'objet |

1.3. À propos des conteneurs

Un conteneur est l'unité de base d'une application OpenShift Container Platform, qui comprend le code de l'application emballé avec ses dépendances, bibliothèques et binaires. Les conteneurs assurent la cohérence entre les environnements et les cibles de déploiement multiples : serveurs physiques, machines virtuelles (VM) et nuages privés ou publics.

Les technologies de conteneurs Linux sont des mécanismes légers permettant d'isoler les processus en cours d'exécution et de limiter l'accès aux seules ressources désignées. En tant qu'administrateur, vous pouvez effectuer diverses tâches sur un conteneur Linux, telles que :

OpenShift Container Platform propose des conteneurs spécialisés appelés conteneurs Init. Les conteneurs Init s'exécutent avant les conteneurs d'application et peuvent contenir des utilitaires ou des scripts de configuration qui ne sont pas présents dans une image d'application. Vous pouvez utiliser un conteneur Init pour effectuer des tâches avant que le reste d'un pod ne soit déployé.

Outre l'exécution de tâches spécifiques sur les nœuds, les pods et les conteneurs, vous pouvez travailler avec l'ensemble du cluster OpenShift Container Platform pour maintenir l'efficacité du cluster et la haute disponibilité des pods d'application.

1.4. Glossaire des termes courants pour les nœuds de OpenShift Container Platform

Ce glossaire définit les termes courants utilisés dans le contenu du site node.

- Conteneur

- Il s'agit d'une image légère et exécutable qui comprend un logiciel et toutes ses dépendances. Les conteneurs virtualisent le système d'exploitation, ce qui permet d'exécuter des conteneurs partout, du centre de données au nuage public ou privé, en passant par l'ordinateur portable d'un développeur.

- Jeu de démons

- Assure qu'une réplique du pod s'exécute sur les nœuds éligibles d'un cluster OpenShift Container Platform.

- évacuation

- Processus de partage de données vers l'extérieur par le biais du trafic sortant d'un réseau à partir d'un pod.

- collecte des ordures

- Le processus de nettoyage des ressources du cluster, telles que les conteneurs et les images terminés qui ne sont pas référencés par des pods en cours d'exécution.

- Autoscaler horizontal (HPA)

- Implémenté comme une ressource API Kubernetes et un contrôleur. Vous pouvez utiliser le HPA pour spécifier le nombre minimum et maximum de pods que vous souhaitez exécuter. Vous pouvez également spécifier l'utilisation du CPU ou de la mémoire que vos pods doivent viser. Le HPA réduit et augmente le nombre de pods lorsqu'un seuil donné de CPU ou de mémoire est franchi.

- Entrée

- Trafic entrant vers un pod.

- Emploi

- Un processus qui s'exécute jusqu'à son terme. Un job crée un ou plusieurs objets pods et s'assure que les pods spécifiés sont terminés avec succès.

- Étiquettes

- Vous pouvez utiliser des étiquettes, qui sont des paires clé-valeur, pour organiser et sélectionner des sous-ensembles d'objets, tels qu'un pod.

- Nœud

- Une machine de travail dans le cluster OpenShift Container Platform. Un nœud peut être une machine virtuelle (VM) ou une machine physique.

- Opérateur de réglage des nœuds

- Vous pouvez utiliser l'opérateur d'optimisation des nœuds pour gérer l'optimisation au niveau des nœuds en utilisant le démon TuneD. Il garantit que les spécifications de réglage personnalisées sont transmises à tous les démons TuneD conteneurisés qui s'exécutent dans le cluster dans un format que les démons comprennent. Les démons s'exécutent sur tous les nœuds de la grappe, un par nœud.

- Opérateur d'assainissement de nœuds autonomes

- L'opérateur s'exécute sur les nœuds de la grappe, identifie et redémarre les nœuds qui ne sont pas en bonne santé.

- Cosse

- Un ou plusieurs conteneurs avec des ressources partagées, telles que le volume et les adresses IP, fonctionnant dans votre cluster OpenShift Container Platform. Un pod est la plus petite unité de calcul définie, déployée et gérée.

- Tolérance

- Indique que le module est autorisé (mais pas obligatoire) à être planifié sur des nœuds ou des groupes de nœuds dont les caractéristiques correspondent à celles du module. Vous pouvez utiliser des tolérances pour permettre à l'ordonnanceur de planifier des pods avec des taints correspondants.

- Souillure

- Un objet central qui comprend une clé, une valeur et un effet. Les taches et les tolérances fonctionnent ensemble pour garantir que les pods ne sont pas programmés sur des nœuds non pertinents.

Chapitre 2. Travailler avec des pods

2.1. Utilisation des dosettes

Un pod est un ou plusieurs conteneurs déployés ensemble sur un hôte, et la plus petite unité de calcul qui peut être définie, déployée et gérée.

2.1.1. Comprendre les dosettes

Les pods sont l'équivalent approximatif d'une instance de machine (physique ou virtuelle) pour un conteneur. Chaque pod se voit attribuer sa propre adresse IP interne, et possède donc tout son espace portuaire. Les conteneurs au sein des pods peuvent partager leur stockage local et leur réseau.

Les pods ont un cycle de vie ; ils sont définis, puis ils sont affectés à l'exécution sur un nœud, puis ils s'exécutent jusqu'à ce que leur(s) conteneur(s) se termine(nt) ou qu'ils soient supprimés pour une autre raison. Les pods, en fonction de la politique et du code de sortie, peuvent être supprimés après la sortie, ou peuvent être conservés pour permettre l'accès aux journaux de leurs conteneurs.

OpenShift Container Platform considère les pods comme largement immuables ; il n'est pas possible d'apporter des modifications à la définition d'un pod pendant qu'il est en cours d'exécution. OpenShift Container Platform met en œuvre les changements en mettant fin à un pod existant et en le recréant avec une configuration modifiée, une ou plusieurs images de base, ou les deux. Les pods sont également considérés comme consommables et ne conservent pas d'état lorsqu'ils sont recréés. C'est pourquoi les pods doivent généralement être gérés par des contrôleurs de niveau supérieur, plutôt que directement par les utilisateurs.

Pour connaître le nombre maximum de pods par hôte de nœud OpenShift Container Platform, voir les limites du cluster.

Les pods nus qui ne sont pas gérés par un contrôleur de réplication ne seront pas reprogrammés en cas d'interruption du nœud.

2.1.2. Exemples de configurations de pods

OpenShift Container Platform exploite le concept Kubernetes d'un pod, qui est un ou plusieurs conteneurs déployés ensemble sur un hôte, et la plus petite unité de calcul qui peut être définie, déployée et gérée.

Voici un exemple de définition d'un pod à partir d'une application Rails. Il démontre de nombreuses caractéristiques des pods, dont la plupart sont abordées dans d'autres sujets et ne sont donc que brièvement mentionnées ici :

Pod définition de l'objet (YAML)

- 1

- Les pods peuvent être "étiquetés" avec une ou plusieurs étiquettes, qui peuvent ensuite être utilisées pour sélectionner et gérer des groupes de pods en une seule opération. Les étiquettes sont stockées au format clé/valeur dans le hachage

metadata. - 2

- La politique de redémarrage des pods avec les valeurs possibles

Always,OnFailure, etNever. La valeur par défaut estAlways. - 3

- OpenShift Container Platform définit un contexte de sécurité pour les conteneurs qui spécifie s'ils sont autorisés à s'exécuter en tant que conteneurs privilégiés, à s'exécuter en tant qu'utilisateur de leur choix, et plus encore. Le contexte par défaut est très restrictif, mais les administrateurs peuvent le modifier si nécessaire.

- 4

containersspécifie un tableau d'une ou plusieurs définitions de conteneurs.- 5

- Le conteneur spécifie où les volumes de stockage externes sont montés dans le conteneur. Dans ce cas, il y a un volume pour stocker l'accès aux informations d'identification dont le registre a besoin pour faire des demandes à l'API OpenShift Container Platform.

- 6

- Spécifiez les volumes à fournir pour le module. Les volumes sont montés au chemin spécifié. Ne les montez pas à la racine du conteneur,

/, ni à un chemin identique dans l'hôte et le conteneur. Cela peut corrompre votre système hôte si le conteneur est suffisamment privilégié, comme l'hôte/dev/ptsfiles. Vous pouvez monter l'hôte en toute sécurité en utilisant/host. - 7

- Chaque conteneur du pod est instancié à partir de sa propre image de conteneur.

- 8

- Les pods qui font des requêtes à l'API de OpenShift Container Platform sont assez courants pour qu'il y ait un champ

serviceAccountpour spécifier l'utilisateur du compte de service auquel le pod doit s'authentifier lorsqu'il fait les requêtes. Cela permet un contrôle d'accès fin pour les composants d'infrastructure personnalisés. - 9

- Le module définit les volumes de stockage que son ou ses conteneurs peuvent utiliser. Dans ce cas, il fournit un volume éphémère pour un volume

secretcontenant les jetons du compte de service par défaut.Si vous attachez des volumes persistants qui ont un nombre élevé de fichiers à des pods, ces pods peuvent échouer ou prendre beaucoup de temps à démarrer. Pour plus d'informations, voir Lors de l'utilisation de volumes persistants avec un nombre élevé de fichiers dans OpenShift, pourquoi les pods ne démarrent-ils pas ou prennent-ils un temps excessif pour atteindre l'état "Ready" ?

Cette définition de pod ne comprend pas les attributs qui sont remplis automatiquement par OpenShift Container Platform après la création du pod et le début de son cycle de vie. La documentation sur les pods Kubernetes contient des détails sur la fonctionnalité et le but des pods.

2.2. Visualisation des nacelles

En tant qu'administrateur, vous pouvez visualiser les pods de votre cluster et déterminer l'état de santé de ces pods et du cluster dans son ensemble.

2.2.1. À propos des cosses

OpenShift Container Platform exploite le concept Kubernetes d'un pod, qui est un ou plusieurs conteneurs déployés ensemble sur un hôte, et la plus petite unité de calcul qui peut être définie, déployée et gérée. Les pods sont l'équivalent approximatif d'une instance de machine (physique ou virtuelle) pour un conteneur.

Vous pouvez afficher une liste des pods associés à un projet spécifique ou consulter les statistiques d'utilisation des pods.

2.2.2. Visualiser les pods d'un projet

Vous pouvez afficher une liste des pods associés au projet en cours, y compris le nombre de répliques, l'état actuel, le nombre de redémarrages et l'âge du pod.

Procédure

Pour visualiser les pods d'un projet :

Modification du projet :

oc project <nom du projet>

$ oc project <nom du projet>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exécutez la commande suivante :

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Par exemple :

oc get pods -n openshift-console

$ oc get pods -n openshift-consoleCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165m

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165mCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez les drapeaux

-o widepour afficher l'adresse IP du pod et le nœud où il se trouve.oc get pods -o wide

$ oc get pods -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.3. Visualisation des statistiques d'utilisation des pods

Vous pouvez afficher les statistiques d'utilisation des pods, qui fournissent les environnements d'exécution des conteneurs. Ces statistiques d'utilisation comprennent la consommation de CPU, de mémoire et de stockage.

Conditions préalables

-

Vous devez avoir l'autorisation

cluster-readerpour voir les statistiques d'utilisation. - Metrics doit être installé pour afficher les statistiques d'utilisation.

Procédure

Pour consulter les statistiques d'utilisation :

Exécutez la commande suivante :

oc adm top pods

$ oc adm top podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Par exemple :

oc adm top pods -n openshift-console

$ oc adm top pods -n openshift-consoleCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15Mi

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15MiCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exécutez la commande suivante pour afficher les statistiques d'utilisation des pods avec étiquettes :

oc adm top pod --selector=''

$ oc adm top pod --selector=''Copy to Clipboard Copied! Toggle word wrap Toggle overflow Vous devez choisir le sélecteur (requête d'étiquette) sur lequel filtrer. Prend en charge

=,==, et!=.

2.2.4. Visualisation des journaux de ressources

Vous pouvez consulter le journal de diverses ressources dans l'interface de commande OpenShift (oc) et dans la console Web. Les journaux se lisent à partir de la queue, ou de la fin, du journal.

Conditions préalables

- Accès à la CLI d'OpenShift (oc).

Procédure (UI)

Dans la console OpenShift Container Platform, naviguez vers Workloads → Pods ou naviguez vers le pod via la ressource que vous souhaitez étudier.

NoteCertaines ressources, telles que les constructions, n'ont pas de pods à interroger directement. Dans ce cas, vous pouvez trouver le lien Logs sur la page Details de la ressource.

- Sélectionnez un projet dans le menu déroulant.

- Cliquez sur le nom du module que vous souhaitez examiner.

- Cliquez sur Logs.

Procédure (CLI)

Visualiser le journal d'un pod spécifique :

oc logs -f <nom_du_pod> -c <nom_du_conteneur>

oc logs -f <nom_du_pod> -c <nom_du_conteneur>Copy to Clipboard Copied! Toggle word wrap Toggle overflow où :

-f- Facultatif : Spécifie que la sortie suit ce qui est écrit dans les journaux.

<pod_name>- Spécifie le nom du module.

<container_name>- Facultatif : Spécifie le nom d'un conteneur. Lorsqu'un module a plus d'un conteneur, vous devez spécifier le nom du conteneur.

Par exemple :

oc logs ruby-58cd97df55-mww7r

$ oc logs ruby-58cd97df55-mww7rCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc logs -f ruby-57f7f4855b-znl92 -c ruby

$ oc logs -f ruby-57f7f4855b-znl92 -c rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow Le contenu des fichiers journaux est imprimé.

Consulter le journal d'une ressource spécifique :

oc logs <object_type>/<resource_name>

oc logs <object_type>/<resource_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Spécifie le type et le nom de la ressource.

Par exemple :

oc logs deployment/ruby

$ oc logs deployment/rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow Le contenu des fichiers journaux est imprimé.

2.3. Configurer un cluster OpenShift Container Platform pour les pods

En tant qu'administrateur, vous pouvez créer et maintenir un cluster efficace pour les pods.

En veillant à l'efficacité de votre cluster, vous pouvez fournir un meilleur environnement à vos développeurs en utilisant des outils tels que ce que fait un pod lorsqu'il quitte, en veillant à ce que le nombre requis de pods soit toujours en cours d'exécution, quand redémarrer les pods conçus pour ne fonctionner qu'une seule fois, limiter la bande passante disponible pour les pods et comment maintenir les pods en cours d'exécution pendant les perturbations.

2.3.1. Configurer le comportement des pods après le redémarrage

Une politique de redémarrage de pod détermine comment OpenShift Container Platform réagit lorsque les conteneurs de ce pod quittent le pod. La politique s'applique à tous les conteneurs de ce pod.

Les valeurs possibles sont les suivantes :

-

Always- Tente de redémarrer un conteneur quitté avec succès sur le pod en continu, avec un délai exponentiel (10s, 20s, 40s) plafonné à 5 minutes. La valeur par défaut estAlways. -

OnFailure- Tente de redémarrer un conteneur défaillant sur le pod avec un délai exponentiel (10s, 20s, 40s) plafonné à 5 minutes. -

Never- N'essaie pas de redémarrer les conteneurs qui sont sortis ou qui ont échoué sur le pod. Les pods échouent immédiatement et quittent le système.

Une fois que le module est lié à un nœud, il ne sera jamais lié à un autre nœud. Cela signifie qu'un contrôleur est nécessaire pour qu'un module puisse survivre à la défaillance d'un nœud :

| Condition | Type de contrôleur | Politique de redémarrage |

|---|---|---|

| Les pods qui sont censés se terminer (tels que les calculs par lots) | Emploi |

|

| Les pods qui sont censés ne pas se terminer (tels que les serveurs web) | Contrôleur de réplication |

|

| Pods qui doivent fonctionner une fois par machine | Jeu de démons | Tous |

Si un conteneur sur un pod échoue et que la politique de redémarrage est définie sur OnFailure, le pod reste sur le nœud et le conteneur est redémarré. Si vous ne souhaitez pas que le conteneur redémarre, utilisez la stratégie de redémarrage Never.

Si un pod entier tombe en panne, OpenShift Container Platform démarre un nouveau pod. Les développeurs doivent prendre en compte la possibilité que les applications soient redémarrées dans un nouveau pod. En particulier, les applications doivent gérer les fichiers temporaires, les verrous, les résultats incomplets, etc. causés par les exécutions précédentes.

L'architecture Kubernetes attend des points d'extrémité fiables de la part des fournisseurs de cloud. Lorsqu'un fournisseur de cloud est en panne, le kubelet empêche OpenShift Container Platform de redémarrer.

Si les points d'extrémité du fournisseur de cloud sous-jacent ne sont pas fiables, n'installez pas un cluster en utilisant l'intégration du fournisseur de cloud. Installez le cluster comme s'il était dans un environnement sans nuage. Il n'est pas recommandé d'activer ou de désactiver l'intégration des fournisseurs de cloud dans un cluster installé.

Pour plus de détails sur la façon dont OpenShift Container Platform utilise la politique de redémarrage avec les conteneurs défaillants, voir les États d'exemple dans la documentation Kubernetes.

2.3.2. Limiter la bande passante disponible pour les pods

Vous pouvez appliquer la mise en forme du trafic de qualité de service à un pod et limiter efficacement sa bande passante disponible. Le trafic sortant (du pod) est géré par la police, qui laisse simplement tomber les paquets dépassant le taux configuré. Le trafic entrant (vers le module) est géré par la mise en forme des paquets en file d'attente afin de traiter efficacement les données. Les limites que vous imposez à un module n'affectent pas la bande passante des autres modules.

Procédure

Pour limiter la bande passante sur un pod :

Rédigez un fichier JSON de définition d'objet et spécifiez la vitesse de circulation des données à l'aide des annotations

kubernetes.io/ingress-bandwidthetkubernetes.io/egress-bandwidth. Par exemple, pour limiter la bande passante de sortie et d'entrée des pods à 10M/s :Définition limitée de l'objet

PodCopy to Clipboard Copied! Toggle word wrap Toggle overflow Créer le pod à l'aide de la définition de l'objet :

oc create -f <file_ou_dir_path>

oc create -f <file_ou_dir_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.3. Comprendre comment utiliser les budgets de perturbation des pods pour spécifier le nombre de pods qui doivent être opérationnels

Un pod disruption budget fait partie de l'API Kubernetes, qui peut être géré avec des commandes oc comme d'autres types d'objets. Ils permettent de spécifier des contraintes de sécurité sur les pods pendant les opérations, comme la vidange d'un nœud pour la maintenance.

PodDisruptionBudget est un objet API qui spécifie le nombre ou le pourcentage minimum de répliques qui doivent être en service à un moment donné. La définition de ces valeurs dans les projets peut être utile lors de la maintenance des nœuds (par exemple, lors de la réduction ou de la mise à niveau d'un cluster) et n'est honorée qu'en cas d'éviction volontaire (et non en cas de défaillance d'un nœud).

La configuration d'un objet PodDisruptionBudget se compose des éléments clés suivants :

- Un sélecteur d'étiquettes, qui est une requête d'étiquettes sur un ensemble de pods.

Un niveau de disponibilité, qui spécifie le nombre minimum de pods qui doivent être disponibles simultanément, soit :

-

minAvailableest le nombre de pods qui doivent toujours être disponibles, même en cas d'interruption. -

maxUnavailableest le nombre de pods qui peuvent être indisponibles lors d'une perturbation.

-

Available fait référence au nombre de pods qui ont la condition Ready=True. Ready=True fait référence au pod qui est capable de servir les requêtes et qui devrait être ajouté aux pools d'équilibrage de charge de tous les services correspondants.

Un maxUnavailable de 0% ou 0 ou un minAvailable de 100% ou égal au nombre de répliques est autorisé mais peut bloquer la vidange des nœuds.

Vous pouvez vérifier les budgets de perturbation des pods dans tous les projets en procédant comme suit :

oc get poddisruptionbudget --all-namespaces

$ oc get poddisruptionbudget --all-namespacesExemple de sortie

NAMESPACE NAME MIN-AVAILABLE SELECTOR another-project another-pdb 4 bar=foo test-project my-pdb 2 foo=bar

NAMESPACE NAME MIN-AVAILABLE SELECTOR

another-project another-pdb 4 bar=foo

test-project my-pdb 2 foo=bar

Le site PodDisruptionBudget est considéré comme sain lorsqu'il y a au moins minAvailable pods en cours d'exécution dans le système. Chaque pod dépassant cette limite peut être expulsé.

En fonction des paramètres de priorité et de préemption des pods, les pods de moindre priorité peuvent être supprimés en dépit de leurs exigences en matière de budget de perturbation des pods.

2.3.3.1. Spécification du nombre de pods qui doivent être opérationnels avec des budgets de perturbation de pods

Vous pouvez utiliser un objet PodDisruptionBudget pour spécifier le nombre ou le pourcentage minimum de répliques qui doivent être opérationnelles à un moment donné.

Procédure

Pour configurer un budget de perturbation de pods :

Créez un fichier YAML avec une définition d'objet similaire à la suivante :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

PodDisruptionBudgetfait partie du groupepolicy/v1API.- 2

- Le nombre minimum de pods qui doivent être disponibles simultanément. Il peut s'agir d'un nombre entier ou d'une chaîne de caractères spécifiant un pourcentage, par exemple

20%. - 3

- Une requête d'étiquette sur un ensemble de ressources. Les résultats de

matchLabelsetmatchExpressionssont logiquement joints. Laissez ce paramètre vide, par exempleselector {}, pour sélectionner tous les pods du projet.

Ou bien :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

PodDisruptionBudgetfait partie du groupepolicy/v1API.- 2

- Le nombre maximum de pods qui peuvent être indisponibles simultanément. Il peut s'agir d'un nombre entier ou d'une chaîne de caractères spécifiant un pourcentage, par exemple

20%. - 3

- Une requête d'étiquette sur un ensemble de ressources. Les résultats de

matchLabelsetmatchExpressionssont logiquement joints. Laissez ce paramètre vide, par exempleselector {}, pour sélectionner tous les pods du projet.

Exécutez la commande suivante pour ajouter l'objet au projet :

oc create -f </path/to/file> -n <project_name>

$ oc create -f </path/to/file> -n <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.4. Prévenir l'enlèvement des nacelles à l'aide de nacelles critiques

Un certain nombre de composants essentiels au bon fonctionnement d'une grappe sont exécutés sur un nœud ordinaire de la grappe plutôt que sur le nœud principal. Un cluster peut cesser de fonctionner correctement si un add-on critique est expulsé.

Les pods marqués comme critiques ne sont pas autorisés à être expulsés.

Procédure

Rendre une nacelle critique :

Créer un spec

Podou modifier les pods existants pour inclure la classe de prioritésystem-cluster-critical:spec: template: metadata: name: critical-pod priorityClassName: system-cluster-criticalspec: template: metadata: name: critical-pod priorityClassName: system-cluster-critical1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Classe de priorité par défaut pour les pods qui ne doivent jamais être expulsés d'un nœud.

Vous pouvez également spécifier

system-node-criticalpour les pods qui sont importants pour le cluster mais qui peuvent être supprimés si nécessaire.Créer la capsule :

oc create -f <nom-de-fichier>.yaml

oc create -f <nom-de-fichier>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.5. Réduction des délais d'attente des pods lors de l'utilisation de volumes persistants avec un nombre élevé de fichiers

Si un volume de stockage contient de nombreux fichiers (~1.000.000 ou plus), vous pouvez rencontrer des dépassements de temps de pod.

Cela peut se produire car, lorsque les volumes sont montés, OpenShift Container Platform modifie récursivement la propriété et les permissions du contenu de chaque volume afin de correspondre à l'adresse fsGroup spécifiée dans un pod securityContext. Pour les gros volumes, la vérification et la modification de la propriété et des autorisations peuvent prendre du temps, ce qui entraîne un démarrage très lent du pod.

Vous pouvez réduire ce délai en appliquant l'une des solutions suivantes :

- Utilisez une contrainte de contexte de sécurité (SCC) pour ignorer le réétiquetage SELinux d'un volume.

-

Utilisez le champ

fsGroupChangePolicydans un SCC pour contrôler la façon dont OpenShift Container Platform vérifie et gère la propriété et les permissions pour un volume. - Utiliser une classe d'exécution pour ignorer le réétiquetage SELinux d'un volume.

Pour plus d'informations, voir Lors de l'utilisation de volumes persistants avec un nombre élevé de fichiers dans OpenShift, pourquoi les pods ne démarrent-ils pas ou prennent-ils un temps excessif pour atteindre l'état " Ready " ?

2.4. Mise à l'échelle automatique des pods avec le pod autoscaler horizontal

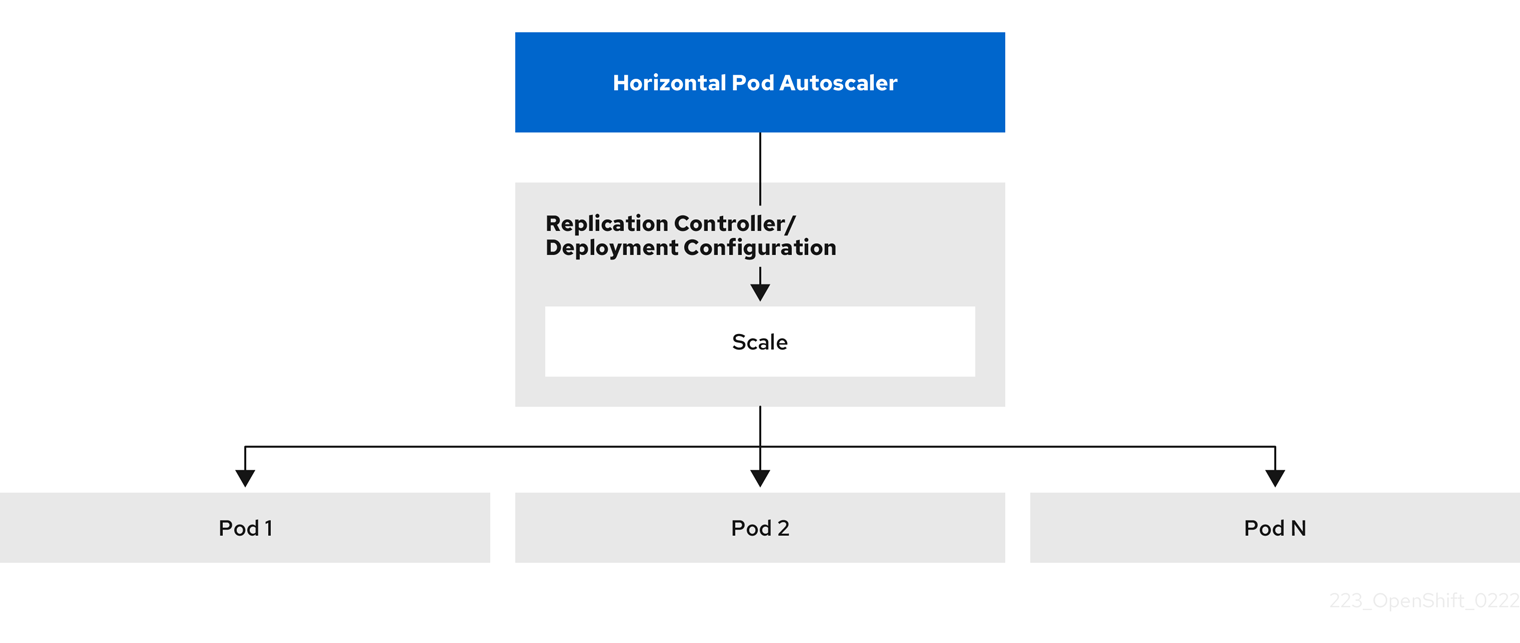

En tant que développeur, vous pouvez utiliser un pod autoscaler horizontal (HPA) pour spécifier comment OpenShift Container Platform doit automatiquement augmenter ou diminuer l'échelle d'un contrôleur de réplication ou d'une configuration de déploiement, en fonction des métriques collectées à partir des pods qui appartiennent à ce contrôleur de réplication ou à cette configuration de déploiement. Vous pouvez créer un HPA pour n'importe quel déploiement, configuration de déploiement, ensemble de répliques, contrôleur de réplication ou ensemble avec état.

Pour plus d'informations sur la mise à l'échelle des pods en fonction de mesures personnalisées, voir Mise à l'échelle automatique des pods en fonction de mesures personnalisées.

Il est recommandé d'utiliser un objet Deployment ou ReplicaSet, sauf si vous avez besoin d'une fonctionnalité ou d'un comportement spécifique fourni par d'autres objets. Pour plus d'informations sur ces objets, voir Comprendre les objets Deployment et DeploymentConfig.

2.4.1. Comprendre les autoscalers de pods horizontaux

Vous pouvez créer un autoscaler de pods horizontal pour spécifier le nombre minimum et maximum de pods que vous souhaitez exécuter, ainsi que l'utilisation du CPU ou de la mémoire que vos pods doivent cibler.

Après avoir créé un autoscaler de pods horizontaux, OpenShift Container Platform commence à interroger les métriques de ressources CPU et/ou mémoire sur les pods. Lorsque ces métriques sont disponibles, l'autoscaler de pods horizontaux calcule le rapport entre l'utilisation actuelle de la métrique et l'utilisation souhaitée de la métrique, et augmente ou réduit l'échelle en conséquence. L'interrogation et la mise à l'échelle se produisent à intervalles réguliers, mais il peut s'écouler une à deux minutes avant que les mesures ne soient disponibles.

Pour les contrôleurs de réplication, cette mise à l'échelle correspond directement aux répliques du contrôleur de réplication. Pour les configurations de déploiement, la mise à l'échelle correspond directement au nombre de répliques de la configuration de déploiement. Notez que la mise à l'échelle automatique ne s'applique qu'au dernier déploiement dans la phase Complete.

OpenShift Container Platform prend automatiquement en compte les ressources et évite une mise à l'échelle automatique inutile lors des pics de ressources, comme lors du démarrage. Les pods dans l'état unready ont une utilisation de 0 CPU lors de la mise à l'échelle et l'autoscaler ignore les pods lors de la mise à l'échelle. Les pods sans métriques connues ont une utilisation de 0\fPU lors de la montée en charge et de 100\fPU lors de la descente en charge. Cela permet une plus grande stabilité lors de la décision HPA. Pour utiliser cette fonctionnalité, vous devez configurer des contrôles de disponibilité afin de déterminer si un nouveau module est prêt à être utilisé.

Pour utiliser les autoscalers de pods horizontaux, votre administrateur de cluster doit avoir correctement configuré les métriques de cluster.

2.4.1.1. Mesures prises en charge

Les métriques suivantes sont prises en charge par les autoscalers de pods horizontaux :

| Métrique | Description | Version de l'API |

|---|---|---|

| Utilisation de l'unité centrale | Nombre de cœurs de CPU utilisés. Peut être utilisé pour calculer un pourcentage de l'unité centrale demandée par le pod. |

|

| Utilisation de la mémoire | Quantité de mémoire utilisée. Peut être utilisé pour calculer un pourcentage de la mémoire demandée par le pod. |

|

Pour l'autoscaling basé sur la mémoire, l'utilisation de la mémoire doit augmenter et diminuer proportionnellement au nombre de répliques. En moyenne :

- Une augmentation du nombre de répliques doit entraîner une diminution globale de l'utilisation de la mémoire (ensemble de travail) par pod.

- Une diminution du nombre de répliques doit entraîner une augmentation globale de l'utilisation de la mémoire par pod.

Utilisez la console web d'OpenShift Container Platform pour vérifier le comportement de la mémoire de votre application et assurez-vous que votre application répond à ces exigences avant d'utiliser l'autoscaling basé sur la mémoire.

L'exemple suivant illustre la mise à l'échelle automatique de l'objet image-registry Deployment . Le déploiement initial nécessite 3 pods, l'objet HPA augmente le minimum à 5 pods. L'objet HPA augmente le minimum à 5. Si l'utilisation du CPU sur les pods atteint 75 %, les pods passent à 7 :

oc autoscale deployment/image-registry --min=5 --max=7 --cpu-percent=75

$ oc autoscale deployment/image-registry --min=5 --max=7 --cpu-percent=75Exemple de sortie

horizontalpodautoscaler.autoscaling/image-registry autoscaled

horizontalpodautoscaler.autoscaling/image-registry autoscaledExemple d'APS pour l'objet image-registry Deployment avec minReplicas fixé à 3

Afficher le nouvel état du déploiement :

oc get deployment image-registry

$ oc get deployment image-registryCopy to Clipboard Copied! Toggle word wrap Toggle overflow Il y a maintenant 5 pods dans le déploiement :

Exemple de sortie

NAME REVISION DESIRED CURRENT TRIGGERED BY image-registry 1 5 5 config

NAME REVISION DESIRED CURRENT TRIGGERED BY image-registry 1 5 5 configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.2. Comment fonctionne l'APH ?

Le pod autoscaler horizontal (HPA) étend le concept de pod autoscaling. Le HPA vous permet de créer et de gérer un groupe de nœuds à charge équilibrée. Le HPA augmente ou diminue automatiquement le nombre de pods lorsqu'un seuil donné de CPU ou de mémoire est franchi.

Figure 2.1. Flux de travail de haut niveau de l'APH

L'HPA est une ressource API dans le groupe API Kubernetes autoscaling. L'autoscaler fonctionne comme une boucle de contrôle avec une valeur par défaut de 15 secondes pour la période de synchronisation. Au cours de cette période, le gestionnaire du contrôleur interroge l'utilisation du CPU, de la mémoire, ou des deux, par rapport à ce qui est défini dans le fichier YAML pour l'HPA. Le gestionnaire de contrôleur obtient les métriques d'utilisation de l'API de métriques de ressources pour les métriques de ressources par pod comme le CPU ou la mémoire, pour chaque pod ciblé par l'HPA.

Si une valeur cible d'utilisation est définie, le contrôleur calcule la valeur d'utilisation en tant que pourcentage de la demande de ressources équivalente sur les conteneurs de chaque pod. Le contrôleur prend ensuite la moyenne de l'utilisation dans tous les pods ciblés et produit un ratio qui est utilisé pour mettre à l'échelle le nombre de répliques souhaitées. L'APH est configuré pour récupérer les métriques sur metrics.k8s.io, qui est fourni par le serveur de métriques. En raison de la nature dynamique de l'évaluation des métriques, le nombre de réplicas peut fluctuer lors de la mise à l'échelle d'un groupe de réplicas.

Pour mettre en œuvre l'APH, tous les pods ciblés doivent avoir une demande de ressource définie sur leurs conteneurs.

2.4.3. A propos des demandes et des limites

L'ordonnanceur utilise la demande de ressources que vous spécifiez pour les conteneurs d'un module, afin de décider sur quel nœud placer le module. Le kubelet applique la limite de ressources que vous spécifiez pour un conteneur afin de s'assurer que le conteneur n'est pas autorisé à utiliser plus que la limite spécifiée. Le kubelet réserve également la quantité demandée de cette ressource système spécifiquement pour l'utilisation de ce conteneur.

Comment utiliser les indicateurs de ressources ?

Dans les spécifications du pod, vous devez spécifier les demandes de ressources, telles que le CPU et la mémoire. Le HPA utilise cette spécification pour déterminer l'utilisation des ressources, puis augmente ou réduit la cible.

Par exemple, l'objet HPA utilise la source de métriques suivante :

Dans cet exemple, l'APH maintient l'utilisation moyenne des modules dans la cible de mise à l'échelle à 60 %. L'utilisation est le rapport entre l'utilisation actuelle de la ressource et la ressource demandée pour le module.

2.4.4. Meilleures pratiques

Tous les pods doivent avoir des demandes de ressources configurées

Le HPA prend une décision de mise à l'échelle basée sur les valeurs observées d'utilisation du CPU ou de la mémoire des pods dans un cluster OpenShift Container Platform. Les valeurs d'utilisation sont calculées en pourcentage des demandes de ressources de chaque pod. Des valeurs de demandes de ressources manquantes peuvent affecter les performances optimales de l'APH.

Configurer la période de refroidissement

Lors de la mise à l'échelle automatique des pods horizontaux, il peut y avoir une mise à l'échelle rapide des événements sans intervalle de temps. Configurez la période de refroidissement pour éviter les fluctuations fréquentes des répliques. Vous pouvez spécifier une période de refroidissement en configurant le champ stabilizationWindowSeconds. La fenêtre de stabilisation est utilisée pour limiter la fluctuation du nombre de répliques lorsque les métriques utilisées pour la mise à l'échelle continuent de fluctuer. L'algorithme de mise à l'échelle automatique utilise cette fenêtre pour déduire un état antérieur souhaité et éviter les changements non désirés de l'échelle de la charge de travail.

Par exemple, une fenêtre de stabilisation est spécifiée pour le champ scaleDown:

behavior:

scaleDown:

stabilizationWindowSeconds: 300

behavior:

scaleDown:

stabilizationWindowSeconds: 300Dans l'exemple ci-dessus, tous les états souhaités au cours des cinq dernières minutes sont pris en compte. Cela permet d'obtenir un maximum glissant et d'éviter que l'algorithme de mise à l'échelle ne supprime fréquemment des nacelles pour en recréer une équivalente quelques instants plus tard.

2.4.4.1. Politiques d'échelonnement

L'API autoscaling/v2 vous permet d'ajouter scaling policies à un pod autoscaler horizontal. Une politique de mise à l'échelle contrôle la façon dont l'autoscaler de pods horizontaux (HPA) de OpenShift Container Platform met à l'échelle les pods. Les politiques de mise à l'échelle vous permettent de limiter le taux de mise à l'échelle des pods par les HPA en définissant un nombre ou un pourcentage spécifique à mettre à l'échelle dans une période de temps spécifiée. Vous pouvez également définir une politique de mise à l'échelle stabilization window, qui utilise les états souhaités calculés précédemment pour contrôler la mise à l'échelle si les métriques fluctuent. Vous pouvez créer plusieurs politiques pour la même direction de mise à l'échelle et déterminer la politique à utiliser en fonction de la quantité de changement. Vous pouvez également limiter la mise à l'échelle par des itérations temporelles. L'APH met à l'échelle les pods au cours d'une itération, puis effectue la mise à l'échelle, si nécessaire, au cours des itérations suivantes.

Exemple d'objet HPA avec une politique de mise à l'échelle

- 1

- Spécifie la direction de la politique de mise à l'échelle, soit

scaleDownouscaleUp. Cet exemple crée une politique de mise à l'échelle vers le bas. - 2

- Définit la politique de mise à l'échelle.

- 3

- Détermine si la politique s'adapte à un nombre spécifique de pods ou à un pourcentage de pods à chaque itération. La valeur par défaut est

pods. - 4

- Détermine la quantité de mise à l'échelle, soit le nombre de pods, soit le pourcentage de pods, à chaque itération. Il n'y a pas de valeur par défaut pour la mise à l'échelle par nombre de modules.

- 5

- Détermine la durée d'une itération de mise à l'échelle. La valeur par défaut est

15secondes. - 6

- La valeur par défaut de la réduction d'échelle en pourcentage est de 100 %.

- 7

- Détermine la politique à utiliser en premier, si plusieurs politiques sont définies. Spécifiez

Maxpour utiliser la stratégie qui autorise le plus grand nombre de changements,Minpour utiliser la stratégie qui autorise le plus petit nombre de changements, ouDisabledpour empêcher l'HPA de se mettre à l'échelle dans cette direction de stratégie. La valeur par défaut estMax. - 8

- Détermine la période de temps pendant laquelle l'APH doit revenir sur les états souhaités. La valeur par défaut est

0. - 9

- Cet exemple permet d'élaborer une politique de mise à l'échelle.

- 10

- Le montant de la mise à l'échelle du nombre de pods. La valeur par défaut de l'augmentation du nombre de modules est de 4 %.

- 11

- Le montant de la mise à l'échelle par le pourcentage de pods. La valeur par défaut de la mise à l'échelle par pourcentage est de 100 %.

Exemple de politique de réduction d'échelle

Dans cet exemple, lorsque le nombre de pods est supérieur à 40, la politique basée sur le pourcentage est utilisée pour la réduction d'échelle, car cette politique entraîne un changement plus important, comme l'exige le site selectPolicy.

S'il y a 80 répliques de pods, lors de la première itération, l'APH réduit les pods de 8, soit 10 % des 80 pods (sur la base des paramètres type: Percent et value: 10 ), en une minute (periodSeconds: 60). Pour l'itération suivante, le nombre de nacelles est de 72. L'APH calcule que 10 % des nacelles restantes représentent 7,2, qu'il arrondit à 8 et réduit de 8 nacelles. À chaque itération suivante, le nombre de nacelles à réduire est recalculé en fonction du nombre de nacelles restantes. Lorsque le nombre de nacelles est inférieur à 40, la politique basée sur les nacelles est appliquée, car le nombre basé sur les nacelles est supérieur au nombre basé sur le pourcentage. Le HPA réduit 4 pods à la fois (type: Pods et value: 4), sur 30 secondes (periodSeconds: 30), jusqu'à ce qu'il reste 20 répliques (minReplicas).

Le paramètre selectPolicy: Disabled empêche l'APH de mettre à l'échelle les pods. Vous pouvez augmenter manuellement l'échelle en ajustant le nombre de répliques dans l'ensemble de répliques ou l'ensemble de déploiement, si nécessaire.

Si elle est définie, vous pouvez visualiser la politique de mise à l'échelle à l'aide de la commande oc edit:

oc edit hpa hpa-resource-metrics-memory

$ oc edit hpa hpa-resource-metrics-memoryExemple de sortie

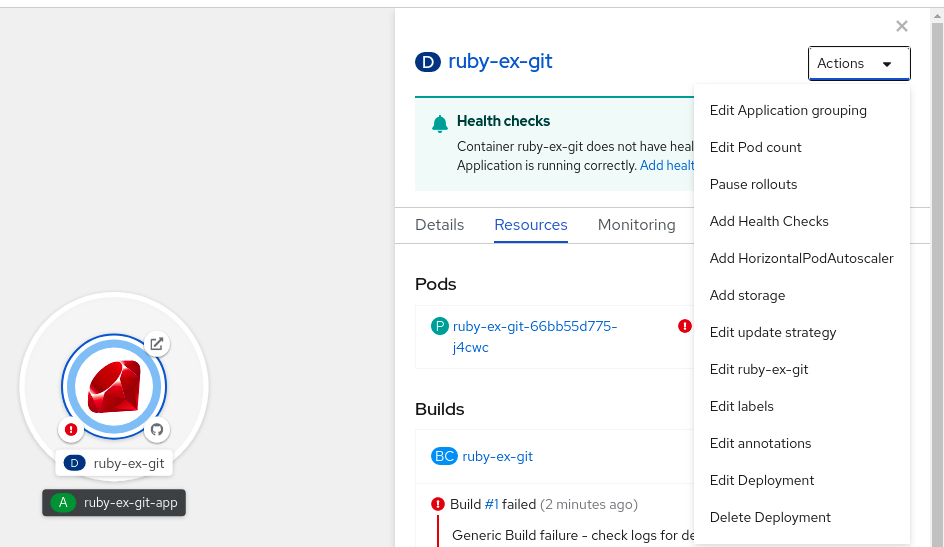

2.4.5. Création d'un pod autoscaler horizontal à l'aide de la console web

Depuis la console web, vous pouvez créer un pod autoscaler horizontal (HPA) qui spécifie le nombre minimum et maximum de pods que vous souhaitez exécuter sur un objet Deployment ou DeploymentConfig. Vous pouvez également définir la quantité d'utilisation de CPU ou de mémoire que vos pods doivent cibler.

Un HPA ne peut pas être ajouté aux déploiements qui font partie d'un service soutenu par un opérateur, d'un service Knative ou d'une carte Helm.

Procédure

Pour créer un HPA dans la console web :

- Dans la vue Topology, cliquez sur le nœud pour faire apparaître le volet latéral.

Dans la liste déroulante Actions, sélectionnez Add HorizontalPodAutoscaler pour ouvrir le formulaire Add HorizontalPodAutoscaler.

Figure 2.2. Ajouter HorizontalPodAutoscaler

Dans le formulaire Add HorizontalPodAutoscaler, définissez le nom, les limites minimales et maximales du pod, l'utilisation du processeur et de la mémoire, et cliquez sur Save.

NoteSi l'une des valeurs de l'utilisation du processeur et de la mémoire est manquante, un avertissement s'affiche.

Pour éditer un HPA dans la console web :

- Dans la vue Topology, cliquez sur le nœud pour faire apparaître le volet latéral.

- Dans la liste déroulante Actions, sélectionnez Edit HorizontalPodAutoscaler pour ouvrir le formulaire Edit Horizontal Pod Autoscaler.

- Dans le formulaire Edit Horizontal Pod Autoscaler, modifiez les limites minimales et maximales du pod et l'utilisation du CPU et de la mémoire, puis cliquez sur Save.

Lors de la création ou de la modification du pod autoscaler horizontal dans la console web, vous pouvez passer de Form view à YAML view.

Pour supprimer un HPA dans la console web :

- Dans la vue Topology, cliquez sur le nœud pour faire apparaître le panneau latéral.

- Dans la liste déroulante Actions, sélectionnez Remove HorizontalPodAutoscaler.

- Dans la fenêtre de confirmation, cliquez sur Remove pour supprimer le HPA.

2.4.6. Création d'un pod autoscaler horizontal pour l'utilisation du CPU à l'aide de la CLI

À l'aide de la CLI d'OpenShift Container Platform, vous pouvez créer un pod autoscaler horizontal (HPA) pour mettre automatiquement à l'échelle un objet existant Deployment, DeploymentConfig, ReplicaSet, ReplicationController, ou StatefulSet. Le HPA met à l'échelle les pods associés à cet objet pour maintenir l'utilisation du CPU que vous spécifiez.

Il est recommandé d'utiliser un objet Deployment ou ReplicaSet, sauf si vous avez besoin d'une fonction ou d'un comportement spécifique fourni par d'autres objets.

Le HPA augmente et diminue le nombre de répliques entre les nombres minimum et maximum pour maintenir l'utilisation spécifiée du CPU dans tous les pods.

Lors de l'autoscaling pour l'utilisation du CPU, vous pouvez utiliser la commande oc autoscale et spécifier le nombre minimum et maximum de pods que vous souhaitez exécuter à tout moment et l'utilisation moyenne du CPU que vos pods doivent cibler. Si vous ne spécifiez pas de minimum, les pods reçoivent des valeurs par défaut du serveur OpenShift Container Platform.

Pour adapter l'autoscale à une valeur de CPU spécifique, créez un objet HorizontalPodAutoscaler avec la CPU cible et les limites du pod.

Conditions préalables

Pour utiliser les autoscalers de pods horizontaux, votre administrateur de cluster doit avoir correctement configuré les métriques du cluster. Vous pouvez utiliser la commande oc describe PodMetrics <pod-name> pour déterminer si les métriques sont configurées. Si les métriques sont configurées, la sortie est similaire à ce qui suit, avec Cpu et Memory affichés sous Usage.

oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internalExemple de sortie

Procédure

Pour créer un pod autoscaler horizontal pour l'utilisation du CPU :

Effectuez l'une des opérations suivantes :

Pour mettre à l'échelle en fonction du pourcentage d'utilisation du processeur, créez un objet

HorizontalPodAutoscalerpour un objet existant :oc autoscale <object_type>/<name> \ --min <number> \ --max <number> \ --cpu-percent=<percent>

$ oc autoscale <object_type>/<name> \1 --min <number> \2 --max <number> \3 --cpu-percent=<percent>4 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Spécifiez le type et le nom de l'objet à mettre à l'échelle. L'objet doit exister et être un

Deployment,DeploymentConfig/dc,ReplicaSet/rs,ReplicationController/rc, ouStatefulSet. - 2

- Optionnellement, spécifier le nombre minimum de répliques lors d'une réduction d'échelle.

- 3

- Spécifiez le nombre maximum de répliques lors de la mise à l'échelle.

- 4

- Spécifiez l'utilisation moyenne de l'unité centrale cible sur tous les pods, représentée en pourcentage de l'unité centrale demandée. Si elle n'est pas spécifiée ou si elle est négative, une politique de mise à l'échelle automatique par défaut est utilisée.

Par exemple, la commande suivante montre la mise à l'échelle automatique de l'objet

image-registryDeployment. Le déploiement initial nécessite 3 pods, l'objet HPA augmente le minimum à 5. L'objet HPA augmente le minimum à 5. Si l'utilisation du CPU sur les pods atteint 75 %, les pods passeront à 7 :oc autoscale deployment/image-registry --min=5 --max=7 --cpu-percent=75

$ oc autoscale deployment/image-registry --min=5 --max=7 --cpu-percent=75Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pour mettre à l'échelle une valeur de CPU spécifique, créez un fichier YAML similaire au suivant pour un objet existant :

Créez un fichier YAML similaire au suivant :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Utilisez l'API

autoscaling/v2. - 2

- Spécifiez un nom pour cet objet autoscaler de pods horizontaux.

- 3

- Indiquez la version API de l'objet à mettre à l'échelle :

-

Pour un objet

Deployment,ReplicaSet,Statefulset, utilisezapps/v1. -

Pour un

ReplicationController, utilisezv1. -

Pour un

DeploymentConfig, utilisezapps.openshift.io/v1.

-

Pour un objet

- 4

- Spécifiez le type d'objet. L'objet doit être un

Deployment,DeploymentConfig/dc,ReplicaSet/rs,ReplicationController/rc, ouStatefulSet. - 5

- Indiquez le nom de l'objet à mettre à l'échelle. L'objet doit exister.

- 6

- Spécifiez le nombre minimum de répliques lors de la réduction d'échelle.

- 7

- Spécifiez le nombre maximum de répliques lors de la mise à l'échelle.

- 8

- Utilisez le paramètre

metricspour l'utilisation de la mémoire. - 9

- Spécifiez

cpupour l'utilisation de l'unité centrale. - 10

- Régler sur

AverageValue. - 11

- Réglé sur

averageValueavec la valeur ciblée de l'unité centrale.

Créer le pod autoscaler horizontal :

oc create -f <nom-de-fichier>.yaml

oc create -f <nom-de-fichier>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Vérifiez que le pod horizontal autoscaler a été créé :

oc get hpa cpu-autoscale

$ oc get hpa cpu-autoscaleCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE cpu-autoscale Deployment/example 173m/500m 1 10 1 20m

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE cpu-autoscale Deployment/example 173m/500m 1 10 1 20mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.7. Création d'un objet autoscaler pod horizontal pour l'utilisation de la mémoire à l'aide de la CLI

À l'aide de la CLI d'OpenShift Container Platform, vous pouvez créer un pod autoscaler horizontal (HPA) pour mettre automatiquement à l'échelle un objet existant Deployment, DeploymentConfig, ReplicaSet, ReplicationController, ou StatefulSet. Le HPA met à l'échelle les pods associés à cet objet pour maintenir l'utilisation moyenne de la mémoire que vous spécifiez, soit une valeur directe, soit un pourcentage de la mémoire demandée.

Il est recommandé d'utiliser un objet Deployment ou ReplicaSet, sauf si vous avez besoin d'une fonction ou d'un comportement spécifique fourni par d'autres objets.

L'APH augmente et diminue le nombre de répliques entre les nombres minimum et maximum pour maintenir l'utilisation de la mémoire spécifiée dans tous les pods.

Pour l'utilisation de la mémoire, vous pouvez spécifier le nombre minimum et maximum de pods et l'utilisation moyenne de la mémoire que vos pods doivent viser. Si vous ne spécifiez pas de minimum, les pods reçoivent des valeurs par défaut du serveur OpenShift Container Platform.

Conditions préalables

Pour utiliser les autoscalers de pods horizontaux, votre administrateur de cluster doit avoir correctement configuré les métriques du cluster. Vous pouvez utiliser la commande oc describe PodMetrics <pod-name> pour déterminer si les métriques sont configurées. Si les métriques sont configurées, la sortie est similaire à ce qui suit, avec Cpu et Memory affichés sous Usage.

oc describe PodMetrics openshift-kube-scheduler-ip-10-0-129-223.compute.internal -n openshift-kube-scheduler

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-129-223.compute.internal -n openshift-kube-schedulerExemple de sortie

Procédure

Pour créer un autoscaler de pods horizontaux pour l'utilisation de la mémoire :

Créez un fichier YAML pour l'un des éléments suivants :

Pour mettre à l'échelle une valeur de mémoire spécifique, créez un objet

HorizontalPodAutoscalersimilaire au suivant pour un objet existant :Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Utilisez l'API

autoscaling/v2. - 2

- Spécifiez un nom pour cet objet autoscaler de pods horizontaux.

- 3

- Indiquez la version API de l'objet à mettre à l'échelle :

-

Pour un objet

Deployment,ReplicaSet, ouStatefulset, utilisezapps/v1. -

Pour un

ReplicationController, utilisezv1. -

Pour un

DeploymentConfig, utilisezapps.openshift.io/v1.

-

Pour un objet

- 4

- Spécifiez le type d'objet. L'objet doit être un

Deployment,DeploymentConfig,ReplicaSet,ReplicationController, ouStatefulSet. - 5

- Indiquez le nom de l'objet à mettre à l'échelle. L'objet doit exister.

- 6

- Spécifiez le nombre minimum de répliques lors de la réduction d'échelle.

- 7

- Spécifiez le nombre maximum de répliques lors de la mise à l'échelle.

- 8

- Utilisez le paramètre

metricspour l'utilisation de la mémoire. - 9

- Spécifiez

memorypour l'utilisation de la mémoire. - 10

- Réglez le type sur

AverageValue. - 11

- Spécifiez

averageValueet une valeur de mémoire spécifique. - 12

- Facultatif : Spécifiez une politique de mise à l'échelle pour contrôler le taux de mise à l'échelle vers le haut ou vers le bas.

Pour mettre à l'échelle un pourcentage, créez un objet

HorizontalPodAutoscalersimilaire au suivant pour un objet existant :Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Utilisez l'API

autoscaling/v2. - 2

- Spécifiez un nom pour cet objet autoscaler de pods horizontaux.

- 3

- Indiquez la version API de l'objet à mettre à l'échelle :

-

Pour un ReplicationController, utilisez

v1. -

Pour un DeploymentConfig, utilisez

apps.openshift.io/v1. -

Pour un objet Deployment, ReplicaSet, Statefulset, utilisez

apps/v1.

-

Pour un ReplicationController, utilisez

- 4

- Spécifiez le type d'objet. L'objet doit être un

Deployment,DeploymentConfig,ReplicaSet,ReplicationController, ouStatefulSet. - 5

- Indiquez le nom de l'objet à mettre à l'échelle. L'objet doit exister.

- 6

- Spécifiez le nombre minimum de répliques lors de la réduction d'échelle.

- 7

- Spécifiez le nombre maximum de répliques lors de la mise à l'échelle.

- 8

- Utilisez le paramètre

metricspour l'utilisation de la mémoire. - 9

- Spécifiez

memorypour l'utilisation de la mémoire. - 10

- Régler sur

Utilization. - 11

- Spécifiez

averageUtilizationet un objectif d'utilisation moyenne de la mémoire sur tous les pods, représenté en pourcentage de la mémoire demandée. Les pods cibles doivent avoir des demandes de mémoire configurées. - 12

- Facultatif : Spécifiez une politique de mise à l'échelle pour contrôler le taux de mise à l'échelle vers le haut ou vers le bas.

Créer le pod autoscaler horizontal :

oc create -f <nom-de-fichier>.yaml

oc create -f <nom-de-fichier>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Par exemple :

oc create -f hpa.yaml

$ oc create -f hpa.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

horizontalpodautoscaler.autoscaling/hpa-resource-metrics-memory created

horizontalpodautoscaler.autoscaling/hpa-resource-metrics-memory createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow Vérifiez que le pod horizontal autoscaler a été créé :

oc get hpa hpa-resource-metrics-memory

$ oc get hpa hpa-resource-metrics-memoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE hpa-resource-metrics-memory Deployment/example 2441216/500Mi 1 10 1 20m

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE hpa-resource-metrics-memory Deployment/example 2441216/500Mi 1 10 1 20mCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc describe hpa hpa-resource-metrics-memory

$ oc describe hpa hpa-resource-metrics-memoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.8. Comprendre les conditions d'état du pod autoscaler horizontal à l'aide de la CLI

Vous pouvez utiliser les conditions d'état définies pour déterminer si l'autoscaler de pods horizontaux (HPA) est capable ou non de se mettre à l'échelle et s'il est actuellement limité de quelque manière que ce soit.

Les conditions d'état HPA sont disponibles avec la version v2 de l'API de mise à l'échelle automatique.

L'APH répond par les états suivants :

La condition

AbleToScaleindique si HPA est en mesure de récupérer et de mettre à jour les mesures, et si des conditions liées au backoff risquent d'empêcher la mise à l'échelle.-

Une condition

Trueindique que la mise à l'échelle est autorisée. -

Une condition

Falseindique que la mise à l'échelle n'est pas autorisée pour la raison spécifiée.

-

Une condition

La condition

ScalingActiveindique si le HPA est activé (par exemple, le nombre de répliques de la cible n'est pas nul) et s'il est en mesure de calculer les mesures souhaitées.-

Une condition

Trueindique que les mesures fonctionnent correctement. -

Une condition

Falseindique généralement un problème de récupération des données.

-

Une condition

La condition

ScalingLimitedindique que l'échelle souhaitée a été plafonnée par le maximum ou le minimum de l'échelle automatique du pod horizontal.-

Une condition

Trueindique que vous devez augmenter ou diminuer le nombre minimum ou maximum de répliques afin de procéder à une mise à l'échelle. La condition

Falseindique que la mise à l'échelle demandée est autorisée.oc describe hpa cm-test

$ oc describe hpa cm-testCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Les messages d'état de l'autoscaler du pod horizontal.

-

Une condition

Voici un exemple d'un module qui ne peut pas être mis à l'échelle :

Exemple de sortie

Voici un exemple de pod qui n'a pas pu obtenir les métriques nécessaires à la mise à l'échelle :

Exemple de sortie

Conditions: Type Status Reason Message ---- ------ ------ ------- AbleToScale True SucceededGetScale the HPA controller was able to get the target's current scale ScalingActive False FailedGetResourceMetric the HPA was unable to compute the replica count: failed to get cpu utilization: unable to get metrics for resource cpu: no metrics returned from resource metrics API

Conditions:

Type Status Reason Message

---- ------ ------ -------

AbleToScale True SucceededGetScale the HPA controller was able to get the target's current scale

ScalingActive False FailedGetResourceMetric the HPA was unable to compute the replica count: failed to get cpu utilization: unable to get metrics for resource cpu: no metrics returned from resource metrics APIVoici un exemple de pod où l'autoscaling demandé était inférieur aux minimums requis :

Exemple de sortie

2.4.8.1. Visualisation des conditions d'état des pods horizontaux autoscaler à l'aide de la CLI

Vous pouvez visualiser les conditions d'état définies sur un pod par le pod autoscaler horizontal (HPA).

Les conditions d'état de l'autoscaler de pods horizontaux sont disponibles avec la version v2 de l'API d'autoscaling.

Conditions préalables

Pour utiliser les autoscalers de pods horizontaux, votre administrateur de cluster doit avoir correctement configuré les métriques du cluster. Vous pouvez utiliser la commande oc describe PodMetrics <pod-name> pour déterminer si les métriques sont configurées. Si les métriques sont configurées, la sortie est similaire à ce qui suit, avec Cpu et Memory affichés sous Usage.

oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internalExemple de sortie

Procédure

Pour afficher les conditions d'état d'un module, utilisez la commande suivante avec le nom du module :

oc describe hpa <pod-name> $ oc describe hpa <pod-name>

oc describe hpa <pod-name> $ oc describe hpa <pod-name>Par exemple :

oc describe hpa cm-test

$ oc describe hpa cm-test

Les conditions apparaissent dans le champ Conditions de la sortie.

Exemple de sortie

2.5. Mise à l'échelle automatique des pods en fonction de mesures personnalisées

En tant que développeur, vous pouvez utiliser le custom metrics autoscaler pour spécifier comment OpenShift Container Platform doit automatiquement augmenter ou diminuer le nombre de pods pour un déploiement, un stateful set, une ressource personnalisée ou un job basé sur des métriques personnalisées qui ne sont pas basées uniquement sur le CPU ou la mémoire.

L'opérateur Custom Metrics Autoscaler pour Red Hat OpenShift est un opérateur optionnel, basé sur Kubernetes Event Driven Autoscaler (KEDA), qui permet aux charges de travail d'être mises à l'échelle en utilisant des sources de métriques supplémentaires autres que les métriques de pod.

L'autoscaler de métriques personnalisées ne prend actuellement en charge que les métriques Prometheus, CPU, mémoire et Apache Kafka.

L'autoscaler de métriques personnalisé est une fonctionnalité d'aperçu technologique uniquement. Les fonctionnalités de l'aperçu technologique ne sont pas prises en charge par les accords de niveau de service (SLA) de production de Red Hat et peuvent ne pas être complètes sur le plan fonctionnel. Red Hat ne recommande pas leur utilisation en production. Ces fonctionnalités offrent un accès anticipé aux fonctionnalités des produits à venir, ce qui permet aux clients de tester les fonctionnalités et de fournir un retour d'information pendant le processus de développement.

Pour plus d'informations sur la portée de l'assistance des fonctionnalités de l'aperçu technologique de Red Hat, voir Portée de l'assistance des fonctionnalités de l'aperçu technologique.

2.5.1. Notes de mise à jour de Custom Metrics Autoscaler Operator

Les notes de mise à jour de Custom Metrics Autoscaler Operator pour Red Hat Openshift décrivent les nouvelles fonctionnalités et améliorations, les fonctionnalités obsolètes et les problèmes connus.

Le Custom Metrics Autoscaler Operator utilise l'Event Driven Autoscaler (KEDA) basé sur Kubernetes et est construit sur le pod autoscaler horizontal (HPA) d'OpenShift Container Platform.

Custom Metrics Autoscaler Operator pour Red Hat OpenShift est fourni en tant que composant installable, avec un cycle de publication distinct de celui de la plate-forme OpenShift Container Platform. La politique de cycle de vie de Red Hat OpenShift Container Platform décrit la compatibilité des versions.

2.5.1.1. Versions prises en charge

Le tableau suivant définit les versions de Custom Metrics Autoscaler Operator pour chaque version d'OpenShift Container Platform.

| Version | Version d'OpenShift Container Platform | Disponibilité générale |

|---|---|---|

| 2.8.2-174 | 4.12 | Avant-première technologique |

| 2.8.2-174 | 4.11 | Avant-première technologique |

| 2.8.2-174 | 4.10 | Avant-première technologique |

2.5.1.2. Notes de publication de Custom Metrics Autoscaler Operator 2.8.2-174

Cette version de Custom Metrics Autoscaler Operator 2.8.2-174 fournit de nouvelles fonctionnalités et des corrections de bugs pour l'exécution de l'Operator dans un cluster OpenShift Container Platform. Les composants de Custom Metrics Autoscaler Operator 2.8.2-174 ont été publiés dans RHEA-2023:1683.

Le Custom Metrics Autoscaler Operator est actuellement une fonctionnalité en avant-première technologique.

2.5.1.2.1. Nouvelles fonctionnalités et améliorations

2.5.1.2.1.1. Aide à la mise à niveau de l'opérateur

Vous pouvez désormais mettre à niveau une version antérieure de l'opérateur Custom Metrics Autoscaler. Voir "Changer le canal de mise à jour d'un opérateur" dans "Ressources supplémentaires" pour plus d'informations sur la mise à niveau d'un opérateur.

2.5.1.2.1.2. soutien indispensable

Vous pouvez désormais collecter des données sur l'opérateur Custom Metrics Autoscaler et ses composants en utilisant l'outil OpenShift Container Platform must-gather. Actuellement, le processus d'utilisation de l'outil must-gather avec Custom Metrics Autoscaler est différent de celui des autres opérateurs. Voir "Gathering debugging data in the \N- Additional resources\N" (Collecte de données de débogage dans les ressources supplémentaires) pour plus d'informations.

2.5.1.3. Notes de publication de Custom Metrics Autoscaler Operator 2.8.2

Cette version de Custom Metrics Autoscaler Operator 2.8.2 apporte de nouvelles fonctionnalités et des corrections de bugs pour l'exécution de l'Operator dans un cluster OpenShift Container Platform. Les composants de Custom Metrics Autoscaler Operator 2.8.2 ont été publiés dans la RHSA-2023:1042.

Le Custom Metrics Autoscaler Operator est actuellement une fonctionnalité en avant-première technologique.

2.5.1.3.1. Nouvelles fonctionnalités et améliorations

2.5.1.3.1.1. Enregistrement des audits

Vous pouvez désormais rassembler et afficher les journaux d'audit de Custom Metrics Autoscaler Operator et de ses composants associés. Les journaux d'audit sont des ensembles chronologiques d'enregistrements relatifs à la sécurité qui documentent la séquence des activités qui ont affecté le système par des utilisateurs individuels, des administrateurs ou d'autres composants du système.

2.5.1.3.1.2. Faire évoluer les applications en fonction des mesures d'Apache Kafka

Vous pouvez maintenant utiliser le KEDA Apache kafka trigger/scaler pour mettre à l'échelle des déploiements basés sur un sujet Apache Kafka.

L'autoscaling basé sur les métriques Apache Kafka est une fonctionnalité Technology Preview (TP) dans toutes les versions TP de Custom Metrics Autoscaler et dans la version Custom Metrics Autoscaler General Availability.

Les fonctionnalités de l'aperçu technologique ne sont pas prises en charge par les accords de niveau de service (SLA) de production de Red Hat et peuvent ne pas être complètes sur le plan fonctionnel. Red Hat ne recommande pas leur utilisation en production.

2.5.1.3.1.3. Mise à l'échelle des applications en fonction des paramètres de l'unité centrale

Vous pouvez désormais utiliser le déclencheur/échelle de CPU de KEDA pour échelonner les déploiements en fonction des métriques de CPU.

2.5.1.3.1.4. Mise à l'échelle des applications en fonction des mesures de la mémoire

Vous pouvez désormais utiliser le déclencheur/échelle de mémoire KEDA pour échelonner les déploiements en fonction des mesures de mémoire.

2.5.2. Comprendre l'autoscaler de métriques personnalisées

L'opérateur Autoscaler Custom Metrics fait évoluer vos pods vers le haut ou vers le bas en fonction de mesures externes personnalisées provenant d'applications spécifiques. Vos autres applications continuent d'utiliser d'autres méthodes de mise à l'échelle. Vous configurez triggers, également appelé scalers, qui est la source d'événements et de métriques que l'autoscaler de métriques personnalisées utilise pour déterminer comment procéder à la mise à l'échelle. L'autoscaler de métriques personnalisées utilise une API de métriques pour convertir les métriques externes en une forme utilisable par OpenShift Container Platform. Le custom metrics autoscaler crée un pod autoscaler horizontal (HPA) qui effectue la mise à l'échelle réelle.

Pour utiliser l'autoscaler de métriques personnalisées, vous devez créer un objet ScaledObject ou ScaledJob, qui est une ressource personnalisée (CR) définissant les métadonnées de mise à l'échelle. Vous spécifiez le déploiement ou le travail à mettre à l'échelle, la source des métriques à mettre à l'échelle (déclencheur) et d'autres paramètres tels que les nombres minimum et maximum de réplicas autorisés.

Vous ne pouvez créer qu'un seul objet ou travail mis à l'échelle pour chaque charge de travail que vous souhaitez mettre à l'échelle. Vous ne pouvez pas non plus utiliser un objet ou un travail mis à l'échelle et le pod autoscaler horizontal (HPA) sur la même charge de travail.

Contrairement au HPA, l'autoscaler de métriques personnalisé peut s'adapter à zéro. Si vous définissez la valeur minReplicaCount dans le Custom Metrics Autoscaler CR sur 0, le Custom Metrics Autoscaler met à l'échelle la charge de travail de 1 à 0 réplica ou de 0 à 1 réplica. C'est ce qu'on appelle activation phase. Après avoir mis à l'échelle jusqu'à 1 réplica, le HPA prend le contrôle de la mise à l'échelle. C'est ce qu'on appelle scaling phase.