Opérateurs

Travailler avec des opérateurs dans OpenShift Container Platform

Résumé

Chapitre 1. Aperçu des opérateurs

Les opérateurs sont parmi les composants les plus importants d'OpenShift Container Platform. Les opérateurs sont la méthode privilégiée pour conditionner, déployer et gérer les services sur le plan de contrôle. Ils peuvent également offrir des avantages aux applications exécutées par les utilisateurs.

Les opérateurs s'intègrent aux API de Kubernetes et aux outils CLI tels que les commandes kubectl et oc. Ils permettent de surveiller les applications, d'effectuer des contrôles de santé, de gérer les mises à jour over-the-air (OTA) et de s'assurer que les applications restent dans l'état que vous avez spécifié.

Bien que les deux suivent des concepts et des objectifs similaires pour les opérateurs, les opérateurs dans OpenShift Container Platform sont gérés par deux systèmes différents, en fonction de leur objectif :

- Les opérateurs de cluster, qui sont gérés par l'opérateur de version de cluster (CVO), sont installés par défaut pour exécuter les fonctions de cluster.

- Des opérateurs supplémentaires facultatifs, gérés par Operator Lifecycle Manager (OLM), peuvent être mis à la disposition des utilisateurs pour qu'ils les exécutent dans leurs applications.

Avec les opérateurs, vous pouvez créer des applications pour surveiller les services en cours d'exécution dans le cluster. Les opérateurs sont conçus spécifiquement pour vos applications. Les opérateurs mettent en œuvre et automatisent les opérations courantes du jour 1, telles que l'installation et la configuration, ainsi que les opérations du jour 2, telles que la montée et la descente en charge automatique et la création de sauvegardes. Toutes ces activités se trouvent dans un logiciel qui s'exécute au sein de votre cluster.

1.1. Pour les développeurs

En tant que développeur, vous pouvez effectuer les tâches suivantes de l'opérateur :

- Installer le SDK CLI de l'opérateur.

- Créer des opérateurs basés sur Go, des opérateurs basés sur Ansible, des opérateurs basés sur Java et des opérateurs basés sur Helm.

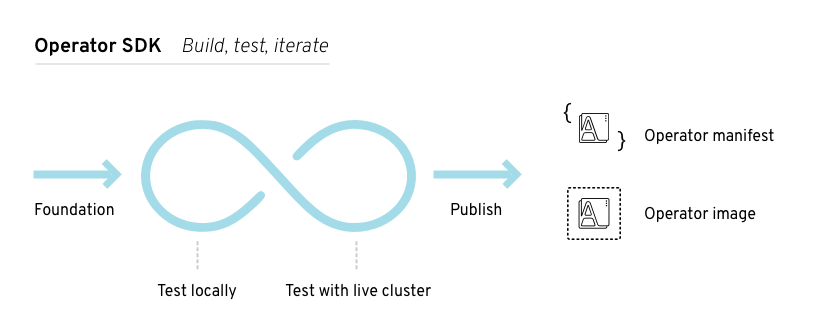

- Utilisez Operator SDK pour créer, tester et déployer un opérateur.

- Installez et abonnez un opérateur à votre espace de noms.

- Créer une application à partir d'un opérateur installé via la console web.

1.2. Pour les administrateurs

En tant qu'administrateur de cluster, vous pouvez effectuer les tâches suivantes de l'opérateur :

- Gérer des catalogues personnalisés

- Autoriser les administrateurs qui ne font pas partie d'un cluster à installer des opérateurs

- Installer un opérateur à partir d'OperatorHub

- Voir le statut de l'opérateur.

- Gérer les conditions de l'opérateur

- Mise à niveau des opérateurs installés

- Supprimer les opérateurs installés

- Configurer la prise en charge du proxy

- Utiliser Operator Lifecycle Manager sur des réseaux restreints

Pour tout savoir sur les opérateurs de clusters fournis par Red Hat, consultez la référence sur les opérateurs de clusters.

1.3. Prochaines étapes

Pour en savoir plus sur les opérateurs, voir Qu'est-ce qu'un opérateur ?

Chapitre 2. Comprendre les opérateurs

2.1. Qu'est-ce qu'un opérateur ?

D'un point de vue conceptuel, Operators prend les connaissances opérationnelles humaines et les encode dans des logiciels qui sont plus facilement partagés avec les consommateurs.

Les opérateurs sont des logiciels qui facilitent la complexité opérationnelle de l'exécution d'un autre logiciel. Ils agissent comme une extension de l'équipe d'ingénierie de l'éditeur du logiciel, en surveillant un environnement Kubernetes (tel que OpenShift Container Platform) et en utilisant son état actuel pour prendre des décisions en temps réel. Les opérateurs avancés sont conçus pour gérer les mises à niveau de manière transparente, réagir automatiquement aux pannes et ne pas prendre de raccourcis, comme sauter un processus de sauvegarde du logiciel pour gagner du temps.

Plus techniquement, les opérateurs sont une méthode de conditionnement, de déploiement et de gestion d'une application Kubernetes.

Une application Kubernetes est une application qui est à la fois déployée sur Kubernetes et gérée à l'aide des API Kubernetes et des outils kubectl ou oc. Pour pouvoir tirer le meilleur parti de Kubernetes, vous avez besoin d'un ensemble d'API cohérentes à étendre afin d'assurer le service et la gestion de vos applications qui s'exécutent sur Kubernetes. Considérez les opérateurs comme le moteur d'exécution qui gère ce type d'application sur Kubernetes.

2.1.1. Pourquoi utiliser des opérateurs ?

Les opérateurs fournissent :

- Répétabilité de l'installation et de la mise à niveau.

- Contrôles constants de l'état de santé de chaque composant du système.

- Mises à jour OTA (Over-the-air) pour les composants OpenShift et le contenu ISV.

- Un lieu où les connaissances des ingénieurs de terrain sont regroupées et diffusées à tous les utilisateurs, et pas seulement à un ou deux d'entre eux.

- Pourquoi déployer sur Kubernetes ?

- Kubernetes (et par extension, OpenShift Container Platform) contient toutes les primitives nécessaires pour construire des systèmes distribués complexes - traitement des secrets, équilibrage de charge, découverte de services, mise à l'échelle automatique - qui fonctionnent sur site et avec des fournisseurs de cloud.

- Pourquoi gérer votre application avec les API de Kubernetes et l'outil

kubectl? -

Ces API sont riches en fonctionnalités, disposent de clients pour toutes les plateformes et s'intègrent au contrôle d'accès et à l'audit du cluster. Un opérateur utilise le mécanisme d'extension de Kubernetes, les définitions de ressources personnalisées (CRD), de sorte que votre objet personnalisé, par exemple

MongoDB, ressemble et agit comme les objets Kubernetes natifs intégrés. - Comment les opérateurs se comparent-ils aux courtiers en services ?

- Un courtier de services est une étape vers la découverte et le déploiement programmatiques d'une application. Cependant, comme il ne s'agit pas d'un processus de longue durée, il ne peut pas exécuter les opérations du deuxième jour comme la mise à niveau, le basculement ou la mise à l'échelle. Les personnalisations et la paramétrisation des paramètres sont fournies au moment de l'installation, contrairement à un opérateur qui surveille constamment l'état actuel de votre cluster. Les services hors cluster conviennent bien à un courtier de services, bien qu'il existe également des opérateurs pour ces services.

2.1.2. Cadre de l'opérateur

L'Operator Framework est une famille d'outils et de capacités permettant d'offrir l'expérience client décrite ci-dessus. Il ne s'agit pas seulement d'écrire du code ; les tests, la livraison et la mise à jour des opérateurs sont tout aussi importants. Les composants de l'Operator Framework sont des outils open source permettant de résoudre ces problèmes :

- SDK de l'opérateur

- L'Operator SDK aide les auteurs d'opérateurs à démarrer, construire, tester et emballer leur propre opérateur en fonction de leur expertise sans avoir besoin de connaître les complexités de l'API Kubernetes.

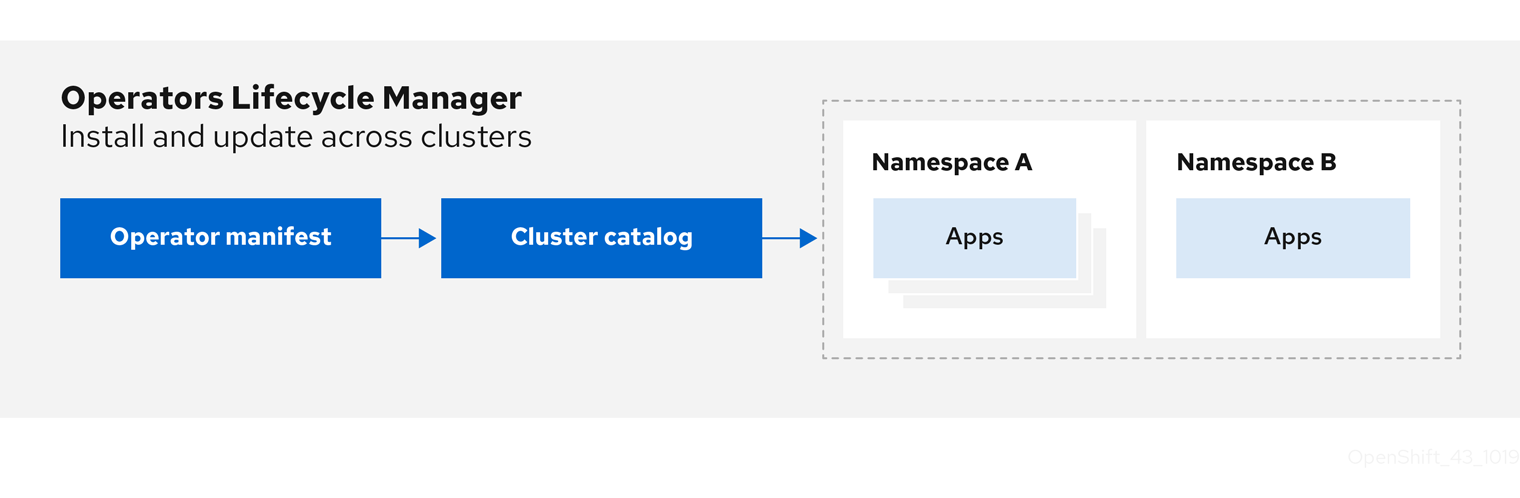

- Gestionnaire du cycle de vie des opérateurs

- Operator Lifecycle Manager (OLM) contrôle l'installation, la mise à niveau et le contrôle d'accès basé sur les rôles (RBAC) des opérateurs dans un cluster. Déployé par défaut dans OpenShift Container Platform 4.12.

- Registre des opérateurs

- Le registre Operator stocke les versions de service de cluster (CSV) et les définitions de ressources personnalisées (CRD) pour la création dans un cluster et stocke les métadonnées Operator sur les paquets et les canaux. Il s'exécute dans un cluster Kubernetes ou OpenShift pour fournir ces données de catalogue d'opérateurs à OLM.

- OperatorHub

- OperatorHub est une console web permettant aux administrateurs de clusters de découvrir et de sélectionner les opérateurs à installer sur leur cluster. Il est déployé par défaut dans OpenShift Container Platform.

Ces outils sont conçus pour être composables, de sorte que vous pouvez utiliser tous ceux qui vous sont utiles.

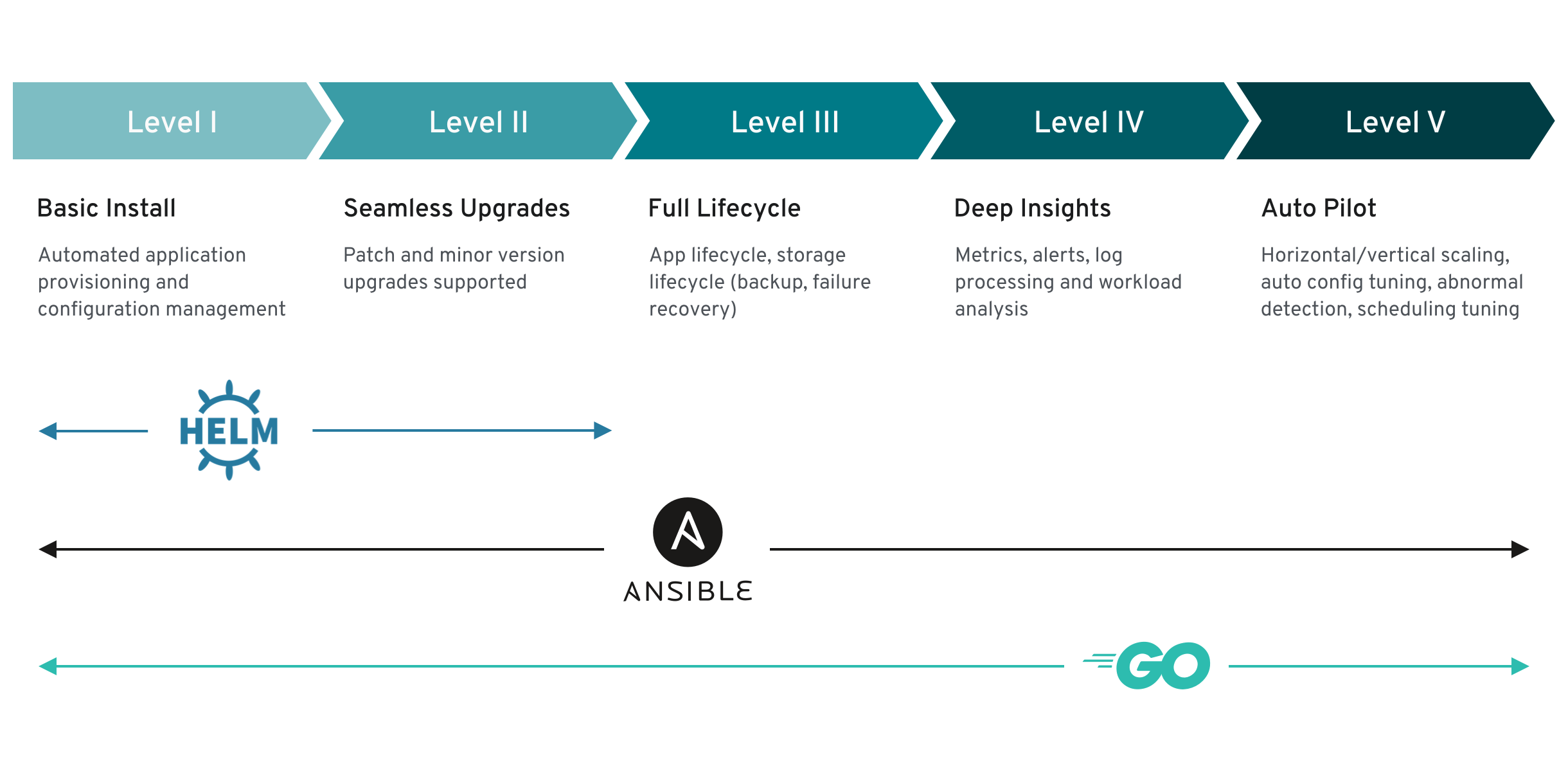

2.1.3. Modèle de maturité de l'opérateur

Le niveau de sophistication de la logique de gestion encapsulée dans un opérateur peut varier. En général, cette logique dépend aussi fortement du type de service représenté par l'opérateur.

Il est toutefois possible de généraliser l'échelle de maturité des opérations encapsulées d'un opérateur pour certains ensembles de capacités que la plupart des opérateurs peuvent inclure. À cette fin, le modèle de maturité de l'opérateur ci-après définit cinq phases de maturité pour les opérations génériques du deuxième jour d'un opérateur :

Figure 2.1. Modèle de maturité de l'opérateur

Le modèle ci-dessus montre également comment ces capacités peuvent être développées au mieux grâce aux fonctionnalités Helm, Go et Ansible de l'Operator SDK.

2.2. Format d'emballage du cadre de l'opérateur

Ce guide décrit le format d'emballage pour les opérateurs pris en charge par Operator Lifecycle Manager (OLM) dans OpenShift Container Platform.

2.2.1. Format de l'offre groupée

Le bundle format pour les opérateurs est un format d'empaquetage introduit par le cadre des opérateurs. Pour améliorer l'évolutivité et permettre aux utilisateurs en amont d'héberger leurs propres catalogues, la spécification du format bundle simplifie la distribution des métadonnées des opérateurs.

Un Operator bundle représente une version unique d'un Operator. Les bundle manifests sur disque sont conteneurisés et expédiés en tant que bundle image, qui est une image de conteneur non rinçable qui stocke les manifestes Kubernetes et les métadonnées de l'opérateur. Le stockage et la distribution de l'image de bundle sont ensuite gérés à l'aide d'outils de conteneur existants tels que podman et docker et de registres de conteneurs tels que Quay.

Les métadonnées de l'opérateur peuvent inclure

- Informations qui identifient l'opérateur, par exemple son nom et sa version.

- Informations supplémentaires qui pilotent l'interface utilisateur, par exemple son icône et quelques exemples de ressources personnalisées (CR).

- API requises et fournies.

- Images liées.

Lors du chargement des manifestes dans la base de données du registre des opérateurs, les exigences suivantes sont validées :

- La liasse doit avoir au moins un canal défini dans les annotations.

- Chaque bundle a exactement une version de service de cluster (CSV).

- Si un CSV possède une définition de ressource personnalisée (CRD), cette CRD doit exister dans l'ensemble.

2.2.1.1. Manifestes

Les manifestes de paquets font référence à un ensemble de manifestes Kubernetes qui définissent le déploiement et le modèle RBAC de l'opérateur.

Un bundle comprend un CSV par répertoire et généralement les CRD qui définissent les API propres au CSV dans son répertoire /manifests.

Exemple de présentation du format de la liasse

Autres objets pris en charge

Les types d'objets suivants peuvent également être inclus de manière facultative dans le répertoire /manifests d'une liasse :

Types d'objets optionnels pris en charge

-

ClusterRole -

ClusterRoleBinding -

ConfigMap -

ConsoleCLIDownload -

ConsoleLink -

ConsoleQuickStart -

ConsoleYamlSample -

PodDisruptionBudget -

PriorityClass -

PrometheusRule -

Role -

RoleBinding -

Secret -

Service -

ServiceAccount -

ServiceMonitor -

VerticalPodAutoscaler

Lorsque ces objets facultatifs sont inclus dans une liasse, Operator Lifecycle Manager (OLM) peut les créer à partir de la liasse et gérer leur cycle de vie en même temps que le CSV :

Cycle de vie des objets optionnels

- Lorsque le CSV est supprimé, OLM supprime l'objet facultatif.

Lorsque le CSV est mis à jour :

- Si le nom de l'objet facultatif est le même, OLM le met à jour à sa place.

- Si le nom de l'objet facultatif a changé entre les versions, OLM le supprime et le recrée.

2.2.1.2. Annotations

Une liasse comprend également un fichier annotations.yaml dans son répertoire /metadata. Ce fichier définit des données agrégées de plus haut niveau qui aident à décrire le format et les informations sur la manière dont l'offre groupée doit être ajoutée à un index d'offres groupées :

Exemple annotations.yaml

- 1

- Le type de média ou le format du bundle de l'opérateur. Le format

registry v1signifie qu'il contient un CSV et les objets Kubernetes associés. - 2

- Le chemin dans l'image vers le répertoire qui contient les manifestes de l'opérateur. Cette étiquette est réservée pour une utilisation future et a pour valeur par défaut

manifests/. La valeurmanifests.v1implique que la liasse contient des manifestes d'opérateurs. - 3

- Le chemin dans l'image vers le répertoire qui contient les fichiers de métadonnées sur la liasse. Cette étiquette est réservée pour une utilisation future et a actuellement pour valeur par défaut

metadata/. La valeurmetadata.v1implique que cette liasse a des métadonnées d'opérateur. - 4

- Le nom du paquet de la liasse.

- 5

- La liste des chaînes auxquelles l'offre groupée est abonnée lorsqu'elle est ajoutée à un registre d'opérateur.

- 6

- Le canal par défaut auquel un opérateur doit être abonné lorsqu'il est installé à partir d'un registre.

En cas de non-concordance, c'est le fichier annotations.yaml qui fait foi, car le registre des opérateurs sur le cluster qui s'appuie sur ces annotations n'a accès qu'à ce fichier.

2.2.1.3. Dépendances

Les dépendances d'un Opérateur sont listées dans un fichier dependencies.yaml dans le dossier metadata/ d'un bundle. Ce fichier est facultatif et n'est actuellement utilisé que pour spécifier les dépendances explicites de la version de l'opérateur.

La liste des dépendances contient un champ type pour chaque élément afin de spécifier de quel type de dépendance il s'agit. Les types de dépendances de l'opérateur suivants sont pris en charge :

olm.package-

Ce type indique une dépendance pour une version spécifique de l'opérateur. Les informations sur la dépendance doivent inclure le nom du paquet et la version du paquet au format semver. Par exemple, vous pouvez spécifier une version exacte telle que

0.5.2ou une plage de versions telle que>0.5.1. olm.gvk- Avec ce type, l'auteur peut spécifier une dépendance avec des informations sur le groupe, la version et le type (GVK), de manière similaire à l'utilisation existante des CRD et des API dans un CSV. Il s'agit d'un chemin permettant aux auteurs d'opérateurs de consolider toutes les dépendances, API ou versions explicites, au même endroit.

olm.constraint- Ce type déclare des contraintes génériques sur des propriétés arbitraires de l'opérateur.

Dans l'exemple suivant, des dépendances sont spécifiées pour un opérateur Prometheus et des CRD etcd :

Exemple de fichier dependencies.yaml

2.2.1.4. À propos de l'interface de programmation opm

L'outil CLI opm est fourni par Operator Framework pour être utilisé avec le format Operator bundle. Cet outil vous permet de créer et de maintenir des catalogues d'opérateurs à partir d'une liste de bundles d'opérateurs qui sont similaires à des dépôts de logiciels. Le résultat est une image de conteneur qui peut être stockée dans un registre de conteneurs et ensuite installée sur un cluster.

Un catalogue contient une base de données de pointeurs vers le contenu du manifeste de l'opérateur qui peut être interrogé par le biais d'une API incluse qui est servie lorsque l'image du conteneur est exécutée. Sur OpenShift Container Platform, Operator Lifecycle Manager (OLM) peut référencer l'image dans une source de catalogue, définie par un objet CatalogSource, qui interroge l'image à intervalles réguliers pour permettre des mises à jour fréquentes des opérateurs installés sur le cluster.

-

Voir Outils CLI pour les étapes d'installation du CLI

opm.

2.2.2. Catalogues basés sur des fichiers

File-based catalogs sont la dernière itération du format de catalogue dans Operator Lifecycle Manager (OLM). Il s'agit d'une évolution du format de base de données SQLite, basée sur du texte brut (JSON ou YAML) et une configuration déclarative, et il est entièrement rétrocompatible. L'objectif de ce format est de permettre l'édition, la composabilité et l'extensibilité du catalogue de l'opérateur.

- Édition

Avec les catalogues basés sur des fichiers, les utilisateurs qui interagissent avec le contenu d'un catalogue sont en mesure d'apporter des modifications directes au format et de vérifier que ces modifications sont valides. Comme ce format est du JSON ou du YAML en texte brut, les responsables de catalogues peuvent facilement manipuler les métadonnées des catalogues à la main ou à l'aide d'outils JSON ou YAML largement connus et pris en charge, tels que l'interface de programmation (CLI)

jq.Cette possibilité de modification permet d'utiliser les fonctions suivantes et les extensions définies par l'utilisateur :

- Promouvoir une offre existante auprès d'un nouveau canal

- Changer le canal par défaut d'un paquet

- Algorithmes personnalisés pour l'ajout, la mise à jour et la suppression des bords de mise à niveau

- Composabilité

Les catalogues basés sur des fichiers sont stockés dans une hiérarchie de répertoires arbitraire, ce qui permet de composer des catalogues. Par exemple, considérons deux répertoires distincts de catalogues basés sur des fichiers :

catalogAetcatalogB. Un responsable de catalogue peut créer un nouveau catalogue combiné en créant un nouveau répertoirecatalogCet en y copiantcatalogAetcatalogB.Cette composabilité permet de créer des catalogues décentralisés. Le format permet aux auteurs d'opérateurs de maintenir des catalogues spécifiques aux opérateurs et aux mainteneurs de construire de manière triviale un catalogue composé de catalogues d'opérateurs individuels. Les catalogues basés sur des fichiers peuvent être composés en combinant plusieurs autres catalogues, en extrayant des sous-ensembles d'un catalogue ou en combinant ces deux méthodes.

NoteLes paquets en double et les paquets en double à l'intérieur d'un paquet ne sont pas autorisés. La commande

opm validaterenvoie une erreur si des doublons sont trouvés.Étant donné que les auteurs d'opérateurs connaissent le mieux leur opérateur, ses dépendances et sa compatibilité avec les mises à jour, ils sont en mesure de maintenir leur propre catalogue spécifique à l'opérateur et de contrôler directement son contenu. Avec les catalogues basés sur des fichiers, les auteurs d'opérateurs sont responsables de la construction et de la maintenance de leurs paquets dans un catalogue. Les responsables des catalogues composites, cependant, ne sont responsables que de la conservation des paquets dans leur catalogue et de la publication du catalogue pour les utilisateurs.

- Extensibilité

La spécification de catalogue basée sur les fichiers est une représentation de bas niveau d'un catalogue. Bien qu'il puisse être maintenu directement dans sa forme de bas niveau, les responsables de catalogues peuvent construire des extensions intéressantes qui peuvent être utilisées par leurs propres outils personnalisés pour effectuer n'importe quel nombre de mutations.

Par exemple, un outil pourrait traduire une API de haut niveau, telle que

(mode=semver), en un format de catalogue de bas niveau, basé sur des fichiers, pour les bords de mise à niveau. Ou encore, un responsable de catalogue pourrait avoir besoin de personnaliser toutes les métadonnées des lots en ajoutant une nouvelle propriété aux lots qui répondent à certains critères.Bien que cette extensibilité permette de développer des outils officiels supplémentaires au-dessus des API de bas niveau pour les futures versions d'OpenShift Container Platform, le principal avantage est que les mainteneurs de catalogues disposent également de cette capacité.

À partir d'OpenShift Container Platform 4.11, le catalogue Operator fourni par Red Hat par défaut est publié dans le format de catalogue basé sur des fichiers. Les catalogues Operator fournis par Red Hat par défaut pour OpenShift Container Platform 4.6 à 4.10 sont publiés dans le format de base de données SQLite déprécié.

Les sous-commandes, drapeaux et fonctionnalités de opm liés au format de base de données SQLite sont également obsolètes et seront supprimés dans une prochaine version. Ces fonctionnalités sont toujours prises en charge et doivent être utilisées pour les catalogues qui utilisent le format de base de données SQLite obsolète.

La plupart des sous-commandes et des drapeaux de opm pour travailler avec le format de base de données SQLite, tels que opm index prune, ne fonctionnent pas avec le format de catalogue basé sur des fichiers. Pour plus d'informations sur l'utilisation des catalogues basés sur des fichiers, voir Gestion des catalogues personnalisés et Mise en miroir des images pour une installation déconnectée à l'aide du plugin oc-mirror.

2.2.2.1. Structure du répertoire

Les catalogues basés sur des fichiers peuvent être stockés et chargés à partir de systèmes de fichiers basés sur des répertoires. Le CLI de opm charge le catalogue en parcourant le répertoire racine et en revenant sur les sous-répertoires. Il tente de charger tous les fichiers qu'il trouve et échoue en cas d'erreur.

Les fichiers hors catalogue peuvent être ignorés à l'aide des fichiers .indexignore, qui obéissent aux mêmes règles que les fichiers .gitignore en ce qui concerne les motifs et la priorité.

Exemple de fichier .indexignore

Les responsables des catalogues ont la possibilité de choisir la disposition qu'ils souhaitent, mais il est recommandé de stocker les blobs de catalogue basés sur les fichiers de chaque paquet dans des sous-répertoires distincts. Chaque fichier individuel peut être au format JSON ou YAML ; il n'est pas nécessaire que tous les fichiers d'un catalogue utilisent le même format.

Structure de base recommandée

Cette structure recommandée a la propriété que chaque sous-répertoire de la hiérarchie des répertoires est un catalogue autonome, ce qui rend la composition, la découverte et la navigation dans le catalogue des opérations triviales du système de fichiers. Le catalogue peut également être inclus dans un catalogue parent en le copiant dans le répertoire racine du catalogue parent.

2.2.2.2. Schémas

Les catalogues basés sur des fichiers utilisent un format, basé sur la spécification du langage CUE, qui peut être étendu avec des schémas arbitraires. Le schéma CUE suivant ( _Meta ) définit le format auquel tous les blobs de catalogues basés sur des fichiers doivent adhérer :

_Meta schéma

Aucun des schémas CUE énumérés dans la présente spécification ne doit être considéré comme exhaustif. La commande opm validate comporte des validations supplémentaires qu'il est difficile, voire impossible, d'exprimer de manière concise dans le langage CUE.

Un catalogue Operator Lifecycle Manager (OLM) utilise actuellement trois schémas (olm.package, olm.channel, et olm.bundle), qui correspondent aux concepts existants de paquet et de liasse d'OLM.

Chaque paquet d'opérateurs d'un catalogue nécessite exactement un blob olm.package, au moins un blob olm.channel et un ou plusieurs blobs olm.bundle.

Tous les schémas olm.* sont réservés aux schémas définis par OLM. Les schémas personnalisés doivent utiliser un préfixe unique, tel qu'un domaine dont vous êtes propriétaire.

2.2.2.2.1. schéma de l'olm.package

Le schéma olm.package définit les métadonnées d'un opérateur au niveau du paquet. Il s'agit de son nom, de sa description, de son canal par défaut et de son icône.

Exemple 2.1. olm.package schéma

2.2.2.2.2. schéma olm.channel

Le schéma olm.channel définit un canal à l'intérieur d'un paquet, les entrées de paquet qui sont membres du canal et les bords de mise à niveau pour ces paquets.

Une liasse peut être incluse en tant qu'entrée dans plusieurs blobs olm.channel, mais elle ne peut avoir qu'une seule entrée par canal.

Il est possible que la valeur de remplacement d'une entrée fasse référence à un autre nom de paquet qui ne peut être trouvé dans ce catalogue ou dans un autre catalogue. Cependant, tous les autres invariants du canal doivent rester vrais, comme le fait qu'un canal n'ait pas plusieurs têtes.

Exemple 2.2. olm.channel schéma

2.2.2.2.3. schéma olm.bundle

Exemple 2.3. olm.bundle schéma

2.2.2.3. Propriétés

Les propriétés sont des éléments arbitraires de métadonnées qui peuvent être attachés à des schémas de catalogues basés sur des fichiers. Le champ type est une chaîne qui spécifie effectivement la signification sémantique et syntaxique du champ value. La valeur peut être n'importe quel JSON ou YAML arbitraire.

OLM définit une poignée de types de propriétés, en utilisant à nouveau le préfixe réservé olm.*.

2.2.2.3.1. propriété olm.package

La propriété olm.package définit le nom et la version du paquet. Il s'agit d'une propriété obligatoire pour les bundles, et il doit y avoir exactement une de ces propriétés. Le champ packageName doit correspondre au champ de première classe package de la liasse et le champ version doit être une version sémantique valide.

Exemple 2.4. olm.package propriété

2.2.2.3.2. propriété olm.gvk

La propriété olm.gvk définit le groupe/la version/le type (GVK) d'une API Kubernetes fournie par ce bundle. Cette propriété est utilisée par OLM pour résoudre un bundle avec cette propriété en tant que dépendance pour d'autres bundles qui listent le même GVK comme API requise. Le GVK doit respecter les validations GVK de Kubernetes.

Exemple 2.5. olm.gvk propriété

2.2.2.3.3. olm.package.required

La propriété olm.package.required définit le nom du package et la plage de versions d'un autre package requis par cette offre groupée. Pour chaque propriété de paquetage requise qu'une offre énumère, OLM s'assure qu'un opérateur est installé sur le cluster pour le paquetage répertorié et dans la plage de versions requise. Le champ versionRange doit être une plage de versions sémantiques (semver) valide.

Exemple 2.6. olm.package.required propriété

2.2.2.3.4. olm.gvk.requis

La propriété olm.gvk.required définit le groupe/la version/le type (GVK) d'une API Kubernetes dont ce bundle a besoin. Pour chaque propriété GVK requise, OLM s'assure qu'il existe un opérateur installé sur le cluster qui la fournit. Le GVK doit respecter les validations GVK de Kubernetes.

Exemple 2.7. olm.gvk.required propriété

2.2.2.4. Exemple de catalogue

Avec les catalogues basés sur des fichiers, les responsables des catalogues peuvent se concentrer sur la curation et la compatibilité des opérateurs. Comme les auteurs d'opérateurs ont déjà produit des catalogues spécifiques pour leurs opérateurs, les responsables de catalogues peuvent construire leur catalogue en rendant chaque catalogue d'opérateur dans un sous-répertoire du répertoire racine du catalogue.

Il existe de nombreuses façons de créer un catalogue basé sur des fichiers ; les étapes suivantes décrivent une approche simple :

Maintenir un seul fichier de configuration pour le catalogue, contenant des références d'images pour chaque opérateur du catalogue :

Exemple de fichier de configuration de catalogue

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exécuter un script qui analyse le fichier de configuration et crée un nouveau catalogue à partir de ses références :

Exemple de script

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.2.5. Lignes directrices

Les lignes directrices suivantes doivent être prises en compte lors de la gestion de catalogues basés sur des fichiers.

2.2.2.5.1. Paquets immuables

En ce qui concerne le gestionnaire du cycle de vie des opérateurs (OLM), il est généralement conseillé de considérer les images des liasses et leurs métadonnées comme immuables.

Si un bundle cassé a été poussé vers un catalogue, vous devez supposer qu'au moins un de vos utilisateurs a effectué une mise à niveau vers ce bundle. Sur la base de cette hypothèse, vous devez publier une autre liasse avec un bord de mise à niveau à partir de la liasse cassée pour vous assurer que les utilisateurs ayant installé la liasse cassée reçoivent une mise à niveau. OLM ne réinstallera pas une liasse installée si le contenu de cette liasse est mis à jour dans le catalogue.

Toutefois, dans certains cas, il est préférable de modifier les métadonnées du catalogue :

-

Promotion des canaux : Si vous avez déjà publié une offre groupée et que vous décidez par la suite de l'ajouter à un autre canal, vous pouvez ajouter une entrée pour votre offre groupée dans un autre blob

olm.channel. -

Nouveaux bords de mise à niveau : Si vous publiez une nouvelle version de l'offre groupée

1.2.z, par exemple1.2.4, mais que1.3.0est déjà disponible, vous pouvez mettre à jour les métadonnées du catalogue pour1.3.0afin d'ignorer1.2.4.

2.2.2.5.2. Contrôle des sources

Les métadonnées du catalogue doivent être stockées dans le contrôle de la source et considérées comme la source de vérité. Les mises à jour des images du catalogue doivent comprendre les étapes suivantes :

- Mettre à jour le répertoire du catalogue contrôlé par la source avec un nouveau commit.

-

Construire et pousser l'image du catalogue. Utilisez une taxonomie d'étiquetage cohérente, telle que

:latestou:<target_cluster_version>, afin que les utilisateurs puissent recevoir les mises à jour d'un catalogue au fur et à mesure qu'elles sont disponibles.

2.2.2.6. Utilisation du CLI

Pour obtenir des instructions sur la création de catalogues basés sur des fichiers à l'aide de l'interface CLI de opm, reportez-vous à la section Gestion des catalogues personnalisés.

Pour obtenir une documentation de référence sur les commandes CLI de opm relatives à la gestion des catalogues basés sur des fichiers, voir Outils CLI.

2.2.2.7. Automatisation

Les auteurs d'opérateurs et les responsables de catalogues sont encouragés à automatiser la maintenance de leurs catalogues avec des flux de travail CI/CD. Les mainteneurs de catalogues peuvent encore améliorer cela en construisant une automatisation GitOps pour accomplir les tâches suivantes :

- Vérifier que les auteurs de demandes d'extraction (PR) sont autorisés à effectuer les modifications demandées, par exemple en mettant à jour la référence de l'image de leur paquet.

-

Vérifiez que les mises à jour du catalogue passent la commande

opm validate. - Vérifiez que les références du bundle ou de l'image de catalogue mis à jour existent, que les images de catalogue s'exécutent correctement dans un cluster et que les opérateurs de ce package peuvent être installés avec succès.

- Fusionner automatiquement les RP qui ont passé les contrôles précédents.

- Reconstruire et republier automatiquement l'image du catalogue.

2.2.3. RukPak (aperçu technologique)

RukPak est une fonctionnalité d'aperçu technologique uniquement. Les fonctionnalités de l'aperçu technologique ne sont pas prises en charge par les accords de niveau de service (SLA) de production de Red Hat et peuvent ne pas être complètes sur le plan fonctionnel. Red Hat ne recommande pas de les utiliser en production. Ces fonctionnalités offrent un accès anticipé aux fonctionnalités des produits à venir, ce qui permet aux clients de tester les fonctionnalités et de fournir un retour d'information pendant le processus de développement.

Pour plus d'informations sur la portée de l'assistance des fonctionnalités de l'aperçu technologique de Red Hat, voir Portée de l'assistance des fonctionnalités de l'aperçu technologique.

OpenShift Container Platform 4.12 introduit le type platform Operator en tant que fonctionnalité d'aperçu technologique. Le mécanisme de la plateforme Operator s'appuie sur le composant RukPak, également introduit dans OpenShift Container Platform 4.12, et ses ressources pour gérer le contenu.

RukPak se compose d'une série de contrôleurs, appelés provisioners, qui installent et gèrent le contenu sur un cluster Kubernetes. RukPak fournit également deux API principales : Bundle et BundleDeployment. Ces composants travaillent ensemble pour apporter du contenu sur le cluster et l'installer, en générant des ressources au sein du cluster.

Un provisionneur place une surveillance sur les ressources Bundle et BundleDeployment qui font explicitement référence au provisionneur. Pour un ensemble donné, le provisionneur décompresse le contenu de la ressource Bundle sur le cluster. Ensuite, lorsqu'une ressource BundleDeployment fait référence à cet ensemble, le provisionneur installe le contenu de l'ensemble et est responsable de la gestion du cycle de vie de ces ressources.

Deux provisionneurs sont actuellement mis en œuvre et fournis avec RukPak : le plain provisioner qui source et décompresse les paquets plain v0, et le registry provisioner qui source et décompresse les paquets Operator Lifecycle Manager (OLM) registry v1.

2.2.3.1. L'offre groupée

Un objet RukPak Bundle représente un contenu à mettre à la disposition d'autres consommateurs dans le cluster. Tout comme le contenu d'une image de conteneur doit être extrait et décompressé pour que le pod puisse commencer à l'utiliser, les objets Bundle sont utilisés pour référencer le contenu qui pourrait avoir besoin d'être extrait et décompressé. En ce sens, un bundle est une généralisation du concept d'image et peut être utilisé pour représenter n'importe quel type de contenu.

Les paquets ne peuvent rien faire par eux-mêmes ; ils ont besoin d'un provisionneur pour décompresser et rendre leur contenu disponible dans le cluster. Ils peuvent être décompressés sur n'importe quel support de stockage arbitraire, tel qu'un fichier tar.gz dans un répertoire monté dans les pods du provisionneur. Chaque objet Bundle est associé à un champ spec.provisionerClassName qui indique l'objet Provisioner qui surveille et décompresse ce type de paquet particulier.

Exemple Bundle objet configuré pour fonctionner avec le provisionneur ordinaire

Les paquets sont considérés comme immuables après leur création.

2.2.3.1.1. Immutabilité de l'offre groupée

Une fois qu'un objet Bundle est accepté par le serveur API, l'ensemble est considéré comme un artefact immuable par le reste du système RukPak. Ce comportement renforce la notion qu'un bundle représente un élément de contenu unique et statique à introduire dans le cluster. Un utilisateur peut être certain qu'un bundle particulier pointe vers un ensemble spécifique de manifestes et qu'il ne peut être mis à jour sans créer un nouveau bundle. Cette propriété s'applique aussi bien aux bundles autonomes qu'aux bundles dynamiques créés par un objet BundleTemplate intégré.

L'immuabilité de l'ensemble est assurée par le webhook principal de RukPak. Ce webhook surveille les événements de l'objet Bundle et, pour toute mise à jour d'une liasse, vérifie si le champ spec de la liasse existante est sémantiquement égal à celui de la liasse mise à jour proposée. Si ce n'est pas le cas, la mise à jour est rejetée par le webhook. D'autres champs de l'objet Bundle, tels que metadata ou status, sont mis à jour au cours du cycle de vie de l'offre groupée ; seul le champ spec est considéré comme immuable.

L'application d'un objet Bundle et la tentative de mise à jour de sa spécification devraient échouer. Par exemple, l'exemple suivant crée un bundle :

Exemple de sortie

bundle.core.rukpak.io/combo-tag-ref created

bundle.core.rukpak.io/combo-tag-ref createdEnsuite, l'application d'un correctif à la liasse pour qu'elle pointe vers une balise plus récente renvoie une erreur :

oc patch bundle combo-tag-ref --type='merge' -p '{"spec":{"source":{"git":{"ref":{"tag":"v0.0.3"}}}}}'

$ oc patch bundle combo-tag-ref --type='merge' -p '{"spec":{"source":{"git":{"ref":{"tag":"v0.0.3"}}}}}'Exemple de sortie

Error from server (bundle.spec is immutable): admission webhook "vbundles.core.rukpak.io" denied the request: bundle.spec is immutable

Error from server (bundle.spec is immutable): admission webhook "vbundles.core.rukpak.io" denied the request: bundle.spec is immutable

Le webhook d'admission du noyau RukPak a rejeté le correctif parce que la spécification de l'ensemble est immuable. La méthode recommandée pour modifier le contenu d'une liasse consiste à créer un nouvel objet Bundle au lieu de le mettre à jour sur place.

Autres considérations sur l'immutabilité

Bien que le champ spec de l'objet Bundle soit immuable, il est toujours possible pour un objet BundleDeployment de pivoter vers une version plus récente du contenu de la liasse sans modifier le champ spec sous-jacent. Ce pivotement involontaire pourrait se produire dans le scénario suivant :

-

Un utilisateur définit une étiquette d'image, une branche Git ou une étiquette Git dans le champ

spec.sourcede l'objetBundle. - La balise image est déplacée vers un nouveau résumé, un utilisateur apporte des modifications à une branche Git, ou un utilisateur supprime et repousse une balise Git sur un commit différent.

- Un utilisateur fait quelque chose qui entraîne la recréation du pod d'unpackage du bundle, comme la suppression du pod d'unpackage.

Si ce scénario se produit, le nouveau contenu de l'étape 2 est décompressé à la suite de l'étape 3. Le déploiement de l'offre groupée détecte les modifications et passe à la version la plus récente du contenu.

Ceci est similaire au comportement d'un pod, où l'une des images de conteneur du pod utilise une balise, la balise est déplacée vers un digest différent, puis à un moment donné dans le futur, le pod existant est reprogrammé sur un nœud différent. À ce moment-là, le nœud extrait la nouvelle image du nouveau résumé et exécute quelque chose de différent sans que l'utilisateur ne le demande explicitement.

Pour être sûr que le contenu sous-jacent de la spécification Bundle ne change pas, utilisez une image basée sur un condensé ou une référence à un commit Git lors de la création de l'offre groupée.

2.2.3.1.2. Paquet simple spec

Un bundle simple dans RukPak est une collection de manifestes YAML Kubernetes statiques et arbitraires dans un répertoire donné.

Le format de liasse simple actuellement mis en œuvre est le format plain v0. Le nom du format de liasse, plain v0, combine le type de liasse (plain) et la version actuelle du schéma (v0).

Le format de la liasse plain v0 est à la version de schéma v0, ce qui signifie qu'il s'agit d'un format expérimental susceptible d'être modifié.

Par exemple, l'illustration suivante montre l'arborescence des fichiers d'un bundle plain v0. Il doit comporter un répertoire manifests/ contenant les ressources Kubernetes nécessaires au déploiement d'une application.

Exemple plain v0 Arborescence des fichiers de la liasse

Les manifestes statiques doivent se trouver dans le répertoire manifests/ et contenir au moins une ressource pour que le bundle soit un bundle plain v0 valide que le provisionneur peut décompresser. Le répertoire manifests/ doit également être plat ; tous les manifestes doivent se trouver au niveau supérieur, sans sous-répertoire.

N'incluez pas de contenu dans le répertoire manifests/ d'un paquet ordinaire qui ne soit pas un manifeste statique. Sinon, un échec se produira lors de la création de contenu sur le cluster à partir de ce bundle. Tout fichier qui ne s'appliquerait pas avec succès avec la commande oc apply entraînera une erreur. Les fichiers YAML ou JSON multi-objets sont également valides.

2.2.3.1.3. Spécification de la liasse de registres

Un bundle de registre, ou registry v1 bundle, contient un ensemble de manifestes YAML Kubernetes statiques organisés dans l'ancien format de bundle Operator Lifecycle Manager (OLM).

2.2.3.2. Déploiement groupé

Un objet BundleDeployment modifie l'état d'un cluster Kubernetes en installant et en supprimant des objets. Il est important de vérifier et de faire confiance au contenu qui est installé et de limiter l'accès à l'API BundleDeployment, à l'aide d'un système RBAC, aux seules personnes qui ont besoin de ces autorisations.

L'API RukPak BundleDeployment pointe vers un objet Bundle et indique qu'il doit être actif. Cela permet notamment de pivoter à partir d'anciennes versions d'un ensemble actif. Un objet BundleDeployment peut également inclure une spécification intégrée pour un ensemble souhaité.

Tout comme les pods génèrent des instances d'images de conteneurs, un déploiement de bundle génère une version déployée d'un bundle. Le déploiement d'un bundle peut être considéré comme une généralisation du concept de pod.

Les spécificités de la manière dont un déploiement de bundle apporte des modifications à un cluster basé sur un bundle référencé sont définies par le provisionneur qui est configuré pour surveiller ce déploiement de bundle.

Exemple BundleDeployment objet configuré pour fonctionner avec le provisionneur ordinaire

2.2.3.3. Provisionneur

Un provisionneur RukPak est un contrôleur qui comprend les API BundleDeployment et Bundle et peut prendre des mesures. Chaque provisionneur se voit attribuer un identifiant unique et est chargé de rapprocher les objets Bundle et BundleDeployment avec un champ spec.provisionerClassName correspondant à cet identifiant particulier.

Par exemple, le "plain provisioner" est capable de décompresser un paquet plain v0 donné sur un cluster et de l'instancier, rendant ainsi le contenu du paquet disponible dans le cluster.

2.3. Cadre de l'opérateur glossaire des termes courants

Cette rubrique fournit un glossaire des termes courants relatifs à l'Operator Framework, y compris Operator Lifecycle Manager (OLM) et Operator SDK.

2.3.1. Termes du cadre commun des opérateurs

2.3.1.1. L'offre groupée

Dans le format bundle, un bundle est une collection d'un CSV d'opérateur, de manifestes et de métadonnées. Ensemble, ils forment une version unique d'un opérateur qui peut être installée sur le cluster.

2.3.1.2. Image de l'offre groupée

Dans le format bundle, un bundle image est une image de conteneur construite à partir de manifestes d'opérateurs et contenant un bundle. Les images de bundle sont stockées et distribuées par des registres de conteneurs spécifiques à l'Open Container Initiative (OCI), tels que Quay.io ou DockerHub.

2.3.1.3. Source du catalogue

Un site catalog source représente un magasin de métadonnées qu'OLM peut interroger pour découvrir et installer des opérateurs et leurs dépendances.

2.3.1.4. Chaîne

Un channel définit un flux de mises à jour pour un opérateur et est utilisé pour déployer des mises à jour pour les abonnés. La tête pointe vers la dernière version de ce canal. Par exemple, un canal stable contient toutes les versions stables d'un opérateur, de la plus ancienne à la plus récente.

Un opérateur peut avoir plusieurs canaux, et un abonnement lié à un certain canal ne recherchera des mises à jour que dans ce canal.

2.3.1.5. Tête de canal

Le site channel head fait référence à la dernière mise à jour connue d'un canal particulier.

2.3.1.6. Version du service de cluster

Un cluster service version (CSV) est un manifeste YAML créé à partir des métadonnées de l'opérateur, qui aide OLM à exécuter l'opérateur dans un cluster. Il s'agit des métadonnées qui accompagnent l'image d'un conteneur Operator, utilisées pour remplir les interfaces utilisateur avec des informations telles que le logo, la description et la version.

Il s'agit également d'une source d'informations techniques nécessaires au fonctionnement de l'opérateur, comme les règles RBAC dont il a besoin et les ressources personnalisées (CR) qu'il gère ou dont il dépend.

2.3.1.7. Dépendance

Un opérateur peut avoir une dépendance dependency à l'égard d'un autre opérateur présent dans le cluster. Par exemple, l'opérateur Vault dépend de l'opérateur etcd pour sa couche de persistance des données.

OLM résout les dépendances en s'assurant que toutes les versions spécifiées des opérateurs et des CRD sont installées sur le cluster pendant la phase d'installation. Cette dépendance est résolue par la recherche et l'installation d'un opérateur dans un catalogue qui satisfait à l'API CRD requise et qui n'est pas lié à des paquets ou à des bundles.

2.3.1.8. Image d'index

Dans le format des bundles, un index image fait référence à une image d'une base de données (un instantané de base de données) qui contient des informations sur les bundles d'opérateurs, y compris les CSV et les CRD de toutes les versions. Cet index peut héberger un historique des opérateurs sur un cluster et être maintenu en ajoutant ou en supprimant des opérateurs à l'aide de l'outil CLI opm.

2.3.1.9. Plan d'installation

Un site install plan est une liste calculée de ressources à créer pour installer ou mettre à niveau automatiquement un CSV.

2.3.1.10. Multitenance

Un tenant dans OpenShift Container Platform est un utilisateur ou un groupe d'utilisateurs qui partagent un accès et des privilèges communs pour un ensemble de charges de travail déployées, généralement représentées par un espace de noms ou un projet. Vous pouvez utiliser les locataires pour fournir un niveau d'isolation entre différents groupes ou équipes.

Lorsqu'un cluster est partagé par plusieurs utilisateurs ou groupes, il est considéré comme un cluster multitenant.

2.3.1.11. Groupe d'opérateurs

Un Operator group configure tous les opérateurs déployés dans le même espace de noms que l'objet OperatorGroup pour qu'ils surveillent leur CR dans une liste d'espaces de noms ou à l'échelle du cluster.

2.3.1.12. Paquet

Dans le format bundle, un package est un répertoire qui contient tout l'historique des versions publiées d'un opérateur pour chaque version. Une version publiée d'un opérateur est décrite dans un manifeste CSV à côté des CRD.

2.3.1.13. Registre

Le site registry est une base de données qui stocke des images de faisceaux d'opérateurs, chacun avec toutes ses versions récentes et historiques dans tous les canaux.

2.3.1.14. Abonnement

Un site subscription permet de maintenir les CSV à jour en suivant un canal dans un paquet.

2.3.1.15. Graphique de mise à jour

Un site update graph relie les versions des CSV entre elles, de la même manière que le graphique de mise à jour de tout autre logiciel. Les opérateurs peuvent être installés de manière séquentielle ou certaines versions peuvent être ignorées. Le graphique de mise à jour ne devrait croître qu'en tête, avec l'ajout de nouvelles versions.

2.4. Gestionnaire du cycle de vie des opérateurs (OLM)

2.4.1. Concepts et ressources du gestionnaire du cycle de vie de l'opérateur

Ce guide fournit une vue d'ensemble des concepts qui régissent Operator Lifecycle Manager (OLM) dans OpenShift Container Platform.

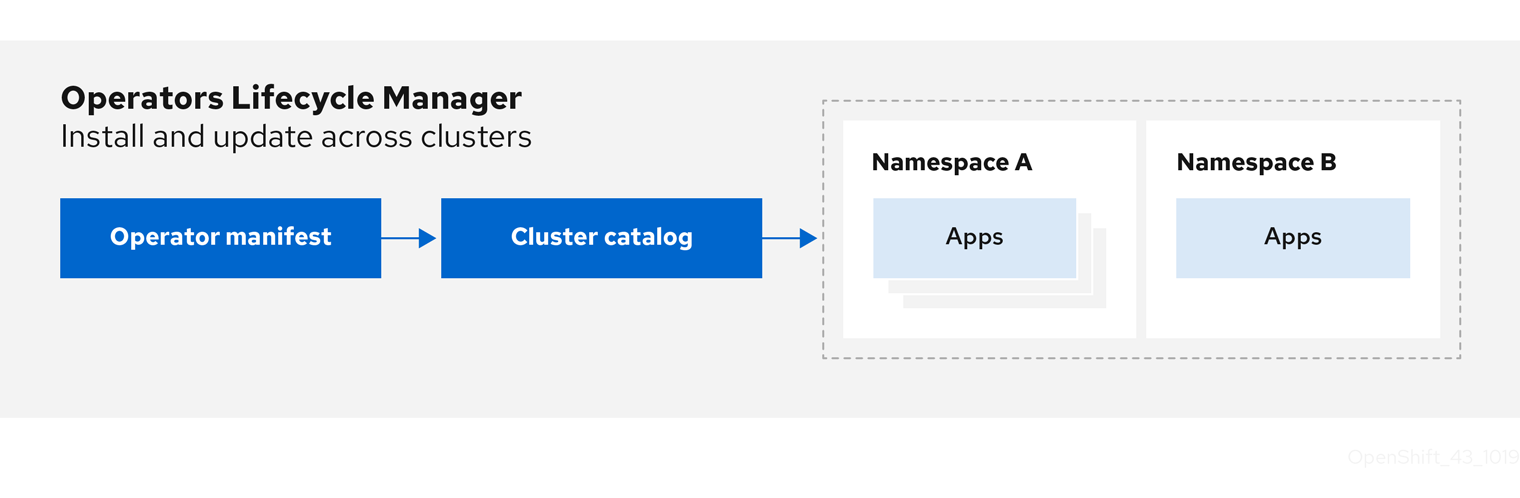

2.4.1.1. Qu'est-ce que l'Operator Lifecycle Manager ?

Operator Lifecycle Manager (OLM) aide les utilisateurs à installer, mettre à jour et gérer le cycle de vie des applications natives Kubernetes (Operators) et de leurs services associés s'exécutant sur leurs clusters OpenShift Container Platform. Il fait partie de l'Operator Framework, une boîte à outils open source conçue pour gérer les opérateurs de manière efficace, automatisée et évolutive.

Figure 2.2. Flux de travail du gestionnaire du cycle de vie de l'opérateur

OLM fonctionne par défaut dans OpenShift Container Platform 4.12, ce qui aide les administrateurs de clusters à installer, mettre à niveau et accorder l'accès aux opérateurs fonctionnant sur leur cluster. La console web d'OpenShift Container Platform fournit des écrans de gestion permettant aux administrateurs de cluster d'installer des opérateurs, ainsi que d'accorder à des projets spécifiques l'accès à l'utilisation du catalogue d'opérateurs disponibles sur le cluster.

Pour les développeurs, une expérience en libre-service permet de provisionner et de configurer des instances de bases de données, de surveillance et de services de big data sans avoir à être des experts en la matière, car l'opérateur dispose de ces connaissances.

2.4.1.2. Ressources OLM

Les définitions de ressources personnalisées (CRD) suivantes sont définies et gérées par Operator Lifecycle Manager (OLM) :

| Ressources | Nom court | Description |

|---|---|---|

|

|

| Métadonnées de l'application. Par exemple : nom, version, icône, ressources nécessaires. |

|

|

| Un référentiel de CSV, CRD et paquets qui définissent une application. |

|

|

| Maintient les CSV à jour en suivant un canal dans un paquet. |

|

|

| Liste calculée des ressources à créer pour installer ou mettre à jour automatiquement un CSV. |

|

|

|

Configure tous les opérateurs déployés dans le même espace de noms que l'objet |

|

| - |

Crée un canal de communication entre OLM et un opérateur qu'il gère. Les opérateurs peuvent écrire dans le tableau |

2.4.1.2.1. Version du service de cluster

Un cluster service version (CSV) représente une version spécifique d'un Operator en cours d'exécution sur un cluster OpenShift Container Platform. Il s'agit d'un manifeste YAML créé à partir des métadonnées de l'opérateur qui aide Operator Lifecycle Manager (OLM) à exécuter l'opérateur dans le cluster.

OLM a besoin de ces métadonnées sur un opérateur pour s'assurer qu'il peut être exécuté en toute sécurité sur un cluster et pour fournir des informations sur la manière dont les mises à jour doivent être appliquées lorsque de nouvelles versions de l'opérateur sont publiées. Cela ressemble à l'empaquetage d'un logiciel pour un système d'exploitation traditionnel ; considérez l'étape d'empaquetage pour OLM comme l'étape à laquelle vous créez votre paquet rpm, deb, ou apk.

Un CSV comprend les métadonnées qui accompagnent l'image d'un conteneur d'opérateur, utilisées pour remplir les interfaces utilisateur avec des informations telles que le nom, la version, la description, les étiquettes, le lien vers le référentiel et le logo.

Un CSV est également une source d'informations techniques nécessaires à l'exécution de l'opérateur, telles que les ressources personnalisées (CR) qu'il gère ou dont il dépend, les règles RBAC, les exigences du cluster et les stratégies d'installation. Ces informations indiquent à OLM comment créer les ressources requises et configurer l'opérateur en tant que déploiement.

2.4.1.2.2. Source du catalogue

Un site catalog source représente un magasin de métadonnées, généralement en faisant référence à un site index image stocké dans un registre de conteneurs. Operator Lifecycle Manager (OLM) interroge les sources du catalogue pour découvrir et installer les opérateurs et leurs dépendances. OperatorHub dans la console web d'OpenShift Container Platform affiche également les opérateurs fournis par les sources du catalogue.

Les administrateurs de cluster peuvent consulter la liste complète des opérateurs fournis par une source de catalogue activée sur un cluster en utilisant la page Administration → Cluster Settings → Configuration → OperatorHub de la console web.

Le site spec d'un objet CatalogSource indique comment construire un pod ou comment communiquer avec un service qui sert l'API gRPC du registre des opérateurs.

Exemple 2.8. Exemple d'objet CatalogSource

- 1

- Nom de l'objet

CatalogSource. Cette valeur est également utilisée comme partie du nom du pod connexe qui est créé dans l'espace de noms demandé. - 2

- Espace de noms dans lequel créer le catalogue. Pour rendre le catalogue disponible à l'échelle du cluster dans tous les espaces de noms, définissez cette valeur sur

openshift-marketplace. Les sources de catalogues fournies par Red Hat par défaut utilisent également l'espace de nomsopenshift-marketplace. Sinon, définissez la valeur sur un espace de noms spécifique pour que l'opérateur ne soit disponible que dans cet espace de noms. - 3

- Facultatif : Pour éviter que les mises à niveau de clusters ne laissent les installations Operator dans un état non pris en charge ou sans chemin de mise à jour continu, vous pouvez activer le changement automatique de la version de l'image d'index de votre catalogue Operator dans le cadre des mises à niveau de clusters.

Définissez l'annotation

olm.catalogImageTemplateavec le nom de votre image d'index et utilisez une ou plusieurs variables de version du cluster Kubernetes comme indiqué lors de la construction du modèle pour la balise d'image. L'annotation remplace le champspec.imageau moment de l'exécution. Voir la section "Modèle d'image pour les sources de catalogue personnalisées" pour plus de détails. - 4

- Nom d'affichage du catalogue dans la console web et la CLI.

- 5

- Image d'index pour le catalogue. En option, peut être omis lors de l'utilisation de l'annotation

olm.catalogImageTemplate, qui définit la spécification d'extraction au moment de l'exécution. - 6

- Poids de la source du catalogue. OLM utilise ce poids pour établir des priorités lors de la résolution des dépendances. Un poids élevé indique que le catalogue est préféré aux catalogues de poids inférieur.

- 7

- Les types de sources sont les suivants :

-

grpcavec une référenceimage: OLM extrait l'image et exécute le pod, qui est censé servir une API conforme. -

grpcavec un champaddress: OLM tente de contacter l'API gRPC à l'adresse indiquée. Ce champ ne doit pas être utilisé dans la plupart des cas. -

configmap: OLM analyse les données de la carte de configuration et exécute un pod qui peut servir l'API gRPC.

-

- 8

- Spécifiez la valeur de

legacyourestricted. Si le champ n'est pas défini, la valeur par défaut estlegacy. Dans une prochaine version d'OpenShift Container Platform, il est prévu que la valeur par défaut soitrestricted. Si votre catalogue ne peut pas s'exécuter avec les autorisationsrestricted, il est recommandé de définir manuellement ce champ surlegacy. - 9

- Facultatif : Pour les sources de catalogue de type

grpc, remplace le sélecteur de nœud par défaut pour le pod qui sert le contenu dansspec.image, s'il est défini. - 10

- Facultatif : Pour les sources de catalogue de type

grpc, remplace le nom de la classe de priorité par défaut pour le pod qui sert le contenu dansspec.image, s'il est défini. Kubernetes fournit les classes de prioritésystem-cluster-criticaletsystem-node-criticalpar défaut. La définition d'un champ vide ("") attribue au pod la priorité par défaut. D'autres classes de priorité peuvent être définies manuellement. - 11

- Facultatif : Pour les sources de catalogue de type

grpc, remplace les tolérances par défaut pour le pod servant le contenu dansspec.image, si elles sont définies. - 12

- Vérifier automatiquement la présence de nouvelles versions à un intervalle donné pour rester à jour.

- 13

- Dernier état observé de la connexion au catalogue. Par exemple :

-

READY: Une connexion est établie avec succès. -

CONNECTING: Une connexion tente de s'établir. -

TRANSIENT_FAILURE: Un problème temporaire s'est produit lors de la tentative d'établissement d'une connexion, tel qu'un dépassement de délai. L'état repassera éventuellement àCONNECTINGet la tentative recommencera.

Pour plus de détails, voir la section États de connectivité dans la documentation gRPC.

-

- 14

- Dernière heure à laquelle le registre du conteneur stockant l'image du catalogue a été interrogé pour s'assurer que l'image est à jour.

- 15

- Informations sur l'état du service de registre des opérateurs du catalogue.

La référence à name d'un objet CatalogSource dans un abonnement indique à OLM où rechercher l'opérateur demandé :

Exemple 2.9. Exemple Subscription objet référençant une source de catalogue

2.4.1.2.2.1. Modèle d'image pour les sources de catalogue personnalisées

La compatibilité de l'opérateur avec le cluster sous-jacent peut être exprimée par une source de catalogue de différentes manières. L'une d'entre elles, utilisée pour les sources de catalogue fournies par défaut par Red Hat, consiste à identifier des balises d'image pour les images d'index qui sont spécifiquement créées pour une version de plateforme particulière, par exemple OpenShift Container Platform 4.12.

Au cours d'une mise à niveau de cluster, la balise d'image d'index pour les sources de catalogue par défaut fournies par Red Hat est mise à jour automatiquement par l'opérateur de version de cluster (CVO) afin que Operator Lifecycle Manager (OLM) tire la version mise à jour du catalogue. Par exemple, lors d'une mise à niveau d'OpenShift Container Platform 4.11 à 4.12, le champ spec.image dans l'objet CatalogSource pour le catalogue redhat-operators est mis à jour de :

registry.redhat.io/redhat/redhat-operator-index:v4.11

registry.redhat.io/redhat/redhat-operator-index:v4.11à :

registry.redhat.io/redhat/redhat-operator-index:v4.12

registry.redhat.io/redhat/redhat-operator-index:v4.12Cependant, l'OVC ne met pas automatiquement à jour les balises d'image pour les catalogues personnalisés. Pour s'assurer que les utilisateurs disposent d'une installation d'Operator compatible et prise en charge après une mise à niveau du cluster, les catalogues personnalisés doivent également être mis à jour pour faire référence à une image d'index mise à jour.

À partir d'OpenShift Container Platform 4.9, les administrateurs de clusters peuvent ajouter l'annotation olm.catalogImageTemplate dans l'objet CatalogSource pour les catalogues personnalisés à une référence d'image qui inclut un modèle. Les variables de version Kubernetes suivantes sont prises en charge pour une utilisation dans le modèle :

-

kube_major_version -

kube_minor_version -

kube_patch_version

Vous devez spécifier la version du cluster Kubernetes et non celle du cluster OpenShift Container Platform, car cette dernière n'est actuellement pas disponible pour le templating.

À condition d'avoir créé et poussé une image d'index avec une balise spécifiant la version Kubernetes mise à jour, la définition de cette annotation permet de modifier automatiquement les versions de l'image d'index dans les catalogues personnalisés après une mise à niveau du cluster. La valeur de l'annotation est utilisée pour définir ou mettre à jour la référence de l'image dans le champ spec.image de l'objet CatalogSource. Cela permet d'éviter que les mises à niveau de cluster ne laissent les installations d'opérateurs dans des états non pris en charge ou sans chemin de mise à jour continu.

Vous devez vous assurer que l'image d'index avec la balise mise à jour, quel que soit le registre dans lequel elle est stockée, est accessible par le cluster au moment de la mise à niveau du cluster.

Exemple 2.10. Exemple de source de catalogue avec un modèle d'image

Si le champ spec.image et l'annotation olm.catalogImageTemplate sont tous deux définis, le champ spec.image est remplacé par la valeur résolue de l'annotation. Si l'annotation n'aboutit pas à une spécification d'extraction utilisable, la source du catalogue revient à la valeur définie pour spec.image.

Si le champ spec.image n'est pas défini et que l'annotation ne se résout pas en une spécification d'extraction utilisable, OLM interrompt le rapprochement de la source du catalogue et la place dans une condition d'erreur lisible par l'homme.

Pour un cluster OpenShift Container Platform 4.12, qui utilise Kubernetes 1.25, l'annotation olm.catalogImageTemplate dans l'exemple précédent se résout à la référence d'image suivante :

quay.io/example-org/example-catalog:v1.25

quay.io/example-org/example-catalog:v1.25

Pour les futures versions d'OpenShift Container Platform, vous pouvez créer des images d'index mises à jour pour vos catalogues personnalisés qui ciblent la version Kubernetes ultérieure utilisée par la version ultérieure d'OpenShift Container Platform. Avec l'annotation olm.catalogImageTemplate définie avant la mise à niveau, la mise à niveau du cluster vers la version ultérieure d'OpenShift Container Platform mettrait automatiquement à jour l'image d'index du catalogue.

2.4.1.2.3. Abonnement

Un subscription, défini par un objet Subscription, représente l'intention d'installer un opérateur. C'est la ressource personnalisée qui relie un opérateur à une source de catalogue.

Les abonnements décrivent le canal d'un paquetage d'opérateur auquel il faut s'abonner et s'il faut effectuer les mises à jour automatiquement ou manuellement. S'il est défini sur automatique, l'abonnement permet à Operator Lifecycle Manager (OLM) de gérer et de mettre à jour l'opérateur afin de garantir que la dernière version est toujours en cours d'exécution dans le cluster.

Exemple d'objet Subscription

Cet objet Subscription définit le nom et l'espace de noms de l'opérateur, ainsi que le catalogue dans lequel les données de l'opérateur peuvent être trouvées. Le canal, tel que alpha, beta, ou stable, permet de déterminer quel flux d'opérateur doit être installé à partir de la source du catalogue.

Les noms des canaux dans un abonnement peuvent varier d'un opérateur à l'autre, mais le système de dénomination doit suivre une convention commune au sein d'un opérateur donné. Par exemple, les noms des canaux peuvent suivre un flux de mises à jour de versions mineures pour l'application fournie par l'opérateur (1.2, 1.3) ou une fréquence de publication (stable, fast).

En plus d'être facilement visible depuis la console web d'OpenShift Container Platform, il est possible d'identifier la disponibilité d'une version plus récente d'un Operator en inspectant l'état de l'abonnement correspondant. La valeur associée au champ currentCSV est la version la plus récente connue par OLM, et installedCSV est la version installée sur le cluster.

2.4.1.2.4. Plan d'installation

Un install plan, défini par un objet InstallPlan, décrit un ensemble de ressources que Operator Lifecycle Manager (OLM) crée pour installer ou mettre à niveau une version spécifique d'un opérateur. La version est définie par une version de service de cluster (CSV).

Pour installer un opérateur, un administrateur de cluster ou un utilisateur ayant reçu des autorisations d'installation d'opérateur doit d'abord créer un objet Subscription. Un abonnement représente l'intention de s'abonner à un flux de versions disponibles d'un opérateur à partir d'une source de catalogue. L'abonnement crée ensuite un objet InstallPlan pour faciliter l'installation des ressources de l'opérateur.

Le plan d'installation doit ensuite être approuvé selon l'une des stratégies d'approbation suivantes :

-

Si le champ

spec.installPlanApprovalde l'abonnement est défini surAutomatic, le plan d'installation est approuvé automatiquement. -

Si le champ

spec.installPlanApprovalde l'abonnement est défini surManual, le plan d'installation doit être approuvé manuellement par un administrateur de cluster ou un utilisateur disposant des autorisations appropriées.

Une fois le plan d'installation approuvé, OLM crée les ressources spécifiées et installe l'opérateur dans l'espace de noms spécifié par l'abonnement.

Exemple 2.11. Exemple d'objet InstallPlan

2.4.1.2.5. Groupes d'opérateurs

Un site Operator group, défini par la ressource OperatorGroup, fournit une configuration multitenant aux opérateurs installés dans OLM. Un groupe d'opérateurs sélectionne des espaces de noms cibles dans lesquels générer l'accès RBAC requis pour les opérateurs qui en font partie.

L'ensemble des espaces de noms cibles est fourni par une chaîne délimitée par des virgules, stockée dans l'annotation olm.targetNamespaces d'une version de service de cluster (CSV). Cette annotation est appliquée aux instances CSV des opérateurs membres et est projetée dans leurs déploiements.

Ressources supplémentaires

2.4.1.2.6. Conditions de l'opérateur

Dans le cadre de son rôle de gestion du cycle de vie d'un opérateur, Operator Lifecycle Manager (OLM) déduit l'état d'un opérateur à partir de l'état des ressources Kubernetes qui définissent l'opérateur. Bien que cette approche fournisse un certain niveau d'assurance qu'un opérateur est dans un état donné, il y a de nombreux cas où un opérateur peut avoir besoin de communiquer des informations à OLM qui ne pourraient pas être déduites autrement. Ces informations peuvent alors être utilisées par OLM pour mieux gérer le cycle de vie de l'opérateur.

OLM fournit une définition de ressource personnalisée (CRD) appelée OperatorCondition qui permet aux opérateurs de communiquer des conditions à OLM. Il existe un ensemble de conditions prises en charge qui influencent la gestion de l'opérateur par OLM lorsqu'elles sont présentes dans le tableau Spec.Conditions d'une ressource OperatorCondition.

Par défaut, le tableau Spec.Conditions n'est pas présent dans un objet OperatorCondition jusqu'à ce qu'il soit ajouté par un utilisateur ou à la suite d'une logique d'opérateur personnalisée.

2.4.2. Architecture du gestionnaire du cycle de vie de l'opérateur

Ce guide présente l'architecture des composants de Operator Lifecycle Manager (OLM) dans OpenShift Container Platform.

2.4.2.1. Responsabilités des composantes

Le gestionnaire du cycle de vie des opérateurs (OLM) est composé de deux opérateurs : l'opérateur OLM et l'opérateur de catalogue.

Chacun de ces opérateurs est responsable de la gestion des définitions de ressources personnalisées (CRD) qui constituent la base du cadre OLM :

| Ressources | Nom court | Propriétaire | Description |

|---|---|---|---|

|

|

| OLM | Métadonnées de l'application : nom, version, icône, ressources nécessaires, installation, etc. |

|

|

| Catalogue | Liste calculée des ressources à créer pour installer ou mettre à jour automatiquement un CSV. |

|

|

| Catalogue | Un référentiel de CSV, CRD et paquets qui définissent une application. |

|

|

| Catalogue | Utilisé pour maintenir les CSV à jour en suivant un canal dans un paquet. |

|

|

| OLM |

Configure tous les opérateurs déployés dans le même espace de noms que l'objet |

Chacun de ces opérateurs est également responsable de la création des ressources suivantes :

| Ressources | Propriétaire |

|---|---|

|

| OLM |

|

| |

|

| |

|

| |

|

| Catalogue |

|

|

2.4.2.2. Opérateur OLM

L'opérateur OLM est chargé de déployer les applications définies par les ressources CSV une fois que les ressources requises spécifiées dans le CSV sont présentes dans le cluster.

L'opérateur OLM ne s'occupe pas de la création des ressources nécessaires ; vous pouvez choisir de créer manuellement ces ressources à l'aide du CLI ou de l'opérateur de catalogue. Cette séparation des préoccupations permet aux utilisateurs de s'approprier progressivement la partie du cadre OLM qu'ils choisissent d'exploiter pour leur application.

L'opérateur OLM utilise le flux de travail suivant :

- Surveillez les versions de service de cluster (CSV) dans un espace de noms et vérifiez que les exigences sont respectées.

Si les conditions sont remplies, exécutez la stratégie d'installation pour le CSV.

NoteUn CSV doit être un membre actif d'un groupe d'opérateurs pour que la stratégie d'installation s'exécute.

2.4.2.3. Opérateur de catalogue

L'opérateur de catalogue est responsable de la résolution et de l'installation des versions de service de cluster (CSV) et des ressources requises qu'elles spécifient. Il est également chargé de surveiller les sources du catalogue pour détecter les mises à jour des paquets dans les canaux et de les mettre à niveau, automatiquement si nécessaire, vers les dernières versions disponibles.

Pour suivre un paquet dans un canal, vous pouvez créer un objet Subscription configurant le paquet souhaité, le canal et l'objet CatalogSource que vous souhaitez utiliser pour extraire les mises à jour. Lorsque des mises à jour sont trouvées, un objet InstallPlan approprié est écrit dans l'espace de noms au nom de l'utilisateur.

L'opérateur de catalogue utilise le flux de travail suivant :

- Connectez-vous à chaque source de catalogue dans le cluster.

Rechercher les plans d'installation non résolus créés par un utilisateur et, le cas échéant, les trouver :

- Rechercher le fichier CSV correspondant au nom demandé et l'ajouter en tant que ressource résolue.

- Pour chaque CRD géré ou requis, ajouter le CRD en tant que ressource résolue.

- Pour chaque CRD requis, trouvez le CSV qui le gère.

- Surveillez les plans d'installation résolus et créez toutes les ressources découvertes, si elles ont été approuvées par un utilisateur ou automatiquement.

- Surveillez les sources et les abonnements du catalogue et créez des plans d'installation basés sur ces sources et abonnements.

2.4.2.4. Registre du catalogue

Le registre de catalogue stocke les CSV et les CRD pour la création dans un cluster et stocke les métadonnées sur les paquets et les canaux.

Un site package manifest est une entrée dans le registre du catalogue qui associe une identité de paquet à des ensembles de CSV. Au sein d'un paquet, les canaux pointent vers un CSV particulier. Comme les CSV font explicitement référence au CSV qu'ils remplacent, un manifeste de paquet fournit à l'opérateur de catalogue toutes les informations nécessaires pour mettre à jour un CSV vers la dernière version d'un canal, en passant par chaque version intermédiaire.

2.4.3. Flux de travail du gestionnaire du cycle de vie de l'opérateur

Ce guide décrit le flux de travail de l'Operator Lifecycle Manager (OLM) dans OpenShift Container Platform.

2.4.3.1. Processus d'installation et de mise à niveau de l'opérateur dans OLM

Dans l'écosystème du gestionnaire du cycle de vie des opérateurs (OLM), les ressources suivantes sont utilisées pour résoudre les problèmes d'installation et de mise à niveau des opérateurs :

-

ClusterServiceVersion(CSV) -

CatalogSource -

Subscription

Les métadonnées des opérateurs, définies dans des fichiers CSV, peuvent être stockées dans une collection appelée source de catalogue. OLM utilise les sources du catalogue, qui utilisent l'API du registre des opérateurs, pour rechercher les opérateurs disponibles ainsi que les mises à niveau des opérateurs installés.

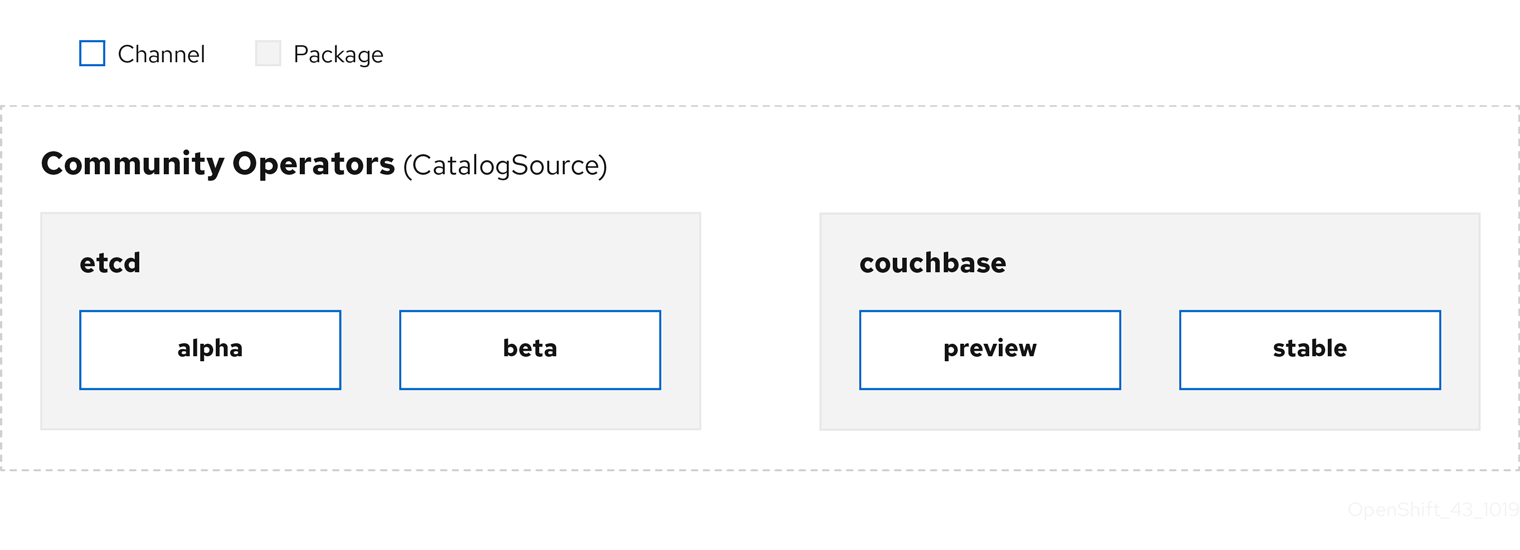

Figure 2.3. Vue d'ensemble des sources du catalogue

Au sein d'un catalogue source, les opérateurs sont organisés en packages et en flux de mises à jour appelés channels, ce qui devrait être un modèle de mise à jour familier d'OpenShift Container Platform ou d'autres logiciels à cycle de publication continu tels que les navigateurs Web.

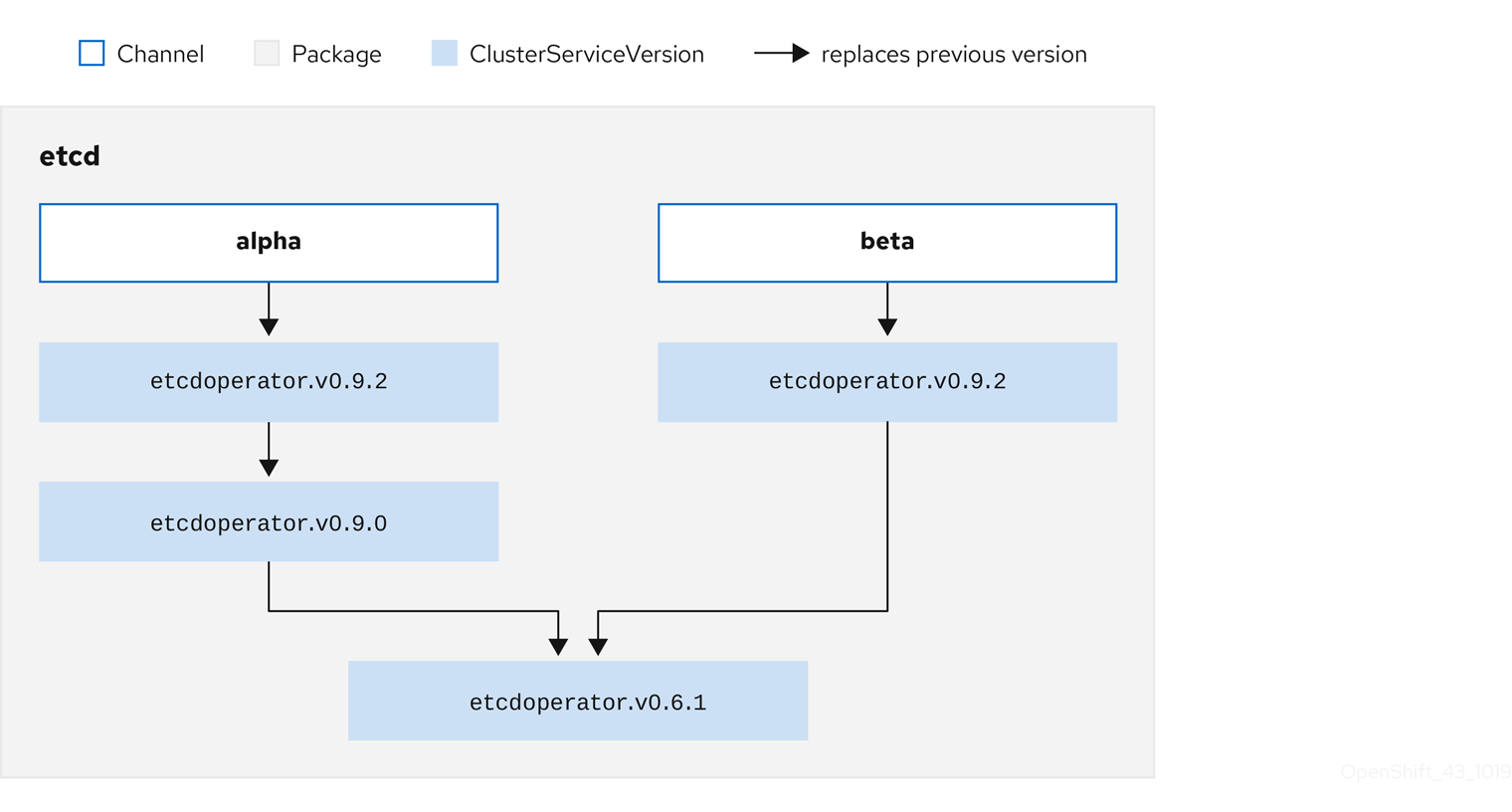

Figure 2.4. Paquets et chaînes dans un catalogue source

Un utilisateur indique un paquet et un canal particuliers dans une source de catalogue particulière dans un subscription, par exemple un paquet etcd et son canal alpha. Si un abonnement est souscrit pour un paquet qui n'a pas encore été installé dans l'espace de nommage, le dernier opérateur pour ce paquet est installé.

OLM évite délibérément les comparaisons de versions, de sorte que l'opérateur "latest" ou "newest" disponible sur un chemin donné catalog → channel → package ne doit pas nécessairement être le numéro de version le plus élevé. Il doit plutôt être considéré comme la référence head d'un canal, à l'instar d'un dépôt Git.

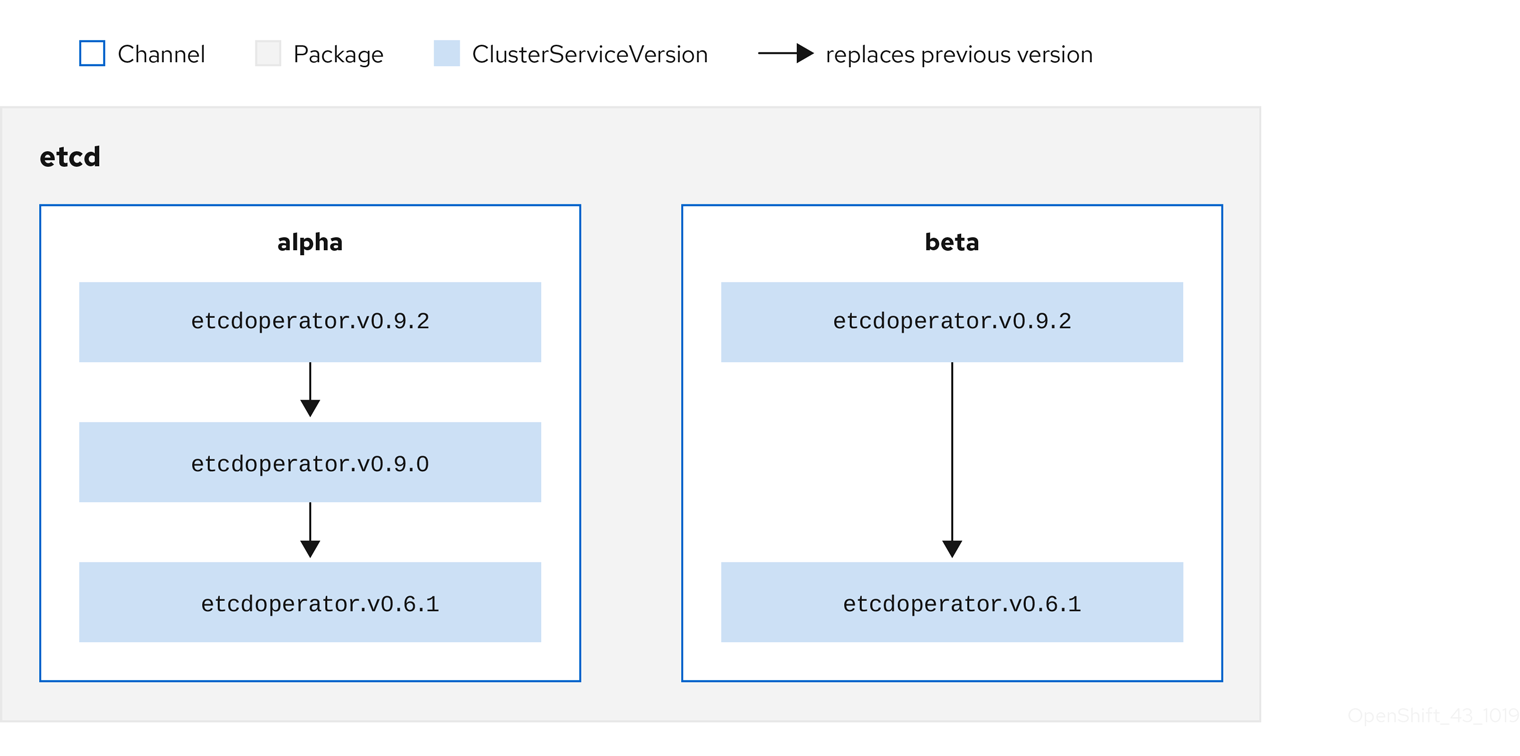

Chaque CSV a un paramètre replaces qui indique l'opérateur qu'il remplace. Il en résulte un graphe de CSV qui peut être interrogé par OLM et dont les mises à jour peuvent être partagées entre les canaux. Les canaux peuvent être considérés comme des points d'entrée dans le graphe des mises à jour :

Figure 2.5. Graphique OLM des mises à jour des canaux disponibles

Exemples de chaînes dans un paquet

Pour qu'OLM puisse demander avec succès des mises à jour, compte tenu d'une source de catalogue, d'un paquet, d'un canal et d'un CSV, un catalogue doit pouvoir renvoyer, sans ambiguïté et de manière déterministe, un CSV unique qui replaces le CSV d'entrée.

2.4.3.1.1. Exemple de chemin de mise à niveau

Pour un exemple de scénario de mise à niveau, considérons un opérateur installé correspondant à la version CSV 0.1.1. OLM interroge la source du catalogue et détecte une mise à niveau dans le canal souscrit avec la nouvelle version CSV 0.1.3 qui remplace une version CSV plus ancienne mais non installée 0.1.2, qui à son tour remplace la version CSV plus ancienne et installée 0.1.1.

OLM remonte de la tête de réseau aux versions précédentes via le champ replaces spécifié dans les CSV pour déterminer le chemin de mise à niveau 0.1.3 → 0.1.2 → 0.1.1; le sens de la flèche indique que la première version remplace la seconde. OLM met à niveau l'opérateur une version à la fois jusqu'à ce qu'il atteigne la tête de canal.

Pour ce scénario, OLM installe la version de l'opérateur 0.1.2 pour remplacer la version existante de l'opérateur 0.1.1. Ensuite, il installe la version de l'opérateur 0.1.3 pour remplacer la version de l'opérateur 0.1.2 précédemment installée. À ce stade, la version de l'opérateur installée 0.1.3 correspond à la tête de canal et la mise à niveau est terminée.

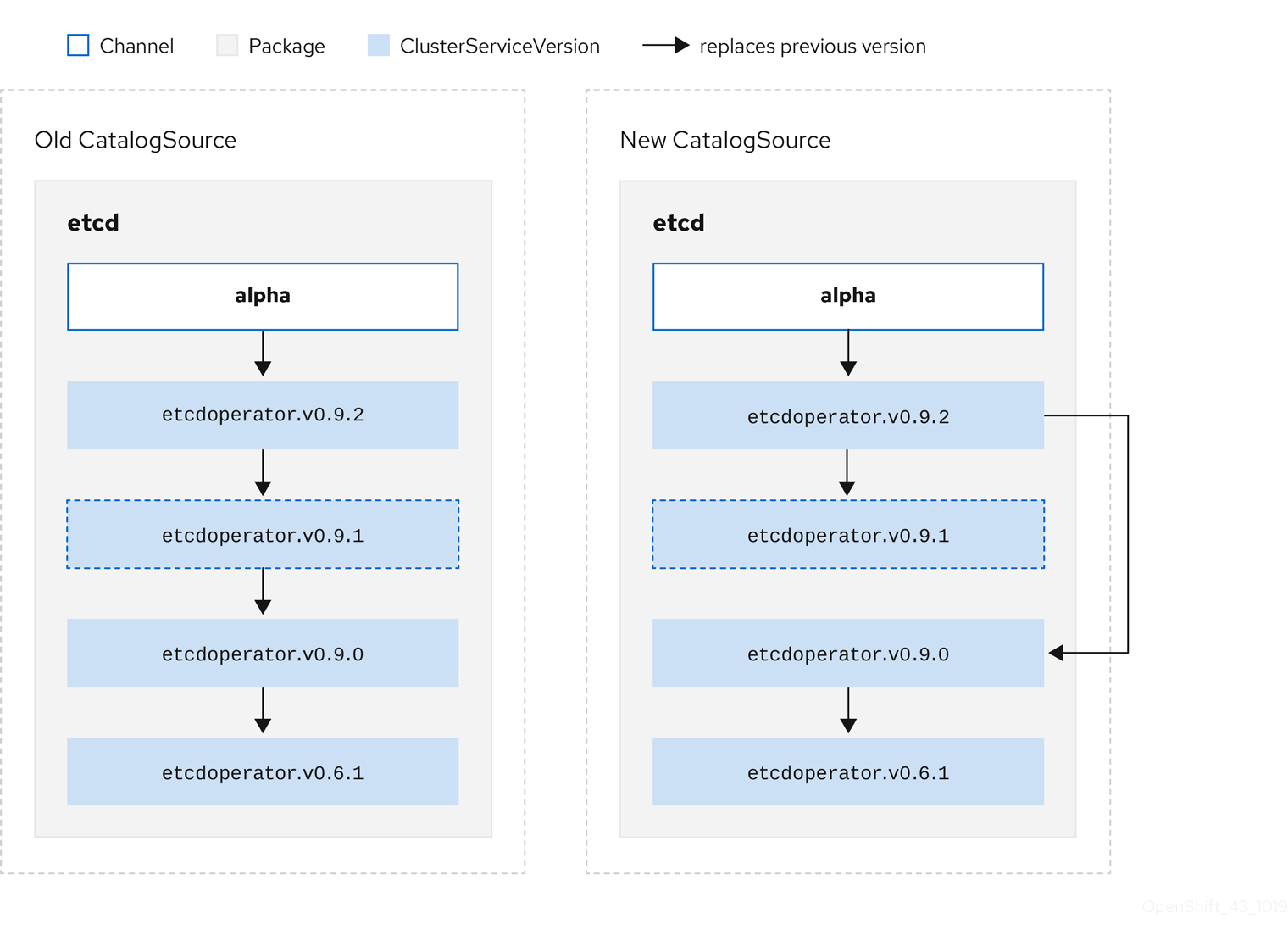

2.4.3.1.2. Sauter des mises à niveau

Le chemin de base pour les mises à niveau dans OLM est le suivant :

- Une source de catalogue est mise à jour avec une ou plusieurs mises à jour d'un opérateur.

- OLM parcourt toutes les versions de l'opérateur jusqu'à la dernière version que contient la source du catalogue.

Cependant, il arrive que cette opération ne soit pas sûre. Dans certains cas, une version publiée d'un opérateur ne doit jamais être installée sur un cluster si ce n'est pas déjà fait, par exemple parce qu'une version introduit une vulnérabilité grave.

Dans ce cas, OLM doit prendre en compte deux états de la grappe et fournir un graphique de mise à jour qui prenne en charge les deux états :

- L'opérateur intermédiaire "bad" a été vu par le cluster et installé.

- L'opérateur intermédiaire "bad" n'a pas encore été installé sur le cluster.

En envoyant un nouveau catalogue et en ajoutant une version skipped, OLM est assuré de toujours recevoir une mise à jour unique, quel que soit l'état du cluster et qu'il ait ou non déjà vu la mauvaise mise à jour.

Exemple de CSV avec la version sautée

Prenons l'exemple suivant : Old CatalogSource et New CatalogSource.

Figure 2.6. Sauter des mises à jour

Ce graphique le confirme :

- Tout opérateur trouvé dans Old CatalogSource a un seul remplaçant dans New CatalogSource.

- Tout opérateur trouvé dans New CatalogSource a un seul remplaçant dans New CatalogSource.

- Si la mauvaise mise à jour n'a pas encore été installée, elle ne le sera jamais.

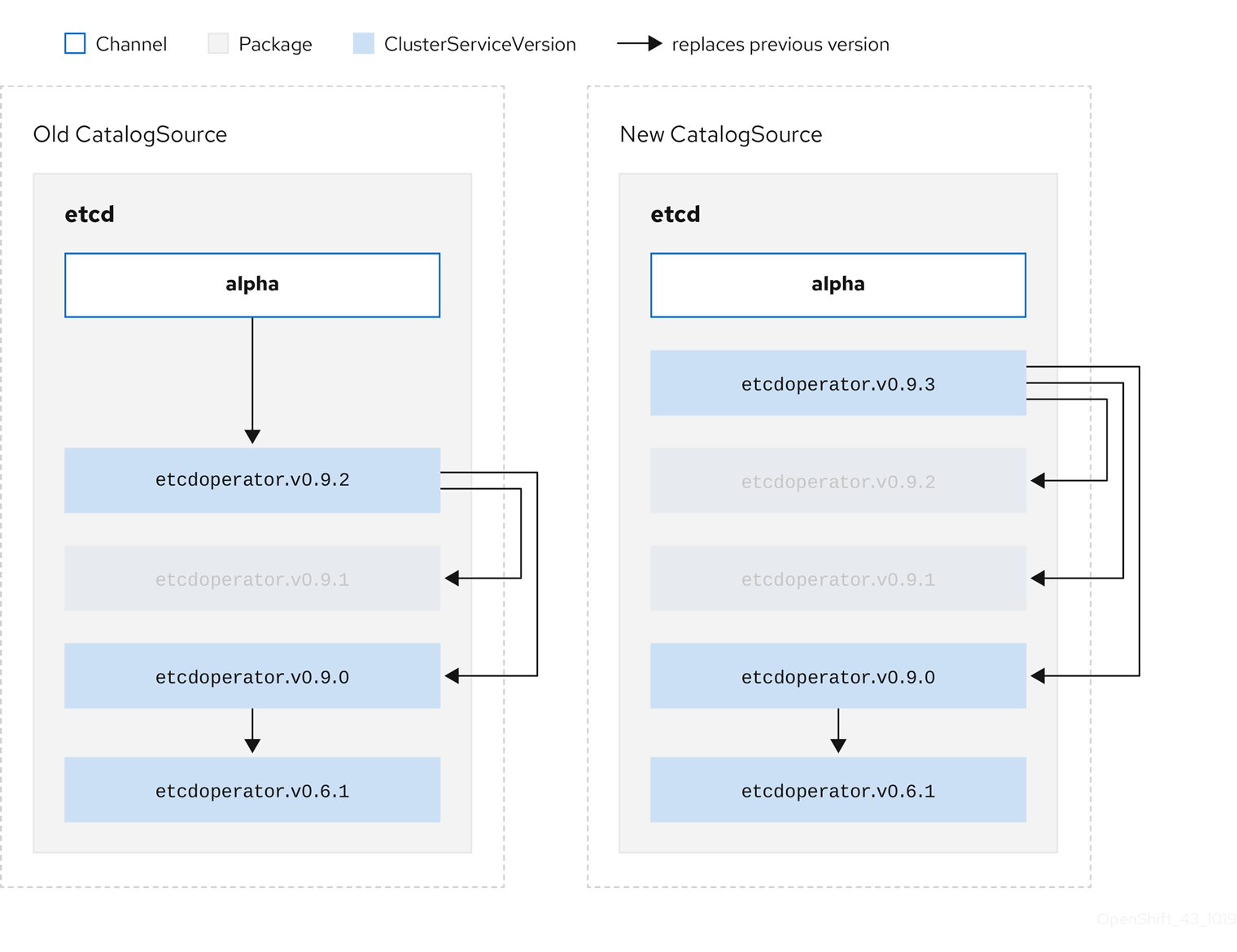

2.4.3.1.3. Remplacement de plusieurs opérateurs

La création de New CatalogSource comme décrit nécessite la publication de CSV qui replace un Opérateur, mais peut skip plusieurs. Ceci peut être réalisé en utilisant l'annotation skipRange:

olm.skipRange : <semver_range>

olm.skipRange : <semver_range>

où <semver_range> a le format de la gamme de versions supporté par la bibliothèque semver.

Lors de la recherche de mises à jour dans les catalogues, si l'en-tête d'un canal comporte une annotation skipRange et que l'opérateur actuellement installé possède un champ de version compris dans la plage, OLM effectue une mise à jour de la dernière entrée du canal.

L'ordre de priorité est le suivant :

-

Tête de chaîne dans la source spécifiée par

sourceNamesur l'abonnement, si les autres critères de saut sont remplis. -

L'opérateur suivant qui remplace l'opérateur actuel, dans la source spécifiée par

sourceName. - Tête de chaîne dans une autre source visible pour l'abonnement, si les autres critères de saut sont remplis.

- L'opérateur suivant qui remplace l'opérateur actuel dans toute source visible par l'abonnement.

Exemple de CSV avec skipRange

2.4.3.1.4. Prise en charge du flux Z

Une version z-stream, ou patch, doit remplacer toutes les versions précédentes de z-stream pour la même version mineure. OLM ne tient pas compte des versions majeures, mineures ou des correctifs, il lui suffit de construire le graphique correct dans un catalogue.

En d'autres termes, OLM doit être capable de prendre un graphique comme dans Old CatalogSource et, comme précédemment, de générer un graphique comme dans New CatalogSource:

Figure 2.7. Remplacement de plusieurs opérateurs

Ce graphique le confirme :

- Tout opérateur trouvé dans Old CatalogSource a un seul remplaçant dans New CatalogSource.

- Tout opérateur trouvé dans New CatalogSource a un seul remplaçant dans New CatalogSource.

- Toute version de z-stream dans Old CatalogSource sera mise à jour avec la dernière version de z-stream dans New CatalogSource.

- Les rejets non disponibles peuvent être considérés comme des nœuds de graphe "virtuels" ; leur contenu n'a pas besoin d'exister, le registre doit simplement répondre comme si le graphe ressemblait à ceci.

2.4.4. Résolution des dépendances de l'Operator Lifecycle Manager

Ce guide présente les cycles de vie de la résolution des dépendances et de la mise à niveau des définitions de ressources personnalisées (CRD) avec Operator Lifecycle Manager (OLM) dans OpenShift Container Platform.

2.4.4.1. À propos de la résolution des dépendances

Le gestionnaire du cycle de vie des opérateurs (OLM) gère la résolution des dépendances et le cycle de vie des mises à jour des opérateurs en cours d'exécution. À bien des égards, les problèmes rencontrés par OLM sont similaires à ceux d'autres gestionnaires de paquets de systèmes ou de langues, tels que yum et rpm.