Virtualisation

Installation, utilisation et notes de version d'OpenShift Virtualization

Résumé

Chapitre 1. À propos de la virtualisation OpenShift

Découvrez les capacités d'OpenShift Virtualization et l'étendue de la prise en charge.

1.1. Ce que vous pouvez faire avec OpenShift Virtualization

OpenShift Virtualization est un module complémentaire à OpenShift Container Platform qui vous permet d'exécuter et de gérer des charges de travail de machines virtuelles en même temps que des charges de travail de conteneurs.

OpenShift Virtualization ajoute de nouveaux objets dans votre cluster OpenShift Container Platform en utilisant les ressources personnalisées de Kubernetes pour activer les tâches de virtualisation. Ces tâches comprennent :

- Création et gestion de machines virtuelles Linux et Windows

- Connexion aux machines virtuelles à l'aide d'une variété de consoles et d'outils CLI

- Importation et clonage de machines virtuelles existantes

- Gestion des contrôleurs d'interface réseau et des disques de stockage attachés aux machines virtuelles

- Migration en direct des machines virtuelles entre les nœuds

Une console web améliorée fournit un portail graphique pour gérer ces ressources virtualisées ainsi que les conteneurs et l'infrastructure du cluster OpenShift Container Platform.

OpenShift Virtualization est conçu et testé pour fonctionner correctement avec les fonctionnalités de Red Hat OpenShift Data Foundation.

Vous pouvez utiliser OpenShift Virtualization avec OVN-Kubernetes, OpenShift SDN, ou l'un des autres plugins réseau certifiés listés dans Certified OpenShift CNI Plug-ins.

Vous pouvez vérifier la conformité de votre cluster OpenShift Virtualization en installant l'opérateur de conformité et en lançant un scan avec les profils ocp4-moderate et ocp4-moderate-node. L'opérateur de conformité utilise OpenSCAP, un outil certifié par le NIST, pour analyser et appliquer les politiques de sécurité.

L'intégration d'OpenShift Virtualization avec l'opérateur de conformité est une fonctionnalité d'aperçu technologique uniquement. Les fonctionnalités de l'aperçu technologique ne sont pas prises en charge par les accords de niveau de service (SLA) de production de Red Hat et peuvent ne pas être complètes sur le plan fonctionnel. Red Hat ne recommande pas de les utiliser en production. Ces fonctionnalités offrent un accès anticipé aux fonctionnalités des produits à venir, ce qui permet aux clients de tester les fonctionnalités et de fournir un retour d'information pendant le processus de développement.

Pour plus d'informations sur la portée de l'assistance des fonctionnalités de l'aperçu technologique de Red Hat, voir Portée de l'assistance des fonctionnalités de l'aperçu technologique.

1.1.1. Version de cluster prise en charge par OpenShift Virtualization

OpenShift Virtualization 4.12 est pris en charge pour une utilisation sur les clusters OpenShift Container Platform 4.12. Pour utiliser la dernière version z-stream d'OpenShift Virtualization, vous devez d'abord passer à la dernière version d'OpenShift Container Platform.

1.2. Différences entre OpenShift et un seul nœud

Vous pouvez installer OpenShift Virtualization sur un cluster à nœud unique.

Lors du provisionnement d'un cluster OpenShift à nœud unique avec l'installateur assisté, le stockage persistant préconfiguré est déployé automatiquement.

- Dans OpenShift Virtualization 4.10 et 4.11, le HostPath Provisioner (HPP) est automatiquement installé.

- Dans OpenShift Virtualization 4.12, l'opérateur OpenShift Data Foundation Logical Volume Manager est la solution de stockage prête à l'emploi. Vous pouvez également procéder à un déploiement manuel à l'aide du HPP.

OpenShift à nœud unique ne prend pas en charge la haute disponibilité. Soyez conscient des différences de fonctionnalité suivantes par rapport à un cluster à nœuds multiples :

- Les budgets d'interruption de la production ne sont pas pris en charge.

- La migration en direct n'est pas prise en charge.

- En raison de différences dans le comportement du stockage, certains modèles de machines virtuelles sont incompatibles avec OpenShift à nœud unique. Pour assurer la compatibilité, les modèles ou les machines virtuelles qui utilisent des volumes de données ou des profils de stockage ne doivent pas avoir la stratégie d'éviction définie.

Chapitre 2. Architecture de virtualisation OpenShift

Découvrez l'architecture de virtualisation d'OpenShift.

2.1. Comment fonctionne l'architecture de virtualisation OpenShift

Après avoir installé OpenShift Virtualization, l'Operator Lifecycle Manager (OLM) déploie des pods d'opérateur pour chaque composant d'OpenShift Virtualization :

-

Calculer :

virt-operator -

Stockage :

cdi-operator -

Réseau :

cluster-network-addons-operator -

Échelle :

ssp-operator -

Templating :

tekton-tasks-operator

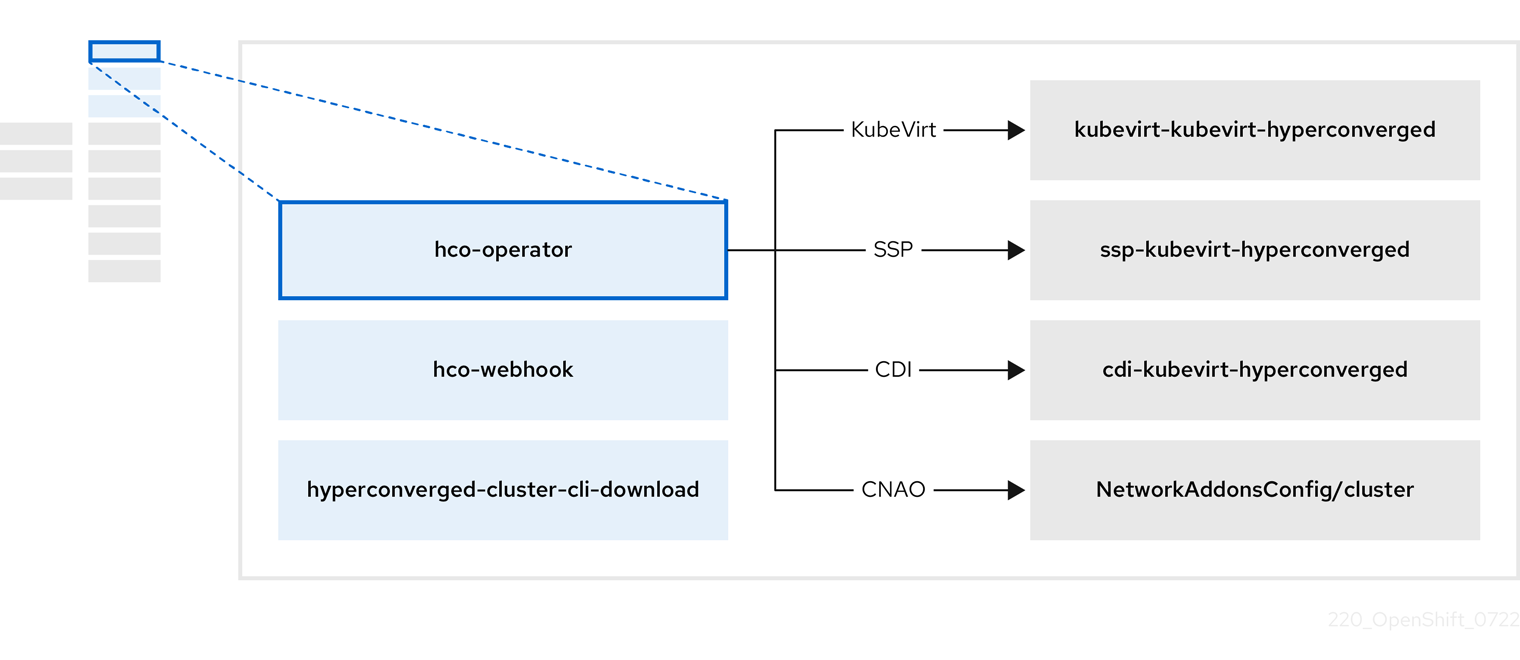

OLM déploie également le pod hyperconverged-cluster-operator, qui est responsable du déploiement, de la configuration et du cycle de vie des autres composants, ainsi que plusieurs pods d'aide : hco-webhook, et hyperconverged-cluster-cli-download.

Une fois que tous les pods opérateurs ont été déployés avec succès, vous devez créer la ressource personnalisée (CR) HyperConverged. Les configurations définies dans la CR HyperConverged servent de source unique de vérité et de point d'entrée pour OpenShift Virtualization, et guident le comportement des CR.

Le CR HyperConverged crée des CR correspondants pour les opérateurs de tous les autres composants dans sa boucle de réconciliation. Chaque opérateur crée ensuite des ressources telles que des ensembles de démons, des cartes de configuration et des composants supplémentaires pour le plan de contrôle d'OpenShift Virtualization. Par exemple, lorsque le hco-operator crée le CR KubeVirt, le virt-operator le réconcilie et crée des ressources supplémentaires telles que virt-controller, virt-handler et virt-api.

L'OLM déploie le site hostpath-provisioner-operator, mais il n'est pas fonctionnel tant que vous n'avez pas créé un CR hostpath provisioner (HPP).

2.2. À propos de l'opérateur hco

Le site hco-operator (HCO) fournit un point d'entrée unique pour déployer et gérer OpenShift Virtualization et plusieurs opérateurs d'aide avec des valeurs par défaut basées sur l'opinion. Il crée également des ressources personnalisées (CR) pour ces opérateurs.

| Component | Description |

|---|---|

|

|

Valide le contenu de la ressource personnalisée |

|

|

Fournit les binaires de l'outil |

|

| Contient tous les opérateurs, CR et objets nécessaires à OpenShift Virtualization. |

|

| Un CR du PAS. Il est automatiquement créé par le HCO. |

|

| UN CDI CR. Celui-ci est automatiquement créé par le HCO. |

|

|

Un CR qui donne des instructions et est géré par le |

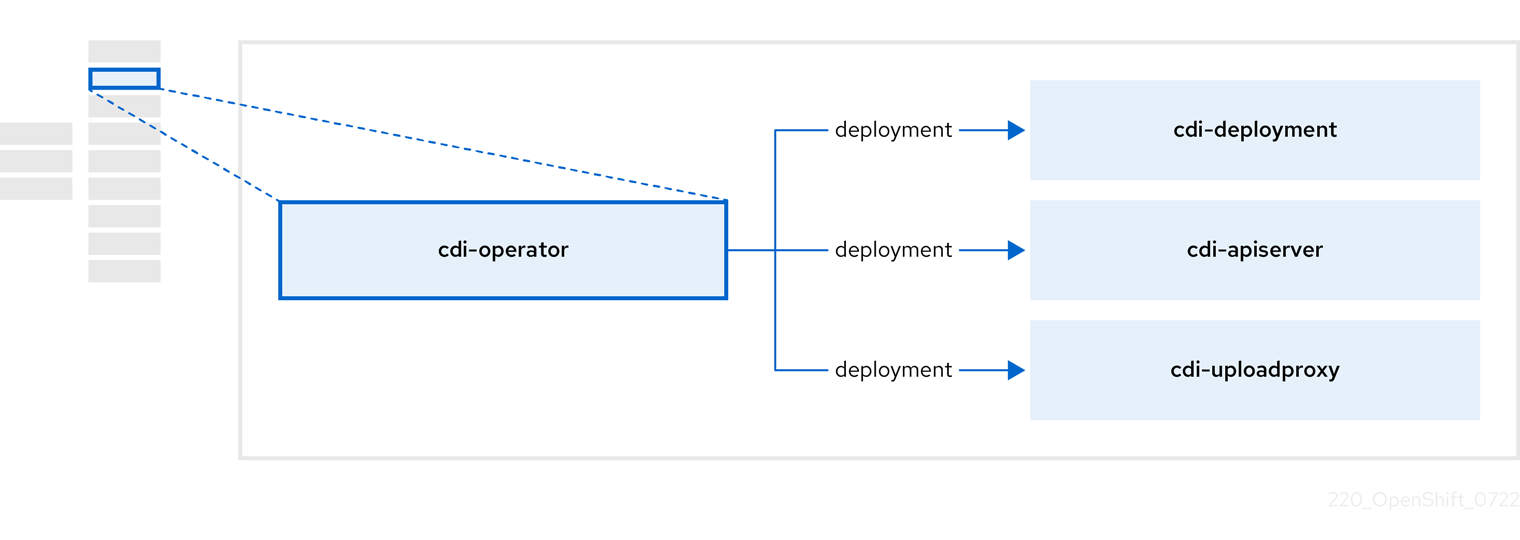

2.3. A propos du cdi-opérateur

Le site cdi-operator gère l'importateur de données conteneurisées (CDI) et ses ressources connexes, qui importent une image de machine virtuelle (VM) dans une revendication de volume persistant (PVC) à l'aide d'un volume de données.

| Component | Description |

|---|---|

|

| Gère l'autorisation de télécharger des disques VM dans des PVC en émettant des jetons de téléchargement sécurisés. |

|

| Dirige le trafic de téléchargement sur disque externe vers le pod de serveur de téléchargement approprié afin qu'il puisse être écrit sur le bon PVC. Nécessite un jeton de téléchargement valide. |

|

| Pod d'aide qui importe une image de machine virtuelle dans un PVC lors de la création d'un volume de données. |

2.4. À propos de l'opérateur cluster-network-addons-operator

Le site cluster-network-addons-operator déploie des composants réseau sur une grappe et gère les ressources correspondantes pour une fonctionnalité réseau étendue.

| Component | Description |

|---|---|

|

| Gère les certificats TLS des webhooks de Kubemacpool. |

|

| Fournit un service de mise en commun des adresses MAC pour les cartes d'interface réseau (NIC) des machines virtuelles (VM). |

|

| Marque les ponts de réseau disponibles sur les nœuds en tant que ressources de nœud. |

|

| Installe des plugins CNI sur les nœuds du cluster, permettant d'attacher des VM à des ponts Linux par le biais de définitions d'attachement au réseau. |

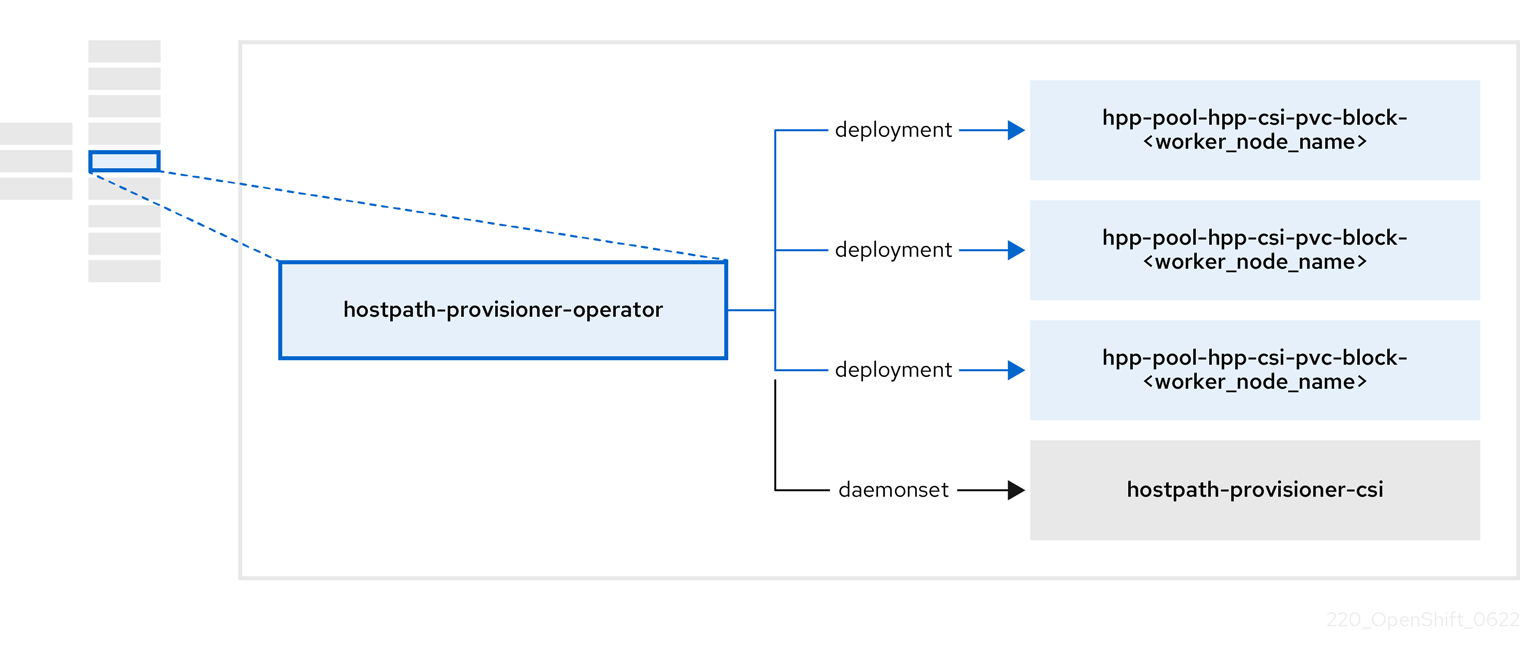

2.5. À propos de l'opérateur hostpath-provisioner-operator

Le site hostpath-provisioner-operator déploie et gère le hostpath provisioner (HPP) multi-nœuds et les ressources associées.

| Component | Description |

|---|---|

|

| Fournit un worker pour chaque nœud où le hostpath provisioner (HPP) est désigné pour s'exécuter. Les pods montent le stockage de secours spécifié sur le nœud. |

|

| Implémente l'interface du pilote de l'interface de stockage de conteneurs (CSI) du HPP. |

|

| Implémente l'interface de pilotage héritée du HPP. |

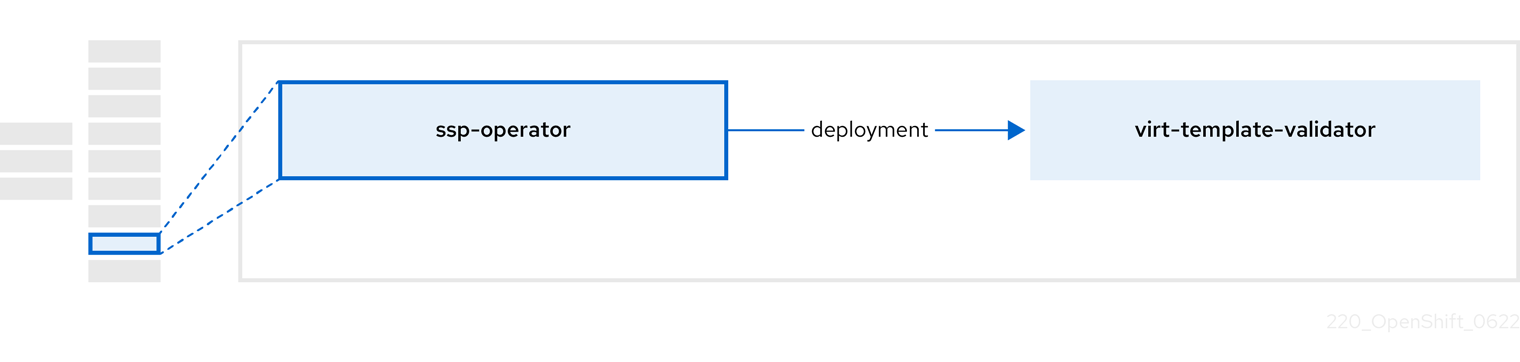

2.6. À propos de l'opérateur ssp

Le site ssp-operator déploie les modèles communs, les sources de démarrage par défaut correspondantes et le validateur de modèles.

| Component | Description |

|---|---|

|

|

Vérifie les annotations |

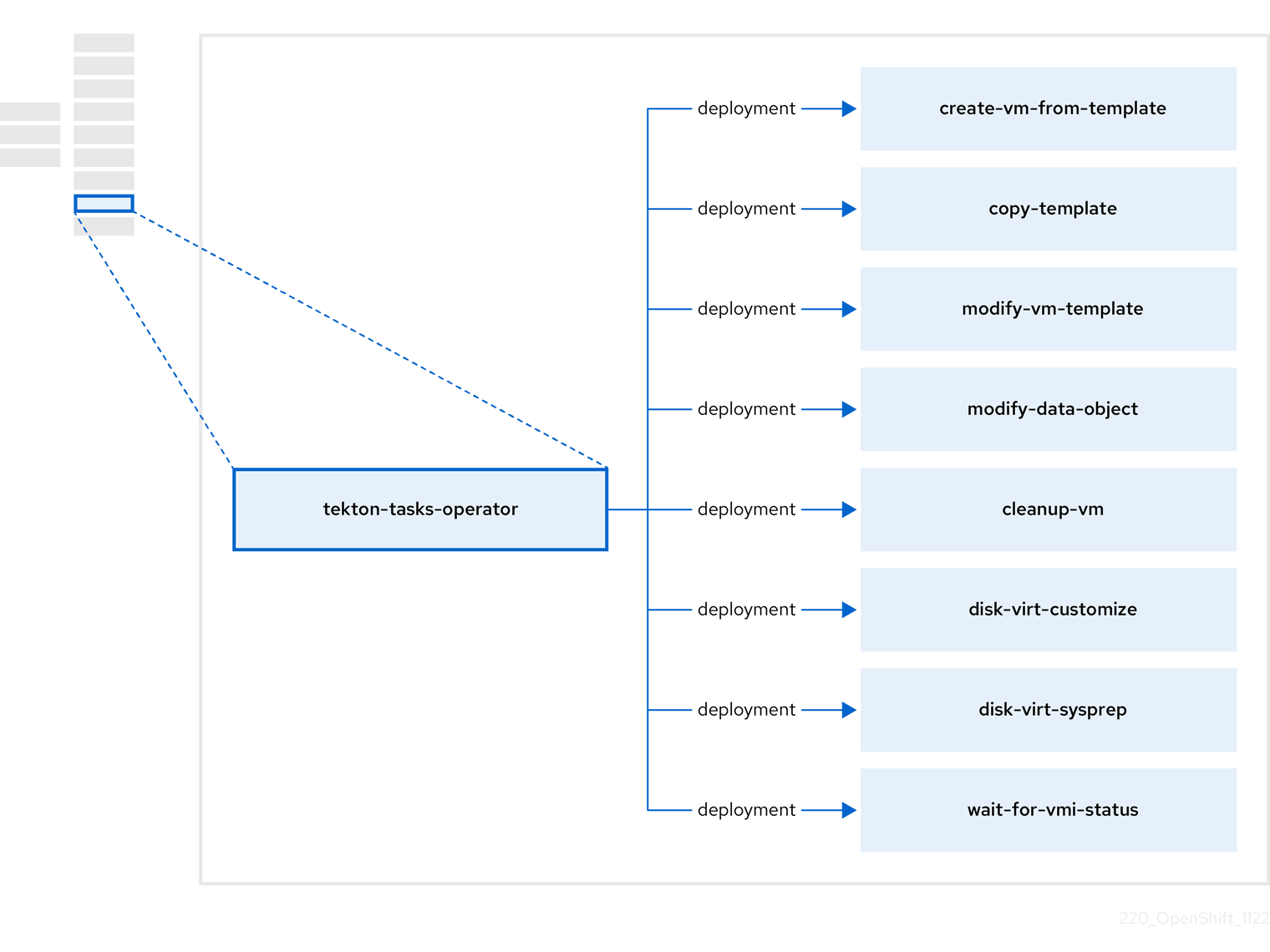

2.7. À propos de l'opérateur tekton-tasks

Le site tekton-tasks-operator déploie des exemples de pipelines montrant l'utilisation d'OpenShift Pipelines pour les VM. Il déploie également des tâches OpenShift Pipeline supplémentaires qui permettent aux utilisateurs de créer des VM à partir de modèles, de copier et de modifier des modèles, et de créer des volumes de données.

| Component | Description |

|---|---|

|

| Crée une VM à partir d'un modèle. |

|

| Copie un modèle de VM. |

|

| Crée ou supprime un modèle de VM. |

|

| Crée ou supprime des volumes de données ou des sources de données. |

|

| Exécute un script ou une commande sur une VM, puis arrête ou supprime la VM. |

|

|

Exécute un script |

|

|

Exécute un script |

|

| Attend un statut VMI spécifique, puis échoue ou réussit en fonction de ce statut. |

2.8. À propos de l'opérateur virtuel

Le site virt-operator déploie, met à niveau et gère OpenShift Virtualization sans perturber les charges de travail actuelles des machines virtuelles (VM).

| Component | Description |

|---|---|

|

| Serveur API HTTP qui sert de point d'entrée pour tous les flux liés à la virtualisation. |

|

|

Observe la création d'un nouvel objet instance VM et crée un pod correspondant. Lorsque le pod est planifié sur un nœud, |

|

|

Surveille toute modification apportée à une VM et demande à |

|

|

Contient la VM créée par l'utilisateur, telle qu'elle est mise en œuvre par |

Chapitre 3. Démarrer avec OpenShift Virtualization

Vous pouvez explorer les caractéristiques et les fonctionnalités d'OpenShift Virtualization en installant et en configurant un environnement de base.

Les procédures de configuration du cluster requièrent les privilèges de cluster-admin.

3.1. Planifier et installer OpenShift Virtualization

Planifier et installer OpenShift Virtualization sur un cluster OpenShift Container Platform :

Ressources pour la planification et l'installation

3.2. Créer et gérer des machines virtuelles

Créer des machines virtuelles (VM) en utilisant la console web :

Se connecter aux machines virtuelles :

- Connectez-vous à la console série ou à la console VNC d'une VM à l'aide de la console web.

- Se connecter à une VM en utilisant SSH.

- Connectez-vous à une VM Windows en utilisant RDP.

Gérer les machines virtuelles :

3.3. Prochaines étapes

Connectez les machines virtuelles aux réseaux secondaires :

- Connecter une VM à un réseau pont Linux.

Connecter une VM à un réseau SR-IOV.

NoteLes VM sont connectées par défaut au réseau pod. Vous devez configurer un réseau secondaire, tel qu'un pont Linux ou un SR-IOV, puis ajouter le réseau à la configuration de la VM.

- Surveillez les ressources, les détails, l'état et les principaux consommateurs à l'aide de la console web.

- Affichez des informations de haut niveau sur les charges de travail des machines virtuelles en utilisant la console web.

- Visualiser les logs d'OpenShift Virtualization en utilisant le CLI.

-

Automatiser les déploiements de VM Windows avec

sysprep. - Migrer en direct des machines virtuelles.

- Sauvegarde et restauration des machines virtuelles.

Chapitre 4. Vue d'ensemble de la console web

La section Virtualization de la console web de OpenShift Container Platform contient les pages suivantes pour gérer et surveiller votre environnement de virtualisation OpenShift.

| Page | Description |

|---|---|

| Gérer et surveiller l'environnement de virtualisation OpenShift. | |

| Créer des machines virtuelles à partir d'un catalogue de modèles. | |

| Configurer et surveiller les machines virtuelles. | |

| Créer et gérer des modèles. | |

| Créer et gérer des DataSources pour les sources de démarrage de VirtualMachine. | |

| Créer et gérer des politiques de migration pour les charges de travail. |

| Icône | Description |

|---|---|

|

| Icône d'édition |

|

| Icône de lien |

4.1. Page de présentation

La page Vue d'ensemble affiche les ressources, les mesures, la progression de la migration et les paramètres au niveau du cluster.

Exemple 4.1. Page de présentation

| Élément | Description |

|---|---|

|

Download virtctl |

Téléchargez l'outil de ligne de commande |

| Ressources, utilisation, alertes et état. | |

| Les plus gros consommateurs de ressources de CPU, de mémoire et de stockage. | |

| Statut des migrations vivantes. | |

| Paramètres à l'échelle du cluster, y compris les limites de migration en direct et les autorisations des utilisateurs. |

4.1.1. Onglet Vue d'ensemble

L'onglet Overview affiche les ressources, l'utilisation, les alertes et l'état.

Exemple 4.2. Overview onglet

| Élément | Description |

|---|---|

| \Carte "Ressources de démarrage |

|

| \Carreau "VirtualMachines | Nombre de machines virtuelles, avec un graphique montrant la tendance des 7 derniers jours. |

| \Utilisation de la vCPU" carreaux | l'utilisation des vCPU, avec un graphique montrant la tendance des 7 derniers jours. |

| \Carreau "Mémoire | Utilisation de la mémoire, avec un graphique montrant la tendance des 7 derniers jours. |

| \Dalle "Storage" (stockage) | Utilisation du stockage, avec un graphique montrant la tendance des 7 derniers jours. |

| \Carreau "Alerts | Alertes d'OpenShift Virtualization, regroupées par gravité. |

| \Carreau "VirtualMachine statuses | Nombre de machines virtuelles, regroupées par état. |

| \Graphique "Machines virtuelles par modèle | Nombre de machines virtuelles créées à partir de modèles, regroupées par nom de modèle. |

4.1.2. Onglet Consommateurs supérieurs

L'onglet Top consumers affiche les principaux consommateurs de CPU, de mémoire et de stockage.

Exemple 4.3. Top consumers onglet

| Élément | Description |

|---|---|

|

View virtualization dashboard | Lien vers Observe → Dashboards, qui affiche les principaux consommateurs d'OpenShift Virtualization. |

| Time period liste | Sélectionnez une période pour filtrer les résultats. |

| Top consumers liste | Sélectionnez le nombre de premiers consommateurs pour filtrer les résultats. |

| \Graphique "CPU | Machines virtuelles dont l'utilisation du processeur est la plus élevée. |

| \Carte "Mémoire | Machines virtuelles utilisant le plus de mémoire. |

| \Tableau des échanges de mémoire | Machines virtuelles dont le trafic d'échange de mémoire est le plus élevé. |

| \Graphique "vCPU wait" (attente de vCPU) | Machines virtuelles ayant les périodes d'attente vCPU les plus élevées. |

| \Tableau "Stockage à travers le débit | Machines virtuelles dont le débit de stockage est le plus élevé. |

| \Graphique "Stockage IOPS | Machines virtuelles ayant le plus grand nombre d'opérations d'entrée/sortie de stockage par seconde. |

4.1.3. Onglet Migrations

L'onglet Migrations affiche l'état des migrations de VirtualMachineInstance.

Exemple 4.4. Migrations onglet

| Élément | Description |

|---|---|

| Time period liste | Sélectionnez une période pour filtrer les VirtualMachineInstanceMigrations. |

| VirtualMachineInstanceMigrations table | Liste des migrations de VirtualMachineInstance. |

4.1.4. Onglet Paramètres

L'onglet Settings affiche les paramètres de l'ensemble du cluster dans les onglets suivants :

| Onglet | Description |

|---|---|

| Version d'OpenShift Virtualization et état des mises à jour. | |

| Limites de migration et paramètres réseau en direct. | |

| Projet pour les modèles Red Hat. | |

| Autorisations pour les utilisateurs à l'échelle du cluster. |

4.1.4.1. Onglet Général

L'onglet General affiche la version d'OpenShift Virtualization et l'état de la mise à jour.

Exemple 4.5. General onglet

| Étiquette | Description |

|---|---|

| Nom du service | Virtualisation OpenShift |

| Fournisseur | Red Hat |

| Version installée | 4.12.2 |

| Mise à jour du statut |

Exemple : |

| Chaîne | Canal sélectionné pour les mises à jour. |

4.1.4.2. Onglet de migration en direct

Vous pouvez configurer la migration en direct dans l'onglet Live migration.

Exemple 4.6. Live migration onglet

| Élément | Description |

|---|---|

| Max. migrations per cluster champ | Sélectionnez le nombre maximum de migrations en direct par cluster. |

| Max. migrations per node champ | Sélectionnez le nombre maximal de migrations en direct par nœud. |

| Live migration network liste | Sélectionnez un réseau secondaire dédié pour la migration en direct. |

4.1.4.3. Onglet Projet de modèles

Vous pouvez sélectionner un projet pour les modèles dans l'onglet Templates project.

Exemple 4.7. Templates project onglet

| Élément | Description |

|---|---|

| Project liste |

Sélectionnez un projet dans lequel stocker les modèles Red Hat. Le projet de modèles par défaut est Si vous souhaitez définir plusieurs projets de modèles, vous devez cloner les modèles de la page Modèles pour chaque projet. |

4.1.4.4. Onglet Autorisations de l'utilisateur

L'onglet User permissions affiche les autorisations des utilisateurs à l'échelle du cluster pour les tâches.

Exemple 4.8. User permissions onglet

| Élément | Description |

|---|---|

| User Permissions table | Liste des tâches, telles que Share templates, et des autorisations. |

4.2. Page de catalogue

Vous pouvez créer une machine virtuelle en sélectionnant un modèle sur la page Catalogue.

Exemple 4.9. Page de catalogue

| Élément | Description |

|---|---|

| Templates project liste | Sélectionnez le projet dans lequel se trouvent vos modèles.

Par défaut, les modèles Red Hat sont stockés dans le projet |

| All items|Default templates | Cliquez sur Default templates pour n'afficher que les modèles par défaut. |

| Boot source available case à cocher | Cochez la case pour afficher les modèles dont la source de démarrage est disponible. |

| Operating system cases à cocher | Cochez les cases pour afficher les modèles avec les systèmes d'exploitation sélectionnés. |

| Workload cases à cocher | Cochez les cases pour afficher les modèles avec les charges de travail sélectionnées. |

| Champ de recherche | Recherche de modèles par mot-clé. |

| Tuiles modèles | Cliquez sur une tuile de modèle pour afficher les détails du modèle et pour créer une machine virtuelle. |

4.3. Page Machines virtuelles

Vous pouvez créer et gérer des machines virtuelles sur la page Machines virtuelles.

Exemple 4.10. Page Machines virtuelles

| Élément | Description |

|---|---|

| Create → From catalog | Créez une machine virtuelle sur la page Catalogue. |

| Create → With YAML | Créer une VirtualMachine en éditant un fichier de configuration YAML. |

| Filter champ | Filtrer les machines virtuelles par état, modèle, système d'exploitation ou nœud. |

| Champ de recherche | Recherchez les machines virtuelles par nom ou par étiquette. |

| VirtualMachines table | Liste des machines virtuelles.

Cliquez sur le menu Options

Cliquez sur une machine virtuelle pour accéder à la page de détails de la machine virtuelle. |

4.3.1. Page de détail de VirtualMachine

Vous pouvez configurer une machine virtuelle sur la page de détails de la machine virtuelle.

Exemple 4.11. Page de détail de VirtualMachine

| Élément | Description |

|---|---|

| Actions menu | Cliquez sur le menu Actions pour sélectionner Stop, Restart, Pause, Clone, Migrate, Copy SSH command, Edit labels, Edit annotations, ou Delete. |

| Utilisation des ressources, alertes, disques et périphériques. | |

| Configurations de machines virtuelles. | |

| Mémoire, CPU, stockage, réseau et mesures de migration. | |

| Fichier de configuration YAML de VirtualMachine. | |

| Configurations d'ordonnancement. | |

| Gestion des cartes de configuration, des secrets et des comptes de service. | |

| Flux d'événements de la machine virtuelle. | |

| Gestion de la session de la console. | |

| Gestion de l'interface réseau. | |

| Gestion des disques. | |

| Cloud-init et gestion des clés SSH. | |

| Gestion des instantanés. |

4.3.1.1. Onglet Vue d'ensemble

L'onglet Overview affiche l'utilisation des ressources, les alertes et les informations de configuration.

Exemple 4.12. Onglet Vue d'ensemble

| Élément | Description |

|---|---|

| \Carreau "Details | Informations générales sur la machine virtuelle. |

| \Carreau "Utilization | CPU, Memory, Storage, et Network transfer. |

| \Carreau "Dispositifs matériels | GPU et dispositifs hôtes. |

| \Carreau "Alerts | Alertes d'OpenShift Virtualization, regroupées par gravité. |

| \Carreau "Snapshots |

Take snapshot |

| \Carreau "Interfaces de réseau | Network interfaces table. |

| \Carreau "Disks | Disks table. |

4.3.1.2. Onglet Détails

Vous pouvez configurer la machine virtuelle dans l'onglet Details.

Exemple 4.13. Onglet Détails

| Élément | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Nom | Nom de la machine virtuelle. |

| Espace de noms | L'espace de noms VirtualMachine. |

| Étiquettes | Cliquez sur l'icône d'édition pour modifier les étiquettes. |

| Annotations | Cliquez sur l'icône d'édition pour modifier les annotations. |

| Description | Cliquez sur l'icône de modification pour saisir une description. |

| Système d'exploitation | Nom du système d'exploitation. |

| CPU|Mémoire | Cliquez sur l'icône d'édition pour modifier la requête CPU|Mémoire.

The number of CPUs is calculated by using the following formula: |

| Type de machine | Type de machine VirtualMachine. |

| Mode d'amorçage | Cliquez sur l'icône d'édition pour modifier le mode de démarrage. |

| Démarrage en mode pause | Cliquez sur l'icône de modification pour activer ce paramètre. |

| Modèle | Nom du modèle utilisé pour créer la machine virtuelle. |

| Créé à | Date de création de la machine virtuelle. |

| Propriétaire | Propriétaire de la machine virtuelle. |

| Statut | Statut de la machine virtuelle. |

| Cosse |

|

| VirtualMachineInstance | Nom de l'instance de la machine virtuelle. |

| Boot order | Cliquez sur l'icône d'édition pour sélectionner une source de démarrage. |

| IP address | Adresse IP de la machine virtuelle. |

| Nom d'hôte | Nom d'hôte de la machine virtuelle. |

| Fuseau horaire | Fuseau horaire de la machine virtuelle. |

| Nœud | Nœud sur lequel s'exécute la machine virtuelle. |

| Profil de la charge de travail | Cliquez sur l'icône d'édition pour modifier le profil de charge de travail. |

| SSH à l'aide de virtctl |

Cliquez sur l'icône de copie pour copier la commande |

| SSH sur NodePort |

La sélection de Create a Service to expose your VirtualMachine for SSH access génère une commande |

| Dispositifs GPU | Cliquez sur l'icône de modification pour ajouter un appareil GPU. |

| Dispositifs hôtes | Cliquez sur l'icône de modification pour ajouter un périphérique hôte. |

| Section des services | Voir les services. |

| Section des utilisateurs actifs | Voir les utilisateurs actifs. |

4.3.1.3. Onglet Métriques

L'onglet Metrics affiche les graphiques d'utilisation de la mémoire, du processeur, du stockage, du réseau et de la migration.

Exemple 4.14. Onglet Métriques

| Élément | Description |

|---|---|

| Time range liste | Sélectionnez une période pour filtrer les résultats. |

|

Virtualization dashboard | Lien vers l'onglet Workloads du projet en cours. |

| Section utilisation | Memory, CPU et Network interface. |

| Espace de stockage | Storage total read/write et Storage iops total read/write. |

| Section réseau | Network in, Network out et Network bandwidth. |

| Section migration | Migration et KV data transfer rate. |

4.3.1.4. Onglet YAML

Vous pouvez configurer la machine virtuelle en modifiant le fichier YAML dans l'onglet YAML.

Exemple 4.15. Onglet YAML

| Élément | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Save bouton | Enregistrer les modifications dans le fichier YAML. |

| Reload bouton | Annulez vos modifications et rechargez le fichier YAML. |

| Cancel bouton | Quittez l'onglet YAML. |

| Download bouton | Téléchargez le fichier YAML sur votre machine locale. |

4.3.1.5. Onglet Programmation

Vous pouvez configurer la planification dans l'onglet Scheduling.

Exemple 4.16. Onglet Programmation

| Paramètres | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Sélecteur de nœuds | Cliquez sur l'icône d'édition pour ajouter une étiquette afin de spécifier les nœuds de qualification. |

| Tolérances | Cliquez sur l'icône d'édition pour ajouter une tolérance afin de spécifier les nœuds de qualification. |

| Règles d'affinité | Cliquez sur l'icône de modification pour ajouter une règle d'affinité. |

| Descheduler interrupteur | Activer ou désactiver l'ordonnanceur. L'ordonnanceur évince un pod en cours d'exécution afin qu'il puisse être reprogrammé sur un nœud plus approprié. |

| Ressources dédiées | Cliquez sur l'icône d'édition pour sélectionner Schedule this workload with dedicated resources (guaranteed policy). |

| Stratégie d'expulsion | Cliquez sur l'icône d'édition pour sélectionner LiveMigrate comme stratégie d'éviction de VirtualMachineInstance. |

4.3.1.6. Onglet Environnement

Vous pouvez gérer les cartes de configuration, les secrets et les comptes de service dans l'onglet Environment.

Exemple 4.17. Onglet Environnement

| Élément | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

|

Add Config Map, Secret or Service Account | Cliquez sur le lien et sélectionnez une carte de configuration, un secret ou un compte de service dans la liste des ressources. |

4.3.1.7. Onglet Événements

L'onglet Events affiche une liste des événements de VirtualMachine.

4.3.1.8. Onglet Console

Vous pouvez ouvrir une session de console sur la machine virtuelle dans l'onglet Console.

Exemple 4.18. Onglet Console

| Élément | Description |

|---|---|

| Section des informations d'identification de l'invité |

Développez Guest login credentials pour afficher les informations d'identification créées avec |

| Console liste | Sélectionnez VNC console ou Serial console. Vous pouvez sélectionner Desktop viewer pour vous connecter aux machines virtuelles Windows en utilisant le protocole Remote Desktop Protocol (RDP). Vous devez installer un client RDP sur une machine du même réseau. |

| Send key liste | Sélectionnez une combinaison de touches à envoyer à la console. |

| Disconnect bouton | Déconnecter la connexion de la console. Vous devez déconnecter manuellement la connexion à la console si vous ouvrez une nouvelle session de console. Dans le cas contraire, la première session de console continue de s'exécuter en arrière-plan. |

4.3.1.9. Onglet Interfaces réseau

Vous pouvez gérer les interfaces réseau dans l'onglet Network interfaces.

Exemple 4.19. Onglet Interfaces réseau

| Paramètres | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Add network interface bouton | Ajouter une interface réseau à la machine virtuelle. |

| Filter champ | Filtrer par type d'interface. |

| Champ de recherche | Recherche d'une interface réseau par nom ou par étiquette. |

| Network interface table | Liste des interfaces réseau.

Cliquez sur le menu Options

|

4.3.1.10. Onglet Disques

Vous pouvez gérer les disques dans l'onglet Disks.

Exemple 4.20. Onglet Disques

| Paramètres | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Add disk bouton | Ajouter un disque à la machine virtuelle. |

| Filter champ | Filtrer par type de disque. |

| Champ de recherche | Recherche d'un disque par son nom. |

| Disks table | Liste des disques de la machine virtuelle.

Cliquez sur le menu Options

|

| File systems table | Liste des systèmes de fichiers de VirtualMachine. |

4.3.1.11. Onglet Scripts

Vous pouvez gérer les clés cloud-init et SSH de la machine virtuelle dans l'onglet Scripts.

Exemple 4.21. Onglet Scripts

| Élément | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Cloud-init | Cliquez sur l'icône d'édition pour modifier les paramètres de démarrage du nuage. |

| Clé SSH autorisée | Cliquez sur l'icône de modification pour créer un nouveau secret ou pour joindre un secret existant. |

4.3.1.12. Onglet Instantanés

Vous pouvez créer des instantanés et restaurer des machines virtuelles à partir d'instantanés dans l'onglet Snapshots.

Exemple 4.22. Onglet Instantanés

| Élément | Description |

|---|---|

| Take snapshot bouton | Créer un instantané. |

| Filter champ | Filtrer les instantanés par état. |

| Champ de recherche | Recherche d'instantanés par nom ou par étiquette. |

| Snapshot table | Liste des instantanés.

Cliquez sur le menu Options

|

4.4. Page des modèles

Vous pouvez créer, modifier et cloner des modèles de machine virtuelle sur la page Modèles.

Vous ne pouvez pas modifier un modèle Red Hat. Vous pouvez cloner un modèle Red Hat et le modifier pour créer un modèle personnalisé.

Exemple 4.23. Page des modèles

| Élément | Description |

|---|---|

| Create Template bouton | Créer un modèle en éditant un fichier de configuration YAML. |

| Filter champ | Filtrer les modèles par type, source de démarrage, fournisseur de modèles ou système d'exploitation. |

| Champ de recherche | Recherchez des modèles par nom ou par étiquette. |

| Templates table | Liste des modèles.

Cliquez sur le menu Options

|

4.4.1. Page de détails du modèle

Vous pouvez visualiser les paramètres du modèle et modifier les modèles personnalisés sur la page Détails du modèle.

Exemple 4.24. Page de détails du modèle

| Élément | Description |

|---|---|

| Actions menu | Cliquez sur le menu Actions pour sélectionner Edit, Clone, Edit boot source, Edit boot source reference, Edit labels, Edit annotations, ou Delete. |

| Paramètres et configurations des modèles. | |

| Fichier de configuration YAML. | |

| Configurations d'ordonnancement. | |

| Gestion de l'interface réseau. | |

| Gestion des disques. | |

| Gestion du Cloud-init, des clés SSH et de Sysprep. | |

| Paramètres. |

4.4.1.1. Onglet Détails

Vous pouvez configurer un modèle personnalisé dans l'onglet Details.

Exemple 4.25. Onglet Détails

| Élément | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Nom | Nom du modèle. |

| Espace de noms | Espace de noms du modèle. |

| Étiquettes | Cliquez sur l'icône d'édition pour modifier les étiquettes. |

| Annotations | Cliquez sur l'icône d'édition pour modifier les annotations. |

| Nom d'affichage | Cliquez sur l'icône d'édition pour modifier le nom d'affichage. |

| Description | Cliquez sur l'icône de modification pour saisir une description. |

| Système d'exploitation | Nom du système d'exploitation. |

| CPU|Mémoire | Cliquez sur l'icône d'édition pour modifier la requête CPU|Mémoire.

The number of CPUs is calculated by using the following formula: |

| Type de machine | Type de machine à gabarit. |

| Mode d'amorçage | Cliquez sur l'icône d'édition pour modifier le mode de démarrage. |

| Modèle de base | Nom du modèle de base utilisé pour créer ce modèle. |

| Créé à | Date de création du modèle. |

| Propriétaire | Propriétaire du modèle. |

| Boot order | Modèle de commande de démarrage. |

| Source de démarrage | Disponibilité de la source de démarrage. |

| Fournisseur | Fournisseur de modèles. |

| Soutien | Niveau de soutien du modèle. |

| Dispositifs GPU | Cliquez sur l'icône de modification pour ajouter un appareil GPU. |

| Dispositifs hôtes | Cliquez sur l'icône de modification pour ajouter un périphérique hôte. |

4.4.1.2. Onglet YAML

Vous pouvez configurer un modèle personnalisé en modifiant le fichier YAML dans l'onglet YAML.

Exemple 4.26. Onglet YAML

| Élément | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Save bouton | Enregistrer les modifications dans le fichier YAML. |

| Reload bouton | Annulez vos modifications et rechargez le fichier YAML. |

| Cancel bouton | Quittez l'onglet YAML. |

| Download bouton | Téléchargez le fichier YAML sur votre machine locale. |

4.4.1.3. Onglet Programmation

Vous pouvez configurer la planification dans l'onglet Scheduling.

Exemple 4.27. Onglet Programmation

| Paramètres | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Sélecteur de nœuds | Cliquez sur l'icône d'édition pour ajouter une étiquette afin de spécifier les nœuds de qualification. |

| Tolérances | Cliquez sur l'icône d'édition pour ajouter une tolérance afin de spécifier les nœuds de qualification. |

| Règles d'affinité | Cliquez sur l'icône de modification pour ajouter une règle d'affinité. |

| Descheduler interrupteur | Activer ou désactiver l'ordonnanceur. L'ordonnanceur évince un pod en cours d'exécution afin qu'il puisse être reprogrammé sur un nœud plus approprié. |

| Ressources dédiées | Cliquez sur l'icône d'édition pour sélectionner Schedule this workload with dedicated resources (guaranteed policy). |

| Stratégie d'expulsion | Cliquez sur l'icône d'édition pour sélectionner LiveMigrate comme stratégie d'éviction de VirtualMachineInstance. |

4.4.1.4. Onglet Interfaces réseau

Vous pouvez gérer les interfaces réseau dans l'onglet Network interfaces.

Exemple 4.28. Onglet Interfaces réseau

| Paramètres | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Add network interface bouton | Ajouter une interface réseau au modèle. |

| Filter champ | Filtrer par type d'interface. |

| Champ de recherche | Recherche d'une interface réseau par nom ou par étiquette. |

| Network interface table | Liste des interfaces réseau.

Cliquez sur le menu Options

|

4.4.1.5. Onglet Disques

Vous pouvez gérer les disques dans l'onglet Disks.

Exemple 4.29. Onglet Disques

| Paramètres | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Add disk bouton | Ajouter un disque au modèle. |

| Filter champ | Filtrer par type de disque. |

| Champ de recherche | Recherche d'un disque par son nom. |

| Disks table | Liste des disques modèles.

Cliquez sur le menu Options

|

4.4.1.6. Onglet Scripts

Vous pouvez gérer les paramètres de démarrage du nuage, les clés SSH et les fichiers de réponse Sysprep dans l'onglet Scripts.

Exemple 4.30. Onglet Scripts

| Élément | Description |

|---|---|

| YAML interrupteur | Réglez sur ON pour voir vos modifications en direct dans le fichier de configuration YAML. |

| Cloud-init | Cliquez sur l'icône d'édition pour modifier les paramètres de démarrage du nuage. |

| Clé SSH autorisée | Cliquez sur l'icône de modification pour créer un nouveau secret ou pour joindre un secret existant. |

| Sysprep |

Cliquez sur l'icône d'édition pour télécharger un fichier de réponse |

4.4.1.7. Onglet Paramètres

Vous pouvez modifier les paramètres des modèles sélectionnés dans l'onglet Parameters.

Exemple 4.31. Onglet Paramètres

| Élément | Description |

|---|---|

| Nom de la VM | Sélectionnez Generated (expression) pour une valeur générée, Value pour définir une valeur par défaut ou None dans la liste Default value type. |

| Espace de noms de la source de données | Sélectionnez Generated (expression) pour une valeur générée, Value pour définir une valeur par défaut ou None dans la liste Default value type. |

| Mot de passe de l'utilisateur du cloud | Sélectionnez Generated (expression) pour une valeur générée, Value pour définir une valeur par défaut ou None dans la liste Default value type. |

4.5. Page DataSources

Vous pouvez créer et configurer des sources de données pour les sources de démarrage de la machine virtuelle sur la page DataSources.

Lorsque vous créez une source de données, une ressource DataImportCron définit une tâche cron pour interroger et importer l'image disque, sauf si vous désactivez les mises à jour automatiques de la source de démarrage.

Exemple 4.32. Page DataSources

| Élément | Description |

|---|---|

| Create DataSource → With form | Créez une source de données en saisissant l'URL du registre, la taille du disque, le nombre de révisions et l'expression cron dans un formulaire. |

| Create DataSources → With YAML | Créez une source de données en éditant un fichier de configuration YAML. |

| Filter champ | Filtrer les DataSources en fonction d'attributs tels que DataImportCron disponible. |

| Champ de recherche | Recherche d'une source de données par nom ou par étiquette. |

| DataSources table | Liste des sources de données.

Cliquez sur le menu Options

|

Cliquez sur une source de données pour afficher la page de détails de la source de données.

4.5.1. Page de détails sur les sources de données

Vous pouvez configurer une source de données sur la page de détails de la source de données.

Exemple 4.33. Page de détails sur les sources de données

| Élément | Description |

|---|---|

| Details onglet | Configurer une source de données en modifiant un formulaire. |

| YAML onglet | Configurer une source de données en éditant un fichier de configuration YAML. |

| Actions menu | Sélectionnez Edit labels, Edit annotations, ou Delete. |

| Nom | Nom de la source de données. |

| Espace de noms | Espace de noms DataSource. |

| Étiquettes | Cliquez sur l'icône d'édition pour modifier les étiquettes. |

| Annotations | Cliquez sur l'icône d'édition pour modifier les annotations. |

| Conditions | Affiche les conditions d'état de la source de données. |

4.6. Page MigrationPolicies

Vous pouvez gérer les politiques de migration pour vos charges de travail sur la page Politiques de migration.

Exemple 4.34. Page MigrationPolicies

| Élément | Description |

|---|---|

| Create MigrationPolicy → With form | Créez une MigrationPolicy en saisissant des configurations et des étiquettes dans un formulaire. |

| Create MigrationPolicy → With YAML | Créer une MigrationPolicy en éditant un fichier de configuration YAML. |

| Name | Label champ de recherche | Recherche d'une MigrationPolicy par nom ou par étiquette. |

| MigrationPolicies table | Liste des politiques de migration.

Cliquez sur le menu Options

|

Cliquez sur une Politique de migration pour afficher la page de détails de la Politique de migration.

4.6.1. Page de détails de la politique de migration

Vous pouvez configurer une MigrationPolicy sur la page de détails de la MigrationPolicy.

Exemple 4.35. Page de détails de la politique de migration

| Élément | Description |

|---|---|

| Details onglet | Configurer une MigrationPolicy en éditant un formulaire. |

| YAML onglet | Configurer une MigrationPolicy en éditant un fichier de configuration YAML. |

| Actions menu | Sélectionnez Edit ou Delete. |

| Nom | Nom de la politique de migration. |

| Description | Description de la politique de migration. |

| Configurations | Cliquez sur l'icône d'édition pour mettre à jour les configurations de la Politique de migration. |

| Largeur de bande par migration |

Demande de bande passante par migration. Pour une bande passante illimitée, réglez la valeur sur |

| Convergence automatique | Politique de convergence automatique. |

| Post-copie | Politique de post-copie. |

| Délai d'achèvement | Valeur du délai d'achèvement en secondes. |

| Étiquettes du projet | Cliquez sur Edit pour modifier les étiquettes du projet. |

| Etiquettes VirtualMachine | Cliquez sur Edit pour modifier les étiquettes de la machine virtuelle. |

Chapitre 5. Notes de version d'OpenShift Virtualization

5.1. Rendre l'open source plus inclusif

Red Hat s'engage à remplacer les termes problématiques dans son code, sa documentation et ses propriétés Web. Nous commençons par ces quatre termes : master, slave, blacklist et whitelist. En raison de l'ampleur de cette entreprise, ces changements seront mis en œuvre progressivement au cours de plusieurs versions à venir. Pour plus de détails, voir le message de notre directeur technique Chris Wright.

5.2. À propos de la virtualisation Red Hat OpenShift

Red Hat OpenShift Virtualization vous permet d'amener des machines virtuelles (VM) traditionnelles dans OpenShift Container Platform où elles s'exécutent aux côtés des conteneurs et sont gérées comme des objets Kubernetes natifs.

OpenShift Virtualization est représenté par le module

![]() .

.

Vous pouvez utiliser OpenShift Virtualization avec le fournisseur de réseau OVN-Kubernetes ou le fournisseur de réseau Container Network Interface (CNI) par défaut d'OpenShiftSDN.

En savoir plus sur ce que vous pouvez faire avec OpenShift Virtualization.

En savoir plus sur l'architecture et les déploiements d'OpenShift Virtualization.

Préparez votre cluster pour la virtualisation OpenShift.

5.2.1. Version de cluster prise en charge par OpenShift Virtualization

OpenShift Virtualization 4.12 est pris en charge pour une utilisation sur les clusters OpenShift Container Platform 4.12. Pour utiliser la dernière version z-stream d'OpenShift Virtualization, vous devez d'abord passer à la dernière version d'OpenShift Container Platform.

5.2.2. Systèmes d'exploitation invités pris en charge

Pour afficher les systèmes d'exploitation invités pris en charge pour OpenShift Virtualization, reportez-vous à Systèmes d'exploitation invités certifiés dans Red Hat OpenStack Platform, Red Hat Virtualization et OpenShift Virtualization.

5.3. Caractéristiques nouvelles et modifiées

OpenShift Virtualization est certifié dans le cadre du programme de validation de la virtualisation de Windows Server (SVVP) de Microsoft pour exécuter des charges de travail Windows Server.

La certification SVVP s'applique à :

- Les travailleurs de Red Hat Enterprise Linux CoreOS. Dans le catalogue SVVP de Microsoft, ils sont nommés Red Hat OpenShift Container Platform 4 on RHEL CoreOS 8.

- CPU Intel et AMD.

-

OpenShift Virtualization n'utilise plus l'option

n'est plus utilisé. OpenShift Virtualization est désormais représenté par le logo

n'est plus utilisé. OpenShift Virtualization est désormais représenté par le logo

pour les versions 4.9 et suivantes.

pour les versions 4.9 et suivantes.

-

Vous pouvez créer un vidage de la mémoire de la VM à des fins d'analyse judiciaire à l'aide de la commande

virtctl memory-dump.

-

Vous pouvez exporter et télécharger un volume à partir d'une machine virtuelle (VM), d'un instantané de VM ou d'une revendication de volume persistant (PVC) pour le recréer sur un cluster différent ou dans un espace de noms différent sur le même cluster à l'aide de la commande

virtctl vmexportou en créant une ressource personnaliséeVirtualMachineExport. Vous pouvez également exporter le vidage de la mémoire à des fins d'analyse médico-légale.

- Vous pouvez découvrir les fonctions et l'organisation de la console web d'OpenShift Virtualization en vous référant à la documentation de présentation de la console web.

-

Vous pouvez utiliser la commande

virtctl sshpour transférer le trafic SSH vers une machine virtuelle en utilisant votre client SSH local ou en copiant la commande SSH depuis la console web d'OpenShift Container Platform.

-

Les volumes de données autonomes et les volumes de données créés lors de l'utilisation de

dataVolumeTemplatepour préparer un disque pour une VM ne sont plus stockés dans le système. Les volumes de données sont désormais automatiquement ramassés et supprimés après la création du PVC.

- OpenShift Virtualization fournit désormais des mesures de migration en direct auxquelles vous pouvez accéder en utilisant le tableau de bord de surveillance d'OpenShift Container Platform.

-

L'opérateur de virtualisation OpenShift lit maintenant le profil de sécurité TLS à l'échelle du cluster à partir de la ressource personnalisée

APIServeret le propage aux composants de virtualisation OpenShift, y compris la virtualisation, le stockage, le réseau et l'infrastructure.

- OpenShift Virtualization dispose de runbooks pour vous aider à résoudre les problèmes qui déclenchent des alertes. Les alertes sont affichées sur la page Virtualization → Overview de la console web. Chaque runbook définit une alerte et fournit des étapes pour diagnostiquer et résoudre le problème. Cette fonctionnalité a été introduite précédemment en tant qu'aperçu technologique et est maintenant disponible de manière générale.

5.3.1. Démarrage rapide

-

Des visites de démarrage rapide sont disponibles pour plusieurs fonctionnalités d'OpenShift Virtualization. Pour afficher les visites, cliquez sur l'icône Help ? dans la barre de menu de l'en-tête de la console OpenShift Virtualization, puis sélectionnez Quick Starts. Vous pouvez filtrer les visites disponibles en saisissant le mot-clé

virtualizationdans le champ Filter.

5.3.2. Mise en réseau

- Vous pouvez maintenant spécifier l'espace de noms dans lequel le contrôle du cluster OpenShift Container Platform doit être exécuté.

- Vous pouvez maintenant configurer un service de répartition de charge en utilisant l'opérateur MetalLB en mode couche 2.

5.3.3. Console web

La page Virtualization → Overview présente les améliorations suivantes en termes de convivialité :

- Un lien Download virtctl est disponible.

- Les informations sur les ressources sont personnalisées pour les utilisateurs administratifs et non administratifs. Par exemple, les utilisateurs non administratifs ne voient que leurs machines virtuelles.

- L'onglet Overview affiche le nombre de VM et l'utilisation des vCPU, de la mémoire et du stockage avec des graphiques montrant la tendance des 7 derniers jours.

- La carte Alerts de l'onglet Overview affiche les alertes regroupées par gravité.

- L'onglet Top Consumers affiche les principaux consommateurs de CPU, de mémoire et de stockage sur une période de temps configurable.

- L'onglet Migrations affiche la progression des migrations de VM.

- L'onglet Settings affiche les paramètres de l'ensemble du cluster, y compris les limites de migration en direct, le réseau de migration en direct et le projet de modèles.

- Vous pouvez créer et gérer des politiques de migration en direct en un seul endroit sur la page Virtualization → MigrationPolicies.

- L'onglet Metrics de la page VirtualMachine details affiche les mesures de mémoire, de CPU, de stockage, de réseau et de migration d'une VM, sur une période de temps configurable.

- Lorsque vous personnalisez un modèle pour créer une VM, vous pouvez définir le commutateur YAML sur ON dans chaque onglet de configuration de la VM pour afficher les modifications en direct dans le fichier de configuration YAML à côté du formulaire.

- L'onglet Migrations de la page Virtualization → Overview affiche la progression des migrations d'instances de machines virtuelles sur une période de temps configurable.

- Vous pouvez désormais définir un réseau dédié pour la migration en direct afin de minimiser les interruptions des charges de travail des locataires. Pour sélectionner un réseau, accédez à Virtualization → Overview → Settings → Live migration.

5.3.4. Fonctionnalités obsolètes

Les fonctionnalités obsolètes sont incluses dans la version actuelle et sont prises en charge. Cependant, elles seront supprimées dans une prochaine version et ne sont pas recommandées pour les nouveaux déploiements.

5.3.5. Fonctionnalités supprimées

Les fonctionnalités supprimées ne sont pas prises en charge dans la version actuelle.

- La prise en charge de l'ancienne ressource personnalisée HPP, et de la classe de stockage associée, a été supprimée pour tous les nouveaux déploiements. Dans OpenShift Virtualization 4.12, l'opérateur HPP utilise le pilote Kubernetes Container Storage Interface (CSI) pour configurer le stockage local. Une ressource personnalisée HPP héritée est prise en charge uniquement si elle a été installée sur une version précédente d'OpenShift Virtualization.

OpenShift Virtualization 4.11 a supprimé la prise en charge de nmstate, y compris les objets suivants :

-

NodeNetworkState -

NodeNetworkConfigurationPolicy -

NodeNetworkConfigurationEnactment

Pour préserver et prendre en charge votre configuration nmstate existante, installez l'opérateur Kubernetes NMState avant de mettre à jour OpenShift Virtualization 4.11. Pour les versions 4.12 pour Extended Update Support (EUS), installez le Kubernetes NMState Operator après la mise à jour vers la version 4.12. Vous pouvez installer l'opérateur à partir de OperatorHub dans la console web d'OpenShift Container Platform, ou en utilisant l'OpenShift CLI (

oc).-

Le Node Maintenance Operator (NMO) n'est plus livré avec OpenShift Virtualization. Vous pouvez installer le NMO à partir de OperatorHub dans la console web d'OpenShift Container Platform, ou en utilisant la CLI d'OpenShift (

oc).Vous devez effectuer l'une des tâches suivantes avant de mettre à jour OpenShift Virtualization 4.11 à partir de OpenShift Virtualization 4.10.2 et des versions 4.10 ultérieures. Pour les versions Extended Update Support (EUS), vous devez effectuer les tâches suivantes avant de mettre à jour OpenShift Virtualization 4.12 à partir de la version 4.10.2 et des versions 4.10 ultérieures :

- Sortir tous les nœuds du mode maintenance.

-

Installez l'ONM autonome et remplacez la ressource personnalisée (CR)

nodemaintenances.nodemaintenance.kubevirt.iopar une CRnodemaintenances.nodemaintenance.medik8s.io.

5.4. Caractéristiques de l'aperçu technologique

Certaines fonctionnalités de cette version sont actuellement en avant-première technologique. Ces fonctionnalités expérimentales ne sont pas destinées à une utilisation en production. Notez l'étendue de l'assistance suivante sur le portail client de Red Hat pour ces fonctionnalités :

Aperçu de la technologie Fonctionnalités Support Champ d'application

- Vous pouvez désormais exécuter des vérifications de cluster OpenShift Container Platform pour mesurer la latence du réseau entre les VM.

L'opérateur de tâches Tekton (TTO) intègre désormais la virtualisation OpenShift avec Red Hat OpenShift Pipelines. TTO inclut des tâches de cluster et des exemples de pipelines qui vous permettent de :

- Créer et gérer des machines virtuelles (VM), des réclamations de volumes persistants (PVC) et des volumes de données.

- Exécuter des commandes dans des machines virtuelles.

-

Manipuler les images de disques avec les outils de

libguestfs. - Installer Windows 10 dans un nouveau volume de données à partir d'une image d'installation de Windows (fichier ISO).

- Personnalisez une installation de base de Windows 10, puis créez une nouvelle image et un nouveau modèle.

- Vous pouvez maintenant utiliser la sonde ping de l'agent invité pour déterminer si l'agent invité QEMU fonctionne sur une machine virtuelle.

- Vous pouvez désormais utiliser Microsoft Windows 11 comme système d'exploitation invité. Cependant, OpenShift Virtualization 4.12 ne prend pas en charge les disques USB, qui sont nécessaires pour une fonction critique de la récupération BitLocker. Pour protéger les clés de récupération, utilisez d'autres méthodes décrites dans le guide de récupération BitLocker.

- Vous pouvez créer des stratégies de migration en direct avec des paramètres spécifiques, tels que l'utilisation de la bande passante, le nombre maximum de migrations parallèles et le délai d'attente, et appliquer les stratégies à des groupes de machines virtuelles en utilisant des étiquettes de machines virtuelles et d'espaces de noms.

5.5. Bug fixes

-

Vous pouvez désormais configurer le CR

HyperConvergedpour activer les périphériques à médiation avant l'installation des pilotes sans perdre la nouvelle configuration des périphériques après l'installation des pilotes. (BZ#2046298) -

Le fournisseur de réseau du cluster OVN-Kubernetes ne se bloque plus en raison de l'utilisation maximale de la RAM et du CPU si vous créez un grand nombre de services

NodePort. (OCPBUGS-1940) - Le clonage de plus de 100 VM à la fois n'échoue plus de manière intermittente si vous utilisez Red Hat Ceph Storage ou Red Hat OpenShift Data Foundation Storage. (BZ#1989527)

5.6. Problèmes connus

- Dans un cluster hétérogène avec différents nœuds de calcul, les machines virtuelles pour lesquelles HyperV Reenlightenment est activé ne peuvent pas être planifiées sur des nœuds qui ne prennent pas en charge la mise à l'échelle du compteur d'horodatage (TSC) ou qui ont la fréquence TSC appropriée. (BZ#2151169)

Lorsque vous utilisez deux pods avec des contextes SELinux différents, les VM avec la classe de stockage

ocs-storagecluster-cephfsne parviennent pas à migrer et l'état de la VM devientPaused. Cela est dû au fait que les deux pods tentent d'accéder au volume CephFSReadWriteManypartagé en même temps. (BZ#2092271)-

Comme solution de contournement, utilisez la classe de stockage

ocs-storagecluster-ceph-rbdpour migrer en direct des VM sur un cluster qui utilise Red Hat Ceph Storage.

-

Comme solution de contournement, utilisez la classe de stockage

La chaîne de nom du provisionneur

TopoLVMa changé dans OpenShift Virtualization 4.12. Par conséquent, l'importation automatique d'images de systèmes d'exploitation peut échouer avec le message d'erreur suivant (BZ#2158521) :DataVolume.storage spec is missing accessMode and volumeMode, cannot get access mode from StorageProfile.

DataVolume.storage spec is missing accessMode and volumeMode, cannot get access mode from StorageProfile.Copy to Clipboard Copied! Toggle word wrap Toggle overflow En guise de solution de rechange :

Mettre à jour le tableau

claimPropertySetsdu profil de stockage :oc patch storageprofile <storage_profile> --type=merge -p '{"spec": {"claimPropertySets": [{"accessModes": ["ReadWriteOnce"], "volumeMode": "Block"}, \ {"accessModes": ["ReadWriteOnce"], "volumeMode": "Filesystem"}]}}'$ oc patch storageprofile <storage_profile> --type=merge -p '{"spec": {"claimPropertySets": [{"accessModes": ["ReadWriteOnce"], "volumeMode": "Block"}, \ {"accessModes": ["ReadWriteOnce"], "volumeMode": "Filesystem"}]}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

Supprimez les volumes de données concernés dans l'espace de noms

openshift-virtualization-os-images. Ils sont recréés avec le mode d'accès et le mode de volume du profil de stockage mis à jour.

Lors de la restauration d'un instantané de VM pour un stockage dont le mode de liaison est

WaitForFirstConsumer, les PVC restaurés restent dans l'étatPendinget l'opération de restauration ne progresse pas.-

Pour contourner le problème, démarrez la VM restaurée, arrêtez-la, puis redémarrez-la. La VM sera planifiée, les PVC seront dans l'état

Boundet l'opération de restauration sera terminée. (BZ#2149654)

-

Pour contourner le problème, démarrez la VM restaurée, arrêtez-la, puis redémarrez-la. La VM sera planifiée, les PVC seront dans l'état

-

Les VM créées à partir de modèles communs sur un cluster Single Node OpenShift (SNO) affichent une alerte

VMCannotBeEvictedcar la stratégie d'éviction par défaut du modèle estLiveMigrate. Vous pouvez ignorer cette alerte ou la supprimer en mettant à jour la stratégie d'éviction de la VM. (BZ#2092412) -

La désinstallation d'OpenShift Virtualization ne supprime pas les étiquettes de nœuds

feature.node.kubevirt.iocréées par OpenShift Virtualization. Vous devez supprimer les étiquettes manuellement. (CNV-22036) Certaines annotations de revendication de volume persistant (PVC) créées par Containerized Data Importer (CDI) peuvent entraîner un blocage indéfini de l'opération de restauration de l'instantané de la machine virtuelle. (BZ#2070366)

En guise de solution de contournement, vous pouvez supprimer les annotations manuellement :

-

Obtenir le nom de la ressource personnalisée (CR) VirtualMachineSnapshotContent à partir de la valeur

status.virtualMachineSnapshotContentNamedans la CRVirtualMachineSnapshot. -

Modifiez le CR

VirtualMachineSnapshotContentet supprimez toutes les lignes qui contiennentk8s.io/cloneRequest. Si vous n'avez pas spécifié de valeur pour

spec.dataVolumeTemplatesdans l'objetVirtualMachine, supprimez tous les objetsDataVolumeetPersistentVolumeClaimde cet espace de noms lorsque les deux conditions suivantes sont remplies :-

Le nom de l'objet commence par

restore-. L'objet n'est pas référencé par les machines virtuelles.

Cette étape est facultative si vous avez spécifié une valeur pour

spec.dataVolumeTemplates.

-

Le nom de l'objet commence par

-

Répétez l'opération de restauration avec le CR

VirtualMachineSnapshotmis à jour.

-

Obtenir le nom de la ressource personnalisée (CR) VirtualMachineSnapshotContent à partir de la valeur

-

Les machines virtuelles Windows 11 ne démarrent pas sur les clusters fonctionnant en mode FIPS. Windows 11 requiert par défaut un dispositif TPM (trusted platform module). Cependant, le paquetage

swtpm(émulateur TPM logiciel) est incompatible avec FIPS. (BZ#2089301)

Si votre cluster OpenShift Container Platform utilise OVN-Kubernetes comme fournisseur d'interface réseau de conteneurs (CNI) par défaut, vous ne pouvez pas attacher un pont Linux ou un périphérique de liaison à l'interface par défaut d'un hôte en raison d'un changement dans la topologie du réseau hôte d'OVN-Kubernetes. (BZ#1885605)

- Comme solution de contournement, vous pouvez utiliser une interface réseau secondaire connectée à votre hôte, ou basculer vers le fournisseur CNI par défaut d'OpenShift SDN.

Dans certains cas, plusieurs machines virtuelles peuvent monter le même PVC en mode lecture-écriture, ce qui peut entraîner une corruption des données. (BZ#1992753)

- En guise de solution, évitez d'utiliser un seul PVC en mode lecture-écriture avec plusieurs machines virtuelles.

Le Pod Disruption Budget (PDB) empêche les interruptions de pods pour les images de machines virtuelles migrables. Si le PDB détecte une interruption de pod,

openshift-monitoringenvoie une alertePodDisruptionBudgetAtLimittoutes les 60 minutes pour les images de machines virtuelles qui utilisent la stratégie d'évictionLiveMigrate. (BZ#2026733)- Pour contourner le problème, il est possible de faire taire les alertes.

OpenShift Virtualization lie un jeton de compte de service utilisé par un pod à ce pod spécifique. OpenShift Virtualization implémente un volume de compte de service en créant une image disque qui contient un jeton. Si vous migrez une VM, le volume de compte de service devient invalide. (BZ#2037611)

- En guise de solution de contournement, utilisez des comptes d'utilisateur plutôt que des comptes de service, car les jetons de compte d'utilisateur ne sont pas liés à un module spécifique.

Si vous clonez plus de 100 VM à l'aide de la stratégie de clonage

csi-clone, le CSI Ceph risque de ne pas purger les clones. La suppression manuelle des clones peut également échouer. (BZ#2055595)-

En guise de solution, vous pouvez redémarrer le site

ceph-mgrpour purger les clones de VM.

-

En guise de solution, vous pouvez redémarrer le site

Chapitre 6. Installing

6.1. Préparer votre cluster pour OpenShift Virtualization

Consultez cette section avant d'installer OpenShift Virtualization pour vous assurer que votre cluster répond aux exigences.

Vous pouvez utiliser n'importe quelle méthode d'installation, y compris le provisionnement par l'utilisateur, le provisionnement par l'installateur ou l'installation assistée, pour déployer OpenShift Container Platform. Cependant, la méthode d'installation et la topologie du cluster peuvent affecter les fonctionnalités d'OpenShift Virtualization, telles que les snapshots ou la migration en direct.

Mode FIPS

Si vous installez votre cluster en mode FIPS, aucune configuration supplémentaire n'est requise pour OpenShift Virtualization.

6.1.1. Exigences en matière de matériel et de système d'exploitation

Passez en revue les exigences suivantes en matière de matériel et de système d'exploitation pour OpenShift Virtualization.

Plates-formes prises en charge

- Serveurs métalliques nus sur site

- Instances Amazon Web Services bare metal. Voir Déployer la virtualisation OpenShift sur des nœuds AWS Bare Metal pour plus de détails.

- Serveurs IBM Cloud Bare Metal. Voir Déployer la virtualisation OpenShift sur les nœuds IBM Cloud Bare Metal pour plus de détails.

L'installation d'OpenShift Virtualization sur des instances AWS bare metal ou sur des serveurs IBM Cloud bare metal est une fonctionnalité d'aperçu technologique uniquement. Les fonctionnalités de l'aperçu technologique ne sont pas prises en charge par les accords de niveau de service (SLA) de production de Red Hat et peuvent ne pas être complètes sur le plan fonctionnel. Red Hat ne recommande pas de les utiliser en production. Ces fonctionnalités offrent un accès anticipé aux fonctionnalités des produits à venir, ce qui permet aux clients de tester les fonctionnalités et de faire part de leurs commentaires au cours du processus de développement.

Pour plus d'informations sur la portée de l'assistance des fonctionnalités de l'aperçu technologique de Red Hat, voir Portée de l'assistance des fonctionnalités de l'aperçu technologique.

- Bare metal instances or servers offered by other cloud providers are not supported.

Exigences en matière de CPU

- Pris en charge par Red Hat Enterprise Linux (RHEL) 8

- Prise en charge des extensions de CPU Intel 64 ou AMD64

- Extensions de virtualisation matérielle Intel VT ou AMD-V activées

- Indicateur NX (pas d'exécution) activé

Storage requirements

- Pris en charge par OpenShift Container Platform

Operating system requirements

Red Hat Enterprise Linux CoreOS (RHCOS) installé sur les nœuds de travail

NoteLes nœuds de travail RHEL ne sont pas pris en charge.

- Si votre cluster utilise des nœuds de travail dotés de différentes unités centrales, des échecs de migration en direct peuvent se produire car les unités centrales n'ont pas toutes les mêmes capacités. Pour éviter de tels échecs, utilisez des CPU ayant une capacité appropriée pour chaque nœud et définissez l'affinité de nœud sur vos machines virtuelles afin de garantir la réussite de la migration. Pour plus d'informations, voir Configuration d'une règle d'affinité de nœuds requise.

6.1.2. Exigences en matière de frais généraux pour les ressources physiques

OpenShift Virtualization est une extension d'OpenShift Container Platform et impose des frais généraux supplémentaires que vous devez prendre en compte lors de la planification d'un cluster. Chaque machine de cluster doit répondre aux exigences suivantes en matière de frais généraux, en plus des exigences d'OpenShift Container Platform. La sursouscription des ressources physiques dans un cluster peut affecter les performances.

Les chiffres indiqués dans cette documentation sont basés sur la méthodologie de test et la configuration de Red Hat. Ces chiffres peuvent varier en fonction de votre propre configuration et de vos environnements.

6.1.2.1. Surcharge de mémoire

Calculez les valeurs de surcharge mémoire pour OpenShift Virtualization en utilisant les équations ci-dessous.

Surcharge de mémoire de la grappe

Memory overhead per infrastructure node ≈ 150 MiB

Memory overhead per infrastructure node ≈ 150 MiBMemory overhead per worker node ≈ 360 MiB

Memory overhead per worker node ≈ 360 MiBEn outre, les ressources de l'environnement de virtualisation OpenShift nécessitent un total de 2179 MiB de RAM qui est réparti sur tous les nœuds de l'infrastructure.

Surcharge de la mémoire de la machine virtuelle

Memory overhead per virtual machine ≈ (1.002 * requested memory) + 146 MiB \

+ 8 MiB * (number of vCPUs) \

+ 16 MiB * (number of graphics devices)

Memory overhead per virtual machine ≈ (1.002 * requested memory) + 146 MiB \

+ 8 MiB * (number of vCPUs) \

+ 16 MiB * (number of graphics devices) Si votre environnement comprend un périphérique réseau SR-IOV (Single Root I/O Virtualization) ou une unité de traitement graphique (GPU), allouez 1 Go de mémoire supplémentaire pour chaque périphérique.

6.1.2.2. Frais généraux de l'unité centrale

Calculez les exigences de surcharge du processeur de cluster pour OpenShift Virtualization en utilisant l'équation ci-dessous. La surcharge de processeur par machine virtuelle dépend de votre configuration individuelle.

Surcharge de l'unité centrale de la grappe

CPU overhead for infrastructure nodes ≈ 4 cores

CPU overhead for infrastructure nodes ≈ 4 coresOpenShift Virtualization augmente l'utilisation globale des services de niveau cluster tels que la journalisation, le routage et la surveillance. Pour prendre en compte cette charge de travail, assurez-vous que les nœuds qui hébergent des composants d'infrastructure ont une capacité allouée pour 4 cœurs supplémentaires (4000 millicores) répartis sur ces nœuds.

CPU overhead for worker nodes ≈ 2 cores + CPU overhead per virtual machine

CPU overhead for worker nodes ≈ 2 cores + CPU overhead per virtual machineChaque nœud de travailleur qui héberge des machines virtuelles doit avoir une capacité de 2 cœurs supplémentaires (2000 millicores) pour les charges de travail de gestion d'OpenShift Virtualization en plus des CPU requis pour les charges de travail des machines virtuelles.

Surcharge de l'unité centrale de la machine virtuelle

Si des CPU dédiés sont demandés, il y a un impact de 1:1 sur les besoins en CPU du cluster. Sinon, il n'y a pas de règles spécifiques concernant le nombre de CPU dont une machine virtuelle a besoin.

6.1.2.3. Stockage en hauteur

Utilisez les directives ci-dessous pour estimer les besoins en frais généraux de stockage pour votre environnement OpenShift Virtualization.

Frais généraux de stockage en grappe

Aggregated storage overhead per node ≈ 10 GiB

Aggregated storage overhead per node ≈ 10 GiB10 GiB est l'impact estimé du stockage sur disque pour chaque nœud du cluster lorsque vous installez OpenShift Virtualization.

Surcharge de stockage de la machine virtuelle

Les frais généraux de stockage par machine virtuelle dépendent des demandes spécifiques d'allocation de ressources au sein de la machine virtuelle. La demande peut concerner le stockage éphémère sur le nœud ou les ressources de stockage hébergées ailleurs dans le cluster. OpenShift Virtualization n'alloue actuellement aucun stockage éphémère supplémentaire pour le conteneur en cours d'exécution lui-même.

6.1.2.4. Exemple :

En tant qu'administrateur de cluster, si vous prévoyez d'héberger 10 machines virtuelles dans le cluster, chacune avec 1 Go de RAM et 2 vCPU, l'impact de la mémoire sur le cluster est de 11,68 Go. L'impact estimé du stockage sur disque pour chaque nœud de la grappe est de 10 Go et l'impact du CPU pour les nœuds de travail qui hébergent les charges de travail des machines virtuelles est d'un minimum de 2 cœurs.

6.1.3. Maximums d'objets

Lors de la planification de votre cluster, vous devez tenir compte des maximums d'objets testés suivants :

6.1.4. Environnements réseau restreints

Si vous installez OpenShift Virtualization dans un environnement restreint sans connectivité internet, vous devez configurer Operator Lifecycle Manager pour les réseaux restreints.

Si vous avez une connectivité internet limitée, vous pouvez configurer la prise en charge du proxy dans Operator Lifecycle Manager pour accéder à l'OperatorHub fourni par Red Hat.

6.1.5. Migration en direct

La migration en direct doit répondre aux exigences suivantes :

-

Stockage partagé avec mode d'accès

ReadWriteMany(RWX). - Mémoire vive et bande passante suffisantes.

- Si la machine virtuelle utilise un modèle de CPU hôte, les nœuds doivent prendre en charge le modèle de CPU hôte de la machine virtuelle.

6.1.6. Instantanés et clonage

Voir les fonctionnalités de stockage d'OpenShift Virtualization pour les exigences en matière d'instantanés et de clonage.

6.1.7. Options de haute disponibilité du cluster

Vous pouvez configurer l'une des options de haute disponibilité (HA) suivantes pour votre cluster :

La haute disponibilité automatique pour l'infrastructure fournie par l'installateur (IPI) est disponible en déployant des contrôles de santé des machines.

NoteDans les clusters OpenShift Container Platform installés à l'aide d'une infrastructure fournie par l'installateur et avec MachineHealthCheck correctement configuré, si un nœud échoue le MachineHealthCheck et devient indisponible pour le cluster, il est recyclé. Ce qui se passe ensuite avec les machines virtuelles exécutées sur le nœud défaillant dépend d'une série de conditions. Voir À propos des stratégies d'exécution pour les machines virtuelles pour des informations plus détaillées sur les résultats potentiels et la façon dont les stratégies d'exécution affectent ces résultats.

La haute disponibilité automatique pour IPI et non-IPI est disponible en utilisant l'opérateur Node Health Check sur le cluster OpenShift Container Platform pour déployer le contrôleur

NodeHealthCheck. Le contrôleur identifie les nœuds malsains et utilise l'opérateur Self Node Remediation pour remédier aux nœuds malsains.ImportantNode Health Check Operator est une fonctionnalité d'aperçu technologique uniquement. Les fonctionnalités de l'aperçu technologique ne sont pas prises en charge par les accords de niveau de service (SLA) de production de Red Hat et peuvent ne pas être complètes sur le plan fonctionnel. Red Hat ne recommande pas de les utiliser en production. Ces fonctionnalités offrent un accès anticipé aux fonctionnalités des produits à venir, ce qui permet aux clients de tester les fonctionnalités et de fournir un retour d'information pendant le processus de développement.

Pour plus d'informations sur la portée de l'assistance des fonctionnalités de l'aperçu technologique de Red Hat, voir Portée de l'assistance des fonctionnalités de l'aperçu technologique.

La haute disponibilité de n'importe quelle plate-forme est possible en utilisant un système de surveillance ou une personne qualifiée pour surveiller la disponibilité des nœuds. Lorsqu'un nœud est perdu, arrêtez-le et exécutez

oc delete node <lost_node>.NoteSans un système de surveillance externe ou une personne qualifiée pour surveiller l'état des nœuds, les machines virtuelles perdent leur haute disponibilité.

6.2. Spécifier des nœuds pour les composants d'OpenShift Virtualization

Spécifiez les nœuds où vous souhaitez déployer les opérateurs de virtualisation OpenShift, les charges de travail et les contrôleurs en configurant les règles de placement des nœuds.

Vous pouvez configurer le placement des nœuds pour certains composants après avoir installé OpenShift Virtualization, mais il ne doit pas y avoir de machines virtuelles présentes si vous souhaitez configurer le placement des nœuds pour les charges de travail.

6.2.1. A propos de l'emplacement des nœuds pour les composants de virtualisation

Vous pourriez vouloir personnaliser l'endroit où OpenShift Virtualization déploie ses composants pour vous assurer que :

- Les machines virtuelles ne se déploient que sur les nœuds destinés aux charges de travail de virtualisation.

- Les opérateurs ne se déploient que sur les nœuds d'infrastructure.

- Certains nœuds ne sont pas affectés par OpenShift Virtualization. Par exemple, vous avez des charges de travail non liées à la virtualisation qui s'exécutent sur votre cluster, et vous voulez que ces charges de travail soient isolées d'OpenShift Virtualization.

6.2.1.1. Comment appliquer les règles de placement des nœuds aux composants de virtualisation ?

Vous pouvez spécifier les règles de placement des nœuds pour un composant en éditant l'objet correspondant directement ou en utilisant la console web.

-

Pour les opérateurs de virtualisation OpenShift que Operator Lifecycle Manager (OLM) déploie, modifiez directement l'objet OLM

Subscription. Actuellement, vous ne pouvez pas configurer les règles de placement des nœuds pour l'objetSubscriptionà l'aide de la console Web. -

Pour les composants que les opérateurs de virtualisation OpenShift déploient, modifiez directement l'objet

HyperConvergedou configurez-le à l'aide de la console web lors de l'installation d'OpenShift Virtualization. Pour le provisionneur de chemins d'accès, modifiez l'objet

HostPathProvisionerdirectement ou configurez-le à l'aide de la console Web.AvertissementVous devez planifier le hostpath provisioner et les composants de virtualisation sur les mêmes nœuds. Sinon, les pods de virtualisation qui utilisent le hostpath provisioner ne peuvent pas s'exécuter.

En fonction de l'objet, vous pouvez utiliser un ou plusieurs des types de règles suivants :

nodeSelector- Permet aux pods d'être planifiés sur des nœuds étiquetés avec la ou les paires clé-valeur que vous spécifiez dans ce champ. Le nœud doit avoir des étiquettes qui correspondent exactement à toutes les paires répertoriées.

affinity- Permet d'utiliser une syntaxe plus expressive pour définir des règles qui font correspondre des nœuds à des pods. Affinity permet également de nuancer la manière dont les règles sont appliquées. Par exemple, vous pouvez spécifier qu'une règle est une préférence plutôt qu'une exigence absolue, de sorte que les modules sont toujours programmés si la règle n'est pas respectée.

tolerations- Permet aux pods d'être planifiés sur des nœuds qui ont des taches correspondantes. Si une tare est appliquée à un nœud, ce nœud n'accepte que les pods qui tolèrent la tare.

6.2.1.2. Emplacement du nœud dans l'objet OLM Subscription

Pour spécifier les nœuds où OLM déploie les opérateurs de virtualisation OpenShift, modifiez l'objet Subscription pendant l'installation de la virtualisation OpenShift. Vous pouvez inclure des règles de placement des nœuds dans le champ spec.config, comme le montre l'exemple suivant :

- 1

- Le champ

configprend en chargenodeSelectorettolerations, mais pasaffinity.

6.2.1.3. Placement des nœuds dans l'objet HyperConverged