This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.MTC (Migration Toolkit for Containers)

OpenShift Container Platform 4 への移行

概要

第1章 OpenShift Container Platform 3 からの移行

1.1. OpenShift Container Platform 3 から 4 への移行について

OpenShift Container Platform 4 には、自己管理型の柔軟で自動化されたクラスターを実現する新規のテクノロジーおよび機能が含まれています。OpenShift Container Platform 4 クラスターがデプロイされ、管理される方法は OpenShift Container Platform 3 とは大きく異なります。

OpenShift Container Platform 3 から OpenShift Container Platform 4 に正常に移行するには、以下の情報を確認することが重要になります。

1.2. 移行の計画

OpenShift Container Platform 4.5 への移行を実行する前に、十分な時間を取って移行を適切に計画できるようにしてください。OpenShift Container Platform 4 ではアーキテクチャーの変更および拡張機能が導入されるため、OpenShift Container Platform 3 クラスターの管理に使用した手順は OpenShift Container Platform 4 で適用されない可能性があります。

この計画ガイドでは、OpenShift Container Platform 3.11 から OpenShift Container Platform 4.5 への移行を前提としています。

本書では、最も重要な OpenShift Container Platform 3 と OpenShift Container Platform 4 の相違点 と、最も注目すべき 移行に関する考慮事項 についての概要を説明します。OpenShift Container Platform 4 クラスターの設定についての詳細は、OpenShift Container Platform ドキュメントの該当するセクションを参照してください。新規機能および他の重要な技術上の変更点についての詳細は、OpenShift Container Platform 4.5 リリースノート を参照してください。

既存の OpenShift Container Platform 3 クラスターを OpenShift Container Platform 4 にアップグレードすることはできません。新規の OpenShift Container Platform 4 インストールで開始する必要があります。コントロールプレーンの設定およびアプリケーションのワークロードの移行に役立つツールを使用できます。

1.2.1. OpenShift Container Platform 3 と OpenShift Container Platform 4 の比較

OpenShift Container Platform 3 では、管理者は Red Hat Enterprise Linux (RHEL) ホストを個別にデプロイし、その後に OpenShift Container Platform をこれらのホストにインストールし、クラスターを作成しました。管理者は、これらのホストを適切に設定し、更新を実行する必要があります。

OpenShift Container Platform 4 では、これまでとは大きく異なる方法で OpenShift Container Platform クラスターがデプロイされ、管理されるようになりました。OpenShift Container Platform 4 には、Operator、マシンセット、および Red Hat Enterprise Linux CoreOS (RHCOS) などの、クラスターの操作に対するコアとなる新たなテクノロジーおよび機能が含まれます。このテクノロジーの移行により、クラスターは管理者が以前に実行していた一部の機能を自己管理できるようになります。また、プラットフォームの安定性と一貫性を確保し、インストールおよびスケーリングを単純化することが可能です。

詳細は、OpenShift Container Platform アーキテクチャー を参照してください。

1.2.1.1. アーキテクチャーの違い

イミュータブルなインフラストラクチャー

OpenShift Container Platform 4 は、コンテナー化されたアプリケーションを実行するために設計された Red Hat Enterprise Linux CoreOS (RHCOS) を使用し、効率的なインストール、Operator ベースの管理、および単純化されたアップグレードを可能にします。RHCOS は、RHEL のようなカスタマイズ可能なオペレーティングシステムではなく、イミュータブルなコンテナーホストです。RHCOS により、OpenShift Container Platform 4 は基礎となるコンテナーホストのデプロイメントを管理し、自動化できます。RHCOS は OpenShift Container Platform の一部です。これは、すべてがコンテナー内で実行され、OpenShift Container Platform を使用してデプロイされることを意味します。

OpenShift Container Platform 4 では、コントロールプレーンノードは RHCOS を実行する必要があるため、コントロールプレーンのフルスタック自動化が維持されます。これにより、OpenShift Container Platform 3 よりも簡単に更新がロールアウトされ、アップグレードが簡単になります。

詳細は、Red Hat Enterprise Linux CoreOS (RHCOS) を参照してください。

Operator

Operator は、Kubernetes アプリケーションをパッケージ化し、デプロイし、管理する方法です。Operator は、ソフトウェアの他の部分を実行する際の運用上の複雑さを軽減します。Operator は環境を監視し、現在の状態を使用してリアルタイムの意思決定を行います。高度な Operator は、自動的にアップグレードし、障害に自動的に対応するように設計されています。

詳細は、Operator について を参照してください。

1.2.1.2. インストールおよび更新の違い

インストールプロセス

OpenShift Container Platform 3.11 をインストールするには、Red Hat Enterprise Linux (RHEL) ホストを準備し、クラスターが必要とする設定値をすべて設定してから、Ansible Playbook を実行してクラスターをインストールし、セットアップする必要がありました。

OpenShift Container Platform 4.5 では、OpenShift インストールプログラムを使用してクラスターに必要なリソースの最小セットを作成できます。クラスターの実行後に、Operator を使用してクラスターをさらに設定し、新規サービスをインストールすることができます。初回の起動後に、Red Hat Enterprise Linux CoreOS (RHCOS) システムは、OpenShift Container Platform クラスターで実行される Machine Config Operator (MCO) によって管理されます。

詳細は、インストールプロセス を参照してください。

Red Hat Enterprise Linux (RHEL) (RHEL) ワーカーマシンを OpenShift Container Platform 4.5 クラスターに追加する場合、Ansible Playbook を使用して、クラスターの実行後に RHEL ワーカーマシンを追加します。詳細は、RHEL コンピュートマシンの OpenShift Container Platform クラスターへの追加 を参照してください。

インフラストラクチャーオプション

OpenShift Container Platform 3.11 では、ユーザーが準備し、維持するインフラストラクチャーにクラスターをインストールする必要があります。OpenShift Container Platform 4 では、独自のインフラストラクチャーを提供するだけでなく、OpenShift Container Platform インストールプログラムがプロビジョニングし、クラスターが維持するインフラストラクチャーにクラスターをデプロイするオプションを提供します。

詳細は、OpenShift Container Platform インストールの概要 を参照してください。

クラスターのアップグレード

OpenShift Container Platform 3.11 では、Ansible Playbook を実行してクラスターをアップグレードします。OpenShift Container Platform 4.5 では、クラスターが、クラスターノードの Red Hat Enterprise Linux CoreOS (RHCOS) への更新を含む独自の更新を管理します。Web コンソールまたは OpenShift CLI から oc adm upgrade コマンドを使用することでクラスターを容易にアップグレードでき、Operator は自動的にアップグレードされます。OpenShift Container Platform 4.5 クラスターに RHEL ワーカーマシンがある場合、Ansible Playbook を引き続き実行してそれらのワーカーマシンをアップグレードする必要があります。

詳細は、クラスターの更新 を参照してください。

1.2.2. 移行に関する考慮事項

OpenShift Container Platform 3.11 から OpenShift Container Platform 4 への移行に影響を与える可能性のある変更やその他の考慮事項を確認します。

1.2.2.1. ストレージに関する考慮事項

OpenShift Container Platform 3.11 から OpenShift Container Platform 4.5 に移行する際に、以下のストレージの変更を考慮してください。

ローカルボリュームの永続ストレージ

ローカルストレージは、OpenShift Container Platform 4.5 ではローカルストレージ Operator を使用する場合にのみサポートされます。OpenShift Container Platform 3.11 のローカルプロビジョナーメソッドの使用はサポートされません。

詳細は、ローカルボリュームを使用した永続ストレージ を参照してください。

FlexVolume 永続ストレージ

FlexVolume プラグインの場所が OpenShift Container Platform 3.11 で変更になりました。OpenShift Container Platform 4.5 の新しい場所は /etc/kubernetes/kubelet-plugins/volume/exec です。割り当て可能な FlexVolume プラグインはサポートされなくなりました。

詳細は、FlexVolume を使用した永続ストレージ を参照してください。

Container Storage Interface (CSI) 永続ストレージ

Container Storage Interface (CSI) を使用した永続ストレージは OpenShift Container Platform 3.11 では テクノロジープレビュー として利用可能でした。OpenShift Container Platform 4.5 は CSI バージョン 1.1.0 を完全にサポートし、複数の CSI ドライバー に同梱されます。そのため、独自のドライバーをインストールできます。

詳細は、Container Storage Interface (CSI) を使用した永続ストレージ を参照してください。

Red Hat OpenShift Container Storage

OpenShift Container Platform 3.11 で使用できる Red Hat OpenShift Container Storage 3 は、バッキングストレージとして Red Hat Gluster Storage を使用します。

OpenShift Container Platform 4 で使用できる Red Hat OpenShift Container Storage 4 は、バッキングストレージとして Red Hat Ceph Storage を使用します。

詳細は、Persistent storage using Red Hat OpenShift Container Storage および interoperability matrix の記事を参照してください。

サポートされていない永続ストレージオプション

OpenShift Container Platform 3.11 の以下の永続ストレージオプションのサポートが OpenShift Container Platform 4.5 で変更になりました。

- GlusterFS はサポート対象外になりました。

- スタンドアロン製品としての CephFS がサポートされなくなりました。

- スタンドアロン製品としての Ceph RBD がサポートされなくなりました。

OpenShift Container Platform 3.11 でこれらのいずれかを使用していた場合は、OpenShift Container Platform 4.5 で完全にサポートされる別の永続ストレージオプションを選択する必要があります。

詳細は、永続ストレージについて を参照してください。

1.2.2.2. ネットワークの考慮事項

OpenShift Container Platform 3.11 から OpenShift Container Platform 4.5 に移行する際に、考慮事項となる以下のネットワークの変更を確認してください。

ネットワーク分離モード

OpenShift Container Platform 3.11 では、ユーザーは ovn-multitenant を使用するように頻繁に切り替えましたが、デフォルトのネットワーク分離モードは ovs-subnet でした。OpenShift Container Platform 4.5 のデフォルトのネットワーク分離モードは、ネットワークポリシーによって制御されます。

OpenShift Container Platform 3.11 クラスターで ovs-subnet または ovs-multitenant モードを使用していた場合、OpenShift Container Platform 4.5 クラスターではネットワークポリシーに切り換えることが推奨されます。ネットワークポリシーはアップストリームでサポートされ、より柔軟であり、ovs-multitenant が実行する機能を提供します。OpenShift Container Platform 4.5 でネットワークポリシーを使用する際に ovs-multitenant 動作を維持する必要がある場合、ネットワークポリシーを使用したマルチテナント分離の設定 手順を実行します。

詳細は、ネットワークポリシーについて を参照してください。

ホスト間のトラフィックの暗号化

OpenShift Container Platform 3.11 では、IPsec を使用してホスト間のトラフィックを暗号化できます。OpenShift Container Platform 4.5 は IPsec をサポートしません。サービス間で相互 TLS を有効にするために、Red Hat OpenShift Service Mesh を使用することが推奨されます。

詳細は、Understanding Red Hat OpenShift Service Mesh を参照してください。

1.2.2.3. ロギングについての考慮事項

OpenShift Container Platform 3.11 から OpenShift Container Platform 4.5 に移行する際に、考慮事項となる以下のロギングの変更を確認してください。

クラスターロギングのデプロイ

OpenShift Container Platform 4 は、クラスターロギングのカスタムリソース (Custom Resource) を使用してクラスターロギングの単純なデプロイメントメカニズムを提供します。

詳細は、クラスターロギングのインストール について参照してください。

集計ロギングデータ

集計ロギングデータを OpenShift Container Platform 3.11 から新規の OpenShift Container Platform 4 クラスターに移行することはできません。

詳細は、クラスターロギングについて を参照してください。

サポートされないロギング設定

OpenShift Container Platform 3.11 で利用可能な一部のロギング設定は OpenShift Container Platform 4.5 でサポートされなくなりました。

明示的にサポートされていないロギングケースの詳細は、メンテナーンスとサポート を参照してください。

1.2.2.4. セキュリティーに関する考慮事項

OpenShift Container Platform 3.11 から OpenShift Container Platform 4.5 へ移行する際に、考慮事項となる以下のセキュリティーの変更を確認してください。

検出エンドポイントへの認証されていないアクセス

OpenShift Container Platform 3.11 では、認証されていないユーザーは検出エンドポイント (例: /api/* および /apis/*) にアクセスできました。セキュリティー上の理由から、検出エンドポイントへの認証されていないアクセスは OpenShift Container Platform 4.5 で許可されなくなりました。認証されていないアクセスを許可する必要がある場合は、必要に応じて RBAC を設定できます。 ただし、これにより内部クラスターコンポーネントが外部ネットワークに公開される可能性があるため、セキュリティー上の影響を考慮してください。

アイデンティティープロバイダー

アイデンティティープロバイダーの設定は、以下の主な変更点を含め、 OpenShift Container Platform 4 で変更されています。

- OpenShift Container Platform 4.5 の要求ヘッダーアイデンティティープロバイダーには相互 TLS が必要ですが、OpenShift Container Platform 3.11 ではこれは必要ではありませんでした。

-

OpenID Connect アイデンティティープロバイダーの設定は OpenShift Container Platform 4.5 で単純化されています。OpenShift Container Platform 3.11 で以前に指定される必要のあったデータが、プロバイダーの

/.well-known/openid-configurationエンドポイントから取得できるようになりました。

詳細は、アイデンティティープロバイダー設定について を参照してください。

1.2.2.5. モニターリングに関する考慮事項

OpenShift Container Platform 3.11 から OpenShift Container Platform 4.5 に移行する際に、考慮事項となる以下のモニターリングの変更を確認してください。

インフラストラクチャーの可用性についてのモニターリングアラート

モニターリング構造の可用性を確保するためにトリガーするデフォルトのアラートは OpenShift Container Platform 3.11 では DeadMansSwitch と呼ばれていました。この名前は OpenShift Container Platform 4 で Watchdog に変更されています。OpenShift Container Platform 3.11 で PagerDuty 統合をこのアラートでセットアップしている場合、OpenShift Container Platform 4 では Watchdog アラートについて PagerDuty 統合をセットアップする必要があります。

詳細は、カスタム Alertmanager 設定の適用 を参照してください。

1.3. 移行ツールおよび前提条件

アプリケーションワークロードを、MTC (Migration Toolkit for Containers) ツールを使用して OpenShift Container Platform 3.7、3.9、3.10、および 3.11 から OpenShift Container Platform 4.5 に移行できます。MTC を使用すると、移行を制御し、アプリケーションのダウンタイムを最小限に抑えることができます。

Kubernetes カスタムリソースをベースとする MTC の Web コンソールおよび API により、namespace の粒度でステートフルなアプリケーションワークロードを移行できます。

MTC は、ソースクラスターからターゲットクラスターにデータを移行するために、ファイルシステムおよびスナップショットによるデータのコピー方法をサポートします。ご使用の環境に適した方法で、ストレージプロバイダーでサポートされる方法を選択できます。

移行フックを使用して、移行中の特定の時点で Ansible Playbook を実行できます。フックは移行計画の作成時に追加されます。

サービスカタログは OpenShift Container Platform 4 では非推奨になっています。サービスカタログでプロビジョニングされたワークロードリソースを OpenShift Container Platform 3 から 4 に移行できますが、移行後にこれらのワークロードで provision、deprovision、または update などのサービスカタログのアクションを実行できません。

MTC の Web コンソールは、サービスカタログリソースを移行できない場合にメッセージを表示します。

移行を開始する前に、移行計画 についての情報を確認してください。

1.3.1. MTC (Migration Toolkit for Containers) ワークフロー

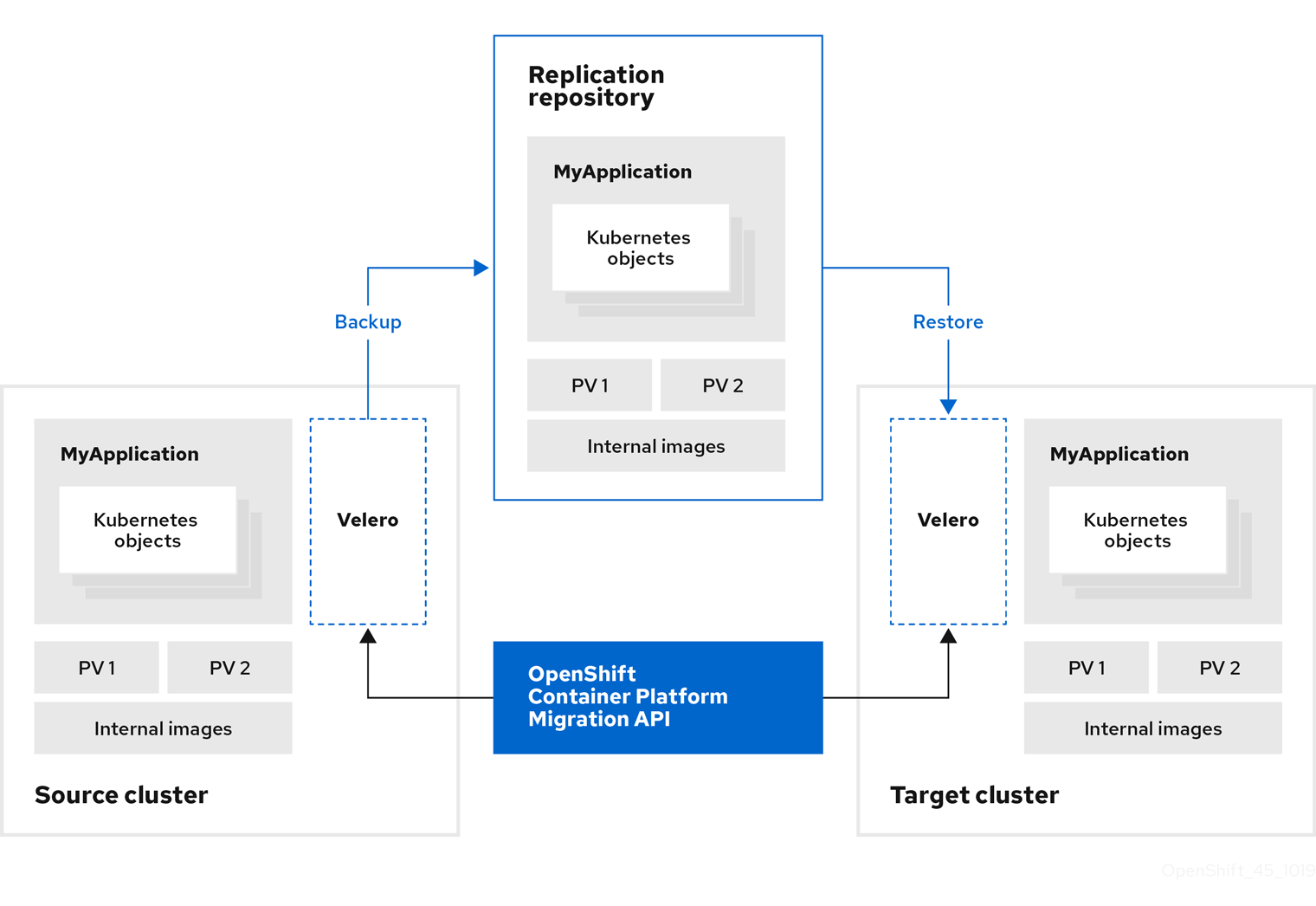

MTC (Migration Toolkit for Containers) ツールを使用すると、MTC Web コンソールまたは Kubernetes API を使用して Kubernetes リソース、永続ボリュームデータ、および内部コンテナーイメージを OpenShift Container Platform ソースクラスターから OpenShift Container Platform 4.5 ターゲットクラスターに移行できます。

(MTC) は以下のリソースを移行します。

- 移行計画に指定される namespace。

namespace スコープのリソース: MTC が namespace を移行する場合、サービスや Pod などのその namespace に関連付けられるすべてのオブジェクトおよびリソースを移行します。さらに、namespace に存在するものの、クラスターレベルに存在しないリソースがクラスターレベルに存在するリソースに依存する場合、MTC は両方のリソースを移行します。

たとえば、SCC (Security Context Constraints) はクラスターレベルに存在するリソースであり、サービスアカウント (SA) は namespace レベルに存在するリソースです。SA が MTC が移行する namespace に存在する場合、MTC は SA にリンクされている SCC を自動的に識別し、それらの SCC も移行します。同様に、MTC は namespace の永続ボリュームにリンクされた永続ボリューム要求 (PVC) を移行します。

- カスタムリソース定義 (CRD) およびカスタムリソース定義 (CRD): MTC は、namespace レベルに存在する CR およびそれらの CR にリンクされた CRB を自動的に移行します。

MTC Web コンソールを使用してアプリケーションを移行するには、以下の手順が必要です。

すべてのクラスターに MTC (Migration Toolkit for Containers Operator) をインストールします。

インターネットアクセスが制限されているか、またはインターネットアクセスのない制限された環境で Migration Toolkit for Containers Operator をインストールできます。ソースおよびターゲットクラスターは、相互に対するネットワークアクセスおよびミラーレジストリーへのネットワークアクセスがなければなりません。

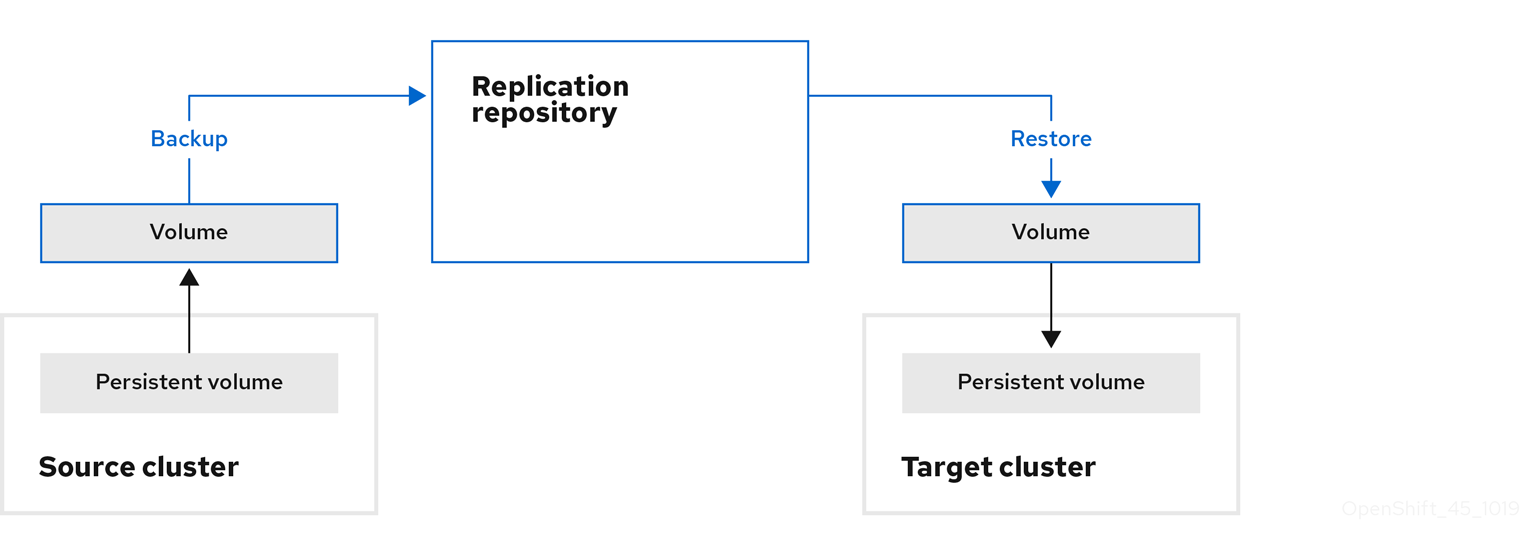

MTC がデータ移行に使用する中間オブジェクトストレージであるレプリケーションリポジトリーを設定します。

ソースおよびターゲットクラスターには、移行時にレプリケーションリポジトリーへのネットワークアクセスがなければなりません。制限された環境では、内部でホストされる S3 ストレージリポジトリーを使用できます。プロキシーサーバーを使用している場合は、レプリケーションリポジトリーとクラスター間のネットワークトラフィックを許可するように設定する必要があります。

- ソースクラスターを MTC の Web コンソールに追加します。

- レプリケーションリポジトリーを MTC の Web コンソールに追加します。

以下のデータ移行オプションのいずれかを使用して、移行計画を作成します。

Copy: MTC は、データをソースクラスターからレプリケーションリポジトリーにコピーし、レプリケーションリポジトリーからターゲットクラスターにコピーします。

注記イメージの直接移行またはボリュームの直接移行を使用している場合、イメージまたはボリュームはソースクラスターからターゲットクラスターに直接コピーされます。

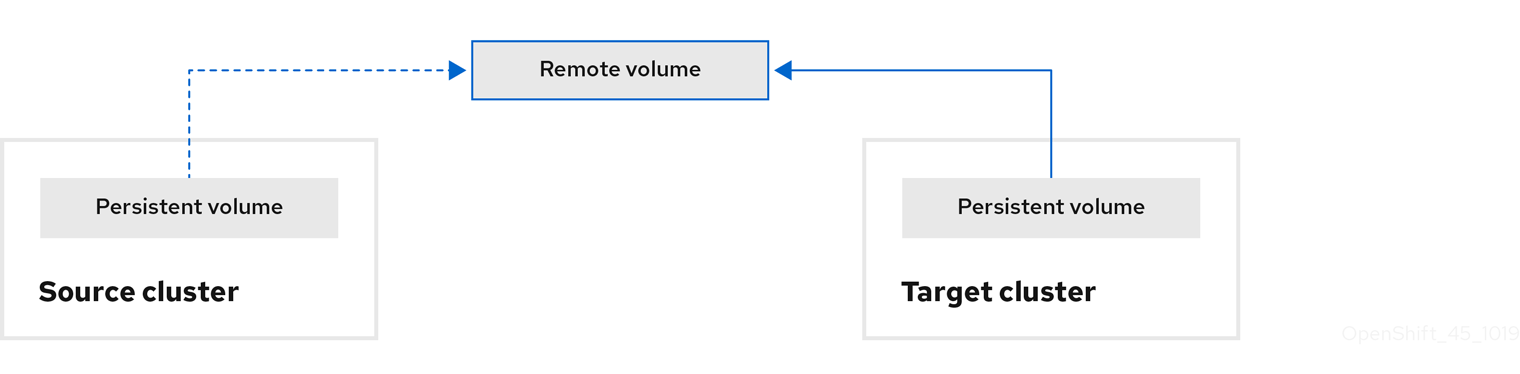

Move: MTC は、ソースクラスターからリモートボリューム (例: NFS) をアンマウントし、リモートボリュームをポイントするターゲットクラスターで PV リソースを作成し、その後にリモートボリュームをターゲットクラスターにマウントします。ターゲットクラスターで実行されているアプリケーションは、ソースクラスターが使用していたものと同じリモートボリュームを使用します。リモートボリュームは、ソースクラスターおよびターゲットクラスターからアクセスできる必要があります。

注記レプリケーションリポジトリーはこの図には表示されていませんが、これは移行に必要です。

以下のオプションのいずれかを使用して、移行計画を実行します。

Stage (オプション) は、アプリケーションを停止せずにデータをターゲットクラスターにコピーします。

ステージングは、移行前にほとんどのデータがターゲットにコピーされるように複数回実行することができます。これにより、移行時間やアプリケーションのダウンタイムが最小限に抑えられます。

- Migrate は、ソースクラスターでアプリケーションを停止し、ターゲットクラスターでそのリソースを再作成します。オプションで、アプリケーションを停止せずにワークロードを移行できます。

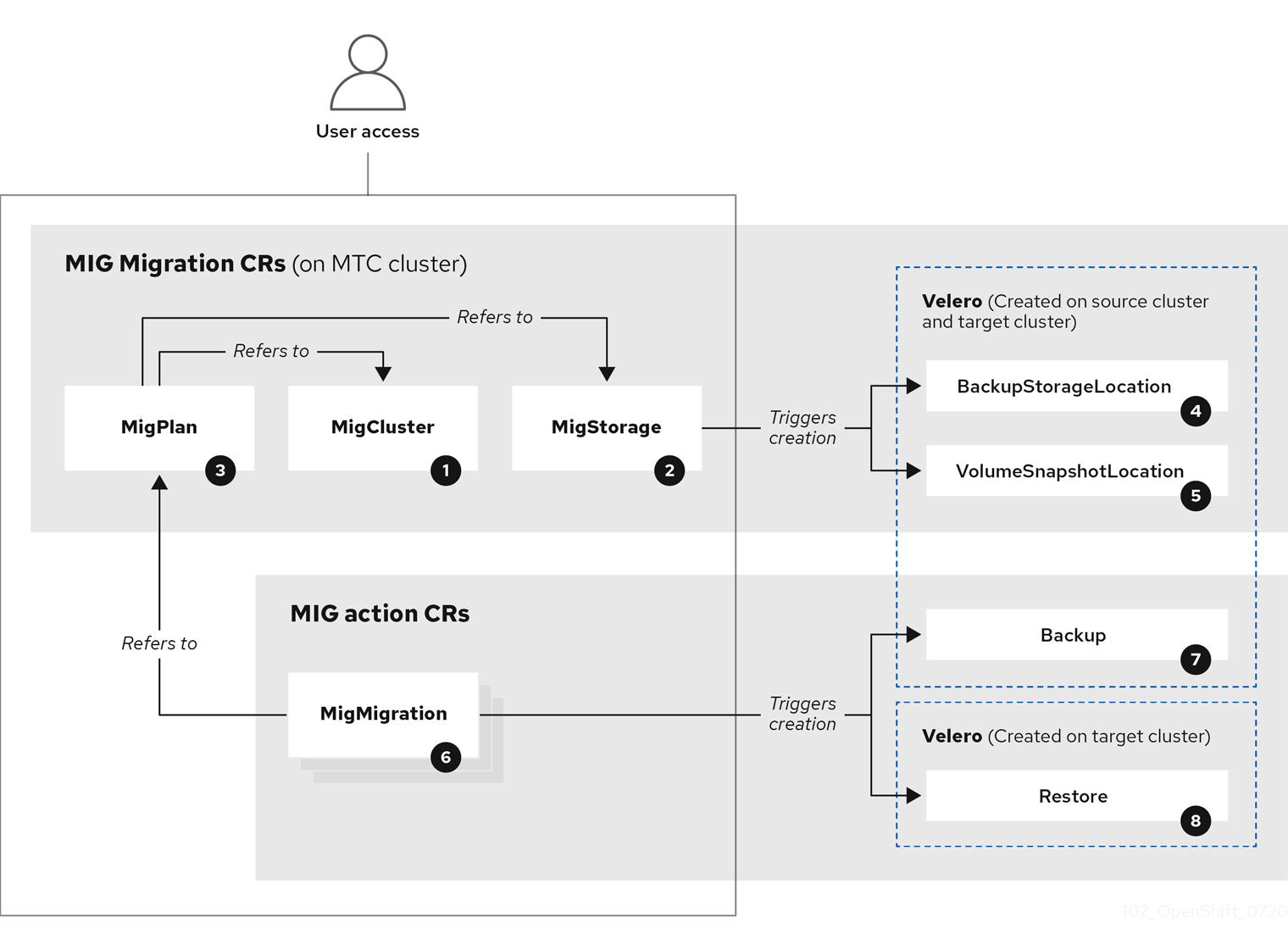

1.3.2. MTC (Migration Toolkit for Containers) カスタムリソース

MTC (Migration Toolkit for Containers) は以下のカスタムリソース (CR) を作成します。

![]() MigCluster (設定、MTC クラスター): クラスター定義

MigCluster (設定、MTC クラスター): クラスター定義

![]() MigStorage (設定、MTC クラスター): ストレージ定義

MigStorage (設定、MTC クラスター): ストレージ定義

![]() MigPlan (設定、MTC クラスター): 移行計画

MigPlan (設定、MTC クラスター): 移行計画

MigPlan CR は、移行されるソースおよびターゲットクラスター、レプリケーションリポジトリー、および namespace を記述します。これは 0、1 または多数の MigMigration CR に関連付けられます。

MigPlan CR を削除すると、関連付けられた MigMigration CR が削除されます。

![]() BackupStorageLocation (設定、MTC クラスター):

BackupStorageLocation (設定、MTC クラスター): Velero バックアップオブジェクトの場所

![]() VolumeSnapshotLocation (設定、MTC クラスター):

VolumeSnapshotLocation (設定、MTC クラスター): Velero ボリュームスナップショットの場所

![]() MigMigration (アクション、MTC クラスター): データのステージングまたは移行時に毎回作成される移行。各

MigMigration (アクション、MTC クラスター): データのステージングまたは移行時に毎回作成される移行。各 MigMigration CR は MigPlan CR に関連付けられます。

![]() Backup (アクション、ソースクラスター): 移行計画の実行時に、

Backup (アクション、ソースクラスター): 移行計画の実行時に、MigMigration CR は各ソースクラスターに 2 つの Velero バックアップ CR を作成します。

- Kubernetes オブジェクトのバックアップ CR #1

- PV データのバックアップ CR #2

![]() Restore (アクション、ターゲットクラスター): 移行計画の実行時に、

Restore (アクション、ターゲットクラスター): 移行計画の実行時に、MigMigration CR はターゲットクラスターに 2 つの Velero 復元 CR を作成します。

- PV データの復元 CR #1 (バックアップ CR #2 の使用)

- Kubernetes オブジェクトの復元 CR #2 (バックアップ CR #1 の使用)

1.3.3. データのコピー方法

MTC (Migration Toolkit for Containers) は、ソースクラスターからターゲットクラスターにデータを移行するために、ファイルシステムおよびスナップショットによるデータのコピー方法をサポートします。ご使用の環境に適した方法で、ストレージプロバイダーでサポートされる方法を選択できます。

1.3.3.1. ファイルシステムのコピー方法

MTC は、データファイルをソースクラスターからレプリケーションリポジトリーにコピーし、そこからターゲットクラスターにコピーします。

| 利点 | 制限 |

|---|---|

|

|

1.3.3.2. スナップショットのコピー方法

MTC は、ソースクラスターのデータのスナップショットを、クラウドプロバイダーのレプリケーションリポジトリーにコピーします。データはターゲットクラスターで復元されます。

AWS、Google Cloud Provider、および Microsoft Azure は、スナップショットのコピー方法をサポートします。

| 利点 | 制限 |

|---|---|

|

|

1.3.4. 移行フックについて

移行フックを使用して、MTC (Migration Toolkit for Containers) を使用した移行中の特定の時点でカスタムコードを実行できます。単一の移行計画に最大 4 つの移行フックを追加し、各フックを移行の異なるフェーズで実行できます。

移行フックは、アプリケーションの休止状態のカスタマイズ、サポート外のデータタイプの手動の移行、および移行後のアプリケーションの更新などのタスクを実行します。

移行フックは、以下の移行手順のいずれかでソースまたはターゲットクラスターで実行されます。

-

PreBackup: リソースがソースクラスターでバックアップされる前 -

PostBackup: リソースがソースクラスターでバックアップされた後 -

PreRestore: リソースがターゲットクラスターで復元される前 -

PostRestore: リソースがターゲットクラスターで復元された後

Ansible Playbook またはカスタムフックコンテナーを使用してフックを作成できます。

Ansible Playbook

Ansible Playbook はフックコンテナーに設定マップとしてマウントされます。フックコンテナーは、MigPlan カスタムリソース (CR) に指定されるクラスター、サービスアカウント、および namespace を使用してジョブとして実行されます。ジョブは、デフォルトの再試行数 6 に達するか、正常に完了するまで実行を継続します。これは、最初の Pod がエビクトされるか、または強制終了される場合でも継続されます。

デフォルトの Ansible ランタイムイメージは registry.redhat.io/rhmtc/openshift-migration-hook-runner-rhel7:1.4 です。このイメージは Ansible Runner イメージをベースとしており、Ansible Kubernetes リソースの python-openshift および更新された oc バイナリーが含まれます。

オプション: デフォルトイメージの代わりに、追加の Ansible モジュールまたはツールを含むカスタム Ansible ランタイムイメージを使用できます。

カスタムフックコンテナー

Ansible Playbook またはカスタムコードを含むカスタムフックコンテナーを作成できます。

1.4. MTC (Migration Toolkit for Containers) のインストールおよびアップグレード

OpenShift Container Platform 4.5 ターゲットクラスターおよび OpenShift Container Platform 3 ソースクラスターに MTC (Migration Toolkit for Containers) をインストールすることができます。

Migration Controller Pod は、デフォルトでターゲットクラスターで実行されます。Migration コントローラー Pod を ソースクラスターまたはリモートクラスター で実行するように設定できます。

1.4.1. 接続された環境での MTC (Migration Toolkit for Containers) のインストール

接続された環境で MTC (Migration Toolkit for Containers) をインストールできます。

すべてのクラスターに同じ MTC バージョンをインストールする必要があります。

1.4.1.1. Migration Toolkit for Containers の OpenShift Container Platform 4.5 ターゲットクラスターへのインストール

MTC (Migration Toolkit for Containers) を OpenShift Container Platform 4.5 ターゲットクラスターにインストールできます。

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。

手順

- OpenShift Container Platform Web コンソールで、Operators → OperatorHub をクリックします。

- Filter by keyword フィールドを使用して、 Migration Toolkit for Containers Operator を見つけます。

Migration Toolkit for Containers Operator を選択し、Install をクリックします。

注記サブスクリプションの承認オプションを Automatic に変更しないでください。MTC (Migration Toolkit for Containers) のバージョンは、ソースとターゲットクラスターで同一である必要があります。

Install をクリックします。

Installed Operators ページで、Migration Toolkit for Containers Operator は、Succeeded のステータスで openshift-migration プロジェクトに表示されます。

- Migration Toolkit for Containers Operator をクリックします。

- Provided APIs の下で Migration Controller タイルを見つけ、Create Instance をクリックします。

- Create をクリックします。

- Workloads → Pods をクリックし、MTC Pod が実行されていることを確認します。

1.4.1.2. OpenShift Container Platform 3 ソースクラスターへの Migration Toolkit for Containers Operator のインストール

Migration Toolkit for Containers (MTC) を手動で OpenShift Container Platform 3 ソースクラスターにインストールできます。

OpenShift Container Platform 3 および 4 クラスターに同じ MTC バージョンをインストールする必要があります。

OpenShift Container Platform 3 クラスターで最新バージョンを使用できるようにするには、移行計画を作成し、実行する準備ができたら operator.yml および controller-3.yml ファイルをダウンロードします。

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。 -

registry.redhat.ioにアクセスできる必要があります。 -

podmanがインストールされている必要があります。 - ソースクラスターは OpenShift Container Platform 3.7、3.9、3.10、または 3.11 である必要があります。

ソースクラスターは、イメージを

registry.redhat.ioからプルするように設定されている必要があります。イメージをプルするには、イメージストリームのシークレットを作成 し、これをクラスター内の各ノードにコピーする必要があります。

手順

Red Hat カスタマーポータルの認証情報を使用して

registry.redhat.ioにログインします。sudo podman login registry.redhat.io

$ sudo podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow operator.ymlファイルをダウンロードします。sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/operator.yml ./

$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/operator.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow controller-3.ymlファイルをダウンロードします。sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/controller-3.yml ./

$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/controller-3.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow - OpenShift Container Platform 3 クラスターにログインします。

クラスターが

registry.redhat.ioで認証できることを確認します。oc run test --image registry.redhat.io/ubi8 --command sleep infinity

$ oc run test --image registry.redhat.io/ubi8 --command sleep infinityCopy to Clipboard Copied! Toggle word wrap Toggle overflow Migration Toolkit for Containers Operator オブジェクトを作成します。

oc create -f operator.yml

$ oc create -f operator.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

Error from server (AlreadyExists)メッセージは無視できます。これらは、以降のリソースで提供される OpenShift Container Platform 3 の以前のバージョン用にリソースを作成する Migration Toolkit for Containers Operator によって生じます。

MigrationControllerオブジェクトを作成します。oc create -f controller-3.yml

$ oc create -f controller-3.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow VeleroおよびResticPod が実行されていることを確認します。oc get pods -n openshift-migration

$ oc get pods -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4.2. 制限された環境での Migration Toolkit for Containers Operator のインストール

制限された環境で Migration Toolkit for Containers Operator をインストールできます。

すべてのクラスターに同じ MTC バージョンをインストールする必要があります。

OpenShift Container Platform 4 のカスタム Operator カタログイメージをビルドし、これをローカルミラーイメージレジストリーにプッシュし、Operator Lifecycle Manager (OLM) をローカルレジストリーから Migration Toolkit for Containers Operator をインストールするように設定できます。

1.4.2.1. Operator カタログイメージのビルド

クラスター管理者は、Operator Lifecycle Manager (OLM) によって使用される Package Manifest Format に基づいてカスタム Operator カタログイメージをビルドできます。カタログイメージは、Docker v2-2 をサポートするコンテナーイメージレジストリーにプッシュできます。ネットワークが制限された環境のクラスターの場合、このレジストリーには、ネットワークが制限されたクラスターのインストール時に作成されたミラーレジストリーなど、クラスターにネットワークアクセスのあるレジストリーを使用できます。

OpenShift Container Platform クラスターの内部レジストリーはターゲットレジストリーとして使用できません。これは、ミラーリングプロセスで必要となるタグを使わないプッシュをサポートしないためです。

以下の例では、お使いのネットワークとインターネットの両方にアクセスできるミラーレジストリーを使用することを前提としています。

Windows および macOS のバージョンは oc adm catalog build コマンドを提供しないため、この手順では oc クライアントの Linux バージョンのみを使用できます。

前提条件

- ネットワークアクセスが無制限のワークステーション

-

ocバージョン 4.3.5+ Linux クライアント -

podmanversion 1.4.4+ - Docker v2-2 をサポートするミラーレジストリーへのアクセス

プライベートレジストリーを使用している場合、後続の手順で使用するために

REG_CREDS環境変数をレジストリー認証情報のファイルパスに設定します。たとえばpodmanCLI の場合は、以下のようになります。REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.json$ REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow quay.io アカウントがアクセスできるプライベート namespace を使用している場合、Quay 認証トークンを設定する必要があります。quay.io 認証情報を使用してログイン API に対して要求を行うことにより、

--auth-tokenフラグで使用できるAUTH_TOKEN環境変数を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

ネットワークアクセスが無制限のワークステーションで、ターゲットミラーレジストリーを使用して認証を行います。

podman login <registry_host_name>

$ podman login <registry_host_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow また、ビルド時にベースイメージをプルできるように、

registry.redhat.ioで認証します。podman login registry.redhat.io

$ podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow Quay.io から

redhat-operatorsカタログをベースにカタログイメージをビルドし、そのイメージにタグを付け、ミラーレジストリーにプッシュします。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- App Registry インスタンスからのプルに使用する組織 (namespace)。

- 2

- ターゲット OpenShift Container Platform クラスターのメジャーバージョンおよびマイナーバージョンに一致するタグを使用して、

--fromをose-operator-registryベースイメージに設定します。 - 3

--filter-by-osを、ターゲットの OpenShift Container Platform クラスターと一致する必要のある、ベースイメージに使用するオペレーティングシステムおよびアーキテクチャーに設定します。使用できる値は、linux/amd64、linux/ppc64le、およびlinux/s390xです。- 4

- カタログイメージに名前を付け、

v1などのタグを追加します。 - 5

- オプション: 必要な場合は、レジストリー認証情報ファイルの場所を指定します。

- 6

- オプション: ターゲットレジストリーの信頼を設定しない場合は、

--insecureフラグを追加します。 - 7

- オプション: 公開されていない他のアプリケーションレジストリーカタログが使用されている場合、Quay 認証トークンを指定します。

出力例

INFO[0013] loading Bundles dir=/var/folders/st/9cskxqs53ll3wdn434vw4cd80000gn/T/300666084/manifests-829192605 ... Pushed sha256:f73d42950021f9240389f99ddc5b0c7f1b533c054ba344654ff1edaf6bf827e3 to example_registry:5000/olm/redhat-operators:v1

INFO[0013] loading Bundles dir=/var/folders/st/9cskxqs53ll3wdn434vw4cd80000gn/T/300666084/manifests-829192605 ... Pushed sha256:f73d42950021f9240389f99ddc5b0c7f1b533c054ba344654ff1edaf6bf827e3 to example_registry:5000/olm/redhat-operators:v1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 無効なマニフェストが Red Hat のカタログに誤って導入されることあります。これが実際に生じる場合には、以下のようなエラーが表示される可能性があります。

エラーのある出力の例

... INFO[0014] directory dir=/var/folders/st/9cskxqs53ll3wdn434vw4cd80000gn/T/300666084/manifests-829192605 file=4.2 load=package W1114 19:42:37.876180 34665 builder.go:141] error building database: error loading package into db: fuse-camel-k-operator.v7.5.0 specifies replacement that couldn't be found Uploading ... 244.9kB/s

... INFO[0014] directory dir=/var/folders/st/9cskxqs53ll3wdn434vw4cd80000gn/T/300666084/manifests-829192605 file=4.2 load=package W1114 19:42:37.876180 34665 builder.go:141] error building database: error loading package into db: fuse-camel-k-operator.v7.5.0 specifies replacement that couldn't be found Uploading ... 244.9kB/sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 通常、これらのエラーは致命的なエラーではなく、該当する Operator パッケージにインストールする予定の Operator やその依存関係が含まれない場合、それらを無視することができます。

1.4.2.2. ネットワークが制限された環境向けの OperatorHub の設定

クラスター管理者は、カスタム Operator カタログイメージを使用し、OLM および OperatorHub をネットワークが制限された環境でローカルコンテンツを使用するように設定できます。この例では、以前にビルドされ、サポートされているレジストリーにプッシュされたカスタム redhat-operators カタログイメージを使用します。

前提条件

- ネットワークアクセスが無制限のワークステーション

- サポートされているレジストリーにプッシュされるカスタム Operator カタログイメージ

-

ocversion 4.3.5+ -

podmanversion 1.4.4+ - Docker v2-2 をサポートするミラーレジストリーへのアクセス

プライベートレジストリーを使用している場合、後続の手順で使用するために

REG_CREDS環境変数をレジストリー認証情報のファイルパスに設定します。たとえばpodmanCLI の場合は、以下のようになります。REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.json$ REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

oc adm catalog mirrorコマンドは、カスタム Operator カタログイメージのコンテンツを抽出し、ミラーリングに必要なマニフェストを生成します。以下のいずれかを選択できます。- コマンドのデフォルト動作で、マニフェストの生成後にすべてのイメージコンテンツをミラーレジストリーに自動的にミラーリングできるようにします。または、

-

--manifests-onlyフラグを追加して、ミラーリングに必要なマニフェストのみを生成しますが、これにより、イメージコンテンツがレジストリーに自動的にミラーリングされる訳ではありません。これは、ミラーリングする内容を確認するのに役立ちます。また、コンテンツのサブセットのみが必要な場合に、マッピングの一覧に変更を加えることができます。次に、そのファイルをoc image mirrorコマンドで使用し、後のステップでイメージの変更済みの一覧をミラーリングできます。

ネットワークアクセスが無制限のワークステーションで、以下のコマンドを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 警告--filter-by-osフラグが設定されていない状態か、または.*以外の値に設定されている場合、コマンドが複数の異なるアーキテクチャーをフィルターし、マニフェスト一覧のダイジェスト (multi-arch image イメージとしても知られる) が変更されます。ダイジェストが間違っていると、それらのイメージおよび Operator の非接続クラスターでのデプロイメントに失敗します。詳細は、BZ#1890951 を参照してください。出力例

using database path mapping: /:/tmp/190214037 wrote database to /tmp/190214037 using database at: /tmp/190214037/bundles.db ...

using database path mapping: /:/tmp/190214037 wrote database to /tmp/190214037 using database at: /tmp/190214037/bundles.db1 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- コマンドで生成される一時的なデータベース。

コマンドの実行後に、

<image_name>-manifests/ディレクトリーが現在のディレクトリーに作成され、以下のファイルが生成されます。-

これにより、

imageContentSourcePolicy.yamlファイルはImageContentSourcePolicyオブジェクトを定義します。このオブジェクトは、ノードを Operator マニフェストおよびミラーリングされたレジストリーに保存されるイメージ参照間で変換できるように設定します。 -

mapping.txtファイルには、すべてのソースイメージが含まれ、これはそれらのイメージをターゲットレジストリー内のどこにマップするかを示します。このファイルはoc image mirrorコマンドと互換性があり、ミラーリング設定をさらにカスタマイズするために使用できます。

直前の手順で

--manifests-onlyフラグを使用して、コンテンツのサブセットのみをミラーリングする場合は、以下を実行します。mapping.txtファイルのイメージの一覧を仕様に変更します。ミラーリングするイメージのサブセットの名前とバージョンが不明な場合は、以下の手順で確認します。oc adm catalog mirrorコマンドで生成された一時的なデータベースに対してsqlite3ツールを実行し、一般的な検索クエリーに一致するイメージの一覧を取得します。出力は、後にmapping.txtファイルを編集する方法を通知するのに役立ちます。たとえば、

clusterlogging.4.3の文字列のようなイメージの一覧を取得するには、以下を実行します。echo "select * from related_image \ where operatorbundle_name like 'clusterlogging.4.3%';" \ | sqlite3 -line /tmp/190214037/bundles.db$ echo "select * from related_image \ where operatorbundle_name like 'clusterlogging.4.3%';" \ | sqlite3 -line /tmp/190214037/bundles.db1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

oc adm catalog mirrorコマンドの直前の出力を参照し、データベースファイルのパスを見つけます。

出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 直前の手順で取得した結果を使用して

mapping.txtファイルを編集し、ミラーリングする必要のあるイメージのサブセットのみを追加します。たとえば、前述の出力例の

image値を使用して、mapping.txtファイルに以下の一致する行が存在することを確認できます。mapping.txtの一致するイメージマッピング。registry.redhat.io/openshift4/ose-logging-kibana5@sha256:aa4a8b2a00836d0e28aa6497ad90a3c116f135f382d8211e3c55f34fb36dfe61=<registry_host_name>:<port>/openshift4-ose-logging-kibana5:a767c8f0 registry.redhat.io/openshift4/ose-oauth-proxy@sha256:6b4db07f6e6c962fc96473d86c44532c93b146bbefe311d0c348117bf759c506=<registry_host_name>:<port>/openshift4-ose-oauth-proxy:3754ea2b

registry.redhat.io/openshift4/ose-logging-kibana5@sha256:aa4a8b2a00836d0e28aa6497ad90a3c116f135f382d8211e3c55f34fb36dfe61=<registry_host_name>:<port>/openshift4-ose-logging-kibana5:a767c8f0 registry.redhat.io/openshift4/ose-oauth-proxy@sha256:6b4db07f6e6c962fc96473d86c44532c93b146bbefe311d0c348117bf759c506=<registry_host_name>:<port>/openshift4-ose-oauth-proxy:3754ea2bCopy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、これらのイメージのみをミラーリングする場合に、

mapping.txtファイルの他のすべてのエントリーを削除し、上記の 2 行のみを残します。

ネットワークアクセスが無制限のワークステーション上で、変更した

mapping.txtファイルを使用し、oc image mirrorコマンドを使用してイメージをレジストリーにミラーリングします。oc image mirror \ [-a ${REG_CREDS}] \ --filter-by-os='.*' \ -f ./redhat-operators-manifests/mapping.txt$ oc image mirror \ [-a ${REG_CREDS}] \ --filter-by-os='.*' \ -f ./redhat-operators-manifests/mapping.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 警告--filter-by-osフラグが設定されていない状態か、または.*以外の値に設定されている場合、コマンドが複数の異なるアーキテクチャーをフィルターし、マニフェスト一覧のダイジェスト (multi-arch image イメージとしても知られる) が変更されます。ダイジェストが間違っていると、それらのイメージおよび Operator の非接続クラスターでのデプロイメントに失敗します。

ImageContentSourcePolicyオブジェクトを適用します。oc apply -f ./redhat-operators-manifests/imageContentSourcePolicy.yaml

$ oc apply -f ./redhat-operators-manifests/imageContentSourcePolicy.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow カタログイメージを参照する

CatalogSourceオブジェクトを作成します。仕様を以下のように変更し、これを

catalogsource.yamlファイルとして保存します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Operator カタログイメージを指定します。

このファイルを使用して

CatalogSourceオブジェクトを作成します。oc create -f catalogsource.yaml

$ oc create -f catalogsource.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

以下のリソースが正常に作成されていることを確認します。

Pod を確認します。

oc get pods -n openshift-marketplace

$ oc get pods -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME READY STATUS RESTARTS AGE my-operator-catalog-6njx6 1/1 Running 0 28s marketplace-operator-d9f549946-96sgr 1/1 Running 0 26h

NAME READY STATUS RESTARTS AGE my-operator-catalog-6njx6 1/1 Running 0 28s marketplace-operator-d9f549946-96sgr 1/1 Running 0 26hCopy to Clipboard Copied! Toggle word wrap Toggle overflow カタログソースを確認します。

oc get catalogsource -n openshift-marketplace

$ oc get catalogsource -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME DISPLAY TYPE PUBLISHER AGE my-operator-catalog My Operator Catalog grpc 5s

NAME DISPLAY TYPE PUBLISHER AGE my-operator-catalog My Operator Catalog grpc 5sCopy to Clipboard Copied! Toggle word wrap Toggle overflow パッケージマニフェストを確認します。

oc get packagemanifest -n openshift-marketplace

$ oc get packagemanifest -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME CATALOG AGE etcd My Operator Catalog 34s

NAME CATALOG AGE etcd My Operator Catalog 34sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

ネットワークが制限された環境の OpenShift Container Platform クラスター Web コンソールで、OperatorHub ページから Operator をインストールできます。

1.4.2.3. 制限された環境での Migration Toolkit for Containers の OpenShift Container Platform 4.5 ターゲットクラスターへのインストール

MTC (Migration Toolkit for Containers) を OpenShift Container Platform 4.5 ターゲットクラスターにインストールできます。

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。 - カスタム Operator カタログを作成し、これをミラーレジストリーにプッシュする必要があります。

- ミラーレジストリーから Migration Toolkit for Containers Operator をインストールするように OLM を設定している必要があります。

手順

- OpenShift Container Platform Web コンソールで、Operators → OperatorHub をクリックします。

- Filter by keyword フィールドを使用して、 Migration Toolkit for Containers Operator を見つけます。

Migration Toolkit for Containers Operator を選択し、Install をクリックします。

注記サブスクリプションの承認オプションを Automatic に変更しないでください。MTC (Migration Toolkit for Containers) のバージョンは、ソースとターゲットクラスターで同一である必要があります。

Install をクリックします。

Installed Operators ページで、Migration Toolkit for Containers Operator は、Succeeded のステータスで openshift-migration プロジェクトに表示されます。

- Migration Toolkit for Containers Operator をクリックします。

- Provided APIs の下で Migration Controller タイルを見つけ、Create Instance をクリックします。

- Create をクリックします。

- Workloads → Pods をクリックし、MTC Pod が実行されていることを確認します。

1.4.2.4. 制限された環境での Migration Toolkit for Containers Operator の OpenShift Container Platform 3 ソースクラスターへのインストール

Migration Toolkit for Containers (MTC) Operator イメージに基づいてマニフェストファイルを作成し、ローカルイメージレジストリーを参照するようにマニフェストを編集できます。次に、ローカルイメージを使用して Migration Toolkit for Containers Operator を OpenShift Container Platform 3 ソースクラスターに作成できます。

OpenShift Container Platform 3 および 4 クラスターに同じ MTC バージョンをインストールする必要があります。

OpenShift Container Platform 3 クラスターで最新バージョンを使用できるようにするには、移行計画を作成し、実行する準備ができたら operator.yml および controller-3.yml ファイルをダウンロードします。

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。 -

registry.redhat.ioにアクセスできる必要があります。 -

podmanがインストールされている必要があります。 - ソースクラスターは OpenShift Container Platform 3.7、3.9、3.10、または 3.11 である必要があります。

- ネットワークアクセスが無制限の Linux ワークステーションが必要です。

- Docker v2-2 をサポートするミラーレジストリーへのアクセスが必要です。

手順

ネットワークアクセスが無制限のワークステーションで、Red Hat カスタマーポータルの認証情報を使用して

registry.redhat.ioにログインします。sudo podman login registry.redhat.io

$ sudo podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow operator.ymlファイルをダウンロードします。sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/operator.yml ./

$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/operator.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow controller-3.ymlファイルをダウンロードします。sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/controller-3.yml ./

$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/controller-3.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform 4 クラスターで

oc adm catalog mirrorの実行時に作成されたmapping.txtファイルから Operator イメージの値を取得します。grep openshift-migration-rhel7-operator ./mapping.txt | grep rhmtc

$ grep openshift-migration-rhel7-operator ./mapping.txt | grep rhmtcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力には、

registry.redhat.ioイメージとミラーレジストリーイメージ間のマッピングが表示されます。出力例

registry.redhat.io/rhmtc/openshift-migration-rhel7-operator@sha256:468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a=<registry.apps.example.com>/rhmtc/openshift-migration-rhel7-operator

registry.redhat.io/rhmtc/openshift-migration-rhel7-operator@sha256:468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a=<registry.apps.example.com>/rhmtc/openshift-migration-rhel7-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Operator 設定ファイルの

imageおよびREGISTRYの値を更新します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - OpenShift Container Platform 3 クラスターにログインします。

Migration Toolkit for Containers Operator オブジェクトを作成します。

oc create -f operator.yml

$ oc create -f operator.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

Error from server (AlreadyExists)メッセージは無視できます。これらは、以降のリソースで提供される OpenShift Container Platform 3 の以前のバージョン用にリソースを作成する Migration Toolkit for Containers Operator によって生じます。

MigrationControllerオブジェクトを作成します。oc create -f controller-3.yml

$ oc create -f controller-3.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow VeleroおよびResticPod が実行されていることを確認します。oc get pods -n openshift-migration

$ oc get pods -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4.3. MTC (Migration Toolkit for Containers) のアップグレード

MTC (Migration Toolkit for Containers) は、OpenShift Container Platform Web コンソールを使用してアップグレードできます。

同じ MTC バージョンがすべてのクラスターにインストールされていることを確認する必要があります。

MTC バージョン 1.3 をアップグレードする場合、MigPlan カスタムリソース (CR) を更新する追加の手順を実行する必要があります。

1.4.3.1. OpenShift Container Platform 4 クラスターでの MTC (Migration Toolkit for Containers) のアップグレード

MTC (Migration Toolkit for Containers) は OpenShift Container Platform Web コンソールを使用して OpenShift Container Platform 4 クラスターでアップグレードできます。

前提条件

-

cluster-admin権限を持つユーザーとしてログインしている。

手順

OpenShift Container Platform コンソールで、Operators → Installed Operators に移動します。

更新が保留中の Operator は Upgrade available のステータスを表示します。

- Migration Toolkit for Containers Operator をクリックします。

- Subscription タブをクリックします。アップグレードの承認を必要とするアップグレードは、Upgrade Status の横に表示されます。たとえば、1 requires approval が表示される可能性があります。

- 1 requires approval をクリックしてから、Preview Install Plan をクリックします。

- アップグレードに利用可能なリソースとして一覧表示されているリソースを確認し、Approve をクリックします。

- Operators → Installed Operators ページに戻り、アップグレードの進捗をモニターします。完了時に、ステータスは Succeeded および Up to date に変更されます。

- Workloads → Pods をクリックし、MTC Pod が実行されていることを確認します。

1.4.3.2. OpenShift Container Platform 3 クラスターでの MTC (Migration Toolkit for Containers) のアップグレード

MTC (Migration Toolkit for Containers) を、podman を使用して OpenShift Container Platform 3 クラスターでアップグレードできます。

前提条件

-

cluster-admin権限を持つユーザーとしてログインしている。 -

registry.redhat.ioにアクセスできる必要があります。 -

podmanがインストールされている必要があります。

手順

Red Hat カスタマーポータルの認証情報を使用して

registry.redhat.ioにログインします。sudo podman login registry.redhat.io

$ sudo podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 最新の

operator.ymlファイルをダウンロードします。sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/operator.yml ./

$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/operator.yml ./1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 必要な場合は z-stream リリースを指定できます。

Migration Toolkit for Containers Operator を置き換えます。

oc replace --force -f operator.yml

$ oc replace --force -f operator.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 変更を適用します。

MTC 1.1.2 以前のバージョンの場合は、

ResticPod を削除します。oc delete pod <restic_pod>

$ oc delete pod <restic_pod>Copy to Clipboard Copied! Toggle word wrap Toggle overflow MTC 1.2 以降のバージョンの場合:

migration-operatorデプロイメントを0にスケーリングし、デプロイメントを停止します。oc scale -n openshift-migration --replicas=0 deployment/migration-operator

$ oc scale -n openshift-migration --replicas=0 deployment/migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow migration-operatorデプロイメントを1にスケーリングし、デプロイメントを開始して変更を適用します。oc scale -n openshift-migration --replicas=1 deployment/migration-operator

$ oc scale -n openshift-migration --replicas=1 deployment/migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

migration-operatorがアップグレードされていることを確認します。oc -o yaml -n openshift-migration get deployment/migration-operator | grep image: | awk -F ":" '{ print $NF }'$ oc -o yaml -n openshift-migration get deployment/migration-operator | grep image: | awk -F ":" '{ print $NF }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 最新の

controller-3.ymlファイルをダウンロードします。sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/controller-3.yml ./

$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-rhel7-operator:v1.4):/controller-3.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration-controllerオブジェクトを作成します。oc create -f controller-3.yml

$ oc create -f controller-3.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform バージョンが 3.10 以前である場合、

migration-controllerサービスアカウントの SCC (Security Context Constraints) をanyuidに設定して、イメージの直接移行およびボリュームの直接移行を有効にします。oc adm policy add-scc-to-user anyuid -z migration-controller -n openshift-migration

$ oc adm policy add-scc-to-user anyuid -z migration-controller -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow MTC Pod が実行されていることを確認します。

oc get pods -n openshift-migration

$ oc get pods -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform 3 クラスターを MTC Web コンソールに追加している場合、アップグレードプロセスにより

openshift-migrationnamespace が削除され、復元されるため、Web コンソースでサービスアカウントトークンを更新する必要があります。サービスアカウントトークンを取得します。

oc sa get-token migration-controller -n openshift-migration

$ oc sa get-token migration-controller -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow - MTC の Web コンソールで、Clusters をクリックします。

-

クラスターの横にある Options メニュー

をクリックし、Edit を選択します。

をクリックし、Edit を選択します。

- Service account token フィールドに新規サービスアカウントトークンを入力します。

- Update cluster をクリックしてから、Close をクリックします。

1.4.3.3. MTC 1.3 から 1.4 へのアップグレード

MTC (Migration Toolkit for Containers) バージョン 1.3.x を 1.4 にアップグレードする場合、MigrationController Pod が実行されているクラスターで MigPlan カスタムリソース (CR) マニフェストを更新する必要があります。

indirectImageMigration および indirectVolumeMigration パラメーターは MTC 1.3 に存在しないため、バージョン 1.4 のそれらのデフォルト値は false になります。つまり、イメージの直接移行およびボリュームの直接移行が有効にされます。直接移行の要件が満たされないため、これらのパラメーターの値が true に変更されない限り、移行計画は Ready 状態になりません。

前提条件

- MTC 1.3 がインストールされている必要があります。

-

cluster-admin権限を持つユーザーとしてログインしている必要があります。

手順

-

MigrationControllerPod が実行されるクラスターにログインします。 MigPlanCR マニフェストを取得します。oc get migplan <migplan> -o yaml -n openshift-migration

$ oc get migplan <migplan> -o yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のパラメーター値を更新し、ファイルを

migplan.yamlとして保存します。... spec: indirectImageMigration: true indirectVolumeMigration: true

... spec: indirectImageMigration: true indirectVolumeMigration: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow MigPlanCR マニフェストを置き換えて変更を適用します。oc replace -f migplan.yaml -n openshift-migration

$ oc replace -f migplan.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新された

MigPlanCR マニフェストを取得して変更を確認します。oc get migplan <migplan> -o yaml -n openshift-migration

$ oc get migplan <migplan> -o yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.5. レプリケーションリポジトリーのオブジェクトストレージの設定

オブジェクトストレージをレプリケーションリポジトリーとして使用するように設定する必要があります。MTC (Migration Toolkit for Containers) は、データをソースクラスターからレプリケーションリポジトリーにコピーしてから、レプリケーションリポジトリーからターゲットクラスターにコピーします。

MTC は、ソースクラスターからターゲットクラスターにデータを以降するために、ファイルシステムおよびスナップショットによるデータのコピー方法 をサポートします。ご使用の環境に適した方法で、ストレージプロバイダーでサポートされる方法を選択できます。

以下のストレージプロバイダーがサポートされています。

- Multi-Cloud Object Gateway (MCG)

- Amazon Web Services (AWS) S3

- Google Cloud Provider (GCP)

- Microsoft Azure

- 汎用 S3 オブジェクトストレージ (例: Minio または Ceph S3)

制限された環境では、内部でホストされるレプリケーションリポジトリーを作成できます。

前提条件

- すべてのクラスターには、レプリケーションリポジトリーへの中断されないネットワークアクセスが必要です。

- 内部でホストされるレプリケーションリポジトリーでプロキシーサーバーを使用する場合は、プロキシーがレプリケーションリポジトリーへのアクセスを許可することを確認する必要があります。

1.5.1. Multi-Cloud Object Gateway ストレージバケットをレプリケーションリポジトリーとして設定する

OpenShift Container Storage Operator をインストールし、Multi-Cloud Object Gateway (MCG) ストレージバケットを MTC (Migration Toolkit for Containers) のレプリケーションリポジトリーとして設定できます。

1.5.1.1. OpenShift Container Storage Operator のインストール

OpenShift Container Storage Operator は、OperatorHub からインストールできます。

手順

- OpenShift Container Platform Web コンソールで、Operators → OperatorHub をクリックします。

- Filter by keyword (この場合は、OCS) を使用し、 OpenShift Container Storage Operator を見つけます。

- OpenShift Container Storage Operator を選択し、Install をクリックします。

- Update Channel、Installation Mode、および Approval Strategy を選択します。

Install をクリックします。

Installed Operators ページで、OpenShift Container Storage Operator は、Succeeded のステータスと共に openshift-storage プロジェクトに表示されます。

1.5.1.2. Multi-Cloud Object Gateway ストレージバケットの作成

Multi-Cloud Object Gateway (MCG) ストレージバケットのカスタムリソース (CR) を作成できます。

手順

OpenShift Container Platform クラスターにログインします。

oc login

$ oc loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow NooBaaCR 設定ファイルnoobaa.ymlを以下の内容で作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow NooBaaオブジェクトを作成します。oc create -f noobaa.yml

$ oc create -f noobaa.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の内容で、

BackingStoreCR 設定ファイルbs.ymlを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow BackingStoreオブジェクトを作成します。oc create -f bs.yml

$ oc create -f bs.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の内容で

BucketClassCR 設定ファイルbc.ymlを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow BucketClassオブジェクトを作成します。oc create -f bc.yml

$ oc create -f bc.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の内容で

ObjectBucketClaimCR 設定ファイルobc.ymlを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- レプリケーションリポジトリーを MTC の Web コンソールに追加するために使用するバケット名を記録します。

ObjectBucketClaimオブジェクトを作成します。oc create -f obc.yml

$ oc create -f obc.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow リソース作成プロセスを監視し、

ObjectBucketClaimステータスがBoundであることを確認します。watch -n 30 'oc get -n openshift-storage objectbucketclaim migstorage -o yaml'

$ watch -n 30 'oc get -n openshift-storage objectbucketclaim migstorage -o yaml'Copy to Clipboard Copied! Toggle word wrap Toggle overflow このプロセスには、5 分から 10 分の時間がかかる場合があります。

以下の値を取得して記録します。この値は、レプリケーションリポジトリーを MTC の Web コンソールに追加する際に必要になります。

S3 エンドポイント:

oc get route -n openshift-storage s3

$ oc get route -n openshift-storage s3Copy to Clipboard Copied! Toggle word wrap Toggle overflow S3 プロバイダーアクセスキー:

oc get secret -n openshift-storage migstorage -o go-template='{{ .data.AWS_ACCESS_KEY_ID }}' | base64 --decode$ oc get secret -n openshift-storage migstorage -o go-template='{{ .data.AWS_ACCESS_KEY_ID }}' | base64 --decodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow S3 プロバイダーシークレットアクセスキー:

oc get secret -n openshift-storage migstorage -o go-template='{{ .data.AWS_SECRET_ACCESS_KEY }}' | base64 --decode$ oc get secret -n openshift-storage migstorage -o go-template='{{ .data.AWS_SECRET_ACCESS_KEY }}' | base64 --decodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.5.2. AWS S3 ストレージバケットをレプリケーションリポジトリーとして設定する

AWS S3 ストレージバケットを MTC (Migration Toolkit for Containers) のレプリケーションリポジトリーとして設定できます。

前提条件

- AWS S3 ストレージバケットは、ソースクラスターおよびターゲットクラスターからアクセスできる必要があります。

- AWS CLI がインストールされていること。

スナップショットのコピー方法を使用する場合は、以下の条件を満たす必要があります。

- EC2 Elastic Block Storage (EBS) にアクセスできる必要があります。

- ソースおよびターゲットクラスターが同じリージョンにある必要があります。

- ソースおよびターゲットクラスターには、同じストレージクラスがある必要があります。

- ストレージクラスはスナップショットと互換性がある必要があります。

手順

AWS S3 バケットを作成します。

aws s3api create-bucket \ --bucket <bucket_name> \ --region <bucket_region>$ aws s3api create-bucket \ --bucket <bucket_name> \1 --region <bucket_region>2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow IAM ユーザー

veleroを作成します。aws iam create-user --user-name velero

$ aws iam create-user --user-name veleroCopy to Clipboard Copied! Toggle word wrap Toggle overflow EC2 EBS スナップショットポリシーを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 1 つまたはすべての S3 バケットの AWS S3 アクセスポリシーを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

"Resource": [ "arn:aws:s3:::*""Resource": [ "arn:aws:s3:::*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow EC2 EBS ポリシーを

veleroに割り当てます。aws iam put-user-policy \ --user-name velero \ --policy-name velero-ebs \ --policy-document file://velero-ec2-snapshot-policy.json

$ aws iam put-user-policy \ --user-name velero \ --policy-name velero-ebs \ --policy-document file://velero-ec2-snapshot-policy.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow AWS S3 ポリシーを

veleroに割り当てます。aws iam put-user-policy \ --user-name velero \ --policy-name velero-s3 \ --policy-document file://velero-s3-policy.json

$ aws iam put-user-policy \ --user-name velero \ --policy-name velero-s3 \ --policy-document file://velero-s3-policy.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow veleroのアクセスキーを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.5.3. Google Cloud Provider ストレージバケットをレプリケーションリポジトリーとして設定する

Google Cloud Provider (GCP) ストレージバケットを MTC (Migration Toolkit for Containers) のレプリケーションリポジトリーとして設定できます。

前提条件

- GCP ストレージバケットは、ソースクラスターおよびターゲットクラスターからアクセスできる必要があります。

-

gsutilがインストールされていること。 スナップショットのコピー方法を使用する場合は、以下の条件を満たす必要があります。

- ソースおよびターゲットクラスターが同じリージョンにある必要があります。

- ソースおよびターゲットクラスターには、同じストレージクラスがある必要があります。

- ストレージクラスはスナップショットと互換性がある必要があります。

手順

gsutilにログインします。gsutil init

$ gsutil initCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Welcome! This command will take you through the configuration of gcloud. Your current configuration has been set to: [default] To continue, you must login. Would you like to login (Y/n)?

Welcome! This command will take you through the configuration of gcloud. Your current configuration has been set to: [default] To continue, you must login. Would you like to login (Y/n)?Copy to Clipboard Copied! Toggle word wrap Toggle overflow BUCKET変数を設定します。BUCKET=<bucket_name>

$ BUCKET=<bucket_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- バケット名を指定します。

ストレージバケットを作成します。

gsutil mb gs://$BUCKET/

$ gsutil mb gs://$BUCKET/Copy to Clipboard Copied! Toggle word wrap Toggle overflow PROJECT_ID変数をアクティブなプロジェクトに設定します。PROJECT_ID=`gcloud config get-value project`

$ PROJECT_ID=`gcloud config get-value project`Copy to Clipboard Copied! Toggle word wrap Toggle overflow veleroIAM サービスアカウントを作成します。gcloud iam service-accounts create velero \ --display-name "Velero Storage"$ gcloud iam service-accounts create velero \ --display-name "Velero Storage"Copy to Clipboard Copied! Toggle word wrap Toggle overflow SERVICE_ACCOUNT_EMAIL変数を作成します。SERVICE_ACCOUNT_EMAIL=`gcloud iam service-accounts list \ --filter="displayName:Velero Storage" \ --format 'value(email)'`

$ SERVICE_ACCOUNT_EMAIL=`gcloud iam service-accounts list \ --filter="displayName:Velero Storage" \ --format 'value(email)'`Copy to Clipboard Copied! Toggle word wrap Toggle overflow ROLE_PERMISSIONS変数を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow velero.serverカスタムロールを作成します。gcloud iam roles create velero.server \ --project $PROJECT_ID \ --title "Velero Server" \ --permissions "$(IFS=","; echo "${ROLE_PERMISSIONS[*]}")"$ gcloud iam roles create velero.server \ --project $PROJECT_ID \ --title "Velero Server" \ --permissions "$(IFS=","; echo "${ROLE_PERMISSIONS[*]}")"Copy to Clipboard Copied! Toggle word wrap Toggle overflow IAM ポリシーバインディングをプロジェクトに追加します。

gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT_EMAIL \ --role projects/$PROJECT_ID/roles/velero.server$ gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT_EMAIL \ --role projects/$PROJECT_ID/roles/velero.serverCopy to Clipboard Copied! Toggle word wrap Toggle overflow IAM サービスアカウントを更新します。

gsutil iam ch serviceAccount:$SERVICE_ACCOUNT_EMAIL:objectAdmin gs://${BUCKET}$ gsutil iam ch serviceAccount:$SERVICE_ACCOUNT_EMAIL:objectAdmin gs://${BUCKET}Copy to Clipboard Copied! Toggle word wrap Toggle overflow IAM サービスアカウントのキーを現在のディレクトリーにある

credentials-veleroファイルに保存します。gcloud iam service-accounts keys create credentials-velero \ --iam-account $SERVICE_ACCOUNT_EMAIL

$ gcloud iam service-accounts keys create credentials-velero \ --iam-account $SERVICE_ACCOUNT_EMAILCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.5.4. Microsoft Azure Blob ストレージコンテナーをレプリケーションリポジトリーとして設定

Microsoft Azure Blob ストレージコンテナーを MTC (Migration Toolkit for Containers) のレプリケーションリポジトリーとして設定できます。

前提条件

- Azure ストレージアカウント があること。

- Azure CLI がインストールされていること。

- Azure Blob ストレージコンテナーがソースクラスターおよびターゲットクラスターからアクセスできること。

スナップショットのコピー方法を使用する場合は、以下の条件を満たす必要があります。

- ソースおよびターゲットクラスターが同じリージョンにある必要があります。

- ソースおよびターゲットクラスターには、同じストレージクラスがある必要があります。

- ストレージクラスはスナップショットと互換性がある必要があります。

手順

AZURE_RESOURCE_GROUP変数を設定します。AZURE_RESOURCE_GROUP=Velero_Backups

$ AZURE_RESOURCE_GROUP=Velero_BackupsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Azure リソースグループを作成します。

az group create -n $AZURE_RESOURCE_GROUP --location <CentralUS>

$ az group create -n $AZURE_RESOURCE_GROUP --location <CentralUS>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 場所を指定します。

AZURE_STORAGE_ACCOUNT_ID変数を設定します。AZURE_STORAGE_ACCOUNT_ID=velerobackups

$ AZURE_STORAGE_ACCOUNT_ID=velerobackupsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Azure ストレージアカウントを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow BLOB_CONTAINER変数を設定します。BLOB_CONTAINER=velero

$ BLOB_CONTAINER=veleroCopy to Clipboard Copied! Toggle word wrap Toggle overflow Azure Blob ストレージコンテナーを作成します。

az storage container create \ -n $BLOB_CONTAINER \ --public-access off \ --account-name $AZURE_STORAGE_ACCOUNT_ID

$ az storage container create \ -n $BLOB_CONTAINER \ --public-access off \ --account-name $AZURE_STORAGE_ACCOUNT_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow veleroのサービスプリンシパルおよび認証情報を作成します。AZURE_SUBSCRIPTION_ID=`az account list --query '[?isDefault].id' -o tsv` \ AZURE_TENANT_ID=`az account list --query '[?isDefault].tenantId' -o tsv` \ AZURE_CLIENT_SECRET=`az ad sp create-for-rbac --name "velero" --role "Contributor" --query 'password' -o tsv` \ AZURE_CLIENT_ID=`az ad sp list --display-name "velero" --query '[0].appId' -o tsv`

$ AZURE_SUBSCRIPTION_ID=`az account list --query '[?isDefault].id' -o tsv` \ AZURE_TENANT_ID=`az account list --query '[?isDefault].tenantId' -o tsv` \ AZURE_CLIENT_SECRET=`az ad sp create-for-rbac --name "velero" --role "Contributor" --query 'password' -o tsv` \ AZURE_CLIENT_ID=`az ad sp list --display-name "velero" --query '[0].appId' -o tsv`Copy to Clipboard Copied! Toggle word wrap Toggle overflow サービスプリンシパルの認証情報を

credentials-veleroファイルに保存します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6. アプリケーションの移行

MTC (Migration Toolkit for Containers) の Web コンソールまたはコマンドラインでアプリケーションを移行できます。

1.6.1. 前提条件

MTC (Migration Toolkit for Containers) には以下の要件があります。

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。 - MTC のバージョンは、すべてのクラスターで同一である必要があります。

アプリケーションが

openshiftnamespace の内部イメージを使用する場合、イメージの必要なバージョンがターゲットクラスターに存在することを確認する必要があります。OpenShift Container Platform 4.5 クラスターで非推奨の OpenShift Container Platform 3 イメージを使用できるように、イメージストリームタグを手動で更新できます。

クラスター:

- ソースクラスターは、最新の z-stream リリースにアップグレードされる必要があります。

-

migration-controllerPod が実行されているクラスターには他のクラスターへの無制限のネットワークアクセスが必要です。 - クラスターには、相互への無制限のネットワークアクセスが必要です。

- クラスターには、レプリケーションリポジトリーへの無制限のネットワークアクセスが必要です。

- クラスターは、ポート 443 で OpenShift ルートを使用して通信できる必要があります。

- クラスターには、Critical (重大) 状態があってはなりません。

- クラスターは Ready (準備) 状態である必要があります。

ボリュームの移行:

- 永続ボリューム (PV) は有効である必要があります。

- PV は永続ボリューム要求にバインドされる必要があります。

- move メソッドを使用して PV をコピーする場合、クラスターにはリモートボリュームへの無制限のネットワークアクセスが必要です。

スナップショット のコピー方法を使用して PV をコピーする場合、以下の前提条件が適用されます。

- クラウドプロバイダーはスナップショットをサポートしている必要があります。

- ボリュームに同じクラウドプロバイダーがなければなりません。

- ボリュームは同じ地理的リージョンにある必要があります。

- ボリュームには同じストレージクラスがなければなりません。

- プロキシー環境でボリュームの直接移行を実行する場合、Stunnel の TCP プロキシーを設定する必要があります。

- イメージの直接移行を実行する場合、ソースクラスターの内部レジストリーを外部トラフィックに公開する必要があります。

1.6.1.1. podman を使用した非推奨の内部イメージの更新

アプリケーションが openshift namespace のイメージを使用する場合、イメージの必要なバージョンがターゲットクラスターに存在する必要があります。

OpenShift Container Platform 3 イメージが OpenShift Container Platform 4.5 で非推奨になる場合、podman を使用してイメージストリームタグを手動で更新できます。

前提条件

-

podmanがインストールされている必要があります。 -

cluster-admin権限を持つユーザーとしてログインしている必要があります。

手順

- ソースおよびターゲットクラスターで内部レジストリーを公開します。

-

非セキュアなレジストリーを使用している場合、レジストリーホスト値を

/etc/container/registries.confの[registries.insecure]セクションの追加し、podmanで TLS 検証エラーが生じないようにします。 ソースクラスターレジストリーにログインします。

podman login -u $(oc whoami) -p $(oc whoami -t) --tls-verify=false <source_cluster>

$ podman login -u $(oc whoami) -p $(oc whoami -t) --tls-verify=false <source_cluster>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ターゲットクラスターレジストリーにログインします。

podman login -u $(oc whoami) -p $(oc whoami -t) --tls-verify=false <target_cluster>

$ podman login -u $(oc whoami) -p $(oc whoami -t) --tls-verify=false <target_cluster>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 非推奨のイメージをプルします。

podman pull <source_cluster>/openshift/<image>

$ podman pull <source_cluster>/openshift/<image>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ターゲットクラスターレジストリーのイメージにタグを付けます。

podman tag <source_cluster>/openshift/<image> <target_cluster>/openshift/<image>

$ podman tag <source_cluster>/openshift/<image> <target_cluster>/openshift/<image>Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージをターゲットクラスター 4 レジストリーにプッシュします。

podman push <target_cluster>/openshift/<image>

$ podman push <target_cluster>/openshift/<image>Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージにターゲットクラスターの有効なイメージストリームがあることを確認します。

oc get imagestream -n openshift | grep <image>

$ oc get imagestream -n openshift | grep <image>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

<image> <target_cluster>/openshift/<image> <versions> more... 6 seconds ago

<image> <target_cluster>/openshift/<image> <versions> more... 6 seconds agoCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.1.2. CA 証明書バンドルファイルの作成

自己署名証明書を使用して MTC (Migration Toolkit for Containers) のクラスターまたはレプリケーションリポジトリーのセキュリティーを保護する場合、証明書の検証は Certificate signed by unknown authority というエラーメッセージを出して失敗する可能性があります。

カスタム CA 証明書バンドルファイルを作成し、クラスターまたはレプリケーションリポジトリーの追加時に MTC の Web コンソールでこれをアップロードできます。

手順

リモートエンドポイントから CA 証明書をダウンロードし、これを CA バンドルファイルとして保存します。

echo -n | openssl s_client -connect <host_FQDN>:<port> \ | sed -ne '/-BEGIN CERTIFICATE-/,/-END CERTIFICATE-/p' > <ca_bundle.cert>

$ echo -n | openssl s_client -connect <host_FQDN>:<port> \

| sed -ne '/-BEGIN CERTIFICATE-/,/-END CERTIFICATE-/p' > <ca_bundle.cert> 1.6.1.3. ボリュームの直接移行のためのプロキシー設定

プロキシーの背後にあるソースクラスターからボリュームの直接移行を実行している場合、MigrationController カスタムリソース (CR) で Stunnel プロキシーを設定する必要があります。Stunnel は、証明書を変更せずに、TCP 接続のソースクラスターとターゲットクラスター間に透過的なトンネルを作成します。

ボリュームの直接移行は 1 つのプロキシーのみをサポートします。ターゲットクラスターもプロキシーの背後にある場合、ソースクラスターはターゲットクラスターのルートにアクセスできません。

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。

手順

-

MigrationControllerPod が実行されるクラスターにログインします。 MigrationControllerCR マニフェストを取得します。oc get migrationcontroller <migration_controller> -n openshift-migration

$ oc get migrationcontroller <migration_controller> -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow stunnel_tcp_proxyパラメーターを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Stunnel プロキシーを指定します:

http://<user_name>:<password>@<ip_address>:<port>

-

マニフェストを

migration-controller.yamlとして保存します。 更新したマニフェストを適用します。

oc replace -f migration-controller.yaml -n openshift-migration

$ oc replace -f migration-controller.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.1.4. 移行フックの Ansible Playbook の作成

Ansible Playbook を作成して移行フックとして使用することができます。フックは、MTC Web コンソールを使用するか、MigPlan カスタムリソース (CR) マニフェストに spec.hooks パラメーターの値を指定して移行計画に追加できます。

Ansible Playbook はフックコンテナーに設定マップとしてマウントされます。フックコンテナーは、MigPlan で指定されるクラスター、サービスアカウントおよび namespace を使用してジョブとして実行されます。フックコンテナーは指定されたサービスアカウントトークンを使用して、タスクがクラスターで実行される前に認証を必要としないようにします。

1.6.1.4.1. Ansible モジュール

Ansible shell モジュールを使用して oc コマンドを実行できます。

shell モジュールの例

- hosts: localhost

gather_facts: false

tasks:

- name: get pod name

shell: oc get po --all-namespaces

- hosts: localhost

gather_facts: false

tasks:

- name: get pod name

shell: oc get po --all-namespaces

k8s_info などの kubernetes.core モジュールを使用して Kubernetes リソースと対話できます。

k8s_facts モジュールの例

fail モジュールを使用して、ゼロ以外の終了ステータスが正常に生成されない場合にゼロ以外の終了ステータスを生成し、フックの成功または失敗が検出されるようにします。フックはジョブとして実行され、フックの成功または失敗のステータスはジョブコンテナーの終了ステータスに基づいて表示されます。

fail モジュールの例

1.6.1.4.2. 環境変数

MigPlan CR 名および移行 namespace は環境変数としてフックコンテナーに渡されます。これらの変数は lookup プラグインを使用してアクセスされます。

環境変数の例

1.6.1.5. 追加リソース

1.6.2. MTC の Web コンソールを使用したアプリケーションの移行

クラスターおよびレプリケーションリポジトリーを MTC の Web コンソールを使用して設定する必要があります。次に、移行計画を作成し、これを実行できます。

1.6.2.1. MTC の Web コンソールの起動

ブラウザーで MTC (Migration Toolkit for Containers) Web コンソールを起動できます。

前提条件

- MTC の Web コンソールには、OpenShift Container Platform Web コンソールにアクセスできる必要があります。

- MTC の Web コンソールには、OAuth 認証サーバーへのネットワークアクセスが必要です。

手順

- MTC がインストールされている OpenShift Container Platform クラスターにログインします。

以下のコマンドを実行して MTC の Web コンソール URL を取得します。

oc get -n openshift-migration route/migration -o go-template='https://{{ .spec.host }}'$ oc get -n openshift-migration route/migration -o go-template='https://{{ .spec.host }}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力は

https://migration-openshift-migration.apps.cluster.openshift.comのようになります。ブラウザーを起動し、MTC の Web コンソールに移動します。

注記Migration Toolkit for Containers Operator のインストール後すぐに MTC の Web コンソールにアクセスしようとする場合、Operator は依然としてクラスターを設定しているため、コンソールが読み込まれない可能性があります。数分待機した後に再試行します。

- 自己署名 CA 証明書を使用している場合、ソースクラスター API サーバーの CA 証明書を受け入れることを求めるプロンプトが出されます。Web ページは、残りの証明書を受け入れるプロセスについて説明します。

- OpenShift Container Platform の ユーザー名 および パスワード を使用してログインします。

1.6.2.2. クラスターの Migration Toolkit for Containers Web コンソールへの追加

クラスターを MTC (Migration Toolkit for Containers) Web コンソールに追加できます。

前提条件

Azure スナップショットを使用してデータをコピーする場合:

- クラスターの Azure リソースグループ名を指定する必要があります。

- クラスターは同じ Azure リソースグループにある必要があります。

- クラスターは同じ地理的な場所にある必要があります。

手順

- クラスターにログインする。

migration-controllerサービスアカウントトークンを取得します。oc sa get-token migration-controller -n openshift-migration

$ oc sa get-token migration-controller -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

eyJhbGciOiJSUzI1NiIsImtpZCI6IiJ9.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJtaWciLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlY3JldC5uYW1lIjoibWlnLXRva2VuLWs4dDJyIiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZXJ2aWNlLWFjY291bnQubmFtZSI6Im1pZyIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VydmljZS1hY2NvdW50LnVpZCI6ImE1YjFiYWMwLWMxYmYtMTFlOS05Y2NiLTAyOWRmODYwYjMwOCIsInN1YiI6InN5c3RlbTpzZXJ2aWNlYWNjb3VudDptaWc6bWlnIn0.xqeeAINK7UXpdRqAtOj70qhBJPeMwmgLomV9iFxr5RoqUgKchZRG2J2rkqmPm6vr7K-cm7ibD1IBpdQJCcVDuoHYsFgV4mp9vgOfn9osSDp2TGikwNz4Az95e81xnjVUmzh-NjDsEpw71DH92iHV_xt2sTwtzftS49LpPW2LjrV0evtNBP_t_RfskdArt5VSv25eORl7zScqfe1CiMkcVbf2UqACQjo3LbkpfN26HAioO2oH0ECPiRzT0Xyh-KwFutJLS9Xgghyw-LD9kPKcE_xbbJ9Y4Rqajh7WdPYuB0Jd9DPVrslmzK-F6cgHHYoZEv0SvLQi-PO0rpDrcjOEQQ

eyJhbGciOiJSUzI1NiIsImtpZCI6IiJ9.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJtaWciLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlY3JldC5uYW1lIjoibWlnLXRva2VuLWs4dDJyIiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZXJ2aWNlLWFjY291bnQubmFtZSI6Im1pZyIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VydmljZS1hY2NvdW50LnVpZCI6ImE1YjFiYWMwLWMxYmYtMTFlOS05Y2NiLTAyOWRmODYwYjMwOCIsInN1YiI6InN5c3RlbTpzZXJ2aWNlYWNjb3VudDptaWc6bWlnIn0.xqeeAINK7UXpdRqAtOj70qhBJPeMwmgLomV9iFxr5RoqUgKchZRG2J2rkqmPm6vr7K-cm7ibD1IBpdQJCcVDuoHYsFgV4mp9vgOfn9osSDp2TGikwNz4Az95e81xnjVUmzh-NjDsEpw71DH92iHV_xt2sTwtzftS49LpPW2LjrV0evtNBP_t_RfskdArt5VSv25eORl7zScqfe1CiMkcVbf2UqACQjo3LbkpfN26HAioO2oH0ECPiRzT0Xyh-KwFutJLS9Xgghyw-LD9kPKcE_xbbJ9Y4Rqajh7WdPYuB0Jd9DPVrslmzK-F6cgHHYoZEv0SvLQi-PO0rpDrcjOEQQCopy to Clipboard Copied! Toggle word wrap Toggle overflow - MTC の Web コンソールで、Clusters をクリックします。

- Add cluster をクリックします。

以下のフィールドに値を入力します。

-

Cluster name: クラスター名には、小文字 (

a-z) および数字 (0-9) を含めることができます。スペースや国際的な文字を含めることはできません。 -

URL: API サーバー URL を指定します (例:

https://<www.example.com>:8443)。 -

Service account token:

migration-controllerサービスアカウントトークンを貼り付けます。 Exposed route host to image registry: イメージの直接移行を使用している場合、ソースクラスターのイメージレジストリーへの公開されたルートを指定します (例:

www.example.apps.cluster.com)。ポートを指定できます。デフォルトのポートは

5000です。- Azure クラスター: Azure スナップショットを使用してデータをコピーする場合は、このオプションを選択する必要があります。

- Azure resource group: このフィールドは、Azure cluster が選択されている場合に表示されます。Azure リソースグループを指定します。

- Require SSL verification: オプション: このオプションを選択してクラスターへの SSL 接続を検証します。

- CA bundle file: このフィールドは、Require SSL verification が選択されている場合に表示されます。自己署名証明書用にカスタム CA 証明書バンドルファイルを作成している場合は、Browse をクリックして CA バンドルファイルを選択し、これをアップロードします。

-

Cluster name: クラスター名には、小文字 (

Add cluster をクリックします。

クラスターが Clusters 一覧に表示されます。

1.6.2.3. MTC の Web コンソールへのレプリケーションリポジトリーの追加

MTC (Migration Toolkit for Containers) の Web コンソールに、オブジェクトストレージバケットをレプリケーションリポジトリーとして追加できます。

前提条件

- データを移行するには、オブジェクトストレージバケットを設定する必要があります。

手順

- MTC の Web コンソールで、Replication repositories をクリックします。

- Add repository をクリックします。

Storage provider type を選択し、以下のフィールドに入力します。

AWS (AWS S3、MCG、および汎用 S3 プロバイダーの場合):

- Replication repository name: MTC の Web コンソールでレプリケーションリポジトリー名を指定します。

- S3 bucket name: 作成した S3 バケットの名前を指定します。

- S3 bucket region: S3 バケットリージョンを指定します。AWS S3 の場合に必須です。Optional (他の S3 プロバイダーの場合)。

-

S3 endpoint: バケットではなく S3 サービスの URL を指定します (例:

https://<s3-storage.apps.cluster.com>)。汎用 S3 プロバイダーの場合は必須です。https://接頭辞を使用する必要があります。 -

S3 provider access key: AWS には

<AWS_SECRET_ACCESS_KEY>を指定するか、または MCG には S3 プロバイダーアクセスキーを指定します。 -

S3 provider secret access key: AWS には

<AWS_ACCESS_KEY_ID>を指定するか、または MCG には S3 プロバイダーシークレットアクセスキーを指定します。 - Require SSL verification: 汎用 S3 プロバイダーを使用している場合は、このチェックボックスをクリアします。

- カスタム CA バンドルを使用する場合は、Browse をクリックし、Base64 でエンコードされた CA バンドルファイルを参照します。

GCP:

- Replication repository name: MTC の Web コンソールでレプリケーションリポジトリー名を指定します。

- GCP bucket name: GCP バケットの名前を指定します。

-

GCP credential JSON blob:

credentials-veleroファイルに文字列を指定します。

Azure:

- Replication repository name: MTC の Web コンソールでレプリケーションリポジトリー名を指定します。

- Azure resource group: Azure Blob ストレージのリソースグループを指定します。

- Azure storage account name: Azure Blob ストレージアカウント名を指定します。

-

Azure credentials - INI file contents:

credentials-veleroファイルに文字列を指定します。

- Add repository をクリックし、接続の検証を待機します。

Close をクリックします。

新規リポジトリーが Replication repositories 一覧に表示されます。

1.6.2.4. MTC の Web コンソールでの移行計画の作成

MTC (Migration Toolkit for Containers) Web コンソールで移行計画を作成できます。

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。 - 同じ MTC バージョンがすべてのクラスターにインストールされていることを確認する必要があります。

- クラスターおよびレプリケーションリポジトリーを MTC の Web コンソールに追加する必要があります。

- move データコピー方法を使用して永続ボリューム (PV) を移行する場合、ソースクラスターおよびターゲットクラスターには、リモートボリュームへの中断されないネットワークアクセスが必要です。

-

イメージの直接移行を使用する必要がある場合、ソースクラスターの

MigClusterカスタムリソースマニフェストは内部イメージレジストリーの公開されたルートを指定する必要があります。

手順

- MTC Web コンソールで、Migration plans をクリックします。

- Add migration plan をクリックします。

Plan name を入力し、Next をクリックします。

移行計画名には、254 以上の小文字の英数字 (

a-z, 0-9) を使用できず、スペースやアンダースコア (_) を含めることはできません。- Source cluster を選択します。

- Target clusterを選択します。

- Replication repository を選択します。

- 移行するプロジェクトを選択し、Next をクリックします。

- Source cluster、Target cluster、および Repository を選択し、 Next をクリックします。

- Namespaces ページで、移行するプロジェクトを選択し、 Next をクリックします。

Persistent volumes ページで、各 PV の Migration type をクリックします。

- Copy オプションは、ソースクラスターの PV のデータをレプリケーションリポジトリーにコピーしてから、データを同様の特徴のある新規に作成された PV でターゲットクラスターで復元します。

- Move オプションは、ソースクラスターからリモートボリューム (例: NFS) をアンマウントし、リモートボリュームをポイントするターゲットクラスターで PV リソースを作成し、その後にリモートボリュームをターゲットクラスターにマウントします。ターゲットクラスターで実行されているアプリケーションは、ソースクラスターが使用していたものと同じリモートボリュームを使用します。

- Next をクリックします。

Copy options ページで、それぞれの PV について Copy method を選択します。

- スナップショットのコピー は、クラウドプロバイダーのスナップショット機能を使用してデータのバックアップおよび復元を行います。この場合、ファイルシステムのコピー を使用する場合よりもはるかに高速になります。

ファイルシステムのコピー は、ソースクラスターのファイルをバックアップし、それらをターゲットクラスターで復元します。

ファイルシステムのコピー方法は、ボリュームの直接移行に必要です。

- Verify copy を選択して、ファイルシステムのコピー で移行されたデータを確認します。データは、各ソースファイルのチェックサムを生成し、復元後のチェックサムを確認して検証されます。データ検証は、パフォーマンスを大幅に低下させます。

Target storage class を選択します。

Filesystem copy を選択している場合、ターゲットストレージクラスを変更できます。

- Next をクリックします。

Migration options ページで、ソースクラスターに公開されたイメージレジストリールートを指定した場合に Direct image migration オプションが選択されます。Filesystem copy でデータを移行する場合、Direct PV migration オプションが選択されます。

直接の移行オプションは、イメージおよびファイルをソースクラスターからターゲットクラスターに直接コピーします。このオプションは、イメージおよびファイルをソースクラスターからレプリケーションリポジトリーにコピーしてから、レプリケーションリポジトリーからターゲットクラスターにコピーする場合よりもはるかに高速になります。

- Next をクリックします。

オプション: Hooks ページで Add Hook をクリックし、移行計画にフックを追加します。

フックはカスタムコードを実行します。単一の移行計画計画に最大 4 つのフックを追加できます。各フックは異なる移行ステップで実行されます。

- Web コンソールに表示するフックの名前を入力します。

- フックが Ansible Playbook の場合はAnsible playbook を選択し、Browse をクリックして Playbook をアップロードするか、フィールドに Playbook の内容を貼り付けます。

- オプション: デフォルトのフックイメージを使用していない場合は、Ansible ランタイムイメージを指定します。

フックが Ansible Playbook ではない場合には、Custom container image をクリックし、イメージ名とパスを指定します。

カスタムコンテナーイメージには、Ansible Playbook を含めることができます。

- Source cluster または Target cluster を選択します。

- Service account name および Service account namespace を入力します。

フックの移行手順を選択します。

- preBackup: アプリケーションのワークロードがソースクラスターでバックアップされる前

- postBackup: アプリケーションのワークロードがソースクラスターでバックアップされた後

- preRestore: アプリケーションのワークロードがターゲットクラスターで復元される前

- postRestore: アプリケーションのワークロードがターゲットクラスターで復元された後

- Add をクリックします。

Finish をクリックします。

移行計画は、Migration plans 一覧に表示されます。

1.6.2.5. MTC の Web コンソールでの移行計画の実行

MTC (Migration Toolkit for Containers) の Web コンソールで作成した移行計画を使用してアプリケーションとデータをステージングしたり、移行したりできます。

移行時に、MTC は移行された永続ボリューム (PV) の回収ポリシーをターゲットクラスターで Retain に設定します。

Backup カスタムリソースには、元の回収ポリシーを示す PVOriginalReclaimPolicy アノテーションが含まれます。移行した PV の回収ポリシーを手動で復元できます。

前提条件

MTC の Web コンソールには以下が含まれている必要があります。

-

Ready状態のソースクラスター -

Ready状態のターゲットクラスター - レプリケーションリポジトリー

- 有効な移行計画

手順

- ソースクラスターにログインします。

古いイメージを削除します。

oc adm prune images

$ oc adm prune imagesCopy to Clipboard Copied! Toggle word wrap Toggle overflow - MTC の Web コンソールにログインし、Migration plans をクリックします。

移行計画の横にある Options メニュー

をクリックし、Stage を選択して、アプリケーションを停止せずにソースクラスターからターゲットクラスターにデータをコピーします。

をクリックし、Stage を選択して、アプリケーションを停止せずにソースクラスターからターゲットクラスターにデータをコピーします。

実際の移行時間を短縮するには、Stage を複数回実行することができます。

-

アプリケーションのワークロードを移行する準備ができたら、移行計画の横にある Options メニュー

をクリックし、Migrate を選択します。

をクリックし、Migrate を選択します。

- オプション: Migrate ウィンドウで Do not stop applications on the source cluster during migration を選択できます。

- Migrate をクリックします。

移行が完了したら、アプリケーションが OpenShift Container Platform Web コンソールで正常に移行されていることを確認します。

- Home → Projects をクリックします。

- 移行されたプロジェクトをクリックしてそのステータスを表示します。

- Routes セクションで Location をクリックし、アプリケーションが機能していることを確認します (該当する場合)。

- Workloads → Pods をクリックし、Pod が移行した namespace で実行されていることを確認します。

- Storage → Persistent volumes をクリックして、移行した永続ボリュームが正常にプロビジョニングされていることを確認します。

1.6.3. コマンドラインでのアプリケーションの移行

MTC カスタムリソース (CR) を使用して、コマンドラインでアプリケーションを移行できます。

アプリケーションをローカルクラスターからリモートクラスター、リモートクラスターからローカルクラスター、およびリモートクラスター間で移行できます。

MTC の用語

クラスターの設定に関連して、以下の用語が使用されます。

hostクラスター:-

migration-controllerPod はhostクラスターで実行されます。 -

hostクラスターでは、直接のイメージ移行に公開されたセキュアなレジストリールートは不要です。

-

-

ローカルクラスター: ローカルクラスターは

hostクラスターと同じである場合が多くありますが、これは必須ではありません。 リモートクラスター:

- リモートクラスターには、直接のイメージ移行に公開されるセキュアなレジストリールートが必要です。

-

リモートクラスターには、

migration-controllerサービスアカウントトークンが含まれるSecretCR が必要です。

移行の実行に関連して、以下の用語が使用されます。

- ソースクラスター: アプリケーションの移行元となるクラスター。

- 宛先クラスター: アプリケーションが移行されるクラスター。

1.6.3.1. MTC (Migration Toolkit for Containers) を使用したアプリケーションの移行

MTC (Migration Toolkit for Containers) API を使用してコマンドラインでアプリケーションを移行できます。

アプリケーションをローカルクラスターからリモートクラスター、リモートクラスターからローカルクラスター、およびリモートクラスター間で移行できます。

この手順では、間接的および直接的な移行を実行する方法を説明します。

- 間接的な移行: イメージ、ボリューム、および Kubernetes オブジェクトはソースクラスターからレプリケーションリポジトリーにコピーされ、その後にレプリケーションリポジトリーから宛先クラスターにコピーされます。

- 直接的な移行: イメージまたはボリュームはソースクラスターから宛先クラスターに直接コピーされます。イメージとボリュームの直接的な移行には、パフォーマンス上の大きなメリットがあります。

以下のカスタムリソース (CR) を作成して移行を実行します。

MigClusterCR:host、ローカル、またはリモートクラスターを定義します。migration-controllerPod はhostクラスターで実行されます。-

SecretCR: リモートクラスターまたはストレージの認証情報が含まれます。 MigStorageCR: レプリケーションリポジトリーを定義します。異なるストレージプロバイダーには、

MigStorageCR マニフェストで異なるパラメーターが必要です。-

MigPlanCR: 移行計画を定義します。 MigMigrationCR: 関連付けられたMigPlanで定義された移行を実行します。以下の目的で、単一の

MigPlanCR に複数のMigMigrationCR を作成できます。- 移行を実行する前に、アプリケーションを停止せずにほとんどのデータをコピーする段階移行 (Stage migration) を実行する。段階移行により、移行のパフォーマンスが向上します。

- 実行中の移行を取り消す。

- 完了した移行をロールバックする

前提条件

-

すべてのクラスターで

cluster-admin権限が必要です。 -

OpenShift Container Platform CLI (

oc) をインストールする必要があります。 - すべてのクラスターに MTC (Migration Toolkit for Containers Operator) をインストールする必要があります。

- インストールされた MTC (Migration Toolkit for Containers Operator) の version は、すべてのクラスターで同一である必要があります。

- オブジェクトストレージをレプリケーションリポジトリーとして設定する必要があります。

- イメージの直接的な移行を実行している場合、すべてのリモートクラスターでセキュアなレジストリールートを公開する必要があります。

- ボリュームの直接移行を使用している場合、ソースクラスターには HTTP プロキシーを設定することはできません。

手順

host-cluster.yamlというhostクラスターのMigClusterCR マニフェストを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow hostクラスターのMigClusterCR を作成します。oc create -f host-cluster.yaml -n openshift-migration

$ oc create -f host-cluster.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 各リモートクラスターに、

cluster-secret.yamlというSecretCR マニフェストを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- リモートクラスターの base64 でエンコードされた

migration-controllerサービスアカウント (SA) トークンを指定します。

以下のコマンドを実行して SA トークンを取得できます。

oc sa get-token migration-controller -n openshift-migration | base64 -w 0

$ oc sa get-token migration-controller -n openshift-migration | base64 -w 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow それぞれのリモートクラスターに

SecretCR を作成します。oc create -f cluster-secret.yaml

$ oc create -f cluster-secret.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow それぞれのリモートクラスターに、

remote-cluster.yamlというMigClusterCR マニフェストを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow それぞれのリモートクラスターについて

MigClusterCR を作成します。oc create -f remote-cluster.yaml -n openshift-migration

$ oc create -f remote-cluster.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow すべてのクラスターが

Ready状態にあることを確認します。oc describe cluster <cluster_name>

$ oc describe cluster <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow storage-secret.yamlというレプリケーションリポジトリーのSecretCR マニフェストを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow AWS 認証情報はデフォルトで base64 でエンコードされます。別のストレージプロバイダーを使用している場合、それぞれのキーを使用して以下のコマンドを実行して、認証情報をエンコードする必要があります。

echo -n "<key>" | base64 -w 0

$ echo -n "<key>" | base64 -w 01 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- キー ID またはシークレットキーを指定します。どちらの値も base64 でエンコードする必要があります。

レプリケーションリポジトリーの

SecretCR を作成します。oc create -f storage-secret.yaml

$ oc create -f storage-secret.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow migstorage.yamlというレプリケーションリポジトリーのMigStorageCR マニフェストを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow MigStorageCR を作成します。oc create -f migstorage.yaml -n openshift-migration

$ oc create -f migstorage.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow MigStorageCR がReady状態にあることを確認します。oc describe migstorage <migstorage_name>

$ oc describe migstorage <migstorage_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow migplan.yamlというMigPlanCR マニフェストを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow MigPlanCR を作成します。oc create -f migplan.yaml -n openshift-migration

$ oc create -f migplan.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow MigPlanインスタンスを表示し、そのインスタンスがReady状態にあることを確認します。oc describe migplan <migplan_name> -n openshift-migration

$ oc describe migplan <migplan_name> -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow migmigration.yamlというMigMigrationCR マニフェストを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow MigMigrationCR を作成し、MigPlanCR に定義された移行を開始します。oc create -f migmigration.yaml -n openshift-migration

$ oc create -f migmigration.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow MigMigrationCR を監視して移行の進捗を確認します。oc watch migmigration <migmigration_name> -n openshift-migration

$ oc watch migmigration <migmigration_name> -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力は以下のようになります。

出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.3.2. MTC カスタムリソースマニフェスト

MTC (Migration Toolkit for Containers) は以下のカスタムリソース (CR) マニフェストを使用して、アプリケーションを移行するための CR を作成します。

1.6.3.2.1. DirectImageMigration

DirectImageMigration CR はイメージをソースクラスターから宛先クラスターに直接コピーします。

1.6.3.2.2. DirectImageStreamMigration

DirectImageStreamMigration CR はイメージストリーム参照をソースクラスターから宛先クラスターに直接コピーします。

1.6.3.2.3. DirectVolumeMigration

DirectVolumeMigration CR は永続ボリューム (PV) をソースクラスターから宛先クラスターに直接コピーします。

- 1

trueの場合、namespace が宛先クラスターの PV について作成されます。- 2

trueの場合、DirectVolumeMigrationProgressCR が移行後に削除されます。デフォルト値はfalseです。これにより、DirectVolumeMigrationProgressCR はトラブルシューティング用に保持されます。- 3

- 宛先クラスターがホストクラスターではない場合は、クラスター名を更新します。

- 4

- 直接的なボリューム移行によって移行される 1 つ以上の PVC を指定します。

- 5

- 各 PVC の namespace を指定します。

- 6

- ソースクラスターの

MigClusterCR 名を指定します。

1.6.3.2.4. DirectVolumeMigrationProgress

DirectVolumeMigrationProgress CR は、DirectVolumeMigration CR の進捗を表示します。

1.6.3.2.5. MigAnalytic

MigAnalytic CR は、関連付けられた MigPlan CR から、イメージの数、Kubernetes リソースおよび PV 容量を収集します。

- 1

MigAnalyticCR に関連付けられたMigPlanCR 名を指定します。- 2

MigAnalyticCR に関連付けられたMigPlanCR 名を指定します。- 3

- オプション:

trueの場合、イメージの数が返されます。 - 4

- オプション:

trueの場合、Kubernetes リソースの数、種類および API バージョンが返されます。 - 5

- オプション:

trueの場合、PV 容量が返されます。 - 6

trueの場合、イメージ名の一覧を返します。デフォルトはfalseであり、出力が過剰に長くなることはありません。- 7

- オプション:

listImagesがtrueの場合、返されるイメージ名の最大数を指定します。 - 8

MigAnalyticCR に関連付けられたMigPlanCR 名を指定します。