認証および認可

ユーザー認証およびユーザーとサービスのアクセス制御の設定

概要

第1章 認証および認可の概要

1.1. OpenShift Container Platform の認証および承認に関する一般的な用語集

この用語集では、OpenShift Container Platform の認証および承認で使用される一般的な用語を定義します。

- authentication

- 認証は、OpenShift Container Platform クラスターへのアクセスを決定し、認証されたユーザーのみが OpenShift Container Platform クラスターにアクセスできるようにします。

- 認可

- 承認は、識別されたユーザーが要求されたアクションを実行する権限を持っているかどうかを決定します。

- ベアラートークン

-

ベアラートークンは、ヘッダー

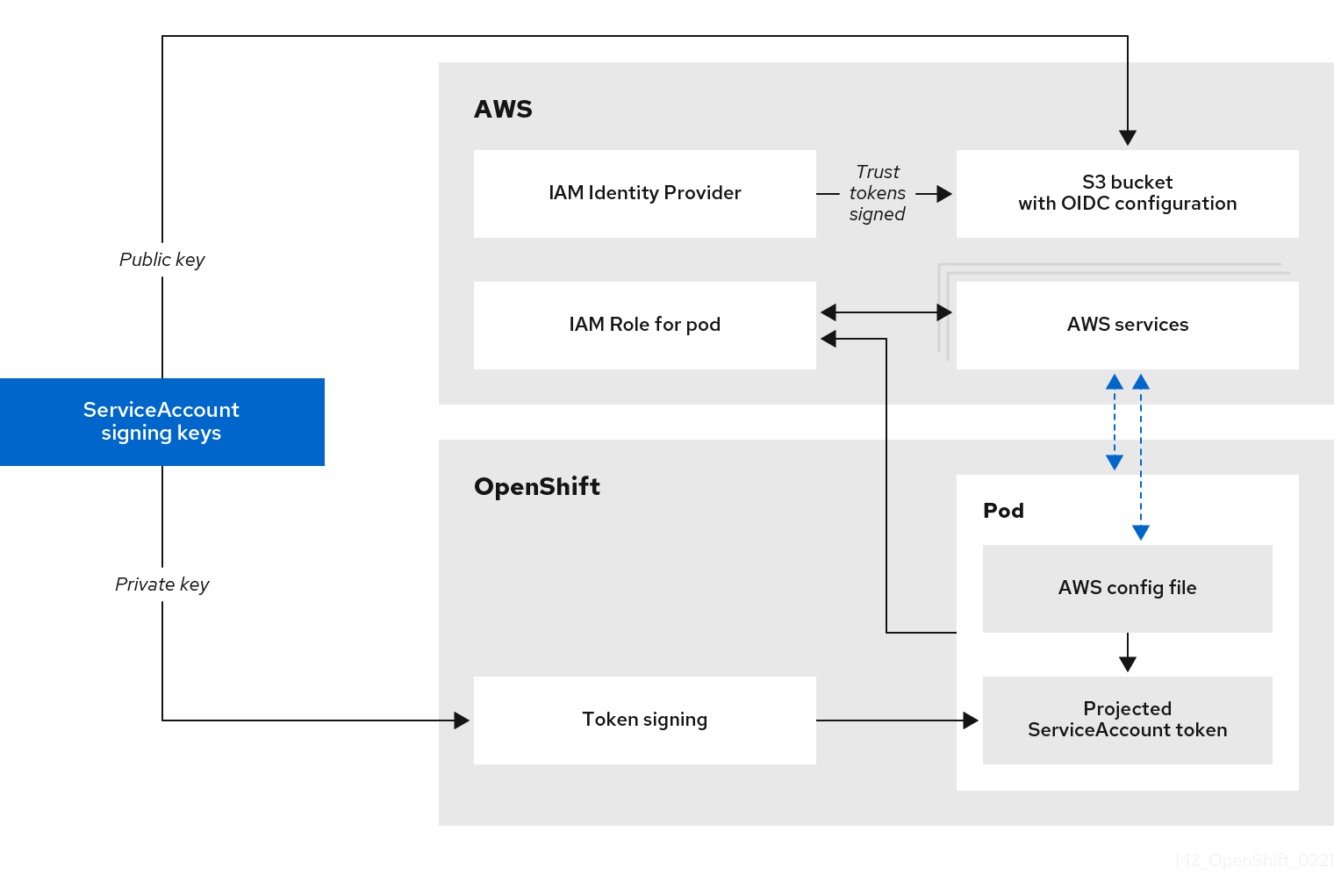

Authorization: Bearer <token>で API を認証するために使用されます。 - Cloud Credential Operator

- Cloud Credential Operator (CCO) は、クラウドプロバイダーの認証情報をカスタムリソース定義 (CRD) として管理します。

- 設定マップ

-

設定マップは、設定データを Pod に注入する方法を提供します。タイプ

ConfigMapのボリューム内の設定マップに格納されたデータを参照できます。Pod で実行しているアプリケーションは、このデータを使用できます。 - containers

- ソフトウェアとそのすべての依存関係を設定する軽量で実行可能なイメージ。コンテナーはオペレーティングシステムを仮想化するため、データセンター、パブリッククラウドまたはプライベートクラウド、またはローカルホストでコンテナーを実行できます。

- カスタムリソース (CR)

- CR は Kubernetes API のエクステンションです。

- group

- グループはユーザーの集まりです。グループは、一度に複数のユーザーに権限を付与する場合に便利です。

- HTPasswd

- HTPasswd は、HTTP ユーザーの認証用のユーザー名とパスワードを格納するファイルを更新します。

- Keystone

- Keystone は、ID、トークン、カタログ、およびポリシーサービスを提供する Red Hat OpenStack Platform (RHOSP) プロジェクトです。

- Lightweight Directory Access Protocol (LDAP)

- LDAP は、ユーザー情報を照会するプロトコルです。

- 手動モード

- 手動モードでは、ユーザーは Cloud Credential Operator (CCO) の代わりにクラウド認証情報を管理します。

- mint モード

- mint モードは、サポートされるプラットフォームで使用する Cloud Credential Operator (CCO) のデフォルトおよび推奨されるベストプラクティスの設定です。このモードでは、CCO は提供される管理者レベルのクラウド認証情報を使用して、必要となる特定のパーミッションのみでクラスター内のコンポーネントの新規の認証情報を作成します。

- namespace

- namespace は、すべてのプロセスから見える特定のシステムリソースを分離します。namespace 内では、その namespace のメンバーであるプロセスのみがそれらのリソースを参照できます。

- node

- ノードは、OpenShift Container Platform クラスター内のワーカーマシンです。ノードは、仮想マシン (VM) または物理マシンのいずれかです。

- OAuth クライアント

- OAuth クライアントは、ベアラートークンを取得するために使用されます。

- OAuth サーバー

- OpenShift Container Platform コントロールプレーンには、設定されたアイデンティティープロバイダーからユーザーのアイデンティティーを決定し、アクセストークンを作成する組み込みの OAuth サーバーが含まれています。

- OpenID Connect

- OpenID Connect は、ユーザーが Single Sign-On (SSO) を使用して OpenID プロバイダーを使用するサイトにアクセスすることを認証するためのプロトコルです。

- passthrough モード

- passthrough モードでは、Cloud Credential Operator (CCO) は提供されるクラウド認証情報を、コンポーネントを要求するコンポーネントに渡します。

- Pod

- Pod は、Kubernetes における最小の論理単位です。Pod には、ワーカーノードで実行される 1 つ以上のコンテナーが含まれます。

- 通常ユーザー

- 最初のログイン時または API 経由でクラスター内に自動的に作成されるユーザー。

- リクエストヘッダー

- 要求ヘッダーは、サーバーが要求の応答を追跡できるように、HTTP 要求コンテキストに関する情報を提供するために使用される HTTP ヘッダーです。

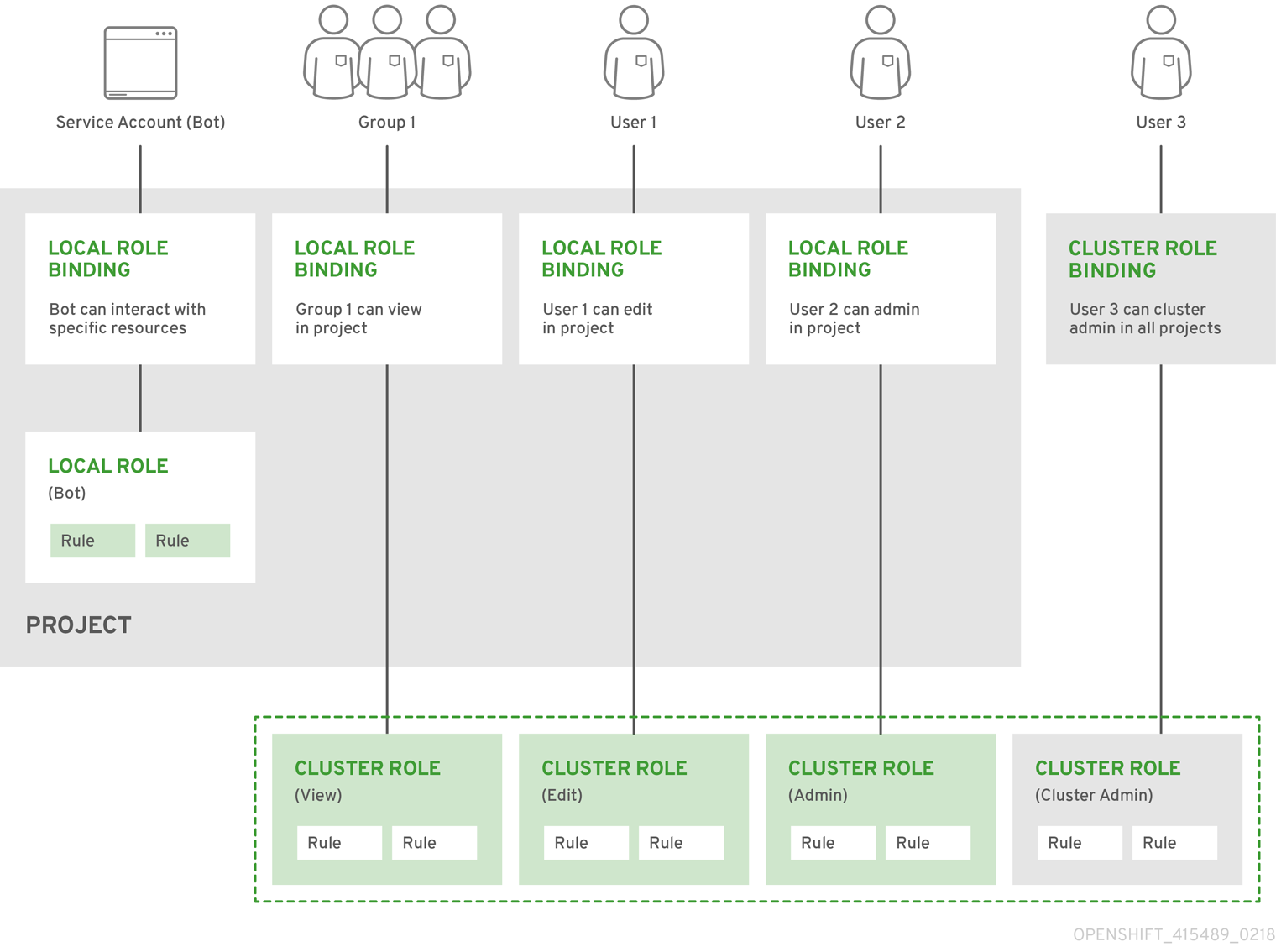

- ロールベースのアクセス制御 (RBAC)

- クラスターユーザーとワークロードが、ロールを実行するために必要なリソースにのみアクセスできるようにするための重要なセキュリティーコントロール。

- サービスアカウント

- サービスアカウントは、クラスターコンポーネントまたはアプリケーションによって使用されます。

- システムユーザー

- クラスターのインストール時に自動的に作成されるユーザー。

- users

- ユーザーは、API にリクエストを送信できるエンティティーです。

1.2. OpenShift Container Platform での認証について

OpenShift Container Platform クラスターへのアクセスを制御するために、クラスター管理者は ユーザー認証 を設定し、承認されたユーザーのみがクラスターにアクセスできます。

OpenShift Container Platform クラスターと対話するには、まずユーザーが OpenShift Container Platform API に対して認証する必要があります。OpenShift Container Platform API へのリクエストで、OAuth アクセストークンまたは X.509 クライアント証明書 を提供することで認証できます。

有効なアクセストークンまたは証明書を提示しない場合、要求は認証されておらず、HTTP401 エラーを受け取ります。

管理者は、次のタスクを通じて認証を設定できます。

- ID プロバイダーの設定: OpenShift Container Platform でサポートされている ID プロバイダーを定義し、クラスターに追加できます。

内部 OAuth サーバーの設定: OpenShift Container Platform コントロールプレーンには、設定された ID プロバイダーからユーザーの ID を判別し、アクセストークンを作成する組み込みの OAuth サーバーが含まれています。トークンの期間と非アクティブタイムアウトを設定し、内部 OAuth サーバーの URL をカスタマイズできます。

注記ユーザーは、自分が所有する OAuth トークンを表示および管理できます。

OAuth クライアントの登録: OpenShift Container Platform には、いくつかのデフォルトの OAuth クライアントが含まれています。追加の OAuth クライアントを登録および設定できます。

注記ユーザーが OAuth トークンのリクエストを送信するときは、トークンを受信して使用するデフォルトまたはカスタムの OAuth クライアントを指定する必要があります。

- Cloud Credentials Operator を使用したクラウドプロバイダークレデンシャルの管理: クラスターコンポーネントは、クラウドプロバイダークレデンシャルを使用して、クラスター関連のタスクを実行するために必要なアクセス許可を取得します。

- システム管理者ユーザーのなりすまし: システム管理者ユーザーになりすます ことで、ユーザーにクラスター管理者権限を付与できます。

1.3. OpenShift Container Platform での承認について

許可には、識別されたユーザーが要求されたアクションを実行するための許可を持っているかどうかを判別することが含まれます。

管理者は、権限を定義し、ルール、ロール、バインディングなどの RBAC オブジェクトを使用してそれらをユーザーに割り当てることができます。OpenShift Container Platform で承認がどのように機能するかを理解するには、承認の評価を参照してください。

プロジェクトと namespaceを介して、OpenShift Container Platform クラスターへのアクセスを制御することもできます。

クラスターへのユーザーアクセスを制御するだけでなく、セキュリティーコンテキスト制約 (SCC) を使用して、Pod が実行できるアクションとアクセスできるリソースを制御することもできます。

以下のタスクを通じて、OpenShift Container Platform の認証を管理できます。

- ローカルおよびクラスターのロールとバインディングの表示。

- ローカルロールを作成し、それをユーザーまたはグループに割り当てます。

- クラスターロールの作成とユーザーまたはグループへの割り当て: OpenShift Container Platform には、デフォルトのクラスターロールのセットが含まれています。追加のクラスターロールを作成して、ユーザーまたはグループに追加できます。

cluster-admin ユーザーの作成: デフォルトでは、クラスターには

kubeadminというクラスター管理者が 1 人だけいます。別のクラスター管理者を作成できます。クラスター管理者を作成する前に、ID プロバイダーが設定されていることを確認してください。注記クラスター管理者ユーザーを作成したら、既存の kubeadmin ユーザーを削除して、クラスターのセキュリティーを向上させます。

- サービスアカウントの作成: サービスアカウントは、通常のユーザークレデンシャルを共有せずに API アクセスを制御する柔軟な方法を提供します。ユーザーは、アプリケーションで、または OAuth クライアントとしてサービスアカウントを作成して使用できます。

- スコープトークン: スコープトークンは、特定の操作のみを実行できる特定のユーザーとして識別するトークンです。スコープ付きトークンを作成して、パーミッションの一部を別のユーザーまたはサービスアカウントに委任できます。

- LDAP グループの同期: LDAP サーバーに保存されているグループを OpenShift Container Platform ユーザーグループと同期することにより、ユーザーグループを 1 か所で管理できます。

第2章 認証について

ユーザーが OpenShift Container Platform と対話できるようにするには、まずクラスターに対して認証する必要があります。認証層は、OpenShift Container Platform API への要求に関連付けられたユーザーを識別します。その後、認可層は要求側ユーザーの情報を使用して、要求が許可されるかどうかを決定します。

管理者は、OpenShift Container Platform の認証を設定できます。

2.1. ユーザー

OpenShift Container Platform の ユーザー は、OpenShift Container Platform API に要求できるエンティティーです。OpenShift Container Platform User オブジェクトは、それらおよびそれらのグループにロールを追加してシステム内のパーミッションを付与できるアクターを表します。通常、これは OpenShift Container Platform と対話している開発者または管理者のアカウントを表します。

ユーザーにはいくつかのタイプが存在します。

| ユーザータイプ | 説明 |

|---|---|

|

|

これは、大半の対話型の OpenShift Container Platform ユーザーが表示される方法です。通常ユーザーは、初回ログイン時にシステムに自動的に作成され、API で作成できます。通常ユーザーは、 |

|

|

これらの多くは、インフラストラクチャーが API と安全に対話できるようにすることを主な目的として定義される際に自動的に作成されます。これらには、クラスター管理者 (すべてのものへのアクセスを持つ)、ノードごとのユーザー、ルーターおよびレジストリーで使用できるユーザー、その他が含まれます。最後に、非認証要求に対してデフォルトで使用される |

|

|

プロジェクトに関連付けられる特殊なシステムユーザーがあります。それらの中には、プロジェクトの初回作成時に自動作成されるものもあれば、プロジェクト管理者が各プロジェクトのコンテンツへのアクセスを定義するために追加で作成するものもあります。サービスアカウントは |

それぞれのユーザーには、OpenShift Container Platform にアクセスするために何らかの認証が必要になります。認証がないか、認証が無効の API 要求は、anonymous システムユーザーによる要求として認証されます。認証が実行されると、認可されているユーザーの実行内容がポリシーによって決定されます。

2.2. グループ

ユーザーは 1 つ以上の グループ に割り当てることができます。それぞれのグループはユーザーの特定のセットを表します。グループは、認可ポリシーを管理し、個々のユーザーにではなく、一度に複数ユーザーにパーミッションを付与する場合などに役立ちます。 たとえば、アクセスをユーザーに個別に付与するのではなく、プロジェクト内の複数のオブジェクトに対するアクセスを許可できます。

明示的に定義されるグループのほかにも、システムグループまたは 仮想グループ がクラスターによって自動的にプロビジョニングされます。

以下のデフォルト仮想グループは最も重要なグループになります。

| 仮想グループ | 説明 |

|---|---|

|

| 認証されたユーザーに自動的に関連付けられます。 |

|

| OAuth アクセストークンで認証されたすべてのユーザーに自動的に関連付けられます。 |

|

| 認証されていないすべてのユーザーに自動的に関連付けられます。 |

2.3. API 認証

OpenShift Container Platform API への要求は以下の方法で認証されます。

- OAuth アクセストークン

-

<namespace_route>/oauth/authorizeおよび<namespace_route>/oauth/tokenエンドポイントを使用して OpenShift Container Platform OAuth サーバーから取得されます。 -

Authorization: Bearer…ヘッダーとして送信されます。 -

websocket 要求の

base64url.bearer.authorization.k8s.io.<base64url-encoded-token>形式の websocket サブプロトコルヘッダーとして送信されます。

-

- X.509 クライアント証明書

- API サーバーへの HTTPS 接続を要求します。

- 信頼される認証局バンドルに対して API サーバーによって検証されます。

- API サーバーは証明書を作成し、これをコントローラーに配布してそれらを認証できるようにします。

無効なアクセストークンまたは無効な証明書での要求は認証層によって拒否され、401 エラーが出されます。

アクセストークンまたは証明証が提供されない場合、認証層は system:anonymous 仮想ユーザーおよび system:unauthenticated 仮想グループを要求に割り当てます。これにより、認可層は匿名ユーザーが実行できる要求 (ある場合) を決定できます。

2.3.1. OpenShift Container Platform OAuth サーバー

OpenShift Container Platform マスターには、組み込まれた OAuth サーバーが含まれます。ユーザーは OAuth アクセストークンを取得して、API に対して認証します。

新しい OAuth のトークンが要求されると、OAuth サーバーは設定済みのアイデンティティプロバイダーを使用して要求したユーザーのアイデンティティーを判別します。

次に、そのアイデンティティーがマップするユーザーを判別し、そのユーザーのアクセストークンを作成し、そのトークンを使用できるように返します。

2.3.1.1. OAuth トークン要求

OAuth トークンのすべての要求は、トークンを受信し、使用する OAuth クライアントを指定する必要があります。以下の OAuth クライアントは、OpenShift Container Platform API の起動時に自動的に作成されます。

| OAuth クライアント | 使用法 |

|---|---|

|

|

対話式ログインを処理できるユーザーエージェントで |

|

|

|

<namespace_route>は namespace のルートを参照します。これは、以下のコマンドを実行して確認できます。oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.host

$ oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow

OAuth トークンのすべての要求には <namespace_route>/oauth/authorize への要求が必要になります。ほとんどの認証統合では、認証プロキシーをこのエンドポイントの前に配置するか、または OpenShift Container Platform を、サポートするアイデンティティープロバイダーに対して認証情報を検証するように設定します。<namespace_route>/oauth/authorize の要求は、CLI などの対話式ログインページを表示できないユーザーエージェントから送られる場合があります。そのため、OpenShift Container Platform は、対話式ログインフローのほかにも WWW-Authenticate チャレンジを使用した認証をサポートします。

認証プロキシーが <namespace_route>/oauth/authorize エンドポイントの前に配置される場合、対話式ログインページを表示したり、対話式ログインフローにリダイレクトする代わりに、認証されていない、ブラウザー以外のユーザーエージェントの WWW-Authenticate チャレンジを送信します。

ブラウザークライアントに対するクロスサイトリクエストフォージェリー (CSRF) 攻撃を防止するため、基本的な認証チャレンジは X-CSRF-Token ヘッダーが要求に存在する場合にのみ送信されます。基本的な WWW-Authenticate チャレンジを受信する必要があるクライアントでは、このヘッダーを空でない値に設定する必要があります。

認証プロキシーが WWW-Authenticate チャレンジをサポートしないか、または OpenShift Container Platform が WWW-Authenticate チャレンジをサポートしないアイデンティティープロバイダーを使用するように設定されている場合、ユーザーはブラウザーで <namespace_route>/oauth/token/request からトークンを手動で取得する必要があります。

2.3.1.2. API の権限借用

OpenShift Container Platform API への要求を、別のユーザーから発信されているかのように設定できます。詳細は、Kubernetes ドキュメントの User impersonation を参照してください。

2.3.1.3. Prometheus の認証メトリクス

OpenShift Container Platform は認証の試行中に以下の Prometheus システムメトリクスをキャプチャーします。

-

openshift_auth_basic_password_countはoc loginユーザー名およびパスワードの試行回数をカウントします。 -

openshift_auth_basic_password_count_resultは、oc loginユーザー名およびパスワードの試行回数を結果 (successまたはerror) 別にカウントします。 -

openshift_auth_form_password_countは Web コンソールのログイン試行回数をカウントします。 -

openshift_auth_form_password_count_resultは結果 (successまたはerror) 別に Web コンソールのログイン試行回数をカウントします。 -

openshift_auth_password_totalはoc loginおよび Web コンソールのログイン試行回数をカウントします。

第3章 内部 OAuth サーバーの設定

3.1. OpenShift Container Platform OAuth サーバー

OpenShift Container Platform マスターには、組み込まれた OAuth サーバーが含まれます。ユーザーは OAuth アクセストークンを取得して、API に対して認証します。

新しい OAuth のトークンが要求されると、OAuth サーバーは設定済みのアイデンティティプロバイダーを使用して要求したユーザーのアイデンティティーを判別します。

次に、そのアイデンティティーがマップするユーザーを判別し、そのユーザーのアクセストークンを作成し、そのトークンを使用できるように返します。

3.2. OAuth トークン要求フローおよび応答

OAuth サーバーは、標準的な Authorization Code Grant (認可コードによるグラント) および Implicit Grant (暗黙的グラント) の OAuth 認証フローをサポートします。

OAuth トークンを、(openshift-challenging-client などの) WWW-Authenticate チャレンジ を要求するように設定された client_id で Implicit Grant (暗黙的グラント) フロー (response_type=token) を使用して要求する場合、以下が /oauth/authorize から送られる可能性のあるサーバー応答、およびそれらの処理方法になります。

| ステータス | 内容 | クライアント応答 |

|---|---|---|

| 302 |

URL フラグメントに |

|

| 302 |

|

失敗します。 オプションで |

| 302 |

他の | これらのルールを使用してリダイレクトに従い、結果を処理します。 |

| 401 |

|

タイプ ( |

| 401 |

| チャレンジの認証ができません。失敗し、応答本体を表示します (これには、OAuth トークンを取得する別の方法についてのリンクまたは詳細が含まれる可能性があります) |

| その他 | その他 | 失敗し、オプションでユーザーに応答本体を提示します。 |

3.3. 内部 OAuth サーバーのオプション

内部 OAuth サーバーには、いくつかの設定オプションを使用できます。

3.3.1. OAuth トークン期間のオプション

内部 OAuth サーバーは以下の 2 種類のトークンを生成します。

| トークン | 説明 |

|---|---|

| アクセストークン | API へのアクセスを付与する永続的なトークン。 |

| 認証コード | アクセストークンの交換にのみ使われる一時的なトークン。 |

どちらの種類のトークンにもデフォルト期間を設定できます。必要な場合は、OAuthClient オブジェクト定義を使用してアクセストークンの期間をオーバーライドできます。

3.3.2. OAuth 付与オプション

OAuth サーバーが、ユーザーが以前にパーミッションを付与していないクライアントに対するトークン要求を受信する場合、OAuth サーバーが実行するアクションは OAuth クライアントの付与ストラテジーによって変わります。

トークンを要求する OAuth クライアントは、独自の付与ストラテジーを提供する必要があります。

以下のデフォルトの方法を使用できます。

| 付与オプション | 説明 |

|---|---|

|

| 付与を自動承認し、要求を再試行します。 |

|

| ユーザーに対して付与の承認または拒否を求めるプロンプトを出します。 |

3.4. 内部 OAuth サーバーのトークン期間の設定

内部 OAuth サーバーのトークン期間についてのデフォルトオプションを設定できます。

デフォルトで、トークンは 24 時間有効になります。24 時間を経過すると、既存のセッションは期限切れになります。

デフォルトの時間では十分ではない場合、以下の手順でこれを変更することができます。

手順

トークン期間オプションを含む設定ファイルを作成します。以下のファイルでは、これを、デフォルト値の 2 倍の 48 時間に設定しています。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

accessTokenMaxAgeSecondsを設定して、アクセストークンの有効期間を制御します。デフォルトの期間は 24 時間または 86400 秒です。この属性を負の値にすることはできません。ゼロに設定すると、デフォルトの有効期間が使用されます。

新規設定ファイルを適用します。

注記既存の OAuth サーバーを更新するため、

oc applyコマンドを使用して変更を適用する必要があります。oc apply -f </path/to/file.yaml>

$ oc apply -f </path/to/file.yaml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 変更が有効になっていることを確認します。

oc describe oauth.config.openshift.io/cluster

$ oc describe oauth.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

... Spec: Token Config: Access Token Max Age Seconds: 172800 ...... Spec: Token Config: Access Token Max Age Seconds: 172800 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. 内部 OAuth サーバーのトークンの非アクティブタイムアウトの設定

OAuth トークンは、設定されるアクティブでない期間の経過後に期限切れになるように設定できます。デフォルトで、トークンの非アクティブタイムアウトは設定されません。

トークンの非アクティブタイムアウトが OAuth クライアントでも設定されている場合、その値は内部 OAuth サーバー設定で設定されるタイムアウトをオーバーライドします。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 - アイデンティティープロバイダー (IDP) を設定している。

手順

OAuth設定を更新して、トークンの非アクティブタイムアウトを設定します。OAuthオブジェクトを編集します。oc edit oauth cluster

$ oc edit oauth clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow spec.tokenConfig.accessTokenInactivityTimeoutフィールドを追加し、タイムアウト値を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 値は適切な単位で設定します。たとえば、400 秒の場合は

400sに、30 分の場合は30mに設定します。許可される最小のタイムアウト値は300sです。

- 変更を適用するためにファイルを保存します。

OAuth サーバー Pod が再起動していることを確認します。

oc get clusteroperators authentication

$ oc get clusteroperators authenticationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の出力にあるように、

PROGRESSINGがFalseと表示されるまで次の手順に移行しないでください。出力例

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE authentication 4.9.0 True False False 145m

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE authentication 4.9.0 True False False 145mCopy to Clipboard Copied! Toggle word wrap Toggle overflow Kubernetes API サーバー Pod の新規リビジョンがロールアウトされていることを確認します。これには数分の時間がかかります。

oc get clusteroperators kube-apiserver

$ oc get clusteroperators kube-apiserverCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の出力にあるように、

PROGRESSINGがFalseと表示されるまで次の手順に移行しないでください。出力例

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE kube-apiserver 4.9.0 True False False 145m

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE kube-apiserver 4.9.0 True False False 145mCopy to Clipboard Copied! Toggle word wrap Toggle overflow PROGRESSINGがTrueと表示されている場合は、数分待機してから再試行します。

検証

- IDP のアイデンティティーでクラスターにログインします。

- コマンドを実行して、コマンドが正常に実行されたことを確認します。

- アイデンティティーを使用せずに、設定されたタイムアウトよりも長く待機します。この手順の例では、400 秒よりも長い時間待機します。

同じアイデンティティーのセッションからのコマンドの実行を試行します。

非アクティブの状態が設定されたタイムアウトよりも長く続くとトークンの有効期限が切れるために、このコマンドは失敗します。

出力例

error: You must be logged in to the server (Unauthorized)

error: You must be logged in to the server (Unauthorized)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. 内部 OAuth サーバー URL のカスタマイズ

クラスターIngress設定のspec.component Routesフィールドでカスタムホスト名と TLS 証明書を設定することにより、内部 OAuth サーバーの URL をカスタマイズできます。

内部 OAuth サーバーの URL を更新すると、OpenShift OAuth サーバーと通信して OAuth アクセストークンを取得する必要があるクラスター内のコンポーネントからの信頼が失われる可能性があります。OAuth サーバーを信頼する必要があるコンポーネントは、OAuth エンドポイントを呼び出すときに適切な CA バンドルを含める必要があります。以下に例を示します。

oc login -u <username> -p <password> --certificate-authority=<path_to_ca.crt>

$ oc login -u <username> -p <password> --certificate-authority=<path_to_ca.crt> - 1

- 自己署名証明書の場合、

ca.crtファイルにカスタム CA 証明書が含まれている必要があります。含まれていない場合、ログインは成功しません。

Cluster Authentication Operator は、OAuth サーバーのサービング証明書をopenshift-config-managed namespace のoauth-serving-cert設定マップに公開します。証明書は、設定マップのdata.ca-bundle.crtキーにあります。

前提条件

- 管理者権限のあるユーザーでクラスターにログインしている。

openshift-confignamespace に TLS 証明書およびキーを含めたシークレットを作成している。これは、カスタムホスト名の接尾辞のドメインがクラスターのドメイン接尾辞に一致しない場合に必要です。接尾辞が一致する場合には、シークレットはオプションです。ヒントoc create secret tlsコマンドを使用して TLS シークレットを作成できます。

手順

クラスター

Ingress設定を編集します。oc edit ingress.config.openshift.io cluster

$ oc edit ingress.config.openshift.io clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow カスタムのホスト名を設定し、オプションで提供する証明書とキーを設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。

3.7. OAuth サーバーメタデータ

OpenShift Container Platform で実行されているアプリケーションは、ビルトイン OAuth サーバーについての情報を検出する必要がある場合があります。たとえば、それらは <namespace_route> のアドレスを手動の設定なしで検出する必要があります。これを支援するために、OpenShift Container Platform は IETF OAuth 2.0 Authorization Server Metadata ドラフト仕様を実装しています。

そのため、クラスター内で実行されているすべてのアプリケーションは、https://openshift.default.svc/.well-known/oauth-authorization-server に対して GET 要求を実行し、以下の情報を取得できます。

- 1

httpsスキームを使用し、クエリーまたはフラグメントコンポーネントがない認可サーバーの発行者 ID です。これは、認可サーバーについての情報が含まれる.well-knownRFC 5785 リソースが公開される場所です。- 2

- 認可サーバーの認可エンドポートの URL です。RFC 6749 を参照してください。

- 3

- 認可サーバーのトークンエンドポイントの URL です。RFC 6749 を参照してください。

- 4

- この認可サーバーがサポートする OAuth 2.0 RFC 6749 スコープの値の一覧を含む JSON 配列です。サポートされるスコープの値すべてが公開される訳ではないことに注意してください。

- 5

- この認可サーバーがサポートする OAuth 2.0

response_type値の一覧を含む JSON 配列です。使用される配列の値は、RFC 7591 の OAuth 2.0 Dynamic Client Registration Protocol で定義されるresponse_typesパラメーターで使用されるものと同じです。 - 6

- この認可サーバーがサポートする OAuth 2.0 grant type の値の一覧が含まれる JSON 配列です。使用される配列の値は、RFC 7591 の

OAuth 2.0 Dynamic Client Registration Protocolで定義されるgrant_typesパラメーターで使用されるものと同じです。 - 7

- この認可サーバーでサポートされる PKCE RFC 7636 コードのチャレンジメソッドの一覧が含まれる JSON 配列です。コード のチャレンジメソッドの値は、RFC 7636 のセクション 4.3 で定義される

code_challenge_methodパラメーターで使用されます。有効なコードのチャレンジメソッドの値は、IANAPKCE Code Challenge Methodsレジストリーで登録される値です。IANA OAuth パラメーター を参照してください。

3.8. OAuth API イベントのトラブルシューティング

API サーバーは、API マスターログへの直接的なアクセスがないとデバッグが困難な unexpected condition のエラーメッセージを返すことがあります。このエラーの根本的な理由は意図的に非表示にされます。 認証されていないユーザーにサーバーの状態についての情報を提供することを避けるためです。

これらのエラーのサブセットは、サービスアカウントの OAuth 設定の問題に関連するものです。これらの問題は、管理者以外のユーザーが確認できるイベントでキャプチャーされます。unexpected condition というサーバーエラーが OAuth の実行時に発生する場合、oc get events を実行し、これらのイベントについて ServiceAccount で確認します。

以下の例では、適切な OAuth リダイレクト URI がないサービスアカウントに対して警告しています。

oc get events | grep ServiceAccount

$ oc get events | grep ServiceAccount出力例

1m 1m 1 proxy ServiceAccount Warning NoSAOAuthRedirectURIs service-account-oauth-client-getter system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

1m 1m 1 proxy ServiceAccount Warning NoSAOAuthRedirectURIs service-account-oauth-client-getter system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

oc describe sa/<service_account_name> を実行すると、指定のサービスアカウント名に関連付けられた OAuth イベントが報告されます。

oc describe sa/proxy | grep -A5 Events

$ oc describe sa/proxy | grep -A5 Events出力例

Events: FirstSeen LastSeen Count From SubObjectPath Type Reason Message --------- -------- ----- ---- ------------- -------- ------ ------- 3m 3m 1 service-account-oauth-client-getter Warning NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

Events:

FirstSeen LastSeen Count From SubObjectPath Type Reason Message

--------- -------- ----- ---- ------------- -------- ------ -------

3m 3m 1 service-account-oauth-client-getter Warning NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>以下は生じる可能性のあるイベントエラーの一覧です。

リダイレクト URI アノテーションが指定されていないか、無効な URI が指定されている

Reason Message NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

Reason Message

NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>無効なルートが指定されている

Reason Message NoSAOAuthRedirectURIs [routes.route.openshift.io "<name>" not found, system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]

Reason Message

NoSAOAuthRedirectURIs [routes.route.openshift.io "<name>" not found, system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]無効な参照タイプが指定されている

Reason Message NoSAOAuthRedirectURIs [no kind "<name>" is registered for version "v1", system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]

Reason Message

NoSAOAuthRedirectURIs [no kind "<name>" is registered for version "v1", system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]SA トークンがない

Reason Message NoSAOAuthTokens system:serviceaccount:myproject:proxy has no tokens

Reason Message

NoSAOAuthTokens system:serviceaccount:myproject:proxy has no tokens第4章 OAuth クライアントの設定

OpenShift Container Platform では、いくつかの OAuth クライアントがデフォルトで作成されます。追加の OAuth クライアントを登録し、設定することもできます。

4.1. デフォルトの OAuth クライアント

以下の OAuth クライアントは、OpenShift Container Platform API の起動時に自動的に作成されます。

| OAuth クライアント | 使用法 |

|---|---|

|

|

対話式ログインを処理できるユーザーエージェントで |

|

|

|

<namespace_route>は namespace のルートを参照します。これは、以下のコマンドを実行して確認できます。oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.host

$ oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. 追加の OAuth クライアントの登録

OpenShift Container Platform クラスターの認証を管理するために追加の OAuth クライアントが必要になる場合は、これを登録することができます。

手順

追加の OAuth クライアントを登録するには、以下を実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- OAuth クライアントの

nameは、<namespace_route>/oauth/authorizeおよび<namespace_route>/oauth/tokenへの要求を実行する際にclient_idパラメーターとして使用されます。 - 2

secretは、<namespace_route>/oauth/tokenへの要求の実行時にclient_secretパラメーターとして使用されます。- 3

<namespace_route>/oauth/authorizeおよび<namespace_route>/oauth/tokenへの要求で指定されるredirect_uriパラメーターは、redirectURIsパラメーター値に一覧表示されるいずれかの URI と等しいか、またはこれによって接頭辞が付けられている必要があります。- 4

grantMethodは、このクライアントがトークンを要求するものの、ユーザーによってアクセスが付与されていない場合に実行するアクションを判別するために使用されます。付与を自動的に承認し、要求を再試行するにはautoを指定し、ユーザーに対して付与の承認または付与を求めるプロンプトを出す場合にはpromptを指定します。

4.3. OAuth クライアントのトークンの非アクティブタイムアウトの設定

OAuth クライアントを、設定されるアクティブでない期間の経過後に OAuth トークンの期限が切れるように設定できます。デフォルトで、トークンの非アクティブタイムアウトは設定されません。

トークンの非アクティブタイムアウトが内部 OAuth サーバー設定でも設定されている場合、OAuth クライアントで設定されるタイムアウトはその値をオーバーライドします。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 - アイデンティティープロバイダー (IDP) を設定している。

手順

OAuthClientクライアント設定を更新して、トークンの非アクティブタイムアウトを設定します。OAuthClientオブジェクトを編集します。oc edit oauthclient <oauth_client>

$ oc edit oauthclient <oauth_client>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<oauth_client>を設定する OAuth クライアントに置き換えます (例:console)。

accessTokenInactivityTimeoutSecondsフィールドを追加し、タイムアウト値を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 許可される最小のタイムアウト値 (秒単位) は

300です。

- 変更を適用するためにファイルを保存します。

検証

- IDP のアイデンティティーでクラスターにログインします。設定したばかりの OAuth クライアントを使用するようにしてください。

- アクションを実行し、これが正常に実行されたことを確認します。

- アイデンティティーを使用せずに、設定されたタイムアウトよりも長く待機します。この手順の例では、600 秒よりも長い時間待機します。

同じアイデンティティーのセッションからアクションの実行を試みます。

非アクティブの状態が設定されたタイムアウトよりも長く続くとトークンの有効期限が切れるために、この試行は失敗します。

第5章 ユーザーが所有する OAuth アクセストークンの管理

ユーザーは、独自の OAuth アクセストークンを確認し、不要になったものを削除できます。

5.1. ユーザーが所有する OAuth アクセストークンの一覧表示

ユーザーが所有する OAuth アクセストークンを一覧表示できます。トークン名には機密性がなく、ログインには使用できません。

手順

ユーザーが所有する OAuth アクセストークンを一覧表示します。

oc get useroauthaccesstokens

$ oc get useroauthaccesstokensCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token1> openshift-challenging-client 2021-01-11T19:25:35Z 2021-01-12 19:25:35 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/implicit user:full <token2> openshift-browser-client 2021-01-11T19:27:06Z 2021-01-12 19:27:06 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/display user:full <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:full

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token1> openshift-challenging-client 2021-01-11T19:25:35Z 2021-01-12 19:25:35 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/implicit user:full <token2> openshift-browser-client 2021-01-11T19:27:06Z 2021-01-12 19:27:06 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/display user:full <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:fullCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定の OAuth クライアントのユーザーが所有する OAuth アクセストークンを一覧表示します。

oc get useroauthaccesstokens --field-selector=clientName="console"

$ oc get useroauthaccesstokens --field-selector=clientName="console"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:full

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:fullCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2. ユーザーが所有する OAuth アクセストークンの詳細の表示

ユーザーが所有する OAuth アクセストークンの詳細を表示します。

手順

ユーザーが所有する OAuth アクセストークンの詳細を記述します。

oc describe useroauthaccesstokens <token_name>

$ oc describe useroauthaccesstokens <token_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. ユーザーが所有する OAuth アクセストークンの削除

oc logout コマンドは、アクティブなセッションの OAuth トークンのみを無効にします。以下の手順を使用して、不要になったユーザーが所有する OAuth トークンを削除できます。

OAuth アクセストークンを削除すると、そのトークンを使用するすべてのセッションからユーザーをログアウトします。

手順

ユーザーが所有する OAuth アクセストークンを削除します。

oc delete useroauthaccesstokens <token_name>

$ oc delete useroauthaccesstokens <token_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

useroauthaccesstoken.oauth.openshift.io "<token_name>" deleted

useroauthaccesstoken.oauth.openshift.io "<token_name>" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第6章 アイデンティティープロバイダー設定について

OpenShift Container Platform マスターには、組み込まれた OAuth サーバーが含まれます。開発者および管理者は OAuth アクセストークンを取得して、API に対して認証します。

管理者は、クラスターのインストール後に、OAuth をアイデンティティープロバイダーを指定するように設定できます。

6.1. OpenShift Container Platform のアイデンティティープロバイダーについて

デフォルトでは、kubeadmin ユーザーのみがクラスターに存在します。アイデンティティープロバイダーを指定するには、アイデンティティープロバイダーを記述し、これをクラスターに追加するカスタムリソースを作成する必要があります。

/、:、および % を含む OpenShift Container Platform ユーザー名はサポートされません。

6.2. サポートされるアイデンティティープロバイダー

以下の種類のアイデンティティープロバイダーを設定できます。

| アイデンティティープロバイダー | 説明 |

|---|---|

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

アイデンティティープロバイダーが定義された後に、RBAC を使用してパーミッションの定義および適用 を実行できます。

6.3. kubeadmin ユーザーの削除

アイデンティティープロバイダーを定義し、新規 cluster-admin ユーザーを作成した後に、クラスターのセキュリティーを強化するために kubeadmin を削除できます。

別のユーザーが cluster-admin になる前にこの手順を実行する場合、OpenShift Container Platform は再インストールされる必要があります。このコマンドをやり直すことはできません。

前提条件

- 1 つ以上のアイデンティティープロバイダーを設定しておく必要があります。

-

cluster-adminロールをユーザーに追加しておく必要があります。 - 管理者としてログインしている必要があります。

手順

kubeadminシークレットを削除します。oc delete secrets kubeadmin -n kube-system

$ oc delete secrets kubeadmin -n kube-systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4. アイデンティティープロバイダーパラメーター

以下のパラメーターは、すべてのアイデンティティープロバイダーに共通するパラメーターです。

| パラメーター | 説明 |

|---|---|

|

| プロバイダー名は、プロバイダーのユーザー名に接頭辞として付加され、アイデンティティー名が作成されます。 |

|

| 新規アイデンティティーがログイン時にユーザーにマップされる方法を定義します。以下の値のいずれかを入力します。

|

mappingMethod パラメーターを add に設定すると、アイデンティティープロバイダーの追加または変更時に新規プロバイダーのアイデンティティーを既存ユーザーにマッピングできます。

6.5. アイデンティティープロバイダー CR のサンプル

以下のカスタムリソース (CR) は、アイデンティティープロバイダーを設定するために使用するパラメーターおよびデフォルト値を示します。この例では、htpasswd アイデンティティープロバイダーを使用しています。

アイデンティティープロバイダー CR のサンプル

第7章 アイデンティティープロバイダーの設定

7.1. htpasswd アイデンティティープロバイダーの設定

htpasswd アイデンティティープロバイダーを設定して、ユーザーが htpasswd ファイルの認証情報を使用して OpenShift Container Platform にログインできるようにします。

htpasswd ID プロバイダーを定義するには、次のタスクを実行します。

-

ユーザーおよびパスワード情報を保存するために

htpasswdファイルを作成 します。 -

htpasswdファイルを表す シークレットを作成 します。 - シークレットを参照する htpasswd ID プロバイダーリソースを定義 します。

- デフォルトの OAuth 設定に リソースを適用して、ID プロバイダーを追加します。

7.1.1. OpenShift Container Platform のアイデンティティープロバイダーについて

デフォルトでは、kubeadmin ユーザーのみがクラスターに存在します。アイデンティティープロバイダーを指定するには、アイデンティティープロバイダーを記述し、これをクラスターに追加するカスタムリソースを作成する必要があります。

/、:、および % を含む OpenShift Container Platform ユーザー名はサポートされません。

7.1.2. htpasswd 認証について

OpenShift Container Platform で htpasswd 認証を使用すると、htpasswd ファイルに基づいてユーザーを識別できます。htpasswd ファイルは、各ユーザーのユーザー名とハッシュ化されたパスワードを含むフラットファイルです。htpasswd ユーティリティーを使用して、このファイルを作成できます。

7.1.3. htpasswd ファイルの作成

htpasswd ファイルの作成方法は、次のいずれかのセクションを参照してください。

7.1.3.1. Linux を使用した htpasswd ファイルの作成

htpasswd アイデンティティープロバイダーを使用するには、htpasswd を使用してクラスターのユーザー名およびパスワードを含むフラットファイルを生成する必要があります。

前提条件

-

htpasswdユーティリティーへのアクセスがあること。Red Hat Enterprise Linux では、これはhttpd-toolsパッケージをインストールして利用できます。

手順

ユーザー名およびハッシュされたパスワードを含むフラットファイルを作成します。

htpasswd -c -B -b </path/to/users.htpasswd> <user_name> <password>

$ htpasswd -c -B -b </path/to/users.htpasswd> <user_name> <password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドにより、ハッシュされたバージョンのパスワードが生成されます。

以下に例を示します。

htpasswd -c -B -b users.htpasswd user1 MyPassword!

$ htpasswd -c -B -b users.htpasswd user1 MyPassword!Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Adding password for user user1

Adding password for user user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルに対する認証情報の追加またはその更新を継続します。

htpasswd -B -b </path/to/users.htpasswd> <user_name> <password>

$ htpasswd -B -b </path/to/users.htpasswd> <user_name> <password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.3.2. Windows を使用した htpasswd ファイルの作成

htpasswd アイデンティティープロバイダーを使用するには、htpasswd を使用してクラスターのユーザー名およびパスワードを含むフラットファイルを生成する必要があります。

前提条件

-

htpasswd.exeへのアクセスがあること。このファイルは、数多くの Apache httpd ディストリビューションの\binディレクトリーに含まれます。

手順

ユーザー名およびハッシュされたパスワードを含むフラットファイルを作成します。

> htpasswd.exe -c -B -b <\path\to\users.htpasswd> <user_name> <password>

> htpasswd.exe -c -B -b <\path\to\users.htpasswd> <user_name> <password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドにより、ハッシュされたバージョンのパスワードが生成されます。

以下に例を示します。

> htpasswd.exe -c -B -b users.htpasswd user1 MyPassword!

> htpasswd.exe -c -B -b users.htpasswd user1 MyPassword!Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Adding password for user user1

Adding password for user user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルに対する認証情報の追加またはその更新を継続します。

> htpasswd.exe -b <\path\to\users.htpasswd> <user_name> <password>

> htpasswd.exe -b <\path\to\users.htpasswd> <user_name> <password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.4. htpasswd シークレットの作成

htpasswd アイデンティティープロバイダーを使用するには、htpasswd ユーザーファイルが含まれるシークレットを定義する必要があります。

前提条件

- htpasswd ファイルを作成します。

手順

htpasswd ユーザーファイルが含まれる

Secretオブジェクトを作成します。oc create secret generic htpass-secret --from-file=htpasswd=<path_to_users.htpasswd> -n openshift-config

$ oc create secret generic htpass-secret --from-file=htpasswd=<path_to_users.htpasswd> -n openshift-config1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 上記のコマンドが示すように、

--from-file引数についてのユーザーファイルを含むシークレットキーにはhtpasswdという名前を指定する必要があります。

ヒントまたは、以下の YAML を適用してシークレットを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.5. htpasswd CR のサンプル

以下のカスタムリソース (CR) は、htpasswd アイデンティティープロバイダーのパラメーターおよび許可される値を示します。

htpasswd CR

7.1.6. アイデンティティープロバイダーのクラスターへの追加

クラスターのインストール後に、アイデンティティープロバイダーをそのクラスターに追加し、ユーザーの認証を実行できるようにします。

前提条件

- OpenShift Container Platform クラスターを作成します。

- アイデンティティープロバイダーのカスタムリソース (CR) を作成します。

- 管理者としてログインしている必要があります。

手順

定義された CR を適用します。

oc apply -f </path/to/CR>

$ oc apply -f </path/to/CR>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記CR が存在しない場合、

oc applyは新規 CR を作成し、さらに以下の警告をトリガーする可能性があります。Warning: oc apply should be used on resources created by either oc create --save-config or oc applyこの場合は、この警告を無視しても問題ありません。アイデンティティープロバイダーのユーザーとしてクラスターにログインし、プロンプトが出されたらパスワードを入力します。

oc login -u <username>

$ oc login -u <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザーが正常にログインされていることを確認し、ユーザー名を表示します。

oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.7. htpasswd アイデンティティープロバイダーの更新

既存の htpasswd アイデンティティープロバイダーにユーザーを追加したり、既存の htpasswd アイデンティティープロバイダーからユーザーを削除したりできます。

前提条件

-

htpasswd ユーザーファイルが含まれる

Secretオブジェクトを作成している。この手順では、htpass-secretという名前であることを前提としています。 -

htpasswd アイデンティティープロバイダーを設定している。この手順では、

my_htpasswd_providerという名前であることを前提としています。 -

htpasswdユーティリティーへのアクセスがある。Red Hat Enterprise Linux では、これはhttpd-toolsパッケージをインストールして利用できます。 - クラスター管理者の権限がある。

手順

htpasswd ファイルを

htpass-secretSecretオブジェクトから取得し、ファイルをお使いのファイルシステムに保存します。oc get secret htpass-secret -ojsonpath={.data.htpasswd} -n openshift-config | base64 --decode > users.htpasswd$ oc get secret htpass-secret -ojsonpath={.data.htpasswd} -n openshift-config | base64 --decode > users.htpasswdCopy to Clipboard Copied! Toggle word wrap Toggle overflow users.htpasswdファイルからユーザーを追加したり、削除したりします。新規ユーザーを追加するには、以下を実行します。

htpasswd -bB users.htpasswd <username> <password>

$ htpasswd -bB users.htpasswd <username> <password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Adding password for user <username>

Adding password for user <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 既存ユーザーを削除するには、以下を実行します。

htpasswd -D users.htpasswd <username>

$ htpasswd -D users.htpasswd <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Deleting password for user <username>

Deleting password for user <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

htpass-secretSecretオブジェクトを、users.htpasswdファイルの更新されたユーザーに置き換えます。oc create secret generic htpass-secret --from-file=htpasswd=users.htpasswd --dry-run=client -o yaml -n openshift-config | oc replace -f -

$ oc create secret generic htpass-secret --from-file=htpasswd=users.htpasswd --dry-run=client -o yaml -n openshift-config | oc replace -f -Copy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用して Operator を置き換えることもできます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 複数のユーザーを削除した場合は、追加でユーザーごとに既存のリソースを削除する必要があります。

Userオブジェクトを削除します。oc delete user <username>

$ oc delete user <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

user.user.openshift.io "<username>" deleted

user.user.openshift.io "<username>" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザーを必ず削除してください。削除しない場合、ユーザーは期限切れでない限り、トークンを引き続き使用できます。

ユーザーの

Identityオブジェクトを削除します。oc delete identity my_htpasswd_provider:<username>

$ oc delete identity my_htpasswd_provider:<username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

identity.user.openshift.io "my_htpasswd_provider:<username>" deleted

identity.user.openshift.io "my_htpasswd_provider:<username>" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.8. Web コンソールを使用したアイデンティティープロバイダーの設定

CLI ではなく Web コンソールを使用してアイデンティティープロバイダー (IDP) を設定します。

前提条件

- クラスター管理者として Web コンソールにログインしている必要があります。

手順

- Administration → Cluster Settings に移動します。

- Configuration タブで、OAuth をクリックします。

- Identity Providers セクションで、Add ドロップダウンメニューからアイデンティティープロバイダーを選択します。

既存の IDP を上書きすることなく、Web コンソールで複数の IDP を指定することができます。

7.2. Keystone アイデンティティープロバイダーの設定

keystone アイデンティティープロバイダーを、OpenShift Container Platform クラスターを Keystone に統合し、ユーザーを内部データベースに保存するように設定された OpenStack Keystone v3 サーバーによる共有認証を有効にするように設定します。この設定により、ユーザーは Keystone 認証情報を使って OpenShift Container Platform にログインできます。

7.2.1. OpenShift Container Platform のアイデンティティープロバイダーについて

デフォルトでは、kubeadmin ユーザーのみがクラスターに存在します。アイデンティティープロバイダーを指定するには、アイデンティティープロバイダーを記述し、これをクラスターに追加するカスタムリソースを作成する必要があります。

/、:、および % を含む OpenShift Container Platform ユーザー名はサポートされません。

7.2.2. Keystone 認証について

Keystone は、アイデンティティー、トークン、カタログ、およびポリシーサービスを提供する OpenStack プロジェクトです。

新規 OpenShift Container Platform ユーザーが Keystone ユーザー名または一意の Keystone ID をベースに設定されるように Keystone との統合を設定できます。どちらの方法でも、ユーザーは Keystone ユーザー名およびパスワードを入力してログインします。OpenShift Container Platform ユーザーを Keystone ID に基づいて作成すると、より安全になります。これは、Keystone ユーザーを削除し、そのユーザー名で新しい Keystone ユーザーを作成すると、新しいユーザーが古いユーザーのリソースにアクセスできる可能性があるためです。

7.2.3. シークレットの作成

アイデンティティープロバイダーは openshift-config namespace で OpenShift Container Platform Secret オブジェクトを使用して、クライアントシークレット、クライアント証明書およびキーをこれに組み込みます。

手順

以下のコマンドを使用して、キーおよび証明書が含まれる

Secretオブジェクトを作成します。oc create secret tls <secret_name> --key=key.pem --cert=cert.pem -n openshift-config

$ oc create secret tls <secret_name> --key=key.pem --cert=cert.pem -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用してシークレットを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.4. 設定マップの作成

アイデンティティープロバイダーは、openshift-config namespace で OpenShift Container Platform ConfigMap オブジェクトを使用し、認証局バンドルをこれに組み込みます。これらは、主にアイデンティティープロバイダーで必要な証明書バンドルを組み込むために使用されます。

手順

以下のコマンドを使用して、認証局が含まれる OpenShift Container Platform

ConfigMapオブジェクトを定義します。認証局はConfigMapオブジェクトのca.crtキーに保存する必要があります。oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用して設定マップを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.5. Keystone CR のサンプル

以下のカスタムリソース (CR) は、Keystone アイデンティティープロバイダーのパラメーターおよび許可される値を示します。

Keystone CR

- 1

- このプロバイダー名は、プロバイダーのユーザー名に接頭辞として付加され、アイデンティティー名が作成されます。

- 2

- このプロバイダーのアイデンティティーと

Userオブジェクト間にマッピングが確立される方法を制御します。 - 3

- Keystone のドメイン名です。Keystone では、ユーザー名はドメインに固有の名前です。単一ドメインのみがサポートされます。

- 4

- Keystone サーバーへの接続に使用する URL です (必須) 。https を使用する必要があります。

- 5

- オプション: 設定済みの URL のサーバー証明書を検証するために使用する PEM エンコードされた認証局バンドルを含む OpenShift Container Platform

ConfigMapオブジェクトへの参照。 - 6

- オプション: 設定済み URL への要求を実行する際に存在させるクライアント証明書を含む OpenShift Container Platform

Secretオブジェクトへの参照。 - 7

- クライアント証明書のキーを含む OpenShift Container Platform

Secretオブジェクトへの参照。tlsClientCertが指定されている場合には必須になります。

7.2.6. アイデンティティープロバイダーのクラスターへの追加

クラスターのインストール後に、アイデンティティープロバイダーをそのクラスターに追加し、ユーザーの認証を実行できるようにします。

前提条件

- OpenShift Container Platform クラスターを作成します。

- アイデンティティープロバイダーのカスタムリソース (CR) を作成します。

- 管理者としてログインしている必要があります。

手順

定義された CR を適用します。

oc apply -f </path/to/CR>

$ oc apply -f </path/to/CR>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記CR が存在しない場合、

oc applyは新規 CR を作成し、さらに以下の警告をトリガーする可能性があります。Warning: oc apply should be used on resources created by either oc create --save-config or oc applyこの場合は、この警告を無視しても問題ありません。アイデンティティープロバイダーのユーザーとしてクラスターにログインし、プロンプトが出されたらパスワードを入力します。

oc login -u <username>

$ oc login -u <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザーが正常にログインされていることを確認し、ユーザー名を表示します。

oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. LDAP アイデンティティープロバイダーの設定

ldap アイデンティティープロバイダーを、単純なバインド認証を使用して LDAPv3 サーバーに対してユーザー名とパスワードを検証するように設定します。

7.3.1. OpenShift Container Platform のアイデンティティープロバイダーについて

デフォルトでは、kubeadmin ユーザーのみがクラスターに存在します。アイデンティティープロバイダーを指定するには、アイデンティティープロバイダーを記述し、これをクラスターに追加するカスタムリソースを作成する必要があります。

/、:、および % を含む OpenShift Container Platform ユーザー名はサポートされません。

7.3.2. LDAP 認証について

認証時に、指定されたユーザー名に一致するエントリーが LDAP ディレクトリーで検索されます。単一の一意の一致が見つかった場合、エントリーの識別名 (DN) と指定されたパスワードを使用した単純なバインドが試みられます。

以下の手順が実行されます。

-

設定された

urlの属性およびフィルターとユーザーが指定したユーザー名を組み合わせて検索フィルターを生成します。 - 生成されたフィルターを使用してディレクトリーを検索します。検索によって 1 つもエントリーが返されない場合は、アクセスを拒否します。

- 検索で取得したエントリーの DN とユーザー指定のパスワードを使用して LDAP サーバーへのバインドを試みます。

- バインドが失敗した場合は、アクセスを拒否します。

- バインドが成功した場合は、アイデンティティー、電子メールアドレス、表示名、および推奨ユーザー名として設定された属性を使用してアイデンティティーを作成します。

設定される url は、LDAP ホストと使用する検索パラメーターを指定する RFC 2255 URL です。URL の構文は以下のようになります。

ldap://host:port/basedn?attribute?scope?filter

ldap://host:port/basedn?attribute?scope?filterこの URL の場合:

| URL コンポーネント | 説明 |

|---|---|

|

|

通常の LDAP の場合は、文字列 |

|

|

LDAP サーバーの名前とポートです。デフォルトは、ldap の場合は |

|

| すべての検索が開始されるディレクトリーのブランチの DN です。これは少なくともディレクトリーツリーの最上位になければなりませんが、ディレクトリーのサブツリーを指定することもできます。 |

|

|

検索対象の属性です。RFC 2255 はコンマ区切りの属性の一覧を許可しますが、属性をどれだけ指定しても最初の属性のみが使用されます。属性を指定しない場合は、デフォルトで |

|

|

検索の範囲です。 |

|

|

有効な LDAP 検索フィルターです。指定しない場合、デフォルトは |

検索の実行時に属性、フィルター、指定したユーザー名が組み合わされて以下のような検索フィルターが作成されます。

(&(<filter>)(<attribute>=<username>))

(&(<filter>)(<attribute>=<username>))たとえば、以下の URL について見てみましょう。

ldap://ldap.example.com/o=Acme?cn?sub?(enabled=true)

ldap://ldap.example.com/o=Acme?cn?sub?(enabled=true)

クライアントが bob というユーザー名を使用して接続を試みる場合、生成される検索フィルターは (&(enabled=true)(cn=bob)) になります。

LDAP ディレクトリーの検索に認証が必要な場合は、エントリー検索の実行に使用する bindDN と bindPassword を指定します。

7.3.3. LDAP シークレットの作成

アイデンティティープロバイダーを使用するには、bindPassword が含まれる OpenShift Container Platform Secret オブジェクトを定義する必要があります。

手順

bindPasswordフィールドが含まれるSecretオブジェクトを作成します。oc create secret generic ldap-secret --from-literal=bindPassword=<secret> -n openshift-config

$ oc create secret generic ldap-secret --from-literal=bindPassword=<secret> -n openshift-config1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

--from-literal引数についての bindPassword を含むシークレットキーはbindPasswordとして指定する必要があります。

ヒントまたは、以下の YAML を適用してシークレットを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.4. 設定マップの作成

アイデンティティープロバイダーは、openshift-config namespace で OpenShift Container Platform ConfigMap オブジェクトを使用し、認証局バンドルをこれに組み込みます。これらは、主にアイデンティティープロバイダーで必要な証明書バンドルを組み込むために使用されます。

手順

以下のコマンドを使用して、認証局が含まれる OpenShift Container Platform

ConfigMapオブジェクトを定義します。認証局はConfigMapオブジェクトのca.crtキーに保存する必要があります。oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用して設定マップを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.5. LDAP CR のサンプル

以下のカスタムリソース (CR) は、LDAP アイデンティティープロバイダーのパラメーターおよび許可される値を示しています。

LDAP CR

- 1

- このプロバイダー名は返されるユーザー名に接頭辞として付加され、アイデンティティー名が作成されます。

- 2

- このプロバイダーのアイデンティティーと

Userオブジェクト間にマッピングが確立される方法を制御します。 - 3

- アイデンティティーとして使用する属性の一覧です。最初の空でない属性が使用されます。少なくとも 1 つの属性が必要です。一覧表示される属性のいずれにも値がない場合、認証は失敗します。定義される属性は raw データとして取得され、バイナリー値の使用を許可します。

- 4

- メールアドレスとして使用する属性の一覧です。最初の空でない属性が使用されます。

- 5

- 表示名として使用する属性の一覧です。最初の空でない属性が使用されます。

- 6

- このアイデンティティーのユーザーをプロビジョニングする際に推奨ユーザー名として使用する属性の一覧です。最初の空でない属性が使用されます。

- 7

- 検索フェーズでバインドするために使用するオプションの DN です。

bindPasswordが定義される場合に設定される必要があります。 - 8

- オプション: バインドパスワードを含む OpenShift Container Platform

Secretオブジェクトへの参照。bindDNが定義される場合に設定される必要があります。 - 9

- オプション: 設定済みの URL のサーバー証明書を検証するために使用する PEM エンコードされた認証局バンドルを含む OpenShift Container Platform

ConfigMapオブジェクトへの参照。insecureがfalseの場合にのみ使用されます。 - 10

trueの場合、サーバーへの TLS 接続は行われません。falseの場合、ldaps://URL は TLS を使用して接続し、ldap://URL は TLS にアップグレードされます。これは、ldaps://URL が使用されている場合はfalseに設定される必要があります。 これらの URL は常に TLS を使用して接続を試行します。- 11

- LDAP ホストと使用する検索パラメーターを指定する RFC 2255 URL です。

LDAP 統合のためのユーザーのホワイトリストを作成するには、lookup マッピング方法を使用します。LDAP からのログインが許可される前に、クラスター管理者は各 LDAP ユーザーの Identity オブジェクトと User オブジェクトを作成する必要があります。

7.3.6. アイデンティティープロバイダーのクラスターへの追加

クラスターのインストール後に、アイデンティティープロバイダーをそのクラスターに追加し、ユーザーの認証を実行できるようにします。

前提条件

- OpenShift Container Platform クラスターを作成します。

- アイデンティティープロバイダーのカスタムリソース (CR) を作成します。

- 管理者としてログインしている必要があります。

手順

定義された CR を適用します。

oc apply -f </path/to/CR>

$ oc apply -f </path/to/CR>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記CR が存在しない場合、

oc applyは新規 CR を作成し、さらに以下の警告をトリガーする可能性があります。Warning: oc apply should be used on resources created by either oc create --save-config or oc applyこの場合は、この警告を無視しても問題ありません。アイデンティティープロバイダーのユーザーとしてクラスターにログインし、プロンプトが出されたらパスワードを入力します。

oc login -u <username>

$ oc login -u <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザーが正常にログインされていることを確認し、ユーザー名を表示します。

oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4. Basic 認証アイデンティティープロバイダーの設定

basic-authentication アイデンティティープロバイダーを、ユーザーがリモートアイデンティティープロバイダーに対して検証された認証情報を使って OpenShift Container Platform にログインできるように設定します。Basic 認証は、汎用的なバックエンド統合メカニズムです。

7.4.1. OpenShift Container Platform のアイデンティティープロバイダーについて

デフォルトでは、kubeadmin ユーザーのみがクラスターに存在します。アイデンティティープロバイダーを指定するには、アイデンティティープロバイダーを記述し、これをクラスターに追加するカスタムリソースを作成する必要があります。

/、:、および % を含む OpenShift Container Platform ユーザー名はサポートされません。

7.4.2. Basic 認証について

Basic 認証は、ユーザーがリモートのアイデンティティープロバイダーに対して検証した認証情報を使用して OpenShift Container Platform にログインすることを可能にする汎用バックエンド統合メカニズムです。

Basic 認証は汎用性があるため、このアイデンティティープロバイダー使用して詳細な認証設定を実行できます。

Basic 認証では、ユーザー ID とパスワードのスヌーピングを防ぎ、中間者攻撃を回避するためにリモートサーバーへの HTTPS 接続を使用する必要があります。

Basic 認証が設定されると、ユーザーはユーザー名とパスワードを OpenShift Container Platform に送信し、サーバー間の要求を行い、認証情報を Basic 認証ヘッダーとして渡すことで、これらの認証情報をリモートサーバーに対して検証することができます。このため、ユーザーはログイン時に認証情報を OpenShift Container Platform に送信する必要があります。

これはユーザー名/パスワードログインの仕組みにのみ有効で、OpenShift Container Platform はリモート認証サーバーに対するネットワーク要求を実行できる必要があります。

ユーザー名およびパスワードは Basic 認証で保護されるリモート URL に対して検証され、JSON が返されます。

401 応答は認証の失敗を示しています。

200 以外のステータスまたは空でないエラーキーはエラーを示しています。

{"error":"Error message"}

{"error":"Error message"}

sub (サブジェクト) キーを持つ 200 ステータスは、成功を示しています。

{"sub":"userid"}

{"sub":"userid"} - 1

- このサブジェクトは認証ユーザーに固有である必要があり、変更することができません。

正常な応答により、以下のような追加データがオプションで提供されることがあります。

nameキーを使用した表示名。以下に例を示します。{"sub":"userid", "name": "User Name", ...}{"sub":"userid", "name": "User Name", ...}Copy to Clipboard Copied! Toggle word wrap Toggle overflow emailキーを使用したメールアドレス。以下に例を示します。{"sub":"userid", "email":"user@example.com", ...}{"sub":"userid", "email":"user@example.com", ...}Copy to Clipboard Copied! Toggle word wrap Toggle overflow preferred_usernameキーを使用した推奨ユーザー名。これは、固有の変更できないサブジェクトがデータベースキーまたは UID であり、判読可能な名前が存在する場合に便利です。これは、認証されたアイデンティティーの OpenShift Container Platform ユーザーをプロビジョニングする場合にヒントとして使われます。以下に例を示します。{"sub":"014fbff9a07c", "preferred_username":"bob", ...}{"sub":"014fbff9a07c", "preferred_username":"bob", ...}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.3. シークレットの作成

アイデンティティープロバイダーは openshift-config namespace で OpenShift Container Platform Secret オブジェクトを使用して、クライアントシークレット、クライアント証明書およびキーをこれに組み込みます。

手順

以下のコマンドを使用して、キーおよび証明書が含まれる

Secretオブジェクトを作成します。oc create secret tls <secret_name> --key=key.pem --cert=cert.pem -n openshift-config

$ oc create secret tls <secret_name> --key=key.pem --cert=cert.pem -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用してシークレットを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.4. 設定マップの作成

アイデンティティープロバイダーは、openshift-config namespace で OpenShift Container Platform ConfigMap オブジェクトを使用し、認証局バンドルをこれに組み込みます。これらは、主にアイデンティティープロバイダーで必要な証明書バンドルを組み込むために使用されます。

手順

以下のコマンドを使用して、認証局が含まれる OpenShift Container Platform

ConfigMapオブジェクトを定義します。認証局はConfigMapオブジェクトのca.crtキーに保存する必要があります。oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用して設定マップを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.5. Basic 認証 CR のサンプル

以下のカスタムリソース (CR) は、Basic 認証アイデンティティープロバイダーのパラメーターおよび許可される値を示します。

Basic 認証 CR

- 1

- このプロバイダー名は返されるユーザー名に接頭辞として付加され、アイデンティティー名が作成されます。

- 2

- このプロバイダーのアイデンティティーと

Userオブジェクト間にマッピングが確立される方法を制御します。 - 3

- Basic 認証ヘッダーで認証情報を受け入れる URL。

- 4

- オプション: 設定済みの URL のサーバー証明書を検証するために使用する PEM エンコードされた認証局バンドルを含む OpenShift Container Platform

ConfigMapオブジェクトへの参照。 - 5

- オプション: 設定済み URL への要求を実行する際に存在させるクライアント証明書を含む OpenShift Container Platform

Secretオブジェクトへの参照。 - 6

- クライアント証明書のキーを含む OpenShift Container Platform

Secretオブジェクトへの参照。tlsClientCertが指定されている場合には必須になります。

7.4.6. アイデンティティープロバイダーのクラスターへの追加

クラスターのインストール後に、アイデンティティープロバイダーをそのクラスターに追加し、ユーザーの認証を実行できるようにします。

前提条件

- OpenShift Container Platform クラスターを作成します。

- アイデンティティープロバイダーのカスタムリソース (CR) を作成します。

- 管理者としてログインしている必要があります。

手順

定義された CR を適用します。

oc apply -f </path/to/CR>

$ oc apply -f </path/to/CR>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記CR が存在しない場合、

oc applyは新規 CR を作成し、さらに以下の警告をトリガーする可能性があります。Warning: oc apply should be used on resources created by either oc create --save-config or oc applyこの場合は、この警告を無視しても問題ありません。アイデンティティープロバイダーのユーザーとしてクラスターにログインし、プロンプトが出されたらパスワードを入力します。

oc login -u <username>

$ oc login -u <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザーが正常にログインされていることを確認し、ユーザー名を表示します。

oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.7. 基本的なアイデンティティープロバイダーの Apache HTTPD 設定の例

OpenShift Container Platform 4 の基本的なアイデンティティープロバイダー (IDP) 設定では、IDP サーバーが成功および失敗について JSON で応答する必要があります。これを可能にするために、Apache HTTPD で CGI スクリプトを使用できます。本セクションでは、いくつかの例を紹介します。

例: /etc/httpd/conf.d/login.conf

例: /var/www/cgi-bin/login.cgi

#!/bin/bash

echo "Content-Type: application/json"

echo ""

echo '{"sub":"userid", "name":"'$REMOTE_USER'"}'

exit 0

#!/bin/bash

echo "Content-Type: application/json"

echo ""

echo '{"sub":"userid", "name":"'$REMOTE_USER'"}'

exit 0例: /var/www/cgi-bin/fail.cgi

#!/bin/bash

echo "Content-Type: application/json"

echo ""

echo '{"error": "Login failure"}'

exit 0

#!/bin/bash

echo "Content-Type: application/json"

echo ""

echo '{"error": "Login failure"}'

exit 07.4.7.1. ファイルの要件

Apache HTTPD Web サーバーで作成するファイルの要件は以下のとおりです。

-

login.cgiおよびfail.cgiは実行可能 (chmod +x) である必要があります。 -

login.cgiおよびfail.cgiには、SELinux が有効にされている場合、適切な SELinux コンテキストがなければなりません:restorecon -RFv /var/www/cgi-bin、またはコンテキストがls -laZを使用してhttpd_sys_script_exec_tであることを確認します。 -

login.cgiは、ユーザーがRequire and Authディレクティブを使用して正常にログインできる場合にのみ実行されます。 -

fail.cgiは、ユーザーがログインに失敗する場合に実行されます (HTTP 401応答が返されます)。

7.4.8. Basic 認証のトラブルシューティング

最もよく起こる問題は、バックエンドサーバーへのネットワーク接続に関連しています。簡単なデバッグの場合は、マスターで curl コマンドを実行します。正常なログインをテストするには、以下のコマンド例の <user> と <password> を有効な認証情報に置き換えます。無効なログインをテストするには、それらを正しくない認証情報に置き換えます。

curl --cacert /path/to/ca.crt --cert /path/to/client.crt --key /path/to/client.key -u <user>:<password> -v https://www.example.com/remote-idp

$ curl --cacert /path/to/ca.crt --cert /path/to/client.crt --key /path/to/client.key -u <user>:<password> -v https://www.example.com/remote-idp正常な応答

sub (サブジェクト) キーを持つ 200 ステータスは、成功を示しています。

{"sub":"userid"}

{"sub":"userid"}サブジェクトは認証ユーザーに固有である必要があり、変更することはできません。

正常な応答により、以下のような追加データがオプションで提供されることがあります。

nameキーを使用した表示名:{"sub":"userid", "name": "User Name", ...}{"sub":"userid", "name": "User Name", ...}Copy to Clipboard Copied! Toggle word wrap Toggle overflow emailキーを使用したメールアドレス:{"sub":"userid", "email":"user@example.com", ...}{"sub":"userid", "email":"user@example.com", ...}Copy to Clipboard Copied! Toggle word wrap Toggle overflow preferred_usernameキーを使用した推奨ユーザー名:{"sub":"014fbff9a07c", "preferred_username":"bob", ...}{"sub":"014fbff9a07c", "preferred_username":"bob", ...}Copy to Clipboard Copied! Toggle word wrap Toggle overflow preferred_usernameキーは、固有の変更できないサブジェクトがデータベースキーまたは UID であり、判読可能な名前が存在する場合に便利です。これは、認証されたアイデンティティーの OpenShift Container Platform ユーザーをプロビジョニングする場合にヒントとして使われます。

失敗の応答

-

401応答は認証の失敗を示しています。 -

200以外のステータスまたは空でないエラーキーはエラーを示しています:{"error":"Error message"}

7.5. 要求ヘッダーアイデンティティープロバイダーの設定

request-header アイデンティティープロバイダーを、X-Remote-User などの要求ヘッダー値から識別するように設定します。通常、これは要求ヘッダー値を設定する認証プロキシーと併用されます。

7.5.1. OpenShift Container Platform のアイデンティティープロバイダーについて

デフォルトでは、kubeadmin ユーザーのみがクラスターに存在します。アイデンティティープロバイダーを指定するには、アイデンティティープロバイダーを記述し、これをクラスターに追加するカスタムリソースを作成する必要があります。

/、:、および % を含む OpenShift Container Platform ユーザー名はサポートされません。

7.5.2. 要求ヘッダー認証について

要求ヘッダーアイデンティティープロバイダーは、X-Remote-User などの要求ヘッダー値からユーザーを識別します。通常、これは要求ヘッダー値を設定する認証プロキシーと併用されます。要求ヘッダーのアイデンティティープロバイダーは、htpasswd、Keystone、LDAP、Basic 認証などの直接パスワードログインを使用する他のアイデンティティープロバイダーと組み合わせることはできません。

さらに、コミュニティーでサポートされる SAML 認証 などの詳細な設定に要求ヘッダーアイデンティティープロバイダーを使用できます。このソリューションは Red Hat ではサポートされていないことに注意してください。

ユーザーがこのアイデンティティープロバイダーを使用して認証を行うには、認証プロキシー経由で https://<namespace_route>/oauth/authorize (およびサブパス) にアクセスする必要があります。これを実行するには、OAuth トークンに対する非認証の要求を https://<namespace_route>/oauth/authorize にプロキシー処理するプロキシーエンドポイントにリダイレクトするよう OAuth サーバーを設定します。

ブラウザーベースのログインフローが想定されるクライアントからの非認証要求をリダイレクトするには、以下を実行します。

-

provider.loginURLパラメーターをインタラクティブなクライアントを認証する認証プロキシー URL に設定してから、要求をhttps://<namespace_route>/oauth/authorizeにプロキシーします。

WWW-Authenticate チャレンジが想定されるクライアントからの非認証要求をリダイレクトするには、以下を実行します。

-

provider.challengeURLパラメーターをWWW-Authenticateチャレンジが予想されるクライアントを認証する認証プロキシー URL に設定し、要求をhttps://<namespace_route>/oauth/authorizeにプロキシーします。

provider.challengeURL および provider.loginURL パラメーターには、URL のクエリー部分に以下のトークンを含めることができます。

${url}は現在の URL と置き換えられ、エスケープされてクエリーパラメーターで保護されます。例:

https://www.example.com/sso-login?then=${url}${query}は最新のクエリー文字列と置き換えられ、エスケープされません。例:

https://www.example.com/auth-proxy/oauth/authorize?${query}

OpenShift Container Platform 4.1 の時点で、プロキシーは相互 TLS をサポートしている必要があります。

7.5.2.1. Microsoft Windows での SSPI 接続サポート

Microsoft Windows での SSPI 接続サポートの使用はテクノロジープレビュー機能としてのみ提供されます。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

OpenShift CLI (oc) は、Microsoft Windows での SSO フローを許可するために Security Support Provider Interface (SSPI) をサポートします。要求ヘッダーのアイデンティティープロバイダーを GSSAPI 対応プロキシーと共に使用して Active Directory サーバーを OpenShift Container Platform に接続する場合、ユーザーは、ドメイン参加済みの Microsoft Windows コンピューターから oc コマンドラインインターフェイスを使用して OpenShift Container Platform に対して自動的に認証されます。

7.5.3. 設定マップの作成

アイデンティティープロバイダーは、openshift-config namespace で OpenShift Container Platform ConfigMap オブジェクトを使用し、認証局バンドルをこれに組み込みます。これらは、主にアイデンティティープロバイダーで必要な証明書バンドルを組み込むために使用されます。

手順

以下のコマンドを使用して、認証局が含まれる OpenShift Container Platform

ConfigMapオブジェクトを定義します。認証局はConfigMapオブジェクトのca.crtキーに保存する必要があります。oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用して設定マップを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.5.4. 要求ヘッダー CR のサンプル

以下のカスタムリソース (CR) は、要求ヘッダーアイデンティティープロバイダーのパラメーターおよび許可される値を示します。

要求ヘッダー CR

- 1

- このプロバイダー名は要求ヘッダーのユーザー名に接頭辞として付加され、アイデンティティー名が作成されます。

- 2

- このプロバイダーのアイデンティティーと

Userオブジェクト間にマッピングが確立される方法を制御します。 - 3

- オプション: 非認証の

/oauth/authorize要求のリダイレクト先となる URL です。これは、ブラウザーベースのクライアントを認証し、その要求をhttps://<namespace_route>/oauth/authorizeにプロキシーします。https://<namespace_route>/oauth/authorizeにプロキシーする URL は/authorize(末尾にスラッシュはない) で終了し、OAuth 承認フローが適切に機能するようにサブパスもプロキシーする必要があります。${url}は現在の URL と置き換えられ、エスケープされてクエリーパラメーターで保護されます。${query}は最新のクエリー文字列と置き換えられます。この属性が定義されない場合は、loginURLが使用される必要があります。 - 4

- オプション: 非認証の

/oauth/authorize要求のリダイレクト先となる URL です。これにより、WWW-Authenticateチャレンジが予想されるクライアントの認証が行われ、それらの要求がhttps://<namespace_route>/oauth/authorizeにプロキシーされます。${url}は現在の URL と置き換えられ、エスケープされてクエリーパラメーターで保護されます。${query}は最新のクエリー文字列と置き換えられます。この属性が定義されない場合は、challengeURLが使用される必要があります。 - 5

- PEM エンコードされた証明書バンドルを含む OpenShift Container Platform

ConfigMapオブジェクトへの参照。リモートサーバーによって表示される TLS 証明書を検証するためにトラストアンカーとして使用されます。重要OpenShift Container Platform 4.1 の時点で、

caフィールドはこのアイデンティティープロバイダーに必要です。これは、プロキシーが相互 TLS をサポートしている必要があることを意味します。 - 6

- オプション: 共通名 (

cn) の一覧。これが設定されている場合は、要求ヘッダーのユーザー名をチェックする前に指定される一覧の Common Name (cn) を持つ有効なクライアント証明書が提示される必要があります。空の場合、すべての Common Name が許可されます。これはcaと組み合わせる場合にのみ使用できます。 - 7

- ユーザーアイデンティティーを順番にチェックする際に使用するヘッダー名。値を含む最初のヘッダーはアイデンティティーとして使用されます。これは必須であり、大文字小文字を区別します。

- 8

- メールアドレスを順番にチェックする際に使用するヘッダー名。値を含む最初のヘッダーはメールアドレスとして使用されます。これは任意であり、大文字小文字を区別します。

- 9

- 表示名を順番にチェックする際に使用するヘッダー名。値を含む最初のヘッダーは表示名として使用されます。これは任意であり、大文字小文字を区別します。

- 10

- 推奨ユーザー名を順番にチェックする際に使用するヘッダー名 (

headersに指定されるヘッダーで決定される変更不可のアイデンティティーと異なる場合)。値を含む最初のヘッダーは、プロビジョニング時に推奨ユーザー名として使用されます。これは任意であり、大文字小文字を区別します。

7.5.5. アイデンティティープロバイダーのクラスターへの追加

クラスターのインストール後に、アイデンティティープロバイダーをそのクラスターに追加し、ユーザーの認証を実行できるようにします。

前提条件

- OpenShift Container Platform クラスターを作成します。

- アイデンティティープロバイダーのカスタムリソース (CR) を作成します。

- 管理者としてログインしている必要があります。

手順

定義された CR を適用します。

oc apply -f </path/to/CR>

$ oc apply -f </path/to/CR>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記CR が存在しない場合、

oc applyは新規 CR を作成し、さらに以下の警告をトリガーする可能性があります。Warning: oc apply should be used on resources created by either oc create --save-config or oc applyこの場合は、この警告を無視しても問題ありません。アイデンティティープロバイダーのユーザーとしてクラスターにログインし、プロンプトが出されたらパスワードを入力します。

oc login -u <username>

$ oc login -u <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザーが正常にログインされていることを確認し、ユーザー名を表示します。

oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.5.6. 要求ヘッダーを使用した Apache 認証設定の例

この例では、要求ヘッダーアイデンティティープロバイダーを使用して OpenShift Container Platform の Apache 認証プロキシーを設定します。

カスタムプロキシー設定

mod_auth_gssapi モジュールの使用は、要求ヘッダーアイデンティティープロバイダーを使用して Apache 認証プロキシーを設定する一般的な方法ですが、必須の方法ではありません。以下の要件を満たすと、他のプロキシーを簡単に使用できます。

-

クライアント要求の

X-Remote-Userヘッダーをブロックして、スプーフィングを防ぎます。 -

RequestHeaderIdentityProvider設定でクライアント証明書の認証を適用します。 -

チャレンジフローを使用してすべての認証要求についての

X-Csrf-Tokenヘッダーを設定する必要があります。 -

/oauth/authorizeエンドポイントとそのサブパスのみがプロキシーされる必要があります。バックエンドサーバーがクライアントを正しい場所に送信できるようリダイレクトは書き換える必要があります。 -

https://<namespace_route>/oauth/authorizeにプロキシーする URL は/authorizeで終了 (末尾のスラッシュなし) する必要があります。たとえば、https://proxy.example.com/login-proxy/authorize?…は、https://<namespace_route>/oauth/authorize?…にプロキシーする必要があります。 -

https://<namespace_route>/oauth/authorizeにプロキシーされる URL のサブパスは、https://<namespace_route>/oauth/authorizeにプロキシーする必要があります。たとえば、https://proxy.example.com/login-proxy/authorize/approve?…は、https://<namespace_route>/oauth/authorize/approve?…にプロキシーする必要があります。

https://<namespace_route> アドレスは OAuth サーバーへのルートであり、oc get route -n openshift-authentication を実行して取得できます。

要求ヘッダーを使用した Apache 認証の設定

この例では、mod_auth_gssapi モジュールを使用し、要求ヘッダーアイデンティティープロバイダーを使用して Apache 認証プロキシーを設定します。

前提条件

mod_auth_gssapiモジュールを Optional チャンネル から取得します。ローカルマシンに以下のパッケージをインストールする必要があります。-

httpd -

mod_ssl -

mod_session -

apr-util-openssl -

mod_auth_gssapi

-

信頼されたヘッダーを送信する要求を検証するために CA を生成します。CA を含む OpenShift Container Platform

ConfigMapオブジェクトを定義します。これは、以下を実行して行います。oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- CA は、

ConfigMapオブジェクトのca.crtキーに保存する必要があります。

ヒントまたは、以下の YAML を適用して設定マップを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - このプロキシー用のクライアント証明書を生成します。この証明書は、x509 証明書ツールを使用して生成できます。信頼されたヘッダーを送信する要求を検証するために、生成した CA でクライアント証明書に署名する必要があります。

- アイデンティティープロバイダーのカスタムリソース (CR) を作成します。

手順

このプロキシーはクライアント証明書を使用して OAuth サーバーに接続します。これは、X-Remote-User ヘッダーを信頼するように設定されます。

-

Apache 設定の証明書を作成します。

SSLProxyMachineCertificateFileパラメーターの値として指定する証明書は、プロキシーをサーバーに対して認証するために使用されるプロキシーのクライアント証明書です。これは、拡張されたキーのタイプとしてTLS Web Client Authenticationを使用する必要があります。 Apache 設定を作成します。以下のテンプレートを使用して必要な設定および値を指定します。

重要テンプレートを十分に確認し、その内容を環境に合うようにカスタマイズします。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記https://<namespace_route>アドレスは OAuth サーバーへのルートであり、oc get route -n openshift-authenticationを実行して取得できます。カスタムリソース (CR) の

identityProvidersスタンザを更新します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定を確認します。

適切なクライアント証明書およびヘッダーを指定して、トークンを要求し、プロキシーをバイパスできることを確認します。

curl -L -k -H "X-Remote-User: joe" \ --cert /etc/pki/tls/certs/authproxy.pem \ https://<namespace_route>/oauth/token/request

# curl -L -k -H "X-Remote-User: joe" \ --cert /etc/pki/tls/certs/authproxy.pem \ https://<namespace_route>/oauth/token/requestCopy to Clipboard Copied! Toggle word wrap Toggle overflow クライアント証明書を提供しない要求が、証明書なしでトークンを要求して失敗することを確認します。

curl -L -k -H "X-Remote-User: joe" \ https://<namespace_route>/oauth/token/request

# curl -L -k -H "X-Remote-User: joe" \ https://<namespace_route>/oauth/token/requestCopy to Clipboard Copied! Toggle word wrap Toggle overflow challengeURLリダイレクトがアクティブであることを確認します。curl -k -v -H 'X-Csrf-Token: 1' \ https://<namespace_route>/oauth/authorize?client_id=openshift-challenging-client&response_type=token

# curl -k -v -H 'X-Csrf-Token: 1' \ https://<namespace_route>/oauth/authorize?client_id=openshift-challenging-client&response_type=tokenCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の手順で使用する

challengeURLリダイレクトをコピーします。このコマンドを実行して、

WWW-Authenticate基本チャレンジ、ネゴシエートチャレンジ、またはそれらの両方のチャレンジを含む401応答を表示します。curl -k -v -H 'X-Csrf-Token: 1' \ <challengeURL_redirect + query>

# curl -k -v -H 'X-Csrf-Token: 1' \ <challengeURL_redirect + query>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Kerberos チケットを使用または使用せずに、OpenShift CLI (

oc) へのログインをテストします。kinitを使用して Kerberos チケットを生成した場合は、これを破棄します。kdestroy -c cache_name

# kdestroy -c cache_name1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Kerberos キャッシュの名前を指定します。

Kerberos 認証情報を使用して

ocツールにログインします。oc login -u <username>

# oc login -u <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow プロンプトで、Kerberos パスワードを入力します。

ocツールからログアウトします。oc logout

# oc logoutCopy to Clipboard Copied! Toggle word wrap Toggle overflow Kerberos 認証情報を使用してチケットを取得します。

kinit

# kinitCopy to Clipboard Copied! Toggle word wrap Toggle overflow プロンプトで、Kerberos ユーザー名およびパスワードを入力します。

ocツールにログインできることを確認します。oc login

# oc loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定が正しい場合は、別の認証情報を入力せずにログインできます。

7.6. GitHub または GitHub Enterprise アイデンティティープロバイダーの設定

github アイデンティティープロバイダーを、GitHub または GitHub Enterprise の OAuth 認証サーバーに対してユーザー名とパスワードを検証するように設定します。OAuth は OpenShift Container Platform と GitHub または GitHub Enterprise 間のトークン交換フローを容易にします。

GitHub 統合を使用して GitHub または GitHub Enterprise のいずれかに接続できます。GitHub Enterprise 統合の場合、インスタンスの hostname を指定する必要があり、サーバーへの要求で使用する ca 証明書バンドルをオプションで指定することができます。

とくに記述がない限り、以下の手順が GitHub および GitHub Enterprise の両方に適用されます。

7.6.1. OpenShift Container Platform のアイデンティティープロバイダーについて

デフォルトでは、kubeadmin ユーザーのみがクラスターに存在します。アイデンティティープロバイダーを指定するには、アイデンティティープロバイダーを記述し、これをクラスターに追加するカスタムリソースを作成する必要があります。

/、:、および % を含む OpenShift Container Platform ユーザー名はサポートされません。

7.6.2. GitHub 認証について

GitHub 認証 を設定することによって、ユーザーは GitHub 認証情報を使用して OpenShift Container Platform にログインできます。GitHub ユーザー ID を持つすべてのユーザーが OpenShift Container Platform クラスターにログインできないようにするために、アクセスを特定の GitHub 組織のユーザーに制限することができます。

7.6.3. GitHub アプリケーションの登録

GitHub または GitHub Enterprise をアイデンティティープロバイダーとして使用するには、使用するアプリケーションを登録する必要があります。

手順

アプリケーションを GitHub で登録します。

- GitHub の場合、Settings → Developer settings → OAuth Apps → Register a new OAuth application をクリックします。

- GitHub Enterprise の場合は、GitHub Enterprise ホームページに移動してから Settings → Developer settings → Register a new application をクリックします。

-

アプリケーション名を入力します (例:

My OpenShift Install)。 -

ホームページ URL (例:

https://oauth-openshift.apps.<cluster-name>.<cluster-domain>) を入力します。 - オプション: アプリケーションの説明を入力します。

認可コールバック URL を入力します。 ここで、URL の終わりにはアイデンティティープロバイダーの

nameが含まれます。https://oauth-openshift.apps.<cluster-name>.<cluster-domain>/oauth2callback/<idp-provider-name>

https://oauth-openshift.apps.<cluster-name>.<cluster-domain>/oauth2callback/<idp-provider-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/github

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/githubCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Register application をクリックします。GitHub はクライアント ID とクライアントシークレットを提供します。これらの値は、アイデンティティープロバイダーの設定を完了するために必要です。

7.6.4. シークレットの作成

アイデンティティープロバイダーは openshift-config namespace で OpenShift Container Platform Secret オブジェクトを使用して、クライアントシークレット、クライアント証明書およびキーをこれに組み込みます。

手順

以下のコマンドを使用して、文字列を含む

Secretオブジェクトを作成します。oc create secret generic <secret_name> --from-literal=clientSecret=<secret> -n openshift-config

$ oc create secret generic <secret_name> --from-literal=clientSecret=<secret> -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用してシークレットを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、証明書ファイルなどのファイルの内容を含む

Secretオブジェクトを定義できます。oc create secret generic <secret_name> --from-file=<path_to_file> -n openshift-config

$ oc create secret generic <secret_name> --from-file=<path_to_file> -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.6.5. 設定マップの作成

アイデンティティープロバイダーは、openshift-config namespace で OpenShift Container Platform ConfigMap オブジェクトを使用し、認証局バンドルをこれに組み込みます。これらは、主にアイデンティティープロバイダーで必要な証明書バンドルを組み込むために使用されます。

この手順は、GitHub Enterprise にのみ必要です。

手順

以下のコマンドを使用して、認証局が含まれる OpenShift Container Platform

ConfigMapオブジェクトを定義します。認証局はConfigMapオブジェクトのca.crtキーに保存する必要があります。oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用して設定マップを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.6.6. GitHub CR のサンプル

以下のカスタムリソース (CR) は、GitHub アイデンティティープロバイダーのパラメーターおよび許可される値を示します。

GitHub CR

- 1

- このプロバイダー名は GitHub の数字ユーザー ID に接頭辞として付加され、アイデンティティー名が作成されます。これはコールバック URL を作成するためにも使用されます。

- 2

- このプロバイダーのアイデンティティーと

Userオブジェクト間にマッピングが確立される方法を制御します。 - 3

- オプション: 設定済みの URL のサーバー証明書を検証するために使用する PEM エンコードされた認証局バンドルを含む OpenShift Container Platform

ConfigMapオブジェクトへの参照。非公開で信頼されているルート証明書で GitHub Enterprise の場合のみ使用されます。 - 4

- 登録済みの GitHub OAuth アプリケーション のクライアント ID。アプリケーションは、

https://oauth-openshift.apps.<cluster-name>.<cluster-domain>/oauth2callback/<idp-provider-name>のコールバック URL を使用して設定する必要があります。 - 5

- GitHub で発行されるクライアントシークレットが含まれる OpenShift Container Platform

Secretオブジェクトへの参照。 - 6

- GitHub Enterprise の場合、

example.comなどのインスタンスのホスト名を指定する必要があります。この値は/setup/settingsファイルにある GitHub Enterprisehostname値に一致する必要があり、ポート番号を含めることはできません。この値が設定されない場合、teamsまたはorganizationsのいずれかが定義される必要があります。GitHub の場合は、このパラメーターを省略します。 - 7

- 組織の一覧です。

hostnameフィールドが設定されていないか、またはmappingMethodがlookupに設定されている場合はorganizationsまたはteamsフィールドを設定する必要があります。これはteamsフィールドと組み合わせて使用することはできません。 - 8

- チームの一覧です。

hostnameフィールドが設定されていないか、またはmappingMethodがlookupに設定されている場合はteamsまたはorganizationsフィールドのいずれかを設定する必要があります。これはorganizationsフィールドと組み合わせて使用することはできません。

organizations または teams が指定されている場合、少なくとも一覧のいずれかの組織のメンバーである GitHub ユーザーのみがログインできます。その組織が clientID で設定された GitHub OAuth アプリケーションを所有していない場合、組織の所有者はこのオプションを使用するためにサードパーティーのアクセスを付与する必要があります。これは組織の管理者が初回の GitHub ログイン時に、または GitHub の組織設定で実行できます。

7.6.7. アイデンティティープロバイダーのクラスターへの追加

クラスターのインストール後に、アイデンティティープロバイダーをそのクラスターに追加し、ユーザーの認証を実行できるようにします。

前提条件

- OpenShift Container Platform クラスターを作成します。

- アイデンティティープロバイダーのカスタムリソース (CR) を作成します。

- 管理者としてログインしている必要があります。

手順

定義された CR を適用します。

oc apply -f </path/to/CR>

$ oc apply -f </path/to/CR>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記CR が存在しない場合、

oc applyは新規 CR を作成し、さらに以下の警告をトリガーする可能性があります。Warning: oc apply should be used on resources created by either oc create --save-config or oc applyこの場合は、この警告を無視しても問題ありません。OAuth サーバーからトークンを取得します。

kubeadminユーザーが削除されている限り、oc loginコマンドは、トークンを取得できる Web ページにアクセスする方法についての情報を提供します。Web コンソールからこのページにアクセスするには、(?) Help → Command Line Tools → Copy Login Commandに移動します。

認証するトークンを渡して、クラスターにログインします。

oc login --token=<token>

$ oc login --token=<token>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記このアイデンティティープロバイダーは、ユーザー名とパスワードを使用してログインすることをサポートしません。

ユーザーが正常にログインされていることを確認し、ユーザー名を表示します。

oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.7. GitLab アイデンティティープロバイダーの設定

GitLab.com またはその他の GitLab インスタンスを ID プロバイダーとして使用して、gitlab ID プロバイダーを設定します。

7.7.1. OpenShift Container Platform のアイデンティティープロバイダーについて

デフォルトでは、kubeadmin ユーザーのみがクラスターに存在します。アイデンティティープロバイダーを指定するには、アイデンティティープロバイダーを記述し、これをクラスターに追加するカスタムリソースを作成する必要があります。

/、:、および % を含む OpenShift Container Platform ユーザー名はサポートされません。

7.7.2. GitLab 認証について

GitLab 認証を設定することによって、ユーザーは GitLab 認証情報を使用して OpenShift Container Platform にログインできます。

GitLab バージョン 7.7.0 から 11.0 を使用する場合は、OAuth 統合 を使用して接続します。GitLab バージョン 11.1 以降の場合は、OAuth ではなく OpenID Connect (OIDC) を使用して接続します。

7.7.3. シークレットの作成

アイデンティティープロバイダーは openshift-config namespace で OpenShift Container Platform Secret オブジェクトを使用して、クライアントシークレット、クライアント証明書およびキーをこれに組み込みます。

手順

以下のコマンドを使用して、文字列を含む

Secretオブジェクトを作成します。oc create secret generic <secret_name> --from-literal=clientSecret=<secret> -n openshift-config

$ oc create secret generic <secret_name> --from-literal=clientSecret=<secret> -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用してシークレットを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、証明書ファイルなどのファイルの内容を含む

Secretオブジェクトを定義できます。oc create secret generic <secret_name> --from-file=<path_to_file> -n openshift-config

$ oc create secret generic <secret_name> --from-file=<path_to_file> -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.7.4. 設定マップの作成

アイデンティティープロバイダーは、openshift-config namespace で OpenShift Container Platform ConfigMap オブジェクトを使用し、認証局バンドルをこれに組み込みます。これらは、主にアイデンティティープロバイダーで必要な証明書バンドルを組み込むために使用されます。

この手順は、GitHub Enterprise にのみ必要です。

手順

以下のコマンドを使用して、認証局が含まれる OpenShift Container Platform

ConfigMapオブジェクトを定義します。認証局はConfigMapオブジェクトのca.crtキーに保存する必要があります。oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用して設定マップを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.7.5. GitLab CR のサンプル

以下のカスタムリソース (CR) は、GitLab アイデンティティープロバイダーのパラメーターおよび許可される値を示します。

GitLab CR

- 1

- このプロバイダー名は GitLab 数字ユーザー ID に接頭辞として付加され、アイデンティティー名が作成されます。これはコールバック URL を作成するためにも使用されます。

- 2

- このプロバイダーのアイデンティティーと

Userオブジェクト間にマッピングが確立される方法を制御します。 - 3

- 登録済みの GitLab OAuth アプリケーション のクライアント ID です。アプリケーションは、

https://oauth-openshift.apps.<cluster-name>.<cluster-domain>/oauth2callback/<idp-provider-name>のコールバック URL を使用して設定する必要があります。 - 4

- GitLab で発行されるクライアントシークレットが含まれる OpenShift Container Platform

Secretオブジェクトへの参照。 - 5

- GitLab プロバイダーのホスト URL です。これは

https://gitlab.com/か、または他の GitLab の自己ホストインスタンスのいずれかになります。 - 6

- オプション: 設定済みの URL のサーバー証明書を検証するために使用する PEM エンコードされた認証局バンドルを含む OpenShift Container Platform

ConfigMapオブジェクトへの参照。

7.7.6. アイデンティティープロバイダーのクラスターへの追加

クラスターのインストール後に、アイデンティティープロバイダーをそのクラスターに追加し、ユーザーの認証を実行できるようにします。

前提条件

- OpenShift Container Platform クラスターを作成します。

- アイデンティティープロバイダーのカスタムリソース (CR) を作成します。

- 管理者としてログインしている必要があります。

手順

定義された CR を適用します。

oc apply -f </path/to/CR>

$ oc apply -f </path/to/CR>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記CR が存在しない場合、

oc applyは新規 CR を作成し、さらに以下の警告をトリガーする可能性があります。Warning: oc apply should be used on resources created by either oc create --save-config or oc applyこの場合は、この警告を無視しても問題ありません。アイデンティティープロバイダーのユーザーとしてクラスターにログインし、プロンプトが出されたらパスワードを入力します。

oc login -u <username>

$ oc login -u <username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ユーザーが正常にログインされていることを確認し、ユーザー名を表示します。

oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8. Google アイデンティティープロバイダーの設定

Google OpenID Connect 統合 を使用して google ID プロバイダーを設定します。

7.8.1. OpenShift Container Platform のアイデンティティープロバイダーについて

デフォルトでは、kubeadmin ユーザーのみがクラスターに存在します。アイデンティティープロバイダーを指定するには、アイデンティティープロバイダーを記述し、これをクラスターに追加するカスタムリソースを作成する必要があります。

/、:、および % を含む OpenShift Container Platform ユーザー名はサポートされません。

7.8.2. Google 認証について

Google をアイデンティティープロバイダーとして使用することで、Google ユーザーはサーバーに対して認証されます。hostedDomain 設定属性を使用して、特定のホストドメインのメンバーに認証を限定することができます。

Google をアイデンティティープロバイダーとして使用するには、<namespace_route>/oauth/token/request を使用してトークンを取得し、コマンドラインツールで使用する必要があります。

7.8.3. シークレットの作成

アイデンティティープロバイダーは openshift-config namespace で OpenShift Container Platform Secret オブジェクトを使用して、クライアントシークレット、クライアント証明書およびキーをこれに組み込みます。

手順

以下のコマンドを使用して、文字列を含む

Secretオブジェクトを作成します。oc create secret generic <secret_name> --from-literal=clientSecret=<secret> -n openshift-config

$ oc create secret generic <secret_name> --from-literal=clientSecret=<secret> -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用してシークレットを作成できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、証明書ファイルなどのファイルの内容を含む

Secretオブジェクトを定義できます。oc create secret generic <secret_name> --from-file=<path_to_file> -n openshift-config

$ oc create secret generic <secret_name> --from-file=<path_to_file> -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.4. Google CR のサンプル

以下のカスタムリソース (CR) は、Google アイデンティティープロバイダーのパラメーターおよび許可される値を示します。

Google CR

- 1

- このプロバイダー名は Google の数字のユーザー ID に接頭辞として付加され、アイデンティティー名が作成されます。これはリダイレクト URL を作成するためにも使用されます。

- 2

- このプロバイダーのアイデンティティーと

Userオブジェクト間にマッピングが確立される方法を制御します。 - 3

- 登録済みの Google プロジェクト のクライアント ID です。プロジェクトは、

https://oauth-openshift.apps.<cluster-name>.<cluster-domain>/oauth2callback/<idp-provider-name>のリダイレクト URI で設定する必要があります。 - 4

- Google で発行されるクライアントシークレットが含まれる OpenShift Container Platform

Secretオブジェクトへの参照。 - 5

- サインインアカウントを制限するために使用される ホスト型ドメイン です。

lookupmappingMethodが使用される場合はオプションになります。空の場合は、すべての Google アカウントの認証が許可されます。

7.8.5. アイデンティティープロバイダーのクラスターへの追加

クラスターのインストール後に、アイデンティティープロバイダーをそのクラスターに追加し、ユーザーの認証を実行できるようにします。

前提条件

- OpenShift Container Platform クラスターを作成します。

- アイデンティティープロバイダーのカスタムリソース (CR) を作成します。

- 管理者としてログインしている必要があります。

手順

定義された CR を適用します。

oc apply -f </path/to/CR>