システムデザインガイド

RHEL 8 システムの設計

概要

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

パート I. インストールの設計

第1章 システム要件とサポート対象のアーキテクチャー

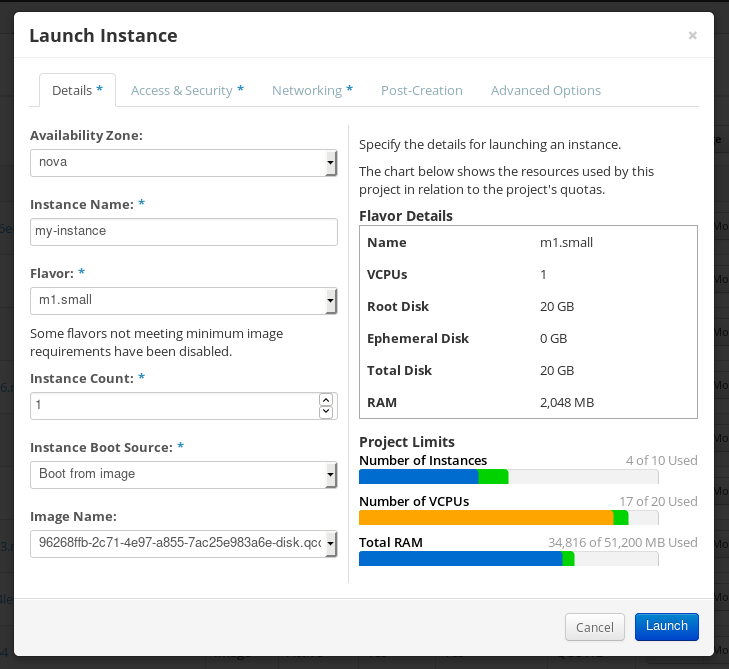

Red Hat Enterprise Linux 8 は、ワークロードの提供にかかる時間や労力の軽減に必要なツールを使用することで、ハイブリッドクラウドデプロイメント全体に安定性、安全性、一貫性のある基盤を提供します。RHEL は、対応しているハイパーバイザー環境やクラウドプロバイダー環境にゲストとしてデプロイすることも、物理インフラストラクチャーにデプロイすることもできるため、アプリケーションは、主要なハードウェアアーキテクチャープラットフォームの革新的な機能を利用できます。

インストールする前に、システム、ハードウェア、セキュリティー、メモリー、および RAID に関するガイドラインを確認してください。

システムを仮想ホストとして使用する場合は、仮想化に必要なハードウェア要件 を確認してください。

Red Hat Enterprise Linux では、次のアーキテクチャーに対応します。

- AMD アーキテクチャーおよび Intel 64 ビットアーキテクチャー

- 64 ビット ARM アーキテクチャー

- IBM Power Systems (リトルエンディアン)

- 64 ビット IBM Z アーキテクチャー

1.1. インストール先として対応しているターゲット

インストールターゲットは、Red Hat Enterprise Linux を格納し、システムを起動するストレージデバイスです。Red Hat Enterprise Linux は、IBMZ、IBM Power、AMD64、Intel 64、および 64 ビット ARM システムで、次のインストールターゲットをサポートしています。

- DASD、SCSI、SATA、SAS などの標準的な内部インターフェイスで接続されたストレージ

- Intel64、AMD64、および arm64 アーキテクチャー上の BIOS/ファームウェア RAID デバイス

-

nd_pmemドライバーがサポートする、セクターモードに設定された Intel 64 および AMD64 アーキテクチャー上の NVDIMM デバイス - DASD (IBM Z アーキテクチャーのみ) や SCSI LUN (マルチパスデバイスを含む) などのファイバーチャネルホストバスアダプターを介して接続されたストレージ。ベンダー提供のドライバーが必要になる場合があります。

- Xen 仮想マシンの Intel のプロセッサーの Xen ブロックデバイス

- KVM 仮想マシンの Intel のプロセッサーの VirtIO ブロックデバイス

Red Hat では、USB ドライブや SD メモリーカードへのインストールはサポートしていません。サードパーティーによる仮想化技術のサポートは、Red Hat Hardware Compatibility List を参照してください。

1.2. システムの仕様

Red Hat Enterprise Linux インストールプログラムはシステムのハードウェアを自動的に検出してインストールするため、特定のシステム情報を提供する必要はありません。ただし、特定の Red Hat Enterprise Linux インストールシナリオでは、将来の参照用にシステム仕様を記録しておくことを推奨します。次のようなシナリオになります。

カスタマイズしたパーティションレイアウトで RHEL をインストール

レコード:システムに接続されているディスクのモデル番号、サイズ、タイプ、およびインターフェイス。たとえば、SATA0 上には Seagate 製 ST3320613AS (320 GB)、SATA1 上には Western Digital WD7500AAKS (750 GB) です。

既存のシステムに、追加のオペレーティングシステムとして RHEL をインストール

レコード:システムで使用するパーティション。この情報には、ファイルシステムの種類、デバイスノード名、ファイルシステムのラベル、およびサイズを記載でき、パーティションを作成する際に特定のパーティションを識別できます。オペレーティングシステムの 1 つが Unix オペレーティングシステムの場合、Red Hat Enterprise Linux はデバイス名を異なる方法で報告することがあります。追加の情報は、mount コマンド、blkid コマンドを実行して表示するか、/etc/fstab ファイルを参照してください。

複数のオペレーティングシステムがインストールされている場合、Red Hat Enterprise Linux インストールプログラムはそのオペレーティングシステムを自動的に検出して、それを起動するようにブートローダーを設定しようとします。追加のオペレーティングシステムが自動的に検出されない場合は、手動で設定できます。

ローカルディスク上のイメージから RHEL をインストールする

レコード:イメージを保存するディスクとディレクトリー。

ネットワーク経由で RHEL のインストール

ネットワークを手動で設定する必要がある場合、つまり DHCP を使用しない場合です。

レコード:

- IP アドレス

- ネットマスク

- ゲートウェイの IP アドレス

- (必要に応じて) サーバーの IP アドレス

ネットワーク要件が不明な場合は、ネットワーク管理者に連絡してください。

iSCSI ターゲットへの RHEL のインストール

レコード:iSCSI ターゲットの場所ネットワークに応じて、CHAP ユーザー名とパスワードと、リバースの CHAP ユーザー名とパスワードが必要になる場合があります。

ドメインに含まれるシステムへの RHEL のインストール

ドメイン名が DHCP サーバーにより提供されることを確認してください。提供されない場合は、インストール中にドメイン名を入力する必要があります。

1.3. ディスクおよびメモリーの要件

複数のオペレーティングシステムがインストールされている場合は、割り当てられたディスク領域が Red Hat Enterprise Linux で必要なディスク領域とは異なることを確認することが重要です。場合によっては、特定のパーティションを Red Hat Enterprise Linux 専用にすることが重要になります。たとえば、AMD64、Intel 64、および 64 ビット ARM の場合は、少なくとも 2 つのパーティション (/ および swap) を RHEL 専用にする必要があります。IBM Power Systems サーバーの場合は、少なくとも 3 つのパーティション (/、swap、および PReP ブートパーティション) を RHEL 専用にする必要があります。

さらに、使用可能なディスク容量が最低 10 GiB 必要です。Red Hat Enterprise Linux をインストールするには、パーティションが分割されていないディスク領域か、削除できるパーティション内に、最低 10 GiB の容量が必要です。詳細は、パーティション設定のリファレンス を参照してください。

| インストールタイプ | 最小 RAM |

|---|---|

| ローカルメディアによるインストール (USB, DVD) |

|

| NFS ネットワークインストール |

|

| HTTP、HTTPS、または FTP ネットワークインストール |

|

最小要件よりも少ないメモリーでもインストールを完了できます。正確な要件は、環境とインストールパスにより異なります。さまざまな構成をテストして、環境に必要な最小 RAM を特定してください。キックスタートファイルを使用して Red Hat Enterprise Linux をインストールする場合も、最小 RAM 要件は標準インストールと同じです。ただし、キックスタートファイルに追加のメモリーを必要とするコマンド、または RAM ディスクにデータを書き込むコマンドが含まれている場合は、追加の RAM が必要になることがあります。詳細は、RHEL の自動インストール を参照してください。

1.4. グラフィックスディスプレイの解像度要件

Red Hat Enterprise Linux をスムーズにエラーなしにインストールするには、システムに次の最小解像度が必要です。

| 製品バージョン | 解決方法 |

|---|---|

| Red Hat Enterprise Linux 8 | 最小: 800 x 600 推奨: 1026 x 768 |

1.5. UEFI セキュアブートとベータ版リリースの要件

UEFI セキュアブートが有効になっているシステムに Red Hat Enterprise Linux のベータ版リリースをインストールする予定がある場合は、UEFI セキュアブートオプションを無効にしてから、インストールを開始します。

UEFI セキュアブートでは、オペレーティングシステムのカーネルが、対応する公開鍵を使用してシステムのファームウェアが検証する、認識済みの秘密鍵で署名されている必要があります。Red Hat Enterprise Linux ベータ版リリースの場合には、カーネルは Red Hat ベータ版固有の公開鍵で署名されていますが、この鍵はデフォルトではシステムで認識できません。その結果、インストールメディアの起動にも失敗します。

第2章 インストールメディアのカスタマイズ

詳細は、RHEL システムイメージのカスタマイズ を参照してください。

第3章 起動可能な RHEL 用インストールメディアの作成

カスタマーポータル から ISO ファイルをダウンロードして、USB や DVD などの起動可能な物理インストールメディアを準備できます。RHEL 8 以降、Red Hat は Server 用と Workstation 用の個別のバリアントを提供しなくなりました。Red Hat Enterprise Linux for x86_64 には、Server 機能と Workstation 機能の両方が含まれています。Server および Workstation の区別は、インストールまたは設定プロセス中にシステム目的ロールを通じて管理されます。

カスタマーポータルから ISO ファイルをダウンロードした後、USB や DVD などの起動可能な物理インストールメディアを作成して、インストールプロセスを続行します。

USB ドライブが禁止されているセキュアな環境では、Image Builder を使用して参照イメージを作成し、デプロイすることを検討してください。この方法により、システムの整合性を維持しながらセキュリティーポリシーへの準拠を確保できます。詳細は、Image Builder のドキュメント を参照してください。

デフォルトでは、インストールメデイアで inst.stage2= 起動オプションが使用され、特定のラベル (たとえば inst.stage2=hd:LABEL=RHEL8\x86_64) に設定されます。ランタイムイメージが含まれるファイルシステムのデフォルトのラベルを変更します。インストールシステムの起動手順をカスタマイズする場合は、このラベルが正しい値に設定されていることを確認します。

3.1. インストール起動用メディアオプション

Red Hat Enterprise Linux インストールプログラムを起動する方法はいくつかあります。

- フルインストール用 DVD または USB フラッシュドライブ

- DVD ISO イメージを使用して、フルインストールの DVD または USB フラッシュドライブを作成します。ソフトウェアパッケージをインストールする場合は、DVD または USB フラッシュドライブを、ブートデバイスおよびインストールソースとして使用できます。

- 最小インストール用の DVD、CD、または USB フラッシュドライブ

- 最小インストール用 CD、DVD、または USB フラッシュドライブは、Boot ISO イメージを使用して作成されます。これには、システムを起動し、インストールプログラムを開始するのに最低限必要なファイルのみが含まれます。コンテンツ配信ネットワーク (CDN) を使用して必要なソフトウェアパッケージをダウンロードする場合は、Boot ISO イメージに、必要なソフトウェアパッケージを含むインストールソースが必要です。

- PXE サーバー

- PXE (preboot execution environment) サーバーを使用すると、インストールプログラムをネットワーク経由で起動させることができます。システムの起動後、ローカルディスクやネットワークの場所などの別のインストールソースからインストールを完了する必要があります。

- Image Builder

- Image Builder を使用すると、システムおよびクラウドイメージをカスタマイズして、仮想環境およびクラウド環境に Red Hat Enterprise Linux をインストールできます。

3.2. 起動可能な DVD の作成

起動可能なインストール DVD は、ディスク書き込みソフトウェアや DVD バーナーを使用して作成できます。ISO イメージファイルから DVD を作成する手順は、オペレーティングシステムや、インストールされているディスク書き込みソフトウェアにより大きく異なります。DVD への ISO イメージファイルの書き込み方法は、お使いの書き込みソフトウェアのドキュメントを参照してください。

起動可能な DVD は、DVD ISO イメージ (フルインストール) または Boot ISO イメージ (最小インストール) のいずれかを使用して作成できます。ただし、DVD ISO イメージが 4.7 GB より大きくなり、1 層または 2 層 DVD に収まらない場合があります。作業を続行する前に、DVD ISO イメージファイルのサイズを確認してください。DVD ISO イメージを使用して起動可能なインストールメディアを作成する場合は、USB フラッシュドライブを使用してください。USB ドライブが禁止されている環境の場合は、Image Builder のドキュメント を参照してください。

3.3. Linux で起動可能な USB デバイスの作成

起動可能な USB デバイスを作成し、それを使用して他のマシンに Red Hat Enterprise Linux をインストールできます。この手順では、警告なしに USB ドライブ上の既存のデータが上書きされます。データをバックアップするか、空のフラッシュドライブを使用してください。起動可能な USB ドライブは、データの保存には使用できません。

前提条件

- Product Downloads ページからフルインストール DVD ISO または最小インストールブート ISO イメージをダウンロードした。

- ISO イメージに十分な容量の USB フラッシュドライブがある。必要なサイズはさまざまですが、推奨される USB サイズは 8 GB です。

手順

- USB フラッシュドライブをシステムに接続します。

ターミナルウィンドウを開き、最近のイベントのログを表示します。

dmesg|tail

$ dmesg|tailCopy to Clipboard Copied! Toggle word wrap Toggle overflow このログの下部に、接続している USB フラッシュドライブから出力されたメッセージが表示されます。接続したデバイスの名前を記録してください。

root ユーザーとしてログインします。

su -

$ su -Copy to Clipboard Copied! Toggle word wrap Toggle overflow プロンプトに従い root パスワードを入力します。

ドライブに割り当てられているデバイスノードを見つけます。この例で使用されているドライブの名前は

sddです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

挿入された USB デバイスが自動的にマウントされる場合は、次の手順に進む前にマウントを解除してください。アンマウントするには、

umountコマンドを使用します。詳細は、umount を使用したファイルシステムのアンマウント を参照してください。 ISO イメージを USB デバイスに直接書き込みます。

dd if=/image_directory/image.iso of=/dev/device

# dd if=/image_directory/image.iso of=/dev/deviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow - /image_directory/image.iso を、ダウンロードした ISO イメージファイルへのフルパスに置き換えます。

device を、

dmesgコマンドで取得したデバイス名に置き換えます。この例では、ISO イメージのフルパスが

/home/testuser/Downloads/rhel-8-x86_64-boot.isoで、検出されたデバイス名がsddです。dd if=/home/testuser/Downloads/rhel-8-x86_64-boot.iso of=/dev/sdd

# dd if=/home/testuser/Downloads/rhel-8-x86_64-boot.iso of=/dev/sddCopy to Clipboard Copied! Toggle word wrap Toggle overflow パーティション名は、通常、数字の接尾辞が付いたデバイス名です。たとえば、

sddがデバイス名の場合、デバイスsdd上のパーティションの名前は、sdd1になります。

-

ddコマンドがデバイスへのイメージの書き込みを終了するのを待ちます。syncコマンドを実行して、キャッシュされた書き込みをデバイスに同期します。データ転送が完了すると、# プロンプトが表示されます。プロンプトが表示されたら、root アカウントからログアウトし、USB ドライブを取り外します。これで、USB ドライブをブートデバイスとして使用できるようになりました。

3.4. Windows で起動可能な USB デバイスの作成

さまざまなツールを使用して、Windows システムに起動可能な USB デバイスを作成できます。https://github.com/FedoraQt/MediaWriter/releases からダウンロードできる Fedora Media Writer を使用できます。Fedora Media Writer はコミュニティー製品であるため、Red Hat のサポート対象外となります。このツールの問題は、https://github.com/FedoraQt/MediaWriter/issues から報告できます。

起動可能なドライブを作成すると、警告なしに USB ドライブ上の既存のデータが上書きされます。データをバックアップするか、空のフラッシュドライブを使用してください。起動可能な USB ドライブは、データの保存には使用できません。

前提条件

- Product Downloads ページからフルインストール DVD ISO または最小インストールブート ISO イメージをダウンロードした。

- ISO イメージに十分な容量の USB フラッシュドライブがある。必要なサイズはさまざまです。

手順

- https://github.com/FedoraQt/MediaWriter/releases から Fedora Media Writer をダウンロードしてインストールします。

- USB フラッシュドライブをシステムに接続します。

- Fedora Media Writer を開きます。

- メイン画面で をクリックして、ダウンロードしておいた Red Hat Enterprise Linux ISO イメージを選択します。

- Write Custom Image 画面で、使用するドライブを選択します。

- をクリックします。起動用メディアの作成プロセスが開始します。プロセスが完了するまでドライブを抜かないでください。ISO イメージのサイズや、USB ドライブの書き込み速度により、この操作には数分かかる場合があります。

- 操作が完了したら、USB ドライブをアンマウントします。これで USB ドライブを起動デバイスとして使用する準備が整いました。

3.5. macOS で起動可能な USB デバイスの作成

起動可能な USB デバイスを作成し、それを使用して他のマシンに Red Hat Enterprise Linux をインストールできます。起動可能な USB ドライブを作成すると、USB ドライブに以前保存されたデータがすべて警告なしに上書きされます。データをバックアップするか、空のフラッシュドライブを使用してください。起動可能な USB ドライブは、データの保存には使用できません。

前提条件

- Product Downloads ページからフルインストール DVD ISO または最小インストールブート ISO イメージをダウンロードした。

- ISO イメージに十分な容量の USB フラッシュドライブがある。必要なサイズはさまざまです。

手順

- USB フラッシュドライブをシステムに接続します。

diskutil listコマンドでデバイスパスを特定します。デバイスパスの形式は/dev/disknumberです。numberはディスクの数になります。ディスク番号は、ゼロ (0) から始まります。通常、disk0は OS X リカバリーディスク、disk1はメインの OS X インストールになります。以下の例では、disk2が USB デバイスです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - NAME、TYPE、および SIZE の列をフラッシュドライブと比較し、USB フラッシュドライブを特定します。たとえば、NAME は、Finder ツールのフラッシュドライブアイコンのタイトルになります。この値は、フラッシュドライブの情報パネルの値と比較することもできます。

フラッシュドライブのファイルシステムボリュームをアンマウントします。

diskutil unmountDisk /dev/disknumber Unmount of all volumes on disknumber was successful

$ diskutil unmountDisk /dev/disknumber Unmount of all volumes on disknumber was successfulCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドが完了すると、デスクトップからフラッシュドライブのアイコンが消えます。アイコンが消えない場合は、誤ったディスクを選択した可能性があります。誤ってシステムディスクのマウントを解除しようとすると、failed to unmount エラーが返されます。

フラッシュドライブに ISO イメージを書き込みます。macOS は、各ストレージデバイスに対してブロック (

/dev/disk*) とキャラクターデバイス (/dev/rdisk*) ファイルの両方を提供します。/dev/rdisknumberキャラクターデバイスにイメージを書き込む方が、/dev/disknumberブロックデバイスに書き込むよりも高速です。たとえば、/Users/user_name/Downloads/rhel-8-x86_64-boot.isoファイルを/dev/rdisk2デバイスに書き込むには、以下のコマンドを実行します。sudo dd if=/Users/user_name/Downloads/rhel-8-x86_64-boot.iso of=/dev/rdisk2 bs=512K status=progress

# sudo dd if=/Users/user_name/Downloads/rhel-8-x86_64-boot.iso of=/dev/rdisk2 bs=512K status=progressCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

if=- インストールイメージへのパス。 -

of=- ターゲットディスクを表す raw ディスクデバイス (/dev/rdisknumber)。 -

bs=512K- データ転送を高速化するためにブロックサイズを 512 KB に設定します。 -

status=progress- 操作中に進行状況インジケーターを表示します。

-

-

ddコマンドがデバイスへのイメージの書き込みを終了するのを待ちます。データ転送が完了すると、# プロンプトが表示されます。プロンプトが表示されたら、root アカウントからログアウトして、USB ドライブを取り外します。これで USB ドライブを起動デバイスとして使用する準備が整いました。

第4章 インストールメディアの起動

USB または DVD を使用して Red Hat Enterprise Linux のインストールを起動できます。

Red Hat コンテンツ配信ネットワーク (CDN) を使用すると、RHEL を登録できます。CDN は地理的に分散された一連の Web サーバーです。これらのサーバーは、たとえば、有効なサブスクリプションを持つ RHEL ホストにパッケージや更新を提供します。

インストール中に、CDN から RHEL を登録してインストールすると、次のような利点があります。

- インストール後すぐに最新のシステムで最新のパッケージを利用できます。

- Red Hat Insights に接続し、システムの目的を有効にするための統合サポートを利用できます。

RHEL 9.6 以降、国防情報システム局 (DISA) のセキュリティー技術実装ガイド (STIG) およびその他のセキュリティープロファイルでは、初回起動時に Federal Information Processing Standards (FIPS) モードが自動的に有効になりません。FIPS 準拠を維持するには、インストールを開始する前に、fips=1 カーネルブートオプションを追加するか、FIPS を明示的に有効にするキックスタート設定を使用して、FIPS モードを手動で有効にする必要があります。インストール前に FIPS が有効になっていないと、これらのセキュリティープロファイルを使用して構築されたシステムが準拠していない可能性があり、ユーザーが知らないうちに非準拠のシステムを展開してしまう可能性があります。コンプライアンスの問題を回避するには、グラフィカルまたはテキストベースのインストーラーを起動する前に、ブートフェーズで FIPS が有効になっていることを確認してください。

前提条件

- 起動可能なインストールメディア (USB または DVD) を作成した。

手順

- Red Hat Enterprise Linux をインストールするシステムの電源を切ります。

- システムからドライブを切断します。

- システムの電源を入れます。

- 起動可能なインストールメディア (USB、DVD、または CD) を挿入します。

- システムの電源は切りますが、ブートメディアは取り出さないでください。

- システムの電源を入れます。

- メディアから起動するため特定のキーやキーの組み合わせを押さなければならない場合や、メディアから起動するようにシステムの BIOS (Basic Input/Output System) を設定しなければならない場合があります。詳細は、システムに同梱されているドキュメントをご覧ください。

- Red Hat Enterprise Linux ブート ウィンドウが開き、利用可能なさまざまなブートオプションが表示されます。

キーボードの矢印キーを使用して必要なブートオプションを選択し、Enter キー を押してブートオプションを選択します。Red Hat Enterprise Linux へようこそ 画面が開き、グラフィカルユーザーインターフェイスを使用して Red Hat Enterprise Linux をインストールできます。

起動画面で、60 秒以内に何も行わないと、インストールプログラムが自動的に開始します。

オプション:利用可能なブートオプションを編集します。

- UEFI ベースのシステム:E を押して、編集モードにします。事前定義済みのコマンドラインを変更して、ブートオプションを追加または削除します。Enter キーを押して、選択を確認します。

- BIOS ベースのシステム:キーボードの Tab キーを押して編集モードに入ります。事前定義済みのコマンドラインを変更して、ブートオプションを追加または削除します。Enter キーを押して、選択を確認します。

第5章 オプション:ブートオプションのカスタマイズ

x86_64 または ARM64 アーキテクチャーに RHEL をインストールする場合は、ブートオプションを編集して、特定の環境に応じてインストールプロセスをカスタマイズできます。

5.1. 起動オプション

ブートコマンドラインに、複数のオプションをスペースで区切って追加できます。インストールプログラム固有のブートオプションは、必ず inst で始まります。使用可能なブートオプションは次のとおりです。

- 等号 "=" 記号を使用するオプション

-

起動オプションに、

=記号を使用する値を指定する必要があります。たとえば、inst.vncpassword=オプションには値 (この場合はパスワード) を指定する必要があります。この例の正しい構文はinst.vncpassword=passwordです。 - 等号 "=" 記号を使用しないオプション

-

この起動オプションでは、値またはパラメーターを使用できません。たとえば、

rd.live.checkオプションでは、インストール開始前にインストールメディアの検証が強制されます。インストールプログラムは、このブートオプションが存在すると検証を実行します。ブートオプションが存在しないと、検証はスキップされます。

特定のメニューエントリーのブートオプションを次の方法でカスタマイズできます。

-

BIOS ベースのシステムの場合:

Tabキーを押して、コマンドラインにカスタム起動オプションを追加します。Escキーを押してboot:プロンプトにアクセスすることもできますが、必要な起動オプションは事前設定されていません。このシナリオでは、その他の起動オプションを使用する前に、Linux オプションを常に指定する必要があります。詳細は、BIOS の boot: プロンプトの編集 を参照してください。 -

UEFI ベースのシステムの場合:

eキーを押して、コマンドラインにカスタム起動オプションを追加します。準備ができたらCtrl+Xを押して、修正したオプションを起動します。

詳細は、UEFI ベースのシステムのブートオプションの編集 を参照してください。

5.2. BIOS で boot: プロンプトの編集

boot: プロンプトを使用すると、最初のオプションは、読み込むインストールプログラムのイメージファイルを常に指定する必要があります。ほとんどの場合、このイメージはキーワードを使用して指定できます。要件に応じて、追加オプションを指定できます。

前提条件

- 起動可能なインストールメディア (USB、CD、または DVD) を作成している。

- メディアからインストールを起動し、起動メニュー画面が開いている。

手順

- ブートメニューが開いたら、キーボードの Esc キーを押します。

-

boot:プロンプトにアクセスできるようになります。 - キーボードの Tab キーを押して、ヘルプコマンドを表示します。

-

キーボードの Enter キーを押して、オプションでインストールを開始します。

boot:プロンプトから起動メニュー画面に戻るには、システムを再起動して、インストールメディアから再度起動します。

5.3. > プロンプトを使用して事前定義されたブートオプションの編集

BIOS ベースの AMD64 および Intel64 システムでは、> プロンプトを使用して、事前定義されたブートオプションを編集できます。

前提条件

- 起動可能なインストールメディア (USB、CD、または DVD) を作成している。

- メディアからインストールを起動し、起動メニュー画面が開いている。

手順

-

ブートメニューでオプションを選択し、キーボードの Tab キーを押します。

>プロンプトにアクセスし、利用可能なオプションを表示します。 -

オプション:オプションの完全なセットを表示するには、

このメディアをテストして RHEL 8 をインストールを選択します。 >プロンプトに必要なオプションを追加します。たとえば、Federal Information Processing Standard (FIPS) 140 で義務付けられている暗号化モジュールのセルフチェックを有効にするには、

fips=1を追加します。>vmlinuz initrd=initrd.img inst.stage2=hd:LABEL=RHEL-9-5-0-BaseOS-x86_64 rd.live.check quiet fips=1

>vmlinuz initrd=initrd.img inst.stage2=hd:LABEL=RHEL-9-5-0-BaseOS-x86_64 rd.live.check quiet fips=1Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enter を押してインストールを開始します。

- Esc キーを押して編集をキャンセルし、ブートメニューに戻ります。

5.5. インストール時のドライバーの更新

Red Hat Enterprise Linux のインストールプロセス中にドライバーを更新できます。ドライバーの更新は完全に任意です。必要がない限り、ドライバーの更新を実行しないでください。Red Hat Enterprise Linux のインストール中にドライバーの更新が必要であることについて、Red Hat、ハードウェアベンダー、または信頼できるサードパーティーベンダーから通知を受けたことを確認してください。

5.5.1. 概要

Red Hat Enterprise Linux は、多数のハードウェアデバイス用のドライバーに対応していますが、新たにリリースしたドライバーには対応していない可能性があります。ドライバーの更新は、そのドライバーが対応していないために、インストールが完了できない場合に限り、実行する必要があります。インストール中にドライバーを更新することは、通常、特定の設定に対応する場合に限り必要になります。たとえば、システムのストレージデバイスへのアクセスを提供するストレージアダプター用ドライバーをインストールします。

ドライバー更新ディスクは、競合するカーネルドライバーを無効にする場合があります。この方法でカーネルモジュールをアンロードすると、インストールエラーが発生することがあります。

5.5.2. ドライバー更新の種類

Red Hat、ハードウェアベンダー、信頼できるサードパーティーは、ドライバー更新を ISO イメージファイルとして提供します。ISO イメージファイルを受け取ったら、ドライバー更新の種類を選択してください。

ドライバー更新の種類

- 自動

-

このドライバー更新方法では、

OEMDRVというラベルの付いたストレージデバイス (CD、DVD、USB フラッシュドライブなど) がシステムに物理的に接続されます。インストールの開始時に、OEMDRVストレージデバイスが存在する場合は、それがドライバー更新ディスクのように扱われ、インストールプログラムはそのドライバーを自動的に読み込みます。 - アシスト付き

-

このインストールプログラムは、ドライバーの更新を指定するように促します。

OEMDRV以外の任意のローカルストレージデバイスラベルを使用できます。インストールを開始するときに、inst.ddブートオプションが指定されます。このオプションにパラメーターを付けずに使用すると、インストールプログラムはシステムに接続されているすべてのストレージデバイスを表示し、ドライバー更新を含むデバイスを選択するように促します。 - 手動

-

ドライバー更新イメージまたは RPM パッケージのパスを手動で指定します。

OEMDRV以外のラベルを持つ任意のローカルストレージ、またはインストールシステムからアクセス可能なネットワークの場所を使用できます。inst.dd=location起動オプションは、インストールの開始時に指定しますが、location は、ドライバー更新ディスクまたは ISO イメージのパスになります。このオプションを指定すると、インストールプログラムは特定の場所にあるドライバー更新を読み込みます。手動でドライバーを更新する場合は、ローカルストレージデバイス、またはネットワークの場所 (HTTP、HTTPS、または FTP サーバー) を指定できます。inst.dd=locationとinst.ddの両方を同時に使用できます。location は、ドライバー更新ディスクまたは ISO イメージのパスになります。このシナリオでは、インストールプログラムは、その場所から、利用可能なドライバーの更新を読み込み、ドライバーの更新が含まれるデバイスを選択するように求められます。

ネットワークの場所からドライバーの更新を読み込むときは、ip= option を使用してネットワークを初期化します。

制限

セキュアブート技術を使用する UEFI システムでは、すべてのドライバーが有効な証明書で署名されている必要があります。Red Hat ドライバーは、Red Hat の秘密鍵のいずれかで署名され、カーネルで対応する公開鍵により認証されます。追加で別のドライバーを読み込む場合は、それが署名されていることを確認してください。

5.5.3. ドライバー更新の準備

この手順では、CD および DVD でドライバー更新の準備を行う方法を説明します。

前提条件

- Red Hat、ハードウェアベンダー、または信頼できるサードパーティーベンダーからドライバー更新の ISO イメージを受け取っている。

- ドライバー更新の ISO イメージを CD または DVD に焼き付けている。

CD または DVD で、.iso で終了する ISO イメージファイルが 1 つしか利用できない場合、書き込み処理は成功していません。CD または DVD に ISO イメージを作成する方法は、システムの書き込みソフトウェアのドキュメントを参照してください。

手順

- ドライバー更新用 CD または DVD をシステムの CD/DVD ドライブに挿入し、システムのファイルマネージャーツールで参照します。

-

rhdd3ファイルが 1 つ利用できることを確認してください。rhdd3は、ドライバーの説明が含まれる署名ファイルと、ディレクトリーのrpmsです。このディレクトリーには、さまざまなアーキテクチャー用のドライバーが同梱される RPM パッケージが含まれます。

5.5.4. 自動ドライバー更新の実行

この手順では、インストール時にドライバーの自動更新を行う方法を説明します。

前提条件

-

OEMDRVラベルの付いた標準のディスクパーティションにドライバーの更新イメージを置くか、OEMDRVドライバー更新イメージを CD または DVD に作成します。RAID や LVM ボリュームなどの高度なストレージは、ドライバーの更新プロセス中はアクセスできない可能性があります。 -

インストールプロセスを開始する前に、ボリュームラベル

OEMDRVが付いたブロックデバイスをシステムに接続しているか、事前に準備した CD または DVD をシステムの CD/DVD ドライブに挿入している。

手順

- 前提条件の手順を完了すると、インストールプログラムの起動時にドライバーが自動的にロードされ、システムのインストールプロセス中にインストールされます。

5.5.5. アシスト付きドライバー更新の実行

この手順では、インストール時に、ドライバーのアシスト付き更新を行う方法を説明します。

前提条件

-

インストールプロセスを開始する前に、

OEMDRVボリュームラベルのないブロックデバイスをシステムに接続し、ドライバーディスクイメージをこのデバイスにコピーしたか、ドライバー更新の CD または DVD を準備して、システムの CD または DVD ドライブに挿入しました。

ISO イメージファイルを CD または DVD に書き込むが、OEMDRV ボリュームラベルがない場合は、引数なしで inst.dd オプションを使用できます。インストールプログラムは、CD または DVD からドライバーをスキャンして選択するオプションを提供します。このシナリオでは、インストールプログラムから、ドライバー更新用 ISO イメージを選択するように求められません。別のシナリオでは、起動オプション inst.dd=location で CD または DVD を使用します。これにより、インストールプログラムが、ドライバー更新に CD または DVD を自動的にスキャンできるようになります。詳細は、手動によるドライバー更新の実行 を参照してください。

手順

- ブートメニューウィンドウで Tab キーを押して、ブートコマンドラインを表示します。

-

起動オプション

inst.ddをコマンドラインに追加し、Enter を押して起動プロセスを実行します。 - メニューから、ローカルディスクパーティション、もしくは CD デバイスまたは DVD デバイスを選択します。インストールプログラムが ISO ファイル、または ドライバー更新 RPM パッケージをスキャンします。

オプション:ドライバー更新 ISO ファイルを選択します。

選択したデバイスまたはパーティション (ドライバー更新 CD または DVD を含む光学ドライブなど) に、ISO イメージファイルではなく、ドライバー更新 RPM パッケージが含まれる場合は、この手順は必要ありません。

必要なドライバーを選択します。

- キーボードの数字キーを使用して、ドライバー選択を切り替えます。

- c を押して、選択したドライバーをインストールします。選択したドライバーが読み込まれ、インストールプロセスが始まります。

5.5.6. 手動によるドライバー更新の実行

この手順では、インストール時にドライバーを手動で更新する方法を説明します。

前提条件

- ドライバー更新の ISO イメージファイルを USB フラッシュドライブまたは Web サーバーに配置し、コンピューターに接続しました。

手順

- ブートメニューウィンドウで Tab キーを押して、ブートコマンドラインを表示します。

-

inst.dd=location起動オプションをコマンドに追加します。場所は、ドライバー更新のファイルがある場所です。通常、イメージファイルは Web サーバー http://server.example.com/dd.iso など、または USB フラッシュドライブ/dev/sdb1などに置きます。ドライバー更新を含む RPM パッケージ http://server.example.com/dd.rpm などを指定することもできます。 - Enter を押して、起動プロセスを実行してください。指定した場所で利用可能なドライバーが自動的に読み込まれ、インストールプロセスが始まります。

5.5.7. ドライバーの無効

この手順では、誤動作しているドライバーを無効にする方法を説明します。

前提条件

- インストールプログラムブートメニューを起動している。

手順

- ブートメニューで Tab キーを押して、ブートコマンドラインを表示します。

起動オプション

modprobe.blacklist=driver_nameをコマンドラインに追加します。driver_name を、無効にするドライバーの名前に置き換えます。以下に例を示します。

modprobe.blacklist=ahci

modprobe.blacklist=ahciCopy to Clipboard Copied! Toggle word wrap Toggle overflow 起動オプション

modprobe.blacklist=を使用して無効にしたドライバーは、インストール済みシステムで無効になり、/etc/modprobe.d/anaconda-blacklist.confファイルに表示されます。- Enter を押して、起動プロセスを実行してください。

第6章 インストーラーでのシステムのカスタマイズ

インストールのカスタマイズフェーズでは、Red Hat Enterprise Linux のインストールを有効にするために、特定の設定タスクを実行する必要があります。これらのタスクには、以下が含まれます。

- ストレージを設定し、マウントポイントを割り当てます。

- インストールするソフトウェアを含むベース環境を選択します。

- root ユーザーのパスワードを設定するか、ローカルユーザーを作成します。

必要に応じて、システム設定を指定したり、ホストをネットワークに接続したりするなど、システムをさらにカスタマイズすることもできます。

6.1. インストーラーの言語の設定

インストールを開始する前に、インストールプログラムで使用する言語を選択できます。

前提条件

- インストールメディアを作成している。

- Boot ISO イメージファイルを使用してインストールソースを指定している。

- インストールを起動している。

手順

- ブートメニューから Red hat Enterprise Linux オプションを選択すると、Welcome to Red Hat Enterprise Screen が表示されます。

Welcome to Red Hat Enterprise Linux 画面の左側のペインで、言語を選択します。または、テキストボックスを使用して希望の言語を検索します。

注記言語はデフォルトで事前に選択されています。ネットワークアクセスが設定されている、つまりローカルメディアではなくネットワークサーバーからシステムを起動した場合、事前選択の言語は、GeoIP モジュールの位置自動検出機能により決定します。起動コマンドラインまたは PXE サーバー設定で

inst.lang=オプションを使用すると、起動オプションで定義した言語が選択されます。- Red Hat Enterprise Linux へようこそ 画面の右側のペインから、お住まいの地域に合ったロケーションを選択してください。

- をクリックして、グラフィカルインストールウィンドウに進みます。

Red Hat Enterprise Linux のプレリリース版をインストールしようとしている場合は、インストールメディアのプレリリースステータスに関する警告メッセージが表示されます。

- インストールを続行するには、 をクリックします。あるいは、

- インストールを終了してシステムを再起動するには、 をクリックします。

6.2. ストレージデバイスの設定

さまざまなストレージデバイスに Red Hat Enterprise Linux をインストールできます。インストール先 画面で、ローカルでアクセス可能な、基本的なストレージデバイスを設定できます。ディスクやソリッドステートドライブなどのローカルシステムに直接接続する基本的なストレージデバイスは、その画面の Local Standard Disks セクションに表示されます。64 ビットの IBM Z の場合は、このセクションに、アクティベートした DASD (Direct Access Storage Devices) が含まれます。

既知の問題により、HyperPAV エイリアスとして設定した DASD を、インストールの完了後に自動的にシステムに割り当てることができません。このようなストレージデバイスはインストール時に利用できますが、インストールが完了して再起動しても、すぐにはアクセスできません。HyperPAV エイリアスデバイスを接続するには、システムの /etc/dasd.conf 設定ファイルに手動で追加します。

6.2.1. インストール先の設定

Installation Destination ウィンドウを使用して、Red Hat Enterprise Linux のインストール先として使用するディスクなどのストレージオプションを設定できます。ディスクは、1 つ以上選択する必要があります。

前提条件

- Installation Summary 画面が開いている。

- データが含まれているディスクを使用する予定の場合は、データをバックアップする。たとえば、既存の Microsoft Windows パーティションを縮小し、Red Hat Enterprise Linux を 2 つ目のシステムとしてインストールする場合、または以前のリリースの Red Hat Enterprise Linux をアップグレードする場合です。パーティションの操作は常にリスクが伴います。たとえば、何らかの理由でプロセスが中断または失敗した場合は、ディスクのデータが失われる可能性があります。

手順

Installation Summary 画面から、Installation Destination をクリックします。Installation Destination 画面で、以下の操作を行います。

Local Standard Disks セクションから、必要なストレージデバイスを選択します。選択したストレージデバイスには白いチェックマークが表示されます。白いチェックマークが付いていないディスクはインストール時には使用されません。自動パーティショニングを選択した場合は無視され、手動パーティショニングでは使用できません。

Local Standard Disks には、SATA、IDE、SCSI ディスク、USB フラッシュ、外部ディスクなど、ローカルで使用可能なすべてのストレージデバイスが表示されます。インストールプログラムの起動後に接続したストレージデバイスは検出されません。リムーバブルドライブを使用して Red Hat Enterprise Linux をインストールする場合は、デバイスを削除するとシステムが使用できなくなります。

オプション:新しいディスクを接続するために追加のローカルストレージデバイスを設定する場合は、ウィンドウの右下にある [更新] リンクをクリックします。Rescan Disks ダイアログボックスが開きます。

をクリックし、スキャン処理が完了するまで待ちます。

インストール時に行ったストレージへの変更は、Rescan Disks をクリックするとすべて失われます。

- をクリックして、Installation Destination 画面に戻ります。検出したディスク (新しいディスクを含む) はすべて、ローカルの標準ディスク セクションに表示されます。

オプション: 特殊なストレージデバイスを追加するには、 をクリックします。

Storage Device Selection ウィンドウが開き、インストールプログラムがアクセスできるすべてのストレージデバイスがリスト表示されます。

オプション: [ストレージ設定] で、自動パーティション分割の [自動] ラジオボタンを選択します。

パーティション設定はカスタマイズできます。詳細は、手動パーティションの設定 を参照してください。

- オプション: 既存のパーティションレイアウトからスペースを再利用するには 、[追加のスペースを使用できるようにします] を選択します。たとえば、使用するディスクに別のオペレーティングシステムが含まれており、このシステムのパーティションを小さくして、Red Hat Enterprise Linux 用の領域を広くする場合などです。

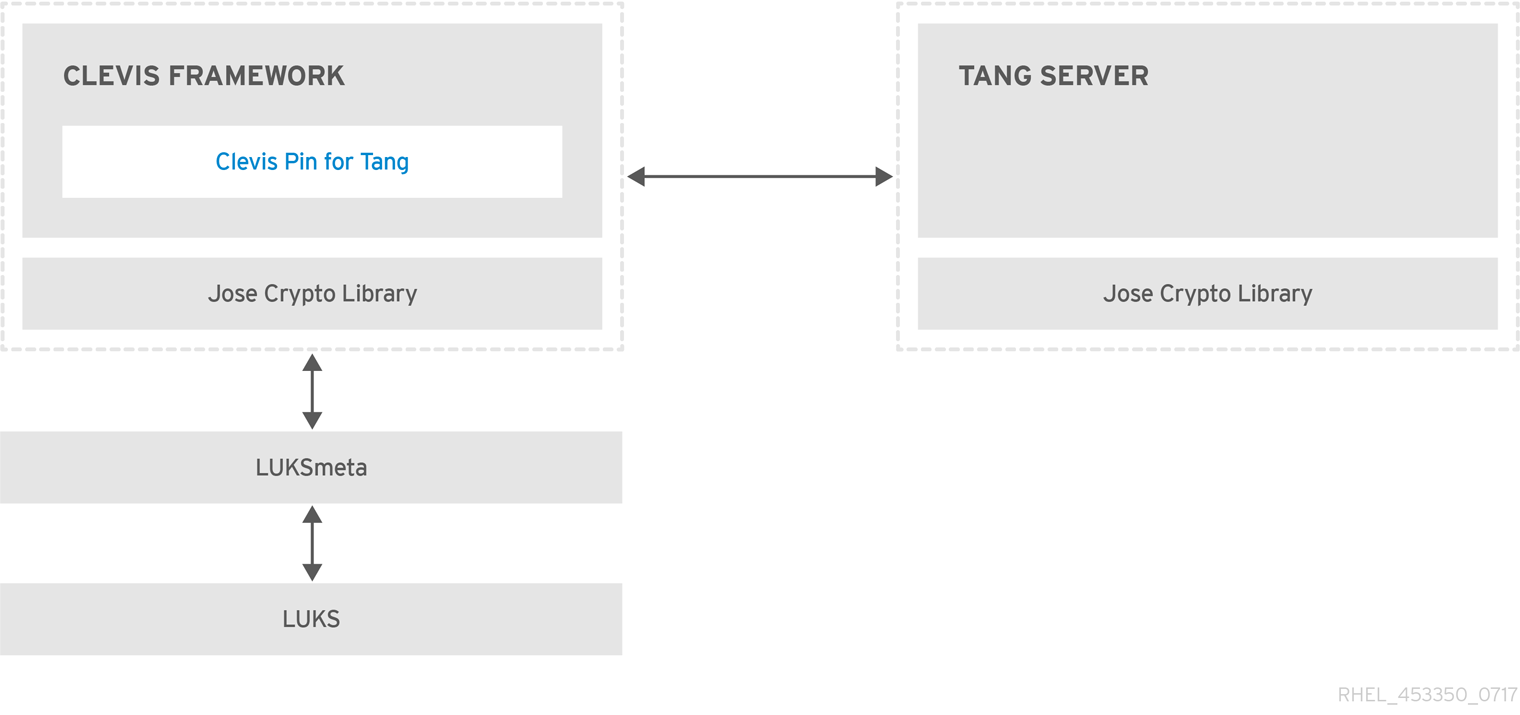

オプション: データの暗号化 を選択し、Linux Unified Key Setup (LUKS) を使用して、(

/bootなどの) システムを起動する必要があるパーティションを除いた、すべてのパーティションを暗号化します。ディスクを暗号化すると、セキュリティーがさらに強化されます。をクリックします。Disk Encryption Passphrase ダイアログボックスが開きます。

- Passphrase フィールドと Confirm フィールドにパスフレーズを入力します。

をクリックして、ディスクの暗号化を完了します。

警告LUKS パスフレーズが分からなくなると、暗号化されたパーティションと、その上にあるデータには完全にアクセスできなくなります。分からなくなったパスフレーズを復元する方法はありません。ただし、キックスタートインストールを実行した場合は、インストール中に暗号パスフレーズを保存し、バックアップ用に暗号化パスフレーズを作成できます。詳細は、RHEL の自動インストール ドキュメントを参照してください。

オプション: 画面左下の 完全なディスク要約とブートローダー をクリックして、ブートローダーを追加するストレージデバイスを選択します。詳細は、ブートローダーの設定 を参照してください。

大概は、ブートローダーをデフォルトの場所に置いておくだけで十分です。たとえば、他のブートローダーからのチェーンロードを必要とするシステムなど、一部の設定ではブートドライブを手動で指定する必要があります。

- をクリックします。

オプション: 自動パーティション分割 と 追加のスペースを確保したい オプションを選択した場合、または選択したディスクに Red Hat Enterprise Linux をインストールするための十分な空き領域がない場合は、ディスク領域の回収 ダイアログボックスが表示されます。そこには、設定されているすべてのディスクデバイスとそれらのデバイス上のすべてのパーティションがリスト表示されます。このダイアログボックスには、現在選択中のパッケージセットを使用したインストールを行う際にシステムに必要となる最小ディスク領域と、解放した領域の容量に関する情報が表示されます。解放プロセスを開始するには、以下を実行します。

- 表示された、利用可能なストレージデバイスのリストを確認します。再利用可能な領域 列には、各エントリーから再利用できる領域のサイズが表示されます。

- 領域を解放するディスクまたはパーティションを選択します。

- 既存のデータを保持しながらパーティション上の空き領域を使用するには、 ボタンを使用します。

- そのパーティション、または選択したディスク上の既存のデータを含むすべてのパーティションを削除するには、 ボタンを使用します。

- 既存のデータを含むすべてのディスク上のすべての既存のパーティションを削除し、この領域を Red Hat Enterprise Linux のインストールに使用できるようにするには、 ボタンを使用します。

をクリックして変更を適用し、グラフィカルインストールに戻ります。

Installation Summary ウィンドウで をクリックするまで、ディスクの変更は行われません。Reclaim Space ダイアログでは、サイズ変更または削除する対象としてパーティションがマークされるだけです。アクションは実行されません。

6.2.2. インストール先の設定時の特殊なケース

インストール先を設定するときに考慮すべき特殊なケースを以下に示します。

-

BIOS によっては、RAID カードからの起動に対応していないため注意が必要です。その場合は、別のディスクなど、RAID アレイ以外のパーティションに

/bootパーティションを作成する必要があります。そのような RAID カードへのパーティション作成には、内蔵ディスクを使用する必要があります。また、/bootパーティションは、ソフトウェア RAID の設定にも必要です。システムのパーティション設定を自動で選択した場合は、/bootパーティションを手動で修正する必要があります。 - Red Hat Enterprise Linux ブートローダーが、別のブートローダーから チェーンロード するように設定するには、インストール先 画面で 完全なディスク要約とブートローダー をクリックして、手動でブートドライブを指定する必要があります。

- マルチパスのストレージデバイスと、非マルチパスのストレージデバイスの両方が使用されているシステムに Red Hat Enterprise Linux をインストールすると、インストールプログラムによる自動パーティション設定のレイアウトに、マルチパスのデバイスと非マルチパスのデバイスが混在したボリュームグループが作成されます。これはマルチパスストレージの目的に反することになります。Installation Destination ウィンドウで、マルチパスデバイスまたは非マルチパスデバイスのどちらかを選択してください。もしくは、手動のパーティション設定を実行してください。

6.2.3. ブートローダーの設定

Red Hat Enterprise Linux は、GRand Unified Bootloader バージョン 2 (GRUB2) を、AMD64、Intel 64、IBM Power Systems、および ARM として使用します。64 ビットの IBM Z では、zipl ブートローダーが使用されます。

ブートローダーは、システムの起動時に実行し、制御をオペレーティングシステムに読み込み、転送する最初のプログラムです。GRUB2 は、互換性のあるオペレーティングシステム (Microsoft Windows を含む) であれば起動可能で、チェーンロードを使用すれば、未対応のオペレーティングシステムのブートローダーにも読み込んだ指示を渡すことができます。

GRUB2 をインストールすると、既存のブートローダーを上書きできます。

オペレーティングシステムがすでにインストールされていると、Red Hat Enterprise Linux インストールプログラムはそのブートローダーを自動的に検出して、別のオペレーティングシステムを起動するように設定します。そのブートローダーが正しく検出されない場合は、インストールの完了後に、追加のオペレーティングシステムを手動で設定できます。

複数のディスクを搭載した Red Hat Enterprise Linux システムをインストールする場合は、ブートローダーをインストールするディスクを手動で指定することを推奨します。

手順

インストール先 画面で 完全なディスク要約とブートローダー をクリックします。選択したディスク ダイアログボックスが開きます。

ブートローダーは、選択したデバイス、または UEFI システムにインストールされます。ガイド付きパーティションの作成時に、そのデバイスに EFI システムパーティション が作成されます。

- 起動デバイスを変更するには、リストからデバイスを選択して をクリックします。起動デバイスとして設定できるデバイスは 1 つだけです。

- 新しいブートローダーのインストールを無効にする場合は、現在起動用として設定されているデバイスを選択し、 をクリックします。これにより、いずれのデバイスにも GRUB2 がインストールされないようになります。

ブートローダーをインストールしないを選択した場合は、システムを直接起動できなくなるため、別の起動方法 (市販のスタンドアロンのブートローダーアプリケーションなど) を使用しなければならなくなります。ブートローダーをインストールしないは、システムを起動させる方法が別に確保されている場合に限定してください。

ブートローダーは、システムが BIOS または UEFI のファームウェアを使用しているか、ブートドライブに GUID Partition Table (GPT) または Master Boot Record (MBR) (msdos としても知られている) があるかどうかによって、特別なパーティションを作成する必要があります。自動パーティション作成を使用していると、インストールプログラムがパーティションを作成します。

6.2.4. ストレージデバイスの選択

ストレージデバイス選択画面には、インストールプログラムがアクセスできるストレージデバイスがリスト表示されます。システムや利用可能なハードウェアによっては、一部のタブが表示されない場合があります。デバイスは、次のタブに分類されます。

- マルチパスデバイス

- 同じシステムにある、複数の SCSI コントローラーやファイバーチャネルポートなどの複数のパスからアクセスできるストレージデバイスです。インストールプログラムで検出できるのは、16 文字または 32 文字の長さのシリアル番号を持つマルチパスストレージデバイスのみです。

- その他の SAN デバイス

- SAN (Storage Area Network) 上にあるデバイスです。

- ファームウェア RAID

- ファームウェア RAID コントローラーに接続されているストレージデバイスです。

- NVDIMM デバイス

- 特定の状況下では、Red Hat Enterprise Linux 8 は、Intel 64 アーキテクチャーおよび AMD64 アーキテクチャー上で、(NVDIMM) デバイスからセクターモードで起動および実行できます。

- IBM Z デバイス

- zSeries Linux FCP (ファイバーチャネルプロトコル) ドライバーで接続されたストレージデバイス、論理ユニット (LUN)、または DASD です。

6.2.5. ストレージデバイスのフィルタリング

ストレージデバイス選択画面では、WWID (World Wide Identifier)、ポート、ターゲット、または論理ユニット番号 (LUN) のいずれかを使用して、ストレージデバイスをフィルタリングできます。

前提条件

- Installation Summary 画面が開いている。

手順

- Installation Summary 画面から、Installation Destination をクリックします。Installation Destination ウィンドウが開き、使用可能なすべてのドライブがリスト表示されます。

- Specialized & Network Disks セクションで、 をクリックします。ストレージデバイスの選択画面が表示されます。

ポート、ターゲット、LUN、または WWID で検索するには、Search by タブをクリックします。

WWID または LUN で検索するには、対応する入力テキストフィールドに値を入力する必要があります。

- Search ドロップダウンメニューから必要なオプションを選択します。

- をクリックして検索を開始します。各デバイスと、対応するチェックボックスが、別の行に表示されます。

インストールプロセス時に必要なデバイスが利用できるようにするには、チェックボックスを選択します。

後続のインストールプロセスで、選択したデバイスの中から、Red Hat Enterprise Linux をインストールするデバイスを選択できます。その他のデバイスの中から、インストール済みシステムに自動的にマウントするものを選択できます。選択したデバイスがインストールプロセスにより自動的に消去されることはなく、デバイスを選択しても、デバイスに保存されているデータが危険にさらされることはありません。

注記インストール後に

/etc/fstabファイルを変更することで、システムにデバイスを追加できます。- をクリックして Installation Destination ウィンドウに戻ります。

ここで選択しないストレージデバイスはすべて、インストールプログラムでは表示されなくなります。別のブートローダーからこのブートローダーをチェーンロードする場合は、ここに表示されているすべてのデバイスを選択します。

6.2.6. 高度なストレージオプションの使用

高度なストレージデバイスを使用するには、iSCSI (SCSI over TCP/IP) ターゲットまたは FCoE (Fibre Channel over Ethernet) の SAN (Storage Area Network) を設定できます。

インストールに iSCSI ストレージデバイスを使用する場合は、インストールプログラム側で iSCSI ストレージデバイスを iSCSI ターゲットとして検出し、そのターゲットにアクセスするための iSCSI セッションを作成できるようにする必要があります。各手順で、CHAP (Challenge Handshake Authentication Protocol) 認証用のユーザー名とパスワードが必要になる場合があります。さらに、検出、またはセッション作成のいずれの場合も、iSCSI ターゲット側でターゲットの接続先となるシステムの iSCSI イニシエーターを認証する (リバース CHAP) ように設定することもできます。CHAP とリバース CHAP を併用する場合は、相互 CHAP または双方向 CHAP と呼ばれます。相互 CHAP を使用すると、特に CHAP 認証とリバース CHAP 認証でユーザー名やパスワードが異なる場合などに、iSCSI 接続に対する最大限の安全レベルを確保できます。

iSCSI 検出と iSCSI ログインの手順を繰り返して、必要な iSCSI ストレージをすべて追加します。初回の検出試行後は、iSCSI イニシエーターの名前を変更できません。iSCSI イニシエーターの名前を変更する場合は、インストールを最初からやり直す必要があります。

6.2.6.1. iSCSI セッションの検出および開始

Red Hat Enterprise Linux インストーラーは、次の 2 つの方法で iSCSI ディスクを検出し、ログインできます。

- iBFT (iSCSI Boot Firmware Table)

-

インストーラーは、起動すると、システムの BIOS またはアドオンブート ROM が iBFT をサポートしているかどうかをチェックします。BIOS は、iSCSI から起動できるシステム用の BIOS 拡張です。BIOS が iBFT に対応している場合は、インストーラーは BIOS から設定済みのブートディスクの iSCSI ターゲット情報を読み取り、このターゲットにログインして、インストールターゲットとして利用可能にします。iSCSI ターゲットに自動的に接続するには、ターゲットにアクセスするためのネットワークデバイスをアクティブ化します。これを行うには、起動オプション

ip=ibftを使用します。詳細は、ネットワーク起動オプション を参照してください。 - iSCSI ターゲットの手動検出および追加

- インストーラーのグラフィカルユーザーインターフェイスで iSCSI セッションを検出して開始し、使用可能な iSCSI ターゲット (ネットワークストレージデバイス) を特定できます。

前提条件

- Installation Summary 画面が開いている。

手順

- Installation Summary 画面から、Installation Destination をクリックします。Installation Destination ウィンドウが開き、使用可能なすべてのドライブがリスト表示されます。

- Specialized & Network Disks セクションで、 をクリックします。ストレージデバイスの選択画面が表示されます。

をクリックします。iSCSI ストレージターゲットの追加 画面が開きます。

重要この方法を使用して手動で追加した iSCSI ターゲットには

/bootパーティションを置くことができません。/bootパーティションを含む iSCSI ターゲットを iBFT で使用するように設定する必要があります。ただし、インストールされたシステムが、たとえば iPXE を使用して、ファームウェアの iBFT 以外の方法で提供された iBFT 設定で iSCSI から起動する場合は、inst.nonibftiscsibootインストーラー起動オプションを使用して/bootパーティション制限を削除できます。- ターゲットの IP アドレス フィールドに、iSCSI ターゲットの IP アドレスを入力します。

iSCSI Initiator Name フィールドに、iSCSI 修飾名 (IQN) の形式で iSCSI イニシエーターの名前を入力します。IQN エントリーには次を含めてください。

-

iqn.の文字列 (ピリオドが必要)。 -

日付コード (企業や組織のインターネットドメイン名またはサブドメイン名が登録された年と月。記述の順序は年を表す 4 桁の数字、ハイフン、月を表す 2 桁の数字、ピリオドの順で設定されます)。たとえば、2010 年 9 月の場合は

2010-09.のようになります。 -

企業や組織のインターネットのドメイン名またはサブドメイン名 (トップレベルのドメインを先頭にして逆順で表します)。たとえば、

storage.example.comのサブドメインは、com.example.storageのようになります。 コロン (:) と、ドメインまたはサブドメイン内でその iSCSI イニシエーターを固有に識別する文字列。たとえば、

:diskarrays-sn-a8675309です。完全な IQN は

iqn.2010-09.storage.example.com:diskarrays-sn-a8675309のようになります。構造を理解しやすくするために、インストールプログラムにより、iSCSI Initiator Nameフィールドにこの形式の名前が事前に入力されます。IQN の詳細は、tools.ietf.org の RFC 3720 - Internet Small Computer Systems Interface (iSCSI) に記載されている 3.2.6. iSCSI Names と、tools.ietf.org の RFC 3721 - Internet Small Computer Systems Interface (iSCSI) Naming and Discovery に記載されている 1. iSCSI Names and Addresses を参照してください。

-

認証のタイプの探索ドロップダウンメニューを使用して、iSCSI 検出に使用する認証タイプを指定します。以下のタイプが使用できます。- 証明書なし

- CHAP 秘密鍵

- CHAP 秘密鍵とリバースペア

次のいずれかを行います。

-

認証タイプに

CHAP ペアを選択した場合は、CHAP ユーザー名とCHAP パスワードの各フィールドに、iSCSI ターゲットのユーザー名とパスワードを入力します。 -

認証タイプに

CHAP 秘密鍵と逆順鍵を選択した場合は、CHAP ユーザー名とCHAP パスワードの各フィールドに、iSCSI ターゲットのユーザー名とパスワードを入力します。また、リバース CHAP ユーザー名とCHAP パスワードの各フィールドに、iSCSI イニシエーターのユーザー名とパスワードを入力します。

-

認証タイプに

-

オプション:

[ターゲットをネットワークインターフェイスにバインドする]チェックボックスをオンにします。 をクリックします。

入力した情報に基づいて、インストールプログラムが iSCSI ターゲットを調べます。検出に成功すると、

iSCSI ターゲットを追加画面には、ターゲットで検出された iSCSI ノードのリストが表示されます。インストールに使用するノードのチェックボックスを選択します。

ノードのログイン認証のタイプメニューには、認証のタイプの探索メニューと同じオプションがあります。ただし、ディスカバリー認証に証明書が必要な場合は、見つかったノードに同じ証明書を使用してログインします。-

探索に証明書を使用ドロップダウンメニューをクリックします。適切な認証情報を指定すると、 ボタンが利用可能になります。 - をクリックして、iSCSI セッションを開始します。

インストーラーは iscsiadm を使用して iSCSI ターゲットを検索し、ログインしますが、iscsiadm は自動的にこれらのターゲットに関する情報を iscsiadm iSCSI データベースに保存します。その後、インストーラーはこのデータベースをインストール済みシステムにコピーし、root パーティションに使用されていない iSCSI ターゲットをマークします。これにより、システムは起動時に自動的にそのターゲットにログインします。root パーティションが iSCSI ターゲットに配置されている場合、initrd がこのターゲットにログインするため、インストーラーは、同じターゲットへのログインが複数回試行されるのを避けるために、このターゲットを起動スクリプトに含めません。

6.2.6.2. FCoE パラメーターの設定

FCoE パラメーターを適切に設定することで、Installation Destination ウィンドウから FCoE (Fibre Channel over Ethernet) デバイスを検出できます。

前提条件

- Installation Summary 画面が開いている。

手順

- Installation Summary 画面から、Installation Destination をクリックします。Installation Destination ウィンドウが開き、使用可能なすべてのドライブがリスト表示されます。

- Specialized & Network Disks セクションで、 をクリックします。ストレージデバイスの選択画面が表示されます。

- をクリックします。FCoE ストレージデバイスを検出するようにネットワークインターフェイスを設定するダイアログボックスが開きます。

-

NICドロップダウンメニューで、FCoE スイッチに接続するネットワークインターフェイスを選択します。 - をクリックして、SAN デバイスのネットワークをスキャンします。

必要なチェックボックスを選択します。

- Use DCB: Data Center Bridging (DCB) は、ストレージネットワークやクラスターでイーサネット接続の効率性を向上させる目的で設計されたイーサネットプロトコルに対する拡張セットです。このチェックボックスを選択して、インストールプログラムによる DCB 認識を有効または無効にします。このオプションは、ネットワークインターフェイスでホストベースの DCBX クライアントを必要とする場合にのみ有効にします。ハードウェアの DCBX クライアントを使用するインターフェイスで設定する場合は、このチェックボックスを無効にします。

- Use auto vlan: 自動 VLAN はデフォルトで有効になり、VLAN 検出を行うかどうかを指定します。このチェックボックスを選択すると、リンク設定が検証された後、イーサネットインターフェイスで FIP (FCoE Initiation Protocol) VLAN 検出プロトコルが実行します。設定が行われていない場合は、検出されたすべての FCoE VLAN に対してネットワークインターフェイスが自動的に作成され、VLAN インターフェイスに FCoE のインスタンスが作成されます。

-

検出された FCoE デバイスが、インストール先 画面の

他の SAN デバイスタブに表示されます。

6.2.6.3. DASD ストレージデバイスの設定

Installation Destination ウィンドウから DASD ストレージデバイスを検出して設定できます。

前提条件

- Installation Summary 画面が開いている。

手順

- Installation Summary 画面から、Installation Destination をクリックします。Installation Destination ウィンドウが開き、使用可能なすべてのドライブがリスト表示されます。

- Specialized & Network Disks セクションで、 をクリックします。ストレージデバイスの選択画面が表示されます。

- をクリックします。Add DASD Storage Target ダイアログボックスが開きます。0.0.0204 などのデバイス番号を指定して、インストールの開始時に検出されなかった追加の DASD を接続するように求められます。

- Device number フィールドに、接続する DASD のデバイス番号を入力します。

をクリックします。

指定したデバイス番号を持つ DASD が検出され、その DASD が接続されていない場合は、ダイアログボックスが閉じ、新たに検出されたドライブが、ドライブのリストに表示されます。次に、必要なデバイスのチェックボックスを選択して、 をクリックします。インストール先 画面の ローカルの標準ディスク セクションで、新しい DASD が選択できるようになります (

DASD device 0.0.xxxxと表示されます)。

無効なデバイス番号を入力した場合、または指定したデバイス番号の DASD がすでにシステムに割り当てられている場合は、ダイアログボックスにエラーメッセージとその理由が表示され、別のデバイス番号で再試行するように求められます。

6.2.6.4. FCP デバイスの設定

FCP デバイスは、64 ビットの IBM Z が DASD デバイスの代わりに、または DASD デバイスに加えて、SCSI デバイスを使用できるようにするものです。FCP デバイスは交換ファブリックスイッチを提供し、これにより 64 ビットの IBM Z システムが SCSI LUN を従来の DASD デバイスとして用いる使い方に加えて、ディスクデバイスとして使えるようにします。

前提条件

- Installation Summary 画面が開いている。

-

FCP のみのインストールで、DASD がないことを示すために、CMS 設定ファイルから

DASD=オプションを削除するか、パラメーターファイルからrd.dasd=オプションを削除した。

手順

- Installation Summary 画面から、Installation Destination をクリックします。Installation Destination ウィンドウが開き、使用可能なすべてのドライブがリスト表示されます。

- Specialized & Network Disks セクションで、 をクリックします。ストレージデバイスの選択画面が表示されます。

をクリックします。Add zFCP Storage Target ダイアログボックスが開き、FCP (ファイバーチャネルプロトコル) ストレージデバイスを追加できます。

64 ビットの IBM Z では、インストールプログラムが FCP LUN をアクティベートするために、FCP デバイスを手動で入力する必要があります。これは、グラフィカルインストールで指定するか、パラメーターもしくは CMS 設定ファイル内で一意のパラメーターエントリーとして指定することで可能になります。設定する各サイトに固有の値を入力する必要があります。

- 4 桁の 16 進数のデバイス番号を、デバイス番号 フィールドに入力します。

RHEL-8.6 以前のリリースをインストールする場合、

zFCPデバイスが NPIV モードで設定されていない場合や、zfcp.allow_lun_scan=0カーネルモジュールパラメーターでauto LUNスキャンが無効になっている場合は、以下の値を指定します。- 16 桁の 16 進数の WWPN (World Wide Port Number) を、WWPN フィールドに入力します。

- 16 桁の 16 進数の FCP LUN 識別子を、LUN フィールドに入力します。

- をクリックして、FCP デバイスに接続します。

新しく追加されたデバイスが、Installation Destination ウィンドウの IBM Z タブに表示されます。

16 進法で小文字のみを使用してください。間違った値を入力して をクリックすると、インストールプログラムにより警告が表示されます。設定情報の編集と、探索の再試行が可能です。値の詳細は、ハードウェアに添付のドキュメントを参照し、システム管理者に確認してください。

6.2.7. NVDIMM デバイスへのインストール

不揮発性デュアルインラインメモリーモジュール (NVDIMM) デバイスは、電源が供給されていない時に、RAM のパフォーマンスと、ディスクのようなデータの持続性を兼ね備えています。特定の状況下では、NVDIMM デバイスから Red Hat Enterprise Linux 8 を起動して実行できます。

6.2.7.1. NVDIMM デバイスをインストール先として使用するための基準

Red Hat Enterprise Linux 8 は、nd_pmem ドライバーがサポートする Intel 64 アーキテクチャーおよび AMD64 アーキテクチャーにある、セクターモードの不揮発性デュアルインラインメモリーモジュール (NVDIMM) デバイスにインストールできます。

NVDIMM デバイスをストレージとして使用するための条件

NVDIMM デバイスをストレージとして使用するには、次の条件を満たす必要があります。

- システムのアーキテクチャーが Intel 64 または AMD64 である。

- NVDIMM デバイスがセクターモードに設定されている。インストールプログラムにより NVDIMM デバイスをこのモードに再設定できます。

- NVDIMM デバイスが、nd_pmem ドライバーで対応している。

NVDIMM デバイスからの起動の条件

以下の条件が満たされる場合には、NVDIMM デバイスからの起動が可能です。

- NVDIMM デバイスを使用するための条件がすべて満たされている。

- システムが UEFI を使用している。

- システムで使用可能なファームウェアまたは UEFI ドライバーが NVDIMM デバイスをサポートしている。UEFI ドライバーは、デバイス自体のオプション ROM から読み込むことができます。

- NVDIMM デバイスが名前空間で利用可能である。

システムの起動中に高性能な NVDIMM デバイスを利用するには、/boot ディレクトリーおよび /boot/efi ディレクトリーをデバイスに置きます。NVDIMM デバイスの XIP (Execute-in-place) 機能は、起動時にはサポートされません。カーネルは従来どおりメモリーに読み込まれます。

6.2.7.2. グラフィカルインストールモードを使用した NVDIMM デバイスの設定

不揮発性デュアルインラインメモリーモジュール (NVDIMM) デバイスは、Red Hat Enterprise Linux 8 で使用するために、グラフィカルインストールを使用して正しく設定する必要があります。

NVDIMM デバイスを再設定するプロセスにより、デバイスに格納されていたデータがすべて失われます。

前提条件

- NVDIMM デバイスがシステムに存在し、その他の、インストールターゲットとして使用するための条件を満たしている。

- インストールが起動し、インストール概要 画面が開いている。

手順

- Installation Summary 画面から、Installation Destination をクリックします。Installation Destination ウィンドウが開き、使用可能なすべてのドライブがリスト表示されます。

- Specialized & Network Disks セクションで、 をクリックします。ストレージデバイスの選択画面が表示されます。

- NVDIMM デバイス タブをクリックします。

デバイスを再設定する場合は、リストから選択します。

デバイスがリストにない場合は、セクターモードになっていません。

- をクリックします。再設定ダイアログが開きます。

必要なセクターサイズを入力し、 をクリックします。

サポートされるセクターサイズは 512 バイトおよび 4096 バイトです。

- 再設定が終了したら、 をクリックします。

- デバイスのチェックボックスを選択します。

をクリックして Installation Destination ウィンドウに戻ります。

再設定した NVDIMM は、特殊なディスクおよびネットワークディスク セクションに表示されます。

- をクリックして、インストール概要 画面に戻ります。

NVDIMM デバイスがインストール先として選択できるようになります。デバイスが起動の要件を満たしている場合は、そのように設定できます。

6.3. root ユーザーの設定とローカルアカウントの作成

6.3.1. root パスワードの設定

インストールプロセスを完了し、管理者 (スーパーユーザーまたは root としても知られている) アカウントでログインするには、root パスワードを設定する必要があります。これらのタスクには、ソフトウェアパッケージのインストールおよび更新と、ネットワーク、ファイアウォール設定、ストレージオプションなどのシステム全体の設定の変更と、ユーザー、グループ、およびファイルのパーミッションの追加または修正が含まれます。

インストールしたシステムの root 権限を取得するには、root アカウントを使用するか、管理者権限を持つユーザーアカウント (wheel グループのメンバー) を作成します。root アカウントは、インストール中に作成されます。管理者アクセスが必要なタスクを実行する必要がある場合に限り、管理者アカウントに切り替えてください。

root アカウントは、システムを完全に制御できます。このアカウントへのアクセスを不正に入手すると、ユーザーの個人ファイルへのアクセスや削除が可能になります。

手順

- インストール概要 画面から、ユーザー設定 > root パスワード を選択します。root パスワード 画面が開きます。

root パスワード フィールドにパスワードを入力します。

強力な root パスワードを作成するための要件は次のとおりです。

- 最低でも 8 文字の長さが 必要

- 数字、文字 (大文字と小文字)、記号を含めることができる

- 大文字と小文字が区別される

- 確認 フィールドにも同じパスワードを入力します。

をクリックして root パスワードを確認し、Installation Summary ウィンドウに戻ります。

脆弱なパスワードを使用して続行する場合は、 を 2 回クリックする必要があります。

6.3.2. ユーザーアカウントの作成

ユーザーアカウントを作成してインストールを完了します。ユーザーアカウントを作成しない場合は、root としてシステムに直接ログインする必要がありますが、これは 推奨されません。

手順

- インストール概要 画面で、ユーザー設定 > ユーザーの作成 を選択します。ユーザーの作成 画面が開きます。

- フルネーム フィールドに、ユーザーアカウント名を入力します。John Smith.

ユーザー名 フィールドに、ユーザー名 (jsmith など) を入力します。

コマンドラインからログインするには、ユーザー名 を使用します。グラフィカル環境をインストールする場合、グラフィカルログインマネージャーは、フルネーム を使用します。

ユーザーに管理者権限が必要な場合は、このユーザーを管理者にする チェックボックスを選択します (インストールプログラムにより、このユーザーが

wheelグループに追加されます)。管理者ユーザーは、

sudoコマンドを実行し、rootパスワードの代わりにユーザーパスワードを使用して、rootのみが実行できるタスクを実行できます。こちらを使用した方が便利な場合もありますが、セキュリティーリスクを引き起こす可能性があります。Require a password to use this account チェックボックスを選択します。

ユーザーに管理者権限を与える場合は、アカウントがパスワードで保護されていることを確認してください。アカウントにパスワードを割り当てない場合は、ユーザーに管理者特権を与えないでください。

- Password フィールドにパスワードを入力します。

- Confirm password フィールドに同じパスワードを入力します。

- をクリックして変更を適用し、Installation Summary 画面に戻ります。

6.3.3. ユーザーの詳細設定の編集

以下の手順では、Advanced User Configuration ダイアログボックスでユーザーアカウントのデフォルト設定を編集する方法を説明します。

手順

- Create User 画面で、 をクリックします。

-

必要に応じて、Home directory フィールドの詳細を変更します。このフィールドには、デフォルトで

/home/usernameが表示されます。 User and Groups IDs セクションでは、次のことができます。

Specify a user ID manually チェックボックスを選択し、 または を使用して、必要な値を入力します。

デフォルト値は 1000 です。ユーザー ID (UID) の 0 ~ 999 はシステムが予約しているため、ユーザーに割り当てることができません。

Specify a group ID manually チェックボックスを選択し、 または を使用して、必要な値を入力します。

デフォルトのグループ名はユーザー名と同じで、デフォルトのグループ ID (GID) は 1000 です。GID の 0 ~ 999 はシステムが予約しているため、ユーザーグループに割り当てることができません。

Group Membership フィールドに、コンマ区切りの追加グループリストを指定します。グループが存在しない場合は作成されます。追加されるグループにカスタムの GID を指定する場合は、カスタムの GID を括弧に入れて指定します。新しいグループにカスタムの GID を指定しない場合は、GID が自動的に割り当てられます。

作成されたユーザーアカウントには、デフォルトグループメンバーシップが常に 1 つあります (Specify a group ID manually フィールドに設定した ID を持つユーザーのデフォルトグループ)。

- をクリックして更新を適用し、Create User 画面に戻ります。

6.4. 手動パーティションの設定

手動パーティション設定を使用して、ディスクパーティションおよびマウントポイントを設定し、Red Hat Enterprise Linux がインストールされているファイルシステムを定義できます。インストールの前に、ディスクデバイスにパーティションを設定するかどうかを検討する必要があります。直接または LVM を使用して、LUN でパーティション設定を使用する場合の利点と欠点の詳細は、Red Hat ナレッジベースソリューション advantages and disadvantages to using partitioning on LUNs を参照してください。

Standard Partitions、LVM、LVM thin provisioning など、さまざまなパーティションおよびストレージオプションが利用できます。これらのオプションは、システムのストレージを効果的に管理するうえで、さまざまな利点と設定を提供します。

- 標準パーティション

-

標準パーティションには、ファイルシステムやスワップ領域が格納されます。標準パーティションは、

/boot、BIOS Boot、およびEFI System パーティションで最も一般的に使用されます。LVM 論理ボリュームは、他のほとんどの用途にも使用できます。 - LVM

-

デバイスタイプに

LVM(または論理ボリューム管理) を選択すると、LVM 論理ボリュームが作成されます。LVM は、物理ディスク使用時のパフォーマンスを向上させます。また、パフォーマンスや信頼性を向上させる高度な設定 (1 つのマウントポイントに複数の物理ディスクを使用する、ソフトウェア RAID を設定するなど) を可能にします。 - LVM シンプロビジョニング

- シンプロビジョニングを使用すると、シンプールと呼ばれる、空き領域のストレージプールを管理でき、アプリケーションで必要になった時に任意の数のデバイスに割り当てることができます。ストレージ領域の割り当ての費用対効果を高くする必要がある場合は、プールを動的に拡張できます。

Red Hat Enterprise Linux のインストールには、少なくとも 1 つのパーティションが必要です。少なくとも /、/home、/boot、および swap パーティションまたはボリュームを使用してください。必要に応じて、その他のパーティションやボリュームを作成することもできます。

データを失わないように、先に進める前に、データのバックアップを作成しておくことが推奨されます。デュアルブートシステムをアップグレードまたは作成する場合は、保存しておくストレージデバイスの全データのバックアップを作成してください。

6.4.1. 推奨されるパーティション設定スキーム

次のマウントポイントに個別のファイルシステムを作成してください。ただし、必要に応じて /usr、/var および /tmp のマウントポイントでファイルシステムを作成することもできます。

-

/boot -

/(ルート) -

/home -

swap -

/boot/efi -

PReP

このパーティションスキームは、ベアメタルのデプロイメントに推奨されますが、仮想およびクラウドのデプロイメントには適用されません。

/bootパーティション (最小限 1 GiB のサイズを推奨)-

/bootにマウントするパーティションには、オペレーティングシステムのカーネルが含まれます。これにより、起動プロセス中に使用されるファイルと共に Red Hat Enterprise Linux 8 が起動します。ほとんどのファームウェアには制限があるため、ファームウェアを保持するための小さなパーティションを作成してください。ほとんどの場合は、1 GiB の boot パーティションで十分です。その他のマウントポイントとは異なり、LVM ボリュームを/bootに使用することはできません。/bootは、別のディスクパーティションに置く必要があります。

RAID カードを実装している場合、BIOS タイプは、RAID カードからの起動に対応していない場合がある点に注意してください。これに該当する場合は、/boot パーティションは別のディスクなどの RAID アレイ以外のパーティションに作成する必要があります。

-

通常、

/bootパーティションは、インストールプログラムにより自動的に作成されます。ただし、/(ルート) パーティションが 2 TiB を超え、起動に (U)EFI を使用する場合は、マシンを正常に起動させるため、2 TiB 未満の/bootパーティションを別途作成する必要があります。 -

手動でパーティション設定する場合は、必ず

/bootパーティションをディスクの最初の 2 TB 以内に配置してください。/bootパーティションを 2 TB の境界を超えて配置すると、インストールが成功しても、システムが起動に失敗します。この制限を超える/bootパーティションを BIOS が読み取れないためです。

/(10 GiB のサイズを推奨)ここは "

/"、つまりルートディレクトリーが配置される場所です。ルートディレクトリーは、ディレクトリー構造のトップレベルです。デフォルトでは、書き込み先のパスに別のファイルシステムがマウントされていない限り (/boot、/homeなど)、すべてのファイルがこのファイルシステムに書き込まれます。root ファイルシステムが 5 GiB の場合は最小インストールが可能ですが、パッケージグループをいくつでもインストールできるように、少なくとも 10 GiB を割り当てておくことが推奨されます。

/ ディレクトリーと /root ディレクトリーを混同しないよう注意してください。/root ディレクトリーは root ユーザーのホームディレクトリーになります。/root ディレクトリーは、root ディレクトリーと区別するため、スラッシュルート ディレクトリーと呼ばれることがあります。

/home: 最小限 1 GiB のサイズを推奨しています-

システムデータとユーザーデータを別々に格納する場合は、

/homeディレクトリー用の専用ファイルシステムを作成します。ファイルシステムのサイズは、ローカルで保存するデータ量やユーザー数などを基に決定してください。こうすることで、ユーザーデータのファイルを消去せずに Red Hat Enterprise Linux 8 をアップグレードしたり、再インストールできるようになります。自動パーティション設定を選択する場合は、/homeファイルシステムが確実に作成されるように、インストールに少なくとも 55 GiB のディスク領域を確保しておくことを推奨します。 swapパーティション (1 GiB 以上のサイズを推奨)仮想メモリーは、swap ファイルシステムによりサポートされています。つまり、システムが処理しているデータを格納する RAM が不足すると、そのデータは swap ファイルシステムに書き込まれます。swap サイズはシステムメモリーのワークロードに依存するため、システムメモリーの合計ではありません。したがって、システムメモリーサイズの合計とは等しくなりません。システムメモリーの作業負荷を判断するためには、システムで実行するアプリケーションの種類、およびそのアプリケーションにより生じる負荷を分析することが重要になります。アプリケーションにより生じる負荷に関するガイダンスは、アプリケーション提供元または開発側より提供されます。

システムで swap 領域が不足すると、システムの RAM メモリーがすべて使用されるため、カーネルがプロセスを終了します。swap 領域が大き過ぎても、割り当てられているストレージデバイスがアイドル状態となり、リソース運用面では効率が悪くなります。また、swap 領域が大き過ぎるとメモリーリークに気付きにくくなる可能性があります。swap パーティションの最大サイズおよび詳細は、

mkswap(8)の man ページを参照してください。システムの RAM の容量別に推奨される swap サイズと、ハイバネートするのに十分なサイズを以下の表に示します。インストールプログラムでシステムのパーティション設定を自動的に設定すると、swap パーティションのサイズはこのガイドラインに沿って決められます。自動パーティション設定では、ハイバネートは使用しないことを前提としています。このため、swap パーティションの上限がディスクの合計サイズの最大 10 % に制限され、インストールプログラムでは、1 TiB を上回るサイズの swap パーティションが作成されません。ハイバネートを行うために十分な swap 領域を設定したい場合、もしくはシステムのストレージ領域の 10 % 以上を swap パーティションに設定したい場合、または 1 TiB を超えるサイズにしたい場合は、パーティション設定のレイアウトを手動で編集する必要があります。

| システム内の RAM の容量 | 推奨されるスワップ領域 | ハイバネートを許可する場合に推奨されるスワップ領域 |

|---|---|---|

| 2 GiB 未満 | RAM 容量の 2 倍 | RAM 容量の 3 倍 |

| 2 GiB - 8 GiB | RAM 容量と同じ | RAM 容量の 2 倍 |

| 8 GiB - 64 GiB | 4 GiB から RAM 容量の半分まで | RAM 容量の 1.5 倍 |

| 64 GiB を超える場合 | ワークロードによる (最小 4 GiB) | ハイバネートは推奨されない |

/boot/efiパーティション (サイズは 200 MiB を推奨)- UEFI ベースの AMD64、Intel 64、および 64 ビットの ARM は、200 MiB の EFI システムパーティションが必要です。推奨される最小サイズは 200 MiB で、デフォルトサイズは 600 MiB で、最大サイズは 600 MiB です。BIOS システムは、EFI システムパーティションを必要としません。

値が、範囲の境界線上にある場合 (システムの RAM が 2 GiB、8 GiB、または 64 GiB などの場合)、swap 領域の決定やハイバネートへのサポートは適宜判断してください。システムリソースに余裕がある場合は、スワップ領域を増やすとパフォーマンスが向上することがあります。

swap 領域を複数のストレージデバイスに分散させても、swap 領域のパフォーマンスが向上します (高速ドライブやコントローラー、インターフェイスなどを備えたシステムで特に効果的)。

多くのシステムでは、パーティションおよびボリュームの数は上述の最小数より多くなります。パーティション設定は、システム固有のニーズに応じて決定してください。パーティションを設定する方法が分からない場合は、インストールプログラムで提供されているデフォルトの自動パーティションのレイアウトをご利用ください。

すぐに必要となるパーティションにのみストレージ容量を割り当ててください。必要に応じて空き容量をいつでも割り当てることができます。

PReP起動パーティション (4 - 8 MiB のサイズを推奨)-

IBM Power System サーバーに Red Hat Enterprise Linux をインストールする場合は、ディスクの最初のパーティションに

PReP起動パーティションが含まれている必要があります。このパーティションには、他の IBM Power Systems サーバーで Red Hat Enterprise Linux を起動できるようにする GRUB ブートローダーが格納されます。

6.4.2. サポート対象のハードウェアストレージ

Red Hat Enterprise Linux のメジャーバージョン間でストレージ技術がどのように設定され、そのサポートがどのように変更したかを理解することが重要になります。

ハードウェア RAID

インストールプロセスを開始する前に、コンピューターのマザーボードが提供する RAID 機能、またはコントローラーカードが接続する RAID 機能を設定する必要があります。アクティブな RAID アレイは、それぞれ Red Hat Enterprise Linux 内で 1 つのドライブとして表示されます。

ソフトウェア RAID

システムに複数のディスクが搭載されている場合は、Red Hat Enterprise Linux インストールプログラムを使用して、複数のドライブを 1 つの Linux ソフトウェア RAID アレイとして動作させることができます。ソフトウェア RAID アレイを使用すると、RAID 機能は専用のハードウェアではなく、オペレーティングシステムにより制御されることになります。

以前から存在している RAID アレイの全メンバーデバイスが、パーティションが設定されていないディスクまたはドライブの場合、インストールプログラムは、アレイをディスクとして扱い、アレイを削除する方法はありません。

USB ディスク

インストール後に外付け USB ストレージを接続して設定できます。ほとんどのデバイスはカーネルにより認識されますが、認識されないデバイスもあります。インストール中にこれらのディスクを設定する必要がない場合は切断して、潜在的な問題を回避してください。

NVDIMM デバイス

不揮発性デュアルインラインメモリーモジュール (NVDIMM) デバイスをストレージとして使用するには、次の条件を満たす必要があります。

- Red Hat Enterprise Linux のバージョンが、7.6 以降である。

- システムのアーキテクチャーが Intel 64 または AMD64 である。

- デバイスが、セクターモードに設定されている。Anaconda で、NVDIMM デバイスをこのモードに再設定できます。

- nd_pmem ドライバーがそのデバイスに対応している。

さらに以下の条件が満たされる場合には、NVDIMM デバイスからの起動が可能です。

- システムが UEFI を使用している。

- システムで使用可能なファームウェアまたは UEFI ドライバーがデバイスをサポートしている。UEFI ドライバーは、デバイス自体のオプション ROM から読み込むことができます。

- デバイスが名前空間で利用可能である。

システムの起動中に高性能な NVDIMM デバイスを利用するには、デバイスに /boot ディレクトリーおよび /boot/efi ディレクトリーを置きます。

NVDIMM デバイスの XIP (Execute-in-place) 機能は、起動時にはサポートされません。カーネルは従来どおりメモリーに読み込まれます。

Intel の BIOS RAID に関する注意点

Red Hat Enterprise Linux は、Intel BIOS RAID セットへのインストールに、mdraid を使用します。このセットは起動プロセスで自動検出されるため、起動するたびにデバイスノードパスが変わる可能性があります。デバイスノードのパス (/dev/sda など) を、ファイルシステムのラベルまたはデバイス UUID に置き換えてください。ファイルシステムのラベルとデバイスの UUID は、blkid コマンドを使用すると確認できます。

6.4.3. 手動パーティションの設定

手動パーティション設定を使用すると、要件に基づいてディスクのパーティションを設定できます。

前提条件

- Installation Summary 画面が開いている。

- インストールプログラムで、すべてのディスクが利用可能である。

手順

インストールに使用するディスクを選択します。

- インストール先 をクリックして、インストール先 画面を開きます。

- 対応するアイコンをクリックして、インストールに必要なディスクを選択します。選択したディスクにはチェックマークが表示されています。

- ストレージの設定 で、カスタム ラジオボタンを選択します。

- オプション: LUKS によるストレージの暗号化を有効にする場合は、データを暗号化する チェックボックスを選択します。

- をクリックします。

ストレージの暗号化を選択した場合は、ディスク暗号化パスフレーズを入力するダイアログボックスが開きます。LUKS パスフレーズを入力します。

2 つのテキストフィールドにパスフレーズを入力してください。キーボードレイアウトを切り替えるには、キーボードアイコンを使用します。

警告パスフレーズを入力するダイアログボックスでは、キーボードレイアウトを変更できません。インストールプログラムでパスフレーズを入力するには、英語のキーボードレイアウトを選択します。

- をクリックします。手動パーティション設定 画面が開きます。

削除したマウントポイントが、左側のペインにリスト表示されます。マウントポイントは、検出されたオペレーティングシステムのインストールごとにまとめられています。したがって、複数のインストールでパーティションを共有していると、ファイルシステムによっては複数回表示されることがあります。

- 左側のペインでマウントポイントを選択します。カスタマイズ可能なオプションが右側のペインに表示されます。

- オプション: システムに既存のファイルシステムがある場合には、インストールに十分な領域があることを確認してください。パーティションを削除するには、リストから選択して、 ボタンをクリックします。ダイアログには、削除されたパーティションが属するシステムが使用しているその他のパーティションをすべて削除するチェックボックスがあります。

オプション: 既存のパーティションがなく、開始点としてパーティションのセットを作成する場合は、左側のペインから希望するパーティションスキーム (Red Hat Enterprise Linux のデフォルトは LVM) を選択し、[Click here to create them automatically] リンクをクリックします。

注記/bootパーティション、/(ルート) ボリューム、およびswapボリュームが、利用可能なストレージのサイズに合わせて作成され、左側のペインにリスト表示されます。これらが標準的なインストールのファイルシステムですが、ファイルシステムとマウントポイントをさらに追加することもできます。- をクリックして変更を適用し、インストール概要 画面に戻ります。

6.4.4. 対応ファイルシステム

手動パーティション設定を行うと、Red Hat Enterprise Linux で利用可能なさまざまなファイルシステムとパーティションタイプを利用して、パフォーマンスを最適化し、互換性を確保し、ディスク領域を効率的に管理できます。

- xfs

-

XFS ファイルシステムは、Red Hat Enterprise Linux のデフォルトのファイルシステムです。これは、最大 16 エクサバイト (約 1,600 万テラバイト) のファイルシステム、最大 8 エクサバイト (約 800 万テラバイト) のファイル、および数千万のエントリーを含むディレクトリー構造に対応する、拡張性に優れた高性能ファイルシステムです。

XFSは、メタデータジャーナリングもサポートしているため、クラッシュに対するより迅速な復元が容易になります。1 つの XFS ファイルシステムでサポートされる最大サイズは 1 PB です。XFS を縮小して空き領域を確保することはできません。 - ext4

-

ext4ファイルシステムは、ext3ファイルシステムをベースとし、改善が加えられています。より大きなファイルシステム、そしてより大きなファイルに対応するようになり、ディスク領域の割り当てに要する時間が短縮され効率化されています。また、ディレクトリー内のサブディレクトリーの数に制限がなく、ファイルシステムチェックが速くなり、ジャーナリングがより強力になりました。1 つのext4ファイルシステムで対応している最大サイズは 50 TB です。 - ext3

-

ext3ファイルシステムはext2ファイルシステムをベースとし、ジャーナリング機能という大きな利点を備えています。ジャーナリングファイルシステムを使用すると、クラッシュが発生するたびに fsck ユーティリティーを実行してメタデータの整合性をチェックする必要がないため、突然終了したあとに、ファイルシステムの復元に要する時間を短縮できます。 - ext2

-

ext2ファイルシステムは標準の Unix ファイルタイプに対応しています (通常のファイル、ディレクトリー、シンボリックリンクなど)。最大 255 文字までの長いファイル名を割り当てることができます。 - swap

- swap パーティションは、仮想メモリーに対応するために使用されます。つまり、システムが処理しているデータを格納する RAM が不足すると、そのデータが swap パーティションに書き込まれます。

- vfat

VFATファイルシステムは Linux ファイルシステムです。FAT ファイルシステムにある Microsoft Windows の長いファイル名と互換性があります。注記VFATファイルシステムは、Linux システムのパーティションではサポートされていません。たとえば、/、/var、/usrなどです。- BIOS ブート

- BIOS 互換モードで、BIOS システムおよび UEFI システムの GUID パーティションテーブル (GPT) を使用するデバイスから起動するのに必要な、非常に小さいパーティションです。

- EFI システムパーティション

- UEFI システムの GUID パーティションテーブル (GPT) でデバイスを起動する場合に必要な、小さいパーティションです。

- PReP

-

この小さなブートパーティションは、ディスクの最初のパーティションにあります。

PReP起動パーティションには GRUB2 ブートローダーが含まれ、その他の IBM Power Systems サーバーが Red Hat Enterprise Linux を起動できるようにします。

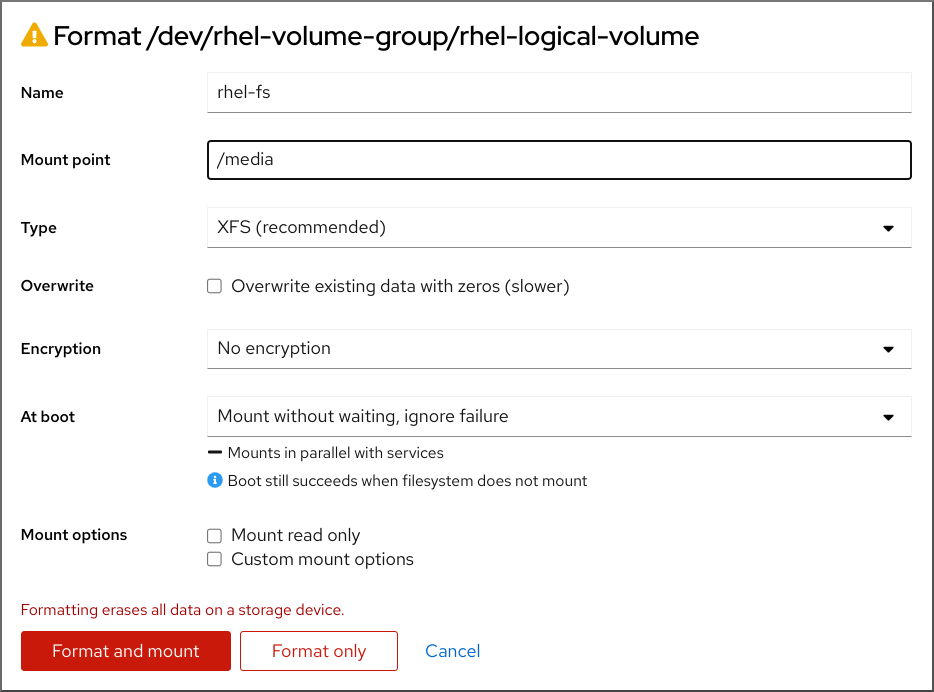

6.4.5. マウントポイントのファイルシステム追加

マウントポイントのファイルシステムは複数追加できます。XFS、ext4、ext3、ext2、swap、VFAT、および BIOS ブート、EFI システムパーティション、PReP などの特定のパーティションなど、利用可能なファイルシステムとパーティションタイプを使用して、システムのストレージを効果的に設定できます。

前提条件

- パーティションの計画が完了している。

-

/var/mail、/usr/tmp、/lib、/sbin、/lib64、/binなどのシンボリックリンクを含むパスにマウントポイントを指定していないことを確認する。RPM パッケージを含むペイロードは、特定のディレクトリーへのシンボリックリンクの作成に依存します。

手順

- をクリックして、マウントポイントのファイルシステムを作成します。マウントポイントを追加します ダイアログが表示されます。

-

マウントポイント ドロップダウンメニューから、事前に設定したパスの中から 1 つ選択するか、別のパスを入力します。たとえば、root パーティションの場合は

/を選択し、ブートパーティションの場合は/bootを選択します。 ファイルシステムのサイズを 要求される容量 フィールドに入力します。たとえば

2GiBです。Desired Capacity に値を指定しなかった場合、または使用可能な領域よりも大きいサイズを指定した場合、残りの空き領域がすべて使用されます。

- をクリックしてパーティションを作成し、手動パーティション設定 画面に戻ります。

6.4.6. マウントポイントのファイルシステム用ストレージの設定

手動で作成した各マウントポイントのパーティションスキームを設定できます。利用可能なオプションは、Standard Partition、LVM、および LVM Thin Provisioning です。Red Hat Enterprise Linux 8 では、Btrf のサポートが非推奨になりました。

/boot パーティションは、選択した値に関係なく、常に標準パーティションに置かれます。

手順

- 非 LVM マウントポイントを 1 つ配置するデバイスを変更するには、左側のペインから必要なマウントポイントを選択します。

- Device(s) 見出しの下にある をクリックします。マウントポイントの設定 ダイアログが開きます。

- 1 つ以上のデバイスを選択し、 をクリックして選択を確認し、手動パーティション設定 画面に戻ります。

- をクリックして、変更を適用します。

- 手動パーティション設定 画面左下で ストレージデバイスが選択されています リンクをクリックして、選択したディスク ダイアログを開いて、ディスク情報を確認します。

- オプション: ローカルディスクとパーティションをすべてリフレッシュするには、 ボタン (円形の矢印ボタン) をクリックします。この作業が必要になるのは、インストールプログラム以外で高度なパーティション設定を行った場合のみです。 ボタンをクリックすると、インストールプログラムに行った設定変更がすべてリセットされます。

6.4.7. マウントポイントのファイルシステムのカスタマイズ

特定の設定を行う場合は、パーティションまたはボリュームをカスタマイズできます。/usr または /var には重要なコンポーネントが含まれているため、このディレクトリーのパーティションをルートボリュームとは別の場所に設定すると、起動プロセスが非常に複雑になります。iSCSI ドライブや FCoE などの場所に配置してしまった場合には、システムが起動できなくなったり、電源オフや再起動の際に Device is busy のエラーでハングしたりする可能性があります。

これらの制限は /usr と /var にのみ適用され、その下のディレクトリーには適用されません。たとえば、/var/www 向けの個別パーティションは問題なく機能します。

手順

左側のペインから、マウントポイントを選択します。

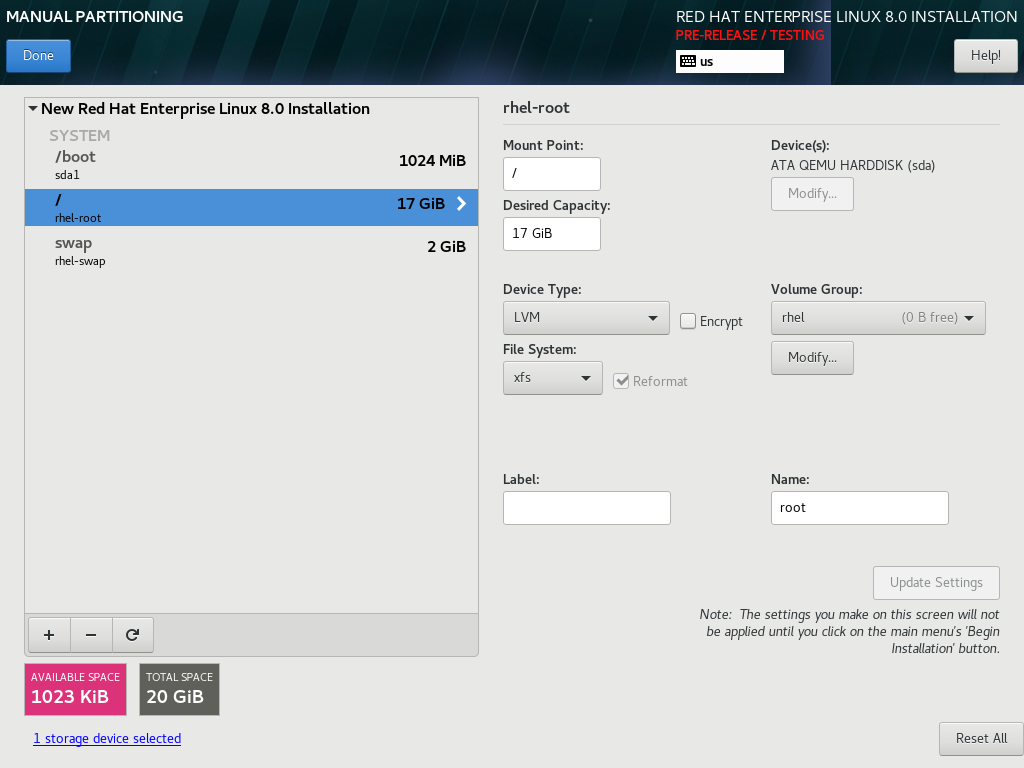

図6.1 パーティションのカスタマイズ

右側のペインで、次のオプションをカスタマイズできます。

-

マウントポイント フィールドに、ァイルシステムのマウントポイントを入力します。たとえば、ファイルシステムが root ファイルシステムの場合は

/を入力します。/bootファイルシステムの場合は/bootを入力します。swap ファイルシステムの場合は、ファイルシステムタイプをswapに設定すれば十分であるため、マウントポイントを設定しないでください。 - 割り当てる容量 フィールドに、ファイルシステムのサイズを入力します。単位には KiB や GiB が使用できます。単位を指定しない場合は、MiB がデフォルトになります。

ドロップダウンの デバイスタイプ から、必要なデバイスタイプ

標準パーティション、LVM、またはLVM シンプロビジョニングを選択します。注記RAIDは、パーティションの作成に 2 つ以上のディスクが選択されている場合にのみ使用できます。RAIDを選択した場合は、RAID レベルも設定できます。同様に、LVMを選択した場合は、ボリュームグループを選択できます。- パーティションまたはボリュームを暗号化する場合は、暗号化 チェックボックスを選択します。後続のインストールプログラムで、パスワードを設定する必要があります。LUKS バージョン ドロップダウンメニューが表示されます。

- ドロップダウンメニューから、LUKS バージョンを選択します。

ファイルシステム ドロップダウンメニューから、このパーティションまたはボリュームに適したファイルシステムタイプを選択します。

注記VFATファイルシステムは、Linux システムのパーティションではサポートされていません。たとえば、/、/var、/usrなどです。- 既存のパーティションをフォーマットする場合は 再フォーマット チェックボックスを選択します。データを保持するには、再フォーマット チェックボックスの選択を解除します。新たに作成したパーティションとボリュームは再フォーマットする必要があるため、チェックボックスの選択を解除することはできません。

- ラベル フィールドのパーティションにラベルを割り当てます。ラベルを使用すると、個別のパーティションの認識とアドレス指定が容易になります。

-

名前 フィールドに名前を入力します。標準パーティションは、作成時に自動的に名前が付けられます。標準パーティションの名前を編集することはできません。たとえば、

/bootの名前sda1を編集することはできません。

-

マウントポイント フィールドに、ァイルシステムのマウントポイントを入力します。たとえば、ファイルシステムが root ファイルシステムの場合は

- をクリックして変更を適用し、必要に応じてカスタマイズする別のパーティションを選択します。変更は、Installation Summary ウィンドウで をクリックするまで適用されません。

- オプション: パーティションの変更を破棄して、最初からやり直すには、 をクリックします。

ファイルシステムとマウントポイントをすべて作成してカスタマイズしたら、 をクリックします。ファイルシステムの暗号化を選択すると、パスフレーズを作成するように求められます。

Summary of Changes ダイアログボックスが開き、インストールプログラムの全ストレージアクションの概要が表示されます。

- をクリックして変更を適用し、Installation Summary ウィンドウに戻ります。

6.4.8. /home ディレクトリーの維持

Red Hat Enterprise Linux 8 グラフィカルインストールでは、RHEL 7 システムで使用されていた /home ディレクトリーを保存できます。RHEL 7 システムの別の /home パーティションに、/home ディレクトリーが存在する場合に限り、/home を予約できます。

さまざまな設定を含む /home ディレクトリーを保持すると、新しい Red Hat Enterprise Linux 8 システムで新しい RHEL 7 システムでの GNOME Shell 環境を、RHEL 8 システムと同じように設定できるようになります。これは、以前の RHEL 7 システムと同様、同じユーザー名と ID を持つ Red Hat Enterprise Linux 8 のユーザーに対してのみ適用されることに注意してください。

前提条件

- コンピューターに RHEL 7 がインストールされている。

-

/homeディレクトリーが RHEL 7 システムの別の/homeパーティションにある。 -

Red Hat Enterprise Linux 8 の

Installation Summaryウィンドウが開いている。

手順

- インストール先 をクリックして、インストール先 画面を開きます。

- ストレージの設定 で、カスタム ラジオボタンを選択します。完了をクリックします。

- をクリックすると、手動パーティション設定 画面が開きます。

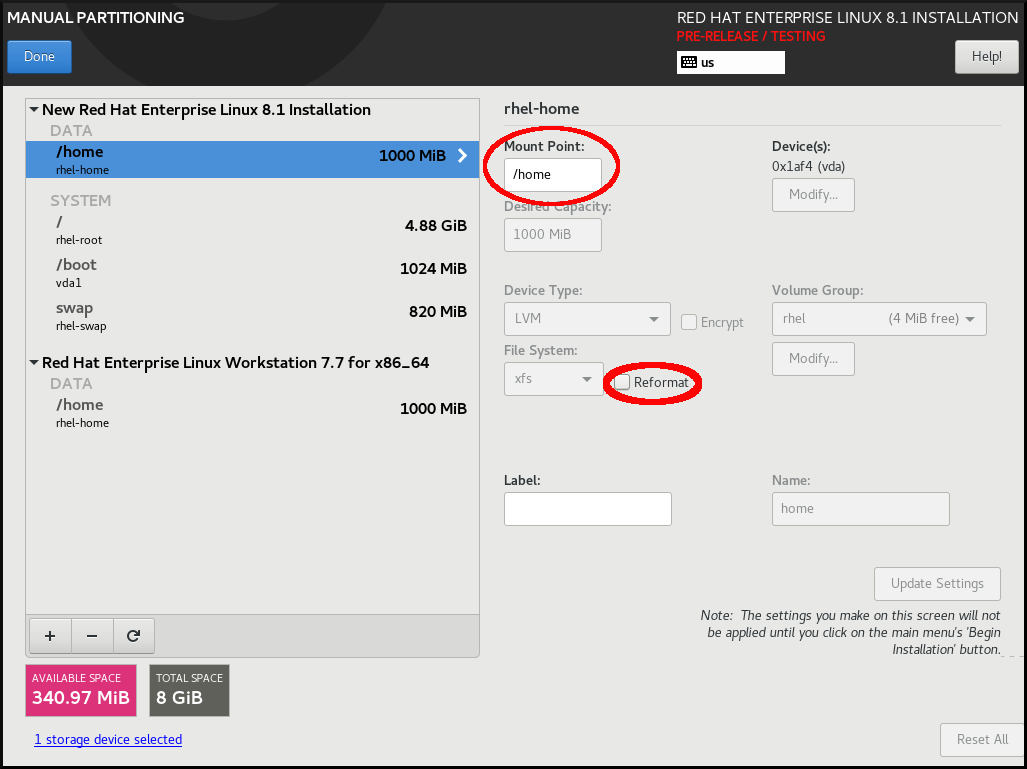

/homeパーティションを選択し、Mount Point:下に/homeを入力し、Reformat チェックボックスの選択を解除します。図6.2 /home がフォーマットされていないことを確認

-

オプション: マウントポイントのファイルシステムのカスタマイズの説明に従って、Red Hat Enterprise Linux 8 システムに必要な

/homeパーティションのさまざまなアスペクトをカスタマイズすることができます。ただし、RHEL 7 システムから/homeを保持するには、Reformat チェックボックスの選択を解除する必要があります。 - 要件に従ってすべてのパーティションをカスタマイズしたら、をクリックします。変更の概要 ダイアログボックスが開きます。

-

変更の概要 ダイアログボックスに

/homeの変更が表示されていないことを確認します。つまり、/homeパーティションは保持されます。 - をクリックして変更を適用し、インストール概要 画面に戻ります。

6.4.9. インストール中のソフトウェア RAID の作成

Redundant Arrays of Independent Disks (RAID) デバイスは、パフォーマンスを向上させ、一部の設定ではより優れたフォールトトレランスを提供するように配置された複数のストレージデバイスから構築されます。RAID デバイスの作成は 1 つのステップで終わり、必要に応じてディスクを追加または削除できます。システムでは、1 つの物理ディスクに 1 つの RAID パーティションが作成できるため、インストールプログラムで使用できるディスク数により、利用できる RAID デバイスのレベルが決定します。たとえば、システムにディスクが 2 つある場合は、RAID 10 デバイスを作成することはできません。少なくともディスクが 3 つ必要になるためです。RHEL は、システムのストレージパフォーマンスと信頼性を最適化するために、インストールされたシステムにストレージを設定するための LVM および LVM シンプロビジョニングを使用したソフトウェア RAID 0、RAID 1、RAID 4、RAID 5、RAID 6、および RAID 10 タイプをサポートしています。

64 ビットの IBM Z では、ストレージサブシステムが RAID を透過的に使用します。ソフトウェア RAID を手動で設定する必要はありません。

前提条件

- RAID 設定オプションは、インストール用に複数のディスクを選択している場合にのみ表示される。作成する RAID タイプに応じて、少なくとも 2 つのディスクが必要です。

- マウントポイントを作成している。マウントポイントを設定して、RAID デバイスを設定します。

- インストール先 画面で ラジオボタンを選択している。

手順

- 手動パーティション設定 画面の左側のペインで、必要なパーティションを選択します。

- デバイス セクションの下にある をクリックします。マウントポイントの設定 ダイアログボックスが開きます。

- RAID デバイスに追加するディスクを選択して、 をクリックします。

- デバイスタイプ ドロップダウンメニューをクリックして、RAID を選択します。

- ファイルシステム のドロップダウンメニューをクリックして、目的のファイルシステムタイプを選択します。

- RAID レベル ドロップダウンメニューをクリックして、目的の RAID レベルを選択します。

- をクリックして、変更を保存します。

- をクリックして設定を適用し、インストールの概要 ウィンドウに戻ります。

6.4.10. LVM 論理ボリュームの作成

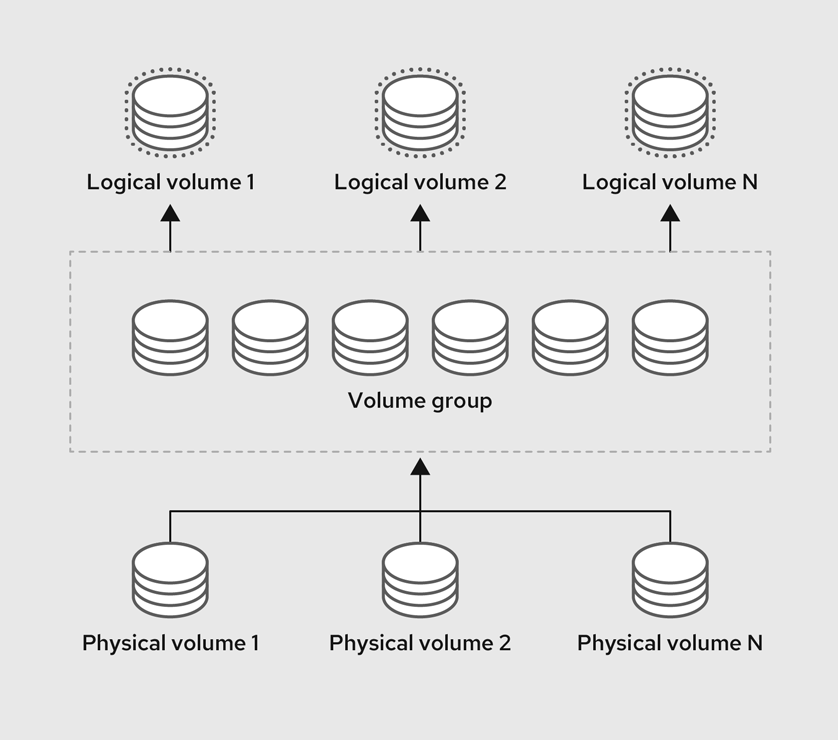

論理ボリュームマネージャー (LVM) は、ディスクや LUN などの基盤となる物理ストレージ領域を、シンプルかつ論理的に表示します。物理ストレージ上のパーティションは物理ボリュームとして表示され、ボリュームグループにグループ化できます。各ボリュームグループは複数の論理ボリュームに分割できます。各論理ボリュームは標準のディスクパーティションによく似ています。したがって、LVM 論理ボリュームは、複数の物理ディスクにまたがることが可能なパーティションとして機能します。

- LVM 設定は、グラフィカルインストールプログラムでのみ利用できます。テキストモードによるインストールの場合は、LVM を設定できません。

-

LVM 設定を作成するには、Ctrl+Alt+F2 を押し、別の仮想コンソールのシェルプロンプトを使用します。このシェルで

vgcreateおよびlvmコマンドを実行できます。テキストモードのインストールに戻るには Ctrl+Alt+F1 を押します。

手順

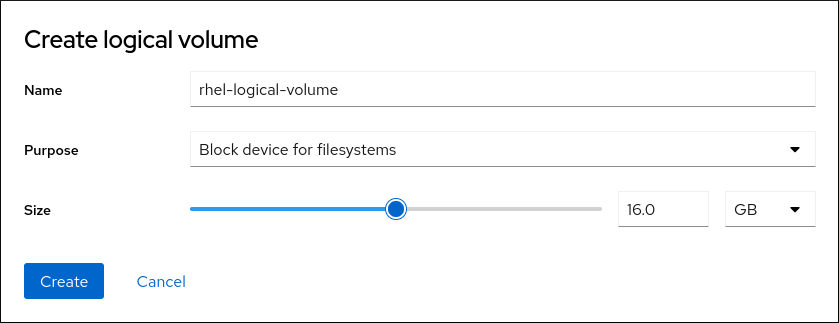

Manual Partitioning ウィンドウから、次のいずれかの方法で新しいマウントポイントを作成します。

- Click here to create them automatically オプションを使用するか、+ ボタンをクリックします。

- ドロップダウンリストからマウントポイントを選択するか、手動で入力します。

ファイルシステムのサイズを Desired Capacity フィールドに入力します。たとえば、

/の場合は 70 GiB、/bootの場合は 1 GiB です。注記:既存のマウントポイントを使用する場合は、この手順をスキップします。

- マウントポイントを選択します。

ドロップダウンメニューで

LVMを選択します。ボリュームグループ ドロップダウンメニューが表示され、新たに作成したボリュームグループ名が表示されます。注記設定ダイアログではボリュームグループの物理エクステントのサイズは指定できません。このサイズは、常にデフォルト値の 4 MiB に設定されます。別の物理エクステントのボリュームグループを作成する場合は、対話シェルに切り替えて、

vgcreateコマンドで手動で作成するか、キックスタートファイルでvolgroup --pesize=sizeコマンドを使用して作成します。キックスタートの詳細は、RHEL の自動インストール を参照してください。- をクリックして、インストール概要 画面に戻ります。

6.4.11. LVM 論理ボリュームを設定する

新しく作成した LVM 論理ボリュームを要件に基づいて設定できます。

/boot パーティションを LVM ボリュームに配置することには対応していません。

手順

Manual Partitioning ウィンドウから、次のいずれかの方法でマウントポイントを作成します。

- Click here to create them automatically オプションを使用するか、+ ボタンをクリックします。

- ドロップダウンリストからマウントポイントを選択するか、手動で入力します。

ファイルシステムのサイズを Desired Capacity フィールドに入力します。たとえば、

/の場合は 70 GiB、/bootの場合は 1 GiB です。注記:既存のマウントポイントを使用する場合は、この手順をスキップします。

- マウントポイントを選択します。

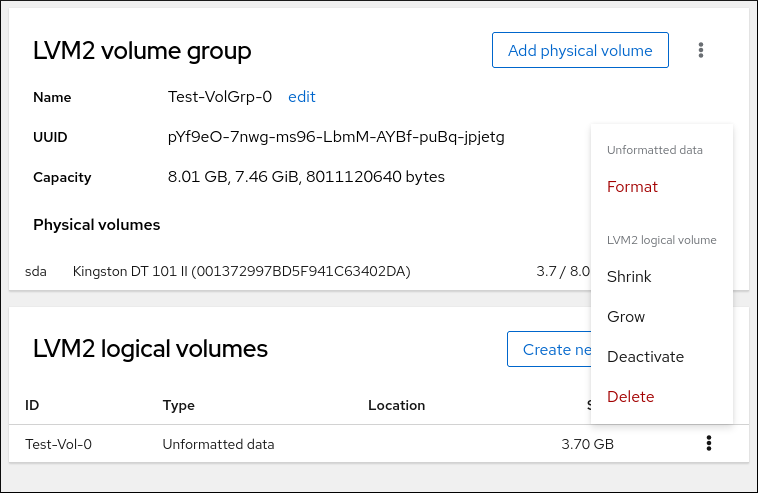

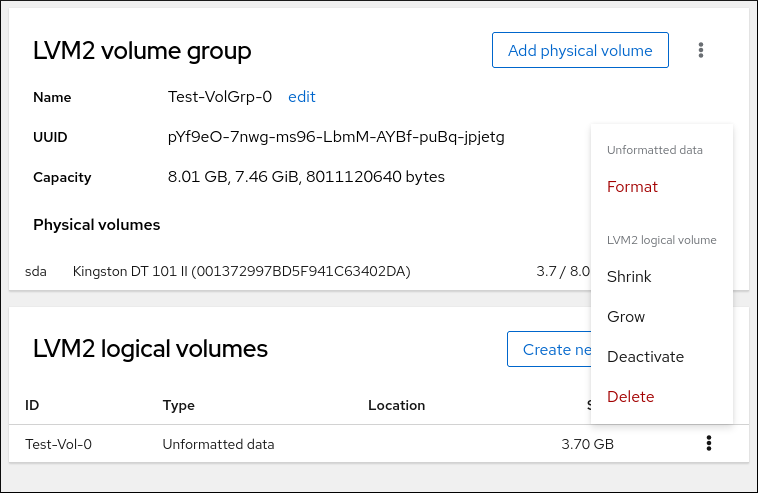

-

デバイスタイプ ドロップダウンメニューをクリックして、

LVMを選択します。ボリュームグループ ドロップダウンメニューが表示され、新たに作成したボリュームグループ名が表示されます。 をクリックして、新たに作成したボリュームグループを設定します。ボリュームグループの設定 ダイアログボックスが開きます。

注記設定ダイアログではボリュームグループの物理エクステントのサイズは指定できません。このサイズは、常にデフォルト値の 4 MiB に設定されます。別の物理エクステントのボリュームグループを作成する場合は、対話シェルに切り替えて、

vgcreateコマンドで手動で作成するか、キックスタートファイルでvolgroup --pesize=sizeコマンドを使用して作成します。詳細は、RHEL の自動インストール ドキュメントを参照してください。オプション: RAID レベル ドロップダウンメニューから、必要な RAID レベルを選択します。

利用可能な RAID レベルは、実際の RAID デバイスと同じです。

- ボリュームグループに暗号化のマークを付けるには、暗号化 チェックボックスを選択します。

Size policy ドロップダウンメニューから、ボリュームグループに対して次のサイズポリシーのいずれかを選択します。

利用可能なポリシーオプションは以下のようになります。

- Automatic

- ボリュームグループのサイズは自動で設定されるため、設定した論理ボリュームを格納するのに適切なサイズになります。ボリュームグループに空の領域が必要ない場合に最適です。

- As large as possible

- 設定した論理ボリュームのサイズに関係なく、最大サイズのボリュームグループが作成されます。これは、ほとんどのデータを LVM に保存する場合、または後で既存の論理ボリュームのサイズを拡大する可能性がある場合、もしくはこのグループに別の論理ボリュームを作成する必要がある場合などに最適です。

- Fixed

- このオプションではボリュームグループのサイズを正確に設定できます。設定している論理ボリュームが格納できるサイズにする必要があります。ボリュームグループに設定する容量が正確に分かっている場合に便利です。

- をクリックして設定を適用し、手動パーティション設定 画面に戻ります。

- をクリックして、変更を保存します。

- をクリックして、インストール概要 画面に戻ります。

6.4.12. パーティション設定に関するアドバイス

すべてのシステムに最善となる分割方法はありません。インストール済みシステムをどのように使用するかによって異なります。ただし、次のヒントは、ニーズに最適なレイアウトを見つけるのに役立つかもしれません。

- たとえば、特定のパーティションを特定のディスクに配置する必要がある場合など、特定の要件を満たすパーティションを最初に作成します。

-

機密データを格納する可能性があるパーティションやボリュームには、暗号化を検討してください。暗号化を行うと、権限を持たない人が物理ストレージデバイスにアクセスできても、暗号化したパーティションにあるデータにアクセスできなくなります。ほとんどの場合は、少なくともユーザーデータが含まれる

/homeパーティションを暗号化してください。 -

場合によっては、

/、/boot、および/home以外のディレクトリーに個別のマウントポイントを作成すると役に立つかもしれません。たとえば、MySQLデータベースを実行するサーバーで、/var/lib/mysql用のマウントポイントを別に持つことで、後でバックアップからデータベースを復元しなくても、再インストール中にデータベースを保存できます。ただし、不要なマウントポイントがあると、ストレージ管理がより困難になります。 -

一部のディレクトリーには、配置できるパーティションレイアウトに関して特別な制限がいくつか適用されます。特に、

/bootディレクトリーは常に、(LVM ボリュームではなく) 物理パーティションに存在する必要があります。 - Linux を初めて使用する場合は、さまざまなシステムディレクトリーとそのコンテンツの詳細を、Linux ファイルシステム階層標準 を確認してください。

- 各カーネルには、おおよそ次のものが必要です。60MiB (initrd 34MiB、11MiB vmlinuz、および 5MiB System.map)

- レスキューモードの場合:100MiB (initrd 76MiB、11MiB vmlinuz、および 5MiB システムマップ)

システムで

kdumpを有効にすると、さらに約 40 MiB(33 MiB の別の initrd) が必要になります。最も一般的なユースケースでは、

/bootにはデフォルトの 1 GiB のパーティションサイズが必要です。ただし、複数のカーネルリリースまたはエラータカーネルを保持する予定の場合は、このパーティションのサイズを増やしてください。-

/varディレクトリーには、Apache Web サーバーなど、多数のアプリケーションのコンテンツが格納されていて、YUM パッケージマネージャーが、ダウンロードしたパッケージの更新を一時的に保管するのに使用します。/varを含むパーティションまたはボリュームは、最低 5 GB となることを確認してください。 -

/usrディレクトリーには、一般的な Red Hat Enterprise Linux インストールの大抵のソフトウェアが格納されています。このディレクトリーを含むパーティションまたはボリュームは、最小インストールの場合は最低 5 GiB、グラフィカル環境のインストールの場合は最低 10 GiB 必要です。 /usrまたは/varのパーティションをルートボリュームとは別の場所に設定すると、これらのディレクトリーには起動に欠かせないコンポーネントが含まれているため、起動プロセスが非常に複雑になります。iSCSI ドライブや FCoE などの場所に配置してしまった場合には、システムが起動できなくなったり、電源オフや再起動の際にDevice is busyのエラーでハングしたりする可能性があります。これらの制限は

/usrと/varにのみ適用され、その下のディレクトリーには適用されません。たとえば、/var/www向けの個別パーティションは、問題なく機能します。重要一部のセキュリティーポリシーでは、管理がより複雑になりますが、

/usrと/varの分離が必要になります。-

LVM ボリュームグループ内の一部領域を未割り当てのまま残しておくことを検討してください。このように未割り当ての領域を残すことで、領域の要件が変化した際に、その他のボリュームからデータを削除したくない場合に、柔軟性が得られます。また、パーティションに

LVM シンプロビジョニングデバイスタイプを選択し、ボリュームに未使用の領域を自動的に処理させることもできます。 - XFS ファイルシステムのサイズを縮小することはできません。このファイルシステムのパーティションまたはボリュームを小さくする必要がある場合は、データのバックアップを作成し、ファイルシステムを破棄して、代わりに小規模なファイルシステムを新たに作成する必要があります。したがって、後でパーティションレイアウトを変更する予定の場合には、代わりに ext4 ファイルシステムを使用してください。

-

インストール後にディスクを追加したり、仮想マシンのディスクを拡張したりしてストレージを拡張する予定がある場合は、論理ボリュームマネージャー (LVM) を使用します。LVM を使用すると、新しいドライブに物理ボリュームを作成し、必要に応じてそのボリュームをボリュームグループおよび論理ボリュームに割り当てることができます。たとえば、システムの

/home(または論理ボリュームに存在するその他のディレクトリー) は簡単に拡張できます。 - システムのファームウェア、起動ドライブのサイズ、および起動ドライブのディスクラベルによっては、BIOS の起動パーティションまたは EFI システムパーティションの作成が必要になる場合があります。システムで BIOS ブートまたは EFI システムパーティションが 必要ない 場合は、グラフィカルインストールで BIOS ブートまたは EFI システムパーティションを作成することはできません。この場合は、メニューに表示されなくなります。

-

インストール後にストレージ設定に変更を加える必要がある場合は、Red Hat Enterprise Linux リポジトリーで役に立つツールがいくつか提供されています。コマンドラインツールを使用する場合は、

system-storage-managerを試してみてください。

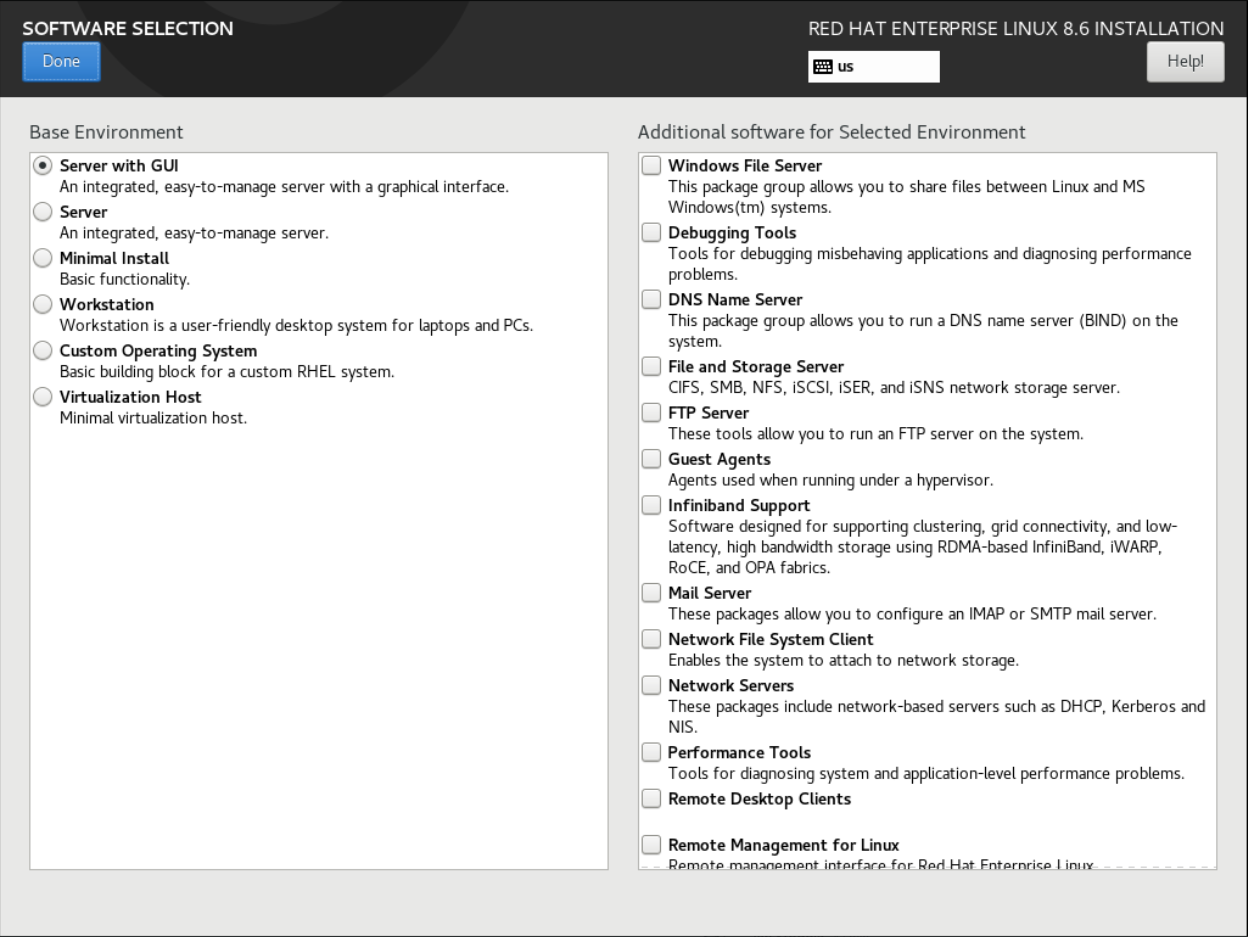

6.5. ベース環境と追加ソフトウェアの選択

必要なソフトウェアパッケージを選択するには、Software Selectio ウィンドウを使用します。パッケージは、ベース環境と追加ソフトウェア別に編成されています。

- Base Environment には、定義済みのパッケージが含まれています。たとえば、Server with GUI (デフォルト)、Server、Minimal Install、Workstation、Custom Operating System、Virtualization Host など、ベース環境を 1 つだけ選択できます。可用性は、インストールソースとして使用されているインストール ISO イメージにより異なります。

- 選択した環境の追加ソフトウェア には、ベース環境用の追加のソフトウェアパッケージが含まれています。複数のソフトウェアパッケージを選択できます。

事前に定義された環境と追加のソフトウェアを使用して、システムをカスタマイズします。ただし、標準的なインストールでは、インストールする個々のパッケージを選択することはできません。特定の環境に含まれるパッケージを表示するには、インストールソースメディア (DVD、CD、USB) にある repository/repodata/*-comps-repository.architecture.xml ファイルを参照してください。XML ファイルには、ベース環境としてインストールされたパッケージの詳細が記載されています。利用可能な環境には <environment> タグ、そして追加のソフトウェアパッケージには <group> タグが付いています。

どのパッケージをインストールする必要があるかわからない場合は、Minimal Install ベース環境を選択してください。最小インストールでは、基本バージョンの Red Hat Enterprise Linux と、最低限の追加ソフトウェアがインストールされます。システムのインストールが完了し、初めてログインした後、YUM パッケージマネージャーを使用して追加のソフトウェアをインストールできます。YUM パッケージマネージャーの詳細は、基本的なシステム設定の設定 ドキュメントを参照してください。

-

任意の RHEL 8 システムから

yum group listコマンドを使用して、ソフトウェア選択の一部としてシステムにインストールされているパッケージのリストを表示します。詳細は、基本的なシステム設定 を参照してください。 -

インストールするパッケージを制御する必要がある場合は、キックスタートファイルの

%packagesセクションにパッケージを定義します。

前提条件

- インストールソースを設定している。

- インストールプログラムが、パッケージのメタデータをダウンロードしている。

- Installation Summary 画面が開いている。

手順

- インストール概要 画面で、ソフトウェアの選択 をクリックします。ソフトウェアの選択 画面が開きます。

ベース環境 ペインで、ベース環境を選択します。たとえば、Server with GUI (デフォルト)、Server、Minimal Install、Workstation、Custom Operating System、Custom Operating System など、ベース環境を 1 つだけ選択できます。デフォルトでは、Server with GUI ベース環境が選択されています。

図6.3 Red Hat Enterprise Linux ソフトウェアの選択

- 選択した環境の追加ソフトウェア ペインから、1 つ以上のオプションを選択します。

- をクリックして設定を適用し、グラフィカルインストールに戻ります。

6.6. オプション: ネットワークとホスト名の設定

ネットワークとホスト名 画面は、ネットワークインターフェイスを設定するために使用されます。ここで選択したオプションは、インストール済みシステムだけでなく、インストール時にリモートからパッケージをダウンロードするなどのタスクを行う際にも利用できます。

以下の手順に従って、ネットワークとホスト名を設定します。

手順

- インストール概要 画面から、 をクリックします。

- 左側のペインのリストから、インターフェイスを選択します。詳細が右側のペインに表示されます。

スイッチを切り替えて、選択したインターフェイスを有効または無効にします。

インターフェイスを手動で追加または削除することはできません。

- をクリックして、仮想ネットワークインターフェイスを追加します。仮想ネットワークインターフェイスは、チーム、ボンド、ブリッジ、または VLAN のいずれかです。

- を選択して、仮想インターフェイスを削除します。

- をクリックして、既存のインターフェイスの IP アドレス、DNS サーバー、またはルーティング設定 (仮想と物理の両方) などの設定を変更します。

ホスト名 フィールドに、システムのホスト名を入力します。

ホスト名は、

hostname.domainname形式の完全修飾ドメイン名 (FQDN)、またはドメインなしの短縮ホスト名のいずれかにします。多くのネットワークには、自動的に接続したシステムにドメイン名を提供する DHCP (Dynamic Host Configuration Protocol) サービスがあります。DHCP サービスがこのシステムにドメイン名を割り当てるようにするには、短縮ホスト名のみを指定します。ホスト名に使用できるのは、英数字と

-または.のみです。ホスト名は 64 文字以下である必要があります。ホスト名は、-および.で開始したり終了したりできません。DNS に準拠するには、FQDN の各部分は 63 文字以下で、ドットを含む FQDN の合計の長さは 255 文字を超えることができません。localhostの値は、ターゲットシステムの静的ホスト名が指定されておらず、(たとえば、DHCP または DNS を使用する NetworkManager による) ネットワーク設定時に、インストールされるシステムの実際のホスト名が設定されることを示しています。静的 IP およびホスト名の設定を使用する場合、短縮名または FQDN を使用するかどうかは、計画したシステムのユースケースによって異なります。Red Hat Identity Management はプロビジョニング時に FQDN を設定しますが、サードパーティーのソフトウェア製品によっては短縮名が必要になる場合があります。いずれの場合も、すべての状況で両方のフォームの可用性を確保するには、

IP FQDN short-aliasの形式で/etc/hostsにホストのエントリーを追加します。- をクリックして、ホスト名をインストーラー環境に適用します。

- また、ネットワークおよびホスト名 画面では、ワイヤレスオプションを選択できます。右側のペインで をクリックして Wifi 接続を選択します。必要に応じてパスワードを入力し、 をクリックします。

6.6.1. 仮想ネットワークインターフェイスの追加

仮想ネットワークインターフェイスを追加できます。

手順

- ネットワークとホスト名 画面で、 ボタンをクリックして、仮想ネットワークインターフェイスを追加します。デバイスの追加 ダイアログが開きます。

使用可能な 4 つのタイプの仮想インターフェイスから 1 つ選択してください。

- Bond: NIC (ネットワークインターフェイスコントローラー) のボンドです。複数の物理ネットワークインターフェイスを 1 つのボンドチャネルに結合する方法です。

- Bridge: NIC ブリッジングです。複数のネットワークを 1 つの集積ネットワークに接続します。

- Team: NIC のチーミングです。複数のリンクを集約する新しい実装方法です。小型のカーネルドライバーを提供することでパケットフローを高速で処理し、各種アプリケーションがその他のすべてのタスクをユーザー領域で行うように設計されています。

- Vlan (仮想 LAN): それぞれ独立している複数のブロードキャストドメインを作成する方法です。

インターフェイスの種類を選択し、 をクリックします。インターフェイスの編集ダイアログボックスが開き、選択したインターフェイスタイプに使用できる設定を編集できます。

詳細は、ネットワークインターフェイスの編集 を参照してください。

- をクリックして仮想インターフェイス設定を確認し、ネットワークおよびホスト名 画面に戻ります。

- オプション: 仮想インターフェイスの設定を変更するには、インターフェイスを選択し、 をクリックします。

6.6.2. ネットワークインターフェイス設定の編集

インストール時に使用する一般的な有線接続の設定を編集できます。その他の種類のネットワークの設定方法は、一部の設定パラメーターが異なる場合がありますが、ここで説明する内容とあまり変わりません。

64 ビットの IBM Z では、ネットワークサブチャンネルをあらかじめグループ化してオンラインに設定する必要があるため、新しい接続を追加することはできません。これは現在、起動段階でのみ行われます。

手順

手動でネットワーク接続を設定するには、ネットワークおよびホスト名 画面からインターフェイスを選択し、 をクリックします。

選択したインターフェイスに固有の編集ダイアログが開きます。表示されるオプションは接続の種類によって異なります。使用可能なオプションは、接続の種類が物理インターフェイス (有線または無線のネットワークインターフェイスコントローラー) か、仮想インターフェイスの追加 で設定した仮想インターフェイス (ボンド、ブリッジ、チーム、または Vlan) かによって若干異なります。

6.6.3. インターフェイス接続の有効化または無効化

特定のインターフェイス接続を有効または無効にできます。

手順

- 全般 タブをクリックします。

-

優先的に自動的に接続 チェックボックスを選択して、デフォルトで接続を有効にします。デフォルトの優先度設定は

0のままにします。 オプション: すべてのユーザーがこのネットワークに接続できる オプションを使用して、システム上のすべてのユーザーがこのネットワークに接続できないようにするか、無効にします。このオプションを無効にすると、

rootだけがこのネットワークに接続できます。重要有線接続で有効にすると、システムは起動時または再起動時に自動的に接続されます。無線接続では、インターフェイスにより、範囲内の既知の無線ネットワークへの接続が試されます。

nm-connection-editorツールを含む NetworkManager の詳細は、Configuring and managing networking のドキュメントを参照してください。をクリックして変更を適用し、ネットワークおよびホスト名 画面に戻ります。

インストール中のこの時点ではその他のユーザーが作成されないため、

root以外の特定のユーザーだけがこのインターフェイスを使用するように許可することはできません。別のユーザーが使用する接続が必要な場合は、インストール後に設定する必要があります。

6.6.4. 静的な IPv4 または IPv6 の設定

デフォルトでは、現在のネットワーク設定に応じて、IPv4 と IPv6 の両方が自動設定に指定されています。つまり、ローカルの IP アドレス、DNS アドレスなどのアドレスは、インターフェイスがネットワークに接続すると自動的に検出されます。多くの場合はこれで十分ですが、IPv4 Settings タブと IPv6 Settings タブで静的な設定を行うこともできます。IPv4 設定または IPv6 設定を設定するには、以下の手順を実行します。

手順

- 静的ネットワーク設定を行うには、IPv 設定タブのいずれかに移動し、方式 ドロップダウンメニューから、自動 以外の方法 (手動 など) を選択します。アドレス ペインが有効になります。

- オプション: IPv6 設定 タブでは、メソッドを 無視する に設定して、このインターフェイスの IPv6 を無効にできます。

- をクリックして、アドレス設定を入力します。

-

追加の DNS サーバー フィールドに IP アドレスを入力します。DNS サーバーの IP アドレス (

10.0.0.1,10.0.0.8など) を 1 つ以上設定できます。 Require IPvX addressing for this connection to complete チェックボックスをオンにします。

IPv4 Settings または IPv6 Settings タブでこのオプションを選択すると、IPv4 または IPv6 が成功した場合にのみこの接続が許可されます。IPv4 および IPv6 の両方でこのオプションを無効にしたままにしておくと、いずれかの IP プロトコル設定に成功した場合にインターフェイスが接続できるようになります。

- をクリックして変更を適用し、ネットワークおよびホスト名 画面に戻ります。

6.6.5. ルートの作成

ルートを設定することで、特定の接続へのアクセスを制御できます。

手順

- IPv4 設定 タブおよび IPv6 設定 タブで、 をクリックして特定の IP プロトコルのルーティング設定を行います。そのインターフェイス用のルート編集ダイアログが開きます。

- をクリックして、ルートを追加します。

- 1 つ以上の静的ルートを設定し、設定していないすべてのルートを無効にするには、自動的に得られたルートを無視する チェックボックスを選択します。

この接続はネットワーク上のリソースにのみ使用 チェックボックスを選択して、デフォルトルートにはならないようにします。

このオプションは、静的ルートを設定していなくても選択できます。このルートは、ローカルまたは VPN 接続を必要とするイントラネットページなど、特定のリソースにアクセスするためにのみ使用されます。公開されているリソースには別の (デフォルトの) ルートが使用されます。追加ルートが設定されているのとは異なり、この設定はインストール済みシステムに転送されます。このオプションは、複数のインターフェイスを設定する場合に限り役に立ちます。

- をクリックして設定を保存し、インターフェイス固有のルートの編集ダイアログボックスに戻ります。

- をクリックして設定を適用し、ネットワークおよびホスト名 画面に戻ります。

6.7. オプション: キーボードレイアウトの設定

Installation Summary 画面からキーボードレイアウトを設定できます。

ロシア語 のようにラテン文字を受け付けないレイアウトを使用する場合は、一緒に 英語 (US) レイアウトも追加して、2 つのレイアウトを切り替えられるようにキーボードを設定します。ラテン文字を含まないレイアウトを選択すると、この後のインストールプロセスで有効な root パスワードおよびユーザー認証情報を入力できない場合があります。これにより、インストールを完了できない可能性があります。

手順

- Installation Summary ウィンドウで、Keyboard をクリックします。

- をクリックして Add a Keyboard Layout ウィンドウを開き、別のレイアウトに変更します。

- リストを参照してレイアウトを選択するか、Search フィールドを使用します。

- 必要なレイアウトを選択し、 をクリックします。デフォルトレイアウトの下に新しいレイアウトが表示されます。

- 必要に応じて をクリックして、使用可能なレイアウトを切り替えるキーボードスイッチを設定します。レイアウト切り替えのオプション 画面が開きます。

- 切り替え用のキーの組み合わせを設定するには、1 つ以上のキーの組み合わせを選択し、 をクリックして選択を確定します。

- オプション: レイアウトを選択したら、[キーボード] ボタンをクリックすると、選択したレイアウトの視覚的な表現を表示する新しいダイアログボックスが開きます。

- をクリックして設定を適用し、グラフィカルインストールに戻ります。

6.8. オプション: 言語サポートの設定

Installation Summary 画面から言語設定を変更できます。

手順

- インストール概要 画面で 言語サポート をクリックします。言語サポート 画面が開きます。左側のペインには、利用可能な言語グループのリストが表示されます。グループの中から 1 つ以上の言語を設定すると、チェックマークが表示され、対応する言語が強調表示されます。

- 左側のペインからグループをクリックして追加の言語を選択し、右側のペインから地域のオプションを選択します。設定するすべての言語に対してこのプロセスを繰り返します。

- オプション: 必要に応じて、テキストボックスに入力して言語グループを検索します。

- をクリックして設定を適用し、グラフィカルインストールに戻ります。

6.10. オプション: システムをサブスクライブし、Red Hat Insights をアクティブ化する

Red Hat Insights は SaaS (Software-as-a-Service) 製品で、継続的に、登録済みの Red Hat ベースのシステムに詳細な分析を提供し、物理環境、仮想環境、クラウド環境、およびコンテナーデプロイメントでセキュリティー、パフォーマンス、および安定性に関する脅威をプロアクティブに特定します。RHEL システムを Red Hat Insights に 登録 すると、予測分析、セキュリティーアラート、パフォーマンス最適化ツールにアクセスできるようになり、セキュアで効率的かつ安定した IT 環境を維持できるようになります。

Red Hat アカウントまたはアクティベーションキーの詳細を使用して Red Hat に登録できます。Connect to Red Hat オプションを使用して、システムを Red Hat Insights に接続できます。

手順

- Installation Summary 画面の Software で、Connect to Red Hat をクリックします。

Account または Activation Key を選択します。

- Account を選択した場合は、Red Hat カスタマーポータルのユーザー名とパスワードの詳細を入力します。

Activation Key を選択した場合は、組織 ID とアクティベーションキーを入力します。

サブスクリプションにアクティベーションキーが登録されている限り、複数のアクティベーションキーをコンマで区切って入力できます。

Set System Purpose チェックボックスをオンにします。

- アカウントで Simple Content Access モードが有効になっている場合でも、サブスクリプションサービスの消費量を正確にレポートするには、システムの目的の値を設定することが重要です。

- アカウントがエンタイトルメントモードである場合、システムの目的を設定すると、エンタイトルメントサーバーが Red Hat Enterprise Linux 8 システムの使用目的を満たす最適なサブスクリプションを決定し、自動的に割り当てることが可能になります。

- 対応するドロップダウンリストから、必要な Role、SLA、および Usage を選択します。

- Red Hat Insights への接続 チェックボックスはデフォルトで有効になっています。Red Hat Insights に接続する必要がない場合には、チェックボックスの選択を解除します。

オプション: オプション をデプロイメントします。

- ネットワーク環境で、外部のインターネットアクセスまたは HTTP プロキシーを介したコンテンツサーバーへのアクセスのみが許可されている場合は、HTTP プロキシーの使用 チェックボックスを選択します。HTTP プロキシーを使用していない場合は、HTTP プロキシーの使用 チェックボックスの選択を解除します。

Satellite Server を実行しているか、内部テストを実行している場合は、カスタムサーバーの URL チェックボックスと カスタムベース URL チェックボックスを選択して、必要な情報を入力します。

重要-

カスタムサーバーの URL フィールドには HTTP プロトコル (

nameofhost.comなど) が必要ありません。ただし、Custom base URL フィールドには HTTP プロトコルが必要です。 - 登録後に カスタムベース URL を変更するには、登録を解除し、新しい詳細を指定してから再登録する必要があります。

-

カスタムサーバーの URL フィールドには HTTP プロトコル (

をクリックしてシステムを登録します。システムが正常に登録され、サブスクリプションが割り当てられると、Red Hat への接続 ウィンドウに、割り当てられているサブスクリプションの詳細が表示されます。

サブスクリプションのサイズによっては、登録および割り当てのプロセスが完了するのに最大 1 分かかることがあります。

をクリックして、インストール概要 画面に戻ります。

Red Hat への接続 の下に 登録 メッセージが表示されます。

6.11. オプション:インストールにネットワークベースのリポジトリーを使用する

自動検出されたインストールメディア、Red Hat CDN、またはネットワークのいずれかからインストールソースを設定できます。インストール概要 画面を最初に開いた時に、インストールプログラムが、システムの起動に使用されたメディアの種類に基づいて、インストールソースを設定しようとします。完全な Red Hat Enterprise Linux Server DVD は、ソースをローカルメディアとして設定します。

前提条件

- Product Downloads ページからフルインストール DVD ISO または最小インストールブート ISO イメージをダウンロードした。

- 起動可能なインストールメディアを作成している。

- Installation Summary 画面が開いている。

手順

インストール概要 画面から、インストールソース をクリックします。インストールソース 画面が開きます。

- 自動検出したインストールメディア セクションを見直して、詳細を確認します。インストールソースを含むメディア (DVD) からインストールプログラムを起動した場合は、このオプションがデフォルトで選択されます。

- をクリックして、メディアの整合性を確認します。

Additional repositories セクションを確認し、AppStream チェックボックスがデフォルトで選択されていることを確認します。

BaseOS および AppStream リポジトリーは、フルインストールイメージの一部としてインストールされます。Red Hat Enterprise Linux 8 のフルインストールを行う場合は、AppStream リポジトリーのチェックボックスを無効にしないでください。

- オプション:Red Hat CDN オプションを選択して、システムを登録し、RHEL サブスクリプションを割り当てて、Red Hat コンテンツ配信ネットワーク (CDN) から RHEL をインストールします。

オプション:ネットワーク上 オプションを選択して、ローカルメディアの代わりに、ネットワーク上からパッケージをダウンロードしてインストールします。このオプションは、ネットワーク接続がアクティブな場合にのみ利用できます。GUI でネットワーク接続を設定する方法は、ネットワークおよびホスト名のオプションの設定 を参照してください。

注記ネットワーク上の場所から追加のリポジトリーをダウンロードしてインストールしない場合は、ソフトウェア選択の設定 に進みます。

- ネットワーク上 ドロップダウンメニューを選択し、パッケージのダウンロードに使用するプロトコルを指定します。この設定は、使用するサーバーによって異なります。

-

アドレスフィールドに、(プロトコルなしで) サーバーアドレスを入力します。NFS を選択すると、入力フィールドが開き、カスタムの NFS マウントオプション を指定できます。このフィールドでは、システム上の

nfs(5)man ページにリストされているオプションを使用できます。 NFS のインストールソースを選択する場合は、ホスト名とパスをコロン (

:) で区切ってアドレスを指定します。たとえば、server.example.com:/path/to/directoryのように指定します。以下の手順は任意で、ネットワークアクセスにプロキシーが使用されているかどうかのみが必要となります。

- をクリックして、HTTP または HTTPS ソースのプロキシーを設定します。

- HTTP プロキシーの有効化 チェックボックスを選択し、プロキシーホスト フィールドに URL を入力します。

- プロキシーサーバーで認証が必要な場合は、認証を使用する チェックボックスを選択します。

- ユーザー名とパスワードを入力します。

をクリックして設定を終了し、プロキシーの設定... ダイアログボックスを終了します。

注記HTTP または HTTPS の URL が、リポジトリーミラーを参照する場合は、URL type ドロップダウンリストから必要なオプションを選択します。ソースの設定が終わると、選択に対して環境と追加のソフトウェアパッケージがすべて利用できます。

- をクリックして、リポジトリーを追加します。

- をクリックして、リポジトリーを削除します。

- アイコンをクリックして、現在のエントリーを、インストールソース 画面を開いたときに表示されていた設定に戻します。

リポジトリーを有効または無効にするには、リストの各エントリーで 有効 列のチェックボックスをクリックします。

ネットワークにプライマリーリポジトリーを設定するときと同じように、追加リポジトリーに名前を付けて設定できます。

- をクリックして設定を適用し、Installation Summary ウィンドウに戻ります。

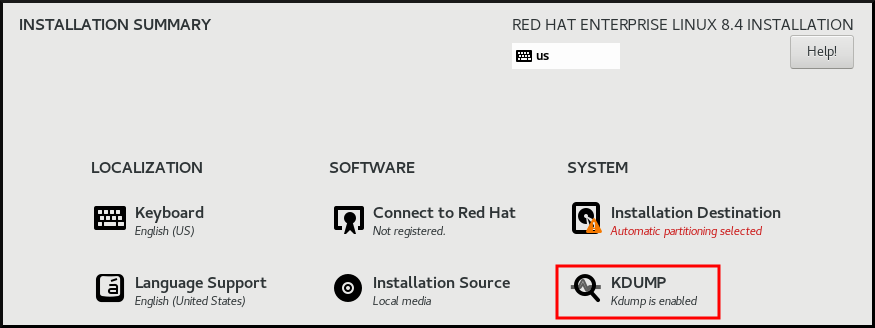

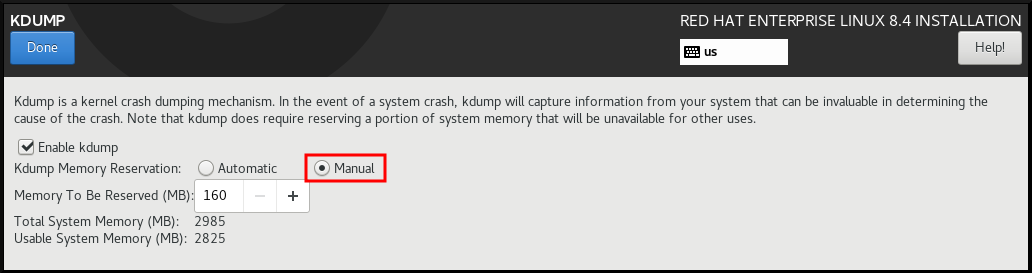

6.12. オプション: Kdump カーネルクラッシュダンプメカニズムの設定

Kdump は、カーネルのクラッシュダンプメカニズムです。システムがクラッシュすると、Kdump が、障害発生時のシステムメモリーの内容をキャプチャーします。キャプチャーしたメモリーを解析すると、クラッシュの原因を見つけることができます。Kdump が有効になっている場合は、システムメモリー (RAM) のごく一部をそれ自身に予約する必要があります。予約したメモリーは、メインのカーネルにアクセスできません。

手順

- インストール概要 画面から、Kdump をクリックします。Kdump 画面が開きます。

- kdump を有効にする チェックボックスを選択します。

- メモリー予約設定を、自動 または 手動 のいずれかから選択します。

- 手動 を選択し、+ ボタンおよび - ボタンを使用して、予約されるメモリー フィールドに、予約するメモリー量 (メガバイト) を入力します。予約入力フィールドの下にある 使用可能なシステムメモリー には、選択したサイズの RAM を予約してから、メインシステムにアクセスできるメモリーの量が示されます。

- をクリックして設定を適用し、グラフィカルインストールに戻ります。

予約するメモリーの量は、システムのアーキテクチャー (AMD64 と Intel 64 の要件は IBM Power とは異なります) と、システムメモリーの総量により決まります。ほとんどの場合は、自動予約で十分です。

カーネルクラッシュダンプの保存場所などの追加設定は、インストール後に system-config-kdump グラフィカルインターフェイスで設定するか、/etc/kdump.conf 設定ファイルに手動で設定できます。

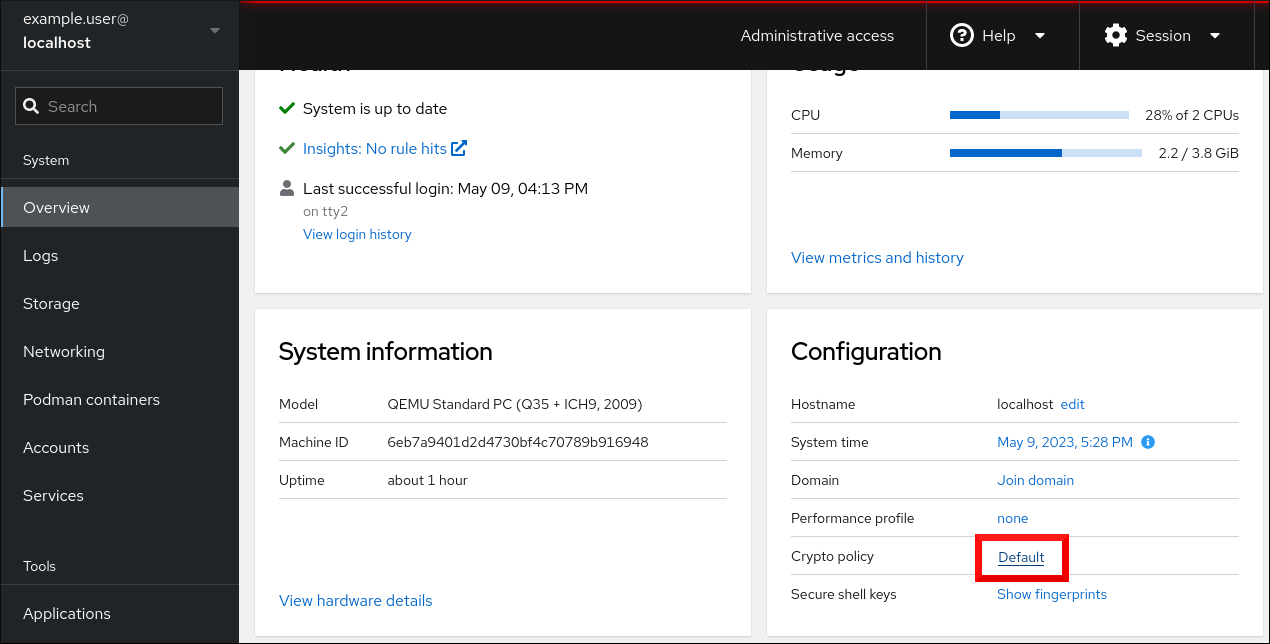

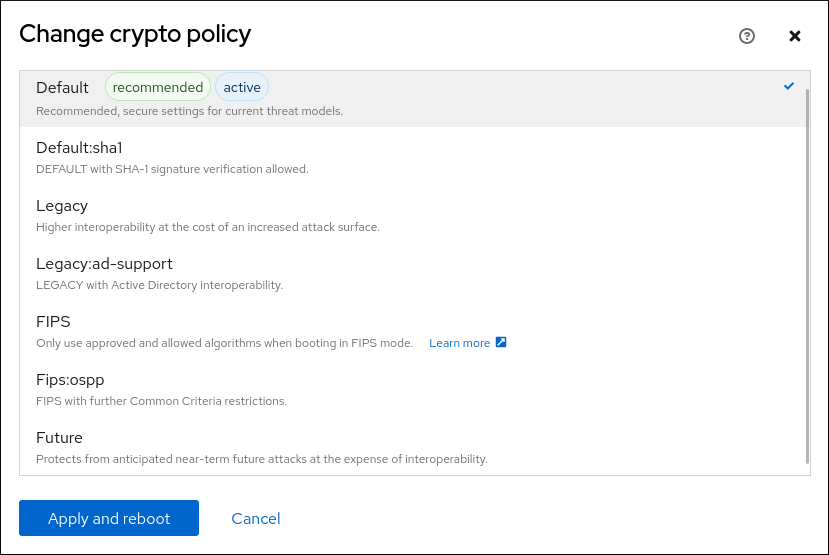

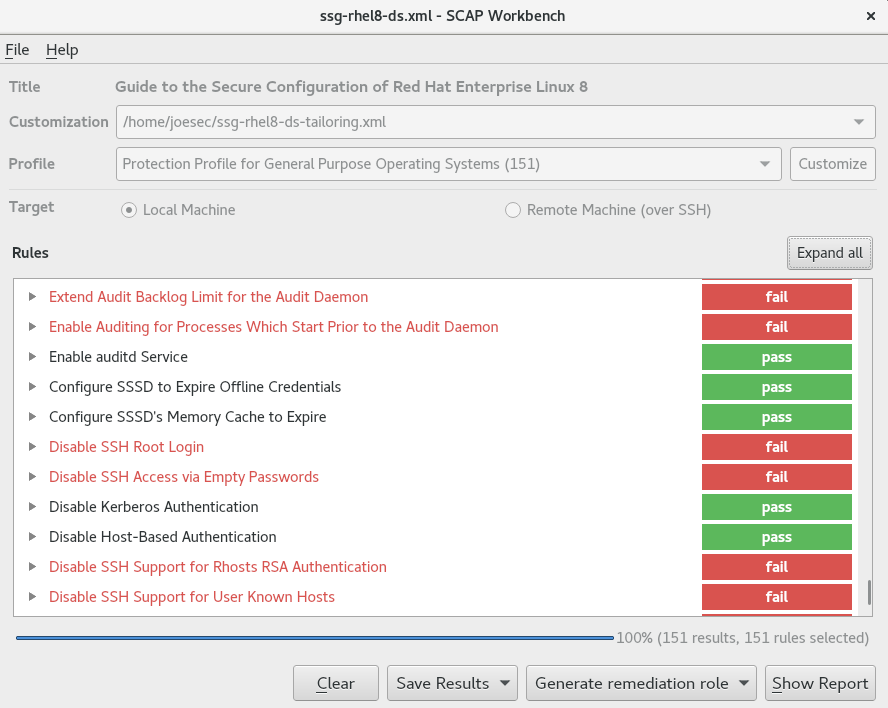

6.13. オプション: セキュリティープロファイルの選択

Red Hat Enterprise Linux 8 のインストール中にセキュリティーポリシーを適用し、初回起動前にシステムで使用するように設定できます。

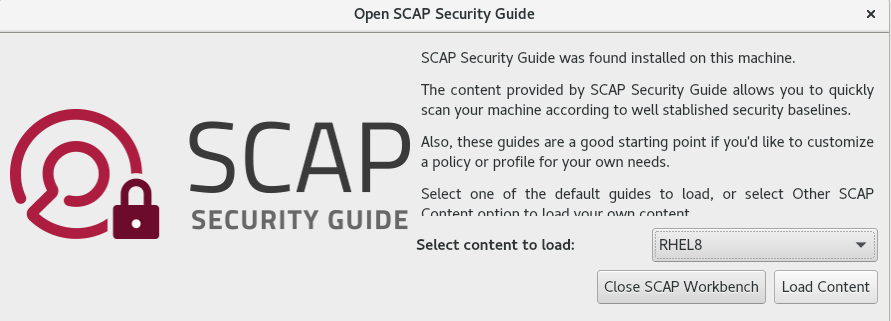

6.13.1. セキュリティーポリシーの概要

Red Hat Enterprise Linux には、特定のセキュリティーポリシーに合わせてシステムの自動設定を有効にする OpenSCAP スイートが同梱されています。このポリシーは、SCAP (Security Content Automation Protocol) 標準を使用して実装されます。パッケージは、AppStream リポジトリーで利用できます。ただし、デフォルトでは、インストールおよびインストール後のプロセスではポリシーが強制されないため、特に設定しない限りチェックは行われません。

インストールプログラムでは、セキュリティーポリシーを適用することは必須ではありません。システムにセキュリティーポリシーを適用する場合は、選択したプロファイルに定義した制限を使用してシステムがインストールされます。openscap-scanner パッケージおよび scap-security-guide パッケージがパッケージ選択に追加され、コンプライアンスおよび脆弱性スキャンのプリインストールツールが利用できるようになります。

セキュリティーポリシーを選択すると、Anaconda GUI インストーラーでは、ポリシーの要件に準拠する設定が必要になります。パッケージの選択が競合したり、別のパーティションが定義されている場合があります。要件がすべて満たされた場合に限り、インストールを開始できます。

インストールプロセスの終了時に、選択した OpenSCAP セキュリティーポリシーにより、システムが自動的に強化され、スキャンされてコンプライアンスが確認され、インストール済みシステムの /root/openscap_data ディレクトリーにスキャン結果が保存されます。

デフォルトでは、インストーラーは、インストールイメージにバンドルされている scap-security-guide パッケージの内容を使用します。外部コンテンツは、HTTP サーバー、HTTPS サーバー、または FTP サーバーから読み込むこともできます。

6.13.2. セキュリティープロファイルの設定

Installation Summary ウィンドウからセキュリティーポリシーを設定できます。

前提条件

- Installation Summary 画面が開いている。

手順

- Installation Summary ウィンドウで、Security Profile をクリックします。Security Profile ウィンドウが開きます。

- システムでセキュリティーポリシーを有効にするには、Apply security policy スイッチを ON に切り替えます。

- 上部ペインに表示されているプロファイルから 1 つ選択します。

をクリックします。

インストール前に適用が必要なプロファイルの変更が、下部ペインに表示されます。

カスタムプロファイルを使用するには、 をクリックします。

別の画面が開いて、有効なセキュリティーコンテンツの URL を入力できます。

をクリックして URL を取得します。

HTTP サーバー、HTTPS サーバー、または FTP サーバーから、カスタムプロファイルを読み込むこともできます。コンテンツのフルアドレス (http:// などのプロトコルを含む) を使用してください。カスタムプロファイルを読み込む前に、ネットワーク接続がアクティブになっている必要があります。インストールプログラムは、コンテンツの種類を自動的に検出します。

- をクリックして、Security Profile ウィンドウに戻ります。

- をクリックして設定を適用し、Installation Summary ウィンドウに戻ります。