This documentation is for a release that is no longer maintained

See documentation for the latest supported version.3.6. 可観測性の設定

OpenShift Dev Spaces 可観測性機能を設定するには、以下を参照してください。

3.6.1. Che-Theia ワークスペース

3.6.1.1. Telemetry の概要

Telemetry は、操作データの明示的かつ論理的なコレクションです。デフォルトで、Telemetry は Red Hat OpenShift Dev Spaces では利用できませんが、Che-Theia エディターにはプラグインメカニズムを使用し、chectl コマンドラインツールの使用データをセグメントを使用して収集できる抽象 API があります。このアプローチは、すべての Che-Theia ワークスペースでテレメトリーが有効になっている Eclipse Che hosted by Red Hat サービスで使用されます。

以下では、Red Hat OpenShift Dev Spaces に独自の Telemetry クライアントを作成する方法について説明し、次に Red Hat OpenShift Dev Spaces Woopra Telemetry プラグイン の概要を示します。

3.6.1.2. ユースケース

Red Hat OpenShift Dev Spaces Telemetry API では、以下の追跡が可能です。

- ワークスペース使用の期間

- ファイルの編集、コミット、およびリモートリポジトリーへのプッシュなどのユーザー駆動型アクション

- ワークスペースで使用されるプログラミング言語および devfile

3.6.1.3. 仕組み

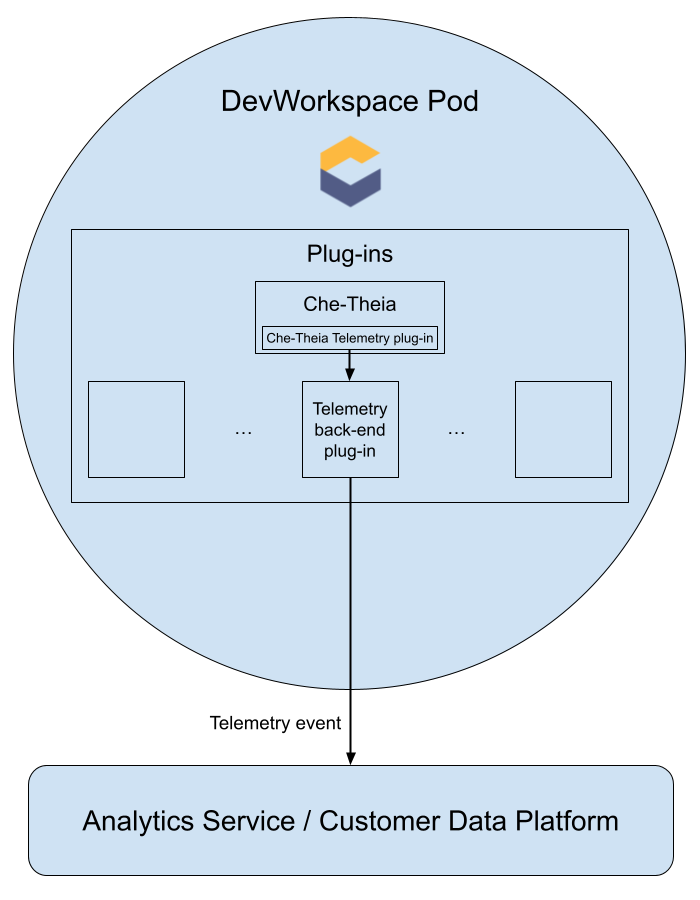

Dev Workspace が起動すると、che-theia コンテナーは、テレメトリーイベントをバックエンドに送信するロールを担うテレメトリープラグインを起動します。$DEVWORKSPACE_TELEMETRY_BACKEND_PORT 環境変数が DevWorkspacePod で設定されている場合、テレメトリープラグインはそのポートでリッスンしているバックエンドにイベントを送信します。バックエンドは、受信したイベントをイベントのバックエンド固有の表現に変換し、設定された分析バックエンド (Segment や Woopra など) に送信します。

3.6.1.4. Che-Theia Telemetry プラグインによってバックエンドに送信されるイベント

| イベント | 説明 |

|---|---|

| WORKSPACE_OPENED | Che-Theia の起動時に送信されます。 |

| COMMIT_LOCALLY |

|

| PUSH_TO_REMOTE |

|

| EDITOR_USED | エディターでファイルが変更されたときに送信されます |

WORKSPACE_INACTIVE や WORKSPACE_STOPPED などの他のイベントは、バックエンドプラグイン内で検出できます。

3.6.1.5. Woopra Telemetry プラグイン

Woopra Telemetry プラグイン は、Telemetry を Red Hat OpenShift Dev Spaces インストールから Segment および Woopra に送信するためにビルドされたプラグインです。このプラグインは 、Red Hat によってホストされる Eclipse Che によって使用されますが、Red Hat OpenShift Dev Spaces デプロイメントはこのプラグインを利用できます。有効な Woopra ドメインおよびセグメント書き込みキー以外の依存関係はありません。プラグインである plugin.yaml の devfile v2 には、プラグインに渡すことのできる 4 つの環境変数があります。

-

WOOPRA_DOMAIN- イベントの送信先となる Woopra ドメイン。 -

SEGMENT_WRITE_KEY- セグメントおよび Woopra にイベントを送信するための書き込みキー。 -

WOOPRA_DOMAIN_ENDPOINT- Woopra ドメインを直接渡さない場合、プラグインは Woopra ドメインを返す指定の HTTP エンドポイントからこれを取得します。 -

SEGMENT_WRITE_KEY_ENDPOINT- セグメント書き込みキーを直接渡さない場合、プラグインはセグメント書き込みキーを返す指定された HTTP エンドポイントからこれを取得します。

Red Hat OpenShift Dev Spaces インストールで Woopra プラグインを有効にするには、以下を実行します。

手順

plugin.yamldevfile v2 ファイルを、環境変数が正しく設定された HTTP サーバーにデプロイします。CheClusterカスタムリソースを設定します。「CLI を使用して CheCluster カスタムリソースの設定」を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6.1.6. Telemetry プラグインの作成

本セクションでは、AbstractAnalyticsManager を拡張し、以下のメソッドを実装する AnalyticsManager クラスを作成する方法を説明します。

-

isEnabled(): Telemetry バックエンドが正しく機能しているかどうかを判断します。これは、常にtrueを返すか、または接続プロパティーがない場合にfalseを返すなど、より複雑なチェックがあることを意味します。 -

destroy(): Telemetry バックエンドをシャットダウンする前に実行されるクリーンアップ方法。このメソッドは、WORKSPACE_STOPPEDイベントを送信します。 -

onActivity()- 特定のユーザーについて一部のアクティビティーが依然として実行されていることを通知します。これは主にWORKSPACE_INACTIVEイベントを送信するために使用されます。 -

onEvent()- Telemetry イベントをWORKSPACE_USEDまたはWORKSPACE_STARTEDなどの Telemetry サーバーに送信します。 -

increaseDuration()- 短時間に多くのイベントを送信するのではなく、現在のイベントの期間を長くします。

次のセクションでは、以下について説明します。

- Telemetry サーバーを作成してイベントを標準出力にエコーします。

- OpenShift Dev Spaces Telemetry クライアントを拡張して、ユーザーのカスタムバックエンドを実装します。

-

カスタムバックエンドの Dev Workspace プラグインを表す

plugin.yamlファイルを作成します。 -

CheClusterカスタムリソースからworkspacesDefaultPlugins属性を設定して、カスタムプラグインの場所を OpenShift Dev Spaces に指定します。

3.6.1.6.1. スタートガイド

以下では、OpenShift Dev Spaces Telemetry システムを拡張してカスタムバックエンドと通信するために必要な手順を説明します。

- イベントを受信するサーバープロセスの作成

- イベントをサーバーに送信するバックエンドを作成する OpenShift Dev Spaces ライブラリーの拡張

- コンテナーでの Telemetry バックエンドのパッケージ化およびイメージレジストリーへのデプロイ

- バックエンドのプラグインを追加し、OpenShift Dev Space に Dev Workspaces にプラグインを読み込むよう指示

Telemetry バックエンドの最終的な例については、here を参照してください。

イベントを受信するサーバーの作成

この例は、Telemetry プラグインからイベントを受信し、標準出力に書き込むサーバーを作成する方法を示しています。

実稼働環境のユースケースでは、独自の Telemetry サーバーを作成するのではなく、サードパーティーの Telemetry システム (Segment、Woopra など) との統合を検討してください。この場合、プロバイダーの API を使用してイベントをカスタムバックエンドからシステムに送信します。

以下の Go コードは、ポート 8080 でサーバーを起動し、イベントを標準出力に書き込みます。

例3.12 main.go

このコードに基づいてコンテナーイメージを作成し、これを OpenShift の openshift-devspaces プロジェクトでデプロイメントとして公開します。サンプル Telemetry サーバーのコードは Telemetry-server-example で利用できます。Telemetry サーバーをデプロイするには、リポジトリーのクローンを作成し、コンテナーをビルドします。

git clone https://github.com/che-incubator/telemetry-server-example cd telemetry-server-example podman build -t registry/organization/telemetry-server-example:latest . podman push registry/organization/telemetry-server-example:latest

$ git clone https://github.com/che-incubator/telemetry-server-example

$ cd telemetry-server-example

$ podman build -t registry/organization/telemetry-server-example:latest .

$ podman push registry/organization/telemetry-server-example:latest

manifest_with_ingress.yaml および manifest_with_route の両方には、Deployment およびサービスの定義が含まれます。また、前者は Kubernetes Ingress も定義しますが、後者は OpenShift Route を定義します。

マニフェストファイルで、プッシュした image に一致する image および host フィールドと、OpenShift クラスターのパブリックホスト名を置き換えます。次に、以下を実行します。

kubectl apply -f manifest_with_[ingress|route].yaml -n openshift-devspaces

$ kubectl apply -f manifest_with_[ingress|route].yaml -n openshift-devspaces3.6.1.6.2. バックエンドプロジェクトの作成

開発時に迅速なフィードバックを得るには、Dev Workspace 内で開発を行うことが推奨されます。これにより、クラスターでアプリケーションを実行し、フロントエンドの Telemetry プラグインからイベントを受信できます。

Maven Quarkus プロジェクトのスキャフォールディング:

mvn io.quarkus:quarkus-maven-plugin:2.7.1.Final:create \ -DprojectGroupId=mygroup -DprojectArtifactId=devworkspace-telemetry-example-plugin \ -DprojectVersion=1.0.0-SNAPSHOTmvn io.quarkus:quarkus-maven-plugin:2.7.1.Final:create \ -DprojectGroupId=mygroup -DprojectArtifactId=devworkspace-telemetry-example-plugin \ -DprojectVersion=1.0.0-SNAPSHOTCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

src/main/java/mygroupとsrc/test/java/mygroupの下にあるファイルを削除します。 -

backend-baseの最新バージョンおよび Maven コーディネートについては、GitHub パッケージ を参照してください。 以下の依存関係を

pom.xmlに追加します。例3.13

pom.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

read:packagesパーミッションでパーソナルアクセストークンを作成し、GitHub パッケージ からorg.eclipse.che.incubator.workspace-telemetry:backend-base依存関係をダウンロードします。 GitHub ユーザー名、個人アクセストークン、

che-incubatorリポジトリーの詳細を~/.m2/settings.xmlファイルに追加します。例3.14

settings.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6.1.6.3. AnalyticsManager の具体的な実装の作成および特殊なロジックの追加

src/main/java/mygroup の下に、プロジェクトに 2 つのファイルを作成します。

-

MainConfiguration.java-AnalyticsManagerに提供される設定が含まれます。 -

AnalyticsManager.java: Telemetry システム固有のロジックが含まれます。

例3.15 MainConfiguration.java

- 1

- MicroProfile 設定アノテーションは、

welcome.message設定を注入するために使用されます。

バックエンドに固有の設定プロパティーを設定する方法の詳細は、Quarkus 設定リファレンスガイド を参照してください。

例3.16 AnalyticsManager.java

org.my.group.AnalyticsManager と org.my.group.MainConfiguration は代替の Bean であるため、src/main/resources/application.properties の quarkus.arc.selected-alternatives プロパティーを使用して指定します。

例3.17 application.properties

quarkus.arc.selected-alternatives=MainConfiguration,AnalyticsManager

quarkus.arc.selected-alternatives=MainConfiguration,AnalyticsManager3.6.1.6.4. Dev Workspace 内でのアプリケーションの実行

Dev Workspace に

DEVWORKSPACE_TELEMETRY_BACKEND_PORT環境変数を設定します。ここで、値は4167に設定されます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat OpenShift Dev Spaces ダッシュボードから Dev Workspace を再起動します。

Dev Workspace のターミナルウィンドウ内で以下のコマンドを実行し、アプリケーションを起動します。

--settingsフラグを使用して、GitHub アクセストークンが含まれるsettings.xmlファイルの場所へのパスを指定します。mvn --settings=settings.xml quarkus:dev -Dquarkus.http.port=${DEVWORKSPACE_TELEMETRY_BACKEND_PORT}$ mvn --settings=settings.xml quarkus:dev -Dquarkus.http.port=${DEVWORKSPACE_TELEMETRY_BACKEND_PORT}Copy to Clipboard Copied! Toggle word wrap Toggle overflow アプリケーションは、フロントエンドプラグインからポート

4167を使用して Telemetry イベントを受け取るようになりました。

検証手順

以下の出力がログに記録されていることを確認します。

INFO [org.ecl.che.inc.AnalyticsManager] (Quarkus Main Thread) No welcome message provided INFO [io.quarkus] (Quarkus Main Thread) devworkspace-telemetry-example-plugin 1.0.0-SNAPSHOT on JVM (powered by Quarkus 2.7.2.Final) started in 0.323s. Listening on: http://localhost:4167 INFO [io.quarkus] (Quarkus Main Thread) Profile dev activated. Live Coding activated. INFO [io.quarkus] (Quarkus Main Thread) Installed features: [cdi, kubernetes-client, rest-client, rest-client-jackson, resteasy, resteasy-jsonb, smallrye-context-propagation, smallrye-openapi, swagger-ui, vertx]

INFO [org.ecl.che.inc.AnalyticsManager] (Quarkus Main Thread) No welcome message provided INFO [io.quarkus] (Quarkus Main Thread) devworkspace-telemetry-example-plugin 1.0.0-SNAPSHOT on JVM (powered by Quarkus 2.7.2.Final) started in 0.323s. Listening on: http://localhost:4167 INFO [io.quarkus] (Quarkus Main Thread) Profile dev activated. Live Coding activated. INFO [io.quarkus] (Quarkus Main Thread) Installed features: [cdi, kubernetes-client, rest-client, rest-client-jackson, resteasy, resteasy-jsonb, smallrye-context-propagation, smallrye-openapi, swagger-ui, vertx]Copy to Clipboard Copied! Toggle word wrap Toggle overflow AnalyticsManagerのonEvent()メソッドがフロントエンドプラグインからイベントを受信することを確認するには、l キーを押して Quarkus ライブコーディングを無効にし、IDE 内のファイルを編集します。以下の出力がログに記録されるはずです。INFO [io.qua.dep.dev.RuntimeUpdatesProcessor] (Aesh InputStream Reader) Live reload disabled INFO [org.ecl.che.inc.AnalyticsManager] (executor-thread-2) The received event is: Edit Workspace File in Che

INFO [io.qua.dep.dev.RuntimeUpdatesProcessor] (Aesh InputStream Reader) Live reload disabled INFO [org.ecl.che.inc.AnalyticsManager] (executor-thread-2) The received event is: Edit Workspace File in CheCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6.1.6.5. isEnabled() の実装

この例では、このメソッドは呼び出されるたびに true を返します。

例3.18 AnalyticsManager.java

@Override

public boolean isEnabled() {

return true;

}

@Override

public boolean isEnabled() {

return true;

}

より複雑なロジックを isEnabled() に設定することができます。たとえば、ホストされている OpenShift Dev Spaces Woopra バックエンド は、バックエンドが有効になっているかどうかを判断する前に、設定プロパティーが存在することを確認します。

3.6.1.6.6. onEvent() の実装

onEvent() は、バックエンドが受信したイベントを Telemetry システムに送信します。サンプルアプリケーションでは、HTTP POST ペイロードを Telemetry サーバーから /event エンドポイントに送信します。

サンプル Telemetry サーバーへの POST 要求の送信

以下の例では、Telemetry サーバーアプリケーションは http://little-telemetry-server-che.apps-crc.testing の URL で OpenShift にデプロイされます。ここで、apps-crc.testing は OpenShift クラスターの Ingress ドメイン名です。

TelemetryService.javaを作成して RESTEasy REST Client を設定します。例3.19

TelemetryService.javaCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

POSTリクエストを行うエンドポイント。

src/main/resources/application.propertiesファイルでTelemetryServiceのベース URL を指定します。例3.20

application.propertiesorg.my.group.TelemetryService/mp-rest/url=http://little-telemetry-server-che.apps-crc.testing

org.my.group.TelemetryService/mp-rest/url=http://little-telemetry-server-che.apps-crc.testingCopy to Clipboard Copied! Toggle word wrap Toggle overflow TelemetryServiceをAnalyticsManagerに挿入し、onEvent()でPOSTリクエストを送信します例3.21

AnalyticsManager.javaCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、HTTP 要求が Telemetry サーバーに送信され、短期間同じイベントが自動的に遅延します。デフォルトの期間は 1500 ミリ秒です。

3.6.1.6.7. increaseDuration() の実装

多くの Telemetry システムはイベント期間を認識します。AbstractAnalyticsManager は、同じ期間内で発生する同様のイベントを 1 つのイベントにマージします。increaseDuration() のこの実装は no-op です。この方法では、ユーザーの Telemetry プロバイダーの API を使用してイベントまたはイベントプロパティーを変更し、イベントの延長期間を反映します。

例3.22 AnalyticsManager.java

@Override

public void increaseDuration(AnalyticsEvent event, Map<String, Object> properties) {}

@Override

public void increaseDuration(AnalyticsEvent event, Map<String, Object> properties) {}3.6.1.6.8. onActivity() の実装

非アクティブなタイムアウトの制限を設定し、最後のイベント時間がタイムアウトよりも長くなる場合は、onActivity() を使用して WORKSPACE_INACTIVE イベントを送信します。

例3.23 AnalyticsManager.java

3.6.1.6.9. destroy() の実装

destroy() が呼び出される際に、WORKSPACE_STOPPED イベントを送信し、接続プールなどのリソースをシャットダウンします。

例3.24 AnalyticsManager.java

@Override

public void destroy() {

onEvent(WORKSPACE_STOPPED, lastOwnerId, lastIp, lastUserAgent, lastResolution, commonProperties);

}

@Override

public void destroy() {

onEvent(WORKSPACE_STOPPED, lastOwnerId, lastIp, lastUserAgent, lastResolution, commonProperties);

}

「Dev Workspace 内でのアプリケーションの実行」 で説明されているように mvn quarkus:dev を実行し、Ctrl+C でアプリケーションを終了すると、WORKSPACE_STOPPED イベントがサーバーに送信されます。

3.6.1.6.10. Quarkus アプリケーションのパッケージ化

アプリケーションをコンテナーにパッケージ化する最適な方法については、Quarkus ドキュメント を参照してください。コンテナーをビルドし、選択したコンテナーレジストリーにプッシュします。

JVM で実行する Quarkus イメージをビルドするための Dockerfile の例

例3.25 Dockerfile.jvm

イメージをビルドするには、以下を実行します。

mvn package && \ podman build -f src/main/docker/Dockerfile.jvm -t image:tag .

mvn package && \

podman build -f src/main/docker/Dockerfile.jvm -t image:tag .Quarkus ネイティブイメージをビルドするための Dockerfile の例

例3.26 Dockerfile.native

イメージをビルドするには、以下を実行します。

mvn package -Pnative -Dquarkus.native.container-build=true && \ podman build -f src/main/docker/Dockerfile.native -t image:tag .

mvn package -Pnative -Dquarkus.native.container-build=true && \

podman build -f src/main/docker/Dockerfile.native -t image:tag .3.6.1.6.11. プラグインの plugin.yaml の作成

DevWorkspacePod でカスタムバックエンドを実行する DevWorkspace プラグインを表す plugin.yamldevfilev2 ファイルを作成します。devfile v2 の詳細については、Devfile v2 documentation を参照してください。

例3.27 plugin.yaml

- 1

- 「Quarkus アプリケーションのパッケージ化」 からビルドされたコンテナーイメージを指定します。

- 2

- Example 4 から

welcome.messageオプションの設定プロパティーの値を設定します。

通常、ユーザーはこのファイルを企業 Web サーバーにデプロイします。本書では、OpenShift で Apache Web サーバーを作成し、そこでプラグインをホストする方法を説明します。

新規 plugin.yaml ファイルを参照する ConfigMap オブジェクトを作成します。

oc create configmap --from-file=plugin.yaml -n openshift-devspaces telemetry-plugin-yaml

$ oc create configmap --from-file=plugin.yaml -n openshift-devspaces telemetry-plugin-yaml

Web サーバーを公開するためにデプロイメント、サービス、およびルートを作成します。デプロイメントはこの ConfigMap オブジェクトを参照し、これを /var/www/html ディレクトリーに配置します。

例3.28 manifest.yaml

oc apply -f manifest.yaml

$ oc apply -f manifest.yaml検証手順

デプロイメントが開始されたら、Web サーバーで

plugin.yamlが利用できることを確認します。curl apache-che.apps-crc.testing/plugin.yaml

$ curl apache-che.apps-crc.testing/plugin.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6.1.6.12. Dev Workspace での Telemetry プラグインの指定

以下を既存の Dev Workspace の

componentsフィールドに追加します。components: ... - name: telemetry-plug-in plugin: uri: http://apache-che.apps-crc.testing/plugin.yamlcomponents: ... - name: telemetry-plug-in plugin: uri: http://apache-che.apps-crc.testing/plugin.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow - OpenShift Dev Spaces ダッシュボードから Dev Workspace を起動します。

検証手順

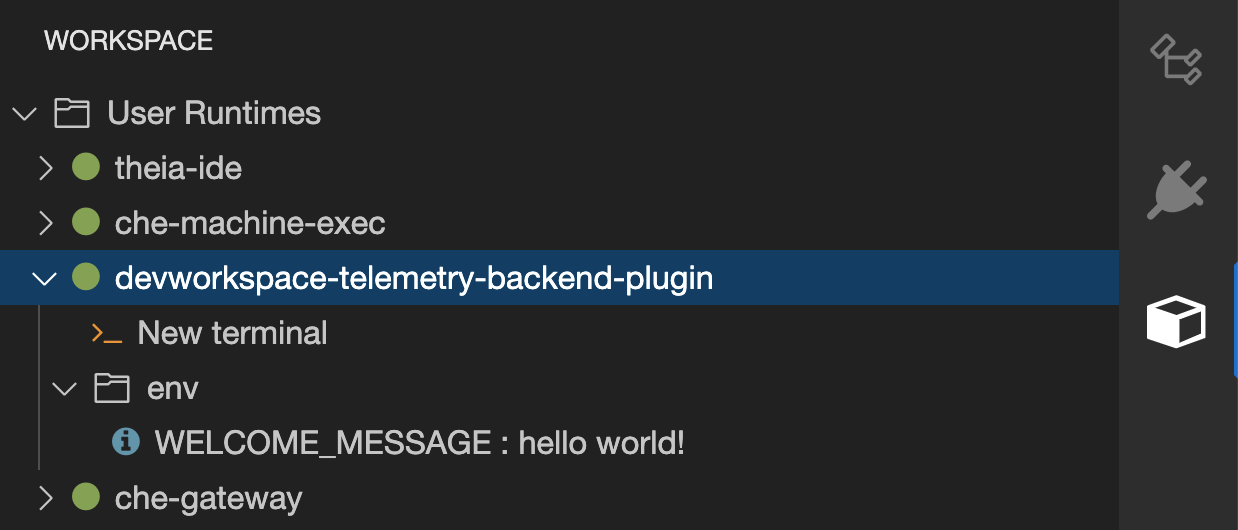

Telemetry-plug-inコンテナーが Dev Workspace Pod で稼働していることを確認します。ここでは、これはエディターで Workspace ビューをチェックして検証されます。

- エディター内のファイルを編集し、Telemetry サーバーのログのサンプルでイベントを確認します。

3.6.1.6.13. すべての Dev Workspaces の Telemetry プラグインの適用

テレメトリープラグインをデフォルトのプラグインとして設定します。デフォルトのプラグインは、新規および既存の Dev Workspaces の Dev Workspace の起動に適用されます。

CheClusterカスタムリソースを設定します。「CLI を使用して CheCluster カスタムリソースの設定」を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証手順

- Red Hat OpenShift Dev Spaces ダッシュボードから新規または既存の Dev Workspace を起動します。

- 「Dev Workspace での Telemetry プラグインの指定」 の検証手順に従って、Telemetry プラグインが機能していることを確認します。

3.6.2. サーバーロギングの設定

OpenShift Dev Spaces サーバーで利用可能な個別のロガーのログレベルを微調整できます。

OpenShift Dev Spaces サーバー全体のログレベルは、Operator の cheLogLevel 設定プロパティーを使用してグローバルに設定されます。「CheCluster カスタムリソースフィールドの参照」を参照してください。Operator によって管理されないインストールでグローバルログレベルを設定するには、che ConfigMap で CHE_LOG_LEVEL 環境変数を指定します。

CHE_LOGGER_CONFIG 環境変数を使用して、OpenShift Dev Spaces サーバーの個々のロガーのログレベルを設定することができます。

3.6.2.1. ログレベルの設定

手順

CheClusterカスタムリソースを設定します。「CLI を使用して CheCluster カスタムリソースの設定」を参照してください。spec: components: cheServer: extraProperties: CHE_LOGGER_CONFIG: "<key1=value1,key2=value2>"spec: components: cheServer: extraProperties: CHE_LOGGER_CONFIG: "<key1=value1,key2=value2>"1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- キーと値のペアのコンマ区切りリスト。キーは OpenShift Dev Spaces サーバーログ出力に表示されるロガーの名前で、値は必要なログレベルになります。

例3.29

WorkspaceManagerのデバッグモードの設定spec: components: cheServer: extraProperties: CHE_LOGGER_CONFIG: "org.eclipse.che.api.workspace.server.WorkspaceManager=DEBUG"spec: components: cheServer: extraProperties: CHE_LOGGER_CONFIG: "org.eclipse.che.api.workspace.server.WorkspaceManager=DEBUG"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6.2.2. ロガーの命名

ロガーの名前は、それらのロガーを使用する内部サーバークラスのクラス名に従います。

3.6.2.3. HTTP トラフィックのロギング

手順

OpenShift Dev Spaces サーバーと Kubernetes または OpenShift クラスターの API サーバー間の HTTP トラフィックをログに記録するには、

CheClusterカスタムリソースを設定します。「CLI を使用して CheCluster カスタムリソースの設定」を参照してください。spec: components: cheServer: extraProperties: CHE_LOGGER_CONFIG: "che.infra.request-logging=TRACE"spec: components: cheServer: extraProperties: CHE_LOGGER_CONFIG: "che.infra.request-logging=TRACE"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6.3. dsc を使用したログの収集

Red Hat OpenShift Dev Spaces のインストールは、OpenShift クラスターで実行されている複数のコンテナーで設定されます。実行中の各コンテナーからログを手動で収集できますが、dsc はプロセスを自動化するコマンドを提供します。

以下のコマンドを使用すると、dsc ツールを使用して OpenShift クラスターから Red Hat OpenShift Dev Spaces ログを収集します。

dsc server:logs既存の Red Hat OpenShift Dev Spaces サーバーログを収集し、ローカルマシンのディレクトリーに保存します。デフォルトでは、ログはマシンの一時ディレクトリーにダウンロードされます。ただし、

-dパラメーターを指定すると上書きできます。たとえば、OpenShift Dev Spaces ログを/home/user/che-logs/ディレクトリーにダウンロードするには、次のコマンドを使用します。dsc server:logs -d /home/user/che-logs/

dsc server:logs -d /home/user/che-logs/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 実行すると、

dsc server:logsはログファイルを保存するディレクトリーを指定するコンソールにメッセージを出力します。Red Hat OpenShift Dev Spaces logs will be available in '/tmp/chectl-logs/1648575098344'

Red Hat OpenShift Dev Spaces logs will be available in '/tmp/chectl-logs/1648575098344'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat OpenShift Dev Spaces がデフォルト以外のプロジェクトにインストールされている場合、

dsc server:logsには-n <NAMESPACE>パラメーターが必要です。ここで、<NAMESPACE>は Red Hat OpenShift Dev Spaces がインストールされた OpenShift プロジェクトです。たとえば、my-namespaceプロジェクトの OpenShift Dev Spaces からログを取得するには、以下のコマンドを使用します。dsc server:logs -n my-namespace

dsc server:logs -n my-namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow dsc server:deploy-

ログは、

dscを使用してインストール時に OpenShift Dev Spaces のインストール時に自動的に収集されます。dsc server:logsと同様に、ディレクトリーのログは-dパラメーターを使用して指定できます。

関連情報

3.6.4. Prometheus および Grafana のモニタリング

クラスター上で実行中の Prometheus および Grafana のインスタンスを使用して、OpenShift Dev Spaces メトリクスを収集および表示できます。

3.6.4.1. Prometheus と Grafana のインストール

template.yaml を適用して Prometheus および Grafana をインストールできます。この例の template.yaml ファイルは、Prometheus および Grafana を使い始めるための基本的な設定、Deployments および Services のモニタリングスタックを提供します。

または、Prometheus Operator と Grafana Operator を使用することもできます。

前提条件

- oc

手順

template.yaml を使用して Prometheus と Grafana をインストールするには、以下を実行します。

Prometheus および Grafana の新規プロジェクト

monitoringを作成します。oc new-project monitoring

$ oc new-project monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow monitoringプロジェクトでtemplate.yamlを適用します。oc apply -f template.yaml -n monitoring

$ oc apply -f template.yaml -n monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow

例3.30 template.yaml

3.6.4.2. Dev Workspace Operator のモニターリング

Dev Workspace Operator が公開するメトリクスを処理するために、モニターリングスタックの例を設定できます。

3.6.4.2.1. Prometheus による Dev Workspace Operator メトリクスの収集

Prometheus を使用して、Dev Workspace Operator に関するメトリクスを収集、保存、および照会するには、以下を実行します。

前提条件

-

devworkspace-controller-metricsサービスは、ポート8443でメトリクスを公開している。これはデフォルトで事前設定されています。 -

devworkspace-webhookserverサービスは、ポート9443でメトリクスを公開している。これはデフォルトで事前設定されています。 -

Prometheus 2.26.0 以降が動作している。Prometheus コンソールは、ポート

9090で実行されており、対応するサービスがあります。Prometheus を初めて実行するための手順 について参照してください。

手順

ClusterRoleBinding を作成して、Prometheus に関連付けられた ServiceAccount を devworkspace-controller-metrics-reader ClusterRole にバインドします。監視スタックの例 では、使用される ServiceAccount の名前は

prometheusです。注記Dev Workspace メトリクスへのアクセスはロールベースアクセスコントロール (RBAC) で保護されているため、ClusterRoleBinding がないとアクセスできません。

例3.31 clusterRoleBinding

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Prometheus は、

devworkspace-controller-metricsサービスが公開するポート8443と、devworkspace-webhookserverサービスが公開するポート9443からメトリクスを収集するように設定します。注記モニターリングスタックのサンプル では、空の設定で

prometheus-configConfigMap がすでに作成されています。Prometheus 設定の詳細を指定するには、ConfigMap のdataフィールドを編集します。例3.32 Prometheus の設定

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ターゲットが収集されるレート。

- 2

- 記録およびアラートルールを再チェックするレート。

- 3

- Prometheus が監視するリソースデフォルトの設定では、2 つのジョブ (

DevWorkspaceおよびDevWorkspace webhooks) が、devworkspace-controller-metricsサービスおよびdevworkspace-webhookserverサービスによって公開された時系列データを収集します。 - 4

- ポート

8443からのメトリクスのスクレイプターゲット。<DWO_project>を、devworkspace-controller-metricsServiceが置かれているプロジェクトに置き換えます。 - 5

- ポート

9443からのメトリクスのスクレイプターゲット。<DWO_project>を、devworkspace-webhookserverServiceが置かれているプロジェクトに置き換えます。

PrometheusDeployment をスケールダウンおよびスケールアップし、直前の手順で更新された ConfigMap を読み取ります。oc scale --replicas=0 deployment/prometheus -n monitoring && oc scale --replicas=1 deployment/prometheus -n monitoring

$ oc scale --replicas=0 deployment/prometheus -n monitoring && oc scale --replicas=1 deployment/prometheus -n monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ポート転送を使用して、ローカルで

Prometheusサービスにアクセスします。oc port-forward svc/prometheus 9090:9090 -n monitoring

$ oc port-forward svc/prometheus 9090:9090 -n monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

localhost:9090/targetsでターゲットエンドポイントを表示して、すべてのターゲットが稼働していることを確認します。 Prometheus コンソールを使用して、メトリクスを表示および照会します。

-

localhost:9090/metricsでメトリクスを表示します。 localhost:9090/graphからメトリクスをクエリーします。詳細は、Using the expression browser を参照してください。

-

3.6.4.2.2. Dev Workspace 固有のメトリクス

次の表は、devworkspace-controller-metrics サービスによって公開される Dev Workspace 固有のメトリックについて説明しています。

| 名前 | 型 | 説明 | ラベル |

|---|---|---|---|

|

| カウンター | Dev Workspace の開始イベントの数。 |

|

|

| カウンター |

|

|

|

| カウンター | 失敗した Dev Workspaces の数。 |

|

|

| ヒストグラム | Dev Workspace の起動にかかった総時間 (秒)。 |

|

| 名前 | 説明 | 値 |

|---|---|---|

|

|

Dev Workspace の |

|

|

|

Dev Workspace の |

|

|

| ワークスペースの起動失敗の理由です。 |

|

| 名前 | 説明 |

|---|---|

|

| Dev Workspace の作成に使用された devfile が無効であるため、起動に失敗しました。 |

|

|

|

|

| 不明な失敗理由。 |

3.6.4.2.3. Grafana ダッシュボードでの Dev Workspace Operator メトリクスの表示

ダッシュボードの例を使用して Grafana の Dev Workspace Operator メトリクスを表示するには、以下を実行します。

前提条件

- Prometheus はメトリクスを収集している。「Prometheus による Dev Workspace Operator メトリクスの収集」を参照してください。

- Grafana バージョン 7.5.3 以降。

-

Grafana はポート

3000で実行されており、対応するサービスがあります。Installing Grafana を参照してください。

手順

- Prometheus インスタンスのデータソースを追加します。Creating a Prometheus data source を参照してください。

-

example

grafana-dashboard.jsonダッシュボードをインポートします。

検証手順

- Grafana コンソールを使用して、Dev Workspace Operator メトリクスダッシュボードを表示します。「Dev Workspace Operator の Grafana ダッシュボード」を参照してください。

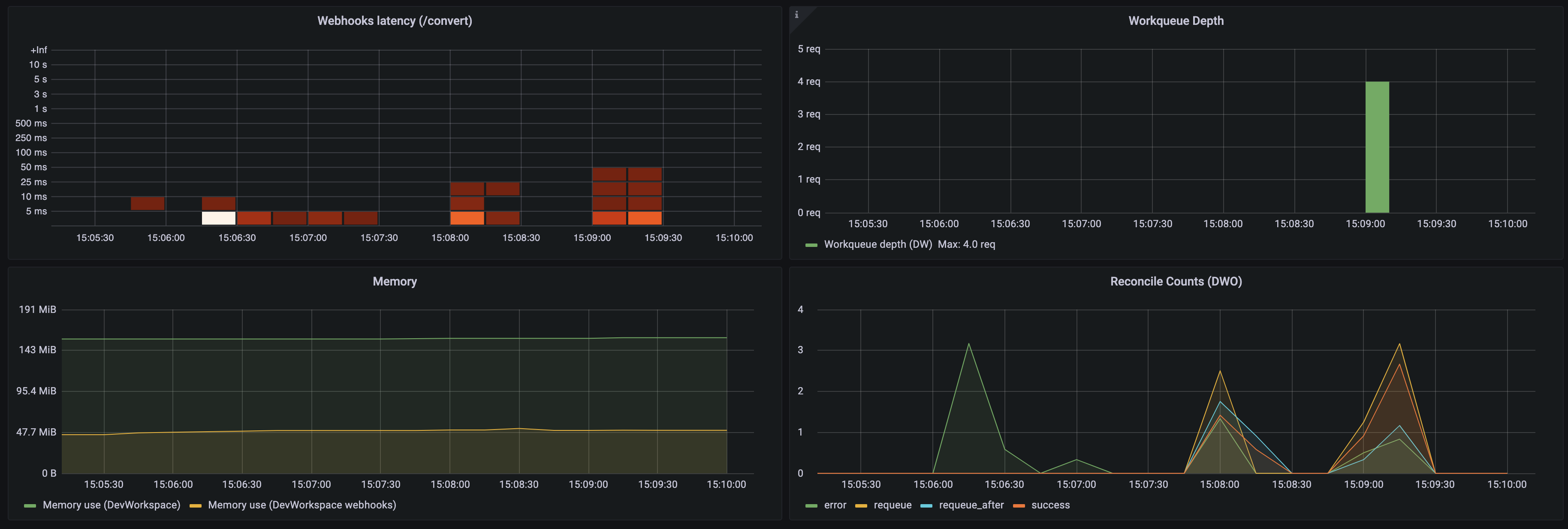

3.6.4.2.4. Dev Workspace Operator の Grafana ダッシュボード

grafana-dashboard.json に基づく サンプルの Grafana ダッシュボードには、Dev Workspace Operator から次のメトリクスが表示されます。

Dev Workspace-specific metrics パネル

図3.1 Dev Workspace-specific metrics パネル

- ワークスペースの平均起動時間

- ワークスペースの平均起動時間。

- ワークスペースの起動

- ワークスペースの起動の成功と失敗の回数。

- ワークスペースの起動時間

- ワークスペースの起動時間を表示するヒートマップ。

- Dev Workspace の成功/失敗

- DevWorkspace の起動の成功と失敗の比較。

- Dev Workspace の失敗率

- ワークスペースの起動失敗回数と総起動回数の比率。

- Dev Workspace 起動失敗の理由

ワークスペース起動失敗の分布を表示する円グラフ:

-

BadRequest -

InfrastructureFailure -

Unknown

-

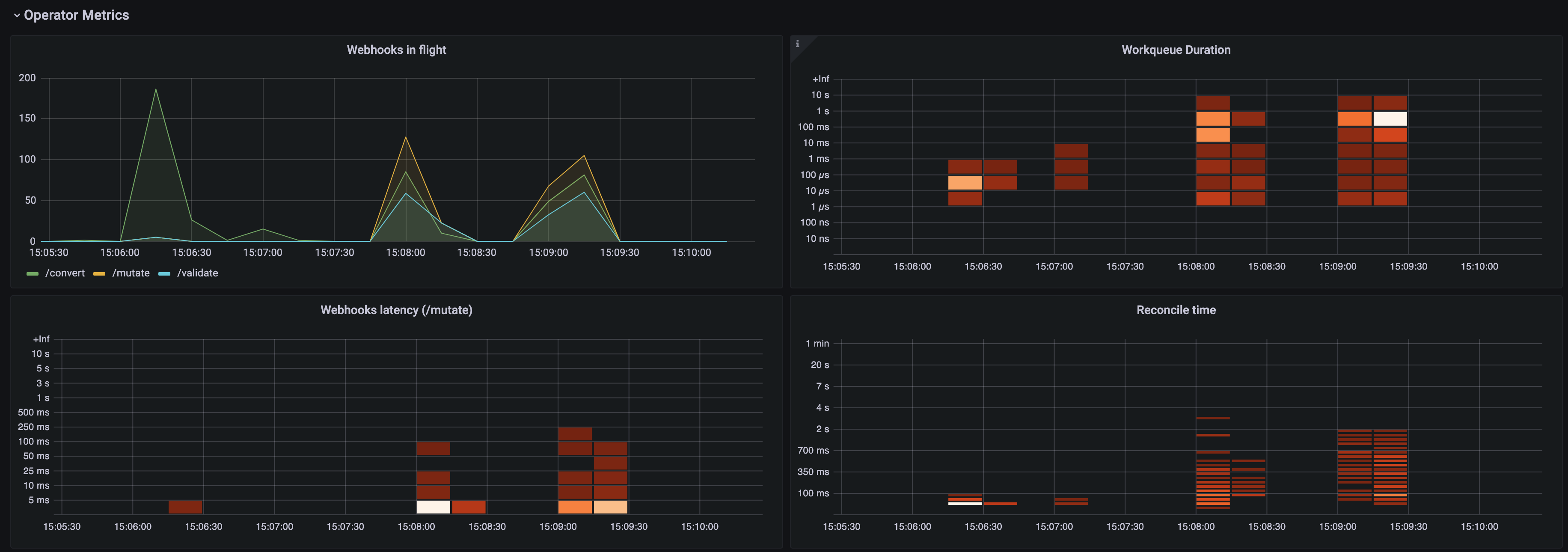

Operator metrics パネル (パート 1)

図3.2 Operator metrics パネル (パート 1)

- 進行中の Webhook

- さまざまな Webhook リクエストの数の比較。

- 作業キューの期間

- 調整リクエストが処理される前にワークキューにとどまる時間を表示するヒートマップ。

- Webhook のレイテンシー (/mutate)

-

/mutateWebhook レイテンシーを表示するヒートマップ。 - 調整時間

- 調整期間を表示するヒートマップ。

Operator metrics パネル (パート 2)

図3.3 Operator metrics パネル (パート 2)

- Webhook のレイテンシー (/convert)

-

/convertWebhook レイテンシーを表示するヒートマップ。 - 作業キューの深さ

- 作業キューにある調整リクエストの数。

- メモリー

- Dev Workspace コントローラーと Dev Workspace Webhook サーバーのメモリー使用状況。

- 調整数 (DWO)

- Dev Workspace コントローラーの 1 秒あたりの平均調整回数。

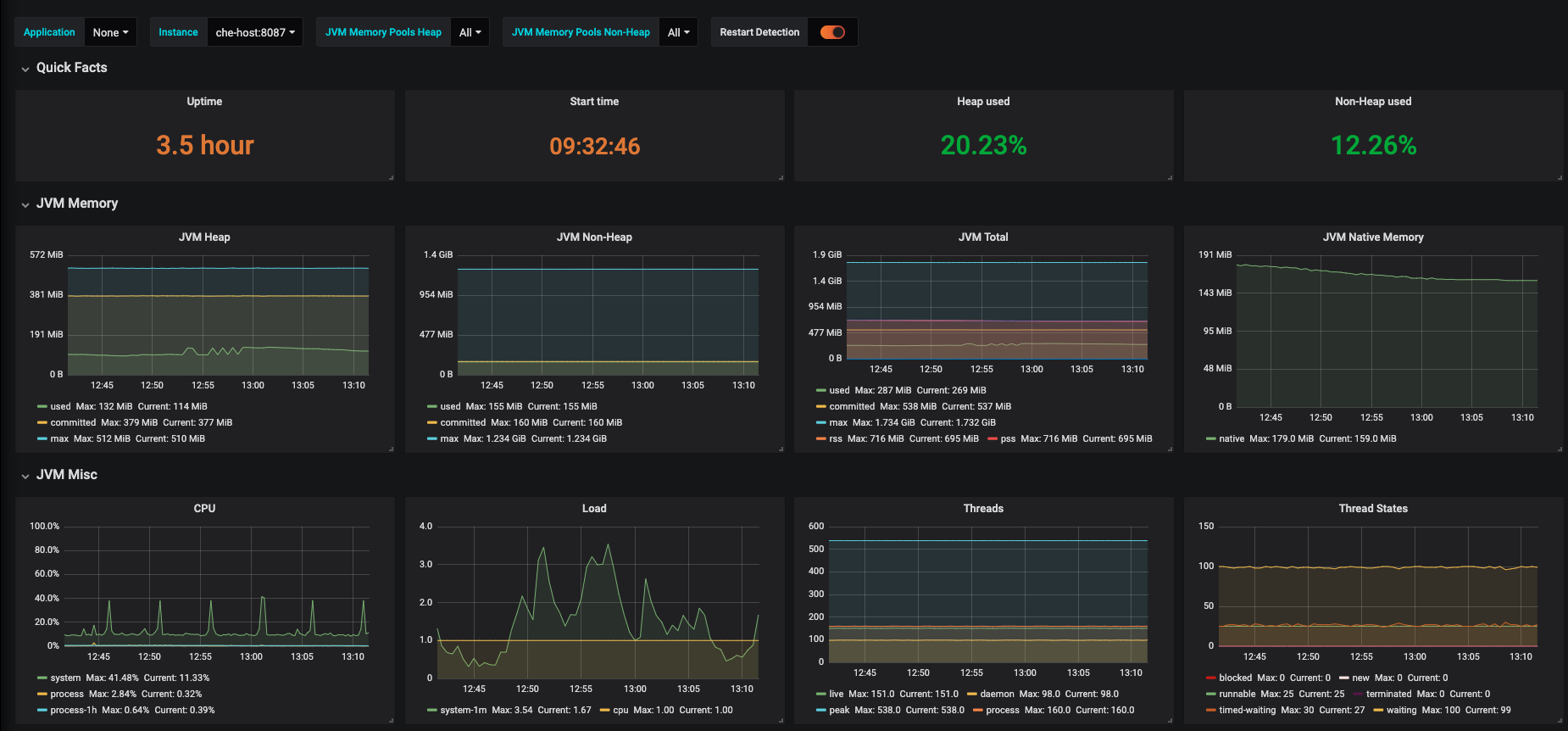

3.6.4.3. Dev Spaces サーバーの監視

OpenShift Dev Spaces サーバーの JVM メモリーやクラ出力ディングなどの JVM メトリクスを公開するように OpenShift Dev Spaces を設定できます。

3.6.4.3.1. OpenShift Dev Spaces サーバーメトリクスの有効化と公開

OpenShift Dev Spaces は、che-host サービスのポート 8087 で JVM メトリクスを公開します。この動作を設定できます。

手順

CheClusterカスタムリソースを設定します。「CLI を使用して CheCluster カスタムリソースの設定」を参照してください。spec: components: metrics: enable: <boolean>spec: components: metrics: enable: <boolean>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 有効にするには

true、無効にするにはfalse。

3.6.4.3.2. Prometheus を使用した OpenShift Dev Spaces メトリクスの収集

Prometheus を使用して、OpenShift Dev Spaces サーバーの JVM メトリクスを収集、保存、および照会するには、以下を実行します。

前提条件

-

OpenShift Dev Spaces は、ポート

8087にメトリクスを公開しています。OpenShift Dev Spaces サーバーの JVM メトリクスの有効化および公開 を参照してください。 -

Prometheus 2.26.0 以降が動作している。Prometheus コンソールは、ポート

9090で実行されており、対応するサービスがあります。Prometheus を初めて実行するための手順 について参照してください。

手順

ポート

8087からメトリクスを収集するように Prometheus を設定します。注記モニターリングスタックのサンプル では、空の設定で

prometheus-configConfigMap がすでに作成されています。Prometheus 設定の詳細を指定するには、ConfigMap のdataフィールドを編集します。例3.33 Prometheus の設定

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ターゲットが収集されるレート。

- 2

- 記録およびアラートルールを再チェックするレート。

- 3

- Prometheus が監視するリソースデフォルト設定では、OpenShift Dev Spaces Server という単一のジョブが、

OpenShift Dev Spaces Serverによって公開された時系列データをスクレイピングします。 - 4

- ポート

8087からのメトリクスのスクレイプターゲット。<OpenShift Dev Spaces_project>を OpenShift Dev Spaces プロジェクトに置き換えます。デフォルトの OpenShift Dev Spaces プロジェクトはopenshift-devspacesです。

PrometheusDeployment をスケールダウンおよびスケールアップし、直前の手順で更新された ConfigMap を読み取ります。oc scale --replicas=0 deployment/prometheus -n monitoring && oc scale --replicas=1 deployment/prometheus -n monitoring

$ oc scale --replicas=0 deployment/prometheus -n monitoring && oc scale --replicas=1 deployment/prometheus -n monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ポート転送を使用して、ローカルで

Prometheusサービスにアクセスします。oc port-forward svc/prometheus 9090:9090 -n monitoring

$ oc port-forward svc/prometheus 9090:9090 -n monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

localhost:9090/targetsでtargetsエンドポイントを表示して、すべてのターゲットが稼働していることを確認します。 Prometheus コンソールを使用して、メトリクスを表示および照会します。

-

localhost:9090/metricsでメトリクスを表示します。 localhost:9090/graphからメトリクスをクエリーします。詳細は、Using the expression browser を参照してください。

-

3.6.4.3.3. Grafana ダッシュボードでの OpenShift Dev Spaces サーバーメトリクスの表示

Grafana で OpenShift Dev Spaces サーバーメトリクスを表示するには、以下を実行します。

前提条件

- Prometheus は、OpenShift Dev Spaces クラスターでメトリクスを収集している。「Prometheus および Grafana のモニタリング」を参照してください。

-

Grafana 6.0 以降がポート

3000で実行されており、対応するサービスがあります。Installing Grafana を参照してください。

手順

- Prometheus インスタンスのデータソースを追加します。Creating a Prometheus data source を参照してください。

- サンプル ダッシュボード をインポートします。Import dashboard を参照してください。

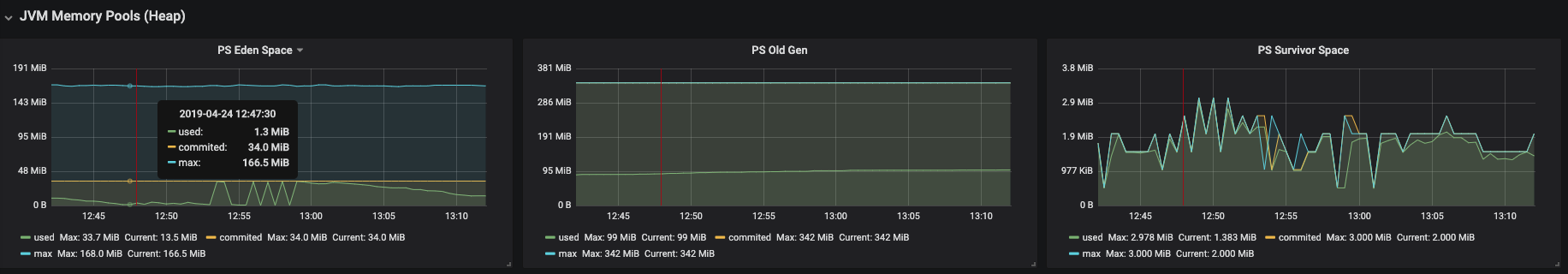

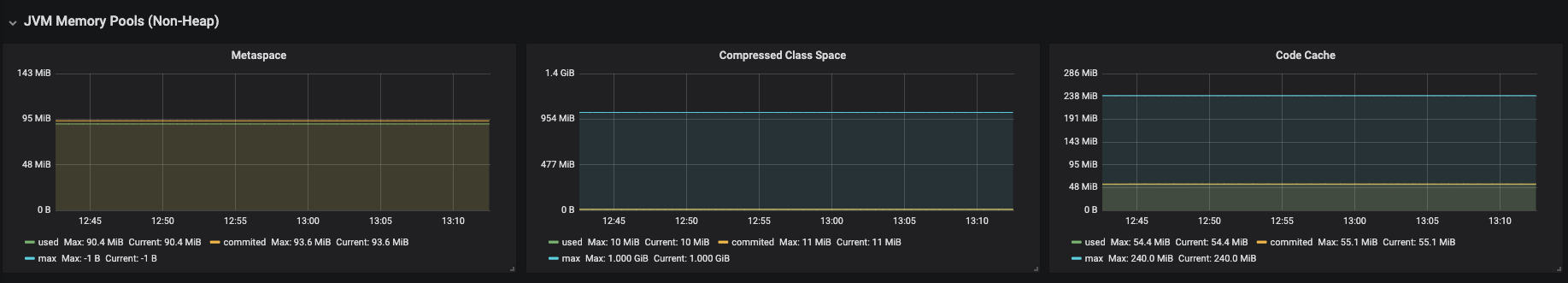

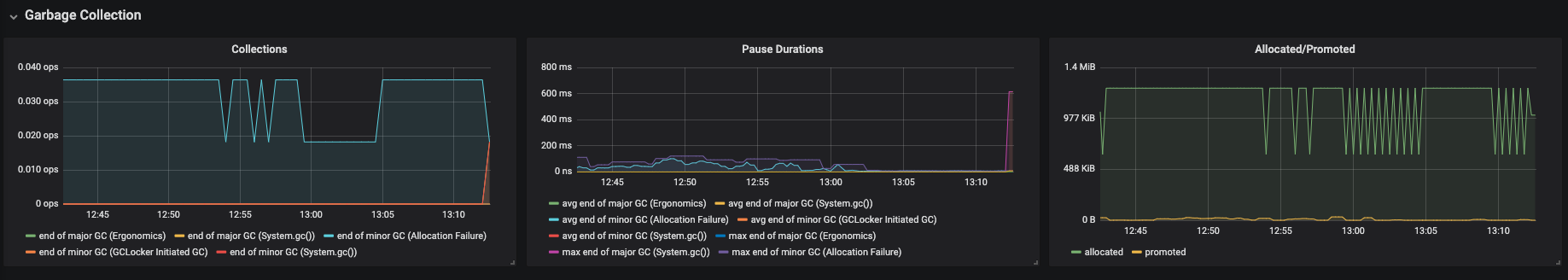

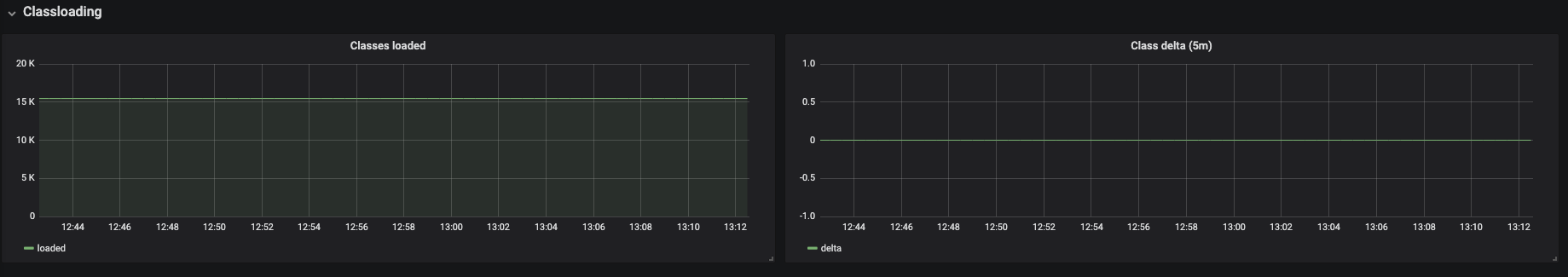

Grafana コンソールで OpenShift Dev Spaces メトリクスを表示します。

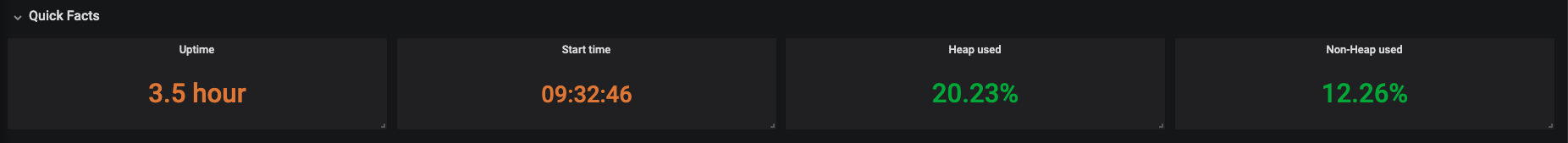

図3.4 OpenShift Dev Spaces サーバーの JVM ダッシュボード

図3.5 クイックファクト

図3.6 JVM メモリー

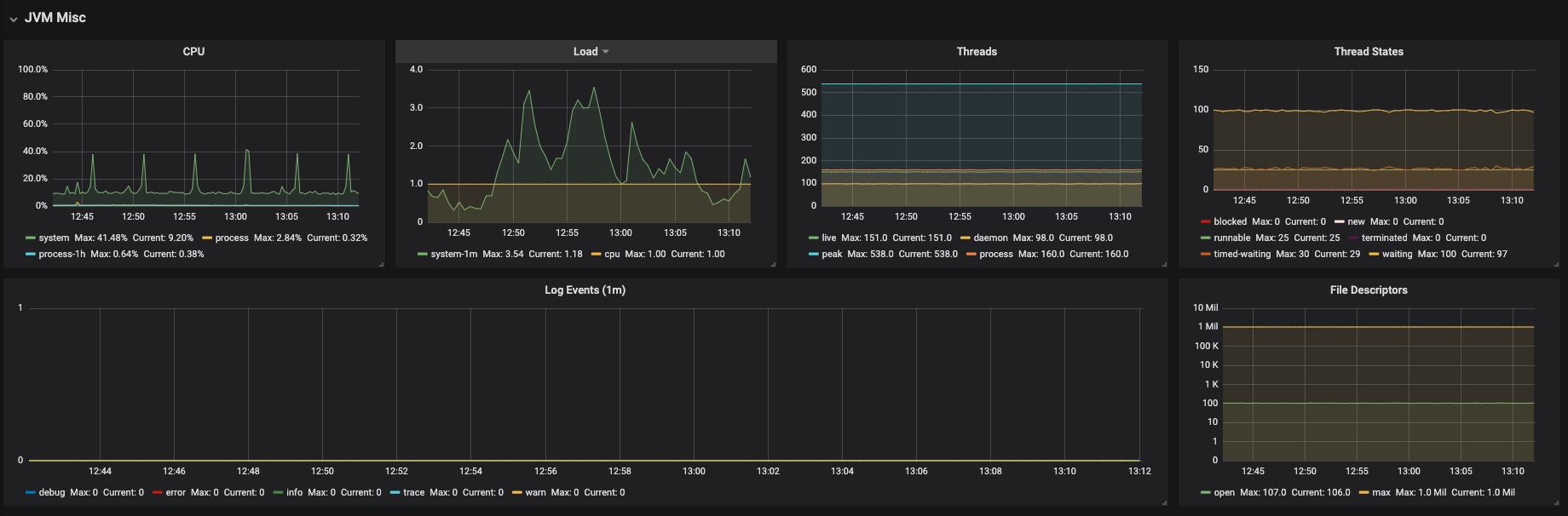

図3.7 JVM Misc

図3.8 JVM メモリープール (ヒープ)

図3.9 JVM メモリープール (非ヒープ)

図3.10 ガベージコレクション

図3.11 クラ出力ディング

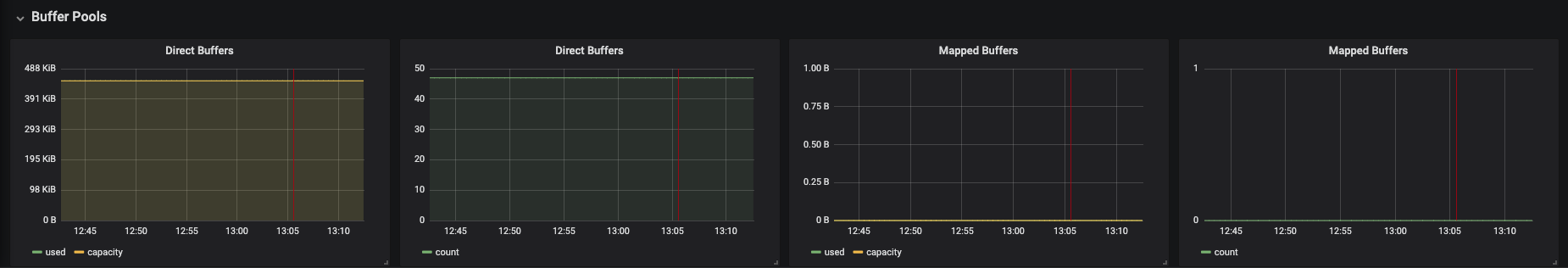

図3.12 バッファープール