확장 및 성능

프로덕션 환경에서 OpenShift Container Platform 클러스터 스케일링 및 성능 튜닝

초록

1장. OpenShift Container Platform 확장성 및 성능 개요

OpenShift Container Platform은 클러스터의 성능 및 규모를 최적화하는 데 도움이 되는 모범 사례와 툴을 제공합니다. 다음 문서에서는 권장 성능 및 확장성 사례, 참조 설계 사양, 최적화 및 짧은 대기 시간 튜닝에 대한 정보를 제공합니다.

Red Hat 지원에 문의하려면 지원 받기를 참조하십시오.

일부 성능 및 확장성 Operator에는 OpenShift Container Platform 릴리스 사이클과 독립적인 릴리스 사이클이 있습니다. 자세한 내용은 Openshift Operator 를 참조하십시오.

권장 성능 및 확장성 사례

계획, 최적화 및 측정

IBM Z 및 IBM LinuxONE에 대한 권장 사례

2장. 권장 성능 및 확장성 사례

2.1. 컨트롤 플레인 권장 사례

이 주제에서는 OpenShift Container Platform의 컨트롤 플레인에 대한 성능 및 확장성 관련 권장 사례를 제공합니다.

2.1.1. 클러스터 스케일링에 대한 권장 사례

이 섹션의 지침은 클라우드 공급자 통합을 통한 설치에만 관련이 있습니다.

다음 모범 사례를 적용하여 OpenShift Container Platform 클러스터의 작업자 머신 수를 스케일링하십시오. 작업자 머신 세트에 정의된 복제본 수를 늘리거나 줄여 작업자 머신을 스케일링합니다.

노드 수가 많아지도록 클러스터를 확장하는 경우 다음을 수행합니다.

- 고가용성을 위해 모든 사용 가능한 영역으로 노드를 분산합니다.

- 한 번에 확장하는 머신 수가 25~50개를 넘지 않도록 합니다.

- 주기적인 공급자 용량 제약 조건을 완화하는 데 도움이 되도록 유사한 크기의 대체 인스턴스 유형을 사용하여 사용 가능한 각 영역에 새 컴퓨팅 머신 세트를 생성하는 것이 좋습니다. 예를 들어 AWS에서 m5.large 및 m5d.large를 사용합니다.

클라우드 제공자는 API 서비스 할당량을 구현할 수 있습니다. 따라서 점진적으로 클러스터를 스케일링하십시오.

컴퓨팅 머신 세트의 복제본이 한 번에 모두 더 높은 숫자로 설정된 경우 컨트롤러가 머신을 생성하지 못할 수 있습니다. OpenShift Container Platform이 배포된 클라우드 플랫폼에서 처리할 수 있는 요청 수는 프로세스에 영향을 미칩니다. 컨트롤러는 상태를 사용하여 머신을 생성하고, 점검하고, 업데이트하는 동안 더 많이 쿼리하기 시작합니다. OpenShift Container Platform이 배포된 클라우드 플랫폼에는 API 요청 제한이 있습니다. 과도한 쿼리로 인해 클라우드 플랫폼 제한으로 인해 머신 생성이 실패할 수 있습니다.

노드 수가 많아지도록 스케일링하는 경우 머신 상태 점검을 활성화하십시오. 실패가 발생하면 상태 점검에서 상태를 모니터링하고 비정상 머신을 자동으로 복구합니다.

대규모 및 밀도가 높은 클러스터의 노드 수를 줄이는 경우 프로세스가 종료되는 노드에서 실행되는 오브젝트를 병렬로 드레이닝하거나 제거해야 하므로 많은 시간이 걸릴 수 있습니다. 또한 제거할 개체가 너무 많으면 클라이언트 요청 처리에 병목 현상이 발생할 수 있습니다. 초당 기본 클라이언트 쿼리(QPS) 및 버스트 비율은 현재 각각 5 및 10 으로 설정됩니다. 이러한 값은 OpenShift Container Platform에서 수정할 수 없습니다.

2.1.2. 컨트롤 플레인 노드 크기 조정

컨트롤 플레인 노드 리소스 요구 사항은 클러스터의 노드 및 오브젝트 수와 유형에 따라 다릅니다. 다음 컨트롤 플레인 노드 크기 권장 사항은 컨트롤 플레인 밀도 중심 테스트 또는 Cluster-density 테스트 결과를 기반으로 합니다. 이 테스트에서는 지정된 수의 네임스페이스에서 다음 오브젝트를 생성합니다.

- 이미지 스트림 1개

- 빌드 한 개

-

5개의 배포:

수면상태의 Pod 복제본 2개, 시크릿 4개, 구성 맵 4개, 각각 1개의 하향 API 볼륨 1개 사용 - 5개의 서비스, 각각 이전 배포 중 하나의 TCP/8080 및 TCP/8443 포트를 가리키는 서비스

- 1 이전 서비스의 첫 번째 경로를 가리키는 경로

- 2048 임의의 문자열 문자를 포함하는 10개의 보안

- 2048 임의의 문자열 문자를 포함하는 구성 맵 10

| 작업자 노드 수 | cluster-density(네임스페이스) | CPU 코어 수 | 메모리(GB) |

|---|---|---|---|

| 24 | 500 | 4 | 16 |

| 120 | 1000 | 8 | 32 |

| 252 | 4000 | 16하지만 OVN-Kubernetes 네트워크 플러그인을 사용하는 경우 24개 | OVN-Kubernetes 네트워크 플러그인을 사용하는 경우 64이지만 128 |

| 501 그러나 OVN-Kubernetes 네트워크 플러그인에서는 테스트되지 않았습니다. | 4000 | 16 | 96 |

위의 표의 데이터는 AWS 상단에서 실행되는 OpenShift Container Platform을 기반으로 하며 r5.4xlarge 인스턴스를 control-plane 노드로 사용하고 m5.2xlarge 인스턴스를 작업자 노드로 사용합니다.

3개의 컨트롤 플레인 노드가 있는 대규모 및 밀도가 높은 클러스터에서는 노드 중 하나가 중지, 재부팅 또는 실패할 때 CPU 및 메모리 사용량이 증가합니다. 전원, 네트워크, 기본 인프라 또는 비용 절감을 위해 클러스터를 종료한 후 클러스터를 다시 시작하는 의도적인 사례로 인해 오류가 발생할 수 있습니다. 나머지 두 컨트롤 플레인 노드는 고가용성이 되기 위해 부하를 처리하여 리소스 사용량을 늘려야 합니다. 이는 컨트롤 플레인 노드가 직렬로 연결, 드레이닝, 재부팅되어 운영 체제 업데이트를 적용하고 컨트롤 플레인 Operator 업데이트를 적용하기 때문에 업그레이드 중에도 이 문제가 발생할 수 있습니다. 단계적 오류를 방지하려면 컨트롤 플레인 노드에서 전체 CPU 및 메모리 리소스 사용량을 사용 가능한 모든 용량의 최대 60 %로 유지하여 리소스 사용량 급증을 처리합니다. 리소스 부족으로 인한 다운타임을 방지하기 위해 컨트롤 플레인 노드에서 CPU 및 메모리를 늘립니다.

노드 크기 조정은 클러스터의 노드 수와 개체 수에 따라 달라집니다. 또한 클러스터에서 개체가 현재 생성되는지에 따라 달라집니다. 개체 생성 중에 컨트롤 플레인은 개체가 running 단계에 있을 때보다 리소스 사용량 측면에서 더 활성화됩니다.

OLM(Operator Lifecycle Manager)은 컨트롤 플레인 노드에서 실행되며, 메모리 공간은 OLM이 클러스터에서 관리해야 하는 네임스페이스 및 사용자 설치된 Operator 수에 따라 다릅니다. OOM이 종료되지 않도록 컨트를 플레인 노드의 크기를 적절하게 조정해야 합니다. 다음 데이터 지점은 클러스터 최대값 테스트 결과를 기반으로 합니다.

| 네임스페이스 수 | 유휴 상태의 OLM 메모리(GB) | 5명의 사용자 operator가 설치된 OLM 메모리(GB) |

|---|---|---|

| 500 | 0.823 | 1.7 |

| 1000 | 1.2 | 2.5 |

| 1500 | 1.7 | 3.2 |

| 2000 | 2 | 4.4 |

| 3000 | 2.7 | 5.6 |

| 4000 | 3.8 | 7.6 |

| 5000 | 4.2 | 9.02 |

| 6000 | 5.8 | 11.3 |

| 7000 | 6.6 | 12.9 |

| 8000 | 6.9 | 14.8 |

| 9000 | 8 | 17.7 |

| 10,000 | 9.9 | 21.6 |

실행 중인 OpenShift Container Platform 4.12 클러스터에서만 컨트롤 플레인 노드 크기를 수정할 수 있습니다.

- 사용자 프로비저닝 설치 방법으로 설치된 클러스터입니다.

- 설치 관리자 프로비저닝 인프라 설치 방법으로 설치된 AWS 클러스터

- 컨트롤 플레인 머신 세트를 사용하여 컨트롤 플레인 시스템을 관리하는 클러스터입니다.

다른 모든 구성의 경우 총 노드 수를 추정하고 설치 중에 제안된 컨트롤 플레인 노드 크기를 사용해야 합니다.

권장 사항은 OpenShift SDN이 있는 OpenShift Container Platform 클러스터에서 네트워크 플러그인으로 캡처된 데이터 포인트를 기반으로 합니다.

OpenShift Container Platform 4.12에서 CPU 코어의 절반(500밀리코어)은 OpenShift Container Platform 3.11 및 이전 버전과 비교되어 기본적으로 시스템에 의해 예약되어 있습니다. 이러한 점을 고려하여 크기가 결정됩니다.

2.1.2.1. 컨트롤 플레인 머신에 더 큰 Amazon Web Services 인스턴스 유형 선택

AWS(Amazon Web Services) 클러스터의 컨트롤 플레인 시스템에 더 많은 리소스가 필요한 경우 사용할 컨트롤 플레인 시스템의 더 큰 AWS 인스턴스 유형을 선택할 수 있습니다.

컨트롤 플레인 머신 세트를 사용하는 클러스터의 절차는 컨트롤 플레인 머신 세트를 사용하지 않는 클러스터의 절차와 다릅니다.

클러스터에서 ControlPlaneMachineSet CR의 상태에 대해 확신이 있는 경우 CR 상태를 확인할 수 있습니다.

2.1.2.1.1. 컨트롤 플레인 머신 세트를 사용하여 Amazon Web Services 인스턴스 유형 변경

컨트롤 플레인 머신 세트 CR(사용자 정의 리소스)에서 사양을 업데이트하여 컨트롤 플레인 시스템이 사용하는 AWS(Amazon Web Services) 인스턴스 유형을 변경할 수 있습니다.

사전 요구 사항

- AWS 클러스터는 컨트롤 플레인 머신 세트를 사용합니다.

절차

다음 명령을 실행하여 컨트롤 플레인 머신 세트 CR을 편집합니다.

oc --namespace openshift-machine-api edit controlplanemachineset.machine.openshift.io cluster

$ oc --namespace openshift-machine-api edit controlplanemachineset.machine.openshift.io clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow providerSpec필드 아래에 다음 행을 편집합니다.providerSpec: value: ... instanceType: <compatible_aws_instance_type>providerSpec: value: ... instanceType: <compatible_aws_instance_type>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 이전 선택과 동일한 기본으로 더 큰 AWS 인스턴스 유형을 지정합니다. 예를 들어

m6i.xlarge를m6i.2xlarge또는m6i.4xlarge로 변경할 수 있습니다.

변경 사항을 저장하십시오.

-

기본

RollingUpdate업데이트 전략을 사용하는 클러스터의 경우 Operator는 변경 사항을 컨트롤 플레인 구성에 자동으로 전파합니다. -

OnDelete업데이트 전략을 사용하도록 구성된 클러스터의 경우 컨트롤 플레인 시스템을 수동으로 교체해야 합니다.

-

기본

2.1.2.1.2. AWS 콘솔을 사용하여 Amazon Web Services 인스턴스 유형 변경

컨트롤 플레인 시스템이 AWS 콘솔에서 인스턴스 유형을 업데이트하여 사용하는 AWS(Amazon Web Services) 인스턴스 유형을 변경할 수 있습니다.

사전 요구 사항

- 클러스터의 EC2 인스턴스를 수정하는 데 필요한 권한을 사용하여 AWS 콘솔에 액세스할 수 있습니다.

-

cluster-admin역할의 사용자로 OpenShift Container Platform 클러스터에 액세스할 수 있습니다.

절차

- AWS 콘솔을 열고 컨트롤 플레인 시스템의 인스턴스를 가져옵니다.

컨트롤 플레인 시스템 인스턴스 하나를 선택합니다.

- 선택한 컨트롤 플레인 시스템의 경우 etcd 스냅샷을 생성하여 etcd 데이터를 백업하십시오. 자세한 내용은 "Backing up etcd"를 참조하십시오.

- AWS 콘솔에서 컨트롤 플레인 머신 인스턴스를 중지합니다.

- 중지된 인스턴스를 선택하고 작업 → 인스턴스 설정 → 인스턴스 유형 변경을 클릭합니다.

-

인스턴스를 더 큰 유형으로 변경하여 유형이 이전 선택과 동일한 기본인지 확인하고 변경 사항을 적용합니다. 예를 들어

m6i.xlarge를m6i.2xlarge또는m6i.4xlarge로 변경할 수 있습니다. - 인스턴스를 시작합니다.

-

OpenShift Container Platform 클러스터에 인스턴스에 대한 해당

Machine오브젝트가 있는 경우 AWS 콘솔의 인스턴스 유형과 일치하도록 오브젝트의 인스턴스 유형을 업데이트합니다.

- 각 컨트롤 플레인 시스템에 대해 이 프로세스를 반복합니다.

2.2. 인프라 권장 사례

이 주제에서는 OpenShift Container Platform의 인프라에 대한 권장 성능 및 확장성 사례를 설명합니다.

2.2.1. 인프라 노드 크기 조정

인프라 노드는 OpenShift Container Platform 환경의 일부를 실행하도록 레이블이 지정된 노드입니다. 인프라 노드 리소스 요구사항은 클러스터 사용 기간, 노드, 클러스터의 오브젝트에 따라 달라집니다. 이러한 요인으로 인해 Prometheus의 지표 또는 시계열 수가 증가할 수 있기 때문입니다. 다음 인프라 노드 크기 권장 사항은 컨트롤 플레인 노드 크기 조정 섹션에 자세히 설명된 클러스터 밀도 테스트에서 관찰된 결과를 기반으로 합니다. 여기서 모니터링 스택 및 기본 ingress-controller가 이러한 노드로 이동되었습니다.

| 작업자 노드 수 | 클러스터 밀도 또는 네임스페이스 수 | CPU 코어 수 | 메모리(GB) |

|---|---|---|---|

| 27 | 500 | 4 | 24 |

| 120 | 1000 | 8 | 48 |

| 252 | 4000 | 16 | 128 |

| 501 | 4000 | 32 | 128 |

일반적으로 클러스터당 세 개의 인프라 노드를 사용하는 것이 좋습니다.

이러한 크기 조정 권장 사항은 지침으로 사용해야 합니다. Prometheus는 고도의 메모리 집약적 애플리케이션입니다. 리소스 사용량은 노드 수, 오브젝트, Prometheus 지표 스크래핑 간격, 지표 또는 시계열, 클러스터 사용 기간 등 다양한 요인에 따라 달라집니다. 또한 라우터 리소스 사용은 경로 수 및 인바운드 요청의 양/유형의 영향을 받을 수 있습니다.

이러한 권장 사항은 클러스터 생성 중에 설치된 모니터링, Ingress 및 레지스트리 인프라 구성 요소를 호스팅하는 인프라 노드에만 적용됩니다.

OpenShift Container Platform 4.12에서 CPU 코어의 절반(500밀리코어)은 OpenShift Container Platform 3.11 및 이전 버전과 비교되어 기본적으로 시스템에 의해 예약되어 있습니다. 명시된 크기 조정 권장 사항은 이러한 요인의 영향을 받습니다.

2.2.2. Cluster Monitoring Operator 스케일링

OpenShift Container Platform은CMO(Cluster Monitoring Operator)가 수집하여 Prometheus 기반 모니터링 스택에 저장하는 지표를 노출합니다. 관리자는 Observe → Dashboards 로 이동하여 OpenShift Container Platform 웹 콘솔의 시스템 리소스, 컨테이너 및 구성 요소 지표에 대한 대시보드를 볼 수 있습니다.

2.2.3. Prometheus 데이터베이스 스토리지 요구사항

Red Hat은 다양한 규모에 대해 다양한 테스트를 수행했습니다.

- 다음 Prometheus 스토리지 요구 사항은 규범이 아니며 참조로 사용해야 합니다. Prometheus에서 수집한 메트릭을 노출하는 Pod, 컨테이너, 경로 또는 기타 리소스 수를 포함하여 워크로드 활동 및 리소스 밀도에 따라 클러스터에서 리소스 사용량이 증가할 수 있습니다.

- 스토리지 요구 사항에 맞게 크기 기반 데이터 보존 정책을 구성할 수 있습니다.

| 노드 수 | Pod 수 (2 Pod당 컨테이너) | Prometheus 스토리지 증가(1일당) | Prometheus 스토리지 증가(15일당) | 네트워크(tsdb 청크당) |

|---|---|---|---|---|

| 50 | 1800 | 6.3GB | 94GB | 16MB |

| 100 | 3600 | 13GB | 195GB | 26MB |

| 150 | 5400 | 19GB | 283GB | 36MB |

| 200 | 7200 | 25GB | 375GB | 46MB |

스토리지 요구사항이 계산된 값을 초과하지 않도록 예상 크기의 약 20%가 오버헤드로 추가되었습니다.

위의 계산은 기본 OpenShift Container Platform Cluster Monitoring Operator용입니다.

CPU 사용률은 약간의 영향을 미칩니다. 50개 노드 및 1,800개 Pod당 비율이 약 40개 중 1개 코어입니다.

OpenShift Container Platform 권장 사항

- 인프라(infra) 노드를 두 개 이상 사용합니다.

- SSD 또는 NVMe(Non-volatile Memory express) 드라이브를 사용하여 openshift-container-storage 노드를 3개 이상 사용합니다.

2.2.4. 클러스터 모니터링 구성

클러스터 모니터링 스택에서 Prometheus 구성 요소의 스토리지 용량을 늘릴 수 있습니다.

절차

Prometheus의 스토리지 용량을 늘리려면 다음을 수행합니다.

YAML 구성 파일

cluster-monitoring-config.yaml을 생성합니다. 예를 들면 다음과 같습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Prometheus 보존의 기본값은

PROMETHEUS_RETENTION_PERIOD=15d입니다. 단위는 s, m, h, d 접미사 중 하나를 사용하는 시간으로 측정됩니다. - 2 4

- 클러스터의 스토리지 클래스입니다.

- 3

- 일반적인 값은

PROMETHEUS_STORAGE_SIZE=2000Gi입니다. 스토리지 값은 일반 정수 또는 E, P, T, G, M, K 접미사 중 하나를 사용하는 고정 지점 정수일 수 있습니다. Ei, Pi, Ti, Gi, Mi, Ki의 power-of-two를 사용할 수도 있습니다. - 5

- 일반적인 값은

ALERTMANAGER_STORAGE_SIZE=20Gi입니다. 스토리지 값은 일반 정수 또는 E, P, T, G, M, K 접미사 중 하나를 사용하는 고정 지점 정수일 수 있습니다. Ei, Pi, Ti, Gi, Mi, Ki의 power-of-two를 사용할 수도 있습니다.

- 보존 기간, 스토리지 클래스 및 스토리지 크기에 대한 값을 추가합니다.

- 파일을 저장합니다.

다음을 실행하여 변경사항을 적용합니다.

oc create -f cluster-monitoring-config.yaml

$ oc create -f cluster-monitoring-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. etcd 관련 권장 사례

이 주제에서는 OpenShift Container Platform의 etcd에 대한 성능 및 확장성 관련 권장 사례를 설명합니다.

2.3.1. etcd 관련 권장 사례

etcd는 디스크에 데이터를 쓰고 디스크에 제안을 유지하므로 디스크 성능에 따라 성능이 달라집니다. etcd는 특별히 I/O 집약적이 아니지만 성능과 안정성을 최적화하려면 대기 시간이 짧은 블록 장치가 필요합니다. etcd의 비관성 프로토콜은 메타데이터를 로그에 영구적으로 저장하는 데 따라 달라지므로 etcd는 디스크 쓰기 대기 시간에 민감합니다. 디스크 속도가 느리고 다른 프로세스의 디스크 활동이 길어지면 fsync 대기 시간이 길어질 수 있습니다.

이러한 대기 시간 동안 etcd가 하트비트를 놓치고 새 제안을 제때 디스크에 커밋하지 않고 궁극적으로 요청 시간 초과 및 임시 리더 손실이 발생할 수 있습니다. 또한 쓰기 대기 시간이 길면 OpenShift API 속도가 느려 클러스터 성능에 영향을 미칩니다. 이러한 이유로 I/O 민감하거나 집약적이며 동일한 기본 I/O 인프라를 공유하는 컨트롤 플레인 노드에서 다른 워크로드를 배치하지 마십시오.

대기 시간에서는 블록 장치 위에서 etcd를 실행하여 8000바이트 이상의 IOPS를 순차적으로 작성할 수 있습니다. 즉, 대기 시간이 10ms인 경우 fdatasync를 사용하여 WAL의 각 쓰기를 동기화하는 것을 염두에 두십시오. 로드된 클러스터의 경우 8000바이트(2ms)의 순차적 500 IOPS를 사용하는 것이 좋습니다. 이 숫자를 측정하려면 fio와 같은 벤치마킹 도구를 사용할 수 있습니다.

이러한 성능을 얻으려면 대기 시간이 짧고 처리량이 높은 SSD 또는 NVMe 디스크가 지원되는 머신에서 etcd를 실행하십시오. 메모리 셀당 1 비트를 제공하고, 내구성이 있고 신뢰할 수 있으며 쓰기 집약적인 워크로드에 이상적입니다.

etcd의 로드는 노드 및 Pod 수와 같은 정적 요인과 Pod 자동 스케일링, Pod 재시작, 작업 실행 및 기타 워크로드 관련 이벤트로 인한 끝점 변경 등 동적 요인에서 발생합니다. etcd 설정의 크기를 정확하게 조정하려면 워크로드의 특정 요구 사항을 분석해야 합니다. etcd의 로드에 영향을 미치는 노드, 포드 및 기타 관련 요인을 고려하십시오.

다음 하드 디스크 기능은 최적의 etcd 성능을 제공합니다.

- 빠른 읽기 작업을 지원하기 위한 짧은 대기 시간.

- 높은 대역폭은 더 빠른 압축 및 조각 모음을 위한 쓰기입니다.

- 대역폭이 높아지면 오류로부터 보다 신속하게 복구할 수 있습니다.

- Solid state drives as a minimum selection, however NVMe 드라이브가 선호됩니다.

- 안정성을 높이기 위해 다양한 제조 업체의 서버 수준 하드웨어.

- 성능 향상을 위한 RAID 0 기술.

- etcd 전용 드라이브 로그 파일 또는 기타 과도한 워크로드를 etcd 드라이브에 배치하지 마십시오.

NAS 또는 SAN 설정 및 회전 드라이브를 사용하지 마십시오. Ceph Rados Block Device(RBD) 및 기타 유형의 네트워크 연결 스토리지로 인해 네트워크 대기 시간이 예측할 수 없습니다. 대규모 etcd 노드에 빠른 스토리지를 제공하려면 PCI 패스스루를 사용하여 NVM 장치를 노드에 직접 전달합니다.

항상 fio와 같은 유틸리티를 사용하여 벤치마크를 수행합니다. 이러한 유틸리티를 사용하여 증가에 따라 클러스터 성능을 지속적으로 모니터링할 수 있습니다.

NFS(Network File System) 프로토콜 또는 기타 네트워크 기반 파일 시스템을 사용하지 마십시오.

배포된 OpenShift Container Platform 클러스터에서 모니터링하기 위한 몇 가지 주요 메트릭은 etcd 디스크 미리 쓰기 시 미리 쓰기 시간 및 etcd 리더 변경 횟수입니다. 이러한 지표를 추적하려면 Prometheus를 사용하십시오.

etcd 멤버 데이터베이스 크기는 일반 작업 중에 클러스터에서 다를 수 있습니다. 이 차이점은 리더 크기가 다른 멤버와 다른 경우에도 클러스터 업그레이드에는 영향을 미치지 않습니다.

OpenShift Container Platform 클러스터를 생성하기 전이나 후에 etcd 하드웨어를 확인하려면 fio를 사용할 수 있습니다.

사전 요구 사항

- Podman 또는 Docker와 같은 컨테이너 런타임은 테스트 중인 머신에 설치됩니다.

-

데이터는

/var/lib/etcd경로에 작성됩니다.

절차

Fio를 실행하고 결과를 분석합니다.

Podman을 사용하는 경우 다음 명령을 실행합니다.

sudo podman run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perf

$ sudo podman run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perfCopy to Clipboard Copied! Toggle word wrap Toggle overflow Docker를 사용하는 경우 다음 명령을 실행합니다.

sudo docker run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perf

$ sudo docker run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perfCopy to Clipboard Copied! Toggle word wrap Toggle overflow

실행에서 캡처된 fsync 지표의 99번째 백분위수를 비교하여 10ms 미만인지 확인하여 디스크 속도가 etcd를 호스팅하기에 충분한지 여부를 출력에서 보고합니다. I/O 성능의 영향을 받을 수 있는 가장 중요한 etcd 지표 중 일부는 다음과 같습니다.

-

etcd_disk_wal_fsync_duration_seconds_bucket지표가 etcd의 WAL fsync 기간 보고 -

etcd_disk_backend_commit_duration_seconds_bucket지표에서 etcd 백엔드 커밋 대기 시간 보고 -

etcd_server_leader_changes_seen_total지표에서 리더 변경을 보고

etcd는 모든 멤버 간에 요청을 복제하므로 성능은 네트워크 입력/출력(I/O) 대기 시간에 따라 크게 달라집니다. 네트워크 대기 시간이 길면 etcd 하트비트가 선택 시간 초과보다 오래 걸리므로 리더 선택이 발생하여 클러스터가 손상될 수 있습니다. 배포된 OpenShift Container Platform 클러스터에서 모니터링되는 주요 메트릭은 각 etcd 클러스터 멤버에서 etcd 네트워크 피어 대기 시간의 99번째 백분위 수입니다. 이러한 메트릭을 추적하려면 Prometheus를 사용하십시오.

histogram_quantile(0.99, rate(etcd_network_peer_round_trip_time_seconds_bucket[2m]) 지표에서 etcd가 멤버 간 클라이언트 요청을 복제하기 위한 왕복 시간을 보고합니다. 50ms보다 작은지 확인하십시오.

2.3.2. etcd를 다른 디스크로 이동

공유 디스크에서 etcd를 별도의 디스크로 이동하여 성능 문제를 방지하거나 해결할 수 있습니다.

MCO(Machine Config Operator)는 OpenShift Container Platform 4.12 컨테이너 스토리지를 위한 보조 디스크를 마운트합니다.

이 인코딩된 스크립트는 다음 장치 유형에 대한 장치 이름만 지원합니다.

- SCSI 또는 SATA

-

/dev/sd* - 가상 장치

-

/dev/vd* - NVMe

-

/dev/nvme*[0-9]*n*

제한

-

새 디스크가 클러스터에 연결되면 etcd 데이터베이스가 root 마운트의 일부입니다. 기본 노드가 다시 생성되는 경우 보조 디스크 또는 의도한 디스크의 일부가 아닙니다. 결과적으로 기본 노드는 별도의

/var/lib/etcd마운트를 생성하지 않습니다.

사전 요구 사항

- 클러스터의 etcd 데이터 백업이 있습니다.

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 클러스터에 액세스할 수 있습니다. - 머신 구성을 업로드하기 전에 디스크를 추가합니다.

-

MachineConfigPool은metadata.labels[machineconfiguration.openshift.io/role]과 일치해야 합니다. 컨트롤러, 작업자 또는 사용자 지정 풀에 적용됩니다.

이 절차에서는 루트 파일 시스템의 일부(예: /var/ )를 설치된 노드의 다른 디스크 또는 파티션으로 이동하지 않습니다.

컨트롤 플레인 머신 세트를 사용할 때 이 절차는 지원되지 않습니다.

절차

새 디스크를 클러스터에 연결하고 디버그 쉘에서

lsblk명령을 실행하여 노드에서 디스크가 감지되었는지 확인합니다.oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow lsblk

# lsblkCopy to Clipboard Copied! Toggle word wrap Toggle overflow lsblk명령에서 보고한 새 디스크의 장치 이름을 확인합니다.다음 스크립트를 생성하고 이름을

etcd-find-secondary-device.sh로 지정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;device_type_glob>를 블록 장치 유형의 쉘 글로 바꿉니다. SCSI 또는 SATA 드라이브의 경우/dev/sd*를 사용합니다. 가상 드라이브의 경우/dev/vd*를 사용합니다. NVMe 드라이브의 경우/dev/nvme*[0-9]*를 사용합니다.

etcd-find-secondary-device.sh스크립트에서 base64로 인코딩된 문자열을 생성하고 해당 내용을 확인합니다.base64 -w0 etcd-find-secondary-device.sh

$ base64 -w0 etcd-find-secondary-device.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같은 콘텐츠를 사용하여

etcd-mc.yml이라는MachineConfigYAML 파일을 만듭니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;encoded_etcd_find_secondary_device_script>를 사용자가 언급한 인코딩된 스크립트 콘텐츠로 바꿉니다.

검증 단계

노드의 디버그 쉘에서

grep /var/lib/etcd /proc/mounts명령을 실행하여 디스크가 마운트되었는지 확인합니다.oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow grep -w "/var/lib/etcd" /proc/mounts

# grep -w "/var/lib/etcd" /proc/mountsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

/dev/sdb /var/lib/etcd xfs rw,seclabel,relatime,attr2,inode64,logbufs=8,logbsize=32k,noquota 0 0

/dev/sdb /var/lib/etcd xfs rw,seclabel,relatime,attr2,inode64,logbufs=8,logbsize=32k,noquota 0 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.3. etcd 데이터 조각 모음

대규모 및 밀도가 높은 클러스터의 경우 키 공간이 너무 커져서 공간 할당량을 초과하면 etcd 성능이 저하될 수 있습니다. 주기적으로 etcd를 유지 관리하고 조각 모음하여 데이터 저장소에서 공간을 확보합니다. etcd 지표에 대한 Prometheus를 모니터링하고 필요한 경우 조각 모음을 모니터링합니다. 그러지 않으면 etcd에서 키 읽기 및 삭제만 수락하는 유지 관리 모드로 클러스터를 배치하는 클러스터 전체 알람을 생성할 수 있습니다.

다음 주요 메트릭을 모니터링합니다.

-

etcd_server_quota_backend_bytes, 현재 할당량 제한 -

etcd_mvcc_db_total_size_in_use_in_bytes. 이는 기록 압축 후 실제 데이터베이스 사용량을 나타냅니다. -

etcd_mvcc_db_total_size_in_bytes.gb는 조각 모음 대기 중인 여유 공간을 포함하여 데이터베이스 크기를 표시합니다.

etcd 기록 압축과 같은 디스크 조각화를 초래하는 이벤트 후 디스크 공간을 회수하기 위해 etcd 데이터를 조각 모음합니다.

기록 압축은 5분마다 자동으로 수행되며 백엔드 데이터베이스에서 공백이 남습니다. 이 분할된 공간은 etcd에서 사용할 수 있지만 호스트 파일 시스템에서 사용할 수 없습니다. 호스트 파일 시스템에서 이 공간을 사용할 수 있도록 etcd 조각을 정리해야 합니다.

조각 모음이 자동으로 수행되지만 수동으로 트리거할 수도 있습니다.

etcd Operator는 클러스터 정보를 사용하여 사용자에게 가장 효율적인 작업을 결정하기 때문에 자동 조각 모음은 대부분의 경우에 적합합니다.

2.3.3.1. 자동 조각 모음

etcd Operator는 디스크 조각 모음을 자동으로 수행합니다. 수동 조작이 필요하지 않습니다.

다음 로그 중 하나를 확인하여 조각 모음 프로세스가 성공했는지 확인합니다.

- etcd 로그

- cluster-etcd-operator Pod

- Operator 상태 오류 로그

자동 조각 모음을 사용하면 Kubernetes 컨트롤러 관리자와 같은 다양한 OpenShift 핵심 구성 요소에서 리더 선택을 실패하여 실패한 구성 요소를 다시 시작할 수 있습니다. 재시작은 무해하며 실행 중인 다음 인스턴스로 장애 조치를 트리거하거나 다시 시작한 후 구성 요소가 다시 시작됩니다.

조각 모음에 대한 로그 출력 예

etcd member has been defragmented: <member_name>, memberID: <member_id>

etcd member has been defragmented: <member_name>, memberID: <member_id>조각 모음 실패에 대한 로그 출력 예

failed defrag on member: <member_name>, memberID: <member_id>: <error_message>

failed defrag on member: <member_name>, memberID: <member_id>: <error_message>2.3.3.2. 수동 조각 모음

Prometheus 경고는 수동 조각 모음을 사용해야 하는 경우를 나타냅니다. 경고는 다음 두 가지 경우에 표시됩니다.

- etcd에서 사용 가능한 공간 50% 이상을 10분 이상 사용하는 경우

- etcd가 10분 이상 총 데이터베이스 크기의 50% 미만을 사용 중인 경우

PromQL 표현식을 사용하여 조각 모음을 사용하여 해제할 etcd 데이터베이스 크기를 MB 단위로 확인하여 조각 모음이 필요한지 여부를 확인할 수도 있습니다. (etcd_mvcc_db_total_size_in_in_bytes - etcd_mvcc_in_in_use_in_bytes)/1024/1024

etcd를 분리하는 것은 차단 작업입니다. 조각 모음이 완료될 때까지 etcd 멤버는 응답하지 않습니다. 따라서 각 pod의 조각 모음 작업 간에 클러스터가 정상 작동을 재개할 수 있도록 1분 이상 대기해야 합니다.

각 etcd 멤버의 etcd 데이터 조각 모음을 수행하려면 다음 절차를 따릅니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

절차

리더가 최종 조각화 처리를 수행하므로 어떤 etcd 멤버가 리더인지 확인합니다.

etcd pod 목록을 가져옵니다.

oc -n openshift-etcd get pods -l k8s-app=etcd -o wide

$ oc -n openshift-etcd get pods -l k8s-app=etcd -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

etcd-ip-10-0-159-225.example.redhat.com 3/3 Running 0 175m 10.0.159.225 ip-10-0-159-225.example.redhat.com <none> <none> etcd-ip-10-0-191-37.example.redhat.com 3/3 Running 0 173m 10.0.191.37 ip-10-0-191-37.example.redhat.com <none> <none> etcd-ip-10-0-199-170.example.redhat.com 3/3 Running 0 176m 10.0.199.170 ip-10-0-199-170.example.redhat.com <none> <none>

etcd-ip-10-0-159-225.example.redhat.com 3/3 Running 0 175m 10.0.159.225 ip-10-0-159-225.example.redhat.com <none> <none> etcd-ip-10-0-191-37.example.redhat.com 3/3 Running 0 173m 10.0.191.37 ip-10-0-191-37.example.redhat.com <none> <none> etcd-ip-10-0-199-170.example.redhat.com 3/3 Running 0 176m 10.0.199.170 ip-10-0-199-170.example.redhat.com <none> <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pod를 선택하고 다음 명령을 실행하여 어떤 etcd 멤버가 리더인지 확인합니다.

oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com etcdctl endpoint status --cluster -w table

$ oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com etcdctl endpoint status --cluster -w tableCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 출력의

ISLEADER 열에 따르면https://10.0.199.170:2379엔드 포인트가 리더입니다. 이전 단계의 출력과 이 앤드 포인트가 일치하면 리더의 Pod 이름은etcd-ip-10-0199-170.example.redhat.com입니다.

etcd 멤버를 분리합니다.

실행중인 etcd 컨테이너에 연결하고 리더가 아닌 pod 이름을 전달합니다.

oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com

$ oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow ETCDCTL_ENDPOINTS환경 변수를 설정 해제합니다.unset ETCDCTL_ENDPOINTS

sh-4.4# unset ETCDCTL_ENDPOINTSCopy to Clipboard Copied! Toggle word wrap Toggle overflow etcd 멤버를 분리합니다.

etcdctl --command-timeout=30s --endpoints=https://localhost:2379 defrag

sh-4.4# etcdctl --command-timeout=30s --endpoints=https://localhost:2379 defragCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Finished defragmenting etcd member[https://localhost:2379]

Finished defragmenting etcd member[https://localhost:2379]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 시간 초과 오류가 발생하면 명령이 성공할 때까지

--command-timeout의 값을 늘립니다.데이터베이스 크기가 감소되었는지 확인합니다.

etcdctl endpoint status -w table --cluster

sh-4.4# etcdctl endpoint status -w table --clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예에서는 etcd 멤버의 데이터베이스 크기가 시작 크기인 104MB와 달리 현재 41MB임을 보여줍니다.

다음 단계를 반복하여 다른 etcd 멤버에 연결하고 조각 모음을 수행합니다. 항상 리더의 조각 모음을 마지막으로 수행합니다.

etcd pod가 복구될 수 있도록 조각 모음 작업에서 1분 이상 기다립니다. etcd pod가 복구될 때까지 etcd 멤버는 응답하지 않습니다.

공간 할당량을 초과하여

NOSPACE경고가 발생하는 경우 이를 지우십시오.NOSPACE경고가 있는지 확인합니다.etcdctl alarm list

sh-4.4# etcdctl alarm listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

memberID:12345678912345678912 alarm:NOSPACE

memberID:12345678912345678912 alarm:NOSPACECopy to Clipboard Copied! Toggle word wrap Toggle overflow 경고를 지웁니다.

etcdctl alarm disarm

sh-4.4# etcdctl alarm disarmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3장. 오브젝트 최대값에 따른 환경 계획

OpenShift Container Platform 클러스터를 계획하는 경우 다음과 같은 테스트된 오브젝트 최대값을 고려하십시오.

이러한 지침은 가능한 가장 큰 클러스터를 기반으로 합니다. 크기가 작은 클러스터의 경우 최대값이 더 낮습니다. etcd 버전 또는 스토리지 데이터 형식을 비롯하여 명시된 임계값에 영향을 주는 요인은 여러 가지가 있습니다.

대부분의 경우 이러한 수치를 초과하면 전체 성능이 저하됩니다. 반드시 클러스터가 실패하는 것은 아닙니다.

Pod 시작 및 중지 Pod와 같이 빠른 변경이 발생하는 클러스터는 문서화된 것보다 실제 가능한 최대 크기를 줄일 수 있습니다.

3.1. OpenShift Container Platform에 대해 테스트된 클러스터 최대값(주요 릴리스)

Red Hat은 OpenShift Container Platform 클러스터 크기 조정에 대한 직접적인 지침을 제공하지 않습니다. 이는 클러스터가 지원되는 OpenShift Container Platform 범위 내에 있는지 여부를 확인하기 때문에 클러스터 스케일링을 제한하는 모든 다차원 요소를 신중하게 고려해야 하기 때문입니다.

OpenShift Container Platform은 절대 클러스터 최대값이 아닌 테스트된 클러스터 최대값을 지원합니다. OpenShift Container Platform 버전, 컨트롤 플레인 워크로드 및 네트워크 플러그인의 모든 조합이 테스트된 것은 아니므로 다음 표가 모든 배포에 대한 스케일링을 절대 예상하지는 않습니다. 모든 측면이 동시에 최대로 확장되지 않을 수 있습니다. 이 표에는 특정 워크로드 및 배포 구성에 대해 테스트된 최대값이 포함되어 있으며 유사한 배포에서 예상되는 항목에 대한 스케일링 가이드 역할을 합니다.

| 최대값 유형 | 4.x 테스트된 최대값 |

|---|---|

| 노드 수 | 2,000 [1] |

| Pod 수 [2] | 150,000 |

| 노드당 Pod 수 | 500 [3] |

| 코어당 Pod 수 | 기본값 없음 |

| 네임스페이스 수 [4] | 10,000 |

| 빌드 수 | 10,000(기본 Pod RAM 512Mi) - S2I(Source-to-Image) 빌드 전략 |

| 네임스페이스당 Pod 수 [5] | 25,000 |

| Ingress 컨트롤러당 경로 및 백엔드 수 | 라우터당 2,000개 |

| 보안 수 | 80,000 |

| 구성 맵 수 | 90,000 |

| 서비스 수 [6] | 10,000 |

| 네임스페이스당 서비스 수 | 5,000 |

| 서비스당 백엔드 수 | 5,000 |

| 네임스페이스당 배포 수 [5] | 2,000 |

| 빌드 구성 수 | 12,000 |

| CRD(사용자 정의 리소스 정의) 수 | 512 [7] |

- 2000 노드 규모에서 OpenShift Container Platform의 컨트롤 플레인 구성 요소를 완화하기 위해 Pod 일시 중지가 배포되었습니다. 유사한 숫자로 확장하는 기능은 특정 배포 및 워크로드 매개변수에 따라 달라집니다.

- 여기에 표시된 Pod 수는 테스트 Pod 수입니다. 실제 Pod 수는 애플리케이션 메모리, CPU 및 스토리지 요구사항에 따라 달라집니다.

-

이 테스트는 작업자 노드가 100개이며 작업자 노드당 Pod가 500개인 클러스터에서 수행되었습니다. 기본

maxPods는 계속 250입니다.maxPods가 500이 되도록 하려면 사용자 정의 kubelet 구성을 사용하여500으로 설정된maxPods가 포함된 클러스터를 생성해야 합니다. 500개의 사용자 Pod가 필요한 경우 노드에서 이미 실행되고 있는 시스템 Pod가 10~15개가 있으므로hostPrefix22가 필요합니다. 연결된 PVC(영구 볼륨 클레임)가 있는 Pod의 최대 수는 PVC가 할당된 스토리지 백엔드에 따라 달라집니다. 이 테스트에서는 OCS v4(OpenShift Data Foundation v4)만 이 문서에서 설명하는 노드당 Pod 수를 충족할 수 있었습니다. - 활성 프로젝트 수가 많은 경우 키 공간이 지나치게 커져서 공간 할당량을 초과하면 etcd 성능이 저하될 수 있습니다. etcd 스토리지를 확보하기 위해 조각 모음을 포함한 etcd에 대한 유지보수를 정기적으로 수행하는 것이 좋습니다.

- 시스템에는 일부 상태 변경에 대한 대응으로 지정된 네임스페이스의 모든 오브젝트에서 반복해야 하는 컨트롤 루프가 많습니다. 단일 네임스페이스에 지정된 유형의 오브젝트가 많이 있으면 루프 비용이 많이 들고 지정된 상태 변경 처리 속도가 느려질 수 있습니다. 이 제한을 적용하면 애플리케이션 요구사항을 충족하기에 충분한 CPU, 메모리 및 디스크가 시스템에 있다고 가정합니다.

- 각 서비스 포트와 각 서비스 백엔드는 iptables에 해당 항목이 있습니다. 지정된 서비스의 백엔드 수는 끝점 오브젝트의 크기에 영향을 미치므로 시스템 전체에서 전송되는 데이터의 크기에 영향을 미칩니다.

-

OpenShift Container Platform에는 OpenShift Container Platform에서 설치한 제품, OpenShift Container Platform 및 사용자가 생성한 CRD를 포함하여 512개의 CRD(사용자 정의 리소스 정의)가 제한됩니다. 512개 이상의 CRD가 생성된 경우

oc명령 요청이 제한될 수 있습니다.

3.1.1. 시나리오 예

예를 들어 500개의 작업자 노드(m5.2xl)를 테스트하고 OpenShift Container Platform 4.12, OVN-Kubernetes 네트워크 플러그인 및 다음 워크로드 오브젝트를 사용하여 지원됩니다.

- 기본값 외에도 200 네임스페이스

- 노드당 Pod 60개, 서버 30개 및 클라이언트 Pod 30개(전체 30개)

- 57 이미지 스트림/ns (전체 11.4k)

- 서버 Pod에서 지원하는 서비스/시간 15개 (3k 합계)

- 이전 서비스에서 지원하는 15개의 경로/시간 (3k 합계)

- 20개의 보안/ns (4k 합계)

- 10개의 구성 맵/ns (2k 합계)

- 6개의 네트워크 정책/ns, 거부를 포함한 allow-from 수신 및 네임스페이스 내 규칙

- 57개의 빌드/시간

다음 요인은 클러스터 워크로드 스케일링에 영향을 미치는 것으로 알려져 있으며 배포를 계획할 때 스케일링 수에 반영되어야 합니다. 자세한 정보 및 지침은 영업 담당자 또는 Red Hat 지원에 문의하십시오.

- 노드당 Pod 수

- Pod당 컨테이너 수

- 사용된 프로브 유형(예: liveness/readiness, exec/http)

- 네트워크 정책 수

- 프로젝트 수 또는 네임스페이스 수

- 프로젝트당 이미지 스트림 수

- 프로젝트당 빌드 수

- 서비스/엔드포인트 및 유형

- 경로 수

- shard 수

- 보안 수

- 구성 맵 수

API 호출 속도 또는 클러스터 구성이 얼마나 빠르게 변경되는지 추정하는 클러스터 "churn"입니다.

-

5분 창에 Pod 생성 요청에 대한 Prometheus 쿼리:

sum(irate(apiserver_request_count{resources",verb="POST"}[5m]) -

5분 창을 통해 초당 모든 API 요청에 대한 Prometheus 쿼리:

sum(irate(apiserver_request_count{}[5m]))

-

5분 창에 Pod 생성 요청에 대한 Prometheus 쿼리:

- CPU의 클러스터 노드 리소스 소비

- 메모리의 클러스터 노드 리소스 사용

3.2. 클러스터 최대값 테스트를 위한 OpenShift Container Platform 환경 및 구성

3.2.1. AWS 클라우드 플랫폼

| 노드 | 플레이버 | vCPU | RAM(GiB) | 디스크 유형 | 디스크 크기(GiB)/IOS | 수량 | 리전 |

|---|---|---|---|---|---|---|---|

| 컨트롤 플레인/etcd [1] | r5.4xlarge | 16 | 128 | gp3 | 220 | 3 | us-west-2 |

| Infra [2] | m5.12xlarge | 48 | 192 | gp3 | 100 | 3 | us-west-2 |

| 워크로드 [3] | m5.4xlarge | 16 | 64 | gp3 | 500 [4] | 1 | us-west-2 |

| Compute | m5.2xlarge | 8 | 32 | gp3 | 100 | 3/25/250/500 [5] | us-west-2 |

- etcd는 대기 시간에 민감하기 때문에 3000 IOPS 및 125MiB의 성능이 있는 gp3 디스크는 컨트롤 플레인/etcd 노드에 사용됩니다. gp3 볼륨은 버스트 성능을 사용하지 않습니다.

- 인프라 노드는 모니터링, Ingress 및 레지스트리 구성 요소를 호스팅하는데 사용되어 대규모로 실행할 수 있는 충분한 리소스가 있는지 확인합니다.

- 워크로드 노드는 성능 및 확장 가능한 워크로드 생성기 실행 전용입니다.

- 성능 및 확장성 테스트 실행 중에 수집되는 대량의 데이터를 저장할 수 있는 충분한 공간을 확보 할 수 있도록 큰 디스크 크기가 사용됩니다.

- 클러스터는 반복적으로 확장되며 성능 및 확장성 테스트는 지정된 노드 수에 따라 실행됩니다.

3.2.2. IBM Power 플랫폼

| 노드 | vCPU | RAM(GiB) | 디스크 유형 | 디스크 크기(GiB)/IOS | 수량 |

|---|---|---|---|---|---|

| 컨트롤 플레인/etcd [1] | 16 | 32 | io1 | GiB당 120 / 10 IOPS | 3 |

| Infra [2] | 16 | 64 | gp2 | 120 | 2 |

| 워크로드 [3] | 16 | 256 | gp2 | 120 [4] | 1 |

| Compute | 16 | 64 | gp2 | 120 | 2개에서 100 [5] |

- etcd는 I/O 집약적이고 대기 시간에 민감하므로 GiB당 120/10 IOPS가 있는 io1 디스크가 컨트롤 플레인/etcd 노드에 사용됩니다.

- 인프라 노드는 모니터링, Ingress 및 레지스트리 구성 요소를 호스팅하는데 사용되어 대규모로 실행할 수 있는 충분한 리소스가 있는지 확인합니다.

- 워크로드 노드는 성능 및 확장 가능한 워크로드 생성기 실행 전용입니다.

- 성능 및 확장성 테스트 실행 중에 수집되는 대량의 데이터를 저장할 수 있는 충분한 공간을 확보 할 수 있도록 큰 디스크 크기가 사용됩니다.

- 클러스터는 반복적으로 확장됩니다.

3.2.3. IBM Z 플랫폼

| 노드 | vCPU [4] | RAM(GiB)[5] | 디스크 유형 | 디스크 크기(GiB)/IOS | 수량 |

|---|---|---|---|---|---|

| 컨트롤 플레인/etcd [1,2] | 8 | 32 | ds8k | 300 / LCU 1 | 3 |

| Compute [1,3] | 8 | 32 | ds8k | 150 / LCU 2 | 4개의 노드(노드당 100/250/500개의 Pod로 확장) |

- 노드는 두 개의 LUN(Logical Control Unit) 간에 분산되어 etcd가 I/O 집약적이고 지연 시간에 민감하므로 컨트롤 플레인/etcd 노드의 디스크 I/O 부하를 최적화합니다. etcd I/O 수요가 다른 워크로드를 방해하지 않아야 합니다.

- 4개의 컴퓨팅 노드는 동시에 100/250/500개의 Pod를 사용하여 여러 번 반복하는 테스트에 사용됩니다. 먼저 Pod를 인스턴스에 사용할 수 있는지 평가하는 데 Pod를 유휴 상태로 설정합니다. 다음으로 네트워크 및 CPU 까다로운 클라이언트/서버 워크로드가 스트레스를 받고 시스템의 안정성을 평가하는 데 사용되었습니다. 클라이언트 및 서버 포드는 쌍으로 배포되었으며 각 쌍은 두 개의 계산 노드에 분산되었습니다.

- 별도의 워크로드 노드를 사용하지 않았습니다. 워크로드는 두 개의 컴퓨팅 노드 간에 마이크로 서비스 워크로드를 시뮬레이션합니다.

- 사용되는 물리적 프로세서 수는 Linux (IFL)에 대한 6 개의 통합 기능입니다.

- 사용된 총 실제 메모리는 512GiB입니다.

3.3. 테스트된 클러스터 최대값에 따라 환경을 계획하는 방법

노드에서 물리적 리소스에 대한 서브스크립션을 초과하면 Pod를 배치하는 동안 Kubernetes 스케줄러가 보장하는 리소스에 영향을 미칩니다. 메모리 교체가 발생하지 않도록 하기 위해 수행할 수 있는 조치를 알아보십시오.

테스트된 최대값 중 일부는 단일 차원에서만 확장됩니다. 클러스터에서 실행되는 오브젝트가 많으면 최대값이 달라집니다.

이 문서에 명시된 수치는 Red Hat의 테스트 방법론, 설정, 구성, 튜닝을 기반으로 한 것입니다. 고유한 개별 설정 및 환경에 따라 수치가 달라질 수 있습니다.

환경을 계획하는 동안 노드당 몇 개의 Pod가 적합할 것으로 예상되는지 결정하십시오.

required pods per cluster / pods per node = total number of nodes needed

required pods per cluster / pods per node = total number of nodes needed노드당 기본 최대 Pod 수는 250입니다. 하지만 노드에 적합한 Pod 수는 애플리케이션 자체에 따라 달라집니다. "애플리케이션 요구 사항에 따라 환경을 계획하는 방법"에 설명된 대로 애플리케이션의 메모리, CPU 및 스토리지 요구 사항을 고려하십시오.

시나리오 예

클러스터당 2,200개의 Pod로 클러스터 규모를 지정하려면 노드당 최대 500개의 Pod가 있다고 가정하여 최소 5개의 노드가 있어야 합니다.

2200 / 500 = 4.4

2200 / 500 = 4.4노드 수를 20으로 늘리면 Pod 배포는 노드당 110개 Pod로 변경됩니다.

2200 / 20 = 110

2200 / 20 = 110다음과 같습니다.

required pods per cluster / total number of nodes = expected pods per node

required pods per cluster / total number of nodes = expected pods per nodeOpenShift Container Platform에는 SDN, DNS, Operator 등과 같은 여러 시스템 Pod가 제공되며 기본적으로 모든 작업자 노드에서 실행됩니다. 따라서 위 공식의 결과는 다를 수 있습니다.

3.4. 애플리케이션 요구사항에 따라 환경을 계획하는 방법

예에 나온 애플리케이션 환경을 고려해 보십시오.

| Pod 유형 | Pod 수량 | 최대 메모리 | CPU 코어 수 | 영구 스토리지 |

|---|---|---|---|---|

| apache | 100 | 500MB | 0.5 | 1GB |

| node.js | 200 | 1GB | 1 | 1GB |

| postgresql | 100 | 1GB | 2 | 10GB |

| JBoss EAP | 100 | 1GB | 1 | 1GB |

예상 요구사항은 CPU 코어 550개, RAM 450GB 및 스토리지 1.4TB입니다.

노드의 인스턴스 크기는 기본 설정에 따라 높게 또는 낮게 조정될 수 있습니다. 노드에서는 리소스 초과 커밋이 발생하는 경우가 많습니다. 이 배포 시나리오에서는 동일한 양의 리소스를 제공하는 데 더 작은 노드를 추가로 실행하도록 선택할 수도 있고 더 적은 수의 더 큰 노드를 실행하도록 선택할 수도 있습니다. 운영 민첩성 및 인스턴스당 비용과 같은 요인을 고려해야 합니다.

| 노드 유형 | 수량 | CPU | RAM(GB) |

|---|---|---|---|

| 노드(옵션 1) | 100 | 4 | 16 |

| 노드(옵션 2) | 50 | 8 | 32 |

| 노드(옵션 3) | 25 | 16 | 64 |

어떤 애플리케이션은 초과 커밋된 환경에 적합하지만 어떤 애플리케이션은 그렇지 않습니다. 대부분의 Java 애플리케이션과 대규모 페이지를 사용하는 애플리케이션은 초과 커밋에 적합하지 않은 애플리케이션의 예입니다. 해당 메모리는 다른 애플리케이션에 사용할 수 없습니다. 위의 예에 나온 환경에서는 초과 커밋이 약 30%이며, 이는 일반적으로 나타나는 비율입니다.

애플리케이션 Pod는 환경 변수 또는 DNS를 사용하여 서비스에 액세스할 수 있습니다. 환경 변수를 사용하는 경우 노드에서 Pod가 실행될 때 활성 서비스마다 kubelet을 통해 변수를 삽입합니다. 클러스터 인식 DNS 서버는 새로운 서비스의 Kubernetes API를 확인하고 각각에 대해 DNS 레코드 세트를 생성합니다. 클러스터 전체에서 DNS가 활성화된 경우 모든 Pod가 자동으로 해당 DNS 이름을 통해 서비스를 확인할 수 있어야 합니다. 서비스가 5,000개를 넘어야 하는 경우 DNS를 통한 서비스 검색을 사용할 수 있습니다. 서비스 검색에 환경 변수를 사용하는 경우 네임스페이스에서 서비스가 5,000개를 넘은 후 인수 목록이 허용되는 길이를 초과하면 Pod 및 배포가 실패하기 시작합니다. 이 문제를 해결하려면 배포의 서비스 사양 파일에서 서비스 링크를 비활성화하십시오.

네임스페이스에서 실행할 수 있는 애플리케이션 Pod 수는 서비스 검색에 환경 변수가 사용될 때 서비스 수와 서비스 이름의 길이에 따라 달라집니다. ARG_MAX 는 새 프로세스의 최대 인수 길이를 정의하고 기본적으로 2097152바이트(2MiB)로 설정됩니다. Kubelet은 네임스페이스에서 실행되도록 예약된 각 pod에 환경 변수를 삽입합니다. 여기에는 다음이 포함됩니다.

-

<SERVICE_NAME>_SERVICE_HOST=<IP> -

<SERVICE_NAME>_SERVICE_PORT=<PORT> -

<SERVICE_NAME>_PORT=tcp://<IP>:<PORT> -

<SERVICE_NAME>_PORT_<PORT>_TCP=tcp://<IP>:<PORT> -

<SERVICE_NAME>_PORT_<PORT>_TCP_PROTO=tcp -

<SERVICE_NAME>_PORT_<PORT>_TCP_PORT=<PORT> -

<SERVICE_NAME>_PORT_<PORT>_TCP_ADDR=<ADDR>

인수 길이가 허용된 값을 초과하고 서비스 이름의 문자 수에 영향을 미치는 경우 네임스페이스의 Pod가 실패합니다. 예를 들어, 5000개의 서비스가 있는 네임스페이스에서 서비스 이름의 제한은 33자이며, 네임스페이스에서 5000개의 Pod를 실행할 수 있습니다.

4장.

4.1.

| 리소스 이름 | 설명 |

|---|---|

|

|

터미널이 아닌 상태에서 모든 Pod의 CPU 요청 합계는 이 값을 초과할 수 없습니다. |

|

|

터미널이 아닌 상태에서 모든 Pod의 메모리 요청 합계는 이 값을 초과할 수 없습니다. |

|

|

터미널이 아닌 상태에서 모든 Pod의 로컬 임시 스토리지 요청 합계는 이 값을 초과할 수 없습니다. |

|

|

터미널이 아닌 상태에서 모든 Pod의 CPU 요청 합계는 이 값을 초과할 수 없습니다. |

|

|

터미널이 아닌 상태에서 모든 Pod의 메모리 요청 합계는 이 값을 초과할 수 없습니다. |

|

|

터미널이 아닌 상태에서 모든 Pod의 임시 스토리지 요청 합계는 이 값을 초과할 수 없습니다. |

|

| 터미널이 아닌 상태에서 모든 Pod의 CPU 제한 합계는 이 값을 초과할 수 없습니다. |

|

| 터미널이 아닌 상태에서 모든 Pod의 메모리 제한 합계는 이 값을 초과할 수 없습니다. |

|

| 터미널이 아닌 상태에서 모든 Pod의 임시 스토리지 제한 합계는 이 값을 초과할 수 없습니다. 이 기능은 기본적으로 비활성화되어 있습니다. |

| 리소스 이름 | 설명 |

|---|---|

|

| 상태와 관계없이 모든 영구 볼륨 클레임의 스토리지 요청 합계는 이 값을 초과할 수 없습니다. |

|

| 프로젝트에 존재할 수 있는 총 영구 볼륨 클레임 수입니다. |

|

| 상태와 관계없이 일치하는 스토리지 클래스가 있는 모든 영구 볼륨 클레임의 스토리지 요청 합계는 이 값을 초과할 수 없습니다. |

|

| 프로젝트에 존재할 수 있는, 일치하는 스토리지 클래스가 있는 총 영구 볼륨 클레임 수입니다. |

| 리소스 이름 | 설명 |

|---|---|

|

| 프로젝트에 존재할 수 있는 터미널이 아닌 상태의 총 Pod 수입니다. |

|

| 프로젝트에 존재할 수 있는 총 복제 컨트롤러 수입니다. |

|

| 프로젝트에 존재할 수 있는 총 리소스 할당량 수입니다. |

|

| 프로젝트에 존재할 수 있는 총 서비스 수입니다. |

|

| 프로젝트에 존재할 수 있는 총 시크릿 수입니다. |

|

|

프로젝트에 존재할 수 있는 총 |

|

| 프로젝트에 존재할 수 있는 총 영구 볼륨 클레임 수입니다. |

|

| 프로젝트에 존재할 수 있는 총 이미지 스트림 수입니다. |

oc create quota <name> --hard=count/<resource>.<group>=<quota>

$ oc create quota <name> --hard=count/<resource>.<group>=<quota> 4.1.1. 확장 리소스에 대한 리소스 할당량 설정

확장 리소스에는 리소스 과다 할당이 허용되지 않으므로 할당량의 해당 확장 리소스에 requests 및 limits를 지정해야 합니다. 다음은 GPU 리소스 nvidia.com/gpu에 대한 리소스 할당량을 설정하는 방법에 대한 예제 시나리오입니다.

절차

oc describe node ip-172-31-27-209.us-west-2.compute.internal | egrep 'Capacity|Allocatable|gpu'

$ oc describe node ip-172-31-27-209.us-west-2.compute.internal | egrep 'Capacity|Allocatable|gpu'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 예에서는 GPU 2개를 사용할 수 있습니다.

이 예에서 할당량은

1입니다.cat gpu-quota.yaml

$ cat gpu-quota.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f gpu-quota.yaml

$ oc create -f gpu-quota.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

resourcequota/gpu-quota created

resourcequota/gpu-quota createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc describe quota gpu-quota -n nvidia

$ oc describe quota gpu-quota -n nvidiaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Name: gpu-quota Namespace: nvidia Resource Used Hard -------- ---- ---- requests.nvidia.com/gpu 0 1

Name: gpu-quota Namespace: nvidia Resource Used Hard -------- ---- ---- requests.nvidia.com/gpu 0 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc create pod gpu-pod.yaml

$ oc create pod gpu-pod.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE gpu-pod-s46h7 1/1 Running 0 1m

NAME READY STATUS RESTARTS AGE gpu-pod-s46h7 1/1 Running 0 1mCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc describe quota gpu-quota -n nvidia

$ oc describe quota gpu-quota -n nvidiaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Name: gpu-quota Namespace: nvidia Resource Used Hard -------- ---- ---- requests.nvidia.com/gpu 1 1

Name: gpu-quota Namespace: nvidia Resource Used Hard -------- ---- ---- requests.nvidia.com/gpu 1 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 노드에 GPU가 2개 있으므로 기술적으로 가능합니다.

oc create -f gpu-pod.yaml

$ oc create -f gpu-pod.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Error from server (Forbidden): error when creating "gpu-pod.yaml": pods "gpu-pod-f7z2w" is forbidden: exceeded quota: gpu-quota, requested: requests.nvidia.com/gpu=1, used: requests.nvidia.com/gpu=1, limited: requests.nvidia.com/gpu=1

Error from server (Forbidden): error when creating "gpu-pod.yaml": pods "gpu-pod-f7z2w" is forbidden: exceeded quota: gpu-quota, requested: requests.nvidia.com/gpu=1, used: requests.nvidia.com/gpu=1, limited: requests.nvidia.com/gpu=1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.2. 할당량 범위

각 할당량에는 일련의 관련 범위가 있을 수 있습니다. 특정 할당량은 열거된 범위의 교집합과 일치하는 경우에만 리소스 사용량을 측정합니다.

할당량에 범위를 추가하면 할당량을 적용할 수 있는 리소스 세트가 제한됩니다. 허용된 설정을 벗어난 리소스를 지정하면 검증 오류가 발생합니다.

| 범위 | 설명 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

BestEffort 범위는 할당량을 제한하여 다음 리소스를 제한합니다.

-

pods

Terminating, NotTerminating, NotBestEffort 범위는 할당량을 제한하여 다음 리소스를 추적합니다.

-

pods -

memory -

requests.memory -

limits.memory -

cpu -

requests.cpu -

limits.cpu -

ephemeral-storage -

requests.ephemeral-storage -

limits.ephemeral-storage

이 기능은 기본적으로 비활성화되어 있습니다.

추가 리소스

4.2.

4.2.1. 할당량 적용

할당량이 생성되고 사용량 통계가 업데이트되면 프로젝트에서 새 콘텐츠 생성을 허용합니다. 리소스를 생성하거나 수정할 때는 리소스 생성 또는 수정 요청에 따라 할당량 사용이 즉시 증가합니다.

리소스를 삭제할 때는 프로젝트에 대한 다음 할당량 통계 전체 재계산 중 할당량 사용이 감소합니다.

구성 가능한 시간에 따라 현재 관찰되는 시스템 값으로 할당량 사용을 줄이는 데 걸리는 시간이 결정됩니다.

4.2.2.

할당량은 이러한 값 중을 제한할 수 있습니다.

할당량에 requests.cpu 또는 requests.memory에 대해 지정된 값이 있는 경우 들어오는 모든 컨테이너에서 해당 리소스를 명시적으로 요청해야 합니다. 할당량에 limits.cpu 또는 limits.memory에 대해 지정된 값이 있는 경우 들어오는 모든 컨테이너에서 해당 리소스에 대한 제한을 명시적으로 지정해야 합니다.

4.2.3. 리소스 할당량 정의의 예

- 1

- 프로젝트에 존재할 수 있는 총 이미지 스트림 수입니다.

- 1

- 프로젝트에 존재할 수 있는 터미널이 아닌 상태의 총 Pod 수입니다.

- 2

- 터미널이 아닌 상태에서 모든 Pod의 CPU 요청 합계는 코어 1개를 초과할 수 없습니다.

- 3

- 터미널이 아닌 상태에서 모든 Pod의 메모리 요청 합계는 1Gi를 초과할 수 없습니다.

- 4

- 터미널이 아닌 상태에서 모든 Pod의 임시 스토리지 요청 합계는 2Gi를 초과할 수 없습니다.

- 5

- 터미널이 아닌 상태에서 모든 Pod의 CPU 제한 합계는 코어 2개를 초과할 수 없습니다.

- 6

- 터미널이 아닌 상태에서 모든 Pod의 메모리 제한 합계는 2Gi를 초과할 수 없습니다.

- 7

- 터미널이 아닌 상태에서 모든 Pod의 임시 스토리지 제한 합계는 4Gi를 초과할 수 없습니다.

- 1

- 터미널이 아닌 상태의 총 Pod 수입니다.

- 2

- 터미널이 아닌 상태에서 모든 Pod의 CPU 제한 합계는 이 값을 초과할 수 없습니다.

- 3

- 터미널이 아닌 상태에서 모든 Pod의 메모리 제한 합계는 이 값을 초과할 수 없습니다.

- 4

- 터미널이 아닌 상태에서 모든 Pod의 임시 스토리지 제한 합계는 이 값을 초과할 수 없습니다.

- 5

- 할당량을

spec.activeDeadlineSeconds가nil로 설정된 일치하는 Pod로만 제한합니다. 빌드 Pod는RestartNever정책을 적용하지 않는 한NotTerminating에 해당합니다.

- 1

- 프로젝트의 총 영구 볼륨 클레임 수

- 2

- 프로젝트의 모든 영구 볼륨 클레임에서 요청된 스토리지 합계는 이 값을 초과할 수 없습니다.

- 3

- 프로젝트의 모든 영구 볼륨 클레임에서 골드 스토리지 클래스에 요청된 스토리지 합계는 이 값을 초과할 수 없습니다.

- 4

- 프로젝트의 모든 영구 볼륨 클레임에서 실버 스토리지 클래스에 요청된 스토리지 합계는 이 값을 초과할 수 없습니다.

- 5

- 프로젝트의 모든 영구 볼륨 클레임에서 실버 스토리지 클래스의 총 클레임 수는 이 값을 초과할 수 없습니다.

- 6

- 프로젝트의 모든 영구 볼륨 클레임에서 브론즈 스토리지 클래스에 요청된 스토리지 합계는 이 값을 초과할 수 없습니다. 이 값을

0으로 설정하면 브론즈 스토리지 클래스에서 스토리지를 요청할 수 없습니다. - 7

- 프로젝트의 모든 영구 볼륨 클레임에서 브론즈 스토리지 클래스에 요청된 스토리지 합계는 이 값을 초과할 수 없습니다. 이 값을

0으로 설정하면 브론즈 스토리지 클래스에서 클레임을 생성할 수 없습니다.

4.2.4. 할당량 생성

oc create -f <resource_quota_definition> [-n <project_name>]

$ oc create -f <resource_quota_definition> [-n <project_name>]

oc create -f core-object-counts.yaml -n demoproject

$ oc create -f core-object-counts.yaml -n demoproject4.2.5. 오브젝트 수 할당량 생성

모든 OpenShift Container Platform 표준 네임스페이스 리소스 유형(예: BuildConfig, DeploymentConfig)에 대해 오브젝트 수 할당량을 생성할 수 있습니다. 오브젝트 할당량 수는 모든 표준 네임스페이스 리소스 유형에 정의된 할당량을 지정합니다.

리소스 할당량을 사용할 때 서버 스토리지에 존재하는 경우 오브젝트는 할당량에 대해 부과됩니다. 이러한 유형의 할당량은 스토리지 리소스의 소진을 방지하는 데 유용합니다.

oc create quota <name> --hard=count/<resource>.<group>=<quota>,count/<resource>.<group>=<quota>

$ oc create quota <name> --hard=count/<resource>.<group>=<quota>,count/<resource>.<group>=<quota>

이 예제에서는 나열된 리소스가 클러스터에 있는 각 프로젝트의 하드 제한으로 제한됩니다.

4.2.6. 할당량 보기

예를 들어

demoproject라는 프로젝트의 경우 다음과 같습니다.oc get quota -n demoproject NAME AGE besteffort 11m compute-resources 2m core-object-counts 29m

$ oc get quota -n demoproject NAME AGE besteffort 11m compute-resources 2m core-object-counts 29mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 관심 있는 할당량을 입력합니다. 예를 들어

core-object-counts할당량은 다음과 같습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.7.

master-restart api master-restart controllers

$ master-restart api

$ master-restart controllers

4.2.8.

추가 리소스

4.3.

리소스 생성 및 수정을 위한 모든 요청은 프로젝트의 각 LimitRange 오브젝트에 대해 평가됩니다. 리소스가 열거된 제약 조건을 위반하는 경우 해당 리소스는 거부됩니다.

코어 및 OpenShift Container Platform 리소스를 모두 하나의 제한 범위 오브젝트로 지정할 수 있습니다.

4.3.1. 컨테이너 제한

지원되는 리소스:

- CPU

- 메모리

지원되는 제한

지정된 경우 컨테이너별로 다음이 true여야 합니다.

컨테이너

| 제약 조건 | 동작 |

|---|---|

|

|

구성에서 |

|

|

구성에서 |

|

|

max

제한 범위가

예를 들어 컨테이너의 |

지원되는 기본값:

default[<resource>]-

기본값은

container.resources.limit[<resource>]to specified value if none입니다. 기본 요청[<resource>]-

기본값은

container.resources.requests[<resource>]to specified value if none입니다.

4.3.2. Pod 제한

지원되는 리소스:

- CPU

- 메모리

지원되는 제한 사항:

Pod의 모든 컨테이너에서 다음 사항이 충족되어야 합니다.

| 제약 조건 | 강제 동작 |

|---|---|

|

|

|

|

|

|

|

|

max |

4.3.3. 이미지 제한

지원되는 리소스:

- 스토리지

리소스 유형 이름:

-

openshift.io/Image

지정된 경우 이미지당 다음 사항이 충족되어야 합니다.

| 제약 조건 | 동작 |

|---|---|

|

|

|

제한을 초과하는 Blob이 레지스트리에 업로드되지 않도록 하려면 할당량을 적용하도록 레지스트리를 구성해야 합니다. REGISTRY_MIDDLEWARE_REPOSITORY_OPENSHIFT_ENFORCEQUOTA 환경 변수를 true 로 설정해야 합니다. 새 배포에 대해 기본적으로 환경 변수는 true 로 설정됩니다.

4.3.4. 이미지 스트림 제한

지원되는 리소스:

-

openshift.io/image-tags -

openshift.io/images

리소스 유형 이름:

-

openshift.io/ImageStream

지정된 경우 이미지 스트림별로 다음 사항이 충족되어야 합니다.

| 제약 조건 | 동작 |

|---|---|

|

|

|

|

|

|

4.3.5. 이미지 참조 수

openshift.io/image-tags 리소스는 고유한 스트림 제한을 나타냅니다. 가능한 참조는 ImageStreamTag, ImageStreamImage 또는 DockerImage 입니다. 태그는 oc tag 및 oc import-image 명령을 사용하거나 이미지 스트림을 사용하여 생성할 수 있습니다. 내부 참조와 외부 참조는 구분되지 않습니다. 그러나 이미지 스트림 사양에 태그된 각 고유 참조는 한 번만 계산됩니다. 내부 컨테이너 이미지 레지스트리에 대한 내보내기는 어떤 방식으로든 제한하지 않지만 태그 제한에 유용합니다.

openshift.io/images 리소스는 이미지 스트림 상태에 기록된 고유한 이미지 이름을 나타냅니다. 내부 레지스트리로 내보낼 수 있는 여러 이미지를 제한하는 데 도움이 됩니다. 내부 및 외부 참조는 구분되지 않습니다.

4.3.6. PersistentVolumeClaim 제한

지원되는 리소스:

- 스토리지

지원되는 제한 사항:

프로젝트의 모든 영구 볼륨 클레임에서 다음 사항이 충족되어야 합니다.

| 제약 조건 | 강제 동작 |

|---|---|

|

| min[<resource>] <= claim.spec.resources.requests[<resource>] (필수) |

|

| claim.spec.resources.requests[<resource>] (필수) <= Max[<resource>] |

제한 범위 오브젝트 정의

추가 리소스

스트림 제한에 대한 자세한 내용은 이미지 스트림 관리를 참조하십시오.

컴퓨팅 리소스 제약 조건에 대한 자세한 내용은 다음을 수행합니다.

CPU 및 메모리 측정 방법에 대한 자세한 내용은 권장 컨트롤 플레인 관행을 참조하십시오.

임시 스토리지에 대한 제한 및 요청을 지정할 수 있습니다. 이 기능에 대한 자세한 내용은 임시 스토리지 이해 를 참조하십시오.

4.4. 제한 범위 작업

4.4.1. 제한 범위 생성

다음은 제한 범위를 생성하기 위해 따라야 하는 절차의 예입니다.

프로세스

오브젝트를 생성합니다.

oc create -f <limit_range_file> -n <project>

$ oc create -f <limit_range_file> -n <project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.2. 제한 보기

웹 콘솔에서 프로젝트의 할당량 페이지로 이동하여 프로젝트에 정의된 제한 범위를 볼 수 있습니다. CLI를 사용하여 다음 단계를 수행하여 제한 범위 세부 정보를 볼 수도 있습니다.

프로세스

프로젝트에 정의된 제한 범위 오브젝트 목록을 가져옵니다. 예를 들어

demoproject라는 프로젝트는 다음과 같습니다.oc get limits -n demoproject

$ oc get limits -n demoprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME AGE resource-limits 6d

NAME AGE resource-limits 6dCopy to Clipboard Copied! Toggle word wrap Toggle overflow 제한 범위를 설명합니다. 예를 들어

resource-limits라는 제한 범위의 경우 다음을 수행합니다.oc describe limits resource-limits -n demoproject

$ oc describe limits resource-limits -n demoprojectCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.3. 제한 범위 삭제

제한 범위를 제거하려면 다음 명령을 실행합니다.

+

oc delete limits <limit_name>

$ oc delete limits <limit_name>S

추가 리소스

사용자가 프로젝트 리소스에 대해 생성, 제한 및 할당량을 관리할 수 있는 프로젝트 수에 대한 다양한 제한을 적용하는 방법에 대한 자세한 내용은 프로젝트당 리소스 할당량을 참조하십시오.

5장. IBM Z & IBM (R) LinuxONE 환경에 대한 호스트 관련 권장 사례

이 주제에서는 IBM Z 및 IBM® LinuxONE의 OpenShift Container Platform에 대한 권장 호스트 사례를 설명합니다.

s390x 아키텍처는 여러 측면에서 고유합니다. 따라서 여기에 제공된 일부 권장 사항은 다른 플랫폼에 적용되지 않을 수 있습니다.

달리 명시되지 않는 한, 이러한 사례는 IBM Z 및 IBM® LinuxONE의 z/VM 및 RHEL(Red Hat Enterprise Linux) KVM 설치에 모두 적용됩니다.

5.1. CPU 과다 할당 관리

고도로 가상화된 IBM Z 환경에서는 인프라 설정 및 크기를 신중하게 계획해야 합니다. 가상화의 가장 중요한 기능 중 하나는 리소스 과다 할당을 수행하여 하이퍼바이저 수준에서 실제로 사용 가능한 것보다 더 많은 리소스를 가상 머신에 할당하는 기능입니다. 이는 워크로드에 따라 달라지며 모든 설정에 적용할 수 있는 금고 규칙이 없습니다.

설정에 따라 CPU 과다 할당과 관련된 모범 사례를 고려하십시오.

- LPAR 레벨(PR/SM 하이퍼바이저)에서는 사용 가능한 모든 물리적 코어(IFL)를 각 LPAR에 할당하지 마십시오. 예를 들어 4개의 물리적 IFL을 사용할 수 있으면 각각 4개의 논리 IFL을 사용하여 세 개의 LPAR을 정의할 수 없습니다.

- LPAR 공유 및 가중치를 확인하고 이해하십시오.

- 과도한 수의 가상 CPU가 성능에 부정적인 영향을 미칠 수 있습니다. 논리 프로세서가 LPAR에 정의되어 있는 것보다 더 많은 가상 프로세서를 게스트에 정의하지 마십시오.

- 더 이상 사용하지 않는 최대 워크로드에 대해 게스트당 가상 프로세서 수를 구성합니다.

- 작게 시작하고 워크로드를 모니터링합니다. 필요한 경우 vCPU 수를 증분적으로 늘립니다.

- 모든 워크로드가 높은 과다 할당 비율에 적합한 것은 아닙니다. 워크로드가 CPU 집약적인 경우 성능 문제 없이 높은 비율을 달성할 수 없습니다. I/O 집약적인 워크로드는 초과 커밋이 높은 경우에도 일관된 성능을 유지할 수 있습니다.

5.2. Transparent Huge Pages 비활성화

THP(Transparent Huge Pages)는 대규모 페이지를 생성, 관리 및 사용하는 대부분의 측면을 자동화합니다. THP는 대규모 페이지를 자동으로 관리하므로 모든 유형의 워크로드에 대해 항상 최적으로 처리되는 것은 아닙니다. THP는 많은 애플리케이션이 자체적으로 대규모 페이지를 처리하기 때문에 성능 회귀 문제가 발생할 수 있습니다. 따라서 THP를 비활성화하는 것이 좋습니다.

5.3. Receive Flow stering으로 네트워킹 성능 향상

수신 흐름 스테이저링(RFS)은 네트워크 대기 시간을 추가로 줄임으로써 Receive Packet stering(RPS)을 확장합니다. RFS는 기술적으로 RPS를 기반으로 하며, CPU 캐시 적중률을 증가시켜 패킷 처리의 효율성을 향상시킵니다. RFS는 이를 달성하며, 또한 CPU 내에서 캐시 적중이 발생할 가능성이 높아지도록 계산에 가장 편리한 CPU를 결정함으로써 큐 길이를 고려합니다. 따라서 CPU 캐시가 덜 무효화되어 캐시를 다시 빌드하려면 주기가 감소합니다. 이렇게 하면 패킷 처리 시간을 줄일 수 있습니다.

5.3.1. MCO(Machine Config Operator)를 사용하여 RFS를 활성화합니다.

절차

다음 MCO 샘플 프로필을 YAML 파일에 복사합니다. 예를 들면

enable-rfs.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow MCO 프로필을 만듭니다.

oc create -f enable-rfs.yaml

$ oc create -f enable-rfs.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 50-enable-rfs라는 항목이 나열되었는지 확인합니다.oc get mc

$ oc get mcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 비활성화하려면 다음을 입력합니다.

oc delete mc 50-enable-rfs

$ oc delete mc 50-enable-rfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. 네트워킹 설정 선택

네트워킹 스택은 OpenShift Container Platform과 같은 Kubernetes 기반 제품의 가장 중요한 구성 요소 중 하나입니다. IBM Z 설정의 경우 네트워킹 설정은 선택한 하이퍼바이저에 따라 다릅니다. 워크로드 및 애플리케이션에 따라 가장 적합한 것이 일반적으로 사용 사례 및 트래픽 패턴에 따라 변경됩니다.

설정에 따라 다음 모범 사례를 고려하십시오.

- 트래픽 패턴을 최적화하기 위해 네트워킹 장치와 관련된 모든 옵션을 고려하십시오. OSA-Express, RoCE Express, HiperSockets, z/VM VSwitch, Linux Bridge(KVM)의 장점을 살펴보고, 다른 옵션으로 인해 설정에 가장 큰 이점을 얻을 수 있습니다.

- 항상 사용 가능한 최신 NIC 버전을 사용하십시오. 예를 들어 OSA Express 7S 10GbE는 10GbE 어댑터인 OSA Express 6S 10GbE와 트랜잭션 워크로드 유형의 GbE와 비교하여 큰 개선을 나타냈습니다.

- 각 가상 스위치는 대기 시간의 추가 계층을 추가합니다.

- 로드 밸런서는 클러스터 외부의 네트워크 통신에 중요한 역할을 합니다. 애플리케이션에 중요한 경우 프로덕션 수준의 하드웨어 로드 밸런서를 사용하는 것이 좋습니다.

- OpenShift Container Platform SDN에는 네트워킹 성능에 영향을 주는 흐름과 규칙이 도입되었습니다. 통신이 중요한 서비스의 현지성을 활용하기 위해 포드의 영향 및 배치를 고려해야 합니다.

- 성능과 기능 간의 균형을 조정합니다.

5.5. z/VM의 HyperPAV로 높은 디스크 성능 보장

DASD 및 ECKD 장치는 IBM Z 환경에서 일반적으로 사용되는 디스크 유형입니다. z/VM 환경의 일반적인 OpenShift Container Platform 설정에서 DASD 디스크는 일반적으로 노드의 로컬 스토리지를 지원하는 데 사용됩니다. HyperPAV 별칭 장치를 설정하여 z/VM 게스트를 지원하는 DASD 디스크에 대해 처리량과 전반적으로 향상된 I/O 성능을 제공할 수 있습니다.

로컬 스토리지 장치에 HyperPAV를 사용하면 성능에 큰 이점이 있습니다. 그러나 처리량과 CPU 비용 사이에 장단점이 있다는 점에 유의해야 합니다.

풀팩 미니disk를 사용하는 z/VM 기반 OpenShift Container Platform 설정의 경우 모든 노드에서 HyperPAV 별칭을 활성화하여 MCO 프로필의 이점을 활용할 수 있습니다. 컨트롤 플레인 및 컴퓨팅 노드 모두에 YAML 구성을 추가해야 합니다.

절차

다음 MCO 샘플 프로필을 컨트롤 플레인 노드의 YAML 파일에 복사합니다. 예를 들면

05-master-kernelarg-hpav.yaml입니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 MCO 샘플 프로필을 계산 노드의 YAML 파일에 복사합니다. 예를 들면

05-worker-kernelarg-hpav.yaml입니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고장치 ID에 맞게

rd.dasd인수를 수정해야 합니다.MCO 프로필을 만듭니다.

oc create -f 05-master-kernelarg-hpav.yaml

$ oc create -f 05-master-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f 05-worker-kernelarg-hpav.yaml

$ oc create -f 05-worker-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 비활성화하려면 다음을 입력합니다.

oc delete -f 05-master-kernelarg-hpav.yaml

$ oc delete -f 05-master-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete -f 05-worker-kernelarg-hpav.yaml

$ oc delete -f 05-worker-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.6. IBM Z 호스트의 RHEL KVM 권장 사항

KVM 가상 서버 환경 최적화는 가상 서버 및 사용 가능한 리소스의 워크로드에 따라 크게 달라집니다. 한 환경에서 성능을 개선하는 것과 동일한 동작이 다른 환경에서 불리한 영향을 미칠 수 있습니다. 특정 설정에 가장 적합한 균형을 찾는 것은 문제가 될 수 있으며 종종 실험이 포함됩니다.

다음 섹션에서는 IBM Z 및 IBM® LinuxONE 환경에서 RHEL KVM과 함께 OpenShift Container Platform을 사용할 때 몇 가지 모범 사례를 소개합니다.

5.6.1. 가상 블록 장치에 I/O 스레드 사용

가상 블록 장치가 I/O 스레드를 사용하도록 하려면 가상 서버 및 이러한 I/O 스레드 중 하나를 사용하도록 각 가상 블록 스레드에 대해 하나 이상의 I/O 스레드를 구성해야 합니다.

다음 예제에서는 연속 10진수 스레드 ID 1, 2 및 3으로 세 개의 I/O 스레드를 구성하기 위해 <iothreads >3</iothreads>를 지정합니다. iothread="2" 매개 변수는 ID 2에서 I/O 스레드를 사용하기 위해 디스크 장치의 드라이버 요소를 지정합니다.

샘플 I/O 스레드 사양

스레드는 디스크 장치에 대한 I/O 작업의 성능을 향상시킬 수 있지만 메모리 및 CPU 리소스도 사용합니다. 동일한 스레드를 사용하도록 여러 장치를 구성할 수 있습니다. 스레드를 장치에 가장 잘 매핑하는 것은 사용 가능한 리소스 및 워크로드에 따라 다릅니다.

소수의 I/O 스레드로 시작합니다. 대부분의 경우 모든 디스크 장치에 대한 단일 I/O 스레드로 충분합니다. 가상 CPU 수보다 많은 스레드를 구성하지 말고 유휴 스레드를 구성하지 마십시오.

virsh iothreadadd 명령을 사용하여 특정 스레드 ID가 있는 I/O 스레드를 실행 중인 가상 서버에 추가할 수 있습니다.

5.6.2. 가상 SCSI 장치 방지

SCSI별 인터페이스를 통해 장치를 해결해야 하는 경우에만 가상 SCSI 장치를 구성합니다. 호스트에서 백업에 관계없이 가상 SCSI 장치가 아닌 가상 블록 장치로 디스크 공간을 구성합니다.

그러나 다음을 위해 SCSI 특정 인터페이스가 필요할 수 있습니다.

- 호스트의 SCSI 연결 video drive용 LUN입니다.

- 가상 DVD 드라이브에 마운트된 호스트 파일 시스템의 DVD ISO 파일입니다.

5.6.3. 디스크의 게스트 캐싱 구성

호스트가 아닌 게스트에서 캐싱을 수행하도록 디스크 장치를 구성합니다.

디스크 장치의 드라이버 요소에 cache="none" 및 io="native" 매개변수가 포함되어 있는지 확인합니다.

<disk type="block" device="disk">

<driver name="qemu" type="raw" cache="none" io="native" iothread="1"/>

...

</disk>

<disk type="block" device="disk">

<driver name="qemu" type="raw" cache="none" io="native" iothread="1"/>

...

</disk>5.6.4. 메모리 balloon 장치 제외

동적 메모리 크기가 필요하지 않은 경우 메모리 balloon 장치를 정의하지 말고 libvirt가 사용자를 위해 생성되지 않도록 합니다. 도메인 구성 XML 파일에 devices 요소의 하위 항목으로 memballoon 매개 변수를 포함합니다.

활성 프로필 목록을 확인합니다.

<memballoon model="none"/>

<memballoon model="none"/>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.6.5. 호스트 스케줄러의 CPU 마이그레이션 알고리즘 튜닝

영향을 이해하는 전문가가 아닌 경우 스케줄러 설정을 변경하지 마십시오. 테스트하지 않고 프로덕션 시스템에 변경 사항을 적용하지 말고 의도된 효과가 있는지 확인합니다.

kernel.sched_migration_cost_ns 매개변수는 나노초 단위를 지정합니다. 작업을 마지막으로 실행한 후 CPU 캐시는 이 간격이 만료될 때까지 유용한 콘텐츠를 갖는 것으로 간주됩니다. 이 간격을 늘리면 작업 마이그레이션 횟수가 줄어듭니다. 기본값은 500000 ns입니다.

실행 가능한 프로세스가 있을 때 CPU 유휴 시간이 예상보다 높은 경우 이 간격을 줄입니다. CPU 또는 노드 간에 작업이 너무 자주 부과되는 경우 해당 작업을 늘립니다.

간격을 60000 ns로 동적으로 설정하려면 다음 명령을 입력합니다.

sysctl kernel.sched_migration_cost_ns=60000

# sysctl kernel.sched_migration_cost_ns=60000

값을 60000 ns로 영구적으로 변경하려면 다음 항목을 /etc/sysctl.conf 에 추가합니다.

kernel.sched_migration_cost_ns=60000

kernel.sched_migration_cost_ns=600005.6.6. cpuset cgroup 컨트롤러 비활성화

이 설정은 cgroups 버전 1이 있는 KVM 호스트에만 적용됩니다. 호스트에서 CPU 핫플러그를 활성화하려면 cgroup 컨트롤러를 비활성화합니다.

절차

-

선택한 편집기를 사용하여

/etc/libvirt/qemu.conf를 엽니다. -

cgroup_controllers행으로 이동합니다. - 전체 행을 복제하고 사본에서 선행 숫자 기호(#)를 제거합니다.

다음과 같이

cpuset항목을 제거합니다.cgroup_controllers = [ "cpu", "devices", "memory", "blkio", "cpuacct" ]

cgroup_controllers = [ "cpu", "devices", "memory", "blkio", "cpuacct" ]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 새 설정을 적용하려면 libvirtd 데몬을 다시 시작해야 합니다.

- 모든 가상 머신을 중지합니다.

다음 명령을 실행합니다.

systemctl restart libvirtd

# systemctl restart libvirtdCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 가상 머신을 재시작합니다.

이 설정은 호스트 재부팅 시 유지됩니다.

5.6.7. 유휴 가상 CPU의 폴링 기간 조정

가상 CPU가 유휴 상태가 되면 KVM은 호스트 리소스를 할당하기 전에 가상 CPU에 대한 정지 조건을 폴링합니다. /sys/module/kvm/parameters/halt_poll_ns 의 sysfs에서 폴링하는 시간 간격을 지정할 수 있습니다. 지정된 시간 동안 폴링을 사용하면 리소스 사용량을 소비하여 가상 CPU의 정지 대기 시간을 줄일 수 있습니다. 워크로드에 따라 폴링 시간이 길거나 짧아질 수 있습니다. 시간 간격은 나노초로 지정됩니다. 기본값은 50000 ns입니다.

낮은 CPU 사용을 최적화하려면 작은 값을 입력하거나 0을 작성하여 폴링을 비활성화합니다.

echo 0 > /sys/module/kvm/parameters/halt_poll_ns

# echo 0 > /sys/module/kvm/parameters/halt_poll_nsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 트랜잭션 워크로드와 같이 짧은 대기 시간을 최적화하려면 큰 값을 입력합니다.

echo 80000 > /sys/module/kvm/parameters/halt_poll_ns

# echo 80000 > /sys/module/kvm/parameters/halt_poll_nsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6장. Node Tuning Operator 사용

Node Tuning Operator에 대해 알아보고, Node Tuning Operator를 사용하여 Tuned 데몬을 오케스트레이션하고 노드 수준 튜닝을 관리하는 방법도 알아봅니다.

6.1. Node Tuning Operator 정보

Node Tuning Operator는 TuneD 데몬을 오케스트레이션하여 노드 수준 튜닝을 관리하고 Performance Profile 컨트롤러를 사용하여 짧은 대기 시간 성능을 달성하는 데 도움이 됩니다. 대부분의 고성능 애플리케이션에는 일정 수준의 커널 튜닝이 필요합니다. Node Tuning Operator는 노드 수준 sysctls 사용자에게 통합 관리 인터페이스를 제공하며 사용자의 필요에 따라 지정되는 사용자 정의 튜닝을 추가할 수 있는 유연성을 제공합니다.

Operator는 OpenShift Container Platform의 컨테이너화된 TuneD 데몬을 Kubernetes 데몬 세트로 관리합니다. 클러스터에서 실행되는 모든 컨테이너화된 TuneD 데몬에 사용자 정의 튜닝 사양이 데몬이 이해할 수 있는 형식으로 전달되도록 합니다. 데몬은 클러스터의 모든 노드에서 노드당 하나씩 실행됩니다.

컨테이너화된 TuneD 데몬을 통해 적용되는 노드 수준 설정은 프로필 변경을 트리거하는 이벤트 시 또는 컨테이너화된 TuneD 데몬이 종료 신호를 수신하고 처리하여 정상적으로 종료될 때 롤백됩니다.

Node Tuning Operator는 Performance Profile 컨트롤러를 사용하여 자동 튜닝을 구현하여 OpenShift Container Platform 애플리케이션에 대해 짧은 대기 시간 성능을 실현합니다. 클러스터 관리자는 다음과 같은 노드 수준 설정을 정의하도록 성능 프로필을 구성합니다.

- 커널을 kernel-rt로 업데이트

- 하우스키핑을 위해 CPU를 선택합니다.

- 워크로드 실행을 위한 CPU 선택.

현재 cgroup v2에서는 CPU 부하 분산을 비활성화하지 않습니다. 따라서 cgroup v2가 활성화된 경우 성능 프로필에서 원하는 동작을 얻지 못할 수 있습니다. 성능 프로필을 사용하는 경우에는 cgroup v2를 활성화하는 것은 권장되지 않습니다.

버전 4.1 이상에서는 Node Tuning Operator가 표준 OpenShift Container Platform 설치에 포함되어 있습니다.

이전 버전의 OpenShift Container Platform에서는 OpenShift 애플리케이션에 대해 짧은 대기 시간 성능을 실현하기 위해 자동 튜닝을 구현하는 데 Performance Addon Operator를 사용했습니다. OpenShift Container Platform 4.11 이상에서는 이 기능은 Node Tuning Operator의 일부입니다.

6.2. Node Tuning Operator 사양 예에 액세스

이 프로세스를 사용하여 Node Tuning Operator 사양 예에 액세스하십시오.

절차

다음 명령을 실행하여 Node Tuning Operator 사양 예제에 액세스합니다.

oc get tuned.tuned.openshift.io/default -o yaml -n openshift-cluster-node-tuning-operator

oc get tuned.tuned.openshift.io/default -o yaml -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

기본 CR은 OpenShift Container Platform 플랫폼의 표준 노드 수준 튜닝을 제공하기 위한 것이며 Operator 관리 상태를 설정하는 경우에만 수정할 수 있습니다. Operator는 기본 CR에 대한 다른 모든 사용자 정의 변경사항을 덮어씁니다. 사용자 정의 튜닝의 경우 고유한 Tuned CR을 생성합니다. 새로 생성된 CR은 노드 또는 Pod 라벨 및 프로필 우선 순위에 따라 OpenShift Container Platform 노드에 적용된 기본 CR 및 사용자 정의 튜닝과 결합됩니다.

특정 상황에서는 Pod 라벨에 대한 지원이 필요한 튜닝을 자동으로 제공하는 편리한 방법일 수 있지만 이러한 방법은 권장되지 않으며 특히 대규모 클러스터에서는 이러한 방법을 사용하지 않는 것이 좋습니다. 기본 Tuned CR은 Pod 라벨이 일치되지 않은 상태로 제공됩니다. Pod 라벨이 일치된 상태로 사용자 정의 프로필이 생성되면 해당 시점에 이 기능이 활성화됩니다. Pod 라벨 기능은 Node Tuning Operator의 향후 버전에서 더 이상 사용되지 않습니다.

6.3. 클러스터에 설정된 기본 프로필

다음은 클러스터에 설정된 기본 프로필입니다.

OpenShift Container Platform 4.9부터 모든 OpenShift TuneD 프로필이 TuneD 패키지와 함께 제공됩니다. oc exec 명령을 사용하여 이러한 프로필의 내용을 볼 수 있습니다.

oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/openshift{,-control-plane,-node} -name tuned.conf -exec grep -H ^ {} \;

$ oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/openshift{,-control-plane,-node} -name tuned.conf -exec grep -H ^ {} \;6.4. TuneD 프로필이 적용되었는지 검증

클러스터 노드에 적용되는 TuneD 프로필을 확인합니다.

oc get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operator

$ oc get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operator출력 예

-

NAME: Profile 오브젝트의 이름입니다. 노드당 하나의 Profile 오브젝트가 있고 해당 이름이 일치합니다. -

TUNED: 적용할 TuneD 프로파일의 이름입니다. -

APPLIED: TuneD 데몬이 원하는 프로필을 적용한 경우True입니다. (True/False/Unknown). -

DEGRADED: TuneD 프로파일 적용 중에 오류가 보고된 경우 (True)./False/Unknown -

AGE: Profile 개체 생성 이후 경과 시간입니다.

6.5. 사용자 정의 튜닝 사양

Operator의 CR(사용자 정의 리소스)에는 두 가지 주요 섹션이 있습니다. 첫 번째 섹션인 profile:은 TuneD 프로필 및 해당 이름의 목록입니다. 두 번째인 recommend:은 프로필 선택 논리를 정의합니다.

여러 사용자 정의 튜닝 사양은 Operator의 네임스페이스에 여러 CR로 존재할 수 있습니다. 새로운 CR의 존재 또는 오래된 CR의 삭제는 Operator에서 탐지됩니다. 기존의 모든 사용자 정의 튜닝 사양이 병합되고 컨테이너화된 TuneD 데몬의 해당 오브젝트가 업데이트됩니다.

관리 상태

Operator 관리 상태는 기본 Tuned CR을 조정하여 설정됩니다. 기본적으로 Operator는 Managed 상태이며 기본 Tuned CR에는 spec.managementState 필드가 없습니다. Operator 관리 상태에 유효한 값은 다음과 같습니다.

- Managed: 구성 리소스가 업데이트되면 Operator가 해당 피연산자를 업데이트합니다.

- Unmanaged: Operator가 구성 리소스에 대한 변경을 무시합니다.

- Removed: Operator가 프로비저닝한 해당 피연산자 및 리소스를 Operator가 제거합니다.

프로필 데이터

profile: 섹션에는 TuneD 프로필 및 해당 이름이 나열됩니다.

권장 프로필

profile: 선택 논리는 CR의 recommend: 섹션에 의해 정의됩니다. recommend: 섹션은 선택 기준에 따라 프로필을 권장하는 항목의 목록입니다.

recommend: <recommend-item-1> # ... <recommend-item-n>

recommend:

<recommend-item-1>

# ...

<recommend-item-n>목록의 개별 항목은 다음과 같습니다.

- 1

- 선택 사항입니다.

- 2

- 키/값

MachineConfig라벨 사전입니다. 키는 고유해야 합니다. - 3

- 생략하면 우선 순위가 높은 프로필이 먼저 일치되거나

machineConfigLabels가 설정되어 있지 않으면 프로필이 일치하는 것으로 가정합니다. - 4

- 선택사항 목록입니다.

- 5

- 프로필 순서 지정 우선 순위입니다. 숫자가 작을수록 우선 순위가 높습니다(

0이 가장 높은 우선 순위임). - 6

- 일치에 적용할 TuneD 프로필입니다. 예를 들어

tuned_profile_1이 있습니다. - 7

- 선택적 피연산자 구성입니다.

- 8

- TuneD 데몬의 디버깅을 켜거나 비활성화합니다. off의 경우 on 또는

false의 경우 옵션이true입니다. 기본값은false입니다. - 9

- TuneD 데몬에 대해

reapply_sysctl기능을 켜거나 off합니다. off의 경우 on 및false의 경우 옵션이true입니다.

<match>는 다음과 같이 재귀적으로 정의되는 선택사항 목록입니다.

- label: <label_name>

value: <label_value>

type: <label_type>

<match>

- label: <label_name>

value: <label_value>

type: <label_type>

<match>

<match>를 생략하지 않으면 모든 중첩 <match> 섹션도 true로 평가되어야 합니다. 생략하면 false로 가정하고 해당 <match> 섹션이 있는 프로필을 적용하지 않거나 권장하지 않습니다. 따라서 중첩(하위 <match> 섹션)은 논리 AND 연산자 역할을 합니다. 반대로 <match> 목록의 항목이 일치하면 전체 <match> 목록이 true로 평가됩니다. 따라서 이 목록이 논리 OR 연산자 역할을 합니다.

machineConfigLabels가 정의되면 지정된 recommend: 목록 항목에 대해 머신 구성 풀 기반 일치가 설정됩니다. <mcLabels>는 머신 구성의 라벨을 지정합니다. 머신 구성은 <tuned_profile_name> 프로필에 대해 커널 부팅 매개변수와 같은 호스트 설정을 적용하기 위해 자동으로 생성됩니다. 여기에는 <mcLabels>와 일치하는 머신 구성 선택기가 있는 모든 머신 구성 풀을 찾고 머신 구성 풀이 할당된 모든 노드에서 <tuned_profile_name> 프로필을 설정하는 작업이 포함됩니다. 마스터 및 작업자 역할이 모두 있는 노드를 대상으로 하려면 마스터 역할을 사용해야 합니다.

목록 항목 match 및 machineConfigLabels는 논리 OR 연산자로 연결됩니다. match 항목은 단락 방식으로 먼저 평가됩니다. 따라서 true로 평가되면 machineConfigLabels 항목이 고려되지 않습니다.

머신 구성 풀 기반 일치를 사용하는 경우 동일한 하드웨어 구성을 가진 노드를 동일한 머신 구성 풀로 그룹화하는 것이 좋습니다. 이 방법을 따르지 않으면 TuneD 피연산자가 동일한 머신 구성 풀을 공유하는 두 개 이상의 노드에 대해 충돌하는 커널 매개변수를 계산할 수 있습니다.

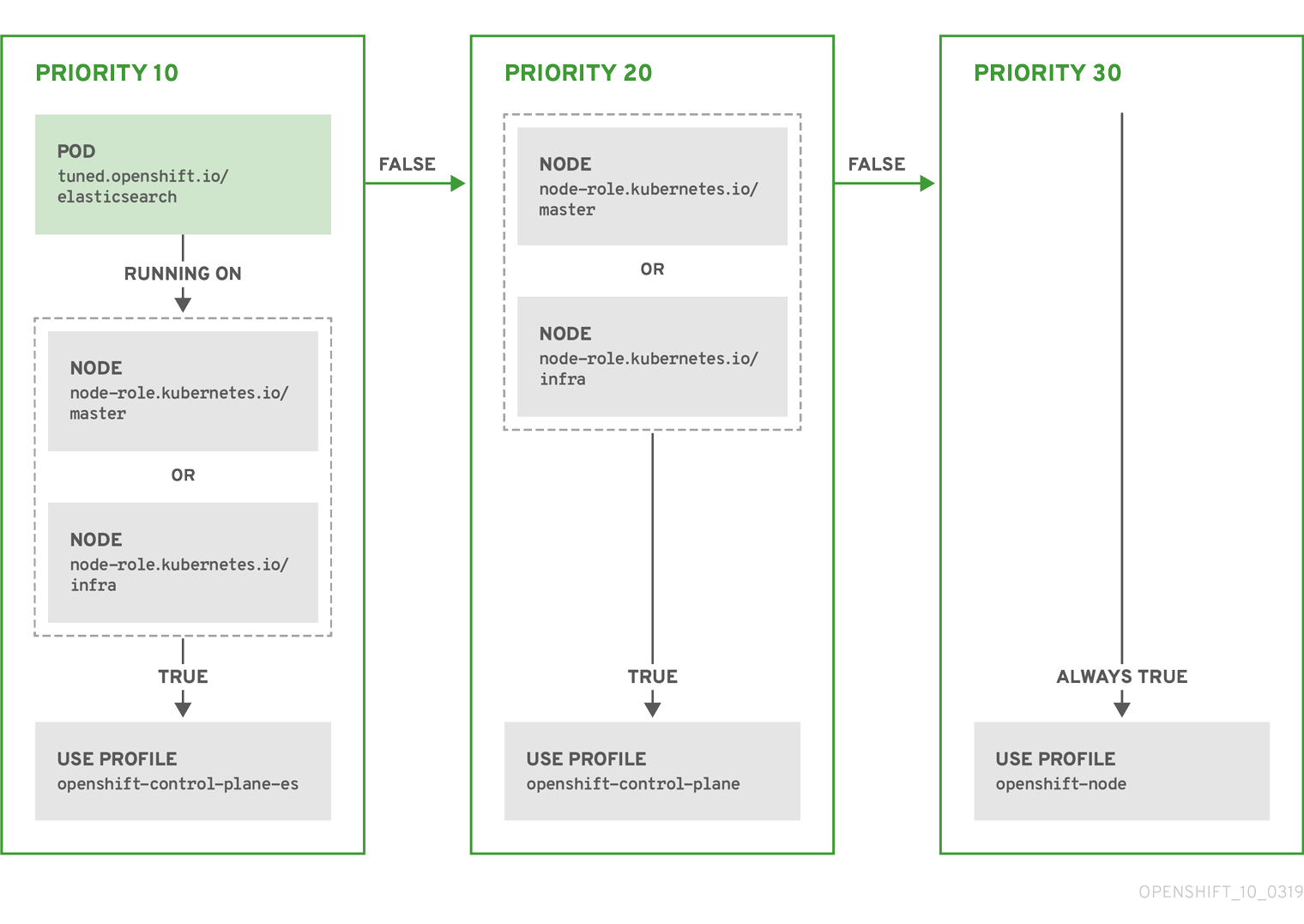

예: 노드 또는 Pod 라벨 기반 일치

위의 CR은 컨테이너화된 TuneD 데몬의 프로필 우선 순위에 따라 recommended.conf 파일로 변환됩니다. 우선 순위가 가장 높은 프로필(10)이 openshift-control-plane-es이므로 이 프로필을 첫 번째로 고려합니다. 지정된 노드에서 실행되는 컨테이너화된 TuneD 데몬은 tuned.openshift.io/elasticsearch 라벨이 설정된 동일한 노드에서 실행되는 Pod가 있는지 확인합니다. 없는 경우 전체 <match> 섹션이 false로 평가됩니다. 라벨이 있는 Pod가 있는 경우 <match> 섹션을 true로 평가하려면 노드 라벨도 node-role.kubernetes.io/master 또는 node-role.kubernetes.io/infra여야 합니다.

우선 순위가 10인 프로필의 라벨이 일치하면 openshift-control-plane-es 프로필이 적용되고 다른 프로필은 고려되지 않습니다. 노드/Pod 라벨 조합이 일치하지 않으면 두 번째로 높은 우선 순위 프로필(openshift-control-plane)이 고려됩니다. 컨테이너화된 TuneD Pod가 node-role.kubernetes.io/master 또는 node-role.kubernetes.io/infra. 라벨이 있는 노드에서 실행되는 경우 이 프로필이 적용됩니다.

마지막으로, openshift-node 프로필은 우선 순위가 가장 낮은 30입니다. 이 프로필에는 <match> 섹션이 없으므로 항상 일치합니다. 지정된 노드에서 우선 순위가 더 높은 다른 프로필이 일치하지 않는 경우 openshift-node 프로필을 설정하는 데 catch-all 프로필 역할을 합니다.

예: 머신 구성 풀 기반 일치

노드 재부팅을 최소화하려면 머신 구성 풀의 노드 선택기와 일치하는 라벨로 대상 노드에 라벨을 지정한 후 위의 Tuned CR을 생성하고 마지막으로 사용자 정의 머신 구성 풀을 생성합니다.

클라우드 공급자별 TuneD 프로필

이 기능을 사용하면 모든 클라우드 공급자별 노드에 OpenShift Container Platform 클러스터의 지정된 클라우드 공급자에 맞게 특별히 조정된 TuneD 프로필이 편리하게 할당될 수 있습니다. 이 작업은 노드 레이블을 추가하거나 머신 구성 풀에 노드를 그룹화하지 않고 수행할 수 있습니다.

이 기능은 <cloud-provider>://< cloud-provider-specific-id> 형식의 노드 오브젝트 값을 사용하고 NTO 피연산자 컨테이너에서 < spec.provider IDcloud-provider> 값으로 파일을 씁니다. 그런 다음 TuneD에서 해당 프로필이 있는 경우 provider-< /var/lib/tuned/provider cloud-provider > 프로필을 로드하는 데 이 파일의 콘텐츠를 사용합니다.

및 openshift -control-planeopenshift-node 프로필 모두의 설정을 상속하는 openshift 프로필은 조건부 프로필 로드를 사용하여 이 기능을 사용하도록 업데이트되었습니다. NTO와 TuneD는 현재 클라우드 공급자별 프로필을 제공하지 않습니다. 그러나 모든 클라우드 공급자별 클러스터 노드에 적용할 사용자 지정 프로필 provider-<cloud- provider>를 생성할 수 있습니다.

GCE 클라우드 공급자 프로필의 예

프로필 상속으로 인해 provider-< cloud-provider > 프로필에 지정된 모든 설정은 openshift 프로필 및 해당 하위 프로필에서 덮어씁니다.

6.6. 사용자 정의 튜닝 예

기본 CR에서 TuneD 프로파일 사용

다음 CR에서는 tuned.openshift.io/ingress-node-label 레이블이 임의의 값으로 설정된 OpenShift Container Platform 노드에 대해 사용자 정의 노드 수준 튜닝을 적용합니다.

예: openshift-control-plane TuneD 프로필을 사용한 사용자 정의 튜닝

사용자 정의 프로필 작성자는 기본 TuneD CR에 제공된 기본 Tuned 데몬 프로필을 포함하는 것이 좋습니다. 위의 예에서는 기본 openshift-control-plane 프로필을 사용하여 작업을 수행합니다.

내장된 TuneD 프로필 사용

NTO 관리 데몬 세트가 성공적으로 롤아웃되면 TuneD 피연산자는 모두 동일한 버전의 TuneD 데몬을 관리합니다. 데몬에서 지원하는 기본 제공 TuneD 프로필을 나열하려면 다음 방식으로 TuneD Pod를 쿼리합니다.

oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/ -name tuned.conf -printf '%h\n' | sed 's|^.*/||'

$ oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/ -name tuned.conf -printf '%h\n' | sed 's|^.*/||'사용자 정의 튜닝 사양에서 이 명령으로 검색한 프로필 이름을 사용할 수 있습니다.

예: 기본 제공 hpc-compute TuneD 프로필 사용

기본 제공 hpc-compute 프로필 외에도 위의 예제에는 기본 Tuned CR 내에 제공된 openshift-node TuneD 데몬 프로필이 포함되어 컴퓨팅 노드에 OpenShift별 튜닝을 사용합니다.

6.7. 지원되는 TuneD 데몬 플러그인

Tuned CR의 profile: 섹션에 정의된 사용자 정의 프로필을 사용하는 경우 [main] 섹션을 제외한 다음 TuneD 플러그인이 지원됩니다.

- audio

- cpu

- disk

- eeepc_she

- modules

- mounts

- net

- scheduler

- scsi_host

- selinux

- sysctl

- sysfs

- usb

- video

- vm

- bootloader

일부 플러그인에서 제공하는 동적 튜닝 기능은 지원되지 않습니다. 다음 TuneD 플러그인은 현재 지원되지 않습니다.

- script

- systemd

TuneD 부트로더 플러그인은 RHCOS(Red Hat Enterprise Linux CoreOS) 작업자 노드만 지원합니다.

추가 리소스

6.8. 호스팅된 클러스터에서 노드 튜닝 구성

호스트 컨트롤 플레인은 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

호스팅된 클러스터의 노드에 노드 수준 튜닝을 설정하려면 Node Tuning Operator를 사용할 수 있습니다. 호스팅된 컨트롤 플레인에서는 Tuned 오브젝트가 포함된 구성 맵을 생성하고 노드 풀에서 해당 구성 맵을 참조하여 노드 튜닝을 구성할 수 있습니다.

프로세스

유효한 tuned 매니페스트를 포함하는 구성 맵을 생성하고 노드 풀에서 매니페스트를 참조합니다. 다음 예제에서

Tuned매니페스트는 값이 있는tuned-1-node-label노드 라벨이 포함된 노드에서vm.dirty_ratio를 55로 설정하는 프로필을 정의합니다.tuned-1.yaml이라는 파일에 다음ConfigMap매니페스트를 저장합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고Tuned 사양의

spec.recommend섹션에 있는 항목에 레이블을 추가하지 않으면 노드 풀 기반 일치로 가정하므로spec.recommend섹션의 우선 순위 프로필이 풀의 노드에 적용됩니다. Tuned.spec.recommend.match섹션에서 레이블 값을 설정하여 더 세분화된 node-label-based 일치를 수행할 수 있지만 노드 풀의.spec.management.upgradeType값을InPlace로 설정하지 않으면 업그레이드 중에 노드 라벨이 유지되지 않습니다.관리 클러스터에

ConfigMap오브젝트를 생성합니다.oc --kubeconfig="$MGMT_KUBECONFIG" create -f tuned-1.yaml

$ oc --kubeconfig="$MGMT_KUBECONFIG" create -f tuned-1.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 노드 풀을 편집하거나 생성하여 노드 풀의

spec.tuningConfig필드에서ConfigMap오브젝트를 참조합니다. 이 예에서는 2개의 노드가 포함된nodepool-1이라는NodePool만 있다고 가정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고여러 노드 풀에서 동일한 구성 맵을 참조할 수 있습니다. 호스트 컨트롤 플레인에서 Node Tuning Operator는 노드 풀 이름과 네임스페이스의 해시를 구분하기 위해 Tuned CR의 이름에 추가합니다. 이 경우 동일한 호스팅 클러스터의 Tuned CR에서 동일한 이름의 TuneD 프로필을 여러 개 생성하지 마십시오.

검증

이제 Tuned 매니페스트가 포함된 ConfigMap 오브젝트를 생성하고 NodePool 에서 참조했기 때문에 Node Tuning Operator는 Tuned 오브젝트를 호스트 클러스터에 동기화합니다. 어떤 Tuned 오브젝트가 정의되고 각 노드에 적용되는 TuneD 프로필을 확인할 수 있습니다.

호스팅 클러스터의

Tuned오브젝트를 나열합니다.oc --kubeconfig="$HC_KUBECONFIG" get tuned.tuned.openshift.io -n openshift-cluster-node-tuning-operator

$ oc --kubeconfig="$HC_KUBECONFIG" get tuned.tuned.openshift.io -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME AGE default 7m36s rendered 7m36s tuned-1 65s

NAME AGE default 7m36s rendered 7m36s tuned-1 65sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 호스팅된 클러스터의

Profile오브젝트를 나열합니다.oc --kubeconfig="$HC_KUBECONFIG" get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operator

$ oc --kubeconfig="$HC_KUBECONFIG" get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME TUNED APPLIED DEGRADED AGE nodepool-1-worker-1 tuned-1-profile True False 7m43s nodepool-1-worker-2 tuned-1-profile True False 7m14s

NAME TUNED APPLIED DEGRADED AGE nodepool-1-worker-1 tuned-1-profile True False 7m43s nodepool-1-worker-2 tuned-1-profile True False 7m14sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고사용자 정의 프로필이 생성되지 않으면

openshift-node프로필이 기본적으로 적용됩니다.튜닝이 올바르게 적용되었는지 확인하려면 노드에서 디버그 쉘을 시작하고 sysctl 값을 확인합니다.

oc --kubeconfig="$HC_KUBECONFIG" debug node/nodepool-1-worker-1 -- chroot /host sysctl vm.dirty_ratio

$ oc --kubeconfig="$HC_KUBECONFIG" debug node/nodepool-1-worker-1 -- chroot /host sysctl vm.dirty_ratioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

vm.dirty_ratio = 55

vm.dirty_ratio = 55Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.9. 커널 부팅 매개변수를 설정하여 호스팅 클러스터의 고급 노드 튜닝

호스트 컨트롤 플레인은 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

커널 부팅 매개변수를 설정해야 하는 호스팅 컨트롤 플레인의 고급 튜닝을 위해 Node Tuning Operator를 사용할 수도 있습니다. 다음 예제에서는 대규모 페이지가 예약된 노드 풀을 생성하는 방법을 보여줍니다.

프로세스

크기가 2MB인 10개의 대규모 페이지를 생성하기 위한

Tuned오브젝트 매니페스트가 포함된ConfigMap오브젝트를 생성합니다.tuned-hugepages.yaml이라는 파일에 이ConfigMap매니페스트를 저장합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고.spec.recommend.match필드는 의도적으로 비어 있습니다. 이 경우 이Tuned오브젝트는 이ConfigMap오브젝트가 참조되는 노드 풀의 모든 노드에 적용됩니다. 동일한 하드웨어 구성을 가진 노드를 동일한 노드 풀로 그룹화합니다. 그렇지 않으면 TuneD 피연산자가 동일한 노드 풀을 공유하는 두 개 이상의 노드에 대해 충돌하는 커널 매개변수를 계산할 수 있습니다.관리 클러스터에

ConfigMap오브젝트를 생성합니다.oc --kubeconfig="$MGMT_KUBECONFIG" create -f tuned-hugepages.yaml

$ oc --kubeconfig="$MGMT_KUBECONFIG" create -f tuned-hugepages.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow NodePool매니페스트 YAML 파일을 생성하고NodePool의 업그레이드 유형을 사용자 지정하고spec.tuningConfig섹션에서 생성한ConfigMap오브젝트를 참조합니다.NodePool매니페스트를 생성하고hypershiftCLI를 사용하여hugepages-nodepool.yaml이라는 파일에 저장합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow hugepages-nodepool.yaml파일에서.spec.management.upgradeType을InPlace.Place.spec.tuningConfig로 설정하고 생성한tuned-hugepagesConfigMap오브젝트를 참조하도록 .spec.tuningConfig를 설정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고새

MachineConfig개체를 적용할 때 노드의 불필요한 재생성을 방지하려면.spec.management.upgradeType을InPlace로 설정합니다.Replace업그레이드 유형을 사용하는 경우 TuneD 피연산자가 계산된 새 커널 부팅 매개변수를 적용하면 노드가 완전히 삭제되고 새 노드가 교체될 수 있습니다.관리 클러스터에

NodePool을 생성합니다.oc --kubeconfig="$MGMT_KUBECONFIG" create -f hugepages-nodepool.yaml

$ oc --kubeconfig="$MGMT_KUBECONFIG" create -f hugepages-nodepool.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

노드를 사용할 수 있게 되면 컨테이너화된 TuneD 데몬은 적용된 TuneD 프로필을 기반으로 필요한 커널 부팅 매개변수를 계산합니다. 노드가 준비되고 재부팅되면 생성된 MachineConfig 오브젝트를 적용한 후 TuneD 프로필이 적용되고 커널 부팅 매개변수가 설정되어 있는지 확인할 수 있습니다.

호스팅 클러스터의

Tuned오브젝트를 나열합니다.oc --kubeconfig="$HC_KUBECONFIG" get tuned.tuned.openshift.io -n openshift-cluster-node-tuning-operator

$ oc --kubeconfig="$HC_KUBECONFIG" get tuned.tuned.openshift.io -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME AGE default 123m hugepages-8dfb1fed 1m23s rendered 123m

NAME AGE default 123m hugepages-8dfb1fed 1m23s rendered 123mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 호스팅된 클러스터의

Profile오브젝트를 나열합니다.oc --kubeconfig="$HC_KUBECONFIG" get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operator

$ oc --kubeconfig="$HC_KUBECONFIG" get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME TUNED APPLIED DEGRADED AGE nodepool-1-worker-1 openshift-node True False 132m nodepool-1-worker-2 openshift-node True False 131m hugepages-nodepool-worker-1 openshift-node-hugepages True False 4m8s hugepages-nodepool-worker-2 openshift-node-hugepages True False 3m57s

NAME TUNED APPLIED DEGRADED AGE nodepool-1-worker-1 openshift-node True False 132m nodepool-1-worker-2 openshift-node True False 131m hugepages-nodepool-worker-1 openshift-node-hugepages True False 4m8s hugepages-nodepool-worker-2 openshift-node-hugepages True False 3m57sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 새

NodePool의 두 작업자 노드에는openshift-node-hugepages프로필이 적용됩니다.튜닝이 올바르게 적용되었는지 확인하려면 노드에서 디버그 쉘을 시작하고

/proc/cmdline을 확인합니다.oc --kubeconfig="$HC_KUBECONFIG" debug node/nodepool-1-worker-1 -- chroot /host cat /proc/cmdline

$ oc --kubeconfig="$HC_KUBECONFIG" debug node/nodepool-1-worker-1 -- chroot /host cat /proc/cmdlineCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

BOOT_IMAGE=(hd0,gpt3)/ostree/rhcos-... hugepagesz=2M hugepages=50

BOOT_IMAGE=(hd0,gpt3)/ostree/rhcos-... hugepagesz=2M hugepages=50Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7장. CPU 관리자 및 토폴로지 관리자 사용

CPU 관리자는 CPU 그룹을 관리하고 워크로드를 특정 CPU로 제한합니다.

CPU 관리자는 다음과 같은 속성 중 일부가 포함된 워크로드에 유용합니다.

- 가능한 한 많은 CPU 시간이 필요합니다.

- 프로세서 캐시 누락에 민감합니다.

- 대기 시간이 짧은 네트워크 애플리케이션입니다.

- 다른 프로세스와 조정하고 단일 프로세서 캐시 공유를 통해 얻는 이점이 있습니다.

토폴로지 관리자는 동일한 NUMA(Non-Uniform Memory Access) 노드의 모든 QoS(Quality of Service) 클래스에 대해 CPU 관리자, 장치 관리자, 기타 힌트 공급자로부터 힌트를 수집하여 CPU, SR-IOV VF, 기타 장치 리소스 등의 Pod 리소스를 정렬합니다.

토폴로지 관리자는 토폴로지 관리자 정책 및 요청된 Pod 리소스를 기반으로 수집된 팁의 토폴로지 정보를 사용하여 노드에서 Pod를 수락하거나 거부할 수 있는지 결정합니다.

토폴로지 관리자는 하드웨어 가속기를 사용하여 대기 시간이 중요한 실행과 처리량이 높은 병렬 계산을 지원하는 워크로드에 유용합니다.

토폴로지 관리자를 사용하려면 정적 정책을 사용하여 CPU 관리자를 구성해야 합니다.

7.1. CPU 관리자 설정

프로세스

선택사항: 노드에 레이블을 지정합니다.

oc label node perf-node.example.com cpumanager=true

# oc label node perf-node.example.com cpumanager=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow CPU 관리자를 활성화해야 하는 노드의

MachineConfigPool을 편집합니다. 이 예에서는 모든 작업자의 CPU 관리자가 활성화됩니다.oc edit machineconfigpool worker

# oc edit machineconfigpool workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 작업자 머신 구성 풀에 레이블을 추가합니다.

metadata: creationTimestamp: 2020-xx-xxx generation: 3 labels: custom-kubelet: cpumanager-enabledmetadata: creationTimestamp: 2020-xx-xxx generation: 3 labels: custom-kubelet: cpumanager-enabledCopy to Clipboard Copied! Toggle word wrap Toggle overflow KubeletConfig,cpumanager-kubeletconfig.yaml, CR(사용자 정의 리소스)을 생성합니다. 이전 단계에서 생성한 레이블을 참조하여 올바른 노드가 새 kubelet 구성으로 업데이트되도록 합니다.machineConfigPoolSelector섹션을 참조하십시오.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 동적 kubelet 구성을 생성합니다.

oc create -f cpumanager-kubeletconfig.yaml

# oc create -f cpumanager-kubeletconfig.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 그러면 kubelet 구성에 CPU 관리자 기능이 추가되고 필요한 경우 MCO(Machine Config Operator)가 노드를 재부팅합니다. CPU 관리자를 활성화하는 데는 재부팅이 필요하지 않습니다.

병합된 kubelet 구성을 확인합니다.

oc get machineconfig 99-worker-XXXXXX-XXXXX-XXXX-XXXXX-kubelet -o json | grep ownerReference -A7

# oc get machineconfig 99-worker-XXXXXX-XXXXX-XXXX-XXXXX-kubelet -o json | grep ownerReference -A7Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 작업자에서 업데이트된

kubelet.conf를 확인합니다.oc debug node/perf-node.example.com sh-4.2# cat /host/etc/kubernetes/kubelet.conf | grep cpuManager

# oc debug node/perf-node.example.com sh-4.2# cat /host/etc/kubernetes/kubelet.conf | grep cpuManagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

cpuManagerPolicy: static cpuManagerReconcilePeriod: 5s

cpuManagerPolicy: static1 cpuManagerReconcilePeriod: 5s2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 코어를 하나 이상 요청하는 Pod를 생성합니다. 제한 및 요청 둘 다 해당 CPU 값이 정수로 설정되어야 합니다. 해당 숫자는 이 Pod 전용으로 사용할 코어 수입니다.

cat cpumanager-pod.yaml

# cat cpumanager-pod.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pod를 생성합니다.

oc create -f cpumanager-pod.yaml

# oc create -f cpumanager-pod.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 레이블 지정한 노드에 Pod가 예약되어 있는지 검증합니다.

oc describe pod cpumanager

# oc describe pod cpumanagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow cgroups가 올바르게 설정되었는지 검증합니다.pause프로세스의 PID(프로세스 ID)를 가져옵니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow QoS(Quality of Service) 계층

Guaranteed의 Pod는kubepods.slice에 있습니다. 다른 QoS 계층의 Pod는kubepods의 하위cgroups에 있습니다.cd /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-pod69c01f8e_6b74_11e9_ac0f_0a2b62178a22.slice/crio-b5437308f1ad1a7db0574c542bdf08563b865c0345c86e9585f8c0b0a655612c.scope for i in `ls cpuset.cpus tasks` ; do echo -n "$i "; cat $i ; done

# cd /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-pod69c01f8e_6b74_11e9_ac0f_0a2b62178a22.slice/crio-b5437308f1ad1a7db0574c542bdf08563b865c0345c86e9585f8c0b0a655612c.scope # for i in `ls cpuset.cpus tasks` ; do echo -n "$i "; cat $i ; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

cpuset.cpus 1 tasks 32706

cpuset.cpus 1 tasks 32706Copy to Clipboard Copied! Toggle word wrap Toggle overflow 작업에 허용되는 CPU 목록을 확인합니다.

grep ^Cpus_allowed_list /proc/32706/status

# grep ^Cpus_allowed_list /proc/32706/statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Cpus_allowed_list: 1

Cpus_allowed_list: 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow GuaranteedPod용으로 할당된 코어에서는 시스템의 다른 Pod(이 경우burstableQoS 계층의 Pod)를 실행할 수 없는지 검증합니다.cat /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-besteffort.slice/kubepods-besteffort-podc494a073_6b77_11e9_98c0_06bba5c387ea.slice/crio-c56982f57b75a2420947f0afc6cafe7534c5734efc34157525fa9abbf99e3849.scope/cpuset.cpus 0 oc describe node perf-node.example.com

# cat /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-besteffort.slice/kubepods-besteffort-podc494a073_6b77_11e9_98c0_06bba5c387ea.slice/crio-c56982f57b75a2420947f0afc6cafe7534c5734efc34157525fa9abbf99e3849.scope/cpuset.cpus 0 # oc describe node perf-node.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 VM에는 두 개의 CPU 코어가 있습니다.

system-reserved설정은 500밀리코어로 설정되었습니다. 즉,Node Allocatable양이 되는 노드의 전체 용량에서 한 코어의 절반이 감산되었습니다.Allocatable CPU는 1500 밀리코어임을 확인할 수 있습니다. 즉, Pod마다 하나의 전체 코어를 사용하므로 CPU 관리자 Pod 중 하나를 실행할 수 있습니다. 전체 코어는 1000밀리코어에 해당합니다. 두 번째 Pod를 예약하려고 하면 시스템에서 해당 Pod를 수락하지만 Pod가 예약되지 않습니다.NAME READY STATUS RESTARTS AGE cpumanager-6cqz7 1/1 Running 0 33m cpumanager-7qc2t 0/1 Pending 0 11s

NAME READY STATUS RESTARTS AGE cpumanager-6cqz7 1/1 Running 0 33m cpumanager-7qc2t 0/1 Pending 0 11sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2. 토폴로지 관리자 정책

토폴로지 관리자는 CPU 관리자 및 장치 관리자와 같은 힌트 공급자로부터 토폴로지 힌트를 수집하고 수집된 힌트로 Pod 리소스를 정렬하는 방법으로 모든 QoS(Quality of Service) 클래스의 Pod 리소스를 정렬합니다.

토폴로지 관리자는 cpumanager-enabled 라는 KubeletConfig CR(사용자 정의 리소스)에서 할당하는 네 가지 할당 정책을 지원합니다.

none정책- 기본 정책으로, 토폴로지 정렬을 수행하지 않습니다.

best-effort정책-

best-effort토폴로지 관리 정책을 사용하는 Pod의 각 컨테이너에서는 kubelet이 각 힌트 공급자를 호출하여 해당 리소스 가용성을 검색합니다. 토폴로지 관리자는 이 정보를 사용하여 해당 컨테이너의 기본 NUMA 노드 선호도를 저장합니다. 선호도를 기본 설정하지 않으면 토폴로지 관리자가 해당 정보를 저장하고 노드에 대해 Pod를 허용합니다. restricted정책-

restricted토폴로지 관리 정책을 사용하는 Pod의 각 컨테이너에서는 kubelet이 각 힌트 공급자를 호출하여 해당 리소스 가용성을 검색합니다. 토폴로지 관리자는 이 정보를 사용하여 해당 컨테이너의 기본 NUMA 노드 선호도를 저장합니다. 선호도를 기본 설정하지 않으면 토폴로지 관리자가 노드에서 이 Pod를 거부합니다. 그러면 Pod는Terminated상태가 되고 Pod 허용 실패가 발생합니다. single-numa-node정책-

single-numa-node토폴로지 관리 정책을 사용하는 Pod의 각 컨테이너에서는 kubelet이 각 힌트 공급자를 호출하여 해당 리소스 가용성을 검색합니다. 토폴로지 관리자는 이 정보를 사용하여 단일 NUMA 노드 선호도가 가능한지 여부를 결정합니다. 가능한 경우 노드에 대해 Pod가 허용됩니다. 단일 NUMA 노드 선호도가 가능하지 않은 경우 토폴로지 관리자가 노드에서 Pod를 거부합니다. 그러면 Pod는 Terminated 상태가 되고 Pod 허용 실패가 발생합니다.

7.3. 토폴로지 관리자 설정

토폴로지 관리자를 사용하려면 cpumanager-enabled 라는 KubeletConfig CR(사용자 정의 리소스)에서 할당 정책을 구성해야 합니다. CPU 관리자를 설정한 경우 해당 파일이 존재할 수 있습니다. 파일이 없으면 파일을 생성할 수 있습니다.

사전 요구 사항

-

CPU 관리자 정책을

static으로 구성하십시오.

절차

토폴로지 관리자를 활성화하려면 다음을 수행합니다.

사용자 정의 리소스에서 토폴로지 관리자 할당 정책을 구성합니다.

oc edit KubeletConfig cpumanager-enabled

$ oc edit KubeletConfig cpumanager-enabledCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4. Pod와 토폴로지 관리자 정책 간의 상호 작용

아래 Pod 사양의 예는 Pod와 토폴로지 관리자 간 상호 작용을 보여주는 데 도움이 됩니다.

다음 Pod는 리소스 요청 또는 제한이 지정되어 있지 않기 때문에 BestEffort QoS 클래스에서 실행됩니다.

spec:

containers:

- name: nginx

image: nginx

spec:

containers:

- name: nginx

image: nginx

다음 Pod는 요청이 제한보다 작기 때문에 Burstable QoS 클래스에서 실행됩니다.

선택한 정책이 none이 아니면 토폴로지 관리자는 이러한 Pod 사양 중 하나를 고려하지 않습니다.

아래 마지막 예의 Pod는 요청이 제한과 동일하기 때문에 Guaranteed QoS 클래스에서 실행됩니다.

토폴로지 관리자는 이러한 Pod를 고려합니다. 토폴로지 관리자는 포드에 대한 토폴로지 힌트 힌트를 얻으려면 CPU 관리자 및 장치 관리자인 힌트 공급자를 참조합니다.

토폴로지 관리자는 이 정보를 사용하여 이 컨테이너에 가장 적합한 토폴로지를 저장합니다. 이 Pod의 경우 CPU 관리자와 장치 관리자는 리소스 할당 단계에서 이러한 저장된 정보를 사용합니다.

8장. NUMA 인식 워크로드 예약