가상화

OpenShift Virtualization 설치, 사용법, 릴리스 정보

초록

1장. OpenShift Virtualization 정보

OpenShift Virtualization의 기능 및 지원 범위에 대해 알아보십시오.

1.1. OpenShift Virtualization으로 수행할 수 있는 작업

OpenShift Virtualization은 컨테이너 워크로드와 함께 가상 머신 워크로드를 실행하고 관리할 수 있는 OpenShift Container Platform의 애드온입니다.

OpenShift Virtualization은 Kubernetes 사용자 정의 리소스를 사용하여 가상화 작업을 활성화하여 OpenShift Container Platform 클러스터에 새 오브젝트를 추가합니다. 다음과 같은 가상화 작업이 지원됩니다.

- Linux 및 Windows 가상 머신 생성 및 관리

- 다양한 콘솔 및 CLI 툴을 통해 가상 머신에 연결

- 기존 가상 머신 가져오기 및 복제

- 가상 머신에 연결된 네트워크 인터페이스 컨트롤러 및 스토리지 디스크 관리

- 노드 간 실시간 가상 머신 마이그레이션

향상된 웹 콘솔에서 제공되는 그래픽 포털을 통해 OpenShift Container Platform 클러스터 컨테이너 및 인프라와 함께 가상화 리소스를 관리할 수 있습니다.

OpenShift Virtualization은 Red Hat OpenShift Data Foundation 기능과 원활하게 작동하도록 설계 및 테스트되었습니다.

OpenShift Data Foundation을 사용하여 OpenShift Virtualization을 배포할 때 Windows 가상 머신 디스크용 전용 스토리지 클래스를 생성해야 합니다. 자세한 내용은 Windows VM용 ODF PersistentVolume 최적화 를 참조하십시오.

OVN-Kubernetes,OpenShift SDN 또는 인증된 OpenShift CNI 플러그인에 나열된 다른 인증 네트워크 플러그인 중 하나와 함께 OpenShift Virtualization을 사용할 수 있습니다.

1.1.1. OpenShift Virtualization 지원 클러스터 버전

OpenShift Container Platform 4.12 클러스터에서 사용할 수 있도록 OpenShift Virtualization 4.12가 지원됩니다. OpenShift Virtualization의 최신 z-stream 릴리스를 사용하려면 먼저 최신 버전의 OpenShift Container Platform으로 업그레이드해야 합니다.

1.2. 단일 노드 OpenShift 차이점

단일 노드 클러스터에 OpenShift Virtualization을 설치할 수 있습니다.

지원 설치 프로그램을 사용하여 단일 노드 OpenShift 클러스터를 프로비저닝하면 사전 구성된 영구 스토리지가 자동으로 배포됩니다.

- OpenShift Virtualization 4.10 및 4.11에서는 HPP(HostPath Provisioner)가 자동으로 설치됩니다.

- OpenShift Virtualization 4.12에서 OpenShift Data Foundation Logical Volume Manager Operator는 즉시 제공되는 스토리지 솔루션입니다. HPP를 사용하여 수동으로 배포할 수도 있습니다.

단일 노드 OpenShift는 고가용성을 지원하지 않습니다. 다중 노드 클러스터의 기능에 다음과 같은 차이점이 있습니다.

- Pod 중단 예산은 지원되지 않습니다.

- 실시간 마이그레이션은 지원되지 않습니다.

- 스토리지 동작의 차이로 인해 일부 가상 머신 템플릿은 단일 노드 OpenShift와 호환되지 않습니다. 호환성을 보장하기 위해 데이터 볼륨 또는 스토리지 프로필을 사용하는 가상 머신에 제거 전략이 설정되어 있지 않아야 합니다.

2장. OpenShift Virtualization 아키텍처

OpenShift Virtualization 아키텍처에 대해 알아보기.

2.1. OpenShift Virtualization 아키텍처의 작동 방식

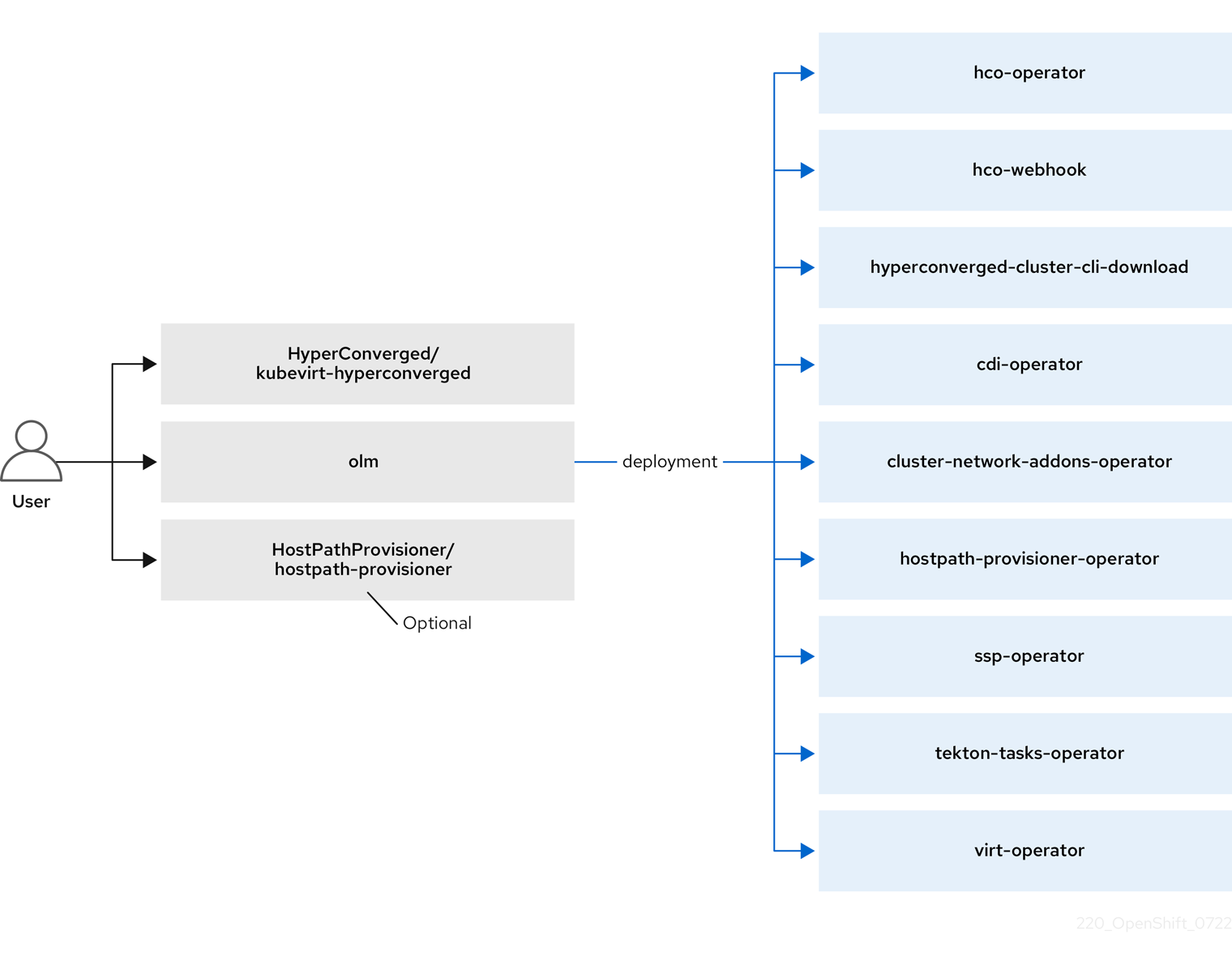

OpenShift Virtualization을 설치한 후 OLM(Operator Lifecycle Manager)은 OpenShift Virtualization의 각 구성 요소에 대해 Operator Pod를 배포합니다.

-

컴퓨팅:

virt-operator -

스토리지:

cdi-operator -

네트워크:

cluster-network-addons-operator -

스케일링:

ssp-operator -

templating:

tekton-tasks-operator

또한 OLM은 다른 구성 요소의 배포, 구성 및 라이프사이클을 담당하는 hyperconverged-cluster-operator Pod 및 hco-webhook, hyperconverged-cluster-cli-download 의 여러 도우미 Pod를 배포합니다.

모든 Operator Pod가 배포된 후 HyperConverged CR(사용자 정의 리소스)을 생성해야 합니다. HyperConverged CR에 설정된 구성은 단일 정보 소스 및 OpenShift Virtualization의 진입점 역할을 하며 CR의 동작을 안내합니다.

HyperConverged CR은 조정 루프 내에서 다른 모든 구성 요소의 Operator에 대한 해당 CR을 생성합니다. 그런 다음 각 Operator는 데몬 세트, 구성 맵, OpenShift Virtualization 컨트롤 플레인에 대한 추가 구성 요소와 같은 리소스를 생성합니다. 예를 들어 hco-operator 에서 KubeVirt CR을 생성할 때 virt-operator 는 이를 조정하고 virt-controller,virt-handler, virt-api 와 같은 추가 리소스를 생성합니다.

OLM은 hostpath-provisioner-operator 를 배포하지만 HBA(Host path 프로비전 프로그램 ) CR을 생성할 때까지 작동하지 않습니다.

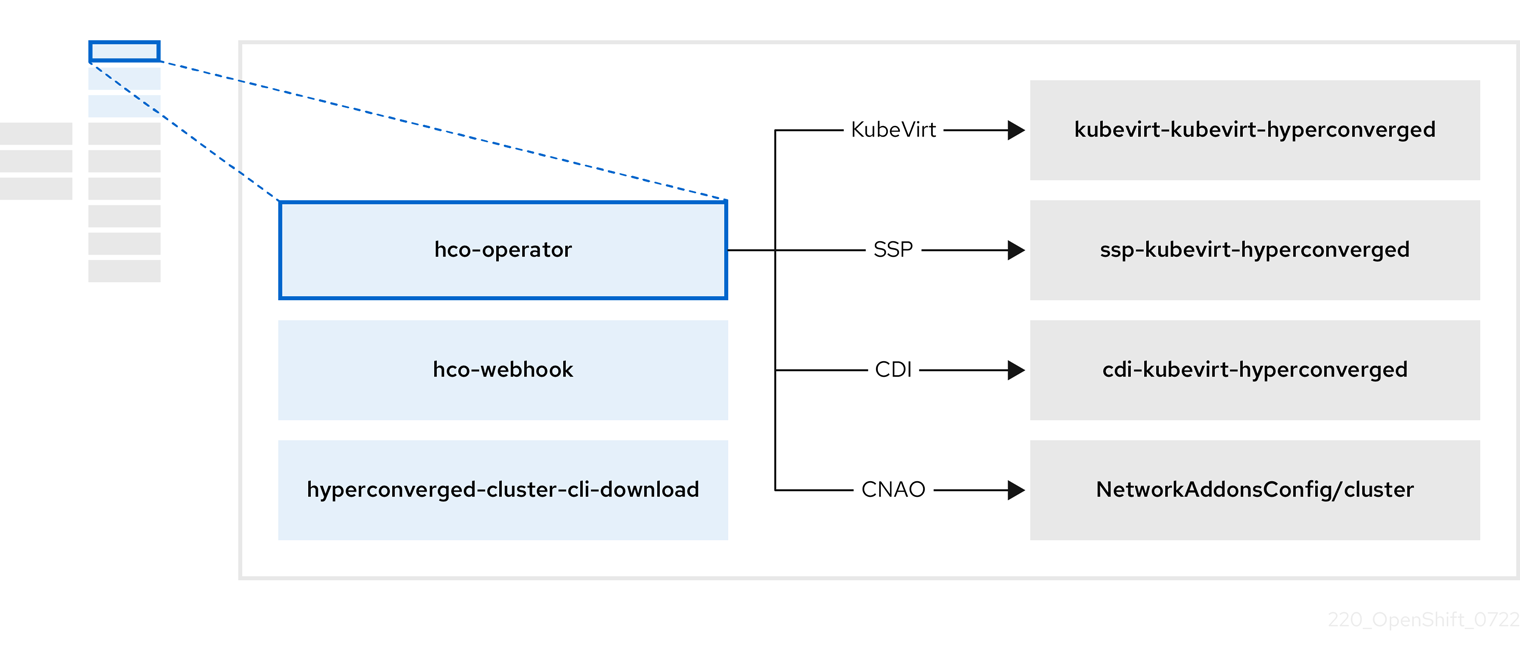

2.2. hco-operator 정보

hco-operator (HCO)는 OpenShift Virtualization 배포 및 관리를 위한 단일 진입점과 의견된 기본값을 사용하여 여러 도우미 운영자를 제공합니다. 또한 해당 Operator에 대한 사용자 정의 리소스(CR)를 생성합니다.

| 구성 요소 | 설명 |

|---|---|

|

|

|

|

|

클러스터에서 직접 다운로드할 수 있도록 |

|

| OpenShift Virtualization에 필요한 모든 Operator, CR 및 오브젝트를 포함합니다. |

|

| SSP CR입니다. 이는 HCO에 의해 자동으로 생성됩니다. |

|

| A CDI CR. 이는 HCO에 의해 자동으로 생성됩니다. |

|

|

|

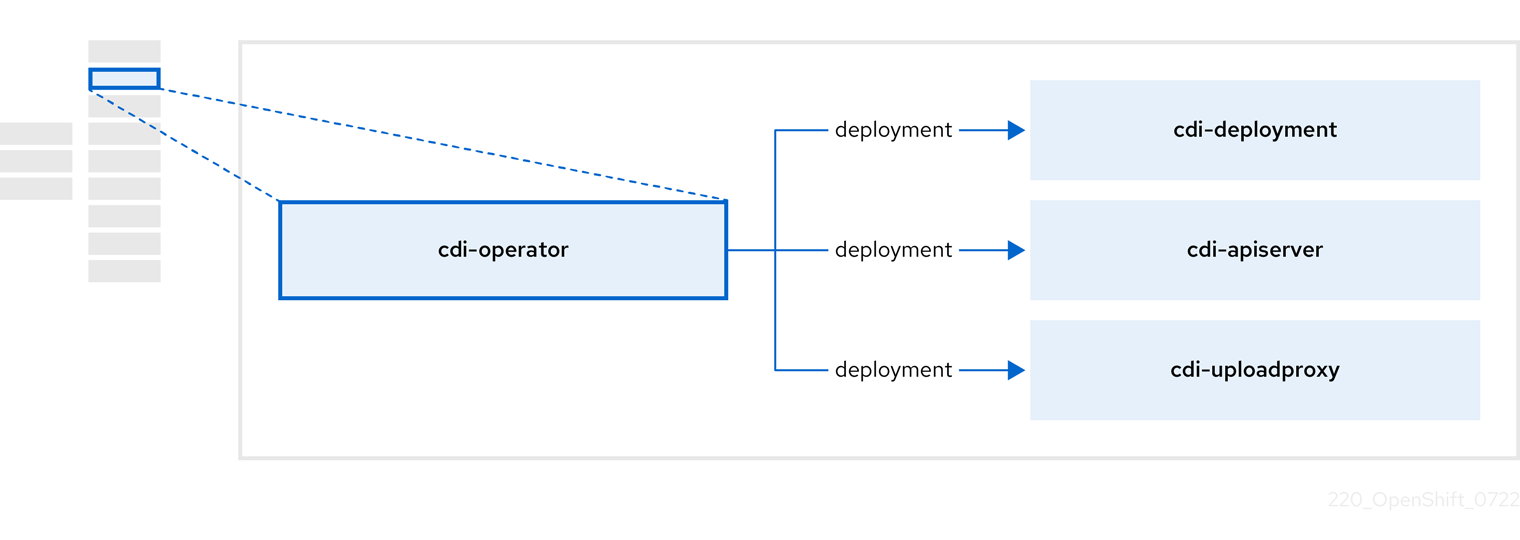

2.3. cdi-operator 정보

cdi-operator 는 데이터 볼륨을 사용하여 가상 머신(VM) 이미지를 PVC(영구 볼륨 클레임)로 가져오는 CDI(Containerized Data Importer) 및 관련 리소스를 관리합니다.

| 구성 요소 | 설명 |

|---|---|

|

| 보안 업로드 토큰을 발행하여 VM 디스크를 PVC에 업로드하는 권한 부여를 관리합니다. |

|

| 올바른 PVC에 쓸 수 있도록 외부 디스크 업로드 트래픽을 적절한 업로드 서버 Pod로 보냅니다. 유효한 업로드 토큰이 필요합니다. |

|

| 데이터 볼륨을 생성할 때 가상 머신 이미지를 PVC로 가져오는 도우미 Pod |

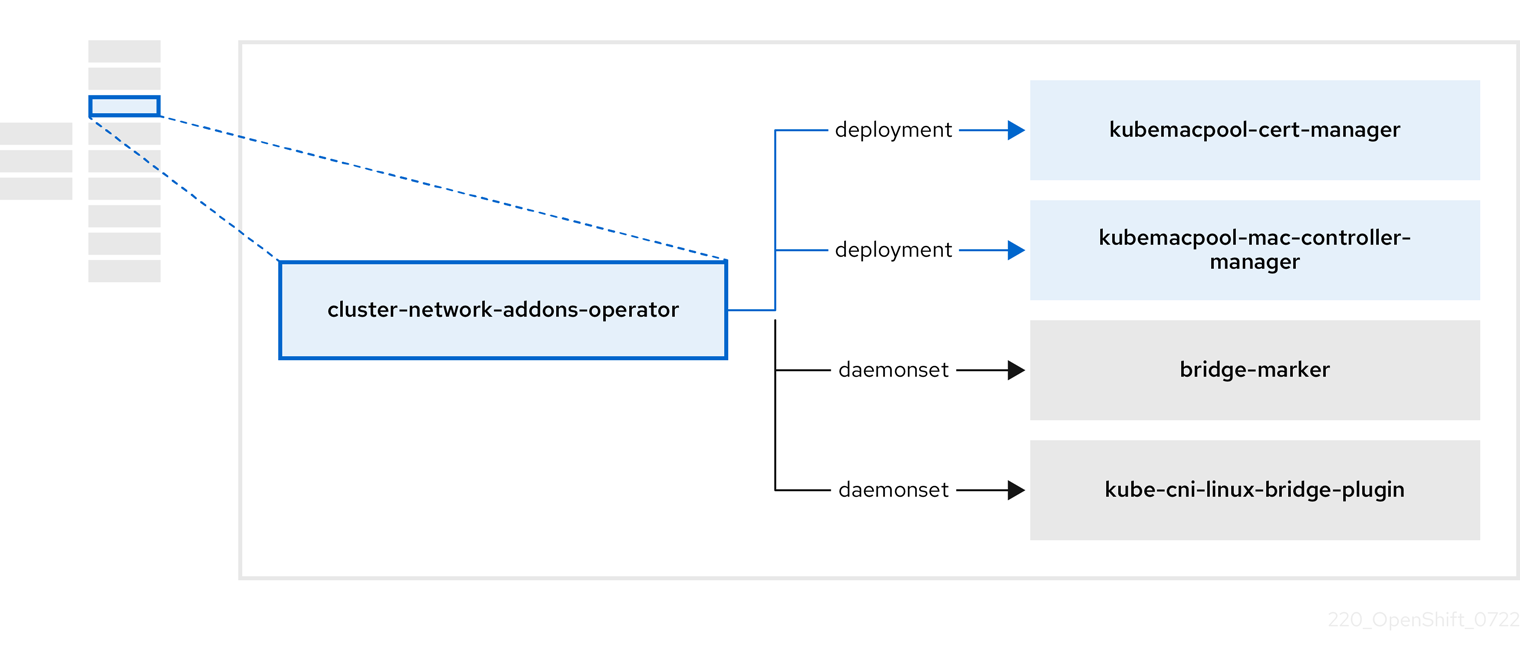

2.4. cluster-network-addons-operator 정보

cluster-network-addons-operator 는 클러스터에 네트워킹 구성 요소를 배포하고 확장된 네트워크 기능을 위한 관련 리소스를 관리합니다.

| 구성 요소 | 설명 |

|---|---|

|

| Kubemacpool의 웹 후크의 TLS 인증서를 관리합니다. |

|

| VM(가상 머신) NIC(네트워크 인터페이스 카드)에 대한 MAC 주소 풀링 서비스를 제공합니다. |

|

| 노드에서 사용 가능한 네트워크 브릿지를 노드 리소스로 표시합니다. |

|

| 클러스터 노드에 CNI 플러그인을 설치하여 네트워크 연결 정의를 통해 VM을 Linux 브리지에 연결할 수 있습니다. |

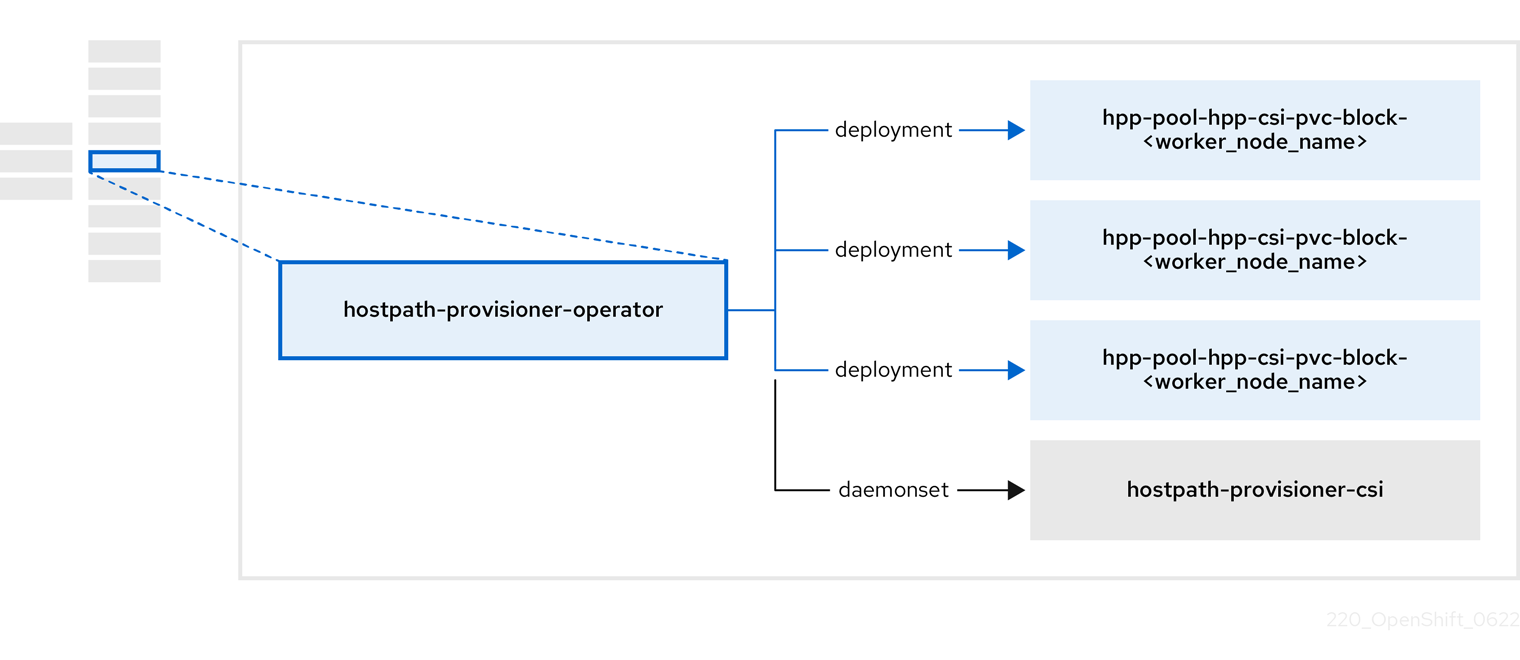

2.5. hostpath-provisioner-operator 정보

hostpath-provisioner-operator 는 다중 노드 호스트 경로 프로비전 프로그램(HPP) 및 관련 리소스를 배포하고 관리합니다.

| 구성 요소 | 설명 |

|---|---|

|

| HPP(Hostpath 프로비전 프로그램)가 실행되도록 지정된 각 노드에 대한 작업자를 제공합니다. Pod는 지정된 백업 스토리지를 노드에 마운트합니다. |

|

| HPP의 CSI(Container Storage Interface) 드라이버 인터페이스를 구현합니다. |

|

| HPP의 레거시 드라이버 인터페이스를 구현합니다. |

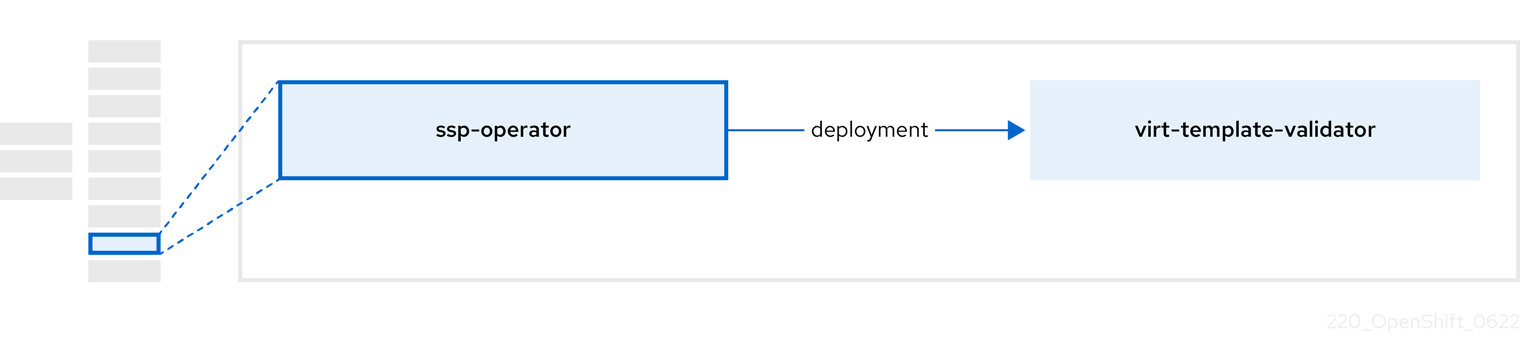

2.6. ssp-operator 정보

ssp-operator 는 공통 템플릿, 관련 기본 부팅 소스 및 템플릿 유효성 검증기를 배포합니다.

| 구성 요소 | 설명 |

|---|---|

|

|

템플릿에서 생성된 가상 머신에서 |

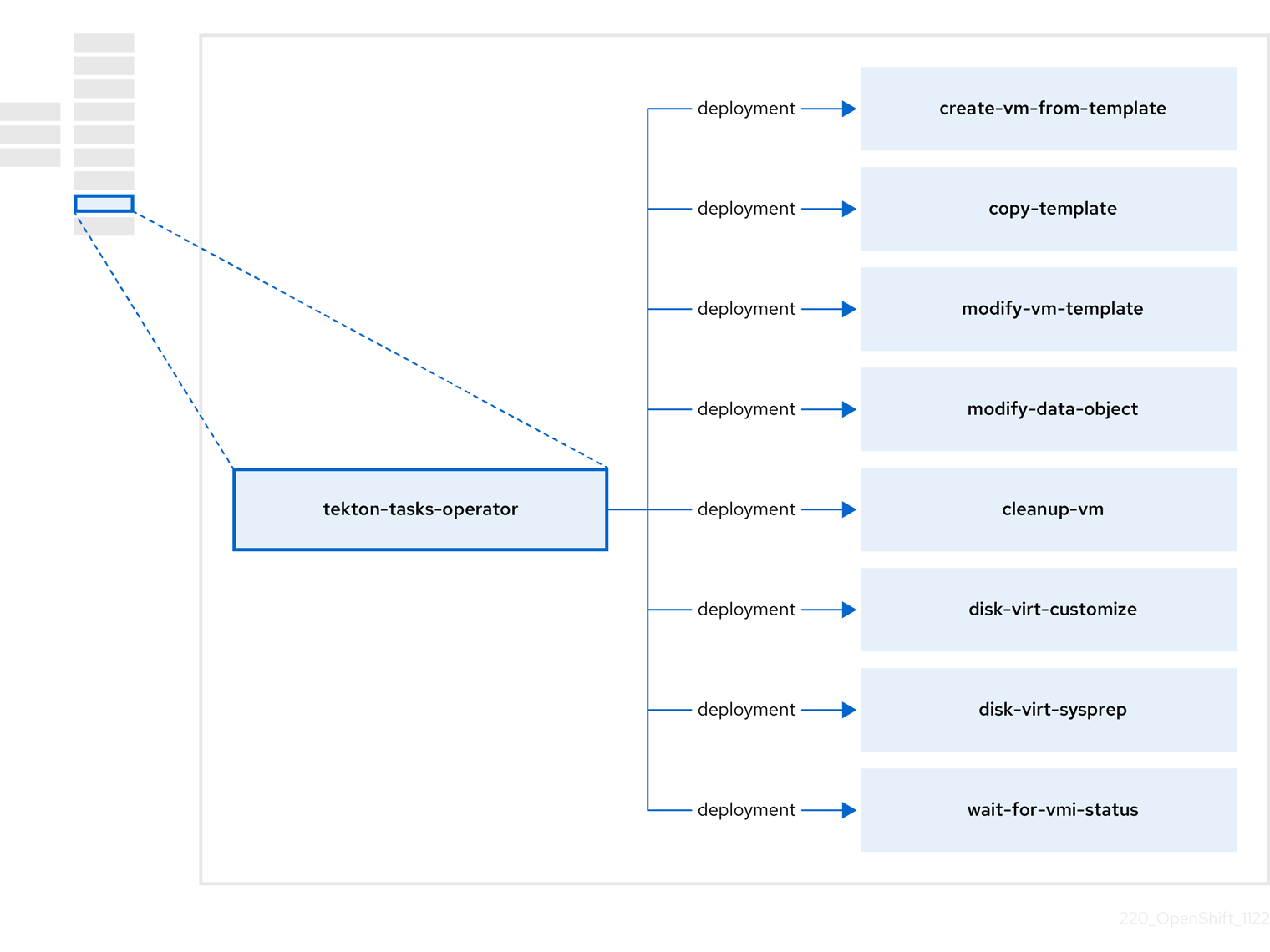

2.7. tekton-tasks-operator 정보

tekton-tasks-operator 는 VM의 OpenShift Pipelines 사용을 보여주는 예제 파이프라인을 배포합니다. 또한 사용자가 템플릿에서 VM을 생성하고 템플릿을 복사 및 수정하고 데이터 볼륨을 생성할 수 있는 추가 OpenShift Pipeline 작업을 배포합니다.

| 구성 요소 | 설명 |

|---|---|

|

| 템플릿에서 VM을 생성합니다. |

|

| VM 템플릿을 복사합니다. |

|

| VM 템플릿을 생성하거나 제거합니다. |

|

| 데이터 볼륨 또는 데이터 소스를 생성하거나 제거합니다. |

|

| VM에서 스크립트 또는 명령을 실행한 다음 VM을 중지하거나 삭제합니다. |

|

|

|

|

|

|

|

| 특정 VMI 상태가 될 때까지 기다린 다음 해당 상태에 따라 실패하거나 성공합니다. |

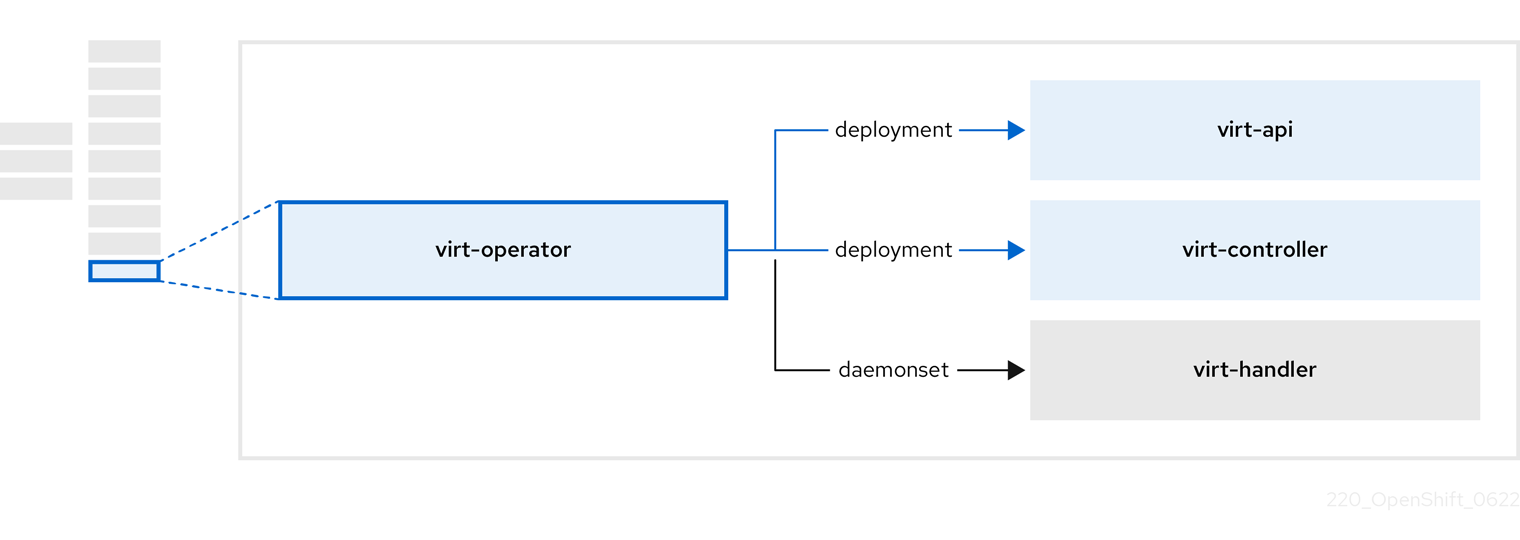

2.8. virt-operator 정보

virt-operator 는 현재 VM(가상 머신) 워크로드를 중단하지 않고 OpenShift Virtualization을 배포, 업그레이드, 관리합니다.

| 구성 요소 | 설명 |

|---|---|

|

| 모든 가상화 관련 흐름에 대한 진입점 역할을 하는 HTTP API 서버입니다. |

|

|

새 VM 인스턴스 오브젝트 생성을 관찰하고 해당 Pod를 생성합니다. Pod가 노드에 예약되면 |

|

|

VM의 변경 사항을 모니터링하고 |

|

|

|

3장. OpenShift Virtualization 시작하기

기본 환경을 설치하고 구성하여 OpenShift Virtualization의 기능 및 기능을 확인할 수 있습니다.

클러스터 구성 절차에는 cluster-admin 권한이 필요합니다.

3.1. OpenShift Virtualization 계획 및 설치

OpenShift Container Platform 클러스터에 OpenShift Virtualization을 계획 및 설치합니다.

계획 및 설치 리소스

3.2. 가상 머신 생성 및 관리

웹 콘솔을 사용하여 VM(가상 머신)을 생성합니다.

- 빠른 VM 생성

- VM을 생성할 템플릿을 사용자 지정합니다.

VM에 연결합니다.

- 웹 콘솔을 사용하여 VM의 직렬 콘솔 또는 VNC 콘솔에 연결합니다.

- SSH를 사용하여 VM에 연결합니다.

- RDP를 사용하여 Windows VM에 연결합니다.

VM을 관리합니다.

3.3. 다음 단계

VM을 보조 네트워크에 연결합니다.

- VM을 Linux 브리지 네트워크에 연결합니다.

- 참고

VM은 기본적으로 Pod 네트워크에 연결됩니다. Linux 브리지 또는 SR-IOV와 같은 보조 네트워크를 구성한 다음 VM 구성에 네트워크를 추가해야 합니다.

- 웹 콘솔을 사용하여 리소스, 세부 정보, 상태 및 상위 소비자를 모니터링합니다.

- 웹 콘솔을 사용하여 VM 워크로드에 대한 고급 정보를 봅니다.

- CLI를 사용하여 OpenShift Virtualization 로그를 확인합니다.

-

sysprep을 사용하여 Windows VM 배포를 자동화 합니다. - 실시간 마이그레이션 VM.

- VM 백업 및 복원.

4장. 웹 콘솔 개요

OpenShift Container Platform 웹 콘솔의 가상화 섹션에는 OpenShift Virtualization 환경을 관리하고 모니터링하기 위한 다음 페이지가 포함되어 있습니다.

| 페이지 | 설명 |

|---|---|

| OpenShift Virtualization 환경을 관리하고 모니터링합니다. | |

| 템플릿 카탈로그에서 VirtualMachine을 생성합니다. | |

| VirtualMachine을 구성하고 모니터링합니다. | |

| 템플릿을 생성하고 관리합니다. | |

| VirtualMachine 부팅 소스의 DataSources를 생성하고 관리합니다. | |

| 워크로드의 MigrationPolicies를 생성하고 관리합니다. |

| icon | 설명 |

|---|---|

|

| 아이콘 편집 |

|

| 링크 아이콘 |

4.1. 개요 페이지

개요 페이지에는 리소스, 지표, 마이그레이션 진행 상황 및 클러스터 수준 설정이 표시됩니다.

예 4.1. 개요 페이지

4.1.1. 개요 탭

개요 탭에는 리소스, 사용량, 경고 및 상태가 표시됩니다.

예 4.2. 개요 탭

| 요소 | 설명 |

|---|---|

| "시작된 리소스" 카드 |

|

| "VirtualMachines" tile | 지난 7일의 추세를 보여주는 차트가 있는 VirtualMachine 수입니다. |

| "vCPU 사용량" 타일 | 지난 7일의 추세를 보여주는 차트가 있는 vCPU 사용량. |

| "메모리" 타일 | 지난 7일의 추세를 보여주는 차트가 있는 메모리 사용량입니다. |

| "스토리지" 타일 | 지난 7일의 추세를 보여주는 차트가 있는 스토리지 사용량입니다. |

| "알erts" 타일 | 심각도별로 그룹화된 OpenShift Virtualization 경고. |

| "VirtualMachine statuses" 타일 | 상태로 그룹화된 VirtualMachine 수입니다. |

| "템플릿당 가상 머신" 차트 | 템플릿 이름으로 그룹화된 템플릿에서 생성된 VirtualMachine 수입니다. |

4.1.2. 상위 소비자 탭

상위 소비자 탭에는 CPU, 메모리 및 스토리지의 상위 소비자가 표시됩니다.

예 4.3. 상위 소비자 탭

| 요소 | 설명 |

|---|---|

|

가상화 대시보드 보기 | Observe → Dashboards 에 연결하여 OpenShift Virtualization의 상위 소비자가 표시됩니다. |

| 기간 목록 | 결과를 필터링할 기간을 선택합니다. |

| 상위 소비자 목록 | 결과를 필터링할 상위 소비자 수를 선택합니다. |

| "CPU" 차트 | CPU 사용량이 가장 많은 VirtualMachine |

| "메모리" 차트 | 메모리 사용량이 가장 많은 VirtualMachine |

| "메모리 스왑 트래픽" 차트 | 메모리 스왑 트래픽이 가장 높은 VirtualMachine |

| "vCPU 대기" 차트 | vCPU 대기 기간이 가장 높은 VirtualMachine |

| "스토리지 처리량" 차트 | 스토리지 처리량이 가장 높은 VirtualMachine |

| "스토리지 IOPS" 차트 | 초당 가장 높은 스토리지 입력/출력 작업이 있는 VirtualMachine입니다. |

4.1.3. 마이그레이션 탭

Migrations 탭에 VirtualMachineInstance 마이그레이션 상태가 표시됩니다.

예 4.4. 마이그레이션 탭

| 요소 | 설명 |

|---|---|

| 기간 목록 | VirtualMachineInstanceMigrations를 필터링할 기간을 선택합니다. |

| VirtualMachineInstanceMigrations 테이블 | VirtualMachineInstance 마이그레이션 목록입니다. |

4.1.4. 설정 탭

Settings 탭에는 다음 탭의 클러스터 전체 설정이 표시됩니다.

| 탭 | 설명 |

|---|---|

| OpenShift Virtualization 버전 및 업데이트 상태 | |

| 실시간 마이그레이션 제한 및 네트워크 설정 | |

| Red Hat 템플릿용 프로젝트. | |

| 클러스터 전체 사용자 권한. |

4.1.4.1. 일반 탭

General (일반) 탭에 OpenShift Virtualization 버전 및 업데이트 상태가 표시됩니다.

예 4.5. 일반 탭

| 레이블 | 설명 |

|---|---|

| 서비스 이름 | OpenShift Virtualization |

| 공급자 | Red Hat |

| 설치된 버전 | 4.12.15 |

| 업데이트 상태 |

예 |

| 채널 | 업데이트를 위해 선택된 채널입니다. |

4.1.4.2. 실시간 마이그레이션 탭

실시간 마이그레이션 탭에서 실시간 마이그레이션 을 구성할 수 있습니다.

예 4.6. 실시간 마이그레이션 탭

| 요소 | 설명 |

|---|---|

| max. 클러스터 필드당 마이그레이션 | 클러스터당 최대 실시간 마이그레이션 수를 선택합니다. |

| max. 노드 필드당 마이그레이션 | 노드당 최대 실시간 마이그레이션 수를 선택합니다. |

| 실시간 마이그레이션 네트워크 목록 | 실시간 마이그레이션을 위해 전용 보조 네트워크를 선택합니다. |

4.1.4.3. 템플릿 프로젝트 탭

템플릿 프로젝트 탭에서 템플릿용 프로젝트를 선택할 수 있습니다.

예 4.7. 템플릿 프로젝트 탭

| 요소 | 설명 |

|---|---|

| 프로젝트 목록 |

Red Hat 템플릿을 저장할 프로젝트를 선택합니다. 기본 템플릿 프로젝트는 여러 템플릿 프로젝트를 정의하려면 각 프로젝트의 템플릿 페이지에 템플릿을 복제해야 합니다. |

4.1.4.4. 사용자 권한 탭

User 권한 탭에는 작업에 대한 클러스터 전체 사용자 권한이 표시됩니다.

예 4.8. 사용자 권한 탭

| 요소 | 설명 |

|---|---|

| 사용자 권한 테이블 | DestinationRule 템플릿 및 권한과 같은 작업 목록입니다. |

4.2. 카탈로그 페이지

카탈로그 페이지에서 템플릿을 선택하여 VirtualMachine을 생성할 수 있습니다.

예 4.9. 카탈로그 페이지

| 요소 | 설명 |

|---|---|

| templates 프로젝트 목록 | 템플릿이 있는 프로젝트를 선택합니다.

기본적으로 Red Hat 템플릿은 |

| 모든 항목|기본 템플릿 | Default 템플릿을 클릭하여 기본 템플릿만 표시합니다. |

| 부팅 소스 사용 가능 확인란 | 확인란을 선택하여 사용 가능한 부팅 소스가 있는 템플릿을 표시합니다. |

| 운영 체제 확인란 | 선택한 운영 체제가 있는 템플릿을 표시하려면 확인란을 선택합니다. |

| 워크로드 확인란 | 선택한 워크로드가 있는 템플릿을 표시하려면 확인란을 선택합니다. |

| 검색 필드 | 템플릿을 키워드로 검색합니다. |

| 템플릿 | 템플릿 타일을 클릭하여 템플릿 세부 정보를 보고 VirtualMachine을 생성합니다. |

4.3. VirtualMachines 페이지

VirtualMachines 페이지에서 VirtualMachines를 생성하고 관리할 수 있습니다.

예 4.10. VirtualMachines 페이지

| 요소 | 설명 |

|---|---|

| 생성 → 카탈로그에서 | 카탈로그 페이지에 VirtualMachine을 생성합니다. |

| YAML을 사용하여 → 생성 | YAML 구성 파일을 편집하여 VirtualMachine을 생성합니다. |

| 필터 필드 | 상태, 템플릿, 운영 체제 또는 노드별로 VirtualMachine을 필터링합니다. |

| 검색 필드 | 이름 또는 라벨별로 VirtualMachines를 검색합니다. |

| VirtualMachines 테이블 | VirtualMachines 목록입니다.

VirtualMachine 옆에 있는 옵션 메뉴

VirtualMachine을 클릭하여 VirtualMachine 세부 정보 페이지로 이동합니다. |

4.3.1. VirtualMachine 세부 정보 페이지

VirtualMachine 세부 정보 페이지에서 VirtualMachine을 구성할 수 있습니다.

예 4.11. VirtualMachine 세부 정보 페이지

| 요소 | 설명 |

|---|---|

| 작업 메뉴 | 작업 메뉴를 클릭하여 중지,다시 시작,일시 중지,복제,마이그레이션,SSH 복사,레이블 편집,주석 편집 또는 삭제를 선택합니다. |

| 리소스 사용, 경고, 디스크 및 장치. | |

| VirtualMachine 구성입니다. | |

| 메모리, CPU, 스토리지, 네트워크 및 마이그레이션 지표. | |

| VirtualMachine YAML 구성 파일. | |

| 구성 예약. | |

| 구성 맵, 시크릿 및 서비스 계정 관리. | |

| VirtualMachine 이벤트 스트림 | |

| 콘솔 세션 관리. | |

| 네트워크 인터페이스 관리. | |

| 디스크 관리. | |

| cloud-init 및 SSH 키 관리. | |

| 스냅샷 관리. |

4.3.1.1. 개요 탭

개요 탭에는 리소스 사용량, 경고 및 구성 정보가 표시됩니다.

예 4.12. 개요 탭

| 요소 | 설명 |

|---|---|

| "자세한 내용" 타일 | 일반 VirtualMachine 정보. |

| "사용" 타일 | CPU,메모리,스토리지 및 네트워크 전송 차트. |

| "하드웨어 장치" 타일 | GPU 및 호스트 장치 |

| "알erts" 타일 | 심각도별로 그룹화된 OpenShift Virtualization 경고. |

| "snapshots" 타일 |

스냅샷 |

| "네트워크 인터페이스" 타일 | 네트워크 인터페이스 테이블. |

| "디스크" 타일 | 디스크 테이블. |

4.3.1.2. 세부 정보 탭

세부 정보 탭에서 VirtualMachine을 구성할 수 있습니다.

예 4.13. 세부 정보 탭

| 요소 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| 이름 | VirtualMachine 이름입니다. |

| 네임스페이스 | VirtualMachine 네임스페이스입니다. |

| 라벨 | 편집 아이콘을 클릭하여 레이블을 편집합니다. |

| 주석 | 편집 아이콘을 클릭하여 주석을 편집합니다. |

| 설명 | 편집 아이콘을 클릭하여 설명을 입력합니다. |

| 운영 체제 | 운영 체제 이름입니다. |

| CPU|Memory | 편집 아이콘을 클릭하여 CPU|Memory 요청을 편집합니다.

CPU 수는 |

| 머신 유형 | VirtualMachine 머신 유형. |

| 부팅 모드 | 편집 아이콘을 클릭하여 부팅 모드를 편집합니다. |

| 일시 중지 모드로 시작 | 편집 아이콘을 클릭하여 이 설정을 활성화합니다. |

| 템플릿 | VirtualMachine을 생성하는 데 사용되는 템플릿의 이름입니다. |

| 작성 위치 | VirtualMachine 생성 날짜. |

| 소유자 | VirtualMachine 소유자. |

| 상태 | VirtualMachine 상태. |

| Pod |

|

| VirtualMachineInstance | VirtualMachineInstance 이름입니다. |

| 부팅 순서 | 편집 아이콘을 클릭하여 부팅 소스를 선택합니다. |

| IP 주소 | VirtualMachine의 IP 주소입니다. |

| 호스트 이름 | VirtualMachine의 호스트 이름입니다. |

| 시간대 | VirtualMachine의 시간대입니다. |

| 노드 | VirtualMachine이 실행 중인 노드입니다. |

| 워크로드 프로필 | 편집 아이콘을 클릭하여 워크로드 프로필을 편집합니다. |

| virtctl을 사용한 SSH |

복사 아이콘을 클릭하여 |

| NodePort를 통한 SSH 연결 |

SSH 액세스를 위해 VirtualMachine을 노출할 서비스 생성을 선택하면 |

| GPU 장치 | 편집 아이콘을 클릭하여 GPU 장치를 추가합니다. |

| 호스트 장치 | 편집 아이콘을 클릭하여 호스트 장치를 추가합니다. |

| 서비스 섹션 | 서비스를 확인합니다. |

| 활성 사용자 섹션 | 활성 사용자 보기. |

4.3.1.3. 지표 탭

Metrics 탭에는 메모리, CPU, 스토리지, 네트워크 및 마이그레이션 사용량 차트가 표시됩니다.

예 4.14. 지표 탭

| 요소 | 설명 |

|---|---|

| 시간 범위 목록 | 결과를 필터링할 시간 범위를 선택합니다. |

|

가상화 대시보드 | 현재 프로젝트의 워크로드 탭에 연결합니다. |

| 사용률 섹션 | 메모리,CPU 및 네트워크 인터페이스 차트. |

| 스토리지 섹션 | 스토리지 총 읽기/쓰기 및 스토리지 iops 총 읽기/쓰기 차트입니다. |

| 네트워크 섹션 | 네트워크( Network Out ) 및 네트워크 대역폭 차트입니다. |

| 마이그레이션 섹션 | 마이그레이션 및 KV 데이터 전송 속도 차트. |

4.3.1.4. YAML 탭

YAML 탭에서 YAML 파일을 편집하여 VirtualMachine을 구성할 수 있습니다.

예 4.15. YAML 탭

| 요소 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| 저장 버튼 | YAML 파일에 대한 변경 사항을 저장합니다. |

| Reload 버튼 | 변경 사항을 삭제하고 YAML 파일을 다시 로드합니다. |

| 취소 버튼 | YAML 탭을 종료합니다. |

| 다운로드 버튼 | YAML 파일을 로컬 머신에 다운로드합니다. |

4.3.1.5. 스케줄링 탭

스케줄링 탭에서 예약을 구성할 수 있습니다.

예 4.16. 스케줄링 탭

| 설정 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| 노드 선택기 | 편집 아이콘을 클릭하여 대상 노드를 지정하는 라벨을 추가합니다. |

| 허용 오차 | 편집 아이콘을 클릭하여 대상 노드를 지정하는 허용 오차를 추가합니다. |

| 유사성 규칙 | 편집 아이콘을 클릭하여 선호도 규칙을 추가합니다. |

| Descheduler 스위치 | Descheduler를 활성화하거나 비활성화합니다. Descheduler는 실행 중인 Pod를 제거하여 더 적합한 노드에 Pod를 다시 예약할 수 있습니다. |

| 전용 리소스 | 편집 아이콘을 클릭하여 전용 리소스를 사용하여 이 워크로드 예약을 선택합니다(보장된 정책). |

| 제거 전략 | 편집 아이콘을 클릭하여 VirtualMachineInstance 제거 전략으로 LiveMigrate 를 선택합니다. |

4.3.1.6. 환경 탭

환경 탭에서 구성 맵, 시크릿 및 서비스 계정을 관리할 수 있습니다.

예 4.17. 환경 탭

| 요소 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

|

구성 맵, 시크릿 또는 서비스 계정 추가 | 링크를 클릭하고 리소스 목록에서 구성 맵, 시크릿 또는 서비스 계정을 선택합니다. |

4.3.1.7. 이벤트 탭

이벤트 탭에는 VirtualMachine 이벤트 목록이 표시됩니다.

4.3.1.8. 콘솔 탭

콘솔 탭에서 VirtualMachine에 대한 콘솔 세션을 열 수 있습니다.

예 4.18. 콘솔 탭

| 요소 | 설명 |

|---|---|

| 게스트 로그인 인증 정보 섹션 |

게스트 로그인 자격 증명을 확장하여 |

| 콘솔 목록 | VNC 콘솔 또는 직렬 콘솔을 선택합니다. RDP(Remote Desktop Protocol)를 사용하여 Windows VirtualMachines에 연결하도록 Desktop 뷰어를 선택할 수 있습니다. 동일한 네트워크의 머신에 RDP 클라이언트를 설치해야 합니다. |

| 키 목록 보내기 | 콘솔에 보낼 키 입력 조합을 선택합니다. |

| 연결 해제 버튼 | 콘솔 연결을 끊습니다. 새 콘솔 세션을 여는 경우 콘솔 연결을 수동으로 연결 해제해야 합니다. 그렇지 않으면 첫 번째 콘솔 세션이 백그라운드에서 계속 실행됩니다. |

4.3.1.9. 네트워크 인터페이스 탭

네트워크 인터페이스 탭에서 네트워크 인터페이스를 관리할 수 있습니다.

예 4.19. 네트워크 인터페이스 탭

| 설정 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| 네트워크 인터페이스 추가 버튼 | 네트워크 인터페이스를 VirtualMachine에 추가합니다. |

| 필터 필드 | 인터페이스 유형별로 필터링합니다. |

| 검색 필드 | 이름 또는 라벨별로 네트워크 인터페이스를 검색합니다. |

| 네트워크 인터페이스 테이블 | 네트워크 인터페이스 목록입니다.

네트워크 인터페이스 옆에 있는 옵션 메뉴

|

4.3.1.10. 디스크 탭

디스크 탭에서 디스크를 관리할 수 있습니다.

예 4.20. 디스크 탭

| 설정 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| 디스크 추가 버튼 | VirtualMachine에 디스크를 추가합니다. |

| 필터 필드 | 디스크 유형별로 필터링합니다. |

| 검색 필드 | 이름으로 디스크를 검색합니다. |

| 디스크 테이블 | VirtualMachine 디스크 목록입니다.

디스크 옆에 있는 옵션 메뉴

|

| 파일 시스템 테이블 | VirtualMachine 파일 시스템 목록입니다. |

4.3.1.11. 스크립트 탭

스크립트 탭에서 VirtualMachine의 cloud-init 및 SSH 키를 관리할 수 있습니다.

예 4.21. 스크립트 탭

| 요소 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| cloud-init | 편집 아이콘을 클릭하여 cloud-init 설정을 편집합니다. |

| 인증된 SSH 키 | 편집 아이콘을 클릭하여 새 보안을 생성하거나 기존 보안을 연결합니다. |

4.3.1.12. 스냅샷 탭

스냅샷을 생성하고 Snapshots 탭의 스냅샷에서 VirtualMachines를 복원할 수 있습니다.

예 4.22. 스냅샷 탭

| 요소 | 설명 |

|---|---|

| 스냅샷 버튼 찍기 | 스냅샷을 생성합니다. |

| 필터 필드 | 상태별로 스냅샷을 필터링합니다. |

| 검색 필드 | 이름 또는 라벨별로 스냅샷을 검색합니다. |

| 스냅샷 테이블 | 스냅샷 목록입니다.

스냅샷 옆에 있는 옵션 메뉴

|

4.4. 템플릿 페이지

템플릿 페이지에서 VirtualMachine 템플릿을 생성, 편집, 복제할 수 있습니다.

Red Hat 템플릿을 편집할 수 없습니다. Red Hat 템플릿을 복제하고 편집하여 사용자 지정 템플릿을 생성할 수 있습니다.

예 4.23. 템플릿 페이지

| 요소 | 설명 |

|---|---|

| 템플릿 생성 버튼 | YAML 구성 파일을 편집하여 템플릿을 생성합니다. |

| 필터 필드 | 유형, 부팅 소스, 템플릿 공급자 또는 운영 체제별로 템플릿을 필터링합니다. |

| 검색 필드 | 이름 또는 레이블별로 템플릿을 검색합니다. |

| 템플릿 테이블 | 템플릿 목록.

템플릿 옆에 있는 옵션 메뉴

|

4.4.1. 템플릿 세부 정보 페이지

템플릿 설정을 보고 템플릿 세부 정보 페이지에서 사용자 지정 템플릿을 편집할 수 있습니다.

예 4.24. 템플릿 세부 정보 페이지

4.4.1.1. 세부 정보 탭

세부 정보 탭에서 사용자 지정 템플릿을 구성할 수 있습니다.

예 4.25. 세부 정보 탭

| 요소 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| 이름 | 템플릿 이름입니다. |

| 네임스페이스 | 템플릿 네임스페이스입니다. |

| 라벨 | 편집 아이콘을 클릭하여 레이블을 편집합니다. |

| 주석 | 편집 아이콘을 클릭하여 주석을 편집합니다. |

| 표시 이름 | 편집 아이콘을 클릭하여 표시 이름을 편집합니다. |

| 설명 | 편집 아이콘을 클릭하여 설명을 입력합니다. |

| 운영 체제 | 운영 체제 이름입니다. |

| CPU|Memory | 편집 아이콘을 클릭하여 CPU|Memory 요청을 편집합니다.

CPU 수는 |

| 머신 유형 | 템플릿 시스템 유형. |

| 부팅 모드 | 편집 아이콘을 클릭하여 부팅 모드를 편집합니다. |

| 기본 템플릿 | 이 템플릿을 생성하는 데 사용되는 기본 템플릿의 이름입니다. |

| 작성 위치 | 템플릿 생성 날짜. |

| 소유자 | 템플릿 소유자. |

| 부팅 순서 | 템플릿 부팅 순서입니다. |

| 부팅 소스 | 부팅 소스 가용성. |

| 공급자 | 템플릿 공급자. |

| 지원 | 템플릿 지원 수준입니다. |

| GPU 장치 | 편집 아이콘을 클릭하여 GPU 장치를 추가합니다. |

| 호스트 장치 | 편집 아이콘을 클릭하여 호스트 장치를 추가합니다. |

4.4.1.2. YAML 탭

YAML 탭에서 YAML 파일을 편집하여 사용자 정의 템플릿을 구성할 수 있습니다.

예 4.26. YAML 탭

| 요소 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| 저장 버튼 | YAML 파일에 대한 변경 사항을 저장합니다. |

| Reload 버튼 | 변경 사항을 삭제하고 YAML 파일을 다시 로드합니다. |

| 취소 버튼 | YAML 탭을 종료합니다. |

| 다운로드 버튼 | YAML 파일을 로컬 머신에 다운로드합니다. |

4.4.1.3. 스케줄링 탭

스케줄링 탭에서 예약을 구성할 수 있습니다.

예 4.27. 스케줄링 탭

| 설정 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| 노드 선택기 | 편집 아이콘을 클릭하여 대상 노드를 지정하는 라벨을 추가합니다. |

| 허용 오차 | 편집 아이콘을 클릭하여 대상 노드를 지정하는 허용 오차를 추가합니다. |

| 유사성 규칙 | 편집 아이콘을 클릭하여 선호도 규칙을 추가합니다. |

| Descheduler 스위치 | Descheduler를 활성화하거나 비활성화합니다. Descheduler는 실행 중인 Pod를 제거하여 더 적합한 노드에 Pod를 다시 예약할 수 있습니다. |

| 전용 리소스 | 편집 아이콘을 클릭하여 전용 리소스를 사용하여 이 워크로드 예약을 선택합니다(보장된 정책). |

| 제거 전략 | 편집 아이콘을 클릭하여 VirtualMachineInstance 제거 전략으로 LiveMigrate 를 선택합니다. |

4.4.1.4. 네트워크 인터페이스 탭

네트워크 인터페이스 탭에서 네트워크 인터페이스를 관리할 수 있습니다.

예 4.28. 네트워크 인터페이스 탭

| 설정 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| 네트워크 인터페이스 추가 버튼 | 네트워크 인터페이스를 템플릿에 추가합니다. |

| 필터 필드 | 인터페이스 유형별로 필터링합니다. |

| 검색 필드 | 이름 또는 라벨별로 네트워크 인터페이스를 검색합니다. |

| 네트워크 인터페이스 테이블 | 네트워크 인터페이스 목록입니다.

네트워크 인터페이스 옆에 있는 옵션 메뉴

|

4.4.1.5. 디스크 탭

디스크 탭에서 디스크를 관리할 수 있습니다.

예 4.29. 디스크 탭

| 설정 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| 디스크 추가 버튼 | 템플릿에 디스크를 추가합니다. |

| 필터 필드 | 디스크 유형별로 필터링합니다. |

| 검색 필드 | 이름으로 디스크를 검색합니다. |

| 디스크 테이블 | 템플릿 디스크 목록.

디스크 옆에 있는 옵션 메뉴

|

4.4.1.6. 스크립트 탭

Scripts 탭에서 cloud-init 설정, SSH 키 및 Sysprep 응답 파일을 관리할 수 있습니다.

예 4.30. 스크립트 탭

| 요소 | 설명 |

|---|---|

| YAML 스위치 | YAML 구성 파일의 실시간 변경 사항을 보려면 ON 으로 설정합니다. |

| cloud-init | 편집 아이콘을 클릭하여 cloud-init 설정을 편집합니다. |

| 인증된 SSH 키 | 편집 아이콘을 클릭하여 새 보안을 생성하거나 기존 보안을 연결합니다. |

| sys |

편집 아이콘을 클릭하여 |

4.4.1.7. 매개변수 탭

Parameters 탭에서 선택한 템플릿 설정을 편집할 수 있습니다.

예 4.31. 매개변수 탭

| 요소 | 설명 |

|---|---|

| VM 이름 | 생성된 값으로 생성됨(expression) 을 선택하고 Value 를 선택하여 기본값을 설정하거나 Default 값 유형 목록에서 None 을 선택합니다. |

| 데이터 소스 네임스페이스 | 생성된 값으로 생성됨(expression) 을 선택하고 Value 를 선택하여 기본값을 설정하거나 Default 값 유형 목록에서 None 을 선택합니다. |

| 클라우드 사용자 암호 | 생성된 값으로 생성됨(expression) 을 선택하고 Value 를 선택하여 기본값을 설정하거나 Default 값 유형 목록에서 None 을 선택합니다. |

4.5. 데이터 소스 페이지

DataSources 페이지에서 VirtualMachine 부팅 소스에 대한 DataSources를 생성하고 구성할 수 있습니다.

DataSource를 생성할 때 자동 부팅 소스 업데이트를 비활성화하지 않는 한 DataImportCron 리소스는 폴링하고 디스크 이미지를 가져올 cron 작업을 정의합니다.

예 4.32. 데이터 소스 페이지

| 요소 | 설명 |

|---|---|

| DataSource → 양식 생성 | 레지스트리 URL, 디스크 크기, 버전 수, cron 표현식을 양식으로 입력하여 DataSource를 생성합니다. |

| YAML을 사용하여 DataSources → YAML 생성 | YAML 구성 파일을 편집하여 DataSource를 생성합니다. |

| 필터 필드 | 사용 가능한 DataImportCron과 같은 속성에 따라 DataSources를 필터링합니다. |

| 검색 필드 | 이름 또는 라벨별로 DataSource를 검색합니다. |

| 데이터 소스 테이블 | 데이터 소스 목록.

DataSource 옆에 있는 옵션 메뉴

|

DataSource를 클릭하여 DataSource 세부 정보 페이지를 확인합니다.

4.5.1. 데이터 소스 세부 정보 페이지

DataSource 세부 정보 페이지에서 DataSource를 구성할 수 있습니다.

예 4.33. 데이터 소스 세부 정보 페이지

| 요소 | 설명 |

|---|---|

| 세부 정보 탭 | 양식을 편집하여 DataSource를 구성합니다. |

| YAML 탭 | YAML 구성 파일을 편집하여 DataSource를 구성합니다. |

| 작업 메뉴 | 레이블 편집,주석 편집 또는 삭제를 선택합니다. |

| 이름 | 데이터 소스 이름입니다. |

| 네임스페이스 | 데이터 소스 네임스페이스. |

| 라벨 | 편집 아이콘을 클릭하여 레이블을 편집합니다. |

| 주석 | 편집 아이콘을 클릭하여 주석을 편집합니다. |

| 조건 | DataSource의 상태 조건을 표시합니다. |

4.6. MigrationPolicies 페이지

MigrationPolicies 페이지에서 워크로드의 MigrationPolicies를 관리할 수 있습니다.

예 4.34. MigrationPolicies 페이지

| 요소 | 설명 |

|---|---|

| MigrationPolicy → 양식 생성 | 구성 및 레이블을 양식에 입력하여 MigrationPolicy를 생성합니다. |

| MigrationPolicy → YAML을 사용하여 생성 | YAML 구성 파일을 편집하여 MigrationPolicy를 생성합니다. |

| 이름 | 라벨 검색 필드 | 이름 또는 라벨별로 MigrationPolicy를 검색합니다. |

| MigrationPolicies 테이블 | MigrationPolicies 목록.

MigrationPolicy 옆에 있는 옵션 메뉴

|

MigrationPolicy를 클릭하여 MigrationPolicy 세부 정보 페이지를 확인합니다.

4.6.1. MigrationPolicy 세부 정보 페이지

MigrationPolicy 세부 정보 페이지에서 MigrationPolicy를 구성할 수 있습니다.

예 4.35. MigrationPolicy 세부 정보 페이지

| 요소 | 설명 |

|---|---|

| 세부 정보 탭 | 양식을 편집하여 MigrationPolicy를 구성합니다. |

| YAML 탭 | YAML 구성 파일을 편집하여 MigrationPolicy를 구성합니다. |

| 작업 메뉴 | 편집 또는 삭제를 선택합니다. |

| 이름 | MigrationPolicy 이름입니다. |

| 설명 | MigrationPolicy 설명. |

| 구성 | 편집 아이콘을 클릭하여 MigrationPolicy 구성을 업데이트합니다. |

| 마이그레이션당 대역폭 |

마이그레이션당 대역폭 요청입니다. 무제한 대역폭의 경우 값을 |

| 자동 통합 | 자동 통합 정책. |

| 복사 후 | 복사 후 정책입니다. |

| 완료 제한 | 완료 시간(초)입니다. |

| 프로젝트 라벨 | Edit (편집)를 클릭하여 프로젝트 레이블을 편집합니다. |

| VirtualMachine 라벨 | 편집 을 클릭하여 VirtualMachine 레이블을 편집합니다. |

5장. OpenShift Virtualization 릴리스 정보

5.1. 보다 포괄적 수용을 위한 오픈 소스 용어 교체

Red Hat은 코드, 문서, 웹 속성에서 문제가 있는 용어를 교체하기 위해 최선을 다하고 있습니다. 먼저 마스터(master), 슬레이브(slave), 블랙리스트(blacklist), 화이트리스트(whitelist) 등 네 가지 용어를 교체하고 있습니다. 이러한 변경 작업은 작업 범위가 크므로 향후 여러 릴리스에 걸쳐 점차 구현할 예정입니다. 자세한 내용은 Red Hat CTO Chris Wright의 메시지에서 참조하십시오.

5.2. Red Hat OpenShift Virtualization 정보

Red Hat OpenShift Virtualization을 사용하면 기존 VM(가상 머신)을 컨테이너와 함께 실행되는 OpenShift Container Platform으로 가져와 네이티브 Kubernetes 오브젝트로 관리할 수 있습니다.

OpenShift Virtualization은

![]() 아이콘으로 표시됩니다.

아이콘으로 표시됩니다.

OVN-Kubernetes 또는 OpenShiftSDN 기본 CNI(Container Network Interface) 네트워크 공급자와 함께 OpenShift Virtualization을 사용할 수 있습니다.

OpenShift Virtualization으로 수행할 수 있는 작업에 대해 자세히 알아보십시오.

OpenShift Virtualization 아키텍처 및 배포에 대해 자세히 알아보십시오.

OpenShift Virtualization을 위한 클러스터를 준비합니다.

5.2.1. OpenShift Virtualization 지원 클러스터 버전

OpenShift Container Platform 4.12 클러스터에서 사용할 수 있도록 OpenShift Virtualization 4.12가 지원됩니다. OpenShift Virtualization의 최신 z-stream 릴리스를 사용하려면 먼저 최신 버전의 OpenShift Container Platform으로 업그레이드해야 합니다.

5.2.2. 지원되는 게스트 운영 체제

OpenShift Virtualization에서 지원되는 게스트 운영 체제를 보려면 Certified Guest Operating Systems in Red Hat OpenStack Platform, Red Hat Virtualization 및 OpenShift Virtualization 을 참조하십시오.

5.3. 새로운 기능 및 변경된 기능

OpenShift Virtualization은 Microsoft의 Windows SVVP(서버 가상화 유효성 검사 프로그램)에서 Windows Server 워크로드를 실행하도록 인증되었습니다.

SVVP 인증은 다음에 적용됩니다.

- Red Hat Enterprise Linux CoreOS 작업자. SVVP 카탈로그에서는 RHEL CoreOS 8의 Red Hat OpenShift Container Platform 4라고 함)

- Intel 및 AMD CPU

-

OpenShift Virtualization에서는 더 이상

로고를 사용하지 않습니다. OpenShift Virtualization은 이제 버전 4.9 이상에 대한

로고를 사용하지 않습니다. OpenShift Virtualization은 이제 버전 4.9 이상에 대한

로고로 표시됩니다.

로고로 표시됩니다.

-

virtctl memory-dump명령을 사용하여 포렌식 분석에 대한 VM 메모리 덤프 를 생성할 수 있습니다.

-

virtctl vm export 명령을 사용하거나수 있습니다. 또한 법의학 분석을 위해 메모리 덤프를 내보낼 수 있습니다.VirtualMachineExport사용자 정의 리소스를 생성하여 다른 클러스터 또는 동일한 클러스터의 다른 네임스페이스에서 VM(가상 머신), VM 스냅샷 또는 PVC(영구 볼륨 클레임)에서 볼륨을 내보내고 다운로드할

-

virtctl ssh명령을 사용하여 로컬 SSH 클라이언트를 사용하거나 OpenShift Container Platform 웹 콘솔에서 SSH 명령을 복사하여 가상 머신에 SSH 트래픽을 전달할 수 있습니다.

-

독립 실행형 데이터 볼륨과

dataVolumeTemplate을 사용하여 VM용 디스크를 준비할 때 생성되는 데이터 볼륨은 더 이상 시스템에 저장되지 않습니다. 이제 PVC가 생성된 후 데이터 볼륨이 자동으로 수집되고 삭제됩니다.

- OpenShift Virtualization은 이제 OpenShift Container Platform 모니터링 대시보드를 사용하여 액세스할 수 있는 실시간 마이그레이션 메트릭 을 제공합니다.

-

OpenShift Virtualization Operator는 이제

APIServer사용자 정의 리소스에서 클러스터 전체 TLS 보안 프로필 을 읽고 가상화, 스토리지, 네트워킹 및 인프라를 포함하여 OpenShift Virtualization 구성 요소로 전달합니다.

- OpenShift Virtualization에는 경고를 트리거하는 문제를 해결하는 데 도움이 되는 runbooks 가 있습니다. 웹 콘솔의 가상화 → 개요 페이지에 경고가 표시됩니다. 각 runbook은 경고를 정의하고 문제를 진단하고 해결하는 단계를 제공합니다. 이 기능은 이전에 기술 프리뷰로 소개되었으며 현재 일반적으로 사용 가능합니다.

5.3.1. 퀵스타트

-

여러 OpenShift Virtualization 기능에 대한 퀵스타트 둘러보기를 사용할 수 있습니다. 둘러보기를 보려면 OpenShift Virtualization 콘솔 헤더에 있는 메뉴 표시줄에서 Help 아이콘 ?을 클릭한 다음 퀵스타트를 선택합니다. 필터 필드에

virtualization키워드를 입력하여 사용 가능한 둘러보기를 필터링할 수 있습니다.

5.3.2. 네트워킹

- 이제 OpenShift Container Platform 클러스터 점검을 실행할 네임스페이스를 지정할 수 있습니다.

- 이제 계층 2 모드에서 MetalLB Operator 를 사용하여 로드 밸런싱 서비스를 구성할 수 있습니다.

5.3.3. 웹 콘솔

가상화 → 개요 페이지에는 다음과 같은 사용성이 향상되었습니다.

- Download virtctl 링크를 사용할 수 있습니다.

- 리소스 정보는 관리자 및 관리자가 아닌 사용자를 위해 사용자 지정됩니다. 예를 들어 관리자가 아닌 사용자는 VM만 볼 수 있습니다.

- 개요 탭에는 지난 7일의 추세를 보여주는 차트가 포함된 VM 수 및 vCPU, 메모리, 스토리지 사용량이 표시됩니다.

- 개요 탭의 경고 카드에는 심각도별로 그룹화된 경고가 표시됩니다.

- Top Consumers 탭에는 구성 가능한 기간 동안 CPU, 메모리 및 스토리지 사용량의 상위 소비자가 표시됩니다.

- Migrations (마이그레이션) 탭에 VM 마이그레이션의 진행 상황이 표시됩니다.

- 설정 탭에는 실시간 마이그레이션 제한, 실시간 마이그레이션 네트워크 및 templates 프로젝트를 포함한 클러스터 전체 설정이 표시됩니다.

- 가상화 → MigrationPolicies 페이지의 단일 위치에서 실시간 마이그레이션 정책을 생성하고 관리할 수 있습니다.

- VirtualMachine details 페이지의 Metrics 탭에는 구성 가능한 기간 동안 VM의 메모리, CPU, 스토리지, 네트워크 및 마이그레이션 메트릭이 표시됩니다.

- VM을 생성하도록 템플릿을 사용자 지정할 때 각 VM 구성 탭에서 YAML 스위치를 ON 으로 설정하여 양식과 함께 YAML 구성 파일의 실시간 변경 사항을 볼 수 있습니다.

- 가상화 → 개요 페이지 의 마이그레이션 탭에 구성 가능한 기간 동안 가상 머신 인스턴스 마이그레이션 진행 상황이 표시됩니다.

- 테넌트 워크로드 중단을 최소화하기 위해 실시간 마이그레이션을 위해 전용 네트워크를 정의할 수 있습니다. 네트워크를 선택하려면 가상화 → 개요 → 설정 → 실시간 마이그레이션 로 이동합니다.

5.3.4. 더 이상 사용되지 않는 기능

더 이상 사용되지 않는 기능은 현재 릴리스에 포함되어 있으며 지원됩니다. 그러나 향후 릴리스에서 제거될 예정이므로 새로운 배포에는 사용하지 않는 것이 좋습니다.

5.3.5. 삭제된 기능

제거된 기능은 현재 릴리스에서 지원되지 않습니다.

- 레거시 HPP 사용자 지정 리소스 및 관련 스토리지 클래스에 대한 지원이 모두 새로운 배포에 대해 제거되었습니다. OpenShift Virtualization 4.12에서 HPP Operator는 Kubernetes CSI(Container Storage Interface) 드라이버를 사용하여 로컬 스토리지를 구성합니다. 레거시 HPP 사용자 지정 리소스는 이전 버전의 OpenShift Virtualization에 설치된 경우에만 지원됩니다.

OpenShift Virtualization 4.11에서는 다음 오브젝트를 포함하여 nmstate 에 대한 지원을 제거했습니다.

-

NodeNetworkState -

NodeNetworkConfigurationPolicy -

NodeNetworkConfigurationEnactment

기존 nmstate 구성을 유지하고 지원하려면 OpenShift Virtualization 4.11로 업데이트하기 전에 Kubernetes NMState Operator 를 설치합니다. EUS(Extended Update Support) 버전의 4.12의 경우 4.12로 업데이트한 후 Kubernetes NMState Operator를 설치합니다. OpenShift Container Platform 웹 콘솔의 OperatorHub 에서 또는 OpenShift CLI(

oc)를 사용하여 Operator를 설치할 수 있습니다.-

Node Maintenance Operator (NMO)는 더 이상 OpenShift Virtualization과 함께 제공되지 않습니다. OpenShift Container Platform 웹 콘솔의 OperatorHub 에서 또는 OpenShift CLI(

oc)를 사용하여 NMO를 설치할 수 있습니다.OpenShift Virtualization 4.10.2 이상 릴리스에서 OpenShift Virtualization 4.11로 업데이트하기 전에 다음 작업 중 하나를 수행해야 합니다. EUS (Extended Update Support) 버전의 경우 4.10.2 이상 4.10 릴리스에서 OpenShift Virtualization 4.12로 업데이트하기 전에 다음 작업을 수행해야 합니다.

- 모든 노드를 유지보수 모드에서 이동합니다.

-

독립 실행형 NMO를 설치하고

nodemaintenances.nodemaintenance.kubevirt.ioCR(사용자 정의 리소스)을nodemaintenances.nodemaintenance.medik8s.ioCR로 교체합니다.

5.4. 기술 프리뷰 기능

이 릴리스의 일부 기능은 현재 기술 프리뷰 단계에 있습니다. 이러한 실험적 기능은 프로덕션용이 아닙니다. 해당 기능은 Red Hat Customer Portal의 지원 범위를 참조하십시오.

- OpenShift Container Platform 클러스터 점검을 실행하여 VM 간 네트워크 대기 시간을 측정할 수 있습니다.

Tekton Tasks Operator(TTO)는 이제 OpenShift Virtualization과 Red Hat OpenShift Pipelines 를 통합합니다. TTO에는 다음을 수행할 수 있는 클러스터 작업 및 예제 파이프라인이 포함되어 있습니다.

- VM(가상 머신), PVC(영구 볼륨 클레임) 및 데이터 볼륨을 생성하고 관리합니다.

- VM에서 명령을 실행합니다.

-

libguestfs툴을 사용하여 디스크 이미지를 조작합니다. - Windows 10을 Windows 설치 이미지(ISO 파일)에서 새 데이터 볼륨에 설치합니다.

- 기본 Windows 10 설치를 사용자 지정한 다음 새 이미지와 템플릿을 만듭니다.

- 게스트 에이전트 ping 프로브를 사용하여 QEMU 게스트 에이전트 가 가상 머신에서 실행 중인지 확인할 수 있습니다.

- 이제 Microsoft Windows 11을 게스트 운영 체제로 사용할 수 있습니다. 그러나 OpenShift Virtualization 4.12는 USB 디스크를 지원하지 않습니다.이 디스크는ECDHE 복구의 중요한 기능에 필요합니다. 복구 키를 보호하려면ECDHE 복구 가이드에 설명된 다른 방법을 사용하십시오.

- 대역폭 사용량, 최대 병렬 마이그레이션 및 시간 초과와 같은 특정 매개 변수로 실시간 마이그레이션 정책을 생성하고 가상 머신 및 네임스페이스 레이블을 사용하여 가상 머신 그룹에 정책을 적용할 수 있습니다.

5.5. 버그 수정

-

드라이버 설치 후 새 장치 구성을 손실하지 않고 드라이버를 설치하기 전에 중재 장치를 사용하도록

HyperConvergedCR을 구성할 수 있습니다. (BZ#2046298) -

NodePort서비스를 많이 생성하는 경우 OVN-Kubernetes 클러스터 네트워크 공급자가 더 이상 최대 RAM 및 CPU 사용량에서 충돌하지 않습니다. (OCPBUGS-1940) - Red Hat Ceph Storage 또는 Red Hat OpenShift Data Foundation Storage를 사용하면 한 번에 100개 이상의 VM 복제가 더 이상 간헐적으로 실패하지 않습니다. (BZ#1989527)

5.6. 확인된 문제

- 단일 스택 IPv6 클러스터에서는 OpenShift Virtualization을 실행할 수 없습니다. (BZ#2193267)

- 다른 컴퓨팅 노드가 있는 이기종 클러스터에서는 TSC(Timest-counter scaling)를 지원하지 않거나 적절한 TSC 빈도를 갖는 노드에 HyperV Reenlightenment가 활성화된 가상 머신을 예약할 수 없습니다. (BZ#2151169)

다른 SELinux 컨텍스트가 있는 두 개의 Pod를 사용하면

ocs-storagecluster-cephfs스토리지 클래스가 있는 VM이 마이그레이션되지 않고 VM 상태가일시 중지됨으로변경됩니다. 두 Pod 모두 공유ReadWriteManyCephFS 볼륨에 동시에 액세스하려고 하기 때문입니다. (BZ#2092271)-

이 문제를 해결하려면

ocs-storagecluster-ceph-rbd스토리지 클래스를 사용하여 Red Hat Ceph Storage를 사용하는 클러스터에서 VM을 실시간 마이그레이션합니다.

-

이 문제를 해결하려면

OpenShift Virtualization 4.12에서

TopoLVM이름 문자열이 변경되었습니다. 결과적으로 다음 오류 메시지와 함께 운영 체제 이미지의 자동 가져오기가 실패할 수 있습니다(BZ#2158521).DataVolume.storage spec is missing accessMode and volumeMode, cannot get access mode from StorageProfile.

DataVolume.storage spec is missing accessMode and volumeMode, cannot get access mode from StorageProfile.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 해결 방법:

스토리지 프로파일의

claimPropertySets배열을 업데이트합니다.oc patch storageprofile <storage_profile> --type=merge -p '{"spec": {"claimPropertySets": [{"accessModes": ["ReadWriteOnce"], "volumeMode": "Block"}, \ {"accessModes": ["ReadWriteOnce"], "volumeMode": "Filesystem"}]}}'$ oc patch storageprofile <storage_profile> --type=merge -p '{"spec": {"claimPropertySets": [{"accessModes": ["ReadWriteOnce"], "volumeMode": "Block"}, \ {"accessModes": ["ReadWriteOnce"], "volumeMode": "Filesystem"}]}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

openshift-virtualization-os-images네임스페이스에서 영향을 받는 데이터 볼륨을 삭제합니다. 업데이트된 스토리지 프로필에서 액세스 모드 및 볼륨 모드로 다시 생성됩니다.

바인딩 모드가

WaitForFirstConsumer인 스토리지에 대한 VM 스냅샷을 복원할 때 복원된 PVC는Pending상태로 유지되고 복원 작업이 진행되지 않습니다.-

이 문제를 해결하려면 복원된 VM을 시작한 다음 중지한 다음 다시 시작합니다. VM이 예약되고 PVC가

Bound상태가 되고 복원 작업이 완료됩니다. (BZ#2149654)

-

이 문제를 해결하려면 복원된 VM을 시작한 다음 중지한 다음 다시 시작합니다. VM이 예약되고 PVC가

-

SNO(Single Node OpenShift) 클러스터에서 공통 템플릿으로 생성된 VM은 템플릿의 기본 제거 전략이

LiveMigrate이므로VMCannotBeEvicted경고를 표시합니다. VM의 제거 전략을 업데이트하여 이 경고를 무시하거나 경고를 제거할 수 있습니다. (BZ#2092412) -

OpenShift Virtualization을 설치 제거해도 OpenShift Virtualization에서 생성한

feature.node.kubevirt.io노드 레이블은 제거되지 않습니다. 라벨을 수동으로 제거해야 합니다. (CNV-22036) CDI(Containerized Data Importer)로 생성된 일부 PVC(영구 볼륨 클레임) 주석은 가상 머신 스냅샷 복원 작업이 무기한 중단될 수 있습니다. (BZ#2070366)

이 문제를 해결하려면 주석을 수동으로 제거할 수 있습니다.

-

VirtualMachineSnapshotContent CR(사용자 정의 리소스) 이름을

VirtualMachineSnapshotCR CR의status.virtualMachineSnapshotContentName값에서 가져옵니다. -

VirtualMachineSnapshotContentCR을 편집하고k8s.io/cloneRequest가 포함된 모든 행을 제거합니다. VirtualMachine오브젝트에서spec.dataVolumeTemplates값을 지정하지 않은 경우 다음 두 조건이 모두 true인 이 네임스페이스의 모든DataVolume및PersistentVolumeClaim오브젝트를 삭제합니다.-

오브젝트의 이름은

restore로시작합니다. 가상 머신에서 오브젝트를 참조하지 않습니다.

spec.dataVolumeTemplates에 값을 지정한 경우 이 단계는 선택 사항입니다.

-

오브젝트의 이름은

-

업데이트된

VirtualMachineSnapshotCR을 사용하여 복원 작업을 반복합니다.

-

VirtualMachineSnapshotContent CR(사용자 정의 리소스) 이름을

-

Windows 11 가상 머신은 FIPS 모드에서 실행되는 클러스터에서 부팅되지 않습니다. Windows 11에는 기본적으로 TPM(신뢰할 수 있는 플랫폼 모듈) 장치가 필요합니다. 그러나

swtpm(software TPM 에뮬레이터) 패키지는 FIPS와 호환되지 않습니다. (BZ#2089301)

OpenShift Container Platform 클러스터에서 OVN-Kubernetes를 기본 CNI(Container Network Interface) 공급자로 사용하는 경우 OVN-Kubernetes의 호스트 네트워크 토폴로지 변경으로 인해 Linux 브리지 또는 본딩 장치를 호스트의 기본 인터페이스에 연결할 수 없습니다. (BZ#1885605)

- 해결 방법으로 호스트에 연결된 보조 네트워크 인터페이스를 사용하거나 OpenShift SDN 기본 CNI 공급자로 전환할 수 있습니다.

경우에 따라 여러 가상 머신이 동일한 PVC를 읽기-쓰기 모드로 마운트할 수 있으므로 데이터가 손상될 수 있습니다. (BZ#1992753)

- 이 문제를 해결하려면 여러 VM에서 읽기-쓰기 모드에서 단일 PVC를 사용하지 마십시오.

Pod Disruption Budget(PDB)은 Pod가 모호한 가상 머신 이미지에 대한 Pod 중단을 방지합니다. PDB에서 Pod 중단을 감지하면

openshift-monitoring는LiveMigrate제거 전략을 사용하는 가상 머신 이미지에 대해 60분마다PodDisruptionBudgetAtLimit경고를 보냅니다. (BZ#2026733)- 해결 방법으로 경고는 음소거 합니다.

OpenShift Virtualization은 Pod에서 사용하는 서비스 계정 토큰을 해당 특정 포드에 연결합니다. OpenShift Virtualization은 토큰이 포함된 디스크 이미지를 생성하여 서비스 계정 볼륨을 구현합니다. VM을 마이그레이션하는 경우 서비스 계정 볼륨이 잘못되었습니다. (BZ#2037611)

- 이 문제를 해결하려면 사용자 계정 토큰이 특정 Pod에 바인딩되지 않으므로 서비스 계정 대신 사용자 계정을 사용하십시오.

csi-clone복제 전략을 사용하여 VM 100개를 복제하는 경우 Ceph CSI에서 복제본을 제거하지 못할 수 있습니다. 복제본을 수동으로 삭제하면 실패할 수도 있습니다. (BZ#2055595)-

이 문제를 해결하려면

ceph-mgr을 다시 시작하여 VM 복제본을 제거할 수 있습니다.

-

이 문제를 해결하려면

블록 스토리지 장치와 함께 LVM(Logical Volume Management)을 사용하는 VM에는 RHCOS(Red Hat Enterprise Linux CoreOS) 호스트와의 충돌을 방지하기 위해 추가 구성이 필요합니다.

-

이 문제를 해결하려면 VM을 생성하고 LVM을 프로비저닝한 후 VM을 다시 시작할 수 있습니다. 이렇게 하면 빈

system.lvmdevices파일이 생성됩니다. (OCPBUGS-5223)

-

이 문제를 해결하려면 VM을 생성하고 LVM을 프로비저닝한 후 VM을 다시 시작할 수 있습니다. 이렇게 하면 빈

6장. 설치

6.1. OpenShift Virtualization을 위한 클러스터 준비

OpenShift Virtualization을 설치하기 전에 이 섹션을 검토하여 클러스터가 요구 사항을 충족하는지 확인합니다.

사용자 프로비저닝, 설치 관리자 프로비저닝 또는 지원 설치 프로그램을 포함하여 설치 방법을 사용하여 OpenShift Container Platform을 배포할 수 있습니다. 그러나 설치 방법과 클러스터 토폴로지는 스냅샷 또는 실시간 마이그레이션과 같은 OpenShift Virtualization 기능에 영향을 줄 수 있습니다.

FIPS 모드

FIPS 모드에서 클러스터를 설치하는 경우 OpenShift Virtualization에 추가 설정이 필요하지 않습니다.

IPv6

단일 스택 IPv6 클러스터에서는 OpenShift Virtualization을 실행할 수 없습니다. (BZ#2193267)

6.1.1. 하드웨어 및 운영 체제 요구 사항

OpenShift Virtualization에 대한 다음 하드웨어 및 운영 체제 요구 사항을 검토합니다.

지원되는 플랫폼

- 온프레미스 베어 메탈 서버

- Amazon Web Services 베어 메탈 인스턴스. 자세한 내용은 AWS 베어 메탈 노드에 OpenShift Virtualization 배포를 참조하십시오.

- IBM Cloud 베어 메탈 서버. 자세한 내용은 IBM Cloud Bare Metal 노드에 OpenShift Virtualization 배포를 참조하십시오.

AWS 베어 메탈 인스턴스에 OpenShift Virtualization을 설치하거나 IBM Cloud Bare Metal Server에 설치하는 것은 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

- 다른 클라우드 공급자가 제공하는 베어 메탈 인스턴스 또는 서버는 지원되지 않습니다.

CPU 요구사항

- RHEL (Red Hat Enterprise Linux) 8에서 지원

- Intel 64 또는 AMD64 CPU 확장 지원

- Intel VT 또는 AMD-V 하드웨어 가상화 확장 기능 활성화

- NX(실행 없음) 플래그를 사용할 수 있음

스토리지 요구사항

- OpenShift Container Platform에서 지원

Red Hat OpenShift Data Foundation을 사용하여 OpenShift Virtualization을 배포하는 경우 Windows 가상 머신 디스크용 전용 스토리지 클래스를 생성해야 합니다. 자세한 내용은 Windows VM용 ODF PersistentVolume 최적화 를 참조하십시오.

운영 체제 요구 사항

작업자 노드에 설치된 RHCOS(Red Hat Enterprise Linux CoreOS)

참고RHEL 작업자 노드는 지원되지 않습니다.

- 클러스터에서 다른 CPU가 있는 작업자 노드를 사용하는 경우 다른 CPU의 기능이 다르기 때문에 실시간 마이그레이션 오류가 발생할 수 있습니다. 이러한 오류를 방지하려면 각 노드에 적절한 용량이 있는 CPU를 사용하고 가상 머신에 노드 선호도를 설정하여 마이그레이션을 성공적으로 수행합니다. 자세한 내용은 필수 노드 유사성 규칙 구성 을 참조하십시오.

6.1.2. 물리적 리소스 오버헤드 요구사항

OpenShift Virtualization은 OpenShift Container Platform의 추가 기능이며 클러스터를 계획할 때 고려해야 하는 추가 오버헤드를 적용합니다. 각 클러스터 머신은 OpenShift Container Platform 요구 사항 이외에도 다음과 같은 오버헤드 요구 사항을 충족해야 합니다. 클러스터에서 물리적 리소스를 초과 구독하면 성능에 영향을 미칠 수 있습니다.

이 문서에 명시된 수치는 Red Hat의 테스트 방법론 및 설정을 기반으로 한 것입니다. 고유한 개별 설정 및 환경에 따라 수치가 달라질 수 있습니다.

6.1.2.1. 메모리 오버헤드

아래 식을 사용하여 OpenShift Virtualization의 메모리 오버헤드 값을 계산합니다.

클러스터 메모리 오버헤드

Memory overhead per infrastructure node ≈ 150 MiB

Memory overhead per infrastructure node ≈ 150 MiBMemory overhead per worker node ≈ 360 MiB

Memory overhead per worker node ≈ 360 MiB또한, OpenShift Virtualization 환경 리소스에는 모든 인프라 노드에 분산된 총 2179MiB의 RAM이 필요합니다.

가상 머신 메모리 오버헤드

Memory overhead per virtual machine ≈ (1.002 × requested memory) \

+ 218 MiB \

+ 8 MiB × (number of vCPUs) \

+ 16 MiB × (number of graphics devices) \

+ (additional memory overhead)

Memory overhead per virtual machine ≈ (1.002 × requested memory) \

+ 218 MiB \

+ 8 MiB × (number of vCPUs) \

+ 16 MiB × (number of graphics devices) \

+ (additional memory overhead) 6.1.2.2. CPU 오버헤드

아래 식을 사용하여 OpenShift Virtualization에 대한 클러스터 프로세서 오버헤드 요구 사항을 계산합니다. 가상 머신당 CPU 오버헤드는 개별 설정에 따라 다릅니다.

클러스터 CPU 오버헤드

CPU overhead for infrastructure nodes ≈ 4 cores

CPU overhead for infrastructure nodes ≈ 4 coresOpenShift Virtualization은 로깅, 라우팅 및 모니터링과 같은 클러스터 수준 서비스의 전반적인 사용률을 높입니다. 이 워크로드를 처리하려면 인프라 구성 요소를 호스팅하는 노드에 4 개의 추가 코어 (4000밀리코어)가 해당 노드에 분산되어 있는지 확인합니다.

CPU overhead for worker nodes ≈ 2 cores + CPU overhead per virtual machine

CPU overhead for worker nodes ≈ 2 cores + CPU overhead per virtual machine가상 머신을 호스팅하는 각 작업자 노드는 가상 머신 워크로드에 필요한 CPU 외에도 OpenShift Virtualization 관리 워크로드에 대한 2개의 추가 코어(2000밀리코어)용 용량이 있어야 합니다.

가상 머신 CPU 오버헤드

전용 CPU가 요청되면 클러스터 CPU 오버헤드 요구 사항에 대한 1:1 영향이 있습니다. 그러지 않으면 가상 머신에 필요한 CPU 수에 대한 구체적인 규칙이 없습니다.

6.1.2.3. 스토리지 오버헤드

아래 지침을 사용하여 OpenShift Virtualization 환경에 대한 스토리지 오버헤드 요구 사항을 추정할 수 있습니다.

클러스터 스토리지 오버헤드

Aggregated storage overhead per node ≈ 10 GiB

Aggregated storage overhead per node ≈ 10 GiB10GiB는 OpenShift Virtualization을 설치할 때 클러스터의 각 노드에 대해 예상되는 온디스크 스토리지 영향입니다.

가상 머신 스토리지 오버헤드

가상 머신당 스토리지 오버헤드는 가상 머신 내의 리소스 할당 요청에 따라 다릅니다. 이 요청은 클러스터의 다른 위치에서 호스팅되는 노드 또는 스토리지 리소스의 임시 스토리지에 대한 요청일 수 있습니다. 현재 OpenShift Virtualization은 실행 중인 컨테이너 자체에 대한 추가 임시 스토리지를 할당하지 않습니다.

6.1.2.4. 예

클러스터 관리자가 클러스터에서 10개의 가상 머신을 호스팅하는 경우 1GiB RAM과 2개의 vCPU가 장착된 메모리의 클러스터 전체에 대한 영향은 11.68GiB입니다. 클러스터의 각 노드에 대한 디스크 스토리지 영향은 10GiB이며 호스트 가상 머신 워크로드가 최소 2개 코어인 작업자 노드에 대한 CPU 영향은 최소 2개입니다.

6.1.3. 오브젝트 최대값

클러스터를 계획할 때 다음과 같은 테스트된 오브젝트 최대값을 고려해야 합니다.

6.1.4. 제한된 네트워크 환경

인터넷 연결이 없는 제한된 환경에 OpenShift Virtualization을 설치하는 경우 제한된 네트워크에 대해 Operator Lifecycle Manager를 구성해야 합니다.

인터넷 연결이 제한된 경우 Red Hat 제공 OperatorHub에 액세스하도록 Operator Lifecycle Manager에서 프록시 지원을 구성할 수 있습니다.

6.1.5. 실시간 마이그레이션

실시간 마이그레이션에는 다음과 같은 요구 사항이 있습니다.

-

RWX(

ReadWriteMany) 액세스 모드를 사용한 공유 스토리지. - 충분한 RAM 및 네트워크 대역폭.

- 가상 머신에서 호스트 모델 CPU를 사용하는 경우 노드에서 가상 머신의 호스트 모델 CPU를 지원해야 합니다.

노드 드레이닝을 지원하기 위해 클러스터에 메모리 요청 용량이 충분한지 확인하여 실시간 마이그레이션을 수행해야 합니다. 다음 계산을 사용하여 필요한 예비 메모리를 확인할 수 있습니다.

Product of (Maximum number of nodes that can drain in parallel) and (Highest total VM memory request allocations across nodes)

Product of (Maximum number of nodes that can drain in parallel) and (Highest total VM memory request allocations across nodes)클러스터에서 병렬로 실행할 수 있는 기본 마이그레이션 수는 5입니다.

6.1.6. 스냅샷 및 복제

스냅샷 및 복제 요구 사항은 OpenShift Virtualization 스토리지 기능을 참조하십시오.

6.1.7. 클러스터 고가용성 옵션

클러스터에 대해 다음과 같은 HA(고가용성) 옵션 중 하나를 구성할 수 있습니다.

머신 상태 점검을 배포하여 설치 관리자 프로비저닝 인프라 (IPI)의 자동 고가용성을 사용할 수 있습니다.

참고설치 관리자 프로비저닝 인프라를 사용하여 설치하고 MachineHealthCheck가 올바르게 구성된 OpenShift Container Platform 클러스터에서는 노드가 MachineHealthCheck에 실패하여 클러스터에서 사용할 수 없게 되는 경우 재활용됩니다. 실패한 노드에서 실행된 VM에서 다음에 수행되는 작업은 일련의 조건에 따라 다릅니다. 잠재적 결과 및 RunStrategies가 이러한 결과에 미치는 영향에 대한 자세한 내용은 가상 머신 의 RunStrategies 정보를 참조하십시오.

-

OpenShift Container Platform 클러스터에서 Node Health Check Operator 를 사용하여

NodeHealthCheck컨트롤러를 배포하면 IPI 및 비 IPI에 대한 자동 고가용성을 사용할 수 있습니다. 컨트롤러는 비정상 노드를 식별하고 Self Node Remediation Operator 또는 Fence Agents Remediation Operator와 같은 수정 공급자를 사용하여 비정상 노드를 수정합니다. 노드 수정, 펜싱 및 유지 관리에 대한 자세한 내용은 Workload Availability for Red Hat OpenShift 설명서를 참조하십시오. 모니터링 시스템 또는 자격을 갖춘 사람이 노드 가용성을 모니터링하는 모든 플랫폼에 대한 고가용성을 사용할 수 있습니다. 노드가 손실되면 노드를 종료하고

oc delete node <lost_node>를 실행합니다.참고외부 모니터링 시스템 또는 인증된 사용자 모니터링 노드 상태가 없으면 가상 머신의 가용성이 저하됩니다.

6.2. OpenShift Virtualization 구성 요소를 위한 노드 지정

노드 배치 규칙을 구성하여 OpenShift Virtualization Operator, 워크로드 및 컨트롤러를 배포할 노드를 지정합니다.

OpenShift Virtualization을 설치한 후에는 일부 구성 요소에 대한 노드 배치를 구성할 수 있지만, 워크로드에 대한 노드 배치를 구성하려면 가상 머신이 없어야 합니다.

6.2.1. 가상화 구성 요소를 위한 노드 배치 정보

다음이 수행되도록 OpenShift Virtualization이 구성 요소를 배포하는 위치를 사용자 지정하는 것이 좋습니다.

- 가상 머신은 가상화 워크로드를 위한 노드에만 배포됩니다.

- Operator는 인프라 노드에만 배포됩니다.

- 특정 노드는 OpenShift Virtualization의 영향을 받지 않습니다. 예를 들어, 클러스터에서 실행되는 가상화와 관련이 없는 워크로드가 있으며 해당 워크로드가 OpenShift Virtualization과 격리되기를 원하는 경우가 이에 해당합니다.

6.2.1.1. 가상화 구성 요소에 노드 배치 규칙을 적용하는 방법

해당 오브젝트를 직접 편집하거나 웹 콘솔을 사용하여 구성 요소의 노드 배치 규칙을 지정할 수 있습니다.

-

OLM(Operator Lifecycle Manager)이 배포하는 OpenShift Virtualization Operator의 경우, OLM

서브스크립션오브젝트를 직접 편집합니다. 현재는 웹 콘솔을 사용하여서브스크립션오브젝트에 대한 노드 배치 규칙을 구성할 수 없습니다. -

OpenShift Virtualization Operator가 배포하는 구성 요소의 경우, OpenShift Virtualization 설치 중에 웹 콘솔을 사용하여

HyperConverged오브젝트를 직접 편집하거나 구성합니다. hostpath 프로비전 프로그램의 경우,

HostPathProvisioner오브젝트를 직접 편집하거나 웹 콘솔을 사용하여 이를 구성합니다.주의hostpath 프로비전 프로그램과 가상화 구성 요소를 동일한 노드에 예약해야 합니다. 예약하지 않으면 hostpath 프로비전 프로그램을 사용하는 가상화 Pod를 실행할 수 없습니다.

오브젝트에 따라, 다음 규칙 유형 중 하나 이상을 사용할 수 있습니다.

nodeSelector- 이 필드에서 지정하는 키-값 쌍으로 라벨이 지정된 노드에 Pod를 예약할 수 있습니다. 노드에는 나열된 모든 쌍과 정확히 일치하는 라벨이 있어야 합니다.

유사성- 더 많은 표현 구문을 사용하여 노드와 Pod의 일치 규칙을 설정할 수 있습니다. 유사성을 사용하면 규칙 적용 방법을 보다 자세하게 설정할 수 있습니다. 예를 들어, 규칙을 엄격한 요구 사항이 아닌 기본 설정으로 지정할 수 있으므로 규칙이 충족되지 않은 경우에도 Pod를 예약할 수 있습니다.

허용 오차- 일치하는 테인트가 있는 노드에 Pod를 예약할 수 있습니다. 테인트가 노드에 적용되는 경우, 해당 노드는 테인트를 허용하는 Pod만 허용합니다.

6.2.1.2. OLM 서브스크립션 오브젝트에서의 노드 배치

OLM이 OpenShift Virtualization Operator를 배포하는 노드를 지정하려면, OpenShift Virtualization 설치 중에 서브스크립션 오브젝트를 편집합니다. 다음 예와 같이 spec.config 필드에 노드 배치 규칙을 추가할 수 있습니다.

- 1

config필드는nodeSelector및허용 오차를 지원하지만유사성은 지원되지 않습니다.

6.2.1.3. HyperConverged 오브젝트에서의 노드 배치

OpenShift Virtualization이 해당 구성 요소를 배포하는 노드를 지정하려면 OpenShift Virtualization을 설치하는 동안 생성한 HyperConverged Cluster 사용자 정의 리소스(CR) 파일에 nodePlacement 개체를 포함할 수 있습니다. 다음 예와 같이 spec.infra 및 spec.workloads 필드에 nodePlacement를 추가할 수 있습니다.

- 1

- The

nodePlacement필드는nodeSelector,affinity및tolerations필드를 지원합니다.

6.2.1.4. HostPathProvisioner 오브젝트에서의 노드 배치

hostpath 프로비전 프로그램을 설치할 때 생성할 HostPathProvisioner 오브젝트의 spec.workload 필드에 노드 배치 규칙을 구성할 수 있습니다.

- 1

워크로드필드는nodeSelector,유사성및허용 오차필드를 지원합니다.

6.2.2. 예시 매니페스트

다음 예시 YAML 파일은 nodePlacement, affinity 및 tolerations 오브젝트를 사용하여 OpenShift Virtualization 구성 요소를 위한 노드 배치를 사용자 지정합니다.

6.2.2.1. Operator Lifecycle Manager 서브스크립션 오브젝트

6.2.2.1.1. 예: OLM 서브스크립션 오브젝트에서 nodeSelector를 사용한 노드 배치

이 예에서는 example.io/example-infra-key = example-infra-value로 라벨이 지정된 노드에 OLM이 OpenShift Virtualization Operator를 배치하도록 nodeSelector를 구성합니다.

6.2.2.1.2. 예: OLM 서브스크립션 오브젝트에서 허용 오차를 사용한 노드 배치

이 예에서는 OpenShift Virtualization Operator를 배포하기 위해 OLM에 예약된 노드가 key=virtualization:NoSchedule 테인트로 라벨이 지정됩니다. 허용 오차가 일치하는 Pod만 이러한 노드에 예약됩니다.

6.2.2.2. HyperConverged 오브젝트

6.2.2.2.1. 예: HyperConverged Cluster CR에서 nodeSelector를 사용한 노드 배치

이 예에서는 인프라 리소스가 example.io/example-infra-key = example-infra-value로 라벨이 지정된 노드에 배치되고 워크로드가 example.io/example-workloads-key = example-workloads-value로 라벨이 지정된 노드에 배치되도록 nodeSelector가 구성됩니다.

6.2.2.2.2. 예: HyperConverged Cluster CR에서 유사성을 사용한 노드 배치

이 예에서는 인프라 리소스가 example.io/example-infra-key = example-value로 라벨이 지정된 노드에 배치되고 워크로드가 example.io/example-workloads-key = example-workloads-value로 라벨이 지정된 노드에 배치되도록 유사성이 구성됩니다. 워크로드에 9개 이상의 CPU를 사용하는 것이 좋지만, 사용할 수 없는 경우에도 Pod가 예약됩니다.

6.2.2.2.3. 예: HyperConverged Cluster CR에서 허용 오차를 사용한 노드 배치

이 예에서는 OpenShift Virtualization 구성 요소를 위해 예약된 노드가 key=virtualization:NoSchedule 테인트로 라벨이 지정됩니다. 허용 오차가 일치하는 Pod만 이러한 노드에 예약됩니다.

6.2.2.3. HostPathProvisioner 오브젝트

6.2.2.3.1. 예: HostPathProvisioner 오브젝트에서 nodeSelector를 사용한 노드 배치

이 예에서는 라벨이 example.io/example-workloads-key = example-workloads-value로 지정된 노드에 워크로드가 배치되도록 nodeSelector가 구성됩니다.

6.3. 웹 콘솔을 사용한 OpenShift Virtualization 설치

OpenShift Virtualization을 설치하여 OpenShift Container Platform 클러스터에 가상화 기능을 추가합니다.

OpenShift Container Platform 4.12 웹 콘솔 을 사용하여 OpenShift Virtualization Operator를 구독하고 배포할 수 있습니다.

6.3.1. OpenShift Virtualization Operator 설치

OpenShift Virtualization Operator는 OpenShift Container Platform 웹 콘솔을 사용하여 설치할 수 있습니다.

사전 요구 사항

- 클러스터에 OpenShift Container Platform 4.12를 설치합니다.

-

OpenShift Container Platform 웹 콘솔에

cluster-admin권한이 있는 사용자로 로그인합니다.

프로세스

- 관리자로 Operator → OperatorHub를 클릭합니다.

- 키워드로 필터링 필드에 가상화를 입력합니다.

- Red Hat 소스 라벨을 사용하여 {CNVOperator CryostatName} 타일을 선택합니다.

- Operator에 대한 정보를 확인하고 Install을 클릭합니다.

Operator 설치 페이지에서 다음을 수행합니다.

- 사용 가능한 업데이트 채널 옵션 목록에서 stable을 선택합니다. 이렇게 하면 OpenShift Container Platform 버전과 호환되는 OpenShift Virtualization 버전을 설치할 수 있습니다.

설치된 네임스페이스의 경우 Operator 권장 네임스페이스 옵션이 선택되어 있는지 확인합니다. 그러면 필수

openshift-cnv네임스페이스에 Operator가 설치되고, 해당 네임스페이스가 존재하지 않는 경우 자동으로 생성됩니다.주의openshift-cnv이외의 네임스페이스에 OpenShift Virtualization Operator를 설치하려고 하면 설치가 실패합니다.승인 전략의 경우 기본값인 자동을 선택하여 OpenShift Virtualization이 안정적인 업데이트 채널에서 새 버전을 사용할 수 있을 때 자동으로 업데이트되도록 하는 것이 좋습니다.

수동 승인 전략을 선택할 수 있지만 클러스터의 지원 가능성 및 기능에 미칠 위험이 높기 때문에 이 방법은 권장할 수 없습니다. 이러한 위험을 완전히 이해하고 자동을 사용할 수 없는 경우에만 수동을 선택합니다.

주의해당 OpenShift Container Platform 버전과 함께 사용할 때만 OpenShift Virtualization을 지원하므로 누락된 OpenShift Virtualization 업데이트가 없으면 클러스터가 지원되지 않을 수 있습니다.

-

openshift-cnv네임스페이스에서 Operator를 사용할 수 있도록 설치를 클릭합니다. - Operator가 설치되면 HyperConverged 생성을 클릭합니다.

- 선택 사항: OpenShift Virtualization 구성 요소에 대한 Infra 및 워크로드 노드 배치 옵션을 구성합니다.

- 생성을 클릭하여 OpenShift Virtualization을 시작합니다.

검증

- 워크로드 → Pods 페이지로 이동하여 모두 실행 중 상태가 될 때까지 OpenShift Virtualization Pod를 모니터링합니다. 모든 Pod에 실행 중 상태가 표시되면 OpenShift Virtualization을 사용할 수 있습니다.

6.3.2. 다음 단계

다음 구성 요소를 추가로 구성하는 것이 좋습니다.

- hostpath 프로비전 프로그램은 OpenShift Virtualization용으로 설계된 로컬 스토리지 프로비전 프로그램입니다. 가상 머신의 로컬 스토리지를 구성하려면 먼저 hostpath 프로비전 프로그램을 활성화해야 합니다.

6.4. CLI를 사용한 OpenShift Virtualization 설치

OpenShift Virtualization을 설치하여 OpenShift Container Platform 클러스터에 가상화 기능을 추가합니다. 명령줄을 사용하여 OpenShift Virtualization Operator를 구독하고 배포하여 클러스터에 매니페스트를 적용할 수 있습니다.

OpenShift Virtualization에서 구성 요소를 설치할 노드를 지정하려면 노드 배치 규칙을 구성합니다.

6.4.1. 사전 요구 사항

- 클러스터에 OpenShift Container Platform 4.12를 설치합니다.

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다.

6.4.2. CLI를 사용하여 OpenShift Virtualization 카탈로그 구독

OpenShift Virtualization을 설치하기 전에 OpenShift Virtualization 카탈로그를 구독해야 합니다. 구독하면 openshift-cnv 네임스페이스에서 OpenShift Virtualization Operator에 액세스할 수 있습니다.

구독하려면 클러스터에 단일 매니페스트를 적용하여 Namespace, OperatorGroup, Subscription 오브젝트를 구성합니다.

절차

다음 매니페스트를 포함하는 YAML 파일을 만듭니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

stable채널을 사용하면 OpenShift Container Platform 버전과 호환되는 OpenShift Virtualization 버전을 설치할 수 있습니다.

다음 명령을 실행하여 OpenShift Virtualization에 필요한

Namespace,OperatorGroup및Subscription오브젝트를 생성합니다.oc apply -f <file name>.yaml

$ oc apply -f <file name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

YAML 파일에서 인증서 교체 매개변수를 구성할 수 있습니다.

6.4.3. CLI를 사용하여 OpenShift Virtualization Operator 배포

oc CLI를 사용하여 OpenShift Virtualization Operator를 배포할 수 있습니다.

사전 요구 사항

-

openshift-cnv네임스페이스의 OpenShift Virtualization 카탈로그에 대한 구독이 활성 상태여야 합니다.

절차

다음 매니페스트를 포함하는 YAML 파일을 만듭니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 OpenShift Virtualization Operator를 배포합니다.

oc apply -f <file_name>.yaml

$ oc apply -f <file_name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

openshift-cnv네임스페이스에서 CSV(클러스터 서비스 버전)의PHASE를 확인하여 OpenShift Virtualization이 성공적으로 배포되었는지 확인합니다. 다음 명령을 실행합니다.watch oc get csv -n openshift-cnv

$ watch oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 배포에 성공하면 다음 출력이 표시됩니다.

출력 예

NAME DISPLAY VERSION REPLACES PHASE kubevirt-hyperconverged-operator.v4.12.15 OpenShift Virtualization 4.12.15 Succeeded

NAME DISPLAY VERSION REPLACES PHASE kubevirt-hyperconverged-operator.v4.12.15 OpenShift Virtualization 4.12.15 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.4. 다음 단계

다음 구성 요소를 추가로 구성하는 것이 좋습니다.

- hostpath 프로비전 프로그램은 OpenShift Virtualization용으로 설계된 로컬 스토리지 프로비전 프로그램입니다. 가상 머신의 로컬 스토리지를 구성하려면 먼저 hostpath 프로비전 프로그램을 활성화해야 합니다.

6.5. virtctl 클라이언트 설치

virtctl 클라이언트는 OpenShift Virtualization 리소스를 관리하는 명령줄 유틸리티입니다. Linux, Windows 및 macOS에서 사용할 수 있습니다.

6.5.1. Linux, Windows 및 macOS에 virtctl 클라이언트 설치

운영 체제에 대한 virtctl 클라이언트를 다운로드하여 설치합니다.

절차

- OpenShift Container Platform 웹 콘솔에서 Virtualization > Overview 로 이동합니다.

-

페이지 오른쪽 상단에 있는 Download virtctl 링크를 클릭하고 운영 체제용

virtctl클라이언트를 다운로드합니다. install

virtctl:Linux의 경우:

아카이브 파일의 압축을 풉니다.

tar -xvf <virtctl-version-distribution.arch>.tar.gz

$ tar -xvf <virtctl-version-distribution.arch>.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

virtctl바이너리를 실행할 수 있도록 합니다.chmod +x <path/virtctl-file-name>

$ chmod +x <path/virtctl-file-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl바이너리를PATH환경 변수의 디렉터리로 이동합니다.다음 명령을 실행하여 경로를 확인할 수 있습니다.

echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow KUBECONFIG환경 변수를 설정합니다.export KUBECONFIG=/home/<user>/clusters/current/auth/kubeconfig

$ export KUBECONFIG=/home/<user>/clusters/current/auth/kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Windows의 경우:

- 아카이브 파일의 압축을 풉니다.

-

추출된 폴더 계층 구조로 이동하고

virtctl실행 파일을 두 번 클릭하여 클라이언트를 설치합니다. virtctl바이너리를PATH환경 변수의 디렉터리로 이동합니다.다음 명령을 실행하여 경로를 확인할 수 있습니다.

path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

macOS의 경우:

- 아카이브 파일의 압축을 풉니다.

virtctl바이너리를PATH환경 변수의 디렉터리로 이동합니다.다음 명령을 실행하여 경로를 확인할 수 있습니다.

echo $PATH

echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.5.2. virtctl을 RPM으로 설치

OpenShift Virtualization 리포지토리를 활성화한 후 RHEL(Red Hat Enterprise Linux)에 virtctl 클라이언트를 RPM으로 설치할 수 있습니다.

6.5.2.1. OpenShift Virtualization 리포지토리 활성화

RHEL(Red Hat Enterprise Linux) 버전에 대해 OpenShift Virtualization 리포지토리를 활성화합니다.

사전 요구 사항

- "Red Hat Container Native Virtualization" 인타이틀먼트에 대한 활성 서브스크립션이 있는 Red Hat 계정에 시스템이 등록됩니다.

절차

subscription-managerCLI 툴을 사용하여 운영 체제에 적합한 OpenShift Virtualization 리포지토리를 활성화합니다.RHEL 8용 리포지토리를 활성화하려면 다음을 실행합니다.

subscription-manager repos --enable cnv-4.12-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable cnv-4.12-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow RHEL 7용 리포지토리를 활성화하려면 다음을 실행합니다.

subscription-manager repos --enable rhel-7-server-cnv-4.12-rpms

# subscription-manager repos --enable rhel-7-server-cnv-4.12-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.5.2.2. yum 유틸리티를 사용하여 virtctl 클라이언트 설치

kubevirt-virtctl 패키지에서 virtctl 클라이언트를 설치합니다.

사전 요구 사항

- RHEL(Red Hat Enterprise Linux) 시스템에서 OpenShift Virtualization 리포지토리를 활성화했습니다.

절차

kubevirt-virtctl패키지를 설치합니다.yum install kubevirt-virtctl

# yum install kubevirt-virtctlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.6. OpenShift Virtualization 설치 제거

웹 콘솔 또는 CLI(명령줄 인터페이스)를 사용하여 OpenShift Virtualization을 설치 제거하여 OpenShift Virtualization 워크로드, Operator 및 해당 리소스를 삭제합니다.

6.6.1. 웹 콘솔을 사용하여 OpenShift Virtualization 설치 제거

웹 콘솔 을 사용하여 다음 작업을 수행하여 OpenShift Virtualization을 설치 제거합니다.

먼저 모든 가상 머신 및 가상 머신 인스턴스를 삭제해야 합니다.

워크로드가 클러스터에 남아 있는 동안 OpenShift Virtualization을 설치 제거할 수 없습니다.

6.6.1.1. HyperConverged 사용자 정의 리소스 삭제

OpenShift Virtualization을 설치 제거하려면 먼저 HyperConverged CR(사용자 정의 리소스)을 삭제합니다.

사전 요구 사항

-

cluster-admin권한이 있는 계정을 사용하여 OpenShift Container Platform 클러스터에 액세스할 수 있습니다.

절차

- Operator → 설치된 Operator 페이지로 이동합니다.

- OpenShift Virtualization Operator를 선택합니다.

- OpenShift Virtualization 배포 탭을 클릭합니다.

-

kubevirt-hyperconverged옆에 있는 옵션 메뉴 를 클릭하고 HyperConverged 삭제 를 선택합니다.

를 클릭하고 HyperConverged 삭제 를 선택합니다.

- 확인 창에서 삭제를 클릭합니다.

6.6.1.2. 웹 콘솔을 사용하여 클러스터에서 Operator 삭제

클러스터 관리자는 웹 콘솔을 사용하여 선택한 네임스페이스에서 설치된 Operator를 삭제할 수 있습니다.

사전 요구 사항

-

cluster-admin권한이 있는 계정을 사용하여 OpenShift Container Platform 클러스터 웹 콘솔에 액세스할 수 있습니다.

절차

- Operator → 설치된 Operator 페이지로 이동합니다.

- 제거하려는 Operator를 찾으려면 이름으로 필터링 필드에 키워드를 스크롤하거나 입력합니다. 그런 다음 해당 Operator를 클릭합니다.

Operator 세부 정보 페이지 오른쪽에 있는 작업 목록에서 Operator 설치 제거를 선택합니다.

Operator를 설치 제거하시겠습니까? 대화 상자가 표시됩니다.

설치 제거를 선택하여 Operator, Operator 배포 및 Pod를 제거합니다. 이 작업 후에 Operator는 실행을 중지하고 더 이상 업데이트가 수신되지 않습니다.

참고이 작업은 CRD(사용자 정의 리소스 정의) 및 CR(사용자 정의 리소스)을 포함하여 Operator에서 관리하는 리소스를 제거하지 않습니다. 웹 콘솔에서 활성화된 대시보드 및 탐색 항목과 계속 실행되는 클러스터 외부 리소스는 수동 정리가 필요할 수 있습니다. Operator를 설치 제거한 후 해당 항목을 제거하려면 Operator CRD를 수동으로 삭제해야 할 수 있습니다.

6.6.1.3. 웹 콘솔을 사용하여 네임스페이스 삭제

OpenShift Container Platform 웹 콘솔을 사용하여 네임스페이스를 삭제할 수 있습니다.

사전 요구 사항

-

cluster-admin권한이 있는 계정을 사용하여 OpenShift Container Platform 클러스터에 액세스할 수 있습니다.

절차

- 관리 → 네임스페이스로 이동합니다.

- 네임스페이스 목록에서 삭제하려는 네임스페이스를 찾습니다.

-

네임스페이스 목록 맨 오른쪽에 있는 옵션 메뉴

에서 네임스페이스 삭제 를 선택합니다.

에서 네임스페이스 삭제 를 선택합니다.

- 네임스페이스 삭제 창이 열리면 삭제할 네임스페이스 이름을 필드에 입력합니다.

- 삭제를 클릭합니다.

6.6.1.4. OpenShift Virtualization 사용자 정의 리소스 정의 삭제

웹 콘솔을 사용하여 OpenShift Virtualization CRD(사용자 정의 리소스 정의)를 삭제할 수 있습니다.

사전 요구 사항

-

cluster-admin권한이 있는 계정을 사용하여 OpenShift Container Platform 클러스터에 액세스할 수 있습니다.

절차

- Administration → CustomResourceDefinitions 로 이동합니다.

-

Label 필터를 선택하고 검색 필드에

operators.coreos.com/kubevirt-hyperconverged.openshift-cnv를 입력하여 OpenShift Virtualization CRD를 표시합니다. -

각 CRD 옆에 있는 옵션 메뉴

를 클릭하고 CustomResourceDefinition 삭제 를 선택합니다.

를 클릭하고 CustomResourceDefinition 삭제 를 선택합니다.

6.6.2. CLI를 사용하여 OpenShift Virtualization 설치 제거

OpenShift CLI(oc)를 사용하여 OpenShift Virtualization을 설치 제거할 수 있습니다.

사전 요구 사항

-

cluster-admin권한이 있는 계정을 사용하여 OpenShift Container Platform 클러스터에 액세스할 수 있습니다. -

OpenShift CLI(

oc)가 설치되어 있습니다. - 모든 가상 머신 및 가상 머신 인스턴스를 삭제했습니다. 워크로드가 클러스터에 남아 있는 동안 OpenShift Virtualization을 설치 제거할 수 없습니다.

절차

HyperConverged사용자 정의 리소스를 삭제합니다.oc delete HyperConverged kubevirt-hyperconverged -n openshift-cnv

$ oc delete HyperConverged kubevirt-hyperconverged -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Virtualization Operator 서브스크립션을 삭제합니다.

oc delete subscription kubevirt-hyperconverged -n openshift-cnv

$ oc delete subscription kubevirt-hyperconverged -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Virtualization

ClusterServiceVersion리소스를 삭제합니다.oc delete csv -n openshift-cnv -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

$ oc delete csv -n openshift-cnv -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Virtualization 네임스페이스를 삭제합니다.

oc delete namespace openshift-cnv

$ oc delete namespace openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 시험 실행 옵션을 사용하여

oc delete crd명령을 실행하여 OpenShift Virtualization CRD(사용자 정의 리소스정의)를 나열합니다.oc delete crd --dry-run=client -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

$ oc delete crd --dry-run=client -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow dry-run옵션 없이oc delete crd명령을 실행하여 CRD를 삭제합니다.oc delete crd -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

$ oc delete crd -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7장. OpenShift Virtualization 업데이트

OLM(Operator Lifecycle Manager)에서 OpenShift Virtualization에 z-stream 및 마이너 버전 업데이트를 제공하는 방법을 알아봅니다.

Node Maintenance Operator (NMO)는 더 이상 OpenShift Virtualization과 함께 제공되지 않습니다. OpenShift Container Platform 웹 콘솔의 OperatorHub 에서 NMO를 설치하거나 OpenShift CLI(

oc)를 사용하여 설치할 수 있습니다. 노드 수정, 펜싱 및 유지 관리에 대한 자세한 내용은 Workload Availability for Red Hat OpenShift 설명서를 참조하십시오.OpenShift Virtualization 4.10.2 이상 릴리스에서 OpenShift Virtualization 4.11로 업데이트하기 전에 다음 작업 중 하나를 수행해야 합니다.

- 모든 노드를 유지보수 모드에서 이동합니다.

-

독립 실행형 NMO를 설치하고

nodemaintenances.nodemaintenance.kubevirt.ioCR(사용자 정의 리소스)을nodemaintenances.nodemaintenance.medik8s.ioCR로 교체합니다.

7.1. OpenShift Virtualization 업데이트 정보

- OLM(Operator Lifecycle Manager)은 OpenShift Virtualization Operator의 라이프사이클을 관리합니다. OpenShift Container Platform 설치 중에 배포되는 Marketplace Operator는 클러스터에서 외부 Operator를 사용할 수 있도록 합니다.

- OLM은 OpenShift Virtualization에 z-stream 및 마이너 버전 업데이트를 제공합니다. OpenShift Container Platform을 다음 마이너 버전으로 업데이트할 때 마이너 버전 업데이트가 제공됩니다. OpenShift Container Platform을 먼저 업데이트하지 않고 OpenShift Virtualization을 다음 마이너 버전으로 업데이트할 수 없습니다.

- OpenShift Virtualization 서브스크립션은 stable 이라는 단일 업데이트 채널을 사용합니다. stable 채널을 사용하면 OpenShift Virtualization 및 OpenShift Container Platform 버전이 호환됩니다.

서브스크립션의 승인 전략이 자동으로 설정되어 있으면 stable 채널에서 새 버전의 Operator를 사용할 수 있는 즉시 업데이트 프로세스가 시작됩니다. 자동 승인 전략을 사용하여 지원 가능한 환경을 유지하는 것이 좋습니다. OpenShift Virtualization의 각 부 버전은 해당 OpenShift Container Platform 버전을 실행하는 경우에만 지원됩니다. 예를 들어 OpenShift Container Platform 4.12에서 OpenShift Virtualization 4.12를 실행해야 합니다.

- 수동 승인 전략을 선택할 수 있지만 클러스터의 지원 가능성과 기능에 미칠 위험이 높기 때문에 이 방법은 권장되지 않는 것이 좋습니다. 수동 승인 전략을 사용하면 보류 중인 모든 업데이트를 수동으로 승인해야 합니다. OpenShift Container Platform 및 OpenShift Virtualization 업데이트가 동기화되지 않으면 클러스터가 지원되지 않습니다.

- 업데이트를 완료하는 데 걸리는 시간은 네트워크 연결에 따라 달라집니다. 대부분의 자동 업데이트는 15분 이내에 완료됩니다.

- OpenShift Virtualization을 업데이트하면 네트워크 연결이 중단되지 않습니다.

- 데이터 볼륨 및 관련 영구 볼륨 클레임은 업데이트 중에 보존됩니다.

hostpath 프로비전 프로그램을 사용하는 가상 머신이 실행 중인 경우 실시간으로 마이그레이션할 수 없으며 OpenShift Container Platform 클러스터 업데이트가 차단될 수 있습니다.

해결 방법으로 클러스터를 업데이트하는 동안 전원이 자동으로 꺼지도록 가상 머신을 재구성할 수 있습니다. evictionStrategy: LiveMigrate 필드를 제거하고 runStrategy 필드를 Always로 설정합니다.

7.1.1. 워크로드 업데이트 정보

OpenShift Virtualization을 업데이트하면 libvirt,virt-launcher, qemu 를 포함한 가상 머신 워크로드가 실시간 마이그레이션을 지원하는 경우 자동으로 업데이트됩니다.

각 가상 머신에는 VMI(가상 머신 인스턴스)를 실행하는 virt-launcher Pod가 있습니다. virt-launcher Pod는 가상 머신(VM) 프로세스를 관리하는 데 사용되는 libvirt 인스턴스를 실행합니다.

HyperConverged CR (사용자 정의 리소스)의 spec.workloadUpdateStrategy 스탠자를 편집하여 워크로드가 업데이트되는 방법을 구성할 수 있습니다. LiveMigrate 및 Evict 의 두 가지 사용 가능한 워크로드 업데이트 방법이 있습니다.

Evict 방법이 VMI Pod를 종료하므로 LiveMigrate 업데이트 전략만 기본적으로 활성화됩니다.

LiveMigrate 가 활성화된 유일한 업데이트 전략인 경우:

- 실시간 마이그레이션을 지원하는 VMI가 업데이트 프로세스 중에 마이그레이션됩니다. VM 게스트는 업데이트된 구성 요소가 활성화된 새 Pod로 이동합니다.

실시간 마이그레이션을 지원하지 않는 VMI는 중단되거나 업데이트되지 않습니다.

-

VMI에

LiveMigrate제거 전략이 있지만 실시간 마이그레이션을 지원하지 않는 경우 업데이트되지 않습니다.

-

VMI에

LiveMigrate 및 Evict 를 모두 사용할 수 있는 경우:

-

실시간 마이그레이션을 지원하는 VMI는

LiveMigrate업데이트 전략을 사용합니다. -

실시간 마이그레이션을 지원하지 않는 VMI는

Evict업데이트 전략을 사용합니다. VMI가항상runStrategy값이 있는VirtualMachine오브젝트에 의해 제어되는 경우 업데이트된 구성 요소가 있는 새 Pod에 새 VMI가 생성됩니다.

마이그레이션 시도 및 타임아웃

워크로드를 업데이트할 때 Pod가 다음 기간 동안 Pending 상태인 경우 실시간 마이그레이션이 실패합니다.

- 5분

-

Pod가 보류 중이므로

Unschedul을 사용할 수 있습니다. - 15분

- 어떤 이유로든 Pod가 보류 중 상태에 있는 경우

VMI가 마이그레이션되지 않으면 virt-controller 에서 다시 마이그레이션하려고 합니다. 이 프로세스는 모든 migratable VMI가 새 virt-launcher Pod에서 실행될 때까지 이 프로세스를 반복합니다. 그러나 VMI가 부적절하게 구성된 경우 이러한 시도는 무기한 반복할 수 있습니다.

각 시도는 마이그레이션 오브젝트에 해당합니다. 최근 5개의 시도만 버퍼에 저장됩니다. 이렇게 하면 디버깅을 위한 정보를 유지하면서 마이그레이션 오브젝트가 시스템에서 누적되는 것을 방지할 수 있습니다.

7.1.2. EUS-to-EUS 업데이트 정보

4.10 및 4.12를 포함한 OpenShift Container Platform의 모든 짝수 마이너 버전은 EUS (Extended Update Support) 버전입니다. 그러나 Kubernetes 설계에는 직렬 마이너 버전 업데이트가 필요하므로 하나의 EUS 버전에서 다음 버전으로 직접 업데이트할 수 없습니다.

소스 EUS 버전에서 다음 홀수의 마이너 버전으로 업데이트한 후 업데이트 경로에 있는 해당 마이너 버전의 모든 z-stream 릴리스로 OpenShift Virtualization을 순차적으로 업데이트해야 합니다. 해당 최신 z-stream 버전으로 업그레이드한 후 OpenShift Container Platform을 대상 EUS 마이너 버전으로 업데이트할 수 있습니다.

OpenShift Container Platform 업데이트가 성공하면 OpenShift Virtualization에 대한 해당 업데이트를 사용할 수 있습니다. 이제 OpenShift Virtualization을 대상 EUS 버전으로 업데이트할 수 있습니다.

7.1.2.1. 업데이트 준비

EUS-to-EUS 업데이트를 시작하기 전에 다음을 수행해야 합니다.

- EUS-to-EUS 업데이트를 시작하기 전에 작업자 노드의 머신 구성 풀을 일시 중지하여 작업자가 두 번 재부팅되지 않도록 합니다.

- 업데이트 프로세스를 시작하기 전에 자동 워크로드 업데이트를 비활성화합니다. 이는 대상 EUS 버전으로 업데이트할 때까지 OpenShift Virtualization이 VM(가상 머신)을 마이그레이션하거나 제거하지 않도록하기 위한 것입니다.

기본적으로 OpenShift Virtualization은 OpenShift Virtualization Operator를 업데이트할 때 virt-launcher Pod와 같은 워크로드를 자동으로 업데이트합니다. HyperConverged 사용자 정의 리소스의 spec.workloadUpdateStrategy 스탠자에서 이 동작을 구성할 수 있습니다.

EUS에서 EUS로의 업데이트 수행 준비에 대해 자세히 알아보십시오.

7.2. EUS-to-EUS 업데이트 중 워크로드 업데이트 방지

EUS (Extended Update Support) 버전에서 다음 버전으로 업데이트하는 경우 OpenShift Virtualization이 업데이트 프로세스 중 워크로드를 마이그레이션하거나 제거하지 않도록 자동 워크로드 업데이트를 수동으로 비활성화해야 합니다.

사전 요구 사항

- OpenShift Container Platform의 EUS 버전을 실행 중이며 다음 EUS 버전으로 업데이트하려고 합니다. 그 사이에 홀수의 버전으로 아직 업데이트하지 않았습니다.

- "EUS-to-EUS 업데이트를 수행하기 위한 준비"를 읽고 OpenShift Container Platform 클러스터와 관련된 경고 및 요구 사항을 알아봅니다.

- OpenShift Container Platform 설명서의 지시에 따라 작업자 노드의 머신 구성 풀을 일시 중지했습니다.

- 기본 자동 승인 전략을 사용하는 것이 좋습니다. 수동 승인 전략을 사용하는 경우 웹 콘솔에서 보류 중인 모든 업데이트를 승인해야 합니다. 자세한 내용은 "Manually a pending Operator update" 섹션을 참조하십시오.

절차

다음 명령을 실행하여 현재

workloadUpdateMethods구성을 백업합니다.WORKLOAD_UPDATE_METHODS=$(oc get kv kubevirt-kubevirt-hyperconverged -n openshift-cnv -o jsonpath='{.spec.workloadUpdateStrategy.workloadUpdateMethods}')$ WORKLOAD_UPDATE_METHODS=$(oc get kv kubevirt-kubevirt-hyperconverged -n openshift-cnv -o jsonpath='{.spec.workloadUpdateStrategy.workloadUpdateMethods}')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 모든 워크로드 업데이트 방법을 끕니다.

oc patch hco kubevirt-hyperconverged -n openshift-cnv --type json -p '[{"op":"replace","path":"/spec/workloadUpdateStrategy/workloadUpdateMethods", "value":[]}]'$ oc patch hco kubevirt-hyperconverged -n openshift-cnv --type json -p '[{"op":"replace","path":"/spec/workloadUpdateStrategy/workloadUpdateMethods", "value":[]}]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

hyperconverged.hco.kubevirt.io/kubevirt-hyperconverged patched

hyperconverged.hco.kubevirt.io/kubevirt-hyperconverged patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 계속하기 전에

HyperConvergedOperator를업그레이드할 수있는지 확인합니다. 다음 명령을 입력하고 출력을 모니터링합니다.oc get hco kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.conditions"

$ oc get hco kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.conditions"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예 7.1. 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- OpenShift Virtualization Operator의

업그레이드 가능상태입니다.

소스 EUS 버전에서 다음 마이너 버전의 OpenShift Container Platform으로 클러스터를 수동으로 업데이트합니다.

oc adm upgrade

$ oc adm upgradeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 검증

다음 명령을 실행하여 현재 버전을 확인합니다.

oc get clusterversion

$ oc get clusterversionCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고OpenShift Container Platform을 다음 버전으로 업데이트하는 것은 OpenShift Virtualization을 업데이트하기 위한 사전 요구 사항입니다. 자세한 내용은 OpenShift Container Platform 설명서의 "클러스터 업데이트" 섹션을 참조하십시오.

OpenShift Virtualization을 업데이트합니다.

- 기본 자동 승인 전략을 사용하면 OpenShift Container Platform을 업데이트한 후 OpenShift Virtualization이 해당 버전으로 자동으로 업데이트됩니다.

- 수동 승인 전략을 사용하는 경우 웹 콘솔을 사용하여 보류 중인 업데이트를 승인합니다.

다음 명령을 실행하여 OpenShift Virtualization 업데이트를 모니터링합니다.

oc get csv -n openshift-cnv

$ oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow - OpenShift Virtualization을 EUS 이외의 마이너 버전에서 사용할 수 있는 모든 z-stream 버전으로 업데이트하여 이전 단계에 표시된 명령을 실행하여 각 업데이트를 모니터링합니다.

다음 명령을 실행하여 OpenShift Virtualization이 EUS 이외의 버전의 최신 z-stream 릴리스로 성공적으로 업데이트되었는지 확인합니다.

oc get hco kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.versions"

$ oc get hco kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.versions"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 업데이트를 수행하기 전에

HyperConvergedOperator에Upgradeable상태가 될 때까지 기다립니다. 다음 명령을 입력하고 출력을 모니터링합니다.oc get hco kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.conditions"

$ oc get hco kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.conditions"Copy to Clipboard Copied! Toggle word wrap Toggle overflow - OpenShift Container Platform을 대상 EUS 버전으로 업데이트합니다.

클러스터 버전을 확인하여 업데이트가 성공했는지 확인합니다.

oc get clusterversion

$ oc get clusterversionCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Virtualization을 대상 EUS 버전으로 업데이트합니다.

- 기본 자동 승인 전략을 사용하면 OpenShift Container Platform을 업데이트한 후 OpenShift Virtualization이 해당 버전으로 자동으로 업데이트됩니다.

- 수동 승인 전략을 사용하는 경우 웹 콘솔을 사용하여 보류 중인 업데이트를 승인합니다.

다음 명령을 실행하여 OpenShift Virtualization 업데이트를 모니터링합니다.

oc get csv -n openshift-cnv

$ oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow VERSION필드가 대상 EUS 버전과 일치하고PHASE필드에Succeeded가 표시되면 업데이트가 완료됩니다.백업한 워크로드 업데이트 방법 구성을 복원합니다.

oc patch hco kubevirt-hyperconverged -n openshift-cnv --type json -p "[{\"op\":\"add\",\"path\":\"/spec/workloadUpdateStrategy/workloadUpdateMethods\", \"value\":$WORKLOAD_UPDATE_METHODS}]"$ oc patch hco kubevirt-hyperconverged -n openshift-cnv --type json -p "[{\"op\":\"add\",\"path\":\"/spec/workloadUpdateStrategy/workloadUpdateMethods\", \"value\":$WORKLOAD_UPDATE_METHODS}]"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

hyperconverged.hco.kubevirt.io/kubevirt-hyperconverged patched

hyperconverged.hco.kubevirt.io/kubevirt-hyperconverged patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 검증

다음 명령을 실행하여 VM 마이그레이션의 상태를 확인합니다.

oc get vmim -A

$ oc get vmim -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow

다음 단계

- 이제 작업자 노드의 머신 구성 풀의 일시 정지를 해제할 수 있습니다.

7.3. 워크로드 업데이트 방법 구성

HyperConverged CR(사용자 정의 리소스)을 편집하여 워크로드 업데이트 방법을 구성할 수 있습니다.

사전 요구 사항

실시간 마이그레이션을 업데이트 방법으로 사용하려면 먼저 클러스터에서 실시간 마이그레이션을 활성화해야 합니다.

참고VirtualMachineInstanceCR에evictionStrategy: LiveMigrate가 포함되어 있고 VMI(가상 머신 인스턴스)가 실시간 마이그레이션을 지원하지 않는 경우 VMI가 업데이트되지 않습니다.

절차

기본 편집기에서

HyperConvergedCR을 열려면 다음 명령을 실행합니다.oc edit hco -n openshift-cnv kubevirt-hyperconverged

$ oc edit hco -n openshift-cnv kubevirt-hyperconvergedCopy to Clipboard Copied! Toggle word wrap Toggle overflow HyperConvergedCR의workloadUpdateStrategy스탠자를 편집합니다. 예를 들면 다음과 같습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 자동화된 워크로드 업데이트를 수행하는 데 사용할 수 있는 방법입니다. 사용 가능한 값은

LiveMigrate및Evict입니다. 이 예에 표시된 대로 두 옵션을 모두 활성화하면 업데이트에서 실시간 마이그레이션을 지원하지 않는 VMI에 실시간 마이그레이션 및Evict를 지원하는 VMI에LiveMigrate를 사용합니다. 자동 워크로드 업데이트를 비활성화하려면workloadUpdateStrategy스탠자를 제거하거나workloadUpdateMethods: []를 설정하여 배열을 비워 둘 수 있습니다. - 2

- 중단이 적은 업데이트 방법입니다. VMI(가상 머신) 게스트를 업데이트된 구성 요소가 활성화된 새 Pod로 마이그레이션하여 실시간 마이그레이션을 지원하는 VMI가 업데이트됩니다.

LiveMigrate가 나열된 유일한 워크로드 업데이트 방법인 경우 실시간 마이그레이션을 지원하지 않는 VMI는 중단되거나 업데이트되지 않습니다. - 3

- 업그레이드 중 VMI Pod를 종료하는 중단 방법입니다.

Evict는 클러스터에서 실시간 마이그레이션이 활성화되지 않은 경우 사용 가능한 유일한 업데이트 방법입니다.runStrategy: always구성된VirtualMachine오브젝트에서 VMI를 제어하는 경우 업데이트된 구성 요소가 있는 새 VMI가 새 Pod에 생성됩니다. - 4

Evict방법을 사용하여 한 번에 업데이트하도록 강제 수행할 수 있는 VMI 수입니다. 이는LiveMigrate방법에는 적용되지 않습니다.- 5

- 다음 워크로드 배치를 제거하기 전에 대기하는 간격입니다. 이는

LiveMigrate방법에는 적용되지 않습니다.

참고HyperConvergedCR의spec.liveMigrationConfig스탠자를 편집하여 실시간 마이그레이션 제한 및 타임아웃을 구성할 수 있습니다.- 변경 사항을 적용하려면 편집기를 저장하고 종료합니다.

7.4. 보류 중인 Operator 업데이트 승인

7.4.1. 보류 중인 Operator 업데이트 수동 승인

설치된 Operator의 서브스크립션에 있는 승인 전략이 수동으로 설정된 경우 새 업데이트가 현재 업데이트 채널에 릴리스될 때 업데이트를 수동으로 승인해야 설치가 시작됩니다.

사전 요구 사항

- OLM(Operator Lifecycle Manager)을 사용하여 이전에 설치한 Operator입니다.

절차

- OpenShift Container Platform 웹 콘솔의 관리자 관점에서 Operator → 설치된 Operator로 이동합니다.

- 보류 중인 업데이트가 있는 Operator에 업그레이드 사용 가능 상태가 표시됩니다. 업데이트할 Operator 이름을 클릭합니다.

- 서브스크립션 탭을 클릭합니다. 승인이 필요한 업데이트는 업그레이드 상태 옆에 표시됩니다. 예를 들어 1 승인 필요가 표시될 수 있습니다.

- 1 승인 필요를 클릭한 다음 설치 계획 프리뷰를 클릭합니다.

- 업데이트에 사용할 수 있는 것으로 나열된 리소스를 검토합니다. 문제가 없는 경우 승인을 클릭합니다.

- Operator → 설치된 Operator 페이지로 다시 이동하여 업데이트 진행 상황을 모니터링합니다. 완료되면 상태가 성공 및 최신으로 변경됩니다.

7.5. 업데이트 상태 모니터링

7.5.1. OpenShift Virtualization 업그레이드 상태 모니터링

OpenShift Virtualization Operator 업그레이드 상태를 모니터링하려면 CSV(클러스터 서비스 버전) PHASE를 확인합니다. 웹 콘솔에서 또는 여기에 제공된 명령을 실행하여 CSV 조건을 모니터링할 수도 있습니다.

PHASE 및 조건 값은 사용 가능한 정보를 기반으로 한 근사치입니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 로그인합니다. -

OpenShift CLI(

oc)를 설치합니다.

절차

다음 명령을 실행합니다.

oc get csv -n openshift-cnv

$ oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow PHASE필드를 확인하여 출력을 검토합니다. 예를 들면 다음과 같습니다.출력 예

VERSION REPLACES PHASE 4.9.0 kubevirt-hyperconverged-operator.v4.8.2 Installing 4.9.0 kubevirt-hyperconverged-operator.v4.9.0 Replacing

VERSION REPLACES PHASE 4.9.0 kubevirt-hyperconverged-operator.v4.8.2 Installing 4.9.0 kubevirt-hyperconverged-operator.v4.9.0 ReplacingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항: 다음 명령을 실행하여 모든 OpenShift Virtualization 구성 요소 조건을 집계한 상태를 모니터링합니다.

oc get hco -n openshift-cnv kubevirt-hyperconverged \ -o=jsonpath='{range .status.conditions[*]}{.type}{"\t"}{.status}{"\t"}{.message}{"\n"}{end}'$ oc get hco -n openshift-cnv kubevirt-hyperconverged \ -o=jsonpath='{range .status.conditions[*]}{.type}{"\t"}{.status}{"\t"}{.message}{"\n"}{end}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 업그레이드가 완료되면 다음과 같은 결과가 나타납니다.

출력 예

ReconcileComplete True Reconcile completed successfully Available True Reconcile completed successfully Progressing False Reconcile completed successfully Degraded False Reconcile completed successfully Upgradeable True Reconcile completed successfully

ReconcileComplete True Reconcile completed successfully Available True Reconcile completed successfully Progressing False Reconcile completed successfully Degraded False Reconcile completed successfully Upgradeable True Reconcile completed successfullyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.5.2. 오래된 OpenShift Virtualization 워크로드 보기

CLI를 사용하여 오래된 워크로드 목록을 볼 수 있습니다.

클러스터에 오래된 가상화 Pod가 있는 경우 OutdatedVirtualMachineInstanceWorkloads 경고가 실행됩니다.

절차

오래된 VMI(가상 머신 인스턴스) 목록을 보려면 다음 명령을 실행합니다.

oc get vmi -l kubevirt.io/outdatedLauncherImage --all-namespaces

$ oc get vmi -l kubevirt.io/outdatedLauncherImage --all-namespacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

VMI가 자동으로 업데이트되도록 워크로드 업데이트를 구성합니다.

8장. 보안 정책

VM(가상 머신) 워크로드는 권한이 없는 Pod로 실행됩니다. VM에서 OpenShift Virtualization 기능을 사용할 수 있도록 일부 포드에는 다른 Pod 소유자가 사용할 수 없는 사용자 정의 보안 정책이 부여됩니다.

-

확장된

container_tSELinux 정책은virt-launcherPod에 적용됩니다. -

SCC( 보안 컨텍스트 제약 조건 )는

kubevirt-controller서비스 계정에 대해 정의됩니다.

8.1. 워크로드 보안 정보

기본적으로 VM(가상 머신) 워크로드는 OpenShift Virtualization에서 루트 권한으로 실행되지 않습니다.

virt-launcher Pod는 각 VM에 대해 세션 모드에서 libvirt 인스턴스를 실행하여 VM 프로세스를 관리합니다. 세션 모드에서 libvirt 데몬은 루트가 아닌 사용자 계정으로 실행되며 동일한 사용자 식별자(UID)에서 실행 중인 클라이언트의 연결만 허용합니다. 따라서 VM은 권한이 없는 Pod로 실행되며 최소 권한의 보안 원칙을 준수합니다.

루트 권한이 필요한 OpenShift Virtualization 기능은 지원되지 않습니다. 기능에 root가 필요한 경우 OpenShift Virtualization에서 사용할 수 없습니다.

8.2. virt-launcher Pod에 대해 확장된 SELinux 정책

virt-launcher Pod에 대한 container_t SELinux 정책은 OpenShift Virtualization의 필수 기능을 사용하도록 확장됩니다.

네트워크 멀티 큐에는 다음 정책이 필요하므로 사용 가능한 vCPU 수가 증가함에 따라 네트워크 성능을 확장할 수 있습니다.

-

allow process self (tun_socket (relabelfrom relabelto attach_queue))

-

다음 정책을 통해

virt-launcher는/proc/cpuinfo및/proc/uptime을 포함하여 /proc 디렉토리 아래에 있는 파일을 읽을 수 있습니다.-

allow process proc_type (file (getattr open read))

-

다음 정책을 사용하면

libvirtd가 네트워크 관련 디버그 메시지를 중계할 수 있습니다.allow process self (netlink_audit_socket (nlmsg_relay))참고이 정책이 없으면 네트워크 디버그 메시지를 릴레이하는 시도가 차단됩니다. 이렇게 하면 노드의 감사 로그를 SELinux 거부로 채울 수 있습니다.

다음 정책을 사용하면

libvirtd가 대규모 페이지를 지원하는 데 필요한hugetblfs에 액세스할 수 있습니다.-

allow process hugetlbfs_t (dir (add_name create write remove_name rmdir setattr)) -

allow process hugetlbfs_t (file (create unlink))

-

다음 정책을 통해

virtiofs가 파일 시스템을 마운트하고 NFS에 액세스할 수 있습니다.-

allow process nfs_t(dir(mounton)) -

allow process proc_t (dir) (mounton) -

allow process proc_t (filesystem (mount unmount))

-

다음 정책은 패스트 네트워킹을 활성화하는 업스트림 Kubevirt에서 상속됩니다.

-

allow process tmpfs_t (filesystem (mount))

-

OpenShift Virtualization은 현재 패스를 지원하지 않습니다.

8.3. kubevirt-controller 서비스 계정에 대한 추가 OpenShift Container Platform 보안 컨텍스트 제약 조건 및 Linux 기능

SCC(보안 컨텍스트 제약 조건)는 Pod에 대한 권한을 제어합니다. 이러한 권한에는 컨테이너 모음인 Pod에서 수행할 수 있는 작업과 액세스할 수 있는 리소스가 포함됩니다. Pod가 시스템에 수용되려면 일련의 조건을 함께 실행해야 하는데, SCC를 사용하여 이러한 조건을 정의할 수 있습니다.

virt-controller 는 클러스터의 가상 머신에 대해 virt-launcher Pod를 생성하는 클러스터 컨트롤러입니다. 이러한 Pod에는 kubevirt-controller 서비스 계정에서 권한이 부여됩니다.

kubevirt-controller 서비스 계정에는 적절한 권한으로 virt-launcher Pod를 생성할 수 있도록 추가 SCC 및 Linux 기능이 부여됩니다. 이러한 확장된 권한을 통해 가상 머신에서 일반적인 Pod의 범위를 벗어나는 OpenShift Virtualization 기능을 사용할 수 있습니다.

kubevirt-controller 서비스 계정에는 다음 SCC가 부여됩니다.

-

scc.AllowHostDirVolumePlugin = true

이를 통해 가상 머신에서 hostpath 볼륨 플러그인을 사용할 수 있습니다. -

scc.AllowPrivilegedContainer = false

virt-launcher Pod가 권한 있는 컨테이너로 실행되지 않습니다. scc.AllowedCapabilities = []corev1.Capability{"SYS_NICE", "NET_BIND_SERVICE", "SYS_PTRACE"}

-

SYS_NICE를 사용하면 CPU 선호도를 설정할 수 있습니다. -

NET_BIND_SERVICE를 사용하면 DHCP 및 Slirp 작업을 수행할 수 있습니다. -

SYS_PTRACE를 사용하면 특정 버전의libvirt가 소프트웨어 TPM(Trusted Platform Module) 에뮬레이터인swtpm의 PID(프로세스 ID)를 찾을 수 있습니다.

-

8.3.1. kubevirt-controller에 대한 SCC 및 RBAC 정의 보기

oc 툴을 사용하여 kubevirt-controller에 대한 SecurityContextConstraints 정의를 볼 수 있습니다.

oc get scc kubevirt-controller -o yaml

$ oc get scc kubevirt-controller -o yaml

oc 툴을 사용하여 kubevirt-controller clusterrole에 대한 RBAC 정의를 볼 수 있습니다.

oc get clusterrole kubevirt-controller -o yaml

$ oc get clusterrole kubevirt-controller -o yaml9장. CLI 툴 사용

다음은 클러스터에서 리소스를 관리하는 데 사용되는 두 가지 기본 CLI 툴입니다.

-

OpenShift Virtualization

virtctl클라이언트 -

OpenShift Container Platform

oc클라이언트

9.1. 사전 요구 사항

-

virtctl클라이언트를 설치해야 합니다.

9.2. OpenShift Container Platform 클라이언트 명령

OpenShift Container Platform oc 클라이언트는 VirtualMachine(vm) 및 VirtualMachineInstance(vmi) 오브젝트 유형을 포함하여 OpenShift Container Platform 리소스를 관리하는 명령줄 유틸리티입니다.

-n <namespace> 플래그를 사용하여 다른 프로젝트를 지정할 수 있습니다.

| 명령 | 설명 |

|---|---|

|

|

OpenShift Container Platform 클러스터에 |

|

| 현재 프로젝트에서 지정된 오브젝트 유형의 오브젝트 목록을 표시합니다. |

|

| 현재 프로젝트의 특정 리소스에 대한 세부 정보를 표시합니다. |

|

| 파일 이름 또는 stdin에서 현재 프로젝트에 리소스를 만듭니다. |

|

| 현재 프로젝트의 리소스를 편집합니다. |

|

| 현재 프로젝트의 리소스를 삭제합니다. |

oc 클라이언트 명령에 대한 자세한 내용은 OpenShift Container Platform CLI 툴 설명서를 참조하십시오.

9.3. virtctl 명령

virtctl 클라이언트는 OpenShift Virtualization 리소스를 관리하는 명령줄 유틸리티입니다.

| 명령 | 설명 |

|---|---|

|

|

|

|

|

|

|

| 특정 명령의 옵션 목록을 확인합니다. |

|

|

|

9.3.1. VM 및 VMI 관리 명령

virtctl 을 사용하여 VM(가상 머신) 또는 VMI(가상 머신 인스턴스) 상태를 관리하고 VM을 마이그레이션할 수 있습니다.

| 명령 | 설명 |

|---|---|

|

| VM을 시작합니다. |

|

| 일시 중지된 상태에서 VM을 시작합니다. 이 옵션을 사용하면 VNC 콘솔에서 부팅 프로세스를 중단할 수 있습니다. |

|

| VM을 중지합니다. |

|

| VM을 강제 중지합니다. 이 옵션을 사용하면 데이터 불일치 또는 데이터 손실이 발생할 수 있습니다. |

|

| VM 또는 VMI를 일시 중지합니다. 머신 상태는 메모리에 유지됩니다. |

|

| VM 또는 VMI의 일시 정지를 해제합니다. |

|