安装后配置

OpenShift Container Platform 的第二天操作

摘要

第 1 章 安装后配置概述

安装 OpenShift Container Platform 后,集群管理员可以配置和自定义以下组件:

- 机器

- 裸机

- 集群

- 节点

- Network

- 存储

- 用户

- 警报和通知

1.1. 安装后配置任务

您可以执行安装后配置任务来配置环境,以满足您的需要。

以下列表详细介绍了这些配置:

-

配置操作系统功能 :Machine Config Operator(MCO) 管理

MachineConfig对象。通过使用 MCO,您可以配置节点和自定义资源。 配置裸机节点 :您可以使用 Bare Metal Operator (BMO) 来管理裸机主机。BMO 可以完成以下操作:

- 检查主机的硬件详情,并将其报告到裸机主机。

- 检查固件并配置 BIOS 设置。

- 使用所需镜像调配主机。

- 在置备主机之前或之后清理主机的磁盘内容。

配置集群功能。您可以修改 OpenShift Container Platform 集群的以下功能:

- 镜像 registry

- 网络配置

- 镜像构建行为

- 用户身份提供程序

- etcd 配置

- 用于处理工作负载的机器集

- 云供应商凭证管理

配置私有集群:默认情况下,安装程序使用公开的 DNS 和端点置备 OpenShift Container Platform。要使集群只能从内部网络进行访问,请配置以下组件使其私有:

- DNS

- Ingress Controller

- API Server

执行节点操作 :默认情况下,OpenShift Container Platform 使用 Red Hat Enterprise Linux CoreOS(RHCOS)计算机器。您可以执行以下操作:

- 添加和删除计算机器。

- 添加和删除污点和容限。

- 配置每个节点的最大 pod 数量。

- 启用设备管理器。

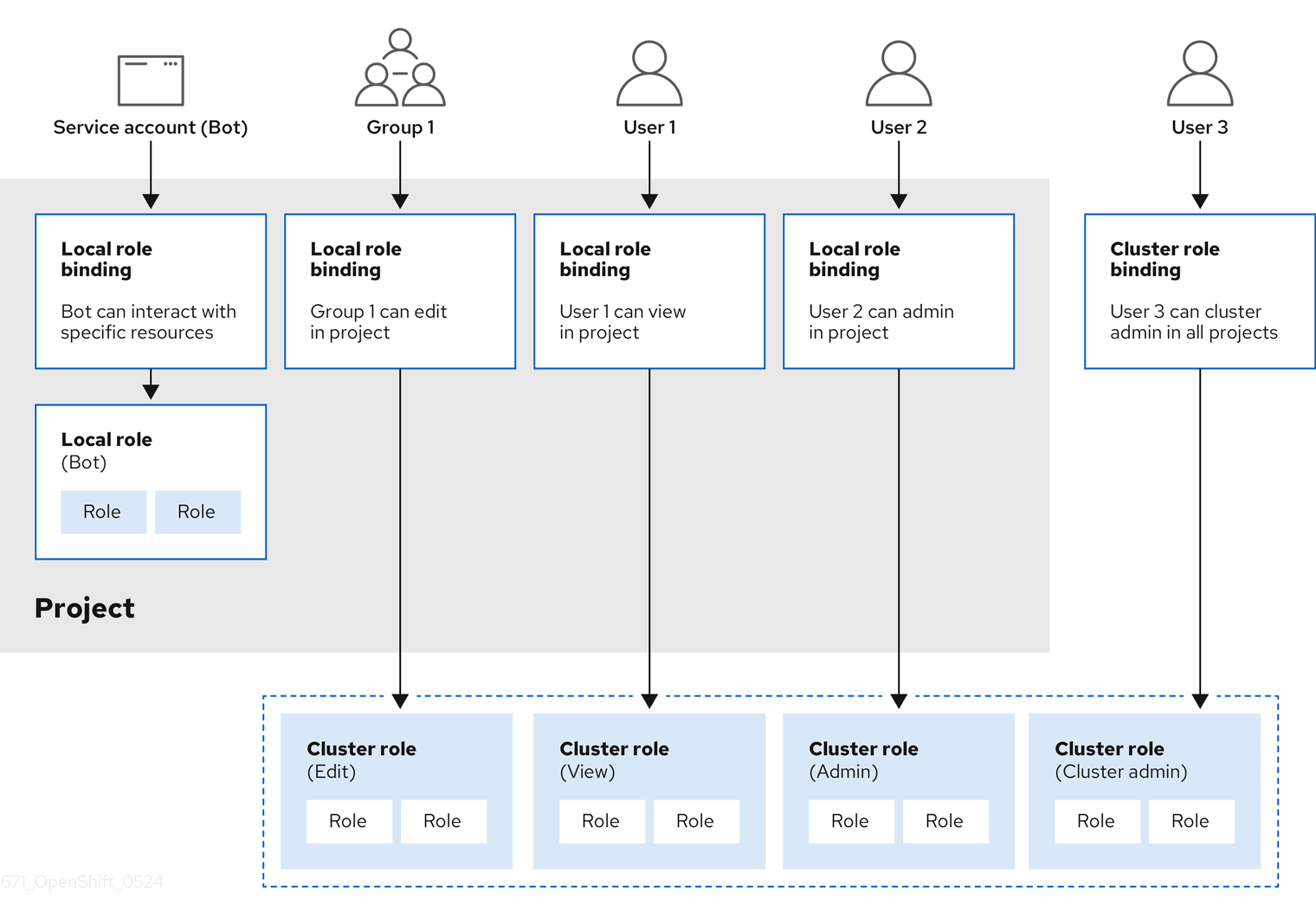

- 配置用户 :OAuth 访问令牌允许用户自行验证 API。您可以配置 OAuth 以执行以下任务:

- 指定身份提供程序

- 使用基于角色的访问控制为用户定义和授予权限

- 从 OperatorHub 安装 Operator

- 配置警报通知 :默认情况下,触发的警报显示在 web 控制台的 Alerting UI 中。您还可以配置 OpenShift Container Platform,将警报通知发送到外部系统。

第 2 章 配置私有集群

安装 OpenShift Container Platform 版本 4.12 集群后,您可以将其某些核心组件设置为私有。

2.1. 关于私有集群

默认情况下,OpenShift Container Platform 被置备为使用可公开访问的 DNS 和端点。在部署私有集群后,您可以将 DNS、Ingress Controller 和 API 服务器设置为私有。

如果集群有任何公共子网,管理员创建的负载均衡器服务可能会公开访问。为确保集群安全性,请验证这些服务是否已明确标注为私有。

DNS

如果在安装程序置备的基础架构上安装 OpenShift Container Platform,安装程序会在预先存在的公共区中创建记录,并在可能的情况下为集群自己的 DNS 解析创建一个私有区。在公共区和私有区中,安装程序或集群为 *.apps 和 Ingress 对象创建 DNS 条目,并为 API 服务器创建 api。

公共和私有区中的 *.apps 记录是相同的,因此当您删除公有区时,私有区为集群无缝地提供所有 DNS 解析。

Ingress Controller

由于默认 Ingress 对象是作为公共对象创建的,所以负载均衡器是面向互联网的,因此在公共子网中。

Ingress Operator 为 Ingress Controller 生成默认证书,以充当占位符,直到您配置了自定义默认证书为止。不要在生产环境集群中使用 Operator 生成的默认证书。Ingress Operator 不轮转其自身的签名证书或它生成的默认证书。Operator 生成的默认证书的目的是作为您配置的自定义默认证书的占位者。

API Server

默认情况下,安装程序为 API 服务器创建适当的网络负载均衡器,供内部和外部流量使用。

在 Amazon Web Services(AWS)上,会分别创建独立的公共和私有负载均衡器。负载均衡器是基本相同的,唯一不同是带有一个额外的、用于在集群内部使用的端口。虽然安装程序根据 API 服务器要求自动创建或销毁负载均衡器,但集群并不管理或维护它们。只要保留集群对 API 服务器的访问,您可以手动修改或移动负载均衡器。对于公共负载均衡器,需要打开端口 6443,并根据 /readyz 路径配置 HTTPS 用于健康检查。

在 Google Cloud 上,创建一个负载均衡器来管理内部和外部 API 流量,因此您不需要修改负载均衡器。

在 Microsoft Azure 上,会创建公共和私有负载均衡器。但是,由于当前实施的限制,您刚刚在私有集群中保留两个负载均衡器。

2.2. 配置要在私有区中发布的 DNS 记录

对于所有 OpenShift Container Platform 集群,无论是公共还是私有,DNS 记录都会默认在公共区中发布。

您可以从集群 DNS 配置中删除公共区,以避免向公共公开 DNS 记录。您可能希望避免公开敏感信息,如内部域名、内部 IP 地址或机构中的集群数量,或者您可能不需要公开发布记录。如果所有能够连接到集群内的服务的客户端都使用具有私有区的 DNS 记录的私有 DNS 服务,则不需要集群的公共 DNS 记录。

部署集群后,您可以通过修改 DNS 自定义资源 (CR) 来修改其 DNS 使其只使用私有区。以这种方式修改 DNS CR 意味着,任何随后创建的 DNS 记录都不会发布到公共 DNS 服务器,从而保持对内部用户隔离的 DNS 记录知识。当您将集群配置为私有时,也可以完成此操作,或者如果您不希望 DNS 记录可以公开解析。

或者,即使在私有集群中,您也可以保留 DNS 记录的公共区,因为它允许客户端为该集群中运行的应用程序解析 DNS 名称。例如,机构可以有连接到公共互联网的机器,然后为特定私有 IP 范围建立 VPN 连接,以连接到私有 IP 地址。这些机器的 DNS 查找使用公共 DNS 来确定这些服务的专用地址,然后通过 VPN 连接到私有地址。

流程

运行以下命令并查看输出,查看集群的

DNSCR:oc get dnses.config.openshift.io/cluster -o yaml

$ oc get dnses.config.openshift.io/cluster -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,

spec部分包含一个私有区和一个公共区。运行以下命令来修补

DNSCR 以删除公共区:oc patch dnses.config.openshift.io/cluster --type=merge --patch='{"spec": {"publicZone": null}}'$ oc patch dnses.config.openshift.io/cluster --type=merge --patch='{"spec": {"publicZone": null}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

dns.config.openshift.io/cluster patched

dns.config.openshift.io/cluster patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 当为

IngressController对象创建DNS记录时,Ingress Operator 会参考 DNS CR 定义。如果只指定私有区,则只创建私有记录。重要当您删除公共区时,不会修改现有 DNS 记录。如果您不再希望公开发布它们,则必须手动删除之前发布的公共 DNS 记录。

验证

运行以下命令并查看输出,查看集群的

DNSCR,并确认已删除公共区:oc get dnses.config.openshift.io/cluster -o yaml

$ oc get dnses.config.openshift.io/cluster -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. 将 Ingress Controller 设置为私有

部署集群后,您可以修改其 Ingress Controller 使其只使用私有区。

流程

修改默认 Ingress Controller,使其仅使用内部端点:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

ingresscontroller.operator.openshift.io "default" deleted ingresscontroller.operator.openshift.io/default replaced

ingresscontroller.operator.openshift.io "default" deleted ingresscontroller.operator.openshift.io/default replacedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除公共 DNS 条目,并更新私有区条目。

2.4. 将 API 服务器限制为私有

将集群部署到 Amazon Web Services(AWS)或 Microsoft Azure 后,可以重新配置 API 服务器,使其只使用私有区。

先决条件

-

安装 OpenShift CLI(

oc)。 -

使用具有

admin权限的用户登陆到 web 控制台。

流程

在云供应商的 web 门户或控制台中,执行以下操作:

找到并删除相关的负载均衡器组件:

- 对于 AWS,删除外部负载均衡器。私有区的 API DNS 条目已指向内部负载均衡器,它使用相同的配置,因此您无需修改内部负载均衡器。

-

对于 Azure,删除负载均衡器的

api-internal规则。

-

在公共区中删除

api.$clustername.$yourdomainDNS 条目。

删除外部负载均衡器:

重要您只能对安装程序置备的基础架构 (IPI) 集群执行以下步骤。对于用户置备的基础架构 (UPI) 集群,您必须手动删除或禁用外部负载均衡器。

如果您的集群使用 control plane 机器集,删除 control plane 机器集中的以下行:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果您的集群没有使用 control plane 机器集,您必须从每个 control plane 机器中删除外部负载均衡器。

在终端中,运行以下命令来列出集群机器:

oc get machine -n openshift-machine-api

$ oc get machine -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow control plane 机器在名称中包含

master。从每个 control plane 机器中删除外部负载均衡器:

运行以下命令,将 control plane 机器对象编辑为:

oc edit machines -n openshift-machine-api <control_plane_name>

$ oc edit machines -n openshift-machine-api <control_plane_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定要修改的 control plane 机器对象名称。

删除描述外部负载均衡器的行,它们在以下示例中被标记:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存更改并退出对象规格。

- 为每个 control plane 机器重复此步骤。

第 3 章 裸机配置

在裸机主机上部署 OpenShift Container Platform 时,在置备前或置备后,有时您需要对主机进行更改。这包括检查主机的硬件、固件和固件详情。它还可以包含格式化磁盘或更改可修改的固件设置。

3.1. 关于 Bare Metal Operator

使用 Bare Metal Operator (BMO) 来置备、管理和检查集群中的裸机主机。

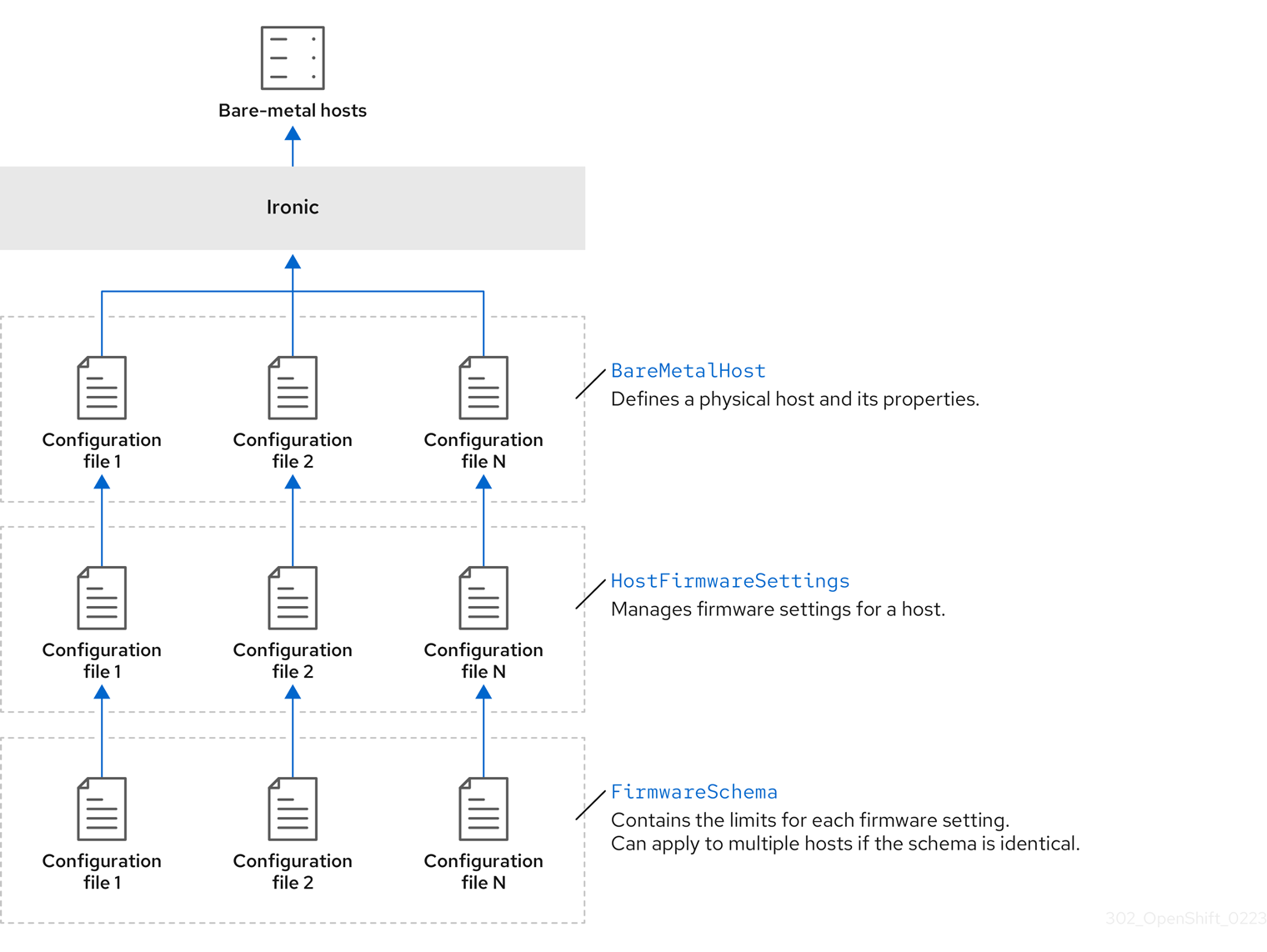

BMO 使用三个资源来完成这些任务:

-

BareMetalHost -

HostFirmwareSettings -

FirmwareSchema

BMO 通过将每个裸机主机映射到 BareMetalHost 自定义资源定义的实例来维护集群中的物理主机清单。每个 BareMetalHost 资源都有硬件、软件和固件详情。BMO 持续检查集群中的裸机主机,以确保每个 BareMetalHost 资源准确详细说明相应主机的组件。

BMO 还使用 HostFirmwareSettings 资源和 FirmwareSchema 资源来详细说明裸机主机的固件规格。

使用 Ironic API 服务在集群中的裸机主机的 BMO 接口。Ironic 服务使用主机上的 Baseboard Management Controller (BMC) 来与机器进行接口。

使用 BMO 可以完成的一些常见任务包括:

- 使用特定镜像置备裸机主机到集群

- 在置备前或取消置备后格式化主机的磁盘内容

- 打开或关闭主机

- 更改固件设置

- 查看主机的硬件详情

3.1.1. 裸机 Operator 架构

Bare Metal Operator (BMO) 使用三个资源来置备、管理和检查集群中的裸机主机。下图演示了这些资源的架构:

BareMetalHost

BareMetalHost 资源定义物理主机及其属性。将裸机主机置备到集群时,您必须为该主机定义 BareMetalHost 资源。对于主机的持续管理,您可以检查 BareMetalHost 中的信息或更新此信息。

BareMetalHost 资源具有置备信息,如下所示:

- 部署规格,如操作系统引导镜像或自定义 RAM 磁盘

- 置备状态

- 基板管理控制器 (BMC) 地址

- 所需的电源状态

BareMetalHost 资源具有硬件信息,如下所示:

- CPU 数量

- NIC 的 MAC 地址

- 主机的存储设备的大小

- 当前电源状态

HostFirmwareSettings

您可以使用 HostFirmwareSettings 资源来检索和管理主机的固件设置。当主机进入 Available 状态时,Ironic 服务读取主机的固件设置并创建 HostFirmwareSettings 资源。BareMetalHost 资源和 HostFirmwareSettings 资源之间存在一对一映射。

您可以使用 HostFirmwareSettings 资源来检查主机的固件规格,或更新主机的固件规格。

在编辑 HostFirmwareSettings 资源的 spec 字段时,您必须遵循特定于供应商固件的 schema。这个模式在只读 FirmwareSchema 资源中定义。

FirmwareSchema

固件设置因硬件供应商和主机模型而异。FirmwareSchema 资源是一个只读资源,其中包含每个主机模型中每个固件设置的类型和限制。数据通过使用 Ironic 服务直接从 BMC 传递。FirmwareSchema 资源允许您识别 HostFirmwareSettings 资源的 spec 字段中可以指定的有效值。

如果 schema 相同,则 FirmwareSchema 资源可应用到许多 BareMetalHost 资源。

3.2. 关于 BareMetalHost 资源

裸机3 引入了 BareMetalHost 资源的概念,它定义了物理主机及其属性。BareMetalHost 资源包含两个部分:

-

BareMetalHost规格 -

BareMetalHost状态

3.2.1. BareMetalHost 规格

BareMetalHost 资源的 spec 部分定义了主机所需状态。

| 参数 | 描述 |

|---|---|

|

|

在置备和取消置备过程中启用或禁用自动清理的接口。当设置为 |

bmc: address: credentialsName: disableCertificateVerification: |

|

|

| 用于置备主机的 NIC 的 MAC 地址。 |

|

|

主机的引导模式。它默认为 |

|

|

对使用主机的另一个资源的引用。如果另一个资源目前没有使用主机,则它可能为空。例如,当 |

|

| 提供的字符串,用于帮助识别主机。 |

|

| 指明主机置备和取消置备是在外部管理的布尔值。当设置时:

|

|

|

包含有关裸机主机的 BIOS 配置的信息。目前,只有 iRMC、S iDRAC、i iLO4 和 iLO5 BMC 支持

|

image: url: checksum: checksumType: format: |

|

|

| 对包含网络配置数据及其命名空间的 secret 的引用,以便在主机引导以设置网络前将其附加到主机。 |

|

|

指示主机是否应开启的布尔值, |

raid: hardwareRAIDVolumes: softwareRAIDVolumes: | (可选)包含有关裸机主机的 RAID 配置的信息。如果没有指定,它会保留当前的配置。 注意 OpenShift Container Platform 4.12 仅支持使用 iRMC 协议进行 BMC 的硬件 RAID。OpenShift Container Platform 4.12 不支持软件 RAID。 请参见以下配置设置:

您可以将 spec:

raid:

hardwareRAIDVolume: []

如果您收到出错信息表示驱动程序不支持 RAID,则将 |

|

|

|

3.2.2. BareMetalHost 状态

BareMetalHost 状态代表主机的当前状态,包括经过测试的凭证、当前的硬件详情和其他信息。

| 参数 | 描述 |

|---|---|

|

| 对 secret 及其命名空间的引用,其中包含最近一组基板管理控制器(BMC)凭证,以便系统能够验证。 |

|

| 置备后端的最后一个错误的详情(若有)。 |

|

| 表示导致主机进入错误状态的问题类别。错误类型包括:

|

|

|

系统中的 CPU 的

|

hardware: firmware: | 包含 BIOS 固件信息。例如,硬件供应商和版本。 |

|

|

|

hardware: ramMebibytes: | 主机的内存量(兆字节(MiB))。 |

|

|

|

hardware:

systemVendor:

manufacturer:

productName:

serialNumber:

|

包含主机的 |

|

| 主机状态最后一次更新的时间戳。 |

|

| 服务器的状态。状态为以下之一:

|

|

| 指明主机是否开机的布尔值。 |

|

|

|

|

| 对 secret 及其命名空间的引用,其中包含发送到置备后端的最后一个 BMC 凭证集合。 |

3.3. 获取 BareMetalHost 资源

BareMetalHost 资源包含物理主机的属性。您必须获取物理主机的 BareMetalHost 资源才能查看其属性。

流程

获取

BareMetalHost资源列表:oc get bmh -n openshift-machine-api -o yaml

$ oc get bmh -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意您可以使用

baremetalhost作为oc get命令的bmh长形式。获取主机列表:

oc get bmh -n openshift-machine-api

$ oc get bmh -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 获取特定主机的

BareMetalHost资源:oc get bmh <host_name> -n openshift-machine-api -o yaml

$ oc get bmh <host_name> -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中

<host_name>是主机的名称。输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. 关于 HostFirmwareSettings 资源

您可以使用 HostFirmwareSettings 资源来检索和管理主机的 BIOS 设置。当主机进入 Available 状态时,Ironic 会读取主机的 BIOS 设置并创建 HostFirmwareSettings 资源。资源包含从基板管理控制器(BMC)返回的完整 BIOS 配置。BareMetalHost 资源中的 firmware 字段会返回三个供应商独立的字段,HostFirmwareSettings 资源通常包含每个主机中特定供应商的字段的许多 BIOS 设置。

HostFirmwareSettings 资源包含两个部分:

-

HostFirmwareSettingsspec。 -

HostFirmwareSettings状态。

3.4.1. HostFirmwareSettings spec

HostFirmwareSettings 资源的 spec 部分定义了主机的 BIOS 所需的状态,默认为空。Ironic 使用 spec.settings 部分中的设置,在主机处于 Preparing 状态时更新基板管理控制器(BMC)。使用 FirmwareSchema 资源,确保不向主机发送无效的名称/值对。如需了解更多详细信息,请参阅 "About the FirmwareSchema resource"。

示例

spec:

settings:

ProcTurboMode: Disabled

spec:

settings:

ProcTurboMode: Disabled- 1

- 在foregoing示例中,

spec.settings部分包含一个 name/value 对,它将把ProcTurboModeBIOS 设置为Disabled。

status 部分中列出的整数参数显示为字符串。例如,"1"。当在 spec.settings 部分中设置整数时,这些值应设置为不带引号的整数。例如,1.

3.4.2. HostFirmwareSettings 状态

status 代表主机的 BIOS 的当前状态。

| 参数 | 描述 |

|---|---|

|

|

|

status:

schema:

name:

namespace:

lastUpdated:

|

固件设置的

|

status: settings: |

|

3.5. 获取 HostFirmwareSettings 资源

HostFirmwareSettings 资源包含物理主机的特定于供应商的 BIOS 属性。您必须获取物理主机的 HostFirmwareSettings 资源才能查看其 BIOS 属性。

流程

获取

HostFirmwareSettings资源的详细列表:oc get hfs -n openshift-machine-api -o yaml

$ oc get hfs -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意您可以使用

hostfirmwaresettings作为oc get命令的hfs长形式。获取

HostFirmwareSettings资源列表:oc get hfs -n openshift-machine-api

$ oc get hfs -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 获取特定主机的

HostFirmwareSettings资源oc get hfs <host_name> -n openshift-machine-api -o yaml

$ oc get hfs <host_name> -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中

<host_name>是主机的名称。

3.6. 编辑 HostFirmwareSettings 资源

您可以编辑已置备的主机的 HostFirmwareSettings。

您只能在主机处于 provisioned 状态时编辑主机,不包括只读值。您不能编辑状态为 externally provisioned 的主机。

流程

获取

HostFirmwareSettings资源列表:oc get hfs -n openshift-machine-api

$ oc get hfs -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑主机的

HostFirmwareSettings资源:oc edit hfs <host_name> -n openshift-machine-api

$ oc edit hfs <host_name> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中

<host_name>是置备的主机的名称。HostFirmwareSettings资源将在终端的默认编辑器中打开。将 name/value 对添加到

spec.settings部分:示例

spec: settings: name: valuespec: settings: name: value1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 使用

FirmwareSchema资源来识别主机的可用设置。您不能设置只读值。

- 保存更改并退出编辑器。

获取主机的机器名称:

oc get bmh <host_name> -n openshift-machine name

$ oc get bmh <host_name> -n openshift-machine nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中

<host_name>是主机的名称。机器名称会出现在CONSUMER字段下。注解机器将其从 machineset 中删除:

oc annotate machine <machine_name> machine.openshift.io/delete-machine=true -n openshift-machine-api

$ oc annotate machine <machine_name> machine.openshift.io/delete-machine=true -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中

<machine_name>是要删除的机器的名称。获取节点列表并计算 worker 节点数量:

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 获取 machineset:

oc get machinesets -n openshift-machine-api

$ oc get machinesets -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 缩放 machineset:

oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n-1>

$ oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n-1>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中

<machineset_name>是 machineset 的名称,<n-1>是 worker 节点数量的减少。当主机进入

Available状态时,扩展 machineset,使HostFirmwareSettings资源更改生效:oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n>

$ oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中

<machineset_name>是 machineset 的名称,<n>是 worker 节点的数量。

3.7. 验证 HostFirmware Settings 资源是否有效

当用户编辑 spec.settings 部分以更改为 HostFirmwareSetting(HFS)资源时,BMO 会针对 FimwareSchema 资源验证更改,这是只读资源。如果设置无效,BMO 会将 status.Condition 的 Type 值设置为 False,并生成事件并将其存储在 HFS 资源中。使用以下步骤验证资源是否有效。

流程

获取

HostFirmwareSetting资源列表:oc get hfs -n openshift-machine-api

$ oc get hfs -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证特定主机的

HostFirmwareSettings资源是否有效:oc describe hfs <host_name> -n openshift-machine-api

$ oc describe hfs <host_name> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中

<host_name>是主机的名称。输出示例

Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal ValidationFailed 2m49s metal3-hostfirmwaresettings-controller Invalid BIOS setting: Setting ProcTurboMode is invalid, unknown enumeration value - Foo

Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal ValidationFailed 2m49s metal3-hostfirmwaresettings-controller Invalid BIOS setting: Setting ProcTurboMode is invalid, unknown enumeration value - FooCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要如果响应返回

ValidationFailed,资源配置中会出现一个错误,您必须更新这些值以符合FirmwareSchema资源。

3.8. 关于 FirmwareSchema 资源

BIOS 设置因硬件供应商和主机模型而异。FirmwareSchema 资源是一个只读资源,其中包含每个主机模型中的每个 BIOS 设置的类型和限值。数据直接通过 Ironic 来自 BMC。FirmwareSchema 允许您识别 HostFirmwareSettings 资源的 spec 字段中可以指定的有效值。FirmwareSchema 资源具有从其设置和限值派生的唯一标识符。相同的主机模型使用相同的 FirmwareSchema 标识符。HostFirmwareSettings 的多个实例可能使用相同的 FirmwareSchema。

| 参数 | 描述 |

|---|---|

|

|

|

3.9. 获取 FirmwareSchema 资源

每个供应商的每个主机模型都有不同的 BIOS 设置。在编辑 HostFirmwareSettings 资源的 spec 部分时,您设置的名称/值对必须符合该主机的固件模式。要确保设置有效的名称/值对,请获取主机的 FirmwareSchema 并查看它。

流程

要获得

FirmwareSchema资源实例列表,请执行以下操作:oc get firmwareschema -n openshift-machine-api

$ oc get firmwareschema -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要获得特定

FirmwareSchema实例,请执行:oc get firmwareschema <instance_name> -n openshift-machine-api -o yaml

$ oc get firmwareschema <instance_name> -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中

<instance_name>是HostFirmwareSettings资源中所述的 schema 实例的名称(请参阅表 3)。

第 4 章 在 OpenShift Container Platform 集群中配置多架构计算机器

带有多架构计算机器的 OpenShift Container Platform 集群是一个支持具有不同架构的计算机器的集群。您可以使用多架构安装程序二进制文件创建 Azure 安装程序置备的集群,使用多架构计算机器部署集群。对于 Azure 安装,请参阅使用自定义在 Azure 上安装集群。

多架构计算机器技术预览功能在安装、升级和运行有效负载时具有有限的可用性。

以下流程解释了如何生成 ARM64 引导镜像,并使用 ARM64 引导镜像创建 Azure 计算机器。这会在集群中添加 ARM64 计算节点,并部署所需的 ARM64 虚拟机 (VM)。本节还演示了如何将现有集群升级到支持多架构计算机器的集群。具有多架构计算机器的集群仅在带有 x86_64 control plane 机器的 Azure 安装程序置备的基础架构中可用。

在 Azure 安装程序置备的基础架构安装中使用多架构计算机器的 OpenShift Container Platform 集群只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

4.1. 使用 Azure 镜像 gallery 创建 ARM64 引导镜像

要使用多架构计算机器配置集群,您必须创建一个 ARM64 引导镜像并将其添加到 Azure 计算机器集中。以下流程描述了如何手动生成 ARM64 引导镜像。

先决条件

-

已安装 Azure CLI (

az)。 - 已使用多架构安装程序二进制文件创建了单架构 Azure 安装程序置备集群。

流程

登录到您的 Azure 帐户:

az login

$ az loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建存储帐户并将 ARM64 虚拟硬盘 (VHD) 上传到您的存储帐户。OpenShift Container Platform 安装程序会创建一个资源组,但引导镜像也可以上传到名为资源组的自定义中:

az storage account create -n ${STORAGE_ACCOUNT_NAME} -g ${RESOURCE_GROUP} -l westus --sku Standard_LRS$ az storage account create -n ${STORAGE_ACCOUNT_NAME} -g ${RESOURCE_GROUP} -l westus --sku Standard_LRS1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

westus对象是一个示例区域。

使用您生成的存储帐户创建存储容器:

az storage container create -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME}$ az storage container create -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您必须使用 OpenShift Container Platform 安装程序 JSON 文件提取 URL 和

aarch64VHD 名称:运行以下命令,提取

URL字段并将其设置为RHCOS_VHD_ORIGIN_URL:RHCOS_VHD_ORIGIN_URL=$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.aarch64."rhel-coreos-extensions"."azure-disk".url')$ RHCOS_VHD_ORIGIN_URL=$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.aarch64."rhel-coreos-extensions"."azure-disk".url')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,提取

aarch64VHD 名称并将其设置为BLOB_NAME作为文件名:BLOB_NAME=rhcos-$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.aarch64."rhel-coreos-extensions"."azure-disk".release')-azure.aarch64.vhd$ BLOB_NAME=rhcos-$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.aarch64."rhel-coreos-extensions"."azure-disk".release')-azure.aarch64.vhdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

生成共享访问令牌 (SAS) 令牌。通过以下命令,使用此令牌将 RHCOS VHD 上传到存储容器:

end=`date -u -d "30 minutes" '+%Y-%m-%dT%H:%MZ'`

$ end=`date -u -d "30 minutes" '+%Y-%m-%dT%H:%MZ'`Copy to Clipboard Copied! Toggle word wrap Toggle overflow sas=`az storage container generate-sas -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME} --https-only --permissions dlrw --expiry $end -o tsv`$ sas=`az storage container generate-sas -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME} --https-only --permissions dlrw --expiry $end -o tsv`Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将 RHCOS VHD 复制到存储容器中:

az storage blob copy start --account-name ${STORAGE_ACCOUNT_NAME} --sas-token "$sas" \ --source-uri "${RHCOS_VHD_ORIGIN_URL}" \ --destination-blob "${BLOB_NAME}" --destination-container ${CONTAINER_NAME}$ az storage blob copy start --account-name ${STORAGE_ACCOUNT_NAME} --sas-token "$sas" \ --source-uri "${RHCOS_VHD_ORIGIN_URL}" \ --destination-blob "${BLOB_NAME}" --destination-container ${CONTAINER_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以使用以下命令检查复制过程的状态:

az storage blob show -c ${CONTAINER_NAME} -n ${BLOB_NAME} --account-name ${STORAGE_ACCOUNT_NAME} | jq .properties.copy$ az storage blob show -c ${CONTAINER_NAME} -n ${BLOB_NAME} --account-name ${STORAGE_ACCOUNT_NAME} | jq .properties.copyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果 status 参数显示

success对象,则复制过程已完成。

使用以下命令创建镜像 gallery:

az sig create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME}$ az sig create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用镜像 gallery 创建镜像定义。在以下示例中,

rhcos-arm64是镜像定义的名称。az sig image-definition create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-arm64 --publisher RedHat --offer arm --sku arm64 --os-type linux --architecture Arm64 --hyper-v-generation V2$ az sig image-definition create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-arm64 --publisher RedHat --offer arm --sku arm64 --os-type linux --architecture Arm64 --hyper-v-generation V2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要获取 VHD 的 URL,并将其设置为

RHCOS_VHD_URL作为文件名称,请运行以下命令:RHCOS_VHD_URL=$(az storage blob url --account-name ${STORAGE_ACCOUNT_NAME} -c ${CONTAINER_NAME} -n "${BLOB_NAME}" -o tsv)$ RHCOS_VHD_URL=$(az storage blob url --account-name ${STORAGE_ACCOUNT_NAME} -c ${CONTAINER_NAME} -n "${BLOB_NAME}" -o tsv)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

RHCOS_VHD_URL文件、您的存储帐户、资源组和镜像 gallery 创建镜像版本。在以下示例中,1.0.0是镜像版本。az sig image-version create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-arm64 --gallery-image-version 1.0.0 --os-vhd-storage-account ${STORAGE_ACCOUNT_NAME} --os-vhd-uri ${RHCOS_VHD_URL}$ az sig image-version create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-arm64 --gallery-image-version 1.0.0 --os-vhd-storage-account ${STORAGE_ACCOUNT_NAME} --os-vhd-uri ${RHCOS_VHD_URL}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 现在生成您的 ARM64 引导镜像。您可以使用以下命令访问镜像的 ID:

az sig image-version show -r $GALLERY_NAME -g $RESOURCE_GROUP -i rhcos-arm64 -e 1.0.0

$ az sig image-version show -r $GALLERY_NAME -g $RESOURCE_GROUP -i rhcos-arm64 -e 1.0.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下示例镜像 ID 在计算机器设置的

recourseID参数中使用:resourceID示例/resourceGroups/${RESOURCE_GROUP}/providers/Microsoft.Compute/galleries/${GALLERY_NAME}/images/rhcos-arm64/versions/1.0.0/resourceGroups/${RESOURCE_GROUP}/providers/Microsoft.Compute/galleries/${GALLERY_NAME}/images/rhcos-arm64/versions/1.0.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. 使用 ARM64 引导镜像在集群中添加多架构计算机器集

要在集群中添加 ARM64 计算节点,您必须创建一个使用 ARM64 引导镜像的 Azure 计算机器集。要在 Azure 上创建自己的自定义计算机器集,请参阅"创建 Azure 上的计算机器集"。

先决条件

-

已安装 OpenShift CLI(

oc)。

流程

-

使用以下命令创建机器集,并修改

resourceID和vmSize参数。此机器集将控制集群中的 ARM64 worker 节点:

oc create -f arm64-machine-set-0.yaml

$ oc create -f arm64-machine-set-0.yaml使用 ARM64 引导镜像的 YAML 机器集示例

+

验证

输入以下命令验证新的 ARM64 机器是否正在运行:

oc get machineset -n openshift-machine-api

$ oc get machineset -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME DESIRED CURRENT READY AVAILABLE AGE <infrastructure_id>-arm64-machine-set-0 2 2 2 2 10m

NAME DESIRED CURRENT READY AVAILABLE AGE <infrastructure_id>-arm64-machine-set-0 2 2 2 2 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以使用以下命令检查节点是否就绪并可访问:

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3. 使用多架构计算机器升级集群

要使用多架构计算机器升级集群,请使用 candidate-4.12 更新频道。如需更多信息,请参阅"了解升级频道"。

只有已使用多架构有效负载的 OpenShift Container Platform 集群才能使用 candidate-4.12 频道更新。

如果要升级现有集群来支持多架构计算机器,您可以执行显式升级命令,如以下步骤所示。这会将您当前的单架构集群更新为使用多架构有效负载的集群。

先决条件

-

已安装 OpenShift CLI(

oc)。

流程

要手动升级集群,请使用以下命令:

oc adm upgrade --allow-explicit-upgrade --to-image <image-pullspec>

$ oc adm upgrade --allow-explicit-upgrade --to-image <image-pullspec>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4. 在多架构计算机器上的镜像流中导入清单列表

在带有多架构计算机器的 OpenShift Container Platform 4.12 集群中,集群中的镜像流不会自动导入清单列表。您必须手动将默认的 importMode 选项改为 PreserveOriginal 选项,才能导入清单列表。

ImageStream 对象的 referencePolicy.type 字段必须设置为 Source 类型才能成功运行。

referencePolicy:

type: Source

referencePolicy:

type: Source先决条件

-

已安装 OpenShift Container Platform CLI (

oc)。

流程

以下示例命令演示了如何对

ImageStreamcli-artifacts 进行补丁,以便cli-artifacts:latest镜像流标签作为清单列表导入。oc patch is/cli-artifacts -n openshift -p '{"spec":{"tags":[{"name":"latest","importPolicy":{"importMode":"PreserveOriginal"}}]}}'oc patch is/cli-artifacts -n openshift -p '{"spec":{"tags":[{"name":"latest","importPolicy":{"importMode":"PreserveOriginal"}}]}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

您可以通过检查镜像流标签来检查是否正确导入的清单列表。以下命令将列出特定标签的各个架构清单。

oc get istag cli-artifacts:latest -n openshift -oyaml

oc get istag cli-artifacts:latest -n openshift -oyamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果存在

dockerImageManifests对象,则清单列表导入成功。dockerImageManifests对象的输出示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 5 章 安装后机器配置任务

有时您需要更改 OpenShift Container Platform 节点上运行的操作系统。这包括更改网络时间服务的设置、添加内核参数或者以特定的方式配置日志。

除了一些特殊功能外,通过创建称为 Machine Config Operator 管理的 MachineConfig 对象,可以对 OpenShift Container Platform 节点上的操作系统进行大多数更改。

本节中的任务介绍了如何使用 Machine Config Operator 的功能在 OpenShift Container Platform 节点上配置操作系统功能。

5.1. 关于 Machine Config Operator

OpenShift Container Platform 4.12 集成了操作系统和集群管理。由于集群管理自己的更新,包括集群节点上 Red Hat Enterprise Linux CoreOS (RHCOS) 的更新,因此 OpenShift Container Platform 提供了可靠的生命周期管理体验,能够简化节点升级的编配。

OpenShift Container Platform 使用三个守护进程集和控制器来简化节点管理。这些守护进程集通过使用标准的 Kubernetes 式构造来编配操作系统更新和主机配置更改。它们包括:

-

machine-config-controller,协调从 control plane 进行的机器升级。它监控所有集群节点并编配其配置更新。 -

machine-config-daemon守护进程集在集群中的每个节点上运行,并根据 MachineConfigController 的指示将机器更新为机器配置定义的配置。 当节点检测到更改时,它会排空其 pod,应用更新并重启。这些更改以 Ignition 配置文件的形式出现,这些文件应用指定的机器配置并控制 kubelet 配置。更新本身在容器中交付。此过程是成功管理 OpenShift Container Platform 和 RHCOS 更新的关键。 -

machine-config-server守护进程集,在加入集群时为 control plane 节点提供 Ignition 配置文件。

机器配置是 Ignition 配置的子集。machine-config-daemon 读取机器配置,以查看是否需要进行 OSTree 更新,或者是否必须应用一系列 systemd kubelet 文件更改、配置更改,或者对操作系统或 OpenShift Container Platform 配置的其他更改。

执行节点管理操作时,您可以创建或修改 KubeletConfig 自定义资源(CR)。

当对机器配置进行修改时,Machine Config Operator(MCO) 会自动重启所有对应的节点,以使更改生效。

要防止节点在机器配置更改后自动重启,在更改之前,必须通过在相应的机器配置池中将 spec.paused 字段设置为 true 来暂停自动引导过程。暂停后,机器配置更改不会生效,除非将 spec.paused 字段设置为 false,且节点已重启至新配置。

确保发生 CA 证书轮转时取消暂停池。如果 MCP 暂停,MCO 无法将新轮转的证书推送到这些节点。这会导致集群降级,并在多个 oc 命令中造成失败,包括 oc debug、oc logs、oc exec 和 oc attach。如果在轮转证书时,如果 MCP 被暂停,则 OpenShift Container Platform Web 控制台的 Alerting UI 中收到警报。

当 MCO 检测到以下任何更改时,它会在不排空或重启节点的情况下应用更新:

-

在机器配置的

spec.config.passwd.users.sshAuthorizedKeys参数中更改 SSH 密钥。 -

在

openshift-config命名空间中更改全局 pull secret 或 pull secret。 -

Kubernetes API Server Operator 自动轮转

/etc/kubernetes/kubelet-ca.crt证书颁发机构(CA)。

-

在机器配置的

当 MCO 检测到对

/etc/containers/registries.conf文件的更改时,如编辑ImageDigestMirrorSet、ImageTagMirrorSet或ImageContentSourcePolicy对象,它会排空对应的节点,应用更改并取消记录节点。对于以下更改,节点排空不会发生:-

增加了一个 registry,带有为每个镜像(mirror)设置了

pull-from-mirror = "digest-only"参数。 -

增加了一个镜像(mirror),带有在一个 registry 中设置的

pull-from-mirror = "digest-only"参数。 -

在

unqualified-search-registries列表中添加项目。

-

增加了一个 registry,带有为每个镜像(mirror)设置了

在某些情况下,节点上的配置与当前应用的机器配置指定不完全匹配。这个状态被称为 配置偏移。Machine Config Daemon(MCD)定期检查节点是否有配置偏移。如果 MCD 检测到配置偏移,MCO 会将节点标记为 降级(degraded),直到管理员更正节点配置。降级的节点在线且可操作,但无法更新。

5.1.1. 机器配置概述

Machine Config Operator(MCO)管理对 systemd、CRI-O 和 Kubelet、内核、Network Manager 和其他系统功能的更新。它还提供了一个 MachineConfig CRD,它可以在主机上写入配置文件(请参阅 machine-config-operator)。了解 MCO 的作用以及如何与其他组件交互对于对 OpenShift Container Platform 集群进行高级系统级更改至关重要。以下是您应该了解的 MCO、机器配置以及它们的使用方式:

- 机器配置按字母顺序处理,按字母顺序增加名称。呈现控制器使用列表中的第一个机器配置作为基础,并将剩余的附加到基本机器配置中。

- 机器配置可以对每个系统的操作系统上的文件或服务进行特定的更改,代表一个 OpenShift Container Platform 节点池。

MCO 应用对机器池中的操作系统的更改。所有 OpenShift Container Platform 集群都以 worker 和 control plane 节点池开头。通过添加更多角色标签,您可以配置自定义节点池。例如,您可以设置一个自定义的 worker 节点池,其中包含应用程序所需的特定硬件功能。但是,本节中的示例着重介绍了对默认池类型的更改。

重要一个节点可以应用多个标签来指示其类型,如

master或worker,但只能是一个单一机器配置池的成员。-

机器配置更改后,MCO 根据

topology.kubernetes.io/zone标签,按区字母更新受影响的节点。如果一个区域有多个节点,则首先更新最旧的节点。对于不使用区的节点,如裸机部署中的节点,节点会按使用的时间升级,首先更新最旧的节点。MCO 一次更新机器配置池中由maxUnavailable字段指定的节点数量。 - 在将 OpenShift Container Platform 安装到磁盘前,必须先进行一些机器配置。在大多数情况下,这可以通过创建直接注入 OpenShift Container Platform 安装程序进程中的机器配置来实现,而不必作为安装后机器配置运行。在其他情况下,您可能需要在 OpenShift Container Platform 安装程序启动时传递内核参数时进行裸机安装,以完成诸如设置每个节点的 IP 地址或高级磁盘分区等操作。

- MCO 管理机器配置中设置的项目。MCO 不会覆盖您对系统进行的手动更改,除非明确告知 MCO 管理冲突文件。换句话说,MCO 只提供您请求的特定更新,它不会声明对整个节点的控制。

- 强烈建议手动更改节点。如果您需要退出某个节点并启动一个新节点,则那些直接更改将会丢失。

-

MCO 只支持写入

/etc和/var目录里的文件,虽然有些目录的符号链接可以通过符号链接到那些区域之一来写入。例如/opt和/usr/local目录。 - Ignition 是 MachineConfig 中使用的配置格式。详情请参阅 Ignition 配置规格 v3.2.0。

- 虽然 Ignition 配置设置可以在 OpenShift Container Platform 安装时直接交付,且以 MCO 提供 Ignition 配置的方式格式化,但 MCO 无法查看这些原始 Ignition 配置是什么。因此,您应该在部署 Ignition 配置前将 Ignition 配置设置嵌套到机器配置中。

-

当由 MCO 管理的文件在 MCO 之外更改时,Machine Config Daemon(MCD)会将该节点设置为

degraded。然而,它不会覆盖这个错误的文件,它应该继续处于degraded(降级)状态。 -

使用机器配置的一个关键原因是,当您为 OpenShift Container Platform 集群中的池添加新节点时,会应用它。

machine-api-operator置备一个新机器, MCO 配置它。

MCO 使用 Ignition 作为配置格式。OpenShift Container Platform 4.6 从 Ignition 配置规格版本 2 移到版本 3。

5.1.1.1. 机器配置可以更改什么?

MCO 可更改的组件类型包括:

config:创建 Ignition 配置对象(请参阅 Ignition 配置规格),以完成修改 OpenShift Container Platform 机器上的文件、systemd 服务和其他功能,包括:

-

Configuration files:创建或覆盖

/var或/etc目录中的文件。 - systemd units:在附加设置中丢弃并设置 systemd 服务的状态,或者添加到现有 systemd 服务中。

用户和组:在安装后更改 passwd 部分中的 SSH 密钥。

重要-

只有

core用户才支持使用机器配置更改 SSH 密钥。 - 不支持使用机器配置添加新用户。

-

只有

-

Configuration files:创建或覆盖

- kernelArguments:在 OpenShift Container Platform 节点引导时在内核命令行中添加参数。

-

kernelType:(可选)使用非标准内核而不是标准内核。使用

realtime来使用 RT 内核(用于 RAN)。这只在选择的平台上被支持。 - fips:启用 FIPS 模式。不应在安装时设置 FIPS,而不是安装后的步骤。

要为集群启用 FIPS 模式,您必须从配置为以 FIPS 模式操作的 Red Hat Enterprise Linux (RHEL) 计算机运行安装程序。有关在 RHEL 中配置 FIPS 模式的更多信息,请参阅在 FIPS 模式中安装该系统。只有在 x86_64、ppc64le 和 s390x 架构的 OpenShift Container Platform 部署中才支持使用 FIPS 验证的或Modules In Process 加密库。

- extensions:通过添加所选预打包软件来扩展 RHCOS 功能。对于这个功能,可用的扩展程序包括 usbguard 和内核模块。

-

Custom resources(用于

ContainerRuntime和Kubelet):在机器配置外,MCO 管理两个特殊自定义资源,用于修改 CRI-O 容器运行时设置(ContainerRuntimeCR)和 Kubelet 服务(KubeletCR)。

MCO 不是更改 OpenShift Container Platform 节点上的操作系统组件的唯一 Operator。其他 Operator 也可以修改操作系统级别的功能。一个例子是 Node Tuning Operator,它允许您通过 Tuned 守护进程配置集进行节点级别的性能优化。

安装后可以进行的 MCO 配置任务包括在以下步骤中。如需在 OpenShift Container Platform 安装过程中或之前完成的系统配置任务,请参阅 RHCOS 裸机安装的描述。

在某些情况下,节点上的配置与当前应用的机器配置指定不完全匹配。这个状态被称为 配置偏移。Machine Config Daemon(MCD)定期检查节点是否有配置偏移。如果 MCD 检测到配置偏移,MCO 会将节点标记为 降级(degraded),直到管理员更正节点配置。降级的节点在线且可操作,但无法更新。有关配置偏移的更多信息,请参阅了解配置偏移检测。

5.1.1.2. 项目

详情请参阅 openshift-machine-config-operator GitHub 站点。

5.1.2. 了解 Machine Config Operator 节点排空行为

当您使用机器配置更改系统功能时(如添加新配置文件、修改 systemd 单元或内核参数或更新 SSH 密钥),Machine Config Operator (MCO) 会应用这些更改,并确保每个节点处于所需的配置状态。

在进行更改后,MCO 会确保生成新的机器配置。在大多数情况下,当应用新的机器配置时,Operator 会在每个受影响的节点上执行以下步骤,直到所有受影响的节点都有更新的配置:

- Cordon.对于额外的工作负载,MCO 会将节点标记为不可调度。

- Drain.MCO 终止节点上运行的所有工作负载,导致工作负载重新调度到其他节点上。

- Apply.MCO 根据需要将新配置写入节点。

- 重新启动.MCO 重启节点。

- Uncordon.对于工作负载,MCO 将节点标记为可调度。

在此过程中,MCO 根据机器配置池中设置的 MaxUnavailable 值维护所需的 pod 数量。

如果 MCO 在 master 节点上排空 pod,请注意以下条件:

- 在单节点 OpenShift 集群中,MCO 会跳过排空操作。

- MCO 不会排空静态 pod,以防止干扰服务(如 etcd)。

在某些情况下,节点不会被排空。如需更多信息,请参阅 "About the Machine Config Operator"。

您可以通过禁用 control plane 重启来缓解排空和重启周期造成的中断。如需更多信息,请参阅"禁用 Machine Config Operator 自动重新引导"。

5.1.3. 了解配置偏移检测

当节点的磁盘上状态与机器配置中配置的内容不同时,可能会出现情况。这称为 配置偏移(drift)。例如,集群管理员可能会手动修改一个文件、systemd 单元文件,或者通过机器配置配置的文件权限。这会导致配置偏移。配置偏移可能会导致 Machine Config Pool 中的节点或机器配置更新时出现问题。

Machine Config Operator(MCO)使用 Machine Config Daemon(MCD)定期检查节点是否有配置偏移。如果检测到,MCO 会将节点和机器配置池(MCP)设置为 Degraded,并报告错误。降级的节点在线且可操作,但无法更新。

MCD 在出现任何以下条件时执行配置偏移检测:

- 当节点引导时。

- 在机器配置中指定的任何文件(Ignition 文件和 systemd 置入单元)后,会在机器配置外修改。

应用新机器配置前。

注意如果您将新机器配置应用到节点,MCD 会临时关闭配置偏移检测。这个关闭是必需的,因为新机器配置必须与节点上的机器配置不同。应用新机器配置后,MCD 将使用新机器配置重启检测配置偏移。

在执行配置偏移检测时,MCD 会验证文件内容和权限是否与当前应用的机器配置指定完全匹配。通常,MCD 在触发检测后检测到小于第二个配置偏移。

如果 MCD 检测到配置偏移,MCD 执行以下任务:

- 向控制台日志发送错误

- 发送 Kubernetes 事件

- 在节点上停止进一步检测

-

将节点和 MCP 设置为

degraded

您可以通过列出 MCP 检查是否有降级的节点:

oc get mcp worker

$ oc get mcp worker

如果您有一个降级的 MCP,DEGRADEDMACHINECOUNT 字段将不为零,类似于以下输出:

输出示例

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE worker rendered-worker-404caf3180818d8ac1f50c32f14b57c3 False True True 2 1 1 1 5h51m

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE

worker rendered-worker-404caf3180818d8ac1f50c32f14b57c3 False True True 2 1 1 1 5h51m您可以通过检查机器配置池来确定问题是否由配置偏移导致:

oc describe mcp worker

$ oc describe mcp worker输出示例

或者,如果您知道哪个节点已降级,请检查该节点:

oc describe node/ci-ln-j4h8nkb-72292-pxqxz-worker-a-fjks4

$ oc describe node/ci-ln-j4h8nkb-72292-pxqxz-worker-a-fjks4输出示例

您可以通过执行以下补救之一来更正配置偏移并将节点返回到 Ready 状态:

- 确保节点上文件的内容和文件权限与机器配置中配置的内容匹配。您可以手动重写文件内容或更改文件权限。

在降级节点上生成一个强制文件。强制文件使 MCD 绕过常见的配置偏移检测并消除了当前的机器配置。

注意在节点上生成强制文件会导致该节点重新引导。

5.1.4. 检查机器配置池状态

要查看 Machine Config Operator(MCO)、其子组件及其管理的资源的状态,请使用以下 oc 命令:

流程

要查看集群中为每个机器配置池 (MCP) 中可用 MCO 管理的节点数量,请运行以下命令:

oc get machineconfigpool

$ oc get machineconfigpoolCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-06c9c4… True False False 3 3 3 0 4h42m worker rendered-worker-f4b64… False True False 3 2 2 0 4h42m

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-06c9c4… True False False 3 3 3 0 4h42m worker rendered-worker-f4b64… False True False 3 2 2 0 4h42mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

- UPDATED

-

True状态表示 MCO 已将当前机器配置应用到该 MCP 中的节点。当前机器配置在oc get mcp输出中的STATUS字段中指定。False状态表示 MCP 中的节点正在更新。 - UPDATING

-

True状态表示 MCO 正在按照MachineConfigPool自定义资源中的规定应用到该 MCP 中的至少一个节点。所需的机器配置是新编辑的机器配置。要进行更新的节点可能不适用于调度。False状态表示 MCP 中的所有节点都已更新。 - DEGRADED

-

True状态表示 MCO 被禁止将当前或所需的机器配置应用到该 MCP 中的至少一个节点,或者配置失败。降级的节点可能不适用于调度。False状态表示 MCP 中的所有节点都就绪。 - MACHINECOUNT

- 表示该 MCP 中的机器总数。

- READYMACHINECOUNT

-

指明正在运行当前机器配置并准备好可以被调度的机器数量。这个值始终小于或等于

UPDATEDMACHINECOUNT的值。 - UPDATEDMACHINECOUNT

- 指明 MCP 中有当前机器配置的机器总数。

- DEGRADEDMACHINECOUNT

- 指明 MCP 中标记为 degraded 或 unreconcilable 的机器总数。

在前面的输出中,有三个 control plane (master) 节点和三个 worker 节点。control plane MCP 和关联的节点更新至当前机器配置。worker MCP 中的节点会更新为所需的机器配置。worker MCP 中的两个节点被更新,一个仍在更新,如

UPDATEDMACHINECOUNT为2。没有问题,如DEGRADEDMACHINECOUNT为0,DEGRADED为False。虽然 MCP 中的节点正在更新,但

CONFIG下列出的机器配置是当前的机器配置,该配置会从这个配置进行更新。更新完成后,列出的机器配置是所需的机器配置,它被更新为 MCP。注意如果节点被封锁,则该节点不包含在

READYMACHINECOUNT中,但包含在MACHINECOUNT中。另外,MCP 状态被设置为UPDATING。因为节点具有当前的机器配置,所以它被计算在UPDATEDMACHINECOUNT总计:输出示例

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-06c9c4… True False False 3 3 3 0 4h42m worker rendered-worker-c1b41a… False True False 3 2 3 0 4h42m

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-06c9c4… True False False 3 3 3 0 4h42m worker rendered-worker-c1b41a… False True False 3 2 3 0 4h42mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要通过检查

MachineConfigPool自定义资源来检查 MCP 中的节点状态,请运行以下命令:oc describe mcp worker

$ oc describe mcp workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果节点被封锁,则节点不包含在

Ready Machine Count中。它包含在Unavailable Machine Count中:输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要查看每个现有的

MachineConfig对象,请运行以下命令:oc get machineconfigs

$ oc get machineconfigsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 请注意,列为

rendered的MachineConfig对象并不意味着要更改或删除。要查看特定机器配置的内容(本例中为

01-master-kubelet),请运行以下命令:oc describe machineconfigs 01-master-kubelet

$ oc describe machineconfigs 01-master-kubeletCopy to Clipboard Copied! Toggle word wrap Toggle overflow 命令的输出显示此

MachineConfig对象同时包含配置文件(cloud.conf和kubelet.conf) 和 systemd 服务(Kubernetes Kubelet):输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

如果应用的机器配置出现问题,您可以随时退出这一更改。例如,如果您运行 oc create -f ./myconfig.yaml 以应用机器配置,您可以运行以下命令来删除该机器配置:

oc delete -f ./myconfig.yaml

$ oc delete -f ./myconfig.yaml如果这是唯一的问题,则受影响池中的节点应返回非降级状态。这会导致呈现的配置回滚到其之前更改的状态。

如果在集群中添加自己的机器配置,您可以使用上例中显示的命令检查其状态以及应用到它们的池的相关状态。

5.2. 使用 MachineConfig 对象配置节点

您可以使用本节中的任务创建 MachineConfig 对象,修改 OpenShift Container Platform 节点上运行的文件、systemd 单元文件和其他操作系统功能。有关使用机器配置的更多信息,请参阅有关 更新 SSH 授权密钥、验证镜像签名、启用 SCTP 的内容,以及为 OpenShift Container Platform 配置 iSCSI initiatorname。

OpenShift Container Platform 支持 Ignition 规格版本 3.2。您创建的所有新机器配置都应该基于 Ignition 规格版本 3.2。如果要升级 OpenShift Container Platform 集群,任何现有的 Ignition 规格版本 2.x 机器配置将自动转换为规格版本 3.2。

在某些情况下,节点上的配置与当前应用的机器配置指定不完全匹配。这个状态被称为 配置偏移。Machine Config Daemon(MCD)定期检查节点是否有配置偏移。如果 MCD 检测到配置偏移,MCO 会将节点标记为 降级(degraded),直到管理员更正节点配置。降级的节点在线且可操作,但无法更新。有关配置偏移的更多信息,请参阅了解配置偏移检测。

使用 "Configuring chrony time service" 部分作为如何将其他配置文件添加到 OpenShift Container Platform 节点的模型。

5.2.1. 配置 chrony 时间服务

您可以通过修改 chrony .conf 文件的内容,并将这些内容作为机器配置传递给节点,从而设置 chrony 时间服务(chronyd)使用的时间服务器和相关设置。

流程

创建一个 Butane 配置,包括

chrony.conf文件的内容。例如,要在 worker 节点上配置 chrony,请创建一个99-worker-chrony.bu文件。注意您在配置文件中指定的 Butane 版本应与 OpenShift Container Platform 版本匹配,并且始终以

0结尾。例如:4.12.0。有关 Butane 的信息,请参阅"使用 Butane 创建机器配置"。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用 Butane 生成

MachineConfig对象文件99-worker-chrony.yaml,其中包含要交付至节点的配置:butane 99-worker-chrony.bu -o 99-worker-chrony.yaml

$ butane 99-worker-chrony.bu -o 99-worker-chrony.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用以下两种方式之一应用配置:

-

如果集群还没有运行,在生成清单文件后,将

MachineConfig对象文件添加到<installation_directory>/openshift目录中,然后继续创建集群。 如果集群已在运行,请应用该文件:

oc apply -f ./99-worker-chrony.yaml

$ oc apply -f ./99-worker-chrony.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

如果集群还没有运行,在生成清单文件后,将

5.2.2. 禁用 chrony 时间服务

您可以使用 MachineConfig 自定义资源 (CR) 为具有特定角色的节点禁用 chrony 时间服务 (chronyd)。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。

流程

创建

MachineConfigCR,为指定节点角色禁用chronyd。在

disable-chronyd.yaml文件中保存以下 YAML:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 要禁用

chronyd的节点角色,如master。

运行以下命令来创建

MachineConfigCR:oc create -f disable-chronyd.yaml

$ oc create -f disable-chronyd.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.3. 为节点添加内核参数

在一些特殊情况下,您可能需要为集群中的一组节点添加内核参数。进行此操作时应小心谨慎,而且您必须先清楚了解所设参数的影响。

不当使用内核参数会导致系统变得无法引导。

您可以设置的内核参数示例包括:

-

nosmt:在内核中禁用对称多线程 (SMT)。多线程允许每个 CPU 有多个逻辑线程。您可以在多租户环境中考虑使用

nosmt,以减少潜在的跨线程攻击风险。禁用 SMT 在本质上相当于选择安全性而非性能。 systemd.unified_cgroup_hierarchy:启用 Linux 控制组版本 2 (cgroup v2)。cgroup v2 是内核控制组的下一个版本,它包括了多个改进。

重要OpenShift Container Platform cgroups 版本 2 支持只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

Enforcing=0:将 Security Enhanced Linux(SELinux)配置为以 permissive 模式运行。在 permissive 模式中,系统会象 enforcing 模式一样加载安全策略,包括标记对象并在日志中记录访问拒绝条目,但它并不会拒绝任何操作。虽然不建议在生产环境系统中使用 permissive 模式,但 permissive 模式会有助于调试。

警告不支持在生产环境中禁用 RHCOS 上的 SELinux。在节点上禁用 SELinux 后,必须在生产集群中重新设置前重新置备它。

如需内核参数的列表和描述,请参阅 Kernel.org 内核参数。

在以下流程中,您要创建一个用于标识以下内容的 MachineConfig 对象:

- 您要添加内核参数的一组机器。本例中为具有 worker 角色的机器。

- 附加到现有内核参数末尾的内核参数。

- 指示机器配置列表中应用更改的位置的标签。

先决条件

- 具有正常运行的 OpenShift Container Platform 集群的管理特权。

流程

列出 OpenShift Container Platform 集群的现有

MachineConfig对象,以确定如何标记您的机器配置:oc get MachineConfig

$ oc get MachineConfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个用于标识内核参数的

MachineConfig对象文件(例如05-worker-kernelarg-selinuxpermissive.yaml)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建新机器配置:

oc create -f 05-worker-kernelarg-selinuxpermissive.yaml

$ oc create -f 05-worker-kernelarg-selinuxpermissive.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查机器配置以查看是否添加了新配置:

oc get MachineConfig

$ oc get MachineConfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查节点:

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以发现,在应用更改时每个 worker 节点上的调度都会被禁用。

前往其中一个 worker 节点并列出内核命令行参数(主机上的

/proc/cmdline中),以检查内核参数确实已发挥作用:oc debug node/ip-10-0-141-105.ec2.internal

$ oc debug node/ip-10-0-141-105.ec2.internalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您应看到

enforcing=0参数已添加至其他内核参数。

5.2.4. 在 RHCOS 上启用带有内核参数的多路径

Red Hat Enterprise Linux CoreOS (RHCOS) 支持主磁盘上的多路径,允许对硬件故障进行更强大的弹性,以实现更高的主机可用性。通过机器配置激活多路径,提供安装后支持。

对于在 OpenShift Container Platform 中置备的节点,推荐在安装过程中启用多路径。在任何 I/O 到未优化路径会导致 I/O 系统错误的设置中,您必须在安装时启用多路径。有关在安装过程中启用多路径的更多信息,请参阅在裸机上安装中的"启用多路径安装后"。

在 IBM Z 和 IBM® LinuxONE 中,您只能在在安装过程中为它配置集群时启用多路径。如需更多信息,请参阅在 IBM Z 和 IBM® LinuxONE 上安装使用 z/VM 的集群"安装 RHCOS 并启动 OpenShift Container Platform bootstrap 过程"。

当在配置了多路径的 IBM Power® 上的带有 "vSCSI" 存储的单个 VIOS 主机中安装或配置了 OpenShift Container Platform 集群作为安装后任务时,启用了多路径的 CoreOS 节点无法引导。此行为是正常的,因为只有一个路径可用于该节点。

先决条件

- 有一个正在运行的 OpenShift Container Platform 集群。

- 以具有管理特权的用户身份登录集群。

- 您已确认为多路径启用了磁盘。只有通过 HBA 适配器连接到 SAN 的主机上才支持多路径。

流程

要在 control plane 节点上启用多路径安装后:

创建机器配置文件,如

99-master-kargs-mpath.yaml,该文件指示集群添加master标签并标识多路径内核参数,例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

在 worker 节点上启用多路径安装后:

创建机器配置文件,如

99-worker-kargs-mpath.yaml,该文件指示集群添加worker标签并标识多路径内核参数,例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

使用之前创建的 master 或 worker YAML 文件创建新机器配置:

oc create -f ./99-worker-kargs-mpath.yaml

$ oc create -f ./99-worker-kargs-mpath.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查机器配置以查看是否添加了新配置:

oc get MachineConfig

$ oc get MachineConfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查节点:

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以发现,在应用更改时每个 worker 节点上的调度都会被禁用。

前往其中一个 worker 节点并列出内核命令行参数(主机上的

/proc/cmdline中),以检查内核参数确实已发挥作用:oc debug node/ip-10-0-141-105.ec2.internal

$ oc debug node/ip-10-0-141-105.ec2.internalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您应看到添加的内核参数。

5.2.5. 在节点中添加实时内核

一些 OpenShift Container Platform 工作负载需要高度确定性。虽然 Linux 不是实时操作系统,但 Linux 实时内核包含一个抢占调度程序,它为操作系统提供实时特征。

如果您的 OpenShift Container Platform 工作负载需要这些实时特征,您可以将机器切换到 Linux 实时内核。对于 OpenShift Container Platform,4.12,您可以使用 MachineConfig 对象进行这个切换。虽然进行这个切换非常简单(只需要把机器配置的 kernelType 设置为 realtime),但进行更改前需要注意:

- 目前,实时内核只支持在 worker 节点上运行,且只支持无线电访问网络(RAN)使用。

- 使用为 Red Hat Enterprise Linux for Real Time 8 认证系统的裸机安装完全支持以下步骤。

- OpenShift Container Platform 中的实时支持仅限于特定的订阅。

- 以下流程也支持与 Google Cloud 搭配使用。

先决条件

- 有一个正在运行的 OpenShift Container Platform 集群(版本 4.4 或更高版本)。

- 以具有管理特权的用户身份登录集群。

流程

为实时内核创建一个机器配置:创建一个 YAML 文件(例如,

99-worker-realtime.yaml),其中包含一个realtime内核类型的MachineConfig对象。本例告诉集群在所有 worker 节点中使用实时内核:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将机器配置添加到集群。键入以下内容将机器配置添加到集群中:

oc create -f 99-worker-realtime.yaml

$ oc create -f 99-worker-realtime.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查实时内核: 每当受影响节点重新引导后,登录到集群,并运行以下命令来确保您配置的节点组中使用实时内核替换了常规内核:

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME STATUS ROLES AGE VERSION ip-10-0-143-147.us-east-2.compute.internal Ready worker 103m v1.25.0 ip-10-0-146-92.us-east-2.compute.internal Ready worker 101m v1.25.0 ip-10-0-169-2.us-east-2.compute.internal Ready worker 102m v1.25.0

NAME STATUS ROLES AGE VERSION ip-10-0-143-147.us-east-2.compute.internal Ready worker 103m v1.25.0 ip-10-0-146-92.us-east-2.compute.internal Ready worker 101m v1.25.0 ip-10-0-169-2.us-east-2.compute.internal Ready worker 102m v1.25.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc debug node/ip-10-0-143-147.us-east-2.compute.internal

$ oc debug node/ip-10-0-143-147.us-east-2.compute.internalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 内核名称包含

rt和 "PREMPT RT" 来表示这是一个实时内核。要返回常规内核,请删除

MachineConfig对象:oc delete -f 99-worker-realtime.yaml

$ oc delete -f 99-worker-realtime.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.6. 配置 journald 设置

如果您需要在 OpenShift Container Platform 节点上配置 journald 服务设置,您可以修改适当的配置文件并将该文件作为机器配置传递给适当的节点池。

此流程描述了如何修改 /etc/systemd/journald.conf 文件中的 journald 限制设置并将其应用到 worker 节点。有关如何使用该文件的详情,请查看 journald.conf 手册页。

先决条件

- 有一个正在运行的 OpenShift Container Platform 集群。

- 以具有管理特权的用户身份登录集群。

流程

创建一个 Butane 配置文件

40-worker-custom-journald.bu,其中包含带有所需设置的/etc/systemd/journald.conf文件。注意您在配置文件中指定的 Butane 版本应与 OpenShift Container Platform 版本匹配,并且始终以

0结尾。例如:4.12.0。有关 Butane 的信息,请参阅"使用 Butane 创建机器配置"。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用 Butane 生成

MachineConfig对象文件40-worker-custom-journald.yaml,包含要发送到 worker 节点的配置:butane 40-worker-custom-journald.bu -o 40-worker-custom-journald.yaml

$ butane 40-worker-custom-journald.bu -o 40-worker-custom-journald.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将机器配置应用到池:

oc apply -f 40-worker-custom-journald.yaml

$ oc apply -f 40-worker-custom-journald.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查是否应用新机器配置,并且节点是否处于降级状态。它可能需要几分钟时间。worker 池将显示更新进行中,每个节点都成功应用了新的机器配置:

oc get machineconfigpool NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-35 True False False 3 3 3 0 34m worker rendered-worker-d8 False True False 3 1 1 0 34m

$ oc get machineconfigpool NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-35 True False False 3 3 3 0 34m worker rendered-worker-d8 False True False 3 1 1 0 34mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要检查是否应用了更改,您可以登录到 worker 节点:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.7. 为 RHCOS 添加扩展

RHCOS 是基于容器的最小 RHEL 操作系统,旨在为所有平台的 OpenShift Container Platform 集群提供一组通用的功能。通常不建议在 RHCOS 系统中添加软件软件包,但 MCO 提供了一个 extensions(扩展) 功能,您可以使用 MCO 为 RHCOS 节点添加一组最小的功能。

目前,有以下扩展可用:

-

usbguard:添加

usbguard扩展可保护 RHCOS 系统不受入侵 USB 设备的攻击。详情请查看 USBGuard。 -

Kerberos:添加

kerberos扩展提供了一种机制,允许用户和机器标识自身对网络进行定义的定义、限制对管理员配置的区域和服务的访问权限。请参阅使用 Kerberos 的详情,包括如何设置 Kerberos 客户端并挂载 Kerberized NFS 共享。

以下流程描述了如何使用机器配置为 RHCOS 节点添加一个或多个扩展。

先决条件

- 有一个正在运行的 OpenShift Container Platform 集群(版本 4.6 或更高版本)。

- 以具有管理特权的用户身份登录集群。

流程

为扩展创建机器配置:创建一个 YAML 文件(如

80-extensions.yaml),其中包含MachineConfigextensions对象。本例告诉集群添加usbguard扩展。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将机器配置添加到集群。键入以下内容将机器配置添加到集群中:

oc create -f 80-extensions.yaml

$ oc create -f 80-extensions.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这会将所有 worker 节点设置为安装

usbguard的 rpm 软件包。检查是否应用了扩展:

oc get machineconfig 80-worker-extensions

$ oc get machineconfig 80-worker-extensionsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME GENERATEDBYCONTROLLER IGNITIONVERSION AGE 80-worker-extensions 3.2.0 57s

NAME GENERATEDBYCONTROLLER IGNITIONVERSION AGE 80-worker-extensions 3.2.0 57sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查是否应用新机器配置,并且节点是否处于降级状态。它可能需要几分钟时间。worker 池将显示更新进行中,每台机器都成功应用了新机器配置:

oc get machineconfigpool

$ oc get machineconfigpoolCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-35 True False False 3 3 3 0 34m worker rendered-worker-d8 False True False 3 1 1 0 34m

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-35 True False False 3 3 3 0 34m worker rendered-worker-d8 False True False 3 1 1 0 34mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查扩展。要检查是否应用了扩展,请运行:

oc get node | grep worker

$ oc get node | grep workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME STATUS ROLES AGE VERSION ip-10-0-169-2.us-east-2.compute.internal Ready worker 102m v1.25.0

NAME STATUS ROLES AGE VERSION ip-10-0-169-2.us-east-2.compute.internal Ready worker 102m v1.25.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc debug node/ip-10-0-169-2.us-east-2.compute.internal

$ oc debug node/ip-10-0-169-2.us-east-2.compute.internalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

... To use host binaries, run `chroot /host` sh-4.4# chroot /host sh-4.4# rpm -q usbguard usbguard-0.7.4-4.el8.x86_64.rpm

... To use host binaries, run `chroot /host` sh-4.4# chroot /host sh-4.4# rpm -q usbguard usbguard-0.7.4-4.el8.x86_64.rpmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.8. 在机器配置清单中载入自定义固件 Blob

因为 /usr/lib 中固件 Blob 的默认位置是只读的,所以您可以通过更新搜索路径来查找自定义固件 Blob。这可让您在 RHCOS 不管理 blob 时载入机器配置清单中的本地固件 Blob。

流程

创建 Butane 配置文件

98-worker-firmware-blob.bu,它会更新搜索路径,以便其为 root 所有且对本地存储可写。以下示例将本地工作站的自定义 blob 文件放在/var/lib/firmware下的节点上。注意您在配置文件中指定的 Butane 版本应与 OpenShift Container Platform 版本匹配,并且始终以

0结尾。例如:4.12.0。有关 Butane 的信息,请参阅"使用 Butane 创建机器配置"。自定义固件 blob 的 Butane 配置文件

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行 Butane 生成

MachineConfig对象文件,该文件使用名为98-worker-firmware-blob.yaml的本地工作站中的固件 blob 副本。固件 blob 包含要传送到节点的配置。以下示例使用--files-dir选项指定工作站上本地文件或目录所在的目录:butane 98-worker-firmware-blob.bu -o 98-worker-firmware-blob.yaml --files-dir <directory_including_package_name>

$ butane 98-worker-firmware-blob.bu -o 98-worker-firmware-blob.yaml --files-dir <directory_including_package_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过两种方式之一将配置应用到节点:

-

如果集群还没有运行,在生成清单文件后,将

MachineConfig对象文件添加到<installation_directory>/openshift目录中,然后继续创建集群。 如果集群已在运行,请应用该文件:

oc apply -f 98-worker-firmware-blob.yaml

$ oc apply -f 98-worker-firmware-blob.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 已为您创建一个

MachineConfig对象 YAML 文件,以完成机器的配置。

-

如果集群还没有运行,在生成清单文件后,将

-

如果将来需要更新

MachineConfig对象,请保存 Butane 配置。

5.3. 配置 MCO 相关的自定义资源

除了管理 MachineConfig 对象外,MCO 管理两个自定义资源(CR):KubeletConfig 和 ContainerRuntimeConfig。这些 CR 可让您更改节点级别的设置,这会影响到 Kubelet 和 CRI-O 容器运行时服务的行为。

5.3.1. 创建 KubeletConfig CR 以编辑 kubelet 参数

kubelet 配置目前被序列化为 Ignition 配置,因此可以直接编辑。但是,在 Machine Config Controller (MCC) 中同时添加了新的 kubelet-config-controller 。这可让您使用 KubeletConfig 自定义资源 (CR) 来编辑 kubelet 参数。

因为 kubeletConfig 对象中的字段直接从上游 Kubernetes 传递给 kubelet,kubelet 会直接验证这些值。kubeletConfig 对象中的无效值可能会导致集群节点不可用。有关有效值,请参阅 Kubernetes 文档。

请考虑以下指导:

-

编辑现有的

KubeletConfigCR 以修改现有设置或添加新设置,而不是为每个更改创建一个 CR。建议您仅创建一个 CR 来修改不同的机器配置池,或用于临时更改,以便您可以恢复更改。 -

为每个机器配置池创建一个

KubeletConfigCR,带有该池需要更改的所有配置。 -

根据需要,创建多个

KubeletConfigCR,每个集群限制为 10。对于第一个KubeletConfigCR,Machine Config Operator (MCO) 会创建一个机器配置,并附带kubelet。对于每个后续 CR,控制器会创建另一个带有数字后缀的kubelet机器配置。例如,如果您有一个带有-2后缀的kubelet机器配置,则下一个kubelet机器配置会附加-3。

如果要将 kubelet 或容器运行时配置应用到自定义机器配置池,则 machineConfigSelector 中的自定义角色必须与自定义机器配置池的名称匹配。

例如,由于以下自定义机器配置池名为 infra,因此自定义角色也必须是 infra :

如果要删除机器配置,以相反的顺序删除它们,以避免超过限制。例如,在删除 kubelet-2 机器配置前删除 kubelet-3 机器配置。

如果您有一个带有 kubelet-9 后缀的机器配置,并且创建了另一个 KubeletConfig CR,则不会创建新的机器配置,即使少于 10 个 kubelet 机器配置。

KubeletConfig CR 示例

oc get kubeletconfig

$ oc get kubeletconfigNAME AGE set-kubelet-config 15m

NAME AGE

set-kubelet-config 15m显示 KubeletConfig 机器配置示例

oc get mc | grep kubelet

$ oc get mc | grep kubelet... 99-worker-generated-kubelet-1 b5c5119de007945b6fe6fb215db3b8e2ceb12511 3.2.0 26m ...

...

99-worker-generated-kubelet-1 b5c5119de007945b6fe6fb215db3b8e2ceb12511 3.2.0 26m

...以下流程演示了如何配置每个节点的最大 pod 数量、每个节点的最大 PID 以及 worker 节点上的最大容器日志大小。

先决条件

为您要配置的节点类型获取与静态

MachineConfigPoolCR 关联的标签。执行以下步骤之一:查看机器配置池:

oc describe machineconfigpool <name>

$ oc describe machineconfigpool <name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

oc describe machineconfigpool worker

$ oc describe machineconfigpool workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果添加了标签,它会出现在

labels下。

如果标签不存在,则添加一个键/值对:

oc label machineconfigpool worker custom-kubelet=set-kubelet-config

$ oc label machineconfigpool worker custom-kubelet=set-kubelet-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

查看您可以选择的可用机器配置对象:

oc get machineconfig

$ oc get machineconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 默认情况下,与 kubelet 相关的配置为

01-master-kubelet和01-worker-kubelet。检查每个节点的最大 pod 的当前值:

oc describe node <node_name>

$ oc describe node <node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

oc describe node ci-ln-5grqprb-f76d1-ncnqq-worker-a-mdv94

$ oc describe node ci-ln-5grqprb-f76d1-ncnqq-worker-a-mdv94Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在

Allocatable小节中找到value: pods: <value>:输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 根据需要配置 worker 节点:

创建一个类似如下的 YAML 文件,其中包含 kubelet 配置:

重要以特定机器配置池为目标的 kubelet 配置也会影响任何依赖的池。例如,为包含 worker 节点的池创建 kubelet 配置也适用于任何子集池,包括包含基础架构节点的池。要避免这种情况,您必须使用仅包含 worker 节点的选择表达式创建新的机器配置池,并让 kubelet 配置以这个新池为目标。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

使用

podPidsLimit在任何 pod 中设置最大 PID 数量。 -

使用

containerLogMaxSize在轮转容器日志文件前设置容器日志文件的最大大小。 使用

maxPods设置每个节点的最大 pod。注意kubelet 与 API 服务器进行交互的频率取决于每秒的查询数量 (QPS) 和 burst 值。如果每个节点上运行的 pod 数量有限,使用默认值(

kubeAPIQPS为50,kubeAPIBurst为100)就可以。如果节点上有足够 CPU 和内存资源,则建议更新 kubelet QPS 和 burst 速率。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

使用

为带有标签的 worker 更新机器配置池:

oc label machineconfigpool worker custom-kubelet=set-kubelet-config

$ oc label machineconfigpool worker custom-kubelet=set-kubelet-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

KubeletConfig对象:oc create -f change-maxPods-cr.yaml

$ oc create -f change-maxPods-cr.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证

KubeletConfig对象是否已创建:oc get kubeletconfig

$ oc get kubeletconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE set-kubelet-config 15m

NAME AGE set-kubelet-config 15mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 根据集群中的 worker 节点数量,等待每个 worker 节点被逐个重启。对于有 3 个 worker 节点的集群,这个过程可能需要大约 10 到 15 分钟。

验证更改是否已应用到节点:

在 worker 节点上检查

maxPods值已更改:oc describe node <node_name>

$ oc describe node <node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 找到

Allocatable小节:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 在本例中,

pods参数应报告您在KubeletConfig对象中设置的值。

验证

KubeletConfig对象中的更改:oc get kubeletconfigs set-kubelet-config -o yaml

$ oc get kubeletconfigs set-kubelet-config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这应该显示

True状态和type:Success,如下例所示:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3.2. 创建 ContainerRuntimeConfig CR 以编辑 CRI-O 参数

您可以为与特定机器配置池(MCP)关联的节点更改与 OpenShift Container Platform CRI-O 运行时关联的一些设置。通过使用 ContainerRuntimeConfig 自定义资源(CR),您可以设置配置值并添加一个标签以匹配 MCP。然后,MCO 会使用更新的值重建关联节点上的 crio.conf 和 storage.conf 配置文件。

要使用 ContainerRuntimeConfig CR 恢复实现的更改,您必须删除 CR。从机器配置池中删除标签不会恢复更改。

您可以使用 ContainerRuntimeConfig CR 修改以下设置:

-

日志级别:

logLevel参数设置 CRI-Olog_level参数,即日志消息的详细程度。默认为info(log_level = info)。其他选项包括fatal、panic、error、warn、debug和trace。 -

Overlay 大小:

overlaySize参数设置 CRI-O Overlay 存储驱动程序size参数,这是容器镜像的最大大小。 -

容器运行时 :

defaultRuntime参数将容器运行时设置为runc或crun。默认为runc。

对 crun 容器运行时的支持只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

您应该为每个机器配置池有一个ContainerRuntimeConfig CR,并为该池分配所有配置更改。如果要将相同的内容应用到所有池,则所有池只需要 oneContainerRuntimeConfig CR。

您应该编辑现有的 ContainerRuntimeConfig CR,以修改现有设置或添加新设置,而不是为每个更改创建新 CR。建议您只创建一个新的 ContainerRuntimeConfig CR 来修改不同的机器配置池,或者用于临时的更改,以便您可以恢复更改。

您可以根据需要创建多个 ContainerRuntimeConfig CR,每个集群的限制为 10。对于第一个 ContainerRuntimeConfig CR,MCO 会创建一个机器配置并附加 containerruntime。对于每个后续 CR,控制器会创建一个带有数字后缀的新 containerruntime 机器配置。例如,如果您有一个带有 -2 后缀的 containerruntime 机器配置,则下一个 containerruntime 机器配置会附加 -3。

如果要删除机器配置,应该以相反的顺序删除它们,以避免超过限制。例如,您应该在删除 containerruntime-2 机器配置前删除 containerruntime-3 机器配置。

如果您的机器配置带有 containerruntime-9 后缀,并且创建了 anotherContainerRuntimeConfig CR,则不会创建新的机器配置,即使少于 10 个 containerruntime 机器配置。

显示多个 ContainerRuntimeConfig CR 示例

oc get ctrcfg

$ oc get ctrcfg输出示例

NAME AGE ctr-overlay 15m ctr-level 5m45s

NAME AGE

ctr-overlay 15m

ctr-level 5m45s显示多个 containerruntime 机器配置示例

oc get mc | grep container

$ oc get mc | grep container输出示例

以下示例将 log_level 字段设置为 debug,并将覆盖大小设置为 8 GB:

ContainerRuntimeConfig CR 示例

前提条件

要启用 crun,您必须启用

TechPreviewNoUpgrade功能集。注意启用

TechPreviewNoUpgrade功能集将无法撤消,并防止次版本更新。不建议在生产环境集群中使用这些功能集。

流程

使用 ContainerRuntimeConfig CR 更改 CRI-O 设置:

为

ContainerRuntimeConfigCR 创建 YAML 文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

ContainerRuntimeConfigCR:oc create -f <file_name>.yaml

$ oc create -f <file_name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证是否已创建 CR:

oc get ContainerRuntimeConfig

$ oc get ContainerRuntimeConfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE overlay-size 3m19s

NAME AGE overlay-size 3m19sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查是否创建了新的

containerruntime机器配置:oc get machineconfigs | grep containerrun

$ oc get machineconfigs | grep containerrunCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

99-worker-generated-containerruntime 2c9371fbb673b97a6fe8b1c52691999ed3a1bfc2 3.2.0 31s

99-worker-generated-containerruntime 2c9371fbb673b97a6fe8b1c52691999ed3a1bfc2 3.2.0 31sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 监控机器配置池,直到所有系统都显示为 ready 状态:

oc get mcp worker

$ oc get mcp workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE worker rendered-worker-169 False True False 3 1 1 0 9h

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE worker rendered-worker-169 False True False 3 1 1 0 9hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证设置是否在 CRI-O 中应用:

打开到机器配置池中节点的

oc debug会话,并运行chroot /host。oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow chroot /host

sh-4.4# chroot /hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证

crio.conf文件中的更改:crio config | grep 'log_level'

sh-4.4# crio config | grep 'log_level'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

log_level = "debug"

log_level = "debug"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 验证 'storage.conf' 文件中的更改:

head -n 7 /etc/containers/storage.conf

sh-4.4# head -n 7 /etc/containers/storage.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3.3. 使用 CRI-O 为 Overlay 设置默认的最大容器根分区大小

每个容器的根分区显示底层主机的所有可用磁盘空间。按照以下说明,为所有容器的 root 磁盘设置最大分区大小。

要配置最大 Overlay 大小以及其他 CRI-O 选项,您可以创建以下 ContainerRuntimeConfig 自定义资源定义 (CRD):

流程

创建配置对象:

oc apply -f overlaysize.yml

$ oc apply -f overlaysize.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要将新的 CRI-O 配置应用到 worker 节点,请编辑 worker 机器配置池:

oc edit machineconfigpool worker

$ oc edit machineconfigpool workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 根据在

ContainerRuntimeConfigCRD 中设置的matchLabels名称添加custom-crio标签:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 保存更改,然后查看机器配置:

oc get machineconfigs

$ oc get machineconfigsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新的

99-worker-generated-containerruntime和rendered-worker-xyz对象被创建:输出示例

99-worker-generated-containerruntime 4173030d89fbf4a7a0976d1665491a4d9a6e54f1 3.2.0 7m42s rendered-worker-xyz 4173030d89fbf4a7a0976d1665491a4d9a6e54f1 3.2.0 7m36s

99-worker-generated-containerruntime 4173030d89fbf4a7a0976d1665491a4d9a6e54f1 3.2.0 7m42s rendered-worker-xyz 4173030d89fbf4a7a0976d1665491a4d9a6e54f1 3.2.0 7m36sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建这些对象后,监控机器配置池以了解要应用的更改:

oc get mcp worker

$ oc get mcp workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow worker 节点将

UPDATING显示为True,以及机器数量、更新的数字和其他详情:输出示例

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE worker rendered-worker-xyz False True False 3 2 2 0 20h

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE worker rendered-worker-xyz False True False 3 2 2 0 20hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 完成后,worker 节点会从

UPDATING转换回False,UPDATEDMACHINECOUNT数与MACHINECOUNT数匹配:输出示例

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE worker rendered-worker-xyz True False False 3 3 3 0 20h

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE worker rendered-worker-xyz True False False 3 3 3 0 20hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 查看 worker 机器,您会看到新的 8 GB 最大大小配置适用于所有 worker:

输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在容器内,您会看到 root 分区现在为 8 GB:

输出示例

~ $ df -h Filesystem Size Used Available Use% Mounted on overlay 8.0G 8.0K 8.0G 0% /

~ $ df -h Filesystem Size Used Available Use% Mounted on overlay 8.0G 8.0K 8.0G 0% /Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 6 章 安装后集群任务

安装 OpenShift Container Platform 后,您可以按照自己的要求进一步扩展和自定义集群。

6.1. 可用的集群自定义

大多数集群配置和自定义在 OpenShift Container Platform 集群部署后完成。有若干配置资源可用。

如果在 IBM Z 上安装集群,则不是所有功能都可用。

您可以修改配置资源来配置集群的主要功能,如镜像 registry、网络配置、镜像构建操作以及用户身份供应商。

如需设置这些资源的当前信息,请使用 oc explain 命令,如 oc explain builds --api-version=config.openshift.io/v1

6.1.1. 集群配置资源

所有集群配置资源都作用于全局范围(而非命名空间),且命名为 cluster。

| 资源名称 | 描述 |

|---|---|

|

| 提供 API 服务器配置,如证书和证书颁发机构。 |

|

| 控制集群的身份提供程序和身份验证配置。 |

|

| 控制集群中所有构建的默认和强制配置。 |

|

| 配置 Web 控制台界面的行为,包括注销行为。 |

|

| 启用 FeatureGates,以便您能使用技术预览功能。 |

|

| 配置应如何对待特定的镜像 registry(允许、禁用、不安全、CA 详情)。 |

|

| 与路由相关的配置详情,如路由的默认域。 |

|

| 配置用户身份供应商,以及与内部 OAuth 服务器流程相关的其他行为。 |

|

| 配置项目的创建方式,包括项目模板。 |

|

| 定义需要外部网络访问的组件要使用的代理。注意:目前不是所有组件都会消耗这个值。 |

|

| 配置 调度程序行为,如配置集和默认节点选择器。 |

6.1.2. Operator 配置资源

这些配置资源是集群范围的实例,即 cluster,控制归特定 Operator 所有的特定组件的行为。

| 资源名称 | 描述 |

|---|---|

|

| 控制控制台外观,如品牌定制 |

|

| 配置 OpenShift 镜像 registry 设置,如公共路由、日志级别、代理设置、资源约束、副本数和存储类型。 |

|

| 配置 Samples Operator,以控制在集群上安装哪些镜像流和模板示例。 |

6.1.3. 其他配置资源

这些配置资源代表一个特定组件的单一实例。在有些情况下,您可以通过创建多个资源实例来请求多个实例。在其他情况下,Operator 只消耗指定命名空间中的特定资源实例名称。如需有关如何和何时创建其他资源实例的详情,请参考具体组件的文档。

| 资源名称 | 实例名称 | 命名空间 | 描述 |

|---|---|---|---|

|

|

|

| 控制 Alertmanager 部署参数。 |

|

|

|

| 配置 Ingress Operator 行为,如域、副本数、证书和控制器放置。 |

6.1.4. 信息资源

可以使用这些资源检索集群信息。有些配置可能需要您直接编辑这些资源。

| 资源名称 | 实例名称 | 描述 |

|---|---|---|

|

|

|

在 OpenShift Container Platform 4.12 中,不得自定义生产集群的 |

|

|

| 无法修改集群的 DNS 设置。您可以查看 DNS Operator 状态。 |

|

|

| 允许集群与其云供应商交互的配置详情。 |

|

|

| 无法在安装后修改集群网络。要自定义您的网络,请遵循相关的流程在安装过程中自定义网络。 |

6.2. 添加 worker 节点

部署 OpenShift Container Platform 集群后,您可以添加 worker 节点来扩展集群资源。您可以根据安装方法和集群的环境,添加 worker 节点的不同方法。

6.2.1. 在安装程序置备的基础架构集群中添加 worker 节点

对于安装程序置备的基础架构集群,您可以手动或自动扩展 MachineSet 对象以匹配可用的裸机主机数量。

要添加裸机主机,您必须配置所有网络先决条件,配置关联的 baremetalhost 对象,然后为集群置备 worker 节点。您可以手动添加裸机主机,或使用 Web 控制台。

6.2.2. 在用户置备的基础架构集群中添加 worker 节点

对于用户置备的基础架构集群,您可以使用 RHEL 或 RHCOS ISO 镜像添加 worker 节点,并使用集群 Ignition 配置文件将其连接到集群。对于 RHEL worker 节点,以下示例使用 Ansible playbook 在集群中添加 worker 节点。对于 RHCOS worker 节点,以下示例使用 ISO 镜像和网络引导来在集群中添加 worker 节点。

6.2.3. 将 worker 节点添加到由 Assisted Installer 管理的集群

对于由 Assisted Installer 管理的集群,您可以使用 Red Hat OpenShift Cluster Manager 控制台(辅助安装程序 REST API)添加 worker 节点,也可以使用 ISO 镜像和集群 Ignition 配置文件手动添加 worker 节点。

6.2.4. 将 worker 节点添加到由 Kubernetes 的多集群引擎管理的集群

对于由 Kubernetes 多集群引擎管理的集群,您可以使用专用多集群引擎控制台添加 worker 节点。

6.3. 调整 worker 节点

如果您在部署过程中错误地定义了 worker 节点的大小,请通过创建一个或多个新计算机器集来调整它们,扩展它们,然后扩展原始的计算机器集,然后再删除它们。

6.3.1. 了解计算机器集和机器配置池之间的区别

MachineSet 对象描述了与云或机器供应商相关的 OpenShift Container Platform 节点。

MachineConfigPool 对象允许 MachineConfigController 组件在升级过程中定义并提供机器的状态。

MachineConfigPool 对象允许用户配置如何将升级应用到机器配置池中的 OpenShift Container Platform 节点。

NodeSelector 对象可以被一个到 MachineSet 对象的引用替换。

6.3.2. 手动扩展计算机器集

要在计算机器集中添加或删除机器实例,您可以手动扩展计算机器集。

这个指南与全自动的、安装程序置备的基础架构安装相关。自定义的、用户置备的基础架构安装没有计算机器集。

先决条件

-

安装 OpenShift Container Platform 集群和

oc命令行。 -

以具有

cluster-admin权限的用户身份登录oc。

流程

运行以下命令,查看集群中的计算机器:

oc get machinesets -n openshift-machine-api

$ oc get machinesets -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 计算机器集以

<clusterid>-worker-<aws-region-az>的形式列出。运行以下命令,查看集群中的计算机器:

oc get machine -n openshift-machine-api

$ oc get machine -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,在要删除的计算机器上设置注解:

oc annotate machine/<machine_name> -n openshift-machine-api machine.openshift.io/delete-machine="true"

$ oc annotate machine/<machine_name> -n openshift-machine-api machine.openshift.io/delete-machine="true"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来扩展计算机器集:

oc scale --replicas=2 machineset <machineset> -n openshift-machine-api

$ oc scale --replicas=2 machineset <machineset> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 或者:

oc edit machineset <machineset> -n openshift-machine-api

$ oc edit machineset <machineset> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提示您还可以应用以下 YAML 来扩展计算机器集:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以扩展或缩减计算机器。需要过几分钟以后新机器才可用。

重要默认情况下,机器控制器会尝试排空在机器上运行的节点,直到成功为止。在某些情况下,如错误配置了 pod 中断预算,排空操作可能无法成功。如果排空操作失败,机器控制器无法继续删除机器。

您可以通过在特定机器上注解

machine.openshift.io/exclude-node-draining来跳过排空节点。

验证

运行以下命令,验证删除所需的机器:

oc get machines

$ oc get machinesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3.3. 计算机器集删除策略

Random、Newest 和 Oldest 是三个支持的删除选项。默认值为 Random,表示在扩展计算机器时随机选择并删除机器。通过修改特定的计算机器集,可以根据用例设置删除策略:

spec: deletePolicy: <delete_policy> replicas: <desired_replica_count>

spec:

deletePolicy: <delete_policy>

replicas: <desired_replica_count>

无论删除策略是什么,都可通过在相关机器上添加 machine.openshift.io/delete-machine=true 注解来指定机器删除的优先级。

默认情况下,OpenShift Container Platform 路由器 Pod 部署在 worker 上。由于路由器需要访问某些集群资源(包括 Web 控制台),除非先重新放置了路由器 Pod,否则请不要将 worker 计算机器集扩展为 0。

对于需要特定节点运行的用例,可以使用自定义计算机器集,在 worker 计算机器集缩减时,控制器会忽略这些服务。这可防止服务被中断。

6.3.4. 创建默认的集群范围节点选择器

您可以组合使用 pod 上的默认集群范围节点选择器和节点上的标签,将集群中创建的所有 pod 限制到特定节点。

使用集群范围节点选择器时,如果您在集群中创建 pod,OpenShift Container Platform 会将默认节点选择器添加到 pod,并将该 pod 调度到具有匹配标签的节点。

您可以通过编辑调度程序 Operator 自定义资源(CR)来配置集群范围节点选择器。您可向节点、计算机器集或机器配置添加标签。将标签添加到计算机器集可确保节点或机器停机时,新节点具有该标签。如果节点或机器停机,添加到节点或机器配置的标签不会保留。

您可以向 pod 添加额外的键/值对。但是,您无法为一个默认的键添加不同的值。

流程

添加默认的集群范围节点选择器:

编辑调度程序 Operator CR 以添加默认的集群范围节点选择器:

oc edit scheduler cluster

$ oc edit scheduler clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用节点选择器的调度程序 Operator CR 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 使用适当的

<key>:<value>对添加节点选择器。

完成此更改后,请等待重新部署

openshift-kube-apiserver项目中的 pod。这可能需要几分钟。只有重新部署 pod 后,默认的集群范围节点选择器才会生效。使用计算机器集或直接编辑节点,为节点添加标签:

在创建节点时,使用计算机器集向由计算机器设置管理的节点添加标签:

运行以下命令,将标签添加到

MachineSet对象中:oc patch MachineSet <name> --type='json' -p='[{"op":"add","path":"/spec/template/spec/metadata/labels", "value":{"<key>"="<value>","<key>"="<value>"}}]' -n openshift-machine-api$ oc patch MachineSet <name> --type='json' -p='[{"op":"add","path":"/spec/template/spec/metadata/labels", "value":{"<key>"="<value>","<key>"="<value>"}}]' -n openshift-machine-api1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 为每个标识添加

<key>/<value>对。

例如:

oc patch MachineSet ci-ln-l8nry52-f76d1-hl7m7-worker-c --type='json' -p='[{"op":"add","path":"/spec/template/spec/metadata/labels", "value":{"type":"user-node","region":"east"}}]' -n openshift-machine-api$ oc patch MachineSet ci-ln-l8nry52-f76d1-hl7m7-worker-c --type='json' -p='[{"op":"add","path":"/spec/template/spec/metadata/labels", "value":{"type":"user-node","region":"east"}}]' -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提示您还可以应用以下 YAML 来向计算机器集中添加标签:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

oc edit命令验证标签是否已添加到MachineSet对象中:例如:

oc edit MachineSet abc612-msrtw-worker-us-east-1c -n openshift-machine-api

$ oc edit MachineSet abc612-msrtw-worker-us-east-1c -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow MachineSet对象示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过缩减至

0并扩展节点来重新部署与该计算机器集关联的节点:例如:

oc scale --replicas=0 MachineSet ci-ln-l8nry52-f76d1-hl7m7-worker-c -n openshift-machine-api

$ oc scale --replicas=0 MachineSet ci-ln-l8nry52-f76d1-hl7m7-worker-c -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc scale --replicas=1 MachineSet ci-ln-l8nry52-f76d1-hl7m7-worker-c -n openshift-machine-api

$ oc scale --replicas=1 MachineSet ci-ln-l8nry52-f76d1-hl7m7-worker-c -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 当节点就绪并可用时,使用

oc get命令验证该标签是否已添加到节点:oc get nodes -l <key>=<value>

$ oc get nodes -l <key>=<value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

oc get nodes -l type=user-node

$ oc get nodes -l type=user-nodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME STATUS ROLES AGE VERSION ci-ln-l8nry52-f76d1-hl7m7-worker-c-vmqzp Ready worker 61s v1.25.0

NAME STATUS ROLES AGE VERSION ci-ln-l8nry52-f76d1-hl7m7-worker-c-vmqzp Ready worker 61s v1.25.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

直接向节点添加标签:

为节点编辑

Node对象:oc label nodes <name> <key>=<value>

$ oc label nodes <name> <key>=<value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如,若要为以下节点添加标签:

oc label nodes ci-ln-l8nry52-f76d1-hl7m7-worker-b-tgq49 type=user-node region=east

$ oc label nodes ci-ln-l8nry52-f76d1-hl7m7-worker-b-tgq49 type=user-node region=eastCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提示您还可以应用以下 YAML 来向节点添加标签:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

oc get命令验证标签是否已添加到节点:oc get nodes -l <key>=<value>,<key>=<value>

$ oc get nodes -l <key>=<value>,<key>=<value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

oc get nodes -l type=user-node,region=east

$ oc get nodes -l type=user-node,region=eastCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME STATUS ROLES AGE VERSION ci-ln-l8nry52-f76d1-hl7m7-worker-b-tgq49 Ready worker 17m v1.25.0

NAME STATUS ROLES AGE VERSION ci-ln-l8nry52-f76d1-hl7m7-worker-b-tgq49 Ready worker 17m v1.25.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3.5. 在 AWS 本地区中创建用户工作负载

创建 Amazon Web Service (AWS) Local Zone 环境并部署了集群后,您可以使用边缘 worker 节点在 Local Zone 子网中创建用户工作负载。

在 openshift-installer 创建集群时,安装程序会自动指定每个边缘 worker 节点的污点效果 NoSchedule。这意味着,如果 pod 与污点的指定容限不匹配,调度程序不会向节点添加新 pod 或部署。您可以修改污点,以更好地控制每个节点如何在每个 Local Zone 子网中创建工作负载。

openshift-installer 创建计算机器集的清单文件,node-role.kubernetes.io/edge 和 node-role.kubernetes.io/worker 标签应用到位于一个 Local Zone 子网中的每个边缘工作节点。

先决条件

-

您可以访问 OpenShift CLI(

oc)。 - 您在带有定义的 Local Zone 子网的虚拟私有云 (VPC) 中部署了集群。

-

您确保 Local Zone 子网上边缘 worker 的计算机器集指定了

node-role.kubernetes.io/edge的污点。

流程

为要在 Local Zone 子网中运行的边缘 worker 节点部署示例应用程序创建一个

deployment资源 YAML 文件。确保指定与边缘 worker 节点的污点匹配的正确容限。在 Local Zone 子网中运行的边缘 worker 节点配置的

deployment资源示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

storageClassName:对于 Local Zone 配置,您必须指定gp2-csi。- 2

kind:定义deployment资源。- 3

name:指定 Local Zone 应用程序的名称。例如,local-zone-demo-app-nyc-1。- 4

namespace :定义您要运行用户工作负载的 AWS Local Zone 的命名空间。例如:local-zone-app-nyc-1a。- 5

zone-group:定义区域所属的组。例如,us-east-1-iah-1。- 6

nodeSelector:目标与指定标签匹配的边缘 worker 节点。- 7

tolerations:设置与 Local Zone 节点的MachineSet清单上定义的污点匹配的值。

为节点创建

service资源 YAML 文件。此资源将来自目标边缘 worker 节点的一个 pod 公开到在 Local Zone 网络中运行的服务。在 Local Zone 子网中运行的边缘 worker 节点配置的

service资源示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow

后续步骤

- 可选: 使用 AWS Load Balancer (ALB) Operator 将目标边缘 worker 节点的 pod 公开给从公共网络在 Local Zone 子网中运行的服务。请参阅安装 AWS Load Balancer Operator。

6.4. 使用 worker 延迟配置集提高高延迟环境中的集群稳定性

如果集群管理员为平台验证执行了延迟测试,他们可以发现需要调整集群的操作,以确保高延迟的情况的稳定性。集群管理员只需要更改一个参数,该参数记录在一个文件中,它控制了 Supervisory 进程读取状态并解释集群的运行状况的四个参数。仅更改一个参数可以以方便、可支持的方式提供集群调整。

Kubelet 进程提供监控集群运行状况的起点。Kubelet 为 OpenShift Container Platform 集群中的所有节点设置状态值。Kubernetes Controller Manager (kube controller) 默认每 10 秒读取状态值。如果 kube 控制器无法读取节点状态值,它会在配置的时间后丢失与该节点联系。默认行为是:

-

control plane 上的节点控制器将节点健康状况更新为

Unhealthy,并奖节点Ready的条件标记为 'Unknown'。 - 因此,调度程序会停止将 pod 调度到该节点。

-

Node Lifecycle Controller 添加了一个

node.kubernetes.io/unreachable污点,对节点具有NoExecute效果,默认在五分钟后调度节点上的任何 pod 进行驱除。

如果您的网络容易出现延迟问题,尤其是在网络边缘中有节点时,此行为可能会造成问题。在某些情况下,Kubernetes Controller Manager 可能会因为网络延迟而从健康的节点接收更新。Kubelet 会从节点中驱除 pod,即使节点处于健康状态。

要避免这个问题,您可以使用 worker 延迟配置集调整 kubelet 和 Kubernetes Controller Manager 在执行操作前等待状态更新的频率。如果在控制平面和 worker 节点间存在网络延迟,worker 节点没有处于最近状态,这个调整有助于集群可以正常工作。

这些 worker 延迟配置集包含预定义的三组参数,它们带有经过仔细调优的值,以控制集群对增加的延迟进行适当地响应。用户不需要手动进行实验以查找最佳值。

您可在安装集群时配置 worker 延迟配置集,或当您发现集群网络中的延迟增加时。

6.4.1. 了解 worker 延迟配置集