存储

在 OpenShift Container Platform 中配置和管理存储

摘要

第 1 章 OpenShift Container Platform 存储概述

OpenShift Container Platform 支持多种存储类型,包括内部存储和云供应商。您可以在 OpenShift Container Platform 集群中管理持久性和非持久性数据的容器存储。

1.1. OpenShift Container Platform 存储的常见术语表

该术语表定义了存储内容中使用的常用术语。

- 访问模式

卷访问模式描述了卷功能。您可以使用访问模式匹配持久性卷声明 (PVC) 和持久性卷 (PV)。以下是访问模式的示例:

- ReadWriteOnce (RWO)

- ReadOnlyMany (ROX)

- ReadWriteMany (RWX)

- ReadWriteOncePod (RWOP)

- Cinder

- Red Hat OpenStack Platform (RHOSP) 的块存储服务,用于管理所有卷的管理、安全性和调度。

- 配置映射

-

配置映射提供将配置数据注入 pod 的方法。您可以在类型为

ConfigMap的卷中引用存储在配置映射中的数据。在 pod 中运行的应用程序可以使用这个数据。 - Container Storage Interface (CSI)

- 在不同容器编配 (CO) 系统之间管理容器存储的 API 规格。

- 动态置备

- 该框架允许您按需创建存储卷,使集群管理员无需预置备持久性存储。

- 临时存储

- Pod 和容器可能需要临时或过渡的本地存储才能进行操作。此临时存储的生命周期不会超过每个 pod 的生命周期,且此临时存储无法在 pod 间共享。

- Fiber 频道

- 用于在数据中心、计算机服务器、交换机和存储之间传输数据的联网技术。

- FlexVolume

- FlexVolume 是一个树外插件接口,它使用基于 exec 的模型与存储驱动程序进行接口。您必须在每个节点上在预定义的卷插件路径中安装 FlexVolume 驱动程序二进制文件,并在某些情况下是 control plane 节点。

- fsGroup

- fsGroup 定义 pod 的文件系统组 ID。

- iSCSI

- 互联网小型计算机系统接口 (iSCSI) 是基于互联网协议的存储网络标准,用于连接数据存储设施。iSCSI 卷允许将现有 iSCSI (通过 IP 的 SCSI)卷挂载到您的 Pod 中。

- hostPath

- OpenShift Container Platform 集群中的 hostPath 卷将主机节点的文件系统中的文件或目录挂载到 pod 中。

- KMS 密钥

- Key Management Service (KMS) 可帮助您在不同服务间实现所需的数据加密级别。您可以使用 KMS 密钥加密、解密和重新加密数据。

- 本地卷

- 本地卷代表挂载的本地存储设备,如磁盘、分区或目录。

- NFS

- 网络文件系统(NFS)允许远程主机通过网络挂载文件系统,并像它们挂载在本地那样与这些文件系统进行交互。这使系统管理员能够将资源整合到网络上的集中式服务器上。

- OpenShift Data Foundation

- OpenShift Container Platform 支持的文件、块存储和对象存储的、内部或混合云的持久性存储供应商

- 持久性存储

- Pod 和容器可能需要永久存储才能正常工作。OpenShift Container Platform 使用 Kubernetes 持久性卷 (PV) 框架来允许集群管理员为集群提供持久性存储。开发人员可以在不了解底层存储基础架构的情况下使用 PVC 来请求 PV 资源。

- 持久性卷 (PV)

- OpenShift Container Platform 使用 Kubernetes 持久性卷 (PV) 框架来允许集群管理员为集群提供持久性存储。开发人员可以在不了解底层存储基础架构的情况下使用 PVC 来请求 PV 资源。

- 持久性卷声明 (PVC)

- 您可以使用 PVC 将 PersistentVolume 挂载到 Pod 中。您可以在不了解云环境的详情的情况下访问存储。

- Pod

- 一个或多个带有共享资源(如卷和 IP 地址)的容器,在 OpenShift Container Platform 集群中运行。pod 是定义、部署和管理的最小计算单元。

- 重新声明策略

-

告知集群在卷被释放后使用什么操作。卷重新声明政策包括

Retain、Recycle或Delete。 - 基于角色的访问控制 (RBAC)

- 基于角色的访问控制 (RBAC) 是一种根据您机构中个别用户的角色监管计算机或网络资源的访问方法。

- 无状态应用程序

- 无状态应用是一种应用程序,它不会为与客户端进行下一个会话而保持在当前会话中生成的客户端数据。

- 有状态应用程序

-

有状态应用是一种应用程序,它会将数据保存到持久磁盘存储中。服务器、客户端和应用程序可以使用持久磁盘存储。您可以使用 OpenShift Container Platform 中的

Statefulset对象来管理一组 Pod 的部署和扩展,并保证这些 Pod 的排序和唯一性。 - 静态置备

- 集群管理员创建多个 PV。PV 包含存储详情。PV 存在于 Kubernetes API 中,可供使用。

- 存储

- OpenShift Container Platform 支持许多类型的存储,包括内部存储和云供应商。您可以在 OpenShift Container Platform 集群中管理持久性和非持久性数据的容器存储。

- Storage class

- 存储类为管理员提供了描述它们所提供的存储类的方法。不同的类可能会映射到服务质量级别、备份策略,以及由集群管理员决定的任意策略。

- VMware vSphere 的虚拟机磁盘 (VMDK) 卷

- 虚拟机磁盘 (VMDK) 是一种文件格式,用于描述虚拟机中使用的虚拟硬盘的容器。

1.2. 存储类型

OpenShift Container Platform 存储广泛分为两类,即临时存储和持久性存储。

1.2.1. 临时存储

Pod 和容器具有临时或临时性,面向无状态应用。临时存储可让管理员和开发人员更好地管理其某些操作的本地存储。如需有关临时存储概述、类型和管理的更多信息,请参阅了解临时存储。

1.2.2. 持久性存储

容器中部署的有状态应用需要持久存储。OpenShift Container Platform 使用名为持久性卷(PV)的预置备存储框架来允许集群管理员置备持久性存储。这些卷中的数据可能超过单个 pod 的生命周期。开发人员可以使用持久性卷声明(PVC)来请求存储要求。如需有关持久性存储概述、配置和生命周期的更多信息,请参阅了解持久性存储。

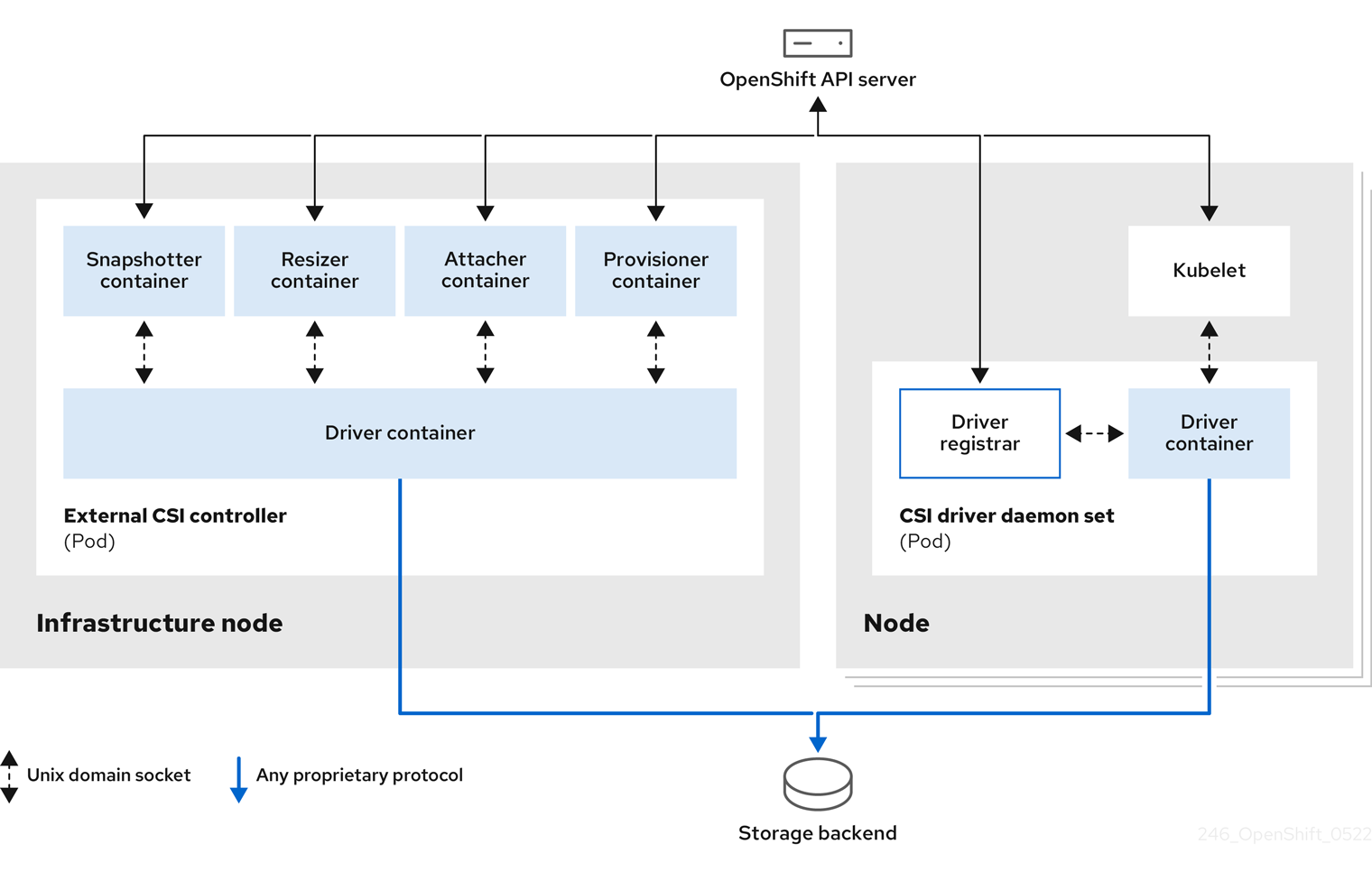

1.3. Container Storage Interface (CSI)

CSI 是在不同容器编配(CO)系统中管理容器存储的 API 规范。您可以在容器原生环境中管理存储卷,而无需具体了解底层存储基础架构。使用 CSI 时,存储可在不同的容器编配系统中有效,无论您使用的存储供应商是什么。如需有关 CSI 的更多信息,请参阅使用容器存储接口(CSI)。

1.4. 动态置备

通过动态置备,您可以按需创建存储卷,使集群管理员无需预置备存储。有关动态置备的更多信息,请参阅动态置备。

第 2 章 了解临时存储

2.1. 概述

除了持久性存储外,Pod 和容器还需要临时或短暂的本地存储才能进行操作。此临时存储的生命周期不会超过每个 pod 的生命周期,且此临时存储无法在 pod 间共享。

Pod 使用临时本地存储进行涂销空间、缓存和日志。与缺少本地存储相关的问题包括:

- Pod 无法检测到有多少可用的本地存储。

- Pod 无法请求保证的本地存储。

- 本地存储是一个最佳资源。

- pod 可能会因为其他 pod 填充本地存储而被驱除。只有在足够的存储被重新声明前,不会接受这些新 pod。

与持久性卷不同,临时存储没有特定结构,它会被节点上运行的所有 pod 共享,并同时会被系统、容器运行时和 OpenShift Container Platform 使用。临时存储框架允许 Pod 指定其临时本地存储需求。它还允许 OpenShift Container Platform 在适当的时候调度 pod,并保护节点不受过度使用本地存储的影响。

虽然临时存储框架允许管理员和开发人员更好地管理本地存储,但 I/O 吞吐量和延迟不会直接生效。

2.2. 临时存储的类型

主分区中始终提供临时本地存储。创建主分区的基本方法有两种: root 和 runtime。

root

默认情况下,该分区包含 kubelet 根目录、/var/lib/kubelet/ 和 /var/log/ 目录。此分区可以在用户 Pod、OS 和 Kubernetes 系统守护进程间共享。Pod 可以通过 EmptyDir 卷、容器日志、镜像层和容器可写层来消耗这个分区。kubelet 管理这个分区的共享访问和隔离。这个分区是临时的,应用程序无法预期这个分区中的任何性能 SLA(如磁盘 IOPS)。

Runtime

这是一个可选分区,可用于 overlay 文件系统。OpenShift Container Platform 会尝试识别并提供共享访问以及这个分区的隔离。容器镜像层和可写入层存储在此处。如果 runtime 分区存在,则 root 分区不包含任何镜像层或者其它可写入的存储。

2.3. 临时存储管理

集群管理员可以通过设置配额在非终端状态的所有 Pod 中定义临时存储的限制范围,及临时存储请求数量,来管理项目中的临时存储。开发人员也可以在 Pod 和容器级别设置这个计算资源的请求和限值。

您可以通过指定请求和限值来管理本地临时存储。pod 中的每个容器可以指定以下内容:

-

spec.containers[].resources.limits.ephemeral-storage -

spec.containers[].resources.requests.ephemeral-storage

临时存储的限制和请求以字节数量来衡量。您可以使用以下后缀之一将存储表示为普通整数或固定点号:E、P、T、G、M、k。您还可以使用两的指数:Ei、Pi、Ti、Gi、Mi Ki。例如,以下数量全部代表大约相同的值:128974848、129e6、129M 和 123Mi。后缀的大小写非常重要。如果您指定了 400m 的临时存储,这个请求 0.4 字节,而不是 400 mebibytes 字节 (400Mi) 或 400 megabytes (400M),这可能是预期的。

以下示例显示了有两个容器的 pod。每个容器请求 2GiB 本地临时存储。每个容器限制为 4GiB 本地临时存储。因此,pod 的请求为 4GiB 本地临时存储,限值为 8GiB 本地临时存储。

pod 规格中的此设置会影响调度程序对调度 pod 的决定,以及 kubelet 如何驱除 pod。首先,调度程序确保调度容器的资源请求总和小于节点的容量。在这种情况下,只有在可用临时存储(可分配资源)超过 4GiB 时,pod 才能分配给节点。

其次,在容器级别上,因为第一个容器设置了资源限值,kubelet 驱除管理器会测量此容器的磁盘用量,并在此容器的存储使用量超过其限制时驱除 pod (4GiB)。在 pod 级别,kubelet 通过添加该 pod 中所有容器的限制来达到总体 pod 存储限制。在本例中,pod 级别的总存储使用量是所有容器的磁盘用量总和,以及 pod 的 emptyDir 卷。如果这个总用量超过整个 pod 存储限制 (4GiB),则 kubelet 也会标记 pod 进行驱除。

有关为项目定义配额的详情,请参考每个项目的配额设置。

2.4. 监控临时存储

您可以使用 /bin/df 作为监控临时容器数据所在卷的临时存储使用情况的工具,即 /var/lib/kubelet 和 /var/lib/containers。如果集群管理员将 /var/lib/containers 放置在单独的磁盘上,则可以使用 df 命令来显示 /var/lib/kubelet 的可用空间。

要在 /var/lib 中显示已用和可用空间的信息,请输入以下命令:

df -h /var/lib

$ df -h /var/lib

输出显示 /var/lib 中的临时存储使用情况:

输出示例

Filesystem Size Used Avail Use% Mounted on /dev/sda1 69G 32G 34G 49% /

Filesystem Size Used Avail Use% Mounted on

/dev/sda1 69G 32G 34G 49% /第 3 章 了解持久性存储

3.1. 持久性存储概述

管理存储与管理计算资源不同。OpenShift Container Platform 使用 Kubernetes 持久性卷 (PV) 框架来允许集群管理员为集群提供持久性存储。开发者可以使用持久性卷声明 (PVC) 来请求 PV 资源而无需具体了解底层存储基础架构。

PVC 是特定于一个项目的,开发人员可创建并使用它作为使用 PV 的方法。PV 资源本身并不特定于某一个项目; 它们可以在整个 OpenShift Container Platform 集群间共享,并可以被任何项目使用。在 PV 绑定到 PVC 后,就不会将 PV 绑定到额外的 PVC。这意味着这个绑定 PV 被限制在一个命名空间(绑定的项目)中。

PV 由 PersistentVolume API 对象定义,它代表了集群中现有存储的片段,这些存储可以由集群管理员静态置备,也可以使用 StorageClass 对象动态置备。它与一个节点一样,是一个集群资源。

PV 是卷插件,与 Volumes 资源类似,但PV 的生命周期独立于任何使用它的 pod。PV 对象获取具体存储(NFS、iSCSI 或者特定 cloud-provider 的存储系统)的实现详情。

存储的高可用性功能由底层的存储架构提供。

PVC 由 PersistentVolumeClaim API 项定义,它代表了开发人员对存储的一个请求。它与一个 pod 类似,pod 会消耗节点资源, PVC 消耗 PV 资源。例如:pod 可以请求特定级别的资源,比如 CPU 和内存,而 PVC 可以请求特定的存储容量和访问模式。例如:它们可以被加载为“只允许加载一次,可读写”,或“可以加载多次,只读”。

3.2. 卷和声明的生命周期

PV 是集群中的资源。PVC 是对这些资源的请求,也是对该资源的声明检查。PV 和 PVC 之间的交互有以下生命周期。

3.2.1. 置备存储

根据 PVC 中定义的开发人员的请求,集群管理员配置一个或者多个动态置备程序用来置备存储及一个匹配的 PV。

另外,集群管理员也可以预先创建多个 PV,它们包含了可用存储的详情。PV 存在于 API 中,且可以被使用。

3.2.2. 绑定声明

当您创建 PVC 时,您会要求特定的存储量,指定所需的访问模式,并创建一个存储类来描述和分类存储。master 中的控制循环会随时检查是否有新的 PVC,并把新的 PVC 与一个适当的 PV 进行绑定。如果没有适当的 PV,则存储类的置备程序会创建一个适当的 PV。

所有 PV 的大小可能会超过 PVC 的大小。这在手动置备 PV 时尤为如此。要最小化超额,OpenShift Container Platform 将会把 PVC 绑定到匹配所有其他标准的最小 PV。

如果匹配的卷不存在,或者相关的置备程序无法创建所需的存储,则请求将会处于未绑定的状态。当出现了匹配的卷时,相应的声明就会与其绑定。例如:在一个集群中有多个手动置备的 50Gi 卷。它们无法和一个请求 100Gi 的 PVC 相匹配。当在这个集群中添加了一个 100Gi PV 时, PVC 就可以和这个 PV 绑定。

3.2.3. 使用 pod 和声明的 PV

pod 使用声明(claim)作为卷。集群通过检查声明来找到绑定的卷,并为 pod 挂载相应的卷。对于那些支持多个访问模式的卷,您必须指定作为 pod 中的卷需要使用哪种模式。

一旦您的声明被绑定后,被绑定的 PV 就会专属于您,直到您不再需要它。您可以通过在 pod 的 volumes 定义中包括 persistentVolumeClaim 来调度 pod 并访问声明的 PV。

如果将具有高文件数的持久性卷附加到 pod,则这些 pod 可能会失败,或者可能需要很长时间才能启动。如需更多信息,请参阅在 OpenShift 中使用具有高文件计数的持久性卷时,为什么 pod 无法启动或占用大量时间来实现"Ready"状态?

3.2.4. 使用中的存储对象保护

使用中的存储对象保护功能确保了被 pod 使用的活跃的 PVC 以及与其绑定的 PV 不会从系统中移除,如果删除它们可能会导致数据丢失。

使用中的存储对象保护功能被默认启用。

当使用 PVC 的 Pod 对象存在时,这个 PVC 被认为是被 Pod 使用的活跃的 PVC。

如果用户删除一个被 pod 使用的活跃的 PVC,这个 PVC 不会被立刻删除。这个删除过程会延迟到 PVC 不再被 pod 使用时才进行。另外,如果集群管理员删除了绑定到 PVC 的 PV,这个 PV 不会被立即删除。这个删除过程会延迟到 PV 不再绑定到 PVC 时才进行。

3.2.5. 释放持久性卷

当不再需要使用一个卷时,您可以从 API 中删除 PVC 对象,这样相应的资源就可以被重新声明。当声明被删除后,这个卷就被认为是已被释放,但它还不可以被另一个声明使用。这是因为之前声明者的数据仍然还保留在卷中,这些数据必须根据相关政策进行处理。

3.2.6. 持久性卷的重新声明策略

持久性卷重新声明(reclaim)策略指定了在卷被释放后集群可以如何使用它。卷重新声明政策包括 Retain、Recycle 或 Delete。

-

Retain策略可为那些支持它的卷插件手动重新声明资源。 -

Recycle策略在从其请求中释放后,将卷重新放入到未绑定的持久性卷池中。

在 OpenShift Container Platform 4 中, Recycle 重新声明策略已被弃用。我们推荐使用动态置备功能。

-

Delete策略删除 OpenShift Container Platform 以及外部基础架构(如 AWS EBS 或者 VMware vSphere)中相关的存储资源中的PersistentVolume。

动态置备的卷总是被删除。

3.2.7. 手动重新声明持久性卷

删除持久性卷生命(PVC)后,持久性卷(PV)仍然存在,并被视为"released(释放)"。但是,由于之前声明的数据保留在卷中,所以无法再使用 PV。

流程

要以集群管理员的身份手动重新声明 PV:

删除 PV。

oc delete pv <pv-name>

$ oc delete pv <pv-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 外部基础架构(如 AWS EBS、GCE PD、Azure Disk 或 Cinder 卷)中的关联的存储资产在 PV 被删除后仍然存在。

- 清理相关存储资产中的数据。

- 删除关联的存储资产。另外,若要重复使用同一存储资产,请使用存储资产定义创建新 PV。

重新声明的 PV 现在可供另一个 PVC 使用。

3.2.8. 更改持久性卷的重新声明策略

更改持久性卷的重新声明策略:

列出集群中的持久性卷:

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim3 manual 3s

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim3 manual 3sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 选择一个持久性卷并更改其重新声明策略:

oc patch pv <your-pv-name> -p '{"spec":{"persistentVolumeReclaimPolicy":"Retain"}}'$ oc patch pv <your-pv-name> -p '{"spec":{"persistentVolumeReclaimPolicy":"Retain"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 验证您选择的持久性卷是否具有正确的策略:

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Retain Bound default/claim3 manual 3s

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Retain Bound default/claim3 manual 3sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在前面的输出中,绑定到声明

default/claim3的卷现在具有Retain重新声明策略。当用户删除声明default/claim3时,这个卷不会被自动删除。

3.3. 持久性卷(PV)

每个 PV 都会包括一个 spec 和 status,它们分别代表卷的规格和状态,例如:

PersistentVolume 对象定义示例

3.3.1. PV 类型

OpenShift Container Platform 支持以下持久性卷插件:

- AliCloud Disk

- AWS Elastic Block Store (EBS)

- AWS Elastic File Store (EFS)

- Azure Disk

- Azure File

- Cinder

- Fibre Channel

- GCP 持久性磁盘

- GCP Filestore

- IBM VPC Block

- HostPath

- iSCSI

- 本地卷

- NFS

- OpenStack Manila

- Red Hat OpenShift Data Foundation

- VMware vSphere

3.3.2. 容量

一般情况下,一个持久性卷(PV)有特定的存储容量。这可以通过使用 PV 的 capacity 属性来设置。

目前,存储容量是唯一可以设置或请求的资源。以后可能会包括 IOPS 、 throughput 等属性。

3.3.3. 访问模式

一个持久性卷可以以资源供应商支持的任何方式挂载到一个主机上。不同的供应商具有不同的功能,每个 PV 的访问模式可以被设置为特定卷支持的特定模式。例如:NFS 可以支持多个读写客户端,但一个特定的 NFS PV 可能会以只读方式导出。每个 PV 都有自己一组访问模式来描述指定的 PV 功能。

声明会与有类似访问模式的卷匹配。用来进行匹配的标准只包括访问模式和大小。声明的访问模式代表一个请求。比声明要求的条件更多的资源可能会匹配,而比要求的条件更少的资源则不会被匹配。例如:如果一个声明请求 RWO,但唯一可用卷是一个 NFS PV(RWO+ROX+RWX),则该声明与这个 NFS 相匹配,因为它支持 RWO。

系统会首先尝试直接匹配。卷的模式必须与您的请求匹配,或包含更多模式。大小必须大于或等于预期值。如果两个卷类型(如 NFS 和 iSCSI)有相同的访问模式,则一个要求这个模式的声明可能会与其中任何一个进行匹配。不同的卷类型之间没有匹配顺序,在同时匹配时也无法选择特定的一个卷类型。

所有有相同模式的卷都被分组,然后按大小(由小到大)进行排序。绑定程序会获取具有匹配模式的组群,并按容量顺序进行查找,直到找到一个大小匹配的项。。

下表列出了访问模式:

| 访问模式 | CLI 缩写 | 描述 |

|---|---|---|

| ReadWriteOnce |

| 卷只可以被一个节点以读写模式挂载。 |

| ReadOnlyMany |

| 卷可以被多个节点以只读形式挂载。 |

| ReadWriteMany |

| 卷可以被多个节点以读写模式挂载。 |

卷访问模式是卷功能的描述。它们不会被强制限制。存储供应商会最终负责处理由于资源使用无效导致的运行时错误。

例如,NFS 提供 ReadWriteOnce 访问模式。如果您需要卷的访问模式为 ROX,则需要在声明中指定 read-only 。供应商中的错误会在运行时作为挂载错误显示。

iSCSI 和 Fibre Channel(光纤通道)卷目前没有隔离机制。您必须保证在同一时间点上只在一个节点使用这些卷。在某些情况下,比如对节点进行 drain 操作时,卷可以被两个节点同时使用。在对节点进行 drain 操作前,需要首先确定使用这些卷的 pod 已被删除。

| 卷插件 | ReadWriteOnce [1] | ReadOnlyMany | ReadWriteMany |

|---|---|---|---|

| AliCloud Disk |

✅ |

- |

- |

| AWS EBS [2] |

✅ |

- |

- |

| AWS EFS |

✅ |

✅ |

✅ |

| Azure File |

✅ |

✅ |

✅ |

| Azure Disk |

✅ |

- |

- |

| Cinder |

✅ |

- |

- |

| Fibre Channel |

✅ |

✅ |

✅ [3] |

| GCP 持久性磁盘 |

✅ |

- |

- |

| GCP Filestore |

✅ |

✅ |

✅ |

| HostPath |

✅ |

- |

- |

| IBM VPC 磁盘 |

✅ |

- |

- |

| iSCSI |

✅ |

✅ |

✅ [3] |

| 本地卷 |

✅ |

- |

- |

| LVM 存储 |

✅ |

- |

- |

| NFS |

✅ |

✅ |

✅ |

| OpenStack Manila |

- |

- |

✅ |

| Red Hat OpenShift Data Foundation |

✅ |

- |

✅ |

| VMware vSphere |

✅ |

- |

✅ [4] |

- ReadWriteOnce(RWO)卷不能挂载到多个节点上。如果节点失败,系统不允许将附加的 RWO 卷挂载到新节点上,因为它已经分配给了故障节点。如果因此遇到多附件错误消息,请强制在关闭或崩溃的节点上删除 pod,以避免关键工作负载中的数据丢失,例如在附加动态持久性卷时。

- 为依赖 Amazon EBS 的 pod 使用重新创建的部署策略。

- 只有原始块卷支持 ReadWriteMany (RWX) 访问模式用于光纤通道和 iSCSI。如需更多信息,请参阅 "Block volume support"。

- 如果底层 vSphere 环境支持 vSAN 文件服务,则 OpenShift Container Platform 安装的 vSphere Container Storage Interface (CSI) Driver Operator 支持 provisioning of ReadWriteMany (RWX )卷。如果您没有配置 vSAN 文件服务,且您请求 RWX,则卷将无法被创建,并记录错误。如需更多信息,请参阅"使用 Container Storage Interface" → "VMware vSphere CSI Driver Operator"。

3.3.4. 阶段

卷可以处于以下几个阶段:

| 阶段 | 描述 |

|---|---|

| Available | 可用资源,还未绑定到任何声明。 |

| Bound | 卷已绑定到一个声明。 |

| Released | 以前使用这个卷的声明已被删除,但该资源还没有被集群重新声明。 |

| Failed | 卷的自动重新声明失败。 |

使用以下命令可以查看与 PV 绑定的 PVC 名称:

oc get pv <pv_claim>

$ oc get pv <pv_claim>3.3.4.1. 挂载选项

您可以使用属性 mountOptions 在挂载 PV 时指定挂载选项。

例如:

挂载选项示例

- 1

- 在将 PV 挂载到磁盘时使用指定的挂载选项。

以下 PV 类型支持挂载选项:

- AWS Elastic Block Store (EBS)

- Azure Disk

- Azure File

- Cinder

- GCE Persistent Disk

- iSCSI

- 本地卷

- NFS

- Red Hat OpenShift Data Foundation(仅限 Ceph RBD)

- VMware vSphere

Fibre Channel 和 HostPath PV 不支持挂载选项。

3.4. 持久性卷声明 (PVC)

每个 PersistentVolumeClaim 对象都会包括一个 spec 和 status,它们分别代表了声明的规格和状态。例如:

PersistentVolumeClaim 对象定义示例

3.4.1. 存储类

另外,通过在 storageClassName 属性中指定存储类的名称,声明可以请求一个特定的存储类。只有具有请求的类的 PV( storageClassName的值与 PVC 中的值相同)才会与 PVC 绑定。集群管理员可配置动态置备程序为一个或多个存储类提供服务。集群管理员可根据需要创建与 PVC 的规格匹配的 PV。

根据使用的平台,Cluster Storage Operator 可能会安装一个默认的存储类。此存储类由 Operator 拥有和控制。不能在定义注解和标签之外将其删除或修改。如果需要实现不同的行为,则必须定义自定义存储类。

集群管理员也可以为所有 PVC 设置默认存储类。当配置了默认存储类时, PVC 必须明确要求将存储类 StorageClass 或 storageClassName设为 "", 以便绑定到没有存储类的 PV。

如果一个以上的存储类被标记为默认,则只能在 storageClassName 被显式指定时才能创建 PVC。因此,应只有一个存储类被设置为默认值。

3.4.2. 访问模式

声明在请求带有特定访问权限的存储时,使用与卷相同的格式。

3.4.3. Resources

象 pod 一样,声明可以请求具体数量的资源。在这种情况下,请求用于存储。同样的资源模型适用于卷和声明。

3.4.4. 声明作为卷

pod 通过将声明作为卷来访问存储。在使用声明时,声明需要和 pod 位于同一个命名空间。集群在 pod 的命名空间中找到声明,并使用它来使用这个声明后台的PersistentVolume。卷被挂载到主机和 pod 中,例如:

挂载卷到主机和 pod 示例

3.5. 块卷支持

OpenShift Container Platform 可以静态置备原始块卷。这些卷没有文件系统。对于可以直接写入磁盘或者实现其自己的存储服务的应用程序来说,使用它可以获得性能优势。

原始块卷可以通过在 PV 和 PVC 规格中指定 volumeMode: Block来置备。

使用原始块卷的 pod 需要配置为允许特权容器。

下表显示了哪些卷插件支持块卷。

| 卷插件 | 手动置备 | 动态置备 | 完全支持 |

|---|---|---|---|

| AliCloud Disk | ✅ | ✅ | ✅ |

| AWS EBS | ✅ | ✅ | ✅ |

| AWS EFS | |||

| Azure Disk | ✅ | ✅ | ✅ |

| Azure File | |||

| Cinder | ✅ | ✅ | ✅ |

| Fibre Channel | ✅ | ✅ | |

| GCP | ✅ | ✅ | ✅ |

| HostPath | |||

| IBM VPC 磁盘 | ✅ | ✅ | ✅ |

| iSCSI | ✅ | ✅ | |

| 本地卷 | ✅ | ✅ | |

| LVM 存储 | ✅ | ✅ | ✅ |

| NFS | |||

| Red Hat OpenShift Data Foundation | ✅ | ✅ | ✅ |

| VMware vSphere | ✅ | ✅ | ✅ |

可手动置备但未提供完全支持的块卷作为技术预览功能提供。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

3.5.1. 块卷示例

PV 示例

- 1

- 需要把

volumeMode设置为Block来代表这个 PV 是一个原始块卷。

PVC 示例

- 1

- 需要把

volumeMode设置为Block来代表请求一个原始块 PVC。

Pod 规格示例

| 值 | 默认 |

|---|---|

| Filesystem | 是 |

| Block | 否 |

PV volumeMode | PVC volumeMode | 绑定结果 |

|---|---|---|

| Filesystem | Filesystem | 绑定 |

| Unspecified | Unspecified | 绑定 |

| Filesystem | Unspecified | 绑定 |

| Unspecified | Filesystem | 绑定 |

| Block | Block | 绑定 |

| Unspecified | Block | 无绑定 |

| Block | Unspecified | 无绑定 |

| Filesystem | Block | 无绑定 |

| Block | Filesystem | 无绑定 |

未指定值时将使用默认值 Filesystem。

3.6. 使用 fsGroup 减少 pod 超时

如果存储卷包含很多文件(1,000,000 或更多),您可能会遇到 pod 超时问题。

这是因为,在默认情况下,OpenShift Container Platform 会递归更改每个卷内容的所有权和权限,以便在挂载卷时与 pod 的 securityContext 中指定的 fsGroup 匹配。对于大型卷,检查和更改所有权和权限可能会非常耗时,从而会减慢 pod 启动的速度。您可以使用 securityContext 中的 fsGroupChangePolicy 字段来控制 OpenShift Container Platform 检查和管理卷的所有权和权限的方式。

fsGroupChangePolicy 定义在 pod 中公开卷之前更改卷的所有权和权限的行为。此字段仅适用于支持 fsGroup- 控制的所有权和权限。此字段有两个可能的值:

-

OnRootMismatch:仅当 root 目录的权限和所有权与卷的预期权限不匹配时才会更改权限和所有权。这有助于缩短更改卷的所有权和权限所需的时间,以减少 pod 超时。 -

Always:当卷被挂载时,始终更改卷的权限和所有权。

fsGroupChangePolicy 示例

- 1

OnRootMismatch指定跳过递归权限更改,这有助于避免 pod 超时问题。

fsGroupChangePolicyfield 对临时卷类型没有影响,如 secret、configMap 和 emptydir。

第 4 章 配置持久性存储

4.1. 使用 AWS Elastic Block Store 的持久性存储

OpenShift Container Platform 支持 AWS Elastic Block Store 卷 (EBS) 。您可以使用 Amazon EC2 为 OpenShift Container Platform 集群置备持久性存储。

Kubernetes 持久性卷框架允许管理员提供带有持久性存储的集群,并使用户可以在不了解底层存储架构的情况下请求这些资源。您可以动态置备 AWS EBS 卷。持久性卷不与某个特定项目或命名空间相关联,它们可以在 OpenShift Container Platform 集群间共享。持久性卷声明是针对某个项目或者命名空间的,相应的用户可请求它。您可以定义 KMS 密钥来加密 AWS 上的 container-persistent 卷。

OpenShift Container Platform 默认使用 in-tree 或非 Container Storage Interface (CSI) 插件来置备 AWS EBS 存储。在以后的 OpenShift Container Platform 版本中,计划使用现有树内插件置备的卷迁移到对应的 CSI 驱动程序。

CSI 自动迁移应该可以无缝进行。迁移不会改变您使用所有现有 API 对象的方式,如持久性卷、持久性卷声明和存储类。有关迁移的更多信息,请参阅 CSI 自动迁移。

完全迁移后,未来的 OpenShift Container Platform 版本将最终删除树内插件。

存储的高可用性功能由底层存储供应商实现。

OpenShift Container Platform 4.12 及更新的版本为 AWS Block in-tree 卷插件提供自动迁移到对应的 CSI 驱动程序。

CSI 自动迁移应该可以无缝进行。迁移不会改变您使用所有现有 API 对象的方式,如持久性卷、持久性卷声明和存储类。有关迁移的更多信息,请参阅 CSI 自动迁移。

4.1.1. 创建 EBS 存储类

存储类用于区分和划分存储级别和使用。通过定义存储类,用户可以获得动态置备的持久性卷。

4.1.2. 创建持久性卷声明

先决条件

当存储可以被挂载为 OpenShift Container Platform 中的卷之前,它必须已存在于底层的存储系统中。

流程

- 在 OpenShift Container Platform 控制台中,点击 Storage → Persistent Volume Claims。

- 在持久性卷声明概述页中,点 Create Persistent Volume Claim。

在出现的页面中定义所需选项。

- 从下拉菜单中选择之前创建的存储类。

- 输入存储声明的唯一名称。

- 选择访问模式。此选择决定了存储声明的读写访问权限。

- 定义存储声明的大小。

- 点击 Create 创建持久性卷声明,并生成一个持久性卷。

4.1.3. 卷格式

在 OpenShift Container Platform 挂载卷并将其传递给容器之前,它会检查卷是否包含由持久性卷定义中的 fsType 参数指定的文件系统。如果没有使用文件系统格式化该设备,该设备中的所有数据都会被删除,并使用指定的文件系统自动格式化该设备。

此验证可让您将未格式化的 AWS 卷用作持久性卷,因为 OpenShift Container Platform 在首次使用前会进行格式化。

4.1.4. 一个节点上的 EBS 卷的最大数目

默认情况下,OpenShift Container Platform 最多支持把 39 个 EBS 卷附加到一个节点。这个限制与 AWS 卷限制一致。卷限制取决于实例类型。

作为集群管理员,您必须使用树内或 Container Storage Interface(CSI)卷及其相应的存储类,但不得同时使用这两个卷类型。对于 in-tree 和 CSI 卷,最大附加的 EBS 卷数量会单独计算,因此每种类型您都最多可以有 39 个 EBS 卷。

有关访问额外存储选项(如卷快照)的详情,请参考 AWS Elastic Block Store CSI Driver Operator。

4.1.5. 使用 KMS 密钥在 AWS 上加密容器持久性卷

在部署到 AWS 时,定义在 AWS 上加密容器持久性卷的 KMS 密钥很有用。

先决条件

- 底层基础架构必须包含存储。

- 您必须在 AWS 上创建客户 KMS 密钥。

流程

创建存储类:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定存储类的名称。

- 2

- 在置备的卷中创建的文件系统。

- 3

- 指定加密 container-persistent 卷时要使用的密钥的完整 Amazon 资源名称 (ARN)。如果没有提供任何密钥,但

encrypted字段被设置为true,则使用默认的 KMS 密钥。请参阅 AWS 文档中的查找 AWS 的密钥 ID 和密钥 ARN。

使用指定 KMS 密钥的存储类创建 PVC:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建工作负载容器以使用 PVC:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. 使用 Azure 持久性存储

OpenShift Container Platform 支持 Microsoft Azure Disk 卷。您可以使用 Azure 为 OpenShift Container Platform 集群置备永久性存储。我们假设您对 Kubernetes 和 Azure 有一定的了解。Kubernetes 持久性卷框架允许管理员提供带有持久性存储的集群,并使用户可以在不了解底层存储架构的情况下请求这些资源。Azure 磁盘卷可以动态部署。持久性卷不与某个特定项目或命名空间相关联,它们可以在 OpenShift Container Platform 集群间共享。持久性卷声明是针对某个项目或者命名空间的,相应的用户可请求它。

OpenShift Container Platform 4.11 及之后的版本为 Azure Disk in-tree 卷插件提供自动迁移到对应的 CSI 驱动程序。

CSI 自动迁移应该可以无缝进行。迁移不会改变您使用所有现有 API 对象的方式,如持久性卷、持久性卷声明和存储类。有关迁移的更多信息,请参阅 CSI 自动迁移。

存储的高可用性功能由底层的存储架构提供。

4.2.1. 创建 Azure 存储类

存储类用于区分和划分存储级别和使用。通过定义存储类,用户可以获得动态置备的持久性卷。

流程

- 在 OpenShift Container Platform 控制台中点击 Storage→ Storage Classes。

- 在存储类概述中,点击 Create Storage Class。

在出现的页面中定义所需选项。

- 输入一个名称来指代存储类。

- 输入描述信息(可选)。

- 选择 reclaim 策略。

从下拉列表中选择

kubernetes.io/azure-disk。-

输入存储帐户类型。这与您的 Azure 存储帐户 SKU 层对应。有效选项为

Premium_LRS、Standard_LRS、StandardSSD_LRS和UltraSSD_LRS。 输入帐户类型。有效选项为

shared、dedicated和managed.重要红帽仅在存储类中支持使用

kind: Managed。使用

Shared和Dedicated时,Azure 会创建非受管磁盘,而 OpenShift Container Platform 为机器 OS(root)磁盘创建一个受管磁盘。但是,因为 Azure Disk 不允许在节点上同时使用受管和非受管磁盘,所以使用Shared或Dedicated创建的非受管磁盘无法附加到 OpenShift Container Platform 节点。

-

输入存储帐户类型。这与您的 Azure 存储帐户 SKU 层对应。有效选项为

- 根据需要为存储类输入附加参数。

- 点 Create 创建存储类。

4.2.2. 创建持久性卷声明

先决条件

当存储可以被挂载为 OpenShift Container Platform 中的卷之前,它必须已存在于底层的存储系统中。

流程

- 在 OpenShift Container Platform 控制台中,点击 Storage → Persistent Volume Claims。

- 在持久性卷声明概述页中,点 Create Persistent Volume Claim。

在出现的页面中定义所需选项。

- 从下拉菜单中选择之前创建的存储类。

- 输入存储声明的唯一名称。

- 选择访问模式。此选择决定了存储声明的读写访问权限。

- 定义存储声明的大小。

- 点击 Create 创建持久性卷声明,并生成一个持久性卷。

4.2.3. 卷格式

在 OpenShift Container Platform 挂载卷并将其传递给容器之前,它会检查它是否包含由 fstype 参数指定的文件系统。如果没有使用文件系统格式化该设备,该设备中的所有数据都会被删除,并使用指定的文件系统自动格式化该设备。

这将可以使用未格式化的 Azure 卷作为持久性卷,因为 OpenShift Container Platform 在第一次使用前会对其进行格式化。

4.2.4. 用于部署带有使用 PVC 的巨型磁盘的机器的机器集

您可以创建在 Azure 上运行的机器集,该机器集用来部署带有巨型磁盘的机器。ultra 磁盘是高性能存储,用于要求最苛刻的数据工作负载。

in-tree 插件和 CSI 驱动程序都支持使用 PVC 启用巨型 磁盘。您还可以在不创建 PVC 的情况下将巨型磁盘部署为数据磁盘。

4.2.4.1. 使用机器集创建带有巨型磁盘的机器

您可以通过编辑机器集 YAML 文件在 Azure 上部署带有巨型磁盘的机器。

先决条件

- 已有 Microsoft Azure 集群。

流程

运行以下命令,复制现有的 Azure

MachineSet自定义资源(CR)并编辑它:oc edit machineset <machine_set_name>

$ oc edit machineset <machine_set_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中

<machine_set_name>是您要使用巨型磁盘置备机器的机器集。在指示的位置中添加以下行:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,使用更新的配置创建机器集:

oc create -f <machine_set_name>.yaml

$ oc create -f <machine_set_name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个包含以下 YAML 定义的存储类:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个持久性卷声明(PVC)来引用包含以下 YAML 定义的

ultra-disk-sc存储类:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建包含以下 YAML 定义的 pod:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

运行以下命令验证机器是否已创建:

oc get machines

$ oc get machinesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 机器应处于

Running状态。对于正在运行并附加节点的机器,请运行以下命令验证分区:

oc debug node/<node_name> -- chroot /host lsblk

$ oc debug node/<node_name> -- chroot /host lsblkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在这个命令中,

oc debug node/<node_name>在节点<node_name>上启动一个调试 shell,并传递一个带有--的命令。传递的命令chroot /host提供对底层主机操作系统二进制文件的访问,lsblk显示连接至主机操作系统计算机的块设备。

后续步骤

要在 pod 中使用大量磁盘,请创建使用挂载点的工作负载。创建一个类似以下示例的 YAML 文件:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.4.2. 启用 ultra 磁盘的机器集的故障排除资源

使用本节中的信息从您可能会遇到的问题了解和恢复。

4.2.4.2.1. 无法挂载由巨型磁盘支持的持久性卷声明

如果挂载了被巨型磁盘支持的持久性卷声明的问题,pod 会一直处于 ContainerCreating 状态,并触发警报。

例如,如果没有在支持托管 pod 的节点的机器上设置 additionalCapabilities.ultraSSDEnabled 参数,则会出现以下出错信息:

StorageAccountType UltraSSD_LRS can be used only when additionalCapabilities.ultraSSDEnabled is set.

StorageAccountType UltraSSD_LRS can be used only when additionalCapabilities.ultraSSDEnabled is set.要解决这个问题,请运行以下命令来描述 pod:

oc -n <stuck_pod_namespace> describe pod <stuck_pod_name>

$ oc -n <stuck_pod_namespace> describe pod <stuck_pod_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3. 使用 Azure File 的持久性存储

OpenShift Container Platform 支持 Microsoft Azure File 卷。您可以使用 Azure 为 OpenShift Container Platform 集群置备永久性存储。我们假设您对 Kubernetes 和 Azure 有一定的了解。

Kubernetes 持久性卷框架允许管理员提供带有持久性存储的集群,并使用户可以在不了解底层存储架构的情况下请求这些资源。您可以动态置备 Azure File 卷。

持久性卷不绑定到单个项目或命名空间,您可以在 OpenShift Container Platform 集群中共享它们。持久性卷声明是针对某个项目或命名空间的,应用程序中可以请求它的用户。

存储的高可用性功能由底层的存储架构提供。

Azure File 卷使用服务器消息块。

在以后的 OpenShift Container Platform 版本中,计划使用现有树内插件置备的卷迁移到对应的 CSI 驱动程序。CSI 自动迁移应该可以无缝进行。迁移不会改变您使用所有现有 API 对象的方式,如持久性卷、持久性卷声明和存储类。有关迁移的更多信息,请参阅 CSI 自动迁移。

完全迁移后,未来的 OpenShift Container Platform 版本将最终删除树内插件。

其他资源

4.3.1. 创建 Azure File 共享持久性卷声明

要创建持久性卷声明,您必须首先定义一个包含 Azure 帐户和密钥的 Secret 对象。此 secret 在 PersistentVolume 定义中使用,应用程序中使用的持久性卷声明将引用该 secret。

先决条件

- 已存在 Azure File 共享。

- 有访问此共享所需的凭证,特别是存储帐户和密钥。

流程

创建包含 Azure File 凭证的

Secret对象:oc create secret generic <secret-name> --from-literal=azurestorageaccountname=<storage-account> \ --from-literal=azurestorageaccountkey=<storage-account-key>

$ oc create secret generic <secret-name> --from-literal=azurestorageaccountname=<storage-account> \1 --from-literal=azurestorageaccountkey=<storage-account-key>2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建引用您创建的

Secret对象的PersistentVolume对象:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建映射到您创建的持久性卷的

PersistentVolumeClaim对象:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.2. 在 pod 中挂载 Azure File 共享

创建持久性卷声明后,应用程序就可以使用它。以下示例演示了在 pod 中挂载此共享。

先决条件

- 已存在一个映射到底层 Azure File 共享的持久性卷声明。

4.4. 使用 Cinder 的持久性存储

OpenShift Container Platform 支持 OpenStack Cinder。我们假设您对 Kubernetes 和 OpenStack 有一定的了解。

Cinder 卷可以动态置备。持久性卷不与某个特定项目或命名空间相关联,它们可以在 OpenShift Container Platform 集群间共享。持久性卷声明是针对某个项目或者命名空间的,相应的用户可请求它。

OpenShift Container Platform 4.11 及之后的版本为 Cinder in-tree 卷插件提供自动迁移到对应的 CSI 驱动程序。

CSI 自动迁移应该可以无缝进行。迁移不会改变您使用所有现有 API 对象的方式,如持久性卷、持久性卷声明和存储类。有关迁移的更多信息,请参阅 CSI 自动迁移。

4.4.1. 使用 Cinder 手动置备

当存储可以被挂载为 OpenShift Container Platform 中的卷之前,它必须已存在于底层的存储系统中。

先决条件

- 为 Red Hat OpenStack Platform(RHOSP)配置 OpenShift Container Platform

- Cinder 卷 ID

4.4.1.1. 创建持久性卷

您必须在对象定义中定义持久性卷 (PV) ,然后才能在 OpenShift Container Platform 中创建它:

流程

将对象定义保存到文件中。

cinder-persistentvolume.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要在卷被格式化并置备后,不要更改

fstype参数的值。更改此值可能会导致数据丢失和 pod 失败。创建在上一步中保存的对象定义文件。

oc create -f cinder-persistentvolume.yaml

$ oc create -f cinder-persistentvolume.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.1.2. 持久性卷格式化

因为 OpenShift Container Platform 在首次使用卷前会进行格式化,所以可以使用未格式化的 Cinder 卷作为 PV。

在 OpenShift Container Platform 挂载卷并将其传递给容器之前,它会检查在 PV 定义中是否包含由 fsType 参数指定的文件系统。如果没有使用文件系统格式化该设备,该设备中的所有数据都会被删除,并使用指定的文件系统自动格式化该设备。

4.4.1.3. Cinder 卷安全

如果在应用程序中使用 Cinder PV,请在其部署配置中配置安全性。

先决条件

-

必须创建一个使用适当

fsGroup策略的 SCC。

流程

创建一个服务帐户并将其添加到 SCC:

oc create serviceaccount <service_account>

$ oc create serviceaccount <service_account>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm policy add-scc-to-user <new_scc> -z <service_account> -n <project>

$ oc adm policy add-scc-to-user <new_scc> -z <service_account> -n <project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在应用程序的部署配置中,提供服务帐户名称和

securityContext:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. 使用 Fibre Channel 持久性存储

OpenShift Container Platform 支持 Fibre Channel,它允许您使用 Fibre Channel 卷为 OpenShift Container Platform 集群提供持久性存储。我们假设您对 Kubernetes 和 Fibre Channel 有一定的了解。

基于 ARM 架构的基础架构不支持使用 Fibre Channel 的持久性存储。

Kubernetes 持久性卷框架允许管理员提供带有持久性存储的集群,并使用户可以在不了解底层存储架构的情况下请求这些资源。持久性卷不与某个特定项目或命名空间相关联,它们可以在 OpenShift Container Platform 集群间共享。持久性卷声明是针对某个项目或者命名空间的,相应的用户可请求它。

存储的高可用性功能由底层的存储架构提供。

4.5.1. 置备

要使用 PersistentVolume API 置备 Fibre Channel 卷,必须提供以下内容:

-

targetWWNs(Fibre Channel 阵列目标的 World Wide Names)。 - 一个有效的 LUN 号码。

- 文件系统类型。

持久性卷和 LUN 之间有一个一对一的映射。

先决条件

- Fibre Channel LUN 必须存在于底层系统中。

PersistentVolume 对象定义

- 1

- 全局广泛的标识符(WWID)。FC

wwids或 FC 目标WWN和lun的组合必须设置,但不能同时设置。建议在 WWN 目标中使用 FC WWID 标识符,因为它可以保证每个存储设备独有,并且独立于用于访问该设备的路径。通过发出 SCSI Indentification Vital Product Data(page 0x83)或单元 Serial Number(page 0x80)来获得 WWID 标识符。FC WWID 被标识为/dev/disk/by-id/来引用磁盘上的数据,即使设备的路径发生了变化,即使从不同系统访问该设备也是如此。 - 2 3

- Fibre Channel WWN 由

/dev/disk/by-path/pci-<IDENTIFIER>-fc-0x<WWN>-lun-<LUN#>代表,但您不需要提供WWN之前(包括0x)和以后(包括-)的部分。

在卷被格式化并置备后,修改 fstype 参数的值会导致数据丢失和 pod 失败。

4.5.1.1. 强制磁盘配额

使用 LUN 分区强制磁盘配额和大小限制。每个 LUN 都被映射到一个持久性卷,持久性卷必须使用唯一的名称。

采用这种方法强制配额可让最终用户以特定数量(如 10Gi)请求持久性存储,并可与相等或更大容量的卷进行匹配。

4.5.1.2. Fibre Channel 卷安全

用户使用持久性卷声明来请求存储。这个声明只在用户的命名空间中有效,且只能被同一命名空间中的 pod 使用。任何尝试访问命名空间中的持久性卷都会导致 pod 失败。

每个 Fibre Channel LUN 必须可以被集群中的所有节点访问。

4.6. 使用 FlexVolume 的持久性存储

FlexVolume 是一个已弃用的功能。弃用的功能仍然包含在 OpenShift Container Platform 中,并将继续被支持。但是,这个功能会在以后的发行版本中被删除,且不建议在新的部署中使用。

虚拟机监控程序 Container Storage Interface(CSI)驱动程序是在 OpenShift Container Platform 中写入卷驱动程序的建议方法。FlexVolume 驱动程序的维护者应该实施 CSI 驱动程序,并将 FlexVolume 用户移到 CSI。FlexVolume 的用户应该将其工作负载移到 CSI 驱动程序。

有关 OpenShift Container Platform 中已弃用或删除的主要功能的最新列表,请参阅 OpenShift Container Platform 发行注记中已弃用和删除的功能部分。

OpenShift Container Platform 支持 FlexVolume,这是一个树外插件,使用可执行模型与驱动程序进行接口。

要从没有内置插件的后端使用存储,您可以通过 FlexVolume 驱动程序来扩展 OpenShift Container Platform,并为应用程序提供持久性存储。

Pod 通过 flexvolume 树内插件与 FlexVolume 驱动程序交互。

4.6.1. 关于 FlexVolume 驱动程序

FlexVolume 驱动程序是一个可执行文件,它位于集群中所有节点的一个明确定义的目录中。OpenShift Container Platform 会在需要挂载或卸载由带有 flexVolume 的 PersistentVolume 对象代表的卷时调用 FlexVolume 驱动程序。

OpenShift Container Platform 不支持 FlexVolume 的 attach 和 detach 操作。

4.6.2. FlexVolume 驱动程序示例

FlexVolume 驱动程序的第一个命令行参数始终是一个操作名称。其他参数都针对于每个操作。大多数操作都使用 JSON 字符串作为参数。这个参数是一个完整的 JSON 字符串,而不是包括 JSON 数据的文件名称。

FlexVolume 驱动程序包含:

-

所有

flexVolume.options。 -

flexVolume的一些选项带有kubernetes.io/前缀 ,如fsType和readwrite。 -

如果使用 secret,secret 的内容带有

kubernetes.io/secret/前缀。

FlexVolume 驱动程序 JSON 输入示例

OpenShift Container Platform 需要有关驱动程序标准输出的 JSON 数据。如果没有指定,输出会描述操作的结果。

FlexVolume 驱动程序默认输出示例

{

"status": "<Success/Failure/Not supported>",

"message": "<Reason for success/failure>"

}

{

"status": "<Success/Failure/Not supported>",

"message": "<Reason for success/failure>"

}

驱动程序的退出代码应该为 0(成功),或 1(失败) 。

操作应该是”幂等”的,这意味着挂载一个已被挂载的卷的结果是一个成功的操作。

4.6.3. 安装 FlexVolume 驱动程序

用于扩展 OpenShift Container Platform 的 FlexVolume 驱动程序仅在节点上执行。要实现 FlexVolume,需要调用的操作列表和安装路径都是必需的。

先决条件

FlexVolume 驱动程序必须实现以下操作:

init初始化驱动程序。它会在初始化所有节点的过程中被调用。

- 参数: 无

- 执行于:节点

- 预期输出:默认 JSON

mount挂载一个卷到目录。这可包括挂载该卷所需的任何内容,包括查找该设备,然后挂载该设备。

-

参数:

<mount-dir><json> - 执行于:节点

- 预期输出:默认 JSON

-

参数:

unmount从目录中卸载卷。这可以包括在卸载后清除卷所必需的任何内容。

-

参数:

<mount-dir> - 执行于:节点

- 预期输出:默认 JSON

-

参数:

mountdevice- 将卷的设备挂载到一个目录,然后 pod 可以从这个目录绑定挂载。

这个 call-out 不会传递 FlexVolume spec 中指定的 "secrets"。如果您的驱动需要 secret,不要实现这个 call-out。

-

参数:

<mount-dir><json> - 执行于:节点

预期输出:默认 JSON

unmountdevice- 从目录中卸载卷的设备。

-

参数:

<mount-dir> - 执行于:节点

预期输出:默认 JSON

-

所有其他操作都应该返回带有

{"status":"Not supported"}及退出代码1的 JSON。

-

所有其他操作都应该返回带有

流程

安装 FlexVolume 驱动程序:

- 确保可执行文件存在于集群中的所有节点上。

-

将可执行文件放在卷插件路径:

/etc/kubernetes/kubelet-plugins/volume/exec/<vendor>~<driver>/<driver>。

例如,要为存储 foo 安装 FlexVolume 驱动程序,请将可执行文件放在: /etc/kubernetes/kubelet-plugins/volume/exec/openshift.com~foo/foo。

4.6.4. 使用 FlexVolume 驱动程序消耗存储

OpenShift Container Platform 中的每个 PersistentVolume 都代表存储后端中的一个存储资产,例如一个卷。

流程

-

使用

PersistentVolume对象来引用已安装的存储。

使用 FlexVolume 驱动程序示例定义持久性卷对象

- 1

- 卷的名称。这是如何通过持久性卷声明或从 pod 识别它。这个名称可以与后端存储中的卷的名称不同。

- 2

- 为这个卷分配的存储量。

- 3

- 驱动程序的名称。这个字段是必须的。

- 4

- 卷中的文件系统。这个字段是可选的。

- 5

- 对 secret 的引用。此 secret 中的键和值在调用时会提供给 FlexVolume 驱动程序。这个字段是可选的。

- 6

- read-only 标记。这个字段是可选的。

- 7

- FlexVolume 驱动程序的额外选项。除了用户在

options字段中指定的标记外,以下标记还会传递给可执行文件:"fsType":"<FS type>", "readwrite":"<rw>", "secret/key1":"<secret1>" ... "secret/keyN":"<secretN>"

"fsType":"<FS type>", "readwrite":"<rw>", "secret/key1":"<secret1>" ... "secret/keyN":"<secretN>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

secret 只会传递到 mount 或 unmount call-outs。

4.7. 使用 GCE Persistent Disk 的持久性存储

OpenShift Container Platform 支持 GCE Persistent Disk 卷 (gcePD)。您可以使用 GCE 为 OpenShift Container Platform 集群置备持久性存储。我们假设您对 Kubernetes 和 GCE 有一定的了解。

Kubernetes 持久性卷框架允许管理员提供带有持久性存储的集群,并使用户可以在不了解底层存储架构的情况下请求这些资源。

GCE Persistent Disk 卷可以动态部署。

持久性卷不与某个特定项目或命名空间相关联,它们可以在 OpenShift Container Platform 集群间共享。持久性卷声明是针对某个项目或者命名空间的,相应的用户可请求它。

OpenShift Container Platform 4.12 及更新的版本为 GCE Persist Disk in-tree 卷插件提供自动迁移到对应的 CSI 驱动程序。

CSI 自动迁移应该可以无缝进行。迁移不会改变您使用所有现有 API 对象的方式,如持久性卷、持久性卷声明和存储类。

有关迁移的更多信息,请参阅 CSI 自动迁移。

存储的高可用性功能由底层的存储架构提供。

4.7.1. 创建 GCE 存储类

存储类用于区分和划分存储级别和使用。通过定义存储类,用户可以获得动态置备的持久性卷。

4.7.2. 创建持久性卷声明

先决条件

当存储可以被挂载为 OpenShift Container Platform 中的卷之前,它必须已存在于底层的存储系统中。

流程

- 在 OpenShift Container Platform 控制台中,点击 Storage → Persistent Volume Claims。

- 在持久性卷声明概述页中,点 Create Persistent Volume Claim。

在出现的页面中定义所需选项。

- 从下拉菜单中选择之前创建的存储类。

- 输入存储声明的唯一名称。

- 选择访问模式。此选择决定了存储声明的读写访问权限。

- 定义存储声明的大小。

- 点击 Create 创建持久性卷声明,并生成一个持久性卷。

4.7.3. 卷格式

在 OpenShift Container Platform 挂载卷并将其传递给容器之前,它会检查卷是否包含由持久性卷定义中的 fsType 参数指定的文件系统。如果没有使用文件系统格式化该设备,该设备中的所有数据都会被删除,并使用指定的文件系统自动格式化该设备。

此验证可让您将未格式化的 GCE 卷用作持久性卷,因为 OpenShift Container Platform 在首次使用前会进行格式化。

4.8. 使用 iSCSI 的持久性存储

您可以使用 iSCSI为 OpenShift Container Platform 集群提供持久性存储。我们假设您对 Kubernetes 和 iSCSI 有一定的了解。

Kubernetes 持久性卷框架允许管理员提供带有持久性存储的集群,并使用户可以在不了解底层存储架构的情况下请求这些资源。

存储的高可用性功能由底层存储供应商实现。

当您在 Amazon Web Services 上使用 iSCSI 时,必须更新默认的安全策略,使其包含 iSCSI 端口中节点间的 TCP 流量。默认情况下,它们是端口 860 和 3260。

用户必须通过安装 iscsi-initiator-utils 软件包并在 /etc/iscsi/initiatorname.iscsi 中配置启动器名称,确保所有 OpenShift Container Platform 节点上已配置了 iSCSI 启动器。iscsi-initiator-utils 软件包已在使用 Red Hat Enterprise Linux CoreOS (RHCOS) 的部署中安装。

如需更多信息,请参阅管理存储设备。

4.8.1. 置备

在将存储作为卷挂载到 OpenShift Container Platform 之前,请确认它已存在于底层的基础架构中。iSCSI 需要的是 iSCSI 目标门户,一个有效的 iSCSI 限定名称 (IQN) ,一个有效的 LUN 号码,文件系统类型,以及 persistenceVolume API。

PersistentVolume 对象定义

4.8.2. 强制磁盘配额

使用 LUN 分区强制磁盘配额和大小限制。每个 LUN 都是一个持久性卷。kubernetes 为持久性卷强制使用唯一的名称。

以这种方式强制配额可让最终用户以特定数量(如 10Gi)请求持久性存储,并与相等或更大容量的对应卷匹配。

4.8.3. iSCSI 卷安全

用户使用 PersistentVolumeClaim 对象请求存储。这个声明只在用户的命名空间中有效,且只能被在同一命名空间中的 pod 调用。尝试使用其他命名空间中的持久性卷声明会导致 pod 失败。

每个 iSCSI LUN 都需要可以被集群中的所有节点访问。

另外,OpenShift Container Platform 可以使用 CHAP 在 iSCSI 目标中验证自己:

4.8.4. iSCSI 多路径

对于基于 iSCSI 的存储,您可以使用相同的 IQN 为多个目标入口 IP 地址配置多路径。通过多路径,当路径中的一个或者多个组件失败时,仍可保证对持久性卷的访问。

要在 pod 规格中指定多路径,请使用 portals 字段。例如:

- 1

- 使用

portals字段添加额外的目标门户。

4.8.5. iSCSI 自定义 initiator IQN

如果 iSCSI 目标仅限于特定的 IQN,则配置自定义 initiator iSCSI 限定名称 (IQN) ,但不会保证 iSCSI PV 附加到的节点具有这些 IQN。

使用 initiatorName 字段指定一个自定义 initiator IQN。

- 1

- 指定 initiator 的名称。

4.9. 使用 NFS 的持久性存储

OpenShift Container Platform 集群可以使用 NFS 来置备持久性存储。持久性卷 (PV) 和持久性卷声明 (PVC) 提供了在项目间共享卷的方法。虽然 PV 定义中包含的与 NFS 相关的信息也可以直接在 Pod 中定义,但是这样做不会使创建的卷作为一个特定的集群资源,从而可能会导致卷冲突。

4.9.1. 置备

当存储可以被挂载为 OpenShift Container Platform 中的卷之前,它必须已存在于底层的存储系统中。要置备 NFS 卷,则需要一个 NFS 服务器和导出路径列表。

流程

为 PV 创建对象定义:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意每个 NFS 卷都必须由集群中的所有可调度节点挂载。

确定创建了 PV:

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWO Available 31s

NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWO Available 31sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建绑定至新 PV 的持久性卷声明:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 确认创建了持久卷声明:

oc get pvc

$ oc get pvcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE nfs-claim1 Bound pv0001 5Gi RWO 2m

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE nfs-claim1 Bound pv0001 5Gi RWO 2mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.9.2. 强制磁盘配额

使用磁盘分区强制磁盘配额和大小限制。每个分区都可以有自己的导出。每个导出都是一个 PV。OpenShift Container Platform 会保证每个 PV 都使用不同的名称,但 NFS 卷服务器和路径的唯一性是由管理员实现的。

采用这种方法强制配额可让软件开发人员以特定数量(如 10Gi)请求持久性存储,并可与相等或更大容量的卷进行匹配。

4.9.3. NFS 卷安全

这部分论述了 NFS 卷安全性,其中包括匹配的权限和 SELinux 考虑。用户需要了解 POSIX 权限、进程 UID 、supplemental 组和 SELinux 的基本知识。

软件开发人员可以使用 PVC 名称,或直接在 Pod 定义中 volumes 部分使用 NFS 插件来请求 NFS 存储。

NFS 服务器中的 /etc/exports 文件包含可访问的 NFS 目录。目标 NFS 目录有 POSIX 拥有者和组群 ID。OpenShift Container Platform NFS 插件使用相同的 POSIX 所有者权限及在导出的 NFS 目录中找到的权限挂载容器的 NFS 目录。然而,容器实际运行时所使用的 UID 与 NFS 挂载的所有者的 UID 不同。这是所需的行为。

例如,目标 NFS 目录在 NFS 服务器中,如下所示:

ls -lZ /opt/nfs -d

$ ls -lZ /opt/nfs -d输出示例

drwxrws---. nfsnobody 5555 unconfined_u:object_r:usr_t:s0 /opt/nfs

drwxrws---. nfsnobody 5555 unconfined_u:object_r:usr_t:s0 /opt/nfsid nfsnobody

$ id nfsnobody输出示例

uid=65534(nfsnobody) gid=65534(nfsnobody) groups=65534(nfsnobody)

uid=65534(nfsnobody) gid=65534(nfsnobody) groups=65534(nfsnobody)

为了可以访问目录,容器必须匹配 SELinux 标签,并使用 UID65534、nfsnobody的所有者,或其 supplemental 组的 5555 运行。

所有者 ID 65534 只是一个示例。虽然 NFS 的 root_squash 把 root,uid 0 映射到 nfsnobody,uid 65534,但 NFS 导出的所有者 ID 可能是任意值。NFS 导出的所有者不需要是 65534 。

4.9.3.1. 组 ID

用来控制 NFS 访问(假设不能在 NFS 导出中修改权限)的建议方法是使用附加组(supplemental group)。OpenShift Container Platform 中的附件组的功能是用于共享存储(NFS 是一个共享存储)。相对块存储(如 iSCSI),使用 fsGroup SCC 策略和在 Pod 的 securityContext 中的fsGroup 值。

在访问持久性存储时,一般情况下最好使用 supplemental 组 ID 而不是使用用户 ID。

示例中目标 NFS 目录上的组 ID 是 5555, Pod 可以使用 Pod 的 securityContext定义中的 supplementalGroups 来设置组 ID。例如:

假设没有可能满足 pod 要求的自定义 SCC,pod 可能与受限 SCC 匹配。这个 SCC 把 supplementalGroups 策略设置为 RunAsAny。这代表提供的任何组群 ID 都被接受,且不进行范围检查。

因此,上面的 pod 可以通过,并被启动。但是,如果需要进行组 ID 范围检查,使用自定义 SCC 就是首选的解决方案。可创建一个定义了最小和最大组群 ID 的自定义 SCC,这样就会强制进行组 ID 范围检查,组 ID 5555 将被允许 。

要使用自定义 SCC,需要首先将其添加到适当的服务帐户(service account)中。例如,在一个特定项目中使用 default 服务账户(除非在 Pod 规格中指定了另外一个账户)。

4.9.3.2. 用户 ID

用户 ID 可以在容器镜像或者 Pod 定义中定义。

通常情况下,最好使用附件组群 ID 而不是用户 ID 来获得对持久性存储的访问。

在上面显示的目标 NFS 目录示例中,容器需要将其 UID 设定为 65534,忽略组 ID。因此可以把以下内容添加到 Pod 定义中:

假设项目为 default 且 SCC 为 restricted,则不允许 pod 请求的用户 ID 65534。因此,pod 会因以下原因失败:

-

它要求

65534作为其用户 ID。 -

Pod 可用的所有 SCC 被检查以决定哪些 SCC 允许 ID 为

65534的用户。虽然检查了 SCC 的所有策略,但这里的焦点是用户 ID。 -

因为所有可用的 SCC 都使用

MustRunAsRange作为其runAsUser策略,所以需要进行 UID 范围检查。 -

65534不包含在 SCC 或项目的用户 ID 范围内。

一般情况下,作为一个最佳实践方案,最好不要修改预定义的 SCC。解决这个问题的的首选方法是,创建一个自定义 SCC,在其中定义最小和最大用户 ID。 UID 范围仍然会被强制检查,UID 65534 会被允许。

要使用自定义 SCC,需要首先将其添加到适当的服务帐户(service account)中。例如,在一个特定项目中使用 default 服务账户(除非在 Pod 规格中指定了另外一个账户)。

4.9.3.3. SELinux

Red Hat Enterprise Linux(RHEL)和 Red Hat Enterprise Linux CoreOS(RHCOS)系统被配置为默认在远程 NFS 服务器中使用 SELinux。

对于非 RHEL 和非 RHCOS 系统,SELinux 不允许从 pod 写入远程 NFS 服务器。NFS 卷正确挂载,但只读。您将需要按照以下步骤启用正确的 SELinux 权限。

先决条件

-

必须安装

container-selinux软件包。这个软件包提供virt_use_nfsSELinux 布尔值。

流程

使用以下命令启用

virt_use_nfs布尔值。使用-P选项可以使这个布尔值在系统重启后仍然有效。setsebool -P virt_use_nfs 1

# setsebool -P virt_use_nfs 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.9.3.4. 导出设置

为了使任意容器用户都可以读取和写入卷, NFS 服务器中的每个导出的卷都应该满足以下条件:

每个导出必须使用以下格式导出:

/<example_fs> *(rw,root_squash)

/<example_fs> *(rw,root_squash)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 必须将防火墙配置为允许到挂载点的流量。

对于 NFSv4,配置默认端口

2049(nfs)。NFSv4

iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPT

# iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 对于 NFSv3,需要配置三个端口:

2049(nfs)、20048(mountd)和111(portmapper)。NFSv3

iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPT

# iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPTCopy to Clipboard Copied! Toggle word wrap Toggle overflow iptables -I INPUT 1 -p tcp --dport 20048 -j ACCEPT

# iptables -I INPUT 1 -p tcp --dport 20048 -j ACCEPTCopy to Clipboard Copied! Toggle word wrap Toggle overflow iptables -I INPUT 1 -p tcp --dport 111 -j ACCEPT

# iptables -I INPUT 1 -p tcp --dport 111 -j ACCEPTCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

必须设置 NFS 导出和目录,以便目标 pod 可以对其进行访问。将导出设定为由容器的主 UID 拥有,或使用

supplementalGroups来允许 pod 组进行访问(如上面的与组 ID 相关的章节所示)。

4.9.4. 重新声明资源

NFS 实现了 OpenShift Container Platform Recyclable 插件接口。自动进程根据在每个持久性卷上设定的策略处理重新声明的任务。

默认情况下,PV 被设置为 Retain。

当一个 PVC 被删除后,PV 被释放,这个 PV 对象不能被重复使用。反之,应该创建一个新的 PV,其基本的卷详情与原始卷相同。

例如:管理员创建一个名为 nfs1的 PV:

用户创建 PVC1,它绑定到 nfs1。然后用户删除了 PVC1,对nfs1的声明会被释放。这将会使 nfs1 的状态变为 Released。如果管理员想要使这个 NFS 共享变为可用,则应该创建一个具有相同 NFS 服务器详情的新 PV,但使用一个不同的 PV 名称:

删除原来的 PV。不建议使用相同名称重新创建。尝试手工把一个 PV 的状态从 Released 改为 Available 会导致错误并可能造成数据丢失。

4.9.5. 其他配置和故障排除

根据所使用的 NFS 版本以及配置,可能还需要额外的配置步骤来进行正确的导出和安全映射。以下是一些可能适用的信息:

|

NFSv4 挂载错误地显示所有文件的所有者为 |

|

| 在 NFSv4 上禁用 ID 映射 |

|

4.10. Red Hat OpenShift Data Foundation

Red Hat OpenShift Data Foundation 是 OpenShift Container Platform 支持的文件、块和对象存储的持久性存储供应商,可以在内部或混合云环境中使用。作为红帽存储解决方案,Red Hat OpenShift Data Foundation 与 OpenShift Container Platform 完全集成,用于部署、管理和监控。如需更多信息,请参阅 Red Hat OpenShift Data Foundation 文档。

虚拟化的 Red Hat Hyperconverged Infrastructure(RHHI)上的 OpenShift Data Foundation 不被支持。它使用超融合节点来托管 OpenShift Container Platform 安装的虚拟机。有关支持的平台的更多信息,请参阅 Red Hat OpenShift Data Foundation 支持性和互操作性指南。

4.11. 使用 VMware vSphere 卷的持久性存储

OpenShift Container Platform 允许使用 VMware vSphere 的虚拟机磁盘 (VMDK) 卷。您可以使用 VMware vSphere 为 OpenShift Container Platform 集群置备持久性存储。我们假设您对 Kubernetes 和 VMware vSphere 已有一定了解。

VMware vSphere 卷可以动态置备。OpenShift Container Platform 在 vSphere 中创建磁盘,并将此磁盘附加到正确的镜像。

OpenShift Container Platform 将新卷置备为独立持久性卷,它们可以在集群中的任何节点上自由附加和分离卷。因此,您无法备份使用快照的卷,或者从快照中恢复卷。如需更多信息 ,请参阅快照限制。

Kubernetes 持久性卷框架允许管理员提供带有持久性存储的集群,并使用户可以在不了解底层存储架构的情况下请求这些资源。

持久性卷不与某个特定项目或命名空间相关联,它们可以在 OpenShift Container Platform 集群间共享。持久性卷声明是针对某个项目或者命名空间的,相应的用户可请求它。

OpenShift Container Platform 默认使用 in-tree (非 CSI)插件来置备 vSphere 存储。

在以后的 OpenShift Container Platform 版本中,计划使用现有树内插件置备的卷迁移到对应的 CSI 驱动程序。CSI 自动迁移应该可以无缝进行。迁移不会改变您使用所有现有 API 对象的方式,如持久性卷、持久性卷声明和存储类。有关迁移的更多信息,请参阅 CSI 自动迁移。

完全迁移后,未来的 OpenShift Container Platform 版本将最终删除树内插件。

4.11.1. 动态置备 VMware vSphere 卷

动态置备 VMware vSphere 卷是推荐的方法。

4.11.2. 先决条件

- 在一个满足您使用的组件要求的 VMware vSphere 版本上安装了 OpenShift Container Platform 集群。有关 vSphere 版本支持的信息,请参阅在 vSphere 上安装集群。

您可以通过以下任一流程使用默认的存储类动态置备这些卷。

4.11.2.1. 使用 UI 动态置备 VMware vSphere 卷

OpenShift Container Platform 安装了一个默认的存储类,其名为 thin,使用 thin 磁盘格式置备卷。

先决条件

- 当存储可以被挂载为 OpenShift Container Platform 中的卷之前,它必须已存在于底层的存储系统中。

流程

- 在 OpenShift Container Platform 控制台中,点击 Storage → Persistent Volume Claims。

- 在持久性卷声明概述页中,点 Create Persistent Volume Claim。

在接下来的页面中定义所需选项。

-

选择

thin存储类。 - 输入存储声明的唯一名称。

- 选择访问模式来决定所创建存储声明的读写访问权限。

- 定义存储声明的大小。

-

选择

- 点击 Create 创建持久性卷声明,并生成一个持久性卷。

4.11.2.2. 使用 CLI 动态置备 VMware vSphere 卷

OpenShift Container Platform 安装了一个默认的 StorageClass,其名为 thin,使用 thin 磁盘格式置备卷。

先决条件

- 当存储可以被挂载为 OpenShift Container Platform 中的卷之前,它必须已存在于底层的存储系统中。

流程 (CLI)

您可以通过创建一个包含以下内容的

pvc.yaml文件来定义 VMware vSphere PersistentVolumeClaim:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令从文件创建

PersistentVolumeClaim对象:oc create -f pvc.yaml

$ oc create -f pvc.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.11.3. 静态置备 VMware vSphere 卷

要静态置备 VMware vSphere 卷,您必须创建虚拟机磁盘供持久性卷框架引用。

先决条件

- 当存储可以被挂载为 OpenShift Container Platform 中的卷之前,它必须已存在于底层的存储系统中。

流程

创建虚拟机磁盘。在静态置备 VMware vSphere 卷前,必须手动创建虚拟机磁盘 (VMDK)。可使用以下任一方法:

使用

vmkfstools创建。通过 Secure Shel (SSH) 访问 ESX,然后使用以下命令创建 VMDK 卷:vmkfstools -c <size> /vmfs/volumes/<datastore-name>/volumes/<disk-name>.vmdk

$ vmkfstools -c <size> /vmfs/volumes/<datastore-name>/volumes/<disk-name>.vmdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

vmware-diskmanager创建:shell vmware-vdiskmanager -c -t 0 -s <size> -a lsilogic <disk-name>.vmdk

$ shell vmware-vdiskmanager -c -t 0 -s <size> -a lsilogic <disk-name>.vmdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow

创建引用 VMDK 的持久性卷。创建包含

PersistentVolume对象定义的pv1.yaml文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要在格式化并置备卷后更改 fsType 参数的值可能会导致数据丢失和 pod 故障。

从文件创建

PersistentVolume对象:oc create -f pv1.yaml

$ oc create -f pv1.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个映射到您在上一步中创建的持久性卷声明。创建包含

PersistentVolumeClaim对象定义的pvc1.yaml文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 从文件创建

PersistentVolumeClaim对象:oc create -f pvc1.yaml

$ oc create -f pvc1.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.11.3.1. 格式化 VMware vSphere 卷

在 OpenShift Container Platform 挂载卷并将其传递给容器之前,它会检查卷是否包含由 PersistentVolume(PV)定义中 fsType 参数值指定的文件系统。如果没有使用文件系统格式化设备,该设备中的所有数据都会被清除,设备也会自动格式化为指定的文件系统。

因为 OpenShift Container Platform 在首次使用卷前会进行格式化,所以您可以使用未格式化的 vSphere 卷作为 PV。

第 5 章 使用本地存储的持久性存储

5.1. 本地存储概述

您可以使用以下解决方案置备本地存储:

- HostPath Provisioner (HPP)

- Local Storage Operator (LSO)

- Logical Volume Manager (LVM) Storage

这些解决方案只支持置备节点本地存储。工作负载绑定到提供存储的节点。如果节点不可用,工作负载也会变得不可用。要保持工作负载可用性(尽管节点失败),您必须确保通过主动或被动复制机制进行存储数据。

5.1.1. HostPath Provisioner 功能概述

您可以使用 HostPath Provisioner (HPP) 执行以下操作:

- 将主机文件系统路径映射到存储类以进行本地存储。

- 静态创建存储类,在节点上配置文件系统路径以进行存储消耗。

- 根据存储类静态置备持久性卷 (PV)。

- 在了解底层存储拓扑时,创建工作负载和 PersistentVolumeClaims (PVC)。

HPP 在上游 Kubernetes 中提供。但是,不建议使用来自上游 Kubernetes 的 HPP。

5.1.2. Local Storage Operator 功能概述

您可以使用 Local Storage Operator (LSO) 执行以下操作:

- 在不修改设备配置的情况下,将存储设备(磁盘或分区)分配给存储类。

-

通过配置

LocalVolume自定义资源 (CR) 以静态置备 PV 和存储类。 - 在了解底层存储拓扑时创建工作负载和 PVC。

LSO 由红帽开发和交付。

5.1.3. LVM 存储功能概述

您可以使用逻辑卷管理器(LVM)存储执行以下操作:

- 将存储设备(磁盘或分区)配置为 lvm2 卷组,并将卷组公开为存储类。

- 在不考虑节点拓扑的情况下,使用 PVC 创建工作负载和请求存储。

LVM 存储使用 TopoLVM CSI 驱动程序,将存储空间动态分配给拓扑中的节点,并置备 PV。

LVM 存储由红帽开发和维护。LVM 存储提供的 CSI 驱动程序是上游项目 "topolvm"。

5.2. 使用本地卷的持久性存储

OpenShift Container Platform 可以使用本地卷来置备持久性存储。本地持久性卷允许您使用标准持久性卷声明接口访问本地存储设备,如磁盘或分区。

无需手动将 pod 调度到节点即可使用本地卷,因为系统了解卷节点的约束。但是,本地卷仍会受到底层节点可用性的影响,而且并不适用于所有应用程序。

本地卷只能用作静态创建的持久性卷。

5.2.1. 安装 Local Storage Operator

默认情况下,OpenShift Container Platform 中不会安装 Local Storage Operator。使用以下流程来安装和配置这个 Operator,从而在集群中启用本地卷。

先决条件

- 访问 OpenShift Container Platform web 控制台或命令行 (CLI)。

流程

创建

openshift-local-storage项目:oc adm new-project openshift-local-storage

$ oc adm new-project openshift-local-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:允许在基础架构节点上创建本地存储。

您可能希望使用 Local Storage Operator 在基础架构节点上创建卷来支持一些组件,如日志记录和监控。

您必须调整默认节点选择器,以便 Local Storage Operator 包含基础架构节点,而不只是 worker 节点。

要阻止 Local Storage Operator 继承集群范围的默认选择器,请输入以下命令:

oc annotate namespace openshift-local-storage openshift.io/node-selector=''

$ oc annotate namespace openshift-local-storage openshift.io/node-selector=''Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:允许在单节点部署中的 CPU 管理池中运行本地存储。

在单节点部署中使用 Local Storage Operator,并允许使用属于

management池的 CPU。在使用管理工作负载分区的单节点安装上执行这个步骤。要允许 Local Storage Operator 在管理 CPU 池上运行,请运行以下命令:

oc annotate namespace openshift-local-storage workload.openshift.io/allowed='management'

$ oc annotate namespace openshift-local-storage workload.openshift.io/allowed='management'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

使用 UI

按照以下步骤,通过 web 控制台安装 Local Storage Operator:

- 登陆到 OpenShift Container Platform Web 控制台。

- 导航至 Operators → OperatorHub。

- 在过滤器框中键入 Local Storage 以查找 Local Storage Operator。

- 点击 Install。

- 在 Install Operator 页面中,选择 A specific namespace on the cluster。从下拉菜单中选择 openshift-local-storage。

- 将 Update Channel 和 Approval Strategy 的值调整为所需的值。

- 点击 Install。

完成后,Web 控制台的 Installed Operators 部分中会列出 Local Storage Operator。

使用 CLI

通过 CLI 安装 Local Storage Operator。

创建对象 YAML 文件,以定义 Local Storage Operator 的 Operator 组和订阅,如

openshift-local-storage.yaml:openshift-local-storage.yaml 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 安装计划的用户批准策略。

输入以下命令来创建 Local Storage Operator 对象:

oc apply -f openshift-local-storage.yaml

$ oc apply -f openshift-local-storage.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在此阶段,Operator Lifecycle Manager (OLM) 已可以了解 Local Storage Operator。Operator 的 ClusterServiceVersion (CSV) 应出现在目标命名空间中,由 Operator 提供的 API 应可用于创建。

通过检查是否创建了所有 pod 和 Local Storage Operator 来验证本地存储安装:

检查是否已创建所有必需的 pod:

oc -n openshift-local-storage get pods

$ oc -n openshift-local-storage get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE local-storage-operator-746bf599c9-vlt5t 1/1 Running 0 19m

NAME READY STATUS RESTARTS AGE local-storage-operator-746bf599c9-vlt5t 1/1 Running 0 19mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 ClusterServiceVersion (CSV) YAML 清单,查看

openshift-local-storage项目中是否有 Local Storage Operator:oc get csvs -n openshift-local-storage

$ oc get csvs -n openshift-local-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME DISPLAY VERSION REPLACES PHASE local-storage-operator.4.2.26-202003230335 Local Storage 4.2.26-202003230335 Succeeded

NAME DISPLAY VERSION REPLACES PHASE local-storage-operator.4.2.26-202003230335 Local Storage 4.2.26-202003230335 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow

如果通过了所有检查,则代表 Local Storage Operator 已被成功安装。

5.2.2. 使用 Local Storage Operator 置备本地卷

无法通过动态置备来创建本地卷。相反,持久性卷可由 Local Storage Operator 创建。本地卷置备程序会在定义的资源中指定的路径上查找任意文件系统或块设备。

先决条件

- 安装了 Local Storage Operator。

您有一个满足以下条件的本地磁盘:

- 它附加到一个节点。

- 它尚未挂载。

- 它不包含分区。

流程

创建本地卷资源。此资源必须定义本地卷的节点和路径。

注意不要在同一设备中使用不同的存储类名称。这样做可创建多个持久性卷 (PV)。

例如:Filesystem

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 安装了 Local Storage Operator 的命名空间。

- 2

- 可选:包含附加了本地存储卷的节点列表的节点选择器。本例使用从

oc get node获取的节点主机名。如果没有定义值,则 Local Storage Operator 会尝试在所有可用节点上查找匹配的磁盘。 - 3

- 创建持久性卷对象时使用的存储类的名称。如果不存在,Local Storage Operator 会自动创建存储类。确保使用唯一标识此本地卷的存储类。

- 4

- 定义本地卷类型的卷模式,可以是

Filesystem或Block。注意原始块卷 (

volumeMode: Block) 不会被格式化为文件系统。仅在 pod 上运行的任何应用程序都可以使用原始块设备时使用此模式。 - 5

- 第一次挂载本地卷时所创建的文件系统。

- 6

- 包含要从中选择的本地存储设备列表的路径。

- 7

- 使用到

LocalVolume资源by-id的实际本地磁盘文件路径(如/dev/disk/by-id/wwn)替换这个值。当置备程序已被成功部署时,会为这些本地磁盘创建 PV。注意如果使用 RHEL KVM 运行 OpenShift Container Platform,则必须为虚拟机磁盘分配序列号。否则,重启后无法识别虚拟机磁盘。您可以使用

virsh edit <VM>命令添加<serial>mydisk</serial>定义。

例如:Block

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 安装了 Local Storage Operator 的命名空间。

- 2

- 可选:包含附加了本地存储卷的节点列表的节点选择器。本例使用从

oc get node获取的节点主机名。如果没有定义值,则 Local Storage Operator 会尝试在所有可用节点上查找匹配的磁盘。 - 3

- 创建持久性卷对象时使用的存储类的名称。

- 4

- 定义本地卷类型的卷模式,可以是

Filesystem或Block。 - 5

- 包含要从中选择的本地存储设备列表的路径。

- 6

- 使用到

LocalVolume资源by-id的实际本地磁盘文件路径(如dev/disk/by-id/wwn)替换这个值。当置备程序已被成功部署时,会为这些本地磁盘创建 PV。

注意如果使用 RHEL KVM 运行 OpenShift Container Platform,则必须为虚拟机磁盘分配序列号。否则,重启后无法识别虚拟机磁盘。您可以使用

virsh edit <VM>命令添加<serial>mydisk</serial>定义。在 OpenShift Container Platform 集群中创建本地卷资源。指定您刚才创建的文件:

oc create -f <local-volume>.yaml

$ oc create -f <local-volume>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证置备程序是否已创建并创建了相应的守护进程集:

oc get all -n openshift-local-storage

$ oc get all -n openshift-local-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意所需和当前的守护进程设定进程数。所需的数量为

0表示标签选择器无效。验证持久性卷是否已创建:

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE local-pv-1cec77cf 100Gi RWO Delete Available local-sc 88m local-pv-2ef7cd2a 100Gi RWO Delete Available local-sc 82m local-pv-3fa1c73 100Gi RWO Delete Available local-sc 48m

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE local-pv-1cec77cf 100Gi RWO Delete Available local-sc 88m local-pv-2ef7cd2a 100Gi RWO Delete Available local-sc 82m local-pv-3fa1c73 100Gi RWO Delete Available local-sc 48mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

编辑 LocalVolume 对象不会更改现有持久性卷的 fsType 或 volumeMode,因为这样做可能会导致破坏性操作。

5.2.3. 在没有 Local Storage Operator 的情况下置备本地卷

无法通过动态置备来创建本地卷。反之,可以通过在对象定义中定义持久性卷(PV)来创建持久性卷。本地卷置备程序会在定义的资源中指定的路径上查找任意文件系统或块设备。

手动置备 PV 的风险包括在删除 PVC 时,在 PV 间可能会出现数据泄漏的问题。建议在置备本地 PV 时自动执行 Local Storage Operator。

先决条件

- 本地磁盘已附加到 OpenShift Container Platform 节点。

流程

定义 PV。使用

PersistentVolume对象定义创建一个文件,如example-pv-filesystem.yaml或example-pv-block.yaml。此资源必须定义本地卷的节点和路径。注意不要在同一设备中使用不同的存储类名称。这将会创建多个 PV。

example-pv-filesystem.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意原始块卷(

volumeMode: block)不能以文件系统格式化。仅在 pod 上运行的任何应用程序都可以使用原始块设备时使用此模式。example-pv-block.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在 OpenShift Container Platform 集群中创建 PV 资源。指定您刚才创建的文件:

oc create -f <example-pv>.yaml

$ oc create -f <example-pv>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证是否已创建本地 PV:

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE example-pv-filesystem 100Gi RWO Delete Available local-sc 3m47s example-pv1 1Gi RWO Delete Bound local-storage/pvc1 local-sc 12h example-pv2 1Gi RWO Delete Bound local-storage/pvc2 local-sc 12h example-pv3 1Gi RWO Delete Bound local-storage/pvc3 local-sc 12h

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE example-pv-filesystem 100Gi RWO Delete Available local-sc 3m47s example-pv1 1Gi RWO Delete Bound local-storage/pvc1 local-sc 12h example-pv2 1Gi RWO Delete Bound local-storage/pvc2 local-sc 12h example-pv3 1Gi RWO Delete Bound local-storage/pvc3 local-sc 12hCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.4. 创建本地卷持久性卷声明

必须静态创建本地卷作为持久性卷声明(PVC),才能被 pod 访问。

先决条件

- 持久性卷是使用本地卷置备程序创建的。

流程

使用对应的存储类创建 PVC:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过指定您刚才创建的文件,在 OpenShift Container Platform 集群中创建 PVC:

oc create -f <local-pvc>.yaml

$ oc create -f <local-pvc>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.5. 附加本地声明

本地卷映射到持久性卷声明后,可在资源内指定。

先决条件

- 同一命名空间中存在持久性卷声明。

流程

在资源规格中包含定义的声明。以下示例在 pod 中声明持久性卷声明:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过指定您刚才创建的文件,在 OpenShift Container Platform 集群中创建资源:

oc create -f <local-pod>.yaml

$ oc create -f <local-pod>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.6. 为本地存储设备自动发现和置备

Local Storage Operator 自动进行本地存储发现和置备。使用此功能,您可以在部署过程中不提供动态置备(如使用裸机、VMware 或带有附加设备的 AWS 存储实例)时简化安装。

自动发现和置备只是一个技术预览功能。技术预览功能不被红帽产品服务等级协议 (SLA) 支持,且可能在功能方面有缺陷。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

在使用内部部署 Red Hat OpenShift Data Foundation 或与平台无关的部署时,完全支持自动发现和置备。

使用以下步骤自动发现本地设备,并为所选设备自动置备本地。

请小心使用 LocalVolumeSet 对象。当您从本地磁盘自动置备持久性卷(PV)时,本地 PV 可能会声明所有匹配的设备。如果使用 LocalVolumeSet 对象,请确保 Local Storage Operator 是管理该节点上本地设备的唯一实体。不支持针对一个节点创建多个 LocalVolumeSet 实例。

先决条件

- 有集群管理员权限。

- 已安装 Local Storage Operator。

- 已将本地磁盘附加到 OpenShift Container Platform 节点。

-

您可以访问 OpenShift Container Platform web 控制台和

oc命令行界面(CLI)。

流程

通过 web 控制台启用本地设备的自动发现:

- 点 Operators → Installed Operators。

-

在

openshift-local-storage命名空间中,点 Local Storage。 - 点 Local Volume Discovery 选项卡。

- 点 Create Local Volume Discovery,然后选择 Form view 或 YAML view。

-

配置

LocalVolumeDiscovery对象参数。 点 Create。

Local Storage Operator 创建名为

auto-discover-devices的本地卷发现实例。

显示节点上持续可用的设备列表:

- 登陆到 OpenShift Container Platform Web 控制台。

- 进入 Compute → Nodes。

- 点要打开的节点名称。此时会显示 "Node Details" 页面。

选择 Disks 标签显示所选设备的列表。

在添加或删除本地磁盘时,设备列表会持续更新。您可以根据名称、状态、类型、型号、容量和模式过滤设备。

从 web 控制台为发现的设备自动置备本地卷:

- 导航到 Operators → Installed Operators,再从 Operators 列表中选择 Local Storage。

- 选择 Local Volume Set → Create Local Volume Set。

- 输入卷集合名称和存储类名称。

选择 All nodes 或 Select nodes 以相应地应用过滤器。

注意无论是使用 All nodes 或 Select nodes 进行过滤,只有 worker 节点可用。

选择您要应用到本地卷集的磁盘类型、模式、大小和限制,然后点 Create。

几分钟后会显示一条信息,表示 "Operator reconciled successfullyd successfully."

另外,也可通过 CLI 为发现的设备置备本地卷:

创建一个对象 YAML 文件来定义本地卷集,如

local-volume-set.yaml,如下例所示:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建本地卷集对象:

oc apply -f local-volume-set.yaml

$ oc apply -f local-volume-set.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 根据存储类验证本地持久性卷是否被动态置备:

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE local-pv-1cec77cf 100Gi RWO Delete Available local-sc 88m local-pv-2ef7cd2a 100Gi RWO Delete Available local-sc 82m local-pv-3fa1c73 100Gi RWO Delete Available local-sc 48m

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE local-pv-1cec77cf 100Gi RWO Delete Available local-sc 88m local-pv-2ef7cd2a 100Gi RWO Delete Available local-sc 82m local-pv-3fa1c73 100Gi RWO Delete Available local-sc 48mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

结果会在从节点中删除后删除。必须手动删除符号链接。

5.2.7. 使用 Local Storage Operator pod 的容限

污点可用于节点,以防止它们运行常规工作负载。要允许 Local Storage Operator 使用污点节点,您必须在 Pod 或 DaemonSet 定义中添加容限。这允许在这些污点节点上运行所创建的资源。

您可以通过 LocalVolume 资源把容限应用到 Local Storage Operator pod,通过节点规格把污点应用到一个节点。节点上的污点指示节点排斥所有不容许该污点的 pod。使用一个没有存在于其他 pod 上的特定污点可确保 Local Storage Operator pod 也可以在该节点上运行。

污点与容限由 key、value 和 effect 组成。作为参数,它表示为 key=value:effect。运算符允许您将其中一个参数留空。

先决条件

- 安装了 Local Storage Operator。

- 本地磁盘已附加到带有一个污点的 OpenShift Container Platform 节点上。

- 污点节点可以置备本地存储。

流程

配置本地卷以便在污点节点上调度:

修改定义

Pod的 YAML 文件并添加LocalVolume规格,如下例所示:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选: 要只在污点节点上创建本地持久性卷,修改 YAML 文件并添加

LocalVolumespec,如下例所示:spec: tolerations: - key: node-role.kubernetes.io/master operator: Existsspec: tolerations: - key: node-role.kubernetes.io/master operator: ExistsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

定义的容限度将传递给生成的守护进程集,允许为包含指定污点的节点创建 diskmaker 和 provisioner pod。

5.2.8. Local Storage Operator 指标

OpenShift Container Platform 为 Local Storage Operator 提供以下指标:

-

lso_discovery_disk_count:每个节点中发现的设备总数 -

lso_lvset_provisioned_PV_count:LocalVolumeSet对象创建的 PV 总数 -

lso_lvset_unmatched_disk_count: Local Storage Operator 没有选择进行置备的磁盘总数,因为不匹配条件 -

lso_lvset_orphaned_symlink_count: 使用 PV 的设备数,它们不再与LocalVolumeSet对象标准匹配 -

lso_lv_orphaned_symlink_count:包含 PV 的设备数,它们不再符合LocalVolume对象标准 -

lso_lv_provisioned_PV_count:LocalVolume置备的 PV 总数

要使用这些指标,请务必:

- 安装 Local Storage Operator 时启用对监控的支持。

-

当升级到 OpenShift Container Platform 4.9 或更高版本时,通过将

operator-metering=true标签添加到命名空间来手动启用指标支持。

5.2.9. 删除 Local Storage Operator 资源

5.2.9.1. 删除本地卷或本地卷集

在一些情况下,必须删除本地卷和本地卷集。虽然删除资源中的条目并删除持久性卷通常就足够,但如果您想要重复使用同一设备路径或者使其不同的存储类进行管理,则需要额外的步骤。

以下流程概述了删除本地卷的示例。同样的步骤也可以用于删除本地卷设置自定义资源的符号链接。

先决条件

持久性卷必须处于

Released或Available状态。警告删除仍在使用中的持久性卷可能会导致数据丢失或崩溃。

流程

编辑之前创建的本地卷以删除所有不需要的磁盘。

编辑集群资源:

oc edit localvolume <local_volume_name> -n openshift-local-storage

$ oc edit localvolume <local_volume_name> -n openshift-local-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

找到

devicePaths下的行,删除所有代表不需要的磁盘的行。

删除所有创建的持久性卷。

oc delete pv <pv_name>

$ oc delete pv <pv_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 删除目录并包含节点上的符号链接。

警告以下步骤涉及以 root 用户身份访问节点。如果在本流程中步骤范围以外修改节点状态,则可能会导致集群不稳定。

oc debug node/<node_name> -- chroot /host rm -rf /mnt/local-storage/<sc_name>

$ oc debug node/<node_name> -- chroot /host rm -rf /mnt/local-storage/<sc_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 用于创建本地卷的存储类的名称。

5.2.9.2. 卸载 Local Storage Operator

要卸载 Local Storage Operator,您必须删除 Operator 以及 openshift-local-storage 项目中创建的所有资源。

当本地存储 PV 仍在使用时,不建议卸载 Local Storage Operator。当 Operator 被移除后 PV 仍然会被保留。但是如果在没有删除 PV 和本地存储资源的情况下重新安装 Operator,则可能会出现不确定的行为。

先决条件

- 访问 OpenShift Container Platform Web 控制台。

流程

运行以下命令,删除项目中安装的任何本地卷资源,如

localvolume、localvolumeset和localvolumediscovery:oc delete localvolume --all --all-namespaces

$ oc delete localvolume --all --all-namespacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete localvolumeset --all --all-namespaces

$ oc delete localvolumeset --all --all-namespacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete localvolumediscovery --all --all-namespaces

$ oc delete localvolumediscovery --all --all-namespacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 从 Web 控制台卸载 Local Storage Operator。

- 登陆到 OpenShift Container Platform Web 控制台。

- 导航到 Operators → Installed Operators。

- 在过滤器框中键入 Local Storage 以查找 Local Storage Operator。

-

点击 Local Storage Operator 末尾的 Options 菜单

。

。

- 点击 Uninstall Operator。

- 在出现的窗口中点击 Remove。

由 Local Storage Operator 创建的 PV 将保留在集群中,直到被删除为止。这些卷不再使用后,运行以下命令删除它们:

oc delete pv <pv-name>

$ oc delete pv <pv-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来删除

openshift-local-storage项目:oc delete project openshift-local-storage

$ oc delete project openshift-local-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. 使用 hostPath 的持久性存储

OpenShift Container Platform 集群中的 hostPath 卷将主机节点的文件系统中的文件或目录挂载到 pod 中。大多数 pod 都不需要 hostPath 卷,但是如果应用程序需要它,它会提供一个快速的测试选项。

集群管理员必须将 pod 配置为以特权方式运行。这样可访问同一节点上的 pod。

5.3.1. 概述

OpenShift Container Platform 支持在单节点集群中使用 hostPath 挂载用于开发和测试目的。

在用于生产环境的集群中,不要使用 hostPath。集群管理员会置备网络资源,如 GCE Persistent Disk 卷、NFS 共享或 Amazon EBS 卷。网络资源支持使用存储类设置动态置备。

hostPath 卷必须静态置备 。

不要挂载到容器 root、/ 或主机和容器中相同的任何路径。如果容器有足够权限,可能会损坏您的主机系统。使用 /host 挂载主机是安全的。以下示例显示主机中的 / 目录被挂载到位于 /host 的容器中。

5.3.2. 静态置备 hostPath 卷

使用 hostPath 卷的 pod 必须通过手动(静态)置备来引用。

流程

使用

PersistentVolume对象定义创建一个pv.yaml文件来定义持久性卷 (PV):Copy to Clipboard Copied! Toggle word wrap Toggle overflow 从该文件创建 PV:

oc create -f pv.yaml

$ oc create -f pv.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 通过创建带有

PersistentVolumeClaim对象定义的pvc.yaml文件来定义 PVC:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 从文件创建 PVC:

oc create -f pvc.yaml

$ oc create -f pvc.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3.3. 在特权 pod 中挂载 hostPath 共享

创建持久性卷声明后,应用程序就可以使用它。以下示例演示了在 pod 中挂载此共享。

先决条件

- 已存在一个映射到底层 hostPath 共享的持久性卷声明。

5.4. 使用逻辑卷管理器存储的持久性存储

逻辑卷管理器存储 (LVM) 存储使用 TopoLVM CSI 驱动程序在单节点 OpenShift 集群中动态置备本地存储。

LVM Storage 使用逻辑卷管理器创建精简配置的卷,并在有限的资源单节点 OpenShift 集群中提供块存储的动态置备。

您可以使用 LVM 存储创建卷组、持久性卷声明(PVC)、卷快照和卷克隆。

5.4.1. 逻辑卷管理器存储安装

您可以在单节点 OpenShift 集群上安装逻辑卷管理器(LVM)存储,并将其配置为为您的工作负载动态置备存储。

您可以使用 OpenShift Container Platform CLI (oc)、OpenShift Container Platform Web 控制台或 Red Hat Advanced Cluster Management (RHACM)将 LVM 存储部署到单节点 OpenShift 集群上。

5.4.1.1. 安装 LVM 存储的先决条件

安装 LVM 存储的先决条件如下:

- 确保至少有 10 milliCPU 和 100 MiB RAM。

- 确保每个受管集群都有用于置备存储的专用磁盘。LVM 存储只使用那些为空且不包含文件系统签名的磁盘。为确保磁盘为空,且不包含文件系统签名,请在使用磁盘前擦除磁盘。

在私有 CI 环境中安装 LVM 存储前,您可以重复使用您在之前的 LVM 存储安装中配置的存储设备,请确保您已擦除未使用的磁盘。如果您在安装 LVM 存储前没有擦除磁盘,则无法重复使用磁盘,而无需人工干预。

注意您不能擦除正在使用的磁盘。

- 如果要使用 Red Hat Advanced Cluster Management (RHACM) 安装 LVM 存储,请确保已在 OpenShift Container Platform 集群上安装 RHACM。请参阅使用 RHACM 安装 LVM 存储部分。

您可以使用 Red Hat OpenShift Container Platform OperatorHub 安装 LVM Storage。

先决条件

- 您可以访问单节点 OpenShift 集群。

-

您可以使用具有

cluster-admin和 Operator 安装权限的帐户。

流程

- 登录 OpenShift Container Platform Web 控制台。

- 点 Operators → OperatorHub。

-

在 Filter by keyword 框中滚动或键入

LVM Storage来查找 LVM Storage。 - 点 Install。

在 Install Operator 页面中设置以下选项:

- Update Channel 为 stable-4.12。

- Installation Mode 为 A specific namespace on the cluster。

-

Installed Namespace 为 Operator recommended namespace openshift-storage。如果

openshift-storage命名空间不存在,它会在 Operator 安装过程中创建。 批准策略为 Automatic 或 Manual。

如果选择 Automatic 更新,Operator Lifecycle Manager(OLM)将自动升级 Operator 的运行实例,而无需任何干预。

如果选择 手动 更新,则 OLM 会创建一个更新请求。作为集群管理员,您必须手动批准该更新请求,才能将 Operator 更新至更新的版本。

- 点 Install。

验证步骤

- 验证 LVM 存储是否显示绿色勾号,代表安装成功。

5.4.1.3. 使用 RHACM 安装 LVM 存储

LVM Storage 使用 Red Hat Advanced Cluster Management (RHACM) 部署在单节点 OpenShift 集群上。当 Operator 应用到与 PlacementRule 资源中指定的选择器匹配的受管集群时,您可以在 RHACM 上创建 Policy 对象。该策略也应用于稍后导入并满足放置规则的集群。

先决条件

-

使用具有

cluster-admin和 Operator 安装权限的账户访问 RHACM 集群。 - LVM 存储要使用在每个单节点 OpenShift 集群上的专用磁盘。

- 单节点 OpenShift 集群需要由 RHACM 管理,无论是导入或创建的。

流程

- 使用 OpenShift Container Platform 凭证登录到 RHACM CLI。

创建要在其中创建策略的命名空间。

oc create ns lvms-policy-ns

# oc create ns lvms-policy-nsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要创建策略,请使用名称(如

policy-lvms-operator.yaml)将以下 YAML 保存到文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要这个

nodeSelector节点过滤器匹配与 pod 标签匹配不同。运行以下命令在命名空间中创建策略:

oc create -f policy-lvms-operator.yaml -n lvms-policy-ns

# oc create -f policy-lvms-operator.yaml -n lvms-policy-ns1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

policy-lvms-operator.yaml是保存策略的文件的名称。

这会在

lvms-policy-ns命名空间中创建Policy、PlacementRule和PlacementBinding对象。该策略会在与放置规则匹配的集群中创建一个Namespace、OperatorGroup、Subscription和LVMCluster资源。这会在与选择条件匹配的单节点 OpenShift 集群上部署 Operator,并将其配置为设置所需资源以置备存储。Operator 使用LVMClusterCR 中指定的所有磁盘。如果没有指定磁盘,Operator 将使用单节点 OpenShift 节点上的所有未使用的磁盘。重要将设备添加到

LVMCluster后,无法删除它。

5.4.1.4. 配置在 LVM 存储中使用的设备大小的限制

使用 LVM 存储配置可用于置备存储的设备大小的限制如下:

- 您可以置备的总存储大小受底层逻辑卷管理器(LVM)精简池的大小以及过度置备因素的限制。

逻辑卷的大小取决于物理扩展(PE)和逻辑扩展(LE)的大小。

- 您可以在创建物理和虚拟设备的过程中定义 PE 和 LE 的大小。

- 默认的 PE 和 LE 大小为 4 MB。

- 如果增加 PE 的大小,LVM 的最大大小由内核限值和您的磁盘空间决定。

| 架构 | RHEL 6 | RHEL 7 | RHEL 8 | RHEL 9 |

|---|---|---|---|---|

| 32 位 | 16 TB | - | - | - |

| 64 位 | 8 EB [1] 100 TB [2] | 8 EB [1] 500 TB [2] | 8 EB | 8 EB |

- 理论大小。

- 测试大小。

5.4.2. 使用 LVM 存储置备存储

您可以使用 Operator 安装过程中创建的存储类置备持久性卷声明 (PVC)。您可以置备块和文件 PVC,当只在创建使用 PVC 的 pod 时才会分配存储。

LVM 存储以 1 GiB 单位置备 PVC。请求的存储将向上舍进到最接近的 GiB。

流程

识别部署 LVM 存储时创建的

StorageClass。StorageClass名称格式为lvms-<device-class-name>。device-class-name是您在PolicyYAML 的LVMCluster中提供的设备名称。例如,如果deviceClass名为vg1,则storageClass名称为lvms-vg1。存储类的

volumeBindingMode设置为WaitForFirstConsumer。要创建需要存储的 PVC,请使用名称(如

pvc.yaml)将以下 YAML 保存到文件中。创建 PVC 的 YAML 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建 PVC:

oc create -f pvc.yaml -ns <application_namespace>

# oc create -f pvc.yaml -ns <application_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在部署使用它的 pod 之前,创建的 PVC 处于

待处理状态。

5.4.3. 扩展 PVC

要在添加额外的容量后利用新的存储,您可以使用 LVM 存储扩展现有持久性卷声明 (PVC)。

先决条件

- 使用动态置备。

-

控制

StorageClass对象的allowVolumeExpansion被设置为true。

流程

运行以下命令,将所需 PVC 资源中的

.spec.resources.requests.storage字段改为新大小:oc patch <pvc_name> -n <application_namespace> -p '{ "spec": { "resources": { "requests": { "storage": "<desired_size>" }}}}'oc patch <pvc_name> -n <application_namespace> -p '{ "spec": { "resources": { "requests": { "storage": "<desired_size>" }}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

观察 PVC 的

status.conditions字段来查看调整大小是否完成。OpenShift Container Platform 在扩展过程中为 PVC 添加Resizing条件,该条件会在扩展完成后删除。

5.4.4. 在单节点 OpenShift 集群上升级 LVM 存储

目前,无法从 OpenShift Data Foundation Logical Volume Manager Operator 4.11 升级到单节点 OpenShift 集群上的 LVM Storage 4.12。

这个过程不会保留数据。

流程

- 备份您要在持久性卷声明 (PVC) 中保留的任何数据。

- 删除 OpenShift Data Foundation Logical Volume Manager Operator 及其 pod 置备的所有 PVC。

- 在 OpenShift Container Platform 4.12 上重新安装 LVM Storage。

- 重新创建工作负载。

- 将升级到 4.12 后将备份数据复制到创建的 PVC。

5.4.5. 单节点 OpenShift 的卷快照

您可以获取由 LVM Storage 置备的持久性卷 (PV) 的卷快照。您还可以为克隆卷创建卷快照。卷快照可帮助您进行以下操作:

备份应用程序数据。

重要卷快照位于与原始数据相同的设备上。要将卷快照用作备份,您需要将快照移到安全位置。您可以使用 OpenShift API 进行数据保护备份和恢复解决方案。

- 恢复到进行卷快照时的状态。

5.4.5.1. 在单节点 OpenShift 中创建卷快照

您可以根据精简池的可用容量和过度置备限制创建卷快照。LVM Storage 创建一个带有 lvms-<deviceclass-name> 名称的 VolumeSnapshotClass。

先决条件

-

确保持久性卷声明(PVC)处于

Bound状态。对于快照的一致性,这是必需的。 - 在进行快照前,您需要停止所有到 PVC 的 I/O。

流程

-

登录到需要运行

oc命令的单节点 OpenShift。 将以下 YAML 保存到带有名称(如

lvms-vol-snapshot.yaml)的文件。创建卷快照的 YAML 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在与 PVC 相同的命名空间中运行以下命令来创建快照:

oc create -f lvms-vol-snapshot.yaml

# oc create -f lvms-vol-snapshot.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

PVC 的只读副本被创建为卷快照。

5.4.5.2. 在单节点 OpenShift 中恢复卷快照

恢复卷快照时,会创建一个新的持久性卷声明 (PVC)。恢复的 PVC 独立于卷快照和源 PVC。

先决条件

- 存储类必须与源 PVC 相同。

请求的 PVC 的大小必须与快照的源卷的大小相同。

重要快照必须恢复到与快照的源卷相同的 PVC。如果需要较大的 PVC,您可以在成功恢复快照后重新定义 PVC 的大小。

流程

- 识别源 PVC 和卷快照名称的存储类名称。

将以下 YAML 保存到带有名称(如

lvms-vol-restore.yaml)的文件,以恢复快照。恢复 PVC 的 YAML 示例。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在与快照相同的命名空间中运行以下命令来创建策略:

oc create -f lvms-vol-restore.yaml

# oc create -f lvms-vol-restore.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4.5.3. 删除单节点 OpenShift 中的卷快照

您可以删除卷快照资源和持久性卷声明 (PVC)。

流程

运行以下命令来删除卷快照资源:

oc delete volumesnapshot <volume_snapshot_name> -n <namespace>

# oc delete volumesnapshot <volume_snapshot_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意当您删除持久性卷声明(PVC)时,PVC 的快照不会被删除。

要删除恢复的卷快照,请运行以下命令删除为恢复卷快照而创建的 PVC:

oc delete pvc <pvc_name> -n <namespace>

# oc delete pvc <pvc_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4.6. 单节点 OpenShift 的卷克隆

克隆是现有存储卷的副本,可以像任何标准卷一样使用。

5.4.6.1. 在单节点 OpenShift 中创建卷克隆

您可以创建一个卷克隆,以制作数据的时点副本。持久性卷声明 (PVC) 不能使用不同的大小克隆。

克隆的 PVC 具有写入访问权限。

先决条件

-

确保 PVC 处于

Bound状态。对于快照的一致性,这是必需的。 -

确保

StorageClass与源 PVC 相同。

流程

- 识别源 PVC 的存储类。

要创建卷克隆,请将以下 YAML 保存到带有名称的文件,如

lvms-vol-clone.yaml:克隆卷的 YAML 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,在与源 PVC 相同的命名空间中创建策略:

oc create -f lvms-vol-clone.yaml

# oc create -f lvms-vol-clone.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4.6.2. 删除单节点 OpenShift 中的克隆卷

您可以删除克隆的卷。

流程

要删除克隆的卷,请运行以下命令来删除克隆的 PVC:

oc delete pvc <clone_pvc_name> -n <namespace>

# oc delete pvc <clone_pvc_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4.7. 监控 LVM 存储

要启用集群监控,您必须在安装 LVM 存储的命名空间中添加以下标签:

openshift.io/cluster-monitoring=true

openshift.io/cluster-monitoring=true5.4.7.1. 指标

您可以通过查看指标来监控 LVM 存储。

下表描述了 topolvm 指标:

| 警报 | 描述 |

|---|---|

|

| 表示 LVM thinpool 中使用的数据空间百分比。 |

|

| 表示 LVM thinpool 中使用的元数据空间百分比。 |

|

| 表示 LVM 精简池的大小(以字节为单位)。 |

|

| 表示 LVM 卷组中的可用空间(以字节为单位)。 |

|

| 表示 LVM 卷组的大小(以字节为单位)。 |

|

| 表示 LVM 精简池的可用过度置备大小(以字节为单位)。 |

指标每 10 分钟更新一次,或者在精简池中有变化(如创建新逻辑卷)时更新。

5.4.7.2. 警报

当精简池和卷组达到最大存储容量时,进一步的操作会失败。这会导致数据丢失。

当使用精简池和卷组超过特定值时,LVM 存储会发送以下警报:

| 警报 | 描述 |

|---|---|

|

| 当卷组和精简池用量超过节点上的 75% 时,会触发此警报。需要删除数据或卷组扩展。 |

|

| 当卷组和精简池使用超过节点上的 85% 时,会触发此警报。在这种情况下,卷组几乎已满。需要删除数据或卷组扩展。 |

|

| 当卷组中的精简池数据 uusage 超过节点上的 75% 时,会触发此警报。需要删除数据或精简池扩展。 |

|

| 当卷组中的精简池数据使用量超过节点上的 85% 时,会触发此警报。需要删除数据或精简池扩展。 |

|

| 当卷组中的精简池元数据使用量超过节点上的 75% 时,会触发此警报。需要删除数据或精简池扩展。 |

|

| 当卷组中的精简池元数据使用量超过节点上的 85% 时,会触发此警报。需要删除数据或精简池扩展。 |

5.4.8. 使用 must-gather 下载日志文件和诊断信息

如果 LVM 存储无法自动解决问题,请使用 must-gather 工具收集日志文件和诊断信息,以便您或红帽支持可以查看问题并确定解决方案。

流程

从连接到 LVM 存储集群的客户端运行

must-gather命令:oc adm must-gather --image=registry.redhat.io/lvms4/lvms-must-gather-rhel9:v4.12 --dest-dir=<directory_name>

$ oc adm must-gather --image=registry.redhat.io/lvms4/lvms-must-gather-rhel9:v4.12 --dest-dir=<directory_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4.8.1. 检查 PVC 处于 Pending 状态

由于多个原因,持久性卷声明 (PVC) 可能会处于 Pending 状态。例如:

- 计算资源不足

- 网络问题

- 不匹配的存储类或节点选择器

- 没有可用卷

-

具有持久性卷 (PV) 的节点处于

Not Ready状态

使用 oc describe 命令识别原因,以查看有关卡住 PVC 的详细信息。

流程

运行以下命令来检索 PVC 列表:

oc get pvc

$ oc get pvcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE lvms-test Pending lvms-vg1 11s

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE lvms-test Pending lvms-vg1 11sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,检查与 PVC 关联的事件处于

Pending状态:oc describe pvc <pvc_name>

$ oc describe pvc <pvc_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<pvc_name>替换为 PVC 的名称。例如:lvms-vg1。

输出示例

Type Reason Age From Message ---- ------ ---- ---- ------- Warning ProvisioningFailed 4s (x2 over 17s) persistentvolume-controller storageclass.storage.k8s.io "lvms-vg1" not found

Type Reason Age From Message ---- ------ ---- ---- ------- Warning ProvisioningFailed 4s (x2 over 17s) persistentvolume-controller storageclass.storage.k8s.io "lvms-vg1" not foundCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4.8.2. 恢复缺少的 LVMS 或 Operator 组件

如果您遇到存储类 "not found" 错误,请检查 LVMCluster 资源,并确保所有逻辑卷管理器存储(LVMS) pod 都在运行。如果 LVMCluster 资源不存在,您可以创建它。

流程

运行以下命令,验证 LVMCluster 资源是否存在:

oc get lvmcluster -n openshift-storage

$ oc get lvmcluster -n openshift-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE my-lvmcluster 65m

NAME AGE my-lvmcluster 65mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果集群没有

LVMCluster资源,请运行以下命令创建一个:oc create -n openshift-storage -f <custom_resource>

$ oc create -n openshift-storage -f <custom_resource>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<custom_resource>替换为根据您的要求量身定制的自定义资源 URL 或文件。

自定义资源示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,检查 LVMS 中的所有 pod 是否处于

openshift-storage命名空间中的Running状态:oc get pods -n openshift-storage

$ oc get pods -n openshift-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE lvms-operator-7b9fb858cb-6nsml 3/3 Running 0 70m topolvm-controller-5dd9cf78b5-7wwr2 5/5 Running 0 66m topolvm-node-dr26h 4/4 Running 0 66m vg-manager-r6zdv 1/1 Running 0 66m

NAME READY STATUS RESTARTS AGE lvms-operator-7b9fb858cb-6nsml 3/3 Running 0 70m topolvm-controller-5dd9cf78b5-7wwr2 5/5 Running 0 66m topolvm-node-dr26h 4/4 Running 0 66m vg-manager-r6zdv 1/1 Running 0 66mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 预期的输出是

lvms-operator和vg-manager的一个运行实例。每个节点预期有一个topolvm-controller和topolvm-node实例。如果