可伸缩性和性能

扩展 OpenShift Container Platform 集群并调整产品环境的性能

摘要

第 1 章 推荐的性能和可扩展性实践

1.1. 推荐的 control plane 实践

本主题为 OpenShift Container Platform 中的 control plane 提供推荐的性能和可扩展性实践。

1.1.1. 扩展集群的建议实践

本节中的指导信息仅与使用云供应商集成的安装相关。

应用以下最佳实践来扩展 OpenShift Container Platform 集群中的 worker 机器数量。您可以通过增加或减少 worker MachineSet 中定义的副本数量来扩展 worker 机器集。

将集群扩展到具有更多节点时:

- 将节点分散到所有可用区以获得更高的可用性。

- 同时扩展的机器数量不要超过 25 到 50 个。

- 考虑在每个可用区创建一个具有类似大小的替代实例类型的新计算机器集,以帮助缓解周期性供应商容量限制。例如,在 AWS 上,使用 m5.large 和 m5d.large。

云供应商可能会为 API 服务实施配额。因此,需要对集群逐渐进行扩展。

如果同时将计算机器集中的副本设置为更高数量,则控制器可能无法创建机器。部署 OpenShift Container Platform 的云平台可以处理的请求数量将会影响该进程。当尝试创建、检查和更新有状态的机器时,控制器会开始进行更多的查询。部署 OpenShift Container Platform 的云平台具有 API 请求限制,如果出现过量查询,则可能会因为云平台的限制而导致机器创建失败。

当扩展到具有大量节点时,启用机器健康检查。如果出现故障,健康检查会监控状况并自动修复不健康的机器。

当对大型且高密度的集群减少节点数时,可能需要大量时间,因为这个过程涉及排空或驱除在同时终止的节点上运行的对象。另外,如果要驱除的对象太多,对客户端的请求处理会出现瓶颈。默认客户端查询每秒(QPS)和突发率当前分别设置为 5 和 10。这些值无法在 OpenShift Container Platform 中修改。

1.1.2. Control plane 节点大小

控制平面节点资源要求取决于集群中的节点和对象的数量和类型。以下控制平面节点大小是基于控制平面密度测试的结果,或 Clusterdensity。此测试会在给定很多命名空间中创建以下对象:

- 1 个镜像流

- 1 个构建

-

5 个部署,其中 2 个 pod 副本处于

睡眠状态,每个状态都挂载 4 个 secret、4 个配置映射和 1 Downward API 卷 - 5 个服务,每个服务都指向前一个部署的 TCP/8080 和 TCP/8443 端口

- 1 个路由指向上一个服务的第一个路由

- 包含 2048 个随机字符串字符的 10 个 secret

- 10 个配置映射包含 2048 个随机字符串字符

| worker 节点数量 | 集群密度(命名空间) | CPU 内核 | 内存 (GB) |

|---|---|---|---|

| 24 | 500 | 4 | 16 |

| 120 | 1000 | 8 | 32 |

| 252 | 4000 | 16,但如果使用 OVN-Kubernetes 网络插件,则为 24 | 64,但在使用 OVN-Kubernetes 网络插件时为 128 |

| 501,但使用 OVN-Kubernetes 网络插件时未测试 | 4000 | 16 | 96 |

上表中的数据基于在 AWS 上运行的 OpenShift Container Platform,使用 r5.4xlarge 实例作为 control-plane 节点,m5.2xlarge 实例作为 worker 节点。

在具有三个 control plane 节点的大型高密度集群中,当其中一个节点停止、重启或失败时,CPU 和内存用量将会激增。故障可能是因为电源、网络、底层基础架构或意外情况造成意外问题,因为集群在关闭后重启,以节约成本。其余两个 control plane 节点必须处理负载才能高度可用,从而增加资源使用量。另外,在升级过程中还会有这个预期,因为 control plane 节点被封锁、排空并按顺序重新引导,以应用操作系统更新以及 control plane Operator 更新。为了避免级联失败,请将 control plane 节点上的总体 CPU 和内存资源使用量保留为最多 60% 的所有可用容量,以处理资源使用量激增。相应地增加 control plane 节点上的 CPU 和内存,以避免因为缺少资源而造成潜在的停机。

节点大小取决于集群中的节点和对象数量。它还取决于集群上是否正在主动创建这些对象。在创建对象时,control plane 在资源使用量方面与对象处于运行(running)阶段的时间相比更活跃。

Operator Lifecycle Manager(OLM)在 control plane 节点上运行,其内存占用量取决于 OLM 在集群中管理的命名空间和用户安装的 operator 的数量。Control plane 节点需要相应地调整大小,以避免 OOM 终止。以下数据基于集群最大测试的结果。

| 命名空间数量 | 处于空闲状态的 OLM 内存(GB) | 安装了 5 个用户 operator 的 OLM 内存(GB) |

|---|---|---|

| 500 | 0.823 | 1.7 |

| 1000 | 1.2 | 2.5 |

| 1500 | 1.7 | 3.2 |

| 2000 | 2 | 4.4 |

| 3000 | 2.7 | 5.6 |

| 4000 | 3.8 | 7.6 |

| 5000 | 4.2 | 9.02 |

| 6000 | 5.8 | 11.3 |

| 7000 | 6.6 | 12.9 |

| 8000 | 6.9 | 14.8 |

| 9000 | 8 | 17.7 |

| 10,000 | 9.9 | 21.6 |

您只能为以下配置修改正在运行的 OpenShift Container Platform 4.12 集群中的 control plane 节点大小:

- 使用用户置备的安装方法安装的集群。

- 使用安装程序置备的基础架构安装方法安装的 AWS 集群。

- 使用 control plane 机器集管理 control plane 机器的集群。

对于所有其他配置,您必须估计节点总数并在安装过程中使用推荐的 control plane 节点大小。

建议基于在带有 OpenShiftSDN 作为网络插件的 OpenShift Container Platform 集群上捕获的数据点。

在 OpenShift Container Platform 4.12 中,与 OpenShift Container Platform 3.11 及之前的版本相比,系统现在默认保留半个 CPU 内核(500 millicore)。确定大小时应该考虑这一点。

如果 Amazon Web Services (AWS) 集群中的 control plane 机器需要更多资源,您可以为 control plane 机器选择更大的 AWS 实例类型。

使用 control plane 机器集的集群的步骤与不使用 control plane 机器集的集群的步骤不同。

如果不确定集群中 ControlPlaneMachineSet CR 的状态,您可以验证 CR 状态。

您可以通过更新 control plane 机器集自定义资源 (CR) 中的规格来更改 control plane 机器使用的 Amazon Web Services (AWS) 实例类型。

先决条件

- 您的 AWS 集群使用 control plane 机器集。

流程

运行以下命令来编辑 control plane 机器集 CR:

oc --namespace openshift-machine-api edit controlplanemachineset.machine.openshift.io cluster

$ oc --namespace openshift-machine-api edit controlplanemachineset.machine.openshift.io clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑

providerSpec字段中的以下行:providerSpec: value: ... instanceType: <compatible_aws_instance_type>providerSpec: value: ... instanceType: <compatible_aws_instance_type>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 使用与之前选择相同的基础指定较大的 AWS 实例类型。例如,您可以将

m6i.xlarge更改为m6i.2xlarge或m6i.4xlarge。

保存您的更改。

-

对于使用默认

RollingUpdate更新策略的集群,Operator 会自动将更改传播到 control plane 配置。 -

对于配置为使用

OnDelete更新策略的集群,您必须手动替换 control plane 机器。

-

对于使用默认

1.1.2.1.2. 使用 AWS 控制台更改 Amazon Web Services 实例类型

您可以通过更新 AWS 控制台中的实例类型来更改 control plane 机器使用的 Amazon Web Services (AWS) 实例类型。

先决条件

- 您可以使用修改集群的 EC2 实例所需的权限访问 AWS 控制台。

-

您可以使用具有

cluster-admin角色的用户访问 OpenShift Container Platform 集群。

流程

- 打开 AWS 控制台并为 control plane 机器获取实例。

选择一个 control plane 机器实例。

- 对于所选 control plane 机器,通过创建 etcd 快照来备份 etcd 数据。如需更多信息,请参阅 "恢复 etcd"。

- 在 AWS 控制台中,停止 control plane 机器实例。

- 选择已停止的实例,然后点 Actions → Instance Settings → Change instance type。

-

将实例更改为较大的类型,确保类型与之前选择相同,并应用更改。例如,您可以将

m6i.xlarge更改为m6i.2xlarge或m6i.4xlarge。 - 启动实例。

-

如果您的 OpenShift Container Platform 集群具有实例对应的

Machine对象,请更新对象的实例类型以匹配 AWS 控制台中设置的实例类型。

- 为每个 control plane 机器重复此步骤。

1.2. 推荐的基础架构实践

本主题为 OpenShift Container Platform 中的基础架构提供推荐的性能和可扩展性实践。

1.2.1. 基础架构节点大小

基础架构节点是标记为运行 OpenShift Container Platform 环境组成部分的节点。基础架构节点的资源要求取决于集群中的集群年龄、节点和对象,因为这些因素可能会导致 Prometheus 的指标或时间序列增加。以下基础架构节点大小是基于在 Control plane 节点大小 部分中详述的集群密度测试中观察到的结果,其中监控堆栈和默认 ingress-controller 被移到这些节点。

| worker 节点数量 | 集群密度或命名空间数量 | CPU 内核 | 内存 (GB) |

|---|---|---|---|

| 27 | 500 | 4 | 24 |

| 120 | 1000 | 8 | 48 |

| 252 | 4000 | 16 | 128 |

| 501 | 4000 | 32 | 128 |

通常,建议每个集群有三个基础架构节点。

这些大小建议应用作指导行。Prometheus 是一个高内存密集型应用程序,资源使用量取决于各种因素,包括节点、对象、Prometheus 指标提取间隔、指标或时间序列以及集群的年龄。此外,路由器资源使用量也可以受到路由数量和入站请求的数量/类型的影响。

这些建议只适用于在集群创建过程中安装监控、Ingress 和 Registry 基础架构组件的基础架构节点。

在 OpenShift Container Platform 4.12 中,与 OpenShift Container Platform 3.11 及之前的版本相比,系统现在默认保留半个 CPU 内核(500 millicore)。这会影响缩放建议。

1.2.2. 扩展 Cluster Monitoring Operator

OpenShift Container Platform 会提供 Cluster Monitoring Operator 在基于 Prometheus 的监控堆栈中收集并存储的数据。作为管理员,您可以通过进入 Observe → Dashboards 来查看 OpenShift Container Platform Web 控制台中的系统资源、容器和组件指标的仪表板。

1.2.3. Prometheus 数据库存储要求

红帽对不同的扩展大小进行了各种测试。

- 以下 Prometheus 存储要求并不具有规定性,应该将它们视为参考信息。取决于具体的工作负载和资源的使用,集群中可能会出现高的资源消耗,包括 Prometheus 收集的指标,如 pod 、容器、路由或其他资源的数量。

- 您可以配置基于大小的数据保留策略,以满足您的存储要求。

| 节点数 | pod 数量(每个 pod 2 个容器) | 每天增加的 Prometheus 存储 | 每 15 天增加的 Prometheus 存储 | 网络(每个 tsdb 块) |

|---|---|---|---|---|

| 50 | 1800 | 6.3 GB | 94 GB | 16 MB |

| 100 | 3600 | 13 GB | 195 GB | 26 MB |

| 150 | 5400 | 19 GB | 283 GB | 36 MB |

| 200 | 7200 | 25 GB | 375 GB | 46 MB |

大约 20%的预期大小被添加为开销,以保证存储要求不会超过计算的值。

上面的计算用于默认的 OpenShift Container Platform Cluster Monitoring Operator。

CPU 利用率会有轻微影响。这个比例为在每 50 个节点和 1800 个 pod 的 40 个内核中大约有 1 个。

针对 OpenShift Container Platform 的建议

- 至少使用两个基础架构 (infra) 节点。

- 至少使用三个带有非易失性存储器 (SSD 或 NVMe) 驱动器的 openshift-container-storage 节点。

1.2.4. 配置集群监控

您可以为集群监控堆栈中的 Prometheus 组件增加存储容量。

流程

为 Prometheus 增加存储容量:

创建 YAML 配置文件

cluster-monitoring-config.yaml。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Prometheus 保留的默认值为

PROMETHEUS_RETENTION_PERIOD=15d。时间单位使用以下后缀之一 : s 、m 、h 、d。 - 2 4

- 集群的存储类。

- 3

- 一个典型的值是

PROMETHEUS_STORAGE_SIZE=2000Gi。存储值可以是一个纯整数,也可以是带有以下后缀之一的整数: E 、P 、T 、G 、M 、K。您也可以使用以下效果相同的后缀:Ei 、Pi 、Ti 、Gi 、Mi 、Ki。 - 5

- 一个典型的值

是 alertmanager_STORAGE_SIZE=20Gi。存储值可以是一个纯整数,也可以是带有以下后缀之一的整数: E 、P 、T 、G 、M 、K。您也可以使用以下效果相同的后缀:Ei 、Pi 、Ti 、Gi 、Mi 、Ki。

- 为保留周期、存储类和存储大小添加值。

- 保存该文件。

运行以下命令应用这些更改:

oc create -f cluster-monitoring-config.yaml

$ oc create -f cluster-monitoring-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3. 推荐的 etcd 实践

本主题为 OpenShift Container Platform 中的 etcd 提供了推荐的性能和可扩展性实践。

1.3.1. 推荐的 etcd 实践

因为 etcd 将数据写入磁盘并在磁盘上持久化,所以其性能取决于磁盘性能。虽然 etcd 并不是有非常高的 I/O 负载,但它需要使用一个具有低延迟的块设备才能获得最佳性能和稳定性。因为 etcd 的共识协议依赖于将元数据永久存储到一个日志 (WAL),所以 etcd 对磁盘的写延迟非常敏感。减慢来自其他进程的磁盘活动和磁盘活动可能会导致长时间的 fsync 延迟。

这些延迟可能会导致 etcd 丢失心跳,不会及时向磁盘提交新的建议,并最终遇到请求超时和临时丢失问题。高写入延迟也会导致 OpenShift API 较慢,这会影响集群性能。由于这些原因,请避免在具有 I/O 敏感或密集型的 control-plane 节点上并置其他工作负载,并共享相同的底层 I/O 基础架构。

就延迟而言,应该在一个可最少以 50 IOPS 按顺序写入 8000 字节的块设备上运行。也就是说,当有一个 10ms 的延迟时,使用 fdatasync 来同步 WAL 中的写入操作。对于高负载的集群,建议使用 8000 字节的连续 500 IOPS (2 毫秒)。要测量这些数字,您可以使用基准测试工具,如 fio。

要实现这样的性能,在由低延迟和高吞吐量的 SSD 或 NVMe 磁盘支持的机器上运行 etcd。考虑使用单层单元(SLC)固态驱动器(SSD)(它为每个内存单元提供 1 位),这是可靠的,非常适合于写密集型工作负载。

影响 etcd 上的负载的因素包括静态因素,如节点和 pod 的数量,以及动态因素,包括因为 pod 自动扩展、pod 重启、作业执行和其他与工作负载相关的事件,以及其他与负载相关的事件。要准确调整 etcd 设置的大小,您必须分析工作负载的特定要求。考虑影响 etcd 负载的节点、pod 和其他相关因素的数量。

以下硬盘功能提供最佳的 etcd 性能:

- 支持快速读取操作的低延迟。

- 高带宽写入,实现更快速的压缩和碎片处理。

- 高带宽读取,加快从故障恢复。

- 固态硬盘是最小的选择,NVMe 驱动器是首选的。

- 来自不同制造商的服务器级硬件可以提高可靠性。

- RAID 0 技术以提高性能。

- 专用 etcd 驱动器。不要将日志文件或其他重重工作负载放在 etcd 驱动器中。

避免 NAS 或 SAN 设置,以及旋转驱动器。Ceph Rados 块设备 (RBD) 和其他类型的网络附加存储可能会导致网络延迟无法预计。要大规模向 etcd 节点提供快速存储,请使用 PCI 透传将 NVM 设备直接传递给节点。

始终使用相关工具(如 fio)进行基准测试。当集群性能增加时,您可以使用这些工具不断监控集群性能。

避免使用网络文件系统 (NFS) 协议或其他基于网络的文件系统。

需要在部署的 OpenShift Container Platform 集群上监控的一些关键指标包括,日志持续时间之前的 etcd 磁盘写入的 p99 值,以及 etcd leader 更改的数量。使用 Prometheus 跟踪这些指标。

在正常操作过程中,etcd 成员数据库大小可能会因集群而异。这种差异不会影响集群升级,即使领导大小与其他成员不同。

要在创建 OpenShift Container Platform 集群之前或之后验证 etcd 的硬件,您可以使用 fio。

先决条件

- 您正在测试的机器上安装了 Podman 或 Docker 等容器运行时。

-

数据被写入

/var/lib/etcd路径。

流程

运行 fio 并分析结果:

如果使用 Podman,请运行以下命令:

sudo podman run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perf

$ sudo podman run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perfCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果使用 Docker,请运行以下命令:

sudo docker run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perf

$ sudo docker run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perfCopy to Clipboard Copied! Toggle word wrap Toggle overflow

输出会报告磁盘是否足够快以运行 etcd,它会检查测试运行中获得的 fsync 指标的 p99 值是否小于 10ms。一些最重要的 etcd 指标可能受到 I/O 性能的影响,如下所示:

-

etcd_disk_wal_fsync_duration_seconds_bucket指标报告了 etcd 的 WAL fsync 持续时间。 -

etcd_disk_backend_commit_duration_seconds_bucket指标报告 etcd 后端提交延迟持续时间 -

etcd_server_leader_changes_seen_total指标报告领导更改

etcd 在所有成员间复制请求,因此其性能会严重依赖于网络输入/输出(I/O)的延迟。大量网络延迟会导致 etcd heartbeat 的时间比选举超时时间更长,这会导致一个可能会对集群造成破坏的领导选举。在部署的 OpenShift Container Platform 集群上监控的一个关键指标是每个 etcd 集群成员上的 etcd 网络对延迟的 p99 百分比。使用 Prometheus 跟踪指标数据。

histogram_quantile(0.99, rate(etcd_network_peer_round_trip_time_seconds_bucket[2m]) 指标报告 etcd 在成员间复制客户端请求的时间。确保它小于 50 ms。

1.3.2. 将 etcd 移动到不同的磁盘

您可以将 etcd 从共享磁盘移到独立磁盘,以防止或解决性能问题。

Machine Config Operator (MCO) 负责为 OpenShift Container Platform 4.12 容器存储挂载辅助磁盘。

这个编码脚本只支持以下设备类型的设备名称:

- SCSI 或 SATA

-

/dev/sd* - 虚拟设备

-

/dev/vd* - NVMe

-

/dev/nvme*[0-9]*n*

限制

-

当新磁盘附加到集群时,etcd 数据库是 root 挂载的一部分。当主节点被重新创建时,它不是二级磁盘的一部分或预期的磁盘。因此,主节点不会创建单独的

/var/lib/etcd挂载。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

您可以使用

cluster-admin权限访问集群。 - 在上传机器配置前添加额外的磁盘。

-

MachineConfigPool必须与metadata.labels[machineconfiguration.openshift.io/role]匹配。这适用于控制器、worker 或自定义池。

这个过程不会将 root 文件系统的部分内容(如 /var/ )移到已安装节点上的另一个磁盘或分区。

流程

将新磁盘附加到集群,并在 debug shell 中运行

lsblk命令来验证节点中是否检测到磁盘:oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow lsblk

# lsblkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 记录下

lsblk命令报告的新磁盘的设备名称。根据您的环境解码和替换脚本中的设备名称。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<device_type_glob>替换为您的块设备类型的 shell glob。对于 SCSI 或 SATA 驱动器,使用/dev/sd*; 对于虚拟驱动器,使用/dev/vd*; 对于 NVMe 驱动器,使用/dev/nvme*[0-9]*n*。

创建名为

etcd-mc.yml的MachineConfigYAML 文件,其内容如下:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 使用之前创建的编码字符串,并将其替换为您记下的编码脚本。

验证步骤

在节点的 debug shell 中运行

grep /var/lib/etcd /proc/mounts命令,以确保挂载磁盘:oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow grep -w "/var/lib/etcd" /proc/mounts

# grep -w "/var/lib/etcd" /proc/mountsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

/dev/sdb /var/lib/etcd xfs rw,seclabel,relatime,attr2,inode64,logbufs=8,logbsize=32k,noquota 0 0

/dev/sdb /var/lib/etcd xfs rw,seclabel,relatime,attr2,inode64,logbufs=8,logbsize=32k,noquota 0 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3.3. 分离 etcd 数据

对于大型、高密度的集群,如果键空间增长过大并超过空间配额,etcd 的性能将会受到影响。定期维护并处理碎片化的 etcd,以释放数据存储中的空间。监控 Prometheus 以了解 etcd 指标数据,并在需要时对其进行碎片处理;否则,etcd 可能会引发一个集群范围的警报,使集群进入维护模式,仅能接受对键的读和删除操作。

监控这些关键指标:

-

etcd_server_quota_backend_bytes,这是当前配额限制 -

etcd_mvcc_db_total_size_in_use_in_bytes,表示历史压缩后实际数据库使用量 -

etcd_mvcc_db_total_size_in_bytes显示数据库大小,包括等待碎片整理的可用空间

在导致磁盘碎片的事件后(如 etcd 历史记录紧凑)对 etcd 数据进行清理以回收磁盘空间。

历史压缩将自动每五分钟执行一次,并在后端数据库中造成混乱。此碎片空间可供 etcd 使用,但主机文件系统不可用。您必须对碎片 etcd 进行碎片清除,才能使这个空间可供主机文件系统使用。

碎片清理会自动发生,但您也可以手动触发它。

自动清理碎片非常适合大多数情况,因为 etcd operator 使用集群信息来确定用户最有效的操作。

1.3.3.1. 自动清理

etcd Operator 自动清理碎片磁盘。不需要人工干预。

查看以下日志之一来验证碎片整理过程是否成功:

- etcd 日志

- cluster-etcd-operator pod

- Operator 状态错误日志

自动清除可能会导致各种 OpenShift 核心组件中的领导选举失败,如 Kubernetes 控制器管理器,这会触发重启失败的组件。重启会有危害,并会触发对下一个正在运行的实例的故障切换,或者组件在重启后再次恢复工作。

成功进行碎片处理的日志输出示例

etcd member has been defragmented: <member_name>, memberID: <member_id>

etcd member has been defragmented: <member_name>, memberID: <member_id>进行碎片处理失败的日志输出示例

failed defrag on member: <member_name>, memberID: <member_id>: <error_message>

failed defrag on member: <member_name>, memberID: <member_id>: <error_message>1.3.3.2. 手动清理

Prometheus 警报指示您需要手动进行碎片处理。该警报在两个情况下显示:

- 当 etcd 使用超过 50% 的可用空间超过了 10 分钟

- 当 etcd 活跃使用小于其数据库总大小的 50% 超过了 10 分钟

您还可以通过检查 etcd 数据库大小(MB)来决定是否需要进行碎片整理。通过 PromQL 表达 (etcd_mvcc_db_total_size_in_bytes - etcd_mvcc_db_total_size_in_use_in_bytes)/1024/1024 来释放空间。

分离 etcd 是一个阻止性操作。在进行碎片处理完成前,etcd 成员将没有响应。因此,在每个下一个 pod 要进行碎片清理前,至少等待一分钟,以便集群可以恢复正常工作。

按照以下步骤对每个 etcd 成员上的 etcd 数据进行碎片处理。

先决条件

-

您可以使用具有

cluster-admin角色的用户访问集群。

流程

确定哪个 etcd 成员是领导成员,因为领导会进行最后的碎片处理。

获取 etcd pod 列表:

oc -n openshift-etcd get pods -l k8s-app=etcd -o wide

$ oc -n openshift-etcd get pods -l k8s-app=etcd -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

etcd-ip-10-0-159-225.example.redhat.com 3/3 Running 0 175m 10.0.159.225 ip-10-0-159-225.example.redhat.com <none> <none> etcd-ip-10-0-191-37.example.redhat.com 3/3 Running 0 173m 10.0.191.37 ip-10-0-191-37.example.redhat.com <none> <none> etcd-ip-10-0-199-170.example.redhat.com 3/3 Running 0 176m 10.0.199.170 ip-10-0-199-170.example.redhat.com <none> <none>

etcd-ip-10-0-159-225.example.redhat.com 3/3 Running 0 175m 10.0.159.225 ip-10-0-159-225.example.redhat.com <none> <none> etcd-ip-10-0-191-37.example.redhat.com 3/3 Running 0 173m 10.0.191.37 ip-10-0-191-37.example.redhat.com <none> <none> etcd-ip-10-0-199-170.example.redhat.com 3/3 Running 0 176m 10.0.199.170 ip-10-0-199-170.example.redhat.com <none> <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 选择 pod 并运行以下命令来确定哪个 etcd 成员是领导:

oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com etcdctl endpoint status --cluster -w table

$ oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com etcdctl endpoint status --cluster -w tableCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 基于此输出的

IS LEADER列,https://10.0.199.170:2379端点是领导。与上一步输出匹配此端点,领导的 pod 名称为etcd-ip-10-0-199-170.example.redhat.com。

清理 etcd 成员。

连接到正在运行的 etcd 容器,传递 不是 领导的 pod 的名称:

oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com

$ oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 取消设置

ETCDCTL_ENDPOINTS环境变量:unset ETCDCTL_ENDPOINTS

sh-4.4# unset ETCDCTL_ENDPOINTSCopy to Clipboard Copied! Toggle word wrap Toggle overflow 清理 etcd 成员:

etcdctl --command-timeout=30s --endpoints=https://localhost:2379 defrag

sh-4.4# etcdctl --command-timeout=30s --endpoints=https://localhost:2379 defragCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Finished defragmenting etcd member[https://localhost:2379]

Finished defragmenting etcd member[https://localhost:2379]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果发生超时错误,增加

--command-timeout的值,直到命令成功为止。验证数据库大小是否已缩小:

etcdctl endpoint status -w table --cluster

sh-4.4# etcdctl endpoint status -w table --clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 本例显示这个 etcd 成员的数据库大小现在为 41 MB,而起始大小为 104 MB。

重复这些步骤以连接到其他 etcd 成员并进行碎片处理。最后才对领导进行碎片清除。

至少要在碎片处理操作之间等待一分钟,以便 etcd pod 可以恢复。在 etcd pod 恢复前,etcd 成员不会响应。

如果因为超过空间配额而触发任何

NOSPACE警告,请清除它们。检查是否有

NOSPACE警告:etcdctl alarm list

sh-4.4# etcdctl alarm listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

memberID:12345678912345678912 alarm:NOSPACE

memberID:12345678912345678912 alarm:NOSPACECopy to Clipboard Copied! Toggle word wrap Toggle overflow 清除警告:

etcdctl alarm disarm

sh-4.4# etcdctl alarm disarmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 2 章 根据对象限制规划您的环境

在规划 OpenShift Container Platform 集群时,请考虑以下对象限制。

这些限制基于最大可能的集群。对于较小的集群,最大值限制会较低。很多因素会影响指定的阈值,包括 etcd 版本或者存储数据格式。

在大多数情况下,超过这些限制会降低整体性能。它不一定意味着集群会出现错误。

对于快速变化的集群(如集群中包括多个启动和停止的 pod)可能会有比记录中小的实际最大大小。

2.1. OpenShift Container Platform 为主发行版本测试了集群最大值

红帽不提供针对 OpenShift Container Platform 集群大小调整的直接指导。这是因为,判断集群是否在 OpenShift Container Platform 支持的边界内,需要仔细考虑限制集群扩展的所有多维因素。

OpenShift Container Platform 支持测试的集群最大值,而不是绝对集群最大值。并非所有 OpenShift Container Platform 版本、control plane 工作负载和网络插件的组合都会被测试,因此下表并不表示所有部署的扩展绝对预期。可能无法同时扩展到所有维度上的最大值。表包含特定工作负载和部署配置的测试的最大值,并充当扩展指南,如类似部署的预期内容。

| 最大类型 | 4.x 测试的最大值 |

|---|---|

| 节点数 | 2,000 [1] |

| pod 数量 [2] | 150,000 |

| 每个节点的 pod 数量 | 500 [3] |

| 每个内核的 pod 数量 | 没有默认值。 |

| 命名空间数量 [4] | 10,000 |

| 构建(build)数 | 10,000(默认 pod RAM 512 Mi)- Source-to-Image (S2I) 构建策略 |

| 每个命名空间的 pod 数量 [5] | 25,000 |

| 每个 Ingress Controller 的路由和后端数量 | 每个路由器 2,000 个 |

| secret 的数量 | 80,000 |

| 配置映射数量 | 90,000 |

| 服务数 [6] | 10,000 |

| 每个命名空间的服务数 | 5,000 |

| 每个服务中的后端数 | 5,000 |

| 每个命名空间的部署数量 [5] | 2,000 |

| 构建配置数 | 12,000 |

| 自定义资源定义 (CRD) 的数量 | 512 [7] |

- 部署暂停 Pod 以在 2000 个节点规模下对 OpenShift Container Platform 的 control plane 组件进行压力测试。扩展至类似数量的功能会根据特定的部署和工作负载参数而有所不同。

- 这里的 pod 数量是 test pod 的数量。实际的 pod 数量取决于应用程序的内存、CPU 和存储要求。

-

这在一个有 100 个 work 节点,每个 worker 节点有 500 个 pod 的集群中测试。默认

maxPods仍为 250。要获得 500maxPods,则必须使用自定义 kubelet 配置将maxPods设置为500来创建集群。如果需要 500 个用户 Pod,则需要hostPrefix为22,因为节点上已经运行了 10-15 个系统 pod。带有 Persistent VolumeClaim (PVC) 的最大 pod 数量取决于分配 PVC 的后端存储。在我们的测试中,只有 OpenShift Data Foundation v4(OCS v4)能够满足本文档中提到的每个节点的 pod 数量。 - 当有大量活跃的项目时,如果键空间增长过大并超过空间配额,etcd 的性能将会受到影响。强烈建议您定期维护 etcd 存储(包括整理碎片)来释放 etcd 存储。

- 系统中有一些控制循环,它们必须对给定命名空间中的所有对象进行迭代,以作为对一些状态更改的响应。在单一命名空间中有大量给定类型的对象可使这些循环的运行成本变高,并降低对给定状态变化的处理速度。限制假设系统有足够的 CPU 、内存和磁盘来满足应用程序的要求。

- 每个服务端口和每个服务后端在 iptables 中都有对应条目。给定服务的后端数量会影响端点对象的大小,这会影响到整个系统发送的数据大小。

-

OpenShift Container Platform 的限制是 512 个总自定义资源定义(CRD),其中包括由 OpenShift Container Platform 安装的产品、与 OpenShift Container Platform 集成并创建了 CRD 的产品。如果创建超过 512 CRD,则

oc命令请求可能会节流。

2.1.1. 示例情境

例如,500 个 worker 节点(m5.2xl)经过测试,并被支持,使用 OpenShift Container Platform 4.12、OVN-Kubernetes 网络插件和以下工作负载对象:

- 除默认值外,200 个命名空间

- 每个节点 60 个 pod;30 个服务器和 30 个客户端 pod (总计 30k)

- 57 镜像流/ns (11.4k 总计)

- 15 services/ns 被服务器 pod 支持 (共 3k)

- 15 routes/ns 被以前的服务支持 (共 3k)

- 20 secrets/ns (共 4k)

- 10 config maps/ns (共 2k)

- 6 个网络策略/ns,包括 deny-all、allow-from ingress 和 in-namespace 规则

- 57 builds/ns

以下因素已知会对集群工作负载扩展有影响(正面的影响或负面的影响),在规划部署时应进行考虑。如需其他信息和指导,请联络您的销售代表或 红帽支持。

- 每个节点的 pod 数量

- 每个 pod 的容器数量

- 使用的探测类型(如 liveness/readiness、exec/http)

- 网络策略数量

- 项目或命名空间数量

- 每个项目的镜像流数

- 项目的构建数

- 服务/日期和类型数

- 路由数

- 分片数量

- secret 的数量

- 配置映射数量

API 调用率或集群 "churn",这是集群配置中快速变化的估算。

-

Prometheus 查询每秒 5 分钟窗口的 pod 创建请求:

sum(irate(apiserver_request_count{resource="pods",verb="POST"}[5m])) -

在 5 分钟的时间内 Prometheus 每秒查询所有 API 请求:

sum(irate(apiserver_request_count{}[5m]))

-

Prometheus 查询每秒 5 分钟窗口的 pod 创建请求:

- CPU 的集群节点资源消耗

- 集群节点资源消耗

2.2. 测试集群最大值的 OpenShift Container Platform 环境和配置

2.2.1. AWS 云平台

| 节点 | Flavor | vCPU | RAM(GiB) | 磁盘类型 | 磁盘大小(GiB)/IOS | 数量 | 区域 |

|---|---|---|---|---|---|---|---|

| control plane/etcd [1] | r5.4xlarge | 16 | 128 | gp3 | 220 | 3 | us-west-2 |

| Infra [2] | m5.12xlarge | 48 | 192 | gp3 | 100 | 3 | us-west-2 |

| Workload [3] | m5.4xlarge | 16 | 64 | gp3 | 500 [4] | 1 | us-west-2 |

| Compute | m5.2xlarge | 8 | 32 | gp3 | 100 | 3/25/250/500 [5] | us-west-2 |

- 带有基准性能为 3000 IOPS 和 125 MiB 每秒的 gp3 磁盘用于 control plane/etcd 节点,因为 etcd 对延迟敏感。gp3 卷不使用突发性能。

- Infra 节点用于托管 Monitoring、Ingress 和 Registry 组件,以确保它们有足够资源可大规模运行。

- 工作负载节点专用于运行性能和可扩展工作负载生成器。

- 使用更大的磁盘,以便有足够的空间存储在运行性能和可扩展性测试期间收集的大量数据。

- 在迭代中扩展了集群,且性能和可扩展性测试是在指定节点数中执行的。

2.2.2. IBM Power 平台

| 节点 | vCPU | RAM(GiB) | 磁盘类型 | 磁盘大小(GiB)/IOS | 数量 |

|---|---|---|---|---|---|

| control plane/etcd [1] | 16 | 32 | io1 | 每个 GiB 120 / 10 IOPS | 3 |

| Infra [2] | 16 | 64 | gp2 | 120 | 2 |

| Workload [3] | 16 | 256 | gp2 | 120 [4] | 1 |

| Compute | 16 | 64 | gp2 | 120 | 2 到 100 [5] |

- 带有 120 / 10 IOPS 的 io1 磁盘用于 control plane/etcd 节点,因为 etcd 非常大,且敏感延迟。

- Infra 节点用于托管 Monitoring、Ingress 和 Registry 组件,以确保它们有足够资源可大规模运行。

- 工作负载节点专用于运行性能和可扩展工作负载生成器。

- 使用更大的磁盘,以便有足够的空间存储在运行性能和可扩展性测试期间收集的大量数据。

- 在迭代中扩展了集群。

2.2.3. IBM Z 平台

| 节点 | vCPU [4] | RAM(GiB)[5] | 磁盘类型 | 磁盘大小(GiB)/IOS | 数量 |

|---|---|---|---|---|---|

| Control plane/etcd [1,2] | 8 | 32 | ds8k | 300 / LCU 1 | 3 |

| Compute [1,3] | 8 | 32 | ds8k | 150 / LCU 2 | 4 节点(每个节点扩展到 100/250/500 pod) |

- 节点在两个逻辑控制单元 (LCU) 之间分发,以优化 control plane/etcd 节点的磁盘 I/O 负载,因为 etcd 非常大,且对延迟敏感。etcd I/O 需求不应干扰其他工作负载。

- 四个计算节点用于运行同时具有 100/250/500 pod 的多个迭代的测试。首先,使用闲置 pod 来评估 pod 是否可以实例。接下来,使用网络和 CPU 要求客户端/服务器工作负载来评估系统在压力下的稳定性。客户端和服务器 pod 是部署范围,每个对分布在两个计算节点上。

- 没有单独的工作负载节点。工作负载在两个计算节点之间模拟微服务工作负载。

- 使用的物理处理器数量是 6 个用于 Linux (IFL)的集成设施。

- 使用的总物理内存为 512 GiB。

2.3. 如何根据经过测试的集群限制规划您的环境

在节点中过度订阅物理资源会影响在 pod 放置过程中对 Kubernetes 调度程序的资源保证。了解可以采取什么措施避免内存交换。

某些限制只在单一维度中扩展。当很多对象在集群中运行时,它们会有所不同。

本文档中给出的数字基于红帽的测试方法、设置、配置和调整。这些数字会根据您自己的设置和环境而有所不同。

在规划您的环境时,请确定每个节点会运行多少 个 pod :

required pods per cluster / pods per node = total number of nodes needed

required pods per cluster / pods per node = total number of nodes needed每个节点的默认最多 pod 数为 250。而在某个节点中运行的 pod 的具体数量取决于应用程序本身。请参阅“如何根据应用程序要求规划您的环境”中的内容来计划应用程序的内存、CPU 和存储要求。

示例情境

如果您计划把集群的规模限制在有 2200 个 pod,则需要至少有五个节点,假设每个节点最多有 500 个 pod:

2200 / 500 = 4.4

2200 / 500 = 4.4如果将节点数量增加到 20,那么 pod 的分布情况将变为每个节点有 110 个 pod:

2200 / 20 = 110

2200 / 20 = 110其中:

required pods per cluster / total number of nodes = expected pods per node

required pods per cluster / total number of nodes = expected pods per nodeOpenShift Container Platform 附带几个系统 pod,如 SDN、DNS、Operator 等,这些 pod 默认在每个 worker 节点上运行。因此,以上公式的结果可能会有所不同。

2.4. 如何根据应用程序要求规划您的环境

考虑应用程序环境示例:

| pod 类型 | pod 数量 | 最大内存 | CPU 内核 | 持久性存储 |

|---|---|---|---|---|

| Apache | 100 | 500 MB | 0.5 | 1 GB |

| node.js | 200 | 1 GB | 1 | 1 GB |

| postgresql | 100 | 1 GB | 2 | 10 GB |

| JBoss EAP | 100 | 1 GB | 1 | 1 GB |

推断的要求: 550 个 CPU 内核、450GB RAM 和 1.4TB 存储。

根据您的具体情况,节点的实例大小可以被增大或降低。在节点上通常会使用资源过度分配。在这个部署场景中,您可以选择运行多个额外的较小节点,或数量更少的较大节点来提供同样数量的资源。在做出决定前应考虑一些因素,如操作的灵活性以及每个实例的成本。

| 节点类型 | 数量 | CPU | RAM (GB) |

|---|---|---|---|

| 节点(选择 1) | 100 | 4 | 16 |

| 节点(选择 2) | 50 | 8 | 32 |

| 节点(选择 3) | 25 | 16 | 64 |

有些应用程序很适合于过度分配的环境,有些则不适合。大多数 Java 应用程序以及使用巨页的应用程序都不允许使用过度分配功能。它们的内存不能用于其他应用程序。在上面的例子中,环境大约会出现 30% 过度分配的情况,这是一个常见的比例。

应用程序 pod 可以使用环境变量或 DNS 访问服务。如果使用环境变量,当 pod 在节点上运行时,对于每个活跃服务,则 kubelet 的变量都会注入。集群感知 DNS 服务器监视 Kubernetes API 提供了新服务,并为每个服务创建一组 DNS 记录。如果整个集群中启用了 DNS,则所有 pod 都应自动根据其 DNS 名称解析服务。如果您必须超过 5000 服务,可以使用 DNS 进行服务发现。当使用环境变量进行服务发现时,参数列表超过了命名空间中 5000 服务后允许的长度,则 pod 和部署将失败。要解决这个问题,请禁用部署的服务规格文件中的服务链接:

可在命名空间中运行的应用程序 pod 数量取决于服务数量以及环境变量用于服务发现时的服务名称长度。系统上的 ARG_MAX 定义新进程的最大参数长度,默认设置为 2097152 字节 (2 MiB)。Kubelet 将环境变量注入到要在命名空间中运行的每个 pod 中,包括:

-

<SERVICE_NAME>_SERVICE_HOST=<IP> -

<SERVICE_NAME>_SERVICE_PORT=<PORT> -

<SERVICE_NAME>_PORT=tcp://<IP>:<PORT> -

<SERVICE_NAME>_PORT_<PORT>_TCP=tcp://<IP>:<PORT> -

<SERVICE_NAME>_PORT_<PORT>_TCP_PROTO=tcp -

<SERVICE_NAME>_PORT_<PORT>_TCP_PORT=<PORT> -

<SERVICE_NAME>_PORT_<PORT>_TCP_ADDR=<ADDR>

如果参数长度超过允许的值,服务名称中的字符数会受到影响,命名空间中的 pod 将开始失败。例如,在一个带有 5000 服务的命名空间中,服务名称的限制为 33 个字符,它可让您在命名空间中运行 5000 个 Pod。

第 3 章 IBM Z 和 IBM (R) LinuxONE 环境的推荐主机实践

本主题为 IBM Z 和 IBM® LinuxONE 上的 OpenShift Container Platform 提供推荐的主机实践。

s390x 架构在很多方面都是唯一的。因此,此处提出的一些建议可能不适用于其他平台。

除非另有说明,否则这些实践适用于 IBM Z 和 IBM® LinuxONE 上的 z/VM 和 Red Hat Enterprise Linux (RHEL) KVM 安装。

3.1. 管理 CPU 过量使用

在高度虚拟化的 IBM Z 环境中,您必须仔细规划基础架构的设置和大小。虚拟化最重要的功能之一是能够进行资源过量使用,从而将更多资源分配给虚拟机,而不是在管理程序级别实际可用。这主要依赖于具体的工作负载,并没有适用于所有环境的“黄金法则”。

根据您的设置,在设计 CPU 过量使用 时请考虑这些最佳实践:

- 在 LPAR 级别 (PR/SM hypervisor),避免将所有可用物理内核 (IFL) 分配给每个 LPAR。例如,当有四个物理 IFL 可用时,您不应该定义三个 LPAR,每个都带有四个逻辑 IFL。

- 检查并了解 LPAR 共享和权重.

- 过多的虚拟 CPU 会对性能造成负面影响。不要将比逻辑处理器定义为 LPAR 更多的虚拟处理器。

- 为峰值工作负载配置每个客户机的虚拟处理器数量,而不是配置更多.

- 从一个小的数量开始,并监控工作负载。如有必要,逐步增加 vCPU 数量。

- 并非所有工作负载都适合适用高过量使用比率。如果工作负载是 CPU 密集型的,那么您可能无法在不对性能造成影响的情况下使用高的比率。对于高 I/O 密集型工作负载,即便具有较高的过量使用比率,也能保持一致的性能。

3.2. 禁用透明巨页

Transparent Huge Pages (THP) 会试图自动执行创建、管理和使用巨页的大部分方面。由于 THP 自动管理巨页,因此并不始终对所有类型的工作负载进行最佳处理。THP 可能会导致性能下降,因为许多应用程序都自行处理巨页。因此,请考虑禁用 THP。

3.3. 使用 Receive Flow Steering(RFS)提高网络性能

通过进一步减少网络延迟,Receive Flow Steering (RFS) 进一步扩展了 Receive Packet Steering (RPS)。RFS 在技术上基于 RPS,通过增加 CPU 缓存命中率来提高数据包处理的效率。RFS 通过确定计算最方便的 CPU,以便缓存命中更有可能在 CPU 中发生,增加了对队列长度的考虑。因此,会减少 CPU 缓存无效的频率,从而只需要较少的循环来重建缓存。这有助于缩短数据包处理运行时间。

3.3.1. 使用 Machine Config Operator (MCO) 激活 RFS

流程

将以下 MCO 示例配置集复制到 YAML 文件中。例如,

enable-rfs.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 MCO 配置集:

oc create -f enable-rfs.yaml

$ oc create -f enable-rfs.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证是否列出了名为

50-enable-rfs的条目:oc get mc

$ oc get mcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要取消激活,请输入:

oc delete mc 50-enable-rfs

$ oc delete mc 50-enable-rfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. 选择您的网络设置

网络堆栈是 OpenShift Container Platform 等基于 Kubernetes 的产品最重要的组件之一。对于 IBM Z 设置,网络设置取决于您选择的虚拟机监控程序。取决于具体的工作负载和应用,最佳实践通常需要根据用例和流量模式进行更改。

根据您的设置,考虑以下最佳实践:

- 考虑有关网络设备的所有选项,以优化您的流量模式。探索 OSA-Express、RoCE Express、HiperSockets、z/VM VSwitch、Linux 网桥 (KVM) 的优势,以确定哪个选项为您的设置带来最大好处。

- 始终使用最新可用的 NIC 版本。例如,OSA Express 7S 10 GbE 与带有事务工作负载类型的 OSA Express 6S 10 GbE 相比有显著改进,尽管两者都是 10 GbE 适配器。

- 每个虚拟交换机都添加了额外的延迟层。

- 负载平衡器在集群外的网络通信中扮演重要角色。如果这对应用程序至关重要,请考虑使用生产环境级的硬件负载平衡器。

- OpenShift Container Platform SDN 引入了影响网络性能的流程和规则。确保对 pod 关联性和放置进行考虑,以便至关重要的服务会受益于本地通信的优势。

- 平衡性能和功能之间的权衡.

3.5. 确保 z/VM 上使用 HyperPAV 的高磁盘性能

DASD 和 ECKD 设备在 IBM Z 环境中通常使用磁盘类型。在 z/VM 环境中的典型 OpenShift Container Platform 设置中,DASD 磁盘通常用于支持节点的本地存储。您可以设置 HyperPAV 别名设备,以便为支持 z/VM 客户机的 DASD 磁盘提供更多吞吐量和总体更好的 I/O 性能。

将 HyperPAV 用于本地存储设备可带来显著的性能优势。但是,您必须考虑吞吐量和 CPU 成本之间有一个权衡。

对于使用 full-pack minidisk 的基于 z/VM 的 OpenShift Container Platform 设置,您可以通过在所有节点中激活 HyperPAV 别名来利用 MCO 配置集的优势。您必须为 control plane 和计算节点添加 YAML 配置。

流程

将以下 MCO 示例配置集复制到 control plane 节点的 YAML 文件中。例如,

05-master-kernelarg-hpav.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将以下 MCO 示例配置集复制到计算节点的 YAML 文件中。例如,

05-worker-kernelarg-hpav.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意您必须修改

rd.dasd参数以适合设备 ID。创建 MCO 配置集:

oc create -f 05-master-kernelarg-hpav.yaml

$ oc create -f 05-master-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f 05-worker-kernelarg-hpav.yaml

$ oc create -f 05-worker-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要取消激活,请输入:

oc delete -f 05-master-kernelarg-hpav.yaml

$ oc delete -f 05-master-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete -f 05-worker-kernelarg-hpav.yaml

$ oc delete -f 05-worker-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. IBM Z 主机上的 RHEL KVM 建议

优化 KVM 虚拟服务器环境很大程度上取决于虚拟服务器的工作负载和可用资源。增强一个环境中性能的相同操作可能会对另一种环境产生负面影响。为特定设置找到最佳平衡可能是一项挑战,通常需要进行各种试验。

下面的部分介绍了在 IBM Z 和 IBM® LinuxONE 环境中将 OpenShift Container Platform 与 RHEL KVM 搭配使用时的一些最佳实践。

3.6.1. 对虚拟块设备使用 I/O 线程

要使虚拟块设备使用 I/O 线程,您必须为虚拟服务器和每个虚拟块设备配置一个或多个 I/O 线程,以使用其中一个 I/O 线程。

以下示例指定了 <iothreads>3</iothreads> 来配置三个 I/O 线程,带有连续十进制线程 ID 1、2 和 3。iothread="2" 参数指定要使用 ID 为 2 的 I/O 线程的磁盘设备的驱动程序元素。

I/O 线程规格示例

线程可以提高磁盘设备的 I/O 操作性能,但也可使用内存和 CPU 资源。您可以将多个设备配置为使用同一线程。线程到设备的最佳映射取决于可用资源和工作负载。

从少量 I/O 线程开始。通常,为所有磁盘设备使用单个 I/O 线程就足够了。不要配置超过虚拟 CPU 数量的线程,也不要配置空闲线程。

您可以使用 virsh iothreadadd 命令将具有特定线程 ID 的 I/O 线程添加到正在运行的虚拟服务器。

3.6.2. 避免虚拟 SCSI 设备

仅在需要通过 SCSI 特定的接口解决设备时配置虚拟 SCSI 设备。将磁盘空间配置为虚拟块设备,而非虚拟 SCSI 设备,无论主机上的支持是什么。

但是,您可能需要以下特定于 SCSI 的接口:

- 主机上 SCSI 附加磁带驱动器的 LUN。

- 在主机文件系统中挂载在虚拟 DVD 驱动器中的 DVD ISO 文件。

3.6.3. 为磁盘配置客户机缓存

将磁盘设备配置为由客户机而不是主机执行缓存。

确保磁盘设备的 driver 元素包含 cache="none" 和 io="native" 参数。

<disk type="block" device="disk">

<driver name="qemu" type="raw" cache="none" io="native" iothread="1"/>

...

</disk>

<disk type="block" device="disk">

<driver name="qemu" type="raw" cache="none" io="native" iothread="1"/>

...

</disk>3.6.4. 排除内存气球(Balloon)设备

除非您需要动态内存大小,否则请不要定义内存气球设备,并确保 libvirt 不会为您创建。将 memballoon 参数作为设备元素的子项包含在您的域配置 XML 文件中。

检查活跃配置集列表:

<memballoon model="none"/>

<memballoon model="none"/>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6.5. 调整主机调度程序的 CPU 迁移算法

除非您非常了解相关的影响,请不要更改调度程序设置。在进行完整的测试并确定相关的影响前,不要对生产系统应用更改。

kernel.sched_migration_cost_ns 参数指定以纳秒为单位的时间间隔。任务最后一次执行后,CPU 缓存被视为具有有用内容,直到此间隔过期为止。增加这个间隔会导致任务迁移减少。默认值为 500000 ns。

如果存在可运行的进程时 CPU 空闲时间高于预期的间隔,请尝试缩短这个间隔。如果任务非常频繁地在 CPU 或节点之间进行转换,请尝试增加它。

要动态将间隔设置为 60000 ns,请输入以下命令:

sysctl kernel.sched_migration_cost_ns=60000

# sysctl kernel.sched_migration_cost_ns=60000

要将值永久更改为 60000 ns,在 /etc/sysctl.conf 中添加以下条目:

kernel.sched_migration_cost_ns=60000

kernel.sched_migration_cost_ns=600003.6.6. 禁用 cpuset cgroup 控制器

此设置仅适用于使用 cgroups 版本 1 的 KVM 主机。要在主机上启用 CPU 热插拔,请禁用 cgroup 控制器。

流程

-

使用您选择的编辑器打开

/etc/libvirt/qemu.conf。 -

转至

cgroup_controllers行。 - 复制整行并从副本中删除前导编号符号(#)。

删除

cpuset条目,如下所示:cgroup_controllers = [ "cpu", "devices", "memory", "blkio", "cpuacct" ]

cgroup_controllers = [ "cpu", "devices", "memory", "blkio", "cpuacct" ]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要使新设置生效,您必须重启 libvirtd 守护进程:

- 停止所有虚拟机。

运行以下命令:

systemctl restart libvirtd

# systemctl restart libvirtdCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 重新启动虚拟机。

此设置在主机重新引导后保留。

3.6.7. 为空闲的虚拟 CPU 调整轮询周期

当虚拟 CPU 空闲时,KVM 会轮询虚拟 CPU 的唤醒条件,然后再分配主机资源。您可以指定时间间隔,在间隔期间在 /sys/module/kvm/parameters/halt_poll_ns 的 sysfs 中进行轮询。在指定时间内,轮询可减少虚拟 CPU 的唤醒延迟,但会牺牲资源使用量。根据工作负载,更长或更短的轮询时间可能很有用。时间间隔以纳秒为单位指定。默认值为 50000 ns。

要针对低 CPU 消耗进行优化,请输入一个小的值或写入 0 来禁用轮询:

echo 0 > /sys/module/kvm/parameters/halt_poll_ns

# echo 0 > /sys/module/kvm/parameters/halt_poll_nsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要针对低延迟进行优化(例如,用于事务的工作负载),请输入一个大的值:

echo 80000 > /sys/module/kvm/parameters/halt_poll_ns

# echo 80000 > /sys/module/kvm/parameters/halt_poll_nsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 4 章 使用 Node Tuning Operator

了解 Node Tuning Operator,以及如何使用它通过编排 tuned 守护进程以管理节点级别的性能优化。

4.1. 关于 Node Tuning Operator

Node Tuning Operator 可以帮助您通过编排 TuneD 守护进程来管理节点级别的性能优化,并使用 Performance Profile 控制器获得低延迟性能。大多数高性能应用程序都需要一定程度的内核级性能优化。Node Tuning Operator 为用户提供了一个统一的、节点一级的 sysctl 管理接口,并可以根据具体用户的需要灵活地添加自定义性能优化设置。

Operator 将为 OpenShift Container Platform 容器化 TuneD 守护进程作为一个 Kubernetes 守护进程集进行管理。它保证了自定义性能优化设置以可被守护进程支持的格式传递到在集群中运行的所有容器化的 TuneD 守护进程中。相应的守护进程会在集群的所有节点上运行,每个节点上运行一个。

在发生触发配置集更改的事件时,或通过接收和处理终止信号安全终止容器化 TuneD 守护进程时,容器化 TuneD 守护进程所应用的节点级设置将被回滚。

Node Tuning Operator 使用 Performance Profile 控制器来实现自动性能优化,从而实现 OpenShift Container Platform 应用程序的低延迟性能。集群管理员配置了性能配置集以定义节点级别的设置,例如:

- 将内核更新至 kernel-rt。

- 为内务选择 CPU。

- 为运行工作负载选择 CPU。

目前,cgroup v2 不支持禁用 CPU 负载均衡。因此,如果您启用了 cgroup v2,则可能无法从性能配置集中获取所需的行为。如果您使用 executeace 配置集,则不建议启用 cgroup v2。

在版本 4.1 及更高版本中,OpenShift Container Platform 标准安装中包含了 Node Tuning Operator。

在早期版本的 OpenShift Container Platform 中,Performance Addon Operator 用来实现自动性能优化,以便为 OpenShift 应用程序实现低延迟性能。在 OpenShift Container Platform 4.11 及更新的版本中,这个功能是 Node Tuning Operator 的一部分。

4.2. 访问 Node Tuning Operator 示例规格

使用此流程来访问 Node Tuning Operator 的示例规格。

流程

运行以下命令以访问 Node Tuning Operator 示例规格:

oc get tuned.tuned.openshift.io/default -o yaml -n openshift-cluster-node-tuning-operator

oc get tuned.tuned.openshift.io/default -o yaml -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

默认 CR 旨在为 OpenShift Container Platform 平台提供标准的节点级性能优化,它只能被修改来设置 Operator Management 状态。Operator 将覆盖对默认 CR 的任何其他自定义更改。若进行自定义性能优化,请创建自己的 Tuned CR。新创建的 CR 将与默认的 CR 合并,并基于节点或 pod 标识和配置文件优先级对节点应用自定义调整。

虽然在某些情况下,对 pod 标识的支持可以作为自动交付所需调整的一个便捷方式,但我们不鼓励使用这种方法,特别是在大型集群中。默认 Tuned CR 并不带有 pod 标识匹配。如果创建了带有 pod 标识匹配的自定义配置集,则该功能将在此时启用。在以后的 Node Tuning Operator 版本中将弃用 pod 标识功能。

4.3. 在集群中设置默认配置集

以下是在集群中设置的默认配置集。

从 OpenShift Container Platform 4.9 开始,所有 OpenShift TuneD 配置集都随 TuneD 软件包一起提供。您可以使用 oc exec 命令查看这些配置集的内容:

oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/openshift{,-control-plane,-node} -name tuned.conf -exec grep -H ^ {} \;

$ oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/openshift{,-control-plane,-node} -name tuned.conf -exec grep -H ^ {} \;4.4. 验证是否应用了 TuneD 配置集

验证应用到集群节点的 TuneD 配置集。

oc get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operator

$ oc get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operator输出示例

-

NAME:配置集(Profile)对象的名称。每个节点有一个 Profile 对象,其名称相互匹配。 -

TUNED:要应用的 TuneD 配置集的名称。 -

APPLIED:如果 TuneD 守护进程应用了所需的配置集,则为True。(True/False/Unknown)。 -

DEGRADED:如果在应用 TuneD 配置集时报告了任何错误则为True(True/False/Unknown)。 -

AGE:创建 Profile 对象后经过的时间。

4.5. 自定义调整规格

Operator 的自定义资源 (CR) 包含两个主要部分。第一部分是 profile:,这是 TuneD 配置集及其名称的列表。第二部分是 recommend:,用来定义配置集选择逻辑。

多个自定义调优规格可以共存,作为 Operator 命名空间中的多个 CR。Operator 会检测到是否存在新 CR 或删除了旧 CR。所有现有的自定义性能优化设置都会合并,同时更新容器化 TuneD 守护进程的适当对象。

管理状态

通过调整默认的 Tuned CR 来设置 Operator Management 状态。默认情况下,Operator 处于 Managed 状态,默认的 Tuned CR 中没有 spec.managementState 字段。Operator Management 状态的有效值如下:

- Managed: Operator 会在配置资源更新时更新其操作对象

- Unmanaged: Operator 将忽略配置资源的更改

- Removed: Operator 将移除 Operator 置备的操作对象和资源

配置集数据

profile: 部分列出了 TuneD 配置集及其名称。

建议的配置集

profile: 选择逻辑通过 CR 的 recommend: 部分来定义。recommend: 部分是根据选择标准推荐配置集的项目列表。

recommend: <recommend-item-1> # ... <recommend-item-n>

recommend:

<recommend-item-1>

# ...

<recommend-item-n>列表中的独立项:

- 1

- 可选。

- 2

MachineConfig标签的键/值字典。键必须是唯一的。- 3

- 如果省略,则会假设配置集匹配,除非设置了优先级更高的配置集,或设置了

machineConfigLabels。 - 4

- 可选列表。

- 5

- 配置集排序优先级。较低数字表示优先级更高(

0是最高优先级)。 - 6

- 在匹配项中应用的 TuneD 配置集。例如

tuned_profile_1。 - 7

- 可选操作对象配置。

- 8

- 为 TuneD 守护进程打开或关闭调试。

true为打开,false为关闭。默认值为false。 - 9

- 为 TuneD 守护进程打开或关闭

reapply_sysctl功能。选择true代表开启,false代表关闭。

<match> 是一个递归定义的可选数组,如下所示:

- label: <label_name>

value: <label_value>

type: <label_type>

<match>

- label: <label_name>

value: <label_value>

type: <label_type>

<match>

如果不省略 <match>,则所有嵌套的 <match> 部分也必须评估为 true。否则会假定 false,并且不会应用或建议具有对应 <match> 部分的配置集。因此,嵌套(子级 <match> 部分)会以逻辑 AND 运算来运作。反之,如果匹配 <match> 列表中任何一项,整个 <match> 列表评估为 true。因此,该列表以逻辑 OR 运算来运作。

如果定义 了 machineConfigLabels,基于机器配置池的匹配会对给定的 recommend: 列表项打开。<mcLabels> 指定机器配置标签。机器配置会自动创建,以在配置集 <tuned_profile_name> 中应用主机设置,如内核引导参数。这包括使用与 <mcLabels> 匹配的机器配置选择器查找所有机器配置池,并在分配了找到的机器配置池的所有节点上设置配置集 <tuned_profile_name>。要针对同时具有 master 和 worker 角色的节点,您必须使用 master 角色。

列表项 match 和 machineConfigLabels 由逻辑 OR 操作符连接。match 项首先以短电路方式评估。因此,如果它被评估为 true,则不考虑 MachineConfigLabels 项。

当使用基于机器配置池的匹配时,建议将具有相同硬件配置的节点分组到同一机器配置池中。不遵循这个原则可能会导致在共享同一机器配置池的两个或者多个节点中 TuneD 操作对象导致内核参数冲突。

示例:基于节点或 pod 标签的匹配

根据配置集优先级,以上 CR 针对容器化 TuneD 守护进程转换为 recommend.conf 文件。优先级最高 (10) 的配置集是 openshift-control-plane-es,因此会首先考虑它。在给定节点上运行的容器化 TuneD 守护进程会查看同一节点上是否在运行设有 tuned.openshift.io/elasticsearch 标签的 pod。如果没有,则整个 <match> 部分评估为 false。如果存在具有该标签的 pod,为了让 <match> 部分评估为 true,节点标签也需要是 node-role.kubernetes.io/master 或 node-role.kubernetes.io/infra。

如果这些标签对优先级为 10 的配置集而言匹配,则应用 openshift-control-plane-es 配置集,并且不考虑其他配置集。如果节点/pod 标签组合不匹配,则考虑优先级第二高的配置集 (openshift-control-plane)。如果容器化 TuneD Pod 在具有标签 node-role.kubernetes.io/master 或 node-role.kubernetes.io/infra 的节点上运行,则应用此配置集。

最后,配置集 openshift-node 的优先级最低 (30)。它没有 <match> 部分,因此始终匹配。如果给定节点上不匹配任何优先级更高的配置集,它会作为一个适用于所有节点的配置集来设置 openshift-node 配置集。

示例:基于机器配置池的匹配

为尽量减少节点的重新引导情况,为目标节点添加机器配置池将匹配的节点选择器标签,然后创建上述 Tuned CR,最后创建自定义机器配置池。

特定于云供应商的 TuneD 配置集

使用此功能,所有针对于 OpenShift Container Platform 集群上的云供应商都可以方便地分配 TuneD 配置集。这可实现,而无需添加额外的节点标签或将节点分组到机器配置池中。

这个功能会利用 spec.providerID 节点对象值(格式为 <cloud-provider>://<cloud-provider-specific-id>),并在 NTO operand 容器中写带有 <cloud-provider> 值的文件 /var/lib/tuned/provider。然后,TuneD 会使用这个文件的内容来加载 provider-<cloud-provider> 配置集(如果这个配置集存在)。

openshift 配置集(openshift-control-plane 和 openshift-node 配置集都从其中继承设置)现在被更新来使用这个功能(通过使用条件配置集加载)。NTO 或 TuneD 目前不提供任何特定云供应商的配置集。但是,您可以创建一个自定义配置集 provider-<cloud-provider>,它将适用于所有针对于所有云供应商的集群节点。

GCE 云供应商配置集示例

由于配置集的继承,provider-<cloud-provider> 配置集中指定的任何设置都会被 openshift 配置集及其子配置集覆盖。

4.6. 自定义调整示例

从默认 CR 中使用 TuneD 配置集

以下 CR 对带有标签 tuned.openshift.io/ingress-node-label 的 OpenShift Container Platform 节点应用节点一级的自定义调整。

示例:使用 openshift-control-plane TuneD 配置集进行自定义性能优化

对于开发自定义配置集的人员。我们强烈建议包括在默认 Tuned CR 中提供的默认 TuneD 守护进程配置集。上面的示例使用默认 openshift-control-plane 配置集。

使用内置 TuneD 配置集

由于 NTO 管理的守护进程集已被成功推出,TuneD 操作对象会管理 TuneD 守护进程的同一版本。要列出守护进程支持的内置 TuneD 配置集,请以以下方式查询任何 TuneD pod:

oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/ -name tuned.conf -printf '%h\n' | sed 's|^.*/||'

$ oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/ -name tuned.conf -printf '%h\n' | sed 's|^.*/||'您可以使用自定义调优规格中检索的配置集名称。

示例:使用内置 hpc-compute TuneD 配置集

除了内置的 hpc-compute 配置集外,上面的示例还包括默认 Tuned CR 中提供的 openshift-node TuneD 守护进程配置集,以对计算节点使用特定于 OpenShift 的调优。

4.7. 支持的 TuneD 守护进程插件

在使用 Tuned CR 的 profile: 部分中定义的自定义配置集时,以下 TuneD 插件都受到支持,但 [main] 部分除外:

- audio

- cpu

- disk

- eeepc_she

- modules

- mounts

- net

- scheduler

- scsi_host

- selinux

- sysctl

- sysfs

- usb

- video

- vm

- bootloader

其中一些插件提供了不受支持的动态性能优化功能。目前不支持以下 TuneD 插件:

- script

- systemd

TuneD bootloader 插件只支持 Red Hat Enterprise Linux CoreOS (RHCOS) worker 节点。

其他资源

4.8. 在托管集群中配置节点性能优化

托管的 control plane 只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

要在托管集群中的节点上设置节点级别性能优化,您可以使用 Node Tuning Operator。在托管的 control plane 中,您可以通过创建包含 Tuned 对象并在节点池中引用这些配置映射的配置映射来配置节点调整。

流程

创建包含有效 tuned 清单的配置映射,并引用节点池中的清单。在以下示例中,

Tuned清单定义了一个配置文件,在包含tuned-1-node-label节点标签的节点上将vm.dirty_ratio设为 55。将以下ConfigMap清单保存到名为tuned-1.yaml的文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果您没有将任何标签添加到 Tuned spec 的

spec.recommend部分中的条目中,则假定基于 node-pool 的匹配,因此spec.recommend部分中的最高优先级配置集应用于池中的节点。虽然您可以通过在 Tuned.spec.recommend.match部分中设置标签值来实现更精细的节点标记匹配,除非您将节点池的.spec.management.upgradeType值设置为InPlace。在管理集群中创建

ConfigMap对象:oc --kubeconfig="$MGMT_KUBECONFIG" create -f tuned-1.yaml

$ oc --kubeconfig="$MGMT_KUBECONFIG" create -f tuned-1.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 通过编辑节点池或创建节点池的

spec.tuningConfig字段中引用ConfigMap对象。在本例中,假设您只有一个NodePool,名为nodepool-1,它含有 2 个节点。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意您可以在多个节点池中引用同一配置映射。在托管的 control plane 中,Node Tuning Operator 会将节点池名称和命名空间的哈希值附加到 Tuned CR 的名称中,以区分它们。在这种情况下,请不要为同一托管集群在不同的 Tuned CR 中创建多个名称相同的 TuneD 配置集。

验证

现在,您已创建包含 Tuned 清单的 ConfigMap 对象并在 NodePool 中引用它,Node Tuning Operator 会将 Tuned 对象同步到托管集群中。您可以验证定义了 Tuned 对象,以及将 TuneD 配置集应用到每个节点。

列出托管的集群中的

Tuned对象:oc --kubeconfig="$HC_KUBECONFIG" get tuned.tuned.openshift.io -n openshift-cluster-node-tuning-operator

$ oc --kubeconfig="$HC_KUBECONFIG" get tuned.tuned.openshift.io -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE default 7m36s rendered 7m36s tuned-1 65s

NAME AGE default 7m36s rendered 7m36s tuned-1 65sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 列出托管的集群中的

Profile对象:oc --kubeconfig="$HC_KUBECONFIG" get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operator

$ oc --kubeconfig="$HC_KUBECONFIG" get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME TUNED APPLIED DEGRADED AGE nodepool-1-worker-1 tuned-1-profile True False 7m43s nodepool-1-worker-2 tuned-1-profile True False 7m14s

NAME TUNED APPLIED DEGRADED AGE nodepool-1-worker-1 tuned-1-profile True False 7m43s nodepool-1-worker-2 tuned-1-profile True False 7m14sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果没有创建自定义配置集,则默认应用

openshift-node配置集。要确认正确应用了调整,请在节点上启动一个 debug shell,并检查 sysctl 值:

oc --kubeconfig="$HC_KUBECONFIG" debug node/nodepool-1-worker-1 -- chroot /host sysctl vm.dirty_ratio

$ oc --kubeconfig="$HC_KUBECONFIG" debug node/nodepool-1-worker-1 -- chroot /host sysctl vm.dirty_ratioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

vm.dirty_ratio = 55

vm.dirty_ratio = 55Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.9. 通过设置内核引导参数来对托管集群进行高级节点调整

托管的 control plane 只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

对于托管 control plane 中的高级性能优化(需要设置内核引导参数),您还可以使用 Node Tuning Operator。以下示例演示了如何创建保留巨页的节点池。

流程

创建一个

ConfigMap对象,其中包含一个Tuned对象清单,用于创建大小为 2 MB 的 10 个巨页。将此ConfigMap清单保存到名为tuned-hugepages.yaml的文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意.spec.recommend.match字段被有意留空。在本例中,这个Tuned对象应用到引用此ConfigMap对象的节点池中的所有节点。将具有相同硬件配置的节点分组到同一节点池中。否则,TuneD 操作对象可以为共享同一节点池的两个或多个节点计算冲突的内核参数。在管理集群中创建

ConfigMap对象:oc --kubeconfig="$MGMT_KUBECONFIG" create -f tuned-hugepages.yaml

$ oc --kubeconfig="$MGMT_KUBECONFIG" create -f tuned-hugepages.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

NodePool清单 YAML 文件,自定义NodePool的升级类型,并引用您在spec.tuningConfig部分中创建的ConfigMap对象。创建NodePool清单,并使用hypershiftCLI 将它保存到名为hugepages-nodepool.yaml的文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在

hugepages-nodepool.yaml文件中,将.spec.management.upgradeType设置为InPlace,并将.spec.tuningConfig设置为引用您创建的tuned-hugepagesConfigMap对象。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意要避免应用新的

MachineConfig对象时不必要的重新创建节点,请将.spec.management.upgradeType设置为InPlace。如果使用Replace升级类型,则节点会被完全删除,当应用 TuneD 操作对象计算的新内核引导参数时,新节点可以替换它们。在管理集群中创建

NodePool:oc --kubeconfig="$MGMT_KUBECONFIG" create -f hugepages-nodepool.yaml

$ oc --kubeconfig="$MGMT_KUBECONFIG" create -f hugepages-nodepool.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

节点可用后,容器化 TuneD 守护进程会根据应用的 TuneD 配置集计算所需的内核引导参数。在节点就绪并重新引导以应用生成的 MachineConfig 对象后,您可以验证是否已应用 TuneD 配置集,并且设置了内核引导参数。

列出托管的集群中的

Tuned对象:oc --kubeconfig="$HC_KUBECONFIG" get tuned.tuned.openshift.io -n openshift-cluster-node-tuning-operator

$ oc --kubeconfig="$HC_KUBECONFIG" get tuned.tuned.openshift.io -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE default 123m hugepages-8dfb1fed 1m23s rendered 123m

NAME AGE default 123m hugepages-8dfb1fed 1m23s rendered 123mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 列出托管的集群中的

Profile对象:oc --kubeconfig="$HC_KUBECONFIG" get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operator

$ oc --kubeconfig="$HC_KUBECONFIG" get profile.tuned.openshift.io -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME TUNED APPLIED DEGRADED AGE nodepool-1-worker-1 openshift-node True False 132m nodepool-1-worker-2 openshift-node True False 131m hugepages-nodepool-worker-1 openshift-node-hugepages True False 4m8s hugepages-nodepool-worker-2 openshift-node-hugepages True False 3m57s

NAME TUNED APPLIED DEGRADED AGE nodepool-1-worker-1 openshift-node True False 132m nodepool-1-worker-2 openshift-node True False 131m hugepages-nodepool-worker-1 openshift-node-hugepages True False 4m8s hugepages-nodepool-worker-2 openshift-node-hugepages True False 3m57sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新

NodePool中的两个 worker 节点都应用了openshift-node-hugepages配置集。要确认正确应用了调整,请在节点上启动一个 debug shell 并检查

/proc/cmdline。oc --kubeconfig="$HC_KUBECONFIG" debug node/nodepool-1-worker-1 -- chroot /host cat /proc/cmdline

$ oc --kubeconfig="$HC_KUBECONFIG" debug node/nodepool-1-worker-1 -- chroot /host cat /proc/cmdlineCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

BOOT_IMAGE=(hd0,gpt3)/ostree/rhcos-... hugepagesz=2M hugepages=50

BOOT_IMAGE=(hd0,gpt3)/ostree/rhcos-... hugepagesz=2M hugepages=50Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 5 章 使用 CPU Manager 和拓扑管理器

CPU Manager 管理 CPU 组并限制特定 CPU 的负载。

CPU Manager 对于有以下属性的负载有用:

- 需要尽可能多的 CPU 时间。

- 对处理器缓存丢失非常敏感。

- 低延迟网络应用程序。

- 需要与其他进程协调,并从共享一个处理器缓存中受益。

拓扑管理器(Topology Manager)从 CPU Manager、设备管理器和其他 Hint 提供者收集提示信息,以匹配相同非统一 内存访问(NUMA)节点上的所有 QoS 类的 pod 资源(如 CPU、SR-IOV VF 和其他设备资源)。

拓扑管理器使用收集来的提示信息中获得的拓扑信息,根据配置的 Topology Manager 策略以及请求的 Pod 资源,决定节点是否被节点接受或拒绝。

拓扑管理器对希望使用硬件加速器来支持对工作延迟有极高要求的操作及高吞吐并发计算的负载很有用。

要使用拓扑管理器,您必须使用 静态 策略配置 CPU Manager。

5.1. 设置 CPU Manager

流程

可选:标记节点:

oc label node perf-node.example.com cpumanager=true

# oc label node perf-node.example.com cpumanager=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑启用 CPU Manager 的节点的

MachineConfigPool。在这个示例中,所有 worker 都启用了 CPU Manager:oc edit machineconfigpool worker

# oc edit machineconfigpool workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为 worker 机器配置池添加标签:

metadata: creationTimestamp: 2020-xx-xxx generation: 3 labels: custom-kubelet: cpumanager-enabledmetadata: creationTimestamp: 2020-xx-xxx generation: 3 labels: custom-kubelet: cpumanager-enabledCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

KubeletConfig,cpumanager-kubeletconfig.yaml,自定义资源 (CR) 。请参阅上一步中创建的标签,以便使用新的 kubelet 配置更新正确的节点。请参见MachineConfigPoolSelector部分:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建动态 kubelet 配置:

oc create -f cpumanager-kubeletconfig.yaml

# oc create -f cpumanager-kubeletconfig.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这会在 kubelet 配置中添加 CPU Manager 功能,如果需要,Machine Config Operator(MCO)将重启节点。要启用 CPU Manager,则不需要重启。

检查合并的 kubelet 配置:

oc get machineconfig 99-worker-XXXXXX-XXXXX-XXXX-XXXXX-kubelet -o json | grep ownerReference -A7

# oc get machineconfig 99-worker-XXXXXX-XXXXX-XXXX-XXXXX-kubelet -o json | grep ownerReference -A7Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 worker 是否有更新的

kubelet.conf:oc debug node/perf-node.example.com sh-4.2# cat /host/etc/kubernetes/kubelet.conf | grep cpuManager

# oc debug node/perf-node.example.com sh-4.2# cat /host/etc/kubernetes/kubelet.conf | grep cpuManagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

cpuManagerPolicy: static cpuManagerReconcilePeriod: 5s

cpuManagerPolicy: static1 cpuManagerReconcilePeriod: 5s2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建请求一个或多个内核的 pod。限制和请求都必须将其 CPU 值设置为一个整数。这是专用于此 pod 的内核数:

cat cpumanager-pod.yaml

# cat cpumanager-pod.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 pod:

oc create -f cpumanager-pod.yaml

# oc create -f cpumanager-pod.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确定为您标记的节点调度了 pod:

oc describe pod cpumanager

# oc describe pod cpumanagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 确认正确配置了

cgroups。获取pause进程的进程 ID(PID):Copy to Clipboard Copied! Toggle word wrap Toggle overflow 服务质量(QoS)等级为

Guaranteed的 pod 被放置到kubepods.slice中。其它 QoS 等级的 pod 会位于kubepods的子cgroups中:cd /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-pod69c01f8e_6b74_11e9_ac0f_0a2b62178a22.slice/crio-b5437308f1ad1a7db0574c542bdf08563b865c0345c86e9585f8c0b0a655612c.scope for i in `ls cpuset.cpus tasks` ; do echo -n "$i "; cat $i ; done

# cd /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-pod69c01f8e_6b74_11e9_ac0f_0a2b62178a22.slice/crio-b5437308f1ad1a7db0574c542bdf08563b865c0345c86e9585f8c0b0a655612c.scope # for i in `ls cpuset.cpus tasks` ; do echo -n "$i "; cat $i ; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

cpuset.cpus 1 tasks 32706

cpuset.cpus 1 tasks 32706Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查任务允许的 CPU 列表:

grep ^Cpus_allowed_list /proc/32706/status

# grep ^Cpus_allowed_list /proc/32706/statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Cpus_allowed_list: 1

Cpus_allowed_list: 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 确认系统中的另一个 pod(在这个示例中,QoS 等级为

burstable的 pod)不能在为等级为Guaranteed的 pod 分配的内核中运行:cat /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-besteffort.slice/kubepods-besteffort-podc494a073_6b77_11e9_98c0_06bba5c387ea.slice/crio-c56982f57b75a2420947f0afc6cafe7534c5734efc34157525fa9abbf99e3849.scope/cpuset.cpus 0 oc describe node perf-node.example.com

# cat /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-besteffort.slice/kubepods-besteffort-podc494a073_6b77_11e9_98c0_06bba5c387ea.slice/crio-c56982f57b75a2420947f0afc6cafe7534c5734efc34157525fa9abbf99e3849.scope/cpuset.cpus 0 # oc describe node perf-node.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 这个 VM 有两个 CPU 内核。

system-reserved设置保留 500 millicores,这代表一个内核中的一半被从节点的总容量中减小,以达到Node Allocatable的数量。您可以看到Allocatable CPU是 1500 毫秒。这意味着您可以运行一个 CPU Manager pod,因为每个 pod 需要一个完整的内核。一个完整的内核等于 1000 毫秒。如果您尝试调度第二个 pod,系统将接受该 pod,但不会调度它:NAME READY STATUS RESTARTS AGE cpumanager-6cqz7 1/1 Running 0 33m cpumanager-7qc2t 0/1 Pending 0 11s

NAME READY STATUS RESTARTS AGE cpumanager-6cqz7 1/1 Running 0 33m cpumanager-7qc2t 0/1 Pending 0 11sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2. 拓扑管理器策略

拓扑管理器通过从 Hint 提供者(如 CPU Manager 和设备管理器)收集拓扑提示来调整所有级别服务质量(QoS)的 Pod 资源,并使用收集的提示来匹配 Pod 资源。

拓扑管理器支持四个分配策略,这些策略在名为 cpumanager-enabled 的 KubeletConfig 自定义资源 (CR) 中分配:

none策略- 这是默认策略,不执行任何拓扑对齐调整。

best-effort策略-

对于带有

best-effort拓扑管理策略的 pod 中的每个容器,kubelet 会调用每个 Hint 提供者来发现其资源的可用性。使用这些信息,拓扑管理器会保存那个容器的首选 NUMA 节点关联性设置。如果关联性没有被首选设置,则拓扑管理器会保存这个设置,并把 pod 分配给节点。 restricted策略-

对于带有

restricted拓扑管理策略的 pod 中的每个容器,kubelet 会调用每个 Hint 提供者来发现其资源的可用性。使用这些信息,拓扑管理器会保存那个容器的首选 NUMA 节点关联性设置。如果关联性没有被首选,则拓扑管理器会从节点拒绝这个 pod,从而导致 pod 处于Terminated状态,且 pod 准入失败。 single-numa-node策略-

对于带有

single-numa-node拓扑管理策略的 pod 中的每个容器,kubelet 会调用每个 Hint 提供者来发现其资源的可用性。使用这个信息,拓扑管理器会决定单个 NUMA 节点关联性是否可能。如果是,pod 将会分配给该节点。如果无法使用单一 NUMA 节点关联性,则拓扑管理器会拒绝来自节点的 pod。这会导致 pod 处于 Terminated 状态,且 pod 准入失败。

5.3. 设置拓扑管理器

要使用拓扑管理器,您必须在名为 cpumanager-enabled 的 KubeletConfig 自定义资源 (CR) 中配置分配策略。如果您设置了 CPU Manager,则该文件可能会存在。如果这个文件不存在,您可以创建该文件。

先决条件

-

将 CPU Manager 策略配置为

static。

流程

激活拓扑管理器:

在自定义资源中配置拓扑管理器分配策略。

oc edit KubeletConfig cpumanager-enabled

$ oc edit KubeletConfig cpumanager-enabledCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. Pod 与拓扑管理器策略的交互

以下的 Pod specs 示例演示了 Pod 与 Topology Manager 的交互。

因为没有指定资源请求或限制,以下 pod 以 BestEffort QoS 类运行。

spec:

containers:

- name: nginx

image: nginx

spec:

containers:

- name: nginx

image: nginx

因为请求小于限制,下一个 pod 以 Burstable QoS 类运行。

如果所选策略不是 none,则拓扑管理器将不考虑其中任何一个 Pod 规格。

因为请求等于限制,最后一个 pod 以 Guaranteed QoS 类运行。

拓扑管理器将考虑这个 pod。拓扑管理器会参考 CPU Manager 和设备管理器的 hint 供应商,以获取 pod 的拓扑提示。

拓扑管理器将使用此信息存储该容器的最佳拓扑。在本 pod 中,CPU Manager 和设备管理器将在资源分配阶段使用此存储的信息。

第 6 章 调度 NUMA 感知工作负载

了解 NUMA 感知调度以及如何使用它来在 OpenShift Container Platform 集群中部署高性能工作负载。

NUMA 感知调度是 OpenShift Container Platform 版本 4.12.0 到 4.12.23 中的技术预览功能。它在 OpenShift Container Platform 版本 4.12.24 及更高版本中是正式发布版本(GA)。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

NUMA Resources Operator 允许您在相同的 NUMA 区域中调度高性能工作负载。它部署一个节点资源导出代理,该代理在可用的集群节点 NUMA 资源以及管理工作负载的辅助调度程序上报告。

6.1. 关于 NUMA 感知调度

非统一内存访问 (NUMA) 是一个计算平台架构,允许不同的 CPU 以不同速度访问不同区域。NUMA 资源拓扑引用与计算节点上相互相对的 CPU、内存和 PCI 设备的位置。在一起的资源表示在同一 NUMA 区域中。对于高性能应用程序,集群需要处理单个 NUMA 区域中的 pod 工作负载。

NUMA 架构允许有多个内存控制器的 CPU 在 CPU 复杂间使用任何可用内存,无论内存所处的位置。这可以以牺牲性能为代价来增加灵活性。使用位于 NUMA 区域以外的内存的 CPU 处理工作负载的速度比单个 NUMA 区域处理的工作负载要慢。另外,对于对 I/O 有限制的工作负载,在远程的 NUMA 区域中的网络接口会减慢访问应用程序的速度。高性能工作负载(如电信工作负载)无法在这些条件下达到操作要求。NUMA 感知调度会调整同一 NUMA 区域中请求的集群计算资源(CPU、内存、设备),以有效地处理对延迟敏感的工作负责或高性能工作负载。NUMA 感知调度还提高了每个计算节点的 pod 密度,以提高资源效率。

默认的 OpenShift Container Platform pod 调度程序调度逻辑考虑整个计算节点的可用资源,而不是单个 NUMA 区域。如果在 kubelet 拓扑管理器中请求最严格的资源协调,则会在将 pod 传递给节点时出现错误条件。相反,如果没有请求限制性最严格的资源协调,则 pod 可以在没有正确的资源协调的情况下被节点接受,从而导致性能更差或无法达到预期。例如,当 pod 调度程序通过不知道 pod 请求的资源可用而导致做出非最佳的调度决定时,pod 创建可能会出现 Topology Affinity Error 状态。调度不匹配决策可能会导致 pod 启动延迟。另外,根据集群状态和资源分配,pod 调度决策可能会因为启动失败而对集群造成额外的负载。

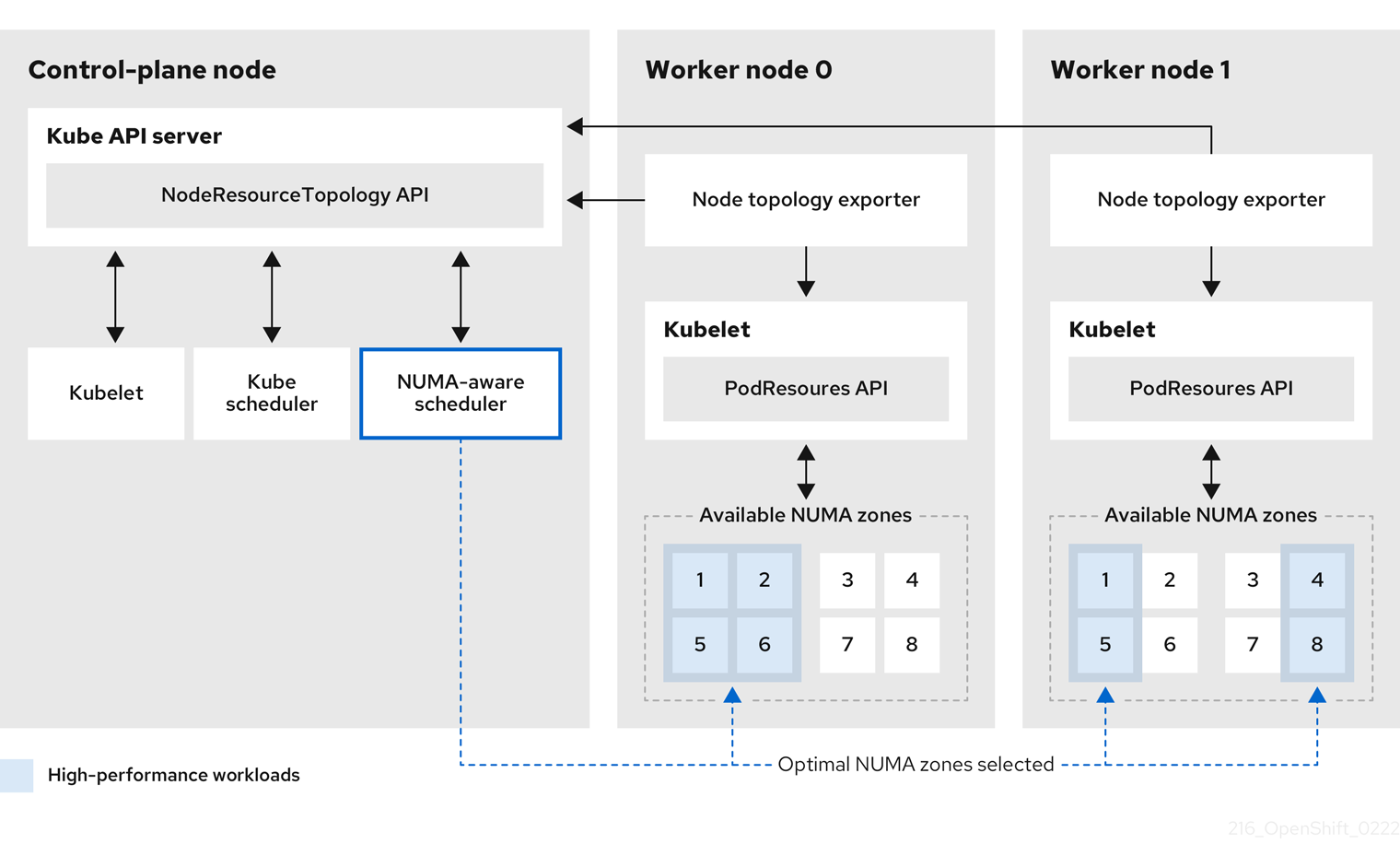

NUMA Resources Operator 部署了一个自定义 NUMA 资源辅助调度程序和其他资源,以缓解默认 OpenShift Container Platform pod 调度程序的缩写。下图显示了 NUMA 感知 pod 调度的高级概述。

图 6.1. NUMA 感知调度概述

- NodeResourceTopology API

-

NodeResourceTopologyAPI 描述了每个计算节点上可用的 NUMA 区资源。 - NUMA 感知调度程序

-

NUMA 感知辅助调度程序从

NodeResourceTopologyAPI 接收有关可用 NUMA 区域的信息,并在可以最佳处理的节点上调度高性能工作负载。 - 节点拓扑 exporter

-

节点拓扑 exporter 会公开每个计算节点的可用 NUMA 区资源到

NodeResourceTopologyAPI。节点拓扑 exporter 守护进程使用PodResourcesAPI 跟踪来自 kubelet 的资源分配。 - PodResources API

-

对于每个节点,

PodResourcesAPI 是本地的,并向 kubelet 公开资源拓扑和可用资源。

其他资源

- 有关在集群中运行二级 pod 调度程序以及如何使用二级 pod 调度程序部署 pod 的更多信息,请参阅使用二级调度程序调度 pod。

6.2. 安装 NUMA Resources Operator

NUMA Resources Operator 部署资源,供您调度 NUMA 感知工作负载和部署。您可以使用 OpenShift Container Platform CLI 或 Web 控制台安装 NUMA Resources Operator。

6.2.1. 使用 CLI 安装 NUMA Resources Operator

作为集群管理员,您可以使用 CLI 安装 Operator。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。

流程

为 NUMA Resources Operator 创建命名空间:

将以下 YAML 保存到

nro-namespace.yaml文件中:apiVersion: v1 kind: Namespace metadata: name: openshift-numaresources

apiVersion: v1 kind: Namespace metadata: name: openshift-numaresourcesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

NamespaceCR:oc create -f nro-namespace.yaml

$ oc create -f nro-namespace.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

为 NUMA Resources Operator 创建 operator 组:

在

nro-operatorgroup.yaml文件中保存以下 YAML:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

OperatorGroupCR:oc create -f nro-operatorgroup.yaml

$ oc create -f nro-operatorgroup.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

为 NUMA Resources Operator 创建订阅:

将以下 YAML 保存到

nro-sub.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

SubscriptionCR:oc create -f nro-sub.yaml

$ oc create -f nro-sub.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

通过检查

openshift-numaresources命名空间中的 CSV 资源来验证安装是否成功。运行以下命令:oc get csv -n openshift-numaresources

$ oc get csv -n openshift-numaresourcesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME DISPLAY VERSION REPLACES PHASE numaresources-operator.v4.12.2 numaresources-operator 4.12.2 Succeeded

NAME DISPLAY VERSION REPLACES PHASE numaresources-operator.v4.12.2 numaresources-operator 4.12.2 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2. 使用 Web 控制台安装 NUMA Resources Operator

作为集群管理员,您可以使用 Web 控制台安装 NUMA Resources Operator。

流程

为 NUMA Resources Operator 创建命名空间:

- 在 OpenShift Container Platform web 控制台中,点 Administration → Namespaces。

-

点 Create Namespace,在 Name 字段中输入

openshift-numaresources,然后点 Create。

安装 NUMA Resources Operator:

- 在 OpenShift Container Platform Web 控制台中,点击 Operators → OperatorHub。

- 从可用的 Operator 列表中选择 NUMA Resources Operator,然后点 Install。

-

在 Installed Namespaces 字段中,选择

openshift-numaresources命名空间,然后点 Install。

可选:验证 NUMA Resources Operator 是否已成功安装:

- 切换到 Operators → Installed Operators 页面。

确保

openshift-numaresources命名空间中列出 NUMA Resources Operator,Status 为 InstallSucceeded。注意在安装过程中,Operator 可能会显示 Failed 状态。如果安装过程结束后有 InstallSucceeded 信息,您可以忽略这个 Failed 信息。

如果 Operator 没有被成功安装,请按照以下步骤进行故障排除:

- 进入 Operators → Installed Operators 页面,检查 Operator Subscriptions 和 Install Plans 选项卡中的 Status 项中是否有任何错误。

-

进入 Workloads → Pods 页面,检查

default项目中的 pod 的日志。

6.3. 调度 NUMA 感知工作负载

运行对延迟敏感工作负载的集群通常具有性能配置集,以帮助最小化工作负载延迟并优化性能。NUMA 感知调度程序根据可用的节点 NUMA 资源部署工作负载,并遵循应用到节点的任何性能配置集设置。NUMA 感知部署和工作负载的性能配置集相结合,确保以最大化性能的方式调度工作负载。

6.3.1. 创建 NUMAResourcesOperator 自定义资源

安装 NUMA Resources Operator 后,创建 NUMAResourcesOperator 自定义资源 (CR) 来指示 NUMA Resources Operator 安装支持 NUMA 感知调度程序所需的所有集群基础架构,包括守护进程集和 API。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。 - 安装 NUMA Resources Operator。

流程

创建

MachineConfigPool自定义资源,为 worker 节点启用自定义 kubelet 配置:将以下 YAML 保存到

nro-machineconfig.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

MachineConfigPoolCR:oc create -f nro-machineconfig.yaml

$ oc create -f nro-machineconfig.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

创建

NUMAResourcesOperator自定义资源:将以下 YAML 保存到

nrop.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 应该与相关

MachineConfigPoolCR 中的 worker 节点匹配。

运行以下命令来创建

NUMAResourcesOperatorCR:oc create -f nrop.yaml

$ oc create -f nrop.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

运行以下命令,验证 NUMA Resources Operator 是否已成功部署:

oc get numaresourcesoperators.nodetopology.openshift.io

$ oc get numaresourcesoperators.nodetopology.openshift.io输出示例

NAME AGE numaresourcesoperator 10m

NAME AGE

numaresourcesoperator 10m6.3.2. 部署 NUMA 感知辅助 pod 调度程序

安装 NUMA Resources Operator 后,执行以下操作来部署 NUMA 感知辅助 pod 调度程序:

- 为所需机器配置集配置 pod admittance 策略

- 创建所需的机器配置池

- 部署 NUMA 感知二级调度程序

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。 - 安装 NUMA Resources Operator。

流程

创建

KubeletConfig自定义资源,为机器配置集配置 pod admittance 策略:将以下 YAML 保存到

nro-kubeletconfig.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

KubeletConfig自定义资源 (CR):oc create -f nro-kubeletconfig.yaml

$ oc create -f nro-kubeletconfig.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

创建

NUMAResourcesScheduler自定义资源来部署 NUMA 感知自定义 pod 调度程序:将以下 YAML 保存到

nro-scheduler.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

NUMAResourcesSchedulerCR:oc create -f nro-scheduler.yaml

$ oc create -f nro-scheduler.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

运行以下命令验证所需资源是否已成功部署:

oc get all -n openshift-numaresources

$ oc get all -n openshift-numaresources输出示例

其他资源

6.3.3. 使用 NUMA 感知调度程序调度工作负载

您可以使用 Deployment CR 将工作负载调度到 NUMA 感知调度程序,该 CR 指定处理工作负载的最低所需资源。

以下示例部署使用 NUMA 感知调度示例工作负载。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。 - 安装 NUMA Resources Operator 并部署 NUMA 感知辅助调度程序。

流程

运行以下命令,获取集群中部署的 NUMA 感知调度程序名称:

oc get numaresourcesschedulers.nodetopology.openshift.io numaresourcesscheduler -o json | jq '.status.schedulerName'

$ oc get numaresourcesschedulers.nodetopology.openshift.io numaresourcesscheduler -o json | jq '.status.schedulerName'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

topo-aware-scheduler

topo-aware-schedulerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个

DeploymentCR,它使用名为topo-aware-scheduler的调度程序,例如:将以下 YAML 保存到

nro-deployment.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

schedulerName必须与集群中部署的 NUMA 感知调度程序的名称匹配,如topo-aware-scheduler。

运行以下命令来创建

DeploymentCR:oc create -f nro-deployment.yaml

$ oc create -f nro-deployment.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证部署是否成功:

oc get pods -n openshift-numaresources

$ oc get pods -n openshift-numaresourcesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,验证

topo-aware-scheduler是否在调度部署的 pod:oc describe pod numa-deployment-1-56954b7b46-pfgw8 -n openshift-numaresources

$ oc describe pod numa-deployment-1-56954b7b46-pfgw8 -n openshift-numaresourcesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal Scheduled 130m topo-aware-scheduler Successfully assigned openshift-numaresources/numa-deployment-1-56954b7b46-pfgw8 to compute-0.example.com

Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal Scheduled 130m topo-aware-scheduler Successfully assigned openshift-numaresources/numa-deployment-1-56954b7b46-pfgw8 to compute-0.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意请求的资源超过可用于调度的部署将失败,并显示

MinimumReplicasUnavailable错误。当所需资源可用时,部署会成功。Pod 会一直处于Pending状态,直到所需资源可用。验证是否为节点列出了预期的分配资源。运行以下命令:

oc describe noderesourcetopologies.topology.node.k8s.io

$ oc describe noderesourcetopologies.topology.node.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 由于已分配给有保证 pod 的资源,

可用的容量会减少。

通过保证 pod 使用的资源从

noderesourcetopologies.topology.node.k8s.io中列出的可用节点资源中减去。对具有

Best-effort或Burstable服务质量 (qosClass) 的pod 的资源分配不会反映在noderesourcetopologies.topology.node.k8s.io下的 NUMA 节点资源中。如果 pod 消耗的资源没有反映在节点资源计算中,请运行以下命令验证 pod 的Guaranteed具有qosClass:oc get pod <pod_name> -n <pod_namespace> -o jsonpath="{ .status.qosClass }"$ oc get pod <pod_name> -n <pod_namespace> -o jsonpath="{ .status.qosClass }"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Guaranteed

GuaranteedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4. 使用手动性能设置调度 NUMA 感知工作负载

运行对延迟敏感工作负载的集群通常具有性能配置集,以帮助最小化工作负载延迟并优化性能。但是,您可以在不功能性能配置集的 pristine 集群中调度 NUMA 感知工作负载。以下工作流带有一个 pristine 集群,您可以使用 KubeletConfig 资源手动配置性能。这不是调度 NUMA 感知工作负载的典型环境。

6.4.1. 使用手动性能设置创建 NUMAResourcesOperator 自定义资源

安装 NUMA Resources Operator 后,创建 NUMAResourcesOperator 自定义资源 (CR) 来指示 NUMA Resources Operator 安装支持 NUMA 感知调度程序所需的所有集群基础架构,包括守护进程集和 API。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。 - 安装 NUMA Resources Operator。

流程

可选:创建

MachineConfigPool自定义资源,为 worker 节点启用自定义 kubelet 配置:注意默认情况下,OpenShift Container Platform 为集群中的 worker 节点创建一个

MachineConfigPool资源。如果需要,您可以创建自定义MachineConfigPool资源。将以下 YAML 保存到

nro-machineconfig.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

MachineConfigPoolCR:oc create -f nro-machineconfig.yaml

$ oc create -f nro-machineconfig.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

创建

NUMAResourcesOperator自定义资源:将以下 YAML 保存到

nrop.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 应该与相关

MachineConfigPoolCR 中的 worker 节点匹配。

运行以下命令来创建

NUMAResourcesOperatorCR:oc create -f nrop.yaml

$ oc create -f nrop.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

运行以下命令,验证 NUMA Resources Operator 是否已成功部署:

oc get numaresourcesoperators.nodetopology.openshift.io

$ oc get numaresourcesoperators.nodetopology.openshift.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE numaresourcesoperator 10m

NAME AGE numaresourcesoperator 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.2. 使用手动性能设置部署 NUMA 感知辅助 pod 调度程序

安装 NUMA Resources Operator 后,执行以下操作来部署 NUMA 感知辅助 pod 调度程序:

- 为所需机器配置集配置 pod admittance 策略。

- 创建所需的机器配置池。

- 部署 NUMA 感知辅助调度程序。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。 - 安装 NUMA Resources Operator。

流程

创建

KubeletConfig自定义资源,为机器配置集配置 pod admittance 策略:将以下 YAML 保存到

nro-kubeletconfig.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

KubeletConfig自定义资源 (CR):oc create -f nro-kubeletconfig.yaml

$ oc create -f nro-kubeletconfig.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

创建

NUMAResourcesScheduler自定义资源来部署 NUMA 感知自定义 pod 调度程序:将以下 YAML 保存到

nro-scheduler.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 为调度程序缓存同步输入间隔值(以秒为单位)。值

5s通常用于大多数实现。

注意-

启用

cacheResyncPeriod规格,以帮助 NUMA Resource Operator 通过监控节点上的待处理资源,并在调度程序缓存中同步此信息,以帮助 NUMA Resource Operator 报告更准确的资源可用性。这也有助于减少Topology Affinity Error错误,因为未优化调度决策。网络负载越低的时间间隔。cacheResyncPeriod规格默认禁用。 -

为

NUMAResourcesOperatorCR 中的podsFingerprinting规格设置Enabled值是cacheResyncPeriod规格的实施要求。

运行以下命令来创建

NUMAResourcesSchedulerCR:oc create -f nro-scheduler.yaml

$ oc create -f nro-scheduler.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

运行以下命令验证所需资源是否已成功部署:

oc get all -n openshift-numaresources

$ oc get all -n openshift-numaresourcesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4.3. 使用手动性能设置使用 NUMA 感知调度程序调度工作负载

您可以使用 Deployment CR 将工作负载调度到 NUMA 感知调度程序,该 CR 指定处理工作负载的最低所需资源。

以下示例部署使用 NUMA 感知调度示例工作负载。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。 - 安装 NUMA Resources Operator 并部署 NUMA 感知辅助调度程序。

流程

运行以下命令,获取集群中部署的 NUMA 感知调度程序名称:

oc get numaresourcesschedulers.nodetopology.openshift.io numaresourcesscheduler -o json | jq '.status.schedulerName'

$ oc get numaresourcesschedulers.nodetopology.openshift.io numaresourcesscheduler -o json | jq '.status.schedulerName'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

topo-aware-scheduler

topo-aware-schedulerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个

DeploymentCR,它使用名为topo-aware-scheduler的调度程序,例如:将以下 YAML 保存到

nro-deployment.yaml文件中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

schedulerName必须与集群中部署的 NUMA 感知调度程序的名称匹配,如topo-aware-scheduler。

运行以下命令来创建

DeploymentCR:oc create -f nro-deployment.yaml

$ oc create -f nro-deployment.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证部署是否成功:

oc get pods -n openshift-numaresources

$ oc get pods -n openshift-numaresourcesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,验证

topo-aware-scheduler是否在调度部署的 pod:oc describe pod numa-deployment-1-56954b7b46-pfgw8 -n openshift-numaresources

$ oc describe pod numa-deployment-1-56954b7b46-pfgw8 -n openshift-numaresourcesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal Scheduled 130m topo-aware-scheduler Successfully assigned openshift-numaresources/numa-deployment-1-56954b7b46-pfgw8 to compute-0.example.com

Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal Scheduled 130m topo-aware-scheduler Successfully assigned openshift-numaresources/numa-deployment-1-56954b7b46-pfgw8 to compute-0.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意请求的资源超过可用于调度的部署将失败,并显示

MinimumReplicasUnavailable错误。当所需资源可用时,部署会成功。Pod 会一直处于Pending状态,直到所需资源可用。验证是否为节点列出了预期的分配资源。

运行以下命令识别运行部署 pod 的节点,将 <namespace> 替换为您在

DeploymentCR 中指定的命名空间:oc get pods -n <namespace> -o wide

$ oc get pods -n <namespace> -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES numa-deployment-1-65684f8fcc-bw4bw 0/2 Running 0 82m 10.128.2.50 worker-0 <none> <none>

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES numa-deployment-1-65684f8fcc-bw4bw 0/2 Running 0 82m 10.128.2.50 worker-0 <none> <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,将 <node_name> 替换为运行部署 pod 的该节点的名称:

oc describe noderesourcetopologies.topology.node.k8s.io <node_name>

$ oc describe noderesourcetopologies.topology.node.k8s.io <node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 由于已分配给有保证 pod 的资源,

可用的容量会减少。

通过保证 pod 使用的资源从

noderesourcetopologies.topology.node.k8s.io中列出的可用节点资源中减去。

对具有

Best-effort或Burstable服务质量 (qosClass) 的pod 的资源分配不会反映在noderesourcetopologies.topology.node.k8s.io下的 NUMA 节点资源中。如果 pod 消耗的资源没有反映在节点资源计算中,请验证 pod 的Guaranteed具有qosClass,且 CPU 请求是一个整数值,而不是十进制值。您可以运行以下命令来验证 pod 是否具有Guaranteed的qosClass:oc get pod <pod_name> -n <pod_namespace> -o jsonpath="{ .status.qosClass }"$ oc get pod <pod_name> -n <pod_namespace> -o jsonpath="{ .status.qosClass }"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Guaranteed

GuaranteedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.5. 可选:为 NUMA 资源更新配置轮询操作

由 NUMA Resources Operator 控制的守护进程在其 nodeGroup 轮询资源以检索有关可用 NUMA 资源的更新。您可以通过在 NUMAResourcesOperator 自定义资源 (CR) 中配置 spec.nodeGroups 规格来微调这些守护进程的轮询操作。这提供了对轮询操作的高级控制。配置这些规格,以改进调度行为,并对子优化调度决策进行故障排除。

配置选项如下:

-

infoRefreshMode:确定轮询 kubelet 的触发器条件。NUMA Resources Operator 向 API 服务器报告生成的信息。 -

infoRefreshPeriod:确定轮询更新之间的持续时间。 podsFingerprinting: 确定节点上当前运行的当前 pod 集合的时间点信息是否公开,以轮询更新。注意podsFingerprinting默认启用。podsFingerprinting是NUMAResourcesSchedulerCR 中的cacheResyncPeriod规格的要求。cacheResyncPeriod规格有助于通过监控节点上的待处理资源来报告更准确的资源可用性。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。 - 安装 NUMA Resources Operator。

流程

在

NUMAResourcesOperatorCR 中配置spec.nodeGroups规格:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 有效值为

Periodic、Event、PeriodicAndEvents。使用Periodic根据您在infoRefreshPeriod中定义的间隔轮询 kubelet。使用Events在每个 pod 生命周期事件时轮询 kubelet。使用PeriodicAndEvents启用这两种方法。 - 2

- 为

Periodic或PeriodicAndEvents刷新模式定义轮询间隔。如果刷新模式是Events,则忽略该字段。 - 3

- 有效值为

Enabled或Disabled。设置为Enabled是NUMAResourcesScheduler中cacheResyncPeriod规格的要求。

验证

部署 NUMA Resources Operator 后,运行以下命令来验证节点组配置是否已应用:

oc get numaresop numaresourcesoperator -o json | jq '.status'

$ oc get numaresop numaresourcesoperator -o json | jq '.status'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.6. 对 NUMA 感知调度进行故障排除

要排除 NUMA 感知 pod 调度的常见问题,请执行以下步骤。

先决条件

-

安装 OpenShift Container Platform CLI(

oc)。 - 以具有 cluster-admin 权限的用户身份登录。

- 安装 NUMA Resources Operator 并部署 NUMA 感知辅助调度程序。

流程

运行以下命令,验证

noderesourcetopologiesCRD 是否已在集群中部署:oc get crd | grep noderesourcetopologies

$ oc get crd | grep noderesourcetopologiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CREATED AT noderesourcetopologies.topology.node.k8s.io 2022-01-18T08:28:06Z

NAME CREATED AT noderesourcetopologies.topology.node.k8s.io 2022-01-18T08:28:06ZCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,检查 NUMA-aware 调度程序名称是否与 NUMA 感知工作负载中指定的名称匹配:

oc get numaresourcesschedulers.nodetopology.openshift.io numaresourcesscheduler -o json | jq '.status.schedulerName'

$ oc get numaresourcesschedulers.nodetopology.openshift.io numaresourcesscheduler -o json | jq '.status.schedulerName'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

topo-aware-scheduler

topo-aware-schedulerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证 NUMA-aware scheduable 节点是否应用了

noderesourcetopologiesCR。运行以下命令:oc get noderesourcetopologies.topology.node.k8s.io

$ oc get noderesourcetopologies.topology.node.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE compute-0.example.com 17h compute-1.example.com 17h

NAME AGE compute-0.example.com 17h compute-1.example.com 17hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意节点数应该等于机器配置池 (

mcp) worker 定义中配置的 worker 节点数量。运行以下命令,验证所有 scheduable 节点的 NUMA 区粒度:

oc get noderesourcetopologies.topology.node.k8s.io -o yaml

$ oc get noderesourcetopologies.topology.node.k8s.io -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.6.1. 检查 NUMA 感知调度程序日志

通过查看日志来排除 NUMA 感知调度程序的问题。如果需要,可以通过修改 NUMAResourcesScheduler 资源的 spec.logLevel 字段来增加调度程序日志级别。可接受值为 Normal、Debug 和 Trace,其中 Trace 是最详细的选项。

要更改辅助调度程序的日志级别,请删除正在运行的调度程序资源,并使用更改后的日志级别重新部署它。在此停机期间,调度程序无法调度新的工作负载。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。

流程

删除当前运行的

NUMAResourcesScheduler资源:运行以下命令来获取活跃的

NUMAResourcesScheduler:oc get NUMAResourcesScheduler

$ oc get NUMAResourcesSchedulerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE numaresourcesscheduler 90m

NAME AGE numaresourcesscheduler 90mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来删除二级调度程序资源:

oc delete NUMAResourcesScheduler numaresourcesscheduler

$ oc delete NUMAResourcesScheduler numaresourcesschedulerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

numaresourcesscheduler.nodetopology.openshift.io "numaresourcesscheduler" deleted

numaresourcesscheduler.nodetopology.openshift.io "numaresourcesscheduler" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

将以下 YAML 保存到文件

nro-scheduler-debug.yaml中。本例将日志级别更改为Debug:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,创建更新的

DebugloggingNUMAResourcesScheduler资源:oc create -f nro-scheduler-debug.yaml

$ oc create -f nro-scheduler-debug.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

numaresourcesscheduler.nodetopology.openshift.io/numaresourcesscheduler created

numaresourcesscheduler.nodetopology.openshift.io/numaresourcesscheduler createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证步骤

检查 NUMA-aware 调度程序是否已成功部署:

运行以下命令检查 CRD 是否已创建成功:

oc get crd | grep numaresourcesschedulers

$ oc get crd | grep numaresourcesschedulersCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CREATED AT numaresourcesschedulers.nodetopology.openshift.io 2022-02-25T11:57:03Z

NAME CREATED AT numaresourcesschedulers.nodetopology.openshift.io 2022-02-25T11:57:03ZCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,检查新的自定义调度程序是否可用:

oc get numaresourcesschedulers.nodetopology.openshift.io

$ oc get numaresourcesschedulers.nodetopology.openshift.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE numaresourcesscheduler 3h26m

NAME AGE numaresourcesscheduler 3h26mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

检查调度程序的日志是否显示增加的日志级别:

运行以下命令,获取在

openshift-numaresources命名空间中运行的 pod 列表:oc get pods -n openshift-numaresources