管理、监控和更新内核

在 Red Hat Enterprise Linux 8 中管理 Linux 内核的指南

摘要

对红帽文档提供反馈

我们感谢您对我们文档的反馈。让我们了解如何改进它。

通过 Jira 提交反馈(需要帐户)

- 登录到 Jira 网站。

- 单击顶部导航栏中的 Create。

- 在 Summary 字段中输入描述性标题。

- 在 Description 字段中输入您对改进的建议。包括文档相关部分的链接。

- 点对话框底部的 Create。

第 1 章 Linux 内核

了解由红帽(红帽内核)提供和维护的 Linux 内核和 Linux 内核 RPM 软件包。使红帽内核保持更新,这可以确保操作系统具有最新的程序错误修复、性能增强和补丁,并与新硬件兼容。

1.1. 内核是什么

内核是 Linux 操作系统的核心部分,其管理系统资源,并提供硬件和软件应用程序之间的接口。

红帽内核是一个基于上游 Linux 主线内核的定制内核,红帽工程师对其进行了进一步的开发和强化,专注于稳定性和与最新技术和硬件的兼容性。

在红帽发布新内核版本前,内核需要通过一组严格的质量保证测试。

红帽内核以 RPM 格式打包,以便它们可以通过 YUM 软件包管理器轻松地升级和验证。

红帽不支持 不是 由红帽编译的内核。

1.2. RPM 软件包

RPM 软件包由用于安装和删除这些文件的文件和元数据的存档组成。具体来说,RPM 软件包包含以下部分:

- GPG 签名

- GPG 签名用于验证软件包的完整性。

- 标头(软件包元数据)

- RPM 软件包管理器使用此元数据来确定软件包依赖项、安装文件的位置及其他信息。

- payload

-

有效负载是一个

cpio归档,其中包含要安装到系统的文件。

RPM 软件包有两种类型。这两种类型都共享文件格式和工具,但内容不同,并实现不同的目的:

源 RPM(SRPM)

SRPM 包含源代码和一个

spec文件,该文件描述了如何将源代码构建为二进制 RPM。另外,SRPM 可以包含源代码的补丁。二进制 RPM

一个二进制 RPM 包含了根据源代码和补丁构建的二进制文件。

1.3. Linux 内核 RPM 软件包概述

kernel RPM 是一个元数据软件包,它不包含任何文件,而是保证正确安装了以下子软件包:

kernel-core-

提供内核的二进制镜像、所有与

initramfs相关的对象来引导系统,以及确保核心功能的最小内核模块数量。仅在虚拟和云环境中使用这个子软件包来为 Red Hat Enterprise Linux 8 内核提供一个快速引导时间和小磁盘空间。 kernel-modules-

提供

kernel-core中不存在的其余内核模块。

上述 kernel 子软件包中的一部分旨在帮助系统管理员减少需要维护的范围,特别是在虚拟化和云环境中。

例如,可选内核软件包:

kernel-modules-extra- 为罕见硬件提供内核模块。默认禁用模块的加载。

kernel-debug- 提供了启用了许多调试选项的内核,以便进行内核诊断,以降低性能为代价。

kernel-tools- 提供了操作 Linux 内核和支持文档的工具。

kernel-devel-

提供了内核标头和 makefile,来足以针对

kernel软件包构建模块。 kernel-abi-stablelists-

提供与 RHEL 内核 ABI 相关的信息,包括外部 Linux 内核模块所需的内核符号列表和

yum插件以协助执行。 kernel-headers- 包括指定 Linux 内核和用户空间库以及程序间接口的 C 标头文件。头文件定义构建大多数标准程序所需的结构和常量。

1.4. 显示内核软件包的内容

通过查询存储库,您可以看到内核软件包是否提供了一个特定的文件,如模块。不需要下载或安装软件包来显示文件列表。

使用 dnf 工具查询文件列表,例如 kernel-core、kernel-modules-core 或 kernel-modules 软件包的文件列表。请注意,kernel 软件包是一个不包含任何文件的元数据软件包。

流程

列出软件包的可用版本:

yum repoquery <package_name>

$ yum repoquery <package_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 显示软件包中的文件列表:

yum repoquery -l <package_name>

$ yum repoquery -l <package_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.5. 安装特定的内核版本

使用 yum 软件包管理器安装新内核。

流程

要安装特定的内核版本,请输入以下命令:

yum install kernel-5.14.0

# yum install kernel-5.14.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6. 更新内核

使用 yum 软件包管理器更新内核。

流程

要更新内核,请输入以下命令:

yum update kernel

# yum update kernelCopy to Clipboard Copied! Toggle word wrap Toggle overflow 此命令将内核以及所有依赖项更新至最新可用版本。

- 重启您的系统以使更改生效。

当从 RHEL 7 升级到 RHEL 8 时,请遵循 从 RHEL 7 升级到 RHEL 8 文档中的相关部分。

1.7. 将内核设置为默认

使用 grubby 命令行工具和 GRUB 将特定内核设置为默认。

流程

使用

grubby工具将内核设置为默认。输入以下命令,使用

grubby工具将内核设置为默认:grubby --set-default $kernel_path

# grubby --set-default $kernel_pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow 命令使用不带

.conf后缀的计算机 ID 作为参数。注意机器 ID 位于

/boot/loader/entries/目录中。

使用

id参数将内核设置为默认。使用

id参数列出引导条目,然后将所需的内核设置为默认:grubby --info ALL | grep id grubby --set-default /boot/vmlinuz-<version>.<architecture>

# grubby --info ALL | grep id # grubby --set-default /boot/vmlinuz-<version>.<architecture>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意要使用

title参数列出引导条目,请执行# grubby --info=ALL | grep title命令。

仅为下次引导设置默认内核。

执行以下命令,仅在下次使用

grub2-reboot命令重新引导时设置默认内核:grub2-reboot <index|title|id>

# grub2-reboot <index|title|id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 警告小心地为下次启动设置默认内核。安装新的内核 RPM、自构建内核,以及手动将条目添加到

/boot/loader/entries/目录中可能会更改索引值。

第 2 章 管理内核模块

了解内核模块、如何显示其信息,以及如何使用内核模块执行基本的管理任务。

2.1. 内核模块简介

Red Hat Enterprise Linux 内核可以使用内核模块进行扩展,该模块提供可选的附加功能,而无需重启系统。在 RHEL 8 中,内核模块是内置于压缩的 < KERNEL_MODULE_NAME>.ko.xz 对象文件中的额外内核代码。

内核模块启用的最常见功能是:

- 添加用于支持新硬件的设备驱动程序

- 支持文件系统,如 GFS2 或者 NFS

- 系统调用

在现代系统中,在需要时会自动载入内核模块。但在某些情况下,需要手动加载或卸载模块。

与内核类似,模块也接受自定义其行为的参数。

您可以使用内核工具对模块执行以下操作:

- 检查当前运行的模块。

- 检查可用来加载到内核的模块。

- 检查模块接受的参数。

- 启用一种机制,来将内核模块加载和卸载到运行的内核中。

2.2. 内核模块依赖关系

某些内核模块有时依赖一个或多个内核模块。/lib/modules/<KERNEL_VERSION>/modules.dep 文件包含相应内核版本的内核模块依赖项的完整列表。

depmod

依赖项文件由 depmod 程序生成,包含在 kmod 软件包中。kmod 提供的很多工具会在执行操作时考虑模块依赖项。因此,很少需要 手动 跟踪依赖项。

内核模块的代码在不受限制的模式下在内核空间中执行。请注意您加载的模块。

weak-modules

除了 depmod 外,Red Hat Enterprise Linux 还提供了 weak-modules 脚本,这是 kmod 软件包的一部分。weak-modules 决定与安装的内核 kABI 兼容的模块。在检查模块内核的兼容性时,weak-modules 按照它们构建的内核的从高到低版本处理符号依赖项。它独立于内核版本单独处理每个模块。

2.3. 列出已安装的内核模块

grubby --info=ALL 命令显示在 !BLS 和 BLS 安装中安装的内核的一个索引列表。

步骤

使用以下命令列出安装的内核:

grubby --info=ALL | grep title

# grubby --info=ALL | grep titleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 下面是所有安装的内核列表:

title=Red Hat Enterprise Linux (4.18.0-20.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0-19.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0-12.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0) 8.0 (Ootpa) title=Red Hat Enterprise Linux (0-rescue-2fb13ddde2e24fde9e6a246a942caed1) 8.0 (Ootpa)

title=Red Hat Enterprise Linux (4.18.0-20.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0-19.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0-12.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0) 8.0 (Ootpa) title=Red Hat Enterprise Linux (0-rescue-2fb13ddde2e24fde9e6a246a942caed1) 8.0 (Ootpa)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

这是 GRUB 菜单中安装的 grubby-8.40-17 内核的列表。

2.4. 列出当前载入的内核模块

查看当前载入的内核模块。

先决条件

-

已安装

kmod软件包。

步骤

要列出所有当前载入的内核模块,请输入:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在上例中:

-

Module列提供了当前载入的模块的 名称。 -

Size列显示每个模块的 内存 量(以 KB 为单位)。 -

Used by列显示 依赖于 特定模块的模块的编号,以及名称(可选)。

-

2.5. 列出所有安装的内核

使用 grubby 实用程序列出系统上所有安装的内核。

先决条件

- 您有 root 权限。

流程

要列出所有安装的内核,请输入:

grubby --info=ALL | grep ^kernel

# grubby --info=ALL | grep ^kernel kernel="/boot/vmlinuz-4.18.0-305.10.2.el8_4.x86_64" kernel="/boot/vmlinuz-4.18.0-240.el8.x86_64" kernel="/boot/vmlinuz-0-rescue-41eb2e172d7244698abda79a51778f1b"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

输出显示了安装的所有内核的路径和版本。

2.6. 显示内核模块信息

使用 modinfo 命令显示指定内核模块的一些详细信息。

先决条件

-

已安装

kmod软件包。

步骤

要显示关于任何内核模块的信息,请输入:

modinfo <KERNEL_MODULE_NAME>

$ modinfo <KERNEL_MODULE_NAME>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以查询所有可用模块的信息,无论它们是否已加载。

parm条目显示用户可以为模块设置的参数,以及它们预期的值类型。注意在输入内核模块的名称时,不要将

.ko.xz扩展附加到名称的末尾。内核模块名称没有扩展名,它们对应的文件有。

2.7. 在系统运行时载入内核模块

扩展 Linux 内核功能的最佳方法是加载内核模块。使用 modprobe 命令查找并将内核模块载入到当前运行的内核中。

重启系统后,这个过程中描述的更改不会保留。有关如何在系统重启后将内核模块载入为 持久性 的详情,请参考 在系统引导时自动载入内核模块。

先决条件

- 根权限

-

已安装

kmod软件包。 - 相关的内核模块没有被加载。要确保情况如此,请列出 当前载入的内核模块 的列表。

流程

选择您要载入的内核模块。

模块位于

/lib/modules/$(uname -r)/kernel/<SUBSYSTEM>/目录中。载入相关内核模块:

modprobe <MODULE_NAME>

# modprobe <MODULE_NAME>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意在输入内核模块的名称时,不要将

.ko.xz扩展附加到名称的末尾。内核模块名称没有扩展名,它们对应的文件有。

验证

(可选)验证载入了相关模块:

lsmod | grep <MODULE_NAME>

$ lsmod | grep <MODULE_NAME>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果正确加载了模块,这个命令会显示相关的内核模块。例如:

lsmod | grep serio_raw

$ lsmod | grep serio_raw serio_raw 16384 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8. 在系统运行时卸载内核模块

要从正在运行的内核中卸载某些内核模块,请使用 modprobe 命令,在系统运行时从当前加载的内核查找和卸载内核模块。

您不能卸载正在运行的系统所使用的内核模块,因为它可能会导致不稳定或系统无法正常工作。

完成不活跃内核模块的卸载后,定义为在引导时自动载入的模块,在重启系统后不会保持卸载状态。有关如何防止此结果的详情,请参考 防止内核模块在系统引导时被自动载入。

先决条件

- 您有 root 权限。

-

kmod软件包已安装。

流程

列出所有载入的内核模块:

lsmod

# lsmodCopy to Clipboard Copied! Toggle word wrap Toggle overflow 选择您要卸载的内核模块。

如果内核模块有依赖项,请在卸载内核模块前卸载它们。有关识别使用依赖项的模块的详情,请参阅列出当前载入的内核模块和内核模块依赖项。

卸载相关内核模块:

modprobe -r <MODULE_NAME>

# modprobe -r <MODULE_NAME>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在输入内核模块的名称时,不要将

.ko.xz扩展附加到名称的末尾。内核模块名称没有扩展名,它们对应的文件有。

验证

(可选)验证相关模块是否已卸载:

lsmod | grep <MODULE_NAME>

$ lsmod | grep <MODULE_NAME>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果模块被成功卸载,这个命令不显示任何输出。

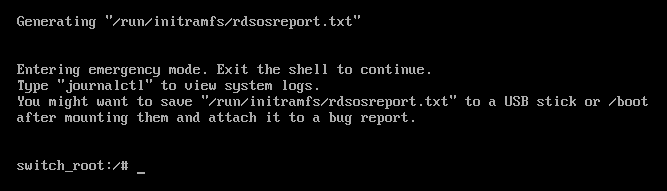

2.9. 在启动过程早期卸载内核模块

在某些情况下,例如,当内核模块有导致系统变得无响应的代码时,用户无法达到永久禁用恶意内核模块的阶段时,您可能需要在引导过程的早期卸载内核模块。要临时阻止内核模块的加载,您可以使用引导装载程序。

您可以在引导序列继续前编辑相关的引导装载程序条目,来卸载所需的内核模块。

此流程中描述的更改在下次重启后 不会持久存在 。有关如何将内核模块添加到 denylist 中,以便在引导过程中不会被自动载入,请参阅 防止在系统引导时自动载入内核模块。

先决条件

- 您有一个可加载的内核模块,但出于某种原因您要防止其加载。

流程

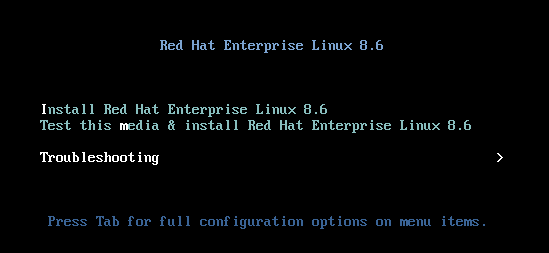

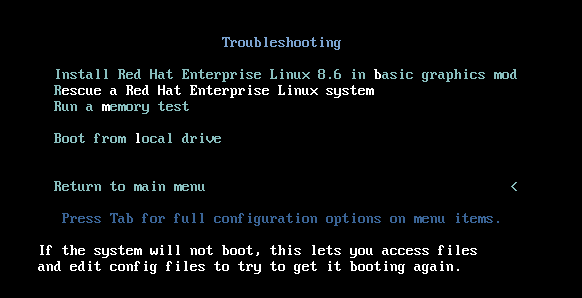

- 将系统启动到引导装载程序中。

- 使用光标键突出显示相关的引导装载程序条目。

按 e 键编辑条目。

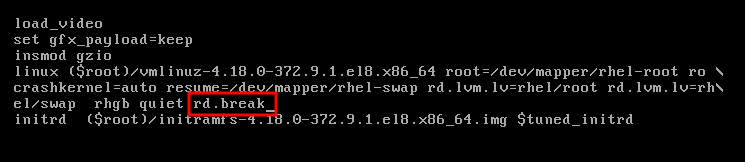

- 使用光标键导航到以 linux 开头的行。

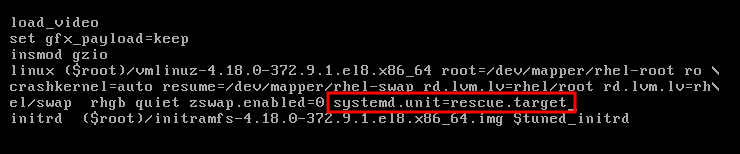

将

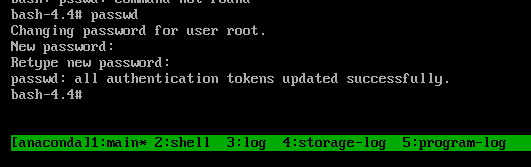

modprobe.blacklist=module_name附加到行尾。图 2.2. 内核引导条目

serio_raw内核模块演示了一个要在引导过程早期卸载的恶意模块。- 按 Ctrl+X 使用修改后的配置启动。

验证

系统引导后,验证相关内核模块是否没有载入:

lsmod | grep serio_raw

# lsmod | grep serio_rawCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.10. 在系统引导时自动载入内核模块

配置内核模块,来在引导过程中自动载入它。

先决条件

- 根权限

-

kmod软件包已安装。

步骤

选择您要在引导过程中载入的内核模块。

模块位于

/lib/modules/$(uname -r)/kernel/<SUBSYSTEM>/目录中。为模块创建配置文件:

echo <MODULE_NAME> > /etc/modules-load.d/<MODULE_NAME>.conf

# echo <MODULE_NAME> > /etc/modules-load.d/<MODULE_NAME>.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意在输入内核模块的名称时,不要将

.ko.xz扩展附加到名称的末尾。内核模块名称没有扩展名,它们对应的文件有。

验证

重启后,验证相关模块是否已载入:

lsmod | grep <MODULE_NAME>

$ lsmod | grep <MODULE_NAME>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

重启系统后,这个过程中描述的更改将会保留。

2.11. 防止在系统引导时自动载入内核模块

您可以通过使用相应的命令在 modprobe 配置文件中列出模块,来防止系统在引导过程中自动载入内核模块。

先决条件

-

此流程中的命令需要 root 权限。使用

su -切换到 root 用户,或在命令前使用sudo。 -

kmod软件包已安装。 - 确定您当前的系统配置不需要您计划拒绝的内核模块。

流程

使用

lsmod命令列出载入到当前运行的内核的模块:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在输出中,识别您要防止加载的模块。

或者,识别您要防止在

/lib/modules/<KERNEL-VERSION>/kernel/<SUBSYSTEM>/目录中加载的而未加载的内核模块,例如:ls /lib/modules/4.18.0-477.20.1.el8_8.x86_64/kernel/crypto/

$ ls /lib/modules/4.18.0-477.20.1.el8_8.x86_64/kernel/crypto/ ansi_cprng.ko.xz chacha20poly1305.ko.xz md4.ko.xz serpent_generic.ko.xz anubis.ko.xz cmac.ko.xz…Copy to Clipboard Copied! Toggle word wrap Toggle overflow

创建一个配置文件作为 denylist :

touch /etc/modprobe.d/denylist.conf

# touch /etc/modprobe.d/denylist.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在您选择的文本编辑器中,使用

blacklist配置命令将您要从自动加载到内核中排除的模块的名称组合在一起,例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 因为

blacklist命令不会阻止模块作为不在 denylist 中的另一个内核模块的依赖项加载,所以您还必须定义install行。在这种情况下,系统运行/bin/false,而不是安装模块。以哈希符号开头的行是注释,您可以用来使文件更易读。注意在输入内核模块的名称时,不要将

.ko.xz扩展附加到名称的末尾。内核模块名称没有扩展名,它们对应的文件有。在重建前,创建当前初始 RAM 磁盘镜像的一个备份副本:

cp /boot/initramfs-$(uname -r).img /boot/initramfs-$(uname -r).bak.$(date +%m-%d-%H%M%S).img

# cp /boot/initramfs-$(uname -r).img /boot/initramfs-$(uname -r).bak.$(date +%m-%d-%H%M%S).imgCopy to Clipboard Copied! Toggle word wrap Toggle overflow 或者,创建与您要阻止内核模块自动载入的内核版本对应的初始 RAM 磁盘镜像的一个备份副本:

cp /boot/initramfs-<VERSION>.img /boot/initramfs-<VERSION>.img.bak.$(date +%m-%d-%H%M%S)

# cp /boot/initramfs-<VERSION>.img /boot/initramfs-<VERSION>.img.bak.$(date +%m-%d-%H%M%S)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

生成一个新的初始 RAM 磁盘镜像以应用更改:

dracut -f -v

# dracut -f -vCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果您为与您系统当前使用的内核版本不同的系统构建初始 RAM 磁盘镜像,请指定目标

initramfs和内核版本:dracut -f -v /boot/initramfs-<TARGET-VERSION>.img <CORRESPONDING-TARGET-KERNEL-VERSION>

# dracut -f -v /boot/initramfs-<TARGET-VERSION>.img <CORRESPONDING-TARGET-KERNEL-VERSION>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

重启系统:

reboot

$ rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

此流程中描述的更改将在重启后生效并保留。如果您在 denylist 中错误地列出了关键内核模块,您可以将系统切换到不稳定或无法正常工作的状态。

2.12. 编译自定义的内核模块

您可以根据硬件和软件级别的各种配置的要求构建一个采样内核模块。

先决条件

kernel-devel、gcc和elfutils-libelf-devel软件包已安装。dnf install kernel-devel-$(uname -r) gcc elfutils-libelf-devel

# dnf install kernel-devel-$(uname -r) gcc elfutils-libelf-develCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 您有 root 权限。

-

您创建了

/root/testmodule/目录,在此编译自定义的内核模块。

步骤

创建包含以下内容的

/root/testmodule/test.c文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow test.c文件是一个源文件,其向内核模块提供主要功能。出于组织需要,该文件已创建在专用的/root/testmodule/目录中。在模块编译后,/root/testmodule/目录将包含多个文件。test.c文件包含来自系统库的文件:-

示例代码中的

printk()函数需要linux/kernel.h头文件。 -

linux/module.h头文件包含在多个 C 源文件之间共享的功能声明和宏定义。

-

示例代码中的

-

按照

init_module ()和cleanup_module ()函数启动和结束内核日志记录函数printk (),后者会打印文本。 使用以下内容创建

/root/testmodule/Makefile文件。obj-m := test.o

obj-m := test.oCopy to Clipboard Copied! Toggle word wrap Toggle overflow Makefile 包含编译器的说明,以生成名为

test.o的对象文件。obj-m指令指定生成的test.ko文件将编译为可加载的内核模块。或者,obj-y指令可指示将test.ko作为内置内核模块构建。编译内核模块。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 编译器将它们链接成最终内核模块(

test.ko)之前,会为每个源文件(test.c)创建一个对象文件(test.c)来作为中间步骤。成功编译后,

/root/testmodule/包含与编译的自定义内核模块相关的其他文件。已编译的模块本身由test.ko文件表示。

验证

可选:检查

/root/testmodule/目录的内容:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将内核模块复制到

/lib/modules/$(uname -r)/目录中:cp /root/testmodule/test.ko /lib/modules/$(uname -r)/

# cp /root/testmodule/test.ko /lib/modules/$(uname -r)/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 更新模块依赖项列表:

depmod -a

# depmod -aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 载入内核模块:

modprobe -v test

# modprobe -v test insmod /lib/modules/4.18.0-305.el8.x86_64/test.koCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证内核模块是否成功载入:

lsmod | grep test

# lsmod | grep test test 16384 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 从内核环缓冲中读取最新的消息:

dmesg

# dmesg [74422.545004] Hello World This is a testCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 3 章 为安全引导签名内核和模块

您可以使用签名的内核和签名的内核模块来加强系统的安全性。在启用了安全引导机制的基于 UEFI 的构建系统中,您可以自我签名一个私有构建的内核或内核模块。另外,您可以将公钥导入到要部署内核或内核模块的目标系统中。

如果启用了安全引导机制,则必须使用私钥签名以下所有组件,并使用对应的公钥进行身份验证:

- UEFI 操作系统引导装载程序

- Red Hat Enterprise Linux 内核

- 所有内核模块

如果这些组件中的任何一个都没有签名和验证,则系统将无法完成引导过程。

RHEL 8 包括:

- 签名的引导装载程序

- 签名的内核

- 签名的内核模块

此外,签名的第一阶段引导装载程序和签名的内核包括嵌入的红帽公钥。这些签名的可执行二进制文件和嵌入式密钥可让 RHEL 8 安装、引导和使用 Microsoft UEFI 安全引导认证认证机构密钥运行。这些密钥由支持 UEFI 安全引导的系统上的 UEFI 固件提供。

- 不是所有基于 UEFI 的系统都包括对安全引导的支持。

- 构建系统(构建和签署内核模块)不需要启用 UEFI 安全引导,甚至不需要是基于 UEFI 的系统。

3.1. 先决条件

要能够为外部构建的内核模块签名,请从以下软件包安装工具:

yum install pesign openssl kernel-devel mokutil keyutils

# yum install pesign openssl kernel-devel mokutil keyutilsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Expand 表 3.1. 所需工具 工具 由软件包提供 用于 用途 efikeygenpesign构建系统

生成公共和专用 X.509 密钥对

opensslopenssl构建系统

导出未加密的私钥

sign-filekernel-devel构建系统

用来使用私钥为内核模块签名的可执行文件

mokutilmokutil目标系统

用于手动注册公钥的可选工具

keyctlkeyutils目标系统

用于在系统密钥环中显示公钥的可选工具

3.2. 什么是 UEFI 安全引导

使用 Unified Extensible Firmware Interface (UEFI)安全引导技术,您可以防止不是由可信密钥签名的内核空间代码的执行。系统引导装载程序使用加密密钥进行签名。固件中的公钥数据库授权密钥签名的过程。然后,您可以在下一个阶段引导装载程序和内核中验证签名。

UEFI 安全引导建立了一个从固件到签名驱动程序和内核模块的信任链,如下所示:

-

UEFI 私钥签名,公钥验证

shim第一阶段引导装载程序。证书颁发机构 (CA)反过来签署公钥。CA 存储在固件数据库中。 -

shim文件包含红帽公钥 Red Hat Secure Boot (CA 密钥 1) 来验证 GRUB 引导装载程序和内核。 - 内核又包含用于验证驱动程序和模块的公钥。

安全引导是 UEFI 规范的引导路径验证组件。规范定义:

- 用于非易失性存储中加密保护的 UEFI 变量的编程接口。

- 在 UEFI 变量中存储可信的 X.509 根证书。

- UEFI 应用程序的验证,如引导装载程序和驱动程序。

- 撤销已知错误的证书和应用程序哈希的流程。

UEFI 安全引导版主可以检测未经授权的更改,但不会 :

- 防止安装或删除第二阶段引导装载程序。

- 需要用户明确确认此类更改。

- 停止引导路径操作。签名在引导过程中被验证,但不会在安装或更新引导装载程序时验证。

如果引导装载程序或内核不是由系统可信密钥签名的,则安全引导会阻止它们启动。

3.3. UEFI 安全引导支持

如果内核和所有载入的驱动程序都使用可信密钥签名了,您可以在启用了 UEFI 安全引导的系统上安装并运行 RHEL 8。红帽提供了由相关红帽密钥签名和验证的内核和驱动程序。

如果要加载外部构建的内核或驱动程序,还必须给它们签名。

UEFI 安全引导施加的限制

- 系统仅在签名被正确验证后才运行 kernel-mode 代码。

- GRUB 模块加载被禁用,因为没有签名和验证 GRUB 模块的基础架构。允许模块加载将在安全引导定义的安全范围内运行不受信任的代码。

- 红帽提供了一个签名的 GRUB 二进制文件,它在 RHEL 8 中具有所有支持的模块。

3.4. 使用 X.509 密钥验证内核模块的要求

在 RHEL 8 中,当加载内核模块时,内核会根据内核系统密钥环中的公共 X.509 密钥检查模块的签名(.builtin_trusted_keys)以及内核平台密钥环(.platform)。.platform 密钥环从第三方平台提供商提供密钥和自定义公钥。内核系统 .blacklist 密钥环中的密钥不包括在验证中。

您需要满足某些条件,才能在启用了 UEFI 安全引导功能的系统上载入内核模块:

如果启用了 UEFI 安全引导,或者指定了

module.sig_enforce内核参数:-

您只能加载那些签名是通过系统密钥环 (

.builtin_trusted_keys) 和平台密钥环 (.platform) 验证的已签名内核模块。 -

公钥不能在系统中被撤销的密钥环 (

.blacklist)。

-

您只能加载那些签名是通过系统密钥环 (

如果禁用了 UEFI 安全引导且未指定

module.sig_enforce内核参数:- 您可以加载未签名的内核模块和签名的内核模块,而无需公钥。

如果系统不基于 UEFI,或者禁用 UEFI 安全引导:

-

只有内核中嵌入的密钥才会加载到

.builtin_trusted_keys和.platform。 - 您无法在不重新构建内核的情况下添加这组密钥。

-

只有内核中嵌入的密钥才会加载到

| 模块已签名 | 找到公钥,且签名有效 | UEFI 安全引导状态 | sig_enforce | 模块载入 | 内核污点 |

|---|---|---|---|---|---|

| 未签名 | - | 未启用 | 未启用 | 成功 | 是 |

| 未启用 | Enabled | Fails | - | ||

| Enabled | - | Fails | - | ||

| 已签名 | 否 | 未启用 | 未启用 | 成功 | 是 |

| 未启用 | Enabled | Fails | - | ||

| Enabled | - | Fails | - | ||

| 已签名 | 是 | 未启用 | 未启用 | 成功 | 否 |

| 未启用 | Enabled | 成功 | 否 | ||

| Enabled | - | 成功 | 否 |

3.5. 公钥的源

在引导过程中,内核会从一组持久性密钥中加载 X.509 密钥到以下密钥环中:

-

系统密钥环 (

.builtin_trusted_keys) -

.platform密钥环 -

系统

.blacklist密钥环

| X.509 密钥源 | 用户可以添加密钥 | UEFI 安全引导状态 | 引导过程中载入的密钥 |

|---|---|---|---|

| 嵌入于内核中 | 否 | - |

|

|

UEFI | 有限 | 未启用 | 否 |

| Enabled |

| ||

|

嵌入在 | 否 | 未启用 | 否 |

| Enabled |

| ||

| Machine Owner Key(MOK)列表 | 是 | 未启用 | 否 |

| Enabled |

|

.builtin_trusted_keys- 在引导时构建的密钥环。

- 提供可信的公钥。

-

查看密钥需要

root权限。

.platform- 在引导时构建的密钥环。

- 从第三方平台提供商和自定义公钥提供密钥。

-

查看密钥需要

root权限。

.blacklist- 带有 X.509 密钥的密钥环,该密钥已被撤销。

-

使用来自

.blacklist的密钥签名的模块将会失败,即使您的公钥位于.builtin_trusted_keys中。

- UEFI 安全引导

db - 签名数据库。

- 存储 UEFI 应用程序、UEFI 驱动程序和引导装载程序的密钥(哈希)。

- 密钥可以加载到机器上。

- UEFI 安全引导

dbx - 已撤销的签名数据库。

- 防止加载密钥。

-

从此数据库撤销的密钥添加到

.blacklist密钥环中。

3.6. 生成公钥和私钥对

要在启用了安全引导的系统上使用自定义内核或自定义内核模块,您必须生成一个公钥和私有 X.509 密钥对。您可以使用生成的私钥为内核或内核模块签名。您还可以通过在向安全引导的 Machine Owner Key (MOK)中添加相应的公钥来验证签名的内核或内核模块。

应用强大的安全措施和访问策略来保护您的私钥内容。对于一个恶意的用户,可以使用这个密钥破坏所有由对应公钥验证的系统。

步骤

创建一个 X.509 公钥和私钥对:

如果您只想为自定义内核 模块 签名:

efikeygen --dbdir /etc/pki/pesign \ --self-sign \ --module \ --common-name 'CN=Organization signing key' \ --nickname 'Custom Secure Boot key'# efikeygen --dbdir /etc/pki/pesign \ --self-sign \ --module \ --common-name 'CN=Organization signing key' \ --nickname 'Custom Secure Boot key'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果要为自定义 内核 签名:

efikeygen --dbdir /etc/pki/pesign \ --self-sign \ --kernel \ --common-name 'CN=Organization signing key' \ --nickname 'Custom Secure Boot key'# efikeygen --dbdir /etc/pki/pesign \ --self-sign \ --kernel \ --common-name 'CN=Organization signing key' \ --nickname 'Custom Secure Boot key'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 当 RHEL 系统运行 FIPS 模式时:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意在 FIPS 模式下,您必须使用

--token选项,以便efikeygen在 PKI 数据库中找到默认的"NSS Certificate DB"令牌。公钥和私钥现在存储在

/etc/pki/pesign/目录中。

好的安全实践是在签名密钥的有效周期内为内核和内核模块签名。但是,sign-file 工具不会警告您,无论有效期日期是什么,密钥在 RHEL 8 中都可用。

3.7. 系统密钥环输出示例

您可以使用 keyutils 软件包中的 keyctl 工具显示系统密钥环上的密钥信息。

先决条件

- 您有 root 权限。

-

您已从

keyutils软件包中安装了keyctl工具。

例 3.1. 密钥环输出

以下是启用了 UEFI 安全引导的 RHEL 8 系统中的 .builtin_trusted_keys、.platform 和 .blacklist 密钥环的简化示例输出。

示例中的 .builtin_trusted_keys 密钥环显示从 UEFI 安全引导 db 密钥以及 Red Hat Secure Boot (CA 密钥 1) (其嵌入在 shim 引导装载程序中)中添加两个密钥。

例 3.2. 内核控制台输出

以下示例显示了内核控制台的输出结果。消息标识带有 UEFI 安全引导相关源的密钥。这包括 UEFI 安全引导 db、嵌入的 shim 和 MOK 列表。

3.8. 通过在 MOK 列表中添加公钥在目标系统中注册公钥

您必须在系统中验证您的公钥以进行内核或内核模块访问,并将其注册到目标系统的平台密钥环(.platform)中。当 RHEL 8 在启用了安全引导机制的基于 UEFI 的系统上引导时,内核会从 db key 数据库导入公钥,并从 dbx 数据库排除撤销的密钥。

Machine Owner Key (MOK)工具允许扩展 UEFI 安全引导密钥数据库。当在启用了安全引导机制的 UEFI 系统中引导 RHEL 8 时,MOK 列表中的密钥会添加到平台密钥环(.platform)中,以及安全引导数据库中的密钥。MOK 密钥列表以同样的方式安全而持久存储,但它是与安全引导数据库独立的工具。

MOK 工具由 shim、MMokManager、GRUB 和 mokutil 实用程序支持,它为基于 UEFI 的系统启用安全密钥管理和身份验证。

要在您的系统中获取内核模块的身份验证服务,请考虑您的系统厂商将公钥合并到其工厂固件镜像中的 UEFI 安全引导密钥数据库中。

先决条件

- 您已生成了一个公钥和私钥对,并了解公钥的有效日期。详情请参阅生成公钥和私钥对。

步骤

将您的公钥导出到

sb_cert.cer文件中:certutil -d /etc/pki/pesign \ -n 'Custom Secure Boot key' \ -Lr \ > sb_cert.cer# certutil -d /etc/pki/pesign \ -n 'Custom Secure Boot key' \ -Lr \ > sb_cert.cerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将您的公钥导入到 MOK 列表中:

mokutil --import sb_cert.cer

# mokutil --import sb_cert.cerCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 输入此 MOK 注册请求的新密码。

重启机器。

shim引导装载程序会注意到待处理的 MOK 密钥注册请求,并启动MokManager.efi,以使您从 UEFI 控制台完成注册。选择

Enroll MOK,在提示时输入之前与此请求关联的密码,并确认注册。您的公钥已添加到 MOK 列表中,这是永久的。

密钥位于 MOK 列表中后,它将会在启用 UEFI 安全引导时自动将其传播到此列表上的

.platform密钥环中。

3.9. 使用私钥签名内核

如果启用了 UEFI 安全引导机制,您可以通过载入签名的内核在系统上获得增强的安全好处。

先决条件

- 您已生成了一个公钥和私钥对,并了解公钥的有效日期。详情请参阅生成公钥和私钥对。

- 您已在目标系统上注册了公钥。详情请查看在 MOK 列表中添加公钥在目标系统中注册公钥。

- 您有一个可用于签名的 ELF 格式的内核镜像。

步骤

在 x64 构架上:

创建一个签名的镜像:

pesign --certificate 'Custom Secure Boot key' \ --in vmlinuz-version \ --sign \ --out vmlinuz-version.signed# pesign --certificate 'Custom Secure Boot key' \ --in vmlinuz-version \ --sign \ --out vmlinuz-version.signedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

vmlinuz文件的版本后缀替换version,使用您之前选择的名称替换Custom Secure Boot key。可选:检查签名:

pesign --show-signature \ --in vmlinuz-version.signed# pesign --show-signature \ --in vmlinuz-version.signedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用签名镜像覆盖未签名的镜像:

mv vmlinuz-version.signed vmlinuz-version

# mv vmlinuz-version.signed vmlinuz-versionCopy to Clipboard Copied! Toggle word wrap Toggle overflow

在 64 位 ARM 架构中:

解压缩

vmlinuz文件:zcat vmlinuz-version > vmlinux-version

# zcat vmlinuz-version > vmlinux-versionCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个签名的镜像:

pesign --certificate 'Custom Secure Boot key' \ --in vmlinux-version \ --sign \ --out vmlinux-version.signed# pesign --certificate 'Custom Secure Boot key' \ --in vmlinux-version \ --sign \ --out vmlinux-version.signedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:检查签名:

pesign --show-signature \ --in vmlinux-version.signed# pesign --show-signature \ --in vmlinux-version.signedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 压缩

vmlinux文件:gzip --to-stdout vmlinux-version.signed > vmlinuz-version

# gzip --to-stdout vmlinux-version.signed > vmlinuz-versionCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除未压缩的

vmlinux文件:rm vmlinux-version*

# rm vmlinux-version*Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.10. 使用私钥签名 GRUB 构建

在启用了 UEFI 安全引导机制的系统上,您可以使用自定义的现有私钥为 GRUB 构建签名。如果您使用自定义 GRUB 构建,或者已经从系统中删除 Microsoft 信任锚,则您必须执行此操作。

先决条件

- 您已生成了一个公钥和私钥对,并了解公钥的有效日期。详情请参阅生成公钥和私钥对。

- 您已在目标系统上注册了公钥。详情请查看在 MOK 列表中添加公钥在目标系统中注册公钥。

- 您有一个可用于签名的 GRUB EFI 二进制文件。

流程

在 x64 构架上:

创建一个签名的 GRUB EFI 二进制文件:

pesign --in /boot/efi/EFI/redhat/grubx64.efi \ --out /boot/efi/EFI/redhat/grubx64.efi.signed \ --certificate 'Custom Secure Boot key' \ --sign# pesign --in /boot/efi/EFI/redhat/grubx64.efi \ --out /boot/efi/EFI/redhat/grubx64.efi.signed \ --certificate 'Custom Secure Boot key' \ --signCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将

Custom Secure Boot key替换为您之前选择的名称。可选:检查签名:

pesign --in /boot/efi/EFI/redhat/grubx64.efi.signed \ --show-signature# pesign --in /boot/efi/EFI/redhat/grubx64.efi.signed \ --show-signatureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用签名的二进制文件覆盖未签名的二进制文件:

mv /boot/efi/EFI/redhat/grubx64.efi.signed \ /boot/efi/EFI/redhat/grubx64.efi# mv /boot/efi/EFI/redhat/grubx64.efi.signed \ /boot/efi/EFI/redhat/grubx64.efiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

在 64 位 ARM 架构中:

创建一个签名的 GRUB EFI 二进制文件:

pesign --in /boot/efi/EFI/redhat/grubaa64.efi \ --out /boot/efi/EFI/redhat/grubaa64.efi.signed \ --certificate 'Custom Secure Boot key' \ --sign# pesign --in /boot/efi/EFI/redhat/grubaa64.efi \ --out /boot/efi/EFI/redhat/grubaa64.efi.signed \ --certificate 'Custom Secure Boot key' \ --signCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将

Custom Secure Boot key替换为您之前选择的名称。可选:检查签名:

pesign --in /boot/efi/EFI/redhat/grubaa64.efi.signed \ --show-signature# pesign --in /boot/efi/EFI/redhat/grubaa64.efi.signed \ --show-signatureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用签名的二进制文件覆盖未签名的二进制文件:

mv /boot/efi/EFI/redhat/grubaa64.efi.signed \ /boot/efi/EFI/redhat/grubaa64.efi# mv /boot/efi/EFI/redhat/grubaa64.efi.signed \ /boot/efi/EFI/redhat/grubaa64.efiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.11. 使用私钥签名内核模块

如果启用了 UEFI 安全引导机制,您可以通过加载签名的内核模块来提高系统的安全性。

在禁用了 UEFI 安全引导的系统上或非 UEFI 系统上,您签名的内核模块也是可以加载的。因此,您不需要提供内核模块的签名和未签名版本。

先决条件

- 您已生成了一个公钥和私钥对,并了解公钥的有效日期。详情请参阅生成公钥和私钥对。

- 您已在目标系统上注册了公钥。详情请查看在 MOK 列表中添加公钥在目标系统中注册公钥。

- 您有一个可以签注的 ELF 镜像格式的内核模块。

流程

将您的公钥导出到

sb_cert.cer文件中:certutil -d /etc/pki/pesign \ -n 'Custom Secure Boot key' \ -Lr \ > sb_cert.cer# certutil -d /etc/pki/pesign \ -n 'Custom Secure Boot key' \ -Lr \ > sb_cert.cerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 从 NSS 数据库中提取密钥作为 PKCS #12 文件:

pk12util -o sb_cert.p12 \ -n 'Custom Secure Boot key' \ -d /etc/pki/pesign# pk12util -o sb_cert.p12 \ -n 'Custom Secure Boot key' \ -d /etc/pki/pesignCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 当上一命令提示时,输入加密私钥的新密码。

导出未加密的私钥:

openssl pkcs12 \ -in sb_cert.p12 \ -out sb_cert.priv \ -nocerts \ -nodes# openssl pkcs12 \ -in sb_cert.p12 \ -out sb_cert.priv \ -nocerts \ -nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要保持未加密的私钥的安全。

为内核模块签名。以下命令将签名直接附加到内核模块文件中的 ELF 镜像中:

/usr/src/kernels/$(uname -r)/scripts/sign-file \ sha256 \ sb_cert.priv \ sb_cert.cer \ my_module.ko# /usr/src/kernels/$(uname -r)/scripts/sign-file \ sha256 \ sb_cert.priv \ sb_cert.cer \ my_module.koCopy to Clipboard Copied! Toggle word wrap Toggle overflow

您的内核模块现在可以被加载。

在 RHEL 8 中,密钥对的有效性日期非常重要。这个密钥没有过期,但必须在其签名密钥的有效周期内对内核模块进行签名。sign-file 实用程序不会提醒您这样做。例如:一个只在 2019 年有效的密钥可用来验证在 2019 年中使用该密钥签名的内核模块。但是,用户无法使用这个密钥在 2020 年签注一个内核模块。

验证

显示关于内核模块签名的信息:

modinfo my_module.ko | grep signer

# modinfo my_module.ko | grep signer signer: Your Name KeyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查签名中是否列出了您在生成过程中输入的名称。

注意附加的签名不包含在 ELF 镜像部分,不是 ELF 镜像的一个正式部分。因此,

readelf等工具无法在内核模块上显示签名。载入模块:

insmod my_module.ko

# insmod my_module.koCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除(未加载)模块:

modprobe -r my_module.ko

# modprobe -r my_module.koCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.12. 载入经过签名的内核模块

在系统密钥环中注册您的公钥(.builtin_trusted_keys)和 MOK 列表,并使用您的私钥签署内核模块,您可以使用 modprobe 命令加载它们。

先决条件

- 您已生成了公钥和私钥对。详情请参阅生成公钥和私钥对。

- 您已经在系统密钥环中注册了公钥。详情请查看在 MOK 列表中添加公钥在目标系统中注册公钥。

- 您用私钥签名了一个内核模块。详情请查看使用私钥签名内核模块。

安装

kernel-modules-extra软件包,它会创建/lib/modules/$(uname -r)/extra/目录:yum -y install kernel-modules-extra

# yum -y install kernel-modules-extraCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

验证您的公钥是否在系统密钥环中:

keyctl list %:.platform

# keyctl list %:.platformCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将内核模块复制到您想要的内核的

extra/目录中:cp my_module.ko /lib/modules/$(uname -r)/extra/

# cp my_module.ko /lib/modules/$(uname -r)/extra/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 更新模块依赖项列表:

depmod -a

# depmod -aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 载入内核模块:

modprobe -v my_module

# modprobe -v my_moduleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选: 要在引导时载入模块,将其添加到

/etc/modules-loaded.d/my_module.conf文件中:echo "my_module" > /etc/modules-load.d/my_module.conf

# echo "my_module" > /etc/modules-load.d/my_module.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证模块是否被成功载入:

lsmod | grep my_module

# lsmod | grep my_moduleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 4 章 配置内核命令行参数

使用内核命令行参数,您可以在引导时更改 Red Hat Enterprise Linux 内核的某些方面的行为。作为系统管理员,您可以控制在引导时设置哪些选项。请注意,某些内核行为只能在引导时设置。

通过修改内核命令行参数来更改系统行为可能会对您的系统造成负面影响。在生产环境中部署更改前,始终测试更改。如需进一步指导,请联系红帽支持团队。

4.1. 什么是内核命令行参数

使用内核命令行参数,您可以覆盖默认值并设置特定的硬件设置。在引导时,您可以配置以下功能:

- Red Hat Enterprise Linux 内核

- 初始 RAM 磁盘

- 用户空间特性

默认情况下,使用 GRUB 引导装载程序的系统的内核命令行参数定义在每个内核引导条目的 /boot/grub2/grubenv 文件的 kernelopts 变量中。

对于 IBM Z,内核命令行参数保存在引导条目配置文件中,因为 zipl 引导装载程序不支持环境变量。因此,无法使用 kernelopts 环境变量。

您可以使用 grubby 工具操作引导装载程序配置文件。使用 grubby,您可以执行以下操作:

- 更改默认的引导条目。

- 从 GRUB 菜单条目中添加或删除参数。

4.2. 了解引导条目

引导条目是存储在配置文件中并绑定到特定内核版本的选项集合。在实践中,您的引导条目至少与您所安装的系统数量相同。引导条目配置文件位于 /boot/loader/entries/ 目录中:

6f9cc9cb7d7845d49698c9537337cedc-4.18.0-5.el8.x86_64.conf

6f9cc9cb7d7845d49698c9537337cedc-4.18.0-5.el8.x86_64.conf

以上文件名由存储在 /etc/machine-id 文件中的计算机 ID 和内核版本组成。

引导条目配置文件包含有关内核版本、初始 ramdisk 镜像和包含内核命令行参数的 kernelopts 环境变量的信息。配置文件可以包含以下内容:

kernelopts 环境变量在 /boot/grub2/grubenv 文件中定义。

4.3. 为所有引导条目更改内核命令行参数

更改系统上所有引导条目的内核命令行参数。

先决条件

-

grubby工具安装在您的系统上。 -

zipl工具安装在 IBM Z 系统中。

流程

添加参数:

grubby --update-kernel=ALL --args="<NEW_PARAMETER>"

# grubby --update-kernel=ALL --args="<NEW_PARAMETER>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 对于使用 GRUB 引导加载程序的系统,该命令会通过向该文件中的

kernelopts变量添加一个新内核参数来更新/boot/grub2/grubenv文件。在 IBM Z 上,更新引导菜单:

zipl

# ziplCopy to Clipboard Copied! Toggle word wrap Toggle overflow

删除参数:

grubby --update-kernel=ALL --remove-args="<PARAMETER_TO_REMOVE>"

# grubby --update-kernel=ALL --remove-args="<PARAMETER_TO_REMOVE>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在 IBM Z 上,更新引导菜单:

zipl

# ziplCopy to Clipboard Copied! Toggle word wrap Toggle overflow

新安装的内核继承之前配置的内核中的内核命令行参数。

4.4. 为单一引导条目更改内核命令行参数

对系统上单个引导条目的内核命令行参数进行更改。

先决条件

-

在您的系统上安装了

grubby和zipl工具。

流程

添加参数:

grubby --update-kernel=/boot/vmlinuz-$(uname -r) --args="<NEW_PARAMETER>"

# grubby --update-kernel=/boot/vmlinuz-$(uname -r) --args="<NEW_PARAMETER>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在 IBM Z 上,更新引导菜单:

grubby --args="<NEW_PARAMETER> --update-kernel=ALL --zipl

# grubby --args="<NEW_PARAMETER> --update-kernel=ALL --ziplCopy to Clipboard Copied! Toggle word wrap Toggle overflow

删除参数:

grubby --update-kernel=/boot/vmlinuz-$(uname -r) --remove-args="<PARAMETER_TO_REMOVE>"

# grubby --update-kernel=/boot/vmlinuz-$(uname -r) --remove-args="<PARAMETER_TO_REMOVE>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在 IBM Z 上,更新引导菜单:

grubby --args="<PARAMETER_TO_REMOVE> --update-kernel=ALL --zipl

# grubby --args="<PARAMETER_TO_REMOVE> --update-kernel=ALL --ziplCopy to Clipboard Copied! Toggle word wrap Toggle overflow

在使用 grub.cfg 文件的系统上,默认情况下每个内核引导条目的 options 参数设置为 kernelopts 变量。此变量在 /boot/grub2/grubenv 配置文件中定义。

在 GRUB 系统中:

-

如果为所有引导条目修改了内核命令行参数,

grubby实用程序会更新/boot/grub2/grubenv文件中的kernelopts变量。 -

如果为单个引导条目修改了内核命令行参数,则扩展

kernelopts变量,修改内核参数,结果值存储在相应的引导条目的/boot/loader/entries/<RELEVANT_KERNEL_BOOT_ENTRY.conf>文件中。

在 zIPL 系统中:

-

grubby修改单个内核引导条目的内核命令行参数并将其存储在/boot/loader/entries/<ENTRY>.conf文件中。

4.5. 在引导时临时更改内核命令行参数

通过在单个引导过程中更改内核参数,对内核惨淡条目进行临时更改。

这个过程只适用于单一引导,且不会永久进行更改。

流程

- 引导进入 GRUB 引导菜单。

- 选择您要启动的内核。

- 按 e 键编辑内核参数。

-

通过移动光标来找到内核命令行。在 64 位 IBM Power 系列和基于 x86-64 BIOS 的系统上内核命令行以

linux开头,或在 UEFI 系统上以linuxefi开头。 将光标移至行末。

注意按 Ctrl+a 跳到行首,按 Ctrl+e 跳到行尾。在某些系统上,Home 和 End 键也可能会正常工作。

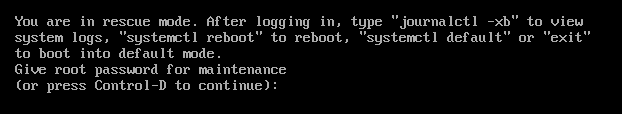

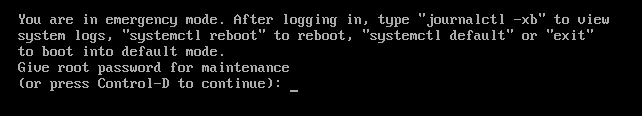

根据需要编辑内核参数。例如,要在紧急模式下运行系统,请在

linux行末尾添加emergency参数:linux ($root)/vmlinuz-4.18.0-348.12.2.el8_5.x86_64 root=/dev/mapper/rhel-root ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quiet emergency

linux ($root)/vmlinuz-4.18.0-348.12.2.el8_5.x86_64 root=/dev/mapper/rhel-root ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quiet emergencyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要启用系统消息,请删除

rhgb和quiet参数。- 按 Ctrl+x 使用所选内核以及修改的命令行参数进行引导。

如果按 Esc 键离开命令行编辑,它将丢弃用户做的所有更改。

4.6. 配置 GRUB 设置以启用串行控制台连接

当您需要连接到无头服务器或嵌入式系统,且网络中断时,串行控制台非常有用。或者,当您需要避免安全规则,并获得不同系统上的登录访问权限时。

您需要配置一些默认的 GRUB 设置,以使用串行控制台连接。

先决条件

- 您有 root 权限。

流程

将下面两行添加到

/etc/default/grub文件中:GRUB_TERMINAL="serial" GRUB_SERIAL_COMMAND="serial --speed=9600 --unit=0 --word=8 --parity=no --stop=1"

GRUB_TERMINAL="serial" GRUB_SERIAL_COMMAND="serial --speed=9600 --unit=0 --word=8 --parity=no --stop=1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 第一行将禁用图形终端。

GRUB_TERMINAL键覆盖GRUB_TERMINAL_INPUT和GRUB_TERMINAL_OUTPUT键的值。第二行调整了波特率(

--speed),奇偶校验和其他值以适合您的环境和硬件。请注意,对于以下日志文件等任务,最好使用更高的波特率,如 115200。更新 GRUB 配置文件。

在基于 BIOS 的机器上:

grub2-mkconfig -o /boot/grub2/grub.cfg

# grub2-mkconfig -o /boot/grub2/grub.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在基于 UEFI 的机器上:

grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfg

# grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- 重启系统以使更改生效。

第 5 章 在运行时配置内核参数

作为系统管理员,您可以修改 Red Hat Enterprise Linux 内核在运行时行为的很多方面。使用 sysctl 命令,并修改 /etc/sysctl.d/ 和 /proc/sys/ 目录中的配置文件来在运行时配置内核参数。

在产品系统中配置内核参数需要仔细规划。非计划的更改可能会导致内核不稳定,需要重启系统。在更改任何内核值之前,验证您是否正在使用有效选项。

有关在 IBM DB2 上调整内核的更多信息,请参阅 为 IBM DB2 调整 Red Hat Enterprise Linux。

5.1. 什么是内核参数

内核参数是您可以在系统运行时调整的可调整值。请注意,要使更改生效,您不需要重启系统或重新编译内核。

可以通过以下方法处理内核参数:

-

sysctl命令 -

挂载于

/proc/sys/目录的虚拟文件系统 -

/etc/sysctl.d/目录中的配置文件

Tunables 被内核子系统划分为不同的类。Red Hat Enterprise Linux 有以下可调整类:

| 可调整类 | 子系统 |

|---|---|

|

| 执行域和个人 |

|

| 加密接口 |

|

| 内核调试接口 |

|

| 特定于设备的信息 |

|

| 全局和特定文件系统的 tunables |

|

| 全局内核 tunables |

|

| 网络 tunables |

|

| Sun 远程过程调用 (NFS) |

|

| 用户命名空间限制 |

|

| 调整和管理内存、缓冲和缓存 |

5.2. 使用 sysctl 临时配置内核参数

使用 sysctl 命令在运行时临时设置内核参数。命令也可用于列出和过滤可调项。

先决条件

- 根权限

流程

列出所有参数及其值。

sysctl -a

# sysctl -a# sysctl -aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意# sysctl -a命令显示内核参数,可在运行时和系统启动时调整。要临时配置一个参数,请输入:

sysctl <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>

# sysctl <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上面的示例命令在系统运行时更改了参数值。更改将立即生效,无需重新启动。

注意在系统重启后,所在的改变会返回到默认状态。

5.3. 使用 sysctl 永久配置内核参数

使用 sysctl 命令永久设置内核参数。

先决条件

- 根权限

流程

列出所有参数。

sysctl -a

# sysctl -a# sysctl -aCopy to Clipboard Copied! Toggle word wrap Toggle overflow 该命令显示所有可在运行时配置的内核参数。

永久配置一个参数:

sysctl -w <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE> >> /etc/sysctl.conf

# sysctl -w <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE> >> /etc/sysctl.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 示例命令会更改可调值,并将其写入

/etc/sysctl.conf文件,该文件会覆盖内核参数的默认值。更改会立即并永久生效,无需重启。

要永久修改内核参数,您还可以手动更改 /etc/sysctl.d/ 目录中的配置文件。

5.4. 使用 /etc/sysctl.d/ 中的配置文件调整内核参数

您必须手动修改 /etc/sysctl.d/ 目录中的配置文件来永久设置内核参数。

先决条件

- 您有 root 权限。

流程

在

/etc/sysctl.d/中创建新配置文件:vim /etc/sysctl.d/<some_file.conf>

# vim /etc/sysctl.d/<some_file.conf># vim /etc/sysctl.d/<some_file.conf>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 包括内核参数,每行一个:

<TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE> <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>

<TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE> <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存配置文件。

重启机器以使更改生效。

或者,在不重启的情况下应用更改:

sysctl -p /etc/sysctl.d/<some_file.conf>

# sysctl -p /etc/sysctl.d/<some_file.conf># sysctl -p /etc/sysctl.d/<some_file.conf>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 该命令允许您从之前创建的配置文件中读取值。

5.5. 通过 /proc/sys/ 临时配置内核参数

通过 /proc/sys/ 虚拟文件系统目录中的文件临时设置内核参数。

先决条件

- 根权限

流程

确定您要配置的内核参数。

ls -l /proc/sys/<TUNABLE_CLASS>/

# ls -l /proc/sys/<TUNABLE_CLASS>/# ls -l /proc/sys/<TUNABLE_CLASS>/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 命令返回的可写入文件可以用来配置内核。具有只读权限的文件提供了对当前设置的反馈。

为内核参数分配一个目标值。

echo <TARGET_VALUE> > /proc/sys/<TUNABLE_CLASS>/<PARAMETER>

# echo <TARGET_VALUE> > /proc/sys/<TUNABLE_CLASS>/<PARAMETER># echo <TARGET_VALUE> > /proc/sys/<TUNABLE_CLASS>/<PARAMETER>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用命令应用的配置更改不是永久的,将在系统重启后消失。

验证

验证新设置内核参数的值。

cat /proc/sys/<TUNABLE_CLASS>/<PARAMETER>

# cat /proc/sys/<TUNABLE_CLASS>/<PARAMETER># cat /proc/sys/<TUNABLE_CLASS>/<PARAMETER>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 7 章 对 GRUB 引导装载程序进行永久性更改

使用 grubby 工具在 GRUB 中进行永久更改。

7.1. 先决条件

- 您已在您的系统上成功安装了 RHEL。

- 您有 root 权限。

7.2. 列出默认的内核

通过列出默认内核,您可以找到默认内核的文件名和索引号,以对 GRUB 引导装载程序进行永久更改。

流程

- 要获取默认内核的文件名,请输入:

grubby --default-kernel

# grubby --default-kernel

/boot/vmlinuz-4.18.0-372.9.1.el8.x86_64- 要获取默认内核的索引号,请输入:

grubby --default-index

# grubby --default-index

07.4. 编辑内核参数

您可以更改现有内核参数中的值。例如,您可以更改虚拟控制台(屏幕)字体和大小。

流程

将虚拟控制台字体更改为

latarcyrheb-sun,大小为32:grubby --args=vconsole.font=latarcyrheb-sun32 --update-kernel /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64

# grubby --args=vconsole.font=latarcyrheb-sun32 --update-kernel /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.6. 添加一个新的引导条目

您可以在引导装载程序菜单条目中添加一个新的引导条目。

流程

将来自默认内核的所有内核参数复制到这个新内核条目中:

grubby --add-kernel=new_kernel --title="entry_title" --initrd="new_initrd" --copy-default

# grubby --add-kernel=new_kernel --title="entry_title" --initrd="new_initrd" --copy-defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 获取可用引导条目列表:

ls -l /boot/loader/entries/*

# ls -l /boot/loader/entries/* -rw-r--r--. 1 root root 408 May 27 06:18 /boot/loader/entries/67db13ba8cdb420794ef3ee0a8313205-0-rescue.conf -rw-r--r--. 1 root root 536 Jun 30 07:53 /boot/loader/entries/67db13ba8cdb420794ef3ee0a8313205-4.18.0-372.9.1.el8.x86_64.conf -rw-r--r-- 1 root root 336 Aug 15 15:12 /boot/loader/entries/d88fa2c7ff574ae782ec8c4288de4e85-4.18.0-193.el8.x86_64.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个新的引导条目。例如,对于 4.18.0-193.el8.x86_64 内核,请按如下所示运行命令:

grubby --grub2 --add-kernel=/boot/vmlinuz-4.18.0-193.el8.x86_64 --title="Red Hat Enterprise 8 Test" --initrd=/boot/initramfs-4.18.0-193.el8.x86_64.img --copy-default

# grubby --grub2 --add-kernel=/boot/vmlinuz-4.18.0-193.el8.x86_64 --title="Red Hat Enterprise 8 Test" --initrd=/boot/initramfs-4.18.0-193.el8.x86_64.img --copy-defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证新添加的引导条目是否在可用的引导条目中列出:

ls -l /boot/loader/entries/*

# ls -l /boot/loader/entries/* -rw-r--r--. 1 root root 408 May 27 06:18 /boot/loader/entries/67db13ba8cdb420794ef3ee0a8313205-0-rescue.conf -rw-r--r--. 1 root root 536 Jun 30 07:53 /boot/loader/entries/67db13ba8cdb420794ef3ee0a8313205-4.18.0-372.9.1.el8.x86_64.conf -rw-r--r-- 1 root root 287 Aug 16 15:17 /boot/loader/entries/d88fa2c7ff574ae782ec8c4288de4e85-4.18.0-193.el8.x86_64.0~custom.conf -rw-r--r-- 1 root root 287 Aug 16 15:29 /boot/loader/entries/d88fa2c7ff574ae782ec8c4288de4e85-4.18.0-193.el8.x86_64.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.7. 使用 grubby 更改默认引导条目

使用 grubby 工具,您可以更改默认引导条目。

流程

- 要在指定为默认内核的内核中进行持久更改,请输入:

grubby --set-default /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64

# grubby --set-default /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64

The default is /boot/loader/entries/67db13ba8cdb420794ef3ee0a8313205-4.18.0-372.9.1.el8.x86_64.conf with index 0 and kernel /boot/vmlinuz-4.18.0-372.9.1.el8.x86_647.9. 为当前和将来的内核更改默认内核选项

通过使用 kernelopts 变量,您可以为当前和将来的内核更改默认内核选项。

流程

列出

kernelopts变量中的内核参数:grub2-editenv - list | grep kernelopts

# grub2-editenv - list | grep kernelopts kernelopts=root=/dev/mapper/rhel-root ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quietCopy to Clipboard Copied! Toggle word wrap Toggle overflow 对内核命令行参数进行更改。您可以添加、删除或修改参数。例如,要添加

debug参数,请输入:grub2-editenv - set "$(grub2-editenv - list | grep kernelopts) <debug>"

# grub2-editenv - set "$(grub2-editenv - list | grep kernelopts) <debug>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:验证新添加到

kernelopts中的参数:grub2-editenv - list | grep kernelopts

# grub2-editenv - list | grep kernelopts kernelopts=root=/dev/mapper/rhel-root ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quiet debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 重启系统以使更改生效。

另一种方法,您可以使用 grubby 命令将参数传递给当前和将来的内核:

grubby --update-kernel ALL --args="<PARAMETER>"

# grubby --update-kernel ALL --args="<PARAMETER>"第 9 章 重新安装 GRUB

您可以重新安装 GRUB 引导装载程序来修复某些问题,通常是由于 GRUB 的安装不正确、缺少文件或损坏的系统造成的。您可以通过恢复缺少的文件并更新引导信息来解决这些问题。

重新安装 GRUB 的原因:

- 升级 GRUB 引导装载程序软件包。

- 将引导信息添加到另一个驱动器中。

- 用户需要 GRUB 引导装载程序来控制安装的操作系统。但是,一些操作系统是使用自己的引导装载程序安装的,重新安装 GRUB 将控制权返回给所需的操作系统。

只有在文件没有损坏时,GRUB 才能恢复这些文件。

9.1. 在基于 BIOS 的机器上重新安装 GRUB

您可以在基于 BIOS 的系统上重新安装 GRUB 引导装载程序。在更新 GRUB 软件包后,总是重新安装 GRUB。

这会覆盖现有的 GRUB ,以安装新的 GRUB。确定系统在安装过程中不会导致数据损坏或引导崩溃。

流程

在安装了它的设备上重新安装 GRUB。例如:如果

sda是您的设备:grub2-install /dev/sda

# grub2-install /dev/sdaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重启您的系统以使更改生效:

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.2. 在基于 UEFI 的机器上重新安装 GRUB

您可以在基于 UEFI 的系统上重新安装 GRUB 引导装载程序。

确定系统在安装过程中不会导致数据损坏或引导崩溃。

流程

重新安装

grub2-efi和shim引导装载程序文件:yum reinstall grub2-efi shim

# yum reinstall grub2-efi shimCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重启您的系统以使更改生效:

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.3. 在 IBM Power 机器上重新安装 GRUB

您可以在 IBM Power 系统的 Power PC Reference Platform (PReP)引导分区上重新安装 GRUB 引导装载程序。在更新 GRUB 软件包后,总是重新安装 GRUB。

这会覆盖现有的 GRUB ,以安装新的 GRUB。确定系统在安装过程中不会导致数据损坏或引导崩溃。

流程

确定存储 GRUB 的磁盘分区:

bootlist -m normal -o

# bootlist -m normal -o sda1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在磁盘分区上重新安装 GRUB:

grub2-install partition

# grub2-install partitionCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用标识的 GRUB 分区(如

/dev/sda1)替换partition。重启您的系统以使更改生效:

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.4. 重置 GRUB

重置 GRUB 会完全删除所有 GRUB 配置文件和系统设置,并重新安装引导装载程序。您可以将所有配置设置重置回其默认值,因此可以修复由文件损坏和无效配置导致的故障。

以下流程将删除用户所做的所有自定义。

流程

删除配置文件:

rm /etc/grub.d/* rm /etc/sysconfig/grub

# rm /etc/grub.d/* # rm /etc/sysconfig/grubCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重新安装软件包。

在基于 BIOS 的机器上:

yum reinstall grub2-tools

# yum reinstall grub2-toolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在基于 UEFI 的机器上:

yum reinstall grub2-efi shim grub2-tools grub2-common

# yum reinstall grub2-efi shim grub2-tools grub2-commonCopy to Clipboard Copied! Toggle word wrap Toggle overflow

重建

grub.cfg文件以使更改生效。在基于 BIOS 的机器上:

grub2-mkconfig -o /boot/grub2/grub.cfg

# grub2-mkconfig -o /boot/grub2/grub.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在基于 UEFI 的机器上:

grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfg

# grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

按照 重新安装 GRUB 流程来在

/boot/分区上恢复 GRUB。

第 10 章 使用密码保护 GRUB

您可以通过两种方式使用密码保护 GRUB:

- 修改菜单条目需要密码,但引导现有菜单条目不需要。

- 修改菜单条目和引导现有菜单条目时需要密码。

第 11 章 在虚拟环境中保留内核 panic 参数

在 RHEL 8 中配置虚拟机时,请不要启用 softlockup_panic 和 nmi_watchdog 内核参数,因为虚拟机可能会遇到错误的软锁定。这不需要一个内核 panic。

在以下部分中找到此建议背后的原因。

11.1. 什么是软锁定

当任务在不重新调度的情况下在 CPU 上的内核空间中执行时,软锁定通常是由程序错误造成的。该任务也不允许任何其他任务在特定 CPU 上执行。因此,用户通过系统控制台会显示警告信息。这个问题也被称为软锁定触发。

11.2. 控制内核 panic 的参数

可设置以下内核参数来控制当检测到软锁定时的系统行为。

softlockup_panic控制当检测到软锁定时内核是否 panic。

Expand 类型 值 效果 整数

0

内核在软锁定时不 panic

整数

1

软锁定中的内核 panics

默认情况下,在 RHEL 8 上这个值为 0。

系统需要首先检测硬锁定才能 panic。检测由

nmi_watchdog参数控制。nmi_watchdog控制锁定检测机制 (

watchdogs) 是否处于活动状态。这个参数是整数类型。Expand 值 效果 0

禁用锁定检测器

1

启用锁定检测器

硬锁定检测器会监控每个 CPU 是否有响应中断的能力。

watchdog_thresh控制 watchdog

hrtimer的频率、NMI 事件和软或硬锁定阈值。Expand 默认阈值 软锁定阈值 10 秒

2 *

watchdog_thresh将此参数设置为 0 可禁用锁定检测。

11.3. 在虚拟环境中有伪装的软锁定

在物理主机上触发的 软锁定 通常代表内核或硬件 bug 。在虚拟环境中的客户机操作系统上发生的同样的现象可能代表假的警告。

主机上的重工作负载或对某些特定资源(如内存)的竞争可能导致错误的软锁定的触发,因为主机可能会调度客户端 CPU 的时间超过 20 秒。当客户机 CPU 再次被调度到在主机上运行时,它会经历一个触发 到期计时器的 时间跳跃。计时器还包括 hrtimer watchdog,其可报告客户机 CPU 上的软锁定。

虚拟化环境中的软锁定可能是假的。当报告对客户机 CPU 的一个软锁定时,您不必启用触发系统 panic 的内核参数。

若要了解客户机中的软锁定,必须了解,主机会作为一个任务调度客户机,客户机然后会调度自己的任务。

第 12 章 为数据库服务器调整内核参数

为确保数据库服务器和数据库的有效操作,您必须配置所需的内核参数集。

12.1. 介绍

数据库服务器是一种提供数据库管理系统 (DBMS) 功能的服务。DBMS 提供数据库管理的实用程序,并与最终用户、应用程序和数据库交互。

Red Hat Enterprise Linux 8 提供以下数据库管理系统:

- MariaDB 10.3

- MariaDB 10.5 - 从 RHEL 8.4 开始提供

- MariaDB 10.11 - 从 RHEL 8.10 开始提供

- MySQL 8.0

- PostgreSQL 10

- PostgreSQL 9.6

- PostgreSQL 12 - 从 RHEL 8.1.1 开始提供

- PostgreSQL 13 - 从 RHEL 8.4 开始提供

- PostgreSQL 15 - 从 RHEL 8.8 开始提供

- PostgreSQL 16 - 从 RHEL 8.10 开始提供

12.2. 影响数据库应用程序性能的参数

以下内核参数会影响数据库应用程序的性能。

- fs.aio-max-nr

定义系统可在服务器中处理的异步 I/O 操作的最大数目。

注意增加

fs.aio-max-nr参数不会在增加 aio 限制外产生任何变化。- fs.file-max

定义系统在任何实例上支持的最大文件句柄数(临时文件名或者分配给打开文件的 ID)。

内核会在应用程序请求文件句柄时动态分配文件。但是,当这些文件被应用程序释放时,内核不会释放这些文件句柄。而是回收这些文件句柄。分配的文件句柄的总数将随时间而增加,即使当前使用的文件句柄的数可能较少。

kernel.shmall-

定义可用于系统范围的共享内存页面总数。要使用整个主内存,

kernel.shmall参数的值应当为主内存大小总计。 kernel.shmmax- 定义 Linux 进程在其虚拟地址空间中可分配的单个共享内存段的最大字节大小。

kernel.shmmni- 定义数据库服务器能够处理的共享内存段的最大数量。

net.ipv4.ip_local_port_range- 系统将此端口范围用于连接到数据库服务器的程序,而无需指定端口号。

net.core.rmem_default- 通过传输控制协议 (TCP) 定义默认接收套接字内存。

net.core.rmem_max- 通过传输控制协议 (TCP) 定义最大接收套接字内存。

net.core.wmem_default- 通过传输控制协议 (TCP) 定义默认发送套接字内存。

net.core.wmem_max- 通过传输控制协议 (TCP) 定义最大发送套接字内存。

vm.dirty_bytes/vm.dirty_ratio-

定义以脏内存百分比为单位的字节/阈值,在该阈值中,生成脏数据的进程会在

write()函数中启动。

一个 vm.dirty_bytes 或 vm.dirty_ratio 可以在同一时间被指定。

vm.dirty_background_bytes/vm.dirty_background_ratio- 定义以脏内存百分比为单位的字节/阈值,达到此阈值时内核会尝试主动将脏数据写入硬盘。

一个 vm.dirty_background_bytes 或 vm.dirty_background_ratio 可以一次指定。

vm.dirty_writeback_centisecs定义负责将脏数据写入硬盘的内核线程定期唤醒之间的时间间隔。

这个内核参数以 100 分之一秒为单位。

vm.dirty_expire_centisecs定义将变旧的脏数据写入硬盘的时间。

这个内核参数以 100 分之一秒为单位。

第 13 章 内核日志记录入门

日志文件提供有关系统的消息,包括内核、服务及其上运行的应用程序。syslog 服务为登录 Red Hat Enterprise Linux 提供了原生支持。各种实用程序使用此系统记录事件并将其整理到日志文件中。这些文件在审核操作系统或故障排除问题时非常有用。

13.1. 什么是内核环缓冲

在引导过程中,控制台提供有关系统启动的初始阶段的重要信息。为避免丢失早期的消息,内核使用环缓冲。此缓冲区会保存由内核代码中的 printk() 函数所产生的所有消息(包括引导消息)。来自内核环缓冲的消息随后由 syslog 服务读取并存储在永久存储上的日志文件中。

环缓冲是一个具有固定大小的循环数据结构,并硬编码到内核中。用户可以通过 dmesg 命令或 /var/log/boot.log 文件显示存储在内核环缓冲中的数据。当环形缓冲区满时,新数据将覆盖旧数据。

13.2. 日志级别和内核日志记录上的 printk 角色

内核报告的每条消息都有一个与它关联的日志级别,用于定义消息的重要性。如什么是内核环缓冲区中所述,内核环缓冲会收集所有日志级别的内核消息。kernel.printk 参数用于定义缓冲区中哪些消息打印到控制台中。

日志级别值按以下顺序划分:

- 0

- 内核紧急情况。系统不可用。

- 1

- 内核警报。必须立即采取行动。

- 2

- 内核情况被视为是关键的。

- 3

- 常见内核错误情况。

- 4

- 常见内核警告情况。

- 5

- 内核注意到一个正常但严重的情况。

- 6

- 内核信息性消息.

- 7

- 内核调试级别消息。

默认情况下,RHEL 8 中的 kernel.printk 有以下值:

sysctl kernel.printk

# sysctl kernel.printk

kernel.printk = 7 4 1 7四个值按顺序定义了以下情况:

- 控制台日志级别,定义打印到控制台的消息的最低优先级。

- 消息没有显式附加日志级别的默认日志级别。

- 为控制台日志级别设置最低的日志级别配置。

在引导时为控制台日志级别设置默认值。

这些值的每一个都定义不同的处理错误消息的规则。

默认的 7 4 1 7 printk 值可以更好地调试内核活动。但是,当与串行控制台耦合时,这个 printk 设置可能会导致大量 I/O 突发,这可能会导致 RHEL 系统变得暂时不响应。为避免这种情况,把 printk 值设置为 4 4 1 7 通常可以正常工作,但其代价是丢失额外的调试信息。

另请注意,某些内核命令行参数(如 quiet 或 debug)会更改默认的 kernel.printk 值。

第 14 章 安装 kdump

在 RHEL 8 安装的新版本上,默认安装并激活 kdump 服务。

14.1. kdump

kdump 是提供崩溃转储机制的服务,并生成崩溃转储或 vmcore 转储文件。vmcore 包括系统内存的内容,以用于分析和故障排除。kdump 使用 kexec 系统调用引导到第二个内核,捕获内核,而不重启。这个内核捕获崩溃的内核的内存内容,并将其保存到一个文件中。第二个内核位于系统内存的保留部分。

当系统出现故障时,内核崩溃转储是唯一可用的信息。因此,在关键任务环境中操作 kdump 非常重要。红帽建议在常规内核更新周期中定期更新和测试 kexec-tools。这在安装新内核功能时非常重要。

如果您在机器上有多个内核,则可以为所有安装的内核或只为指定的内核启用 kdump。安装 kdump 时,系统会创建一个默认的 /etc/kdump.conf 文件。/etc/kdump.conf 包含默认最小 kdump 配置,您可以编辑它来自定义 kdump 配置。

14.2. 使用 Anaconda 安装 kdump

Anaconda 安装程序在交互安装过程中为 kdump 配置提供了一个图形界面屏幕。您可以启用 kdump ,并保留所需的内存量。

流程

在 Anaconda 安装程序上,点 KDUMP 并启用

kdump:- 在 Kdump Memory Reservation 中,如果您必须自定义内存保留,请选择 Manual'。

在 KDUMP > Memory for Reserved (MB) 中,设置

kdump所需的内存保留。

14.3. 在命令行中安装 kdump

安装选项,如自定义 Kickstart 安装,在某些情况下 不会 默认安装或启用 kdump。以下流程帮助您在这种情况下启用 kdump。

先决条件

- 一个有效的 RHEL 订阅。

-

包含用于您系统 CPU 架构的

kexec-tools软件包的存储库。 -

满足

kdump配置和目标的要求。详情请查看 支持的 kdump 配置和目标。

流程

检查您的系统上是否已安装了

kdump:rpm -q kexec-tools

# rpm -q kexec-toolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果安装了该软件包,输出:

kexec-tools-2.0.17-11.el8.x86_64

kexec-tools-2.0.17-11.el8.x86_64Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果没有安装该软件包,输出:

package kexec-tools is not installed

package kexec-tools is not installedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 安装

kdump和其他必要的软件包:dnf install kexec-tools

# dnf install kexec-toolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

从 kernel-3.10.0-693.el7 开始,kdump 支持 Intel IOMMU 驱动程序。对于 kernel-3.10.0-514[.XYZ].el7 及早期版本,您必须确保 Intel IOMMU 被禁用,以防止无响应的捕获内核。

第 15 章 在命令行中配置 kdump

在系统引导过程中为 kdump 保留内存。您可以在系统的 Grand Unified Bootloader (GRUB)配置文件中配置内存大小。内存大小取决于配置文件中指定的 crashkernel= 值,以及系统的物理内存的大小。

15.1. 估算 kdump 大小

在规划和构建 kdump 环境时,务必要知道崩溃转储文件所需的空间。

makedumpfile --mem-usage 命令估计崩溃转储文件所需的空间。它生成一个内存使用率报告。报告帮助您决定转储级别以及可以安全排除的页。

流程

输入以下命令生成内存用量报告:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

makedumpfile --mem-usage 命令会以页为单位报告所需的内存。这意味着您必须根据内核页面大小计算所使用的内存大小。

默认情况下,RHEL 内核在 AMD64 和 Intel 64 CPU 构架上使用 4 KB 大小的页,在 IBM POWER 构架上使用 64 KB 大小的页。

15.2. 配置 kdump 内存用量

为 kdump 的内存保留在系统引导过程中发生。内存大小是在系统的 Grand Unified Bootloader (GRUB)配置中设定的。内存大小取决于配置文件中指定的 crashkernel= 选项的值以及系统物理内存的大小。

您可以使用多种方式定义 crashkernel= 选项。您可以指定 crashkernel= 值或配置 auto 选项。crashkernel=auto 参数根据系统中的物理内存总量自动保留内存。配置后,内核将自动为捕获内核保留适当数量的所需内存。这有助于防止内存不足(OOM)错误。

kdump 的自动内存分配因系统硬件架构和可用内存大小而异。

例如,在 AMD64 和 Intel 64 上,crashkernel=auto 参数仅在可用内存超过 1GB 时才起作用。64 位 ARM 架构和 IBM Power 系统需要超过 2 GB 的可用内存。

如果系统自动分配低于最小内存阈值,您可以手动配置保留内存量。

先决条件

- 您在系统上具有 root 权限。

-

满足

kdump配置和目标的要求。详情请查看 支持的 kdump 配置和目标。

流程

准备

crashkernel=选项。例如:要保留 128 MB 内存,请使用:

crashkernel=128M

crashkernel=128MCopy to Clipboard Copied! Toggle word wrap Toggle overflow 或者,您可以根据安装的内存总量将保留内存量设置为变量。变量中的内存保留语法为

crashkernel=<range1>:<size1>,<range2>:<size2>。例如:crashkernel=512M-2G:64M,2G-:128M

crashkernel=512M-2G:64M,2G-:128MCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果系统内存总量为 512 MB 和 2 GB,则命令保留 64 MB 内存。如果内存量超过 2 GB,则内存保留为 128 MB。

保留内存的偏移。

有些系统需要保留具有特定固定偏移量的内存,因为

crashkernel保留在早期发生,您可能需要为特殊用途保留更多内存。当您定义了一个偏移时,保留的内存将从这个偏移位置开始。要偏移保留的内存,请使用以下语法:crashkernel=128M@16M

crashkernel=128M@16MCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在这个示例中,

kdump从 16 MB 开始保留 128 MB 内存(物理地址0x01000000)。如果将偏移参数设置为 0 或完全省略,kdump会自动偏移保留内存。在设置变量内存保留时,也可以使用此语法。在这种情况下,偏移总是指定最后一个。例如:crashkernel=512M-2G:64M,2G-:128M@16M

crashkernel=512M-2G:64M,2G-:128M@16MCopy to Clipboard Copied! Toggle word wrap Toggle overflow

将

crashkernel=选项应用到引导装载程序配置:grubby --update-kernel=ALL --args="crashkernel=<value>"

# grubby --update-kernel=ALL --args="crashkernel=<value>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将

<value>替换为您在上一步中准备的crashkernel=选项的值。

15.3. 配置 kdump 目标

崩溃转储通常以一个文件形式存储在本地文件系统中,直接写入设备。另外,您可以使用 NFS 或 SSH 协议通过网络发送崩溃转储。一次只能设置其中一个选项来保留崩溃转储文件。默认行为是将其存储在本地文件系统的 /var/crash/ 目录中。

先决条件

- 您在系统上具有 root 权限。

-

满足

kdump配置和目标的要求。详情请查看 支持的 kdump 配置和目标。

流程

要将崩溃转储文件保存在本地文件系统的

/var/crash/目录中,请编辑/etc/kdump.conf文件并指定路径:path /var/crash

path /var/crashCopy to Clipboard Copied! Toggle word wrap Toggle overflow 选项

path /var/crash代表kdump在其中保存崩溃转储文件的文件系统的路径。注意-

当您在

/etc/kdump.conf文件中指定转储目标时,路径是相对于指定的转储目标。 -

当您没有在

/etc/kdump.conf文件中指定转储目标时,该路径表示根目录的绝对路径。

根据当前系统中挂载的文件系统,会自动配置转储目标和调整的转储路径。

-

当您在

要保护

kdump生成的崩溃转储文件以及附带文件,您应该为目标目的地目录设置正确的属性,如用户权限和 SELinux 上下文。另外,您可以定义一个脚本,如kdump.conf文件中的kdump_post.sh,如下所示:kdump_post <path_to_kdump_post.sh>

kdump_post <path_to_kdump_post.sh>Copy to Clipboard Copied! Toggle word wrap Toggle overflow kdump_post指令指定kdump完成捕获并将崩溃转储保存到指定的目的地 后 执行的 shell 脚本或命令。您可以使用此机制扩展kdump的功能,以执行包括调整文件权限在内的操作。-

kdump目标配置

*grep -v ^# /etc/kdump.conf | grep -v ^$*

# *grep -v ^# /etc/kdump.conf | grep -v ^$*

ext4 /dev/mapper/vg00-varcrashvol

path /var/crash

core_collector makedumpfile -c --message-level 1 -d 31

转储目标已指定了(ext4 /dev/mapper/vg00-varcrashvol),因此它被挂载到 /var/crash。path 选项也被设置为 /var/crash。因此,kdump 将 vmcore 文件保存在 /var/crash/var/crash 目录中。

要更改保存崩溃转储的本地目录,以

root用户身份编辑/etc/kdump.conf配置文件:-

从

#path /var/crash行的开头删除哈希符号(#)。 使用预期的目录路径替换该值。例如:

path /usr/local/cores

path /usr/local/coresCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要在 RHEL 8 中,当

kdumpsystemd服务启动时,使用path指令定义为kdump目标的目录必须存在,以避免失败。与早期版本的 RHEL 不同,如果服务启动时目录不存在,则不再自动创建该目录。

-

从

要将文件写入不同的分区,请编辑

/etc/kdump.conf配置文件:根据您的选择,从

#ext4行的开头删除哈希符号(#)。-

设备名称(

#ext4 /dev/vg/lv_kdump行) -

文件系统标签(

#ext4 LABEL=/boot行) -

UUID(

#ext4 UUID=03138356-5e61-4ab3-b58e-27507ac41937行)

-

设备名称(

将文件系统类型和设备名称、标签或 UUID 改为所需的值。指定 UUID 值的正确语法是

UUID="correct-uuid"和UUID=correct-uuid。例如:ext4 UUID=03138356-5e61-4ab3-b58e-27507ac41937

ext4 UUID=03138356-5e61-4ab3-b58e-27507ac41937Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要建议使用

LABEL=或UUID=指定存储设备。无法保证/dev/sda3等磁盘设备名称在重启后保持一致。当您在 IBM Z 硬件上使用 Direct Access Storage Device (DASD)时,请确保在执行

kdump之前,转储设备已在/etc/dasd.conf中正确指定了。

要将崩溃转储直接写入设备,请编辑

/etc/kdump.conf配置文件:-

从

#raw /dev/vg/lv_kdump行的开头删除哈希符号(#)。 使用预期的设备名称替换该值。例如:

raw /dev/sdb1

raw /dev/sdb1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

从

使用

NFS协议将崩溃转储保存到远程机器上:-

从

#nfs my.server.com:/export/tmp行的开头删除哈希符号(#)。 使用有效的主机名和目录路径替换该值。例如:

nfs penguin.example.com:/export/cores

nfs penguin.example.com:/export/coresCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重启

kdump服务以使更改生效:sudo systemctl restart kdump.service

sudo systemctl restart kdump.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意当使用 NFS 指令指定 NFS 目标时,

kdump.service会自动尝试挂载 NFS 目标,来检查磁盘空间。不需要提前挂载 NFS 目标。要防止kdump.service挂载目标,请在kdump.conf中使用dracut_args --mount指令。这将启用kdump.service,通过--mount参数指定 NFS 目标来调用dracut工具。

-

从

使用 SSH 协议将崩溃转储保存到远程机器上:

-

从

#ssh user@my.server.com行的开头删除哈希符号(#)。 - 使用有效的用户名和密码替换该值。

在配置中包含您的 SSH 密钥。

-

从

#sshkey /root/.ssh/kdump_id_rsa行的开头删除哈希符号。 将该值改为您要转储的服务器中有效密钥的位置。例如:

ssh john@penguin.example.com sshkey /root/.ssh/mykey

ssh john@penguin.example.com sshkey /root/.ssh/mykeyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

从

-

从

15.4. 配置 kdump 核心收集器

kdump 服务使用 core_collector 程序捕获崩溃转储镜像。在 RHEL 中,makedumpfile 工具是默认的内核收集器。它通过以下方式帮助缩小转储文件:

- 压缩崩溃转储文件的大小,并使用各种转储级别仅复制必要的页。

- 排除不必要的崩溃转储页。

- 过滤崩溃转储中包含的页面类型。

RHEL 7 及更高版本中默认启用了崩溃转储文件压缩。

如果您需要自定义崩溃转储文件压缩,请按照以下流程操作。

语法

core_collector makedumpfile -l --message-level 1 -d 31

core_collector makedumpfile -l --message-level 1 -d 31选项

-

-c、-l或-p:指定每个页的压缩 dump 文件的格式,使用zlib用于-c选项、使用lzo用于-l新选项,或snappy用于-p选项。 -

-d(dump_level):排除页面,它们不会复制到转储文件中。 -

--message-level:指定消息类型。您可以通过使用这个选项指定message_level来限制打印的输出。例如,把message_level设置为 7 可打印常见消息和错误消息。message_level的最大值为 31。

先决条件

- 您在系统上具有 root 权限。

-

满足

kdump配置和目标的要求。详情请查看 支持的 kdump 配置和目标。

流程

-

以

root用户身份编辑/etc/kdump.conf配置文件,并删除#core_collector makedumpfile -l --message-level 1 -d 31开头的哈希符号("#")。 - 输入以下命令来启用崩溃转储文件压缩:

core_collector makedumpfile -l --message-level 1 -d 31

core_collector makedumpfile -l --message-level 1 -d 31

-l 选项指定 转储 压缩的文件格式。-d 选项将转储级别指定为 31。message-level 选项将消息级别指定为 1。

另外,请考虑使用 -c 和 -p 选项的示例:

使用

-c压缩崩溃转储文件:core_collector makedumpfile -c -d 31 --message-level 1

core_collector makedumpfile -c -d 31 --message-level 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

-p压缩崩溃转储文件:core_collector makedumpfile -p -d 31 --message-level 1

core_collector makedumpfile -p -d 31 --message-level 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

15.5. 配置 kdump 默认失败响应

默认情况下,当 kdump 不能在配置的目标位置创建崩溃转储文件时,系统会重启,转储在此过程中会丢失。您可以更改默认失败响应,并将 kdump 配置为在将内核转储保存到主目标时执行不同的操作。额外的操作是:

dump_to_rootfs-

将内核转储保存到

root文件系统。 reboot- 重启系统,在此过程中会丢失内核转储。

halt- 停止系统,在此过程中会丢失内核转储。

poweroff- 关闭系统,在此过程中会丢失内核转储。

shell-

从

initramfs中运行 shell 会话,您可以手动记录内核转储。 final_action-

在

kdump成功或在 shell 或dump_to_rootfs失败操作完成后,启用额外的操作,如reboot、halt和poweroff。默认为reboot。 failure_action-

指定在内核崩溃中转储可能失败时要执行的操作。默认为

reboot。

先决条件

- root 权限。

-

满足

kdump配置和目标的要求。详情请查看 支持的 kdump 配置和目标。

流程

-

作为

root用户,从/etc/kdump.conf配置文件中的#failure_action 将值替换为所需操作。

failure_action poweroff

failure_action poweroffCopy to Clipboard Copied! Toggle word wrap Toggle overflow

15.6. kdump 的配置文件

kdump 内核的配置文件是 /etc/sysconfig/kdump。此文件控制 kdump 内核命令行参数。对于大多数配置,请使用默认选项。然而,在某些情况下,您可能需要修改某些参数来控制 kdump 内核行为。例如:修改 KDUMP_COMMANDLINE_APPEND 选项,以附加 kdump 内核命令行来获取详细的调试输出或修改 KDUMP_COMMANDLINE_REMOVE 选项,以从 kdump 命令行中删除参数。

KDUMP_COMMANDLINE_REMOVE这个选项从当前

kdump命令行中删除参数。它删除了可能导致kdump错误或kdump内核引导失败的参数。这些参数可能已从之前的KDUMP_COMMANDLINE进程解析了,或者从/proc/cmdline文件继承了。如果未配置此变量,它将继承

/proc/cmdline文件中的所有值。配置此选项还提供了有助于调试问题的信息。要删除某些参数,请将其添加到

KDUMP_COMMANDLINE_REMOVE中,如下所示:

KDUMP_COMMANDLINE_REMOVE="hugepages hugepagesz slub_debug quiet log_buf_len swiotlb"

# KDUMP_COMMANDLINE_REMOVE="hugepages hugepagesz slub_debug quiet log_buf_len swiotlb"KDUMP_COMMANDLINE_APPEND此选项将参数附加到当前命令行。这些参数可能已被之前的

KDUMP_COMMANDLINE_REMOVE变量解析了。对于

kdump内核,禁用某些模块,如mce、cgroup、numa,hest_disable有助于防止内核错误。这些模块可能会消耗为kdump保留的大部分内核内存,或者导致kdump内核引导失败。要在

kdump内核命令行中禁用内存cgroups,请运行以下命令:

KDUMP_COMMANDLINE_APPEND="cgroup_disable=memory"

KDUMP_COMMANDLINE_APPEND="cgroup_disable=memory"15.7. 测试 kdump 配置

配置 kdump 后,您必须手动测试系统崩溃,并确保在定义的 kdump 目标中生成了 vmcore 文件。vmcore 文件是从新引导的内核的上下文中捕获的。因此,vmcore 有用于调试内核崩溃的重要信息。

不要对活动状态的生产环境系统测试 kdump。测试 kdump 的命令将导致内核崩溃,且数据丢失。根据您的系统架构,确保您安排了充足的维护时间,因为 kdump 测试可能需要多次重启,且启动时间很长。

如果 vmcore 文件在 kdump 测试过程中没有生成 ,请在再次运行测试前识别并修复问题,以使 kdump 测试成功。

如果进行任何手动系统修改,您必须在任何系统修改的最后测试 kdump 配置。例如,如果您进行以下任何更改,请确保为以下情形测试 kdump 配置,以获取最佳 kdump 性能:

- 软件包升级。

- 硬件级别的更改,如存储或网络更改。

- 固件升级。

- 包括第三方模块的新安装和应用程序升级。

- 如果您使用热插拔机制在支持此机制的硬件上添加更多内存。

-

在

/etc/kdump.conf或/etc/sysconfig/kdump文件中进行更改后。

先决条件

- 您在系统上具有 root 权限。

-

您已保存了所有重要数据。测试

kdump的命令导致内核崩溃及数据丢失。 - 您已根据系统架构安排了大量机器维护时间。

流程

启用

kdump服务:kdumpctl restart

# kdumpctl restartCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

kdumpctl检查kdump服务的状态:kdumpctl status

# kdumpctl status kdump:Kdump is operationalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 另外,如果您使用

systemctl命令,输出会打印在systemd日志中。启动内核崩溃来测试

kdump配置。sysrq-trigger组合键导致内核崩溃,并在需要时可能重启系统。echo c > /proc/sysrq-trigger

# echo c > /proc/sysrq-triggerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在内核重启时,

address-YYYY-MM-DD-HH:MM:SS/vmcore文件在您在/etc/kdump.conf文件中指定的位置创建。默认值为/var/crash/。

15.8. 系统崩溃后 kdump 生成的文件

系统崩溃后,kdump 服务会将内核内存捕获在转储文件(vmcore)中,它还会生成额外的诊断文件,以帮助故障排除和事后分析。

kdump 生成的文件:

-

vmcore- 崩溃时包含系统内存的主内核内存转储文件。它包含根据kdump配置中指定的core_collector程序配置的数据。默认情况下,包含内核数据结构、进程信息、堆栈跟踪和其他诊断信息。 -

vmcore-dmesg.txt- panic 的主内核中的内核环缓冲区日志的内容(dmesg)。 -

kexec-dmesg.log- 有从收集vmcore数据的辅助kexec内核执行中得到的内核和系统日志消息。

15.9. 启用和禁用 kdump 服务

您可以配置,以对特定的内核或所有安装的内核启用或禁用 kdump 功能。您必须定期测试 kdump 功能,并验证其是否正确运行。

先决条件

- 您在系统上具有 root 权限。

-

您已为配置和目标完成了

kdump要求。请参阅 支持的 kdump 配置和目标。 -

用于安装

kdump的所有配置都是根据需要设置的。

流程

为

multi-user.target启用kdump服务:systemctl enable kdump.service

# systemctl enable kdump.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在当前会话中启动服务:

systemctl start kdump.service

# systemctl start kdump.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 停止

kdump服务:systemctl stop kdump.service

# systemctl stop kdump.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 禁用

kdump服务:systemctl disable kdump.service

# systemctl disable kdump.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

建议将 kptr_restrict=1 设置为默认值。当将 kptr_restrict 设置为(1)作为默认值时,kdumpctl 服务会加载崩溃内核,而无论是否启用了内核地址空间布局(KASLR)。

如果 kptr_restrict 没有被设置为 1,并且 KASLR 被启用了,则生成的 /proc/kore 文件的内容全为零。kdumpctl 服务无法访问 /proc/kcore 文件,并加载崩溃内核。kexec-kdump-howto.txt 文件显示一条警告信息,建议您设置 kptr_restrict=1。验证 sysctl.conf 文件中的以下内容,以确保 kdumpctl 服务加载崩溃内核:

-

sysctl.conf文件中的内核kptr_restrict=1。

15.10. 防止内核驱动程序为 kdump 加载

您可以通过在 /etc/sysconfig/kdump 配置文件中添加 KDUMP_COMMANDLINE_APPEND= 变量来从加载某些内核驱动程序中控制捕获内核。使用这个方法,您可以防止来自加载指定的内核模块中的 kdump 初始 RAM 磁盘镜像 initramfs 。这有助于防止内存不足(OOM) killer 错误或其他崩溃内核失败。

您可以使用以下配置选项之一附加 KDUMP_COMMANDLINE_APPEND= 变量:

-

rd.driver.blacklist=<modules> -

modprobe.blacklist=<modules>

先决条件

- 您在系统上具有 root 权限。

流程

显示载入到当前运行内核的模块的列表。选择您要阻止其加载的内核模块:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 更新

/etc/sysconfig/kdump文件中的KDUMP_COMMANDLINE_APPEND=变量。例如:KDUMP_COMMANDLINE_APPEND="rd.driver.blacklist=hv_vmbus,hv_storvsc,hv_utils,hv_netvsc,hid-hyperv"

KDUMP_COMMANDLINE_APPEND="rd.driver.blacklist=hv_vmbus,hv_storvsc,hv_utils,hv_netvsc,hid-hyperv"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 另外,考虑以下使用

modprobe.blacklist=<modules>配置选项的示例:KDUMP_COMMANDLINE_APPEND="modprobe.blacklist=emcp modprobe.blacklist=bnx2fc modprobe.blacklist=libfcoe modprobe.blacklist=fcoe"

KDUMP_COMMANDLINE_APPEND="modprobe.blacklist=emcp modprobe.blacklist=bnx2fc modprobe.blacklist=libfcoe modprobe.blacklist=fcoe"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重启

kdump服务:systemctl restart kdump

# systemctl restart kdumpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

15.11. 在使用加密磁盘的系统中运行 kdump

当您运行 LUKS 加密的分区时,系统需要一定数量的可用内存。如果系统可用内存量小于所需的可用内存量,则 cryptsetup 实用程序无法挂载分区。因此,在第二个内核(捕获内核)中将 vmcore 文件捕获到加密的目标位置会失败。

kdumpctl estimate 命令可帮助您估算 kdump 所需的内存量。kdumpctl estimate 打印推荐的 crashkernel 值,这是 kdump 所需的最合适的内存大小。

推荐的 crashkernel 值是根据当前的内核大小、内核模块、initramfs 和 LUKS 加密的目标内存要求计算的。

如果您使用自定义 crashkernel= 选项,kdumpctl estimate 会打印 LUKS required size 的值。值是 LUKS 加密目标所需的内存大小。

流程

输出估计的

crashkernel=值:Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

通过增加

crashkernel=值来配置所需的内存量。 - 重启系统。

如果 kdump 服务仍无法将转储文件保存到加密的目标,请根据需要增大 crashkernel= 值。

第 16 章 在 web 控制台中配置 kdump

您可以使用 RHEL 8 web 控制台设置并测试 kdump 配置。Web 控制台可以在引导时启用 kdump 服务。使用 web 控制台,您可以为 kdump 配置保留的内存,并以未压缩或压缩格式选择 vmcore 的保存位置。

16.1. 在 web 控制台中配置 kdump 内存使用率和目标位置

您可以为 kdump 内核配置内存保留,并指定目标位置,来使用 RHEL web 控制台界面捕获 vmcore 转储文件。

先决条件

- 必须安装并可以访问 Web 控制台。详情请参阅安装 Web 控制台。

流程

-

在 web 控制台中,打开 选项卡,并通过将 Kernel crash dump 开关设置为 on 来启动

kdump服务。 在终端中配置

kdump内存使用情况,例如:sudo grubby --update-kernel ALL --args crashkernel=512M

$ sudo grubby --update-kernel ALL --args crashkernel=512MCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重启系统以应用更改。

- 在 Kernel dump 选项卡中,点 Crash dump location 字段末尾的 Edit。

指定保存

vmcore转储文件的目标目录:- 对于本地文件系统,从下拉菜单中选择 Local Filesystem。

对于使用 SSH 协议的远程系统,从下拉菜单中选择 Remote over SSH ,并指定以下字段:

- 在 Server 字段中,输入远程服务器地址。

- 在 SSH key 字段中,输入 SSH 密钥位置。

- 在 Directory 字段中,输入目标目录。

对于使用 NFS 协议的远程系统,从下拉菜单中选择 Remote over NFS ,并指定以下字段:

- 在 Server 字段中,输入远程服务器地址。

- 在 Export 字段中,输入 NFS 服务器的共享文件夹的位置。

在 Directory 字段中,输入目标目录。

注意您可以通过选择 Compression 复选框来减小

vmcore文件的大小。

可选:点击 View automation script 显示自动化脚本。

此时会打开一个带有生成的脚本的窗口。您可以浏览 shell 脚本和 Ansible playbook 生成选项选项卡。

可选:点击 Copy to clipboard 复制脚本。

您可以使用此脚本在多台机器上应用相同的配置。

验证

- 单击 。

在 Test kdump settings 下点 Crash system。

警告当您启动系统崩溃时,内核操作会停止,导致系统崩溃,并造成数据丢失。

第 17 章 启用 kdump

对于 RHEL 8 系统,您可以在特定内核或所有安装的内核中配置或者禁用 kdump 功能。但是,您必须定期测试 kdump 功能,并验证其工作状态。

17.1. 为所有安装的内核启用 kdump

在 kexec 工具安装后,kdump 服务通过启用 kdump.service 启动。您可以为在机器上安装的所有内核启用并启动 kdump 服务。

先决条件

- 有管理员特权。

流程

将

crashkernel=命令行参数添加到所有安装的内核中:grubby --update-kernel=ALL --args="crashkernel=xxM"

# grubby --update-kernel=ALL --args="crashkernel=xxM"Copy to Clipboard Copied! Toggle word wrap Toggle overflow xxM是所需的内存(以 MB 为单位)。重启系统:

reboot

# rebootCopy to Clipboard Copied! Toggle word wrap Toggle overflow 启用

kdump服务:systemctl enable --now kdump.service

# systemctl enable --now kdump.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

检查

kdump服务是否正在运行:systemctl status kdump.service

# systemctl status kdump.service ○ kdump.service - Crash recovery kernel arming Loaded: loaded (/usr/lib/systemd/system/kdump.service; enabled; vendor preset: disabled) Active: active (live)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

17.2. 为特定安装的内核启用 kdump

您可以为机器上的特定内核启用 kdump 服务。

先决条件

- 有管理员特权。

流程

列出安装在机器上的内核。

ls -a /boot/vmlinuz-*

# ls -a /boot/vmlinuz-* /boot/vmlinuz-0-rescue-2930657cd0dc43c2b75db480e5e5b4a9 /boot/vmlinuz-4.18.0-330.el8.x86_64 /boot/vmlinuz-4.18.0-330.rt7.111.el8.x86_64Copy to Clipboard Copied! Toggle word wrap Toggle overflow 向系统的 Grand Unified Bootloader (GRUB)配置中添加特定的

kdump内核。例如:

grubby --update-kernel=vmlinuz-4.18.0-330.el8.x86_64 --args="crashkernel=xxM"

# grubby --update-kernel=vmlinuz-4.18.0-330.el8.x86_64 --args="crashkernel=xxM"Copy to Clipboard Copied! Toggle word wrap Toggle overflow xxM是所需的内存保留(以 MB 为单位)。启用

kdump服务。systemctl enable --now kdump.service

# systemctl enable --now kdump.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

检查

kdump服务是否正在运行。systemctl status kdump.service

# systemctl status kdump.service ○ kdump.service - Crash recovery kernel arming Loaded: loaded (/usr/lib/systemd/system/kdump.service; enabled; vendor preset: disabled) Active: active (live)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

17.3. 禁用 kdump 服务

您可以停止 kdump.service ,并在 RHEL 8 系统上禁用该服务。

先决条件

-

满足

kdump配置和目标的要求。详情请查看支持的 kdump 配置和目标。 -

安装

kdump的所有配置都是根据您的需要设置的。详情请参阅 安装 kdump。

流程

要在当前会话中停止

kdump服务:systemctl stop kdump.service

# systemctl stop kdump.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要禁用

kdump服务:systemctl disable kdump.service

# systemctl disable kdump.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

建议将 kptr_restrict=1 设置为默认值。当将 kptr_restrict 设置为(1)作为默认值时,kdumpctl 服务会加载崩溃内核,而无论是否启用了内核地址空间布局(KASLR)。

如果 kptr_restrict 没有设置为 1,且 KASLR 被启用了,则 /proc/kore 文件的内容被生成为全零。kdumpctl 服务无法访问 /proc/kcore 文件,并加载崩溃内核。kexec-kdump-howto.txt 文件显示一条警告信息,建议您设置 kptr_restrict=1。验证 sysctl.conf 文件中的以下内容,以确保 kdumpctl 服务加载崩溃内核:

-

sysctl.conf文件中的内核kptr_restrict=1。

第 18 章 支持的 kdump 配置和目标

kdump 机制是 Linux 内核的一个功能,它在发生内核崩溃时生成一个崩溃转储文件。内核转储文件有关键的信息,可帮助分析和确定内核崩溃的根本原因。崩溃可能是因为各种因素,举几个例子,如硬件问题或第三方内核模块问题。

通过使用提供的信息和流程,您可以执行以下操作:

- 识别 RHEL 8 系统支持的配置和目标。

- 配置 kdump。

- 验证 kdump 操作。

18.1. kdump 的内存要求

要让 kdump 捕获内核崩溃转储,并保存它以便进一步分析,应该为捕获内核永久保留系统内存的一部分。保留时,主内核无法使用系统内存的这一部分。

内存要求因某些系统参数而异。主要因素之一就是系统的硬件构架。要识别确切的机器架构,如 Intel 64 和 AMD64,也称为 x86_64,并将其输出到标准输出,请使用以下命令:

uname -m

$ uname -m$ uname -m

使用上述最小内存要求的列表,您可以设置合适的内存大小,来在最新可用版本上为 kdump 自动保留内存。内存大小取决于系统的架构和总可用物理内存。

| 架构 | 可用内存 | 最小保留内存 |

|---|---|---|

|

AMD64 和 Intel 64 ( | 1 GB 到 4 GB | 192 MB 内存 |

| 4 GB 到 64 GB | 256 MB 内存 | |

| 64 GB 及更多 | 512 MB 内存 | |

|

64 位 ARM 架构 ( | 2 GB 及更多 | 480 MB 内存 |

|

IBM Power 系统 ( | 2 GB 到 4 GB | 384 MB 内存 |

| 4 GB 到 16 GB | 512 MB 内存 | |

| 16 GB 到 64 GB | 1 GB 内存 | |

| 64 GB 到 128 GB | 2 GB 内存 | |

| 128 GB 及更多 | 4 GB 内存 | |

|

IBM Z ( | 1 GB 到 4 GB | 192 MB 内存 |

| 4 GB 到 64 GB | 256 MB 内存 | |

| 64 GB 及更多 | 512 MB 内存 |

在很多系统中,kdump 可以估算所需内存量并自动保留。默认情况下,此行为是启用的,但仅适用于内存总量超过特定数量的系统,这些内存因系统架构而异。

根据系统中内存总量自动配置保留内存是最佳工作量估算。实际需要的内存可能因其他因素(如 I/O 设备)而异。内存不足可能导致在出现内核 panic 时,debug 内核无法作为捕获内核引导。要避免这个问题,请充分增加崩溃内核内存。

18.2. 自动内存保留的最小阈值

默认情况下,kexec-tools 工具配置 crashkernel 命令行参数,并为 kdump 保留一定的内存量。但是,在某些系统上,仍可在引导装载程序配置文件中使用 crashkernel=auto 参数,或者在图形配置工具中启用这个选项来为 kdump 分配内存。要使此自动保留正常工作,系统中需要有一定数量的总内存。内存要求因系统架构而异。如果系统内存小于指定的阈值,则您必须手动配置内存。

| 构架 | 所需的内存 |

|---|---|

|

AMD64 和 Intel 64 ( | 2 GB |

|

IBM Power 系统 ( | 2 GB |

|

IBM Z ( | 4 GB |

RHEL 9 及更新的版本不再支持引导命令行中的 crashkernel=auto 选项。

18.3. 支持的 kdump 目标

当发生内核崩溃时,操作系统会将转储文件保存在配置的或默认的目标位置上。您可以将转储文件直接保存到设备上,将其作为文件存储在本地文件系统上,或者通过网络发送转储文件。使用以下转储目标的列表,您可以知道 kdump 目前支持的或不支持的目标。

| 目标类型 | 支持的目标 | 不支持的目标 |

|---|---|---|

| 物理存储 |

|

|

| 网络 |

|

|

| 虚拟机监控程序(Hypervisor) |

| |

| 文件系统 | ext[234]、XFS 和 NFS 文件系统。 |

|

| 固件 |

|

18.4. 支持的 kdump 过滤等级

要缩小转储文件的大小,kdump 使用 makedumpfile 内核收集器压缩数据,并排除不需要的信息,例如,您可以使用 -8 级别来删除 hugepages 和 hugetlbfs 页。makedumpfile 当前支持的级别可在 Filtering levels for `kdump` 表中看到。

| 选项 | 描述 |

|---|---|

|

| 零页 |

|

| 缓存页 |

|

| 缓存私有 |

|

| 用户页 |

|

| 可用页 |

18.5. 支持的默认故障响应

默认情况下,当 kdump 创建内核转储失败时,操作系统会重启。但是,当无法将内核转储保存到主目标上时,您可以将 kdump 配置为执行不同的操作。

| 选项 | 描述 |

|---|---|

|

| 尝试将内核转储保存到 root 文件系统。这个选项在与网络目标合并时特别有用:如果网络目标无法访问,这个选项配置 kdump 以在本地保存内核转储。之后会重启该系统。 |

|

| 重启系统,这个过程会丢失 core 转储文件。 |

|

| 关闭系统,这个过程会丢失 core 转储文件。 |

|

| 关闭系统,这个此过程会丢失 core 转储。 |

|

| 从 initramfs 内运行 shell 会话,允许用户手动记录核心转储。 |

|

|

在 |

18.6. 使用 final_action 参数

当 kdump 成功或者 kdump 无法在配置的目标处保存 vmcore 文件时,您可以使用 final_action 参数执行额外的操作,如 reboot、halt 和 poweroff。如果没有指定 final_action 参数,则 reboot 是默认的响应。

流程

要配置

final_action,请编辑/etc/kdump.conf文件并添加以下选项之一:-

final_action reboot -

final_action halt -

final_action poweroff

-

重启

kdump服务,以使更改生效。kdumpctl restart

# kdumpctl restartCopy to Clipboard Copied! Toggle word wrap Toggle overflow

18.7. 使用 failure_action 参数

failure_action 参数指定在内核崩溃时转储失败时要执行的操作。failure_action 的默认操作是 重启 系统。

参数接受以下要执行的操作:

reboot- 转储失败后重启系统。

dump_to_rootfs- 当配置了非 root 转储目标时,将转储文件保存在 root 文件系统上。

halt- 关闭系统。

poweroff- 停止系统上正在运行的操作。

shell-

在

initramfs中启动 shell 会话,您可以从中手动执行其他恢复操作。

流程

要将操作配置为在转储失败时执行的操作,请编辑

/etc/kdump.conf文件并指定其中一个failure_action选项:-

failure_action reboot -

failure_action halt -

failure_action poweroff -

failure_action shell -

failure_action dump_to_rootfs

-

重启

kdump服务,以使更改生效。kdumpctl restart

# kdumpctl restartCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 19 章 固件支持的转储机制

固件支持的转储 (fadump) 是一个转储捕获机制,作为 IBM POWER 系统中 kdump 机制的替代选择。kexec 和 kdump 机制可用于在 AMD64 和 Intel 64 系统中捕获内核转储。但是,一些硬件(如小型系统和大型机计算机)使用板上固件来隔离内存区域,并防止意外覆盖对分析崩溃很重要的数据。fadump 工具针对 fadump 机制及其与 IBM POWER 系统上 RHEL 的集成进行了优化。

19.1. IBM PowerPC 硬件支持转储固件

fadump 实用程序从带有 PCI 和 I/O 设备的完全重设系统中捕获 vmcore 文件。这种机制使用固件在崩溃期间保留内存区域,然后重复使用 kdump 用户空间脚本保存 vmcore 文件。内存区域由所有系统内存内容组成,但引导内存、系统注册和硬件页面表条目 (PTE) 除外。

fadump 机制通过重新引导分区并使用新内核转储之前内核崩溃中的数据,提供比传统转储类型的更高可靠性。fadump 需要一个基于 IBM POWER6 处理器或更高版本的硬件平台。

有关 fadump 机制的详情,包括针对 PowerPC 重置硬件的方法,请查看 /usr/share/doc/kexec-tools/fadump-howto.txt 文件。

未保留的内存区域(称为引导内存)是在崩溃事件后成功引导内核所需的 RAM 量。默认情况下,引导内存大小为 256MB 或系统 RAM 总量的 5%,以较大者为准。

与 kexec-initiated 事件不同,fadump 机制使用 production 内核恢复崩溃转储。崩溃后引导时,PowerPC 硬件使设备节点 /proc/device-tree/rtas/ibm.kernel-dump 可供 proc 文件系统 (procfs) 使用。fadump-aware kdump 脚本,检查存储的 vmcore,然后完全完成系统重启。

19.2. 启用固件支持的转储机制

您可以通过启用固件支持的转储(fadump)机制来增强 IBM POWER 系统的崩溃转储功能。

在安全引导环境中,GRUB 引导装载程序分配一个引导内存区域,称为 Real Mode Area (RMA)。RMA 有 512 MB 大小的内存,在引导组件之间分配。如果组件超过其大小分配,则 GRUB 会失败,并显示内存不足(OOM)错误。

不要在 RHEL 8.7 和 8.6 版本的安全引导环境中启用固件支持的转储(fadump)机制。GRUB2 引导装载程序失败,并显示以下错误:

error: ../../grub-core/kern/mm.c:376:out of memory. Press any key to continue…

error: ../../grub-core/kern/mm.c:376:out of memory.

Press any key to continue…

仅当您因为 fadump 配置而增加默认 initramfs 大小时,系统才是可恢复的。

有关恢复系统的临时解决方案方法的详情,请参考 GRUB 内存不足(OOM)中的系统引导结束 文章。

流程

-

安装和配置

kdump。 启用

fadump=on内核选项:grubby --update-kernel=ALL --args="fadump=on"

# grubby --update-kernel=ALL --args="fadump=on"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:如果要指定保留引导内存而不是使用默认值,请启用

crashkernel=xxM选项,其中xx是以 MB 为单位所需的内存量:grubby --update-kernel=ALL --args="crashkernel=xxM fadump=on"

# grubby --update-kernel=ALL --args="crashkernel=xxM fadump=on"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要当指定引导选项时,在运行前测试所有引导选项。如果

kdump内核无法引导,请逐渐增加crashkernel=参数中指定的值来设置适当的值。

19.3. IBM Z 硬件支持的固件转储机制

IBM Z 系统支持以下固件支持的转储机制:

-

独立转储 (sadump) -

VMDUMP

IBM Z 系统支持并使用 kdump 基础架构。但是,使用 IBM Z 的固件支持的转储(fadump)方法之一有以下优点:

-

系统控制台启动和控制

sadump机制,并将其存储在IPL可引导设备中。 -

VMDUMP机制与sadump类似。此工具也从系统控制台启动,但会从硬件检索生成的转储并将其复制到系统以进行分析。 -

这些方法(与其他基于硬件的转储机制类似)能够在

kdump服务启动前捕获机器在早期启动阶段的状态。 -

虽然

VMDUMP包含接收转储文件到 Red Hat Enterprise Linux 系统的机制,但VMDUMP的配置和控制是从 IBM Z 硬件控制台管理的。

19.4. 在 Fujitsu PRIMEQUEST 系统中使用 sadump

当 kdump 无法成功完成时,Fujitsu sadump 机制提供了一个 回退 转储捕获。您可以从系统管理局(MMB)接口手动调用 sadump。使用 MMB,为 Intel 64 或 AMD64 服务器配置 kdump,然后继续启用 sadump。

流程

在

/etc/sysctl.conf文件中添加或编辑以下行,以确保sadump的kdump按预期启动:kernel.panic=0 kernel.unknown_nmi_panic=1

kernel.panic=0 kernel.unknown_nmi_panic=1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 警告特别是,请确保在

kdump后系统不会重启。如果系统在kdump保存vmcore文件失败后重启,则无法调用sadump。适当地将

/etc/kdump.conf中的failure_action参数设置为halt或shell。failure_action shell

failure_action shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 20 章 分析内核转储

要识别系统崩溃的原因,您可以使用 crash 工具,它提供类似于 GNU Debugger (GDB)的交互式提示。通过使用 crash,您可以分析由 kdump、netdump、diskdump 或 xendump 创建的内核转储以及正在运行的 Linux 系统。另外,您可以使用 Kernel Oops Analyzer 或 Kdump Helper 工具。

20.1. 安装 crash 工具

使用提供的信息,了解所需的软件包,以及安装 crash 工具的流程。默认情况下,在 RHEL 8 系统中可能无法安装 crash 工具。crash 是一个工具,可在内核崩溃发生并且创建内核转储文件时以交互方式分析系统状态。内核转储文件也称为 vmcore 文件。

流程

启用相关的软件仓库:

subscription-manager repos --enable baseos repository

# subscription-manager repos --enable baseos repositoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow subscription-manager repos --enable appstream repository

# subscription-manager repos --enable appstream repositoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow subscription-manager repos --enable rhel-8-for-x86_64-baseos-debug-rpms