Ce contenu n'est pas disponible dans la langue sélectionnée.

Advanced networking

Specialized and advanced networking topics in OpenShift Container Platform

Abstract

Chapter 1. Verifying connectivity to an endpoint

The Cluster Network Operator (CNO) runs a controller, the connectivity check controller, that performs a connection health check between resources within your cluster. By reviewing the results of the health checks, you can diagnose connection problems or eliminate network connectivity as the cause of an issue that you are investigating.

1.1. Connection health checks that are performed

To verify that cluster resources are reachable, a TCP connection is made to each of the following cluster API services:

- Kubernetes API server service

- Kubernetes API server endpoints

- OpenShift API server service

- OpenShift API server endpoints

- Load balancers

To verify that services and service endpoints are reachable on every node in the cluster, a TCP connection is made to each of the following targets:

- Health check target service

- Health check target endpoints

1.2. Implementation of connection health checks

The connectivity check controller orchestrates connection verification checks in your cluster. The results for the connection tests are stored in PodNetworkConnectivity objects in the openshift-network-diagnostics namespace. Connection tests are performed every minute in parallel.

The Cluster Network Operator (CNO) deploys several resources to the cluster to send and receive connectivity health checks:

- Health check source

-

This program deploys in a single pod replica set managed by a

Deploymentobject. The program consumesPodNetworkConnectivityobjects and connects to thespec.targetEndpointspecified in each object. - Health check target

- A pod deployed as part of a daemon set on every node in the cluster. The pod listens for inbound health checks. The presence of this pod on every node allows for the testing of connectivity to each node.

You can configure the nodes which network connectivity sources and targets run on with a node selector. Additionally, you can specify permissible tolerations for source and target pods. The configuration is defined in the singleton cluster custom resource of the Network API in the config.openshift.io/v1 API group.

Pod scheduling occurs after you have updated the configuration. Therefore, you must apply node labels that you intend to use in your selectors before updating the configuration. Labels applied after updating your network connectivity check pod placement are ignored.

Refer to the default configuration in the following YAML:

Default configuration for connectivity source and target pods

- 1

- Specifies the network diagnostics configuration. If a value is not specified or an empty object is specified, and

spec.disableNetworkDiagnostics=trueis set in thenetwork.operator.openshift.iocustom resource namedcluster, network diagnostics are disabled. If set, this value overridesspec.disableNetworkDiagnostics=true. - 2

- Specifies the diagnostics mode. The value can be the empty string,

All, orDisabled. The empty string is equivalent to specifyingAll. - 3

- Optional: Specifies a selector for connectivity check source pods. You can use the

nodeSelectorandtolerationsfields to further specify thesourceNodepods. These are optional for both source and target pods. You can omit them, use both, or use only one of them. - 4

- Optional: Specifies a selector for connectivity check target pods. You can use the

nodeSelectorandtolerationsfields to further specify thetargetNodepods. These are optional for both source and target pods. You can omit them, use both, or use only one of them.

1.3. Configuring pod connectivity check placement

As a cluster administrator, you can configure which nodes the connectivity check pods run by modifying the network.config.openshift.io object named cluster.

Prerequisites

-

Install the OpenShift CLI (

oc).

Procedure

Edit the connectivity check configuration by entering the following command:

oc edit network.config.openshift.io cluster

$ oc edit network.config.openshift.io clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

In the text editor, update the

networkDiagnosticsstanza to specify the node selectors that you want for the source and target pods. - Save your changes and exit the text editor.

Verification

- Verify that the source and target pods are running on the intended nodes by entering the following command:

oc get pods -n openshift-network-diagnostics -o wide

$ oc get pods -n openshift-network-diagnostics -o wideExample output

1.4. PodNetworkConnectivityCheck object fields

The PodNetworkConnectivityCheck object fields are described in the following tables.

| Field | Type | Description |

|---|---|---|

|

|

|

The name of the object in the following format:

|

|

|

|

The namespace that the object is associated with. This value is always |

|

|

|

The name of the pod where the connection check originates, such as |

|

|

|

The target of the connection check, such as |

|

|

| Configuration for the TLS certificate to use. |

|

|

| The name of the TLS certificate used, if any. The default value is an empty string. |

|

|

| An object representing the condition of the connection test and logs of recent connection successes and failures. |

|

|

| The latest status of the connection check and any previous statuses. |

|

|

| Connection test logs from unsuccessful attempts. |

|

|

| Connect test logs covering the time periods of any outages. |

|

|

| Connection test logs from successful attempts. |

The following table describes the fields for objects in the status.conditions array:

| Field | Type | Description |

|---|---|---|

|

|

| The time that the condition of the connection transitioned from one status to another. |

|

|

| The details about last transition in a human readable format. |

|

|

| The last status of the transition in a machine readable format. |

|

|

| The status of the condition. |

|

|

| The type of the condition. |

The following table describes the fields for objects in the status.conditions array:

| Field | Type | Description |

|---|---|---|

|

|

| The timestamp from when the connection failure is resolved. |

|

|

| Connection log entries, including the log entry related to the successful end of the outage. |

|

|

| A summary of outage details in a human readable format. |

|

|

| The timestamp from when the connection failure is first detected. |

|

|

| Connection log entries, including the original failure. |

1.4.1. Connection log fields

The fields for a connection log entry are described in the following table. The object is used in the following fields:

-

status.failures[] -

status.successes[] -

status.outages[].startLogs[] -

status.outages[].endLogs[]

| Field | Type | Description |

|---|---|---|

|

|

| Records the duration of the action. |

|

|

| Provides the status in a human readable format. |

|

|

|

Provides the reason for status in a machine readable format. The value is one of |

|

|

| Indicates if the log entry is a success or failure. |

|

|

| The start time of connection check. |

1.5. Verifying network connectivity for an endpoint

As a cluster administrator, you can verify the connectivity of an endpoint, such as an API server, load balancer, service, or pod, and verify that network diagnostics is enabled.

Prerequisites

-

Install the OpenShift CLI (

oc). -

Access to the cluster as a user with the

cluster-adminrole.

Procedure

Confirm that network diagnostics are enable by entering the following command:

oc get network.config.openshift.io cluster -o yaml

$ oc get network.config.openshift.io cluster -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Example output

Copy to Clipboard Copied! Toggle word wrap Toggle overflow List the current

PodNetworkConnectivityCheckobjects by entering the following command:oc get podnetworkconnectivitycheck -n openshift-network-diagnostics

$ oc get podnetworkconnectivitycheck -n openshift-network-diagnosticsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Example output

Copy to Clipboard Copied! Toggle word wrap Toggle overflow View the connection test logs:

- From the output of the previous command, identify the endpoint that you want to review the connectivity logs for.

View the object by entering the following command:

oc get podnetworkconnectivitycheck <name> \ -n openshift-network-diagnostics -o yaml

$ oc get podnetworkconnectivitycheck <name> \ -n openshift-network-diagnostics -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow where

<name>specifies the name of thePodNetworkConnectivityCheckobject.Example output

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapter 2. Changing the MTU for the cluster network

As a cluster administrator, you can change the maximum transmission unit (MTU) for the cluster network after cluster installation. This change is disruptive as cluster nodes must be rebooted to finalize the MTU change.

2.1. About the cluster MTU

During installation, the cluster network maximum transmission unit (MTU) is set automatically based on the primary network interface MTU of cluster nodes. Typically, you do not need to override the detected MTU, but in some instances you must override it.

You might want to change the MTU of the cluster network for one of the following reasons:

- The MTU detected during cluster installation is not correct for your infrastructure.

- Your cluster infrastructure now requires a different MTU, such as from the addition of nodes that need a different MTU for optimal performance.

Only the OVN-Kubernetes network plugin supports changing the MTU value.

2.1.1. Service interruption considerations

When you initiate a maximum transmission unit (MTU) change on your cluster the following effects might impact service availability:

- At least two rolling reboots are required to complete the migration to a new MTU. During this time, some nodes are not available as they restart.

- Specific applications deployed to the cluster with shorter timeout intervals than the absolute TCP timeout interval might experience disruption during the MTU change.

2.1.2. MTU value selection

When planning your maximum transmission unit (MTU) migration there are two related but distinct MTU values to consider.

- Hardware MTU: This MTU value is set based on the specifics of your network infrastructure.

-

Cluster network MTU: This MTU value is always less than your hardware MTU to account for the cluster network overlay overhead. The specific overhead is determined by your network plugin. For OVN-Kubernetes, the overhead is

100bytes.

If your cluster requires different MTU values for different nodes, you must subtract the overhead value for your network plugin from the lowest MTU value that is used by any node in your cluster. For example, if some nodes in your cluster have an MTU of 9001, and some have an MTU of 1500, you must set this value to 1400.

To avoid selecting an MTU value that is not acceptable by a node, verify the maximum MTU value (maxmtu) that is accepted by the network interface by using the ip -d link command.

2.1.3. How the migration process works

The following table summarizes the migration process by segmenting between the user-initiated steps in the process and the actions that the migration performs in response.

| User-initiated steps | OpenShift Container Platform activity |

|---|---|

| Set the following values in the Cluster Network Operator configuration:

| Cluster Network Operator (CNO): Confirms that each field is set to a valid value.

If the values provided are valid, the CNO writes out a new temporary configuration with the MTU for the cluster network set to the value of the Machine Config Operator (MCO): Performs a rolling reboot of each node in the cluster. |

| Reconfigure the MTU of the primary network interface for the nodes on the cluster. You can use one of the following methods to accomplish this:

| N/A |

|

Set the | Machine Config Operator (MCO): Performs a rolling reboot of each node in the cluster with the new MTU configuration. |

2.2. Changing the cluster network MTU

As a cluster administrator, you can increase or decrease the maximum transmission unit (MTU) for your cluster.

You cannot roll back an MTU value for nodes during the MTU migration process, but you can roll back the value after the MTU migration process completes.

The migration is disruptive and nodes in your cluster might be temporarily unavailable as the MTU update takes effect.

The following procedures describe how to change the cluster network MTU by using machine configs, Dynamic Host Configuration Protocol (DHCP), or an ISO image. If you use either the DHCP or ISO approaches, you must refer to configuration artifacts that you kept after installing your cluster to complete the procedure.

Prerequisites

-

You have installed the OpenShift CLI (

oc). -

You have access to the cluster using an account with

cluster-adminpermissions. -

You have identified the target MTU for your cluster. The MTU for the OVN-Kubernetes network plugin must be set to

100less than the lowest hardware MTU value in your cluster. - If your nodes are physical machines, ensure that the cluster network and the connected network switches support jumbo frames.

- If your nodes are virtual machines (VMs), ensure that the hypervisor and the connected network switches support jumbo frames.

2.2.1. Checking the current cluster MTU value

To ensure network stability and performance in a hybrid environment where part of your cluster is in the cloud and part is an on-premise environment, you can obtain the current maximum transmission unit (MTU) for the cluster network.

Procedure

To obtain the current MTU for the cluster network, enter the following command:

oc describe network.config cluster

$ oc describe network.config clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Example output

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.2. Preparing your hardware MTU configuration

Many ways exist to configure the hardware maximum transmission unit (MTU) for your cluster nodes. The following examples show only the most common methods. Verify the correctness of your infrastructure MTU. Select your preferred method for configuring your hardware MTU in the cluster nodes.

Procedure

Prepare your configuration for the hardware MTU:

If your hardware MTU is specified with DHCP, update your DHCP configuration such as with the following dnsmasq configuration:

dhcp-option-force=26,<mtu>

dhcp-option-force=26,<mtu>Copy to Clipboard Copied! Toggle word wrap Toggle overflow where:

<mtu>- Specifies the hardware MTU for the DHCP server to advertise.

- If your hardware MTU is specified with a kernel command line with PXE, update that configuration accordingly.

If your hardware MTU is specified in a NetworkManager connection configuration, complete the following steps. This approach is the default for OpenShift Container Platform if you do not explicitly specify your network configuration with DHCP, a kernel command line, or some other method. Your cluster nodes must all use the same underlying network configuration for the following procedure to work unmodified.

Find the primary network interface by entering the following command:

oc debug node/<node_name> -- chroot /host nmcli -g connection.interface-name c show ovs-if-phys0

$ oc debug node/<node_name> -- chroot /host nmcli -g connection.interface-name c show ovs-if-phys0Copy to Clipboard Copied! Toggle word wrap Toggle overflow where:

<node_name>- Specifies the name of a node in your cluster.

Create the following

NetworkManagerconfiguration in the<interface>-mtu.conffile:[connection-<interface>-mtu] match-device=interface-name:<interface> ethernet.mtu=<mtu>

[connection-<interface>-mtu] match-device=interface-name:<interface> ethernet.mtu=<mtu>Copy to Clipboard Copied! Toggle word wrap Toggle overflow where:

<interface>- Specifies the primary network interface name.

<mtu>- Specifies the new hardware MTU value.

2.2.3. Creating MachineConfig objects

Use the following procedure to create the MachineConfig objects.

Procedure

Create two

MachineConfigobjects, one for the control plane nodes and another for the worker nodes in your cluster:Create the following Butane config in the

control-plane-interface.bufile:NoteThe Butane version you specify in the config file should match the OpenShift Container Platform version and always ends in

0. For example,4.19.0. See "Creating machine configs with Butane" for information about Butane.Copy to Clipboard Copied! Toggle word wrap Toggle overflow Create the following Butane config in the

worker-interface.bufile:NoteThe Butane version you specify in the config file should match the OpenShift Container Platform version and always ends in

0. For example,4.19.0. See "Creating machine configs with Butane" for information about Butane.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Create

MachineConfigobjects from the Butane configs by running the following command:for manifest in control-plane-interface worker-interface; do butane --files-dir . $manifest.bu > $manifest.yaml done$ for manifest in control-plane-interface worker-interface; do butane --files-dir . $manifest.bu > $manifest.yaml doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow WarningDo not apply these machine configs until explicitly instructed later in this procedure. Applying these machine configs now causes a loss of stability for the cluster.

2.2.4. Beginning the MTU migration

Start the maximum transmission unit (MTU) migration by specifying the migration configuration for the cluster network and machine interfaces. The Machine Config Operator performs a rolling reboot of the nodes to prepare the cluster for the MTU change.

Procedure

To begin the MTU migration, specify the migration configuration by entering the following command. The Machine Config Operator performs a rolling reboot of the nodes in the cluster in preparation for the MTU change.

oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": { "mtu": { "network": { "from": <overlay_from>, "to": <overlay_to> } , "machine": { "to" : <machine_to> } } } } }'$ oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": { "mtu": { "network": { "from": <overlay_from>, "to": <overlay_to> } , "machine": { "to" : <machine_to> } } } } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow where:

<overlay_from>- Specifies the current cluster network MTU value.

<overlay_to>-

Specifies the target MTU for the cluster network. This value is set relative to the value of

<machine_to>. For OVN-Kubernetes, this value must be100less than the value of<machine_to>. <machine_to>- Specifies the MTU for the primary network interface on the underlying host network.

oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": { "mtu": { "network": { "from": 1400, "to": 9000 } , "machine": { "to" : 9100} } } } }'$ oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": { "mtu": { "network": { "from": 1400, "to": 9000 } , "machine": { "to" : 9100} } } } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow As the Machine Config Operator updates machines in each machine config pool, the Operator reboots each node one by one. You must wait until all the nodes are updated. Check the machine config pool status by entering the following command:

oc get machineconfigpools

$ oc get machineconfigpoolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow A successfully updated node has the following status:

UPDATED=true,UPDATING=false,DEGRADED=false.NoteBy default, the Machine Config Operator updates one machine per pool at a time, causing the total time the migration takes to increase with the size of the cluster.

2.2.5. Verifying the machine configuration

Verify the machine configuration on your hosts to confirm that the maximum transmission unit (MTU) migration applied successfully. Checking the configuration state and system settings help ensures that the nodes use the correct migration script.

Procedure

Confirm the status of the new machine configuration on the hosts:

To list the machine configuration state and the name of the applied machine configuration, enter the following command:

oc describe node | egrep "hostname|machineconfig"

$ oc describe node | egrep "hostname|machineconfig"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Example output

kubernetes.io/hostname=master-0 machineconfiguration.openshift.io/currentConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/desiredConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/reason: machineconfiguration.openshift.io/state: Done

kubernetes.io/hostname=master-0 machineconfiguration.openshift.io/currentConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/desiredConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/reason: machineconfiguration.openshift.io/state: DoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow Verify that the following statements are true:

-

The value of

machineconfiguration.openshift.io/statefield isDone. -

The value of the

machineconfiguration.openshift.io/currentConfigfield is equal to the value of themachineconfiguration.openshift.io/desiredConfigfield.

-

The value of

To confirm that the machine config is correct, enter the following command:

oc get machineconfig <config_name> -o yaml | grep ExecStart

$ oc get machineconfig <config_name> -o yaml | grep ExecStartCopy to Clipboard Copied! Toggle word wrap Toggle overflow where:

<config_name>-

Specifies the name of the machine config from the

machineconfiguration.openshift.io/currentConfigfield.

The machine config must include the following update to the systemd configuration:

ExecStart=/usr/local/bin/mtu-migration.sh

ExecStart=/usr/local/bin/mtu-migration.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.6. Applying the new hardware MTU value

Use the following procedure to apply the new hardware maximum transmission unit (MTU) value.

Procedure

Update the underlying network interface MTU value:

If you are specifying the new MTU with a NetworkManager connection configuration, enter the following command. The MachineConfig Operator automatically performs a rolling reboot of the nodes in your cluster.

for manifest in control-plane-interface worker-interface; do oc create -f $manifest.yaml done$ for manifest in control-plane-interface worker-interface; do oc create -f $manifest.yaml doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow - If you are specifying the new MTU with a DHCP server option or a kernel command line and PXE, make the necessary changes for your infrastructure.

As the Machine Config Operator updates machines in each machine config pool, the Operator reboots each node one by one. You must wait until all the nodes are updated. Check the machine config pool status by entering the following command:

oc get machineconfigpools

$ oc get machineconfigpoolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow A successfully updated node has the following status:

UPDATED=true,UPDATING=false,DEGRADED=false.NoteBy default, the Machine Config Operator updates one machine per pool at a time, causing the total time the migration takes to increase with the size of the cluster.

Confirm the status of the new machine configuration on the hosts:

To list the machine configuration state and the name of the applied machine configuration, enter the following command:

oc describe node | egrep "hostname|machineconfig"

$ oc describe node | egrep "hostname|machineconfig"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Example output

kubernetes.io/hostname=master-0 machineconfiguration.openshift.io/currentConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/desiredConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/reason: machineconfiguration.openshift.io/state: Done

kubernetes.io/hostname=master-0 machineconfiguration.openshift.io/currentConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/desiredConfig: rendered-master-c53e221d9d24e1c8bb6ee89dd3d8ad7b machineconfiguration.openshift.io/reason: machineconfiguration.openshift.io/state: DoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow Verify that the following statements are true:

-

The value of

machineconfiguration.openshift.io/statefield isDone. -

The value of the

machineconfiguration.openshift.io/currentConfigfield is equal to the value of themachineconfiguration.openshift.io/desiredConfigfield.

-

The value of

To confirm that the machine config is correct, enter the following command:

oc get machineconfig <config_name> -o yaml | grep path:

$ oc get machineconfig <config_name> -o yaml | grep path:Copy to Clipboard Copied! Toggle word wrap Toggle overflow where:

<config_name>-

Specifies the name of the machine config from the

machineconfiguration.openshift.io/currentConfigfield.

If the machine config is successfully deployed, the previous output contains the

/etc/NetworkManager/conf.d/99-<interface>-mtu.conffile path and theExecStart=/usr/local/bin/mtu-migration.shline.

2.2.7. Finalizing the MTU migration

Finalize the MTU migration to apply the new maximum transmission unit (MTU) settings to the OVN-Kubernetes network plugin. This updates the cluster configuration and triggers a rolling reboot of the nodes to complete the process.

Procedure

To finalize the MTU migration, enter the following command for the OVN-Kubernetes network plugin:

oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": null, "defaultNetwork":{ "ovnKubernetesConfig": { "mtu": <mtu> }}}}'$ oc patch Network.operator.openshift.io cluster --type=merge --patch \ '{"spec": { "migration": null, "defaultNetwork":{ "ovnKubernetesConfig": { "mtu": <mtu> }}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow where:

<mtu>-

Specifies the new cluster network MTU that you specified with

<overlay_to>.

After finalizing the MTU migration, each machine config pool node is rebooted one by one. You must wait until all the nodes are updated. Check the machine config pool status by entering the following command:

oc get machineconfigpools

$ oc get machineconfigpoolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow A successfully updated node has the following status:

UPDATED=true,UPDATING=false,DEGRADED=false.

Verification

To get the current MTU for the cluster network, enter the following command:

oc describe network.config cluster

$ oc describe network.config clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Get the current MTU for the primary network interface of a node:

To list the nodes in your cluster, enter the following command:

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow To obtain the current MTU setting for the primary network interface on a node, enter the following command:

oc adm node-logs <node> -u ovs-configuration | grep configure-ovs.sh | grep mtu | grep <interface> | head -1

$ oc adm node-logs <node> -u ovs-configuration | grep configure-ovs.sh | grep mtu | grep <interface> | head -1Copy to Clipboard Copied! Toggle word wrap Toggle overflow where:

<node>- Specifies a node from the output from the previous step.

<interface>- Specifies the primary network interface name for the node.

Example output

ens3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 8051

ens3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 8051Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapter 3. Network bonding considerations

You can use network bonding, also known as link aggregration, to combine many network interfaces into a single, logical interface. This means that you can use different modes for handling how network traffic distributes across bonded interfaces. Each mode provides fault tolerance and some modes provide load balancing capabilities to your network. Red Hat supports Open vSwitch (OVS) bonding and kernel bonding.

3.1. Open vSwitch (OVS) bonding

With an OVS bonding configuration, you create a single, logical interface by connecting each physical network interface controller (NIC) as a port to a specific bond. This single bond then handles all network traffic, effectively replacing the function of individual interfaces.

Consider the following architectural layout for OVS bridges that interact with OVS interfaces:

- A network interface uses a bridge Media Access Control (MAC) address for managing protocol-level traffic and other administrative tasks, such as IP address assignment.

- The physical MAC addresses of physical interfaces do not handle traffic.

- OVS handles all MAC address management at the OVS bridge level.

This layout simplifies bond interface management as bonds act as data paths, where centralized MAC address management happens at the OVS bridge level.

For OVS bonding, you can select either active-backup mode or balance-slb mode. A bonding mode specifies the policy for how bond interfaces get used during network transmission.

3.1.1. Enable active-backup mode for your cluster

The active-backup mode provides fault tolerance for network connections by switching to a backup link where the primary link fails.

The mode specifies the following ports for your cluster:

- An active port where one physical interface sends and receives traffic at any given time.

- A standby port where all other ports act as backup links and continously monitor their link status.

During a failover process, if an active port or its link fails, the bonding logic switches all network traffic to a standby port. This standby port becomes the new active port. For failover to work, all ports in a bond must share the same Media Access Control (MAC) address.

3.1.2. Enabling OVS balance-slb mode for your cluster

You can enable the Open vSwitch (OVS) balance-slb mode so that two or more physical interfaces can share their network traffic. A balance-slb mode interface can give source load balancing (SLB) capabilities to a cluster that runs virtualization workloads, without requiring load balancing negotiation with the network switch.

Currently, source load balancing runs on a bond interface, where the interface connects to an auxiliary bridge, such as br-phy. Source load balancing balances only across different Media Access Control (MAC) address and virtual local area network (VLAN) combinations. Note that all OVN-Kubernetes pod traffic uses the same MAC address and VLAN, so this traffic cannot be load balanced across many physical interfaces.

The following diagram shows balance-slb mode on a simple cluster infrastructure layout. Virtual machines (VMs) connect to specific localnet NetworkAttachmentDefinition (NAD) custom resource definition (CRDs), NAD 0 or NAD 1. Each NAD provides VMs with access to the underlying physical network, supporting VLAN-tagged or untagged traffic. A br-ex OVS bridge receives traffic from VMs and passes the traffic to the next OVS bridge, br-phy. The br-phy bridge functions as the controller for the SLB bond. The SLB bond balances traffic from different VM ports over the physical interface links, such as eno0 and eno1. Additionally, ingress traffic from either physical interface can pass through the set of OVS bridges to reach the VMs.

Figure 3.1. OVS balance-slb mode operating on a localnet with two NADs

You can integrate the balance-slb mode interface into primary or secondary network types by using OVS bonding. Note the following points about OVS bonding:

- Supports the OVN-Kubernetes CNI plugin and easily integrates with the plugin.

-

Natively supports

balance-slbmode.

Prerequisites

-

You have more than one physical interface attached to your primary network and you defined the interfaces in a

MachineConfigfile. -

You created a manifest object and defined a customized

br-exbridge in the object configuration file. - You have more than one physical interfaces attached to your primary network and you defined the interfaces in a NAD CRD file.

Procedure

For each bare-metal host that exists in a cluster, in the

install-config.yamlfile for your cluster define anetworkConfigsection similar to the following example:Copy to Clipboard Copied! Toggle word wrap Toggle overflow where:

enp1s0- The interface for the provisioned network interface controller (NIC).

enp2s0- The first bonded interface that pulls in the Ignition config file for the bond interface.

mtu-

Manually set the

br-exmaximum transmission unit (MTU) on the bond ports. enp3s0- The second bonded interface is part of a minimal configuration that pulls ignition during cluster installation.

Define each network interface in an NMState configuration file:

Example NMState configuration file that defines many network interfaces

Copy to Clipboard Copied! Toggle word wrap Toggle overflow where:

mtu-

Manually set the

br-exMTU on the bond ports.

Use the

base64command to encode the interface content of the NMState configuration file:base64 -w0 <nmstate_configuration>.yml

$ base64 -w0 <nmstate_configuration>.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow <nmstate_configuration>: Where the-w0option prevents line wrapping during the base64 encoding operation.Create

MachineConfigmanifest files for themasterrole and theworkerrole. Ensure that you embed the base64-encoded string from an earlier command into eachMachineConfigmanifest file. The following example manifest file configures themasterrole for all nodes that exist in a cluster. You can also create a manifest file formasterandworkerroles specific to a node.Copy to Clipboard Copied! Toggle word wrap Toggle overflow where:

name- The name of the policy.

source- Writes the encoded base64 information to the specified path.

path-

Specify the path to the

cluster.ymlfile. For each node in your cluster, you can specify the short hostname path to your node, such as<node_short_hostname>.yml.

Save each

MachineConfigmanifest file to the./<installation_directory>/manifestsdirectory, where<installation_directory>is the directory in which the installation program creates files.The Machine Config Operator (MCO) takes the content from each manifest file and consistently applies the content to all selected nodes during a rolling update.

3.2. Kernel bonding

You can use kernel bonding, which is a built-in Linux kernel function where link aggregation can exist among many Ethernet interfaces, to create a single logical physical interface. Kernel bonding allows multiple network interfaces to be combined into a single logical interface, which can enhance network performance by increasing bandwidth and providing redundancy in case of a link failure.

Kernel bonding is the default mode if no bond interfaces depend on OVS bonds. This bonding type does not give the same level of customization as supported OVS bonding.

For kernel-bonding mode, the bond interfaces exist outside, which means they are not in the data path, of the bridge interface. Network traffic in this mode is not sent or received on the bond interface port but instead requires additional bridging capabilities for MAC address assignment at the kernel level.

If you enabled kernel-bonding mode on network controller interfaces (NICs) for your nodes, you must specify a Media Access Control (MAC) address failover. This configuration prevents node communication issues with the bond interfaces, such as eno1f0 and eno2f0.

Red Hat supports only the following value for the fail_over_mac parameter:

-

0: Specifies thenonevalue, which disables MAC address failover so that all interfaces receive the same MAC address as the bond interface. This is the default value.

Red Hat does not support the following values for the fail_over_mac parameter:

-

1: Specifies theactivevalue and sets the MAC address of the primary bond interface to always remain the same as active interfaces. If during a failover, the MAC address of an interface changes, the MAC address of the bond interface changes to match the new MAC address of the interface. -

2: Specifies thefollowvalue so that during a failover, an active interface gets the MAC address of the bond interface and a formerly active interface receives the MAC address of the newly active interface.

Chapter 4. Using the Stream Control Transmission Protocol (SCTP)

As a cluster administrator, you can use the Stream Control Transmission Protocol (SCTP) on a bare-metal cluster.

4.1. Support for SCTP on OpenShift Container Platform

As a cluster administrator, you can enable SCTP on the hosts in the cluster. On Red Hat Enterprise Linux CoreOS (RHCOS), the SCTP module is disabled by default.

SCTP is a reliable message based protocol that runs on top of an IP network.

When enabled, you can use SCTP as a protocol with pods, services, and network policy. A Service object must be defined with the type parameter set to either the ClusterIP or NodePort value.

4.1.1. Example configurations using SCTP protocol

You can configure a pod or service to use SCTP by setting the protocol parameter to the SCTP value in the pod or service object.

In the following example, a pod is configured to use SCTP:

In the following example, a service is configured to use SCTP:

In the following example, a NetworkPolicy object is configured to apply to SCTP network traffic on port 80 from any pods with a specific label:

4.2. Enabling Stream Control Transmission Protocol (SCTP)

As a cluster administrator, you can load and enable the blacklisted SCTP kernel module on worker nodes in your cluster.

Prerequisites

-

Install the OpenShift CLI (

oc). -

Access to the cluster as a user with the

cluster-adminrole.

Procedure

Create a file named

load-sctp-module.yamlthat contains the following YAML definition:Copy to Clipboard Copied! Toggle word wrap Toggle overflow To create the

MachineConfigobject, enter the following command:oc create -f load-sctp-module.yaml

$ oc create -f load-sctp-module.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Optional: To watch the status of the nodes while the MachineConfig Operator applies the configuration change, enter the following command. When the status of a node transitions to

Ready, the configuration update is applied.oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3. Verifying Stream Control Transmission Protocol (SCTP) is enabled

You can verify that SCTP is working on a cluster by creating a pod with an application that listens for SCTP traffic, associating it with a service, and then connecting to the exposed service.

Prerequisites

-

Access to the internet from the cluster to install the

ncpackage. -

Install the OpenShift CLI (

oc). -

Access to the cluster as a user with the

cluster-adminrole.

Procedure

Create a pod starts an SCTP listener:

Create a file named

sctp-server.yamlthat defines a pod with the following YAML:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Create the pod by entering the following command:

oc create -f sctp-server.yaml

$ oc create -f sctp-server.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Create a service for the SCTP listener pod.

Create a file named

sctp-service.yamlthat defines a service with the following YAML:Copy to Clipboard Copied! Toggle word wrap Toggle overflow To create the service, enter the following command:

oc create -f sctp-service.yaml

$ oc create -f sctp-service.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Create a pod for the SCTP client.

Create a file named

sctp-client.yamlwith the following YAML:Copy to Clipboard Copied! Toggle word wrap Toggle overflow To create the

Podobject, enter the following command:oc apply -f sctp-client.yaml

$ oc apply -f sctp-client.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Run an SCTP listener on the server.

To connect to the server pod, enter the following command:

oc rsh sctpserver

$ oc rsh sctpserverCopy to Clipboard Copied! Toggle word wrap Toggle overflow To start the SCTP listener, enter the following command:

nc -l 30102 --sctp

$ nc -l 30102 --sctpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Connect to the SCTP listener on the server.

- Open a new terminal window or tab in your terminal program.

Obtain the IP address of the

sctpserviceservice. Enter the following command:oc get services sctpservice -o go-template='{{.spec.clusterIP}}{{"\n"}}'$ oc get services sctpservice -o go-template='{{.spec.clusterIP}}{{"\n"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow To connect to the client pod, enter the following command:

oc rsh sctpclient

$ oc rsh sctpclientCopy to Clipboard Copied! Toggle word wrap Toggle overflow To start the SCTP client, enter the following command. Replace

<cluster_IP>with the cluster IP address of thesctpserviceservice.nc <cluster_IP> 30102 --sctp

# nc <cluster_IP> 30102 --sctpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapter 5. Associating secondary interfaces metrics to network attachments

Administrators can use the pod_network_info metric to classify and monitor secondary network interfaces. The metric does this by adding a label that identifies the interface type, typically based on the associated NetworkAttachmentDefinition resource.

5.1. Extending secondary network metrics for monitoring

Secondary devices, or interfaces, are used for different purposes. Metrics from secondary network interfaces need to be classified to allow for effective aggregation and monitoring.

Exposed metrics contain the interface but do not specify where the interface originates. This is workable when there are no additional interfaces. However, relying on interface names alone becomes problematic when secondary interfaces are added because it is difficult to identify their purpose and use their metrics effectively..

When adding secondary interfaces, their names depend on the order in which they are added. Secondary interfaces can belong to distinct networks that can each serve a different purposes.

With pod_network_name_info it is possible to extend the current metrics with additional information that identifies the interface type. In this way, it is possible to aggregate the metrics and to add specific alarms to specific interface types.

The network type is generated from the name of the NetworkAttachmentDefinition resource, which distinguishes different secondary network classes. For example, different interfaces belonging to different networks or using different CNIs use different network attachment definition names.

5.2. Network Metrics Daemon

The Network Metrics Daemon is a daemon component that collects and publishes network related metrics.

The kubelet is already publishing network related metrics you can observe. These metrics are:

-

container_network_receive_bytes_total -

container_network_receive_errors_total -

container_network_receive_packets_total -

container_network_receive_packets_dropped_total -

container_network_transmit_bytes_total -

container_network_transmit_errors_total -

container_network_transmit_packets_total -

container_network_transmit_packets_dropped_total

The labels in these metrics contain, among others:

- Pod name

- Pod namespace

-

Interface name (such as

eth0)

These metrics work well until new interfaces are added to the pod, for example via Multus, as it is not clear what the interface names refer to.

The interface label refers to the interface name, but it is not clear what that interface is meant for. In case of many different interfaces, it would be impossible to understand what network the metrics you are monitoring refer to.

This is addressed by introducing the new pod_network_name_info described in the following section.

5.3. Metrics with network name

The Network Metrics daemonset publishes a pod_network_name_info gauge metric, with a fixed value of 0.

Example of pod_network_name_info

pod_network_name_info{interface="net0",namespace="namespacename",network_name="nadnamespace/firstNAD",pod="podname"} 0

pod_network_name_info{interface="net0",namespace="namespacename",network_name="nadnamespace/firstNAD",pod="podname"} 0The network name label is produced using the annotation added by Multus. It is the concatenation of the namespace the network attachment definition belongs to, plus the name of the network attachment definition.

The new metric alone does not provide much value, but combined with the network related container_network_* metrics, it offers better support for monitoring secondary networks.

Using a promql query like the following ones, it is possible to get a new metric containing the value and the network name retrieved from the k8s.v1.cni.cncf.io/network-status annotation:

Chapter 6. BGP routing

6.1. About BGP routing

This feature provides native Border Gateway Protocol (BGP) routing capabilities for the cluster.

If you are using the MetalLB Operator and there are existing FRRConfiguration CRs in the metallb-system namespace created by cluster administrators or third-party cluster components other than the MetalLB Operator, you must ensure that they are copied to the openshift-frr-k8s namespace or that those third-party cluster components use the new namespace. For more information, see Migrating FRR-K8s resources.

6.1.1. About Border Gateway Protocol (BGP) routing

OpenShift Container Platform supports BGP routing through FRRouting (FRR), a free, open source internet routing protocol suite for Linux, UNIX, and similar operating systems. FRR-K8s is a Kubernetes-based daemon set that exposes a subset of the FRR API in a Kubernetes-compliant manner. As a cluster administrator, you can use the FRRConfiguration custom resource (CR) to access FRR services.

6.1.1.1. Supported platforms

BGP routing is supported on the following infrastructure types:

- Bare metal

BGP routing requires that you have properly configured BGP for your network provider. Outages or misconfigurations of your network provider might cause disruptions to your cluster network.

6.1.1.2. Considerations for use with the MetalLB Operator

The MetalLB Operator is installed as an add-on to the cluster. Deployment of the MetalLB Operator automatically enables FRR-K8s as an additional routing capability provider and uses the FRR-K8s daemon installed by this feature.

Before upgrading to 4.18, any existing FRRConfiguration in the metallb-system namespace not managed by the MetalLB operator (added by a cluster administrator or any other component) needs to be copied to the openshift-frr-k8s namespace manually, creating the namespace if necessary.

If you are using the MetalLB Operator and there are existing FRRConfiguration CRs in the metallb-system namespace created by cluster administrators or third-party cluster components other than MetalLB Operator, you must:

-

Ensure that these existing

FRRConfigurationCRs are copied to theopenshift-frr-k8snamespace. -

Ensure that the third-party cluster components use the new namespace for the

FRRConfigurationCRs that they create.

6.1.1.3. Cluster Network Operator configuration

The Cluster Network Operator API exposes the following API field to configure BGP routing:

-

spec.additionalRoutingCapabilities: Enables deployment of the FRR-K8s daemon for the cluster, which can be used independently of route advertisements. When enabled, the FRR-K8s daemon is deployed on all nodes.

6.1.1.4. BGP routing custom resources

The following custom resources are used to configure BGP routing:

FRRConfiguration- This custom resource defines the FRR configuration for the BGP routing. This CR is namespaced.

6.1.2. Configuring the FRRConfiguration CRD

To customize routing behavior beyond standard MetalLB capabilities, configure the FRRConfiguration custom resource (CR).

The following reference examples demonstrate how to define specific FRRouting (FRR) parameters to enable advanced services, such as receiving routes:

- The

routersparameter -

You can use the

routersparameter to configure multiple routers, one for each Virtual Routing and Forwarding (VRF) resource. For each router, you must define the Autonomous System Number (ASN).

You can also define a list of Border Gateway Protocol (BGP) neighbors to connect to, as in the following example:

Example FRRConfiguration CR

- The

toAdvertiseparameter -

By default,

FRR-K8sdoes not advertise the prefixes configured as part of a router configuration. To advertise the prefixes, you use thetoAdvertiseparameter.

You can advertise a subset of the prefixes, as in the following example:

Example FRRConfiguration CR

-

allowed.prefixes: Advertises a subset of prefixes.

The following example shows you how to advertise all of the prefixes:

Example FRRConfiguration CR

allowed.mode: Advertises all prefixes.- The

toReceiveparameter -

By default,

FRR-K8sdoes not process any prefixes advertised by a neighbor. You can use thetoReceiveparameter to process such addresses.

- The

You can configure for a subset of the prefixes, as in this example:

Example FRRConfiguration CR

-

prefixes: The prefix is applied if the prefix length is less than or equal to theleprefix length and greater than or equal to thegeprefix length.

The following example configures FRR to handle all the prefixes announced:

Example FRRConfiguration CR

- The

bgpparameter -

You can use the

bgpparameter to define variousBFDprofiles and associate them with a neighbor. In the following example,BFDbacks up theBGPsession andFRRcan detect link failures:

Example FRRConfiguration CR

- The

nodeSelectorparameter -

By default,

FRR-K8sapplies the configuration to all nodes where the daemon is running. You can use thenodeSelectorparameter to specify the nodes to which you want to apply the configuration. For example:

Example FRRConfiguration CR

- The

interfaceparameter - :_mod-docs-content-type: SNIPPET

The spec.bgp.routers.neighbors.interface field is a Technology Preview feature only. Technology Preview features are not supported with Red Hat production service level agreements (SLAs) and might not be functionally complete. Red Hat does not recommend using them in production. These features provide early access to upcoming product features, enabling customers to test functionality and provide feedback during the development process.

For more information about the support scope of Red Hat Technology Preview features, see Technology Preview Features Support Scope.

You can use the interface field to configure unnumbered BGP peering by using the following example configuration:

Example FRRConfiguration CR

-

neighbors.interface: Activates unnumbered BGP peering.

To use the interface parameter, you must establish a point-to-point, layer 2 connection between the two BGP peers. You can use unnumbered BGP peering with IPv4, IPv6, or dual-stack, but you must enable IPv6 RAs (Router Advertisements). Each interface is limited to one BGP connection.

If you use this parameter, you cannot specify a value in the spec.bgp.routers.neighbors.address parameter.

The parameters for the FRRConfiguration custom resource are described in the following table:

| Parameter | Type | Description |

|---|---|---|

|

|

| Specifies the routers that FRR is to configure (one per VRF). |

|

|

| The Autonomous System Number (ASN) to use for the local end of the session. |

|

|

|

Specifies the ID of the |

|

|

| Specifies the host VRF used to establish sessions from this router. |

|

|

| Specifies the neighbors to establish BGP sessions with. |

|

|

|

Specifies the ASN to use for the remote end of the session. If you use this parameter, you cannot specify a value in the |

|

|

|

Detects the ASN to use for the remote end of the session without explicitly setting it. Specify |

|

|

|

Specifies the IP address to establish the session with. If you use this parameter, you cannot specify a value in the |

|

|

|

Specifies the interface name to use when establishing a session. Use this field to configure unnumbered BGP peering. There must be a point-to-point, layer 2 connection between the two BGP peers. You can use unnumbered BGP peering with IPv4, IPv6, or dual-stack, but you must enable IPv6 RAs (Router Advertisements). Each interface is limited to one BGP connection. The |

|

|

|

Specifies the port to dial when establishing the session. Defaults to |

|

|

|

Specifies the password to use for establishing the BGP session. |

|

|

|

Specifies the name of the authentication secret for the neighbor. The secret must be of type "kubernetes.io/basic-auth", and in the same namespace as the FRR-K8s daemon. The key "password" stores the password in the secret. |

|

|

| Specifies the requested BGP hold time, per RFC4271. Defaults to 180s. |

|

|

|

Specifies the requested BGP keepalive time, per RFC4271. Defaults to |

|

|

| Specifies how long BGP waits between connection attempts to a neighbor. |

|

|

| Indicates if the BGPPeer is a multi-hop away. |

|

|

| Specifies the name of the BFD Profile to use for the BFD session associated with the BGP session. If not set, the BFD session is not set up. |

|

|

| Represents the list of prefixes to advertise to a neighbor, and the associated properties. |

|

|

| Specifies the list of prefixes to advertise to a neighbor. This list must match the prefixes that you define in the router. |

|

|

|

Specifies the mode to use when handling the prefixes. You can set to |

|

|

| Specifies the prefixes associated with an advertised local preference. You must specify the prefixes associated with a local preference in the prefixes allowed to be advertised. |

|

|

| Specifies the prefixes associated with the local preference. |

|

|

| Specifies the local preference associated with the prefixes. |

|

|

| Specifies the prefixes associated with an advertised BGP community. You must include the prefixes associated with a local preference in the list of prefixes that you want to advertise. |

|

|

| Specifies the prefixes associated with the community. |

|

|

| Specifies the community associated with the prefixes. |

|

|

| Specifies the prefixes to receive from a neighbor. |

|

|

| Specifies the information that you want to receive from a neighbor. |

|

|

| Specifies the prefixes allowed from a neighbor. |

|

|

|

Specifies the mode to use when handling the prefixes. When set to |

|

|

| Disables MP BGP to prevent it from separating IPv4 and IPv6 route exchanges into distinct BGP sessions. |

|

|

| Specifies all prefixes to advertise from this router instance. |

|

|

| Specifies the list of BFD profiles to use when configuring the neighbors. |

|

|

| The name of the BFD Profile to be referenced in other parts of the configuration. |

|

|

|

Specifies the minimum interval at which this system can receive control packets, in milliseconds. Defaults to |

|

|

|

Specifies the minimum transmission interval, excluding jitter, that this system wants to use to send BFD control packets, in milliseconds. Defaults to |

|

|

| Configures the detection multiplier to determine packet loss. To determine the connection loss-detection timer, multiply the remote transmission interval by this value. |

|

|

|

Configures the minimal echo receive transmission-interval that this system can handle, in milliseconds. Defaults to |

|

|

| Enables or disables the echo transmission mode. This mode is disabled by default, and not supported on multihop setups. |

|

|

| Mark session as passive. A passive session does not attempt to start the connection and waits for control packets from peers before it begins replying. |

|

|

| For multihop sessions only. Configures the minimum expected TTL for an incoming BFD control packet. |

|

|

| Limits the nodes that attempt to apply this configuration. If specified, only those nodes whose labels match the specified selectors attempt to apply the configuration. If it is not specified, all nodes attempt to apply this configuration. |

|

|

| Defines the observed state of FRRConfiguration. |

6.2. Enabling BGP routing

As a cluster administrator, you can enable OVN-Kubernetes Border Gateway Protocol (BGP) routing support for your cluster.

6.2.1. Enabling Border Gateway Protocol (BGP) routing

As a cluster administrator, you can enable Border Gateway Protocol (BGP) routing support for your cluster on bare-metal infrastructure.

If you are using BGP routing in conjunction with the MetalLB Operator, the necessary BGP routing support is enabled automatically. You do not need to manually enable BGP routing support.

6.2.1.1. Enabling BGP routing support

As a cluster administrator, you can enable BGP routing support for your cluster.

Prerequisites

-

You have installed the OpenShift CLI (

oc). -

You are logged in to the cluster as a user with the

cluster-adminrole. - The cluster is installed on compatible infrastructure.

Procedure

To enable a dynamic routing provider, enter the following command:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3. Disabling BGP routing

As a cluster administrator, you can enable OVN-Kubernetes Border Gateway Protocol (BGP) routing support for your cluster.

6.3.1. Disabling Border Gateway Protocol (BGP) routing

As a cluster administrator, you can disable Border Gateway Protocol (BGP) routing support for your cluster on bare-metal infrastructure.

6.3.1.1. Enabling BGP routing support

As a cluster administrator, you can disable BGP routing support for your cluster.

Prerequisites

-

You have installed the OpenShift CLI (

oc). -

You are logged in to the cluster as a user with the

cluster-adminrole. - The cluster is installed on compatible infrastructure.

Procedure

To disable dynamic routing, enter the following command:

oc patch Network.operator.openshift.io/cluster --type=merge -p '{ "spec": { "additionalRoutingCapabilities": null } }'$ oc patch Network.operator.openshift.io/cluster --type=merge -p '{ "spec": { "additionalRoutingCapabilities": null } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4. Migrating FRR-K8s resources

All user-created FRR-K8s custom resources (CRs) in the metallb-system namespace under OpenShift Container Platform 4.17 and earlier releases must be migrated to the openshift-frr-k8s namespace. As a cluster administrator, complete the steps in this procedure to migrate your FRR-K8s custom resources.

6.4.1. Migrating FRR-K8s resources

You can migrate the FRR-K8s FRRConfiguration custom resources from the metallb-system namespace to the openshift-frr-k8s namespace.

Prerequisites

-

You have installed the OpenShift CLI (

oc). -

You are logged in to the cluster as a user with the

cluster-adminrole.

Procedure

When upgrading from an earlier version of OpenShift Container Platform with the Metal LB Operator deployed, you must manually migrate your custom FRRConfiguration configurations from the metallb-system namespace to the openshift-frr-k8s namespace. To move these CRs, enter the following commands:

To create the

openshift-frr-k8snamespace, enter the following command:oc create namespace openshift-frr-k8s

$ oc create namespace openshift-frr-k8sCopy to Clipboard Copied! Toggle word wrap Toggle overflow To automate the migration, create a shell script named

migrate.shwith the following contents:Copy to Clipboard Copied! Toggle word wrap Toggle overflow To execute the migration, run the following command:

bash migrate.sh

$ bash migrate.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Verification

To confirm that the migration succeeded, run the following command:

oc get frrconfigurations.frrk8s.metallb.io -n openshift-frr-k8s

$ oc get frrconfigurations.frrk8s.metallb.io -n openshift-frr-k8sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

After the migration is complete, you can remove the FRRConfiguration custom resources from the metallb-system namespace.

Chapter 7. Route advertisements

7.1. About route advertisements

This feature provides route advertisement capabilities for the OVN-Kubernetes network plugin. A Border Gateway Router (BGP) provider is required. For more information, see About BGP routing.

7.1.1. Advertise cluster network routes with Border Gateway Protocol

With route advertisements enabled, you can advertise network routes for the default pod network and user-defined networks to the provider network, including EgressIPs, and importing routes from the provider network to the default pod network and CUDNs. This simplifies routing while improving failover visibility, and eliminates manual route management.

From the provider network, IP addresses advertised from the default pod network and user defined networks can be reached directly and vice versa.

For example, you can import routes to the default pod network so you no longer need to manually configure routes on each node. Previously, you might have been setting the routingViaHost parameter to true and manually configuring routes on each node to approximate a similar configuration. With route advertisements you can accomplish this task seamlessly with routingViaHost parameter set to false.

You could also set the routingViaHost parameter to true in the Network custom resource CR for your cluster, but you must then manually configure routes on each node to simulate a similar configuration. When you enable route advertisements, you can set routingViaHost=false in the Network CR without having to then manually configure routes one each node.

Route reflectors on the provider network are supported and can reduce the number of BGP connections required to advertise routes on large networks.

If you use EgressIPs with route advertisements enabled, the layer 3 provider network is aware of EgressIP failovers. This means that you can locate cluster nodes that host EgressIPs on different layer 2 segments whereas before only the layer 2 provider network was aware so that required all the egress nodes to be on the same layer 2 segment.

7.1.1.1. Supported platforms

Advertising routes with border gateway protocol (BGP) is supported on the bare-metal infrastructure type.

7.1.1.2. Infrastructure requirements

To use route advertisements, you must have configured BGP for your network infrastructure. Outages or misconfigurations of your network infrastructure might cause disruptions to your cluster network.

7.1.1.3. Compatibility with other networking features

Route advertisements support the following OpenShift Container Platform Networking features:

- Multiple external gateways (MEG)

- MEG is not supported with this feature.

- EgressIPs

Supports the use and advertisement of EgressIPs. The node where an egress IP address resides advertises the EgressIP. An egress IP address must be on the same layer 2 network subnet as the egress node. The following limitations apply:

- Advertising EgressIPs from a user-defined network (CUDN) operating in layer 2 mode are not supported.

- Advertising EgressIPs for a network that has both egress IP addresses assigned to the primary network interface and egress IP addresses assigned to additional network interfaces is impractical. All EgressIPs are advertised on all of the BGP sessions of the selected FRRConfiguration instances, regardless of whether these sessions are established over the same interface that the EgressIP is assigned to or not, potentially leading to unwanted advertisements.

- Services

- Works with the MetalLB Operator to advertise services to the provider network.

- Egress service

- Full support.

- Egress firewall

- Full support.

- Egress QoS

- Full support.

- Network policies

- Full support.

- Direct pod ingress

- Full support for the default cluster network and cluster user-defined (CUDN) networks.

7.1.1.4. Considerations for use with the MetalLB Operator

The MetalLB Operator is installed as an add-on to the cluster. Deployment of the MetalLB Operator automatically enables FRR-K8s as an additional routing capability provider. This feature and the MetalLB Operator use the same FRR-K8s deployment.

7.1.1.5. Considerations for naming cluster user-defined networks (CUDNs)

When referencing a VRF device in a FRRConfiguration CR, the VRF name is the same as the CUDN name for VRF names that are less than or equal to 15 characters. It is recommended to use a VRF name no longer than 15 characters so that the VRF name can be inferred from the CUDN name.

7.1.1.6. BGP routing custom resources

The following custom resources (CRs) are used to configure route advertisements with BGP:

RouteAdvertisements-

This CR defines the advertisements for the BGP routing. From this CR, the OVN-Kubernetes controller generates a

FRRConfigurationobject that configures the FRR daemon to advertise cluster network routes. This CR is cluster scoped. FRRConfiguration-

This CR is used to define BGP peers and to configure route imports from the provider network into the cluster network. Before applying

RouteAdvertisementsobjects, at least one FRRConfiguration object must be initially defined to configure the BGP peers. This CR is namespaced.

7.1.1.7. OVN-Kubernetes controller generation of FRRConfiguration objects

An FRRConfiguration object is generated for each network and node selected by a RouteAdvertisements CR with the appropriate advertised prefixes that apply to each node. The OVN-Kubernetes controller checks whether the RouteAdvertisements-CR-selected nodes are a subset of the nodes that are selected by the RouteAdvertisements-CR-selected FRR configurations.

Any filtering or selection of prefixes to receive are not considered in FRRConfiguration objects that are generated from the RouteAdvertisement CRs. Configure any prefixes to receive on other FRRConfiguration objects. OVN-Kubernetes imports routes from the VRF into the appropriate network.

7.1.1.8. Cluster Network Operator configuration

The Cluster Network Operator (CNO) API exposes several fields to configure route advertisements:

-

spec.additionalRoutingCapabilities.providers: Specifies an additional routing provider, which is required to advertise routes. The only supported value isFRR, which enables deployment of the FRR-K8S daemon for the cluster. When enabled, the FRR-K8S daemon is deployed on all nodes. -

spec.defaultNetwork.ovnKubernetesConfig.routeAdvertisements: Enables route advertisements for the default cluster network and CUDN networks. Thespec.additionalRoutingCapabilitiesfield must be set toFRRto enable this feature.

7.1.2. RouteAdvertisements object configuration

You can define an RouteAdvertisements object, which is cluster scoped, with the following properties.

The fields for the RouteAdvertisements custom resource (CR) are described in the following table:

| Field | Type | Description |

|---|---|---|

|

|

|

Specifies the name of the |

|

|

|

Specifies an array that can contain a list of different types of networks to advertise. Supports only the |

|

|

|

Determines which |

|

|

| Specifies which networks to advertise among default cluster network and cluster user defined networks (CUDNs). |

|

|

|

Limits the advertisements to selected nodes. When |

|

|

|

Determines which router to advertise the routes in. Routes are advertised on the routers associated with this virtual routing and forwarding (VRF) target, as specified on the selected |

7.1.3. Examples advertising pod IP addresses with BGP

The following examples describe several configurations for advertising pod IP addresses and EgressIPs with Border Gateway Protocol (BGP). The external network border router has the 172.18.0.5 IP address. These configures assume that you have configured an external route reflector that can relay routes to all nodes on the cluster network.

7.1.3.1. Advertising the default cluster network

In this scenario, the default cluster network is exposed to the external network so that pod IP addresses and EgressIPs are advertised to the provider network.

This scenario relies upon the following FRRConfiguration object:

FRRConfiguration CR

When the OVN-Kubernetes controller sees this RouteAdvertisements CR, it generates further FRRConfiguration objects based on the selected ones that configure the FRR daemon to advertise the routes for the default cluster network.

An example of a FRRConfiguration CR generated by OVN-Kubernetes

In the example generated FRRConfiguration object, <default_network_host_subnet> is the subnet of the default cluster network that is advertised to the provider network.

7.1.3.2. Advertising pod IPs from a cluster user-defined network over BGP

In this scenario, the blue cluster user-defined network (CUDN) is exposed to the external network so that the network’s pod IP addresses and EgressIPs are advertised to the provider network.

This scenario relies upon the following FRRConfiguration object:

FRRConfiguration CR

With this FRRConfiguration object, routes will be imported from neighbor 172.18.0.5 into the default VRF and are available to the default cluster network.

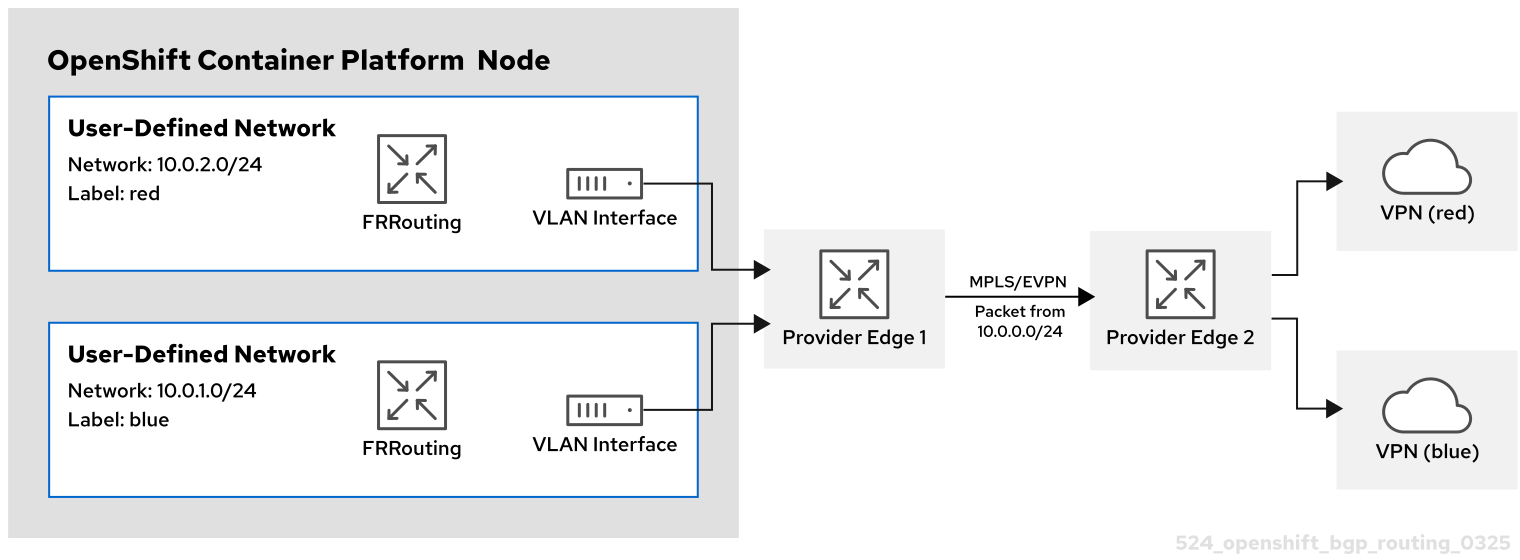

The CUDNs are advertised over the default VRF as illustrated in the following diagram:

- Red CUDN

-

A VRF named

redassociated with a CUDN namedred -

A subnet of

10.0.0.0/24

-

A VRF named

- Blue CUDN

-

A VRF named

blueassociated with a CUDN namedblue -

A subnet of

10.0.1.0/24

-

A VRF named

In this configuration, two separate CUDNs are defined. The red network covers the 10.0.0.0/24 subnet and the blue network covers the 10.0.1.0/24 subnet. The red and blue networks are labeled as export: true.

The following RouteAdvertisements CR describes the configuration for the red and blue tenants:

RouteAdvertisements CR for the red and blue tenants

When the OVN-Kubernetes controller sees this RouteAdvertisements CR, it generates further FRRConfiguration objects based on the selected ones that configure the FRR daemon to advertise the routes. The following example is of one such configuration object, with the number of FRRConfiguration objects created depending on the node and networks selected.

An example of a FRRConfiguration CR generated by OVN-Kubernetes

The generated FRRConfiguration object configures the subnet 10.0.1.0/24, which belongs to network blue, to be imported into the default VRF and advertised to the 172.18.0.5 neighbor. An FRRConfiguration object is generated for each network and nodes selected by a RouteAdvertisements CR with the appropriate prefixes that apply to each node.

When the targetVRF field is omitted, the routes are leaked and advertised over the default VRF. Additionally, routes that were imported to the default VRF after the definition of the initial FRRConfiguration object are also imported into the blue VRF.

7.1.3.3. Advertising pod IPs from a cluster user-defined network over BGP with VPN

In this scenario, a VLAN interface is attached to the VRF device associated with the blue network. This setup provides a VRF lite design, where FRR-K8S is used to advertise the blue network only over the corresponding BGP session on the blue network VRF/VLAN link to the next hop Provide Edge (PE) router. The red tenant uses the same configuration. The blue and red networks are labeled as export: true.

This scenario does not support the use of EgressIPs.

The following diagram illustrates this configuration:

- Red CUDN

-

A VRF named

redassociated with a CUDN namedred - A VLAN interface attached to the VRF device and connected to the external PE router

-

An assigned subnet of

10.0.2.0/24

-

A VRF named

- Blue CUDN

-

A VRF named

blueassociated with a CUDN namedblue - A VLAN interface attached to the VRF device and connected to the external PE router

-

An assigned subnet of

10.0.1.0/24

-

A VRF named

This approach is available only when you set routingViaHost=true in the ovnKubernetesConfig.gatewayConfig specification of the OVN-Kubernetes network plugin.

In the following configuration, an additional FRRConfiguration CR configures peering with the PE router on the blue and red VLANs:

FRRConfiguration CR manually configured for BGP VPN setup

The following RouteAdvertisements CR describes the configuration for the blue and red tenants:

RouteAdvertisements CR for the blue and red tenants

In the RouteAdvertisements CR, the targetVRF is set to auto so that advertisements occur within the VRF device that corresponds to the individual networks that are selected. In this scenario, the pod subnet for blue is advertised over the blue VRF device, and the pod subnet for red is advertised over the red VRF device. Additionally, each BGP session imports routes to only the corresponding CUDN VRF as defined by the initial FRRConfiguration object.

When the OVN-Kubernetes controller sees this RouteAdvertisements CR, it generates further FRRConfiguration objects based on the selected ones that configure the FRR daemon to advertise the routes for the blue and red tenants.

FRRConfiguration CR generated by OVN-Kubernetes for blue and red tenants

In this scenario, any filtering or selection of routes to receive must be done in the FRRConfiguration CR that defines peering relationships.

7.2. Enabling route advertisements

As a cluster administrator, you can configure additional route advertisements for your cluster. You must use the OVN-Kubernetes network plugin.

7.2.1. Enabling route advertisements

As a cluster administrator, you can enable additional routing support for your cluster.

Prerequisites

-

You have installed the OpenShift CLI (

oc). -

You are logged in to the cluster as a user with the

cluster-adminrole. - The cluster is installed on compatible infrastructure.

Procedure

To enable a routing provider and additional route advertisements, enter the following command:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. Disabling route advertisements

As a cluster administrator, you can disable additional route advertisements for your cluster.

7.3.1. Disabling route advertisements

As a cluster administrator, you can disable additional route advertisements for your cluster.

Prerequisites

-

You have installed the OpenShift CLI (

oc). -

You are logged in to the cluster as a user with the

cluster-adminrole. - The cluster is installed on compatible infrastructure.

Procedure

To disable additional routing support, enter the following command:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4. Example route advertisements setup