Ingress と負荷分散

OpenShift Container Platform でサービスを公開し、外部トラフィックを管理する

概要

第1章 ルート

1.1. 基本的なルートの作成

HTTP で暗号化されていない場合は、ルートオブジェクトで基本的なルートを作成できます。

1.1.1. HTTP ベースのルートの作成

以下の手順に従って、hello-openshift アプリケーションを例に、Web アプリケーションへの簡単な HTTP ベースのルートを作成できます。

公開 URL でアプリケーションをホストするルートを作成できます。ルートは、アプリケーションのネットワークセキュリティー設定に応じて、セキュリティーで保護される場合と保護されない場合があります。HTTP ベースのルートとは、セキュアではないルートで、基本的な HTTP ルーティングプロトコルを使用してセキュリティー保護されていないアプリケーションポートでサービスを公開します。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - 管理者としてログインしている。

- あるポートを公開する Web アプリケーションと、そのポートでトラフィックをリッスンする TCP エンドポイントがあります。

手順

次のコマンドを実行して、

hello-openshiftというプロジェクトを作成します。oc new-project hello-openshift

$ oc new-project hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行してプロジェクトに Pod を作成します。

oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.json

$ oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、

hello-openshiftというサービスを作成します。oc expose pod/hello-openshift

$ oc expose pod/hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

hello-openshiftアプリケーションに対して、セキュアではないルートを作成します。oc expose svc hello-openshift

$ oc expose svc hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

作成した

routeリソースを確認するには、次のコマンドを実行します。oc get routes -o yaml hello-openshift

$ oc get routes -o yaml hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 作成したセキュアでないルートの YAML 定義の例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

host-

サービスを参照するエイリアス DNS レコードを指定します。このフィールドには、

www.example.comなどの有効な DNS 名を指定できます。DNS 名は DNS952 サブドメイン規則に従う必要があります。指定しない場合は、ルート名が自動的に生成されます。 targetPortこのルートが指すサービスによって選択される Pod のターゲットポートを指定します。

注記デフォルトの Ingress ドメインを表示するには、以下のコマンドを実行します。

oc get ingresses.config/cluster -o jsonpath={.spec.domain}$ oc get ingresses.config/cluster -o jsonpath={.spec.domain}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.1.2. パスベースのルート

パスベースのルートは、URL に対して比較できるパスコンポーネントを指定します。この場合、ルートのトラフィックは HTTP ベースである必要があります。そのため、それぞれが異なるパスを持つ同じホスト名を使用して複数のルートを提供できます。ルーターは、最も具体的なパスの順に基づいてルートと一致する必要があります。

以下の表は、ルートのサンプルおよびそれらのアクセシビリティーを示しています。

| ルート | 比較対象 | アクセス可能 |

|---|---|---|

| www.example.com/test | www.example.com/test | はい |

| www.example.com | いいえ | |

| www.example.com/test および www.example.com | www.example.com/test | はい |

| www.example.com | はい | |

| www.example.com | www.example.com/text | Yes (ルートではなく、ホストで一致) |

| www.example.com | はい |

パスが 1 つでセキュリティー保護されていないルート

- 1

- パスは、パスベースのルートに唯一追加される属性です。

ルーターは TLS を終了させず、要求のコンテンツを読み込みことができないので、パスベースのルーティングは、passthrough TLS を使用する場合には利用できません。

1.1.3. Ingress Controller シャーディングのルート作成

ルートを使用すると、URL でアプリケーションをホストできます。Ingress Controller のシャーディングは、一連の Ingress Controller 間での着信トラフィック負荷のバランスをとるのに役立ちます。特定の Ingress Controller へのトラフィックを分離することもできます。たとえば、Company A のトラフィックをある Ingress Controller に指定し、Company B を別の Ingress Controller に指定できます。

以下の手順では、例として hello-openshift アプリケーションを使用して、Ingress Controller シャーディングのルートを作成する方法を説明します。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - プロジェクト管理者としてログインしている。

- ポートを公開する Web アプリケーションと、そのポート上のトラフィックをリッスンする HTTP または TLS エンドポイントがある。

- シャーディング用に Ingress Controller を設定している。

手順

次のコマンドを実行して、

hello-openshiftというプロジェクトを作成します。oc new-project hello-openshift

$ oc new-project hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行してプロジェクトに Pod を作成します。

oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.json

$ oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、

hello-openshiftというサービスを作成します。oc expose pod/hello-openshift

$ oc expose pod/hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow hello-openshift-route.yamlというルート定義を作成します。シャーディング用に作成したルートの YAML 定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行し、

hello-openshift-route.yamlを使用してhello-openshiftアプリケーションへのルートを作成します。oc -n hello-openshift create -f hello-openshift-route.yaml

$ oc -n hello-openshift create -f hello-openshift-route.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

次のコマンドを使用して、ルートのステータスを取得します。

oc -n hello-openshift get routes/hello-openshift-edge -o yaml

$ oc -n hello-openshift get routes/hello-openshift-edge -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 結果の

Routeリソースは次のようになります。出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ingress Controller またはルーターがルートを公開するために使用するホスト名。

hostフィールドの値は、Ingress Controller によって自動的に決定され、そのドメインを使用します。この例では、Ingress Controller のドメインは<apps-sharded.basedomain.example.net>です。 - 2

- Ingress Controller のホスト名。ホスト名が設定されていない場合、ルートは代わりにサブドメインを使用できます。サブドメインを指定すると、ルートを公開する Ingress Controller のドメインが自動的に使用されます。ルートが複数の Ingress Controller によって公開される場合、ルートは複数の URL でホストされます。

- 3

- Ingress Controller の名前。この例では、Ingress Controller の名前は

shardedです。

1.1.4. Ingress オブジェクトを使用したルートの作成

一部のエコシステムコンポーネントには Ingress リソースとの統合機能がありますが、ルートリソースとは統合しません。これに対応するために、OpenShift Container Platform は Ingress オブジェクトの作成時に管理されるルートオブジェクトを自動的に作成します。これらのルートオブジェクトは、対応する Ingress オブジェクトが削除されると削除されます。

手順

OpenShift Container Platform コンソールで Ingress オブジェクトを定義するか、

oc createコマンドを実行します。Ingress の YAML 定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

route.openshift.io/terminationアノテーションは、Routeのspec.tls.terminationフィールドを設定するために使用できます。Ingressにはこのフィールドがありません。許可される値はedge、passthrough、およびreencryptです。その他のすべての値は警告なしに無視されます。アノテーション値が設定されていない場合は、edgeがデフォルトルートになります。デフォルトの edge ルートを実装するには、TLS 証明書の詳細をテンプレートファイルで定義する必要があります。- 3

Ingressオブジェクトを操作する場合、ルートを操作する場合とは異なり、明示的なホスト名を指定する必要があります。<host_name>.<cluster_ingress_domain>構文 (apps.openshiftdemos.comなど) を使用して、*.<cluster_ingress_domain>ワイルドカード DNS レコードとクラスターのサービング証明書を利用できます。それ以外の場合は、選択したホスト名の DNS レコードがあることを確認する必要があります。route.openshift.io/terminationアノテーションでpassthroughの値を指定する場合は、仕様でpathを''に設定し、pathTypeをImplementationSpecificに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc apply -f ingress.yaml

$ oc apply -f ingress.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- 2

route.openshift.io/destination-ca-certificate-secretを Ingress オブジェクトで使用して、カスタム宛先証明書 (CA) でルートを定義できます。アノテーションは、生成されたルートに挿入される kubernetes シークレットsecret-ca-certを参照します。-

Ingress オブジェクトから宛先 CA を使用してルートオブジェクトを指定するには、シークレットの

data.tls.crt指定子に PEM エンコード形式の証明書を使用してkubernetes.io/tlsまたはOpaqueタイプのシークレットを作成する必要があります。

-

Ingress オブジェクトから宛先 CA を使用してルートオブジェクトを指定するには、シークレットの

ルートを一覧表示します。

oc get routes

$ oc get routesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 結果には、

frontend-で始まる名前の自動生成ルートが含まれます。NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD frontend-gnztq www.example.com frontend 443 reencrypt/Redirect None

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD frontend-gnztq www.example.com frontend 443 reencrypt/Redirect NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow このルートを検査すると、以下のようになります。

自動生成されるルートの YAML 定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.2. ルートのセキュリティー保護

HTTP Strict Transport Security (HSTS)を使用してルートを保護できます。

1.2.1. HTTP Strict Transport Security

HTTP Strict Transport Security (HSTS) ポリシーは、HTTPS トラフィックのみがルートホストで許可されるブラウザークライアントに通知するセキュリティーの拡張機能です。また、HSTS は、HTTP リダイレクトを使用せずに HTTPS トランスポートにシグナルを送ることで Web トラフィックを最適化します。HSTS は Web サイトとの対話を迅速化するのに便利です。

HSTS ポリシーが適用されると、HSTS はサイトから Strict Transport Security ヘッダーを HTTP および HTTPS 応答に追加します。HTTP を HTTPS にリダイレクトするルートで insecureEdgeTerminationPolicy 値を使用できます。HSTS を強制している場合は、要求の送信前にクライアントがすべての要求を HTTP URL から HTTPS に変更するため、リダイレクトの必要がなくなります。

クラスター管理者は、以下を実行するために HSTS を設定できます。

- ルートごとに HSTS を有効にします。

- ルートごとに HSTS を無効にします。

- ドメインごとに HSTS を適用するか、ドメインと組み合わせた namespace ラベルを使用します。

HSTS はセキュアなルート (edge-terminated または re-encrypt) でのみ機能します。この設定は、HTTP または passthrough ルートには適していません。

1.2.1.1. ルートごとの HTTP Strict Transport Security の有効化

HTTP Strict Transport Security (HSTS) は HAProxy テンプレートに実装され、haproxy.router.openshift.io/hsts_header アノテーションを持つ edge および re-encrypt ルートに適用されます。

前提条件

- プロジェクトの管理者権限があるユーザーで、クラスターにログインしている。

-

OpenShift CLI (

oc) がインストールされている。

手順

ルートで HSTS を有効にするには、

haproxy.router.openshift.io/hsts_header値を edge-terminated または re-encrypt ルートに追加します。次のコマンドを実行すると、oc annotateツールを使用してこれを実行できます。コマンドを適切に実行するには、haproxy.router.openshift.io/hsts_header ルートアノテーション内のセミコロン (;) も二重引用符 ("") で囲まれていることを確認してください。最大経過時間を

31536000ミリ秒 (約 8.5 時間) に設定するannotateコマンドの例oc annotate route <route_name> -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header=max-age=31536000;\ includeSubDomains;preload"

$ oc annotate route <route_name> -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header=max-age=31536000;\ includeSubDomains;preload"Copy to Clipboard Copied! Toggle word wrap Toggle overflow アノテーションで設定されたルートの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 必須。

max-ageは、HSTS ポリシーが有効な期間 (秒単位) を測定します。0に設定すると、これはポリシーを無効にします。 - 2

- オプション:

includeSubDomainsは、クライアントに対し、ホストのすべてのサブドメインにホストと同じ HSTS ポリシーを持つ必要があることを指示します。 - 3

- オプション:

max-ageが 0 より大きい場合、preloadをhaproxy.router.openshift.io/hsts_headerに追加し、外部サービスがこのサイトをそれぞれの HSTS プリロードリストに含めることができます。たとえば、Google などのサイトはpreloadが設定されているサイトの一覧を作成します。ブラウザーはこれらのリストを使用し、サイトと対話する前でも HTTPS 経由で通信できるサイトを判別できます。preloadを設定していない場合、ブラウザーはヘッダーを取得するために、HTTPS を介してサイトと少なくとも 1 回対話している必要があります。

1.2.1.2. ルートごとの HTTP Strict Transport Security の無効化

ルートごとに HTTP Strict Transport Security (HSTS) を無効にするには、ルートアノテーションの max-age の値を 0 に設定します。

前提条件

- プロジェクトの管理者権限があるユーザーで、クラスターにログインしている。

-

OpenShift CLI (

oc) がインストールされている。

手順

HSTS を無効にするには、以下のコマンドを入力してルートアノテーションの

max-ageの値を0に設定します。oc annotate route <route_name> -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=0"

$ oc annotate route <route_name> -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用して config map を作成できます。

ルートごとに HSTS を無効にする例

metadata: annotations: haproxy.router.openshift.io/hsts_header: max-age=0metadata: annotations: haproxy.router.openshift.io/hsts_header: max-age=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow namespace のすべてのルートで HSTS を無効にするには、following コマンドを入力します。

oc annotate route --all -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=0"

$ oc annotate route --all -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

すべてのルートのアノテーションをクエリーするには、以下のコマンドを入力します。

oc get route --all-namespaces -o go-template='{{range .items}}{{if .metadata.annotations}}{{$a := index .metadata.annotations "haproxy.router.openshift.io/hsts_header"}}{{$n := .metadata.name}}{{with $a}}Name: {{$n}} HSTS: {{$a}}{{"\n"}}{{else}}{{""}}{{end}}{{end}}{{end}}'$ oc get route --all-namespaces -o go-template='{{range .items}}{{if .metadata.annotations}}{{$a := index .metadata.annotations "haproxy.router.openshift.io/hsts_header"}}{{$n := .metadata.name}}{{with $a}}Name: {{$n}} HSTS: {{$a}}{{"\n"}}{{else}}{{""}}{{end}}{{end}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Name: routename HSTS: max-age=0

Name: routename HSTS: max-age=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.2.1.3. ドメインごとの HTTP Strict Transport Security の適用

セキュアなルートに対してドメインごとに HTTP Strict Transport Security (HSTS) を適用するには、Ingress 仕様に requiredHSTSPolicies レコードを追加して、HSTS ポリシーの設定を取得します。

requiredHSTSPolicy を設定して HSTS を適用する場合は、新規に作成されたルートは準拠された HSTS ポリシーアノテーションで設定する必要があります。

準拠しない HSTS ルートを持つアップグレードされたクラスターを処理するには、ソースでマニフェストを更新し、更新を適用できます。

oc expose route コマンドまたは oc create route コマンドを使用して、HSTS を強制するドメインにルートを追加することはできません。このコマンドの API はアノテーションを受け入れないためです。

HSTS がすべてのルートに対してグローバルに要求されている場合でも、セキュアではないルートや非 TLS ルートに適用することはできません。

前提条件

- プロジェクトの管理者権限があるユーザーで、クラスターにログインしている。

-

OpenShift CLI (

oc) がインストールされている。

手順

次のコマンドを実行し、必要に応じてフィールドを更新して、Ingress 設定 YAML を編集します。

oc edit ingresses.config.openshift.io/cluster

$ oc edit ingresses.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow HSTS ポリシーの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 必須。

requiredHSTSPoliciesは順番に検証され、最初に一致するdomainPatternsが適用されます。 - 2

- 必須。1 つ以上の

domainPatternsホスト名を指定する必要があります。任意の数のドメインをリスト表示できます。さまざまなdomainPatternsについて、Enforcing オプションの複数のセクションを含めることができます。 - 3

- オプション:

namespaceSelectorを含める場合、ルートを配置するプロジェクトのラベルと一致する必要があります。これにより、ルートに設定された HSTS ポリシーを適用する必要があります。domainPatternsではなくnamespaceSelectorのみに一致するルートは検証されません。 - 4

- 必須。

max-ageは、HSTS ポリシーが有効な期間 (秒単位) を測定します。このポリシー設定により、最小および最大のmax-ageを適用することができます。-

largestMaxAgeの値は0から2147483647の範囲内で指定する必要があります。これを指定しないと、上限が強制されないことを意味します。 -

smallestMaxAgeの値は0から2147483647の範囲内で指定する必要があります。トラブルシューティングのために HSTS を無効にするには、0を入力します。HSTS を無効にする必要がない場合は1を入力します。これを指定しないと、下限が強制されません。

-

- 5

- オプション:

haproxy.router.openshift.io/hsts_headerにpreloadを含めることで、外部サービスがこのサイトをそれぞれの HSTS プリロードリストに含めることができます。ブラウザーはこれらの一覧を使用し、サイトと対話する前でも HTTPS 経由で通信できるサイトを判別できます。preload設定がない場合、ブラウザーは少なくともサイトと通信してヘッダーを取得する必要があります。preloadは、以下のいずれかで設定できます。-

RequirePreload:preloadはRequiredHSTSPolicyで必要になります。 -

RequireNoPreload:preloadはRequiredHSTSPolicyによって禁止されます。 -

NoOpinion:preloadはRequiredHSTSPolicyに重要ではありません。

-

- 6

- オプション:

includeSubDomainsPolicyは、以下のいずれかで設定できます。-

RequireIncludeSubDomains:includeSubDomainsはRequiredHSTSPolicyで必要です。 -

RequireNoIncludeSubDomains:includeSubDomainsはRequiredHSTSPolicyによって禁止されています。 -

NoOpinion:includeSubDomainsはRequiredHSTSPolicyに重要ではありません。

-

oc annotate commandを入力して、HSTS をクラスターのすべてのルートまたは特定の namespace に適用することができます。HSTS をクラスターのすべてのルートに適用するには、

oc annotate commandを実行します。以下に例を示します。oc annotate route --all --all-namespaces --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=31536000"

$ oc annotate route --all --all-namespaces --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=31536000"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 特定の namespace のすべてのルートに HSTS を適用するには、

oc annotate commandを実行します。以下に例を示します。oc annotate route --all -n my-namespace --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=31536000"

$ oc annotate route --all -n my-namespace --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=31536000"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

設定した HSTS ポリシーを確認できます。以下に例を示します。

必要な HSTS ポリシーの

maxAgeセットを確認するには、以下のコマンドを入力します。oc get clusteroperator/ingress -n openshift-ingress-operator -o jsonpath='{range .spec.requiredHSTSPolicies[*]}{.spec.requiredHSTSPolicies.maxAgePolicy.largestMaxAge}{"\n"}{end}'$ oc get clusteroperator/ingress -n openshift-ingress-operator -o jsonpath='{range .spec.requiredHSTSPolicies[*]}{.spec.requiredHSTSPolicies.maxAgePolicy.largestMaxAge}{"\n"}{end}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow すべてのルートで HSTS アノテーションを確認するには、以下のコマンドを入力します。

oc get route --all-namespaces -o go-template='{{range .items}}{{if .metadata.annotations}}{{$a := index .metadata.annotations "haproxy.router.openshift.io/hsts_header"}}{{$n := .metadata.name}}{{with $a}}Name: {{$n}} HSTS: {{$a}}{{"\n"}}{{else}}{{""}}{{end}}{{end}}{{end}}'$ oc get route --all-namespaces -o go-template='{{range .items}}{{if .metadata.annotations}}{{$a := index .metadata.annotations "haproxy.router.openshift.io/hsts_header"}}{{$n := .metadata.name}}{{with $a}}Name: {{$n}} HSTS: {{$a}}{{"\n"}}{{else}}{{""}}{{end}}{{end}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Name: <_routename_> HSTS: max-age=31536000;preload;includeSubDomains

Name: <_routename_> HSTS: max-age=31536000;preload;includeSubDomainsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3. ルートの設定

アノテーション、ヘッダー、Cookie などを使用して、ルート設定をカスタマイズできます。

1.3.1. ルートのタイムアウトの設定

Service Level Availability (SLA) で必要とされる、低タイムアウトが必要なサービスや、バックエンドでの処理速度が遅いケースで高タイムアウトが必要なサービスがある場合は、既存のルートに対してデフォルトのタイムアウトを設定することができます。

OpenShift Container Platform クラスターの前にユーザー管理の外部ロードバランサーを設定した場合は、ユーザー管理の外部ロードバランサーのタイムアウト値がルートのタイムアウト値よりも高いことを確認してください。この設定により、クラスターが使用するネットワーク上でのネットワーク輻輳の問題を防ぐことができます。

前提条件

- 実行中のクラスターでデプロイ済みの Ingress Controller が必要になります。

手順

oc annotateコマンドを使用して、ルートにタイムアウトを追加します。oc annotate route <route_name> \ --overwrite haproxy.router.openshift.io/timeout=<timeout><time_unit>$ oc annotate route <route_name> \ --overwrite haproxy.router.openshift.io/timeout=<timeout><time_unit>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- サポートされる時間単位は、マイクロ秒 (us)、ミリ秒 (ms)、秒 (s)、分 (m)、時間 (h)、または日 (d) です。

以下の例では、2 秒のタイムアウトを

myrouteという名前のルートに設定します。oc annotate route myroute --overwrite haproxy.router.openshift.io/timeout=2s

$ oc annotate route myroute --overwrite haproxy.router.openshift.io/timeout=2sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3.2. HTTP ヘッダーの設定

OpenShift Container Platform は、HTTP ヘッダーを操作するためのさまざまな方法を提供します。ヘッダーを設定または削除する場合、Ingress Controller の特定のフィールドまたは個々のルートを使用して、リクエストヘッダーと応答ヘッダーを変更できます。ルートアノテーションを使用して特定のヘッダーを設定することもできます。ヘッダーを設定するさまざまな方法は、連携時に課題となる可能性があります。

IngressController または Route CR 内のヘッダーは設定または削除のみ可能で、追加はできません。HTTP ヘッダーに値が設定されている場合、その値は完全である必要があるため、今後追加する必要はありません。X-Forwarded-For ヘッダーなどのヘッダーを追加することが適切な状況では、spec.httpHeaders.actions の代わりに spec.httpHeaders.forwardedHeaderPolicy フィールドを使用します。

1.3.2.1. 優先順位

同じ HTTP ヘッダーを Ingress Controller とルートの両方で変更すると、HAProxy は、それがリクエストヘッダーであるか応答ヘッダーであるかに応じて、特定の方法でアクションの優先順位を付けます。

- HTTP 応答ヘッダーの場合、Ingress Controller で指定されたアクションは、ルートで指定されたアクションの後に実行されます。これは、Ingress Controller で指定されたアクションが優先されることを意味します。

- HTTP リクエストヘッダーの場合、ルートで指定されたアクションは、Ingress Controller で指定されたアクションの後に実行されます。これは、ルートで指定されたアクションが優先されることを意味します。

たとえば、クラスター管理者は、次の設定を使用して、Ingress Controller で X-Frame-Options 応答ヘッダーに値 DENY を設定します。

IngressController 仕様の例

ルート所有者は、クラスター管理者が Ingress Controller に設定したものと同じ応答ヘッダーを設定しますが、次の設定を使用して値 SAMEORIGIN を設定します。

Route 仕様の例

IngressController 仕様と Route 仕様の両方で X-Frame-Options 応答ヘッダーが設定されている場合、特定のルートでフレームが許可されている場合でも、Ingress Controller のグローバルレベルでこのヘッダーに設定された値が優先されます。リクエストヘッダーの場合、Route 仕様の値が IngressController 仕様の値をオーバーライドします。

この優先順位付けは、haproxy.config ファイルで次のロジックが使用されるため発生します。このロジックでは、Ingress Controller がフロントエンドと見なされ、個々のルートがバックエンドと見なされます。フロントエンド設定に適用されるヘッダー値 DENY は、バックエンドで設定されている値 SAMEORIGIN で同じヘッダーをオーバーライドします。

さらに、Ingress Controller またはルートのいずれかで定義されたアクションは、ルートアノテーションを使用して設定された値をオーバーライドします。

1.3.2.2. 特殊なケースのヘッダー

次のヘッダーは、設定または削除が完全に禁止されているか、特定の状況下で許可されています。

| ヘッダー名 | IngressController 仕様を使用して設定可能かどうか | Route 仕様を使用して設定可能かどうか | 不許可の理由 | 別の方法で設定可能かどうか |

|---|---|---|---|---|

|

| いいえ | いいえ |

| いいえ |

|

| いいえ | はい |

| いいえ |

|

| いいえ | いいえ |

|

はい: |

|

| いいえ | いいえ | HAProxy が設定する Cookie は、クライアント接続を特定のバックエンドサーバーにマップするセッション追跡に使用されます。これらのヘッダーの設定を許可すると、HAProxy のセッションアフィニティーが妨げられ、HAProxy の Cookie の所有権が制限される可能性があります。 | はい:

|

1.3.3. ルート内の HTTP リクエストおよびレスポンスヘッダーの設定または削除

コンプライアンス目的またはその他の理由で、特定の HTTP 要求および応答ヘッダーを設定または削除できます。これらのヘッダーは、Ingress Controller によって提供されるすべてのルート、または特定のルートに対して設定または削除できます。

たとえば、ルートを提供する Ingress Controller によってデフォルトのグローバルな場所が指定されている場合でも、コンテンツが複数の言語で記述されていると、Web アプリケーションが特定のルートの別の場所でコンテンツを提供するように指定できます。

以下の手順では Content-Location HTTP リクエストヘッダーを設定するルートを作成し、アプリケーション (https://app.example.com) に URL が関連付けられ、https://app.example.com/lang/en-us のロケーションにダイレクトされるようにします。アプリケーショントラフィックをこの場所にダイレクトすると、特定のルートを使用する場合はすべて、アメリカ英語で記載された Web コンテンツにアクセスすることになります。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - プロジェクト管理者として OpenShift Container Platform クラスターにログインしている。

- ポートを公開する Web アプリケーションと、そのポート上のトラフィックをリッスンする HTTP または TLS エンドポイントがある。

手順

ルート定義を作成し、

app-example-route.yamlというファイルに保存します。HTTP ヘッダーディレクティブを使用して作成されたルートの YAML 定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- HTTP ヘッダーに対して実行するアクションのリスト。

- 2

- 変更するヘッダーのタイプ。この場合は、応答ヘッダーです。

- 3

- 変更するヘッダーの名前。設定または削除できる使用可能なヘッダーのリストは、HTTP ヘッダーの設定 を参照してください。

- 4

- ヘッダーに対して実行されるアクションのタイプ。このフィールドには、

SetまたはDeleteの値を指定できます。 - 5

- HTTP ヘッダーの設定時は、

値を指定する必要があります。値は、そのヘッダーで使用可能なディレクティブのリストからの文字列 (例:DENY)にすることも、HAProxy の動的値構文を使用して解釈される動的値にすることもできます。この場合、値はコンテンツの相対位置に設定されます。

新しく作成したルート定義を使用して、既存の Web アプリケーションへのルートを作成します。

oc -n app-example create -f app-example-route.yaml

$ oc -n app-example create -f app-example-route.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

HTTP リクエストヘッダーの場合、ルート定義で指定されたアクションは、Ingress Controller の HTTP リクエストヘッダーに対して実行されたアクションの後に実行されます。これは、ルート内のこれらのリクエストヘッダーに設定された値が、Ingress Controller に設定された値よりも優先されることを意味します。HTTP ヘッダーの処理順序の詳細は、HTTP ヘッダーの設定 を参照してください。

1.3.4. Cookie の使用によるルートのステートフル性の維持

OpenShift Container Platform は、すべてのトラフィックを同じエンドポイントにヒットさせることによりステートフルなアプリケーションのトラフィックを可能にするスティッキーセッションを提供します。ただし、エンドポイント Pod が再起動、スケーリング、または設定の変更などによって終了する場合、このステートフル性はなくなります。

OpenShift Container Platform は Cookie を使用してセッションの永続化を設定できます。Ingress Controller はユーザー要求を処理するエンドポイントを選択し、そのセッションの Cookie を作成します。Cookie は要求の応答として戻され、ユーザーは Cookie をセッションの次の要求と共に送り返します。Cookie は Ingress Controller に対し、セッションを処理しているエンドポイントを示し、クライアント要求が Cookie を使用して同じ Pod にルーティングされるようにします。

Cookie は、HTTP トラフィックを表示できないので、passthrough ルートで設定できません。代わりに、送信元 IP アドレスをベースに数が計算され、バックエンドを判断します。

バックエンドが変わると、トラフィックが間違ったサーバーに転送されてしまい、スティッキーではなくなります。送信元 IP を非表示にするロードバランサーを使用している場合は、すべての接続に同じ番号が設定され、トラフィックは同じ Pod に送られます。

1.3.4.1. Cookie を使用したルートのアノテーション

ルート用に自動生成されるデフォルト名を上書きするために Cookie 名を設定できます。これにより、ルートトラフィックを受信するアプリケーションが Cookie 名を認識できるようになります。Cookie を削除すると、次の要求でエンドポイントの再選択が強制的に実行される可能性があります。その結果、サーバーがオーバーロードしている場合は、クライアントからの要求を取り除き、それらの再分配を試行します。

手順

指定される cookie 名でルートにアノテーションを付けます。

oc annotate route <route_name> router.openshift.io/cookie_name="<cookie_name>"

$ oc annotate route <route_name> router.openshift.io/cookie_name="<cookie_name>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

<route_name>- ルートの名前を指定します。

<cookie_name>- cookie の名前を指定します。

たとえば、ルート

my_routeに cookie 名my_cookieでアノテーションを付けるには、以下を実行します。oc annotate route my_route router.openshift.io/cookie_name="my_cookie"

$ oc annotate route my_route router.openshift.io/cookie_name="my_cookie"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 変数でルートのホスト名を取得します。

ROUTE_NAME=$(oc get route <route_name> -o jsonpath='{.spec.host}')$ ROUTE_NAME=$(oc get route <route_name> -o jsonpath='{.spec.host}')Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

<route_name>- ルートの名前を指定します。

cookie を保存してからルートにアクセスします。

curl $ROUTE_NAME -k -c /tmp/cookie_jar

$ curl $ROUTE_NAME -k -c /tmp/cookie_jarCopy to Clipboard Copied! Toggle word wrap Toggle overflow ルートに接続する際に、直前のコマンドによって保存される cookie を使用します。

curl $ROUTE_NAME -k -b /tmp/cookie_jar

$ curl $ROUTE_NAME -k -b /tmp/cookie_jarCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3.5. ルート固有のアノテーション

Ingress Controller は、公開するすべてのルートのデフォルトオプションを設定できます。個別のルートは、アノテーションに個別の設定を指定して、デフォルトの一部をオーバーライドできます。Red Hat では、ルートアノテーションの Operator 管理ルートへの追加はサポートしません。

複数の送信元 IP またはサブネットを含む許可リストを作成するには、スペースで区切られたリストを使用します。他の区切りタイプを使用すると、リストが警告やエラーメッセージなしに無視されます。

| 変数 | 説明 | デフォルトで使用される環境変数 |

|---|---|---|

|

|

ロードバランシングアルゴリズムを設定します。使用できるオプションは、 |

passthrough ルートの |

|

|

関連の接続を追跡する Cookie の使用を無効にします。 | |

|

| このルートに使用するオプションの cookie を指定します。名前は、大文字、小文字、数字、"_" または "-" を任意に組み合わせて指定する必要があります。デフォルトは、ルートのハッシュ化された内部キー名です。 | |

|

|

ルーターからバッキングされる Pod に対して許容される接続最大数を設定します。 | |

|

|

| |

|

|

同じ送信元 IP アドレスで行われる同時 TCP 接続の数を制限します。数値を受け入れます。 | |

|

|

同じ送信元 IP アドレスを持つクライアントが HTTP 要求を実行できるレートを制限します。数値を受け入れます。 | |

|

|

同じ送信元 IP アドレスを持つクライアントが TCP 接続を確立するレートを制限します。数値を受け入れます。 | |

|

| ルートのサーバー側のタイムアウトを設定します。(TimeUnits) |

|

|

| このタイムアウトは、cleartext、edge、reencrypt、または passthrough のルートを介した WebSocket などトンネル接続に適用されます。cleartext、edge、または reencrypt のルートタイプでは、このアノテーションは、タイムアウト値がすでに存在するタイムアウトトンネルとして適用されます。passthrough のルートタイプでは、アノテーションは既存のタイムアウト値の設定よりも優先されます。 |

|

|

|

設定できるのは、IngressController または Ingress config です。このアノテーションでは、ルーターを再デプロイし、HA プロキシーが haproxy |

|

|

| バックエンドのヘルスチェックの間隔を設定します。(TimeUnits) |

|

|

| ルートの許可リストを設定します。許可リストは、承認したソースアドレスの IP アドレスおよび CIDR 範囲のリストをスペース区切りにしたリストです。許可リストに含まれていない IP アドレスからの要求は破棄されます。

| |

|

| edge terminated または re-encrypt ルートの Strict-Transport-Security ヘッダーを設定します。 | |

|

| バックエンドの要求の書き換えパスを設定します。 | |

|

| Cookie を制限するために値を設定します。値は以下のようになります。

この値は、re-encrypt および edge ルートにのみ適用されます。詳細は、SameSite cookie のドキュメント を参照してください。 | |

|

|

ルートごとに

|

|

-

デフォルトでは、ルーターは 5 秒ごとにリロードされ、最初から Pod 間の接続のバランスがリセットされます。その結果、

roundrobin状態はリロード間で保持されません。このアルゴリズムは、Pod のコンピューティング能力とストレージ容量がほぼ同じである場合に最適に機能します。たとえば、CI/CD パイプラインの使用により、アプリケーションまたはサービスのエンドポイントが継続的に変更される場合、結果的にバランスが不均一になる可能性があります。その場合は別のアルゴリズムを使用します。 許可リストの IP アドレスと CIDR 範囲の数が 61 を超えると、それらは別のファイルに書き込まれます。これは

haproxy.configファイルから参照されます。このファイルは、/var/lib/haproxy/router/allowlistsフォルダーに保存されます。注記アドレスが許可リストに書き込まれることを確認するには、CIDR 範囲の完全なリストが Ingress Controller 設定ファイルに記載されていることを確認します。etcd オブジェクトサイズ制限は、ルートアノテーションのサイズを制限します。このため、許可リストに追加できる IP アドレスと CIDR 範囲の最大数のしきい値が作成されます。

環境変数を編集することはできません。

ルータータイムアウト変数

TimeUnits は数字、その後に単位を指定して表現します。us *(マイクロ秒)、ms (ミリ秒、デフォルト)、s (秒)、m (分)、h *(時間)、d (日)

正規表現: [1-9][0-9]*(us\|ms\|s\|m\|h\|d)

| 変数 | デフォルト | 説明 |

|---|---|---|

|

|

| バックエンドでの後続の liveness チェックの時間の長さ。 |

|

|

| クライアントがルートに接続する場合の TCP FIN タイムアウトの期間を制御します。接続切断のために送信された FIN が指定の時間内に応答されない場合は、HAProxy が接続を切断します。小さい値を設定し、ルーターでリソースをあまり使用していない場合には、リスクはありません。 |

|

|

| クライアントがデータを確認するか、送信するための時間の長さ。 |

|

|

| 最大接続時間。 |

|

|

| ルーターからルートをバッキングする Pod の TCP FIN タイムアウトを制御します。 |

|

|

| サーバーがデータを確認するか、送信するための時間の長さ。 |

|

|

| TCP または WebSocket 接続が開放された状態で保つ時間数。このタイムアウト期間は、HAProxy が再読み込みされるたびにリセットされます。 |

|

|

|

新しい HTTP 要求が表示されるまで待機する最大時間を設定します。この値が低すぎる場合には、ブラウザーおよびアプリケーションの

有効なタイムアウト値には、想定した個別のタイムアウトではなく、特定の変数を合計した値に指定することができます。たとえば、 |

|

|

| HTTP 要求の伝送にかかる時間。 |

|

|

| ルーターがリロードし、新規の変更を受け入れる最小の頻度を許可します。 |

|

|

| HAProxy メトリクスの収集タイムアウト。 |

ルート設定のカスタムタイムアウト

- 1

- HAProxy 対応の単位 (

us、ms、s、m、h、d) で新規のタイムアウトを指定します。単位が指定されていない場合は、msがデフォルトになります。

passthrough ルートのサーバー側のタイムアウト値を低く設定し過ぎると、WebSocket 接続がそのルートで頻繁にタイムアウトする可能性があります。

特定の IP アドレスを 1 つだけ許可するルート

metadata:

annotations:

haproxy.router.openshift.io/ip_allowlist: 192.168.1.10

metadata:

annotations:

haproxy.router.openshift.io/ip_allowlist: 192.168.1.10複数の IP アドレスを許可するルート

metadata:

annotations:

haproxy.router.openshift.io/ip_allowlist: 192.168.1.10 192.168.1.11 192.168.1.12

metadata:

annotations:

haproxy.router.openshift.io/ip_allowlist: 192.168.1.10 192.168.1.11 192.168.1.12IP アドレスの CIDR ネットワークを許可するルート

metadata:

annotations:

haproxy.router.openshift.io/ip_allowlist: 192.168.1.0/24

metadata:

annotations:

haproxy.router.openshift.io/ip_allowlist: 192.168.1.0/24IP アドレスと IP アドレスの CIDR ネットワークの両方を許可するルート

metadata:

annotations:

haproxy.router.openshift.io/ip_allowlist: 180.5.61.153 192.168.1.0/24 10.0.0.0/8

metadata:

annotations:

haproxy.router.openshift.io/ip_allowlist: 180.5.61.153 192.168.1.0/24 10.0.0.0/8書き換えターゲットを指定するルート

- 1

- バックエンドの要求の書き換えパスとして

/を設定します。

ルートに haproxy.router.openshift.io/rewrite-target アノテーションを設定すると、要求をバックエンドアプリケーションに転送する前に Ingress Controller がこのルートを使用して HTTP 要求のパスを書き換える必要があることを指定します。spec.path で指定されたパスに一致する要求パスの一部は、アノテーションで指定された書き換えターゲットに置き換えられます。

以下の表は、spec.path、要求パス、および書き換えターゲットの各種の組み合わせに関するパスの書き換え動作の例を示しています。

| Route.spec.path | 要求パス | 書き換えターゲット | 転送された要求パス |

|---|---|---|---|

| /foo | /foo | / | / |

| /foo | /foo/ | / | / |

| /foo | /foo/bar | / | /bar |

| /foo | /foo/bar/ | / | /bar/ |

| /foo | /foo | /bar | /bar |

| /foo | /foo/ | /bar | /bar/ |

| /foo | /foo/bar | /baz | /baz/bar |

| /foo | /foo/bar/ | /baz | /baz/bar/ |

| /foo/ | /foo | / | 該当なし (要求パスがルートパスに一致しない) |

| /foo/ | /foo/ | / | / |

| /foo/ | /foo/bar | / | /bar |

haproxy.router.openshift.io/rewrite-target 内の特定の特殊文字は、適切にエスケープする必要があるため、特別な処理が必要です。これらの文字がどのように処理されるかは、次の表を参照してください。

| 以下の文字の場合 | 以下の文字を使用 | 注記 |

|---|---|---|

| # | \# | # は書き換え式を終了させるので使用しないでください。 |

| % | % または %% | %%% のような変則的なシーケンスは避けてください。 |

| ‘ | \’ | ‘ は無視されるので避けてください。 |

その他の有効な URL 文字はすべてエスケープせずに使用できます。

1.3.6. スループットの問題のトラブルシューティング方法

OpenShift Container Platform でデプロイされるアプリケーションでは、特定のサービス間で非常に長い待ち時間が発生するなど、ネットワークのスループットの問題が生じることがあります。

Pod のログが問題の原因を指摘しない場合は、以下の方法を使用してパフォーマンスの問題を分析します。

pingまたはtcpdumpなどのパケットアナライザーを使用して Pod とそのノード間のトラフィックを分析します。たとえば、問題を生じさせる動作を再現している間に各ノードで

tcpdumpツールを実行 します。両サイトでキャプチャーしたデータを確認し、送信および受信タイムスタンプを比較して Pod への/からのトラフィックの待ち時間を分析します。待ち時間は、ノードのインターフェイスが他の Pod やストレージデバイス、またはデータプレーンからのトラフィックでオーバーロードする場合に OpenShift Container Platform で発生する可能性があります。tcpdump -s 0 -i any -w /tmp/dump.pcap host <podip 1> && host <podip 2>

$ tcpdump -s 0 -i any -w /tmp/dump.pcap host <podip 1> && host <podip 2>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

podipは Pod の IP アドレスです。oc get pod <pod_name> -o wideコマンドを実行して Pod の IP アドレスを取得します。

tcpdumpは、これらの 2 つの Pod 間のすべてのトラフィックが含まれる/tmp/dump.pcapのファイルを生成します。ファイルサイズを最小限に抑えるために問題を再現するすぐ前と問題を再現したすぐ後ににアナライザーを実行することが良いでしょう。次のコマンドを使用して、ノード間でパケットアナライザーを実行 することもできます。tcpdump -s 0 -i any -w /tmp/dump.pcap port 4789

$ tcpdump -s 0 -i any -w /tmp/dump.pcap port 4789Copy to Clipboard Copied! Toggle word wrap Toggle overflow ストリーミングのスループットおよび UDP スループットを測定するために

iperfなどの帯域幅測定ツールを使用します。最初に Pod からツールを実行し、次にノードから実行して、ボトルネックを特定します。-

iperfのインストールおよび使用に関する詳細は、こちらの Red Hat ソリューション を参照してください。

-

- 場合によっては、レイテンシーの問題が原因で、クラスターがルーター Pod を含むノードを異常としてマークすることがあります。ワーカーレイテンシープロファイルを使用して、アクションを実行する前にクラスターがノードからステータスの最新情報を受け取る頻度を調節します。

-

クラスターでレイテンシーの低いノードとレイテンシーの高いノードが指定されている場合は、Ingress Controller の

spec.nodePlacementフィールドを設定して、ルーター Pod の配置を制御します。

1.3.7. ルートの受付ポリシーの設定

管理者およびアプリケーション開発者は、同じドメイン名を持つ複数の namespace でアプリケーションを実行できます。これは、複数のチームが同じホスト名で公開されるマイクロサービスを開発する組織を対象としています。

複数の namespace での要求の許可は、namespace 間の信頼のあるクラスターに対してのみ有効にする必要があります。有効にしないと、悪意のあるユーザーがホスト名を乗っ取る可能性があります。このため、デフォルトの受付ポリシーは複数の namespace 間でのホスト名の要求を許可しません。

前提条件

- クラスター管理者の権限。

手順

以下のコマンドを使用して、

ingresscontrollerリソース変数の.spec.routeAdmissionフィールドを編集します。oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=merge$ oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow イメージコントローラー設定例

spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow ヒントまたは、以下の YAML を適用してルートの受付ポリシーを設定できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3.8. デュアルスタックネットワーク用の OpenShift Container Platform Ingress Controller の設定

OpenShift Container Platform クラスターが IPv4 および IPv6 デュアルスタックネットワーク用に設定されている場合、クラスターは OpenShift Container Platform ルートによって外部からアクセス可能です。

Ingress Controller は、IPv4 エンドポイントと IPv6 エンドポイントの両方を持つサービスを自動的に提供しますが、シングルスタックまたはデュアルスタックサービス用に Ingress Controller を設定できます。

前提条件

- ベアメタルに OpenShift Container Platform クラスターをデプロイしていること。

-

OpenShift CLI (

oc) がインストールされている。

手順

Ingress Controller が、IPv4 / IPv6 を介してトラフィックをワークロードに提供するようにするには、

ipFamiliesフィールドおよびipFamilyPolicyフィールドを設定して、サービス YAML ファイルを作成するか、既存のサービス YAML ファイルを変更します。以下に例を示します。サービス YAML ファイルの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow これらのリソースは、対応する

endpointsを生成します。Ingress Controller は、endpointslicesを監視するようになりました。endpointsを表示するには、以下のコマンドを入力します。oc get endpoints

$ oc get endpointsCopy to Clipboard Copied! Toggle word wrap Toggle overflow endpointslicesを表示するには、以下のコマンドを入力します。oc get endpointslices

$ oc get endpointslicesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4. 高度なルートの作成

複数のタイプの TLS 終端を使用してクライアントに証明書を提供できます。以下のセクションでは、カスタム証明書を使用して re-encrypt、edge、および passthrough ルートを作成する方法を説明します。

1.4.1. カスタム証明書を使用した edge ルートの作成

oc create route コマンドを使用し、edge TLS termination とカスタム証明書を使用してセキュアなルートを設定できます。edge ルートの場合、Ingress Controller は、トラフィックを宛先 Pod に転送する前に TLS 暗号を終了します。ルートは、Ingress Controller がルートに使用する TLS 証明書およびキーを指定します。

この手順では、カスタム証明書および edge TLS termination を使用して Route リソースを作成します。以下では、証明書/キーのペアが現在の作業ディレクトリーの tls.crt および tls.key ファイルにあることを前提としています。必要な場合には、証明書チェーンを完了するために CA 証明書を指定することもできます。tls.crt、tls.key、および (オプションで) ca.crt を実際のパス名に置き換えます。frontend を、公開する必要のあるサービスの名前に置き換えます。www.example.com を適切な名前に置き換えます。

前提条件

- PEM エンコードされたファイルに証明書/キーのペアが必要です。ここで、証明書はルートホストに対して有効となっています。

- 証明書チェーンを完了する PEM エンコードされたファイルの別の CA 証明書が必要です。

- 公開する必要のあるサービスが必要です。

パスワードで保護されるキーファイルはサポートされません。キーファイルからパスフレーズを削除するには、以下のコマンドを使用します。

openssl rsa -in password_protected_tls.key -out tls.key

$ openssl rsa -in password_protected_tls.key -out tls.key手順

edge TLS termination およびカスタム証明書を使用して、セキュアな

Routeリソースを作成します。oc create route edge --service=frontend --cert=tls.crt --key=tls.key --ca-cert=ca.crt --hostname=www.example.com

$ oc create route edge --service=frontend --cert=tls.crt --key=tls.key --ca-cert=ca.crt --hostname=www.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 結果として生成される

Routeリソースを検査すると、以下のようになります。セキュアなルートの YAML 定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 他のオプションは、

oc create route edge --helpを参照してください。

1.4.2. カスタム証明書を使用した re-encrypt ルートの作成

oc create route コマンドを使用し、カスタム証明書と共に re-encrypt TLS termination を使用してセキュアなルートを設定できます。

この手順では、カスタム証明書および reencrypt TLS termination を使用して Route リソースを作成します。以下では、証明書/キーのペアが現在の作業ディレクトリーの tls.crt および tls.key ファイルにあることを前提としています。また、Ingress Controller がサービスの証明書を信頼できるように宛先 CA 証明書を指定する必要もあります。必要な場合には、証明書チェーンを完了するために CA 証明書を指定することもできます。tls.crt、tls.key、cacert.crt、および (オプションで) ca.crt を実際のパス名に置き換えます。frontend を、公開する必要のある Service リソースに置き換えます。www.example.com を適切な名前に置き換えます。

前提条件

- PEM エンコードされたファイルに証明書/キーのペアが必要です。ここで、証明書はルートホストに対して有効となっています。

- 証明書チェーンを完了する PEM エンコードされたファイルの別の CA 証明書が必要です。

- PEM エンコードされたファイルの別の宛先 CA 証明書が必要です。

- 公開する必要のあるサービスが必要です。

パスワードで保護されるキーファイルはサポートされません。キーファイルからパスフレーズを削除するには、以下のコマンドを使用します。

openssl rsa -in password_protected_tls.key -out tls.key

$ openssl rsa -in password_protected_tls.key -out tls.key手順

reencrypt TLS 終端およびカスタム証明書を使用してセキュアな

Routeリソースを作成します。oc create route reencrypt --service=frontend --cert=tls.crt --key=tls.key --dest-ca-cert=destca.crt --ca-cert=ca.crt --hostname=www.example.com

$ oc create route reencrypt --service=frontend --cert=tls.crt --key=tls.key --dest-ca-cert=destca.crt --ca-cert=ca.crt --hostname=www.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 結果として生成される

Routeリソースを検査すると、以下のようになります。セキュアなルートの YAML 定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 他のオプションは、

oc create route reencrypt --helpを参照してください。

1.4.3. passthrough ルートの作成

oc create route コマンドを使用して、passthrough 終端を使用したセキュアなルートを設定できます。passthrough 終端では、ルーターが TLS 終端を提供せずに、暗号化されたトラフィックが宛先に直接送信されます。したがって、ルート上に鍵や証明書は必要ありません。

前提条件

- 公開する必要のあるサービスが必要です。

手順

Routeリソースを作成します。oc create route passthrough route-passthrough-secured --service=frontend --port=8080

$ oc create route passthrough route-passthrough-secured --service=frontend --port=8080Copy to Clipboard Copied! Toggle word wrap Toggle overflow 結果として生成される

Routeリソースを検査すると、以下のようになります。passthrough 終端を使用したセキュアなルート

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 宛先 Pod は、エンドポイントでトラフィックに証明書を提供します。これは、必須となるクライアント証明書をサポートするための唯一の方法です (相互認証とも呼ばれる)。

1.4.4. Ingress アノテーションでの宛先 CA 証明書を使用したルート作成

route.openshift.io/destination-ca-certificate-secret アノテーションを Ingress オブジェクトで使用して、カスタム宛先 CA 証明書でルートを定義できます。

前提条件

- PEM エンコードされたファイルで証明書/キーのペアを持つことができます。ここで、証明書はルートホストに対して有効となっています。

- 証明書チェーンを完了する PEM エンコードされたファイルの別の CA 証明書が必要です。

- PEM エンコードされたファイルの別の宛先 CA 証明書が必要です。

- 公開する必要のあるサービスが必要です。

手順

次のコマンドを入力して、宛先 CA 証明書のシークレットを作成します。

oc create secret generic dest-ca-cert --from-file=tls.crt=<file_path>

$ oc create secret generic dest-ca-cert --from-file=tls.crt=<file_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

oc -n test-ns create secret generic dest-ca-cert --from-file=tls.crt=tls.crt

$ oc -n test-ns create secret generic dest-ca-cert --from-file=tls.crt=tls.crtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

secret/dest-ca-cert created

secret/dest-ca-cert createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow route.openshift.io/destination-ca-certificate-secretを Ingress アノテーションに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- アノテーションは kubernetes シークレットを参照します。

このアノテーションで参照されているシークレットは、生成されたルートに挿入されます。

出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4.5. 外部管理証明書を使用したルートの作成

ルート API の .spec.tls.externalCertificate フィールドを使用して、サードパーティーの証明書管理ソリューションで OpenShift Container Platform ルートを設定できます。シークレットを介して外部で管理されている TLS 証明書を参照できるため、手動での証明書管理が不要になります。

外部で管理されている証明書を使用すると、エラーを減らし、証明書の更新のスムーズなロールアウトを確保し、OpenShift ルーターが更新された証明書を迅速に提供できるようになります。外部で管理された証明書は、edge ルートと re-encrypt ルートの両方で使用できます。

前提条件

-

tlsタイプの有効な証明書またはキーペアを含むシークレットが必要です。コマンド例:.keyキーとtls.crtキーの両方を含む、PEM でエンコードされた$ oc create secret tls myapp-tls --cert=server.crt --key=server.key.

手順

以下のコマンドを実行して、シークレットと同じ namespace に

ロールオブジェクトを作成し、ルーターのサービスアカウントの読み取りアクセスを許可するようにします。oc create role secret-reader --verb=get,list,watch --resource=secrets --resource-name=<secret-name> \ --namespace=<current-namespace>

$ oc create role secret-reader --verb=get,list,watch --resource=secrets --resource-name=<secret-name> \ --namespace=<current-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

<secret-name>: シークレットの実際の名前を指定します。 -

<current-namespace>: シークレットとルートの両方が存在する namespace を指定します。

-

以下のコマンドを実行して、シークレットと同じ namespace に

rolebindingオブジェクトを作成し、ルーターサービスアカウントを新たに作成されたロールにバインドします。oc create rolebinding secret-reader-binding --role=secret-reader --serviceaccount=openshift-ingress:router --namespace=<current-namespace>

$ oc create rolebinding secret-reader-binding --role=secret-reader --serviceaccount=openshift-ingress:router --namespace=<current-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

<current-namespace>: シークレットとルートの両方が存在する namespace を指定します。

-

次の例を使用して、

routeを定義し、証明書を含むシークレットを指定する YAML ファイルを作成します。セキュアなルートの YAML 定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

<secret-name>: シークレットの実際の名前を指定します。

-

次のコマンドを実行して

routeリソースを作成します。oc apply -f <route.yaml>

$ oc apply -f <route.yaml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow &

lt;route.yaml>: 生成された YAML ファイル名を指定します。シークレットが存在し、証明書/キーペアがある場合、すべての前提条件が満たされていれば、ルーターは生成された証明書を提供します。

注記.spec.tls.externalCertificateが指定されていない場合、ルーターはデフォルトの生成された証明書を使用します。.spec.tls.externalCertificateフィールドを使用する場合は、.spec.tls.certificateフィールドまたは.spec.tls.keyフィールドを指定することはできません。

1.4.6. Ingress オブジェクトを介してデフォルトの証明書を使用してルートを作成する

TLS 設定を指定せずに Ingress オブジェクトを作成すると、OpenShift Container Platform は安全でないルートを生成します。デフォルトの Ingress 証明書を使用してセキュアな edge 終端ルートを生成する Ingress オブジェクトを作成するには、次のように空の TLS 設定を指定できます。

前提条件

- 公開したいサービスがあります。

-

OpenShift CLI (

oc) にアクセスできる。

手順

Ingress オブジェクトの YAML ファイルを作成します。この例では、ファイルの名前は

example-ingress.yamlです。Ingress オブジェクトの YAML 定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- この正確な構文を使用して、カスタム証明書を指定せずに TLS を指定します。

次のコマンドを実行して、Ingress オブジェクトを作成します。

oc create -f example-ingress.yaml

$ oc create -f example-ingress.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

以下のコマンドを実行して、OpenShift Container Platform が Ingress オブジェクトの予期されるルートを作成したことを確認します。

oc get routes -o yaml

$ oc get routes -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第2章 Ingress クラスタートラフィックの設定

2.1. Ingress クラスタートラフィックの設定の概要

OpenShift Container Platform は、クラスター内で実行されるサービスを使用してクラスター外からの通信を可能にする以下の方法を提供します。

以下の方法が推奨されます。以下は、これらの方法の優先される順です。

- HTTP/HTTPS を使用する場合は Ingress Controller を使用する。

- HTTPS 以外の TLS で暗号化されたプロトコルを使用する場合、たとえば、SNI ヘッダーを使用する TLS の場合は、Ingress Controller を使用します。

-

それ以外の場合は、ロードバランサー、外部 IP、または

NodePortを使用します。

| 方法 | 目的 |

|---|---|

| HTTP/HTTPS トラフィックおよび HTTPS 以外の TLS で暗号化されたプロトコル (TLS と SNI ヘッダーの使用など) へのアクセスを許可します。 | |

| プールから割り当てられた IP アドレスを使用した非標準ポートへのトラフィックを許可します。ほとんどのクラウドプラットフォームは、ロードバランサーの IP アドレスでサービスを開始する方法を提供します。 | |

| マシンネットワーク上のプールから特定の IP アドレスまたはアドレスへのトラフィックを許可します。ベアメタルインストールまたはベアメタルのようなプラットフォームの場合、MetalLB は、ロードバランサーの IP アドレスを使用してサービスを開始する方法を提供します。 | |

| 特定の IP アドレスを使用した非標準ポートへのトラフィックを許可します。 | |

| クラスターのすべてのノードでサービスを公開します。 |

2.1.1. 比較: 外部 IP アドレスへのフォールトトレランスアクセス

外部 IP アドレスへのアクセスを提供する通信メソッドの場合、IP アドレスへのフォールトトレランスアクセスは別の考慮事項となります。以下の機能は、外部 IP アドレスへのフォールトトレランスアクセスを提供します。

- IP フェイルオーバー

- IP フェイルオーバーはノードセットの仮想 IP アドレスのプールを管理します。これは、Keepalived および Virtual Router Redundancy Protocol (VRRP) で実装されます。IP フェイルオーバーはレイヤー 2 のメカニズムのみで、マルチキャストに依存します。マルチキャストには、一部のネットワークに欠点がある場合があります。

- MetalLB

- MetalLB にはレイヤー 2 モードがありますが、マルチキャストは使用されません。レイヤー 2 モードには、1 つのノードで外部 IP アドレスのトラフィックをすべて転送する欠点があります。

- 外部 IP アドレスの手動割り当て

- クラスターを、外部 IP アドレスをサービスに割り当てるために使用される IP アドレスブロックで設定できます。デフォルトでは、この機能は無効にされています。この機能は柔軟性がありますが、クラスターまたはネットワーク管理者に最大の負担をかけます。クラスターは、外部 IP 宛てのトラフィックを受信する準備ができていますが、各顧客は、トラフィックをノードにルーティングする方法を決定する必要があります。

2.2. サービスの ExternalIP の設定

クラスター管理者は、トラフィックをクラスター内のサービスに送信できるクラスター外の IP アドレスブロックを選択できます。

この機能は通常、ベアメタルハードウェアにインストールされているクラスターに最も役立ちます。

2.2.1. 前提条件

- ネットワークインフラストラクチャーは、外部 IP アドレスのトラフィックをクラスターにルーティングする必要があります。

2.2.2. ExternalIP について

非クラウド環境の場合、OpenShift Container Platform は、Service オブジェクトの spec.externalIPs[] パラメーターで外部 IP アドレスを指定するための ExternalIP 機能の使用をサポートしています。ExternalIP で設定されたサービスは、type=NodePort を持つサービスと同様に機能し、トラフィックは負荷分散のためにローカルノードに送信されます。

クラウド環境の場合、クラウドの自動デプロイメントのためにロードバランサーサービスを使用し、サービスのエンドポイントをターゲットに設定します。

パラメーターの値を指定すると、OpenShift Container Platform はサービスに追加の仮想 IP アドレスを割り当てます。IP アドレスは、クラスターに定義したサービスネットワークの外部に存在することができます。

ExternalIP はデフォルトで無効になっているため、ExternalIP 機能を有効にすると、外部 IP アドレスへのクラスター内トラフィックがそのサービスに送信されるため、サービスにセキュリティーリスクが生じる可能性があります。この設定は、クラスターユーザーが外部リソース宛ての機密トラフィックをインターセプトできることを意味します。

MetalLB 実装または IP フェイルオーバーデプロイメントのいずれかを使用して、次の方法で ExternalIP リソースをサービスに接続できます。

- 外部 IP の自動割り当て

-

OpenShift Container Platform は、

spec.type=LoadBalancerを設定してServiceオブジェクトを作成する際に、IP アドレスをautoAssignCIDRsCIDR ブロックからspec.externalIPs[]配列に自動的に割り当てます。この設定では、OpenShift Container Platform はロードバランサーサービスタイプのクラウドバージョンを実装し、サービスに IP アドレスを割り当てます。自動割り当てはデフォルトでは無効になっており、クラスター管理者が「ExternalIP の設定」セクションの説明に従い設定する必要があります。 - 外部 IP の手動割り当て

-

OpenShift Container Platform は

Serviceオブジェクトの作成時にspec.externalIPs[]配列に割り当てられた IP アドレスを使用します。別のサービスによってすでに使用されている IP アドレスを指定することはできません。

MetalLB 実装または IP フェイルオーバーデプロイメントのいずれかを使用して外部 IP アドレスブロックをホストした後、外部 IP アドレスブロックがクラスターにルーティングされるようにネットワークインフラストラクチャーを設定する必要があります。この設定は、ノードからのネットワークインターフェイスに IP アドレスが設定されていないことを意味します。トラフィックを処理するには、静的な Address Resolution Protocol (ARP) エントリーなどの方法を使用して、ルーティングと外部 IP へのアクセスを設定する必要があります。

OpenShift Container Platform は以下の機能を追加して Kubernetes の ExternalIP 機能を拡張します。

- 設定可能なポリシーでの、ユーザーによる外部 IP アドレスの使用の制限

- 要求時の外部 IP アドレスのサービスへの自動割り当て

2.2.3. ExternalIP の設定

Network.config.openshift.io カスタムリソース (CR) の以下のパラメーターは、OpenShift Container Platform での外部 IP アドレスの使用を制御します。

-

spec.externalIP.autoAssignCIDRsは、サービスの外部 IP アドレスを選択する際にロードバランサーによって使用される IP アドレスブロックを定義します。OpenShift Container Platform は、自動割り当て用の単一 IP アドレスブロックのみをサポートします。手動で ExternalIP をサービスに割り当てる場合は、数に限りのある共有 IP アドレスのポートスペースを管理する必要があるため、この設定はそ手動で設定するよりも少ない手順で行えます。自動割り当てを有効にすると、Cloud Controller Manager Operator は、設定でspec.type=LoadBalancerが定義されているServiceオブジェクトに外部 IP アドレスを割り当てます。 -

spec.externalIP.policyは、IP アドレスを手動で指定する際に許容される IP アドレスブロックを定義します。OpenShift Container Platform は、spec.externalIP.autoAssignCIDRsパラメーターで定義した IP アドレスブロックにポリシールールを適用しません。

ルーティングが正しく行われると、設定された外部 IP アドレスブロックからの外部トラフィックは、サービスが公開する TCP ポートまたは UDP ポートを介してサービスのエンドポイントに到達できます。

クラスター管理者は、ExternalIP へのルーティングを設定する必要があります。割り当てる IP アドレスブロックがクラスター内の 1 つ以上のノードで終了することを確認する必要もあります。詳細は、Kubernetes External IPs を参照してください。

OpenShift Container Platform は、自動と手動の両方の IP アドレス割り当てをサポートしています。このサポートにより、各アドレスが最大 1 つのサービスに割り当てられ、他のサービスによって公開されているポートに関係なく、各サービスが選択したポートを公開できることが保証されます。

OpenShift Container Platform の autoAssignCIDRs で定義された IP アドレスブロックを使用するには、ホストのネットワークに必要な IP アドレスの割り当ておよびルーティングを設定する必要があります。

以下の YAML は、外部 IP アドレスが設定されたサービスを説明しています。

spec.externalIPs[] が設定された Service オブジェクトの例

クラウドプロバイダープラットフォームでプライベートクラスターを実行する場合は、次の patch コマンドを実行して、Ingress Controller のロードバランサーの公開スコープを internal に変更できます。

oc -n openshift-ingress-operator patch ingresscontrollers/ingress-controller-with-nlb --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"loadBalancer":{"scope":"Internal"}}}}'

$ oc -n openshift-ingress-operator patch ingresscontrollers/ingress-controller-with-nlb --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"loadBalancer":{"scope":"Internal"}}}}'このコマンドを実行すると、Ingress Controller は OpenShift Container Platform アプリケーションのルートへのアクセスを内部ネットワークのみに制限します。

2.2.4. 外部 IP アドレスの割り当ての制限

クラスター管理者は、IP アドレスブロックを指定してサービスの IP アドレスを許可または拒否できます。制限は、cluster-admin 権限を持たないユーザーにのみ適用されます。クラスター管理者は、サービスの spec.externalIPs[] フィールドを任意の IP アドレスに常に設定できます。

policy オブジェクトの spec.ExternalIP.policy パラメーターに Classless Inter-Domain Routing (CIDR) アドレスブロックを指定して、IP アドレスポリシーを設定します。

policy オブジェクトとその CIDR パラメーターの JSON 形式の例

ポリシーの制限を設定する際に、以下のルールが適用されます。

-

policyが{}に設定されている場合、spec.ExternalIPs[]を使用してServiceオブジェクトを作成すると、サービスが失敗します。これは、OpenShift Container Platform のデフォルト設定です。policy: nullの場合も同じ動作になります。 policyが設定され、policy.allowedCIDRs[]またはpolicy.rejectedCIDRs[]のいずれかが設定される場合、以下のルールが適用されます。-

allowedCIDRs[]とrejectedCIDRs[]の両方が設定される場合、rejectedCIDRs[]がallowedCIDRs[]よりも優先されます。 -

allowedCIDRs[]が設定される場合、spec.ExternalIPs[]が設定されているServiceオブジェクトの作成は、指定された IP アドレスが許可される場合にのみ正常に実行されます。 -

rejectedCIDRs[]が設定される場合、spec.ExternalIPs[]が設定されているServiceオブジェクトの作成は、指定された IP アドレスが拒否されていない場合にのみ正常に実行されます。

-

2.2.5. ポリシーオブジェクトの例

このセクションの例では、さまざまな spec.externalIP.policy 設定を示します。

以下の例のポリシーは、外部 IP アドレスが指定されたサービスを OpenShift Container Platform が作成できないようにします。

Serviceオブジェクトのspec.externalIPs[]に指定された値を拒否するポリシーの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例では、

allowedCIDRsおよびrejectedCIDRsフィールドの両方が設定されます。許可される、および拒否される CIDR ブロックの両方を含むポリシーの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例では、

policyは{}に設定されます。これが設定されている場合、oc get networks.config.openshift.io -o yamlコマンドを使用して設定を表示してもpolicyパラメーターはコマンド出力に表示されません。policy: nullの場合も同じ動作になります。Serviceオブジェクトのspec.externalIPs[]に指定された値を許可するポリシーの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.6. ExternalIP アドレスブロックの設定

ExternalIP アドレスブロックの設定は、cluster という名前の Network カスタムリソース (CR) で定義されます。ネットワーク CR は config.openshift.io API グループに含まれます。

クラスターのインストール時に、Cluster Version Operator (CVO) は cluster という名前のネットワーク CR を自動的に作成します。このタイプのその他の CR オブジェクトの作成はサポートされていません。

以下の YAML は ExternalIP 設定を説明しています。

cluster という名前の network.config.openshift.io CR

以下の YAML は、policy スタンザのフィールドを説明しています。

Network.config.openshift.io policy スタンザ

policy: allowedCIDRs: [] rejectedCIDRs: []

policy:

allowedCIDRs: []

rejectedCIDRs: [] 2.2.6.1. 外部 IP 設定の例

外部 IP アドレスプールの予想される複数の設定が以下の例で表示されています。

以下の YAML は、自動的に割り当てられた外部 IP アドレスを有効にする設定を説明しています。

spec.externalIP.autoAssignCIDRsが設定された設定例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の YAML は、許可された、および拒否された CIDR 範囲のポリシールールを設定します。

spec.externalIP.policyが設定された設定例Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.7. クラスターの外部 IP アドレスブロックの設定

クラスター管理者は、以下の ExternalIP を設定できます。

-

Serviceオブジェクトのspec.clusterIPフィールドを自動的に設定するために OpenShift Container Platform によって使用される ExternalIP アドレスブロック。 -

IP アドレスを制限するポリシーオブジェクトは

Serviceオブジェクトのspec.clusterIP配列に手動で割り当てられます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

オプション: 現在の外部 IP 設定を表示するには、以下のコマンドを入力します。

oc describe networks.config cluster

$ oc describe networks.config clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定を編集するには、以下のコマンドを入力します。

oc edit networks.config cluster

$ oc edit networks.config clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例のように ExternalIP 設定を変更します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

externalIPスタンザの設定を指定します。

更新された ExternalIP 設定を確認するには、以下のコマンドを入力します。

oc get networks.config cluster -o go-template='{{.spec.externalIP}}{{"\n"}}'$ oc get networks.config cluster -o go-template='{{.spec.externalIP}}{{"\n"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.9. 次のステップ

2.3. Ingress Controller を使用した Ingress クラスターの設定

OpenShift Container Platform は、クラスター内で実行されるサービスを使用してクラスター外からの通信を可能にする方法を提供します。この方法は Ingress Controller を使用します。

2.3.1. Ingress Controller およびルートの使用

Ingress Operator は Ingress Controller およびワイルドカード DNS を管理します。

Ingress Controller の使用は、最も一般的な、OpenShift Container Platform クラスターへの外部アクセスを許可する方法です。

Ingress Controller は外部要求を許可し、設定されたルートに基づいてそれらをプロキシー送信するよう設定されます。これは、HTTP、SNI を使用する HTTPS、SNI を使用する TLS に限定されており、SNI を使用する TLS で機能する Web アプリケーションやサービスには十分な設定です。

管理者と連携して Ingress Controller を設定します。外部要求を許可し、設定されたルートに基づいてそれらをプロキシー送信するように Ingress Controller を設定します。

管理者はワイルドカード DNS エントリーを作成してから Ingress Controller を設定できます。その後は管理者に問い合わせることなく edge Ingress Controller と連携できます。

デフォルトで、クラスター内のすべての Ingress Controller はクラスター内の任意のプロジェクトで作成されたすべてのルートを許可します。

Ingress Controller:

- デフォルトでは 2 つのレプリカがあるので、これは 2 つのワーカーノードで実行する必要があります。

- 追加のノードにレプリカを組み込むためにスケールアップすることができます。

このセクションの手順では、クラスターの管理者が事前に行っておく必要のある前提条件があります。

2.3.2. 前提条件

以下の手順を開始する前に、管理者は以下の条件を満たしていることを確認する必要があります。

- 要求がクラスターに到達できるように、クラスターネットワーク環境に対して外部ポートをセットアップします。

クラスター管理者ロールを持つユーザーが 1 名以上いることを確認します。このロールをユーザーに追加するには、以下のコマンドを実行します。

oc adm policy add-cluster-role-to-user cluster-admin username

$ oc adm policy add-cluster-role-to-user cluster-admin usernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1 つ以上のマスターと 1 つ以上のノードを持つ OpenShift Container Platform クラスターと、クラスターへのネットワークアクセス権を持つクラスター外部のシステムを用意します。この手順では、外部システムがクラスターと同じサブセットにあることを前提とします。別のサブセットの外部システムに必要な追加のネットワーク設定は、このトピックでは扱いません。

2.3.3. プロジェクトおよびサービスの作成

公開するプロジェクトとサービスが存在しない場合は、プロジェクトを作成してからサービスを作成します。

プロジェクトとサービスがすでに存在する場合は、サービスを公開してルートを作成する手順に進みます。

前提条件

-

OpenShift CLI (

oc) をインストールし、クラスター管理者としてログインしている。

手順

oc new-projectコマンドを実行して、サービス用の新しいプロジェクトを作成します。oc new-project <project_name>

$ oc new-project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc new-appコマンドを使用してサービスを作成します。oc new-app nodejs:12~https://github.com/sclorg/nodejs-ex.git

$ oc new-app nodejs:12~https://github.com/sclorg/nodejs-ex.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービスが作成されたことを確認するには、以下のコマンドを実行します。

oc get svc -n <project_name>

$ oc get svc -n <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE nodejs-ex ClusterIP 172.30.197.157 <none> 8080/TCP 70s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE nodejs-ex ClusterIP 172.30.197.157 <none> 8080/TCP 70sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記デフォルトで、新規サービスには外部 IP アドレスがありません。

2.3.4. ルートの作成によるサービスの公開

oc expose コマンドを使用して、サービスをルートとして公開することができます。

前提条件

- OpenShift Container Platform にログインしている。

手順

公開するサービスが置かれているプロジェクトにログインします。

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc expose serviceコマンドを実行して、ルートを公開します。oc expose service nodejs-ex

$ oc expose service nodejs-exCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

route.route.openshift.io/nodejs-ex exposed

route.route.openshift.io/nodejs-ex exposedCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービスが公開されていることを確認するには、

curlなどのツールを使用して、クラスター外からサービスにアクセスできることを確認します。ルートのホスト名を見つけるには、次のコマンドを入力します。

oc get route

$ oc get routeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD nodejs-ex nodejs-ex-myproject.example.com nodejs-ex 8080-tcp None

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD nodejs-ex nodejs-ex-myproject.example.com nodejs-ex 8080-tcp NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホストが GET 要求に応答することを確認するには、次のコマンドを入力します。

curlコマンドの例curl --head nodejs-ex-myproject.example.com

$ curl --head nodejs-ex-myproject.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

HTTP/1.1 200 OK ...

HTTP/1.1 200 OK ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.5. OpenShift Container Platform での Ingress シャーディング

OpenShift Container Platform では、Ingress Controller はすべてのルートを提供することも、ルートのサブセットを提供することもできます。デフォルトでは、Ingress Controller は、クラスター内の任意の namespace で作成されたすべてのルートを提供します。別の Ingress Controller をクラスターに追加して、選択した特性に基づくルートのサブセットである シャード を作成することにより、ルーティングを最適化できます。ルートをシャードのメンバーとしてマークするには、ルートまたは namespace の メタデータ フィールドでラベルを使用します。Ingress Controller は、選択式 とも呼ばれる セレクター を使用して、ルートのプール全体からルートのサブセットを選択し、サービスを提供します。

Ingress シャーディングは、受信トラフィックを複数の Ingress Controller 間で負荷分散する場合に、トラフィックを分離して特定の Ingress Controller にルーティングする場合、または次のセクションで説明する他のさまざまな理由で役立ちます。

デフォルトでは、各ルートはクラスターのデフォルトドメインを使用します。ただし、代わりにルーターのドメインを使用するようにルートを設定できます。

2.3.6. Ingress Controller のシャーディング

Ingress シャーディング (ルーターシャーディングとも呼ばれます) を使用して、ルート、namespace、またはその両方にラベルを追加することで、一連のルートを複数のルーターに分散できます。Ingress Controller は、対応する一連のセレクターを使用して、指定されたラベルが含まれるルートのみを許可します。各 Ingress シャードは、特定の選択式を使用してフィルタリングされたルートで構成されます。

トラフィックがクラスターに送信される主要なメカニズムとして、Ingress Controller への要求が大きくなる可能性があります。クラスター管理者は、以下を実行するためにルートをシャード化できます。

- Ingress Controller またはルーターを複数のルートに分散し、変更に対する応答を高速化する。

- 特定のルートに、他のルートとは異なる信頼性保証を割り当てる。

- 特定の Ingress Controller に異なるポリシーを定義することを許可します。

- 特定のルートのみが追加機能を使用することを許可します。

- たとえば、異なるアドレスで異なるルートを公開し、内部ユーザーおよび外部ユーザーが異なるルートを認識できるようにします。

- Blue-Green デプロイ時に、あるバージョンのアプリケーションから別のバージョンにトラフィックを転送する。

Ingress Controller がシャーディングされると、特定のルートがグループ内の 0 個以上の Ingress Controller に受け入れられます。ルートのステータスから、Ingress Controller がルートを許可したかどうかがわかります。Ingress Controller は、ルートがシャードに固有のものである場合にのみルートを許可します。

シャーディングを使用すると、ルートのサブセットを複数の Ingress Controller に分散できます。ルートのサブセットは、重複なし (従来 のシャーディング) にすることも、重複あり (オーバーラップ シャーディング) にすることもできます。

次の表に、3 つのシャーディング方法の概要を示します。

| シャーディング方法 | 説明 |

|---|---|

| namespace セレクター | Ingress Controller に namespace セレクターを追加すると、namespace セレクターに一致するラベルを持つ namespace 内のすべてのルートが Ingress シャードに追加されます。namespace 内に作成されたすべてのルートを Ingress Controller で提供する場合は、この方法を検討してください。 |

| ルートセレクター | Ingress Controller にルートセレクターを追加すると、ルートセレクターに一致するラベルを持つすべてのルートが Ingress シャードに追加されます。ルートのサブセットのみ、または namespace 内の特定のルートのみを Ingress Controller で提供する場合は、この方法を検討してください。 |

| namespace およびルートセレクター | namespace セレクターとルートセレクター両方の方法で Ingress Controller のスコープを指定します。namespace セレクターとルートセレクター両方の方法の柔軟性が必要な場合は、この方法を検討してください。 |

2.3.6.1. 従来のシャーディングの例

キー値が finance と ops に設定されたラベルセレクター spec.namespaceSelector.matchExpressions を持つ、設定済みの Ingress Controller finops-router の例:

finops-router の YAML 定義の例

キー値が dev に設定されたラベルセレクター spec.namespaceSelector.matchLabels.name を持つ、設定済みの Ingress Controller dev-router の例:

dev-router の YAML 定義の例

すべてのアプリケーションルートが、それぞれ name:finance、name:ops、name:dev などのラベルが付けられた別々の namespace にある場合は、設定によって 2 つの Ingress Controller 間でルートが効果的に分散されます。コンソール、認証、およびその他の目的の OpenShift Container Platform ルートは処理しないでください。

前のシナリオでは、シャーディングは重複するサブセットを持たないパーティション設定の特別なケースとなります。ルートは複数のルーターシャード間で分割されます。

デフォルト の Ingress Controller は、namespaceSelector または routeSelector フィールドに除外対象のルートが含まれていない限り、引き続きすべてのルートを提供します。デフォルトの Ingress Controller からルートを除外する方法の詳細は、この Red Hat ナレッジベースのソリューション と「デフォルトの Ingress Controller のシャーディング」のセクションを参照してください。

2.3.6.2. 重複シャーディングの例

キー値が dev と ops に設定されたラベルセレクター spec.namespaceSelector.matchExpressions を持つ、設定済みの Ingress Controller devops-router の例:

devops-router の YAML 定義の例

name:dev および name:ops という 名前の namespace のルートは、2 つの異なる Ingress Controller によって処理されるようになりました。この設定では、ルートのサブセットが重複しています。

重複するルートのサブセットを使用すると、より複雑なルーティングルールを作成できます。たとえば、優先度の低いトラフィックを devops-router に送信しながら、優先度の高いトラフィックを専用の finops-router に迂回させることができます。

2.3.6.3. デフォルトの Ingress Controller のシャーディング

新しい Ingress シャードを作成した後に、デフォルトの Ingress Controller と、新しい Ingress シャードの両方により許可されるルートが存在する場合があります。これは、デフォルトの Ingress Controller にセレクターがなく、デフォルトですべてのルートを許可するためです。

namespace セレクターまたはルートセレクターを使用して、Ingress Controller が特定のラベルが割り当てられたルートの処理を制限できます。次の手順では、namespace セレクターを使用して、デフォルトの Ingress Controller が新しく分割された finance、ops、および dev ルートにサービスを提供しないように制限します。これにより、Ingress シャードがさらに分離されます。

OpenShift Container Platform のすべての管理ルートを同じ Ingress Controller で保持する必要があります。したがって、これらの重要なルートを除外するセレクターをデフォルトの Ingress Controller に追加することは避けてください。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - プロジェクト管理者としてログインしている。

手順

次のコマンドを実行して、デフォルトの Ingress Controller を変更します。

oc edit ingresscontroller -n openshift-ingress-operator default

$ oc edit ingresscontroller -n openshift-ingress-operator defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress Controller を編集して、

finance、ops、およびdevラベルのいずれかを持つルートを除外するnamespaceSelectorを含めます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

デフォルトの Ingress Controller では、name:finance、name:ops、および name:dev という名前の namespace が提供されなくなります。

2.3.6.4. Ingress シャーディングと DNS

クラスター管理者は、プロジェクト内のルーターごとに個別の DNS エントリーを作成します。ルーターは不明なルートを別のルーターに転送することはありません。

以下の例を考慮してください。

-

Router A はホスト 192.168.0.5 にあり、

*.foo.comのルートを持つ。 -

Router B はホスト 192.168.1.9 にあり、

*.example.comのルートを持つ。

個別の DNS エントリーは、*.foo.com をルーター A をホストするノードに解決し、*.example.com をルーター B をホストするノードに解決する必要があります。

-

*.foo.com A IN 192.168.0.5 -

*.example.com A IN 192.168.1.9

2.3.6.5. ルートラベルを使用した Ingress Controller のシャーディングの設定

ルートラベルを使用した Ingress Controller のシャーディングとは、Ingress Controller がルートセレクターによって選択される任意 namespace の任意のルートを提供することを意味します。

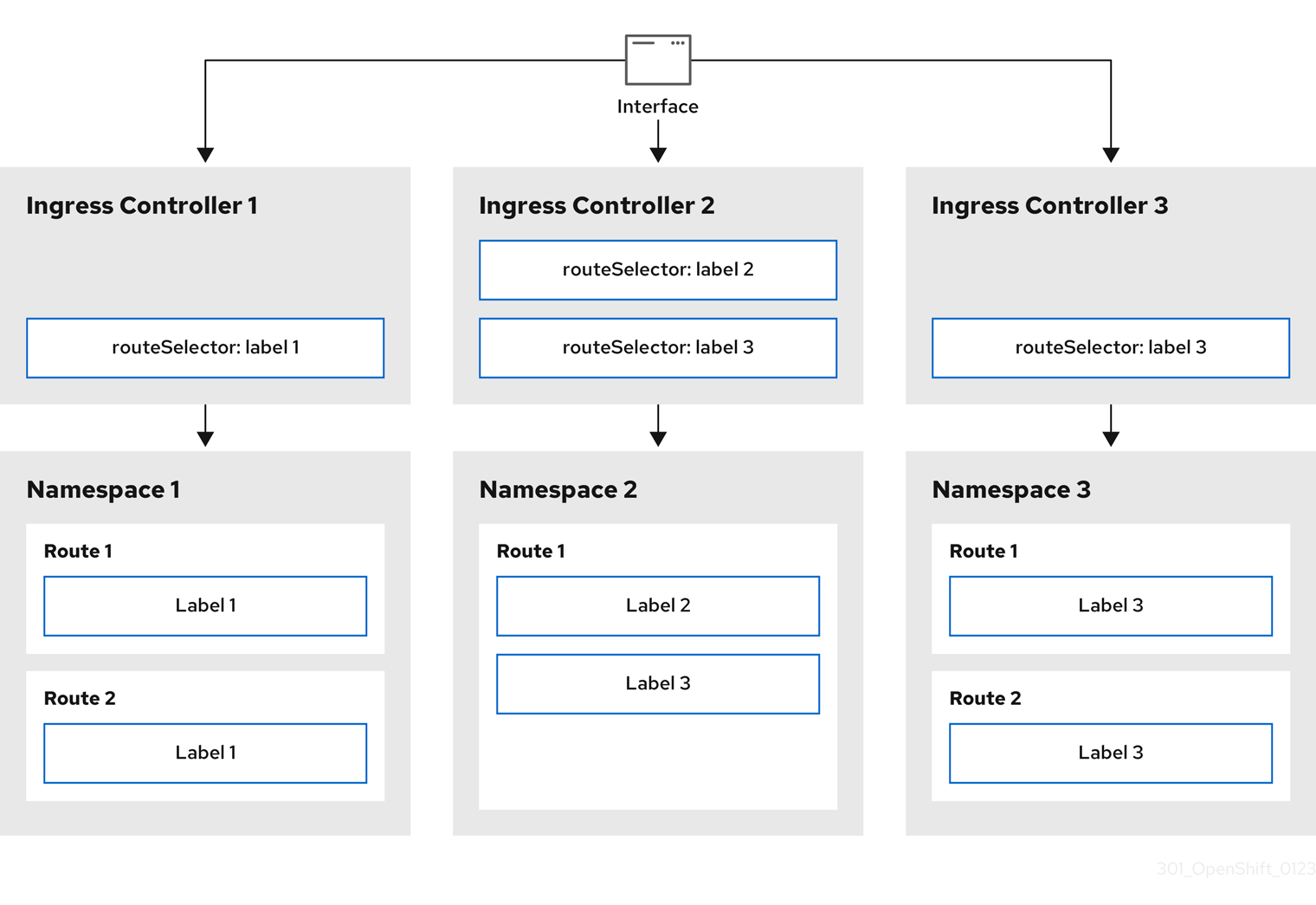

図2.1 ルートラベルを使用した Ingress シャーディング

Ingress Controller のシャーディングは、一連の Ingress Controller 間で着信トラフィックの負荷を分散し、トラフィックを特定の Ingress Controller に分離する際に役立ちます。たとえば、Company A のトラフィックをある Ingress Controller に指定し、Company B を別の Ingress Controller に指定できます。

手順

router-internal.yamlファイルを編集します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ingress Controller が使用するドメインを指定します。このドメインは、デフォルトの Ingress Controller ドメインとは異なる必要があります。

Ingress Controller の

router-internal.yamlファイルを適用します。oc apply -f router-internal.yaml

# oc apply -f router-internal.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress Controller は、

type: shardedというラベルのある namespace のルートを選択します。router-internal.yamlで設定されたドメインを使用して新しいルートを作成します。oc expose svc <service-name> --hostname <route-name>.apps-sharded.basedomain.example.net

$ oc expose svc <service-name> --hostname <route-name>.apps-sharded.basedomain.example.netCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.6.6. namespace ラベルを使用した Ingress Controller のシャーディングの設定

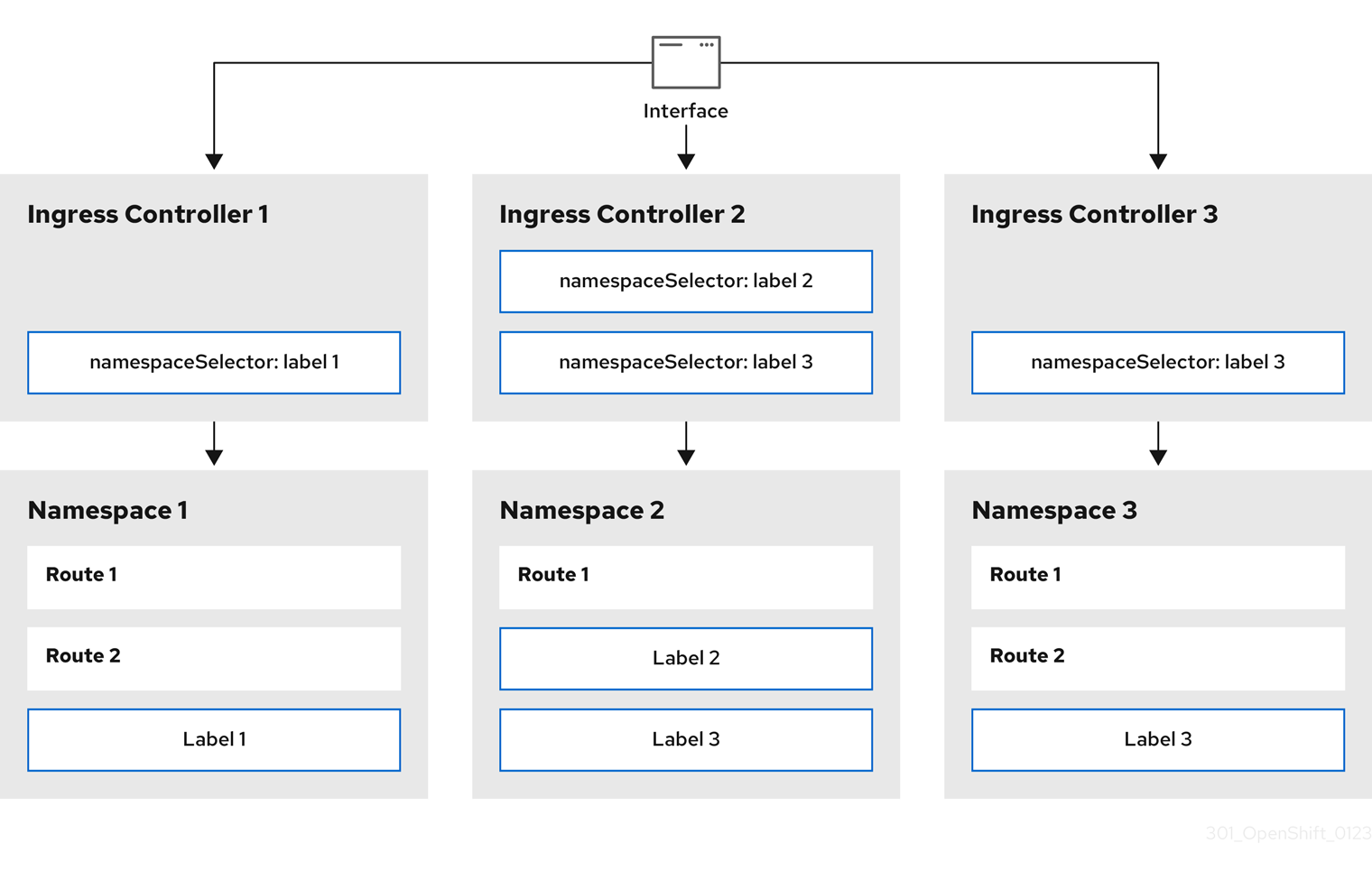

namespace ラベルを使用した Ingress Controller のシャーディングとは、Ingress Controller が namespace セレクターによって選択される任意の namespace の任意のルートを提供することを意味します。

図2.2 namespace ラベルを使用した Ingress シャーディング

Ingress Controller のシャーディングは、一連の Ingress Controller 間で着信トラフィックの負荷を分散し、トラフィックを特定の Ingress Controller に分離する際に役立ちます。たとえば、Company A のトラフィックをある Ingress Controller に指定し、Company B を別の Ingress Controller に指定できます。

手順

router-internal.yamlファイルを編集します。cat router-internal.yaml

$ cat router-internal.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ingress Controller が使用するドメインを指定します。このドメインは、デフォルトの Ingress Controller ドメインとは異なる必要があります。

Ingress Controller の

router-internal.yamlファイルを適用します。oc apply -f router-internal.yaml

$ oc apply -f router-internal.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress Controller は、

type: shardedというラベルのある namespace セレクターによって選択される namespace のルートを選択します。router-internal.yamlで設定されたドメインを使用して新しいルートを作成します。oc expose svc <service-name> --hostname <route-name>.apps-sharded.basedomain.example.net

$ oc expose svc <service-name> --hostname <route-name>.apps-sharded.basedomain.example.netCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.6.7. Ingress Controller シャーディングのルート作成

ルートを使用すると、URL でアプリケーションをホストできます。Ingress Controller のシャーディングは、一連の Ingress Controller 間での着信トラフィック負荷のバランスをとるのに役立ちます。特定の Ingress Controller へのトラフィックを分離することもできます。たとえば、Company A のトラフィックをある Ingress Controller に指定し、Company B を別の Ingress Controller に指定できます。

以下の手順では、例として hello-openshift アプリケーションを使用して、Ingress Controller シャーディングのルートを作成する方法を説明します。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - プロジェクト管理者としてログインしている。

- ポートを公開する Web アプリケーションと、そのポート上のトラフィックをリッスンする HTTP または TLS エンドポイントがある。

- シャーディング用に Ingress Controller を設定している。

手順

次のコマンドを実行して、

hello-openshiftというプロジェクトを作成します。oc new-project hello-openshift

$ oc new-project hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行してプロジェクトに Pod を作成します。

oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.json

$ oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、

hello-openshiftというサービスを作成します。oc expose pod/hello-openshift

$ oc expose pod/hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow hello-openshift-route.yamlというルート定義を作成します。シャーディング用に作成したルートの YAML 定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行し、

hello-openshift-route.yamlを使用してhello-openshiftアプリケーションへのルートを作成します。oc -n hello-openshift create -f hello-openshift-route.yaml

$ oc -n hello-openshift create -f hello-openshift-route.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

次のコマンドを使用して、ルートのステータスを取得します。

oc -n hello-openshift get routes/hello-openshift-edge -o yaml

$ oc -n hello-openshift get routes/hello-openshift-edge -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 結果の

Routeリソースは次のようになります。出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ingress Controller またはルーターがルートを公開するために使用するホスト名。

hostフィールドの値は、Ingress Controller によって自動的に決定され、そのドメインを使用します。この例では、Ingress Controller のドメインは<apps-sharded.basedomain.example.net>です。 - 2

- Ingress Controller のホスト名。ホスト名が設定されていない場合、ルートは代わりにサブドメインを使用できます。サブドメインを指定すると、ルートを公開する Ingress Controller のドメインが自動的に使用されます。ルートが複数の Ingress Controller によって公開される場合、ルートは複数の URL でホストされます。

- 3

- Ingress Controller の名前。この例では、Ingress Controller の名前は

shardedです。

2.3.6.8. 関連情報

2.4. Ingress Controller エンドポイント公開戦略の設定

endpointPublishingStrategy は Ingress Controller エンドポイントを他のネットワークに公開し、ロードバランサーの統合を有効にし、他のシステムへのアクセスを提供するために使用されます。

Red Hat OpenStack Platform (RHOSP) では、クラウドプロバイダーがヘルスモニターを作成するように設定されている場合にのみ、LoadBalancerService エンドポイントの公開ストラテジーがサポートされます。RHOSP 16.2 の場合、このストラテジーは Amphora Octavia プロバイダーを使用する場合にのみ可能です。

詳細は、RHOSP インストールドキュメントの「RHOSP Cloud Controller Manager オプションの設定」セクションを参照してください。

2.4.1. Ingress Controller エンドポイントの公開ストラテジー

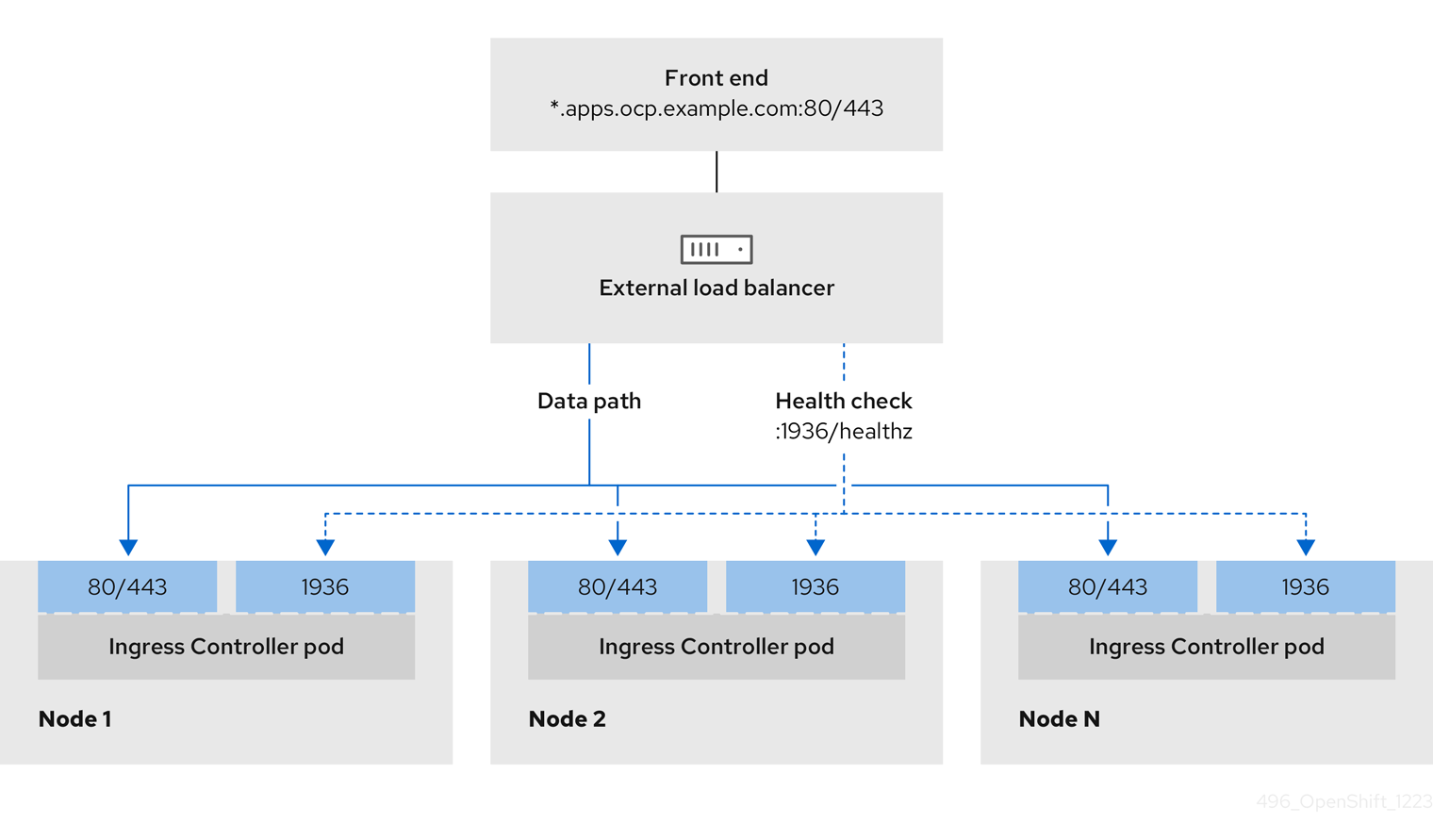

NodePortService エンドポイントの公開ストラテジー

NodePortService エンドポイント公開ストラテジーは、Kubernetes NodePort サービスを使用して Ingress Controller を公開します。

この設定では、Ingress Controller のデプロイメントはコンテナーのネットワークを使用します。NodePortService はデプロイメントを公開するために作成されます。特定のノードポートは OpenShift Container Platform によって動的に割り当てられますが、静的ポートの割り当てをサポートするために、管理対象の NodePortService のノードポートフィールドへの変更が保持されます。

図2.3 NodePortService の図

前述の図では、OpenShift Container Platform Ingress NodePort エンドポイントの公開戦略に関する以下のような概念を示しています。

- クラスターで利用可能なノードにはすべて、外部からアクセス可能な独自の IP アドレスが割り当てられています。クラスター内で動作するサービスは、全ノードに固有の NodePort にバインドされます。

-

たとえば、クライアントが図に示す IP アドレス

10.0.128.4に接続してダウンしているノードに接続した場合に、ノードポートは、サービスを実行中で利用可能なノードにクライアントを直接接続します。このシナリオでは、ロードバランシングは必要ありません。イメージが示すように、10.0.128.4アドレスがダウンしており、代わりに別の IP アドレスを使用する必要があります。

Ingress Operator は、サービスの .spec.ports[].nodePort フィールドへの更新を無視します。

デフォルトで、ポートは自動的に割り当てられ、各種の統合用のポート割り当てにアクセスできます。ただし、既存のインフラストラクチャーと統合するために静的ポートの割り当てが必要になることがありますが、これは動的ポートに対応して簡単に再設定できない場合があります。静的ノードポートとの統合を実行するには、マネージドのサービスリソースを直接更新できます。

詳細は、NodePort に関する Kubernetes サービスのドキュメント を参照してください。

HostNetwork エンドポイントの公開ストラテジー

HostNetwork エンドポイント公開ストラテジーは、Ingress Controller がデプロイされるノードポートで Ingress Controller を公開します。

HostNetwork エンドポイント公開ストラテジーを持つ Ingress Controller には、ノードごとに 1 つの Pod レプリカのみを設定できます。n のレプリカを使用する場合、それらのレプリカをスケジュールできる n 以上のノードを使用する必要があります。各 Pod はスケジュールされるノードホストでポート 80 および 443 を要求するので、同じノードで別の Pod がそれらのポートを使用している場合、レプリカをノードにスケジュールすることはできません。

HostNetwork オブジェクトには、オプションのバインディングポートのデフォルト値が httpPort:80、httpsPort:443、statsPort:1936 の hostNetwork フィールドがあります。ネットワークに異なるバインディングポートを指定することで、HostNetwork ストラテジーに対して、同じノードに複数の Ingress Controller をデプロイできます。

例

2.4.1.1. Ingress Controller エンドポイント公開スコープの内部への設定

クラスター管理者がクラスターをプライベートに指定せずに新しいクラスターをインストールすると、scope が External に設定されたデフォルトの Ingress Controller が作成されます。クラスター管理者は、External スコープの Ingress Controller を Internal に変更できます。

前提条件

-

ocCLI がインストールされている。

手順

Externalスコープの Ingress Controller をInternalに変更するには、次のコマンドを入力します。oc -n openshift-ingress-operator patch ingresscontrollers/default --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"type":"LoadBalancerService","loadBalancer":{"scope":"Internal"}}}}'$ oc -n openshift-ingress-operator patch ingresscontrollers/default --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"type":"LoadBalancerService","loadBalancer":{"scope":"Internal"}}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress Controller のステータスを確認するには、次のコマンドを入力します。

oc -n openshift-ingress-operator get ingresscontrollers/default -o yaml

$ oc -n openshift-ingress-operator get ingresscontrollers/default -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ステータス状態が

Progressingの場合は、さらにアクションを実行する必要があるかどうかを示します。たとえば、ステータスの状態によっては、次のコマンドを入力して、サービスを削除する必要があることを示している可能性があります。oc -n openshift-ingress delete services/router-default

$ oc -n openshift-ingress delete services/router-defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービスを削除すると、Ingress Operator はサービスを

Internalとして再作成します。

2.4.1.2. Ingress Controller エンドポイント公開スコープの外部への設定

クラスター管理者がクラスターをプライベートに指定せずに新しいクラスターをインストールすると、scope が External に設定されたデフォルトの Ingress Controller が作成されます。

Ingress Controller のスコープは、インストール中またはインストール後に Internal になるように設定でき、クラスター管理者は Internal の Ingress Controller を External に変更できます。

一部のプラットフォームでは、サービスを削除して再作成する必要があります。

スコープを変更すると、場合によっては数分間、Ingress トラフィックが中断される可能性があります。これが該当するのは、サービスを削除して再作成する必要があるプラットフォームです。理由は、この手順により、OpenShift Container Platform が既存のサービスロードバランサーのプロビジョニングを解除して新しいサービスロードバランサーをプロビジョニングし、DNS を更新する可能性があるためです。

前提条件

-

ocCLI がインストールされている。

手順

Internalスコープの入力コントローラーをExternalに変更するには、次のコマンドを入力します。oc -n openshift-ingress-operator patch ingresscontrollers/private --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"type":"LoadBalancerService","loadBalancer":{"scope":"External"}}}}'$ oc -n openshift-ingress-operator patch ingresscontrollers/private --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"type":"LoadBalancerService","loadBalancer":{"scope":"External"}}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress Controller のステータスを確認するには、次のコマンドを入力します。

oc -n openshift-ingress-operator get ingresscontrollers/default -o yaml

$ oc -n openshift-ingress-operator get ingresscontrollers/default -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ステータス状態が

Progressingの場合は、さらにアクションを実行する必要があるかどうかを示します。たとえば、ステータスの状態によっては、次のコマンドを入力して、サービスを削除する必要があることを示している可能性があります。oc -n openshift-ingress delete services/router-default

$ oc -n openshift-ingress delete services/router-defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービスを削除すると、Ingress Operator はサービスを

Externalとして再作成します。

2.4.1.3. Ingress Controller への単一の NodePort サービスの追加

各プロジェクトに NodePort タイプの Service を作成する代わりに、NodePortService エンドポイント公開ストラテジーを使用するカスタム Ingress Controller を作成できます。Ingress シャーディングを介して、すでに HostNetwork Ingress Controller が存在する可能性のあるノードにルートのセットを適用する場合は、ポートの競合を防ぐために、このような Ingress Controller の設定を検討してください。

各プロジェクトに NodePort タイプの Service を設定する前に、次の考慮事項を確認してください。

- Nodeport Ingress Controller ドメインのワイルドカード DNS レコードを作成する必要があります。Nodeport Ingress Controller ルートには、ワーカーノードのアドレスからアクセスできます。ルートに必要な DNS レコードの詳細は、「user-provisioned DNS 要件」を参照してください。

-

サービス用のルートを公開し、カスタム Ingress Controller ドメインの

--hostname引数を指定する必要があります。 -

アプリケーション Pod にアクセスできるようにするには、

NodePortタイプのServiceに割り当てられているポートをルートに追加する必要があります。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-admin権限を持つユーザーとしてログインしている。 - ワイルドカード DNS レコードが作成されている。

手順

Ingress Controller のカスタムリソース (CR) ファイルを作成します。

IngressControllerオブジェクトの情報を定義する CR ファイルの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

IngressControllerCR のカスタムのnameを指定します。- 2

- Ingress Controller が提供する DNS の名前。たとえば、デフォルトの ingresscontroller ドメインは

apps.ipi-cluster.example.comであるため、<custom_ic_domain_name>にはnodeportsvc.ipi-cluster.example.comを指定します。 - 3

- カスタム Ingress Controller を含むノードのラベルを指定します。

- 4

- namespace のセットのラベルを指定します。

<key>:<value>は、キーと値のペアのマップに置き換えます。<key>は新しいラベルの一意の名前、<value>はその値です。たとえば、ingresscontroller: custom-icです。

oc label nodeコマンドを使用してノードにラベルを追加します。oc label node <node_name> <key>=<value>

$ oc label node <node_name> <key>=<value>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<value>は、IngressControllerCR のnodePlacementセクションで指定したキーと値のペアと同じである必要があります。

IngressControllerオブジェクトを作成します。oc create -f <ingress_controller_cr>.yaml

$ oc create -f <ingress_controller_cr>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow IngressControllerCR 用に作成されたサービスのポートを確認します。oc get svc -n openshift-ingress

$ oc get svc -n openshift-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow router-nodeport-custom-ic3サービスのポート80:32432/TCPを示す出力例NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE router-internal-default ClusterIP 172.30.195.74 <none> 80/TCP,443/TCP,1936/TCP 223d router-nodeport-custom-ic3 NodePort 172.30.109.219 <none> 80:32432/TCP,443:31366/TCP,1936:30499/TCP 155m

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE router-internal-default ClusterIP 172.30.195.74 <none> 80/TCP,443/TCP,1936/TCP 223d router-nodeport-custom-ic3 NodePort 172.30.109.219 <none> 80:32432/TCP,443:31366/TCP,1936:30499/TCP 155mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいプロジェクトを作成するために、次のコマンドを入力します。

oc new-project <project_name>

$ oc new-project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しい namespace にラベルを付けるために、次のコマンドを入力します。

oc label namespace <project_name> <key>=<value>

$ oc label namespace <project_name> <key>=<value>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<key>=<value>は、Ingress Controller CR のnamespaceSelectorセクションの値と同じである必要があります。

クラスター内に新しいアプリケーションを作成します。

oc new-app --image=<image_name>

$ oc new-app --image=<image_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<image_name>の例は、quay.io/openshifttest/hello-openshift:multiarchです。

サービスの

Routeオブジェクトを作成して、Pod がサービスを使用してアプリケーションをクラスターの外部に公開できるようにします。oc expose svc/<service_name> --hostname=<svc_name>-<project_name>.<custom_ic_domain_name>

$ oc expose svc/<service_name> --hostname=<svc_name>-<project_name>.<custom_ic_domain_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記--hostname引数で、カスタム Ingress Controller のドメイン名を指定する必要があります。これを行わない場合、Ingress Operator がデフォルトの Ingress Controller を使用してクラスターのすべてのルートを提供します。ルートのステータスが

Admittedであり、カスタム Ingress Controller のメタデータがルートに含まれていることを確認します。oc get route/hello-openshift -o json | jq '.status.ingress'

$ oc get route/hello-openshift -o json | jq '.status.ingress'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow デフォルトの

IngressControllerCR を更新して、デフォルトの Ingress Controller がNodePortタイプのServiceを管理しないようにします。他のすべてのクラスタートラフィックは、引き続きデフォルトの Ingress Controller によって監視します。oc patch --type=merge -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"namespaceSelector":{"matchExpressions":[{"key":"<key>","operator":"NotIn","values":["<value>]}]}}}'$ oc patch --type=merge -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"namespaceSelector":{"matchExpressions":[{"key":"<key>","operator":"NotIn","values":["<value>]}]}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

次のコマンドを入力して、DNS エントリーがクラスターの内外にルーティングできることを確認します。このコマンドでは、上記の手順で

oc label nodeコマンドを実行してラベルを追加したノードの IP アドレスが出力されます。dig +short <svc_name>-<project_name>.<custom_ic_domain_name>

$ dig +short <svc_name>-<project_name>.<custom_ic_domain_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターが DNS 解決に外部 DNS サーバーの IP アドレスを使用していることを確認するために、次のコマンドを入力してクラスターの接続を確認します。

curl <svc_name>-<project_name>.<custom_ic_domain_name>:<port>

$ curl <svc_name>-<project_name>.<custom_ic_domain_name>:<port>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Hello OpenShift!

Hello OpenShift!Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. ロードバランサーを使用した Ingress クラスターの設定

OpenShift Container Platform は、クラスター内で実行されるサービスを使用してクラスター外からの通信を可能にする方法を提供します。この方法では、ロードバランサーを使用します。

2.5.1. ロードバランサーを使用したトラフィックのクラスターへの送信

特定の外部 IP アドレスを必要としない場合、ロードバランサーサービスを OpenShift Container Platform クラスターへの外部アクセスを許可するよう設定することができます。

ロードバランサーサービスは固有の IP を割り当てます。ロードバランサーには単一の edge ルーター IP があります (これは仮想 IP (VIP) の場合もありますが、初期の負荷分散では単一マシンになります。

プールが設定される場合、これはクラスター管理者によってではなく、インフラストラクチャーレベルで実行されます。

このセクションの手順では、クラスターの管理者が事前に行っておく必要のある前提条件があります。

2.5.2. 前提条件

以下の手順を開始する前に、管理者は以下の条件を満たしていることを確認する必要があります。

- 要求がクラスターに到達できるように、クラスターネットワーク環境に対して外部ポートをセットアップします。

クラスター管理者ロールを持つユーザーが 1 名以上いることを確認します。このロールをユーザーに追加するには、以下のコマンドを実行します。

oc adm policy add-cluster-role-to-user cluster-admin username

$ oc adm policy add-cluster-role-to-user cluster-admin usernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow - OpenShift Container Platform クラスターを、1 つ以上のマスターと 1 つ以上のノード、およびクラスターへのネットワークアクセスのあるクラスター外のシステムと共に用意します。この手順では、外部システムがクラスターと同じサブセットにあることを前提とします。別のサブセットの外部システムに必要な追加のネットワーク設定は、このトピックでは扱いません。

2.5.3. プロジェクトおよびサービスの作成

公開するプロジェクトとサービスが存在しない場合は、プロジェクトを作成してからサービスを作成します。

プロジェクトとサービスがすでに存在する場合は、サービスを公開してルートを作成する手順に進みます。

前提条件

-

OpenShift CLI (

oc) をインストールし、クラスター管理者としてログインしている。

手順

oc new-projectコマンドを実行して、サービス用の新しいプロジェクトを作成します。oc new-project <project_name>

$ oc new-project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc new-appコマンドを使用してサービスを作成します。oc new-app nodejs:12~https://github.com/sclorg/nodejs-ex.git

$ oc new-app nodejs:12~https://github.com/sclorg/nodejs-ex.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービスが作成されたことを確認するには、以下のコマンドを実行します。

oc get svc -n <project_name>

$ oc get svc -n <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE nodejs-ex ClusterIP 172.30.197.157 <none> 8080/TCP 70s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE nodejs-ex ClusterIP 172.30.197.157 <none> 8080/TCP 70sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記デフォルトで、新規サービスには外部 IP アドレスがありません。

2.5.4. ルートの作成によるサービスの公開

oc expose コマンドを使用して、サービスをルートとして公開することができます。

前提条件

- OpenShift Container Platform にログインしている。

手順

公開するサービスが置かれているプロジェクトにログインします。

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc expose serviceコマンドを実行して、ルートを公開します。oc expose service nodejs-ex

$ oc expose service nodejs-exCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

route.route.openshift.io/nodejs-ex exposed