Applications dans le domaine de la construction

Créer et gérer des applications sur OpenShift Container Platform

Résumé

Chapitre 1. Aperçu des applications dans le domaine de la construction

Avec OpenShift Container Platform, vous pouvez créer, modifier, supprimer et gérer des applications à l'aide de la console web ou de l'interface de ligne de commande (CLI).

1.1. Travailler sur un projet

Les projets permettent d'organiser et de gérer les applications de manière isolée. Vous pouvez gérer l'ensemble du cycle de vie du projet, y compris la création, la visualisation et la suppression d'un projet dans OpenShift Container Platform.

Après avoir créé le projet, vous pouvez accorder ou révoquer l'accès à un projet et gérer les rôles de cluster pour les utilisateurs à l'aide de la perspective du développeur. Vous pouvez également modifier la ressource de configuration du projet lors de la création d'un modèle de projet utilisé pour le provisionnement automatique de nouveaux projets.

En utilisant le CLI, vous pouvez créer un projet en tant qu'utilisateur différent en vous faisant passer pour un autre utilisateur lors d'une requête à l'API de OpenShift Container Platform. Lorsque vous demandez la création d'un nouveau projet, OpenShift Container Platform utilise un point de terminaison pour provisionner le projet selon un modèle personnalisable. En tant qu'administrateur de cluster, vous pouvez choisir d'empêcher un groupe d'utilisateurs authentifiés d'auto-approvisionner de nouveaux projets.

1.2. Travailler sur une application

1.2.1. Création d'une application

Pour créer des applications, vous devez avoir créé un projet ou avoir accès à un projet avec les rôles et permissions appropriés. Vous pouvez créer une application en utilisant la perspective développeur dans la console web, les opérateurs installés ou le CLI de OpenShift Container Platform. Les applications à ajouter au projet peuvent provenir de Git, de fichiers JAR, de devfiles ou du catalogue de développeurs.

Vous pouvez également utiliser des composants qui incluent du code source ou binaire, des images et des modèles pour créer une application à l'aide de la CLI d'OpenShift Container Platform. Avec la console web d'OpenShift Container Platform, vous pouvez créer une application à partir d'un Operator installé par un administrateur de cluster.

1.2.2. Gestion d'une application

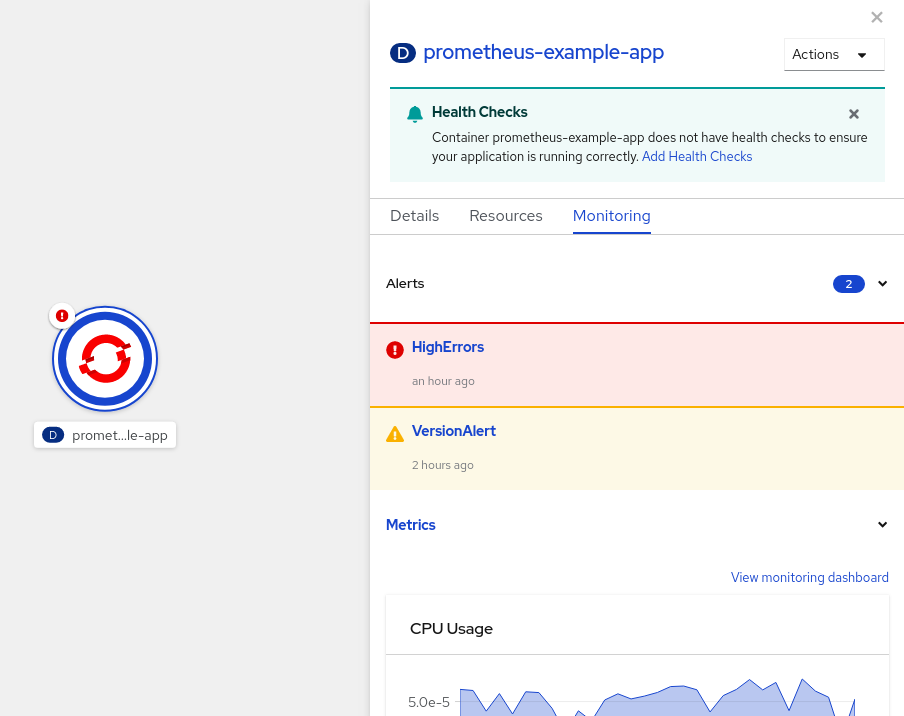

Après avoir créé l'application, vous pouvez utiliser la console web pour surveiller les mesures de votre projet ou de votre application. Vous pouvez également modifier ou supprimer l'application à l'aide de la console web. Lorsque l'application est en cours d'exécution, toutes les ressources de l'application ne sont pas utilisées. En tant qu'administrateur de cluster, vous pouvez choisir d'inactiver ces ressources évolutives afin de réduire la consommation de ressources.

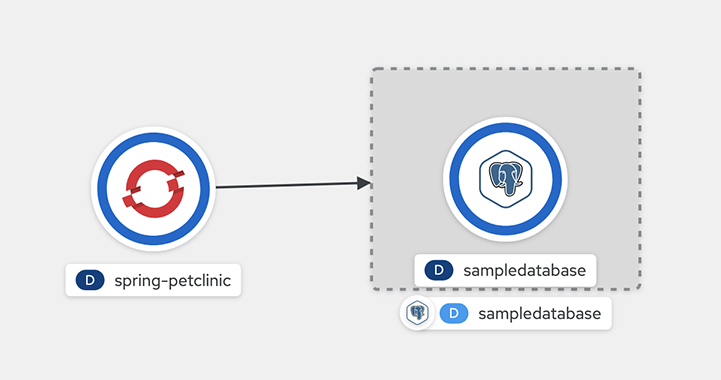

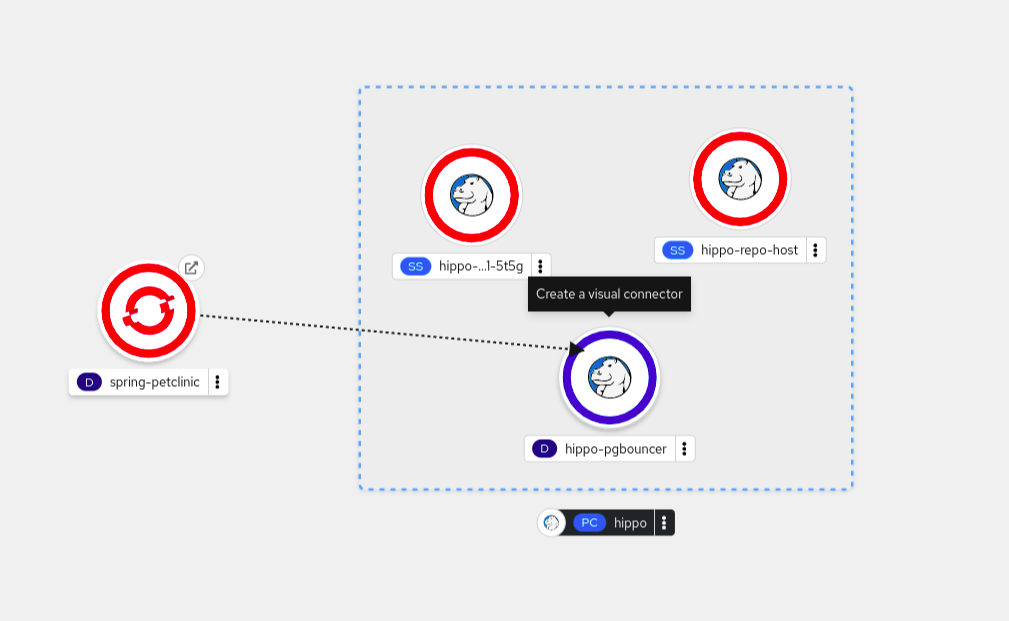

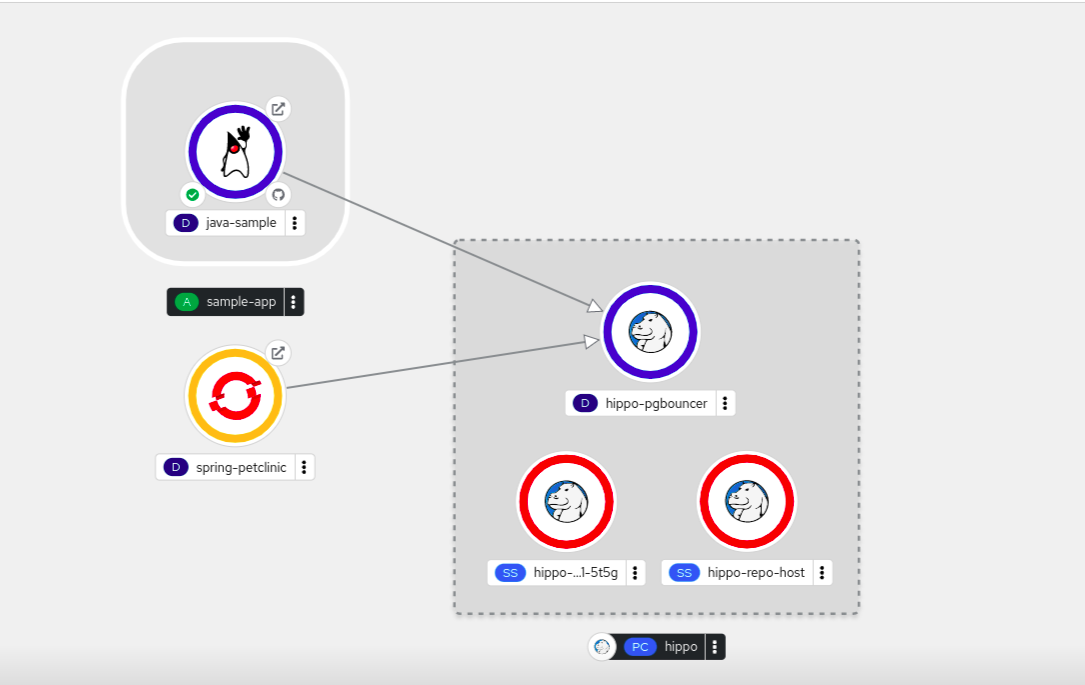

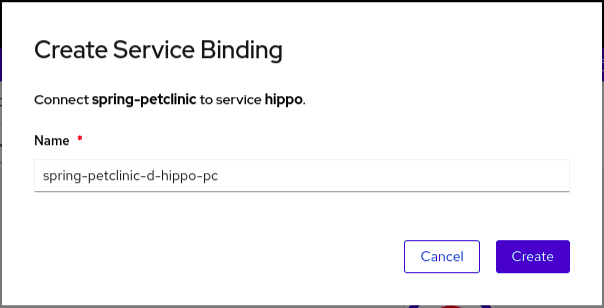

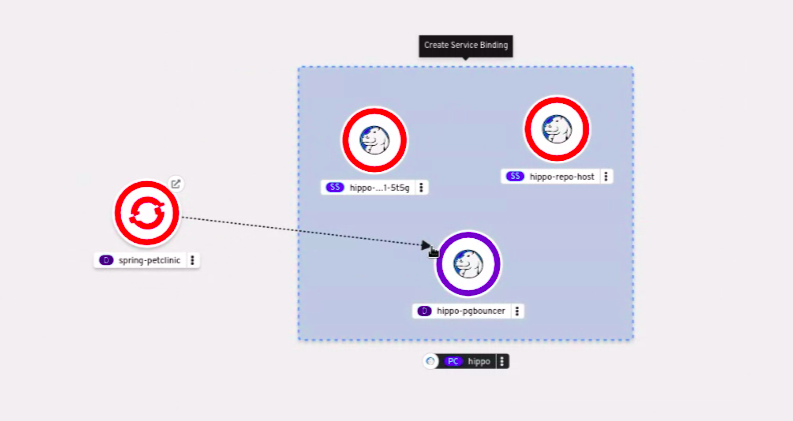

1.2.3. Connecter une application à des services

Une application utilise des services d'appui pour construire et connecter des charges de travail, qui varient en fonction du fournisseur de services. Grâce à l'opérateur de liaison de services, vous pouvez, en tant que développeur, lier des charges de travail avec des services d'appui gérés par l'opérateur, sans aucune procédure manuelle pour configurer la connexion de liaison. Vous pouvez également appliquer la liaison de services aux environnements IBM Power, IBM zSystems et IBM® LinuxONE.

1.2.4. Déploiement d'une application

Vous pouvez déployer votre application à l'aide des objets Deployment ou DeploymentConfig et les gérer à partir de la console web. Vous pouvez créer des stratégies de déploiement qui permettent de réduire les temps d'arrêt lors d'une modification ou d'une mise à niveau de l'application.

Vous pouvez également utiliser Helm, un gestionnaire de paquets logiciels qui simplifie le déploiement d'applications et de services sur les clusters OpenShift Container Platform.

1.3. Utilisation de Red Hat Marketplace

La place de marché Red Hat est une place de marché cloud ouverte où vous pouvez découvrir et accéder à des logiciels certifiés pour les environnements basés sur des conteneurs qui fonctionnent sur des clouds publics et sur site.

Chapitre 2. Projets

2.1. Travailler avec des projets

Le site project permet à une communauté d'utilisateurs d'organiser et de gérer son contenu indépendamment des autres communautés.

Les projets commençant par openshift- et kube- sont des projets par défaut. Ces projets hébergent des composants de cluster qui s'exécutent sous forme de pods et d'autres composants d'infrastructure. En tant que tel, OpenShift Container Platform ne vous permet pas de créer des projets commençant par openshift- ou kube- à l'aide de la commande oc new-project. Les administrateurs de clusters peuvent créer ces projets à l'aide de la commande oc adm new-project.

Vous ne pouvez pas attribuer de SCC aux pods créés dans l'un des espaces de noms par défaut : default kube-system , kube-public, openshift-node, openshift-infra et openshift. Vous ne pouvez pas utiliser ces espaces de noms pour exécuter des pods ou des services.

2.1.1. Création d'un projet à l'aide de la console web

Si l'administrateur de votre cluster l'autorise, vous pouvez créer un nouveau projet.

Les projets commençant par openshift- et kube- sont considérés comme critiques par OpenShift Container Platform. Ainsi, OpenShift Container Platform ne vous permet pas de créer des projets commençant par openshift- à l'aide de la console Web.

Vous ne pouvez pas attribuer de SCC aux pods créés dans l'un des espaces de noms par défaut : default kube-system , kube-public, openshift-node, openshift-infra et openshift. Vous ne pouvez pas utiliser ces espaces de noms pour exécuter des pods ou des services.

Procédure

- Naviguez jusqu'à Home → Projects.

- Cliquez sur Create Project.

- Entrez les détails de votre projet.

- Cliquez sur Create.

2.1.2. Création d'un projet à l'aide de la perspective du développeur dans la console web

Vous pouvez utiliser la perspective Developer dans la console web d'OpenShift Container Platform pour créer un projet dans votre cluster.

Les projets commençant par openshift- et kube- sont considérés comme critiques par OpenShift Container Platform. Ainsi, OpenShift Container Platform ne vous permet pas de créer des projets commençant par openshift- ou kube- à l'aide de la perspective Developer. Les administrateurs de cluster peuvent créer ces projets à l'aide de la commande oc adm new-project.

Vous ne pouvez pas attribuer de SCC aux pods créés dans l'un des espaces de noms par défaut : default kube-system , kube-public, openshift-node, openshift-infra et openshift. Vous ne pouvez pas utiliser ces espaces de noms pour exécuter des pods ou des services.

Conditions préalables

- Assurez-vous que vous disposez des rôles et autorisations appropriés pour créer des projets, des applications et d'autres charges de travail dans OpenShift Container Platform.

Procédure

Vous pouvez créer un projet en utilisant la perspective Developer, comme suit :

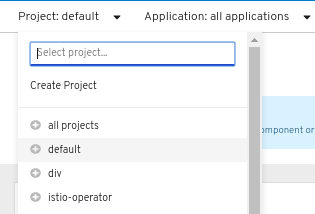

Cliquez sur le menu déroulant Project pour obtenir une liste de tous les projets disponibles. Sélectionnez Create Project.

Figure 2.1. Créer un projet

-

Dans la boîte de dialogue Create Project, saisissez un nom unique, tel que

myproject, dans le champ Name. - Optionnel : Ajoutez les détails Display Name et Description pour le projet.

- Cliquez sur Create.

- Utilisez le panneau de navigation de gauche pour accéder à la vue Project et voir le tableau de bord de votre projet.

En option :

- Utilisez le menu déroulant Project en haut de l'écran et sélectionnez all projects pour lister tous les projets de votre cluster.

- Utilisez l'onglet Details pour voir les détails du projet.

- Si vous disposez des autorisations adéquates pour un projet, vous pouvez utiliser l'onglet Project Access pour accorder ou révoquer les privilèges administrator, edit et view pour le projet.

2.1.3. Création d'un projet à l'aide de l'interface de programmation

Si l'administrateur de votre cluster l'autorise, vous pouvez créer un nouveau projet.

Les projets commençant par openshift- et kube- sont considérés comme critiques par OpenShift Container Platform. Ainsi, OpenShift Container Platform ne vous permet pas de créer des projets commençant par openshift- ou kube- à l'aide de la commande oc new-project. Les administrateurs de clusters peuvent créer ces projets à l'aide de la commande oc adm new-project.

Vous ne pouvez pas attribuer de SCC aux pods créés dans l'un des espaces de noms par défaut : default kube-system , kube-public, openshift-node, openshift-infra et openshift. Vous ne pouvez pas utiliser ces espaces de noms pour exécuter des pods ou des services.

Procédure

Exécutez :

oc new-project <project_name> \ --description="<description>" --display-name="<display_name>"$ oc new-project <project_name> \ --description="<description>" --display-name="<display_name>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Par exemple :

oc new-project hello-openshift \ --description="This is an example project" \ --display-name="Hello OpenShift"$ oc new-project hello-openshift \ --description="This is an example project" \ --display-name="Hello OpenShift"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Le nombre de projets que vous êtes autorisé à créer peut être limité par l'administrateur du système. Une fois la limite atteinte, il se peut que vous deviez supprimer un projet existant pour en créer un nouveau.

2.1.4. Visualiser un projet à l'aide de la console web

Procédure

- Naviguez jusqu'à Home → Projects.

Sélectionnez un projet à visualiser.

Sur cette page, cliquez sur Workloads pour voir les charges de travail du projet.

2.1.5. Visualisation d'un projet à l'aide de l'interface de programmation

Lorsque vous consultez des projets, vous ne pouvez voir que les projets auxquels vous avez accès en vertu de la politique d'autorisation.

Procédure

Pour afficher une liste de projets, exécutez :

oc get projects

$ oc get projectsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Vous pouvez passer du projet actuel à un autre projet pour les opérations de l'interface de programmation. Le projet spécifié est alors utilisé dans toutes les opérations ultérieures qui manipulent le contenu d'un projet :

oc project <nom_du_projet>

oc project <nom_du_projet>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.6. Fournir des autorisations d'accès à votre projet à l'aide de la perspective du développeur

Vous pouvez utiliser la vue Project dans la perspective Developer pour accorder ou révoquer des autorisations d'accès à votre projet.

Procédure

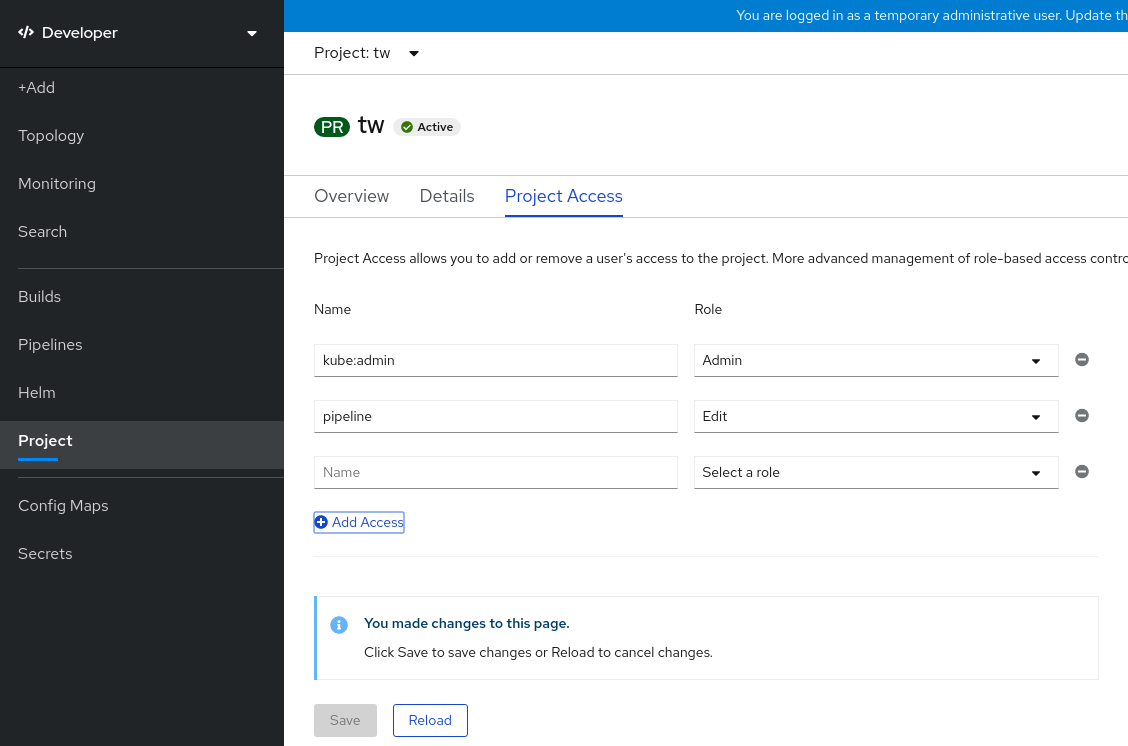

Pour ajouter des utilisateurs à votre projet et leur donner accès à Admin, Edit ou View:

- Dans la perspective Developer, accédez à la vue Project.

- Dans la page Project, sélectionnez l'onglet Project Access.

Cliquez sur Add Access pour ajouter une nouvelle ligne d'autorisations à celles qui sont définies par défaut.

Figure 2.2. Autorisations de projet

- Saisissez le nom de l'utilisateur, cliquez sur la liste déroulante Select a role et sélectionnez un rôle approprié.

- Cliquez sur Save pour ajouter les nouvelles autorisations.

Vous pouvez également utiliser :

- La liste déroulante Select a role, pour modifier les autorisations d'accès d'un utilisateur existant.

- L'icône Remove Access, pour supprimer complètement les autorisations d'accès d'un utilisateur existant au projet.

Le contrôle d'accès avancé basé sur les rôles est géré dans les vues Roles et Roles Binding de la perspective Administrator.

2.1.7. Personnaliser les rôles de cluster disponibles à l'aide de la perspective du développeur

Les utilisateurs d'un projet sont affectés à un rôle de groupe en fonction de leur contrôle d'accès. Vous pouvez accéder à ces rôles en vous rendant sur le site Project → Project access → Role. Par défaut, ces rôles sont Admin, Edit, et View.

Pour ajouter ou modifier les rôles du cluster pour un projet, vous pouvez personnaliser le code YAML du cluster.

Procédure

Pour personnaliser les différents rôles de cluster d'un projet :

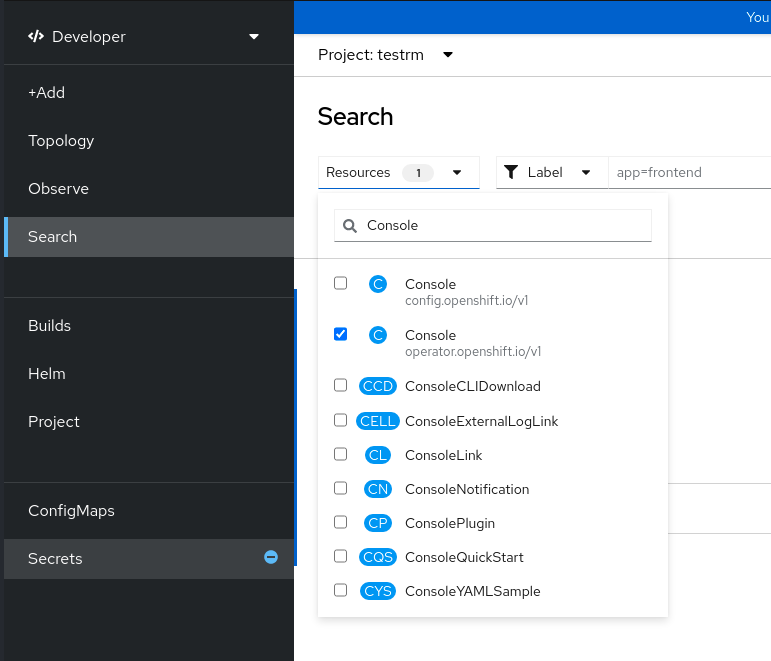

-

Dans la vue Search, utilisez la liste déroulante Resources pour rechercher

Console. Parmi les options disponibles, sélectionnez l'option Console

operator.openshift.io/v1.Figure 2.3. Recherche d'une ressource de la console

- Sélectionnez cluster dans la liste Name.

- Naviguez vers l'onglet YAML pour visualiser et modifier le code YAML.

Dans le code YAML sous

spec, ajoutez ou modifiez la liste deavailableClusterRoleset enregistrez vos modifications :Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.8. Ajouter à un projet

Procédure

- Sélectionnez Developer dans le sélecteur de contexte en haut du menu de navigation de la console web.

- Cliquez sur Add

- En haut de la page, sélectionnez le nom du projet que vous souhaitez ajouter.

- Cliquez sur une méthode à ajouter à votre projet, puis suivez le flux de travail.

Vous pouvez également ajouter des composants à la topologie à l'aide de la recherche rapide.

2.1.9. Vérifier l'état d'un projet à l'aide de la console web

Procédure

- Naviguez jusqu'à Home → Projects.

- Sélectionnez un projet pour connaître son statut.

2.1.10. Vérifier l'état d'un projet à l'aide de l'interface de programmation

Procédure

Exécutez :

oc status

$ oc statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow Cette commande fournit une vue d'ensemble du projet en cours, avec ses composants et leurs relations.

2.1.11. Suppression d'un projet à l'aide de la console web

Vous pouvez supprimer un projet en utilisant la console web d'OpenShift Container Platform.

Si vous n'avez pas le droit de supprimer le projet, l'option Delete Project n'est pas disponible.

Procédure

- Naviguez jusqu'à Home → Projects.

- Localisez le projet que vous souhaitez supprimer dans la liste des projets.

-

À l'extrême droite de la liste des projets, sélectionnez Delete Project dans le menu Options

.

.

- Lorsque le volet Delete Project s'ouvre, saisissez le nom du projet que vous souhaitez supprimer dans le champ.

- Cliquez sur Delete.

2.1.12. Suppression d'un projet à l'aide de l'interface de programmation

Lorsque vous supprimez un projet, le serveur met à jour l'état du projet en le faisant passer de Active à Terminating. Ensuite, le serveur efface tout le contenu d'un projet qui est dans l'état Terminating avant de supprimer définitivement le projet. Tant qu'un projet est dans l'état Terminating, vous ne pouvez pas ajouter de nouveau contenu au projet. Les projets peuvent être supprimés à partir du CLI ou de la console web.

Procédure

Exécutez :

oc delete project <project_name> $ oc delete project <project_name>

oc delete project <project_name> $ oc delete project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2. Créer un projet en tant qu'autre utilisateur

L'usurpation d'identité vous permet de créer un projet en tant qu'utilisateur différent.

2.2.1. L'usurpation d'identité de l'API

Vous pouvez configurer une requête à l'API OpenShift Container Platform pour qu'elle agisse comme si elle provenait d'un autre utilisateur. Pour plus d'informations, voir User impersonation dans la documentation Kubernetes.

2.2.2. Se faire passer pour un utilisateur lors de la création d'un projet

Vous pouvez vous faire passer pour un autre utilisateur lorsque vous créez une demande de projet. Comme system:authenticated:oauth est le seul groupe bootstrap à pouvoir créer des demandes de projet, vous devez vous faire passer pour ce groupe.

Procédure

Pour créer une demande de projet au nom d'un autre utilisateur :

oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauth$ oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauthCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. Configuration de la création de projets

Dans OpenShift Container Platform, projects est utilisé pour regrouper et isoler des objets liés. Lorsqu'une demande est faite pour créer un nouveau projet à l'aide de la console web ou de la commande oc new-project, un point de terminaison dans OpenShift Container Platform est utilisé pour provisionner le projet selon un modèle, qui peut être personnalisé.

En tant qu'administrateur de cluster, vous pouvez autoriser et configurer la façon dont les développeurs et les comptes de service peuvent créer, ou self-provision, leurs propres projets.

2.3.1. A propos de la création de projets

Le serveur API de OpenShift Container Platform fournit automatiquement de nouveaux projets basés sur le modèle de projet identifié par le paramètre projectRequestTemplate dans la ressource de configuration de projet du cluster. Si le paramètre n'est pas défini, le serveur API crée un modèle par défaut qui crée un projet avec le nom demandé et attribue à l'utilisateur demandeur le rôle admin pour ce projet.

Lorsqu'une demande de projet est soumise, l'API substitue les paramètres suivants dans le modèle :

| Paramètres | Description |

|---|---|

|

| Le nom du projet. Obligatoire. |

|

| Le nom d'affichage du projet. Peut être vide. |

|

| La description du projet. Peut être vide. |

|

| Le nom d'utilisateur de l'utilisateur administrateur. |

|

| Le nom d'utilisateur de l'utilisateur demandeur. |

L'accès à l'API est accordé aux développeurs ayant le rôle self-provisioner et le rôle de cluster self-provisioners. Ce rôle est disponible par défaut pour tous les développeurs authentifiés.

2.3.2. Modifier le modèle pour les nouveaux projets

En tant qu'administrateur de cluster, vous pouvez modifier le modèle de projet par défaut afin que les nouveaux projets soient créés en fonction de vos besoins.

Pour créer votre propre modèle de projet personnalisé :

Procédure

-

Connectez-vous en tant qu'utilisateur disposant des privilèges

cluster-admin. Générer le modèle de projet par défaut :

oc adm create-bootstrap-project-template -o yaml > template.yaml

oc adm create-bootstrap-project-template -o yaml > template.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

Utilisez un éditeur de texte pour modifier le fichier

template.yamlgénéré en ajoutant des objets ou en modifiant des objets existants. Le modèle de projet doit être créé dans l'espace de noms

openshift-config. Chargez votre modèle modifié :oc create -f template.yaml -n openshift-config

$ oc create -f template.yaml -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Modifiez la ressource de configuration du projet à l'aide de la console Web ou de la CLI.

En utilisant la console web :

- Naviguez jusqu'à la page Administration → Cluster Settings.

- Cliquez sur Configuration pour afficher toutes les ressources de configuration.

- Trouvez l'entrée pour Project et cliquez sur Edit YAML.

Utilisation de la CLI :

Modifier la ressource

project.config.openshift.io/cluster:oc edit project.config.openshift.io/cluster

$ oc edit project.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Mettez à jour la section

specpour inclure les paramètresprojectRequestTemplateetname, et définissez le nom de votre modèle de projet téléchargé. Le nom par défaut estproject-request.Ressource de configuration de projet avec modèle de projet personnalisé

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Après avoir enregistré vos modifications, créez un nouveau projet pour vérifier que vos modifications ont bien été appliquées.

2.3.3. Désactiver l'auto-provisionnement des projets

Vous pouvez empêcher un groupe d'utilisateurs authentifiés d'auto-approvisionner de nouveaux projets.

Procédure

-

Connectez-vous en tant qu'utilisateur disposant des privilèges

cluster-admin. Affichez l'utilisation de la liaison de rôle du cluster

self-provisionersen exécutant la commande suivante :oc describe clusterrolebinding.rbac self-provisioners

$ oc describe clusterrolebinding.rbac self-provisionersCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Passez en revue les sujets de la section

self-provisioners.Supprimez le rôle de cluster

self-provisionerdu groupesystem:authenticated:oauth.Si la liaison des rôles du cluster

self-provisionerslie uniquement le rôleself-provisionerau groupesystem:authenticated:oauth, exécutez la commande suivante :oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'$ oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Si la liaison du rôle de cluster

self-provisionerslie le rôleself-provisionerà plus d'utilisateurs, de groupes ou de comptes de service que le groupesystem:authenticated:oauth, exécutez la commande suivante :oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauth$ oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauthCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Modifiez le lien du rôle de cluster

self-provisionerspour empêcher les mises à jour automatiques du rôle. Les mises à jour automatiques réinitialisent les rôles de cluster à l'état par défaut.Pour mettre à jour l'attribution des rôles à l'aide de l'interface de ligne de commande :

Exécutez la commande suivante :

oc edit clusterrolebinding.rbac self-provisioners

$ oc edit clusterrolebinding.rbac self-provisionersCopy to Clipboard Copied! Toggle word wrap Toggle overflow Dans la définition de rôle affichée, définissez la valeur du paramètre

rbac.authorization.kubernetes.io/autoupdatesurfalse, comme indiqué dans l'exemple suivant :Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Pour mettre à jour l'attribution des rôles à l'aide d'une seule commande :

oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'$ oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Connectez-vous en tant qu'utilisateur authentifié et vérifiez qu'il n'est plus possible d'auto-provisionner un projet :

oc new-project test

$ oc new-project testCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Error from server (Forbidden): You may not request a new project via this API.

Error from server (Forbidden): You may not request a new project via this API.Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pensez à personnaliser ce message de demande de projet pour fournir des instructions plus utiles et spécifiques à votre organisation.

2.3.4. Personnalisation du message de demande de projet

Lorsqu'un développeur ou un compte de service qui n'est pas en mesure d'auto-provisionner des projets fait une demande de création de projet à l'aide de la console web ou de la CLI, le message d'erreur suivant est renvoyé par défaut :

You may not request a new project via this API.

You may not request a new project via this API.Les administrateurs de clusters peuvent personnaliser ce message. Envisagez de le mettre à jour pour fournir des instructions supplémentaires sur la manière de demander un nouveau projet spécifique à votre organisation. Par exemple :

-

Pour demander un projet, contactez votre administrateur système à l'adresse

projectname@example.com. -

Pour demander un nouveau projet, remplissez le formulaire de demande de projet situé à l'adresse

https://internal.example.com/openshift-project-request.

Pour personnaliser le message de demande de projet :

Procédure

Modifiez la ressource de configuration du projet à l'aide de la console Web ou de la CLI.

En utilisant la console web :

- Naviguez jusqu'à la page Administration → Cluster Settings.

- Cliquez sur Configuration pour afficher toutes les ressources de configuration.

- Trouvez l'entrée pour Project et cliquez sur Edit YAML.

Utilisation de la CLI :

-

Connectez-vous en tant qu'utilisateur disposant des privilèges

cluster-admin. Modifier la ressource

project.config.openshift.io/cluster:oc edit project.config.openshift.io/cluster

$ oc edit project.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

Connectez-vous en tant qu'utilisateur disposant des privilèges

Mettez à jour la section

specpour inclure le paramètreprojectRequestMessageet définissez la valeur de votre message personnalisé :Ressource de configuration de projet avec message de demande de projet personnalisé

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Par exemple :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Après avoir enregistré vos modifications, essayez de créer un nouveau projet en tant que développeur ou compte de service qui n'est pas en mesure d'auto-provisionner des projets afin de vérifier que vos modifications ont été appliquées avec succès.

Chapitre 3. Création d'applications

3.1. Créer des applications à l'aide de la perspective du développeur

La perspective Developer de la console web vous offre les options suivantes à partir de la vue Add pour créer des applications et des services associés et les déployer sur OpenShift Container Platform :

Getting started resources: Utilisez ces ressources pour vous aider à démarrer avec la Developer Console. Vous pouvez choisir de masquer l'en-tête à l'aide du menu Options

.

.

- Creating applications using samples: Utiliser des échantillons de code existants pour commencer à créer des applications sur OpenShift Container Platform.

- Build with guided documentation: Suivez la documentation guidée pour créer des applications et vous familiariser avec les concepts et terminologies clés.

- Explore new developer features: Explorez les nouvelles fonctionnalités et ressources de la perspective Developer.

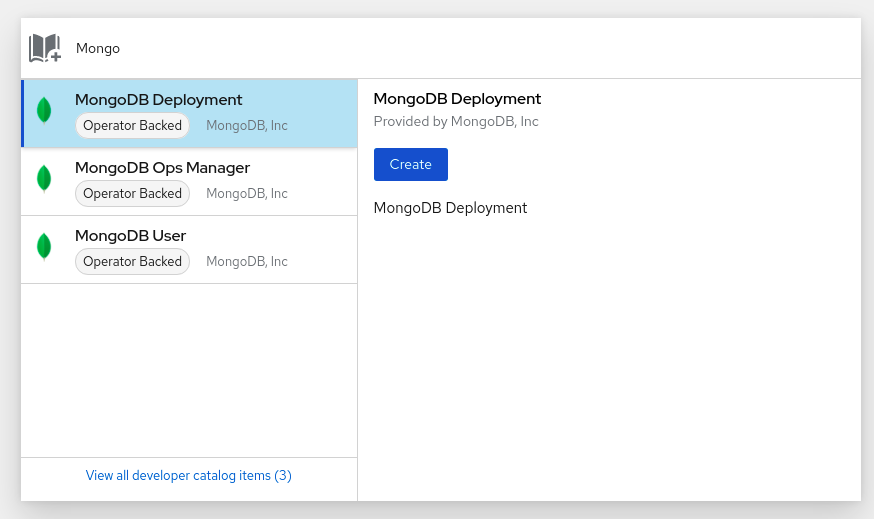

Developer catalog: Explorez le catalogue des développeurs pour sélectionner les applications, services ou sources nécessaires aux constructeurs d'images, puis ajoutez-les à votre projet.

- All Services: Parcourez le catalogue pour découvrir les services d'OpenShift Container Platform.

- Database: Sélectionnez le service de base de données requis et ajoutez-le à votre application.

- Operator Backed: Sélectionner et déployer le service géré par l'opérateur requis.

- Helm chart: Sélectionnez la carte Helm requise pour simplifier le déploiement des applications et des services.

- Devfile: Sélectionnez un fichier de développement sur le site Devfile registry pour définir de manière déclarative un environnement de développement.

Event Source: Sélectionner une source d'événements pour s'intéresser à une classe d'événements provenant d'un système particulier.

NoteL'option Services gérés est également disponible si le RHOAS Operator est installé.

- Git repository: Importez une base de code existante, un fichier Devfile ou un fichier Docker depuis votre dépôt Git en utilisant les options From Git, From Devfile, ou From Dockerfile respectivement, pour construire et déployer une application sur OpenShift Container Platform.

- Container images: Utiliser des images existantes à partir d'un flux d'images ou d'un registre pour les déployer sur OpenShift Container Platform.

- Pipelines: Utilisez Tekton pipeline pour créer des pipelines CI/CD pour votre processus de livraison de logiciels sur OpenShift Container Platform.

Serverless: Explorer les options Serverless pour créer, construire et déployer des applications sans état et sans serveur sur OpenShift Container Platform.

- Channel: Créer un canal Knative pour créer une couche de transmission et de persistance des événements avec des implémentations en mémoire et fiables.

- Samples: Explorer les exemples d'applications disponibles pour créer, construire et déployer rapidement une application.

- Quick Starts: Explorez les options de démarrage rapide pour créer, importer et exécuter des applications à l'aide d'instructions et de tâches étape par étape.

From Local Machine: Explorez la tuile From Local Machine pour importer ou télécharger des fichiers sur votre machine locale afin de créer et de déployer facilement des applications.

- Import YAML: Chargement d'un fichier YAML pour créer et définir des ressources pour la construction et le déploiement d'applications.

- Upload JAR file: Télécharger un fichier JAR pour créer et déployer des applications Java.

- Share my Project: Cette option permet d'ajouter ou de supprimer des utilisateurs à un projet et de leur fournir des options d'accessibilité.

- Helm Chart repositories: Cette option permet d'ajouter des référentiels Helm Chart dans un espace de noms.

- Re-ordering of resources: Utilisez ces ressources pour réorganiser les ressources épinglées ajoutées à votre volet de navigation. L'icône de glisser-déposer s'affiche sur le côté gauche de la ressource épinglée lorsque vous la survolez dans le volet de navigation. La ressource glissée ne peut être déposée que dans la section où elle se trouve.

Notez que certaines options, telles que Pipelines, Event Source, et Import Virtual Machines, ne sont affichées que lorsque OpenShift Pipelines Operator, OpenShift Serverless Operator, et OpenShift Virtualization Operator sont installés, respectivement.

3.1.1. Conditions préalables

Pour créer des applications à l'aide de la perspective Developer, il faut s'assurer que

- Vous vous êtes connecté à la console web.

- Vous avez créé un projet ou avez accès à un projet avec les rôles et autorisations appropriés pour créer des applications et d'autres charges de travail dans OpenShift Container Platform.

Pour créer des applications sans serveur, en plus des prérequis précédents, assurez-vous que :

3.1.2. Création d'exemples d'applications

Vous pouvez utiliser les exemples d'applications dans le flux Add de la perspective Developer pour créer, construire et déployer rapidement des applications.

Conditions préalables

- Vous vous êtes connecté à la console web de OpenShift Container Platform et vous êtes dans la perspective Developer.

Procédure

- Dans la vue Add, cliquez sur la tuile Samples pour afficher la page Samples.

- Sur la page Samples, sélectionnez l'un des exemples de candidature disponibles pour voir le formulaire Create Sample Application.

Sur le site Create Sample Application Form:

- Dans le champ Name, le nom du déploiement est affiché par défaut. Vous pouvez modifier ce nom si nécessaire.

- Dans le site Builder Image Version, une image de constructeur est sélectionnée par défaut. Vous pouvez modifier cette version de l'image en utilisant la liste déroulante Builder Image Version.

- Un exemple d'URL de dépôt Git est ajouté par défaut.

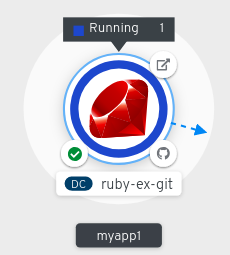

- Cliquez sur Create pour créer l'exemple d'application. L'état de construction de l'application d'exemple est affiché sur la vue Topology. Une fois l'application exemple créée, vous pouvez voir le déploiement ajouté à l'application.

3.1.3. Création d'applications à l'aide de Quick Starts

La page Quick Starts vous montre comment créer, importer et exécuter des applications sur OpenShift Container Platform, avec des instructions et des tâches étape par étape.

Conditions préalables

- Vous vous êtes connecté à la console web de OpenShift Container Platform et vous êtes dans la perspective Developer.

Procédure

- Dans la vue Add, cliquez sur le lien View all quick starts pour afficher la page Quick Starts.

- Dans la page Quick Starts, cliquez sur la tuile correspondant au démarrage rapide que vous souhaitez utiliser.

- Cliquez sur Start pour commencer le démarrage rapide.

3.1.4. Importer une base de code depuis Git pour créer une application

Vous pouvez utiliser la perspective Developer pour créer, construire et déployer une application sur OpenShift Container Platform en utilisant une base de code existante sur GitHub.

La procédure suivante vous guide à travers l'option From Git dans la perspective Developer pour créer une application.

Procédure

- Dans la vue Add, cliquez sur From Git dans la tuile Git Repository pour afficher le formulaire Import from git.

-

Dans la section Git, entrez l'URL du dépôt Git pour la base de code que vous souhaitez utiliser pour créer une application. Par exemple, entrez l'URL de cet exemple d'application Node.js

https://github.com/sclorg/nodejs-ex. L'URL est ensuite validée. Facultatif : vous pouvez cliquer sur Show Advanced Git Options pour ajouter des détails tels que

- Git Reference pour pointer vers le code d'une branche, d'une balise ou d'un commit spécifique à utiliser pour construire l'application.

- Context Dir pour spécifier le sous-répertoire du code source de l'application que vous voulez utiliser pour construire l'application.

- Source Secret pour créer un site Secret Name avec des informations d'identification permettant d'extraire votre code source d'un dépôt privé.

Facultatif : vous pouvez importer un fichier de développement, un fichier Docker ou une image de construction via votre dépôt Git pour personnaliser davantage votre déploiement.

- Si votre dépôt Git contient un fichier devfile, un fichier Docker ou une image builder, il est automatiquement détecté et renseigné dans les champs de chemin respectifs. Si un fichier devfile, un fichier Docker et une image builder sont détectés dans le même dépôt, le fichier devfile est sélectionné par défaut.

- Pour modifier le type d'importation de fichiers et sélectionner une stratégie différente, cliquez sur l'option Edit import strategy.

- Si plusieurs devfiles, Dockerfiles ou images de constructeur sont détectés, pour importer un devfile, un Dockerfile ou une image de constructeur spécifique, spécifiez les chemins respectifs relatifs au répertoire contextuel.

Une fois l'URL Git validée, l'image du constructeur recommandée est sélectionnée et marquée d'une étoile. Si l'image du constructeur n'est pas détectée automatiquement, sélectionnez-en une. Pour l'URL

https://github.com/sclorg/nodejs-exGit, l'image du constructeur Node.js est sélectionnée par défaut.- Facultatif : Utilisez la liste déroulante Builder Image Version pour spécifier une version.

- En outre, il est possible de choisir une stratégie différente en utilisant le site : Utilisez le site Edit import strategy pour sélectionner une autre stratégie.

- Facultatif : Pour l'image du constructeur Node.js, utilisez le champ Run command pour remplacer la commande d'exécution de l'application.

Dans la section General:

-

Dans le champ Application, saisissez un nom unique pour le groupe d'applications, par exemple

myapp. Assurez-vous que le nom de l'application est unique dans un espace de noms. Le champ Name pour identifier les ressources créées pour cette application est automatiquement rempli sur la base de l'URL du dépôt Git s'il n'y a pas d'applications existantes. S'il y a des applications existantes, vous pouvez choisir de déployer le composant dans une application existante, de créer une nouvelle application ou de garder le composant non assigné.

NoteLe nom de la ressource doit être unique dans un espace de noms. Modifiez le nom de la ressource si vous obtenez une erreur.

-

Dans le champ Application, saisissez un nom unique pour le groupe d'applications, par exemple

Dans la section Resources, sélectionnez :

- Deploymentil s'agit de créer une application à la manière de Kubernetes.

- Deployment Configl'objectif est de créer une application de type OpenShift Container Platform.

Serverless Deploymentpour créer un service Knative.

NoteVous pouvez définir la préférence de ressource par défaut pour l'importation en parcourant la page Préférences utilisateur et en cliquant sur Applications → champ Resource type. L'option Serverless Deployment s'affiche dans le formulaire Import from Git uniquement si l'opérateur OpenShift Serverless est installé dans votre cluster. Pour plus de détails, reportez-vous à la documentation d'OpenShift Serverless.

- Dans la section Pipelines, sélectionnez Add Pipeline, puis cliquez sur Show Pipeline Visualization pour voir le pipeline de l'application. Un pipeline par défaut est sélectionné, mais vous pouvez choisir le pipeline que vous souhaitez dans la liste des pipelines disponibles pour l'application.

Facultatif : dans la section Advanced Options, les adresses Target port et Create a route to the application sont sélectionnées par défaut afin que vous puissiez accéder à votre application à l'aide d'une URL publique.

Si votre application n'expose pas ses données sur le port public par défaut, 80, décochez la case et définissez le numéro du port cible que vous souhaitez exposer.

- Facultatif : Vous pouvez utiliser les options avancées suivantes pour personnaliser davantage votre application :

- Routage

En cliquant sur le lien Routing, vous pouvez effectuer les actions suivantes :

- Personnaliser le nom d'hôte de l'itinéraire.

- Spécifiez le chemin que le routeur surveille.

- Sélectionnez le port cible pour le trafic dans la liste déroulante.

Sécurisez votre itinéraire en cochant la case Secure Route. Sélectionnez le type de terminaison TLS requis et définissez une politique pour le trafic non sécurisé dans les listes déroulantes correspondantes.

NotePour les applications sans serveur, le service Knative gère toutes les options de routage ci-dessus. Cependant, vous pouvez personnaliser le port cible pour le trafic, si nécessaire. Si le port cible n'est pas spécifié, le port par défaut de

8080est utilisé.

- Cartographie du domaine

Si vous créez un site Serverless Deployment, vous pouvez ajouter un mappage de domaine personnalisé au service Knative lors de sa création.

Dans la section Advanced options, cliquez sur Show advanced Routing options.

- Si le CR de mappage de domaine que vous souhaitez mapper au service existe déjà, vous pouvez le sélectionner dans le menu déroulant Domain mapping.

-

Si vous voulez créer un nouveau CR de mappage de domaine, tapez le nom de domaine dans la case et sélectionnez l'option Create. Par exemple, si vous tapez

example.com, l'option Create est Create "example.com".

- Bilans de santé

Cliquez sur le lien Health Checks pour ajouter des sondes de préparation, d'activité et de démarrage à votre application. Toutes les sondes ont des données par défaut pré-remplies ; vous pouvez ajouter les sondes avec les données par défaut ou les personnaliser selon vos besoins.

Pour personnaliser les sondes de santé :

- Cliquez sur Add Readiness Probe, si nécessaire, modifiez les paramètres pour vérifier si le conteneur est prêt à traiter les demandes, et cochez la case pour ajouter la sonde.

- Cliquez sur Add Liveness Probe, si nécessaire, modifiez les paramètres pour vérifier si un conteneur est toujours en cours d'exécution, et cochez la case pour ajouter la sonde.

Cliquez sur Add Startup Probe, si nécessaire, modifiez les paramètres pour vérifier si l'application dans le conteneur a démarré, et cochez la case pour ajouter la sonde.

Pour chacune des sondes, vous pouvez spécifier le type de demande - HTTP GET, Container Command, ou TCP Socket, dans la liste déroulante. Le formulaire change en fonction du type de demande sélectionné. Vous pouvez ensuite modifier les valeurs par défaut des autres paramètres, tels que les seuils de réussite et d'échec de la sonde, le nombre de secondes avant d'effectuer la première sonde après le démarrage du conteneur, la fréquence de la sonde et la valeur du délai d'attente.

- Configuration et déploiement de la construction

Cliquez sur les liens Build Configuration et Deployment pour voir les options de configuration correspondantes. Certaines options sont sélectionnées par défaut ; vous pouvez les personnaliser davantage en ajoutant les déclencheurs et les variables d'environnement nécessaires.

Pour les applications sans serveur, l'option Deployment n'est pas affichée car la ressource de configuration Knative maintient l'état souhaité pour votre déploiement au lieu d'une ressource

DeploymentConfig.

- Mise à l'échelle

Cliquez sur le lien Scaling pour définir le nombre de pods ou d'instances de l'application que vous souhaitez déployer initialement.

Si vous créez un déploiement sans serveur, vous pouvez également configurer les paramètres suivants :

-

Min Pods détermine la limite inférieure du nombre de pods qui doivent fonctionner à tout moment pour un service Knative. Ce paramètre est également connu sous le nom de

minScale. -

Max Pods détermine la limite supérieure du nombre de pods qui peuvent être en cours d'exécution à tout moment pour un service Knative. Ce paramètre est également connu sous le nom de

maxScale. - Concurrency target détermine le nombre de requêtes simultanées souhaitées pour chaque instance de l'application à un moment donné.

- Concurrency limit détermine la limite du nombre de requêtes simultanées autorisées pour chaque instance de l'application à un moment donné.

- Concurrency utilization détermine le pourcentage de la limite de requêtes simultanées qui doit être atteint avant que Knative ne mette à l'échelle des pods supplémentaires pour gérer le trafic additionnel.

-

Autoscale window définit la fenêtre temporelle sur laquelle les métriques sont moyennées afin de fournir des informations pour les décisions de mise à l'échelle lorsque l'autoscaler n'est pas en mode panique. Un service est mis à l'échelle zéro si aucune demande n'est reçue pendant cette fenêtre. La durée par défaut de la fenêtre d'autoscale est

60s. Cette fenêtre est également connue sous le nom de fenêtre stable.

-

Min Pods détermine la limite inférieure du nombre de pods qui doivent fonctionner à tout moment pour un service Knative. Ce paramètre est également connu sous le nom de

- Limite des ressources

- Cliquez sur le lien Resource Limit pour définir la quantité de ressources CPU et Memory qu'un conteneur est garanti ou autorisé à utiliser lorsqu'il est en cours d'exécution.

- Étiquettes

Cliquez sur le lien Labels pour ajouter des étiquettes personnalisées à votre application.

- Cliquez sur Create pour créer l'application et une notification de réussite s'affiche. Vous pouvez voir l'état de la construction de l'application dans la vue Topology.

3.1.5. Téléchargement de fichiers JAR pour faciliter le déploiement d'applications Java

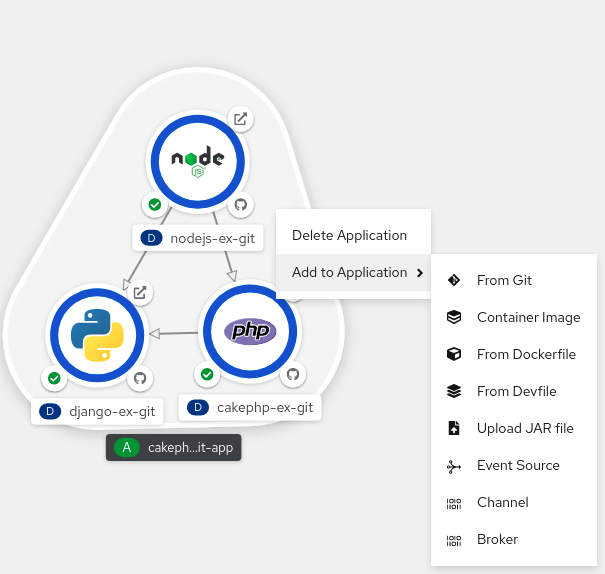

Vous pouvez utiliser les fichiers JAR dans la vue Topology de la perspective Developer pour déployer vos applications Java. Vous pouvez télécharger un fichier JAR à l'aide des options suivantes :

- Naviguez jusqu'à la vue Add de la perspective Developer et cliquez sur Upload JAR file dans la tuile From Local Machine. Parcourez et sélectionnez votre fichier JAR, ou glissez-déposez un fichier JAR pour déployer votre application.

- Naviguez jusqu'à la vue Topology et utilisez l'option Upload JAR file, ou glissez-déposez un fichier JAR pour déployer votre application.

- Utilisez le menu en contexte dans la vue Topology, puis utilisez l'option Upload JAR file pour télécharger votre fichier JAR afin de déployer votre application.

Suivez les instructions suivantes pour télécharger un fichier JAR dans la vue Topology afin de déployer une application Java :

Procédure

- Dans la vue Topology, cliquez avec le bouton droit de la souris n'importe où dans la vue Topology pour afficher le menu Add to Project.

- Survolez le menu Add to Project pour voir les options du menu, puis sélectionnez l'option Upload JAR file pour voir le formulaire Upload JAR file. Vous pouvez également faire glisser et déposer le fichier JAR dans la vue Topology.

- Dans le champ JAR file, recherchez le fichier JAR requis sur votre machine locale et téléchargez-le. Vous pouvez également glisser-déposer le fichier JAR dans le champ. Un message d'alerte s'affiche en haut à droite si un type de fichier incompatible est glissé-déposé dans la vue Topology. Une erreur de champ s'affiche si un type de fichier incompatible est déposé sur le champ dans le formulaire de téléchargement.

- Vous pouvez également spécifier des commandes Java optionnelles pour personnaliser votre application déployée. L'icône d'exécution et l'image du constructeur sont sélectionnées par défaut. Si une image de constructeur n'est pas détectée automatiquement, sélectionnez-en une. Si nécessaire, vous pouvez modifier la version à l'aide de la liste déroulante Builder Image Version.

- Dans le champ facultatif Application Name, saisissez un nom unique pour votre application d'étiquetage des ressources.

- Dans le champ Name, saisissez un nom de composant unique pour les ressources associées.

- Facultatif : Dans la liste déroulante Advanced options → Resource type, sélectionnez un autre type de ressource dans la liste des types de ressources par défaut.

- Dans le site Advanced options, cliquez sur Create a Route to the Application pour configurer une URL publique pour votre application déployée.

Cliquez sur Create pour déployer l'application. L'utilisateur voit une notification de toast l'informant que le fichier JAR est en train d'être téléchargé et que cela prend un certain temps. La notification de toast comprend également un lien permettant de consulter les journaux de construction.

NoteSi l'utilisateur tente de fermer l'onglet du navigateur pendant que la construction est en cours, une alerte web s'affiche pour demander à l'utilisateur s'il souhaite réellement quitter la page.

Une fois le fichier JAR téléchargé et l'application déployée, vous pouvez voir le déploiement dans la vue Topology.

3.1.6. Utilisation du registre Devfile pour accéder aux fichiers Devfile

Vous pouvez utiliser les devfiles dans le flux Add de la perspective Developer pour créer une application. Le flux Add offre une intégration complète avec le registre communautaire des devfiles. Un fichier devfile est un fichier YAML portable qui décrit votre environnement de développement sans qu'il soit nécessaire de le configurer à partir de zéro. En utilisant la perspective Devfile registry, vous pouvez utiliser un fichier devfile préconfiguré pour créer une application.

Procédure

- Naviguez vers Developer Perspective → Add → Developer Catalog → All Services. Une liste de tous les services disponibles sur le site Developer Catalog s'affiche.

- Sous All Services, sélectionnez Devfiles pour rechercher les fichiers de développement qui prennent en charge un langage ou un cadre particulier. Vous pouvez également utiliser le filtre par mot-clé pour rechercher un fichier de développement particulier à l'aide de son nom, de son étiquette ou de sa description.

- Cliquez sur le fichier de développement que vous souhaitez utiliser pour créer une application. La tuile devfile affiche les détails du devfile, y compris le nom, la description, le fournisseur et la documentation du devfile.

- Cliquez sur Create pour créer une application et la visualiser dans la vue Topology.

3.1.7. Utiliser le catalogue du développeur pour ajouter des services ou des composants à votre application

Vous utilisez le catalogue de développeurs pour déployer des applications et des services basés sur des services soutenus par l'opérateur, tels que les bases de données, les images de constructeurs et les diagrammes Helm. Le catalogue des développeurs contient une collection de composants d'application, de services, de sources d'événements ou de constructeurs source-image que vous pouvez ajouter à votre projet. Les administrateurs de clusters peuvent personnaliser le contenu mis à disposition dans le catalogue.

Procédure

- Dans la perspective Developer, naviguez jusqu'à la vue Add et, à partir de la tuile Developer Catalog, cliquez sur All Services pour afficher tous les services disponibles sur Developer Catalog.

- Sous All Services, sélectionnez le type de service ou le composant que vous devez ajouter à votre projet. Pour cet exemple, sélectionnez Databases pour obtenir la liste de tous les services de base de données, puis cliquez sur MariaDB pour afficher les détails du service.

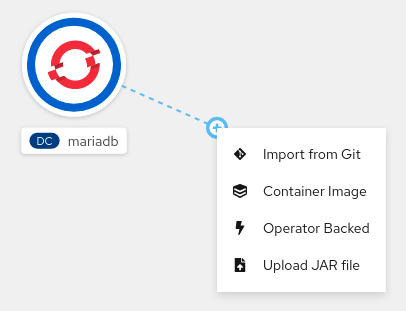

Cliquez sur Instantiate Template pour afficher un modèle automatiquement rempli avec les détails du service MariaDB, puis cliquez sur Create pour créer et afficher le service MariaDB dans la vue Topology.

Figure 3.1. MariaDB dans la topologie

3.2. Création d'applications à partir d'opérateurs installés

Operators sont une méthode de conditionnement, de déploiement et de gestion d'une application Kubernetes. Vous pouvez créer des applications sur OpenShift Container Platform à l'aide d'opérateurs qui ont été installés par un administrateur de cluster.

Ce guide présente aux développeurs un exemple de création d'applications à partir d'un opérateur installé en utilisant la console web d'OpenShift Container Platform.

3.2.1. Création d'un cluster etcd à l'aide d'un opérateur

Cette procédure décrit la création d'un nouveau cluster etcd à l'aide de l'opérateur etcd, géré par Operator Lifecycle Manager (OLM).

Conditions préalables

- Accès à un cluster OpenShift Container Platform 4.12.

- L'opérateur etcd a déjà été installé par un administrateur sur l'ensemble du cluster.

Procédure

-

Créez un nouveau projet dans la console web d'OpenShift Container Platform pour cette procédure. Cet exemple utilise un projet appelé

my-etcd. Naviguez jusqu'à la page Operators → Installed Operators. Les opérateurs qui ont été installés sur la grappe par l'administrateur de la grappe et qui sont disponibles pour être utilisés sont affichés ici sous la forme d'une liste de versions de service de grappe (CSV). Les CSV sont utilisées pour lancer et gérer le logiciel fourni par l'opérateur.

AstuceVous pouvez obtenir cette liste à partir de l'interface de programmation en utilisant :

oc get csv

$ oc get csvCopy to Clipboard Copied! Toggle word wrap Toggle overflow Sur la page Installed Operators, cliquez sur l'opérateur etcd pour obtenir plus de détails et connaître les actions disponibles.

Comme indiqué sous Provided APIs, cet opérateur met à disposition trois nouveaux types de ressources, dont un pour un etcd Cluster (la ressource

EtcdCluster). Ces objets fonctionnent de la même manière que les objets Kubernetes natifs intégrés, tels queDeploymentouReplicaSet, mais contiennent une logique spécifique à la gestion de etcd.Créer un nouveau cluster etcd :

- Dans la boîte API etcd Cluster, cliquez sur Create instance.

-

L'écran suivant vous permet d'apporter des modifications au modèle minimal de départ d'un objet

EtcdCluster, comme la taille de l'amas. Pour l'instant, cliquez sur Create pour finaliser. Cela déclenche le démarrage par l'opérateur des pods, des services et des autres composants du nouveau cluster etcd.

Cliquez sur le cluster etcd example, puis sur l'onglet Resources pour voir que votre projet contient maintenant un certain nombre de ressources créées et configurées automatiquement par l'Opérateur.

Vérifiez qu'un service Kubernetes a été créé pour vous permettre d'accéder à la base de données depuis d'autres pods de votre projet.

Tous les utilisateurs ayant le rôle

editdans un projet donné peuvent créer, gérer et supprimer des instances d'application (un cluster etcd, dans cet exemple) gérées par des opérateurs qui ont déjà été créés dans le projet, en libre-service, comme dans un service en nuage. Si vous souhaitez donner cette possibilité à d'autres utilisateurs, les administrateurs du projet peuvent ajouter le rôle à l'aide de la commande suivante :oc policy add-role-to-user edit <user> -n <target_project>

$ oc policy add-role-to-user edit <user> -n <target_project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Vous disposez désormais d'un cluster etcd qui réagit aux pannes et rééquilibre les données lorsque les pods deviennent malsains ou sont migrés entre les nœuds du cluster. Plus important encore, les administrateurs de clusters ou les développeurs disposant d'un accès approprié peuvent désormais facilement utiliser la base de données avec leurs applications.

3.3. Création d'applications à l'aide de l'interface de programmation

Vous pouvez créer une application OpenShift Container Platform à partir de composants qui incluent du code source ou binaire, des images et des modèles en utilisant la CLI d'OpenShift Container Platform.

L'ensemble des objets créés par new-app dépend des artefacts transmis en entrée : référentiels de sources, images ou modèles.

3.3.1. Créer une application à partir du code source

La commande new-app permet de créer des applications à partir du code source d'un dépôt Git local ou distant.

La commande new-app crée une configuration de construction, qui elle-même crée une nouvelle image d'application à partir de votre code source. La commande new-app crée également un objet Deployment pour déployer la nouvelle image et un service pour fournir un accès équilibré au déploiement de votre image.

OpenShift Container Platform détecte automatiquement si la stratégie de construction pipeline, source ou docker doit être utilisée, et dans le cas de la construction source, détecte une image de constructeur de langage appropriée.

3.3.1.1. Locale

Pour créer une application à partir d'un dépôt Git dans un répertoire local :

oc new-app /<chemin d'accès au code source>

oc new-app /<chemin d'accès au code source>

Si vous utilisez un dépôt Git local, le dépôt doit avoir un remote nommé origin qui pointe vers une URL accessible par le cluster OpenShift Container Platform. S'il n'y a pas de remote reconnu, l'exécution de la commande new-app créera un build binaire.

3.3.1.2. A distance

Pour créer une application à partir d'un dépôt Git distant :

oc new-app https://github.com/sclorg/cakephp-ex

$ oc new-app https://github.com/sclorg/cakephp-exPour créer une application à partir d'un dépôt Git privé et distant :

oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

$ oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

Si vous utilisez un dépôt Git distant privé, vous pouvez utiliser l'option --source-secret pour spécifier un secret de clone source existant qui sera injecté dans votre configuration de construction pour accéder au dépôt.

Vous pouvez utiliser un sous-répertoire de votre dépôt de code source en spécifiant un drapeau --context-dir. Pour créer une application à partir d'un dépôt Git distant et d'un sous-répertoire contextuel :

oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

$ oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

De plus, lorsque vous spécifiez une URL distante, vous pouvez spécifier une branche Git à utiliser en ajoutant #<branch_name> à la fin de l'URL :

oc new-app https://github.com/openshift/ruby-hello-world.git#beta4

$ oc new-app https://github.com/openshift/ruby-hello-world.git#beta43.3.1.3. Détection de la stratégie de construction

OpenShift Container Platform détermine automatiquement la stratégie de construction à utiliser en détectant certains fichiers :

Si un fichier Jenkins existe dans le répertoire racine ou le répertoire contextuel spécifié du référentiel source lors de la création d'une nouvelle application, OpenShift Container Platform génère une stratégie de construction de pipeline.

NoteLa stratégie de construction

pipelineest obsolète ; envisagez d'utiliser Red Hat OpenShift Pipelines à la place.- Si un fichier Docker existe dans le répertoire racine ou le répertoire contextuel spécifié du référentiel source lors de la création d'une nouvelle application, OpenShift Container Platform génère une stratégie de construction Docker.

- Si aucun fichier Jenkins ou Docker n'est détecté, OpenShift Container Platform génère une stratégie de construction de source.

Ignorez la stratégie de construction détectée automatiquement en attribuant à l'indicateur --strategy la valeur docker, pipeline ou source.

oc new-app /home/user/code/myapp --strategy=docker

$ oc new-app /home/user/code/myapp --strategy=docker

La commande oc nécessite que les fichiers contenant les sources de compilation soient disponibles dans un dépôt Git distant. Pour toutes les constructions de sources, vous devez utiliser git remote -v.

3.3.1.4. Détection des langues

Si vous utilisez la stratégie de construction des sources, new-app tente de déterminer le constructeur de langage à utiliser en fonction de la présence de certains fichiers dans le répertoire racine ou le répertoire contextuel spécifié du référentiel :

| Langue | Dossiers |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Après la détection d'une langue, new-app recherche sur le serveur OpenShift Container Platform des balises de flux d'images ayant une annotation supports correspondant à la langue détectée, ou un flux d'images correspondant au nom de la langue détectée. Si aucune correspondance n'est trouvée, new-app recherche dans le registre Docker Hub une image dont le nom correspond à la langue détectée.

Vous pouvez remplacer l'image que le constructeur utilise pour un référentiel source particulier en spécifiant l'image, soit un flux d'images ou une spécification de conteneur, et le référentiel avec un ~ comme séparateur. Notez que dans ce cas, la détection de la stratégie de construction et la détection de la langue ne sont pas effectuées.

Par exemple, pour utiliser le flux d'images myproject/my-ruby dont la source se trouve dans un dépôt distant :

oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

$ oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

Pour utiliser le flux d'images du conteneur openshift/ruby-20-centos7:latest avec la source dans un dépôt local :

oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

$ oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

La détection de la langue nécessite que le client Git soit installé localement afin que votre dépôt puisse être cloné et inspecté. Si Git n'est pas disponible, vous pouvez éviter l'étape de détection de la langue en spécifiant l'image du constructeur à utiliser avec votre référentiel à l'aide de la syntaxe <image>~<repository>.

L'invocation de -i <image> <repository> nécessite que new-app tente de cloner repository afin de déterminer le type d'artefact, ce qui échouera si Git n'est pas disponible.

L'invocation -i <image> --code <repository> demande à new-app de cloner repository pour déterminer si image doit être utilisé comme constructeur du code source ou déployé séparément, comme dans le cas d'une image de base de données.

3.3.2. Créer une application à partir d'une image

Vous pouvez déployer une application à partir d'une image existante. Les images peuvent provenir de flux d'images dans le serveur OpenShift Container Platform, d'images dans un registre spécifique ou d'images dans le serveur Docker local.

La commande new-app tente de déterminer le type d'image spécifié dans les arguments qui lui sont transmis. Toutefois, vous pouvez indiquer explicitement à new-app s'il s'agit d'une image conteneur en utilisant l'argument --docker-image ou d'un flux d'images en utilisant l'argument -i|--image-stream.

Si vous spécifiez une image à partir de votre dépôt Docker local, vous devez vous assurer que la même image est disponible pour les nœuds du cluster OpenShift Container Platform.

3.3.2.1. Image Docker Hub MySQL

Créez une application à partir de l'image MySQL de Docker Hub, par exemple :

oc new-app mysql

$ oc new-app mysql3.3.2.2. Image dans un registre privé

Créer une application en utilisant une image dans un registre privé, spécifier la spécification complète de l'image du conteneur :

oc new-app myregistry:5000/example/myimage

$ oc new-app myregistry:5000/example/myimage3.3.2.3. Flux d'images existant et balise de flux d'images optionnelle

Créer une application à partir d'un flux d'images existant et d'une balise de flux d'images optionnelle :

oc new-app my-stream:v1

$ oc new-app my-stream:v13.3.3. Créer une application à partir d'un modèle

Vous pouvez créer une application à partir d'un modèle précédemment stocké ou d'un fichier de modèle, en spécifiant le nom du modèle comme argument. Par exemple, vous pouvez stocker un modèle d'application et l'utiliser pour créer une application.

Téléchargez un modèle d'application dans la bibliothèque de modèles de votre projet actuel. L'exemple suivant télécharge un modèle d'application à partir d'un fichier appelé examples/sample-app/application-template-stibuild.json:

oc create -f examples/sample-app/application-template-stibuild.json

$ oc create -f examples/sample-app/application-template-stibuild.json

Créez ensuite une nouvelle application en faisant référence au modèle d'application. Dans cet exemple, le nom du modèle est ruby-helloworld-sample:

oc new-app ruby-helloworld-sample

$ oc new-app ruby-helloworld-sample

Pour créer une nouvelle application en faisant référence à un fichier modèle dans votre système de fichiers local, sans le stocker au préalable dans OpenShift Container Platform, utilisez l'argument -f|--file. Par exemple :

oc new-app -f examples/sample-app/application-template-stibuild.json

$ oc new-app -f examples/sample-app/application-template-stibuild.json3.3.3.1. Paramètres du modèle

Lors de la création d'une application basée sur un modèle, utilisez l'argument -p|--param pour définir les valeurs des paramètres définis par le modèle :

oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

$ oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

Vous pouvez stocker vos paramètres dans un fichier, puis utiliser ce fichier avec --param-file lors de l'instanciation d'un modèle. Si vous souhaitez lire les paramètres à partir de l'entrée standard, utilisez --param-file=-. Voici un exemple de fichier appelé helloworld.params:

ADMIN_USERNAME=admin ADMIN_PASSWORD=mypassword

ADMIN_USERNAME=admin

ADMIN_PASSWORD=mypasswordFaire référence aux paramètres du fichier lors de l'instanciation d'un modèle :

oc new-app ruby-helloworld-sample --param-file=helloworld.params

$ oc new-app ruby-helloworld-sample --param-file=helloworld.params3.3.4. Modifier la création d'une application

La commande new-app génère des objets OpenShift Container Platform qui construisent, déploient et exécutent l'application créée. Normalement, ces objets sont créés dans le projet en cours et reçoivent des noms dérivés des dépôts de sources d'entrée ou des images d'entrée. Cependant, avec new-app, vous pouvez modifier ce comportement.

| Objet | Description |

|---|---|

|

|

Un objet |

|

|

Pour l'objet |

|

|

Un objet |

|

|

La commande |

| Autres | D'autres objets peuvent être générés lors de l'instanciation de modèles, en fonction du modèle. |

3.3.4.1. Spécification des variables d'environnement

Lorsque vous générez des applications à partir d'un modèle, d'une source ou d'une image, vous pouvez utiliser l'argument -e|--env pour transmettre des variables d'environnement au conteneur d'application au moment de l'exécution :

oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

$ oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

Les variables peuvent également être lues à partir d'un fichier en utilisant l'argument --env-file. Voici un exemple de fichier appelé postgresql.env:

POSTGRESQL_USER=user POSTGRESQL_DATABASE=db POSTGRESQL_PASSWORD=password

POSTGRESQL_USER=user

POSTGRESQL_DATABASE=db

POSTGRESQL_PASSWORD=passwordLire les variables du fichier :

oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

$ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

En outre, les variables d'environnement peuvent être fournies sur l'entrée standard en utilisant --env-file=-:

cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

$ cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

Les objets BuildConfig créés dans le cadre du traitement new-app ne sont pas mis à jour avec les variables d'environnement transmises avec l'argument -e|--env ou --env-file.

3.3.4.2. Spécifier les variables de l'environnement de construction

Lorsque vous générez des applications à partir d'un modèle, d'une source ou d'une image, vous pouvez utiliser l'argument --build-env pour transmettre des variables d'environnement au conteneur de compilation au moment de l'exécution :

oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

$ oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

Les variables peuvent également être lues à partir d'un fichier en utilisant l'argument --build-env-file. Voici un exemple de fichier appelé ruby.env:

HTTP_PROXY=http://myproxy.net:1337/ GEM_HOME=~/.gem

HTTP_PROXY=http://myproxy.net:1337/

GEM_HOME=~/.gemLire les variables du fichier :

oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

$ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

En outre, les variables d'environnement peuvent être fournies sur l'entrée standard en utilisant --build-env-file=-:

cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-

$ cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-3.3.4.3. Spécification des étiquettes

Lorsque vous générez des applications à partir de sources, d'images ou de modèles, vous pouvez utiliser l'argument -l|--label pour ajouter des étiquettes aux objets créés. Les étiquettes facilitent la sélection collective, la configuration et la suppression des objets associés à l'application.

oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world

$ oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world3.3.4.4. Visualisation de la sortie sans création

Pour voir une simulation de l'exécution de la commande new-app, vous pouvez utiliser l'argument -o|--output avec une valeur yaml ou json. Vous pouvez ensuite utiliser la sortie pour prévisualiser les objets créés ou la rediriger vers un fichier que vous pouvez modifier. Lorsque vous êtes satisfait, vous pouvez utiliser oc create pour créer les objets OpenShift Container Platform.

Pour enregistrer les artefacts de new-app dans un fichier, procédez comme suit :

oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

$ oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yamlModifier le fichier :

vi myapp.yaml

$ vi myapp.yamlCréez une nouvelle application en faisant référence au fichier :

oc create -f myapp.yaml

$ oc create -f myapp.yaml3.3.4.5. Création d'objets avec des noms différents

Les objets créés par new-app sont normalement nommés d'après le référentiel source ou l'image utilisée pour les générer. Vous pouvez définir le nom des objets produits en ajoutant le drapeau --name à la commande :

oc new-app https://github.com/openshift/ruby-hello-world --name=myapp

$ oc new-app https://github.com/openshift/ruby-hello-world --name=myapp3.3.4.6. Création d'objets dans un autre projet

Normalement, new-app crée des objets dans le projet en cours. Cependant, vous pouvez créer des objets dans un autre projet en utilisant l'argument -n|--namespace:

oc new-app https://github.com/openshift/ruby-hello-world -n myproject

$ oc new-app https://github.com/openshift/ruby-hello-world -n myproject3.3.4.7. Création d'objets multiples

La commande new-app permet de créer plusieurs applications en spécifiant plusieurs paramètres à new-app. Les étiquettes spécifiées dans la ligne de commande s'appliquent à tous les objets créés par la commande unique. Les variables d'environnement s'appliquent à tous les composants créés à partir de la source ou des images.

Pour créer une application à partir d'un référentiel source et d'une image Docker Hub :

oc new-app https://github.com/openshift/ruby-hello-world mysql

$ oc new-app https://github.com/openshift/ruby-hello-world mysql

Si un dépôt de code source et une image de constructeur sont spécifiés en tant qu'arguments séparés, new-app utilise l'image de constructeur comme constructeur pour le dépôt de code source. Si ce n'est pas le cas, spécifiez l'image du constructeur requise pour la source en utilisant le séparateur ~.

3.3.4.8. Regroupement d'images et de sources dans un même module

La commande new-app permet de déployer plusieurs images ensemble dans un seul pod. Pour spécifier les images à regrouper, utilisez le séparateur . L'argument de ligne de commande --group peut également être utilisé pour spécifier les images à regrouper. Pour regrouper l'image construite à partir d'un référentiel source avec d'autres images, spécifiez son image de construction dans le groupe :

oc new-app ruby+mysql

$ oc new-app ruby+mysqlPour déployer une image construite à partir de la source et une image externe ensemble :

oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql

$ oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql3.3.4.9. Recherche d'images, de modèles et d'autres données

Pour rechercher des images, des modèles et d'autres entrées pour la commande oc new-app, ajoutez les drapeaux --search et --list. Par exemple, pour trouver toutes les images ou tous les modèles qui incluent PHP :

oc new-app --search php

$ oc new-app --search phpChapitre 4. Visualisation de la composition des applications à l'aide de la vue Topologie

La vue Topology dans la perspective Developer de la console web fournit une représentation visuelle de toutes les applications d'un projet, de leur état de construction, et des composants et services qui leur sont associés.

4.1. Conditions préalables

Pour afficher vos applications dans la vue Topology et interagir avec elles, assurez-vous que

- Vous vous êtes connecté à la console web.

- Vous disposez des rôles et autorisations appropriés dans un projet pour créer des applications et d'autres charges de travail dans OpenShift Container Platform.

- Vous avez créé et déployé une application sur OpenShift Container Platform en utilisant la perspective Developer .

- Vous êtes dans la perspective Developer .

4.2. Visualiser la topologie de votre application

Vous pouvez naviguer vers la vue Topology en utilisant le panneau de navigation de gauche dans la perspective Developer. Après avoir déployé une application, vous êtes automatiquement dirigé vers Graph view où vous pouvez voir l'état des pods d'application, accéder rapidement à l'application sur une URL publique, accéder au code source pour le modifier et voir l'état de votre dernier build. Vous pouvez faire un zoom avant et arrière pour voir plus de détails sur une application particulière.

La vue Topology vous permet de surveiller vos applications à l'aide de la vue List. Utilisez l'icône List view (

![]() ) pour afficher une liste de toutes vos applications et utilisez l'icône Graph view (

) pour afficher une liste de toutes vos applications et utilisez l'icône Graph view (

![]() ) pour revenir à la vue graphique.

) pour revenir à la vue graphique.

Vous pouvez personnaliser les vues comme vous le souhaitez à l'aide des éléments suivants :

- Utilisez le champ Find by name pour trouver les composants requis. Les résultats de la recherche peuvent apparaître en dehors de la zone visible ; cliquez sur Fit to Screen dans la barre d'outils en bas à gauche pour redimensionner la vue Topology afin d'afficher tous les composants.

La liste déroulante Display Options permet de configurer la vue Topology des différents groupes d'applications. Les options disponibles dépendent des types de composants déployés dans le projet :

Mode (Connectivity ou Consumption)

- Connectivité : Sélectionnez cette option pour afficher toutes les connexions entre les différents nœuds de la topologie.

- Consommation : Sélectionnez cette option pour afficher la consommation de ressources pour tous les nœuds de la topologie.

Expand groupe

- Machines virtuelles : Permet d'afficher ou de masquer les machines virtuelles.

- Groupes d'applications : Permet de condenser les groupes d'applications en cartes avec une vue d'ensemble d'un groupe d'applications et des alertes qui lui sont associées.

- Communiqués Helm : Clair pour condenser les composants déployés en tant que version Helm dans des cartes présentant une vue d'ensemble d'une version donnée.

- Services Knative : Clear to condense the Knative Service components into cards with an overview of a given component.

- Groupements d'opérateurs : Permet de condenser les composants déployés avec un opérateur dans des cartes présentant une vue d'ensemble du groupe donné.

Show sur la base de Pod Count ou Labels

- Nombre de pods : Sélectionnez cette option pour afficher le nombre de gousses d'un composant dans l'icône du composant.

- Étiquettes : Permet d'afficher ou de masquer les étiquettes des composants.

La vue Topology vous offre également l'option Export application pour télécharger votre application au format ZIP. Vous pouvez ensuite importer l'application téléchargée dans un autre projet ou un autre cluster. Pour plus de détails, voir Exporting an application to another project or cluster dans la section Additional resources.

4.3. Interagir avec les applications et les composants

La vue Topology dans la perspective Developer de la console web offre les options suivantes pour interagir avec les applications et les composants :

-

Cliquez sur Open URL (

) pour voir votre application exposée par la route sur une URL publique.

) pour voir votre application exposée par la route sur une URL publique.

Cliquez sur Edit Source code pour accéder à votre code source et le modifier.

NoteCette fonctionnalité n'est disponible que lorsque vous créez des applications à l'aide des options From Git, From Catalog et From Dockerfile.

-

Passez votre curseur sur l'icône en bas à gauche du pod pour voir le nom de la dernière version et son statut. L'état de la construction de l'application est indiqué par New (

), Pending (

), Pending (

), Running (

), Running (

), Completed (

), Completed (

), Failed (

), Failed (

), et Canceled (

), et Canceled (

).

).

L'état ou la phase du pod est indiqué par des couleurs et des infobulles différentes :

-

Running (

) : Le pod est lié à un nœud et tous les conteneurs sont créés. Au moins un conteneur est toujours en cours d'exécution ou est en train de démarrer ou de redémarrer.

) : Le pod est lié à un nœud et tous les conteneurs sont créés. Au moins un conteneur est toujours en cours d'exécution ou est en train de démarrer ou de redémarrer.

-

Not Ready (

) : Les pods qui exécutent plusieurs conteneurs ne sont pas tous prêts.

) : Les pods qui exécutent plusieurs conteneurs ne sont pas tous prêts.

-

Warning(

) : Les conteneurs dans les pods sont en train d'être terminés, mais la terminaison n'a pas réussi. Certains conteneurs peuvent être dans d'autres états.

) : Les conteneurs dans les pods sont en train d'être terminés, mais la terminaison n'a pas réussi. Certains conteneurs peuvent être dans d'autres états.

-

Failed(

) : Tous les conteneurs du pod se sont terminés, mais au moins un conteneur s'est terminé par un échec. C'est-à-dire que le conteneur est sorti avec un statut non nul ou a été interrompu par le système.

) : Tous les conteneurs du pod se sont terminés, mais au moins un conteneur s'est terminé par un échec. C'est-à-dire que le conteneur est sorti avec un statut non nul ou a été interrompu par le système.

-

Pending(

) : Le pod est accepté par le cluster Kubernetes, mais un ou plusieurs des conteneurs n'ont pas été configurés et rendus prêts à fonctionner. Cela inclut le temps qu'un pod passe à attendre d'être planifié ainsi que le temps passé à télécharger des images de conteneurs sur le réseau.