This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.アプリケーション

OpenShift Container Platform 4.2 でのアプリケーションの作成および管理

概要

第1章 プロジェクト

1.1. プロジェクトの使用

プロジェクト を使用することにより、あるユーザーコミュニティーは、他のコミュニティーと切り離された状態で独自のコンテンツを整理し、管理することができます。

openshift- および kube- で始まる名前のプロジェクトはデフォルトプロジェクトです。これらのプロジェクトは、Pod として実行されるクラスターコンポーネントおよび他のインフラストラクチャーコンポーネントをホストします。そのため、OpenShift Container Platform では oc new-project コマンドを使用して openshift- または kube- で始まる名前のプロジェクトを作成することができません。クラスター管理者は、oc adm new-project コマンドを使用してこれらのプロジェクトを作成できます。

1.1.1. Web コンソールを使用したプロジェクトの作成

クラスター管理者が許可する場合、新規プロジェクトを作成できます。

openshift- および kube- で始まる名前のプロジェクトは OpenShift Container Platform によって重要 (Critical) と見なされます。そのため、OpenShift Container Platform では、Web コンソールを使用して openshift- で始まる名前のプロジェクトを作成することはできません。

手順

- Home → Projects に移動します。

- Create Project をクリックします。

- プロジェクトの詳細を入力します。

- Create をクリックします。

1.1.2. Web コンソールでの Developer パースペクティブを使用したプロジェクトの作成

OpenShift Container Platform Web コンソールの Developer パースペクティブを使用し、namespace でプロジェクトを作成できます。

openshift- および kube で始まる名前のプロジェクトは、Pod として実行されるクラスターコンポーネントおよび他のインフラストラクチャーコンポーネントをホストします。そのため、OpenShift Container Platform では、CLI を使用して openshift- または kube- で始まる名前のプロジェクトを作成することはできません。クラスター管理者は、oc adm new-project コマンドを使用してこれらのプロジェクトを作成できます。

前提条件

- OpenShift Container Platform のプロジェクト、アプリケーション、および他のワークロードを作成するために適切なロールおよびパーミッションがあることを確認します。

手順

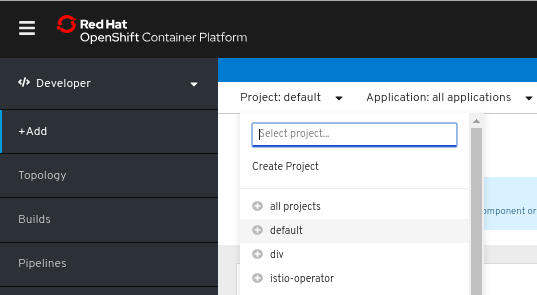

以下のように、Developer パースペクティブを使用してプロジェクトを作成できます。

Add ビューでは、Project ドロップダウンメニューをクリックして、利用可能なすべてのプロジェクトの一覧を表示します。Create Project を選択します。

-

Create Project ダイアログボックスで、Name フィールドに一意の名前を入力します。たとえば、Name フィールドにプロジェクトの名前として

myprojectを入力します。 - オプション: プロジェクトの Display Name および Description の詳細を追加します。

- Create をクリックします。

これでプロジェクトが作成され、アプリケーションおよび他のワークロードをこのプロジェクトに追加することができます。

1.1.3. CLI を使用したプロジェクトの作成

クラスター管理者が許可する場合、新規プロジェクトを作成できます。

openshift- および kube- で始まる名前のプロジェクトは OpenShift Container Platform によって重要 (Critical) と見なされます。そのため、OpenShift Container Platform では oc new-project コマンドを使用して openshift- または kube- で始まる名前のプロジェクトを作成することができません。クラスター管理者は、oc adm new-project コマンドを使用してこれらのプロジェクトを作成できます。

手順

- 以下を実行します。

oc new-project <project_name> \

--description="<description>" --display-name="<display_name>"

$ oc new-project <project_name> \

--description="<description>" --display-name="<display_name>"以下は例になります。

oc new-project hello-openshift \

--description="This is an example project" \

--display-name="Hello OpenShift"

$ oc new-project hello-openshift \

--description="This is an example project" \

--display-name="Hello OpenShift"作成できるプロジェクトの数は、システム管理者によって制限される場合があります。上限に達すると、新規プロジェクトを作成できるように既存プロジェクトを削除しなければならない場合があります。

1.1.4. Web コンソールを使用したプロジェクトの表示

手順

- Home → Projects に移動します。

表示するプロジェクトを選択します。

このページで、Workloads ボタンをクリックして、プロジェクトのワークロードを確認します。

1.1.5. CLI を使用したプロジェクトの表示

プロジェクトを表示する際は、認証ポリシーに基づいて、表示アクセスのあるプロジェクトだけを表示できるように制限されます。

手順

プロジェクトの一覧を表示するには、以下を実行します。

oc get projects

$ oc get projectsCopy to Clipboard Copied! Toggle word wrap Toggle overflow CLI 操作について現在のプロジェクトから別のプロジェクトに切り換えることができます。その後の操作についてはすべて指定のプロジェクトが使用され、プロジェクトスコープのコンテンツの操作が実行されます。

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.1.6. プロジェクトへの追加

手順

- Web コンソールのナビゲーションメニューの上部にあるコンテキストセレクターから Developer を選択します。

- +Add をクリックします。

- ページの上部で、追加するプロジェクトの名前を選択します。

- プロジェクトに追加する方法をクリックし、ワークフローに従います。

1.1.7. Web コンソールを使用したプロジェクトステータスの確認

手順

- Home → Projects に移動します。

- ステータスを確認するプロジェクトを選択します。

1.1.8. CLI を使用したプロジェクトステータスの確認

手順

以下を実行します。

oc status

$ oc statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドは、コンポーネントとそれらの各種の関係を含む現在のプロジェクトの概要を示します。

1.1.9. Web コンソールを使用したプロジェクトの削除

OpenShift Container Platform Web コンソールを使用してプロジェクトを削除できます。

プロジェクトを削除するパーミッションがない場合は、Delete Project オプションが選択できなくなります。

手順

- Home → Projects に移動します。

- プロジェクトの一覧から削除するプロジェクトを見つけます。

-

プロジェクト一覧の右側にある Options メニューから Delete Project を選択します。

をクリックします。

をクリックします。

- Delete Project ペインが開いたら、フィールドから削除するプロジェクトの名前を入力します。

- Delete をクリックします。

1.1.10. CLI を使用したプロジェクトの削除

プロジェクトを削除する際に、サーバーはプロジェクトのステータスを Active から Terminating に更新します。次に、サーバーは Terminating 状態のプロジェクトからすべてのコンテンツをクリアしてから、最終的にプロジェクトを削除します。プロジェクトのステータスが Terminating の場合、新規のコンテンツをプロジェクトに追加することはできません。プロジェクトは CLI または Web コンソールから削除できます。

手順

以下を実行します。

oc delete project <project_name>

$ oc delete project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.2. 別のユーザーとしてのプロジェクトの作成

権限の借用機能により、別のユーザーとしてプロジェクトを作成することができます。

1.2.1. API の権限借用

OpenShift Container Platform API への要求を、別のユーザーから発信されているかのように設定できます。詳細は、Kubernetes ドキュメントの「User impersonation」を参照してください。

1.2.2. プロジェクト作成時のユーザー権限の借用

プロジェクト要求を作成する際に別のユーザーの権限を借用できます。system:authenticated:oauth はプロジェクト要求を作成できる唯一のブートストラップグループであるため、そのグループの権限を借用する必要があります。

手順

別のユーザーの代わりにプロジェクト要求を作成するには、以下を実行します。

oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauth$ oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauthCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3. プロジェクト作成の設定

OpenShift Container Platform では、プロジェクト は関連するオブジェクトをグループ分けし、分離するために使用されます。Web コンソールまたは oc new-project コマンドを使用して新規プロジェクトの作成要求が実行されると、OpenShift Container Platform のエンドポイントは、カスタマイズ可能なテンプレートに応じてプロジェクトをプロビジョニングするために使用されます。

クラスター管理者は、開発者やサービスアカウントが独自のプロジェクトを作成し、プロジェクトの セルフプロビジョニング を実行することを許可し、その方法を設定できます。

1.3.1. プロジェクト作成について

OpenShift Container Platform API サーバーは、クラスターのプロジェクト設定リソースの projectRequestTemplate パラメーターで識別されるプロジェクトテンプレートに基づいて新規プロジェクトを自動的にプロビジョニングします。パラメーターが定義されない場合、API サーバーは要求される名前でプロジェクトを作成するデフォルトテンプレートを作成し、要求するユーザーをプロジェクトの admin (管理者) ロールに割り当てます。

プロジェクト要求が送信されると、API はテンプレートで以下のパラメーターを置き換えます。

| パラメーター | 説明 |

|---|---|

|

| プロジェクトの名前。必須。 |

|

| プロジェクトの表示名。空にできます。 |

|

| プロジェクトの説明。空にできます。 |

|

| 管理ユーザーのユーザー名。 |

|

| 要求するユーザーのユーザー名。 |

API へのアクセスは、self-provisioner ロールと self-provisioners のクラスターロールバインディングで開発者に付与されます。デフォルトで、このロールはすべての認証された開発者が利用できます。

1.3.2. 新規プロジェクトのテンプレートの変更

クラスター管理者は、デフォルトのプロジェクトテンプレートを変更し、新規プロジェクトをカスタム要件に基づいて作成することができます。

独自のカスタムプロジェクトテンプレートを作成するには、以下を実行します。

手順

-

cluster-admin権限を持つユーザーとしてのログイン。 デフォルトのプロジェクトテンプレートを生成します。

oc adm create-bootstrap-project-template -o yaml > template.yaml

$ oc adm create-bootstrap-project-template -o yaml > template.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

オブジェクトを追加するか、または既存オブジェクトを変更することにより、テキストエディターで生成される

template.yamlファイルを変更します。 プロジェクトテンプレートは、

openshift-confignamespace に作成される必要があります。変更したテンプレートを読み込みます。oc create -f template.yaml -n openshift-config

$ oc create -f template.yaml -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Web コンソールまたは CLI を使用し、プロジェクト設定リソースを編集します。

Web コンソールの使用

- Administration → Cluster Settings ページに移動します。

- Global Configuration をクリックし、すべての設定リソースを表示します。

- Project のエントリーを見つけ、Edit YAML をクリックします。

CLI の使用

project.config.openshift.io/clusterリソースを編集します。oc edit project.config.openshift.io/cluster

$ oc edit project.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow

specセクションを、projectRequestTemplateおよびnameパラメーターを組み込むように更新し、アップロードされたプロジェクトテンプレートの名前を設定します。デフォルト名はproject-requestです。カスタムプロジェクトテンプレートを含むプロジェクト設定リソース

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を保存した後、変更が正常に適用されたことを確認するために、新しいプロジェクトを作成します。

1.3.3. プロジェクトのセルフプロビジョニングの無効化

認証されたユーザーグループによる新規プロジェクトのセルフプロビジョニングを禁止することができます。

手順

-

cluster-admin権限を持つユーザーとしてのログイン。 以下のコマンドを実行して、

self-provisionersクラスターロールバインディングの使用を確認します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow self-provisionersセクションのサブジェクトを確認します。self-provisionerクラスターロールをグループsystem:authenticated:oauthから削除します。self-provisionersクラスターロールバインディングがself-provisionerロールのみをsystem:authenticated:oauthグループにバインドする場合、以下のコマンドを実行します。oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'$ oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow self-provisionersクラスターロールバインディングがself-provisionerロールをsystem:authenticated:oauthグループ以外のユーザー、グループまたはサービスアカウントにバインドする場合、以下のコマンドを実行します。oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauth$ oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauthCopy to Clipboard Copied! Toggle word wrap Toggle overflow

ロールへの自動更新を防ぐには、

self-provisionersクラスターロールバインディングを編集します。自動更新により、クラスターロールがデフォルトの状態にリセットされます。CLI を使用してロールバインディングを更新するには、以下を実行します。

以下のコマンドを実行します。

oc edit clusterrolebinding.rbac self-provisioners

$ oc edit clusterrolebinding.rbac self-provisionersCopy to Clipboard Copied! Toggle word wrap Toggle overflow 表示されるロールバインディングで、以下の例のように

rbac.authorization.kubernetes.io/autoupdateパラメーター値をfalseに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

単一コマンドを使用してロールバインディングを更新するには、以下を実行します。

oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'$ oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

認証されたユーザーとしてログインし、プロジェクトのセルフプロビジョニングを実行できないことを確認します。

oc new-project test Error from server (Forbidden): You may not request a new project via this API.

$ oc new-project test Error from server (Forbidden): You may not request a new project via this API.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 組織に固有のより有用な説明を提供できるようこのプロジェクト要求メッセージをカスタマイズすることを検討します。

1.3.4. プロジェクト要求メッセージのカスタマイズ

プロジェクトのセルフプロビジョニングを実行できない開発者またはサービスアカウントが Web コンソールまたは CLI を使用してプロジェクト作成要求を行う場合、以下のエラーメッセージがデフォルトで返されます。

You may not request a new project via this API.

You may not request a new project via this API.クラスター管理者はこのメッセージをカスタマイズできます。これを、組織に固有の新規プロジェクトの要求方法の情報を含むように更新することを検討します。以下は例になります。

-

プロジェクトを要求するには、システム管理者 (

projectname@example.com) に問い合わせてください。 -

新規プロジェクトを要求するには、

https://internal.example.com/openshift-project-requestにあるプロジェクト要求フォームに記入します。

プロジェクト要求メッセージをカスタマイズするには、以下を実行します。

手順

Web コンソールまたは CLI を使用し、プロジェクト設定リソースを編集します。

Web コンソールの使用

- Administration → Cluster Settings ページに移動します。

- Global Configuration をクリックし、すべての設定リソースを表示します。

- Project のエントリーを見つけ、Edit YAML をクリックします。

CLI の使用

-

cluster-admin権限を持つユーザーとしてのログイン。 project.config.openshift.io/clusterリソースを編集します。oc edit project.config.openshift.io/cluster

$ oc edit project.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

specセクションを、projectRequestMessageパラメーターを含むように更新し、値をカスタムメッセージに設定します。カスタムプロジェクト要求メッセージを含むプロジェクト設定リソース

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下は例になります。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を保存した後に、プロジェクトをセルフプロビジョニングできない開発者またはサービスアカウントとして新規プロジェクトの作成を試行し、変更が正常に適用されていることを確認します。

第2章 アプリケーションライフサイクル管理

2.1. Developer パースペクティブを使用したアプリケーションの作成

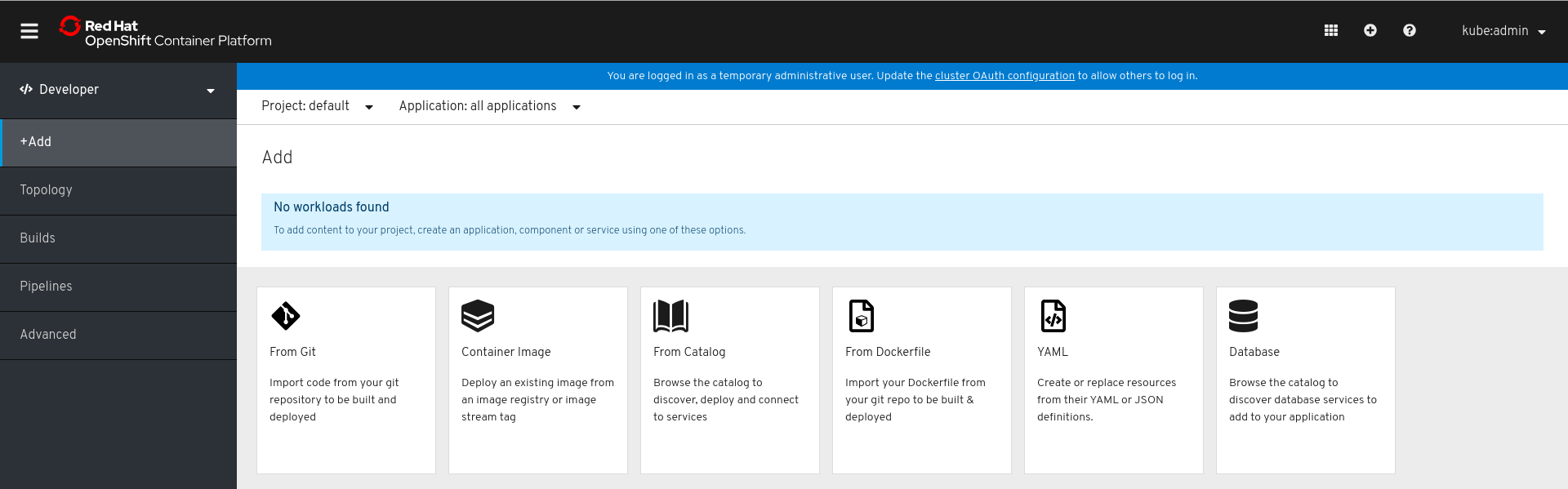

Web コンソールの Developer パースペクティブでは、Add ビューからアプリケーションおよび関連サービスを作成し、それらを OpenShift Container Platform にデプロイするための以下のオプションが提供されます。

- From Git: このオプションを使用して、Git リポジトリーの既存のコードベースをインポートし、OpenShift Container Platform でアプリケーションを作成し、ビルドし、デプロイします。

- Container Image: イメージストリームまたはレジストリーからの既存イメージを使用し、これを OpenShift Container Platform にデプロイします。

- From Catalog: Developer Catalog で、イメージビルダーに必要なアプリケーション、サービス、またはソースを選択し、これをプロジェクトに追加します。

- From Dockerfile: Git リポジトリーから dockerfile をインポートし、アプリケーションをビルドし、デプロイします。

- YAML: エディターを使用して YAML または JSON 定義を追加し、リソースを作成し、変更します。

- Database : Developer Catalog を参照して、必要なデータベースサービスを選択し、これをアプリケーションに追加します。

上記のオプションの Serverless セクションは、Serverless Operator がクラスターにインストールされている場合にのみ表示されます。OpenShift Serverless はテクノロジープレビュー機能です。

前提条件

Developer パースペクティブを使用してアプリケーションを作成するには、以下を確認してください。

- Web コンソールにログインしている。

- Developer パースペクティブにいる。

- OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するための適切なプロジェクト内のロールおよびパーミッションがある。

2.1.1. Git のコードベースのインポートおよびアプリケーションの作成

以下の手順では、Developer パースペクティブの Git からのインポートオプションを使用してアプリケーションを作成します。

以下のように GitHub で既存のコードベースを使用して、OpenShift Container Platform でアプリケーションを作成し、ビルドし、デプロイします。

手順

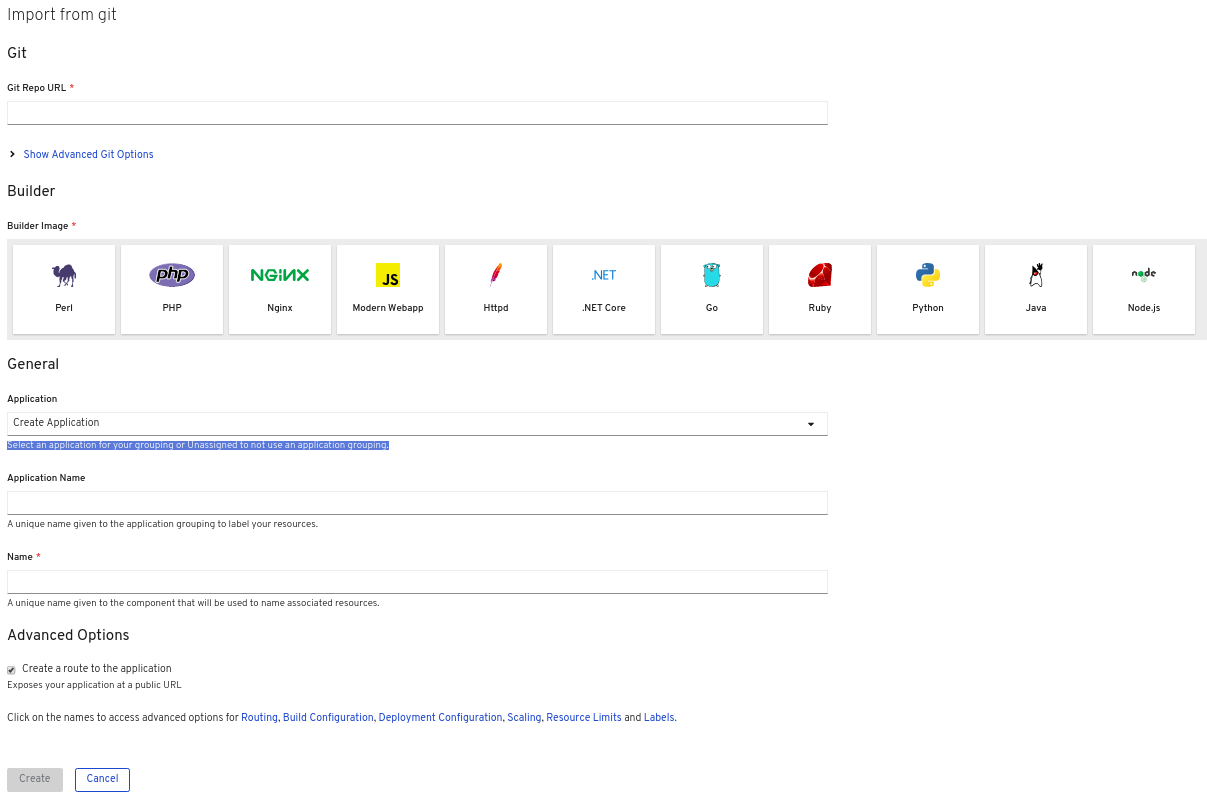

Add ビューで From Git をクリックし、Import from Git フォームを表示します。

-

Git セクションで、アプリケーションの作成に使用するコードベースの Git リポジトリー URL を入力します。たとえば、このサンプル nodejs アプリケーションの URL

https://github.com/sclorg/nodejs-exを入力します。 オプション: Show Advanced Git Options をクリックし、以下のような詳細を追加できます。

- Git Reference: アプリケーションのビルドに使用する特定のブランチ、タグ、またはコミットのコードを参照します。

- Context Dir: アプリケーションのビルドに使用するアプリケーションのソースコードのサブディレクトリーを指定します。

- Source Secret: プライベートリポジトリーからソースコードをプルするための認証情報で Secret Name を作成します。

- Builder セクションで、必要なビルダーイメージを選択して、ビルダーイメージの詳細を確認します。必要に応じて、Builder Image Version のドロップダウンリストを使用してバージョンを変更できます。たとえば、Node.js ビルダーイメージを選択します。

General セクションで、以下を実行します。

-

Application Name フィールドで、アプリケーションを分類するために一意の名前 (

myappなど) を入力します。アプリケーション名が namespace で一意であることを確認します。 Name フィールドで、このアプリケーション用に作成されたリソースが自動的に設定されることを確認します。

注記リソース名は namespace で一意である必要があります。エラーが出る場合はリソース名を変更します。

-

Application Name フィールドで、アプリケーションを分類するために一意の名前 (

Serverless セクションで、Enable scaling to zero when idle を選択し、Pod が自動的にゼロにスケーリングし、アイドル時のリソース消費を防止するサーバーレスアプリケーションを作成します。

注記Serverless セクションは、Serverless Operator がクラスターにインストールされている場合にのみ、Import from git フォームに表示されます。詳細は、OpenShift Serverless のインストールについてのドキュメントを参照してください。

- Advanced Options セクションでは、Create a route to the application がデフォルトで選択されるため、公開されている URL を使用してアプリケーションにアクセスできます。アプリケーションをパブリックルートに公開したくない場合は、チェックボックスをクリアできます。

オプション: 以下の高度なオプションを使用してアプリケーションをさらにカスタマイズできます。

- ルーティング

Routing リンクをクリックして、以下を実行します。

- ルートのホスト名をカスタマイズします。

- ルーターが監視するパスを指定します。

- ドロップダウンリストから、トラフィックのターゲットポートを選択します。

Secure Route チェックボックスを選択してルートを保護します。必要な TLS 終端タイプを選択し、各ドロップダウンリストから非セキュアなトラフィックについてのポリシーを設定します。

サーバーレスアプリケーションの場合、Knative Service が上記のすべてのルーティングオプションを管理します。ただし、必要に応じて、トラフィックのターゲットポートをカスタマイズできます。ターゲットポートが指定されていない場合、デフォルトポートの

8080が使用されます。

- ビルドおよびデプロイメント設定

- Build Configuration および Deployment Configuration リンクをクリックして、各設定オプションを表示します。オプションの一部はデフォルトで選択されています。必要なトリガーおよび環境変数を追加して、オプションをさらにカスタマイズできます。サーバーレスアプリケーションの場合、Deployment Configuration オプションは表示されません。これは、Knative 設定リソースが DeploymentConfig の代わりにデプロイメントの状態を維持するためです。

- スケーリング

Scaling リンクをクリックして、最初にデプロイするアプリケーションの Pod 数またはインスタンス数を定義します。

サーバーレスアプリケーションの場合、以下を実行できます。

- Autoscaler で設定できる Pod 数の上限および下限を設定します。下限が指定されない場合は、デフォルトでゼロに設定されます。

- 指定された時点でのアプリケーションインスタンスごとに必要な同時要求数のソフト制限を定義します。自動スケーリングの推奨設定です。指定されていない場合は、クラスター設定で指定した値を使用します。

- 指定された時点でのアプリケーションインスタンスごとに許可される同時要求数のハード制限を定義します。これは、リビジョンテンプレートで設定されます。指定されていない場合、デフォルトでクラスター設定で指定された値に設定されます。

- リソースの制限

- Resource Limit リンクをクリックして、コンテナーが実行時に保証または使用が許可されている CPU および メモリー リソースの量を設定します。

- ラベル

- Labels リンクをクリックして、カスタムラベルをアプリケーションに追加します。

- Create をクリックして、アプリケーションを作成し、Topology ビューでビルドのステータスを確認します。

2.2. インストールされた Operator からのアプリケーションの作成

Operator は、Kubernetes アプリケーションをパッケージ化し、デプロイし、管理する方法です。クラスター管理者によってインストールされる Operator を使用して、アプリケーションを OpenShift Container Platform で作成できます。

以下では、開発者を対象に、OpenShift Container Platform Web コンソールを使用して、インストールされた Operator からアプリケーションを作成する例を示します。

追加リソース

- Operator の仕組みおよび Operator Lifecycle Manager の OpenShift Container Platform への統合方法に関する詳細は、『Operator 』ガイドを参照してください。

2.2.1. Operator を使用した etcd クラスターの作成

この手順では、Operator Lifecycle Manager (OLM) で管理される etcd Operator を使用した新規 etcd クラスターの作成について説明します。

前提条件

- OpenShift Container Platform 4.2 クラスターへのアクセス

- 管理者によってクラスターにすでにインストールされている etcd Operator

手順

- この手順を実行するために OpenShift Container Platform Web コンソールで新規プロジェクトを作成します。この例では、my-etcd というプロジェクトを使用します。

Operators → Installed Operators ページに移動します。クラスター管理者によってクラスターにインストールされ、使用可能にされた Operator が ClusterServiceVersion (CSV) の一覧としてここに表示されます。CSV は Operator によって提供されるソフトウェアを起動し、管理するために使用されます。

ヒント以下を使用して、CLI でこの一覧を取得できます。

oc get csv

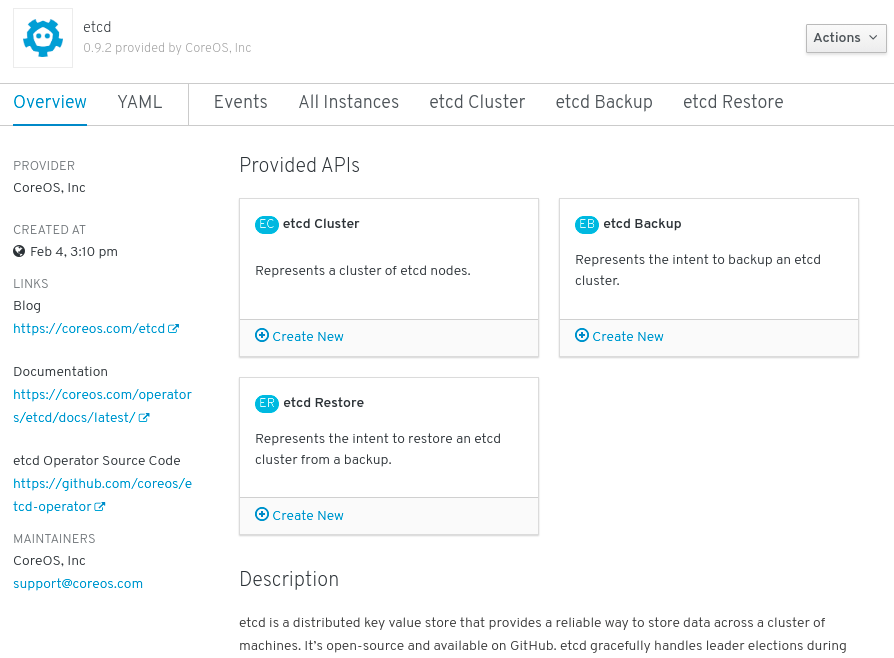

$ oc get csvCopy to Clipboard Copied! Toggle word wrap Toggle overflow Installed Operators ページで、Copied をクリックしてから、etcd Operator をクリックして詳細情報および選択可能なアクションを表示します。

図2.1 etcd Operator の概要

Provided APIs に表示されているように、この Operator は 3 つの新規リソースタイプを利用可能にします。これには、etcd クラスター (

EtcdClusterリソース) のタイプが含まれます。これらのオブジェクトは、DeploymentsまたはReplicaSetsなどの組み込み済みのネイティブ Kubernetes オブジェクトと同様に機能しますが、これらには etcd を管理するための固有のロジックが含まれます。新規 etcd クラスターを作成します。

- etcd Cluster API ボックスで、Create New をクリックします。

-

次の画面では、クラスターのサイズなど

EtcdClusterオブジェクトのテンプレートを起動する最小条件への変更を加えることができます。ここでは Create をクリックして確定します。これにより、Operator がトリガーされ、Pod、サービス、および新規 etcd クラスターの他のコンポーネントが起動します。

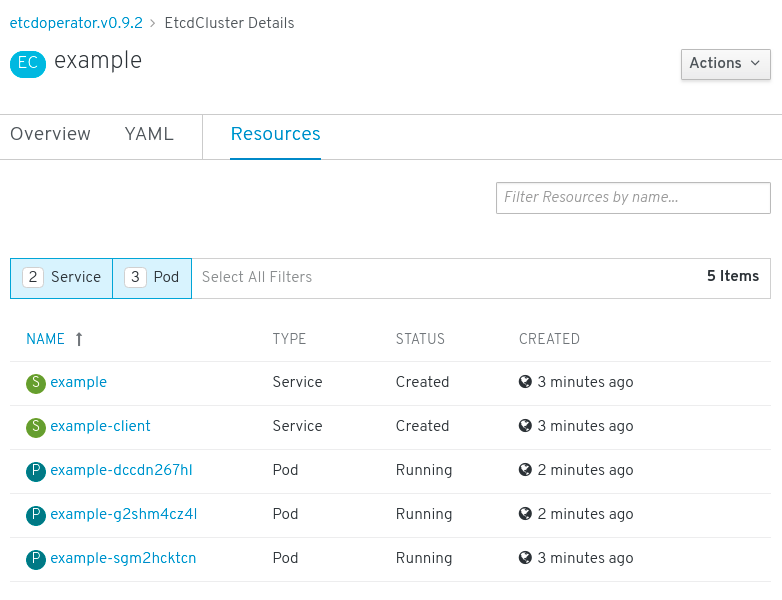

Resources タブをクリックして、プロジェクトに Operator によって自動的に作成され、設定された数多くのリソースが含まれることを確認します。

図2.2 etcd Operator リソース

Kubernetes サービスが作成され、プロジェクトの他の Pod からデータベースにアクセスできることを確認します。

所定プロジェクトで

editロールを持つすべてのユーザーは、クラウドサービスのようにセルフサービス方式でプロジェクトにすでに作成されている Operator によって管理されるアプリケーションのインスタンス (この例では etcd クラスター) を作成し、管理し、削除することができます。この機能を持つ追加のユーザーを有効にする必要がある場合、プロジェクト管理者は以下のコマンドを使用してこのロールを追加できます。oc policy add-role-to-user edit <user> -n <target_project>

$ oc policy add-role-to-user edit <user> -n <target_project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

これで、etcd クラスターは Pod が正常でなくなったり、クラスターのノード間で移行する際の障害に対応し、データのリバランスを行います。最も重要な点として、適切なアクセスを持つクラスター管理者または開発者は独自のアプリケーションでデータベースを簡単に使用できるようになります。

2.3. CLI を使用したアプリケーションの作成

OpenShift Container Platform CLI を使用して、ソースまたはバイナリーコード、イメージおよびテンプレートを含むコンポーネントから OpenShift Container Platform アプリケーションを作成できます。

new-app で作成したオブジェクトのセットは、ソースリポジトリー、イメージまたはテンプレートなどのインプットとして渡されるアーティファクトによって異なります。

2.3.1. ソースコードからのアプリケーションの作成

new-app コマンドを使用して、ローカルまたはリモート Git リポジトリーのソースコードからアプリケーションを作成できます。

new-app コマンドは、ビルド設定を作成し、これはソースコードから新規のアプリケーションイメージを作成します。new-app コマンドは通常、デプロイメント設定を作成して新規のイメージをデプロイするほか、サービスを作成してイメージを実行するデプロイメントへの負荷分散したアクセスを提供します。

OpenShift Container Platform は、Pipeline または Source ビルドストラテジーのいずれを使用すべきかを自動的に検出します。また、Source ビルドの場合は、適切な言語のビルダーイメージを検出します。

2.3.1.1. ローカル

ローカルディレクトリーの Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

oc new-app /<path to source code>

$ oc new-app /<path to source code>

ローカル Git リポジトリーを使用する場合には、リポジトリーで OpenShift Container Platform クラスターがアクセス可能な URL を参照する origin という名前のリモートリポジトリーが必要です。認識されているリモートがない場合は、new-app コマンドを実行してバイナリービルドを作成します。

2.3.1.2. リモート

リモート Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

oc new-app https://github.com/sclorg/cakephp-ex

$ oc new-app https://github.com/sclorg/cakephp-exプライベートのリモート Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

$ oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

プライベートリモート Git リポジトリーを使用する場合には、--source-secret フラグを使用して、既存のソースクローンのシークレットを指定できます。このシークレットは、BuildConfig に挿入され、リポジトリーにアクセスできるようになります。

--context-dir フラグを指定することで、ソースコードリポジトリーのサブディレクトリーを使用できます。リモート Git リポジトリーおよびコンテキストサブディレクトリーを使用してアプリケーションを作成する場合は、以下を実行します。

oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

$ oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

また、リモート URL を指定する場合は、以下のように URL の最後に #<branch_name> を追加することで、使用する Git ブランチを指定できます。

oc new-app https://github.com/openshift/ruby-hello-world.git#beta4

$ oc new-app https://github.com/openshift/ruby-hello-world.git#beta42.3.1.3. ビルドストラテジーの検出

新規アプリケーションの作成時に Jenkinsfile がソースリポジトリーのルート または指定されたコンテキストディレクトリーに存在する場合に、OpenShift Container Platform は Pipeline ビルドストラテジーを生成します。

それ以外の場合は、ソースビルドストラテジーが生成されます。

ビルドストラテジーを上書きするには、--strategy フラグを pipeline または sourceのいずれかに設定します。

oc new-app /home/user/code/myapp --strategy=docker

$ oc new-app /home/user/code/myapp --strategy=docker

oc コマンドを使用するには、ビルドソースを含むファイルがリモートの git リポジトリーで利用可能である必要があります。すべてのソースビルドには、git remote -v を使用する必要があります。

2.3.1.4. 言語の検出

Source ビルドストラテジーを使用する場合に、new-app はリポジトリーのルート または指定したコンテキストディレクトリーに特定のファイルが存在するかどうかで、使用する言語ビルダーを判別しようとします。

| 言語 | ファイル |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

言語の検出後、new-app は OpenShift Container Platform サーバーで、検出言語と一致する supports アノテーションを持つイメージストリームタグを検索するか、または検出された言語の名前に一致するイメージストリームを検索します。一致するものが見つからない場合には、new-app は Docker Hub レジストリー で名前をベースにした検出言語と一致するイメージの検索を行います。

~ をセパレーターとして使用し、イメージ (イメージストリームまたはコンテナーの仕様) とリポジトリーを指定して、特定のソースリポジトリーにビルダーが使用するイメージを上書きすることができます。この方法を使用すると、ビルドストラテジーの検出および言語の検出は実行されない点に留意してください。

たとえば、リモートリポジトリーのソースを使用して myproject/my-ruby イメージストリームを作成する場合は、以下を実行します。

oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

$ oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

ローカルリポジトリーのソースを使用して openshift/ruby-20-centos7:latest コンテナーのイメージストリームを作成するには、以下を実行します。

oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

$ oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

言語の検出では、リポジトリーのクローンを作成し、検査できるように Git クライアントをローカルにインストールする必要があります。Git が使用できない場合、<image>~<repository> 構文を指定し、リポジトリーで使用するビルダーイメージを指定して言語の検出手順を回避することができます。

-i <image> <repository> 呼び出しでは、アーティファクトのタイプを判別するために new-app が repository のクローンを試行する必要があります。そのため、これは Git が利用できない場合には失敗します。

-i <image> --code <repository> 呼び出しでは、image がソースコードのビルダーとして使用されるか、またはデータベースイメージの場合のように別個にデプロイされる必要があるかどうかを判別するために、new-app が repository のクローンを作成する必要があります。

2.3.2. イメージからアプリケーションを作成する方法

既存のイメージからアプリケーションのデプロイが可能です。イメージは、OpenShift Container Platform サーバー内のイメージストリーム、指定したレジストリー内のイメージ、またはローカルの Docker サーバー内のイメージから取得できます。

new-app コマンドは、渡された引数に指定されたイメージの種類を判断しようとします。ただし、イメージが、--docker-image 引数を使用したコンテナーイメージなのか、または -i|--image 引数を使用したイメージストリームなのかを、new-app に明示的に指示できます。

ローカル Docker リポジトリーからイメージを指定した場合、同じイメージが OpenShift Container Platform のクラスターノードでも利用できることを確認する必要があります。

2.3.2.1. DockerHub MySQL イメージ

たとえば、DockerHub MySQL イメージからアプリケーションを作成するには、以下を実行します。

oc new-app mysql

$ oc new-app mysql2.3.2.2. プライベートレジストリーのイメージ

プライベートのレジストリーのイメージを使用してアプリケーションを作成し、コンテナーイメージの仕様全体を以下のように指定します。

oc new-app myregistry:5000/example/myimage

$ oc new-app myregistry:5000/example/myimage2.3.2.3. 既存のイメージストリームおよびオプションの イメージストリームタグ

既存のイメージストリームおよびオプションのイメージストリームタグでアプリケーションを作成します。

oc new-app my-stream:v1

$ oc new-app my-stream:v12.3.3. テンプレートからのアプリケーションの作成

テンプレート名を引数として指定することで、事前に保存したテンプレートまたはテンプレートファイルからアプリケーションを作成することができます。たとえば、サンプルアプリケーションテンプレートを保存し、これを利用してアプリケーションを作成できます。

保存したテンプレートからアプリケーションを作成します。以下は例になります。

oc create -f examples/sample-app/application-template-stibuild.json oc new-app ruby-helloworld-sample

$ oc create -f examples/sample-app/application-template-stibuild.json

$ oc new-app ruby-helloworld-sample

事前に OpenShift Container Platform に保存することなく、ローカルファイルシステムでテンプレートを直接使用するには、-f|--file 引数を使用します。以下は例になります。

oc new-app -f examples/sample-app/application-template-stibuild.json

$ oc new-app -f examples/sample-app/application-template-stibuild.json2.3.3.1. テンプレートパラメーター

テンプレートをベースとするアプリケーションを作成する場合、以下の -p|--param 引数を使用してテンプレートで定義したパラメーター値を設定します。

oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

$ oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

パラメーターをファイルに保存しておいて、--param-file を指定して、テンプレートをインスタンス化する時にこのファイルを使用することができます。標準入力からパラメーターを読み込む場合は、以下のように--param-file=- を使用します。

cat helloworld.params ADMIN_USERNAME=admin ADMIN_PASSWORD=mypassword $ oc new-app ruby-helloworld-sample --param-file=helloworld.params $ cat helloworld.params | oc new-app ruby-helloworld-sample --param-file=-

$ cat helloworld.params

ADMIN_USERNAME=admin

ADMIN_PASSWORD=mypassword

$ oc new-app ruby-helloworld-sample --param-file=helloworld.params

$ cat helloworld.params | oc new-app ruby-helloworld-sample --param-file=-2.3.4. アプリケーション作成の変更

new-app コマンドは、OpenShift Container Platform オブジェクトを生成します。このオブジェクトにより、作成されるアプリケーションがビルドされ、デプロイされ、実行されます。通常、これらのオブジェクトは現在のプロジェクトに作成され、これらのオブジェクトには入力ソースリポジトリーまたはインプットイメージから派生する名前が割り当てられます。ただし、new-app でこの動作を変更することができます。

| オブジェクト | 説明 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

| その他 | テンプレートのインスタンスを作成する際に、他のオブジェクトをテンプレートに基づいて生成できます。 |

2.3.4.1. 環境変数の指定

テンプレート、ソースまたはイメージからアプリケーションを生成する場合、-e|--env 引数を使用し、ランタイムに環境変数をアプリケーションコンテナーに渡すことができます。

oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

$ oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

変数は、--env-file 引数を使用してファイルから読み取ることもできます。

cat postgresql.env POSTGRESQL_USER=user POSTGRESQL_DATABASE=db POSTGRESQL_PASSWORD=password $ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

$ cat postgresql.env

POSTGRESQL_USER=user

POSTGRESQL_DATABASE=db

POSTGRESQL_PASSWORD=password

$ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

さらに --env-file=- を使用することで、標準入力で環境変数を指定することもできます。

cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

$ cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

-e|--env または --env-file 引数で渡される環境変数では、new-app 処理の一環として作成される BuildConfig オブジェクトは更新されません。

2.3.4.2. ビルド環境変数の指定

テンプレート、ソースまたはイメージからアプリケーションを生成する場合、--build-env 引数を使用し、ランタイムに環境変数をビルドコンテナーに渡すことができます。

oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

$ oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

変数は、--build-env-file 引数を使用してファイルから読み取ることもできます。

cat ruby.env HTTP_PROXY=http://myproxy.net:1337/ GEM_HOME=~/.gem $ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

$ cat ruby.env

HTTP_PROXY=http://myproxy.net:1337/

GEM_HOME=~/.gem

$ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

さらに --build-env-file=- を使用して、環境変数を標準入力で指定することもできます。

cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-

$ cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-2.3.4.3. ラベルの指定

ソース、イメージ、またはテンプレートからアプリケーションを生成する場合、-l|--label 引数を使用し、作成されたオブジェクトにラベルを追加できます。ラベルを使用すると、アプリケーションに関連するオブジェクトを一括で選択、設定、削除することが簡単になります。

oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world

$ oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world2.3.4.4. 作成前の出力の表示

new-app コマンドの実行に関するドライランを確認するには、yaml または json の値と共に -o|--output 引数を使用できます。次にこの出力を使用して、作成されるオブジェクトのプレビューまたは編集可能なファイルへのリダイレクトを実行できます。問題がなければ、oc create を使用して OpenShift Container Platform オブジェクトを作成できます。

new-app アーティファクトをファイルに出力するには、これらを編集し、作成します。

oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

vi myapp.yaml

oc create -f myapp.yaml

$ oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

$ vi myapp.yaml

$ oc create -f myapp.yaml2.3.4.5. 別名でのオブジェクトの作成

通常 new-app で作成されるオブジェクトの名前はソースリポジトリーまたは生成に使用されたイメージに基づいて付けられます。コマンドに --name フラグを追加することで、生成されたオブジェクトの名前を設定できます。

oc new-app https://github.com/openshift/ruby-hello-world --name=myapp

$ oc new-app https://github.com/openshift/ruby-hello-world --name=myapp2.3.4.6. 別のプロジェクトでのオブジェクトの作成

通常 new-app は現在のプロジェクトにオブジェクトを作成します。ただし、-n|--namespace 引数を使用して、別のプロジェクトにオブジェクトを作成することができます。

oc new-app https://github.com/openshift/ruby-hello-world -n myproject

$ oc new-app https://github.com/openshift/ruby-hello-world -n myproject2.3.4.7. 複数のオブジェクトの作成

new-app コマンドは、複数のパラメーターを new-app に指定して複数のアプリケーションを作成できます。コマンドラインで指定するラベルは、単一コマンドで作成されるすべてのオブジェクトに適用されます。環境変数は、ソースまたはイメージから作成されたすべてのコンポーネントに適用されます。

ソースリポジトリーおよび Docker Hub イメージからアプリケーションを作成するには、以下を実行します。

oc new-app https://github.com/openshift/ruby-hello-world mysql

$ oc new-app https://github.com/openshift/ruby-hello-world mysql

ソースコードリポジトリーおよびビルダーイメージが別個の引数として指定されている場合、new-app はソースコードリポジトリーのビルダーとしてそのビルダーイメージを使用します。これを意図していない場合は、~ セパレーターを使用してソースに必要なビルダーイメージを指定します。

2.3.4.8. 単一 Pod でのイメージとソースのグループ化

new-app コマンドにより、単一 Pod に複数のイメージをまとめてデプロイできます。イメージのグループ化を指定するには + セパレーターを使用します。--group コマンドライン引数をグループ化する必要のあるイメージを指定する際に使用することもできます。ソースリポジトリーからビルドされたイメージを別のイメージと共にグループ化するには、そのビルダーイメージをグループで指定します。

oc new-app ruby+mysql

$ oc new-app ruby+mysqlソースからビルドされたイメージと外部のイメージをまとめてデプロイするには、以下を実行します。

oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql

$ oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql2.3.4.9. イメージ、テンプレート、および他の入力の検索

イメージ、テンプレート、および oc new-app コマンドの他の入力内容を検索するには、--search フラグおよび --list フラグを追加します。たとえば、PHP を含むすべてのイメージまたはテンプレートを検索するには、以下を実行します。

oc new-app --search php

$ oc new-app --search php2.4. Topology ビューを使用したアプリケーション構成の表示

Web コンソールの Developer パースペクティブにある Topology ビューは、プロジェクト内のすべてのアプリケーション、それらのビルドステータスおよびアプリケーションに関連するコンポーネントとサービスを視覚的に表示します。

前提条件

Topology ビューでアプリケーションを表示し、それらと対話するには、以下を確認します。

- Web コンソールにログインしている。

- Developer パースペクティブにいる。

- OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するための適切なプロジェクト内のロールおよびパーミッションがある。

- Developer パースペクティブを使用して OpenShift Container Platform でアプリケーションを作成し、デプロイしている。

2.4.1. アプリケーションのトポロジーの表示

Developer パースペクティブの左側のナビゲーションパネルを使用すると、Topology ビューに移動できます。アプリケーションを作成したら、Topology ビューに自動的に移動します。ここでは、アプリケーション Pod のステータスの確認、パブリック URL でのアプリケーションへの迅速なアクセス、ソースコードへのアクセスとその変更、最終ビルドのステータスの確認ができます。ズームインおよびズームアウトにより、特定のアプリケーションの詳細を表示することができます。

サーバーレスアプリケーションは、Knative シンボルで視覚的に表示されます (

)。

)。

サーバーレスアプリケーションは、Topology ビューでの読み込みおよび表示にしばらく時間がかかります。サーバーレスアプリケーションを作成すると、これは最初にサービスリソースを作成し、次にリビジョンを作成します。続いてデプロイされて Topology ビューに表示されます。これが唯一のワークロードの場合には、Add ページにリダイレクトされる可能性があります。リビジョンがデプロイされると、サーバーレスアプリケーションは Topology ビューに表示されます。

Pod のステータスまたはフェーズは、色で区別され、ツールチップで次のように表示されます。Running (

)、Not Ready (

)、Not Ready (

)、Warning (

)、Warning (

)、Failed (

)、Failed (

)、Pending (

)、Pending (

)、Succeeded (

)、Succeeded (

)、Terminating (

)、Terminating (

)、または Unknown (

)、または Unknown (

)。Pod のステータスについての詳細は、Kubernetes ドキュメント を参照してください。

)。Pod のステータスについての詳細は、Kubernetes ドキュメント を参照してください。

アプリケーションを作成し、イメージがデプロイされると、ステータスは Pending と表示されます。アプリケーションをビルドすると、Runningと表示されます。

以下のように、異なるタイプのリソースオブジェクトのインジケーターと共に、アプリケーションリソース名が追加されます。

- DC: DeploymentConfigs

- D: Deployment

- SS: StatefulSet

- DS: Daemonset

2.4.2. アプリケーションとの対話

Web コンソールの Developer パースペクティブの Topology ビューは、アプリケーションと対話するための以下のオプションを提供します。

-

Open URL (

) をクリックして、パブリック URL のルートで公開されるアプリケーションを表示します。

) をクリックして、パブリック URL のルートで公開されるアプリケーションを表示します。

Edit Source code をクリックして、ソースコードにアクセスし、これを変更します。

注記この機能は、From Git、From Catalog、および From Dockerfile オプションを使用してアプリケーションを作成する場合にのみ利用できます。

Eclipse Che Operator がクラスターにインストールされている場合、Che ワークスペース

が作成され、ソースコードを編集するためにワークスペースにダイレクトされます。インストールされていない場合には、ソースコードがホストされている Git リポジトリー

が作成され、ソースコードを編集するためにワークスペースにダイレクトされます。インストールされていない場合には、ソースコードがホストされている Git リポジトリー

にダイレクトされます。

にダイレクトされます。

-

カーソルを Pod の左下のアイコンの上に置き、最新ビルドおよびそのステータスを確認します。アプリケーションビルドのステータスは次のように表示されます。 New (

)、Pending (

)、Pending (

)、Running (

)、Running (

)、Completed (

)、Completed (

)、Failed (

)、Failed (

)、および Canceled (

)、および Canceled (

)。

)。

2.4.3. アプリケーション Pod のスケーリングおよびビルドとルートの確認

Topology ビューは、Overview パネルでデプロイ済みのコンポーネントの詳細を提供します。Overview および Resources タブを使用して、アプリケーション Pod をスケーリングし、ビルドのステータス、サービスおよびルートについて以下のように確認できます。

コンポーネントノードをクリックし、右側の Overview パネルを確認します。Overview タブを使用して、以下を実行します。

- 上下の矢印を使用して Pod をスケーリングし、アプリケーションのインスタンス数の増減を手動で調整します。サーバーレスアプリケーションの場合、Pod は、チャネルのトラフィックに基づいてアイドルおよびスケールアップ時に自動的にゼロにスケーリングされます。

- アプリケーションの ラベル、アノテーション および ステータス を確認します。

Resources タブをクリックして、以下を実行します。

- すべての Pod の一覧を確認し、それらのステータスを表示し、ログにアクセスし、Pod をクリックして Pod の詳細を表示します。

- ビルド、ステータスを確認し、ログにアクセスし、必要に応じて新規ビルドを開始します。

- コンポーネントによって使用されるサービスとルートを確認します。

サーバーレスアプリケーションの場合、Resources タブは、そのコンポーネントに使用されるリビジョン、ルート、および設定に関する情報を提供します。

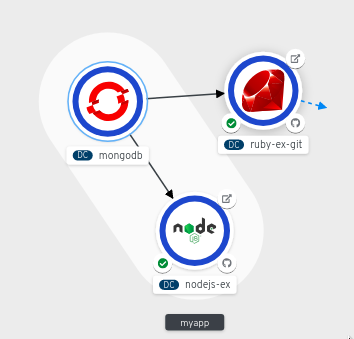

2.4.4. アプリケーション内での複数コンポーネントのグループ化

Add ページを使用して、複数のコンポーネントまたはサービスをプロジェクトに追加し、Topology ページを使用してアプリケーショングループ内のアプリケーションとリソースをグループ化できます。以下の手順では、MongoDB データベースサービスを Node.js コンポーネントを使用して既存のアプリケーションに追加します。

前提条件

- Developer パースペクティブを使用して、OpenShift Container Platform に Node.js アプリケーションを作成し、デプロイしている。

手順

以下のように MongoDB サービスを作成し、これをプロジェクトにデプロイします。

- Developer パースペクティブで、Add ビューに移動して Database オプションを選択し、Developer Catalogを確認します。ここには、アプリケーションにコンポーネントまたはサービスとして追加できる複数のオプションがあります。

- MongoDB オプションをクリックし、サービスの詳細を確認します。

- Instantiate Template をクリックして、MongoDB サービスの詳細情報を含む自動的に設定されたテンプレートを表示し、Create をクリックしてサービスを作成します。

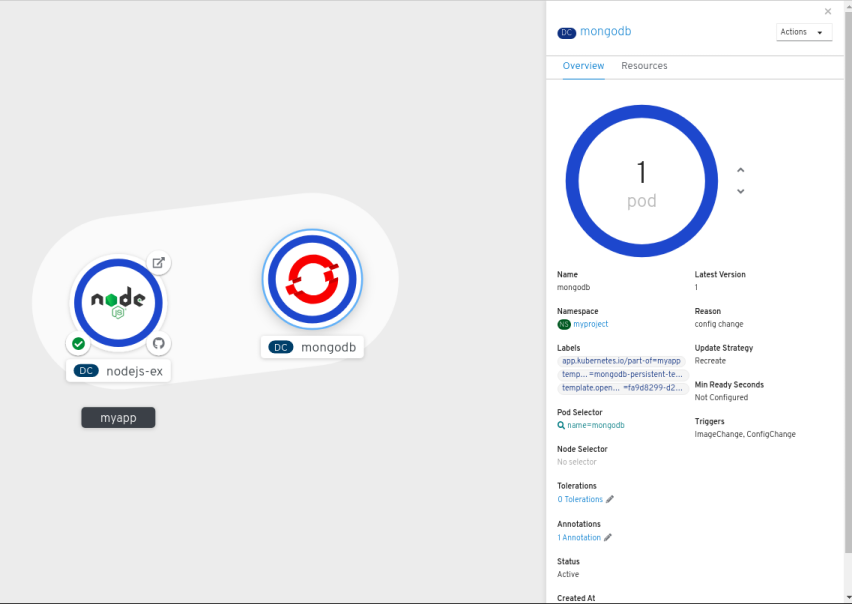

- 左側のナビゲーションパネルで Topology をクリックし、プロジェクトにデプロイされた MongoDB サービスを表示します。

- MongoDB サービスを既存のアプリケーショングループに追加するには、mongodb Pod を選択して、これをアプリケーションにドラッグします。MongoDB サービスは既存のアプリケーショングループに追加されます。

コンポーネントをドラッグし、これをアプリケーショングループに追加すると、必要なラベルがコンポーネントに自動的に追加されます。MongoDB サービスノードをクリックし、Overview パネルの Labels セクションに追加されたラベル

app.kubernetes.io/part-of=myappを確認します。

または、以下のようにコンポーネントをアプリケーションに追加することもできます。

- MongoDB サービスをアプリケーションに追加するには、mongodb Pod をクリックし、右側の Overview パネルを確認します。

- パネルの右上にある Actions ドロップダウンメニューをクリックし、Edit Application Grouping を選択します。

- Edit Application Grouping ダイアログボックスで、Select an Application ドロップダウンリストをクリックし、適切なアプリケーショングループを選択します。

- Save をクリックし、アプリケーショングループに追加された MongoDB サービスを表示します。

2.4.5. アプリケーション内および複数のアプリケーション間でのコンポーネントの接続

アプリケーション内で複数のコンポーネントをグループ化することに加え、Topology ビューを使用してコンポーネントを相互に接続することもできます。MongoDB サービスは、以下のように Node.js アプリケーションを使用して接続できます。

前提条件

- Developer パースペクティブを使用して、OpenShift Container Platform に Node.js アプリケーションを作成し、デプロイしている。

- Developer パースペクティブを使用して、OpenShift Container Platform に MongoDB サービスを作成し、デプロイしている。

手順

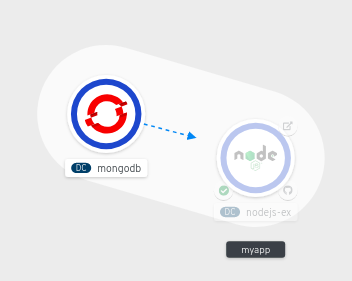

カーソルを MongoDB サービスの上に置き、ノードの矢印を確認します。

- 矢印をクリックして Node.js コンポーネントの方にドラッグし、 MongoDB サービスをこれに接続します。

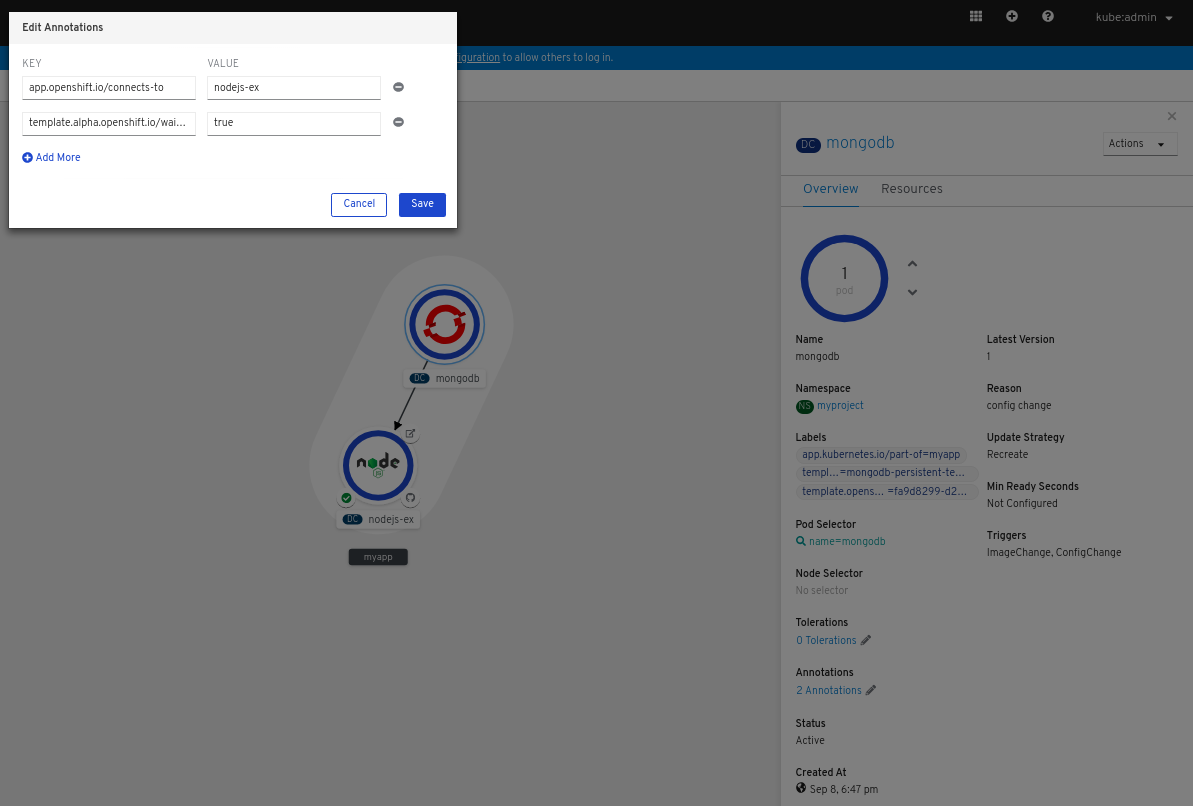

MongoDB サービスをクリックし、Overview パネルを表示します。Annotations セクションで、編集 アイコンをクリックして Key =

app.openshift.io/connects-toおよび Value =nodejs-exアノテーションがサービスに追加されていることを確認します。

他のアプリケーションやコンポーネントを同様に作成し、それらの間の接続を確立することができます。

2.4.6. Topology ビューに使用するラベルとアノテーション

Topology ビューは、以下のラベルおよびアノテーションを使用します。

- ノードに表示されるアイコン

-

ノードのアイコンは、最初に

app.openshift.io/runtimeラベルを使用してからapp.kubernetes.io/nameラベルを使用して一致するアイコンを検索して定義されます。このマッチングは、事前定義されたアイコンセットを使用して行われます。 - ソースコードエディターまたはソースへのリンク

-

app.openshift.io/vcs-uriアノテーションは、ソースコードエディターへのリンクを作成するために使用されます。 - ノードコネクター

-

app.openshift.io/connects-toアノテーションは、ノードに接続するために使用されます。 - アプリケーションのグループ化

-

app.kubernetes.io/part-of=<appname>ラベルは、アプリケーション、サービス、およびコンポーネントをグループ化するために使用されます。

OpenShift Container Platform アプリケーションで使用する必要のあるラベルとアノテーションの詳細については、「Guidelines for labels and annotations for OpenShift applications」を参照してください。

第3章 サービスブローカー

3.1. サービスカタログのインストール

サービスカタログは OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

3.1.1. サービスカタログについて

マイクロサービスベースのアプリケーションを開発して、クラウドネイティブのプラットフォームで実行する場合には、サービスプロバイダーやプラットフォームに合わせて、異なるリソースをプロビジョニングし、その位置情報 (coordinate)、認証情報および設定を共有する数多くの方法を利用できます。

開発者がよりシームレスに作業できるように、OpenShift Container Platform には Kubernetes 向けの Open Service Broker API (OSB API) の実装である サービスカタログ が含まれています。これにより、OpenShift Container Platform にデプロイされているアプリケーションをさまざまな種類のサービスブローカーに接続できます。

サービスカタログでは、クラスター管理者が 1 つの API 仕様を使用して、複数のプラットフォームを統合できます。OpenShift Container Platform Web コンソールは、サービスカタログにサービスブローカーによって提供されるクラスターサービスカタログを表示するので、ユーザーはこれらのサービスをそれぞれのアプリケーションで使用できるようにサービスの検出やインスタンス化を実行できます。

結果として、サービスのユーザーは異なるプロバイダーが提供する異なるタイプのサービスを簡単かつ一貫して使用できるという利点が得られます。また、サービスプロバイダーは、複数のプラットフォームにアクセスできる統合ポイントという利点を得られます。

サービスカタログは、OpenShift Container Platform 4 ではデフォルトでインストールされません。

3.1.2. サービスカタログのインストール

OpenShift Ansible Broker またはテンプレートサービスブローカーからサービスを使用することを計画する場合、以下の手順を実行してサービスカタログをインストールする必要があります。

サービスカタログの API サーバーおよびコントローラーマネージャーのカスタムリソースは OpenShift Container Platform にデフォルトで作成されますが、初期の状態は managementState がRemoved になります。サービスカタログをインストールするには、それらのリソースの managementState を Managed に変更する必要があります。

手順

サービスカタログ API サーバーを有効にします。

以下のコマンドを使用して、サービスカタログ API サーバーリソースを編集します。

oc edit servicecatalogapiservers

$ oc edit servicecatalogapiserversCopy to Clipboard Copied! Toggle word wrap Toggle overflow specの下で、managementStateフィールドをManagedに設定します。spec: logLevel: Normal managementState: Managed

spec: logLevel: Normal managementState: ManagedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 変更を適用するためにファイルを保存します。

Operator はサービスカタログ API サーバーコンポーネントをインストールします。OpenShift Container Platform 4 の時点では、このコンポーネントは

openshift-service-catalog-apiservernamespace にインストールされます。

サービスカタログコントローラーマネージャーを有効にします。

以下のコマンドを使用して、サービスカタログコントローラーマネージャーのリソースを編集します。

oc edit servicecatalogcontrollermanagers

$ oc edit servicecatalogcontrollermanagersCopy to Clipboard Copied! Toggle word wrap Toggle overflow specの下で、managementStateフィールドをManagedに設定します。spec: logLevel: Normal managementState: Managed

spec: logLevel: Normal managementState: ManagedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 変更を適用するためにファイルを保存します。

Operator はサービスカタログコントローラーマネージャーをインストールします。OpenShift Container Platform 4 の時点で、このコンポーネントは

openshift-service-catalog-controller-managernamespace にインストールされます。

3.2. テンプレートサービスブローカーのインストール

テンプレートサービスブローカーをインストールし、これが提供するテンプレートアプリケーションへのアクセスを取得します。

テンプレートサービスブローカーは OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

前提条件

3.2.1. テンプレートサービスブローカーについて

テンプレートサービスブローカー は、サービスカタログに対し、初期リリース以降 OpenShift Container Platform に同梱されるデフォルトのインスタントアプリケーションおよびクイックスタートテンプレートを可視化します。さらにテンプレートサービスブローカーは、Red Hat、クラスター管理者、またはユーザーないしはサードパーティーベンダーのいずれかが作成する OpenShift Container Platform テンプレートのいずれのコンテンツもサービスとして利用可能にすることができます。

デフォルトで、テンプレートサービスブローカーは openshift プロジェクトからグローバルに利用できるオブジェクトを表示します。また、これはクラスター管理者が選択する他のプロジェクトを監視するように設定することもできます。

テンプレートサービスブローカーは、OpenShift Container Platform 4 ではデフォルトでインストールされません。

3.2.2. テンプレートサービスブローカー Operator のインストール

前提条件

- サービスカタログがインストールされていること。

手順

以下の手順では、Web コンソールを使用してテンプレートサービスブローカー Operator をインストールします。

namespace を作成します。

- Web コンソールで Administration → Namespaces に移動し、Create Namespace をクリックします。

Name フィールドに

openshift-template-service-brokerを入力し、Create をクリックします。注記namespace は

openshift-で開始する必要があります。

-

Operators → OperatorHub ページに移動します。

openshift-template-service-brokerプロジェクトが選択されていることを確認します。 - Template Service Broker Operator を選択します。

- Operator についての情報を確認してから、Install をクリックします。

- デフォルトの選択を確認し、Subscribe をクリックします。

次に、テンプレートサービスブローカーを起動し、これが提供するテンプレートアプリケーションへのアクセスを取得します。

3.2.3. テンプレートサービスブローカーの起動

テンプレートサービスブローカー Operator のインストール後に、以下の手順でテンプレートサービスブローカーを起動します。

前提条件

- サービスカタログがインストールされていること。

- テンプレートサービスブローカー Operator がインストールされていること。

手順

-

Web コンソールで Operators → Installed Operators に移動し、

openshift-template-service-brokerプロジェクトを選択します。 - Template Service Broker Operator を選択します。

- Provided APIs で、Template Service Broker について Create New をクリックします。

- デフォルトの YAML を確認し、Create をクリックします。

テンプレートサービスブローカーが起動していることを確認します。

テンプレートサービスブローカーの起動後に、Catalog → Developer Catalog に移動し、Service Class チェックボックスを選択して利用可能なテンプレートアプリケーションを表示できます。テンプレートサービスブローカーが起動し、テンプレートアプリケーションが利用可能になるまで数分の時間がかかる場合があります。

これらのサービスクラスが表示されない場合は、以下の項目のステータスを確認できます。

テンプレートサービスブローカー Pod のステータス

-

openshift-template-service-broker プロジェクトの Workloads → Pods ページから、

apiserver-で起動する Pod のステータスが Running であり、Ready の準備状態であることを確認します。

-

openshift-template-service-broker プロジェクトの Workloads → Pods ページから、

クラスターサービスブローカーのステータス

- Catalog → Broker Management → Service Brokers ページから、template-service-broker サービスブローカーのステータスが Ready であることを確認します。

サービスカタログコントローラーマネージャー Pod のログ

-

openshift-service-catalog-controller-manager プロジェクトの Workloads → Pods ページから、それぞれの Pod のログを確認し、

Successfully fetched catalog entries from brokerのメッセージと共にログエントリーが表示されていることを確認します。

-

openshift-service-catalog-controller-manager プロジェクトの Workloads → Pods ページから、それぞれの Pod のログを確認し、

3.3. テンプレートアプリケーションのプロビジョニング

3.3.1. テンプレートアプリケーションのプロビジョニング

以下の手順では、テンプレートサービスブローカーによって利用可能にされたサンプル PostgreSQL テンプレートアプリケーションをプロビジョニングします。

前提条件

- サービスカタログがインストールされていること。

- テンプレートサービスブローカーがインストールされていること。

手順

プロジェクトを作成します。

- Web コンソールで、Home → Projects に移動し、Create Project をクリックします。

-

test-postgresqlを Name フィールドに入力し、Create をクリックします。

サービスインスタンスを作成します。

- Catalog → Developer Catalog ページに移動します。

- PostgreSQL (Ephemeral) テンプレートアプリケーションを選択し、Create Service Instance をクリックします。

- デフォルトの選択を確認し、それ以外の必要なフィールドを設定してから Create をクリックします。

Catalog → Provisioned Services に移動し、postgresql-ephemeral サービスインスタンスが作成され、ステータスが Ready であることを確認します。

Home → Events ページで進捗を確認できます。しばらくすると、postgresql-ephemeral のイベントが「The instance was provisioned successfully」というメッセージと共に表示されるはずです。

サービスバインディングを作成します。

- Provisioned Services ページから、postgresql-ephemeral をクリックし、Create Service Binding をクリックします。

デフォルトのサービスバインディング名を確認し、Create をクリックします。

これにより、指定された名前を使用してバインディングの新規シークレットが作成されます。

作成されたシークレットを確認します。

- Workloads → Secrets に移動し、postgresql-ephemeral という名前のシークレットが作成されていることを確認します。

- postgresql-ephemeral をクリックし、他のアプリへのバインディングに使用されるキーと値のペアを Data セクションで確認します。

3.4. テンプレートサービスブローカーのアンインストール

テンプレートサービスブローカーは、これが提供するテンプレートアプリケーションへのアクセスを必要としなくなった場合にアンインストールできます。

テンプレートサービスブローカーは OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

3.4.1. テンプレートサービスブローカーのアンインストール

以下の手順では、Web コンソールを使用してテンプレートサービスブローカーおよび Operator をアンインストールします。

クラスターにテンプレートサービスブローカーからプロビジョニングされたサービスがある場合には、これをアンインストールしないでください。アンインストールすると、サービスを管理しようとする際にエラーが生じる可能性があります。

前提条件

- テンプレートサービスブローカーがインストールされていること。

手順

この手順では、テンプレートサービスブローカーが openshift-template-service-broker プロジェクトにインストールされていることを前提とします。

テンプレートサービスブローカーのアンインストール

- Operators → Installed Operators に移動し、ドロップダウンメニューから openshift-template-service-broker プロジェクトを選択します。

- Template Service Broker Operator をクリックします。

- Template Service Broker タブを選択します。

- template-service-broker をクリックします。

- Actions ドロップダウンメニューから、Delete Template Service Broker を選択します。

確認ポップアップ画面から Delete をクリックします。

テンプレートサービスブローカーのアンインストールが終了し、テンプレートアプリケーションは Developer Catalog からすぐに削除されます。

テンプレートサービスブローカー Operator のアンインストール

- Operators → Installed Operators ページに移動し、 Filter by name にスクロールするか、またはキーワードを入力して Template Service Broker Operator 検索し、これをクリックします。

- Operator Details ページの右側で、Actions ドロップダウンメニューから Uninstall Operator を選択します。

- Remove Operator Subscription ウィンドウでプロンプトが表示されたら、インストールに関連するすべてのコンポーネントを削除する場合は、Also completely remove the Operator from the selected namespace チェックボックスをオプションで選択します。これにより CSV が削除され、次に Operator に関連付けられた Pod、Deployment、CRD および CR が削除されます。

- Remove を選択します。この Operator は実行を停止し、更新を受信しなくなります。テンプレートサービスブローカー Operator がクラスターにインストールされていない状態になります。

テンプレートサービスブローカーのアンインストール後に、ユーザーはテンプレートサービスブローカーによって提供されるテンプレートアプリケーションにアクセスできなくなります。

3.5. OpenShift Ansible Broker のインストール

OpenShift Ansible Broker をインストールし、これが提供するサービスバンドルへのアクセスを取得します。

OpenShift Ansible Broker は OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

前提条件

3.5.1. OpenShift Ansible Broker について

OpenShift Ansible Broker は、Ansible playbook bundles (APB) で定義されるアプリケーションを管理する Open Service Broker (OSB) API の実装です。APB は、OpenShift Container Platform のコンテナーアプリケーションを定義し、配信する方法を提供し、Ansible ランタイムと共にコンテナーイメージに組み込まれた Ansible Playbook のバンドルで構成されています。APB は Ansible を活用し、複雑なデプロイメントを自動化する標準メカニズムを構築します。

OpenShift Ansible Brokerは、以下の基本的なワークフローに従います。

- ユーザーは、OpenShift Container Platform Web コンソールを使用してサービスカタログから利用可能なアプリケーションの一覧を要求します。

- サービスカタログは、OpenShift Ansible Broker から利用可能なアプリケーションの一覧を要求します。

- OpenShift Ansible Broker は定義されたコンテナーイメージレジストリーと通信し、利用可能な APB の情報を得ます。

- ユーザーは特定の APB をプロビジョニングする要求を実行します。

- OpenShift Ansible Broker は、APB でプロビジョニングメソッドを呼び出して、ユーザーのプロビジョニング要求に対応します。

OpenShift Ansible Broker は、OpenShift Container Platform 4 ではデフォルトでインストールされません。

3.5.1.1. Ansible Playbook Bundle

Ansible Playbook Bundle (APB) は、Ansible ロールおよび Playbook の既存の投資を活用できるようにする軽量アプリケーション定義です。

APB は、名前の付いた Playbook が含まれる単純なディレクトリーを使用し、プロビジョニングやバインドなどの OSB API アクションを実行します。apb.yml ファイルで定義するメタデータには、デプロイメント時に使用する必須/任意のパラメーターの一覧が含まれています。

3.5.2. OpenShift Ansible Service Broker Operator のインストール

前提条件

- サービスカタログがインストールされていること。

手順

以下の手順では、Web コンソールを使用して OpenShift Ansible Service Broker Operator をインストールします。

namespace を作成します。

- Web コンソールで Administration → Namespaces に移動し、Create Namespace をクリックします。

openshift-ansible-service-brokerを Name フィールドに、openshift.io/cluster-monitoring=trueを Labels フィールドに入力し、Create をクリックします。注記namespace は

openshift-で開始する必要があります。

クラスターのロールバインディングを作成します。

- Administration → Role Bindings に移動し、Create Binding をクリックします。

- Binding Type については、Cluster-wide Role Binding (ClusterRoleBinding) を選択します。

-

Role Binding については、

ansible-service-brokerを Name フィールドに入力します。 - Role については、admin を選択します。

-

Subject については、Service Account オプションを選択し、

openshift-ansible-service-brokernamespace を選択してopenshift-ansible-service-broker-operatorを Subject Name フィールドに入力します。 - Create をクリックします。

Red Hat Container Catalog に接続するためにシークレットを作成します。

-

Workloads → Secrets に移動します。

openshift-ansible-service-brokerプロジェクトが選択されていることを確認します。 - Create → Key/Value Secret をクリックします。

-

asb-registry-authを シークレット名 として入力します。 -

usernameの Key および Red Hat Container Catalog ユーザー名の Value を追加します。 -

Add Key/Value をクリックし、

passwordの Key および Red Hat Container Catalog パスワードの Value を追加します。 - Create をクリックします。

-

Workloads → Secrets に移動します。

-

Operators → OperatorHub ページに移動します。

openshift-ansible-service-brokerプロジェクトが選択されていることを確認します。 - OpenShift Ansible Service Broker Operator を選択します。

- Operator についての情報を確認してから、Install をクリックします。

- デフォルトの選択を確認し、Subscribe をクリックします。

次に、OpenShift Ansible Broker を起動し、これが提供するサービスバンドルへのアクセスを取得します。

3.5.3. OpenShift Ansible Broker の起動

OpenShift Ansible Broker Operator のインストール後に、以下の手順で OpenShift Ansible Broker を起動します。

前提条件

- サービスカタログがインストールされていること。

- OpenShift Ansible Service Broker Operator がインストールされていること。

手順

-

Web コンソールで Operators → Installed Operators に移動し、

openshift-ansible-service-brokerプロジェクトを選択します。 - OpenShift Ansible Service Broker Operator を選択します。

- Provided APIs で、Automation Broker について Create New をクリックします。

以下を、提供されているデフォルトの YAML の

specフィールドに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow これは、OpenShift Ansible Service Broker Operator のインストール時に作成されたシークレットを参照します。これにより、Red Hat Container Catalog に接続できます。

- 追加の OpenShift Ansible Broker 設定オプションを設定し、Create をクリックします。

OpenShift Ansible Broker が起動したことを確認します。

OpenShift Ansible Broker の起動後に、Catalog → Developer Catalog に移動し、Service Class チェックボックスを選択して利用可能なサービスバンドルを表示できます。OpenShift Ansible Broker が起動し、サービスバンドルが利用可能になるまで数分の時間がかかる場合があります。

これらのサービスクラスが表示されない場合は、以下の項目のステータスを確認できます。

OpenShift Ansible Broker Pod のステータス

-

openshift-ansible-service-broker プロジェクトの Workloads → Pods ページから、

asb-で起動する Pod のステータスが Running であり、Ready の準備状態であることを確認します。

-

openshift-ansible-service-broker プロジェクトの Workloads → Pods ページから、

クラスターサービスブローカーのステータス

- Catalog → Broker Management → Service Brokers ページから、ansible-service-broker サービスブローカーのステータスが Ready であることを確認します。

サービスカタログコントローラーマネージャー Pod のログ

-

openshift-service-catalog-controller-manager プロジェクトの Workloads → Pods ページから、それぞれの Pod のログを確認し、

Successfully fetched catalog entries from brokerのメッセージと共にログエントリーが表示されていることを確認します。

-

openshift-service-catalog-controller-manager プロジェクトの Workloads → Pods ページから、それぞれの Pod のログを確認し、

3.5.3.1. OpenShift Ansible Broker 設定オプション

OpenShift Ansible Broker の以下のオプションを設定できます。

| YAML キー | 説明 | デフォルト値 |

|---|---|---|

|

| Broker インスタンスを特定するために使用される名前。 |

|

|

| Broker が置かれている namespace。 |

|

|

| Broker に使用されている完全修飾イメージ。 |

|

|

| Broker イメージ自体に使用されるプルポリシー。 |

|

|

| Broker のデプロイメントに使用されるノードセレクター文字列。 |

|

|

| Broker レジストリー設定の yaml 一覧として表現される。これにより、ユーザーは Broker が検出し、APB の取得に使用するイメージレジストリーを設定できます。 | デフォルトレジストリー配列 を参照してください。 |

|

| Broker のログに使用されるログレベル。 |

|

|

| APB Pod に使用されるプルポリシー。 |

|

|

| APB を実行するために使用されるサービスアカウントに付与されるロール。 |

|

|

| APB の完了後に APB を実行するために作成された一時 namespace が削除されたかどうか (結果の如何は問わない)。 |

|

|

| 結果がエラーの場合のみ、APB の完了後に APB を実行するために作成された一時 namespace が削除されたかどうか。 |

|

|

| Broker が起動時にブートストラップルーチンを実行する必要があるかどうか。 |

|

|

| APB のインベントリーを更新する Broker ブートストラップ間の間隔。 |

|

|

| Experimental: バインド操作時に APB を実行する Broker を切り替えます。 |

|

|

|

APB の実行中に、Broker がユーザーのパーミッションをエスカレートするかどうか。これは、Broker が起点となるユーザー承認を実行してユーザーが APB サンドボックスに付与されたパーミッションを持つようにするため、通常は |

|

|

| Broker が受信する低レベル HTTP 要求を出力するかどうか。 |

|

registries のデフォルト配列

3.6. OpenShift Ansible Broker の設定

OpenShift Ansible Broker は OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

3.6.1. OpenShift Ansible Broker の設定

以下の手順では、OpenShift Ansible Broker の設定をカスタマイズします。

前提条件

- OpenShift Ansible Broker がインストールされていること。

手順

この手順では、ansible-service-broker を OpenShift Ansible Broker 名前とインストール先のプロジェクトの両方に使用していることを前提とします。

-

Web コンソールで Operators → Installed Operators に移動し、

ansible-service-brokerプロジェクトを選択します。 - OpenShift Ansible Service Broker Operator を選択します。

-

Automation Broker タブで、

ansible-service-brokerを選択します。 YAML タブの

specフィールドの下で OpenShift Ansible Broker 設定オプションを追加するか、または更新します。以下は例になります。

spec: keepNamespace: true sandboxRole: edit

spec: keepNamespace: true sandboxRole: editCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Save をクリックして変更を適用します。

3.6.1.1. OpenShift Ansible Broker 設定オプション

OpenShift Ansible Broker の以下のオプションを設定できます。

| YAML キー | 説明 | デフォルト値 |

|---|---|---|

|

| Broker インスタンスを特定するために使用される名前。 |

|

|

| Broker が置かれている namespace。 |

|

|

| Broker に使用されている完全修飾イメージ。 |

|

|

| Broker イメージ自体に使用されるプルポリシー。 |

|

|

| Broker のデプロイメントに使用されるノードセレクター文字列。 |

|

|

| Broker レジストリー設定の yaml 一覧として表現される。これにより、ユーザーは Broker が検出し、APB の取得に使用するイメージレジストリーを設定できます。 | デフォルトレジストリー配列を参照してください。 |

|

| Broker のログに使用されるログレベル。 |

|

|

| APB Pod に使用されるプルポリシー。 |

|

|

| APB を実行するために使用されるサービスアカウントに付与されるロール。 |

|

|

| APB の完了後に APB を実行するために作成された一時 namespace が削除されたかどうか (結果の如何は問わない)。 |

|

|

| 結果がエラーの場合のみ、APB の完了後に APB を実行するために作成された一時 namespace が削除されたかどうか。 |

|

|

| Broker が起動時にブートストラップルーチンを実行する必要があるかどうか。 |

|

|

| APB のインベントリーを更新する Broker ブートストラップ間の間隔。 |

|

|

| Experimental: バインド操作時に APB を実行する Broker を切り替えます。 |

|

|

|

APB の実行中に、Broker がユーザーのパーミッションをエスカレートするかどうか。これは、Broker が起点となるユーザー承認を実行してユーザーが APB サンドボックスに付与されたパーミッションを持つようにするため、通常は |

|

|

| Broker が受信する低レベル HTTP 要求を出力するかどうか。 |

|

registries のデフォルト配列

3.6.2. OpenShift Ansible Broker のモニタリング設定

Prometheus が OpenShift Ansible Broker をモニターできるようにするには、以下のリソースを作成して、OpenShift Ansible Broker がインストールされている namespace にアクセスできるように Prometheus にパーミッションを付与する必要があります。

前提条件

OpenShift Ansible Broker がインストールされていること。

注記この手順では、OpenShift Ansible Broker が

openshift-ansible-service-brokernamespace にインストールされていることを前提とします。

手順

ロールを作成します。

- Administration → Roles に移動し、Create Role をクリックします。

エディターで YAML を以下に置き換えます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Create をクリックします。

ロールバインディングを作成します。

- Administration → Role Bindings に移動し、Create Binding をクリックします。

- Binding Type について、Namespace Role Binding (RoleBinding) を選択します。

-

Role Binding について、

prometheus-k8sを Name フィールドに、openshift-ansible-service-brokerを Namespace フィールドに入力します。 - Role について、prometheus-k8s を選択します。

-

Subject について、Service Account オプションを選択し、

openshift-monitoringnamespace を選択してからprometheus-k8sを Subject Name フィールドに入力します。 - Create をクリックします。

Prometheus は OpenShift Ansible Broker メトリクスにアクセスできるようになります。

3.7. サービスバンドルのプロビジョニング

3.7.1. サービスバンドルのプロビジョニング

以下の手順では、OpenShift Ansible Broker で利用可能にされている PostgreSQL サービスバンドル (APB) のサンプルをプロビジョニングします。

前提条件

- サービスカタログがインストールされていること。

- OpenShift Ansible Broker がインストールされていること。

手順

プロジェクトを作成します。

- Web コンソールで、Home → Projects に移動し、Create Project をクリックします。

-

test-postgresql-apbを Name フィールドに入力し、Create をクリックします。

サービスインスタンスを作成します。

- Catalog → Developer Catalog ページに移動します。

- PostgreSQL (APB) サービスバンドルを選択し、Create Service Instance をクリックします。

- デフォルトの選択を確認し、それ以外の必要なフィールドを設定してから Create をクリックします。

Catalog → Provisioned Services に移動し、dh-postgresql-apb サービスインスタンスが作成され、ステータスが Ready であることを確認します。

Home → Events ページで進捗を確認できます。しばらくすると、dh-postgresql-apb のイベントが「The instance was provisioned successfully」というメッセージと共に表示されるはずです。

サービスバインディングを作成します。

- Provisioned Services ページから、dh-postgresql-apb をクリックし、Create Service Binding をクリックします。

デフォルトのサービスバインディング名を確認し、Create をクリックします。

これにより、指定された名前を使用してバインディングの新規シークレットが作成されます。

作成されたシークレットを確認します。

- Workloads → Secrets に移動し、dh-postgresql-apb という名前のシークレットが作成されていることを確認します。

- dh-postgresql-apb をクリックし、他のアプリへのバインディングに使用されるキーと値のペアを Data セクションで確認します。

3.8. OpenShift Ansible Broker のアンインストール

OpenShift Ansible Broker は、これが提供するサービスバンドルへのアクセスが必要なくなった場合にアンインストールできます。

OpenShift Ansible Broker は OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

3.8.1. OpenShift Ansible Broker のアンインストール

以下の手順では、Web コンソールを使用して OpenShift Ansible Broker およびその Operator をアンインストールします。

クラスターに OpenShift Ansible Broker からプロビジョニングされたサービスがある場合には、これをアンインストールしないでください。アンインストールすると、サービスを管理しようとする際にエラーが生じる可能性があります。

前提条件

- OpenShift Ansible Broker がインストールされていること。

手順

この手順では、OpenShift Ansible Broker が openshift-ansible-service-broker プロジェクトにインストールされていることを前提とします。

OpenShift Ansible Broker をアンインストールします。

- Operators → Installed Operators に移動し、ドロップダウンメニューから openshift-ansible-service-broker プロジェクトを選択します。

- OpenShift Ansible Service Broker Operator をクリックします。

- Automation Broker タブを選択します。

- ansible-service-broker をクリックします。

- Actions ドロップダウンメニューから、Delete Automation Broker を選択します。

確認ポップアップ画面から Delete をクリックします。

OpenShift Ansible Broker のアンインストールが終了し、サービスバンドルは Developer Catalog からすぐに削除されます。

OpenShift Ansible Service Broker Operator のアンインストール

- Operators → Installed Operators ページから、Filter by name にスクロールするか、キーワードを入力して OpenShift Ansible Service Broker Operator を検索してから、これをクリックします。

- Operator Details ページの右側で、Actions ドロップダウンメニューから Uninstall Operator を選択します。

- Remove Operator Subscription ウィンドウでプロンプトが表示されたら、インストールに関連するすべてのコンポーネントを削除する場合は、Also completely remove the Operator from the selected namespace チェックボックスをオプションで選択します。これにより CSV が削除され、次に Operator に関連付けられた Pod、Deployment、CRD および CR が削除されます。

- Remove を選択します。この Operator は実行を停止し、更新を受信しなくなります。

OpenShift Ansible Service Broker Operator がクラスターにインストールされていない状態になります。

OpenShift Ansible Broker のアンインストール後に、ユーザーは OpenShift Ansible Broker で提供されるサービス バンドルにアクセスできなくなります。

第4章 Deployment

4.1. Deployment および DeploymentConfig について

OpenShift Container Platform の Deployment および DeploymentConfig は、一般的なユーザーアプリケーションに対する詳細な管理を行うためのよく似ているものの、異なる 2 つの方法を提供します。これらは、以下の個別の API オブジェクトで構成されています。

- アプリケーションの特定のコンポーネントの必要な状態を記述する、Pod テンプレートとしての DeploymentConfig または Deployment。

- DeploymentConfig には 1 つまたは複数の ReplicationController が使用され、これには Pod テンプレートとしての DeploymentConfig の特定の時点の状態のレコードが含まれます。同様に、Deployment には ReplicationController を継承する 1 つ以上の ReplicaSet が使用されます。

- アプリケーションの特定バージョンのインスタンスを表す 1 つ以上の Pod。

4.1.1. デプロイメントのビルディングブロック

Deployment および DeploymentConfig は、それぞれビルディングブロックとして、ネイティブ Kubernetes API オブジェクトの ReplicationController および ReplicaSet の使用によって有効にされます。

ユーザーは、DeploymentConfig または Deployment によって所有される ReplicationController、ReplicaSet、または Pod を操作する必要はありません。デプロイメントシステムは変更を適切に伝播します。

既存のデプロイメントストラテジーが特定のユースケースに適さない場合で、デプロイメントのライフサイクル期間中に複数の手順を手動で実行する必要がある場合は、カスタムデプロイメントストラテジーを作成することを検討してください。

以下のセクションでは、これらのオブジェクトの詳細情報を提供します。

4.1.1.1. ReplicationController

ReplicationController は、Pod の指定された数のレプリカが常時実行されるようにします。Pod が終了するか、または削除される場合、ReplicationController 定義された数を満たすように追加のインスタンス化を行います。同様に、必要以上の数の Pod が実行されている場合には、定義された数に一致させるために必要な数の Pod を削除します。

ReplicationController 設定は以下で構成されています。

- 必要なレプリカ数 (これはランタイム時に調整可能)。

- レプリケートされた Pod の作成時に使用する Pod 定義。

- 管理された Pod を特定するためのセレクター。

セレクターは、ReplicationController が管理する Pod に割り当てられるラベルセットです。これらのラベルは、Pod 定義に組み込まれ、ReplicationController がインスタンス化します。ReplicationController は、必要に応じて調整できるよう、セレクターを使用してすでに実行中の Pod 数を判別します。

ReplicationController は、負荷またはトラフィックに基づいて自動スケーリングを実行せず、追跡も実行しません。この場合は、レプリカ数を外部の自動スケーラーで調整する必要があります。

以下は ReplicationController 定義の例です。

4.1.1.2. ReplicaSet

ReplicationController と同様に、ReplicaSet は、指定された数の Pod レプリカが特定の時点で実行されるようにするネイティブの Kubernetes API オブジェクトです。ReplicaSet と ReplicationController の相違点は、ReplicaSet ではセットベースのセレクター要件をサポートし、レプリケーションコントローラーは等価ベースのセレクター要件のみをサポートする点です。

カスタム更新のオーケストレーションが必要な場合や、更新が全く必要のない場合にのみ ReplicaSet を使用します。それ以外は Deployment を使用します。ReplicaSet は個別に使用できますが、Pod の作成/削除/更新のオーケストレーションを実行するためにデプロイメントで使用されます。Deployment は ReplicaSet を自動的に管理し、Pod に宣言型の更新を加えるので、作成する ReplicaSet を手動で管理する必要はありません。

以下は、ReplicaSet 定義の例になります。

4.1.2. DeploymentConfig

ReplicationController ベースにビルドされた OpenShift Container Platform は、DeploymentConfig の概念に基づいてソフトウェア開発およびデプロイメントライフサイクルの拡張サポートを追加します。最も単純なケースでは、DeploymentConfig は新規の ReplicationController を作成し、これに Pod を起動させます。

ただし、DeploymentConfig の OpenShift Container Platform デプロイメントは、イメージの既存デプロイメントから新規デプロイメントに移行する機能を提供し、ReplicationController の作成前後に実行されるフックも定義します。

DeploymentConfig デプロイメントシステムは以下の機能を提供します。

- アプリケーションを実行するためのテンプレートである DeploymentConfig。

- イベントへの対応として自動化されたデプロイメントを駆動するトリガー。

- 直前のバージョンから新規バージョンに移行するためのユーザーによるカスタマイズが可能なデプロイメントストラテジー。ストラテジーは通常デプロイメントプロセスと呼ばれ、Pod 内で実行されます。

- デプロイメントのライフサイクル中の異なる時点でカスタム動作を実行するためのフックのセット (ライフサイクルフック)。

- デプロイメントの失敗時に手動または自動でロールバックをサポートするためのアプリケーションのバージョン管理。

- レプリケーションの手動および自動スケーリング。

DeploymentConfig を作成すると、ReplicationController が、DeploymentConfig の Pod テンプレートとして作成されます。DeploymentConfig が変更されると、最新の Pod テンプレートで新しい ReplicationController が作成され、デプロイメントプロセスが実行されて以前の ReplicationController のスケールダウン、および新規 ReplicationController のスケールアップが行われます。

アプリケーションのインスタンスは、作成時にサービスローダーバランサーやルーターに対して自動的に追加/削除されます。アプリケーションが正常なシャットダウン機能をサポートしている限り、アプリケーションが TERM シグナルを受け取ると、実行中のユーザー接続が通常通り完了できるようにすることができます。

OpenShift Container Platform DeploymentConfig オブジェクトは以下の詳細を定義します。

-

ReplicationController定義の要素。 - 新規デプロイメントの自動作成のトリガー。

- デプロイメント間の移行ストラテジー。

- ライフサイクルフック。

デプロイヤー Pod は、デプロイメントがトリガーされるたびに、手動または自動であるかを問わず、(古い ReplicationController のスケールダウン、新規 ReplicationController のスケールアップおよびフックの実行などの) デプロイメントを管理します。デプロイメント Pod は、Deployment のログを維持するために Deployment の完了後は無期限で保持されます。デプロイメントが別のものに置き換えられる場合、以前の ReplicationController は必要に応じて簡単なロールバックを有効にできるように保持されます。

DeploymentConfig 定義の例

4.1.3. Deployment

Kubernetes は、Deployment という OpenShift Container Platform のファーストクラスのネイティブ API オブジェクトを提供します。Deployment は、OpenShift Container Platform 固有の DeploymentConfig として機能します。

DeploymentConfig の様に、Deployment は Pod テンプレートとして、アプリケーションの特定コンポーネントの必要な状態を記述します。Deployment は、Pod のライフサイクルをオーケストレーションする ReplicaSet を作成します。

たとえば、以下の Deployment 定義は ReplicaSet を作成し、1 つの hello-openshift Pod を起動します。

Deployment の定義

4.1.4. Deployment および DeploymentConfig の比較

Kubernetes Deployment および OpenShift Container Platform でプロビジョニングされる DeploymentConfig の両方が OpenShift Container Platform でサポートされていますが、DeploymentConfig で提供される特定の機能または動作が必要でない場合、Deployment を使用することが推奨されます。

以下のセクションでは、使用するタイプの決定に役立つ 2 つのオブジェクト間の違いを詳述します。

4.1.4.1. 設計

Deployment と DeploymentConfig の重要な違いの 1 つとして、ロールアウトプロセスで各設計で選択される CAP theorem (原則) のプロパティーがあります。DeploymentConfig は整合性を優先しますが、Deployment は整合性よりも可用性を優先します。

DeploymentConfig の場合、デプロヤー Pod を実行するノードがダウンする場合、ノードの置き換えは行われません。プロセスは、ノードが再びオンラインになるまで待機するか、または手動で削除されます。ノードを手動で削除すると、対応する Pod も削除されます。つまり、kubelet は関連付けられた Pod も削除するため、Pod を削除してロールアウトの固定解除を行うことはできません。

一方、Deployment ロールアウトはコントローラーマネージャーから実行されます。コントローラーマネージャーはマスター上で高可用性モードで実行され、リーダー選択アルゴリズムを使用して可用性を整合性よりも優先するように設定します。障害の発生時には、他の複数のマスターが同時に同じ Deployment に対して作用する可能性がありますが、この問題は障害の発生直後に調整されます。

4.1.4.2. DeploymentConfig 固有の機能

自動ロールバック

現時点で、Deployment では、問題の発生時の最後に正常にデプロイされた ReplicaSet への自動ロールバックをサポートしていません。

トリガー

Deployment の場合、デプロイメントの Pod テンプレートに変更があるたびに新しいロールアウトが自動的にトリガーされるので、暗黙的な ConfigChange トリガーが含まれます。Pod テンプレートの変更時に新たなロールアウトが不要な場合には、デプロイメントを以下のように停止します。

oc rollout pause deployments/<name>

$ oc rollout pause deployments/<name>ライフサイクルフック

Deployment ではライフサイクルフックをサポートしていません。

カスタムストラテジー

Deployment では、ユーザーが指定するカスタムデプロイメントストラテジーをサポートしていません。

4.1.4.3. Deployment 固有の機能

ロールオーバー

Deployment のデプロイメントプロセスは、すべての新規ロールアウトにデプロイヤー Pod を使用する DeploymentConfig とは対照的に、コントローラーループで実行されます。つまり、Deployment は任意の数のアクティブな ReplicaSet を指定することができ、デプロイメントコントローラーがすべての古い ReplicaSet をスケールダウンし、最新の ReplicaSet をスケールアップします。

DeploymentConfig では、実行できるデプロイヤー Pod は最大 1 つとなっています。複数のデプロイヤーがある場合は競合が生じ、それぞれが最新の ReplicationController であると考えるコントローラーをスケールアップしようとします。これにより、2 つの ReplicationController のみを一度にアクティブにできます。最終的には Deployment のロールアウトが加速します。

比例スケーリング

Deployment コントローラーのみが Deployment が所有する新旧の ReplicaSet のサイズについての信頼できる情報源であるため、継続中のロールアウトのスケーリングが可能です。追加のレプリカはそれぞれの ReplicaSet のサイズに比例して分散されます。

DeploymentConfig については、DeploymentConfig コントローラーが新規 ReplicationController のサイズに関してデプロイヤープロセスと競合するためにロールアウトが続行されている場合はスケーリングできません。

ロールアウト中の一時停止

Deployment はいつでも一時停止できます。つまり、継続中のロールアウトも一時停止できます。一方、デプロイヤー Pod は現時点で一時停止できないので、ロールアウト時に DeploymentConfig を一時停止しようとしても、デプロイヤープロセスはこの影響を受けず、完了するまで続行されます。

4.2. デプロイメントプロセスの管理

4.2.1. DeploymentConfig の管理

DeploymentConfig は、OpenShift Container Platform Web コンソールの Workloads ページからか、または oc CLI を使用して管理できます。以下の手順は、特に指定がない場合の CLI の使用法を示しています。

4.2.1.1. デプロイメントの開始

アプリケーションのデプロイメントプロセスを開始するために、ロールアウト を開始できます。

手順

既存の DeploymentConfig から新規デプロイメントプロセスを開始するには、以下のコマンドを実行します。

oc rollout latest dc/<name>

$ oc rollout latest dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記デプロイメントプロセスが進行中の場合には、このコマンドを実行すると、メッセージが表示され、新規 ReplicationController はデプロイされません。

4.2.1.2. デプロイメントの表示

アプリケーションの利用可能なすべてのリビジョンについての基本情報を取得するためにデプロイメントを表示できます。

手順

現在実行中のデプロイメントプロセスを含む、指定した DeploymentConfig についての最近作成されたすべての ReplicationController についての詳細を表示するには、以下を実行します。

oc rollout history dc/<name>

$ oc rollout history dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow リビジョンに固有の詳細情報を表示するには、

--revisionフラグを追加します。oc rollout history dc/<name> --revision=1

$ oc rollout history dc/<name> --revision=1Copy to Clipboard Copied! Toggle word wrap Toggle overflow デプロイメント設定およびその最新バージョンの詳細については、

oc describeコマンドを使用します。oc describe dc <name>

$ oc describe dc <name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.1.3. デプロイメントの再試行

現行リビジョンの DeploymentConfig がデプロイに失敗した場合、デプロイメントプロセスを再起動することができます。

手順

失敗したデプロイメントプロセスを再起動するには、以下を実行します。

oc rollout retry dc/<name>

$ oc rollout retry dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 最新リビジョンのデプロイメントに成功した場合には、このコマンドによりメッセージが表示され、デプロイメントプロセスはこれ以上試行されません。

注記デプロイメントを再試行すると、デプロイメントプロセスが再起動され、新しいデプロイメントリビジョンは作成されません。再起動された ReplicationController は、失敗したときと同じ設定を使用します。

4.2.1.4. デプロイメントのロールバック

ロールバックすると、アプリケーションを以前のリビジョンに戻します。この操作は、REST API、CLI または Web コンソールで実行できます。

手順

最後にデプロイして成功した設定のリビジョンにロールバックするには以下を実行します。

oc rollout undo dc/<name>

$ oc rollout undo dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow DeploymentConfig のテンプレートは、undo コマンドで指定されたデプロイメントのリビジョンと一致するように元に戻され、新規 ReplicationController が起動します。

--to-revisionでリビジョンが指定されない場合には、最後に成功したデプロイメントのリビジョンが使用されます。ロールバックの完了直後に新規デプロイメントプロセスが誤って開始されないように、DeploymentConfig のイメージ変更トリガーがロールバックの一部として無効にされます。

イメージ変更トリガーを再度有効にするには、以下を実行します。

oc set triggers dc/<name> --auto

$ oc set triggers dc/<name> --autoCopy to Clipboard Copied! Toggle word wrap Toggle overflow

DeploymentConfig は、最新のデプロイメントプロセスが失敗した場合の、設定の最後に成功したリビジョンへの自動ロールバックもサポートします。この場合、デプロイに失敗した最新のテンプレートはシステムで修正されないので、ユーザーがその設定の修正を行う必要があります。

4.2.1.5. コンテナー内でのコマンドの実行

コマンドをコンテナーに追加して、イメージの ENTRYPOINT を却下してコンテナーの起動動作を変更することができます。これは、指定したタイミングでデプロイメントごとに 1 回実行できるライフサイクルフックとは異なります。

手順

commandパラメーターを、DeploymentConfig のspecフィールドを追加します。commandコマンドを変更するargsフィールドも追加できます (またはcommandが存在しない場合には、ENTRYPOINT)。Copy to Clipboard Copied! Toggle word wrap Toggle overflow たとえば、

-jarおよび/opt/app-root/springboots2idemo.jar引数を指定して、javaコマンドを実行するには、以下を実行します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.1.6. デプロイメントログの表示

手順

指定の DeploymentConfig に関する最新リビジョンのログをストリームするには、以下を実行します。

oc logs -f dc/<name>

$ oc logs -f dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 最新のリビジョンが実行中または失敗した場合には、コマンドが、Pod のデプロイを行うプロセスのログを返します。成功した場合には、アプリケーションの Pod からのログを返します。

以前に失敗したデプロイメントプロセスからのログを表示することも可能です。 ただし、これらのプロセス (以前の ReplicationController およびデプロイヤー Pod) が存在し、手動でプルーニングまたは削除されていない場合に限ります。

oc logs --version=1 dc/<name>

$ oc logs --version=1 dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.1.7. デプロイメントトリガー

DeploymentConfig には、クラスター内のイベントに対応する新規デプロイメントプロセスの作成を駆動するトリガーを含めることができます。

トリガーが DeploymentConfig に定義されていない場合は、ConfigChange トリガーがデフォルトで追加されます。トリガーが空のフィールドとして定義されている場合には、デプロイメントは手動で起動する必要があります。

ConfigChange デプロイメントトリガー

ConfigChange トリガーにより、DeploymentConfig の Pod テンプレートで設定の変更が検出されるたびに、新規の ReplicationController が作成されます。

ConfigChange トリガーが DeploymentConfig に定義されている場合は、DeploymentConfig 自体が作成された直後に、最初の ReplicationController が自動的に作成され、一時停止されません。

ConfigChange デプロイメントトリガー

triggers: - type: "ConfigChange"

triggers:

- type: "ConfigChange"ImageChange デプロイメントトリガー

ImageChange トリガーにより、イメージストリームタグの内容の変更時に常に新規 ReplicationController が生成されます (イメージの新規バージョンがプッシュされるタイミング)。

ImageChange デプロイメントトリガー

- 1

imageChangeParams.automaticフィールドがfalseに設定されると、トリガーが無効になります。

上記の例では、origin-ruby-sample イメージストリームの latest タグの値が変更され、新しいイメージの値が DeploymentConfig の helloworld コンテナーに指定されている現在のイメージと異なる場合に、helloworld コンテナーの新規イメージを使用して、新しい ReplicationController が作成されます。

ImageChange トリガーが DeploymentConfig (ConfigChange トリガーと automatic=false、または automatic=true) で定義されていて、ImageChange トリガーで参照されている ImageStreamTag がまだ存在していない場合には、ビルドにより、イメージが、ImageStreamTag にインポートまたはプッシュされた直後に初回のデプロイメントプロセスが自動的に開始されます。

4.2.1.7.1. デプロイメントトリガーの設定

手順

oc set triggersコマンドを使用して、DeploymentConfig にデプロイメントトリガーを設定することができます。たとえば、ImageChangeTriggerを設定するには、以下のコマンドを使用します。oc set triggers dc/<dc_name> \ --from-image=<project>/<image>:<tag> -c <container_name>$ oc set triggers dc/<dc_name> \ --from-image=<project>/<image>:<tag> -c <container_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.1.8. デプロイメントリソースの設定

このリソースはクラスター管理者が一時ストレージのテクノロジープレビュー機能を有効にしている場合にのみ利用できます。この機能はデフォルトでは無効にされています。

デプロイメントは、ノードでリソース (メモリー、CPU および一時ストレージ) を消費する Pod を使用して完了します。デフォルトで、Pod はバインドされていないノードのリソースを消費します。ただし、プロジェクトにデフォルトのコンテナー制限が指定されている場合には、Pod はその上限までリソースを消費します。

デプロイメントストラテジーの一部としてリソース制限を指定して、リソースの使用を制限することも可能です。デプロイメントリソースは、Recreate (再作成)、Rolling (ローリング) または Custom (カスタム) のデプロイメントストラテジーで使用できます。

手順

以下の例では、

resources、cpu、memory、およびephemeral-storageはそれぞれオプションです。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ただし、クォータがプロジェクトに定義されている場合には、以下の 2 つの項目のいずれかが必要です。

明示的な

requestsで設定したresourcesセクション:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

requestsオブジェクトは、クォータ内のリソース一覧に対応するリソース一覧を含みます。

-

プロジェクトで定義される制限の範囲。

LimitRangeオブジェクトのデフォルト値がデプロイメントプロセス時に作成される Pod に適用されます。

デプロイメントリソースを設定するには、上記のいずれかのオプションを選択してください。それ以外の場合は、デプロイ Pod の作成は、クォータ基準を満たしていないことを示すメッセージを出して失敗します。

4.2.1.9. 手動のスケーリング

ロールバック以外に、手動スケーリングにより、レプリカの数を詳細に管理できます。

Pod は oc autoscale コマンドを使用して自動スケーリングすることも可能です。

手順

DeploymentConfig を手動でスケーリングするには、

oc scaleコマンドを使用します。たとえば、以下のコマンドは、frontendDeploymentConfig のレプリカを3に設定します。oc scale dc frontend --replicas=3

$ oc scale dc frontend --replicas=3Copy to Clipboard Copied! Toggle word wrap Toggle overflow レプリカの数は最終的に、DeploymentConfig の

frontendで設定した希望のデプロイメントの状態と現在のデプロイメントの状態に伝播されます。

4.2.1.10. DeploymentConfig からのプライベートリポジトリーへのアクセス

シークレットを DeploymentConfig に追加し、プライベートリポジトリーからイメージにアクセスできるようにします。この手順では、OpenShift Container Platform Web コンソールを使用する方法を示します。

手順

- 新規プロジェクトを作成します。

- Workloads ページから、プライベートイメージリポジトリーにアクセスするための認証情報を含むシークレットを作成します。

- DeploymentConfig を作成します。

- DeploymentConfig エディターページで、Pull Secret を設定し、変更を保存します。

4.2.1.11. 特定のノードへの Pod の割り当て

ラベル付きのノードと合わせてノードセレクターを使用し、Pod の配置を制御することができます。

クラスター管理者は、プロジェクトに対して デフォルトのノードセレクターを設定して 特定のノードに Pod の配置を制限できます。開発者は、Pod 設定にノードセレクターを設定して、ノードをさらに制限することができます。

手順

Pod の作成時にノードセレクターを追加するには、Pod 設定を編集し、

nodeSelectorの値を追加します。これは、単一の Pod 設定や、Pod テンプレートに追加できます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ノードセレクターが有効な場合に作成される Pod は指定されたラベルを持つノードに割り当てられます。ここで指定されるラベルは、クラスター管理者によって追加されるラベルと併用されます。

たとえば、プロジェクトに

type=user-nodeとregion=eastのラベルがクラスター管理者により追加され、上記のdisktype: ssdラベルを Pod に追加した場合に、Pod は 3 つのラベルすべてが含まれるノードにのみスケジュールされます。注記ラベルには値を 1 つしか設定できないので、

region=eastが管理者によりデフォルト設定されている Pod 設定にregion=westのノードセレクターを設定すると、Pod が全くスケジュールされなくなります。

4.2.1.12. 異なるサービスアカウントでの Pod の実行

デフォルト以外のサービスアカウントで Pod を実行できます。

手順

DeploymentConfig を編集します。

oc edit dc/<deployment_config>

$ oc edit dc/<deployment_config>Copy to Clipboard Copied! Toggle word wrap Toggle overflow serviceAccountとserviceAccountNameパラメーターをspecフィールドに追加し、使用するサービスアカウントを指定します。spec: securityContext: {} serviceAccount: <service_account> serviceAccountName: <service_account>spec: securityContext: {} serviceAccount: <service_account> serviceAccountName: <service_account>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3. DeploymentConfig ストラテジーの使用

デプロイメントストラテジー は、アプリケーションを変更またはアップグレードする 1 つの方法です。この目的は、ユーザーには改善が加えられていることが分からないように、ダウンタイムなしに変更を加えることにあります。

エンドユーザーは通常ルーターによって処理されるルート経由でアプリケーションにアクセスするため、デプロイメントストラテジーは、DeploymentConfig 機能またはルーティング機能に重点を置きます。DeploymentConfig に重点を置くストラテジーは、アプリケーションを使用するすべてのルートに影響を与えます。ルーター機能を使用するストラテジーは個別のルートにターゲットを設定します。

デプロイメントストラテジーの多くは、DeploymentConfig でサポートされ、追加のストラテジーはルーター機能でサポートされます。このセクションでは、DeploymentConfig ストラテジーについて説明します。

デプロイメントストラテジーの選択

デプロイメントストラテジーを選択する場合に、以下を考慮してください。

- 長期間実行される接続は正しく処理される必要があります。

- データベースの変換は複雑になる可能性があり、アプリケーションと共に変換し、ロールバックする必要があります。

- アプリケーションがマイクロサービスと従来のコンポーネントを使用するハイブリッドの場合には、移行の完了時にダウンタイムが必要になる場合があります。

- これを実行するためのインフラストラクチャーが必要です。

- テスト環境が分離されていない場合は、新規バージョンと以前のバージョン両方が破損してしまう可能性があります。

デプロイメントストラテジーは、readiness チェックを使用して、新しい Pod の使用準備ができているかを判断します。readiness チェックに失敗すると、DeploymentConfig は、タイムアウトするまで Pod の実行を再試行します。デフォルトのタイムアウトは、10m で、値は dc.spec.strategy.*params の TimeoutSeconds で設定します。

4.3.1. ローリングストラテジー

ローリングデプロイメントは、以前のバージョンのアプリケーションインスタンスを、新しいバージョンのアプリケーションインスタンスに徐々に置き換えます。ローリングストラテジーは、DeploymentConfig にストラテジーが指定されていない場合に使用されるデフォルトのデプロイメントストラテジーです。

ローリングデプロイメントは通常、新規 Pod が readiness check によって ready になるのを待機してから、古いコンポーネントをスケールダウンします。重大な問題が生じる場合、ローリングデプロイメントは中止される場合があります。

ローリングデプロイメントの使用のタイミング

- ダウンタイムを発生させずに、アプリケーションの更新を行う場合

- 以前のコードと新しいコードの同時実行がアプリケーションでサポートされている場合

ローリングデプロイメントとは、以前のバージョンと新しいバージョンのコードを同時に実行するという意味です。これは通常、アプリケーションで N-1 互換性に対応する必要があります。

ローリングストラテジー定義の例

- 1

- 各 Pod が次に更新されるまで待機する時間。指定されていない場合、デフォルト値は

1となります。 - 2

- 更新してからデプロイメントステータスをポーリングするまでの間待機する時間。指定されていない場合、デフォルト値は

1となります。 - 3

- イベントのスケーリングを中断するまでの待機時間。この値はオプションです。デフォルトは

600です。ここでの 中断 とは、自動的に以前の完全なデプロイメントにロールバックされるという意味です。 - 4

maxSurgeはオプションで、指定されていない場合には、デフォルト値は25%となります。以下の手順の次にある情報を参照してください。- 5

maxUnavailableはオプションで、指定されていない場合には、デフォルト値は25%となります。以下の手順の次にある情報を参照してください。- 6

preおよびpostはどちらもライフサイクルフックです。

ローリングストラテジー:

-

preライフサイクルフックを実行します。 - サージ数に基づいて新しい ReplicationController をスケールアップします。

- 最大利用不可数に基づいて以前の ReplicationController をスケールダウンします。

- 新しい ReplicationController が希望のレプリカ数に到達して、以前の ReplicationController の数がゼロになるまで、このスケーリングを繰り返します。

-

postライフサイクルフックを実行します。

スケールダウン時には、ローリングストラテジーは Pod の準備ができるまで待機し、スケーリングを行うことで可用性に影響が出るかどうかを判断します。Pod をスケールアップしたにもかかわらず、準備が整わない場合には、デプロイメントプロセスは最終的にタイムアウトして、デプロイメントに失敗します。

maxUnavailable パラメーターは、更新時に利用できない Pod の最大数です。maxSurge パラメーターは、元の Pod 数を超えてスケジュールできる Podの 最大数です。どちらのパラメーターも、パーセント (例: 10%) または絶対値 (例: 2) のいずれかに設定できます。両方のデフォルト値は 25% です。

以下のパラメーターを使用して、デプロイメントの可用性やスピードを調整できます。以下は例になります。

-

maxUnavailable*=0およびmaxSurge*=20%が指定されていると、更新時および急速なスケールアップ時に完全なキャパシティーが維持されるようになります。 -

maxUnavailable*=10%およびmaxSurge*=0が指定されていると、追加のキャパシティーを使用せずに更新を実行します (インプレース更新)。 -

maxUnavailable*=10%およびmaxSurge*=10%の場合は、キャパシティーが失われる可能性がありますが、迅速にスケールアップおよびスケールダウンします。

一般的に、迅速にロールアウトする場合は maxSurge を使用します。リソースのクォータを考慮して、一部に利用不可の状態が発生してもかまわない場合には、maxUnavailable を使用します。

4.3.1.1. カナリアデプロイメント

OpenShift Container Platform におけるすべてのローリングデプロイメントは カナリアデプロイメント です。新規バージョン (カナリア) はすべての古いインスタンスが置き換えられる前にテストされます。readiness チェックが成功しない場合、カナリアインスタンスは削除され、DeploymentConfig は自動的にロールバックされます。

readiness チェックはアプリケーションコードの一部であり、新規インスタンスが使用できる状態にするために必要に応じて高度な設定をすることができます。(実際のユーザーワークロードを新規インスタンスに送信するなどの) アプリケーションのより複雑なチェックを実装する必要がある場合、カスタムデプロイメントや blue-green デプロイメントストラテジーの実装を検討してください。

4.3.1.2. ローリングデプロイメントの作成

ローリングデプロイメントは OpenShift Container Platform のデフォルトタイプです。CLI を使用してローリングデプロイメントを作成できます。

手順

DockerHub にあるデプロイメントイメージの例を基にアプリケーションを作成します。

oc new-app openshift/deployment-example

$ oc new-app openshift/deployment-exampleCopy to Clipboard Copied! Toggle word wrap Toggle overflow ルーターをインストールしている場合は、ルートを使用してアプリケーションを利用できるようにしてください (または、サービス IP を直接使用してください)。

oc expose svc/deployment-example

$ oc expose svc/deployment-exampleCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

deployment-example.<project>.<router_domain>でアプリケーションを参照し、v1イメージが表示されることを確認します。 レプリカが最大 3 つになるまで、DeploymentConfig をスケーリングします。

oc scale dc/deployment-example --replicas=3

$ oc scale dc/deployment-example --replicas=3Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいバージョンの例を

latestとタグ付けして、新規デプロイメントを自動的にトリガーします。oc tag deployment-example:v2 deployment-example:latest

$ oc tag deployment-example:v2 deployment-example:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

ブラウザーで、

v2イメージが表示されるまでページを更新します。 CLI を使用している場合は、以下のコマンドで、バージョン 1 に Pod がいくつあるか、バージョン 2 にはいくつあるかを表示します。Web コンソールでは、Pod が徐々に v2 に追加され、v1 から削除されます。

oc describe dc deployment-example

$ oc describe dc deployment-exampleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

デプロイメントプロセス時に、新規 ReplicationController は徐々にスケールアップされます。(rediness チェックをパスした後に) 新規 Pod に ready のマークが付けられると、デプロイメントプロセスは継続されます。

Pod が準備状態にならない場合、プロセスは中止し、DeploymentConfig は直前のバージョンにロールバックします。

4.3.2. 再作成ストラテジー

再作成ストラテジーは、基本的なロールアウト動作で、デプロイメントプロセスにコードを挿入するためのライフサイクルフックをサポートします。

再作成ストラテジー定義の例

再作成ストラテジー:

-

preライフサイクルフックを実行します。 - 以前のデプロイメントをゼロにスケールダウンします。

-

任意の

midライフサイクルフックを実行します。 - 新規デプロイメントをスケールアップします。

-

postライフサイクルフックを実行します。

スケールアップ中に、デプロイメントのレプリカ数が複数ある場合は、デプロイメントの最初のレプリカが準備できているかどうかが検証されてから、デプロイメントが完全にスケールアップされます。最初のレプリカの検証に失敗した場合には、デプロイメントは失敗とみなされます。

再作成デプロイメントの使用のタイミング:

- 新規コードを起動する前に、移行または他のデータの変換を行う必要がある場合

- 以前のバージョンと新しいバージョンのアプリケーションコードの同時使用をサポートしていない場合

- 複数のレプリカ間での共有がサポートされていない、RWO ボリュームを使用する場合

再作成デプロイメントでは、短い期間にアプリケーションのインスタンスが実行されなくなるので、ダウンタイムが発生します。ただし、以前のコードと新しいコードは同時には実行されません。

4.3.3. カスタムストラテジー

カスタムストラテジーでは、独自のデプロイメントの動作を提供できるようになります。

カスタムストラテジー定義の例

上記の例では、organization/strategy コンテナーイメージにより、デプロイメントの動作が提供されます。オプションの command 配列は、イメージの Dockerfile で指定した CMD ディレクティブを上書きします。指定したオプションの環境変数は、ストラテジープロセスの実行環境に追加されます。

さらに、OpenShift Container Platform は以下の環境変数をデプロイメントプロセスに提供します。

| 環境変数 | 説明 |

|---|---|

|

| 新規デプロイメント名 (ReplicationController) |

|

| 新規デプロイメントの namespace |