This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.Serverless

OpenShift Serverless のインストール、使用法、およびリリースノート

概要

第1章 リリースノート

リリースノートには、新機能、非推奨機能、互換性を損なう変更、既知の問題に関する情報が記載されています。以下のリリースノートは、OpenShift Container Platform 上の最新の OpenShift Serverless リリースに適用されます。

OpenShift Serverless 機能の概要については、OpenShift Serverless について を参照してください。

OpenShift Serverless はオープンソースの Knative プロジェクトに基づいています。

最新の Knative コンポーネントリリースの詳細は、Knative ブログ を参照してください。

1.1. API バージョンについて

API バージョンは、OpenShift Serverless の特定の機能およびカスタムリソースの開発状況を示す重要な指標です。正しい API バージョンを使用していないリソースをクラスター上に作成すると、デプロイメントで問題が発生する可能性があります。

OpenShift Serverless Operator は、最新バージョンを使用するように非推奨の API を使用する古いリソースを自動的にアップグレードします。たとえば、v1beta1 などの古いバージョンの ApiServerSource API を使用するクラスターにリソースを作成した場合、OpenShift Serverless Operator はこれらのリソースを自動的に更新し、これが利用可能な場合に API の v1 バージョンを使用するように、v1beta1 バージョンは非推奨になりました。

非推奨となった古いバージョンは、今後のリリースで削除される可能性があります。API の非推奨バージョンを使用すると、リソースが失敗することはありません。ただし、削除された API のバージョンを使用しようとすると、リソースが失敗します。問題を回避するために、マニフェストが最新バージョンを使用するように更新されていることを確認します。

1.2. 一般提供およびテクノロジープレビュー機能

一般提供 (GA) の機能は完全にサポートされており、実稼働での使用に適しています。テクノロジープレビュー (TP) 機能は実験的な機能であり、本番環境での使用を目的としたものではありません。TP 機能の詳細については、Red Hat Customer Portal の Technology Preview のサポート範囲 を参照してください。

次の表は、どの OpenShift Serverless 機能が GA であり、どの機能が TP であるかに関する情報を提供します。

| 機能 | 1.23 | 1.24 | 1.25 |

|---|---|---|---|

|

| TP | TP | TP |

| サービスメッシュ mTLS | GA | GA | GA |

|

| GA | GA | GA |

| HTTPS リダイレクト | GA | GA | GA |

| Kafka ブローカー | TP | TP | GA |

| Kafka シンクコ | TP | TP | GA |

| Knative サービスの init コンテナーのサポート | TP | GA | GA |

| Knative サービスの PVC サポート | TP | TP | TP |

| 内部トラフィックの TLS | - | - | TP |

1.3. 非推奨および削除された機能

以前のリリースで一般提供 (GA) またはテクノロジープレビュー (TP) であった一部の機能は、非推奨または削除されました。非推奨の機能は依然として OpenShift Serverless に含まれており、引き続きサポートされますが、本製品の今後のリリースで削除されるため、新規デプロイメントでの使用は推奨されません。

OpenShift Serverless で非推奨となり、削除された主な機能の最新の一覧については、以下の表を参照してください。

| 機能 | 1.20 | 1.21 | 1.22 から 1.25 |

|---|---|---|---|

|

| 非推奨 | 非推奨 | 廃止 |

|

| 非推奨 | 廃止 | 廃止 |

1.4. Red Hat OpenShift Serverless 1.25.0 のリリースノート

OpenShift Serverless 1.25.0 が公開されました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.4.1. 新機能

- OpenShift Serverless は Knative Serving 1.4 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 1.4 を使用するようになりました。

- OpenShift Serverless は Kourier 1.4 を使用するようになりました。

-

OpenShift Serverless は Knative (

kn) CLI 1.4 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 1.4 を使用するようになりました。

-

kn funcCLI プラグインはfunc1.7.0 を使用するようになりました。 - 関数を作成およびデプロイするための統合開発環境 (IDE) プラグインが、Visual Studio Code および IntelliJ で利用できるようになりました。

Knative Kafka ブローカーが一般提供されるようになりました。Knative Kafka ブローカーは、Apache Kafka を直接ターゲットとする、Knative ブローカー API の高性能な実装です。

MT-Channel-Broker ではなく、Knative Kafka ブローカーを使用することをお勧めします。

-

Knative Kafka シンクが一般提供されるようになりました。

KafkaSinkはCloudEventを取得し、Apache Kafka トピックに送信します。イベントは、構造化コンテンツモードまたはバイナリーコンテンツモードのいずれかで指定できます。 - 内部トラフィックの TLS の有効化がテクノロジープレビューとして利用可能になりました。

1.4.2. 修正された問題

- 以前のバージョンでは、Knative Serving には liveness プローブの失敗後にコンテナーが再起動された場合に readiness プローブが失敗する問題がありました。この問題は修正されています。

1.4.3. 既知の問題

- 連邦情報処理標準 (FIPS) モードは、Kafka ブローカー、Kafka ソース、および Kafka シンクに対して無効になっています。

-

SinkBindingオブジェクトは、サービスのカスタムリビジョン名をサポートしません。

1.5. Red Hat OpenShift Serverless 1.24.0 のリリースノート

OpenShift Serverless 1.24.0 が公開されました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.5.1. 新機能

- OpenShift Serverless は Knative Serving 1.3 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 1.3 を使用するようになりました。

- OpenShift Serverless は Kourier 1.3 を使用するようになりました。

-

OpenShift Serverless は、Knative (

kn) CLI 1.3 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 1.3 を使用するようになりました。

-

kn funcCLI プラグインはfunc0.24 を使用するようになりました。 - Knative サービスの初期化コンテナーのサポートが一般提供 (GA) になりました。

- OpenShift Serverless ロジックが開発者プレビューとして利用できるようになりました。これにより、サーバーレスアプリケーションを管理するための宣言型ワークフローモデルを定義できます。

- OpenShift Serverless で Cost Management Service を使用できるようになりました。

1.5.2. 修正された問題

OpenShift Serverless を Red Hat OpenShift Service Mesh と統合すると、クラスターに存在するシークレットが多すぎると、起動時に

net-istio-controllerPod がメモリー不足になります。シークレットフィルターリングを有効にできるようになりました。これにより、

net-istio-controllerは、networking.internal.knative.dev/certificate-uidラベルを持つシークレットのみを考慮するようになり、必要なメモリー量が削減されます。- OpenShift Serverless 機能テクノロジープレビューは、デフォルトで Cloud Native Buildpacks を使用してコンテナーイメージをビルドするようになりました。

1.5.3. 既知の問題

- 連邦情報処理標準 (FIPS) モードは、Kafka ブローカー、Kafka ソース、および Kafka シンクに対して無効になっています。

OpenShift Serverless 1.23 では、KafkaBindings および kafka

-bindingWebhook のサポートが削除されました。ただし、既存のkafkabindings.webhook.kafka.sources.knative.dev MutatingWebhookConfigurationが残り、もはや存在しないkafka-source-webhookサービスを指している可能性があります。クラスター上の KafkaBindings の特定の仕様については、

kafkabindings.webhook.kafka.sources.knative.dev MutatingWebhookConfigurationを設定して、Webhook を介して Deployment、Knative Services、または Jobs などのさまざまなリソースに作成および更新イベントを渡すことができます。その後失敗します。この問題を回避するには、OpenShift Serverless 1.23 にアップグレードした後、クラスターから

kafkabindings.webhook.kafka.sources.knative.dev MutatingWebhookConfigurationを手動で削除します。oc delete mutatingwebhookconfiguration kafkabindings.webhook.kafka.sources.knative.dev

$ oc delete mutatingwebhookconfiguration kafkabindings.webhook.kafka.sources.knative.devCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6. Red Hat OpenShift Serverless 1.23.0 のリリースノート

OpenShift Serverless 1.23.0 が公開されました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.6.1. 新機能

- OpenShift Serverless は Knative Serving 1.2 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 1.2 を使用するようになりました。

- OpenShift Serverless は Kourier 1.2 を使用するようになりました。

-

OpenShift Serverless は Knative (

kn) CLI 1.2 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 1.2 を使用するようになりました。

-

kn funcCLI プラグインはfunc0.24 を使用するようになりました。 -

Kafka ブローカーで

kafka.eventing.knative.dev/external.topicアノテーションを使用できるようになりました。このアノテーションを使用すると、ブローカー自体の内部トピックを作成する代わりに、既存の外部管理トピックを使用できます。 -

kafka-ch-controllerおよびkafka-webhookKafka コンポーネントが存在しなくなりました。これらのコンポーネントはkafka-webhook-eventingコンポーネントに置き換えられました。 - OpenShift Serverless Functions Technology Preview は、デフォルトで Source-to-Image (S2I) を使用してコンテナーイメージをビルドするようになりました。

1.6.2. 既知の問題

- 連邦情報処理標準 (FIPS) モードは、Kafka ブローカー、Kafka ソース、および Kafka シンクに対して無効になっています。

-

Kafka ブローカーを含む namespace を削除する場合、ブローカーの

auth.secret.ref.nameシークレットがブローカーの前に削除されると、namespace ファイナライザーが削除されない可能性があります。 多数の Knative サービスで OpenShift Serverless を実行すると、Knative アクティベーター Pod がデフォルトのメモリー制限である 600MB 近くで実行される可能性があります。これらの Pod は、メモリー消費がこの制限に達すると再起動される可能性があります。アクティベーターデプロイメントの要求と制限は、

KnativeServingカスタムリソースを変更することで設定できます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

関数のローカルビルド戦略として CloudNativeBuildpack を使用している場合、

kn funcは podman を自動的に起動したり、リモートデーモンへの SSH トンネルを使用したりすることはできません。これらの問題の回避策は、関数をデプロイする前に、ローカル開発コンピューターで Docker または podman デーモンを既に実行していることです。 - 現時点で、クラスター上の関数ビルドが Quarkus および Golang ランタイムで失敗します。これらは Node、Typescript、Python、および Springboot ランタイムで正常に機能します。

1.7. Red Hat OpenShift Serverless 1.22.0 のリリースノート

OpenShift Serverless 1.22.0 が公開されました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.7.1. 新機能

- OpenShift Serverless は Knative Serving 1.1 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 1.1 を使用するようになりました。

- OpenShift Serverless は Kourier 1.1 を使用するようになりました。

-

OpenShift Serverless は Knative (

kn) CLI 1.1 を使用するようになりました。 - OpenShift Serverless は KnativeKafka1.1 を使用するようになりました。

-

kn funcCLI プラグインはfunc0.23 を使用するようになりました。 - Knative サービスの初期コンテナーサポートがテクノロジープレビューとして利用できるようになりました。

- Knative サービスの永続ボリュームクレーム (PVC) サポートが、テクノロジープレビューとして利用できるようになりました。

-

knative-serving、knative-serving-ingress、knative-eventing、およびknative-kafkaシステムネームボックスに、デフォルトでknative.openshift.io/part-of:"openshift-serverless"ラベルが付けられるようになりました。 - Knative Eventing-Kafka Broker/Trigger ダッシュボードが追加されました。これにより、Web コンソールで Kafka ブローカーとトリガーメトリックを視覚化できます。

- Knative Eventing-KafkaSink ダッシュボードが追加されました。これにより、Web コンソールで KafkaSink メトリックを視覚化できます。

- Knative Eventing-Broker/Trigger ダッシュボードは、Knative Eventing-Channel-based Broker/Trigger と呼ばれるようになりました。

-

knative.openshift.io/part-of: " openshift-serverless "ラベルが、knative.openshift.io/system-namespaceラベルに置き換わりました。 -

Knative Serving YAML 設定ファイルの命名スタイルがキャメルケース (

ExampleName) からハイフンスタイル (example-name) に変更されました。このリリース以降、Knative Serving YAML 設定ファイルを作成または編集するときは、ハイフンスタイルの表記を使用してください。

1.7.2. 既知の問題

- 連邦情報処理標準 (FIPS) モードは、Kafka ブローカー、Kafka ソース、および Kafka シンクに対して無効になっています。

1.8. Red Hat OpenShift Serverless 1.21.0 のリリースノート

OpenShift Serverless 1.21.0 が利用可能になりました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.8.1. 新機能

- OpenShift Serverless は Knative Serving 1.0 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 1.0 を使用するようになりました。

- OpenShift Serverless は Kourier 1.0 を使用するようになりました。

-

OpenShift Serverless は、Knative (

kn) CLI 1.0 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 1.0 を使用するようになりました。

-

kn funcCLI プラグインはfunc0.21 を使用するようになりました。 - Kafka シンクがテクノロジープレビューとして利用できるようになりました。

-

Knative オープンソースプロジェクトは、camel-cased 設定キーを廃止し、kebab-cased キーを一貫して使用することを支持し始めました。その結果、OpenShift Serverless 1.18.0 リリースノートで前述した

defaultExternalSchemeキーは非推奨になり、default-external-schemeキーに置き換えられました。キーの使用方法は同じです。

1.8.2. 修正された問題

-

OpenShift Serverless 1.20.0 では、サービスにイベントを送信するための

kn event sendの使用に影響するイベント配信の問題がありました。この問題は修正されています。 -

OpenShift Serverless 1.20.0 (

func0.20) では、httpテンプレートを使用して作成された TypeScript 関数をクラスターにデプロイできませんでした。この問題は修正されています。 -

OpenShift Serverless 1.20.0 (

func0.20) では、gcr.ioレジストリーを使用した関数のデプロイがエラーで失敗しました。この問題は修正されています。 -

OpenShift Serverless 1.20.0 (

func0.20) では、kn func createコマンドを使用して Springboot 関数プロジェクトディレクトリーを作成してから、kn func buildコマンドを実行するとエラーメッセージが表示されて失敗しました。この問題は修正されています。 -

OpenShift Serverless 1.19.0 (

func0.19) では、一部のランタイムが podman を使用して関数をビルドできませんでした。この問題は修正されています。

1.8.3. 既知の問題

現在、ドメインマッピングコントローラーは、現在サポートされていないパスを含むブローカーの URI を処理できません。

つまり、

DomainMappingカスタムリソース (CR) を使用してカスタムドメインをブローカーにマップする場合は、ブローカーの入力サービスを使用してDomainMappingCR を設定し、ブローカーの正確なパスをカスタムドメインに追加する必要があります。DomainMappingCRの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow その場合、ブローカーの URI は

<domain-name>/<broker-namespace>/<broker-name>になります。

1.9. Red Hat OpenShift Serverless 1.20.0 のリリースノート

OpenShift Serverless 1.20.0 が利用可能になりました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.9.1. 新機能

- OpenShift Serverless は Knative Serving 0.26 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 0.26 を使用するようになりました。

- OpenShift Serverless は Kourier 0.26 を使用するようになりました。

-

OpenShift Serverless は、Knative (

kn) CLI 0.26 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 0.26 を使用するようになりました。

-

kn funcCLI プラグインはfunc0.20 を使用するようになりました。 Kafka ブローカーがテクノロジープレビュー機能として利用可能になりました。

重要現在テクノロジープレビューにある Kafka ブローカーは、FIPS ではサポートされていません。

-

kn eventプラグインがテクノロジープレビュー機能として利用可能になりました。 -

knservicecreateコマンドの--min-scaleフラグと--max-scaleフラグは廃止されました。代わりに、-scale-minフラグと--scale-maxフラグを使用してください。

1.9.2. 既知の問題

OpenShift Serverless は、HTTPS を使用するデフォルトアドレスで Knative サービスをデプロイします。クラスター内のリソースにイベントを送信する場合、送信側にはクラスターの認証局 (CA) が設定されていません。これにより、クラスターがグローバルに受け入れ可能な証明書を使用しない限り、イベント配信は失敗します。

たとえば、一般にアクセス可能なアドレスへのイベント配信は機能します。

kn event send --to-url https://ce-api.foo.example.com/

$ kn event send --to-url https://ce-api.foo.example.com/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 一方、サービスがカスタム CA によって発行された HTTPS 証明書でパブリックアドレスを使用する場合、この配信は失敗します。

kn event send --to Service:serving.knative.dev/v1:event-display

$ kn event send --to Service:serving.knative.dev/v1:event-displayCopy to Clipboard Copied! Toggle word wrap Toggle overflow ブローカーやチャネルなどの他のアドレス指定可能なオブジェクトへのイベント送信は、この問題の影響を受けず、期待どおりに機能します。

- 現在、Kafka ブローカーは Federal Information Processing Standards (FIPS) モードが有効になっているクラスターでは動作しません。

kn func createコマンドで Springboot 関数プロジェクトディレクトリーを作成する場合、それ以降のkn func buildコマンドの実行は、以下のエラーメッセージと共に失敗します。[analyzer] no stack metadata found at path '' [analyzer] ERROR: failed to : set API for buildpack 'paketo-buildpacks/ca-certificates@3.0.2': buildpack API version '0.7' is incompatible with the lifecycle

[analyzer] no stack metadata found at path '' [analyzer] ERROR: failed to : set API for buildpack 'paketo-buildpacks/ca-certificates@3.0.2': buildpack API version '0.7' is incompatible with the lifecycleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 回避策として、関数設定ファイル

func.yamlでbuilderプロパティーをgcr.io/paketo-buildpacks/builder:baseに変更します。gcr.ioレジストリーを使用した関数のデプロイは、以下のエラーメッセージと共に失敗します。Error: failed to get credentials: failed to verify credentials: status code: 404

Error: failed to get credentials: failed to verify credentials: status code: 404Copy to Clipboard Copied! Toggle word wrap Toggle overflow 回避策として、

quay.ioまたはdocker.ioなどのgcr.io以外のレジストリーを使用します。httpテンプレートで作成された Typescript 関数は、クラスターへのデプロイに失敗します。回避策として、

func.yamlファイルで以下のセクションを置き換えます。buildEnvs: []

buildEnvs: []Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上記を以下のように置き換えます。

buildEnvs: - name: BP_NODE_RUN_SCRIPTS value: build

buildEnvs: - name: BP_NODE_RUN_SCRIPTS value: buildCopy to Clipboard Copied! Toggle word wrap Toggle overflow funcバージョン 0.20 では、一部のランタイムが podman を使用して関数をビルドできない場合があります。以下のようなエラーメッセージが表示される場合があります。ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOF

ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow この問題には、以下の回避策があります。

--time=0をサービスExecStart定義に追加して、podman サービスを更新します。サービス設定の例

ExecStart=/usr/bin/podman $LOGGING system service --time=0

ExecStart=/usr/bin/podman $LOGGING system service --time=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して podman サービスを再起動します。

systemctl --user daemon-reload

$ systemctl --user daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl restart --user podman.socket

$ systemctl restart --user podman.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow

または、TCP を使用して podman API を公開することもできます。

podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534

$ podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.10. Red Hat OpenShift Serverless 1.19.0 のリリースノート

OpenShift Serverless 1.19.0 が利用可能になりました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.10.1. 新機能

- OpenShift Serverless は Knative Serving 0.25 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 0.25 を使用するようになりました。

- OpenShift Serverless は Kourier 0.25 を使用するようになりました。

-

OpenShift Serverless は Knative (

kn) CLI 0.25 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 0.25 を使用するようになりました。

-

kn funcCLI プラグインはfunc0.19 を使用するようになりました。 -

KafkaBindingAPI は OpenShift Serverless 1.19.0 で非推奨となり、今後のリリースで廃止される予定です。 - HTTPS リダイレクトがサポートされ、クラスターに対してグローバルに設定することも、各 Knative サービスごとに設定することもできるようになりました。

1.10.2. 修正された問題

- 以前のリリースでは、Kafka チャネルディスパッチャーは、ローカルコミットが成功するのを待ってからしか応答していませんでした。これにより、Apache Kafka ノードに障害が発生した場合に、イベントが失われる可能性がありました。Kafka チャネルディスパッチャーは、すべての同期レプリカがコミットするのを待ってから応答するようになりました。

1.10.3. 既知の問題

funcバージョン 0.19 では、一部のランタイムが podman を使用して関数をビルドできない場合があります。以下のようなエラーメッセージが表示される場合があります。ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOF

ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow この問題には、以下の回避策があります。

--time=0をサービスExecStart定義に追加して、podman サービスを更新します。サービス設定の例

ExecStart=/usr/bin/podman $LOGGING system service --time=0

ExecStart=/usr/bin/podman $LOGGING system service --time=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して podman サービスを再起動します。

systemctl --user daemon-reload

$ systemctl --user daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl restart --user podman.socket

$ systemctl restart --user podman.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow

または、TCP を使用して podman API を公開することもできます。

podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534

$ podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.11. Red Hat OpenShift Serverless 1.18.0 のリリースノート

OpenShift Serverless 1.18.0 が利用可能になりました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.11.1. 新機能

- OpenShift Serverless は Knative Serving 0.24.0 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 0.24.0 を使用するようになりました。

- OpenShift Serverless は Kourier 0.24.0 を使用するようになりました。

-

OpenShift Serverless は Knative (

kn) CLI 0.24.0 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 0.24.7 を使用するようになりました。

-

kn funcCLI プラグインはfunc0.18.0 を使用するようになりました。 今後の OpenShift Serverless 1.19.0 リリースでは、外部ルートの URL スキームはデフォルトで HTTPS になり、セキュリティーが強化されます。

この変更をワークロードに適用する必要がない場合は、以下の YAML を

KnativeServingカスタムリソース (CR) に追加してから 1.19.0 にアップグレードする前にデフォルト設定を上書きできます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 変更を 1.18.0 ですでに適用する必要がある場合には、以下の YAML を追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 今後の OpenShift Serverless 1.19.0 リリースでは、Kourier ゲートウェイが公開されるデフォルトのサービスタイプは

ClusterIPであり、LoadBalancerではありません。この変更をワークロードに適用する必要がない場合は、以下の YAML を

KnativeServingカスタムリソース定義 (CRD) に追加してから 1.19.0 にアップグレードする前にデフォルト設定を上書きできます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

OpenShift Serverless で

emptyDirボリュームを使用できるようになりました。詳細は、Knative Serving に関する OpenShift Serverless ドキュメントを参照してください。 -

kn funcを使用して関数を作成すると、Rust テンプレートが利用できるようになりました。

1.11.2. 修正された問題

- 以前の 1.4 バージョンの Camel-K は OpenShift Serverless 1.17.0 と互換性がありませんでした。Camel-K の問題が修正され、Camel-K バージョン 1.4.1 を OpenShift Serverless 1.17.0 で使用できます。

以前のバージョンでは、Kafka チャネルまたは新しい Kafka ソースの新しいサブスクリプションを作成する場合は、新しく作成されたサブスクリプションまたはシンクが準備完了ステータスを報告した後、Kafka データプレーンがメッセージをディスパッチする準備ができるまでに遅延が生じる可能性があります。

その結果、データプレーンが準備完了ステータスを報告していないときに送信されたメッセージは、サブスクライバーまたはシンクに配信されない可能性があります。

OpenShift Serverless 1.18.0 では、問題が修正され、初期メッセージが失われなくなりました。この問題の詳細は、ナレッジベースの記事 #6343981 を参照してください。

1.11.3. 既知の問題

Knative

knCLI の古いバージョンは、Knative Serving および Knative Eventing API の古いバージョンを使用する可能性があります。たとえば、knCLI のバージョン 0.23.2 はv1alpha1API バージョンを使用します。一方、OpenShift Serverless の新しいリリースでは、古い API バージョンをサポートしない可能性があります。たとえば、OpenShift Serverless 1.18.0 は

kafkasources.sources.knative.devAPI のバージョンv1alpha1をサポートしなくなりました。そのため、

knが古い API を検出できないため、新しい OpenShift Serverless で古いバージョンの KnativeknCLI を使用するとエラーが発生する可能性がありました。たとえば、knCLI のバージョン 0.23.2 は OpenShift Serverless 1.18.0 では機能しません。問題を回避するには、OpenShift Serverless リリースで利用可能な最新の

knCLI バージョンを使用します。OpenShift Serverless 1.18.0 については、KnativeknCLI 0.24.0 を使用します。

1.12. Red Hat OpenShift Serverless 1.17.0 のリリースノート

OpenShift Serverless 1.17.0 が利用可能になりました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.12.1. 新機能

- OpenShift Serverless は Knative Serving 0.23.0 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 0.23.0 を使用するようになりました。

- OpenShift Serverless は Kourier 0.23.0 を使用するようになりました。

-

OpenShift Serverless は Knative

knCLI 0.23.0 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 0.23.0 を使用するようになりました。

-

kn funcCLI プラグインはfunc0.17.0 を使用するようになりました。 今後の OpenShift Serverless 1.19.0 リリースでは、外部ルートの URL スキームはデフォルトで HTTPS になり、セキュリティーが強化されます。

この変更をワークロードに適用する必要がない場合は、以下の YAML を

KnativeServingカスタムリソース (CR) に追加してから 1.19.0 にアップグレードする前にデフォルト設定を上書きできます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - mTLS 機能は一般に利用可能 (GA) になりました。

-

kn funcを使用して関数を作成すると、Typescript テンプレートが利用できるようになりました。 Knative Eventing 0.23.0 で API バージョンへの変更

-

OpenShift Serverless バージョン 1.14.0 で非推奨となった

KafkaChannelAPI のv1alpha1バージョンが削除されました。設定マップのChannelTemplateSpecパラメーターにこの古いバージョンの参照が含まれる場合は、これを仕様のこの部分を更新して、正しい API バージョンを使用する必要があります。

-

OpenShift Serverless バージョン 1.14.0 で非推奨となった

1.12.2. 既知の問題

新しい OpenShift Serverless リリースで古いバージョンの Knative

knCLI の使用を試行する場合は、API が見つからないとエラーが発生します。たとえば、バージョン 0.22.0 を使用する

knCLI の 1.16.0 リリースと、Knative Serving および Knative Eventing API の 0.23.0 バージョンを使用する 1.17.0 OpenShift Serverless リリースを使用する場合、CLI は、古い 0.22.0 API バージョンを探し続けるため、機能しません。問題を回避するために、OpenShift Serverless リリースの最新の

knCLI バージョンを使用していることを確認してください。- 本リリースでは、Kafka チャネルメトリクスは、対応する Web コンソールダッシュボードで監視されず、表示されません。これは、Kafka ディスパッチャーの調整プロセスが大幅に変更されたためです。

Kafka チャネルまたは新しい Kafka ソースの新しいサブスクリプションを作成する場合は、新しく作成されたサブスクリプションまたはシンクが準備完了ステータスを報告した後、Kafka データプレーンがメッセージをディスパッチする準備ができるまでに遅延が生じる可能性があります。

その結果、データプレーンが準備完了ステータスを報告していない間に送信されたメッセージは、サブスクライバーまたはシンクに配信されない場合があります。

この問題および可能な回避策に関する詳細は、ナレッジアーティクル #6343981 を参照してください。

Camel-K 1.4 リリースは、OpenShift Serverless バージョン 1.17.0 と互換性がありません。これは、Camel-K 1.4 が Knative バージョン 0.23.0 で削除された API を使用するためです。現在、この問題に対する回避策はありません。OpenShift Serverless で Camel-K 1.4 を使用する必要がある場合は、OpenShift Serverless バージョン 1.17.0 にアップグレードしないでください。

注記この問題は修正され、Camel-K バージョン 1.4.1 は OpenShift Serverless 1.17.0 と互換性があります。

1.13. Red Hat OpenShift Serverless 1.16.0 のリリースノート

OpenShift Serverless 1.16.0 が利用可能になりました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.13.1. 新機能

- OpenShift Serverless は Knative Serving 0.22.0 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 0.22.0 を使用するようになりました。

- OpenShift Serverless は Kourier 0.22.0 を使用するようになりました。

-

OpenShift Serverless は Knative

knCLI 0.22.0 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 0.22.0 を使用するようになりました。

-

kn funcCLI プラグインはfunc0.16.0 を使用するようになりました。 -

kn func emitコマンドが関数knプラグインに追加されました。このコマンドを使用してイベントを送信し、ローカルにデプロイされた機能をテストできます。

1.13.2. 既知の問題

- OpenShift Serverless 1.16.0 にアップグレードする前に、OpenShift Container Platform をバージョン 4.6.30、4.7.11、またはそれ以降にアップグレードする必要があります。

AMQ Streams Operator は、OpenShift Serverless Operator のインストールまたはアップグレードを妨げる可能性があります。これが生じる場合、以下のエラーが Operator Lifecycle Manager (OLM) によって出力されます。

WARNING: found multiple channel heads: [amqstreams.v1.7.2 amqstreams.v1.6.2], please check the `replaces`/`skipRange` fields of the operator bundles.

WARNING: found multiple channel heads: [amqstreams.v1.7.2 amqstreams.v1.6.2], please check the `replaces`/`skipRange` fields of the operator bundles.Copy to Clipboard Copied! Toggle word wrap Toggle overflow この問題を修正するには、OpenShift Serverless Operator をインストールまたはアップグレードする前に AMQ Streams Operator をアンインストールしてください。その後、AMQ Streams Operator を再インストールできます。

- サービスメッシュが mTLS で有効にされている場合、サービスメッシュが Prometheus のメトリクスの収集を阻止するため、Knative Serving のメトリクスはデフォルトで無効にされます。Service Mesh および mTLS で使用する Knative Serving メトリクスを有効にする方法は、Serverless ドキュメントの Integrating Service Mesh with OpenShift Serverless セクションを参照してください。

Istio Ingress を有効にしてサービスメッシュ CR をデプロイする場合、

istio-ingressgatewayPod に以下の警告が表示される可能性があります。2021-05-02T12:56:17.700398Z warning envoy config [external/envoy/source/common/config/grpc_subscription_impl.cc:101] gRPC config for type.googleapis.com/envoy.api.v2.Listener rejected: Error adding/updating listener(s) 0.0.0.0_8081: duplicate listener 0.0.0.0_8081 found

2021-05-02T12:56:17.700398Z warning envoy config [external/envoy/source/common/config/grpc_subscription_impl.cc:101] gRPC config for type.googleapis.com/envoy.api.v2.Listener rejected: Error adding/updating listener(s) 0.0.0.0_8081: duplicate listener 0.0.0.0_8081 foundCopy to Clipboard Copied! Toggle word wrap Toggle overflow Knative サービスにもアクセスできない場合があります。

以下の回避策を使用して、

knative-local-gatewayサービスを再作成することでこの問題を修正できます。istio-systemnamespace の既存のknative-local-gatewayサービスを削除します。oc delete services -n istio-system knative-local-gateway

$ oc delete services -n istio-system knative-local-gatewayCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の YAML が含まれる

knative-local-gatewayサービスを作成し、適用します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

クラスターに 1000 の Knative サービスがあり、Knative Serving の再インストールまたはアップグレードを実行する場合、

KnativeServingカスタムリソース (CR) の状態がReadyになった後に最初の新しいサービスを作成すると遅延が生じます。3scale-kourier-controlサービスは、新しいサービスの作成を処理する前に、既存のすべての Knative サービスを調整します。これにより、新規サービスは状態がReadyに更新されるまで、IngressNotConfiguredまたはUnknownの状態で約 800 秒を費やすことになります。Kafka チャネルまたは新しい Kafka ソースの新しいサブスクリプションを作成する場合は、新しく作成されたサブスクリプションまたはシンクが準備完了ステータスを報告した後、Kafka データプレーンがメッセージをディスパッチする準備ができるまでに遅延が生じる可能性があります。

その結果、データプレーンが準備完了ステータスを報告していない間に送信されたメッセージは、サブスクライバーまたはシンクに配信されない場合があります。

この問題および可能な回避策に関する詳細は、ナレッジアーティクル #6343981 を参照してください。

1.14. Red Hat OpenShift Serverless 1.15.0 のリリースノート

OpenShift Serverless 1.15.0 が公開されました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.14.1. 新機能

- OpenShift Serverless は Knative Serving 0.21.0 を使用するようになりました。

- OpenShift Serverless は Knative Eventing Operator 0.21.0 を使用するようになりました。

- OpenShift Serverless は Kourier 0.21.0 を使用するようになりました。

-

OpenShift Serverless は Knative

knCLI 0.21.0 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 0.21.1 を使用するようになりました。

- OpenShift Serverless Functions はテクノロジープレビューとして利用可能になりました。

これまでプライベートサービスの作成に使用されていた serving.knative.dev/visibility ラベルは非推奨になりました。既存のサービスを更新して、代わりに networking.knative.dev/visibility ラベルを使用する必要があります。

1.14.2. 既知の問題

Kafka チャネルまたは新しい Kafka ソースの新しいサブスクリプションを作成する場合は、新しく作成されたサブスクリプションまたはシンクが準備完了ステータスを報告した後、Kafka データプレーンがメッセージをディスパッチする準備ができるまでに遅延が生じる可能性があります。

その結果、データプレーンが準備完了ステータスを報告していない間に送信されたメッセージは、サブスクライバーまたはシンクに配信されない場合があります。

この問題および可能な回避策に関する詳細は、ナレッジアーティクル #6343981 を参照してください。

1.15. Red Hat OpenShift Serverless 1.14.0 のリリースノート

OpenShift Serverless 1.14.0 が公開されました。以下では、OpenShift Container Platform 上の OpenShift Serverless に関連する新機能、変更点および既知の問題について説明します。

1.15.1. 新機能

- OpenShift Serverless は Knative Serving 0.20.0 を使用するようになりました。

- OpenShift Serverless は Knative Eventing 0.20.0 を使用しています。

- OpenShift Serverless は Kourier 0.20.0 を使用するようになりました。

-

OpenShift Serverless は Knative

knCLI 0.20.0 を使用するようになりました。 - OpenShift Serverless は Knative Kafka 0.20.0 を使用するようになりました。

OpenShift Serverless での Knative Kafka は一般に利用可能 (GA) になりました。

重要OpenShift Serverless の

KafkaChannelおよびKafkaSourceオブジェクトの API のv1beta1バージョンのみがサポートされます。非推奨となったv1alpha1バージョンの API は使用しないでください。-

OpenShift Serverless のインストールおよびアップグレード用の Operator チャネルが OpenShift Container Platform 4.6 以降のバージョンで

stableに更新されました。 OpenShift Serverless は、IBM Power Systems、IBM Z、および LinuxONE でサポートされるようになりましたが、以下の機能はまだサポートされていません。

- Knative Kafka の機能。

- OpenShift Serverless 機能の developer プレビュー。

1.15.2. 既知の問題

-

Kafka チャネルのサブスクリプションには

READYのマークが付けられず、SubscriptionNotMarkedReadyByChannel状態のままになることがあります。これを修正するには、Kafka チャネルの dispatcher を再起動します。 Kafka チャネルまたは新しい Kafka ソースの新しいサブスクリプションを作成する場合は、新しく作成されたサブスクリプションまたはシンクが準備完了ステータスを報告した後、Kafka データプレーンがメッセージをディスパッチする準備ができるまでに遅延が生じる可能性があります。

その結果、データプレーンが準備完了ステータスを報告していない間に送信されたメッセージは、サブスクライバーまたはシンクに配信されない場合があります。

この問題および可能な回避策に関する詳細は、ナレッジアーティクル #6343981 を参照してください。

第2章 発見

2.1. OpenShift Serverless について

OpenShift Serverless は、Kubernetes ネイティブなビルディングブロックを提供します。開発者はこれらを使用して、OpenShift Container Platform 上でサーバーレスのイベント駆動型アプリケーションを作成およびデプロイできます。OpenShift Serverless はオープンソースの Knative プロジェクト をベースとし、エンタープライズレベルのサーバーレスプラットフォームを有効にすることで、ハイブリッドおよびマルチクラウド環境に対して移植性と一貫性をもたらします。

2.1.1. Knative Serving

Knative Serving は、クラウドネイティブアプリケーション の作成、デプロイ、管理を希望する開発者をサポートします。これにより、オブジェクトのセットが OpenShift Container Platform クラスター上のサーバーレスワークロードの動作を定義し制御する Kubernetes カスタムリソース定義 (CRD) として提供されます。

開発者はこれらの CRD を使用して、複雑なユースケースに対応するためにビルディングブロックとして使用できるカスタムリソース (CR) インスタンスを作成します。以下に例を示します。

- サーバーレスコンテナーの迅速なデプロイ

- Pod の自動スケーリング

2.1.1.1. Knative Serving リソース

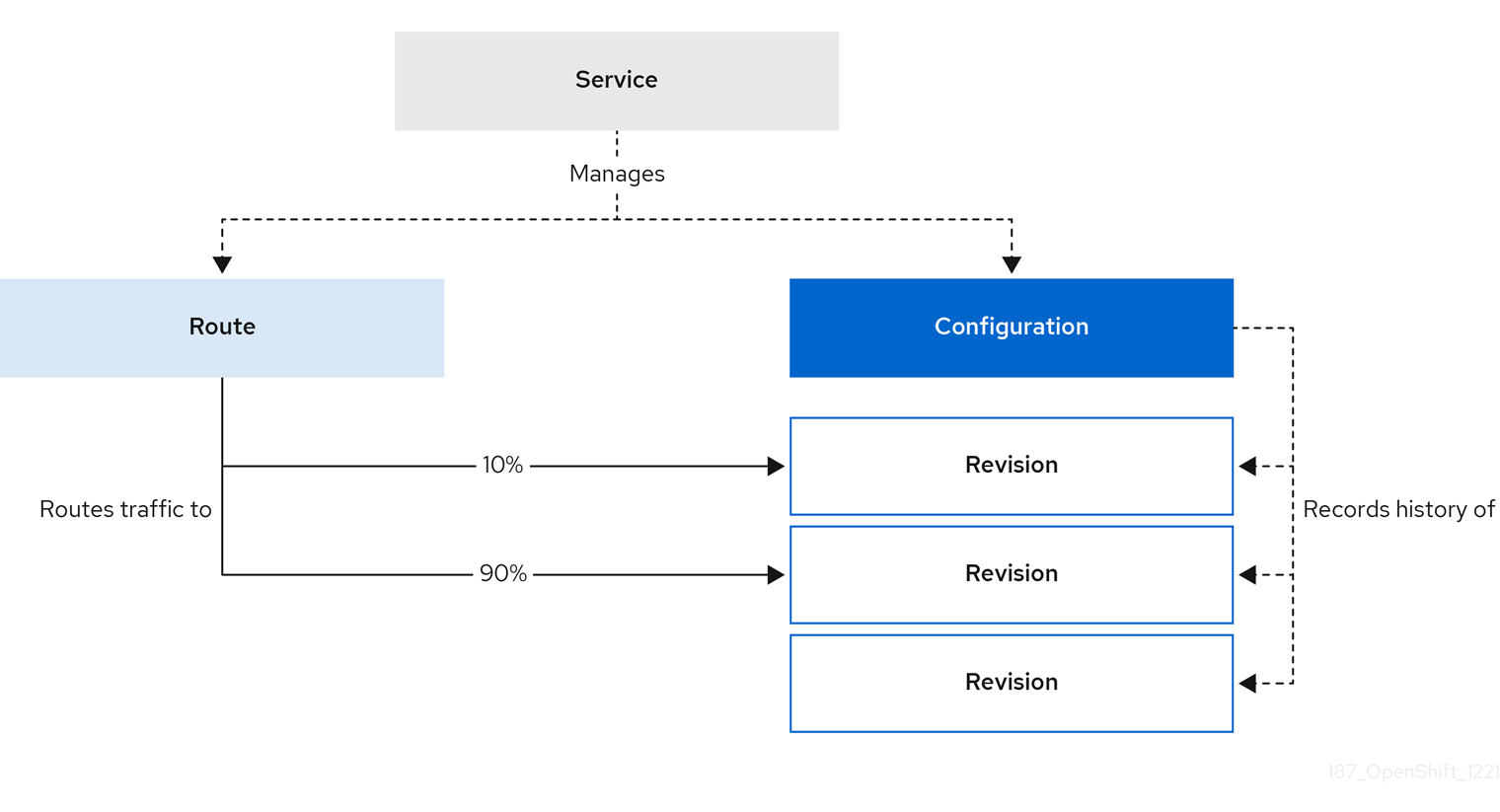

- サービス

-

service.serving.knative.devCRD はワークロードのライフサイクルを自動的に管理し、アプリケーションがネットワーク経由でデプロイされ、到達可能であることを確認します。これは、ユーザーが作成したサービスまたはカスタムリソースに対して加えられるそれぞれの変更についての ルート、設定、および新規リビジョンを作成します。Knative での開発者の対話のほとんどは、サービスを変更して実行されます。 - Revision

-

revision.serving.knative.devCRD は、ワークロードに対して加えられるそれぞれの変更についてのコードおよび設定の特定の時点におけるスナップショットです。Revision (リビジョン) はイミュータブル (変更不可) オブジェクトであり、必要な期間保持することができます。 - Route

-

route.serving.knative.devCRD は、ネットワークのエンドポイントを、1 つ以上のリビジョンにマップします。部分的なトラフィックや名前付きルートなどのトラフィックを複数の方法で管理することができます。 - Configuration

-

configuration.serving.knative.devCRD は、デプロイメントの必要な状態を維持します。これにより、コードと設定を明確に分離できます。設定を変更すると、新規リビジョンが作成されます。

2.1.2. Knative Eventing

OpenShift Container Platform 上の Knative Eventing を使用すると、開発者はサーバーレスアプリケーションと共に イベント駆動型のアーキテクチャー を使用できます。イベント駆動型のアーキテクチャーは、イベントプロデューサーとイベントコンシューマー間の関係を切り離すという概念に基づいています。

イベントプロデューサーはイベントを作成し、イベントシンクまたはコンシューマーはイベントを受信します。Knative Eventing は、標準の HTTP POST リクエストを使用してイベントプロデューサーとシンク間でイベントを送受信します。これらのイベントは CloudEvents 仕様 に準拠しており、すべてのプログラミング言語でのイベントの作成、解析、および送受信を可能にします。

Knative Eventing は以下のユースケースをサポートします。

- コンシューマーを作成せずにイベントを公開する

- イベントを HTTP POST としてブローカーに送信し、バインディングを使用してイベントを生成するアプリケーションから宛先設定を分離できます。

- パブリッシャーを作成せずにイベントを消費

- Trigger を使用して、イベント属性に基づいて Broker からイベントを消費できます。アプリケーションはイベントを HTTP POST として受信します。

複数のタイプのシンクへの配信を有効にするために、Knative Eventing は複数の Kubernetes リソースで実装できる以下の汎用インターフェイスを定義します。

- アドレス指定可能なリソース

-

HTTP 経由でイベントの

status.address.urlフィールドに定義されるアドレスに配信されるイベントを受信し、確認することができます。KubernetesServiceリソースはアドレス指定可能なインターフェイスにも対応します。 - 呼び出し可能なリソース

-

HTTP 経由で配信されるイベントを受信し、これを変換できます。HTTP 応答ペイロードで

0または1の新規イベントを返します。返されるイベントは、外部イベントソースからのイベントが処理されるのと同じ方法で処理できます。

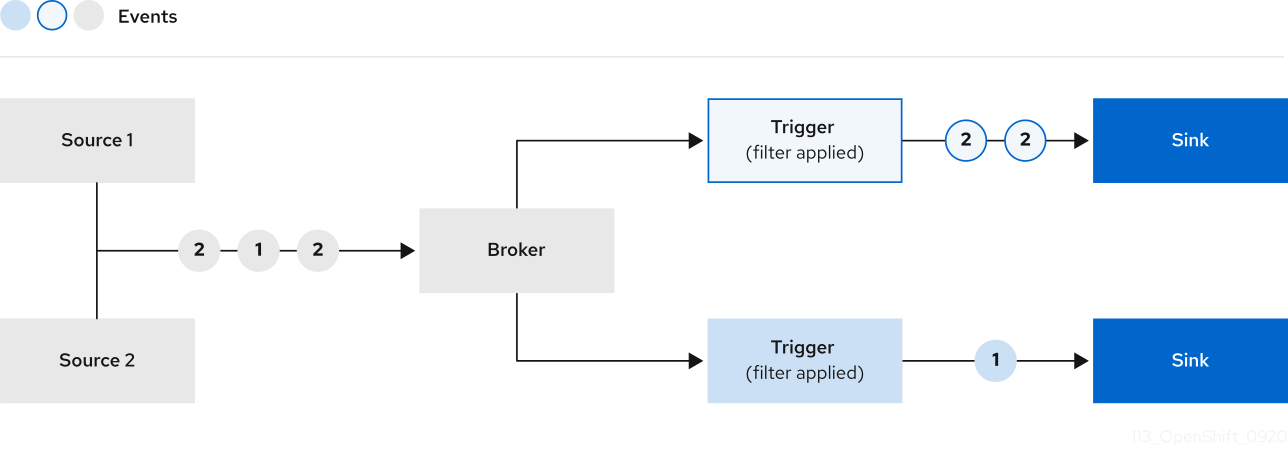

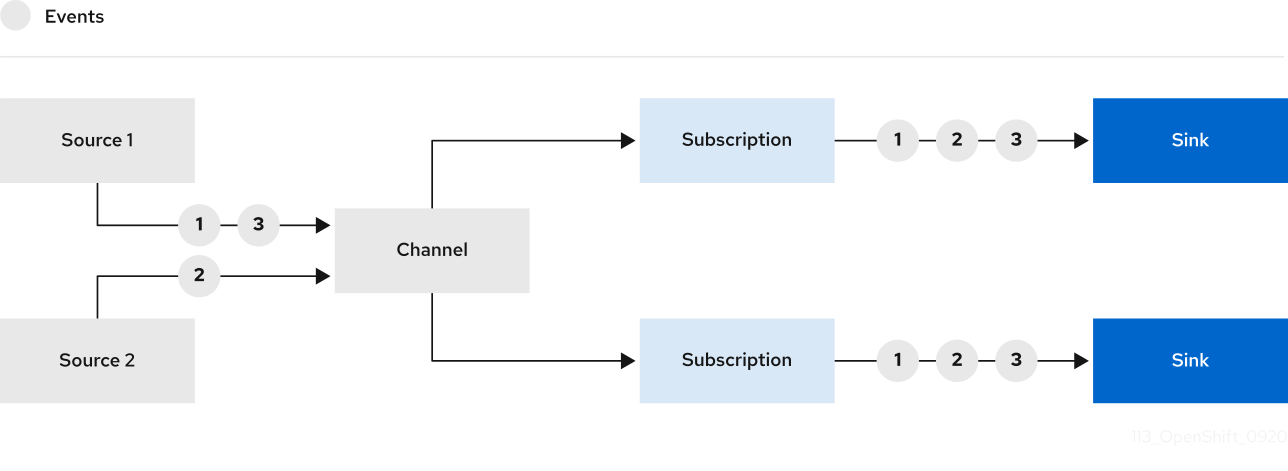

以下を使用して、イベントをイベントソースから複数のイベントシンクに伝播できます。

- Channels and subscriptions、または

- ブローカー と トリガー。

2.1.3. サポートされる構成

OpenShift Serverless(最新バージョンおよび以前のバージョン) のサポートされる機能、設定、および統合のセットは、サポートされる設定 についてのページで確認できます。

2.1.4. スケーラビリティーおよびパフォーマンス

OpenShift Serverless は、3 つのメインノードと 3 つのワーカーノードの設定でテストされています。各ノードには、64 個の CPU、457 GB のメモリー、および 394 GB のストレージがあります。

この設定を使用して作成できる Knative サービスの最大数は 3,000 です。これは、OpenShift Container Platform の Kubernetes サービスの制限である 10,000 に相当します。これは、1 つの Knative サービスが 3 つの Kubernetes サービスを作成するためです。

ゼロ応答時間からの平均スケールは約 3.4 秒で、最大応答時間は 8 秒で、単純な Quarkus アプリケーションの 99.9 パーセンタイルは 4.5 秒でした。これらの時間は、アプリケーションとアプリケーションの実行時間によって異なる場合があります。

2.2. OpenShift Serverless Functions について

OpenShift Serverless Functions により、開発者は OpenShift Container Platform で Knative サービスとしてステートレスでイベント駆動型の関数を作成およびデプロイできます。kn func CLI は Knative kn CLI のプラグインとして提供されます。kn func CLI を使用して、クラスター上の Knative サービスとしてコンテナーイメージを作成、ビルド、デプロイできます。

OpenShift Serverless Functions は、テクノロジープレビュー機能としてのみご利用いただけます。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

2.2.1. 含まれるランタイム

OpenShift Serverless Functions は、以下のランタイムの基本機能を作成するために使用できるテンプレートを提供します。

2.2.2. 次のステップ

2.3. イベントソース

Knative イベントソース には、クラウドイベントの生成またはインポート、これらのイベントの別のエンドポイントへのリレー (sink とも呼ばれる) を行う Kubernetes オブジェクトを指定できます。イベントに対応する分散システムを開発するには、イベントのソースが重要になります。

OpenShift Container Platform Web コンソールの Developer パースペクティブ、Knative (kn) CLI を使用するか、YAML ファイルを適用することで、Knative イベントソースを作成および管理できます。

現時点で、OpenShift Serverless は以下のイベントソースタイプをサポートします。

- API サーバーソース

- Kubernetes API サーバーイベントを Knative に送ります。API サーバーソースは、Kubernetes リソースが作成、更新、または削除されるたびに新規イベントを送信します。

- Ping ソース

- 指定された cron スケジュールに、固定ペイロードを使用してイベントを生成します。

- Kafka イベントソース

- Kafka クラスターをイベントソースとしてシンクに接続します。

カスタムイベントソース を作成することもできます。

2.4. ブローカー

ブローカーはトリガーと組み合わせて、イベントをイベントソースからイベントシンクに配信できます。イベントは、HTTP POST リクエストとしてイベントソースからブローカーに送信されます。イベントがブローカーに送信された後に、それらはトリガーを使用して CloudEvent 属性 でフィルターされ、HTTP POST リクエストとしてイベントシンクに送信できます。

2.4.1. ブローカータイプ

クラスター管理者は、クラスターのデフォルトブローカー実装を設定できます。ブローカーを作成する場合、Broker オブジェクトで設定を指定しない限り、デフォルトのブローカー実装が使用されます。

2.4.1.1. 開発目的でのデフォルトブローカーの実装

Knative は、デフォルトのチャネルベースのブローカー実装を提供します。このチャネルベースのブローカーは、開発およびテストの目的で使用できますが、実稼働環境での適切なイベント配信の保証は提供しません。デフォルトのブローカーは、デフォルトで InMemoryChannel チャネル実装によってサポートされています。

Kafka を使用してネットワークホップを削減する場合は、Kafka ブローカーの実装を使用します。チャネルベースのブローカーが KafkaChannel チャネル実装によってサポートされるように設定しないでください。

2.4.1.2. 実稼働環境対応の Kafka ブローカーの実装

実稼働環境に対応した Knative Eventing デプロイメントの場合、Red Hat は Knative Kafka ブローカーの実装を使用することをお勧めします。Kafka ブローカーは、Knative ブローカーの Apache Kafka ネイティブ実装であり、CloudEvents を Kafka インスタンスに直接送信します。

Kafka ブローカーの連邦情報処理標準 (FIPS) モードが無効になっています。

Kafka ブローカーは、イベントの保存とルーティングのために Kafka とネイティブに統合されています。これにより、他のブローカータイプよりもブローカーとトリガーモデルの Kafka との統合性が向上し、ネットワークホップを削減することができます。Kafka ブローカー実装のその他の利点は次のとおりです。

- 少なくとも 1 回の配信保証

- CloudEvents パーティショニング拡張機能に基づくイベントの順序付き配信

- コントロールプレーンの高可用性

- 水平方向にスケーラブルなデータプレーン

Knative Kafka ブローカーは、バイナリーコンテンツモードを使用して、受信 CloudEvents を Kafka レコードとして保存します。これは、CloudEvent のすべての属性と拡張機能が Kafka レコードのヘッダーとしてマップされ、CloudEvent の data 仕様が Kafka レコードの値に対応することを意味します。

2.4.2. 次のステップ

2.5. チャネルおよびサブスクリプション

チャネルは、単一のイベント転送および永続レイヤーを定義するカスタムリソースです。イベントがイベントソースまたは生成側からチャネルに送信された後に、これらのイベントはサブスクリプションを使用して複数の Knative サービスまたは他のシンクに送信できます。

サポートされている Channel オブジェクトをインスタンス化することでチャネルを作成し、Subscription オブジェクトの delivery 仕様を変更して再配信の試行を設定できます。

Channel オブジェクトが作成されると、変更用の受付 Webhook はデフォルトのチャネル実装に基づいて Channel オブジェクトの spec.channelTemplate プロパティーのセットを追加します。たとえば、InMemoryChannel のデフォルト実装の場合、Channel オブジェクトは以下のようになります。

チャネルコントローラーは、その後に spec.channelTemplate 設定に基づいてサポートするチャネルインスタンスを作成します。

spec.channelTemplate プロパティーは作成後に変更できません。それらは、ユーザーではなくデフォルトのチャネルメカニズムで設定されるためです。

このメカニズムが上記の例で使用される場合、汎用バッキングチャネルおよび InMemoryChannel チャネルなど 2 つのオブジェクトが作成されます。別のデフォルトチャネルの実装を使用している場合、InMemoryChannel は実装に固有のものに置き換えられます。たとえば、Knative Kafka の場合、KafkaChannel チャネルが作成されます。

バッキングチャネルは、サブスクリプションをユーザー作成のチャネルオブジェクトにコピーし、ユーザー作成チャネルオブジェクトのステータスを、バッキングチャネルのステータスを反映するように設定します。

2.5.1. チャネルの実装タイプ

InMemoryChannel および KafkaChannel チャネルの実装は、開発目的で OpenShift Serverless で使用できます。

以下は、InMemoryChannel タイプのチャネルの制限です。

- イベントの永続性は利用できません。Pod がダウンすると、その Pod のイベントが失われます。

-

InMemoryChannelチャネルはイベントの順序を実装しないため、チャネルで同時に受信される 2 つのイベントはいずれの順序でもサブスクライバーに配信できます。 -

サブスクライバーがイベントを拒否する場合、再配信はデフォルトで試行されません。

Subscriptionオブジェクトのdelivery仕様を変更することで、再配信の試行を設定できます。

Kafka チャネルの詳細は、Knative Kafka のドキュメントを参照してください。

2.5.2. 次のステップ

- チャネルを作成します。

- クラスター管理者の場合、チャネルのデフォルト設定を設定できます。チャネルのデフォルトの設定 を参照してください。

第3章 インストール

3.1. OpenShift Serverless Operator のインストール

OpenShift Serverless Operator をインストールすると、OpenShift Container Platform クラスターに Knative Serving、Knative Eventing、Knative Kafka をインストールして使用することができます。OpenShift Serverless Operator は、クラスターの Knative カスタムリソース定義 (CRD) を管理し、各コンポーネントの個別の設定マップを直接修正することなくそれらを設定できるようにします。

3.1.1. 作業を開始する前に

OpenShift Serverless をインストールする前に、サポートされる設定および前提条件についての以下の情報を確認してください。

- OpenShift Serverless は、ネットワークが制限された環境でのインストールに対してサポートされません。

- 現時点で、OpenShift Serverless は単一クラスター上でのマルチテナント設定で使用することはできません。

3.1.1.1. クラスターサイズ要件の定義

OpenShift Serverless をインストールし、使用するには、OpenShift Container Platform クラスターのサイズを適切に設定する必要があります。OpenShift Serverless を実行するために必要な総サイズは、インストールされているコンポーネントとデプロイされているアプリケーションに依存し、デプロイメントによって異なる場合があります。

以下の要件は、OpenShift Container Platform クラスターのワーカーマシンのプールにのみ関連します。コントロールプレーンは一般的なスケジューリングには使用されず、要件から省略されます。

デフォルトで、各 Pod は約 400m の CPU を要求し、推奨値のベースはこの値になります。アプリケーションの実際の CPU 要求を減らすと、レプリカ数が増える可能性があります。

クラスターで高可用性 (HA) を有効にしている場合、これには Knative Serving コントロールプレーンの各レプリカについて 0.5 - 1.5 コアおよび 200MB - 2GB のメモリーが必要です。

3.1.1.2. マシンセットを使用したクラスターのスケーリング

OpenShift Container Platform MachineSet API を使用して、クラスターを必要なサイズに手動でスケールアップすることができます。最小要件は、通常 2 つのマシンを追加することによってデフォルトのマシンセットのいずれかをスケールアップする必要があることを意味します。マシンセットの手動によるスケーリング を参照してください。

3.1.2. OpenShift Serverless Operator のインストール

OpenShift Container Platform Web コンソールを使用して、OperatorHub から OpenShift Serverless Operator をインストールできます。この Operator をインストールすることで、Knative コンポーネントをインストールして使用することができます。

前提条件

- クラスター管理者のアクセスを持つ OpenShift Container Platform アカウントを使用できる。

- OpenShift Container Platform Web コンソールにログインしている。

手順

- OpenShift Container Platform Web コンソールで、Operators → OperatorHub ページに移動します。

- スクロールするか、またはこれらのキーワード Serverless を Filter by keyword ボックス に入力して OpenShift Serverless Operator を検索します。

- Operator についての情報を確認してから、Install をクリックします。

Install Operator ページで以下を行います。

-

Installation Mode は All namespaces on the cluster (default) になります。このモードは、デフォルトの

openshift-serverlessnamespace で Operator をインストールし、クラスターのすべての namespace を監視し、Operator をこれらの namespace に対して利用可能にします。 -

Installed Namespace は

openshift-serverlessです。 - Update Channel として stable チャネルを選択します。stable チャネルは、OpenShift Serverless Operator の最新の安定したリリースのインストールを可能にします。

- Automatic または Manual 承認ストラテジーを選択します。

-

Installation Mode は All namespaces on the cluster (default) になります。このモードは、デフォルトの

- Install をクリックし、Operator をこの OpenShift Container Platform クラスターの選択した namespace で利用可能にします。

Catalog → Operator Management ページから、OpenShift Serverless Operator サブスクリプションのインストールおよびアップグレードの進捗をモニターできます。

- 手動 の承認ストラテジーを選択している場合、サブスクリプションのアップグレードステータスは、その Install Plan を確認し、承認するまで Upgrading のままになります。Install Plan ページでの承認後に、サブスクリプションのアップグレードステータスは Up to date に移行します。

- 自動 の承認ストラテジーを選択している場合、アップグレードステータスは、介入なしに Up to date に解決するはずです。

検証

サブスクリプションのアップグレードステータスが Up to date に移行したら、Catalog → Installed Operators を選択して OpenShift Serverless Operator が表示され、その Status が最終的に関連する namespace で InstallSucceeded に解決することを確認します。

上記通りにならない場合:

- Catalog → Operator Management ページに切り替え、Operator Subscriptions および Install Plans タブで Status の下の失敗またはエラーの有無を確認します。

-

さらにトラブルシューティングの必要な問題を報告している Pod のログについては、Workloads → Pods ページの

openshift-serverlessプロジェクトの Pod のログで確認できます。

OpenShift Serverless で Red Hat 分散トレースを使用する 場合は、KnativeServing または KnativeEventing をインストールする前に、Red Hat 分散トレースをインストールして設定する必要があります。

3.1.4. 次のステップ

- OpenShift Serverless Operator のインストール後に、Knative Serving をインストールするか、Knative Eventing をインストールする ことができます。

3.2. Knative Serving のインストール

Knative Serving をインストールすると、クラスター上で Knative サービスや関数を作成することができます。また、オートスケーリングやネットワークオプションなどの追加機能をアプリケーションに利用することも可能です。

OpenShift Serverless Operator をインストールした後、デフォルトの設定で Knative Serving をインストールするか、KnativeServing カスタムリソース (CR) でより高度な設定を行うことが可能です。KnativeServing CR の設定オプションの詳細については、グローバル設定を参照してください。

OpenShift Serverless で Red Hat 分散トレースを使用する 場合は、KnativeServing をインストールする前に、Red Hat 分散トレースをインストールして設定する必要があります。

3.2.1. Web コンソールを使用した Knative Serving のインストール

OpenShift Serverless Operator をインストールした後、OpenShift Container Platform の Web コンソールを使用して Knative Serving をインストールします。デフォルトの設定で Knative Serving をインストールするか、KnativeServing カスタムリソース (CR) でより詳細な設定を行うことが可能です。

前提条件

- クラスター管理者のアクセスを持つ OpenShift Container Platform アカウントを使用できる。

- OpenShift Container Platform Web コンソールにログインしている。

- OpenShift Serverless Operator がインストールされている。

手順

- OpenShift Container Platform Web コンソールの Administrator パースペクティブで、Operators → Installed Operators に移動します。

- ページ上部の Project ドロップダウンメニューが Project: knative-serving に設定されていることを確認します。

- OpenShift Serverless Operator の Provided API 一覧で Knative Serving をクリックし、Knative Serving タブに移動します。

- Create Knative Serving をクリックします。

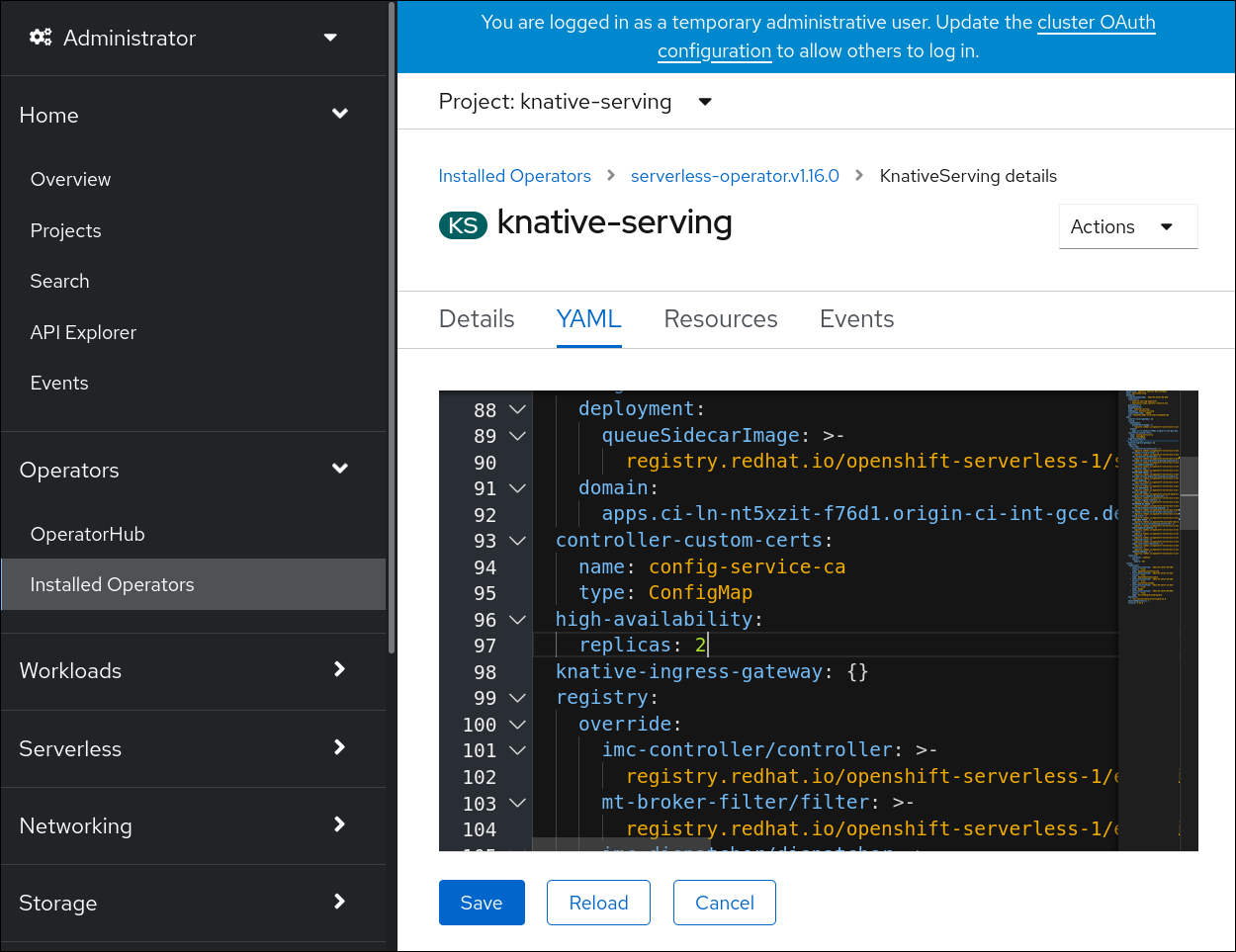

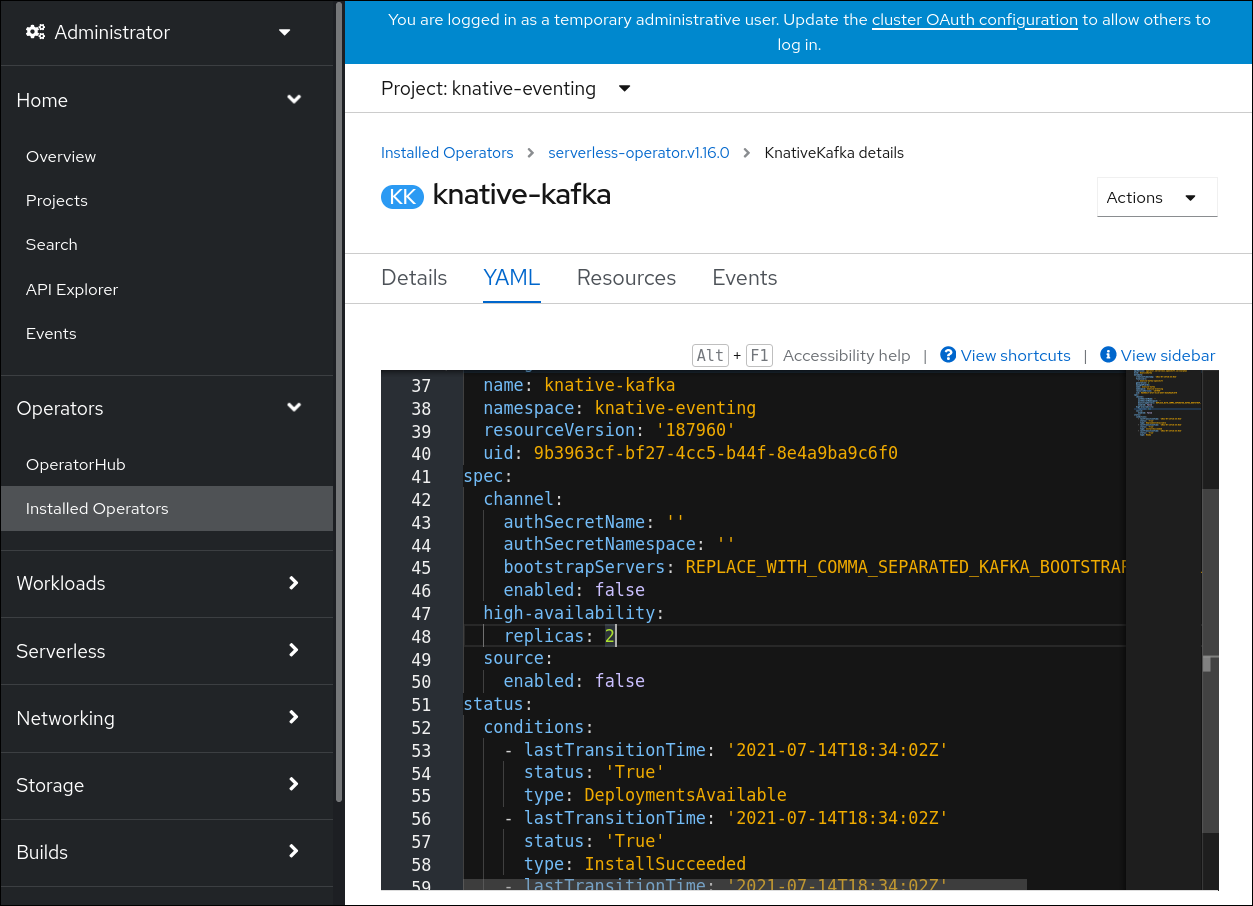

Create Knative Serving ページで、Create をクリックしてデフォルト設定を使用し、Knative Serving をインストールできます。

また、Knative Serving インストールの設定を変更するには、提供されるフォームを使用するか、または YAML を編集して

KnativeServingオブジェクトを編集します。-

KnativeServingオブジェクト作成を完全に制御する必要がない単純な設定には、このフォームの使用が推奨されます。 KnativeServingオブジェクトの作成を完全に制御する必要のあるより複雑な設定には、YAML の編集が推奨されます。YAML にアクセスするには、Create Knative Serving ページの右上にある edit YAML リンクをクリックします。フォームを完了するか、または YAML の変更が完了したら、Create をクリックします。

注記KnativeServing カスタムリソース定義の設定オプションについての詳細は、高度なインストール設定オプション についてのドキュメントを参照してください。

-

-

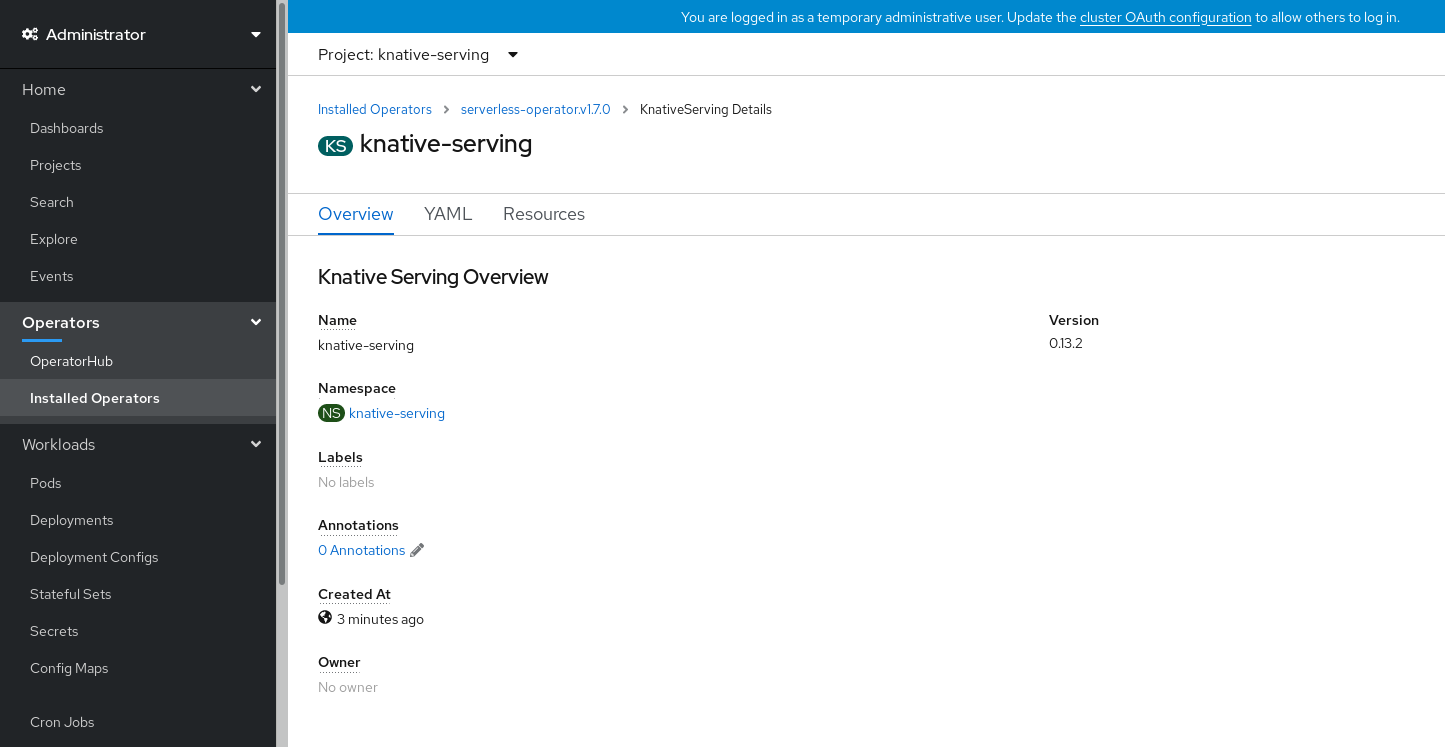

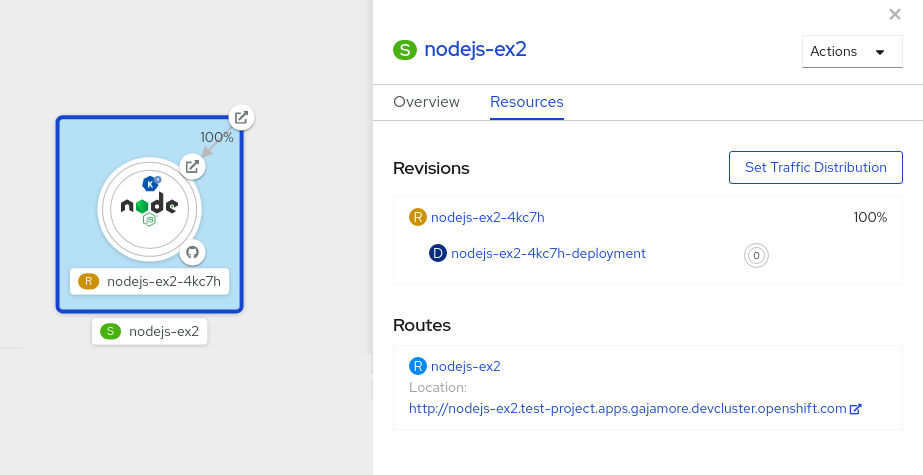

Knative Serving のインストール後に、

KnativeServingオブジェクトが作成され、Knative Serving タブに自動的にダイレクトされます。リソースの一覧にknative-servingカスタムリソースが表示されます。

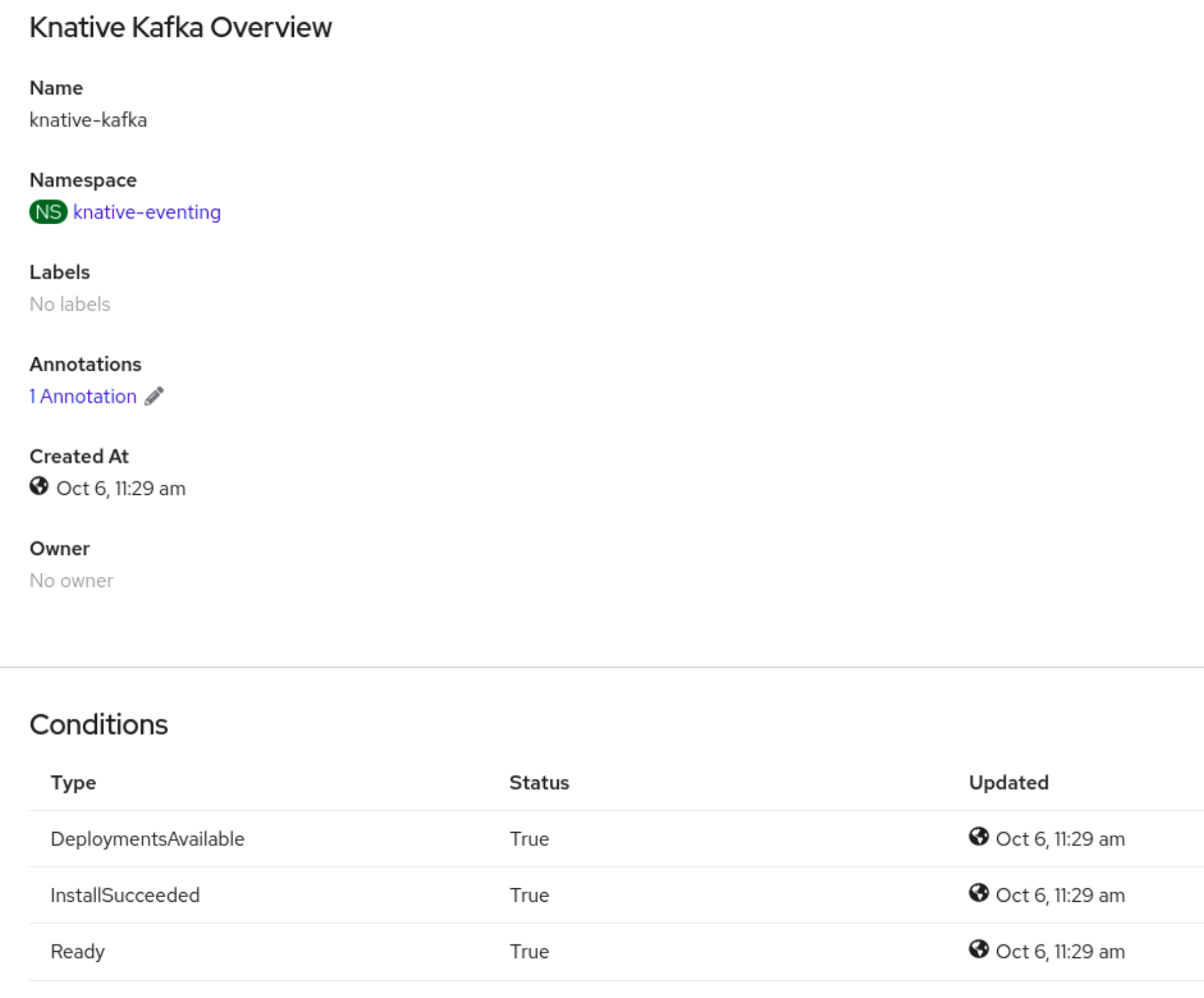

検証

-

Knative Serving タブで

knative-servingカスタムリソースをクリックします。 Knative Serving Overview ページに自動的にダイレクトされます。

- スクロールダウンして、Conditions の一覧を確認します。

ステータスが True の条件の一覧が表示されます (例のイメージを参照)。

注記Knative Serving リソースが作成されるまでに数分の時間がかかる場合があります。Resources タブでステータスを確認できます。

- 条件のステータスが Unknown または False である場合は、しばらく待ってから、リソースが作成されたことを再度確認します。

3.2.2. YAML を使用した Knative Serving のインストール

OpenShift Serverless Operator をインストールした後、デフォルトの設定で Knative Serving をインストールするか、KnativeServing カスタムリソース (CR) でより高度な設定を行うことが可能です。YAML ファイルとoc CLI を利用して、以下の手順で Knative Serving をインストールすることができます。

前提条件

- クラスター管理者のアクセスを持つ OpenShift Container Platform アカウントを使用できる。

- OpenShift Serverless Operator がインストールされている。

-

OpenShift CLI (

oc) をインストールしている。

手順

serving.yamlという名前のファイルを作成し、以下の YAML サンプルをこれにコピーします。apiVersion: operator.knative.dev/v1alpha1 kind: KnativeServing metadata: name: knative-serving namespace: knative-servingapiVersion: operator.knative.dev/v1alpha1 kind: KnativeServing metadata: name: knative-serving namespace: knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow serving.yamlファイルを適用します。oc apply -f serving.yaml

$ oc apply -f serving.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

インストールが完了したことを確認するには、以下のコマンドを実行します。

oc get knativeserving.operator.knative.dev/knative-serving -n knative-serving --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'$ oc get knativeserving.operator.knative.dev/knative-serving -n knative-serving --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

DependenciesInstalled=True DeploymentsAvailable=True InstallSucceeded=True Ready=True

DependenciesInstalled=True DeploymentsAvailable=True InstallSucceeded=True Ready=TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Knative Serving リソースが作成されるまでに数分の時間がかかる場合があります。

条件のステータスが

UnknownまたはFalseである場合は、しばらく待ってから、リソースが作成されたことを再度確認します。Knative Serving リソースが作成されていることを確認します。

oc get pods -n knative-serving

$ oc get pods -n knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 必要なネットワークコンポーネントが、自動的に作成された

knative-serving-ingressnamespace にインストールされていることを確認します。oc get pods -n knative-serving-ingress

$ oc get pods -n knative-serving-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME READY STATUS RESTARTS AGE net-kourier-controller-7d4b6c5d95-62mkf 1/1 Running 0 76s net-kourier-controller-7d4b6c5d95-qmgm2 1/1 Running 0 76s 3scale-kourier-gateway-6688b49568-987qz 1/1 Running 0 75s 3scale-kourier-gateway-6688b49568-b5tnp 1/1 Running 0 75s

NAME READY STATUS RESTARTS AGE net-kourier-controller-7d4b6c5d95-62mkf 1/1 Running 0 76s net-kourier-controller-7d4b6c5d95-qmgm2 1/1 Running 0 76s 3scale-kourier-gateway-6688b49568-987qz 1/1 Running 0 75s 3scale-kourier-gateway-6688b49568-b5tnp 1/1 Running 0 75sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2.3. 次のステップ

- Knative イベント駆動型アーキテクチャーを使用する必要がある場合は、Knative Eventing をインストール できます。

3.3. Knative Eventing のインストール

クラスターでイベント駆動型アーキテクチャーを使用するには、Knative Eventing をインストールします。イベントソース、ブローカー、チャネルなどの Knative コンポーネントを作成し、それらを使用してアプリケーションや外部システムにイベントを送信することができます。

OpenShift Serverless Operator をインストールした後、デフォルトの設定で Knative Eventing をインストールするか、KnativeEventing カスタムリソース (CR) でより高度な設定を行うことが可能です。KnativeEventing CR の設定オプションの詳細については、グローバル設定 を参照してください。

OpenShift Serverless で Red Hat 分散トレースを使用する 場合は、Knative Eventing をインストールする前に、Red Hat 分散トレースをインストールして設定する必要があります。

3.3.1. Web コンソールを使用した Knative Eventing のインストール

OpenShift Serverless Operator をインストールした後、OpenShift Container Platform の Web コンソールを使用して Knative Eventing をインストールします。デフォルトの設定で Knative Eventing をインストールするか、KnativeEventing カスタムリソース (CR) でより詳細な設定を行うことが可能です。

前提条件

- クラスター管理者のアクセスを持つ OpenShift Container Platform アカウントを使用できる。

- OpenShift Container Platform Web コンソールにログインしている。

- OpenShift Serverless Operator がインストールされている。

手順

- OpenShift Container Platform Web コンソールの Administrator パースペクティブで、Operators → Installed Operators に移動します。

- ページ上部の Project ドロップダウンメニューが Project: knative-eventing に設定されていることを確認します。

- OpenShift Serverless Operator の Provided API 一覧で Knative Eventing をクリックし、Knative Eventing タブに移動します。

- Create Knative Eventing をクリックします。

Create Knative Eventing ページでは、提供されるデフォルトのフォームを使用するか、または YAML を編集して

KnativeEventingオブジェクトを設定できます。KnativeEventingオブジェクト作成を完全に制御する必要がない単純な設定には、このフォームの使用が推奨されます。オプション。フォームを使用して

KnativeEventingオブジェクトを設定する場合は、Knative Eventing デプロイメントに対して実装する必要のある変更を加えます。

Create をクリックします。

KnativeEventingオブジェクトの作成を完全に制御する必要のあるより複雑な設定には、YAML の編集が推奨されます。YAML にアクセスするには、Create Knative Eventing ページの右上にある edit YAML リンクをクリックします。オプション。YAML を編集して

KnativeEventingオブジェクトを設定する場合は、Knative Eventing デプロイメントについて実装する必要のある変更を YAML に加えます。

- Create をクリックします。

-

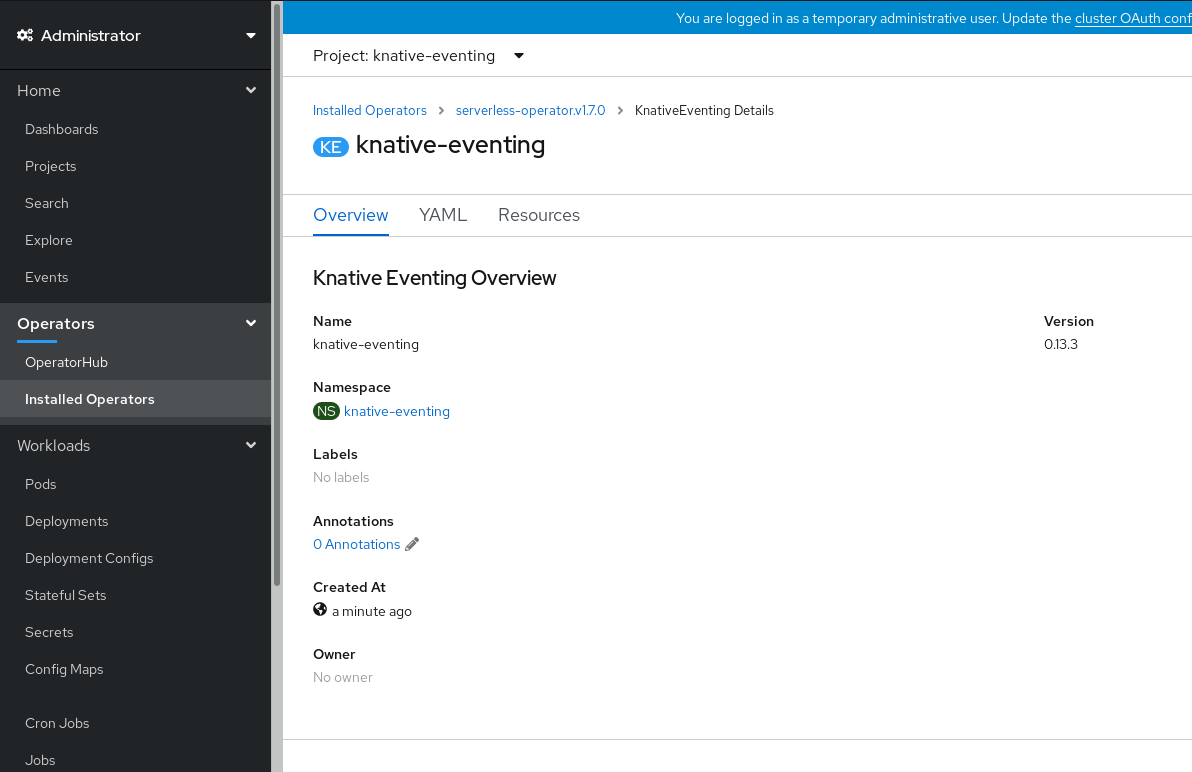

Knative Eventing のインストール後に、

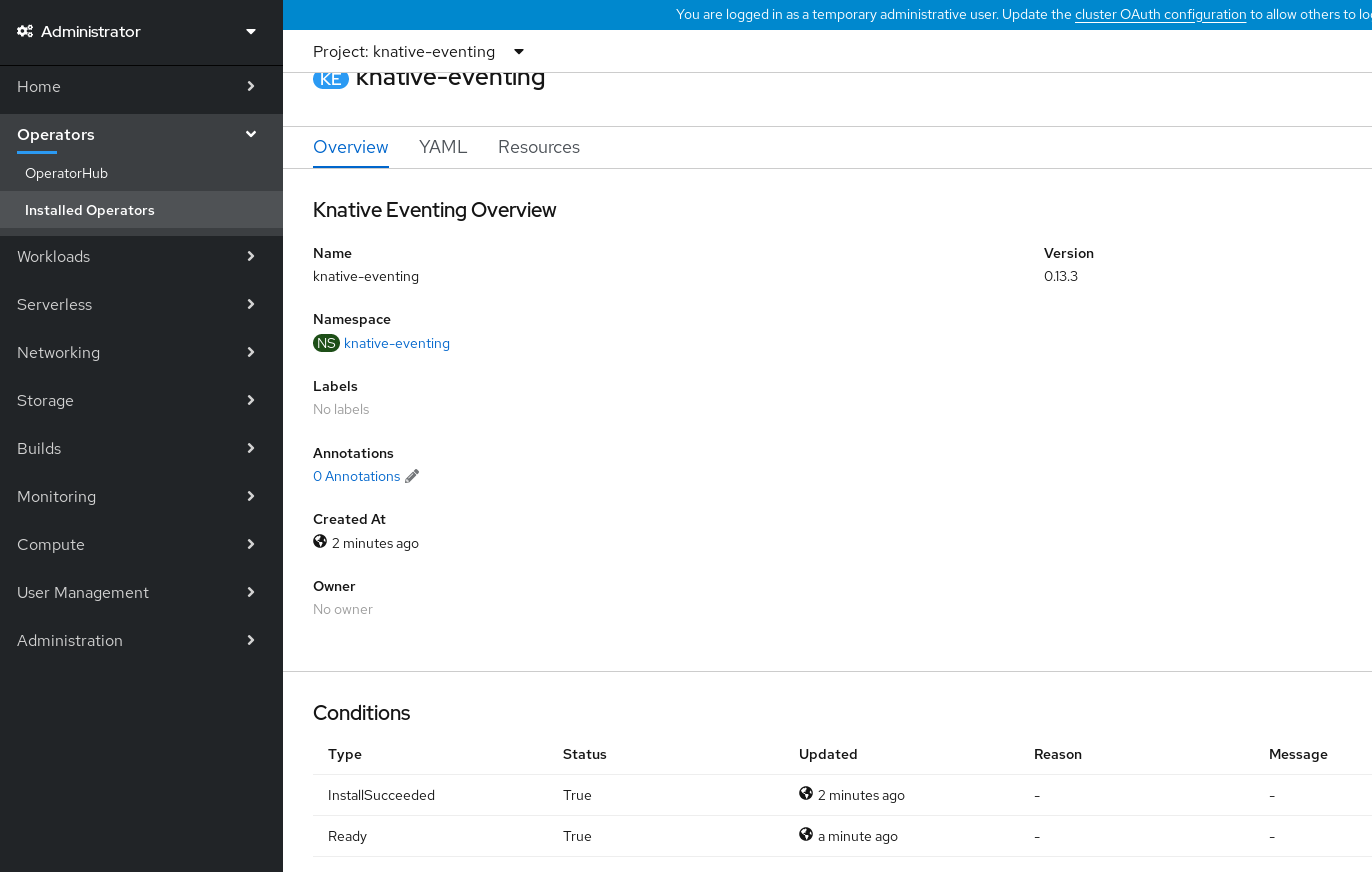

KnativeEventingオブジェクトが作成され、Knative Eventing タブに自動的にダイレクトされます。リソースの一覧にknative-eventingリソースが表示されます。

検証

-

Knative Eventing タブで

knative-eventingカスタムリソースをクリックします。 Knative Eventing Overview ページに自動的にダイレクトされます。

- スクロールダウンして、Conditions の一覧を確認します。

ステータスが True の条件の一覧が表示されます (例のイメージを参照)。

注記Knative Eventing リソースが作成されるまでに数秒の時間がかかる場合があります。Resources タブでステータスを確認できます。

- 条件のステータスが Unknown または False である場合は、しばらく待ってから、リソースが作成されたことを再度確認します。

3.3.2. YAML を使用した Knative Eventing のインストール

OpenShift Serverless Operator をインストールした後、デフォルトの設定で Knative Eventing をインストールするか、KnativeEventing カスタムリソース (CR) でより高度な設定を行うことが可能です。YAML ファイルと oc CLI を利用して、以下の手順で Knative Eventing をインストールすることができます。

前提条件

- クラスター管理者のアクセスを持つ OpenShift Container Platform アカウントを使用できる。

- OpenShift Serverless Operator がインストールされている。

-

OpenShift CLI (

oc) をインストールしている。

手順

-

eventing.yamlという名前のファイルを作成します。 以下のサンプル YAML を

eventing.yamlにコピーします。apiVersion: operator.knative.dev/v1alpha1 kind: KnativeEventing metadata: name: knative-eventing namespace: knative-eventingapiVersion: operator.knative.dev/v1alpha1 kind: KnativeEventing metadata: name: knative-eventing namespace: knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow - オプション。Knative Eventing デプロイメントについて実装する必要のある変更を YAML に加えます。

以下を入力して

eventing.yamlファイルを適用します。oc apply -f eventing.yaml

$ oc apply -f eventing.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

以下のコマンドを入力して出力を確認し、インストールが完了したことを確認します。

oc get knativeeventing.operator.knative.dev/knative-eventing \ -n knative-eventing \ --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'$ oc get knativeeventing.operator.knative.dev/knative-eventing \ -n knative-eventing \ --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

InstallSucceeded=True Ready=True

InstallSucceeded=True Ready=TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Knative Eventing リソースが作成されるまでに数秒の時間がかかる場合があります。

-

条件のステータスが

UnknownまたはFalseである場合は、しばらく待ってから、リソースが作成されたことを再度確認します。 以下のコマンドを実行して Knative Eventing リソースが作成されていることを確認します。

oc get pods -n knative-eventing

$ oc get pods -n knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.3. 次のステップ

- Knative サービスを使用する場合は、Knative Serving をインストールできます。

3.4. OpenShift Serverless の削除

必要に応じて OpenShift Serverless をクラスターから削除するには、OpenShift Serverless Operator およびその他の OpenShift Serverless コンポーネントを手動で削除します。OpenShift Serverless Operator を削除する前に、Knative Serving および Knative Eventing を削除する必要があります。

3.4.1. Knative Serving のアンインストール

OpenShift Serverless Operator を削除する前に、Knative Serving を削除する必要があります。Knative Serving をアンインストールするには、KnativeServing カスタムリソース (CR) を削除してから knative-serving namespace を削除する必要があります。

前提条件

- クラスター管理者のアクセスを持つ OpenShift Container Platform アカウントを使用できる。

-

OpenShift CLI (

oc) をインストールしている。

手順

KnativeServingCR を削除します。oc delete knativeservings.operator.knative.dev knative-serving -n knative-serving

$ oc delete knativeservings.operator.knative.dev knative-serving -n knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドが実行され、すべての Pod が

knative-servingnamespace から削除された後に、namespace を削除します。oc delete namespace knative-serving

$ oc delete namespace knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.2. Knative Eventing のアンインストール

OpenShift Serverless Operator を削除する前に、Knative Eventing を削除する必要があります。Knative Eventing をアンインストールするには、KnativeEventing カスタムリソース (CR) を削除してから knative-eventing namespace を削除する必要があります。

前提条件

- クラスター管理者のアクセスを持つ OpenShift Container Platform アカウントを使用できる。

-

OpenShift CLI (

oc) をインストールしている。

手順

KnativeEventingCR を削除します。oc delete knativeeventings.operator.knative.dev knative-eventing -n knative-eventing

$ oc delete knativeeventings.operator.knative.dev knative-eventing -n knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドが実行され、すべての Pod が

knative-eventingnamespace から削除された後に、namespace を削除します。oc delete namespace knative-eventing

$ oc delete namespace knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3. OpenShift Serverless Operator の削除

Knative Serving と Knative Eventing を削除した後、OpenShift Serverless Operator を削除することができます。これは、OpenShift Container Platform の Web コンソールまたは oc CLI を使用して行うことができます。

3.4.3.1. Web コンソールの使用によるクラスターからの Operator の削除

クラスター管理者は Web コンソールを使用して、選択した namespace からインストールされた Operator を削除できます。

前提条件

-

cluster-adminパーミッションを持つアカウントを使用して OpenShift Container Platform クラスター Web コンソールにアクセスできること。

手順

- Operators → Installed Operators ページからスクロールするか、または Filter by name にキーワードを入力して必要な Operator を見つけます。次に、それをクリックします。

Operator Details ページの右側で、Actions 一覧から Uninstall Operator を選択します。

Uninstall Operator? ダイアログボックスが表示され、以下が通知されます。

Operator を削除しても、そのカスタムリソース定義や管理リソースは削除されません。Operator がクラスターにアプリケーションをデプロイしているか、またはクラスター外のリソースを設定している場合、それらは引き続き実行され、手動でクリーンアップする必要があります。

このアクションにより、Operator および Operator のデプロイメントおよび Pod が削除されます (ある場合)。CRD および CR を含む Operator によって管理される Operand およびリソースは削除されません。Web コンソールは、一部の Operator のダッシュボードおよびナビゲーションアイテムを有効にします。Operator のアンインストール後にこれらを削除するには、Operator CRD を手動で削除する必要があります。

- Uninstall を選択します。この Operator は実行を停止し、更新を受信しなくなります。

3.4.3.2. CLI の使用によるクラスターからの Operator の削除

クラスター管理者は CLI を使用して、選択した namespace からインストールされた Operator を削除できます。

前提条件

-

cluster-adminパーミッションを持つアカウントを使用して OpenShift Container Platform クラスターにアクセスできる。 -

ocコマンドがワークステーションにインストールされていること。

手順

サブスクライブされた Operator (例:

jaeger) の現行バージョンをcurrentCSVフィールドで確認します。oc get subscription jaeger -n openshift-operators -o yaml | grep currentCSV

$ oc get subscription jaeger -n openshift-operators -o yaml | grep currentCSVCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

currentCSV: jaeger-operator.v1.8.2

currentCSV: jaeger-operator.v1.8.2Copy to Clipboard Copied! Toggle word wrap Toggle overflow サブスクリプション (例:

jaeger) を削除します。oc delete subscription jaeger -n openshift-operators

$ oc delete subscription jaeger -n openshift-operatorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

subscription.operators.coreos.com "jaeger" deleted

subscription.operators.coreos.com "jaeger" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 直前の手順で

currentCSV値を使用し、ターゲット namespace の Operator の CSV を削除します。oc delete clusterserviceversion jaeger-operator.v1.8.2 -n openshift-operators

$ oc delete clusterserviceversion jaeger-operator.v1.8.2 -n openshift-operatorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

clusterserviceversion.operators.coreos.com "jaeger-operator.v1.8.2" deleted

clusterserviceversion.operators.coreos.com "jaeger-operator.v1.8.2" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.3. 障害のあるサブスクリプションの更新

Operator Lifecycle Manager (OLM) で、ネットワークでアクセスできないイメージを参照する Operator をサブスクライブする場合、以下のエラーを出して失敗した openshift-marketplace namespace でジョブを見つけることができます。

出力例

ImagePullBackOff for Back-off pulling image "example.com/openshift4/ose-elasticsearch-operator-bundle@sha256:6d2587129c846ec28d384540322b40b05833e7e00b25cca584e004af9a1d292e"

ImagePullBackOff for

Back-off pulling image "example.com/openshift4/ose-elasticsearch-operator-bundle@sha256:6d2587129c846ec28d384540322b40b05833e7e00b25cca584e004af9a1d292e"出力例

rpc error: code = Unknown desc = error pinging docker registry example.com: Get "https://example.com/v2/": dial tcp: lookup example.com on 10.0.0.1:53: no such host

rpc error: code = Unknown desc = error pinging docker registry example.com: Get "https://example.com/v2/": dial tcp: lookup example.com on 10.0.0.1:53: no such hostその結果、サブスクリプションはこの障害のある状態のままとなり、Operator はインストールまたはアップグレードを実行できません。

サブスクリプション、クラスターサービスバージョン (CSV) その他の関連オブジェクトを削除して、障害のあるサブスクリプションを更新できます。サブスクリプションを再作成した後に、OLM は Operator の正しいバージョンを再インストールします。

前提条件

- アクセス不可能なバンドルイメージをプルできない障害のあるサブスクリプションがある。

- 正しいバンドルイメージにアクセスできることを確認している。

手順

Operator がインストールされている namespace から

SubscriptionおよびClusterServiceVersionオブジェクトの名前を取得します。oc get sub,csv -n <namespace>

$ oc get sub,csv -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME PACKAGE SOURCE CHANNEL subscription.operators.coreos.com/elasticsearch-operator elasticsearch-operator redhat-operators 5.0 NAME DISPLAY VERSION REPLACES PHASE clusterserviceversion.operators.coreos.com/elasticsearch-operator.5.0.0-65 OpenShift Elasticsearch Operator 5.0.0-65 Succeeded

NAME PACKAGE SOURCE CHANNEL subscription.operators.coreos.com/elasticsearch-operator elasticsearch-operator redhat-operators 5.0 NAME DISPLAY VERSION REPLACES PHASE clusterserviceversion.operators.coreos.com/elasticsearch-operator.5.0.0-65 OpenShift Elasticsearch Operator 5.0.0-65 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow サブスクリプションを削除します。

oc delete subscription <subscription_name> -n <namespace>

$ oc delete subscription <subscription_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターサービスバージョンを削除します。

oc delete csv <csv_name> -n <namespace>

$ oc delete csv <csv_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow openshift-marketplacenamespace の失敗したジョブおよび関連する設定マップの名前を取得します。oc get job,configmap -n openshift-marketplace

$ oc get job,configmap -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME COMPLETIONS DURATION AGE job.batch/1de9443b6324e629ddf31fed0a853a121275806170e34c926d69e53a7fcbccb 1/1 26s 9m30s NAME DATA AGE configmap/1de9443b6324e629ddf31fed0a853a121275806170e34c926d69e53a7fcbccb 3 9m30s

NAME COMPLETIONS DURATION AGE job.batch/1de9443b6324e629ddf31fed0a853a121275806170e34c926d69e53a7fcbccb 1/1 26s 9m30s NAME DATA AGE configmap/1de9443b6324e629ddf31fed0a853a121275806170e34c926d69e53a7fcbccb 3 9m30sCopy to Clipboard Copied! Toggle word wrap Toggle overflow ジョブを削除します。

oc delete job <job_name> -n openshift-marketplace

$ oc delete job <job_name> -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、アクセスできないイメージのプルを試行する Pod は再作成されなくなります。

設定マップを削除します。

oc delete configmap <configmap_name> -n openshift-marketplace

$ oc delete configmap <configmap_name> -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Web コンソールの OperatorHub を使用した Operator の再インストール

検証

Operator が正常に再インストールされていることを確認します。

oc get sub,csv,installplan -n <namespace>

$ oc get sub,csv,installplan -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.4. OpenShift Serverless カスタムリソース定義の削除

OpenShift Serverless のアンインストール後に、Operator および API カスタムリソース定義 (CRD) はクラスター上に残ります。以下の手順を使用して、残りの CRD を削除できます。

Operator および API CRD を削除すると、Knative サービスを含む、それらを使用して定義されたすべてのリソースも削除されます。

前提条件

- クラスター管理者のアクセスを持つ OpenShift Container Platform アカウントを使用できる。

- Knative Serving をアンインストールし、OpenShift Serverless Operator を削除している。

-

OpenShift CLI (

oc) をインストールしている。

手順

残りの OpenShift Serverless CRD を削除するには、以下のコマンドを実行します。

oc get crd -oname | grep 'knative.dev' | xargs oc delete

$ oc get crd -oname | grep 'knative.dev' | xargs oc deleteCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第4章 Knative CLI

4.1. Knative CLI のインストール

Knative (kn) CLI には、独自のログインメカニズムがありません。クラスターにログインするには、OpenShift (oc) CLI をインストールし、oc login コマンドを使用する必要があります。CLI のインストールオプションは、オペレーティングシステムによって異なる場合があります。

ご使用のオペレーティングシステム用に oc CLI をインストールする方法および oc でのログイン方法についての詳細は、OpenShift CLI の使用開始 についてのドキュメントを参照してください。

Knative (kn) CLI を使用して OpenShift Serverless をインストールすることはできません。クラスター管理者は、OpenShift Serverless Operator のインストール のドキュメントで説明されているように、OpenShift Serverless Operator をインストールし、Knative コンポーネントをセットアップする必要があります。

新しい OpenShift Serverless リリースで古いバージョンの Knative (kn) CLI の使用を試行する場合は、API が見つからないとエラーが発生します。

たとえば、バージョン 1.2 を使用する Knative (kn) CLI の 1.23.0 リリースと、Knative Serving および Knative Eventing API の 1.3 バージョンを使用する 1.24.0 OpenShift Serverless リリースを使用する場合、CLI は古い 1.2 API バージョンを探し続けるため、機能しません。

問題を回避するために、OpenShift Serverless リリースの最新の Knative (kn) CLI バージョンを使用していることを確認してください。

4.1.1. OpenShift Container Platform Web コンソールを使用した Knative CLI のインストール

OpenShift Container Platform Web コンソールを使用すると、Knative (kn) CLI をインストールするための合理化された直感的なユーザーインターフェイスが提供されます。\OpenShift Serverless Operator をインストールすると、OpenShift Container PlatformWeb コンソールの コマンドラインツール ページから Linux (amd64、s390x、ppc64le)、macOS、または Windows 用の Knative (kn) CLI をダウンロードするためのリンクが表示されます。

前提条件

- OpenShift Container Platform Web コンソールにログインしている。

OpenShift Serverless Operator および Knative Serving が OpenShift Container Platform クラスターにインストールされている。

重要libc が利用できない場合は、CLI コマンドの実行時に以下のエラーが表示される場合があります。

kn: No such file or directory

$ kn: No such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

この手順の検証手順を使用する場合は、OpenShift (

oc) CLI をインストールする必要があります。

手順

-

Command Line Tools ページから Knative (

kn) CLI をダウンロードします。Command Line Tools ページには、Web コンソールの右上の アイコンをクリックして、リストの Command Line Tools を選択します。

アイコンをクリックして、リストの Command Line Tools を選択します。

アーカイブを展開します。

tar -xf <file>

$ tar -xf <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

knバイナリーをPATHにあるディレクトリーに移動します。 PATHを確認するには、以下を実行します。echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

以下のコマンドを実行して、正しい Knative CLI リソースおよびルートが作成されていることを確認します。

oc get ConsoleCLIDownload

$ oc get ConsoleCLIDownloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME DISPLAY NAME AGE kn kn - OpenShift Serverless Command Line Interface (CLI) 2022-09-20T08:41:18Z oc-cli-downloads oc - OpenShift Command Line Interface (CLI) 2022-09-20T08:00:20Z

NAME DISPLAY NAME AGE kn kn - OpenShift Serverless Command Line Interface (CLI) 2022-09-20T08:41:18Z oc-cli-downloads oc - OpenShift Command Line Interface (CLI) 2022-09-20T08:00:20ZCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get route -n openshift-serverless

$ oc get route -n openshift-serverlessCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD kn kn-openshift-serverless.apps.example.com knative-openshift-metrics-3 http-cli edge/Redirect None

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD kn kn-openshift-serverless.apps.example.com knative-openshift-metrics-3 http-cli edge/Redirect NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.2. RPM パッケージマネージャーを使用した Linux 用の Knative CLI のインストール

Red Hat Enterprise Linux (RHEL) の場合、yum や dnf などのパッケージマネージャーを使用して、Knative (kn) CLI を RPM としてインストールできます。これにより、Knative CLI バージョンをシステムで自動的に管理できます。たとえば、dnf upgrade のようなコマンドを使用すると、新しいバージョンが利用可能な場合、kn を含むすべてのパッケージがアップグレードされます。

前提条件

- お使いの Red Hat アカウントに有効な OpenShift Container Platform サブスクリプションがある。

手順

Red Hat Subscription Manager に登録します。

subscription-manager register

# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 最新のサブスクリプションデータをプルします。

subscription-manager refresh

# subscription-manager refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow 登録済みのシステムにサブスクリプションを添付します。

subscription-manager attach --pool=<pool_id>

# subscription-manager attach --pool=<pool_id>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 有効な OpenShift Container Platform サブスクリプションのプール ID

Knative (

kn) CLI に必要なリポジトリーを有効にします。Linux (x86_64, amd64)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-x86_64-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-x86_64-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Linux on IBM Z and LinuxONE (s390x)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-s390x-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-s390x-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Linux on IBM Power (ppc64le)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-ppc64le-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-ppc64le-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

パッケージマネージャーを使用して、Knative (

kn) CLI を RPM としてインストールします。yumコマンドの例yum install openshift-serverless-clients

# yum install openshift-serverless-clientsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.3. Linux の Knative CLI のインストール

RPM または別のパッケージマネージャーがインストールされていない Linux ディストリビューションを使用している場合は、Knative (kn) CLI をバイナリーファイルとしてインストールできます。これを行うには、tar.gz アーカイブをダウンロードして解凍し、バイナリーを PATH のディレクトリーに追加する必要があります。

前提条件

RHEL または Fedora を使用していない場合は、ライブラリーパスのディレクトリーに libc がインストールされていることを確認してください。

重要libc が利用できない場合は、CLI コマンドの実行時に以下のエラーが表示される場合があります。

kn: No such file or directory

$ kn: No such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

Knative (

kn) CLI のtar.gzアーカイブをダウンロードします。アーカイブを展開します。

tar -xf <filename>

$ tar -xf <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

knバイナリーをPATHにあるディレクトリーに移動します。 PATHを確認するには、以下を実行します。echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.4. macOS の Knative CLI のインストール

macOS を使用している場合は、Knative (kn) CLI をバイナリーファイルとしてインストールできます。これを行うには、tar.gz アーカイブをダウンロードして解凍し、バイナリーを PATH のディレクトリーに追加する必要があります。

手順

-

Knative (

kn)CLItar.gzアーカイブ をダウンロードします。 - アーカイブを解凍して解凍します。

-

knバイナリーをPATHにあるディレクトリーに移動します。 PATHを確認するには、ターミナルウィンドウを開き、以下を実行します。echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.5. Windows の Knative CLI のインストール

Windows を使用している場合は、Knative (kn) CLI をバイナリーファイルとしてインストールできます。これを行うには、ZIP アーカイブをダウンロードして解凍し、バイナリーを PATH のディレクトリーに追加する必要があります。

手順

-

Knative (

kn) CLIZIP アーカイブ をダウンロードします。 - ZIP プログラムでアーカイブを展開します。

-

knバイナリーをPATHにあるディレクトリーに移動します。 PATHを確認するには、コマンドプロンプトを開いて以下のコマンドを実行します。path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. Knative CLI の設定

config.yaml 設定ファイルを作成することで、Knative (kn) CLI セットアップをカスタマイズできます。--config フラグを使用してこの設定を指定できます。指定しない場合、設定がデフォルトの場所から選択されます。デフォルトの設定場所は XDGBaseDirectory 仕様 に準拠しており、UNIX システムと Windows システムでは異なります。

UNIX システムの場合:

-

XDG_CONFIG_HOME環境変数が設定されている場合、Knative (kn) CLI が検索するデフォルト設定の場所は$XDG_CONFIG_HOME/knになります。 -

XDG_CONFIG_HOME環境変数が設定されていない場合、Knative (kn) CLI は$HOME/.config/kn/config.yamlのユーザーのホームディレクトリーにある設定を検索します。

Windows システムの場合、デフォルトの Knative (kn) CLI 設定の場所は %APPDATA%\kn です。

設定ファイルのサンプル

- 1

- Knative (

kn) CLI がPATH環境変数でプラグインを検索するかどうかを指定します。これはブール型の設定オプションです。デフォルト値はfalseです。 - 2

- Knative (

kn) CLI がプラグインを検索するディレクトリーを指定します。前述のように、デフォルトのパスはオペレーティングシステムによって異なります。これには、ユーザーに表示される任意のディレクトリーを指定できます。 - 3

sink-mappings仕様は、Knative (kn) CLI コマンドで--sinkフラグを使用する場合に使用される Kubernetes のアドレス可能なリソースを定義します。- 4

- シンクの記述に使用する接頭辞。サービスの

svc、channel、およびbrokerは Knative (kn) CLI で事前に定義される接頭辞です。 - 5

- Kubernetes リソースの API グループ。

- 6

- Kubernetes リソースのバージョン。

- 7

- Kubernetes リソースタイプの複数形の名前。例:

servicesまたはbrokers

4.3. Knative CLI プラグイン

Knative (kn) CLI は、プラグインの使用をサポートします。これにより、カスタムコマンドとコアディストリビューションの一部ではない他の共有コマンドを追加でき、kn インストールの機能の拡張を可能にします。Knative (kn) CLI プラグインは主な kn 機能として同じ方法で使用されます。

現在、Red Hat は kn-source-kafka プラグインと kn-event プラグインをサポートしています。

kn-event プラグインは、テクノロジープレビュー機能のみです。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

4.3.1. kn-event プラグインを使用してイベントを作成する

kn event build コマンドのビルダーのようなインターフェイスを使用して、イベントをビルドできます。その後、そのイベントを後で送信するか、別のコンテキストで使用できます。

前提条件

-

Knative (

kn) CLI をインストールしている。

手順

イベントをビルドします。

kn event build --field <field-name>=<value> --type <type-name> --id <id> --output <format>

$ kn event build --field <field-name>=<value> --type <type-name> --id <id> --output <format>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

-

--fieldフラグは、データをフィールド/値のペアとしてイベントに追加します。これは複数回使用できます。 -

--typeフラグを使用すると、イベントのタイプを指定する文字列を指定できます。 -

--idフラグは、イベントの ID を指定します。 jsonまたはyaml引数を--outputフラグと共に使用して、イベントの出力形式を変更できます。これらのフラグはすべてオプションです。

簡単なイベントのビルド

kn event build -o yaml

$ kn event build -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow YAML 形式のビルドされたイベント

Copy to Clipboard Copied! Toggle word wrap Toggle overflow サンプルトランザクションイベントのビルド

Copy to Clipboard Copied! Toggle word wrap Toggle overflow JSON 形式のビルドされたイベント

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

4.3.2. kn-event プラグインを使用したイベントの送信

kn event send コマンドを使用して、イベントを送信できます。イベントは、公開されているアドレス、または Kubernetes サービスや Knative サービス、ブローカー、チャネル等のクラスター内のアドレス指定可能なリソースのいずれかに送信できます。このコマンドは、kn event build コマンドと同じビルダーのようなインターフェイスを使用します。

前提条件

-

Knative (

kn) CLI をインストールしている。

手順

イベントの送信:

kn event send --field <field-name>=<value> --type <type-name> --id <id> --to-url <url> --to <cluster-resource> --namespace <namespace>

$ kn event send --field <field-name>=<value> --type <type-name> --id <id> --to-url <url> --to <cluster-resource> --namespace <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

-

--fieldフラグは、データをフィールド/値のペアとしてイベントに追加します。これは複数回使用できます。 -

--typeフラグを使用すると、イベントのタイプを指定する文字列を指定できます。 -

--idフラグは、イベントの ID を指定します。 -

イベントを一般にアクセス可能な宛先に送信する場合は、

--to-urlフラグを使用して URL を指定します。 イベントをクラスター内の Kubernetes リソースに送信する場合は、

--toフラグを使用して宛先を指定します。-

<Kind>:<ApiVersion>:<name>形式を使用して Kubernetes リソースを指定します。

-

--namespaceフラグは namespace を指定します。省略すると、namespace は現在のコンテキストから取得されます。--to-urlまたは--toのいずれかを使用する必要がある宛先の仕様を除き、これらのフラグはすべてオプションです。以下の例は、イベントを URL に送信するケースを示しています。

コマンドの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例は、イベントをクラスター内のリソースに送信するケースを示しています。

コマンドの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

4.4. Knative Serving CLI コマンド

以下の Knative (kn) CLI コマンドを使用して、クラスター上の Knative Serving タスクを完了できます。

4.4.1. kn service コマンド

以下のコマンドを使用して Knative サービスを作成し、管理できます。

4.4.1.1. Knative CLI を使用したサーバーレスアプリケーションの作成

Knative (kn) CLI を使用してサーバーレスアプリケーションを作成すると、YAML ファイルを直接修正するよりも合理的で直感的なユーザーインターフェイスが得られます。kn service create コマンドを使用して、基本的なサーバーレスアプリケーションを作成できます。

前提条件

- OpenShift Serverless Operator および Knative Serving がクラスターにインストールされていること。

-

Knative (

kn) CLI をインストールしている。 - OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するために、プロジェクトを作成しているか、適切なロールおよびパーミッションを持つプロジェクトにアクセスできる。

手順

Knative サービスを作成します。

kn service create <service_name> --image <image> --tag <tag-value>

$ kn service create <service_name> --image <image> --tag <tag-value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 詳細は以下のようになります。

-

--imageは、アプリケーションのイメージの URI です。 --tagは、サービスで作成される初期リビジョンにタグを追加するために使用できるオプションのフラグです。コマンドの例

kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest$ kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

4.4.1.2. Knative CLI を使用したサーバーレスアプリケーションの更新

サービスを段階的に構築する際に、コマンドラインで kn service update コマンドを使用し、対話式のセッションを使用できます。kn service apply コマンドとは対照的に、kn service update コマンドを使用する際は、Knative サービスの完全な設定ではなく、更新が必要な変更のみを指定する必要があります。

コマンドの例

新規の環境変数を追加してサービスを更新します。

kn service update <service_name> --env <key>=<value>

$ kn service update <service_name> --env <key>=<value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいポートを追加してサービスを更新します。

kn service update <service_name> --port 80

$ kn service update <service_name> --port 80Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しい要求および制限パラメーターを追加してサービスを更新します。

kn service update <service_name> --request cpu=500m --limit memory=1024Mi --limit cpu=1000m

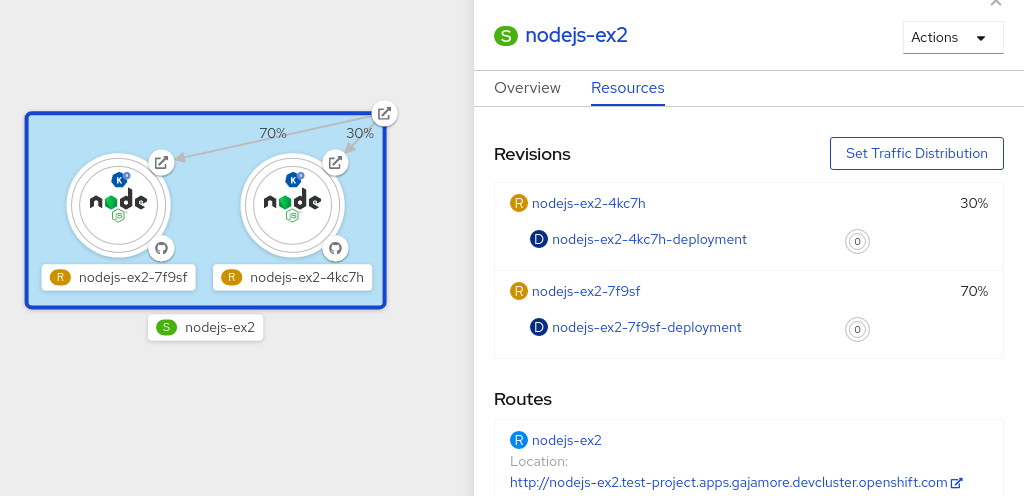

$ kn service update <service_name> --request cpu=500m --limit memory=1024Mi --limit cpu=1000mCopy to Clipboard Copied! Toggle word wrap Toggle overflow latestタグをリビジョンに割り当てます。kn service update <service_name> --tag <revision_name>=latest

$ kn service update <service_name> --tag <revision_name>=latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービスの最新の

READYリビジョンについて、testingからstagingにタグを更新します。kn service update <service_name> --untag testing --tag @latest=staging

$ kn service update <service_name> --untag testing --tag @latest=stagingCopy to Clipboard Copied! Toggle word wrap Toggle overflow testタグをトラフィックの 10% を受信するリビジョンに追加し、残りのトラフィックをサービスの最新のREADYリビジョンに送信します。kn service update <service_name> --tag <revision_name>=test --traffic test=10,@latest=90

$ kn service update <service_name> --tag <revision_name>=test --traffic test=10,@latest=90Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.1.3. サービス宣言の適用

kn service apply コマンドを使用して Knative サービスを宣言的に設定できます。サービスが存在しない場合は、これが作成されますが、それ以外の場合は、既存のサービスが変更されたオプションで更新されます。

kn service apply コマンドは、ユーザーがターゲットの状態を宣言するために単一コマンドでサービスの状態を詳細に指定したい場合など、とくにシェルスクリプトや継続的インテグレーションパイプラインで役に立ちます。

kn service apply を使用する場合は、Knative サービスの詳細な設定を指定する必要があります。これは kn service update コマンドとは異なります。このコマンドでは、更新する必要のあるオプションを指定するだけで済みます。

コマンドの例

サービスを作成します。

kn service apply <service_name> --image <image>

$ kn service apply <service_name> --image <image>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 環境変数をサービスに追加します。

kn service apply <service_name> --image <image> --env <key>=<value>

$ kn service apply <service_name> --image <image> --env <key>=<value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow JSON または YAML ファイルからサービス宣言を読み取ります。

kn service apply <service_name> -f <filename>

$ kn service apply <service_name> -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.1.4. Knative CLI を使用したサーバーレスアプリケーションの記述

kn service describe コマンドを使用して Knative サービスを記述できます。

コマンドの例

サービスを記述します。

kn service describe --verbose <service_name>

$ kn service describe --verbose <service_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow --verboseフラグは任意ですが、さらに詳細な説明を提供するために追加できます。通常の出力と詳細の出力の違いについては、以下の例に示されます。--verboseフラグを使用しない出力例Copy to Clipboard Copied! Toggle word wrap Toggle overflow --verboseフラグを使用する出力例Copy to Clipboard Copied! Toggle word wrap Toggle overflow サービスを YAML 形式で記述します。

kn service describe <service_name> -o yaml

$ kn service describe <service_name> -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービスを JSON 形式で記述します。

kn service describe <service_name> -o json

$ kn service describe <service_name> -o jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービス URL のみを出力します。

kn service describe <service_name> -o url

$ kn service describe <service_name> -o urlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.2. Knative CLI オフラインモードについて

kn service コマンドを実行すると、変更が即座にクラスターに伝播されます。ただし、別の方法として、オフラインモードで kn service コマンドを実行できます。オフラインモードでサービスを作成すると、クラスター上で変更は発生せず、代わりにサービス記述子ファイルがローカルマシンに作成されます。

Knative CLI のオフラインモードはテクノロジープレビュー機能としてのみご利用いただけます。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

記述子ファイルの作成後、手動で変更し、バージョン管理システムで追跡できます。記述子ファイルで kn service create -f、kn service apply -f または oc apply -f コマンドを使用して変更をクラスターに伝播することもできます。

オフラインモードには、いくつかの用途があります。

- 記述子ファイルを使用してクラスターで変更する前に、記述子ファイルを手動で変更できます。

- バージョン管理システムでは、サービスの記述子ファイルをローカルで追跡できます。これにより、記述子ファイルを再利用できます。たとえば、継続的インテグレーション (CI) パイプライン、開発環境またはデモなどで、ターゲットクラスター以外の配置が可能になります。

-

作成した記述子ファイルを検証して Knative サービスについて確認できます。特に、生成されるサービスが

knコマンドに渡されるさまざまな引数によってどのように影響するかを確認できます。

オフラインモードには、高速で、クラスターへの接続を必要としないという利点があります。ただし、オフラインモードではサーバー側の検証がありません。したがって、サービス名が一意であることや、指定のイメージをプルできることなどを確認できません。

4.4.2.1. オフラインモードを使用したサービスの作成

オフラインモードで kn service コマンドを実行すると、クラスター上で変更は発生せず、代わりにサービス記述子ファイルがローカルマシンに作成されます。記述子ファイルを作成した後、クラスターに変更を伝播する前にファイルを変更することができます。

Knative CLI のオフラインモードはテクノロジープレビュー機能としてのみご利用いただけます。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

前提条件

- OpenShift Serverless Operator および Knative Serving がクラスターにインストールされていること。

-

Knative (

kn) CLI をインストールしている。

手順

オフラインモードでは、ローカルの Knative サービス記述子ファイルを作成します。

kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest \ --target ./ \ --namespace test$ kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest \ --target ./ \ --namespace testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Service 'event-display' created in namespace 'test'.

Service 'event-display' created in namespace 'test'.Copy to Clipboard Copied! Toggle word wrap Toggle overflow --target ./フラグはオフラインモードを有効にし、./を新しいディレクトリーツリーを保存するディレクトリーとして指定します。既存のディレクトリーを指定せずに、

--target my-service.yamlなどのファイル名を使用すると、ディレクトリーツリーは作成されません。代わりに、サービス記述子ファイルmy-service.yamlのみが現在のディレクトリーに作成されます。ファイル名には、

.yaml、.ymlまたは.json拡張子を使用できます。.jsonを選択すると、JSON 形式でサービス記述子ファイルが作成されます。--namespace testオプションは、新規サービスをテストnamespace に配置します。--namespaceを使用せずに、OpenShift クラスターにログインしている場合には、記述子ファイルが現在の namespace に作成されます。それ以外の場合は、記述子ファイルがdefaultの namespace に作成されます。

作成したディレクトリー構造を確認します。

tree ./

$ tree ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

--targetで指定する現在の./ディレクトリーには新しいtest/ディレクトリーが含まれます。このディレクトリーの名前は、指定の namespace をもとに付けられます。 -

test/ディレクトリーには、リソースタイプの名前が付けられたksvcディレクトリーが含まれます。 -

ksvcディレクトリーには、指定のサービス名に従って命名される記述子ファイルevent-display.yamlが含まれます。

-

生成されたサービス記述子ファイルを確認します。

cat test/ksvc/event-display.yaml

$ cat test/ksvc/event-display.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいサービスに関する情報を一覧表示します。

kn service describe event-display --target ./ --namespace test

$ kn service describe event-display --target ./ --namespace testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow --target ./オプションは、namespace サブディレクトリーを含むディレクトリー構造のルートディレクトリーを指定します。または、

--targetオプションで YAML または JSON ファイルを直接指定できます。使用可能なファイルの拡張子は、.yaml、.yml、および.jsonです。--namespaceオプションは、namespace を指定し、この namespace は必要なサービス記述子ファイルを含むサブディレクトリーのknと通信します。--namespaceを使用せず、OpenShift クラスターにログインしている場合には、knは現在の namespace をもとに名前が付けられたサブディレクトリーでサービスを検索します。それ以外の場合は、knはdefault/サブディレクトリーで検索します。

サービス記述子ファイルを使用してクラスターでサービスを作成します。

kn service create -f test/ksvc/event-display.yaml

$ kn service create -f test/ksvc/event-display.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.3. kn container コマンド

以下のコマンドを使用して、Knative サービス仕様で複数のコンテナーを作成し、管理できます。

4.4.3.1. Knative クライアントマルチコンテナーのサポート

kn container add コマンドを使用して、YAML コンテナーの仕様を標準出力に出力できます。このコマンドは、定義を作成するために他の標準の kn フラグと共に使用できるため、マルチコンテナーのユースケースに役立ちます。

kn container add コマンドは、kn service create コマンドで使用できるコンテナー関連のすべてのフラグを受け入れます。UNIX パイプ (|) を使用して kn container add コマンドを連結して、一度に複数のコンテナー定義を作成することもできます。

コマンドの例