第13章 Hibernate Search

13.1. Hibernate Search を初めて使う場合

13.1.1. Hibernate Search について

Hibernate Search は、Hibernate アプリケーションに全文検索機能を提供します。SQL ベースのソリューションが適切でない検索アプリケーションに特に適しています (全文、あいまい、および位置情報検索を含む)。Hibernate Search は全文検索エンジンとして Apache Lucene を使用しますが、メンテナンスオーバーヘッドを最小化するよう設計されています。設定後は、インデックス作成、クラスタリング、およびデータ同期化が透過的にメンテナンスされ、ユーザーはビジネス要件を満たすことに集中できます。

JBoss EAP の以前のリリースには Hibernate 4.2 と Hibernate Search 4.6 が含まれていました。JBoss EAP 7 には、Hibernate 5 と Hibernate Search 5.5 が含まれます。

Hibernate Search 5.5 は Java 7 と連携し、Lucene 5.3.x に基づいて構築されています。ネイティブ Lucene API を使用している場合は、このバージョンを使用してください。

13.1.2. 概要

Hibernate Search は、Apache Lucene によりサポートされるインデックス作成コンポーネントとインデックス検索コンポーネントから構成されます。データベースに対してエンティティーが挿入、更新、または削除されるたびに、Hibernate Search はこのイベントを (Hibernate イベントシステム経由で) 追跡し、インデックスアップデートをスケジュールします。これらすべてのアップデートは、Apache Lucene API を直接使用せずに処理されます。代わりに、基礎となる Lucene インデックスとの対話は IndexManager 経由で処理されます。デフォルトでは、IndexManager と Lucene インデックス間には 1 対 1 の関係があります。IndexManager は選択された back end、reader strategy、および DirectoryProvider を含む特定のインデックス設定を抽象化します。

インデックスが作成されると、基礎となる Lucene インフラストラクチャーを使用する代わりに、エンティティーを検索し、管理対象エンティティーのリストを返すことができます。同じ永続化コンテキストが Hibernate と Hibernate Search 間で共有されます。FullTextSession クラスは、アプリケーションコードが統一された org.hibernate.Query または javax.persistence.Query API を HQL、JPA-QL、またはネイティブクエリーとまったく同じように使用できるように Hibernate Session クラス上に構築されます。

JDBC ベースであるかどうかに関係なく、すべての操作にはトランザクション形式のバッチモードが推奨されます。

データベースと Hibernate Search の両方において、JDBC または JTA に関係なくトランザクションで操作を実行することが推奨されます。

Hibernate Search は、Hibernate または EntityManager の長い会話パターン (アトミック会話) で完全に動作します。

13.1.3. Directory Provider について

Hibernate Search インフラストラクチャーの一部である Apache Lucene には、インデックスを格納するディレクトリーという概念があります。Hibernate Search は、ディレクトリープロバイダー経由で Lucene ディレクトリーの初期化と設定を処理します。

directory_provider プロパティーは、インデックスを格納するために使用するディレクトリープロバイダーを指定します。デフォルトのファイルシステムディレクトリープロバイダーは、filesystem であり、インデックスを格納するローカルファイルシステムを使用します。

13.1.4. ワーカーについて

Lucene インデックスに対するアップデートは、Hibernate Search ワーカーによって処理されます。ワーカーはすべてのエンティティーの変更を受け取り、それらをコンテキスト別にキューに格納し、コンテキストが終了したら適用します。最も一般的なコンテキストはトランザクションですが、エンティティーの変更または他のアプリケーションイベントの数によって異なることがあります。

効率を向上させるために、対話はバッチ処理され、一般的にコンテキストの終了時に適用されます。トランザクション外部では、インデックスアップデート操作は、実際のデータベース操作の直後に実行されます。実行中のトランザクションの場合は、トランザクションコミットフェーズに対してインデックスアップデート操作がスケジュールされ、トランザクションロールバックの場合は、破棄されます。ワーカーには特定のバッチサイズ制限を設定できます。この制限を超えると、コンテキストに関係なくインデックス作成が実行されます。

インデックスアップデートのこの処理方法は以下の 2 つの利点があります。

- パフォーマンス: Lucene インデックス作成のパフォーマンスは、操作をバッチで実行した場合に向上します。

- ACIDity: 実行したワークは、データベーストランザクションにより実行されたワークと同じスコープを持ち、トランザクションがコミットされた場合にのみ実行されます。これは、厳密には ACID ではありませんが、ACID の動作は全文検索インデックスにほとんど役に立ちません。インデックスはいつでもソースから再構築できます。

2 つのバッチモード (スコープなしと従来のもの) の関係は、オートコミットと従来の動作の関係に似ています。パフォーマンスの観点からは、トランザクションモードが推奨されます。スコープの選択は透過的に行われます。Hibernate Search は、トランザクションの存在を検出し、スコープを調整します。

13.1.5. バックエンドセットアップおよび操作

13.1.5.1. バックエンド

Hibernate Search は、さまざまなバックエンドを使用してワークのバッチを処理します。バックエンドは設定オプション default.worker.backend に制限されません。このプロパティーは、バックエンド設定の一部である BackendQueueProcessor インターフェースの実装を指定します。バックエンドをセットアップするには、JMS バックエンドなどの追加の設定が必要です。

13.1.5.2. Lucene

Lucene モードでは、ノードのすべてのインデックスアップデートが、ディレクトリープロバイダーを使用した Lucene ディレクトリーに対する同じノードにより実行されます。このモードは、非クラスター環境または共有ディレクトリーストアがあるクラスター環境で使用します。

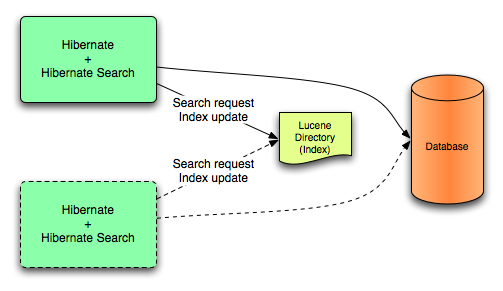

図13.1 Lucene バックエンド設定

Lucene モードは、ディレクトリーでロックストラテジーを管理する非クラスターアプリケーションまたはクラスターアプリケーションを対象とします。Lucene モードの第一の利点は、Lucene クエリーの変更の単純化と即時的な可視性です。Near Real Time (NRT) バックエンドは非クラスターおよび非共有インデックス設定向けの代替バックエンドです。

13.1.5.3. JMS

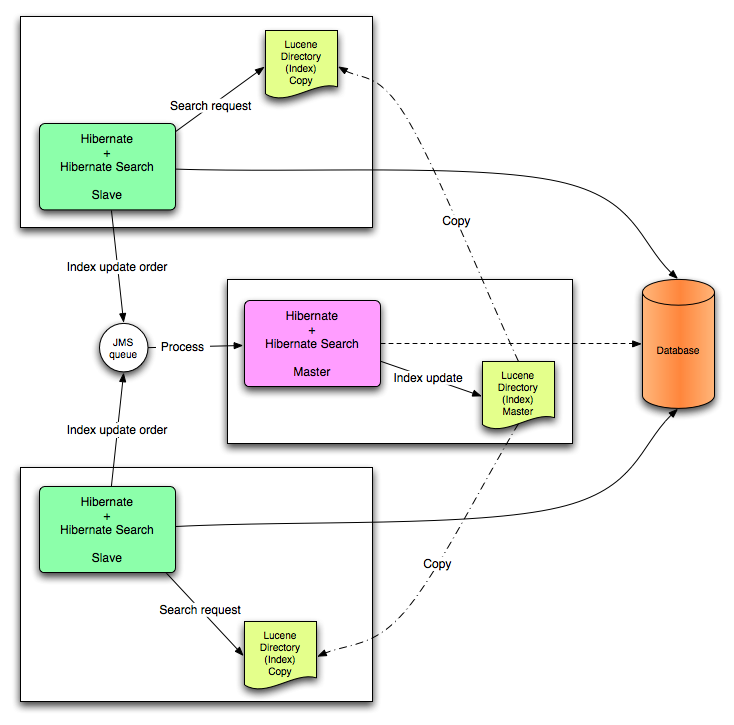

ノードのインデックスアップデートは JMS キューに送信されます。特別なリーダーがキューを処理し、マスターインデックスをアップデートします。マスターおよびスレーブパターンを確立するために、マスターインデックスはスレーブコピーに定期的に複製されます。マスターは Lucene インデックスアップデートを行います。スレーブは読み書き操作を受け取りますが、読み取り操作をローカルインデックスコピーで処理します。Lucene インデックスを更新するのはマスターだけです。また、マスターのみがアップデート操作でローカル変更を適応できます。

図13.2 JMS バックエンド設定

このモードは、スループットが重要であり、インデックスアップデートの遅延が許容されるクラスタ環境を対象とします。JMS プロバイダーにより、信頼性が保証され、ローカルインデックスコピーを変更するためにスレーブが使用されます。

13.1.6. リーダーストラテジー

クエリーを実行する場合は、Hibernate Search がリーダーストラテジーを使用して Apache Lucene インデックスを処理します。頻繁なアップデート、読み取りが大部分、非同期インデックスアップデートなどのアプリケーションのプロファイルに基づいてリーダーストラテジーを選択します。

13.1.6.3. カスタムリーダーストラテジー

カスタムリーダーストラテジーは、org.hibernate.search.reader.ReaderProvider の実装を使用して記述できます。実装はスレッドセーフである必要があります。

13.2. Configuration (設定)

13.2.1. 最小設定

Hibernate Search は、設定と操作に柔軟性を提供するよう設計されており、デフォルト値は大部分のユースケースに適合するよう慎重に選択されます。最低でも、Directory Provider とプロパティーを設定する必要があります。デフォルトの Directory Provider は filesystem であり、インデックスストレージにローカルファイルシステムが使用されます。利用可能な Directory Provider とその設定の詳細については、DirectoryProvider Configuration を参照してください。

Hibernate を直接使用している場合は、DirectoryProvider などの設定を設定ファイルの hibernate.properties または hibernate.cfg.xml で指定する必要があります。Hibernate を JPA で使用している場合、設定ファイルは persistence.xml になります。

13.2.2. IndexManager の設定

Hibernate Search は、このインターフェースに対して複数の実装を提供します。

-

directory-based: LuceneDirectory抽象化を使用してインデックスファイルを管理するデフォルトの実装。 -

near-real-time: 各コミット時にディスクへの書き込みのフラッシュを回避します。また、このインデックスマネージャーはDirectoryベースですが、Lucene の Near Real-Time (NRT) 機能を使用します。

デフォルト値以外の IndexManager を指定するには、以下のプロパティーを指定します。

hibernate.search.[default|<indexname>].indexmanager = near-real-time

13.2.2.1. Directory-based

Directory-based 実装は、デフォルトの IndexManager 実装です。高度な設定が可能であり、リーダーストラテジー、バックエンド、およびディレクトリープロバイダーに対して個別の設定を指定できます。

13.2.2.2. Near Real Time

NRTIndexManager は、デフォルトの IndexManager の拡張であり、レイテンシーの低いインデックス書き込みに Lucene NRT (Near Real Time) 機能を使用します。ただし、lucene 以外の別のバックエンドに対する設定は無視され、Directory に対する排他的な書き込みロックが取得されます。

IndexWriter は、低いレイテンシーを提供するために各変更をディスクにフラッシュしません。クエリーは、フラッシュされていないインデックスライターバッファーからアップデートされた状態を読み取ることができます。ただし、IndexWriter が終了した場合やアプリケーションがクラッシュした場合は、アップデートが失われ、インデックスを再構築する必要があることがあります。

記載された欠点が原因でデータが制限された非クラスタ Web サイトには Near Real Time 設定が推奨されます (パフォーマンスを向上させるためにマスターノードを個別に設定できます)。

13.2.2.3. Custom

カスタマイズ IndexManager をセットアップするにはカスタム実装に完全修飾クラス名を指定します。以下のように、実装に対して引数のないコンストラクターをセットアップします。

[default|<indexname>].indexmanager = my.corp.myapp.CustomIndexManager

カスタムインデックスマネージャー実装では、デフォルト実装と同じコンポーネントが必要ありません。たとえば、Directory インターフェースを公開しないリモートインデックスサービスに委任します。

13.2.3. DirectoryProvider 設定

DirectoryProvider は、Directory に対する Hibernate Search の抽象化であり、基礎となる Lucene リソースの設定と初期化を処理します。ディレクトリープロバイダーおよびプロパティーには、Hibernate Search で利用可能なディレクトリープロバイダーと対応するオプションが示されます。

各インデックスエンティティーは、Lucene インデックスに関連付けられます (複数のエンティティーが同じインデックスを共有する場合を除く)。インデックスの名前は、@Indexed アノテーションの index プロパティーにより提供されます。index プロパティーが指定されない場合は、インデックスクラスの完全修飾名が名前として使用されます (推奨)。

DirectoryProvider と追加のオプションは、接頭辞 hibernate.search.<indexname> を使用して設定できます。名前 default (hibernate.search.default) は予約され、すべてのインデックスに適用するプロパティーを定義するために使用できます。ディレクトリープロバイダーの設定には、hibernate.search.default.directory_provider を使用してデフォルトディレクトリープロバイダーをファイルシステムのものにどのように設定するかが示されています。hibernate.search.default.indexBase により、インデックス用のデフォルトベースディレクトリーが設定されます。結果として、エンティティー Status のインデックスが /usr/lucene/indexes/org.hibernate.example.Status に作成されます。

ただし、Rule エンティティーのインデックスはメモリ内ディレクトリーを使用します。これは、このエンティティーのデフォルトディレクトリープロバイダーがプロパティー hibernate.search.Rules.directory_provider によりオーバーライドされるためです。

最後に、Action エンティティーは、hibernate.search.Actions.directory_provider 経由で指定されたカスタムディレクトリープロバイダー CustomDirectoryProvider を使用します。

インデックス名の指定

package org.hibernate.example;

@Indexed

public class Status { ... }

@Indexed(index="Rules")

public class Rule { ... }

@Indexed(index="Actions")

public class Action { ... }

ディレクトリープロバイダーの設定

hibernate.search.default.directory_provider = filesystem hibernate.search.default.indexBase=/usr/lucene/indexes hibernate.search.Rules.directory_provider = ram hibernate.search.Actions.directory_provider = com.acme.hibernate.CustomDirectoryProvider

定義された設定スキームを使用して、ディレクトリープロバイダーやベースディレクトリーなどの共通のルールを簡単に定義したり、これらのデフォルト値をインデックスごとに後でオーバーライドしたりできます。

ディレクトリープロバイダーおよびプロパティー

- ram

- なし

- filesystem

ファイルシステムベースのディレクトリー。使用されるディレクトリーは <indexBase>/< indexName >

- indexBase : ベースディレクトリー

- indexName: @Indexed.index をオーバーライドする (共有インデックスの場合に有用)

- locking_strategy : オプション (LockFactory 設定を参照)

-

filesystem_access_type: この

DirectoryProviderにより使用されるFSDirectory実装のタイプを決定できます。許可される値は、auto(デフォルト値。Windows 以外のシステムではNIOFSDirectory、Windows ではSimpleFSDirectoryを選択)、simple (SimpleFSDirectory)、nio (NIOFSDirectory)、mmap (MMapDirectory)です。この設定を変更する前にこれらの Directory 実装の Javadocs を参照してください。NIOFSDirectoryまたはMMapDirectoryを使用するとパフォーマンスが大幅に向上することがありますが、問題も発生します。

filesystem-masterファイルシステムベースのディレクトリー (

filesystemなど)。通常は、インデックスもソースディレクトリー (コピーディレクトリー) にコピーされます。更新期間の推奨値は、情報をコピーする時間よりも 50% (以上) 大きい値です (デフォルトでは 3600 秒 - 60 分)。

コピーは増分コピーメカニズムに基づき、平均コピー時間が短縮されることに注意してください。

DirectoryProvider は、通常 JMS バックエンドクラスターのマスターノートで使用されます。

buffer_size_on_copyは、オペレーティングシステムと利用可能な RAM に依存します。最良の結果を得るには、16〜64MB の値を使用することが推奨されます。- indexBase: ベースディレクトリー

- indexName: @Indexed.index をオーバーライドする (共有インデックスの場合に有用)

- sourceBase: ソース (コピー) ベースディレクトリー

-

source: ソースディレクトリー接尾辞 (デフォルト値は

@Indexed.index)。実際のソースディレクトリー名は<sourceBase>/<source> - refresh: 秒単位の更新期間 (コピーは refresh 秒ごとに実行されます)。以下の refresh 期間が経過した時にまだコピーが実行中である場合は、2 番目のコピー操作が省略されます。

- buffer_size_on_copy: 単一の低レベルコピー命令で移動する MegaBytes のサイズ。デフォルト値は 16MB です。

- locking_strategy : オプション (LockFactory 設定を参照)

-

filesystem_access_type: この

DirectoryProviderにより使用されるFSDirectory実装のタイプを決定できます。許可される値は、auto(デフォルト値。Windows 以外のシステムではNIOFSDirectory、Windows ではSimpleFSDirectoryを選択)、simple (SimpleFSDirectory)、nio (NIOFSDirectory)、mmap (MMapDirectory)です。この設定を変更する前にこれらの Directory 実装の Javadocs を参照してください。NIOFSDirectoryまたはMMapDirectoryを使用するとパフォーマンスが大幅に向上することがありますが、問題も発生します。

filesystem-slaveファイルシステムベースのディレクトリー (

filesystemなど)。通常は、マスターバージョン (ソース) が取得されます。ロックや不整合な検索結果を避けるために、2 つのローカルコピーが保持されます。更新期間の推奨値は、情報をコピーする時間よりも 50% (以上) 大きい値です (デフォルトでは 3600 秒 - 60 分)。

コピーは増分コピーメカニズムに基づき、平均コピー時間が短縮されることに注意してください。refresh 期間が経過した時にまだコピーが実行中である場合は、2 番目のコピー操作が省略されます。

JMS バックエンドを使用してスレーブノードで一般的に使用される DirectoryProvider。

buffer_size_on_copyは、オペレーティングシステムと利用可能な RAM に依存します。最良の結果を得るには、16〜64MB の値を使用することが推奨されます。- indexBase: ベースディレクトリー

- indexName: @Indexed.index をオーバーライドする (共有インデックスの場合に有用)

- sourceBase: ソース (コピー) ベースディレクトリー

-

source: ソースディレクトリー接尾辞 (デフォルト値は

@Indexed.index)。実際のソースディレクトリー名は<sourceBase>/<source> - refresh: 秒単位の更新期間 (コピーは refresh 秒ごとに実行されます)。

- buffer_size_on_copy: 単一の低レベルコピー命令で移動する MegaBytes のサイズ。デフォルト値は 16MB です。

- locking_strategy : オプション (LockFactory 設定を参照)

- retry_marker_lookup: オプションであり、デフォルト値は 0 です。Hibernate Search がソースディレクトリーのマーカーファイルをチェックする回数を定義します。試行の間隔は 5 秒です。

-

retry_initialize_period: オプション。再試行初期化機能を有効にするために秒を整数値で設定します。スレーブがマスターインデックスを見つけることができない場合は、見つかるまでバックグラウンドで再試行され、アプリケーションの起動は阻止されません。インデックスが初期化される前に実行された fullText クエリーはブロックされませんが、空の結果を返します。オプションを有効にしない場合や、明示的にゼロに設定しない場合は、再試行タイマーのスケジュールの代わりに、失敗して例外が発生します。無効なインデックスなしでアプリケーションが起動しないようにし、初期化タイムアウトを制御する場合は、代わりに

retry_marker_lookupを参照してください。 -

filesystem_access_type: この

DirectoryProviderにより使用されるFSDirectory実装のタイプを決定できます。許可される値は、auto (デフォルト値。Windows 以外のシステムではNIOFSDirectory、Windows ではSimpleFSDirectoryを選択)、simple (SimpleFSDirectory)、nio (NIOFSDirectory)、mmap (MMapDirectory)です。この設定を変更する前にこれらの Directory 実装の Javadocs を参照してください。NIOFSDirectoryまたはMMapDirectoryを使用するとパフォーマンスが大幅に向上することがありますが、問題も発生します。

組み込みのディレクトリープロバイダーがニーズを満たさない場合は、org.hibernate.store.DirectoryProvider インターフェースを実装して独自のディレクトリープロバイダーを記述できます。この場合は、プロバイダーの完全修飾クラス名を directory_provider プロパティーに渡します。追加のプロパティーは、接頭辞 hibernate.search.<indexname> を使用して渡すことができます。

13.2.4. ワーカー設定

ワーカー設定を介して Hibernate Search がどのように Lucene と対話するかを定義できます。複数のアーキテクチャーコンポーネントと拡張が存在します。

ワーカー設定を使用して Infinispan クエリーが Lucene と対話する方法を定義します。この設定では、複数のアーキテクチャーコンポーネントと拡張が存在します。

最初に、Worker について説明します。Worker インターフェースの実装は、すべてのエンティティーの変更を受け取り、コンテキスト別にキューに格納し、コンテキストが終了したら適用します。最も直感的なコンテキスト (特に ORM との接続) はトランザクションです。このため、Hibernate Search は、トランザクションごとにすべての変更をスコープ指定するためにデフォルトで TransactionalWorker を使用します。ただし、コンテキストがエンティティーの変更や他のアプリケーション (ライフサイクル) イベントの数などに依存するシナリオが考えられます。

| プロパティー | 説明 |

|---|---|

|

|

使用する |

|

|

接頭辞が |

|

|

コンテキストごとにバッチ化されたインデックス作成操作の最大数を定義します。この制限に到達すると、コンテキストがまだ終了していなくてもインデックス作成がトリガーされます。このプロパティーは、 |

コンテキストが終了すると、インデックスの変更を準備し、適用します。これは、新しいスレッド内で同期的または非同期的に行えます。同期のアップデートの利点は、インデックスが常にデータベースと同期されることです。その一方で、非同期アップデートでは、ユーザー応答時間を最小化できます。非同期アップデートの欠点は、データベースとインデックスの状態が一致しない場合があることです。

以下のオプションはインデックスごとに異なることがあります。実際には、indexName 接頭辞または default を使用してすべてのインデックスのデフォルト値を設定します。

| プロパティー | 説明 |

|---|---|

|

|

|

|

|

バックエンドは、スレッドプールを使用して、同じトランザクションコンテキスト (またはバッチ) からアップデートを同時に適用できます。デフォルト値は 1 です。トランザクションごとに多くの操作がある場合は、大きい値を試行できます。 |

|

|

スレッドプールが枯渇した場合のワークキューの最大数を定義します。非同期実行の場合のみ役に立ちます。デフォルト値は無制限です。制限に達すると、メインスレッドによりワークが実行されます。 |

これまで、どの実行モードであるかに関係なく、すべてのワークは同じ仮想マシン (VM) 内で実行されました。1 つの VM に対してワークの合計量は変わりませんでした。問題に対処するために、委任という優れた方法があります。hibernate.search.default.worker.backend を設定することにより、インデックス作成ワークを別のサーバーに送信できます。繰り返しますが、このオプションは、各インデックスに対して個別に設定できます。

| プロパティー | 説明 |

|---|---|

|

|

また、 |

| プロパティー | 説明 |

|---|---|

|

|

InitialContext を初期化するために JNDI プロパティーを定義します (必要な場合)。JNDI は JMS バックエンドによってのみ使用されます。 |

|

|

JMS バックエンドに必要です。JMS 接続ファクトリーをルックアップする JNDI 名を定義します (Red Hat JBoss Enterprise Application Platform ではデフォルトで |

|

|

JMS バックエンドに必要です。JMS キューをルックアップする JNDI 名を定義します。キューはワークメッセージをポストするために使用されます。 |

お気づきになったかもしれませんが、示された一部のプロパティーは相互に影響を及ぼします。つまり、すべてのプロパティー値の組み合わせが有効であるとは限りません。実際には、機能しない設定を使用することがあります。これは、特に、示された一部のインターフェースの独自の実装を提供する場合に当てはまります。独自の Worker または BackendQueueProcessor 実装を記述する前に既存のコードを調べてください。

13.2.4.1. JMS マスター/スレーブバックエンド

本セクションでは、マスター/スレーブ Hibernate Search アーキテクチャーの設定方法について詳しく説明します。

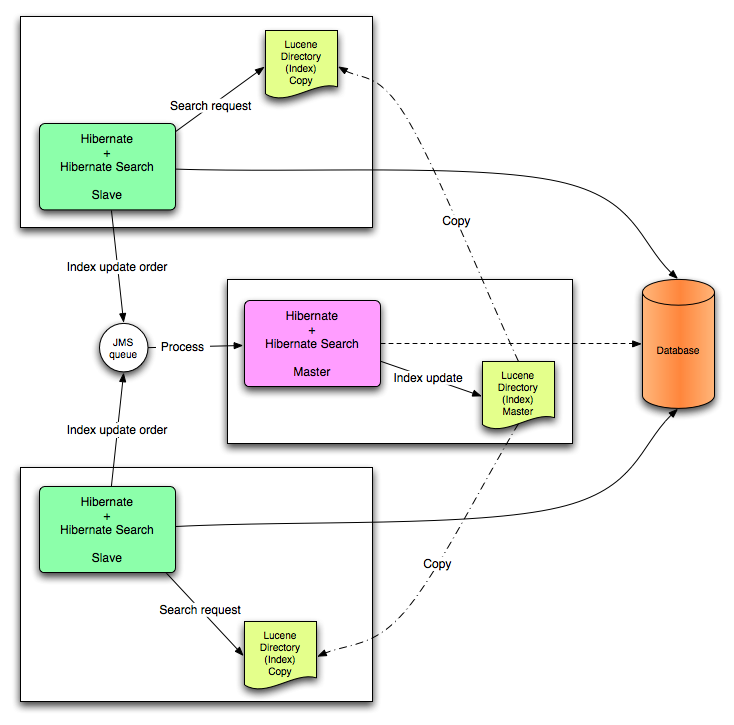

図13.3 JMS バックエンド設定

13.2.4.2. スレーブノード

各インデックスアップデート操作は、JMS キューに送信されます。インデックスクエリー操作はローカルインデックスコピーで実行されます。

JMS スレーブ設定

### slave configuration ## DirectoryProvider # (remote) master location hibernate.search.default.sourceBase = /mnt/mastervolume/lucenedirs/mastercopy # local copy location hibernate.search.default.indexBase = /Users/prod/lucenedirs # refresh every half hour hibernate.search.default.refresh = 1800 # appropriate directory provider hibernate.search.default.directory_provider = filesystem-slave ## Back-end configuration hibernate.search.default.worker.backend = jms hibernate.search.default.worker.jms.connection_factory = /ConnectionFactory hibernate.search.default.worker.jms.queue = queue/hibernatesearch #optional jndi configuration (check your JMS provider for more information) ## Optional asynchronous execution strategy # hibernate.search.default.worker.execution = async # hibernate.search.default.worker.thread_pool.size = 2 # hibernate.search.default.worker.buffer_queue.max = 50

検索結果を高速化するには、ファイルシステムローカルコピーが推奨されます。

13.2.4.3. マスターノード

各インデックスアップデート操作は、JMS キューから取得され、実行されます。マスターインデックスは定期的にコピーされます。

JMS キュー内のインデックスアップデート操作が実行され、マスターインデックスが定期的にコピーされます。

JMS マスター設定

### master configuration ## DirectoryProvider # (remote) master location where information is copied to hibernate.search.default.sourceBase = /mnt/mastervolume/lucenedirs/mastercopy # local master location hibernate.search.default.indexBase = /Users/prod/lucenedirs # refresh every half hour hibernate.search.default.refresh = 1800 # appropriate directory provider hibernate.search.default.directory_provider = filesystem-master ## Back-end configuration #Back-end is the default for Lucene

JMS からインデックスワークキューを処理するために、Hibernate Search フレームワーク設定以外に、メッセージ駆動 Bean を記述して、セットアップする必要があります。

インデックス作成キューを処理するメッセージ駆動 Bean

@MessageDriven(activationConfig = {

@ActivationConfigProperty(propertyName="destinationType",

propertyValue="javax.jms.Queue"),

@ActivationConfigProperty(propertyName="destination",

propertyValue="queue/hibernatesearch"),

@ActivationConfigProperty(propertyName="DLQMaxResent", propertyValue="1")

} )

public class MDBSearchController extends AbstractJMSHibernateSearchController

implements MessageListener {

@PersistenceContext EntityManager em;

//method retrieving the appropriate session

protected Session getSession() {

return (Session) em.getDelegate();

}

//potentially close the session opened in #getSession(), not needed here

protected void cleanSessionIfNeeded(Session session)

}

}

このサンプルは、Hibernate Search ソースコードで利用可能な抽象 JMS コントローラークラスから継承され、JavaEE MDB を実装します。この実装はサンプルとして提供され、Java EE メッセージ駆動 Bean 以外のものを使用するよう調整できます。

13.2.5. Lucene インデックス作成のチューニング

13.2.5.1. Lucene インデックス作成パフォーマンスのチューニング

Hibernate Search では、基礎となる Lucene IndexWriter に渡される mergeFactor、maxMergeDocs、maxBufferedDocs などのパラメーターセットを指定して、Lucene インデックス作成パフォーマンスをチューニングできます。これらのパラメーターは、インデックスまたはシャードごとにすべてのインデックスに適用するデフォルト値として指定します。

さまざまなユースケースに対してチューニングできる複数の低レベル IndexWriter 設定があります。これらのパラメーターは、以下のように indexwriter キーワードでグループ化されます。

hibernate.search.[default|<indexname>].indexwriter.<parameter_name>

特定のシャード設定の indexwriter 値に値が設定されていない場合は、Hibernate Search がインデックスセクションをチェックし、その後でデフォルトセクションをチェックします。

以下の表の設定では、次のように Animal インデックスの 2 番目のシャードで適用される設定になります。

-

max_merge_docs= 10 -

merge_factor= 20 -

ram_buffer_size= 64MB -

term_index_interval= Lucene default

他のすべての値は Lucene で定義されたデフォルト値を使用します。

すべての値のデフォルトでは、Lucene の独自のデフォルトになります。このため、インデックス作成パフォーマンスと動作プロパティーのリストにリストされた値は使用している Lucene のバージョンによって異なります。示された値はバージョン 2.4 に対して相対的になります。

Hibernate Search の以前のバージョンでは batch プロパティーと transaction プロパティーが使用されていました。これは、バックエンドが常に同じ設定を使用してワークを実行するため、現在該当しません。

| プロパティー | 説明 | デフォルト値 |

|---|---|---|

|

|

同じインデックスに書き込む必要がある他のプロセスがない場合は、 |

|

|

|

各インデックスには、インデックスに適用するアップデートを含む「パイプライン」が含まれます。このキューがいっぱいである場合は、キューに操作を追加すると、ブロック操作になります。 |

|

|

|

バッファされたメモリ内削除用語を適用およびフラッシュする前に必要な削除用語の最小数を決定します。メモリ内にバッファされたドキュメントがある場合、ドキュメントはマージされ、新しいセグメントが作成されます。 |

無効 (RAM 使用によりフラッシュ) |

|

|

インデックス作成中にメモリ内にバッファされるドキュメントの量を制御します。値が大きなると、より多くの RAM が消費されます。 |

無効 (RAM 使用によりフラッシュ) |

|

|

セグメントで許可されたドキュメントの最大数を定義します。頻繁にインデックスが変わる場合は、小さい値が適切です。インデックスが頻繁に変わらない場合は、値が大きいと、検索パフォーマンスが向上します。 |

無制限 (Integer.MAX_VALUE) |

|

|

セグメントマージの頻度とサイズを制御します。 挿入の実行時にセグメントインデックスをマージする頻度を決定します。値が小さいと、インデックス作成中の RAM の使用量が小さくなり、最適化されていないインデックスでの検索が高速になりますが、インデックス作成時間が長くなります。値が大きいと、インデックス作成中の RAM の使用量が大きくなり、最適化されていないインデックスでの検索が低速になりますが、インデックス作成時間は短くなります。したがって、大きい値 (> 10) はバッチインデックス作成に最適であり、小さい値 (< 10) は対話的に維持するインデックスに最適です。値は 2 よりも小さくしないでください。 |

10 |

|

|

セグメントマージの頻度とサイズを制御します。次のセグメントマージ操作でこのサイズ (MB 単位) よりも小さいセグメントが常に考慮されます。この値が大きすぎると、頻度が少ない場合であってもマージ操作のコストが高くなることがあります。 |

0 MB (実際には 1K 以下) |

|

|

セグメントマージの頻度とサイズを制御します。 このサイズ (MB 単位) よりも大きいセグメントは大きいセグメントでマージされません。 これにより、メモリーの要件が少なくなり、最適な検索速度が失われる一部のマージ操作を回避できます。インデックスの最適化時に、この値は無視されます。

|

無制限 |

|

|

セグメントマージの頻度とサイズを制御します。

インデックスの最適化時でも、このサイズ (MB 単位) よりも大きいセグメントは大きいセグメントでマージされません (

|

無制限 |

|

|

セグメントマージの頻度とサイズを制御します。

マージポリシーを推測する場合に削除されたドキュメントを考慮しない場合は、

|

|

|

|

ドキュメントバッファー専用の RAM の量 (MB 単位) を制御します。max_buffered_docs とともに使用すると、最初に発生したイベントに対してフラッシュが実行されます。 一般的に、インデックス作成パフォーマンスを向上させるには、ドキュメント数の代わりに RAM 使用量によりフラッシュし、できるだけ大きい RAM バッファーを使用することが推奨されます。 |

16 MB |

|

|

エキスパート: インデックス用語間の間隔を設定します。 値が大きいと、IndexReader が使用するメモリーが少なくなりますが、用語へのランダムアクセスは遅くなります。値が小さいと、IndexReader が使用するメモリーが多くなり、用語へのランダムアクセスが速くなります。詳細については、Lucene ドキュメンテーションを参照してください。 |

128 |

|

|

複合ファイル形式を使用する利点は、使用するファイル記述子が少なくなることです。欠点は、インデックスの作成時間が長くなり、一時ディスク容量が大きくなることです。インデックス作成時間を短縮するためにこのパラメーターを

ブール値パラメーター。“true” または “false” を使用します。このオプションのデフォルト値は |

true |

|

|

すべてのエンティティーの変更で Lucene インデックスのアップデートが必要になるわけではありません。アップデートされたすべてのエンティティープロパティー (ダーティープロパティー) のインデックスが作成されていない場合は、Hibernate Search によりインデックスの再作成プロセスが省略されます。

各アップデートイベントで呼び出す必要があるカスタム

この最適化は、

ブール値パラメーター。“true” または “false” を使用します。このオプションのデフォルト値は |

true |

blackhole バックエンドは、本番稼働で使用することを目的としません。インデックス作成のボトルネックを特定するツールとしてのみ使用してください。

13.2.5.2. Lucene IndexWriter

さまざまなユースケースに対してチューニングできる複数の低レベル IndexWriter 設定があります。これらのパラメーターは、以下のように indexwriter キーワードでグループ化されます。

default.<indexname>.indexwriter.<parameter_name>

シャード設定の indexwriter に値が設定されていない場合は、Hibernate Search がインデックスセクションをチェックし、その後でデフォルトセクションをチェックします。

13.2.5.3. パフォーマンスオプション設定

以下の設定では、次のように Animal インデックスの 2 番目のシャードで適用される設定になります。

パフォーマンスオプション設定例

default.Animals.2.indexwriter.max_merge_docs = 10 default.Animals.2.indexwriter.merge_factor = 20 default.Animals.2.indexwriter.term_index_interval = default default.indexwriter.max_merge_docs = 100 default.indexwriter.ram_buffer_size = 64

-

max_merge_docs= 10 -

merge_factor= 20 -

ram_buffer_size= 64MB -

term_index_interval= Lucene default

他のすべての値は Lucene で定義されたデフォルト値を使用します。

Lucene デフォルト値は、Hibernate Search のデフォルト設定です。したがって、以下の表にリストされた値は使用している Lucene のバージョンによって異なります。示された値はバージョン 2.4 に対して相対的になります。Lucene インデックス作成パフォーマンスの詳細については、Lucene ドキュメンテーションを参照してください。

バックエンドでは常に同じ設定を使用してワークが実行されます。

| プロパティー | 説明 | デフォルト値 |

|---|---|---|

|

|

同じインデックスに書き込む必要がある他のプロセスがない場合は、 |

|

|

|

各インデックスには、インデックスに適用するアップデートを含む「パイプライン」が含まれます。このキューがいっぱいである場合は、キューに操作を追加すると、ブロック操作になります。 |

|

|

|

バッファされたメモリ内削除用語を適用およびフラッシュする前に必要な削除用語の最小数を決定します。メモリ内にバッファされたドキュメントがある場合、ドキュメントはマージされ、新しいセグメントが作成されます。 |

無効 (RAM 使用によりフラッシュ) |

|

|

インデックス作成中にメモリ内にバッファされるドキュメントの量を制御します。値が大きなると、より多くの RAM が消費されます。 |

無効 (RAM 使用によりフラッシュ) |

|

|

セグメントで許可されたドキュメントの最大数を定義します。頻繁にインデックスが変わる場合は、小さい値が適切です。インデックスが頻繁に変わらない場合は、値が大きいと、検索パフォーマンスが向上します。 |

無制限 (Integer.MAX_VALUE) |

|

|

セグメントマージの頻度とサイズを制御します。 挿入の実行時にセグメントインデックスをマージする頻度を決定します。値が小さいと、インデックス作成中の RAM の使用量が小さくなり、最適化されていないインデックスでの検索が高速になりますが、インデックス作成時間が長くなります。値が大きいと、インデックス作成中の RAM の使用量が大きくなり、最適化されていないインデックスでの検索が低速になりますが、インデックス作成時間は短くなります。したがって、大きい値 (> 10) はバッチインデックス作成に最適であり、小さい値 (< 10) は対話的に維持するインデックスに最適です。値は 2 よりも小さくしないでください。 |

10 |

|

|

セグメントマージの頻度とサイズを制御します。 次のセグメントマージ操作でこのサイズ (MB 単位) よりも小さいセグメントが常に考慮されます。 この設定値が大きすぎると、コストがかかるマージ操作になる場合があります (頻度は少なくなります)。

|

0 MB (実際には 1K 以下) |

|

|

セグメントマージの頻度とサイズを制御します。 このサイズ (MB 単位) よりも大きいセグメントは大きいセグメントでマージされません。 これにより、メモリーの要件が少なくなり、最適な検索速度が失われる一部のマージ操作を回避できます。インデックスの最適化時に、この値は無視されます。

|

無制限 |

|

|

セグメントマージの頻度とサイズを制御します。

インデックスの最適化時でも、このサイズ (MB 単位) よりも大きいセグメントは大きいセグメントでマージされません (

|

無制限 |

|

|

セグメントマージの頻度とサイズを制御します。

マージポリシーを推測する場合に削除されたドキュメントを考慮しない場合は、

|

|

|

|

ドキュメントバッファー専用の RAM の量 (MB 単位) を制御します。max_buffered_docs とともに使用すると、最初に発生したイベントに対してフラッシュが実行されます。 一般的に、インデックス作成パフォーマンスを向上させるには、ドキュメント数の代わりに RAM 使用量によりフラッシュし、できるだけ大きい RAM バッファーを使用することが推奨されます。 |

16 MB |

|

|

エキスパート: インデックス用語間の間隔を設定します。 値が大きいと、IndexReader が使用するメモリーが少なくなりますが、用語へのランダムアクセスは遅くなります。値が小さいと、IndexReader が使用するメモリーが多くなり、用語へのランダムアクセスが速くなります。詳細については、Lucene ドキュメンテーションを参照してください。 |

128 |

|

|

複合ファイル形式を使用する利点は、使用するファイル記述子が少なくなることです。欠点は、インデックスの作成時間が長くなり、一時ディスク容量が大きくなることです。インデックス作成時間を短縮するためにこのパラメーターを

ブール値パラメーター。“true” または “false” を使用します。このオプションのデフォルト値は |

true |

|

|

すべてのエンティティーの変更で Lucene インデックスのアップデートが必要になるわけではありません。アップデートされたすべてのエンティティープロパティー (ダーティープロパティー) のインデックスが作成されていない場合は、Hibernate Search によりインデックスの再作成プロセスが省略されます。

各アップデートイベントで呼び出す必要があるカスタム

この最適化は、

ブール値パラメーター。“true” または “false” を使用します。このオプションのデフォルト値は |

true |

13.2.5.4. インデックス作成速度のチューニング

アーキテクチャーで許可される場合は、インデックス作成の効率を向上させるために default.exclusive_index_use=true を保持します。

インデックス作成速度をチューニングする場合は、最初にオブジェクトのロードを最適化し、インデックス作成プロセスをチューニングするベースラインとして実現するタイミングを使用することが推奨されます。ワーカーバックエンドとして blackhole を設定し、インデックス作成ルーチンを開始します。このバックエンドは Hibernate Search を無効にしません。インデックスに対して必要な変更セットが生成されますが、それらの変更セットはインデックスに対してフラッシュされるのではなく破棄されます。hibernate.search.indexing_strategy を manual に設定するのとは異なり、blackhole を使用すると、データベースからより多くのデータがロードされることがあります (関連付けられたエンティティーのインデックスが再び作成されるため)。

hibernate.search.[default|<indexname>].worker.backend blackhole

blackhole バックエンドは、本番稼働で使用することを目的としません。インデックス作成のボトルネックを特定する診断ツールとしてのみ使用してください。

13.2.5.5. セグメントサイズの制御

以下のオプションを使用すると、作成するセグメントの最大サイズを設定できます。

-

merge_max_size -

merge_max_optimize_size -

merge_calibrate_by_deletes

セグメントサイズの制御

//to be fairly confident no files grow above 15MB, use: hibernate.search.default.indexwriter.ram_buffer_size = 10 hibernate.search.default.indexwriter.merge_max_optimize_size = 7 hibernate.search.default.indexwriter.merge_max_size = 7

マージ操作に対して max_size をハード制限セグメントサイズの半分未満に設定します (セグメントのマージでは 2 つのセグメントが結合されるため)。

新しいセグメントは最初に期待したものよりも大きい場合がありますが、作成されるセグメントは ram_buffer_size よりも大幅に大きくなりません。このしきい値は推定値としてチェックされます。

13.2.6. LockFactory 設定

Lucene ディレクトリーは、Hibernate Search で管理された各インデックス用の LockingFactory 経由でカスタムロックストラテジーを使用して設定できます。

一部のロックストラテジーは、ファイルシステムレベルのロックを必要とし、RAM ベースのインデックスで使用できます。このストラテジーを使用する場合は、ロックマーカーファイルを格納するファイルシステムの場所を参照するよう IndexBase 設定オプションを指定する必要があります。

ロックファクトリーを選択するには、hibernate.search.<index>.locking_strategy オプションを以下のいずれかのオプションに設定します。

- simple

- native

- single

- none

| 名前 | クラス | 説明 |

|---|---|---|

|

LockFactory 設定 |

org.apache.lucene.store.SimpleFSLockFactory |

Java のファイル API に基づいた安全な実装。マーカーファイルを作成することによりインデックスの使用をマークします。 何らかの理由でアプリケーションを終了する必要がある場合はアプリケーションを再び起動する前にこのファイルを削除する必要があります。 |

|

|

org.apache.lucene.store.NativeFSLockFactory |

この実装には NFS の既知の問題があります。ネットワーク共有で使用しないでください。

|

|

|

org.apache.lucene.store.SingleInstanceLockFactory |

この LockFactory はファイルマーカーを使用しませんが、メモリーに保持される Java オブジェクトロックです。したがって、これは、インデックスが他のプロセスで共有されない場合のみ使用できます。

これは、 |

|

|

org.apache.lucene.store.NoLockFactory |

このインデックスへの変更はロックにより調整されません。 |

ロックストラテジー設定の例は以下のとおりです。

hibernate.search.default.locking_strategy = simple hibernate.search.Animals.locking_strategy = native hibernate.search.Books.locking_strategy = org.custom.components.MyLockingFactory

13.2.7. インデックス形式の互換性

Hibernate Search は、アプリケーションを新しいバージョンに移植するための後方互換性がある API またはツールを現在提供していません。API はインデックスの書き込みと検索に Apache Lucene を使用します。場合によっては、インデックス形式のアップデートが必要になることがあります。この場合は、データのインデックスを再び作成する必要があることがあります (Lucene が古い形式を読み取れないとき)。

インデックス形式をアップデートする前にインデックスをバックアップします。

Hibernate Search は、hibernate.search.lucene_version 設定プロパティーを公開します。このプロパティーによって、Analyzers と他の Lucene クラスが古いバージョンの Lucene で定義された動作に準拠するよう指示されます。lucene-core.jar に含まれる org.apache.lucene.util.Version も参照してください。オプションが指定されていない場合は、Hibernate Search によって、Lucene がデフォルトのバージョンを使用するよう指示されます。アップグレードの実行時に変更が自動的に行われないように、使用するバージョンを設定で明示的に定義することが推奨されます。アップグレード後に、必要に応じて設定値を明示的に更新できます。

Analyzers と Lucene 3.0 で作成されたインデックスとの互換性を維持する

hibernate.search.lucene_version = LUCENE_30

設定された SearchFactory はグローバルであり、該当するパラメーターを含むすべての Lucene API が影響を受けます。Lucene が使用され、Hibernate Search が省略された場合は、整合的な結果を得るために同じ値を適用してください。

13.3. アプリケーション用 Hibernate Search

13.3.1. Hibernate Seach の最初のステップ

アプリケーションに対して Hiberate 検索を初めて使用する場合は、以下のトピックを参照してください。

13.3.2. Maven を使用した Hibernate Seach の有効化

Maven プロジェクトで以下の設定を使用して、hibernate-search-orm 依存関係を追加します。

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.hibernate</groupId>

<artifactId>hibernate-search-orm</artifactId>

<version>5.5.1.Final-redhat-1</version>

</dependency>

</dependencies>

</dependencyManagement>

<dependencies>

<dependency>

<groupId>org.hibernate</groupId>

<artifactId>hibernate-search-orm</artifactId>

<scope>provided</scope>

</dependency>

</dependencies>13.3.3. アノテーションの追加

本項では、本の詳細が含まれるデータベースを保有していると仮定します。アプリケーションには Hibernate によって管理される example.Book および example.Author クラスが含まれ、アプリケーションにフリーテキスト検索機能を追加して本の検索を有効にします。

例: Hibernate Search 固有のアノテーションを追加する前の Book および Author エンティティー

package example;

...

@Entity

public class Book {

@Id

@GeneratedValue

private Integer id;

private String title;

private String subtitle;

@ManyToMany

private Set<Author> authors = new HashSet<Author>();

private Date publicationDate;

public Book() {}

// standard getters/setters follow here

...

}package example;

...

@Entity

public class Author {

@Id

@GeneratedValue

private Integer id;

private String name;

public Author() {}

// standard getters/setters follow here

...

}

Book および Author クラスにいくつかのアノテーションを追加する必要があります。最初のアノテーション @Indexed は Book をインデックス可能とマーク付けします。設計上、Hibernate Search はトークン化されていない ID をインデックスに保存し、指定エンティティーのインデックスが単一になるようにします。@DocumentId はこのために使用するプロパティーをマーク付けし、ほとんどの場合でデータベースの主キーと同じになります。@Id アノテーションが存在する場合は、@DocumentId は任意のアノテーションになります。

次に、検索可能にしたいフィールドをそのようにマーク付けする必要があります。この例では、最初に title および subtitle の両方に @Field アノテーションを付けます。パラメーター index=Index.YES はテキストがインデックス化されるようにし、analyze=Analyze.YES はデフォルトの Lucene アナライザーを使用してテキストが分析されるようにします。通常、分析とは文を個別の単語にチャンク化し、「a」や「the」などの頻繁に使用される単語を潜在的に除外することを意味します。アナライザーの詳細は後で説明します。@Field 内に指定する 3 つ目のパラメーターは store=Store.NO であり、実際のデータがインデックスで保存されないようにします。このデーターがインデックスで保存されるかどうかは、検索の機能と関係ありません。Lucene の観点から見ると、インデックスが作成された後にデータを保持する必要はありません。データを保存する利点は、射影を用いて読み出しができることです。

射影を使用しない場合、Hibernate Search はクエリーの基準に一致するエンティティーのデータベース識別子を見つけるために、デフォルトどおりに Lucene クエリーを実行し、これらの識別子を使用してデータベースから管理対象オブジェクトを読み出します。射影を使用するかどうかは、ケースバイケースで決定します。デフォルトでは管理対象オブジェクトを返すのに対し、射影はオブジェクトアレイのみを返すため、デフォルトの動作が推奨されます。index=Index.YES、analyze=Analyze.YES 、および store=Store.NO は 3 つのパラメーターのデフォルト値であり、省略できます。

次に説明するアノテーションは @DateBridge です。このアノテーションは、Hibernate Search の組み込みフィールドブリッジの 1 つです。Lucene インデックスは完全に文字列ベースです。そのため、Hibernate Search はインデックス化されたフィールドのデータ型を文字列に変換し、文字列をインデックス化されたフィールドのデータ型に変換する必要があります。複数の事前定義済みブリッジが提供されますが、その 1 つが java.util.Date を指定の解決方法で String に変換する DateBridge です。詳細については、ブリッジを参照してください。

最後のアノテーションは @IndexedEmbedded です。このアノテーションは、関連するエンティティー (@ManyToMany、@*ToOne、@Embedded、および @ElementCollection) を所有するエンティティーの一部としてインデックス化するために使用されます。Lucene インデックスドキュメントはオブジェクトの関係を認識しないフラットなデータ構造であるため、これが必要になります。著者名を検索可能にするには、著者名が本の一部としてインデックス化される必要があります。@IndexedEmbedded の他にも、インデックスに含めたい関連エンティティーのすべてのフィールドを @Indexed でマーク付けする必要があります。詳細については、埋め込みオブジェクトおよび関連付けられたオブジェクトを参照してください。

エンティティーマッピングの詳細については、エンティティーのマッピングを参照してください。

例: Hibernate 検索アノテーションを追加した後のエンティティー

package example;

...

@Entity

public class Book {

@Id

@GeneratedValue

private Integer id;

private String title;

private String subtitle;

@Field(index = Index.YES, analyze=Analyze.NO, store = Store.YES)

@DateBridge(resolution = Resolution.DAY)

private Date publicationDate;

@ManyToMany

private Set<Author> authors = new HashSet<Author>();

public Book() {

}

// standard getters/setters follow here

...

}package example;

...

@Entity

public class Author {

@Id

@GeneratedValue

private Integer id;

private String name;

public Author() {

}

// standard getters/setters follow here

...

}13.3.4. インデックス化

Hibernate Search は、Hibernate Core から永続化、更新、または削除された各エンティティーを透過的にインデックス化します。しかし、データベースにすでに存在するデータに対して最初の Lucene インデックスを作成する必要があります。上記のプロパティーとアノテーションを追加したら、本の最初のバッチインデックスをトリガーします。これには、以下のコードスニペットの 1 つを使用します。

例: Hibernate セッションを使用したデータのインデックス化

FullTextSession fullTextSession = org.hibernate.search.Search.getFullTextSession(session); fullTextSession.createIndexer().startAndWait();

例: JPA を使用したデータのインデックス化

EntityManager em = entityManagerFactory.createEntityManager(); FullTextEntityManager fullTextEntityManager = org.hibernate.search.jpa.Search.getFullTextEntityManager(em); fullTextEntityManager.createIndexer().startAndWait();

上記のコードを実行した後、/var/lucene/indexes/example.Book 以下に Lucene インデックスが作成されるはずです。Luke でこのインデックスを確認してみてください。Hibernate Search がどのように機能するかがわかるはずです。

13.3.5. 検索

検索を実行するには、Lucene API または Hibernate Search クエリー DSL のいずれかを使用して Lucene クエリーを作成します。クエリーを org.hibernate.Query でラップして、Hibernate API から必要な機能を取得します。以下のコードは、インデックス化されたフィールドに対してクエリーを準備します。このコードを実行すると、Book のリストが返されます。

例: Hibernate Search セッションを使用した検索の作成および実行

FullTextSession fullTextSession = Search.getFullTextSession(session);

Transaction tx = fullTextSession.beginTransaction();

// create native Lucene query using the query DSL

// alternatively you can write the Lucene query using the Lucene query parser

// or the Lucene programmatic API. The Hibernate Search DSL is recommended though

QueryBuilder qb = fullTextSession.getSearchFactory()

.buildQueryBuilder().forEntity( Book.class ).get();

org.apache.lucene.search.Query query = qb

.keyword()

.onFields("title", "subtitle", "authors.name", "publicationDate")

.matching("Java rocks!")

.createQuery();

// wrap Lucene query in a org.hibernate.Query

org.hibernate.Query hibQuery =

fullTextSession.createFullTextQuery(query, Book.class);

// execute search

List result = hibQuery.list();

tx.commit();

session.close();例: JPA を使用した検索の作成および実行

EntityManager em = entityManagerFactory.createEntityManager();

FullTextEntityManager fullTextEntityManager =

org.hibernate.search.jpa.Search.getFullTextEntityManager(em);

em.getTransaction().begin();

// create native Lucene query using the query DSL

// alternatively you can write the Lucene query using the Lucene query parser

// or the Lucene programmatic API. The Hibernate Search DSL is recommended though

QueryBuilder qb = fullTextEntityManager.getSearchFactory()

.buildQueryBuilder().forEntity( Book.class ).get();

org.apache.lucene.search.Query query = qb

.keyword()

.onFields("title", "subtitle", "authors.name", "publicationDate")

.matching("Java rocks!")

.createQuery();

// wrap Lucene query in a javax.persistence.Query

javax.persistence.Query persistenceQuery =

fullTextEntityManager.createFullTextQuery(query, Book.class);

// execute search

List result = persistenceQuery.getResultList();

em.getTransaction().commit();

em.close();13.3.6. アナライザー

インデックス化された本のエンティティーの題名が Refactoring: Improving the Design of Existing Code であり、refactor、refactors、refactored、および refactoring クエリーのヒットが必要であると仮定します。インデックス化と検索を行うときに、言葉のステミングを適用する Lucene のアナライザークラスを選択します。Hibernate Search はアナライザーを設定する方法を複数提供します (詳細については、デフォルトのアナライザーとクラスによるアナライザーを参照)。

-

設定ファイルで

analyzerプロパティーを設定します。指定されたクラスがデフォルトのアナライザーになります。 -

エンティティーレベルで

@Analyzerアノテーションを設定します。 -

フィールドレベルで

@Analyzerアノテーションを設定します。

完全修飾クラス名または使用するアナライザーを指定するか、@Analyzer アノテーションを使用して @AnalyzerDef アノテーションによって定義されたアナライザーを確認します。アナライザーを確認する場合はファクトリーを持つ Solr アナライザーフレームワークが使用されます。ファクトリークラスの詳細については、Solr JavaDoc または Solr Wiki (http://wiki.apache.org/solr/AnalyzersTokenizersTokenFilters) の対応する項を参照してください。

この例では StandardTokenizerFactory が LowerCaseFilterFactory と SnowballPorterFilterFactory の 2 つのフィルターファクトリーによって使用されます。トークナイザーは句読点とハイフンで言葉を分割しますが、メールアドレスとインターネットのホスト名は分割しません。この操作とその他の一般的な操作には、標準のトークナイザーが適しています。小文字フィルターはトークンのすべての文字を小文字に変換し、snowball フィルターは言語固有のステミングを適用します。

Solr フレームワークを使用する場合は、任意数のフィルターを用いてトークナイザーを使用します。

例: @AnalyzerDef および Solr フレームワークを使用したアナライザーの定義および使用

@Indexed

@AnalyzerDef(

name = "customanalyzer",

tokenizer = @TokenizerDef(factory = StandardTokenizerFactory.class),

filters = {

@TokenFilterDef(factory = LowerCaseFilterFactory.class),

@TokenFilterDef(factory = SnowballPorterFilterFactory.class,

params = { @Parameter(name = "language", value = "English") })

})

public class Book implements Serializable {

@Field

@Analyzer(definition = "customanalyzer")

private String title;

@Field

@Analyzer(definition = "customanalyzer")

private String subtitle;

@IndexedEmbedded

private Set authors = new HashSet();

@Field(index = Index.YES, analyze = Analyze.NO, store = Store.YES)

@DateBridge(resolution = Resolution.DAY)

private Date publicationDate;

public Book() {

}

// standard getters/setters follow here

...

}

@AnalyzerDef を使用してアナライザーを定義した後、@Analyzer を使用してエンティティーおよびプロパティーに適用します。この例では、customanalyzer は定義されていますが、エンティティーに適用されていません。アナライザーは title および subtitle プロパティーのみに適用されます。アナライザーの定義はグローバルです。エンティティーに対してアナライザーを定義し、必要に応じて他のエンティティーの定義を再使用します。

13.4. インデックス構造へのエンティティーのマッピング

13.4.1. エンティティーのマッピング

エンティティーをインデックス化するために必要なメタデータ情報はすべてアノテーションを用いて記述されるため、XML マッピングファイルは必要ありません。基本的な Hibernate 設定には Hibernate マッピングを使用できますが、Hibernate Search 固有の設定はアノテーションを用いて表現する必要があります。

13.4.1.1. 基本的なマッピング

最初に、エンティティーのマッピングで最も一般的に使用されるアノテーションについて説明します。

Lucene ベースの Query API は、以下の一般的なアノテーションを使用してエンティティーをマップします。

- @Indexed

- @Field

- @NumericField

- @Id

13.4.1.2. @Indexed

最初に、永続クラスをインデックス可能であると宣言する必要があります。これを行うには、クラスに @Indexed アノテーションを付けます (@Indexedアノテーションが付いていないエンティティーはインデックス化プロセスによって無視されます)。

@Entity

@Indexed

public class Essay {

...

}

また、任意で @Indexed アノテーションの index 属性を指定して、インデックスのデフォルト名を変更することもできます。

13.4.1.3. @Field

エンティティーの各プロパティー (または属性) に対して、インデックス化する方法を記述できます。デフォルト (アノテーションなし) では、プロパティーはインデックス化プロセスで無視されます。

Hibernate Search 5 よりも前のリリースでは、数値フィールドのエンコーディングは @NumericField で明示的に要求された場合のみ選択されました。Hibernate Search 5 では、このエンコーディングは数値の種類に応じて自動的に選択されます。数値のエンコーディングを回避するために、@Field.bridge または @FieldBridge を使用して非数値フィールドブリッジを明示的に指定できます。パッケージ org.hibernate.search.bridge.builtin には、数字を文字列としてエンコードする一連のブリッジ (org.hibernate.search.bridge.builtin.IntegerBridge など) が含まれます。

@Field はプロパティーをインデックス化されたプロパティーとして宣言します。また、以下の属性を 1 つまたは複数設定することにより、インデックス化プロセスの複数の側面を設定できます。

-

name: この名前でプロパティーが Lucene Document に保存されます。デフォルト値はプロパティー名 (JavaBeans 慣例に準拠する) になります。 -

store: プロパティーを Lucene インデックスに保存するかどうかを定義します。値を保存する場合はStore.YESを指定します (インデックス領域の消費が増えますが、射影は許可されます)。圧縮して保存する場合はStore.COMPRESSを指定します (CPU の消費が増えます)。保存しない場合はStore.NOを指定します (デフォルト値です)。プロパティーが保存されると、元の値を Lucene Document から取得できます。これは、要素のインデックス化の有無には関係しません。 index: プロパティーがインデックス化されるかどうかを示します。Index.NOを指定するとインデックス化されず、クエリーでは見つかりません。Index.YESを選択すると、要素がインデックス化され、検索可能になります。デフォルト値はIndex.YESです。Index.NOは、プロパティーを検索可能にする必要がなく、射影を利用できるようにする場合に便利です。注記analyzeおよびnormsはプロパティーのインデックス化が必要になるため、Index.NOをAnalyze.YESまたはNorms.YESとともに使用しても意味がありません。analyze: プロパティーが分析されるかどうかを決定します。Analyze.YESの場合は分析され、Analyze.NOの場合は分析されません。デフォルト値はAnalyze.YESです。注記プロパティーを分析するかどうかは、要素をそのまま検索するか、または要素に含まれる言葉を基に検索するかによって異なります。テキストフィールドを分析することは意味がありますが、データフィールドの分析はほとんど必要ないでしょう。

注記ソートに使用されるフィールドは分析しないでください。

-

norms: インデックス時間のブースティング情報を保存するかどうかを示します。保存する場合はNorms.YES、保存しない場合はNorms.NOを指定します。保存しないと大量のメモリーを節約できますが、インデックス時間のブースティング情報を使用できません。デフォルト値はNorms.YESです。 termVector: 単語 (term) と出現頻度 (frequency) のペアを示します。この属性を使用すると、インデックス化中にドキュメント内で term vector を保存できます。デフォルト値はTermVector.NOです。この属性の値は次のとおりです。

値 定義 TermVector.YES

各ドキュメントに term vector を保存します。これにより、同期された 2 つのアレイが生成されます (1 つのアレイには document term が含まれ、もう 1 つのアレイには term の頻度が含まれます)。

TermVector.NO

term vector を保存しません。

TermVector.WITH_OFFSETS

term vector およびトークンオフセット情報を保存します。これは、TermVector.YES と同じですが、言葉の開始および終了オフセット位置情報が含まれます。

TermVector.WITH_POSITIONS

term vector およびトークン位置情報を保存します。これは、TermVector.YES と同じですが、ドキュメントで言葉が発生する順序位置 (ordinal position) が含まれます。

TermVector.WITH_POSITION_OFFSETS

term vector、トークン位置、およびオフセット情報を保存します。これは、YES、WITH_OFFSETS、および WITH_POSITIONS の組み合わせです。

indexNullAs: デフォルトでは、null の値は無視されインデックス化されませんが、indexNullAsを使用するとnullの値のトークンとして挿入される文字列を指定できます。デフォルトでは、nullの値がインデックス化されないことを示すField.DO_NOT_INDEX_NULLに設定されます。Field.DEFAULT_NULL_TOKENに設定すると、デフォルトのnullトークンが使用されます。設定でデフォルトのnullトークンを指定するには、hibernate.search.default_null_tokenを使用します。このプロパティーが設定されず、Field.DEFAULT_NULL_TOKENが指定された場合は、デフォルトで文字列「null」が使用されます。注記indexNullAsパラメーターが使用される場合、検索で同じトークンを使用してnullの値を検索することが重要になります。また、分析されないフィールド (Analyze.NO) のみでこの機能を使用することが推奨されます。警告カスタムの FieldBridge または TwoWayFieldBridge を実装する場合、null 値のインデックス化の処理は開発者に委ねられます (LuceneOptions.indexNullAs() の JavaDocs を参照してください)。

13.4.1.4. @NumericField

@NumericField は @Field と同種のアノテーションで、@Field または @DocumentId と同じスコープで指定できます。このアノテーションは Integer、Long、Float、および Double プロパティーに指定できます。インデックス化するときに、トライ木の構造を使用して値がインデックス化されます。プロパティーが数値のフィールドとしてインデックス化されると、効率的に範囲クエリーおよびソートを実行でき、標準の @Field プロパティーで同じクエリーを実行するよりもかなり高速に順序付けできます。@NumericField アノテーションには以下のパラメーターを使用できます。

| 値 | 定義 |

|---|---|

|

forField |

(任意設定) 数値としてインデックス化される関連する @Field の名前を指定します。プロパティーに 1 つの @Field 宣言以外が含まれる場合のみ必須です。 |

|

precisionStep |

(任意設定) トライ木構造がインデックスに保存される方法を変更します。precisionSteps を小さくするとディスク使用量が増え、範囲およびソートクエリーが高速になります。値を大きくすると、使用される容量が少なくなり、範囲クエリーの速度が通常の @Fields で実行される範囲クエリーの速度に近くなります。デフォルト値は 4 です。 |

@NumericField は Double、Long、Integer、および Float のみをサポートします。他の数値型に対して Lucene の同様の機能を利用できません。そのため、他の型はデフォルトまたはカスタムの TwoWayFieldBridge を用いた文字列のエンコーディングを使用する必要があります。

型の変換中に近似に対応できるのであればカスタムの NumericFieldBridge を使用できます。

例: カスタム NumericFieldBridge の定義

public class BigDecimalNumericFieldBridge extends NumericFieldBridge {

private static final BigDecimal storeFactor = BigDecimal.valueOf(100);

@Override

public void set(String name, Object value, Document document, LuceneOptions luceneOptions) {

if ( value != null ) {

BigDecimal decimalValue = (BigDecimal) value;

Long indexedValue = Long.valueOf( decimalValue.multiply( storeFactor ).longValue() );

luceneOptions.addNumericFieldToDocument( name, indexedValue, document );

}

}

@Override

public Object get(String name, Document document) {

String fromLucene = document.get( name );

BigDecimal storedBigDecimal = new BigDecimal( fromLucene );

return storedBigDecimal.divide( storeFactor );

}

}13.4.1.5. @Id

エンティティーの id (識別子) プロパティーは、特定のエンティティーのインデックスを一意にするために Hibernate Search によって使用される特別なプロパティーです。設計上、id は保存する必要があり、トークン化できません。プロパティーをインデックス識別子としてマーク付けするには、@DocumentId アノテーションを使用します。JPA を使用し、@Id が指定済みである場合は、@DocumentId を省略できます。選択したエンティティー識別子はドキュメント識別子としても使用されます。

Infinispan クエリーはエンティティーの id プロパティーを使用してインデックスが一意に識別されるようにします。設計上、ID は保存され、トークンに変換しないようにする必要があります。プロパティーをインデックス ID としてマークするには、@DocumentId アノテーションを使用します。

例: インデックス化されたプロパティーの指定

@Entity

@Indexed

public class Essay {

...

@Id

@DocumentId

public Long getId() { return id; }

@Field(name="Abstract", store=Store.YES)

public String getSummary() { return summary; }

@Lob

@Field

public String getText() { return text; }

@Field @NumericField( precisionStep = 6)

public float getGrade() { return grade; }

}

上記の例では、id、Abstract、text、および grade の 4 つのフィールドでインデックスを定義します。デフォルトでは、JavaBean 仕様に従ってフィールド名に大文字が使用されていないことに注意してください。grade フィールドは、デフォルトよりも若干 precision step (精度ステップ) が大きく、数値としてアノテーションが付けられます。

13.4.1.6. プロパティーを複数回マッピングする

場合によっては、インデックスごとに若干異なるインデックス化ストラテジーでプロパティーを複数回マッピングする必要があることがあります。たとえば、フィールドでクエリーをソートするには、フィールドが分析されていない必要があります。このプロパティーで単語を基に検索し、ソートも行うには、インデックス化する必要があります (1 度分析し、1 度分析しません)。@Fields はこれを可能にします。

例: @Fields を使用してプロパティーを複数回マッピングする

@Entity

@Indexed(index = "Book" )

public class Book {

@Fields( {

@Field,

@Field(name = "summary_forSort", analyze = Analyze.NO, store = Store.YES)

} )

public String getSummary() {

return summary;

}

...

}

この例では、フィールド summary が 2 回インデックス化されます。summary としてトークン化される方法で 1 度インデックス化され、summary_forSort として非トークン化される方法でもう 1 度インデックス化されます。

13.4.1.7. 埋め込みオブジェクトおよび関連付けられたオブジェクト

関連付けられたオブジェクトおよび埋め込みオブジェクトは、ルートエンティティーインデックスの一部としてインデックス化できます。これは、関連付けられたオブジェクトのプロパティーを基にエンティティーを検索する場合に便利です。この目的は、関連付けられた市が Atlanta (Lucene クエリーパーサー言語では address.city:Atlanta に変換されます) である場所を返すことです。場所 (place) フィールドは Place インデックスでインデックス化されます。Place インデックスドキュメントには、クエリーが可能な address.id、address.street、および address.city フィールドも含まれます。

例: アソシエーションのインデックス化

@Entity

@Indexed

public class Place {

@Id

@GeneratedValue

@DocumentId

private Long id;

@Field

private String name;

@OneToOne( cascade = { CascadeType.PERSIST, CascadeType.REMOVE } )

@IndexedEmbedded

private Address address;

....

}

@Entity

public class Address {

@Id

@GeneratedValue

private Long id;

@Field

private String street;

@Field

private String city;

@ContainedIn

@OneToMany(mappedBy="address")

private Set<Place> places;

...

}

@IndexedEmbedded 技術を使用するときに Lucene インデックスでデータが非正規化されるため、Hibernate Search は Place オブジェクトと Address オブジェクトの変更を認識し、インデックスを最新の状態にする必要があります。Address の変更時に Lucene ドキュメントが確実に更新されるように、双方向の関係の逆側を @ContainedIn でマーク付けします。

@ContainedIn は、エンティティーを示すアソシエーションと埋め込みオブジェクト (コレクション) の両方に便利です。

これまでの説明を踏まえ、@IndexedEmbedded をネストする例を以下に示します。

例: @IndexedEmbedded と @ContainedIn のネストの使用

@Entity

@Indexed

public class Place {

@Id

@GeneratedValue

@DocumentId

private Long id;

@Field

private String name;

@OneToOne( cascade = { CascadeType.PERSIST, CascadeType.REMOVE } )

@IndexedEmbedded

private Address address;

....

}

@Entity

public class Address {

@Id

@GeneratedValue

private Long id;

@Field

private String street;

@Field

private String city;

@IndexedEmbedded(depth = 1, prefix = "ownedBy_")

private Owner ownedBy;

@ContainedIn

@OneToMany(mappedBy="address")

private Set<Place> places;

...

}

@Embeddable

public class Owner {

@Field

private String name;

...

}

@*ToMany、@*ToOne、および @Embedded 属性には @IndexedEmbedded アノテーションを付けることができます。その後、関連付けられたクラスの属性は主要なエンティティーインデックスへ追加されます。インデックスに以下のフィールドが含まれます。

- id

- name

- address.street

- address.city

- address.ownedBy_name

デフォルトの接頭辞は propertyName. で、従来のオブジェクトナビゲーションの慣例に従います。これをオーバーライドするには ownedBy プロパティーで示されたように prefix 属性を使用します。

空の文字列には接頭辞を設定できません。

オブジェクトグラフにクラス (インスタンスではない) の循環依存関係が含まれる場合は、depth プロパティーが必要になります。Owner が Place を参照する場合がこの例になります。Hibernate Search では、想定された深さに達すると (またはオブジェクトグラフの境界に達すると)、インデックス化された埋め込み属性が含まれなくなります。自己参照を持つクラスが循環依存関係の例になります。この例では、depth が 1 に設定されているため、Owner (存在する場合) の @IndexedEmbedded 属性は無視されます。

オブジェクトアソシエーションに @IndexedEmbedded を使用すると、以下のように Lucene のクエリー構文を使用してクエリーを表現できます。

名前に JBoss が含まれ、住所の市が Atlanta である場所を返す場合、Lucene クエリーでは次のようになります。

+name:jboss +address.city:atlanta

名前に JBoss が含まれ、所有者の名前に Joe が含まれる場所を返す場合、Lucene クエリーでは次のようになります。

+name:jboss +address.ownedBy_name:joe

この挙動は、関係結合操作をより効率的に模擬しますが、データが重複されます。そのままの状態では Lucene インデックスにはアソシエーションの観念がなく、結合操作は存在しないことに注意してください。完全テキストのインデックス速度や機能充実の利点を活かしながらリレーショナルモデルの正規化を維持するのに役立つ可能性があります。

関連付けされたオブジェクト自体が @Indexed である場合があります。

@IndexedEmbedded がエンティティーを参照する場合、関連付けは指向性を持つ必要があり、前述の例のように逆側には @ContainedIn アノテーションを付ける必要があります。このアノテーションを付けないと、関連付けられたエンティティーが更新されたときに Hibernate Search はルートインデックスを更新できません (前述の例では、関連付けられた Address インスタンスが更新されたときに Place インデックスドキュメントを更新する必要があります)。

場合によっては、@IndexedEmbedded アノテーションが付けられたオブジェクト型が Hibernate および Hibernate Search が対象とするオブジェクト型でないことがあります。これは、実装の代わりにインターフェースが使用される場合に特に当てはまります。このため、targetElement パラメーターを使用して Hibernate Search が対象とするオブジェクト型をオーバーライドできます。

例: @IndexedEmbedded の targetElement プロパティーの使用

@Entity

@Indexed

public class Address {

@Id

@GeneratedValue

@DocumentId

private Long id;

@Field

private String street;

@IndexedEmbedded(depth = 1, prefix = "ownedBy_", )

@Target(Owner.class)

private Person ownedBy;

...

}

@Embeddable

public class Owner implements Person { ... }

13.4.1.8. 特定パスへ埋め込むオブジェクトの制限

@IndexedEmbedded アノテーションは、depth の代わりとして使用でき、depth とともに使用できる includePaths 属性も提供します。

depth のみを使用すると、埋め込まれた型のインデックス化されたフィールドすべてが同じ深さで再帰的に追加されます。このため、必要でない可能性がある他のすべてのフィールドを追加せずに特定のパスのみを選択することが難しくなります。

不必要なエンティティーのロードおよびインデックス化を回避するために、必要なパスのみを指定できます。通常のアプリケーションにはパスごとに異なる深さが必要になることがあり、以下の例で示されたようにパスを明示的に指定する必要があることがあります。

例: @IndexedEmbedded の includePaths プロパティーの使用

@Entity

@Indexed

public class Person {

@Id

public int getId() {

return id;

}

@Field

public String getName() {

return name;

}

@Field

public String getSurname() {

return surname;

}

@OneToMany

@IndexedEmbedded(includePaths = { "name" })

public Set<Person> getParents() {

return parents;

}

@ContainedIn

@ManyToOne

public Human getChild() {

return child;

}

...//other fields omitted

上記の例のようにマッピングを使用すると、name、surname、親の name、またはこれらの組み合わせで Person を検索できます。親の surname はインデックス化されないため、親の surname では検索ができませんが、インデックス化の速度が速くなり、スペースを節約でき、全体的なパフォーマンスが向上します。

@IndexedEmbeddedincludePaths には、指定されたパスと、depth の制限された値を指定して通常インデックス化するものが含まれます。includePaths を使用するときに depth を未定義にすると、depth`=0` を設定した場合と同様の挙動になり、含まれたパスのみがインデックス化されます。

例: @IndexedEmbedded の includePaths プロパティーの使用

@Entity

@Indexed

public class Human {

@Id

public int getId() {

return id;

}

@Field

public String getName() {

return name;

}

@Field

public String getSurname() {

return surname;

}

@OneToMany

@IndexedEmbedded(depth = 2, includePaths = { "parents.parents.name" })

public Set<Human> getParents() {

return parents;

}

@ContainedIn

@ManyToOne

public Human getChild() {

return child;

}

...//other fields omitted上記の例では、各 Human の name および surname 属性がインデックス化されます。depth 属性により、親の name と surname は再帰的に 2 つ目の行までインデックス化されます。Person、Person の親、または祖父母の name または surname を使用して検索できます。第 2 レベルを越えると、もう 1 つのレベルをインデックス化しますが、name のみで surname は対象になりません。

この結果、インデックスには以下のフィールドが含まれます。

-

id: 主キーとして -

_hibernate_class: エンティティータイプを保存します -

name: 直接フィールドとして -

surname: 直接フィールドとして -

parents.name: depth 1 の埋め込まれたフィールドとして -

parents.surname: depth 1 の埋め込まれたフィールドとして -

parents.parents.name: depth 2 の埋め込まれたフィールドとして -

parents.parents.surname: depth 2 の埋め込まれたフィールドとして -

parents.parents.parents.name: includePaths によって指定された追加パスとして。最初のparents.はフィールド名から推測され、残りのパスは includePaths の属性になります。

必要なクエリーを最初に定義してアプリケーションを設計すると、その時点でユースケースの実装に必要なフィールドや不必要なフィールドが分かるため、インデックス化されたパスの明示的な制御が簡単になります。

13.4.2. ブースティング

Lucene は、特定のドキュメントやフィールドに異なる重要度を与えることができるブースティング (boosting) という概念を持ちます。Lucene はインデックス時ブースティング (Index time boosting) と検索時ブースティング (Search time boosting) を区別します。今後の項では、Hibernate Search を使用してインデックス時ブースティングを実現する方法を説明します。

13.4.2.1. 静的なインデックス時ブースティング

インデックス化されたクラスやプロパティーの静的なブースト値を定義するには、@Boost アノテーションを使用します。このアノテーションを @Field 内で使用するか、メソッドまたはクラスレベルで直接指定します。

例: @Boost の異なる使用方法

@Entity

@Indexed

public class Essay {

...

@Id

@DocumentId

public Long getId() { return id; }

@Field(name="Abstract", store=Store.YES, boost=@Boost(2f))

@Boost(1.5f)

public String getSummary() { return summary; }

@Lob

@Field(boost=@Boost(1.2f))

public String getText() { return text; }

@Field

public String getISBN() { return isbn; }

}上記の例では、Essay が検索リストの最上部に達する可能性は 1.7 倍になります。summary フィールドは isbn フィールドよりも 3.0 倍重要になります (プロパティーの @Field.boost と @Boost は累積的であるため、2 x 1.5 になります)。text フィールドは isbn フィールドよりも 1.2 倍重要になります。この説明は厳密には正しくありませんが、わかりやすく実際の感覚では現実とほぼ同じになります。

13.4.2.2. 動的なインデックス時ブースティング

静的なインデックス時ブースティングで使用された @Boost アノテーションは静的ブースト係数を定義します。この係数は、実行時のインデックス化済みエンティティーのの状態とは関係ありません。ただし、ブースト係数がエンティティーの実際の状態に依存する可能性があるユースケースがあります。この場合は、@DynamicBoost アノテーションをカスタム BoostStrategy とともに使用できます。

例: 動的なブーストの例

public enum PersonType {

NORMAL,

VIP

}

@Entity

@Indexed

@DynamicBoost(impl = VIPBoostStrategy.class)

public class Person {

private PersonType type;

// ....

}

public class VIPBoostStrategy implements BoostStrategy {

public float defineBoost(Object value) {

Person person = ( Person ) value;

if ( person.getType().equals( PersonType.VIP ) ) {

return 2.0f;

}

else {

return 1.0f;

}

}

}

上記の例では、VIPBoostStrategy を、インデックス化するときに使用される BoostStrategy インターフェースの実装として指定することにより、動的ブーストがクラスレベルで定義されています。@DynamicBoost はクラスまたはフィールドレベルに配置できます。エンティティー全体が defineBoost メソッドに渡されるか、またはアノテーションが付けられたフィールド/プロパティーの値のみが渡されるかはアノテーションの配置によります。渡されたオブジェクトを正しい型にキャストするのはユーザーに任されています。この例では、VIP の person のインデックス化された値はすべて普通の person の値よりも重要度が 2 倍になります。

指定された BoostStrategy 実装は、パブリックの引数のないコンストラクターを定義する必要があります。

エンティティーで @Boostアノテーションと @DynamicBoost アノテーションを組み合わせることができます。定義されたブースト係数はすべて累積的です。

13.4.3. 分析

Analysis とはテキストを 1 つの言葉 (単語) に変換するプロセスのことであり、フルテキスト検索エンジンの主要機能の 1 つです。Lucene は Analyzer の概念を使用してこのプロセスを制御します。以下の項では、Hibernate Search が提供するアナライザーの設定方法を複数取り上げます。

13.4.3.1. デフォルトのアナライザーとクラスによるアナライザー

トークン化されたフィールドをインデックス化するために使用されるデフォルトのアナライザークラスは、hibernate.search.analyzer プロパティーから設定可能です。このプロパティーのデフォルト値は org.apache.lucene.analysis.standard.StandardAnalyzer です。

また、エンティティー、プロパティーおよび @Field ごとにアナライザークラスを定義することもできます。@Field ごとの定義は、単一のプロパティーから複数のフィールドをインデックス化するときに便利です。

Example: Different ways of using @Analyzer

@Entity

@Indexed

@Analyzer(impl = EntityAnalyzer.class)

public class MyEntity {

@Id

@GeneratedValue

@DocumentId

private Integer id;

@Field

private String name;

@Field

@Analyzer(impl = PropertyAnalyzer.class)

private String summary;

@Field(analyzer = @Analyzer(impl = FieldAnalyzer.class)

private String body;

...

}

この例では、トークン化されたプロパティー (name) をインデックス化するために EntityAnalyzer が使用されます。例外は summary と body であり、これらはそれぞれ PropertyAnalyzer と FieldAnalyzer によってインデックス化されます。

通常、同じエンティティーで異なるアナライザーを使用することは推奨されません。特に、クエリー全体で同じアナライザーを使用する QueryParser を使用する場合、クエリーの構築がより複雑になり、初心者にとって結果の予測がより困難になります。原則的に、フィールドではインデックス化とクエリーに同じアナライザーを使用します。

13.4.3.2. 名前付きのアナライザー

アナライザーの使用は非常に複雑になることがあります。そのため、Hibernate Search にはアナライザー定義の概念が導入されています。アナライザー定義は多くの @Analyzer 宣言による再使用が可能であり、以下のもので構成されます。

- 名前: 定義を参照するために使用される一意の文字列。

- 文字フィルターのリスト: 各文字フィルターはトークン化の前に入力文字を事前処理します。文字フィルターは文字を追加、変更、または削除できます。一般的な使用例の 1 つが文字の正規化です。

- トークナイザー: 入力ストリームを個別の単語にトークン化します。

- フィルターのリスト: 各フィルターは単語を削除または変更します。また、トークナイザーによって提供されたストリームに単語を追加することもあります。

文字フィルターのリスト、トークナイザー、およびそれに続くフィルターのリストによってタスクが分離され、各コンポーネントの再使用が容易になり、非常に柔軟にカスタマイズされたアナライザーを構築できます (レゴブロックのように)。通常、文字フィルターが文字入力の事前処理を行った後、Tokenizer が文字入力をトークンに変換してトークン化プロセスを開始します。その後、TokenFilter によってトークンがさらに処理されます。Hibernate Search は Solr アナライザーフレームワークを使用してこのインフラストラクチャーをサポートします。

ここで、以下に示された具体的な例を確認してみましょう。最初に、文字フィルターはそのファクトリーによって定義されます。例ではマッピング文字フィルターが使用され、マッピングファイルに指定されたルールを基にして入力の文字を置き換えます。次にトークナイザーが定義されます。この例では標準のトークナイザーが使用されます。最後にフィルターのリストがファクトリーによって定義されます。この例では、専用の単語プロパティーファイルを読み取って StopFilter フィルターが構築されます。また、フィルターは大文字と小文字を区別しないことが想定されます。

例: @AnalyzerDef および Solr フレームワーク

@AnalyzerDef(name="customanalyzer",

charFilters = {

@CharFilterDef(factory = MappingCharFilterFactory.class, params = {

@Parameter(name = "mapping",

value = "org/hibernate/search/test/analyzer/solr/mapping-chars.properties")

})

},

tokenizer = @TokenizerDef(factory = StandardTokenizerFactory.class),

filters = {

@TokenFilterDef(factory = ISOLatin1AccentFilterFactory.class),

@TokenFilterDef(factory = LowerCaseFilterFactory.class),

@TokenFilterDef(factory = StopFilterFactory.class, params = {

@Parameter(name="words",

value= "org/hibernate/search/test/analyzer/solr/stoplist.properties" ),

@Parameter(name="ignoreCase", value="true")

})

})

public class Team {

...

}フィルターと文字フィルターは、@AnalyzerDef アノテーションに定義された順序で適用されます。順序が関係することに注意してください。

トークナイザー、トークンフィルター、または文字フィルターの一部には設定またはメタデータファイルなどのリソースをロードするものがあります。これには停止フィルターと類義語フィルターが該当します。リソース文字セットが VM のデフォルトを使用しない場合、resource_charset パラメーターを追加して明示的に指定できます。

例: 特定の文字セットを使用したプロパティーファイルのロード

@AnalyzerDef(name="customanalyzer",

charFilters = {

@CharFilterDef(factory = MappingCharFilterFactory.class, params = {

@Parameter(name = "mapping",

value = "org/hibernate/search/test/analyzer/solr/mapping-chars.properties")

})

},

tokenizer = @TokenizerDef(factory = StandardTokenizerFactory.class),

filters = {

@TokenFilterDef(factory = ISOLatin1AccentFilterFactory.class),

@TokenFilterDef(factory = LowerCaseFilterFactory.class),

@TokenFilterDef(factory = StopFilterFactory.class, params = {

@Parameter(name="words",

value= "org/hibernate/search/test/analyzer/solr/stoplist.properties" ),

@Parameter(name="resource_charset", value = "UTF-16BE"),

@Parameter(name="ignoreCase", value="true")

})

})

public class Team {

...

}以下の例で示されているように、アナライザー定義は定義後に @Analyzer 宣言で再使用できます。

例: 名前によるアナライザーの参照

@Entity

@Indexed

@AnalyzerDef(name="customanalyzer", ... )

public class Team {

@Id

@DocumentId

@GeneratedValue

private Integer id;

@Field

private String name;

@Field

private String location;

@Field

@Analyzer(definition = "customanalyzer")

private String description;

}@AnalyzerDef によって宣言されたアナライザーインスタンスは、SearchFactory で名前を用いて使用することもできます。これはクエリーの構築時に役に立ちます。

Analyzer analyzer = fullTextSession.getSearchFactory().getAnalyzer("customanalyzer");クエリーのフィールドは、共通の「言語」を話すよう、フィールドをインデックス化するために使用したのと同じアナライザーで分析する必要があります。クエリーとインデックス化プロセスの間では同じトークンが再使用されます。このルールには例外もありますが、ほとんどの場合に当てはまります。完全に理解して作業を行っている場合以外はこのルールに従ってください。

13.4.3.3. 使用可能なアナライザー

Solr および Lucene には便利なデフォルトの文字フィルター、トークナイザー、およびフィルターが多く含まれています。文字フィルターファクトリー、トークナイザーファクトリー、およびフィルターファクトリーの完全なリストについては、http://wiki.apache.org/solr/AnalyzersTokenizersTokenFilters を参照してください。この一部を以下に示します。

| ファクトリー | 説明 | パラメーター |

|---|---|---|

|

MappingCharFilterFactory |

リソースファイルに指定されたマッピングを基に、1 つ以上の文字を置き換えます。 |

|

|

HTMLStripCharFilterFactory |

標準の HTML タグを削除し、テキストは保持します。 |

none |

| ファクトリー | 説明 | パラメーター |

|---|---|---|

|

StandardTokenizerFactory |

Lucene の標準トークナイザーを使用します。 |

none |

|

HTMLStripCharFilterFactory |

標準の HTML タグを削除してテキストは保持し、StandardTokenizer へ渡します。 |

none |

|

PatternTokenizerFactory |

指定の正規表現パターンでテキストを改行します。 |

pattern: トークン化に使用する正規表現。 group: トークンに抽出するパターングループを示します。 |

| ファクトリー | 説明 | パラメーター |

|---|---|---|

|

StandardFilterFactory |

頭字語からピリオドを削除し、単語からアポストロフィー (') を削除します。 |

none |

|

LowerCaseFilterFactory |

すべての言葉を小文字にします。 |

none |

|

StopFilterFactory |

ストップワードのリストと一致する言葉 (トークン) を削除します。 |

words: ストップワードが含まれるリソースファイルを示します。 ignoreCase: ストップワードを比較するときに case を無視する場合は true、無視しない場合は false。 |

|

SnowballPorterFilterFactory |

単語を指定言語の語根にします。たとえば、protect、protects、および protection はすべて同じ語根を持ちます。このようなフィルターを使用すると、関連する単語に一致する検索を実行できます。 |

|

IDEの org.apache.lucene.analysis.TokenizerFactory および org.apache.lucene.analysis.TokenFilterFactory の実装をすべてチェックし、利用できる実装を確認することが推奨されます。

13.4.3.4. 動的アナライザーの選択

これまでの説明では、アナライザーを指定する方法はすべて静的でした。しかし、多言語のアプリケーションなど、インデックス化されるエンティティーの現在の状態に応じてアナライザーを選択すると便利なユースケースもあります。たとえば、BlogEntry クラスの場合、アナライザーはエントリーの言語プロパティーに依存できます。このプロパティーに応じて、実際のテキストをインデックス化するために適切な言語固有のステマーを選択する必要があります。

動的なアナライザー選択を有効にするために、Hibernate Search では AnalyzerDiscriminator アノテーションが導入されました。以下の例は、このアノテーションの使用方法を示しています。

例: @AnalyzerDiscriminator の使用方法

@Entity

@Indexed

@AnalyzerDefs({

@AnalyzerDef(name = "en",

tokenizer = @TokenizerDef(factory = StandardTokenizerFactory.class),

filters = {

@TokenFilterDef(factory = LowerCaseFilterFactory.class),

@TokenFilterDef(factory = EnglishPorterFilterFactory.class

)

}),

@AnalyzerDef(name = "de",

tokenizer = @TokenizerDef(factory = StandardTokenizerFactory.class),

filters = {

@TokenFilterDef(factory = LowerCaseFilterFactory.class),

@TokenFilterDef(factory = GermanStemFilterFactory.class)

})

})

public class BlogEntry {

@Id

@GeneratedValue

@DocumentId

private Integer id;

@Field

@AnalyzerDiscriminator(impl = LanguageDiscriminator.class)

private String language;

@Field

private String text;

private Set<BlogEntry> references;

// standard getter/setter

...

}public class LanguageDiscriminator implements Discriminator {

public String getAnalyzerDefinitionName(Object value, Object entity, String field) {

if ( value == null || !( entity instanceof BlogEntry ) ) {

return null;

}

return (String) value;

}

}

@AnalyzerDiscriminator を使用する前に、動的に使用されるすべてのアナライザーを @AnalyzerDef 定義で事前に定義する必要があります。この場合は、アナライザーを動的に選択するためのクラスまたはエンティティーの特定のプロパティーに @AnalyzerDiscriminator アノテーションを配置します。AnalyzerDiscriminator の impl パラメーターを使用して、Discriminator インターフェースの具体的な実装を指定します。このインターフェースに実装を提供することはユーザーに任されています。実装しなければならない唯一のメソッドは getAnalyzerDefinitionName() であり、このメソッドは Lucene ドキュメントにフィールドが追加されるたびに呼び出されます。インデックス化されるエンティティーもインターフェースメソッドへ渡されます。AnalyzerDiscriminator がクラスレベルではなくプロパティーレベルに配置された場合のみ value パラメーターが設定されます。この場合、値はこのプロパティーの現在の値を表します。

Discriminator インターフェースの実装は、既存アナライザー定義の名前を返す必要がありますが、デフォルトのアナライザーをオーバーライドしない場合は null を返す必要があります。上記の例では、言語パラメーターが @AnalyzerDefs で指定された名前に一致する「de」または「en」のどちらかであることを仮定します。

13.4.3.5. アナライザーの読み出し

ステミングや音声的近似などを活用するために、ドメインモデルで複数のアナライザーが使用された場合にアナライザーを読み出すことができます。この場合、同じアナライザーを使用してクエリーを構築します。この代わりに、正しいアナライザーを自動的に選択する Hibernate Search クエリー DSL を使用することもできます。

Lucene プログラム API または Lucene クエリーパーサーのいずれを使用する場合でも、指定のエンティティーのスコープ指定されたアナライザーを読み出しできます。スコープ指定されたアナライザーは、インデックス化されたフィールドに応じて適切なアナライザーを適用するアナライザーです。各フィールドで動作する各エンティティーには複数のアナライザーを定義できます。スコープ指定されたアナライザーはすべてのアナライザーをコンテキストを意識したアナライザーに統合します。この理論は若干複雑ですが、クエリーで正しいアナライザーを使用することは簡単です。

子エンティティーにプログラムを用いたマッピングを使用する場合、子エンティティーによって定義されたフィールドのみが表示されます。親エンティティーから継承されたフィールドやメソッドは設定できません。親エンティティーから継承されたプロパティーを設定するには、子エンティティーでプロパティーをオーバーライドするか、親エンティティーに対してプログラムを用いたマッピングを作成します。これは、子エンティティーで再定義しないと親エンティティーのフィールドまたはメソッドにアノテーションをつけられない場合にアノテーションの使用を模擬します。

例: フルテキストのクエリー構築時におけるスコープ指定されたアナライザーの使用

org.apache.lucene.queryParser.QueryParser parser = new QueryParser(

"title",

fullTextSession.getSearchFactory().getAnalyzer( Song.class )

);

org.apache.lucene.search.Query luceneQuery =

parser.parse( "title:sky Or title_stemmed:diamond" );

org.hibernate.Query fullTextQuery =

fullTextSession.createFullTextQuery( luceneQuery, Song.class );

List result = fullTextQuery.list(); //return a list of managed objects

上記の例では、歌のタイトルが 2 つのフィールドでインデックス化されます。標準のアナライザーは title フィールドで使用され、ステミングアナライザーは title_stemmed フィールドで使用されます。検索ファクトリーによって提供されたアナライザーを使用して、クエリーは目的のフィールドに応じて適切なアナライザーを使用します。

@AnalyzerDef によって定義されたアナライザーは、searchFactory.getAnalyzer(String) を使用して定義名で取得することもできます。

13.4.4. ブリッジ

これまでの説明では、エンティティーの基本的なマッピングで重要な条件の 1 つが無視されていました。Lucene では、すべてのインデックスフィールドを文字列として表す必要があります。インデックス化するには @Field アノテーションが付けられたエンティティープロパティーをすべて文字列に変換する必要があります。これまでの説明で取り上げなかった理由は、Hibernate Search のビルトインブリッジによってほとんどのプロパティーが変換されるためです。しかし、場合によっては変換プロセスでさらに細かい制御が必要になることがあります。

13.4.4.1. ビルトインブリッジ

Hibernate Search には、Java プロパティー型とそのフルテキスト表現との間のビルドインブリッジが含まれています。

- null

-

デフォルトでは

null要素はインデックス化されません。 Lucene は null 要素をサポートしませんが、場合によってはnullの値を表すカスタムトークンを挿入すると便利なことがあります。 - java.lang.String

- 文字列は short、Short、integer、Integer、long、Long、float、Float、double と同様にインデックス化されます。

- Double、BigInteger、BigDecimal

数字は文字列の表現に変換されます。Lucene はそのままでは数字を比較できず (範囲指定のクエリーで使用)、パディングを行う必要があることに注意してください。

注記Range クエリーの使用には欠点があるため、代わりに結果クエリーを適切な範囲にフィルターする Filter クエリーを使用できます。Hibernate Search では、カスタム StringBridge の使用もサポートされています (カスタムブリッジを参照)。

- java.util.Date

日付はグリニッジ標準時 (GMT) で yyyyMMddHHmmssSSS の形式で保存されます。たとえば、アメリカ東部標準時 (EST) の 2006 年 11 月 7 日午後 4 時 3 分 12 秒は 200611072203012 になります。内部の形式は気にする必要はありません。TermRangeQuery を使用するときに重要なのは、日付がグリニッジ標準時で表されることを認識することです。

通常、日付をミリ秒まで保存する必要はありません。

@DateBridgeはインデックスに保存するのに適切な精度 (resolution) を定義します (@DateBridge(resolution=Resolution.DAY))。日付パターンはこの定義に従って省略されます。

@Entity

@Indexed

public class Meeting {

@Field(analyze=Analyze.NO)

private Date date;

...

MILLISECOND よりも小さい精度を持つ日付を @DocumentId にすることはできません。

デフォルトの Date ブリッジは Lucene の DateTools を使用して String からの変換と String への変換を行います。つまり、すべての日付は GMT 時間で表されます。日付を固定の時間帯で保存することが要件である場合は、カスタムの日付ブリッジを実装する必要があります。日付のインデックス化および検索に関するアプリケーションの要件を理解するようにしてください。

- java.net.URI、java.net.URL

- URI および URL は文字列の表現に変換されます。

- java.lang.Class

- クラスは完全修飾クラス名に変換されます。クラスがリハイドレートされる場合は、スレッドコンテキストクラスローダーが使用されます。

13.4.4.2. カスタムブリッジ

場合によっては Hibernate Search のビルトインブリッジが一部のプロパティータイプに対応しなかったり、ブリッジによって使用される String 表現が要件に合わなかったりすることがあります。この問題に対応する方法を以下に説明します。

13.4.4.2.1. StringBridge

最も簡単な方法は、想定される Object から String へのブリッジの実装を Hibernate Search に提供することです。これを行うには、org.hibernate.search.bridge.StringBridge インターフェースを実装する必要があります。同時に使用されるため、すべての実装はスレッドセーフである必要があります。

例: カスタムの StringBridge 実装

/**

* Padding Integer bridge.

* All numbers will be padded with 0 to match 5 digits

*

* @author Emmanuel Bernard

*/

public class PaddedIntegerBridge implements StringBridge {

private int PADDING = 5;

public String objectToString(Object object) {

String rawInteger = ( (Integer) object ).toString();

if (rawInteger.length() > PADDING)

throw new IllegalArgumentException( "Try to pad on a number too big" );

StringBuilder paddedInteger = new StringBuilder( );

for ( int padIndex = rawInteger.length() ; padIndex < PADDING ; padIndex++ ) {

paddedInteger.append('0');

}

return paddedInteger.append( rawInteger ).toString();

}

}

前の例で定義された文字列ブリッジの場合、@FieldBridge アノテーションによってすべてのプロパティーおよびフィールドでこのブリッジを使用できます。

@FieldBridge(impl = PaddedIntegerBridge.class) private Integer length;

13.4.4.2.2. パラメーター化されたブリッジ

ブリッジ実装をより柔軟にするために、パラメーターをブリッジ実装に渡すこともできます。以下の例では、ParameterizedBridge インターフェースが実装され、パラメーターは @FieldBridge アノテーションを介して渡されます。

例: ブリッジ実装へパラメーターを渡す

public class PaddedIntegerBridge implements StringBridge, ParameterizedBridge {

public static String PADDING_PROPERTY = "padding";

private int padding = 5; //default

public void setParameterValues(Map<String,String> parameters) {

String padding = parameters.get( PADDING_PROPERTY );

if (padding != null) this.padding = Integer.parseInt( padding );

}

public String objectToString(Object object) {

String rawInteger = ( (Integer) object ).toString();

if (rawInteger.length() > padding)

throw new IllegalArgumentException( "Try to pad on a number too big" );

StringBuilder paddedInteger = new StringBuilder( );

for ( int padIndex = rawInteger.length() ; padIndex < padding ; padIndex++ ) {

paddedInteger.append('0');

}

return paddedInteger.append( rawInteger ).toString();

}

}

//property

@FieldBridge(impl = PaddedIntegerBridge.class,

params = @Parameter(name="padding", value="10")

)

private Integer length;

ParameterizedBridge インターフェースは、StringBridge、TwoWayStringBridge、FieldBridge 実装によって実装できます。

すべての実装はスレッドセーフである必要がありますが、パラメーターは初期化時に設定され、この段階では特別な措置は必要ありません。

13.4.4.2.3. 型対応ブリッジ

以下に適用されているブリッジの型を取得すると便利な場合があります。

- フィールド/ゲッターレベルのブリッジに対するプロパティーの戻り値の型。

- クラスレベルのブリッジに対するクラス型。

例としては、独自の方法で列挙を処理し、実際の列挙型にアクセスする必要があるブリッジが挙げられます。AppliedOnTypeAwareBridge を実装するすべてのブリッジは、ブリッジが適用されている型をインジェクトします。パラメーターと同様に、インジェクトされた型はスレッドセーフに関しては特別な注意が必要ありません。

13.4.4.2.4. 双方向ブリッジ

@DocumentId アノテーションが付けられた ID プロパティーでブリッジ実装を使用することが想定される場合、TwoWayStringBridge を使用する必要があります。これは StringBridge が若干拡張されたものです。Hibernate Search は識別子の文字列表現を読み取り、オブジェクトを生成する必要があります。@FieldBridge アノテーションの使用方法は同じです。

例: ID プロパティーに使用できる TwoWayStringBridge の実装

public class PaddedIntegerBridge implements TwoWayStringBridge, ParameterizedBridge {

public static String PADDING_PROPERTY = "padding";

private int padding = 5; //default

public void setParameterValues(Map parameters) {

Object padding = parameters.get( PADDING_PROPERTY );

if (padding != null) this.padding = (Integer) padding;

}

public String objectToString(Object object) {

String rawInteger = ( (Integer) object ).toString();

if (rawInteger.length() > padding)

throw new IllegalArgumentException( "Try to pad on a number too big" );

StringBuilder paddedInteger = new StringBuilder( );

for ( int padIndex = rawInteger.length() ; padIndex < padding ; padIndex++ ) {

paddedInteger.append('0');

}

return paddedInteger.append( rawInteger ).toString();

}

public Object stringToObject(String stringValue) {

return new Integer(stringValue);

}

}

//id property

@DocumentId

@FieldBridge(impl = PaddedIntegerBridge.class,

params = @Parameter(name="padding", value="10")

private Integer id;「object = stringToObject( objectToString( object ) )」のように、双方向処理をべき等にすることが重要になります。

13.4.4.2.5. FieldBridge

一部のユースケースでは、プロパティーを Lucene インデックスにマップするときにオブジェクトから文字列への単純な変換以上のものが必要になることがあります。柔軟性を最大化にするために、ブリッジを FieldBridge として実装することもできます。このインターフェースはプロパティー値を提供し、その値を Lucene Document で自由にマップできるようにします。たとえば、1 つのプロパティーを 2 つの異なるドキュメントフィールドに保存できます。インターフェースは Hibernate UserType の概念と非常に似ています。

例: FieldBridge インターフェースの実装

/**

* Store the date in 3 different fields - year, month, day - to ease Range Query per

* year, month or day (eg get all the elements of December for the last 5 years).

* @author Emmanuel Bernard

*/

public class DateSplitBridge implements FieldBridge {

private final static TimeZone GMT = TimeZone.getTimeZone("GMT");

public void set(String name, Object value, Document document, LuceneOptions luceneOptions) {

Date date = (Date) value;

Calendar cal = GregorianCalendar.getInstance(GMT);

cal.setTime(date);

int year = cal.get(Calendar.YEAR);

int month = cal.get(Calendar.MONTH) + 1;

int day = cal.get(Calendar.DAY_OF_MONTH);

// set year

luceneOptions.addFieldToDocument(

name + ".year",

String.valueOf( year ),

document );

// set month and pad it if needed

luceneOptions.addFieldToDocument(

name + ".month",

month < 10 ? "0" : "" + String.valueOf( month ),

document );

// set day and pad it if needed

luceneOptions.addFieldToDocument(

name + ".day",

day < 10 ? "0" : "" + String.valueOf( day ),

document );

}

}

//property

@FieldBridge(impl = DateSplitBridge.class)

private Date date;

上記の例では、フィールドは直接 Document へ追加されていません。追加は LuceneOptions ヘルパーに委譲されています。このヘルパーは Store や TermVector などの @Field で選択されたオプションを適用したり、選択された @Boost の値を適用したりします。特に、COMPRESS 実装の複雑さをカプセル化するのに便利です。LuceneOptions に委譲して Document にフィールドを追加することが推奨されますが、必要な場合は Document を直接編集し、LuceneOptions を無視することも可能です。

LuceneOptions のようなクラスは、Lucene API の変更からアプリケーションを守り、コードを簡単にするために作成されます。可能な場合はこのようなクラスを使用してください。ただし、柔軟性がさらに必要な場合、使用は強制されません。

13.4.4.2.6. ClassBridge

場合によっては、エンティティーのプロパティーを複数組み合わせ、特定の方法で Lucene インデックスへインデックス化すると便利です。@ClassBridge および @ClassBridges アノテーションは、プロパティーレベルではなくクラスレベルで定義できます。この場合、カスタムフィールドブリッジ実装は特定のプロパティーでなく値パラメーターとしてエンティティーインスタンスを受け取ります。以下の例では示されていませんが、@ClassBridge は項基本的なマッピングで説明されている termVector 属性をサポートします。

例: クラスブリッジの実装

@Entity

@Indexed

(name="branchnetwork",

store=Store.YES,

impl = CatFieldsClassBridge.class,

params = @Parameter( name="sepChar", value=" " ) )

public class Department {

private int id;

private String network;

private String branchHead;

private String branch;

private Integer maxEmployees

...

}

public class CatFieldsClassBridge implements FieldBridge, ParameterizedBridge {

private String sepChar;

public void setParameterValues(Map parameters) {

this.sepChar = (String) parameters.get( "sepChar" );

}

public void set( String name, Object value, Document document, LuceneOptions luceneOptions) {

// In this particular class the name of the new field was passed

// from the name field of the ClassBridge Annotation. This is not

// a requirement. It just works that way in this instance. The

// actual name could be supplied by hard coding it below.

Department dep = (Department) value;

String fieldValue1 = dep.getBranch();

if ( fieldValue1 == null ) {

fieldValue1 = "";

}

String fieldValue2 = dep.getNetwork();

if ( fieldValue2 == null ) {

fieldValue2 = "";

}

String fieldValue = fieldValue1 + sepChar + fieldValue2;

Field field = new Field( name, fieldValue, luceneOptions.getStore(),

luceneOptions.getIndex(), luceneOptions.getTermVector() );

field.setBoost( luceneOptions.getBoost() );

document.add( field );

}

}

この例では、特定の CatFieldsClassBridge が department インスタンスへ適用され、フィールドブリッジによってブランチとネットワークの両方が連結され、連結がインデックス化されます。

13.5. クエリー

Hibernate SearchHibernate Search は Lucene クエリーを実行し、InfinispanHibernate セッションによって管理されるドメインオブジェクトを読み出しできます。検索は Hibernate パラダイムの範囲で Lucene の機能を提供し、Hibernate の従来の検索メカニズム (HQL、Criteria クエリー、ネイティブ SQL クエリー) に他の可能性を提供します。

クエリーの準備および実行は、以下の 4 つの段階で構成されます。

- FullTextSession の作成

- Hibernate QueryHibernate Search クエリー DSL (推奨) または Lucene Query API を使用した Lucene クエリーの作成

- org.hibernate.Query を使用した Lucene クエリーのラッピング

- サンプル list() または scroll() の呼び出しによる検索の実行

クエリー機能にアクセスするには、FullTextSession を使用します。この検索固有のセッションはクエリーおよびインデックス化の機能を提供するために正規の org.hibernate.Session をラップします。

例: FullTextSession の作成

Session session = sessionFactory.openSession(); ... FullTextSession fullTextSession = Search.getFullTextSession(session);

FullTextSession を使用して、Hibernate SearchHibernate Search クエリー DSL またはネイティブ Lucene クエリーを使用したフルテキストクエリーを構築します。

Hibernate SearchHibernate Search クエリー DSL を使用する場合は以下のコードを使用します。

final QueryBuilder b = fullTextSession.getSearchFactory().buildQueryBuilder().forEntity( Myth.class ).get();

org.apache.lucene.search.Query luceneQuery =

b.keyword()

.onField("history").boostedTo(3)

.matching("storm")

.createQuery();

org.hibernate.Query fullTextQuery = fullTextSession.createFullTextQuery( luceneQuery );

List result = fullTextQuery.list(); //return a list of managed objectsこの代わりに、Lucene クエリーパーサーまたは Lucene プログラム API のいずれかを使用して Lucene クエリーを記述します。

例: QueryParser を用いた Lucene クエリーの作成

SearchFactory searchFactory = fullTextSession.getSearchFactory();

org.apache.lucene.queryParser.QueryParser parser =

new QueryParser("title", searchFactory.getAnalyzer(Myth.class) );

try {

org.apache.lucene.search.Query luceneQuery = parser.parse( "history:storm^3" );

}

catch (ParseException e) {

//handle parsing failure

}

org.hibernate.Query fullTextQuery = fullTextSession.createFullTextQuery(luceneQuery);

List result = fullTextQuery.list(); //return a list of managed objectsLucene クエリー上に構築された Hibernate クエリーは org.hibernate.Query です。このクエリーは HQL (Hibernate Query Language)、Native、Criteria などの他の Hibernate クエリー機能と同じパラダイム内に留まります。クエリーには list()、uniqueResult()、iterate() and scroll() などのメソッドを使用します。

Hibernate Java Persistence API では同じ拡張を使用できます。

例: JPA API を使用した Search クエリーの作成

EntityManager em = entityManagerFactory.createEntityManager();

FullTextEntityManager fullTextEntityManager =

org.hibernate.search.jpa.Search.getFullTextEntityManager(em);

...

final QueryBuilder b = fullTextEntityManager.getSearchFactory()

.buildQueryBuilder().forEntity( Myth.class ).get();

org.apache.lucene.search.Query luceneQuery =

b.keyword()

.onField("history").boostedTo(3)

.matching("storm")

.createQuery();

javax.persistence.Query fullTextQuery = fullTextEntityManager.createFullTextQuery( luceneQuery );

List result = fullTextQuery.getResultList(); //return a list of managed objects以下の例では Hibernate API を使用しますが、FullTextQuery が読み出される方法を調整するだけで Java Persistence API を使用して同じ例を簡単に書き直すことができます。

13.5.1. クエリーの構築

Hibernate Search クエリーは Lucene クエリー上で構築されるため、ユーザーはすべての Lucene クエリータイプを使用できます。クエリーが構築されると、Hibernate Search は org.hibernate.Query をクエリー操作 API として使用してさらにクエリー処理を行います。

13.5.1.1. Lucene API を使用した Lucene クエリーの構築

Lucene API では、クエリーパーサー (簡単なクエリー) または Lucene プログラム API (複雑なクエリー) を使用します。Lucene クエリーの構築は、Hibernate Search ドキュメントの範囲外になります。詳細については、オンラインの Lucene ドキュメント、Lucene in Action、または Hibernate Search in Action を参照してください。

13.5.1.2. Lucene クエリーの構築

Lucene プログラム API はフルテキストクエリーを有効にします。しかし、Lucene プログラム API を使用する場合はパラメーターを同等の文字列に変換し、さらに正しいアナライザーを適切なフィールドに適用する必要があります。たとえば、N-gram アナライザーは複数の N-gram を指定の言葉のトークンとして使用し、そのように検索する必要があります。この作業には QueryBuilder の使用が推奨されます。

Hibernate Search クエリー API は以下の特徴を持ちます。

- メソッド名は英語になります。そのため、API 操作は一連の英語のフレーズや指示として読み取りおよび理解されます。

- 現在入力した接頭辞の補完を可能にし、ユーザーが適切なオプションを選択できる IDE 自動補完を使用します。

- チェイニングメソッドパターンを頻繁に使用します。

- API 操作の使用および読み取りは簡単です。

API を使用するには、最初に指定の indexedentitytype にアタッチされるクエリービルダーを作成します。この QueryBuilder は、使用するアナライザーと適用するフィールドブリッジを認識します。複数の QueryBuilder を作成できます (クエリーのルートに関係する各エンティティー型ごと)。QueryBuilder は SearchFactory から派生します。

QueryBuilder mythQB = searchFactory.buildQueryBuilder().forEntity( Myth.class ).get();

指定のフィールドに使用するアナライザーをオーバーライドすることもできます。

QueryBuilder mythQB = searchFactory.buildQueryBuilder()

.forEntity( Myth.class )

.overridesForField("history","stem_analyzer_definition")

.get();クエリービルダーは Lucene クエリーの構築に使用されるようになりました。Lucene のクエリーパーサーを使用して生成されたカスタマイズ済みクエリーまたは Lucene プログラム API を使用してアセンブルされた Query オブジェクトは、Hibernate Search DSL とともに使用されます。

13.5.1.3. キーワードクエリー

以下の例は特定の単語を検索する方法を示しています。

Query luceneQuery = mythQB.keyword().onField("history").matching("storm").createQuery();| パラメーター | 説明 |

|---|---|

|

keyword() |

このパラメーターを使用して特定の単語を見つけます。 |

|

onField() |

このパラメーターを使用して単語を検索する Lucene フィールドを指定します。 |

|

matching() |

このパラメーターを使用して検索する文字列の一致を指定します。 |

|

createQuery() |

Lucene クエリーオブジェクトを作成します。 |

-