백업 및 복원

OpenShift Container Platform 클러스터 백업 및 복원

초록

1장. 백업 및 복원

1.1. 컨트롤 플레인 백업 및 복원 작업

클러스터 관리자는 일정 기간 동안 OpenShift Container Platform 클러스터를 중지하고 나중에 다시 시작해야 할 수 있습니다. 클러스터를 다시 시작하는 몇 가지 이유는 클러스터에서 유지 관리를 수행하거나 리소스 비용을 줄여야 하기 때문입니다. OpenShift Container Platform에서는 나중에 클러스터를 쉽게 다시 시작할 수 있도록 클러스터의 정상 종료 를 수행할 수 있습니다.

클러스터를 종료하기 전에 etcd 데이터를 백업해야 합니다. etcd는 모든 리소스 오브젝트의 상태를 유지하는 OpenShift Container Platform의 키-값 저장소입니다. etcd 백업은 재해 복구에서 중요한 역할을 합니다. OpenShift Container Platform에서는 비정상적인 etcd 멤버를 교체할 수도 있습니다.

클러스터를 다시 실행하려면 클러스터를 정상적으로 다시 시작합니다.

클러스터의 인증서는 설치 날짜 이후 1년 후에 만료됩니다. 클러스터를 종료하고 인증서가 계속 유효한 동안 정상적으로 다시 시작할 것으로 예상할 수 있습니다. 클러스터가 만료된 컨트롤 플레인 인증서를 자동으로 검색하지만 CSR(인증서 서명 요청)을 계속 승인해야 합니다.

다음과 같이 OpenShift Container Platform이 예상대로 작동하지 않는 몇 가지 상황이 발생할 수 있습니다.

- 노드 오류 또는 네트워크 연결 문제와 같은 예기치 않은 조건으로 인해 재시작 후 작동하지 않는 클러스터가 있습니다.

- 클러스터에서 실수로 중요한 것을 삭제했습니다.

- 대부분의 컨트롤 플레인 호스트가 손실되어 etcd 쿼럼이 손실됩니다.

저장된 etcd 스냅샷을 사용하여 클러스터를 이전 상태로 복원하여 재해 상황에서 항상 복구할 수 있습니다.

1.2. 애플리케이션 백업 및 복원 작업

클러스터 관리자는 OADP(OpenShift API for Data Protection)를 사용하여 OpenShift Container Platform에서 실행되는 애플리케이션을 백업하고 복원할 수 있습니다.

OADP는 Velero CLI 툴 다운로드 의 표에 따라 설치하는 OADP 버전에 적합한 Velero 버전을 사용하여 네임스페이스 단위로 Kubernetes 리소스 및 내부 이미지를 백업하고 복원합니다. OADP는 스냅샷 또는 Restic을 사용하여 PV(영구 볼륨)를 백업하고 복원합니다. 자세한 내용은 OADP 기능을 참조하십시오.

1.2.1. OADP 요구사항

OADP에는 다음과 같은 요구 사항이 있습니다.

-

cluster-admin역할의 사용자로 로그인해야 합니다. 다음 스토리지 유형 중 하나와 같이 백업을 저장하기 위한 오브젝트 스토리지가 있어야 합니다.

- OpenShift Data Foundation

- Amazon Web Services

- Microsoft Azure

- Google Cloud Platform

- S3 호환 오브젝트 스토리지

OCP 4.11 이상에서 CSI 백업을 사용하려면 OADP 1.1.x 를 설치합니다.

OADP 1.0.x 는 OCP 4.11 이상에서 CSI 백업을 지원하지 않습니다. OADP 1.0.x에는 Velero 1.7 x가 포함되어 있으며 OCP 4.11 이상에는 존재하지 않는 API 그룹 snapshot.storage.k8s.io/v1beta1 이 예상됩니다.

S3 스토리지용 CloudStorage API는 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

스냅샷을 사용하여 PV를 백업하려면 기본 스냅샷 API가 있거나 다음 공급자와 같은 CSI(Container Storage Interface) 스냅샷을 지원하는 클라우드 스토리지가 있어야 합니다.

- Amazon Web Services

- Microsoft Azure

- Google Cloud Platform

- CSI 스냅샷 지원 클라우드 스토리지(예: Ceph RBD 또는 Ceph FS)

스냅샷을 사용하여 PV를 백업하지 않으려면 기본적으로 OADP Operator에 의해 설치된 Restic 을 사용할 수 있습니다.

1.2.2. 애플리케이션 백업 및 복원

Backup CR(사용자 정의 리소스)을 생성하여 애플리케이션을 백업합니다. 백업 CR 생성을 참조하십시오. 다음 백업 옵션을 구성할 수 있습니다.

- 백업 작업 전후에 명령을 실행할 백업 후크 생성

- 백업 예약

- 파일 시스템 백업을 통한 애플리케이션 백업: Kopia 또는 Restic

-

Restore(CR)을 생성하여 애플리케이션 백업을 복원합니다. 복원 CR 생성을 참조하십시오. - 복원 작업 중에 init 컨테이너 또는 애플리케이션 컨테이너에서 명령을 실행하도록 복원 후크 를 구성할 수 있습니다.

2장. 클러스터를 안전하게 종료

이 문서에서는 클러스터를 안전하게 종료하는 프로세스를 설명합니다. 유지 관리를 위해 또는 리소스 비용을 절약하기 위해 일시적으로 클러스터를 종료해야 할 수 있습니다.

2.1. 전제 조건

클러스터를 종료하기 전에 etcd 백업을 수행합니다.

중요클러스터를 다시 시작할 때 문제가 발생할 경우 클러스터를 복원 할 수 있도록 이 단계를 수행하기 전에 etcd 백업을 해 두는 것이 중요합니다.

예를 들어 다음 조건으로 인해 재시작된 클러스터의 오작동이 발생할 수 있습니다.

- 종료 중 etcd 데이터 손상

- 하드웨어로 인한 노드 오류

- 네트워크 연결 문제

클러스터를 복구하지 못하는 경우 이전 클러스터 상태로 복원 단계를 따르십시오.

2.2. 클러스터 종료

나중에 클러스터를 다시 시작하기 위해 안전한 방법으로 클러스터를 종료할 수 있습니다.

설치 날짜부터 1년까지 클러스터를 종료하고 정상적으로 다시 시작할 수 있습니다. 설치 날짜로부터 1년 후에는 클러스터 인증서가 만료됩니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. - etcd 백업이 수행되었습니다.

프로세스

연장된 기간 동안 클러스터를 종료하는 경우 인증서 만료 날짜를 확인하고 다음 명령을 실행합니다.

oc -n openshift-kube-apiserver-operator get secret kube-apiserver-to-kubelet-signer -o jsonpath='{.metadata.annotations.auth\.openshift\.io/certificate-not-after}'$ oc -n openshift-kube-apiserver-operator get secret kube-apiserver-to-kubelet-signer -o jsonpath='{.metadata.annotations.auth\.openshift\.io/certificate-not-after}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

2022-08-05T14:37:50Zuser@user:~ $

2022-08-05T14:37:50Zuser@user:~ $1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 클러스터를 정상적으로 다시 시작할 수 있도록 지정된 날짜 또는 그 이전에 클러스터를 다시 시작하도록 계획합니다. 클러스터가 재시작되면 프로세스에서 kubelet 인증서를 복구하기 위해 보류 중인 인증서 서명 요청(CSR)을 수동으로 승인해야 할 수 있습니다.

클러스터의 모든 노드를 예약 불가로 표시합니다. 클라우드 공급자의 웹 콘솔에서 이 작업을 수행하거나 다음 반복문을 실행하여 수행할 수 있습니다.

for node in $(oc get nodes -o jsonpath='{.items[*].metadata.name}'); do echo ${node} ; oc adm cordon ${node} ; done$ for node in $(oc get nodes -o jsonpath='{.items[*].metadata.name}'); do echo ${node} ; oc adm cordon ${node} ; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 방법을 사용하여 Pod를 비웁니다.

for node in $(oc get nodes -l node-role.kubernetes.io/worker -o jsonpath='{.items[*].metadata.name}'); do echo ${node} ; oc adm drain ${node} --delete-emptydir-data --ignore-daemonsets=true --timeout=15s --force ; done$ for node in $(oc get nodes -l node-role.kubernetes.io/worker -o jsonpath='{.items[*].metadata.name}'); do echo ${node} ; oc adm drain ${node} --delete-emptydir-data --ignore-daemonsets=true --timeout=15s --force ; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터의 모든 노드를 종료합니다. 클라우드 공급자 웹 콘솔의 웹 콘솔에서 또는 다음 반복문을 실행하여 이 작업을 수행할 수 있습니다. 이러한 방법 중 하나를 사용하여 노드를 종료하면 Pod가 정상적으로 종료되어 데이터 손상 가능성을 줄일 수 있습니다.

참고할당된 API VIP가 있는 컨트롤 플레인 노드가 루프에서 처리된 마지막 노드인지 확인합니다. 그렇지 않으면 shutdown 명령이 실패합니다.

for node in $(oc get nodes -o jsonpath='{.items[*].metadata.name}'); do oc debug node/${node} -- chroot /host shutdown -h 1; done$ for node in $(oc get nodes -o jsonpath='{.items[*].metadata.name}'); do oc debug node/${node} -- chroot /host shutdown -h 1; done1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

-h 1은 컨트롤 플레인 노드가 종료되기 전에 이 프로세스가 지속됩니다. 10개 이상의 노드가 있는 대규모 클러스터의 경우-h 10이상으로 설정하여 모든 컴퓨팅 노드를 먼저 종료할 시간이 있는지 확인합니다.

출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고종료하기 전에 OpenShift Container Platform과 함께 제공되는 표준 Pod의 컨트롤 플레인 노드를 드레인할 필요가 없습니다. 클러스터 관리자는 클러스터를 다시 시작한 후 워크로드를 완전히 다시 시작해야 합니다. 사용자 지정 워크로드로 인해 종료하기 전에 컨트롤 플레인 노드를 드레 이한 경우 다시 시작한 후 클러스터가 다시 작동하기 전에 컨트롤 플레인 노드를 스케줄 대상으로 표시해야합니다.

외부 스토리지 또는 LDAP 서버와 같이 더 이상 필요하지 않은 클러스터 종속성을 중지합니다. 이 작업을 수행하기 전에 공급 업체의 설명서를 확인하십시오.

중요클라우드 공급자 플랫폼에 클러스터를 배포한 경우 연결된 클라우드 리소스를 종료, 일시 중지 또는 삭제하지 마십시오. 일시 중지된 가상 머신의 클라우드 리소스를 삭제하면 OpenShift Container Platform이 성공적으로 복원되지 않을 수 있습니다.

3장. 클러스터를 정상적으로 다시 시작

이 문서에서는 정상 종료 후 클러스터를 다시 시작하는 프로세스에 대해 설명합니다.

다시 시작한 후 클러스터가 정상적으로 작동할 것으로 예상되지만 예상치 못한 상황으로 인해 클러스터가 복구되지 않을 수 있습니다. 예를 들면 다음과 같습니다.

- 종료 중 etcd 데이터 손상

- 하드웨어로 인한 노드 오류

- 네트워크 연결 문제

클러스터를 복구하지 못하는 경우 이전 클러스터 상태로 복원 단계를 따르십시오.

3.1. 전제 조건

3.2. 클러스터를 다시 시작

클러스터가 정상적으로 종료된 후 클러스터를 다시 시작할 수 있습니다.

전제 조건

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있습니다. - 이 프로세스에서는 클러스터를 정상적으로 종료하고 있는 것을 전제로 하고 있습니다.

프로세스

컨트롤 플레인 노드를 켭니다.

클러스터 설치의

admin.kubeconfig를 사용하고 API 가상 IP 주소(VIP)가 up인 경우 다음 단계를 완료합니다.-

KUBECONFIG환경 변수를admin.kubeconfig경로로 설정합니다. 클러스터의 각 컨트롤 플레인 노드에 대해 다음 명령을 실행합니다.

oc adm uncordon <node>

$ oc adm uncordon <node>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

admin.kubeconfig인증 정보에 액세스할 수 없는 경우 다음 단계를 완료합니다.- SSH를 사용하여 컨트롤 플레인 노드에 연결합니다.

-

localhost-recovery.kubeconfig파일을/root디렉터리에 복사합니다. 해당 파일을 사용하여 클러스터의 각 컨트롤 플레인 노드에 대해 다음 명령을 실행합니다.

oc adm uncordon <node>

$ oc adm uncordon <node>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 외부 스토리지 또는 LDAP 서버와 같은 클러스터의 종속 장치를 시작합니다.

모든 클러스터 시스템을 시작합니다.

클라우드 제공 업체의 웹 콘솔에서 시스템을 시작하는 것과 같이 클라우드 환경에 적합한 방법을 사용하여 시스템을 시작합니다.

약 10분 정도 기다린 후 컨트롤 플레인 노드의 상태를 확인합니다.

모든 컨트롤 플레인 노드가 준비되었는지 확인합니다.

oc get nodes -l node-role.kubernetes.io/master

$ oc get nodes -l node-role.kubernetes.io/masterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 출력에 표시된 대로 노드의 상태가

Ready인 경우 컨트롤 플레인 노드는 준비된 것입니다.NAME STATUS ROLES AGE VERSION ip-10-0-168-251.ec2.internal Ready master 75m v1.26.0 ip-10-0-170-223.ec2.internal Ready master 75m v1.26.0 ip-10-0-211-16.ec2.internal Ready master 75m v1.26.0

NAME STATUS ROLES AGE VERSION ip-10-0-168-251.ec2.internal Ready master 75m v1.26.0 ip-10-0-170-223.ec2.internal Ready master 75m v1.26.0 ip-10-0-211-16.ec2.internal Ready master 75m v1.26.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 컨트롤 플레인 노드가 준비되지 않은 경우 승인해야하는 보류중인 인증서 서명 요청(CSR)이 있는지 확인합니다.

현재 CSR의 목록을 가져옵니다.

oc get csr

$ oc get csrCopy to Clipboard Copied! Toggle word wrap Toggle overflow CSR의 세부 사항을 검토하여 CSR이 유효한지 확인합니다.

oc describe csr <csr_name>

$ oc describe csr <csr_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<csr_name>은 현재 CSR 목록에 있는 CSR의 이름입니다.

각각의 유효한 CSR을 승인합니다.

oc adm certificate approve <csr_name>

$ oc adm certificate approve <csr_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

컨트롤 플레인 노드가 준비되면 모든 작업자 노드가 준비되었는지 확인합니다.

oc get nodes -l node-role.kubernetes.io/worker

$ oc get nodes -l node-role.kubernetes.io/workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 출력에 표시된 대로 작업자 노드의 상태가

Ready인 경우 작업자 노드는 준비된 것입니다.NAME STATUS ROLES AGE VERSION ip-10-0-179-95.ec2.internal Ready worker 64m v1.26.0 ip-10-0-182-134.ec2.internal Ready worker 64m v1.26.0 ip-10-0-250-100.ec2.internal Ready worker 64m v1.26.0

NAME STATUS ROLES AGE VERSION ip-10-0-179-95.ec2.internal Ready worker 64m v1.26.0 ip-10-0-182-134.ec2.internal Ready worker 64m v1.26.0 ip-10-0-250-100.ec2.internal Ready worker 64m v1.26.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 작업자 노드가 준비되지 않은 경우 승인해야하는 보류중인 인증서 서명 요청(CSR)이 있는지 확인합니다.

현재 CSR의 목록을 가져옵니다.

oc get csr

$ oc get csrCopy to Clipboard Copied! Toggle word wrap Toggle overflow CSR의 세부 사항을 검토하여 CSR이 유효한지 확인합니다.

oc describe csr <csr_name>

$ oc describe csr <csr_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<csr_name>은 현재 CSR 목록에 있는 CSR의 이름입니다.

각각의 유효한 CSR을 승인합니다.

oc adm certificate approve <csr_name>

$ oc adm certificate approve <csr_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

클러스터가 제대로 시작되었는지 확인합니다.

성능이 저하된 클러스터 Operator가 없는지 확인합니다.

oc get clusteroperators

$ oc get clusteroperatorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow DEGRADED조건이True로 설정된 클러스터 Operator가 없는지 확인합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 모든 노드가

Ready상태에 있는지 확인합니다.oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 모든 노드의 상태가

Ready상태인지 확인합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터가 제대로 시작되지 않은 경우 etcd 백업을 사용하여 클러스터를 복원해야 할 수 있습니다.

컨트롤 플레인 및 작업자 노드가 준비되면 클러스터의 모든 노드를 예약 가능으로 표시합니다. 다음 명령을 실행합니다.

for node in $(oc get nodes -o jsonpath='{.items[*].metadata.name}'); do echo ${node} ; oc adm uncordon ${node} ; donefor node in $(oc get nodes -o jsonpath='{.items[*].metadata.name}'); do echo ${node} ; oc adm uncordon ${node} ; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4장. OADP 애플리케이션 백업 및 복원

4.1. 데이터 보호를 위한 OpenShift API 소개

OADP(OpenShift API for Data Protection) 제품은 OpenShift Container Platform에서 고객 애플리케이션을 보호합니다. OpenShift Container Platform 애플리케이션, 애플리케이션 관련 클러스터 리소스, 영구 볼륨 및 내부 이미지를 다루는 포괄적인 재해 복구 보호 기능을 제공합니다. OADP는 컨테이너화된 애플리케이션과 VM(가상 머신)을 모두 백업할 수 있습니다.

그러나 OADP는 etcd 또는 {OCP-short} Operator의 재해 복구 솔루션 역할을 하지 않습니다.

OADP 지원은 고객 워크로드 네임스페이스 및 클러스터 범위 리소스에 제공됩니다.

4.1.1. OpenShift API for Data Protection API

OADP(OpenShift API for Data Protection)는 여러 가지 접근 방식을 통해 백업을 사용자 지정하고 불필요하거나 부적절한 리소스가 포함되지 않도록 하는 API를 제공합니다.

OADP는 다음 API를 제공합니다.

4.1.1.1. OpenShift API for Data Protection 지원

| 버전 | OCP 버전 | 정식 출시일 (GA) | 완전 지원 종료 | 유지 관리 종료 | Extended Update Support (EUS) | EUS(Extended Update Support) Term 2 |

| 1.3 |

| 2023년 11월 29일 | 2024년 7월 10일 | 1.5 릴리스 | 2025년 10월 31일 EUS는 OCP 4.14에 있어야 합니다. | 2026년 10월 31일 EUS 용어 2는 OCP 4.14에 있어야 합니다. |

4.1.1.1.1. 지원되지 않는 OADP Operator 버전

| 버전 | 정식 출시일 (GA) | 완전 지원 종료 | 유지 관리 종료 |

| 1.2 | 2023년 6월 14일 | 2023년 11월 29일 | 2024년 7월 10일 |

| 1.1 | 2022년 9월 1일 | 2023년 6월 14일 | 2023년 11월 29일 |

| 1.0 | 2022년 2월 9일 | 2022년 9월 1일 | 2023년 6월 14일 |

EUS에 대한 자세한 내용은 확장 업데이트 지원을 참조하십시오.

EUS 용어 2에 대한 자세한 내용은 Extended Update Support Term 2 를 참조하십시오.

4.2. OADP 릴리스 노트

4.2.1. OADP 1.3 릴리스 노트

OADP(OpenShift API for Data Protection) 1.3의 릴리스 노트는 새로운 기능 및 개선 사항, 더 이상 사용되지 않는 기능, 제품 권장 사항, 알려진 문제, 해결된 문제에 대해 설명합니다.

4.2.1.1. OADP 1.3.6 릴리스 노트

OADP(OpenShift API for Data Protection) 1.3.6은 컨테이너의 상태 등급을 새로 고치기 위해 릴리스되는 컨테이너 전용(CGO) 릴리스입니다. OADP 1.3.5에 비해 제품 자체의 코드가 변경되지 않았습니다.

4.2.1.2. OADP 1.3.5 릴리스 노트

OADP(OpenShift API for Data Protection) 1.3.5는 컨테이너의 상태 등급을 새로 고치기 위해 릴리스되는 컨테이너 전용(CGO) 릴리스입니다. 제품 자체에서 OADP 1.3.4에 비해 코드가 변경되지 않았습니다.

4.2.1.3. OADP 1.3.4 릴리스 노트

OADP(OpenShift API for Data Protection) 1.3.4 릴리스 노트에는 해결된 문제 및 알려진 문제가 나열됩니다.

4.2.1.3.1. 해결된 문제

backup spec.resourcepolicy.kind 매개변수가 대소문자를 구분하지 않음

이전에는 backup spec.resourcepolicy.kind 매개변수가 하위 수준 문자열에서만 지원되었습니다. 이번 수정으로 이제 대소문자를 구분하지 않습니다. OADP-2944

olm.maxOpenShiftVersion을 사용하여 OCP 4.16 버전으로 클러스터를 업그레이드하지 마십시오.

클러스터 operator-lifecycle-manager Operator는 마이너 OpenShift Container Platform 버전 간에 업그레이드할 수 없습니다. olm.maxOpenShiftVersion 매개변수를 사용하면 OADP 1.3이 설치된 경우 OpenShift Container Platform 4.16 버전으로 업그레이드할 수 없습니다. OpenShift Container Platform 4.16 버전으로 업그레이드하려면 OCP 4.15 버전의 OADP 1.3을 OADP 1.4로 업그레이드하십시오. OADP-4803

BSL 및 VSL이 클러스터에서 제거됨

이전에는 DPA(데이터 보호 애플리케이션)가 backupLocations 또는 snapshotLocations 섹션에서 Backup Storage Locations(BSL) 또는 Volume Snapshot Locations(VSL)를 제거하도록 수정된 경우 DPA가 삭제될 때까지 BSL 또는 VSL이 클러스터에서 제거되지 않았습니다. 이번 업데이트를 통해 BSL/VSL이 클러스터에서 제거됩니다. OADP-3050

DPA는 시크릿 키를 조정하고 검증합니다.

이전에는 DPA(데이터 보호 애플리케이션)가 잘못된 VSL(volume Snapshot Locations) 시크릿 키 이름에 성공적으로 조정되었습니다. 이번 업데이트를 통해 DPA는 VSL에서 조정하기 전에 시크릿 키 이름을 검증합니다. OADP-3052

Velero의 클라우드 인증 정보 권한이 제한됨

이전에는 Velero의 클라우드 인증 정보 권한이 0644 권한으로 마운트되었습니다. 결과적으로 소유자와 그룹을 제외한 /credentials/cloud 파일을 읽을 수 있어 스토리지 액세스 키와 같은 중요한 정보에 더 쉽게 액세스할 수 있었습니다. 이번 업데이트를 통해 이 파일의 권한이 0640으로 업데이트되고 소유자 및 그룹을 제외한 다른 사용자가 이 파일에 액세스할 수 없습니다.

ArgoCD 관리 네임스페이스가 백업에 포함된 경우 경고가 표시됩니다.

ArgoCD 및 Velero가 동일한 네임스페이스를 관리하면 백업 작업 중에 경고가 표시됩니다. OADP-4736

이 릴리스에 포함된 보안 수정 목록은 RHSA-2024:9960 권고에 설명되어 있습니다.

이 릴리스에서 해결된 모든 문제의 전체 목록은 Jira의 OADP 1.3.4 해결 문제 목록을 참조하십시오.

4.2.1.3.2. 확인된 문제

Cryostat 애플리케이션 Pod는 복원 후 CrashLoopBackoff 상태로 들어갑니다.

OADP 복원 후 Cryostat 애플리케이션 pod는 CrashLoopBackoff 상태가 될 수 있습니다. 이 문제를 해결하려면 OADP를 복원한 후 오류 또는 CrashLoopBackoff 상태를 반환하는 StatefulSet Pod를 삭제합니다. StatefulSet 컨트롤러는 이러한 Pod를 다시 생성하고 정상적으로 실행됩니다. OADP-3767

defaultVolumesToFSBackup 및 defaultVolumesToFsBackup 플래그는 동일하지 않습니다.

dpa.spec.configuration.velero.defaultVolumesToFSBackup 플래그가 backup.spec.defaultVolumesToFsBackup 플래그와 동일하지 않으므로 혼동이 발생할 수 있습니다. OADP-3692

복원이 실패로 표시되더라도 PodVolumeRestore가 작동합니다.

podvolumerestore 는 복원이 실패로 표시된 경우에도 데이터 전송을 계속합니다. OADP-3039

Velero가 initContainer 사양 복원을 건너뛸 수 없음

Velero는 필요하지 않은 경우에도 restore-wait init 컨테이너를 복원할 수 있습니다. OADP-3759

4.2.1.4. OADP 1.3.3 릴리스 노트

OADP(OpenShift API for Data Protection) 1.3.3 릴리스 노트에는 해결된 문제 및 알려진 문제가 나열됩니다.

4.2.1.4.1. 해결된 문제

네임스페이스 이름이 37자를 초과하면 OADP가 실패합니다.

37자 이상이 있고 새 DPA를 생성할 때 네임스페이스에 OADP Operator를 설치할 때 cloud-credentials 보안에 레이블이 지정됩니다. 이번 릴리스에서는 이 문제가 해결되었습니다. OADP-4211

OADP 이미지 PullPolicy가 Always로 설정

이전 버전의 OADP에서는 adp-controller-manager 및 Velero Pod의 이미지 PullPolicy가 Always 로 설정되었습니다. 이는 레지스트리에 대한 네트워크 대역폭이 제한될 수 있는 에지 시나리오에서 문제가 발생하여 Pod를 다시 시작한 후 복구 시간이 느려졌습니다. OADP 1.3.3에서 openshift-adp-controller-manager 및 Velero Pod의 이미지 PullPolicy는 IfNotPresent 로 설정됩니다.

이 릴리스에 포함된 보안 수정 목록은 RHSA-2024:4982 권고에 설명되어 있습니다.

이 릴리스에서 해결된 모든 문제의 전체 목록은 Jira의 OADP 1.3.3 해결 문제 목록을 참조하십시오.

4.2.1.4.2. 확인된 문제

Cryostat 애플리케이션 pod는 OADP를 복원한 후 CrashLoopBackoff 상태로 들어갑니다.

OADP 복원 후 Cryostat 애플리케이션 pod는 CrashLoopBackoff 상태에 입력할 수 있습니다. 이 문제를 해결하려면 OADP를 복원한 후 오류 또는 CrashLoopBackoff 상태를 반환하는 StatefulSet Pod를 삭제합니다. StatefulSet 컨트롤러는 이러한 Pod를 다시 생성하고 정상적으로 실행됩니다.

4.2.1.5. OADP 1.3.2 릴리스 노트

OADP(OpenShift API for Data Protection) 1.3.2 릴리스 노트에는 해결된 문제 및 알려진 문제가 나열됩니다.

4.2.1.5.1. 해결된 문제

BSL에 유효한 사용자 정의 시크릿을 사용하는 경우 DPA 실패

DPA는 백업 스토리지 위치(BSL)에 유효한 사용자 정의 시크릿을 사용하지만 기본 시크릿이 없는 경우 조정할 수 없습니다. 해결방법은 처음에 필요한 기본 cloud-credentials 를 생성하는 것입니다. 사용자 정의 보안이 다시 생성되면 해당 보안의 존재를 확인하고 사용할 수 있습니다.

CVE-2023-45290: oadp-velero-container: Golang net/http: Request.ParseMultipartForm의 메모리 소진

이전 버전의 OADP에 영향을 미치는 net/http Golang 표준 라이브러리 패키지에서 취약점이 발견되었습니다. Request.ParseMultipartForm을 사용하여 명시적으로 또는 Request.FormValue,Request.PostFormValue 또는 Request.FormFile을 사용하여 명시적으로 multipart 양식을 구문 분석할 때 구문 분석 양식의 총 크기에 대한 제한은 단일 양식 줄을 읽는 동안 사용되는 메모리에 적용되지 않습니다. 이렇게 하면 긴 줄이 포함된 악의적인 입력으로 인해 임의로 많은 양의 메모리를 할당하여 메모리 소모가 발생할 수 있습니다. 이 취약점은 OADP 1.3.2에서 해결되었습니다.

자세한 내용은 CVE-2023-45290 에서 참조하십시오.

CVE-2023-45289: oadp-velero-container: Golang net/http/cookiejar: 민감한 헤더 및 쿠키를 HTTP 리디렉션에서 올바르게 전달하지 않음

이전 버전의 OADP에 영향을 미치는 net/http/cookiejar Golang 표준 라이브러리 패키지에서 취약점이 발견되었습니다. HTTP 리디렉션을 하위 도메인 일치 또는 초기 도메인의 정확한 일치가 아닌 도메인으로 리디렉션하는 경우 http.Client 는 Authorization 또는 Cookie와 같은 중요한 헤더를 전달하지 않습니다. 악의적인 HTTP 리디렉션으로 인해 중요한 헤더가 예기치 않게 전달될 수 있습니다. 이 취약점은 OADP 1.3.2에서 해결되었습니다.

자세한 내용은 CVE-2023-45289 를 참조하십시오.

CVE-2024-24783: oadp-velero-container: Golang crypto/x509: 알 수 없는 공개 키 알고리즘이 있는 인증서의 패닉 확인

이전 버전의 OADP에 영향을 미치는 crypto/x509 Golang 표준 라이브러리 패키지에서 취약점이 발견되었습니다. 알 수 없는 공개 키 알고리즘이 포함된 인증서 체인을 확인하면 Certificate.Verify 에 패닉 상태가 됩니다. 이는 Config.ClientAuth를 VerifyClientCertIfGiven 또는 RequireAndVerifyClientCert로 설정하는 모든 crypto/tls 클라이언트 및 서버에 영향을 미칩니다. 기본 동작은 TLS 서버가 클라이언트 인증서를 확인하지 않는 것입니다. 이 취약점은 OADP 1.3.2에서 해결되었습니다.

자세한 내용은 CVE-2024-24783 에서 참조하십시오.

CVE-2024-24784: oadp-velero-plugin-container: Golang net/mail: 표시 이름의 댓글이 잘못 처리됨

이전 버전의 OADP에 영향을 미치는 net/mail Golang 표준 라이브러리 패키지에서 취약점이 발견되었습니다. ParseAddressList 함수는 주석을 잘못 처리하고, 괄호 안의 텍스트, 이름을 표시합니다. 이는 주소 구문 분석기를 따르는 잘못된 정렬이므로 다른 구문 분석을 사용하는 프로그램에서 서로 다른 신뢰 결정을 내릴 수 있습니다. 이 취약점은 OADP 1.3.2에서 해결되었습니다.

자세한 내용은 CVE-2024-24784 를 참조하십시오.

CVE-2024-24785: oadp-velero-container: Golang: html/template: MarshalJSON 메서드에서 반환된 오류는 템플릿을 이스케이프할 수 있습니다.

이전 버전의 OADP에 영향을 미치는 html/template Golang 표준 라이브러리 패키지에서 취약점이 발견되었습니다. MarshalJSON 메서드에서 반환된 오류에 사용자 제어 데이터가 포함된 경우 HTML/template 패키지의 컨텍스트 자동 이스케이프 동작을 분할하여 후속 작업이 예기치 않은 콘텐츠를 템플릿에 삽입할 수 있습니다. 이 취약점은 OADP 1.3.2에서 해결되었습니다.

자세한 내용은 CVE-2024-24785 를 참조하십시오.

이 릴리스에서 해결된 모든 문제의 전체 목록은 Jira의 OADP 1.3.2 해결 문제 목록을 참조하십시오.

4.2.1.5.2. 확인된 문제

Cryostat 애플리케이션 pod는 OADP를 복원한 후 CrashLoopBackoff 상태로 들어갑니다.

OADP 복원 후 Cryostat 애플리케이션 pod는 CrashLoopBackoff 상태에 입력할 수 있습니다. 이 문제를 해결하려면 OADP를 복원한 후 오류 또는 CrashLoopBackoff 상태를 반환하는 StatefulSet Pod를 삭제합니다. StatefulSet 컨트롤러는 이러한 Pod를 다시 생성하고 정상적으로 실행됩니다.

4.2.1.6. OADP 1.3.1 릴리스 노트

OADP(OpenShift API for Data Protection) 1.3.1 릴리스 노트에는 새로운 기능 및 해결된 문제가 나열됩니다.

4.2.1.6.1. 새로운 기능

OADP 1.3.0 Data Mover가 완전 지원됨

OADP 1.3.0에 기술 프리뷰로 도입된 OADP 내장 데이터 Mover는 이제 컨테이너화된 워크로드와 가상 머신 워크로드 모두에 대해 완전히 지원됩니다.

4.2.1.6.2. 해결된 문제

IBM Cloud(R) Object Storage가 백업 스토리지 공급자로 지원됨

IBM Cloud® Object Storage는 이전에 지원되지 않는 AWS S3 호환 백업 스토리지 공급자 중 하나입니다. 이번 업데이트를 통해 IBM Cloud® Object Storage가 AWS S3 호환 백업 스토리지 공급자로 지원됩니다.

OADP Operator에서 누락된 지역 오류를 올바르게 보고

이전에는 AWS Backup Storage Location (BSL) 구성에 region 을 지정하지 않고 profile:default 를 지정하면 OADP Operator에서 DPA(Data Protection Application) 사용자 정의 리소스(CR)에서 누락된 리전 오류를 보고하지 못했습니다. 이번 업데이트에서는 AWS의 DPA BSL 사양의 검증이 수정되었습니다. 결과적으로 OADP Operator에서 누락된 지역 오류를 보고합니다.

사용자 정의 레이블은 openshift-adp 네임스페이스에서 제거되지 않음

이전에는 openshift-adp-controller-manager Pod가 openshift-adp 네임스페이스에 연결된 레이블을 재설정했습니다. 이로 인해 Argo CD와 같은 사용자 정의 레이블이 필요한 애플리케이션의 동기화 문제로 인해 부적절한 기능이 발생했습니다. 이번 업데이트를 통해 이 문제가 수정되었으며 사용자 정의 레이블은 openshift-adp 네임스페이스에서 제거되지 않습니다.

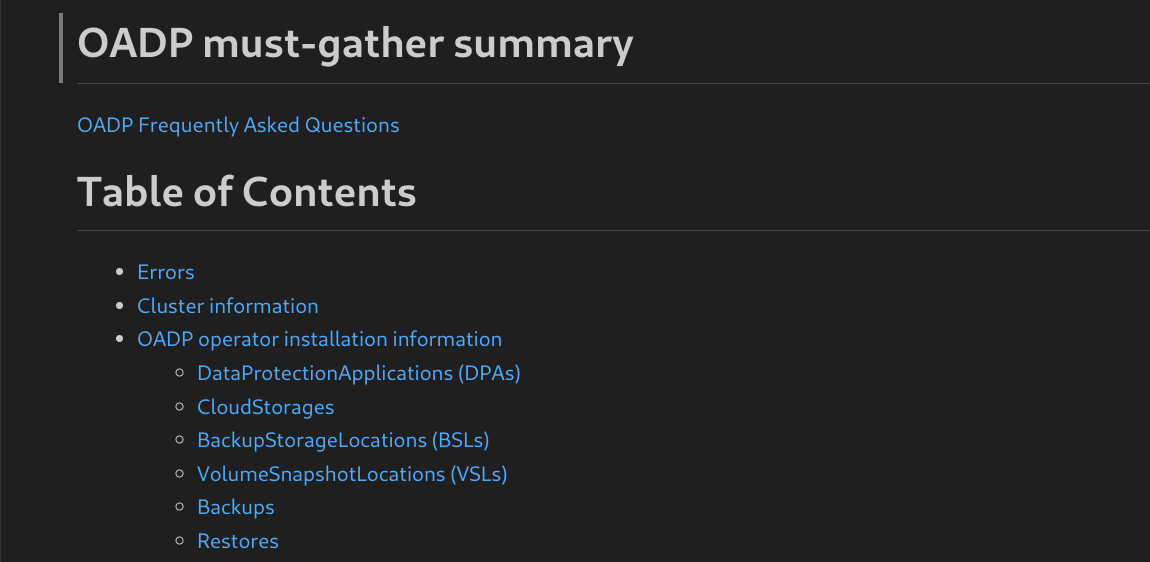

OADP must-gather 이미지는 CRD를 수집합니다.

이전에는 OADP must-gather 이미지가 OADP에서 제공하는 CRD(사용자 정의 리소스 정의)를 수집하지 않았습니다. 결과적으로 지원 쉘에서 데이터를 추출하는 데 omg 툴을 사용할 수 없었습니다. 이번 수정으로 must-gather 이미지는 이제 OADP에서 제공하는 CRD를 수집하고 omg 툴을 사용하여 데이터를 추출할 수 있습니다.

가비지 컬렉션에는 기본 빈도 값에 대한 올바른 설명이 있습니다.

이전에는 garbage-collection-frequency 필드에 기본 빈도 값에 대한 잘못된 설명이 있었습니다. 이번 업데이트를 통해 garbage-collection-frequency 의 gc-controller 조정 기본 빈도에 대해 1시간의 올바른 값이 있습니다.

OperatorHub에서 FIPS 모드 플래그를 사용할 수 있습니다.

fips-compliant 플래그를 true 로 설정하면 OperatorHub의 OADP Operator 목록에 FIPS 모드 플래그가 추가되었습니다. 이 기능은 OADP 1.3.0에서 활성화되었지만 Red Hat Container 카탈로그에 FIPS가 활성화된 것으로 표시되지 않았습니다.

csiSnapshotTimeout이 짧은 기간으로 설정된 경우 CSI 플러그인에 nil 포인터가 패닉되지 않음

이전 버전에서는 csiSnapshotTimeout 매개변수가 단기간에 설정된 경우 CSI 플러그인에 다음 오류가 발생했습니다. plugin panicked: runtime error: invalid memory address or nil pointer dereference.

이번 수정으로 다음 오류와 함께 백업이 실패합니다. volumesnapshot의 조정 대기 시간이 초과 되었습니다.

이 릴리스에서 해결된 모든 문제의 전체 목록은 Jira의 OADP 1.3.1 해결 문제 목록을 참조하십시오.

4.2.1.6.3. 확인된 문제

IBM Power(R) 및 IBM Z(R) 플랫폼에 배포된 단일 노드 OpenShift 클러스터의 백업 및 스토리지 제한 사항

IBM Power® 및 IBM Z® 플랫폼에 배포된 Single-node OpenShift 클러스터에 대한 다음 백업 및 스토리지 관련 제한을 검토하십시오.

- 스토리지

- 현재 NFS 스토리지만 IBM Power® 및 IBM Z® 플랫폼에 배포된 단일 노드 OpenShift 클러스터와 호환됩니다.

- Backup

-

kopia및restic와 같은 파일 시스템 백업을 사용하는 백업 애플리케이션만 백업 및 복원 작업을 지원합니다.

Cryostat 애플리케이션 Pod는 OADP를 복원한 후 CrashLoopBackoff 상태로 입력합니다.

OADP 복원 후 Cryostat 애플리케이션 pod는 CrashLoopBackoff 상태에 입력할 수 있습니다. 이 문제를 해결하려면 OADP를 복원한 후 오류 또는 CrashLoopBackoff 상태의 StatefulSet Pod를 삭제합니다. StatefulSet 컨트롤러는 이러한 Pod를 다시 생성하고 정상적으로 실행됩니다.

4.2.1.7. OADP 1.3.0 릴리스 노트

OADP(OpenShift API for Data Protection) 1.3.0 릴리스에는 새로운 기능, 해결된 문제 및 버그, 알려진 문제가 포함되어 있습니다.

4.2.1.7.1. 새로운 기능

Velero 내장 DataMover는 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

OADP 1.3에는 CSI(Container Storage Interface) 볼륨 스냅샷을 원격 오브젝트 저장소로 이동하는 데 사용할 수 있는 기본 제공 데이터 Mover가 포함되어 있습니다. 기본 제공 Data Mover를 사용하면 오류, 실수로 삭제 또는 클러스터 손상이 발생하는 경우 원격 오브젝트 저장소에서 상태 저장 애플리케이션을 복원할 수 있습니다. Kopia를 업로드기 메커니즘으로 사용하여 스냅샷 데이터를 읽고 Unified Repository에 씁니다.

파일 시스템 백업을 통한 애플리케이션 백업: Kopia 또는 Restic

Velero의 파일 시스템 백업(FSB)은 Restic 경로와 Kopia 경로의 두 가지 백업 라이브러리를 지원합니다.

Velero를 사용하면 두 경로 중 하나를 선택할 수 있습니다.

backup의 경우 uploader-type 플래그를 통해 설치 중 경로를 지정합니다. 유효한 값은 restic 또는 kopia 입니다. 이 필드는 값이 지정되지 않은 경우 기본값은 kopia 입니다. 설치 후에는 선택을 변경할 수 없습니다.

GCP 클라우드 인증

GCP(Google Cloud Platform) 인증을 사용하면 수명이 짧은 Google 인증 정보를 사용할 수 있습니다.

GCP with Workload Identity Federation을 사용하면 IAM(Identity and Access Management)을 사용하여 서비스 계정을 가장하는 기능을 포함하여 외부 ID IAM 역할을 부여할 수 있습니다. 이렇게 하면 서비스 계정 키와 관련된 유지 관리 및 보안 위험이 제거됩니다.

AWS ROSA STS 인증

ROSA(Red Hat OpenShift Service) 클러스터에서 OADP(OpenShift API for Data Protection)를 사용하여 애플리케이션 데이터를 백업하고 복원할 수 있습니다.

ROSA는 다양한 AWS 컴퓨팅, 데이터베이스, 분석, 머신 러닝, 네트워킹, 모바일 및 기타 서비스와 원활한 통합을 제공하여 고객에게 차별화된 경험을 구축하고 제공합니다.

AWS 계정에서 직접 서비스에 등록할 수 있습니다.

클러스터가 생성되면 OpenShift 웹 콘솔을 사용하여 클러스터를 작동할 수 있습니다. ROSA 서비스는 OpenShift API 및 CLI(명령줄 인터페이스) 툴도 사용합니다.

4.2.1.7.2. 해결된 문제

ACM 애플리케이션이 복원 후 관리 클러스터에서 제거 및 다시 생성됨

복원 활성화 시 관리 클러스터의 애플리케이션이 삭제되고 다시 생성되었습니다. OADP 1.2(OpenShift API for Data Protection) 백업 및 복원 프로세스는 이전 버전보다 빠릅니다. OADP 성능 변경으로 인해 ACM 리소스를 복원할 때 이러한 동작이 발생했습니다. 따라서 다른 리소스보다 먼저 일부 리소스가 복원되어 관리 클러스터에서 애플리케이션이 제거되었습니다. OADP-2686

Pod 보안 표준으로 인해 Restic 복원이 부분적으로 실패했습니다.

상호 운용성 테스트 중에 OpenShift Container Platform 4.14에 Pod 보안 모드가 적용 되도록 설정되어 이로 인해 Pod가 거부됩니다. 이는 복원 순서 때문에 발생했습니다. Pod가 podSecurity 표준을 위반하여 Pod가 Pod를 거부했기 때문에 SCC(보안 컨텍스트 제약 조건) 리소스 전에 포드가 생성되었습니다. Velero 서버에서 restore 우선순위 필드를 설정하는 경우 복원에 성공합니다. OADP-2688

Velero가 여러 네임스페이스에 설치된 경우 가능한 Pod 볼륨 백업 실패

Velero가 여러 네임스페이스에 설치된 경우 PVB(Pod Volume Backup) 기능에 회귀 문제가 있었습니다. PVB 컨트롤러가 자체 네임스페이스의 PVB로 올바르게 제한되지 않았습니다. OADP-2308

OADP Velero 플러그인 반환 "Received EOF, stop recv loop" 메시지

OADP에서 Velero 플러그인은 별도의 프로세스로 시작되었습니다. Velero 작업이 완료되면 해당 작업이 성공적으로 종료됩니다. 따라서 디버그 로그에 recv 루프 메시지를 중지하여 수신된 EOF 가 표시되면 오류가 발생한 것은 아닙니다. 플러그인 작업이 완료되었음을 의미합니다. OADP-2176

CVE-2023-39325 Multiple HTTP/2 enabled 웹 서버는 DDoS 공격에 취약합니다(Rapid Reset Attack)

이전 릴리스의 OADP 릴리스에서는 요청 취소가 여러 스트림을 빠르게 재설정할 수 있기 때문에 HTTP/2 프로토콜이 서비스 거부 공격에 취약했습니다. 서버는 스트림을 설정하고 해체하는 동시에 연결당 최대 활성 스트림 수에 대한 서버 측 제한에 도달하지 않아야 했습니다. 이로 인해 서버 리소스 사용량으로 인해 서비스가 거부되었습니다.

자세한 내용은 CVE-2023-39325 (Rapid Reset Attack)를 참조하십시오.

이 릴리스에서 해결된 모든 문제의 전체 목록은 Jira의 OADP 1.3.0 해결 문제 목록을 참조하십시오.

4.2.1.7.3. 확인된 문제

csiSnapshotTimeout이 짧은 기간으로 설정된 경우 nil 포인터에 CSI 플러그인 오류

csiSnapshotTimeout 이 짧은 기간으로 설정된 경우 nil 포인터에 CSI 플러그인 오류가 발생합니다. 경우에 따라 짧은 기간 내에 스냅샷을 완료하는 데 성공하지만 plugin panicked: runtime error: invalid memory address 또는 nil 포인터 역참조 와 함께 백업 PartiallyFailed 가 패닉되는 경우가 있습니다.

volumeSnapshotContent CR에 오류가 있을 때 백업이 PartiallyFailed로 표시됩니다.

VolumeSnapshotBeingCreated 주석 제거와 관련된 VolumeSnapshotContent CR에 오류가 있는 경우 백업을 WaitingForPluginOperationsPartiallyFailed 단계로 이동합니다. OADP-2871

최초 30,000개 리소스 복원 시 성능 문제 발생

existing-resource-policy 없이 처음으로 Cryostat 리소스를 복원할 때 두 번째 및 세 번째 시도 중에 update를 위해 설정된 existing-resource-policy를 사용하여 복원하는 데 걸리는 두 배의 시간이 걸립니다. OADP-3071

Datadownload 작업이 관련 PV를 릴리스하기 전에 복원 후 후크가 실행될 수 있습니다.

Data Mover 작업의 비동기적 특성으로 인해 관련 Pod PV(영구 볼륨 클레임)를 PVC(영구 볼륨 클레임)에서 릴리스하기 전에 후크를 시도할 수 있습니다.

GCP-Workload Identity Federation VSL 백업 PartiallyFailed

VSL 백업은 GCP 워크로드 ID가 GCP에 설정된 경우 부분적으로Failed 됩니다.

이 릴리스에서 알려진 모든 문제의 전체 목록은 Jira의 OADP 1.3.0 알려진 문제 목록을 참조하십시오.

4.2.1.7.4. 업그레이드 노트

항상 다음 마이너 버전으로 업그레이드합니다. 버전을 건너뛰지 마십시오. 이후 버전으로 업데이트하려면 한 번에 하나의 채널만 업그레이드합니다. 예를 들어 OADP(OpenShift API for Data Protection) 1.1에서 1.3으로 업그레이드하려면 먼저 1.2로 업그레이드한 다음 1.3으로 업그레이드합니다.

4.2.1.7.4.1. OADP 1.2에서 1.3으로 변경

Velero 서버가 버전 1.11에서 1.12로 업데이트되었습니다.

OADP(OpenShift API for Data Protection) 1.3은 VolumeSnapshotMover(VSM) 또는volsync Data Mover 대신 Velero 기본 제공 데이터 Mover를 사용합니다.

이렇게 하면 다음이 변경됩니다.

-

spec.features.dataMover필드와 VSM 플러그인은 OADP 1.3과 호환되지 않으며 DPA(DataProtectionApplication) 구성에서 구성을 제거해야 합니다. - volsync Operator는 더 이상 Data Mover 기능에 필요하지 않으며 제거할 수 있습니다.

-

사용자 정의 리소스 정의

volumesnapshotbackups.datamover.oadp.openshift.io및volumesnapshotrestores.datamover.oadp.openshift.io는 더 이상 필요하지 않으며 제거할 수 있습니다. - OADP-1.2 Data Mover에 사용된 시크릿은 더 이상 필요하지 않으며 제거할 수 있습니다.

OADP 1.3은 Restic에 대한 대체 파일 시스템 백업 툴인 Kopia를 지원합니다.

Kopia를 사용하려면 다음 예와 같이 새

spec.configuration.nodeAgent필드를 사용합니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow spec.configuration.restic필드는 OADP 1.3에서 더 이상 사용되지 않으며 향후 OADP 버전에서 제거될 예정입니다. 사용 중단 경고가 표시되지 않도록 하려면restic키와 해당 값을 제거하고 다음 새 구문을 사용합니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

향후 OADP 릴리스에서는 kopia 툴이 기본 uploaderType 값이 될 계획입니다.

4.2.1.7.4.2. OADP 1.2 기술 프리뷰 데이터에서 업그레이드

OADP(OpenShift API for Data Protection) 1.2 Data Mover 백업을 OADP 1.3으로 복원 할 수 없습니다. 애플리케이션 데이터 보호의 격차를 방지하려면 OADP 1.3으로 업그레이드하기 전에 다음 단계를 완료합니다.

프로세스

- 클러스터 백업이 충분하고 CSI(Container Storage Interface) 스토리지를 사용할 수 있는 경우 CSI 백업을 사용하여 애플리케이션을 백업합니다.

클러스터 백업을 꺼야 하는 경우:

-

--default-volumes-to-fs-backup=true 또는 backup.spec.defaultVolumesToFsBackup옵션을 사용하는 파일 시스템 백업으로 애플리케이션을 백업합니다. -

오브젝트 스토리지 플러그인으로 애플리케이션을 백업합니다(예:

velero-plugin-for-aws).

-

Restic 파일 시스템 백업의 기본 시간 초과 값은 1시간입니다. OADP 1.3.1 이상에서는 Restic 및 Kopia의 기본 시간 초과 값은 4시간입니다.

OADP 1.2 데이터 관리 백업을 복원하려면 OADP를 제거하고 OADP 1.2를 설치 및 구성해야 합니다.

4.2.1.7.4.3. DPA 구성 백업

현재 DPA( DataProtectionApplication ) 구성을 백업해야 합니다.

프로세스

다음 명령을 실행하여 현재 DPA 구성을 저장합니다.

예제

oc get dpa -n openshift-adp -o yaml > dpa.orig.backup

$ oc get dpa -n openshift-adp -o yaml > dpa.orig.backupCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.1.7.4.4. OADP Operator 업그레이드

OADP(OpenShift API for Data Protection) Operator를 업그레이드할 때 다음 시퀀스를 사용합니다.

프로세스

-

OADP Operator의 서브스크립션 채널을

stable-1.2에서stable-1.3으로 변경합니다. - Operator 및 컨테이너가 업데이트 및 재시작될 수 있는 시간을 허용합니다.

4.2.1.7.4.5. DPA를 새 버전으로 변환

Data Mover를 사용하여 클러스터에서 백업을 이동해야 하는 경우 다음과 같이 DPA( DataProtectionApplication ) 매니페스트를 재구성합니다.

프로세스

- Operators → 설치된 Operators 를 클릭하고 OADP Operator를 선택합니다.

- 제공된 API 섹션에서 추가 보기를 클릭합니다.

- DataProtectionApplication 상자에서 인스턴스 만들기 를 클릭합니다.

YAML View 를 클릭하여 현재 DPA 매개변수를 표시합니다.

현재 DPA의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow DPA 매개변수를 업데이트합니다.

-

DPA에서

features.dataMover키와 값을 제거합니다. - VolumeSnapshotMover(VSM) 플러그인을 제거합니다.

nodeAgent키와 값을 추가합니다.업데이트된 DPA 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

DPA에서

- DPA가 성공적으로 조정될 때까지 기다립니다.

4.2.1.7.4.6. 업그레이드 확인

다음 절차를 사용하여 업그레이드를 확인합니다.

프로세스

다음 명령을 실행하여 OADP(OpenShift API for Data Protection) 리소스를 확인하여 설치를 확인합니다.

oc get all -n openshift-adp

$ oc get all -n openshift-adpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 DPA(

DataProtectionApplication)가 조정되었는지 확인합니다.oc get dpa dpa-sample -n openshift-adp -o jsonpath='{.status}'$ oc get dpa dpa-sample -n openshift-adp -o jsonpath='{.status}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

{"conditions":[{"lastTransitionTime":"2023-10-27T01:23:57Z","message":"Reconcile complete","reason":"Complete","status":"True","type":"Reconciled"}]}{"conditions":[{"lastTransitionTime":"2023-10-27T01:23:57Z","message":"Reconcile complete","reason":"Complete","status":"True","type":"Reconciled"}]}Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

유형이Reconciled으로 설정되어 있는지 확인합니다. 백업 스토리지 위치를 확인하고 다음 명령을 실행하여

PHASE가 사용가능한지 확인합니다.oc get backupstoragelocations.velero.io -n openshift-adp

$ oc get backupstoragelocations.velero.io -n openshift-adpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME PHASE LAST VALIDATED AGE DEFAULT dpa-sample-1 Available 1s 3d16h true

NAME PHASE LAST VALIDATED AGE DEFAULT dpa-sample-1 Available 1s 3d16h trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow

OADP 1.3에서는 DPA( DataProtectionApplication ) 구성을 생성하는 대신 백업당 클러스터에서 데이터 이동을 시작할 수 있습니다.

명령 예

velero backup create example-backup --include-namespaces mysql-persistent --snapshot-move-data=true

$ velero backup create example-backup --include-namespaces mysql-persistent --snapshot-move-data=true설정 파일 예

4.3. OADP 성능

4.3.1. OADP 권장 네트워크 설정

OADP(OpenShift API for Data Protection)에서 지원되는 환경을 위해 {OCP-short} 노드, S3 스토리지 및 {OCP-short} 네트워크 요구 사항을 충족하는 지원되는 클라우드 환경에서 안정적이고 탄력적인 네트워크를 보유해야 합니다.

최적의 데이터 경로가 있는 원격 S3 버킷을 사용한 배포에 대한 백업 및 복원 작업을 성공적으로 수행하려면 네트워크 설정이 최적의 조건에서 다음과 같은 최소 요구 사항을 충족하는 것이 좋습니다.

- 대역폭(오브젝트 스토리지에 대한 네트워크 업로드 속도): 작은 백업의 경우 2Mbps 이상, 더 큰 백업의 데이터 볼륨에 따라 10-100Mbps입니다.

- 패킷 손실: 1%

- 패킷 손상: 1%

- 대기 시간: 100ms

OpenShift Container Platform 네트워크가 최적으로 작동하고 OpenShift Container Platform 네트워크 요구 사항을 충족하는지 확인하십시오.

Red Hat은 표준 백업 및 복원 실패를 지원하지만 권장 임계값을 충족하지 않는 네트워크 설정으로 인한 오류를 지원하지 않습니다.

4.4. OADP 기능 및 플러그인

OpenShift API for Data Protection(OADP) 기능은 애플리케이션을 백업 및 복원하는 옵션을 제공합니다.

기본 플러그인을 사용하면 Velero가 특정 클라우드 공급자와 통합하고 OpenShift Container Platform 리소스를 백업 및 복원할 수 있습니다.

4.4.1. OADP 기능

OpenShift API for Data Protection(OADP)은 다음 기능을 지원합니다.

- Backup

OADP를 사용하여 OpenShift Platform의 모든 애플리케이션을 백업하거나 유형, 네임스페이스 또는 레이블별로 리소스를 필터링할 수 있습니다.

OADP는 Kubernetes 오브젝트 및 내부 이미지를 오브젝트 스토리지에 아카이브 파일로 저장하여 백업합니다. OADP는 기본 클라우드 스냅샷 API 또는 CSI(Container Storage Interface)를 사용하여 스냅샷을 생성하여 PV(영구 볼륨)를 백업합니다. 스냅샷을 지원하지 않는 클라우드 공급자의 경우 OADP는 Restic을 통해 리소스 및 PV 데이터를 백업합니다.

참고백업 및 복원에 성공하려면 애플리케이션의 백업에서 Operator를 제외해야 합니다.

- Restore

백업에서 리소스 및 PV를 복원할 수 있습니다. 백업의 모든 오브젝트를 복원하거나 네임스페이스, PV 또는 라벨별로 오브젝트를 필터링할 수 있습니다.

참고백업 및 복원에 성공하려면 애플리케이션의 백업에서 Operator를 제외해야 합니다.

- 스케줄

- 지정된 간격으로 백업을 예약할 수 있습니다.

- 후크

-

후크를 사용하여 Pod의 컨테이너에서 명령을 실행할 수 있습니다(예:

fsfreeze파일 시스템). 백업 또는 복원 전이나 후에 실행되도록 후크를 구성할 수 있습니다. 복원 후크는 init 컨테이너 또는 애플리케이션 컨테이너에서 실행될 수 있습니다.

4.4.2. OADP 플러그인

OADP(OpenShift API for Data Protection)는 백업 및 스냅샷 작업을 지원하기 위해 스토리지 공급자와 통합된 기본 Velero 플러그인을 제공합니다. Velero 플러그인을 기반으로 사용자 지정 플러그인 을 생성할 수 있습니다.

OADP는 OpenShift Container Platform 리소스 백업, OpenShift Virtualization 리소스 백업 및 CSI(Container Storage Interface) 스냅샷에 대한 플러그인도 제공합니다.

| OADP 플러그인 | 함수 | 스토리지 위치 |

|---|---|---|

|

| Kubernetes 오브젝트를 백업하고 복원합니다. | AWS S3 |

| 스냅샷을 사용하여 볼륨을 백업하고 복원합니다. | AWS EBS | |

|

| Kubernetes 오브젝트를 백업하고 복원합니다. | Microsoft Azure Blob 스토리지 |

| 스냅샷을 사용하여 볼륨을 백업하고 복원합니다. | Microsoft Azure Managed Disks | |

|

| Kubernetes 오브젝트를 백업하고 복원합니다. | Google Cloud Storage |

| 스냅샷을 사용하여 볼륨을 백업하고 복원합니다. | Google Compute Engine Disks | |

|

| OpenShift Container Platform 리소스를 백업하고 복원합니다. [1] | 오브젝트 저장소 |

|

| OpenShift Virtualization 리소스를 백업하고 복원합니다. [2] | 오브젝트 저장소 |

|

| CSI 스냅샷을 사용하여 볼륨을 백업하고 복원합니다. [3] | CSI 스냅샷을 지원하는 클라우드 스토리지 |

|

| VolumeSnapshotMover는 클러스터 삭제와 같은 상황에서 상태 저장 애플리케이션을 복구하는 동안 사용할 스냅샷을 클러스터에서 오브젝트 저장소로 재배치합니다. [4] | 오브젝트 저장소 |

- 필수.

- 가상 머신 디스크는 CSI 스냅샷 또는 Restic을 사용하여 백업됩니다.

csi플러그인은 Kubernetes CSI 스냅샷 API를 사용합니다.-

OADP 1.1 이상에서는

snapshot.storage.k8s.io/v1을 사용합니다. -

OADP 1.0 uses

snapshot.storage.k8s.io/v1beta1

-

OADP 1.1 이상에서는

- OADP 1.2만 해당

4.4.3. OADP Velero 플러그인 정보

Velero를 설치할 때 다음 두 가지 유형의 플러그인을 구성할 수 있습니다.

- 기본 클라우드 공급자 플러그인

- 사용자 정의 플러그인

두 가지 유형의 플러그인은 모두 선택 사항이지만 대부분의 사용자는 하나 이상의 클라우드 공급자 플러그인을 구성합니다.

4.4.3.1. 기본 Velero 클라우드 공급자 플러그인

배포 중에 oadp_v1alpha1_dpa.yaml 파일을 구성할 때 다음과 같은 기본 Velero 클라우드 공급자 플러그인을 설치할 수 있습니다.

-

AWS(Amazon Web Services) -

GCP(Google Cloud Platform) -

Azure(Microsoft Azure) -

OpenShift(OpenShift Velero 플러그인) -

CSI(컨테이너 스토리지 인터페이스) -

KubeVirt(KubeVirt)

배포 중에 oadp_v1alpha1_dpa.yaml 파일에 원하는 기본 플러그인을 지정합니다.

파일 예

다음 .yaml 파일은 openshift,aws,azure, gcp 플러그인을 설치합니다.

4.4.3.2. 사용자 정의 Velero 플러그인

배포 중에 oadp_v1alpha1_dpa.yaml 파일을 구성할 때 플러그인 이미지 및 이름을 지정하여 사용자 정의 Velero 플러그인을 설치할 수 있습니다.

배포 중에 oadp_v1alpha1_dpa.yaml 파일에 원하는 사용자 지정 플러그인을 지정합니다.

파일 예

다음 .yaml 파일은 기본 openshift,azure, gcp 플러그인 및 이름이 custom-plugin-example 이고 quay.io/example-repo/custom-velero-plugin 이미지가 있는 사용자 정의 플러그인을 설치합니다.

4.4.3.3. Velero 플러그인에서 "received EOF, stop recv loop" 메시지를 반환

Velero 플러그인은 별도의 프로세스로 시작됩니다. Velero 작업이 성공적으로 완료되거나 실패하면 종료됩니다. 디버그 로그에서 recv 루프 메시지를 중지하여 수신된 EOF 를 수신하면 플러그인 작업이 완료되었음을 나타냅니다. 이는 오류가 발생했음을 의미하지 않습니다.

4.4.4. OADP에서 지원되는 아키텍처

OADP(OpenShift API for Data Protection)는 다음과 같은 아키텍처를 지원합니다.

- AMD64

- ARM64

- PPC64le

- s390x

OADP 1.2.0 이상 버전은 ARM64 아키텍처를 지원합니다.

4.4.5. IBM Power 및 IBM Z에 대한 OADP 지원

OADP(OpenShift API for Data Protection)는 플랫폼에서 사용할 수 없습니다. 다음 정보는 IBM Power® 및 IBM Z®에만 관련이 있습니다.

- OADP 1.1.7은 IBM Power® 및 IBM Z® 모두에 대해 OpenShift Container Platform 4.11에 대해 성공적으로 테스트되었습니다. 다음 섹션에서는 이러한 시스템의 백업 위치 측면에서 OADP 1.1.7에 대한 테스트 및 지원 정보를 제공합니다.

- OADP 1.2.3은 IBM Power® 및 IBM Z® 모두에 대해 OpenShift Container Platform 4.12, 4.13, 4.14 및 4.15에 대해 성공적으로 테스트되었습니다. 다음 섹션에서는 이러한 시스템의 백업 위치 측면에서 OADP 1.2.3에 대한 테스트 및 지원 정보를 제공합니다.

- OADP 1.3.6은 IBM Power® 및 IBM Z® 모두에 대해 OpenShift Container Platform 4.12, 4.13, 4.14 및 4.15에 대해 성공적으로 테스트되었습니다. 다음 섹션에서는 이러한 시스템의 백업 위치 관점에서 OADP 1.3.6에 대한 테스트 및 지원 정보를 제공합니다.

4.4.5.1. IBM Power를 사용하여 대상 백업 위치에 대한 OADP 지원

- OpenShift Container Platform 4.11 및 4.12로 실행 중인 IBM Power®는 OADP(OpenShift API for Data Protection) 1.1.7을 사용하여 AWS S3 백업 위치 대상에 대해 성공적으로 테스트되었습니다. 이 테스트에는 AWS S3 대상만 포함되었지만 Red Hat은 OpenShift Container Platform 4.11 및 4.12를 사용하여 IBM Power® 실행을 지원하며 AWS가 아닌 모든 S3 백업 위치 대상에 대해 OADP 1.1.7도 지원합니다.

- OpenShift Container Platform 4.12, 4.13, 4.14, 4.15 및 OADP 1.2.3에서 실행되는 IBM Power®는 AWS S3 백업 위치 대상에 대해 성공적으로 테스트되었습니다. 이 테스트는 AWS S3 대상만 포함했지만 Red Hat은 AWS가 아닌 모든 S3 백업 위치 대상에 대해 OpenShift Container Platform 4.12, 4.13. 4.14, 4.15 및 OADP 1.2.3을 사용하여 IBM Power® 실행을 지원합니다.

- OpenShift Container Platform 4.12, 4.13, 4.14, 4.15 및 OADP 1.3.6에서 실행 중인 IBM Power®는 AWS S3 백업 위치 대상에 대해 성공적으로 테스트되었습니다. 이 테스트에는 AWS S3 대상만 포함되었지만 Red Hat은 AWS가 아닌 모든 S3 백업 위치 대상에 대해 OpenShift Container Platform 4.12, 4.13, 4.14, 4.15, OADP 1.3.6을 사용하여 IBM Power® 실행을 지원합니다.

4.4.5.2. OADP 테스트 및 IBM Z를 사용하여 대상 백업 위치 지원

- OpenShift Container Platform 4.11 및 4.12로 실행 중인 IBM Z®는 OADP(OpenShift API for Data Protection) 1.1.7을 사용하여 AWS S3 백업 위치 대상에 대해 성공적으로 테스트되었습니다. 이 테스트에는 AWS S3 대상만 포함되었지만 Red Hat은 OpenShift Container Platform 4.11 및 4.12를 사용하여 IBM Z® 실행을 지원하며 AWS가 아닌 모든 S3 백업 위치 대상에 대해 OADP 1.1.7도 지원합니다.

- OpenShift Container Platform 4.12, 4.13, 4.14, 4.15 및 OADP 1.2.3에서 실행 중인 IBM Z®는 AWS S3 백업 위치 대상에 대해 성공적으로 테스트되었습니다. 이 테스트는 AWS S3 대상만 포함했지만 Red Hat은 AWS가 아닌 모든 S3 백업 위치 대상에 대해 OpenShift Container Platform 4.12, 4.14, 4.15 및 OADP 1.2.3을 사용하여 IBM Z® 실행을 지원합니다.

- OpenShift Container Platform 4.12, 4.13, 4.14 및 4.15에서 실행 중인 IBM Z®는 AWS S3 백업 위치 대상에 대해 성공적으로 테스트되었습니다. 이 테스트는 AWS S3 대상만 포함했지만 Red Hat은 AWS가 아닌 모든 S3 백업 위치 대상에 대해 OpenShift Container Platform 4.12, 4.13 4.14, 4.15 및 1.3.6을 사용하여 IBM Z® 실행을 지원합니다.

4.4.5.2.1. IBM Power(R) 및 IBM Z(R) 플랫폼을 사용하는 OADP의 알려진 문제

- 현재 IBM Power® 및 IBM Z® 플랫폼에 배포된 단일 노드 OpenShift 클러스터에 대한 백업 방법 제한 사항이 있습니다. 현재 NFS 스토리지만 이러한 플랫폼의 단일 노드 OpenShift 클러스터와 호환됩니다. 또한 Kopia 및 Restic과 같은 파일 시스템 백업(FSB) 메서드만 백업 및 복원 작업에 지원됩니다. 현재 이 문제에 대한 해결방법이 없습니다.

4.4.6. OADP 플러그인의 알려진 문제

다음 섹션에서는 OADP(OpenShift API for Data Protection) 플러그인의 알려진 문제에 대해 설명합니다.

4.4.6.1. 시크릿이 누락되어 이미지 스트림 백업 중 Velero 플러그인 패닉

백업 및 백업 스토리지 위치(BSL)가 데이터 보호 애플리케이션(DPA)의 범위 외부에서 관리되는 경우, OADP 컨트롤러는 DPA 조정에서 관련 oadp-<bsl_name>-<bsl_provider>-registry-secret 을 생성하지 않습니다.

백업이 실행되면 다음 패닉 오류와 함께 이미지 스트림 백업에 OpenShift Velero 플러그인이 패닉됩니다.

024-02-27T10:46:50.028951744Z time="2024-02-27T10:46:50Z" level=error msg="Error backing up item" backup=openshift-adp/<backup name> error="error executing custom action (groupResource=imagestreams.image.openshift.io, namespace=<BSL Name>, name=postgres): rpc error: code = Aborted desc = plugin panicked: runtime error: index out of range with length 1, stack trace: goroutine 94…

024-02-27T10:46:50.028951744Z time="2024-02-27T10:46:50Z" level=error msg="Error backing up item"

backup=openshift-adp/<backup name> error="error executing custom action (groupResource=imagestreams.image.openshift.io,

namespace=<BSL Name>, name=postgres): rpc error: code = Aborted desc = plugin panicked:

runtime error: index out of range with length 1, stack trace: goroutine 94…4.4.6.1.1. 패닉 오류를 방지하기 위한 해결방법

Velero 플러그인 패닉 오류를 방지하려면 다음 단계를 수행합니다.

관련 라벨을 사용하여 사용자 지정 BSL에 레이블을 지정합니다.

oc label backupstoragelocations.velero.io <bsl_name> app.kubernetes.io/component=bsl

$ oc label backupstoragelocations.velero.io <bsl_name> app.kubernetes.io/component=bslCopy to Clipboard Copied! Toggle word wrap Toggle overflow BSL 레이블이 지정된 후 DPA가 조정될 때까지 기다립니다.

참고DPA 자체를 약간 변경하여 강제로 조정할 수 있습니다.

DPA가 조정되면 관련

oadp-<bsl_name>-<bsl_provider>-registry-secret이 생성되고 올바른 레지스트리 데이터가 입력되었는지 확인합니다.oc -n openshift-adp get secret/oadp-<bsl_name>-<bsl_provider>-registry-secret -o json | jq -r '.data'

$ oc -n openshift-adp get secret/oadp-<bsl_name>-<bsl_provider>-registry-secret -o json | jq -r '.data'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.6.2. OpenShift ADP 컨트롤러 분할 오류

cloudstorage 및 restic 이 활성화된 DPA를 구성하는 경우 openshift-adp-controller-manager Pod가 충돌하고 크래시 루프 세그먼트 오류로 인해 Pod가 실패할 때까지 무기한 재시작합니다.

상호 배타적 필드이므로 velero 또는 cloudstorage 를 정의할 수 있습니다.

-

velero및cloudstorage가 모두 정의되어 있는 경우openshift-adp-controller-manager가 실패합니다. -

velero또는cloudstorage가 정의되지 않은 경우openshift-adp-controller-manager가 실패합니다.

이 문제에 대한 자세한 내용은 OADP-1054 를 참조하십시오.

4.4.6.2.1. OpenShift ADP 컨트롤러 분할 오류 해결

DPA를 구성할 때 velero 또는 cloudstorage 를 정의해야 합니다. DPA에 두 API를 모두 정의하면 크래시 루프 분할 오류와 함께 openshift-adp-controller-manager Pod가 실패합니다.

4.4.7. OADP 및 FIPS

연방 정보 처리 표준(FIPS)은 연방 정보 보안 관리법(Federal Information Security Management Act,FISMA)에 따라 미국 연방 정부에서 개발한 일련의 컴퓨터 보안 표준입니다.

OADP(OpenShift API for Data Protection)가 테스트되었으며 FIPS 지원 OpenShift Container Platform 클러스터에서 작동합니다.

4.5. OADP 사용 사례

4.5.1. 데이터 보호 및 {odf-first}용 OpenShift API를 사용한 백업

다음은 애플리케이션을 백업하기 위해 OADP 및 {odf-short}을 사용하는 사용 사례입니다.

4.5.1.1. OADP 및 {odf-short}을 사용하여 애플리케이션 백업

이 사용 사례에서는 OADP를 사용하여 애플리케이션을 백업하고 {odf-first}에서 제공하는 오브젝트 스토리지에 백업을 저장합니다.

- OBC(오브젝트 버킷 클레임)를 생성하여 백업 스토리지 위치를 구성합니다. {odf-short}을 사용하여 Amazon S3 호환 오브젝트 스토리지 버킷을 구성합니다. {odf-short}은 MultiCloud Object Gateway(NooBaa MCG) 및 Ceph Object Gateway(RGW), 개체 스토리지 서비스라고도 합니다. 이 사용 사례에서는 NooBaa MCG를 백업 스토리지 위치로 사용합니다.

-

aws공급자 플러그인을 사용하여 OADP와 함께 NooBaa MCG 서비스를 사용합니다. - BPA(데이터 보호 애플리케이션)를 백업 스토리지 위치(BSL)로 구성합니다.

- 백업 CR(사용자 정의 리소스)을 생성하고 백업할 애플리케이션 네임스페이스를 지정합니다.

- 백업을 생성하고 확인합니다.

사전 요구 사항

- OADP Operator가 설치되어 있습니다.

- {odf-short} Operator를 설치했습니다.

- 별도의 네임스페이스에서 실행 중인 데이터베이스가 있는 애플리케이션이 있습니다.

절차

다음 예와 같이 OBC 매니페스트 파일을 생성하여 NooBaa MCG 버킷을 요청합니다.

OBC의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 OBC를 생성합니다.

oc create -f <obc_file_name>

$ oc create -f <obc_file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 오브젝트 버킷 클레임 매니페스트의 파일 이름을 지정합니다.

OBC를 생성할 때 {odf-short}은 오브젝트 버킷 클레임과 동일한 이름의

시크릿및구성 맵을 생성합니다.시크릿에는 버킷 인증 정보가 있으며구성 맵에는 버킷에 액세스하는 데 필요한 정보가 있습니다. 생성된 구성 맵에서 버킷 이름과 버킷 호스트를 가져오려면 다음 명령을 실행합니다.oc extract --to=- cm/test-obc

$ oc extract --to=- cm/test-obc1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

test-obc는 OBC의 이름입니다.

출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 생성된

보안에서 버킷 인증 정보를 가져오려면 다음 명령을 실행합니다.oc extract --to=- secret/test-obc

$ oc extract --to=- secret/test-obcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

# AWS_ACCESS_KEY_ID ebYR....xLNMc # AWS_SECRET_ACCESS_KEY YXf...+NaCkdyC3QPym

# AWS_ACCESS_KEY_ID ebYR....xLNMc # AWS_SECRET_ACCESS_KEY YXf...+NaCkdyC3QPymCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

openshift-storage네임스페이스의 s3 경로에서 S3 끝점의 공용 URL을 가져옵니다.oc get route s3 -n openshift-storage

$ oc get route s3 -n openshift-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령에 표시된 대로 오브젝트 버킷 인증 정보를 사용하여

cloud-credentials파일을 만듭니다.[default] aws_access_key_id=<AWS_ACCESS_KEY_ID> aws_secret_access_key=<AWS_SECRET_ACCESS_KEY>

[default] aws_access_key_id=<AWS_ACCESS_KEY_ID> aws_secret_access_key=<AWS_SECRET_ACCESS_KEY>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령에 표시된 대로

cloud-credentials파일 콘텐츠를 사용하여cloud-credentials시크릿을 생성합니다.oc create secret generic \ cloud-credentials \ -n openshift-adp \ --from-file cloud=cloud-credentials

$ oc create secret generic \ cloud-credentials \ -n openshift-adp \ --from-file cloud=cloud-credentialsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예와 같이 DPA(Data Protection Application)를 구성합니다.

DPA 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 DPA를 생성합니다.

oc apply -f <dpa_filename>

$ oc apply -f <dpa_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 DPA가 성공적으로 생성되었는지 확인합니다. 예제 출력에서

status오브젝트에type필드가Reconciled으로 설정되어 있음을 확인할 수 있습니다. 즉, DPA가 성공적으로 생성됩니다.oc get dpa -o yaml

$ oc get dpa -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 백업 스토리지 위치(BSL)를 사용할 수 있는지 확인합니다.

oc get backupstoragelocations.velero.io -n openshift-adp

$ oc get backupstoragelocations.velero.io -n openshift-adpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME PHASE LAST VALIDATED AGE DEFAULT dpa-sample-1 Available 3s 15s true

NAME PHASE LAST VALIDATED AGE DEFAULT dpa-sample-1 Available 3s 15s trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예와 같이 백업 CR을 구성합니다.

백업 CR 예시

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 애플리케이션을 백업할 네임스페이스를 지정합니다.

다음 명령을 실행하여 백업 CR을 만듭니다.

oc apply -f <backup_cr_filename>

$ oc apply -f <backup_cr_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 실행하여 백업 오브젝트가

Completed단계에 있는지 확인합니다. 자세한 내용은 예제 출력을 참조하십시오.oc describe backup test-backup -n openshift-adp

$ oc describe backup test-backup -n openshift-adpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5.2. OADP(OpenShift API for Data Protection) 복원 사용 사례

다음은 OADP를 사용하여 다른 네임스페이스로 백업을 복원하는 사용 사례입니다.

4.5.2.1. OADP를 사용하여 애플리케이션을 다른 네임스페이스로 복원

OADP를 새 대상 네임스페이스 test-restore-application 에 사용하여 애플리케이션 백업을 복원합니다. 백업을 복원하려면 다음 예와 같이 복원 사용자 정의 리소스(CR)를 생성합니다. restore CR에서 소스 네임스페이스는 백업에 포함된 애플리케이션 네임스페이스를 나타냅니다. 그런 다음 프로젝트를 새 복원 네임스페이스로 변경하고 리소스를 확인하여 복원을 확인합니다.

사전 요구 사항

- OADP Operator를 설치했습니다.

- 복원할 애플리케이션의 백업이 있습니다.

프로세스

다음 예와 같이 복원 CR을 생성합니다.

CR 복원 예시

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 복원 CR을 적용합니다.

oc apply -f <restore_cr_filename>

$ oc apply -f <restore_cr_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 실행하여 복원이

완료된단계에 있는지 확인합니다.oc describe restores.velero.io <restore_name> -n openshift-adp

$ oc describe restores.velero.io <restore_name> -n openshift-adpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 복원된 네임스페이스

test-restore-application로 변경합니다.oc project test-restore-application

$ oc project test-restore-applicationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 영구 볼륨 클레임(pvc), 서비스(svc), 배포, 시크릿, 구성 맵과 같은 복원된 리소스를 확인합니다.

oc get pvc,svc,deployment,secret,configmap

$ oc get pvc,svc,deployment,secret,configmapCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5.3. 백업 중 자체 서명된 CA 인증서 포함

DPA(Data Protection Application)에 자체 서명된 CA(인증 기관) 인증서를 추가한 다음 애플리케이션을 백업할 수 있습니다. {odf-first}에서 제공하는 NooBaa 버킷에 백업을 저장합니다.

4.5.3.1. 애플리케이션 및 자체 서명된 CA 인증서 백업

{odf-short}에서 제공하는 s3.openshift-storage.svc 서비스는 자체 서명된 서비스 CA로 서명된 TLS(Transport Layer Security Protocol) 인증서를 사용합니다.

알 수 없는 기관 오류로 서명된 인증서 를 방지하려면 DataProtectionApplication CR(사용자 정의 리소스)의 백업 스토리지 위치(BSL) 섹션에 자체 서명된 CA 인증서를 포함해야 합니다. 이 경우 다음 작업을 완료해야 합니다.

- OBC(오브젝트 버킷 클레임)를 생성하여 NooBaa 버킷을 요청합니다.

- 버킷 세부 정보를 추출합니다.

-

DataProtectionApplicationCR에 자체 서명된 CA 인증서를 포함합니다. - 애플리케이션을 백업합니다.

사전 요구 사항

- OADP Operator가 설치되어 있습니다.

- {odf-short} Operator를 설치했습니다.

- 별도의 네임스페이스에서 실행 중인 데이터베이스가 있는 애플리케이션이 있습니다.

절차

다음 예와 같이 OBC 매니페스트를 생성하여 NooBaa 버킷을 요청합니다.

ObjectBucketClaimCR의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 OBC를 생성합니다.

oc create -f <obc_file_name>

$ oc create -f <obc_file_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow OBC를 생성할 때 {odf-short}은 오브젝트 버킷 클레임과 동일한 이름의

시크릿및ConfigMap을 생성합니다.보안오브젝트에는 버킷 인증 정보가 포함되어 있으며ConfigMap오브젝트에는 버킷에 액세스하는 데 필요한 정보가 포함되어 있습니다. 생성된 구성 맵에서 버킷 이름과 버킷 호스트를 가져오려면 다음 명령을 실행합니다.oc extract --to=- cm/test-obc

$ oc extract --to=- cm/test-obc1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- OBC의 이름은

test-obc입니다.

출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 보안오브젝트에서 버킷 인증 정보를 가져오려면 다음 명령을 실행합니다.oc extract --to=- secret/test-obc

$ oc extract --to=- secret/test-obcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

# AWS_ACCESS_KEY_ID ebYR....xLNMc # AWS_SECRET_ACCESS_KEY YXf...+NaCkdyC3QPym

# AWS_ACCESS_KEY_ID ebYR....xLNMc # AWS_SECRET_ACCESS_KEY YXf...+NaCkdyC3QPymCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예제 구성을 사용하여 오브젝트 버킷 자격 증명으로

cloud-credentials파일을 생성합니다.[default] aws_access_key_id=<AWS_ACCESS_KEY_ID> aws_secret_access_key=<AWS_SECRET_ACCESS_KEY>

[default] aws_access_key_id=<AWS_ACCESS_KEY_ID> aws_secret_access_key=<AWS_SECRET_ACCESS_KEY>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

cloud-credentials파일 콘텐츠를 사용하여cloud-credentials시크릿을 생성합니다.oc create secret generic \ cloud-credentials \ -n openshift-adp \ --from-file cloud=cloud-credentials

$ oc create secret generic \ cloud-credentials \ -n openshift-adp \ --from-file cloud=cloud-credentialsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

openshift-service-ca.crt구성 맵에서 서비스 CA 인증서를 추출합니다. 인증서를Base64형식으로 인코딩하고 다음 단계에서 사용할 값을 기록해야 합니다.oc get cm/openshift-service-ca.crt \ -o jsonpath='{.data.service-ca\.crt}' | base64 -w0; echo$ oc get cm/openshift-service-ca.crt \ -o jsonpath='{.data.service-ca\.crt}' | base64 -w0; echoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

LS0tLS1CRUdJTiBDRVJUSUZJQ0FURS0... ....gpwOHMwaG9CRmk5a3....FLS0tLS0K

LS0tLS1CRUdJTiBDRVJUSUZJQ0FURS0... ....gpwOHMwaG9CRmk5a3....FLS0tLS0KCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예와 같이 버킷 이름 및 CA 인증서를 사용하여

DataProtectionApplicationCR 매니페스트 파일을 구성합니다.Example

DataProtectionApplicationCRCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

DataProtectionApplicationCR을 생성합니다.oc apply -f <dpa_filename>

$ oc apply -f <dpa_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

DataProtectionApplicationCR이 성공적으로 생성되었는지 확인합니다.oc get dpa -o yaml

$ oc get dpa -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 백업 스토리지 위치(BSL)를 사용할 수 있는지 확인합니다.

oc get backupstoragelocations.velero.io -n openshift-adp

$ oc get backupstoragelocations.velero.io -n openshift-adpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME PHASE LAST VALIDATED AGE DEFAULT dpa-sample-1 Available 3s 15s true

NAME PHASE LAST VALIDATED AGE DEFAULT dpa-sample-1 Available 3s 15s trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예제를 사용하여

BackupCR을 구성합니다.BackupCR의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 애플리케이션을 백업할 네임스페이스를 지정합니다.

다음 명령을 실행하여

BackupCR을 생성합니다.oc apply -f <backup_cr_filename>

$ oc apply -f <backup_cr_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 실행하여

Backup오브젝트가Completed단계에 있는지 확인합니다.oc describe backup test-backup -n openshift-adp

$ oc describe backup test-backup -n openshift-adpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.6. OADP 설치

4.6.1. OADP 설치 정보

클러스터 관리자는 OADP Operator를 설치하여 OADP(OpenShift API for Data Protection)를 설치합니다. OADP Operator는 Velero 1.14 를 설치합니다.

OADP 1.0.4부터 모든 OADP 1.0.z 버전은 Migration Toolkit for Containers Operator의 종속성으로만 사용할 수 있으며 독립 실행형 Operator로 사용할 수 없습니다.

Kubernetes 리소스 및 내부 이미지를 백업하려면 다음 스토리지 유형 중 하나와 같은 백업 위치로 오브젝트 스토리지가 있어야 합니다.

- Amazon Web Services

- Microsoft Azure

- Google Cloud Platform

- Multicloud Object Gateway

- AWS S3 호환 오브젝트 스토리지(예: Multicloud Object Gateway 또는 MinIO)

개별 OADP 배포에 대해 동일한 네임스페이스 내에서 여러 백업 스토리지 위치를 구성할 수 있습니다.

달리 지정하지 않는 한 "NooBa"는 경량 오브젝트 스토리지를 제공하는 오픈 소스 프로젝트를 나타내며 "MCG(Multicloud Object Gateway)는 NooBaa의 Red Hat 배포를 나타냅니다.

MCG에 대한 자세한 내용은 애플리케이션을 사용하여 Multicloud Object Gateway 액세스를 참조하십시오.

오브젝트 스토리지의 버킷 생성을 자동화하는 CloudStorage API는 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

CloudStorage API는CloudStorage 오브젝트를 사용하고 OADP에서 CloudStorage API를 사용하여 BackupStorageLocation 으로 사용할 S3 버킷을 자동으로 생성하도록 하는 경우 기술 프리뷰 기능입니다.

CloudStorage API는 기존 S3 버킷을 지정하여 BackupStorageLocation 오브젝트를 수동으로 생성할 수 있도록 지원합니다. S3 버킷을 자동으로 생성하는 CloudStorage API는 현재 AWS S3 스토리지에만 활성화됩니다.

스냅샷 또는 FSB(파일 시스템 백업)를 사용하여 PV(영구 볼륨)를 백업할 수 있습니다.

스냅샷을 사용하여 PV를 백업하려면 다음 클라우드 공급자 중 하나와 같이 기본 스냅샷 API 또는 CSI(Container Storage Interface) 스냅샷을 지원하는 클라우드 공급자가 있어야 합니다.

- Amazon Web Services

- Microsoft Azure

- Google Cloud Platform

- CSI 스냅샷 지원 클라우드 공급자 (예: OpenShift Data Foundation)

OCP 4.11 이상에서 CSI 백업을 사용하려면 OADP 1.1.x 를 설치합니다.

OADP 1.0.x 는 OCP 4.11 이상에서 CSI 백업을 지원하지 않습니다. OADP 1.0.x에는 Velero 1.7 x가 포함되어 있으며 OCP 4.11 이상에는 존재하지 않는 API 그룹 snapshot.storage.k8s.io/v1beta1 이 예상됩니다.

클라우드 공급자가 스냅샷을 지원하지 않거나 스토리지가 NFS인 경우 오브젝트 스토리지에서 File System Backup: Kopia 또는 Restic을 사용하여 애플리케이션을 백업하여 애플리케이션을 백업할 수 있습니다.

기본 Secret 을 생성한 다음 데이터 보호 애플리케이션을 설치합니다.

4.6.1.1. AWS S3 호환 백업 스토리지 공급자

OADP는 다양한 백업 및 스냅샷 작업에 사용하기 위해 많은 오브젝트 스토리지 공급자와 호환됩니다. 여러 오브젝트 스토리지 공급자가 완전히 지원되며, 일부 오브젝트 스토리지 공급자는 지원되지만 작동하지 않으며 일부에는 알려진 제한 사항이 있습니다.

4.6.1.1.1. 지원되는 백업 스토리지 공급자

다음 AWS S3 호환 오브젝트 스토리지 공급자는 AWS 플러그인을 통해 백업 스토리지 위치로 사용하기 위해 OADP에서 완전히 지원합니다.

- MinIO

- MCG(Multicloud Object Gateway)

- AWS(Amazon Web Services) S3

- IBM Cloud® Object Storage S3

- Ceph RADOS Gateway(Ceph Object Gateway)

- Red Hat Container Storage

- Red Hat OpenShift Data Foundation

- GCP(Google Cloud Platform)

- Microsoft Azure

GCP(Google Cloud Platform) 및 Microsoft Azure에는 자체 Velero 오브젝트 저장소 플러그인이 있습니다.

4.6.1.1.2. 지원되지 않는 백업 스토리지 공급자

다음 AWS S3 호환 오브젝트 스토리지 공급자는 백업 스토리지 위치로 사용하기 위해 AWS 플러그인을 통해 Velero와 함께 작업하는 것으로 알려져 있지만 이는 지원되지 않으며 Red Hat에서 테스트하지 않았습니다.

- IBM Cloud

- Oracle Cloud

- DigitalOcean

- MCG(Multicloud Object Gateway)를 사용하여 설치하지 않는 한 NooBaa

- Tencent Cloud

- Quobyte

- Cloudian HyperStore

달리 지정하지 않는 한 "NooBa"는 경량 오브젝트 스토리지를 제공하는 오픈 소스 프로젝트를 나타내며 "MCG(Multicloud Object Gateway)는 NooBaa의 Red Hat 배포를 나타냅니다.

MCG에 대한 자세한 내용은 애플리케이션을 사용하여 Multicloud Object Gateway 액세스를 참조하십시오.

4.6.1.1.3. 알려진 제한이 있는 백업 스토리지 공급자

다음 AWS S3 호환 오브젝트 스토리지 공급자는 제한된 기능 세트로 AWS 플러그인을 통해 Velero와 함께 작동하는 것으로 알려져 있습니다.

- Swift - 백업 스토리지의 백업 스토리지 위치로 사용하기 위해 작동하지만 파일 시스템 기반 볼륨 백업 및 복원에는 Restic과 호환되지 않습니다.

4.6.1.2. OpenShift Data Foundation에서 재해 복구를 위해 MCG(Multicloud Object Gateway) 구성

OpenShift Data Foundation에서 MCG 버킷 backupStorageLocation 에 클러스터 스토리지를 사용하는 경우 MCG를 외부 오브젝트 저장소로 구성합니다.

MCG를 외부 오브젝트 저장소로 구성하지 않으면 백업을 사용할 수 없게 될 수 있습니다.

달리 지정하지 않는 한 "NooBa"는 경량 오브젝트 스토리지를 제공하는 오픈 소스 프로젝트를 나타내며 "MCG(Multicloud Object Gateway)는 NooBaa의 Red Hat 배포를 나타냅니다.

MCG에 대한 자세한 내용은 애플리케이션을 사용하여 Multicloud Object Gateway 액세스를 참조하십시오.

프로세스

- 하이브리드 또는 Multicloud용 스토리지 리소스 추가 에 설명된 대로 MCG를 외부 오브젝트 저장소로 구성합니다.

4.6.1.3. OADP 업데이트 채널 정보

OADP Operator를 설치할 때 업데이트 채널을 선택합니다. 이 채널은 OADP Operator 및 수신하는 Velero에 대한 업그레이드를 결정합니다. 언제든지 채널을 전환할 수 있습니다.

다음 업데이트 채널을 사용할 수 있습니다.

-

stable 채널이 더 이상 사용되지 않습니다. stable 채널에는

OADP.v1.1.z용 OADPClusterServiceVersion및OADP.v1.0.z의 이전 버전의 패치(z-stream 업데이트)가 포함되어 있습니다. - stable-1.0 채널은 더 이상 사용되지 않으며 지원되지 않습니다.

- stable-1.1 채널은 더 이상 사용되지 않으며 지원되지 않습니다.

- stable-1.2 채널은 더 이상 사용되지 않으며 지원되지 않습니다.

-

stable-1.3 채널에는 최신 OADP 1.3

ClusterServiceVersion인OADP.v1.3.z가 포함되어 있습니다. -

stable-1.4 채널에는 최신 OADP 1.4

ClusterServiceVersion인OADP.v1.4.z가 포함되어 있습니다.

자세한 내용은 OpenShift Operator 라이프 사이클 을 참조하십시오.

어떤 업데이트 채널이 적합합니까?

-

stable 채널이 더 이상 사용되지 않습니다. stable 채널을 이미 사용 중인 경우

OADP.v1.1.z에서 업데이트를 계속 받을 수 있습니다. - OADP 1.y를 설치하고 패치를 계속 받을 stable-1.y 업데이트 채널을 선택합니다. 이 채널을 선택하면 버전 1.y.z에 대한 모든 z-stream 패치가 제공됩니다.

언제 업데이트 채널을 전환해야 합니까?

- OADP 1.y가 설치되어 있고 해당 y-stream용 패치를 받으려면 stable 업데이트 채널에서 stable-1.y 업데이트 채널로 전환해야 합니다. 그런 다음 버전 1.y.z에 대한 모든 z-stream 패치를 받게 됩니다.

- OADP 1.0이 설치되어 있고 OADP 1.1로 업그레이드한 다음 OADP 1.1용 패치를 수신하려면 stable-1.0 업데이트 채널에서 stable-1.1 업데이트 채널로 전환해야 합니다. 그런 다음 버전 1.1.z에 대한 모든 z-stream 패치를 받게 됩니다.

- OADP 1.y가 설치되어 있고 y 가 0보다 큰 경우 OADP 1.0으로 전환하려면 OADP Operator를 제거한 다음 stable-1.0 업데이트 채널을 사용하여 다시 설치해야 합니다. 그런 다음 버전 1.0.z에 대한 모든 z-stream 패치를 받게 됩니다.

업데이트 채널을 전환하여 OADP 1.y에서 OADP 1.0으로 전환할 수 없습니다. Operator를 설치 제거한 다음 다시 설치해야 합니다.

4.6.1.4. 여러 네임스페이스에 OADP 설치

여러 프로젝트 소유자가 자체 OADP 인스턴스를 관리할 수 있도록 OADP(OpenShift API for Data Protection)를 동일한 클러스터의 여러 네임스페이스에 설치할 수 있습니다. 이 사용 사례는 파일 시스템 백업(FSB) 및 CSI(Container Storage Interface)에서 검증되었습니다.

다음 추가 요구 사항과 함께 이 문서에 포함된 플랫폼별 절차에 의해 지정된 대로 OADP의 각 인스턴스를 설치합니다.

- 동일한 클러스터에 OADP의 모든 배포는 동일한 버전이어야 합니다(예: 1.1.4). 동일한 클러스터에 다양한 버전의 OADP를 설치하는 것은 지원되지 않습니다.

-

OADP의 개별 배포마다 고유한 인증 정보 세트 및 하나 이상의

BackupStorageLocation구성이 있어야 합니다. 동일한 네임 스페이스 내에서 여러BackupStorageLocation구성을 사용할 수도 있습니다. - 기본적으로 각 OADP 배포에는 네임스페이스 간에 클러스터 수준 액세스 권한이 있습니다. OpenShift Container Platform 관리자는 보안 및 RBAC 설정을 신중하게 검토하고 각 OADP 인스턴스에 올바른 권한이 있는지 확인하기 위해 필요한 변경을 수행해야 합니다.

4.6.1.5. OADP는 백업 데이터 불변성을 지원하지 않습니다.

OADP 1.3부터 대상 오브젝트 스토리지에 불변성 옵션이 구성된 경우 백업이 예상대로 작동하지 않을 수 있습니다. 이러한 불변성 옵션은 다른 이름으로 참조합니다. 예를 들면 다음과 같습니다.

- S3 객체 잠금

- 오브젝트 보존

- 버킷 버전 관리

- 한 번 읽기 많은(WORM) 버킷 작성

지원이 없는 주요 이유는 OADP가 처음에 백업 상태를 완료로 저장한 다음 비동기 작업이 진행 중인지 여부를 조사하기 때문입니다.

OADP 1.3 이전 버전에서는 불변 구성이 있는 오브젝트 스토리지도 지원되지 않았습니다. 백업이 작동하는 경우에도 몇 가지 문제가 발생할 수 있습니다. 예를 들어 백업이 삭제될 때 버전 오브젝트는 삭제되지 않습니다.

특정 공급자 및 구성에 따라 백업이 경우에 따라 작동할 수 있습니다.

- S3 오브젝트 잠금은 버전이 지정된 버킷에만 적용되므로 AWS S3 서비스는 백업을 지원합니다. 새 버전의 오브젝트 데이터를 업데이트할 수 있습니다. 그러나 백업이 삭제되면 이전 버전의 오브젝트는 삭제되지 않습니다.

- Azure Storage Blob은 버전화된 수준의 불변성 및 컨테이너 수준 불변성을 모두 지원합니다. 버전화된 상황에서 데이터 불변성은 여전히 OADP에서 작동할 수 있지만 컨테이너 수준에서는 작동하지 않습니다.

- GCP Cloud 스토리지 정책은 버킷 수준의 불변성만 지원합니다. 따라서 GCP 환경에서 구현하는 것은 불가능합니다.

4.6.1.6. 수집된 데이터를 기반으로 하는 Velero CPU 및 메모리 요구 사항

다음 권장 사항은 규모 및 성능 랩에서 수행된 성능 관찰을 기반으로 합니다. 백업 및 복원 리소스는 플러그인 유형, 해당 백업 또는 복원에 필요한 리소스 양, 해당 리소스와 관련된 PV(영구 볼륨)에 포함된 해당 데이터의 영향을 받을 수 있습니다.

4.6.1.6.1. 구성에 대한 CPU 및 메모리 요구 사항

| 구성 유형 | [1] 평균 사용량 | [2] 대규모 사용 | resourceTimeouts |

|---|---|---|---|

| CSI | Velero: cpu- 요청 200m, 제한 1000m memory - 256Mi 요청, 제한 1024Mi | Velero: CPU- 요청 200m, 제한 2000m memory- requests 256Mi, Limits 2048Mi | 해당 없음 |

| Restic | [3] Restic: CPU- 요청 1000m, 제한 2000m memory - 16Gi 요청, 32Gi 제한 | [4] Restic: CPU - 2000m 요청, 8000m 제한 Memory - 16Gi 요청, 제한 40Gi | 900m |

| [5] Data Mover | 해당 없음 | 해당 없음 | 10m - 평균 사용량 60m - 대규모 사용 |

- 평균 사용량 - 대부분의 사용 상황에 대해 이러한 설정을 사용합니다.

- 대규모 사용 - 대규모 PV(500GB 사용), 다중 네임스페이스(100+) 또는 단일 네임스페이스(2000 pods+) 내의 여러 Pod 및 대규모 데이터 세트와 관련된 백업 및 복원을 위한 최적의 성능을 위해 이러한 설정을 사용합니다.

- Restic 리소스 사용량은 데이터 양 및 데이터 유형에 해당합니다. 예를 들어 많은 작은 파일 또는 대량의 데이터가 있으면 Restic에서 대량의 리소스를 사용할 수 있습니다. Velero 문서는 500m을 제공된 기본값으로 참조합니다. 대부분의 테스트에서는 1000m 제한이 있는 200m 요청을 찾았습니다. Velero 문서에서 인용한 대로 정확한 CPU 및 메모리 사용은 환경 제한 외에도 파일 및 디렉터리의 크기에 따라 달라집니다.

- CPU를 늘리면 백업 및 복원 시간 개선에 큰 영향을 미칩니다.

- Data Mover - Data Mover 기본 resourceTimeout은 10m입니다. 테스트 결과 대규모 PV(500GB 사용량)를 복원하려면 resourceTimeout을 60m로 늘려야 합니다.

가이드 전체에 나열된 리소스 요구 사항은 평균 사용량 전용입니다. 큰 용도의 경우 위의 표에 설명된 대로 설정을 조정합니다.

4.6.1.6.2. 대규모 사용을 위한 nodeagent CPU

테스트 결과 NodeAgent CPU를 늘리면 OADP(OpenShift API for Data Protection)를 사용할 때 백업 및 복원 시간을 크게 향상시킬 수 있습니다.

성능 분석 및 기본 설정에 따라 OpenShift Container Platform 환경을 조정할 수 있습니다. Kopia를 파일 시스템 백업에 사용할 때 워크로드에서 CPU 제한을 사용합니다.

Pod에서 CPU 제한을 사용하지 않는 경우 Pod에서 사용 가능한 경우 초과 CPU를 사용할 수 있습니다. CPU 제한을 지정하는 경우 한도를 초과하면 Pod가 제한될 수 있습니다. 따라서 Pod의 CPU 제한 사용은 안티 패턴으로 간주됩니다.

Pod가 초과 CPU를 활용할 수 있도록 CPU 요청을 정확하게 지정하고 있는지 확인합니다. CPU 제한이 아닌 CPU 요청에 따라 리소스 할당이 보장됩니다.

테스트 결과 20개 코어 및 32Gi 메모리가 있는 Kopia를 실행하면 100GB 이상의 데이터, 여러 네임스페이스 또는 2000개 이상의 Pod가 단일 네임스페이스에서 백업 및 복원 작업을 지원했습니다. 이러한 리소스 사양을 사용하여 CPU 제한 또는 메모리 포화 상태로 감지된 테스트입니다.

일부 환경에서는 Pod가 재시작되지 않도록 Ceph MDS Pod 리소스를 조정해야 할 수 있습니다. 이 경우 기본 설정으로 리소스 포화 상태로 인해 리소스 포화 상태가 발생합니다.

Ceph MDS Pod에서 Pod 리소스 제한을 설정하는 방법에 대한 자세한 내용은 rook-ceph Pod에서 CPU 및 메모리 리소스 변경을 참조하십시오.

4.6.2. OADP Operator 설치

OLM(Operator Lifecycle Manager)을 사용하여 OpenShift Container Platform 4.13에 OADP(OpenShift API for Data Protection) Operator를 설치할 수 있습니다.

OADP Operator는 Velero 1.14 를 설치합니다.

사전 요구 사항

-

cluster-admin권한이 있는 사용자로 로그인해야 합니다.

절차

- OpenShift Container Platform 웹 콘솔에서 Operator → OperatorHub를 클릭합니다.

- 키워드로 필터링 필드를 사용하여 OADP Operator 를 찾습니다.

- OADP Operator 를 선택하고 설치를 클릭합니다.

-

설치를 클릭하여

openshift-adp프로젝트에서 Operator를 설치합니다. - Operators → 설치된 Operators 를 클릭하여 설치를 확인합니다.

4.6.2.1. OADP-Velero-OpenShift Container Platform 버전 관계

| OADP 버전 | Velero 버전 | OpenShift Container Platform 버전 |

|---|---|---|

| 1.1.0 | 4.9 이상 | |

| 1.1.1 | 4.9 이상 | |

| 1.1.2 | 4.9 이상 | |

| 1.1.3 | 4.9 이상 | |

| 1.1.4 | 4.9 이상 | |

| 1.1.5 | 4.9 이상 | |

| 1.1.6 | 4.11 이상 | |

| 1.1.7 | 4.11 이상 | |

| 1.2.0 | 4.11 이상 | |

| 1.2.1 | 4.11 이상 | |

| 1.2.2 | 4.11 이상 | |

| 1.2.3 | 4.11 이상 | |

| 1.3.0 | 4.10 - 4.15 | |

| 1.3.1 | 4.10 - 4.15 | |

| 1.3.2 | 4.10 - 4.15 | |

| 1.3.3 | 4.10 - 4.15 | |

| 1.4.0 | 4.14 이상 | |

| 1.4.1 | 4.14 이상 |

4.7. AWS S3 호환 스토리지를 사용하여 OADP 구성

4.7.1. Amazon Web Services를 사용하여 데이터 보호를 위한 OpenShift API 구성

OADP Operator를 설치하여 AWS(Amazon Web Services)를 사용하여 OADP(OpenShift API for Data Protection)를 설치합니다. Operator는 Velero 1.14 를 설치합니다.

OADP 1.0.4부터 모든 OADP 1.0.z 버전은 Migration Toolkit for Containers Operator의 종속성으로만 사용할 수 있으며 독립 실행형 Operator로 사용할 수 없습니다.

Velero에 대해 AWS를 구성하고, 기본 보안 보안을 생성한 다음 데이터 보호 애플리케이션을 설치합니다. 자세한 내용은 OADP Operator 설치를 참조하십시오.

제한된 네트워크 환경에서 OADP Operator를 설치하려면 먼저 기본 OperatorHub 소스를 비활성화하고 Operator 카탈로그를 미러링해야 합니다. 자세한 내용은 제한된 네트워크에서 Operator Lifecycle Manager 사용을 참조하십시오.

4.7.1.1. Amazon Web Services 구성

OpenShift API for Data Protection(OADP)을 위해 AWS(Amazon Web Services)를 구성합니다.

사전 요구 사항

- AWS CLI가 설치되어 있어야 합니다.

절차

BUCKET변수를 설정합니다.BUCKET=<your_bucket>

$ BUCKET=<your_bucket>Copy to Clipboard Copied! Toggle word wrap Toggle overflow REGION변수를 설정합니다.REGION=<your_region>

$ REGION=<your_region>Copy to Clipboard Copied! Toggle word wrap Toggle overflow AWS S3 버킷을 생성합니다.

aws s3api create-bucket \ --bucket $BUCKET \ --region $REGION \ --create-bucket-configuration LocationConstraint=$REGION$ aws s3api create-bucket \ --bucket $BUCKET \ --region $REGION \ --create-bucket-configuration LocationConstraint=$REGION1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

us-east-1은LocationConstraint를 지원하지 않습니다. 리전이us-east-1인 경우--create-bucket-configuration LocationConstraint=$REGION을 생략합니다.

IAM 사용자를 생성합니다.

aws iam create-user --user-name velero

$ aws iam create-user --user-name velero1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Velero를 사용하여 여러 S3 버킷이 있는 여러 클러스터를 백업하려면 각 클러스터에 대해 고유한 사용자 이름을 생성합니다.

velero-policy.json파일을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 정책을 연결하여

velero사용자에게 최소한의 필요한 권한을 부여합니다.aws iam put-user-policy \ --user-name velero \ --policy-name velero \ --policy-document file://velero-policy.json

$ aws iam put-user-policy \ --user-name velero \ --policy-name velero \ --policy-document file://velero-policy.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow velero사용자에 대한 액세스 키를 생성합니다.aws iam create-access-key --user-name velero

$ aws iam create-access-key --user-name veleroCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow credentials-velero파일을 생성합니다.cat << EOF > ./credentials-velero [default] aws_access_key_id=<AWS_ACCESS_KEY_ID> aws_secret_access_key=<AWS_SECRET_ACCESS_KEY> EOF

$ cat << EOF > ./credentials-velero [default] aws_access_key_id=<AWS_ACCESS_KEY_ID> aws_secret_access_key=<AWS_SECRET_ACCESS_KEY> EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow Data Protection Application을 설치하기 전에

credentials-velero파일을 사용하여 AWS에 대한Secret오브젝트를 생성합니다.

4.7.1.2. 백업 및 스냅샷 위치 및 시크릿 정보

DataProtectionApplication CR(사용자 정의 리소스)에 백업 및 스냅샷 위치와 해당 시크릿을 지정합니다.

백업 위치

AWS S3 호환 오브젝트 스토리지를 Multicloud Object Gateway, Red Hat Container Storage; Ceph Object Gateway, Red Hat OpenShift Data Foundation 또는 MinIO와 같은 백업 위치로 지정합니다.

Velero는 OpenShift Container Platform 리소스, Kubernetes 오브젝트 및 내부 이미지를 오브젝트 스토리지의 아카이브 파일로 백업합니다.

스냅샷 위치

클라우드 공급자의 기본 스냅샷 API를 사용하여 영구 볼륨을 백업하는 경우 클라우드 공급자를 스냅샷 위치로 지정해야 합니다.

CSI(Container Storage Interface) 스냅샷을 사용하는 경우 CSI 드라이버를 등록하기 위해 VolumeSnapshotClass CR을 생성하므로 스냅샷 위치를 지정할 필요가 없습니다.

FSB(File System Backup)를 사용하는 경우 FSB가 오브젝트 스토리지에서 파일 시스템을 백업하므로 스냅샷 위치를 지정할 필요가 없습니다.

보안

백업 및 스냅샷 위치에서 동일한 자격 증명을 사용하거나 스냅샷 위치가 필요하지 않은 경우 기본 Secret 을 생성합니다.

백업 및 스냅샷 위치에서 다른 인증 정보를 사용하는 경우 두 개의 시크릿 오브젝트를 생성합니다.

-

백업

위치에대한 사용자 지정 보안(DataProtectionApplicationCR에서 지정) -

DataProtectionApplicationCR에서 참조하지 않는 스냅샷 위치에 대한 기본 보안입니다.

데이터 보호 애플리케이션에는 기본 보안이 필요합니다. 그렇지 않으면 설치에 실패합니다.

설치 중에 백업 또는 스냅샷 위치를 지정하지 않으려면 빈 credentials-velero 파일을 사용하여 기본 Secret 을 생성할 수 있습니다.

4.7.1.2.1. 기본 보안 생성

백업 및 스냅샷 위치에서 동일한 자격 증명을 사용하거나 스냅샷 위치가 필요하지 않은 경우 기본 보안을 생성합니다.

Secret 의 기본 이름은 cloud-credentials 입니다.

DataProtectionApplication 사용자 정의 리소스 (CR)에는 기본 보안이 필요합니다. 그렇지 않으면 설치에 실패합니다. 백업 위치 Secret 이 지정되지 않은 경우 기본 이름이 사용됩니다.

설치 중에 백업 위치 자격 증명을 사용하지 않으려면 빈 credentials-velero 파일을 사용하여 기본 이름으로 Secret 을 생성할 수 있습니다.

사전 요구 사항

- 오브젝트 스토리지 및 클라우드 스토리지의 경우 동일한 인증 정보를 사용해야 합니다.

- Velero에 대한 오브젝트 스토리지를 구성해야 합니다.

절차

클라우드 공급자에 적절한 형식으로 백업 스토리지 위치에 대한

credentials-velero파일을 생성합니다.다음 예제를 참조하십시오.

[default] aws_access_key_id=<AWS_ACCESS_KEY_ID> aws_secret_access_key=<AWS_SECRET_ACCESS_KEY>

[default] aws_access_key_id=<AWS_ACCESS_KEY_ID> aws_secret_access_key=<AWS_SECRET_ACCESS_KEY>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 기본 이름으로

SecretCR(사용자 정의 리소스)을 생성합니다.oc create secret generic cloud-credentials -n openshift-adp --from-file cloud=credentials-velero

$ oc create secret generic cloud-credentials -n openshift-adp --from-file cloud=credentials-veleroCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Data Protection Application을 설치할 때 DataProtectionApplication CR의 spec.backupLocations.credential 블록에서 Secret 을 참조합니다.

4.7.1.2.2. 다양한 자격 증명에 대한 프로필 생성

백업 및 스냅샷 위치에서 다른 인증 정보를 사용하는 경우 credentials-velero 파일에 별도의 프로필을 생성합니다.

그런 다음 Secret 오브젝트를 생성하고 DataProtectionApplication CR(사용자 정의 리소스)에 프로필을 지정합니다.

절차

다음 예제와 같이 백업 및 스냅샷 위치에 대한 별도의 프로필이 있는

credentials-velero파일을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow credentials-velero파일을 사용하여Secret오브젝트를 생성합니다.oc create secret generic cloud-credentials -n openshift-adp --from-file cloud=credentials-velero

$ oc create secret generic cloud-credentials -n openshift-adp --from-file cloud=credentials-velero1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예제와 같이

DataProtectionApplicationCR에 프로필을 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.1.2.3. AWS를 사용하여 백업 스토리지 위치 구성

다음 예제 절차에 표시된 대로 AWS 백업 스토리지 위치(BSL)를 구성할 수 있습니다.

사전 요구 사항

- AWS를 사용하여 오브젝트 스토리지 버킷을 생성했습니다.

- OADP Operator가 설치되어 있습니다.

절차

사용 사례에 적용할 수 있는 값으로 BSL CR(사용자 정의 리소스)을 구성합니다.

백업 스토리지 위치

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1 1

- 오브젝트 저장소 플러그인의 이름입니다. 이 예제에서 플러그인은

aws입니다. 이 필드는 필수입니다. - 2

- 백업을 저장할 버킷의 이름입니다. 이 필드는 필수입니다.

- 3

- 백업을 저장할 버킷 내 접두사입니다. 이 필드는 선택 사항입니다.

- 4

- 백업 스토리지 위치에 대한 자격 증명입니다. 사용자 지정 인증 정보를 설정할 수 있습니다. 사용자 정의 인증 정보가 설정되지 않은 경우 기본 인증 정보의 시크릿이 사용됩니다.

- 5

- 시크릿 인증 정보 데이터 내의

키입니다. - 6

- 인증 정보가 포함된 시크릿의 이름입니다.

- 7

- 버킷이 있는 AWS 리전입니다. s3ForcePathStyle이 false인 경우 선택 사항입니다.

- 8

- 가상 호스트 버킷 주소 지정 대신 경로 스타일 주소 지정을 사용할지 여부를 결정하는 부울 플래그입니다. MinIO 또는 NooBaa와 같은 스토리지 서비스를 사용하는 경우

true로 설정합니다. 이 필드는 선택적 필드입니다. 기본값은false입니다. - 9

- 명시적성을 위해 AWS S3 URL을 지정할 수 있습니다. 이 필드는 주로 MinIO 또는 NooBaa와 같은 스토리지 서비스를 위한 것입니다. 이 필드는 선택적 필드입니다.

- 10

- 이 필드는 주로 MinIO 또는 NooBaa와 같은 스토리지 서비스에 사용됩니다. 이 필드는 선택적 필드입니다.

- 11

- 오브젝트 업로드에 사용할 서버 측 암호화 알고리즘의 이름입니다(예:

AES256). 이 필드는 선택적 필드입니다. - 12

- AWS KMS 키 ID를 지정합니다. 예제에 표시된 대로 별칭(예:

alias/<KMS-key-alias-name> ) 또는 전체ARN을 지정하여 S3에 저장된 백업의 암호화를 활성화할 수 있습니다.kmsKeyId는customerKeyEncryptionFile과 함께 사용할 수 없습니다. 이 필드는 선택적 필드입니다. - 13

SSE-C고객 키가 있는 파일을 지정하여 S3에 저장된 백업의 고객 키 암호화를 활성화합니다. 파일에는 32바이트 문자열이 포함되어야 합니다.customerKeyEncryptionFile필드는velero컨테이너 내에서 마운트된 시크릿을 가리킵니다.velerocloud-credentials시크릿에 다음 키-값 쌍을 추가합니다.customer-key: <your_b64_encoded_32byte_string>.customerKeyEncryptionFile필드는kmsKeyId필드와 함께 사용할 수 없습니다. 기본값은 빈 문자열("")이며 이는SSE-C가 비활성화되어 있습니다. 이 필드는 선택적 필드입니다.- 14

- 서명된 URL을 생성하는 데 사용되는 서명 알고리즘의 버전입니다. 서명된 URL을 사용하여 백업을 다운로드하거나 로그를 가져옵니다. 유효한 값은

1및4입니다. 기본 버전은4입니다. 이 필드는 선택적 필드입니다. - 15

- 인증 정보 파일에 있는 AWS 프로필의 이름입니다. 기본값은

default입니다. 이 필드는 선택적 필드입니다. - 16

- 오브젝트 저장소에 연결할 때 TLS 인증서를 확인하지 않으려면

insecureSkipTLSVerify필드를true로 설정합니다(예: MinIO를 사용한 자체 서명 인증서의 경우).true로 설정하는 것은 중간자 공격에 취약하며 프로덕션 워크로드에는 권장되지 않습니다. 기본값은false입니다. 이 필드는 선택적 필드입니다. - 17

- 인증 정보 파일을 공유 구성 파일로 로드하려면

enableSharedConfig필드를true로 설정합니다. 기본값은false입니다. 이 필드는 선택적 필드입니다. - 18

- AWS S3 오브젝트에 주석을 달 태그를 지정합니다. 키-값 쌍으로 태그를 지정합니다. 기본값은 빈 문자열(

"")입니다. 이 필드는 선택적 필드입니다. - 19

- 오브젝트를 S3에 업로드하는 데 사용할 체크섬 알고리즘을 지정합니다. 지원되는 값은 CRC32 ,

CRC32CSHA1,SHA256입니다. 필드를 빈 문자열("")으로 설정하면 체크섬 검사를 건너뜁니다. 기본값은CRC32입니다. 이 필드는 선택적 필드입니다.

4.7.1.2.4. 추가 데이터 보안을 위한 OADP SSE-C 암호화 키 생성

AWS(Amazon Web Services) S3는 Amazon S3 관리 키(SSE-S3)를 Amazon S3의 모든 버킷의 기본 암호화 수준으로 적용하여 서버 측 암호화를 적용합니다.

OADP(OpenShift API for Data Protection)는 클러스터에서 스토리지로 데이터를 전송할 때 SSL/TLS, HTTPS, velero-repo-credentials 시크릿을 사용하여 데이터를 암호화합니다. AWS 인증 정보가 손실되거나 도난된 경우 백업 데이터를 보호하려면 추가 암호화 계층을 적용합니다.

velero-plugin-for-aws 플러그인은 몇 가지 추가 암호화 방법을 제공합니다. 해당 구성 옵션을 검토하고 추가 암호화를 구현하는 것이 좋습니다.

SSE-C(고객 제공 키)와 함께 서버 측 암호화를 사용하여 고유한 암호화 키를 저장할 수 있습니다. 이 기능은 AWS 인증 정보가 노출되는 경우 추가 보안을 제공합니다.

암호화 키를 안전하고 안전한 방식으로 저장해야 합니다. 암호화 키가 없는 경우 암호화된 데이터 및 백업을 복구할 수 없습니다.

사전 요구 사항

OADP 마운트를

/credentials의 Velero pod에 포함하는 시크릿을 만들려면 cloud-credentials :cloud-credentials에 다음과 같은 기본 시크릿 이름을 사용하고 다음 라벨 중 하나를 비워 둡니다.-

dpa.spec.backupLocations[].velero.credential dpa.spec.snapshotLocations[].velero.credential다음은 알려진 문제에 대한 해결 방법입니다. https://issues.redhat.com/browse/OADP-3971.

-

다음 절차에는 인증 정보를 지정하지 않는 spec:backupLocations 블록의 예가 포함되어 있습니다. 이 예제에서는 OADP 시크릿 마운트를 트리거합니다.

-

cloud-credentials와 다른 이름으로 백업 위치가 필요한 경우 인증 정보 이름이 포함되지 않은 다음 예제의 스냅샷 위치를 추가해야 합니다. 예제에는 인증 정보 이름이 없기 때문에 스냅샷 위치는cloud-credentials를 스냅샷 생성의 시크릿으로 사용합니다.

인증 정보가 지정되지 않은 DPA의 스냅샷 위치 예

절차

SSE-C 암호화 키를 생성합니다.

임의의 번호를 생성하고 다음 명령을 실행하여

sse.key라는 파일로 저장합니다.dd if=/dev/urandom bs=1 count=32 > sse.key

$ dd if=/dev/urandom bs=1 count=32 > sse.keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow Base64를 사용하여

sse.key를 인코딩하고 다음 명령을 실행하여 결과를sse_encoded.key라는 파일로 저장합니다.cat sse.key | base64 > sse_encoded.key

$ cat sse.key | base64 > sse_encoded.keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

sse_encoded.key라는 파일을customer-key라는 새 파일에 연결합니다.ln -s sse_encoded.key customer-key

$ ln -s sse_encoded.key customer-keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

OpenShift Container Platform 시크릿을 생성합니다.

처음에 OADP를 설치하고 구성하는 경우 다음 명령을 실행하여 AWS 인증 정보 및 암호화 키 시크릿을 동시에 생성합니다.

oc create secret generic cloud-credentials --namespace openshift-adp --from-file cloud=<path>/openshift_aws_credentials,customer-key=<path>/sse_encoded.key

$ oc create secret generic cloud-credentials --namespace openshift-adp --from-file cloud=<path>/openshift_aws_credentials,customer-key=<path>/sse_encoded.keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기존 설치를 업데이트하는 경우 다음 예와 같이

DataProtectionApplicationCR 매니페스트의cloud-credential시크릿블록 값을 편집합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

다음 예제와 같이

DataProtectionApplicationCR 매니페스트의backupLocations블록에서customerKeyEncryptionFile속성 값을 편집합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 주의기존 설치에서 시크릿 인증 정보를 올바르게 마운트하려면 Velero 포드를 다시 시작해야 합니다.

설치가 완료되었으며 OpenShift Container Platform 리소스를 백업하고 복원할 수 있습니다. AWS S3 스토리지에 저장된 데이터는 새 키로 암호화되며 추가 암호화 키 없이는 AWS S3 콘솔 또는 API에서 다운로드할 수 없습니다.

검증

추가 키를 포함하지 않고 암호화된 파일을 다운로드할 수 없는지 확인하려면 테스트 파일을 만들고 업로드한 다음 다운로드하려고 합니다.

다음 명령을 실행하여 테스트 파일을 생성합니다.

echo "encrypt me please" > test.txt

$ echo "encrypt me please" > test.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 테스트 파일을 업로드합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 다운로드해 보십시오. Amazon 웹 콘솔 또는 터미널에서 다음 명령을 실행합니다.

s3cmd get s3://<bucket>/test.txt test.txt

$ s3cmd get s3://<bucket>/test.txt test.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 파일이 추가 키로 암호화되므로 다운로드에 실패합니다.

다음 명령을 실행하여 추가 암호화 키로 파일을 다운로드합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 파일 내용을 읽습니다.

cat downloaded.txt

$ cat downloaded.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

encrypt me please

encrypt me pleaseCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.1.2.4.1. Velero에서 지원하는 파일의 SSE-C 암호화 키로 파일 다운로드

SSE-C 암호화 키를 확인하는 경우 Velcro로 백업된 파일의 추가 암호화 키로 파일을 다운로드할 수도 있습니다.

절차

- 다음 명령을 실행하여 Velero에서 백업한 파일의 추가 암호화 키로 파일을 다운로드합니다.

4.7.1.3. 데이터 보호 애플리케이션 구성

Velero 리소스 할당을 설정하거나 자체 서명된 CA 인증서를 활성화하여 데이터 보호 애플리케이션을 구성할 수 있습니다.

4.7.1.3.1. Velero CPU 및 메모리 리소스 할당 설정

DataProtectionApplication CR(사용자 정의 리소스) 매니페스트를 편집하여 Velero Pod에 대한 CPU 및 메모리 리소스 할당을 설정합니다.

사전 요구 사항

- OADP(Data Protection) Operator가 설치되어 있어야 합니다.

절차

다음 예제와 같이

DataProtectionApplicationCR 매니페스트의spec.configuration.velero.podConfig.ResourceAllocations블록의 값을 편집합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Kopia는 OADP 1.3 이상 릴리스에서 옵션입니다. Kopia를 파일 시스템 백업에 사용할 수 있으며, Kopia는 기본 제공 Data Mover 사례에서만 사용할 수 있습니다.

Kopia는 Restic보다 리소스 집약적이므로 그에 따라 CPU 및 메모리 요구 사항을 조정해야 할 수 있습니다.

nodeSelector 필드를 사용하여 노드 에이전트를 실행할 수 있는 노드를 선택합니다. nodeSelector 필드는 권장되는 노드 선택 제약 조건의 가장 간단한 형식입니다. 지정된 라벨은 각 노드의 라벨과 일치해야 합니다.

자세한 내용은 노드 에이전트 및 노드 라벨 구성을 참조하십시오.

4.7.1.3.2. 자체 서명된 CA 인증서 활성화

알 수 없는 기관 오류로 서명된 인증서를 방지하려면 활성화해야 합니다.

DataProtectionApplication CR(사용자 정의 리소스) 매니페스트를 편집하여 오브젝트 스토리지에 자체 서명된 CA 인증서를

사전 요구 사항

- OADP(Data Protection) Operator가 설치되어 있어야 합니다.

절차

DataProtectionApplicationCR 매니페스트의spec.backupLocations.velero.objectStorage.caCert매개변수 및spec.backupLocations.velero.config매개변수를 편집합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.1.3.2.1. Velero 배포에 별칭이 지정된 velero 명령과 함께 CA 인증서 사용

별칭을 생성하여 시스템에 로컬로 설치하지 않고 Velero CLI를 사용할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 OpenShift Container Platform 클러스터에 로그인해야 합니다. OpenShift CLI(

oc)가 설치되어 있어야 합니다.aliased Velero 명령을 사용하려면 다음 명령을 실행합니다.

alias velero='oc -n openshift-adp exec deployment/velero -c velero -it -- ./velero'

$ alias velero='oc -n openshift-adp exec deployment/velero -c velero -it -- ./velero'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 별칭이 작동하는지 확인합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령으로 CA 인증서를 사용하려면 다음 명령을 실행하여 Velero 배포에 인증서를 추가할 수 있습니다.

CA_CERT=$(oc -n openshift-adp get dataprotectionapplications.oadp.openshift.io <dpa-name> -o jsonpath='{.spec.backupLocations[0].velero.objectStorage.caCert}') [[ -n $CA_CERT ]] && echo "$CA_CERT" | base64 -d | oc exec -n openshift-adp -i deploy/velero -c velero -- bash -c "cat > /tmp/your-cacert.txt" || echo "DPA BSL has no caCert"$ CA_CERT=$(oc -n openshift-adp get dataprotectionapplications.oadp.openshift.io <dpa-name> -o jsonpath='{.spec.backupLocations[0].velero.objectStorage.caCert}') $ [[ -n $CA_CERT ]] && echo "$CA_CERT" | base64 -d | oc exec -n openshift-adp -i deploy/velero -c velero -- bash -c "cat > /tmp/your-cacert.txt" || echo "DPA BSL has no caCert"Copy to Clipboard Copied! Toggle word wrap Toggle overflow velero describe backup <backup_name> --details --cacert /tmp/<your_cacert>.txt

$ velero describe backup <backup_name> --details --cacert /tmp/<your_cacert>.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 백업 로그를 가져오려면 다음 명령을 실행합니다.

velero backup logs <backup_name> --cacert /tmp/<your_cacert.txt>

$ velero backup logs <backup_name> --cacert /tmp/<your_cacert.txt>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이러한 로그를 사용하여 백업할 수 없는 리소스에 대한 오류 및 경고를 볼 수 있습니다.

-

Velero 포드가 다시 시작되면

/tmp/your-cacert.txt파일이 사라지고 이전 단계의 명령을 다시 실행하여/tmp/your-cacert.txt파일을 다시 생성해야 합니다. 다음 명령을 실행하여

/tmp/your-cacert.txt파일이 여전히 있는지 확인할 수 있습니다.oc exec -n openshift-adp -i deploy/velero -c velero -- bash -c "ls /tmp/your-cacert.txt" /tmp/your-cacert.txt

$ oc exec -n openshift-adp -i deploy/velero -c velero -- bash -c "ls /tmp/your-cacert.txt" /tmp/your-cacert.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow

향후 OpenShift API for Data Protection(OADP) 릴리스에서는 이 단계가 필요하지 않도록 Velero 포드에 인증서를 마운트할 계획입니다.

4.7.1.4. 데이터 보호 애플리케이션 설치

DataProtectionApplication API의 인스턴스를 생성하여 DPA( Data Protection Application )를 설치합니다.

사전 요구 사항

- OADP Operator를 설치해야 합니다.

- 오브젝트 스토리지를 백업 위치로 구성해야 합니다.

- 스냅샷을 사용하여 PV를 백업하는 경우 클라우드 공급자는 기본 스냅샷 API 또는 CSI(Container Storage Interface) 스냅샷을 지원해야 합니다.

-

백업 및 스냅샷 위치에서 동일한 자격 증명을 사용하는 경우 기본 이름