Hosted Control Plane

OpenShift Container Platform で Hosted Control Plane を使用する

概要

第1章 Hosted Control Plane のリリースノート

リリースノートには、新機能、非推奨機能、変更、既知の問題に関する情報が記載されています。

1.1. OpenShift Container Platform 4.17 用の Hosted Control Plane のリリースノート

このリリースでは、OpenShift Container Platform 4.17 用の Hosted Control Plane が利用可能になりました。OpenShift Container Platform 4.17 用の Hosted Control Plane は、multicluster engine for Kubernetes Operator バージョン 2.7 をサポートしています。

1.1.1. 新機能および機能拡張

今回のリリースでは、以下の概念に関連する拡張機能が追加されました。

1.1.1.1. カスタムの taint と toleration (テクノロジープレビュー)

hcp CLI -tolerations 引数を使用するか、hc.Spec.Tolerations API ファイルを使用して、容認をホステッドコントロールプレーン Pod に適用できるようになりました。この機能は、テクノロジープレビューとしてのみ利用できます。詳細は、カスタムの taint および toleration を参照してください。

1.1.1.2. OpenShift Virtualization における NVIDIA GPU デバイスのサポート (テクノロジープレビュー)

OpenShift Virtualization の Hosted Control Plane では、1 つ以上の NVIDIA グラフィックスプロセッシングユニット (GPU) デバイスをノードプールにアタッチできます。この機能は、テクノロジープレビューとしてのみ利用できます。詳細は、hcp CLI を使用して NVIDIA GPU デバイスをアタッチする および NodePool リソースを使用して NVIDIA GPU デバイスをアタッチする を参照してください。

1.1.1.3. AWS におけるテナンシーのサポート

AWS でホステッドクラスターを作成するときに、EC2 インスタンスを共有ハードウェアで実行するか、シングルテナントハードウェアで実行するかを指定できます。詳細は、AWS 上にホステッドクラスターを作成する を参照してください。

1.1.1.4. ホステッドクラスターでの OpenShift Container Platform バージョンのサポート

ホステッドクラスターに、サポートされているさまざまな OpenShift Container Platform バージョンをデプロイできます。詳細は、ホステッドクラスターでサポートされている OpenShift Container Platform バージョン を参照してください。

1.1.1.5. 非接続環境における OpenShift Virtualization の Hosted Control Plane の一般提供を開始

このリリースでは、非接続環境における OpenShift Virtualization の Hosted Control Plane が一般提供されます。詳細は、非接続環境で OpenShift Virtualization に Hosted Control Plane をデプロイする を参照してください。

1.1.1.6. AWS における ARM64 OpenShift Container Platform クラスターの Hosted Control Plane の一般提供を開始

このリリースでは、AWS における ARM64 OpenShift Container Platform クラスターの Hosted Control Plane が一般提供されます。詳細は、ARM64 アーキテクチャーでのホステッドクラスターの実行 を参照してください。

1.1.1.7. IBM Z における Hosted Control Plane の一般提供を開始

このリリースでは、IBM Z 上の Hosted Control Plane が一般提供されます。詳細は、IBM Z への Hosted Control Plane のデプロイ を参照してください。

1.1.1.8. IBM Power における Hosted Control Plane の一般提供を開始

このリリースでは、IBM Power 上の Hosted Control Plane が一般提供されます。詳細は、IBM Power への Hosted Control Plane のデプロイ を参照してください。

1.1.2. バグ修正

-

以前は、ホストされたクラスタープロキシーが設定され、HTTP または HTTPS エンドポイントを持つアイデンティティープロバイダー (IDP) が使用されていた場合、プロキシー経由で送信される前に IDP のホスト名が解決されませんでした。その結果、データプレーンでのみ解決できるホスト名は IDP では解決できませんでした。この更新により、IPD トラフィックを

konnectivityトンネル経由で送信する前に DNS ルックアップが実行されます。その結果、データプレーンでのみ解決できるホスト名を持つ IDP は、Control Plane Operator によって検証できるようになります。(OCPBUGS-41371) -

以前は、ホストされたクラスターの

controllerAvailabilityPolicyがSingleReplicaに設定されていた場合、ネットワークコンポーネント上のpodAntiAffinityによってコンポーネントの可用性がブロックされていました。このリリースにより、この問題は解決されました。(OCPBUGS-39313) -

以前は、ホストされたクラスターイメージ設定で指定された

AddedTrustedCAは、image-registry-Operatorによって期待されたとおりにopenshift-confignamespace に調整されず、コンポーネントは利用できませんでした。このリリースにより、この問題は解決されました。(OCPBUGS-39225) - 以前は、コアオペレーティングシステムの変更により、Red Hat HyperShift の定期的な適合ジョブが失敗していました。この失敗したジョブにより、OpenShift API のデプロイメントが失敗していました。このリリースでは、更新時に 1 つのファイルがコピーされるのではなく、個々の信頼済み認証局 (CA) 証明書が再帰的にコピーされるため、定期的な適合ジョブが成功し、OpenShift API が期待どおりに実行されます。(OCPBUGS-38941)

-

以前は、ホストされたクラスター内の Konnectivity プロキシーエージェントは常にすべての TCP トラフィックを HTTP/S プロキシー経由で送信していました。また、トラフィックでは解決された IP アドレスのみ受信するため、

NO_PROXY設定のホスト名も無視されました。その結果、LDAP トラフィックなどのプロキシーされることを意図していないトラフィックが、設定に関係なくプロキシーされました。このリリースでは、プロキシーはソース (コントロールプレーン) で完了し、Konnectivity エージェントのプロキシー設定が削除されました。その結果、LDAP トラフィックなどのプロキシーされることを意図していないトラフィックはプロキシーされなくなります。ホスト名を含むNO_PROXY設定は尊重されます。(OCPBUGS-38637) -

以前は、

azure-disk-csi-driver-controllerイメージは、registryOverrideを使用するときに適切なオーバーライド値を取得しませんでした。これは、値がazure-disk-csi-driverデータプレーンイメージに伝播されるのを避けるため、意図的に行われたものです。この更新では、別のイメージオーバーライド値を追加することで問題が解決されました。その結果、azure-disk-csi-driver-controllerがregistryOverrideで使用できるようになり、azure-disk-csi-driverデータプレーンイメージに影響を与えなくなりました。(OCPBUGS-38183) - 以前は、プロキシー管理クラスター上で実行されていた Hosted Control Plane 内の AWS クラウドコントローラーマネージャーは、クラウド API 通信にプロキシーを使用しませんでした。このリリースにより、この問題は修正されました。(OCPBUGS-37832)

以前は、ホストされたクラスターのコントロールプレーンで実行される Operator のプロキシーが、データプレーンで実行される konnectivity エージェント Pod のプロキシー設定によって実行されていました。アプリケーションプロトコルに基づいてプロキシーが必要かどうかを区別することはできませんでした。

OpenShift Container Platform との互換性を保つために、HTTPS または HTTP 経由の IDP 通信はプロキシーする必要がありますが、LDAP 通信はプロキシーする必要ありません。このタイプのプロキシーでは、トラフィックが Konnectivity エージェントに到達するまでに宛先 IP アドレスのみ使用可能になるため、ホスト名に依存する

NO_PROXYエントリーも無視されます。このリリースでは、ホステッドクラスターでのプロキシーはコントロールプレーンで

konnectivity-https-proxyおよびkonnectivity-socks5-proxyを介して呼び出され、Konnectivity エージェントからのプロキシートラフィックが停止されます。その結果、LDAP サーバー宛のトラフィックはプロキシーされなくなります。その他の HTTPS または HTTPS トラフィックは正しくプロキシーされます。ホスト名を指定すると、NO_PROXY設定が適用されます。(OCPBUGS-37052)以前は、IDP 通信のプロキシーが Konnectivity エージェントで行われていました。トラフィックが Konnectivity に到達するまでに、そのプロトコルとホスト名が利用できなくなっていました。その結果、OAUTH サーバー Pod のプロキシーが正しく実行されていませんでした。プロキシーを必要とするプロトコル (

http/s) とプロキシーを必要としないプロトコル (ldap://) が区別されていませんでした。さらに、HostedCluster.spec.configuration.proxy仕様で設定されているno_proxy変数が考慮されませんでした。このリリースでは、OAUTH サーバーの Konnectivity サイドカーでプロキシーを設定することにより、

no_proxy設定を考慮しながら、トラフィックを適切にルーティングできるようになりました。その結果、ホストされたクラスターにプロキシーが設定されている場合、OAUTH サーバーがアイデンティティープロバイダーと適切に通信できるようになりました。(OCPBUGS-36932)-

以前は、Hosted Cluster Config Operator (HCCO) は、

HostedClusterオブジェクトからImageContentSourcesフィールドを削除した後、ImageDigestMirrorSetCR (IDMS) を削除しませんでした。その結果、IDMS は、本来は保持されるべきではないにもかかわらず、HostedClusterオブジェクトに保持されていました。このリリースでは、HCCO はHostedClusterオブジェクトからの IDMS リソースの削除を管理します。(OCPBUGS-34820) -

以前は、非接続環境に

hostedClusterをデプロイするには、hypershift.openshift.io/control-plane-operator-imageアノテーションを設定する必要がありました。この更新により、アノテーションは不要になりました。さらに、メタデータインスペクターはホストされた Operator の調整中に期待どおりに機能し、OverrideImagesは期待どおりに設定されます。(OCPBUGS-34734) - 以前は、AWS 上のホストされたクラスターは、VPC のプライマリー CIDR 範囲を活用して、データプレーン上でセキュリティーグループルールを生成していました。その結果、複数の CIDR 範囲を持つ AWS VPC にホストされたクラスターをインストールした場合、生成されたセキュリティーグループルールでは不十分な可能性がありました。この更新により、提供された Machine CIDR 範囲に基づいてセキュリティーグループルールが生成され、この問題が解決されます。(OCPBUGS-34274)

- 以前は、OpenShift Cluster Manager コンテナーには適切な TLS 証明書がありませんでした。その結果、接続されていないデプロイメントではイメージストリームを使用できませんでした。このリリースでは、この問題を解決するために、TLS 証明書が projected ボリュームとして追加されました。(OCPBUGS-31446)

- 以前は、OpenShift Virtualization における multicluster engine for Kubernetes Operator コンソールの一括破棄オプションでは、ホステッドクラスターが破棄されませんでした。このリリースでは、この問題は解決されました。(ACM-10165)

-

以前は、Hosted Control Plane クラスター設定の

additionalTrustBundleパラメーターを更新しても、コンピュートノードに適用されませんでした。このリリースでは、additionalTrustBundleパラメーターの更新が Hosted Control Plane クラスター内に存在するコンピュートノードに自動的に適用されるように修正されました。この修正を含むバージョンに更新すると、バンドルの選択に既存ノードの自動ロールアウトが行われます。(OCPBUGS-36680)

1.1.3. 既知の問題

-

アノテーションと

ManagedClusterリソース名が一致しない場合、multicluster engine for Kubernetes Operator コンソールにはクラスターの状態がPending importとして表示されます。このようなクラスターは、multicluster engine Operator で使用できません。アノテーションがなく、ManagedCluster名がHostedClusterリソースのInfra-ID値と一致しない場合も、同じ問題が発生します。 - multicluster engine for Kubernetes Operator コンソールを使用して、既存のホステッドクラスターに新しいノードプールを追加すると、オプションのリストに同じバージョンの OpenShift Container Platform が複数回表示される場合があります。必要なバージョンの一覧で任意のインスタンスを選択できます。

ノードプールが 0 ワーカーにスケールダウンされても、コンソールのホストのリストには、

Ready状態のノードが表示されます。ノードの数は、次の 2 つの方法で確認できます。- コンソールでノードプールに移動し、ノードが 0 であることを確認します。

コマンドラインインターフェイスで、以下のコマンドを実行します。

次のコマンドを実行して、ノードプールにあるノード数が 0 個であることを確認します。

oc get nodepool -A

$ oc get nodepool -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、クラスター内にあるノード数が 0 個であることを確認します。

oc get nodes --kubeconfig

$ oc get nodes --kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、クラスターにバインドされているエージェント数が 0 と報告されていることを確認します。

oc get agents -A

$ oc get agents -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow

デュアルスタックネットワークを使用する環境でホステッドクラスターを作成すると、次の DNS 関連の問題が発生する可能性があります。

-

service-ca-operatorPod のCrashLoopBackOff状態: Pod が Hosted Control Plane 経由で Kubernetes API サーバーに到達しようとすると、kube-systemnamespace のデータプレーンプロキシーがリクエストを解決できないため、Pod はサーバーに到達できません。この問題は、HAProxy セットアップでフロントエンドが IP アドレスを使用し、バックエンドが Pod が解決できない DNS 名を使用するために発生します。 -

Pod が

ContainerCreating状態でスタックする: この問題は、openshift-service-ca-operatorが DNS Pod が DNS 解決に必要とするmetrics-tlsシークレットを生成できないために発生します。その結果、Pod は Kubernetes API サーバーを解決できません。これらの問題を解決するには、デュアルスタックネットワークの DNS サーバー設定を行います。

-

-

エージェントプラットフォームでは、Hosted Control Plane 機能により、エージェントがイグニションのプルに使用するトークンが定期的にローテーションされます。その結果、少し前に作成されたエージェントリソースがある場合、Ignition のプルに失敗する可能性があります。回避策として、エージェント仕様で

IgnitionEndpointTokenReferenceプロパティーのシークレットを削除し、その後にエージェントリソースのラベルを追加または変更します。システムは新しいトークンを使用してシークレットを再作成します。 ホステッドクラスターをそのマネージドクラスターと同じ namespace に作成した場合、マネージドホステッドクラスターをデタッチすると、ホステッドクラスターが含まれるマネージドクラスター namespace 内のすべてが削除されます。次の状況では、マネージドクラスターと同じ namespace にホステッドクラスターが作成される可能性があります。

- デフォルトのホステッドクラスターのクラスター namespace を使用し、multicluster engine for Kubernetes Operator のコンソールを介して Agent プラットフォーム上にホステッドクラスターを作成した場合。

- ホステッドクラスターの namespace をホステッドクラスターの名前と同じになるよう指定して、コマンドラインインターフェイスまたは API を介してホステッドクラスターを作成した場合。

ホストされた新しいクラスターに対してクラスター全体のプロキシーを設定した場合、クラスター全体のプロキシーが設定されているとワーカーノードが Kubernetes API サーバーに到達できないため、そのクラスターのデプロイメントが失敗する可能性があります。この問題を解決するには、ホストされたクラスターの設定ファイルで、

noProxyフィールドに次のいずれかの情報を追加して、データプレーンから Kubernetes API サーバーへのトラフィックがプロキシーをスキップするようにします。- 外部 API アドレス。

-

内部 API アドレス。デフォルトは

172.20.0.1です。 -

kubernetesというフレーズ。 - サービスネットワーク CIDR。

- クラスターネットワーク CIDR。

1.1.4. 一般提供およびテクノロジープレビュー機能

一般提供 (GA) の機能は完全にサポートされており、実稼働での使用に適しています。テクノロジープレビュー (TP) 機能は実験的な機能であり、本番環境での使用を目的としたものではありません。TP 機能の詳細は、Red Hat Customer Portal のテクノロジープレビュー機能のサポート範囲 を参照してください。

IBM Power および IBM Z の場合、コントロールプレーンは 64 ビット x86 アーキテクチャーベースのマシンタイプで実行し、ノードプールは IBM Power または IBM Z で実行する必要があります。

Hosted Control Plane の GA 機能および TP 機能は、次の表を参照してください。

| 機能 | 4.15 | 4.16 | 4.17 |

|---|---|---|---|

| Amazon Web Services (AWS) 上の OpenShift Container Platform の Hosted Control Plane | テクノロジープレビュー | 一般提供 | 一般提供 |

| ベアメタル上の OpenShift Container Platform の Hosted Control Plane | 一般提供 | 一般提供 | 一般提供 |

| OpenShift Virtualization 上の OpenShift Container Platform の Hosted Control Plane | 一般提供 | 一般提供 | 一般提供 |

| 非ベアメタルエージェントマシンを使用した OpenShift Container Platform の Hosted Control Plane | テクノロジープレビュー | テクノロジープレビュー | テクノロジープレビュー |

| Amazon Web Services 上の ARM64 OpenShift Container Platform クラスター用の Hosted Control Plane | テクノロジープレビュー | テクノロジープレビュー | 一般提供 |

| IBM Power 上の OpenShift Container Platform の Hosted Control Plane | テクノロジープレビュー | テクノロジープレビュー | 一般提供 |

| IBM Z 上の OpenShift Container Platform の Hosted Control Plane | テクノロジープレビュー | テクノロジープレビュー | 一般提供 |

| RHOSP 上の OpenShift Container Platform の Hosted Control Plane | 利用不可 | 利用不可 | 開発者プレビュー |

第2章 Hosted Control Plane の概要

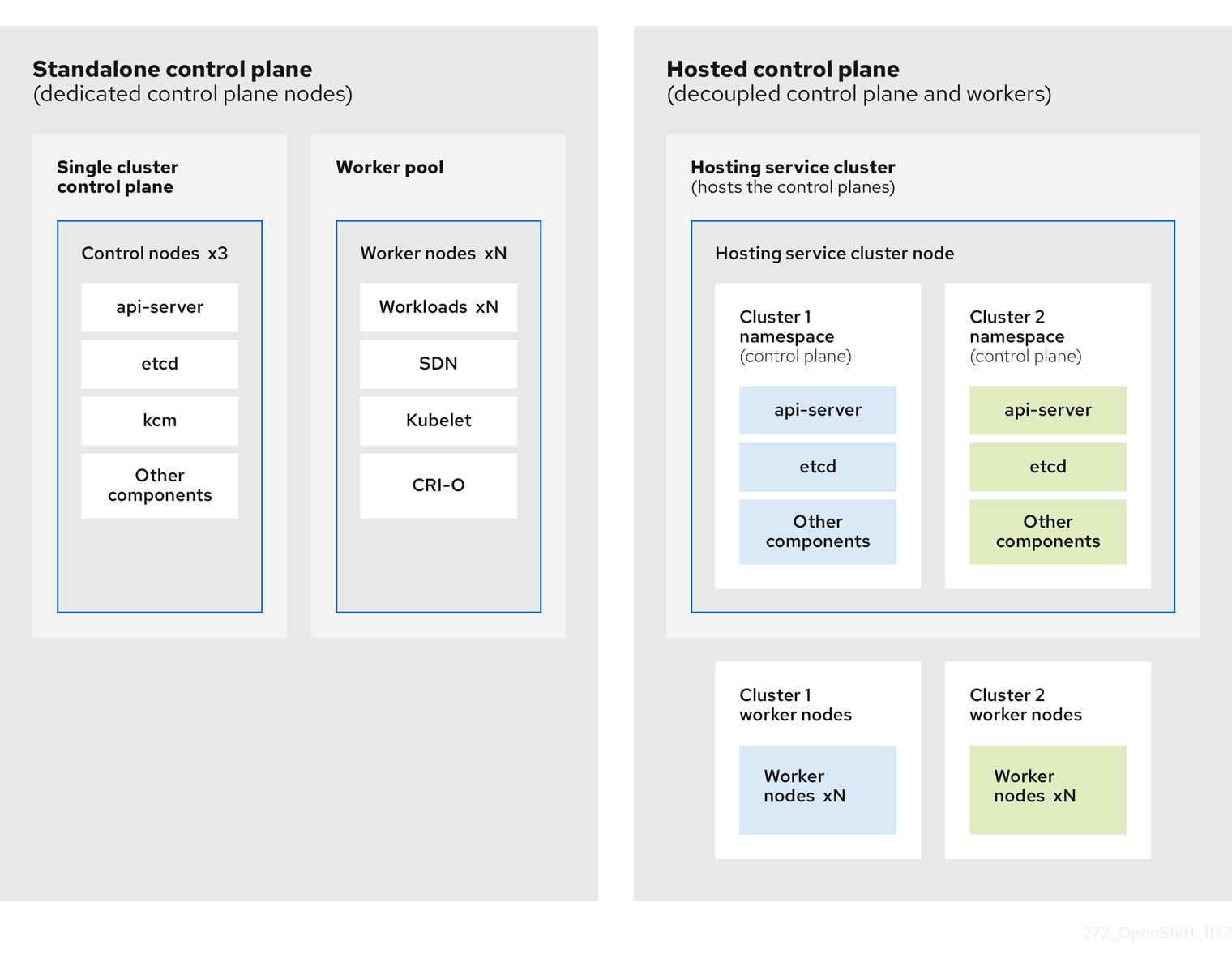

OpenShift Container Platform クラスターは、スタンドアロンまたは Hosted Control Plane という 2 つの異なるコントロールプレーン設定を使用してデプロイできます。スタンドアロン設定では、専用の仮想マシンまたは物理マシンを使用してコントロールプレーンをホストします。OpenShift Container Platform の Hosted Control Plane を使用すると、各コントロールプレーンに専用の仮想マシンまたは物理マシンを用意する必要なく、管理クラスター上の Pod としてコントロールプレーンを作成できます。

2.1. Hosted Control Plane の概要

Hosted Control Plane は、次のプラットフォームで サポートされているバージョンの multicluster engine for Kubernetes Operator を使用することで利用できます。

- Agent プロバイダーを使用したベアメタル

- 非ベアメタルエージェントマシン (テクノロジープレビュー機能)

- OpenShift Virtualization

- Amazon Web Services (AWS)

- IBM Z

- IBM Power

Hosted Control Plane 機能はデフォルトで有効になっています。

multicluster engine Operator は Red Hat Advanced Cluster Management (RHACM) の不可欠な要素であり、RHACM ではデフォルトで有効になっています。ただし、Hosted Control Plane を使用するのに RHACM は必要ありません。

2.1.1. Hosted Control Plane のアーキテクチャー

OpenShift Container Platform は、多くの場合、クラスターがコントロールプレーンとデータプレーンで構成される結合モデルまたはスタンドアロンモデルでデプロイされます。コントロールプレーンには、API エンドポイント、ストレージエンドポイント、ワークロードスケジューラー、および状態を保証するアクチュエーターが含まれます。データプレーンには、ワークロードとアプリケーションが実行されるコンピュート、ストレージ、およびネットワークが含まれます。

スタンドアロンコントロールプレーンは、クォーラムを確保できる最小限の数で、物理または仮想のノードの専用グループによってホストされます。ネットワークスタックは共有されます。クラスターへの管理者アクセスにより、クラスターのコントロールプレーン、マシン管理 API、およびクラスターの状態に影響を与える他のコンポーネントを可視化できます。

スタンドアロンモデルは正常に機能しますが、状況によっては、コントロールプレーンとデータプレーンが分離されたアーキテクチャーが必要になります。そのような場合には、データプレーンは、専用の物理ホスティング環境がある別のネットワークドメインに配置されています。コントロールプレーンは、Kubernetes にネイティブなデプロイやステートフルセットなど、高レベルのプリミティブを使用してホストされます。コントロールプレーンは、他のワークロードと同様に扱われます。

2.1.2. Hosted Control Plane の利点

Hosted Control Plane を使用すると、真のハイブリッドクラウドアプローチへの道が開かれ、その他のさまざまなメリットも享受できます。

- コントロールプレーンが分離され、専用のホスティングサービスクラスターでホストされるため、管理とワークロードの間のセキュリティー境界が強化されます。その結果、クラスターのクレデンシャルが他のユーザーに漏洩する可能性が低くなります。インフラストラクチャーのシークレットアカウント管理も分離されているため、クラスターインフラストラクチャーの管理者が誤ってコントロールプレーンインフラストラクチャーを削除することはありません。

- Hosted Control Plane を使用すると、より少ないノードで多数のコントロールプレーンを実行できます。その結果、クラスターはより安価になります。

- コントロールプレーンは OpenShift Container Platform で起動される Pod で構成されるため、コントロールプレーンはすぐに起動します。同じ原則が、モニタリング、ロギング、自動スケーリングなどのコントロールプレーンとワークロードに適用されます。

- インフラストラクチャーの観点からは、レジストリー、HAProxy、クラスター監視、ストレージノードなどのインフラストラクチャーをテナントのクラウドプロバイダーのアカウントにプッシュして、テナントでの使用を分離できます。

- 運用上の観点からは、マルチクラスター管理はさらに集約され、クラスターの状態と一貫性に影響を与える外部要因が少なくなります。Site Reliability Engineer は、一箇所で問題をデバッグしてクラスターのデータプレーンに移動できるため、解決までの時間 (TTR) が短縮され、生産性が向上します。

2.2. Hosted Control Plane と OpenShift Container Platform の違い

Hosted Control Plane は、OpenShift Container Platform の 1 つのフォームファクターです。ホステッドクラスターとスタンドアロンの OpenShift Container Platform クラスターは、設定と管理が異なります。OpenShift Container Platform と Hosted Control Plane の違いを理解するには、次の表を参照してください。

2.2.1. クラスターの作成とライフサイクル

| OpenShift Container Platform | Hosted Control Plane |

|---|---|

|

|

既存の OpenShift Container Platform クラスターに、 |

2.2.2. Cluster configuration

| OpenShift Container Platform | Hosted Control Plane |

|---|---|

|

|

コントロールプレーンに影響するリソースを、 |

2.2.3. etcd 暗号化

| OpenShift Container Platform | Hosted Control Plane |

|---|---|

|

|

|

2.2.4. Operator とコントロールプレーン

| OpenShift Container Platform | Hosted Control Plane |

|---|---|

| スタンドアロンの OpenShift Container Platform クラスターには、コントロールプレーンコンポーネントごとに個別の Operator が含まれています。 | ホステッドクラスターには、管理クラスターの Hosted Control Plane の namespace で実行される Control Plane Operator という名前の単一の Operator が含まれています。 |

| etcd は、コントロールプレーンノードにマウントされたストレージを使用します。etcd のクラスター Operator が etcd を管理します。 | etcd は、ストレージに永続ボリューム要求を使用し、Control Plane Operator によって管理されます。 |

| Ingress Operator、ネットワーク関連の Operator、および Operator Lifecycle Manager (OLM) は、クラスター上で実行されます。 | Ingress Operator、ネットワーク関連の Operator、および Operator Lifecycle Manager (OLM) は、管理クラスターの Hosted Control Plane の namespace で実行されます。 |

| OAuth サーバーは、クラスター内で実行され、クラスター内のルートを通じて公開されます。 | OAuth サーバーは、コントロールプレーン内で実行され、管理クラスター上のルート、ノードポート、またはロードバランサーを通じて公開されます。 |

2.2.5. 更新

| OpenShift Container Platform | Hosted Control Plane |

|---|---|

|

Cluster Version Operator (CVO) が更新プロセスをオーケストレーションし、 |

Hosted Control Plane を更新すると、 |

| OpenShift Container Platform クラスターを更新すると、コントロールプレーンとコンピュートマシンの両方が更新されます。 | ホステッドクラスターを更新すると、コントロールプレーンのみが更新されます。ノードプールの更新は個別に実行します。 |

2.2.6. マシンの設定と管理

| OpenShift Container Platform | Hosted Control Plane |

|---|---|

|

|

|

| コントロールプレーンマシンのセットが利用可能です。 | コントロールプレーンマシンのセットが存在しません。 |

|

|

|

|

|

|

| マシンとマシンセットがクラスター内で公開されます。 | アップストリームの Cluster CAPI Operator からのマシン、マシンセット、およびマシンデプロイメントが、マシンを管理するために使用されます。ただし、これらはユーザーには公開されません。 |

| クラスターを更新すると、すべてのマシンセットが自動的にアップグレードされます。 | ホステッドクラスターの更新とは別にノードプールを更新します。 |

| インプレースアップグレードだけがクラスターでサポートされています。 | 置換アップグレードとインプレースアップグレードの両方が、ホステッドクラスターでサポートされています。 |

| Machine Config Operator がマシンの設定を管理します。 | Hosted Control Plane には Machine Config Operator が存在しません。 |

|

|

|

| Machine Config Daemon (MCD) が各ノードの設定の変更と更新を管理します。 | インプレースアップグレードの場合、ノードプールコントローラーが、一度だけ実行され、設定に基づいてマシンを更新する Pod を作成します。 |

| SR-IOV Operator などのマシン設定リソースを変更できます。 | マシン設定リソースを変更することはできません。 |

2.2.7. ネットワーク

| OpenShift Container Platform | Hosted Control Plane |

|---|---|

| Kube API サーバーとノードが同じ Virtual Private Cloud (VPC) 内に存在するため、Kube API サーバーはノードと直接通信します。 | Kube API サーバーは Konnectivity を介してノードと通信します。Kube API サーバーとノードは、別々の Virtual Private Cloud (VPC) 内に存在します。 |

| ノードは内部ロードバランサーを介して Kube API サーバーと通信します。 | ノードは外部ロードバランサーまたはノードポートを介して Kube API サーバーと通信します。 |

2.2.8. Web コンソール

| OpenShift Container Platform | Hosted Control Plane |

|---|---|

| Web コンソールにコントロールプレーンのステータスが表示されます。 | Web コンソールにコントロールプレーンのステータスが表示されません。 |

| Web コンソールを使用してクラスターを更新できます。 | Web コンソールを使用してホステッドクラスターを更新することはできません。 |

| Web コンソールにマシンなどのインフラストラクチャーリソースが表示されます。 | Web コンソールにインフラストラクチャーリソースが表示されません。 |

|

Web コンソールを使用して、 | Web コンソールを使用してマシンを設定することはできません。 |

2.3. Hosted Control Plane、multicluster engine Operator、および RHACM の関係

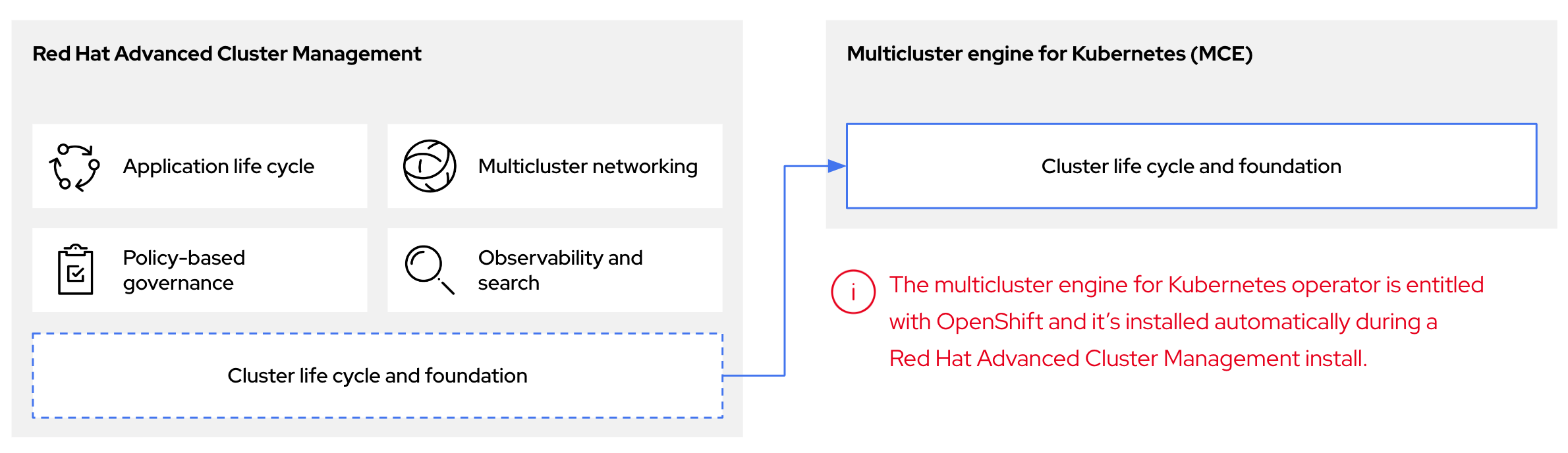

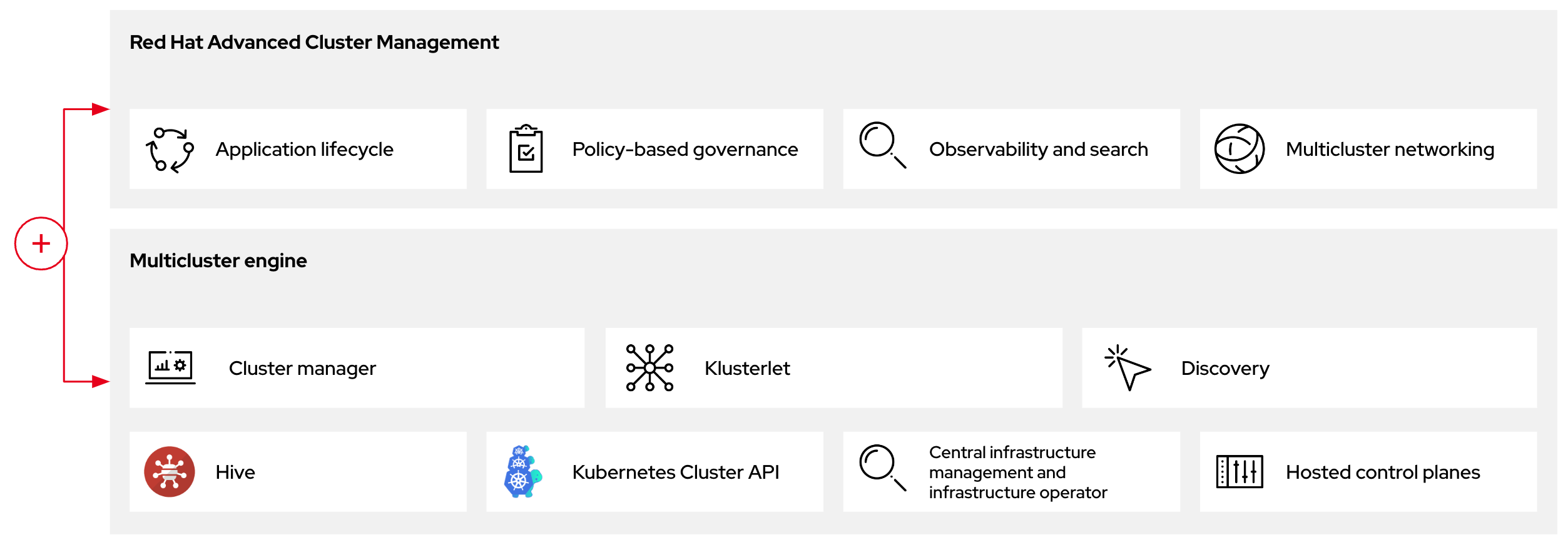

Hosted Control Plane は、multicluster engine for Kubernetes Operator を使用して設定できます。multicluster engine Operator のクラスターライフサイクルにより、さまざまなインフラストラクチャークラウドプロバイダー、プライベートクラウド、オンプレミスデータセンターにおける Kubernetes クラスターの作成、インポート、管理、破棄のプロセスが定義されます。

multicluster engine Operator は Red Hat Advanced Cluster Management (RHACM) の不可欠な要素であり、RHACM ではデフォルトで有効になっています。ただし、Hosted Control Plane を使用するのに RHACM は必要ありません。

multicluster engine Operator は、OpenShift Container Platform および RHACM ハブクラスターにクラスター管理機能を提供するクラスターライフサイクル Operator です。multicluster engine Operator は、クラスター群の管理を強化し、クラウドとデータセンター全体の OpenShift Container Platform クラスターのライフサイクル管理を支援します。

図2.1 クラスターライフサイクルと基盤

OpenShift Container Platform の multicluster engine Operator は、スタンドアロンクラスターマネージャーとして、または RHACM ハブクラスターの一部として使用できます。

管理クラスターはホスティングクラスターとも呼ばれます。

OpenShift Container Platform クラスターは、スタンドアロンまたは Hosted Control Plane という 2 つの異なるコントロールプレーン設定を使用してデプロイできます。スタンドアロン設定では、専用の仮想マシンまたは物理マシンを使用してコントロールプレーンをホストします。OpenShift Container Platform の Hosted Control Plane を使用すると、各コントロールプレーンに専用の仮想マシンまたは物理マシンを用意する必要なく、管理クラスター上の Pod としてコントロールプレーンを作成できます。

図2.2 RHACM と multicluster engine Operator の概要図

2.3.1. RHACM での multicluster engine Operator ホステッドクラスターの検出

ホステッドクラスターを Red Hat Advanced Cluster Management (RHACM) ハブクラスターに移行し、RHACM 管理コンポーネントを使用して管理する場合は、Red Hat Advanced Cluster Management の公式ドキュメント の手順を参照してください。

2.4. Hosted Control Plane のバージョン管理

Hosted Control Plane 機能には次のコンポーネントが含まれています。これらのコンポーネントには、個別のバージョン管理とサポートレベルが必要な場合があります。

- 管理クラスター

- HyperShift Operator

-

Hosted Control Plane (

hcp) コマンドラインインターフェイス (CLI) -

hypershift.openshift.ioAPI - Control Plane Operator

2.4.1. 管理クラスター

実稼働環境で使用する管理クラスターでは、OperatorHub から入手できる multicluster engine for Kubernetes Operator が必要です。multicluster engine Operator には、HyperShift Operator のサポートされているビルドがバンドルされています。管理クラスターのサポートを継続するには、multicluster engine Operator が動作する OpenShift Container Platform のバージョンを使用する必要があります。一般に、multicluster engine Operator の新しいリリースは、以下の OpenShift Container Platform のバージョンで動作します。

- OpenShift Container Platform の最新の一般提供バージョン

- OpenShift Container Platform の最新の一般提供バージョンより 2 つ前のバージョン

管理クラスター上の HyperShift Operator を通じてインストールできる OpenShift Container Platform バージョンの完全なリストは、HyperShift Operator のバージョンによって異なります。ただし、リストには常に、管理クラスターと同じ OpenShift Container Platform バージョンと、管理クラスターよりも 2 つ前のマイナーバージョンが含まれます。たとえば、管理クラスターが 4.17 とサポートされているバージョンの multicluster engine Operator を実行している場合、HyperShift Operator は 4.17、4.16、4.15、および 4.14 ホステッドクラスターをインストールできます。

OpenShift Container Platform のメジャー、マイナー、またはパッチバージョンのリリースごとに、Hosted Control Plane の 2 つのコンポーネントがリリースされます。

- HyperShift Operator

-

hcpコマンドラインインターフェイス (CLI)

2.4.2. HyperShift Operator

HyperShift Operator は、HostedCluster API リソースによって表されるホステッドクラスターのライフサイクルを管理します。HyperShift Operator は、OpenShift Container Platform の各リリースでリリースされます。HyperShift Operator は、hypershift namespace に supported-versions config map を作成します。この config map には、サポートされているホステッドクラスターのバージョンが含まれています。

同じ管理クラスター上で異なるバージョンのコントロールプレーンをホストできます。

supported-versions config map オブジェクトの例

2.4.3. Hosted Control Plane CLI

hcp CLI を使用してホステッドクラスターを作成できます。CLI は multicluster engine Operator からダウンロードできます。hcp version コマンドを実行すると、CLI が kubeconfig ファイルに対してサポートする最新の OpenShift Container Platform が出力に表示されます。

2.4.4. hypershift.openshift.io API

HostedCluster や NodePool などの hypershift.openshift.io API リソースを使用して、大規模な OpenShift Container Platform クラスターを作成および管理できます。HostedCluster リソースには、コントロールプレーンと共通データプレーンの設定が含まれます。HostedCluster リソースを作成すると、ノードが接続されていない、完全に機能するコントロールプレーンが作成されます。NodePool リソースは、HostedCluster リソースにアタッチされたスケーラブルなワーカーノードのセットです。

API バージョンポリシーは、通常、Kubernetes API のバージョン管理 のポリシーと一致します。

Hosted Control Plane の更新には、ホステッドクラスターとノードプールの更新が含まれます。詳細は、「Hosted Control Plane の更新」を参照してください。

2.4.5. Control Plane Operator

Control Plane Operator は、次のアーキテクチャー用の各 OpenShift Container Platform ペイロードリリースイメージの一部としてリリースされます。

- amd64

- arm64

- multi-arch

2.5. Hosted Control Plane の一般的な概念とペルソナの用語集

OpenShift Container Platform の Hosted Control Plane を使用する場合は、その主要な概念と関連するペルソナを理解することが重要です。

2.5.1. 概念

- データプレーン

- ワークロードとアプリケーションが実行されるコンピュート、ストレージ、ネットワークを含む、クラスターの一部分。

- ホステッドクラスター

- コントロールプレーンと API エンドポイントが管理クラスターでホストされている OpenShift Container Platform クラスター。ホステッドクラスターには、コントロールプレーンとそれに対応するデータプレーンが含まれます。

- ホステッドクラスターのインフラストラクチャー

- テナントまたはエンドユーザーのクラウドアカウントに存在するネットワーク、コンピュート、およびストレージリソース。

- Hosted Control Plane

- 管理クラスターで実行される OpenShift Container Platform コントロールプレーン。ホステッドクラスターの API エンドポイントによって公開されます。コントロールプレーンのコンポーネントには、etcd、Kubernetes API サーバー、Kubernetes コントローラーマネージャー、および VPN が含まれます。

- ホスティングクラスター

- 管理クラスター を参照してください。

- マネージドクラスター

- ハブクラスターが管理するクラスター。この用語は、Red Hat Advanced Cluster Management で multicluster engine for Kubernetes Operator が管理するクラスターライフサイクル特有の用語です。マネージドクラスターは、管理クラスター とは異なります。詳細は、マネージドクラスター を参照してください。

- 管理クラスター

- HyperShift Operator がデプロイされる OpenShift Container Platform クラスター。ホステッドクラスターのコントロールプレーンをホストします。管理クラスターは ホスティングクラスター と同義です。

- 管理クラスターのインフラストラクチャー

- 管理クラスターのネットワーク、コンピュート、およびストレージリソース。

- ノードプール

- ホステッドクラスターに関連付けられたコンピュートノードのセットを管理するリソース。コンピュートノードは、ホステッドクラスター内でアプリケーションとワークロードを実行します。

2.5.2. 想定ユーザー

- クラスターインスタンス管理者

-

このロールを引き受けるユーザーは、スタンドアロン OpenShift Container Platform の管理者と同等です。このユーザーには、プロビジョニングされたクラスター内で

cluster-adminロールがありますが、クラスターがいつ、どのように更新または設定されるかを制御できない可能性があります。このユーザーは、クラスターに投影された設定を表示するための読み取り専用アクセス権を持っている可能性があります。 - クラスターインスタンスユーザー

- このロールを引き受けるユーザーは、スタンドアロン OpenShift Container Platform の開発者と同等です。このユーザーには、OperatorHub またはマシンに対するビューがありません。

- クラスターサービスコンシューマー

- このロールを引き受けるユーザーは、コントロールプレーンとワーカーノードを要求したり、更新を実行したり、外部化された設定を変更したりできます。通常、このユーザーはクラウド認証情報やインフラストラクチャー暗号化キーを管理したりアクセスしたりしません。クラスターサービスのコンシューマーペルソナは、ホステッドクラスターを要求し、ノードプールと対話できます。このロールを引き受けるユーザーには、論理境界内でホステッドクラスターとノードプールを作成、読み取り、更新、または削除するための RBAC があります。

- クラスターサービスプロバイダー

このロールを引き受けるユーザーは通常、管理クラスター上で

cluster-adminロールを持ち、HyperShift Operator とテナントのホステッドクラスターのコントロールプレーンの可用性を監視および所有するための RBAC を持っています。クラスターサービスプロバイダーのペルソナは、次の例を含むいくつかのアクティビティーを担当します。- コントロールプレーンの可用性、稼働時間、安定性を確保するためのサービスレベルオブジェクトの所有

- コントロールプレーンをホストするための管理クラスターのクラウドアカウントの設定

- ユーザーがプロビジョニングするインフラストラクチャーの設定 (利用可能なコンピュートリソースのホスト認識を含む)

第3章 Hosted Control Plane のデプロイの準備

3.1. Hosted Control Plane の要件

Hosted Control Plane において、管理クラスター とは HyperShift Operator がデプロイされ、ホステッドクラスターのコントロールプレーンがホストされる OpenShift Container Platform クラスターです。

コントロールプレーンはホステッドクラスターに関連付けられており、単一の namespace 内の Pod として実行されます。クラスターのサービスコンシューマーがホステッドクラスターを作成すると、コントロールプレーンから独立したワーカーノードが作成されます。

Hosted Control Plane には次の要件が適用されます。

- HyperShift Operator を実行するには、管理クラスターに少なくとも 3 つのワーカーノードが必要です。

- 管理クラスターとワーカーノードの両方を、オンプレミス (ベアメタルプラットフォームや OpenShift Virtualization 上など) で実行できます。さらに、管理クラスターとワーカーノードの両方を、Amazon Web Services (AWS) などのクラウドインフラストラクチャー上で実行することもできます。

-

管理クラスターを AWS で実行し、ワーカーノードをオンプレミスで実行する、またはワーカーノードを AWS で実行し、管理クラスターをオンプレミスで実行するなど、混合インフラストラクチャーを使用する場合は、

PublicAndPrivate公開ストラテジーを使用し、サポートマトリックスのレイテンシー要件に従う必要があります。 - Bare Metal Operator がマシンを起動するベアメタルホスト (BMH) デプロイメントでは、Hosted Control Plane が Baseboard Management Controller (BMC) にアクセスできる必要があります。Redfish の自動化を有効にするために、BMH の BMC があるネットワークに Cluster Baremetal Operator がアクセスすることをセキュリティープロファイルで禁止している場合は、BYO ISO サポートを使用できます。ただし、BYO モードでは、OpenShift Container Platform は BMH の電源オンを自動化できません。

3.1.1. Hosted Control Plane のサポートマトリックス

Multicluster engine for Kubernetes Operator には HyperShift Operator が含まれているため、Hosted Control Plane のリリースは multicluster engine Operator のリリースと一致します。詳細は、OpenShift Operator のライフサイクル を参照してください。

3.1.1.1. 管理クラスターのサポート

サポートされているスタンドアロンの OpenShift Container Platform クラスターは、すべて管理クラスターにすることができます。

シングルノードの OpenShift Container Platform クラスターは、管理クラスターとしてはサポートされていません。リソースに制約がある場合は、スタンドアロンの OpenShift Container Platform コントロールプレーンと Hosted Control Plane 間でインフラストラクチャーを共有できます。詳細は、「Hosted Control Plane とスタンドアロンコントロールプレーン間でのインフラストラクチャーの共有」を参照してください。

次の表は、multicluster engine Operator のバージョンと、それらをサポートする管理クラスターのバージョンをマッピングしています。

| 管理クラスターのバージョン | サポートされている multicluster engine Operator バージョン |

|---|---|

| 4.14 - 4.15 | 2.4 |

| 4.14 - 4.16 | 2.5 |

| 4.14 - 4.17 | 2.6 |

| 4.15 - 4.17 | 2.7 |

3.1.1.2. ホステッドクラスターのサポート

ホステッドクラスターの場合、管理クラスターのバージョンとホステッドクラスターのバージョンの間に直接的な関係はありません。ホステッドクラスターのバージョンは、使用している multicluster engine Operator バージョンに含まる HyperShift Operator により異なります。

管理クラスターとホステッドクラスター間の最大遅延が 200 ミリ秒であることを確認してください。この要件は、管理クラスターが AWS 上にあり、ワーカーノードがオンプレミスにある場合など、混合インフラストラクチャーのデプロイメントでは特に重要です。

次の表は、multicluster engine Operator のバージョンと、その multicluster engine Operator バージョンに関連付けられている HyperShift Operator を使用して作成できるホステッドクラスターのバージョンを示しています。

| ホステッドクラスターのバージョン | multicluster engine Operator 2.4 | multicluster engine Operator 2.5 | multicluster engine Operator 2.6 | multicluster engine Operator 2.7 |

|---|---|---|---|---|

| 4.14 | はい | はい | はい | はい |

| 4.15 | いいえ | はい | はい | はい |

| 4.16 | いいえ | いいえ | はい | はい |

| 4.17 | いいえ | いいえ | いいえ | はい |

3.1.1.3. ホステッドクラスタープラットフォームのサポート

次の表は、Hosted Control Plane の各プラットフォームでサポートされている OpenShift Container Platform のバージョンを示しています。

IBM Power および IBM Z の場合、コントロールプレーンは 64 ビット x86 アーキテクチャーベースのマシンタイプで実行し、ノードプールは IBM Power または IBM Z で実行する必要があります。

次の表に示す管理クラスターのバージョンは、multicluster engine Operator が有効になっている OpenShift Container Platform バージョンを意味します。

| ホステッドクラスターのプラットフォーム | 管理クラスターのバージョン | ホステッドクラスターのバージョン |

|---|---|---|

| Amazon Web Services | 4.16 - 4.17 | 4.16 - 4.17 |

| IBM Power | 4.17 | 4.17 |

| IBM Z | 4.17 | 4.17 |

| OpenShift Virtualization | 4.14 - 4.17 | 4.14 - 4.17 |

| ベアメタル | 4.14 - 4.17 | 4.14 - 4.17 |

| 非ベアメタルエージェントマシン (テクノロジープレビュー) | 4.16 - 4.17 | 4.16 - 4.17 |

3.1.1.4. multicluster engine Operator の更新

multicluster engine Operator の別バージョンに更新する場合、その multicluster engine Operator バージョンに含まれる HyperShift Operator がサポートしているバージョンのホステッドクラスターは、引き続き実行できます。次の表は、更新後の multicluster engine Operator バージョンでサポートされるホステッドクラスターバージョンを示しています。

| 更新後の multicluster engine Operator バージョン | サポートされるホステッドクラスターバージョン |

|---|---|

| 2.4 から 2.5 に更新 | OpenShift Container Platform 4.14 |

| 2.5 から 2.6 に更新 | OpenShift Container Platform 4.14 - 4.15 |

| 2.6 から 2.7 に更新 | OpenShift Container Platform 4.14 - 4.16 |

たとえば、管理クラスターに OpenShift Container Platform 4.14 ホステッドクラスターがあり、multicluster engine Operator 2.4 から 2.5 に更新した場合、ホステッドクラスターは引き続き実行できます。

3.1.1.5. テクノロジープレビュー機能

次のリストは、このリリースのテクノロジープレビュー機能を示しています。

- 非接続環境の IBM Z の Hosted Control Plane

- Hosted Control Plane のカスタムの taint と toleration

- OpenShift Virtualization の Hosted Control Plane 上の NVIDIA GPU デバイス

3.1.2. Hosted Control Plane の CIDR 範囲

OpenShift Container Platform に Hosted Control Plane をデプロイするには、次の必須の Classless Inter-Domain Routing (CIDR) サブネット範囲を使用してください。

-

v4InternalSubnet: 100.65.0.0/16 (OVN-Kubernetes) -

clusterNetwork: 10.132.0.0/14 (Pod ネットワーク) -

serviceNetwork: 172.31.0.0/16

OpenShift Container Platform の CIDR 範囲の定義に関する詳細は、「CIDR 範囲の定義」を参照してください。

3.2. Hosted Control Plane のサイジングに関するガイダンス

一定数のワーカーノード内に収容できる Hosted Control Plane の数には、ホステッドクラスターのワークロードやワーカーノードの数など、多くの要因が影響します。このサイジングガイドを使用して、ホステッドクラスターの容量計画に役立ててください。このガイダンスでは、高可用性 Hosted Control Plane トポロジーを前提としています。負荷ベースのサイジングの例は、ベアメタルクラスターで測定されました。クラウドベースのインスタンスには、メモリーサイズなど、さまざまな制限要因が含まれる場合があります。

次のリソース使用量のサイズ測定値をオーバーライドし、メトリクスサービスの監視を無効化することもできます。

次の高可用性 Hosted Control Plane の要件を参照してください。この要件は、OpenShift Container Platform バージョン 4.12.9 以降でテストされたものです。

- 78 Pod

- etcd 用の 3 つの 8 GiB PV

- 最小仮想 CPU: 約 5.5 コア

- 最小メモリー: 約 19 GiB

3.2.1. Pod の制限

各ノードの maxPods 設定は、コントロールプレーンノードに収容できるホステッドクラスターの数に影響します。すべてのコントロールプレーンノードの maxPods 値に注意することが重要です。高可用性の Hosted Control Plane ごとに約 75 個の Pod を計画します。

ベアメタルノードの場合、マシンに十分なリソースがある場合でも、Pod 要件を考慮すると、各ノードに約 3 つの Hosted Control Plane が使用されるため、デフォルトで maxPods 設定に 250 が指定されていることが制限要因となる可能性があります。KubeletConfig 値を設定して maxPods 値を 500 に設定すると、Hosted Control Plane の密度が増し、追加のコンピュートリソースを活用できるようになります。

3.2.2. 要求ベースのリソース制限

クラスターがホストできる Hosted Control Plane の最大数は、Pod からの Hosted Control Plane CPU およびメモリー要求に基づいて計算されます。

高可用性 Hosted Control Plane は、5 つの仮想 CPU と 18 GB のメモリーを要求する 78 個の Pod で構成されます。これらのベースライン数値は、クラスターワーカーノードのリソース容量と比較され、Hosted Control Plane の最大数を推定します。

3.2.3. 負荷ベースの制限

クラスターがホストできる Hosted Control Plane の最大数は、Hosted Control Plane の Kubernetes API サーバーに何らかのワークロードが配置されたときの Hosted Control Plane Pod の CPU とメモリーの使用量に基づいて計算されます。

次の方法を使用して、ワークロードの増加に伴う Hosted Control Plane のリソース使用量を測定しました。

- KubeVirt プラットフォームを使用し、それぞれ 8 つの仮想 CPU と 32 GiB を使用する 9 つのワーカーを持つホステッドクラスター

次の定義に基づいて、API コントロールプレーンのストレスに重点を置くように設定されたワークロードテストプロファイル:

- 各 namespace にオブジェクトを作成し、合計 100 の namespace まで拡張しました。

- オブジェクトの継続的な削除と作成により、API のストレスを増加させます。

- ワークロードの 1 秒あたりのクエリー数 (QPS) とバースト設定を高く設定して、クライアント側のスロットリングを排除します。

負荷が 1000 QPS 増加すると、Hosted Control Plane のリソース使用量が、仮想 CPU 9 個分およびメモリー 2.5 GB 分増加します。

一般的なサイジングが目的の場合は、1000 QPS の API レートを 中程度 のホステッドクラスターの負荷、2000 QPS の API レートを 高程度 のホステッドクラスターの負荷とみなしてください。

このテストでは、予想される API 負荷に基づいてコンピュートリソースの使用量を増やすために、推定係数を定めています。正確な使用率は、クラスターのワークロードのタイプとペースによって異なる場合があります。

次の例は、ワークロードおよび API レート定義の Hosted Control Plane リソースのスケーリングを示しています。

| QPS (API レート) | 仮想 CPU の使用量 | メモリーの使用量 (GiB) |

|---|---|---|

| 低負荷 (50 QPS 未満) | 2.9 | 11.1 |

| 中負荷 (1000 QPS) | 11.9 | 13.6 |

| 高負荷 (2000 QPS) | 20.9 | 16.1 |

Hosted Control Plane のサイジングは、コントロールプレーンの負荷と、大量の API アクティビティー、etcd アクティビティー、またはその両方を引き起こすワークロードに関係します。データベースの実行など、データプレーンの負荷に重点を置くホスト型 Pod ワークロードでは、API レートが高くならない可能性があります。

3.2.4. サイジング計算の例

この例では、次のシナリオに対してサイジングのガイダンスを提供します。

-

hypershift.openshift.io/control-planeノードとしてラベル付けされたベアメタルワーカー 3 つ -

maxPods値を 500 に設定している - 負荷ベースの制限に応じて、予想される API レートは中または約 1000 である

| 制限の説明 | サーバー 1 | サーバー 2 |

|---|---|---|

| ワーカーノード上の仮想 CPU 数 | 64 | 128 |

| ワーカーノードのメモリー (GiB) | 128 | 256 |

| ワーカーあたりの最大 Pod 数 | 500 | 500 |

| コントロールプレーンのホストに使用されるワーカーの数 | 3 | 3 |

| 最大 QPS ターゲットレート (1 秒あたりの API リクエスト) | 1000 | 1000 |

| ワーカーノードのサイズと API レートに基づいた計算値 | サーバー 1 | サーバー 2 | 計算の注記 |

| 仮想 CPU リクエストに基づくワーカーあたりの最大ホストコントロールプレーン数 | 12.8 | 25.6 | ワーカーの仮想 CPU の数 ÷ Hosted Control Plane あたりの合計仮想 CPU 要求数 5 |

| 仮想 CPU 使用率に基づくワーカーあたりの最大 Hosted Control Plane 数 | 5.4 | 10.7 | 仮想 CPU の数 ÷ (アイドル状態の仮想 CPU 使用率の測定値 2.9 + (QPS ターゲットレート ÷ 1000) x QPS 増分 1000 あたりの仮想 CPU 使用率の測定値 9.0) |

| メモリーリクエストに基づくワーカーごとの最大 Hosted Control Plane | 7.1 | 14.2 | ワーカーのメモリー (GiB) ÷ Hosted Control Plane あたりの合計メモリー要求 18 GiB |

| メモリー使用量に基づくワーカーあたりの最大 Hosted Control Plane 数 | 9.4 | 18.8 | ワーカーのメモリー (GiB) ÷ (アイドル状態のメモリー使用率の測定値 11.1 + (QPS ターゲットレート ÷ 1000) x QPS 増分 1000 あたりのメモリー使用率の測定値 2.5) |

| ノードごとの Pod の制限に基づくワーカーごとの最大 Hosted Control Plane | 6.7 | 6.7 |

500 |

| 前述の最大値の中の最小値 | 5.4 | 6.7 | |

| 仮想 CPU の制限要因 |

| ||

| 管理クラスター内の Hosted Control Plane の最大数 | 16 | 20 | 前述の各最大値の最小値 x 3 control-plane 用ワーカー |

| 名前 | 説明 |

|

| 高可用性 Hosted Control Plane のリソース要求に基づく、クラスターがホストできる Hosted Control Plane の推定最大数。 |

|

| すべての Hosted Control Plane がクラスターの Kube API サーバーに約 50 QPS を送信する場合、クラスターがホストできる Hosted Control Plane の推定最大数。 |

|

| すべての Hosted Control Plane がクラスターの Kube API サーバーに約 1000 QPS を送信する場合、クラスターがホストできる Hosted Control Plane の推定最大数。 |

|

| すべての Hosted Control Plane がクラスターの Kube API サーバーに約 2000 QPS を送信する場合、クラスターがホストできる Hosted Control Plane の推定最大数。 |

|

| Hosted Control Plane の既存の平均 QPS に基づいて、クラスターがホストできる Hosted Control Plane の推定最大数。アクティブな Hosted Control Plane がない場合、QPS が低くなることが予想されます。 |

3.3. リソース使用率測定値のオーバーライド

リソース使用率のベースライン測定値のセットは、ホステッドクラスターごとに異なる場合があります。

3.3.1. ホステッドクラスターのリソース使用率測定値のオーバーライド

リソース使用率の測定値は、クラスターのワークロードの種類とペースに基づいてオーバーライドできます。

手順

次のコマンドを実行して、

ConfigMapリソースを作成します。oc create -f <your-config-map-file.yaml>

$ oc create -f <your-config-map-file.yaml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow <your-config-map-file.yaml>はhcp-sizing-baselineconfig map を含む YAML ファイルの名前に置き換えます。local-clusternamespace にhcp-sizing-baselineconfig map を作成し、オーバーライドする測定値を指定します。config map は、次の YAML ファイルのようになります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して

hypershift-addon-agentデプロイメントを削除し、hypershift-addon-agentPod を再起動します。oc delete deployment hypershift-addon-agent \ -n open-cluster-management-agent-addon

$ oc delete deployment hypershift-addon-agent \ -n open-cluster-management-agent-addonCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

hypershift-addon-agentPod ログを監視します。次のコマンドを実行して、オーバーライドされた測定値が config map 内で更新されていることを確認します。oc logs hypershift-addon-agent -n open-cluster-management-agent-addon

$ oc logs hypershift-addon-agent -n open-cluster-management-agent-addonCopy to Clipboard Copied! Toggle word wrap Toggle overflow ログは以下の出力のようになります。

出力例

2024-01-05T19:41:05.392Z INFO agent.agent-reconciler agent/agent.go:793 setting cpuRequestPerHCP to 5 2024-01-05T19:41:05.392Z INFO agent.agent-reconciler agent/agent.go:802 setting memoryRequestPerHCP to 18 2024-01-05T19:53:54.070Z INFO agent.agent-reconciler agent/hcp_capacity_calculation.go:141 The worker nodes have 12.000000 vCPUs 2024-01-05T19:53:54.070Z INFO agent.agent-reconciler agent/hcp_capacity_calculation.go:142 The worker nodes have 49.173369 GB memory

2024-01-05T19:41:05.392Z INFO agent.agent-reconciler agent/agent.go:793 setting cpuRequestPerHCP to 5 2024-01-05T19:41:05.392Z INFO agent.agent-reconciler agent/agent.go:802 setting memoryRequestPerHCP to 18 2024-01-05T19:53:54.070Z INFO agent.agent-reconciler agent/hcp_capacity_calculation.go:141 The worker nodes have 12.000000 vCPUs 2024-01-05T19:53:54.070Z INFO agent.agent-reconciler agent/hcp_capacity_calculation.go:142 The worker nodes have 49.173369 GB memoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow オーバーライドされた測定値が

hcp-sizing-baselineconfig map で適切に更新されない場合、hypershift-addon-agentPod ログに次のエラーメッセージが表示されることがあります。エラーの例

2024-01-05T19:53:54.052Z ERROR agent.agent-reconciler agent/agent.go:788 failed to get configmap from the hub. Setting the HCP sizing baseline with default values. {"error": "configmaps \"hcp-sizing-baseline\" not found"}2024-01-05T19:53:54.052Z ERROR agent.agent-reconciler agent/agent.go:788 failed to get configmap from the hub. Setting the HCP sizing baseline with default values. {"error": "configmaps \"hcp-sizing-baseline\" not found"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.2. メトリクスサービスモニタリングの無効化

hypershift-addon マネージドクラスターアドオンを有効にすると、メトリクスサービスモニタリングがデフォルトで設定され、OpenShift Container Platform モニタリングが hypershift-addon からメトリクスを収集できるようになります。

手順

次の手順を実行して、メトリクスサービスの監視を無効にできます。

次のコマンドを実行して、ハブクラスターにログインします。

oc login

$ oc loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

hypershift-addon-deploy-configアドオンのデプロイメント設定の仕様を編集します。oc edit addondeploymentconfig hypershift-addon-deploy-config \ -n multicluster-engine

$ oc edit addondeploymentconfig hypershift-addon-deploy-config \ -n multicluster-engineCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例に示すように、

disableMetrics=trueカスタマイズ変数を仕様に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- カスタマイズ変数

disableMetrics=trueは、新規および既存のhypershift-addonマネージドクラスターアドオンのメトリクスサービス監視を無効にします。

次のコマンドを実行して、設定の仕様に変更を適用します。

oc apply -f <filename>.yaml

$ oc apply -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. Hosted Control Plane のコマンドラインインターフェイスのインストール

Hosted Control Plane のコマンドラインインターフェイスである hcp は、Hosted Control Plane の使用を開始するために使用できるツールです。管理や設定などの Day 2 運用には、GitOps や独自の自動化ツールを使用してください。

3.4.1. ターミナルからの Hosted Control Plane コマンドラインインターフェイスのインストール

ターミナルから、Hosted Control Plane のコマンドラインインターフェイス (CLI) である hcp をインストールできます。

前提条件

- OpenShift Container Platform クラスターに multicluster engine for Kubernetes Operator 2.5 がインストールされている。multicluster engine Operator は、Red Hat Advanced Cluster Management をインストールすると自動的にインストールされます。Red Hat Advanced Cluster Management を使用せずに、OpenShift Container Platform OperatorHub から multicluster engine Operator を Operator としてインストールすることもできます。

手順

次のコマンドを実行して、

hcpバイナリーをダウンロードするための URL を取得します。oc get ConsoleCLIDownload hcp-cli-download -o json | jq -r ".spec"

$ oc get ConsoleCLIDownload hcp-cli-download -o json | jq -r ".spec"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して

hcpバイナリーをダウンロードします。wget <hcp_cli_download_url>

$ wget <hcp_cli_download_url>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

hcp_cli_download_urlは、前の手順で取得した URL に置き換えます。

次のコマンドを実行して、ダウンロードしたアーカイブを解凍します。

tar xvzf hcp.tar.gz

$ tar xvzf hcp.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

hcpバイナリーファイルを実行可能にします。chmod +x hcp

$ chmod +x hcpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

hcpバイナリーファイルをパス内のディレクトリーに移動します。sudo mv hcp /usr/local/bin/.

$ sudo mv hcp /usr/local/bin/.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Mac コンピューターに CLI をダウンロードすると、hcp バイナリーファイルに関する警告が表示される場合があります。バイナリーファイルを実行できるようにするには、セキュリティー設定を調整する必要があります。

検証

次のコマンドを実行して、使用可能なパラメーターのリストが表示されることを確認します。

hcp create cluster <platform> --help

$ hcp create cluster <platform> --help1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

hcp create clusterコマンドを使用すると、ホステッドクラスターを作成および管理できます。サポートされているプラットフォームは、aws、agent、およびkubevirtです。

3.4.2. Web コンソールを使用した Hosted Control Plane コマンドラインインターフェイスのインストール

OpenShift Container Platform Web コンソールを使用して、Hosted Control Plane のコマンドラインインターフェイス (CLI) である hcp をインストールできます。

前提条件

- OpenShift Container Platform クラスターに multicluster engine for Kubernetes Operator 2.5 がインストールされている。multicluster engine Operator は、Red Hat Advanced Cluster Management をインストールすると自動的にインストールされます。Red Hat Advanced Cluster Management を使用せずに、OpenShift Container Platform OperatorHub から multicluster engine Operator を Operator としてインストールすることもできます。

手順

- OpenShift Container Platform Web コンソールから、Help アイコン → Command Line Tools をクリックします。

- お使いのプラットフォーム用の Download hcp CLI をクリックします。

次のコマンドを実行して、ダウンロードしたアーカイブを解凍します。

tar xvzf hcp.tar.gz

$ tar xvzf hcp.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、バイナリーファイルを実行可能にします。

chmod +x hcp

$ chmod +x hcpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、バイナリーファイルをパス内のディレクトリーに移動します。

sudo mv hcp /usr/local/bin/.

$ sudo mv hcp /usr/local/bin/.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Mac コンピューターに CLI をダウンロードすると、hcp バイナリーファイルに関する警告が表示される場合があります。バイナリーファイルを実行できるようにするには、セキュリティー設定を調整する必要があります。

検証

次のコマンドを実行して、使用可能なパラメーターのリストが表示されることを確認します。

hcp create cluster <platform> --help

$ hcp create cluster <platform> --help1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

hcp create clusterコマンドを使用すると、ホステッドクラスターを作成および管理できます。サポートされているプラットフォームは、aws、agent、およびkubevirtです。

3.4.3. コンテンツゲートウェイを使用した Hosted Control Plane コマンドラインインターフェイスのインストール

コンテンツゲートウェイを使用して、Hosted Control Plane のコマンドラインインターフェイス (CLI) である hcp をインストールできます。

前提条件

- OpenShift Container Platform クラスターに multicluster engine for Kubernetes Operator 2.5 がインストールされている。multicluster engine Operator は、Red Hat Advanced Cluster Management をインストールすると自動的にインストールされます。Red Hat Advanced Cluster Management を使用せずに、OpenShift Container Platform OperatorHub から multicluster engine Operator を Operator としてインストールすることもできます。

手順

-

コンテンツゲートウェイ に移動し、

hcpバイナリーをダウンロードします。 次のコマンドを実行して、ダウンロードしたアーカイブを解凍します。

tar xvzf hcp.tar.gz

$ tar xvzf hcp.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

hcpバイナリーファイルを実行可能にします。chmod +x hcp

$ chmod +x hcpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

hcpバイナリーファイルをパス内のディレクトリーに移動します。sudo mv hcp /usr/local/bin/.

$ sudo mv hcp /usr/local/bin/.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Mac コンピューターに CLI をダウンロードすると、hcp バイナリーファイルに関する警告が表示される場合があります。バイナリーファイルを実行できるようにするには、セキュリティー設定を調整する必要があります。

検証

次のコマンドを実行して、使用可能なパラメーターのリストが表示されることを確認します。

hcp create cluster <platform> --help

$ hcp create cluster <platform> --help1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

hcp create clusterコマンドを使用すると、ホステッドクラスターを作成および管理できます。サポートされているプラットフォームは、aws、agent、およびkubevirtです。

3.5. ホステッドクラスターのワークロードの分散

OpenShift Container Platform の Hosted Control Plane を初めて使用する前に、ホステッドクラスターの Pod をインフラストラクチャーノードにスケジュールできるように、ノードを適切にラベル付けする必要があります。また、ノードのラベリングは以下の理由で重要です。

-

高可用性と適切なワークロードのデプロイメントを確保するため。たとえば、

node-role.kubernetes.io/infraラベルを設定して、OpenShift Container Platform サブスクリプションに control-plane ワークロード数が割り当てられないようにできます。 - コントロールプレーンのワークロードが管理クラスター内の他のワークロードから分離されるようにするため。

ワークロードには管理クラスターを使用しないでください。ワークロードは、コントロールプレーンが実行されるノード上で実行してはなりません。

3.5.1. 管理クラスターノードのラベル付け

Hosted Control Plane をデプロイするには、適切なノードのラベル付けを行う必要があります。

管理クラスターの管理者は、管理クラスターノードで次のラベルと taint を使用して、コントロールプレーンのワークロードをスケジュールします。

-

hypershift.openshift.io/control-plane: true: このラベルとテイントを使用して、Hosted Control Plane ワークロードの実行専用にノードを割り当てます。値をtrueに設定すると、コントロールプレーンノードが他のコンポーネント (管理クラスターのインフラストラクチャーコンポーネントや誤ってデプロイされたその他のワークロードなど) と共有されるのを回避できます。 -

hypershift.openshift.io/cluster: ${HostedControlPlane Namespace}: ノードを単一のホステッドクラスター専用にする場合は、このラベルとテイントを使用します。

コントロールプレーン Pod をホストするノードに以下のラベルを適用します。

-

node-role.kubernetes.io/infra: このラベルを使用して、サブスクリプションにコントロールプレーンワークロード数が割り当てられないようにします。 topology.kubernetes.io/zone: このラベルを管理クラスターノードで使用して、障害ドメイン全体に高可用性クラスターをデプロイします。ゾーンは、ゾーンが設定されているノードの場所、ラック名、またはホスト名である場合があります。たとえば、管理クラスターには、worker-1a、worker-1b、worker-2a、およびworker-2bのノードがあります。worker-1aとworker-1bノードはrack1にあり、worker-2aノードと worker-2b ノードはrack2にあります。各ラックをアベイラビリティゾーンとして使用するには、次のコマンドを入力します。oc label node/worker-1a node/worker-1b topology.kubernetes.io/zone=rack1

$ oc label node/worker-1a node/worker-1b topology.kubernetes.io/zone=rack1Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc label node/worker-2a node/worker-2b topology.kubernetes.io/zone=rack2

$ oc label node/worker-2a node/worker-2b topology.kubernetes.io/zone=rack2Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ホステッドクラスターの Pod には許容範囲があり、スケジューラーはアフィニティールールを使用して Pod をスケジュールします。Pod は、control-plane と Pod の cluster のテイントを許容します。スケジューラーは、hypershift.openshift.io/control-plane および hypershift.openshift.io/cluster: ${HostedControlPlane Namespace} でラベル付けされたノードへの Pod のスケジューリングを優先します。

ControllerAvailabilityPolicy オプションには、HighlyAvailable を使用します。これは、Hosted Control Plane のコマンドラインインターフェイス (hcp) がデプロイするデフォルト値です。このオプションを使用する場合は、topology.kubernetes.io/zone をトポロジーキーとして設定することで、別々の障害ドメインにまたがるホステッドクラスター内の各デプロイメントに対して Pod をスケジュールできます。別々の障害ドメインにまたがるホステッドクラスター内のデプロイメントに対する Pod のスケジュールは、高可用性コントロールプレーンでのみ可能です。

手順

ホステッドクラスターがその Pod をインフラストラクチャーノードにスケジュールすることを要求できるようにするには、次の例に示すように HostedCluster.spec.nodeSelector を設定します。

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""

spec:

nodeSelector:

node-role.kubernetes.io/infra: ""こうすることで、各ホステッドクラスターの Hosted Control Plane が適格なインフラストラクチャーノードワークロードとなり、基盤となる OpenShift Container Platform ノードに資格を与える必要がなくなります。

3.5.2. 優先クラス

4 つの組み込み優先クラスは、ホステッドクラスター Pod の優先順位とプリエンプションに影響を与えます。管理クラスター内に Pod は、次の上位から下位の順序で作成できます。

-

hypershift-operator: HyperShift Operator Pod。 -

hypershift-etcd: etcd 用の Pod。 -

hypershift-api-critical: API 呼び出しとリソース許可が成功するために必要な Pod。これらの Pod には、kube-apiserver、集約 API サーバー、Web フックなどの Pod が含まれます。 -

hypershift-control-plane: API クリティカルではないものの、クラスターバージョンの Operator など、高い優先順位が必要なコントロールプレーン内の Pod。

3.5.3. カスタムの taint と toleration

デフォルトでは、ホステッドクラスターの Pod は、control-plane および cluster taint を許容します。ただし、HostedCluster.spec.tolerations を設定することで、ホステッドクラスターがホステッドクラスターごとにこれらの taint を許容できるように、ノードでカスタムの taint を使用することもできます。

ホステッドクラスターの toleration を渡す機能は、テクノロジープレビュー機能です。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行い、フィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、以下のリンクを参照してください。

設定例

spec:

tolerations:

- effect: NoSchedule

key: kubernetes.io/custom

operator: Exists

spec:

tolerations:

- effect: NoSchedule

key: kubernetes.io/custom

operator: Exists

hcp CLI の引数 --tolerations を使用して、クラスターを作成するときに、ホステッドクラスターに toleration を設定することもできます。

CLI 引数の例

--toleration="key=kubernetes.io/custom,operator=Exists,effect=NoSchedule"

--toleration="key=kubernetes.io/custom,operator=Exists,effect=NoSchedule"

ホステッドクラスターごとにホステッドクラスター Pod の配置を細かく制御するには、カスタムの toleration を nodeSelectors とともに使用します。ホステッドクラスターのグループを同じ場所に配置し、他のホステッドクラスターから分離することができます。ホステッドクラスターをインフラノードとコントロールプレーンノードに配置することもできます。

ホステッドクラスターの toleration は、コントロールプレーンの Pod にのみ適用されます。管理クラスターで実行される他の Pod や、仮想マシンを実行する Pod などのインフラストラクチャー関連の Pod を設定するには、別のプロセスを使用する必要があります。

3.6. Hosted Control Plane 機能の有効化または無効化

Hosted Control Plane 機能と hypershift-addon マネージドクラスターアドオンは、デフォルトで有効になっています。機能を無効にする場合、または無効にした後に手動で有効にする場合は、次の手順を参照してください。

3.6.1. Hosted Control Plane 機能の手動での有効化

Hosted Control Plane を手動で有効にする必要がある場合は、次の手順を実行します。

手順

次のコマンドを実行して機能を有効にします。

oc patch mce multiclusterengine --type=merge -p \ '{"spec":{"overrides":{"components":[{"name":"hypershift","enabled": true}]}}}'$ oc patch mce multiclusterengine --type=merge -p \ '{"spec":{"overrides":{"components":[{"name":"hypershift","enabled": true}]}}}'1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- デフォルトの

MultiClusterEngineリソースインスタンス名はmulticlusterengineですが、$ oc get mceコマンドを実行し、クラスターからMultiClusterEngine名を取得できます。

次のコマンドを実行して、

hypershiftおよびhypershift-local-hosting機能がMultiClusterEngineカスタムリソースで有効になっていることを確認します。oc get mce multiclusterengine -o yaml

$ oc get mce multiclusterengine -o yaml1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- デフォルトの

MultiClusterEngineリソースインスタンス名はmulticlusterengineですが、$ oc get mceコマンドを実行し、クラスターからMultiClusterEngine名を取得できます。

出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6.1.1. local-cluster の hypershift-addon マネージドクラスターアドオンを手動で有効にする

Hosted Control Plane 機能を有効にすると、hypershift-addon マネージドクラスターアドオンが自動的に有効になります。hypershift-addon マネージドクラスターアドオンを手動で有効にする必要がある場合は、次の手順を実行して hypershift-addon を使用し、HyperShift Operator を local-cluster にインストールします。

手順

次の例のようなファイルを作成して、

hypershift-addonという名前のManagedClusterAddonアドオンを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行してこのファイルを適用します。

oc apply -f <filename>

$ oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow filenameは、作成したファイル名に置き換えます。次のコマンドを実行して、

hypershift-addonマネージドクラスターアドオンがインストールされていることを確認します。oc get managedclusteraddons -n local-cluster hypershift-addon

$ oc get managedclusteraddons -n local-cluster hypershift-addonCopy to Clipboard Copied! Toggle word wrap Toggle overflow アドオンがインストールされている場合、出力は以下の例のようになります。

NAME AVAILABLE DEGRADED PROGRESSING hypershift-addon True

NAME AVAILABLE DEGRADED PROGRESSING hypershift-addon TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow

hypershift-addon マネージドクラスターアドオンがインストールされ、ホスティングクラスターを使用してホステッドクラスターを作成および管理できるようになります。

3.6.2. Hosted Control Plane 機能の無効化

HyperShift Operator をアンインストールして、Hosted Control Plane 機能を無効にすることができます。Hosted Control Plane 機能を無効にする場合は、ホステッドクラスターの管理 のトピックで説明されているように、multicluster engine Operator のホステッドクラスターとマネージドクラスターリソースを破棄する必要があります。

3.6.2.1. HyperShift Operator のアンインストール

HyperShift Operator をアンインストールし、local-cluster から hypershift-addon を無効にするには、以下の手順を実行します。

手順

以下のコマンドを実行して、ホステッドクラスターが実行されていないことを確認します。

oc get hostedcluster -A

$ oc get hostedcluster -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要ホステッドクラスターが実行中の場合、

hypershift-addonが無効になっていても、HyperShift Operator はアンインストールされません。以下のコマンドを実行して

hypershift-addonを無効にします。oc patch mce multiclusterengine --type=merge -p \ '{"spec":{"overrides":{"components":[{"name":"hypershift-local-hosting","enabled": false}]}}}'$ oc patch mce multiclusterengine --type=merge -p \1 '{"spec":{"overrides":{"components":[{"name":"hypershift-local-hosting","enabled": false}]}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- デフォルトの

MultiClusterEngineリソースインスタンス名はmulticlusterengineですが、$ oc get mceコマンドを実行し、クラスターからMultiClusterEngine名を取得できます。

注記hypershift-addonを無効にした後、multicluster engine Operator コンソールからlocal-clusterのhypershift-addonを無効にすることもできます。

3.6.2.2. Hosted Control Plane 機能の無効化

Hosted Control Plane 機能を無効にするには、次の手順を実行します。

前提条件

- HyperShift Operator をアンインストールした。詳細は、「HyperShift Operator のアンインストール」を参照してください。

手順

次のコマンドを実行して、Hosted Control Plane 機能を無効にします。

oc patch mce multiclusterengine --type=merge -p \ '{"spec":{"overrides":{"components":[{"name":"hypershift","enabled": false}]}}}'$ oc patch mce multiclusterengine --type=merge -p \1 '{"spec":{"overrides":{"components":[{"name":"hypershift","enabled": false}]}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- デフォルトの

MultiClusterEngineリソースインスタンス名はmulticlusterengineですが、$ oc get mceコマンドを実行し、クラスターからMultiClusterEngine名を取得できます。

次のコマンドを実行すると、

MultiClusterEngineカスタムリソースでhypershiftおよびhypershift-local-hosting機能が無効になっていることを確認できます。oc get mce multiclusterengine -o yaml

$ oc get mce multiclusterengine -o yaml1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- デフォルトの

MultiClusterEngineリソースインスタンス名はmulticlusterengineですが、$ oc get mceコマンドを実行し、クラスターからMultiClusterEngine名を取得できます。

hypershiftとhypershift-local-hostingのenabled:フラグがfalseに設定されている次の例を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第4章 Hosted Control Plane のデプロイ

4.1. AWS への Hosted Control Plane のデプロイ

ホステッドクラスター は、API エンドポイントとコントロールプレーンが管理クラスターでホストされている OpenShift Container Platform クラスターです。ホステッドクラスターには、コントロールプレーンとそれに対応するデータプレーンが含まれます。オンプレミスで Hosted Control Plane を設定するには、管理クラスターに multicluster engine for Kubernetes Operator をインストールする必要があります。hypershift-addon マネージドクラスターアドオンを使用して既存のマネージドクラスターに HyperShift Operator をデプロイすると、そのクラスターを管理クラスターとして有効にして、ホステッドクラスターの作成を開始できます。hypershift-addon マネージドクラスターアドオンは、local-cluster マネージドクラスターでデフォルトで有効になっています。

ホステッドクラスターは、multicluster engine Operator のコンソールか、Hosted Control Plane のコマンドラインインターフェイス (CLI) である hcp を使用して作成できます。ホステッドクラスターは、マネージドクラスターとして自動的にインポートされます。ただし、この multicluster engine Operator への自動インポート機能を無効にする こともできます。

4.1.1. AWS への Hosted Control Plane のデプロイの準備

Amazon Web Services (AWS) に Hosted Control Plane をデプロイする準備をする際には、次の情報を考慮してください。

- 各ホステッドクラスターの名前がクラスター全体で一意である。multicluster engine Operator によってホステッドクラスターを管理するには、ホステッドクラスター名を既存のマネージドクラスターと同じにすることはできません。

-

ホステッドクラスター名として

clustersを使用しないでください。 - 管理クラスターとワーカーは、Hosted Control Plane の同じプラットフォーム上で実行してください。

- ホステッドクラスターは、multicluster engine Operator のマネージドクラスターの namespace には作成できない。

4.1.1.1. 管理クラスターを設定するための前提条件

管理クラスターを設定するには、次の前提条件を満たす必要があります。

- OpenShift Container Platform クラスターに multicluster engine for Kubernetes Operator 2.5 以降がインストールされている。multicluster engine Operator は、Red Hat Advanced Cluster Management (RHACM) をインストールすると、自動的にインストールされます。multicluster engine Operator は、OpenShift Container Platform OperatorHub から Operator として RHACM なしでインストールすることもできます。

multicluster engine Operator のマネージド OpenShift Container Platform クラスターが少なくとも 1 つある。multicluster engine Operator バージョン 2.5 以降では、

local-clusterが自動的にインポートされます。次のコマンドを実行して、ハブクラスターの状態を確認できます。oc get managedclusters local-cluster

$ oc get managedclusters local-clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

awsコマンドラインインターフェイス (CLI) がインストールされている。 -

Hosted Control Plane の CLI である

hcpがインストールされている。

4.1.2. hcp CLI を使用して AWS 上のホステッドクラスターにアクセスする

hcp コマンドラインインターフェイス (CLI) を使用して kubeconfig ファイルを生成することで、ホステッドクラスターにアクセスできます。

手順

次のコマンドを入力して、

kubeconfigファイルを生成します。hcp create kubeconfig --namespace <hosted_cluster_namespace> \ --name <hosted_cluster_name> > <hosted_cluster_name>.kubeconfig

$ hcp create kubeconfig --namespace <hosted_cluster_namespace> \ --name <hosted_cluster_name> > <hosted_cluster_name>.kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow kubeconfigファイルを保存した後、次のコマンドを入力してホステッドクラスターにアクセスできます。oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodes

$ oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.3. Amazon Web Services S3 バケットと S3 OIDC シークレットの作成

Amazon Web Services (AWS) でホステッドクラスターを作成して管理するには、S3 バケットと S3 OIDC シークレットを作成する必要があります。

手順

次のコマンドを実行して、クラスターの OIDC 検出ドキュメントをホストするためのパブリックアクセスを持つ S3 バケットを作成します。

aws s3api create-bucket --bucket <bucket_name> \ --create-bucket-configuration LocationConstraint=<region> \ --region <region>

$ aws s3api create-bucket --bucket <bucket_name> \1 --create-bucket-configuration LocationConstraint=<region> \2 --region <region>3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow aws s3api delete-public-access-block --bucket <bucket_name>

$ aws s3api delete-public-access-block --bucket <bucket_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<bucket_name>は、作成する S3 バケットの名前に置き換えます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<bucket_name>は、作成する S3 バケットの名前に置き換えます。

aws s3api put-bucket-policy --bucket <bucket_name> \ --policy file://policy.json

$ aws s3api put-bucket-policy --bucket <bucket_name> \1 --policy file://policy.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<bucket_name>は、作成する S3 バケットの名前に置き換えます。

注記Mac コンピューターを使用している場合は、ポリシーを機能させるためにバケット名をエクスポートする必要があります。

-

HyperShift Operator 用に

hypershift-operator-oidc-provider-s3-credentialsという名前の OIDC S3 シークレットを作成します。 -

シークレットを

local-clusternamespace に保存します。 次の表を参照して、シークレットに次のフィールドが含まれていることを確認します。

Expand 表4.1 AWS シークレットの必須フィールド フィールド名 説明 bucketホステッドクラスターの OIDC 検出ドキュメントをホストするためのパブリックアクセスを備えた S3 バケットが含まれています。

credentialsバケットにアクセスできる

defaultプロファイルの認証情報を含むファイルへの参照。デフォルトでは、HyperShift はdefaultプロファイルのみを使用してbucketを操作します。regionS3 バケットのリージョンを指定します。

AWS シークレットを作成するには、次のコマンドを実行します。

oc create secret generic <secret_name> \ --from-file=credentials=<path>/.aws/credentials \ --from-literal=bucket=<s3_bucket> \ --from-literal=region=<region> \ -n local-cluster

$ oc create secret generic <secret_name> \ --from-file=credentials=<path>/.aws/credentials \ --from-literal=bucket=<s3_bucket> \ --from-literal=region=<region> \ -n local-clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記シークレットの障害復旧バックアップは自動的に有効になりません。障害復旧用に

hypershift-operator-oidc-provider-s3-credentialsシークレットのバックアップを有効にするラベルを追加するには、次のコマンドを実行します。oc label secret hypershift-operator-oidc-provider-s3-credentials \ -n local-cluster cluster.open-cluster-management.io/backup=true

$ oc label secret hypershift-operator-oidc-provider-s3-credentials \ -n local-cluster cluster.open-cluster-management.io/backup=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.4. ホステッドクラスター用のルーティング可能なパブリックゾーンの作成

ホステッドクラスター内のアプリケーションにアクセスするには、ルーティング可能なパブリックゾーンを設定する必要があります。パブリックゾーンが存在する場合は、この手順を省略します。省略しないと、パブリックゾーンによって既存の機能に影響が生じます。

手順

DNS レコードのルーティング可能なパブリックゾーンを作成するには、次のコマンドを入力します。

aws route53 create-hosted-zone \ --name <basedomain> \ --caller-reference $(whoami)-$(date --rfc-3339=date)

$ aws route53 create-hosted-zone \ --name <basedomain> \1 --caller-reference $(whoami)-$(date --rfc-3339=date)Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<basedomain>は、ベースドメイン (例:www.example.com) に置き換えます。

4.1.5. AWS IAM ロールと STS 認証情報の作成

Amazon Web Services (AWS) でホステッドクラスターを作成する前に、AWS IAM ロールと STS 認証情報を作成する必要があります。

手順

次のコマンドを実行して、ユーザーの Amazon Resource Name (ARN) を取得します。

aws sts get-caller-identity --query "Arn" --output text

$ aws sts get-caller-identity --query "Arn" --output textCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

arn:aws:iam::1234567890:user/<aws_username>

arn:aws:iam::1234567890:user/<aws_username>Copy to Clipboard Copied! Toggle word wrap Toggle overflow この出力は、次のステップで

<arn>の値として使用します。ロールの信頼関係設定を含む JSON ファイルを作成します。以下の例を参照してください。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<arn>は、前のステップでメモしたユーザーの ARN に置き換えます。

次のコマンドを実行して、Identity and Access Management (IAM) ロールを作成します。

aws iam create-role \ --role-name <name> \ --assume-role-policy-document file://<file_name>.json \ --query "Role.Arn"

$ aws iam create-role \ --role-name <name> \1 --assume-role-policy-document file://<file_name>.json \2 --query "Role.Arn"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

arn:aws:iam::820196288204:role/myrole

arn:aws:iam::820196288204:role/myroleCopy to Clipboard Copied! Toggle word wrap Toggle overflow ロールの次の権限ポリシーを含む

policy.jsonという名前の JSON ファイルを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

policy.jsonファイルをロールに割り当てます。aws iam put-role-policy \ --role-name <role_name> \ --policy-name <policy_name> \ --policy-document file://policy.json

$ aws iam put-role-policy \ --role-name <role_name> \1 --policy-name <policy_name> \2 --policy-document file://policy.json3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

sts-creds.jsonという名前の JSON ファイル内の STS 認証情報を取得します。aws sts get-session-token --output json > sts-creds.json

$ aws sts get-session-token --output json > sts-creds.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow sts-creds.jsonファイルの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.6. Hosted Control Plane 用の AWS PrivateLink の有効化

PrivateLink を使用して Amazon Web Services (AWS) で Hosted Control Plane をプロビジョニングするには、Hosted Control Plane 用の AWS PrivateLink を有効にします。

手順

-

HyperShift Operator の AWS 認証情報シークレットを作成し、

hypershift-operator-private-link-credentialsという名前を付けます。このシークレットは、管理クラスターとして使用されているマネージドクラスターの namespace であるマネージドクラスター namespace に配置する必要があります。local-clusterを使用した場合は、local-clusternamespace にシークレットを作成します。 - シークレットに必要なフィールドが含まれることを確認するには、以下の表を参照してください。

| フィールド名 | 説明 | 任意または必須 |

|---|---|---|

|

| Private Link で使用するリージョン | 必須 |

|

| 認証情報アクセスキー ID。 | 必須 |

|

| 認証情報アクセスキーのシークレット。 | 必須 |

AWS シークレットを作成するには、次のコマンドを実行します。

oc create secret generic <secret_name> \ --from-literal=aws-access-key-id=<aws_access_key_id> \ --from-literal=aws-secret-access-key=<aws_secret_access_key> \ --from-literal=region=<region> -n local-cluster

$ oc create secret generic <secret_name> \

--from-literal=aws-access-key-id=<aws_access_key_id> \

--from-literal=aws-secret-access-key=<aws_secret_access_key> \

--from-literal=region=<region> -n local-cluster

シークレットの障害復旧バックアップは自動的に有効になりません。以下のコマンドを実行して、障害復旧用に hypershift-operator-private-link-credentials シークレットのバックアップを有効にするラベルを追加します。

oc label secret hypershift-operator-private-link-credentials \ -n local-cluster \ cluster.open-cluster-management.io/backup=""

$ oc label secret hypershift-operator-private-link-credentials \

-n local-cluster \

cluster.open-cluster-management.io/backup=""4.1.7. AWS 上の Hosted Control Plane 用の外部 DNS を有効にする

Hosted Control Plane では、コントロールプレーンとデータプレーンが分離されています。DNS は、次の 2 つの独立した領域で設定できます。

-

ホステッドクラスター (

*.apps.service-consumer-domain.comなどのドメイン) 内のワークロードの Ingress。 -

サービスプロバイダーのドメイン

*.service-provider-domain.comを介した API または OAuth エンドポイントなど、管理クラスター内のサービスエンドポイントの Ingress。

hostedCluster.spec.dns の入力は、ホステッドクラスター内のワークロードの Ingress を管理します。hostedCluster.spec.services.servicePublishingStrategy.route.hostname の入力は、管理クラスター内のサービスエンドポイントの Ingress を決定します。

外部 DNS は、LoadBalancer または Route の公開タイプを指定し、その公開タイプのホスト名を提供するホステッドクラスター Services の名前レコードを作成します。Private または PublicAndPrivate エンドポイントアクセスタイプを持つホステッドクラスターの場合、APIServer サービスと OAuth サービスのみがホスト名をサポートします。Private ホステッドクラスターの場合、DNS レコードが VPC 内の Virtual Private Cloud (VPC) エンドポイントのプライベート IP アドレスに解決されます。

Hosted Control Plane は、次のサービスを公開します。

-

APIServer -

OIDC

これらのサービスは、HostedCluster 仕様の servicePublishingStrategy フィールドを使用して公開できます。デフォルトでは、servicePublishingStrategy の LoadBalancer および Route タイプの場合、次のいずれかの方法でサービスを公開できます。

-

LoadBalancerタイプのServiceのステータスにあるロードバランサーのホスト名を使用する方法 -

Routeリソースのstatus.hostフィールドを使用する方法

ただし、マネージドサービスのコンテキストで Hosted Control Plane をデプロイすると、これらの方法によって、基盤となる管理クラスターの Ingress サブドメインが公開され、管理クラスターのライフサイクルと障害復旧のオプションが制限される可能性があります。

DNS 間接化が LoadBalancer および Route 公開タイプに階層化されている場合、マネージドサービスオペレーターは、サービスレベルドメインを使用してすべてのパブリックホステッドクラスターサービスを公開できます。このアーキテクチャーでは、DNS 名を新しい LoadBalancer または Route に再マッピングできますが、管理クラスターの Ingress ドメインは公開されません。Hosted Control Plane は、外部 DNS を使用して間接層を実現します。

管理クラスターの hypershift namespace に HyperShift Operator と一緒に external-dns をデプロイできます。外部 DNS は、external-dns.alpha.kubernetes.io/hostname アノテーションを持つ Services または Routes を監視します。このアノテーションは、A レコードなどの Service、または CNAME レコードなどの Route を参照する DNS レコードを作成するために使用されます。

外部 DNS はクラウド環境でのみ使用できます。その他の環境では、DNS とサービスを手動で設定する必要があります。

外部 DNS の詳細は、外部 DNS を参照してください。

4.1.7.1. 前提条件

Amazon Web Services (AWS) で Hosted Control Plane の外部 DNS を設定する前に、次の前提条件を満たす必要があります。

- 外部パブリックドメインを作成した。

- AWS Route53 管理コンソールにアクセスできる。

- Hosted Control Plane 用に AWS PrivateLink を有効にした。

4.1.7.2. Hosted Control Plane の外部 DNS の設定

Hosted Control Plane は、外部 DNS またはサービスレベル DNS を使用してプロビジョニングできます。

-

HyperShift Operator 用の Amazon Web Services (AWS) 認証情報シークレットを作成し、

local-clusternamespace でhypershift-operator-external-dns-credentialsという名前を付けます。 次の表を参照して、シークレットに必須フィールドが含まれていることを確認してください。

Expand 表4.3 AWS シークレットの必須フィールド フィールド名 説明 任意または必須 providerサービスレベル DNS ゾーンを管理する DNS プロバイダー。

必須

domain-filterサービスレベルドメイン。

必須

credentialsすべての外部 DNS タイプをサポートする認証情報ファイル。

AWS キーを使用する場合はオプション

aws-access-key-id認証情報アクセスキー ID。

AWS DNS サービスを使用する場合はオプション

aws-secret-access-key認証情報アクセスキーのシークレット。

AWS DNS サービスを使用する場合はオプション

AWS シークレットを作成するには、次のコマンドを実行します。

oc create secret generic <secret_name> \ --from-literal=provider=aws \ --from-literal=domain-filter=<domain_name> \ --from-file=credentials=<path_to_aws_credentials_file> -n local-cluster

$ oc create secret generic <secret_name> \ --from-literal=provider=aws \ --from-literal=domain-filter=<domain_name> \ --from-file=credentials=<path_to_aws_credentials_file> -n local-clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記シークレットの障害復旧バックアップは自動的に有効になりません。障害復旧のためにシークレットをバックアップするには、次のコマンドを入力して

hypershift-operator-external-dns-credentialsを追加します。oc label secret hypershift-operator-external-dns-credentials \ -n local-cluster \ cluster.open-cluster-management.io/backup=""

$ oc label secret hypershift-operator-external-dns-credentials \ -n local-cluster \ cluster.open-cluster-management.io/backup=""Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.7.3. パブリック DNS ホストゾーンの作成

パブリック DNS ホストゾーンは、パブリックホステッドクラスターを作成するために、External DNS Operator によって使用されます。

外部 DNS ドメインフィルターとして使用するパブリック DNS ホストゾーンを作成できます。AWS Route 53 管理コンソールで次の手順を実行します。

手順

- Route 53 管理コンソールで、Create hosted zone をクリックします。

- Hosted zone configuration ページでドメイン名を入力し、タイプとして Public hosted zone が選択されていることを確認し、Create hosted zone をクリックします。

- ゾーンが作成されたら、Records タブの Value/Route traffic to 列の値をメモします。

- メインドメインで、DNS 要求を委任ゾーンにリダイレクトするための NS レコードを作成します。Value フィールドに、前の手順でメモした値を入力します。

- Create records をクリックします。

次の例のように、新しいサブゾーンにテストエントリーを作成し、

digコマンドでテストして、DNS ホストゾーンが機能していることを確認します。dig +short test.user-dest-public.aws.kerberos.com

$ dig +short test.user-dest-public.aws.kerberos.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

192.168.1.1

192.168.1.1Copy to Clipboard Copied! Toggle word wrap Toggle overflow LoadBalancerおよびRouteサービスのホスト名を設定するホステッドクラスターを作成するには、次のコマンドを入力します。hcp create cluster aws --name=<hosted_cluster_name> \ --endpoint-access=PublicAndPrivate \ --external-dns-domain=<public_hosted_zone> ...

$ hcp create cluster aws --name=<hosted_cluster_name> \ --endpoint-access=PublicAndPrivate \ --external-dns-domain=<public_hosted_zone> ...1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<public_hosted_zone>は、作成したパブリックホストゾーンに置き換えます。

ホステッドクラスターの

servicesブロックの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Control Plane Operator は、Services と Routes リソースを作成し、external-dns.alpha.kubernetes.io/hostname のアノテーションを付けます。Services と Routes の場合、Control Plane Operator は、サービスエンドポイントの servicePublishingStrategy フィールドの hostname パラメーターの値を使用します。DNS レコードを作成するには、external-dns デプロイメントなどのメカニズムを使用できます。

サービスレベルの DNS 間接化をパブリックサービスにのみ設定できます。プライベートサービスは hypershift.local プライベートゾーンを使用するため、hostname を設定できません。

次の表は、サービスとエンドポイントの組み合わせに対して hostname を設定することが有効な場合を示しています。

| サービス | Public | PublicAndPrivate | Private |

|---|---|---|---|

|

| Y | Y | N |

|

| Y | Y | N |

|

| Y | N | N |

|

| Y | N | N |

4.1.7.4. AWS 上で外部 DNS を使用してホステッドクラスターを作成する

Amazon Web Services (AWS) で PublicAndPrivate または Public 公開ストラテジーを使用してホステッドクラスターを作成するには、管理クラスターで次のアーティファクトが設定されている必要があります。

- パブリック DNS ホストゾーン

- External DNS Operator

- HyperShift Operator

ホステッドクラスターは、hcp コマンドラインインターフェイス (CLI) を使用してデプロイできます。

手順

管理クラスターにアクセスするには、次のコマンドを入力します。

export KUBECONFIG=<path_to_management_cluster_kubeconfig>

$ export KUBECONFIG=<path_to_management_cluster_kubeconfig>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、External DNS Operator が実行されていることを確認します。

oc get pod -n hypershift -lapp=external-dns

$ oc get pod -n hypershift -lapp=external-dnsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME READY STATUS RESTARTS AGE external-dns-7c89788c69-rn8gp 1/1 Running 0 40s

NAME READY STATUS RESTARTS AGE external-dns-7c89788c69-rn8gp 1/1 Running 0 40sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 外部 DNS を使用してホステッドクラスターを作成するには、次のコマンドを入力します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Amazon Resource Name (ARN) を指定します (例:

arn:aws:iam::820196288204:role/myrole)。 - 2

- インスタンスタイプを指定します (例:

m6i.xlarge)。 - 3

- AWS リージョンを指定します (例:

us-east-1)。 - 4

- ホステッドクラスター名を指定します (例:

my-external-aws)。 - 5

- サービスコンシューマーが所有するパブリックホストゾーンを指定します (例:

service-consumer-domain.com)。 - 6

- ノードのレプリカ数を指定します (例:

2)。 - 7

- プルシークレットファイルへのパスを指定します。

- 8

- 使用するサポート対象の OpenShift Container Platform バージョンを指定します (例:

4.17.0-multi)。 - 9

- サービスプロバイダーが所有するパブリックホストゾーンを指定します (例:

service-provider-domain.com)。 - 10

PublicAndPrivateとして設定します。外部 DNS は、PublicまたはPublicAndPrivate設定でのみ使用できます。- 11

- AWS STS 認証情報ファイルへのパスを指定します (例:

/home/user/sts-creds/sts-creds.json)。

4.1.8. AWS 上でホステッドクラスターを作成する

hcp コマンドラインインターフェイス (CLI) を使用して、Amazon Web Services (AWS) 上にホステッドクラスターを作成できます。

Amazon Web Services (AWS) 上の Hosted Control Plane では、デフォルトで AMD64 ホステッドクラスターを使用します。ただし、Hosted Control Plane を ARM64 ホステッドクラスターで実行することもできます。詳細は、「ARM64 アーキテクチャーでのホステッドクラスターの実行」を参照してください。

ノードプールとホステッドクラスターの互換性のある組み合わせは、次の表を参照してください。

| ホステッドクラスター | ノードプール |

|---|---|

| AMD64 | AMD64 または ARM64 |

| ARM64 | ARM64 または AMD64 |

前提条件

-

Hosted Control Plane の CLI である

hcpを設定した。 -

local-clusterマネージドクラスターを管理クラスターとして有効にした。 - AWS Identity and Access Management (IAM) ロールと AWS Security Token Service (STS) 認証情報を作成した。

手順

AWS 上にホステッドクラスターを作成するには、次のコマンドを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ホステッドクラスターの名前を指定します (例:

example)。 - 2

- インフラストラクチャー名を指定します。

<hosted_cluster_name>と<infra_id>には同じ値を指定する必要があります。そうしないと、multicluster engine for Kubernetes Operator のコンソールに、クラスターが正しく表示されない可能性があります。 - 3

- ベースドメインを指定します (例:

example.com)。 - 4

- AWS STS 認証情報ファイルへのパスを指定します (例:

/home/user/sts-creds/sts-creds.json)。 - 5

- プルシークレットへのパスを指定します (例:

/user/name/pullsecret)。 - 6

- AWS リージョン名を指定します (例:

us-east-1)。 - 7

- ノードプールのレプリカ数を指定します (例:

3)。 - 8

- デフォルトでは、

HostedClusterとNodePoolのすべてのカスタムリソースがclustersnamespace に作成されます。--namespace <namespace>パラメーターを使用すると、特定の namespace にHostedClusterおよびNodePoolカスタムリソースを作成できます。 - 9

- Amazon Resource Name (ARN) を指定します (例:

arn:aws:iam::820196288204:role/myrole)。 - 10

- EC2 インスタンスを共有テナントハードウェア上で実行するか、シングルテナントハードウェア上で実行するかを指定する場合は、このフィールドを含めます。

--render-intoフラグを含めると、Kubernetes リソースが、このフィールドで指定した YAML ファイルにレンダリングされます。この場合、次のステップに進み、YAML ファイルを編集します。

前のコマンドに

--render-intoフラグを含めた場合は、指定した YAML ファイルを編集します。YAML ファイルのNodePool仕様を編集して、EC2 インスタンスを共有ハードウェア上で実行するか、シングルテナントハードウェア上で実行するかを指定します。次に例を示します。サンプル YAML ファイル

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ホステッドクラスターのステータスを確認し、

AVAILABLEの値がTrueであることを確認します。以下のコマンドを実行します。oc get hostedclusters -n <hosted_cluster_namespace>

$ oc get hostedclusters -n <hosted_cluster_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、ノードプールのリストを取得します。

oc get nodepools --namespace <hosted_cluster_namespace>

$ oc get nodepools --namespace <hosted_cluster_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.8.1. AWS 上のホステッドクラスターへのアクセス

リソースから kubeconfig ファイルと kubeadmin 認証情報を直接取得することで、ホステッドクラスターにアクセスできます。

ホステッドクラスターのアクセスシークレットを理解している必要があります。ホステッドクラスター namespace にはホステッドクラスターリソースが含まれており、Hosted Control Plane namespace では Hosted Control Plane が実行されます。シークレット名の形式は次のとおりです。

-

kubeconfigシークレット:<hosted-cluster-namespace>-<name>-admin-kubeconfig.たとえば、clusters-hypershift-demo-admin-kubeconfigです。 -

kubeadminパスワードシークレット:<hosted-cluster-namespace>-<name>-kubeadmin-password。たとえば、clusters-hypershift-demo-kubeadmin-passwordです。

手順

kubeconfigシークレットには Base64 でエンコードされたkubeconfigフィールドが含まれており、これをデコードしてファイルに保存し、次のコマンドで使用できます。oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodes

$ oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow kubeadminパスワードシークレットも Base64 でエンコードされます。これをデコードし、そのパスワードを使用して、ホステッドクラスターの API サーバーまたはコンソールにログインできます。

4.1.8.2. kubeadmin 認証情報を使用して AWS 上のホステッドクラスターにアクセスする

Amazon Web Services (AWS) にホステッドクラスターを作成した後、kubeconfig ファイル、アクセスシークレット、および kubeadmin 認証情報を取得して、ホステッドクラスターにアクセスできます。

ホステッドクラスターのリソースとアクセスシークレットは、ホステッドクラスターの namespace に格納されます。Hosted Control Plane は、Hosted Control Plane の namespace で実行されます。

シークレット名の形式は次のとおりです。

-

kubeconfigシークレット:<hosted_cluster_namespace>-<name>-admin-kubeconfig。たとえば、clusters-hypershift-demo-admin-kubeconfigです。 -

kubeadminパスワードシークレット:<hosted_cluster_namespace>-<name>-kubeadmin-password。たとえば、clusters-hypershift-demo-kubeadmin-passwordです。

kubeadmin パスワードシークレットは、Base64 でエンコードされています。kubeconfig シークレットには、Base64 でエンコードされた kubeconfig 設定が含まれています。Base64 でエンコードされた kubeconfig 設定をデコードし、<hosted_cluster_name>.kubeconfig ファイルに保存する必要があります。

手順

デコードされた

kubeconfig設定を含む<hosted_cluster_name>.kubeconfigファイルを使用して、ホステッドクラスターにアクセスします。以下のコマンドを入力します。oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodes

$ oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow API サーバーまたはホステッドクラスターのコンソールにログインするには、

kubeadminパスワードシークレットをデコードする必要があります。

4.1.8.3. hcp CLI を使用して AWS 上のホステッドクラスターにアクセスする

hcp コマンドラインインターフェイス (CLI) を使用して、ホステッドクラスターにアクセスできます。

手順

次のコマンドを入力して、

kubeconfigファイルを生成します。hcp create kubeconfig --namespace <hosted_cluster_namespace> \ --name <hosted_cluster_name> > <hosted_cluster_name>.kubeconfig

$ hcp create kubeconfig --namespace <hosted_cluster_namespace> \ --name <hosted_cluster_name> > <hosted_cluster_name>.kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow kubeconfigファイルを保存したら、次のコマンドを入力してホステッドクラスターにアクセスします。oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodes

$ oc --kubeconfig <hosted_cluster_name>.kubeconfig get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.9. ホステッドクラスターでカスタム API サーバー証明書を設定する

API サーバーのカスタム証明書を設定するには、HostedCluster 設定の spec.configuration.apiServer セクションで証明書の詳細を指定します。

カスタム証明書は、Day 1 操作または Day 2 操作の中で設定できます。ただし、サービス公開ストラテジーはホステッドクラスターの作成中に設定した後は変更できないため、設定する予定の Kubernetes API サーバーのホスト名を知っておく必要があります。

前提条件

管理クラスターにカスタム証明書が含まれる Kubernetes シークレットを作成しました。シークレットには次の鍵が含まれています。

-

tls.crt: 証明書 -

tls.key: 秘密鍵

-

-

HostedCluster設定にロードバランサーを使用するサービス公開ストラテジーが含まれている場合は、証明書のサブジェクト代替名 (SAN) が内部 API エンドポイント (api-int) と競合しないことを確認してください。内部 API エンドポイントは、プラットフォームによって自動的に作成および管理されます。カスタム証明書と内部 API エンドポイントの両方で同じホスト名を使用すると、ルーティングの競合が発生する可能性があります。このルールの唯一の例外は、PrivateまたはPublicAndPrivate設定で AWS をプロバイダーとして使用する場合です。このような場合、SAN の競合はプラットフォームによって管理されます。 - 証明書は外部 API エンドポイントに対して有効である必要があります。

- 証明書の有効期間は、クラスターの予想されるライフサイクルと一致します。

手順

次のコマンドを入力して、カスタム証明書を使用してシークレットを作成します。

oc create secret tls sample-hosted-kas-custom-cert \ --cert=path/to/cert.crt \ --key=path/to/key.key \ -n <hosted_cluster_namespace>

$ oc create secret tls sample-hosted-kas-custom-cert \ --cert=path/to/cert.crt \ --key=path/to/key.key \ -n <hosted_cluster_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例に示すように、カスタム証明書の詳細を使用して

HostedCluster設定を更新します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、

HostedCluster設定に変更を適用します。oc apply -f <hosted_cluster_config>.yaml

$ oc apply -f <hosted_cluster_config>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

- API サーバー Pod をチェックして、新しい証明書がマウントされていることを確認します。

- カスタムドメイン名を使用して API サーバーへの接続をテストします。

-

ブラウザーで、または

opensslなどのツールを使用して、証明書の詳細を確認します。

4.1.10. AWS 上の複数のゾーンにホステッドクラスターを作成する

hcp コマンドラインインターフェイス (CLI) を使用して、Amazon Web Services (AWS) 上の複数のゾーンにホステッドクラスターを作成できます。

前提条件

- AWS Identity and Access Management (IAM) ロールと AWS Security Token Service (STS) 認証情報を作成した。

手順

次のコマンドを実行して、AWS 上の複数のゾーンにホステッドクラスターを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ホステッドクラスターの名前を指定します (例:

example)。 - 2

- ノードプールのレプリカ数を指定します (例:

2)。 - 3

- ベースドメインを指定します (例:

example.com)。 - 4

- プルシークレットへのパスを指定します (例:

/user/name/pullsecret)。 - 5

- Amazon Resource Name (ARN) を指定します (例:

arn:aws:iam::820196288204:role/myrole)。 - 6

- AWS リージョン名を指定します (例:

us-east-1)。 - 7

- AWS リージョン内のアベイラビリティーゾーンを指定します (例:

us-east-1a、us-east-1b)。 - 8

- AWS STS 認証情報ファイルへのパスを指定します (例:

/home/user/sts-creds/sts-creds.json)。

指定したゾーンごとに、次のインフラストラクチャーが作成されます。

- パブリックサブネット

- プライベートサブネット

- NAT ゲートウェイ

- プライベートルートテーブル

パブリックルートテーブルはパブリックサブネット間で共有されます。

ゾーンごとに 1 つの NodePool リソースが作成されます。ノードプール名の末尾にはゾーン名が付けられます。ゾーンのプライベートサブネットは spec.platform.aws.subnet.id に設定されます。

4.1.10.1. AWS STS 認証情報を指定してホステッドクラスターを作成する

hcp create cluster aws コマンドを使用してホステッドクラスターを作成する場合は、ホステッドクラスターのインフラストラクチャーリソースを作成する権限を持つ Amazon Web Services (AWS) アカウントの認証情報を指定する必要があります。

インフラストラクチャーリソースの例としては、次のものがあります。

- Virtual Private Cloud (VPC)

- サブネット

- ネットワークアドレス変換 (NAT) ゲートウェイ

次のいずれかの方法で AWS 認証情報を指定できます。

- AWS Security Token Service (STS) 認証情報

- multicluster engine Operator からの AWS クラウドプロバイダーのシークレット

手順

AWS STS 認証情報を指定して AWS 上にホステッドクラスターを作成するには、次のコマンドを入力します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ホステッドクラスターの名前を指定します (例:

example)。 - 2

- ノードプールのレプリカ数を指定します (例:

2)。 - 3

- ベースドメインを指定します (例:

example.com)。 - 4

- プルシークレットへのパスを指定します (例:

/user/name/pullsecret)。 - 5

- AWS STS 認証情報ファイルへのパスを指定します (例:

/home/user/sts-creds/sts-creds.json)。 - 6

- AWS リージョン名を指定します (例:

us-east-1)。 - 7

- Amazon Resource Name (ARN) を指定します (例:

arn:aws:iam::820196288204:role/myrole)。

4.1.11. ARM64 アーキテクチャーでのホステッドクラスターの実行

Amazon Web Services (AWS) 上の Hosted Control Plane では、デフォルトで AMD64 ホステッドクラスターを使用します。ただし、Hosted Control Plane を ARM64 ホステッドクラスターで実行することもできます。

ノードプールとホステッドクラスターの互換性のある組み合わせは、次の表を参照してください。

| ホステッドクラスター | ノードプール |

|---|---|

| AMD64 | AMD64 または ARM64 |

| ARM64 | ARM64 または AMD64 |

4.1.11.1. ARM64 OpenShift Container Platform クラスターにホステッドクラスターを作成する

デフォルトのリリースイメージをマルチアーキテクチャーリリースイメージでオーバーライドすることで、Amazon Web Services (AWS) の ARM64 OpenShift Container Platform クラスターでホステッドクラスターを実行できます。

マルチアーキテクチャーリリースイメージを使用しない場合、ホステッドクラスターでマルチアーキテクチャーリリースイメージを使用するか、リリースイメージに基づいて NodePool カスタムリソースを更新するまで、ノードプール内のコンピュートノードが作成されず、ノードプールのリコンシリエーションが停止します。

前提条件

- AWS にインストールされた、64 ビット ARM インフラストラクチャーの OpenShift Container Platform クラスターがある。詳細は、Create an OpenShift Container Platform Cluster: AWS (ARM) を参照してください。

- AWS Identity and Access Management (IAM) ロールと AWS Security Token Service (STS) 認証情報を作成する。詳細は、「AWS IAM ロールと STS 認証情報の作成」を参照してください。

手順

次のコマンドを入力して、ARM64 OpenShift Container Platform クラスターにホステッドクラスターを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ホステッドクラスターの名前を指定します (例:

example)。 - 2

- ノードプールのレプリカ数を指定します (例:

3)。 - 3

- ベースドメインを指定します (例:

example.com)。 - 4

- プルシークレットへのパスを指定します (例:

/user/name/pullsecret)。 - 5

- AWS STS 認証情報ファイルへのパスを指定します (例:

/home/user/sts-creds/sts-creds.json)。 - 6

- AWS リージョン名を指定します (例:

us-east-1)。 - 7

- 使用するサポート対象の OpenShift Container Platform バージョンを指定します (例: