サポート

OpenShift Container Platform のサポート

概要

第1章 サポートの概要

Red Hat は、クラスターのデータを収集し、モニタリングとトラブルシューティングを行うためのツールをクラスター管理者に提供します。

1.1. サポートの利用

サポートの利用: Red Hat カスタマーポータルにアクセスして、ナレッジベースの記事の確認、サポートケースの作成、追加の製品ドキュメントおよびリソースの確認を行ってください。

1.2. リモートヘルスモニタリングの問題

リモートヘルスモニタリングの問題: OpenShift Container Platform はクラスターの Telemetry および設定データを収集し、Telemeter Client および Insights Operator を使用してこのデータを Red Hat に報告します。Red Hat はこのデータを使用して、接続されたクラスター での問題を理解し、解決します。接続されたクラスターと同様に、ネットワークが制限された環境で、リモートヘルスモニタリングを使用 できます。OpenShift Container Platform は以下を使用してデータを収集して正常性を監視します。

Telemetry: Telemetry クライアントは、4 分 30 秒ごとにメトリクス値を収集し、Red Hat にアップロードします。Red Hat はこのデータを使用して以下を行います。

- クラスターの監視。

- OpenShift Container Platform のアップグレードのロールアウト。

- アップグレードエクスペリエンスの向上。

Insights Operator: OpenShift Container Platform は、デフォルトで Insights Operator をインストールして有効にします。この Operator は、2 時間ごとに設定とコンポーネントの障害ステータスを報告します。Insights Operator は次のことに役立ちます。

- 発生する可能性のあるクラスターの問題を事前に特定する。

- Red Hat OpenShift Cluster Manager でソリューションと予防措置を提供する。

Telemetry 情報を確認 できます。

リモートヘルスレポートを有効にしている場合は、Insights を使用してクラスターの問題を特定 します。必要に応じて、リモートヘルスレポートを無効にできます。

1.3. クラスターに関するデータの収集

クラスターに関するデータの収集: Red Hat は、サポートケースの作成時にデバッグ情報を収集することを推奨します。デバッグ情報があると、Red Hat サポートが根本原因を分析するのに役立ちます。クラスター管理者は、以下を使用してクラスターに関するデータを収集できます。

-

must-gather ツール:

must-gatherツールを使用してクラスターの情報を収集し、問題のデバッグを行います。 -

sosreport:

sosreportツールを使用して、デバッグ目的で設定の詳細、システム情報、および診断データを収集します。 - Cluster ID: Red Hat サポートに情報を提供する際に、クラスターの一意 ID を取得します。

-

ブートストラップノードのジャーナルログ:

bootkube.serviceのjournaldユニットログと、ブートストラップノードからコンテナーログを収集し、ブートストラップ関連の問題をトラブルシューティングします。 -

クラスターノードのジャーナルログ: ノード関連の問題のトラブルシューティングに、各クラスターの

/var/logにあるログと、journaldユニットログを収集します。 - ネットワークトレース: Red Hat サポートがネットワーク関連の問題をトラブルシューティングできるように、固有の OpenShift Container Platform クラスターノードまたはコンテナーからネットワークパケットトレースを提供します。

1.4. 問題のトラブルシューティング

クラスター管理者は、以下の OpenShift Container Platform コンポーネントの問題を監視し、トラブルシューティングできます。

インストールの問題: OpenShift Container Platform のインストールは段階を追って進められます。以下を実行できます。

- インストールステージの監視。

- インストールのどの段階で発生するかの判断。

- 複数のインストールの問題調査。

- 失敗したインストールからのログ収集。

ノードの問題: クラスター管理者は、ノードのステータス、リソースの使用状況、および設定を確認して、ノード関連の問題を検証およびトラブルシューティングできます。以下に対してクエリーを実行できます。

- ノード上の kubelet のステータス。

- クラスターノードジャーナルログ。

Crio の問題: クラスター管理者は、各クラスターノードで CRI-O コンテナーランタイムエンジンのステータスを確認できます。コンテナーランタイムの問題が発生した場合には、以下を実行します。

- CRI-O journald ユニットログを収集します。

- CRI-O ストレージをクリーンアップします。

オペレーティングシステムの問題: OpenShift Container Platform は Red Hat Enterprise Linux CoreOS で実行されます。オペレーティングシステムの問題が発生した場合は、カーネルクラッシュの手順を調査してください。以下の点を行うようにしてください。

- kdump が有効である。

- kdump 設定をテストする。

- コアダンプを分析する。

ネットワークの問題: クラスター管理者は以下を実行して、Open vSwitch の問題をトラブルシューティングできます。

- Open vSwitch のログレベルを一時的に設定する。

- Open vSwitch のログレベルを永続的に設定する。

- Open vSwitch のログを表示する。

Operator の問題: クラスター管理者は以下を実行して、Operator の問題を解決できます。

- Operator サブスクリプションのステータスを確認する。

- Operator Pod の正常性を確認する。

- Operator ログを収集する。

Pod の問題: クラスター管理者は、Pod のステータスを確認して以下を実行し、Pod 関連の問題のトラブルシューティングを行うことができます。

- Pod およびコンテナーのログを確認する。

- root アクセスでデバッグ Pod を起動する。

Source-to-Image の問題: クラスター管理者は S2I ステージを確認し、S2I プロセスのどこで障害が発生したかを判断できます。Source-to-Image(S2I) の問題を解決するには、以下を収集します。

- Source-to-Image 診断データ。

- アプリケーションの障害を調査するためのアプリケーション診断データ。

ストレージの問題: 障害のあるノードがアタッチしたボリュームをアンマウントできないことが原因で、新しいノードにボリュームをマウントできない場合、マルチアタッチストレージエラーが発生します。クラスター管理者は、以下を実行して、複数アタッチされているストレージの問題を解決できます。

- RWX ボリュームを使用して、複数割り当てを有効にします。

- RWO ボリュームの使用時に障害が発生したノードを回復するか、削除します。

モニタリングの問題: クラスター管理者は、モニタリングに関するトラブルシューティングページの手順を実行してください。ユーザー定義プロジェクトのメトリクスが利用できない場合や、Prometheus が大量のディスク領域を消費している場合は、以下を確認します。

- ユーザー定義のメトリクスが利用できない理由を調べる。

- Prometheus が大量のディスク領域を消費している理由を特定する。

-

OpenShift CLI (

oc) の問題: ログレベルを増やすことで OpenShift CLI (oc) の問題を調査します。

第2章 クラスターリソースの管理

OpenShift Container Platform でグローバル設定オプションを適用できます。Operator はこれらの設定をクラスター全体に適用します。

2.1. クラスターリソースの操作

OpenShift Container Platform の OpenShift CLI (oc) ツールを使用してクラスターリソースを操作できます。oc api-resources コマンドの実行後に表示されるクラスターリソースを編集できます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

Web コンソールにアクセスできるか、

ocCLI ツールがインストールされている。

手順

適用された設定 Operator を確認するには、以下のコマンドを実行します。

oc api-resources -o name | grep config.openshift.io

$ oc api-resources -o name | grep config.openshift.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定可能なクラスターリソースを表示するには、以下のコマンドを実行します。

oc explain <resource_name>.config.openshift.io

$ oc explain <resource_name>.config.openshift.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターのカスタムリソース定義 (CRD) オブジェクトの設定を表示するには、以下のコマンドを実行します。

oc get <resource_name>.config -o yaml

$ oc get <resource_name>.config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターリソース設定を編集するには、以下のコマンドを実行します。

oc edit <resource_name>.config -o yaml

$ oc edit <resource_name>.config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第3章 サポート

3.1. サポート

このドキュメントで説明されている手順、または OpenShift Container Platform 全般で問題が発生した場合は、Red Hat カスタマーポータル にアクセスしてください。

カスタマーポータルでは、次のことができます。

- Red Hat 製品に関するアーティクルおよびソリューションを対象とした Red Hat ナレッジベースの検索またはブラウズ。

- Red Hat サポートに対するサポートケースの送信。

- その他の製品ドキュメントへのアクセス。

クラスターの問題を特定するには、OpenShift Cluster Manager で Insights を使用できます。Insights により、問題の詳細と、利用可能な場合は問題の解決方法に関する情報が提供されます。

このドキュメントを改善するための提案がある場合、またはエラーを見つけた場合は、最も関連性の高いドキュメントコンポーネントについて Jira 課題 を送信してください。セクション名や OpenShift Container Platform バージョンなどの具体的な情報を提供してください。

3.2. Red Hat ナレッジベースについて

Red Hat ナレッジベース は、お客様が Red Hat の製品やテクノロジーを最大限に活用できるようにするための豊富なコンテンツを提供します。Red Hat ナレッジベースは、Red Hat 製品のインストール、設定、および使用に関する記事、製品ドキュメント、および動画で構成されています。さらに、既知の問題に対する解決策を検索でき、それぞれに根本原因の簡潔な説明と修復手順が記載されています。

3.3. Red Hat ナレッジベースの検索

OpenShift Container Platform の問題が発生した場合には、初期検索を実行して、解決策を Red Hat ナレッジベース内ですでに見つけることができるかどうかを確認できます。

前提条件

- Red Hat カスタマーポータルのアカウントがある。

手順

- Red Hat カスタマーポータル にログインします。

- Search をクリックします。

検索フィールドに、問題に関連する次のようなキーワードと文字列を入力します。

- OpenShift Container Platform コンポーネント (etcd など)

- 関連する手順 (installation など)

- 明示的な失敗に関連する警告、エラーメッセージ、およびその他の出力

- Enter キーをクリックします。

- オプション: OpenShift Container Platform 製品フィルターを選択します。

- オプション: Documentation コンテンツタイプフィルターを選択します。

3.4. サポートケースの作成

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift CLI (

oc) がインストールされている。 - Red Hat カスタマーポータルのアカウントがある。

- Red Hat の Standard または Premium サブスクリプションがある。

手順

- Red Hat カスタマーポータルの Customer Support ページ にログインします。

- Get support をクリックします。

Customer Support ページの Cases タブで、以下を行います。

- オプション: 必要に応じて、事前に入力されたアカウントと所有者の詳細を変更します。

- 問題に該当するカテゴリー (Bug、Defect など) を選択し、Continue をクリックします。

以下の情報を入力します。

- Summary フィールドには、問題の簡潔で説明的な概要と、確認されている現象および予想される動作の詳細情報を入力します。

- Product ドロップダウンメニューから OpenShift Container Platform を選択します。

- Version ドロップダウンから 4.17 を選択します。

- Red Hat ナレッジベースで推奨されるソリューション一覧を確認してください。この一覧に上げられているソリューションは、報告しようとしている問題に適用される可能性があります。提案されている記事が問題に対応していない場合は、Continue をクリックします。

- 報告している問題に対する一致に基づいて推奨される Red Hat ナレッジベースソリューションの一覧が更新されることを確認してください。ケース作成プロセスでより多くの情報を提供すると、このリストの絞り込みが行われます。提案されている記事が問題に対応していない場合は、Continue をクリックします。

- アカウント情報が予想通りに表示されていることを確認し、そうでない場合は適宜修正します。

自動入力された OpenShift Container Platform クラスター ID が正しいことを確認します。正しくない場合は、クラスター ID を手動で取得します。

OpenShift Container Platform Web コンソールを使用してクラスター ID を手動で取得するには、以下を実行します。

- Home → Overview に移動します。

- Details セクションの Cluster ID フィールドで値を見つけます。

または、OpenShift Container Platform Web コンソールで新規サポートケースを作成し、クラスター ID を自動的に入力することができます。

- ツールバーから、(?)Help → Open Support Case に移動します。

- Cluster ID 値が自動的に入力されます。

OpenShift CLI (

oc) を使用してクラスター ID を取得するには、以下のコマンドを実行します。oc get clusterversion -o jsonpath='{.items[].spec.clusterID}{"\n"}'$ oc get clusterversion -o jsonpath='{.items[].spec.clusterID}{"\n"}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

プロンプトが表示されたら、以下の質問に回答し、Continue をクリックします。

- What are you experiencing? What are you expecting to happen?

- Define the value or impact to you or the business.

- Where are you experiencing this behavior? What environment?

- When does this behavior occur? Frequency? 繰り返し発生するか。At certain times?

-

関連する診断データファイルをアップロードし、Continue をクリックします。まずは、

oc adm must-gatherコマンドを使用して収集されるデータと、そのコマンドによって収集されない問題に固有のデータを含めることが推奨されます。 - 関連するケース管理の詳細情報を入力し、Continue をクリックします。

- ケースの詳細をプレビューし、Submit をクリックします。

第4章 接続クラスターを使用したリモートヘルスモニタリング

4.1. リモートヘルスモニタリングについて

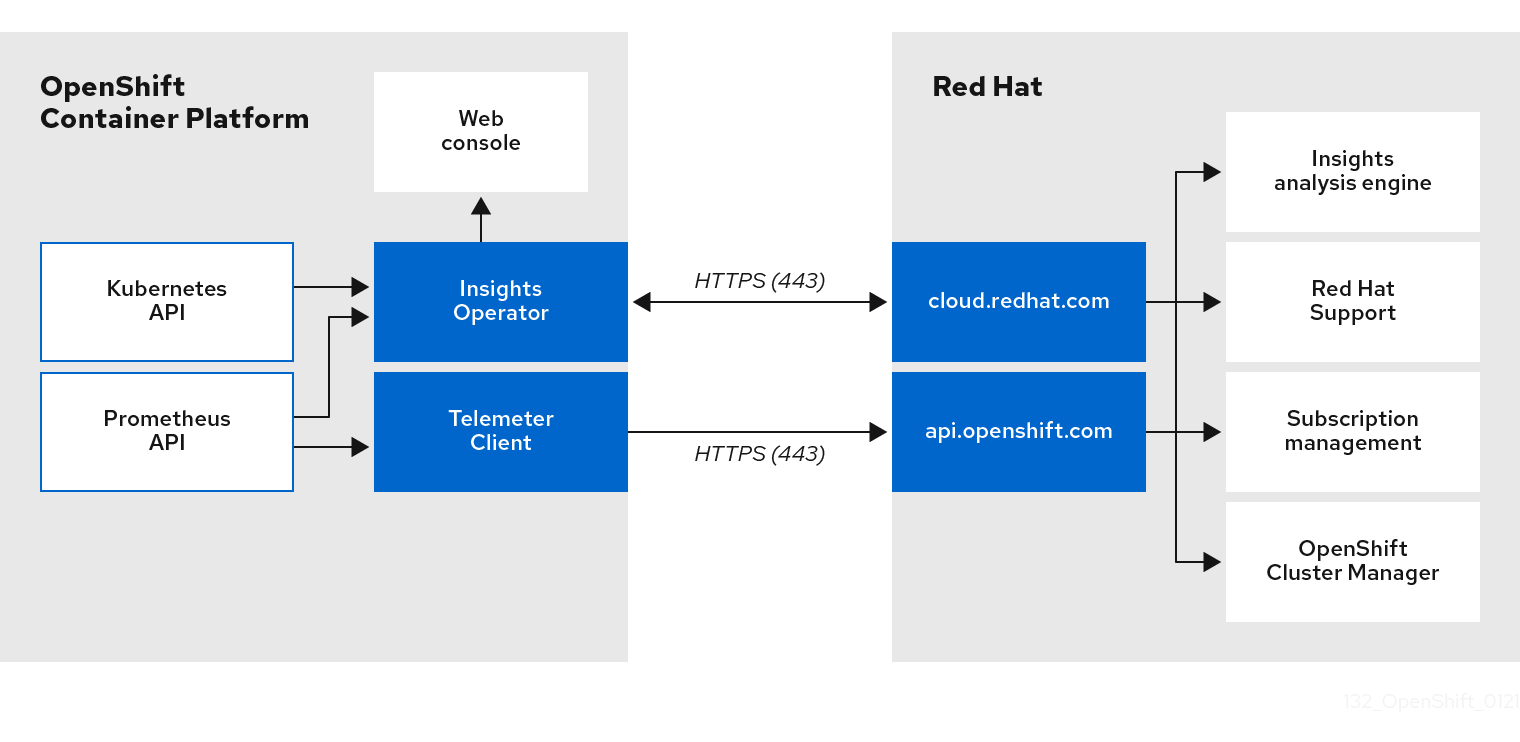

OpenShift Container Platform は、クラスターに関する Telemetry および設定データを収集し、Telemeter Client および Insights Operator を使用してこれを Red Hat にレポートします。Red Hat に提供されるデータは、このドキュメントで説明されている利点を提供します。

Telemetry および Insights Operator 経由でデータを Red Hat にレポートするクラスターは 接続クラスター (connected cluster) と見なされます。

Telemetry は、OpenShift Container Platform Telemeter Client によって Red Hat に送信される情報を表すために Red Hat が使用する用語です。サブスクリプション管理の自動化、クラスターの健全性の監視、サポートの支援、カスタマークスペリエンスの向上を可能にするために、軽量の属性データが接続クラスターから Red Hat に送信されます。

Insights Operator は OpenShift Container Platform 設定データを収集し、これを Red Hat に送信します。データは、クラスターがさらされる可能性のある問題に関する洞察を生み出すために使用されます。これらの洞察は、OpenShift Cluster Manager でクラスター管理者に伝達されます。

これらの 2 つのプロセスの詳細は、このドキュメントを参照してください。

Telemetry および Insights Operator の利点

ユーザーにとって、Telemetry および Insights Operator には次のような利点があります。

- 問題の特定および解決の強化。エンドユーザーには正常と思われるイベントも、Red Hat は多くのお客様を含む全体的な視点で観察できます。この視点により、一部の問題はより迅速に特定され、エンドユーザーがサポートケースを作成したり、Jira 問題 を作成しなくても解決することが可能です。

-

高度なリリース管理。OpenShift Container Platform は

candidate、fast、およびstableリリースチャネルを提供し、これにより更新ストラテジーを選択することができます。リリースのfastからstableに移行できるかどうかは、更新の成功率やアップグレード時に確認されるイベントに依存します。接続クラスターから提供される情報により、Red Hat はstableチャネルのリリースの品質を高め、fastチャネルで見つかった問題に対してより迅速に対応することができます。 - ターゲットが絞られた新機能の優先付け。収集されるデータは、最も使用される OpenShift Container Platform の領域に関する洞察を提供します。この情報により、Red Hat はお客様に最も大きな影響を与える新機能の開発に重点的に取り組むことができます。

- 効率的なサポートエクスペリエンス。Red Hat カスタマーポータル でサポートチケットを作成する際に、接続クラスターのクラスター ID を指定できます。これにより、Red Hat は接続された情報を使用してクラスター固有の効率化されたサポートエクスペリエンスを提供できます。このドキュメントは、強化されたサポートエクスペリエンスの詳細情報を提供しています。

- 予測分析。OpenShift Cluster Manager に表示されるお客様のクラスターに関する分析情報は、接続クラスターから収集された情報によって実現されています。Red Hat は、OpenShift Container Platform クラスターがさらされる問題を特定するのに役立つディープラーニング (深層学習)、機械学習、および人工知能の自動化の適用に取り組んでいます。

4.1.1. Telemetry について

Telemetry は厳選されたクラスターモニタリングメトリクスのサブセットを Red Hat に送信します。Telemeter Client はメトリクスの値を 4 分 30 秒ごとに取得し、データを Red Hat にアップロードします。これらのメトリクスは、このドキュメントで説明しています。

このデータのストリームは、Red Hat によってリアルタイムでクラスターをモニターし、お客様に影響を与える問題に随時対応するために使用されます。またこれにより、Red Hat がサービスへの影響を最小限に抑えつつつアップグレードエクスペリエンスの継続的な改善に向けた OpenShift Container Platform のアップグレードのデプロイメントを可能にします。

このデバッグ情報は、サポートケースでレポートされるデータへのアクセスと同じ制限が適用された状態で Red Hat サポートおよびエンジニアリングチームが利用できます。接続クラスターのすべての情報は、OpenShift Container Platform をより使用しやすく、より直感的に使用できるようにするために Red Hat によって使用されます。

4.1.1.1. Telemetry で収集される情報

以下の情報は、Telemetry によって収集されます。

4.1.1.1.1. システム情報

- OpenShift Container Platform クラスターのバージョン情報、および更新バージョンの可用性を特定するために使用されるインストールの更新の詳細を含むバージョン情報

- クラスターごとに利用可能な更新の数、更新に使用されるチャネルおよびイメージリポジトリー、更新の進捗情報、および更新で発生するエラーの数などの更新情報

- インストール時に生成される一意でランダムな識別子

- クラウドインフラストラクチャーレベルのノード設定、ホスト名、IP アドレス、Kubernetes Pod 名、namespace、およびサービスなど、Red Hat サポートがお客様にとって有用なサポートを提供するのに役立つ設定の詳細

- クラスターにインストールされている OpenShift Container Platform フレームワークコンポーネントおよびそれらの状態とステータス

- 動作が低下した Operator の "関連オブジェクト" として一覧表示されるすべての namespace のイベント

- 動作が低下したソフトウェアに関する情報

- 証明書の有効性に関する情報

- OpenShift Container Platform がデプロイされているプラットフォームの名前およびデータセンターの場所

4.1.1.1.2. サイジング情報

- CPU コアの数およびそれぞれに使用される RAM の容量を含む、クラスター、マシンタイプ、およびマシンに関するサイジング情報

- etcd メンバーの数および etcd クラスターに保存されるオブジェクトの数

- ビルドストラテジータイプ別のアプリケーションビルドの数

4.1.1.1.3. 使用情報

- コンポーネント、機能および拡張機能に関する使用率の情報

- テクノロジープレビューおよびサポート対象外の設定に関する使用率の詳細

Telemetry は、ユーザー名やパスワードなどの識別情報を収集しません。Red Hat は、意図的な個人情報の収集は行いません。誤って個人情報を受信したことが明らかになった場合、Red Hat はその情報を削除します。Telemetry データが個人データに該当する場合は、Red Hat プライバシーステートメント を参照し、Red Hat のプライバシー方針を確認してください。

4.1.2. Insights Operator について

Insights Operator は設定およびコンポーネントの障害ステータスを定期的に収集し、デフォルトで 2 時間ごとにそのデータを Red Hat に報告します。この情報により、Red Hat は設定や Telemetry で報告されるデータよりも深層度の高いデータを評価できます。

OpenShift Container Platform のユーザーは、Red Hat Hybrid Cloud Console の Insights Advisor サービスで各クラスターのレポートを表示できます。問題が特定されると、Insights は詳細を提供します。利用可能な場合は、問題の解決方法に関する手順が提供されます。

Insights Operator は、ユーザー名、パスワード、または証明書などの識別情報を収集しません。Red Hat Insights のデータ収集とコントロールの詳細は、Red Hat Insights のデータおよびアプリケーションセキュリティー を参照してください。

Red Hat は、接続されたすべてのクラスター情報を使用して、以下を実行します。

- Red Hat Hybrid Cloud Console の Insights Advisor サービスで、潜在的なクラスターの問題を特定し、解決策と予防措置を提供します。

- 集計される情報および重要な情報を製品およびサポートチームに提供し、OpenShift Container Platform の強化を図ります。

- OpenShift Container Platform の直感的な使用方法

4.1.2.1. Insights Operator によって収集される情報

以下の情報は、Insights Operator によって収集されます。

- OpenShift Container Platform バージョンおよび環境に固有の問題を特定するためのクラスターおよびそのコンポーネントに関する一般的な情報

- 誤った設定や設定するパラメーターに固有の問題の判別に使用するクラスターのイメージレジストリー設定などの設定ファイル

- クラスターコンポーネントで発生するエラー

- 実行中の更新の進捗情報、およびコンポーネントのアップグレードのステータス

- OpenShift Container Platform がデプロイされているプラットフォームとクラスターが配置されているリージョンの詳細

- クラスターのワークロード情報が離散的な Secure Hash Algorithm (SHA) 値に変換されました。これにより、Red Hat は機密情報を失うことなくセキュリティーおよびバージョンの脆弱性のワークロードを評価できます。

-

Operator が問題を報告する場合、

openshift-*およびkube-*プロジェクトのコア OpenShift Container Platform Pod に関する情報が収集されます。これには、状態、リソース、セキュリティーコンテキスト、ボリューム情報などが含まれます。

4.1.3. Telemetry および Insights Operator データフローについて

Telemeter Client は、Prometheus API から選択した時系列データを収集します。時系列データは、処理するために 4 分 30 秒ごとに api.openshift.com にアップロードされます。

Insights Operator は、選択したデータを Kubernetes API および Prometheus API からアーカイブに収集します。アーカイブは、処理のために 2 時間ごとに OpenShift Cluster Manager にアップロードされます。Insights Operator は、OpenShift Cluster Manager から最新の Insights 分析もダウンロードします。これは、OpenShift Container Platform Web コンソールの Overview ページに含まれる Insights status ポップアップを設定するために使用されます。

Red Hat との通信はすべて、Transport Layer Security (TLS) および相互証明書認証を使用して、暗号化されたチャネル上で行われます。すべてのデータは移動中および停止中に暗号化されます。

顧客データを処理するシステムへのアクセスは、マルチファクター認証と厳格な認証制御によって制御されます。アクセスは、知る必要がある場合に限って付与され、必要な操作に制限されます。

Telemetry および Insights Operator データフロー

4.1.4. リモートヘルスモニタリングデータの使用方法に関する追加情報

リモートヘルスモニタリングを有効にするために収集される情報の詳細は、Information collected by Telemetry および Information collected by the Insights Operator を参照してください。

このドキュメントで前述したとおり、Red Hat は、サポートおよびアップグレードの提供、パフォーマンス/設定の最適化、サービスへの影響の最小化、脅威の特定および修復、トラブルシューティング、オファリングおよびユーザーエクスペリエンスの強化、問題への対応および請求を目的として (該当する場合)、お客様の Red Hat 製品使用データを収集します。

収集における対策

Red Hat は、Telemetry および設定データを保護するために設計された技術的および組織的な対策を採用しています。

共有

Red Hat は、ユーザーエクスペリエンスの向上に向けて、Telemetry および Insights Operator で収集されるデータを内部で共有する場合があります。Red Hat は、以下の目的で Red Hat のビジネスパートナーと、お客様を特定しない集約された形式で Telemetry および設定データを共有する場合があります。つまり、パートナーが市場およびお客様の Red Hat のオファリングの使用をより良く理解できるように支援することを目的とするか、それらのパートナーと共同でサポートしている製品の統合を効果的に行うことを目的としています。

サードパーティー

Red Hat は、Telemetry および設定データの収集、分析、および保管を支援するために、特定のサードパーティーと連携する場合があります。

ユーザーコントロール/Telemetry および設定データ収集の有効化および無効化

リモートヘルスレポート の手順に従って、OpenShift Container Platform Telemetry と Insights Operator を無効にできます。

4.2. リモートヘルスモニタリングによって収集されるデータの表示

管理者は、Telemetry と Insights Operator によって収集されたメトリクスを確認できます。

4.2.1. Telemetry によって収集されるデータの表示

Telemetry でキャプチャーされるクラスターとコンポーネントの時系列データを表示することができます。

前提条件

-

OpenShift Container Platform CLI (

oc) をインストールしている。 -

cluster-adminロールまたはcluster-monitoring-viewロールを持つユーザーとしてクラスターにアクセスできる。

手順

- クラスターにログインします。

- 次のコマンドを実行すると、クラスターの Prometheus サービスにクエリーが実行され、Telemetry によってキャプチャーされた時系列データの完全なセットが返されます。

次の例には、OpenShift Container Platform on AWS に固有の値がいくつか含まれています。

4.2.2. Insights Operator によって収集されるデータの表示

Insights Operator で収集されるデータを確認することができます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

Insights Operator の現在実行中の Pod の名前を検索します。

INSIGHTS_OPERATOR_POD=$(oc get pods --namespace=openshift-insights -o custom-columns=:metadata.name --no-headers --field-selector=status.phase=Running)

$ INSIGHTS_OPERATOR_POD=$(oc get pods --namespace=openshift-insights -o custom-columns=:metadata.name --no-headers --field-selector=status.phase=Running)Copy to Clipboard Copied! Toggle word wrap Toggle overflow Insights Operator で収集される最近のデータアーカイブをコピーします。

oc cp openshift-insights/$INSIGHTS_OPERATOR_POD:/var/lib/insights-operator ./insights-data

$ oc cp openshift-insights/$INSIGHTS_OPERATOR_POD:/var/lib/insights-operator ./insights-dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow

最近の Insights Operator アーカイブが insights-data ディレクトリーで利用可能になります。

4.3. リモートヘルスレポート

クラスターの健全性と使用状況データのレポートを オプトイン (有効化) または オプトアウト (無効化) することができます。

4.3.1. リモートヘルスレポートの有効化

組織がリモートヘルスレポートを無効にしている場合は、この機能を再度有効にできます。OpenShift Container Platform Web コンソールの Overview ページの Status タイルに表示される Insights not available というメッセージから、リモートヘルスレポートが無効になっていることを確認できます。

リモートヘルスレポートを有効にするには、新しい認可トークンを使用してグローバルクラスタープルシークレットを変更する必要があります。リモートヘルスレポートを有効にすると、Insights Operator と Telemetry の両方が有効になります。

4.3.2. グローバルクラスタープルシークレットの変更によるリモートヘルスレポートの有効化

既存のグローバルクラスタープルシークレットを変更して、リモートヘルスレポートを有効にすることができます。リモートヘルスモニタリングを無効にしている場合は、Red Hat OpenShift Cluster Manager から console.openshift.com アクセストークンを使用して新しいプルシークレットをダウンロードする必要があります。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 - OpenShift Cluster Manager へのアクセス。

手順

- Red Hat Hybrid Cloud Console の Downloads ページに移動します。

Tokens → Pull secret から、Download ボタンをクリックします。

pull-secretファイルには、JSON 形式のcloud.openshift.comアクセストークンが含まれています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow グローバルクラスタープルシークレットをローカルファイルシステムにダウンロードします。

oc get secret/pull-secret -n openshift-config \ --template='{{index .data ".dockerconfigjson" | base64decode}}' \ > pull-secret$ oc get secret/pull-secret -n openshift-config \ --template='{{index .data ".dockerconfigjson" | base64decode}}' \ > pull-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow プルシークレットのバックアップコピーを作成します。

cp pull-secret pull-secret-backup

$ cp pull-secret pull-secret-backupCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

テキストエディターで

pull-secretファイルを開きます。 -

先ほどダウンロードした

pull-secretファイルのcloud.openshift.comJSON エントリーをauthsファイルに追加します。 - ファイルを保存します。

次のコマンドを実行して、クラスター内のシークレットを更新します。

oc set data secret/pull-secret -n openshift-config \ --from-file=.dockerconfigjson=pull-secret

$ oc set data secret/pull-secret -n openshift-config \ --from-file=.dockerconfigjson=pull-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットが更新され、クラスターがレポートを開始するまで、数分間待つ必要がある場合があります。

検証

OpenShift Container Platform Web コンソールから検証チェックを行うには、次の手順を実行します。

- OpenShift Container Platform Web コンソールの Overview ページに移動します。

- Status タイルの Insights セクションを確認します。このセクションに、検出された問題の件数が表示されます。

OpenShift CLI (

oc) から検証チェックを行うには、次のコマンドを入力し、statusパラメーターの値がfalseになっていることを確認します。oc get co insights -o jsonpath='{.status.conditions[?(@.type=="Disabled")]}'$ oc get co insights -o jsonpath='{.status.conditions[?(@.type=="Disabled")]}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.3. リモートヘルスレポートを無効にした場合の影響

OpenShift Container Platform では、お客様は使用状況情報のレポートを無効にできます。

リモートヘルスレポートを無効にする前に、接続クラスターの次の利点をご確認ください。

- Red Hat による問題への対応が迅速化し、カスタマーサポートが強化されます。

- 製品のアップグレードがクラスターに与える影響を Red Hat が把握できます。

- 接続クラスターは、サブスクリプションとエンタイトルメントのプロセスを簡素化するのに役立ちます。

- 接続クラスターにより、OpenShift Cluster Manager サービスがクラスターの概要とサブスクリプションステータスを提供できるようになります。

実稼働前、テスト、および実稼働クラスターでは、健全性および使用状況のレポートを有効にしておくことを検討してください。これにより、Red Hat がお客様の環境における OpenShift Container Platform の適格性評価に参加し、製品の問題に対してより迅速に対応できるようになります。

接続クラスターでリモートヘルスレポートを無効にした場合の結果を以下に示します。

- サポートケースが作成されていない場合、Red Hat が製品のアップグレードの成功やクラスターの健全性を確認することができなくなります。

- Red Hat が、設定データを使用してカスタマーサポートケースの優先順位付けを改善することや、お客様にとって重要な設定を特定することができなくなります。

- OpenShift Cluster Manager が、健全性や使用状況の情報など、クラスターに関するデータを表示できなくなります。

-

使用状況の自動レポート機能を利用できないため、お客様が

console.redhat.comWeb コンソールにサブスクリプション情報を手動で入力する必要があります。

ネットワークが制限された環境でも、プロキシーの適切な設定により Telemetry と Insights のデータは収集されます。

4.3.4. リモートヘルスレポートの無効化

既存のグローバルクラスタープルシークレットを変更して、リモートヘルスレポートを無効にすることができます。この設定により、Telemetry と Insights Operator の両方が無効になります。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

グローバルクラスタープルシークレットをローカルファイルシステムにダウンロードします。

oc extract secret/pull-secret -n openshift-config --to=.

$ oc extract secret/pull-secret -n openshift-config --to=.Copy to Clipboard Copied! Toggle word wrap Toggle overflow テキストエディターで、ダウンロードした

.dockerconfigjsonファイルを編集し、cloud.openshift.comJSON エントリーを削除します。"cloud.openshift.com":{"auth":"<hash>","email":"<email_address>"}"cloud.openshift.com":{"auth":"<hash>","email":"<email_address>"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow - ファイルを保存します。

クラスターのシークレットを更新します。詳細は、「グローバルクラスタープルシークレットの更新」を参照してください。

クラスター内のシークレットが更新されるまで、数分間待つ必要がある場合があります。

4.3.5. 非接続クラスターの登録

リモートヘルスレポートの無効化によるクラスターへの影響を回避するために、非接続の OpenShift Container Platform クラスターを Red Hat Hybrid Cloud Console に登録してください。詳細は、「リモートヘルスレポートを無効にした場合の影響」を参照してください。

お客様は非接続クラスターを登録することで、引き続きサブスクリプションの使用状況を Red Hat に報告できます。そうすることで、Red Hat はサブスクリプションに関連する正確な使用状況と容量の傾向を返せるようになります。その結果、お客様はその返された情報を使用して、すべてのリソースに対するサブスクリプションの割り当てをより適切に管理できるようになります。

前提条件

-

OpenShift Container Platform Web コンソールに

cluster-adminロールとしてログインしている。 - Red Hat Hybrid Cloud Console にログインできる。

手順

- Red Hat Hybrid Cloud Console の Register disconnected cluster Web ページに移動します。

- オプション: Red Hat Hybrid Cloud Console のホームページから Register disconnected cluster Web ページにアクセスするには、ナビゲーションメニュー項目の Cluster List に移動し、Register cluster ボタンを選択します。

- Register disconnected cluster ページの指定されたフィールドにクラスターの詳細を入力します。

- このページの Subscription settings セクションから、ご使用の Red Hat サブスクリプションオファリングに適用するサブスクリプション設定を選択します。

- 非接続クラスターを登録するには、Register cluster ボタンを選択します。

- サブスクリプションサービスでのサブスクリプションデータの表示方法 (サブスクリプションサービスのスタートガイド)

4.3.6. グローバルクラスタープルシークレットの更新

現在のプルシークレットを置き換えるか、新しいプルシークレットを追加することで、クラスターのグローバルプルシークレットを更新できます。

この手順は、インストール時に使用したレジストリーとは別のレジストリーにイメージを保存する必要がある場合に使用してください。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

オプション: 既存のプルシークレットに新しいプルシークレットを追加するには、以下の手順を実行します。

以下のコマンドを入力してプルシークレットをダウンロードします。

oc get secret/pull-secret -n openshift-config --template='{{index .data ".dockerconfigjson" | base64decode}}' > <pull_secret_location>$ oc get secret/pull-secret -n openshift-config --template='{{index .data ".dockerconfigjson" | base64decode}}' > <pull_secret_location>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<pull_secret_location>: プルシークレットファイルへのパスを指定します。

以下のコマンドを実行して、新しいプルシークレットを追加します。

oc registry login --registry="<registry>" \ --auth-basic="<username>:<password>" \ --to=<pull_secret_location>

$ oc registry login --registry="<registry>" \1 --auth-basic="<username>:<password>" \2 --to=<pull_secret_location>3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow プルシークレットファイルを手動で更新することもできます。

以下のコマンドを実行して、クラスターのグローバルプルシークレットを更新します。

oc set data secret/pull-secret -n openshift-config \ --from-file=.dockerconfigjson=<pull_secret_location>

$ oc set data secret/pull-secret -n openshift-config \ --from-file=.dockerconfigjson=<pull_secret_location>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<pull_secret_location>: 新しいプルシークレットファイルへのパスを指定します。

この更新はすべてのノードにロールアウトされます。これには、クラスターのサイズに応じて多少時間がかかる場合があります。

注記OpenShift Container Platform 4.7.4 の時点で、グローバルプルシークレットへの変更によってノードの drain (Pod の退避) の実行または再起動がトリガーされなくなりました。

関連情報

4.4. Insights を使用したクラスターの問題の特定

Insights は、Insights Operator から送信されるデータを繰り返し分析します。このデータには、Deployment Validation Operator (DVO) からのワークロード推奨事項も含まれます。OpenShift Container Platform のユーザーは、Red Hat Hybrid Cloud Console の Insights Advisor サービスで結果を表示できます。

4.4.1. OpenShift Container Platform の Red Hat Insights Advisor について

Insights Advisor サービスを使用すると、OpenShift Container Platform クラスターの健全性を評価および監視できます。個々のクラスターとインフラストラクチャー全体のどちらに懸念があるかにかかわらず、サービスの可用性、フォールトトレランス、パフォーマンス、またはセキュリティーに影響を及ぼす可能性のある問題にさらされていることを認識することが重要です。

クラスターに Deployment Validation Operator (DVO) がインストールされている場合は、クラスターの健全性の問題につながる可能性がある設定を持つワークロードも推奨事項で示されます。

Insights による分析の結果は、Red Hat Hybrid Cloud Console の Insights Advisor サービスで確認できます。Red Hat Hybrid Cloud Console では、次のアクションを実行できます。

- 特定の推奨事項の影響を受けるクラスターとワークロードを表示する。

- 強力なフィルタリング機能を使用して、結果をその推奨事項だけに絞り込む。

- 個々の推奨事項とそれが示すリスクの詳細を確認し、個々のクラスターに合わせた解決策を確認する。

- 結果を他の関係者と共有する。

4.4.2. Insights Advisor の推奨事項について

Insights Advisor サービスは、クラスターとワークロードのサービス可用性、フォールトトレランス、パフォーマンス、またはセキュリティーに悪影響を与える可能性のあるさまざまなクラスターの状態とコンポーネント設定に関する情報をまとめて提供します。この情報セットは、Insights Advisor サービスでは推奨事項と呼ばれます。クラスターの推奨事項には次の情報が含まれます。

- Name: 推奨事項の簡単な説明

- Added: 推奨事項が Insights Advisor サービスのアーカイブに公開されたタイミング

- Category: 問題がサービスの可用性、フォールトトレランス、パフォーマンス、またはセキュリティーに悪影響を及ぼす可能性があるかどうか

- Total risk: 状態がクラスターまたはワークロードに悪影響を与える 可能性 と、悪影響が発生した場合のシステム運用への 影響度 から算出された値

- Clusters: 推奨事項が検出されたクラスターのリスト

- Description: クラスターへの影響を含む、問題の簡単な概要

4.4.3. クラスターの潜在的な問題の表示

このセクションでは、OpenShift Cluster Manager の Insights Advisor に Insights レポートを表示する方法を説明します。

Insights はクラスターを繰り返し分析し、最新の結果を表示することに注意してください。問題を修正した場合や新しい問題が検出された場合などは、これらの結果が変化する可能性があります。

前提条件

- クラスターが OpenShift Cluster Manager に登録されている。

- リモートヘルスレポートが有効になっている (デフォルト)。

- OpenShift Cluster Manager にログインしている。

手順

OpenShift Cluster Manager で、Advisor → Recommendations に移動します。

結果に応じて、Insights Advisor サービスは次のいずれかを表示します。

- Insights で問題が特定されなかった場合は、No matching recommendations found が表示されます。

- Insights が検出した問題のリストで、リスク (低、中、重要、および重大) ごとにグループ化されています。

- Insights によるクラスター分析が行われていない場合は、No clusters yet が表示されます。分析は、クラスターがインストールされて登録され、インターネットに接続された直後に開始します。

問題が表示された場合は、エントリーの前にある > アイコンをクリックして詳細を確認してください。

問題によっては、Red Hat が提供する関連情報へのリンクがあります。

4.4.4. Insights Advisor サービスの推奨事項をすべて表示する

Recommendations ビューはデフォルトで、クラスターで検出された推奨事項のみを表示します。ただし、Advisor サービスのアーカイブにあるすべての推奨事項を表示することもできます。

前提条件

- リモートヘルスレポートが有効になっている (デフォルト)。

- クラスターが Red Hat Hybrid Cloud Console に 登録 されています。

- OpenShift Cluster Manager にログインしている。

手順

- OpenShift Cluster Manager で、Advisor → Recommendations に移動します。

Clusters Impacted フィルターおよび Status フィルターの横にある X アイコンをクリックします。

これで、クラスターの潜在的な推奨事項をすべて参照できます。

4.4.5. Advisor の推奨事項のフィルター

場合によっては、Insights Advisor サービスによって多数の推奨事項が返されることがあります。最も重要な推奨事項に焦点を当てるために、Advisor の推奨事項 リストにフィルターを適用して、優先度の低い推奨事項を除外できます。

デフォルトでは、フィルターは 1 つ以上のクラスターに影響を与える有効な推奨事項のみを表示するように設定されています。Insights ライブラリー内のすべての推奨事項または無効化された推奨事項を表示するには、フィルターをカスタマイズできます。

フィルターを適用するには、フィルタータイプを選択し、ドロップダウンリストで使用できるオプションに基づき値を設定します。推奨事項のリストには、複数のフィルターを適用できます。

次のフィルタータイプを設定できます。

- Name: 名前で推奨事項を検索します。

- Total risk: クラスターに対する悪影響の可能性と重大度を示す値として、Critical、Important、Moderate、Low から 1 つ以上選択します。

- Impact: クラスター操作の継続性に対する潜在的な影響を示す値を、Critical、High、Medium、Low から 1 つ以上選択します。

- Likelihood: 推奨事項が実行された場合にクラスターに悪影響を及ぼす可能性を示す値を、Critical、High、Medium、Low から 1 つ以上選択します。

- Category: 注目するカテゴリーを、Service Availability、Performance、Fault Tolerance、Security、Best Practice から 1 つ以上選択します。

- Status: ラジオボタンをクリックして、有効な推奨事項 (デフォルト)、無効な推奨事項、またはすべての推奨事項を表示します。

- Clusters impacted: 現在 1 つ以上のクラスターに影響を与えている推奨事項、影響を与えていない推奨事項、またはすべての推奨事項を表示するようにフィルターを設定します。

- Risk of change: 解決策の実装がクラスター操作に及ぼす可能性のあるリスクを示す値を、High、Moderate、Low、Very low から 1 つ以上選択します。

4.4.5.1. Insights Advisor サービスの推奨事項のフィルタリング

OpenShift Container Platform クラスターマネージャーは、推奨事項リストに表示される推奨事項をフィルターできます。フィルターを適用すると、報告される推奨事項の数を減らし、最も優先度の高い推奨事項に集中できます。

次の手順は、Category フィルターの設定方法および削除方法を示していますが、この手順は任意のフィルタータイプおよびそれぞれの値にも適用できます。

前提条件

Hybrid Cloud Console の OpenShift Cluster Manager にログインしている。

手順

- OpenShift > Advisor > Recommendations に移動します。

- メインのフィルタータイプドロップダウンリストで、Category フィルタータイプを選択します。

- フィルター値のドロップダウンリストを展開し、表示する推奨事項の各カテゴリー横にあるチェックボックスを選択します。不要なカテゴリーのチェックボックスはオフのままにします。

- オプション: フィルターを追加して、リストをさらに絞り込みます。

選択したカテゴリーの推奨事項のみがリストに表示されます。

検証

- フィルターを適用した後、更新された推奨事項リストを表示できます。適用されたフィルターは、デフォルトのフィルターの隣に追加されます。

4.4.5.2. Insights Advisor サービスの推奨事項からフィルターを削除する

推奨事項のリストには、複数のフィルターを適用できます。準備が完了したフィルターは、個別に削除することも、完全にリセットすることもできます。

フィルターを個別に削除する

- デフォルトのフィルターを含め、各フィルターの横にある X アイコンをクリックすると、フィルターを個別に削除できます。

デフォルト以外のフィルターをすべて削除する

- Reset filters をクリックすると、適用したフィルターのみが削除され、デフォルトのフィルターはそのまま残ります。

4.4.6. Insights Advisor サービスの推奨事項を無効にする

クラスターに影響を与える特定の推奨事項を無効にして、それらがレポートに表示されないようにできます。単一のクラスターまたはすべてのクラスターの推奨を無効にできます。

すべてのクラスターの推奨を無効にすると、今後のクラスターにも適用されます。

前提条件

- リモートヘルスレポートが有効になっている (デフォルト)。

- クラスターが OpenShift Cluster Manager に登録されている。

- OpenShift Cluster Manager にログインしている。

手順

- OpenShift Cluster Manager で、Advisor → Recommendations に移動します。

- オプション: 必要に応じて、Clusters Impacted および Status フィルターを使用します。

次のいずれかの方法でアラートを無効にします。

アラートを無効にするには、以下を実行します。

-

アラートの Options メニュー

をクリックし、Disable recommendation をクリックします。

をクリックし、Disable recommendation をクリックします。

- 理由を入力し、Save をクリックします。

-

アラートの Options メニュー

アラートを無効にする前に、そのアラートの影響を受けるクラスターを表示するには、以下を実行します。

- 無効にする推奨事項の名前をクリックします。その推奨事項のページに移動します。

- Affected clusters セクションで、クラスターのリストを確認します。

- Actions → Disable recommendation をクリックして、すべてのクラスターのアラートを無効にします。

- 理由を入力し、Save をクリックします。

4.4.7. 以前に無効にした Insights Advisor サービスの推奨事項を有効にする

ある推奨事項をすべてのクラスターに対して無効にすると、その推奨事項は Insights Advisor サービスに表示されなくなります。この動作は変更できます。

前提条件

- リモートヘルスレポートが有効になっている (デフォルト)。

- クラスターが OpenShift Cluster Manager に登録されている。

- OpenShift Cluster Manager にログインしている。

手順

- OpenShift Cluster Manager で、Advisor → Recommendations に移動します。

無効になっている推奨事項から、表示する推奨事項をフィルタリングします。

- Status ドロップダウンメニューから Status を選択します。

- Filter by status ドロップダウンメニューから、Disabled を選択します。

- オプション: Clusters impacted フィルターをクリアします。

- 有効にする推奨事項を特定します。

-

Options メニュー

をクリックし、Enable recommendation をクリックします。

をクリックし、Enable recommendation をクリックします。

4.4.8. ワークロードに関する Insights Advisor サービスの推奨事項について

Red Hat Insights for OpenShift の Advisor サービスを使用すると、クラスターだけでなくワークロードにも影響する推奨事項に関する情報を表示および管理できます。Advisor サービスは、デプロイメント検証を活用し、OpenShift クラスターの管理者がデプロイメントポリシーに対する実行時の違反をすべて把握できるように支援します。ワークロードの推奨事項は、Red Hat Hybrid Cloud Console の OpenShift > Advisor > Workloads で確認できます。詳細は、次の関連情報を参照してください。

4.4.9. Web コンソールでの Insights ステータスの表示

Insights はクラスターを繰り返し分析し、OpenShift Container Platform Web コンソールでクラスターの特定された潜在的な問題のステータスを表示することができます。このステータスには、さまざまなカテゴリーの問題の数が表示され、詳細は OpenShift Cluster Manager のレポートへのリンクが表示されます。

前提条件

- クラスターが OpenShift Cluster Manager に 登録されている。

- リモートヘルスレポートが有効になっている (デフォルト)。

- OpenShift Container Platform Web コンソールにログインしている。

手順

- OpenShift Container Platform Web コンソールで、Home → Overview に移動します。

Status カードの Insights をクリックします。

ポップアップウィンドウには、リスクごとにグループ化された潜在的な問題がリスト表示されます。詳細を表示するには、個々のカテゴリーをクリックするか、View all recommendations in Insights Advisor を表示します。

4.5. Insights Operator の使用

Insights Operator は設定およびコンポーネントの障害ステータスを定期的に収集し、デフォルトで 2 時間ごとにそのデータを Red Hat に報告します。この情報により、Red Hat は設定や Telemetry で報告されるデータよりも深層度の高いデータを評価できます。OpenShift Container Platform のユーザーは、Red Hat Hybrid Cloud Console の Insights Advisor サービスにレポートを表示できます。

4.5.1. Insights Operator の設定

Insights Operator 設定は、デフォルトの Operator 設定と、openshift-insights namespace の insights-config ConfigMap オブジェクト、または openshift-config namespace のサポートシークレットのいずれかに保存されている設定を組み合わせたものです。

ConfigMap オブジェクトかサポートシークレットが存在する場合、含まれる属性値によってデフォルトの Operator 設定値がオーバーライドされます。ConfigMap オブジェクトとサポートシークレットが 両方とも 存在する場合、Operator は ConfigMap オブジェクトを読み取ります。

ConfigMap オブジェクトはデフォルトでは存在しないため、OpenShift Container Platform クラスター管理者が作成する必要があります。

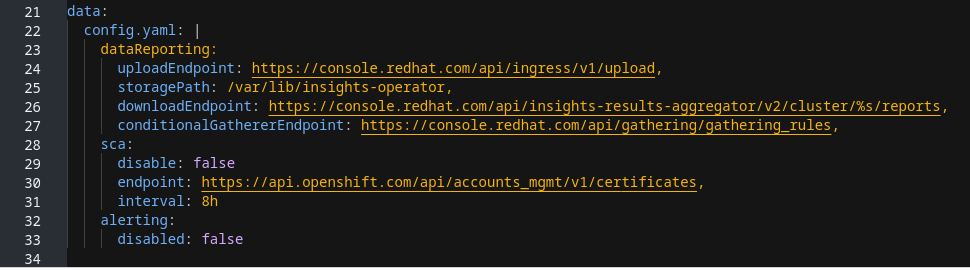

ConfigMap オブジェクトの設定の構造

この insights-config ConfigMap オブジェクトの例 (config.yaml 設定) は、標準の YAML 形式を使用した設定オプションを示しています。

設定可能な属性とデフォルト値

次の表は、使用可能な設定属性を示しています。

insights-config ConfigMap オブジェクトは、標準の YAML 形式に準拠しています。子の値が親属性の下にあり、2 つのスペースでインデントされています。Obfuscation 属性では、親属性の子として箇条書きで値を入力します。

| Attribute name | 説明 | 値のタイプ | デフォルト値 |

|---|---|---|---|

alerting:

disabled: false

| クラスターの Prometheus インスタンスへの Insights Operator アラートを無効にします。 | Boolean |

|

clusterTransfer:

endpoint: <url>

| クラスター転送データを確認およびダウンロードするためのエンドポイント。 | URL | https://api.openshift.com/api/accounts_mgmt/v1/cluster_transfers/ |

clusterTransfer:

interval: 1h0m0s

| 利用可能なクラスター転送をチェックする頻度を設定します。 | 時間間隔 |

|

dataReporting:

interval: 30m0s

| データの収集とアップロードの頻度を設定します。 | 時間間隔 |

|

dataReporting:

uploadEndpoint: <url>

| アップロードエンドポイントを設定します。 | URL | |

dataReporting:

storagePath: <path>

| アーカイブされたデータが保存されるパスを設定します。 | ファイルパス | /var/lib/insights-operator |

dataReporting:

downloadEndpoint: <url>

| 最新の Insights 分析をダウンロードするためのエンドポイントを指定します。 | URL | |

dataReporting:

conditionalGathererEndpoint: <url>

| 条件付き収集ルール定義を提供するためのエンドポイントを設定します。 | URL | |

dataReporting:

obfuscation:

- networking

| IP アドレスとクラスタードメイン名のグローバル難読化を有効にします。 | String | 該当なし |

dataReporting:

obfuscation:

- workload_names

| Data Validation Operator データの難読化を有効にします。クラスターリソースのリソース ID はアーカイブファイルでのみ表示され、リソース名は表示されません。 | String | 該当なし |

proxy:

httpProxy: http://example.com,

httpsProxy: http://example.com,

noProxy: test.org

| Insights Operator のカスタムプロキシーを設定します。 | URL | デフォルトなし |

sca:

interval: 8h0m0s

| Simple Content Access (SCA) エンタイトルメントをダウンロードする頻度を指定します。 | 時間間隔 |

|

sca:

endpoint: <url>

| Simple Content Access (SCA) エンタイトルメントをダウンロードするためのエンドポイントを指定します。 | URL | https://api.openshift.com/api/accounts_mgmt/v1/entitlement_certificates |

sca:

disabled: false

| Simple Content Access エンタイトルメントのダウンロードを無効にします。 | Boolean |

|

4.5.1.1. insights-config ConfigMap オブジェクトの作成

この手順では、Insights Operator によるカスタム設定を行うための Insights-config ConfigMap オブジェクトを作成する方法を説明します。

デフォルトの Insights Operator 設定を変更する前に、Red Hat サポートに相談することを推奨します。

前提条件

- リモートヘルスレポートが有効になっている (デフォルト)。

-

cluster-adminロールを持つユーザーとして OpenShift Container Platform Web コンソールにログインしている。

手順

- Workloads → ConfigMaps に移動し、Project: openshift-insights を選択します。

- Create ConfigMap をクリックします。

Configure via: YAML view を選択し、次のように設定を入力します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - オプション: Form view を選択し、フォームで必要な情報を入力します。

- ConfigMap Name フィールドに insights-config と入力します。

- Key フィールドに config.yaml と入力します。

- Value フィールドで、ファイルを探してフィールドにドラッグアンドドロップするか、設定パラメーターを手動で入力します。

-

Create をクリックすると、

ConfigMapオブジェクトと設定情報が表示されます。

4.5.2. Insights Operator アラートについて

Insights Operator は、Prometheus モニタリングシステムを介して Alertmanager にアラートを宣言します。これらのアラートは、以下のいずれかの方法を使用して、OpenShift Container Platform Web コンソールのアラート UI で表示できます。

- Administrator パースペクティブで、Observe → Alerting をクリックします。

- Developer パースペクティブで、Observe → <project_name> → Alerts タブをクリックします。

現在、Insights Operator は、条件が満たされたときに次のアラートを送信します。

| アラート | 説明 |

|---|---|

|

| Insights Operator が無効になっています。 |

|

| Red Hat Subscription Management で、Simple Content Access が有効になっていません。 |

|

| Insights に、クラスターに関するアクティブな推奨事項があります。 |

4.5.2.1. Insights Operator アラートの無効化

Insights Operator がクラスター Prometheus インスタンスにアラートを送信しないようにするには、insights-config ConfigMap オブジェクトを作成または編集します。

以前は、クラスター管理者は、openshift-config namespace の サポートシークレット を使用して Insights Operator 設定を作成または編集していました。Red Hat Insights が、Operator を設定するための ConfigMap オブジェクトの作成をサポートするようになりました。両方とも存在する場合、Operator はサポートシークレットよりも config map 設定を優先します。

insights-config ConfigMap オブジェクトが存在しない場合は、カスタム設定を初めて追加するときに作成する必要があります。ConfigMap オブジェクト内の設定は、config/pod.yaml ファイルで定義されているデフォルト設定よりも優先されることに注意してください。

前提条件

- リモートヘルスレポートが有効になっている (デフォルト)。

-

OpenShift Container Platform Web コンソールに

cluster-adminとしてログインしている。 -

insights-config

ConfigMapオブジェクトが、openshift-insightsnamespace に存在する。

手順

- Workloads → ConfigMaps に移動し、Project: openshift-insights を選択します。

-

insights-config

ConfigMapオブジェクトをクリックして開きます。 - Actions をクリックし、Edit ConfigMap を選択します。

- YAML view のラジオボタンをクリックします。

ファイル内で、

alerting属性をdisabled: trueに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save をクリックします。insights-config config-map の詳細ページが開きます。

-

config.yamlのalerting属性の値がdisabled: trueに設定されていることを確認します。

変更を保存すると、Insights Operator はクラスターの Prometheus インスタンスにアラートを送信しなくなります。

4.5.2.2. Insights Operator アラートの有効化

アラートを無効にすると、Insights Operator はクラスター Prometheus インスタンスにアラートを送信しなくなります。アラートは再度有効にできます。

以前は、クラスター管理者は、openshift-config namespace の サポートシークレット を使用して Insights Operator 設定を作成または編集していました。Red Hat Insights が、Operator を設定するための ConfigMap オブジェクトの作成をサポートするようになりました。両方とも存在する場合、Operator はサポートシークレットよりも config map 設定を優先します。

前提条件

- リモートヘルスレポートが有効になっている (デフォルト)。

-

OpenShift Container Platform Web コンソールに

cluster-adminとしてログインしている。 -

insights-config

ConfigMapオブジェクトが、openshift-insightsnamespace に存在する。

手順

- Workloads → ConfigMaps に移動し、Project: openshift-insights を選択します。

-

insights-config

ConfigMapオブジェクトをクリックして開きます。 - Actions をクリックし、Edit ConfigMap を選択します。

- YAML view のラジオボタンをクリックします。

ファイル内で、

alerting属性をdisabled: falseに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save をクリックします。insights-config config-map の詳細ページが開きます。

-

config.yamlのalerting属性の値がdisabled: falseに設定されていることを確認します。

変更を保存すると、Insights Operator はクラスター Prometheus インスタンスにアラートを再度送信します。

4.5.3. Insights Operator アーカイブのダウンロード

Insights Operator は、収集したデータをクラスターの openshift-insights namespace にあるアーカイブに保存します。Insights Operator によって収集されたデータをダウンロードして確認できます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

Insights Operator の実行中の Pod の名前を見つけます。

oc get pods --namespace=openshift-insights -o custom-columns=:metadata.name --no-headers --field-selector=status.phase=Running

$ oc get pods --namespace=openshift-insights -o custom-columns=:metadata.name --no-headers --field-selector=status.phase=RunningCopy to Clipboard Copied! Toggle word wrap Toggle overflow Insights Operator で収集される最近のデータアーカイブをコピーします。

oc cp openshift-insights/<insights_operator_pod_name>:/var/lib/insights-operator ./insights-data

$ oc cp openshift-insights/<insights_operator_pod_name>:/var/lib/insights-operator ./insights-data1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<insights_operator_pod_name>を、前のコマンドから出力された Pod 名に置き換えます。

最近の Insights Operator アーカイブが insights-data ディレクトリーで利用可能になります。

4.5.4. Insights Operator の収集操作の実行

Insights Operator データ収集操作をオンデマンドで実行できます。次の手順では、OpenShift Web コンソールまたは CLI を使用して収集操作のデフォルトのリストを実行する方法を説明します。オンデマンド収集機能をカスタマイズして、選択した収集操作を除外できます。デフォルトのリストからの収集操作を無効にすると、クラスターに効果的な推奨事項を提供する Insights Advisor の機能が低下します。クラスター内で Insights Operator の収集操作を無効にしていた場合は、この手順がそれらのパラメーターをオーバーライドします。

DataGather カスタムリソースはテクノロジープレビューのみの機能です。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行い、フィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

クラスターでテクノロジープレビューを有効にすると、Insights Operator は個々の Pod で収集操作を実行します。これは、Insights Operator のテクノロジープレビュー機能セットの一部であり、新しいデータ収集機能をサポートします。

4.5.4.1. Insights Operator の収集期間の表示

Insights Operator がアーカイブに含まれる情報を収集する際にかかる時間を表示できます。これは、Insights Operator のリソースの使用状況と Insights Advisor の問題を理解する上で役立ちます。

前提条件

- Insights Operator アーカイブの最新のコピー。

手順

アーカイブから

/insights-operator/gathers.jsonを開きます。このファイルには、Insights Operator 収集操作のリストが含まれています。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

duration_in_msは、各収集操作にかかるミリ秒単位の時間です。

- 各収集操作に異常がないか検査します。

4.5.4.2. Web コンソールから Insights Operator の収集操作を実行する

データを収集するには、OpenShift Container Platform Web コンソールを使用して Insights Operator の収集操作を実行できます。

前提条件

-

cluster-adminロールを持つユーザーとして OpenShift Container Platform Web コンソールにログインしている。

手順

- コンソールで、Administration → CustomResourceDefinitions を選択します。

- CustomResourceDefinitions ページの Search by name フィールドで DataGather リソース定義を見つけ、クリックします。

- CustomResourceDefinition details ページで、Instances タブをクリックします。

- Create DataGather をクリックします。

新しい

DataGather操作を作成するには、次の設定ファイルを編集し、変更を保存します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

収集操作の名前に periodic-gathering- の接頭辞は追加しないでください。この文字列は他の管理操作用に予約されており、意図した収集操作に影響を及ぼす可能性があります。

検証

- コンソールで Workloads → Pods を選択します。

- Pods ページで Project プルダウンメニューに移動し、Show default projects を選択します。

-

Project プルダウンメニューから

openshift-insightsプロジェクトを選択します。 -

openshift-insightsプロジェクトの Pod のリストで、新しい収集オペレーションに選択した名前の接頭辞が付いていることを確認します。完了すると、Insights Operator は処理のためにデータを Red Hat に自動的にアップロードします。

4.5.4.3. OpenShift CLI から Insights Operator 収集操作を実行する

OpenShift Container Platform コマンドラインインターフェイスを使用して、Insights Operator の収集操作を実行できます。

前提条件

-

cluster-adminロールを持つユーザーとして OpenShift Container Platform にログインしている。

手順

次のコマンドを入力して、収集操作を実行します。

oc apply -f <your_datagather_definition>.yaml

$ oc apply -f <your_datagather_definition>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow <your_datagather_definition>.yamlを、以下のパラメーターが含まれる設定ファイルに置き換えます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

収集操作の名前に periodic-gathering- の接頭辞は追加しないでください。この文字列は他の管理操作用に予約されており、意図した収集操作に影響を及ぼす可能性があります。

検証

-

openshift-insightsプロジェクトの Pod のリストで、新しい収集オペレーションに選択した名前の接頭辞が付いていることを確認します。完了すると、Insights Operator は処理のためにデータを Red Hat に自動的にアップロードします。

4.5.4.4. Insights Operator の収集操作の無効化

Insights Operator の収集操作を無効にすることができます。収集操作を無効にすると、Insights Operator が Insights クラスターレポートを収集して Red Hat に送信しなくなるため、組織のプライバシーを高めることができます。これにより、クラスター転送などの Red Hat との通信を必要とする他のコア機能に影響を与えることなく、クラスターの Insights 分析と推奨事項が無効になります。Insights Operator アーカイブの /insights-operator/gathers.json ファイルから、クラスターに対して試行された収集操作のリストを表示できます。一部の収集操作は、特定の条件が満たされた場合にのみ発生し、最新のアーカイブには表示されない可能性があることに注意してください。

InsightsDataGather カスタムリソースは、テクノロジープレビュー機能としてのみ提供されます。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行い、フィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

クラスターでテクノロジープレビューを有効にすると、Insights Operator は個々の Pod で収集操作を実行します。これは、Insights Operator のテクノロジープレビュー機能セットの一部であり、新しいデータ収集機能をサポートします。

前提条件

-

cluster-adminロールを持つユーザーとして OpenShift Container Platform Web コンソールにログインしている。

手順

- Administration → CustomResourceDefinitions に移動します。

- CustomResourceDefinitions ページで、Search by name フィールドを使用して InsightsDataGather リソース定義を見つけてクリックします。

- CustomResourceDefinition details ページで、Instances タブをクリックします。

- cluster をクリックし、YAML タブをクリックします。

InsightsDataGather設定ファイルに対して次のいずれかの編集を実行して、収集操作を無効にします。Save をクリックします。

変更を保存すると、Insights Operator の収集設定が更新され、操作は行われなくなります。

収集操作を無効にすると、クラスターに効果的な推奨事項を提供する Insights Advisor サービスの機能が低下します。

4.5.4.5. Insights Operator の収集操作の有効化

収集操作が無効になっている場合は、Insights Operator の収集操作を有効にできます。

InsightsDataGather カスタムリソースは、テクノロジープレビュー機能としてのみ提供されます。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行い、フィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

前提条件

-

cluster-adminロールを持つユーザーとして OpenShift Container Platform Web コンソールにログインしている。

手順

- Administration → CustomResourceDefinitions に移動します。

- CustomResourceDefinitions ページで、Search by name フィールドを使用して InsightsDataGather リソース定義を見つけてクリックします。

- CustomResourceDefinition details ページで、Instances タブをクリックします。

- cluster をクリックし、YAML タブをクリックします。

次のいずれかの編集を実行して、収集操作を有効にします。

Save をクリックします。

変更を保存すると、Insights Operator の収集設定が更新され、その影響を受けた収集操作が開始します。

収集操作を無効にすると、クラスターに効果的な推奨事項を提供する Insights Advisor の機能が低下します。

4.5.5. Deployment Validation Operator のデータの難読化

デフォルトでは、Deployment Validation Operator (DVO) をインストールすると、OpenShift Container Platform の Insights Operator によって収集および処理されるデータに、リソースの名前と一意の識別子 (UID) が追加されます。クラスター管理者の場合は、Insights Operator を設定して、Deployment Validation Operator (DVO) からのデータを難読化することができます。たとえば、アーカイブファイル内のワークロード名を難読化して、Red Hat に送信することができます。

リソースの名前を難読化するには、次の手順で説明するように、insights-config ConfigMap オブジェクトの obfuscation 属性を手動で設定し、workload_names 値を含める必要があります。

前提条件

- リモートヘルスレポートが有効になっている (デフォルト)。

- "cluster-admin" ロールを使用して OpenShift Container Platform Web コンソールにログインしている。

-

insights-config

ConfigMapオブジェクトが、openshift-insightsnamespace に存在する。 - クラスターがセルフマネージドであり、Deployment Validation Operator がインストールされている。

手順

- Workloads → ConfigMaps に移動し、Project: openshift-insights を選択します。

-

insights-configConfigMapオブジェクトをクリックして開きます。 - Actions をクリックし、Edit ConfigMap を選択します。

- YAML view のラジオボタンをクリックします。

ファイル内で、

workload_names値を使用してobfuscation属性を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save をクリックします。insights-config config-map の詳細ページが開きます。

-

config.yamlのobfuscation属性の値が- workload_namesに設定されていることを確認します。

4.6. 限定的なネットワーク環境でのリモートヘルスレポートの使用

Insights Operator アーカイブを手動で収集し、アップロードして限定的なネットワーク環境から問題を診断できます。

ネットワークが制限された環境で Insights Operator を使用するには、以下を行う必要があります。

- Insights Operator アーカイブのコピーを作成します。

- Insights Operator アーカイブを console.redhat.com にアップロードします。

さらに、アップロード前に Insights Operator データを 難読化 することを選択できます。

4.6.1. Insights Operator の収集操作の実行

Insights Operator アーカイブを作成するには、収集操作を実行する必要があります。

前提条件

-

cluster-adminとして OpenShift Container Platform にログインしている。

手順

以下のテンプレートを使用して、

gather-job.yamlという名前のファイルを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow insights-operatorイメージバージョンをコピーします。oc get -n openshift-insights deployment insights-operator -o yaml

$ oc get -n openshift-insights deployment insights-operator -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

insights-operatorイメージのバージョンを指定します。

gather-job.yamlでイメージのバージョンを貼り付けます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 既存の値を

insights-operatorイメージのバージョンに置き換えます。

収集ジョブを作成します。

oc apply -n openshift-insights -f gather-job.yaml

$ oc apply -n openshift-insights -f gather-job.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ジョブ Pod の名前を見つけます。

oc describe -n openshift-insights job/insights-operator-job

$ oc describe -n openshift-insights job/insights-operator-jobCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - ここでは、以下のようになります。

-

insights-operator-job-<your_job>は Pod の名前です。

操作が完了したことを確認します。

oc logs -n openshift-insights insights-operator-job-<your_job> insights-operator

$ oc logs -n openshift-insights insights-operator-job-<your_job> insights-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

I0407 11:55:38.192084 1 diskrecorder.go:34] Wrote 108 records to disk in 33ms

I0407 11:55:38.192084 1 diskrecorder.go:34] Wrote 108 records to disk in 33msCopy to Clipboard Copied! Toggle word wrap Toggle overflow 作成したアーカイブを保存します。

oc cp openshift-insights/insights-operator-job-<your_job>:/var/lib/insights-operator ./insights-data

$ oc cp openshift-insights/insights-operator-job-<your_job>:/var/lib/insights-operator ./insights-dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow ジョブをクリーンアップします。

oc delete -n openshift-insights job insights-operator-job

$ oc delete -n openshift-insights job insights-operator-jobCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.6.2. Insights Operator アーカイブのアップロード

Insights Operator アーカイブを console.redhat.com に手動でアップロードし、潜在的な問題を診断できます。

前提条件

-

cluster-adminとして OpenShift Container Platform にログインしている。 - 制限なくインターネットアクセスができるワークステーションがある。

- Insights Operator アーカイブのコピーを作成している。

手順

dockerconfig.jsonファイルをダウンロードします。oc extract secret/pull-secret -n openshift-config --to=.

$ oc extract secret/pull-secret -n openshift-config --to=.Copy to Clipboard Copied! Toggle word wrap Toggle overflow dockerconfig.jsonファイルから"cloud.openshift.com"の"auth"トークンをコピーします。Copy to Clipboard Copied! Toggle word wrap Toggle overflow console.redhat.com にアーカイブをアップロードします。

curl -v -H "User-Agent: insights-operator/one10time200gather184a34f6a168926d93c330 cluster/<cluster_id>" -H "Authorization: Bearer <your_token>" -F "upload=@<path_to_archive>; type=application/vnd.redhat.openshift.periodic+tar" https://console.redhat.com/api/ingress/v1/upload

$ curl -v -H "User-Agent: insights-operator/one10time200gather184a34f6a168926d93c330 cluster/<cluster_id>" -H "Authorization: Bearer <your_token>" -F "upload=@<path_to_archive>; type=application/vnd.redhat.openshift.periodic+tar" https://console.redhat.com/api/ingress/v1/uploadCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<cluster_id>はクラスター ID、<your_token>はプルシークレットからのトークン、<path_to_archive>は Insights Operator アーカイブへのパスに置き換えます。操作に成功すると、コマンドは

"request_id"と"account_number"を返します。出力例

* Connection #0 to host console.redhat.com left intact {"request_id":"393a7cf1093e434ea8dd4ab3eb28884c","upload":{"account_number":"6274079"}}%* Connection #0 to host console.redhat.com left intact {"request_id":"393a7cf1093e434ea8dd4ab3eb28884c","upload":{"account_number":"6274079"}}%Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証手順

- https://console.redhat.com/openshift にログインします。

- 左側のペインの Cluster List メニューをクリックします。

- クラスターの詳細を表示するには、クラスターの名前をクリックします。

クラスターの Insights Advisor タブを開きます。

アップロードに成功すると、タブには以下のいずれかが表示されます。

- Your cluster passed all recommendations: Insights Advisor で何も問題が特定されなかった場合。

- Insights Advisor が検出した問題。リスク (低、中、重要および重大) 別に優先度が付けられます。

4.6.3. Insights Operator データの難読化の有効化

難読化を有効にして、機密性が高く、識別可能な IPv4 アドレスとクラスターベースドメインをマスクし、Insights Operator が console.redhat.com に送信できるようにします。

この機能は利用可能ですが、Red Hat ではサポートサービスをより効果的に行えるように、難読化を無効のままにすることを推奨します。

難読化は、識別されていない値をクラスター IPv4 アドレスに割り当て、メモリーに保持される変換テーブルを使用して、データを console.redhat.com にアップロードする前に、Insights Operator アーカイブ全体で IP アドレスを難読化バージョンに変更します。

クラスターベースドメインでは、難読化により、ベースドメインがハードコードされたサブ文字列に変更されます。たとえば、cluster-api.openshift.example.com は cluster-api.<CLUSTER_BASE_DOMAIN> になります。

以下の手順では、openshift-config namespace で support シークレットを使用して難読化を有効にします。

前提条件

-

OpenShift Container Platform Web コンソールに

cluster-adminとしてログインしている。

手順

- Workloads → Secrets に移動します。

- openshift-config プロジェクトを選択します。

- Search by name フィールドを使用して support シークレットを検索します。存在しない場合には、Create → Key/value secret をクリックして作成します。

-

Options メニュー

をクリックしてから Edit Secret をクリックします。

をクリックしてから Edit Secret をクリックします。

- Add Key/Value をクリックします。

-

値が

trueのenableGlobalObfuscationという名前のキーを作成し、Save をクリックします。 - Workloads → Pods に移動します。

-

openshift-insightsプロジェクトを選択します。 -

insights-operatorPod を検索します。 -

insights-operatorPod を再起動するには、Options メニュー をクリックしてから Delete Pod をクリックします。

をクリックしてから Delete Pod をクリックします。

検証

- Workloads → Secrets に移動します。

- openshift-insights プロジェクトを選択します。

- Search by name フィールドを使用して obfuscation-translation-table シークレットを検索します。

obfuscation-translation-table シークレットが存在する場合は、難読化が有効になって機能します。

または、Insights Operator アーカイブの /insights-operator/gathers.json で "is_global_obfuscation_enabled": true の値を確認できます。

4.7. Insights Operator を使用した Simple Content Access エンタイトルメントのインポート

Insights Operator は、OpenShift Cluster Manager から Simple Content Access エンタイトルメントを定期的にインポートして openshift-config-managed namespace の etc-pki-entitlement シークレットに保存します。Simple Content Access は Red Hat のサブスクリプションツールの機能で、エンタイトルメントツールの動作を簡素化します。この機能は、サブスクリプションツールを設定する複雑さを伴わずに、Red Hat のサブスクリプションが提供するコンテンツを簡単に利用できます。

以前は、クラスター管理者は、openshift-config namespace の サポートシークレット を使用して Insights Operator 設定を作成または編集していました。Red Hat Insights が、Operator を設定するための ConfigMap オブジェクトの作成をサポートするようになりました。両方とも存在する場合、Operator はサポートシークレットよりも config map 設定を優先します。

Insights Operator は 8 時間ごとに Simple Content Access エンタイトルメントをインポートしますが、openshift-insights namespace の insights-config ConfigMap オブジェクトを使用すると、インポートを設定または無効にすることができます。

インポートを機能させるには、Red Hat Subscription Management で Simple Content Access を有効にする必要があります。

4.7.1. Simple Content Access のインポート間隔の設定

openshift-insights namespace の insights-config ConfigMap オブジェクトを使用して、Insights Operator が Simple Content Access (SCA) エンタイトルメントをインポートする頻度を設定できます。エンタイトルメントのインポートは通常 8 時間ごとに行われますが、insights-config ConfigMap オブジェクトで Simple Content Access の設定を更新すると、SCA のこの間隔を短くすることができます。

この手順では、インポート間隔を 2 時間 (2h) に更新する方法を説明します。時間 (h) または時間と分を指定できます (例: 2h30m)。

前提条件

- リモートヘルスレポートが有効になっている (デフォルト)。

-

cluster-adminロールを持つユーザーとして OpenShift Container Platform Web コンソールにログインしている。 -

insights-config

ConfigMapオブジェクトが、openshift-insightsnamespace に存在する。

手順

- Workloads → ConfigMaps に移動し、Project: openshift-insights を選択します。

-

insights-config

ConfigMapオブジェクトをクリックして開きます。 - Actions をクリックし、Edit ConfigMap を選択します。

- YAML view のラジオボタンをクリックします。

コンテンツを 2 時間ごとにインポートするには、ファイルの

sca属性をinterval: 2hに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save をクリックします。insights-config config-map の詳細ページが開きます。

-

config.yamlのsca属性の値がinterval: 2hに設定されていることを確認します。

4.7.2. Simple Content Access インポートの無効化

openshift-insights namespace の insights-config ConfigMap オブジェクトを使用して、Simple Content Access エンタイトルメントのインポートを無効にできます。

前提条件

- リモートヘルスレポートが有効になっている (デフォルト)。

-

OpenShift Container Platform Web コンソールに

cluster-adminとしてログインしている。 -

insights-config

ConfigMapオブジェクトが、openshift-insightsnamespace に存在する。

手順

- Workloads → ConfigMaps に移動し、Project: openshift-insights を選択します。

-

insights-config

ConfigMapオブジェクトをクリックして開きます。 - Actions をクリックし、Edit ConfigMap を選択します。

- YAML view のラジオボタンをクリックします。

ファイルで、

sca属性をdisabled: trueに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save をクリックします。insights-config config-map の詳細ページが開きます。

-

config.yamlのsca属性の値がdisabled: trueに設定されていることを確認します。

4.7.3. 無効にしていたシンプルコンテンツアクセスインポートの有効化

シンプルコンテンツアクセスエンタイトルメントのインポートが無効になっている場合、Insights Operator はシンプルコンテンツアクセスエンタイトルメントをインポートしません。この動作は変更できます。

前提条件

- リモートヘルスレポートが有効になっている (デフォルト)。

-

cluster-adminロールを持つユーザーとして OpenShift Container Platform Web コンソールにログインしている。 -

insights-config

ConfigMapオブジェクトが、openshift-insightsnamespace に存在する。

手順

- Workloads → ConfigMaps に移動し、Project: openshift-insights を選択します。

-

insights-config

ConfigMapオブジェクトをクリックして開きます。 - Actions をクリックし、Edit ConfigMap を選択します。

- YAML view のラジオボタンをクリックします。

ファイル内で、

sca属性をdisabled: falseに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save をクリックします。insights-config config-map の詳細ページが開きます。

-

config.yamlのsca属性の値がdisabled: falseに設定されていることを確認します。

第5章 クラスターに関するデータの収集

サポートケースを作成する際、ご使用のクラスターに関するデバッグ情報を Red Hat サポートに提供していただくと Red Hat のサポートに役立ちます。

以下を提供することが推奨されます。

5.1. must-gather ツールについて

oc adm must-gather CLI コマンドは、以下のような問題のデバッグに必要となる可能性のあるクラスターからの情報を収集します。

- リソース定義

- サービスログ

デフォルトで、oc adm must-gather コマンドはデフォルトのプラグインイメージを使用し、./must-gather.local に書き込みを行います。

または、以下のセクションで説明されているように、適切な引数を指定してコマンドを実行すると、特定の情報を収集できます。

1 つ以上の特定の機能に関連するデータを収集するには、以下のセクションに示すように、イメージと共に

--image引数を使用します。以下に例を示します。

oc adm must-gather \ --image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.17.33

$ oc adm must-gather \ --image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.17.33Copy to Clipboard Copied! Toggle word wrap Toggle overflow 監査ログを収集するには、以下のセクションで説明されているように

-- /usr/bin/gather_audit_logs引数を使用します。以下に例を示します。

oc adm must-gather -- /usr/bin/gather_audit_logs

$ oc adm must-gather -- /usr/bin/gather_audit_logsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記- ファイルのサイズを小さくするために、監査ログはデフォルトの情報セットの一部として収集されません。

-

Windows オペレーティングシステムでは、

oc rsyncコマンドで使用するためにcwRsyncクライアントをインストールし、PATH変数に追加します。

oc adm must-gather を実行すると、ランダムな名前を持つ新規 Pod がクラスターの新規プロジェクトに作成されます。データはその Pod 上で収集され、現在の作業ディレクトリー内の must-gather.local で始まる新しいディレクトリーに保存されます。

以下に例を示します。

NAMESPACE NAME READY STATUS RESTARTS AGE ... openshift-must-gather-5drcj must-gather-bklx4 2/2 Running 0 72s openshift-must-gather-5drcj must-gather-s8sdh 2/2 Running 0 72s ...

NAMESPACE NAME READY STATUS RESTARTS AGE

...

openshift-must-gather-5drcj must-gather-bklx4 2/2 Running 0 72s

openshift-must-gather-5drcj must-gather-s8sdh 2/2 Running 0 72s

...

任意で、--run-namespace オプションを使用して、特定の namespace で oc adm must-gather コマンドを実行できます。

以下に例を示します。

oc adm must-gather --run-namespace <namespace> \ --image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.17.33

$ oc adm must-gather --run-namespace <namespace> \

--image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.17.335.1.1. Red Hat サポート用のクラスターに関するデータの収集

oc adm must-gather CLI コマンドを使用して、クラスターに関するデバッグ情報を収集できます。

セルフマネージドのホステッドクラスターをデバッグするための情報を収集する場合は、「Hosted Control Plane のトラブルシューティング用の情報収集」を参照してください。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift Container Platform CLI (

oc) がインストールされている。

手順

must-gatherデータを保存するディレクトリーに移動します。注記クラスターが非接続環境にある場合は、追加の手順を実行する必要があります。ミラーレジストリーに信頼される CA がある場合、まず信頼される CA をクラスターに追加する必要があります。非接続環境のすべてのクラスターに対して、デフォルトの

must-gatherイメージをイメージストリームとしてインポートする必要があります。oc import-image is/must-gather -n openshift

$ oc import-image is/must-gather -n openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm must-gatherコマンドを実行します。oc adm must-gather

$ oc adm must-gatherCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要非接続環境を使用している場合には、must-gather の一部として

--imageフラグを使用し、ペイロードイメージを参照します。注記このコマンドは、デフォルトでランダムなコントロールプレーンノードを選択するため、Pod は

NotReadyおよびSchedulingDisabled状態のコントロールプレーンノードにスケジュールされる場合があります。このコマンドが失敗する場合 (クラスターで Pod をスケジュールできない場合など)、

oc adm inspectコマンドを使用して、特定リソースに関する情報を収集します。注記収集する推奨リソースは、Red Hat サポートにお問い合わせください。

作業ディレクトリーに作成された

must-gatherディレクトリーから圧縮ファイルを作成します。固有の must-gather データの日付とクラスター ID を必ず提供してください。クラスター ID を確認する方法の詳細は、How to find the cluster-id or name on OpenShift cluster を参照してください。たとえば、Linux オペレーティングシステムを使用するコンピューターで以下のコマンドを実行します。tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>

$ tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<must_gather_local_dir>は、実際のディレクトリー名に置き換えます。

- Red Hat カスタマーポータルの カスタマーサポート ページ で、圧縮ファイルをサポートケースに添付します。

5.1.2. must-gather フラグ

次の表にリストされているフラグは、oc adm must-gather コマンドで使用できます。

| フラグ | コマンドの例 | 説明 |

|---|---|---|

|

|

|

クラスター上の、 |

|

|

| 収集されたデータが書き込まれるローカルマシン上の特定のディレクトリーを設定します。 |

|

|

|

|

|

|

|

実行する |

|

|

|

実行する |

|

|

| 使用する特定のノードを設定します。指定しない場合は、デフォルトでランダムマスターが使用されます。 |

|

|

| 使用する特定のノードセレクターを設定します。クラスターノードのセットで同時にデータをキャプチャーする必要があるコマンドとイメージを指定する場合にのみ関連します。 |

|

|

|

|

|

|

|

指定された期間よりも新しいログのみを返します。デフォルトはすべてのログです。プラグインが推奨されますが、このサポートには必要はありません。 |

|

|

|

(RFC3339) 形式で表現された特定の日時以降のログのみを返します。デフォルトはすべてのログです。プラグインが推奨されますが、このサポートには必要はありません。 |

|

|

| 収集したデータをコピーする Pod 上の特定のディレクトリーを設定します。 |

|

|

| タイムアウトする前にデータを収集する時間の長さ。秒、分、時間で表されます (例: 3s、5m、2h)。指定する時間は 0 より大きい必要があります。指定されていない場合はデフォルトで 10 分になります。 |

|

|

|

|

5.1.3. 特定の機能に関するデータ収集

oc adm must-gather CLI コマンドを --image または --image-stream 引数と共に使用して、特定に機能に関するデバッグ情報を収集できます。must-gather ツールは複数のイメージをサポートするため、単一のコマンドを実行して複数の機能に関するデータを収集できます。

| イメージ | 目的 |

|---|---|

|

| OpenShift Virtualization のデータ収集。 |

|

| OpenShift Serverless のデータ収集。 |

|

| Red Hat OpenShift Service Mesh のデータ収集。 |

|

| Hosted Control Plane のデータ収集。 |

|

| Migration Toolkit for Containers のデータ収集。 |

|

| Red Hat OpenShift Data Foundation のデータ収集。 |

|

| ロギング用のデータ収集。 |

|

| Network Observability Operator のデータ収集。 |

|

| OpenShift Shared Resource CSI Driver のデータ収集。 |

|

| ローカルストレージ Operator のデータ収集。 |

|

| OpenShift サンドボックスコンテナーのデータ収集。 |

|

| Red Hat Workload Availability Operator のデータ収集。これには、Self Node Remediation (SNR) Operator、Fence Agents Remediation (FAR) Operator、Machine Deletion Remediation (MDR) Operator、Node Health Check (NHC) Operator、および Node Maintenance Operator (NMO) が含まれます。 NHC Operator バージョンが 0.9.0 より前 の場合は、このイメージを使用します。 詳細は、修復、フェンシング、およびメンテナンス (Workload Availability for Red Hat OpenShift ドキュメント) の各 Operator の「データの収集」セクションを参照してください。 |

|

| Red Hat Workload Availability Operator のデータ収集。これには、Self Node Remediation (SNR) Operator、Fence Agents Remediation (FAR) Operator、Machine Deletion Remediation (MDR) Operator、Node Health Check (NHC) Operator、および Node Maintenance Operator (NMO) が含まれます。 NHC Operator バージョンが 0.9.0 以降 の場合は、このイメージを使用します。 詳細は、修復、フェンシング、およびメンテナンス (Workload Availability for Red Hat OpenShift ドキュメント) の各 Operator の「データの収集」セクションを参照してください。 |

|

| NUMA Resources Operator (NRO) のデータ収集。 |

|

| PTP Operator のデータ収集。 |

|

| Red Hat OpenShift GitOps のデータ収集。 |

|

| Secrets Store CSI Driver Operator のデータ収集。 |

|

| LVM Operator のデータ収集。 |

|

| Compliance Operator のデータ収集。 |

OpenShift Container Platform コンポーネントのイメージの最新バージョンを確認するには、Red Hat カスタマーポータルの OpenShift Operator ライフサイクル Web ページを参照してください。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift Container Platform CLI (

oc) がインストールされている。

手順

-

must-gatherデータを保存するディレクトリーに移動します。 oc adm must-gatherコマンドを 1 つまたは複数の--imageまたは--image-stream引数と共に実行します。注記-

特定の機能データに加えてデフォルトの

must-gatherデータを収集するには、--image-stream=openshift/must-gather引数を追加します。 - Custom Metrics Autoscaler に関するデータの収集は、以下の関連情報セクションを参照してください。

たとえば、以下のコマンドは、デフォルトのクラスターデータと OpenShift Virtualization に固有の情報の両方を収集します。

oc adm must-gather \ --image-stream=openshift/must-gather \ --image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.17.33

$ oc adm must-gather \ --image-stream=openshift/must-gather \1 --image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.17.332 Copy to Clipboard Copied! Toggle word wrap Toggle overflow must-gatherツールを追加の引数と共に使用し、OpenShift Logging およびクラスター内の Red Hat OpenShift Logging Operator に関連するデータを収集できます。OpenShift Logging の場合、以下のコマンドを実行します。oc adm must-gather --image=$(oc -n openshift-logging get deployment.apps/cluster-logging-operator \ -o jsonpath='{.spec.template.spec.containers[?(@.name == "cluster-logging-operator")].image}')$ oc adm must-gather --image=$(oc -n openshift-logging get deployment.apps/cluster-logging-operator \ -o jsonpath='{.spec.template.spec.containers[?(@.name == "cluster-logging-operator")].image}')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例5.1 OpenShift Logging の

must-gatherの出力例Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

特定の機能データに加えてデフォルトの

oc adm must-gatherコマンドを 1 つまたは複数の--imageまたは--image-stream引数と共に実行します。たとえば、以下のコマンドは、デフォルトのクラスターデータと KubeVirt に固有の情報の両方を収集します。oc adm must-gather \ --image-stream=openshift/must-gather \ --image=quay.io/kubevirt/must-gather

$ oc adm must-gather \ --image-stream=openshift/must-gather \1 --image=quay.io/kubevirt/must-gather2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 作業ディレクトリーに作成された

must-gatherディレクトリーから圧縮ファイルを作成します。固有の must-gather データの日付とクラスター ID を必ず提供してください。クラスター ID を確認する方法の詳細は、How to find the cluster-id or name on OpenShift cluster を参照してください。たとえば、Linux オペレーティングシステムを使用するコンピューターで以下のコマンドを実行します。tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>

$ tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<must_gather_local_dir>は、実際のディレクトリー名に置き換えます。

- Red Hat カスタマーポータルの カスタマーサポート ページ で、圧縮ファイルをサポートケースに添付します。

5.1.4. ネットワークログの収集

クラスター内のすべてのノードでネットワークログを収集できます。

手順

-- gather_network_logsを指定してoc adm must-gatherコマンドを実行します。oc adm must-gather -- gather_network_logs

$ oc adm must-gather -- gather_network_logsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記デフォルトでは、

must-gatherツールはクラスター内のすべてのノードから OVNnbdbおよびsbdbデータベースを収集します。OVNnbdbデータベースの OVN-Kubernetes トランザクションを含む追加のログを含めるには、-- gather_network_logsオプションを追加します。作業ディレクトリーに作成された

must-gatherディレクトリーから圧縮ファイルを作成します。固有の must-gather データの日付とクラスター ID を必ず提供してください。クラスター ID を確認する方法の詳細は、How to find the cluster-id or name on OpenShift cluster を参照してください。たとえば、Linux オペレーティングシステムを使用するコンピューターで以下のコマンドを実行します。tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>

$ tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<must_gather_local_dir>は、実際のディレクトリー名に置き換えます。

- Red Hat カスタマーポータルの カスタマーサポート ページ で、圧縮ファイルをサポートケースに添付します。

5.1.5. must-gather ストレージ制限の変更

oc adm must-gather コマンドを使用してデータを収集する場合、情報のデフォルトの最大ストレージは、コンテナーのストレージ容量の 30% です。30% の制限に達すると、コンテナーが強制終了し、収集プロセスが停止します。すでに収集された情報は、ローカルストレージにダウンロードされます。must-gather コマンドを再度実行するには、ストレージ容量がより大きなコンテナーを使用するか、最大ボリュームの割合を調整する必要があります。

コンテナーがストレージ制限に達すると、次の例のようなエラーメッセージが生成されます。

出力例

Disk usage exceeds the volume percentage of 30% for mounted directory. Exiting...

Disk usage exceeds the volume percentage of 30% for mounted directory. Exiting...前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift CLI (

oc) がインストールされている。

手順

volume-percentageフラグを指定してoc adm must-gatherコマンドを実行します。新しい値として 100 を超える値を指定することはできません。oc adm must-gather --volume-percentage <storage_percentage>

$ oc adm must-gather --volume-percentage <storage_percentage>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2. クラスター ID の取得

Red Hat サポートに情報を提供する際には、クラスターに固有の識別子を提供していただくと役に立ちます。OpenShift Container Platform Web コンソールを使用してクラスター ID を自動入力できます。Web コンソールまたは OpenShift CLI (oc) を使用してクラスター ID を手動で取得することもできます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

Web コンソールまたはインストールされている OpenShift CLI (

oc) にアクセスできる。

手順

Web コンソールを使用してサポートケースを開き、クラスター ID の自動入力を行うには、以下を実行します。

- ツールバーから、(?)Help に移動し、リストから Share Feedback を選択します。

- Tell us about your experience ウィンドウで Open a support case をクリックします。

Web コンソールを使用してクラスター ID を手動で取得するには、以下を実行します。

- Home → Overview に移動します。

- 値は Details セクションの Cluster ID フィールドで利用できます。

OpenShift CLI (

oc) を使用してクラスター ID を取得するには、以下のコマンドを実行します。oc get clusterversion -o jsonpath='{.items[].spec.clusterID}{"\n"}'$ oc get clusterversion -o jsonpath='{.items[].spec.clusterID}{"\n"}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. sosreport について

sosreport は、設定の詳細、システム情報、および診断データを Red Hat Enterprise Linux (RHEL) および Red Hat Enterprise Linux CoreOS (RHCOS) システムから収集するツールです。sosreport は、ノードに関連する診断情報を収集するための標準化した方法を提供します。この情報は、問題の診断のために Red Hat サポートに提供できます。

サポートによっては、Red Hat サポートは特定の OpenShift Container Platform ノードの sosreport アーカイブを収集するよう依頼する場合があります。たとえば、oc adm must-gather の出力に含まれないシステムログまたは他のノード固有のデータを確認する必要がある場合があります。

5.4. OpenShift Container Platform クラスターノードの sosreport アーカイブの生成

OpenShift Container Platform 4.17 クラスターノードの sosreport を生成する際に推奨される方法は、デバッグ Pod を使用することです。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 - ホストへの SSH アクセスがあること。

-

OpenShift CLI (

oc) がインストールされている。 - Red Hat の Standard または Premium サブスクリプションがある。

- Red Hat カスタマーポータルのアカウントがある。

- 既存の Red Hat サポートケース ID がある。

手順

クラスターノードのリストを取得します。

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow ターゲットノードのデバッグセッションに入ります。この手順は、

<node_name>-debugというデバッグ Pod をインスタンス化します。oc debug node/my-cluster-node

$ oc debug node/my-cluster-nodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow NoExecuteエフェクトで taint が付けられたターゲットノードで、デバッグセッションに入るには、ダミー namespace に toleration を追加して、そのダミー namespace でデバッグ Pod を起動します。oc new-project dummy

$ oc new-project dummyCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc patch namespace dummy --type=merge -p '{"metadata": {"annotations": { "scheduler.alpha.kubernetes.io/defaultTolerations": "[{\"operator\": \"Exists\"}]"}}}'$ oc patch namespace dummy --type=merge -p '{"metadata": {"annotations": { "scheduler.alpha.kubernetes.io/defaultTolerations": "[{\"operator\": \"Exists\"}]"}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc debug node/my-cluster-node

$ oc debug node/my-cluster-nodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow /hostをデバッグシェル内の root ディレクトリーとして設定します。デバッグ Pod は、Pod 内の/hostにホストの root ファイルシステムをマウントします。root ディレクトリーを/hostに変更すると、ホストの実行パスに含まれるバイナリーを実行できます。chroot /host

# chroot /hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Red Hat Enterprise Linux CoreOS (RHCOS) を実行する OpenShift Container Platform 4.17 クラスターノードは、イミュータブルです。クラスターの変更を適用するには、Operator を使用します。SSH を使用したクラスターノードへのアクセスは推奨されません。ただし、OpenShift Container Platform API が利用できない場合や、kubelet がターゲットノードで適切に機能しない場合、

oc操作がその影響を受けます。この場合は、代わりにssh core@<node>.<cluster_name>.<base_domain>を使用してノードにアクセスできます。sosreportを実行するために必要なバイナリーおよびプラグインが含まれるtoolboxコンテナーを起動します。toolbox

# toolboxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記既存の

toolboxPod がすでに実行されている場合、toolboxコマンドは以下を出力します。'toolbox-' already exists. Trying to start….podman rm toolbox-で実行中の toolbox コンテナーを削除して、sosreportプラグインの問題を回避するために、新規の toolbox コンテナーを生成します。sosreportアーカイブを収集します。sos reportコマンドを実行して、crioおよびpodmanで必要なトラブルシューティングデータを収集します。sos report -k crio.all=on -k crio.logs=on -k podman.all=on -k podman.logs=on

# sos report -k crio.all=on -k crio.logs=on -k podman.all=on -k podman.logs=on1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

-kにより、デフォルト以外のsosreportプラグインパラメーターを定義できます。

オプション: ノードからの OVN-Kubernetes ネットワーク設定に関する情報をレポートに含めるには、次のコマンドを実行します。

sos report --all-logs

# sos report --all-logsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - プロンプトが表示されたら Enter を押して続行します。

-

Red Hat サポートケース ID を指定します。

sosreportは ID をアーカイブのファイル名に追加します。 sosreport出力は、アーカイブの場所とチェックサムを提供します。以下の出力参照例は、ケース ID01234567を参照します。Your sosreport has been generated and saved in: /host/var/tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz The checksum is: 382ffc167510fd71b4f12a4f40b97a4e

Your sosreport has been generated and saved in: /host/var/tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz1 The checksum is: 382ffc167510fd71b4f12a4f40b97a4eCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- toolbox コンテナーはホストの root ディレクトリーを

/hostにマウントするため、sosreportアーカイブのファイルパスはchroot環境外にあります。

以下の方法のいずれかを使用して、解析のために

sosreportアーカイブを Red Hat サポートに提供します。既存の Red Hat サポートケースにファイルをアップロードします。

oc debug node/<node_name>コマンドを実行してsosreportアーカイブを連結し、出力をファイルにリダイレクトします。このコマンドは、直前のoc debugセッションを終了していることを前提としています。oc debug node/my-cluster-node -- bash -c 'cat /host/var/tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz' > /tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz

$ oc debug node/my-cluster-node -- bash -c 'cat /host/var/tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz' > /tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- デバッグコンテナーは、ホストの root ディレクトリーを

/hostにマウントします。連結のためにターゲットファイルを指定する際に、デバッグコンテナーの root ディレクトリー (/hostを含む) から絶対パスを参照します。

注記Red Hat Enterprise Linux CoreOS (RHCOS) を実行する OpenShift Container Platform 4.17 クラスターノードは、イミュータブルです。クラスターの変更を適用するには、Operator を使用します。

scpを使用してクラスターノードからsosreportアーカイブを転送することは推奨されません。ただし、OpenShift Container Platform API が利用できない場合や、kubelet がターゲットノードで適切に機能しない場合、oc操作がその影響を受けます。この状態では、scp core@<node>.<cluster_name>.<base_domain>:<file_path> <local_path>を実行して、ノードからsosreportアーカイブをコピーすることができます。- Red Hat カスタマーポータルの Customer Support ページ にある既存のサポートケースに移動します。

- Attach files を選択し、プロンプトに従ってファイルをアップロードします。

5.5. ブートストラップノードのジャーナルログのクエリー

ブートストラップ関連の問題が発生した場合、ブートストラップノードから bootkube.service の journald ユニットログおよびコンテナーログを収集できます。

前提条件

- ブートストラップノードへの SSH アクセスがある。

- ブートストラップノードの完全修飾ドメイン名がある。

手順

OpenShift Container Platform のインストール時にブートストラップに対して

bootkube.serviceのjournaldユニットログのクエリーを実行。<bootstrap_fqdn>をブートストラップノードの完全修飾ドメイン名に置き換えます。ssh core@<bootstrap_fqdn> journalctl -b -f -u bootkube.service

$ ssh core@<bootstrap_fqdn> journalctl -b -f -u bootkube.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記ブートストラップノードの

bootkube.serviceのログは etcd のconnection refusedエラーを出力し、ブートストラップサーバーがコントロールプレーンノードの etcd に接続できないことを示します。etcd が各コントロールプレーンノードで起動し、ノードがクラスターに参加した後には、エラーは発生しなくなるはずです。ブートストラップノードで

podmanを使用してブートストラップノードのコンテナーからログを収集します。<bootstrap_fqdn>をブートストラップノードの完全修飾ドメイン名に置き換えます。ssh core@<bootstrap_fqdn> 'for pod in $(sudo podman ps -a -q); do sudo podman logs $pod; done'

$ ssh core@<bootstrap_fqdn> 'for pod in $(sudo podman ps -a -q); do sudo podman logs $pod; done'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.6. クラスターノードジャーナルログのクエリー

個別のクラスターノードの /var/log 内で journald ユニットログおよびその他のログを収集できます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift CLI (

oc) がインストールされている。 - API サービスが機能している。

- ホストへの SSH アクセスがあること。

手順

OpenShift Container Platform クラスターノードに対して、

kubeletのjournaldユニットログのクエリーを実行します。以下の例では、コントロールプレーンノードのみがクエリーされます。oc adm node-logs --role=master -u kubelet

$ oc adm node-logs --role=master -u kubelet1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- クエリーを実行して他のユニットログを取得するために、

kubeletを適宜置き換えます。

クラスターノードの

/var/log/の下にある特定のサブディレクトリーからログを収集します。/var/log/サブディレクトリー内に含まれるログの一覧を取得します。以下の例では、すべてのコントロールプレーンノードの/var/log/openshift-apiserver/にあるファイルをリスト表示します。oc adm node-logs --role=master --path=openshift-apiserver

$ oc adm node-logs --role=master --path=openshift-apiserverCopy to Clipboard Copied! Toggle word wrap Toggle overflow /var/log/サブディレクトリー内の特定ログを確認します。以下の例は、すべてのコントロールプレーンノードから/var/log/openshift-apiserver/audit.logコンテンツを出力します。oc adm node-logs --role=master --path=openshift-apiserver/audit.log

$ oc adm node-logs --role=master --path=openshift-apiserver/audit.logCopy to Clipboard Copied! Toggle word wrap Toggle overflow API が機能しない場合は、代わりに SSH を使用して各ノードのログを確認します。次の例では、

/var/log/openshift-apiserver/audit.logの末尾を表示 (tail) します。ssh core@<master-node>.<cluster_name>.<base_domain> sudo tail -f /var/log/openshift-apiserver/audit.log

$ ssh core@<master-node>.<cluster_name>.<base_domain> sudo tail -f /var/log/openshift-apiserver/audit.logCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記Red Hat Enterprise Linux CoreOS (RHCOS) を実行する OpenShift Container Platform 4.17 クラスターノードは、イミュータブルです。クラスターの変更を適用するには、Operator を使用します。SSH を使用したクラスターノードへのアクセスは推奨されません。SSH 経由で診断データの収集を試行する前に、

oc adm must gatherおよびその他のocコマンドを実行して収集されるデータが十分であるかどうかを確認してください。ただし、OpenShift Container Platform API が利用できない場合や、kubelet がターゲットノードで適切に機能しない場合、oc操作がその影響を受けます。この場合は、代わりにssh core@<node>.<cluster_name>.<base_domain>を使用してノードにアクセスできます。

5.7. ネットワークトレースメソッド

パケットキャプチャーレコードの形式でネットワークトレースを収集すると、Red Hat がネットワークの問題のトラブルシューティングをサポートできます。

OpenShift Container Platform では、ネットワークトレースの実行方法として 2 種類サポートします。以下の表を確認し、ニーズに合った方法を選択します。

| メソッド | 利点および機能 |

|---|---|

| ホストのネットワークトレースの収集 | 1 つ以上のノードで同時に指定する期間で、パケットキャプチャーを実行します。パケットキャプチャーファイルは、指定した期間に達すると、ノードからクライアントマシンに転送されます。 特定のアクションが原因でネットワーク通信に問題を発生される理由をトラブルシューティングでいます。パケットキャプチャーを実行し、問題を発生させるアクションを実行してログで問題を診断します。 |

| OpenShift Container Platform ノードまたはコンテナーからのネットワークトレースの収集 |

1 つのノードまたは 1 つのコンテナーでパケットキャプチャーを実行します。パケットキャプチャーの期間を制御できるように パケットキャプチャーを手動で開始し、ネットワーク通信の問題をトリガーしてから、パケットキャプチャーを手動で停止できます。

この方法では、 |

5.8. ホストのネットワークトレースの収集

ネットワーク関連の問題のトラブルシューティングは、ネットワーク通信を追跡して複数のノードで同時にパケットをキャプチャーすることで簡素化されます。

oc adm must-gather コマンドおよび registry.redhat.io/openshift4/network-tools-rhel8 コンテナーイメージの組み合わせを使用して、ノードからパケットキャプチャーを収集できます。パケットキャプチャーの分析は、ネットワーク通信の問題のトラブルシューティングに役立ちます。

oc adm must-gather コマンドは、特定のノードの Pod で tcpdump コマンドの実行に使用されます。tcpdump コマンドは、Pod でキャプチャーされたパケットを記録します。tcpdump コマンドを終了すると、oc adm must-gather コマンドは、Pod からクライアントマシンにキャプチャーされたパケットが含まれるファイルを転送します。

以下の手順で使用するコマンド例は、tcpdump コマンドを使用してパケットキャプチャーを実行する方法を示しています。ただし、--image 引数で指定したコンテナーイメージでコマンドを実行すると、複数のノードから同時にトラブルシューティング情報を収集できます。

前提条件

-

cluster-adminロールを持つユーザーとして OpenShift Container Platform にログインしている。 -

OpenShift CLI (

oc) がインストールされている。

手順

以下のコマンドを実行して、一部のノードでホストネットワークからパケットキャプチャーを実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow <.>