ベアメタルへのインストール

ベアメタルへの OpenShift Container Platform のインストール

概要

第1章 ベアメタルクラスターのインストールの準備

1.1. 前提条件

- OpenShift Container Platform のインストールおよび更新 プロセスの詳細を確認している。

- クラスターインストール方法の選択およびそのユーザー向けの準備 を確認している。

1.2. OpenShift Virtualization のベアメタルクラスターのインストール要件

ベアメタルクラスターで OpenShift Virtualization を使用する予定の場合は、インストール中にクラスターが正しく設定されていることを確認する必要があります。これは、OpenShift Virtualization でクラスターのインストール後には変更できない特定の設定が必要なためです。

1.2.1. OpenShift Virtualization の高可用性要件

OpenShift Virtualization のコンテキストで高可用性 (HA) 機能について説明する場合、Infrastructure カスタムリソース (CR) の controlPlaneTopology および infrastructureTopology フィールドによって決定される、コアクラスターコンポーネントのレプリケーションモデルのみを指します。これらのフィールドを HighlyAvailable に設定すると、一般的なクラスター全体のアプリケーション HA とは異なる、コンポーネントの冗長性が提供されます。これらのフィールドを SingleReplica に設定すると、コンポーネントの冗長性が無効になり、OpenShift Virtualization HA 機能が無効になります。

OpenShift Virtualization HA 機能を使用する予定の場合は、クラスターのインストール時に 3 つのコントロールプレーンノードが必要です。クラスターの Infrastructure CR 内の controlPlaneTopology ステータスは HighlyAvailable でなければなりません。

シングルノードクラスターに OpenShift Virtualization をインストールできますが、シングルノードの OpenShift は高可用性をサポートしません。

1.2.2. OpenShift Virtualization のライブマイグレーション要件

ライブマイグレーションを使用する予定の場合は、複数のワーカーノードが必要です。クラスターの

InfrastructureCR のinfrastructureTopologyステータスはHighlyAvailableでなければなりません。また、少なくとも 3 つのワーカーノードが推奨されます。注記シングルノードクラスターに OpenShift Virtualization をインストールできますが、シングルノードの OpenShift はライブマイグレーションをサポートしません。

- ライブマイグレーションには共有ストレージが必要です。OpenShift Virtualization のストレージは、ReadWriteMany (RWX) アクセスモードをサポートし、使用する必要があります。

1.2.3. OpenShift Virtualization の SR-IOV 要件

Single Root I/O Virtualization (SR-IOV) を使用する予定の場合は、ネットワークインターフェイスコントローラー (NIC) が OpenShift Container Platform でサポートされていることを確認してください。

1.3. SR-IOV デバイスの NIC パーティショニング

OpenShift Container Platform は、デュアルポートのネットワークインターフェイスカード (NIC) を搭載したサーバーにデプロイできます。1 つの高速デュアルポート NIC を複数の仮想機能 (VF) に分割し、SR-IOV を有効にすることができます。

この機能は、Link Aggregation Control Protocol (LACP) による高可用性のための結合の使用をサポートします。

物理 NIC で宣言できる LACP は 1 つだけです。

OpenShift Container Platform クラスターは、以下の方法を使用して、2 つの物理機能 (PF) に 2 つの VF を持つ結合インターフェイスにデプロイできます。

Agent-based Installer

注記nmstateの最低限必要なバージョンは次のとおりです。-

RHEL 8 バージョンの

1.4.2-4 -

RHEL 9 バージョンの

2.2.7

-

RHEL 8 バージョンの

- installer-provisioned infrastructure によるインストール

- user-provisioned infrastructure によるインストール

1.4. ベアメタルに OpenShift Container Platform をインストールする方法の選択

OpenShift Container Platform インストールプログラムは、クラスターをデプロイするための 4 つの方法を提供します。

- インタラクティブ: Web ベースの Assisted Installer を使用してクラスターをデプロイできます。これは、ネットワークがインターネットに接続されているクラスターに推奨されるアプローチです。Assisted Installer は、OpenShift Container Platform をインストールする最も簡単な方法であり、スマートなデフォルトを提供し、クラスターをインストールする前に事前検証を実行します。また、自動化および高度な設定シナリオのための RESTful API も提供します。

- ローカルエージェントベース: エアギャップネットワークまたはネットワークが制限された環境用の Agent-based Installer を使用して、クラスターをローカルにデプロイできます。この方法では、Assisted Installer の多くの利点を得られますが、最初に Agent-based Installer をダウンロードして設定する必要があります。設定はコマンドラインインターフェイスで行います。このアプローチは、エアギャップまたは制限されたネットワークに最適です。

- 自動化: installer-provisioned infrastructure とそれが維持するクラスターにクラスターをデプロイできます。インストーラーは、各クラスターホストのベースボード管理コントローラー (BMC) をプロビジョニングに使用します。接続されたネットワーク、エアギャップされたネットワーク、または制限されたネットワークの両方でクラスターをデプロイできます。

- 完全な制御: お客様が準備および保守するインフラストラクチャー にクラスターをデプロイメントできます。これにより、最大限のカスタマイズ性が提供されます。接続されたネットワーク、エアギャップされたネットワーク、または制限されたネットワークの両方でクラスターをデプロイできます。

クラスターには次の特徴があります。

- 単一障害点のない高可用性インフラストラクチャーがデフォルトで利用可能である。

- 管理者は適用される更新内容および更新タイミングを制御できる。

installer-provisioned installation および user-provisioned installation のプロセスの詳細は、インストールプロセス を参照してください。

1.4.1. installer-provisioned infrastructure へのクラスターのインストール

以下の方法を使用して、OpenShift Container Platform インストールプログラムでプロビジョニングされるベアメタルインフラストラクチャーに、クラスターをインストールできます。

- インストーラーによってプロビジョニングされるクラスターのベアメタルへのインストール

- インストーラーによるプロビジョニングを使用して、OpenShift Container Platform をベアメタルにインストールできます。

1.4.2. user-provisioned infrastructure へのクラスターのインストール

以下の方法のいずれかを使用して、独自にプロビジョニングするベアメタルインフラストラクチャーに、クラスターをインストールできます。

- ユーザーによってプロビジョニングされるクラスターのベアメタルへのインストール

- OpenShift Container Platform はユーザーがプロビジョニングするインフラストラクチャーにインストールできます。user-provisioned infrastructure を含むクラスターの場合、必要なマシンすべてをデプロイする必要があります。

- ネットワークをカスタマイズしたユーザープロビジョニング型ベアメタルクラスターのインストール

- ネットワークをカスタマイズして、user-provisioned infrastructure にベアメタルクラスターをインストールできます。ネットワーク設定をカスタマイズすることにより、クラスターは環境内の既存の IP アドレスの割り当てと共存でき、既存の MTU および VXLAN 設定と統合できます。ネットワークのカスタマイズのほとんどは、インストールステージで適用する必要があります。

- ネットワークが制限された環境でのユーザープロビジョニング型ベアメタルクラスターのインストール

- ミラーレジストリーを使用して、制限されたネットワークまたは非接続のネットワークに、ユーザーがプロビジョニングするベアメタルクラスターをインストールできます。また、このインストール方法を使用して、クラスターが外部コンテンツに対する組織の制御の条件を満たすコンテナーイメージのみを使用するようにすることもできます。

第2章 user-provisioned infrastructure

2.1. ユーザーによってプロビジョニングされるクラスターのベアメタルへのインストール

OpenShift Container Platform 4.19 では、プロビジョニングするベアメタルインフラストラクチャーにクラスターをインストールできます。

以下の手順に従って仮想化環境またはクラウド環境にクラスターをデプロイメントできる場合もありますが、ベアメタルプラットフォーム以外の場合の追加の考慮事項に注意してください。このような環境に OpenShift Container Platform クラスターをインストールする前に、guidelines for deploying OpenShift Container Platform on non-tested platforms の情報を確認してください。

2.1.1. 前提条件

- OpenShift Container Platform のインストールおよび更新 プロセスの詳細を確認した。

- クラスターインストール方法の選択およびそのユーザー向けの準備 を確認した。

ファイアウォールを使用する場合は、クラスターがアクセスを必要とする サイトを許可するようにファイアウォールを設定 している。

注記プロキシーを設定する場合は、このサイトリストも確認してください。

2.1.2. OpenShift Container Platform のインターネットアクセス

OpenShift Container Platform 4.19 では、クラスターをインストールするためにインターネットアクセスが必要です。

次のアクションを実行するには、インターネットにアクセスできる必要があります。

- OpenShift Cluster Manager にアクセスし、インストールプログラムをダウンロードし、サブスクリプション管理を実行します。クラスターがインターネットにアクセスでき、Telemetry を無効にしていない場合、そのサービスによってクラスターのサブスクリプションが自動的に有効化されます。

- クラスターのインストールに必要なパッケージを取得するために Quay.io にアクセスします。

- クラスターの更新を実行するために必要なパッケージを取得します。

クラスターでインターネットに直接アクセスできない場合、プロビジョニングする一部のタイプのインフラストラクチャーでネットワークが制限されたインストールを実行できます。このプロセスで、必要なコンテンツをダウンロードし、これを使用してミラーレジストリーにインストールパッケージを設定します。インストールタイプに応じて、クラスターのインストール環境でインターネットアクセスが不要となる場合があります。クラスターを更新する前に、ミラーレジストリーのコンテンツを更新します。

2.1.3. user-provisioned infrastructure を使用したクラスターの要件

user-provisioned infrastructure を含むクラスターの場合、必要なマシンすべてをデプロイする必要があります。

このセクションでは、user-provisioned infrastructure に OpenShift Container Platform をデプロイする要件を説明します。

2.1.3.1. クラスターのインストールに必要なマシン

最小の OpenShift Container Platform クラスターでは以下のホストが必要です。

| ホスト | 説明 |

|---|---|

| 1 つの一時的なブートストラップマシン | クラスターでは、ブートストラップマシンが OpenShift Container Platform クラスターを 3 つのコントロールプレーンマシンにデプロイする必要があります。クラスターのインストール後にブートストラップマシンを削除できます。 |

| 3 つのコントロールプレーンマシン | コントロールプレーンマシンは、コントロールプレーンを設定する Kubernetes および OpenShift Container Platform サービスを実行します。 |

| 少なくとも 2 つのコンピュートマシン (ワーカーマシンとしても知られる)。 | OpenShift Container Platform ユーザーが要求するワークロードは、コンピュートマシンで実行されます。 |

例外として、ゼロ (0) コンピュートマシンを 3 つのコントロールプレーンマシンのみで構成されるベアメタルクラスターで実行できます。これにより、テスト、開発、および実稼働に使用するための小規模なリソース効率の高いクラスターが、クラスター管理者および開発者に提供されます。1 つのコンピュートマシンの実行はサポートされていません。

クラスターの高可用性を維持するには、これらのクラスターマシンに別の物理ホストを使用します。

ブートストラップおよびコントロールプレーンマシンでは、Red Hat Enterprise Linux CoreOS (RHCOS) をオペレーティングシステムとして使用する必要があります。ただし、コンピュートマシンは、Red Hat Enterprise Linux CoreOS (RHCOS)、Red Hat Enterprise Linux (RHEL) 8.6 以降から選択できます。

RHCOS は Red Hat Enterprise Linux (RHEL) 9.2 をベースとしており、そのハードウェア認定および要件がすべて継承されることに注意してください。Red Hat Enterprise Linux テクノロジーの機能と制限 を参照してください。

2.1.3.2. クラスターインストールの最小リソース要件

それぞれのクラスターマシンは、以下の最小要件を満たしている必要があります。

| マシン | オペレーティングシステム | CPU [1] | RAM | ストレージ | 1 秒あたりの入出力 (IOPS) [2] |

|---|---|---|---|---|---|

| ブートストラップ | RHCOS | 4 | 16 GB | 100 GB | 300 |

| コントロールプレーン | RHCOS | 4 | 16 GB | 100 GB | 300 |

| Compute | RHCOS、RHEL 8.6 以降 [3] | 2 | 8 GB | 100 GB | 300 |

- 1 つの CPU は、同時マルチスレッド (SMT) またはハイパースレッディングが有効にされていない場合に 1 つの物理コアと同等です。これが有効にされている場合、(コアごとのスレッド x コア数) x ソケット数 = CPU という数式を使用して対応する比率を計算します。

- OpenShift Container Platform および Kubernetes はディスクのパフォーマンスに敏感であり、特に 10 ms p99 fsync 期間を必要とするコントロールプレーンノード上の etcd には、高速ストレージが推奨されます。多くのクラウドプラットフォームでは、ストレージサイズと IOPS が連動してスケーリングされるため、十分なパフォーマンスを得るには、ストレージボリュームを過剰に割り当てる必要がある場合がある点に注意してください。

- すべての user-provisioned installation と同様に、クラスターで RHEL コンピュートマシンの使用を選択する場合は、システム更新の実行、パッチの適用、その他すべての必要なタスクの完了など、オペレーティングシステムのライフサイクルの管理と保守をすべて担当します。RHEL 7 コンピュートマシンの使用は非推奨となり、OpenShift Container Platform 4.10 以降で削除されています。

OpenShift Container Platform バージョン 4.19 の場合、RHCOS は RHEL バージョン 9.6 に基づいています。これは、マイクロアーキテクチャー要件を更新します。次のリストには、各アーキテクチャーに必要な最小限の命令セットアーキテクチャー (ISA) が含まれています。

- x86-64 アーキテクチャーには x86-64-v2 ISA が必要

- ARM64 アーキテクチャーには ARMv8.0-A ISA が必要

- IBM Power アーキテクチャーには Power 9 ISA が必要

- s390x アーキテクチャーには z14 ISA が必要

詳細は、アーキテクチャー (RHEL ドキュメント) を参照してください。

プラットフォームのインスタンスタイプがクラスターマシンの最小要件を満たす場合、これは OpenShift Container Platform で使用することがサポートされます。

2.1.3.3. 証明書署名要求の管理

ユーザーがプロビジョニングするインフラストラクチャーを使用する場合、クラスターの自動マシン管理へのアクセスは制限されるため、インストール後にクラスターの証明書署名要求 (CSR) のメカニズムを提供する必要があります。kube-controller-manager は kubelet クライアント CSR のみを承認します。machine-approver は、kubelet 認証情報を使用して要求されるサービング証明書の有効性を保証できません。適切なマシンがこの要求を発行したかどうかを確認できないためです。kubelet 提供証明書の要求の有効性を検証し、それらを承認する方法を判別し、実装する必要があります。

2.1.3.4. vSphere 上のベアメタルクラスターの要件

クラスター内のすべての仮想マシンで、disk.EnableUUID パラメーターを必ず有効にしてください。

2.1.3.5. user-provisioned infrastructure のネットワーク要件

すべての Red Hat Enterprise Linux CoreOS (RHCOS) マシンでは、起動時に initramfs でネットワークを設定し、Ignition 設定ファイルを取得する必要があります。

初回の起動時に、マシンには DHCP サーバーを使用して設定される IP アドレス設定、または必要な起動オプションを指定して静的に設定される IP アドレス設定が必要です。ネットワーク設定の確立後に、マシンは HTTP または HTTPS サーバーから Ignition 設定ファイルをダウンロードします。その後、Ignition 設定ファイルは各マシンの正確な状態を設定するために使用されます。Machine Config Operator はインストール後に、新しい証明書やキーの適用など、マシンへの追加の変更を完了します。

- クラスターマシンの長期管理に DHCP サーバーを使用することが推奨されます。DHCP サーバーが永続 IP アドレス、DNS サーバー情報、およびホスト名をクラスターマシンに提供するように設定されていることを確認します。

- DHCP サービスが user-provisioned infrastructure で利用できない場合は、IP ネットワーク設定および DNS サーバーのアドレスを RHCOS のインストール時にノードに提供することができます。ISO イメージからインストールしている場合は、ブート引数として渡すことができます。静的 IP プロビジョニングと高度なネットワークオプションの詳細は、RHCOS のインストールと OpenShift Container Platform ブートストラッププロセスの開始 のセクションを参照してください。

Kubernetes API サーバーはクラスターマシンのノード名を解決できる必要があります。API サーバーおよびワーカーノードが異なるゾーンに置かれている場合、デフォルトの DNS 検索ゾーンを、API サーバーでノード名を解決できるように設定することができます。もう 1 つの実行可能な方法として、ノードオブジェクトとすべての DNS 要求の両方において、ホストを完全修飾ドメイン名で常に参照します。

2.1.3.5.1. DHCP を使用したクラスターノードのホスト名の設定

Red Hat Enterprise Linux CoreOS (RHCOS) マシンでは、ホスト名は NetworkManager 経由で設定されます。デフォルトでは、マシンは DHCP 経由でホスト名を取得します。ホスト名が DHCP によって提供されない場合、カーネル引数を介して静的に設定される場合、または別の方法でホスト名が取得される場合は、逆引き DNS ルックアップによって取得されます。逆引き DNS ルックアップは、ネットワークがノードで初期化された後に発生し、解決に時間がかかる場合があります。その他のシステムサービスは、これより前に起動し、ホスト名を localhost または同様のものとして検出できます。これを回避するには、DHCP を使用して各クラスターノードのホスト名を指定できます。

また、DHCP を介してホスト名を設定すると、DNS スプリットホライズンが実装されている環境での手動の DNS レコード名設定エラーを回避できます。

2.1.3.5.2. ネットワーク接続の要件

OpenShift Container Platform クラスターのコンポーネントが通信できるように、マシン間のネットワーク接続を設定する必要があります。すべてのマシンではクラスターの他のすべてのマシンのホスト名を解決できる必要があります。

このセクションでは、必要なポートの詳細を説明します。

インターネットに接続された OpenShift Container Platform 環境では、プラットフォームコンテナーのイメージをプルし、Red Hat にテレメトリーデータを提供するために、すべてのノードがインターネットにアクセスできる必要があります。

| プロトコル | ポート | 説明 |

|---|---|---|

| ICMP | 該当なし | ネットワーク到達性のテスト |

| TCP |

| メトリクス |

|

|

ホストレベルのサービス。ポート | |

|

| Kubernetes が予約するデフォルトポート | |

|

| このポートは、マシン設定サーバーからのトラフィックを処理し、トラフィックをコントロールプレーンマシンに送信します。 | |

| UDP |

| Geneve |

|

|

ポート | |

|

| IPsec IKE パケット | |

|

| IPsec NAT-T パケット | |

|

|

UDP ポート | |

| TCP/UDP |

| |

| Kubernetes ノードポート | ESP | 該当なし |

| プロトコル | ポート | 説明 |

|---|---|---|

| TCP |

| Kubernetes API |

| プロトコル | ポート | 説明 |

|---|---|---|

| TCP |

| etcd サーバーおよびピアポート |

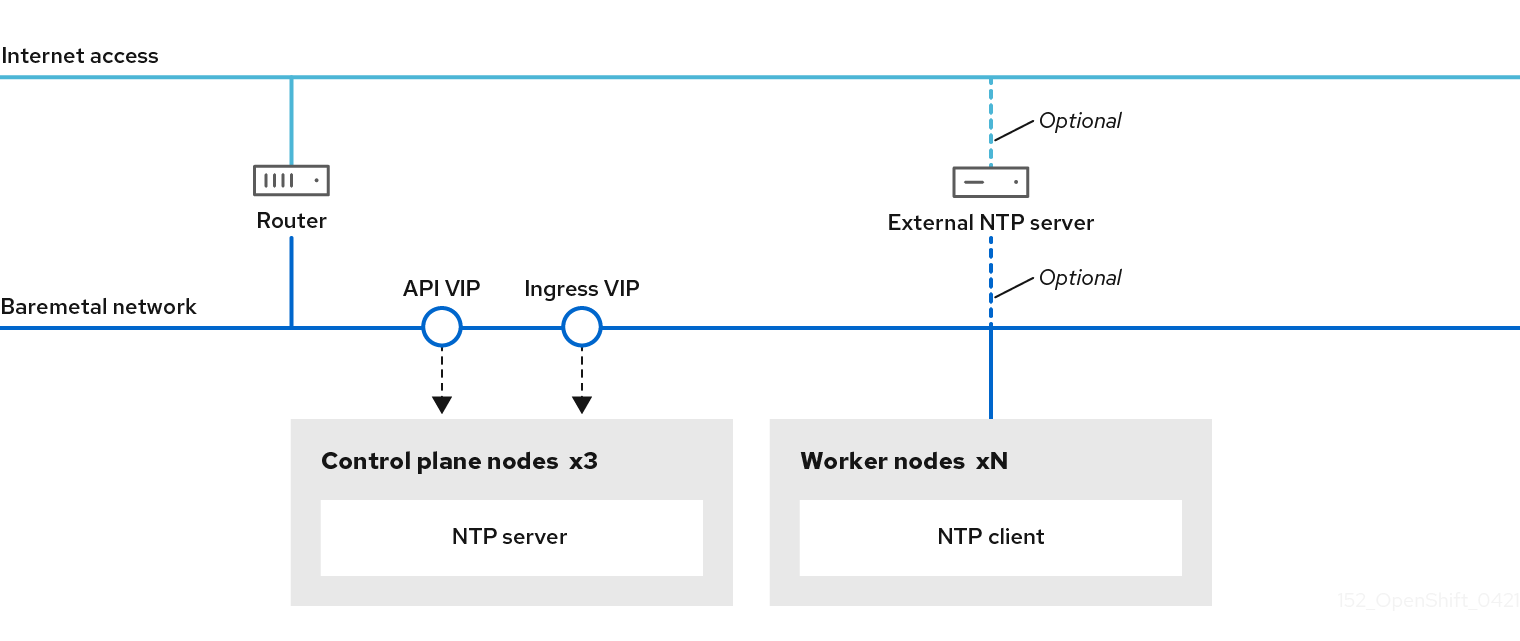

2.1.3.5.3. user-provisioned infrastructure の NTP 設定

OpenShift Container Platform クラスターは、デフォルトでパブリック Network Time Protocol (NTP) サーバーを使用するように設定されます。ローカルのエンタープライズ NTP サーバーを使用する必要があるか、クラスターが切断されたネットワークにデプロイされている場合は、特定のタイムサーバーを使用するようにクラスターを設定できます。詳細は、chrony タイムサービスの設定 のドキュメントを参照してください。

DHCP サーバーが NTP サーバー情報を提供する場合、Red Hat Enterprise Linux CoreOS (RHCOS) マシンの chrony タイムサービスは情報を読み取り、NTP サーバーとクロックを同期できます。

2.1.3.6. user-provisioned DNS 要件

OpenShift Container Platform のデプロイメントでは、以下のコンポーネントに DNS 名前解決が必要です。

- Kubernetes API

- OpenShift Container Platform のアプリケーションワイルドカード

- ブートストラップ、コントロールプレーンおよびコンピュートマシン

また、Kubernetes API、ブートストラップマシン、コントロールプレーンマシン、およびコンピュートマシンに逆引き DNS 解決も必要です。

DNS A/AAAA または CNAME レコードは名前解決に使用され、PTR レコードは逆引き名前解決に使用されます。ホスト名が DHCP によって提供されていない場合は、Red Hat Enterprise Linux CoreOS (RHCOS) は逆引きレコードを使用してすべてのノードのホスト名を設定するため、逆引きレコードは重要です。さらに、逆引きレコードは、OpenShift Container Platform が動作するために必要な証明書署名要求 (CSR) を生成するために使用されます。

各クラスターノードにホスト名を提供するために DHCP サーバーを使用することが推奨されます。詳細は、user-provisioned infrastructure に関する DHCP の推奨事項 のセクションを参照してください。

以下の DNS レコードは、user-provisioned OpenShift Container Platform クラスターに必要で、これはインストール前に設定されている必要があります。各レコードで、<cluster_name> はクラスター名で、<base_domain> は、install-config.yaml ファイルに指定するベースドメインです。完全な DNS レコードは <component>.<cluster_name>.<base_domain>. の形式を取ります。

| コンポーネント | レコード | 説明 |

|---|---|---|

| Kubernetes API |

| API ロードバランサーを特定するための DNS A/AAAA または CNAME レコード、および DNS PTR レコード。これらのレコードは、クラスター外のクライアントおよびクラスター内のすべてのノードで解決できる必要があります。 |

|

| API ロードバランサーを内部的に識別するための DNS A/AAAA または CNAME レコード、および DNS PTR レコード。これらのレコードは、クラスター内のすべてのノードで解決できる必要があります。 重要 API サーバーは、Kubernetes に記録されるホスト名でワーカーノードを解決できる必要があります。API サーバーがノード名を解決できない場合、プロキシーされる API 呼び出しが失敗し、Pod からログを取得できなくなる可能性があります。 | |

| ルート |

| アプリケーション Ingress ロードバランサーを参照するワイルドカード DNS A/AAAA または CNAME レコード。アプリケーション Ingress ロードバランサーは、Ingress コントローラー Pod を実行するマシンをターゲットにします。Ingress コントローラー Pod はデフォルトでコンピュートマシンで実行されます。これらのレコードは、クラスター外のクライアントおよびクラスター内のすべてのノードで解決できる必要があります。

たとえば、 |

| ブートストラップマシン |

| ブートストラップマシンを識別するための DNS A / AAAA または CNAME レコード、および DNS PTR レコード。これらのレコードは、クラスター内のノードで解決できる必要があります。 |

| コントロールプレーンマシン |

| コントロールプレーンノードの各マシンを特定するための DNS A/AAAA または CNAME レコードおよび DNS PTR レコード。これらのレコードは、クラスター内のノードで解決できる必要があります。 |

| コンピュートマシン |

| ワーカーノードの各マシンを特定するための DNS A/AAAA または CNAME レコード、および DNS PTR レコード。これらのレコードは、クラスター内のノードで解決できる必要があります。 |

OpenShift Container Platform 4.4 以降では、DNS 設定で etcd ホストおよび SRV レコードを指定する必要はありません。

dig コマンドを使用して、名前および逆引き名前解決を確認することができます。検証手順の詳細は、user-provisioned infrastructure の DNS 解決の検証 のセクションを参照してください。

2.1.3.6.1. user-provisioned クラスターの DNS 設定の例

このセクションでは、user-provisioned infrastructure に OpenShift Container Platform をデプロイするための DNS 要件を満たす A および PTR レコード設定サンプルを提供します。サンプルは、特定の DNS ソリューションを選択するためのアドバイスを提供することを目的としていません。

この例では、クラスター名は ocp4 で、ベースドメインは example.com です。

user-provisioned クラスターの DNS A レコードの設定例

BIND ゾーンファイルの以下の例は、user-provisioned クラスターの名前解決の A レコードの例を示しています。

例2.1 DNS ゾーンデータベースのサンプル

- 1

- Kubernetes API の名前解決を提供します。レコードは API ロードバランサーの IP アドレスを参照します。

- 2

- Kubernetes API の名前解決を提供します。レコードは API ロードバランサーの IP アドレスを参照し、内部クラスター通信に使用されます。

- 3

- ワイルドカードルートの名前解決を提供します。レコードは、アプリケーション Ingress ロードバランサーの IP アドレスを参照します。アプリケーション Ingress ロードバランサーは、Ingress コントローラー Pod を実行するマシンをターゲットにします。Ingress コントローラー Pod はデフォルトでコンピュートマシンで実行されます。注記

この例では、同じロードバランサーが Kubernetes API およびアプリケーションの Ingress トラフィックに使用されます。実稼働のシナリオでは、API およびアプリケーション Ingress ロードバランサーを個別にデプロイし、それぞれのロードバランサーインフラストラクチャーを分離してスケーリングすることができます。

- 4

- ブートストラップマシンの名前解決を提供します。

- 5 6 7

- コントロールプレーンマシンの名前解決を提供します。

- 8 9

- コンピュートマシンの名前解決を提供します。

user-provisioned クラスターの DNS PTR レコードの設定例

以下の BIND ゾーンファイルの例では、user-provisioned クラスターの逆引き名前解決の PTR レコードの例を示しています。

例2.2 逆引きレコードの DNS ゾーンデータベースの例

PTR レコードは、OpenShift Container Platform アプリケーションのワイルドカードには必要ありません。

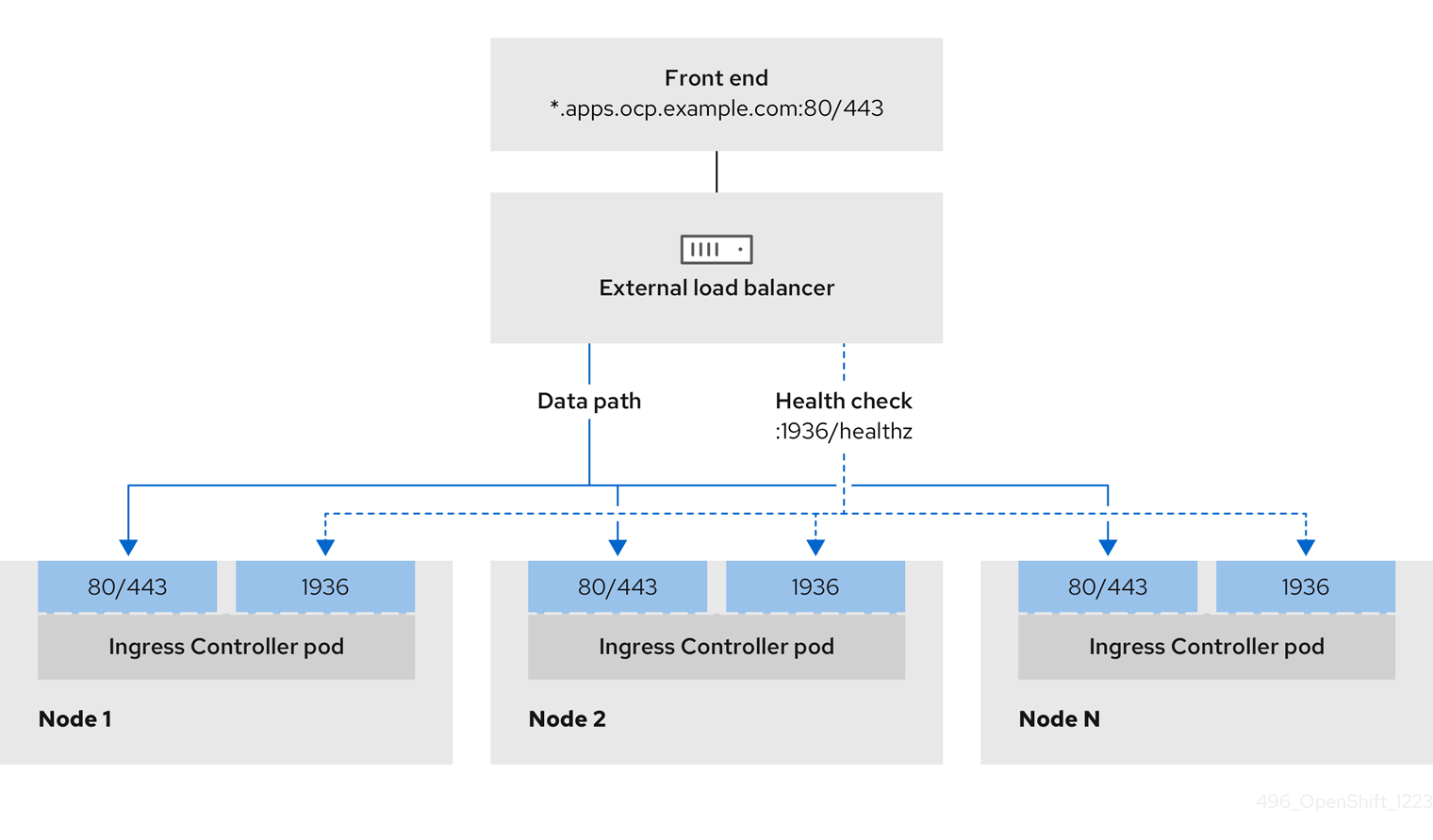

2.1.3.7. user-provisioned infrastructure の負荷分散要件

OpenShift Container Platform をインストールする前に、API およびアプリケーションの Ingress 負荷分散インフラストラクチャーをプロビジョニングする必要があります。実稼働のシナリオでは、API およびアプリケーション Ingress ロードバランサーを個別にデプロイし、それぞれのロードバランサーインフラストラクチャーを分離してスケーリングすることができます。

Red Hat Enterprise Linux (RHEL) インスタンスを使用して API およびアプリケーション Ingress ロードバランサーをデプロイする場合は、RHEL サブスクリプションを別途購入する必要があります。

負荷分散インフラストラクチャーは以下の要件を満たす必要があります。

API ロードバランサー: プラットフォームと対話およびプラットフォームを設定するためのユーザー向けの共通のエンドポイントを提供します。以下の条件を設定します。

- Layer 4 の負荷分散のみ。これは、Raw TCP または SSL パススルーモードと呼ばれます。

- ステートレス負荷分散アルゴリズム。オプションは、ロードバランサーの実装によって異なります。

重要API ロードバランサーのセッションの永続性は設定しないでください。Kubernetes API サーバーのセッション永続性を設定すると、OpenShift Container Platform クラスターとクラスター内で実行される Kubernetes API の過剰なアプリケーショントラフィックによりパフォーマンスの問題が発生する可能性があります。

ロードバランサーのフロントとバックの両方で以下のポートを設定します。

Expand 表2.7 API ロードバランサー ポート バックエンドマシン (プールメンバー) 内部 外部 説明 6443ブートストラップおよびコントロールプレーン。ブートストラップマシンがクラスターのコントロールプレーンを初期化した後に、ブートストラップマシンをロードバランサーから削除します。API サーバーのヘルスチェックプローブの

/readyzエンドポイントを設定する必要があります。X

X

Kubernetes API サーバー

22623ブートストラップおよびコントロールプレーン。ブートストラップマシンがクラスターのコントロールプレーンを初期化した後に、ブートストラップマシンをロードバランサーから削除します。

X

マシン設定サーバー

注記ロードバランサーは、API サーバーが

/readyzエンドポイントをオフにしてからプールから API サーバーインスタンスを削除するまで最大 30 秒かかるように設定する必要があります。/readyzの後の時間枠内でエラーが返されたり、正常になったりする場合は、エンドポイントが削除または追加されているはずです。5 秒または 10 秒ごとのプロービングで、2 回連続成功すると正常、3 回連続失敗すると異常と判断する設定は、十分にテストされた値です。Application Ingress ロードバランサー: クラスター外から送られるアプリケーショントラフィックの Ingress ポイントを提供します。Ingress ルーターの作業用の設定が OpenShift Container Platform クラスターに必要です。

以下の条件を設定します。

- Layer 4 の負荷分散のみ。これは、Raw TCP または SSL パススルーモードと呼ばれます。

- 選択可能なオプションやプラットフォーム上でホストされるアプリケーションの種類に基づいて、接続ベースの永続化またはセッションベースの永続化が推奨されます。

ヒントクライアントの実際の IP アドレスがアプリケーション Ingress ロードバランサーによって確認できる場合、ソースの IP ベースのセッション永続化を有効にすると、エンドツーエンドの TLS 暗号化を使用するアプリケーションのパフォーマンスを強化できます。

ロードバランサーのフロントとバックの両方で以下のポートを設定します。

Expand 表2.8 アプリケーション Ingress ロードバランサー ポート バックエンドマシン (プールメンバー) 内部 外部 説明 443デフォルトで Ingress コントローラー Pod、コンピュート、またはワーカーを実行するマシン。

X

X

HTTPS トラフィック

80デフォルトで Ingress コントローラー Pod、コンピュート、またはワーカーを実行するマシン。

X

X

HTTP トラフィック

注記ゼロ (0) コンピュートノードで 3 ノードクラスターをデプロイする場合、Ingress コントローラー Pod はコントロールプレーンノードで実行されます。3 ノードクラスターデプロイメントでは、HTTP および HTTPS トラフィックをコントロールプレーンノードにルーティングするようにアプリケーション Ingress ロードバランサーを設定する必要があります。

2.1.3.7.1. user-provisioned クラスターのロードバランサーの設定例

このセクションでは、user-provisioned クラスターの負荷分散要件を満たす API およびアプリケーション Ingress ロードバランサーの設定例を説明します。この例は、HAProxy ロードバランサーの /etc/haproxy/haproxy.cfg 設定です。この例では、特定の負荷分散ソリューションを選択するためのアドバイスを提供することを目的としていません。

この例では、同じロードバランサーが Kubernetes API およびアプリケーションの Ingress トラフィックに使用されます。実稼働のシナリオでは、API およびアプリケーション Ingress ロードバランサーを個別にデプロイし、それぞれのロードバランサーインフラストラクチャーを分離してスケーリングすることができます。

HAProxy をロードバランサーとして使用し、SELinux が enforcing に設定されている場合は、setsebool -P haproxy_connect_any=1 を実行して、HAProxy サービスが設定済みの TCP ポートにバインドできることを確認する必要があります。

例2.3 API およびアプリケーション Ingress ロードバランサーの設定例

- 1

- ポート

6443は Kubernetes API トラフィックを処理し、コントロールプレーンマシンを参照します。 - 2 4

- ブートストラップエントリーは、OpenShift Container Platform クラスターのインストール前に有効にし、ブートストラッププロセスの完了後にそれらを削除する必要があります。

- 3

- ポート

22623はマシン設定サーバートラフィックを処理し、コントロールプレーンマシンを参照します。 - 5

- ポート

443は HTTPS トラフィックを処理し、Ingress コントローラー Pod を実行するマシンを参照します。Ingress コントローラー Pod はデフォルトでコンピュートマシンで実行されます。 - 6

- ポート

80は HTTP トラフィックを処理し、Ingress コントローラー Pod を実行するマシンを参照します。Ingress コントローラー Pod はデフォルトでコンピュートマシンで実行されます。注記ゼロ (0) コンピュートノードで 3 ノードクラスターをデプロイする場合、Ingress コントローラー Pod はコントロールプレーンノードで実行されます。3 ノードクラスターデプロイメントでは、HTTP および HTTPS トラフィックをコントロールプレーンノードにルーティングするようにアプリケーション Ingress ロードバランサーを設定する必要があります。

HAProxy をロードバランサーとして使用する場合は、HAProxy ノードで netstat -nltupe を実行して、ポート 6443、22623、443、および 80 で haproxy プロセスがリッスンしていることを確認することができます。

2.1.4. カスタマイズした br-ex ブリッジを含むマニフェストオブジェクトの作成

configure-ovs.sh シェルスクリプトを使用してベアメタルプラットフォームで br-ex ブリッジを設定する代わりに、NMState 設定ファイルを含む MachineConfig オブジェクトを作成できます。ホスト nmstate-configuration.service および nmstate.service により、クラスター内で実行される各ノードに NMState 設定ファイルが適用されます。

カスタマイズした br-ex ブリッジを含むマニフェストオブジェクトを作成する場合は、次のユースケースを検討してください。

-

Open vSwitch (OVS) または OVN-Kubernetes

br-exブリッジネットワークの変更など、ブリッジにインストール後の変更を加えたい場合。configure-ovs.shシェルスクリプトは、ブリッジへのインストール後の変更をサポートしていません。 - ホストまたはサーバーの IP アドレスで使用可能なインターフェイスとは異なるインターフェイスにブリッジをデプロイします。

-

configure-ovs.shシェルスクリプトでは不可能な、ブリッジの高度な設定を実行したいと考えています。これらの設定にスクリプトを使用すると、ブリッジが複数のネットワークインターフェイスに接続できず、インターフェイス間のデータ転送が促進されない可能性があります。

単一のネットワークインターフェイスコントローラー (NIC) とデフォルトのネットワーク設定を備えた環境が必要な場合は、configure-ovs.sh シェルスクリプトを使用します。

Red Hat Enterprise Linux CoreOS (RHCOS) をインストールしてシステムを再起動すると、Machine Config Operator がクラスター内の各ノードに Ignition 設定ファイルを注入し、各ノードが br-ex ブリッジネットワーク設定を受け取るようになります。設定の競合を防ぐために、configure-ovs.sh シェルスクリプトは、br-ex ブリッジを設定しない信号を受け取ります。

次のインターフェイス名は予約されており、NMstate 設定では使用できません。

-

br-ext -

br-int -

br-local -

br-nexthop -

br0 -

ext-vxlan -

ext -

genev_sys_* -

int -

k8s-* -

ovn-k8s-* -

patch-br-* -

tun0 -

vxlan_sys_*

前提条件

-

オプション: NMState 設定を検証できるように、

nmstateAPI をインストールしました。

手順

カスタマイズされた

br-exブリッジネットワークの base64 情報をデコードした NMState 設定ファイルを作成します。カスタマイズされた

br-exブリッジネットワークの NMState 設定の例Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

interfaces.name- インターフェイスの名前。

interfaces.type- イーサネットのタイプ。

interfaces.state- 作成後のインターフェイスの要求された状態。

ipv4.enabled- この例では、IPv4 と IPv6 を無効にします。

port.name- ブリッジが接続されるノードの NIC。

auto-route-metric-

br-exデフォルトルートに常に最高の優先度 (最も低いメトリック値) を付与するには、パラメーターを48に設定します。この設定により、NetworkManagerサービスによって自動的に設定される他のインターフェイスとのルーティングの競合が防止されます。

catコマンドを使用して、NMState 設定の内容を base64 でエンコードします。cat <nmstate_configuration>.yml | base64

$ cat <nmstate_configuration>.yml | base64Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

<nmstate_configuration>-

<nmstate_configuration>を NMState リソース YAML ファイルの名前に置き換えます。

MachineConfigマニフェストファイルを作成し、次の例に類似したカスタマイズされたbr-exブリッジネットワーク設定を定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

metadata.name- ポリシーの名前。

contents.source- エンコードされた base64 情報を指定されたパスに書き込みます。

pathクラスター内の各ノードに対して、ノードへのホスト名パスと、マシンタイプに応じた base-64 でエンコードされた Ignition 設定ファイルデータを指定します。

workerロールは、クラスター内のノードのデフォルトロールです。各ノードまたはMachineConfigマニフェストファイルのすべてのノードに短いホスト名パスを指定する場合は、$(hostname -s)などの設定ファイルに .yml 拡張を使用する必要があります。.ymlクラスター内のすべてのノードに適用する単一のグローバル設定が

/etc/nmstate/openshift/cluster.yml設定ファイルで指定されている場合は、各ノードの短いホスト名パス (例:/etc/nmstate/openshift/<node_hostname>.yml) を指定する必要はありません。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

次のステップ

-

コンピュートノードをスケーリングして、クラスター内に存在する各コンピュートノードに、カスタマイズされた

br-exブリッジを含むマニフェストオブジェクトを適用します。詳細は、関連情報 セクションの「クラスターの拡張」を参照してください。

2.1.4.1. 各マシンセットをコンピュートノードにスケーリング

カスタマイズされた br-ex ブリッジ設定を OpenShift Container Platform クラスター内のすべてのコンピュートノードに適用するには、MachineConfig カスタムリソース (CR) を編集し、そのロールを変更する必要があります。さらに、ホスト名、認証情報など、ベアメタルマシンの情報を定義する BareMetalHost CR を作成する必要があります。

これらのリソースを設定した後、マシンセットをスケーリングして、マシンセットが各コンピュートノードにリソース設定を適用し、ノードを再起動できるようにする必要があります。

前提条件

-

カスタマイズされた

br-exブリッジ設定を含むMachineConfigマニフェストオブジェクトを作成しました。

手順

次のコマンドを入力して

MachineConfigCR を編集します。oc edit mc <machineconfig_custom_resource_name>

$ oc edit mc <machineconfig_custom_resource_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 各コンピュートノード設定を CR に追加して、CR がクラスター内の定義済みコンピュートノードごとにロールを管理できるようにします。

-

最小限の静的 IP 設定を持つ

extraworker-secretという名前のSecretオブジェクトを作成します。 次のコマンドを入力して、クラスター内の各ノードに

extraworker-secretシークレットを適用します。このステップでは、各コンピュートノードに Ignition 設定ファイルへのアクセスを提供します。oc apply -f ./extraworker-secret.yaml

$ oc apply -f ./extraworker-secret.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow BareMetalHostリソースを作成し、preprovisioningNetworkDataNameパラメーターでネットワークシークレットを指定します。ネットワークシークレットが添付された

BareMetalHostリソースの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターの

openshift-machine-apinamespace 内でBareMetalHostオブジェクトを管理するために、次のコマンドを入力して namespace に変更します。oc project openshift-machine-api

$ oc project openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow マシンセットを取得します。

oc get machinesets

$ oc get machinesetsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、各マシンセットをスケールします。このコマンドはマシンセットごとに実行する必要があります。

oc scale machineset <machineset_name> --replicas=<n>

$ oc scale machineset <machineset_name> --replicas=<n>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<machineset_name>はマシンセットの名前です。<n>はコンピュートノードの数です。

2.1.5. クラスターで OVS balance-slb モードを有効にする

2 つ以上の物理インターフェイスがネットワークトラフィックを共有できるように、Open vSwitch (OVS) の balance-slb モードを有効にできます。balance-slb モードのインターフェイスは、ネットワークスイッチとのソースロードバランシングを必要とせずに、仮想化ワークロードを実行するクラスターにソース負荷分散 (SLB) 機能を提供できます。

現在、ソースロードバランシングはボンディングインターフェイスで実行されます。このインターフェイスは br-phy などの補助ブリッジに接続します。ソースロードバランシングは、Media Access Control (MAC) アドレスと仮想ローカルエリアネットワーク (VLAN) の組み合わせが複数存在する場合にのみ、負荷分散を行います。OVN-Kubernetes Pod のトラフィックはすべて同じ MAC アドレスと VLAN を使用するため、このトラフィックを多数の物理インターフェイス間で負荷分散することはできないことに注意してください。

次の図は、単純なクラスターインフラストラクチャーレイアウトでの balance-slb モードを示しています。仮想マシン (VM) は、特定の localnet NetworkAttachmentDefinition (NAD) カスタムリソース定義 (CRD)、NAD 0 または NAD 1 に接続します。各 NAD は、仮想マシンに基盤となる物理ネットワークへのアクセスを提供し、タグ付きまたはタグなしの VLAN トラフィックをサポートしています。br-ex OVS ブリッジは仮想マシンからのトラフィックを受信し、そのトラフィックを次の OVS ブリッジである br-phy に渡します。br-phy ブリッジは SLB ボンディングのコントローラーとして機能します。SLB ボンディングは、eno0 や eno1 などの物理インターフェイスリンクを介して、異なる仮想マシンポートからのトラフィックを分散します。さらに、どちらの物理インターフェイスからの Ingress トラフィックも、OVS ブリッジのセットを通過して仮想マシンに到達できます。

図2.1 2 つの NAD を持つローカルネット上で動作する OVS balance-slb モード

OVS ボンディングを使用して、balance-slb モードインターフェイスをプライマリーまたはセカンダリーネットワークタイプに統合できます。OVS ボンディングでは、次の点に注意してください。

- OVN-Kubernetes CNI プラグインをサポートし、プラグインと簡単に統合できます。

-

ネイティブで

balance-slbモードをサポートします。

前提条件

-

プライマリーネットワークに複数の物理インターフェイスが接続されており、それらのインターフェイスを

MachineConfigファイルで定義した。 -

マニフェストオブジェクトを作成し、カスタマイズした

br-exブリッジをオブジェクト設定ファイルで定義した。 - プライマリーネットワークに複数の物理インターフェイスが接続されており、それらのインターフェイスを NAD CRD ファイルで定義した。

手順

クラスター内に存在するベアメタルホストごとに、クラスターの

install-config.yamlファイルで、次の例のようにnetworkConfigセクションを定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow NMState 設定ファイルで各ネットワークインターフェイスを定義します。

多数のネットワークインターフェイスを定義する NMState 設定ファイルの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ボンディングポートの

br-exMTU を手動で設定します。

base64コマンドを使用して、NMState 設定ファイルのインターフェイスコンテンツをエンコードします。base64 -w0 <nmstate_configuration>.yml

$ base64 -w0 <nmstate_configuration>.yml1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

-w0オプションは、base64 エンコード操作中に行の折り返しを防止します。

masterロールとworkerロールのMachineConfigマニフェストファイルを作成します。前のコマンドからの base64 エンコード文字列を各MachineConfigマニフェストファイルに必ず埋め込んでください。次のマニフェストファイルの例では、クラスター内に存在するすべてのノードに対してmasterロールを設定します。ノード固有のmasterロールとworkerロールのマニフェストファイルを作成することもできます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 各

MachineConfigマニフェストファイルを./<installation_directory>/manifestsディレクトリーに保存します。<installation_directory>は、インストールプログラムがファイルを作成するディレクトリーです。Machine Config Operator (MCO) が各マニフェストファイルからコンテンツを取得し、ローリング更新中に選択されたすべてのノードにそのコンテンツを一貫して適用します。

2.1.6. user-provisioned infrastructure の準備

user-provisioned infrastructure に OpenShift Container Platform をインストールする前に、基礎となるインフラストラクチャーを準備する必要があります。

このセクションでは、OpenShift Container Platform インストールの準備としてクラスターインフラストラクチャーを設定するために必要な手順の概要を説明します。これには、クラスターノード用の IP ネットワークおよびネットワーク接続を設定し、ファイアウォール経由で必要なポートを有効にし、必要な DNS および負荷分散インフラストラクチャーの設定が含まれます。

準備後、クラスターインフラストラクチャーは、user-provisioned infrastructure を使用したクラスターの要件 セクションで説明されている要件を満たす必要があります。

前提条件

- OpenShift Container Platform 4.x Tested Integrations ページを確認した。

- user-provisioned infrastructure を使用したクラスターの要件 セクションで説明されているインフラストラクチャーの要件を確認した。

手順

DHCP を使用して IP ネットワーク設定をクラスターノードに提供する場合は、DHCP サービスを設定します。

- ノードの永続 IP アドレスを DHCP サーバー設定に追加します。設定で、関連するネットワークインターフェイスの MAC アドレスを、各ノードの目的の IP アドレスと一致させます。

DHCP を使用してクラスターマシンの IP アドレスを設定する場合、マシンは DHCP を介して DNS サーバー情報も取得します。DHCP サーバー設定を介してクラスターノードが使用する永続 DNS サーバーアドレスを定義します。

注記DHCP サービスを使用しない場合、IP ネットワーク設定と DNS サーバーのアドレスを RHCOS インストール時にノードに指定する必要があります。ISO イメージからインストールしている場合は、ブート引数として渡すことができます。静的 IP プロビジョニングと高度なネットワークオプションの詳細は、RHCOS のインストールと OpenShift Container Platform ブートストラッププロセスの開始 のセクションを参照してください。

DHCP サーバー設定でクラスターノードのホスト名を定義します。ホスト名に関する考慮事項の詳細は、DHCP を使用したクラスターノードのホスト名の設定 セクションを参照してください。

注記DHCP サービスを使用しない場合、クラスターノードは逆引き DNS ルックアップを介してホスト名を取得します。

- ネットワークインフラストラクチャーがクラスターコンポーネント間の必要なネットワーク接続を提供することを確認します。要件に関する詳細は、user-provisioned infrastructure のネットワーク要件 のセクションを参照してください。

OpenShift Container Platform クラスターコンポーネントで通信するために必要なポートを有効にするようにファイアウォールを設定します。必要なポートの詳細は、user-provisioned infrastructure のネットワーク要件 のセクションを参照してください。

重要デフォルトで、ポート

1936は OpenShift Container Platform クラスターにアクセスできます。これは、各コントロールプレーンノードがこのポートへのアクセスを必要とするためです。Ingress ロードバランサーを使用してこのポートを公開しないでください。これを実行すると、Ingress コントローラーに関連する統計やメトリクスなどの機密情報が公開される可能性があるためです。

クラスターに必要な DNS インフラストラクチャーを設定します。

- Kubernetes API、アプリケーションワイルドカード、ブートストラップマシン、コントロールプレーンマシン、およびコンピュートマシンの DNS 名前解決を設定します。

Kubernetes API、ブートストラップマシン、コントロールプレーンマシン、およびコンピュートマシンの逆引き DNS 解決を設定します。

OpenShift Container Platform DNS 要件の詳細は、user-provisioned DNS 要件 のセクションを参照してください。

DNS 設定を検証します。

- インストールノードから、Kubernetes API、ワイルドカードルート、およびクラスターノードのレコード名に対して DNS ルックアップを実行します。応答の IP アドレスが正しいコンポーネントに対応することを確認します。

インストールノードから、ロードバランサーとクラスターノードの IP アドレスに対して逆引き DNS ルックアップを実行します。応答のレコード名が正しいコンポーネントに対応することを確認します。

DNS 検証手順の詳細は、user-provisioned infrastructure の DNS 解決の検証 のセクションを参照してください。

- 必要な API およびアプリケーションの Ingress 負荷分散インフラストラクチャーをプロビジョニングします。要件に関する詳細は、user-provisioned infrastructure の負荷分散要件 のセクションを参照してください。

一部の負荷分散ソリューションでは、負荷分散を初期化する前に、クラスターノードの DNS 名前解決を有効化する必要があります。

2.1.7. user-provisioned infrastructure の DNS 解決の検証

OpenShift Container Platform を user-provisioned infrastructure にインストールする前に、DNS 設定を検証できます。

このセクションの検証手順は、クラスターのインストール前に正常に実行される必要があります。

前提条件

- user-provisioned infrastructure に必要な DNS レコードを設定している。

手順

インストールノードから、Kubernetes API、ワイルドカードルート、およびクラスターノードのレコード名に対して DNS ルックアップを実行します。応答に含まれる IP アドレスが正しいコンポーネントに対応することを確認します。

Kubernetes API レコード名に対してルックアップを実行します。結果が API ロードバランサーの IP アドレスを参照することを確認します。

dig +noall +answer @<nameserver_ip> api.<cluster_name>.<base_domain>

$ dig +noall +answer @<nameserver_ip> api.<cluster_name>.<base_domain>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<nameserver_ip>をネームサーバーの IP アドレスに、<cluster_name>をクラスター名に、<base_domain>をベースドメイン名に置き換えます。

出力例

api.ocp4.example.com. 604800 IN A 192.168.1.5

api.ocp4.example.com. 604800 IN A 192.168.1.5Copy to Clipboard Copied! Toggle word wrap Toggle overflow Kubernetes 内部 API レコード名に対してルックアップを実行します。結果が API ロードバランサーの IP アドレスを参照することを確認します。

dig +noall +answer @<nameserver_ip> api-int.<cluster_name>.<base_domain>

$ dig +noall +answer @<nameserver_ip> api-int.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

api-int.ocp4.example.com. 604800 IN A 192.168.1.5

api-int.ocp4.example.com. 604800 IN A 192.168.1.5Copy to Clipboard Copied! Toggle word wrap Toggle overflow *.apps.<cluster_name>.<base_domain>DNS ワイルドカードルックアップの例をテストします。すべてのアプリケーションのワイルドカードルックアップは、アプリケーション Ingress ロードバランサーの IP アドレスに解決する必要があります。dig +noall +answer @<nameserver_ip> random.apps.<cluster_name>.<base_domain>

$ dig +noall +answer @<nameserver_ip> random.apps.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

random.apps.ocp4.example.com. 604800 IN A 192.168.1.5

random.apps.ocp4.example.com. 604800 IN A 192.168.1.5Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記出力例では、同じロードバランサーが Kubernetes API およびアプリケーションの Ingress トラフィックに使用されます。実稼働のシナリオでは、API およびアプリケーション Ingress ロードバランサーを個別にデプロイし、それぞれのロードバランサーインフラストラクチャーを分離してスケーリングすることができます。

randomは、別のワイルドカード値に置き換えることができます。たとえば、OpenShift Container Platform コンソールへのルートをクエリーできます。dig +noall +answer @<nameserver_ip> console-openshift-console.apps.<cluster_name>.<base_domain>

$ dig +noall +answer @<nameserver_ip> console-openshift-console.apps.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

console-openshift-console.apps.ocp4.example.com. 604800 IN A 192.168.1.5

console-openshift-console.apps.ocp4.example.com. 604800 IN A 192.168.1.5Copy to Clipboard Copied! Toggle word wrap Toggle overflow ブートストラップ DNS レコード名に対してルックアップを実行します。結果がブートストラップノードの IP アドレスを参照することを確認します。

dig +noall +answer @<nameserver_ip> bootstrap.<cluster_name>.<base_domain>

$ dig +noall +answer @<nameserver_ip> bootstrap.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

bootstrap.ocp4.example.com. 604800 IN A 192.168.1.96

bootstrap.ocp4.example.com. 604800 IN A 192.168.1.96Copy to Clipboard Copied! Toggle word wrap Toggle overflow - この方法を使用して、コントロールプレーンおよびコンピュートノードの DNS レコード名に対してルックアップを実行します。結果が各ノードの IP アドレスに対応していることを確認します。

インストールノードから、ロードバランサーとクラスターノードの IP アドレスに対して逆引き DNS ルックアップを実行します。応答に含まれるレコード名が正しいコンポーネントに対応することを確認します。

API ロードバランサーの IP アドレスに対して逆引き参照を実行します。応答に、Kubernetes API および Kubernetes 内部 API のレコード名が含まれていることを確認します。

dig +noall +answer @<nameserver_ip> -x 192.168.1.5

$ dig +noall +answer @<nameserver_ip> -x 192.168.1.5Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

5.1.168.192.in-addr.arpa. 604800 IN PTR api-int.ocp4.example.com. 5.1.168.192.in-addr.arpa. 604800 IN PTR api.ocp4.example.com.

5.1.168.192.in-addr.arpa. 604800 IN PTR api-int.ocp4.example.com.1 5.1.168.192.in-addr.arpa. 604800 IN PTR api.ocp4.example.com.2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記PTR レコードは、OpenShift Container Platform アプリケーションのワイルドカードには必要ありません。アプリケーション Ingress ロードバランサーの IP アドレスに対する逆引き DNS 解決の検証手順は必要ありません。

ブートストラップノードの IP アドレスに対して逆引き参照を実行します。結果がブートストラップノードの DNS レコード名を参照していることを確認します。

dig +noall +answer @<nameserver_ip> -x 192.168.1.96

$ dig +noall +answer @<nameserver_ip> -x 192.168.1.96Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

96.1.168.192.in-addr.arpa. 604800 IN PTR bootstrap.ocp4.example.com.

96.1.168.192.in-addr.arpa. 604800 IN PTR bootstrap.ocp4.example.com.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - この方法を使用して、コントロールプレーンおよびコンピュートノードの IP アドレスに対して逆引きルックアップを実行します。結果が各ノードの DNS レコード名に対応していることを確認します。

2.1.8. クラスターノードの SSH アクセス用のキーペアの生成

OpenShift Container Platform のインストール時に、インストールプログラムに SSH 公開鍵を提供できます。この鍵は、Ignition 設定ファイルを介して Red Hat Enterprise Linux CoreOS (RHCOS) ノードに渡され、ノードへの SSH アクセスを認証するために使用されます。鍵は各ノードの core ユーザーの ~/.ssh/authorized_keys リストに追加されます。これにより、パスワードなしの認証が可能になります。

鍵がノードに渡されたら、鍵ペアを使用して、core ユーザーとして RHCOS ノードに SSH 接続できます。SSH 経由でノードにアクセスするには、秘密鍵のアイデンティティーをローカルユーザーの SSH で管理する必要があります。

インストールのデバッグまたは障害復旧を実行するためにクラスターノードに対して SSH を実行する場合は、インストールプロセスの間に SSH 公開鍵を指定する必要があります。./openshift-install gather コマンドでは、SSH 公開鍵がクラスターノードに配置されている必要もあります。

障害復旧およびデバッグが必要な実稼働環境では、この手順を省略しないでください。

プラットフォーム固有の方法で設定した鍵ではなく、ローカルの鍵を使用する必要があります。

手順

クラスターノードへの認証に使用するローカルマシンに既存の SSH キーペアがない場合は、これを作成します。たとえば、Linux オペレーティングシステムを使用するコンピューターで以下のコマンドを実行します。

ssh-keygen -t ed25519 -N '' -f <path>/<file_name>

$ ssh-keygen -t ed25519 -N '' -f <path>/<file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 新しい SSH キーのパスとファイル名 (

~/.ssh/id_ed25519など) を指定します。既存のキーペアがある場合は、公開鍵が~/.sshディレクトリーにあることを確認します。

注記x86_64、ppc64le、およびs390xアーキテクチャーのみで FIPS 140-2/140-3 検証のために NIST に提出された RHEL 暗号化ライブラリーを使用する OpenShift Container Platform クラスターをインストールする予定がある場合は、ed25519アルゴリズムを使用するキーを作成しないでください。代わりに、rsaアルゴリズムまたはecdsaアルゴリズムを使用するキーを作成します。SSH 公開鍵を表示します。

cat <path>/<file_name>.pub

$ cat <path>/<file_name>.pubCopy to Clipboard Copied! Toggle word wrap Toggle overflow たとえば、次のコマンドを実行して

~/.ssh/id_ed25519.pub公開鍵を表示します。cat ~/.ssh/id_ed25519.pub

$ cat ~/.ssh/id_ed25519.pubCopy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルユーザーの SSH エージェントに SSH 秘密鍵 ID が追加されていない場合は、それを追加します。キーの SSH エージェント管理は、クラスターノードへのパスワードなしの SSH 認証、または

./openshift-install gatherコマンドを使用する場合は必要になります。注記一部のディストリビューションでは、

~/.ssh/id_rsaおよび~/.ssh/id_dsaなどのデフォルトの SSH 秘密鍵のアイデンティティーは自動的に管理されます。ssh-agentプロセスがローカルユーザーに対して実行されていない場合は、バックグラウンドタスクとして開始します。eval "$(ssh-agent -s)"

$ eval "$(ssh-agent -s)"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Agent pid 31874

Agent pid 31874Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記クラスターが FIPS モードにある場合は、FIPS 準拠のアルゴリズムのみを使用して SSH キーを生成します。鍵は RSA または ECDSA のいずれかである必要があります。

SSH プライベートキーを

ssh-agentに追加します。ssh-add <path>/<file_name>

$ ssh-add <path>/<file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

~/.ssh/id_ed25519などの、SSH プライベートキーのパスおよびファイル名を指定します。

出力例

Identity added: /home/<you>/<path>/<file_name> (<computer_name>)

Identity added: /home/<you>/<path>/<file_name> (<computer_name>)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

次のステップ

- OpenShift Container Platform をインストールする際に、SSH パブリックキーをインストールプログラムに指定します。クラスターを独自にプロビジョニングするインフラストラクチャーにインストールする場合は、キーをインストールプログラムに指定する必要があります。

2.1.9. インストールプログラムの取得

OpenShift Container Platform をインストールする前に、インストールに使用しているホストにインストールファイルをダウンロードします。

前提条件

- 500 MB のローカルディスク領域がある Linux または macOS を実行するコンピューターが必要です。

手順

Red Hat Hybrid Cloud Console の Cluster Type ページに移動します。Red Hat アカウントがある場合は、認証情報を使用してログインします。アカウントがない場合はこれを作成します。

ヒント- ページの Run it yourself セクションからインフラストラクチャープロバイダーを選択します。

- OpenShift Installer のドロップダウンメニューからホストオペレーティングシステムとアーキテクチャーを選択し、Download Installer をクリックします。

ダウンロードしたファイルを、インストール設定ファイルを保存するディレクトリーに配置します。

重要- インストールプログラムは、クラスターのインストールに使用するコンピューターにいくつかのファイルを作成します。クラスターのインストール完了後は、インストールプログラムおよびインストールプログラムが作成するファイルを保持する必要があります。クラスターを削除するには、両方のファイルが必要です。

- インストールプログラムで作成されたファイルを削除しても、クラスターがインストール時に失敗した場合でもクラスターは削除されません。クラスターを削除するには、特定のクラウドプロバイダー用の OpenShift Container Platform のアンインストール手順を実行します。

インストールプログラムを展開します。たとえば、Linux オペレーティングシステムを使用するコンピューターで以下のコマンドを実行します。

tar -xvf openshift-install-linux.tar.gz

$ tar -xvf openshift-install-linux.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat OpenShift Cluster Manager からインストールプルシークレット をダウンロードします。このプルシークレットを使用し、OpenShift Container Platform コンポーネントのコンテナーイメージを提供する Quay.io など、組み込まれた各種の認証局によって提供されるサービスで認証できます。

Red Hat カスタマーポータル からインストールプログラムを取得することもできます。このページでは、ダウンロードするインストールプログラムのバージョンを指定できます。ただし、このページにアクセスするには、有効なサブスクリプションが必要です。

2.1.10. OpenShift CLI のインストール

OpenShift CLI (oc) をインストールすると、コマンドラインインターフェイスから OpenShift Container Platform を操作できます。oc は Linux、Windows、または macOS にインストールできます。

以前のバージョンの oc をインストールした場合、それを使用して OpenShift Container Platform のすべてのコマンドを実行することはできません。

新しいバージョンの oc をダウンロードしてインストールしてください。

2.1.10.1. Linux への OpenShift CLI のインストール

以下の手順を使用して、OpenShift CLI (oc) バイナリーを Linux にインストールできます。

手順

- Red Hat カスタマーポータルの Download OpenShift Container Platform ページに移動します。

- Product Variant リストからアーキテクチャーを選択します。

- Version リストから適切なバージョンを選択します。

- OpenShift v4.19 Linux Clients エントリーの横にある Download Now をクリックして、ファイルを保存します。

アーカイブを展開します。

tar xvf <file>

$ tar xvf <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ocバイナリーを、PATHにあるディレクトリーに配置します。PATHを確認するには、以下のコマンドを実行します。echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

OpenShift CLI のインストール後に、

ocコマンドを使用して利用できます。oc <command>

$ oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.10.2. Windows への OpenShift CLI のインストール

以下の手順を使用して、OpenShift CLI (oc) バイナリーを Windows にインストールできます。

手順

- Red Hat カスタマーポータルの Download OpenShift Container Platform ページに移動します。

- Version リストから適切なバージョンを選択します。

- OpenShift v4.19 Windows Client エントリーの横にある Download Now をクリックして、ファイルを保存します。

- ZIP プログラムでアーカイブを展開します。

ocバイナリーを、PATHにあるディレクトリーに移動します。PATHを確認するには、コマンドプロンプトを開いて以下のコマンドを実行します。path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

OpenShift CLI のインストール後に、

ocコマンドを使用して利用できます。oc <command>

C:\> oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.10.3. macOS への OpenShift CLI のインストール

以下の手順を使用して、OpenShift CLI (oc) バイナリーを macOS にインストールできます。

手順

- Red Hat カスタマーポータルの Download OpenShift Container Platform ページに移動します。

- バージョン ドロップダウンリストから適切なバージョンを選択します。

OpenShift v4.19 macOS Clients エントリーの横にある Download Now をクリックして、ファイルを保存します。

注記macOS arm64 の場合は、OpenShift v4.19 macOS arm64 Client エントリーを選択します。

- アーカイブを展開し、解凍します。

ocバイナリーをパスにあるディレクトリーに移動します。PATHを確認するには、ターミナルを開き、以下のコマンドを実行します。echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ocコマンドを使用してインストールを確認します。oc <command>

$ oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.11. インストール設定ファイルの手動作成

クラスターをインストールするには、インストール設定ファイルを手動で作成する必要があります。

前提条件

- インストールプログラムで使用するための SSH 公開鍵がローカルマシン上に存在する。この鍵は、デバッグや障害復旧のために、クラスターノードへの SSH 認証に使用できます。

- OpenShift Container Platform インストールプログラムとクラスターのプルシークレットを取得している。

手順

必要なインストールアセットを保存するためのインストールディレクトリーを作成します。

mkdir <installation_directory>

$ mkdir <installation_directory>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要このディレクトリーは必ず作成してください。ブートストラップ X.509 証明書などの一部のインストールアセットは、有効期限が短いため、インストールディレクトリーを再利用しないでください。別のクラスターインストールの個別のファイルを再利用する必要がある場合は、それらをディレクトリーにコピーすることができます。ただし、インストールアセットのファイル名はリリース間で変更される可能性があります。インストールファイルを以前のバージョンの OpenShift Container Platform からコピーする場合は注意してください。

提供されているサンプルの

install-config.yamlファイルテンプレートをカスタマイズし、ファイルを<installation_directory>に保存します。注記この設定ファイルの名前を

install-config.yamlと付ける必要があります。多くのクラスターのインストールに使用できるように、

install-config.yamlファイルをバックアップします。重要インストールプロセスの次のステップで

install-config.yamlファイルを使用するため、今すぐこのファイルをバックアップしてください。

2.1.11.1. ベアメタルのサンプル install-config.yaml ファイル

install-config.yaml ファイルをカスタマイズして、OpenShift Container Platform クラスターのプラットフォームに関する詳細を指定するか、必要なパラメーターの値を変更することができます。

- 1

- クラスターのベースドメイン。すべての DNS レコードはこのベースのサブドメインである必要があり、クラスター名が含まれる必要があります。

- 2 5

controlPlaneセクションは単一マッピングですが、computeセクションはマッピングのシーケンスになります。複数の異なるデータ構造の要件を満たすには、computeセクションの最初の行はハイフン-で始め、controlPlaneセクションの最初の行はハイフンで始めることができません。1 つのコントロールプレーンプールのみが使用されます。- 3 6

- 同時マルチスレッド (SMT) またはハイパースレッディングを有効/無効にするかどうかを指定します。デフォルトでは、SMT はマシンのコアのパフォーマンスを上げるために有効にされます。パラメーター値を

Disabledに設定するとこれを無効にすることができます。SMT を無効にする場合、これをすべてのクラスターマシンで無効にする必要があります。これにはコントロールプレーンとコンピュートマシンの両方が含まれます。注記同時マルチスレッド (SMT) はデフォルトで有効になっています。SMT が BIOS 設定で有効になっていない場合は、

hyperthreadingパラメーターは効果がありません。重要BIOS または

install-config.yamlファイルであるかに関係なくhyperthreadingを無効にする場合、容量計画においてマシンのパフォーマンスの大幅な低下が考慮に入れられていることを確認します。 - 4

- OpenShift Container Platform を user-provisioned infrastructure にインストールする場合は、この値を

0に設定する必要があります。installer-provisioned installation では、パラメーターはクラスターが作成し、管理するコンピュートマシンの数を制御します。user-provisioned installation では、クラスターのインストールの終了前にコンピュートマシンを手動でデプロイする必要があります。注記3 ノードクラスターをインストールする場合は、Red Hat Enterprise Linux CoreOS (RHCOS) マシンをインストールする際にコンピュートマシンをデプロイしないでください。

- 7

- クラスターに追加するコントロールプレーンマシンの数。クラスターをこれらの値をクラスターの etcd エンドポイント数として使用するため、値はデプロイするコントロールプレーンマシンの数に一致する必要があります。

- 8

- DNS レコードに指定したクラスター名。

- 9

- Pod IP アドレスの割り当てに使用する IP アドレスのブロック。このブロックは既存の物理ネットワークと重複できません。これらの IP アドレスは Pod ネットワークに使用されます。外部ネットワークから Pod にアクセスする必要がある場合、ロードバランサーおよびルーターを、トラフィックを管理するように設定する必要があります。注記

クラス E の CIDR 範囲は、将来の使用のために予約されています。クラス E CIDR 範囲を使用するには、ネットワーク環境がクラス E CIDR 範囲内の IP アドレスを受け入れるようにする必要があります。

- 10

- それぞれの個別ノードに割り当てるサブネット接頭辞長。たとえば、

hostPrefixが23に設定されている場合、各ノードに指定のcidrから/23サブネットが割り当てられます。これにより、510 (2^(32 - 23) - 2) Pod IP アドレスが許可されます。外部ネットワークからのノードへのアクセスを提供する必要がある場合には、ロードバランサーおよびルーターを、トラフィックを管理するように設定します。 - 11

- インストールするクラスターネットワークプラグイン。サポートされる値はデフォルト値の

OVNKubernetesのみです。 - 12

- サービス IP アドレスに使用する IP アドレスプール。1 つの IP アドレスプールのみを入力できます。このブロックは既存の物理ネットワークと重複できません。外部ネットワークからサービスにアクセスする必要がある場合、ロードバランサーおよびルーターを、トラフィックを管理するように設定します。

- 13

- プラットフォームを

noneに設定する必要があります。プラットフォーム用に追加のプラットフォーム設定変数を指定することはできません。重要プラットフォームタイプ

noneでインストールされたクラスターは、Machine API を使用したコンピュートマシンの管理など、一部の機能を使用できません。この制限は、クラスターに接続されている計算マシンが、通常はこの機能をサポートするプラットフォームにインストールされている場合でも適用されます。このパラメーターは、インストール後に変更することはできません。 - 14

- FIPS モードを有効または無効にするかどうか。デフォルトでは、FIPS モードは有効にされません。FIPS モードが有効にされている場合、OpenShift Container Platform が実行される Red Hat Enterprise Linux CoreOS (RHCOS) マシンがデフォルトの Kubernetes 暗号スイートをバイパスし、代わりに RHCOS で提供される暗号モジュールを使用します。重要

クラスターで FIPS モードを有効にするには、FIPS モードで動作するように設定された Red Hat Enterprise Linux (RHEL) コンピューターからインストールプログラムを実行する必要があります。RHEL で FIPS モードを設定する方法の詳細は、RHEL から FIPS モードへの切り替え を参照してください。

FIPS モードでブートされた Red Hat Enterprise Linux (RHEL) または Red Hat Enterprise Linux CoreOS (RHCOS) を実行する場合、OpenShift Container Platform コアコンポーネントは、x86_64、ppc64le、および s390x アーキテクチャーのみで、FIPS 140-2/140-3 検証のために NIST に提出された RHEL 暗号化ライブラリーを使用します。

- 15

- Red Hat OpenShift Cluster Manager からのプルシークレット。このプルシークレットを使用し、OpenShift Container Platform コンポーネントのコンテナーイメージを提供する Quay.io など、組み込まれた各種の認証局によって提供されるサービスで認証できます。

- 16

- Red Hat Enterprise Linux CoreOS (RHCOS) の

coreユーザーの SSH 公開鍵。注記インストールのデバッグまたは障害復旧を実行する必要のある実稼働用の OpenShift Container Platform クラスターでは、

ssh-agentプロセスが使用する SSH キーを指定します。

2.1.11.2. インストール時のクラスター全体のプロキシーの設定

実稼働環境では、インターネットへの直接アクセスを拒否し、代わりに HTTP または HTTPS プロキシーを使用することができます。プロキシー設定を install-config.yaml ファイルで行うことにより、新規の OpenShift Container Platform クラスターをプロキシーを使用するように設定できます。

ベアメタルインストールでは、install-config.yaml ファイルの networking.machineNetwork[].cidr フィールドで指定される範囲にあるノード IP アドレスを割り当てない場合、それらを proxy.noProxy フィールドに含める必要があります。

前提条件

-

既存の

install-config.yamlファイルがある。 クラスターがアクセスする必要のあるサイトを確認済みで、それらのいずれかがプロキシーをバイパスする必要があるかどうかを判別している。デフォルトで、すべてのクラスター Egress トラフィック (クラスターをホストするクラウドに関するクラウドプロバイダー API に対する呼び出しを含む) はプロキシーされます。プロキシーを必要に応じてバイパスするために、サイトを

Proxyオブジェクトのspec.noProxyフィールドに追加している。注記Proxyオブジェクトのstatus.noProxyフィールドには、インストール設定のnetworking.machineNetwork[].cidr、networking.clusterNetwork[].cidr、およびnetworking.serviceNetwork[]フィールドの値が設定されます。Amazon Web Services (AWS)、Microsoft Azure、および Red Hat OpenStack Platform (RHOSP) へのインストールの場合、

Proxyオブジェクトのstatus.noProxyフィールドには、インスタンスメタデータのエンドポイント (169.254.169.254) も設定されます。

手順

install-config.yamlファイルを編集し、プロキシー設定を追加します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- クラスター外の HTTP 接続を作成するために使用するプロキシー URL。URL スキームは

httpである必要があります。 - 2

- クラスター外で HTTPS 接続を作成するために使用するプロキシー URL。

- 3

- プロキシーから除外するための宛先ドメイン名、IP アドレス、または他のネットワーク CIDR のコンマ区切りのリスト。サブドメインのみと一致するように、ドメインの前に

.を付けます。たとえば、.y.comはx.y.comに一致しますが、y.comには一致しません。*を使用し、すべての宛先のプロキシーをバイパスします。 - 4

- 指定されている場合、インストールプログラムは HTTPS 接続のプロキシーに必要な 1 つ以上の追加の CA 証明書が含まれる

user-ca-bundleという名前の設定マップをopenshift-confignamespace に生成します。次に Cluster Network Operator は、これらのコンテンツを Red Hat Enterprise Linux CoreOS (RHCOS) 信頼バンドルにマージするtrusted-ca-bundleconfig map を作成し、この config map はProxyオブジェクトのtrustedCAフィールドで参照されます。additionalTrustBundleフィールドは、プロキシーのアイデンティティー証明書が RHCOS 信頼バンドルからの認証局によって署名されない限り必要になります。 - 5

- オプション:

trustedCAフィールドのuser-ca-bundle設定マップを参照するProxyオブジェクトの設定を決定するポリシー。許可される値はProxyonlyおよびAlwaysです。Proxyonlyを使用して、http/httpsプロキシーが設定されている場合にのみuser-ca-bundle設定マップを参照します。Alwaysを使用して、常にuser-ca-bundle設定マップを参照します。デフォルト値はProxyonlyです。

注記インストールプログラムは、プロキシーの

readinessEndpointsフィールドをサポートしません。注記インストーラーがタイムアウトした場合は、インストーラーの

wait-forコマンドを使用してデプロイメントを再起動してからデプロイメントを完了します。以下に例を示します。./openshift-install wait-for install-complete --log-level debug

$ ./openshift-install wait-for install-complete --log-level debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow - ファイルを保存し、OpenShift Container Platform のインストール時にこれを参照します。

インストールプログラムは、指定の install-config.yaml ファイルのプロキシー設定を使用する cluster という名前のクラスター全体のプロキシーを作成します。プロキシー設定が指定されていない場合、cluster Proxy オブジェクトが依然として作成されますが、これには spec がありません。

cluster という名前の Proxy オブジェクトのみがサポートされ、追加のプロキシーを作成することはできません。

2.1.11.3. 3 ノードクラスターの設定

オプションで、3 台のコントロールプレーンマシンのみで構成されるベアメタルクラスターに、ゼロコンピュートマシンをデプロイできます。これにより、テスト、開発、および実稼働に使用するための小規模なリソース効率の高いクラスターが、クラスター管理者および開発者に提供されます。

3 ノードの OpenShift Container Platform 環境では、3 つのコントロールプレーンマシンがスケジュール対象となります。つまり、アプリケーションのワークロードがそれらで実行されるようにスケジュールされます。

前提条件

-

既存の

install-config.yamlファイルがある。

手順

以下の

computeスタンザに示されるように、コンピュートレプリカの数がinstall-config.yamlファイルで0に設定されることを確認します。compute: - name: worker platform: {} replicas: 0compute: - name: worker platform: {} replicas: 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記デプロイするコンピュートマシンの数にかかわらず、OpenShift Container Platform を user-provisioned infrastructure にインストールする際に、コンピュートマシンの

replicasパラメーターの値を0に設定する必要があります。installer-provisioned installation では、パラメーターはクラスターが作成し、管理するコンピュートマシンの数を制御します。これは、コンピュートマシンが手動でデプロイされる、user-provisioned installation には適用されません。

3 ノードのクラスターのインストールで、以下の手順を実行します。

- ゼロ (0) コンピュートノードで 3 ノードクラスターをデプロイする場合、Ingress コントローラー Pod はコントロールプレーンノードで実行されます。3 ノードクラスターデプロイメントでは、HTTP および HTTPS トラフィックをコントロールプレーンノードにルーティングするようにアプリケーション Ingress ロードバランサーを設定する必要があります。詳細は、user-provisioned infrastructure の負荷分散要件 のセクションを参照してください。

-

以下の手順で Kubernetes マニフェストファイルを作成する際に、

<installation_directory>/manifests/cluster-scheduler-02-config.ymlファイルのmastersSchedulableパラメーターがtrueに設定されていることを確認します。これにより、アプリケーションのワークロードがコントロールプレーンノードで実行できます。 - Red Hat Enterprise Linux CoreOS (RHCOS) マシンを作成する際は、コンピュートノードをデプロイしないでください。

2.1.12. Kubernetes マニフェストおよび Ignition 設定ファイルの作成

一部のクラスター定義ファイルを変更し、クラスターマシンを手動で起動する必要があるため、クラスターがマシンを設定するために必要な Kubernetes マニフェストと Ignition 設定ファイルを生成する必要があります。

インストール設定ファイルは Kubernetes マニフェストに変換されます。マニフェストは Ignition 設定ファイルにラップされます。これはクラスターマシンを設定するために後で使用されます。

-

OpenShift Container Platform のインストールプログラムが生成する Ignition 設定ファイルには、24 時間が経過すると期限切れになり、その後に更新される証明書が含まれます。証明書を更新する前にクラスターが停止し、24 時間経過した後にクラスターを再起動すると、クラスターは期限切れの証明書を自動的に復元します。例外として、kubelet 証明書を回復するために保留状態の

node-bootstrapper証明書署名要求 (CSR) を手動で承認する必要があります。詳細は、コントロールプレーン証明書の期限切れの状態からのリカバリー に関するドキュメントを参照してください。 - 24 時間証明書はクラスターのインストール後 16 時間から 22 時間にローテーションするため、Ignition 設定ファイルは、生成後 12 時間以内に使用することを推奨します。12 時間以内に Ignition 設定ファイルを使用することにより、インストール中に証明書の更新が実行された場合のインストールの失敗を回避できます。

前提条件

- OpenShift Container Platform インストールプログラムを取得していること。

-

install-config.yamlインストール設定ファイルを作成していること。

手順

OpenShift Container Platform のインストールプログラムが含まれるディレクトリーに切り替え、クラスターの Kubernetes マニフェストを生成します。

./openshift-install create manifests --dir <installation_directory>

$ ./openshift-install create manifests --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<installation_directory>には、作成したinstall-config.yamlファイルが含まれるインストールディレクトリーを指定します。

警告3 ノードクラスターをインストールしている場合は、以下の手順を省略してコントロールプレーンノードをスケジュール対象にします。

重要コントロールプレーンノードをデフォルトのスケジュール不可からスケジュール可に設定するには、追加のサブスクリプションが必要です。これは、コントロールプレーンノードがコンピュートノードになるためです。

<installation_directory>/manifests/cluster-scheduler-02-config.ymlKubernetes マニフェストファイルのmastersSchedulableパラメーターがfalseに設定されていることを確認します。この設定により、Pod がコントロールプレーンマシンにスケジュールされなくなります。-

<installation_directory>/manifests/cluster-scheduler-02-config.ymlファイルを開きます。 -

mastersSchedulableパラメーターを見つけ、これがfalseに設定されていることを確認します。 - ファイルを保存し、終了します。

-

Ignition 設定ファイルを作成するには、インストールプログラムが含まれるディレクトリーから以下のコマンドを実行します。

./openshift-install create ignition-configs --dir <installation_directory>

$ ./openshift-install create ignition-configs --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<installation_directory>には、同じインストールディレクトリーを指定します。

Ignition 設定ファイルは、インストールディレクトリー内のブートストラップ、コントロールプレーン、およびコンピュートノード用に作成されます。

kubeadmin-passwordおよびkubeconfigファイルが./<installation_directory>/authディレクトリーに作成されます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.13. RHCOS のインストールおよび OpenShift Container Platform ブートストラッププロセスの開始

OpenShift Container Platform を独自にプロビジョニングするベアメタルインフラストラクチャーにインストールするには、Red Hat Enterprise Linux CoreOS (RHCOS) をマシンにインストールする必要があります。RHCOS のインストール時に、インストールするマシンのタイプに、OpenShift Container Platform インストールプログラムによって生成された Ignition 設定ファイルを指定する必要があります。適切なネットワーク、DNS、および負荷分散インフラストラクチャーが設定されている場合、OpenShift Container Platform ブートストラッププロセスは RHCOS マシンの再起動後に自動的に開始されます。

RHCOS をマシンにインストールするには、ISO イメージまたはネットワーク PXE ブートを使用する手順のいずれかを実行します。

このインストールガイドに含まれるコンピュートノードのデプロイメント手順は、RHCOS 固有のものです。代わりに RHEL ベースのコンピュートノードのデプロイを選択する場合は、システム更新の実行、パッチの適用、その他すべての必要なタスクの完了など、オペレーティングシステムのライフサイクルの管理と保守をすべて担当します。RHEL8 コンピュートマシンのみがサポートされています。

以下の方法を使用して、ISO および PXE のインストール時に RHCOS を設定できます。

-

カーネル引数: カーネル引数を使用してインストール固有の情報を提供できます。たとえば、HTTP サーバーにアップロードした RHCOS インストールファイルの場所と、インストールするノードタイプの Ignition 設定ファイルの場所を指定できます。PXE インストールの場合、

APPENDパラメーターを使用して、ライブインストーラーのカーネルに引数を渡すことができます。ISO インストールの場合は、ライブインストール起動プロセスを中断してカーネル引数を追加できます。いずれのインストールの場合でも、特殊なcoreos.inst.*引数を使用してライブインストーラーに指示を与えたり、標準のカーネルサービスをオンまたはオフにするために標準のインストールブート引数を使用したりできます。 -

Ignition 設定: OpenShift Container Platform Ignition 設定ファイル (

*.ign) は、インストールするノードのタイプに固有のものです。RHCOS のインストール時にブートストラップ、コントロールプレーン、またはコンピュートノードの Ignition 設定ファイルの場所を渡して、初回起動時に有効にされるようにします。特別なケースでは、ライブシステムに渡すために個別の制限付き Ignition 設定を作成できます。この Ignition 設定は、インストールが正常に完了したことをプロビジョニングシステムに報告するなどの一連のタスクを実行する可能性があります。この特別な Ignition 設定は、インストール済みシステムの初回ブート時に適用されるcoreos-installerによって使用されます。標準のコントロールプレーンおよびコンピュートノードの Ignition 設定をライブ ISO に直接指定しないでください。 coreos-installer: ライブ ISO インストーラーをシェルプロンプトで起動できます。これにより、初回のブート前にさまざまな方法で永続的なシステムの準備を行うことができます。特に、coreos-installerコマンドを実行すると、追加するさまざまなアーティファクトを特定し、ディスクパーティションを使用し、ネットワークを設定できます。場合によっては、ライブシステムで機能を設定し、それらをインストールされたシステムにコピーできます。注記バージョン

0.17.0-3以降、coreos-installerプログラムを実行するには RHEL 9 以降が必要です。古いバージョンのcoreos-installerを使用して、新しい OpenShift Container Platform リリースの RHCOS アーティファクトをカスタマイズし、メタルイメージをディスクにインストールすることもできます。coreos-installerバイナリーの古いバージョンは、coreos-installerimage mirror ページからダウンロードできます。

ISO または PXE インストールを使用するかどうかは、状況によって異なります。PXE インストールには、利用可能な DHCP サービスとさらなる準備が必要ですが、インストールプロセスはさらに自動化することが可能です。ISO インストールは主に手動によるプロセスで、複数のマシンを設定する場合には使用しにくい可能性があります。

2.1.13.1. ISO イメージを使用した RHCOS のインストール

ISO イメージを使用してマシンに RHCOS をインストールできます。

前提条件

- クラスターの Ignition 設定ファイルを作成している。

- 適切なネットワーク、DNS、および負荷分散インフラストラクチャーを設定している。

- お使いのコンピューターからアクセスでき、作成するマシンからもアクセスできる HTTP サーバーがある。

- ネットワークやディスクパーティションなどのさまざまな機能の設定方法について、高度な RHCOS インストール設定 のセクションを確認している。

手順

それぞれの Ignition 設定ファイルの SHA512 ダイジェストを取得します。たとえば、Linux を実行しているシステムで以下を使用して、

bootstrap.ignIgnition 設定ファイルの SHA512 ダイジェストを取得できます。sha512sum <installation_directory>/bootstrap.ign

$ sha512sum <installation_directory>/bootstrap.ignCopy to Clipboard Copied! Toggle word wrap Toggle overflow ダイジェストは、クラスターノードの Ignition 設定ファイルの信頼性を検証するために、後の手順で

coreos-installerに提供されます。インストールプログラムが作成したブートストラップ、コントロールプレーン、およびコンピュートノード Ignition 設定ファイルを HTTP サーバーにアップロードします。これらのファイルの URL をメモします。

重要HTTP サーバーに保存する前に、Ignition 設定で設定内容を追加したり、変更したりできます。インストールの完了後にコンピュートマシンをさらにクラスターに追加する予定の場合には、これらのファイルを削除しないでください。

インストールホストから、Ignition 設定ファイルが URL で利用可能であることを確認します。以下の例では、ブートストラップノードの Ignition 設定ファイルを取得します。

curl -k http://<HTTP_server>/bootstrap.ign

$ curl -k http://<HTTP_server>/bootstrap.ign1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

% Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 0 0 0 0 0 0 0 0 --:--:-- --:--:-- --:--:-- 0{"ignition":{"version":"3.2.0"},"passwd":{"users":[{"name":"core","sshAuthorizedKeys":["ssh-rsa...% Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 0 0 0 0 0 0 0 0 --:--:-- --:--:-- --:--:-- 0{"ignition":{"version":"3.2.0"},"passwd":{"users":[{"name":"core","sshAuthorizedKeys":["ssh-rsa...Copy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドで

bootstrap.ignをmaster.ignまたはworker.ignに置き換え、コントロールプレーンおよびコンピュートノードの Ignition 設定ファイルも利用可能であることを検証します。RHCOS イメージのミラー ページから、オペレーティングシステムインスタンスをインストールするための推奨される方法に必要な RHCOS イメージを取得することは可能ですが、RHCOS イメージの正しいバージョンを取得するための推奨される方法は、

openshift-installコマンドの出力から取得することです。openshift-install coreos print-stream-json | grep '\.iso[^.]'

$ openshift-install coreos print-stream-json | grep '\.iso[^.]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

"location": "<url>/art/storage/releases/rhcos-4.19-aarch64/<release>/aarch64/rhcos-<release>-live.aarch64.iso", "location": "<url>/art/storage/releases/rhcos-4.19-ppc64le/<release>/ppc64le/rhcos-<release>-live.ppc64le.iso", "location": "<url>/art/storage/releases/rhcos-4.19-s390x/<release>/s390x/rhcos-<release>-live.s390x.iso", "location": "<url>/art/storage/releases/rhcos-4.19/<release>/x86_64/rhcos-<release>-live.x86_64.iso",

"location": "<url>/art/storage/releases/rhcos-4.19-aarch64/<release>/aarch64/rhcos-<release>-live.aarch64.iso", "location": "<url>/art/storage/releases/rhcos-4.19-ppc64le/<release>/ppc64le/rhcos-<release>-live.ppc64le.iso", "location": "<url>/art/storage/releases/rhcos-4.19-s390x/<release>/s390x/rhcos-<release>-live.s390x.iso", "location": "<url>/art/storage/releases/rhcos-4.19/<release>/x86_64/rhcos-<release>-live.x86_64.iso",Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要RHCOS イメージは OpenShift Container Platform の各リリースごとに変更されない可能性があります。インストールする OpenShift Container Platform バージョンと等しいか、それ以下のバージョンの内で最も新しいバージョンのイメージをダウンロードする必要があります。利用可能な場合は、OpenShift Container Platform バージョンに一致するイメージのバージョンを使用します。この手順には ISO イメージのみを使用します。RHCOS qcow2 イメージは、このインストールではサポートされません。

ISO ファイルの名前は以下の例のようになります。

rhcos-<version>-live.<architecture>.isoISO を使用し、RHCOS インストールを開始します。以下のインストールオプションのいずれかを使用します。

- ディスクに ISO イメージを書き込み、これを直接起動します。

- Lights Out Management (LOM) インターフェイスを使用して ISO リダイレクトを使用します。

オプションを指定したり、ライブ起動シーケンスを中断したりせずに、RHCOS ISO イメージを起動します。インストーラーが RHCOS ライブ環境でシェルプロンプトを起動するのを待ちます。

注記RHCOS インストール起動プロセスを中断して、カーネル引数を追加できます。ただし、この ISO 手順では、カーネル引数を追加する代わりに、以下の手順で説明しているように

coreos-installerコマンドを使用する必要があります。coreos-installerコマンドを実行し、インストール要件を満たすオプションを指定します。少なくとも、該当するノードタイプ用の Ignition 設定ファイルを指す URL と、インストール先のデバイスを指定する必要があります。sudo coreos-installer install --ignition-url=http://<HTTP_server>/<node_type>.ign <device> \ --ignition-hash=sha512-<digest>

$ sudo coreos-installer install --ignition-url=http://<HTTP_server>/<node_type>.ign <device> \1 --ignition-hash=sha512-<digest>2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記TLS を使用する HTTPS サーバーを使用して Ignition 設定ファイルを提供する場合は、

coreos-installerを実行する前に、内部認証局 (CA) をシステムのトラストストアに追加できます。以下の例では、

/dev/sdaデバイスへのブートストラップノードのインストールを初期化します。ブートストラップノードの Ignition 設定ファイルは、IP アドレス 192.168.1.2 で HTTP Web サーバーから取得されます。+

sudo coreos-installer install --ignition-url=http://192.168.1.2:80/installation_directory/bootstrap.ign /dev/sda \ --ignition-hash=sha512-a5a2d43879223273c9b60af66b44202a1d1248fc01cf156c46d4a79f552b6bad47bc8cc78ddf0116e80c59d2ea9e32ba53bc807afbca581aa059311def2c3e3b

$ sudo coreos-installer install --ignition-url=http://192.168.1.2:80/installation_directory/bootstrap.ign /dev/sda \

--ignition-hash=sha512-a5a2d43879223273c9b60af66b44202a1d1248fc01cf156c46d4a79f552b6bad47bc8cc78ddf0116e80c59d2ea9e32ba53bc807afbca581aa059311def2c3e3bマシンのコンソールで RHCOS インストールの進捗を監視します。

重要OpenShift Container Platform のインストールを開始する前に、各ノードでインストールが成功していることを確認します。インストールプロセスを監視すると、発生する可能性のある RHCOS インストールの問題の原因を特定する上でも役立ちます。

- RHCOS のインストール後、システムを再起動する必要があります。システムの再起動後、指定した Ignition 設定ファイルを適用します。

コンソール出力をチェックして、Ignition が実行されたことを確認します。

コマンドの例

Ignition: ran on 2022/03/14 14:48:33 UTC (this boot) Ignition: user-provided config was applied

Ignition: ran on 2022/03/14 14:48:33 UTC (this boot) Ignition: user-provided config was appliedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 継続してクラスターの他のマシンを作成します。

重要この時点でブートストラップおよびコントロールプレーンマシンを作成する必要があります。コントロールプレーンマシンがデフォルトのスケジュール対象にされていない場合、OpenShift Container Platform のインストール前に少なくとも 2 つのコンピュートマシンも作成します。

必要なネットワーク、DNS、およびロードバランサーインフラストラクチャーが配置されている場合、OpenShift Container Platform ブートストラッププロセスは RHCOS ノードの再起動後に自動的に起動します。

注記RHCOS ノードには、

coreユーザーのデフォルトのパスワードは含まれません。ノードには、ssh core@<node>.<cluster_name>.<base_domain>を、install_config.yamlファイルで指定したパブリックキーとペアになる SSH プライベートキーへのアクセスのあるユーザーとして実行してアクセスできます。RHCOS を実行する OpenShift Container Platform 4 クラスターノードは変更できず、Operator を使用してクラスターの変更を適用します。SSH を使用したクラスターノードへのアクセスは推奨されません。ただし、インストールの問題を調査する際に、OpenShift Container Platform API が利用できない場合や、kubelet がターゲットノードで適切に機能しない場合、デバッグまたは障害復旧に SSH アクセスが必要になることがあります。

2.1.13.2. PXE または iPXE ブートを使用した RHCOS のインストール

PXE または iPXE ブートを使用してマシンに RHCOS をインストールできます。

前提条件

- クラスターの Ignition 設定ファイルを作成している。

- 適切なネットワーク、DNS および負荷分散インフラストラクチャーを設定している。

- 適切な PXE または iPXE インフラストラクチャーを設定していること。

- お使いのコンピューターからアクセスでき、作成するマシンからもアクセスできる HTTP サーバーがある。

- ネットワークやディスクパーティションなどのさまざまな機能の設定方法について、高度な RHCOS インストール設定 のセクションを確認している。

手順

インストールプログラムが作成したブートストラップ、コントロールプレーン、およびコンピュートノード Ignition 設定ファイルを HTTP サーバーにアップロードします。これらのファイルの URL をメモします。

重要HTTP サーバーに保存する前に、Ignition 設定で設定内容を追加したり、変更したりできます。インストールの完了後にコンピュートマシンをさらにクラスターに追加する予定の場合には、これらのファイルを削除しないでください。

インストールホストから、Ignition 設定ファイルが URL で利用可能であることを確認します。以下の例では、ブートストラップノードの Ignition 設定ファイルを取得します。

curl -k http://<HTTP_server>/bootstrap.ign

$ curl -k http://<HTTP_server>/bootstrap.ign1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

% Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 0 0 0 0 0 0 0 0 --:--:-- --:--:-- --:--:-- 0{"ignition":{"version":"3.2.0"},"passwd":{"users":[{"name":"core","sshAuthorizedKeys":["ssh-rsa...% Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 0 0 0 0 0 0 0 0 --:--:-- --:--:-- --:--:-- 0{"ignition":{"version":"3.2.0"},"passwd":{"users":[{"name":"core","sshAuthorizedKeys":["ssh-rsa...Copy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドで

bootstrap.ignをmaster.ignまたはworker.ignに置き換え、コントロールプレーンおよびコンピュートノードの Ignition 設定ファイルも利用可能であることを検証します。RHCOS イメージミラー ページからオペレーティングシステムインスタンスをインストールするための推奨される方法に必要な RHCOS

kernel、initramfs、およびrootfsファイルを取得することは可能ですが、RHCOS ファイルの正しいバージョンを取得するための推奨される方法は、openshift-installコマンドの出力から取得することです。openshift-install coreos print-stream-json | grep -Eo '"https.*(kernel-|initramfs.|rootfs.)\w+(\.img)?"'

$ openshift-install coreos print-stream-json | grep -Eo '"https.*(kernel-|initramfs.|rootfs.)\w+(\.img)?"'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要RHCOS アーティファクトは OpenShift Container Platform の各リリースごとに変更されない可能性があります。インストールする OpenShift Container Platform バージョンと等しいか、それ以下のバージョンの内で最も新しいバージョンのイメージをダウンロードする必要があります。この手順で説明されている適切な

kernel、initramfs、およびrootfsアーティファクトのみを使用します。RHCOS QCOW2 イメージは、このインストールタイプではサポートされません。ファイル名には、OpenShift Container Platform のバージョン番号が含まれます。以下の例のようになります。

-

kernel:rhcos-<version>-live-kernel-<architecture> -

initramfs:rhcos-<version>-live-initramfs.<architecture>.img -

rootfs:rhcos-<version>-live-rootfs.<architecture>.img

-

rootfs、kernel、およびinitramfsファイルを HTTP サーバーにアップロードします。重要インストールの完了後にコンピュートマシンをさらにクラスターに追加する予定の場合には、これらのファイルを削除しないでください。

- RHCOS のインストール後にマシンがローカルディスクから起動されるようにネットワークブートインフラストラクチャーを設定します。

RHCOS イメージの PXE または iPXE インストールを設定し、インストールを開始します。

ご使用の環境に関する以下の例で示されるメニューエントリーのいずれかを変更し、イメージおよび Ignition ファイルが適切にアクセスできることを確認します。

PXE(

x86_64) の場合:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1 1

- HTTP サーバーにアップロードしたライブ

kernelファイルの場所を指定します。URL は HTTP、TFTP、または FTP である必要があります。HTTPS および NFS はサポートされません。 - 2

- 複数の NIC を使用する場合、

ipオプションに単一インターフェイスを指定します。たとえば、eno1という名前の NIC で DHCP を使用するには、ip=eno1:dhcpを設定します。 - 3

- HTTP サーバーにアップロードした RHCOS ファイルの場所を指定します。

initrdパラメーター値はinitramfsファイルの場所であり、coreos.live.rootfs_urlパラメーター値はrootfsファイルの場所、またcoreos.inst.ignition_urlパラメーター値はブートストラップ Ignition 設定ファイルの場所になります。APPEND行にカーネル引数を追加して、ネットワークやその他の起動オプションを設定することもできます。

注記この設定では、グラフィカルコンソールを使用するマシンでシリアルコンソールアクセスを有効にしません。別のコンソールを設定するには、

APPEND行に 1 つ以上のconsole=引数を追加します。たとえば、console=tty0 console=ttyS0を追加して、最初の PC シリアルポートをプライマリーコンソールとして、グラフィカルコンソールをセカンダリーコンソールとして設定します。詳細は、How does one set up a serial terminal and/or console in Red Hat Enterprise Linux? と、「高度な RHCOS インストール設定」セクションの「PXE および ISO インストール用シリアルコンソールの有効化」を参照してください。iPXE (

x86_64+aarch64) の場合:kernel http://<HTTP_server>/rhcos-<version>-live-kernel-<architecture> initrd=main coreos.live.rootfs_url=http://<HTTP_server>/rhcos-<version>-live-rootfs.<architecture>.img coreos.inst.install_dev=/dev/sda coreos.inst.ignition_url=http://<HTTP_server>/bootstrap.ign initrd --name main http://<HTTP_server>/rhcos-<version>-live-initramfs.<architecture>.img boot

kernel http://<HTTP_server>/rhcos-<version>-live-kernel-<architecture> initrd=main coreos.live.rootfs_url=http://<HTTP_server>/rhcos-<version>-live-rootfs.<architecture>.img coreos.inst.install_dev=/dev/sda coreos.inst.ignition_url=http://<HTTP_server>/bootstrap.ign1 2 initrd --name main http://<HTTP_server>/rhcos-<version>-live-initramfs.<architecture>.img3 bootCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- HTTP サーバーにアップロードした RHCOS ファイルの場所を指定します。

kernelパラメーター値はkernelファイルの場所であり、initrd=main引数は UEFI システムでの起動に必要であり、coreos.live.rootfs_urlパラメーター値はrootfsファイルの場所であり、coreos.inst.ignition_urlパラメーター値はブートストラップ Ignition 設定ファイルの場所になります。 - 2

- 複数の NIC を使用する場合、

ipオプションに単一インターフェイスを指定します。たとえば、eno1という名前の NIC で DHCP を使用するには、ip=eno1:dhcpを設定します。 - 3

- HTTP サーバーにアップロードした

initramfsファイルの場所を指定します。

注記この設定では、グラフィカルコンソールを使用するマシンでシリアルコンソールアクセスを有効にしません。別のコンソールを設定するには、

kernel行にconsole=引数を 1 つ以上追加します。たとえば、console=tty0 console=ttyS0を追加して、最初の PC シリアルポートをプライマリーコンソールとして、グラフィカルコンソールをセカンダリーコンソールとして設定します。詳細は、How does one set up a serial terminal and/or console in Red Hat Enterprise Linux? と、「高度な RHCOS インストール設定」セクションの「PXE および ISO インストール用シリアルコンソールの有効化」を参照してください。注記aarch64アーキテクチャーで CoreOSkernelをネットワークブートするには、IMAGE_GZIPオプションが有効になっているバージョンの iPXE ビルドを使用する必要があります。iPXE のIMAGE_GZIPオプション を参照してください。aarch64上の PXE (第 2 段階として UEFI と Grub を使用) の場合:menuentry 'Install CoreOS' { linux rhcos-<version>-live-kernel-<architecture> coreos.live.rootfs_url=http://<HTTP_server>/rhcos-<version>-live-rootfs.<architecture>.img coreos.inst.install_dev=/dev/sda coreos.inst.ignition_url=http://<HTTP_server>/bootstrap.ign initrd rhcos-<version>-live-initramfs.<architecture>.img }menuentry 'Install CoreOS' { linux rhcos-<version>-live-kernel-<architecture> coreos.live.rootfs_url=http://<HTTP_server>/rhcos-<version>-live-rootfs.<architecture>.img coreos.inst.install_dev=/dev/sda coreos.inst.ignition_url=http://<HTTP_server>/bootstrap.ign1 2 initrd rhcos-<version>-live-initramfs.<architecture>.img3 }Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- HTTP/TFTP サーバーにアップロードした RHCOS ファイルの場所を指定します。

kernelパラメーター値は、TFTP サーバー上のkernelファイルの場所になります。coreos.live.rootfs_urlパラメーター値はrootfsファイルの場所であり、coreos.inst.ignition_urlパラメーター値は HTTP サーバー上のブートストラップ Ignition 設定ファイルの場所になります。 - 2

- 複数の NIC を使用する場合、

ipオプションに単一インターフェイスを指定します。たとえば、eno1という名前の NIC で DHCP を使用するには、ip=eno1:dhcpを設定します。 - 3

- TFTP サーバーにアップロードした

initramfsファイルの場所を指定します。

マシンのコンソールで RHCOS インストールの進捗を監視します。

重要OpenShift Container Platform のインストールを開始する前に、各ノードでインストールが成功していることを確認します。インストールプロセスを監視すると、発生する可能性のある RHCOS インストールの問題の原因を特定する上でも役立ちます。

- RHCOS のインストール後に、システムは再起動します。再起動中、システムは指定した Ignition 設定ファイルを適用します。

コンソール出力をチェックして、Ignition が実行されたことを確認します。

コマンドの例

Ignition: ran on 2022/03/14 14:48:33 UTC (this boot) Ignition: user-provided config was applied

Ignition: ran on 2022/03/14 14:48:33 UTC (this boot) Ignition: user-provided config was appliedCopy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターのマシンの作成を続行します。

重要この時点でブートストラップおよびコントロールプレーンマシンを作成する必要があります。コントロールプレーンマシンがデフォルトのスケジュール対象にされていない場合、クラスターのインストール前に少なくとも 2 つのコンピュートマシンを作成します。

必要なネットワーク、DNS、およびロードバランサーインフラストラクチャーが配置されている場合、OpenShift Container Platform ブートストラッププロセスは RHCOS ノードの再起動後に自動的に起動します。

注記RHCOS ノードには、

coreユーザーのデフォルトのパスワードは含まれません。ノードには、ssh core@<node>.<cluster_name>.<base_domain>を、install_config.yamlファイルで指定したパブリックキーとペアになる SSH プライベートキーへのアクセスのあるユーザーとして実行してアクセスできます。RHCOS を実行する OpenShift Container Platform 4 クラスターノードは変更できず、Operator を使用してクラスターの変更を適用します。SSH を使用したクラスターノードへのアクセスは推奨されません。ただし、インストールの問題を調査する際に、OpenShift Container Platform API が利用できない場合や、kubelet がターゲットノードで適切に機能しない場合、デバッグまたは障害復旧に SSH アクセスが必要になることがあります。

2.1.13.3. 高度な RHCOS インストール設定

OpenShift Container Platform 用の Red Hat Enterprise Linux CoreOS (RHCOS) ノードを手動でプロビジョニングする主な利点は、デフォルトの OpenShift Container Platform インストール方法では利用できない設定を実行できることです。このセクションでは、以下のような手法で実行できるいくつかの設定を説明します。

- カーネル引数をライブインストーラーに渡す

-

ライブシステムからの

coreos-installerの手動による実行 - ライブ ISO または PXE ブートイメージのカスタマイズ

このセクションで説明されている手動の Red Hat Enterprise Linux CoreOS (RHCOS) インストールの高度な設定トピックは、ディスクパーティション設定、ネットワーク、および複数の異なる方法での Ignition 設定の使用に関連しています。

2.1.13.3.1. PXE および ISO インストールの高度なネットワーキングオプションの使用

OpenShift Container Platform ノードのネットワークはデフォルトで DHCP を使用して、必要な設定をすべて収集します。静的 IP アドレスを設定したり、ボンディングなどの特別な設定を行う場合は、以下のいずれかの方法で実行できます。

- ライブインストーラーの起動時に、特別なカーネルパラメーターを渡します。

- マシン設定を使用してネットワークファイルをインストール済みシステムにコピーします。

- ライブインストーラーのシェルプロンプトからネットワークを設定し、それらの設定をインストール済みシステムにコピーして、インストール済みシステムの初回起動時に有効になるようにします。

PXE または iPXE インストールを設定するには、以下のオプションのいずれかを使用します。

- 「詳細な RHCOS インストールリファレンスの表」を参照してください。

- マシン設定を使用してネットワークファイルをインストール済みシステムにコピーします。

ISO インストールを設定するには、以下の手順に従います。

手順

- ISO インストーラーを起動します。

-

ライブシステムシェルプロンプトから、

nmcliまたはnmtuiなどの利用可能な RHEL ツールを使用して、ライブシステムのネットワークを設定します。 coreos-installerコマンドを実行してシステムをインストールし、--copy-networkオプションを追加してネットワーク設定をコピーします。以下に例を示します。sudo coreos-installer install --copy-network \ --ignition-url=http://host/worker.ign /dev/disk/by-id/scsi-<serial_number>$ sudo coreos-installer install --copy-network \ --ignition-url=http://host/worker.ign /dev/disk/by-id/scsi-<serial_number>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要--copy-networkオプションは、/etc/NetworkManager/system-connectionsにあるネットワーク設定のみをコピーします。特に、システムのホスト名はコピーされません。- インストール済みのシステムで再起動します。

2.1.13.3.2. ディスクパーティション設定

ディスクパーティションは、Red Hat Enterprise Linux CoreOS (RHCOS) のインストール時に OpenShift Container Platform クラスターノードに作成されます。デフォルトのパーティション設定をオーバーライドしない限り、特定のアーキテクチャーの各 RHCOS ノードで同じパーティションレイアウトが使用されます。RHCOS のインストール時に、ルートファイルシステムのサイズが拡大し、ターゲットデバイスの残りの使用可能なスペースが使用されます。

ノードでカスタムパーティションスキームを使用すると、OpenShift Container Platform が一部のノードパーティションでモニタリングやアラートを行わなくなる可能性があります。デフォルトのパーティション設定をオーバーライドする場合は、OpenShift Container Platform がホストファイルシステムを監視する方法の詳細について Understanding OpenShift File System Monitoring (eviction conditions) を参照してください。

OpenShift Container Platform は、次の 2 つのファイルシステム識別子を監視します。

-

nodefs:/var/lib/kubeletを含むファイルシステム -

imagefs:/var/lib/containersを含むファイルシステム

デフォルトのパーティションスキームの場合、nodefs と imagefs は同じルートファイルシステム (/) を監視します。

RHCOS を OpenShift Container Platform クラスターノードにインストールするときにデフォルトのパーティション設定をオーバーライドするには、別のパーティションを作成する必要があります。コンテナーとコンテナーイメージ用に別のストレージパーティションを追加する状況を考えてみましょう。たとえば、/var/lib/containers を別のパーティションにマウントすると、kubelet が /var/lib/containers を imagefs ディレクトリーとして、ルートファイルシステムを nodefs ディレクトリーとして個別に監視します。

より大きなファイルシステムをホストするためにディスクサイズを変更した場合は、別の /var/lib/containers パーティションを作成することを検討してください。多数の割り当てグループによって発生する CPU 時間の問題を軽減するには、xfs 形式のディスクのサイズを変更することを検討してください。

2.1.13.3.2.1. 個別の /var パーティションの作成

通常は、RHCOS のインストール時に作成されるデフォルトのディスクパーティションを使用する必要があります。ただし、拡張するディレクトリーの個別のパーティションの作成が必要となる場合もあります。

OpenShift Container Platform は、ストレージを /var ディレクトリーまたは /var のサブディレクトリーのいずれかに割り当てる単一のパーティションの追加をサポートします。以下に例を示します。

-

/var/lib/containers: イメージやコンテナーがシステムにさらに追加されると拡張するコンテナー関連のコンテンツを保持します。 -

/var/lib/etcd: etcd ストレージのパフォーマンスの最適化などの目的で分離する必要のあるデータを保持します。 /var: 監査などの目的に合わせて分離させる必要のあるデータを保持します。重要ディスクサイズが 100 GB を超える場合、特に 1 TB を超える場合は、別の

/varパーティションを作成します。

/var ディレクトリーのコンテンツを個別に保存すると、必要に応じてこれらの領域のストレージの拡大を容易にし、後で OpenShift Container Platform を再インストールして、そのデータをそのまま保持することができます。この方法では、すべてのコンテナーを再度プルする必要はありません。また、システムの更新時に大きなログファイルをコピーする必要もありません。

/var ディレクトリーまたは /var のサブディレクトリーの個別のパーティションを使用すると、パーティション設定されたディレクトリーでのデータの増加によりルートファイルシステムが一杯になることを避けることもできます。

以下の手順では、インストールの準備フェーズでノードタイプの Ignition 設定ファイルにラップされるマシン設定マニフェストを追加して、別の /var パーティションを設定します。

手順

インストールホストで、OpenShift Container Platform のインストールプログラムが含まれるディレクトリーに切り替え、クラスターの Kubernetes マニフェストを生成します。

openshift-install create manifests --dir <installation_directory>

$ openshift-install create manifests --dir <installation_directory>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 追加のパーティションを設定する Butane 設定を作成します。たとえば、

$HOME/clusterconfig/98-var-partition.buファイルに名前を付け、ディスクのデバイス名をworkerシステムのストレージデバイスの名前に変更し、必要に応じてストレージサイズを設定します。以下の例では、/varディレクトリーを別のパーティションにマウントします。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- パーティションを設定する必要のあるディスクのストレージデバイス名。

- 2

- データパーティションをブートディスクに追加する場合は、25000 のメビバイトの最小のオフセット値が推奨されます。ルートファイルシステムは、指定したオフセットまでの利用可能な領域をすべて埋めるためにサイズを自動的に変更します。オフセット値の指定がない場合や、指定した値が推奨される最小値よりも小さい場合、生成されるルートファイルシステムのサイズは小さ過ぎるため、RHCOS の再インストールでデータパーティションの最初の部分が上書きされる可能性があります。

- 3

- データパーティションのサイズ (メビバイト単位)。

- 4

- コンテナーストレージに使用されるファイルシステムでは、

prjquotaマウントオプションを有効にする必要があります。

注記個別の

/varパーティションを作成する場合、異なるインスタンスタイプに同じデバイス名がない場合は、コンピュートノードに異なるインスタンスタイプを使用することはできません。Butane config からマニフェストを作成し、

clusterconfig/openshiftディレクトリーに保存します。たとえば、以下のコマンドを実行します。butane $HOME/clusterconfig/98-var-partition.bu -o $HOME/clusterconfig/openshift/98-var-partition.yaml

$ butane $HOME/clusterconfig/98-var-partition.bu -o $HOME/clusterconfig/openshift/98-var-partition.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ignition 設定ファイルを作成します。

openshift-install create ignition-configs --dir <installation_directory>

$ openshift-install create ignition-configs --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<installation_directory>には、同じインストールディレクトリーを指定します。

Ignition 設定ファイルは、インストールディレクトリー内のブートストラップ、コントロールプレーン、およびコンピュートノード用に作成されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow <installation_directory>/manifestディレクトリーおよび<installation_directory>/openshiftディレクトリーのファイルは、98-var-partitionカスタムMachineConfigオブジェクトが含まれるファイルを含む Ignition 設定ファイルにラップされます。

次のステップ

- RHCOS のインストール時に Ignition 設定ファイルを参照して、カスタムディスクのパーティション設定を適用することができます。

2.1.13.3.2.2. 既存パーティションの保持

ISO インストールの場合は、インストーラーに 1 つ以上の既存パーティションを維持させる coreos-installer コマンドにオプションを追加することができます。PXE インストールの場合、coreos.inst.* オプションを APPEND パラメーターに追加して、パーティションを保持できます。

保存したパーティションは、既存の OpenShift Container Platform システムからのデータパーティションである可能性があります。パーティションラベルまたは番号のいずれかで保持する必要のあるディスクパーティションを特定できます。

既存のパーティションを保存し、それらのパーティションが RHCOS の十分な領域を残さない場合、インストールは失敗します。この場合、保存したパーティションが破損することはありません。

ISO インストール時の既存パーティションの保持

この例では、パーティションラベルが data (data*) で始まるパーティションを保持します。

coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \ --save-partlabel 'data*' \ /dev/disk/by-id/scsi-<serial_number>

# coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \

--save-partlabel 'data*' \

/dev/disk/by-id/scsi-<serial_number>

以下の例では、ディスク上の 6 番目のパーティションを保持する方法で coreos-installer を実行する方法を説明しています。

coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \ --save-partindex 6 /dev/disk/by-id/scsi-<serial_number>

# coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \

--save-partindex 6 /dev/disk/by-id/scsi-<serial_number>この例では、パーティション 5 以上を保持します。

coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \ --save-partindex 5- /dev/disk/by-id/scsi-<serial_number>

# coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \

--save-partindex 5- /dev/disk/by-id/scsi-<serial_number>

パーティションの保存が使用された以前の例では、coreos-installer はパーティションをすぐに再作成します。

PXE インストール時の既存パーティションの保持

この APPEND オプションは、パーティションラベルが 'data' ('data*') で始まるパーティションを保持します。

coreos.inst.save_partlabel=data*

coreos.inst.save_partlabel=data*

この APPEND オプションは、パーティション 5 以上を保持します。

coreos.inst.save_partindex=5-

coreos.inst.save_partindex=5-

この APPEND オプションは、パーティション 6 を保持します。

coreos.inst.save_partindex=6

coreos.inst.save_partindex=62.1.13.3.3. Ignition 設定の特定

RHCOS の手動インストールを実行する場合、提供できる Ignition 設定には 2 つのタイプがあり、それぞれを提供する理由もそれぞれ異なります。

-

Permanent install Ignition config: すべての手動の RHCOS インストールは、

bootstrap.ign、master.ign、およびworker.ignなどのopenshift-installerが生成した Ignition 設定ファイルのいずれかを渡し、インストールを実行する必要があります。

これらの Ignition 設定ファイルを直接変更することは推奨されません。前述のセクションの例で説明されているように、Ignition 設定ファイルにラップされるマニフェストファイルを更新できます。

PXE インストールの場合、coreos.inst.ignition_url= オプションを使用して、APPEND 行に Ignition 設定を渡します。ISO インストールの場合、シェルプロンプトで ISO を起動した後に、--ignition-url= オプションを指定した coreos-installer コマンドラインで Ignition 設定を特定します。いずれの場合も、HTTP プロトコルおよび HTTPS プロトコルのみがサポートされます。

-

Live install Ignition config: このタイプは、

coreos-installercustomizeサブコマンドとそのさまざまなオプションを使用して作成できます。この方法では、Ignition 設定はライブインストールメディアに渡され、起動直後に実行され、RHCOS システムがディスクにインストールされる前または後にセットアップタスクを実行します。この方法は、マシン設定を使用して実行できない高度なパーティション設定など、一度の適用後に再度適用する必要のないタスクの実行にのみ使用する必要があります。

PXE または ISO ブートの場合、Ignition 設定を作成し、ignition.config.url= オプションに対して APPEND を実行し、Ignition 設定の場所を特定できます。また、ignition.firstboot ignition.platform.id=metal も追加する必要があります。追加しない場合は、ignition.config.url が無視されます。

2.1.13.3.4. デフォルトのコンソール設定

OpenShift Container Platform 4.19 ブートイメージからインストールされた Red Hat Enterprise Linux CoreOS (RHCOS) ノードは、ほとんどの仮想化セットアップおよびベアメタルセットアップに対応するためのデフォルトコンソールを使用します。クラウドおよび仮想化プラットフォームが異なれば、選択したアーキテクチャーに応じて、異なるデフォルト設定が使用される場合があります。ベアメタルインストールではカーネルのデフォルト設定が使用されます。これは通常、グラフィカルコンソールがプライマリーコンソールで、シリアルコンソールが無効になっていることを意味します。

デフォルトのコンソールが特定のハードウェア設定と一致しない場合や、デフォルトのコンソールを調整する必要がある特定のニーズがある場合があります。以下に例を示します。

- デバッグ目的で、コンソールの緊急シェルにアクセスしたいと考えています。

- クラウドプラットフォームは、グラフィカルコンソールへの対話型アクセスを提供しませんが、シリアルコンソールを提供します。

- 複数のコンソールを有効にしたい。

コンソール設定は、ブートイメージから継承されます。これは、既存のクラスター内の新しいノードが、デフォルトのコンソールへの変更の影響を受けないことを意味します。

次の方法で、ベアメタルインストール用にコンソールを設定できます。

-

コマンドラインで手動で

coreos-installerを使用する。 -

--dest-consoleオプションを指定したcoreos-installer iso customizeまたはcoreos-installer pxe customizeサブコマンドを使用して、プロセスを自動化するカスタムイメージを作成します。

高度なカスタマイズを行うには、カーネル引数ではなく、coreos-installer iso または coreos-installer pxe サブコマンドを使用してコンソール設定を実行します。

2.1.13.3.5. PXE および ISO インストール用のシリアルコンソールの有効化

デフォルトでは、Red Hat Enterprise Linux CoreOS (RHCOS) シリアルコンソールは無効になっており、すべての出力はグラフィカルコンソールに書き込まれます。ISO インストール用にシリアルコンソールを有効にし、シリアルコンソールとグラフィカルコンソールの両方に出力が送信されるようにブートローダーを再設定できます。

手順

- ISO インストーラーを起動します。

coreos-installerコマンドを実行してシステムをインストールし、--consoleオプションを 1 回追加してグラフィカルコンソールを指定し、2 回目にシリアルコンソールを指定します。coreos-installer install \ --console=tty0 \ --console=ttyS0,<options> \ --ignition-url=http://host/worker.ign /dev/disk/by-id/scsi-<serial_number>