This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.ストレージ

OpenShift Container Platform でのストレージの設定および管理

概要

第1章 OpenShift Container Platform ストレージの概要

OpenShift Container Platform は、オンプレミスおよびクラウドプロバイダーの両方で、複数のタイプのストレージをサポートします。OpenShift Container Platform クラスターで、永続データおよび非永続データ用のコンテナーストレージを管理できます。

1.1. ストレージタイプ

OpenShift Container Platform ストレージは、一時ストレージおよび永続ストレージという 2 つのカテゴリーに大別されます。

1.1.1. 一時ストレージ

Pod およびコンテナーは性質上、一時的または遷移的であり、ステートレスアプリケーション用に設計されています。一時ストレージを使用すると、管理者および開発者は一部の操作についてローカルストレージをより適切に管理できるようになります。一時ストレージの概要、タイプ、および管理についての詳細は、一時ストレージについて を参照してください。

1.1.2. 永続ストレージ

コンテナーにデプロイされるステートフルアプリケーションには永続ストレージが必要です。OpenShift Container Platform は、永続ボリューム (PV) と呼ばれる事前にプロビジョニングされたストレージフレームワークを使用して、クラスター管理者が永続ストレージをプロビジョニングできるようにします。これらのボリューム内のデータは、個々の Pod のライフサイクルを超えて存在することができます。開発者は Persistent Volume Claim(永続ボリューム要求、PVC) を使用してストレージ要件を要求できます。永続ストレージの概要、設定、およびライフサイクルについての詳細は、永続ストレージについて を参照してください。

1.2. Container Storage Interface (CSI)

CSI は、異なるコンテナーオーケストレーション (CO) システム間でコンテナーストレージを管理するための API 仕様です。基礎となるストレージインフラストラクチャーについての特定の知識がなくても、コンテナーネイティブ環境でストレージボリュームを管理できます。CSI により、使用しているストレージベンダーに関係なく、ストレージは異なるコンテナーオーケストレーションシステム間で均一に機能します。CSI の詳細は、Using Container Storage Interface (CSI) を参照してください。

1.3. 動的プロビジョニング

動的プロビジョニングにより、ストレージボリュームをオンデマンドで作成し、クラスター管理者がストレージを事前にプロビジョニングする必要をなくすことができます。動的プロビジョニングについての詳細は、動的プロビジョニング を参照してください。

第2章 一時ストレージについて

2.1. 概要

永続ストレージに加え、Pod とコンテナーは、操作に一時または短期的なローカルストレージを必要とする場合があります。この一時ストレージは、個別の Pod の寿命より長くなることはなく、一時ストレージは Pod 間で共有することはできません。

Pod は、スクラッチスペース、キャッシュ、ログに一時ローカルストレージを使用します。ローカルストレージのアカウントや分離がないことに関連する問題には、以下が含まれます。

- Pod は利用可能なローカルストレージのサイズを認識しない。

- Pod がローカルストレージを要求しても確実に割り当てられない可能性がある。

- ローカルストレージはベストエフォートのリソースである。

- Pod は、他の Pod でローカルストレージがいっぱいになるとエビクトされる可能性があり、十分なストレージが回収されるまで、新しい Pod は入れない。

一時ストレージは、永続ボリュームとは異なり、体系化されておらず、システム、コンテナーランタイム、Openshift Container Platform での他の用途に加え、ノードで実行中のすべての Pod 間で領域を共有します。一時ストレージフレームワークにより、Pod は短期的なローカルストレージのニーズを指定できます。またこれにより、OpenShift Container Platform は該当する場合に Pod をスケジュールし、ローカルストレージの過剰な使用に対してノードを保護することができます。

一時ストレージフレームワークでは、管理者および開発者がこのローカルストレージの管理を改善できますが、I/O スループットやレイテンシーに関する確約はありません。

2.2. 一時ストレージのタイプ

一時ローカルストレージは常に、プライマリーパーティションで利用できるようになっています。プライマリーパーティションを作成する基本的な方法には、Root、ランタイム の 2 つがあります。

Root

このパーティションでは、kubelet の root ディレクトリー /var/lib/kubelet/ (デフォルト) と /var/log/ ディレクトリーを保持します。このパーティションは、ユーザーの Pod、OS、Kubernetes システムのデーモン間で共有できます。Pod は、EmptyDir ボリューム、コンテナーログ、イメージ階層、コンテナーの書き込み可能な階層を使用して、このパーティションを使用できます。Kubelet はこのパーティションの共有アクセスおよび分離を管理します。このパーティションは一時的なもので、アプリケーションは、このパーティションからディスク IOPS などのパフォーマンス SLA は期待できません。

ランタイム

これは、ランタイムがオーバーレイファイルシステムに使用可能なオプションのパーティションです。OpenShift Container Platform は、このパーティションの分離および共有アクセスを特定して提供します。コンテナーイメージ階層と書き込み可能な階層は、ここに保存されます。ランタイムパーティションが存在する場合は、root パーティションにはイメージ階層もその他の書き込み可能階層も含まれません。

2.3. 一時ストレージ管理

クラスター管理者は、非終了状態のすべての Pod の一時ストレージに対して制限範囲や一時ストレージの要求数を定義するクォータを設定することで、プロジェクト内で一時ストレージを管理できます。開発者は Pod およびコンテナーのレベルで、このコンピュートリソースの要求および制限を設定することもできます。

2.4. 一時ストレージのモニタリング

/bin/df をツールとして使用し、一時コンテナーデータが置かれているボリューム (/var/lib/kubelet および /var/lib/containers) の一時ストレージの使用をモニターすることができます。/var/lib/kubelet のみが使用できる領域は、クラスター管理者によって /var/lib/containers が別のディスクに置かれる場合に df コマンドを使用すると表示されます。

/var/lib での使用済みおよび利用可能な領域の人間が判読できる値を表示するには、以下のコマンドを実行します。

df -h /var/lib

$ df -h /var/lib

この出力には、/var/lib での一時ストレージの使用状況が表示されます。

出力例

Filesystem Size Used Avail Use% Mounted on /dev/sda1 69G 32G 34G 49% /

Filesystem Size Used Avail Use% Mounted on

/dev/sda1 69G 32G 34G 49% /第3章 永続ストレージについて

3.1. 永続ストレージの概要

ストレージの管理は、コンピュートリソースの管理とは異なります。OpenShift Container Platform は Kubernetes 永続ボリューム (PV) フレームワークを使用してクラスター管理者がクラスターの永続ストレージのプロビジョニングを実行できるようにします。開発者は、永続ボリューム要求 (PVC) を使用すると、基礎となるストレージインフラストラクチャーについての特定の知識がなくても PV リソースを要求することができます。

PVC はプロジェクトに固有のもので、開発者が PV を使用する手段として作成し、使用します。PV リソース自体のスコープはいずれの単一プロジェクトにも設定されず、それらは OpenShift Container Platform クラスター全体で共有でき、すべてのプロジェクトから要求できます。PV が PVC にバインドされた後は、その PV を追加の PVC にバインドすることはできません。これにはバインドされた PV を単一の namespace (バインディングプロジェクトの namespace) にスコープ設定する作用があります。

PV は、クラスター管理者によって静的にプロビジョニングされているか、または StorageClass オブジェクトを使用して動的にプロビジョニングされているクラスター内の既存ストレージの一部を表す、PersistentVolume API オブジェクトで定義されます。これは、ノードがクラスターリソースであるのと同様にクラスター内のリソースです。

PV は Volumes などのボリュームプラグインですが、PV を使用する個々の Pod から独立したライフサイクルを持ちます。PV オブジェクトは、NFS、iSCSI、またはクラウドプロバイダー固有のストレージシステムのいずれの場合でも、ストレージの実装の詳細をキャプチャーします。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

PVC は、開発者によるストレージの要求を表す PersistentVolumeClaim API オブジェクトによって定義されます。これは Pod がノードリソースを消費する点で Pod に似ており、PVC は PV リソースを消費します。たとえば、Pod は特定のレベルのリソース (CPU およびメモリーなど) を要求し、PVC は特定のストレージ容量およびアクセスモードを要求できます。たとえば、それらは読み取り/書き込みで 1 回、読み取り専用で複数回マウントできます。

3.2. ボリュームおよび要求のライフサイクル

PV はクラスターのリソースです。PVC はそれらのリソースの要求であり、リソースに対する要求チェックとして機能します。PV と PVC 間の相互作用には以下のライフサイクルが設定されます。

3.2.1. ストレージのプロビジョニング

PVC で定義される開発者からの要求に対応し、クラスター管理者はストレージおよび一致する PV をプロビジョニングする 1 つ以上の動的プロビジョナーを設定します。

または、クラスター管理者は、使用可能な実際のストレージの詳細を保持する多数の PV を前もって作成できます。PV は API に存在し、利用可能な状態になります。

3.2.2. 要求のバインド

PVC の作成時に、ストレージの特定容量の要求、必要なアクセスモードの指定のほか、ストレージクラスを作成してストレージの記述や分類を行います。マスターのコントロールループは新規 PVC の有無を監視し、新規 PVC を適切な PV にバインドします。適切な PV がない場合には、ストレージクラスのプロビジョナーが PV を作成します。

すべての PV のサイズが PVC サイズを超える可能性があります。これは、手動でプロビジョニングされる PV にとくに当てはまります。超過を最小限にするために、OpenShift Container Platform は他のすべての条件に一致する最小の PV にバインドします。

要求は、一致するボリュームが存在しないか、ストレージクラスを提供するいずれの利用可能なプロビジョナーで作成されない場合には無期限でバインドされないままになります。要求は、一致するボリュームが利用可能になるとバインドされます。たとえば、多数の手動でプロビジョニングされた 50Gi ボリュームを持つクラスターは 100Gi を要求する PVC に一致しません。PVC は 100Gi PV がクラスターに追加されるとバインドされます。

3.2.3. Pod および要求した PV の使用

Pod は要求をボリュームとして使用します。クラスターは要求を検査して、バインドされたボリュームを検索し、Pod にそのボリュームをマウントします。複数のアクセスモードをサポートするボリュームの場合、要求を Pod のボリュームとして使用する際に適用するモードを指定する必要があります。

要求が存在し、その要求がバインドされている場合、バインドされた PV を必要な期間保持することができます。Pod のスケジュールおよび要求された PV のアクセスは、persistentVolumeClaim を Pod のボリュームブロックに組み込んで実行できます。

ファイル数が多い永続ボリュームを Pod に割り当てる場合、それらの Pod は失敗するか、または起動に時間がかかる場合があります。詳細は、When using Persistent Volumes with high file counts in OpenShift, why do pods fail to start or take an excessive amount of time to achieve "Ready" state? を参照してください。

3.2.4. 使用中のストレージオブジェクトの保護

使用中のストレージオブジェクトの保護機能を使用すると、Pod または PVC にバインドされる PV によってアクティブに使用されている PVC がシステムから削除されないようにすることができます。これらが削除されると、データが失われる可能性があります。

使用中のストレージオブジェクトの保護はデフォルトで有効にされています。

PVC は、PVC を使用する Pod オブジェクトが存在する場合に Pod によってアクティブに使用されます。

ユーザーが Pod によってアクティブに使用されている PVC を削除する場合でも、PVC はすぐに削除されません。PVC の削除は、PVC が Pod によってアクティブに使用されなくなるまで延期されます。また、クラスター管理者が PVC にバインドされる PV を削除しても、PV はすぐに削除されません。PV の削除は、PV が PVC にバインドされなくなるまで延期されます。

3.2.5. 永続ボリュームの解放

ボリュームの処理が終了したら、API から PVC オブジェクトを削除できます。これにより、リソースを回収できるようになります。ボリュームは要求の削除時に解放 (リリース) されたものとみなされますが、別の要求で利用できる状態にはなりません。以前の要求側に関連するデータはボリューム上に残るので、ポリシーに基づいて処理される必要があります。

3.2.6. 永続ボリュームの回収ポリシー

永続ボリュームの回収ポリシーは、クラスターに対してリリース後のボリュームの処理方法について指示します。ボリュームの回収ポリシーは、Retain、Recycle または Delete のいずれかにすることができます。

-

Retain回収ポリシーは、サポートするボリュームプラグインのリソースの手動による回収を許可します。 -

Recycle回収ポリシーは、ボリュームがその要求からリリースされると、バインドされていない永続ボリュームのプールにボリュームをリサイクルします。

Recycle 回収ポリシーは OpenShift Container Platform 4 では非推奨となっています。動的プロビジョニングは、同等またはそれ以上の機能で推奨されます。

-

Delete回収ポリシーは、OpenShift Container Platform のPersistentVolumeオブジェクトと、AWS EBS または VMware vSphere などの外部インフラストラクチャーの関連するストレージアセットの両方を削除します。

動的にプロビジョニングされたボリュームは常に削除されます。

3.2.7. 永続ボリュームの手動回収

永続ボリューム要求 (PVC) が削除されても、永続ボリューム (PV) は依然として存在し、released (リリース済み) とみなされます。ただし、PV は、直前の要求側のデータがボリューム上に残るため、別の要求には利用できません。

手順

クラスター管理者として PV を手動で回収するには、以下を実行します。

PV を削除します。

oc delete pv <pv-name>

$ oc delete pv <pv-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow AWS EBS、GCE PD、Azure Disk、Cinder ボリュームなどの外部インフラストラクチャーの関連するストレージアセットは、PV の削除後も引き続き存在します。

- 関連するストレージアセットのデータをクリーンアップします。

- 関連するストレージアセットを削除します。または、同じストレージアセットを再利用するには、ストレージアセットの定義で新規 PV を作成します。

回収される PV が別の PVC で使用できるようになります。

3.2.8. 永続ボリュームの回収ポリシーの変更

永続ボリュームの回収ポリシーを変更するには、以下を実行します。

クラスターの永続ボリュームを一覧表示します。

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim3 manual 3s

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim3 manual 3sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 永続ボリュームの 1 つを選択し、その回収ポリシーを変更します。

oc patch pv <your-pv-name> -p '{"spec":{"persistentVolumeReclaimPolicy":"Retain"}}'$ oc patch pv <your-pv-name> -p '{"spec":{"persistentVolumeReclaimPolicy":"Retain"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 選択した永続ボリュームに正しいポリシーがあることを確認します。

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Retain Bound default/claim3 manual 3s

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Retain Bound default/claim3 manual 3sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 上記の出力では、要求

default/claim3にバインドされたボリュームにRetain回収ポリシーが含まれるようになりました。ユーザーが要求default/claim3を削除した場合、ボリュームは自動的に削除されません。

3.3. 永続ボリューム

各 PV には、以下の例のように、ボリュームの仕様およびステータスである spec および status が含まれます。

PersistentVolume オブジェクト定義の例

3.3.1. PV の種類

OpenShift Container Platform は以下の永続ボリュームプラグインをサポートします。

- AWS Elastic Block Store (EBS)

- Azure Disk

- Azure File

- Cinder

- ファイバーチャネル

- GCE Persistent Disk

- HostPath

- iSCSI

- ローカルボリューム

- NFS

- OpenStack Manila

- Red Hat OpenShift Container Storage

- VMware vSphere

3.3.2. 容量

通常、永続ボリューム (PV) には特定のストレージ容量があります。これは PV の capacity 属性を使用して設定されます。

現時点で、ストレージ容量は設定または要求できる唯一のリソースです。今後は属性として IOPS、スループットなどが含まれる可能性があります。

3.3.3. アクセスモード

永続ボリュームは、リソースプロバイダーでサポートされるすべての方法でホストにマウントできます。プロバイダーには各種の機能があり、それぞれの PV のアクセスモードは特定のボリュームでサポートされる特定のモードに設定されます。たとえば、NFS は複数の読み取り/書き込みクライアントをサポートしますが、特定の NFS PV は読み取り専用としてサーバー上でエクスポートされる可能性があります。それぞれの PV は、その特定の PV の機能について記述するアクセスモードの独自のセットを取得します。

要求は、同様のアクセスモードのボリュームに一致します。一致する条件はアクセスモードとサイズの 2 つの条件のみです。要求のアクセスモードは要求 (request) を表します。そのため、より多くのアクセスを付与することはできますが、アクセスを少なくすることはできません。たとえば、要求により RWO が要求されるものの、利用できる唯一のボリュームが NFS PV (RWO+ROX+RWX) の場合に、要求は RWO をサポートする NFS に一致します。

直接的なマッチングが常に最初に試行されます。ボリュームのモードは、要求モードと一致するか、要求した内容以上のものを含む必要があります。サイズは予想されるものより多いか、またはこれと同等である必要があります。2 つのタイプのボリューム (NFS および iSCSI など) のどちらにも同じセットのアクセスモードがある場合、それらのいずれかがそれらのモードを持つ要求に一致する可能性があります。ボリュームのタイプ間で順序付けすることはできず、タイプを選択することはできません。

同じモードのボリュームはすべて分類され、サイズ別 (一番小さいものから一番大きいもの順) に分類されます。バインダーは一致するモードのグループを取得し、1 つのサイズが一致するまでそれぞれを (サイズの順序で) 繰り返し処理します。

以下の表では、アクセスモードをまとめています。

| アクセスモード | CLI の省略形 | 説明 |

|---|---|---|

| ReadWriteOnce |

| ボリュームは単一ノードで読み取り/書き込みとしてマウントできます。 |

| ReadOnlyMany |

| ボリュームは数多くのノードで読み取り専用としてマウントできます。 |

| ReadWriteMany |

| ボリュームは数多くのノードで読み取り/書き込みとしてマウントできます。 |

ボリュームのアクセスモードは、ボリューム機能の記述子になります。それらは施行されている制約ではありません。ストレージプロバイダーはリソースの無効な使用から生じるランタイムエラーに対応します。

たとえば、NFS は ReadWriteOnce アクセスモードを提供します。ボリュームの ROX 機能を使用する必要がある場合は、要求に read-only のマークを付ける必要があります。プロバイダーのエラーは、マウントエラーとしてランタイム時に表示されます。

iSCSI およびファイバーチャネルボリュームには現在、フェンシングメカニズムがありません。ボリュームが一度に 1 つのノードでのみ使用されるようにする必要があります。ノードのドレイン (解放) などの特定の状況では、ボリュームは 2 つのノードで同時に使用できます。ノードをドレイン (解放) する前に、まずこれらのボリュームを使用する Pod が削除されていることを確認してください。

| ボリュームプラグイン | ReadWriteOnce [1] | ReadOnlyMany | ReadWriteMany |

|---|---|---|---|

| AWS EBS [2] | ✅ | - | - |

| Azure File | ✅ | ✅ | ✅ |

| Azure Disk | ✅ | - | - |

| Cinder | ✅ | - | - |

| ファイバーチャネル | ✅ | ✅ | - |

| GCE Persistent Disk | ✅ | - | - |

| HostPath | ✅ | - | - |

| iSCSI | ✅ | ✅ | - |

| ローカルボリューム | ✅ | - | - |

| NFS | ✅ | ✅ | ✅ |

| OpenStack Manila | - | - | ✅ |

| Red Hat OpenShift Container Storage | ✅ | - | ✅ |

| VMware vSphere | ✅ | - | - |

- ReadWriteOnce (RWO) ボリュームは複数のノードにマウントできません。ノードに障害が発生すると、システムは、すでに障害が発生しているノードに割り当てられているため、割り当てられた RWO ボリュームを新規ノードにマウントすることはできません。複数割り当てのエラーメッセージが表示される場合には、シャットダウンまたはクラッシュしたノードで Pod を強制的に削除し、動的永続ボリュームの割り当て時などの重要なワークロードでのデータ損失を回避します。

- AWS EBS に依存する Pod の再作成デプロイメントストラテジーを使用します。

3.3.4. フェーズ

ボリュームは以下のフェーズのいずれかにあります。

| フェーズ | 説明 |

|---|---|

| Available | まだ要求にバインドされていない空きリソースです。 |

| Bound | ボリュームが要求にバインドされています。 |

| Released | 要求が削除されていますが、リソースがまだクラスターにより回収されていません。 |

| Failed | ボリュームが自動回収に失敗しています。 |

以下を実行して PV にバインドされている PVC の名前を表示できます。

oc get pv <pv-claim>

$ oc get pv <pv-claim>3.3.4.1. マウントオプション

属性 mountOptions を使用して PV のマウント中にマウントオプションを指定できます。

以下に例を示します。

マウントオプションの例

- 1

- 指定のマウントオプションは、PV がディスクにマウントされている時に使用されます。

以下の PV タイプがマウントオプションをサポートします。

- AWS Elastic Block Store (EBS)

- Azure Disk

- Azure File

- Cinder

- GCE Persistent Disk

- iSCSI

- ローカルボリューム

- NFS

- Red Hat OpenShift Container Storage (Ceph RBD のみ)

- VMware vSphere

ファイバーチャネルおよび HostPath PV はマウントオプションをサポートしません。

3.4. 永続ボリューム要求 (PVC)

各 PersistentVolumeClaim オブジェクトには、永続ボリューム要求 (PVC) の仕様およびステータスである spec および status が含まれます。 以下が例になります。

PersistentVolumeClaim オブジェクト定義の例

3.4.1. ストレージクラス

要求は、ストレージクラスの名前を storageClassName 属性に指定して特定のストレージクラスをオプションでリクエストできます。リクエストされたクラスの PV、つまり PVC と同じ storageClassName を持つ PV のみが PVC にバインドされます。クラスター管理者は 1 つ以上のストレージクラスを提供するように動的プロビジョナーを設定できます。クラスター管理者は、PVC の仕様に一致する PV をオンデマンドで作成できます。

Cluster Storage Operator は、使用されるプラットフォームに応じてデフォルトのストレージクラスをインストールする可能性があります。このストレージクラスは Operator によって所有され、制御されます。アノテーションとラベルを定義するほかは、これを削除したり、変更したりすることはできません。異なる動作が必要な場合は、カスタムストレージクラスを定義する必要があります。

クラスター管理者は、すべての PVC にデフォルトストレージクラスを設定することもできます。デフォルトのストレージクラスが設定されると、PVC は "" に設定された StorageClass または storageClassName アノテーションがストレージクラスなしの PV にバインドされるように明示的に要求する必要があります。

複数のストレージクラスがデフォルトとしてマークされている場合、PVC は storageClassName が明示的に指定されている場合にのみ作成できます。そのため、1 つのストレージクラスのみをデフォルトとして設定する必要があります。

3.4.2. アクセスモード

要求は、特定のアクセスモードのストレージを要求する際にボリュームと同じ規則を使用します。

3.4.3. リソース

要求は、Pod の場合のようにリソースの特定の数量を要求できます。今回の例では、ストレージに対する要求です。同じリソースモデルがボリュームと要求の両方に適用されます。

3.4.4. ボリュームとしての要求

Pod は要求をボリュームとして使用することでストレージにアクセスします。この要求を使用して、Pod と同じ namespace 内に要求を共存させる必要があります。クラスターは Pod の namespace で要求を見つけ、これを使用して要求をサポートする PersistentVolume を取得します。以下のように、ボリュームはホストにマウントされ、Pod に組み込まれます。

ホストおよび Pod のサンプルへのボリュームのマウント

3.5. ブロックボリュームのサポート

OpenShift Container Platform は、raw ブロックボリュームを静的にプロビジョニングできます。これらのボリュームにはファイルシステムがなく、ディスクに直接書き込むアプリケーションや、独自のストレージサービスを実装するアプリケーションにはパフォーマンス上の利点があります。

raw ブロックボリュームは、PV および PVC 仕様で volumeMode: Block を指定してプロビジョニングされます。

raw ブロックボリュームを使用する Pod は、特権付きコンテナーを許可するように設定する必要があります。

以下の表は、ブロックボリュームをサポートするボリュームプラグインを表示しています。

| ボリュームプラグイン | 手動のプロビジョニング | 動的なプロビジョニング | 完全対応 |

|---|---|---|---|

| AWS EBS | ✅ | ✅ | ✅ |

| Azure Disk | ✅ | ✅ | ✅ |

| Azure File | |||

| Cinder | ✅ | ✅ | |

| ファイバーチャネル | ✅ | ✅ | |

| GCP | ✅ | ✅ | ✅ |

| HostPath | |||

| iSCSI | ✅ | ✅ | |

| ローカルボリューム | ✅ | ✅ | |

| NFS | |||

| Red Hat OpenShift Container Storage | ✅ | ✅ | ✅ |

| VMware vSphere | ✅ | ✅ | ✅ |

手動でプロビジョニングできるものの、完全にサポートされていないブロックボリュームはいずれも、テクノロジープレビューとしてのみ提供されます。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。Red Hat のテクノロジープレビュー機能のサポート範囲についての詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

3.5.1. ブロックボリュームの例

PV の例

- 1

volumeModeをBlockに設定して、この PV が raw ブロックボリュームであることを示します。

PVC の例

- 1

volumeModeをBlockに設定して、raw ブロック PVC が要求されていることを示します。

Pod 仕様の例

| 値 | デフォルト |

|---|---|

| Filesystem | Yes |

| Block | No |

PV volumeMode | PVC volumeMode | バインディングの結果 |

|---|---|---|

| Filesystem | Filesystem | バインド |

| Unspecified | Unspecified | バインド |

| Filesystem | Unspecified | バインド |

| Unspecified | Filesystem | バインド |

| Block | Block | バインド |

| Unspecified | Block | バインドなし |

| Block | Unspecified | バインドなし |

| Filesystem | Block | バインドなし |

| Block | Filesystem | バインドなし |

値を指定しないと、Filesystem のデフォルト値が指定されます。

第4章 永続ストレージの設定

4.1. AWS Elastic Block Store を使用した永続ストレージ

OpenShift Container Platform は AWS Elastic Block Store volumes (EBS) をサポートします。Amazon EC2 を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes および AWS についてのある程度の理解があることが前提となります。

Kubernetes 永続ボリュームフレームワークは、管理者がクラスターのプロビジョニングを永続ストレージを使用して実行できるようにし、ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。AWS Elastic Block Store ボリュームは動的にプロビジョニングできます。永続ボリュームは単一のプロジェクトまたは namespace にバインドされず、それらは OpenShift Container Platform クラスター間で共有できます。永続ボリューム要求 (PVC) はプロジェクトまたは namespace に固有のもので、ユーザーによって要求されます。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

4.1.2. EBS ストレージクラスの作成

ストレージクラスを使用すると、ストレージのレベルや使用状況を区別し、記述することができます。ストレージクラスを定義することにより、ユーザーは動的にプロビジョニングされた永続ボリュームを取得できます。

手順

- OpenShift Container Platform コンソールで、Storage → Storage Classes をクリックします。

- ストレージクラスの概要では、Create Storage Class をクリックします。

表示されるページで必要なオプションを定義します。

- ストレージクラスを参照するための名前を入力します。

- オプションの説明を入力します。

- 回収ポリシーを選択します。

ドロップダウンリストから

kubernetes.io/aws-ebsを選択します。注記同等の CSI ドライバーでストレージクラスを作成するには、ドロップダウンリストから

ebs.csi.aws.comを選択します。詳細は、AWS Elastic Block Store CSI ドライバー Operatorを参照してください。- 必要に応じてストレージクラスの追加パラメーターを入力します。

- Create をクリックしてストレージクラスを作成します。

4.1.3. 永続ボリューム要求 (PVC) の作成

前提条件

ストレージは、ボリュームとして OpenShift Container Platform にマウントされる前に基礎となるインフラストラクチャーになければなりません。

手順

- OpenShift Container Platform コンソールで、Storage → Persistent Volume Claims をクリックします。

- 永続ボリューム要求 (PVC) の概要で、Create Persistent Volume Claim をクリックします。

表示されるページで必要なオプションを定義します。

- ドロップダウンメニューから以前に作成されたストレージクラスを選択します。

- ストレージ要求の一意の名前を入力します。

- アクセスモードを選択します。これにより、作成されたストレージ要求の読み取り/書き込みアクセスが決定されます。

- ストレージ要求のサイズを定義します。

- Create をクリックして永続ボリューム要求 (PVC) を作成し、永続ボリュームを生成します。

4.1.4. ボリュームのフォーマット

OpenShift Container Platform は、ボリュームをマウントしてコンテナーに渡す前に、永続ボリューム定義の fsType パラメーターで指定されたファイルシステムがボリュームにあるかどうか確認します。デバイスが指定されたファイルシステムでフォーマットされていない場合、デバイスのデータはすべて消去され、デバイスはそのファイルシステムで自動的にフォーマットされます。

これにより、OpenShift Container Platform がフォーマットされていない AWS ボリュームを初回の使用前にフォーマットするため、それらを永続ボリュームとして使用することが可能になります。

4.1.5. ノード上の EBS ボリュームの最大数

OpenShift Container Platform では、デフォルトで 1 つのノードに最大 39 の EBS ボリュームを割り当てることができます。この制限は、AWS ボリュームの制限 に合致します。ボリュームの制限は、インスタンスのタイプによって異なります。

クラスター管理者は、In-tree または Container Storage Interface (CSI) ボリュームのいずれかと、それぞれのストレージクラスを使用する必要がありますが、ボリュームの両方のタイプを同時に使用することはできません。割り当てられている EBS ボリュームの最大数は、In-tree および CSI ボリュームについて別々にカウントされます。

4.2. Azure を使用した永続ストレージ

OpenShift Container Platform では、Microsoft Azure Disk ボリュームがサポートされます。Azure を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と Azure についてのある程度の理解があることが前提となります。Kubernetes 永続ボリュームフレームワークは、管理者がクラスターのプロビジョニングを永続ストレージを使用して実行できるようにし、ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。Azure Disk ボリュームは動的にプロビジョニングできます。永続ボリュームは単一のプロジェクトまたは namespace にバインドされず、それらは OpenShift Container Platform クラスター間で共有できます。Persistent volume claim (PVC) はプロジェクトまたは namespace に固有のもので、ユーザーによって要求されます。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

4.2.1. Azure ストレージクラスの作成

ストレージクラスを使用すると、ストレージのレベルや使用状況を区別し、記述することができます。ストレージクラスを定義することにより、ユーザーは動的にプロビジョニングされた永続ボリュームを取得できます。

手順

- OpenShift Container Platform コンソールで、Storage → Storage Classes をクリックします。

- ストレージクラスの概要では、Create Storage Class をクリックします。

表示されるページで必要なオプションを定義します。

- ストレージクラスを参照するための名前を入力します。

- オプションの説明を入力します。

- 回収ポリシーを選択します。

ドロップダウンリストから

kubernetes.io/azure-diskを選択します。-

ストレージアカウントのタイプを入力します。これは、Azure ストレージアカウントの SKU の層に対応します。有効なオプションは、

Premium_LRS、Standard_LRS、StandardSSD_LRS、およびUltraSSD_LRSです。 アカウントの種類を入力します。有効なオプションは

shared、dedicatedおよびmanagedです。重要Red Hat は、ストレージクラスでの

kind: Managedの使用のみをサポートします。SharedおよびDedicatedの場合、Azure は管理対象外のディスクを作成しますが、OpenShift Container Platform はマシンの OS (root) ディスクの管理ディスクを作成します。ただし、Azure Disk はノードで管理ディスクおよび管理対象外ディスクの両方の使用を許可しないため、SharedまたはDedicatedで作成された管理対象外ディスクを OpenShift Container Platform ノードに割り当てることはできません。

-

ストレージアカウントのタイプを入力します。これは、Azure ストレージアカウントの SKU の層に対応します。有効なオプションは、

- 必要に応じてストレージクラスの追加パラメーターを入力します。

- Create をクリックしてストレージクラスを作成します。

4.2.2. 永続ボリューム要求 (PVC) の作成

前提条件

ストレージは、ボリュームとして OpenShift Container Platform にマウントされる前に基礎となるインフラストラクチャーになければなりません。

手順

- OpenShift Container Platform コンソールで、Storage → Persistent Volume Claims をクリックします。

- 永続ボリューム要求 (PVC) の概要で、Create Persistent Volume Claim をクリックします。

表示されるページで必要なオプションを定義します。

- ドロップダウンメニューから以前に作成されたストレージクラスを選択します。

- ストレージ要求の一意の名前を入力します。

- アクセスモードを選択します。これにより、作成されたストレージ要求の読み取り/書き込みアクセスが決定されます。

- ストレージ要求のサイズを定義します。

- Create をクリックして永続ボリューム要求 (PVC) を作成し、永続ボリュームを生成します。

4.2.3. ボリュームのフォーマット

OpenShift Container Platform は、ボリュームをマウントしてコンテナーに渡す前に、永続ボリューム定義の fsType パラメーターで指定されたファイルシステムがボリュームにあるかどうか確認します。デバイスが指定されたファイルシステムでフォーマットされていない場合、デバイスのデータはすべて消去され、デバイスはそのファイルシステムで自動的にフォーマットされます。

これにより、OpenShift Container Platform がフォーマットされていない Azure ボリュームを初回の使用前にフォーマットするため、それらを永続ボリュームとして使用することが可能になります。

4.3. Azure File を使用した永続ストレージ

OpenShift Container Platform では、Microsoft Azure File ボリュームがサポートされます。Azure を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と Azure についてのある程度の理解があることが前提となります。

Kubernetes 永続ボリュームフレームワークは、管理者がクラスターのプロビジョニングを永続ストレージを使用して実行できるようにし、ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。Azure File ボリュームを動的にプロビジョニングできます。

永続ボリュームは、単一のプロジェクトまたは namespace にバインドされず、OpenShift Container Platform クラスター全体で共有できます。永続ボリューム要求 (PVC) はプロジェクトまたは namespace に固有のもので、アプリケーションで使用できるようにユーザーによって要求されます。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

Azure File ボリュームは Server Message Block を使用します。

4.3.1. Azure File 共有永続ボリューム要求 (PVC) の作成

永続ボリューム要求 (PVC) を作成するには、最初に Azure アカウントおよびキーを含む Secret オブジェクトを定義する必要があります。このシークレットは PersistentVolume 定義に使用され、アプリケーションで使用できるように永続ボリューム要求 (PVC) によって参照されます。

前提条件

- Azure File 共有があること。

- この共有にアクセスするための認証情報 (とくにストレージアカウントおよびキー) が利用可能であること。

手順

Azure File の認証情報が含まれる

Secretオブジェクトを作成します。oc create secret generic <secret-name> --from-literal=azurestorageaccountname=<storage-account> \ --from-literal=azurestorageaccountkey=<storage-account-key>

$ oc create secret generic <secret-name> --from-literal=azurestorageaccountname=<storage-account> \1 --from-literal=azurestorageaccountkey=<storage-account-key>2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 作成した

Secretオブジェクトを参照するPersistentVolumeを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 作成した永続ボリュームにマップする

PersistentVolumeClaimオブジェクトを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.2. Azure File 共有の Pod へのマウント

永続ボリューム要求 (PVC) の作成後に、これをアプリケーション内で使用できます。以下の例は、この共有を Pod 内にマウントする方法を示しています。

前提条件

- 基礎となる Azure File 共有にマップされる永続ボリューム要求 (PVC) があること。

手順

既存の永続ボリューム要求 (PVC) をマウントする Pod を作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4. Cinder を使用した永続ストレージ

OpenShift Container Platform は OpenStack Cinder をサポートします。これには、Kubernetes と OpenStack についてある程度の理解があることが前提となります。

Cinder ボリュームは動的にプロビジョニングできます。永続ボリュームは単一のプロジェクトまたは namespace にバインドされず、それらは OpenShift Container Platform クラスター間で共有できます。永続ボリューム要求 (PVC) はプロジェクトまたは namespace に固有のもので、ユーザーによって要求されます。

4.4.1. Cinder を使用した手動プロビジョニング

ストレージは、ボリュームとして OpenShift Container Platform にマウントされる前に基礎となるインフラストラクチャーになければなりません。

前提条件

- Red Hat OpenStack Platform (RHOSP) 用に設定された OpenShift Container Platform

- Cinder ボリューム ID

4.4.1.1. 永続ボリュームの作成

OpenShift Container Platform に永続ボリューム (PV) を作成する前に、オブジェクト定義でこれを定義する必要があります。

手順

オブジェクト定義をファイルに保存します。

cinder-persistentvolume.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要ボリュームをフォーマットしてプロビジョニングした後には、

fstypeパラメーターの値は変更しないでください。この値を変更すると、データの損失や、Pod の障害につながる可能性があります。前のステップで保存したオブジェクト定義ファイルを作成します。

oc create -f cinder-persistentvolume.yaml

$ oc create -f cinder-persistentvolume.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.1.2. 永続ボリュームのフォーマット

OpenShift Container Platform は初回の使用前にフォーマットするため、フォーマットされていない Cinder ボリュームを PV として使用できます。

OpenShift Container Platform がボリュームをマウントし、これをコンテナーに渡す前に、システムは PV 定義の fsType パラメーターで指定されたファイルシステムがボリュームに含まれるかどうかをチェックします。デバイスが指定されたファイルシステムでフォーマットされていない場合、デバイスのデータはすべて消去され、デバイスはそのファイルシステムで自動的にフォーマットされます。

4.4.1.3. Cinder ボリュームのセキュリティー

お使いのアプリケーションで Cinder PV を使用する場合に、そのデプロイメント設定にセキュリティーを追加します。

前提条件

-

適切な

fsGroupストラテジーを使用する SCC が作成される必要があります。

手順

サービスアカウントを作成して、そのアカウントを SCC に追加します。

oc create serviceaccount <service_account>

$ oc create serviceaccount <service_account>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm policy add-scc-to-user <new_scc> -z <service_account> -n <project>

$ oc adm policy add-scc-to-user <new_scc> -z <service_account> -n <project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow アプリケーションのデプロイ設定で、サービスアカウント名と

securityContextを指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. ファイバーチャネルを使用した永続ストレージ

OpenShift Container Platform ではファイバーチャネルがサポートされており、ファイバーチャネルボリュームを使用して OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と Fibre Channel についてある程度の理解があることが前提となります。

Kubernetes 永続ボリュームフレームワークは、管理者がクラスターのプロビジョニングを永続ストレージを使用して実行できるようにし、ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。永続ボリュームは単一のプロジェクトまたは namespace にバインドされず、それらは OpenShift Container Platform クラスター間で共有できます。Persistent volume claim (PVC) はプロジェクトまたは namespace に固有のもので、ユーザーによって要求されます。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

4.5.1. プロビジョニング

PersistentVolume API を使用してファイバーチャネルボリュームをプロビジョニングするには、以下が利用可能でなければなりません。

-

targetWWN(ファイバーチャネルターゲットのワールドワイド名の配列)。 - 有効な LUN 番号。

- ファイルシステムの種類。

永続ボリュームと LUN は 1 対 1 でマッピングされます。

前提条件

- ファイバーチャネル LUN は基礎となるインフラストラクチャーに存在している必要があります。

PersistentVolume オブジェクト定義

- 1

- World wide identifier (WWID)

FCwidsまたは FCtargetWWNsおよびlunの組み合わせは設定する必要がありますが、両方を同時に設定することはできません。WWN ターゲットよりも FC WWID 識別子が推奨されます。FC WWID 識別子は、各ストレージデバイスに固有のものであり、デバイスのアクセスに使用されるパスに依存しないためです。この識別子は、SCSI Inquiry を発行して Device Identification Vital Product Data (page 0x83) または Unit Serial Number (page 0x80) を取得することにより獲得できます。FC WWID は、デバイスへのパスが変更したり、別のシステムからデバイスにアクセスする場合でも、ディスク上のデータ参照に/dev/disk/by-id/と識別されます。 - 2 3

- ファイバーチャネル WWN は、

/dev/disk/by-path/pci-<IDENTIFIER>-fc-0x<WWN>-lun-<LUN#>として識別されます。ただし、WWNまでのパス (0xを含む) と WWN の後の文字 (-(ハイフン) を含む) を入力する必要はありません。

ボリュームをフォーマットしてプロビジョニングした後に fstype パラメーターの値を変更すると、データ損失や Pod にエラーが発生する可能性があります。

4.5.1.1. ディスククォータの実施

LUN パーティションを使用してディスククォータとサイズ制限を実施します。各 LUN は単一の永続ボリュームにマップされ、固有の名前を永続ボリュームにに使用する必要があります。

この方法でクォータを実施すると、エンドユーザーは永続ストレージを具体的な量 (10Gi など) で要求することができ、これを同等またはそれ以上の容量の対応するボリュームに一致させることができます。

4.5.1.2. ファイバーチャネルボリュームのセキュリティー

ユーザーは永続ボリューム要求 (PVC) でストレージを要求します。この要求はユーザーの namespace にのみ存在し、同じ namespace 内の Pod からのみ参照できます。namespace をまたいで永続ボリュームにアクセスしようとすると、Pod にエラーが発生します。

それぞれのファイバーチャネル LUN は、クラスター内のすべてのノードからアクセスできる必要があります。

4.6. FlexVolume を使用した永続ストレージ

OpenShift Container Platform は、ドライバーとのインターフェイスに実行可能なモデルを使用する out-of-tree 形式のプラグイン、FlexVolume をサポートします。

組み込みプラグインがないバックエンドのストレージを使用する場合は、FlexVolume ドライバーを使用して OpenShift Container Platform を拡張し、アプリケーションに永続ストレージを提供できます。

Pod は、flexvolume の in-tree 形式のプラグインを使用して FlexVolume ドライバーと対話します。

4.6.1. FlexVolume ドライバーについて

FlexVolume ドライバーは、クラスター内のすべてのノードの明確に定義されたディレクトリーに格納されている実行可能ファイルです。OpenShift Container Platform は、flexVolume をソースとする PersistentVolume オブジェクトによって表されるボリュームのマウントまたはアンマウントが必要になるたびに、FlexVolume ドライバーを呼び出します。

OpenShift Container Platform では、FlexVolume について割り当ておよび割り当て解除の操作はサポートされません。

4.6.2. FlexVolume ドライバーの例

FlexVolume ドライバーの最初のコマンドライン引数は常に操作名です。その他のパラメーターは操作ごとに異なります。ほとんどの操作は、JSON (JavaScript Object Notation) 文字列をパラメーターとして取ります。このパラメーターは完全な JSON 文字列であり、JSON データを含むファイルの名前ではありません。

FlexVolume ドライバーには以下が含まれます。

-

すべての

flexVolume.options。 -

kubernetes.io/という接頭辞が付いたflexVolumeのいくつかのオプション。たとえば、fsTypeやreadwriteなどです。 -

kubernetes.io/secret/という接頭辞が付いた参照先シークレット (指定されている場合) の内容。

FlexVolume ドライバーの JSON 入力例

OpenShift Container Platform は、ドライバーの標準出力に JSON データが含まれていると想定します。指定されていない場合、出力には操作の結果が示されます。

FlexVolume ドライバーのデフォルトの出力例

{

"status": "<Success/Failure/Not supported>",

"message": "<Reason for success/failure>"

}

{

"status": "<Success/Failure/Not supported>",

"message": "<Reason for success/failure>"

}

ドライバーの終了コードは、成功の場合は 0、エラーの場合は 1 です。

操作はべき等です。 すでに割り当てられているボリュームのマウント操作は成功します。

4.6.3. FlexVolume ドライバーのインストール

OpenShift Container Platform を拡張するために使用される FlexVolume ドライバーはノードでのみ実行されます。FlexVolume を実装するには、呼び出す操作の一覧とインストールパスのみが必要になります。

前提条件

FlexVolume ドライバーは、以下の操作を実装する必要があります。

initドライバーを初期化します。すべてのノードの初期化中に呼び出されます。

- 引数: なし

- 実行場所: ノード

- 予期される出力: デフォルトの JSON

mountボリュームをディレクトリーにマウントします。これには、デバイスの検出、その後のデバイスのマウントを含む、ボリュームのマウントに必要なあらゆる操作が含まれます。

-

引数:

<mount-dir><json> - 実行場所: ノード

- 予期される出力: デフォルトの JSON

-

引数:

unmountボリュームをディレクトリーからアンマウントします。これには、アンマウント後にボリュームをクリーンアップするために必要なあらゆる操作が含まれます。

-

引数:

<mount-dir> - 実行場所: ノード

- 予期される出力: デフォルトの JSON

-

引数:

mountdevice- ボリュームのデバイスを、個々の Pod がマウントをバインドするディレクトリーにマウントします。

この呼び出しでは FlexVolume 仕様に指定されるシークレットを渡しません。ドライバーでシークレットが必要な場合には、この呼び出しを実装しないでください。

-

引数:

<mount-dir><json> - 実行場所: ノード

予期される出力: デフォルトの JSON

unmountdevice- ボリュームのデバイスをディレクトリーからアンマウントします。

-

引数:

<mount-dir> - 実行場所: ノード

予期される出力: デフォルトの JSON

-

その他のすべての操作は、

{"status": "Not supported"}と終了コード1を出して JSON を返します。

-

その他のすべての操作は、

手順

FlexVolume ドライバーをインストールします。

- この実行可能ファイルがクラスター内のすべてのノードに存在することを確認します。

-

この実行可能ファイルをボリュームプラグインのパス (

/etc/kubernetes/kubelet-plugins/volume/exec/<vendor>~<driver>/<driver>) に配置します。

たとえば、ストレージ foo の FlexVolume ドライバーをインストールするには、実行可能ファイルを /etc/kubernetes/kubelet-plugins/volume/exec/openshift.com~foo/foo に配置します。

4.6.4. FlexVolume ドライバーを使用したストレージの使用

OpenShift Container Platform の各 PersistentVolume オブジェクトは、ストレージバックエンドの 1 つのストレージアセット (ボリュームなど) を表します。

手順

-

インストールされているストレージを参照するには、

PersistentVolumeオブジェクトを使用します。

FlexVolume ドライバーを使用した永続ボリュームのオブジェクト定義例

- 1

- ボリュームの名前。これは永続ボリューム要求 (PVC) を使用するか、または Pod からボリュームを識別するために使用されます。この名前は、バックエンドストレージのボリューム名とは異なるものにすることができます。

- 2

- このボリュームに割り当てられるストレージの量。

- 3

- ドライバーの名前。このフィールドは必須です。

- 4

- ボリュームに存在するオプションのファイルシステム。このフィールドはオプションです。

- 5

- シークレットへの参照。このシークレットのキーと値は、起動時に FlexVolume ドライバーに渡されます。このフィールドはオプションです。

- 6

- 読み取り専用のフラグ。このフィールドはオプションです。

- 7

- FlexVolume ドライバーの追加オプション。

optionsフィールドでユーザーが指定するフラグに加え、以下のフラグも実行可能ファイルに渡されます。"fsType":"<FS type>", "readwrite":"<rw>", "secret/key1":"<secret1>" ... "secret/keyN":"<secretN>"

"fsType":"<FS type>", "readwrite":"<rw>", "secret/key1":"<secret1>" ... "secret/keyN":"<secretN>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

シークレットは、呼び出しのマウント/マウント解除を目的とする場合にのみ渡されます。

4.7. GCE Persistent Disk を使用した永続ストレージ

OpenShift Container Platform では、GCE Persistent Disk ボリューム (gcePD) がサポートされます。GCE を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と GCE についてある程度の理解があることが前提となります。

Kubernetes 永続ボリュームフレームワークは、管理者がクラスターのプロビジョニングを永続ストレージを使用して実行できるようにし、ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。

GCE Persistent Disk ボリュームは動的にプロビジョニングできます。

永続ボリュームは単一のプロジェクトまたは namespace にバインドされず、それらは OpenShift Container Platform クラスター間で共有できます。Persistent volume claim (PVC) はプロジェクトまたは namespace に固有のもので、ユーザーによって要求されます。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

4.7.1. GCE ストレージクラスの作成

ストレージクラスを使用すると、ストレージのレベルや使用状況を区別し、記述することができます。ストレージクラスを定義することにより、ユーザーは動的にプロビジョニングされた永続ボリュームを取得できます。

手順

- OpenShift Container Platform コンソールで、Storage → Storage Classes をクリックします。

- ストレージクラスの概要では、Create Storage Class をクリックします。

表示されるページで必要なオプションを定義します。

- ストレージクラスを参照するための名前を入力します。

- オプションの説明を入力します。

- 回収ポリシーを選択します。

-

ドロップダウンリストから

kubernetes.io/gce-pdを選択します。 - 必要に応じてストレージクラスの追加パラメーターを入力します。

- Create をクリックしてストレージクラスを作成します。

4.7.2. 永続ボリューム要求 (PVC) の作成

前提条件

ストレージは、ボリュームとして OpenShift Container Platform にマウントされる前に基礎となるインフラストラクチャーになければなりません。

手順

- OpenShift Container Platform コンソールで、Storage → Persistent Volume Claims をクリックします。

- 永続ボリューム要求 (PVC) の概要で、Create Persistent Volume Claim をクリックします。

表示されるページで必要なオプションを定義します。

- ドロップダウンメニューから以前に作成されたストレージクラスを選択します。

- ストレージ要求の一意の名前を入力します。

- アクセスモードを選択します。これにより、作成されたストレージ要求の読み取り/書き込みアクセスが決定されます。

- ストレージ要求のサイズを定義します。

- Create をクリックして永続ボリューム要求 (PVC) を作成し、永続ボリュームを生成します。

4.7.3. ボリュームのフォーマット

OpenShift Container Platform は、ボリュームをマウントしてコンテナーに渡す前に、永続ボリューム定義の fsType パラメーターで指定されたファイルシステムがボリュームにあるかどうか確認します。デバイスが指定されたファイルシステムでフォーマットされていない場合、デバイスのデータはすべて消去され、デバイスはそのファイルシステムで自動的にフォーマットされます。

これにより、OpenShift Container Platform がフォーマットされていない GCE ボリュームを初回の使用前にフォーマットするため、それらを永続ボリュームとして使用することが可能になります。

4.8. hostPath を使用した永続ストレージ

OpenShift Container Platform クラスター内の hostPath ボリュームは、ファイルまたはディレクトリーをホストノードのファイルシステムから Pod にマウントします。ほとんどの Pod には hostPath ボリュームは必要ありませんが、アプリケーションが必要とする場合は、テスト用のクイックオプションが提供されます。

クラスター管理者は、特権付き Pod として実行するように Pod を設定する必要があります。これにより、同じノードの Pod へのアクセスが付与されます。

4.8.1. 概要

OpenShift Container Platform は単一ノードクラスターでの開発およびテスト用の hostPath マウントをサポートします。

実稼働クラスターでは、hostPath を使用しません。代わりにクラスター管理者は、GCE Persistent Disk ボリューム、NFS 共有、Amazon EBS ボリュームなどのネットワークリソースをプロビジョニングします。ネットワークリソースは、ストレージクラスを使用した動的プロビジョニングの設定をサポートします。

hostPath ボリュームは静的にプロビジョニングする必要があります。

コンテナーのルート (/) や、ホストとコンテナーで同じパスにはマウントしないでください。これは、コンテナーに十分な特権が付与されている場合、ホストシステムを破壊する可能性があります。ホストをマウントするには、/host を使用するのが安全です。以下の例では、ホストの / ディレクトリーが /host でコンテナーにマウントされています。

4.8.2. hostPath ボリュームの静的なプロビジョニング

hostPath ボリュームを使用する Pod は、手動の (静的) プロビジョニングで参照される必要があります。

手順

永続ボリューム (PV) を定義します。

PersistentVolumeオブジェクト定義を使用してpv.yamlファイルを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルから PV を作成します。

oc create -f pv.yaml

$ oc create -f pv.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 永続ボリューム要求 (PVC) を定義します。

PersistentVolumeClaimオブジェクト定義を使用して、ファイルpvc.yamlを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルから PVC を作成します。

oc create -f pvc.yaml

$ oc create -f pvc.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.8.3. 特権付き Pod での hostPath 共有のマウント

永続ボリューム要求 (PVC) の作成後に、これをアプリケーション内で使用できます。以下の例は、この共有を Pod 内にマウントする方法を示しています。

前提条件

- 基礎となる hostPath 共有にマップされる永続ボリューム要求 (PVC) があること。

手順

既存の永続ボリューム要求 (PVC) をマウントする特権付き Pod を作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.9. iSCSI を使用した永続ストレージ

iSCSI を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と iSCSI についてある程度の理解があることが前提となります。

Kubernetes 永続ボリュームフレームワークは、管理者がクラスターのプロビジョニングを永続ストレージを使用して実行できるようにし、ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

Amazon Web Services で iSCSI を使用する場合、iSCSI ポートのノード間の TCP トラフィックを組み込むようにデフォルトのセキュリティーポリシーを更新する必要があります。デフォルトで、それらのポートは 860 および 3260 です。

iscsi-initiator-utils パッケージをインストールし、/etc/iscsi/initiatorname.iscsi でイニシエーター名を設定して、iSCSI イニシエーターがすべての OpenShift Container Platform ノードですでに設定されていることを確認しておく。iscsi-initiator-utils パッケージは、Red Hat Enterprise Linux CoreOS (RHCOS) を使用するデプロイメントにすでにインストールされている。

詳細は、ストレージデバイスの管理 を参照してください。

4.9.1. プロビジョニング

OpenShift Container Platform でストレージをボリュームとしてマウントする前に、基礎となるインフラストラクチャーにストレージが存在することを確認します。iSCSI に必要になるのは、iSCSI ターゲットポータル、有効な iSCSI 修飾名 (IQN)、有効な LUN 番号、ファイルシステムタイプ、および PersistentVolume API のみです。

PersistentVolume オブジェクト定義

4.9.2. ディスククォータの実施

LUN パーティションを使用してディスククォータとサイズ制限を実施します。それぞれの LUN には 1 つの永続ボリュームです。Kubernetes では、永続ボリュームに一意の名前を使用する必要があります。

この方法でクォータを実施すると、エンドユーザーは永続ストレージを具体的な量 (10Gi など) で要求することができ、同等かそれ以上の容量の対応するボリュームに一致させることができます。

4.9.3. iSCSI ボリュームのセキュリティー

ユーザーは PersistentVolumeClaim オブジェクトでストレージを要求します。この要求はユーザーの namespace にのみ存在し、同じ namespace 内の Pod からのみ参照できます。namespace をまたいで永続ボリューム要求 (PVC) にアクセスしようとすると、Pod にエラーが発生します。

それぞれの iSCSI LUN は、クラスター内のすべてのノードからアクセスできる必要があります。

4.9.3.1. チャレンジハンドシェイク認証プロトコル (CHAP) 設定

オプションで、OpenShift は CHAP を使用して iSCSI ターゲットに対して自己認証を実行できます。

4.9.4. iSCSI のマルチパス化

iSCSI ベースのストレージの場合は、複数のターゲットポータルの IP アドレスに同じ IQN を使用することでマルチパスを設定できます。マルチパス化により、パス内の 1 つ以上のコンポーネントで障害が発生した場合でも、永続ボリュームにアクセスすることができます。

Pod 仕様でマルチパスを指定するには、portals フィールドを使用します。以下に例を示します。

- 1

portalsフィールドを使用してターゲットポータルを追加します。

4.9.5. iSCSI のカスタムイニシエーター IQN

iSCSI ターゲットが特定に IQN に制限されている場合に、カスタムイニシエーターの iSCSI Qualified Name (IQN) を設定します。 ただし、iSCSI PV が割り当てられているノードが必ずこれらの IQN を使用する保証はありません。

カスタムのイニシエーター IQN を指定するには、initiatorName フィールドを使用します。

- 1

- イニシエーターの名前を指定します。

4.10. ローカルボリュームを使用した永続ストレージ

OpenShift Container Platform は、ローカルボリュームを使用する永続ストレージでプロビジョニングすることが可能です。ローカルの永続ボリュームを使用すると、標準の永続ボリューム要求 (PVC) インターフェイスを使用して、ディスクやパーティションなどのローカルのストレージデバイスにアクセスできます。

ローカルボリュームは、Pod をノードに手動でスケジュールせずに使用できます。ボリュームのノード制約がシステムによって認識されるためです。ただし、ローカルボリュームは、依然として基礎となるノードの可用性に依存しており、すべてのアプリケーションに適している訳ではありません。

ローカルボリュームは、静的に作成された永続ボリュームとしてのみ使用できます。

4.10.1. ローカルストレージ Operator のインストール

ローカルストレージ Operator はデフォルトで OpenShift Container Platform にインストールされません。以下の手順を使用してこの Operator をインストールし、クラスター内でローカルボリュームを有効にできるように設定します。

前提条件

- OpenShift Container Platform Web コンソールまたはコマンドラインインターフェイス (CLI) へのアクセス。

手順

openshift-local-storageプロジェクトを作成します。oc adm new-project openshift-local-storage

$ oc adm new-project openshift-local-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: インフラストラクチャーノードでのローカルストレージの作成を許可します。

ロギングやモニタリングなどのコンポーネントに対応するために、ローカルストレージ Operator を使用してインフラストラクチャーノードでボリュームを作成する必要がある場合があります。

ローカルストレージ Operator にワーカーノードだけでなくインフラストラクチャーノードが含まれるように、デフォルトのノードセレクターを調整する必要があります。

ローカルストレージ Operator がクラスター全体のデフォルトセレクターを継承しないようにするには、以下のコマンドを実行します。

oc annotate project openshift-local-storage openshift.io/node-selector=''

$ oc annotate project openshift-local-storage openshift.io/node-selector=''Copy to Clipboard Copied! Toggle word wrap Toggle overflow

UI での操作

Web コンソールからローカルストレージ Operator をインストールするには、以下の手順を実行します。

- OpenShift Container Platform Web コンソールにログインします。

- Operators → OperatorHub に移動します。

- Local Storage をフィルターボックスに入力して、ローカルストレージ Operator を見つけます。

- Install をクリックします。

- Install Operator ページで、A specific namespace on the cluster を選択します。ドロップメニューから openshift-local-storage を選択します。

- Update Channel および Approval Strategy の値を必要な値に調整します。

- Install をクリックします。

これが完了すると、ローカルストレージ Operator は Web コンソールの Installed Operators セクションに一覧表示されます。

CLI からの操作

CLI からローカルストレージ Operator をインストールします。

以下のコマンドを実行して OpenShift Container Platform のメジャーおよびマイナーバージョンを取得します。これは、次の手順の

channelの値に必要です。OC_VERSION=$(oc version -o yaml | grep openshiftVersion | \ grep -o '[0-9]*[.][0-9]*' | head -1)$ OC_VERSION=$(oc version -o yaml | grep openshiftVersion | \ grep -o '[0-9]*[.][0-9]*' | head -1)Copy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルストレージ Operator の Operator グループおよびサブスクリプションを定義するために、オブジェクト YAML ファイル (例:

openshift-local-storage.yaml) を作成します。例: openshift-local-storage.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- インストール計画のユーザー承認ポリシー。

以下のコマンドを実行して、ローカルストレージ Operator オブジェクトを作成します。

oc apply -f openshift-local-storage.yaml

$ oc apply -f openshift-local-storage.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow この時点で、Operator Lifecycle Manager (OLM) はローカルストレージ Operator を認識できるようになります。Operator の ClusterServiceVersion (CSV) はターゲット namespace に表示され、Operator で指定される API は作成用に利用可能になります。

すべての Pod およびローカルストレージ Operator が作成されていることを確認して、ローカルストレージのインストールを検証します。

必要な Pod すべてが作成されていることを確認します。

oc -n openshift-local-storage get pods

$ oc -n openshift-local-storage get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME READY STATUS RESTARTS AGE local-storage-operator-746bf599c9-vlt5t 1/1 Running 0 19m

NAME READY STATUS RESTARTS AGE local-storage-operator-746bf599c9-vlt5t 1/1 Running 0 19mCopy to Clipboard Copied! Toggle word wrap Toggle overflow ClusterServiceVersion (CSV) YAML マニフェストをチェックして、ローカルストレージ Operator が

openshift-local-storageプロジェクトで利用できることを確認します。oc get csvs -n openshift-local-storage

$ oc get csvs -n openshift-local-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME DISPLAY VERSION REPLACES PHASE local-storage-operator.4.2.26-202003230335 Local Storage 4.2.26-202003230335 Succeeded

NAME DISPLAY VERSION REPLACES PHASE local-storage-operator.4.2.26-202003230335 Local Storage 4.2.26-202003230335 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow

すべてのチェックが渡されると、ローカルストレージ Operator が正常にインストールされます。

4.10.2. ローカルストレージ Operator を使用したローカルボリュームのプロビジョニング

ローカルボリュームは動的プロビジョニングで作成できません。代わりに、永続ボリュームがローカルストレージ Operator によって作成されることがあります。このローカルボリュームプロビジョナーは、定義されたリソースで指定されているパスでファイルシステムまたはブロックボリュームデバイスを検索します。

前提条件

- ローカルストレージ Operator がインストールされていること。

以下の条件を満たすローカルディスクがある。

- ノードに接続されている。

- マウントされていない。

- パーティションが含まれていない。

手順

ローカルボリュームリソースを作成します。これは、ノードおよびローカルボリュームへのパスを定義する必要があります。

注記同じデバイスに別のストレージクラス名を使用しないでください。これを行うと、複数の永続ボリューム (PV) が作成されます。

例: ファイルシステム

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ローカルストレージ Operator がインストールされている namespace。

- 2

- オプション: ローカルストレージボリュームが割り当てられているノードの一覧が含まれるノードセレクター。以下の例では、

oc get nodeから取得したノードホスト名を使用します。値が定義されない場合、ローカルストレージ Operator は利用可能なすべてのノードで一致するディスクの検索を試行します。 - 3

- ボリュームモード (

FilesystemまたはBlock) で、ローカルボリュームのタイプを定義します。 - 4

- ローカルボリュームの初回マウント時に作成されるファイルシステム。

- 5

- 選択するローカルストレージデバイスの一覧を含むパスです。

- 6

- この値を、

LocalVolumeリソースby-idへの実際のローカルディスクのファイルパスに置き換えます (例:/dev/disk/by-id/wwn)。プロビジョナーが正常にデプロイされると、これらのローカルディスク用に PV が作成されます。

注記raw ブロックボリューム (

volumeMode: block) はファイルシステムでフォーマットされません。このモードは、Pod で実行しているすべてのアプリケーションが raw ブロックデバイスを使用できる場合にのみ使用してください。例: ブロック

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ローカルストレージ Operator がインストールされている namespace。

- 2

- オプション: ローカルストレージボリュームが割り当てられているノードの一覧が含まれるノードセレクター。以下の例では、

oc get nodeから取得したノードホスト名を使用します。値が定義されない場合、ローカルストレージ Operator は利用可能なすべてのノードで一致するディスクの検索を試行します。 - 3

- ボリュームモード (

FilesystemまたはBlock) で、ローカルボリュームのタイプを定義します。 - 4

- 選択するローカルストレージデバイスの一覧を含むパスです。

- 5

- この値を、

LocalVolumeリソースby-idへの実際のローカルディスクのファイルパスに置き換えます (例:dev/disk/by-id/wwn)。プロビジョナーが正常にデプロイされると、これらのローカルディスク用に PV が作成されます。

先に作成したファイルを指定して、OpenShift Container Platform クラスターにローカルボリュームリソースを作成します。

oc create -f <local-volume>.yaml

$ oc create -f <local-volume>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow プロビジョナーが作成され、対応するデーモンセットが作成されていることを確認します。

oc get all -n openshift-local-storage

$ oc get all -n openshift-local-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow デーモンセットプロセスの必要な数と現在の数に注意してください。必要な数が

0の場合、これはラベルセレクターが無効であることを示します。永続ボリュームが作成されていることを確認します。

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE local-pv-1cec77cf 100Gi RWO Delete Available local-sc 88m local-pv-2ef7cd2a 100Gi RWO Delete Available local-sc 82m local-pv-3fa1c73 100Gi RWO Delete Available local-sc 48m

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE local-pv-1cec77cf 100Gi RWO Delete Available local-sc 88m local-pv-2ef7cd2a 100Gi RWO Delete Available local-sc 82m local-pv-3fa1c73 100Gi RWO Delete Available local-sc 48mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

LocalVolume オブジェクトを編集しても、既存の永続ボリュームの fsType または volumeMode は変更されません。これが破壊的な操作になる可能性があるためです。

4.10.3. ローカルストレージ Operator のないローカルボリュームのプロビジョニング

ローカルボリュームは動的プロビジョニングで作成できません。代わりに、永続ボリュームは、永続ボリューム (PV) をオブジェクト定義に定義して作成できます。このローカルボリュームプロビジョナーは、定義されたリソースで指定されているパスでファイルシステムまたはブロックボリュームデバイスを検索します。

PV の手動プロビジョニングには、PVC の削除時に PV 全体でデータ漏洩が発生するリスクが含まれます。ローカルストレージ Operator は、ローカル PV のプロビジョニング時にデバイスのライフサイクルを自動化するために使用することが推奨されます。

前提条件

- ローカルディスクが OpenShift Container Platform ノードに割り当てられていること。

手順

PV を定義します。

PersistentVolumeオブジェクト定義を使用して、example-pv-filesystem.yamlまたはexample-pv-block.yamlなどのファイルを作成します。このリソースは、ノードおよびローカルボリュームへのパスを定義する必要があります。注記同じデバイスに別のストレージクラス名を使用しないでください。同じ名前を使用すると、複数の PV が作成されます。

example-pv-filesystem.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記raw ブロックボリューム (

volumeMode: block) はファイルシステムでフォーマットされません。このモードは、Pod で実行しているすべてのアプリケーションが raw ブロックデバイスを使用できる場合にのみ使用します。example-pv-block.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform クラスターに PV リソースを作成します。作成したばかりのファイルを指定します。

oc create -f <example-pv>.yaml

$ oc create -f <example-pv>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ローカル PV が作成されていることを確認します。

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE example-pv-filesystem 100Gi RWO Delete Available local-storage 3m47s example-pv1 1Gi RWO Delete Bound local-storage/pvc1 local-storage 12h example-pv2 1Gi RWO Delete Bound local-storage/pvc2 local-storage 12h example-pv3 1Gi RWO Delete Bound local-storage/pvc3 local-storage 12h

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE example-pv-filesystem 100Gi RWO Delete Available local-storage 3m47s example-pv1 1Gi RWO Delete Bound local-storage/pvc1 local-storage 12h example-pv2 1Gi RWO Delete Bound local-storage/pvc2 local-storage 12h example-pv3 1Gi RWO Delete Bound local-storage/pvc3 local-storage 12hCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.10.4. ローカルボリュームの永続ボリューム要求 (PVC) の作成

ローカルボリュームは、Pod でアクセスされる永続ボリューム要求 (PVC) として静的に作成される必要があります。

前提条件

- 永続ボリュームがローカルボリュームプロビジョナーを使用して作成されていること。

手順

対応するストレージクラスを使用して PVC を作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 作成したファイルを指定して、PVC を OpenShift Container Platform クラスターに作成します。

oc create -f <local-pvc>.yaml

$ oc create -f <local-pvc>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.10.5. ローカル要求を割り当てます。

ローカルボリュームが永続ボリューム要求 (PVC) にマップされた後に、これをリソース内に指定できます。

前提条件

- 永続ボリューム要求 (PVC) が同じ namespace に存在する。

手順

定義された要求をリソースの仕様に追加します。以下の例では、Pod 内で永続ボリューム要求 (PVC) を宣言します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 作成したファイルを指定して、OpenShift Container Platform クラスターにリソースを作成します。

oc create -f <local-pod>.yaml

$ oc create -f <local-pod>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.10.6. 詳細は、ローカルストレージデバイスの自動検出およびプロビジョニングについて参照してください。

ローカルストレージ Operator はローカルストレージ検出およびプロビジョニングを自動化します。この機能を使用すると、ベアメタル、VMware、または割り当てられたデバイスを持つ AWS ストアインスタンスなど、デプロイメント時に動的プロビジョニングが利用できない場合にインストールを単純化できます。

自動検出およびプロビジョニングはテクノロジープレビュー機能としてのみご利用いただけます。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

ローカルデバイスを自動的に検出し、選択したデバイスのローカルボリュームを自動的にプロビジョニングするには、以下の手順を使用します。

LocalVolumeSet オブジェクトの使用には注意が必要です。ローカルディスクから永続ボリューム (PV) を自動的にプロビジョニングする場合、ローカル PV は一致するすべてのデバイスを要求する可能性があります。LocalVolumeSet オブジェクトを使用している場合、ローカルストレージ Operator がノードでローカルデバイスを管理する唯一のエンティティーであることを確認します。

前提条件

- クラスター管理者パーミッションがある。

- ローカルストレージ Operator がインストールされていること。

- ローカルディスクが OpenShift Container Platform ノードに割り当てられていること。

-

OpenShift Container Platform Web コンソールまたは

ocコマンドラインインターフェイス (CLI) へのアクセスがあること。

手順

Web コンソールからローカルデバイスの自動検出を有効にするには、以下を行います。

- Administrator パースペクティブで、Operators → Installed Operators に移動し、Local Volume Discovery タブをクリックします。

- Create Local Volume Discovery をクリックします。

利用可能なディスクをすべてのノードまたは特定のノードのどちらで検出する必要があるかに応じて、All nodes または Select nodes のいずれかを選択します。

注記All nodes または Select nodes を使用してフィルターするかどうかにかかわらず、ワーカーノードのみが利用可能になります。

- Create をクリックします。

auto-discover-devices という名前のローカルボリューム検出インスタンスが表示されます。

ノードで利用可能なデバイスの連続リストを表示するには、以下を実行します。

- OpenShift Container Platform Web コンソールにログインします。

- Compute → Nodes に移動します。

- 開くノードの名前をクリックします。Node Details ページが表示されます。

Disks タブを選択して、選択したデバイスの一覧を表示します。

ローカルディスクを追加または削除しても、デバイス一覧の更新が継続的に行われます。名前、ステータス、タイプ、モデル、容量、およびモードでデバイスをフィルターできます。

Web コンソールから検出されたデバイスのローカルボリュームを自動的にプロビジョニングするには、以下を実行します。

- Operators → Installed Operators に移動し、Operator の一覧から Local Storage を選択します。

- Local Volume Set → Create Local Volume Set を選択します。

- ボリュームセット名とストレージクラス名を入力します。

All nodes または Select nodes を選択し、適宜フィルターを適用します。

注記All nodes または Select nodes を使用してフィルターするかどうかにかかわらず、ワーカーノードのみが利用可能になります。

ローカルボリュームセットに適用するディスクタイプ、モード、サイズ、および制限を選択し、Create をクリックします。

メッセージが数分後に表示され、Operator reconciled successfully という Operator の調整が正常に行われたことが示唆されます。

または、CLI から検出されたデバイスのローカルボリュームをプロビジョニングするには、以下を実行します。

以下の例に示されるように、オブジェクト YAML ファイルを作成し、

local-volume-set.yamlなどのローカルボリュームセットを定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルボリュームセットオブジェクトを作成します。

oc apply -f local-volume-set.yaml

$ oc apply -f local-volume-set.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ローカル永続ボリュームがストレージクラスに基づいて動的にプロビジョニングされていることを確認します。

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE local-pv-1cec77cf 100Gi RWO Delete Available example-storageclass 88m local-pv-2ef7cd2a 100Gi RWO Delete Available example-storageclass 82m local-pv-3fa1c73 100Gi RWO Delete Available example-storageclass 48m

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE local-pv-1cec77cf 100Gi RWO Delete Available example-storageclass 88m local-pv-2ef7cd2a 100Gi RWO Delete Available example-storageclass 82m local-pv-3fa1c73 100Gi RWO Delete Available example-storageclass 48mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

結果は、ノードから削除された後に削除されます。シンボリックリンクは手動で削除する必要があります。

4.10.7. ローカルストレージ Operator Pod での容認の使用

テイントはノードに適用し、それらが一般的なワークロードを実行しないようにすることができます。ローカルストレージ Operator がテイントのマークが付けられたノードを使用できるようにするには、容認を Pod または DaemonSet 定義に追加する必要があります。これにより、作成されたリソースをこれらのテイントのマークが付けられたノードで実行できるようになります。

容認を LocalVolume リソースでローカルストレージ Operator Pod に適用し、テイントをノード仕様でノードに適用します。ノードのテイントはノードに対し、テイントを容認しないすべての Pod を拒否するよう指示します。他の Pod にはない特定のテイントを使用することで、ローカルストレージ Operator Pod がそのノードでも実行されるようにできます。

テイントおよび容認は、key、value、および effect で設定されています。引数として、これは key=value:effect として表現されます。演算子により、これらの 3 つのパラメーターのいずれかを空のままにすることができます。

前提条件

- ローカルストレージ Operator がインストールされていること。

- ローカルディスクがテイントを持つ OpenShift Container Platform ノードに割り当てられている。

- テイントのマークが付けられたノードがローカルストレージのプロビジョニングを行うことが想定されます。

手順

テイントのマークが付けられたノードでスケジュールするようにローカルボリュームを設定するには、以下を実行します。

以下の例に示されるように、

Podを定義する YAML ファイルを変更し、LocalVolume仕様を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: テイントのマークが付けられたノードでのみローカル永続ボリュームを作成するには、以下の例のように YAML ファイルを変更し、

LocalVolume仕様を追加します。spec: tolerations: - key: node-role.kubernetes.io/master operator: Existsspec: tolerations: - key: node-role.kubernetes.io/master operator: ExistsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

定義された容認は結果として作成されるデーモンセットに渡されます。これにより、diskmaker およびプロビジョナー Pod を指定されたテイントが含まれるノード用に作成できます。

4.10.8. ローカルストレージ Operator のリソースの削除

4.10.8.1. ローカルボリュームまたはローカルボリュームセットの削除

ローカルボリュームおよびローカルボリュームセットを削除する必要がある場合があります。リソースのエントリーを削除し、永続ボリュームを削除することで通常は十分ですが、同じデバイスパスを再使用する場合や別のストレージクラスでこれを管理する必要がある場合には、追加の手順が必要になります。

以下の手順では、ローカルボリュームを削除する例の概要を説明します。同じ手順を使用して、ローカルボリュームセットのカスタムリソースのシンボリックリンクを削除することもできます。

前提条件

永続ボリュームの状態は

ReleasedまたはAvailableである必要があります。警告使用中の永続ボリュームを削除すると、データの損失や破損につながる可能性があります。

手順

以前に作成したローカルボリュームを編集して、不要なディスクを削除します。

クラスターリソースを編集します。

oc edit localvolume <name> -n openshift-local-storage

$ oc edit localvolume <name> -n openshift-local-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

devicePathsの下の行に移動し、不要なディスクを表すものを削除します。

作成した永続ボリュームを削除します。

oc delete pv <pv-name>

$ oc delete pv <pv-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ノードのシンボリックリンクを削除します。

警告以下の手順では、root ユーザーとしてノードにアクセスする必要があります。この手順のステップ以外にノードの状態を変更すると、クラスターが不安定になる可能性があります。

ノードにデバッグ Pod を作成します。

oc debug node/<node-name>

$ oc debug node/<node-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ルートディレクトリーをホストに切り替えます。

chroot /host

$ chroot /hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow ローカルボリュームのシンボリックリンクを含むディレクトリーに移動します。

cd /mnt/openshift-local-storage/<sc-name>

$ cd /mnt/openshift-local-storage/<sc-name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ローカルボリュームの作成に使用されるストレージクラスの名前。

削除したデバイスに属するシンボリックリンクを削除します。

rm <symlink>

$ rm <symlink>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.10.8.2. ローカルストレージ Operator のアンインストール

ローカルストレージ Operator をアンインストールするには、Operator および openshift-local-storage プロジェクトの作成されたすべてのリソースを削除する必要があります。

ローカルストレージ PV がまだ使用中の状態でローカルストレージ Operator をアンインストールすることは推奨されません。PV は Operator の削除後も残りますが、PV およびローカルストレージリソースを削除せずに Operator がアンインストールされ、再インストールされる場合に予測できない動作が生じる可能性があります。

前提条件

- OpenShift Container Platform Web コンソールにアクセスします。

手順

プロジェクトにインストールされているローカルボリュームリソースを削除します (

localvolume、localvolumeset、localvolumediscovery等)。oc delete localvolume --all --all-namespaces oc delete localvolumeset --all --all-namespaces oc delete localvolumediscovery --all --all-namespaces

$ oc delete localvolume --all --all-namespaces $ oc delete localvolumeset --all --all-namespaces $ oc delete localvolumediscovery --all --all-namespacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow Web コンソールからローカルストレージ Operator をアンインストールします。

- OpenShift Container Platform Web コンソールにログインします。

- Operators → Installed Operators に移動します。

- Local Storage をフィルターボックスに入力して、ローカルストレージ Operator を見つけます。

-

ローカルストレージ Operator の末尾にある Options メニュー

をクリックします。

をクリックします。

- Uninstall Operator をクリックします。

- 表示されるウィンドウで Remove をクリックします。

ローカルストレージ Operator で作成された PV は削除されるまでクラスターに残ります。これらのボリュームが使用されなくなったら、以下のコマンドを実行してこれらのボリュームを削除します。

oc delete pv <pv-name>

$ oc delete pv <pv-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow openshift-local-storageプロジェクトを削除します。oc delete project openshift-local-storage

$ oc delete project openshift-local-storageCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.11. NFS を使用した永続ストレージ

OpenShift Container Platform クラスターは、NFS を使用する永続ストレージでプロビジョニングすることが可能です。永続ボリューム (PV) および永続ボリューム要求 (PVC) は、プロジェクト全体でボリュームを共有するための便利な方法を提供します。PV 定義に含まれる NFS に固有の情報は、Pod 定義で直接定義することも可能ですが、この方法の場合にはボリュームが一意のクラスターリソースとして作成されされないため、ボリュームが競合の影響を受けやすくなります。

4.11.1. プロビジョニング

ストレージは、ボリュームとして OpenShift Container Platform にマウントされる前に基礎となるインフラストラクチャーになければなりません。NFS ボリュームをプロビジョニングするには、NFS サーバーの一覧とエクスポートパスのみが必要です。

手順

PV のオブジェクト定義を作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ボリュームの名前。これは、各種の

oc <command> podコマンドの PV アイデンティティーです。 - 2

- このボリュームに割り当てられるストレージの量。

- 3

- これはボリュームへのアクセスの制御に関連するように見えますが、実際はラベルの場合と同様に、PVC を PV に一致させるために使用されます。現時点では、

accessModesに基づくアクセスルールは適用されていません。 - 4

- 使用されているボリュームタイプ。 この場合は

nfsプラグインです。 - 5

- NFS サーバーがエクスポートしているパス。

- 6

- NFS サーバーのホスト名または IP アドレス

- 7

- PV の回収ポリシー。これはボリュームのリリース時に生じることを定義します。

注記各 NFS ボリュームは、クラスター内のスケジュール可能なすべてのノードによってマウント可能でなければなりません。

PV が作成されたことを確認します。

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWO Available 31s

NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWO Available 31sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新規 PV にバインドされる永続ボリューム要求 (PVC) を作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 永続ボリューム要求 (PVC) が作成されたことを確認します。

oc get pvc

$ oc get pvcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE nfs-claim1 Bound pv0001 5Gi RWO 2m

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE nfs-claim1 Bound pv0001 5Gi RWO 2mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.11.2. ディスククォータの実施

ディスクパーティションを使用して、ディスククォータとサイズ制限を実施することができます。それぞれのパーティションを独自のエクスポートとすることができ、それぞれのエクスポートは 1 つの PV になります。それぞれのエクスポートは 1 つの PV になります。OpenShift Container Platform は PV に固有の名前を適用しますが、NFS ボリュームのサーバーとパスの一意性については管理者に委ねられています。

この方法でクォータを実施すると、開発者は永続ストレージを具体的な量 (10Gi など) で要求することができ、同等かそれ以上の容量の対応するボリュームに一致させることができます。

4.11.3. NFS ボリュームのセキュリティー

このセクションでは、一致するパーミッションや SELinux の考慮点を含む、NFS ボリュームのセキュリティーについて説明します。ユーザーは、POSIX パーミッションやプロセス UID、補助グループおよび SELinux の基礎的な点を理解している必要があります。

開発者は、Pod 定義の volumes セクションで、PVC を名前で参照するか、または NFS ボリュームのプラグインを直接参照して NFS ストレージを要求します。

NFS サーバーの /etc/exports ファイルにはアクセス可能な NFS ディレクトリーが含まれています。ターゲットの NFS ディレクトリーには、POSIX の所有者とグループ ID があります。OpenShift Container Platform NFS プラグインは、同じ POSIX の所有者とエクスポートされる NFS ディレクトリーにあるパーミッションを使って、コンテナーの NFS ディレクトリーをマウントします。ただし、コンテナーは NFS マウントの所有者と同等の有効な UID では実行されません。 これは期待される動作です。

ターゲットの NFS ディレクトリーが NFS サーバーに表示される場合を例に取って見てみましょう。

ls -lZ /opt/nfs -d

$ ls -lZ /opt/nfs -d出力例

drwxrws---. nfsnobody 5555 unconfined_u:object_r:usr_t:s0 /opt/nfs

drwxrws---. nfsnobody 5555 unconfined_u:object_r:usr_t:s0 /opt/nfsid nfsnobody

$ id nfsnobody出力例

uid=65534(nfsnobody) gid=65534(nfsnobody) groups=65534(nfsnobody)

uid=65534(nfsnobody) gid=65534(nfsnobody) groups=65534(nfsnobody)

次に、コンテナーは SELinux ラベルに一致し、ディレクトリーにアクセスするために UID の 65534、nfsnobody 所有者、または補助グループの 5555 のいずれかで実行される必要があります。

所有者 ID 65534 は一例として使用されています。NFS の root_squash が root、uid 0 を nfsnobody、uid 65534 にマップしても、NFS エクスポートは任意の所有者 ID を持つことができます。所有者 65534 は NFS エクスポートには必要ありません。

4.11.3.1. グループ ID

NFS アクセスに対応する際の推奨される方法として、補助グループを使用することができます (NFS エクスポートのパーミッションを変更するオプションがないことを前提としています)。OpenShift Container Platform の補助グループは共有ストレージに使用されます (例: NFS)。これとは対照的に、iSCSI などのブロックストレージは、Pod の securityContext で fsGroup SCC ストラテジーと fsGroup の値を使用します。

永続ストレージへのアクセスを取得するには、通常はユーザー ID ではなく、補助グループ ID を使用することが推奨されます。

ターゲット NFS ディレクトリーの例で使用したグループ ID は 5555 なので、Pod は、supplementalGroups を使用してグループ ID を Pod の securityContext 定義の下で定義することができます。以下に例を示します。

Pod の要件を満たすカスタム SCC が存在しない場合、Pod は restricted SCC に一致する可能性があります。この SCC では、supplementalGroups ストラテジーが RunAsAny に設定されています。 これは、指定されるグループ ID は範囲のチェックなしに受け入れられることを意味します。

その結果、上記の Pod は受付をパスして起動します。しかし、グループ ID の範囲をチェックすることが望ましい場合は、カスタム SCC の使用が推奨されます。カスタム SCC は、最小および最大のグループ ID が定義され、グループ ID の範囲チェックが実施され、グループ ID の 5555 が許可されるように作成できます。

カスタム SCC を使用するには、まずこれを適切なサービスアカウントに追加する必要があります。たとえば、Pod 仕様に指定がない場合には、指定されたプロジェクトで default サービスアカウントを使用します。

4.11.3.2. ユーザー ID

ユーザー ID は、コンテナーイメージまたは Pod 定義で定義することができます。

永続ストレージへのアクセスを取得する場合、通常はユーザー ID ではなく、補助グループ ID を使用することが推奨されます。

上記のターゲット NFS ディレクトリーの例では、コンテナーは UID を 65534 (ここではグループ ID を省略します) に設定する必要があります。 したがって以下を Pod 定義に追加することができます。

プロジェクトが default で、SCC が restricted の場合、Pod で要求されるユーザー ID の 65534 は許可されません。したがって、Pod は以下の理由で失敗します。

-

65534をそのユーザー ID として要求する。 -

ユーザー ID

65534を許可する SCC を確認するために Pod で利用できるすべての SCC が検査される。SCC のすべてのポリシーがチェックされますが、ここでのフォーカスはユーザー ID になります。 -

使用可能なすべての SCC が独自の

runAsUserストラテジーとしてMustRunAsRangeを使用しているため、UID の範囲チェックが要求される。 -

65534は SCC またはプロジェクトのユーザー ID 範囲に含まれていない。

一般に、事前定義された SCC は変更しないことが勧められています。ただし、この状況を改善するには、カスタム SCC を作成することが推奨されます。 カスタム SCC は、最小および最大のユーザー ID が定義され、UID 範囲のチェックの実施が設定されており、UID 65534 が許可されるように作成できます。

カスタム SCC を使用するには、まずこれを適切なサービスアカウントに追加する必要があります。たとえば、Pod 仕様に指定がない場合には、指定されたプロジェクトで default サービスアカウントを使用します。

4.11.3.3. SELinux

Red Hat Enterprise Linux (RHEL) および Red Hat Enterprise Linux CoreOS (RHCOS) システムは、デフォルトでリモートの NFS サーバーで SELinux を使用するように設定されます。

RHEL および RHCOS 以外のシステムの場合、SELinux は Pod からリモートの NFS サーバーへの書き込みを許可しません。NFS ボリュームは正常にマウントされますが、読み取り専用です。以下の手順で、正しい SELinux パーミッションを有効にする必要があります。

前提条件

-

container-selinuxパッケージがインストールされている必要があります。このパッケージはvirt_use_nfsSELinux ブール値を提供します。

手順

以下のコマンドを使用して

virt_use_nfsブール値を有効にします。-Pオプションを使用すると、再起動後もこのブール値を永続化できます。setsebool -P virt_use_nfs 1

# setsebool -P virt_use_nfs 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.11.3.4. エクスポート設定

任意のコンテナーユーザーにボリュームの読み取りと書き出しを許可するには、NFS サーバーにエクスポートされる各ボリュームは以下の条件を満たしている必要があります。

すべてのエクスポートは、次の形式を使用してエクスポートする必要があります。

/<example_fs> *(rw,root_squash)

/<example_fs> *(rw,root_squash)Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイアウォールは、マウントポイントへのトラフィックを許可するように設定する必要があります。

NFSv4 の場合、デフォルトのポート

2049(nfs) を設定します。NFSv4

iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPT

# iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPTCopy to Clipboard Copied! Toggle word wrap Toggle overflow NFSv3 の場合、以下の 3 つのポートを設定します。

2049(nfs)、20048(mountd)、111(portmapper)。NFSv3

iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPT

# iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPTCopy to Clipboard Copied! Toggle word wrap Toggle overflow iptables -I INPUT 1 -p tcp --dport 20048 -j ACCEPT

# iptables -I INPUT 1 -p tcp --dport 20048 -j ACCEPTCopy to Clipboard Copied! Toggle word wrap Toggle overflow iptables -I INPUT 1 -p tcp --dport 111 -j ACCEPT

# iptables -I INPUT 1 -p tcp --dport 111 -j ACCEPTCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

NFS エクスポートとディレクトリーは、ターゲット Pod からアクセスできるようにセットアップされる必要があります。この場合、エクスポートをコンテナーのプライマリー UID で所有されるように設定するか、または上記のグループ ID に示されるように

supplementalGroupsを使用して Pod にグループアクセスを付与します。

4.11.4. リソースの回収

NFS は OpenShift Container Platform の Recyclable プラグインインターフェイスを実装します。回収タスクは、それぞれの永続ボリュームに設定されるポリシーに基づいて自動プロセスによって処理されます。

デフォルトで、PV は Retain に設定されます。

PV への要求が削除され、PV がリリースされると、PV オブジェクトを再利用できません。代わりに、新規の PV が元のボリュームと同じ基本ボリュームの情報を使って作成されます。

たとえば、管理者は nfs1 という名前の PV を作成するとします。

ユーザーは、nfs1 にバインドされる PVC1 を作成します。次にユーザーは PVC1 を削除し、nfs1 への要求を解除します。これにより、nfs1 は Released になります。管理者が同じ NFS 共有を利用可能にする必要がある場合には、同じ NFS サーバー情報を使って新規 PV を作成する必要があります。 この場合、PV の名前は元の名前とは異なる名前にします。

元の PV を削除して、PV を同じ名前で再作成することは推奨されません。PV のステータスを Released から Available に手動で変更しようとすると、エラーが発生し、データが失われる可能性があります。

4.11.5. その他の設定とトラブルシューティング

適切なエクスポートとセキュリティーマッピングを行うため、使用している NFS のバージョンおよびその設定方法に応じて追加の設定が必要になることがあります。以下は例になります。

|

NFSv4 のマウントにすべてのファイルの所有者が |

|

| NFSv4 の ID マッピングが無効になっている |

|

4.12. Red Hat OpenShift Container Storage

Red Hat OpenShift Container Storage は、インハウスまたはハイブリッドクラウドのいずれの場合でもファイル、ブロックおよびオブジェクトストレージをサポートし、OpenShift Container Platform のすべてに対応する永続ストレージのプロバイダーです。Red Hat のストレージソリューションとして、Red Hat OpenShift Container Storage は、デプロイメント、管理およびモニターリングを行うために OpenShift Container Platform に完全に統合されています。

Red Hat OpenShift Container Storage は、独自のドキュメントライブラリーを提供します。以下の Red Hat OpenShift Container Storage ドキュメントすべては https://access.redhat.com/documentation/ja-jp/red_hat_openshift_container_storage/4.6/ から入手できます。

OpenShift Container Platform でインストールされた仮想マシンをホストするハイパーコンバージドノードを使用する Red Hat Hyperconverged Infrastructure (RHHI) for Virtualization の上部にある OpenShift Container Storage は、サポートされる設定ではありません。サポートされるプラットフォームについての詳細は、Red Hat OpenShift Container Storage Supportability and Interoperability Guide を参照してください。

| Red Hat OpenShift Container Storage についてのトピック | Red Hat OpenShift Container Storage ドキュメントの参照先 |

|---|---|

| プランニング | |

| 新機能、既知の問題、主なバグ修正およびテクノロジープレビュー | |

| サポートされるワークロード、レイアウト、ハードウェアおよびソフトウェア要件、サイジング、スケーリングに関する推奨事項 | |

| デプロイ | |

| 環境がインターネットに直接接続していない場合のデプロイの準備 | |

| ローカルまたはクラウドストレージの Amazon Web Services を使用した Red Hat OpenShift Container Storage のデプロイ | Amazon Web Services を使用した OpenShift Container Storage 4.6 のデプロイ |

| ベアメタルインフラストラクチャーでの Red Hat OpenShift Container Storage のローカルストレージへのデプロイ | |

| 外部の Red Hat Ceph Storage クラスターを使用するように Red Hat OpenShift Container Storage をデプロイする | |

| Google Cloud クラスターを使用した OpenShift Container Storage のデプロイおよび管理 | Google Cloud を使用した OpenShift Container Storage 4.6 のデプロイおよび管理 |

| IBM Z インフラストラクチャーでローカルストレージを使用するための Red Hat OpenShift Container Storage のデプロイおよび管理 | |

| IBM Power Systems への Red Hat OpenShift Container Storage のデプロイおよび管理 | IBM Power Systems を使用した OpenShift Container Storage のデプロイおよび管理 |

| Red Hat OpenStack Platform (RHOSP) での Red Hat OpenShift Container Storage のデプロイおよび管理 | Red Hat OpenStack Platform を使用した OpenShift Container Storage 4.6 のデプロイおよび管理 |

| Red Hat Virtualization (RHV) での Red Hat OpenShift Container Storage のデプロイおよび管理 | Red Hat Virtualization Platform を使用した OpenShift Container Storage 4.6 のデプロイおよび管理 |

| VMWare vSphere クラスターへの OpenShift Container Storage のデプロイ | |

| Red Hat OpenShift Container Storage の最新バージョンへの更新 | |

| 管理 | |

| スナップショットおよびクローンを含む、Red Hat OpenShift Container Storage のコアサービスおよびホスト型アプリケーションへのストレージの割り当て | |

| Multicloud Object Gateway (NooBaa) を使用したハイブリッドクラウドまたはマルチクラウド環境でのストレージリソースの管理 | |

| Red Hat OpenShift Container Storage のストレージデバイスの安全な置き換え | |

| Red Hat OpenShift Container Storage クラスターのノードの安全な置き換え | |

| Red Hat OpenShift Container Storage でのスケーリング操作 | |

| Red Hat OpenShift Container Storage 4.6 クラスターのモニターリング | |

| エラーおよび問題のトラブルシューティング | |

| OpenShift Container Platform クラスターのバージョン 3 からバージョン 4 への移行 | |

4.13. VMware vSphere ボリュームを使用した永続ストレージ

OpenShift Container Platform では、VMWare vSphere の仮想マシンディスク (VMDK: Virtual Machine Disk) ボリュームの使用が可能となります。VMWare vSphere を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と VMWare vSphere についてのある程度の理解があることが前提となります。

VMware vSphere ボリュームは動的にプロビジョニングできます。OpenShift Container Platform は vSphere にディスクを作成し、このディスクを正しいイメージに割り当てます。

OpenShift Container Platform は、自由にクラスターないのノードにあるボリュームをアタッチしたり、アタッチ解除できるように、個別の永続ディスクとして新規ボリュームをプロビジョニングします。そのため、スナップショットを使用するボリュームをバックアップしたり、スナップショットからボリュームを復元したりできません。詳細は、スナップショットの制限 を参照してください。

Kubernetes 永続ボリュームフレームワークは、管理者がクラスターのプロビジョニングを永続ストレージを使用して実行できるようにし、ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。

永続ボリュームは単一のプロジェクトまたは namespace にバインドされず、それらは OpenShift Container Platform クラスター間で共有できます。永続ボリューム要求 (PVC) はプロジェクトまたは namespace に固有のもので、ユーザーによって要求されます。

4.13.1. VMware vSphere ボリュームの動的プロビジョニング

VMware vSphere ボリュームの動的プロビジョニングは推奨される方法です。

4.13.2. 前提条件

- 使用するコンポーネントの要件を満たす VMware vSphere バージョンにインストールされている OpenShift Container Platform クラスター。VSphere バージョンのサポートに関する詳細は、クラスターの vSphere へのインストール を参照してください。

以下のいずれかの手順を使用し、デフォルトのストレージクラスを使用してそれらのボリュームを動的にプロビジョニングできます。

4.13.2.1. UI を使用した VMware vSphere ボリュームの動的プロビジョニング

OpenShift Container Platform は、ボリュームをプロビジョニングするために thin ディスク形式を使用する thin という名前のデフォルトのストレージクラスをインストールします。

前提条件

- ストレージは、ボリュームとして OpenShift Container Platform にマウントされる前に基礎となるインフラストラクチャーになければなりません。

手順

- OpenShift Container Platform コンソールで、Storage → Persistent Volume Claims をクリックします。

- 永続ボリューム要求 (PVC) の概要で、Create Persistent Volume Claim をクリックします。

結果のページで必要なオプションを定義します。

-

thinストレージクラスを選択します。 - ストレージ要求の一意の名前を入力します。

- アクセスモードを選択し、作成されるストレージ要求の読み取り/書き込みアクセスを決定します。

- ストレージ要求のサイズを定義します。

-

- Create をクリックして永続ボリューム要求 (PVC) を作成し、永続ボリュームを生成します。

4.13.2.2. CLI を使用した VMware vSphere ボリュームの動的プロビジョニング

OpenShift Container Platform は、ボリュームをプロビジョニングするために thin ディスク形式を使用する thin という名前のデフォルトの StorageClass をインストールします。

前提条件

- ストレージは、ボリュームとして OpenShift Container Platform にマウントされる前に基礎となるインフラストラクチャーになければなりません。

手順 (CLI)

以下の内容でファイル

pvc.yamlを作成して VMware vSphere PersistentVolumeClaim を定義できます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルから

PersistentVolumeClaimオブジェクトを作成します。oc create -f pvc.yaml

$ oc create -f pvc.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.13.3. VMware vSphere ボリュームの静的プロビジョニング

VMware vSphere ボリュームを静的にプロビジョニングするには、永続ボリュームフレームワークが参照する仮想マシンディスクを作成する必要があります。

前提条件

- ストレージは、ボリュームとして OpenShift Container Platform にマウントされる前に基礎となるインフラストラクチャーになければなりません。

手順

仮想マシンディスクを作成します。VMware vSphere ボリュームを静的にプロビジョニングする前に、仮想マシンディスク (VMDK) を手動で作成する必要があります。以下の方法のいずれかを使用します。

vmkfstoolsを使用して作成します。セキュアシェル (SSH) を使用して ESX にアクセスし、以下のコマンドを使用して vmdk ボリュームを作成します。vmkfstools -c <size> /vmfs/volumes/<datastore-name>/volumes/<disk-name>.vmdk

$ vmkfstools -c <size> /vmfs/volumes/<datastore-name>/volumes/<disk-name>.vmdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow vmware-diskmanagerを使用して作成します。shell vmware-vdiskmanager -c -t 0 -s <size> -a lsilogic <disk-name>.vmdk

$ shell vmware-vdiskmanager -c -t 0 -s <size> -a lsilogic <disk-name>.vmdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow

VMDK を参照する永続ボリュームを作成します。

PersistentVolumeオブジェクト定義を使用してpv1.yamlファイルを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ボリュームの名前。この名前は永続ボリューム要求 (PVC) または Pod で識別されるものです。

- 2

- このボリュームに割り当てられるストレージの量。

- 3

- vSphere ボリュームの

vsphereVolumeで使用されるボリュームタイプ。ラベルは vSphere VMDK ボリュームを Pod にマウントするために使用されます。ボリュームの内容はアンマウントされても保持されます。このボリュームタイプは、VMFS データストアと VSAN データストアの両方がサポートされます。 - 4

- 使用する既存の VMDK ボリューム。

vmkfstoolsを使用した場合、前述のようにボリューム定義で、データストア名を角かっこ[]で囲む必要があります。 - 5

- マウントするファイルシステムタイプです。ext4、xfs、または他のファイルシステムなどが例になります。

重要ボリュームをフォーマットしてプロビジョニングした後に fsType パラメーターの値を変更すると、データ損失や Pod にエラーが発生する可能性があります。

ファイルから

PersistentVolumeオブジェクトを作成します。oc create -f pv1.yaml

$ oc create -f pv1.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 直前の手順で作成した永続ボリュームにマップする永続ボリューム要求 (PVC) を作成します。

PersistentVolumeClaimオブジェクト定義を使用して、ファイルpvc1.yamlを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルから

PersistentVolumeClaimオブジェクトを作成します。oc create -f pvc1.yaml

$ oc create -f pvc1.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.13.3.1. VMware vSphere ボリュームのフォーマット

OpenShift Container Platform は、ボリュームをマウントしてコンテナーに渡す前に、PersistentVolume (PV) 定義の fsType パラメーター値で指定されたファイルシステムがボリュームに含まれることを確認します。デバイスが指定されたファイルシステムでフォーマットされていない場合、デバイスのデータはすべて消去され、デバイスはそのファイルシステムで自動的にフォーマットされます。

OpenShift Container Platform は初回の使用前にフォーマットするため、フォーマットされていない vSphere ボリュームを PV として使用できます。

第5章 Container Storage Interface (CSI) の使用

5.1. CSI ボリュームの設定

Container Storage Interface (CSI) により、OpenShift Container Platform は CSI インターフェイス を永続ストレージとして実装するストレージバックエンドからストレージを使用できます。

OpenShift Container Platform 4.6 は、CSI 仕様 のバージョン 1.2.0 をサポートします。

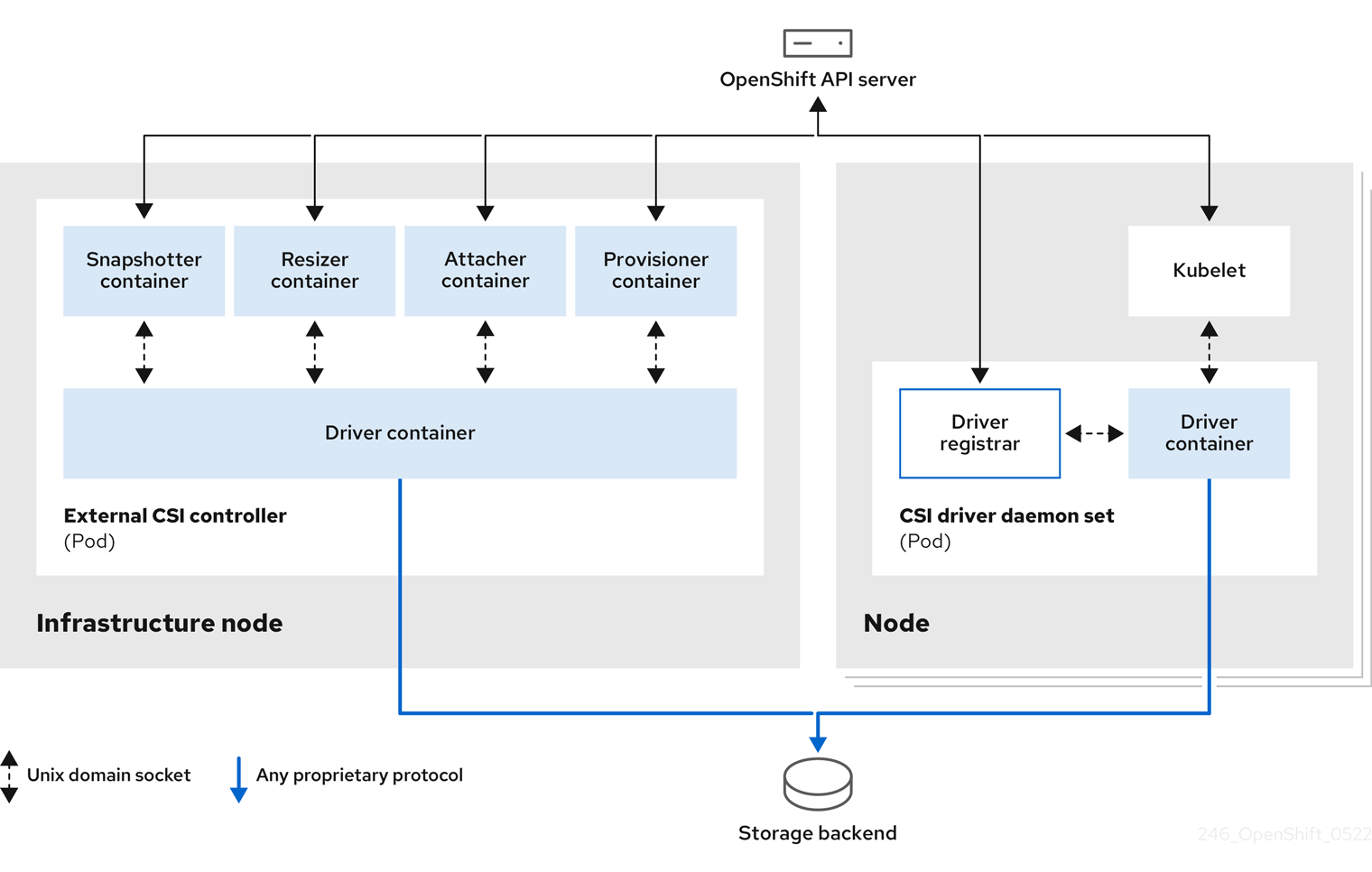

5.1.1. CSI アーキテクチャー

CSI ドライバーは通常、コンテナーイメージとして提供されます。これらのコンテナーは、実行先の OpenShift Container Platform を認識しません。OpenShift Container Platform でサポートされる CSI 互換のストレージバックエンドを使用するには、クラスター管理者は、OpenShift Container Platform とストレージドライバーの橋渡しとして機能するコンポーネントを複数デプロイする必要があります。

以下の図では、OpenShift Container Platform クラスターの Pod で実行されるコンポーネントの俯瞰図を示しています。

異なるストレージバックエンドに対して複数の CSI ドライバーを実行できます。各ドライバーには、独自の外部コントローラーのデプロイメントおよびドライバーと CSI レジストラーを含むデーモンセットが必要です。

5.1.1.1. 外部の CSI コントローラー

外部の CSI コントローラーは、5 つのコンテナーを含む 1 つまたは複数の Pod を配置するデプロイメントです。

-

スナップショットコンテナーは、

VolumeSnapshotおよびVolumeSnapshotContentオブジェクトを監視し、VolumeSnapshotContentオブジェクトの作成および削除を担当します。 -

リサイザーコンテナーは、

PersistentVolumeClaimオブジェクトでより多くのストレージを要求した場合に、PersistentVolumeClaimの更新を監視し、CSI エンドポイントに対してControllerExpandVolume操作をトリガーするサイドカーコンテナーです。 -

OpenShift Container Platform からの

attachおよびdetachの呼び出しを適切な CSI ドライバーへのControllerPublishおよびControllerUnpublish呼び出しに変換する外部の CSI アタッチャーコンテナー。 -

OpenShift Container Platform からの

provisionおよびdelete呼び出しを適切な CSI ドライバーへのCreateVolumeおよびDeleteVolume呼び出しに変換する外部の CSI プロビジョナーコンテナー。 - CSI ドライバーコンテナー

CSI アタッチャーおよび CSI プロビジョナーコンテナーは、Unix Domain Socket を使用して、CSI ドライバーコンテナーと通信し、CSI の通信が Pod 外に出ないようにします。CSI ドライバーは Pod 外からはアクセスできません。

通常、attach、detach、provision および delete 操作では、CSI ドライバーがストレージバックエンドに対する認証情報を使用する必要があります。CSI コントローラー Pod をインフラストラクチャーノードで実行し、コンピュートノードで致命的なセキュリティー違反が発生した場合でも認証情報がユーザープロセスに漏洩されないようにします。

外部のアタッチャーは、サードパーティーの attach または detach 操作をサポートしない CSI ドライバーに対しても実行する必要があります。外部のアタッチャーは、CSI ドライバーに対して ControllerPublish または ControllerUnpublish 操作を実行しません。ただし、必要な OpenShift Container Platform 割り当て API を実装できるように依然として実行する必要があります。

5.1.1.2. CSI ドライバーのデーモンセット

CSI ドライバーのデーモンセットは、OpenShift Container Platform が CSI ドライバーによって提供されるストレージをノードにマウントして、永続ボリューム (PV) としてユーザーワークロード (Pod) で使用できるように、全ノードで Pod を実行します。CSI ドライバーがインストールされた Pod には、以下のコンテナーが含まれます。

-

ノード上で実行中の

openshift-nodeサービスに CSI ドライバーを登録する CSI ドライバーレジストラー。このノードで実行中のopenshift-nodeプロセスは、ノードで利用可能な Unix Domain Socket を使用して CSI ドライバーに直接接続します。 - CSI ドライバー

ノードにデプロイされた CSI ドライバーには、ストレージバックエンドへの認証情報をできる限り少なく指定する必要があります。OpenShift Container Platform は、NodePublish/NodeUnpublish および NodeStage/NodeUnstage (実装されている場合) などの CSI 呼び出しのノードプラグインセットのみを使用します。

5.1.2. OpenShift Container Platform でサポートされる CSI ドライバー

OpenShift Container Platform はデフォルトで特定の Container Storage Interface (CSI) ドライバーをインストールし、In-tree(インツリー) ボリュームプラグインでは不可能なユーザーストレージオプションを提供します。

これらのサポートされるストレージアセットにマウントする CSI でプロビジョニングされた永続ボリュームを作成するには、OpenShift Container Platform は必要な CSI ドライバー Operator、CSI ドライバー、および必要なストレージクラスをインストールします。Operator およびドライバーのデフォルト namespace についての詳細は、特定の CSI ドライバー Operator のドキュメントを参照してください。

以下の表は、OpenShift Container Platform と共にインストールされる CSI ドライバーと、ボリュームスナップショット、クローン作成、およびサイズ変更などの対応する CSI 機能について説明しています。

| CSI ドライバー | CSI ボリュームスナップショット | CSI のクローン作成 | CSI のサイズ変更 |

|---|---|---|---|

| AWS EBS (テクノロジープレビュー) | ✅ | - | ✅ |

| OpenStack Manila | ✅ | - | - |

| Red Hat Virtualization (oVirt) | - | - | - |

CSI ドライバーが上記の表に記載されていない場合は、CSI ストレージベンダーが提供するインストール手順に従って、サポートされている CSI 機能を使用する必要があります。

5.1.3. 動的プロビジョニング

永続ストレージの動的プロビジョニングは、CSI ドライバーおよび基礎となるストレージバックエンドの機能により異なります。CSI ドライバーのプロバイダーは、OpenShift Container Platform でのストレージクラスの作成方法および設定に利用でじるパラメーターについての文書を作成する必要があります。

作成されたストレージクラスは、動的プロビジョニングを有効にするために設定できます。

5.1.4. CSI ドライバーの使用例

以下の例では、テンプレートを変更せずにデフォルトの MySQL テンプレートをインストールします。

前提条件

- CSI ドライバーがデプロイされている。

- 動的プロビジョニング用にストレージクラスが作成されている。

手順

MySQL テンプレートを作成します。

oc new-app mysql-persistent

# oc new-app mysql-persistentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

--> Deploying template "openshift/mysql-persistent" to project default ...

--> Deploying template "openshift/mysql-persistent" to project default ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc get pvc

# oc get pvcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE mysql Bound kubernetes-dynamic-pv-3271ffcb4e1811e8 1Gi RWO cinder 3s

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE mysql Bound kubernetes-dynamic-pv-3271ffcb4e1811e8 1Gi RWO cinder 3sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2. CSI インラインの一時ボリューム

Container Storage Interface (CSI) のインライン一時ボリュームを使用すると、Pod のデプロイ時にインラインの一時ボリュームを作成し、Pod の破棄時にそれらを削除する Pod 仕様を定義できます。

この機能は、サポートされている Container Storage Interface (CSI) ドライバーでのみ利用できます。

CSI インラインの一時ボリュームは、テクノロジープレビュー機能としてのみご利用可能です。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

5.2.1. CSI インラインの一時ボリュームの概要

従来は、Container Storage Interface (CSI) ドライバーでサポートされるボリュームは PersistentVolume および PersistentVolumeClaim オブジェクトの組み合わせでのみ使用できます。

この機能により、PersistentVolume オブジェクトではなく、Pod 仕様に CSI ボリュームを直接指定できます。インラインボリュームは一時的なボリュームであり、Pod の再起動後は永続化されません。

5.2.1.1. サポートの制限

デフォルトで、OpenShift Container Platform は以下の制限下で CSI インラインの一時ボリュームのクローン作成をサポートします。

- サポートは CSI ドライバーでのみ利用可能です。in-tree (インツリー) および FlexVolumes はサポートされません。

- OpenShift Container Platform には CSI ドライバーが含まれません。コミュニティーまたはストレージベンダー が提供する CSI ドライバーを使用します。CSI ドライバーの提供されるインストール手順に従います。

-

CSI ドライバーは、

Ephemeral機能を含む、インラインボリューム機能を実装していない可能性があります。詳細は、CSI ドライバーのドキュメントを参照してください。

5.2.2. Pod 仕様への CSI インライン一時ボリュームの埋め込み

CSI インラインの一時ボリュームを OpenShift Container Platform の Pod 仕様に埋め込むことができます。ランタイム時に、ネストされたインラインボリュームは、関連付けられた Pod の一時的なライフサイクルに従うため、CSI ドライバーは Pod の作成および破棄時にボリューム操作のすべてのフェーズをすべて処理できます。

手順

-